Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones

¿Son eficaces los programas y sistemas educativos actuales? Durante los últimos años, es cada vez mayor el debate generado en torno a este tema. Muchos expertos argumentan que las teorías y prácticas educativas implementadas en los centros carecen de evidencia científica. El esfuerzo y los medios empleados en estas prácticas de dudosa utilidad obligan, además, a dejar de lado aquellas otras teorías cuya eficacia está probada.

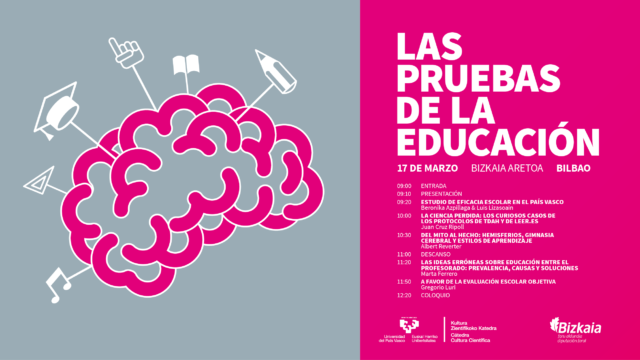

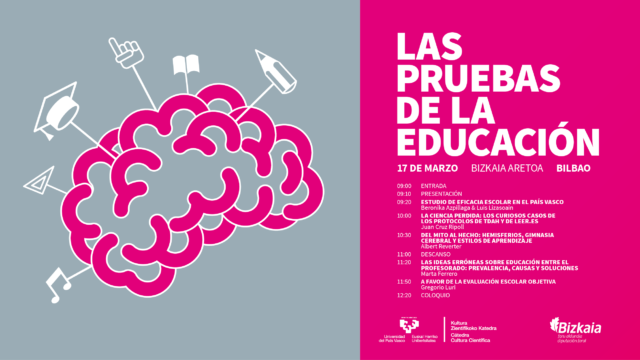

Con el objetivo de abordar esta situación, el Bizkaia Aretoa de Bilbao acogió el pasado 17 de marzo la jornada titulada “Las pruebas de la educación”, donde varios expertos abordaron cuestiones relacionadas con la educación desde un punto de vista científico.

“Las pruebas de la educación” forma parte de una serie de eventos organizados por la Cátedra de Cultura Científica de la UPV/EHU para abordar cuestiones del día a día como la educación o el arte desde una perspectiva científica. La dirección del seminario corrió a cargo de la doctora en psicología Marta Ferrero.

La propia Marta Ferrero trató en la cuarta ponencia sobre las ideas erróneas sobre educación más extendidas entre el profesorado. En ella identificó los factores que facilitan o provocan la creciente aparición de ideas pseudocientíficas en el ámbito escolar y propuso algunas soluciones a diferentes niveles.

Las ideas erróneas sobre educación entre el profesoradoEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ciencia perdida: los curiosos casos de los protocolos de TDAH y de leer.es

- Estudio de eficacia escolar en el País Vasco

- Mestizajes: La ciencia en “La educación de Henri Adams”, por José Manuel Sánchez Ron

Del mito al hecho: hemisferios, gimnasia cerebral y estilos de aprendizaje

¿Son eficaces los programas y sistemas educativos actuales? Durante los últimos años, es cada vez mayor el debate generado en torno a este tema. Muchos expertos argumentan que las teorías y prácticas educativas implementadas en los centros carecen de evidencia científica. El esfuerzo y los medios empleados en estas prácticas de dudosa utilidad obligan, además, a dejar de lado aquellas otras teorías cuya eficacia está probada.

Con el objetivo de abordar esta situación, el Bizkaia Aretoa de Bilbao acogió el pasado 17 de marzo la jornada titulada “Las pruebas de la educación”, donde varios expertos abordaron cuestiones relacionadas con la educación desde un punto de vista científico.

“Las pruebas de la educación” forma parte de una serie de eventos organizados por la Cátedra de Cultura Científica de la UPV/EHU para abordar cuestiones del día a día como la educación o el arte desde una perspectiva científica. La dirección del seminario corrió a cargo de la doctora en psicología Marta Ferrero.

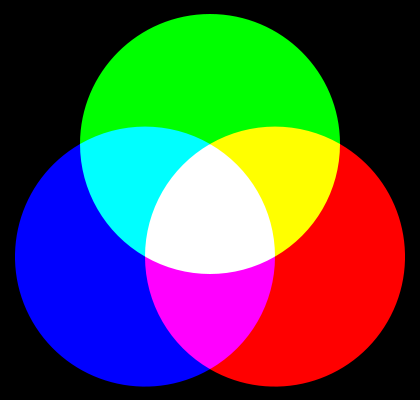

En esta tercera conferencia el El maestro y divulgador Albert Reverter abordó diversas cuestiones pseudocientíficas en materia educativa como la teoría según la cual las personas aprendemos mejor si se nos enseña en nuestro estilo de aprendizaje preferido. También se ocupó de la llamada “gimnasia cerebral” que consiste en una serie de ejercicios dirigidos a activar el cerebro, promover la reestructuración neurológica y facilitar la capacidad de aprender. A pesar de su gran popularidad, no hay estudios científicos que avalen su eficacia.

Del mito al hechoEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Del mito al hecho: hemisferios, gimnasia cerebral y estilos de aprendizaje se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Dejad de propagar el mito de los estilos de aprendizaje

- La ciencia perdida: los curiosos casos de los protocolos de TDAH y de leer.es

- Estudio de eficacia escolar en el País Vasco

Prosopagnosia, la incapacidad de reconocer los rostros

Prosopagnosia o ceguera al rostro (Imagen vía pexels)

Diariamente, por norma general, nos cruzamos y tenemos trato con un gran número de personas. Algunos son individuos a los que tan solo hemos visto en una ocasión pero que reconocemos gracias a que nuestro cerebro almacenó información sobre ellos (normalmente reteniendo alguna peculiaridad o un rasgo físico característico).

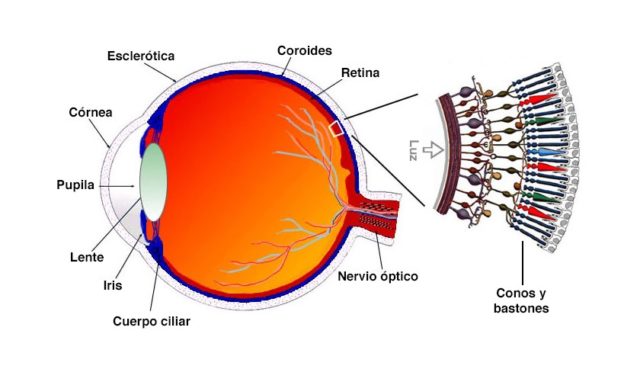

El área específica del reconocimiento facial en nuestro cerebro se encuentra en el giro fusiforme desde donde se empieza a procesar toda la información que entra por nuestros ojos, por lo que cualquier persona (que no padezca de un trastorno visual, evidentemente) cuando se cruza con otro individuo es capaz de reconocerlo si ya lo había visto con anterioridad e incluso, si es la primera vez, retiene información sobre los rasgos del mismo que en un futuro servirá para recordar de quién se trata (nuestra memoria es capaz de identificarlo en aproximadamente cien milisegundos).

Pero al igual que la inmensa mayoría de nosotros logra reconocer a alguien (obviamente, algunas veces con ciertas dificultades para terminar de ubicar y recordar su nombre, de qué o dónde lo conocimos) en el planeta se estima que hay un dos por ciento de la población que padece un curioso trastorno de agnosia visual llamado ‘Prosopagnosia’ y por el cual es incapaz de reconocer cualquier rostro.

La prosopagnosia o ceguera al rostro consiste en ver a alguien y no saber quién es, a pesar de que ese ‘alguien’ se trate de un familiar muy allegado y que convive con quien padece este curioso trastorno.

Existen diversos grados dentro de esta patología y, dependiendo del nivel de afectación del mismo, el prosopagnósico puede incluso llegar a no reconocerse a si mismo cuando se ve en una fotografía en la que aparece e incluso, en casos extremos, cuando pasa frente a un espejo.

La mayoría de ellos pueden distinguir los ojos, nariz o boca dentro de una cara, son capaces de señalar a qué parte del rostro corresponden y ubicarlo en él, pero les es imposible que su cerebro los ordene visualmente para reconocerlos en su conjunto dentro del rostro de alguien.

También son capaces de distinguir entre los rostros de varias personas diferentes, saber que cada una de ellas no son el mismo individuo, pero se sienten totalmente incapaces de averiguar quién es quién e identificarlas.

Una simple sonrisa, la forma de guiñar un ojo o de ladear la cabeza puede ser clave para que el prosopagnósico pueda tener una referencia clara sobre a quién pertenece y poder así reconocer fácilmente cuando se encuentran de nuevo.

El retener y memorizar esos rasgos y peculiaridades faciales, como tics, una cicatriz, si lleva bigote, forma de la nariz e incluso el modo de reír, caminar, si lleva gafas o tiene el pelo ondulado o recogido con una coleta, se convierte en algo fundamental para las personas que padecen la ceguera al rostro, por lo que cualquier cambio físico, por sutil que este sea (afeitarse, teñirse el pelo, cambiar de montura de gafas o de peinado…), puede provocar que el prosopagnósico no reconozca a quien tiene frente a él.

Actualmente no existe tratamiento farmacológico para curar esta patología, por lo que los enfermos que sufren esta agnosia visual se apoyan en terapias en las que les enseñan a memorizar el mayor número de datos sobre los rasgos faciales de las personas que les rodean, lo cual les ayuda a salir airosos para reconocer a determinadas personas y así evitar cualquier situación social embarazosa.

Prosopagnosia, la incapacidad de reconocer los rostros (Imagen vía Hubert Figuière-Flickr)

Entre las pruebas y terapias a las que son sometidos se encuentran algunas pruebas basadas en el famoso ‘test de Reconocimiento Facial de Benton’ (creado en 1946 por el profesor en neuropsicología, de la Universidad de Iowa, Arthur Lester Benton) diseñado para evaluar la percepción y memoria visual y en el que en lugar de presentar una serie de figuras o dibujos abstractos (que posteriormente el paciente debe reproducir) se realiza con imágenes de personas en las que debe señalarse las características de la cara de estas y emparejar las fotografías con la que corresponde (rostros de frente, perfil, iluminados y vistos desde diferentes ángulos, que hacen que el cambio de perspectiva pueda hacer que varíen sustancialmente los rasgos).

Aunque en un principio se asoció esta patología únicamente a una lesión en el hemisferio derecho del cerebro, posteriormente se estableció que era necesaria una lesión bilateral y simétrica en ambos hemisferios para padecer tal desorden. Durante largo tiempo se tuvo el convencimiento que la prosopagnosia era una de las consecuencias tras haber sufrido algún accidente cerebrovascular, tumor cerebral e incluso, aunque con menor frecuencia, un traumatismo craneoencefálico o infecciones del Sistema Nervioso Central, siendo denominada ‘prosopagnosia adquirida’, pero, gracias a los avances e investigaciones que se han desarrollando en el campo de la neurología, se ha logrado identificar que también existe un vínculo genético y que esta agnosia puede tener un origen congénito (‘prosopagnosia evolutivas o de desarrollo’) desarrollándose desde la infancia sin que tenga asociada una lesión específica.

Varios son los grados de incidencia de la ceguera al rostro y cada individuo puede padecerla en mayor o menor medida pero si tuviéramos que diferenciarla en dos bloques estos serían la ‘prosopagnosia asociativa’, en la que el paciente puede llegar a reconocer algún rostro gracias a aquellos rasgos faciales que ha memorizado y la ‘prosopagnosia aperceptiva’, por la cual se es incapaz de analizar la estructura facial, distinguir y memorizar las peculiaridades de cualquier individuo e incluso no tener la capacidad de percibir la sensación de familiaridad que se tiene al reconocer un rostro.

Para encontrar la etimología del término debemos buscar en la composición de los vocablos griegos prosopon (cara) y agnosia (ausencia de conocimiento). Fue el neurólogo alemán Joachim Bodamer quien, en 1947, acuñó dicho término el cual incluyó en un ensayo que escribió sobre la prosopagnosia, diferenciándola de la agnosia general y de la alexia y describiéndola como […]la interrupción selectiva de la percepción de rostros, tanto del propio como del de los demás, los que pueden ser vistos pero no reconocidos como los que son propios de determinada persona[…].

A pesar de ser una patología englobada dentro de las catalogadas como ‘enfermedades raras’ y que afecta a una de cada cincuenta personas, varios son los personajes populares a los que se les ha diagnosticado, entre ellos el famoso neurólogo Oliver Sacks, quien escribió sobre la prosopagnosia en 1985, en el libro ‘El hombre que confundió a su mujer con un sombrero’, incluso antes de saber que la padecía; la primatóloga Jane Goodall; la princesa Victoria de Suecia; la periodista de The Times Mary Ann Sieghart (su hija Evie también la padece) o el conocidísimo actor hollywoodiense Brad Pitt (según declaró en una entrevista realizada en 2013, aunque reconoció no estar diagnosticado por un especialista).

Este post ha sido realizado por Alfred López (@Yelqtls) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Fuentes de consulta y más info:

http://www.jpsychores.com/article/S0022-3999(08)00157-8/abstract

http://www.visionlab.harvard.edu/Members/Ken/Papers/130NeurologyDuchaine04.pdf

https://pdfs.semanticscholar.org/3c99/7a718e53a5d5363b631a7d9116498fcd3069.pdf

http://www.tandfonline.com/doi/abs/10.1080/17470218.2016.1173076

http://dx.doi.org/10.1080/02643299008253437

http://www.sciencedirect.com/science/article/pii/0022510X72900044

http://biorxiv.org/content/early/2017/01/15/100479

http://dx.doi.org/10.1016/j.tics.2005.02.011

http://www.uninet.edu/neurocon/congreso-1/conferencias/neuropsicologia-2-2.html

https://www.wired.com/2006/11/blind/

Fuentes de las imágenes:

https://www.pexels.com/photo/apples-blurryface-dress-moonlight-80864/

https://www.flickr.com/photos/hfiguiere/10199319943

El artículo Prosopagnosia, la incapacidad de reconocer los rostros se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El sesgo a la izquierda al reconocer un rostro

- Los volcanes de Venus

- ¿Por qué el Rover Curiosity es más lento que un caracol?

Por qué los colegios no deberían enseñar habilidades de pensamiento crítico generales

Carl Hendrick

Foto cortesía de la Armada de los Estados Unidos / Flickr

Ser controlador de tráfico aéreo no es fácil. Parte fundamental del trabajo es una capacidad cognitiva llamada “conciencia situacional” que implica “la extracción continua de información ambiental [y la] integración de esta información con conocimiento previo para formar una imagen mental coherente”. Grandes cantidades de información fluida deben mantenerse en la mente y, bajo extrema presión, se toman decisiones de vida o muerte a lo largo de turnos rotatorios de 24 horas. El trabajo es tan estresante y exigente mentalmente que, en la mayoría de los países, los controladores de tráfico aéreo cumplen los requisitos para una jubilación anticipada. En los Estados Unidos, deben retirarse a los 56 sin excepciones.

En los años sesenta se realizaron una interesante serie de experimentos sobre las capacidades mentales de los controladores de tráfico aéreo. Los investigadores querían explorar si poseían una capacidad aumentada general para “seguir varias cosas a la vez” y si esa habilidad podía aplicarse a otras situaciones. Tras observarlos en su trabajo, los investigadores asignaron a los controladores de tráfico aéreo un conjunto de tareas genéricas con formas y colores basadas en la memoria. Lo extraordinario fue que, cuando se les evaluaba en estas tareas alejadas de su área de conocimiento, los controladores de tráfico aéreo no eran mejores que cualquier otro. Sus extraordinariamente sofisticadas capacidades cognitivas no se aplican fuera de su ámbito profesional.

Desde comienzos de los años ochenta, sin embargo, los colegios se han visto cada vez más cautivados por la idea de que los estudiantes deben aprender un conjunto de destrezas de razonamiento generalizadas para prosperar en el mundo contemporáneo; y especialmente en el mercado de trabajo contemporáneo. Llámense “habilidades de aprendizaje del siglo XXI” o “pensamiento crítico”, el objetivo es equipar a los estudiantes con un conjunto de métodos generales de resolución de problemas que pueden aplicarse a cualquier campo; los líderes empresariales los aplauden como parte esencial de la preparación para el siglo XXI. Naturalmente, queremos que niños y graduados tengan un conjunto de herramientas cognitivas multipropósito que les permitan manejarse en el mundo. Es una vergüenza, entonces, que hayamos fallado a la hora de aplicar un mínimo de pensamiento crítico a la cuestión de si una cosa así se puede enseñar.

Tal y como sugerían los estudios de los años sesenta sobre los controladores aéreos, para ser bueno en un campo concreto tienes que saber un montón de él: no es fácil trasladar esas habilidades a otros ámbitos. Esto es aún más cierto con el tipo de conocimiento complejo y especializado que conlleva la pericia profesional: estudios posteriores encontraron que cuanto más complejo es el campo, más importante es el conocimiento específico de ese campo. Esta no traslabilidad de la habilidad cognitiva está bien establecida en la investigación psicológica y ha sido replicada muchas veces. Otros estudios, por ejemplo, han demostrado que la capacidad de recordar largas series de dígitos no se transfiere a la capacidad de recordar largas series de letras. Sin duda esto no es sorprendente, ya que todos conocemos personas que son muy “inteligentes” en sus vidas profesionales y que, sin embargo, parece que toman decisiones estúpidas en sus vidas personales.

En casi cualquier campo, cuanto mayor es el nivel de habilidad, más probable es que la pericia se haga más concreta. En un equipo de fútbol, por ejemplo, ha diferentes “campos” o posiciones: portero, defensa, delantero. Dentro de éstas, hay todavía más categorías: defensa central, lateral, mediocentro atacante, mediocentro defensivo, delantero centro. Bueno, podría estar bien para un grupo de aficionados, jugando un partido amistoso, cambiar de posiciones. Pero, a nivel profesional, si pones un lateral izquierdo en la posición del delantero centro o a un centrocampista en la de portero, los jugadores estarían perdidos. Para que puedan tomar decisiones excelentes en fracciones de segundo y ejecutar estrategias robustas y eficaces necesitan miles de modelos mentales concretos, y miles de horas de práctica para crear esos modelos, todos los cuales son concretos y exclusivos de una posición.

Por supuesto, el pensamiento crítico es una parte esencial del equipamiento mental de un estudiante. Sin embargo, no puede separarse del contexto. Enseñar a los estudiantes “destrezas de razonamiento” separadas del resto de su currículo no tiene sentido y es ineficaz. Como dice el pedagogo estadounidense Daniel Willingham:

Si recuerdas a un estudiante suficientemente a menudo que “mire un problema desde múltiples perspectivas”, aprenderá que debe hacer eso, pero si no sabe mucho de un problema, no puede pensar sobre él desde múltiples perspectivas…el pensamiento crítico (así como el pensamiento científico y cualquier otro pensamiento basado en un campo) no es una habilidad. No hay un conjunto de destrezas de pensamiento críticas que pueden adquirirse y usarse sin tener en cuenta el contexto.

Esta separación de los ideales cognitivos del conocimiento contextual no se circunscribe al aprendizaje del pensamiento crítico. Algunos colegios se precian de colocar las “destrezas de aprendizaje para el siglo XXI” como parte fundamental de su misión. Se ha llegado incluso a sugerir que algunas de estas nebulosas habilidades son ahora tan importantes como la alfabetización y que debería otorgárseles el mismo estatus. Un ejemplo de esto son los juegos de entrenamiento mental que afirman que ayudan a los niños a ser más inteligentes, estar más alerta y ser capaces de aprender más rápido. Sin embargo, investigaciones recientes ha demostrado que los juegos de entrenamiento mental son solo buenos para una cosa: ser bueno en los juegos de entrenamiento mental. La afirmación de que ofrecen a los estudiantes un conjunto general de habilidades de resolución de problemas fue recientemente rebatida por un estudio que revisó más de 130 artículos de investigación, que concluía:

No conocemos prueba alguna de mejora general en cognición, rendimiento académico, desempeño profesional, y/o competencias sociales que se derive de una práctica descontextualizada de habilidades cognitivas carentes de contenido de un campo concreto.

Lo mismo aplica para la enseñanza de “predisposiciones” como la “mentalidad de crecimiento” (centrada en la voluntad y el esfuerzo en oposición al talento innato) o la “firmeza” (la determinación para superar obstáculos). No está claro que estas disposiciones se puedan enseñar, y no hay pruebas de que enseñarlas aparte de un tema concreto tenga efecto alguno.

En vez de enseñar habilidades de pensamiento crítico genéricas, deberíamos centrarnos en habilidades de pensamiento crítico concretas para un tema que busquen ampliar el conocimiento individual del estudiante del tema y desentrañar los complicados misterios propios de cada tema. Por ejemplo, si un estudiante de literatura sabe que la madre de Mary Shelley murió poco después del nacimiento de Mary y que la misma Shelley perdió varios hijos al poco de nacer, la comprensión del estudiante de la obsesión de Victor Frankenstein con crear vida a partir de la muerte, y del lenguaje empleado para describirla, será mejor que si se aproxima al texto sin este conocimiento. Un estudiante de física que investiga por qué dos aviones se comportan de forma diferente durante el vuelo puede saber cómo “pensar críticamente” gracias al método científico pero, sin un sólido conocimiento de factores contingentes como la temperatura del aire exterior y un repertorio de casos de estudio previos en los que fijarse, el estudiante tendrá dificultades para saber en qué hipótesis centrarse y qué variables descartar.

Como escribe Willingham: “Los procesos del pensamiento están entrelazados con aquello en lo que se piensa”. Los estudiantes necesitan que se les den cosas reales y significativas del mundo con las que y sobre las que pensar, si los profesores quieren influir en cómo hacen ese pensar.

Sobre el autor: Carl Hendrick es responsable de aprendizaje e investigación en el Wellington College (Berkshire, Reino Unido) y está terminando su doctorado en educación en el King’s College de Londres.

Texto traducido y adaptado por César Tomé López a partir del original publicado por Aeon el 5 de diciembre de 2016 bajo una licencia Creative Commons (CC BY-ND 4.0)

![]()

El artículo Por qué los colegios no deberían enseñar habilidades de pensamiento crítico generales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El encéfalo bilingüe: por qué no existe un modelo único

- La ciencia perdida: los curiosos casos de los protocolos de TDAH y de leer.es

- El corpus de confusión consistente del inglés oral

La ciencia y la duda

Lo más complicado y duro de practicar ciencia es mantener la permanente capacidad de hacerse preguntas: sobrevivir mentalmente en un entorno de duda continua. Porque la esencia del conocimiento científico es su volubilidad: cualquier teoría, hipótesis o hecho puede ser descartado debido a un nuevo avance, a un nuevo descubrimiento. Todo el andamiaje de lo que creemos saber es volátil; nada es permanente ni debe ser considerado fijo e inmutable. La obligación de cualquier científico es poner constantemente en duda todo lo que cree que sabe.

Y sí; es cierto que a veces y por razones diversas se cuelan en el corpus del conocimiento científico cosas que no son ciertas. La tradición, los intereses comerciales, los errores y la simple mala praxis contribuyen a engrosar el listado de errores de la ciencia. Hay múltiples razones por las que hechos, datos o interpretaciones falsas se pueden perpetuar, muchas de ellas derivadas de los intereses personales de alguien. Y no hablamos sólo de intereses económicos: en la ciencia a menudo el dinero no es la divisa más importante superada con mucho por el prestigio y la reputación. La resistencia a admitir errores o malas interpretaciones que puedan dañar el estátus de un científico o de una escuela o instituto puede ser un importante obstáculo para aceptar correcciones.

También es verdad que la desconfianza radical es poco práctica, y que nunca se replican los experimentos ajenos con ánimo de comprobar sus resultados. Si cada científico tuviese que demostrar todos los presupuestos de su disciplina desde cero para poder avanzar un paso más no sólo se repetiría sin necesidad una enorme cantidad de trabajo, sino que los avances serían muy lentos. De hecho el uso del trabajo anterior como peldaño para avanzar sirve en la práctica como sistema de comprobación: un resultado falso dura poco no porque nadie se dedique a comprobarlo, sino porque otros lo usarán como etapa intermedia en sus propios experimentos. Si no funciona, se sabrá: este no es el principal problema.

Para algunas personas, sin embargo, esta característica inestabilidad de la ciencia es inaceptable. Hay quien necesita sentir que conoce cuáles son los hechos básicos y permanentes sobre el cosmos y se siente inseguro cuando las respuestas a las preguntas cambian. Algunas personas sienten una especie de inestabilidad filosófica cuando las explicaciones sobre el mundo real varían, como si el universo mismo fuese tan poco inamovible como las teorías con las que lo explicamos. En el fondo todos nos sentimos más cómodos con las historias que conocemos y con las teorías con las que nos criamos y educamos; todo cambio de paradigma científico conlleva una cierta incomodidad, un esfuerzo mental de readaptación contra el que la inercia de nuestra mente se rebela.

Pero esta es la esencia del conocimiento científico: su capacidad de avanzar, de sobrepasar las teorías precedentes, de buscar nuevas y mejores explicaciones. Un científico debe estar dispuesto a aceptar que las ideas y teorías que aprendió en la carrera serán superadas por nuevos descubrimientos y nuevas hipótesis, incluso algunas suyas si tiene suerte. Aceptar que lo que antaño sabías ya no sirve no es fácil, pero si se quiere hacer ciencia es necesario. No es este un campo en el que se vayan a sentir cómodos quienes necesitan un cimiento firme e inamovible en el que asentar su concepción del universo. Porque a diferencia de otros sistemas de conocimiento que aspiran a ser equiparables la ciencia, cuando se equivoca, cambia de teoría. Y aunque para sus practicantes no sea fácil la duda constante como método de conocimiento es, sin duda, mucho más potente.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La ciencia y la duda se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia, poder y comercio

- De los héroes de la ciencia y sus frágiles teorías

- Pozos de conocimiento: el problema de la profundidad

Los castillos de arena en Titán no necesitan agua

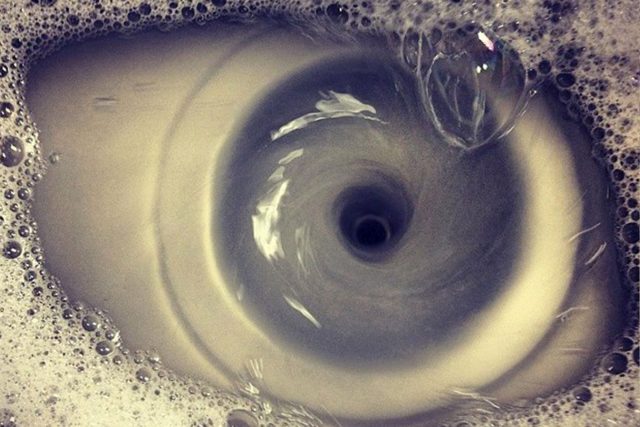

Imagen compuesta de Titan formada a partir de 4 imágenes tomadas por la sonda Cassini en 2004.

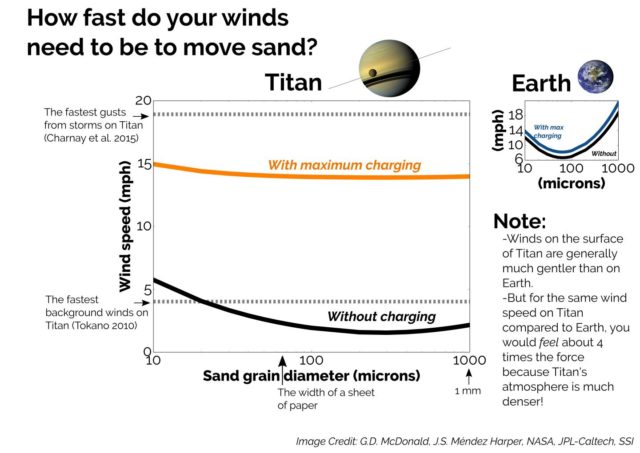

Los vientos predominantes en Titán, la luna de Saturno, van de Este a Oeste sobre la superficie del satélite, pero las dunas de algo que podemos llamar arena (aunque no lo sea) de casi 100 m de alto se forman en la dirección contraria. Varias teorías se han propuesto para explicar este fenómeno, pero ninguna es completamente satisfactoria.

Ahora un grupo de investigadores encabezado por Joshua Méndez Harper, del Georgia Institute of Technology (EE.UU.), ha realizado una serie de experimentos que sugieren que las partículas que cubren la superficie de Titán están cargadas eléctricamente.

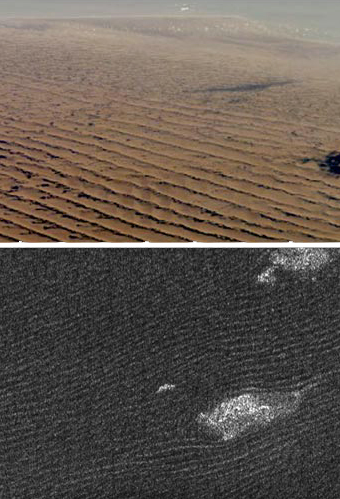

Arriba dunas de arena en el desierto de namibia (Tierra); abajo, dunas en la región de Belet (Titán)

Cuando el viento sopla con velocidad suficiente (unos 25 km/h; lo que representa la fuerza de un viento de unos 100 km/h en la Tierra, ya que la atmósfera de Titán tiene 4 veces la densidad de la de nuestro planeta) los gránulos “salen volando” y rebotando en un movimiento que los geólogos llaman saltación. Estos gránulos no son silicatos (como la arena de la Tierra) sino probablemente algún tipo de hidrocarburo oscuro (como si fuese hollín); recordemos que en Titán hay lagos y mares de metano y etano líquidos.

Durante la saltación los choques de los gránulos entre sí y con los componentes de la atmósfera rica en nitrógeno provocan que adquieran carga eléctrica por fricción, y terminan formando agrupaciones unidas electrostáticamente que adquieren tamaño suficiente como para que sean difíciles de mover. Mantendrían la carga durante días, si no meses, uniéndose a otras sustancias hidrocarbonadas presentes en el medio. Como resultado, los vientos predominantes, muy suaves, serían incapaces de mover las dunas.

El experimento se llevó a cabo en unas condiciones como las de Titán en un recipiente cilíndrico a presión. Se introdujeron granos de naftaleno y bifenilo, dos compuestos que se cree que existen en la superficie de Titán, en una atmósfera de nitrógeno puro. Tras 20 minutos de hacer girar el cilindro los investigadores midieron las características eléctricas de cada grano conforme salía del tubo.

Todas las partículas estaban cargadas y aproximadamente el 5 % no salía del tubo. Los experimentos se repitieron con arena y con ceniza volcánica; en estos casos todo el contenido salía del tubo. Ello se debe a que los silicatos de arena y cenizas adquieren carga, pero es pequeña y se disipa pronto. Por eso hace falta agua para construir castillos de arena en la playa. En Titán, simplemente, no hace falta.

Referencia:

J.S. Méndez Harper et al (2017) Electrification of sand on Titan and its influence on sediment transport Nature Geoscience doi: 10.1038/ngeo2921

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Los castillos de arena en Titán no necesitan agua se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una proteína humana para potabilizar agua

- El agua lunar creada por el Sol

- La fragmentación del agua al congelarse

Un convite matemático ‘de altura’

Hace casi cuatro años, en la entrada Guateque en el Aftermath del blog de la Facultad de Ciencia y Tecnología de la UPV/EHU, adaptaba una propuesta vista en el libro [1].

En esa anotación, y en una supuesta fiesta que iba a tener lugar en el Aftermath –el universo en el que viven los matemáticos ‘inmortales’ tras su fallecimiento (ver [2])–, los invitados reaccionaban tras recibir la invitación al convite. En tono de humor, las respuestas de cada científico se relacionaban de alguna manera con las aportaciones matemáticas que habían realizado.

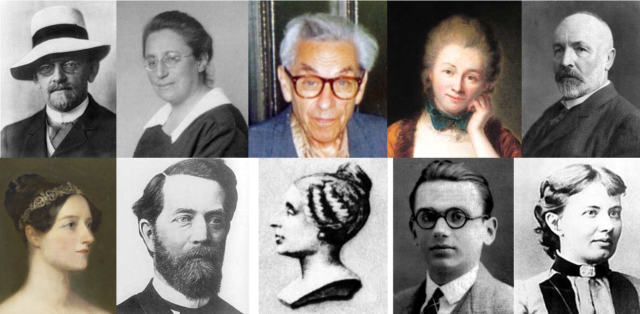

Entre los veintiún científicos que aparecían no había ninguna mujer… Hoy realizo en esta entrada el mismo ejercicio, pero eligiendo a cinco de los veintiún ‘ilustres’ matemáticos de Guateque en el Aftermath, introduciendo las respuestas de otras cinco no menos ilustres científicas, y proponiendo, para finalizar, un juego.

Empecemos con el listado de las reacciones ante esta invitación de estas diez insignes personalidades de la ciencia. Cada concepto matemático aparece en negrita y se explica en una nota final.

De arriba abajo y de izquierda a derecha: David Hilbert, Emmy Noether, Paul Erdös, Émilie du Châtelet, Georg Cantor, Ada Lovelace, Felix Klein, Sophie Germain, Kurt Gödel y Sofía Kovalevskaya. Imágenes extraídas de la Wikipedia.

Las reacciones ante la invitación

-

David Hilbert cerrará su hotel (ver [3]) por esta noche, y espera que nadie se aproxime demasiado a su espacio vital durante la fiesta.

-

Emmy Noether dice que solo asistirá si August Möbius lleva unos anillos de chocolate que él mismo prepara –él los llama ‘cintas’– que le han dicho que le salen ‘ideales’ (ver [4]).

-

Paul Erdös ha invitado a sus amigos, a los amigos de sus amigos, a los amigos de los amigos de sus amigos… (ver [5]).

-

Émilie du Châtelet espera encontrar a Isaac Newton desde el principio… tiene mucho que discutir con él sobre su forma de redactar (ver [6]).

-

Georg Cantor no es capaz de contar todas las invitaciones que ha recibido (ver [7]).

-

Ada Lovelace tiene muy bien programada su agenda, y acudirá sin dudarlo (ver [8]).

-

Felix Klein dice que él se ocupará de las botellas (ver [9]).

-

Sophie Germain sólo irá a la fiesta si le garantizan que el número de asistentes es primo, y además un primo de su familia… (ver [10]).

-

.Kurt Gödelinsiste en que la invitación no es completa y no lo será nunca. Pero él estará allí aunque nunca podrá probarlo (ver [11]).

-

Sofia Kovalevskaya llevará unas peonzas para jugar: en la última fiesta, los rompecabezas que llevó Martin Gardner no le gustaron nada… (ver [12]).

El juego final

El juego final consiste en proponer otras posibles respuestas a esta supuesta invitación a esta selecta fiesta… esas frases deben proceder de mujeres matemáticas (ya fallecidas, y se puede elegir a las cinco anteriores también), y en ellas debe de estar incluida, de alguna manera, una alusión a sus aportaciones matemáticas (explicándolas).

Podéis enviar las propuestas a esta dirección de correo electrónico. Si hay suficientes, haremos una entrada (citando a sus autoras o autores) en el blog Mujeres con ciencia de la Cátedra de Cultura Científica de la UPV/EHU. ¡Animaos!

Notas

[1] Bruno Winckler, Recueil de blagues mathématiques et autres curiosités, Ellipses, 2011.

[2] En inglés aftermath significa secuela. Aquí se trata de un juego de palabras ‘After math’, es decir, ‘después de las matemáticas’. Se usa en este sentido, por ejemplo, en el musical Fermat’s last tango de Joshua Rosenblum y Joanne Sydney Lessner.

[3] El ejemplo del hotel infinito es una construcción abstracta debida a David Hilbert para explicar alguna de las ‘paradojas’ que envuelve el concepto de infinito. La introdujo durante la conferencia Über das Unendliche impartida en 1924. Raúl Ibáñez lo explicaba en Una de mates: El hotel infinito.

[4] Emmy Noether, la madre del álgebra abstracta, trabajo en teoría de anillos y de ideales. La cinta se refiere, por supuesto, a la cinta de Möbius.

[5] Se está hablando del número de Erdös, al que también nos referimos en la entrada El número de Erdős-Bacon-Sabbath.

[6] Émilie du Châtelet tradujo los Principia de Newton al francés.

[7] Georg Cantor formalizó el concepto de infinito a través de los llamados números transfinitos.

[8] Ada Lovelace pasa por ser la primera persona programadora de la historia.

[9] La botella de Klein es una superficie, de la que hemos hablado en las entradas La botella de Klein: geometría ‘palindrómica’ y Una visión topológica de la Odisea.

[10] Se está hablando de los números primos de Germain.

[11] Se refiere a los teoremas de incompletitud de Gödel y a la indecibilidad, ambos enmarcados en la teoría de lógica matemática.

[12] Sofía Kovalevskaya recibió en 1888 el Premio Bordin de la Academia de Ciencias de París por su trabajo Sobre la rotación de un cuerpo sólido alrededor de un punto fijo, es decir, un trabajo sobre el movimiento de una peonza.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Un convite matemático ‘de altura’ se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:A mayor tamaño, mayor complejidad

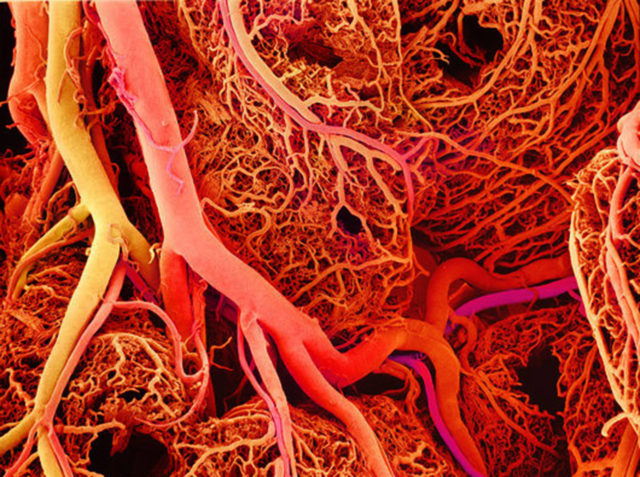

A partir del modelo animal básico consistente en una estructura procedente de tres capas embrionarias (ectodermo, mesodermo y endodermo), una simetría bilateral y la aparición de una cavidad interna, la división del trabajo biológico se acentúa considerablemente, con lo que la complejidad aumenta cada vez más.

Recordemos ahora que en el curso de la evolución de los animales se ha producido un aumento global del tamaño corporal. Pues bien, ese aumento del tamaño no habría sido posible sin el proceso paralelo del aumento de la complejidad organizativa y funcional. Por expresarlo de forma muy simple: no sería posible que un animal del tamaño y forma de un tortuga estuviese constituido por un bloque de células ameboides todas iguales.

Podemos considerar que el número de tipos celulares distintos que hay en un organismo constituye un indicador de su complejidad. Al fin y al cabo, cada uno de los tipos celulares realiza alguna tarea diferenciada del resto y es habitual que forme parte de algún tejido u órgano en concreto. Y cuantos más tejidos diferentes y órganos tiene un animal, más compleja es su organización y funcionamiento1.

Los representantes de los grupos más antiguos que aún perviven (Porifera) tienen alrededor de diez tipos celulares y algunos de esos tipos ni siquiera se organizan en tejidos, menos aún en órganos. Los animales con simetría bilateral más antiguos dotados de celoma tienen treinta tipos celulares. Los artrópodos tienen alrededor de cincuenta y los cefalópodos del orden de setenta y cinco. Los anfibios tienen cerca de ciento cincuenta. Las aves alrededor de ciento ochenta. Y los homínidos doscientos diez. Si el filo Porifera surgió hace aproximadamente unos quinientos ochenta millones de años y los primeros animales de simetría bilateral –con un número estimado de treinta tipos celulares distintos- aparecieron hace unos quinientos setenta millones de años, el ritmo de aparición de nuevos tipos celulares ha sido, aproximadamente, de uno cada tres millones de años. En resumen, conforme han ido apareciendo nuevos grupos animales, el número de funciones diferentes que es desempeñado por tipos celulares distintos no ha dejado de aumentar. De acuerdo con ese criterio, la complejidad organizativa y funcional ha sido cada vez mayor.

La especialización celular, como se ha dicho, refleja en gran medida un funcionamiento basado en órganos y sistemas y es la consecuencia, y a la vez reflejo, de una forma de división del trabajo de la que muy probablemente se deriva una mayor eficacia biológica. Así pues, en el curso de la evolución de los animales la división del trabajo no ha dejado de acentuarse. Creemos, además, que ese proceso es el que ha permitido el aumento del tamaño de los linajes de metazoos, aunque no lo ha hecho obligatorio. Por esa razón la mayor parte de los animales están organizados como un conjunto de sistemas que funcionan de forma armónica.

Para ilustrar los principios a los que me he referido en el párrafo anterior, fijémonos en la respiración. En los animales que carecen de sistema circulatorio (poríferos, cnidarios, gusanos planos, por ejemplo) el oxígeno no puede penetrar más de 1 mm desde el exterior del organismo, por lo que las mitocondrias más alejadas de la superficie corporal no pueden estar más alejadas del medio respiratorio que esa distancia. Eso, obviamente, limita mucho el tamaño total que puede alcanzarse. Sin embargo, una vez los animales cuentan con un medio líquido que circula por el interior del organismo y que pone en contacto unos sistemas con otros y el conjunto de ellos con el exterior, las limitaciones al tamaño motivadas por la difusión de los gases respiratorios se relajan considerablemente. Por otra parte, si, por las razones que fuese, los animales necesitan que la mayor parte de su superficie corporal sea impermeable al paso de diferentes sustancias, se requiere de un enclave especial en el que realizar el intercambio de gases: el sistema respiratorio. Éste, a su vez, si está asociado al sistema vascular, ya se encuentra en disposición de captar el oxígeno necesario, y transferirlo al plasma o sangre y, a través de ella, enviarlo a todos los tejidos. Hay una notabilísima excepción a ese esquema que es la de los insectos, que respiran a través de un sistema traqueal, pero precisamente por eso, el tamaño máximo que puede alcanzar un insecto está muy limitado. Una mosca no podría alcanzar el tamaño de un cerdo, por ejemplo, porque su sistema traqueal no se lo permitiría.

El ejemplo que he utilizado (sistema circulatorio y sistema respiratorio) ilustra bien a las claras la forma en que la especialización basada en tipos celulares distintos organizados en órganos y sistemas conlleva una mayor eficacia en el desempeño de una función y cómo esa mayor eficacia permite -en este caso de forma palmaria, no tanto en otros- mayores tamaños corporales.

Todas estas cosas pueden parecer obvias. Pero no lo son.

Referencias:

John Tyler Bonner (2006): Why Size Matters. Princeton University Press, Princeton.

James W Valentine, Allen G. Colins & C. Porter Meyer (1994): Morphological Complexity Increase in Metazoans. Palebiology 20 (2): 131-142

Nota:

1 Esto es, obviamente, muy discutible, pues depende de cómo definamos la complejidad. A los efectos que aquí interesan, sin embargo, me parece que el número de tipos celulares diferentes es un buen indicador. La idea la he tomado de Valentine et al (1994).

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo A mayor tamaño, mayor complejidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historia mínima de la complejidad animal

- Evolución del tamaño animal

- De la edad y tamaño del universo

De la reforma a la revolución

Thomas Wijck (1640-1677), “El Alquimista”. Óleo sobre madera, 43 x 37,5 cm. Ámsterdam, Rijksmuseum.

En los siglos XIV y XV las artes químicas, como tales, avanzaron poco, salvo en lo que se refiere a los trucos del alquimista estafador. Las avances técnicos del siglo XVI tampoco fueron espectaculares. De hecho, este periodo no fue otra cosa que una pausa en la investigación que se empleó en la reforma de la propia consideración de la química.

El objetivo de la química fue redefinido y reajustado. La minería, la medicina y la parte noble de la alquimia pasaron a estar interrelacionadas. Se pusieron en su sitio a las autoridades del pasado y surgieron nuevas basadas en nuevos libros cuyas afirmaciones podían comprobase en la práctica por mineros, metalúrgicos, farmacéuticos y médicos. Se puso un énfasis especial en los preparados químicos de uso en medicina y en la forma de prepararlos por parte de los farmacéuticos, que ahora debían ser también alquimistas, lo que tuvo un efecto muy estimulante en las investigaciones de los siglos posteriores.

Si bien no se avanzó mucho teóricamente, sí se pusieron las bases durante la Reforma para lo que después se llamaría la Revolución Química. Pero con la reforma también llegó la reacción, y en el siglo XVII habría casi tantos pasos para atrás como pasos hacia adelante.

La Europa del siglo XVII estaba en una etapa de grandes cambios, de ambigüedades y al frente del inicio de la globalización. Un ejemplo en lo político es Inglaterra donde, en la primera mitad de siglo, el rey Carlos I era descabezado (literalmente) durante la Guerra Civil Inglesa, para, en la segunda mitad, sustituir al católico Jacobo II por su protestante hija María II, tras una votación en el Parlamento que incluyó la Declaración de Derechos (1689), limitando los poderes del monarca.

Diego Velázquez, “La rendición de Breda” (1634-35). Óleo sobre lienzo, 307 x 367 cm. Madrid, Museo del Prado. La obra representa el momento en que Justino de Nassau rindió la ciudad de Breda, en 1625, a las tropas españolas al mando del general Ambrosio Spínola, que aparece recibiendo las llaves de la ciudad de manos de su enemigo.

Mientras, la Guerra de los Treinta Años (1618-1648) es la última gran guerra de religión pero la primera gran lucha nacionalista por la hegemonía continental, barriendo prácticamente las últimas trazas de feudalismo.

La exploración y colonización del mundo (África, Asia, América, Australia) supuso la aparición de un flujo continuo de nuevos productos (azúcar, café, tabaco, tomates, patatas, maíz, por nombrar algunos), que cambiaron muchos usos y costumbres. También un torrente de nueva información que forzaron a muchos a cambiar su cosmovisión. La creencia en la superioridad europea también llevó al restablecimiento de una práctica perdida con el Imperio Romano, la esclavitud.

La higiene brillaba por su ausencia y las grandes ciudades de Europa eran básicamente un pestilente foco de basuras y enfermedades. Los ricos comienzan con la costumbre de huir de ellas en verano, hacia mansiones que construyen en el campo.

El siglo XVII será el de la Revolución Científica pero, y esto se subraya poco, para las ciencias macroscópicas, física y astronomía, no así para la química.

Efectivamente, cuando a Richard Feynman le pidieron que resumiera en una frase el conocimiento científico más importante que tenemos, tras reflexionar un momento, dijo: “Todo está hecho de átomos”. Esto, que hoy damos por sentado y como algo poco menos que evidente, fue una suposición que ganó peso en el siglo XIX y que sólo se pudo confirmar más allá de toda duda razonable cuando Jean Perrin demostró en 1908 que la teoría del movimiento browniano formulada por Albert Einstein en 1905 era correcta.

En el siglo XVII, por tanto, para los químicos los principios fundamentales de su arte les eran desconocidos. Se intuía que la materia estaba compuesta por algún número indeterminado de los llamados “elementos” (que no hay que confundir con los actuales) y que éstos estaban presentes en todas las clases de materia. Esta hipótesis, muy vaga, era de poca utilidad práctica. Sin embargo, a finales de siglo se producirán aproximaciones a una definición alternativa.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo De la reforma a la revolución se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La Reforma química

- Las matemáticas como herramienta (II): La Revolución Científica y el cálculo

- Biringuccio, la química práctica y rentable del XVI

Las razones del asesino

Las razones para matar son muchas y variadas, según el interesado en este asunto que nos lo cuente. Aquí van varios ejemplos. Agatha Christie dice que la causa puede ser pasional, el dinero o una idea. Erle Stanley Gardner habla del poder y el dinero, y añade que es inevitable en una sociedad tan competitiva como era Estados Unidos en la época de Perry Mason, en los cincuenta del pasado siglo. Y John Verdon, escritor de este siglo, repite el sexo, el dinero, el poder, la venganza y los delirios o misiones sagradas. Arthur Koestler, filósofo y ensayista, se acerca a algunas de las propuestas más actuales de la neurociencia cuando afirma que matamos por una coordinación insuficiente entre el neocórtex racional y el hipotálamo emocional que nos lleva a ”esa veta única, alucinatoria, asesina, que lo ha impulsado a matar, torturar y hacer la guerra.” Es más, para Peter Morrall, el crimen fascina, intriga y repugna a la vez.

Cayetano Galeote: El honor de un cura

Narciso Martínez Izquierdo

El obispo Narciso Martínez Izquierdo había nacido 1830 en Pineda de la Sierra, Guadalajara. El cura Cayetano Galeote Cotilla había nacido en 1841 en Vélez Málaga. Sus caminos se encontraron el 18 de abril de 1886, Domingo de Ramos, en la escalinata de entrada a la Catedral de San Isidoro de Madrid. De esta manera, una vida disoluta, un obispo estricto, un asunto de política eclesiástica y una cuestión de honor acabaron en un asesinato. En esa fecha y en ese lugar, el cura Galeote disparó tres veces contra el Obispo Martínez Izquierdo que, atendido en el sitio, fue llevado al hospital y falleció al día siguiente.

Narciso Martínez Izquierdo venía de una familia de labradores que, como era habitual en la época, mandaba a uno de sus hijos al seminario pues era la mejor manera de alimentarlo y educarlo sin muchos gastos. Pero el joven Narciso hizo una brillante carrera en la Iglesia y llegó a Obispo de Salamanca en 1874 y a Obispo de Madrid en 1885. Además, participó en política y fue diputado carlista en 1871 y 1873, y senador en 1876 y 1881. Dadas sus opiniones fuertemente conservadoras, se opuso a la libertad de cultos en la Constitución de 1886 y a la instauración del matrimonio civil en los debates en las Cortes en 1881. Era muy estricto en cuanto al comportamiento del clero, lo que no le hizo muy popular entre algunos de sus administrados. Cuenta Benito Pérez Galdós que, nada más ser nombrado Obispo de Madrid, inició una campaña contra la corrupción en el clero y, entre otras cosas, obligó a los sacerdotes a inscribirse en una sola iglesia y, así, terminar con el sistema de misas diarias dobles, triples o cuádruples que seguían muchos curas para aumentar sus ingresos pues se cobraba por misa celebrada. Los que no cumplían veían como el Obispo les retiraba la licencia para celebrar la misa.

Cayetano Galeote Cotilla, natural de Vélez Málaga, provenía también de familia pobre que con dificultad alimentaba a sus seis hijos. El niño Cayetano, con pocos años, enfermó de otitis bilateral y de ello le quedó la sordera de un oído para toda su vida. Al acabar sus estudios de sacerdocio, fue destinado un tiempo en Madrid, luego en Puerto Rico durante cinco años y, además, fue capellán castrense en Fernando Poo. En 1880 regresó a Madrid y se inició el drama que aquí contamos.

El cura Galeote era un sacerdote inestable que cambiaba a menudo de parroquia en busca de mayores ingresos. Era lo que denominaba un “cura suelto, sin oficio ni beneficio”, iba donde más y mejor pagaban una misa. Sordo desde niño, de mal carácter, violento e irascible, fue descrito por un compañero de colegio como “un verdadero epiléptico”. Finalmente, era notorio y público que, en sus numerosos cambios de domicilio le seguía siempre su ama de llaves, su “sobrina”, Doña Tránsito Durdal, de 33 años y natural de Marbella, con quien parece ser vivía amancebado. En el juicio se utilizó, en este sentido, el hecho demostrado de que en la casa del cura sólo había una cama.

Esta mujer es, quizá, la figura misteriosa de este drama. Según Pérez Galdós, “no es una mujer vulgar”. De figura esbelta, fisonomía inteligente y modales corteses, los que la vieron la describen como de unos treinta años, “guapetona, alta, ojos negros, boca grande y conjunto agradable.” Acompañaba al cura Galeote cuando en 1880 regresó a Madrid desde Fernando Poo. Cómo se encontraron e iniciaron su vida en común y de qué tipo de era esa vida, todos son misterios cuya respuesta sólo se vislumbró en el juicio y en las crónicas de la prensa.

Según su declaración, el cura Galeote disparó contra el Obispo como reparación de su honra mancillada y para hacerse justicia. Todo comenzó con una disputa con el cura Vizcaíno, Rector de la Capilla del Cristo de la Salud. Galeote consideró, quisquilloso a más no poder como era, que Vizcaíno le había retirado el saludo y no le trataba con la educación debida. Además, prohibió a Galeote cantar misa en la Capilla, prohibición que Galeote ignoró. La Junta de la Capilla le destituyó y Galeote se sintió insultado, además de perder unos buenos ingresos. Indignado, Galeote se entrevistó o escribió al Obispo, a su secretario, a su confesor, al Nuncio y a algún que otro político. Cada vez más insolente y amenazador, más tarde confesó que había acechado, con el revólver cargado, al cura Vizcaíno y al Obispo. Y el 18 de abril, Domingo de Ramos, cumplió sus amenazas.

En el juicio no se debatió en absoluto sobre la culpabilidad del cura Galeote pues medio Madrid le había visto disparar al Obispo y, además, él mismo se apresuró a confesar el crimen. Lo que se discutió fue su responsabilidad, o sea, si en el momento de los hechos era dueño de sus actos o era un loco rematado y, por lo tanto, irresponsable. Uno de los psiquiatras que le examinó le describe como “un hombre de carácter violento, poco humilde, tenaz, de imaginación excitable, cargante, iracundo, acalorado, pronunciadamente nervioso, receloso, acusador, insultador, raro, extravagante; es decir, un sacerdote imposible y que no atendía a razones.” Y este mismo psiquiatra, partidario de las teorías degeneracionistas del delincuente promovidas por Cesare Lombroso en las que el aspecto físico revela las cualidades mentales, hace una descripción de Galeote realmente impactante: “es un hombre de complexión recia, seco de carnes, enjuto de rostro, de cráneo chico, cara larga, frente cuadrada, estrecha y oblicua, quijadas pronunciadas, cuyos dientes salen unos hacia el paladar, y otros divergen empujando el belfo lo que le impide cerrar bien los labios, por entre los cuales despide espumarajos de saliva cuando se excita.” Y así sigue el psiquiatra durante varios párrafos de los que aquí nos vamos a librar.

Más sencillo es Pérez Galdós al describir al cura Galeote. Es “de nariz pequeña y corva, la boca muy grande y muy separada de la nariz, los ojos negros y vivos, la frente despejada.”

En resumen, para los psiquiatras de la defensa, Galeote es un paranoide con delirio persecutorio. Realmente, en el juicio tuvo una conducta sorprendente. Uno de los psiquiatras que leyó su informe al tribunal fue un joven médico llamado Jaime Vera, con un trabajo profundo, directo, preciso y, se agradece, comprensible para cualquiera. Según el corresponsal de El Socialista, una vez leyó el informe, Galeote, entusiasmado, “le alzó en sus robustos brazos, como quien alza una pluma, y le paseó triunfalmente alrededor de la sala, en medio de la estupefacción de todos.” En realidad, Galeote no quería que le declarasen loco; aseguraba que su crimen era por su honor, que el Obispo le “trató como a un perro” y que “matose a sí mismo” y, así, su honra quedó reparada.

Cada vez que su abogado defensor hablaba de su locura, el cura protestaba enérgicamente. Pero nadie le hacía caso. Benito Pérez Galdós, que asistió al juicio como periodista y corresponsal, vio en el acusado, como el resto de la prensa, a una persona extraña, enérgica y de rara conducta. Así lo describe: “el reo se ha permitido las mayores extravagancias, ya desconociendo la autoridad del presidente, ya interrumpiendo a cada instante las declaraciones de los testigos; pasando bruscamente del llanto a la ira, siempre agitado y nervioso, sus palabras, sus apóstrofes, ora epigramáticos, ora terribles, han excitado vivamente el interés público”. Galdós, finalmente, se pregunta, “y en resumidas cuentas, ¿está loco o no?”

El cura Galeote fue condenado a muerte el 9 de octubre de 1886. Sin embargo, su rara conducta en la cárcel llevó al tribunal ordenar un nuevo reconocimiento a una comisión formada por seis médicos, que dictaminó delirio persecutorio. Este informe fue ratificado por la Real Academia de Medicina el 3 de diciembre de 1887. El reo fue encerrado en el manicomio de Leganés donde murió en 1922.

Pirámide de Manslow

Cuando son los asesinos los que hablan de justificación casi siempre comienzan afirmando que no querían matar, pero han matado y, en el fondo, ha sido sin querer, un accidente, no sé cómo ocurrió,… Por el contrario, la mayoría de las personas en nuestra sociedad occidental, en un momento u otro de su vida, querrían matar, pero no lo hacen. Veamos lo que dicen los expertos de las razones para matar. Podemos empezar con lo que Abraham Maslow escribió en 1943 sobre la motivación humana. Se puede suponer que lo que nos motiva en nuestra vida es, también, lo que nos impulsa a matar. La motivación, según Maslow, comienza con la fisiología, es decir, con las necesidades fisiológicas básicas como la comida, la respiración o el descanso. Después, o más arriba en esta pirámide que estamos construyendo, están las necesidades de seguridad que incluyen nuestra protección, la casa o el territorio. Y por encima está la pertenencia a algo o a alguien y el amor, con el afecto, la amistad y el grupo. También necesitamos la autoestima y la confianza en nosotros mismos cuando buscamos el respeto, el éxito y el estatus. Finalmente, queremos la autorrealización con la moralidad y la creatividad.

Para cubrir estas necesidades es por lo que, en las circunstancias adecuadas, nuestra especie mata a un semejante, o a muchos. Philip Zimbardo fue el que ensayó cómo es que personas normales, como usted y como yo, si se me permite personalizar, acaban cometiendo actos crueles y atroces. Es lo que nos enseñó Hannah Arendt cuando asistió en Jerusalén al juicio de Adolf Eichmann, responsable de la organización del exterminio de judíos en la Segunda Guerra Mundial. No era un asesino cruel y sanguinario, era, simplemente, un funcionario obediente y eficaz que cumplía órdenes. Y sus órdenes eran exterminar a los judíos, y millones murieron bajo la responsabilidad del funcionario Eichmann.

August Hirt: Por la ciencia y el nazismo

El 23 de noviembre de 1944, la 2ª División Blindada de la Francia Libre bajo el mando del general Leclerc, adscrita al 2º Ejército de Estados Unidos de George Patton, entró en Estrasburgo, expulsó al ejército alemán y liberó la ciudad. De inmediato y tal como establecía el protocolo habitual, varios grupos del ejército francés entraron en diferentes instituciones de la ciudad en busca de pruebas y testimonios sobre la ocupación. Entre otros, entraron en el Instituto de Anatomía de la Universidad de Estrasburgo y, en el sótano, encontraron decenas de cadáveres, completos o desmembrados, cuidadosamente conservados en alcohol.

No había pasado un mes desde la llegada de Leclerc cuando, el 17 de diciembre, comenzaba sus averiguaciones una comisión de oficiales médicos cuyas órdenes eran investigar posibles crímenes de guerra en relación con los cuerpos humanos encontrados en el sótano del Instituto. Pronto descubrieron que la colección pertenecía a August Hirt, profesor de Anatomía y director del Instituto.

Monolito con los nombres de las víctimas de Hirt

August Hirt había nacido en Mannheim el 28 de abril de 1898. Fue voluntario en el ejército alemán durante la Primera Guerra Mundial, herido gravemente en 1916 y condecorado. Inició sus estudios de Medicina en la Universidad de Heidelberg y se doctoró en 1922 con una tesis sobre el sistema nervioso simpático en reptiles. Fue profesor de Anatomía en la Universidad de Greifswald en 1936. En los años siguientes contribuyó con hallazgos significativos al desarrollo de la microscopía de fluorescencia y fue el autor del concepto de epifluorescencia. Tiene, hasta 1940, un buen curriculum de investigación, con 27 artículos publicados sobre el sistema nervioso y la microscopía de fluorescencia . Siguió investigando, a su manera como veremos más adelante, pero a partir de 1940 no volvió a publicar ningún trabajo. Por esta época, se afilia al Partido Nazi y en la Segunda Guerra Mundial alcanza el grado de Obertsturmführer en las SS y, en 1941, el de Sturmbannführer. En 1942 ingresa en la sociedad Ahnenerbe.

También en 1941 es nombrado director del Instituto de Anatomía de la entonces llamada Reichsuniversitat de Estrasburgo. En los años de guerra, Hirt, junto a Wolfram Sievers, de la Ahnenerbe, y Sigmund Rascher, médico en el campo de concentración de Dachau y colaborador de Mengele, y con la coordinación con Adolf Eischmann, planeó y realizó experimentos con los prisioneros del campo de concentración de Struthof-Natzweiler, situado cerca de Estrasburgo. En particular, su labor principal fue organizar la recogida de cuerpos para la colección del Instituto de Anatomía. En el sótano en el que entraron los hombres de Leclerc había 86 cadáveres.

En 1933, la manía de Himmler por las pseudociencias y por las investigaciones raciales le había llevado a fundar Ahnenerbe o “Herencia de los Antepasados” (¿recuerdan las películas de Indiana Jones y lo que buscaban los nazis?) que, desde 1935, se dedicó a estudiar todo lo relacionado con la “raza nórdica indo-germánica”. Da una idea de sus objetivos el nombre completo de la institución: “Herencia de los Antepasados – Sociedad de Estudios para una Prehistoria Espiritual”. Es evidente por qué Hirt solicitaba fondos y prisioneros a través de la Ahnenerbe y de su director, Wolfram Sievers.

Hirt pretendía crear una colección de cuerpos de judíos para las generaciones futuras, cuando aquella raza hubiera sido exterminada por completo. En concreto, y en carta fechada en febrero de 1942, Hirt quiere cráneos de comisarios soviéticos judíos con el “propósito de dedicarlos a investigaciones científicas”, y además solicita fondos para construir un nuevo microscopio con el que hacer observaciones en vivo. La carta llevaba dos notas adjuntas. En la primera, que se ha perdido, detallaba la nueva técnica microscópica, derivada de la que había desarrollado en sus investigaciones antes de la guerra. En la segunda nota, que se conserva, da instrucciones detalladas a la Wehrmacht y a la Policía Militar de cómo localizar, identificar, tomar datos antropólogicos, ejecutar a los comisarios (lo que llama, con cínico eufemismo, “muerte inducida”) , separar su cabeza y enviarla a Estrasburgo en un recipiente con líquido conservante.

Para Hirt, la colección de Estrasburgo estaba bien provista, pero le faltaban judíos y la guerra en el Este le da la oportunidad que buscaba. Considera los cráneos de los comisarios soviéticos judíos como el no va más de la degradación humana, incluso los considera infrahumanos. Su sueño era desarrollar una nueva disciplina, la Anatomía de la Razas. Quiere reunir en su museo muestras de la especie humana y su ausencia total de respeto hacia los hombres que considera inferiores le ofrece, en medio de la guerra, la oportunidad de conseguirlo. Hirt propone y la Ahnenerbe, Sievers y Himmler, con la ayuda de Rascher y la organización de Eichmann, disponen. El fantasma de la ciencia se convierte en cruel realidad.

Además de las instrucciones para conseguir los cráneos de los comisarios, y en coordinación con Rascher y Eichmann, Hirt organizó el traslado de reclusos, elegidos por ser judíos, desde otros campos de concentración hasta el de Struthof-Natzweiler, donde eran ejecutados por el jefe del campo, Josef Kramer. Este, que fue capturado por los aliados, lo cuenta así en los interrogatorios: “A principios de 1943, recibo los 80 internados destinados a ser suprimidos con la ayuda del gas que me había enviado Hirt. Comencé por llevar a la cámara de gas, una tarde hacia las 4, y con la ayuda de una camioneta, un primer grupo de unas 15 mujeres. Les dije que debían pasar por la cámara de desinfección, y les oculté que iban a ser asfixiadas. Ayudado por algunos SS, les hice desnudarse y entrar en la cámara de gas. Cuando cerraba la puerta, comenzaron a gritar… Di la luz del interior de la cámara con un conmutador externo… y observé lo que ocurría en el interior, medio minuto, y después se derrumbaron.”

Los cuerpos se conservaban en Estrasburgo hasta que Hirt procedía a separar la cabeza y obtener el cráneo; siempre ordenaba destruir lo que quedaba de los cadáveres. Es posible que estos cadáveres, o quizá otros ejecutados de la misma manera, fueron los encontrados en el sótano del Instituto de Anatomía. Hirt también ordenaba destruir los tatuajes que identificaban a los prisioneros de los campos de concentración. El único cadáver con tatuaje fue rápidamente identificado por la comisión médica de los aliados como el de Menahem Taffel. El médico francés Henri Henripierre, ayudante a la fuerza de Hirt, fue quien destruyó los tatuajes, pero los memorizó, los apuntó y guardó los datos durante años.

Unas semanas antes de entrar Leclerc en Estrasburgo, Hirt huyó. Meses después se entregó al alcalde de Schönenbach, cerca de Friburgo, en Alemania. Y el 2 de junio de 1945 volvió a desaparecer; hay quien asegura que se suicidó y otros, en cambio, creen que se esfumó entre los miles de refugiados que entonces recorrían Europa. Como tenía doble nacionalidad, alemana y suiza, en este último país estuvo en busca y captura hasta 1959. En Metz, Francia, fue juzgado en rebeldía en 1953 y condenado a muerte.

Los cargos contra Hirt procedían de tres hallazgos: la carta que he mencionado con las instrucciones para ejecutar comisarios soviéticos judíos; los 86 cadáveres encontrados en el sótano del Instituto de Anatomía; y, en tercer lugar, las preparaciones histológicas encontradas en la Facultad de Medicina de la Universidad de Estrasburgo, descubiertas también al entrar las tropas de Leclerc en la ciudad. Sobre las 54 preparaciones encontradas, el profesor Christian Champy, uno de los mejores histólogos franceses de la época, hizo un informe que trastornó el mundo de la Medicina, incapaz de creer que hubiera médicos que cometieran semejantes atrocidades.

Tras la liberación, el doctor Reisler, junto con la policía francesa, registró las dependencias a cargo de Hirt en la Facultad de Medicina y encontró una serie de preparaciones de testículo humano así como varios cadáveres en los que faltaba un testículo. El doctor Henry Henrypierre, ayudante de Hirt, contó que le habían ordenado hacer las preparaciones histológicas del testículo izquierdo de los cadáveres. Cuando las preparaciones fueron encontradas estaban hechas hacía poco tiempo y los materiales utilizados todavía estaban frescos. Champy y Reisler redactaron un informe que se leyó en la sesión de la Academia de Medicina celebrada el 1 de mayo de 1945 (el 7 de mayo, Alemania se rindió a los aliados y terminó la guerra en Europa).

Son 54 preparaciones que provienen de, al menos, siete individuos. Las lesiones que se observan indican que son consecuencia de inyecciones en el testículo de sustancias tóxicas o irritantes. Por el estado de las lesiones, las inyecciones se han hecho entre ocho días y varias semanas antes de la muerte del sujeto. En la hipótesis más favorable, es decir, suponiendo que las inyecciones se han puesto con anestesia, las lesiones producidas han tenido que ser muy dolorosas. El resto de los tejidos están en buen estado, lo que implica que la persona fue asesinada para tomar la muestra en el momento que se consideró oportuno. Dos de los testículos provienen de dos adolescentes de entre 13 y 15 años. No se consigue averiguar la finalidad de los experimentos. Otra vez el fantasma de la ciencia se hace cruel realidad.

Núrenberg, 1938

Para Zimbardo, la línea que separa el bien del mal es muy tenue, tal como explica Antonio Crego en su blog en Investigación y Ciencia. El paso que hay que dar, a menudo suave e imperceptible, depende de circunstancias externas y de factores como el sistema legal, económico, social, político y cultural.

Se da el primer paso sin más, sin pensarlo mucho. Hay que recordar las declaraciones de muchos acusados de corrupción en política cuando explican y tratan de justificar su conducta. Volvamos a Zimbardo.

Una vez dado el primer paso, se impone deshumanizar al contrario, a las futuras víctimas. Así es más sencillo no sentir repugnancia o arrepentimiento por el mal que se hará. Después, es aconsejable perderse en la multitud, no ser un individuo sino alguien entre muchos. Ayudan los uniformes, las máscaras, los grupos, y hasta la música, y así se llega a los linchamientos. Ya hemos difuminado y repartido entre muchos la responsabilidad personal. También es interesante como excusa la obediencia debida, la obediencia ciega, la obediencia de Eichmann; otro lo ordenó y no hubo más remedio que obedecer. Es obvio que el grupo y la obediencia no permiten en absoluto la crítica a los comportamientos violentos. Todo lleva, en último término, a la tolerancia neutra del mal, a la banalidad que definía Hannah Arendt.

Kandido Azpiazu Beristain: Uno de los nuestros

Era el 21 de septiembre de 1962 en Azkoitia, Gipuzkoa, después de comer, hacia las cuatro de la tarde. Una mujer, con un niño de la mano y otro en brazos paseaba. Al chaval se le escapó el balón con el que jugaba y salió a la calle. El niño no lo dudó y salió de inmediato a recogerlo y su madre le siguió. Venía un camión. Un hombre, sentado en una silla a la puerta de una tienda de muebles, cogió al bebé de brazos de su madre mientras esta saltaba a la calzada. Ambos, madre e hijo murieron atropellados por el camión. El hombre que salvó al bebé se llamaba Ramón Baglietto y el niño, de 11 meses, era Kandido Azpiazu Beristain.

Ramón Baglietto

Han pasado 18 años. Estamos a 18 de mayo de 1980. En la carretera entre Elgoibar y Azkoitia, un Seat 131 robado, con el conductor y un pasajero, se sitúa en paralelo a un Seat 124 blanco y disparan con una metralleta Steiner y con pistolas Browning. El 124 se sale de la calzada y se estrella contra un árbol. El pasajero del 131 sale del coche, se acerca al 124 y con la pistola le dispara el tiro de gracia. No quiere errores, solo muertos. El militante de ETA se llama Kandido Azpiazu Beristain y el asesinado es Ramón Baglietto.

Ahora pasamos otros 25 años y llegamos al 16 de marzo de 2005. Ese día, un etarra salido de la cárcel 10 años antes, se instala como cristalero en una lonja del número 14 de la calle Ibai Ondo de Azkoitia. En ese portal, dos pisos más arriba, vive la viuda de un asesinado por ETA, ahora concejala del PP en el ayuntamiento de su pueblo por donde se mueve siempre acompañada de sus dos guardaespaldas. La viuda se llama Pilar Elías, su marido era Ramón Baglietto, y el cristalero es Kandido Azpiazu Beristain.

Ramón Baglietto, apodado El Pintor, había nacido en Bilbao en 1936 y, en 1962, cuando el accidente con el camión, tenía una tienda de muebles en Azkoitia y estaba prometido a Pilar Elías, la hija del viejo Elías, propietario de la única gasolinera en la carretera de Elgoibar. Fue teniente de alcalde y militante de UCD. Cuando fue asesinado tenía dos hijos, de 9 y 13 años. Su tienda de muebles estaba en la Avenida de Calvo Sotelo, hoy Xabier Munibe Kalea.

María Pilar Elías era de Azkoitia e hija, como ya he dicho, del dueño de la gasolinera de la carretera de Elgoibar. Nació en 1942 en la casa en que todavía vive, en la calle Ibai Ondo, frente al río Urola. En los bajos está la cristalería de Kandido Azpiazu. Tiene, en 2006, dos hijos y tres nietos. Después del asesinato de su marido, años más tarde, fue concejala del PP en el Ayuntamiento de su pueblo durante mucho tiempo, hasta 2011.

Kandido Azpiazu Beristain, de Azkoitia, donde nació el 20 de octubre de 1961, hijo de José Azpiazu, carpintero, y María Nieves Beristain, sus labores, que murió con su hijo mayor, de dos años, José Manuel, atropellados por un camión. Desde los 14 años, Kandido se movió por ambientes de la izquierda abertzale y a los 16 ya quiso entrar en ETA. Empezó a trabajar de carpintero, como su padre, aunque en otra empresa, pero a los 18 años cometió sus primeros atentados y acabó en la cárcel. Se casó con Milagros y tuvo, por lo menos, una hija. Su padre se volvió a casar y nunca le contó a su hijo que Ramón Baglietto le había salvado la vida cuando era un bebé. No se lo relató pero, después del asesinato, nunca pudo aceptar que su hijo había matado al que le salvó la vida.

Todos vecinos del mismo pueblo, todos se conocen desde niños, todos son uno de los nuestros. Por lo menos, eso parece. Pero Kandido Azpiazu nos aclaró algunas dudas en una entrevista que se publicó en 2001. Por ejemplo,

“-Yo no soy un asesino.

-Pero usted ha matado.

-Porque tenía que hacerse.”

…

“-¿Cómo te convertiste en asesino?

-Yo no soy un asesino.

-Has matado.

-Por necesidad histórica.”

…

“Y era bonita esa sensación de ser vasco. Desde que tengo uso de razón he luchado por la independencia de los vascos.”

…

“-Uno siempre era consciente -dice Azpiazu- de que algún día haríamos lo que después realmente hicimos. Era un largo proceso. Uno no se dice de repente: ‘Hoy me convierto en autor de atentados’, ¿entiendes?, ¿entiendes? Uno madura hasta que…”

…

“-¿Te asustaste?

-Nosotros no sentimos el deseo de matar.

-¿No te pudiste negar?

-No quise.

-Ese momento… Ese momento fue duro.

-¿Tuviste miedo?

-No. Uno estaba preparado para entregar su vida.

-¿Conocías a la persona?

-Sí.”

…

“-Tuvo que ser así.

-¿Por qué?

-Ese hombre formaba parte del aparato opresor, era conocido de Marcelino Oreja, el entonces ministro de Asuntos Exteriores del Estado español.

-¿Y eso bastaba?

-La decisión vino de arriba.”

La decisión vino de Eugenio Etxebeste, Anton, entonces número dos de ETA y además, no hay que olvidarlo, primo del asesinado Ramón Baglietto.

“-¿Cómo le mataste?

-Una acción armada no se hace con globos. Lo que ocurrió fue la acción de un miembro consecuente… Nada más.

-¿Te arrepientes?

-Tuvo que ser así. Uno no se sentía orgulloso de ello, no se sentía ni odio ni alegría.”

O, también, al hábito humano primario, como afirmó Alfred Hitchcock. Para el cineasta, nuestra especie mata porque le da la gana, e, incluso, si no hay costumbre de hacerlo, por la cultura del entorno, para experimentar lo que se siente al matar. O, según Robert Mitchum en “La batalla de Anzio”, “el hombre mata porque le gusta matar”. Es más, como propone Peter Morrall, detrás de muchos crímenes está el Schadenfreude, la alegría que provoca la desgracia ajena.

En fin, a nuestra especie le fascina matar, aunque sea, a veces, una banalidad, como decía Hannah Arendt, y, si no podemos matar, nos fascina cómo lo hacen otros.

Referencias:

Arendt, H. 1967. Eichmann en Jerusalén: un estudio sobre la banalidad del mal. Ed. Lumen. Barcelona. 440 pp.

Aumüller, G. & K. Grundmann. 2002. Anatomy during the Third Reich – The Institute of Anatomy at the University of Marburg, as an example. Annals of Anatomy 184: 295-303.

Bernadac, C. 1979. Los médicos malditos. Luis de Caralt Ed. Barcelona. 243 pp.

Boo, M.I. 1977. La perspectiva de Galdós en el asesinato del obispo Martínez Izquierdo. Anales galdosianos 12: 141-145.

Campos Marín, R. 2003. Criminalidad y locura en la Restauración. El proceso del cura Galeote (1886-1888). Frenia 3: 111-145.

Champy, C. & Risler. 1945. Sur une série de préparations histologiques trouvées dans le laboratoire d’un professeur allemand. Expériences faites sur l’homme au champ de Struthof. Bulletin de l’Académie de Médecine 129: 263-266.

Delarue, J. 1963. La Gestapo. Ed. Bruguera. Barcelona. 444 pp.

Hildebrandt, S. 2009. Anatomy in the Third Reich: An outline, Part 1. National Socialist politics, anatomical institutions, and anatomists. Clinical Anatomy 22: 883-893.

Koch, E. 2001. Confesiones de un asesino. El País 14 agosto.

Malvar, A. 2006. El cristalero de hierro. El Mundo 8 enero.

Maslow, A.H. 1943. A theory of human motivation. Psychological Review 50: 370-396.

Morrall, P. 2006. Murder and society. John Wiley & Sons. Chichester. 214 pp.

Ordaz, P. 2005. Víctima y verdugo, puerta con puerta. El País 4 diciembre.

Ricard, R. 1966. El asesinato del Obispo Martínez Izquierdo (1886) y el clero madrileño en la época de Galdós. Anales galdosianos 1: 125-129.

Ternon, I. & S. Helman. 1971. Historia de la Medicina SS o El mito del racismo biológico. Fomento de Cultura Ed. Valencia. 408 pp.

Wechsler, P. 2005 (1991). La Faculté de Medecine de la “Reichsuniversität Strassburg” (1941-1945) à l’heure nationale-socialiste. These Doctorat en Medecine, Université Louis Pasteur Strasbourg.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Las razones del asesino se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- 8 razones para que los niños estudien ciencias… o cualquier otra cosa

- Ingredientes para la receta: El arroz

- Historias de la malaria: El árbol de la quina

¿Son las ‘beachrocks’ una prueba del Antropoceno?

Nikole Arrieta, del Departamento de Química Analítica de la UPV/EHU, encabeza el equipo autor de un estudio en el que se analizan las beachrocks, formaciones de arena cementada en las que han quedado atrapados desechos industriales derivados de las actividades metalúrgicas. Estas peculiares rocas atestiguan el impacto del desarrollo industrial y su influencia en el entorno costero.

“El estudio de ciertos fenómenos geológicos ayuda a reconstruir el pasado ambiental y a determinar la influencia que ha tenido el ser humano en el medio, puesto que lo registran todo. Incluso podrán ofrecer información valiosa para afrontar posibles efectos del cambio climático”, afirma Arrieta.

Formación de arena cementada situada en Tunelboka. Foto: Nikole Arrieta. UPV/EHU.

Se trata de formaciones rocosas que se producen en zonas intermareales, normalmente en zonas tropicales y subtropicales. A pesar de ello, también es posible encontrarlas en la costa vizcaína. Las beachrocks estudiados son formaciones recientes situadas en la margen derecha del estuario Nerbioi-Ibaizabal, donde han sufrido una gran influencia de la actividad humana.

“Su presencia en latitudes templadas como la nuestra es rara, hay 8-10 casos en todo el mundo” añade Arrieta. Estas formaciones sedimentarias son derivadas de la precipitación intergranular de cementos carbonatados (CaCO3). “Entre los diferentes sedimentos se ha formado un cemento. Así, la arena, en vez de estar suelta, como en las playas normales, forma estas rocas”, explica Arrieta.

Sin embargo, aunque normalmente los cementos de los que están compuestos las beachrocks son carbonatados, las formaciones geológicas de la costa vasca presentan además cementos ferruginosos. Las escorias atrapadas en los cuerpos cementados han sufrido procesos de disolución por fenómenos de meteorización o atmosféricos, como la lluvia ácida, llegando a reprecipitar en los poros como sales insolubles de hierro.

La investigación se ha centrado en la caracterización de dichos cementos. Por una parte, para estudiar los tipos de cementos se han aplicado innovadoras técnicas espectroscópicas que han permitido analizar exhaustivamente las distintas fases minerales. “A escala microscópica, aparecen distintas capas de cemento, y cada una aporta una información sobre el momento en que han precipitado, las condiciones que había, etc.”.

Por otro lado, han analizado los materiales atrapados en esos cementos, donde “hemos encontrado escorias de fundición de la revolución industrial, incluso residuos con sellos de empresas europeas que al venir con sus barcos echaban sus escorias. Por ello, en las playas encontramos los llamados tecnofósiles o vestigios de la actividad humana, en este caso desechos industriales de empresas internacionales que ayudan a estimar la edad de la beachrock”.

Todo ello constituiría un ejemplo del registro geológico de la época del Antropoceno, actualmente discutida entre especialistas de todo el mundo. Y es que, según los científicos partidarios de esta denominación, la Tierra se encuentra en una nueva época geológica, “la era del ser humano”, ya que la acción humana genera grandes cambios que dejan su huella en los estratos geológicos de la Tierra. Sus detractores, en cambio, argumentan que se trata de una cuestión más política que científica.

Esta edad geológica abarcaría el periodo más reciente del Cuaternario, y actualmente está siendo de gran interés para especialistas de todo el mundo. “Los estratos de Tunelboka, una cala situada en la margen derecha del estuario donde se centra la investigación, han sido discutidos a nivel mundial de cara a ser evidencias del Antropoceno”, señala Arrieta. Y es que, además de haber muy pocos emplazamientos en el mundo en latitudes templadas que presenten este fenómeno, “aún son menos los que presentan las características de los nuestros; la cantidad de escorias que contienen es desorbitada. He colaborado con distintos investigadores de reconocido prestigio de universidades de Estados Unidos y Australia, y todos quedan prendados al ver las fotos o materiales del emplazamiento”.