El flujo sanguíneo se reorganiza en respuesta a las necesidades

Como vimos aquí, en reposo, el corazón humano bombea sangre a razón de 5 litros por minuto (l m-1). La sangre que sale por la aorta y se dirige a los tejidos procedente de los pulmones va cargada de O2. Veamos cómo se reparte ese flujo entre unos órganos y otros.

El sistema digestivo recibe 1,35 l min-1, un 27% del total. El tracto digestivo recibe 1 l min-1, y el resto 0,35 l min-1, aproximadamente, va directamente al hígado, aunque este órgano recibe, a través del sistema portal hepático, un flujo adicional procedente precisamente del intestino con sustancias recién absorbidas. Este flujo sanguíneo proporciona oxígeno a un tejido metabólicamente muy activo. Pero también está al servicio de la incorporación al organismo de los nutrientes digeridos y absorbidos, y su posterior remisión al hígado para su posible almacenamiento o transformación, y al resto de los tejidos para su uso; en este segundo caso, no obstante, la sangre ha de volver al corazón para su redistribución posterior.

El segundo destino que más sangre recibe en reposo son los riñones, a los que se dirige un 20% del total de sangre bombeada en un ciclo de contracción-relajación del ventrículo izquierdo del corazón. El flujo que reciben los riñones es de 1 l min-1. Aunque las células renales son muy activas metabólicamente por el trabajo de transporte iónico que efectúan, la principal razón de ese elevado flujo es la necesidad de filtrar la sangre en los glomérulos renales para limpiarla de las sustancias de deshecho (urea, principalmente) y para ajustar los elementos del balance de agua y sales, de manera que tal balance resulte equilibrado y pueda mantenerse la constancia en las propiedades osmóticas e iónicas del medio interno.

La muscultura esquelética recibe 750 ml min-1 (un 15%) del flujo sanguíneo. Puede parecer una cifra importante, pero no lo es en términos relativos, ya que la musculatura esquelética representa alrededor de la mitad de la masa corporal.

Por comparación, mayor importancia relativa tiene el flujo de sangre que riega el encéfalo: 650 ml min-1(13%). No debe sorprender ese valor, dado que el tejido encefálico es el de mayor actividad metabólica: algo más del 20% de la del conjunto del organismo en reposo. Ese elevado metabolismo es el que alimenta energéticamente el mantenimiento de los gradientes iónicos de los que depende la transmisión de los impulsos nerviosos, así como el conjunto de procesos implicados en las sinapsis químicas. Hay que tener en cuenta que la masa encefálica es de entre 1,3 y 1,5 kg. dependiendo de la talla del individuo, o sea, representa del orden del 2% de la masa corporal solamente.

La piel recibe 450 ml min-1 (un 9%), el corazón 150 ml min-1 (3%) y los huesos y resto de elementos corporales, 650 ml min-1 (13%).

Las cosas cambian de forma sustancial si el individuo debe hacer alguna actividad física. Para empezar, en condiciones de ejercicio moderado el gasto cardiaco se multiplica por 2,5: pasa a ser de 12,5 l min-1. Pero el cambio no consiste solo en un aumento del flujo sanguíneo total; también cambia, y mucho, el reparto de ese flujo entre los diferentes órganos.

El cambio más importante es el que registra el riego muscular. Se multiplica por más de diez y de los 750 ml min-1 en reposo pasa a 8 l min-1; o sea, casi dos terceras partes (64%) del flujo total se dirige a la musculatura esquelética bajo esas condiciones. La razón de ese aumento no requiere explicaciones adicionales. La piel y el corazón son los otros órganos cuya irrigación aumenta de forma importante. La piel pasa a recibir 1,7 l min-1 (el 13,6%); no hay que perder de vista que la piel es el principal enclave a través del cual disipamos energía en forma de calor hacia el exterior. Y el aumento de la irrigación cardiaca, que pasa a ser de 550 ml min-1 (4,4 %) obedece, precisamente, a la necesidad de aumentar el gasto cardiaco elevando la frecuencia de latido.

Nada sorprendentemente, el encéfalo recibe el mismo riego sanguíneo (650 ml min-1) que en reposo, lo que da idea de la importancia de mantener la actividad encefálica constante, incluso cuando otras requieren aportes adicionales de O2 y nutrientes.

Y luego están los órganos cuyo riego disminuye, tanto en términos absolutos como relativos, porque las funciones que desempeñan permiten una reducción a veces importante, ya que no es esencial que se mantengan a un nivel constante en todo momento. El tracto digestivo pasa a recibir 600 ml min-1 (4,8%), los riñones, 550 ml min-1 (4,4%) y huesos y demás elementos, 450 ml min-1 (3,6%).

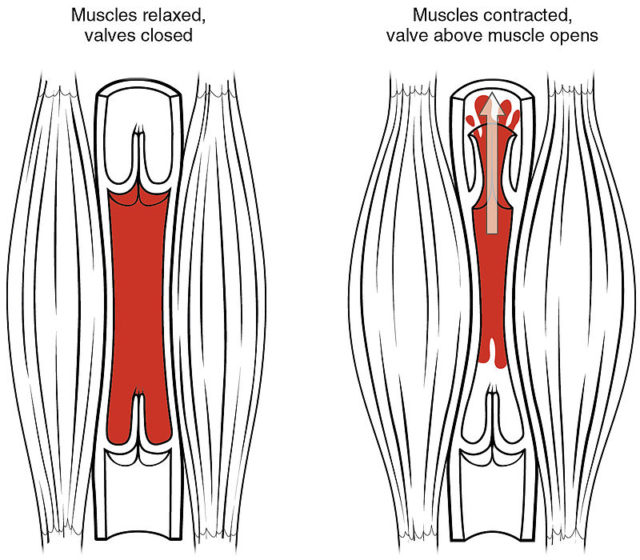

Los ajustes necesarios para redirigir el flujo sanguíneo se producen en el sistema de arteriolas. Se trata del sistema que, en conjunto, más resistencia ofrece a la circulación de la sangre; por esa razón es en esa parte de la circulación general donde se produce la caída más grande de la presión sanguínea: su valor medio pasa de unos 90 mm Hg al salir de las grandes arterias, a los aproximadamente 40 mm Hg al llegar a los capilares. Pues bien, pequeñas modificaciones en el tono arteriolar, aumentando o disminuyendo el diámetro interno de los vasos de unas zonas o de otras, dan lugar a cambios muy grandes en el flujo de sangre a través de los diferentes tejidos. Y esos cambios responden a señales intrínsecas. Esto no implica que no haya control extrínseco del diámetro de las arteriolas. Lo hay y corre a cargo del sistema nervioso simpático, pero, al parecer, el objeto de tal control no es el de regular el flujo, sino controlar la presión arterial en su conjunto.

Las señales que generan los cambios locales de flujo son químicas y tienen que ver con la actividad metabólica de los tejidos afectados. Se trata, por ello, de un control local, intrínseco. La reducción de la concentración de O2 en la sangre produce vasodilatación arteriolar. Así, cuando el consumo de oxígeno es alto en los músculos esqueléticos, su concentración baja rápidamente y ese descenso provoca una mayor apertura de las arteriolas que riegan esos músculos. Además de la disminución de la concentración de O2, el aumento de la de CO2 –provocada por la misma causa- tiene el mismo efecto. La acidificación del entorno –por efecto de la combinación de CO2 con el agua y por el aumento en la concentración de lactato- da lugar también a un aumento en el diámetro de las arteriolas. Otro factor es la elevación del K+ extracelular; esa elevación se produce cuando las bombas Na+-K+ no son capaces de reintroducir en las células (neuronas encefálicas o células musculares) el K+ que sale al exterior como consecuencia de los frecuentes potenciales de acción que ocurren en zonas especialmente activas. Una concentración osmótica elevada tiene el mismo efecto; ocurre cuando el metabolismo celular es muy alto y da lugar a la producción excesiva de moléculas osmóticamente activas, algunas de las cuales abandonan las células hacia el líquido intersticial. Y en el músculo cardiaco especialmente, la liberación de adenosina que se produce en respuesta a una elevada actividad metabólica o falta de oxígeno, también provoca un aumento del diámetro arteriolar y, por lo tanto, del flujo sanguíneo hacia la zona afectada.

Cuando, por las razones que sea, eches a correr y experimentes un aumento del ritmo cardiaco y un mayor flujo de calor hacia la superficie de tu cuerpo, quizás recuerdes esto que has leído aquí.

El artículo El flujo sanguíneo se reorganiza en respuesta a las necesidades se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Los cimientos de la química neumática al estilo van Helmont (y 3)

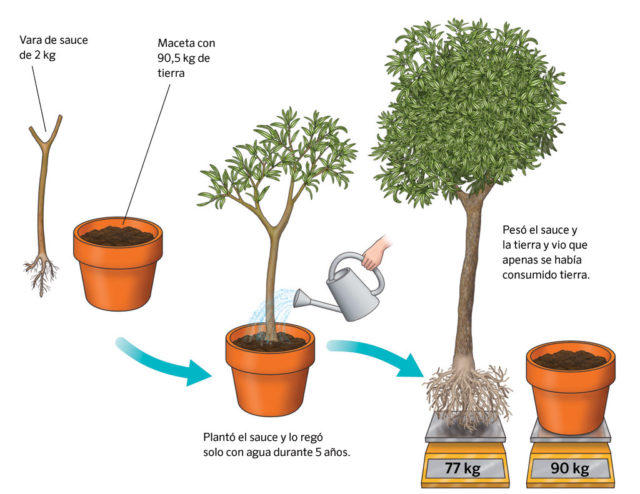

El principio de conservación de la materia es algo que está implícito en van Helmont ya que asume en sus experimentos que se conserva independientemente de los cambios que sufra. Extendió esta idea a los metales, algo que los alquimistas veían de forma completamente opuesta. Según van Helmont, cuando los metales se disolvían en los ácidos no se destruían sino que se podían recuperar gramo por gramo (cosa muy útil si te persiguen los nazis).

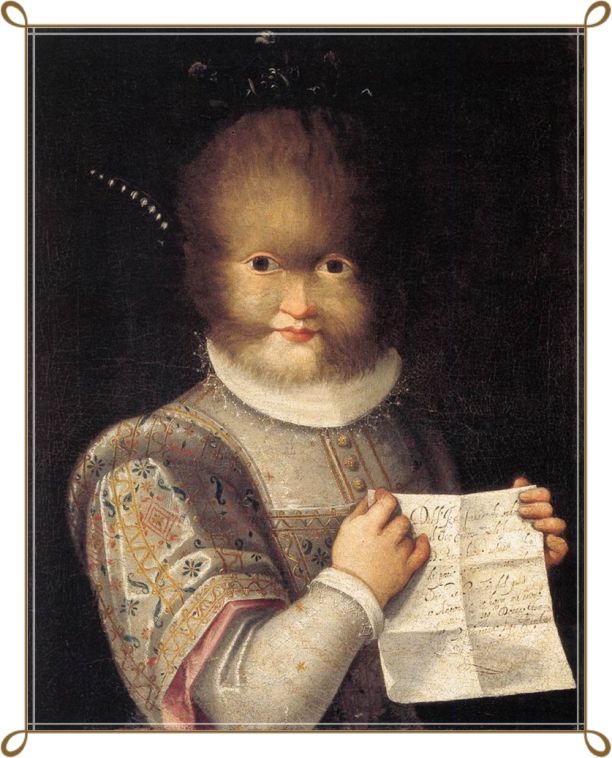

Angelo Sala. Imagen: Wellcome Library, London. Wellcome Images

Estas ideas, sin embargo, no eran exclusivas de van Helmont. Por ejemplo, su contemporáneo Angelo Sala describe en Anatomia vitrioli (1617) como había disuelto una cierta cantidad de cobre en ácido sulfúrico, recuperado químicamente el cobre metálico y encontrado que pesaba exactamente lo mismo que el cobre con el que había comenzado el experimento.

No solo eso, Sala también demostró algo muy importante y que hoy se da (o debería darse) por sentado: pudo preparar en el laboratorio un sulfato de cobre hidratado que era exactamente igual al sulfato de cobre hidratado que se encuentra en la naturaleza, una idea revolucionaria para la época. Pero Sala no tenía la influencia y el prestigio de van Helmont, por lo que hoy no aparece en casi ningún libro de historia de la química, entre otras cosas, porque sus ideas más que notables, no tuvieron impacto.

Sin embargo, van Helmont tenía tanta influencia que incluso sus especulaciones más evidentemente arbitrarias tuvieron eco. Así, van Helmont postuló la existencia del alcahest, el disolvente universal, que tenía la propiedad de devolver las sustancias a sus estado primitivo, esto es, a agua, el componente básico de todo. Los químicos contemporáneos, que habían dejado de buscar la piedra filosofal, emplearon mucho tiempo y esfuerzo buscando el alcahest, incluido el famoso Robert Boyle.

La química moderna empezará realmente con la investigación de los gases por los llamados químicos neumáticos y será van Helmont el que establezca las bases de esta nueva área de investigación. Eso sí, con la esquizofrenia característica del siglo.

Para van Helmont como el aire no podía convertirse en agua, tenía que ser un elemento diferente. Sin embargo, existía una serie de sustancias “parecidas al aire” que aparecían frecuentemente en el transcurso de las reacciones químicas. Para referirse a ellas van Helmont empezó a utilizar el término gas, que en neerlandés suena muy parecido a caos, un término que Paracelso usó para referirse al aire en otro sentido.

Obviamente, para van Helmont los gases eran simplemente agua, no aire, ya que cualquier sustancia se convertía en gas e iba a la atmósfera por la muerte de sus “fermentos”. Un gas era caos porque no tenía forma. Un gas podía condensar en vapor (visible como distinto del aire) y caer en forma de lluvia (precipitar) por la influencia del blas, un término que la jerga química no terminó de aceptar y con el que van Helmont se refería a una especie de influencia o poder astral, “gravitacional”, que producía el cambio y el movimiento en el universo.

Como hemos visto, el siglo XVII produce grandes avances en la química pero también modelos teóricos arcaicos o arcaizantes. Serán ya otros nombres, todavía arrastrando algunas ideas alquímicas, los que comiencen este mismo siglo con la historia moderna de la química: Robert Boyle, Robert Hooke, John Mayow, John Joachim Becher, Georg Ernest Stahl o Stephen Hales ya no son alquimistas.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los cimientos de la química neumática al estilo van Helmont (y 3) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las transmutaciones de van Helmont (2)

- Jan van Helmont, filósofo por el fuego (1)

- El siglo de la esquizofrenia química

Historias de la malaria: El parásito

Terciana: Calentura intermitente que repite cada tercer día.

Cuartana: Calentura, casi siempre de origen palúdico, que entra con frío, de cuatro en cuatro días.

(Diccionario de la Lengua Española).

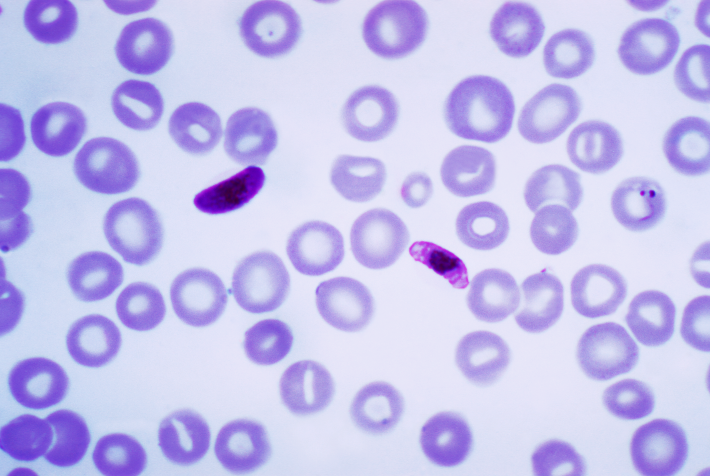

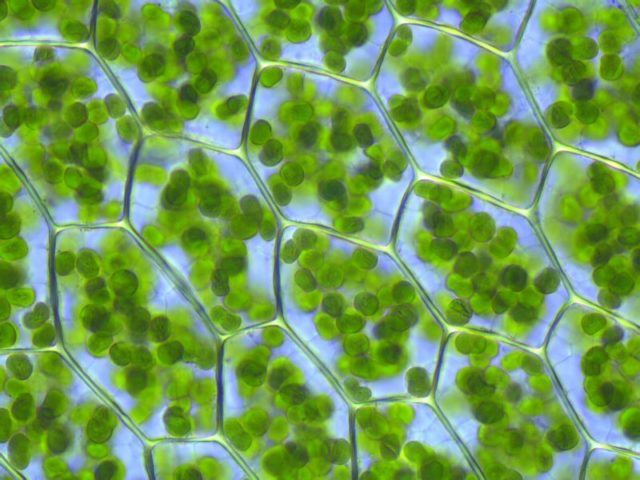

Fue el médico militar francés Alphonse Laveran, del que hablaré en otro capítulo de esta serie, quien demostró en 1880, con la ayuda de un microscopio no muy potente, que el parásito que provoca la malaria tenía, según vio en preparaciones de sangre fresca de enfermos, un cuerpo globular ciliado que, años más tarde se asignó a un protozoo del género Plasmodium. Ahora nosotros vamos a conocer en detalle al protagonista principal de las historias de la malaria.

Plasmodium falciparum

Son cuatro las especies de Plasmodium que causan la malaria en nuestra especie. El Plasmodium falciparum es la especie más letal, la más asociada a la mortalidad que provoca el parásito de la malaria. Menos letales son las otras tres especies implicadas: Plasmodium vivax, Plasmodium malariae y Plasmodium ovale.

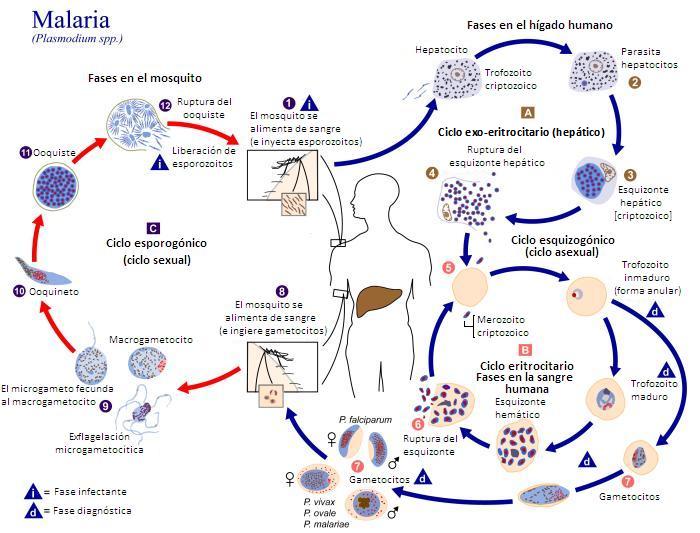

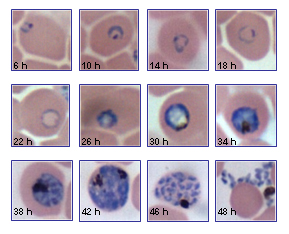

El ciclo vital de los plasmodios tiene dos fases: una sexual en la hembra del mosquito transmisor, y otra asexual en el huésped vertebrado. Esta fase en el vertebrado tiene, a su vez, dos fases: la primera, una vez llega por la picadura del mosquito, en las células del hígado, y la segunda en los glóbulos rojos de la sangre. La descarga de los parásitos en gran cantidad desde los glóbulos rojos es la que provoca las fiebres típicas de la malaria.

Una vez que el insecto pica al vertebrado huésped, y se carga de células sexuales del parásito y, en el estómago del insecto, se unen, forman el zigoto o huevo fecundado que, a su vez, se rompe en abundantes células del protozoo llamadas esporocitos que llegan a las glándulas salivares del mosquito y, cuando éste pica, son descargados a la sangre del huésped vertebrado, y el ciclo comienza de nuevo.

Los esporocitos atraviesan la pared del digestivo del vertebrado y llegan al hígado, en una hora más o menos, y allí se multiplican formando los merozoitos que se descargan a la sangre e invaden los glóbulos rojos. Se vuelven a dividir hasta formar más merozoitos y, finalmente, las células sexuales que, cuando pica el mosquito, llegan a su estómago, y vuelve a comenzar el ciclo.

Complicado pero así consiguen tantos parásitos el éxito evolutivo que tienen.

La reproducción del Plasmodium en los glóbulos rojos tarda unas 48 horas en el falciparum, vivax y ovale, y 72 horas en malariae. El ciclo de 48 horas es el que provoca las fiebres que se llaman tercianas, con un acceso un día de cada dos. Si es con falciparum, es la terciana maligna; si es con ovale o vivax, es la fiebre terciana benigna. En malariae, con el ciclo de 72 horas, aparecen la fiebre que se denomina cuartana, con un día de cada tres.

El ciclo completo del desarrollo de los protozoos en la especie humana es de 9 a 15 días en falciparum, de 12 días en vivax y ovale, y de 20 días en malariae. Los parásitos no sobreviven en el huésped más de un año, para el falciparum, o de dos años, para el vivax y el ovale. El P. malariae plantea más problemas pues puede mantenerse hasta algunas decenas de años. En conclusión, si se controlan los insectos durante tres años en un determinado enclave con malaria, el parásito desaparece. Se hizo en la década de los sesenta en Estados Unidos, Puerto Rico y otros países y se erradicó la enfermedad.

La entrada de los protozoos en los glóbulos rojos se consigue por la unión del parásito a receptores de membrana de las células de la sangre. Si no hay unión, el plasmodio no puede entrar en el glóbulo rojo y completar su ciclo de crecimiento y, por tanto, no hay ataques de fiebre en el enfermo. Es lo que ocurre en África con el vivax que no consigue entrar en los glóbulos rojos. Es una especie que no aparece en muchas zonas de África, precisamente las mismas zonas en que gran parte de la población, entre el 90% y el 100%, tiene la mutación negativa del grupo sanguíneo Duffy. En esta mutación, el receptor de membrana, una proteína que caracteriza al grupo Duffy, no se sintetiza y, por tanto, no está en la membrana de los glóbulos rojos. Y el vivax, para entrar en la célula, se une precisamente a ese receptor Duffy. Y, por ello, al faltar el receptor no puede entrar en el glóbulo rojo. Se ha propuesto que por esta causa ha desaparecido de grandes zonas de África. Está en chimpancés y gorilas, pero no en la especie humana.

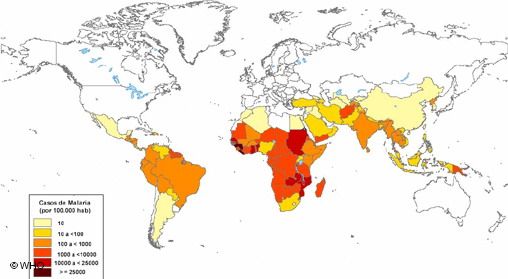

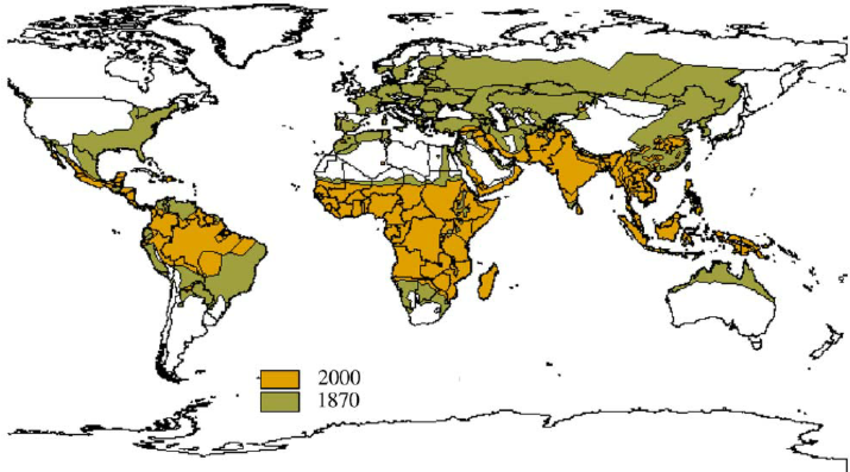

El ciclo vital del parásito en el mosquito necesita de una temperatura ambiente elevada. En el Plasmodium falciparum es de más de 26ºC, con una mínima para poder desarrollarse de 18ºC, y el ciclo dura diez días. En vivax es de 8-9 días, en ovale son 12-14 días, y en malariae es de 14-15 días. Estas especies están, por esa restricción de temperaturas, confinadas al trópico y, si aparecen en zonas más templadas, es porque el mosquito vive en interiores, climatizados por nuestra especie, con un microclima más estable y temperaturas no tan bajas como en el exterior.

Con estas limitaciones de temperatura, es indudable el impacto que puede tener el calentamiento global para un aumento del área de distribución del Plasmodium. Ya está ocurriendo en el sur y el este de África, y la epidemia de malaria en Madagascar a finales de los ochenta, a partir de 1987, en zonas de altitud y con clima más fresco que en la costa, donde la enfermedad, con pequeños focos, había desaparecido en 1960, es un buen ejemplo. En pocos años alcanzó los 25000 muertos.

El origen y la expansión del plasmodio es anterior a la especie humana. La propagación por todo el planeta tuvo, cuando ya parasitaba a nuestra especie, precisamente en la extraordinaria movilidad y adaptación a todos los entornos del Homo sapiens.

Su origen según algunos expertos, está en algún protozoo, parásito del intestino de vertebrados, que consiguió atravesar la pared del tubo digestivo y adaptarse a vivir en otros órganos y, muy importante, en la sangre del huésped. Después, en un segundo paso, encontró un huésped invertebrado en los mosquitos picadores y chupadores de sangre. Hay que recordar que mosquitos parecidos a los actuales ya existían hace unos 150 millones de años.

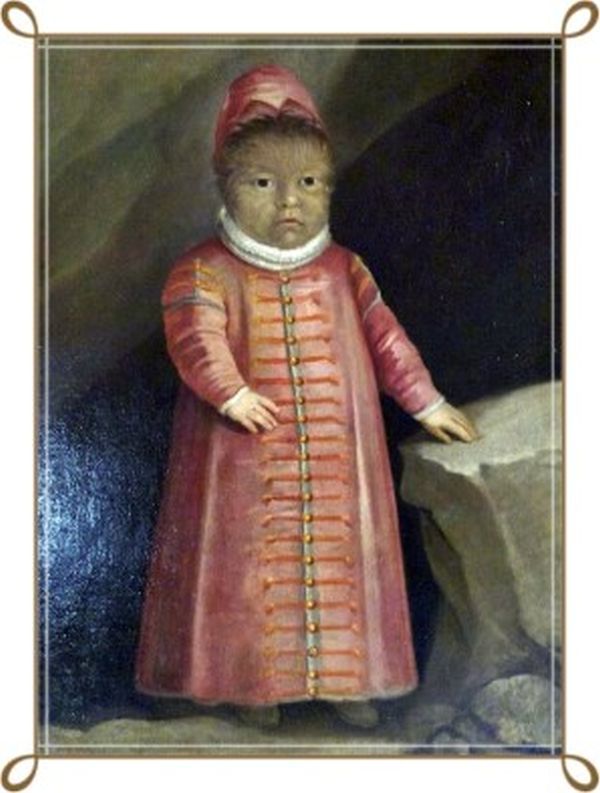

Las líneas más antiguas de plasmodios de la malaria están en reptiles y aves y, en una línea más reciente, aparece en mamíferos, incluyendo a primates y a nuestra especie. Algunos dicen que el paso de falciparum de aves, quizá domésticas, a Homo sapiens, es reciente, de hace entre 5000 y 10000 años. Otros autores proponen que el parásito de humanos viene del chimpancé y que el paso se puede fechar hace unos 8 millones de años, cuando aparecieron las especies que llevarían, por una parte, a los chimpancés actuales y, por otra, a la especie humana. Las pruebas directas más antiguas de la malaria en la especie humana, aún con descripciones médicas y literarias anteriores, están en las momias egipcias, desde hace unos 4000 años, y en los cadáveres de cementerios cercanos a Roma y fechados hace unos 2000 años, en la época imperial. El análisis de ADN y pruebas inmunológicas de esos cuerpos han demostrado la presencia de falciparum. Incluso la momia de Tutankamon y las de tres familiares suyos, enterrados hace unos 3500 años, dan positivo al análisis de ADN de falciparum.

Ahora empezamos a conocer el genoma de los plasmodios. Tienen 14 cromosomas. Y el estudio del ADN lleva a estudiar su evolución. Por ejemplo, algunos de los plasmodios de humanos, en los análisis genéticos, son muy parecidos a los que se encuentran en otros monos actuales y, por tanto, el paso de la malaria a humanos sería más reciente. Así, el protozoo más cercano al falciparum se encuentra en los gorilas, y el de vivax en gorilas y chimpancés.

Además, el análisis genético ha permitido detectar que hay infecciones mixtas, con más de una de las especies de plasmodios en las zonas donde se localiza más de una. Es interesante que las infecciones con vivax o con malariae reducen la gravedad de la infección con falciparum. Incluso se ha encontrado otro plasmodio, parásito del macaco, que, a veces, también parásita a la especie humana. Es el Plasmodium knowlesi.

En cuanto al origen geográfico de la malaria en nuestra especie parece que se localiza en el centro y el este de África, en la región de Etiopía. Desde allí, por el valle del Nilo, llegó al Mediterráneo y, después, hacia el oeste y el norte, a Europa, y hacia el este a Oriente Medio, la India y el sudeste de Asia.

Plasmodium vivax es la especie que tiene una distribución más amplia, en el trópico, subtrópico y zonas templadas. P. falciparum es la especie más común en el trópico y subtrópicos y, rara vez, en zonas templadas. P. malariae tiene igual distribución que falciparum pero es menos común. Y P. ovale se encuentra en el África tropical y, esporádicamente, en otras zonas del planeta.

Referencias:

Bianucci, R. et al. 2007. Immunological evidence of Plasmodium falciparum infectyion in an Egyptian child mummy from the Early Dynastic Period. Journal of Archaeological Science doi: 10.106/j.jas.2007.11.019

Bray, R.S. & P.C.C. Garnham. 1982. The life-cycle of primate malaria parasites. British Medical Bulletin 38: 117-122.

Brockington, F. 1964. La salud en el mundo. EUDEBA. Buenos Aires. 403 pp.

Bruce-Chwatt, L.J. 1965. Paleogénesis and paleo-epidemiology of primate malaria. Bulletin of the WHO 32: 363-387.

Coluzzi, M. 1994. Malaria and the Afrotropical ecosystems: Impact of man-made environmental changes. Parasitologia 36: 223-227.

Earle, D.P. 1979. A history of malaria and its ironies. Transactions of the American Clinical and Climatological Association 90: 1-26.

Gentilini, M. et al. 1977. Médecine Tropicale. Flammarion-Sciences. Paris. 561 pp.

Hawas, Z. et al. 2010. Ancestry and pathology in King Tutankhemum’s family. Journal of American Medical Association 303: 638-647.

Hommel, M. 2007. Morphologie, biologie et cycle des Plasmodium parasites de l’homme. Bulletin de l’Académie nationale de médecine 191: 1235-1246.

Howes, R.E. et al. 2011. The global distribution of the Duffy blood group. Nature Communications DOI: 10.1038/ncomms1265

Laremruata, A. et al. 2013. Molecular identification of falciparum malaria and human tuberculosis co-infections in mummies from the Fayum Depression (Lower Egypt). PLOS ONE 8: e60307

Lepers, J.P.et al. 1990. Newly transmitted Plasmodium falciparum malaria in the central highland plateaux of Madagascar: assessment of clinical impact in a rural community. Bulletin of the WHO 68: 217-222.

Lu, W. Et al. 2014. African origins of the malaria parasite Plasmodium vivax. Nature Communications DOI: 10.1038/ncomms4346

Marciniak, S. et al. 2016. Plasmodium falciparum malaria in 1st-2nd century CE southern Italy. Current Biology DOI: 10.1016/j.cub.2016.10.016

Meibalan, E. & M. Marti. 2017. Biology of malaria transmission. Cold Spring Harbor Perspectives in Medicine 7: a025452

Mercereau, O. & D. Ménard. 2010. Plasmodium vivax and the Duffy antigen: A paradigm revisited. Transfusion Clinique et Biologique doi: 10.1016/j-tracli.2010.06.005

Pagès, F. 1953. Le paludisme. PUF. Paris. 113 pp.

Schlagenhauf, P. 2004. Malaria: from prehistory to present. Infectious Disease Clinics of North America 18: 189-205.

Tan, S.Y. & A. Ahana. 2009. Charles Laveran (1845-1922): Nobel laureate pioneer of malaria. Singapore Medical Journal 50: 657-658.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Historias de la malaria: El parásito se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historias de la malaria: El charlatán y caballero Sir Robert Talbor

- Historias de la malaria: El árbol de la quina

- Una buena colección de historias maravillosas

Migrantes nocturnos y radares meteorológicos

El primer estudio realizado en el Golfo de Bizkaia a gran escala sobre la migración nocturna de aves ha mostrado que la migración se realiza por el mar y tierra en primavera y por tierra en otoño, al contrario de lo que se creía. Para este trabajo, llevado a cabo entre la Sociedad de Ciencias Aranzadi y el Departamento de Matemáticas Aplicadas de la UPV/EHU, ha sido clave la utilización de radares meteorológicos como método de observación ornitológica.

Foto: Nadja Weisshaupt

La investigación realizada por Nadja Weisshaupt durante su tesis doctoral, pionera en el estudio de la migración nocturna en el Golfo de Bizkaia, rompe con varias creencias: “Se pensaba que la migración se realiza como un frente amplio en otoño, pero en mi estudio he visto que no es así”. Y es que, en cuanto a las épocas de migración, los resultados afirman que se registra una alta actividad nocturna en primavera y poca actividad en todo el otoño en Punta Galea. La migración otoñal se realiza más hacia los Pirineos, posiblemente evitando el cruce del mar. Por otro lado, las observaciones lunares han permitido establecer que las aves paseriformes (el grupo que abarca los pájaros cantores) predominan como migrantes nocturnos, aunque también se registra un pequeño porcentaje de aves acuáticas.

La migración de las aves incluye el desplazamiento de millones de individuos entre sus áreas de cría y los entornos a los que se desplazan para pasar el invierno. Durante sus migraciones, las aves recorren grandes distancias, para lo cual han de parar a menudo y reponer fuerzas para proseguir su viaje. Para poder alimentarse y descansar, necesitan ecosistemas adecuados en sus lugares de paso; la ausencia de entornos apropiados puede tener consecuencias tanto en la población como en la conservación de estas especies. En este escenario, el conocimiento de las estrategias migratorias es capital, tanto desde un punto de vista biológico y ecológico, como de la conservación. “Para proteger un espacio, es indispensable disponer de una base científica”, explica Nadja Weisshaupt, autora del estudio.

La migración de aves ha dado lugar a múltiples estudios científicos, en Euskadi sobre todo por anillamiento de aves capturadas, con el objeto de analizar los diversos factores que influyen en los patrones y dinámicas relacionados con la migración de las aves. “Sin embargo, hasta el momento se carecía de datos sobre la migración nocturna activa en el Golfo de Bizkaia”, añade. Con el objetivo de cubrir esta necesidad, partiendo de los conocimientos previos por anillamiento desde Aranzadi y la base de datos del radar de Punta Galea de Euskalmet, Weisshaupt ha abordado el estudio de la migración nocturna de aves en la costa del Golfo de Bizkaia.

Dadas las dificultades de visibilidad de noche y la necesidad de cubrir largas distancias, se recurrió a diversos métodos de observación: radares, cámara térmica y observaciones lunares.

Los radares meteorológicos constituyen la herramienta clave de este estudio. Se ha trabajado con dos tipos de radares. Uno de ellos es el perfilador de Euskalmet que se encuentra en Punta Galea. El perfilador realiza mediciones de viento, y en épocas de migración, registra señales que no corresponden a vientos, sino a las aves que pasan. Este hecho, que supone un gran problema para la calidad de los datos meteorológicos, resulta útil para el estudio de aves. “Es interesante, porque hemos tenido que luchar bastante para que la gente crea que es posible utilizar perfiladores para estudios ornitológicos”, señala Weisshaupt. El segundo tipo de radar mide la precipitación. El radar de Kapildui, por ejemplo, también de Euskalmet. La onda de este tipo de radar es más corta que la del perfilador, aunque también registra aves.

Pero no todos los radares son válidos; durante el estudio se ha constatado que los diferentes servicios meteorológicos se someten a diferentes niveles de procesamiento y filtrado de forma que los datos disponibles ya no contienen información biológica. Como consecuencia, se han descartado los radares de AEMET que hubiera cubierto la costa sur del golfo, pues solo los datos del radar de Kapildui de Euskalmet y de los radares franceses contienen información válida. Con estos cinco radares restantes se ha utilizado un algoritmo que permite automatizar la extracción de datos de aves de los radares meteorológicos, desarrollado por el doctor Adriaan Dokter de la Universidad de Ámsterdam, mediante una colaboración realizada dentro de la Acción COST ENRAM (European Network for the Radar Surveillance of Animal Movement) a nivel europeo.

El segundo tipo de herramienta, la cámara térmica, registra la radiación de infrarrojos que emiten varios objetos, por lo que detecta “la temperatura de un ave, 40-41 ºC, que contrasta claramente con la temperatura ambiente. La cámara permite especificar si las aves observadas son paseriformes, si van solas o en grupos. Además se obtiene la dirección y la intensidad de la migración del espacio de tiempo analizado”.

Finalmente, la observación lunar se realiza desde dos días antes hasta dos días después de la luna llena. “En este caso, se ha utilizado para complementar la información obtenida de los otros sistemas, a fin de especificar la composición de las aves migratorias”.

Referencia:

Nadja Weisshaupt, Mercedes Maruri, and Juan Arizaga (2014) Bird migration across the Bay of Biscay observed by meteorological radar [PDF] ERAD-14

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Migrantes nocturnos y radares meteorológicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Algoritmos para que los parques eólicos no interfieran con los radares

- El aporte de amonio aumenta la producción de sustancias anticancerígenas en el brócoli

- Equilibrio tautomérico en un sistema modelo de gran interés biológico

Ensayo sobre el azul

Puedo escribir los versos más tristes esta noche.

Escribir, por ejemplo: “La noche está estrellada,

y tiritan, azules, los astros, a lo lejos”.

Pablo Neruda – Poema XX – Canta Chavela Vargas

El brillo de las estrellas, el reflejo de las olas, la inmensidad de la bóveda celeste, unas pupilas azules… El azul ha inspirado cientos de canciones y versos a lo largo de la historia y, como no podía ser de otro modo, también ha jugado un papel fundamental en la Historia del Arte. Desde que el ser humano intenta representar su entorno o sus sensaciones, los artistas se las han tenido que ingeniar para lograr pigmentos que reflejen este omnipresente color.

Pero… ¿Qué es el azul? Desde una perspectiva científica no es más que una región del espectro electromagnético que apenas abarca las longitudes de onda entre los 450 y los 495 nanómetros. Y, sin embargo, en esa ínfima franja podemos encontrar variedades sobre las que discutir hasta la saciedad: azul marino, celeste, turquesa, vaquero, etc. ¿Es, por lo tanto, correcto decir que se trata de un solo color? Por lo menos, no en Rusia. El ruso segmenta nuestro azul en dos colores diferenciados: el golubóy (equivalente al azul celeste) y el síniy (equivalente al azul marino). En el otro extremo está el vietnamita que emplea la misma palabra para el azul y el verde. Cosas del lenguaje.

Emaidazue freskura

ura eskutik eskura

izarren salda urdina edanda

bizi naiz gustora1.

Xabier Amuriza – Mendian gora haritza – Canta Imanol

No hay otro cielo como el que Giotto pintó en la Capilla Scrovegni. Y el gran responsable, además del propio maestro italiano, es el pigmento empleado: el azul ultramar. Ya lo dijo Cennino Cennini en el Capítulo LXII de El libro del arte: “El azul ultramar es un color noble, bello, más perfecto que ningún otro color, faltan palabras para describirlo”. Así que no seré yo quien ose intentarlo. En la Imagen 1 podéis ver la cúpula de esta capilla. Aunque ya sabéis que escasas son las fotos que hacen justicia a una obra de arte. Para disfrutarla de verdad y sufrir el síndrome de Stendhal no tenéis más remedio que visitar alguna vez Padova, en el Véneto italiano.

Cúpula de la Capilla de los Scrovegni de Giotto (1305-6). Fuente.

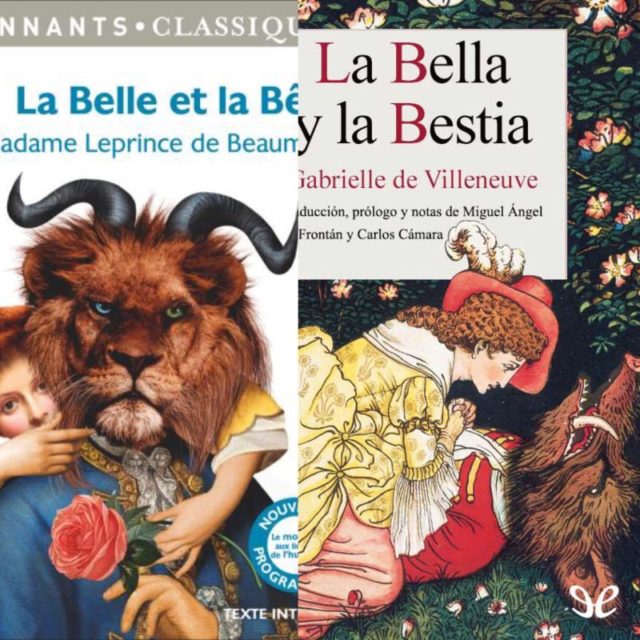

El azul ultramar llegaba a Italia en el ocaso del medievo por vía marítima (ultramarinus) y de ahí su nombre. Se obtenía principalmente de la minas del valle de Kokcha en Afganistán, donde abundaba el lapislázuli, una piedra semipreciosa con alto contenido en lazurita, el mineral al que le debe su preciado color el azul ultramar (Na8-10Al6Si6O24S2-4). Ya os podéis imaginar que tal y como estaban las carreteras en aquella época el valor del producto era exorbitado. De hecho, muy pocos se lo podían permitir y estaba reservado para unos usos muy concretos, mayormente para pintar la ropa de la Virgen que, como madre de Dios, se merecía el mejor de los azules.

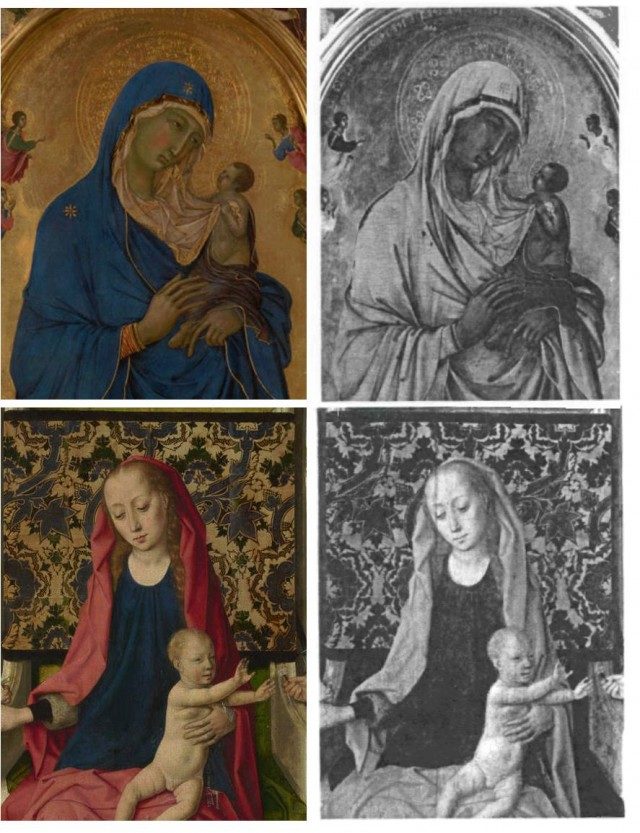

Afortunadamente para los bolsillos menos pudientes existía en Europa una alternativa conocida como azul citramarino (en contraposición al anterior) o azurita. El que fuera el azul más popular en la época bajomedieval y en el Renacimiento se extraía de un carbonato básico de cobre (2·CuCO3·Cu(OH)2) abundante en las montañas germanas, por lo que también se conoce como azul de Alemania o azul de las montañas. Ahora bien, el uso de este pigmento acarreaba ciertos problemas. Por una parte, el color no es nada estable: bien puede adquirir tonos verduzcos si el mineral se transforma en malaquita (verde) o puede oscurecerse si el cobre se oxida (CuO) y forma tenorita (negra). De ahí que algunas pinturas que originalmente eran azules parezcan ahora verdes o negras. Por otra parte, que costase menos que el ultramarino no quiere decir que fuese barato. Ante esta situación, enseguida se disparó el interés por lograr pigmentos azules artificiales que reemplazasen a los obtenidos de forma natural.

Y, mira por donde, aunque consideremos a Europa el ombligo del mundo y centro de la cultura artística, lo cierto es que ese interés había surgido muchísimos siglos antes en Egipto. De hecho, fueron los egipcios quienes allá por el 2500 a.e.c. lograron el primer pigmento sintético de la historia: el azul egipcio, un silicato de cobre y calcio (CaCuSi4O10). Para ello se mezclaba a altas temperaturas (unos 800 ⁰C) arena (fuente del silicato), carbonato cálcico (fuente de calcio) y malaquita (fuente de cobre), añadiendo natrón (Na2CO3) como fundente, lo que ayudaba a rebajar la temperatura de fundido. Gracias a este proceso se lograba un color azul muy estable que ha llegado hasta nuestros días en perfecto estado en muchos casos. Y, en cambio, azules como los que empleó Rafael la friolera de 4000 años después han cambiado de color completamente. Egipto 1 – Europa 0.

En una entrada anterior vimos que el azul ultramar empleado por Duccio (arriba) no absorbe la luz infrarroja y se transparenta en la imagen infrarroja, mientras que la azurita de Dirk Bouts (abajo) sí la absorbe y deja una imagen oscura en el infrarrojo.

Bleu, bleu, l’amour est bleu.

Berce mon cœur, mon cœur amoureux.

Bleu, bleu l’amour est bleu.

Bleu, comme le ciel qui joue dans tes yeux2.

André Popp y Pierre Cour – L’amour est bleu – Canta Vicky

A partir del s. XVIII, el país que más se esforzó por sintetizar el ansiado pigmento azul fue Francia (como buena madre de la química moderna). Desde la Edad Media se había adaptado para su uso en pintura el esmalte, un óxido de cobalto que se empleaba para elaborar cristal del color que protagoniza este artículo (para hacer justicia, diremos que también los egipcios fueron pioneros en el uso del cobalto, allá por el s. XXVII a.e.c). En cualquier caso, no fue hasta principios del s. XIX cuando se empezó a comercializar el conocido como azul cobalto cuya composición mejorada (CoO·Al2O3) es la lograda en 1807 por el químico Louis Jaques Thénard. Este pigmento, todavía en uso, tuvo una gran acogida y fue empleado por los pintores impresionistas varias décadas después de su descubrimiento. En la imagen 3 vemos un obra en la que Renoir lo empleó.

Les parapluies (180×115 cm) de Renoir (1881-1886). Fuente.

Esta obra resulta fascinante desde el punto de vista de la paleta pictórica, ya que el azul cobalto no es el único azul empleado. Entre 1880 y 1885 el pintor francés cambió su paleta considerablemente y dejó dicho pigmento de lado para emplear el ultramar. Justo en el periodo en el que realizó Los paraguas. Así, gracias a los estudios realizados en la National Gallery, sabemos que en este cuadro se mezclan ambos pigmentos, cubriendo en ciertos puntos el azul ultramar lo anteriormente pintado con el óxido de cobalto. Pero, recapitulemos un poco. ¿No habíamos dicho que el ultramarino era increíblemente costoso? ¿Acaso había descubierto Renoir una mina? ¿Tendría contactos en Afganistán? Lo cierto es que el azul empleado por Renoir ya no venía de Asia, sino de su propio país. Francia había conseguido sintetizar tan ansiado compuesto. Gracias al descubrimiento de su composición química y a un premio ofrecido por el Gobierno a quien lograse producir el pigmento (otorgado a Jean-Baptiste Guimet), en 1830 se empezó a sintetizar de forma industrial (de forma independiente los alemanes habían logrado el mismo hito).

Azul, líneas en el mar que profundo

y sin domar acaricia una verdad.

Antonio Vega – Se dejaba llevar por ti – Canta Antonio Vega

En los primeros años del s. XVIII, es decir, varias décadas antes de que el azul cobalto y el ultramarino sintético existiesen, un artesano apellidado Diesbach había descubierto un pigmento que se hizo tremendamente popular. Al parecer se trató de un curioso caso de serendipia. Diesbach estaba intentando lograr una laca de cochinilla de color rojo, pero en el proceso dio accidentalmente con un producto azul: había nacido el azul de Prusia. En 1724 se empezó a comercializar este compuesto, de una complejidad mayor de la que su breve fórmula química indica (Fe7(CN)18) ya que el hierro tiene diferentes estados de oxidación.

Numerosos artistas se echaron en los brazos del recién llegado. Un nuevo azul, mucho más intenso y que no era fugaz como el índigo u otros pigmentos naturales. Traspasó todas las fronteras y llegó incluso al país del Sol Naciente de la mano de los comerciantes holandeses. Allí, el gran Hokusai lo empleó para elaborar la más famosa pieza de ukiyo-e (estampas realizadas con grabados en madera): La gran ola de Kanagawa, cuya copia del museo Metropolitan de Nueva York podéis disfrutar en la imagen 4.

La gran ola de Kanagawa (26×38 cm) Hokusai (1829-33). Fuente.

Tu pupila es azul, y cuando ríes,

su claridad suave me recuerda

el trémulo fulgor de la mañana,

que en el mar se refleja.

Gustavo Adolfo Becquer –Rima XIII– “Canta” Re-v accesibilidad (lengua de signos española)

Al pensar en arte y ojos, puede que os venga a la cabeza “Big Eyes”, aquella película protagonizada hace unos años por Amy Adams y basada en la vida de Margaret Keane. Las pinturas de esta artista se caracterizan por tener unos personajes con unos ojos superlativos (Imagen 5). Pero, en este caso, hay otros ojos que me interesan más y que son, cómo no, azules. Los que pintó Amadeo Modigliani inspirados por su gran musa, y también pintora, Jeanne Hébuterne. Musa, pintora y devota compañera hasta el sacrificio extremo, ya que a la muerte de su amante se quitó la vida, poniendo un trágico final a su historia de “amor”.

Izquierda: Play time (20×25 cm) de Margaret Keane; fuente. Derecha: Ojos azules (retrato de Jeanne Hébuterne) (55×43 cm) de Amadeo Modigliani (1917); fuente.

Y os quería hablar de Modigliani y otro pigmento azul: el cerúleo. Al igual que en algún caso anterior hay que destacar la presencia de cobalto en este compuesto, pero también la del estaño. Hablando con propiedad, es un estannato de cobalto (CoO · n SnO2). Pese a que se conoce desde 1821, solo se empleó de forma intensiva desde que George Rowney lo comenzase a comercializar en Inglaterra en 1860. El origen etimológico de este pigmento es la palabra latina caeruleus que, a su vez, deriva de caelum (cielo) y, no en vano, ha sido muy empleado desde que irrumpió en el mercado para pintar la bóveda celeste. Y, ¿dónde queda Modigliani en todo esto? Pues resulta que Modigliani no usaba este pigmento. Es decir, el pintor italiano no tenía este azul en su paleta (ya hemos visto que hay una multitud de opciones) y, gracias a ello, se pudo detectar una más que posible falsificación de una cuadro que se le atribuía. Hace ya unos años, dicho cuadro fue ofrecido para realizar una retrospectiva sobre su obra pero, al realizar los análisis químicos, ¡oh sorpresa!, encontraron azul cerúleo. La presencia de este pigmento y la ausencia de otros muy habituales en la paleta de Modigliani fueron motivo suficiente para que la pintura fuese rechazada por los organizadores de la exposición. Una vez más, los análisis químicos y un riguroso estudio del modo de trabajar del artista sirvieron para esclarecer la verdad.

She wore blue velvet

bluer than velvet was the night

softer than satin was the light

from the stars3

Bernie Wayne y Lee Morris –Blue velvet– Canta Isabella Rosellini

Kyle MacLachlan observa ensimismado a Isabella Rosellini mientras ésta canta Blue Velvet en la película homónima de David Lynch. Blue velvet, terciopelo azul. Y es que, más allá de las diferentes gamas y tonos del azul, los artistas también pueden jugar con las texturas. Y eso lo hizo a las mil maravillas Yves Klein cuando creó la pintura que lleva su nombre. En este caso el secreto hay que buscarlo más allá del pigmento (ultramar sintético), concretamente en el aglutinante. Los químicos de la farmacéutica Rhône Poulenc desarrollaron para él el Rhodopas M, un polímero vinílico que, junto con alcohol etílico y el ultramar, forman el International Klein Blue. Pero no me detendré a dar explicaciones sobre esto cuando tan bien explicado ha sido aquí (también lo tenéis en versión youtuber).

Victoria de Samotracia (S 9) (50×26×30 cm) de Yves Klein (1973). El arte clásico y el contemporáneo se funden en una sola obra. Fuente.

En definitiva, el azul es mucho más que un color (y más que dos). Es también un fascinante episodio de la Historia de Química. Es el cielo de Giotto, un estado de ánimo, la Venus de Klein, el manto de la Virgen, los ojos de Jeanne, unos versos sueltos, un periodo de Picasso, la ola de Hokusai y la excusa para un sinfín de acordes.

Traducciones de los versos:

1Dadme la frescura

el agua de mano en mano

bebiendo el caldo azul de las estrellas

vivo yo a gusto.

2Azul, azul, el amor es azul.

Arrullando mi corazón, enamorado.

Azul, azul, el amor es azul.

Azul como el cielo que juega en tus ojos.

3Ella vestía de terciopelo azul

más azul que el terciopelo era la noche

más suave que el satén era la luz

de las estrellas

Para saber más:

Cennino Cennini “El libro del arte” Ediciones Akal (1988).

Xavier Durán “El artista en el laboratorio” Universidad de Valencia (2008).

Deborah Garcia Bello (2013) “La química del azul de Klein”

M. Douma (2008). “Pigments through the Ages”

R. Klockenkämper et al. (2000) “Analysis of Pigments and Inks on Oil Paintings and Historical Manuscripts Using Total Reflection X-Ray Fluorescence Spectrometry” X-Ray Spectrom. 29, 119–129. DOI: 10.1002/(SICI)1097-4539(200001/02)29:13.0.CO;2-W

Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

El artículo Ensayo sobre el azul se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:#Naukas16 La mejor charla de la historia

Fernando Frías se embarca en una divertidísima búsqueda de la unidad de medida de la calidad de las charlas.

Fernando Frías: ''La mejor charla de la historia''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo #Naukas16 La mejor charla de la historia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 La verdadera historia de la penicilina

- #Naukas16 Te vamos a salvar la vida

- #Naukas16 ¿Cómo saber si tu funeraria te estafa?

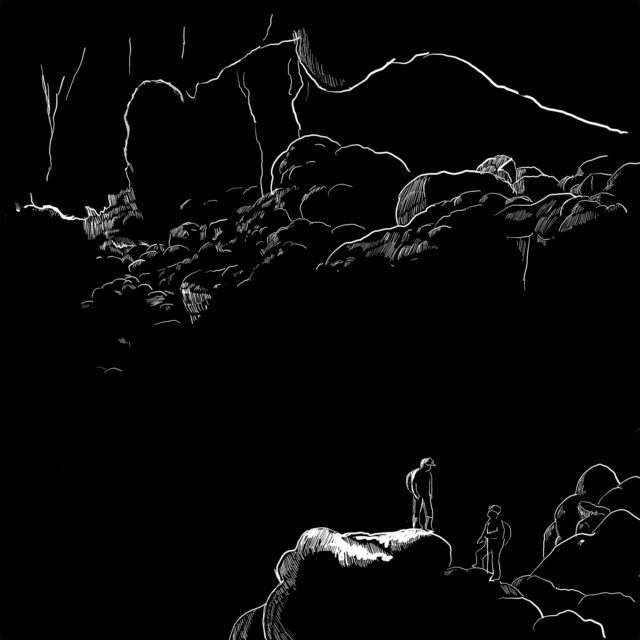

Catástrofe Ultravioleta #15 INFRAMUNDO

Catástrofe Ultravioleta #15 INFRAMUNDO

Nos adentramos en las cavidades de la tierra para conocer los secretos más sorprendentes del inframundo. Galerías formadas por la lava de los volcanes, cuevas orientadas al solsticio e incluso astronautas que se entrenan en las profundidades antes de viajar al espacio.

Agradecimientos: Alfredo Lainez y todo el personal de la Cueva del Viento, César Esteban y el equipo de arqueoastronomía del Instituto de Astrofísica de Canarias, al siempre singular Pepe Cervera, al gran Ray Jaen y a los astronautas Pedro Duque y Chris Hadfield.

* Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el apoyo de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

Puedes conocernos en nuestra web: Catastrofeultravioleta.com y seguirnos en el twitter Catastrofe_UV. También puedes encontrar todos los capítulos en este enlace.

El artículo Catástrofe Ultravioleta #15 INFRAMUNDO se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Catástrofe Ultravioleta #14 VULCANO

- Preparados para una Catástrofe Ultravioleta

- Catástrofe Ultravioleta #13 LEVIATÁN

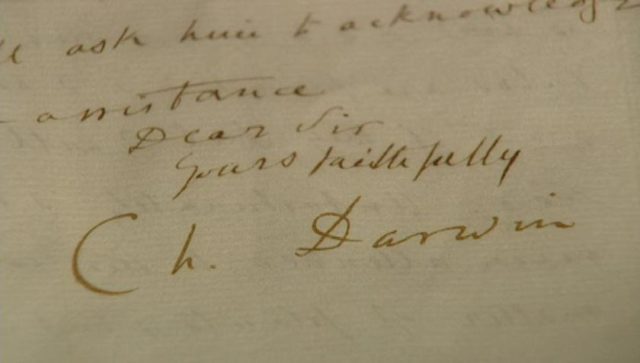

Las cartas de Darwin: Casi me vuelvo a casa antes de las Galápagos

Las cartas de Darwin, una serie para conocer aspectos sorprendentes de la vida del naturalista

La segunda expedición del HMS Beagle se extendió durante casi cinco años, es decir, más del doble de la duración que el joven Darwin pensó antes de embarcarse. Sus estimaciones iniciales, guiadas por la carta que Henslow le envió, eran de dos años.

Carta de John Stevens Henslow a Charles Darwin [24 de agosto de 1831]

“El viaje habrá de durar dos años y, si llevas contigo una buena cantidad de libros, puede lograrse todo lo que te plazca. Tendrás amplias oportunidades a tu disposición”

Todo pintaba bien antes de embarcar, sin embargo (y gracias al anterior artículo de esta serie) ya sabemos cómo fue la vida del joven naturalista a bordo de aquel barco. Constantes mareos en alta mar, incomodidades y estrecheces en el reducido espacio del Beagle… lo cierto es que nuestro protagonista estuvo a punto de abandonar la expedición en numerosas ocasiones.

De hecho, el propio Darwin a los pocos meses de zarpar ya intuyó que el viaje no iba a ser un camino de rosas y que tendría que evitar la tentación de abandonar si quería completar todo el viaje. Cuando llegó a Brasil, apenas cinco meses después de salir de Inglaterra, ya hacía patentes esas dudas en sus comunicaciones con Henslow.

Carta de Charles Darwin a John Stevens Henslow [mayo/junio de 1832]

“A veces temo que no podré resistir todo el viaje, pues creo que por lo menos durará cinco años. La mente requiere cerrarse a piedra y lodo antes de observar calmadamente tal intervalo de separación de todos los amigos”.

En esa etapa del viaje, y antes de llegar a Montevideo, Darwin reitera sus dudas sobre si podrá acabar el viaje en otra carta a John Maurice Herbert, uno de sus amigos estudiantes durante su época de Cambridge.

Carta de Charles Darwin a John Maurice Herbert [6 de junio de 1832]

“En un viaje de este tipo, si uno obtiene muchos placeres grandes y nuevos, por otra parte la pérdida de no deja de ser considerable. ¿Cómo habría de agradarte que súbitamente se te prohibiera durante cinco años ver a todas las personas y lugares que has conocido y amado desde siempre? Te aseguro que en ocasiones esta reflexión me desconcierta. Dales mis recuerdos sinceros a los excelentes amigos que quedan y a los que tuve el gusto de conocer en Cambridge”.

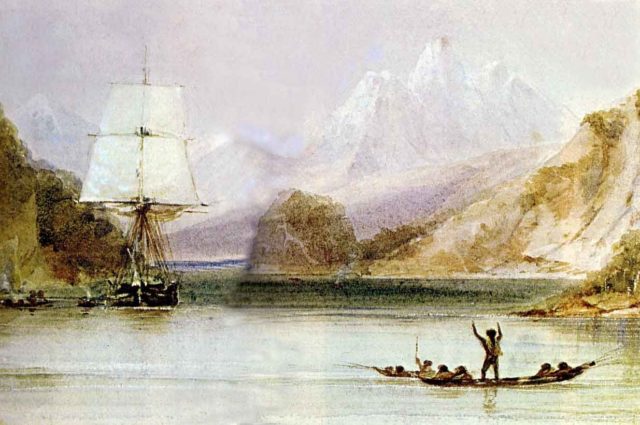

El HMS Beagle en Tierra de Fuego, cuadro realizado por Conrad Martens, uno de los pintores de la expedición.

Su nostalgia por su familia y amistades quedará reflejada en las cartas que durante todo el viaje escribió a su padre, a sus hermanas y a muchos de sus colegas y profesores. Sin embargo la gota que colmó el vaso ocurrió en Chile cuando, durante su prolongada estancia en Valparaiso, Charles Darwin decidió (al menos por unos momentos) abandonar el barco y volverse a Inglaterra.

Su relación con el capitán FitzRoy (que abordaremos en otro capítulo de esta serie) tuvo siempre altos y bajos, y en uno de aquellos momentos tensos el propio Darwin decidió que ya no quería seguir con la expedición.

Una serie de circunstancias llevaron a una disminución de las fuerzas de FitzRoy, a lo que se sumó una notable depresión, que desembocaron en su abandono momentáneo de su puesto de capitán. El segundo Comandante del barco, John Clements Wickham (que terminaría siendo el comandante de la tercera expedición del Beagle) tomó el mando y Darwin volvió a reconsiderar sus ideas.

Carta de Charles Darwin a su hermana Catherine Darwin [8 de noviembre de 1834]

“Tan pronto como el capitán se sintió inválido, determiné dejar el Beagle, aunque era absurdo que esta revolución de cinco minutos afectara todos mis sentimientos. Por mucho tiempo me afligía y apesadumbraba el tiempo interminable del viaje (aunque nunca lo habría abandonado), pero ese momento pasó y no pude determinarme a regresar. No podía abandonar todos los castillos geológicos en el aire que había estado construyendo durante estos dos años. Toda una noche la pasé pensando en el placer de volver a ver Shrewsbury, pero las llanuras desoladas del Perú alcanzaron la victoria”.

No sería la última vez que Darwin consideró apearse del barco y volver a Inglaterra por su cuenta. En esa misma carta el joven confiesa que había organizado su propio plan fuera del Beagle que le hubiera llevado de vuelta a casa en solo unos meses.

“Me hice el siguiente plan (sé que me denostarán y quizá si lo hubiera puesto en ejecución mi padre me hubiera mandado un apercibimiento): examinar las Cordilleras de Chile durante el verano y en el invierno ir de puerto en puerto por la costa del Perú hasta Lima y regresar en un año a Valparaíso, cruzar las Cordilleras hasta Buenos Aires y tomar un barco a Inglaterra. ¿No habría sido ésta una buena excursión y en 16 meses hubiera estado de vuelta con ustedes? Haber aguantado Tierra del Fuego y no ver el Pacífico hubiera sido digno de lástima. Tal como están las cosas en la actualidad, todo es perfecto: la intención de completar las pequeñas partes de la investigación de la costa suroeste no habría tenido mayor interés y la costa es, de hecho, absolutamente peligrosa y el clima peor que el de las cercanías del cabo de Hornos. Cuando estemos mar adentro estoy seguro de que el capitán volverá a sentirse bien. En realidad, ya ha recuperado sus modos inflexibles y fríos que había perdido”.

Darwin ideó este plan de regreso a Inglaterra a finales de 1834, algo que de haberse producido le hubiera impedido visitar las Galápagos en septiembre de 1835.

Litografía recreando la llegada del HMS Beagle a las islas Galápagos

A las tensiones en el barco y sus continuos mareos con el “mal de mar” se unió una petición por parte de su padre que, al conocer que a finales de 1834, su hijo había estado enfermo durante varios días, quiso que se rindiera y regresara a casa.

Carta de sus hermanas Catherine y Caroline Darwin [28 de enero de 1835]

“Papa me pide que te dé un mensaje de su parte: desea que te urja a que abandones el Beagle y regreses a casa, y que veas esa grave enfermedad como una advertencia. Papá dice que si tu salud empieza a fallar una vez, habrás de sentir doblemente el efecto de cualquier clima insalubre, y que está muy inquieto por ti y muy temeroso de las fiebres que te pueden afectar en esos países.

Papá está muy, pero muy ansioso, y desea que te ruegue que recuerdes que pronto hará cuatro años desde que nos dejaste, lo que con toda seguridad es una larga parte de tu vida para dedicarla a la historia natural. Si esperaras a que el Beagle regrese, serán otros tantos años de nuevo; el tiempo de tu viaje se va alargando y alargando cada vez que tenemos noticias de él. Estamos desesperados al respecto. Piensa en lo que dice papá, mi querido Charles. Su consejo es siempre tan juicioso en el largo plazo, y sé prudente a tiempo y regresa antes de que tu salud se arruine; si la pierdes por una vez, nunca podrás recuperarla por entero”.

Por suerte, la salud de Darwin mejoró, las tensiones con el capitán FitzRoy volvieron a su cauce y las dudas sobre el rumbo del Beagle terminaron finalmente.

Carta de Charles Darwin a su hermana Caroline Darwin [10 de marzo de 1835]

“Mi querida Caroline: Estamos ahora con calma unas leguas fuera de Valparaíso y en vez de gemir más por nuestra mala fortuna, empezaré esta carta para ti. La primera y mejor de las noticias que debo contarte es que nuestro viaje por fin tiene un fin definido y cierto ya fijado. Empezaba a sentirme bastante desdichado y me había determinado a dar el paso [de abandonar el Beagle] si el capitán no hubiera decidido su conclusión. Sé de cierto que estamos camino de Inglaterra aunque ese camino no sea el más corto.[…]

El 01 de junio el Beagle partirá de Valparaíso hacia Lima, y solo toca un puerto intermedio, y de allí iremos a Guayaquil, las islas Galápagos y a las Marquesas de modo de llegar a Otaheite a mediados de noviembre y a Sydney a fines de enero del año próximo. […] Esperamos llegar a Inglaterra en septiembre de 1836 […]

El capitán vuelve a ser él mismo y gracias al cielo tan ansioso por llegar a la vieja Inglaterra como el resto de nosotros”.

Meses más tarde, mientras se encontraba en Lima, Darwin recibió la carta de sus hermanas que le pedían de parte de su padre que regresara inmediatamente a Inglaterra. Como podéis imaginar, el correo en estas épocas tardaba mucho tiempo en llegar y más en las circunstancias de encontrarse viajando a bordo de un barco que iba cambiando de puerto con cierta frecuencia. Afortunadamente, cuando recibió la carta de su hermana, Darwin se había repuesto completamente de su enfermedad, la vida en el Beagle se había apaciguado y por fin conocían el rumbo exacto con el que terminarían su viaje.

En agosto de 1835, y a pocas semanas de partir para Galápagos, Darwin leyó la petición de regreso que su padre había enviado con la carta de sus hermanas y, por suerte, contestó que seguiría con el viaje.

Carta de Charles Darwin a su hermana Caroline Darwin [12 de agosto de 1835]

“Recibí tres cartas más que completan la cadena desde Inglaterra a febrero de 1835. El capitán FitzRoy llegó con buen ánimo y en poco tempo zarparemos hacia las Galápagos. Estoy a la vez complacido y apesadumbrado por todos los afectuosos mensajes de ustedes que desean que regrese a casa. Si piensan ustedes que no deseo verlos, están espoleando a un caballo deseoso, pero pueden incursionar en mis sentimientos de profunda mortificación, pues si no por otra causa, la mala salud me habría compelido a dejar el Beagle. Digo que debería, ya que estarán de acuerdo conmigo en que en estos momentos carecería de valor pensar en un paso así”.

Fue una suerte que recibiera con retraso aquella carta de sus hermanas ya que si la hubiera recibido antes, y hubiera sabido que su padre insistía tanto en que regresara, lo más probable es que Darwin se hubiera embarcado en uno de los barcos que regresaba a Inglaterra y que tenía a mano en el puerto.

Carta de Charles Darwin a su primo William Darwin Fox [12 de agosto de 1835]

“Este viaje está siendo terriblemente largo. Deseo tan vehemente regresar, pero no me permito mirar hacia el futuro, ya que no sé qué será de mí. […] El otro día vi un barco que navegaba hacia Inglaterra y era un gran peligro saberlo por lo fácil que hubiera sido convertirme en desertor”.

A pesar de todos los contratiempos, de los cambios de opinión, de las idas y venidas en el ánimo y la salud de Darwin… finalmente, el Beagle retomó el rumbo y el 15 de septiembre de 1835, atracó en las Islas Galápagos.

El artículo Las cartas de Darwin: Casi me vuelvo a casa antes de las Galápagos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: La vida a bordo de un balandro ataúd

- Las cartas de Darwin: ¿Dejamos que el chaval se vaya de viaje?

- Las Cartas de Darwin: El sueño truncado de Canarias

¿Demuestran el Brexit y Trump que vivimos en una simulación por ordenador?

Michael Frazer

![]()

Acontecimientos políticos recientes han puesto al mundo del revés. El Reino Unido votando a favor del Brexit y los Estados Unidos eligiendo a Donald Trump como presidente eran cosas impensables hace 18 meses. De hecho, son tan extraordinarias que algunos se han preguntado si no podrían ser un indicio de que estamos realmente viviendo en algún tipo de simulación por ordenador o experimento alienígena.

Estos acontecimientos inesperados podrían ser experimentos para ver como nuestros sistemas políticos se las arreglan bajo presión. O podrían ser bromas crueles a nuestra costa realizadas por los guardianes alienígenas del zoo. O puede que sean solo pequeños problemas técnicos en el sistema que se suponía que no tenían que pasar. Quizás la reciente confusión en los Oscars o la improbable victoria del Leicester City en la Premier League inglesa o la de los New England Patriots en la Superbowl sean fallos similares.

El problema de usar estos complicados acontecimientos políticos como prueba de que nuestro mundo es una simulación es lo poco ética que sería una situación así. Si hubiese realmente un poder robot o alienígena que fuese lo suficientemente inteligente para controlar nuestras vidas de esta manera, existe una alta probabilidad de que hubiesen desarrollado el sentido moral de no hacerlo.

Los filósofos han estado discutiendo la posibilidad de que el mundo sea solo una ilusión durante cientos de años. Volvió recientemente a la atención pública cuando el fundador de SpaceX y Tesla Elon Musk sugirió que probablemente estemos viviendo en una simulación por ordenador, una versión para la vida real de The Matrix.

Haciéndose eco del filósofo Nick Bostrom, Musk argumentaba que la potencia computacional está aumentando tan rápidamente que nuestros descendientes encontrarían fácil llevar a cabo tantas simulaciones del universo como quisieran. Esto llevaría a un número ilimitado de universos simulados, pero solo seguiría habiendo un solo universo real. Las probabilidades de que el nuestro fuese el real serían infinitesimales.

Bostrom llega a la conclusión de que una de estas tres cosas tiene que ser ciertas. O bien la humanidad se extingue antes de que desarrolle una tecnología que haga posibles las simulaciones. O las civilizaciones avanzadas escogen libremente no llevar a cabo esas simulaciones. O estamos probablemente viviendo en una simulación. Bostrom y Musk apuestan por esta última opción.

La cuestión a la que nos enfrentamos es si acontecimientos inesperados como Trump o el Brexit hacen más o menos posible que estemos viviendo en una simulación. ¿Son el tipo de cosa que esperaríamos ver en un universo simulado?

¿Vivimos en un mundo virtual? | Shutterstock

Los politólogos habitualmente no pueden realizar experimentos en el mundo real para comprobar sus teorías como hacen otros científicos. Pero, ¿qué pasaría si pudiesen llevar a cabo una gigantesca simulación por ordenador para conseguir sus datos’ Brexit y Trump podrían ser experimentos deliberados diseñados para ver lo que ocurre cuando características claves de nuestro mundo se ponen bajo presión. ¿Puede la constitución de Estados Unidos protegerse a sí misma, incluso cuando los funcionarios son malévolos o incompetentes? ¿Puede el Reino Unido prosperar fuera de la Unión Europea? ¿Puede la democracia sobrevivir sin la protección de la OTAN?

Pero los experimentos en política global en el mundo real no solo serían prohibitivamente difíciles y caros. También serían inmorales. Está mal hacer sufrir a los sujetos de una investigación sin su consentimiento informado. El conocimiento puede ser valioso, pero no lo suficientemente valioso como para justificar la crueldad en su búsqueda.

Cada vez más venimos a darnos cuenta de que estas limitaciones éticas aplican no solo a los otros humanos, sino a todos los seres capaces de sufrir, incluyendo tanto a animales como a las inteligencias artificiales conscientes. Bostrom ha argumentado que en tanto una consciencia es capaz de experiencia subjetiva, el dolor o el miedo son experimentados de la misma manera, independientemente de si se manifiesta en neuronas o circuitos.

Puede que aún no tengamos una inteligencia artificial consciente, pero la Unión Europea ya está redactando borradores de propuestas para la protección de las “personas electrónicas”. E, igual que estaría mal para nosotros llevar a cabo experimentos crueles con una inteligencia artifical consciente, también estaría mal para nuestros amos digitales el realizarlos con nosotros. Esta es una buena razón para pensar que las civilizaciones avanzadas elegirían no simular nuestro mundo, incluso si tuvieran la capacidad técnica de hacerlo, porque hacerlo sería moralmente malo.

Monstruosidad moral

Bostrom argumenta que no está claro que crear un universo como el nuestro estaría mal, a pesar del sufrimiento que existe. También señala que nuestros posibles amos digitales, como los dioses de las religiones tradicionales, podrían recompensarnos con un gozoso más allá (simulado). Esta es una respuesta teológica tradicional a lo que se conoce como el problema del mal. Pero aún permanece la pregunta de si es ético hacernos sufrir primero y dar una compensación después.

Este argumento tampoco salva la sugerencia de que los acontecimientos recientes hacen más probable una simulación, más bien al contrario. Cuanto peor se vuelve el mundo, menos probable es que sea moralmente aceptable haberlo creado.

Por supuesto, incluso si simular nuestro mundo está mal, nuestros amos digitales lo podrían hacer de todos modos. No todas las civilizaciones avanzadas técnicamente son morales. Los nazis eran conocidos por su capacidad técnica. No es disparatado pensar que una victoria alemana en la Segunda Guerra Mundial, si bien una monstruosidad moral, no habría sido un desastre para la ciencia.

Pero hay una razón por la que el mundo descrito por Philip K. Dick en The Man in the High Castle [El hombre en el castillo], que recoge una situación así, está amenazado por una destrucción nuclear inminente. Sin la ética para limitar su uso, la ciencia y la tecnología son peligros graves para la supervivencia humana.

Lo que hace mucho más probable que una simulación del universo no sea creada nunca. O bien nuestros descendientes serán lo suficientemente éticos para no destruirse unos a otros y por tanto suficientemente éticos como para no simular un sufrimiento como el nuestro, o la humanidad se extinguirá antes de que sea capaz.

Tal y como dijo W. H. Auden, “debemos amarnos unos a otros o morir”. Y nunca pondríamos a criaturas a las que amamos en un mundo simulado lleno de malaria, hambrunas, guerras civiles…y Donald Trump.

Sobre el autor: Michael Frazer es profesor de teoría social y política en la Universidad de East Anglia

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 10 de marzo de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0)

![]()

El artículo ¿Demuestran el Brexit y Trump que vivimos en una simulación por ordenador? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una simulación más eficiente de la evolución del Sistema Solar

- Un ordenador químico que llega donde no llegan otros

- #Quantum13 El timo del ordenador cuántico comercial

El azúcar oculto en los alimentos

Esta semana me han sucedido dos situaciones muy similares relacionadas con las dudas que suscita el tema de los azúcares presentes en los alimentos. La primera me sucedió en la tienda que hay al lado del cine que suelo frecuentar:

Yo estaba en la cola de la caja para pagar mis compras. Había una mujer delante de mí rebuscando entre los chupachups y me pregunta “¿Cuáles son los que no llevan azúcar?” Le indico cuáles son y le señalo la leyenda «sin azúcar» que figura en el envoltorio. Me pregunta “¿Y cómo sé si realmente no llevan azúcar?” Le contesto que si pone «sin azúcar» es que son sin azúcar, sin duda, que puede confiar en el etiquetado y que, de hecho, esos caramelos son aptos para diabéticos. La mujer se lleva uno de esos chupachups, me da las gracias y me dice “Habrá que confiar, pero a saber qué ingredientes llevan ocultos”. “Las etiquetas dicen la verdad, por ley”, le digo. No tenía tiempo de explayarme, la película estaba a punto de empezar.

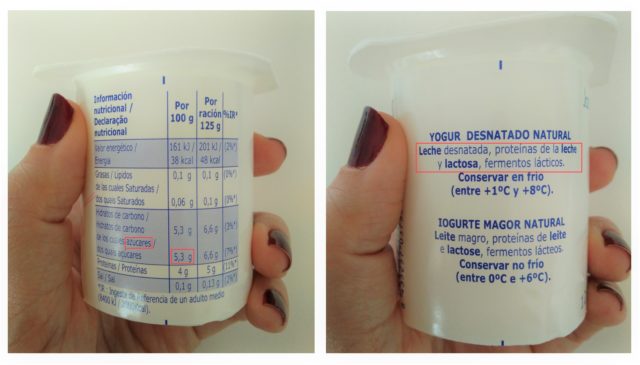

La segunda anécdota me sucedió en la sección de yogures del supermercado. Una señora me dice “Nena, ¿me puedes mirar si estos yogures llevan azúcar? El médico me ha dicho que los compre sin azúcar y no encuentro ninguno”. La señora me enseña la tabla nutricional del yogur natural que ha cogido y señala los azúcares: 5,3 g por cada 100 g de producto. Le digo que ese azúcar no es el azúcar al que se refiere su médico, que ese azúcar es el que contiene la leche del yogur y es distinto al azúcar común. Le digo que mire en la lista de ingredientes del yogur y, si en esa lista no está el azúcar, puede estar tranquila. Le señalo la lista de ingredientes: leche desnatada, proteínas de la leche, lactosa y fermentos lácticos. ¿Ve? No aparece el azúcar, este es un yogur natural desnatado, sin azúcar añadido. “Podrían ponerlo más claro”, me dice. Le doy la razón.

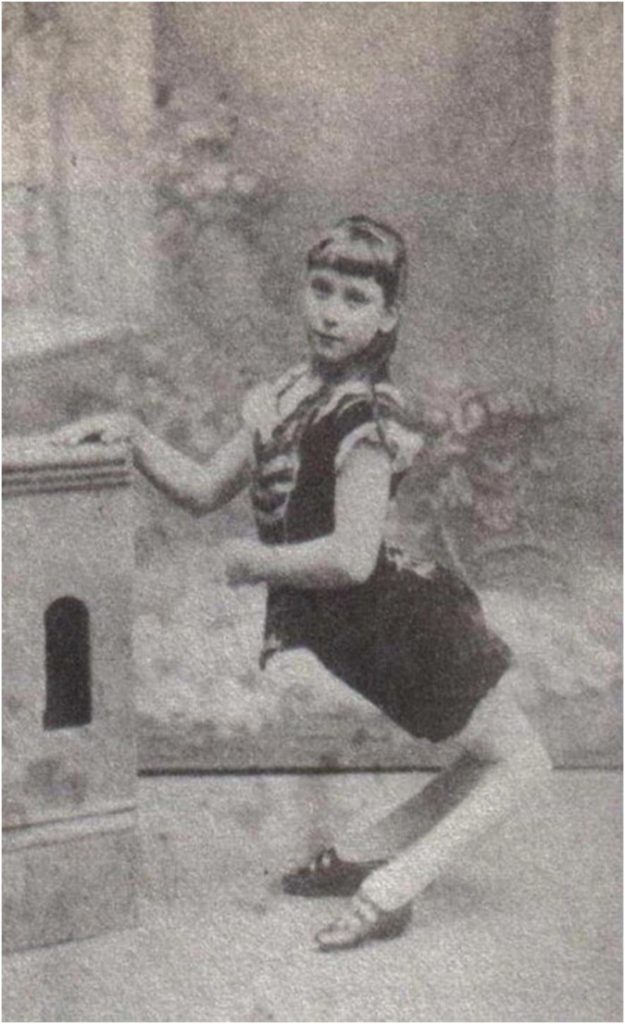

Información nutricional y lista de ingredientes de un yogur.

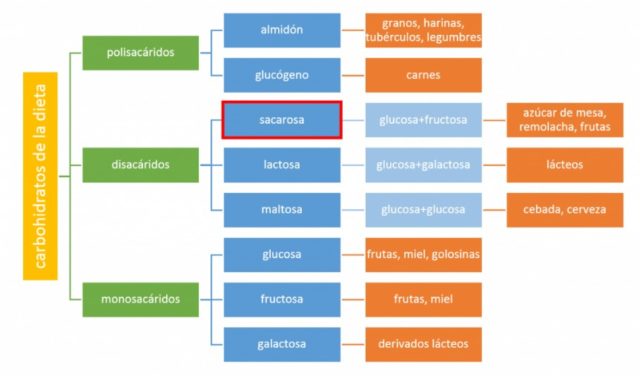

Cuando coloquialmente hablamos de azúcar realmente nos referimos a una sustancia en concreto: la sacarosa. La sacarosa es el azúcar de mesa, el de los terrones.

En rigor, existen varios azúcares, como la lactosa (leche), la fructosa (frutas y miel), la maltosa (cerveza), la sacarosa (azúcar de mesa), etc. Todos ellos son hidratos de carbono. Como metabolizamos unos y otros de forma diferente, es bueno tener en cuenta que existen diferentes azúcares a la hora de interpretar correctamente la información del etiquetado de los alimentos.

En la etiqueta de un alimento figuran dos datos: la información nutricional y la lista de ingredientes. Cuando nos fijamos en la información nutricional de un alimento se nos indica qué hidratos de carbono son azúcares, y ahí no se hace distinción entre lactosa, sacarosa, fructosa… sino que se suman todos ellos. Por eso un yogur natural sin azúcar puede tener 5,3 g de azúcares, porque esa cantidad se corresponde con la lactosa de la leche, no con azúcar común añadido para endulzar. En cambio, en la lista de ingredientes sí se especifica si el alimento lleva azúcar añadido, ya que figuraría como un ingrediente más. Por eso, para saber si un alimento lleva azúcar añadido, hay que fijarse en la lista de ingredientes.

En la actualidad se ha puesto el foco en los denominados azúcares libres. La recomendación de la Organización Mundial de la Salud es que el consumo de azúcares libres se debería reducir a menos del 10% de la ingesta calórica total, es decir, a un máximo de 25g de azúcares libres al día (el equivalente a 6 terrones).

¿Qué es el azúcar libre? Según la OMS, el azúcar libre es:

1. Azúcar añadido. Aquí entra el azúcar común (sacarosa) que añadimos al café o a los postres, por ejemplo; y el azúcar que figura en la lista de ingredientes de un alimento, como el que contienen los refrescos, las galletas, los cereales, la bollería, el cacao soluble, algunos panes blancos, etc.

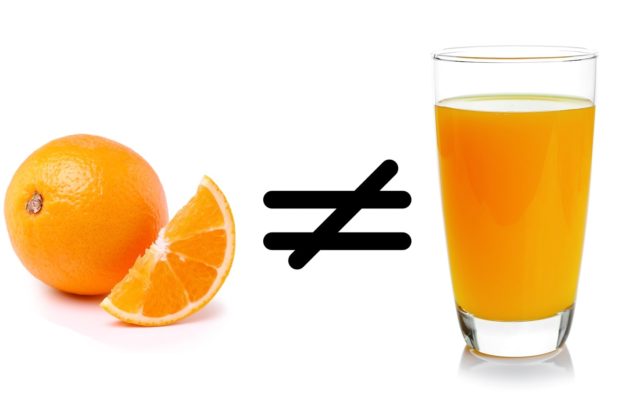

2. Azúcar naturalmente presente en algunos alimentos y que tiene efectos similares en nuestro organismo al azúcar añadido. Este es el caso de la miel, los siropes y los zumos.

No se considera azúcar libre a los azúcares presentes en frutas y verduras, y por eso no hay ninguna restricción nutricional recomendada para estos alimentos. De ahí la recomendación de los nutricionistas de consumir frutas enteras (o batidos con frutas enteras) en lugar de zumos (aunque sean caseros).

La recomendación de la OMS de reducir la ingesta de azúcares libres se fundamenta en la probada relación entre el consumo de estos azúcares y la mayor incidencia de enfermedades como la obesidad y la diabetes tipo II. Los índices actuales de población con sobrepeso y obesidad son alarmantes.

Las recomendaciones de la OMS, así como los consejos de los dietistas-nutricionistas, no pretenden demonizar los placeres. Lo que se pretende es que cuando tomas la decisión de, por ejemplo, beberte un zumo, no lo hagas creyendo que es una elección saludable y comparable a consumir una fruta, aunque lo parezca. Beberte un zumo es una elección que haces por placer, no por salud, la cual también es una razón absolutamente legítima.

Cuando te tomas un bollo, una chocolatina, un refresco… lo haces porque te apetece y no hay ninguna intención saludable en tu decisión. Nadie pretende que creas que un bollo de color rosa es un alimento saludable. En cambio, la publicidad de productos con frutas o verduras, como zumos, potitos, papillas con azúcares añadidos, pueden dar la impresión de producto saludable cuando no siempre lo son.

Lo que se intenta con este bombardeo de información acerca de los azúcares es que los consumidores tomemos conciencia del abuso de azúcares libres en nuestra dieta, sus efectos sobre la salud y que seamos consecuentes si queremos serlo. La forma de hacerlo es muy sencilla: limitar el consumo de zumos, miel, siropes y, sobre todo, alimentos con azúcares añadidos. También hay que tener en cuenta que ninguno de estos azúcares está oculto en los alimentos: siempre figurará en la lista de ingredientes. Esto está completamente regulado en las normas de etiquetado: cualquier alimento que contenga azúcar ha de indicarlo en su etiqueta como ingrediente. De no hacerlo, no pasaría los controles de seguridad y sería retirado del mercado.

Insinuar que existen ingredientes ocultos en los alimentos es sembrar la desconfianza y promover el desconocimiento de los consumidores; es la manida, populista y reprochable estrategia del miedo.

Cuando los consumidores leemos «sin azúcar» en la etiqueta de un producto y nos cuestionamos si es verdad, esta sospecha se debe principalmente a dos motivos: un motivo es que cierta publicidad de la industria alimentaria es intencionadamente ambigua y eso ha suscitado desconfianza en el sector y, el otro motivo, es que se abusa de la embaucadora estrategia de la sospecha sistemática, del «que no te engañen». No, no hay engaño posible en la lista de ingredientes y en la información nutricional de los alimentos. Esta información es cierta y se verifica. No existe el azúcar oculto en los alimentos, aparece bien claro en la lista de ingredientes, por ley.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo El azúcar oculto en los alimentos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Lo dicen en la tele: un alimento natural no lleva aditivos

- Dani y Fiti sobre los alimentos

- El mejor lacón con grelos tiene su ciencia

La Cátedra de Cultura Científica en 2016

Se presentan a continuación las actividades realizadas por la Cátedra de Cultura Científica de la UPV/EHU a lo largo del año 2016. Las actividades se han ordenado en función de su naturaleza, diferenciando las de divulgación (conferencias y eventos con ese fin), de otras actividades. Las colaboraciones con otras entidades y las presentaciones (conferencias, mesas redondas, coloquios u otras) en que ha participado el director de la Cátedra también se han presentado de manera separada.

Este blog publica artículos de divulgación científica de alto nivel en inglés. Durante 2016 ha publicado semanalmente entre 3 y 4 artículos. En 2016 publicó un total de 223 artículos, lo que significa que el número de publicaciones ha disminuido con respecto a 2015 en un 7,4%. El consumo de contenidos del blog ha descendido un 20% con respecto al pasado año (292.773 páginas en 2015 y 231.387 en 2016). Ese descenso es consecuencia, principalmente, de haber publicado un menor número de artículos. El consumo, sin embargo, ha sido de mayor calidad. Muestra de ello es, por un lado, el incremento de consultas por sesión de cada usuario (un 2,84% más por sesión que en 2015) y el aumento del tiempo de cada visita en un 6%. Mapping Ignorance ha tenido un total 171.346 visitas y 133.190 visitantes, los cuales consumieron un total de 231.387 páginas.

Durante 2016 ha seguido creciendo su presencia en redes sociales. En Twitter la cuenta @MapIgnorance ha incorporado 531 usuarios nuevos durante 2016 (en diciembre cerró el año con un total de 3.013 seguidores). Tanto los usuarios del blog como los seguidores en Twitter son mayoritariamente extranjeros (el 79% de los mismos). El blog cuenta con un total de 407 suscriptores que siguen su contenido vía correo electrónico.

Cuaderno de Cultura Científica

El Cuaderno ha continuado creciendo en secciones y número de anotaciones durante 2016. Durante 2016 publicó un total de 584 anotaciones. De ellas 535 fueron artículos y 49 textos informativos sobre eventos (conferencias, jornadas, cursos, etc.) La actividad del blog ha sido diaria y continuada durante los 365 días del año y ha incrementado su consumo entre los usuarios. Así en 2016 se volvió a incrementar el número de páginas consumidas (un 36% con respecto a 2015), con un total de 1.370.352 páginas consultadas. El número de usuarios ha pasado ha pasado de 503.870 en 2015 a 720.784 en 2016. Del mismo modo las visitas al blog crecieron en 2016, pasando de 705.239 (2015) a 999.328 en 2016 (creciemiento de 40,99%).

Este aumento es también palpable en su cuenta de Twitter, @CCCientifica, que ganó 6.729 nuevos seguidores en 2016 frente a los 4.085 seguidores adquiridos en 2015. Así en diciembre de 2016 Cuaderno cerró el año con un total de 15.811 seguidores. El 53% de los usuarios del Cuaderno proceden de países extranjeros, lo que pone de relieve la creciente proyección internacional del blog. 1.882 usuarios siguen el contenido del blog a través de la suscripción por correo electrónico.

En 2016 el blog editado en euskara y que se publica con el dominio .eus incrementó su actividad publicando un total de 437 anotaciones (397 artículos y 40 textos sobre diversos eventos: jornadas, cursos, conferencias…). La edición de artículos ha sido diaria, y por segundo año consecutivo el blog ha consolidado su actividad con nuevas secciones, un mayor número de artículos y la incorporación de nuevas colaboraciones. Este incremento ha tenido reflejo en el consumo: 82.226 páginas en 2016 frente a las 73.588 de 2015; el número de usuarios ha crecido un 25,65% respecto a 2015, llegando a los 28.900 (mientras en 2015 fueron 23.000) y ha recibido un total de 45.000 visitas (un 14% más que en 2015).

Así mismo, ha crecido su público a través de su cuenta de Twitter, @zientzia_k. En 2015 había ganado 375 seguidores, llegando a las puertas de los 1.000, y durante 2016 incrementó esa cifra en 368 seguidores, llegando a un total de 1.364 a finales de diciembre. Zientzia Kaiera es seguido principalmente por usuarios que residen en el País Vasco (un %70 del total). Por otro lado, un total de 140 usuarios siguen los artículos editados en Zientzia Kaiera a través del correo electrónico, vía suscripción.

En mayo de 2016 Mujeres con Ciencia cumplió su segundo año de andadura. Si durante 2015 el proyecto se consolidó, en 2016 ha seguido avanzado de manera firme. Así, ha publicado un total de 682 artículos, de los cuales 158 eran efemérides que recuerdan el nacimiento y la labor de las científicas en los distintos ámbitos de la ciencia y la tecnología. Los resultados de consumo del blog han mejorado de forma notable por segundo año consecutivo, incrementándose su consumo un 62,29% respecto al año anterior. Mujeres con Ciencia ha tenido 257.125 visitantes que han realizado un total de 368.379 visitas y han consumido 516.408 páginas.

Del mismo modo, su seguimiento en Twitter, a través de la cuenta @mujerconciencia, ha obtenido similares resultados, logrando incrementar en un 108% su influencia, tras registrar durante 2016 un aumento de 6.492 seguidores (en diciembre de 2016 @mujerconciencia cerró el año con un total de 12.506 seguidores). Por otro lado cabe destacar el aumento relativo de los visitantes procedentes de España, que han pasado en 2015 de representar el 55,54% de las visitas al 62,96% durante 2016.

Cienciasfera es un agregador de blogs de ciencia. Se publica con el objeto de disponer de un medio ágil para que quien esté interesado pueda acceder a los mejores blogs de ciencia que se publican en español. Hay más de 150 blogs afiliados y las anotaciones se clasifican de acuerdo con su disciplina.

Este sitio cumple dos objetivos. Por un lado constituye una plataforma mediante la que acceder a la mejor información científica de actualidad, pues selecciona las informaciones científicas de más interés de cada día a partir de un conjunto de medios digitales de calidad contrastada. El sitio es trilingüe (castellano, vasco e inglés) por lo que referencia noticias de medios que se publican en los tres idiomas. El acceso a la mejor información científica se completa con entradas a dos agregadores de blogs de ciencia (Science Seeker, en inglés, y Cienciasfera, en español) y a la anotación semanal en Zientzia Kaiera que recoge todas las publicaciones sobre ciencia en lengua vasca en la red. Y por otro lado, da acceso a los cuatro blogs de la Cátedra, así como a sus canales de videos en Youtube y Vimeo.

Conferencias organizadas Matemáticas para mentes inquietas

Este programa, realizado en colaboración con Aupatuz, asociación de familiares de menores con altas capacidades intelectuales del País Vasco, consta de una serie de diálogos, conferencias y sesiones de taller dirigidas a niños y niñas de hasta 15 años de edad. Estas actividades se han desarrollado en cinco sesiones en las siguientes fechas:

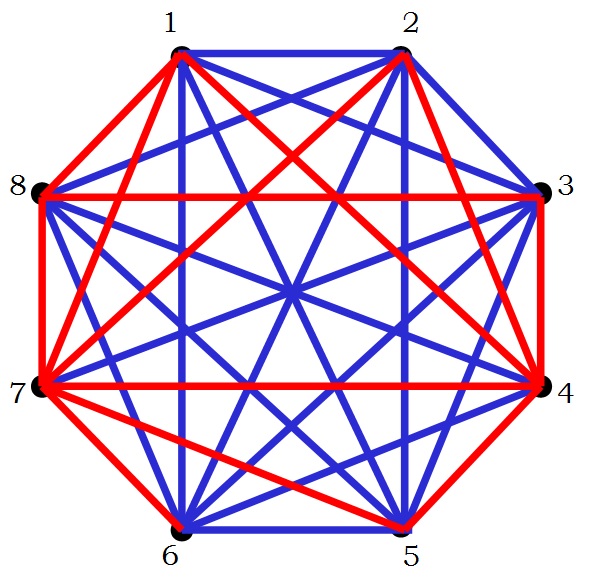

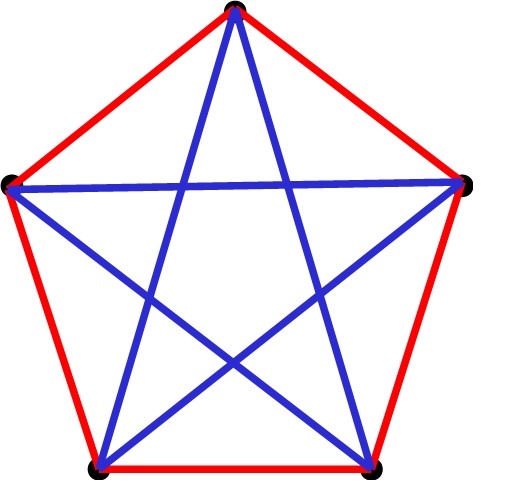

- 20 de febrero: Taller común (para todos los chavales de 9 a 15 años junto con sus familias): Realizando una escultura en familia, la estrella dodecaédrica (a cargo de Pedro Alegría, Raúl Ibáñez, profesores de la UPV/EHU, con estudiantes del Grado de Matemáticas).

- 12 de marzo: Taller 1 (para chavales de 9 a 11 años): Lógica-mente. Problemas y acertijos matemáticos para poner a prueba tu capacidad de pensamiento lógico (Raúl Ibáñez, profesor de la UPV/EHU). Taller 2 (para chavales de 12 a 15 años): Lógica-mente. Problemas y acertijos matemáticos para poner a prueba tu capacidad de pensamiento lógico (Pedro Alegría, profesor de la UPV/EHU).

- 9 de abril: Taller 1 (para chavales de 9 a 11 años): Jugando con el geoplano (Esperanza Noronha, docente). Taller 2 (para chavales de 12 a 15 años): Taller de estadística (Irantzu Barrio y Arantza Urkaregi, profesoras UPV/EHU).

- 7 de mayo: Taller 1 (para chavales de 9 a 11 años): Taller de estadística (Irantzu Barrio y Arantza Urkaregi, profesoras UPV/EHU). Taller 2 (para chavales de 12 a 15 años): Taller de criptografía (Alex Aginagalde, profesor IES Arrigorriaga).