Potencial diana terapéutica contra el miedo

Fuente: Alex Green / Pexels

Fuente: Alex Green / PexelsLos trastornos relacionados con el miedo reúnen algunas de las afecciones psiquiátricas más diagnosticadas, entre ellas el trastorno de pánico, varias fobias y el trastorno de estrés postraumático. Estos trastornos son muy perturbadores para la vida profesional y social de las personas afectadas y representan costes sociales considerables.

Un equipo de investigación liderado por la Universidad de Coimbra (UC), en el que también ha participado Garikoitz Azkona Mendoza, profesor titular de la UPV/EHU, ha identificado un nuevo mediador responsable de la alteración de los recuerdos relacionados con el miedo. El equipo científico cree que este descubrimiento podría ayudar a crear nuevas terapias más eficaces para el tratamiento de los trastornos de ansiedad. Estas patologías se caracterizan por un miedo exagerado o inapropiado y un déficit en la extinción de este, y son una de las afecciones de salud más prevalentes en todo el mundo, agravadas por la pandemia.

En el estudio, haciendo uso de un modelo conductual para la extinción del miedo, el equipo ha podido identificar «un aumento de la activación de la proteína TrkC en la amígdala (la región cerebral que controla la respuesta al miedo) en la fase de formación de recuerdos de extinción del miedo, lo que conduce a un aumento de la plasticidad sináptica (la capacidad de las neuronas de cambiar la forma en que se comunican entre sí en función de los estímulos que reciben)», explica Mónica Santos, investigadora del Centro de Neurociencia y Biología Celular de la UC (CNC-UC) y del Centro de Innovación en Biomedicina y Biotecnología (CIBB).

Actualmente, una de las opciones terapéuticas para los trastornos de ansiedad es la terapia de exposición, que se basa en el mecanismo de extinción del miedo. Sin embargo, «las terapias de exposición, así como el uso de fármacos como ansiolíticos y antidepresivos, no son 100 % eficaces en el tratamiento de estos problemas de salud y, por ello, esta investigación abre nuevas opciones terapéuticas para esta categoría de trastornos», afirma Mónica Santos.

«Este estudio valida la vía TrkC como potencial diana terapéutica para personas con trastornos relacionados con el miedo y revela que la combinación de terapias de exposición con fármacos que potencian la plasticidad sináptica puede representar una forma más eficaz y duradera de tratar los trastornos de ansiedad», añade la responsable de la investigación.

En cuanto a los próximos pasos, el equipo de investigación pretende «identificar compuestos que tengan la capacidad de activar específicamente la molécula TrkC y así poder ser utilizados como fármacos aliados a la terapia de exposición en el tratamiento de pacientes con trastornos de ansiedad», explica la investigadora.

Referencia:

Gianluca Masella, Francisca Silva, Elisa Corti, Garikoitz Azkona, Maria Francisca Madeira, Ângelo R. Tomé, Samira G. Ferreira, Rodrigo A. Cunha, Carlos B. Duarte & Mónica Santos (2024) The amygdala NT3-TrkC pathway underlies inter-individual differences in fear extinction and related synaptic plasticity Molecular Psychiatry doi: 10.1038/s41380-024-02412-z

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Potencial diana terapéutica contra el miedo se ha escrito en Cuaderno de Cultura Científica.

¿De dónde ha salido este fósil?

Foto: Kvnga / Unsplash

Foto: Kvnga / UnsplashCuando estamos haciendo un estudio geológico en algún lugar porque queremos descubrir qué medio ambiente se desarrolló en esa zona hace millones de años, lo más fácil es buscar un afloramiento de rocas sedimentarias e intentar identificar algún fósil que nos dé una pista rápida. Así, si en una roca aparecen, por ejemplo, los restos fosilizados de un trilobites, diremos que esos materiales se formaron en el fondo del mar. Incluso, podemos asignarle una edad aproximada a esa roca, en este caso hace entre 500 y 250 millones de años, ya que es el rango de tiempo geológico desde que aparecieron los trilobites hasta que se extinguieron.

Hasta aquí todo muy fácil, pero, ¿de verdad es así de sencillo en la vida real? ¿Y si os dijera que ese fósil no se formó ni en el mismo sitio ni en el mismo momento en que lo hizo la roca en la que aparece? Pues, para evitar sacar este tipo de conclusiones erróneas a la hora de realizar las reconstrucciones de los ambientes del pasado, existe una disciplina de la Paleontología llamada tafonomía. Su nombre, procedente del griego y que viene a significar algo así como “normas de enterramiento”, ya nos está indicando que se trata de aquellos estudios que se les realizan a los restos bióticos para comprender sus aventuras y desventuras desde que pasan a formar parte del registro sedimentario hasta que nos los encontramos fosilizados en la actualidad.

Fotografía de lupa binocular de una población viva normal, formada por una mezcla de ejemplares adultos y juveniles, de una especie de ostrácodo típica de medio ambiente de lago somero. Foto: Blanca María Martínez

Fotografía de lupa binocular de una población viva normal, formada por una mezcla de ejemplares adultos y juveniles, de una especie de ostrácodo típica de medio ambiente de lago somero. Foto: Blanca María MartínezPara ponernos en situación de para qué sirve la tafonomía, voy a hacer un pequeño símil. Si, en la actualidad, queremos conocer los organismos que habitan en un medio ambiente concreto, nos vamos allí y hacemos un censo de los que viven, comen, se reproducen y mueren en ese medio, dejando aparte aquellos que, digamos, pasan por allí de repente (como si fuese un área de servicio, parando un momento para comer o descansar antes de seguir su viaje), ya que estos últimos no habitan en ese ambiente y podrían darnos una información errónea sobre su ecología. Pues gracias a la tafonomía podemos hacer lo mismo en los medios del pasado, identificar los organismos que realmente habitaban el ambiente en el que se formó la roca donde encontramos los restos fósiles, a los que llamamos asociación autóctona, separándolos de aquellos que han acabado depositados en este medio por haber sufrido algún tipo de transporte tras su muerte, a los que denominamos asociación alóctona.

Para poder diferenciar entre elementos alóctonos y autóctonos debemos fijarnos en el aspecto que presentan todos los restos que componen la asociación fósil encontrada en la roca y, para ello y de manera muy resumida, utilizamos tres grandes grupos de herramientas tafonómicas que son indispensables a la hora de realizar reconstrucciones paleoambientales.

Las herramientas tafonómicasLa primera es el análisis poblacional. En este caso no me refiero a que haya mucha o poca diversidad de organismos, con diferentes grupos y especies, porque eso depende de las condiciones ecológicas del medio, sino que tenemos que prestar atención a qué ejemplares aparecen en cada una de las especies. En una asociación autóctona aparecerá una mezcla de adultos y juveniles y, si tienen dimorfismo sexual, machos y hembras. Pero si únicamente encontramos ejemplares adultos o solo ejemplares juveniles, debemos sospechar que han sido transportados por corrientes de agua desde otro lugar y se han depositado en el medio en el que se formó esa roca, por lo que no nos darían una información fiable de este ambiente.

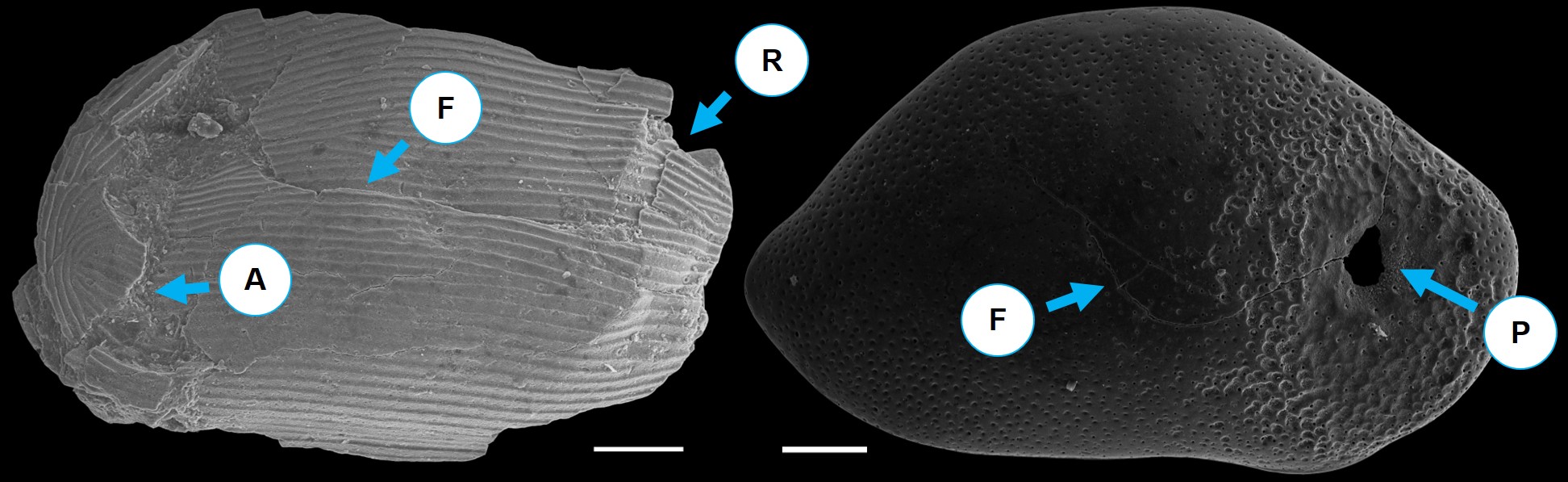

Ejemplos de procesos de alteración mecánica en el exterior de dos valvas de dos especies marinas de ostrácodos actuales. A) Abrasión; F) Fractura; R) Rotura; P) Perforación. Fotografías de Microscopio Electrónico de Barrido, donde la escala representa 0,1mm. Foto: Blanca María Martínez

Ejemplos de procesos de alteración mecánica en el exterior de dos valvas de dos especies marinas de ostrácodos actuales. A) Abrasión; F) Fractura; R) Rotura; P) Perforación. Fotografías de Microscopio Electrónico de Barrido, donde la escala representa 0,1mm. Foto: Blanca María MartínezLa segunda herramienta es el estudio de las alteraciones mecánicas que han sufrido los restos fósiles. Aquí se incluye el análisis de todas las fracturas, roturas, abrasiones y perforaciones que se pueden observar en los ejemplares. Por regla general, cuanta mayor es la alteración mecánica que sufren, mayor ha sido el transporte hidrodinámico de estos organismos, por lo que aquellos que se encuentran más afectados representarían la asociación alóctona que debemos descartar. Pero, como en toda regla, hay algunas excepciones que la confirman. Por ejemplo, en algunas ocasiones podemos encontrarnos con elementos fósiles muy frágiles, ya que los organismos no necesitaban generar unos caparazones gruesos para proteger su cuerpo blando porque no estaban sometidos a condiciones ecológicas demasiado exigentes. Es habitual que estos restos aparezcan muy fracturados, pero no porque sufrieran un transporte durante su depósito, sino porque se nos han roto durante la extracción y procesado de las muestras en el laboratorio. O también es frecuente que aparezcan ejemplares muy perforados y rotos debido a la bioturbación de otros animales que rompieron la coraza para alimentarse de sus partes blandas. Y esto indica que, o bien estaban vivos en ese momento y fueron depredados, o bien acababan de morir y acudieron los carroñeros para comérselos. En estos dos casos especiales, esas especies formarían parte de la asociación autóctona.

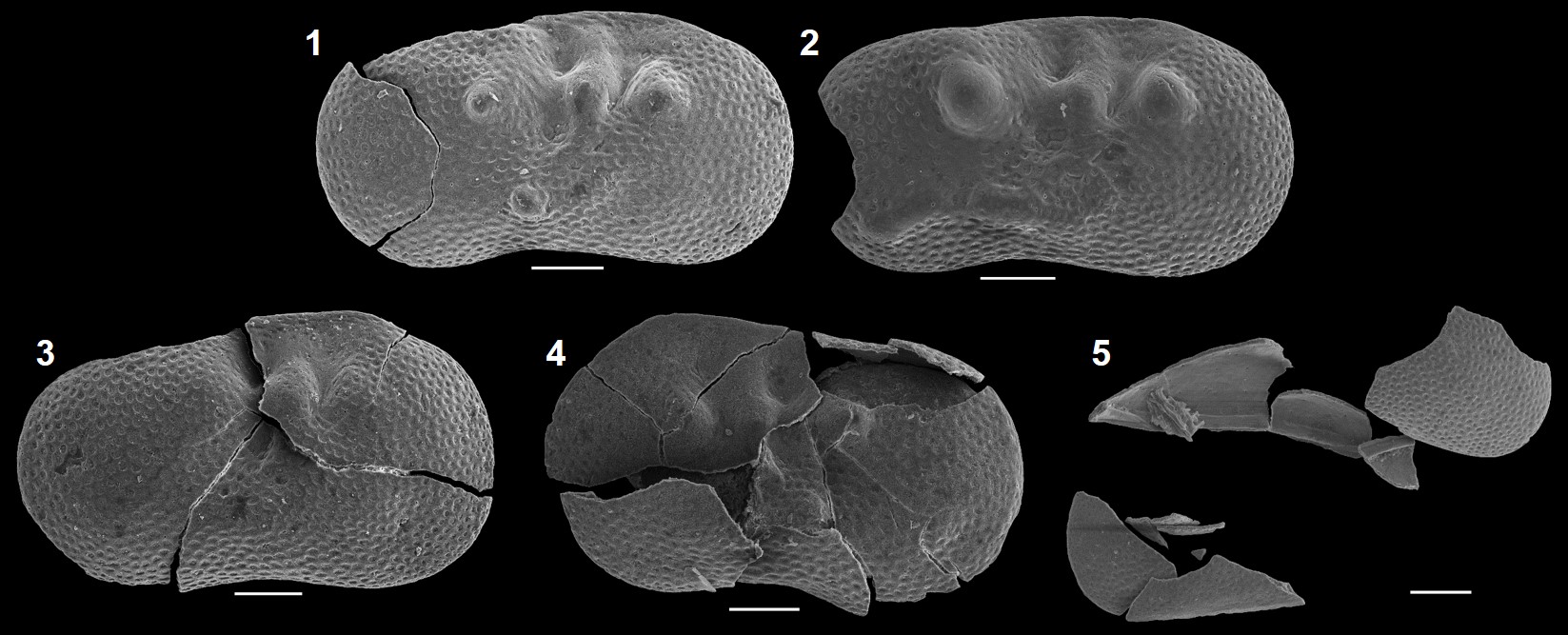

Grados de alteración mecánica en valvas de una especie de ostrácodo típica de arroyos actuales. Los grados 1 y 2 corresponden con ejemplares autóctonos, mientras que los grados 3, 4 y 5 representan ejemplares alóctonos. Fotografías de Microscopio Electrónico de Barrido, donde la escala representa 0,1mm. Foto: Blanca María Martínez

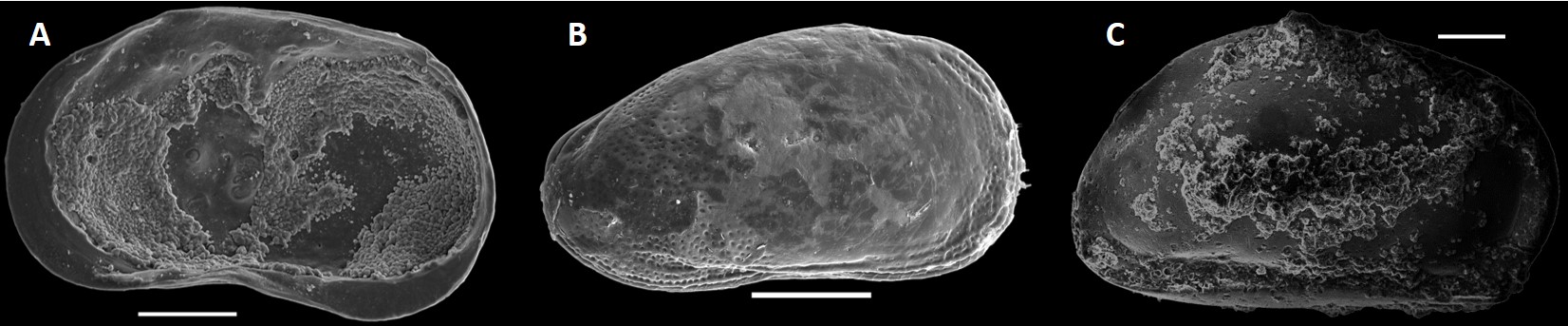

Grados de alteración mecánica en valvas de una especie de ostrácodo típica de arroyos actuales. Los grados 1 y 2 corresponden con ejemplares autóctonos, mientras que los grados 3, 4 y 5 representan ejemplares alóctonos. Fotografías de Microscopio Electrónico de Barrido, donde la escala representa 0,1mm. Foto: Blanca María MartínezY la tercera herramienta tafonómica es el análisis de las alteraciones químicas de los ejemplares. En este caso, se trata de identificar disoluciones, recristalizaciones (un mineral de nueva formación reemplaza a otro de su misma composición) o encostramientos (formación de una capa mineral superficial generalmente de diferente composición) en los restos fósiles. Estas alteraciones se pueden producir durante el depósito de los ejemplares antes de su enterramiento o, de manera más habitual, durante el propio proceso de fosilización y formación de las rocas. Para diferenciar entre la asociación fósil autóctona y la alóctona, hay que comprobar el aspecto general de la muestra que estemos estudiando, incluida la propia roca que incluía los restos: si los ejemplares han sufrido los mismos procesos de alteración química que el resto de la muestra, son autóctonos; si tienen un grado de conservación diferente, son alóctonos.

Ejemplos de procesos de alteración química en la superficie interna (A) y externa (B y C) de tres especies de ostrácodos típicos de estuarios y marismas. A) Recristalización; B) Disolución; C) Encostramiento. Fotografías de Microscopio Electrónico de Barrido, donde la escala representa 0,1mm. Foto: Blanca María MartínezEn qué ambiente vivió el fósil

Ejemplos de procesos de alteración química en la superficie interna (A) y externa (B y C) de tres especies de ostrácodos típicos de estuarios y marismas. A) Recristalización; B) Disolución; C) Encostramiento. Fotografías de Microscopio Electrónico de Barrido, donde la escala representa 0,1mm. Foto: Blanca María MartínezEn qué ambiente vivió el fósil

Una vez realizado el análisis tafonómico completo podemos identificar los restos fósiles que componen la asociación autóctona, que nos permitirá realizar la reconstrucción paleoambiental de ese medio, así como darle una edad geológica lo más precisa posible. Pero no debemos descartar por completo la asociación alóctona, porque nos estará dando información de ciertos procesos hidrodinámicos que acontecieron en este ambiente, pudiendo también identificar el área fuente de las corrientes de agua.

Para explicarme, que este último párrafo me ha quedado demasiado técnico, voy a volver al ejemplo del principio, esa roca con restos de trilobites que no eran de ahí. Imaginaos que, después de estudiar la muestra con detalle hemos identificado una asociación autóctona formada por organismos microscópicos que nos permiten caracterizar el medio como un lago continental de hace unos 20 Millones de años en el que desembocaban algunos pequeños ríos y arroyos en momentos esporádicos. Pues la presencia de unos restos de trilobites alóctonos de hace unos 300 Millones de años nos estaría diciendo que esos riachuelos procederían de unas rocas concretas situadas al norte de ese lago, no de otras circundantes al sur, porque son las únicas de esa edad y que incluyen ese tipo de fósiles. Es decir, que gracias a la asociación transportada podemos complementar algunos detalles de la reconstrucción paleoambiental realizada con la asociación autóctona.

Los estudios tafonómicos son básicos en cualquier estudio paleontológico para evitar meter la pata en tus conclusiones y lo tenemos tan interiorizado que lo vamos haciendo sobre la marcha según estudiamos la muestra. Pero, como os he dicho antes, para hacerlo bien tenemos que tener una visión general de la roca y de todos los restos fósiles que incluye, ya que hay que comparar el aspecto de los organismos que vayamos a estudiar con todo lo demás. Por este motivo, siempre decimos a la gente que nunca extraiga fósiles de las rocas en las que están si se encuentran alguno durante sus excursiones, porque sacarían el ejemplar de contexto y perdería todo el valor científico y toda la información que nos puede aportar. Recuerda, si te encuentras un fósil en alguna roca, sácale una foto y déjalo donde está, o destruirías millones de años de información que nos permiten reconstruir la historia de este planeta.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo ¿De dónde ha salido este fósil? se ha escrito en Cuaderno de Cultura Científica.

La teselación de József Kürschák

József Kürschák nació el 14 de marzo de 1864 en Buda (Hungría). Su padre, András Kürschák, falleció cuando él tenía solo seis años. A partir de entonces fue criado solo por su madre, Jozefa Teller, en Budapest (fundada en 1872 al unificarse las ciudades de Buda, Óbuda y Pest), ciudad que se había convertido en un lugar privilegiado de educación y de vida intelectual y artística. Allí Kürschák asistió a la escuela secundaria.

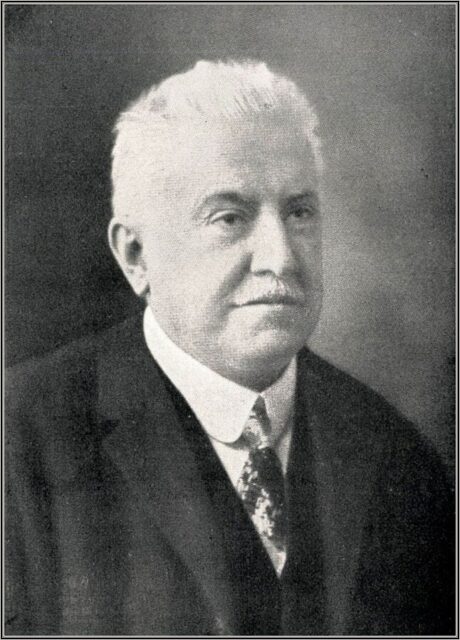

József Kürschák. Fuente: Wikimedia Commons.

József Kürschák. Fuente: Wikimedia Commons.

Ingresó en la Universidad Politécnica de Budapest en 1881 y se graduó en 1886. Tras dos años trabajando como docente de matemáticas y física en una escuela de enseñanza secundaria en Eslovaquia, regresó a la Universidad Politécnica de Budapest para dedicarse a la investigación. Se doctoró en 1890 y durante toda su carrera siguió vinculado a este centro de enseñanza superior.

La teselación de KürschákEn un artículo publicado en 1978 en la revista The Mathematical Gazette, los autores (los matemáticos Gerald L. Alexanderson y Kenneth Seydel) describían un trabajo de Kürschák, escrito en 1898, en el que se estudian algunas propiedades de un dodecágono regular inscrito en la circunferencia unitaria.

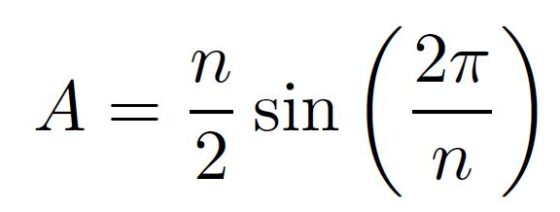

Los autores dedican su texto a demostrar el siguiente teorema:

El área de un dodecágono regular inscrito en una circunferencia unitaria es 3.

Podría parecer extraño destinar un artículo de cinco páginas a probar este resultado, puesto que el área de los polígonos regulares (inscritos en una circunferencia unitaria) se calcula sin dificultad usando herramientas trigonométricas. De hecho, es:

donde n es el número de lados del polígono. Es decir, en este caso en el que n = 12, el área es 3.

Sin embargo, el argumento que empleaba Kürschák es puramente geométrico. Se trata de una prueba sin palabras en la que el matemático demuestra que un dodecágono puede diseccionarse en un conjunto de triángulos que, reorganizados de la manera adecuada, rellenan tres cuadrados de lados de longitud 1. Y Kürschák usa para ello una teselación, de la que los autores del artículo de 1978 dicen con admiración:

La teselación es tan bonita e ingeniosa que creemos que debería conocerse mejor.

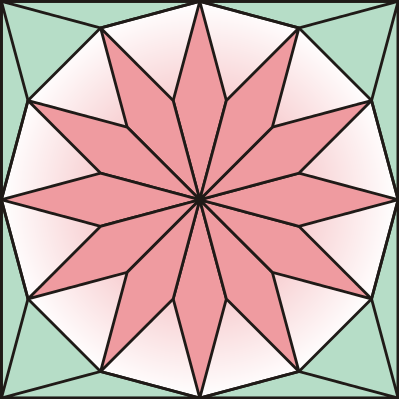

La teselación de Kürschák. Fuente: Wikimedia Commons.

La teselación de Kürschák. Fuente: Wikimedia Commons.

Esta teselación de un cuadrado posee dos tipos de baldosas triangulares: son 16 triángulos equiláteros (cuyos lados son de la misma longitud que los lados del dodecágono) y 32 triángulos isósceles (cada rombo de color rosa está formado por dos de ellos, iguales a los ocho que definen el perímetro del cuadrado. Dos de sus ángulos son de 15 grados y el restante de 150 grados) dispuestos como se indica en la imagen superior. En la siguiente animación se puede ver cómo se utiliza la teselación de Kürschák para calcular el área de dodecágono.

https://www.youtube.com/watch?v=7lCJDdD_fHs

Sin duda, Gerald L. Alexanderson y Kenneth Seydel tienen razón en que es una demostración tan hermosa que vale la pena recordarla.

József Kürschák: investigador y docenteKürschák no sólo se dedicó a la construcción de demostraciones geométricas sin palabras. Trabajó en diferentes ramas de las matemáticas, entre otras, en ecuaciones diferenciales, álgebra, teoría de números o cálculo de variaciones.

En la década de 1910 obtuvo el reconocimiento internacional por su teoría de valoraciones, según la cual, al generalizar el valor absoluto y el valor límite, estos conceptos pueden extenderse a estructuras abstractas. Esta teoría fue posteriormente completada por Alexander Ostrowski.

En teoría de números, simplificó la demostración de David Hilbert de la conjetura de Waring (todo número natural puede expresarse como suma de no más de cuatro cuadrados, de 9 cubos, de 18 cuartas potencias, etc.). Además, en varios de sus trabajos se ocupó de la irreducibilidad de determinantes y matrices.

Kürschák fue un docente apreciado. Muchos reconocidos matemáticos disfrutaron de sus enseñanzas, entre ellos John von Neumann, Edward Teller o Dénes König, que defendió su tesis doctoral (Elementary Discussion of Rotations and Finite Rotation Group of a Space of Many Dimensions) en 1907 con una memoria supervisada por Kürschák y Hermann Minkowski.

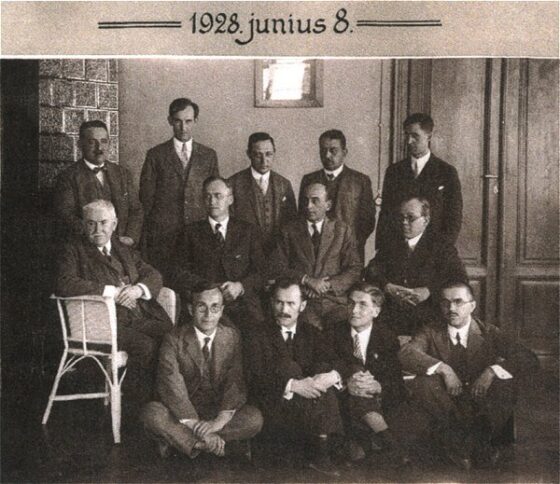

Universidad de Szeged, 1928. De izquierda a derecha (de pie): Frigyes Riesz, Béla Kerékjártó, Alfréd Haar, Gyula Kőnig, Rudolf Ortvay. Sentados en sillas: József Kürschák, George David Birkhoff, Oliver Dimon Kellog, Lipót Fejér. Sentados en el suelo: Tibor Radó, István Lipka, László Kalmár y Pál Szász. Fuente: Wikimedia Commons.

Universidad de Szeged, 1928. De izquierda a derecha (de pie): Frigyes Riesz, Béla Kerékjártó, Alfréd Haar, Gyula Kőnig, Rudolf Ortvay. Sentados en sillas: József Kürschák, George David Birkhoff, Oliver Dimon Kellog, Lipót Fejér. Sentados en el suelo: Tibor Radó, István Lipka, László Kalmár y Pál Szász. Fuente: Wikimedia Commons.Además, Kürschák fue uno de los principales organizadores de los concursos de matemáticas de su país. Para honrar sus contribuciones en esta área, el Concurso de Matemáticas Loránd Eötvös, iniciado en 1925, pasó a llamarse Concurso de Matemáticas József Kürschák en 1949. Él había fallecido dieciséis años antes, el 26 de marzo de 1933.

Referencias

-

Kürschák’s Tile, Futility Closet, 24 de febrero de 2024

-

Alexander Bogomolny, Kürschak’s Tile and Theorem. What is this about? A Mathematical Droodle, Cut the Knot

-

J J O’Connor and E F Robertson, József Kürschák, MacTutor History of Mathematics Archives, University of St Andrews

-

József Kürschák, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo La teselación de József Kürschák se ha escrito en Cuaderno de Cultura Científica.

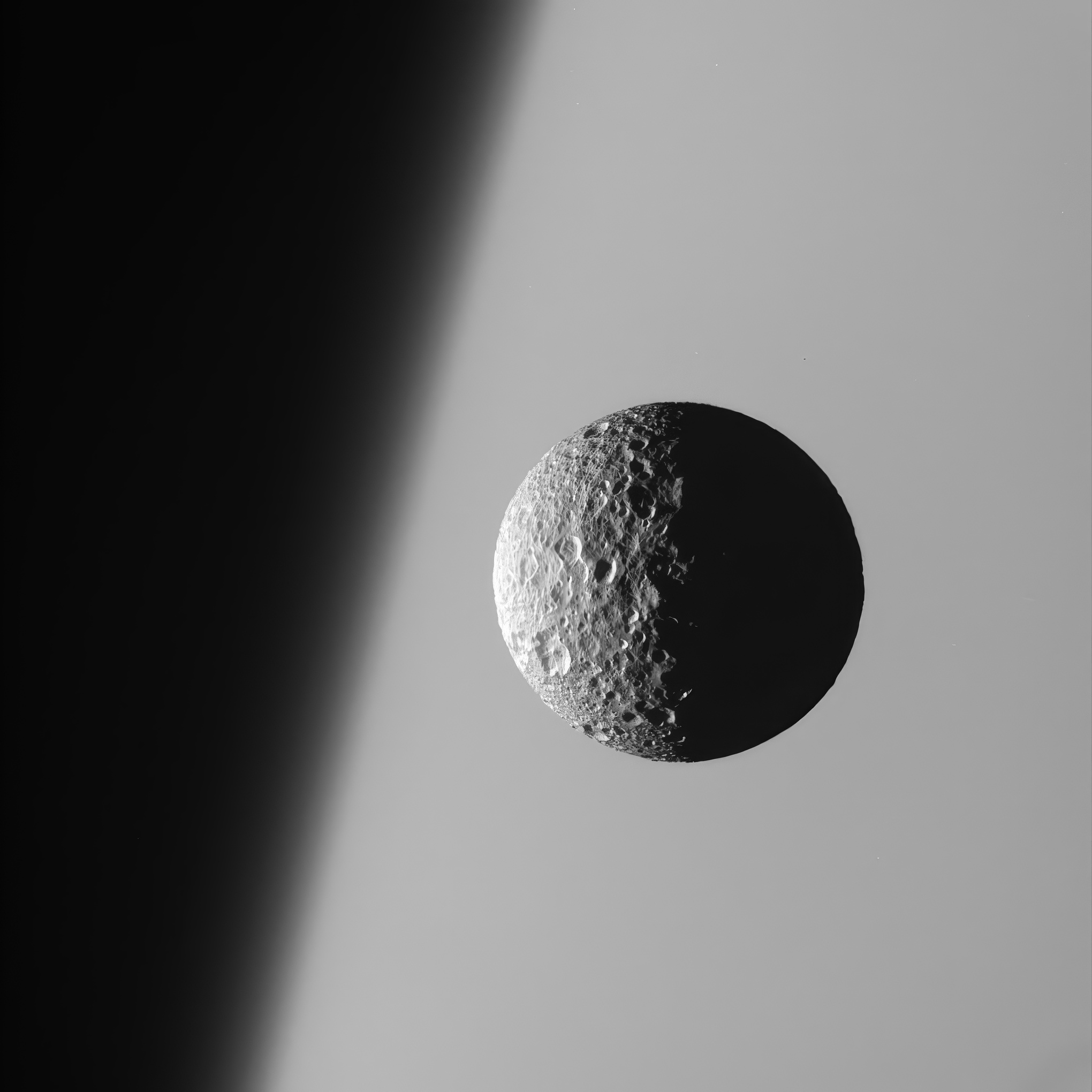

Los mejores barrios para empezar una vida en la galaxia

Algunos vecindarios de la Vía Láctea pueden ser más adecuados que otros para crear planetas habitables.

Un artículo de Rebecca Boyle Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Ilustración: Kristina Armitage / Quanta Magazine

Ilustración: Kristina Armitage / Quanta MagazinePara albergar vida, al menos tal como la conocemos, un planeta debe orbitar una estrella que sea relativamente tranquila y estable. La órbita del planeta también debe ser casi circular para que el planeta experimente un calor similar durante todo el año. Y no debe estar demasiado caliente, para que el agua de la superficie no hierva; ni demasiado frío, para que el agua no se quede fijada en hielo; sino el adecuado, para que los ríos y los mares permanezcan líquidos.

Estas características definen una “zona habitable” alrededor de las estrellas, lugares tentadores a los que apuntar en la búsqueda de exoplanetas aptos para la vida. Pero los científicos someten cada vez más a toda la galaxia a un escrutinio similar. De la misma manera que los continentes con biosferas distintas albergan flora y fauna distintas, diferentes regiones de la galaxia podrían albergar diferentes poblaciones de estrellas y planetas. La turbulenta historia de la Vía Láctea significa que no todos los rincones de la galaxia son iguales y que solo algunas regiones galácticas podrían ser las adecuadas para crear planetas que creemos que podrían estar habitados.

Conforme los científicos exoplanetarios afinan sus ideas sobre dónde buscar vida extraterrestre, ahora están considerando el origen de la estrella y su vecindario, explica Jesper Nielsen, astrónomo de la Universidad de Copenhague. Nuevas simulaciones, junto con observaciones de satélites que buscan planetas y monitorean millones de estrellas, están pintando una imagen de cómo diferentes vecindarios galácticos (y tal vez incluso diferentes galaxias) forman planetas de manera diferente.

«Esto, a su vez, puede ayudarnos a comprender mejor hacia dónde apuntar nuestros telescopios», afirma Nielsen.

Geografía galácticaHoy, la Vía Láctea tiene una estructura complicada. Su agujero negro supermasivo central está rodeado por el «bulbo», una espesa masa de estrellas que contiene a algunos de los ciudadanos más ancianos de la galaxia. El bulbo está rodeado por el “disco delgado”, la estructura que se puede ver serpenteando sobre nuestras cabezas en una noche clara y oscura. La mayoría de las estrellas, incluido el Sol, se encuentran en los brazos en espiral del disco delgado, que están abrazados por un «disco grueso» más ancho que contiene estrellas más viejas. Y un halo difuso, mayoritariamente esférico, de materia oscura, gas caliente y algunas estrellas envuelve toda la arquitectura.

Durante al menos dos décadas, los científicos se han preguntado si las condiciones habitables varían entre esas estructuras. El primer estudio sobre la habitabilidad galáctica data de 2004, cuando los científicos australianos Charles Lineweaver, Yeshe Fenner y Brad Gibson modelaron la historia de la Vía Láctea y la utilizaron para estudiar dónde podrían encontrarse zonas habitables. Querían saber qué estrellas anfitrionas tenían suficientes elementos pesados (como carbono y hierro) para formar planetas rocosos, qué estrellas habían existido el tiempo suficiente para que evolucionara vida compleja y qué estrellas (y cualquier planeta en órbita) estaban a salvo de las supernovas vecinas. Terminaron definiendo una “zona habitable galáctica”, una región en forma de dónut con el agujero centrado en el centro de la galaxia. El límite interior de la región comienza a unos 22.000 años luz del centro galáctico y su límite exterior termina a unos 29.000 años luz.

En las dos décadas posteriores los astrónomos han intentado definir con mayor precisión las variables que controlan la evolución tanto estelar como planetaria dentro de la galaxia, explica Kevin Schlaufman, astrónomo de la Universidad Johns Hopkins. Por ejemplo, continúa, los planetas nacen en discos de polvo que rodean a estrellas recién nacidas y, en pocas palabras, si “un disco protoplanetario tiene mucho material que puede formar rocas, entonces producirá más planetas”.

Algunas regiones de la galaxia pueden estar más densamente sembradas con esos ingredientes formadores de planetas que otras, y los científicos están trabajando ahora para comprender en qué medida los vecindarios galácticos influyen en los planetas que albergan.

Aquí hay exoplanetasEntre los aproximadamente 4.000 exoplanetas conocidos, hasta ahora existen pocas reglas que rijan qué tipos de planetas están en qué sitio; ningún sistema estelar se parece mucho al nuestro, y la mayoría de ellos ni siquiera se parecen mucho entre sí.

Nielsen y sus colegas querían saber si los planetas podrían formarse de manera diferente en el disco grueso, el disco delgado y el halo de la Vía Láctea. En general, las estrellas del disco delgado contienen más elementos pesados que las del disco grueso, lo que significa que surgieron de nubes que también podrían contener más ingredientes formadores de planetas. Utilizando datos del satélite de seguimiento de estrellas Gaia de la Agencia Espacial Europea, Nielsen y sus colegas primero separaron las estrellas en función de la abundancia de ciertos elementos. Luego simularon la formación de planetas entre esas poblaciones.

Sus simulaciones, que publicaron en octubre, mostraron que los planetas gigantes gaseosos y las supertierras (el tipo más común de exoplaneta) crecen más abundantemente en el disco delgado, probablemente porque (como se esperaba) esas estrellas tienen más material de construcción con el cual trabajar. También descubrieron que las estrellas más jóvenes con elementos más pesados tienden a albergar más planetas en general, y que los planetas gigantes son más comunes que los más pequeños. Por el contrario, los gigantes gaseosos son casi inexistentes en el disco grueso y el halo.

Schlaufman, que no participó en el trabajo, comenta que los resultados tienen sentido. La composición del polvo y el gas a partir del cual nacen las estrellas es crucial para determinar si las estrellas formarán planetas. Y aunque esa composición puede variar según la ubicación, argumenta que si bien la ubicación puede preparar el escenario para la construcción de mundos de una estrella, puede no determinar el resultado final.

Las simulaciones de Nielsen son teóricas, pero algunas observaciones recientes respaldan sus hallazgos.

En junio, un estudio que utilizó datos del telescopio espacial Kepler de la NASA, que busca planetas, encontró que las estrellas en el disco delgado de la Vía Láctea tienen más planetas, especialmente supertierras y mundos de tamaño subneptuno, que las estrellas en el disco grueso. Una explicación, apunta Jessie Christiansen, científica exoplanetaria del Instituto de Tecnología de California y coautora del estudio, es que las estrellas viejas del disco grueso pueden haber nacido cuando los ingredientes para formar planetas eran escasos, antes de que generaciones de estrellas moribundas sembrase el cosmos con los componentes básicos de los mundos. O tal vez las estrellas de disco grueso nacieron en ambientes densos y de alta radiación, donde la turbulencia impide que los planetas nacientes lleguen a fusionarse.

A los planetas les puede ir mejor en áreas abiertas, como los suburbios, en lugar de en áreas “urbanas” densamente pobladas, afirma Christiansen. Nuestro sol se encuentra en una de esas zonas suburbanas escasamente pobladas.

Otras TierrasLos estudios de Christiansen y las simulaciones de Nielsen se encuentran entre los primeros en estudiar la ocurrencia de planetas en función del vecindario galáctico; Vedant Chandra, astrónomo del Centro Harvard-Smithsonian de Astrofísica, se está preparando para ir un paso más allá y estudiar si la formación de planetas podría haber sido diferente en algunas de las galaxias que la Vía Láctea consumió a medida que crecía. En el futuro Nielsen espera que estudios e instrumentos perfeccionados, como el próximo telescopio espacial Nancy Grace Roman de la NASA, nos ayuden a comprender la formación de planetas de la misma manera que los demógrafos entienden las poblaciones. ¿Podemos predecir qué tipos de estrellas albergarán qué tipos de planetas? ¿Es más probable que las Tierras se formen en ciertos vecindarios? Y si sabemos dónde mirar, ¿encontraremos algo mirándonos?

Sabemos que vivimos en una zona habitable, en un mundo que orbita alrededor de una estrella tranquila. Pero cómo empezó la vida en la Tierra, y cuándo y por qué, es la pregunta más importante de todos los campos de la ciencia. Quizás los científicos también deberían pensar en la historia del origen de nuestra estrella, e incluso en la de los ancestros estelares que dieron forma a nuestro rincón de la Vía Láctea, hace miles de millones de años.

“¿Era inevitable la vida en la Tierra? ¿Fue especial?” se pregunta Chandra. «Solo una vez que empieces a tener esta imagen global… podrás empezar a responder preguntas como esa».

El artículo original, The Best Neighborhoods for Starting a Life in the Galaxy, se publicó el 24 de enero de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo Los mejores barrios para empezar una vida en la galaxia se ha escrito en Cuaderno de Cultura Científica.

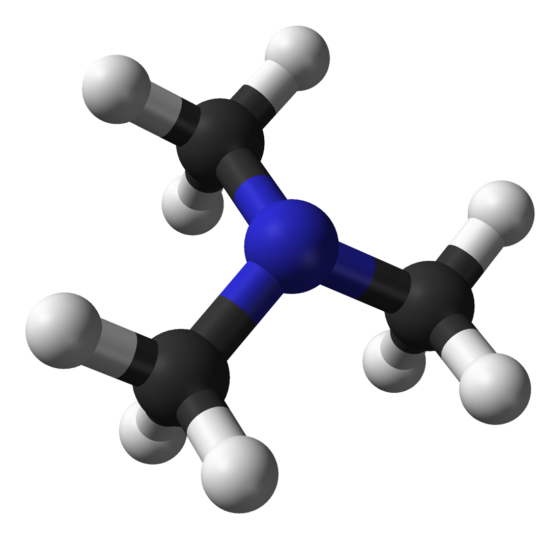

Aquí huele a pescado podrido: la trimetilamina

Pocos olores hay tan desagradables como el del pescado en mal estado. Cuando esa lubina comprada hace varios días que permanece en la nevera empieza a desprender un aroma nauseabundo, no hay vuelta atrás: la trimetilamina ya ha aparecido como producto de descomposición. Esta molécula también es la responsable del mal aliento y del molesto olor de algunas personas con alteraciones en el metabolismo de determinados aminoácidos.

Fuente: Pexels¿Qué es la trimetilamina?

Fuente: Pexels¿Qué es la trimetilamina?

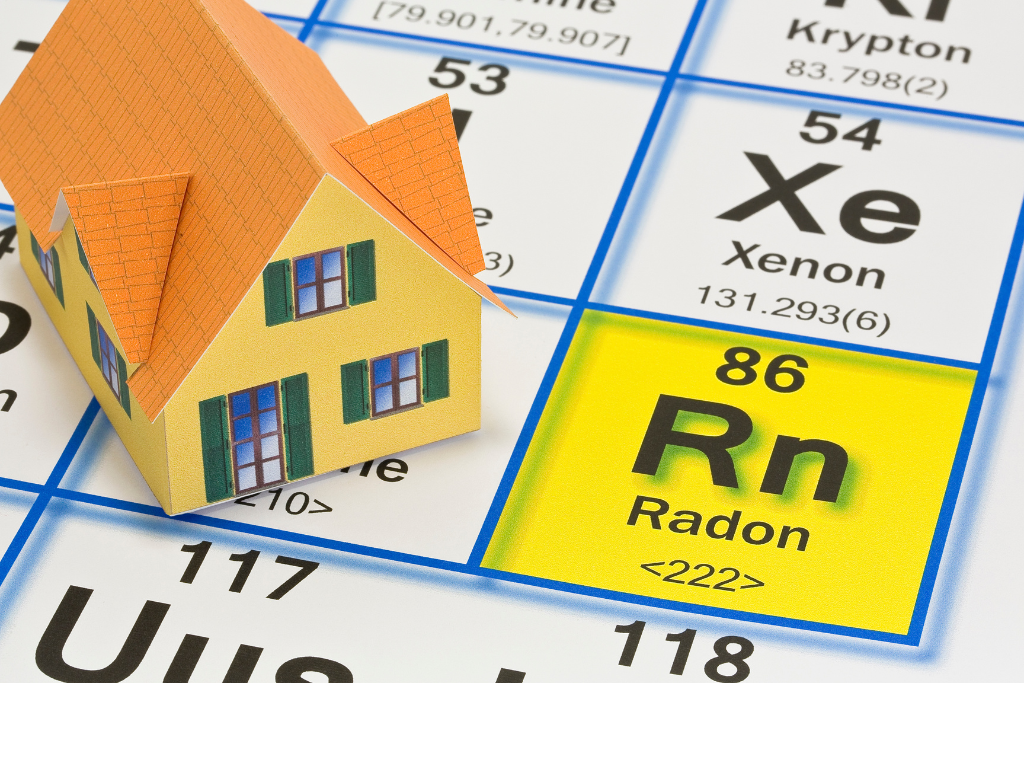

La trimetilamina (TMA), compuesto orgánico de fórmula N(CH3)3, es un gas irritante e incoloro a temperatura ambiente que en contacto con las membranas de las mucosas causa necrosis y corrosión. Se trata de una amina terciaria, fácilmente soluble en el agua y más básica que el amoniaco. La TMA es un producto de degradación microbiana de macromoléculas nitrogenadas tales como la colina, la L-carnitina y la betaína presentes en los tejidos de animales y plantas.

Trimetilamina. Nitrógeno en azul, carbono en negro, hidrógeno en blanco. Fuente: Wikimedia Commons

Trimetilamina. Nitrógeno en azul, carbono en negro, hidrógeno en blanco. Fuente: Wikimedia CommonsEn el agua salada, los animales marinos presentan sustancias que equilibran y limitan la concentración salina en el interior de sus células. Entre estos compuestos, el óxido de trimetilamina (TMAO) supone alrededor del 5% del tejido muscular de los peces de mar (atún, anchoa, dorada, gallo, pez espada, rodaballo…). Aunque este componente es inodoro y no da sabor, el TMAO se oxida y se transforma en TMA pocos minutos tras la muerte del pez por la acción de las bacterias y enzimas de su cuerpo. A eso hay que sumar la acción del aire, que también contribuye a la degradación de las grasas y de la urea en amoniaco. Todo ello compone una fétida mezcla de compuestos volátiles que son señal inequívoca de que el pescado no está fresco.

El olor a pescado en los humanosLos seres humanos también sintetizamos TMA como producto de la degradación de aminoácidos como la colina y la carnitina, pero en individuos sanos pasa desapercibido al transformarse a TMAO en el hígado y excretarse en la orina. Existe un trastorno del metabolismo por el cual algunas personas desprenden un intenso olor a pescado en descomposición debido a un fallo de las enzimas que llevan a cabo esta reacción. Aunque es una enfermedad rara, la trimetilaminuria o síndrome del olor a pescado tiene un origen genético y provoca que las personas afectadas expulsen elevadas concentraciones de TMA en la orina, el sudor, el aliento y otros fluidos, como los vaginales en las mujeres.

Los niveles elevados de trimetilamina no son tóxicos para el organismo, pero el olor corporal de las personas con trimetilaminuria puede degenerar en problemas psicosociales por aislamiento y baja autoestima. Actualmente, no existe tratamiento específico y las recomendaciones para mitigar el mal olor pasan por reducir la ingesta de productos ricos en aminoácidos ricos en azufre y nitrógeno (como los pescados azules, las legumbres, la carne y la clara de huevo).

Fuente: PexelsUna delicatessen sueca apestosa

Fuente: PexelsUna delicatessen sueca apestosa

El mal olor que desprende el pescado suele ser un indicador fiable de que no se encuentra en buen estado y nos puede ahorrar una desagradable intoxicación alimentaria. Sin embargo, existe una curiosa excepción: el surströmming. Este producto típico de Suecia consiste en arenques del Mar Báltico fermentados y es considerado uno de los alimentos más hediondos jamás creados por el ser humano. En este caso, el mal olor no se debe a la TMA desprendida por el pescado, sino a los productos de la fermentación que se encuentran en la propia salmuera. El surströmming suele venderse en latas, donde las bacterias del género Haloanaerobium producen dióxido de carbono y varios componentes que provocan su particular olor: ácido propanoico, sulfuro de hidrógeno (huevo podrido), ácido butírico (mantequilla rancia) y ácido acético (vinagre).

Pese a ser un producto tradicional, su consumo está descendiendo y la respuesta parece encontrarse en la genética. Un estudio publicado en la revista Current Biology relacionó la aversión hacia el hedor de este producto con una variante genética del gen TAAR5, responsable de la síntesis de un receptor olfativo encargado de detectar la ya archiconocida TMA. Vamos, que cientos de años de evolución nos han preparado para evitar la comida podrida.

En conclusión, el olor desagradable del pescado podrido se debe al compuesto volátil trimetilamina. Esta molécula, formada a partir de la descomposición bacteriana de TMAO presente en el pescado, aumenta a medida que progresa la degradación y su detección olfativa nos alerta de que el producto no se encuentra fresco. Más allá del pescado en mal estado, la trimetilamina también está vinculada al olor penetrante del mal aliento y el sudor de algunas personas que presentan alteraciones en el metabolismo de algunos aminoácidos. Un mal olor que también está presente y nos hace rechazar otros platos típicos, como el sueco surströmming, en el que el repugnante aroma se debe a la fermentación. En conjunto, la trimetilamina ejemplifica la intersección entre la química, la percepción sensorial y la cultura culinaria.

Referencias:

1. Instituto Nacional de Seguridad y Salud en el Trabajo DLEP 142 – Trimetilamina

2. Márquez Moreno (2013) Síndrome del olor a pescado: trimetilaminuria Formación Activa en Pediatría de Atención Primaria 6, 4

Sobre la autora: Raquel Gómez Molina es química especialista en laboratorio clínico y comunicación científica

El artículo Aquí huele a pescado podrido: la trimetilamina se ha escrito en Cuaderno de Cultura Científica.

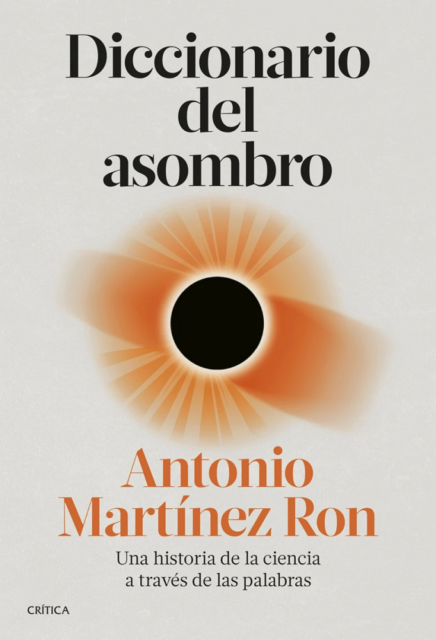

Diccionario del asombro

Quizás conozca la palabra clina, o quizás no. Expresa la variación gradual de un rasgo. La palabra fue idea de Julian Huxley, quien la usó para referirse a la variación gradual, a lo largo de un espacio geográfico, de rasgos fenotípicos dentro de una misma especie. Proviene del griego cline (κλινειν), que significa «inclinación», un étimo que contiene, a su vez, la raíz indoeuropea klei, que expresa inclinación, pendiente o subida.

Los términos científicos sinclinal y anticlinal también están relacionados con Klei. Pero la presencia de esa raíz no se limita a términos técnicos, ni muchísimo menos. El lenguaje común está plagado de palabras que la contienen: Inclinar, reclinar, declinar, proclive, clínica, cliente y hasta clima, son palabras relacionadas con klei. Y es probable que clítoris también sea una de ellas.

La etimología es una disciplina preciosa. Además de satisfacer la curiosidad acerca del origen de las palabras, el hecho de conocer cómo se han generado significados transfiriendo propiedades de unos objetos a otros o de unos hechos a otros –en otras palabras, cómo se ha recurrido a elaboraciones metafóricas para expresar nuevas nociones– aporta un conocimiento más profundo también de los conceptos a los que dan nombre las palabras.

En “Diccionario del asombro. Una historia de la ciencia a través de las palabras” hay bastante de esto. Antonio Martínez Ron, su autor, ha escogido un término por cada letra del alfabeto y, a la vez que introduce el marco conceptual al que corresponde la palabra, hace un breve recorrido, a medio camino entre temporal y etimológico, por las nociones y términos emparentados con el que da título al capítulo.

A cada uno de los capítulos antecede un calendario en forma de línea vertical de la que salen, en su correspondiente fecha de creación, las diversas palabras que nombran conceptos relacionados con el de la palabra que da nombre al capítulo. Así, el capítulo “G de Gen” viene precedido de un calendario en el que aparece, en primer lugar “eugenesia” y que termina con “CRISPR”. A lo largo del tiempo transcurrido desde la primera a la última han pasado cromosoma, ácido nucleico, clon, genética, gen, epigenética, transhumanismo, meme y LUCA, aunque en el texto se van glosando muchas otras, siempre con la fecha en que se usaron por primera vez. De esa forma se puede trazar la historia de la disciplina, en este caso de la genética.

A lo largo de las sucesivas letras –de los sucesivos capítulos–, Martínez Ron va construyendo de ese modo una historia de la ciencia diferente, en la que, a la dimensión cronológica, se une otra terminológica que redunda en un conocimiento más profundo de las nociones y de la secuencia de hallazgos que jalonaron el desarrollo del campo del saber al que pertenecen esas nociones.

En sendos apéndices, el autor, de propina, nos ofrece dos breves colecciones adicionales de palabras. En la primera incluye términos creados originalmente en idioma español; no son muchos, pero es una colección interesante, con alguna incorporación muy reciente. Y en el segundo apéndice incluye otra relación de palabras que al autor le ha parecido que debían figurar en su diccionario y para las que no había encontrado acomodo en los capítulos regulares.

Hay un apotegma vasco que dice «izena duenak izana du». Literalmente, «lo que tiene nombre, tiene ser» o, lo que es lo mismo, «lo que tiene nombre, existe». En cierto modo, resulta más expresivo en forma negativa, porque igualmente podría decirse que lo que carece de nombre, no existe. El proverbio vasco refleja fielmente una de las ideas que inspiran el “Diccionario del asombro”. El avance del conocimiento científico produce nuevos conceptos. Pero los conceptos no cristalizan, no se pueden compartir, difundir, ni utilizar, si no se nombran. De hecho, en muchas ocasiones ni tan siquiera existen en tanto no se les da un nombre: izena duenak, izana du. La etimología es una fecunda fuente de saber, también en ciencia.

Título: Diccionario del asombro. Una historia de la ciencia a través de las palabras

Autor: Antonio Martínez Ron

Ed. Crítica, 2023.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

Una versión de este texto de Juan Ignacio Pérez Iglesias apareció anteriormente en Lecturas y Conjeturas (Substack).

El artículo Diccionario del asombro se ha escrito en Cuaderno de Cultura Científica.

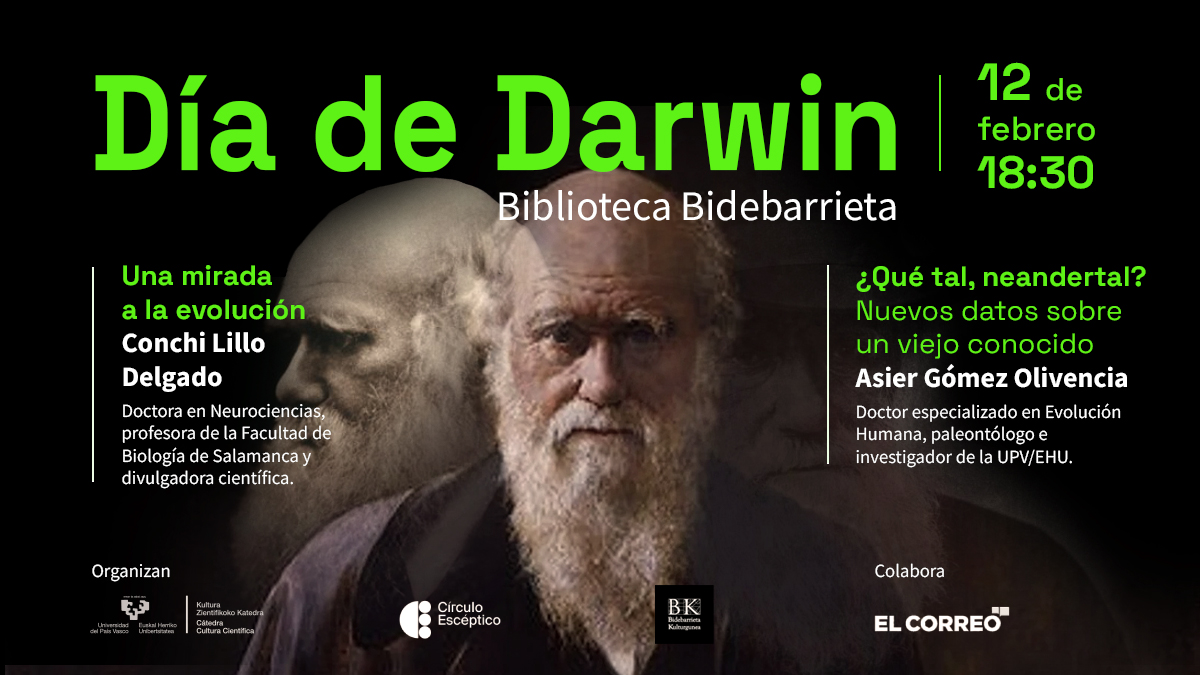

Día de Darwin 2024: evolución del sistema visual y neandertales

Tras 150 años siendo objeto de estudio, ¿se puede decir algo nuevo sobre los neandertales? ¿Sabemos cómo ha condicionado la visión en la evolución de los seres vivos? Esas son algunas de las preguntas que se van a plantear en la decimoctava edición del Día de Darwin.

Esta nueva edición tuvo lugar el 12 de febrero en la Biblioteca Bidebarrieta de Bilbao, justo cuando se cumplen 215 años del nacimiento del geólogo y biólogo inglés Charles Darwin y contará con la participación de la doctora en Neurociencias y profesora de la Facultad de Biología de Salamanca Conchi Lillo Delgado y el doctor, paleontólogo e investigador de la UPV/EHU, Asier Gómez Olivencia que ofrecerán dos charlas de 40 minutos cada una.

Lillo Delgado ofrece la charla “Una mirada a la evolución” en la que, partiendo desde las curiosidades y características de los vertebrados e invertebrados, explica cómo funciona el sistema visual de los seres vivos que, captando las formas, colores y profundidad del mundo que les rodean han desarrollado ventajas evolutivas para sobrevivir y defenderse.

Gómez Olivencia, por su parte, acerca al público los últimos descubrimientos que se han hecho en torno a los neandertales con la charla titulada “¿Qué tal, neandertal? Nuevos datos sobre un viejo conocido”, en la que profundiza en los nuevos hallazgos gracias a la utilización de nuevas tecnologías y la revisión de yacimientos clásicos.

El Día de Darwin es una iniciativa organizada desde 2007 por la Cátedra de Cultura Científica de la Universidad del País Vasco, el Círculo Escéptico y la Biblioteca Bidebarrieta de Bilbao. Una cita que se ha convertido en ineludible para los y las aficionadas a la ciencia y que cuenta con la ayuda del diario El Correo.

PonentesConchi Lillo Delgado es bióloga y doctora en Neurociencias y profesora en la Facultad de Biología de la Universidad de Salamanca. Su área de investigación es el de la neurobiología de la visión en el Instituto de Neurociencias de Castilla y León. En su faceta de divulgadora científica hay que destacar la publicación del libro ¡Abre los ojos! y la colaboración con distintas plataformas de divulgación como Naukas, The Conversation o una sección quincenal en el programa Hoy por Hoy en Ser Salamanca.

Asier Gómez Olivencia es doctor y paleontólogo especializado en Evolución Humana. Cuenta con una dilatada experiencia de investigación y publicación con más de 90 artículos científicos. Realizó su tesis en el Equipo de Investigación de Atapuerca, ha trabajado en la Universidad de Cambridge y en el Musée de l´Homme de París y en 2014 se incorporó a la Universidad del País Vasco, primero como investigador Ikerbasque y después como investigador Ramón y Cajal. Además de excavar en Atapuerca, dirige la excavación en varios yacimientos de Euskadi.

Edición realizada por César Tomé López

El artículo Día de Darwin 2024: evolución del sistema visual y neandertales se ha escrito en Cuaderno de Cultura Científica.

Las cinco imágenes de la supernova Refsdal

Una técnica pionera para medir la velocidad de expansión del universo ofrece una visión nueva e independiente sobre un viejo debate y podría ayudar a determinar la edad del universo con mayor precisión. Uno de los miembros del equipo que la ha desarrollado es Tom Broadhurst, profesor de investigación Ikerbasque de la UPV/EHU y asociado del DIPC.

En astronomía hay dos mediciones precisas de la expansión del universo, conocida también como «constante de Hubble». Una se calcula a partir de las observaciones próximas de las supernovas (las enormes explosiones que se producen al finalizar el ciclo de vida de algunas estrellas) y la segunda emplea el «fondo cósmico de microondas» o la radiación que comenzó a fluir libremente por el universo poco después del Big Bang. Pero estas dos mediciones difieren en un 10 % aproximadamente, lo que ha suscitado un amplio debate entre los físicos y los astrónomos. Si ambas mediciones son precisas, ello significa que la teoría actual que sostienen los científicos sobre la composición del universo es incompleta.

Un equipo internacional del que forma parte Tom Broadhurst, profesor de investigación Ikerbasque de la Universidad del País Vasco (UPV/EHU) y asociado del Donostia International Physics Center (DIPC), ha realizado un nuevo cálculo de la constante de Hubble analizando la luz de múltiples apariciones de una supernova.

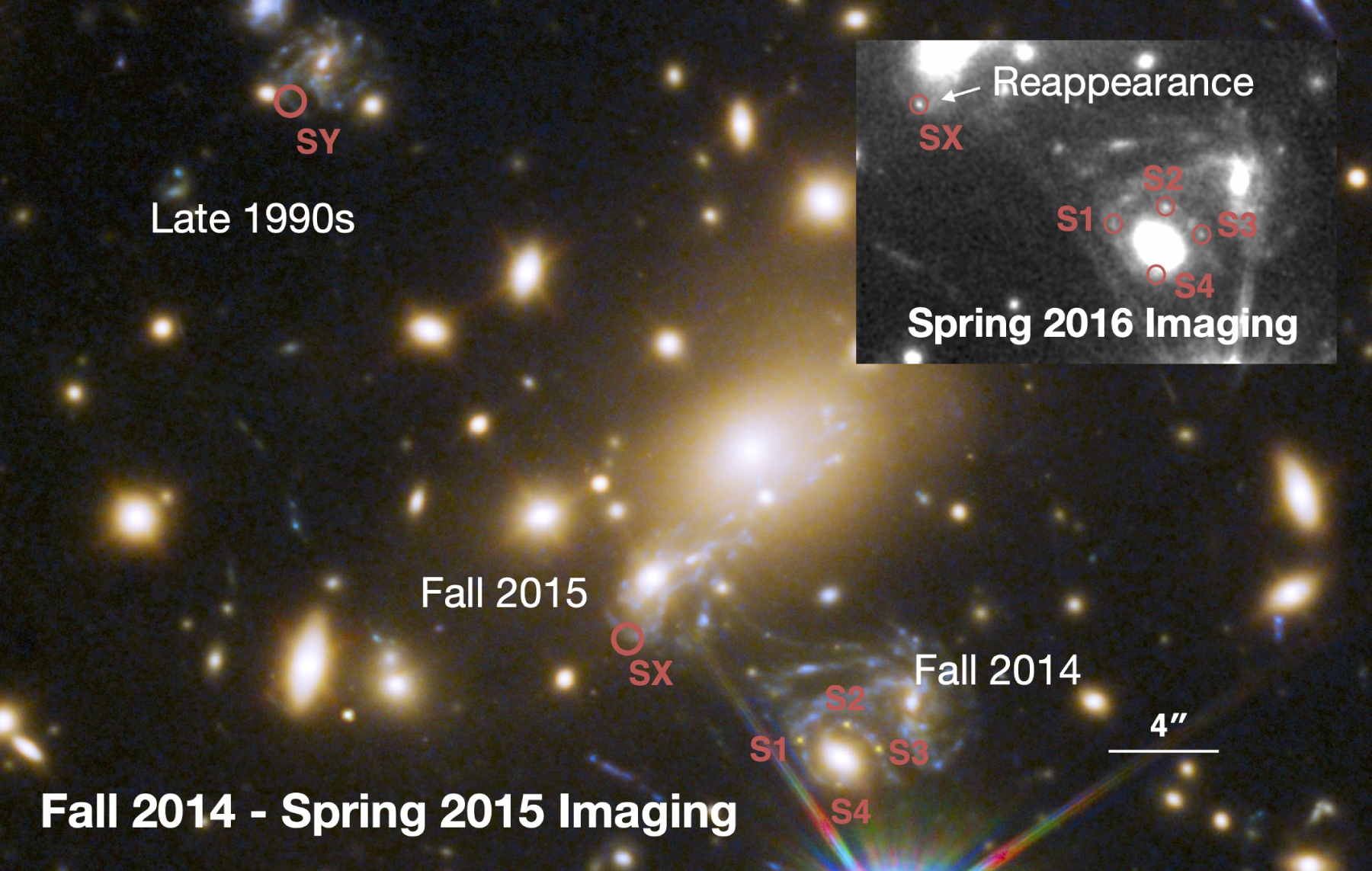

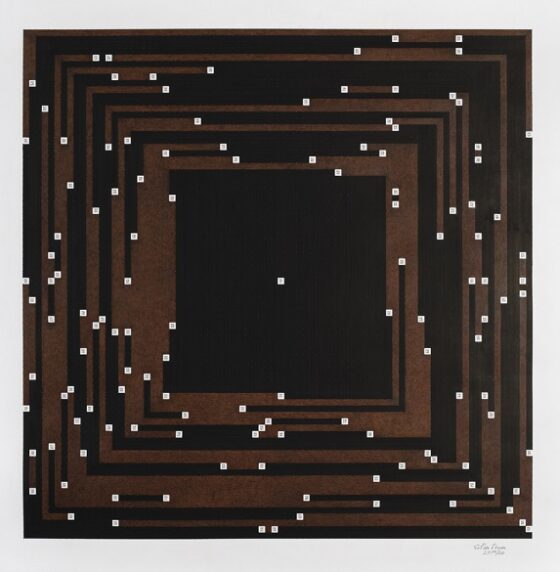

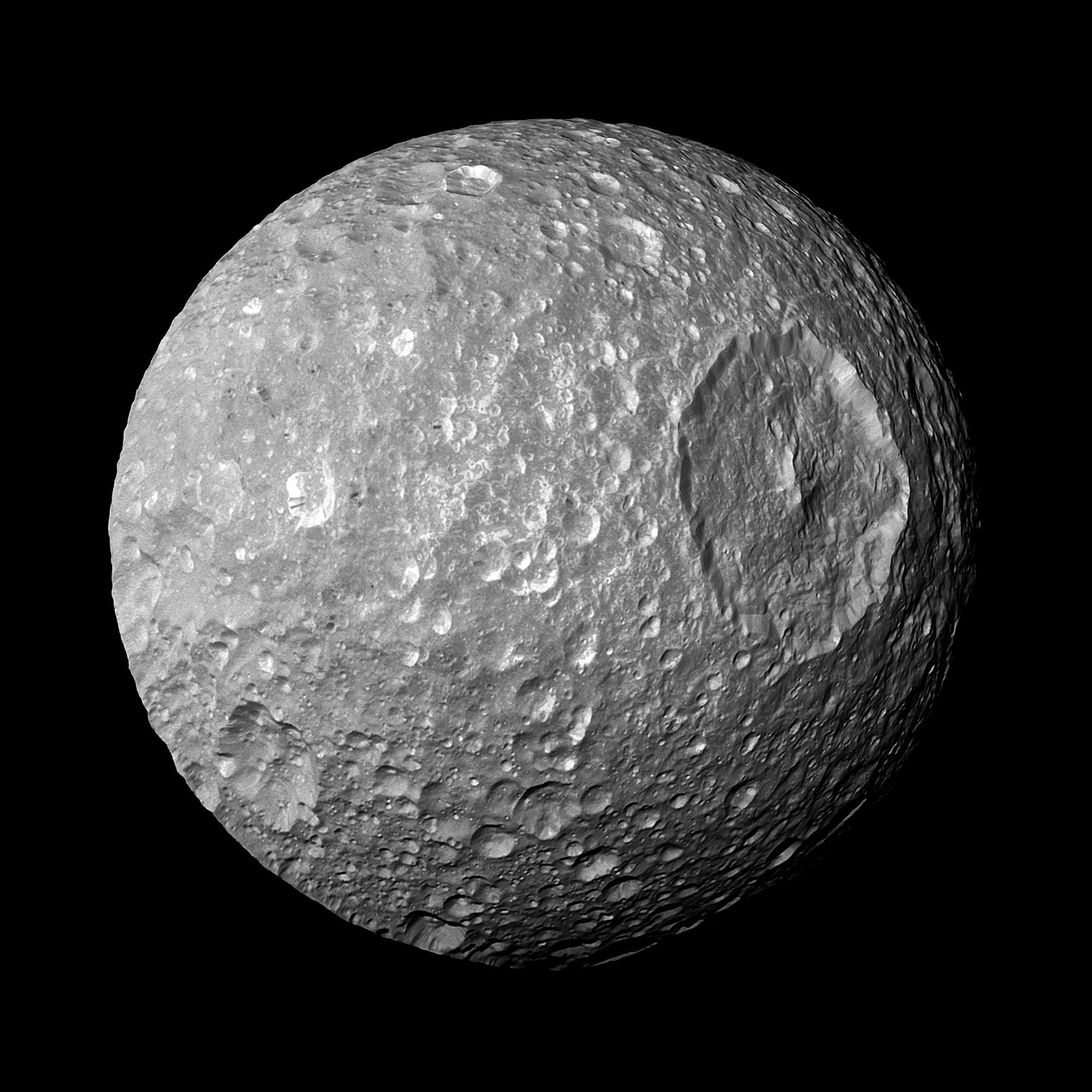

Imagen del cúmulo de galaxias MACS J1149 y las localizaciones y el tiempo de las apariciones de la supernova Refsdal. Fuente: Patrick L. Kelly et al (2023) ApJ 948 93

Imagen del cúmulo de galaxias MACS J1149 y las localizaciones y el tiempo de las apariciones de la supernova Refsdal. Fuente: Patrick L. Kelly et al (2023) ApJ 948 93«Si las nuevas mediciones independientes confirman esta discrepancia entre ambas mediciones de la constante de Hubble, ello haría tambalear nuestros conocimientos y comprensión sobre el cosmos», señala Patrick Kelly, autor principal del estudio y profesor adjunto de la Escuela de Física y Astronomía de la Universidad de Minnesota. «La gran pregunta es si hay un posible problema con una o ambas mediciones. Nuestra investigación aborda esto midiendo de manera independiente y completamente diferente la tasa de expansión del universo».

Relación entre materia oscura y energía oscuraEl equipo ha calculado esta tasa de expansión utilizando datos de la supernova Refsdal, el primer ejemplo de supernova observada con una imagen multiplicada, es decir, el telescopio capturó cuatro imágenes diferentes del mismo evento cósmico. Tras el descubrimiento, equipos de todo el mundo predijeron que la supernova reaparecería en una nueva posición en 2015 y el equipo de la Universidad de Minnesota detectó esta imagen adicional. Estas imágenes múltiples aparecieron porque la supernova fue distorsionada por la lente gravitacional de un cúmulo de galaxias, un fenómeno por el cual la masa del cúmulo dobla y aumenta la luz. Empleando los retardos entre las apariciones de las imágenes de 2014 y 2015, los investigadores han podido medir la constante de Hubble aplicando una teoría desarrollada en 1964 por el astrónomo noruego Sjur Refsdal y que previamente no se había podido poner en práctica.

La nueva medición de la constante de Hubble coincide más con la del fondo cósmico de microondas «y confirma nuestra tesis de que la velocidad de expansión del universo se ve dominada por la presión exterior de la energía oscura y se compensa con la autogravedad de la materia oscura, de tal manera que actualmente se está acelerando», concluye Tom Broadhurst.

Referencias:

Patrick L. Kelly, Steven Rodney, Tommaso Treu, Masamune Oguri, Wenlei Chen, Adi Zitrin, Simon Birrer, Vivien Bonvin, Luc Dessart, Jose M. Diego, Alexei V. Filippenko, Ryan J. Foley, Daniel Gilman, Jens Hjorth, Mathilde Jauzac, Kaisey Mandel, Martin Millón, Justin Pierel, Keren Sharon, Stephen Thorp, Liliya Williams, Tom Broadhurst, Alan Dressler, Or Graur, Saurabh Jha, Curtis McCully, Marc Postman, Kasper Borello Schmidt, Brad E. Tucker, Anja von der Linden (2023) Constraints on Hubble constant from Supernova Refsdal’s reappearance Science doi: 10.1126/science.abh1322

Patrick L. Kelly, Steven Rodney, Tommaso Treu, Simon Birrer, Vivien Bonvin, Luc Dessart, Ryan J. Foley, Alexei V. Filippenko, Daniel Gilman, Saurabh Jha, Jens Hjorth, Kaisey Mandel, Martin Millon, Justin Pierel, Stephen Thorp, Adi Zitrin, Tom Broadhurst, Wenlei Chen, Jose M. Diego, Alan Dressler, Or Graur, Mathilde Jauzac, Matthew A. Malkan, Curtis McCully, Masamune Oguri, Marc Postman, Kasper Borello Schmidt, Keren Sharon, Brad E. Tucker, Anja von der Linden eta Joachim Wambsganss (2023) The Magnificent Five Images of Supernova Refsdal: Time Delay and Magnification Measurements The Astrophysical Journal doi: 10.3847/1538-4357/ac4ccb

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Las cinco imágenes de la supernova Refsdal se ha escrito en Cuaderno de Cultura Científica.

Viendo pasar el tiempo

¿Qué es, pues, el tiempo? Si nadie me lo pregunta, lo sé; pero si quiero explicárselo al que me lo pregunta, no lo sé. Lo que sí digo sin vacilación es que sé que si nada pasase no habría tiempo pasado; y si nada sucediese, no habría tiempo futuro; y si nada existiese, no habría tiempo presente.

Esta es una de las citas más populares de San Agustín de Hipona. Aparece en sus Confesiones (397-398 d. C.). Y, aunque él hacía este planteamiento desde el punto de vista de la teología, lo cierto es que también estaba planteando una de las cuestiones más fundamentales de la física.

Foto: zero take / Unsplash

Foto: zero take / UnsplashLa física trata de desentrañar las leyes que rigen el universo a través, en primer lugar, de la observación de los fenómenos de la naturaleza, pero curiosamente, en estas leyes se manifiesta una propiedad que choca de frente con nuestra experiencia: no determinan ninguna dirección preferente para el transcurrir del tiempo. Las leyes de la mecánica clásica, del electromagnetismo, la relatividad o la mecánica cuántica funcionan «hacia delante» y «hacia atrás», no diferencian entre pasado y futuro; y también da igual cuándo empecemos a medir, se cumplen en cualquier instante. Decimos que presentan simetría temporal.

¿Por qué, entonces, tenemos la sensación de que el tiempo va siempre en la misma dirección? Vivimos en un mundo de causas y efectos que, de hecho, utilizamos para ordenar y explicar el mundo que observamos. No experimentamos regresiones al pasado ni bucles ni saltos temporales ―aunque en ocasiones daríamos cualquier cosa porque fuera así―, sino que todo sucede en una línea ordenada de eventos sucesivos. ¿Cuál es la explicación? ¿Acaso está mal el formalismo de la física? ¿Qué nos estamos perdiendo?

Para responder a todas estas preguntas hay que sumergirse en las matemáticas sobre las que se sostiene el andamiaje de la física. En concreto, en uno de sus principios más conocidos: el de la conservación de la energía.

En 1915, Emmy Noether formuló el que probablemente sea uno de los teoremas más bellos de la física: «A cada simetría continua le corresponde una ley de conservación, y viceversa». Así, la simetría espacial ―traslaciones en el espacio―, estaría relacionada con la conservación del momento lineal; la simetría de rotación, con la conservación del momento angular, y la temporal… con la conservación de la energía. Existen más, pero, de momento, nos quedaremos con estos ejemplos. Todo esto se puede expresar de una manera más sencilla: las leyes de la física son las mismas aquí, a cincuenta metros de aquí y en una galaxia muy, muy lejana; también si miramos nuestro sistema de frente, de espaldas, por arriba, por abajo o de lado. Y, por supuesto, siguen siendo las mismas hoy, que ayer, que en la antigua Mesopotamia, y tampoco esperamos que cambien sustancialmente con el paso de los eones.

La matemática Emmy Noether (1882-1935). Foto: CC BY-SA 2.0/Konrad Jacobs, Erlangen

La matemática Emmy Noether (1882-1935). Foto: CC BY-SA 2.0/Konrad Jacobs, Erlangen

He aquí la clave: la simetría temporal está relacionada con el teorema de conservación de la energía, así que no existirá simetría temporal en aquellos tipos de fenómenos en los que la energía no se conserve. Y nuestro entorno está lleno de ellos. Sirvan como ejemplo los sistemas que disipan calor.

La flecha del tiempo termodinámicaFue en el ámbito de la termodinámica donde se encontró por primera vez una ley que parecía explicar por qué vemos que determinados procesos siempre se desarrollan en un sentido y no en otro, y nos da esa percepción de dirección temporal «hacia delante»; el teorema de Clausius: «Es imposible un proceso cuyo único resultado sea transferir energía en forma de calor de un objeto a otro a mayor temperatura». O, dicho de otra forma: la transferencia de calor siempre se produce desde los cuerpos más calientes a los más fríos, salvo que se realice un trabajo externo. Rudolf Clausius definió también la entropía como esa parte de la energía de un sistema que no se puede aprovechar para realizar ningún trabajo, y llegó a la conclusión de que, en sistemas aislados, esta magnitud tendía a incrementarse con el tiempo. Le había otorgado entidad matemática al principio que Nicolás Carnot había planteado en 1834, o segundo principio de la termodinámica.

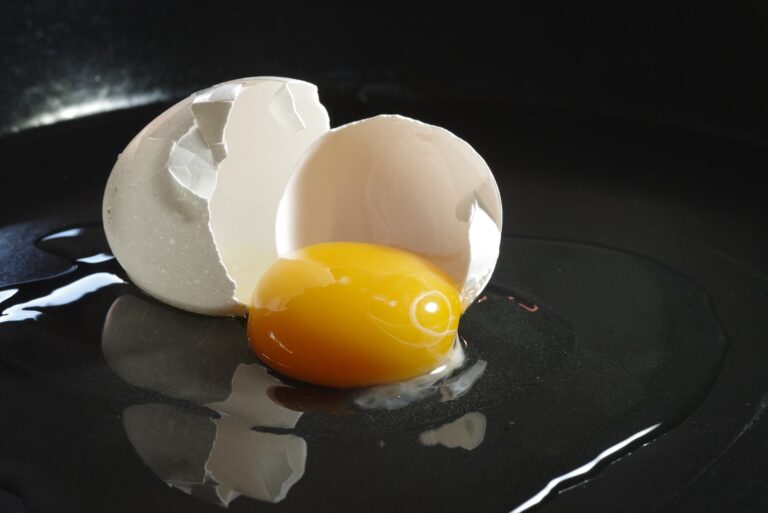

Seguro que cualquiera ha visto cómo se rompe un huevo al caer al suelo, pero nadie ha observado que, espontáneamente, un huevo roto se vuelva a recomponer. La ley de Clausius establece una dirección preferente para el transcurrir del tiempo, y esa dirección es aquella en la que la entropía de un sistema aumenta. Este sería un ejemplo. Foto: CC BY-SA 4.0/Balise42

Seguro que cualquiera ha visto cómo se rompe un huevo al caer al suelo, pero nadie ha observado que, espontáneamente, un huevo roto se vuelva a recomponer. La ley de Clausius establece una dirección preferente para el transcurrir del tiempo, y esa dirección es aquella en la que la entropía de un sistema aumenta. Este sería un ejemplo. Foto: CC BY-SA 4.0/Balise42

Ludwig Boltzmann ampliaría el concepto de entropía de Clausius aplicándolo al ámbito de la mecánica estadística, esto es, la rama de la termodinámica que estudia el comportamiento de sistemas compuestos por un gran número de partículas. A partir del análisis estadístico de los comportamientos microscópicos de átomos y moléculas, se pueden deducir propiedades macroscópicas como la temperatura, el volumen o la presión, así como la entropía. Es por esta visión de Boltzmann por lo que habitualmente se suele definir la entropía como el grado de «desorden» de un sistema, pero no es exactamente eso.

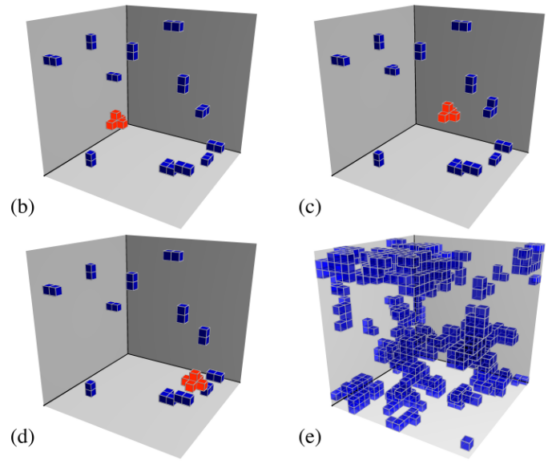

En el mundo de los sistemas termodinámicos formados por muchas partículas existen innumerables, y diferentes, configuraciones microscópicas que pueden dar lugar a las mismas propiedades macroscópicas. Veámoslo con un ejemplo muy fácil: la habitación de un adolescente. ¿Cuántas formas hay de que la habitación de un adolescente esté recogida y cuántas de que esté hecha un desastre? Para el primer caso, seguramente solo unas pocas: la ropa debe estar en el armario, la cama hecha, el escritorio ordenado…, pero para el segundo caso la cosa cambia. Las maneras en que el cuarto de un adolescente puede estar hecho una pocilga son incontables y mucho más numerosas. La forma en la que se pueden distribuir los objetos, enseres, ropa y bolsas vacías de patatas fritas son muchísimas más, sin lugar a dudas. Así que, probablemente, cuando una madre o un padre entren a la habitación de sus hijos por sorpresa se la van a encontrar desordenada.

Esto es lo que, en realidad, nos dice la entropía de Boltzmann sobre la dirección del tiempo: de todas las configuraciones que puede adoptar un sistema microscópico, hay una probabilidad aplastantemente más alta de encontrarlo en un estado desordenado que en uno ordenado. No es que haya una magia oculta que haga que todo fluya irremediablemente hacia el desorden, es que, poniendo un ejemplo, las posibles configuraciones de las moléculas de H₂O para encontrar agua en forma de cubitos de hielo ―sistema ordenado― son muchísimo más bajas que las posibles configuraciones de esas mismas moléculas para encontrar agua líquida o vapor ―sistemas desordenados―. ¿Sería imposible que el huevo que aparecía en la imagen anterior se recompusiera espontáneamente? Bueno… las leyes de la física no lo prohíben, pero la posibilidad es tan remota ―tan, tan, tan extremadamente remota―, que no tiene sentido ni planteársela.

Otras flechas del tiempoPor supuesto, la flecha del tiempo termodinámica que hemos explicado no es la única que existe. Con el tiempo se han ido descubriendo otro tipo de sistemas que también muestran una asimetría temporal. Esta también se manifiesta en la evolución temporal que ha sufrido nuestro universo tras el big bang, hacia un estado de mayor entropía ―flecha del tiempo cosmológica―; en el proceso de medida de un sistema cuántico ―flecha del tiempo de la mecánica cuántica―, en algunos procesos nucleares, como el decaimiento radiactivo. Pero lo que no sabemos es si esto sucede porque el tiempo es una especie de variable intrínseca del universo o por la manera en la que hemos planteando las leyes físicas. Y esa es la verdadera cuestión.

Todo esto significa, básicamente, que la cuestión de la dirección del tiempo sigue sin resolverse. No sabemos realmente lo que es en un sentido fundamental. Percibimos cómo fluye, observamos sus efectos… mientras, al mismo tiempo, algunas teorías también nos han revelado que no es necesario para entender el mundo que nos rodea.

La gravedad cuántica de bucles, por ejemplo, está intentando nuevas aproximaciones en ese sentido, y plantea el tiempo como una «propiedad emergente» de los sistemas cuánticos, no como una variable fundamental. De esta manera, esta teoría, que busca unificar la física cuántica y la teoría de la relatividad, explica el universo a través de relaciones, de eventos, no de «objetos que se mueven respecto a algo» más rápido o más despacio. Carlo Rovelli lo explica con esta frase: «la cosas no son, acontecen», esto es, cambian unas respecto a otras, pero no necesitan del tiempo para describir cómo se produce ese cambio. No… no se trata de conceptos muy fáciles de entender.

La cuestión de la flecha del tiempo es, probablemente, uno de los mayores enigmas de la física. ¿Cómo se acabará resolviendo? Paradójicamente… seguro que el tiempo lo dirá.

Referencias:

Neuenschwander, Dwight E. (2011). Emmy Noether’s wonderful theorem. The Johns Hopkins University Press.

Rovelli, Carlo (2018). El orden del tiempo. Anagrama.

Zeh, Dieter H. (2007). The physical basis of the direction of time. Springer.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Viendo pasar el tiempo se ha escrito en Cuaderno de Cultura Científica.

Los números primos de Sophie Germain

En noviembre de 2022, la artista donostiarra Esther Ferrer, la directora de Tabakalera, el Centro Internacional de Cultura Contemporánea de Donostia, Edurne Ormazabal, y el alcalde de Donostia/San Sebastián, Eneko Goia, presentaron ante la prensa una intervención artística para la futura plaza de acceso a Tabakalera. Como se pudo leer en diferentes medios de comunicación, se trata de una instalación que forma parte de su serie El poema de los números primos, realizada en cerámica de colores azul y verde, los que para la artista definen la ciudad de San Sebastián, junto con otros dos colores, el gris y el dorado. Este último es un homenaje a la matemática francesa Sophie Germain (1776-1831).

Proyecto del nuevo acceso al Centro Internacional de Cultura Contemporánea de Donostia, Tabakalera, con la instalación donada por la artista Esther FerrerLa matemática Sophie Germain

Proyecto del nuevo acceso al Centro Internacional de Cultura Contemporánea de Donostia, Tabakalera, con la instalación donada por la artista Esther FerrerLa matemática Sophie Germain

Nació en París, el 1 de abril de 1776, en una familia burguesa que participó en la revolución francesa. Durante la misma se refugió en su casa y dedicó su tiempo a la lectura de libros de la biblioteca. La impresionó mucho una historia de las matemáticas y la anécdota de la muerte de Arquímedes. Este gran matemático griego, que ya en su época alcanzó cierta fama, murió a manos de un legionario romano mientras se hallaba absorto en la resolución de un problema geométrico, durante el asalto de Siracusa (véase una explicación más extensa sobre su muerte en la entrada Muerte entre las ecuaciones (Historias de muerte y matemáticas 1)). Estudió matemáticas por su cuenta, aunque con la oposición de su familia (por la noche le quitaban la luz, la calefacción y la ropa).

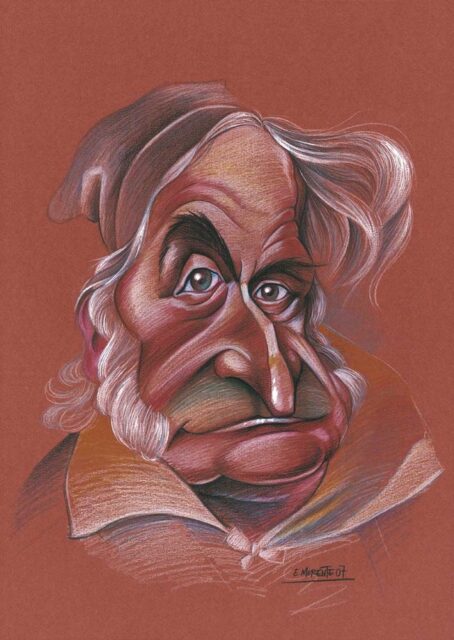

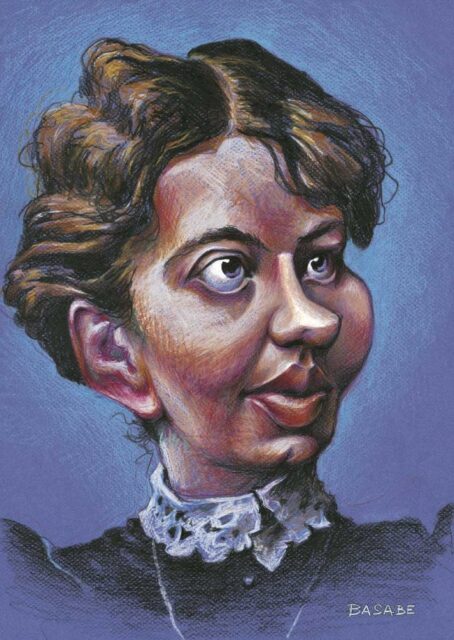

Caricatura de Sophie Germain, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de Sophie Germain, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Como la Escuela Politécnica de París, que fue fundada en 1794, cuando Sophie tenía 18 años, no admitía a las mujeres como alumnas (de hecho, no las admitiría hasta 1972), ella consiguió hacerse con algunos apuntes, como los de Química del químico francés Antoine François, Conde de Fourcroy (1755-1809) o los de Análisis Matemático del matemático franco-italiano, Joseph-Louis Lagrange (1736-1818). Al final del periodo lectivo los estudiantes solían presentar sus investigaciones, o comentarios, a sus profesores, así que Sophie Germain envió un trabajo a Lagrange, firmándolo como Antoine-Auguste Leblanc, un antiguo alumno de la Escuela Politécnica. Este trabajo impresionó a Lagrange, quien quiso conocer al estudiante. Al averiguar su verdadera identidad la felicitó, la animó a seguir estudiando y predijo que tendría éxito como matemática. Ese encuentro la hizo famosa en la comunidad científica y empezó a relacionarse con científicos de la época. Alcanzó cierta notoriedad. Muchos le enviaban sus trabajos o se querían entrevistar con ella.

Caricatura de Joseph-Louis Lagrange, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de Joseph-Louis Lagrange, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Cuando Sophie Germain empezó a escribir al gran matemático alemán Carl Friedrich Gauss (1777-1855) para compartir con él sus investigaciones en Teoría de Números (intentaba demostrar el Teorema de Fermat), firmó sus cartas con el seudónimo de “Monsieur Leblanc”. En 1906 con motivo de la campaña de Prusia de Napoleón, Sophie Germain temió que algo le ocurriera a Gauss y le escribió a un militar amigo suyo para que velara por la seguridad del matemático. El militar le escribió a Germain para comunicarle que Gauss estaba bien, que este le agradecía su mediación, pero que no conocía a ninguna Sophie Germain. Entonces la matemática francesa tuvo que escribirle para contarle que ella era Monsieur Leblanc. Gauss sorprendido al conocer su identidad, le escribió una carta alabando su talento, su valor y su genio, y comentando como una mujer encuentra más obstáculos que un hombre para trabajar en matemáticas debido a los prejuicios.

Caricatura de Carl Friedrich Gauss, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de Carl Friedrich Gauss, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)El resultado que lleva su nombre fue un avance muy importante en la demostración del Teorema de Fermat (que no se demostraría hasta 1995, por Andrew Wiles). Posteriormente se dedicaría al estudio de las superficies elásticas, intentando explicar matemáticamente los experimentos del físico alemán Ernst Florenz Friedrich Chladni (1756- 1827), los patrones geométricos que forma la música sobre las placas metálicas con arena, lo que le valdría el Premio de la Academia de Ciencias. Trabajó en otros temas como la curvatura o incluso en Filosofía de la Ciencia. Su ensayo filosófico Considérations générales sur l’état des Sciences y des Lettres aux différentes époques de leur culture / Consideraciones generales sobre las Ciencias y las Letras en las diferentes épocas de su cultura (1833), para identificar los procesos intelectuales de las “Ciencias” y las “Letras” e incluso de todas las actividades humanas, fue elogiado por el filósofo Augusto Comte.

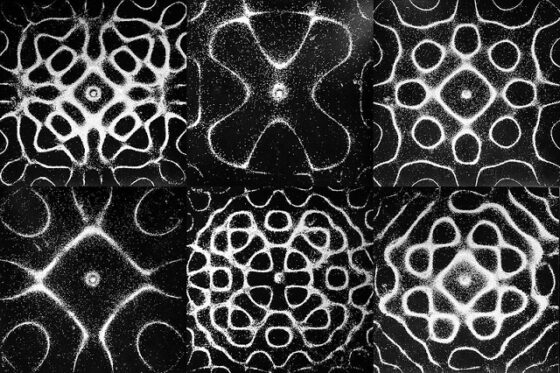

Si se esparce arena en una placa metálica y se le hace vibrar con música, por ejemplo, un arco de violín, la arena se distribuye formando patrones geométricos. Fotografía de Chris Smith, de su proyecto Pattern 365, en flickr

Si se esparce arena en una placa metálica y se le hace vibrar con música, por ejemplo, un arco de violín, la arena se distribuye formando patrones geométricos. Fotografía de Chris Smith, de su proyecto Pattern 365, en flickr

Dedicó toda su vida a las matemáticas, no se casó nunca y murió de cáncer de mama en 1831. Poco antes de su muerte, en 1830, Gauss intentó que la Universidad de Gotinga, en Alemania, le otorgara el título de Doctor Honoris Causa, pero a pesar de su gran influencia en esta universidad, su propuesta fue rechazada.

El último teorema de FermatComo se comentaba más arriba el teorema que lleva asociado el nombre de esta matemática francesa, el teorema de Germain, que da lugar al concepto de número primo de Sophie Germain, está relacionado con el famoso último teorema de Fermat.

Empecemos recordando brevemente este importante resultado de la Teoría de Números (para más información sobre el mismo se puede leer la entrada Euler y el último teorema de Fermat o el artículo Avatares literarios del último teorema de Fermat).

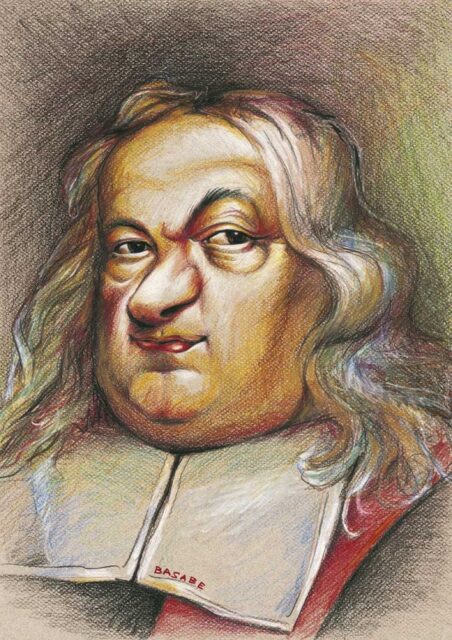

Caricatura de Pierre de Fermat, realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de Pierre de Fermat, realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)El jurista francés y aficionado a las matemáticas Pierre de Fermat (1601-1665), inspirado en el problema de expresar el cuadrado de un número como la suma de los cuadrados de dos números, es decir, buscar soluciones de números enteros positivos a la ecuación pitagórica x2 + y2 = z2 (existen infinitas soluciones, ternas pitagóricas, como (3,4,5) o (5,12,13)), problema que aparecía en el libro Aritmética del matemático griego Diofanto (alrededor del siglo III o siglo IV), se planteó extender ese problema a cualquier potencia y afirmó tener una demostración (el famoso margen en su ejemplar del libro de Diofanto), del hecho de que no existían soluciones para cualquier potencia, diferente de 2. Sin embargo, esa demostración nunca apareció y fue el inicio de una gran aventura matemática, la búsqueda de una demostración del llamado último teorema de Fermat.

Último teorema de Fermat: No es posible encontrar tres números enteros positivos x, y, z tales que verifiquen la ecuación, xn + yn = zn, para n mayor, o igual, que 3.

El primer avance significativo en los intentos por demostrar el teorema de Fermat, en más de un siglo, se produjo de la mano del matemático suizo Leonhard Euler (1707-1783). Este estaba estudiando los papeles de Pierre de Fermat cuando en mitad de una demostración encontró un razonamiento válido para el teorema de Fermat cuando n = 4, es decir, de que no existen números enteros positivos x, y, z tales que x4 + y4 = z4. La técnica que utilizaba Fermat era la conocida con el nombre de “descenso infinito”.

Euler hizo uso de la técnica del descenso infinito, pero utilizando números complejos en el razonamiento, para demostrar la conjetura de Fermat para el caso n = 3, x3 + y3 = z3. Aunque Euler cometió un error en dicha demostración, el resultado necesario para corregirlo estaba en otro de los trabajos del matemático suizo, por lo que se sigue considerando válida su demostración. Las ideas de la demostración de Euler fueron generalizadas por matemáticos como el alemán Peter Gustav Lejeune Dirichlet (1805-1859), el francés Adrien-Marie Legendre (1752-1833) o el francés Gabriel Lamé (1795-1870) para probar algunos otros casos particulares, como, por ejemplo, n = 5 y 7.

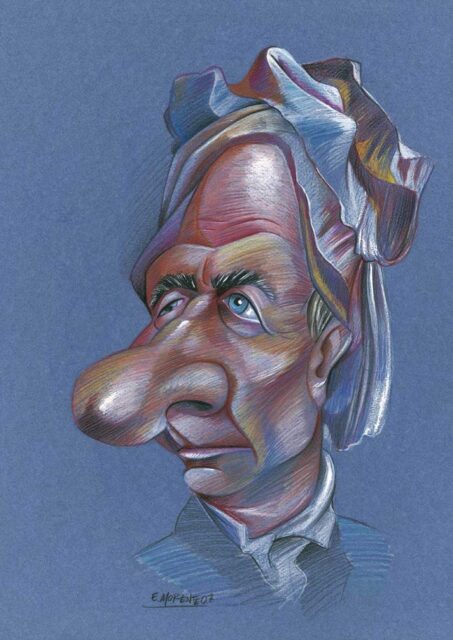

Caricatura de Leonhard Euler, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)

Caricatura de Leonhard Euler, realizada por Enrique Morente, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Después del trabajo de Euler quedó claro que bastaba demostrar el último teorema de Fermat para los números primos impares. El argumento es el siguiente. Si un número primo p divide a n, entonces tendremos que n será el producto del número primo p con otro número q, es decir, n = pq. Por lo tanto, la ecuación xn + yn = zn, puede escribirse como

![]()

de donde se deduce, que si la ecuación xp + yp = zp, no tiene solución, tampoco la tendrá la anterior. Por otra parte, si ningún número primo impar divide a n, entonces n será una potencia de 2 y entonces 4 divide a n (para n = 2, ya sabemos la solución, son los triples pitagóricos). Por el mismo argumento anterior, si 4 divide a n, basta demostrar que la ecuación x4 + y4 = z4 no tiene solución, como ya sabemos, por el propio Fermat (a través de Euler, claro).

En consecuencia, había que intentar demostrar el último teorema de Fermat para los números primos impares. Pero solo se conocía la demostración para los primeros números primos impares, 3, 5 y 7. Y precisamente el primer resultado general vino de la mano de la matemática francesa Sophie Germain.

Caricatura de Sofía Kovalévskaya (1850-1891), realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Los primos de Sophie Germain

Caricatura de Sofía Kovalévskaya (1850-1891), realizada por Gerardo Basabe de Viñaspre, para la exposición de la Real Sociedad Matemática Española, El rostro humano de las matemáticas (2008)Los primos de Sophie Germain

El estudio de la ecuación xp + yp = zp, para p un número primo impar, se dividió en dos casos. El primer caso cuando p no divide a x, y y z (es decir, que x, y y z no son múltiplos de p) y el segundo caso cuando p sí divide a alguno de los tres, x, y o z. El resultado de Germain se refería al estudio del primer caso del último teorema de Fermat y es el siguiente.

Teorema de Germain: Si p es un número primo, tal que 2p + 1 también es primo, entonces no existen números enteros x, y, z, no nulos y no múltiplos de p, tales que xp + yp = zp.

Este resultado de Germain fue el primer resultado general en la demostración del último teorema de Fermat, que establecía una familia de números primos para los cuales no se cumplía el primer caso del último teorema de Fermat.

Debido al resultado anterior, a los números primos p tales que 2p + 1 es también primo se les llama primos de Sophie Germain (o primos de Germain). Por ejemplo, los números 2, 3 o 5 son primos de Sophie Germain, ya que 2 x 2 + 1 = 5, 2 x 3 + 1 = 7 y 2 x 5 + 1 = 11 son también primos. La sucesión de números primos de Sophie Germain es la sucesión A005384 de la Enciclopedia On-line de Sucesiones de Números Enteros – OEIS, y los primeros miembros de la sucesión son:

2, 3, 5, 11, 23, 29, 41, 53, 83, 89, 113, 131, 173, 179, 191, 233, 239, 251, 281, 293, 359, 419, 431, 443, 491, 509, 593, 641, 653, 659, 683, 719, 743, 761, 809, 911, 953, 1013, 1019, 1031, 1049, 1103, 1223, 1229, 1289, 1409, 1439, 1451, 1481, 1499, 1511, 1559, …

A los números primos de la forma 2p + 1, tales que p es un número primo (por lo tanto, p es un primo de Germain), se les llama números primos seguros. El nombre se deriva de la importancia de los números primos de Germain p y los primos seguros 2p + 1 en la criptografía. La sucesión de números primos seguros es la sucesión A005385 de la Enciclopedia On-line de Sucesiones de Números Enteros – OEIS, y los primeros miembros de la sucesión son:

5, 7, 11, 23, 47, 59, 83, 107, 167, 179, 227, 263, 347, 359, 383, 467, 479, 503, 563, 587, 719, 839, 863, 887, 983, 1019, 1187, 1283, 1307, 1319, 1367, 1439, 1487, 1523, 1619, 1823, 1907, 2027, 2039, 2063, 2099, 2207, 2447, 2459, 2579, 2819, 2879, 2903, 2963, …

Se desconoce, al igual que ocurre con los números primos gemelos (véase la entrada Números primos gemelos, parientes y sexis (1)), si existen infinitos números primos de Sophie Germain. Y, de nuevo, como en otros temas, se buscan números primos de Germain lo más grandes posibles. Como puede verse en la página web dedicada a los números primos y sus records, The Prime pages, el número primo de Sophie Germain más grande conocido, a día de hoy, fue obtenido en febrero de 2016, y es el número

![]()

que tiene 388.342 dígitos.

Mirando la lista de los números primos de Sophie Germain anterior podemos descubrir cuestiones como la siguiente. Si tomamos el número 2, que es un primo de Germain, resulta que el número primo seguro asociado, 2 x 2 + 1 = 5, también es primo de Germain. Más aún, el número primo seguro asociado al 5, 2 x 5 + 1 = 11, también es primo de Germain. Pero podemos continuar más, ya que 2 x 11 + 1 = 23 también es un primo de Germain. Aunque, este camino se termina aquí, puesto que 2 x 23 + 1 = 47, que ya no lo es. En cualquier caso, observamos que podemos generar cadenas de números de Germain concatenados. De hecho, a las cadenas de números primos de Sophie Germain concatenados, incluido el número primo seguro asociado al último de la cadena, en el caso anterior la cadena 2, 5, 11, 23, 47, se las llama cadenas de Cunningham, que reciben ese nombre en honor al matemático indio-británico Allan J. C. Cunningham (1842-1928). Las cadenas de Cunningham tienen la siguiente forma, si p es el número primo de Germain inicial:

![]()

Otro ejemplo de cadena de Cunningham es 89, 179, 359, 719, 1439 y 2879. En 2008, el matemático polaco Jaroslaw Wroblewski descubrió la cadena más larga conocida, a día de hoy, formada por 17 elementos. Esta cadena empieza por el número primo de Sophie Germain (con 22 dígitos):

2.759.832.934.171.386.593.519.

El poema de los números primosEsther Ferrer es una reconocida artista cuyo arte transita entre el minimalismo y el arte conceptual, así como una pionera del arte de la performance. Su trabajo ha sido reconocido con múltiples galardones como el Premio Nacional de Artes Plásticas, en 2008, el Premio Gure Artea, en 2012, o los siguientes premios en 2014, Premio MAV (Mujeres en las Artes Visuales), Prix Marie Claire pour l’Art Contemporain y Premio Velázquez de las Artes Plásticas. Una recomendación para las personas interesadas en conocer su trayectoria artística es el documental Esther Ferrer: Hilos de Tiempo (Josu Rekalde, 2020).

Cartel del documental Esther Ferrer: Hilos de Tiempo (2020), dirigido por Josu Rekalde

Cartel del documental Esther Ferrer: Hilos de Tiempo (2020), dirigido por Josu RekaldeEn su arte podemos encontrar muchos elementos relacionados con las matemáticas, tanto como fuente de inspiración, como herramienta de creación artística, desde los números primos con los que trabaja desde la década de los años 1970, hasta el infinito en el número pi, pasando por la combinatoria, el azar, las ilusiones ópticas o la geometría. Algunas de las entradas del Cuaderno de Cultura Científica estudian esta interesante interacción, como Variaciones artísticas del teorema de Napoleón, sobre una serie de obras titulada Triángulo de Napoleón que está relacionada con un resultado clásico de la geometría, el teorema de Napoleón, o la entrada ¿Es normal el número pi?, en la cual se explica la importancia de las matemáticas en la estética de la obra Pi (2009-2010). Pero una de las herramientas de creación artística más importantes en la producción de Esther Ferrer son los números primos. De sus procesos creativos y obras relacionadas con los mismos se ha escrito en las entradas El poema de los números primos, El poema de los números primos (2) o Números primos gemelos, parientes y sexis (1), pero también en el libro La gran familia de los números (Libros de la Catarata – ICMAT – FESPM, 2021).

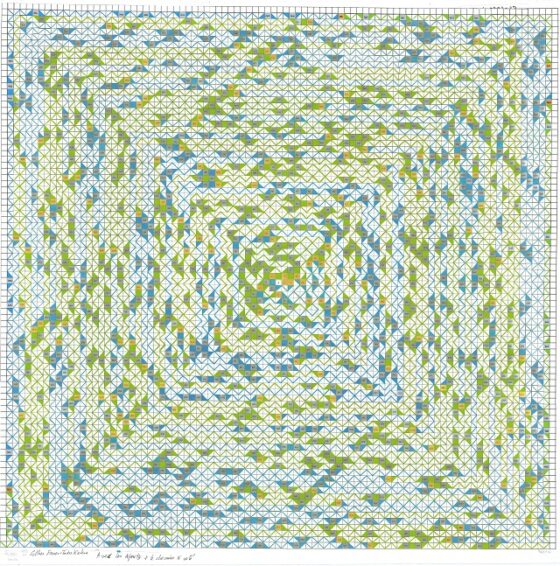

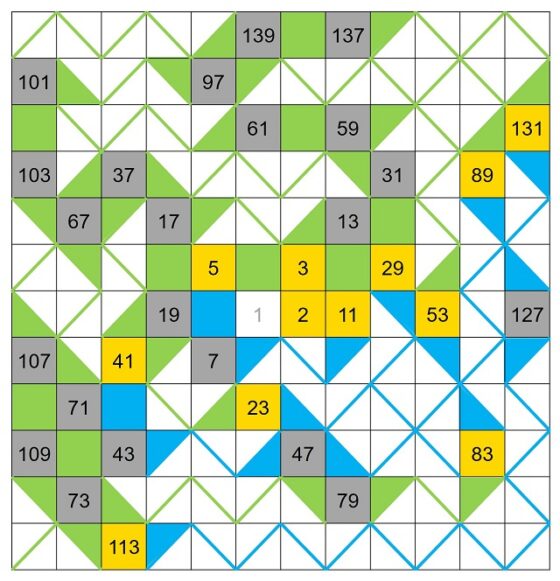

Boceto de la instalación para la nueva plaza de acceso a Tabakalera, perteneciente a la serie El poema de los números primos, de Esther Ferrer. Mi más sincero agradecimiento a Esther Ferrer por permitirme mostrar este hermoso boceto, cuya realización se podrá disfrutar en breve en Tabakalera (Donostia)

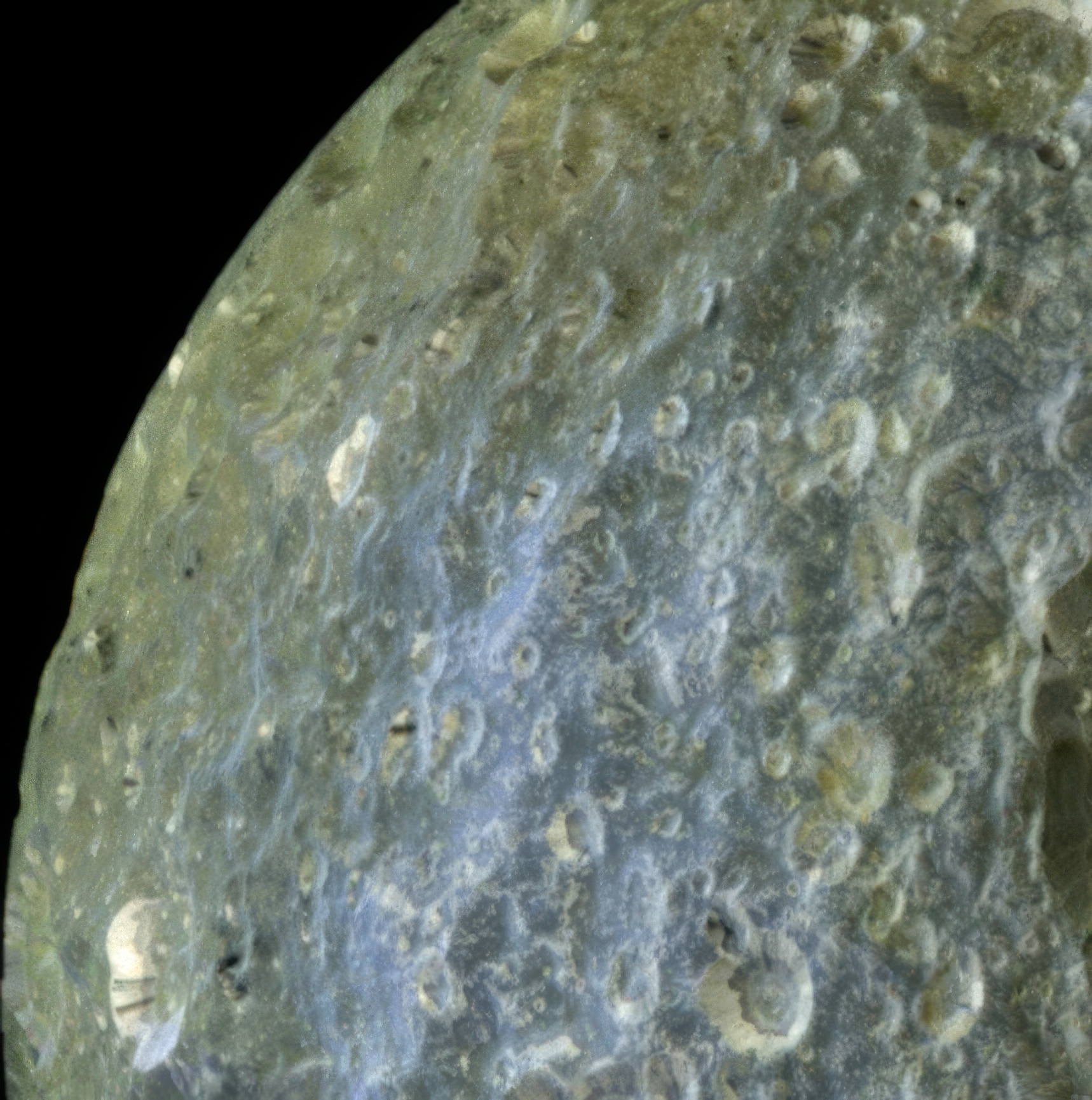

Boceto de la instalación para la nueva plaza de acceso a Tabakalera, perteneciente a la serie El poema de los números primos, de Esther Ferrer. Mi más sincero agradecimiento a Esther Ferrer por permitirme mostrar este hermoso boceto, cuya realización se podrá disfrutar en breve en Tabakalera (Donostia)La instalación para la nueva plaza de acceso a Tabakalera, perteneciente a la serie El poema de los números primos, de Esther Ferrer, se construye utilizando la espiral de Ulam (véase la entrada El poema de los números primos, para una lectura más en profundidad de esta estructura geométrica plana numérica) y los números primos de Sophie Germain, que se han explicado en esta misma entrada, mediante un proceso creativo similar al de algunas de las obras de las series El poema de los números primos y Un mar de números primos, que explicaremos a continuación.

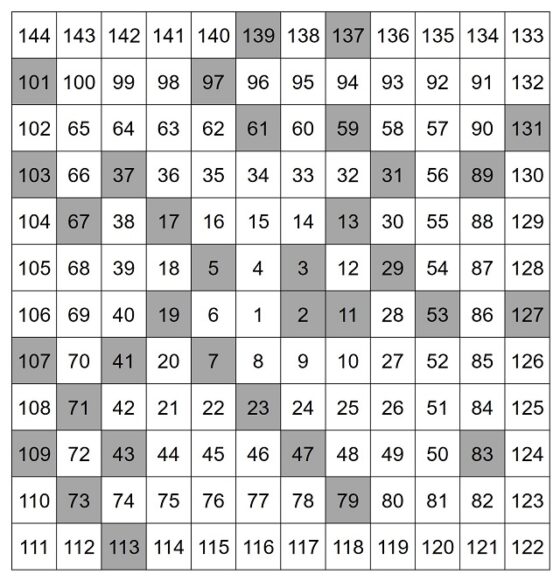

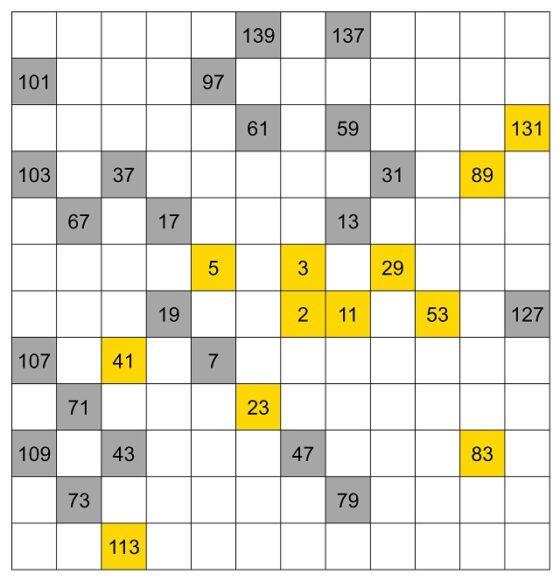

La espiral de Ulam es una estructura geométrica plana, de tipo reticular, en la que los números naturales son escritos en espiral, empezando en el 1 y en el sentido contrario a las agujas del reloj, destacando los números primos. En la siguiente imagen se muestra la espiral de Ulam hasta el número 144 (aunque es un número bajo ya se puede percibir la idea de su proceso de construcción), con las casillas de los números primos (como 2, 3, 5, 7 11, etcétera) en gris, lo que permite observar la distribución de los números primos en la misma (sobre todo para grandes retículas, como hizo el matemático polaco Stanislaw Ulam (1909-1984)).

Espiral de Ulam hasta el número 144, con las casillas de los números primos en gris

Espiral de Ulam hasta el número 144, con las casillas de los números primos en gris

El boceto de la instalación de Esther Ferrer, que luego se trasladará a la obra formada por baldosas ubicada en la nueva entrada de Tabakalera, consiste en una espiral de Ulam de 88 filas y 89 columnas, es decir, 7.832 casillas (desde el número 1, en el centro de la retícula cuadrada, al número 7.832 en la esquina de abajo a la izquierda). En las casillas/baldosas con números compuestos, es decir, no primos, se han borrado los números, mientras que se han dejado escritos los números primos en sus correspondientes casillas, pero además estas casillas, están pintadas de gris (la última casilla gris de la espiral de Ulam, luego de un número primo, es el 7.829), salvo algunas que serán doradas. Estas se corresponden con otro elemento importante en esta obra, como comentábamos más arriba, son los números primos de Sophie Germain. Las casillas que contienen estos números van pintadas de dorado, en lugar de gris, como homenaje a la matemática francesa (la última casilla dorada de la espiral es el número 7.823).