Un túnel transatlántico

Por algún curioso motivo, hay ideas, que, pase el tiempo que pase, no dejan de ser «innovadoras». No importa si ya se le ocurrieron a alguien hace más de cien años, ni si se llevaron a cabo con relativo éxito, también da igual si se han escrito novelas y hasta rodado películas sobre ellas: siempre habrá algún gurú tecnológico que las redescubra y las presente como novedosas. La posibilidad de construir un túnel transatlántico que una Europa con América es una de esas ideas.

A finales del siglo XIX, y hasta los años cincuenta del siglo XX —cuando comenzaron los primeros vuelos comerciales transatlánticos—, cruzar el océano que separaba el Viejo del Nuevo Continente en un barco de vapor podía llevar más de una semana, y no siempre en condiciones óptimas de comodidad. En un momento, además, en el que la industrialización y la idea de progreso tecnológico marcaban la agenda, fue cuestión de muy poco tiempo que a algunos visionarios se les empezaran a ocurrir formas —más o menos disparatadas— de solucionar ese problema.

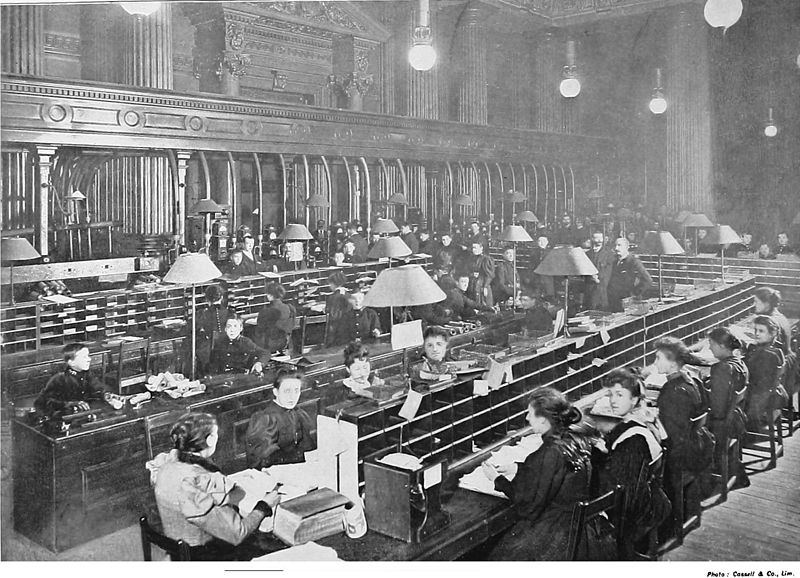

El germen de todo esto se remonta al ingeniero George Medhurst. Entre finales del siglo XVIII y principios del XIX patentó algunos sistemas de propulsión que utilizaban aire comprimido. Este invento llevó a los sistemas de envío mediante tubos neumáticos que se utilizaron en edificios como la Oficina General de Correos en Londres e incluso a la invención del ferrocarril atmosférico: una especie de rudimentario sistema de hyperloop que, aunque con bastantes problemas, llegó a entrar en funcionamiento y probarse en alguna ocasión con personas.

Sala de tubos neumáticos de la Oficina General de Correos en Londres, alrededor de 1897-1899. Créditos: Dominio público.

Sala de tubos neumáticos de la Oficina General de Correos en Londres, alrededor de 1897-1899. Créditos: Dominio público.

Medhurst solo sembró una semilla que otros se encargarían de nutrir, pero parece que la idea arraigó en el imaginario colectivo porque, desde entonces, empezaron a proliferar historias de ficción en las que los túneles neumáticos se convirtieron en el transporte del futuro. Dadas las velocidades que se calculó que podrían alcanzar los vehículos que circularan por ellos, normalmente trenes, eran la solución perfecta para acortar distancias entre continentes.

Parece que el primero que utilizó esta idea fue Michel Verne, hijo de Julio Verne, en Un expreso del futuro, publicada en francés en 1888 y traducida al inglés en 1985. Pero pronto muchos otros la irían refinando, como Hugo Gernsback, en Ralph 124c 41+ (1911) o Lucille Taylor Hansen, en «The undersea tube» (1929). Las películas sobre el tema se remontan, casi, casi, a los orígenes del cine de ciencia ficción, sirva como ejemplo la francoalemana Der Tunnel (1933), que vio su versión inglesa dos años después, y que se basaba en la novela homónima de Bernhard Kellerman, escrita en 1913.

El túnel trasatlántico (1935) fue la versión inglesa de Der Tunnel. Su estética podría parecer moderna incluso hoy. Por su antigüedad, la película está libre de derechos y se puede encontrar fácilmente en internet.

El túnel trasatlántico (1935) fue la versión inglesa de Der Tunnel. Su estética podría parecer moderna incluso hoy. Por su antigüedad, la película está libre de derechos y se puede encontrar fácilmente en internet.Créditos: Dominio público.

Pero ¿sería factible llevar a cabo, a día de hoy, semejante obra de ingeniería? Pues, pese a las promesas de algunos magnates, parece que no. Si todavía no se ha conseguido desarrollar un hyperloop en tierra, ni siquiera para trayectos relativamente cortos, conseguir hacerlo bajo el océano y para un trayecto de más de 5000 km es poco menos que inalcanzable. Construir simplemente algo similar al Eurotúnel ya sería una empresa titánica, y no digamos en aquellos tramos que podrían encontrarse a más de 8000 m de profundidad y a presiones más de 800 veces mayores que a nivel del mar. Pensemos que el Titanic se encuentra a 3784 m y, como se ha demostrado, bajar hasta ahí no suele ser ni fácil ni una buena idea sin una cuidadosa preparación. A eso se añaden las dificultades logísticas. Ya solo el transporte de los materiales requeriría una cantidad estratosférica de recursos y, además, las obras en alta mar solo podrían llevarse a cabo en determinadas épocas del año, cuando el clima fuera favorable, lo que ralentizaría —y encarecería— muchísimo el proceso.

Aun así, veamos las diferentes opciones de diseño que ya se han planteado. Una sería excavar bajo el lecho marino, en caso de que tuviéramos maquinaria que lo permitiera, o, por ejemplo, instalar módulos prefabricados sobre él. En ambos casos, y asumiendo que las altas presiones no fueran un problema —que lo serían, especialmente en el segundo caso, si hay que bajar a unir los fragmentos de túnel—, el escollo sería cruzar la dorsal mesoatlántica, con su alta tasa de actividad volcánica y sísmica, por no mencionar el desplazamiento de las placas tectónicas, así que, en principio, estas opciones quedarían descartadas. Otra posibilidad que se ha planteado sería construir el túnel mediante módulos «flotantes», sumergidos a unas decenas de metros de la superficie, utilizando un sistema de lastres similar al de los submarinos y algún tipo de anclaje al fondo mediante cables o columnas —algo que ya plantearía un reto de ingeniería de envergadura similar al propio túnel—. En este caso, las corrientes o el oleaje harían muy difícil estabilizarlo, incluso con tecnología similar a la que se utiliza en las plataformas petrolíferas, por no mencionar la fatiga estructural.

A todo lo anterior habría que añadir las tareas de mantenimiento, ya no solo de la estructura en sí, sino de los sistemas de energía y ventilación, de comunicaciones… y habría que contar con salidas de emergencia y un plan de evacuación que, en esas condiciones y de no funcionar a la perfección, podrían convertir cualquier error de funcionamiento en una tragedia. Y no hablemos del impacto que algo así podría tener en el ecosistema marino. Así que, al menos de momento, parece que el túnel transatlántico nos daría demasiados quebraderos de cabeza, ¿nos compensan, teniendo la opción de viajar en avión?

Lamentablemente, parece que tendremos que esperar, pero no desistamos del todo. Como ha sucedido tantas otras veces, nunca se sabe cuándo el desarrollo científico y tecnológico dará con la clave que no permita construir nuestro túnel submarino. Al fin y al cabo, hace no tanto, veíamos imposible volar como las aves o que un ordenador escribiera poesía, así que, ¿quién sabe qué será lo siguiente?

Bibliografía

Bowler, P. J. (2017). A history of the future. Cambridge University Press.

Discovery Channel (2003). Transatlantic tunnel. Extreme engineering.

Self, D. (2020). Pneumatic Networks. The Museum of RetroTechnology.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Un túnel transatlántico se ha escrito en Cuaderno de Cultura Científica.

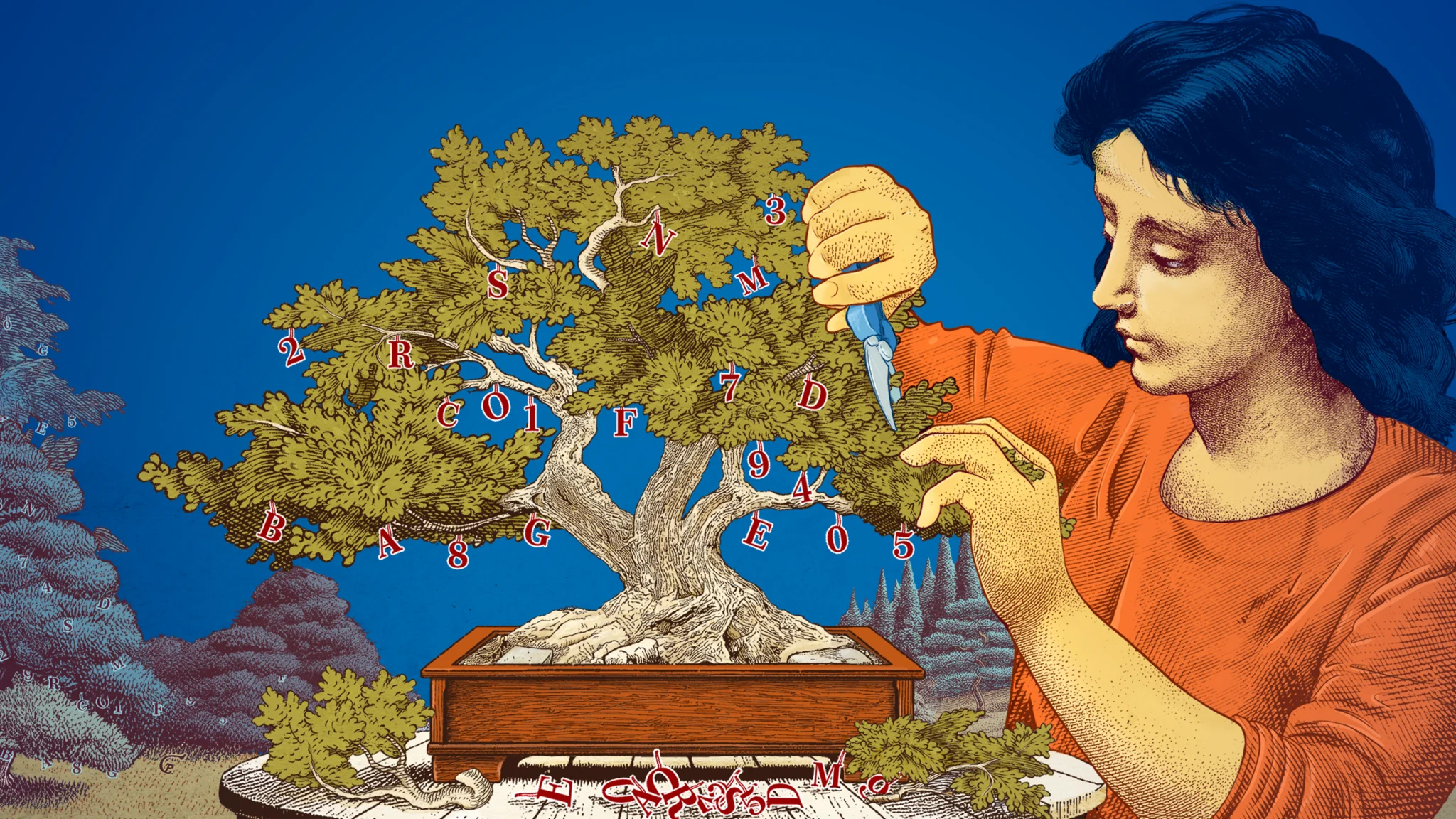

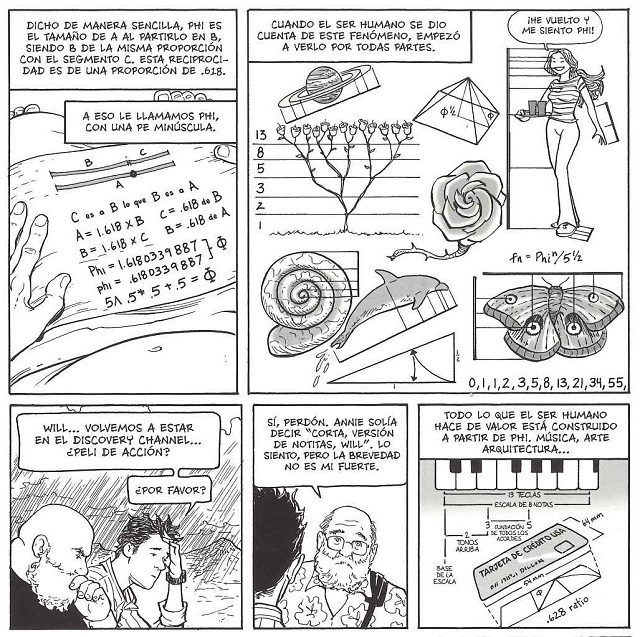

El sistema de numeración en base Phi

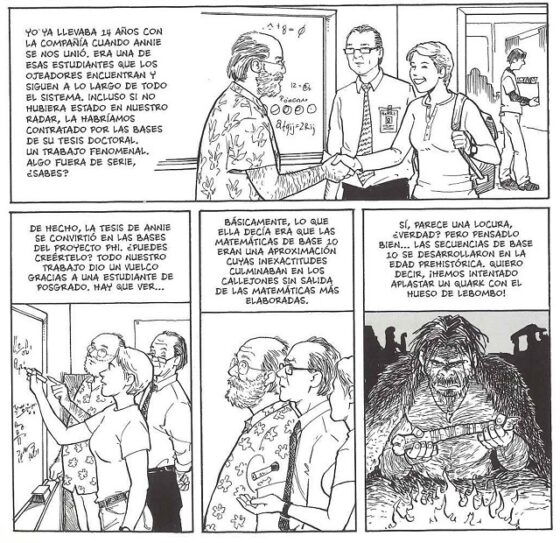

En la pasada entrada del Cuaderno de Cultura Científica titulada ECHO, un cómic áureo, que habíamos dedicado a la presencia del número áureo, de la divina proporción, en la serie de cómic ECHO (2008-2011), del dibujante y guionista estadounidense Terry Moore, se mencionaba que uno de los personajes, que era matemática, había propuesto sustituir el sistema de numeración decimal (en base 10) por el sistema de numeración en base Phi en la investigación científica. En esta entrada vamos a explicar qué es el sistema de numeración en base Phi.

Portadas de los números 1, 9, 10, 11, 19 y 30 del cómic ECHO de Terry MooreEl sistema de numeración decimal

Portadas de los números 1, 9, 10, 11, 19 y 30 del cómic ECHO de Terry MooreEl sistema de numeración decimal

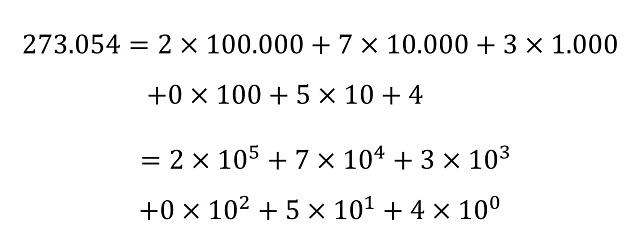

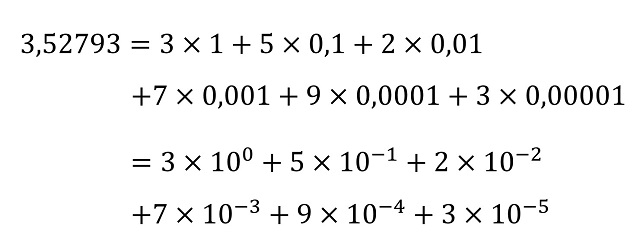

Empecemos, recordando que el sistema de numeración posicional moderno utilizado en casi todo el mundo es el decimal, es decir, que tiene base 10 (véase el libro Los secretos de la multiplicación, de los babilonios a los ordenadores). Por lo tanto, consta de diez cifras básicas, 0, 1, 2, 3, 4, 5, 6, 7, 8, 9 y todo número natural se puede representar con ellas al expresarlo en función de las potencias de 10. Por ejemplo, el número 273.054 tiene el valor de 2 veces la cantidad de 100.000 (centenas de millar), 7 veces la cantidad de 10.000 (decenas de millar), 3 veces la cantidad de 1.000 (unidades de millar), 0 veces la cantidad de 100 (centenas), 5 veces la cantidad de 10 (decenas) y 4 veces la unidad 1, que son las potencias de 10, a saber, 100.000 = 105, 10.000 = 104, 1.000 = 103, 100 = 102, 10 = 101 y 1 = 100.

Ejemplo del significado de la representación posicional decimal de un número (natural)

Ejemplo del significado de la representación posicional decimal de un número (natural)Pero este sistema de numeración no solo nos sirve para representar los números naturales (bueno, los enteros, incluido el signo negativo), sino también los números reales, es decir, también aquellos que tienen una parte decimal. Por ejemplo, el número real, de hecho, racional, [3,52793] tiene el valor de 3 veces la unidad, 5 veces la cantidad de [0,1] (décimas), 2 veces la cantidad de [0,01] (centésimas), 7 veces la cantidad de [0,001] (milésimas), 9 veces la cantidad de [0,0001] (diezmilésimas) y 3 veces la cantidad de [0,00001] (cienmilésimas), que son también las potencias de 10, aunque ahora se incluyen las negativas, a saber, 0,1 = 10-1; 0,01 = 10-2; 0,001 = 10-3; 0,0001 = 10-4 y 0,00001 = 10-5.

Ejemplo del significado de la representación posicional decimal de un número real (en este caso, racional)Sistema de numeración en base b (natural)

Ejemplo del significado de la representación posicional decimal de un número real (en este caso, racional)Sistema de numeración en base b (natural)

Aunque el sistema de numeración (posicional) decimal es el que utilizamos de manera natural en nuestra vida cotidiana, sabemos que existen otros sistemas de numeración en otras bases, como el sistema de numeración binario o en base 2, b = 2, que es el que utilizan nuestros ordenadores, los sistemas octal (base 8, b = 8) y hexadecimal (base 16, b = 16), que también son muy utilizados en informática, el sistema duodecimal o docenal (base 12, b = 12), que es por el que abogan como sistema cotidiano los miembros de las sociedades The Dozenal Society of America y The Dozenal Society of Great Britain (véase la entrada El sistema duodecimal, o si los humanos hubiésemos tenido seis dedos en las manos) o el sistema sexagesimal (base sesenta, b = 60), que ya utilizaron los babilonios, pero en general para cualquier número natural b mayor o igual que 2, como b = 3 (sistema ternario), b = 4 (sistema cuaternario), b = 5 (quinario), etcétera. De algunos de estos sistemas ya hemos hablado en algunas entradas del Cuaderno de Cultura Científica, como Las bases de numeración o cómo hacer trucos de magia binarios o Sobre cómo escribir el número pi en base cuatro.

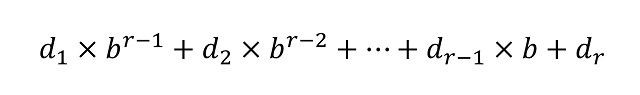

En general, dada una base de numeración b –por ejemplo, como cualquiera de las que hemos comentado 2, 3, 4, 5, 8, 12, 16 o 60– la representación posicional de cualquier número en la misma viene dada por una expresión d1d2…dr (donde los dígitos di –para i entre 1 y r– pertenecen a la familia de las b cifras básicas del sistema de numeración, que tienen valores entre 0 y b – 1) teniendo en cuenta que el número puede escribirse, de forma única, como

Por lo tanto, la representación del número está ligada a la base elegida. Así, si tomamos el sistema binario (b = 2) el anterior número (273.054) se representa como (1000010101010011110)2, ya que “273.054” = 218 + 213 + 211 + 29 + 27 + 24 + 23 + 22 + 21; en la base octal (b = 8) como (1.025.236)8, porque “273.054” = 1 x 86 + 2 x 84 + 5 x 83 + 2 x 82 + 3 x 8 + 6; o en la base hexadecimal (b = 16), donde las cifras básicas son denotadas por 0, 1, …, 9, A, B, C, D, E, F, como (42A9E)16, puesto que “273.054” = 4 x 164 + 2 x 163 + A x 162 + 9 x 16 + E, donde estamos utilizando el subíndice de las representaciones (2, 8 y 16) para recordar que esa es una representación en esa base de numeración.

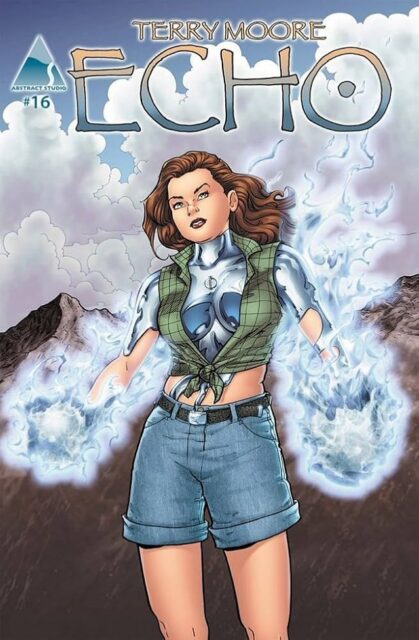

See The Good / Ver lo Bueno, de la artista estadounidense Leslie Rowñland, perteneciente a su serie sobre el código binario

See The Good / Ver lo Bueno, de la artista estadounidense Leslie Rowñland, perteneciente a su serie sobre el código binarioDe la misma forma se representan los números decimales. Por ejemplo, si se considera el número 0,696044921875 (escrito de forma natural, en base decimal), este se representa de las siguientes formas en distintas bases:

a) en base binaria (b = 2), como (0,101100100011)2, puesto que “0,696044921875” = 2-1 + 2-3 + 2-4 + 2-7 + 2-11 + 2-12 = 0,5 + 0,125 + 0,0625 + 0,0078125 + 0,00048828125 + 0,000244140625;

b) en base cuaternaria (b = 4), como (0,230203)4, puesto que “0,696044921875” = 2 x 4-1 + 3 x 4-2 + 2 x 4-4 + 3 x 4-6 = 2 x 0,25 + 3 x 0,0625 + 2 x 0,00390625 + 3 x 0,000244140625;

c) base octal (b = 8), como (5443)8, puesto que “0,696044921875” = 5 x 8-1 + 4 x 8-2 + 4 x 8-3 + 3 x 8-4 = 5 x 0,125 + 4 x 0,015625 + 4 x 0,001953125 + 3 x 0,000244140625;

d) en base hexadecimal (b = 16), donde las cifras básicas son 0, 1, …, 9, A, B, C, D, E, F, como (0,B23)16, puesto que “0,696044921875” = B x 16-1 + 2 x 16-2 + 3 x 16-3 = 11 x 0,0625 + 2 x 0,00390625 + 3 x 0,000244140625.

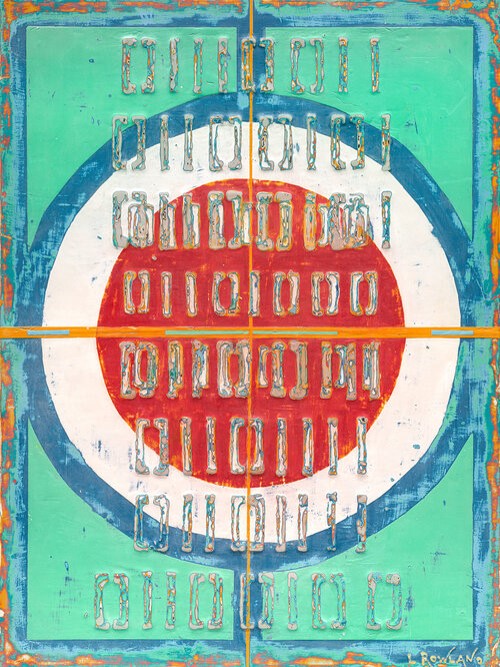

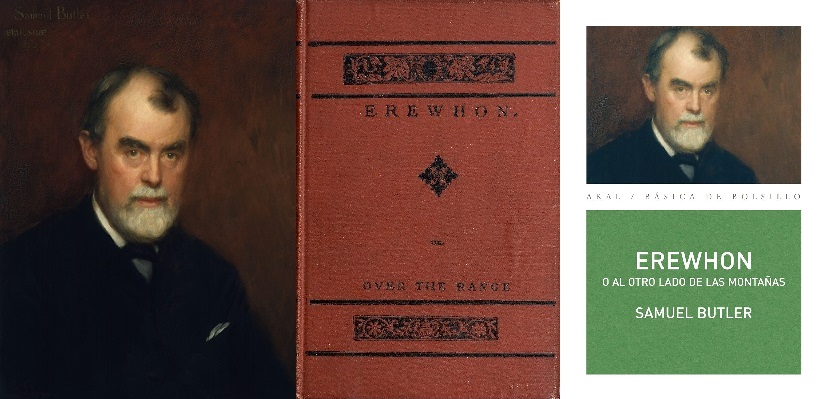

¿Un sistema de numeración irracional?Como se comentaba al principio de esta entrada, uno de los personajes del cómic ECHO, del dibujante y guionista de cómic estadounidense Terry Moore, proponía sustituir el sistema de numeración decimal por el sistema de numeración en base Phi en la investigación científica.

Portada del número 16, de 30, del cómic ECHO de Terry Moore, en el que aparece su protagonista con una especie de armadura metálica que está empezando a cubrirle el cuerpo y que tiene la letra Phi, del número áureo, en la parte superior del tórax

Portada del número 16, de 30, del cómic ECHO de Terry Moore, en el que aparece su protagonista con una especie de armadura metálica que está empezando a cubrirle el cuerpo y que tiene la letra Phi, del número áureo, en la parte superior del tóraxPero el número áureo Phi no es un número natural, como las bases que hemos explicado más arriba y a las que podemos estar más acostumbrados (al menos si nos interesan los números), más aún, es un número irracional (sobre los números irracionales podéis leer la entrada El infinito en un segmento (2)), con infinitos decimales que se extienden sin fin, pero sin ningún patrón periódico.

Phi = 1, 61803398874989484820458683436563811772030917…

¿Es posible que Phi sea la base de un sistema de numeración? La respuesta es afirmativa, de hecho, si no fuese así no estaríamos escribiendo esta entrada.

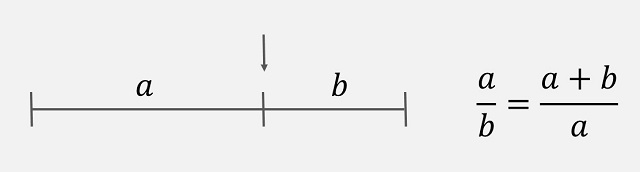

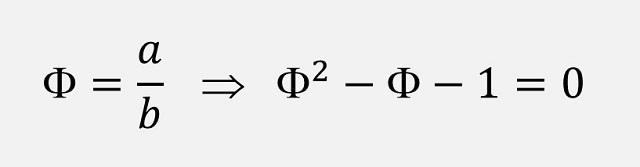

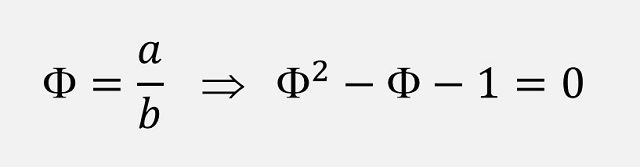

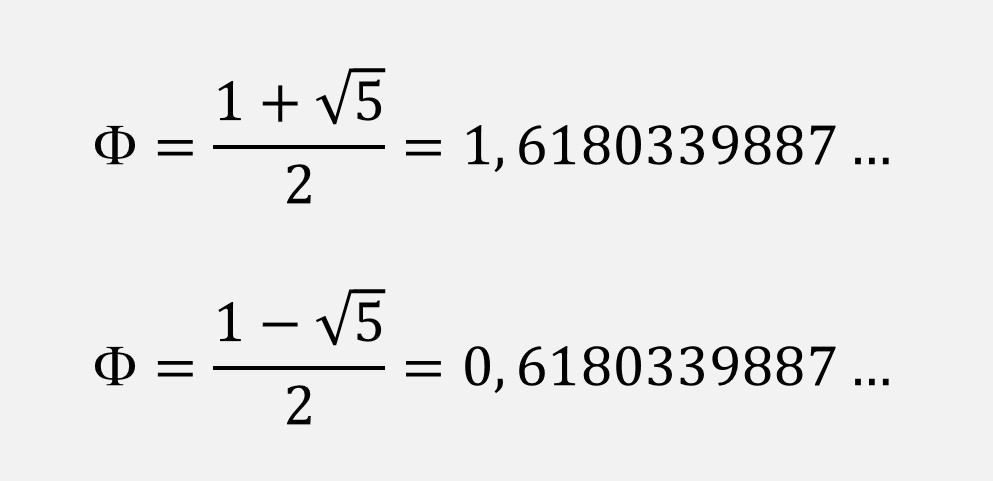

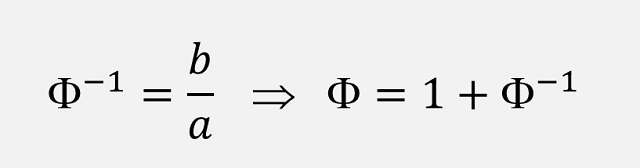

Recordemos brevemente la definición de Phi y la ecuación algebraica asociada, que nos va a ser de utilidad para nuestro objetivo de escribir los números como potencias de la razón áurea.

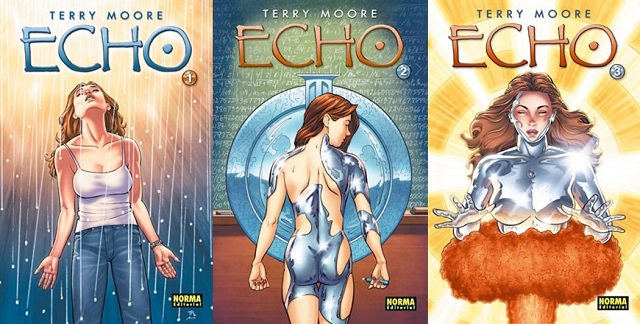

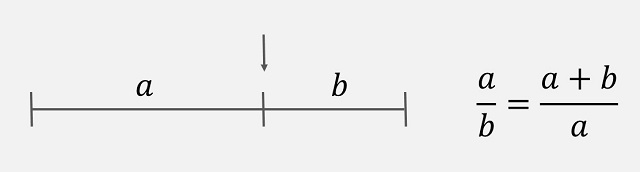

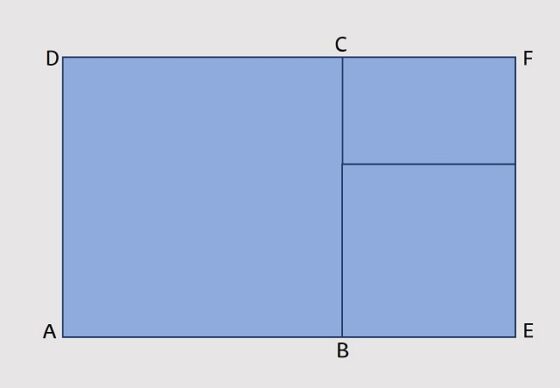

Se dice que un segmento de recta está dividido en extrema y media razón cuando la longitud del segmento total es a la parte mayor, como la de esta parte mayor es a la menor. Es decir, si tenemos un segmento como el que aparece en la siguiente imagen, buscamos el punto del mismo que divide al segmento en dos partes, de longitudes a y b, de forma que la proporción o razón (división) entre la parte mayor y la menor, a/b, es igual a la proporción entre la longitud del segmento y la parte mayor (a + b)/a.

Ahora, si llamamos Phi (Φ) al cociente a/b, la condición anterior se puede escribir como la ecuación algebraica siguiente:

Esta es una ecuación algebraica de segundo grado, cuyas soluciones, sin más que utilizar la conocida fórmula de resolución de la ecuación de segundo grado que estudiamos en el instituto, son las siguientes (una es Phi y la otra es 1 – Phi, que teniendo en cuenta que Phi-1 = b / a en la expresión de definición de Phi, se tiene que la otra raíz es 1 – Phi = – Phi-1).

En conclusión, tenemos dos fórmulas que nos van a ser de mucha utilidad a la hora de expresar los números naturales como sumas de potencias de Phi.

Para representar los números naturales en base Phi, primero vamos a ver que podemos expresar los números naturales como suma de potencias de Phi, positivas o negativas. Para lo cual van a ser de mucha utilidad las dos identidades anteriores del número Phi y basta jugar un poco con ellas para obtener las siguientes igualdades.

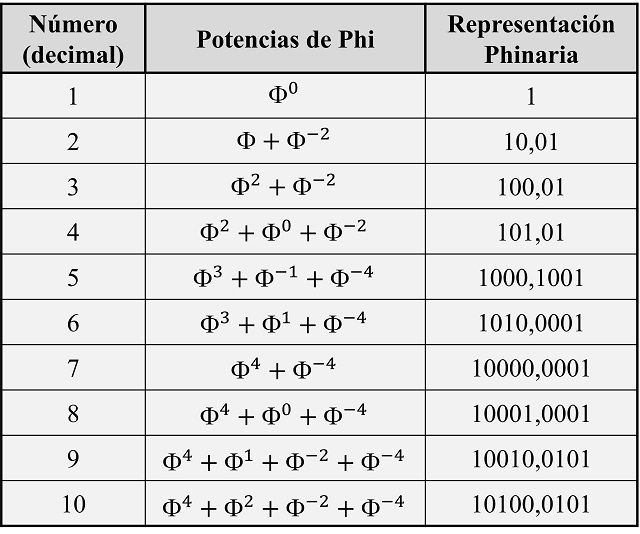

Los diez primeros números, de 1 a 10, expresados como potencias de Phi

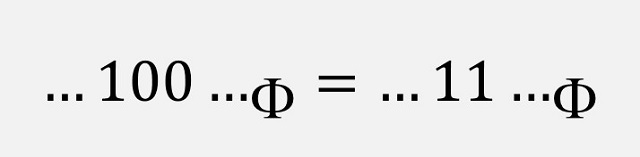

Los diez primeros números, de 1 a 10, expresados como potencias de PhiLo primero que observamos al realizar las anteriores identidades de los primeros números naturales es que, efectivamente, es posible expresarlos como suma de potencias de Phi. Por lo tanto, podemos representar esos números utilizando únicamente dos cifras básicas, 1 (para las potencias de Phi que están) y 0 (para las potencias de Phi que no están), aunque, como se utilizan potencias negativas, las representaciones van a tener una expresión con “decimales”, es decir, utilizaremos una “coma” y se van a colocar los coeficientes, 0s y 1s, de las potencias positivas a la izquierda y de las negativas a la derecha de la coma, como es habitual en cualquier sistema de numeración. En la siguiente tabla se han recogido las que serían las representaciones de los diez primeros números (teniendo en cuenta las anteriores igualdades).

Representaciones en base Phi de los números naturales del 1 al 10

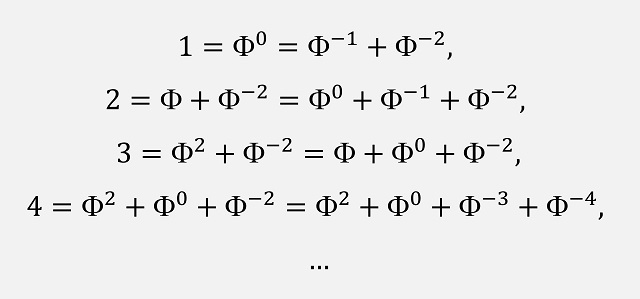

Representaciones en base Phi de los números naturales del 1 al 10Aunque hay algún pero que podemos poner antes de afirmar que estas serían las representaciones en base Phi de los números naturales. La cuestión es que los números pueden representarse como suma de potencias, positivas y negativas, del número Phi de más de una manera, como podemos observar para los siguientes números.

Los números 1, 2, 3, 4, etc pueden expresarse como sumas de potencias de Phi de formas distintas

Los números 1, 2, 3, 4, etc pueden expresarse como sumas de potencias de Phi de formas distintasSi tenemos en cuenta lo anterior, cada número tendría más de una representación Phinaria, lo cual no es deseable. En concreto, para los números que hemos mostrado arriba se tendría que el número uno tendría al menos dos representaciones, como 1 y como 0,11; el número dos tendría al menos otras dos, a saber, 10,01 y 1,11; el tres otras dos, que son 100,01 y 11,01; o el cuatro tendría las representaciones 101,01 y 101,0011; y así podríamos seguir. Más aún, hemos puesto dos expresiones de los números como suma de potencias de Phi, pero podríamos poner más de dos. Por ejemplo, para el número dos tendríamos infinitas formas de expresarlo como potencias, positivas y negativas, de Phi, como se muestra en la siguiente imagen.

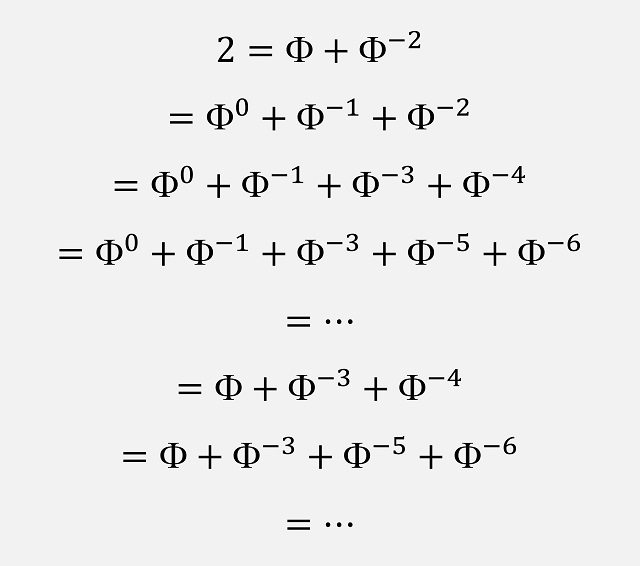

Existen infinitas maneras de expresar un número como suma de potencia de Phi

Existen infinitas maneras de expresar un número como suma de potencia de PhiY si lo expresamos en forma de representaciones Phinarias con ceros y unos, serían

10,01 = 1,11 = 1,1011 = 1,101011 = … = 10,0011 = 10,001011 =…

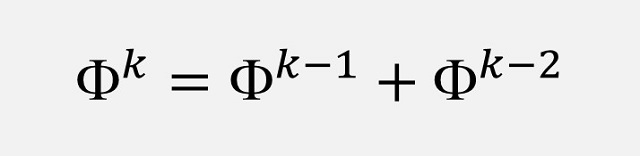

Por lo tanto, debemos buscar una forma de asignar a cada número una representación en base Phi única. Jugando con las anteriores expresiones hemos podido darnos cuenta de que se verifica la expresión

que está detrás del hecho de que existan muchas maneras de expresar los números naturales como sumas de potencias de Phi. Si pensamos en las representaciones Phinarias, la anterior igualdad se traduce a la siguiente igualdad

donde hemos utilizado el subíndice Phi para indicar que estamos con representaciones Phinarias. Esta expresión es la responsable de la existencia de infinitas representaciones, como podemos observar en las representaciones en base Phi anteriores del número dos. Así, se observa por ejemplo que

10,01 = 1,11.

Más aún, a toda representación Phinaria que termine en 1 se le puede sustituir el 1 por 011, por lo anterior, así en el caso del número dos tenemos que

10,01 = 10,0011 = 10,001011 =…

o también

1,11 = 1,1011 = 1,101011 = …

Representaciones en base Phi minimales y maximalesCon el objetivo de poder asignar una representación en base Phi única para cada número natural se van a introducir las representaciones Phinarias maximales y minimales.

Una representación Phinaria de un número natural se dice que es minimal si es la que posee la menor cantidad de unos (1) de entre todas las representaciones en base Phi de dicho número. Por la propiedad anterior, de que en toda representación Phinaria se puede sustituir 11 por 100, se tiene que las representaciones minimales son aquellas para las cuales no hay dos unos consecutivos (11). Así, la representación Phinaria minimal de todas las representaciones en base Phi del número dos que se han mostrado más arriba, es 10,01. Las demás representaciones tienen tres unos (1,11; 10,0011), cuatro unos (1,1011; 10,001011) o más (1,101011, etc.). De esta manera:

todo número natural posee una única representación en base Phi minimal (sin unos consecutivos).

De hecho, esta representación es la que se suele utilizar de forma habitual, por lo que se la denomina representación Phinaria estándar (o simplemente representación Phinaria, cuando no hay lugar a dudas).

Aunque también se podría considerar la denominada representación en base Phi maximal de un número natural, que es aquella que tiene la mayor cantidad de unos (1) de entre todas las representaciones Phinarias de dicho número, pero que no termine en 011 (así evitamos esa ampliación infinita por la parte de la derecha que hemos observado con el número dos). Estas representaciones no tienen dos ceros consecutivos (00). Si observamos las representaciones Phinarias del número dos que se han mostrado más arriba, las únicas que no terminan en 011 son 10,01 y 11,1. Por lo tanto, la representación en base Phi maximal de dos es 1,11. Y ahora también tenemos que:

todo número natural posee una única representación en base Phi maximal (sin unos consecutivos).

Vamos a terminar incluyendo las representaciones minimales (estándar) y maximales de los primeros números naturales.

Ahora ya sabemos cuál es la representación en base Phi de los números naturales (la que hemos denominado estándar). Por ejemplo, el año en el que estamos, mientras escribo esta entrada, que es el año 2025 se escribiría en base Phi como

1 010 010 000 101 010,000 001 000 010 000 1.

Más aún, no solo se representan los números naturales (enteros), sino que se podrían representar, de nuevo, todos los números reales, pero no vamos a entrar en ello en esta entrada.

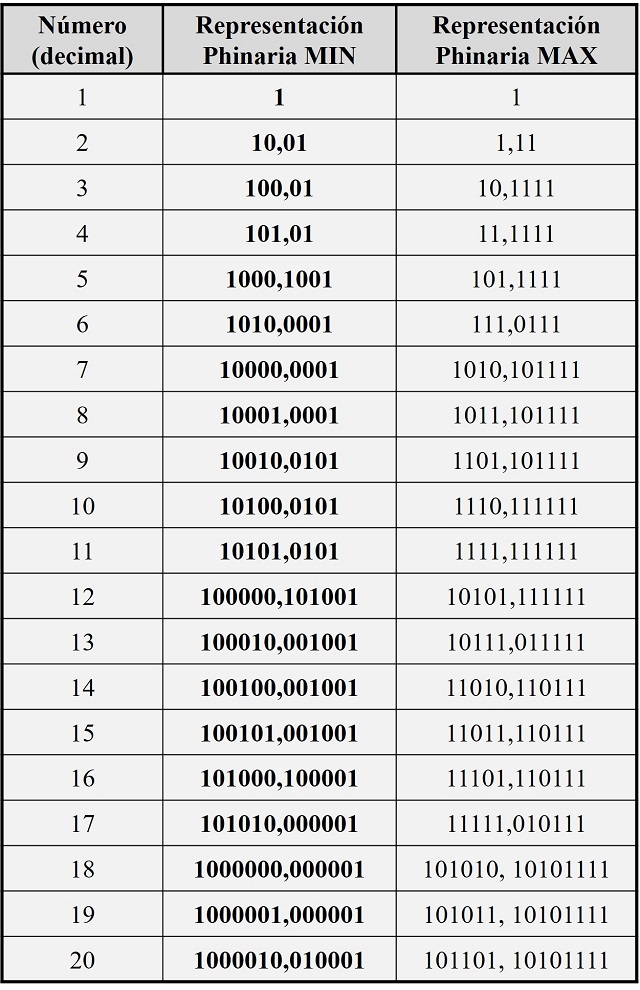

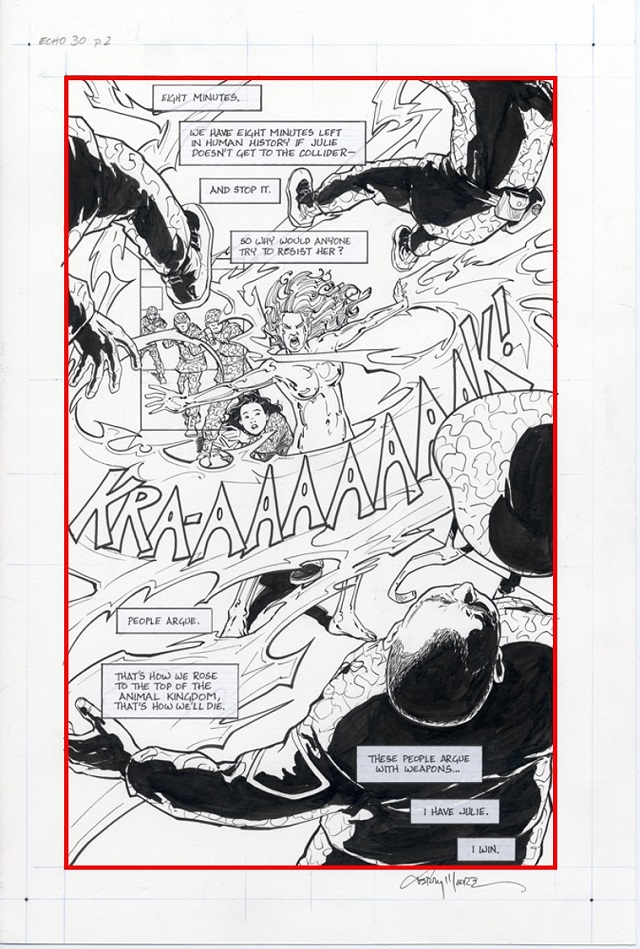

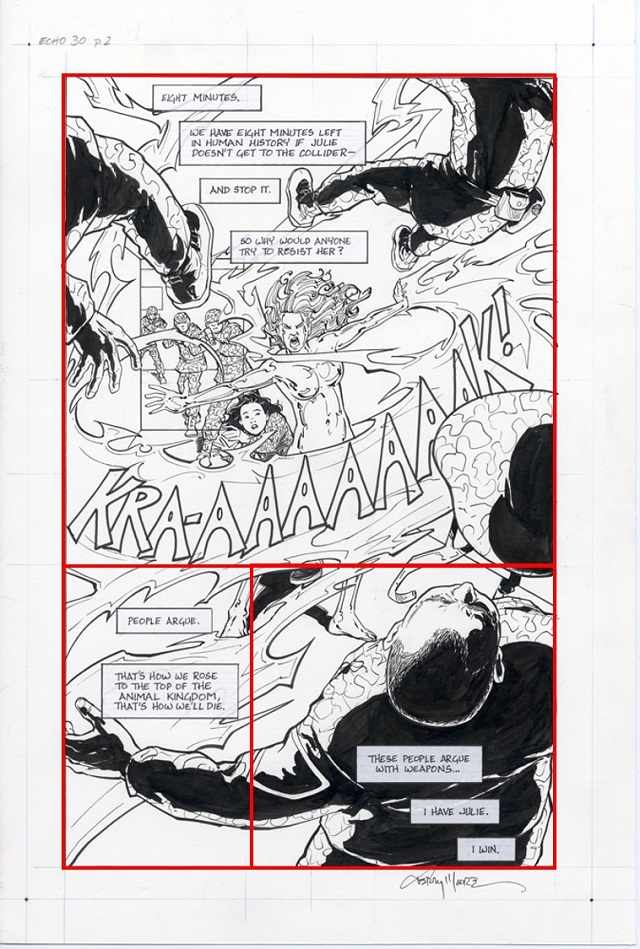

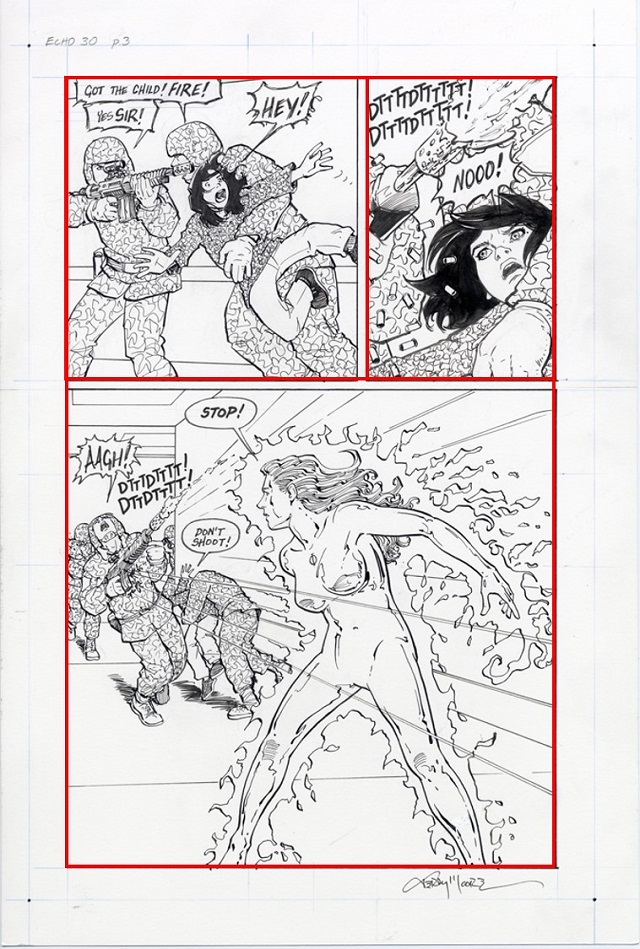

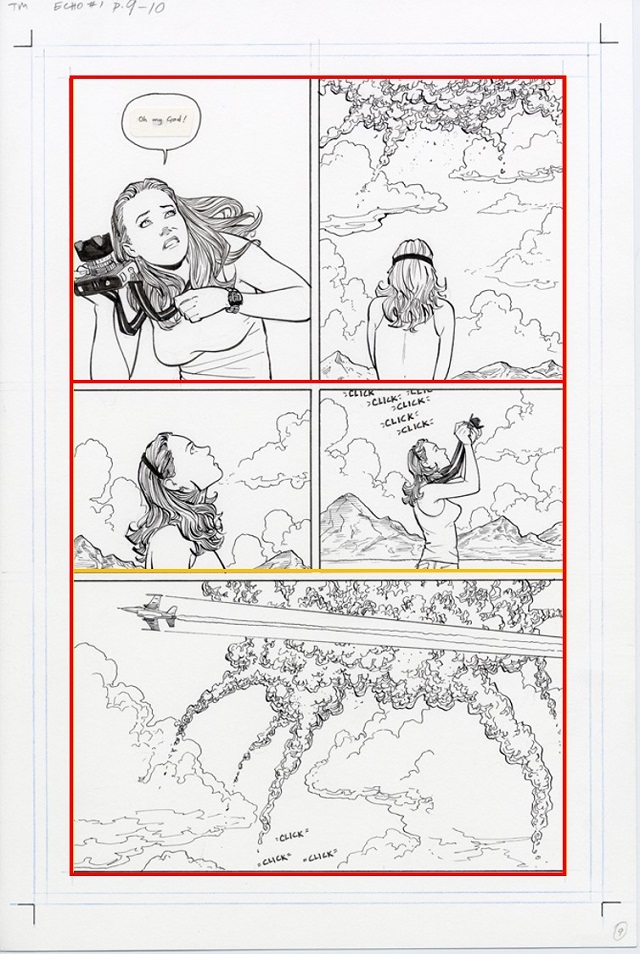

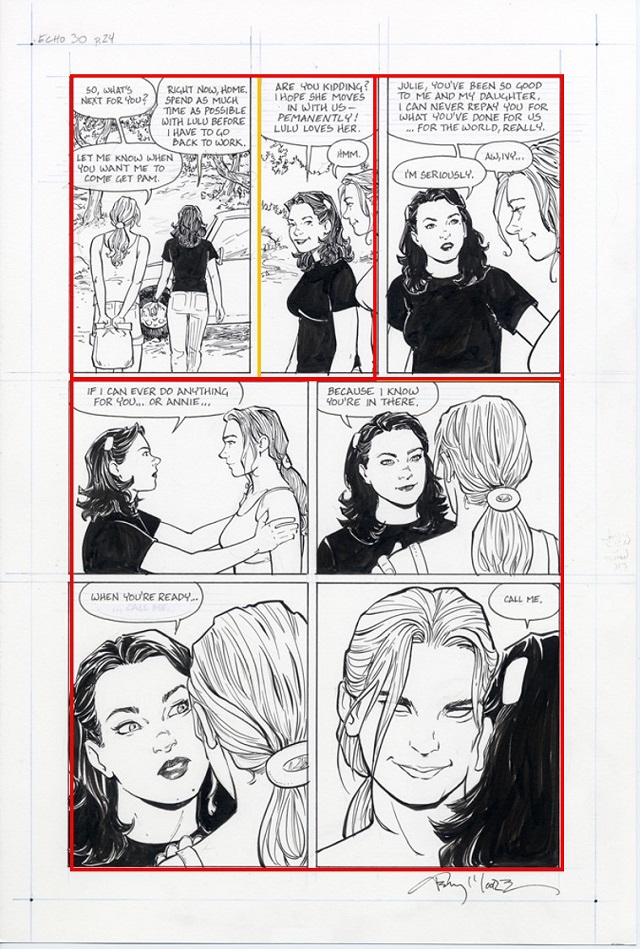

Dibujo original de la página 2, del número 1, del cómic ECHO (2008-2011) de Terry Moore. Imagen de la página web de Abstracts Studio

Dibujo original de la página 2, del número 1, del cómic ECHO (2008-2011) de Terry Moore. Imagen de la página web de Abstracts StudioBibliografía

1.- Mario Livio, La proporción áurea, La historia de phi, el número más sorprendente del mundo, Ariel, 2006.

2.- Ron Knott: Using Powers of Phi to represent Integers (Base Phi)

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El sistema de numeración en base Phi se ha escrito en Cuaderno de Cultura Científica.

La textura de los alimentos como generador de emociones en la infancia

La textura es un aspecto fundamental en la aceptación de los alimentos por parte de la población infantil. A lo largo de los años, numerosos estudios [1]–[3] han demostrado que los niños y niñas tienden a preferir texturas homogéneas y fáciles de masticar, mientras que las texturas más complejas pueden generar rechazo. Sin embargo, la aceptabilidad no es el único criterio que influye en sus elecciones alimentarias. En este sentido, estudios predictivos [4]–[6] han mostrado que el comportamiento alimentario está influenciado en gran medida por respuestas inconscientes e involuntarias como las emociones.

Foto: Raymond Petrik / UnsplashEmociones y alimentos: una conexión profunda

Foto: Raymond Petrik / UnsplashEmociones y alimentos: una conexión profunda

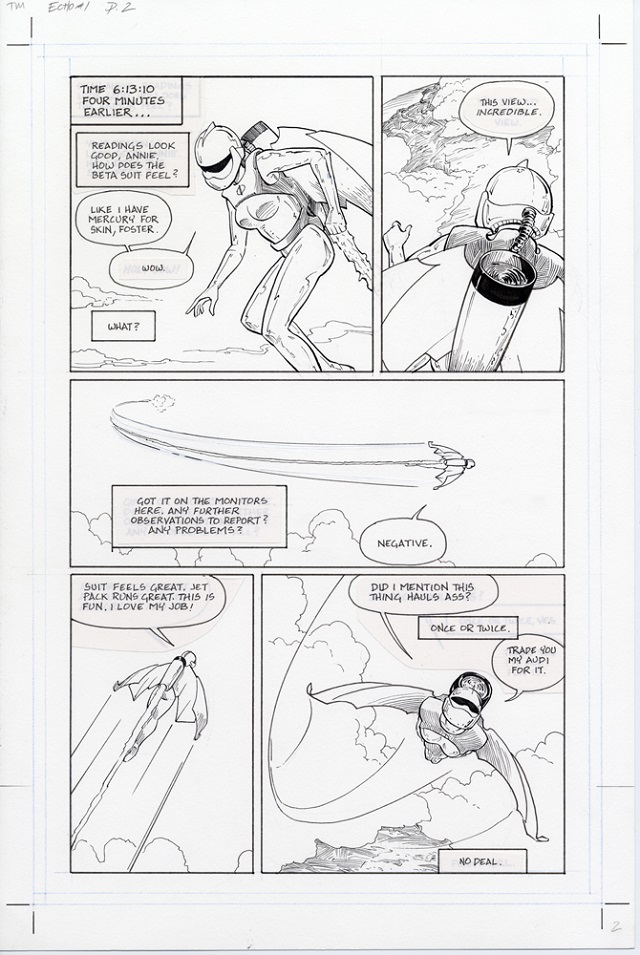

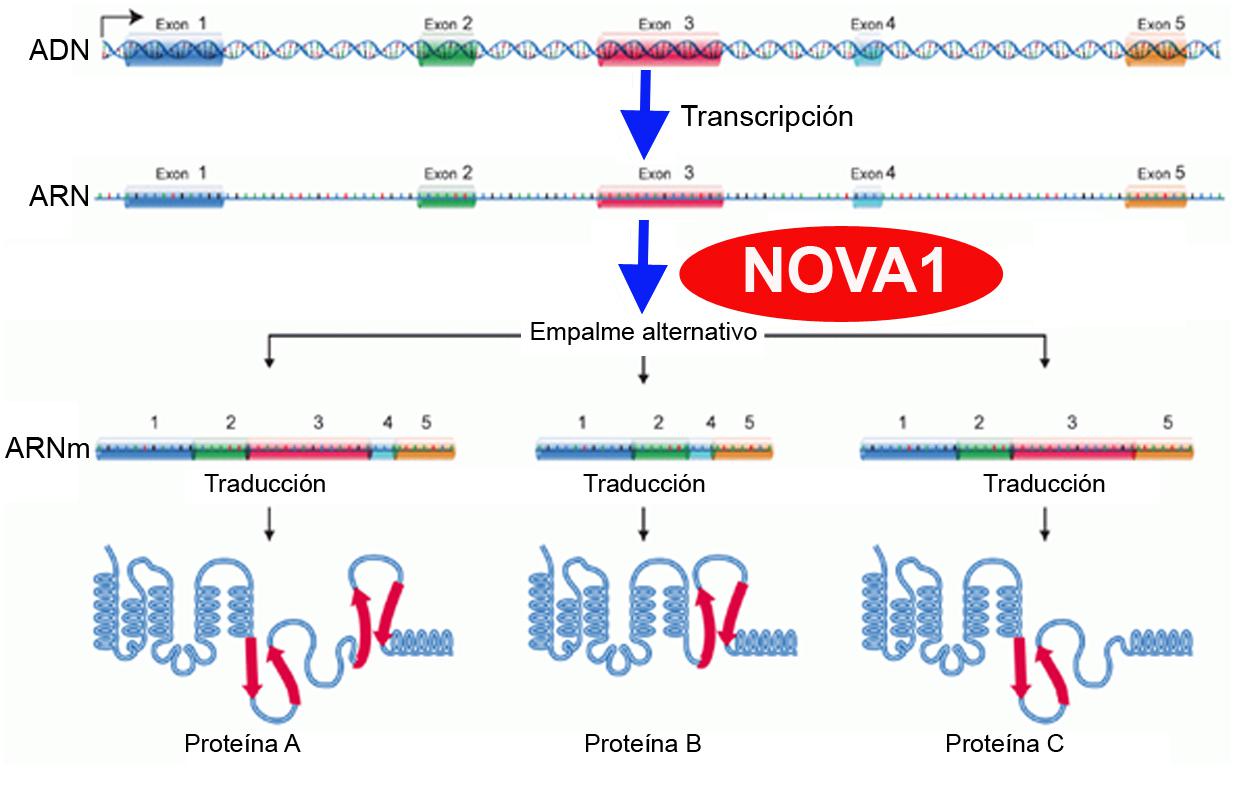

Desde hace siglos, los filósofos y científicos han intentado responder a una pregunta fundamental: ¿qué es una emoción y cómo se genera? Existen distintas teorías que buscan explicarlo.La teoría de las emociones básicas [7], inspirada en Darwin [8], sostiene que las emociones son respuestas universales e innatas que nos han ayudado a sobrevivir a lo largo de la evolución. Según esta perspectiva, emociones como la alegría, el miedo o la ira están asociadas a patrones específicos de expresiones faciales y reacciones fisiológicas. Un ejemplo de estos patrones se muestra en la Figura 1.

Figura 1. Proceso de generación de las emociones de acuerdo con la teoría de las emociones básicas que muestra cómo se evalúa la información y se traduce en acciones que desarrolla el individuo en función del evento desencadenante de la emoción [9]. La figura también muestra un ejemplo relacionado con la emoción de miedo.

Figura 1. Proceso de generación de las emociones de acuerdo con la teoría de las emociones básicas que muestra cómo se evalúa la información y se traduce en acciones que desarrolla el individuo en función del evento desencadenante de la emoción [9]. La figura también muestra un ejemplo relacionado con la emoción de miedo.Por otro lado, las teorías dimensionales [10] consideran que las emociones no son categorías discretas, sino experiencias que varían en dos dimensiones principales: la valencia emocional (cómo de positiva o negativa es la emoción) y el nivel de activación emocional (cómo de excitada o relajada es la emoción). Finalmente, las teorías de la evaluación (o appraisal en inglés) [11] sugieren que las emociones surgen a partir de la evaluación cognitiva que hacemos de una situación, basándonos en nuestras experiencias previas. Desde este punto de vista, el cerebro no solo reacciona automáticamente, sino que interpreta el contexto y ajusta la respuesta emocional de forma flexible.

Aunque cada teoría aborda la emoción desde una perspectiva distinta, todas coinciden en que se trata de un fenómeno complejo que involucra múltiples componentes del organismo: desde cambios conductuales o fisiológicos hasta procesos cognitivos que influyen en nuestra forma de actuar.

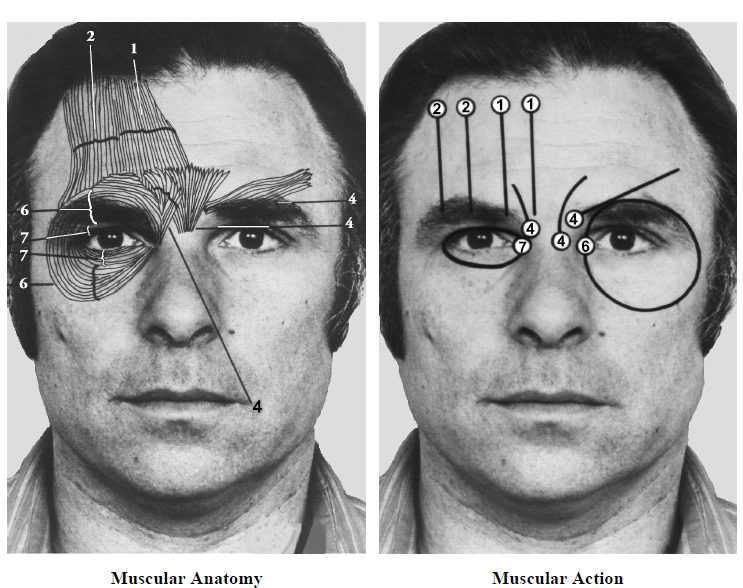

Una de estas respuestas conductuales puede ser la expresión facial. Desde hace décadas, los científicos han estudiado cómo la expresión de nuestra cara refleja nuestras emociones. En este sentido, el sistema Facial Action Coding System (FACS; Figura 2) [12], desarrollado por Paul Ekman y colaboradores, establece que ciertos movimientos musculares en el rostro están asociados a puntos concretos de la expresión (denominados en inglés Action Units o AUs) que a su vez se relacionan con emociones básicas como la alegría, la tristeza o el miedo.

Figura 2. Ejemplo de la identificación de músculos y puntos de expresión facial (Action Units) en la zona superior de la cara de acuerdo con el sistema FACS [12].

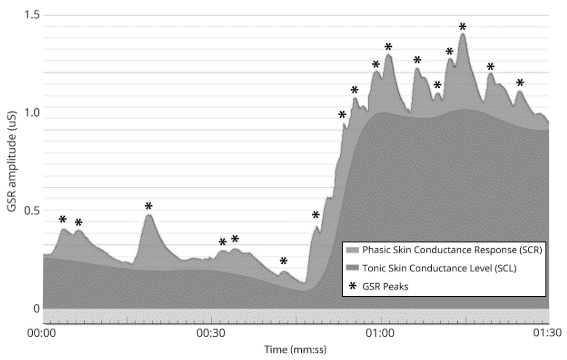

Figura 2. Ejemplo de la identificación de músculos y puntos de expresión facial (Action Units) en la zona superior de la cara de acuerdo con el sistema FACS [12].Mientras que el rostro refleja la emoción a nivel conductual, el sistema nervioso autónomo (ANS por sus siglas en inglés) revela lo que sucede en el interior del cuerpo. Una de las formas de medir esta respuesta es a través de la conductividad de la piel (SCR, por sus siglas en inglés; Figura 3), un método que detecta cambios en la actividad de las glándulas sudoríparas en la piel, especialmente en las manos. Cuando experimentamos una emoción intensa—como sorpresa, miedo o excitación—, nuestro sistema nervioso activa automáticamente la producción de sudor. Estos pequeños cambios en la humedad de la piel alteran su conductividad eléctrica, lo que puede ser medido mediante sensores colocados en los dedos.

Figura 3. Curva de la actividad electrodérmica en la que se diferencian dos fases: (i) fase tónica (SCL), relacionada con cambios suaves de la actividad eléctrica; y (ii) fase fásica (SCR), en la cual se generan cambios de la actividad eléctrica ocasionados por eventos desencadenantes como las emociones [13]–[15] Los picos de respuesta electrodérmica se corresponden con aumentos de SCR por encima de un umbral específico.La textura de los alimentos y las emociones en la infancia

Figura 3. Curva de la actividad electrodérmica en la que se diferencian dos fases: (i) fase tónica (SCL), relacionada con cambios suaves de la actividad eléctrica; y (ii) fase fásica (SCR), en la cual se generan cambios de la actividad eléctrica ocasionados por eventos desencadenantes como las emociones [13]–[15] Los picos de respuesta electrodérmica se corresponden con aumentos de SCR por encima de un umbral específico.La textura de los alimentos y las emociones en la infancia

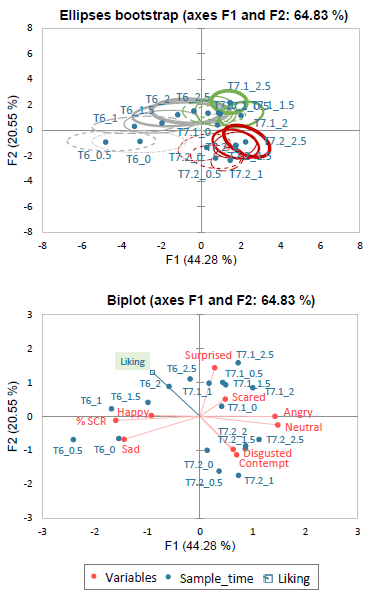

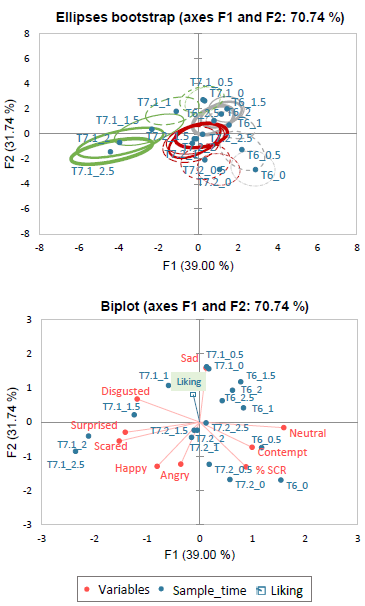

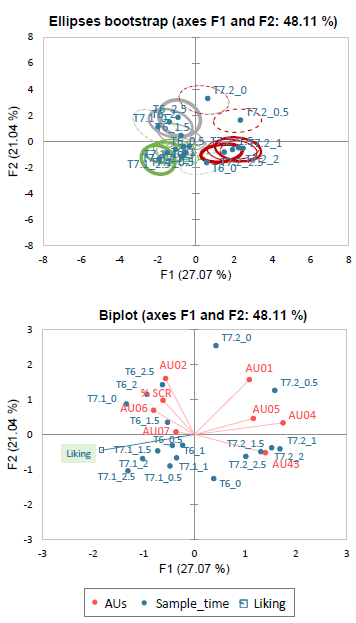

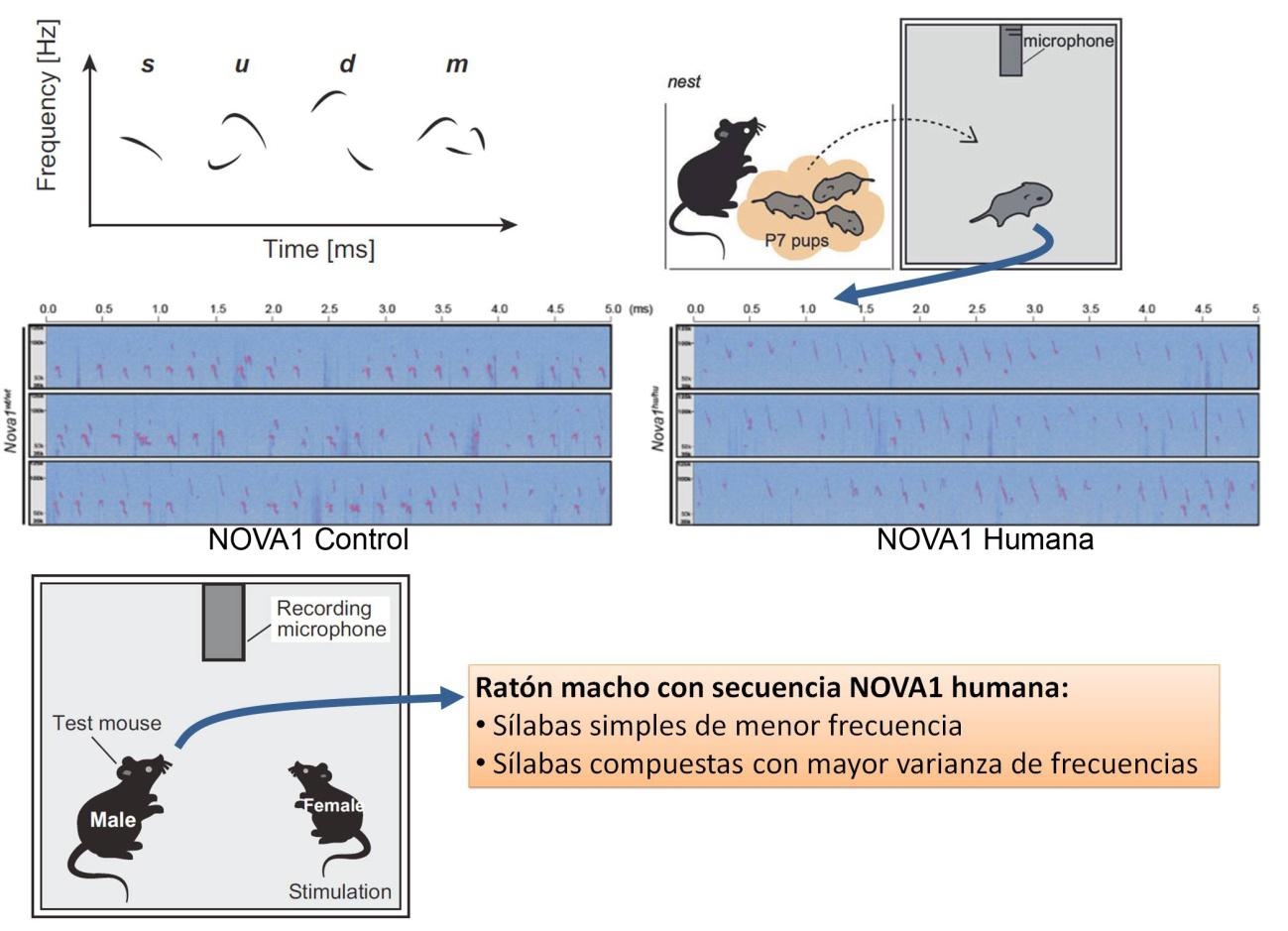

En este contexto, un estudio reciente publicado en la revista científica Food Quality and Preference [16] ha profundizado en la relación que existe entre la textura de los alimentos y las emociones de la población infantil analizando cómo reaccionan los niños y niñas de entre 5 y 12 años ante alimentos sólidos con diferentes texturas. Para ello, se combinaron métodos tradicionales, como los cuestionarios, con tecnologías avanzadas que miden tanto sus expresiones faciales como la conductividad de su piel, lo que permite captar reacciones emocionales tanto conscientes como inconscientes.

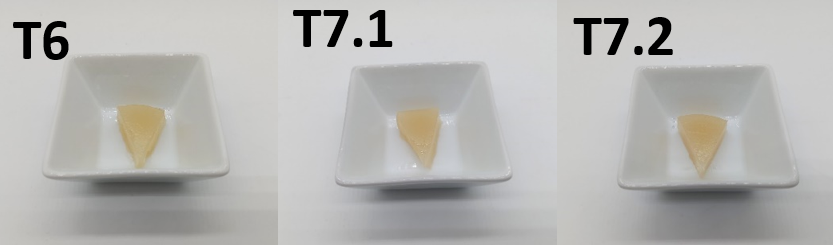

En este estudio, las investigadoras trabajaron con un grupo de 45 niños y niñas, a quienes se les ofrecieron tres muestras de un mismo producto elaborado a partir de zumo de manzana, pero con distintas texturas: una blanda (denominada T6), otra de fácil masticación (T7.1) y una más firme (T7.2; Figura 4). Cada individuo evaluó estos productos en cuatro etapas sensoriales: observación, olfacción, manipulación y consumo. Durante todo el proceso, sus expresiones faciales fueron registradas con el software de reconocimiento automatizado FaceReader (Noldus Information Technology, Países Bajos) que analiza estos movimientos musculares y los traduce en emociones específicas, así como su nivel de excitación emocional que se midió con sensores de conductividad de la piel. Además, después de probar cada muestra, se les pidió que calificaran cuánto les gustaba en una escala del 1 al 7.

Figura 4. Muestras evaluadas en el estudio da Quinta et al. (2024) [16] con textura blanda (denominada T6), textura de fácil masticación (T7.1) y textura firme (T7.2).

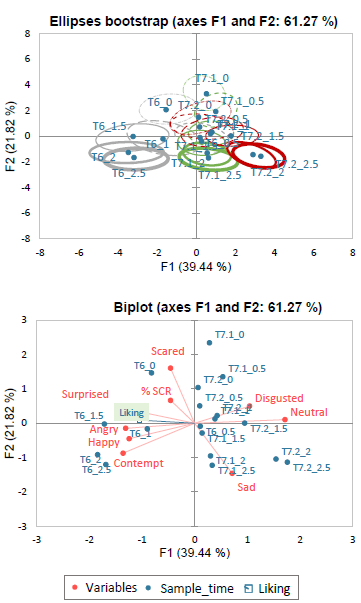

Figura 4. Muestras evaluadas en el estudio da Quinta et al. (2024) [16] con textura blanda (denominada T6), textura de fácil masticación (T7.1) y textura firme (T7.2).Uno de los hallazgos más llamativos fue que, aunque los niños y niñas calificaron los tres productos con niveles de aceptabilidad similares (textura T6: 4,6+1,8; textura T7.1: 4,6+2,0; textura T7.2: 4.3+2.0), sus reacciones emocionales fueron significativamente diferentes según la textura del alimento y la etapa sensorial en la que se encontraban (Figuras 5-8).

-

El producto más blando provocó más expresiones faciales de sonrisa en la fase inicial.

-

Las texturas más firmes generaron más expresiones de miedo y desagrado, especialmente durante la masticación. La textura más dura también generó expresiones faciales de miedo y sorpresa durante la fase de consumo, lo que sugiere una reacción negativa de alerta ante lo que se percibe como un alimento más difícil de masticar.

-

Curiosamente, las investigadoras también encontraron que las reacciones emocionales eran más intensas y la activación emocional mayor durante la observación y la olfacción que durante la manipulación y el consumo. Esto sugiere que la población infantil de edad escolar desarrolla expectativas sobre el alimento antes de probarlo, y que estas expectativas pueden influir en su respuesta emocional cuando finalmente lo consumen.

Figura 5. Perfil emocional obtenido durante la observación de diferentes texturas sólidas en población infantil (N = 45). En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms.

Figura 5. Perfil emocional obtenido durante la observación de diferentes texturas sólidas en población infantil (N = 45). En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms. Figura 6. Perfil emocional obtenido durante la olfacción de diferentes texturas sólidas en población infantil (N = 45). En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms.

Figura 6. Perfil emocional obtenido durante la olfacción de diferentes texturas sólidas en población infantil (N = 45). En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms. Figura 7. Perfil emocional obtenido durante la manipulación de diferentes texturas sólidas en población infantil (N = 45). En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms.

Figura 7. Perfil emocional obtenido durante la manipulación de diferentes texturas sólidas en población infantil (N = 45). En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms. Figura 8. Perfil emocional obtenido durante el consumo de diferentes texturas sólidas en población infantil (N = 45). Durante la fase de consumo los resultados se muestran en base al movimiento observado en los puntos de expresión facial correspondientes a la parte superior de la cara para evitar alteraciones de la medida ocasionadas por la masticación y el procesado oral del alimento1. En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms.Industria y nutricionistas

Figura 8. Perfil emocional obtenido durante el consumo de diferentes texturas sólidas en población infantil (N = 45). Durante la fase de consumo los resultados se muestran en base al movimiento observado en los puntos de expresión facial correspondientes a la parte superior de la cara para evitar alteraciones de la medida ocasionadas por la masticación y el procesado oral del alimento1. En el gráfico de elipses, la forma y el grosor de las líneas corresponden a la evolución del tiempo de exposición. Los tiempos iniciales de exposición se representan con líneas punteadas y finas, mientras que los tiempos de exposición más largos corresponden a líneas continuas y más gruesas. Los productos con diferentes texturas aparecen coloreados de diferente manera, siendo: T6 = gris. T7.1 = verde. T7.2= rojo. Las etiquetas para los rangos de tiempo aparecen en cada gráfico de la siguiente manera: Textura_0: 0–500 ms. Textura_0.5: 500–1000 ms. Textura_1: 1000–1500 ms. Textura_1.5: 1500–2000 ms. Textura_2: 2000–2500 ms. Textura_2.5: 2500–3000 ms.Industria y nutricionistas

Estos resultados son especialmente relevantes para la industria alimentaria y para quienes trabajan en nutrición infantil. Aunque el público infantil pueda aceptar un alimento desde el punto de vista del gusto, su respuesta emocional podría afectar su disposición a consumirlo regularmente. Por ejemplo, si un alimento genera expresiones faciales de sorpresa y/o miedo durante la observación o la olfacción, es posible que sea rechazado antes de probarlo, incluso si luego gusta su sabor. Esto refuerza la idea de que, para mejorar la aceptación de ciertos alimentos es crucial considerar no solo su sabor, sino también la forma en que se presentan y su textura.

Referencias:

[1] A. S. Szczesniak, “Texture is a sensory property,” Food Qual. Prefer., vol. 13, no. 4, pp. 215–225, 2002, doi: 10.1016/S0950-3293(01)00039-8.

[2] M. Laureati et al., “Individual differences in texture preferences among European children: Development and validation of the Child Food Texture Preference Questionnaire (CFTPQ),” Food Qual. Prefer., vol. 80, p. 103828, 2020, doi: https://doi.org/10.1016/j.foodqual.2019.103828.

[3] M. Laureati, C. Cattaneo, V. Lavelli, V. Bergamaschi, P. Riso, and E. Pagliarini, “Application of the check-all-that-apply method (CATA) to get insights on children’s drivers of liking of fiber-enriched apple purees,” J. Sens. Stud., vol. 32, no. 2, 2017, doi: 10.1111/joss.12253.

[4] J. R. Dalenberg, S. Gutjar, G. J. Ter Horst, K. De Graaf, R. J. Renken, and G. Jager, “Evoked emotions predict food choice,” PLoS One, vol. 9, no. 12, pp. 1–16, 2014, doi: 10.1371/journal.pone.0115388.

[5] G. Juodeikiene et al., “Effects of emotional responses to certain foods on the prediction of consumer acceptance,” Food Res. Int., vol. 112, no. May, pp. 361–368, 2018, doi: 10.1016/j.foodres.2018.06.064.

[6] S. S. Samant, M. J. Chapko, and H. S. Seo, “Predicting consumer liking and preference based on emotional responses and sensory perception: A study with basic taste solutions,” Food Res. Int., vol. 100, no. April, pp. 325–334, 2017, doi: 10.1016/j.foodres.2017.07.021.

[7] P. Ekman, “All emotions are basic,” in The nature of emotion, P. Ekman and R. J. Davidson, Eds., Oxford University Press, 1994, pp. 56–58.

[8] C. Darwin, The expression of the emotions in man and animals. Cambridge: Cambridge University Press, 1872. doi: DOI: 10.1017/CBO9781139833813.

[9] R. Plutchik, “The nature of emotions: Human emotions have deep evolutionary roots, a fact that may explain their complexity and provide tools for clinical practice,” Am. Sci., vol. 89, no. 4, pp. 344–350, Apr. 2001, [Online]. Available: http://www.jstor.org/stable/27857503

[10] J. A. Russell, “A circumplex model of affect,” J. Pers. Soc. Psychol., vol. 39, no. 6, pp. 1161–1178, 1980, doi: 10.1037/h0077714.

[11] L. Barrett, “Solving the emotion paradox: Categorization and the experience of emotion,” Pers. Soc. Psychol. Rev., vol. 10, pp. 20–46, Feb. 2006, doi: 10.1207/s15327957pspr1001_2.

[12] P. Ekman, W. Friesen, and J. C. Hager, Facial Action Coding System: The manual on CD-ROM. Instructor’s Guide. Salt Lake City: Network Information Research Co, 2002.

[13] iMotions Biometric Research Simplified, “What is GSR? The definite guide,” 2015. [Online]. Available: https://imotions.com/guides/facial-expression-analysis/

[14] J. J. J. Braithwaite et al., “A guide for analysing Electrodermal Activity (EDA) & Skin Conductance Responses (SCRs) for psychological experiments,” 2015. doi: 10.1017.S0142716405050034.

[15] S. D. Kreibig, “Autonomic nervous system activity in emotion : A review,” Biol. Psychol., vol. 84, no. 3, pp. 14–41, 2010, doi: 10.1016/j.biopsycho.2010.03.010.

[16] N. da Quinta, A. B. Baranda, Y. Ríos, R. Llorente, A. B. Naranjo, and I. Martinez de Marañón, “Children’s physiological and behavioural response during the observation, olfaction, manipulation, and consumption of food products with varied textures. Part 2: Solid products,” Food Qual. Prefer., vol. 115, p. 105120, 2024, doi: https://doi.org/10.1016/j.foodqual.2024.105120.

[17] R. Soussignan and B. Schaal, “Children’ s facial responsiveness to odors: Influences of hedonic valence of odor, gender, age, and social presence,” Dev. Psychol., vol. 32, no. 2, pp. 367–379, 1996, doi: 10.1037/0012-1649.32.2.367.

[18] G. G. Zeinstra, M. A. Koelen, D. Colindres, F. J. Kok, and C. de Graaf, “Facial expressions in school-aged children are a good indicator of ‘dislikes’, but not of ‘likes,’” Food Qual. Prefer., vol. 20, no. 8, pp. 620–624, 2009, doi: 10.1016/j.foodqual.2009.07.002.

Nota:

1 El significado de los puntos de expresión facial de la parte superior de la cara es: AU01: elevador de cejas interno (inner brow raiser); AU02: elevador de cejas externo (outer brow raiser); AU04: bajador o descensor de cejas (brow lowerer); AU05: elevador de párpado superior (upper lid raiser); AU06: elevador de mejillas (cheek raiser); AU07: tensor de párpado (lid tightener); AU43: ojos cerrados (eyes closed) [12].

La asociación de dichos puntos de expresión facial con emociones se realizó en base a las indicaciones aportadas por otras publicaciones científicas [12], [17], [18]. Los puntos de expresión AU01, AU02, AU04 y AU43 se asociaron con emociones negativas. Por otro lado, AU06 se asoció con emociones neutras. Finalmente, se consideró que AU05 y AU07 no tienen relación directa con una emoción.

Sobre la autora: Noelia Da Quinta es doctora en Calidad y Seguridad alimentarias e investigadora postdoctoral en comportamiento del consumidor en AZTI.

Sobre AZTI: El propósito de AZTI es impulsar un cambio positivo para el futuro de las personas, contribuyendo a una sociedad saludable, sostenible e íntegra. Especializado en el medio marino y la alimentación, AZTI aporta productos y tecnologías de vanguardia y de valor añadido basados en ciencia e investigación sólidas. AZTI es miembro de Basque Research and Technology Alliance (BRTA).

Basque Research & Technology Alliance (BRTA) es un consorcio que se anticipa a los retos socioeconómicos futuros globales y de Euskadi y que responde a los mismos mediante la investigación y el desarrollo tecnológico, proyectándose internacionalmente. Los centros de BRTA colaboran en la generación de conocimiento y su transferencia a la sociedad e industria vascas para que sean más innovadoras y competitivas. BRTA es una alianza de 17 centros tecnológicos y centros de investigación cooperativa y cuenta con el apoyo del Gobierno Vasco, SPRI y las Diputaciones Forales de Araba, Bizkaia y Gipuzkoa.

El artículo La textura de los alimentos como generador de emociones en la infancia se ha escrito en Cuaderno de Cultura Científica.

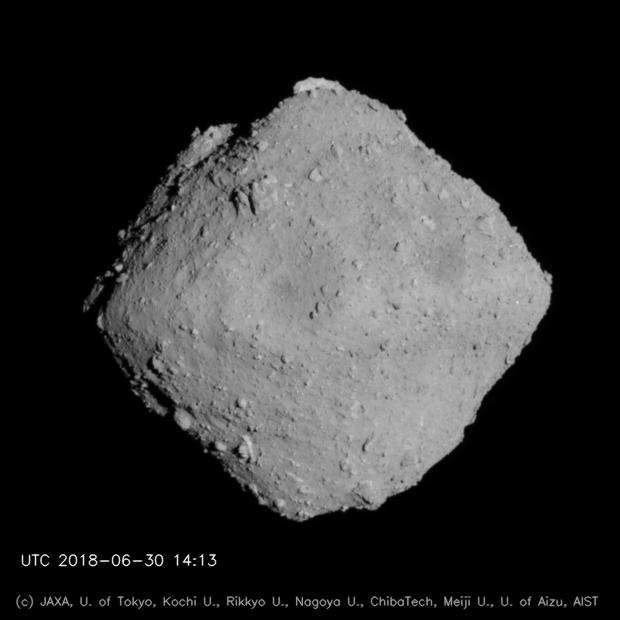

Los casquetes polares de Marte y el interior del planeta rojo

Cuando en una de esas noches en las que Marte y la Tierra se encuentran relativamente cerca -bueno, cerca en el sentido astronómico, ya que es difícil que nos acerquemos a menos de 55 millones de kilómetros- y miramos con un telescopio modesto, hay algo que salta a la vista y que, sin poder ver ningún otro detalle de la superficie con tanta claridad entre la turbulencia atmosférica, nos hace sentir cierta familiaridad: los casquetes polares de Marte.

Más allá de que para los geólogos las capas de polvo y hielo de los casquetes polares -como una inmensa tarta de chocolate y galletas- pueden albergar una importantísima información sobre la historia climática del planeta rojo, hay algo más que nos pueden enseñar estas grandes masas de hielo al igual que las hemos podido aprovechar en la Tierra: conocer mejor la rigidez del manto y, a la vez, como de frío está el interior del planeta.

Marte observado desde el telescopio espacial Hubble. El casquete polar del hemisferio Norte es claramente visible en la parte superior del planeta. Si en vez de rojo, fuese azul, muy probablemente encontraríamos un parecido todavía más asombroso con nuestro planeta. Cortesía de JPL/NASA/STScI.

Marte observado desde el telescopio espacial Hubble. El casquete polar del hemisferio Norte es claramente visible en la parte superior del planeta. Si en vez de rojo, fuese azul, muy probablemente encontraríamos un parecido todavía más asombroso con nuestro planeta. Cortesía de JPL/NASA/STScI.En la Tierra tenemos una compleja historia de periodos glaciares e interglaciares. Durante las popularmente conocidas como “edades del hielo” -los periodos glaciares-, sobre los continentes suelen formarse grandes masas de hielo y, con su enorme peso, tienen la capacidad de ir hundiendo la corteza que hay debajo, flexionándola como cuando clavamos un dedo sobre una bola antiestrés.

Cuando el clima va cambiando hacia un periodo más cálido -o interglaciar- y el hielo comienza a fundirse, este peso se va liberando y la corteza “rebota” hacia arriba en un proceso que conocemos como rebote isostático, que como decía en el párrafo anterior, nos da pistas sobre el estado del interior de nuestro planeta.

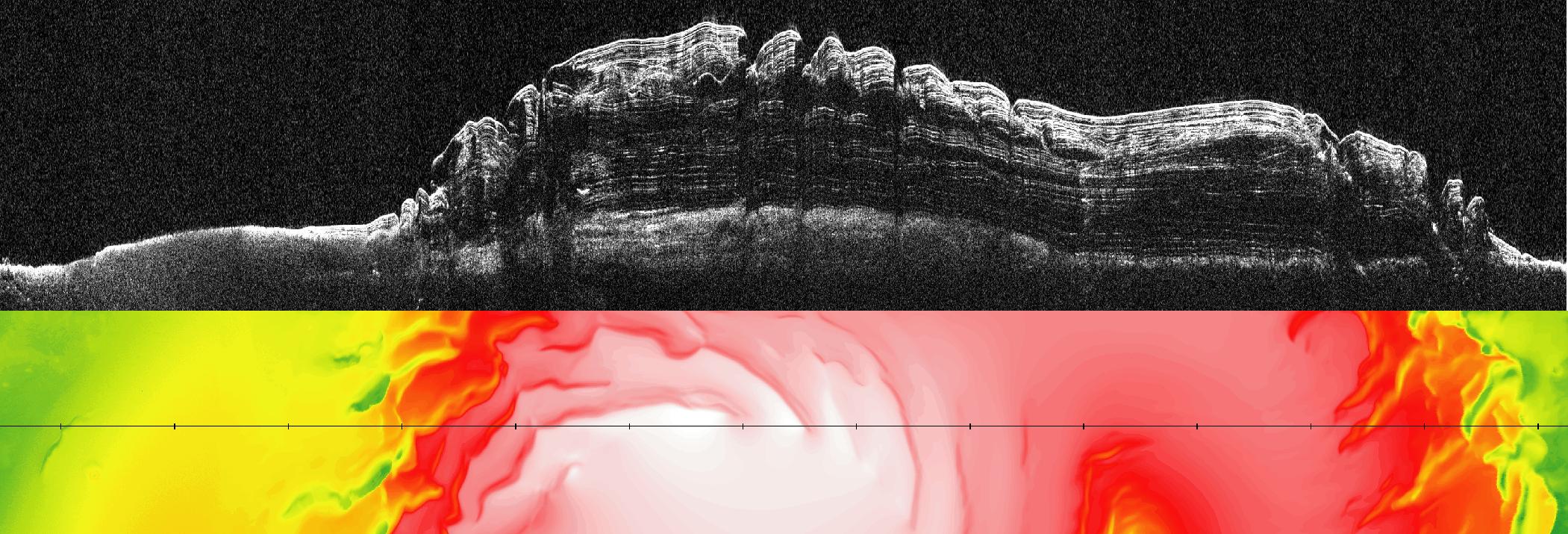

En Marte podemos medir estos procesos gracias al casquete de hielo que existe en el polo Norte, un enorme depósito de hielo y polvo de varios kilómetros de espesor acumulados durante millones de años y que es capaz de, por su peso, deformar la corteza de con una magnitud que podemos medir a través de las misiones espaciales. Y un nuevo artículo publicado por Broquet et al. (2025), nos ha abierto, gracias a la deformación que produce el peso de este hielo sobre la corteza del planeta, una ventana para conocer mejor el funcionamiento interno de Marte.

¿Cómo han abordado los científicos este problema? Porque no ha habido ninguna misión específica dedicada a estudiar esta cuestión en la superficie de Marte, pero tampoco desde la órbita. A pesar de eso, han logrado cuatro indicios diferentes para reconstruir con más detalle estos procesos de deformación y respuesta de la corteza y el manto marciano.

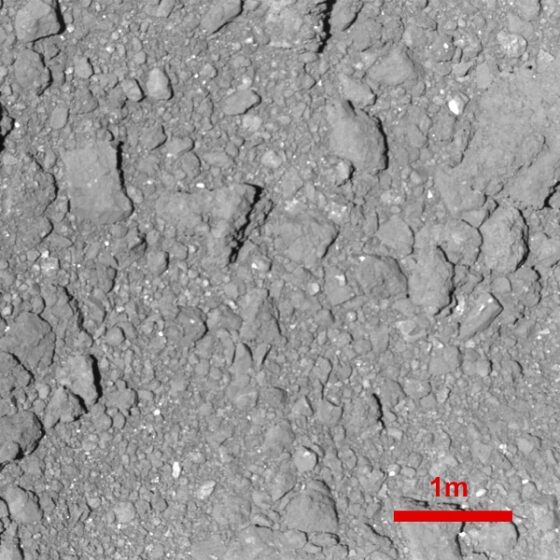

La primera de estas pistas viene dada por el estudio de los perfiles de radar tomados por los instrumentos MARSIS y SHARAD, que les ha permitido observar una especie de “radiografía” de los casquetes polares gracias a las ondas de radio que rebotan -y en algunos casos son absorbidas- por las distintas capas del casquete polar. Con estos perfiles se ha podido calcular el espesor real de la capa de hielo y estudiar el estado de las rocas que soportan esta masa de hielo, descubriendo que no ha sufrido una flexura o flexión muy grande como consecuencia del peso.

En esta imagen podemos ver un perfil de radar del polo norte marciano tomado por el instrumento SHARAD que viaja a bordo de la sonda Mars Reconaissance Orbiter. Se aprecian perfectamente distintas capas dentro del hielo -quizás relacionadas con alternancias climáticas- así como la roca sobre la que se apoya el hielo. Cortesía de NASA/JPL-Caltech/University of Rome/SwRI.

En esta imagen podemos ver un perfil de radar del polo norte marciano tomado por el instrumento SHARAD que viaja a bordo de la sonda Mars Reconaissance Orbiter. Se aprecian perfectamente distintas capas dentro del hielo -quizás relacionadas con alternancias climáticas- así como la roca sobre la que se apoya el hielo. Cortesía de NASA/JPL-Caltech/University of Rome/SwRI.Por otro, el estudio del campo gravitatorio de Marte, que no es estático, sino que va cambiando con el paso del tiempo. Cuando el hielo se va acumulando sobre los casquetes y se deforma la corteza, ocurren cambios sutiles que se pueden ir siguiendo a lo largo de los años marcianos, permitiendo a los científicos ver que parte de la superficie rebota o se hunde. Este hecho incluso puede observarse con el cambio de las estaciones, ya que hay parte del hielo que se sublima a la atmósfera durante la primavera y el verano y cae de nuevo durante el invierno, generando una alteración del campo gravitatorio suficientemente perceptible.

Los datos sísmicos de la misión InSight han sido también muy importantes, ya que de ellos se aprecia que no han ocurrido terremotos importantes cerca del polo norte, indicando que la deformación en la corteza del planeta es muy pequeña, permitiendo acotar a los científicos que cantidad de flexión está sufriendo la corteza con respecto a la actividad sísmica observada. Por cierto, este hecho tiene también una derivada práctica importante, y es que, de cara al riesgo sísmico para las futuras misiones tripuladas marcianas, el polo norte podría ser relativamente “tranquilo” y, por lo tanto, un lugar seguro. Si las rocas que sirven de apoyo al casquete polar hubiesen sufrido una mayor deformación, lo más probable es que hubiese una mayor actividad sísmica también.

Por último, los investigadores han confeccionado una serie de modelos físicos que simulan la evolución del calor interno de Marte desde su formación hasta el día de hoy, permitiendo poner a prueba varios escenarios sobre como podía ser la estructura interna del planeta, y, combinando estos escenarios con los datos reales, saber cuales podrían ser los más certeros.

¿Y qué resultados arroja la combinación de todos estos datos junto con los modelos? El primero es que el manto de Marte, la capa que hay justo debajo de la corteza, es más viscosa de lo que se había pensado hasta ahora. La viscosidad, en este sentido, es la resistencia a fluir del manto. Esto no quiere decir que el manto esté fundido, si no que, a escala geológica, las rocas del manto se comportan como un fluido, pero se encuentran en estado sólido.

Detalle del casquete polar del hemisferio norte tomado por la sonda europea Mars Express. Se aprecia muy bien la forma “arremolinada” de las capas de hielo y polvo. Cortesía de ESA/DLR/FU Berlin (G. Neukum).

Detalle del casquete polar del hemisferio norte tomado por la sonda europea Mars Express. Se aprecia muy bien la forma “arremolinada” de las capas de hielo y polvo. Cortesía de ESA/DLR/FU Berlin (G. Neukum).Esto es importante porque un manto muy viscoso nos indica que el interior de Marte está hoy relativamente frío -si no sería menos viscoso- y que los elementos radiogénicos que producen calor a partir de la desintegración radioactiva probablemente no estén distribuidos de una manera uniforme en su interior. Y de hecho es probable que muchos de estos elementos estén concentrados en la corteza, permitiendo que, por otro lado, esta esté más caliente.

Las implicaciones de esta observación son muy importantes: Sabemos que Marte ha tenido actividad volcánica en el pasado reciente -incluso en los últimos miles de años- y que puede que este fenómeno se deba no a la presencia de magmas que puedan provenir del manto, sino que estos podrían incluso formarse dentro de la propia corteza gracias a una mayor concentración de elementos radiogénicos suficientes para elevar la temperatura, fundir la roca y dar lugar a los magmas que posteriormente fluirían hacia la superficie.

Para concluir, otro aspecto que me ha parecido muy interesante del estudio es que el casquete polar del hemisferio norte es relativamente joven -a escala geológica- y que el hielo podría haberse estado acumulando desde hace entre 1.7 y 1.2 millones de años, por lo que la deformación de la corteza todavía estaría en marcha y no podemos apreciar todavía su verdadera magnitud debido a la lentitud de este proceso. Dicho esto, el poder establecer una fecha para cuando se comenzó a formar este casquete polar nos puede ayudar a comprender mejor la historia climática del planeta y la relación de este con los distintos ciclos astronómicos (oblicuidad, excentricidad, precesión…).

Todavía nos queda mucho para saber todos los detalles de la estructura interna del planeta Marte, pero cada trocito que descubrimos -aunque sea a través de misiones que muchas veces no parecen conectadas entre si- nos ayuda a estar más cerca de poder responder a por que Marte y la Tierra son planetas tan diferentes.

Bibliografía:

A. Broquet, et al. (2025) Glacial Isostatic Adjustment Reveals Mars’s Interior Viscosity Structure. Nature doi: 10.1038/s41586-024-08565-9

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Los casquetes polares de Marte y el interior del planeta rojo se ha escrito en Cuaderno de Cultura Científica.

Glaucoma, un vacío inquietante en un campo lleno de milagros

El glaucoma afecta a más de 70 millones de personas y representa la segunda causa principal de ceguera en todo el mundo. Foto: Pixabay CC

El glaucoma afecta a más de 70 millones de personas y representa la segunda causa principal de ceguera en todo el mundo. Foto: Pixabay CCMás allá de la celebrada conversión del agua en vino, si tuviésemos que citar el milagro bíblico por excelencia seguramente diríamos «devolverles la vista a los ciegos». Pero, lo que durante siglos ha sido casi una habilidad mágica, disponible en exclusiva para divinidades, en nuestros días empieza a considerarse algo accesible y cercano en numerosas investigaciones biomédicas. Vivimos tiempos fascinantes en biomedicina y, cuando hablamos de «curar la ceguera» nos encontramos, casi a diario, un buen puñado de estudios científicos y noticias que nos colocan un paso más cerca de conseguirlo.

Ya sea con células madre para recuperar lesiones oculares, o implantes biónicos que, mediante neuroestimulación, podrían permitir restaurar funciones sensoriales, o el desarrollo avanzado de prototipos de córnea artificial, e incluso mediante técnicas de edición genética CRISPR para reparar la retina. Las posibilidades que se abren ante nosotros son tantas y tan variadas que no parece demasiado arriesgado adelantar que, en las próximas décadas, asistiremos a la conclusión de un milagro milenario.

Sin embargo existen ciertas enfermedades de la vista que no parecen avanzar tan rápido, determinados trastornos que afectan a un alto porcentaje de las personas ciegas y que no aún no cuentan con ningún avance revolucionario. Es el caso del glaucoma un amplio y heterogéneo grupo de enfermedades oculares neurodegenerativas caracterizadas por un daño gradual e irreversible del nervio óptico que en la actualidad afecta a más de 70 millones de personas. El daño por glaucoma es permanente, no cuenta con cura o tratamiento y se ha convertido en la segunda causa principal de ceguera en todo el mundo.

Ante este aparente vacío entre tanto milagro cotidiano y, teniendo en cuenta las elevadas cifras que ostenta el glaucoma, cualquier avance sobre el tema, por pequeño y lejano que parezca, resulta más que bienvenido. Encontramos un esperanzador ejemplo en un estudio publicado hace unas semanas en PNAS Nexus, el journal open Access de la célebre Proceedings of the National Academy of Sciences (PNAS), por el que se presentan dos anticuerpos que «podrían detener esta degradación y posiblemente salvar la visión de las personas antes de que sea demasiado tarde».

Comencemos el análisis de este estudio con una aproximación a las causas que generan la enfermedad. En términos generales el glaucoma consiste en un daño al nervio óptico, responsable de llevar al cerebro las imágenes convertidas en impulsos eléctricos en la retina. La mayoría de las veces ese daño en el nervio óptico está provocado por un aumento de la presión intraocular. Si nuestro ojo fuese un balón de baloncesto su correcto funcionamiento dependería de una delicada presurización, que está regulada por la producción y el drenaje equilibrados del humor acuoso, un líquido transparente que nutre el segmento anterior ocular. En un ojo sano, ese líquido se drena continuamente permitiendo una correcta visión mientras que «en la mayoría de las formas de glaucoma un drenaje deficiente del humor acuoso desemboca en un aumento de la presión intraocular».

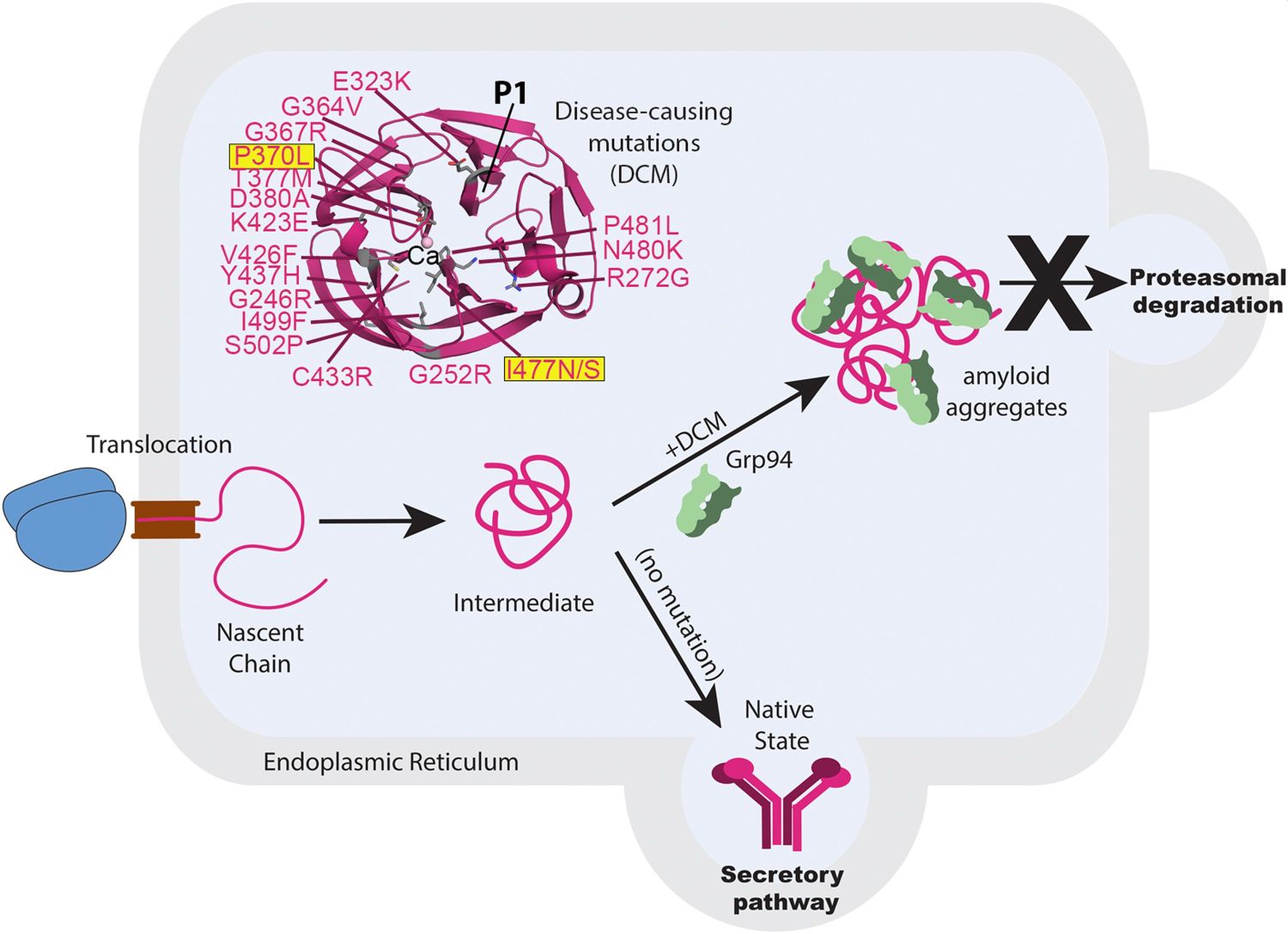

Este mal drenaje del líquido y su consecuente aumento de la presión pueden tener varias causas y la principal de ellas nos lleva a hablar de una proteína en concreto que, a la postre, se ha convertido en la protagonista del nuevo estudio: la miocilina.

Las proteínas realizan o regulan miles de funciones en nuestro cuerpo y, a grandes rasgos, son largas cadenas de aminoácidos que se pliegan de determinadas formas para realizar su trabajo. Es fundamental que el plegamiento sea el correcto, de lo contrario, la proteína no podrá llevar a cabo su función biológica. De hecho, es un problema inquietante ya que una proteína mal plegada puede «contagiar» su mala configuración a otras, dando lugar a un amplio grupo de enfermedades, como el Alzheimer, el Parkinson, o las enfermedades priónicas. Precisamente, la investigación sobre plegamiento de proteínas realizada en este tipo de enfermedades neurodegenerativas ha sido la base e inspiración para la nueva publicación sobre el glaucoma.

«Una de las mutaciones que causa glaucoma congénito y que es la responsable de un alto porcentaje de los casos de esta enfermedad provoca que una proteína, miocilina, debido a esta mutación, se sintetice mal plegada en las células que la producen, perdiendo su función», nos explica la neurocientífica Conchi Lillo, investigadora en patologías visuales en el Instituto de Neurociencias de Castilla y León y profesora titular de la Universidad de Salamanca. «Esta proteína es importante para el correcto drenaje del humor acuoso que baña la cámara anterior del ojo, así que el mal funcionamiento de la proteína, debido a este plegamiento incorrecto, provoca que este drenaje no se produzca de una forma eficiente».

Descripción general del mecanismo patogénico subyacente al glaucoma asociado a la miocilina. Fuente: Raquel L Lieberman, et al. (2025) PNAS Nexus

Descripción general del mecanismo patogénico subyacente al glaucoma asociado a la miocilina. Fuente: Raquel L Lieberman, et al. (2025) PNAS NexusEn el estudio publicado en PNAS Nexus los autores presentan un posible tratamiento para frenar el glaucoma congénito producido por el mal plegamiento de la miocilina empleando anticuerpos generados en el laboratorio que son capaces de neutralizar la forma incorrecta de la proteína. «Los anticuerpos que neutralizan la miocilina mal plegada se sintetizaron inmunizando a ratones con antígenos de esta proteína. La reacción inmunitaria que provoca esta inmunización en su organismo hace que en su suero sanguíneo aparezcan los anticuerpos contra ese antígeno, que se pueden aislar y utilizar para comprobar si son eficaces para neutralizar miocilina», explica Lillo. «Para ello, se probó su efectividad usando estos anticuerpos aislados en células en cultivo que expresaban esta proteína miocilina mal plegada, comprobando que efectivamente, realizaban esa función».

El glaucoma representa un vacío en un mundo repleto de milagros. Entre los extraordinarios éxitos logrados en el complejo, y casi divino, arte de devolver la vista al ciego, esta patología sigue siendo un preocupante oasis en el que avanzar está siendo muy difícil. Por eso resulta fácil dejarse entusiasmar por cualquier pequeño detalle o ventana al futuro, pero hay que ser realista y entender que este estudio publicado aún está muy lejos de ser aplicable. «Son resultados prometedores porque se ha encontrado una posible diana terapéutica para abordar la raíz del problema que se produce en el glaucoma, pero hay que tener cautela con las expectativas, ya que este “posible tratamiento” no se ha probado aún en animales de experimentación y ni siquiera las células en cultivo empleadas para estas pruebas son las que en los ojos humanos producen la miocilina mal plegada en la enfermedad de glaucoma».

Referencias:

Raquel L Lieberman, et al. «Antibody-mediated clearance of an ER-resident aggregate that causes glaucoma» PNAS Nexus (2025) DOI:10.1093/pnasnexus/pgae556

Tess Malone «Under Pressure: Georgia Tech Researchers Discover a New Way to Treat Glaucoma» Georgia Tech (2025)

Sobre el autor: Javier «Irreductible» Peláez (Puertollano, 1974) es escritor y comunicador científico. Autor de 500 años de frío. La gran aventura del Ártico (Crítica, 2019) y Planeta Océano (Crítica 2022). Es uno de los fundadores de la plataforma Naukas.com, editor de ciencia en Yahoo España y Latinoamérica. Es guionista científico en los programas de televisión «El Cazador de Cerebros» y «Órbita Laika» de RTVE. Durante más de una década ha escrito en diferentes medios de comunicación (El País, El Español, National Geographic, Voz Populi). Es autor de los podcasts Catástrofe Ultravioleta y La Aldea Irreductible, y ha colaborado en diferentes proyectos radiofónicos y televisivos (Radio Nacional de España, Radio Televisión Canaria). Es ganador de tres premios Bitácoras, un premio Prisma a la mejor web de divulgación científica y un Premio Ondas al mejor programa de radio digital.

El artículo Glaucoma, un vacío inquietante en un campo lleno de milagros se ha escrito en Cuaderno de Cultura Científica.

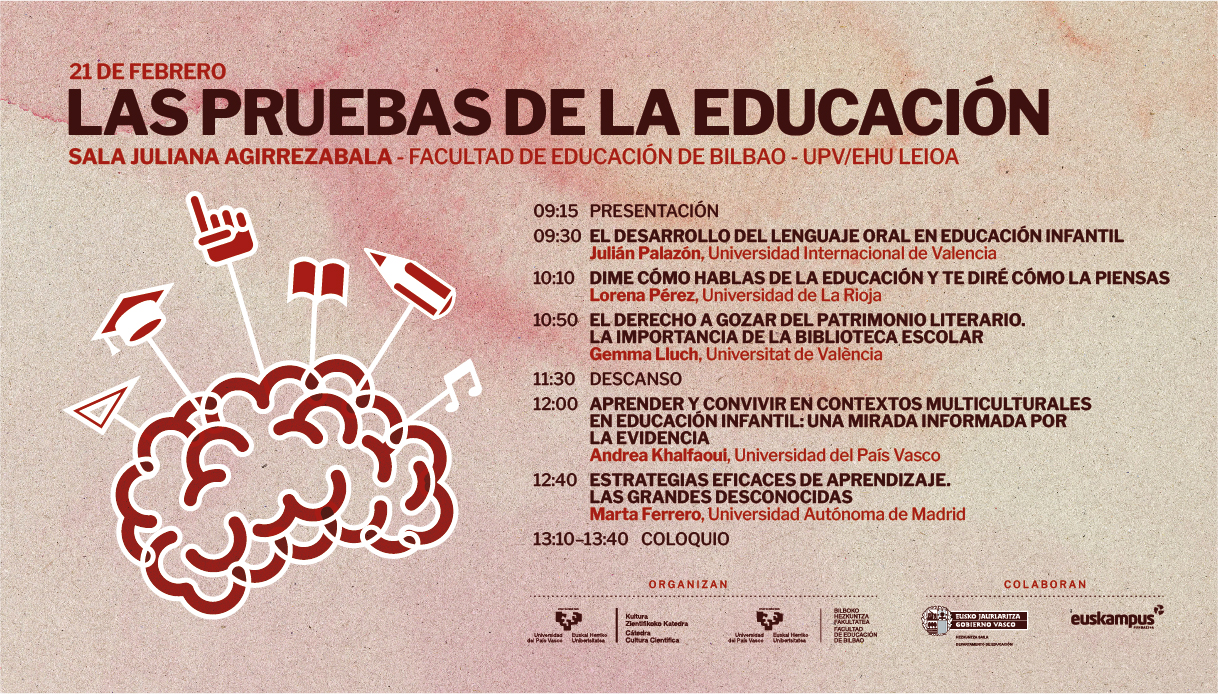

Aprender y convivir en contextos multiculturales en educación infantil

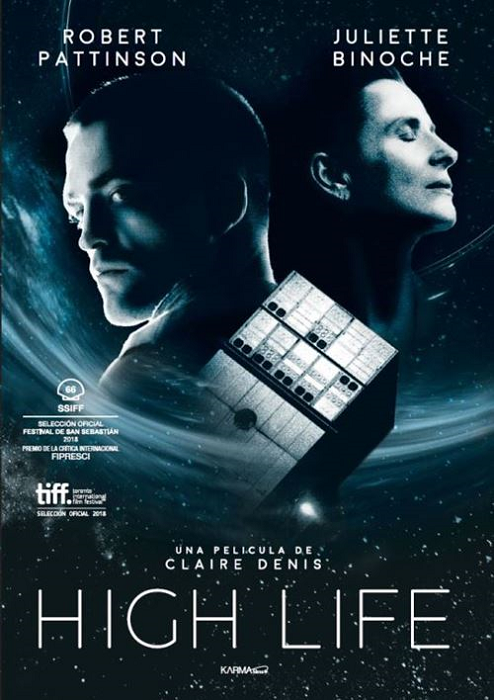

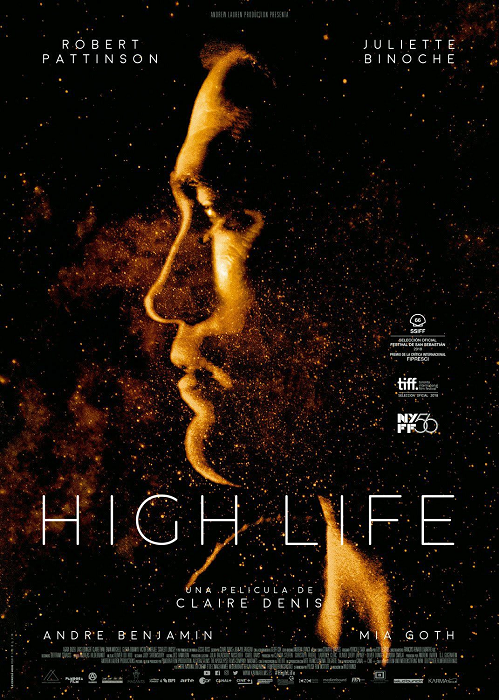

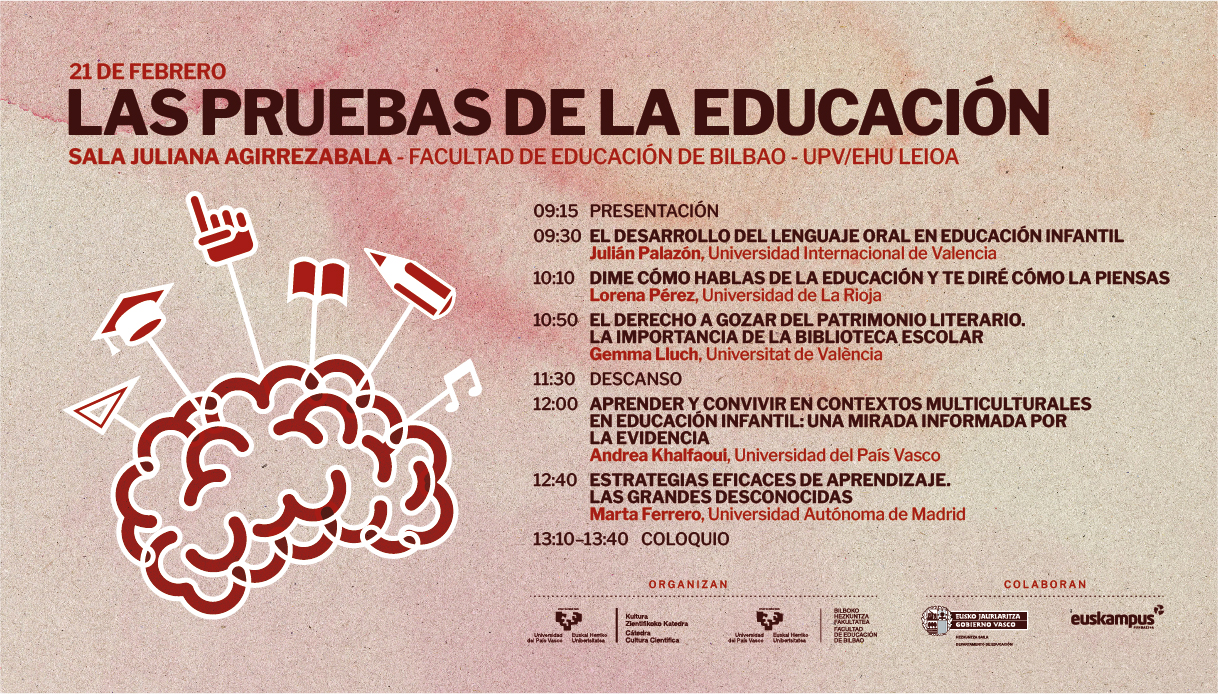

La jornada Las Pruebas de la Educación regresó un año más para revisar la eficacia de las estrategias educativas actuales a partir de la evidencia científica. El desarrollo del lenguaje oral en la infancia y su poder en la creación de distintas realidades sobre un mismo tema, así como la riqueza del aprendizaje en entornos multiculturales fueron algunas de las cuestiones analizadas durante la séptima edición de este seminario.

Andrea Khalfaoui, profesora en el departamento de Ciencias de la Educación en la Universidad del País Vasco, argumenta en “Aprender y convivir en contextos multiculturales en Educación Infantil: una mirada informada por la evidencia” cómo la multiculturalidad, presente hoy día en muchas aulas, puede emplearse como palanca de aprendizaje.

La jornada, fruto de la colaboración entre la Cátedra de Cultura Científica de la Universidad del País Vasco y la Facultad de Educación de Bilbao, tuvo lugar el 21 de febrero de 2025 en la sala Juliana Agirrezabala de la Facultad de Educación de Bilbao de la Universidad del País Vasco UPV/EHU en Leioa (Bizkaia). Las ponencias fueron impartidas por un abanico de expertos y expertas del ámbito de la educación, la formación y el aprendizaje.

La séptima edición del seminario está especialmente dirigida a profesionales del ámbito de la educación y a quienes, en un futuro, formarán parte de este colectivo. El objetivo es crear un espacio de reflexión compartida, desde la evidencia científica, sobre la validez de las estrategias utilizadas hoy en día.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Aprender y convivir en contextos multiculturales en educación infantil se ha escrito en Cuaderno de Cultura Científica.

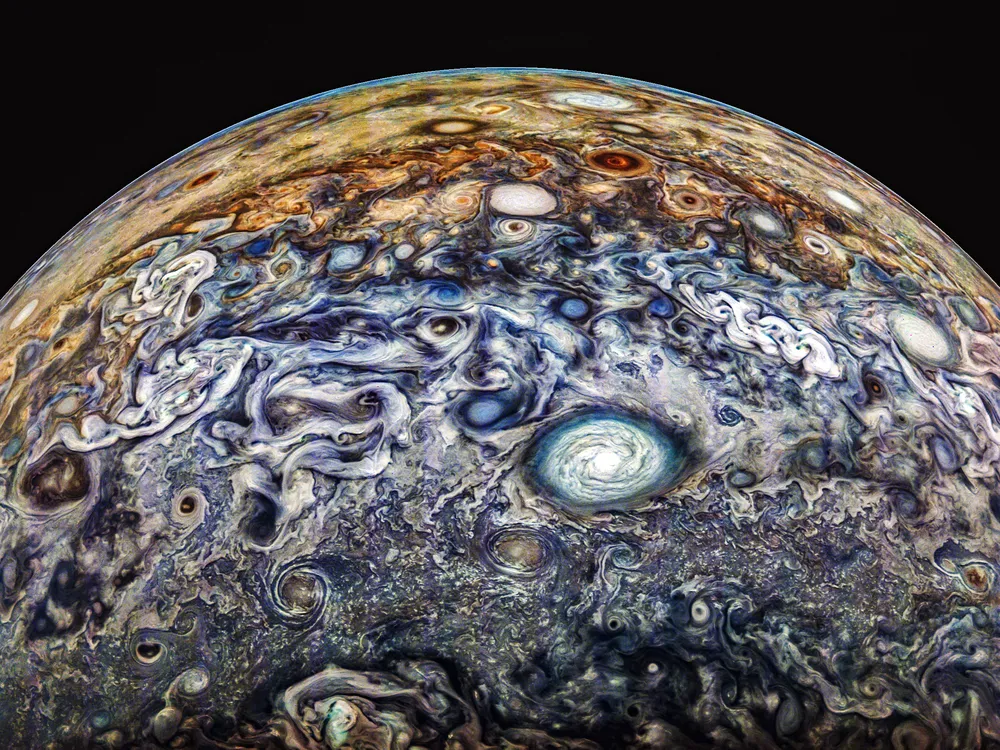

El fascinante invento para detectar materia oscura en el interior de Júpiter

Miremos a los cielos imitando a los antiguos. Y con ello tratemos de entender cosas casi incomprensibles como la materia oscura. Acaso esto alivie el desconsuelo de que sea más sencilla la cosmología que la política.

Hagamos volar nuestra curiosidad como si fuera una cometa pensando en unas partículas ligeras y extrañas. Y redondeemos nuestro juego de niños imaginando planetas gigantes que quieren atraparlas. Pues de eso justamente trata uno de los últimos retos de la astrofísica: pretende descubrir a fondo la naturaleza de la materia oscura entendiéndola como algo formado por partículas hipotéticas propuestas por los científicos. Y para ello se recurre a Júpiter, uno de nuestros vecinos pesados. Y cuando digo pesado no es que nos aburra, sino que es muy masivo. No por casualidad lo llamamos el gigante rojo.

Imagen procesada de Júpiter tomada por la sonda Juno. Fuente: NASA / JPL / SwRI / MSSS / Gerald Eichstädt / Thomas Thomopoulos CC BY 3.0El poderío de Júpiter para atrapar WIMP

Imagen procesada de Júpiter tomada por la sonda Juno. Fuente: NASA / JPL / SwRI / MSSS / Gerald Eichstädt / Thomas Thomopoulos CC BY 3.0El poderío de Júpiter para atrapar WIMP

Este planeta fundamentalmente gaseoso tiene una densidad baja, y su gravedad en la superficie tan solo es algo más de 2 veces la de la Tierra. Sin embargo, el campo gravitatorio en el interior parece que podría ser muy intenso, según sugieren las complejas mediciones de la misión Juno. Esto se debería a la presencia de elementos metálicos atrapados a muy altas presiones en el núcleo del planeta.

Este poderío gravitatorio confiere a Júpiter la capacidad de atrapar unas partículas ligeras que teóricamente podrían componer la materia oscura, los llamados WIMP. Claro que “ligera” significa aquí que es una partícula con la misma energía que un protón o un neutrón, es decir, del orden del gigaelectronvoltio.

Como bien sabían los electroduendes, esta sería precisamente la energía necesaria para hacer que un electrón se mueva por una diferencia de potencial de mil millones de voltios. No debería sorprendernos esta semejanza en escalas de energía. De hecho, hay hipótesis que sugieren que las partículas de materia oscura podrían ser neutrones espejo.

Pero no solo tenemos que entender qué es la materia oscura. Tan o más importante es detectarla.

Materia oscura errantePodría haber partículas de materia oscura vagando por el universo que se adentrasen en el acogedor Júpiter. Y en ese traicionero albergue sufrirían diversos choques con todo el resto de partículas (idénticas o las del propio planeta). Sería como si la materia oscura jugase un campeonato planetario de billar. En cada uno de estos topetazos las partículas de materia oscura irían perdiendo energía para quedar finalmente aniquiladas siguiendo las reglas de la mecánica cuántica, que este año está de aniversario.

El fructífero resultado de la destrucción de los WIMP sería la emisión de neutrinos susceptibles de ser detectados en la Tierra.

Los efectos de la aniquilaciónUna de las maneras de saber que ha llegado a nuestro planeta uno de esos neutrinos, fruto de la aniquilación de los WIMP, es el efecto Cherenkov. Se manifiesta como un destello característico en forma de cono de luz azul (pura radiación electromagnética) que producen ciertas partículas cargadas.

Para que el efecto se produzca, las cargas han de viajar más rápido que la luz al atravesar un medio como agua o gas. Pero no nos llevemos las manos a la cabeza: por su naturaleza, esas partículas no superarían la velocidad de la luz en el vacío. Este fenómeno luminoso es muy parecido al “boom sónico”. Y en el campo de la astrofísica experimental se construyen sensores especializados que identifican esas vertiginosas partículas y miden sus velocidades.

El medio de preferencia de muchos de estos sensores es el agua, por la particular interacción que tienen los neutrinos con el H₂O. Además, no nos vamos a engañar, el agua es abundante y barata (o lo era).

Los detectores colosalesPero para hacernos una idea del tamaño de un bicharraco de estos vamos con los datos del detector Super-Kamiokande (de tipo Cherenkov, obviamente). Este ingenio, crucial para entender algunos aspectos de la física de los neutrinos, contiene 50 000 toneladas de agua purísima.

Conviene enfatizar que los neutrinos que escaparían de Júpiter, como cualquier otro neutrino, no tienen carga. Así que no son exactamente esas las partículas que detectarían el detector Cherenkov. Más bien iría a la caza y captura de partículas cargadas secundarias surgidas de las interacción de los neutrinos con la materia. En concreto, serían producidas en esos encuentros no consentidos entre los neutrinos y las moléculas de agua.

Pero sabiendo que Super-Kamiokande se ha usado para detectar neutrinos solares y sumando dos y dos surge esta pregunta: ¿no serviría el Sol también como diana idónea para la materia oscura ligera?

La temperatura importaEn principio el campo gravitatorio del Sol es también muy intenso y tiene capacidad de ser penetrado por los WIMP. Debería ser entonces susceptible de poder usarse del mismo modo que Júpiter.

La contrariedad es que el interior de nuestra estrella tiene una temperatura elevadísima. Por este motivo, los núcleos atómicos protagonistas de los choques más relevantes se moverían muy rápido. Esto causaría una ganancia de energía cinética por parte de la partícula ligera de materia oscura. Con este aumento de velocidad, a las partículas de materia oscura les sería más fácil escapar de esa prisión estelar sin ser aniquiladas. Y si no se aniquilan, no podríamos detectarlas.

En cambio, la temperatura de Júpiter aún siendo alta no lo es tanto y le resulta más fácil capturar WIMP. Pasa algo parecido a lo que ocurre con la sopa del cuento de Ricitos de Oro y los tres osos. Para que un astro pueda atrapar en su interior a la materia oscura ha de estar a una temperatura propicia.

El invento para el porvenirEl afán por comprender estos y otros fenómenos impulsa la construcción de detectores aún más potentes, como el proyectado Hyper-Kamiokande, un ingenio que ahora cuenta con participación española. Este futuro detector tendrá 5 veces más agua que su predecesor. Sus colosales especificaciones lo harán protagonista de mucha física del futuro.

Pero siempre me queda la duda de si realmente queremos llegar a ese porvenir. Descubrir por fin la naturaleza de la materia oscura traerá consigo cierta melancolía. Poco a poco nos quedaremos sin preguntas que resolver y la física será solo para nostálgicos. Aunque la intuición, o la esperanza, me dicen que falta mucho para que el universo nos ceda todos sus secretos.![]()

Sobre la autora: Ruth Lazkoz es catedrática de física teórica de la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo El fascinante invento para detectar materia oscura en el interior de Júpiter se ha escrito en Cuaderno de Cultura Científica.

(Ni son) tierras (ni son) raras

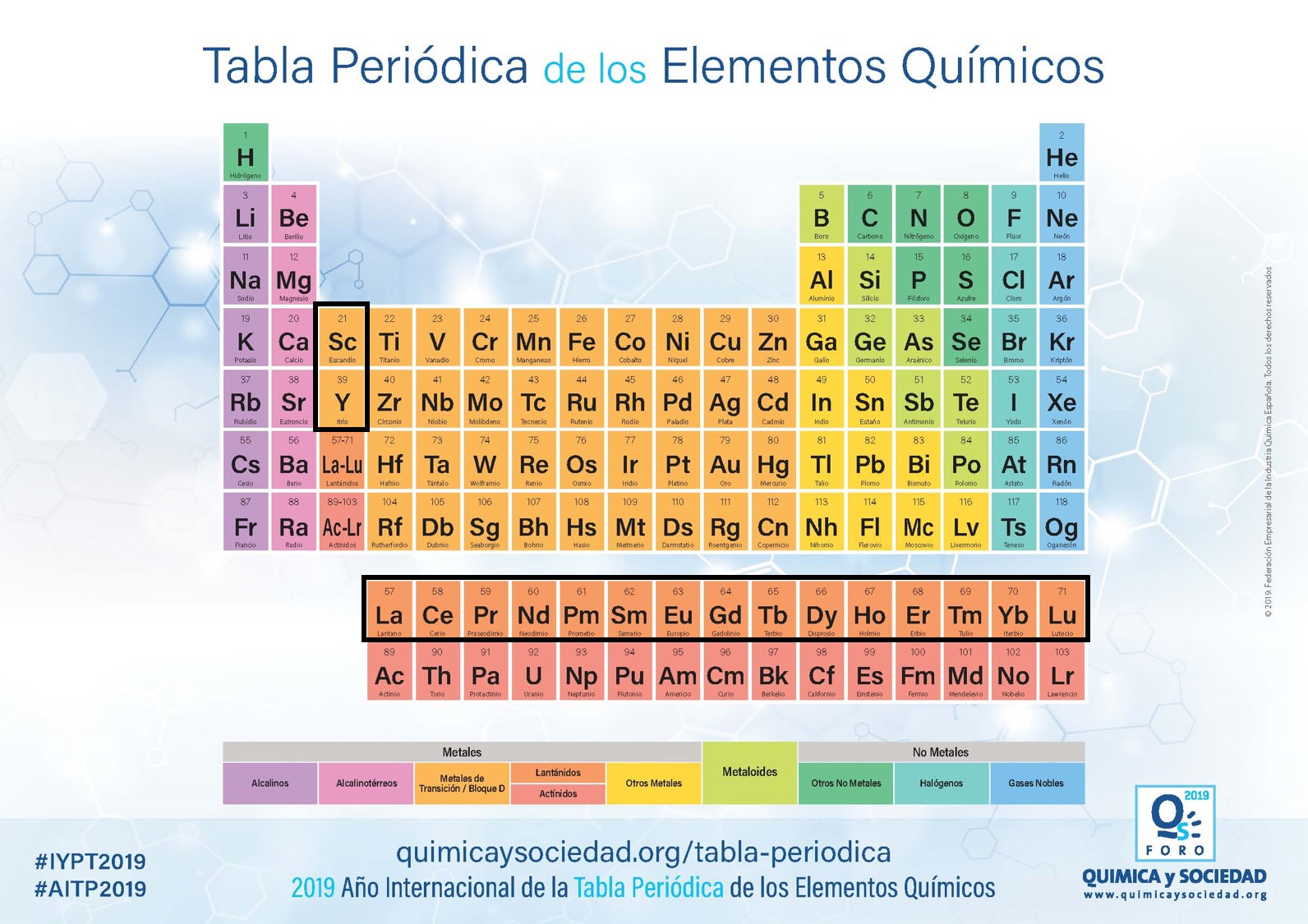

Uno de los temas más candentes de la actualidad mundial son las tierras raras, debido a la urgencia que están mostrando ciertos países por hacerse con ellas. Pero, ¿qué son las tierras raras? Y ¿por qué son tan importantes?

Pues debo comenzar diciendo que su nombre nos lleva, directamente, a dos errores. Por un lado, la palabra tierra hace que pensemos en ese sedimento que cubre la parte más superficial del terreno, es decir, en algún tipo de suelo, pero nada más lejos de la realidad. Tierra es un término arcaico utilizado en química para referirse a los elementos que aparecen en forma de óxidos en la naturaleza y que se ha mantenido hasta la actualidad, prácticamente a modo de homenaje, pero no tiene nada que ver con la definición geológica de “tierra” como sedimento. Y, por otro lado, la palabra rara nos lleva a suponer que son muy escasos, pero tampoco es cierto. Estos elementos son relativamente comunes en nuestro planeta, incluso en términos totales que calcula que son más abundantes que todo el oro presente en la Tierra, pero se les denomina “raros” porque, generalmente, aparecen en concentraciones muy pequeñas dentro de los minerales y rocas y, sobre todo, porque su diferenciación química (es decir, su extracción del resto de componentes de los minerales) es muy compleja y bastante difícil.

Tabla periódica de los elementos químicos, donde se marcan las tierras raras. Fuente: Federación Empresarial de la Industria Química Española vía Química y Sociedad

Tabla periódica de los elementos químicos, donde se marcan las tierras raras. Fuente: Federación Empresarial de la Industria Química Española vía Química y SociedadEntonces, ¿qué son las tierras raras? Pues este término hace referencia a 17 elementos químicos de la Tabla Periódica, los 15 de la serie de los lantánidos* (lantano, cerio, praseodimio, neodimio, prometio, samario, europio, gadolinio, terbio, disprosio, holmio, erbio, tulio, iterbio y lutecio) a los que se suman el escandio y el itrio. Estos elementos no aparecen en nuestro planeta en forma nativa, como lo pueden hacer el cobre o el oro, sino que siempre aparecen formando compuestos en la estructura química de ciertos minerales en concentraciones muy bajas, concretamente de partes por millón (para que os hagáis una idea, las concentraciones en porcentaje corresponden a 1/100 partes, mientras que las concentraciones en partes por millón equivalen a 1/1.000.000 del total).

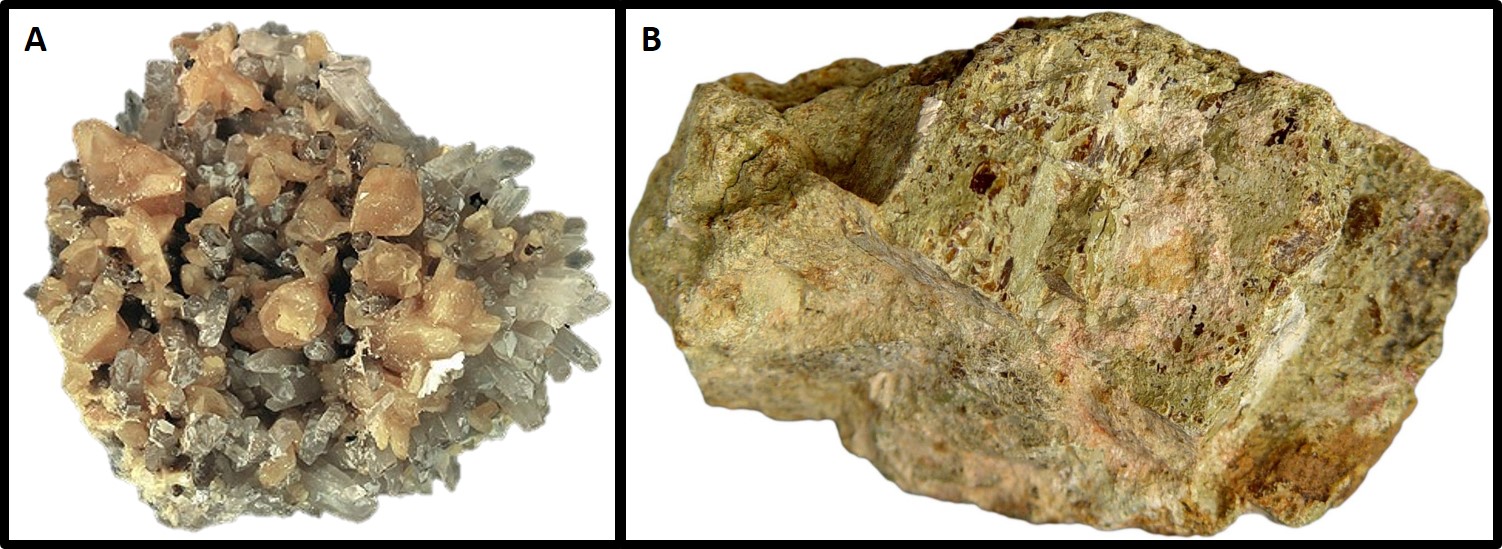

Las tierras raras pueden aparecer en minerales más o menos conocidos, como el apatito o los clinopiroxenos, o en otros con nombres algo más raros, como la monacita o la bastnasita. Pero estos minerales con ciertas concentraciones de tierras raras no se forman en cualquier lugar, sino que lo hacen en contextos geológicos muy concretos. Principalmente, se trata de zonas en las que afloran rocas ígneas, principalmente volcánicas, que se han producido por el ascenso de magmas muy profundos que se han ido enriqueciendo en estos elementos químicos mientras iban ascendiendo por el manto y la corteza terrestres. También aparecen en lugares que han sufrido metamorfismos particulares en los que han estado relacionados fluidos hidrotermales que han atravesado rocas ricas en tierras raras y, en su circulación hacia la superficie, han ido precipitándolas a su paso en diferentes venas minerales. Y hay un tercer contexto un poco más especial aún, los medios sedimentarios formados por la erosión y el depósito de fragmentos de estas rocas ígneas y metamórficas con minerales que incluyen tierras raras en su composición.

A) Ejemplar con cristales del mineral monacita (de color anaranjado) entre cristales de cuarzo (incoloros), extraído de la mina Siglo Veinte, en Bolivia. B) Ejemplar del mineral bastnasita obtenido en Burundi. Fuentes: A) Robert M. Lavinsky / Wikimedia Commons, B) Kouame / Wikimedia Commons

A) Ejemplar con cristales del mineral monacita (de color anaranjado) entre cristales de cuarzo (incoloros), extraído de la mina Siglo Veinte, en Bolivia. B) Ejemplar del mineral bastnasita obtenido en Burundi. Fuentes: A) Robert M. Lavinsky / Wikimedia Commons, B) Kouame / Wikimedia CommonsComo os decía al principio, la explotación de estos yacimientos minerales no es ni barata, ni sencilla. Los minerales que incluyen tierras raras suelen aparecer entremezclados con otros que no nos interesan, por lo que hay que hacer una selección previa, junto con un estudio geológico muy detallado, de las zonas y los materiales que queremos extraer. Y, una vez obtenidos esos minerales, hay que someterlos a un proceso químico largo y complejo para poder aislar las tierras raras. Eso implica un análisis preliminar de la viabilidad económica del yacimiento, para asegurar que se va a obtener un beneficio con su explotación, porque es muy fácil que las empresas acaben en bancarrota si no tienen cuidado.

Una vez visto todo esto, ¿por qué son tan famosas e importantes las tierras raras? Pues por sus propiedades magnéticas y luminiscentes. Actualmente se han convertido en componentes indispensables en la estrategia de transición ecológica, ya que forman parte de catalizadores, imanes, baterías, componentes electrónicos o pantallas de aerogeneradores, vehículos eléctricos o mecanismos informáticos. También tienen un papel primordial en el avance médico, ya que permiten generar nuevas herramientas de diagnóstico y tratamiento para enfermedades tan dañinas como el cáncer. Por estos motivos, han entrado de cabeza en los listados de materiales críticos y estratégicos a nivel mundial, por lo que su búsqueda y explotación evitará la dependencia de Europa o Estados Unidos de terceros países, como China, principal exportador de tierras raras en la actualidad.

Pero hay un motivo menos noble y más prosaico por el que han cobrado tanta importancia social hoy en día. Las tierras raras también son unos materiales básicos para el desarrollo de la industria armamentística. Satélites más eficientes, mejores sistemas de comunicación, nuevos dispositivos de posicionamiento y vigilancia nocturna, vehículos militares autopropulsados y con dispositivos de blindaje mejorados, armamento con mayor capacidad destructiva, capaces de recorrer distancias más largas y con más autonomía, y un largo etcétera. Quizás este uso de las tierras raras explica más cosas de las que suceden en el mundo actual que la búsqueda de un futuro más sostenible.