El arboretum de la UPV/EHU

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

En el espacio de aproximadamente 11 hectáreas de extensión, sobre una pendiente orientada al sur que salva un desnivel de 40 metros entre cima que ocupan las facultades de Ciencia y Tecnología y Medicina y el pequeño embalse de Lertutxe (25.900 m2), se halla el Arboretum de la UPV/EHU. Se extiende entre los términos municipales de Leioa y Erandio (Bizkaia) y las obras de acondicionamiento comenzaron en 2009. Este terreno, perteneciente a la universidad, ya fue destinado a ocupar un Jardín Botánico en anteriores planificaciones, pero esto jamás llegó a realizarse por diversas causas. Finalmente se abordó, con el apoyo de la Diputación Foral de Bizkaia, la instalación de un arboretum, basado en una colección viva de árboles.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Un arboretum (conjunto de árboles) es una colección de especies leñosas, fundamentalmente árboles y grandes arbustos dispuestos de una manera poco densa, como en un parque inglés. Existen numerosos ejemplos de este equipamiento, sobre todo en el mundo anglosajón, presentando algunos una antigüedad notable, como es el caso del de Westonbirt en el Reino Unido (1829), el Arnold Arboretum de la Universidad de Harvard (Massachussets, EE.UU.), de 1872 o el National Arboretum, en Washington, desde 1927.

Los Jardines Botánicos modernos, y de forma más modesta, también los arboreta, cumplen en la actualidad las siguientes funciones de apoyo a: la investigación, la docencia, la conservación de la biodiversidad y la educación ambiental. En el caso que nos ocupa, varias tesis doctorales centraron su investigación en el embalse de Lertutxe, pero la actividad investigadora se halla actualmente detenida por falta total de programas que la financien. Además, el Arboretum de la UPV/EHU cuenta con algunos elementos conmemorativos que le son propios. Con arreglo a los recursos disponibles, se trata de cumplir con estos cometidos mediante las estructuras que se describen a continuación.

Docencia

Es la principal actividad. Ella se fundamenta en la existencia de una serie de elementos que ocupan buena parte de la extensión del Arboretum.

Colección de árboles y arbustos (Arboretum propiamente dicho). Está formada por un conjunto de árboles que bien son de plantación reciente o son individuos establecidos de forma natural (en este último caso, las especies corresponden en gran parte a la flora autóctona y los individuos son los de mayor edad y porte). En este Arboretum se pueden distinguir cinco sub-colecciones: 1. Árboles y formaciones autóctonas, 2. Árboles de las regiones templadas del Hemisferio Sur (Cono sur de Suramérica, Australia, Suráfrica y Nueva Zelanda); 3. Árboles de las regiones templadas de Asia; 4. Árboles de Norteamérica; 5. Árboles de la Región Mediterránea.

Heliosciámetro. Es un elemento de alto interés didáctico. La palabra deriva del griego helios (sol), skias (imagen, sombra, proyección) y metro (medir), y se trata de una versión actualizada del primitivo gnomon de egipcios y babilonios, tal vez el instrumento astronómico conocido más antiguo. El dispositivo que aquí se presenta consiste en un poste rematado por una lente que proyecta sobre el suelo la sombra del Sol y permite realizar diversas medidas en función de la trayectoria recorrida por esta sombra. Se indican numerosos parámetros astronómicos, como altura del Sol sobre el horizonte local, hora solar, hora de salida (orto) y puesta (ocaso) del Sol, puntos de salida y puesta del Sol, situación del Sol en el Zodíaco, etc. Toda una clase de astronomía.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

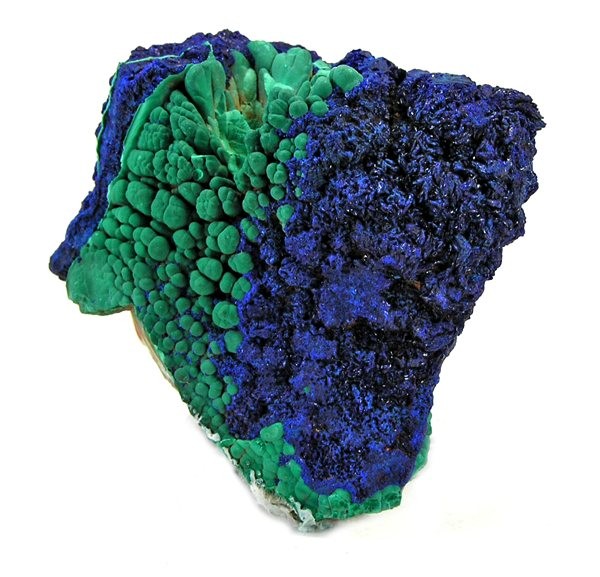

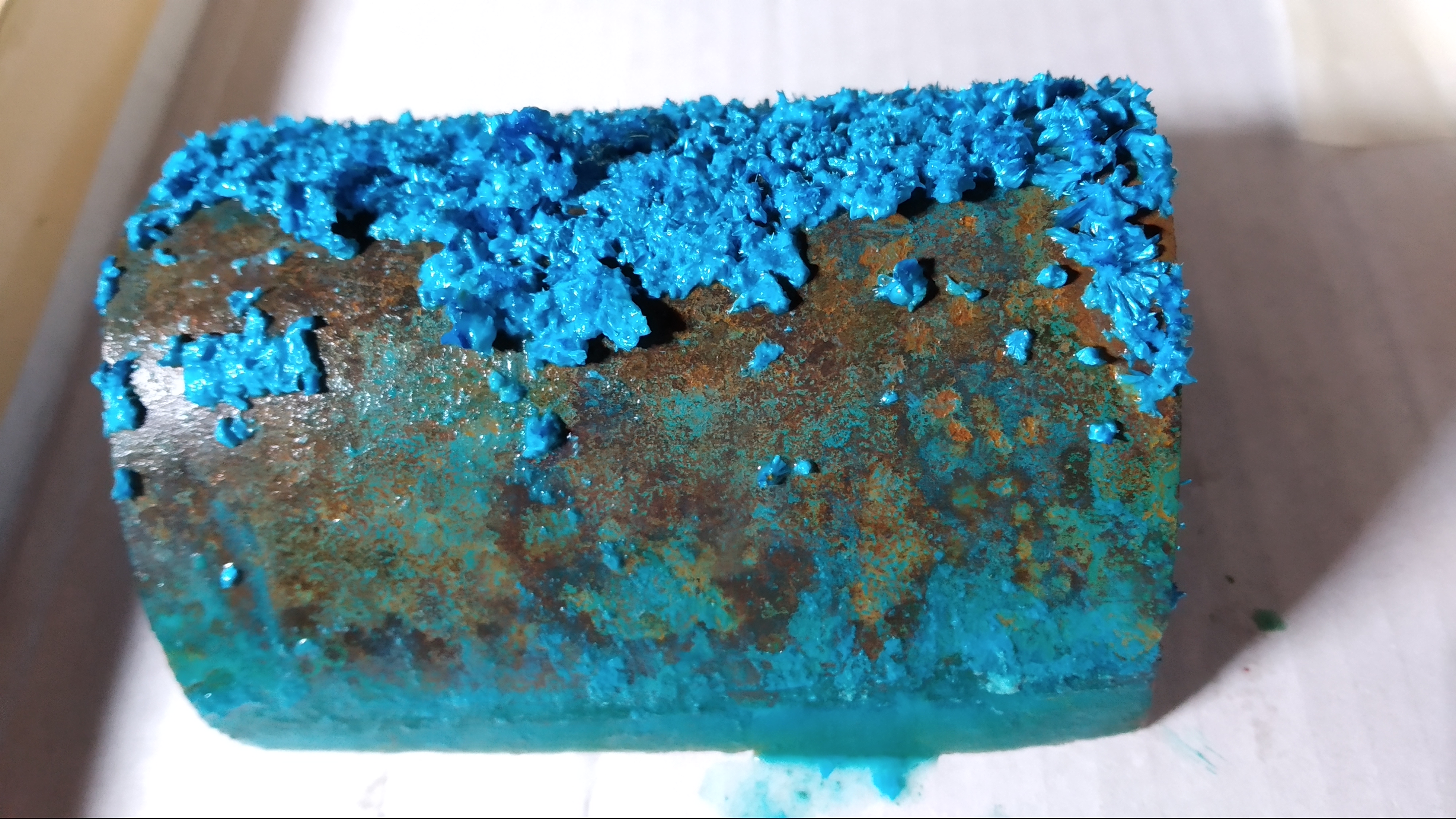

Colección de rocas del País Vasco. Está formada actualmente por una veintena de muestras de rocas, representativa de la variedad de tipos de rocas de Bizkaia principalmente. Es propósito de la UPV/EHU incrementar la colección para lograr una representatividad que abarque un territorio mayor.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Embalse de Lertutxe. De modesta extensión y aguas someras, si bien alcanza los casi 7 m en su punto más profundo, es un elemento de alto valor paisajístico y ecológico en el Arboretum. Se utiliza como espacio para recogida de muestras en las prácticas de Ecología de Aguas por los alumnos del grado de Biología y del Máster en Biodiversidad, Funcionamiento y gestión de Ecosistemas. En él habita una población de patos salvajes que se pretende conservar, lo que implica el mantenimiento de las comunidades naturales de carrizos y espadañas que pueblan todo el perímetro del embalse.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Fragmento de bosque natural. Por circunstancias de abandono durante muchos años, en el entorno del riachuelo de Lertutxe se ha desarrollado espontáneamente un pequeño bosque de robles y alisos que ha alcanzado en la actualidad una alta naturalidad gracias a que durante largos años no ha sido intervenido. Este pequeño bosque tiene un notable valor para el Arboretum y para la UPV/EHU representa una oportunidad única de poder mostrar a los estudiantes (de cualquier nivel) y “a pie de universidad” un ejemplo de bosque natural.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Conservación de la Biodiversidad

Bosque natural. El pequeño bosque natural que hemos comentado tiene un notable valor porque corresponde a dos tipos de hábitat protegidos por la Unión Europea (códigos 9190 y 91E0*) y porque, gracias al abandono de tantos años, se halla en un excelente estado de naturalidad. Ambas circunstancias hacen que la preservación de este pequeño fragmento de bosque natural autóctono constituya una participación de la UPV/EHU en los esfuerzos en materia de conservación del patrimonio natural.

Fauna. Se pretende que el Arboretum de la UPV/EHU está habitado por una fauna, tanto terrestre como acuática, que encuentre en esta zona un espacio en el que establecerse de forma permanente. En este sentido, ya se ha prohibido la caza y se han llevado a cabo actuaciones repobladoras como suelta de aves rapaces, anátidas y otros animales. En la medida de lo posible, las especies animales vivientes en el Arboretum contarán con un refugio para su subsistencia.

Educación Ambiental

Feria de las plantas de los 5 continentes. En el primer fin de semana de octubre de cada año se celebra una feria de plantas ornamentales y útiles en el recinto del Arboretum. Participan más de una treintena de expositores de diversos lugares que ofrecen a la venta sus plantas al público. Se trata de expositores especializados, cada uno en un tipo de planta, y con una perspectiva geográfica amplia, de modo que se puedan encontrar especies vegetales de diversas partes del mundo. El objeto de esta feria es fomentar el conocimiento sobre las plantas del público en general y su afición por cultivarlas.

Visitas guiadas. Se realizan recorridos por los senderos y caminos del Arboretum para observar las especies arbóreas y arbustivas, el Helosciámetro, el ejemplo de bosque atlántico, las especies acuáticas del embalse, las aves, la colección de rocas, etc. Estas visitas se hacen por grupos en ocasiones propicias, como son las ferias, y son guiadas por personas adiestradas a tal efecto.

Elementos conmemorativos

Bosque de la Vida. Es un elemento prominente en el espacio del Arboretum que tiene un reconocido valor artístico. Su condición de lugar de inhumación de las personas que donaron sus restos a la ciencia, le convierte en un elemento de profunda significación y de reconocimiento a su generosidad y a la de sus familiares.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Espiral conmemorativa del inicio de la docencia en Euskara en la UPV/EHU. Esta espiral, que conmemora el inicio de los estudios en euskera en la facultad de Ciencia y Tecnología, cuenta con una serie de árboles plantados a lo largo del adoquinado que dibuja la espiral. Estos árboles están ordenados de más primitivo a más evolucionado y proceden de los 5 continentes, en representación de la vocación universal de nuestra universidad.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Bosque de los honoris causa. Es un espacio dedicado a los árboles que plantan las personas premiadas por nuestra universidad con un doctorado de honor (Doctoris honoris causa). Es una forma de honrar y perpetuar en la memoria a las personas distinguidas de esta forma.

Foto: Antonio Secilla.

Foto: Antonio Secilla.

Sobre el autor: Javier Loidi es catedrático de botánica en el Departamento de Biología Vegetal y Ecología de la UPV/EHU.

El artículo El arboretum de la UPV/EHU se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Espectrometría de masas: de un isótopo de neón a elefantes que vuelan

- Cartografiando territorio inexplorado: imagen por espectrometría de masas

- Proteómica: cuando las proteínas y la espectrometría de masas van de la mano

Humildemente, el mundo es mejor gracias a mí

Wonder Woman por Greg Guillemin

Wonder Woman por Greg Guillemin

Tenemos más y mejor acceso a la información, sin embargo, tenemos la impresión de que estamos más desinformados que nunca. Hay medios de comunicación con un equipo editorial y de revisores que nos ofrecen garantías. Hay comunicadores con un historial impecable de honestidad y saber hacer. Pero en cuanto ponemos un ojo fuera de estos lugares de confianza, estamos perdidos. A ver si se citan las fuentes, a ver si quien firma es una voz autorizada, a ver si está publicado en un medio serio, a ver si lo que cuenta coincide con lo que yo ya sé. Todo eso está muy bien, pero en estos tiempos de posverdad, para decidir si algo es información o desinformación, es tan importante el qué se cuenta como el cómo se cuenta.

Una de las técnicas más persuasivas es el storytelling, es decir, contar historias y con ellas establecer conexiones emocionales. Esta técnica a menudo se emplea en divulgación científica y, sobre todo, en publicidad. Los desinformadores también conocen su poder de persuasión, pero hay un formato en concreto del que abusan y nos facilita la tarea de identificarlos: el relato heroico. De ahí el título de este artículo.

-

Las fuentes no lo son todo.

Si en un artículo se citan o se enlazan las fuentes de información, es más probable que lo que ahí se cuente sea cierto. No obstante, no es un criterio implacable. Las fuentes pueden ser o no fuentes de calidad. En los artículos sobre temas científicos suelen enlazarse estudios científicos, los llamados papers. El sistema de publicaciones científicas funciona mediante un método de revisión y verificación de datos que nos ofrece garantías. Aun así, es difícil identificar si realmente estamos ante un paper o un artículo cualquiera, si el paper es bueno, si la metodología el paper se corresponde con el tema del artículo… Es decir, casi tienes que ser experto para comprobar si la fuente es fiable y coherente o no. Así que eso de “comprobar las fuentes” no sirve para todos.

De hecho, casi cualquiera puede publicar un post citando fuentes que corroboren su tesis. Es tan fácil como entrar en Google Scholar y buscar algún estudio que confirme, o al menos no contradiga, lo que quieres contar. A esto se le llama cherry piking: filtrar la información para quedarnos exclusivamente con la que nos da la razón. Esto solemos hacerlo de forma inconsciente, puesto que todos padecemos, en mayor o menor medida, un sesgo de confirmación. Algunos filtran para engañar, pero la mayoría filtran sometidos a su sesgo de confirmación. Los lectores también.

-

Todos tenemos sesgos de confirmación y los desinformadores lo saben.

Es más probable que demos por cierta una información si esta se corresponde con lo que ya sabemos. Nuestros conocimientos previos sobre el tema pueden ser un arma de doble filo. Por un lado, pueden ayudarnos a discernir, y por otro pueden servir de semilla para la desinformación. Depende de la calidad de lo que sepamos, de si son conocimientos o de si son prejuicios, y a veces es difícil identificarlos.

Por ejemplo, una de las razones por las que el movimiento antivacunas ha calado es porque se fundamenta en prejuicios sobre el sector farmacéutico. El rechazo a los aditivos alimentarios se fundamenta en prejuicios sobre el sector alimentario. La creencia de que los cosméticos contienen tóxicos se fundamenta en prejuicios hacia el sector. ¿Cómo es posible que una persona con estudios superiores decida no vacunar a sus hijos? ¿Cómo es posible que alguien que sepa la química suficiente como para identificar los aditivos de un alimento, los rechace? ¿Cómo es posible que alguien tenga los conocimientos como para reconocer cuáles son los tensioactivos en la fórmula de un champú y crea que son tóxicos?

A menudo pronuncio la frase “Cuantas más cosas sabemos, mejores decisiones tomamos”. Esto es falso. No se trata de saber más cosas, sino de tener conocimientos de calidad. No se trata de saber más, sino de saber mejor.

De hecho, siguiendo con el ejemplo de los antivacunas, estos manejan más información que el resto. Esa es una de las razones por las que resulta tan complicado debatir con un antivacunas, porque son gente muy informada, o mejor dicho, muy desinformada.

En este sentido puede resultar interesante el documental de Netflix “La Tierra es plana”. Los terraplanistas también son gente muy desinformada, hacen sus propios experimentos tratando de confirmar su teoría. Los diseñan para tal fin. Buscan papers que confirmen sus hipótesis. Tienen el sesgo de confirmación a tope. Los que no somos terraplanistas también. Y demás no hacemos experimentos para corroborarlo. Por eso me parece especialmente brillante la intervención del físico Lamar Glover en el documental: “Conspiracionistas, antivacunas, terraplanistas… Cuando dejamos gente atrás, mentes brillantes mutan y se anquilosan. Son científicos en potencia totalmente equivocados”.

Si entramos en foros de conocidos anticientíficos, como antivacunas, o como quienes afirman que un desinfectante industrial es la cura del cáncer, veremos que en sus publicaciones enlazan fuentes y que además se apoyan fuertemente en los prejuicios que existen sobre el sector farmacéutico. No es de extrañar que su desinformación pueda parecer información ante ojos inexpertos.

Quien tiene demasiado presentes los traspiés de la industria farmacéutica, es probable que infravalore todos sus logros, y que le resulte convincente cualquier idea conspiranoica sobre este sector. Por este motivo gran parte del relato de los anticientíficos y charlatanes se fundamenta en reiterar los errores de la industria. Su propaganda depende del menosprecio hacia un sector entero.

-

El relato heroico como fórmula del éxito desinformador.

Pensemos en cualquier charlatán anticientífico que nos venga a la mente. Hecho.

Seguramente se presenta como alguien sin demasiado poder pero muy motivado para luchar contra algo más grande que él. La industria farmacéutica, la industria alimentaria, el gobierno. Cualquier cosa grande. Hace hincapié en definirse como un donnadie. Un simple agricultor, un simple investigador, un simple ciudadano de a pie. Los héroes de nuestro tiempo son, con frecuencia, autoproclamados mindundis. Esto les da mucha credibilidad, por aquello de la empatía, y por aquello de que nos hacen sentir partícipes. Todos podemos ser héroes y tal.

Su historia empieza de la nada. Abriendo un blog como cualquier hijo de vecino. Sin ánimo de lucro, por supuesto. El voluntarismo es súper importante para mantener la credibilidad. Simplemente empezó a investigar y a escribir sus cosillas para despertar el sentido crítico de la gente. Porque la educación es súper importante y se fragua en un blog. Porque una entrada en un blog puede desarmar a toda una industria. Lo hace por la gente. Para que la gente sea libre y viva en un mundo mejor.

Su obra benefactora se abre camino. Un día sale en la tele. Y luego publica un libro y da charlas. Va por ahí contando la verdad y, según él, poniendo súper nerviosa a la industria de nosequé. A veces cuenta que se ponen en contacto con él para reñirle muy fuerte. Es importante contarlo, porque si el malo no te amenaza, eres un héroe de mierda.

Es muy importante que el malo sea un ente. No es una persona, es un ente. La industria, los gobiernos, el gran hermano que te vigila. A veces es una empresa, pero suficientemente grande como para que entre dentro de la categoría de ente. Una multinacional. Eso, eso, multinacional, que son todas el demonio rojo.

Nadie se convierte en héroe relatando su batalla contra las patatas fritas Manolo. A ver si van a pensar que es una rencilla personal con Manolo y no una lucha súper importante en defensa de los derechos fundamentales y esas cosas serias. Además, a quién le importan las patatas de Manolo, habiendo multinacionales y gobiernos del mal.

El charlatán es un rebelde. Es indomable. Es el azote de lo preestablecido. Su historia es convincente porque es una historia que mola. El relato heroico funciona, con un malo muy malo y muy grande, y con un bueno cargado de buenas intenciones. Un tipo humilde, como tú y como yo. Un tipo que humildemente está haciendo nuestro mundo mejor.

-

Conclusión

Los desinformadores resultan convincentes porque sus intervenciones lo tienen todo: fuentes, prejuicios y un relato heroico.

La tarea de identificar la veracidad de lo que cuentan es complicada a través de las fuentes y a través de la identificación de nuestros propios prejuicios. Por eso, el formato cobra protagonismo a la hora de detectar la desinformación. Si una información se nos presenta en forma de relato heroico, con toda probabilidad, estamos ante un impostor.

Igual que criticamos a los charlatanes que sueltan lindezas sobre las farmacéuticas para venderse a sí mismos y sus pseudoterapias, apliquemos el mismo detector de charlatanería sobre aquellos que dicen enfrentarse a “la perversa industria alimentaria”. Cualquiera que con orgullo diga enfrentarse al “eje del mal”, ya sea la industria, los gobiernos, o el lado oscuro, es un donnadie con ínfulas. Un desinformador que ha convertido su lucha inventada en su empresa, en una cuestión identitaria, en su cometido vital.

El relato heroico es una vaga maniobra de persuasión propia de la posverdad. Detectarlo es, probablemente, la mejor estrategia de identificar la desinformación.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Humildemente, el mundo es mejor gracias a mí se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Puedes presumir de tener la mejor piel del mundo.

- ¿Por qué si nunca hemos vivido mejor que ahora el mundo nos parece cada vez peor?

- Así es la mejor crema antiedad según la ciencia

¿Pueden los números enamorarse de su propia imagen?

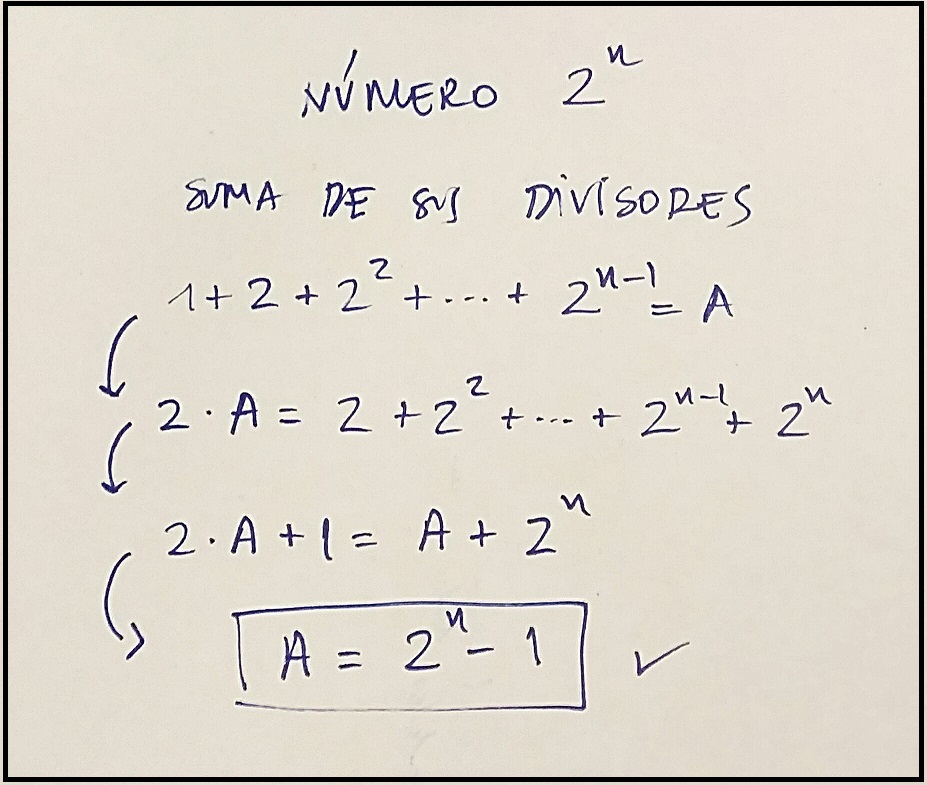

En la entrada Los números enamorados del Cuaderno de Cultura Científica, habíamos presentado algunas familias de números naturales que deben su propiedad definitoria al comportamiento de sus divisores, en concreto, de sus divisores propios, es decir, entre los divisores no se considera al propio número. Estuvimos hablando de los números perfectos, abundantes, deficientes, casi perfectos, multi-perfectos, ambiciosos, sublimes, amigos, novios, sociables, intocables, prácticos, raros, e incluso, poderosos.

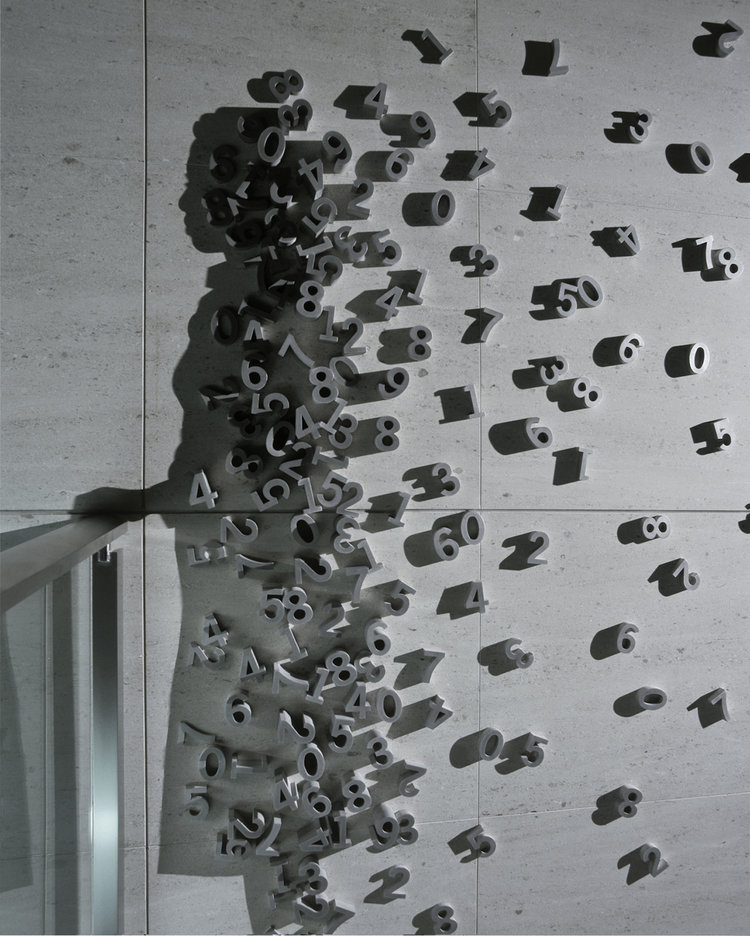

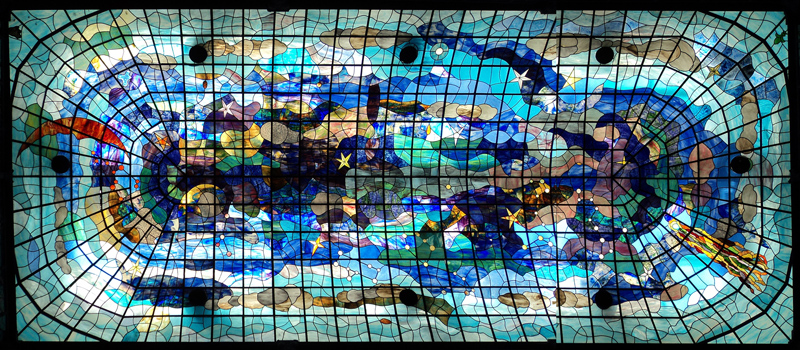

Detalle de la obra “CITY VIEW” (2003), de la artista japonesa, que vive en Nueva York, Kumi Yamashita. La obra pertenece a la colección permanente de Namba Parks Tower, en Osaka (Japón). Fotografía de la página web de la artista

Detalle de la obra “CITY VIEW” (2003), de la artista japonesa, que vive en Nueva York, Kumi Yamashita. La obra pertenece a la colección permanente de Namba Parks Tower, en Osaka (Japón). Fotografía de la página web de la artistaEn esta entrada vamos a hablar de una serie de familias de números que podríamos denominar en su conjunto como narcisistas, aunque esta sea la denominación particular de una de esas familias. Estos números tienen la propiedad de que, si se toman las cifras que componen cada uno de ellos, después se elevan estas a ciertas potencias y se suman los resultados, se obtiene de nuevo el número.

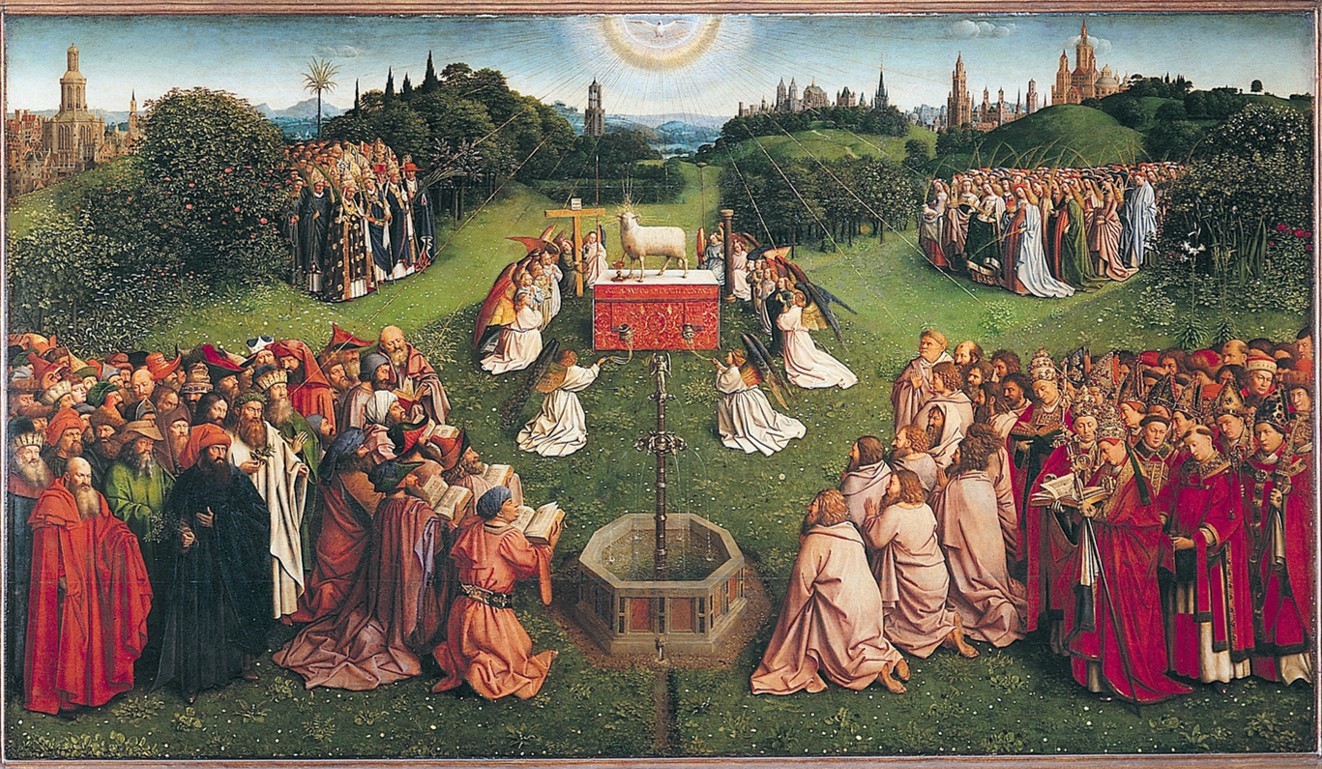

Recordemos que una persona narcisista es aquella que “cuida demasiado de su arreglo personal, o se precia de atractivo, como enamorado de sí mismo” y el concepto viene del mito griego en el cual el joven y apuesto Narciso se enamoró de su propia imagen reflejada en el agua. En el concepto de números narcisistas la imagen reflejada sería la suma de las potencias de sus cifras, que, al ser el propio número, sería como el enamoramiento de Narciso de su propia imagen reflejada.

Narciso (1594-1596), del artista italiano Caravaggio, perteneciente a la colección de la Galeria Nazionale d’Arte Antica. Imagen de Wikimedia Commons

Narciso (1594-1596), del artista italiano Caravaggio, perteneciente a la colección de la Galeria Nazionale d’Arte Antica. Imagen de Wikimedia CommonsEmpecemos este recorrido por la familia de números que recibe precisamente el apelativo de números narcisistas. Esta familia está formada por aquellos números que son iguales a la suma de las potencias de sus cifras elevadas a la cantidad de cifras que tiene el número. Por ejemplo, el número 153 es un número narcisista, puesto que, teniendo 3 cifras, que son 1, 5 y 3, se cumple que 13 + 53 + 33 = 1 + 125 + 27 = 153; o también, el número 1634, ya que 14 + 64 + 34 + 44 = 1 + 1296 + 81 + 256 = 1.634.

Los números narcisistas menores que 100.000 son: 1, 2, 3, 4, 5, 6, 7, 8, 9, 153, 370, 371, 407, 1.634, 8.208, 9.474, 54.748, 92.727 y 93.084.

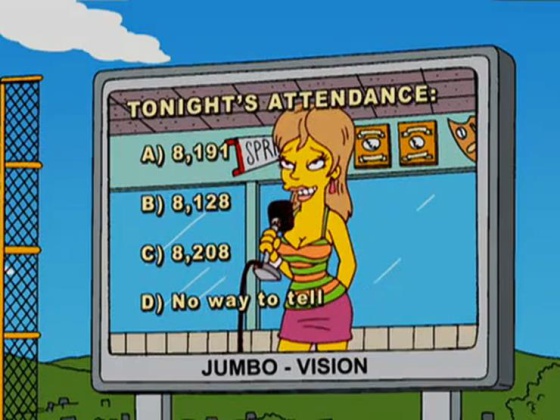

Fijémonos en uno en concreto, el número narcisista 8.208. Este ha alcanzado una cierta fama por haber aparecido en la serie televisiva Los Simpson. Como puede leerse en el libro Los Simpson y las matemáticas del matemático y divulgador Simon Singh, la historia de ese y otros dos números que aparecen en un capítulo de la temporada 17 de esta serie es muy curiosa.

Dentro de la comunidad matemática es conocido que algunos de los guionistas y productores de la serie Los Simpson, así como de la serie Futurama, tienen estudios de matemáticas, y en general, de ciencias, lo que ha motivado que en ambas series aparezcan muchísimas referencias matemáticas. Simon Singh cuenta como, en particular, la profesora Sarah Greenwald, de la Universidad Estatal de los Apalaches, y el profesor Andrew Nestler, de la Universidad de Santa Mónica, empezaron a recoger todas esas referencias y a utilizarlas en sus clases de matemáticas. Cuando esto llegó al oído de los guionistas de la serie Los Simpson, en 2005, decidieron invitarlos a la lectura de un futuro episodio, ese que tendría el título Marge, Homer y el deporte en pareja. Cuando los dos invitados se marcharon, los guionistas se percataron de que en ese episodio no habían incluido ninguna referencia matemática, lo cual les pareció que había sido algo descortés hacia sus invitados y decidieron revisar el guion e incluir un guiño a las matemáticas.

Imagen del episodio Marge, Homer y el deporte en pareja, en la que aparecen tres números curiosos, uno de ellos un número narcisista, 8.208

Imagen del episodio Marge, Homer y el deporte en pareja, en la que aparecen tres números curiosos, uno de ellos un número narcisista, 8.208Como se puede ver en la anterior imagen de ese capítulo, decidieron incluir en la pantalla del estadio de béisbol, una mención a la cantidad de público asistente, dando cuatro opciones. La primera 8.191, que es lo que se conoce como un número primo de Mersenne, los cuales son de la forma 2p – 1, en concreto, 213 – 1 = 8.191. La segunda es 8.128, que es un número triangular (véase la entrada El asesinato de Pitágoras, historia y matemáticas (y II)). La tercera cantidad era el número narcisista 8.208, que verifica que 8.208 = 84 + 24 + 04 + 84. La última opción era simplemente que no se podía conocer esa cantidad.

Es fácil observar que solo existe un número finito de números narcisistas. Veámoslo. Si tomamos un número con n cifras, se tiene que ese número es mayor que 10n – 1 y menor que 10n. Por otra parte, la suma de las potencias de sus cifras elevadas a la cantidad de cifras del número alcanza como mucho el valor de 9n + … + 9n (sumado n veces) = n x 9n. Pero resulta que para n > 60, se tiene que n x 9n n – 1, luego la suma de las potencias de las cifras del número elevadas a la cantidad de cifras nunca podrá alcanzar al número. Es decir, no existen números narcisistas con más de 60 cifras.

De hecho, solamente hay 88 números narcisistas (puede verse aquí la lista completa), como fue demostrado por D. T. Winter, en 1985. Además, el mayor de ellos solamente tiene 39 cifras, es

115.132.219.018.763.992.565.095.597.973.971.522.401.

El matemático británico G. H. Hardy (1877 – 1947), en su libro Apología de un matemático, dice en referencia a estos números…

Se trata de hechos excepcionales, ideales para las columnas de acertijos y similares que aparecen en la sección de pasatiempos del periódico para entretener a los aficionados a las matemáticas, pero no hay nada en ellos que atraiga mucho a un matemático.

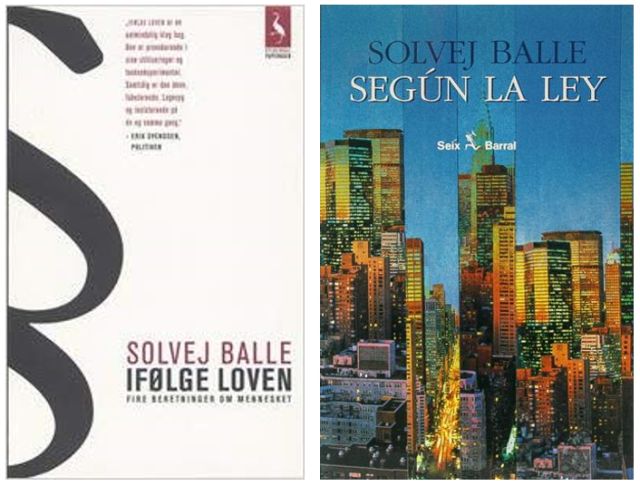

Portada de la edición en castellano, de la editorial Capitán Swing, del libro Apología de un matemático, de G. H. Hardy

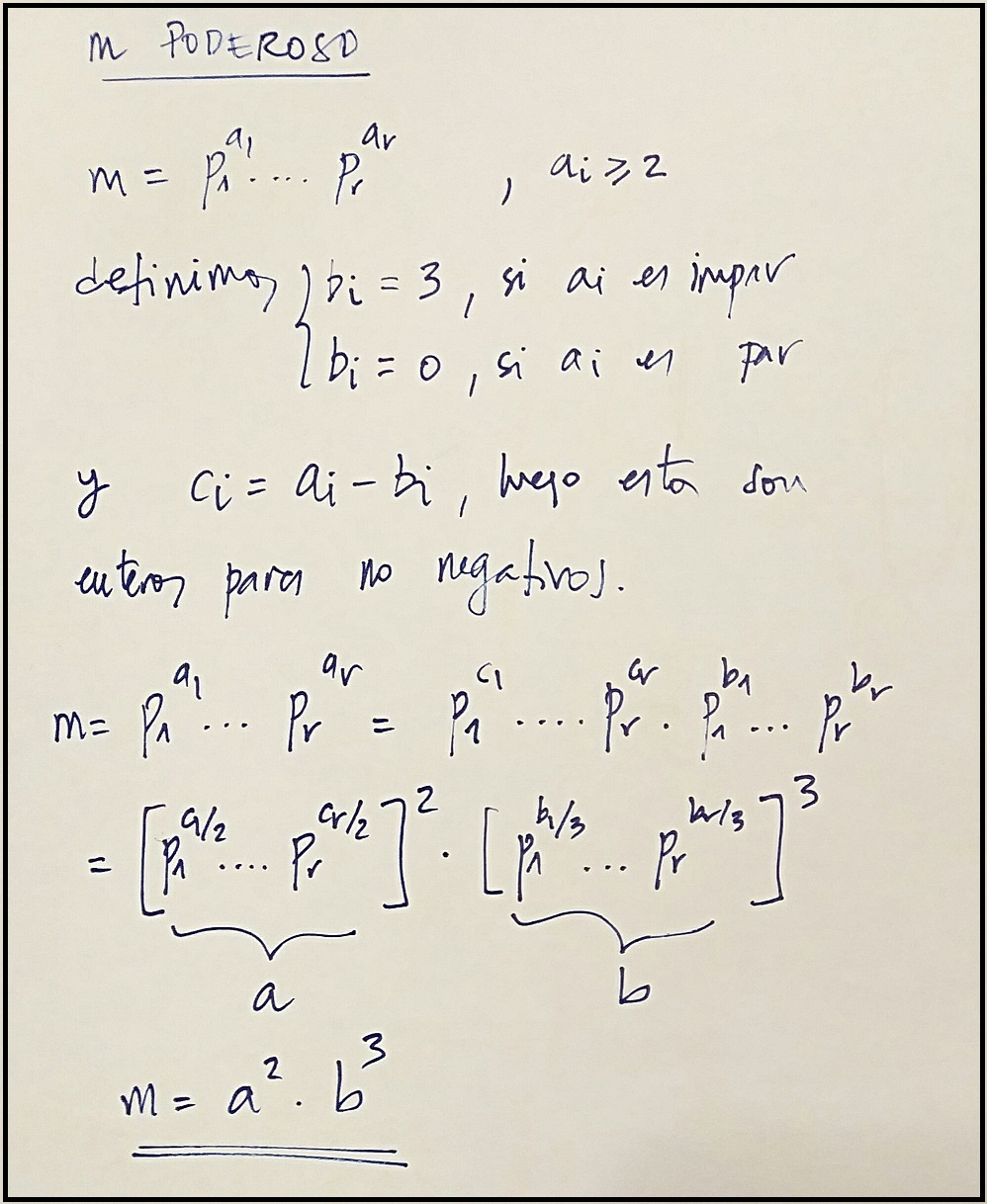

Portada de la edición en castellano, de la editorial Capitán Swing, del libro Apología de un matemático, de G. H. HardyEste concepto puede extenderse a una familia un poco más amplia, la de los números que son iguales a la suma de las potencias de sus cifras elevadas a una cantidad fija cualquiera, no necesariamente la cantidad de cifras del número, que es el caso de los números narcisistas. Por ejemplo, el número 4.150, que puede expresarse como la suma de las potencias quintas de sus cifras (que son solo cuatro), así 45 + 15 + 55 + 05 = 1.024 + 1 + 3.125 = 4.150. En una nota en la revista Mathematical Gazette, de 1968, se sugiere el nombre de “powerful numbers”, que es el mismo nombre que reciben los números que en la anterior entrada del Cuaderno de Cultura Científica, Los números enamorados, se denominaron poderosos, por lo que llamaremos a estos otros, números potentes. Por otra parte, en el libro Mathematics on vacation, su autor, el químico, editor y matemático recreativo Joseph Madachy (1927 – 2014), les llama números “invariantes digitales perfectos”.

Los números potentes menores de 100.000 son: 1, 2, 3, 4, 5, 6, 7, 8, 9, 153, 370, 371, 407, 1.634, 4.150, 4.151, 8.208, 9.474, 54.748, 92.727 y 93.084, solamente dos más que los narcisistas, a saber, 4.150 y 4.151. El siguiente número poderoso, que además no es narcisista, es 194.979 = l5 + 95 + 45 + 95 + 75 + 95.

En la enciclopedia on-line de sucesiones de números enteros, en la información sobre la sucesión A023052, aparece un listado de los 255 números potentes conocidos. El más grande, que además no es narcisista, tiene 105 cifras y se obtiene al elevar cada una de sus cifras a la potencia 109 y sumarlas. Es …

926.141.173.758.288.802.620.975.817.393.837.795.715.817.835.556.117.230.343.321.424.553.048.655.411.019.641.033.929.959.544.403.221.763.375

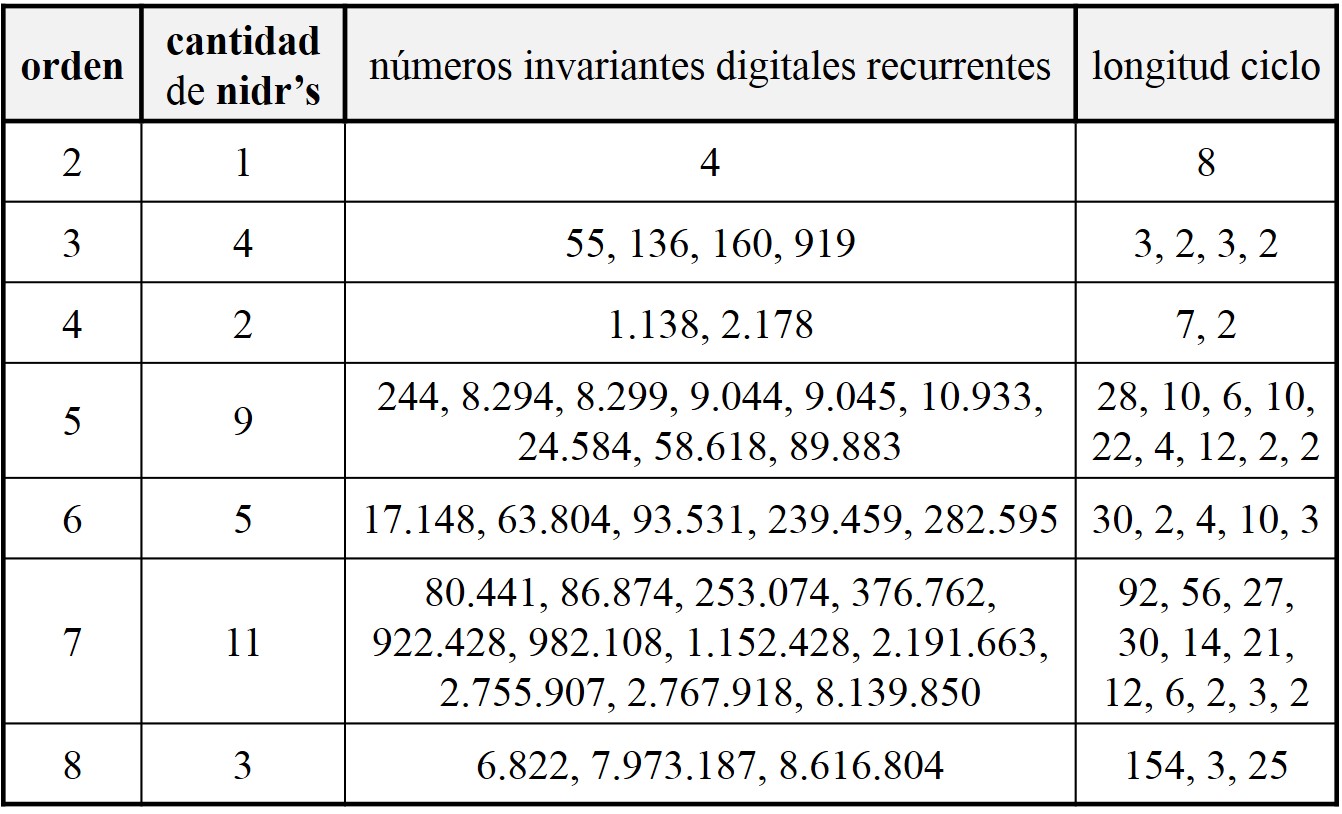

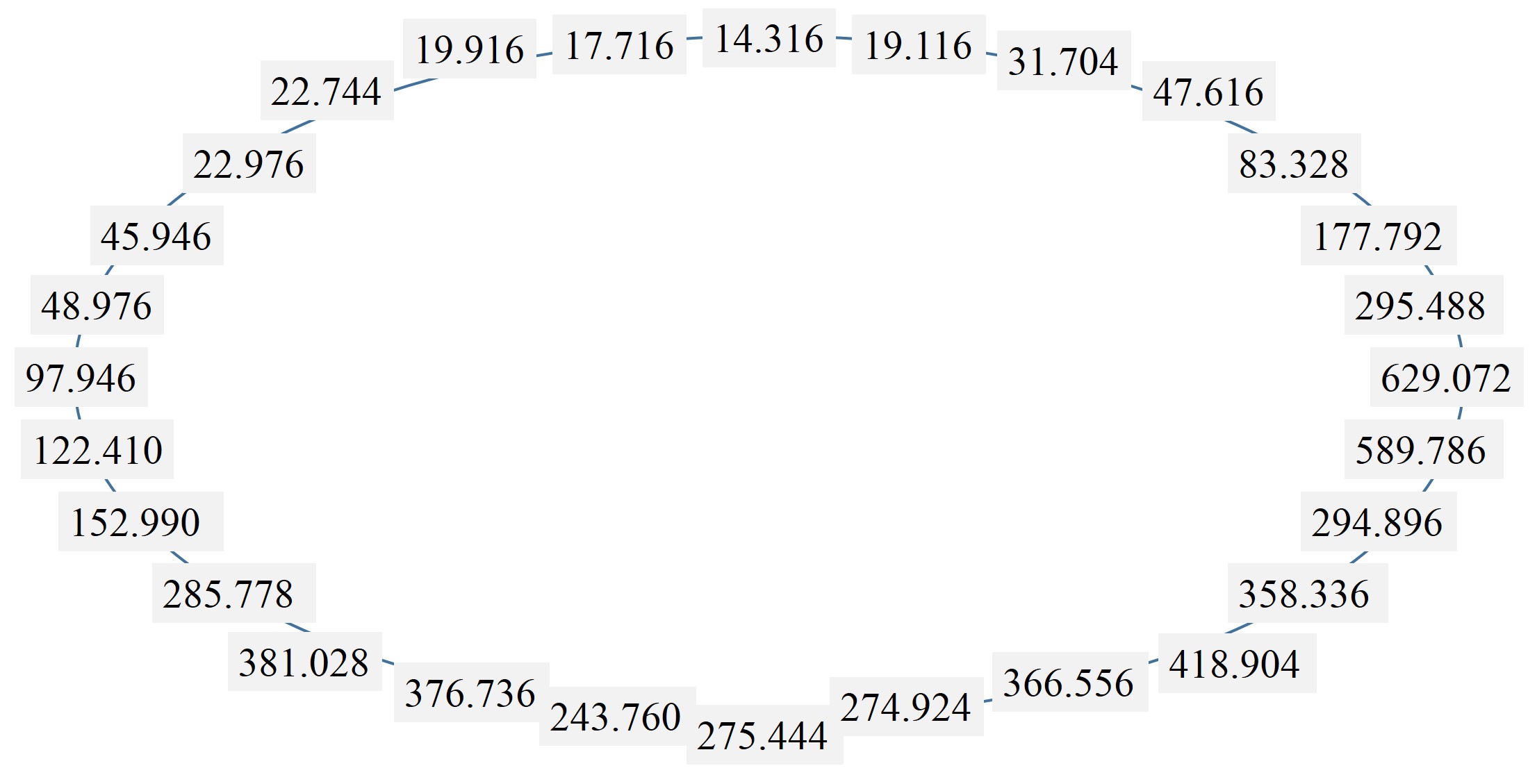

A raíz del concepto de número invariante digital perfecto, Joseph Madachy define los “números invariantes digitales recurrentes”, que podríamos denominar también números potentes recurrentes. Un número es un invariante digital recurrente, de orden k, si al construir la sucesión de números, empezando por el mismo, formados por las sumas de las potencias k-ésimas de las cifras del número anterior, se llega de nuevo al número original en un número finito de pasos, llamado longitud del ciclo. Por ejemplo, el número 55 es un invariante digital recurrente de orden 3, ya que 53 + 53 = 250, 23 + 53 + 03 = 133 y 13 + 33 + 33 = 55, siendo longitud del ciclo igual a 3.

Veamos un ejemplo de orden 4, el número 1.138. Calculemos la sucesión asociada, 14 + 14 + 34 + 84 = 4.179, 44 + 14 + 74 + 94 = 9.219, 94 + 24 + 14 + 94 = 13.139, 14 + 34 + 14 + 34 + 94 = 6.725, 64 + 74 + 24 + 54 = 4.338, 44 + 34 + 34 + 84 = 4.514 y regresamos al origen, después de un ciclo de longitud 8, 44 + 54 + 14 + 44 = 1.138.

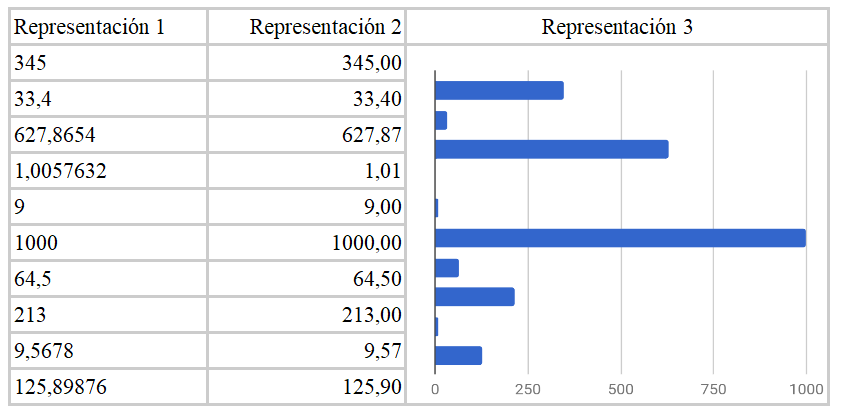

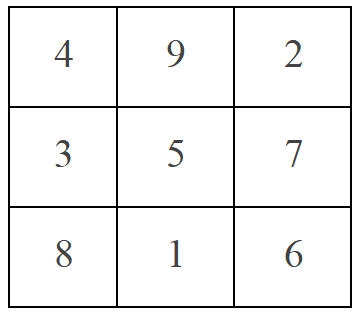

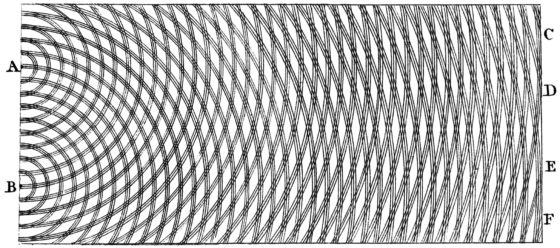

Tabla de números invariantes digitales recurrentes de órdenes, entre 2 y 8

Tabla de números invariantes digitales recurrentes de órdenes, entre 2 y 8Otra familia de números relacionada con los números narcisistas, pero a la que nadie parece haber bautizado, son aquellos números que son iguales a la suma de las potencias de sus cifras elevadas a la posición que ocupan en el número, empezando por la izquierda. Por ejemplo, los números 89, 175, 2.427 y 2.646.798 son de estos números, ya que:

81 + 92 = 8 + 81 = 89,

11 + 72 + 53 = 1 + 49 + 125 = 175,

21 + 42 + 23 + 74 = 2 + 16 + 8 + 2.401 = 2.427, y

21 + 62 + 43 + 64 + 75 + 96 + 87 =

2 + 36 + 64 + 1.296 + 16.807 + 531.441 + 2.097.152 = 2.646.798.

De nuevo, se puede demostrar que esta familia de números es finita. Más aún, no puede haber números de esta familia con más de 22 cifras. Veámoslo.

Si tenemos un número con n cifras, entonces el número es mayor que 10n – 1 y si además pertenece a esta familia, será menor que 9 + 92 + … + 9n, pero, por la fórmula para la suma de los primeros números de la serie geométrica, esta suma es igual a 9 x (9n – 1) / 8 n + 1 / 8. En consecuencia, 10n – 1 n + 1 / 8, que nos lleva, tomando logaritmos, a que n

De hecho, solo hay 19 números que verifiquen esta propiedad: 1, 2, 3, 4, 5, 6, 7, 8, 9, 89, 135, 175, 518, 598, 1.306, 1.676, 2.427, 2.646.798 y 12.157.692.622.039.623.539, y el mayor tiene 20 cifras.

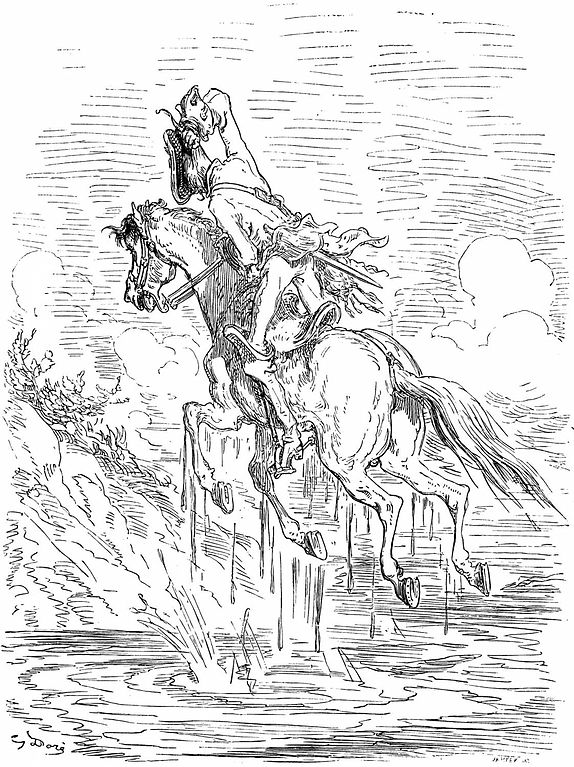

Otra familia de números relacionada con los números narcisistas es la formada por los números de Munchausen, aquellos números que son iguales a la suma de sus cifras elevadas a ellas mismas. Por ejemplo, el número 3.435 es un número de Munchausen, ya que 33 + 44 + 33 + 55 = 3.435.

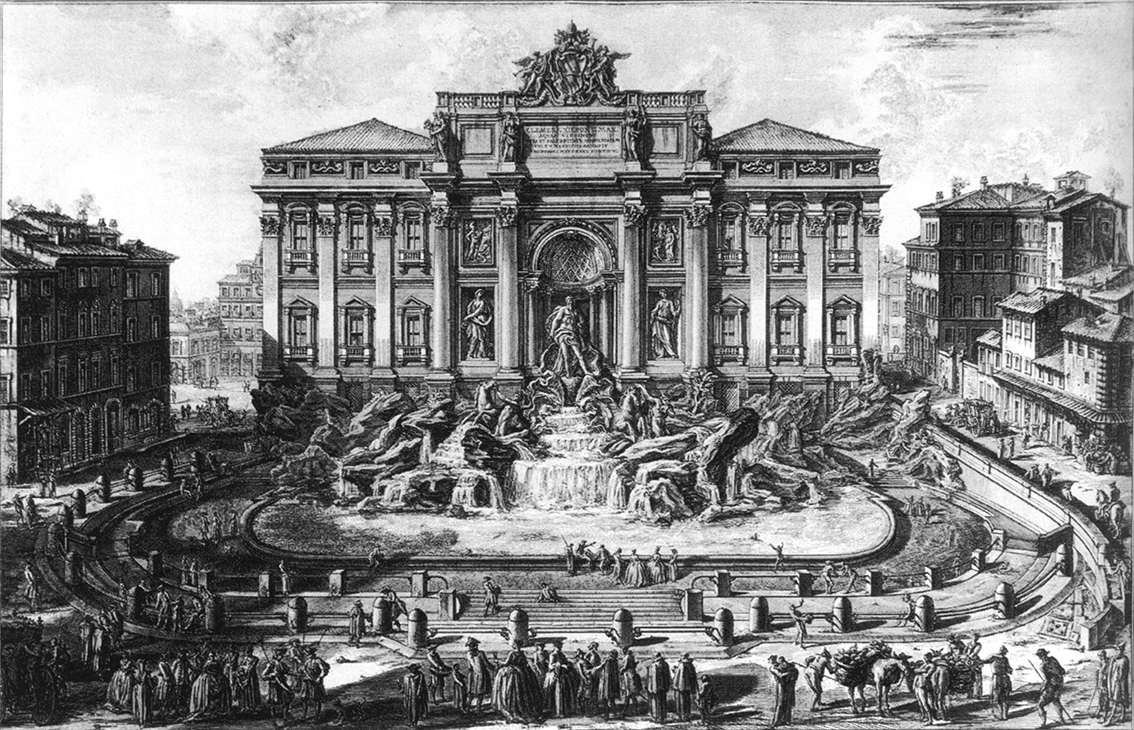

El nombre fue sugerido por el matemático e ingeniero de software holandés Daan van Berkel, en su artículo On a curious property of 3435 (2009), en referencia al barón de Munchausen. En los números de Munchausen cada cifra se eleva a sí misma, de la misma forma que el barón de Munchausen se eleva a sí mismo, tirando de su coleta, con lo cual consigue volar y evita caer en una ciénaga.

Ilustración de la edición francesa de 1862 del libro Las aventuras del barón de Munchausen de Rudolf Erich Raspe (1785), realizada por el ilustrador francés Gustave Doré (1832 – 1883), en la que el barón de Munchausen sale volando de una ciénaga tirando de su coleta hacia arriba. Imagen de Wikimedia Commons.

Ilustración de la edición francesa de 1862 del libro Las aventuras del barón de Munchausen de Rudolf Erich Raspe (1785), realizada por el ilustrador francés Gustave Doré (1832 – 1883), en la que el barón de Munchausen sale volando de una ciénaga tirando de su coleta hacia arriba. Imagen de Wikimedia Commons.Esta es una propiedad muy rígida. El único número de Munchausen, salvo el número 1 que lo es trivialmente, es el número 3.435, como demostró Daan van Berkel. Luego, podemos decir que este es un número muy especial.

Aunque si observamos la definición nos encontramos con un problema. Si una de las cifras del número es el 0, entonces tenemos que sumar 00 y esto es un problema. ¿Cuánto vale 00? Aunque es una polémica no cerrada del todo, la posición de la comunidad matemática es que ese valor debe ser 1. En ese caso, como demostró Daan van Berkel, solo hay dos números de Munchausen 1 y 3.435.

Sin embargo, si admitiésemos que 00 = 0, o modificamos la definición para que solo se considerasen las cifras no nulas, entonces habría otro número de esta familia, el 438.579.088, que verifica que

44 + 33 + 88 + 55 + 77 + 99 + 88 + 88 = 438.579.088.

Número 3.435 realizado con las Tarjetas de Cumpleaños Art Nouveau de la diseñadora estadounidense Laura Beckman. Imágenes de la página de Laura Beckman

Número 3.435 realizado con las Tarjetas de Cumpleaños Art Nouveau de la diseñadora estadounidense Laura Beckman. Imágenes de la página de Laura BeckmanTambién se pueden definir los números de Munchausen opuestos, es decir, aquellos números que son iguales a la suma de sus cifras elevadas a ellas mismas, pero no cada una con la suya, sino en el sentido opuesto. Por ejemplo, si consideramos el número 325, sus cifras son 3, 2 y 5, y vamos a tomar sus potencias elevadas a las cifras, pero en el orden opuesto, 5, 2, 3, quedando 35 + 22 + 53 = 243 + 4 + 125 = 372, luego este número no es de Munchausen opuesto. De nuevo, existen solamente dos números en esta familia:

48.625 = 45 + 82 + 66 + 28 + 54,

397.612 = 32 + 91 + 76 + 67 + 19 + 23.

Escultura Passing Time (2011), del artista neozelandés Anton Parsons, en Christchurch (Nueva Zelanda). Imagen de la página web de Anton Parsons

Escultura Passing Time (2011), del artista neozelandés Anton Parsons, en Christchurch (Nueva Zelanda). Imagen de la página web de Anton ParsonsLo cierto es que el concepto de número narcisista ha generado una enorme familia de generalizaciones. A continuación, haremos un breve repaso por algunas de ellas.

A. Suma de dos cuadrados. Si existiera un número narcisista con dos cifras, lo cual ya sabemos que no existe, entonces este sería igual a la suma de los cuadrados de sus cifras. Se puede generalizar este concepto para números de más de dos cifras, pero dividiendo al número en dos “mitades” de cifras. Es decir, a esta familia pertenecen los números que son iguales a las sumas de los cuadrados de dos “mitades” del número. Veamos algunos ejemplos:

1233 = 122 + 332, 8833 = 882 + 332, 5.882.353 = 5882 + 23532,

1.765.038.125 = 17.6502 + 38.1252, 116.788.321.168 = 116.7882 + 321.1682.

B. Suma de tres cubos. De forma análoga, se pueden considerar aquellos números que son iguales a la suma de los cubos de tres “tercios” del número.

22 18 59 = 223 + 183 + 593,

166 500 333 = 1663 + 5003 + 3333.

C. Números factoriones. Estos números son aquellos que son iguales a la suma de los factoriales de sus cifras. Por ejemplo, 145 es un factorión, ya que

1! + 4! + 5! = 1 + 24 + 120 = 145.

Los números 1 y 2 son trivialmente números factoriones, ya que 1! = 1 y 2! = 2. Y el número 40.585 también es un número factorión, ya que

4! + 0! + 5! + 8! + 5! = 24 + 1 + 120 + 40320 + 120 = 40.585.

Resulta que estos son los únicos factoriones que existen. Supongamos que tenemos un número de n cifras, entonces este es mayor que 10n – 1, pero si es un número factorión, entonces es menor que la mayor suma posible de los factoriales de sus dígitos, que es n x 9!, de donde, 10n – 1 n x 9!. Pero resulta que, para n = 8 se obtiene que 107 = 10.000.000 > n x 9! = 2.903.040, luego no existen números factoriones de 8 cifras. Y, por inducción, se puede demostrar que ocurre para todos los n mayores o iguales que 8. Para n = 7, la suma máxima de los factoriales de las cifras que se puede obtener es 7 x 9! = 2.540.160, luego solo hay que comprobar los que son menores que esta cantidad. Y solo existen los cuatro anteriores.

D. Pares de números, o números “amigos”, para estas propiedades.

Por ejemplo, un par de números tales que la suma de los cuadrados de dos “mitades” de cada uno de ellos da el otro número, como los números 3.869 y 6.205, para los cuales

382 + 692 = 1.444 + 4.761 = 6.205 y 622 + 052 = 3844 + 25 = 3.869,

o el par de números

5.965 = 772 + 062 y 7.706 = 592 + 652.

Lo mismo para los cubos,

13 + 33 + 63 = 244 y 23 + 43 + 43 = 136,

o los factoriales, donde los tres números 169, 36.301 y 1.454 forman una cadena:

1! + 6! + 9! = 36.301, 3! + 6! + 3! + 0! + 1! = 1.454 y 1! + 4! + 5! + 1! = 169.

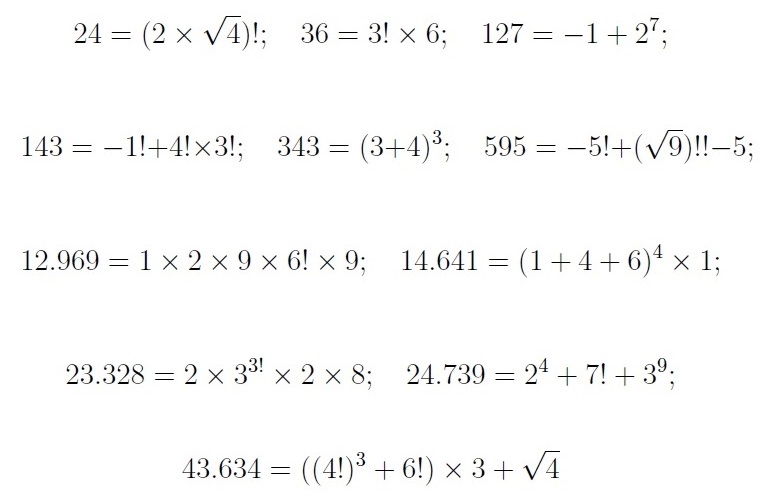

E. Números narcisistas salvajes. Estos números, al igual que los narcisistas, pueden ser expresados a partir de sus cifras, pero de una forma particular, las cifras deben de aparecer en el orden que aparecen en el número y pueden utilizarse las operaciones siguientes, suma, resta, multiplicación, división, potencia, radical y factorial.

Mostremos una pequeña colección de distintos números narcisistas salvajes

E incluso, se puede considerar que el orden de las cifras sea cualquiera, en cuyo caso se habla de números selfie. Un par de ejemplos serían

34.562 = 2 − (3 − 5) x6! x4!y87.369 = (3! + 7) x8! / 6 + 9.

Social circle (2011), del artista neozelandés Anton Parsons. Imagen de la página web de Anton Parsons

Social circle (2011), del artista neozelandés Anton Parsons. Imagen de la página web de Anton Parsons Bibliografía

1.- Clifford A. Pickover, El prodigio de los números. Desafíos, paradojas y curiosidades matemáticas, Ma Non Troppo (ediciones Robinbook), 2002.

2.- Clifford A. Pickover, La maravilla de los números. Un viaje por los secretos de las matemáticas, sus desafíos y caprichos, Ma Non Troppo (ediciones Robinbook), 2002.

3.- Joseph Madachy, Mathematics on vacation, Charles Scribner’s sons, 1966.

4.- Wolfram Mathworld: Narcissistic Number

5.- Simon Singh, Los Simpson y las matemáticas, Ariel, 2013.

6.- G. H. Hardy, Apología de un matemático, Capitán Swing, 2017.

7.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A0230052 (números potentes o invariantes digitales perfectos)

8.- Wolfram Mathworld: Recurring Digital Invariant

9.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A032799

10.- Daan van Berkel, On a curious property of 3435 (2009) (arXiv:0911.3038)

11.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A046253 (números de Munchausen)

12.- Harvey Heinz, Narcissistic numbers

13.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A014080 (números factoriones)

14.- George D. Poole, Integers and the sum of the factorials of their digits, Mathematics Magazine, vol. 44, n. 5, p. 278-279 (1971).

15.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A193069 (números narcisistas salvajes)

16.- I. J. Taneja, Different Types of Pretty Wild Narcissistic Numbers: Selfie Representations-I, RGMIA Research Report Collection, n. 18, Article 32, pp. 1-43 (2015).

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo ¿Pueden los números enamorarse de su propia imagen? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Construye tu propia calculadora de sumas y restas

- La magia de los números (el teorema de Moessner)

- Los números enamorados

Los colores del cielo

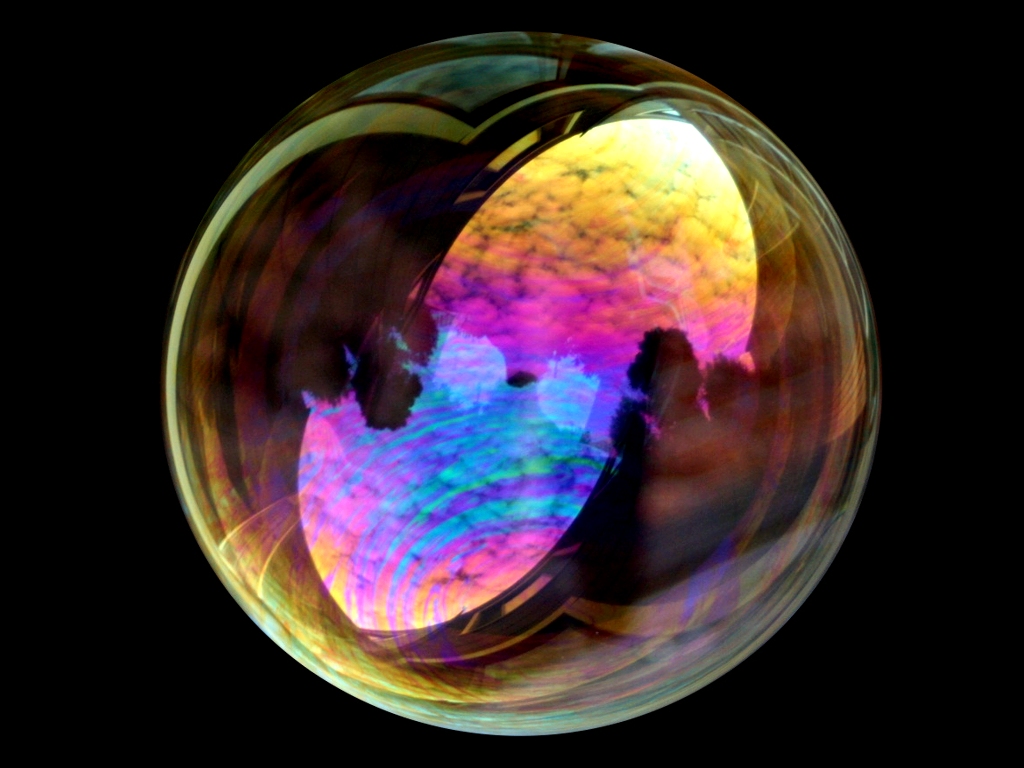

Imagen: Pixabay

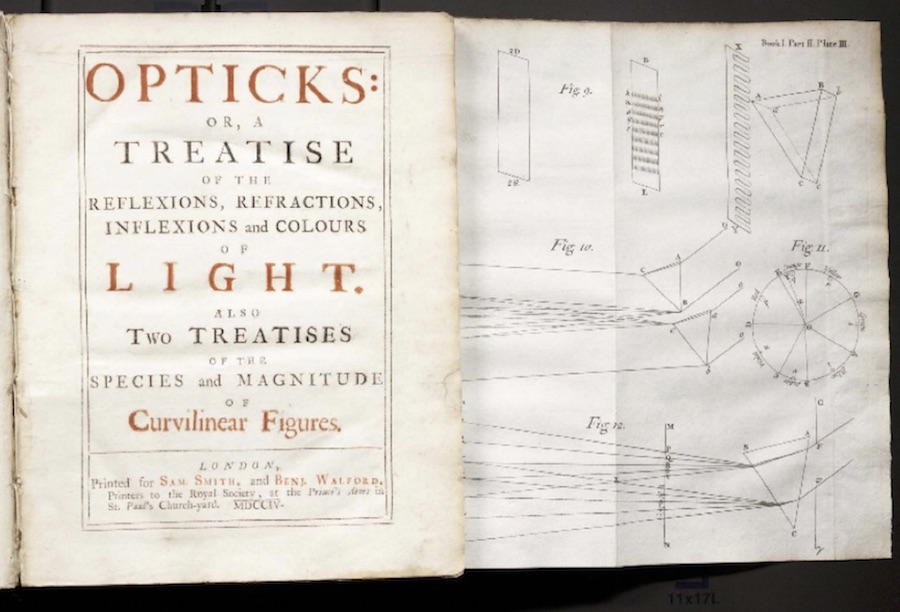

Imagen: PixabayNewton sugirió que los colores aparentes de los objetos dependen de qué color se refleja o dispersa más fuertemente para quien observa el objeto. En general, no hay una forma sencilla de predecir a partir de la estructura de la superficie, de la composición química o de cualquier otro factor qué colores reflejará o dispersará una sustancia. Eso no quiere decir que existan, sino que se basan en modelos matemáticamente muy complejos. Sin embargo, algo que la mayoría de nosotros vemos todos los días se puede explicar de una forma bastante simplificada a la par que instructiva: los colores del cielo

Thomas Young demostró experimentalmente que diferentes longitudes de onda de la luz corresponden a diferentes colores. La longitud de onda de la luz se puede especificar en unidades de nanómetros (nm; 1 nm = 10-9 m) o, alternativamente, en ångstroms (Å), el nombre de Anders Jonas Ångstrom, un astrónomo sueco que, en 1862, utilizó técnicas espectroscópicas para detectar La presencia de hidrógeno en el Sol. Un ångstrom es igual a 10-10 m. El rango del espectro visible para los humanos es de aproximadamente 400 nm (4000 Å) para luz violeta a, aproximadamente, 700 nm (7000 Å) para la luz roja.

Los pequeños obstáculos pueden dispersar la energía de una onda incidente de cualquier tipo en todas las direcciones, y la cantidad de dispersión depende de la longitud de onda. Como regla general, cuanto mayor sea la longitud de onda en comparación con el tamaño del obstáculo, menor será la dispersión de la onda por el obstáculo. Para partículas más pequeñas que una longitud de onda, la cantidad de dispersión de luz varía inversamente con la cuarta potencia de la longitud de onda. Por ejemplo, como la longitud de onda de la luz roja es aproximadamente el doble de la longitud de onda de la luz azul, la dispersión de la luz roja es solo alrededor de un dieciseisavo* de la dispersión de la luz azul.

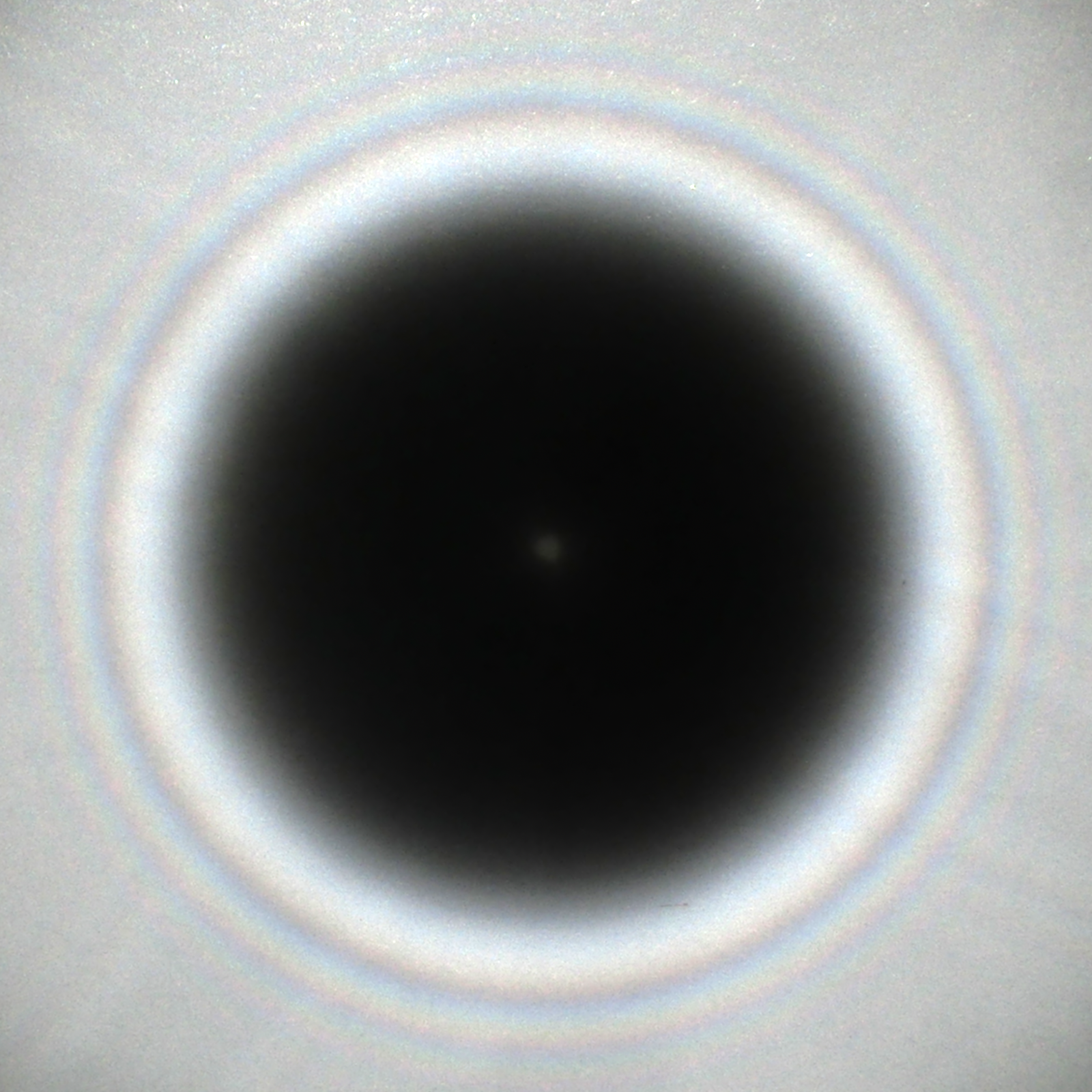

Imagen: Pixabay

Imagen: PixabayCon este simple dato ya sabemos por qué el cielo de mediodía de un día despejado es azul. La luz del Sol se dispersa por las moléculas y las micropartículas partículas de polvo presentes en las capas altas de la atmósfera. Todos estos obstáculos tienen dimensiones muy pequeñas en comparación con las longitudes de onda de la luz visible. Por lo tanto, en un día claro, la luz dispersa mucho más la luz de longitud de onda corta (luz azul) que la luz de longitudes de onda más largas y, por así decirlo, llena la luz azul llena el cielo de punta a punta. Debemos ser conscientes de que el color depende del observador. Cuando miras hacia arriba en un cielo despejado, es principalmente esta luz dispersada la que entra en tus ojos. El rango de longitudes de onda cortas dispersas (y la sensibilidad al color del ojo humano) conduce a la sensación de azul.

Imagen: Pixabay

Imagen: PixabayPero, ¿qué ocurre un día con neblina cuando observamos la puesta de sol o el amanecer? Lo que nuestro ojo recibe directamente del Sol es un haz de luz en el que las longitudes de onda más cortas se han dispersado completamente por el camino, no así las longitudes de onda más largas. De esta forma percibes el cielo alrededor del Sol poniente como rojizo.

Imagen: Pixabay

Imagen: PixabaySi la Tierra no tuviera atmósfera, no habría dispersión de la luz, el cielo aparecería negro y las estrellas serían visibles durante el día. De hecho, comenzando en altitudes de aproximadamente 16 km, donde la atmósfera se vuelve bastante fina, el cielo se ve negro y las estrellas se pueden ver durante el día, como han descubierto los que hayan volado a gran altitud, incluidos los astronautas [2].

Imagen: Pixabay

Imagen: PixabaySi la luz es dispersada por partículas considerablemente más grandes que una longitud de onda (como las gotas de agua en una nube), no hay mucha diferencia en la dispersión de diferentes longitudes de onda. Como todas las longitudes de onda se dispersan, el resultado de su mezcla es blanco. Blanco color nube.

Imagen: Sergio Cambelo / flickr

Imagen: Sergio Cambelo / flickrEse azul grisáceo o parduzco que a menudo cubre las grandes ciudades es causado principalmente por partículas emitidas por motores de combustión interna (automóviles, camiones, calderas de calefacción [3]) y por plantas industriales. La mayoría de estas partículas contaminantes son invisibles, y varían en tamaño, desde los 10-6 m hasta los 10-9 m. Dichas partículas proporcionan una base a la que se adhieren gases, líquidos y otros sólidos. Estas partículas más grandes dispersan la luz y producen neblina. La gravedad tiene poco efecto sobre las partículas [4] hasta que se vuelven muy grandes. Pueden permanecer en la atmósfera durante meses si no se limpian por la lluvia, nieve o el viento en cantidad y tiempo suficientes.

Más información en Y el Sol se volvió azul

Notas:

[1] Un dieciseisavo (1/16) es 1 dividido entre 24.

[2] Por eso en la Luna, donde no hay atmósfera el cielo se ve negro y se ven las estrellas aun estando al sol. Los conspiranoicos suelen citar las imágenes del cielo lunar negro pero sin estrellas como prueba de que los viajes a la Luna fueron un montaje. Lo único que demuestran es que no saben de fotografía: si el sol está presente tienes que tener muy poco tiempo de exposición y el obturador casi cerrado para que se vean cosas que son muchísimo más brillantes para la cámara que las estrellas.

[3] Estas calderas funcionan con gasóleo, biomasa o…carbón. Por ejemplo, se estima que en Madrid Central a comienzos de 2019 aun estaban operativas 200 calderas de carbón y unas 4000 de gasóleo (fuente). Las calderas generan la mitad de las partículas que contaminan el aire (EEA).

[4] Que están en un fluido, en el aire, no en el vacío.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los colores del cielo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:¡Salvad a las ranas!

Ranas. Imagen: Wikimedia Commons

Ranas. Imagen: Wikimedia CommonsSi un hongo llamado Batrachochytrium dendrobatidis no les tiene a usted y a toda su familia asustados y amenazados es porque no son ustedes una rana, un sapo u otro tipo de anfibio. Porque si lo fuesen, lo estarían. El Bd (acortemos) ha sido declarado recientemente como el patógeno más peligroso para la biodiversidad del que se tiene noticia hasta ahora: es responsable de la desaparición de 90 especies de anfibios y amenaza a más de 500. De ellas, 124 han reducido el número de sus ejemplares hasta en un 90% y no está claro que puedan llegar a recuperarse nunca. Los especialistas no saben a día de hoy cómo detenerlo.

Un estudio llevado a cabo en 2018 sugiere que el hongo se originó en la península de Corea y desde allí se diseminó por todo el mundo en animales infectados que se colaron en las cargas de exportación, ya fuese como polizones o como mercancías alimenticias o como mascotas. Hoy se puede encontrar en más de 60 países de todo el mundo y está causando estragos en América Latina, Asia y África.

Este patógeno se transmite por contacto directo o a través de aguas infectadas y ataca a los animales a través de la keratina presente en su piel, que forma parte del sistema respiratorio de los anfibios. Así, causa que se vayan asfixiando a la vez que deteriora su sistema inmune y termina causándoles un ataque cardíaco.

Suena terrible, y lo es, pero el Bd ha tenido al menos un aspecto positivo para las ranas y similares: estamos hablando de ellas y de las amenazas que sufren. Como les pasa a muchos animales menos agraciados que tigres, pandas, delfines, águilas y elefantes, sus penurias, incluidas aquellas que el ser humano les causa, pasan más desapercibidas y se les defiende menos, a pesar de ser parte imprescindible de muchos ecosistemas, necesarios para que se mantengan los equilibrios tróficos y dependientes de la conservación de los recursos naturales.

Y eso que son unos animales fascinantes de los que la mayoría no sabemos lo suficiente. Por si es su caso, aquí van algunas cosas sobre las ranas que quizá usted no sepa.

¿En qué se diferencia una rana de un sapo?

En lo que a su taxonomía se refiere, ranas y sapos forman parte del género Anuro y de forma generalizada se les llama anuros a ambos. A partir de aquí, las diferencias entre ambos son a nivel coloquial y popular, pero taxonómicamente no hay una categorización establecida.

Rana Silverstoneia flotator, originaria de Costa Rica y Panamá. Imagen: Wikimedia Commons

Rana Silverstoneia flotator, originaria de Costa Rica y Panamá. Imagen: Wikimedia Commons

Se considera que las ranas son, en general, más pequeñas, de piel suave y brillante, y más gráciles, con patas más finas que les permiten dar mayores saltos. Por el contrario los sapos son más rugosos, de colores más discretos y más corpulentos, con saltos más pequeños. Las ranas ponen sus huevos en racimos mientras que los sapos los ponen en forma de ristras.

Sin embargo, no todas las especies cumplen todas estas características, y por eso no es una división oficial.

¿Por qué las ranas no se congelan en invierno?

Los anfibios han colonizado prácticamente todos los hábitats del mundo, y en algunos de ellos puede llegar a hacer mucho frío. Dado el porcentaje de agua que contiene su cuerpo, y que son por naturaleza animales de sangre fría, ¿cómo lo hacen para no congelarse en invierno?

Las ranas hibernan, como hacen otros animales, como respuesta al frío del invierno. Para hibernar, buscan un espacio que les proteja del tiempo y de los depredadores y se acomodan en él. Entonces su metabolismo se ralentiza de forma drástica y consiguen dormir durante meses utilizando para ello las reservas de energía que van acumulando durante las estaciones cálidas. Cuando vuelve a hacer calor, despiertan y salen de su escondrijo para volver a alimentarse y dedicarse a la gustosa tarea de aparearse.

Sapo común en plena reproducción. Imagen: Wikimedia Commons

Sapo común en plena reproducción. Imagen: Wikimedia Commons

Las ranas acuáticas pueden hacer esto bajo el agua, pero a diferencia de otros animales acuáticos, como las tortugas, que se pueden enterrar bajo el barro y obtener de él las pequeñísimas cantidades de oxígeno que requieren durante la hibernación, las ranas deben situarse cerca de corrientes de agua ricas en oxígeno e hibernar sobre el barro no bajo él. Muchas salen ligeramente del letargo y nadan lentamente de vez en cuando.

Las ranas terrestres hibernan en tierra, a menudo enterrándose bien bajo el suelo para situarse a salvo de depredadores y también huyendo del nivel de congelación. Otras se evitan el esfuerzo de cavar y enterrarse ubicándose en grietas lo suficientemente profundas de troncos o rocas para quedar fuera del alcance de cualquiera que pretenda darles un bocado.

Para evitar que el frío les haga daño mientras hibernan cuentan con un efectivo sistema anticongelante: una alta concentración de glucosa en sus órganos vitales evitan que se congelen. Pueden llegar a formarse algunos cristales de hielo en algunas partes del cuerpo, como por ejemplo la vejiga, y el animal parecerá muerto durante semanas pero cuando llegue la primavera y las temperaturas suban, esos cristales desaparecerán, el cuerpo de la rana estará intacto y ésta recuperará su actividad sin problema.

¿Cómo evitan deshidratarse en las estaciones secas?

Si bien la mayoría de los anfibios viven en lugares donde ninguna estación es tan seca como para suponer un problema, unas pocas se han adaptado para conquistar esos hábitats. En esos casos, practican la estivación, la versión veraniega de la hibernación: el animal entra en un estado durmiente como respuesta a las condiciones extremas temporales del entorno.

Para hacerlo, se entierran en el suelo, allí donde aun se conserva un poco de humedad y mientras duermen ponen en marcha un ingenioso truco: generan varias capas de piel muerta, formando una especie de capullo impermeable que les envuelve y les ayuda a conservar su propia humedad, dejando expuestos al exterior solamente los agujeros respiratorios para evitar asfixiarse. Cuando termina la estación seca y vuelven las lluvias, se liberan de su caparazón y regresan a la superficie para rehidratarse.

¿Por qué pasan de renacuajos a ranas?

Cuando nacen, las ranas no son ranas más pequeñas, sino un renacuajo, que a simple vista parece un animal de una especie totalmente distinta: una cabeza grande y redondeada con una ancha cola que les permite desplazarse y alimentarse en el agua. Pocas semanas después desarrollan las poderosas patas traseras que les ayudan a saltar fuera del agua y alimentarse en un terreno nuevo. No son las únicas que practican la metamorfosis, muchos peces e insectos lo hacen también. Pero ¿por qué?

Renacuajo de la rana bermeja, días antes de su metamorfosis. Imagen: Wikimedia Commons

Renacuajo de la rana bermeja, días antes de su metamorfosis. Imagen: Wikimedia CommonsSegún la investigadora holandesa Anna ten Brink, se trata de una estrategia que permite a una especie aumentar potencialmente sus opciones de alimentación, y es una estrategia tan eficaz que, sin bien ha aparecido contadas veces a lo largo de la evolución, una vez que lo hace rara vez desaparece.

Ten Brink y su equipo partieron de la idea de que los animales que no se metamorfosean y siempre tienen el mismo tipo de cuerpo adaptado al mismo tipo de entorno, están bien preparados para comer un tipo de alimento durante toda su vida. Pero si ese entorno contiene otro tipo de alimento, ¿podrían los adultos incorporarlo si durante su crecimiento su anatomía cambiaba de una forma distinta?

La respuesta que observaron es que los animales esto rara vez ocurre, ya que entonces las crías tendrían más dificultad para nutrirse del primer alimento y un mayor porcentaje moriría antes de llegar a la edad adulta.

Aquí, la metamorfosis es una solución evidente: los animales jóvenes siguen adaptados al alimento original y los adultos cambian completamente de cuerpo para poder consumir el segundo. Claro que esto supone pagar un alto precio en forma de una gran cantidad de calorías y el riesgo de que el proceso salga mal y el animal sufra defectos que acorten notablemente su vida.

Incluso aunque salga bien, el periodo de metamorfosis es un momento de especial vulnerabilidad en el que no pueden huir ni defenderse en caso de ataque de un depredador. Por eso ten Brink especula que la metamorfosis sale adelante cuando la recompensa evolutiva es realmente buena, cuando los que la completan tienen a su alcance una alimentación muy nutritiva que les permite reproducirse numerosamente con éxito.

Referencias:

A deadly amphibian disease goes global – Science

The Evolutionary Ecology of Metamorphosis – The American Naturalist

¿Por qué un animal cambiaría su cuerpo por otro? – The New York Times

How do frogs survive winter? Why don’t they freeze to death – American Scientist

What’s The Difference Between a Frog and a Toad? – Live Science

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo ¡Salvad a las ranas! se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¡Salvad a la hija!

- ¿Por qué si nunca hemos vivido mejor que ahora el mundo nos parece cada vez peor?

- Las ventajas (para ti y para los demás) de ser egoísta de vez en cuando

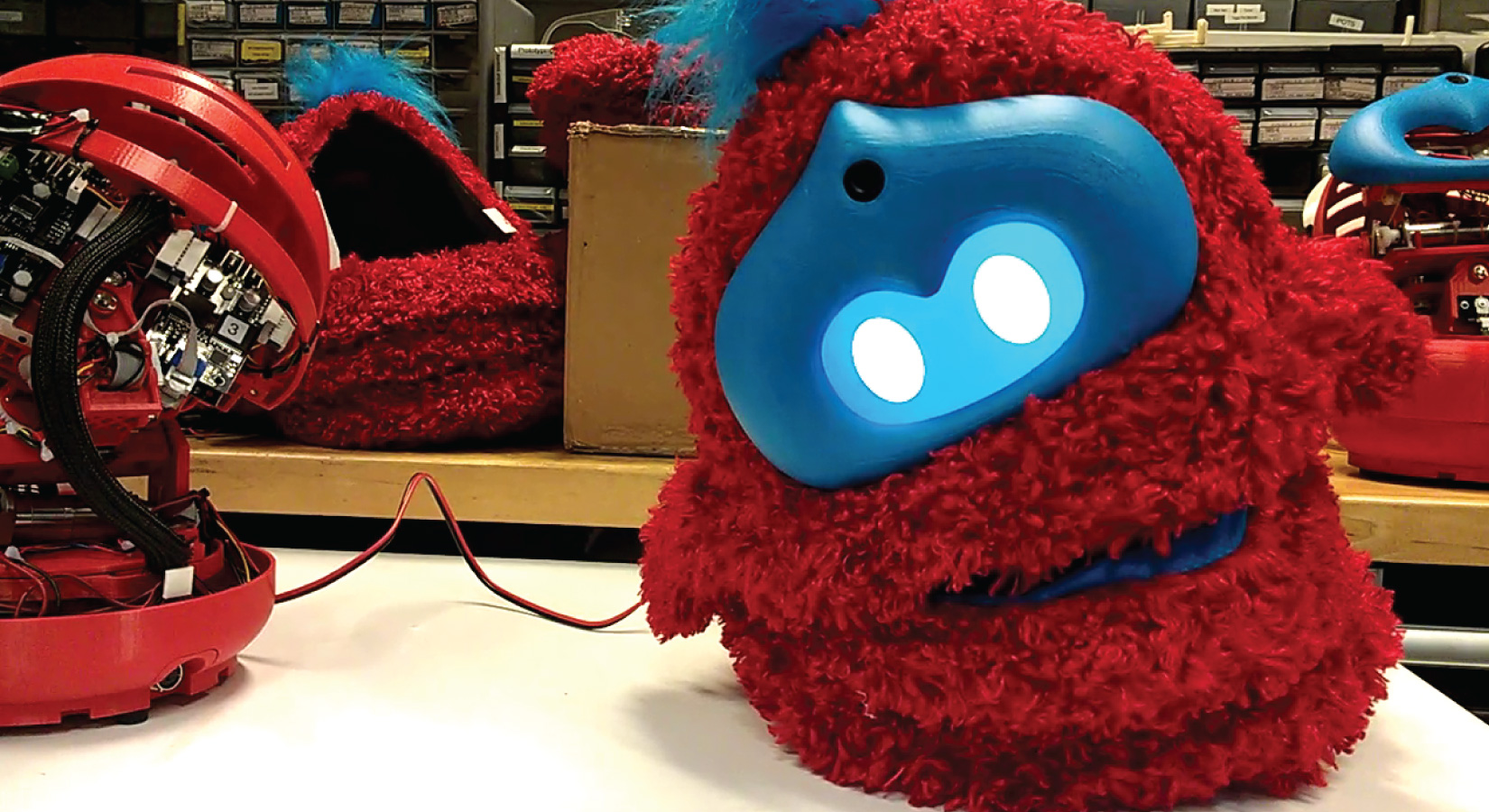

Tega enseña lenguaje

Fuente: Affectiva

Fuente: AffectivaTega cuenta historias a niños y niñas leyéndoles libros ilustrados. De vez en cuando les hace preguntas para conocer su opinión acerca de lo que les ha contado, saber si le entienden, interesarse por el significado de alguna palabra o conocer sus ideas sobre algún aspecto en particular de lo que les ha leído.

Al contar historias se mueve, adopta posturas diferentes y pone caras. También ilustra lo que cuenta con imágenes que proyecta en una pantalla. Además, se fija y registra la expresión facial y la disposición corporal de quien escucha el cuento; de esa forma sabe si le interesa y está atento a lo que dice. Y al acabar de leerle el libro, le pide que se lo cuente con sus propias palabras.

Tega es un robot con cubierta de peluche que ha sido desarrollado por un equipo del Massachusetts Institute of Technology (MIT) formado por ingenieros, informáticos y artistas. Lo han diseñado para que enseñe lenguaje a niños y niñas de corta edad, y fue presentado a finales de enero pasado en Hawai, en la AAAI Conference on Artificial Intelligence.

Tega ha demostrado ser competente en la tarea para la que fue creado. En el marco de un experimento leyó cuentos a niños y niñas de entre 4 y 6 años de edad. Lo hizo en sesiones semanales de una hora de duración. En un grupo las lecturas eran personalizadas. Cada vez que interactuaba con los chiquillos Tega aprendía, sabía más de sus habilidades y conocimientos verbales. De esa forma, para la siguiente sesión escogía un cuento más adecuado al nivel de competencia verbal de cada uno de ellos, tanto por las estructuras que eran capaces de manejar como por el vocabulario que conocían. Y además, iba sustituyendo algunas palabras por sinónimos menos conocidos.

En un segundo grupo las lecturas no eran personificadas. Tega escogía al azar la historia de una biblioteca de cuentos. Eso sí, cada dos semanas elevaba la dificultad del texto. Además de los dos grupos que interactuaron con el robot, el equipo utilizó un grupo de control que no interactuó con Tega.

Varias semanas después de terminar las sesiones, el equipo evaluó el conocimiento de vocabulario en los dos grupos experimentales y en el control. Todos los que habían interactuado con el robot habían mejorado sus conocimientos verbales, pero los del grupo con los que Tega se había relacionado de forma personalizada mejoraron más. En un test de conocimiento verbal cometieron un 23% menos de errores que antes de las sesiones con el robot. Y la tasa de error de quienes no habían interactuado de forma personalizada con él solo se redujo la mitad que la del grupo anterior. Los del grupo control no mejoraron.

Además de saber más vocabulario, los pequeños que habían interactuado con Tega de forma personalizada contaban historias más largas y más complejas que los otros niños, y su lenguaje corporal indicaba que prestaban una mayor atención al robot durante las sesiones.

No han creado Tega para que enseñe lenguaje como lo harían maestros y maestras. Lo han hecho para que sirva de apoyo al personal docente y para su uso bajo circunstancias especiales. Pero uno no puede dejar de pensar que cada vez son más los ámbitos en los que se diseñan robots para sustituir o “complementar” actividades humanas. Antes pensábamos que los robots se limitarían a la manufactura, limpieza y tareas repetitivas, en general. Pero ya hay muñecas sexuales robóticas, se proyectan androides que cuiden a personas y, como acabamos de ver, se crean robots capaces de enseñar porque, entre otras habilidades, pueden aprender.

Fuentes: Tega, a New Social Robot Platform; Tega; Smart and fluffy storytelling robot to be trialled in US classrooms

——————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Tega enseña lenguaje se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El aprendizaje continuo mejora la interacción de robots con humanos en lenguaje natural

- El lenguaje de la química

- Mestizajes: Intuición, arte y lenguaje, por Itziar Laka

¿Qué pasa en tu cerebro cuando duermes?

De la misma forma que el hígado, el corazón, los pulmones o los riñones no dejan de funcionar cuando duermes, el encéfalo tampoco lo hace. Si alguno de estos órganos lo hiciese el resultado es el mismo: la muerte. Pero, si la consciencia no está operativa, ¿a qué se dedica el cerebro mientras dormimos?

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Qué pasa en tu cerebro cuando duermes? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Hemos intentando contactar con extraterrestres?

- ¿Cómo demonios funcionan las copas musicales?

- #Naukas16 Qué pasa cuando le das un péndulo a una máquina

Geología, Antropoceno y cambio climático

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Nauru. Fuente: Wikimedia Commons

Nauru. Fuente: Wikimedia CommonsTras su lanzamiento por Paul Crutzen en el año 2000, el alcance social y académico del Antropoceno ha crecido de una manera sorprendente. Este concepto se acuñó para materializar nuestra percepción de que las actividades humanas han cambiado el Sistema Tierra. El comportamiento de los océanos, la atmósfera, la superficie terrestre, la criosfera, la biosfera y el clima ya no es el mismo que ha caracterizado durante más de 11.000 años la época geológica en la que formalmente aún vivimos, el Holoceno.

El hecho de que los humanos podamos afectar de modo tan significativo el curso de la evolución geológica de nuestro planeta dio pie en 2009 a la creación del Grupo de Trabajo sobre Antropoceno que está examinando la posibilidad de la formalización e inclusión del término en la Tabla Cronoestratigráfica Internacional (conocida como la Escala del Tiempo Geológico). Ya que la historia de la Tierra anterior a la documentación humana sólo se puede reconstruir a partir de su registro en las rocas, este enfoque centrado en el análisis de las evidencias contenidas en los sedimentos recientes es fundamental para comparar adecuadamente las historias moderna y antigua de nuestro planeta y, por lo tanto, para medir la magnitud y la velocidad de la perturbación planetaria provocada por los humanos.

El Antropoceno se caracteriza por un conjunto de señales de naturaleza sedimentaria, biológica y química que se pueden encontrar en la mayor parte de la superficie terrestre. Algunas de estas evidencias tienen equivalentes en unidades geológicas más antiguas (por ejemplo, el enriquecimiento en metales), pero otras señales son completamente novedosas (como los radioisótopos artificiales o los plásticos dentro de los sedimentos). Estas evidencias reflejan una fase distinta en la historia de la Tierra, que se alejó de su estabilidad general holocena a partir de la Revolución Industrial y, en particular, desde la “Gran Aceleración” en el crecimiento de la población humana, la industrialización y la globalización a mediados del siglo XX, momento que se considera como el límite más adecuado para marcar su inicio.

Desde el punto de vista climático, el rápido aumento de los gases de efecto invernadero desde el siglo XIX (Figura 1) ha provocado un creciente ascenso de la temperatura y del nivel del mar, acompañados por una pérdida de hielo en los continentes. Este calentamiento ha alcanzado ya niveles más altos que los detectados durante el Holoceno y se acerca a los de otras etapas interglaciares del periodo Cuaternario.

Figura 1. Tasas de cambio en las concentraciones de gases de efecto invernadero desde el inicio de la Revolución Industrial. La década de 1950 marca una aceleración de su crecimiento (gráficos originales en W. Steffen, W. Broadgate, L. Deutsch, O. Gaffney y C. Ludwig (2015) “The trajectory of the Anthropocene: The Great Acceleration” The Anthropocene Review 2, 81-98). Imagen tomada de WWF (2018) “Informe Planeta Vivo-2018: Apuntando más alto”. M. Grooten y R.E.A. Almond (Eds.), Suiza.

Figura 1. Tasas de cambio en las concentraciones de gases de efecto invernadero desde el inicio de la Revolución Industrial. La década de 1950 marca una aceleración de su crecimiento (gráficos originales en W. Steffen, W. Broadgate, L. Deutsch, O. Gaffney y C. Ludwig (2015) “The trajectory of the Anthropocene: The Great Acceleration” The Anthropocene Review 2, 81-98). Imagen tomada de WWF (2018) “Informe Planeta Vivo-2018: Apuntando más alto”. M. Grooten y R.E.A. Almond (Eds.), Suiza.La asociación de los humanos con las regiones costeras se remonta a las primeras civilizaciones, cuando nos concentramos en las desembocaduras de los ríos, deltas y estuarios, debido a la disponibilidad de alimentos abundantes y accesibles. Durante el siglo XX, la zona costera ha cambiado profundamente a medida que las poblaciones humanas iban creciendo y los ambientes costeros se ocupaban para la agricultura, la urbanización y la industria. Gran parte de la población mundial vive hoy en las áreas costeras con una densidad 3 veces superior al promedio mundial y la mayoría de las megaciudades planetarias también se encuentran en la costa. Sin embargo, los registros instrumentales y geológicos muestran que la velocidad de aumento reciente del nivel marino es anómala con respecto a los últimos miles de años y muchas zonas costeras se encuentran ahora amenazadas. Se ha observado globalmente una transición en el ascenso marino desde valores relativamente bajos durante el Holoceno superior (3 mm/año.

El estudio del nivel marino es un campo muy interdisciplinar y de creciente importancia. En el 1º informe de evaluación del IPCC (1990) no había referencia alguna a los cambios en el nivel del mar anteriores al siglo XX. Ya en el 3º informe de evaluación (2001) se incorporó el cambio del nivel marino a escalas de tiempo más largas, pero sólo en el 4º informe (2007) se agrupó la información geológica sobre el paleoclima en un solo capítulo, como asimismo se ha hecho en el 5º y último informe de evaluación (2013). Los registros instrumentales del nivel del mar comenzaron con el mareógrafo de Ámsterdam en 1682 y la altimetría de precisión por satélite se inició tras el lanzamiento del TOPEX/Poseidon a finales de 1992. Estos datos han demostrado que las velocidades de cambio del nivel del mar varían regionalmente y a escalas temporales de décadas debido a cambios en la densidad del océano. Es ahí donde los datos geológicos se hacen necesarios para poder situar estas estimaciones instrumentales en un contexto temporal a más largo plazo (Figura 2).

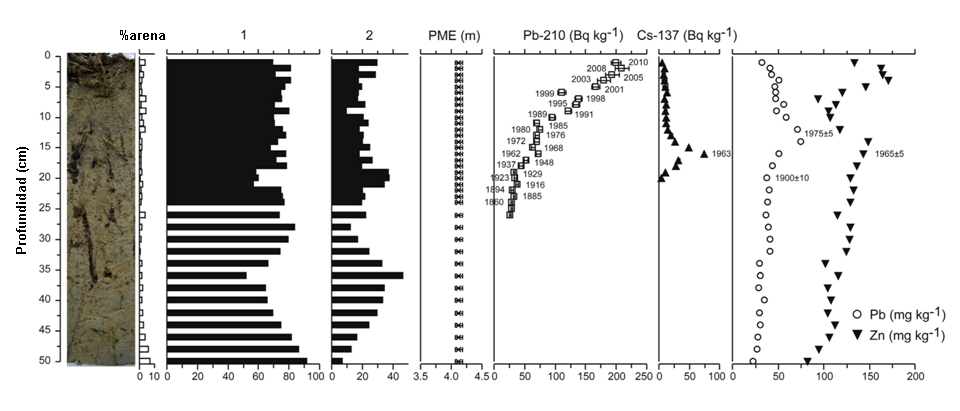

Figura 2. Fotografía del testigo, contenido en arena, principales especies de microfósiles (1: Entzia macrescens; 2: Trochammina inflata), elevación de la paleomarisma (PME), actividad de los radioisótopos Pb-210 y Cs-137 y distribución del Pb y Zn durante los últimos 300 años en un sondeo perforado en la marisma de Murueta (Reserva de la Biosfera de Urdaibai). Imagen modificada de A. García-Artola, A. Cearreta y E. Leorri (2015) “Relative sea-level changes in the Basque coast (northern Spain, Bay of Biscay) during the Holocene and Anthropocene: The Urdaibai estuary case” Quaternary International 364, 172-180. DOI: 10.1016/j.quaint.2014.06.040

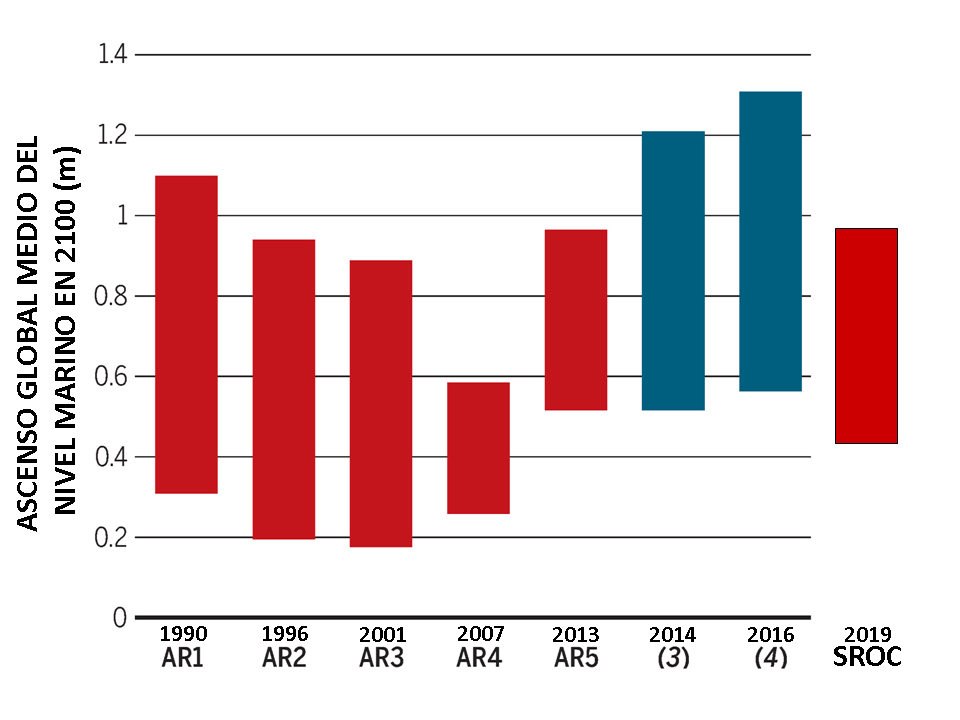

Figura 2. Fotografía del testigo, contenido en arena, principales especies de microfósiles (1: Entzia macrescens; 2: Trochammina inflata), elevación de la paleomarisma (PME), actividad de los radioisótopos Pb-210 y Cs-137 y distribución del Pb y Zn durante los últimos 300 años en un sondeo perforado en la marisma de Murueta (Reserva de la Biosfera de Urdaibai). Imagen modificada de A. García-Artola, A. Cearreta y E. Leorri (2015) “Relative sea-level changes in the Basque coast (northern Spain, Bay of Biscay) during the Holocene and Anthropocene: The Urdaibai estuary case” Quaternary International 364, 172-180. DOI: 10.1016/j.quaint.2014.06.040Durante el siglo XX, el nivel del mar ha aumentado globalmente unos 30 cm y la magnitud del ascenso del nivel marino previsto para este siglo es un tema muy controvertido. Las últimas proyecciones del IPCC (2019) auguran un aumento medio del nivel del mar a finales del siglo XXI de 28–57 cm para un escenario con reducción drástica de las emisiones de efecto invernadero, y de 55–140 cm si hubiese un crecimiento de estas emisiones. Otras estimaciones recientes sugieren que el ascenso medio global del nivel del mar podría incluso superar los 150-200 cm en el año 2100 (Figura 3). Esta diferencia en las previsiones refleja las grandes incertidumbres que existen sobre el comportamiento futuro de los casquetes glaciares de Groenlandia y Antártida.

Figura 3. Las distintas proyecciones del nivel marino para el año 2010 realizadas a partir de modelos han variado mucho a lo largo del tiempo desde la publicación del Primer Informe de Evaluación del IPCC (AR1) en 1990 hasta el último Informe Especial sobre el Océano y la Criosfera (SROC) de 2019. Imagen modificada de M. Oppenheimer y R.B. Alley (2016) “How high will the seas rise?” Science 354, 1375-1377. DOI: 10.1126/science.aak9460

Figura 3. Las distintas proyecciones del nivel marino para el año 2010 realizadas a partir de modelos han variado mucho a lo largo del tiempo desde la publicación del Primer Informe de Evaluación del IPCC (AR1) en 1990 hasta el último Informe Especial sobre el Océano y la Criosfera (SROC) de 2019. Imagen modificada de M. Oppenheimer y R.B. Alley (2016) “How high will the seas rise?” Science 354, 1375-1377. DOI: 10.1126/science.aak9460El aumento del nivel del mar tiene una amplia gama de efectos sobre las zonas costeras que incluyen la inundación y pérdida de marismas, la erosión de playas, dunas y acantilados, la incursión de agua salada en acuíferos y centros urbanos, y el desplazamiento general de los ecosistemas costeros hacia tierra. La magnitud de estos impactos y sus consecuencias estarán asociadas, además, con los efectos de otros procesos humanos que han estado operando en el litoral durante décadas, como la disminución del aporte fluvial de sedimentos, la extracción de aguas subterráneas o la ocupación de las tierras costeras.

La duración del Antropoceno hasta ahora ha sido geológicamente muy breve, equivalente a una vida humana, pero sus impactos ya han cambiado de manera irrevocable el curso futuro de la historia de nuestro planeta. Algunos de estos cambios son irreversibles, incluso si la humanidad y sus efectos ambientales desaparecieran mañana mismo, y sus consecuencias persistirán durante siglos, milenios y millones de años.

Para saber más:

C.N. Waters, J. Zalasiewicz, C. Summerhayes, A.D. Barnosky, C. Poirier, A. Gałuszka, A. Cearreta, M. Edgeworth, E. Ellis, M.A. Ellis, C. Jeandel, R. Leinfelder, J.R. McNeill, D. deB. Richter, W. Steffen, J. Syvitski, D. Vidas, M. Wagreich, M. Williams, A. Zhisheng, J. Grinevald, E. Odada, N. Oreskes, y A.P. Wolfe (2016) “The Anthropocene is functionally and stratigraphically distinct from the Holocene” Science 351, 137 (aad2622.1-aad2622.10). DOI: 10.1126/science.aad2622

C. Summerhayes y A. Cearreta (2019) “Chapter 6. Climate Change and the Anthropocene” En: J. Zalasiewicz, C.N. Waters, M. Williams y C.P. Summerhayes (Eds.), The Anthropocene as a geological time unit: A guide to the scientific evidence and current debate. Cambridge University Press, 200-241. DOI: 10.1017/9781108621359

Sobre los autores: Alejandro Cearreta y Ane García Artola pertenecen al Departamento de Estratigrafía y Paleontología de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Geología, Antropoceno y cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Verdín, eucaliptos y cambio climático

- Los ecosistemas acuáticos de África y el cambio climático

- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

Por qué nos fascinan los neandertales

![]()

Réplica de un cráneo neandertal en la cueva de San Miguel (St. Michael’s Cave), Gibraltar. Boaski / Flikr

Réplica de un cráneo neandertal en la cueva de San Miguel (St. Michael’s Cave), Gibraltar. Boaski / FlikrEntre los muchos enigmas de la ciencia prehistórica que provocan fascinación, tanto a científicos como al público interesado, la desaparición de los neandertales ocupa un lugar privilegiado.

Los neandertales poblaron Europa y Asia occidental desde hace unos 300.000 años y desaparecieron hace poco más de 40.000, coincidiendo con la llegada a Europa de los Humanos modernos –nuestra especie– tras su salida de África. Este último es uno de los períodos más críticos en la Prehistoria humana, pues no sólo incluyó un cambio de poblaciones definitivo, sino también una importante transformación cultural.

Dicha transformación supuso el asentamiento en todo el viejo mundo de los comportamientos complejos que caracterizarían el posterior desarrollo de las formas de vida asociadas a nuestra especie. Los prehistoriadores llevamos más de un siglo discutiendo sobre los factores y características de estos procesos de cambio, sin haber consensuado aún interpretaciones plenamente satisfactorias.

Las implicaciones ideológicas que supone el estudio de un pariente evolutivo tan cercano a la humanidad actual, y por tanto vital para entendernos a nosotros mismos, han provocado que la investigación de los neandertales haya estado históricamente cargada de prejuicios y mitos diversos. Sin embargo, los avances teóricos y metodológicos de las últimas décadas han permitido que actualmente el problema sobre su desaparición se plantee como una de las controversias científicas de mayor complejidad en el campo de la Prehistoria.

“El mito”, o la historia de la investigación sobre los neandertales

La investigación de Homo neanderthalensis, como se denominó la especie definida a partir de los restos humanos encontrados en 1856 en el valle de Neander (Alemania), es uno de los mejores ejemplos de cómo en ocasiones la ciencia puede verse influida por el contexto histórico en el que se desarrolla.

Las implicaciones ideológicas y sociales que conllevó el reconocimiento de una humanidad remota, distinta pero emparentada con la actual, inauguraron una tradición investigadora sobre los Neandertales en la que éstos, de forma más o menos directa, han sido objeto de prejuicios e ideologías de distinto pelaje.

Valle de Neander. Cordula / Wikimedia Commons

Valle de Neander. Cordula / Wikimedia CommonsLas primeras interpretaciones que acusaron estas influencias externas a la ciencia se dieron ya desde finales del siglo XIX y principios del XX, en un contexto de fuerte oposición a la teoría de la evolución formulada por Darwin solo tres años después del descubrimiento de los restos de Neander. Entonces, una compleja mezcla de ideas racistas, colonialistas y religiosas contribuyeron a dibujar un neandertal troglodítico y animalizado, esencialmente distinto a nosotros, para el que en todo caso se tenían aún muy pocas evidencias arqueológicas y paleontológicas.

Tras la Segunda Guerra Mundial, las ideologías dominantes viraron para fomentar la imagen de un neandertal más humanizado y capaz. Sin embargo, durante los años 80 el péndulo volvió a oscilar y la visión del neandertal basculó hacia interpretaciones que le volvían a alejar de la humanidad moderna, tanto en capacidades culturales como en naturaleza biológica.

Es esta última visión, y en cierto modo las reminiscencias de las imágenes animalizadas de principios de siglo, la que cuestionan la mayoría de los investigadores desde hace tres décadas, y a la cual suelen enfrentar sus investigaciones.

Podemos situar en la última década del siglo XX el comienzo de una etapa historiográfica, la actual, en la que la investigación sobre los neandertales ha alcanzado una verdadera madurez científica. Aunque las implicaciones ideológicas que supone el estudio de este tipo humano siguen flotando en el ambiente, el asentamiento de la Prehistoria como una ciencia interdisciplinar, con métodos y técnicas avanzados, ha hecho que nuestro conocimiento actual de esta especie humana se encuentre fundamentalmente basado en evidencias y pruebas empíricas. Algunas de ellas presentan una solidez científica que apenas podía ser imaginada pocos años atrás.

Por ello, el enigma de la desaparición de los neandertales, históricamente cargado de tópicos y prejuicios, es hoy investigado como un complejo problema científico de primera magnitud. Arqueólogos, paleoantropólogos, geólogos, ecólogos o físicos, entre otros, aúnan esfuerzos para recomponer un puzle poliédrico y, como siempre en Prehistoria, parcial e incompleto.

Por tanto, puede concluirse sin ambages que, en los últimos años, las influencias externas a la investigación meramente científica han perdido fuerza para dejar paso a marcos de trabajo cada vez más objetivos. Hemos pasado del mito al logos.

“El logos”, o la investigación interdisciplinar de un problema científico

El planteamiento tradicional del problema de la desaparición neandertal se hacía en términos simples y dicotómicos. O bien nuestra especie, superior en biología y tecnología, protagonizó un proceso de suplantación poblacional, más o menos violento y a escala continental, o bien los neandertales evolucionaron cultural y anatómicamente hacia las formas modernas de Homo sapiens.

Hoy en día se da la situación paradójica (en realidad bastante habitual en ciencia) de que, sabiendo bastante más sobre el problema, somos incapaces de defender teorías tan definidas. Las nuevas evidencias arqueológicas, paleontológicas, geológicas, paleoecológicas y paleogenéticas nos han empujado progresivamente a abandonar la idea de un proceso de cambio único y monolítico, y valorar, por el contrario, marcos interpretativos basados en la variabilidad regional y cronológica.

Hoy sabemos que neandertales y Humanos modernos tuvieron descendencia fértil en varios momentos y regiones geográficas, pero aún desconocemos si esos procesos de hibridación fueron responsables de la desaparición (en este caso asimilación) de los neandertales en toda su extensión geográfica. Sabemos también que los neandertales fueron capaces de desarrollar tecnologías y estrategias de subsistencia complejas durante el Paleolítico medio, pero no tenemos aún la seguridad de que dichas estrategias contribuyeran directamente al posterior desarrollo cultural del Paleolítico superior.

Sabemos que los neandertales tuvieron la inteligencia e inquietudes necesarias para desarrollar comportamientos simbólicos, incluyendo probablemente la creación de las primeras grafías pintadas en cuevas, pero se discute si dichos comportamientos fueron recurrentes, o incluso si los métodos utilizados para su verificación son fiables.

Comparación de un cráneo de Homo sapiens y de un neandertal. Wikimedia Commons

Comparación de un cráneo de Homo sapiens y de un neandertal. Wikimedia CommonsHasta hace poco creíamos saber que neandertales y Humanos modernos convivieron durante milenios en distintas regiones europeas, pero el refinamiento de los métodos de datación nos ha obligado a cuestionar fuertemente esa idea. Igualmente, creíamos saber que los neandertales estaban especialmente adaptados a climas fríos, pero hoy se baraja la hipótesis de que la variabilidad climática fuera un factor relevante para su desaparición.