Por qué hoy el Titanic no se habría hundido

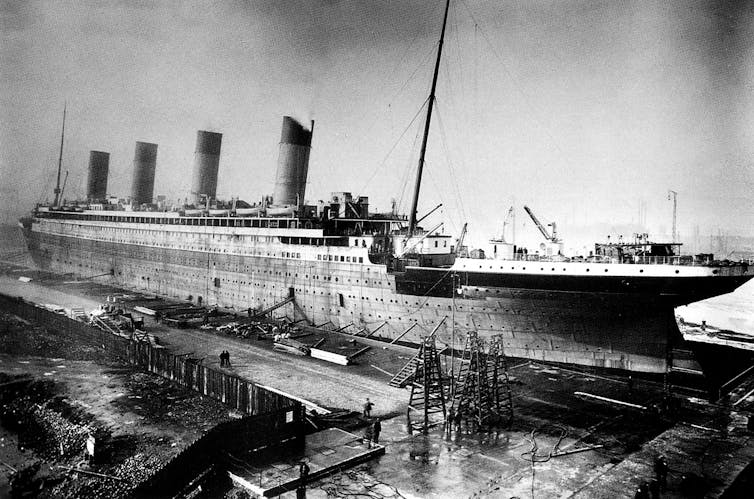

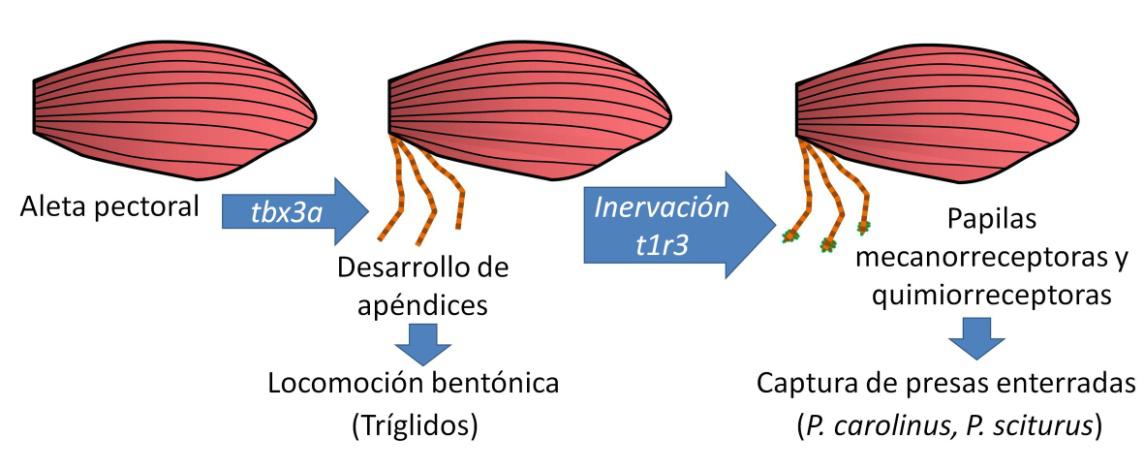

El Titanic durante su construcción. Foto:Robert John Welch (1859-1936) / Wikimedia Commons

El Titanic durante su construcción. Foto:Robert John Welch (1859-1936) / Wikimedia Commons

La falta de un conocimiento adecuado en ciencia e ingeniería de materiales, así como priorizar otros intereses, ha contribuido a algunos de los mayores desastres tecnológicos de la historia. Son ejemplos icónicos la tragedia del transbordador espacial Challenger; los dramáticos accidentes del Havilland Comet, el Columbia y los buques Pendleton y Fort Mercer, además de la caída del puente Hasselt Road en Bélgica. Sin olvidarnos del desastre del Titanic.

Todas estas catástrofes se habrían evitado con los avances en materiales que conocemos hoy.

La fragilidad del acero del TitanicEl 1 de septiembre de 1985, Robert Ballard encontró el Titanic a 3 700 m en el fondo del océano Atlántico. El barco se había dividido en dos secciones principales, separadas por unos 600 m. La colisión había creado aberturas en el casco por un total de 1 115 m².

Durante una expedición a los restos del naufragio en el Atlántico Norte el 15 de agosto de 1996, los investigadores trajeron acero del casco del barco para realizar análisis metalúrgicos. El minucioso análisis desveló que el acero tenía una alta temperatura de transición dúctil-frágil, lo que le hacía inadecuado para el servicio a bajas temperaturas. En el momento de la colisión, la temperatura del agua era –2° C.

Hoy, la calidad de estos aceros se ha multiplicado exponencialmente.

El error se mantuvo en los Liberty shipsDurante la Segunda Guerra Mundial, Estados Unidos construyó más de 6 000 buques Liberty ships para apoyar a Gran Bretaña. Una de las peculiaridades en su fabricación fue que la planchas de acero del casco estaban soldadas y no unidas por remaches. Cuando tres de estos buques se partieron literalmente por la mitad, la razón pareció estar clara en un primer momento y se responsabilizó a la soldadura de las planchas. Sin embargo, la verdadera causa estaba relacionada con la fragilidad del acero a bajas temperaturas.

En 1943 el petrolero SS Schenectady estaba amarrado en el muelle de prueba de Swan Island. El casco se agrietó casi por la mitad.

En 1943 el petrolero SS Schenectady estaba amarrado en el muelle de prueba de Swan Island. El casco se agrietó casi por la mitad.Wikimedia commons

Estos buques, junto con el SS Schenectady y los Pendleton y Fort Mercer, soportaron temperaturas próximas a -2⁰ C , como las que sufrió el Titanic al hundirse en el Atlántico Norte en 1912

A esas temperaturas, el acero utilizado en los cascos se volvía frágil, rompiéndose con facilidad. La clave del problema radica en la temperatura que determina cuándo un material pasa de ser dúctil a frágil (DBTT). Este cambio de comportamiento no se descubrió hasta años después y ha supuesto un reto para la investigación metalúrgica en la última mitad de siglo.

Los avances en metalurgia del siglo XX han permitido modificar la composición del acero para que no ocurra una transición tan brusca y poder reducir este riesgo. Hoy en día sabemos que la relación entre los elementos que forman el acero es clave para optimizar su comportamiento, y también que esto influye en su sensibilidad a las bajas temperaturas y su susceptibilidad a la formación de grietas.

Con algunos cambios en la composición del acero, muchos desastres se habrían evitado. Y no solo el hundimiento de barcos.

Challenger: el efecto de la temperaturaLa tragedia del Challenger en 1986 fue uno de los desastres más impactantes del siglo XX. Este vuelo de la NASA tenía una relevancia especial, ya que a bordo iba Christa McAuliffe, una profesora seleccionada para el programa Teachers in Space, promovido por el gobierno de Ronald Reagan.

Se esperaba que el lanzamiento reavivara el interés en los viajes espaciales, mostrando su creciente seguridad. Sin embargo, 73 segundos después del despegue el Challenger se desintegró a 14,6 kilómetros de altura, causando la muerte de los siete tripulantes.

La investigación reveló que el accidente fue causado por un fallo en las juntas tóricas de los propulsores de combustible sólido. Estas juntas, fabricadas con fluoroelastómeros (FKM), tenían pérdida de elasticidad a bajas temperaturas.

La mañana del lanzamiento, la temperatura era de -3⁰ C, lo que impidió que las juntas se sellaran adecuadamente. Esto permitió la fuga de gases calientes que provocaron la ruptura del propulsor derecho, desatando el desastre.

En 1986 ya sabía que las juntas tóricas eran vulnerables a bajas temperaturas, y varios expertos sugirieron posponer el despegue. Pero la presión por el éxito de la misión prevaleció, ignorando las advertencias sobre el comportamiento del material en condiciones adversas.

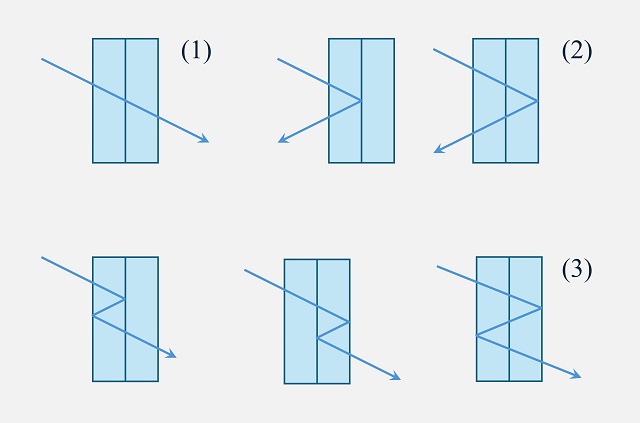

Havilland Comet y la fatiga del metalEl Havilland DH.106 Comet fue el primer avión comercial a reacción y marcó un hito en la aviación cuando comenzó a operar en 1949. Propulsado por turbinas, volaba a mayor altitud y con menos turbulencias, lo que mejoraba la comodidad para los pasajeros. Su diseño aerodinámico, con alas en flecha y motores empotrados, lo hacía más eficiente.

Sin embargo, entre 1953 y 1954 el Comet sufrió una serie de accidentes, incluido el vuelo G-ALYV, que se desintegró sobre Calcuta.

Inicialmente, se pensó que las causas eran climáticas. Pero la investigación reveló un problema en el diseño estructural del avión: las ventanas cuadradas.

Detalle de las ventanas del Havilland DH Comet que provocaban la ruptura del avión.

Detalle de las ventanas del Havilland DH Comet que provocaban la ruptura del avión.Wikimedia commons, CC BY

Estas ventanas actuaban como concentradores de tensiones, lo que generaba grietas debido a los ciclos de presión durante los vuelos. Con cada ciclo, las fisuras aumentaban hasta provocar una descompresión explosiva, causando la desintegración del avión.

Este descubrimiento resultó clave para la industria de la aviación, que adoptó las ventanas ovaladas que ahora vemos en los aviones para evitar la concentración de tensiones y reducir el riesgo de fatiga del metal.

Trasbordador espacial Columbia: la corrosiónEl 1 de febrero de 2003, el transbordador espacial Columbia se desintegró durante su reingreso a la atmósfera, causando la muerte de sus siete tripulantes.

El desastre se debió a un daño en el ala izquierda, causado por una pieza de espuma aislante que se desprendió durante el lanzamiento, afectando las planchas de protección térmica. Este daño expuso la estructura interna del transbordador a los gases calientes de la atmósfera, lo que debilitó la nave y causó su desintegración.

Uno de los factores fue la corrosión de los materiales metálicos, que se agrava en el espacio debido a la exposición al oxígeno elemental altamente reactivo en las capas superiores de la atmósfera. Desde entonces, las inspecciones de seguridad han prestado mayor atención a la corrosión de los materiales, que ya no se pasa por alto, lo que evita futuros accidentes.

La apuesta por la ciencia e ingeniería de materialesLos desastres mencionados resaltan la importancia de la ciencia e ingeniería de materiales en la seguridad y el éxito de las tecnologías modernas.

Entender cómo se comportan los materiales en diferentes condiciones es fundamental para prevenir fallos catastróficos. Figuras como Elon Musk han destacado la importancia de esta disciplina, alentando a estudiar carreras en ciencia e ingeniería, cruciales para el desarrollo de la industria espacial y otros campos. Y, como hemos visto, para evitar terribles accidentes en la historia futura.![]()

Sobre la autora: Paula Alvaredo Olmos, Profesora Titular en Ciencia e Ingeniería de Materiales, Universidad Carlos III

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Por qué hoy el Titanic no se habría hundido se ha escrito en Cuaderno de Cultura Científica.

Naukas Pro 2024: Corrientes oceánicas y submarinos amarillos

Los últimos avances en el ámbito de las energías renovables marinas o la proliferación de los microplásticos fueron algunos de los temas que componen la última edición de NAUKAS PRO. Una cita en la que el personal investigador se sube al escenario del Euskalduna Bilbao para hablar de las investigaciones más destacadas del momento en un ámbito concreto.

En esta ocasión el personal investigador de la Universidad del País Vasco, de la Estación Marina de Plentzia (PiE-UPV/EHU), AZTI, Tecnalia o el CSIC acercaron las últimas investigaciones relacionadas en el ámbito marítimo.

La conferencia Corrientes oceánicas y submarinos amarillos corre a cargo de Anna Rubio Company, investigadora del Centro de Investigación Marina y Alimentaria AZTI.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2024: Corrientes oceánicas y submarinos amarillos se ha escrito en Cuaderno de Cultura Científica.

Desimetrización enantioselectiva de ciclobutanos

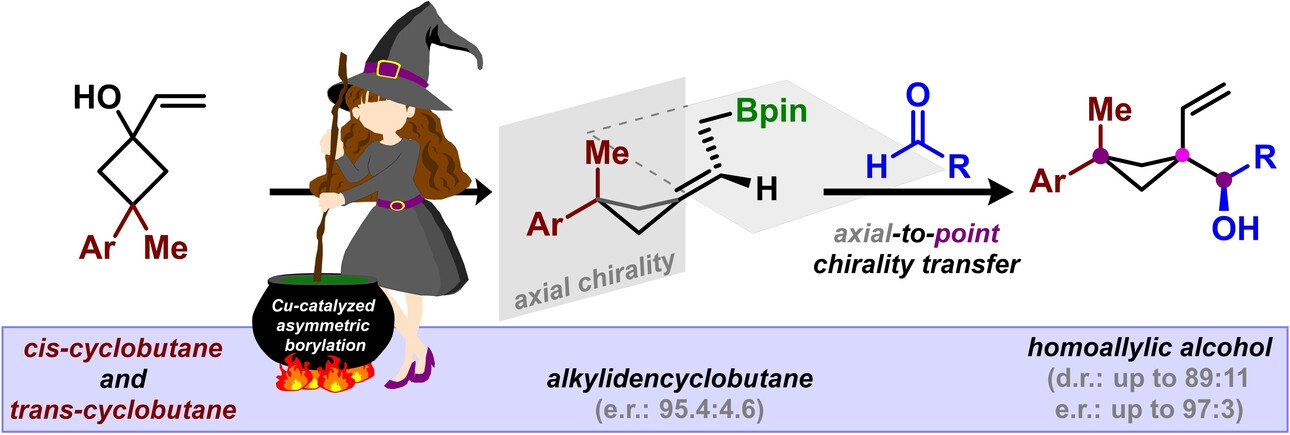

Los sistemas vivos están basados en biomoléculas que son asimétricas. El Grupo de Investigación en Catálisis metálica y Organocatálisis liderado por el catedrático de la Universidad del País Vasco José Luis Vicario ha conseguido, en colaboración con la Universidad Rovira i Virgili, “sintetizar moléculas con una asimetría esquiva utilizando una novedosa metodología que abre una nueva vía a un tipo de estructuras moleculares nunca conseguidas hasta el momento, que potencialmente podrían utilizarse como fármacos, entre otras cosas”.

El grupo de la Facultad de Ciencia y Tecnología de la UPV/EHU, que trabaja en síntesis asimétrica de moléculas orgánicas de pequeño tamaño, ha conseguido “sintetizar moléculas cíclicas intrínsecamente asimétricas empleando catálisis. Hemos desarrollado una metodología eficaz y directa, utilizando pequeñas cantidades de un catalizador derivado del cobre, un metal abundante y no nocivo”, señala el Catedrático de Química Orgánica de la UPV/EHU.

La gran mayoría de moléculas orgánicas (basadas en una estructura de carbono) no son planas, tienen geometría tridimensional. Dependiendo de la manera en que los átomos se ordenan dentro de cada molécula se pueden obtener resultados. En algunos casos una molécula y su imagen especular (es decir, dos moléculas simétricas que guardan la misma relación que la que tiene un objeto con su imagen en un espejo) pueden tener propiedades totalmente diferentes.

Utilicemos el símil de las manos para explicarlo: nuestras manos son las imágenes especulares una de la otra; se puede decir que son idénticas. Sin embargo, cuando se dispone una mano sobre la otra (no en disposición de juntar las palmas, sino superponiendo una mano a la otra), la posición de los dedos no es la misma. Ocurre lo mismo con algunas moléculas, la organización de los átomos no coincide. Cada una de las imágenes especulares de una molécula que no son superponibles se llama enantiómero.

Simétricas pero con propiedades muy diferentes“En la naturaleza y en farmacología existen muchísimos ejemplos en los que los dos enantiómeros tienen propiedades dispares. Es el caso de la talidomida (un fármaco administrado como sedante y calmante de las náuseas durante los tres primeros meses de embarazo, que provocó miles de casos de malformaciones congénitas), uno de los enantiómeros tiene propiedades analgésicas y el otro produce malformaciones —explica el doctor de la UPV/EHU Efraim Reyes, uno de los autores principales del trabajo—. Eso ocurre porque las dianas terapéuticas no interaccionan de la misma manera con un enantiómero u otro. Por tanto, es fundamental controlar la síntesis de este tipo de moléculas, para conseguir únicamente uno de los dos enantiómeros”.

La investigadora predoctoral Josebe Hurtado ha sido capaz de construir selectivamente una de las dos moléculas enantioméricas de un grupo de ciclobutanos (moléculas cíclicas que contienen esencialmente átomos de carbono e hidrógeno), “mediante la desimetrización; es decir, rompiendo la simetría planar y convirtiéndolas en bloques sintéticos elementales de moléculas más complejas”, explica su director de tesis Efraim Reyes.

Este logro responde a un gran reto actual y un área de investigación de interés creciente. “Hemos conseguido sintetizar moléculas con una asimetría axial (sustentada en un eje), que no tiene precedente en la naturaleza y que abre una puerta al estudio de un nuevo tipo de moléculas, que pueden servir también para desarrollar nuevas vías terapéuticas”, añade Vicario. Además, a través de un estricto control de las reacciones “hemos roto la simetría planar para convertirla en asimetría axial y a continuación en asimetría puntual (sustentada en un punto)”, explica el profesor catedrático de la UPV/EHU. Esto demuestra “que existe una posibilidad real de que las biomoléculas con asimetría puedan tener también un origen común”.

La desimetrización espontánea, origen de la vidaEste hallazgo recuerda a una de las teorías relacionadas con el origen de la vida, que se basa en que mediante una desimetrización espontánea de la simetría se formaron las moléculas que dieron lugar a la vida. “Una de las teorías del origen de la vida, muy aceptada, dice que originalmente solo había moléculas simétricas y que por un proceso de desimetrización espontánea surgieron moléculas asimétricas, que son evidentemente el origen de la vida, porque todo nuestro organismo y los sistemas vivos están basados en biomoléculas que son asimétricas y solo contienen uno de los dos enantiómeros”, concluye Reyes.

Referencia:

Josebe Hurtado, Nerea Iragorri, Efraim Reyes, Jose L. Vicario, Elena Fernández (2024) Cu-Catalyzed Enantioselective Borylative Desymmetrization of 1-Vinyl Cyclobutanols and Axial-to-Point Chirality Transfer in a Diastereoconvergent/Stereoretentive Allylation Scenery Angewandte Chemie International Edition doi: 10.1002/anie.202411232

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Desimetrización enantioselectiva de ciclobutanos se ha escrito en Cuaderno de Cultura Científica.

Amianto, una historia de terror

Basta pronunciar la palabra amianto, o asbesto, para que a muchos —y, sobre todo, a los propietarios de las casas de los programas de reformas— se nos pongan los pelos de punta. Utilizada desde la Antigüedad en numerosos ámbitos, las propiedades de esta fibra mineral son ampliamente conocidas desde entonces, algunas muy útiles, de ahí su popularidad, y otras muy dañinas. Aun así, no fue hasta 2005 cuando la Unión Europea prohibió completamente su uso —algunos países miembros ya lo habían empezado a eliminar mucho antes—. Pero ¿qué es exactamente el amianto?, ¿para qué se ha utilizado a lo largo de la historia?, ¿por qué es tan peligroso? Para empezar, hasta que se empezaron a estudiar sus nocivos efectos sobre la salud, fue el material del futuro, un compuesto milagroso a prueba de todo… y con aplicaciones para casi todo.

Fibras de amianto (tremolita, en este caso) sobre un mineral de muscovita. Créditos: Dominio Público/Aram Dulyan

Fibras de amianto (tremolita, en este caso) sobre un mineral de muscovita. Créditos: Dominio Público/Aram Dulyan

El amianto es un grupo de seis minerales fibrosos de origen metamórfico compuestos de silicatos —los de mayor abundancia en la naturaleza—: grunerita (o amosita, para la variante fibrosa), crisotilo, riebeckita (crocidolita), tremolita, bisolita (actinolita) y antofilita. La combinación de este origen mineral y que se presente en forma de fibras largas, flexibles y resistentes es lo que le otorga tanto sus propiedades como su versatilidad. Estamos ante un material ignífugo, con excelentes propiedades aislantes tanto eléctricas como térmicas, una gran durabilidad, resistencia química y mecánica, y, sobre todo, abundante y barato. Su ligereza y que se presente en forma de fibras posibilita, además, manipularlo con facilidad, pero también es lo que lo convierte en un peligro para la salud.

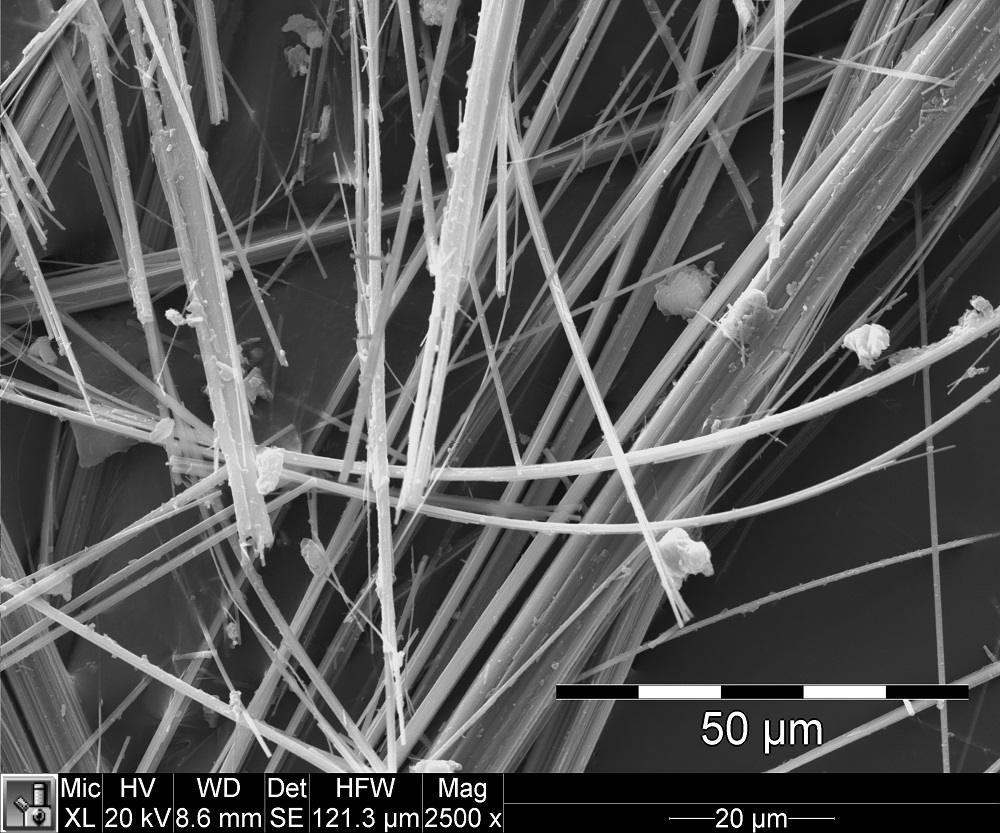

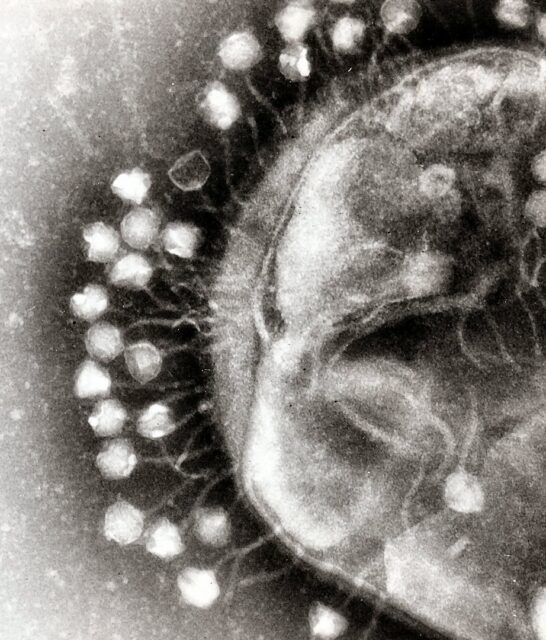

Microfibras de amianto (amosita), vistas a través de un microscopio electrónico de barrido. El pequeño tamaño que pueden alcanzar hace que puedan inhalarse sin detectarse. Una vez alojadas en los pulmones, el cuerpo tiene mucha dificultad para eliminarlas. Créditos: CC BY-SA 3.0/Ravaka

Microfibras de amianto (amosita), vistas a través de un microscopio electrónico de barrido. El pequeño tamaño que pueden alcanzar hace que puedan inhalarse sin detectarse. Una vez alojadas en los pulmones, el cuerpo tiene mucha dificultad para eliminarlas. Créditos: CC BY-SA 3.0/Ravaka

La inhalación de fibras microscópicas de amianto, que pueden encontrarse flotando en el ambiente en cualquier entorno en el que se esté trabajando con él, puede provocar graves patologías. Estas se quedan alojadas en los pulmones durante largo tiempo, dada la dificultad del cuerpo para eliminarlas, lo que, a largo plazo, acaba produciendo inflamación y daño celular. Aparecen así enfermedades como la asbestosis, que causa fibrosis pulmonar, o ciertos tipos de cáncer como el de pulmón y el mesotelioma, que afecta a la pleura o el peritoneo.

Que las personas que trabajaban con amianto enfermaban se sabe desde casi los orígenes de su uso. Existen testimonios incluso de Plinio el Viejo, que ya habló del padecimiento pulmonar de los esclavos que manipulaban habitualmente amianto, y en 1899, se documentó clínicamente en Londres el primer caso de fibrosis pulmonar de una trabajadora del amianto de 33 años por inhalación de estas fibras. Las primeras regulaciones del trabajo con amianto, dada su alta peligrosidad, se remontan a los años treinta, por eso sorprende que no haya sido hasta hace relativamente poco cuando por fin se han tomado medidas. Y no solo eso: la locura comercial y la mayor expansión de la industria del amianto se produjo, incluso sabiendo esta información, durante la década de los años cuarenta, con su pico durante los cincuenta y los sesenta.

A lo largo de la historia de la ciencia ha sido habitual que, ante la llegada de un nuevo descubrimiento o adelanto tecnológico, este se haya visto como una especie de santo grial o piedra filosofal que iba a solucionar todos nuestros problemas. Sucedió con la electricidad, con la radiactividad —recordemos todos aquellos productos de uso cotidiano que llevaban radio, como pastas de dientes—, e incluso puede que esté sucediendo ahora con la inteligencia artificial. El amianto no se quedó atrás, pero con la diferencia de que, en su momento de mayor auge, como hemos comentado, sí se conocían los riesgos que su uso implicaba.

La mayoría de aplicaciones del amianto son de sobra conocidas. En la construcción se ha usado como aislamiento, revestimiento, para aumentar la durabilidad y resistencia de los suelos… En la industria automotriz, era un material habitual en pastillas de freno y embragues, pero las aplicaciones más espeluznantes fueron, probablemente, en el ámbito textil, para la confección de ropa ignífuga. Se utilizó incluso en electrodomésticos, sobre todo en aquellos que generan calor, como calentadores, hornos y secadores. Lo que tal vez muchos no sepan es que, durante mucho tiempo, se promovió muchísimo su uso en objetos mucho más cotidianos. Y, para muestra, este documento de 1942:

Cortinas, fundas, manteles… también mantas, guantes de cocina, bolsas, cuerdas… incluso el tejido para confeccionarlos uno mismo se anunciaba como maravilloso. Todos estos productos se vendían con total, demasiada, normalidad. Por ejemplo, para los fanáticos de la Navidad que ya estén pensando en la decoración de su árboles y belenes existía incluso nieve artificial hecha de amianto.

Nieve decorativa de amianto y mica. Créditos: Flickr/Asbestorama fuck you

Nieve decorativa de amianto y mica. Créditos: Flickr/Asbestorama fuck you

Parece que del mismo tipo que la que le cayó a Dorothy, el Espantapájaros y el León de camino a Oz.

La nieve artificial que se usó en El mago de Oz en 1939 eran fibras de amianto. Créditos: Metro Goldwyn Mayer

La nieve artificial que se usó en El mago de Oz en 1939 eran fibras de amianto. Créditos: Metro Goldwyn Mayer

Solo cabe hacerse una pregunta cuando la historia nos pone en situaciones similares: ¿cuál es nuestra prioridad? ¿El beneficio económico o el beneficio humano? El uso de amianto, a diferencia de lo que sucedió con el radio y sus efectos, no se promovió desde la ignorancia.

Bibliografía

The Mesothelioma Center. (s. f.). History of asbestos. Asbestos.com. https://www.asbestos.com/asbestos/history/

Asbestorama. Perfil de Flickr. https://www.flickr.com/photos/asbestos_pix/asbestos

Rare Historial Photos (s. f.). Vintage photos show how asbestos products were once marketed, 1930s-1970s. Rare Historial Photos. https://rarehistoricalphotos.com/asbestos-vintage-advertisements/

Tweedale, G. (2000). Magic mineral to killer dust. Oxford University Press.

.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Amianto, una historia de terror se ha escrito en Cuaderno de Cultura Científica.

Fibonacci está en todas partes (y III)

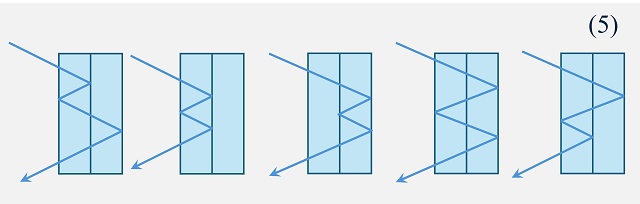

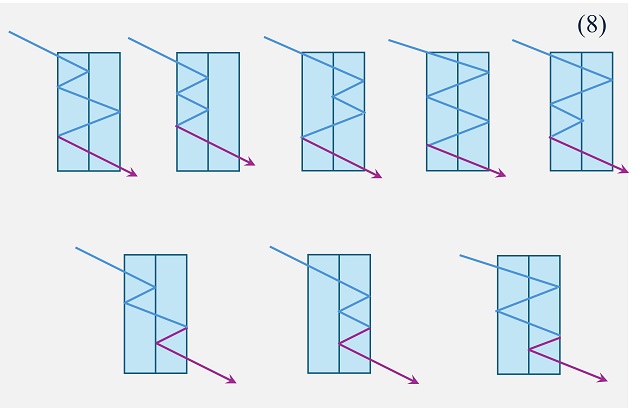

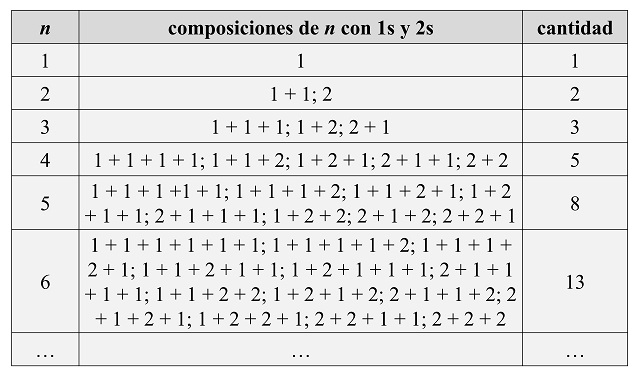

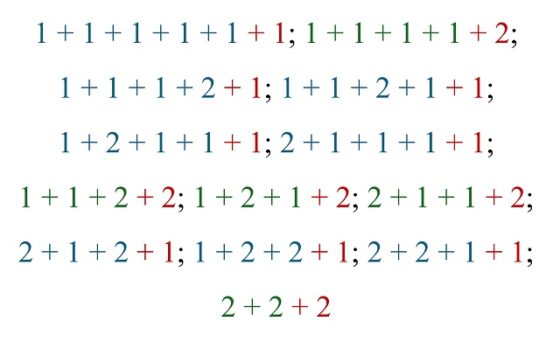

Esta es la última jornada de un paseo por algunos lugares de lo más curiosos e inesperados, en los que aparecen los números de Fibonacci. Durante la primera jornada, recogida en la entrada del Cuaderno de Cultura Científica titulada Fibonacci en todas partes (I), visitamos espacios destacados como el árbol genealógico de un zángano (abeja macho), los paseos de una abeja por un panal de dos filas de celdas o los embaldosados con fichas de dominó, mientras que para la segunda jornada, Fibonacci en todas partes (II), reservamos la visita a lugares de interés como la óptica de la luz, unas escaleras que se suben, o se bajan, de una en una o de dos en dos, y las sumas de números con unos y doses.

Girasole (en italiano), acrílico sobre lienzo, 60 x 70 cm, del artista suizo Eugen Jost. Obra perteneciente a la exposición Everything is numberPintando un edificio de apartamentos

Girasole (en italiano), acrílico sobre lienzo, 60 x 70 cm, del artista suizo Eugen Jost. Obra perteneciente a la exposición Everything is numberPintando un edificio de apartamentos

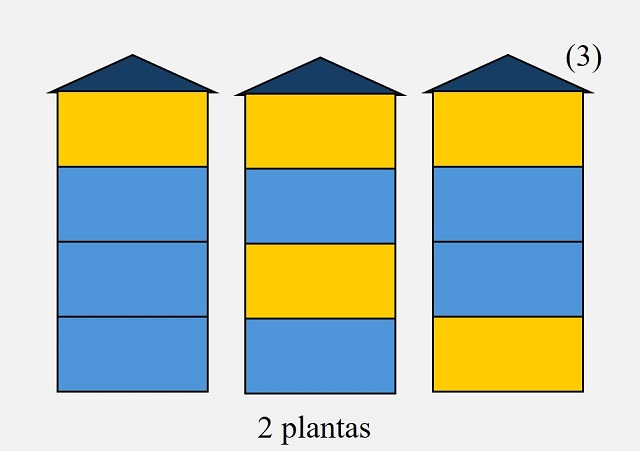

Con el problema de pintar un edificio de apartamentos con dos colores distintos iniciamos la tercera jornada de este paseo. El enunciado de este clásico problema dice así.

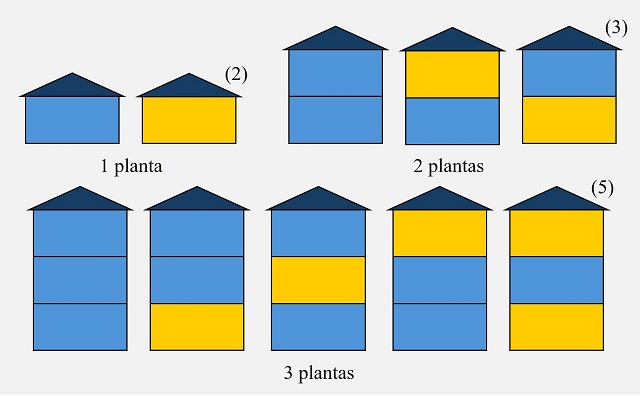

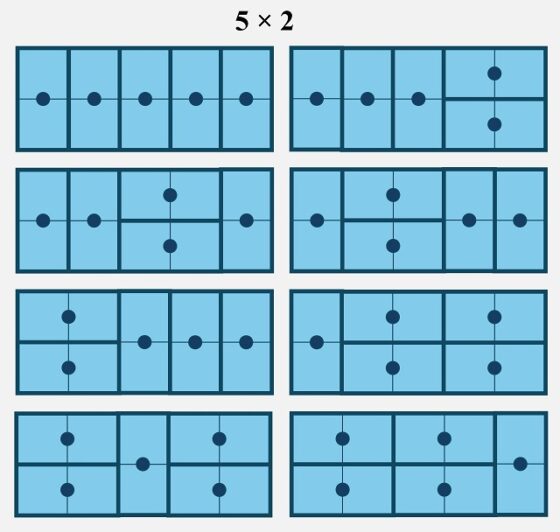

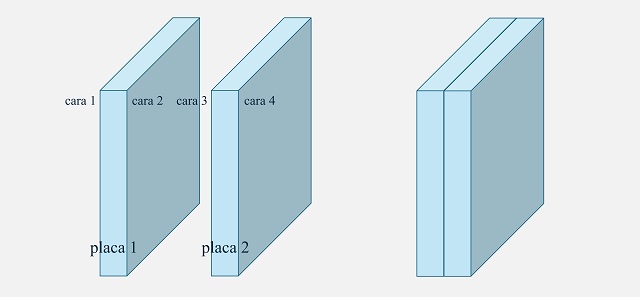

Problema: Si un edificio de apartamentos de n plantas va a ser pintado de azul y amarillo, de manera que cada planta esté pintada de un color y no haya dos plantas adyacentes pintadas ambas de amarillo, ¿de cuántas formas es posible hacerlo?

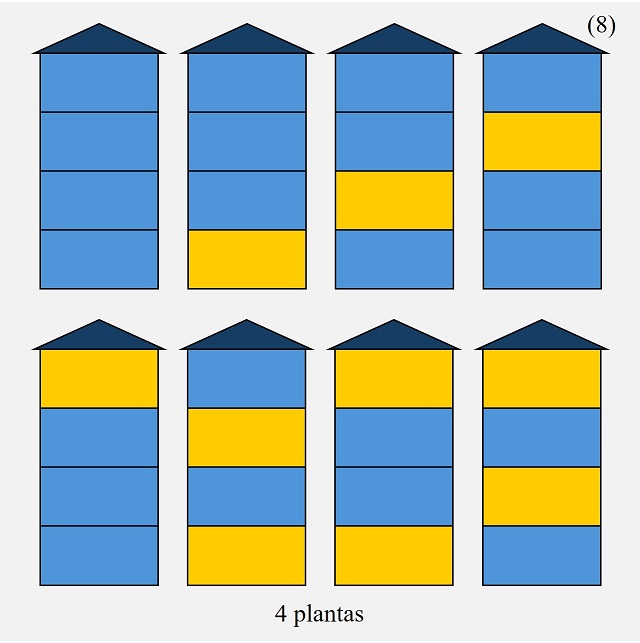

Para resolver este problema, podemos empezar de forma experimental, viendo qué ocurre para los edificios con un número pequeño de plantas. Para un edificio de apartamentos con una sola planta, existen solo dos opciones (2), pintar esa única planta de azul o de amarillo. Para dos plantas, hay tres opciones (3), pintar las dos plantas de azul, ambas de amarillo no es posible, o pintar cada planta de un color, lo cual se puede hacer de dos formas distintas, como se observa en la siguiente imagen. Mientras que para un edificio de tres plantas pueden pintarse todas de azul, puede pintarse una de amarillo, que puede ser la primera, la segunda o la tercera planta, o pueden pintarse dos plantas de amarillo, que por la condición de que no haya plantas amarillas contiguas, solo puede hacerse de una manera, en las plantas de los extremos, en total cinco formas distintas (5).

Maneras de pintar un edificio de apartamentos de una, dos o tres plantas de azul y amarillo, si el color amarillo no lo pueden compartir plantas contiguas

Maneras de pintar un edificio de apartamentos de una, dos o tres plantas de azul y amarillo, si el color amarillo no lo pueden compartir plantas contiguas

Si ahora consideramos un edificio de cuatro plantas, puede pintarse todo de azul, con una planta amarilla y hay cuatro plantas, o con dos plantas amarillas, que puede hacerse de tres formas diferentes sin que coincidan de amarillo plantas adyacentes, pero no es posible que tres o cuatro plantas estén pintadas de amarillo. En total, hay ocho (8) maneras de pintar el edificio de apartamentos.

Formas de pintar un edificio de apartamentos de cuatro plantas de azul y amarillo, si el color amarillo no lo pueden compartir plantas contiguas

Formas de pintar un edificio de apartamentos de cuatro plantas de azul y amarillo, si el color amarillo no lo pueden compartir plantas contiguas

Como observamos los números que nos salen son 2, 3, 5 y 8, que son números de la sucesión de Fibonacci. Veamos que es la sucesión de Fibonacci, empezando en 2 y 3, viendo que satisface la condición recursiva, que la cantidad de maneras de pintar un edificio de n plantas se puede obtener a partir de las de n – 1 y n – 2 plantas. Para ello, observemos qué ocurre con el caso de n = 4 (cuatro plantas).

Si tomamos los edificios de 3 plantas (n – 1, en general) y consideramos una planta más, por encima de las otras, pintada de azul, generaremos algunos de los casos posibles para un edificio de 4 plantas (n, en general), tantos como las formas de pintar un edificio de 3 plantas (n – 1 plantas en general), que son 5 maneras distintas. Observemos que no podemos pintar de amarillo en todos los casos puesto que en algunos la última planta está pintada de amarillo, por lo que coincidirían dos plantas amarillas, mientras que los casos en los que la última planta es azul, aunque sí podríamos pintar la siguiente de amarillo, ese caso va a estar considerado en los casos que se derivan del edificio de n – 2 plantas (2 plantas en nuestro ejemplo), que veremos a continuación. Recíprocamente, si tomamos las maneras de pintar un edificio de 4 plantas (n, en general) en las cuales su última planta es azul, son todas las de 3 plantas (n – 1), a las que le añadimos una última planta azul.

Las distintas maneras de pintar un edificio de 4 plantas, en las cuales su última planta es azul, son todas las posibles para 3 plantas, a las que le añadimos una última planta azul

Las distintas maneras de pintar un edificio de 4 plantas, en las cuales su última planta es azul, son todas las posibles para 3 plantas, a las que le añadimos una última planta azul

Si tomamos los edificios de 2 plantas (n – 2, en general) y consideramos dos plantas más, por encima de las otras, pintadas de amarillo y azul (de arriba a abajo), generaremos algunos de los casos posibles para un edificio de 4 plantas (n, en general), tantos como las formas de pintar un edificio de 2 plantas (n – 2 plantas en general), que son 3 maneras distintas. Observemos que no podríamos pedir pintar esas dos plantas superiores de azul y amarillo, ya que podrían coincidir dos plantas adyacentes amarillas, además los casos en los que sí se pueda, ya que la última planta de las anteriores es azul, ya está considerado en el caso anterior. Más aún, así cubrimos todos los casos de un edificio de 4 plantas (n, en general) en las cuales su última planta es amarilla.

Las distintas maneras de pintar un edificio de 4 plantas, en las cuales su última planta es amarilla, son todas las posibles para 2 plantas, a las que le añadimos dos plantas más, por encima de las otras, pintadas de amarillo y azul (de arriba a abajo)

Las distintas maneras de pintar un edificio de 4 plantas, en las cuales su última planta es amarilla, son todas las posibles para 2 plantas, a las que le añadimos dos plantas más, por encima de las otras, pintadas de amarillo y azul (de arriba a abajo)

En consecuencia, hemos demostrado que se cumple la misma propiedad recursiva que para la sucesión de Fibonacci, Fn = Fn – 1 + Fn – 2. Por lo tanto, el número de formas distintas de pintar un edificio de apartamentos de n plantas, pintado de azul y amarillo, de manera que cada planta esté pintada de un color y no haya dos plantas adyacentes pintadas ambas de amarillo, es Fn + 2.

Palabras de n-bitsEmpecemos por lo elemental. Una palabra de n-bits es una cadena de n bits, donde un bit –acrónimo de bi[nary digi]t / dígito binario– es la unidad mínima de información y se corresponde con un dígito del sistema de numeración binario, 0 ó 1. Así, 1001001 sería una palabra de 7-bits o 1010101110110 una palabra de 13-bits.

Si lo pensamos un momento, resulta que la cuestión anterior de pintar de dos colores (azul y amarillo) un edificio de n plantas es equivalente al siguiente resultado.

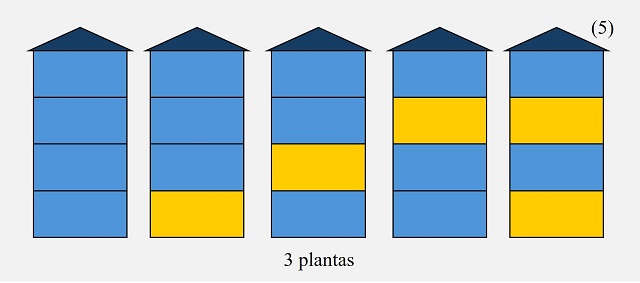

Teorema: El número de palabras de n-bits que no contengan dos 1s consecutivos es igual a Fn + 2.

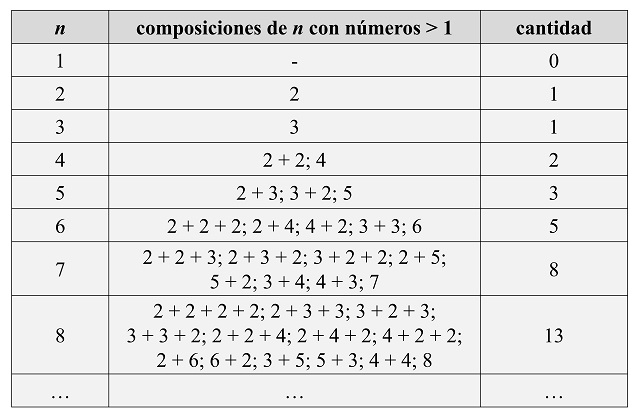

Veamos en la siguiente tabla, las palabras de n-bits para longitudes n pequeñas.

Número de palabras de n-bits que no contengan dos 1s consecutivos

Número de palabras de n-bits que no contengan dos 1s consecutivosLa demostración del teorema anterior es la misma que la de las maneras de pintar un edificio. Si se consideran las palabras de n-bits, las que terminan en 1 (por la derecha) son las palabras de (n – 1)-bits a las que se les añade un 1 por la derecha, mientras que las palabras que terminan en 0 son las palabras de (n – 2)-bits a las que se les añade 10 por la derecha.

Lanzar una monedaLlegados a este punto del paseo, nos podemos plantear una visita extra a un lugar que es un problema de probabilidad.

Problema: Si lanzamos una moneda n veces (sea n la cantidad que queramos), ¿cuál es la probabilidad de que no haya dos lanzamientos adyacentes que sean ambos cara?

Empecemos recordando que la probabilidad de que un evento ocurra se calcula dividiendo “el número de casos favorables” entre “el número de casos posibles” (pueden leerse las entradas relacionadas con la probabilidad, La probabilidad en el banquillo de los acusados o El cuento de la ruleta rusa ). Así, dada una determinada familia con dos “hijos”, si nos preguntamos cuál es la probabilidad de que los dos sean chicas, tendríamos que calcular primero el espacio muestral, es decir, el espacio de todos los casos posibles. En esta ocasión, habrá cuatro posibles casos (chica, chica), (chica, chico), (chico, chica) y (chico, chico), donde el orden en el par expresa el orden cronológico de nacimiento. Como solo uno de los cuatro es favorable, son dos chicas, la probabilidad de que los dos “hijos” sean chicas es 1/4 = 0,25, es decir, una probabilidad del 25%.

Escena de la película No es país para viejos (2007), dirigida por Joel Coen y Ethan Coen, e interpretada por Tommy Lee Jones, Javier Bardem y Josh Brolin, entre otros, en la cual el personaje interpretado por Javier Bardem, un asesino a sueldo, decide si deja vivir al dependiente de una gasolinera lanzando una moneda al aire

Escena de la película No es país para viejos (2007), dirigida por Joel Coen y Ethan Coen, e interpretada por Tommy Lee Jones, Javier Bardem y Josh Brolin, entre otros, en la cual el personaje interpretado por Javier Bardem, un asesino a sueldo, decide si deja vivir al dependiente de una gasolinera lanzando una moneda al airePara analizar nuestro problema, si lanzamos una moneda al aire puede salir cara (que vamos expresarlo, para simplificar, pero también para disponer de una notación simple, con un 1) o puede salir cruz (que lo expresaremos con un 0). De esta manera, si lanzamos una moneda n veces, la representación de un posible resultado es un n-bit. Por ejemplo, si hablamos de lanzar la moneda 5 veces, entonces 10011 representa la posibilidad de que salga cara / cruz / cruz / cara / cara, mientras que 00101 sería cruz / cruz / cara / cruz / cara.

Por lo tanto, ya estamos en condiciones de calcular la probabilidad de que, si lanzamos una moneda n veces, no haya dos lanzamientos adyacentes que sean ambos cara. En primer lugar, calculemos el número de casos posibles. Estos son, teniendo en cuenta la descripción anterior de los posibles lanzamientos, todas las palabras de n-bits, que son 2n, ya que cada vez que lanzamos la moneda hay dos posibilidades, cara (1) o cruz (0), en un total de n lanzamientos. Y ahora toca calcular el número de los casos posibles, que, por la descripción anterior, son las palabras de n-bits para las que no hay dos 1s consecutivos, que ya hemos calculado y que es igual al número de Fibonacci Fn + 2.

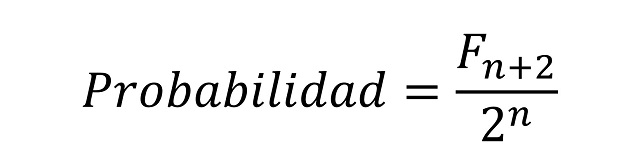

Por lo tanto, la probabilidad de que, si lanzamos una moneda n veces, no haya dos lanzamientos adyacentes que sean ambos cara, es igual a:

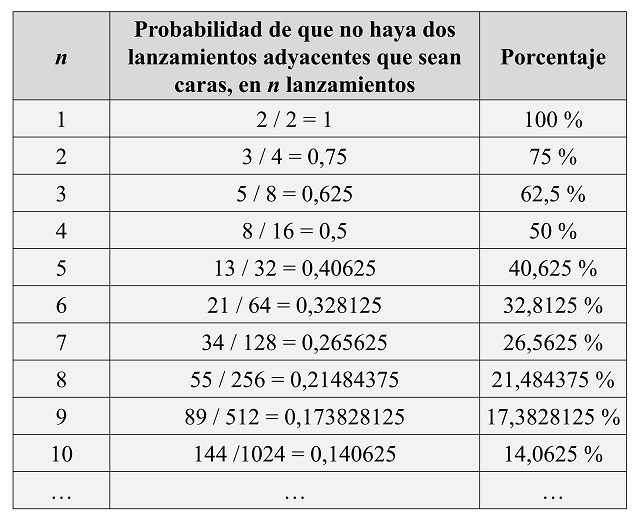

Por ejemplo, si lanzamos una moneda 5 veces, la probabilidad de que no haya dos lanzamientos consecutivos que sean cara es 13 / 32 = 0,40625, es decir, un 40,625 por ciento. Si vamos realizando cada vez más lanzamientos, nos podemos plantear si esa probabilidad aumenta o disminuye. Si lo pensamos un poco, intuitivamente es bastante claro que esa probabilidad irá disminuyendo, ya que con más lanzamientos será más fácil que salgan dos caras seguidas. Veamos qué pasa con las primeras cantidades de lanzamientos.

Efectivamente, la probabilidad va disminuyendo, como intuíamos. Esto se debe, matemáticamente, a que la sucesión de las potencias de 2 crece más rápido que la sucesión de los números de Fibonacci.

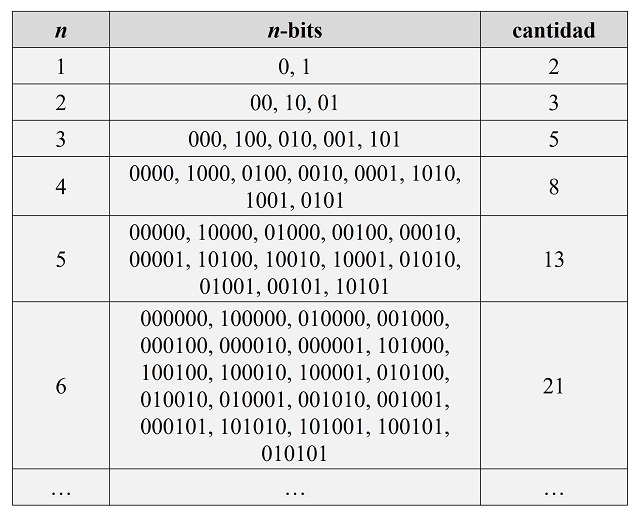

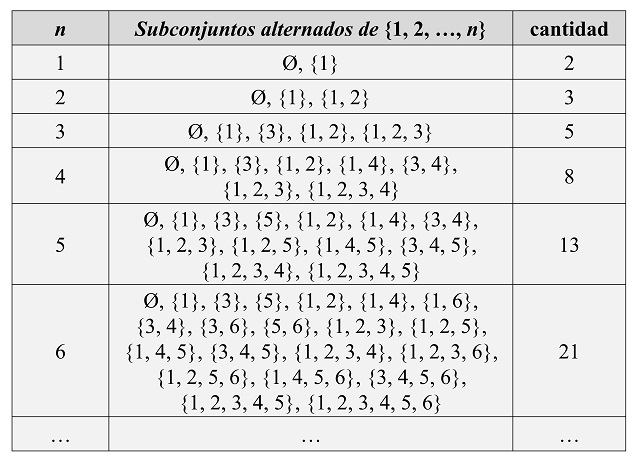

Subconjuntos alternadosVamos a terminar este paseo con un problema propuesto por el matemático francés Olry Terquem (1782-1862), del que ya hablamos en la entrada La circunferencia de los nueve puntos.

Un subconjunto del conjunto {1, 2, 3, …, n – 1, n} se dice que es alternado si sus elementos, cuando se colocan en orden creciente, siguen el patrón impar, par, impar, par, etcétera. Por ejemplo, los conjuntos {4}, {3, 6} o {1, 2, 5, 6} son subconjuntos alternados de {1, 2, 3, 4, 5, 6}, mientras que {2, 4, 5} o {1, 2, 3, 5} no lo son. El problema que se planteó Terquem fue calcular el número de subconjuntos alternados del conjunto {1, 2, 3, …, n – 1, n}. Veamos qué ocurre para los primeros casos.

Cantidad de subconjuntos alternados del conjunto {1, 2, 3, …, n}, para n = 1, 2, 3, 4, 5, 6

Cantidad de subconjuntos alternados del conjunto {1, 2, 3, …, n}, para n = 1, 2, 3, 4, 5, 6Por lo tanto, el número de subconjuntos alternados del conjunto {1, 2, 3, …, n – 1. n} es igual al número de Fibonacci Fn + 2.

Podemos llegar a la sucesión de Fibonacci de muchas otras maneras, pero esas os las dejo para quienes os animéis a indagar sobre este tema.

Coyote Breath / Aliento de coyote (2016), monotipo de la artista estadounidense Holli Marmon

Coyote Breath / Aliento de coyote (2016), monotipo de la artista estadounidense Holli MarmonBibliografía

1.- Alfred S. Posamentier, Ingmar Lehmann, The Fabulous Fibonacci Numbers, Prometheus Books, 2007.

2.- Thomas Koshy, Fibonacci and Lucas Numbers with Applications, John Wiley & Sons, 2001.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Fibonacci está en todas partes (y III) se ha escrito en Cuaderno de Cultura Científica.

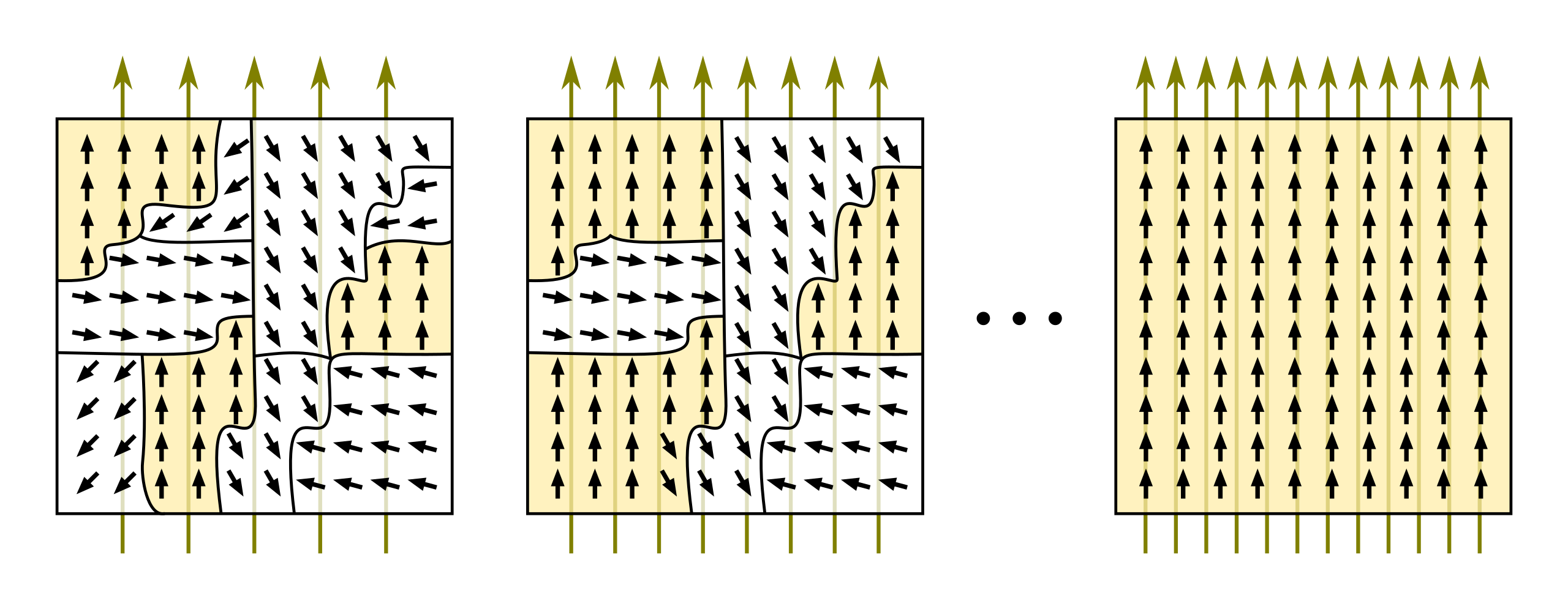

Un magnetómetro de tamaño atómico

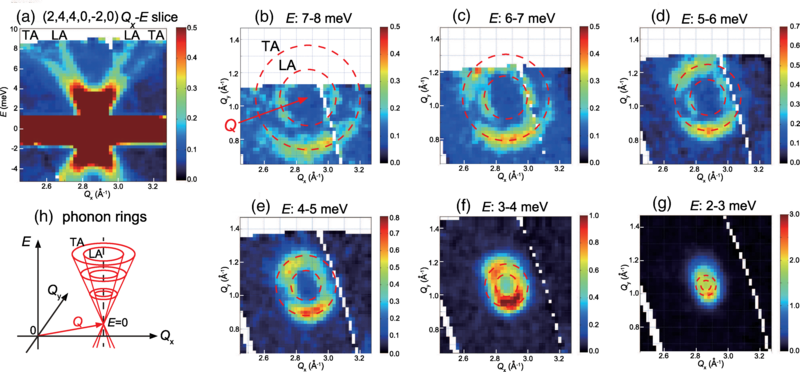

Si colocas unos cuantos átomos de hierro en fila sus espines magnéticos pueden organizarse en un patrón antiferromagnético alterno. O, mejor dicho, patrones. Debido a su naturaleza cuántica los átomos se encuentran en una superposición de dos estados antiferromagnéticos. Normalmente, la fila de átomos oscila rápidamente entre los dos estados. Pero un equipo de investigadores acaba de demostrar que es posible llevar una cadena corta de átomos de hierro a un punto diabólico, con el efecto de alargar espectacularmente el tiempo que la cadena pasa en un estado u otro. Este efecto podría ser la base sobre la que fabricar un magnetómetro de tamaño atómico.

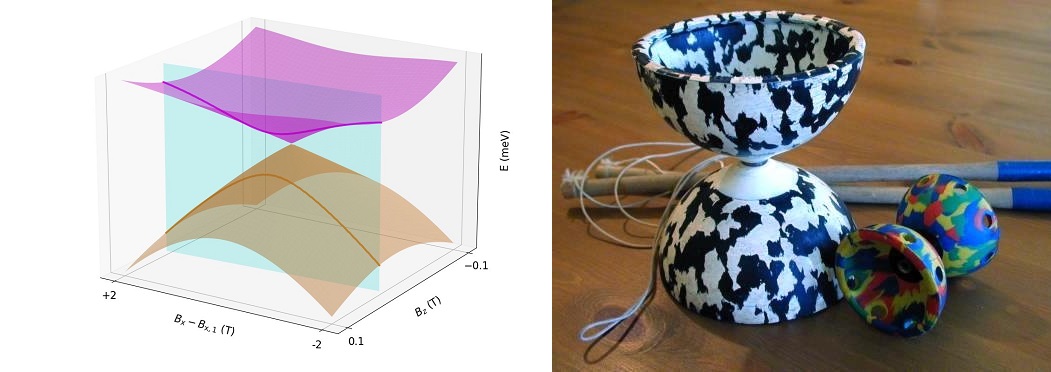

A la izquierda diábolo, figura geométrica (véase el texto). Fuente: Elbertse et al. (2024). A la derecha, diábolos, juguetes. Fuente: StoatBringer / Wikimedia Commons

A la izquierda diábolo, figura geométrica (véase el texto). Fuente: Elbertse et al. (2024). A la derecha, diábolos, juguetes. Fuente: StoatBringer / Wikimedia CommonsEl punto diabólico recibe su nombre del diábolo, un yoyó chino cuyas dos mitades cónicas opuestas se unen en un cuello estrecho. Si se representa gráficamente la energía de una cadena de espín antiferromagnética frente a la fuerza del campo magnético aplicado se obtiene una forma similar: un cono que apunta hacia arriba es el estado fundamental, mientras que el cono que apunta hacia abajo es el primer estado excitado. En su unión (el punto diabólico), los dos estados están degenerados.

Elbertse et al. (2024)

Elbertse et al. (2024)Para crear su punto diabólico los investigadores colocaron cinco átomos de hierro sobre una superficie de nitruro de cobre a baja temperatura y en un vacío ultraalto. Encontraron que un campo magnético aplicado en paralelo a la superficie tenía el valor justo para crear unos estados fundamental y excitado casi degenerados.

Midiendo el giro del átomo central con un microscopio de efecto túnel los investigadores descubrieron que, en el punto diabólico, el patrón antiferromagnético cambiaba de dirección aproximadamente cada 10 segundos. Al variar el campo paralelo y aplicar un campo perpendicular adicional puediron crear un mapa de las condiciones alejadas del punto diabólico. A la distancia más grande, el tiempo de cambio de dirección se redujo en 3 órdenes de magnitud.

Los investigadores afirman que la sensibilidad del tiempo de cambio de dirección al campo magnético local podría aprovecharse para construir un magnetómetro de tamaño atómico.

Referencias:

R. J. G. Elbertse, D. Borodin, J. Oh, T. Ahn, J. Hwang, J. C. Rietveld, A. J. Heinrich, F. Delgado, S. Otte, and Y. Bae (2024) Long-Lived Magnetization in an Atomic Spin Chain Tuned to a Diabolic Point Phys. Rev. Lett. doi: 10.1103/PhysRevLett.133.166703

C. Tomé López (2017) Defeating spin decoherence Mapping Ignorance ISSN 2529-8992

C. Day (2024) Diabolical Nanomagnets Physics 17, s118

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Un magnetómetro de tamaño atómico se ha escrito en Cuaderno de Cultura Científica.

¿Procede la Luna de un intercambio de parejas planetario?

La Tierra, nuestro planeta, tiene un único satélite natural. Esta obviedad, que a veces queda en un segundo plano por la llegada de pequeños “satélites” temporales, es algo más que una mera curiosidad. Si echamos un vistazo a los planetas interiores -Mercurio, Venus, la Tierra y Marte- dos de ellos carecen de satélites y Marte tiene dos cuya diferencia de tamaños con el planeta es de alrededor de 2,5 órdenes de magnitud menores, tan pequeños en comparación con el planeta que no fueron descubiertos hasta la segunda mitad del siglo XIX.

Sin embargo, si nos fijamos en los planetas exteriores -Júpiter, Saturno, Urano y Neptuno- estos cuentan con un extraordinario rebaño de satélites, lo que nos lleva a hacernos la siguiente pregunta, ¿Por qué los gigantes gaseosos y de hielo tienen tantos satélites, pero no pasa lo mismo con los planetas terrestres? ¿Es más difícil la formación de satélites alrededor de planetas pequeños? ¿O quizás, si se forman, van perdiéndose a lo largo del tiempo a causa de distintos procesos?

Existen tres grandes mecanismos que dan origen a los satélites: acreción, captura y grandes impactos. En el caso de la acreción, los satélites se forman a partir del material que queda “sobrante” tras la formación de un planeta. Es parecido a como los planetas se forman alrededor de las estrellas, solo que en este caso ocurre alrededor de un planeta. Muy probablemente este fue el proceso dominante en los gigantes gaseosos y de hielo de nuestro Sistema Solar.

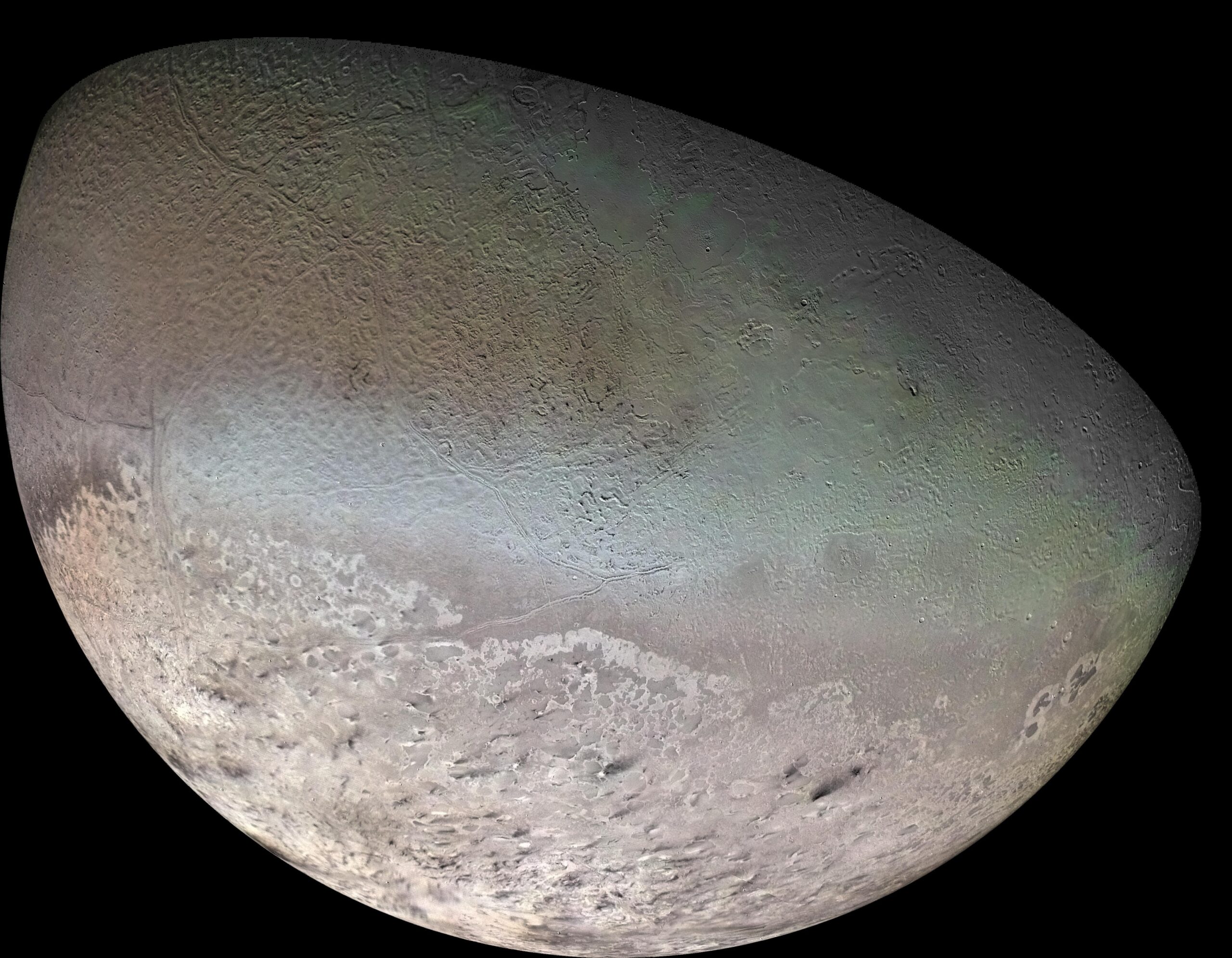

Figura 1. Tritón, el satélite de Neptuno, observado en 1989 por la Voyager 2. Imagen cortesía de NASA/JPL/USGS.

Figura 1. Tritón, el satélite de Neptuno, observado en 1989 por la Voyager 2. Imagen cortesía de NASA/JPL/USGS.El mecanismo de captura de un satélite ocurre cuando un objeto, a veces un asteroide -en sensu lato– o un sistema binario es atrapado por el campo gravitatorio de un planeta, como podría ser el caso de Tritón, el satélite de Neptuno o incluso los dos satélites de Marte, Fobos y Deimos.

También se pueden formar satélites a partir de grandes impactos, cuando dos cuerpos colisionan y se expulsa una gran cantidad de materia a la órbita de uno de estos. Lentamente todos esos materiales pueden ir coalesciendo formando uno o varios satélites. Esta es la teoría dominante desde hace décadas sobre la formación de nuestra Luna.

Pero un nuevo estudio publicado por Williams et al. (2024) en The Planetary Science Journal propone una nueva alternativa: La captura por intercambio binario, un proceso por el cual un planeta puede capturar uno de los cuerpos de un sistema binario, parejas de objetos que orbitan uno alrededor del otro.

Los sistemas binarios son un fenómeno común en el universo: Parejas de objetos que están unidos gravitatoriamente el uno al otro. Los vemos en la población de asteroides, e incluso en el cinturón de Kuiper donde, por ejemplo, el sistema formado por Plutón y Caronte podría ser considerado como binario ya que el centro de gravedad del sistema no cae dentro de Plutón.

Pero, ¿qué novedad propone realmente este artículo? El mecanismo de captura por intercambio binario sugiere que si tuviésemos un encuentro cercano con un sistema binario -valga la redundancia-, las interacciones gravitatorias entre los tres cuerpos podrían romper el vínculo de los que forman el sistema binario pudiendo uno de ellos entrar en órbita alrededor del otro planeta.

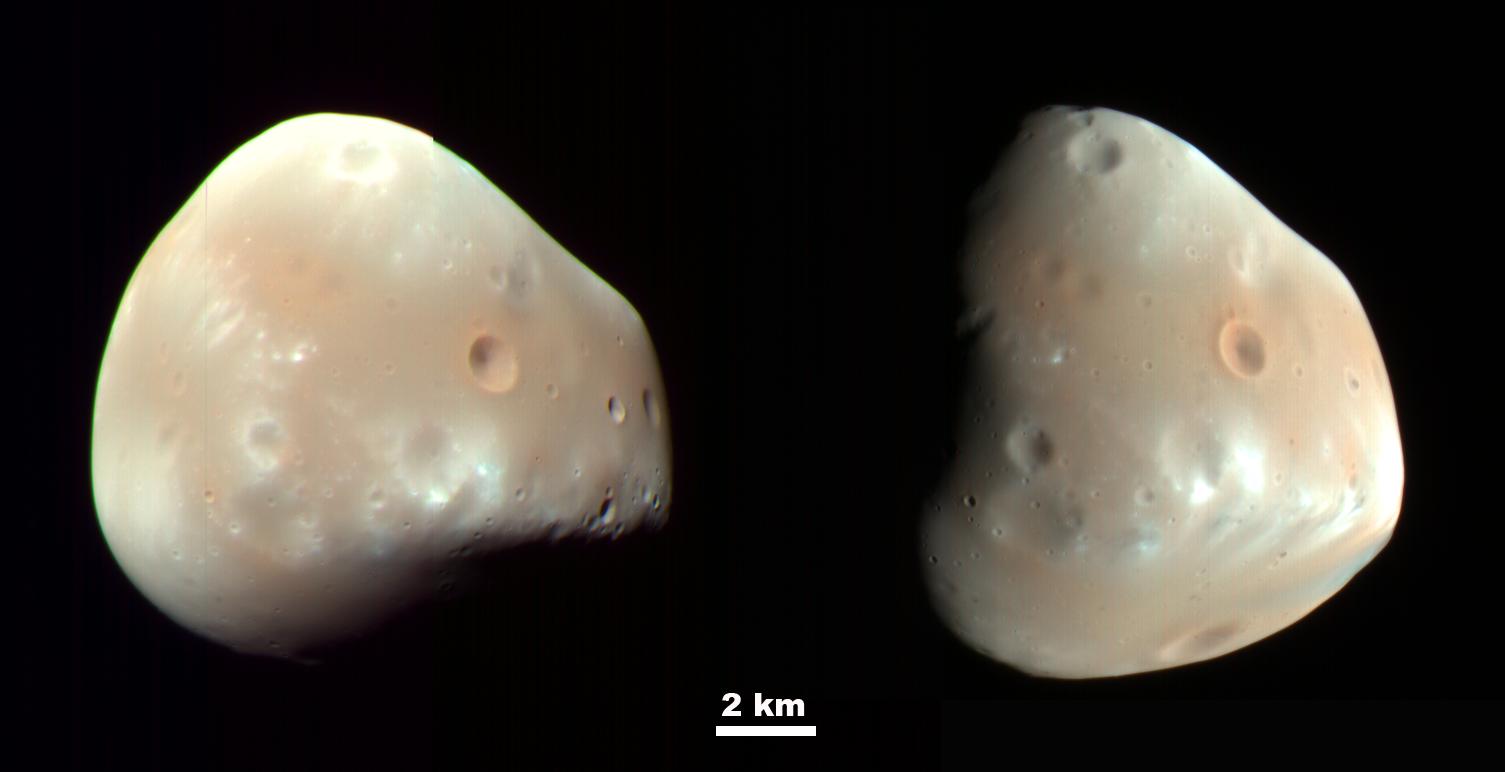

Figura 2. Imagen de Deimos, uno de los dos satélites de Marte. ¿Se formó en el entorno del planeta rojo o es un asteroide capturado? Imagen cortesía de NASA/JPL-Caltech/University of Arizona.

Figura 2. Imagen de Deimos, uno de los dos satélites de Marte. ¿Se formó en el entorno del planeta rojo o es un asteroide capturado? Imagen cortesía de NASA/JPL-Caltech/University of Arizona.Para llegar a esta conclusión, los científicos han realizado una serie de simulaciones en las cuales ocurren distintos encuentros entre un planeta del tamaño de la Tierra y distintos sistemas binarios con el objetivo de observar si estos encuentros son capaces por sí solos de dejar un satélite del tamaño de nuestra Luna alrededor de un planeta como la Tierra.

Los resultados hablan por sí solos, ya que satélites de entre 0.01 y 0.1 veces la masa de la Tierra (es decir, de la masa de la Luna y más pequeños) podrían ser capturados por un planeta como el nuestro bajo unas condiciones adecuadas. De hecho, un encuentro lento y más directo entre el sistema binario y el planeta incrementaría las posibilidades del intercambio.

Pero a esta teoría le surge un problema: La órbita del nuevo satélite tiene que ser estable para mantenerse durante miles de millones de años y no acabar colisionando con el planeta. Y en el caso de nuestra Luna, también es importante explicar cómo puede haber conseguido tener una órbita tan circular, ya que la órbita resultante de la captura sería muy excéntrica.

Las interacciones gravitatorias y en especial las fuerzas de marea -las mismas que provocan las mareas en nuestros océanos- podrían hacer que este satélite capturado adquiriese una órbita cada vez más circular y volviéndola estable durante miles de millones de años.

Figura 3. ¿Cómo se formó nuestra Luna? ¿Fue a través de un gran impacto o por un intercambio binario? Imagen cortesía de NASA/JPL/USGS.

Figura 3. ¿Cómo se formó nuestra Luna? ¿Fue a través de un gran impacto o por un intercambio binario? Imagen cortesía de NASA/JPL/USGS.Obviamente hay muchos puntos que solucionar en esta teoría: para capturar un satélite de esta manera tuvo que existir un sistema binario en las proximidades de la Tierra y encontrarnos con una geometría y velocidad muy concretas. Pero independientemente de nuestro caso, Tritón, el satélite de Neptuno, podría ser uno de esos satélites capturados mediante este proceso.

Todavía quedan muchas páginas por escribir sobre la formación de nuestra Luna y de todos los satélites del Sistema Solar, así que este nuevo mecanismo añade un nuevo proceso que complementa a las otras teorías sobre como se forman los satélites de los planetas y al mismo tiempo arroja algo de luz a como podrían haber sido esas primeras etapas caóticas de la formación de nuestro sistema planetario.

¿Vendrá esta nueva teoría para quedarse o nos servirá para explicar el origen de otros satélites de nuestro Sistema Solar y más allá? El tiempo lo dirá, pero sin duda, nos ayudará a comprender mejor la dinámica de nuestro Sistema Solar, especialmente en sus primeras etapas tras la formación planetaria.

Referencias:

Williams, Darren M, and Michael E Zugger (2024) Forming Massive Terrestrial Satellites through Binary-Exchange Capture. The Planetary Science Journal, vol. 5, no. 9, 1 Sept. 2024, pp. 208–208, doi: 10.3847/psj/ad5a9a

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo ¿Procede la Luna de un intercambio de parejas planetario? se ha escrito en Cuaderno de Cultura Científica.

El muelle de la Tierra

Edward Page Mitchell (1852-1927) fue un periodista norteamericano especialmente reconocido por los relatos de ciencia ficción que publicó en el diario The Sun de Nueva York, del que llegó a ser editor jefe hasta su jubilación en 1926. En 1973 se publicó una antología de 30 de sus primeras narraciones (1874-1886) bajo el título “The crystal man” [1], que correspondía con uno de sus más sugerentes relatos sobre la invisibilidad y que fue publicado en 1881, 16 años antes de que la famosa novela de H. G. Wells viera la luz.

Diez historias de Mitchell fueron traducidas y publicadas en castellano [2], en las que -además del hombre invisible- se tratan cuestiones como el viaje en el tiempo, el cerebro artificial (superior a la máquina analítica de Babbage) o la teleportación. De estos diez excelentes relatos de ciencia ficción, mi favorito no tiene que ver con las posibles tecnologías cuánticas o la infame IA, que tan a menudo se citan hoy día incorrectamente. Se trata del Taquipompo.

El TaquipompoUna pareja enamorada pide permiso para casarse, pero el obstáculo principal se encuentra en que el novio demuestre su verdadero merecimiento para entrar en una familia matemática insigne. Sin entrar en más detalles del relato, cuya lectura recomiendo efusivamente, mostraremos a continuación algunas resoluciones matemáticas y físicas del artilugio protagonista.

Para transportar objetos rápidamente debemos usar tierra, mar o aire, y además gastar mucha energía. De forma mucho más eficiente, mucho más rápida y sin gasto de energía usamos el Taquipompo. ¿Cómo funciona el Taquipompo en la Tierra?

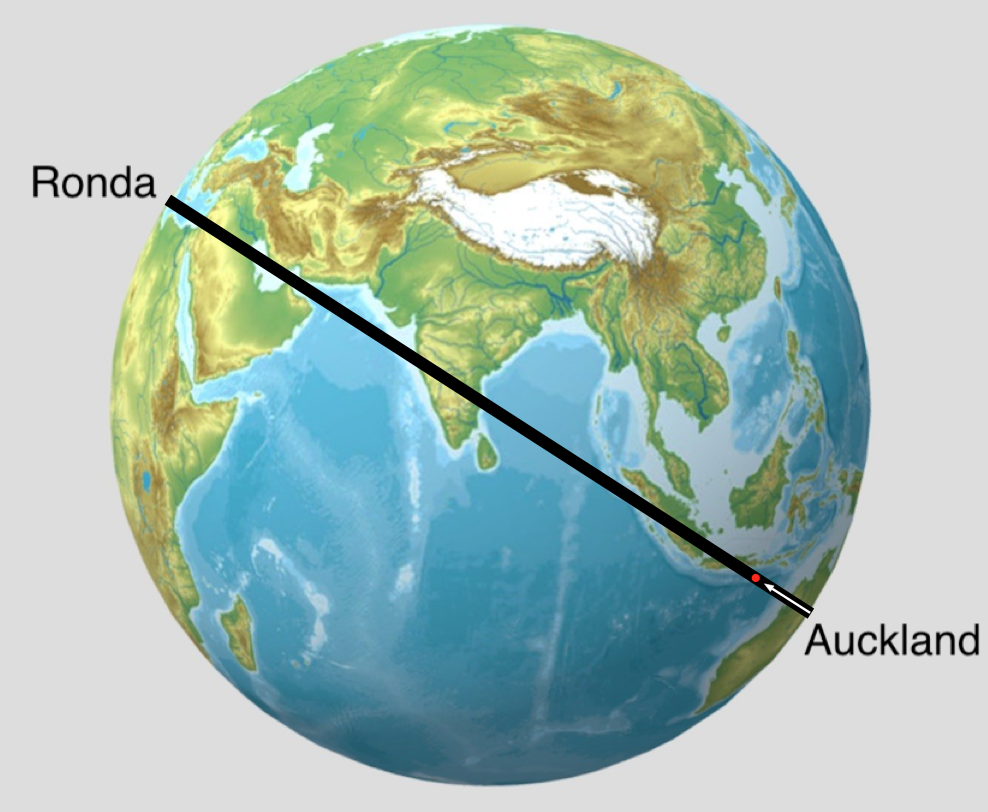

Para hacer cálculos, a los físicos nos gusta establecer hipótesis simplificadoras, como la famosa vaca esférica en el vacío. En este caso supondremos que podemos hacer un agujero desde Auckland (Nueva Zelanda) a Ronda (España). Como son ciudades antípodas una de la otra y suponemos que nuestro planeta es una esfera, el túnel pasa por el centro de la Tierra. Supondremos además que la densidad de la Tierra es constante y que el agujero lo vaciamos de aire. Esto es el Taquipompo, como lo ilustramos en la Figura 1.

Figura 1. Transporte rápido de mercancías entre antípodas. Fuente: Sketchfab globo-terráqueo-mapa-físico modificado CC Commons

Figura 1. Transporte rápido de mercancías entre antípodas. Fuente: Sketchfab globo-terráqueo-mapa-físico modificado CC CommonsCómo funciona

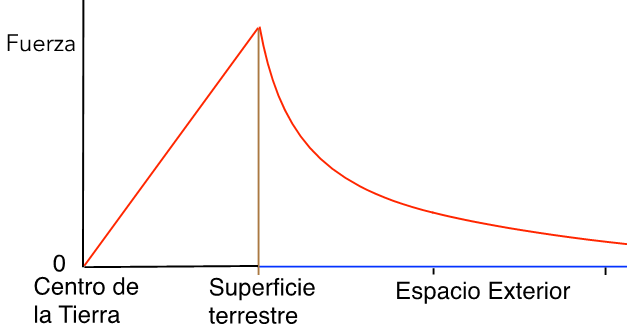

Tenemos que hacer un envío urgente desde Auckland a Ronda así que directamente tiramos el paquete por el agujero. La ley de gravitación universal nos dice que hacia el exterior del planeta su fuerza gravitatoria es inversamente proporcional al cuadrado de la distancia, pero ¿qué pasa por dentro del túnel mientras cae la pieza que hemos enviado? Los cálculos no son difíciles, pero tampoco son triviales, porque la aceleración no es constante sino dependiente de la distancia del objeto al centro de la Tierra.

Si utilizamos la Ley de Gauss aplicada al campo gravitatorio, y calculamos el volumen de la esfera cuyo radio es la distancia del objeto al centro de la Tierra, podemos demostrar que la aceleración (y la fuerza sobre dicho objeto) desciende linealmente con la distancia al centro de la Tierra. De esta manera resulta muy sencillo calcular la constante de proporcionalidad de la fuerza sobre el cuerpo que hemos enviado por el Taquipompo, que depende de la densidad del planeta y de la constante de gravitación universal.

En la Figura 2 ilustramos la fuerza gravitatoria que la Tierra ejerce sobre el objeto, sea por dentro del túnel como en el espacio exterior. El cambio radical se produce en la superficie del planeta. Dentro del Taquipompo esta fuerza proporcional a la distancia es idéntica a la Ley de Hooke para los muelles, lo cual nos indica que la Tierra se comporta como un resorte.

Figura 2. Fuerza de atracción de la Tierra sobre el objeto, en función de su posición respecto del centro del planeta

Figura 2. Fuerza de atracción de la Tierra sobre el objeto, en función de su posición respecto del centro del planeta

Nos encantan a los físicos los osciladores armónicos, que aparecen en los vaivenes de los muelles, en los instrumentos musicales o en todo tipo de ondas, con las que queremos explicar todo el Universo. En el humilde caso del Taquipompo lo que esto nos dice es que el paquete urgente que mandábamos de Auckland a Ronda caerá al centro de la Tierra con aceleración linealmente descendente, superará el punto medio a máxima velocidad, y simétricamente llegará a Ronda. Si no recogemos el paquete en Ronda, éste volverá a caer y llegará de vuelta a Auckland; y tanto la ida como la vuelta sin gastar energía.

Cifras del Taquipompo en el planeta Tierra¿Cuánto tarda el transporte desde una localidad a la otra? Un sencillo cálculo integral -usando la constante de gravitación universal G (6,67 10-11 N m2/kg2) y la densidad de la Tierra (5520 kg/m3)- nos permite deducir que al Taquipompo le bastan 2530 segundos para colocar el envío en su destino (es decir: poco más de 42 minutos), y da igual que el paquete sea pesado o ligero.

En términos del movimiento armónico simple este tiempo es la mitad del período de oscilación, luego el período de este movimiento armónico son T=5060 segundos (viaje de ida y vuelta). La frecuencia en Hercios (Hz) de esta oscilación es el inverso del período.

El Taquipompo es mucho más rápido que cualquier otro medio de transporte de los que disponemos hoy día. Si calculamos el pico de velocidad que adquiere el artilugio en el centro de la Tierra, éste resulta ser 7910 m/s para cualquier paquete que enviemos, y no gastamos combustible ni electricidad. Esperamos que este logro fuera de suficiente entidad como para que la feliz pareja del relato de Edward P. Mitchell demostrara su merecimiento.

Referencias

[1] Sam Moskowitz (Ed.) (1973) The Crystal Man: Stories by Edward Page Mitchell. Doubleday Science Fiction ISBN: 978-0385031394

[2] Edward Page Mitchell (2015) El espectroscopio del alma. Orciny Press ISBN: 978-8494318115

Sobre el autor: Victor Etxebarria Ecenarro es Catedrático de Ingeniería de Sistemas y Automática en la Universidad del País Vasco (UPV/EHU)

El artículo El muelle de la Tierra se ha escrito en Cuaderno de Cultura Científica.

Naukas Pro 2024: Deduciendo paleoclimas a partir de sedimentos marinos

Los últimos avances en el ámbito de las energías renovables marinas o la proliferación de los microplásticos fueron algunos de los temas que componen la última edición de NAUKAS PRO. Una cita en la que el personal investigador se sube al escenario del Euskalduna Bilbao para hablar de las investigaciones más destacadas del momento en un ámbito concreto.

En esta ocasión el personal investigador de la Universidad del País Vasco, de la Estación Marina de Plentzia (PiE-UPV/EHU), AZTI, Tecnalia o el CSIC acercaron las últimas investigaciones relacionadas en el ámbito marítimo.

La conferencia Deduciendo paleoclimas a partir de sedimentos marinos corre a cargo de Aitor Payros Agirre, investigador del Departamento de Geología de la UPV/EHU

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2024: Deduciendo paleoclimas a partir de sedimentos marinos se ha escrito en Cuaderno de Cultura Científica.

Un algoritmo para aumentar la resolución de los mapas de áreas quemadas

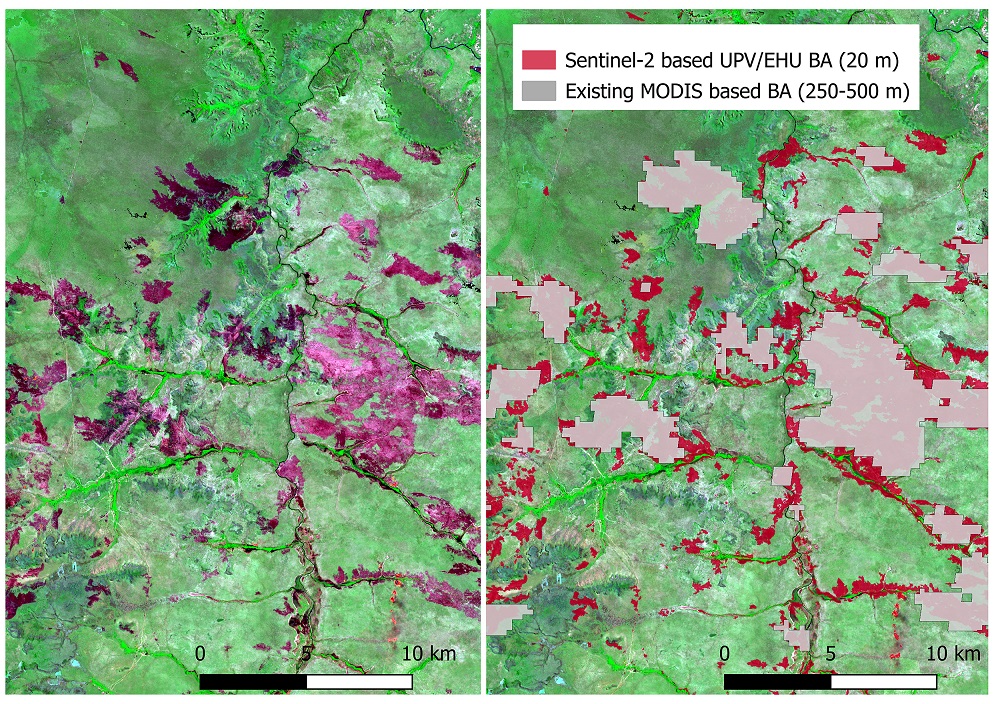

Utilizando datos de dos satélites que recogen imágenes ópticas y de otros cuatro satélites que miden las altas temperaturas causadas por los incendios, un equipo de investigadoras propone un algoritmo para obtener la cartografía global de las áreas quemadas con una mayor resolución.

Fuente: Bastarrika et al (2024)

Fuente: Bastarrika et al (2024)La obtención de información precisa y actualizada de las zonas afectadas por el fuego es fundamental para comprender mejor la calidad del aire, los ciclos biogeoquímicos o el clima, así como para contribuir a la gestión de los incendios. Hace unas décadas, la cartografía o mapeo de las áreas quemadas se realizaba a partir del estudio de las zonas rurales pero, desde el lanzamiento de satélites para la observación de la Tierra, la teledetección se ha convirtido en una opción más práctica para localizar las zonas quemadas, ya que los satélites facilitan la medición de la cobertura de los incendios, tanto a escala regional como mundial.

El problema de las zonas cartografiadas mediante satélites se encuentra en la resolución. De hecho, hasta ahora la resolución de las observaciones globales ha sido mala. “El error de omisión en los productos actuales es muy grande: muchas zonas que están realmente quemadas no se identifican como tales”, señala Aitor Bastarrika, investigador de la UPV/EHU. “Los sistemas actuales utilizan un tamaño de píxel de entre 250 y 500 metros, por lo que no detectan incendios que no alcancen los 250 metros. Y en algunos ecosistemas son muy frecuentes los incendios de esas dimensiones”.

El estudio liderado por Aitor Bastarrika ha desarrollado un algoritmo para lograr una mayor resolución, utilizando datos de seis satélites diferentes. Por un lado, han aprovechado las imágenes captadas por los dos satélites ópticos de la constelación Sentinel-2: ofrecen una buena resolución espacial, de 10-20 metros, pero con una baja frecuencia temporal, ya que solo se obtienen imágenes de un lugar determinado cada 5 días. Por otro lado, se han aprovechado los productos MODIS (derivados de los satélites Terra y Aqua) y VIIRS (derivados de los satélites Suomi NPP y NOAA-20) que detectan incendios activos: detectan estos puntos de alta temperatura con una resolución espacial baja de 375-1000 metros, pero con una frecuencia alta, ya que recogen datos todos los días.

Un algoritmo probado en cientos de áreasEl algoritmo desarrollado por el equipo de Bastarrika utiliza los datos de los dos productos para la detección de incendios activos y con ellos entrena un sistema de imágenes ópticas de cara a desarrollar un sistema de clasificación. Posteriormente proporciona predicciones sobre lo que se ha quemado y lo que no. “Además, estas previsiones se han probado en 576 áreas de todo el mundo, es decir, el algoritmo se ha analizado en todos los ecosistemas en los que las zonas quemadas son significativas”, explica Bastarrika.

El algoritmo desarrollado por el equipo de Bastarrika no es el único, hay otras propuestas similares. Sin embargo, la aportación de los investigadores de la UPV/EHU es especialmente importante porque el algoritmo está preparado para ser aplicado a escala global y para obtener resultados con una resolución media. “Ya existen algoritmos para cartografiar zonas concretas con una resolución media, pero nuestra propuesta sirve para cartografiar áreas quemadas de todo el mundo, lo hace con una resolución aceptable y está lista para ser utilizada”.

De cara al futuro, el objetivo es crear nuevos productos con este algoritmo desarrollado. “Así como hasta ahora están preparados para usar sistemas de baja resolución, a partir de ahora el objetivo es crear productos que ofrezcan resultados con un nivel de resolución medio. Pasar de baja a media resolución supondría una gran contribución a la hora de identificar algunos ecosistemas y de estudiar el clima”, ha afirmado Bastarrika.

Referencia:

Aitor Bastarrika, Armando Rodriguez-Montellano, Ekhi Roteta, Stijn Hantson, Magí Franquesa, Leyre Torre, Jon Gonzalez-Ibarzabal, Karmele Artano, Pilar Martinez-Blanco, Amaia Mesanza, Jesús A. Anaya, Emilio Chuvieco (2024) An automatic procedure for mapping burned areas globally using Sentinel-2 and VIIRS/MODIS active fires in Google Earth Engine ISPRS Journal of Photogrammetry and Remote Sensing doi: 10.1016/j.isprsjprs.2024.08.019

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un algoritmo para aumentar la resolución de los mapas de áreas quemadas se ha escrito en Cuaderno de Cultura Científica.

¿Por qué la llaman piedra si quieren decir roca?

La banda italiana de heavy metal Wind Rose acaba de lanzar un nuevo disco que incluye una canción titulada “Rock and Stone” (roca y piedra), sumándose así a la apasionante discusión sobre qué término es el correcto, si son o no sinónimos o cuándo hay que usar una palabra o la otra. Por suerte (o desgracia, ya veremos), la Real Academia Española (RAE) de la Lengua ha acudido en nuestro rescate, añadiendo unas definiciones precisas para piedra y roca que pueden (o no) aclararnos todas estas dudas. Veamos lo que nos dicen.

Habrá quien las llame piedras, pero son rocas. Foto: Sean Stratton / Unsplash

Habrá quien las llame piedras, pero son rocas. Foto: Sean Stratton / UnsplashLa RAE tiene varias acepciones para la palabra piedra, pero si nos fijamos en la primera, a priori la más importante, definen este término como “sustancia mineral, más o menos dura y compacta”. Por su parte, la primera definición de roca es “piedra, o vena de ella, muy dura y sólida”. Vamos, que parece que lo que diferencia ambos conceptos es la dureza que presentan: si es muy dura, se trata de una roca, mientras que si es más blandita, sería una piedra. Y aquí es donde se nos erizan los pelos de la nuca a todas las personas profesionales de la Geología.

La dureza es una propiedad de los minerales que se refiere a su resistencia mecánica a sufrir una fractura o alteración permanente en la superficie al aplicarles un objeto u otro mineral. Aunque la más conocida es la de Mohs, existen diversas escalas que ordenan los minerales de acuerdo a su dureza, y en ninguna de ellas encontramos una división en dos grandes grupos que nos diga “de aquí hasta aquí son piedras y a partir de aquí son rocas”. Entonces, ¿de dónde se ha sacado la RAE que el criterio diferenciador entre ambos conceptos es la dureza? Pues de una malinterpretación de una vulgarización geológica.

Me explico. Como en cualquier otra ciencia, en Geología nos encanta hacer clasificaciones de absolutamente todo y ponerle nombres a cuál más complicado a cada uno de los subgrupos definidos. Y una de estas clasificaciones se fundamenta en el tamaño de grano del sedimento, es decir, en el diámetro de las partículas que son erosionadas, transportadas y depositadas en la superficie terrestre, antes de su enterramiento y litificación. Así se ha definido la escala granulométrica de Udden-Wentworth, que incluye tres grandes grupos: lodo, que alberga las partículas con diámetros inferiores a 0,063 mm; arena, que se refiere a los materiales con diámetros comprendidos entre 0,063 mm y 2 mm; y grava, para sedimentos de diámetros superiores a 2 mm. Estos son los nombres oficiales, los que encontraréis en los libros de texto y en las publicaciones científicas de índole geológica. Pero, ¿sabéis cómo los nombramos en privado las y los geólogos? Barro, arena y piedras.

Escala granulométrica de Udden-Wentworth donde se detallan los tres grandes grupos de sedimentos, con los valores límites del diámetro de las partículas y los subgrupos que podemos encontrar en cada uno de ellos. Imagen modificada de Setiawan, B., Antonie, S. y Adhiperdana, B. (2019). Grain-size characteristics of Aceh’s coastal deposits. IOP Conference Series: Materials Science and Engineering. 523.

Escala granulométrica de Udden-Wentworth donde se detallan los tres grandes grupos de sedimentos, con los valores límites del diámetro de las partículas y los subgrupos que podemos encontrar en cada uno de ellos. Imagen modificada de Setiawan, B., Antonie, S. y Adhiperdana, B. (2019). Grain-size characteristics of Aceh’s coastal deposits. IOP Conference Series: Materials Science and Engineering. 523.Aquí es donde encontramos la palabra que buscábamos, en una denominación informal que hace referencia a pequeños fragmentos de roca, generalmente de menos de 20 o 30 cm de diámetro, que podemos coger con la mano y meterlos en la mochila cuando estamos en el campo. Pero esta definición de piedra es el secreto mejor guardado de las personas que nos dedicamos a la Geología, jamás diremos en público que usamos estos términos para referirnos a los materiales sedimentarios. Por eso la RAE ha errado en su definición, ya que no tenían toda la información: el tamaño de grano no tiene nada que ver con la dureza de los materiales.

Piedra es roca alteradaPero no todo va a estar mal en el diccionario de la lengua española. Si prestamos atención a la cuarta y última acepción del término roca, veremos que dice “material sólido de origen natural formado por una asociación de minerales o por uno solo, que constituye una parte importante de la corteza terrestre”. Esa definición es casi perfecta, parece directamente sacada de un manual de Geología. ¿Y en el caso de piedra? Pues en la segunda entrada pone “trozo de piedra que se usa en la construcción”, mientras que la tercera alude a “piedra labrada con alguna inscripción o figura”, entendiendo en ambas el término piedra como esa “sustancia mineral, más o menos dura y compacta”. De nuevo, ambas entradas dan en el clavo. Porque la verdadera diferencia entre los conceptos roca y piedra, mundialmente aceptada en el ámbito geológico y que debería permear en la sociedad en general, es que una roca es un material sólido natural, mientras que una piedra es una roca que ha sido alterada de alguna manera por el ser humano (cortada, pulida, tallada, etc.). De esta manera, cuando vamos a una cantera encontraremos un afloramiento de rocas que van a ser explotadas y, en cuanto cortamos un nivel para sacar unas losas con las que trabajar, tendremos en nuestras manos unas piedras ornamentales.

A) Afloramiento de roca caliza, material sólido natural. B) Ejemplo de piedra caliza, una roca transformada por el ser humano como elemento decorativo.

A) Afloramiento de roca caliza, material sólido natural. B) Ejemplo de piedra caliza, una roca transformada por el ser humano como elemento decorativo.Así que, aunque las personas profesionales de la Geología nos enfademos con el resto del mundo cuando usa la palabra piedra, no podemos decir nada si se están refiriendo a la encimera de la cocina, a la baldosa de la acera o a una punta de flecha encontrada en una excavación arqueológica. Pero seguiremos corrigiendo a la gente si llama piedra a un guijarro que se encuentre en el margen del cauce de un río, porque eso, aunque sea pequeña, es una roca, ya que es un material natural que no ha sufrido ninguna manufactura humana. Y permitidme un último consejo, no os quedéis solo con la primera entrada de la definición de una palabra cuando la busquéis en el diccionario, porque ya hemos visto que, a veces, son las últimas las que te dan la descripción correcta.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo ¿Por qué la llaman piedra si quieren decir roca? se ha escrito en Cuaderno de Cultura Científica.

Las matemáticas del “Día del mol”

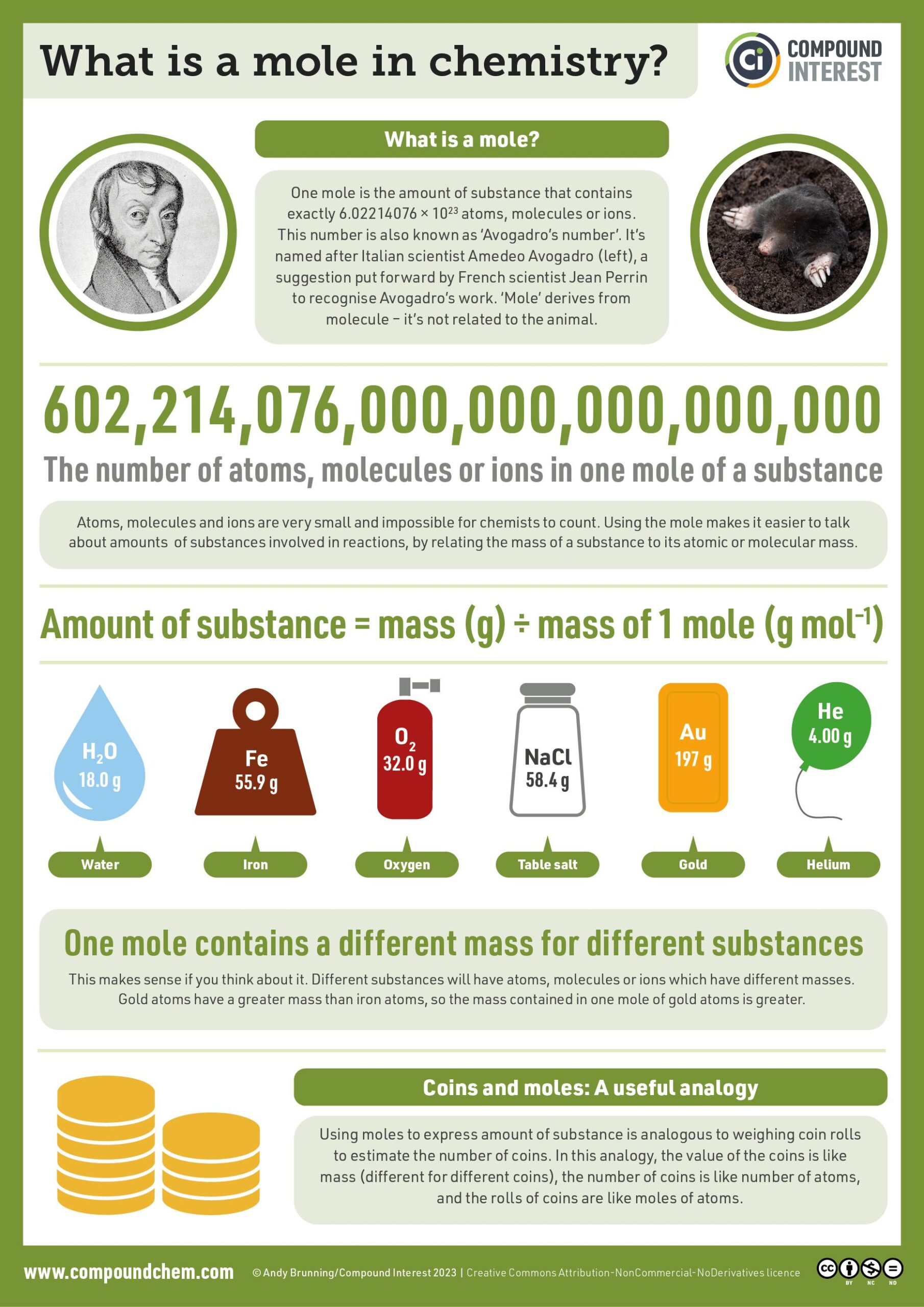

Hoy, como cada 23 de octubre, se celebra el Día del mol. Es una celebración informal que festejan las personas vinculadas a la química de manera profesional o amateur.

Imagen del #MoleDay 2014. Fuente: Andy Brunning/Compound Interest.

Imagen del #MoleDay 2014. Fuente: Andy Brunning/Compound Interest.

No se celebra durante todo el día; se hace solo entre las 6:02 de la mañana y las 6:02 de la tarde de cada 23 de octubre. Estas horas y esta fecha –escritas a la manera anglosajona– quedarían representadas por

6:02 10/23

una expresión que recuerda a la forma decimal del número de Avogadro con tres cifras significativas: 6,02 x 1023.

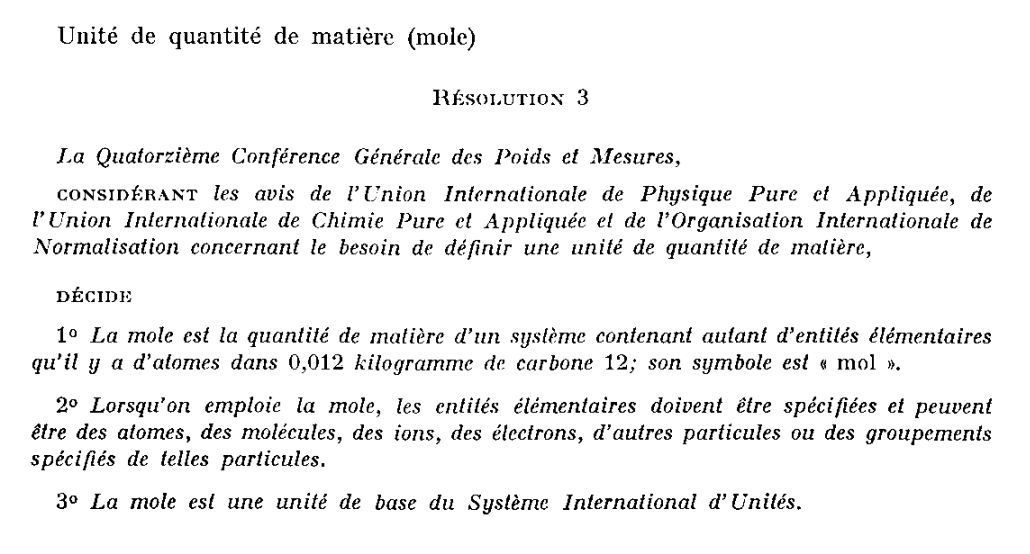

El mol como unidad de medidaEl mol es la unidad con que se mide la cantidad de sustancia; es una de las siete magnitudes físicas fundamentales del Sistema Internacional de Unidades (SI). Se adoptó como unidad de medida el 4 de octubre de 1971.

La decisión se tomó en la 14e Conférence Générale des Poids et Mesures (CGPM), el órgano de decisión de la Oficina Internacional de Pesas y Medidas, que se encarga de tomar decisiones en materia de metrología y, en particular, en lo que afecta al SI.

Fuente: Comptes Rendus des Séances de la quatorzième CGPM (Paris, 4-8 octobre 1971), pág. 78.

Fuente: Comptes Rendus des Séances de la quatorzième CGPM (Paris, 4-8 octobre 1971), pág. 78.

En la imagen anterior, extraída del informe de la CGPM de 1971, se puede leer:

La Decimocuarta Conferencia General de Pesos y Medidas,

TENIENDO EN CUENTA las opiniones de la Unión Internacional de Física Pura y Aplicada, de la Unión Internacional de Química Pura y Aplicada y de la Organización Internacional de Normalización sobre la necesidad definir una unidad de cantidad de materia,

DECIDE

-

El mol es la cantidad de sustancia de un sistema conteniendo tantas entidades elementales como átomos hay en 0,012 kilogramos de carbono 12; su símbolo es «mol».

-

Cuando se emplea el mol, las entidades elementales deben especificarse y pueden ser átomos, moléculas, iones, electrones, otras partículas o agrupaciones especificadas de tales partículas.

-

El mol es una unidad de base del Sistema Internacional de Unidades.

La constante de Avogadro es el número de entidades elementales –normalmente átomos o moléculas– en un mol de una sustancia cualquiera. Su nombre* se debe al físico y químico Amedeo Avogadro (1776-1856), quien formuló la ley de Avogadro en 1812: “Volúmenes iguales de gases distintos bajo las mismas condiciones de presión y temperatura contienen el mismo número de partículas”.

Así, un mol de cualquier sustancia contiene exactamente ese número de átomos o moléculas. Por supuesto, dependiendo de la masa de los átomos o moléculas, la masa total de un mol de una sustancia puede variar: un mol de agua pesa un poco más de 18 gramos, mientras que un mol de sal común, el cloruro de sodio, pesa 58,4 gramos.

El Día del molEl Día del mol comenzó a gestarse a partir de la publicación de un artículo escrito en 1985 por Margaret Christoph, profesora de ciencias de Delaware. En él mencionaba que celebraba un día de química con su alumnado cada mes de octubre. Inspirado por este escrito, el 15 de mayo de 1991, el profesor de química de enseñanza secundaria Maurice Oehler fundó la National Mole Day Foundation (NMDF). Y el Día del mol empezó a celebrarse desde ese año para despertar el interés por la química:

La gente lo suficientemente loca como para celebrar el Día del mol tiene que ser maravillosa. No estoy seguro de lo que le depara el futuro a la fundación, pero sí sé que es viable y que seguirá entusiasmando a los niños con la química. Mi objetivo es que al menos todos los profesores de química se enteren y celebren de alguna manera el Día del mol cada año. Tenemos un largo camino por recorrer, pero lo estamos logrando.

En inglés “mol” es «mole”, pero “mole” es también “topo”, ese enigmático mamífero subterráneo. Por ese doble sentido, la NMDF tiene un topo como “mascota”. Un mol es una cantidad realmente grande:

Un topo oriental (Scalopus aquaticus) pesa alrededor de 75 gramos, lo que significa que un mol de topos pesa

(6,022 × 1023) × 75 g ≈ 4,52 × 1022 kg.

Eso es un poco más de la mitad de la masa de nuestra luna.

Los mamíferos están compuestos principalmente de agua. Un kilogramo de agua ocupa un litro de volumen, por lo que si los moles de topos pesan 4,52×1022 kilogramos, ocupan aproximadamente 4,52×1022 litros de volumen. Es posible que notes que ignoramos los espacios entre los topos. En un momento, verás por qué.

La raíz cúbica de 4,52×1022litros es 3562 kilómetros, lo que significa que estamos hablando de una esfera con un radio de 2210 kilómetros, o un cubo de 2213 millas por cada lado. (Es una coincidencia muy interesante que nunca había notado antes: una milla cúbica equivale casi exactamente a 4/3π kilómetros cúbicos, por lo que una esfera con un radio de X kilómetros tiene el mismo volumen que un cubo de X millas por cada lado).

Si estos moles de topos fueran liberados sobre la superficie de la Tierra, la llenarían hasta alcanzar 80 kilómetros de altura, casi hasta el (antiguo) borde del espacio […]

Cada año, este especial día tiene un tema protagonista, elegido con mucho sentido del humor e involucrando algún juego de palabras. En 2024 el tema elegido es “EncantMole” e invita a explorar los aspectos mágicos de los topos, los moles y el “encantador” mundo de los átomos y las moléculas. ¡A celebrarlo!

Cartel oficial del Día del mol. Fuente: NMDF.

Cartel oficial del Día del mol. Fuente: NMDF.

Referencias

- Margaret Christoph. Mole day. The Science Teacher 52 (7) (1985) 47–48

- Mole Day

- Andy Brunning, Mole Day – What is a mole in chemistry?, Compound Interest,23 octubre 2014

- A mole of moles, xkcd

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y editora de Mujeres con Ciencia

* Nota del Editor: Su nombre, que no su cálculo ni su definición. Véase a este respecto Las constantes de Planck y el caballo blanco de Santiago, últimos párrafos.

El artículo Las matemáticas del “Día del mol” se ha escrito en Cuaderno de Cultura Científica.

Un siglo para un gran avance en un problema matemático que parece simple

Una nueva prueba sobre los números primos ilumina la sutil relación entre la suma y la multiplicación, y aumenta la esperanza de avances en la famosa conjetura abc.

Una mañana del pasado noviembre, el matemático Héctor Pastén finalmente resolvió el problema que lo había perseguido durante más de una década utilizando un truco de productividad archiconocido: la procrastinación.

Tenía que ponerse a redactar un examen final para su clase de teoría de números en la Pontificia Universidad Católica de Chile en Santiago. Para evitarlo, se puso a pensar, por enésima vez, en una de sus secuencias favoritas: 2, 5, 10, 17, 26 y así sucesivamente, la lista de todos los números de la forma n2 + 1 (donde n es un número entero).

Los matemáticos han utilizado esta secuencia durante más de un siglo para investigar la complicada relación entre la suma y la multiplicación, una tensión que se encuentra en el corazón de la teoría de números. Los problemas fundamentales sobre la multiplicación (por ejemplo, sobre cómo se factorizan los números en primos) de repente se vuelven mucho más profundos y desafiantes tan pronto como la suma entra en escena. Una de las cuestiones abiertas más grandes de las matemáticas, por ejemplo, pregunta si todo número par mayor que 2 es la suma de dos primos; otra pregunta si hay infinitos pares de primos que difieren solo en 2, como 11 y 13.

La sucesión n2 + 1 ofrece un buen punto de partida para investigar la relación entre la suma y la multiplicación, porque combina uno de los tipos más simples de multiplicación (elevar un número al cuadrado) con uno de los tipos más simples de adición (sumar 1). Eso no significa que la sucesión en sí sea simple. Los matemáticos aún no pueden responder a preguntas elementales sobre ella, como por ejemplo si contiene infinitos números primos. “No hace falta mucho para llegar al límite de nuestro conocimiento”, afirma Andrew Granville de la Universidad de Montreal. Cuando los matemáticos logran desplazar este límite, aunque sea un poco, las técnicas que desarrollan a menudo arrojan luz sobre cuestiones mucho más amplias sobre la suma y la multiplicación.

Pastén intentaba demostrar que los números de la secuencia siempre deben tener al menos un factor primo que sea bastante grande. La mañana en que debería haber estado preparando el examen final, finalmente lo logró, al descubrir cómo incorporar información sobre los factores primos de n2 + 1 en la estructura de una ecuación llamada curva elíptica.

Ese día, durante el almuerzo, le describió la prueba a su esposa, la matemática Natalia García-Fritz. Dada la sorprendente solidez de su resultado, ella “me dijo que probablemente debería comprobarlo muchas veces”, cuenta Pastén. “Esa tarde lo hice y los teoremas seguían ahí”.

Héctor Pastén pasó más de una década intentando resolver un problema matemático en la intersección de la suma y la multiplicación. Finalmente lo logró cuando decidió posponer la redacción de un examen final para uno de sus cursos. Foto: Natalia García-Fritz

Héctor Pastén pasó más de una década intentando resolver un problema matemático en la intersección de la suma y la multiplicación. Finalmente lo logró cuando decidió posponer la redacción de un examen final para uno de sus cursos. Foto: Natalia García-FritzHabía un solo inconveniente: Pastén no tenía ningún examen que poner a sus alumnos. Les pidió que escribieran un ensayo sobre el tema que quisieran. “El resultado fue un trabajo de muy alta calidad”, dice.

Pastén envió su prueba a Inventiones Mathematicae, una de las revistas más importantes de matemáticas, donde fue aceptada en poco más de un mes, un abrir y cerrar de ojos según los estándares de publicación habituales en el campo. “Es un avance encantador en algo que no ha experimentado mucho progreso durante prácticamente 100 años”, comenta Cameron Stewart de la Universidad de Waterloo. Los matemáticos esperan que también se traduzca en avances en secuencias numéricas relacionadas.

La técnica de Pastén también le permitió avanzar en ciertos casos de la conjetura abc, otra cuestión que trata de la interacción entre la suma y la multiplicación, y uno de los problemas sin resolver más famosos —y controvertidos— de las matemáticas. “Las ideas nuevas (y correctas) en esta área han sido escasas”, escribe Granville en un correo electrónico. “La originalidad y la promesa de sus métodos merecen mucha atención”.

Primos grandesSi una secuencia de números se hace cada vez más grande, eso no garantiza que sus factores primos más grandes hagan lo mismo. Tomemos la secuencia n2: los números 1, 4, 9, 16, etc. Es fácil encontrar números en esta secuencia cuyos factores primos sean pequeños. Por ejemplo, cualquier potencia de 2 en esta lista (4, 16, 64, 256, 1024…) tiene solo un factor primo: 2.

Pero cuando se añade 1 a esta secuencia, “se destruye por completo toda la información que se tenía” sobre los factores primos, afirma Pastén. “Los primos se comportan de una manera muy loca”.

En 1898, Carl Størmer demostró que, a diferencia de la sucesión n2, los factores primos más grandes números en la sucesión n2+ 1 se acercan al infinito a medida que n crece. Este hallazgo demostró que “algo interesante está sucediendo, algo inusual”, explica Stewart.

A mediados de la década de 1930, los matemáticos Kurt Mahler (arriba) y Sarvadaman Chowla demostraron de forma independiente que había un límite en la velocidad a la que podía crecer el mayor factor primo de una secuencia de números. El nuevo trabajo marca la primera mejora importante de su resultado. Fotos: MFO; cortesía de Shelby White y Leon Levy Archives Center

A mediados de la década de 1930, los matemáticos Kurt Mahler (arriba) y Sarvadaman Chowla demostraron de forma independiente que había un límite en la velocidad a la que podía crecer el mayor factor primo de una secuencia de números. El nuevo trabajo marca la primera mejora importante de su resultado. Fotos: MFO; cortesía de Shelby White y Leon Levy Archives CenterPero Størmer no pudo determinar con qué rapidez crecen los factores primos más grandes de n2 + 1, un siguiente paso natural en la caracterización del comportamiento de la secuencia.

Si empiezas a calcular números de la secuencia, la mayoría de ellos parecen tener al menos un factor primo muy grande. Pero, ocasionalmente, hay una caída enorme. Por ejemplo, un número de la secuencia, 586.034.187.508.450, tiene un factor primo de 67.749.617.053. Pero el factor primo más grande del siguiente número de la secuencia, 586.034.235.924.737, es solo 89. Son estas excepciones las que hacen que el problema sea difícil.

A mediados de la década de 1930, Sarvadaman Chowla y Kurt Mahler demostraron de forma independiente que, para cualquier valor de n, el mayor factor primo de n2+ 1 siempre debe ser al menos tan grande como log(log n). Pero log(log n) crece increíblemente despacio (si lo graficamos, parece plano a simple vista). Los matemáticos sospechaban que el mayor factor primo de n2 + 1 en realidad crece mucho más rápido, pero no podían demostrarlo.

En 2001, Stewart y Kunrui Yu, de la Universidad de Ciencia y Tecnología de Hong Kong, desarrollaron un nuevo enfoque para estudiar los factores primos en secuencias, utilizando un área de las matemáticas llamada teoría de la trascendencia. Dos años después, Julien Haristoy descubrió cómo aplicar su método a la secuencia n2 + 1 , logrando una pequeña mejora respecto del resultado de Chowla y Mahler.

Pero desde entonces, el tema había quedado en un punto muerto. “Hacía tiempo que necesitabamos un nuevo ingrediente”, apunta Granville.

Exponentes pequeñosPastén lleva más de una década cultivando ese nuevo ingrediente. En 2012, cuando era estudiante de posgrado en la Queen’s University de Kingston (Ontario), su director, Ram Murty, le sugirió que se centrara en problemas que exploraran la interacción entre la suma y la multiplicación.