Lidokaina superheroi-lanetan

1. irudia: Lidokaina duten Strepsils pastillak. (Argazkia: – Flickr / Karen Melchior – CC BY-NC-SA 2.0 lizentziapean)

Bizitza etapa ezberdinetan bana daiteke eta lidokaina superheroiaren sorreran ere bi dira gertatzen diren etapak: amidazioa eta ordezkapena [1].

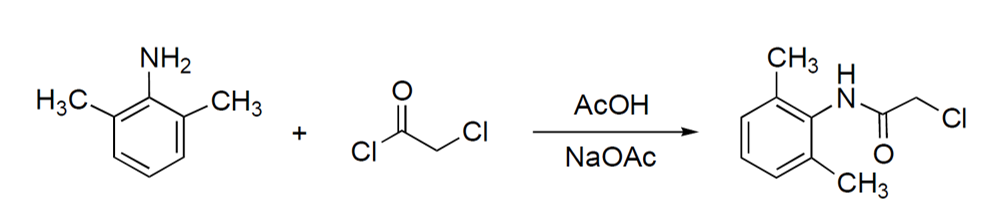

Lehen etapan, hau da, amidazio erreakzioa emateko (2. irudia), bi konposatu nahastu eta hirugarren bat tantaz tanta gehitzen da; dimetilanilina eta azido azetikoa (ozpina) dira nahasten diren bi konposatuak eta kloroazetil kloruroa tantaka gehitzen dena. Erreakzio hori organikoa izanik, giro-tenperaturan gauzatzea zaila da; horregatik, prozesua azkartzeko, giro-tenperaturatik gora egiten da lan.

2. irudia: Amidazio erreakzioan erreakzionatzen duten konposatuak eta erreakzioaren produktua. (Egileak: Idoia Mutiloa eta Maria Zubiria)

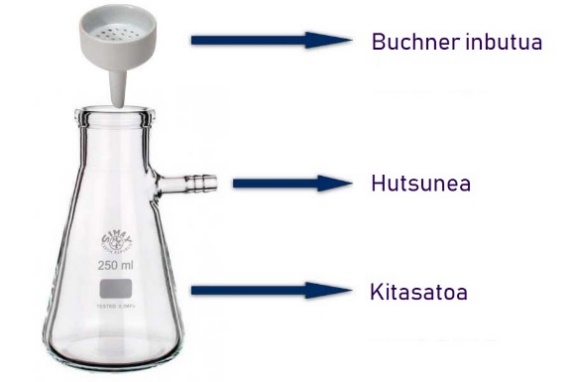

Gatza lortzeko, ezinbestekoa da erreakzio horren bidez lortutako produktua hoztea. Hoztutako gatz hori Buchner inbutua eta kitasatoa deritzen tresnen bidez iragazi ondoren (3. Irudia) lehenengo etapa amaitutzat ematen da. Gatz hori izango da bigarren etaparen abiapuntua.

Behin produktua lortuta, bigarren erreakzioa hasi aurretik, nahitaez frogatu behar da lortutako produktua intereseko dela; horretarako, produktuaren fusio-puntua (likido/solido aldaketa eragiten duen tenperatura) neurtzen da.

3. irudia: Lehenengo erreakzioko gatza iragazteko behar den materiala: Buchner inbutua eta kitasatoa. (Argazkia: matrazaforado.com-etik hartuta eta egileek moldatuta)

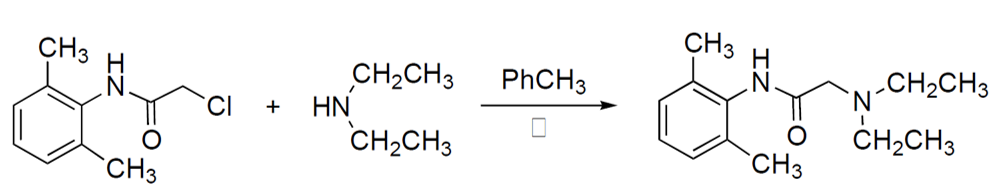

Ondoren, lidokaina sortzeko bigarren etapari ekiten zaio, hau da, ordezkapen-erreakzioari (4. irudia). Etapa honetan, toluenoa eta dietilamina gehitzen zaizkio lehen etapan lortutako gatzari. Produktuak nahastean lortu den disoluzioa, lehenengo etapan bezala, organikoa da; hori dela eta, tenperatura igo behar da. Baina aurreko pausoarekin alderatuta, honetan kristal batzuk agertzen dira. Izan ere, Kimikan oso zaila da lehenengotik nahi den produktu purua sortzea, erreakzioan zehar ezpurutasunak sortzen direlako. Hain zuzen ere, sortu diren kristal horiek ezpurutasunak dira eta lidokaina sintetizatu ahal izateko kanporatu egin behar dira.

4. irudia: Ordezkapen-erreakzioan parte hartzen duten konposatuak eta erreakzioaren produktua: lidokaina. (Egileak: Idoia Mutiloa eta Maria Zubiria)

Ezpurutasunak bota ahal izateko, disoluzioari azido klorhidrikoa gehitzen zaio lidokaina ur disoluzioan gera dadin. Horrek kontraesana dirudi, baina hainbat konposatu organiko azidoekin tratatuz gero, konposatuen izaera organikoa jaitsi eta ur-disoluzioan gera daitezke disolbatuta. Lidokainaren kasuan, hau gertatzen da: intereseko produktua protonatuta, aldatu egiten da bere izaera. Pauso horretan lortzen da ezpurutasun guztiak fase organikoan eta intereseko produktua ur-fasean geratzea Dekantazio-inbutu bat erabiliz (5. irudia), fase organikoa ezabatzen da.

5. irudia: Dekantazio-inbutua. (Argazkia: Wikipedia / PRHaney – CC BY-SA 3.0 lizentziapean)

Jarraian, aurreko pausoaren guztiz kontrakoa egiten da: lidokaina ur-fasetik fase organikora igarotzen da. Horretarako, pentanoa gehitzen da, lidokainak afinitate handiagoa baitu. Horrela, ur-faseko lidokaina guztia edo gehiena fase organikoan geratuko da disolbatuta, produktua protoigabetuta, izaera organikoa berreskuratu egiten delako. Ondoren, disoluzioa sartzen da. Bertan dentsitate-desberdintasun bat dagoenez, fase organikoa inbutuaren goiko aldean geratzen da eta beraz, ur-fasea kanporatzea erraza suertatzen da. Pauso hori behin eta berriro egiten da, lidokaina kopurua ahalik eta handiena izan dadin.

Esperimentua gogobetekoa izan dadin, ahalik eta lidokaina kantitate handiena lortzen saiatu behar da; honek erraza ematen du, baina ez da horrela izaten. Pauso asko egin behar dira lidokaina lortu ahal izateko. Bestalde, disoluzioan konposatu ugari egonik, horrek guztiak produktuaren galera dakar.

Ur-faseko lidokaina guztia fase organikoan dagoenean, fasea dekantazio-inbututik atera eta Erlenmeyer matrazera aldatzen da. Disoluzio organikoan gera daitekeen ura botatzeko, sodio sulfatoa (Na2SO4) gehitzen da. Behin fase organikoa baizik ez dagoela, disoluzioa errotabaporean (6. irudia) jartzen da: horrela eginda, sistemaren presioa asko handitzen da, eta ondorioz, disoluzioaren irakite-puntua asko jaisten da; horrela, pentanoaren lurrunketa errazten da.

6. irudia: Lidokaina lortzeko erabiltzen den errotabaporea. (Argazkia: Wikimedia / Gmhofmann – jabego publikoko irudia)

Prozesu hori amaituta, matrazean geratzen den hautsa lidokaina da. Lehen esan bezala, frogatu egin behar da lortutako produktua interesekoa den; horregatik, fusio-puntuaren azterketa egiten da. Lortzen den emaitza bibliografiarekin bat baldin badator, lidokainaren sorreraren prozesua amaitutzat ematen da.

Jakina da sintetizatutako lidokaina hau ezin dela zuzenean hartu gaixotasunei aurre egiteko. Lidokainaren bidez gaixotasunei aurre egiteko sortu izan dira enpresa handiak. Izan ere, bertan egiten diren kalitate-frogei esker gizakiak kontsumi lezake lidokaina eta horrela, munstroak errazago garai litezke.

Oharrak:

[1] Reilly, Thomas J. (1999). The Preparation of Lidocaine. Journal of Chemical Education , 76(11), 1557. DOI: 10.1021/ed076p1557

———————————————————————————-

Egileez: Idoia Mutiloa eta Maria Zubiria Gipuzkoako Campuseko Kimika Graduko ikasleak dira UPV/EHUn.

Artikulua, Maxux Aranzabe irakasleak Komunikazioa Euskaraz: Zientzia eta Teknologia ikasgaian bultzatutako Kutsadura kimikoa jardueraren harira idatzitako lana da.

———————————————————————————-

The post Lidokaina superheroi-lanetan appeared first on Zientzia Kaiera.

¡Salvad a las ranas!

Ranas. Imagen: Wikimedia Commons

Ranas. Imagen: Wikimedia CommonsSi un hongo llamado Batrachochytrium dendrobatidis no les tiene a usted y a toda su familia asustados y amenazados es porque no son ustedes una rana, un sapo u otro tipo de anfibio. Porque si lo fuesen, lo estarían. El Bd (acortemos) ha sido declarado recientemente como el patógeno más peligroso para la biodiversidad del que se tiene noticia hasta ahora: es responsable de la desaparición de 90 especies de anfibios y amenaza a más de 500. De ellas, 124 han reducido el número de sus ejemplares hasta en un 90% y no está claro que puedan llegar a recuperarse nunca. Los especialistas no saben a día de hoy cómo detenerlo.

Un estudio llevado a cabo en 2018 sugiere que el hongo se originó en la península de Corea y desde allí se diseminó por todo el mundo en animales infectados que se colaron en las cargas de exportación, ya fuese como polizones o como mercancías alimenticias o como mascotas. Hoy se puede encontrar en más de 60 países de todo el mundo y está causando estragos en América Latina, Asia y África.

Este patógeno se transmite por contacto directo o a través de aguas infectadas y ataca a los animales a través de la keratina presente en su piel, que forma parte del sistema respiratorio de los anfibios. Así, causa que se vayan asfixiando a la vez que deteriora su sistema inmune y termina causándoles un ataque cardíaco.

Suena terrible, y lo es, pero el Bd ha tenido al menos un aspecto positivo para las ranas y similares: estamos hablando de ellas y de las amenazas que sufren. Como les pasa a muchos animales menos agraciados que tigres, pandas, delfines, águilas y elefantes, sus penurias, incluidas aquellas que el ser humano les causa, pasan más desapercibidas y se les defiende menos, a pesar de ser parte imprescindible de muchos ecosistemas, necesarios para que se mantengan los equilibrios tróficos y dependientes de la conservación de los recursos naturales.

Y eso que son unos animales fascinantes de los que la mayoría no sabemos lo suficiente. Por si es su caso, aquí van algunas cosas sobre las ranas que quizá usted no sepa.

¿En qué se diferencia una rana de un sapo?

En lo que a su taxonomía se refiere, ranas y sapos forman parte del género Anuro y de forma generalizada se les llama anuros a ambos. A partir de aquí, las diferencias entre ambos son a nivel coloquial y popular, pero taxonómicamente no hay una categorización establecida.

Rana Silverstoneia flotator, originaria de Costa Rica y Panamá. Imagen: Wikimedia Commons

Rana Silverstoneia flotator, originaria de Costa Rica y Panamá. Imagen: Wikimedia Commons

Se considera que las ranas son, en general, más pequeñas, de piel suave y brillante, y más gráciles, con patas más finas que les permiten dar mayores saltos. Por el contrario los sapos son más rugosos, de colores más discretos y más corpulentos, con saltos más pequeños. Las ranas ponen sus huevos en racimos mientras que los sapos los ponen en forma de ristras.

Sin embargo, no todas las especies cumplen todas estas características, y por eso no es una división oficial.

¿Por qué las ranas no se congelan en invierno?

Los anfibios han colonizado prácticamente todos los hábitats del mundo, y en algunos de ellos puede llegar a hacer mucho frío. Dado el porcentaje de agua que contiene su cuerpo, y que son por naturaleza animales de sangre fría, ¿cómo lo hacen para no congelarse en invierno?

Las ranas hibernan, como hacen otros animales, como respuesta al frío del invierno. Para hibernar, buscan un espacio que les proteja del tiempo y de los depredadores y se acomodan en él. Entonces su metabolismo se ralentiza de forma drástica y consiguen dormir durante meses utilizando para ello las reservas de energía que van acumulando durante las estaciones cálidas. Cuando vuelve a hacer calor, despiertan y salen de su escondrijo para volver a alimentarse y dedicarse a la gustosa tarea de aparearse.

Sapo común en plena reproducción. Imagen: Wikimedia Commons

Sapo común en plena reproducción. Imagen: Wikimedia Commons

Las ranas acuáticas pueden hacer esto bajo el agua, pero a diferencia de otros animales acuáticos, como las tortugas, que se pueden enterrar bajo el barro y obtener de él las pequeñísimas cantidades de oxígeno que requieren durante la hibernación, las ranas deben situarse cerca de corrientes de agua ricas en oxígeno e hibernar sobre el barro no bajo él. Muchas salen ligeramente del letargo y nadan lentamente de vez en cuando.

Las ranas terrestres hibernan en tierra, a menudo enterrándose bien bajo el suelo para situarse a salvo de depredadores y también huyendo del nivel de congelación. Otras se evitan el esfuerzo de cavar y enterrarse ubicándose en grietas lo suficientemente profundas de troncos o rocas para quedar fuera del alcance de cualquiera que pretenda darles un bocado.

Para evitar que el frío les haga daño mientras hibernan cuentan con un efectivo sistema anticongelante: una alta concentración de glucosa en sus órganos vitales evitan que se congelen. Pueden llegar a formarse algunos cristales de hielo en algunas partes del cuerpo, como por ejemplo la vejiga, y el animal parecerá muerto durante semanas pero cuando llegue la primavera y las temperaturas suban, esos cristales desaparecerán, el cuerpo de la rana estará intacto y ésta recuperará su actividad sin problema.

¿Cómo evitan deshidratarse en las estaciones secas?

Si bien la mayoría de los anfibios viven en lugares donde ninguna estación es tan seca como para suponer un problema, unas pocas se han adaptado para conquistar esos hábitats. En esos casos, practican la estivación, la versión veraniega de la hibernación: el animal entra en un estado durmiente como respuesta a las condiciones extremas temporales del entorno.

Para hacerlo, se entierran en el suelo, allí donde aun se conserva un poco de humedad y mientras duermen ponen en marcha un ingenioso truco: generan varias capas de piel muerta, formando una especie de capullo impermeable que les envuelve y les ayuda a conservar su propia humedad, dejando expuestos al exterior solamente los agujeros respiratorios para evitar asfixiarse. Cuando termina la estación seca y vuelven las lluvias, se liberan de su caparazón y regresan a la superficie para rehidratarse.

¿Por qué pasan de renacuajos a ranas?

Cuando nacen, las ranas no son ranas más pequeñas, sino un renacuajo, que a simple vista parece un animal de una especie totalmente distinta: una cabeza grande y redondeada con una ancha cola que les permite desplazarse y alimentarse en el agua. Pocas semanas después desarrollan las poderosas patas traseras que les ayudan a saltar fuera del agua y alimentarse en un terreno nuevo. No son las únicas que practican la metamorfosis, muchos peces e insectos lo hacen también. Pero ¿por qué?

Renacuajo de la rana bermeja, días antes de su metamorfosis. Imagen: Wikimedia Commons

Renacuajo de la rana bermeja, días antes de su metamorfosis. Imagen: Wikimedia CommonsSegún la investigadora holandesa Anna ten Brink, se trata de una estrategia que permite a una especie aumentar potencialmente sus opciones de alimentación, y es una estrategia tan eficaz que, sin bien ha aparecido contadas veces a lo largo de la evolución, una vez que lo hace rara vez desaparece.

Ten Brink y su equipo partieron de la idea de que los animales que no se metamorfosean y siempre tienen el mismo tipo de cuerpo adaptado al mismo tipo de entorno, están bien preparados para comer un tipo de alimento durante toda su vida. Pero si ese entorno contiene otro tipo de alimento, ¿podrían los adultos incorporarlo si durante su crecimiento su anatomía cambiaba de una forma distinta?

La respuesta que observaron es que los animales esto rara vez ocurre, ya que entonces las crías tendrían más dificultad para nutrirse del primer alimento y un mayor porcentaje moriría antes de llegar a la edad adulta.

Aquí, la metamorfosis es una solución evidente: los animales jóvenes siguen adaptados al alimento original y los adultos cambian completamente de cuerpo para poder consumir el segundo. Claro que esto supone pagar un alto precio en forma de una gran cantidad de calorías y el riesgo de que el proceso salga mal y el animal sufra defectos que acorten notablemente su vida.

Incluso aunque salga bien, el periodo de metamorfosis es un momento de especial vulnerabilidad en el que no pueden huir ni defenderse en caso de ataque de un depredador. Por eso ten Brink especula que la metamorfosis sale adelante cuando la recompensa evolutiva es realmente buena, cuando los que la completan tienen a su alcance una alimentación muy nutritiva que les permite reproducirse numerosamente con éxito.

Referencias:

A deadly amphibian disease goes global – Science

The Evolutionary Ecology of Metamorphosis – The American Naturalist

¿Por qué un animal cambiaría su cuerpo por otro? – The New York Times

How do frogs survive winter? Why don’t they freeze to death – American Scientist

What’s The Difference Between a Frog and a Toad? – Live Science

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo ¡Salvad a las ranas! se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¡Salvad a la hija!

- ¿Por qué si nunca hemos vivido mejor que ahora el mundo nos parece cada vez peor?

- Las ventajas (para ti y para los demás) de ser egoísta de vez en cuando

Kandidiasiari aurre egiteko tratamendu berria begi-bistan

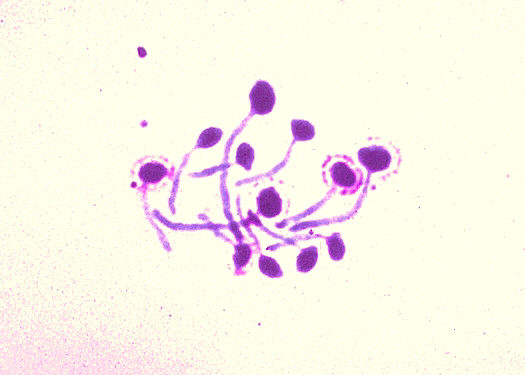

Irudia: Tratamendu berritzaile eta erraza garatu dute baginako kandidiasia gaixotasunaren jatorri den Candida Albicans onddoaren aurka borrokatzeko.

Baginako kandidiasiak ez dakar arrisku handirik eguneroko bizitzara baina gaixotasuna duenaren bizi kalitatea murriztu egiten du, haren jarduera mugatuz. Gaixotasunaren sintomak dira, esaterako, askotan jasanezinak diren azkura eta erresumina. Baginako kandidiasia pairatu duten bost emakumetatik bat Candida onddoaren eramaile kroniko bihurtzen da eta, ondorioz, infekzioak pairatzen ditu aldizka. Errepikatzen diren kandidiasi horiek erresistenteak bihurtzen dira ohiko tratamenduen aurrean.

Umetokiko zelula amekin egindako ikerketak bide berria ireki du Candida Albicans onddoari aurre egiteko. Aktibitate antineoplasikoa (bular tumore zelulen aurkakoa) duten umetokiko zelula amek jariatzen duten “sekretoma”-k (zitokina koktelak) Candida albicans bezalako onddo patogenoen aurkako eragina duen ikertu dute. Izan ere, tumore-zelulak bezala, eukariotak dira Candida albicans onddoak.

Ikerketaren emaitzek erakutsi dute sekretomak Candida onddo espezie batzuen aurkako oso aktibitate ona duela eta ona edo erregularra beste batzuentzat. Azpimarratzekoa da normalean kandidiasia tratazteko farmakoei erresistenteak diren Candida anduien aurka erakutsitako aktibitatea. Gogoratu beharra dago Candida albicans onddoa baginako kandidiasien %80aren baino gehiagoaren arduraduna dela.

Umetokiko zelula amek, bestalde, immunodeprimitutako pazienteen odoletik ateratako Candida albicans anduien (sentiberak zein tratamenduaren aurrean erresistenteak) hazkundea ere eten dute. Onddoen ondoriozko septizemiak (odol infekzioak) heriotza arrazoi garrantzitsua dira paziente talde horretan, horien aurka egun dauden tratamendu mediko eskas eta urrien aurrean erresistente egiten direnean bereziki.

Ikertutako umetokiko zelula amen andui berezi honek (hUCESCs-k) Candida albicans onddoaren aurka agertzen duen jarduera sendoagoaren zioa bere jatorria izan daiteke. Umetokiko zelula amak oso leku berezian dute jatorria: “umetoki lepoaren eraldatze lekua”. Oso zaurgarria da biologikoki eta etengabeko harremana du baginarekin eta horrek dakartzan mehatxuekin: onddoak, bakterioak, birusak eta kanpotik datozen mikrobio patogeno guztiak. Testuinguru horretan, umetoki lepoko zelula ama mesenkimalek, espeziearen bilakaeran zehar, defentsa mekanismo boteretsuak garatu ahal izan dituzte: balizko mehatxu guztien aurka egin eta espeziaren biziraupena bermatzea xede duten molekula faktore ugari kanpoko ingurura igortzen dituzte.

Umetokiko zelula amak edo umetoki lepoko zelula ama mesenkimalak (hUCESCs edo “human Uterine Cervical Stem Cells” ingelesez) apenas inbaditzailea den metodo baten bidez lortzen dira, ohiko ginekologia azterketan egiten ohi den lepoaren eskuilatzean oinarritua. Aurreko ikerlanetan ikertzaile ezberdinek ikusi ahal izan dutenez, gainera, sekretomak baldintzatutako inguruneak (zelula horiek igorri duten molekula multzoa) potentzial handia dauka ere bularreko minbiziaren aurkako tumoreen aurka, gaitasun birsortzaile handia kornea lesioetan, bai eta potentzial immunoarautzaile handia ere.

Iturria: UPV/EHUko prentsa bulegoa: Tratamendu berritzailea eta erraza Candida Albicans onddoaren aurka.

Erreferentzia bibliografikoa:

Schneider, José, et al., (2018). Antifungal Activity of the Human Uterine Cervical Stem Cells Conditioned Medium (hUCESC-CM) Against Candida albicans and Other Medically Relevant Species of Candida. Frontiers in Microbiology, 9, e2818. DOI: 10.3389/fmicb.2018.02818.

The post Kandidiasiari aurre egiteko tratamendu berria begi-bistan appeared first on Zientzia Kaiera.

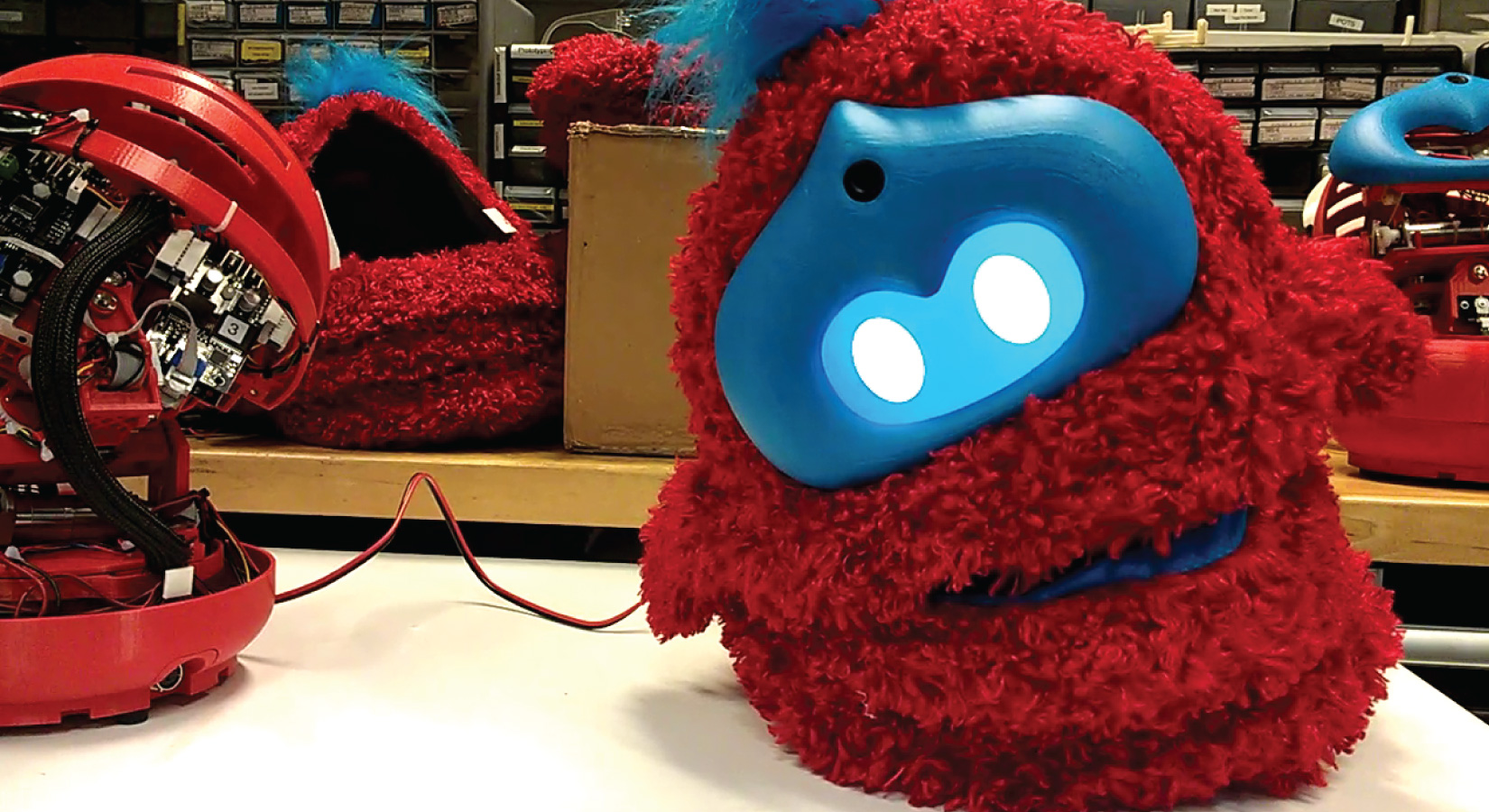

Tega enseña lenguaje

Fuente: Affectiva

Fuente: AffectivaTega cuenta historias a niños y niñas leyéndoles libros ilustrados. De vez en cuando les hace preguntas para conocer su opinión acerca de lo que les ha contado, saber si le entienden, interesarse por el significado de alguna palabra o conocer sus ideas sobre algún aspecto en particular de lo que les ha leído.

Al contar historias se mueve, adopta posturas diferentes y pone caras. También ilustra lo que cuenta con imágenes que proyecta en una pantalla. Además, se fija y registra la expresión facial y la disposición corporal de quien escucha el cuento; de esa forma sabe si le interesa y está atento a lo que dice. Y al acabar de leerle el libro, le pide que se lo cuente con sus propias palabras.

Tega es un robot con cubierta de peluche que ha sido desarrollado por un equipo del Massachusetts Institute of Technology (MIT) formado por ingenieros, informáticos y artistas. Lo han diseñado para que enseñe lenguaje a niños y niñas de corta edad, y fue presentado a finales de enero pasado en Hawai, en la AAAI Conference on Artificial Intelligence.

Tega ha demostrado ser competente en la tarea para la que fue creado. En el marco de un experimento leyó cuentos a niños y niñas de entre 4 y 6 años de edad. Lo hizo en sesiones semanales de una hora de duración. En un grupo las lecturas eran personalizadas. Cada vez que interactuaba con los chiquillos Tega aprendía, sabía más de sus habilidades y conocimientos verbales. De esa forma, para la siguiente sesión escogía un cuento más adecuado al nivel de competencia verbal de cada uno de ellos, tanto por las estructuras que eran capaces de manejar como por el vocabulario que conocían. Y además, iba sustituyendo algunas palabras por sinónimos menos conocidos.

En un segundo grupo las lecturas no eran personificadas. Tega escogía al azar la historia de una biblioteca de cuentos. Eso sí, cada dos semanas elevaba la dificultad del texto. Además de los dos grupos que interactuaron con el robot, el equipo utilizó un grupo de control que no interactuó con Tega.

Varias semanas después de terminar las sesiones, el equipo evaluó el conocimiento de vocabulario en los dos grupos experimentales y en el control. Todos los que habían interactuado con el robot habían mejorado sus conocimientos verbales, pero los del grupo con los que Tega se había relacionado de forma personalizada mejoraron más. En un test de conocimiento verbal cometieron un 23% menos de errores que antes de las sesiones con el robot. Y la tasa de error de quienes no habían interactuado de forma personalizada con él solo se redujo la mitad que la del grupo anterior. Los del grupo control no mejoraron.

Además de saber más vocabulario, los pequeños que habían interactuado con Tega de forma personalizada contaban historias más largas y más complejas que los otros niños, y su lenguaje corporal indicaba que prestaban una mayor atención al robot durante las sesiones.

No han creado Tega para que enseñe lenguaje como lo harían maestros y maestras. Lo han hecho para que sirva de apoyo al personal docente y para su uso bajo circunstancias especiales. Pero uno no puede dejar de pensar que cada vez son más los ámbitos en los que se diseñan robots para sustituir o “complementar” actividades humanas. Antes pensábamos que los robots se limitarían a la manufactura, limpieza y tareas repetitivas, en general. Pero ya hay muñecas sexuales robóticas, se proyectan androides que cuiden a personas y, como acabamos de ver, se crean robots capaces de enseñar porque, entre otras habilidades, pueden aprender.

Fuentes: Tega, a New Social Robot Platform; Tega; Smart and fluffy storytelling robot to be trialled in US classrooms

——————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Tega enseña lenguaje se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El aprendizaje continuo mejora la interacción de robots con humanos en lenguaje natural

- El lenguaje de la química

- Mestizajes: Intuición, arte y lenguaje, por Itziar Laka

Asteon zientzia begi-bistan #248

Berriki ondorioztatu dute baleak batez ere oroimenean oinarritzen direla bidaian zehar janaria non dagoen jakiteko. PNAS aldizkarian argitaratutako bi ikerketek baleen migrazioari buruzko zalantzak argitu dituzte. Juanma Gallegok testu honetan azaldu digunez, fosilak aztertu dituzte eta ikusi dute gutxienez 270.000 urte atzera doan jarduna dela. Oxigeno-18 isotopoaren analisian oinarritu dute lana eta Alaskan, Kalifornian eta Panaman hartutako datuak baliatu dituzte. Zehaztasun gehiago ezagutu nahi badituzu, irakurri osorik artikulua!

GenetikaEbola, zika, lassa-sukarra bezalako gaixotasunei aurre egiteko, gakoa detekzio goiztiarra da. Bada normalean epidemia horiek hasten diren urrutiko eremuetan ez dute birusa detektatzeko eta identifikatzeko oinarrizko baliabiderik. Beraz, laginak laborategira bidali behar dira analisirako, eta horrek emaitzak atzeratzen ditu. Bada, teknika berri bat garatu dute CRISPR-CAS-ean oinarritua. Metodologia berriari izena jarri diote jada: Sherlock. Nola funtzionatzen du tresnak? Ez galdu Berriako artikulua!

Genetikari buruz maiz entzuten diren bi galdera ekarri dizkigu Koldo Garciak: bata, familia batean bikiak izandako emakume asko badaude ea bikiak izateko probabilitatea handitzen ote zen; bestea, familian begi urdinak edo argiak dituzten pertsonak badaude, ea posible den haurrek begi argiak izatea, gurasoek begi ilunak badituzte ere. Lehenengoari dagokionez, bi biki mota ezberdindu behar ditugu: biki monozigotikoak eta biki dizigotikoak. Garciak azaltzen digunaren arabera, gene gutxi lotu dira biki dizigotikoak izateko probabilitatearekin eta biki monozigotikoen kasuan ez dirudi gene-oinarririk dagoenik. Bigarren galderari dagokionez, begien kolorean gene askok hartzen dute parte.

Emakumeak zientzianAsteon, Gerty Cori biokimikaria ezagutzeko aukera izan dugu. Medikuntzako Nobel saria jaso zuen 1947an Coriren edo glukosaren zikloa aurkitzeagatik –bere senarra eta Bernardo Houssay-ekin batera-. Sari hori irabazi zuen hirugarren emakumea izan zen, eta lehenengoa Fisiologia eta Medikuntza alorrean. Oro har, Coriren zikloa gibelaren eta giharren arteko erreserba-substantzien zirkulazioari deitzen zaio. Baina zertan datza zehatz-mehatz? Ez galdu!

AstronomiaAurreko astean ezagutu genuen albistea: lehen aldiz espazio irekira emakumezkoz soilik osatutako lantaldea bidaltzeko asmoa zuen NASAk. Zehazki bi emakumek egin behar zuten misio hori: Christina Kochek eta Anne McClainek. Baina Elhuyar aldizkarian irakur daitekeenez, badirudi orain planaz aldatu dutela. NASAk ohar bidez adierazi duenez, ez dute jantzi egokirik bi emakumerentzat. Hortaz, Nick Haguek ordezkatuko du McClain.

Berriak ere eman du honen berri. Dirudienez, agentziak segurtasuna eta plangintza argudiatu ditu, baina andreek aspaldi salatu dute jantziekin dagoen arazoa. Dena dela, hori ez da emakumezko astronautek salatu duten bazterketa bakarra. Artikuluan azaltzen digutenez, gaur emakumezkoek gizonezkoek baino denbora laburragoa pasa dezakete espazioan, adibidez. Astronauta batek espazio estazioan Lurrean baino askoz erradiazio gehiago jasotzen du. NASAk emakumezkoei ezartzen dien gehienezko erradiazio muga gizonezkoena baino %20 baxuagoa da. Horren gainean, NASAk dio kezka dagoela erradiazio horrek umetokiko, obarioetako edo bularretako minbizia garatzeko arriskua handitu dezakeelako.

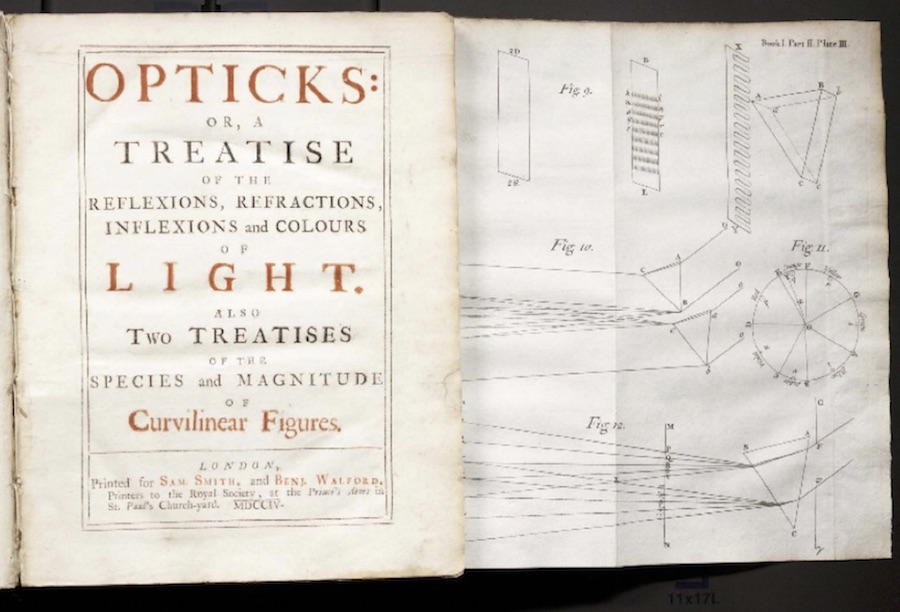

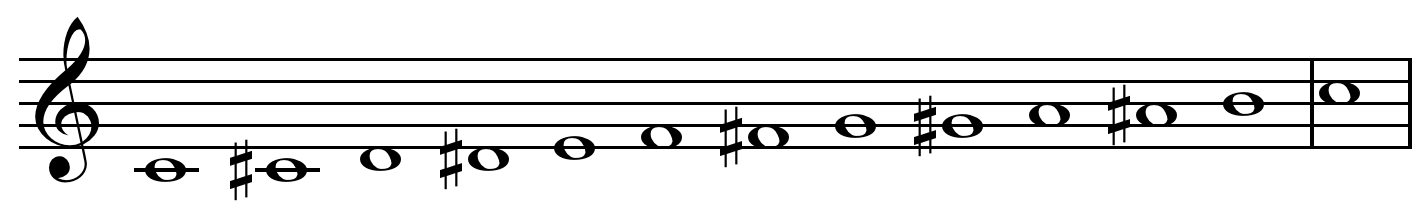

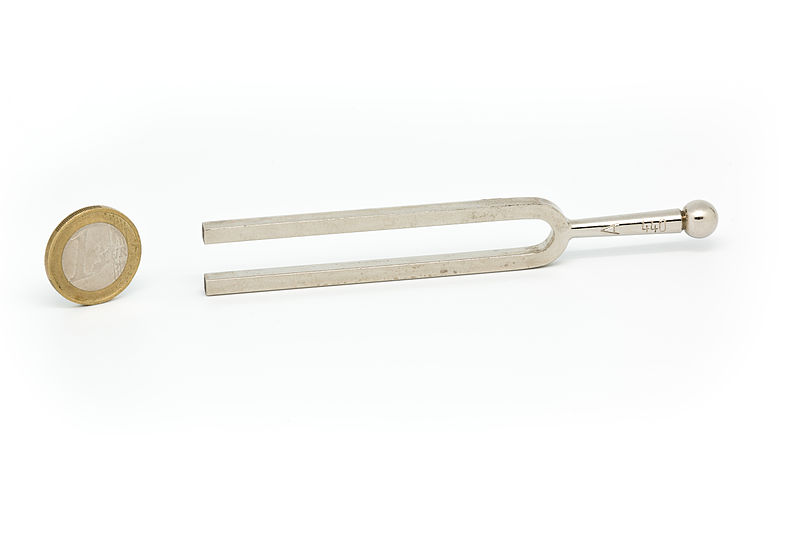

AkustikaAsteon musika-notak eta bibrazio maiztasunak izan ditu mintzagai Josu Lopez Gazpiok. Lehenik eta behin, musikaren eskalaren zentzua azaltzen digu: do batetik hurrengo do-ra bibrazioaren maiztasuna bikoiztu egiten da. Orain dakigunez, nota bati dagokion soinu bakoitza maiztasun jakin batekin lotzen da eta, maiztasunaren bikoitzera iristean, notak berriro izen berdina du. Galdera bat planteatzen da tartean: zergatik jartzen zaie izen bera bibrazio-maiztasun bikoitza duten soinuei?

OsasunaOsasun sistemen jardunaz aritu da Berrian Felipe Aizpuru osasun ikertzailea. Jardun hori hobetzeko digitalizazioa aipatzen du: “Osakidetzak egunero gutxi gorabehera 100.000 kontaktu dauzka herritarrekin… Informazio hori guztia pilatu eta ondo aztertzen badugu, datu horiek ezagutza bihur daitezke”. Datu horiek ahalik eta modu egokienean erabiltzeko eskandinaviarrek erabiltzen dituzten sistemak eredu dituzte. Horretaz gain, gainpreskripzioari buruz mintzatu da.

GeologiaXX. mendeko zientzia-aurkikuntza aipagarrienen artean plaka-tektonikaren teoria dago ezbairik gabe, Lurraren kanpoko azal zurruna (litosfera) nola mugitzen eta birziklatzen den azaltzen duena, alegia. Ereduak 50 urte bete ditu. Testu honetan, teoria horren hastapenak eta garapena azaltzen dira. Gogora dezagun, egun, Lurra dela ezagutzen dugun planeta bakarra plaka-tektonikaren ereduaren arabera jokatzen duena. Plaka-tektonikaren garapenari esker, klima jasangarriagoa eragin du Lurrean, eta ondorioz, bizitza garatzeko aukerak izugarri handitu ditu.

DibulgazioaZientziaren munduak oso espazio gutxi izan ohi du telebistan. Badira, hala ere, zientzia jorratzen duten saioak; Orbita laika, adibidez. Aurten formatua berritu dute Berrian irakurri daitekeenez. Aitor Gutierrez programako zuzendariak nabarmendu du lehen denboraldiaren esentzia berreskuratu nahi izan dutela, “baina science show baterantz eboluzionatuz”. Aipatzekoa da saio honek EHUren laguntza jasotzen duela.

–——————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————–

Egileaz: Uxue Razkin kazetaria da.

——————————————————————

The post Asteon zientzia begi-bistan #248 appeared first on Zientzia Kaiera.

¿Qué pasa en tu cerebro cuando duermes?

De la misma forma que el hígado, el corazón, los pulmones o los riñones no dejan de funcionar cuando duermes, el encéfalo tampoco lo hace. Si alguno de estos órganos lo hiciese el resultado es el mismo: la muerte. Pero, si la consciencia no está operativa, ¿a qué se dedica el cerebro mientras dormimos?

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Qué pasa en tu cerebro cuando duermes? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Hemos intentando contactar con extraterrestres?

- ¿Cómo demonios funcionan las copas musicales?

- #Naukas16 Qué pasa cuando le das un péndulo a una máquina

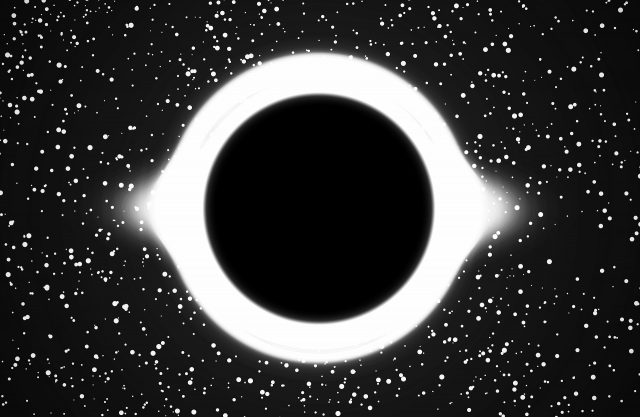

Ezjakintasunaren kartografia #255

Bai, zulo beltzek sekulako masa dute, espaziodenboran distortsioa sortu eta argiak haietatik ihes egitea saihesten duena. Zoragarri. Baina, non dago zulo beltz baten masa? Francisco R. Villatoro-k azaltzen du Where is the mass inside a black hole?

Txinatarrek, komunistak haiek, haien ekonomia ekonomia modu arrakastatsuan erreformatu bazuten, zergatik sobietarrek ezin izan zuten? José Luis Ferreirak klabe batzuk ditu: Why the Soviet Union could not be reformed

Van der Waals materialak oso interesgarriak dira berez. Baina ezaugarrietako batzuk lodierarekiko duten dependentziak propietate konbinazio benetan bereziak topatzea dakar. DIPC-ren A unique combination of properties in a van der Waals antiferromagnet

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #255 appeared first on Zientzia Kaiera.

Geología, Antropoceno y cambio climático

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Nauru. Fuente: Wikimedia Commons

Nauru. Fuente: Wikimedia CommonsTras su lanzamiento por Paul Crutzen en el año 2000, el alcance social y académico del Antropoceno ha crecido de una manera sorprendente. Este concepto se acuñó para materializar nuestra percepción de que las actividades humanas han cambiado el Sistema Tierra. El comportamiento de los océanos, la atmósfera, la superficie terrestre, la criosfera, la biosfera y el clima ya no es el mismo que ha caracterizado durante más de 11.000 años la época geológica en la que formalmente aún vivimos, el Holoceno.

El hecho de que los humanos podamos afectar de modo tan significativo el curso de la evolución geológica de nuestro planeta dio pie en 2009 a la creación del Grupo de Trabajo sobre Antropoceno que está examinando la posibilidad de la formalización e inclusión del término en la Tabla Cronoestratigráfica Internacional (conocida como la Escala del Tiempo Geológico). Ya que la historia de la Tierra anterior a la documentación humana sólo se puede reconstruir a partir de su registro en las rocas, este enfoque centrado en el análisis de las evidencias contenidas en los sedimentos recientes es fundamental para comparar adecuadamente las historias moderna y antigua de nuestro planeta y, por lo tanto, para medir la magnitud y la velocidad de la perturbación planetaria provocada por los humanos.

El Antropoceno se caracteriza por un conjunto de señales de naturaleza sedimentaria, biológica y química que se pueden encontrar en la mayor parte de la superficie terrestre. Algunas de estas evidencias tienen equivalentes en unidades geológicas más antiguas (por ejemplo, el enriquecimiento en metales), pero otras señales son completamente novedosas (como los radioisótopos artificiales o los plásticos dentro de los sedimentos). Estas evidencias reflejan una fase distinta en la historia de la Tierra, que se alejó de su estabilidad general holocena a partir de la Revolución Industrial y, en particular, desde la “Gran Aceleración” en el crecimiento de la población humana, la industrialización y la globalización a mediados del siglo XX, momento que se considera como el límite más adecuado para marcar su inicio.

Desde el punto de vista climático, el rápido aumento de los gases de efecto invernadero desde el siglo XIX (Figura 1) ha provocado un creciente ascenso de la temperatura y del nivel del mar, acompañados por una pérdida de hielo en los continentes. Este calentamiento ha alcanzado ya niveles más altos que los detectados durante el Holoceno y se acerca a los de otras etapas interglaciares del periodo Cuaternario.

Figura 1. Tasas de cambio en las concentraciones de gases de efecto invernadero desde el inicio de la Revolución Industrial. La década de 1950 marca una aceleración de su crecimiento (gráficos originales en W. Steffen, W. Broadgate, L. Deutsch, O. Gaffney y C. Ludwig (2015) “The trajectory of the Anthropocene: The Great Acceleration” The Anthropocene Review 2, 81-98). Imagen tomada de WWF (2018) “Informe Planeta Vivo-2018: Apuntando más alto”. M. Grooten y R.E.A. Almond (Eds.), Suiza.

Figura 1. Tasas de cambio en las concentraciones de gases de efecto invernadero desde el inicio de la Revolución Industrial. La década de 1950 marca una aceleración de su crecimiento (gráficos originales en W. Steffen, W. Broadgate, L. Deutsch, O. Gaffney y C. Ludwig (2015) “The trajectory of the Anthropocene: The Great Acceleration” The Anthropocene Review 2, 81-98). Imagen tomada de WWF (2018) “Informe Planeta Vivo-2018: Apuntando más alto”. M. Grooten y R.E.A. Almond (Eds.), Suiza.La asociación de los humanos con las regiones costeras se remonta a las primeras civilizaciones, cuando nos concentramos en las desembocaduras de los ríos, deltas y estuarios, debido a la disponibilidad de alimentos abundantes y accesibles. Durante el siglo XX, la zona costera ha cambiado profundamente a medida que las poblaciones humanas iban creciendo y los ambientes costeros se ocupaban para la agricultura, la urbanización y la industria. Gran parte de la población mundial vive hoy en las áreas costeras con una densidad 3 veces superior al promedio mundial y la mayoría de las megaciudades planetarias también se encuentran en la costa. Sin embargo, los registros instrumentales y geológicos muestran que la velocidad de aumento reciente del nivel marino es anómala con respecto a los últimos miles de años y muchas zonas costeras se encuentran ahora amenazadas. Se ha observado globalmente una transición en el ascenso marino desde valores relativamente bajos durante el Holoceno superior (3 mm/año.

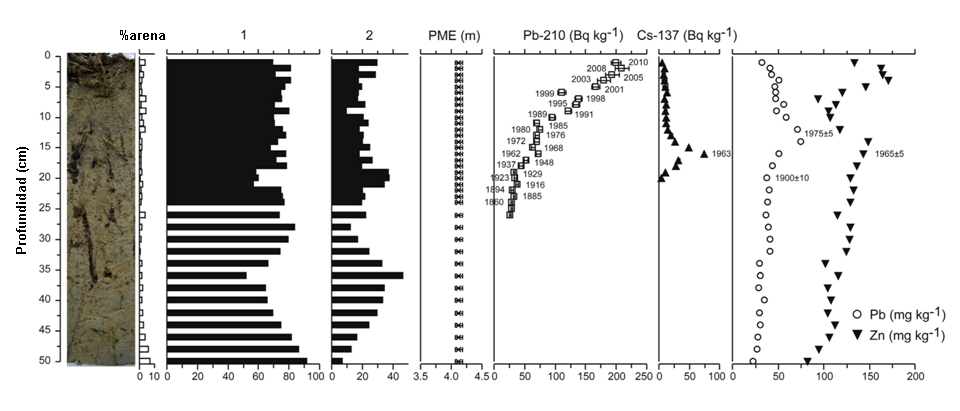

El estudio del nivel marino es un campo muy interdisciplinar y de creciente importancia. En el 1º informe de evaluación del IPCC (1990) no había referencia alguna a los cambios en el nivel del mar anteriores al siglo XX. Ya en el 3º informe de evaluación (2001) se incorporó el cambio del nivel marino a escalas de tiempo más largas, pero sólo en el 4º informe (2007) se agrupó la información geológica sobre el paleoclima en un solo capítulo, como asimismo se ha hecho en el 5º y último informe de evaluación (2013). Los registros instrumentales del nivel del mar comenzaron con el mareógrafo de Ámsterdam en 1682 y la altimetría de precisión por satélite se inició tras el lanzamiento del TOPEX/Poseidon a finales de 1992. Estos datos han demostrado que las velocidades de cambio del nivel del mar varían regionalmente y a escalas temporales de décadas debido a cambios en la densidad del océano. Es ahí donde los datos geológicos se hacen necesarios para poder situar estas estimaciones instrumentales en un contexto temporal a más largo plazo (Figura 2).

Figura 2. Fotografía del testigo, contenido en arena, principales especies de microfósiles (1: Entzia macrescens; 2: Trochammina inflata), elevación de la paleomarisma (PME), actividad de los radioisótopos Pb-210 y Cs-137 y distribución del Pb y Zn durante los últimos 300 años en un sondeo perforado en la marisma de Murueta (Reserva de la Biosfera de Urdaibai). Imagen modificada de A. García-Artola, A. Cearreta y E. Leorri (2015) “Relative sea-level changes in the Basque coast (northern Spain, Bay of Biscay) during the Holocene and Anthropocene: The Urdaibai estuary case” Quaternary International 364, 172-180. DOI: 10.1016/j.quaint.2014.06.040

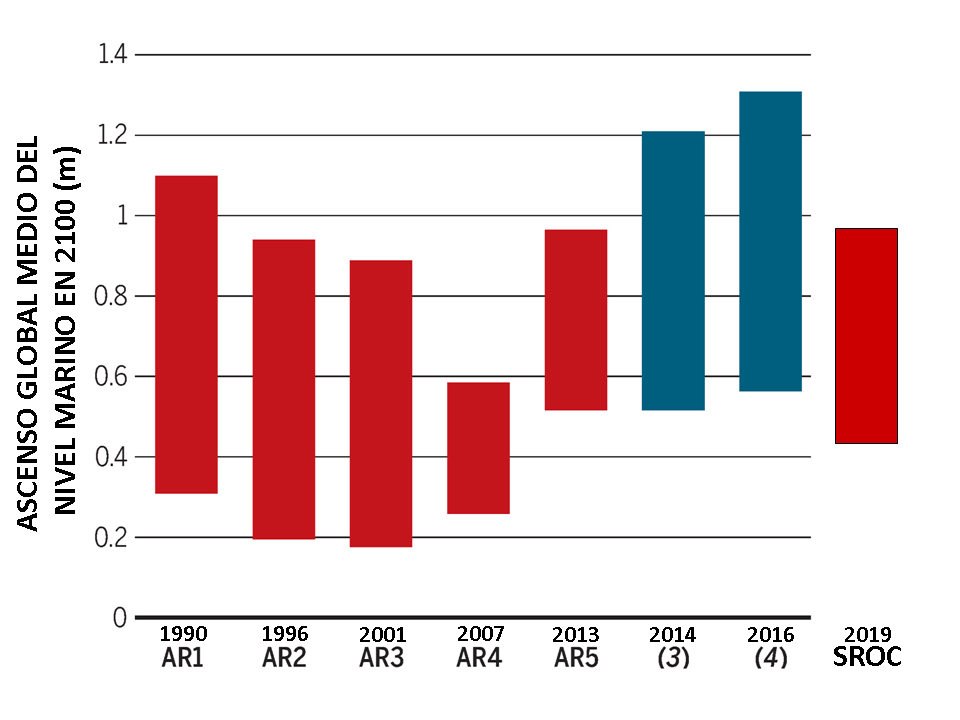

Figura 2. Fotografía del testigo, contenido en arena, principales especies de microfósiles (1: Entzia macrescens; 2: Trochammina inflata), elevación de la paleomarisma (PME), actividad de los radioisótopos Pb-210 y Cs-137 y distribución del Pb y Zn durante los últimos 300 años en un sondeo perforado en la marisma de Murueta (Reserva de la Biosfera de Urdaibai). Imagen modificada de A. García-Artola, A. Cearreta y E. Leorri (2015) “Relative sea-level changes in the Basque coast (northern Spain, Bay of Biscay) during the Holocene and Anthropocene: The Urdaibai estuary case” Quaternary International 364, 172-180. DOI: 10.1016/j.quaint.2014.06.040Durante el siglo XX, el nivel del mar ha aumentado globalmente unos 30 cm y la magnitud del ascenso del nivel marino previsto para este siglo es un tema muy controvertido. Las últimas proyecciones del IPCC (2019) auguran un aumento medio del nivel del mar a finales del siglo XXI de 28–57 cm para un escenario con reducción drástica de las emisiones de efecto invernadero, y de 55–140 cm si hubiese un crecimiento de estas emisiones. Otras estimaciones recientes sugieren que el ascenso medio global del nivel del mar podría incluso superar los 150-200 cm en el año 2100 (Figura 3). Esta diferencia en las previsiones refleja las grandes incertidumbres que existen sobre el comportamiento futuro de los casquetes glaciares de Groenlandia y Antártida.

Figura 3. Las distintas proyecciones del nivel marino para el año 2010 realizadas a partir de modelos han variado mucho a lo largo del tiempo desde la publicación del Primer Informe de Evaluación del IPCC (AR1) en 1990 hasta el último Informe Especial sobre el Océano y la Criosfera (SROC) de 2019. Imagen modificada de M. Oppenheimer y R.B. Alley (2016) “How high will the seas rise?” Science 354, 1375-1377. DOI: 10.1126/science.aak9460

Figura 3. Las distintas proyecciones del nivel marino para el año 2010 realizadas a partir de modelos han variado mucho a lo largo del tiempo desde la publicación del Primer Informe de Evaluación del IPCC (AR1) en 1990 hasta el último Informe Especial sobre el Océano y la Criosfera (SROC) de 2019. Imagen modificada de M. Oppenheimer y R.B. Alley (2016) “How high will the seas rise?” Science 354, 1375-1377. DOI: 10.1126/science.aak9460El aumento del nivel del mar tiene una amplia gama de efectos sobre las zonas costeras que incluyen la inundación y pérdida de marismas, la erosión de playas, dunas y acantilados, la incursión de agua salada en acuíferos y centros urbanos, y el desplazamiento general de los ecosistemas costeros hacia tierra. La magnitud de estos impactos y sus consecuencias estarán asociadas, además, con los efectos de otros procesos humanos que han estado operando en el litoral durante décadas, como la disminución del aporte fluvial de sedimentos, la extracción de aguas subterráneas o la ocupación de las tierras costeras.

La duración del Antropoceno hasta ahora ha sido geológicamente muy breve, equivalente a una vida humana, pero sus impactos ya han cambiado de manera irrevocable el curso futuro de la historia de nuestro planeta. Algunos de estos cambios son irreversibles, incluso si la humanidad y sus efectos ambientales desaparecieran mañana mismo, y sus consecuencias persistirán durante siglos, milenios y millones de años.

Para saber más:

C.N. Waters, J. Zalasiewicz, C. Summerhayes, A.D. Barnosky, C. Poirier, A. Gałuszka, A. Cearreta, M. Edgeworth, E. Ellis, M.A. Ellis, C. Jeandel, R. Leinfelder, J.R. McNeill, D. deB. Richter, W. Steffen, J. Syvitski, D. Vidas, M. Wagreich, M. Williams, A. Zhisheng, J. Grinevald, E. Odada, N. Oreskes, y A.P. Wolfe (2016) “The Anthropocene is functionally and stratigraphically distinct from the Holocene” Science 351, 137 (aad2622.1-aad2622.10). DOI: 10.1126/science.aad2622

C. Summerhayes y A. Cearreta (2019) “Chapter 6. Climate Change and the Anthropocene” En: J. Zalasiewicz, C.N. Waters, M. Williams y C.P. Summerhayes (Eds.), The Anthropocene as a geological time unit: A guide to the scientific evidence and current debate. Cambridge University Press, 200-241. DOI: 10.1017/9781108621359

Sobre los autores: Alejandro Cearreta y Ane García Artola pertenecen al Departamento de Estratigrafía y Paleontología de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Geología, Antropoceno y cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Verdín, eucaliptos y cambio climático

- Los ecosistemas acuáticos de África y el cambio climático

- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

Gerty Theresa Cori (1896-1957): Glukogenoaren prozesua argitzen

Demagun spinning klase batean gaudela eta gorputzak energia behar duela, baina une horretan muskuluak ez duela oxigeno nahikorik. Orduan, Coriren zikloa aktibatzen da: muskulu-ehunean dagoen glukosa laktato bihurtzen da hartzidura laktiko prozesu baten bitartez, hau da, laktatoa birziklatu egiten da muskuluak behar duen glukosa lortzeko. Baina laktatoa soilik gibelean bihur daiteke glukosa. Hortaz, odolaren bitartez iristen da gibelera eta bertan bihurtzen da glukosa. Azkenik, giharrera itzuliko da berriz zikloa osatuz. Prozesu hori aurkitzeagatik jaso zuen Gerty Corik Medikuntzako Nobel saria 1947an –bere senarra eta Bernardo Houssay-ekin batera–; sari hori irabazi zuen hirugarren emakumea izan zen, eta lehenengoa Fisiologia eta Medikuntza alorrean.

1. irudia: Gerty Theresa Cori biokimikaria (Argazkia: Wikimedia / National Library of Medicine – Jabego publikoko irudia)

Diskriminazioa eta soldata baxuaGerty Cori Pragan jaio zen (Txekiar Errepublika, 1896). Medikuntza ikasi zuen hiriko Medical School of German Unibertsitate prestigiotsuan eta 1920an graduatu zen. Bertan, Carl Ferdinand Cori ezagutu zuen, gerora bere senarra izango zena. Ezkondu eta berehala, biak Vienara joan ziren bizitzera. Bertan, Children’s Carolinen Hospital izenekoan hasi zen lanean pediatra gisa; bere senarra, berriz, laborategi batean. Gertyk gustuko zuen bere lana baina era berean ikerketarako grina pizten hasi zitzaion. Horretaz gain, artikulu zientifikoak publikatzen hasi zen; lehenengoak odolari buruzkoak izan ziren, adibidez.

Edonola ere, Lehen Mundu Gerraren eraginez, Ameriketako Estatu Batuetara emigratu behar izan zuten. New Yorkera iritsi zirenean, Gaixotasun Gaiztoak ikertzeko Estatuko Institutuan hasi ziren lanean, eta, besteak beste, karbohidratoen metabolismoen inguruko ikerketak abiatu zituzten. Biokimikari gisa lan egin zuten biek ala biek baina Gertyren soldata askoz ere baxuagoa izan ohi zen. Hori gutxi balitz, hainbat unibertsitatek bakarrik bere senarra kontratatzeko asmoa zuten, biek prestakuntza bera izan arren. Hori dela eta, Carlek beti azaltzen zuen bere emaztearekin lan egin nahi zuela baina, tamalez, ez zioten kasu handirik egiten.

2. irudia: Gerty Cori eta Carl Cori biokimikariak laborategian. (Argazkia: Wikimedia / Silvia Semeraro – Creative Commons Attribution-Share Alike 4.0 International lizentziapean)

Modu berean, elkarrekin egindako ikerketen azalpenak argitaratzen zituztenean –The Journal of Biological Chemistry bezalakoetan, esaterako– oso gutxitan agertzen zen Gertyren sinadura bakarrik. Edozein kasutan ere, pairatu zuen diskriminaziorik handiena 1931n jazo zen. Bere senarra Washingtoneko Medikuntzako Eskolan ikertzaile gisa hasi zen lanean eta bere emaztea lankide izan nahi zuenez, lanpostu bat eskatu zuen harentzat. Hori lortu ahal izateko, haren esperientzia eta ezagutza zein zen azaldu zien. Alabaina, Gerty onartu zuten baina ikertzaile laguntzaile gisa, eta gutxiago kobratuz, jakina. Ia hamar urte geroago lortu zuen irakasle laguntzailea izatea, eta geroago, irakasle titular gisa aritzea.

Biokimika hauspotuzEstatu Batuetan zeudela, azukrearen funtzionamendua animalietan, eta intsulina eta epinefrinaren efektuak ikertu zituzten. Ondoren, karbohidratoen metabolismoari buruzko lanak ere egin zituzten. Halaber, glukosa-1-fosfato molekula islatzea lortu zuten, “Cori éster” izenaz ezagutzen dena, alegia. Izan ere, igelaren giharra ikertuz, aurkitu zuten glukogenoaren degradazioa ahalbidetzen zuen konposatu hori. Horrekin batera, haren egitura argitu zuten, baita glukogenoa katalizatzeko gai den entzima ere: glukogeno fosforilasa. Geroxeago, eta lehen aipatu moduan, Coriren zikloa argitzea lortu zuten.

3. irudia: Gerty Cori eta Carl Cori 1947. urtean Medikuntzako Nobel saria jasotzen joan zirenean. (Argazkia: Wikimedia / Silvia Semeraro – CC BY-SA 4.0 lizentziapean)

Lan hori egiteagatik esleitu zitzaion Nobela. Zoritxarrez, saria jaso eta berehala, mieloesklerosia diagnostikatu zioten, hezur-muinaren gaixotasun hilgarri bat. Alabaina, Gertyk biokimika alorrean ikertzen jarraitu zuen 1957an zendu zen arte. Bere azken urteetan, glukogenosia izan zuen ikergai, glukogenoa metatzearen kariaz sortzen diren gaixotasunak, alegia.

Ez zen bizitza osoan gelditu, eta bere lanek eta ikerketek fruituak eman zituzten. Sariei dagokienez, esan beharra dago mordoa lortu zituela: Garvan-Olin Domina (1948), St. Louis Saria (1948) eta Borden Saria (1951) dira aipatzekoak, besteak beste. Gainera, Estatu Batuetatik barna banatu zen zigilu batek omendu zuen bere lana 2008an; irudian glucosa-1-fosfatoaren formula kimikoa agertzen zen baina irudiek akats bat zeukaten, formula gaizki inprimatu zuten. Halaber, National Science Fundazioko eta Ameriketako Estatu Batuetako Zientzien Akademia Nazionaleko kide izan zen. 2004. urtean, Ameriketako Kimikako Elkarteak National historial Chemical Landmark gisa izendatu zituen Coritarrak.

Gerty Coriren lanak mugak hautsi zituen; emakume horren izenak ilargirainoko oihartzuna izan zuen. Eta ez, ez da esajerazioa, izan ere, Ilargiko krater bati Cori izena jarri zioten haren eta senarraren aurkikuntzen omenez.

Iturriak:

- Biografías y Vidas: Gerty Theresa Cori

- Mujeres con ciencia: La doctora reconocida, Gerty Cori (1896-1957)

- The Nobel Prize: Gerty Cori

———————————————————————–

Egileaz: Uxue Razkin (@UxueRazkin) kazetaria da.

———————————————————————–

The post Gerty Theresa Cori (1896-1957): Glukogenoaren prozesua argitzen appeared first on Zientzia Kaiera.

Por qué nos fascinan los neandertales

![]()

Réplica de un cráneo neandertal en la cueva de San Miguel (St. Michael’s Cave), Gibraltar. Boaski / Flikr

Réplica de un cráneo neandertal en la cueva de San Miguel (St. Michael’s Cave), Gibraltar. Boaski / FlikrEntre los muchos enigmas de la ciencia prehistórica que provocan fascinación, tanto a científicos como al público interesado, la desaparición de los neandertales ocupa un lugar privilegiado.

Los neandertales poblaron Europa y Asia occidental desde hace unos 300.000 años y desaparecieron hace poco más de 40.000, coincidiendo con la llegada a Europa de los Humanos modernos –nuestra especie– tras su salida de África. Este último es uno de los períodos más críticos en la Prehistoria humana, pues no sólo incluyó un cambio de poblaciones definitivo, sino también una importante transformación cultural.

Dicha transformación supuso el asentamiento en todo el viejo mundo de los comportamientos complejos que caracterizarían el posterior desarrollo de las formas de vida asociadas a nuestra especie. Los prehistoriadores llevamos más de un siglo discutiendo sobre los factores y características de estos procesos de cambio, sin haber consensuado aún interpretaciones plenamente satisfactorias.

Las implicaciones ideológicas que supone el estudio de un pariente evolutivo tan cercano a la humanidad actual, y por tanto vital para entendernos a nosotros mismos, han provocado que la investigación de los neandertales haya estado históricamente cargada de prejuicios y mitos diversos. Sin embargo, los avances teóricos y metodológicos de las últimas décadas han permitido que actualmente el problema sobre su desaparición se plantee como una de las controversias científicas de mayor complejidad en el campo de la Prehistoria.

“El mito”, o la historia de la investigación sobre los neandertales

La investigación de Homo neanderthalensis, como se denominó la especie definida a partir de los restos humanos encontrados en 1856 en el valle de Neander (Alemania), es uno de los mejores ejemplos de cómo en ocasiones la ciencia puede verse influida por el contexto histórico en el que se desarrolla.

Las implicaciones ideológicas y sociales que conllevó el reconocimiento de una humanidad remota, distinta pero emparentada con la actual, inauguraron una tradición investigadora sobre los Neandertales en la que éstos, de forma más o menos directa, han sido objeto de prejuicios e ideologías de distinto pelaje.

Valle de Neander. Cordula / Wikimedia Commons

Valle de Neander. Cordula / Wikimedia CommonsLas primeras interpretaciones que acusaron estas influencias externas a la ciencia se dieron ya desde finales del siglo XIX y principios del XX, en un contexto de fuerte oposición a la teoría de la evolución formulada por Darwin solo tres años después del descubrimiento de los restos de Neander. Entonces, una compleja mezcla de ideas racistas, colonialistas y religiosas contribuyeron a dibujar un neandertal troglodítico y animalizado, esencialmente distinto a nosotros, para el que en todo caso se tenían aún muy pocas evidencias arqueológicas y paleontológicas.

Tras la Segunda Guerra Mundial, las ideologías dominantes viraron para fomentar la imagen de un neandertal más humanizado y capaz. Sin embargo, durante los años 80 el péndulo volvió a oscilar y la visión del neandertal basculó hacia interpretaciones que le volvían a alejar de la humanidad moderna, tanto en capacidades culturales como en naturaleza biológica.

Es esta última visión, y en cierto modo las reminiscencias de las imágenes animalizadas de principios de siglo, la que cuestionan la mayoría de los investigadores desde hace tres décadas, y a la cual suelen enfrentar sus investigaciones.

Podemos situar en la última década del siglo XX el comienzo de una etapa historiográfica, la actual, en la que la investigación sobre los neandertales ha alcanzado una verdadera madurez científica. Aunque las implicaciones ideológicas que supone el estudio de este tipo humano siguen flotando en el ambiente, el asentamiento de la Prehistoria como una ciencia interdisciplinar, con métodos y técnicas avanzados, ha hecho que nuestro conocimiento actual de esta especie humana se encuentre fundamentalmente basado en evidencias y pruebas empíricas. Algunas de ellas presentan una solidez científica que apenas podía ser imaginada pocos años atrás.

Por ello, el enigma de la desaparición de los neandertales, históricamente cargado de tópicos y prejuicios, es hoy investigado como un complejo problema científico de primera magnitud. Arqueólogos, paleoantropólogos, geólogos, ecólogos o físicos, entre otros, aúnan esfuerzos para recomponer un puzle poliédrico y, como siempre en Prehistoria, parcial e incompleto.

Por tanto, puede concluirse sin ambages que, en los últimos años, las influencias externas a la investigación meramente científica han perdido fuerza para dejar paso a marcos de trabajo cada vez más objetivos. Hemos pasado del mito al logos.

“El logos”, o la investigación interdisciplinar de un problema científico

El planteamiento tradicional del problema de la desaparición neandertal se hacía en términos simples y dicotómicos. O bien nuestra especie, superior en biología y tecnología, protagonizó un proceso de suplantación poblacional, más o menos violento y a escala continental, o bien los neandertales evolucionaron cultural y anatómicamente hacia las formas modernas de Homo sapiens.

Hoy en día se da la situación paradójica (en realidad bastante habitual en ciencia) de que, sabiendo bastante más sobre el problema, somos incapaces de defender teorías tan definidas. Las nuevas evidencias arqueológicas, paleontológicas, geológicas, paleoecológicas y paleogenéticas nos han empujado progresivamente a abandonar la idea de un proceso de cambio único y monolítico, y valorar, por el contrario, marcos interpretativos basados en la variabilidad regional y cronológica.

Hoy sabemos que neandertales y Humanos modernos tuvieron descendencia fértil en varios momentos y regiones geográficas, pero aún desconocemos si esos procesos de hibridación fueron responsables de la desaparición (en este caso asimilación) de los neandertales en toda su extensión geográfica. Sabemos también que los neandertales fueron capaces de desarrollar tecnologías y estrategias de subsistencia complejas durante el Paleolítico medio, pero no tenemos aún la seguridad de que dichas estrategias contribuyeran directamente al posterior desarrollo cultural del Paleolítico superior.

Sabemos que los neandertales tuvieron la inteligencia e inquietudes necesarias para desarrollar comportamientos simbólicos, incluyendo probablemente la creación de las primeras grafías pintadas en cuevas, pero se discute si dichos comportamientos fueron recurrentes, o incluso si los métodos utilizados para su verificación son fiables.

Comparación de un cráneo de Homo sapiens y de un neandertal. Wikimedia Commons

Comparación de un cráneo de Homo sapiens y de un neandertal. Wikimedia CommonsHasta hace poco creíamos saber que neandertales y Humanos modernos convivieron durante milenios en distintas regiones europeas, pero el refinamiento de los métodos de datación nos ha obligado a cuestionar fuertemente esa idea. Igualmente, creíamos saber que los neandertales estaban especialmente adaptados a climas fríos, pero hoy se baraja la hipótesis de que la variabilidad climática fuera un factor relevante para su desaparición.

Nos encontramos en un momento de grandes cambios teóricos e interpretativos, en el que el final de los neandertales se estudia desde un marco interdisciplinar alejado de los mitos y prejuicios del pasado, por más que en ocasiones estos traten de volverse a incluir en escena. Al obtener evidencias cada vez más certeras en distintos ámbitos, el problema se hace aún más complejo, y evitamos las respuestas simplistas y viciadas que se han propuesto en el pasado.

Son especialmente relevantes los proyectos de investigación a escala regional realizados con metodologías modernas e interdisciplinares, cada vez más numerosos y relevantes en la península ibérica. Precisamente, esta macro región geográfica se ha revelado clave para estudiar el final de los neandertales y el primer poblamiento europeo de Humanos modernos, pues es probable que aquí se produjeran los últimos episodios de este complejo proceso de cambio biocultural.

Y aunque nuestras respuestas probablemente nunca serán definitivas, si mantenemos el pensamiento crítico y el método científico como guías, sin duda se acercarán cada vez más a la realidad prehistórica.![]()

Sobre el autor: Manuel Alcaraz Castaño es investigador en arqueología del Paleolítico en la Universidad de Alcalá

This article is republished from The Conversation under a Creative Commons license. Original article.

El artículo Por qué nos fascinan los neandertales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Neandertales ¿crónica de una muerte anunciada?, por María Martinón-Torres

- La cronología de la desaparición de los neandertales

- Los neandertales respiraban de otra manera

Datos que entran por los ojos

Si uno le pregunta a Google Images qué es un una gráfica, puede encontrarse con un esperpento como el siguiente:

Más allá de la fealdad generalizada y los colores estridentes, la web y los medios de comunicación están plagados de ejemplos de malas representaciones de datos. Ejemplos donde el artificio y la ornamentación pervierten la función de estas poderosas herramientas.

¿Qué es una gráfica entonces? Dado que Google no parece ser de gran ayuda en este caso, yo os propongo la siguiente definición: una gráfica es una representación de datos numéricos mediante recursos visuales que permite interpretarlos y extraer información de ellos. Las gráficas son herramientas de comunicación para un tipo de mensaje muy determinado (los datos) y un tipo de receptor muy determinado (monos con buenos ojos), y como tal, utilizan un código muy especializado.

Los ojos son nuestra principal fuente de información. Se estima que nuestras retinas reciben unos 10 Gbps de información, de los cuales, pasan por el nervio óptico unos 100 Mbps hasta nuestro córtex visual. De hecho, según calculan los neurocientíficos, al menos un tercio de nuestro cerebro está ocupado procesando información visual. Por eso, a veces, cerramos los ojos cuando intentamos concentrarnos: para ser capaces de destinar más recursos a pensar o recordar mejor. En realidad, no es que tengamos una vista muy buena en comparación con otras especies. En lo que realmente somos buenos es en el análisis de la imagen, en extraer información útil a partir de lo que vemos… como caras de otros monos o un león camuflado en las hierbas.

En cambio, nuestra memoria de trabajo es bastante más modesta. Quizás resulte familiar la conocida como ley de Miller: “the magic number seven, plus or minus two1”. Es uno de los artículos más citados en psicología y, aunque ha sido revisada y matizada posteriormente, viene a decir que, en general, los humanos no podemos retener más de 7 elementos o grupos en nuestra memoria a corto plazo. Es decir, que si nos dan un listado de, pongamos, 10 cosas, nos va a resultar difícil retenerlas todas a la vez en nuestra cabeza y hacer comparaciones entre ellas mentalmente.

Por tanto, la magia de la visualización de datos consiste en convertir “cifras” (números abstractos que requerirían nuestra pobre memoria para ser comparados) en estímulos visuales, de esos que somos tan buenos en analizar.

Por poner un ejemplo, os proponemos encontrar el número más alto en tres tipos de representaciones distintas:

En la primera representación, habréis tenido algunos problemas para encontrarlo, y probablemente hayáis escaneado varias veces la lista, hacia arriba y hacia abajo, para recordar un número o comprobar otra vez dónde estaba la coma de los decimales. En la segunda representación, las cifras están estandarizadas para mostrar dos posiciones decimales. Una vez visto este detalle, la alineación a la derecha hace que encontrar el número más grande sea prácticamente inmediato, dado que “sobresale” hacia la izquierda más que los demás. Pero fijaos que ya hemos recurrido a un truco visual, tomando un atajo que nos permite evitar la memorización, y esto se hace especialmente evidente en la representación final en forma de gráfica.

Existe otro ejemplo muy representativo del poder de nuestros ojos procedente, en este caso, del mundo de los juegos. El juego es como sigue:

- Hay 2 jugadores.

- Cada jugador escoge un número del 1 al 9 en su turno.

- Una vez un número es escogido, nadie puede volver a usarlo.

- Gana el jugador que primero sume 15 usando 3 números.

Planteado de esta manera, es posible que al lector le cueste hacerse a una idea de en qué consiste el juego o qué estrategia elegir. Parece ciertamente complejo. Jugar requiere retener en la memoria una lista de los números escogidos, las posibles sumas que se forman con ellos y los números eliminados por el otro jugador. Todo un dolor de cabeza. Sin embargo, este mismo juego puede presentarse de manera visual, simplificándose enormemente: Esta representación visual resume todas las posibles combinaciones, ya que cualquier fila, columna o diagonal suma 15; nos revela, además, algunas propiedades interesantes de estos números. Por ejemplo, el 5 participa en más sumas cuyo resultado es 15 que ningún otro número (ya que se encuentra en el centro de la distribución). Los números pares participan, cada uno, en 3 sumas. Los números impares sólo pueden formar 2 sumas. Son propiedades matemáticas que podríamos haber deducido de haber analizado en detalle el problema inicial. Pero la representación visual nos permite pensar de manera visual, sin abstracciones previas.

Esta representación visual resume todas las posibles combinaciones, ya que cualquier fila, columna o diagonal suma 15; nos revela, además, algunas propiedades interesantes de estos números. Por ejemplo, el 5 participa en más sumas cuyo resultado es 15 que ningún otro número (ya que se encuentra en el centro de la distribución). Los números pares participan, cada uno, en 3 sumas. Los números impares sólo pueden formar 2 sumas. Son propiedades matemáticas que podríamos haber deducido de haber analizado en detalle el problema inicial. Pero la representación visual nos permite pensar de manera visual, sin abstracciones previas.

En definitiva, la gracia de las gráficas y de las representaciones visuales de cualquier tipo de problema es que convierten datos abstractos, que nuestra memoria de trabajo no puede retener, en estímulos perceptivos, que entran en nuestra cabeza sin necesidad de mediación, sin necesidad de que comprendamos y retengamos cada uno de esos numeritos. Esto las convierte, a su vez, en un arma enormemente peligrosa. Precisamente porque las gráficas hacen innecesario el proceso de lectura (de interpretación mediada y meditada de los datos), es muy fácil engañar y distorsionar los datos recurriendo a su poder.

Referencia:

1Miller, G. A. (1956). “The magical number seven, plus or minus two: Some limits on our capacity for processing information”. Psychological Review. 63(2): 81–97

Sobre los autores: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica. Iñaki Úcar es doctor en telemática por la Universidad Carlos III de Madrid e investigador postdoctoral del UC3M-Santander Big Data Institute.

El artículo Datos que entran por los ojos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sal de la piscina si te pican los ojos y no mezcles lejía con amoniaco

- #Naukas14 Arqueología de datos

- Colonialismo científico: los investigadores africanos se rebelan contra el expolio de datos genéticos

Plaka-tektonika: 50 urte eta sasoian

Plaka-tektonikaren aurretik geologiako arlo desberdinetako ikerketek eta ezagutzak ibilbide propioak egiten zituzten, beraien arteko loturarik gabe. Tolesak eta failak deskribatuta eta sailkatuta zeuden, bolkan mota desberdinak ezagutzen ziren, arroka igneoak ezaugarri geokimikoen bidez bereizten ziren, arroka sedimentarioen egiturak eta bakoitzaren esanahia definituta zeuden, ……. baina plaka-tektonikak beraien arteko loturak definitzeko gaitasuna erakutsi du, prozesu horien guztien jatorria eta arrazoiak erakusteaz gain.

Benetan garrantzitsuak izan diren zientzia-ideiek, une jakin bat iritsi arte erantzunik gabe egon diren zenbait arazo konpontzeko gaitasuna erakutsi ohi dute, eztabaidagunean gertatu direnean diruditen bezain bakunak, argiak eta intuitiboak izateaz gain. Plaka-tektonika da horren adibide egokietako bat; izan ere, azaldu dezake Himalaiaren garaiera, munduan gertatzen diren lurrikaren jatorria, Australiako martsupialen agerpena, arroka bolkanikoen ezaugarri kimikoak zein ozeanoen sakonera eta morfologia.

1915. urtean Alfred Wegener poloetako esploratzaile eta meteorologo alemanak zabaldu zuen eztabaida kontinenteetako jitoaren ideiaren karira. Hego Amerika eta Afrikako kostaldeen antzekotasunaz ohartuta, iradoki zuen kontinenteak ez direla estatikoak eta denborarekin horizontalean mugitzeko gaitasuna dutela. Hala ere, bere ideiak alboratuta geratu ziren, bai Munduko Gerraren osteko alemanen aurkako sentimenduak zirela kausa, bai eta ezin izan zuelako kontinenteak mugiarazteko mekanismo fidagarririk iradoki

Bigarren Mundu Gerran garatutako sonarrak eta magnetometroak helburu militarretatik urrundu eta zientzia-helburuekin erabili zirenean iritsi zen iraultza; hala gertatu zen ozeanoen morfologia ezagutu ahala, ozeano-gandorretan plakak sortu eta subdukzio-eremuetan deusezta zitezkeela iradoki zenean. Ozeanoen ezagutzak ekarri zuen plaka-tektonikaren sorrera.

Egun, Lurraren 150 km-ko azal zurruna edo litosfera (lurrazala gehi mantu zati bat) 15 plaka nagusitan dago banatuta (1. irudia). Plaka horiek etengabeko mugimenduan dihardute, gure azazkalak hasten diren abiadura berbera hartuta eta ondorioz elkarrengandik urrundu, hurbildu edo zeharka mugituta.

1. irudia: Lurraren azaleko 15 plaka nagusiak eta beraien arteko mugimendu erlatiboak. (Iturria: U.S. Geological Survey – USGS)

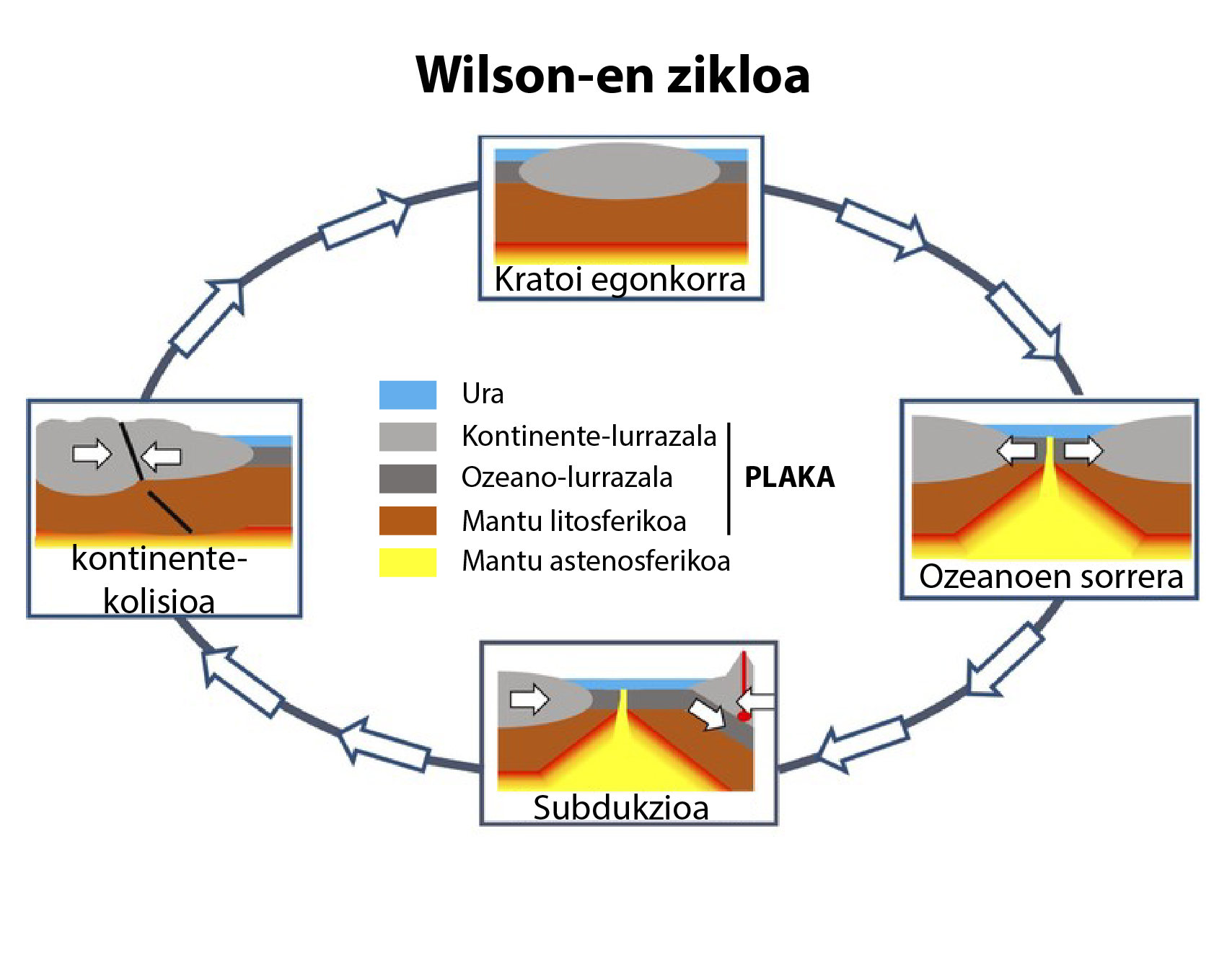

Erradiometriako datazioek adierazten dute ez dagoela 200 Ma baino zaharragoa den ozeanorik eta kontinenteak aldiz, askoz zaharragoak izan daitezkeela. Horrek erakusten du Lurraren bilakaeran ozeanoak sortu eta desagertu egiten direla “Wilsonen zikloa” deritzon prozesuaren bidez (2. irudia).

Kontinente guztiak elkarren ondoan egon zirenetik, Pangea superkontinentea eratuz, urrunduz joan dira. Adibidez, Afrika eta Hego-marra kendu Amerika elkarren ondoan egon ziren baina estentsio-indarren eraginpean urrunduz joan dira eta bien artean ozeano Atlantikoa garatu da. Izan ere, egun Atlantikoak handitzen dihardu, ozeanoaren erdiko gandorrean material berria sortzen ari baita. Ondorioz, Galiza eta Ipar Amerikako kostaldearen arteko distantzia urtero zenbait zentimetro handiago bilakatzen ari da.

2. irudia: “Wilsonen zikloaren” eskema erraztua. (Iturria: Philip Heron, CC BY lizentziapean)

Ozeanoak aldiz, itxi eta desagertu egiten dira ozeano-litosferak beste plaken azpitik barneratzen direnean subdukzioa deritzon prozesuaren bidez. Hego Ameriketako Pazifikoko kostaldean Nazka ozeano-plaka Hego Ameriketako kontinente-plakaren azpitik mantuan barneratzen ari da eta prozesu motel baina etengabearen eraginez Ande mendikatea eratu da.

Ozeano-litosfera sortu egiten deneko plaken arteko muga eratzailez eta ozeano-litosfera suntsitzen deneko plaken arteko muga suntsitzaileaz gain, plaken arteko beste muga mota bat dago. Horretan plaka bat bestearekiko horizontalki mugitzen da, elkar marruskatuz, Ipar Amerikako hego-mendebaldean, San Andreseko faila ospetsuan gertatzen den bezala (1. irudia).

Teoriaren hastapenetan uste zuten plakak mantuko konbekzio-mugimenduen eraginez mugitzen zirela. Aldiz, datuak pilatu ahala ohartu gara subdukzio-eremuetan mantuan hondoratzen den ezpal ozeanikoak eragiten duen indarra (ezpalen tirada edo slab pull) dela mugimenduaren eragile nagusia. Hori ziurtatzeko nahiko da jakitea subdukzio-eremu gehien dituzten plakak (Australia, Pazifiko eta Nazka plakak) direla abiadura handiena erakusten dutenak.

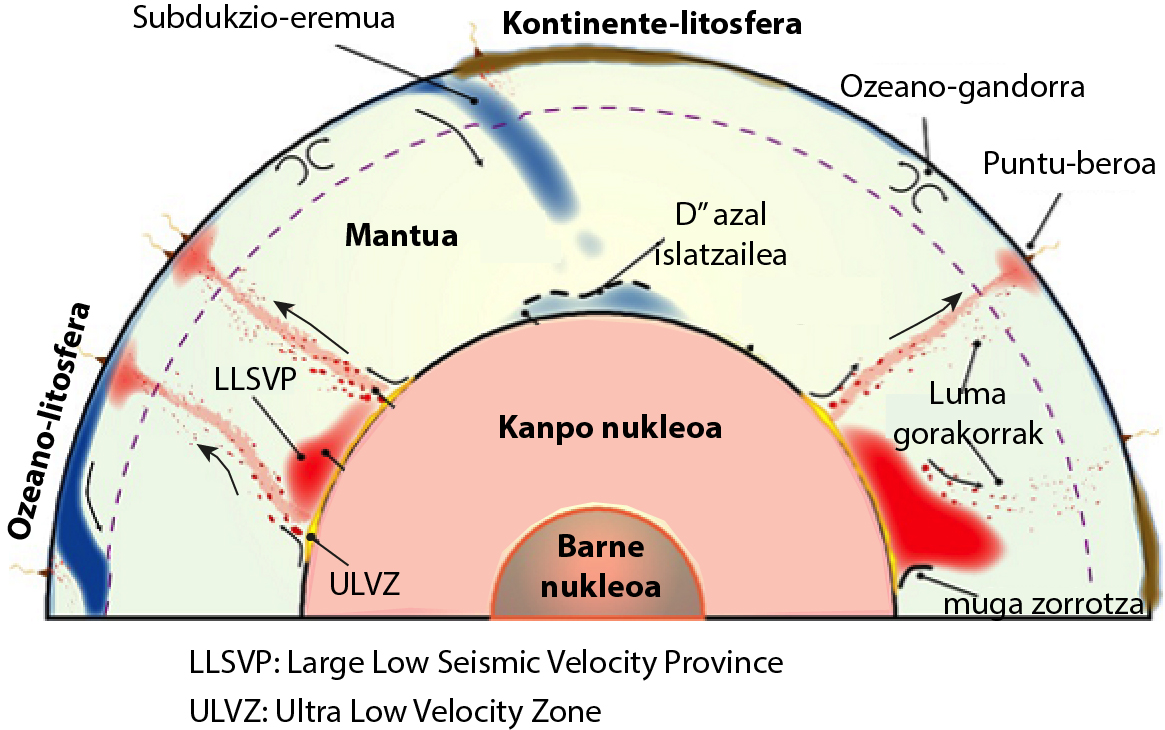

Mantuan hondoratutako ozeano-litosferaren ezpalek konbekzio-korronte beherakorra eragiten dute. Gainera, nukleo eta mantuaren arteko mugan pilatzen direnean, nukleoaren eta mantuaren arteko bero-transferentziari eragiten diote eta mantuko tenperatura altuagoko eremuen kokapena baldintza dezakete. Mantuko tenperatura altuko eremuetatik abiatzen dira kontinenteen-apurketa eta subdukzio-eremu berrien sorrera eragiten dituzten konbekzio-korronte gorakorrak (3. irudia).

3. irudia: Mantuaren dinamikari buruzko eskema erraztua. (Ilustrazioa: Arturo Apraiz – Rost-tik (2013) eraldatuta)

Plaka-tektonika iragan geologikoan eta Lurretik kanpoPlaka-tektonika eta berari lotutako elkarrekintzak Lurraren barneko etengabeko hozketaren ondorio dira. Oso ondo ezagutzen da plaka-tektonikaren ereduak nola jokatzen duen egungo Lurraren ezaugarri fisiko eta kimikoekiko (Apraiz, 2004), baina iraganean Lurraren tenperatura handiagoa zenean, ez dago argi zein izan zitekeen bere jokabidea. Azken ikerketek iradokitzen dute plaka-tektonikarekin lotutako prozesuak orokortu egin zirela orain dela 3.500 eta 2.800 Ma. Aurretik, badirudi Lurrak estalki jarraitua zuela, mugimendurik gabekoa, eta noizean behin, jatorria mantuan zuten magma kopuru handien eraginez puskatu ondoren, estalkia loditu egiten zela eta subdukzio-eremu lokalak garatuko zirela agian (Lenardic, 2018). Beraz, badirudi plaka-tektonika Lurrak baldintza fisiko-kimiko jakin batzuk lortu zituenean baino ez zela garatu. Plaka-tektonikaren aurretik noizbehinkakoak ziren mantuaren, lurrazalaren, hidrosferaren eta atmosferaren arteko elkarrekintzak, baina plaka-tektonika orokortu zenetik aldiz, elkarrekintzak jarraituak izan dira.

Hurrengoko hamarkadetan, zehaztu egin beharko da bizitzeko moduko Unibertsoaren eremuan ezagutzen ari diren milioika exoplanetetan plaka-tektonikaren arrastorik ote dagoen. Egun, Lurra da ezagutzen dugun planeta bakarra plaka-tektonikaren ereduaren arabera jokatzen duena. Eguzki-sisteman adibidez, Artizarra Lurraren antzeko planetatzat jotzen da, baina bien arteko desberdintasun handiak daude, Artizarraren klima jasanezina delako eta ez dagoelako plaka-tektonikaren arrastorik.

Argi dago plaka-tektonikaren garapenak klima jasangarriagoa eragin duela Lurrean, eta ondorioz, bizitza garatzeko aukerak izugarri handitu dituela. Litosfera-plaken sorrerak eta plaka horiek mantuarekin, atmosferarekin eta ozeanoekin garatu dituzten elkarrekintzak, biosfera garatu eta mantendu ahal izateko ingurunea eta baliabideak sortu dituzte.

Gehiago jakiteko:

- Apraiz, A. Plaka-tektonika: Lurraren funtzionamendua ulertzeko teoria. Udako Euskal Unibertsitatea (UEU), 2004, Bilbo.

- Rost, Sebastian (2013). Core-mantle boundary landscapes. Nature Geoscience, 6, 89-90. DOI: https://doi.org/10.1038/ngeo1715

- Lenardic, A. (2018). The diversity of tectonic modes and thoughts about transitions between them”. Philosophical Transactions of the Royal Society of London, 376(2132), pii: 20170416. DOI: http:dx.doi.org/10.1098/rsta.2017.0416

———————————————————————————-

Egileaz: Arturo Apraiz UPV/EHUko Geodinamika saileko irakaslea eta ikertzailea da.

———————————————————————————-

The post Plaka-tektonika: 50 urte eta sasoian appeared first on Zientzia Kaiera.

Cuatro leyes consumadas siguiendo una banda de Möbius

La escritora danesa Solvej Balle (1962) publicó en 1983 Ifølge loven Fire beretninger om mennesket,novelatraducida al castellano como Según la ley. Cuatro relatos sobre el ser humano (Seix Barral, 1995).

Como indica el título, cuatro historias componen este libro. Son cuatro metáforas sobre la búsqueda de la verdad. Son cuatro relatos sobre las obsesiones de otras tantas personas que realizan su peculiar búsqueda para llegar a entender la naturaleza del ser humano.

La banda de Möbius estructura la novela que, a priori, podría parecer formada por relatos independientes. Pero cada historia lleva a la siguiente, y la cuarta conduce inevitablemente a la primera, que reanuda el ciclo interminable del libro. La habitual metáfora de la banda de Möbius, pensada como la cinta del eterno retorno, se muestra de este modo en la novela.

Cuatro son también las leyes que actúan como hilo conductor de esta singular narración, algunas de ellas conocidas leyes científicas. Describimos brevemente cada relato.

1. Ley sobre examen forense y autopsia

De acuerdo con la ley, el cuerpo que después del óbito ofrece dudas sobre la causa de la muerte deberá ser sometido a autopsia.

Ley sobre examen forense y autopsia (Dinamarca)

El bioquímico canadiense Nicholas S. investiga sobre el misterio de la verticalidad del cuerpo humano. Presencia la autopsia de una joven que ha fallecido de hipotermia –se ha suicidado– y que ha donado su cuerpo a la ciencia. Estudia con minuciosidad el cerebro del cadáver en cuya corteza busca ‘un determinado color verde’ que probaría la existencia de una sustancia denominada filodoxa-tri-fosfato que –según una teoría muy controvertida– desempeñaría un papel fundamental en el movimiento bípedo del ser humano…

Si esta sustancia era un error, éste era de la evolución, no suyo. Si la naturaleza había cometido un error, su misión no era ocultarlo.

2. Ley del talión

El que maltrate a su prójimo será tratado de la misma manera; fractura por fractura, ojo por ojo y diente por diente, es decir, recibirá lo mismo que él ha hecho al prójimo.

Levítico, 24:19-21

Tanja L., estudiante de Derecho en Suiza, posee poderes paranormales y sospecha que provoca –en contra de su voluntad– caídas y accidentes, causando de este modo dolor y sufrimientos a otras personas. Desea descubrir la naturaleza del dolor, y para ello viaja a Barcelona, Madrid y París, buscando señales que le ayuden a descifrarlo.

Su búsqueda había sido un malentendido. Había aprendido bastante sobre la fragilidad y la fuerza destructora del ser humano, pero no podía lastimarse con tanta facilidad a una persona.

3. Ley de la gravedad

Dos cuerpos de diferente peso se moverán a la misma velocidad de caída en el vacío.

Ley de la caída de los cuerpos de Galileo

René G. es un matemático danés con un único deseo: no ser nadie.

Deseaba saber hasta qué punto podía acercarse un ser humano a la transparencia del no ser y estaba seguro de que, una vez hubiese alcanzado ese punto cero, podría hacer lo que se esperaba de él, proseguir sus estudios, realizar su trabajo sobre las relaciones entre los teoremas de incompletitud de Gödel y los postulados paralelos no euclidianos, y después pasar el resto de su vida describiendo sosegados círculos alrededor del punto cero humano.

Pero, no es tan fácil…

4. Ley de la termodinámica

En un sistema aislado, los procesos en los que interviene el calor suceden sólo en una dirección

Segunda ley de la termodinámica

Alette V. es una escultora canadiense que se dedica a realizar bustos a los transeúntes. Adora la materia inanimada y sueña con fundirse con ella. En ese afán por desprenderse de su parte humana, decide suicidarse dejándose morir de hipotermia. Así, su cadáver pasará a ser un objeto más en su habitación.

Trasladaba las personas al mundo de los objetos. […] Ella pertenecía a los objetos, pero ¿qué era?

Alette ha donado su cuerpo-objeto a la ciencia… un bioquímico canadiense llamado Nicholas S. conseguirá el cerebro de la fallecida para avanzar en sus investigaciones sobre el misterio de la verticalidad del cuerpo humano…

Nota: Adaptado de “Según la ley. Cuatro relatos sobre el ser humano”, de Solvej Balle, en DivulgaMAT, 2013

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Cuatro leyes consumadas siguiendo una banda de Möbius se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Poesía retorcida sobre banda de Möbius

- La Formación Jaizkibel y sus singulares geoformas “de Möbius”

- El teorema de los cuatro colores (1): una historia que comienza en 1852

Baleen migrazioak oroimenean du oinarri, eta oso aspaldikoa da

Ehunka mila urtetan zehar itsasoetako erregina izan zen espeziea desagertzeko zorian egon zen, gizakiaren presioa zela eta. Eta gaur egun oraindik ere espeziearen egoera ez da suziriak botatzeko modukoa. Balea urdinaz (Balaenoptera musculus) ari gara; dakigula, munduan inoiz egon den animaliarik handienaz, hain zuzen.

IWC Baleen Nazioarteko Batzordeak 1966an debekatu zuen espeziearen ehiza, baina Sobietar Batasuneko flotek 1972. urtera arte ezkutuan ehizatu zituzten. IUCN Naturaren Kontserbaziorako Nazioarteko Erakundeak kudeatzen duen Zerrenda Gorriaren arabera, egun munduan 5.000-15.000 balea geratzen dira.

1. irudia: Satelite bidezko irudien bitartez baleen migrazioa eta krillaren mugimendua alderatu dituzte, eta ikusi dute bi aldagaiak bat datozela. (Argazkia: Thomas Kelley /Unsplash)

Makinaria biologiko erraldoi hau mantentzea ez da erraza. Krustazeo ñimiñoek osatzen duten krilla da baleen elikagai ohikoena, eta janari hori non dagoen jakitea ezinbestekoa dute bizirik iraun ahal izateko. Ez da edonolako kontua: eguneko hiru tona janari prozesatzeko ahalmena du zetazeo hauetako bakoitzak.

Janari hori eskuragarri izateko, ordea, migrazioa egin behar dute. Janaria ur hotzetan lortu ohi duten arren, hainbeste elikagairik ez dagoen ekuatore aldeko ur beroetan hazten dituzte balekumeak. Hau zergatik egiten duten eboluzioaren misterioa da. Teorian, bederen, ur hotzetan kumeak hazteko arazorik ez lukete izango —hala egiten du Balea australak (Eubalaena australis)—. Hipotesi batek dio agian baleek beherago dauden latitudeetan eboluzionatu zutela, bertan elikagaia gehiago zegoen antzinako garai batean, baina gero kontinenteen jitoa gertatu eta gero ur-lasterretan egon ziren aldaketak zirela eta, elikagai horiek guztiek gorago egin zuten. Baleak haien atzetik joan ziren, baina jatorrizko hazte lekuetara itzultzen jarraitu zutela dio hipotesiak.

Dena dela, hipotesi honen aurkako froga indartsua aurkeztu dute aste honetan PNAS aldizkarian. Ikertzaileek ondorioztatu dute baleek aspalditik egiten dutela gaur egun egiten duten migrazio berdina. Aspalditik diogunean, aspalditik diogu: gutxienez 270.000 urte aipatu dute ikerketa honetan. Oxigeno-18 isotopoaren analisian oinarritu dute lana. Alaskan, Kalifornian eta Panaman hartutako datuak baliatu dituzte.