La topología frágil es una extraño monstruo

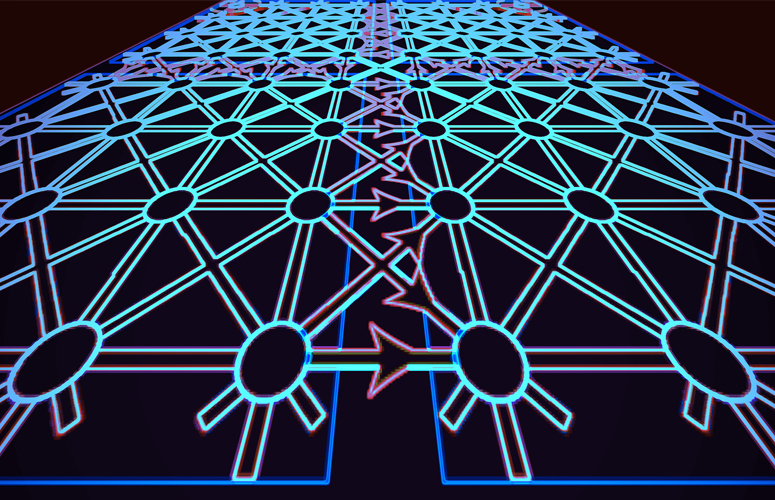

Los electrones circulan sobre la superficie de ciertos materiales cristalinos inusuales, los aislantes topológicos, excepto las veces que no lo hacen. Dos nuevos estudios publicados en la revista Science explican la fuente de ese insólito comportamiento y describen un mecanismo para restaurar la conductividad en estos cristales, apreciados por su potencial uso en futuras tecnologías, incluyendo los ordenadores cuánticos.

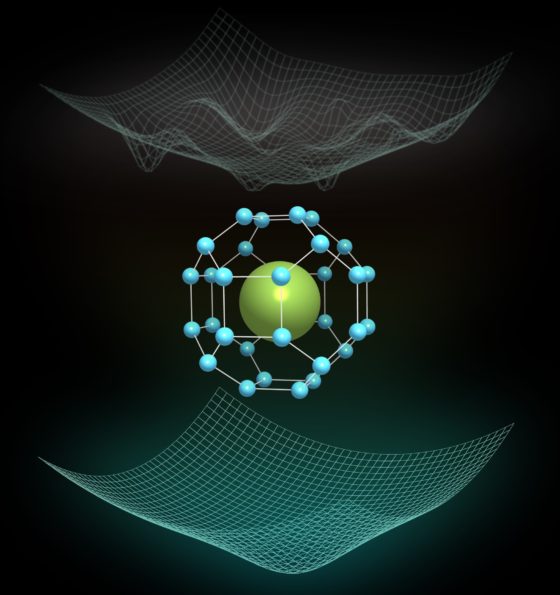

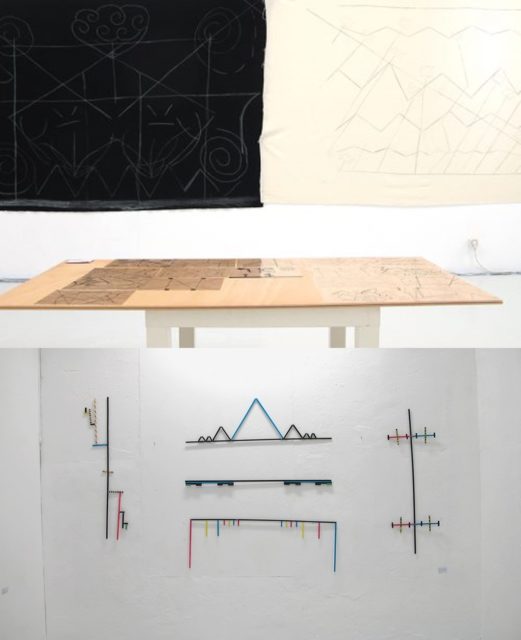

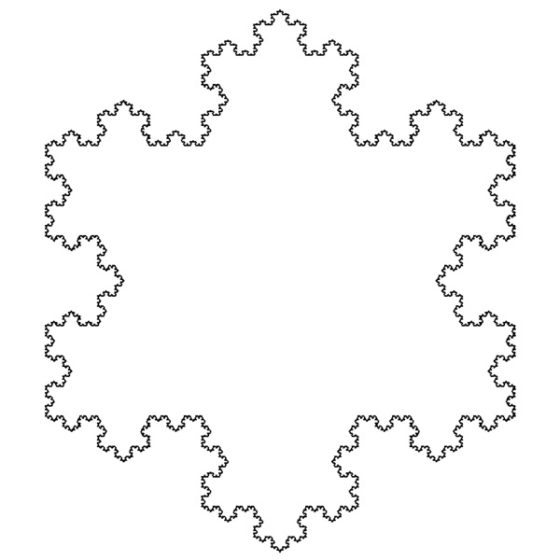

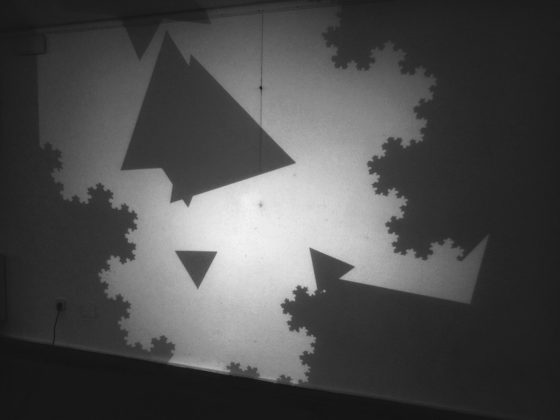

Los aislantes topológicos tienen un lado frágil. Imagen cortesía de Zhi-Da Song, Universidad de Princeton.

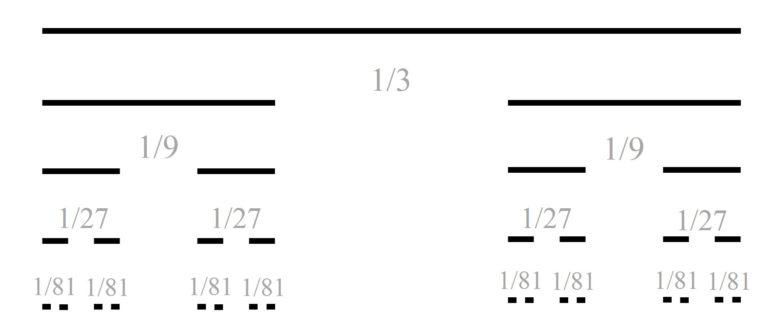

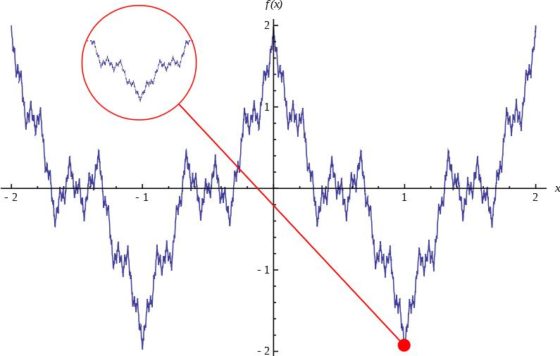

Los aislantes topológicos tienen un lado frágil. Imagen cortesía de Zhi-Da Song, Universidad de Princeton.Durante los últimos 15 años, una clase de materiales conocidos como aislantes topológicos ha dominado la búsqueda de los materiales del futuro. Estos cristales tienen una propiedad poco común: su interior es aislante —los electrones no pueden fluir—, pero sus superficies son conductoras perfectas, donde los electrones fluyen sin resistencia.

Esa era la realidad hasta que hace dos años se descubrió que algunos materiales topológicos son incapaces de conducir la corriente en su superficie, un fenómeno que se acuñó con el nombre de «topología frágil».

«La topología frágil es una extraño monstruo: ahora se predice su existencia en cientos de materiales», comenta B. Andrei Bernevig, profesor de física en Princeton y coautor de ambos trabajos. «Es como si el principio habitual en el que nos hemos basado para determinar experimentalmente un estado topológico se desmoronara”.

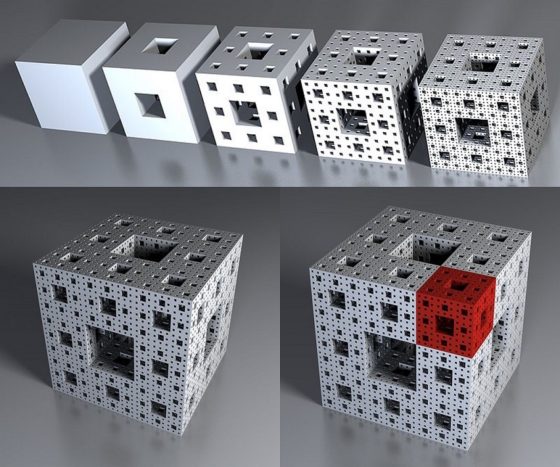

Para conocer cómo se forman los estados frágiles, los investigadores recurrieron a dos recursos: las ecuaciones matemáticas y la impresión 3D. Con la colaboración de Luis Elcoro, profesor del Departamento de Física de la Materia Condensada de la Facultad de Ciencia y Tecnología de la UPV/EHU, Bernevig y el investigador postdoctoral de Princeton Zhi-Da Song, construyeron una teoría matemática para explicar lo que ocurre en el interior de los materiales. A continuación, Sebastian Huber y su equipo en el ETH Zurich, en colaboración con investigadores de Princeton, el Instituto Científico Weizmann en Israel, la Universidad Tecnológica del Sur de China y la Universidad de Wuhan, probaron esa teoría construyendo un material topológico de tamaño real con piezas de plástico impresas en 3D.

Los materiales topológicos toman su nombre del campo de las matemáticas que explica cómo objetos diferentes, por ejemplo las rosquillas o las tazas de café, están relacionadas (ambas tienen un agujero). Esos mismos principios pueden explicar cómo saltan los electrones de un átomo a otro en la superficie de los aproximadamente 20.000 materiales topológicos identificados hasta la fecha. Los fundamentos teóricos de los materiales topológicos les valieron el Premio Nobel de Física de 2016 a F. Duncan Haldane, David J. Thouless y Michael Kosterlitz.

Lo que hace que estos cristales sean tan interesantes para la comunidad científica son sus paradójicas propiedades electrónicas. El interior del cristal no tiene la capacidad de conducir la corriente, es un aislante. Pero si se corta el cristal por la mitad, los electrones se deslizarán sin ninguna resistencia por las superficies que acaban de surgir, protegidos por su naturaleza topológica.

La explicación radica en la conexión entre los electrones de la superficie y los del interior. Los electrones pueden ser considerados no como partículas individuales, sino como ondas que se extienden como las ondas de agua que se generan al arrojar un guijarro a un estanque. En esta visión de la mecánica cuántica, la ubicación de cada electrón se describe por una onda que se extiende y que se denomina función de onda cuántica. En un material topológico, la función de onda cuántica de un electrón del interior se extiende hasta el borde del cristal, o límite de la superficie. Esta conexión entre el interior y el borde da lugar a un estado en la superficie perfectamente conductor.

Esta “correspondencia de interior-borde (bulk-boundary correspondence en inglés)” fue ampliamente aceptada para explicar la conducción topológica de la superficie hasta hace dos años, cuando varios trabajos científicos revelaron la existencia de la topología frágil. A diferencia de los estados topológicos habituales, los estados topológicos frágiles no contienen estados de conducción en la superficie. «El habitual principio de interior-borde se desmoronó», explica Bernevig. Pero no se pudo esclarecer cómo sucede exactamente.

En el primero de los dos trabajos publicados en Science, Bernevig, Song y Elcoro proporcionan una explicación teórica para una nueva correspondencia interior-borde que explica la topología frágil. Los autores muestran que la función de onda de los electrones en topología frágil solo se extiende hasta la superficie en condiciones específicas, que los investigadores han acuñado como correspondencia interior-borde retorcida.

El equipo descubrió, además, que se puede ajustar esa correspondencia interior-borde retorcida, y así hacer reaparecer los estados conductores de la superficie. «Basándonos en las formas de la función de onda, diseñamos un conjunto de mecanismos para introducir interferencias en el borde de tal manera que el estado del borde se convierta inevitablemente en conductor perfecto», comenta Luis Elcoro, profesor de la UPV/EHU.

Encontrar nuevos principios generales es algo que siempre fascina a los físicos, pero este nuevo tipo de correspondencia interior-borde podría además tener un valor práctico, según los investigadores. «La correspondencia interior-borde retorcida de la topología frágil proporciona un procedimiento potencial para controlar el estado de la superficie, que podría ser útil en aplicaciones de mecánica, electrónica y óptica», declara Song.

Pero probar que la teoría funciona era prácticamente imposible, dado que se tendría que interferir en los bordes a escalas atómicas infinitesimalmente pequeñas. Así que el equipo recurrió a otros colaboradores para construir un modelo de tamaño real con el que poner a prueba sus ideas.

En el segundo artículo de Science, Sebastian Huber y su equipo en el ETH Zurich construyeron la imitación en plástico de un cristal topológico a gran escala imprimiendo sus partes en impresoras 3D. Utilizaron ondas de sonido para representar las funciones de onda de los electrones. Insertaron barreras para bloquear el tránsito de las ondas sonoras, lo que es análogo a cortar el cristal para dejar al descubierto las superficies conductoras. De esta manera, los investigadores imitaron la condición de borde retorcido, y luego mostraron que manipulándolo, podían demostrar que una onda sonora que circula libremente se propaga a través de la superficie.

«Esta fue una idea y una ejecución muy de vanguardia», añade Huber. «Ahora podemos mostrar que prácticamente todos los estados topológicos que se han materializado en nuestros sistemas artificiales son frágiles, y no estables como se pensaba en el pasado. Este trabajo proporciona esa confirmación, pero aún más, introduce un nuevo principio general».

Referencias:

Valerio Peri, Zhi-Da Song, Marc Serra-Garcia, Pascal Engeler, Raquel Queiroz, Xueqin Huang, Weiyin Deng, Zhengyou Liu, B. Andrei Bernevig, and Sebastian D. Huber (2020) Experimental characterization of fragile topology in an acoustic metamaterial Science doi: 10.1126/science.aaz7654

Zhi-Da Song, Luis Elcoro, B. Andrei Bernevig (2020) Twisted Bulk-Boundary Correspondence of Fragile Topology Science doi: 10.1126/science.aaz7650

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La topología frágil es una extraño monstruo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Aislantes topológicos en sólidos amorfos

- La teoría de bandas de los sólidos se hace topológica

- Un aislante topológico intrínsecamente magnético

Jean Sammet (1928-2017): programazioaren lengoaiak argitu zizkigun emakumea

1. irudia: Jean Sammet informatikaria aitzindaria izan zen konputazio lengoaien alorrean. (Argazkia: SDTimes)

Batzuek akaso, programazioa, alor gisa alegia, kaotiko eta nahasi samar ikusiko dute; miopiadun batek betaurrekoak kentzean sentituko lukeen sentsazioa bailitzan. Ez zitzaion, alabaina, estatubatuar informatikariari horixe gertatu, hark zenbakiak maite zituen eta. Agian, gainerakoak horrenbeste harritzen dituen horrek gidatuta aukeratu zuen Matematika, eta helburu bakarra izan zuen: jende guztiak gai izan beharko luke ordenagailu batekin komunikatzeko.

COBOL (COmmon Business Oriented Language) eta FORMAC (FORmula MAnipulation Compiler) programazio-lengoaiak diseinatu eta garatzeagatik bilakatu zen Sammet aitzindari arlo konputazionalean. Halaber, ACM (Association for Computing Machinery) elkarteko fundatzailea eta lehenengo zuzendaria izan zen.

Uko egitetik liluraraJean Sammet 1928an jaio zen New Yorken. Bere gurasoak, Harry eta Ruth Sammet, abokatuak ziren. Euren alabaren nahia Bronx High School of Science-n ikastea zen, hiriko eskola ospetsuenetarikoan, alegia, baina ez zuten onartu emakumea izateagatik. Hortaz, Julia Richman High School ikastetxean eman zuen izena. Horren ondotik, Matematikako gradua ikasi zuen Mount Holyoke Unibertsitatean. 1948an, titulua lortzeaz gain, arlo horretako klaseak eman zituen laguntzaile gisa. Urtebete geroago, matematikako masterra egin zuen Illinoisko Unibertsitatean.

Ordenagailuen munduak ez zuen batere erakartzen hasieran, alor horri uko egitetik oso gertu zegoen, baina ikasketa akademiko gisa ezarri zutenean, iritziz aldatu zuen. Izan ere, Jeanek 2000. urteko elkarrizketa batean azpimarratu zuen moduan, ordenagailu bat ikusten zuen bakoitzean pentsatzen zuen ez zuela “hardware-pieza lizun horrekin” zerikusirik izan nahi. Batzuetan, norberaren uste osoa zalantzan jarri, eta hasieran pentsatzen zenuenaren kontrakoa egin behar da. Hori dibertigarriagoa da.

1951n, Metropolitan Life Insurance enpresan hasi zen lanean. Urtebete baino ez zuen eman bertan, irakasle izatea nahiago baitzuen. Hala, irakaskuntzan murgildu zen, eta Columbiako Unibertsitatean eman zituen klaseak. Bere programatzaile-lanari dagokionez, esan beharra dago hiru espaziotan garatu zuela. Lehenik, 1955ean, Sperry Gyroscope enpresan hasi zen, eta programatzaileen lehen taldea ikuskatu zuen bertan. Edonola ere, ez zuen alboratu irakasle-lana, horrek ere asebetetzen baitzuen. Modu honetan, 1956 eta 1958 bitartean, Adelphi Unibertsitateko graduondoko batean, Ordenagailuen programazioa ikasgaiaz arduratu zen.

2. irudia: Jean Sammet informatikaria, 1979. urtean hitzaldi bat eman aurretik Marylandeko Unibertsitatean. (Argazkia: Nytimes.com / Ben Shneiderman)

Bigarrenik, Sylvania Electric Products enpresan kontratatu zuten eta 1961era arte iraun zuen bertan. Hasieran, oinarrizkoak ziren lanak egin zituen, adibidez, MOBIDIC (MOBIle DIgital Computer) ordenagailuaren softwarearen garapena kudeatu zuen. Ordenagailu hori AEBtako Seinaleen Armada-gorputzarentzat eraiki zuten. Oro har, enpresa hartan, matematikariak postu ugari izan zituen; aipagarriena da COBOL programazio-lengoaia garatu zuen taldeko kide izan zela. Mundu guztiak bere ordenagailuan erabil zezakeen lengoaia zen COBOL, baina, kontuan hartu behar da sistema hori negozio kontuetarako bideratuta zegoela batez ere. Sammetek hobekuntzak egin zituen, unibertsalagoa bihurtu zuen sistema, gainontzeko arloetan ere erabili ahal izateko, hala nola, bankuetan eta osasunean.

Azkenik, 1961ean, IBM taldean hasi zen lanean; bertan, Bostoneko Programazio Zentroa kudeatzea eta antolatzea izan zuen helburu. Kalkulu sinbolikorako erabili zen lehenengo lengoaia eta programazio-sistemaren (FORMAC) garapena zuzendu zituen. Horretaz gain, programazio-lengoaiaren teknologiako gerente bilakatu zen Sammet 1965ean, aipaturiko enpresako sistema-garapenen departamentuan. Geroago, ADA programazio-lengoaia sortzeko proiektua zuzendu zuen.

Eskuliburu bat eta goraipamen ugariUrteetan zehar egindako lan eta ezagutza guztiak Programming Languages: History and Fundamentals liburuan (1969) bildu zituen, programazio-lengoaien inguruan idatzitako oinarrizko eskuliburuan. Argitalpenaz gain, ugariak izan ziren jaso zituen goraipamenak programazio alorrean egindako lanagatik. 1974an, ACMren (Association for Computing Machinery) lehendakari izateko hautatu zuten (bi urte igaro zituen karguan). Horretaz gain, 1978an, SIGPLAN izeneko elkartea zuzendu zuen, ACMren barruan zegoen erakundea, hain zuzen ere.

1977an, Konputazioaren Historiaren batzordea antolatu zuen American Federation of Information Processing Societies (AFIPS) izeneko elkarterako. Gainera, Sammet bertako zuzendaria izan zen. Halaber, Estatu Batuetako Ingeniaritza Akademiako kide izendatu zuten. Urtebete geroago, honoris causa doktoretza eman zioten Mount Holyoke Unibertsitatean. Horretaz gain, Bostoneko Ordenagailuaren Museoko Administrazio Kontseiluko kide bilakatu zen.

1988an erretiroa hartu eta gutxira, Ada Lovelace Saria jaso zuen, Konputazio alorrean lan egiten duten Emakumeen Elkartearen eskutik. Aipaturiko sari eta errekonozimendu askok ziurtatzen dute Sammetek egindako lan aitzindaria, bera izan baitzen programazio-lengoaien munduan bide-urratzaileetako bat. Sariei dagokienez, nabarmentzekoak dira, alde batetik, IEEE Institutuak (Institute of Electrical and Electronics Engineers) 2009. urtean eman zion saria, eta bestetik, 2013an National Center for Women & Information Technologyren (NCWIT) eskutik jaso zuena.

Badira euren lanaren bitartez besteon bizitza erraztea lortzen duten pertsonak. Sammet izango genuke horren adibide. Haren lanak eta programazio-lengoaien erabilerak erraztu egin zuten gizakien eta makinen arteko harremana; bat-batean, ordenagailuak lan batzuk egiteko tresna eraginkorrak bihurtu ziren. Hiru urte pasa dira ikertzaile estatubatuarra hil zenetik, baina bere ondareak bizirik dirau. 50eko hamarkadan fikzioa zirudien erronka gainditzea lortu zuen.

Iturriak:

- Computer History Museum, Jean Sammet.

- El Mundo, 2017ko ekainaren 5a: Muere Jean Sammet, pionera de los lenguajes de programación.

- Foro Histórico de las Telecomunicaciones, Sammet, Jean E.

- The New York Ties, 2017ko ekainaren 4a: Jean Sammet, Co-Designer of a Pioneering Computer Language, Dies at 89.

———————————————————————–

Egileaz: Uxue Razkin (@UxueRazkin) kazetaria da.

———————————————————————–

The post Jean Sammet (1928-2017): programazioaren lengoaiak argitu zizkigun emakumea appeared first on Zientzia Kaiera.

Así funcionan las baterías de litio

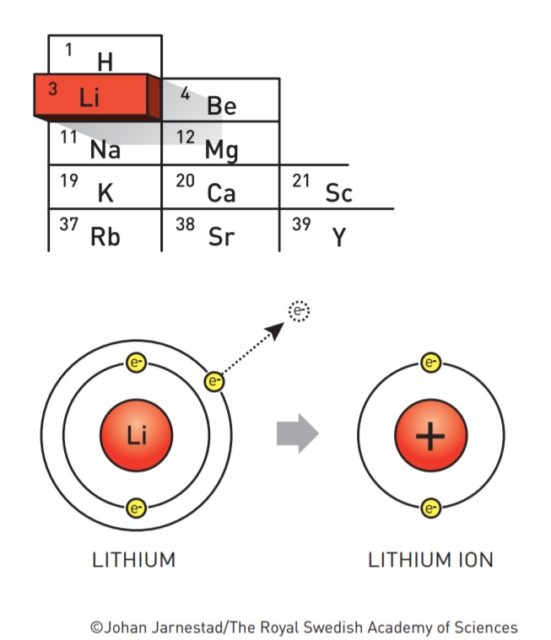

Antes de que se empezasen a fabricar baterías de litio ya se fantaseaba con la idea de poder hacer baterías de litio. La razón es que el litio es un metal que tiene tendencia a desprenderse de su electrón más externo. Al fin y al cabo, la electricidad es el tránsito de electrones, así que para producir electricidad necesitamos sustancias que tiendan a desprenderse de ellos.

Fuente: nobelprize.org

Fuente: nobelprize.org

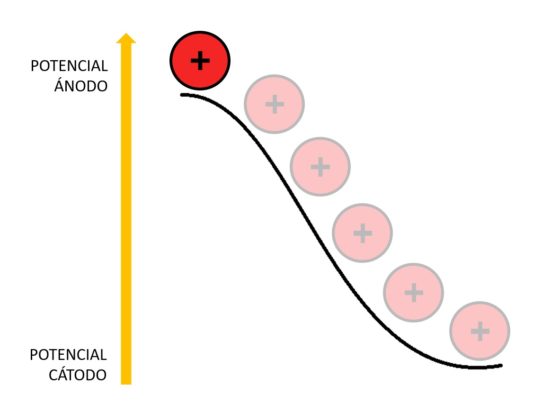

El litio es el metal con el menor potencial de reducción (-3,05V). Esto significa que es el elemento químico que más tendencia tiene a regalar electrones. Cuando regala su electrón más externo, el litio se queda cargado positivamente. Lo representamos como Li+ y lo llamamos ion litio. De ahí que las baterías de litio también se llamen baterías de ion-litio.

Que el litio ceda electrones con tanta alegría obviamente es una ventaja, pero al mismo tiempo es una maldición. Cede electrones a cualquiera. Al aire, al agua, a todo. Esto significa que es un metal muy inestable, que se oxida rápidamente en contacto con el aire, y que en contacto con el agua reacciona de forma violenta. Esa es la razón por la que la historia de las baterías de litio no ha sido un camino de rosas.

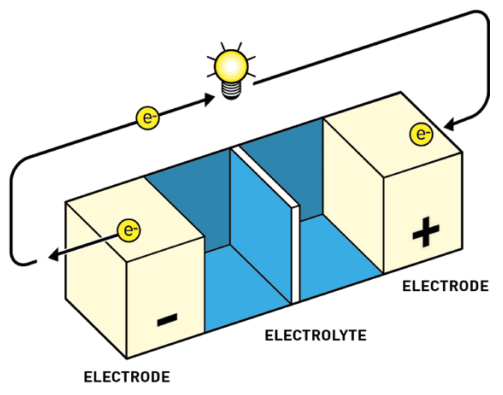

Las baterías tienen todas un mismo esquema fundamental:

-

Ánodo o electrodo negativo. Aquí es donde alguna sustancia se desprende de electrones. A estas reacciones de pérdida de electrones las denominamos reacciones de oxidación. Por convenio, al representar baterías o pilas el ánodo se dibuja a la izquierda.

-

Cátodo o electrodo positivo. Aquí es donde alguna sustancia acepta los electrones. A estas reacciones de captura de electrones las denominamos reacciones de reducción. Es la reacción inversa a la oxidación. Por convenio, al representar baterías o pilas el cátodo se dibuja a la derecha.

-

Electrolito. El electrolito actúa como separador entre el cátodo y el ánodo. Sirve para mantener el equilibrio entre las cargas del ánodo y el cátodo, ya que, si los electrones fluyen de ánodo a cátodo, se produce una diferencia de potencial, algo así como una descompensación de cargas, que frena el flujo de más electrones. El electrolito permite el flujo de iones (no de electrones) que reequilibran la carga entre ambos lados.

El ánodo y el cátodo están unidos en la batería por medio del electrolito. También se unen por fuera por medio de un conductor externo a través del cual solo circulan electrones. El conductor tiene dos extremos, polo positivo y polo negativo, como cualquier pila. Así que por el electrolito fluyen los iones de litio de un extremo a otro, y por el conductor externo fluyen los electrones.

En las baterías recargables las reacciones de oxidación (ceder electrones) y reducción (captar electrones) son reversibles, pueden fluir en ambas direcciones.

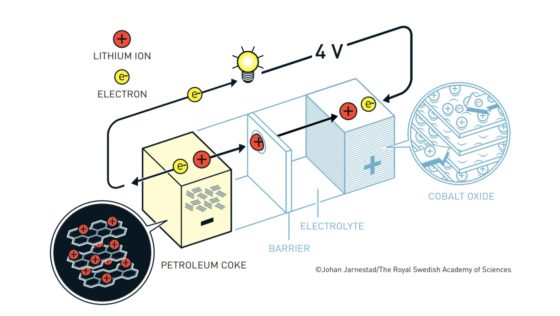

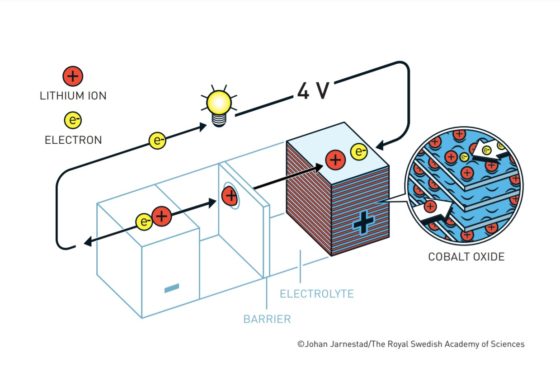

Batería Yoshino. Fuente: nobelprize.org

Batería Yoshino. Fuente: nobelprize.orgLas baterías de ion litio actuales más habituales tienen un cátodo de óxido de cobalto y un ánodo de un material similar al grafito denominado coque. Tanto el cátodo como en el ánodo tienen una disposición laminar en la que pueden albergar al litio. El litio viajará de cátodo a ánodo o de ánodo a cátodo a través del electrolito según el ciclo de carga o descarga. Los electrones, en cambio, circularán a través de un circuito externo.

-

Esto es lo que ocurre cuando se usa la batería

Cuando la batería está cargada, todo el litio está en el ánodo de coque. Durante la descarga los iones fluyen a través del electrolito desde el ánodo de coque hacia al cátodo de óxido de cobalto-litio. Los electrones también fluyen desde el ánodo al cátodo, pero lo hacen a través del circuito exterior, alimentando el móvil, el ordenador o el coche.

Como los iones de litio en el coque están a un potencial electroquímico más alto que en el óxido de cobalto-litio, caen desde el potencial del ánodo al potencial del cátodo. Esa es la razón por la que la batería aporta energía al aparato al que esté conectada.

Imagen: Deborah García Bello

Imagen: Deborah García Bello

El voltaje ofrecido por la batería depende de la diferencia de potencial entre el cátodo y el ánodo. Cuanto mayor sea esta diferencia, mayor voltaje obtendremos.

Cuando todos los iones de litio llegan al cátodo, la batería estará completamente descargada.

-

Esto es lo que ocurre cuando cargamos la batería

La carga de la batería se realiza conectando la batería a una fuente de energía externa como la red eléctrica. Los electrones de la red eléctrica entran en el ánodo a través del circuito externo. Esto provoca que los iones de litio abandonen el cátodo y regresen al ánodo a través del electrolito. Tanto los electrones como los iones litio se quedan acomodados en el ánodo entre las diferentes capas de coque. Cuando no fluyen más indica que la batería está completamente cargada.

La batería almacena energía en este proceso porque el potencial electroquímico del coque es más elevado que el del óxido de cobalto-litio. Esto quiere decir que los iones de litio han tenido que subir desde el potencial del cátodo hasta el potencial del ánodo.

-

Las evolución de las baterías de litio

A lo largo de la historia se han creado diferentes baterías. La de Volta, de 1800, usaba como electrodos zinc y cadmio, llegando a obtener hasta 1,1 V. Las baterías de plomo-ácido que hoy en día se utilizan en muchos coches producen 2 V cada una. Se suelen colocar 6 para producir los habituales 12V. También hay baterías de níquel-hierro (NiFe), de niquel-cadmio (NiCd), de níquel-hidruro metálico (NiMH)…

El problema que presentan estas baterías es que contienen metales tóxicos como el plomo o el cadmio. Además, ofrecen densidades energéticas relativamente bajas. Cuanto mayor sea la densidad de energía, más energía habrá disponible para acumular o transportar (por volumen o por masa). Así, las baterías de plomo-ácido ofrecen 30 Wh/kg de densidad energética, las de NiFe 40 Wh/kg, las de NiCd 50 Wh/kg y las de NiMH 80 Wh/kg. En cambio, las de ion litio ofrecen al menos 120 Wh/kg y un voltaje mayor, de 4,2 V. Hay que tener en cuenta que las pilas alcalinas clásicas, las AA, solo ofrecen 1,5 V. Por eso las baterías de litio son tan compactas y los teléfonos móviles se han aligerado tanto.

El boom en la carrera investigadora de las baterías de litio se desató en los 70 a causa de la crisis del petróleo. Estaba claro que el ánodo perfecto tendría que ser de litio. Ahora faltaba descubrir el cátodo perfecto.

La primera batería de ion litio tenía un cátodo de sulfuro de litio y titanio (LixTiS2) que era capaz de acomodar en su interior los iones de litio que llegaban desde el ánodo. El ánodo era de litio metálico, y el electrolito era de LiPF6 disuelto en carbonato de propileno. En este electrolito el litio estaba protegido tanto del agua como del aire, ganando estabilidad. Así se lograban 2,5 V. La primera batería de litio comercial fue una evolución de esta, desarrollada por la empresa Exxon. En ella se usaba litio como ánodo, TiS2 como cátodo y perclorato de litio (LiClO4) disuelto en dioxolano como electrolito.

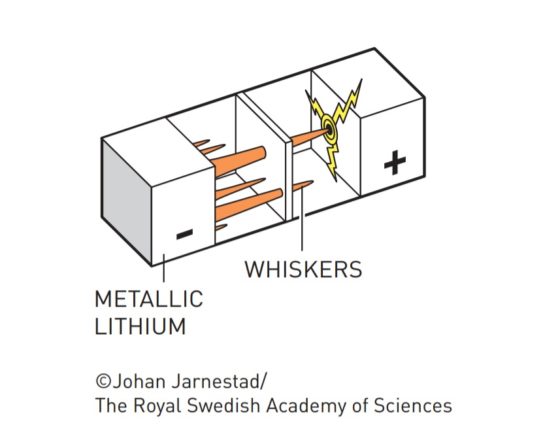

Dendritas («whiskers»). Fuente: nobelprize.org

Dendritas («whiskers»). Fuente: nobelprize.org

Pero se encontraron con un problema: cuando estas baterías se sobrecalentaban, llegaban a explotar. Descubrieron que lo que ocurría es que tras cada ciclo de carga y descarga se iban formando dendritas de litio que traspasaban la barrera de electrolito hasta llegar al cátodo, produciendo así un cortocircuito.

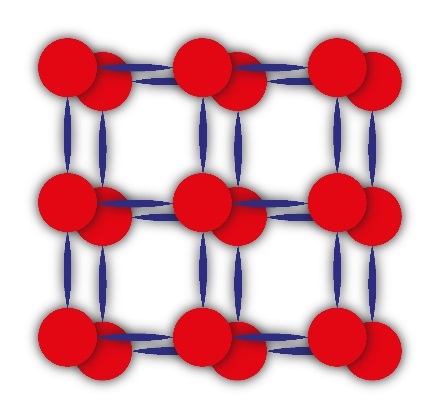

El problema parecía resolverse usando un ánodo diferente. En lugar de un sulfuro metálico, se probó con un óxido metálico, en concreto el dióxido de cobalto (CoO2) que, combinado con el litio se denomina óxido de cobalto-litio (LiCoO2). El LiCoO2 tiene un potencial de reducción tan alto, que ni siquiera hacía indispensable el uso de litio metálico puro como ánodo, sino que podría usarse otra sustancia que acomodase al litio de forma más estable y segura.

Batería Goodenough. Fuente: nobelprize.org

Batería Goodenough. Fuente: nobelprize.org

La respuesta llegaría en 1985 de la mano de la corporación japonesa Asahi Kasei. Descubrieron que el coque de petróleo —un sólido carbonoso derivado del refinado del petróleo— era capaz de acomodar al litio de forma muy eficiente. En muchos textos se le llama grafito. Es cierto que se le parece, pero no es exactamente grafito, sino un material de carbono que presenta dominios cristalinos grafíticos —en capas— y dominios no cristalinos. Entre unos y otros se acomodan los iones de litio.

Imagen: Litio en coque de petróleo. Fuente: nobelprize.org

Imagen: Litio en coque de petróleo. Fuente: nobelprize.org

En 1991, la empresa Sony, en colaboración con Asahi Kasei, sacaron a la venta la primera batería ion litio comercial con ánodo de óxido de cobalto-litio y cátodo de coque. El hecho de que los iones de litio entren y salgan ordenadamente en el ánodo y en el cátodo, forzados por las estructuras bidimensionales del coque y del óxido del cobalto, garantiza que las baterías apenas tengan efecto memoria. Es decir, las podemos cargar sin esperar a que se hayan descargado completamente sin miedo a que la batería se vicie.

En la actualidad se producen baterías de litio con cátodos todavía más eficientes. Como el cobalto es un elemento químico caro y relativamente escaso, el óxido de cobalto-litio se ha sustituido por el de fosfato de hierro-litio (LiFePO4) haciéndolas más baratas de producir. Se conocen como LFP, y adoptan estructuras cristalográficas diferentes. La de LFP con estructura tipo olivino es la que en la actualidad comercializa Sony. Puede durar 10 años si se carga a diario, cuando normalmente no sobrepasaban los 3-4 años. También tienen carga rápida, ya que en 2 h cargan el 95% de su capacidad.

En 2019 el desarrollo de las baterías de ion litio logró el Premio Nobel de Química repartido a partes iguales entre el alemán John B. Goodenough, el británico M. Stanley Whittingham, y el japonés Akira Yoshino. Whittingham fue quien lideró la investigación en la electrointercalación de iones de litio en disulfuros metálicos en los años 70. John Goodenough, que trabajó para Exxon, en los años 80 fue quien propuso la solución a que las baterías explotasen cuando se calentaban. Lo resolvió con el cátodo de óxido de cobalto-litio. Akira Yoshino, que trabajaba para la Corporación Asahi Kasei, en 1985 propuso el ánodo de coque.

La investigación actual en baterías de ion-litio se fundamenta en mejorar su eficiencia y el número ce ciclos de carga y descarga que pueden soportar. Se está experimentando con baterías de dióxido de carbono y litio, aunque hay expertos que aseguran que el futuro estará en el litio-grafeno.

Referencias:

They developed the world’s most powerful battery. Nobelprice.org.

Scientific Background on the Nobel Prize in Chemistry 2019 LITHIUM-ION BATTERIES. Nobelprize.org.

Baterías de iones litio, ¿cómo son?. Por Ignacio Mártil en CdeComunicación

Premio Nobel de Química 2019: Goodenough, Whittingham y Yoshino por las baterías de ión-litio. Por Francis Villatoro en La ciencia de la mula Francis.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Así funcionan las baterías de litio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Baterías de litio y oxígeno sólido

- Las baterías ion sodio, la alternativa estacionaria

- ADN para la nueva generación de baterías

Zirkoniozko material porotsu berriak: egitura sendoen bila

1. irudia: Zr-MOFek basamortuan uraren lorpena ahalbidetu dute. 2018. urtean,.

MOFak (ingelesez metal-organic frameworks) ordena handiko material hibrido porotsuak dira, metalez eta estekatzaile organikoz osatutako koordinazio-konposatuen sare hedatuak. Konposatu horietako sare-nodoak ioi metalikoz edo kluster metalikoz osatuta daude. Kluster horiei bigarren mailako eraikin-unitate deritze, edo SBU (ingelesez, secondary building units). Barruko metalaren arabera mota askotako SBUak daude, MOFen eraketan faktore determinatzailea izanik. Nodoen arteko konexioetan estekatzaile organikoak zubi gisa agertzen dira (nagusiki azido karboxilikoak), eta koordinazio-loturen bidez SBUekin lotuta geratzen dira. Antolamendu horren ondorioz porotasun iraunkorra duten sare irekiak sortzen dira, kristalezko esponja molekularrak antzekoak direnak.

2. irudia: Plastilinaz eta zotzez eratutako MOFa. (Irudia: Luz Fidalgo).

Hurrengo analogia hau argigarria izan daiteke. Demagun plastilina bolatxoak eta zotzak ditugula. Bolatxo batean 90 graduko angelua eratuz lau zotz sartuko ditugu eta zotz bakoitzari beste bolatxo bat gehituko dugu. Jarraian bolatxo bakoitean posizio berdinean beste hiru zotz kokatuko ditugu. Hiru dimentsioetan prozedura honi jarraituz, espazioan hedatzen den sare porotsu bat eratuko da, 1.irudian agertzen den moduan. Bolatxoak Zr-klusterrak badira eta zotzak ligando organikoak, horra hor gure Zr-MOFa!

Ikusgarriak dira eskaintzen dizkiguten aukerak bai metalari bai estekatzaile organikoari dagokienez. Hain aldakortasun handiak milaka konposatu sortzeko modua ematen du, eta CSD (Cambridge Structural Database) datu-basean 84000 mila MOFen egiturak agertzen dira. Konposatu horiek porotsuak izan daitezke beren bolumenaren % 90 arte, eta BET (Brunauer-Emmmett-Teller) azalera espezifikoari dagokionez, MOF bat azukre-koskor bat izatekotan sei futbol-zelaiei dagokiena izango litzateke. Harrigarria!

Azken urteotan, MOFen aurrerakuntza horrekin lotuta berezko arazoak ere ageri dira, haien artean ezegonkortasun kimikoa eta termikoa. Hori dela eta, propietate horiek areagotu nahian izugarrizko esfortzuak egin dira eta zientzialariak sendoagoak diren MOFen bila ari dira. Abiapuntua konposatu horietako loturek irmotasuna irabaztea da eta xede horretarako Zr(IV) MOFak baliagarriak izan daitezkeela egiaztatu dute.

Zirkonioak oxidazio-egoera, karga-dentsitatea eta eratzen dituen loturen polarizazioa altua du. Faktore horien ondorioz, Zr(IV)-aren eta karboxilato anioien artean afinitate handia sortzen da.

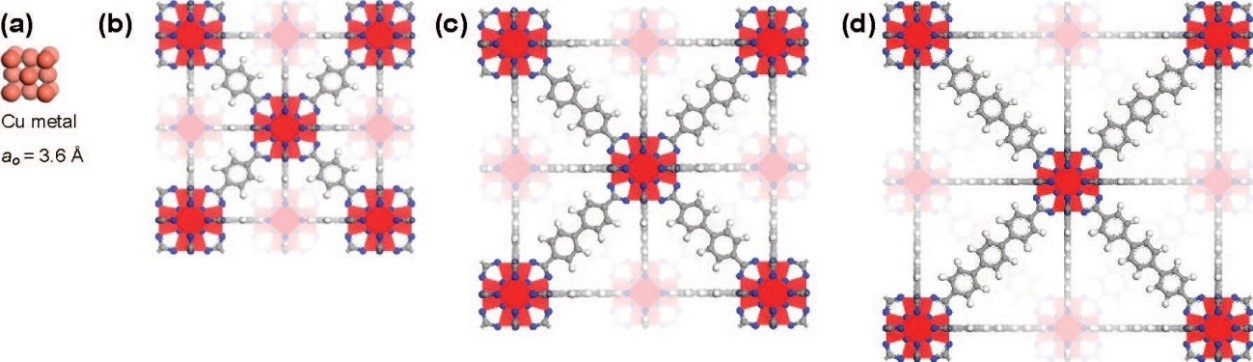

Zr-MOFen lotura honen sendotasunaren lehendabiziko froga 2008.urtean lortu zen, Osloko unibertsitateko Cavka eta lankideek Zr(IV)-MOFaren sintesi berria argitaratu zutenean. 2. irudian ikusten dira UiO-66, UiO-67 eta UiO-68 deritzen MOFak, guztietan SBU bera agertzen denez, Zr6(µ3–O)4(µ3–OH)4(CO2)12. Konposatu horiek guztiek ohiz kanpoko portaera dute. Beraren agerpenak iraultza bat ekarri zuen ikerkuntza-eremu honetara.

3. irudia: Zr(IV)-MOF a) Cu-aren gelaxka-unitatea; b) UiO-66-ren egitura; c) UiO-67-ren egitura; d) UiO-68-ren egitura. (Iturria: DOI: 10.1021/ja8057953)

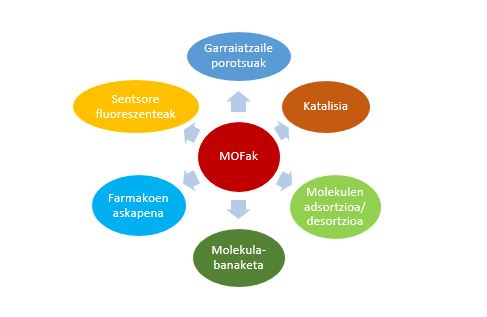

4. irudian azken urteotan izugarrizko garapena izan duten MOFen aplikazio batzuk ageri dira. Nanoteknologia arloan, ere, agertzen ari dira nano-MOF motako konposatuak.

4. irudia: MOFen zenbait aplikazio.

Ikerketa-talde askok Zr-MOFek duten propietateen artean adsortzioarekiko selektibotasuna azpimarratu dute. Adibidez, CO2/CH4 eta CO2/N2 nahasketekin egindako lana, negutegi-efektuan gas horiek duten eraginagatik.

Bestalde, Zr-MOFek basamortuan uraren lorpena ahalbidetu dute. 2018. urtean, Omar Yaghy eta lankideek garatutako gailuan, gaueko aire hezea adsortzioz eta egunean geroko kondentsazioz, 200mL MOF-Kg-tik eskuratu dute.

Azkenik, Zr-MOFak aplikazio biologikoetarako bereziki egokiak dira, bio-bateragarritasun bikaina baitute eta farmakoen askapenean erabiliak dira. Zalantzarik gabe, Zr-MOFak etorkizun handiko materialak dira.

Gehiago jakiteko:

- Chen, Zhijie, et al., (2019). Reticular chemistry in the rational synthesis of functional zirconium cluster-based MOFs. Coordination Chemistry Reviews 386 (2019) 32–49. DOI: https://doi.org/10.1016/j.ccr.2019.01.017

- Fathieh, Farhad, et al., (2018). Practical water production from desert air. Science. Advance, 4. DOI: https://doi.org/10.1126/sciadv.aat3198

- Aldizkaria: Ekaia

- Zenbakia: Ekaia 35

- Artikuluaren izena: Zirkoniozko material porotsu berriak: egitura sendoen bila.

- Laburpena: MOFak (ingelesez metal-organic frameworks) ordena handiko material hibrido porotsuak dira, ioi metalikoz eta estekatzaile organikoz osatutako koordinazio-konposatuen sare hedatuak. Azken urteotan, material porotsuek teknologiaren arloan izan duten interes handiak sustatuta MOF konposatuen aurrerakuntza handia izan da. Hala gertatzeko arrazoien artean berezko ezaugarri eta propietate interesgarriak daude, baita aplikazio ugari eta askotarikoak ere. Aurrerakuntza horrekin lotuta MOFen arazoak ere ageri dira, haien artean ezegonkortasun kimikoa eta termikoa. Hori dela eta, zientzialariok sendoagoak diren MOFen bila ari gara, eta, ildo horri dagokionez, Zr-MOFak adierazgarriak dira beren ohiz kanpoko portaeragatik. Zalantzarik gabe, etorkizun handiko materialak dira.

- Egileak: Luz Fidalgo Mayo.

- Argitaletxea: UPV/EHUko argitalpen zerbitzua.

- ISSN: 0214-9001

- Orrialdeak: 165-183

- DOI: 10.1387/ekaia.19546

————————————————–

Egileez:

Luz Fidalgo Mayo UPV/EHUko Farmazia Fakultateko Kimika Ez-Organikoa sailekoa da.

———————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Zirkoniozko material porotsu berriak: egitura sendoen bila appeared first on Zientzia Kaiera.

Teselando el plano con pentágonos

Imagen: Osckar Espinosa / Pixabay

Imagen: Osckar Espinosa / Pixabay

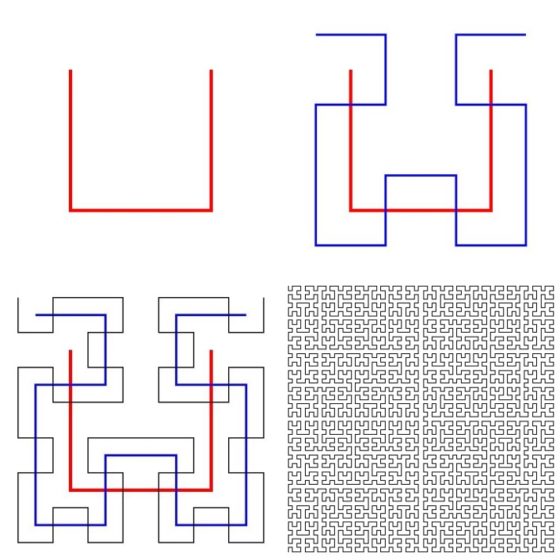

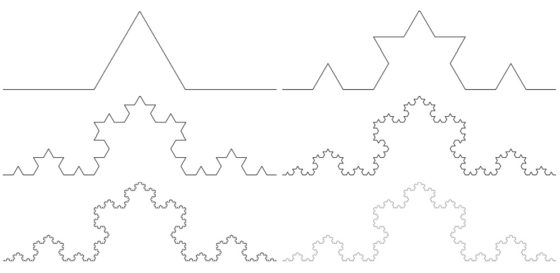

Una teselación o mosaico del plano consiste en una serie de polígonos –las teselas o losetas– que lo cubren sin dejar zonas vacías, de manera que si dos teselas se tocan, lo hacen necesariamente lado con lado o vértice con vértice.

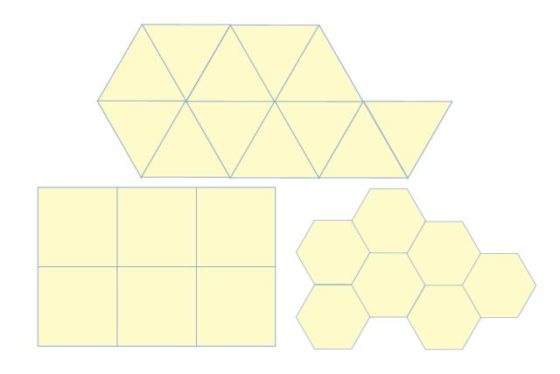

En su obra Harmonice mundi el astrónomo Johannes Kepler estudió qué polígonos regulares podían cubrir el plano. Es decir, se preguntaba si existen mosaicos que utilicen un polígono regular como única tesela base. La respuesta es sencilla: los únicos que existen son los mosaicos por triángulos, cuadrados y hexágonos regulares.

Teselando el plano con triángulos, cuadrados y hexágonos regulares. Imagen: Wikimedia Commons.

Teselando el plano con triángulos, cuadrados y hexágonos regulares. Imagen: Wikimedia Commons.

¿Por qué no hay más? Por ejemplo, en el caso del pentágono regular, su ángulo interno es de 108 grados. Si deseáramos teselar el plano con pentágonos regulares, los vértices de dos losetas colindantes deberían tocarse sin dejar ningún hueco. Pero esto imposible, ya que 360 no es divisible por 108. De otra manera, si colocamos pentágonos regulares alrededor de un vértice, se observa en seguida que solo pueden colocarse tres, pero queda un espacio que no puede cubrirse con pentágonos.

Recordemos que un polígono regular de n lados posee ángulos internos de 180(n-2)/n grados. Así, para polígonos con siete o más lados, el ángulo interior es mayor que 120 grados pero menor que 180, con lo que llegamos a la misma conclusión que con el pentágono. Es decir, el triángulo, el cuadrado y el hexágono (regulares) son los únicos polígonos regulares cuyos ángulos internos (60 grados, 90 grados y 120 grados, respectivamente) son divisores de 360 grados.

En el estudio de mosaicos podríamos proseguir preguntarnos qué sucede al mezclar varios polígonos regulares para cubrir el plano –teselaciones semirregulares, de estos solo hay ocho–, o al usar una única pieza no regular, o al utilizar varias no regulares. Estos problemas no son sencillos de resolver. Cuando su estudio comenzó a sistematizarse llevó al desarrollo de técnicas matemáticas complejas aplicadas al estudio de teselaciones del plano (y del espacio) que después han encontrado utilidad en otros campos.

Vamos a elegir uno de estos problemas tomando el pentágono como pieza clave. La pregunta que nos planteamos es: ¿se puede teselar el plano con un único pentágono (convexo) no regular? La respuesta es que se puede, y además existen solo quince maneras de hacerlo –parece casi seguro que esta es la cantidad, aunque está en fase de revisión–.

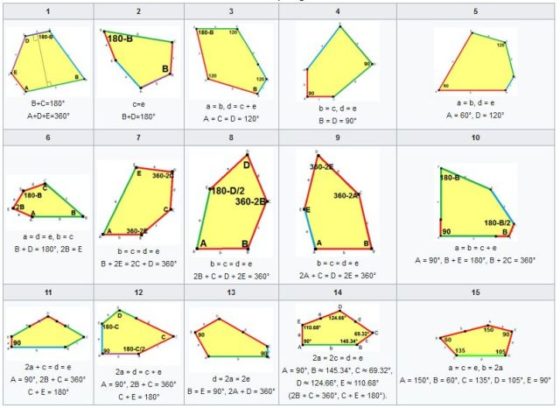

Los quince tipos de pentágonos convexos que teselan el plano. Se denotan con letras minúsculas los lados de cada pentágono a, b, c, d, e y con letras mayúsculas los ángulos internos. Imagen: Wikimedia Commons.

Los quince tipos de pentágonos convexos que teselan el plano. Se denotan con letras minúsculas los lados de cada pentágono a, b, c, d, e y con letras mayúsculas los ángulos internos. Imagen: Wikimedia Commons.

Citamos a continuación a las personas que han descubierto estas quince clases de pentágonos: Karl Reinhardt(1895-1941)encontró cinco en 1918 (ver [1]);Richard B. Kershner (1913-1982) halló tres más en 1968 (ver [2]); Richard James descubrió el noveno tipo en 1975 tras leer un artículo de Martin Gardner sobre teselaciones pentagonales en la revista Scientific American; ese artículo también inspiró a Marjorie Rice (1923-2017) quien halló otros cuatro tipos en 1976 y 1977 (ver [3] y [4]); Rolf Stein (ver [5]) encontró el decimocuarto tipo de pentágono en 1985; y en 2015 Casey Mann, Jennifer McLoud y David Von Derau descubrieron una nueva clase (ver [6]) con ayuda de un programa informático.

El 1 de mayo de 2017 Michaël Rao anunció (ver [7]) que había realizado una prueba asistida por ordenador en la que demostraba que estos quince pentágonos convexos eran los únicos que teselaban el plano con un único tipo de loseta. La parte computacional de su demostración ha sido revisada y no contiene errores, aunque aún no se ha publicado la prueba definitiva revisada por pares.

De este grupo de personas, algunas no son matemáticas. Richard James es informático y Marjorie Rice matemática aficionada. Ambos se enamoraron de este problema leyendo el artículo de Martin Gardner indicado anteriormente. Y emprendieron su búsqueda en solitario.

El caso de Marjorie es muy especial: aunque no tenía formación en matemáticas, desarrolló su propio sistema de notación para representar las restricciones y las relaciones entre los lados y ángulos de los pentágonos que estaba intentando encontrar. Fue la matemática Doris Schattschneider quien descifró la notación de Marjorie Rice y quien se ocupó de difundir sus descubrimientos entre la comunidad matemática. En la página Intriguing Tesselations, Marjorie Rice mostraba con orgullo sus descubrimientos y algunos mosaicos decorativos que diseñó a partir de ellos. ¡Admirable!

Referencias:

[1] Karl Reinhardt.Über die Zerlegung der Ebene in Polygone, Dissertation Frankfurt am Main (1918), páginas 77-81

[2] Richard Kershner. On paving the plane, American Mathematical Monthly 75 (8) (1968) 839-844

[3] Doris Schattschneider.Tiling the plane with congruent pentagons, Mathematics Magazine 51 (1) (1978) 29-44

[4] Marjorie Rice. Tesselations, Intriguing Tesselations

[5]Doris Schattschneider. A new pentagon tiler, Mathematics Magazine 58 (5) (1985) 308

[6] Casey Mann, Jennifer McLoud-Mann, David Von Derau, Convex pentagons that admit i-block transitive tilings. arXiv:1510.01186(publicado posteriormente en Geometriae Dedicata 194 (2018)141-167)

[7] Michael Rao.Exhaustive search of convex pentagons which tile the plane. arXiv:1708.00274

[8] Natalie Wolchover. Pentagon Tiling Proof Solves Century-Old Math Problem. Quanta Magazine, 11 julio 2017

[9] Pedro Alegría. El caso de los 14 pentágonos que embaldosan un espacio infinito. ABC Ciencia, 10 abril 2017

[10] Teselados pentagonales, Wikipedia [consultado 15 febrero 2020]

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Teselando el plano con pentágonos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

- Shizuo Kakutani y sus teoremas

- La característica de Euler de una superficie: un invariante topológico

Eskuak ondo garbitzea, gaitz infekziosoen aurkako gakoetako bat

Komun publiko batetik atera berritan bazaude eta, doktoretza tesia egiteko adinean egon daitekeen gazteren bat ikusten baduzu, libreta eskutan, zertan ari zaren kuxkuxeatzen eta gaizki disimulatzen, ez haserretu. Edo, behintzat, ez moskeatu gehiegi. Kontuan izan agian ikertzaile bat izan daitekeela, gizateria salbatu nahian. Ados, bai, agian hau gehiegi esatea da. Gizateria salbatzen lagundu nahian, akaso.

Kuxkuxeroaren helburua zure portaera behatzea izan daiteke. Zertarako, bada? Ba, jakiteko ea, behin heldutasunera iritsita, gurasoek txikitan behin eta berriz gogorarazten zizuten agindu hori benetan jarraitzen ote duzun: “Komunetik ateratzean, arren, ondo garbitu eskuak”.

1. irudia: Argi dago eskuen garbitze soilarekin ez dagoela modurik gaitz baten zabalkuntza nazioartean ekiditeko, baina ikertzaileek uste dute oso lagungarria izango litzatekeela garbiketa-tasak handitzea. (Argazkia: Dan Watson/Unsplash)

Ez da soilik arreta erakartzeko kazetariek erabiltzen duten amu txotxolo horietako bat. Era horretako ikerketak egin egiten dira. 2003an, esaterako, halako behaketa baten gaineko emaitzak argitaratu zituzten, mikrobiologiari buruzko kongresu batean. AEBtako aireportuetan egindako ikerketa izan zen. New York, Chicago, San Francisco, Dallas, Miami eta Toronto hirietako aireportuetan 7.541 lagunen portaera aztertu zuten. Eta emaitzek berretsi zutenez, benetako datuak eskuratzeko, galdetzea baino, beharrezkoa da zuzenean begiratzea. Aurreko ikerketetan ikusia zuten jendeari galdetuz gero %95ek esaten zutela baietz, eskuak garbitzen zituztela, baina benetan soilik %67k egiten zuten. 2003ko azterketa horretan, SARS gaitzaren zabalkuntza puri-purian zegoenean, behaketetan eskuratutako datuak hobeak izan ziren: ikusi zuten %78k hori benetan egiten zutela. Sexuaren arabera, emakumezkoak (%83) gizonezkoak (%74) baino txukunago aritu ziren.

Ikerketa horiek aireportuetan egiteak badu arrazoi garrantzitsu bat: nodo baten modura funtzionatzen dute. Bai airelineatarako, pertsonentzako… zein birusetarako ere. Aireportuetan leku askotako lagunak elkartzen dira eta, normala denez, objektu desberdin asko ukitzen dituzte: aulkietako beso-euskarriak, segurtasun-kontroletan objektu pertsonalak uzteko erabiltzen azpilak edota ateetako heldulekuak, esate baterako.

Hori guztia kontuan hartuta, azpiegitura horietan higienea handitzearen garrantzia nabarmendu dute ikerketa berri batean. Massachusettseko Teknologia Institutuko ikertzaileek Risk Analysis aldizkarian proposatu dutenez, munduko hamar aireportutan eskuak garbitzeko tasa handitze soilarekin, gaitz biral baten zabalkuntza asko murriztuko litzateke.

Dena dela, garbiketa horrek egokia izan behar duela azaldu dute. Izan ere, eskuak garbitzen dituztenen artean ere, askok ez dute ondo egiten. Ondo egiteko, gomendatzen da ura eta xaboia erabiltzea, 15-20 segundo inguruz eskuak igurtziz. Halere, askok ura baino ez dute erabiltzen. Germenen propagazioa ekiditeko, gainera, gutxienez ordubetean behin egin behar dela diote. Eta oraingoan aipatu ez badute ere, aurreko ikerketa batek agerian utzi zuen garbitzeaz gain garrantzitsua dela ere eskuak ondo lehortzea.

Hortaz, kalkulatu dute aireportuetan dabiltzan bidaiarien %20k baino ez daramatzatela eskuak ondo garbituta. Bada, munduko aireportu guztienetan kopuru hori hirukoiztuz gero –ondo garbitutako eskuak dituzten bidaiarien kopurua %60ra pasata–, horrek lortuko luke mundu mailan gaitzaren propagazio-maila ia %70 atzeratzea.

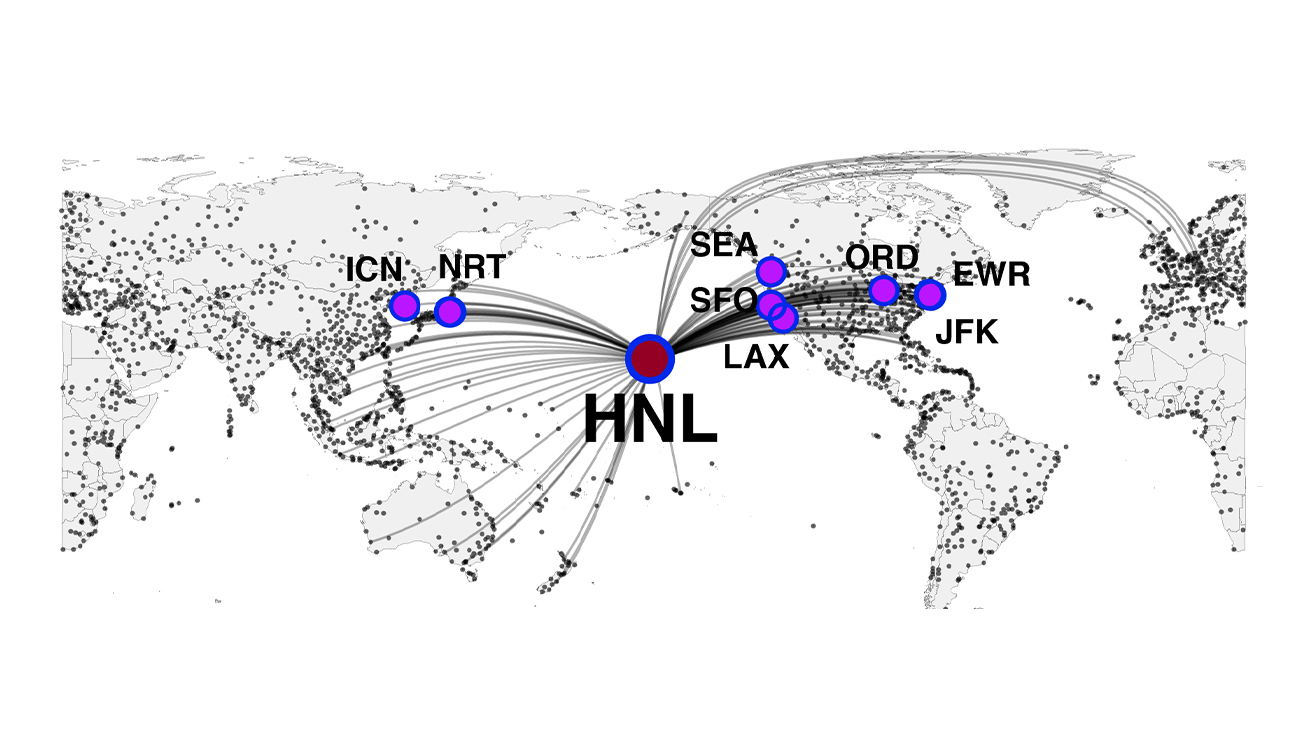

2. irudia: Munduko hainbat aireporturen kokapena eta beste aireportuekiko loturak aztertu dituzte, eta ikusi dute faktore horiek trafiko-kopurua baino garrantzitsuagoak direla gaitzen zabalkuntzari dagokionez. Irudian, Honoluluren adibidea. (Irudia: Nicolaides et al./Risk Analisys)

Halako neurri bat munduko aireportu guztietan ezartzea zaila litzatekeela aitortuta, kalkulatu dute noraino lagunduko lukeen horrelako garbitze-tasak munduko hamar aireportutan lortzeak. Gaitzen zabalkuntza %37 atzera litekeela ondorioztatu dute. Aireportu horien aukeraketa, gaitz infekziosoaren hasierako agerraldiaren jatorriaren arabera egin beharko litzateke. Wuhango koronabirusaren gorakada baino lehenago egindako ikerketa izan arren, egileek diote azken krisi honetan ere aplikagarri direla ondorioak, kutsagarria den edozein gaitzi dagokiolako.

Epidemiologia ereduetan eta datuetan oinarritutako simulazioak baliatu dituzte ikerketa egiteko. Besteak beste, nazioarteko hegaldien inguruko datuak, aireportuetan izaten diren itxarote-tasak eta pertsonen arteko zein pertsonen eta objektuen arteko elkarrekintzei buruzko balioespenak kontuan hartu dituzte, eta baita historikoki izurriteek izan duten bilakaeraren inguruan aurreko ikerketek esan dutena ere.

Higiene neurriak indartzeko, gaiari buruzko komunikazio kanpainen beharra azpimarratu dute. Egin duten beste kalkulu baten arabera, munduko aireportu guztietan eskuen garbitze-tasa %10 handituz gero, nazioarteko gaitz infekziosoen zabaltzea %24 murriztuko litzateke.

Ikertzaileek identifikatu dituzte munduan gaitzen zabalpenean eragin handiena izan dezaketen 120 aireportuak, eta ikusi dute ez direla izan behar, halabeharrez, trafiko gehien dutenak. Kokapena ere garrantzitsua izan daiteke. Tokio (Japonia) eta Honolulu (AEB) jarri dituzte adibidetzat. Hurrenez hurren, trafikoari dagokionez 46. eta 117. postuetan daude, baina euren kokapena eta bertan izaten diren loturak direla eta, garrantzi nabarmena izan ahal dute nazioarteko gaitz infekziosoen zabalkuntzan.

Erreferentzia bibliografikoa:

Nicolaides, C., Avraam, D., Cueto‐Felgueroso, L., González, M.C. and Juanes, R. (2020). Hand‐Hygiene Mitigation Strategies Against Global Disease Spreading through the Air Transportation Network. Risk Analysis. doi:10.1111/risa.13438

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Eskuak ondo garbitzea, gaitz infekziosoen aurkako gakoetako bat appeared first on Zientzia Kaiera.

El principio de complementareidad

Foto: Leonardo Yip / Unsplash

Foto: Leonardo Yip / UnsplashLa mecánica cuántica se fundó sobre la existencia de la dualidad onda-corpúsculo de la luz y la materia, y el enorme éxito de la mecánica cuántica, incluida la interpretación de probabilidad, parece reforzar la importancia de esta dualidad. Pero, ¿cómo puede considerarse un corpúsculo como que «realmente» tenga propiedades de onda? ¿Y cómo puede pensarse que una onda tenga «realmente» propiedades de corpúsculo?

Se podría construir una mecánica cuántica consistente sobre la idea de que un haz de luz o un electrón pueden describirse simultáneamente por los conceptos incompatibles de onda y corpúsculo. En 1927, sin mebargo, Niels Bohr se percató de que precisamente la palabra «simultáneamente» era la clave para mantener la coherencia. Se dio cuenta de que nuestros modelos, o imágenes, de la materia y la luz se basan en su comportamiento en distintos experimentos en nuestros laboratorios. En algunos experimentos, como el efecto fotoeléctrico o el efecto Compton, la luz se comporta como si constara de partículas; en otros experimentos, como el experimento de doble rendija, la luz se comporta como si estuviera formada por ondas. Del mismo modo, en experimentos como el de J.J. Thomson con los rayos catódicos, los electrones se comportan como si fueran partículas; en otros experimentos, como los estudios de difracción de su hijo G.P. Thomson, los electrones se comportan como si fueran ondas. Pero la luz y los electrones nunca se comportan simultáneamente como si estuviesen constituidos por partículas y ondas. En cada experimento específico se comportan como corpúsculos o como ondas, pero nunca como ambos.

Esto le sugirió a Bohr que las descripciones corpusculares y ondulatorias de la luz y de la materia son ambas necesarias aunque sean lógicamente incompatibles entre sí. Deben considerarse como «complementarias» entre sí, es decir, como dos caras diferentes de la misma moneda. Esto llevó a Bohr a formular lo que se llama el principio de complementariedad:

Los dos modelos, corpuscular y ondulatorio, son necesarios para una descripción completa de la materia y de la radiación electromagnética. Dado que estos dos modelos son mutuamente excluyentes, no se pueden usar simultáneamente. Cada experimento, o el experimentador que diseña el experimento, selecciona una u otra descripción como la descripción adecuada para ese experimento.

Bohr demostró que este principio es una consecuencia fundamental de la mecánica cuántica. Afrontó la cuestión de la dualidad onda-corpúsculo, no resolviéndola a favor de ondas o partículas, sino incorporándola en los cimientos mismos de la física cuántica. Al igual que hizo con su modelo de átomo, Bohr transformó una dificultad en la base del sistema, a pesar de que esto supusiese contradecir la física clásica.

Es importante comprender qué significa realmente el principio de complementariedad. Al aceptar la dualidad onda-corpúsculo como un hecho de la naturaleza, Bohr lo que afirmaba es que la luz y los electrones (u otros objetos) tienen potencialmente las propiedades de las partículas y las ondas, hasta que se observan, momento en el que se comportan como si fueran una cosa u otra, dependiendo del experimento y la elección del experimentador. Esta era una afirmación de una enorme importancia, porque significaba que lo que observamos en nuestros experimentos no es lo que la naturaleza realmente es cuando no la estamos observando.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El principio de complementareidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El principio de incertidumbre, cualitativamente

- El comportamiento corpuscular de la luz: el efecto Compton

- El principio de incertidumbre, cuantitativamente

Diabetesa ulertzeko bidean (II): metabolismoan akatsak daudenean

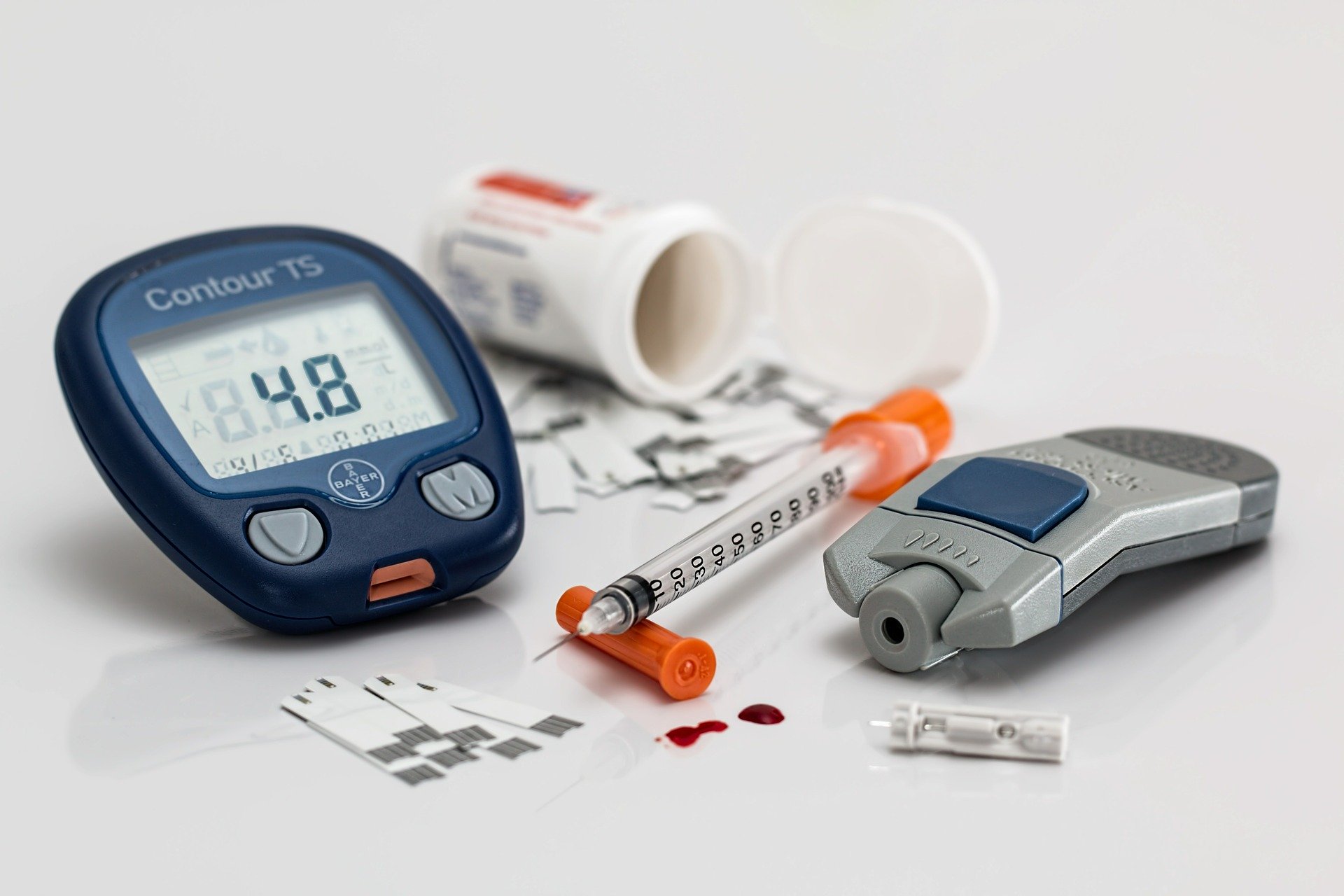

Irudia: Diabetesa duten gaixoentzat beharrezkoa da odoleko glukosaren kontzentrazioa kontrolatzea eta beharrezkoa denean intsulina injektatzea. (Argazkia: Steve Buissinne – domeinu publikoko irudia. Iturria: pixabay.com)

Diabetesa aspalditik ezagutzen den gaixotasuna da. Ideia bat emate aldera, kontuan izan behar dugu diabetesaren lehen deskribapena Ebers papiroan dagoela, k.a. 1.500. urtean. Erromatarrek eta greziarrek diabetesa ezagutzen zuten. Garai hartan, norbaitek diabetesa zuen edo ez jakiteko haren gernua dastatu behar zen. Horrela, greziarrak konturatu ziren zenbait lagunen gernua mellitus zela, alegia, gozoa zela -eztia, mellita hitzetik dator-. Orain badakigu zapore hori gehiegizko glukosa kontzentrazioaren kausa dela. Modu horretan, greziarrek bazekiten gaixotasun hori zutenek edari gozoak edan bezala kanporatzen zituztela gernuaren bidez -alegia, gernua ere gozoa zela- sifoi bat balitz bezala. Sifoi hitzaren baliokide greziarra diabetes da eta hortik, hain zuzen ere, diabetes mellitus.

Diabetesa duten gaixoek egarri handia izan ohi dute eta baita pixa egiteko gogo handia ere. Sintoma horietan oinarrituta, historian zehar hainbat aurkikuntza egin dira diabetesari buruz. 1679an, Thomas Willis mediku ingelesak sintoma horiek zituzten gaixoen gernuaren hondakinak dastatu zituen eta bi diabetes mota berezitu zituen: diabetes gozoa eta zaporerik gabeko diabetesa -esan beharrik ez dago nola iritsi zen ondorio horretara-. Gaur egun dakigunez, diabetes mellitusa diabetes gozoa da eta odoleko glukosa maila handiegiarekin lotzen da. Zaporerik gabeko diabetesa, aldiz, guztiz desberdina den gaixotasuna da eta hormona antidiuretikoaren gabeziarekin lotzen da. Hala ere, antzeko sintomak ematen dituenez, izen bera dute biek. Hortaz, garrantzitsua da jakitea diabetes mellitus eta diabetes zaporegabea fisiologikoki gaixotasun desberdinak direla. Oro har, diabetesa aipatzen denean lehenengoaz ari gara.

Diabetesa, beraz, pertsona baten odoleko glukosa maila behar baino gorago dagoenean izaten da. Oro har, odoleko azukre maila normaltzat jotzen da 65-100 mg/dl artean badago -baraurik- eta 140 mg/dl azpitik otordutik ordu bat edo bi igaro denean. Maila hori gaindituz gero, litekeena da pertsona horrek diabetesa izatea. Azukre kantitate handiegi horrek hainbat kalte ekar ditzake begietan, giltzurrunen funtzionamenduan, nerbio sisteman, eta abar. Oro har, epe luzera agertzen diren arazoak izan ohi dira. Diabetesa mota desberdinetakoa izan daiteke, baina, motarik arruntenak 1 mota eta 2 mota deiturikoak dira. Horien arteko desberdintasuna ulertzeko, lehenik eta behin beharrezkoa da glukosaren metabolismoaren erregulazioan gehiago sakontzea.

Glukosaren metabolismoa intsulinak erregulatzen du. Bere funtzio garrantzitsuena glukosa odoletik zeluletara igarotzen laguntzea da, modu horretan odoleko glukosa kontzentrazioa murriztuz. Era berean, intsulinak gibeleko glukogeno sintesia aktibatzen du eta prozesu horrek ere glukosa kontzentrazioa murrizten du. Alabaina, pankreak intsulinarik jariatzen ez badu, zeluletako paretetan dauden glukosa garraiatzaileak ez dira behar bezala aktibatzen eta glukosa ez da modu eraginkorrean sartzen zeluletara. Egoera honi 1 motako diabetesa deritzo, alegia, intsulina gabeziaren ondorioz odoleko glukosa kontzentrazioa murrizten ez denean.

Halere, bada beste akats mota bat glukosaren metabolismoaren erregulazioan. Zenbait kasutan, intsulina egon daiteke, bai, baina zeluletako intsulina hartzaileetan egotea akatsa -alegia, intsulinarekin lotu behar diren zelulako paretaren atalak-. Lotura hori ez bada modu egokian gertatzen, glukosa garraiatzaileak ez dira behar bezala aktibatzen eta glukosa ez da zeluletara sartzen. Bigarren arazo hori duten gaixoek 2 motako diabetesa dute, hots, pankreak intsulina jariatzen du, baina, intsulina ez da modu egokian lotzen hartzailearekin.

1 motako diabetesa haurtzaro edo nerabezaroan agertu ohi da, nahiz eta beranduago ere ager daitekeen. Oro har, mota honetako diabetesa bat-batean agertzen da eta intsulina hartuz kontrola daiteke. 2 motako diabetesa helduaroan agertzen da normalean eta horrek ez du zertan betirako izan behar; tratatzen bada, adibidez gizentasunaren aurka egiten bada, desagertu egin daiteke. 1 motako diabetesa baino askoz ere ohikoagoa da biztanlerian -%90-95- eta, orokorrean, sintomak ez dira hain agerikoak. Askotan ez du inongo minik sortzen eta denbora luzean oharkabean pasa daiteke -horrexegatik daude diagnostikatu gabeko kasu asko-. Oro har, 2 motako diabetesa elikadura desegokiaren eta kirol gabeziaren ondorioa izaten da. 1 motakoa, aldiz, ezin da era eraginkorrean saihestu. 1 motako diabetesa norberaren immunitate-sistemak pankrean dauden beta zelulak erasotzen dituenean gertatzen da eta horren arrazoiak genetikoak edo ingurunearenak izan daitezke -esaterako, gaixotasun birikoak jasan ondoren-.

Diabetes mellitusaren tratamenduari dagokionez, historian zehar hainbat modutara egin da, aurkikuntza berriek tratamendu eraginkorragoak ekartzen zituzten neurrian, baina, hori guztia hurrengorako utziko dugu.

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea, irakaslea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

Diabetesari buruzko artikulu-sorta:

- Diabetesa ulertzeko bidean (I): glukosaren metabolismoa

- Diabetesa ulertzeko bidean (II): metabolismoan akatsak daudenean

The post Diabetesa ulertzeko bidean (II): metabolismoan akatsak daudenean appeared first on Zientzia Kaiera.

Sesgos ideológicos que aquejan a la ciencia

Mapa de la previsión de la trayectoria del huracán Dorian alterado para que se ajustase a las declaraciones de Donald Trump en el sentido de que podía afectar a Alabama.

Mapa de la previsión de la trayectoria del huracán Dorian alterado para que se ajustase a las declaraciones de Donald Trump en el sentido de que podía afectar a Alabama.Los cognitivos no son los únicos sesgos que afectan al desarrollo de la ciencia. También hay sesgos ideológicos. Quienes se dedican a la investigación científica no son ajenos a la influencia de la cosmovisión, la ideología, las creencias, etc., y esos factores inciden en el desarrollo de la ciencia o en aspectos colaterales a la misma aunque de importantes repercusiones sociales. Los científicos llevados por sus creencias se ven afectados por sesgos (inconscientes, no serían casos de mala ciencia voluntaria) que les llevan realizar una actividad científica poco rigurosa (eligiendo datos -cherry picking- , interpretándolos, etc.) en la dirección de sostener con sus conclusiones científicas lo que ya creían antes de comenzar. El “razonamiento motivado” a que se ha hecho mención en la anotación anterior estaría en la base cognitiva de este comportamiento y la motivación sería un fuerte convencimiento ideológico.

En lo que a este aspecto se refiere y antes de poner algunos ejemplos ilustrativos, conviene advertir de que la incidencia de los sesgos es mayor cuanto más complejos son los sistemas que se estudian, más son las variables en juego y más difícil resulta aislar los efectos de los factores cuyo efecto se desea establecer empíricamente. La ciencia funciona a partir de la identificación de regularidades en los sistemas que estudia, pero esa identificación arroja mayores garantías cuando el sistema permite fijar o excluir factores que pueden incidir en ellas de forma incontrolada y limitar el análisis al efecto de aquellos que pueden ser modificados a voluntad o, al menos, medidos con precisión. La física es, en ese sentido, la disciplina cuyas observaciones ofrecen mayores garantías pues los sistemas que estudia son fácilmente acotables. Y a las ciencias sociales les ocurre lo contrario: es muy difícil eliminar factores de confusión y fijar con garantías los factores que se desea analizar. Y cuando es especialmente difícil descartar factores de confusión y fijar o controlar efectos de unas pocas variables, queda un amplio margen para la influencia de las motivaciones de carácter ideológico, tanto en el diseño de las investigaciones como en el posterior análisis de los resultados.

Quizás los antecedentes más antiguos del efecto de los sesgos ideológicos se remontan a los mismos orígenes de la ciencia moderna. En la controversia acerca del heliocentrismo o la naturaleza geométrica de las órbitas de los planetas (del movimiento de los cuerpos celestes, al fin y al cabo) ejercieron un efecto claro las creencias de sus protagonistas.

Algunos de los sesgos tuvieron carácter general en ciertas épocas. Las ideas de superioridad de la (supuesta) “raza blanca” o de las personas de origen caucásico con respecto a otras (supuestas) “razas” o procedencias condicionaron la investigación que se hizo en las épocas en que eran predominantes. Los prejuicios en relación con la capacidad de las mujeres para desempeñar roles considerados masculinos han ejercido una influencia muy fuerte en fechas relativamente recientes e, incluso, hoy lo siguen ejerciendo. Marlenne Zuk (2013) ha revisado críticamente algunas ideas muy extendidas acerca del (supuesto) “origen evolutivo” de las diferencias entre hombres y mujeres y ha refutado las bases de algunas de ellas.

Las creencias religiosas han alimentado actitudes claramente anticientíficas. En la actualidad el ejemplo más claro, quizás, de esta actitud es el del bioquímico Michael J. Behe, profesor de la Universidad de Lehigh, en Pensilvania (EEUU). Behe se opone a la teoría de la evolución por selección natural y defiende el llamado “diseño inteligente” que es, en realidad, una forma sofisticada de creacionismo. Según Behe, ciertas estructuras bioquímicas son demasiado complejas como para poder ser explicadas en virtud de los mecanismos de la evolución. Desarrolló el concepto de “complejidad irreducible” como un “sistema individual compuesto de varias partes bien coordinadas que interaccionan para desempeñar la función básica de este, de modo que si se eliminara cualquiera de esas partes dejaría de funcionar por completo”.

La ideología política puede tener también una influencia notable. No solo entre el púbico general, también en la comunidad científica la negación del cambio climático, en sus diferentes modalidades, está vinculada al campo conservador. La base ideológica está aquí relacionada con lo que podría considerarse una visión “optimista” del mundo, según la cual la naturaleza no tiene límites, ni desde el punto de vista de la disponibilidad o existencia de los recursos naturales, ni de la capacidad para asimilar la influencia de las actividades humanas. Esa visión optimista, junto con el hecho de que los efectos que se le atribuyen al cambio climático nos remiten a un futuro que se percibe como indefinido, neutraliza el peso de los argumentos y datos en que se basa el consenso científico al respecto.

Las actitudes anticientíficas más características de la izquierda suelen estar relacionadas con cuestiones de carácter ambiental y de salud. Sostienen que ciertas tecnologías ejercen efectos negativos sobre la salud de las personas y del medio ambiente. Se incluye en esa categoría, por ejemplo, la oposición a los organismos modificados genéticamente. Quienes defienden esas posturas suelen invocar el hecho de que son fuente de enriquecimiento para las empresas que las fabrican y comercializan, y que sus intereses se anteponen a otras consideraciones, incluidas las relativas a la salud de las personas o del medio ambiente.

Es probablemente una motivación de esa naturaleza la que anima a investigadores como Gilles-Eric Seralini. Seralini es conocido por sus opiniones contrarias a los transgénicos. En 2012 publicó un artículo en Food and Chemical Toxicology cuya conclusión era que el consumo de maíz transgénico provocaba el crecimiento de tumores en ratas de laboratorio que acababa provocándoles la muerte. El artículo, tras ser duramente criticado por numerosos científicos, fue finalmente retractado al año siguiente al entender el editor que no cumplía los estándares propios de una publicación científica debido a sus graves deficiencias metodológicas. La impresión que causa un caso como ese es que el investigador ha sacrificado el rigor exigible a un trabajo científico al objeto de obtener los resultados que mejor se acomodan a sus expectativas. J M Mulet (2013) ha expuesto aquí con claridad los pormenores de este caso.

Fuente:

Zuk, M (2013): Paleofantasy: What Evolution Really Tells Us about Sex, Diet, and How We Live. Norton & Co, New York.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo Sesgos ideológicos que aquejan a la ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sesgos cognitivos que aquejan a la ciencia

- Ciencia Patológica

- #Naukas14 Algunos trucos para reducir sesgos

Mikrobio materia iluna

Izaki bizidunak topatu diren lekurik ustekabekoenak, agian, sakonera handian dauden harkaitzen barnealdeak dira. Mikrobio formak bizi dira lurrazaletik eta itsas hondotik metro gutxi batzuetara, baita sakonera handiagoetan ere. Bakterioak eta arkeoak topatu dituzte lurrazaletik 5 kilometrora, lur azpian Txinan. Halaber, mikrobioak topatu dituzte itsas hondoa baino 2,5 kilometro beherago.

Irudia: Laborategietan kultibatu gabeko mikrobioen populazioari mikrobio materia iluna esaten zaio. Tennesseeko Unibertsitateko Karen Lloyd irakaslearen taldea lehena izan da mikrobio horien populazioa kalkulatzen. (Argazkia: Erabilera publikoko irudia. Iturria: Pixabay.com)

Arroken barruan, arrakalen eta poroen barnean, biosfera oso bat dago. Kalkulatu da organismo horiek guztiak 2 mila milioi km³-ko arroka bolumenean banatuta daudela (Lurreko ozeano guztiek okupatzen duten bolumenaren bikoitza), eta 1030 zelula izango lituzketela, hau da, Lurreko mikrobio-bizitzaren %70. Izan ere, zatirik handiena lurpeko biosferan dago, bakterioek eta arkeoak dira gehien bat, nahiz eta alga zelulabakarrak eta onddoak ere badauden.

Mikroorganismo horietatik gutxi batzuk heterotrofoak dira, hots, materia organikoz elikatzen dira; eta oso oxigeno gutxi edo batere ez dagoen inguruneetan bizi direnez, normalean, anaerobioak dira asko eta asko. Nolanahi ere, gehienak kimiolitotrofoak dira: gai inorganikoak dira euren energia iturri. Mikroorganismo horiek hondakinak sortzen dituzte, eta beste izaki bizidun batzuk elikatzen diren kate trofikoaren oinarria dira hondakinok. Gutxienez kasu batean, sare trofiko horretan superharrapakari bat dago, Halicephalobus mephisto har nematodoa, milimetro erdiko luzerakoa. 2011n topatu zuten urre meatze batean, 1.300 metroko sakoneran.

Bizitza forma anitz dago inguru batzuetan, eta oso gutxi beste batzuetan, edo espezie bakar bat. Hegoafrikako Mponeng urre meatzean, 2,8 km-ko sakoneran, ezagutzen den ekosistema bereziena topatu da: organismoen % 99,9 baino gehiago espezie bakar batekoak dira; Desulforudis audaxviator bakteriokoak.

Eta oraindik ere izaki bizidun asko eta asko dago lurpean nork aurkituko, ezagutzen dugun biologiaz oso bestelako organismoak, baiki. Seguru asko, bide metaboliko ezezagunak dituzte, eta litekeena da metabolismo oso geldokoak izatea. 2010ean, Pazifiko Hegoaldeko Ozeano Bareko sedimentuetan lurperatutako mikrobioak topatu zituzten, eta bertan 100 milioi urte zeramatzatela kalkulatu da. Bizirik zeuden, baina oso jarduera metaboliko txikia zuten.

Mikroorganismoen metabolismoa bizi diren arroken konposizio kimikoaren araberakoa da. Hau da, arroka granitoa, basaltoa, hareharria edo buztina den. Heterogenotasun metaboliko horri esker, mikrobio komunitateak asko aldatzen dira leku batetik bestera, arrokak ez direlako berdinak leku guztietan.

Lurpeko biosfera horri mikrobio materia iluna deitzen zaio, unibertsoko materia ilunaren analogiaz. Hori bai, materia mikrobianoa ezagutzen hasiak gara. Eta ez genuke baztertu behar halakorik gure planetan soilik topatzea: Marteko lur azpiak biosfera propioa izan lezake.

Iturria:

Lawton, Graham, (2019): Earth’s deep, dark secret. New Scientist, 242 (3229), 42-45. DOI: https://doi.org/10.1016/S0262-4079(19)30841-3.

———————————————————————————-

Egileaz: Juan Ignacio Pérez Iglesias (@Uhandrea) UPV/EHUko Fisiologiako katedraduna da eta Kultura Zientifikoko Katedraren arduraduna.

———————————————————————————

The post Mikrobio materia iluna appeared first on Zientzia Kaiera.

Los números del sistema circulatorio humano

Imagen: PIXOLOGICSTUDIO/Science Photo Library

Imagen: PIXOLOGICSTUDIO/Science Photo LibraryEl corazón es el único músculo humano que se contrae una y otra vez desde que se forma hasta que se detiene, tras lo cual y si no media intervención, sobreviene la muerte.

Dieciocho días después de la fecundación se empieza a desarrollar en el embrión, un proceso que concluye prácticamente en la octava semana. Es el primer órgano que empieza a funcionar; lo hace con tres semanas, cuando aún es un tubo cardiaco primitivo. En la quinta, configurado ya como un corazón, late a 80 pulsaciones por minuto (bpm en adelante). El ritmo se eleva hasta alcanzar en la novena -cuando ya se han formado los tabiques, las válvulas y las cuatro cámaras- valores máximos, que varían entre 155 y 195 bpm. El ritmo desciende a partir de ese momento hasta los 120-160 bpm.

El corazón adulto late a una frecuencia algo superior a un latido por segundo, aunque varía entre unos individuos y otros, dependiendo del peso, la edad, la condición física y el sexo. En promedio, late cien mil veces cada día, alrededor de treinta millones al cabo de una vida.

Su trabajo consiste en bombear sangre a través de dos sistemas de vasos. El de menores dimensiones la conduce a los pulmones -donde capta O2 y se desprende de CO2– y la trae de vuelta al corazón. El mayor la impulsa para limpiarla en los filtros renales, suministrar O2 a las células, recoger el CO2 que producen, llevar las moléculas de alimento del sistema digestivo a los tejidos, transportar hormonas y otras sustancias, conducir las plaquetas a donde sean necesarias, trasladar las células del sistema inmunitario para combatir el ataque de patógenos, distribuir calor por el organismo y desempeñar otras funciones de comunicación y transporte de sustancias entre órganos.

En reposo, un corazón de adulto bombea a los tejidos alrededor de cinco litros de sangre por minuto, lo que supone unos siete mil doscientos litros diarios. En otras palabras, bombea toda la sangre del cuerpo en un minuto, aunque en condiciones de actividad intensa, ese tiempo se reduce a quince segundos. Los tres órganos que más sangre reciben son el sistema digestivo (27%), los riñones (20%) y el encéfalo (un 15%). Ahora bien, la musculatura puede llegar a recibir dos terceras partes del flujo sanguíneo total cuando el organismo hace un ejercicio intenso.

Los vasos sanguíneos del cuerpo humano recorrerían, dispuestos uno detrás del otro, del orden de cuarenta mil kilómetros, aunque esa distancia resulta de sumar la correspondiente a miles de vasos que circulan en paralelo, puesto que el sistema circulatorio se ramifica en arterias, arteriolas y capilares para alcanzar así hasta el último rincón de nuestro cuerpo, y luego reagruparse en vénulas y venas antes de retornar al corazón. Por esa razón, cada gota de sangre, célula sanguínea o partícula en suspensión no recorre esa distancia cada vez que completa una vuelta al sistema. Dado que una célula sanguínea, por ejemplo, tarda en promedio un minuto en completar el circuito, viaja a una velocidad aproximada de dos kilómetros por hora y recorre unos treinta y tres metros.

Un 45% del volumen sanguíneo está ocupado por glóbulos rojos (también llamados eritrocitos), células carentes de núcleo encargadas de transportar O2 y CO2 y cuya vida se limita a unos cuatro meses. Cada día se renuevan del orden de cien mil millones de estas células. A lo largo de su breve vida, un eritrocito pasa por el corazón unas ciento cincuenta mil veces y recorre del orden de ciento sesenta mil kilómetros.

Y todo esto sin que, prácticamente, nos demos cuenta.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Los números del sistema circulatorio humano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un viaje a través del sistema circulatorio humano

- La emergencia de un doble sistema circulatorio

- ¿Cuántas células hay en el cuerpo humano?

Asteon zientzia begi-bistan #290

Azken urteetan, modan jarri da proteina asko dituzten dietak. Horren harira, publikatu den ikerketa batean ikusi dute dieta horiek arterietan plaken pilatzea eragiten dutela. Testuan azaltzen digutenez, proteina maila altu hauek odolean zenbait aminoazidoren kopuruak handitzen dituzte, eta horrek sistema immuneko zelula makrofagoak akabatzen dituzte. Horren ondorioz, arteriak estutzen dira eta kasurik larrienetan, guztiz buxatzeko aukera dago.

Testosterona hormonaren mailaren eta zenbait gaixotasunen arteko lotura aztertzen duen ikerketarik handiena publikatu dute. Datuen arabera, testosterona-maila altua izateak bularreko eta endometrioko minbizia izateko arriskua handitzen du emakumezkoetan, eta prostatako minbiziarena gizonezkoetan. Elhuyar aldizkarian aurkituko dituzue xehetasunak.

Epilepsiaren Nazioarteko Egunaren harira, Berriako artikulu honetan gaixotasun kroniko honi buruz mintzatu dira. Kristinak eta Mikelek euren esperientziak azaldu dizkigute, gaitz hori hobeto ulertze aldera.

GenetikaGenetikan doktorea den Koldo Garcia elkarrizketatu dute Geuria.eus-en. Egun, ikertzaile lanetan ari da Biodonostia Osasun Ikerketako Institutuan, gaixotasun gastrointestinalen sailean. Bertan, genetika erabilita, gaixotasun horiek hobeto ezagutzen eta tratamendu hobeagoak egin daitezkeen ikertzen dute. Taldearen helburu nagusia da gaixotasun gastrointestinala (GI) sortzen duten mekanismo genetikoak azaltzea. Halaber, Garciak azaltzen digu zein den ikerkuntzaren egungo egoera eta zientziaren dibulgazio-lanaren garrantzia. Ez galdu!

EboluzioaRichard Wrangham primatologoaren Cathing Fire: How Cooking Made Us Human liburua aipatzen da testu honetan. Izan ere, eta autorearen hipotesiaren arabera, Homo erectus espezieak lortu zuen sua kontrolatzea eta elikagaiak kozinatzea, eta hori funtsezkoa izan zen garunaren eta adimenaren garapenerako. Elikagaiak kozinatuz handitu egin zen hauek digeritzeko eta xurgatzeko eraginkortasuna, eta horrek ondorio ebolutibo sakonak izan zituen.

AstrofisikaBerriki jakin dugu Arrakoth, iazko azarora arte Ultima Thule bezala ezagutu genuen Neptunoz haraindiko objektua, bi planetesimalen arteko batuketatik sortu zela. Hala berretsi du nazoarteko ikertzaile talde batek. Izan ere, objektuaren eraketa ez zen talka batengatik izan, “leunkiro” egindako grabitazio-hurbilpen baten emaitza baizik. Honi buruzko informazio gehiago Elhuyar aldizkarian topatuko duzue.

MaterialakNanoteknologiak ikerkuntza arlo askotan garrantzi handia du, elikagaigintzan, esaterako. Lan honetan, nanoteknologia elikadura sektorean ezartzeak eragindako aurrerapen nagusiak aurkezten dira eta zehazki, hiru arlo hauetan: nano-aberastutako elikagaiak, elikagai biltegiratzeko diseinu berriak eta nanosentsoreak. Horretaz gain, nanoteknologiaren erabilpenak eragindako eztabaida aztertzen da testuan.

FisikaAurreko astean eman genuen honen berri: Ion Errea ikertzailearen taldeak frogatu zuen tenperatura oso handiko supereroaleak lor daitezkeela askoz ere presio txikiagoetan. Honek iraultza ekar dezake, izan ere, etorkizunean presio baxuagoko material supereroaleak identifikatzeko oinarriak ezarri dituzte. Informazio gehiago Elhuyar aldizkariko artikulu honetan aurki dezakezue.

KlimatologiaHimalaiako glaziarretan industria-iraultzaren hastapenetatik poluitzaileak metatu zirela frogatu dute. Elhuyar aldizkariak azaldu digunez, ikerketak agerian utzi du Britainia Handian sortu zen industria-iraultzak eragin nabarmena izan zuela airean, izotz-zutabean ordura arte baino metal toxiko gehiago aurkitu baitute 1780tik aurrera. Baina ez zen bakarrik industria-iraultza izan horren eragile, nekazaritzak ere eragina izan zuen izan ere, nekazaritzarako lurrak lortzeko basoei su emateak zinka askatzen baitu atmosferara.

AstronomiaAurten, AEBk, Europako Batasunak eta Errusiak, Txinak eta Arabiar Emirerri Batuek misioak bidaliko dituzte Martera, bizitza arrastoak aurkitzera. Antolatuta dituzten misioen artean, ikertu nahi dute ea Marte bizia edukitzeko moduko planeta bat izan zen eta mikrobioak bizi izan ziren. Noizbait pertsonak bidali ahal izateko esperimentuak ere egingo dituzte. Marte hobeto ezagutzeko misioez gain, 2020an ilargia eta eguzkia izango dute helburu aipaturiko herrialdeek. Berriako artikuluan informazio guztia.

–——————————————————————–

Asteon zientzia begi-bistan igandeetako atala da. Astean zehar sarean zientzia euskaraz jorratu duten artikuluak biltzen ditugu. Begi-bistan duguna erreparatuz, Interneteko “zientzia” antzeman, jaso eta laburbiltzea da gure helburua.

———————————————————————————-

Egileaz: Uxue Razkin (@UxueRazkin) kazetaria da.

———————————————————————————-

The post Asteon zientzia begi-bistan #290 appeared first on Zientzia Kaiera.

Día de Darwin 2020: Evolución del Sistema Solar + Teoría evolutiva y medicina

El Día de Darwin se celebra en la capital vizcaína desde el año 2007, formando parte actualmente del calendario de citas ineludibles para los amantes de la ciencia. La Cátedra de Cultura Científica y el Círculo Escéptico este año han vuelto a conmemorar el 12 de febrero el aniversario del nacimiento del científico Charles Darwin, autor de la teoría de la evolución por selección natural. Hace ya 211 años que nació el reconocido científico y, en esta decimocuarta edición del Día de Darwin, las ponencias se centraron en la evolución del Sistema Solar y la relación entre la teoría evolutiva y la medicina.

La ponencia titulada “Pasado, presente y futuro del Sistema Solar” corre a cargo de Itziar Garate Lopez. La charla describe el Sistema Solar, una complicada familia de astros que cuenta con distintos tipos de planetas, lunas, asteroides y cometas orbitando una estrella nada extraordinaria, además de cómo pudo formarse en nuestra vecindad estelar, cómo ha cambiado desde entonces y cual es el futuro que le espera.

Itziar Garate Lopez es licenciada en Física por la Universidad de La Laguna y doctora en Ciencia, Tecnología y Observación Espacial por la UPV/EHU. Actualmente es profesora en el Departamento de Física Aplicada I de la Escuela de Ingeniería de Bilbao (UPV/EHU) e investigadora del Grupo de Ciencias Planetarias de la misma universidad. Anteriormente fue investigadora postoctoral del Centre National d’Études Spatiales en la Sorbonne Université. Su línea de investigación se centra en el estudio de la dinámica atmosférica de los planetas terrestres Venus y Marte y, más en concreto, en la formación y evolución de los vórtices polares venusianos.

En la segunda ponencia, “Teoría evolutiva y medicina: caminos convergentes”, Luis Carlos Álvaro González aborda la medicina desde una perspectiva diferente. La medicina ha vivido de espaldas a la teoría evolutiva por razones históricas y las propuestas de convergencia han ido surgiendo en los últimos años. Estas propuestas permiten un acercamiento, fundamentado en mecanismos operativos simples, que explican trastornos degenerativos, el envejecimiento con múltiples patologías asociadas, las enfermedades vasculares, los trastornos autoinmunes, diversas infecciones o las migrañas.

Luis Carlos Álvaro González es médico neurólogo del Hospital de Basurto de Bilbao y profesor del Departamento de Neurociencias de la UPV/EHU. Es autor de más de 100 publicaciones en su ámbito clínico, además de revisor de revistas especializadas nacionales e internacionales y miembro de comités editoriales. Ha sido premiado por su labor y dedicación en el área de la neurología. Autor de varios libros de divulgación de su especialidad, participa activamente en la investigación y difusión de la teoría evolutiva en el escenario clínico y para el público no experto.

La sesión está enmarcada en el ciclo Bidebarrieta Científica, una iniciativa que organiza todos los meses la Cátedra de Cultura Científica de la UPV/EHU y la Biblioteca Bidebarrieta para divulgar asuntos científicos de actualidad.

Edición realizada por César Tomé López

El artículo Día de Darwin 2020: Evolución del Sistema Solar + Teoría evolutiva y medicina se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los primeros pasos de la evolución darwiniana y sesgos cognitivos y evolución (Día de Darwin 2018)

- Una simulación más eficiente de la evolución del Sistema Solar

- Planeta X, en busca del inquilino invisible del sistema solar

Ezjakintasunaren kartografia #295

Zientzia merkatu bihurtu eta aura erromantikoa galdu duen beldur direnentzat, onbidezko irakurketa izan daiteke Jesús Zamoraren artikulua. Aurreiritziak tartean sartu ezean, noski. The marketization of science and the ‘marketization’ of science studies (& 2)

Alzheimerra goiz detektatzeko moduen bilaketan kandidatu berria: T zelulak. Rosa García-Verdugoren T cells could be key for early Alzheimer’s detection

Erreakzio biokimikoak katalizatzeko gai diren proteinak dira entzimak. Zikloadizio erreakzio bat katalizatzeko gai den proteina topatu dute DIPCn, organismo bizietan halakorik ez da aurkitu. Izena ere asmatu behar izan dute. Huisgenases, new protein catalysts which are not enzymes

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #295 appeared first on Zientzia Kaiera.