¿Puede la física resolver problemas en medicina?

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

La física y la medicina son dos actividades científicas que parecen estar muy alejadas una de la otra. Sin embargo, el listado de los premios Nobel de medicina, nos enseña que hay varios galardones concedidos a Físicos, o en base a una metodología Física. De hecho, el primer galardonado de este tipo, el sueco Allver Gullstrand, recibió en 1911 el Premio Nobel de Medicina y fue nominado al Nobel de Física tanto en 1910 como en 1911. En 1911, el Comité Nobel de Física, del cual Gullstrand era miembro, sugirió que el premio Nobel había de ser para él. Al mismo tiempo el Comité Nobel de Medicina estaba considerando su nombre para el Nobel. Gullstrand declinó el Premio Nobel en Física a favor del Nobel de Medicina [1]. Gullstrand es la única persona que ha declinado un Premio Nobel y ha aceptado otro. Sin contarle a él, son solo tres personas las que no han aceptado un Nobel: los de literatura de 1958 y 1964 por los escritores, ruso Boris L. Pasternak y francés Jean-Paul Sartre, respectivamente, y el Nobel de la Paz por el Vietnamita Le Duc Tho en 1973.

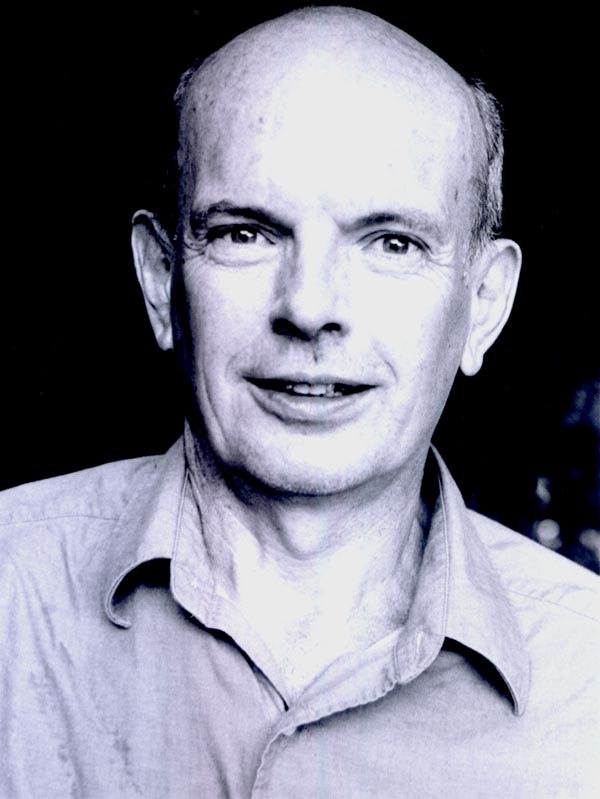

Imagen 1. Allver Gullstrand, premio Nobel en 1911. Fuente: Wikimedia Commons

Imagen 1. Allver Gullstrand, premio Nobel en 1911. Fuente: Wikimedia Commons

Es interesante reseñar que Gullstrand tenía una fuerte personalidad y como miembro de la Real Academia de Ciencias Sueca formo parte en 1921 del Comité que se opuso a que Albert Einstein recibiese el Nobel de Física en 1921 por la teoría de la relatividad general, que Gundstrand consideraba equivocada [1].

Allver Gullstrand fue galardonado en 1911 con el premio Nobel en Medicina por sus investigaciones sobre la refracción de la luz a través del medio trasparente del ojo vivo. Si esto no es una metodología Física, que me digan qué es!!! Tres años después de recibir el premio Nobel abandonó la cirugía oftalmológica para dedicarse completamente a la investigación sobre instrumentos ópticos y diseño de instrumentación y técnicas quirúrgicas. La lámpara de hendidura, presente hoy en día en la mayoría de las mesas de los oculistas es una de sus invenciones.

Imagen 2. Lámpara de hendidura. Fuente: Wikimedia Commons

Imagen 2. Lámpara de hendidura. Fuente: Wikimedia Commons

Hubo que esperar 11 años hasta que una metodología Física recogiera otro Premio Nobel de Medicina. El inglés, Licenciado en Matemáticas, Archibald Vivian Hill recibió el Premio Nobel de Medicina de 1922 por la investigación relativa al cambio de temperatura que se produce al poner a trabajar los músculos. Su trabajo sobre la función muscular, especialmente la observación y medida de los cambios de temperatura asociados con el funcionamiento de los músculos, se extendió posteriormente a estudios similares sobre el mecanismo del paso de los impulsos nerviosos. Se desarrollaron técnicas muy sensibles, capaces de medir cambios de temperatura del orden de 0,003 °C en periodos de solo centésimas de segundo. Estas investigaciones dieron un gran impulso a la biofísica y se dice que el gran interés por la misma se debe a sus aportaciones.

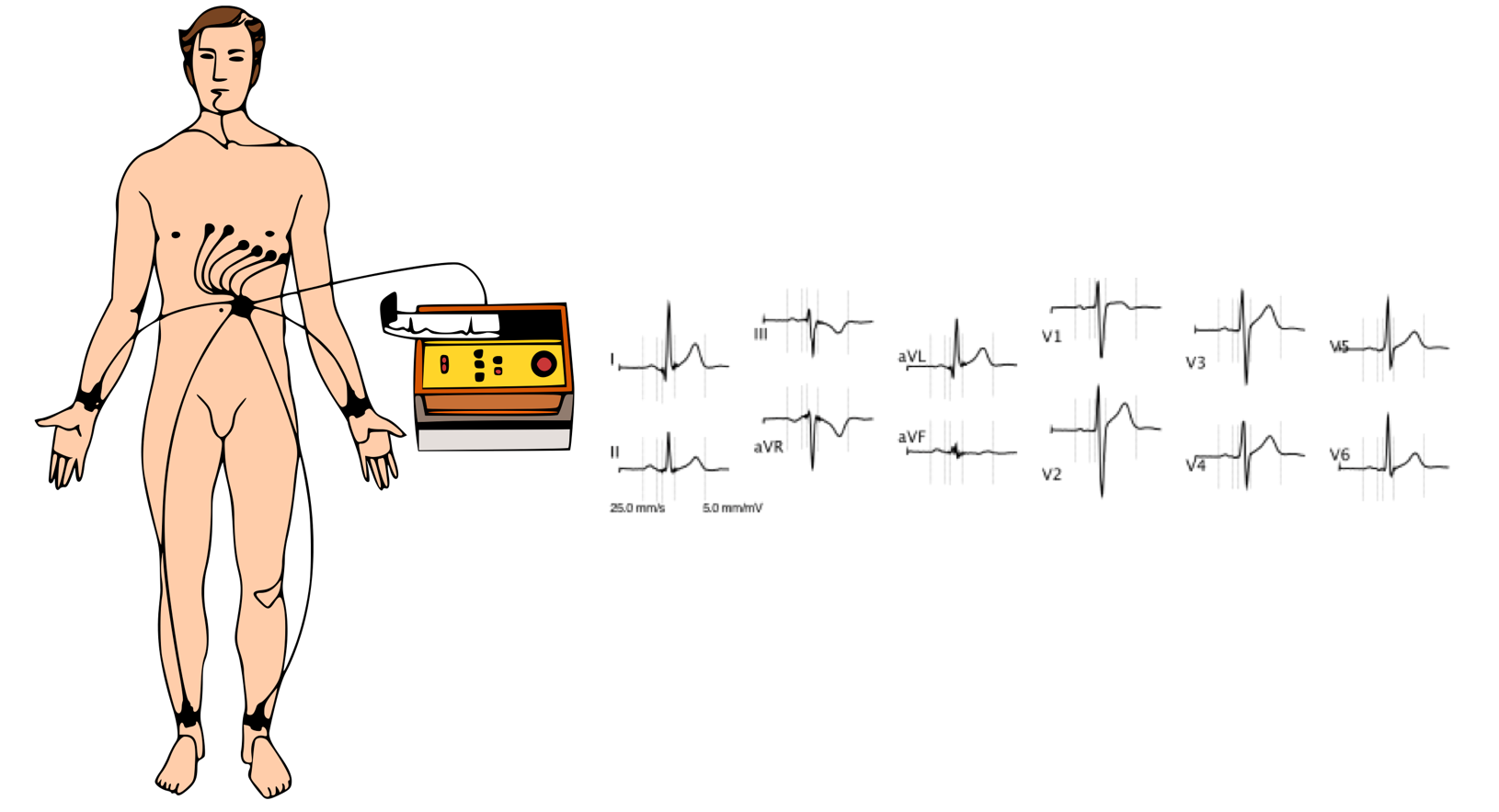

En 1924 el médico holandés Willen Einthoven fue galardonado con el premio Nobel de Medicina por el descubrimiento del mecanismo del electrocardiograma. El electrocardiograma es la representación gráfica de la actividad eléctrica del corazón en función del tiempo. Actualmente tiene una función relevante en cribado y diagnóstico de enfermedades cardiovasculares y alteraciones metabólicas. Como es bien conocido, el electrocardiograma se obtiene colocando sobre la zona del pecho 10 electrodos sujetos con cinta de velcro que se conectan mediante cables al aparato para medir los voltajes entre los electrodos (derivaciones, 12 en total). Podemos decir en forma figurada que cada derivación es una “fotografía” de la actividad eléctrica del corazón, tomada desde un ángulo diferente.

Imagen 3. Obtención de electrocardiograma y “fotografías” de la actividad eléctrica del corazón. Fuente: Wikimedia Commons

Imagen 3. Obtención de electrocardiograma y “fotografías” de la actividad eléctrica del corazón. Fuente: Wikimedia Commons

Los Premios Nobel de Medicina relacionados con la Física presentados hasta ahora se produjeron en las áreas de óptica, termodinámica y señales eléctricas. Sin embargo, el de 1946 (al igual que los dos siguientes) estuvo relacionado con los rayos X. Al genetista estadounidense Hermann Joseph Muller se le galardonó con el Premio Nobel por el descubrimiento de la producción de mutaciones mediante la irradiación con rayos X.

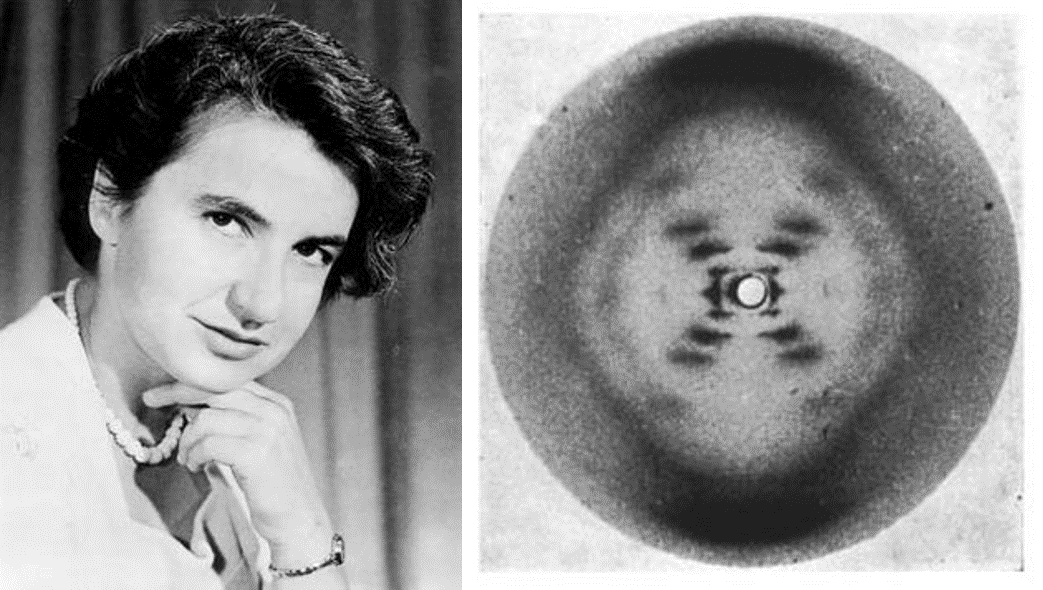

En el Premio Nobel de Medicina de 1962 también se utilizaron los rayos X, pero en este caso para realizar análisis estructurales mediante difracción de los mismos. La química inglesa Rosalind Elsie Franklin trabajando junto al físico neozelandes Maurice Wilkins sobre la difracción de rayos X de la molécula de ADN, describen la estructura de doble hélice del Ácido Desoxidorribonucleico, el ADN, que posteriormente servirá de base para la descripción de dicha estructura por el biólogo estadounidense James Dewey Watson y el físico inglés Francis Harry Compton Crick. La estructura de la molécula de doble hélice que es el ADN dio al mundo la llave para entender todos los secretos de la vida. Toda la vida en la tierra, desde la bacteria más pequeña hasta el ser humano, existe gracias al ADN. Este descubrimiento les valió el premio Nobel de Medicina de 1962 a 3 de estos científicos. Sin embargo, a pesar de que la contribución de la científica Rosalind Franklin fue fundamental (fue quien diseño y realizó los experimentos de difracción de rayos X, sin los cuales no hubieran podido llegar a descifrar la doble hélice), no obtuvo el reconocimiento Nobel por haber fallecido.

Imagen 4. Rosalind Elsie Franklin y la fotografía 51, imagen de la difracción con Rayos X de una molécula de ADN, realizada en 1951 por Rosalind Franklin y Raymond Gosling. Fuente: Composición a partir de imágenes de Wikimedia Commons

Imagen 4. Rosalind Elsie Franklin y la fotografía 51, imagen de la difracción con Rayos X de una molécula de ADN, realizada en 1951 por Rosalind Franklin y Raymond Gosling. Fuente: Composición a partir de imágenes de Wikimedia Commons

¿Cómo llegaron a poder de Watson y Crick los difractogramas realizados por Rosalind Franklin? Así como los comentarios de Watson sobre Rosalind dan para mucho, y son un reflejo de la discriminación que han sufrido muchas mujeres científicas, pero esto nos daría para todo un artículo y no es el objetivo de este [2].

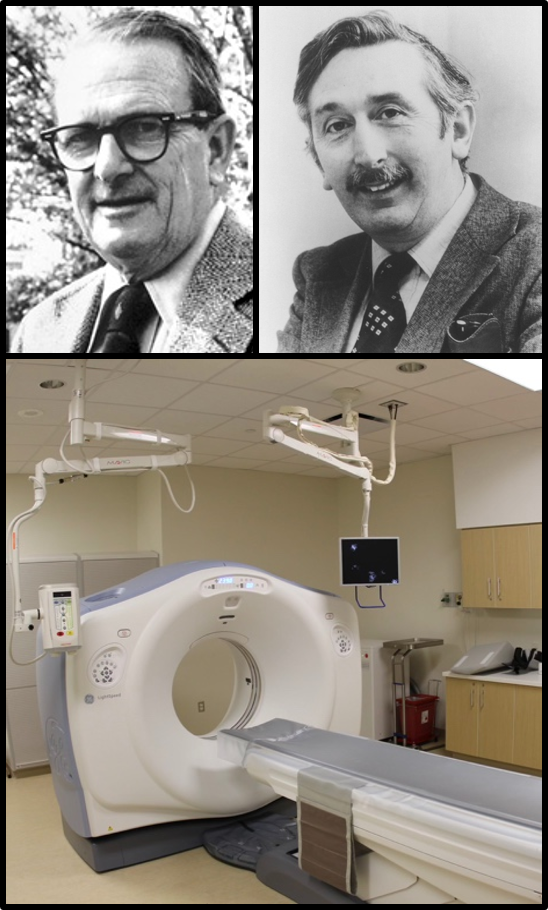

Los siguientes Premios Nobel de Medicina relacionados con la Física se concedieron a descubrimiento/invenciones de técnicas de imagen que actualmente conocemos muy bien. El primero, de 1979, también está relacionado con los rayos X, fue para el físico sudafricano Allan McLeod Cormack y el ingeniero electrónico inglés Godfrey Newbold Hounsfield, por el desarrollo y descubrimiento de la Tomografía Axial Computerizada, que conocemos coloquialmente como TAC o escáner. El TAC revolucionó el diagnóstico médico en todo el mundo, ya que trajo un gran avance en la detección y localización de tumores, permitiendo a los médicos ver el interior del cuerpo humano en tres dimensiones. Godfrey comentó en una entrevista que el The New York Times le realizó en 1973 “el avance consistía en darse cuenta de que al escanear objetos desde muchos ángulos era posible extraer el 100% de la información de los rayos X”. El diagnóstico basado en imágenes del interior del cuerpo obtenidas por medio de los rayos X se utiliza desde principios del siglo XX. Sin embargo, las radiografías clásicas no permiten observar el relieve, ni distinguir con claridad los tejidos. El escáner resuelve esta situación, obteniendo gran número de imágenes de rayos X (ya sea sucesivamente, haciendo girar el aparato, o simultáneamente, mediante varios emisores y detectores).

Imagen 5. Arriba: los premios Nobel de 1979 Allan McLeod Cormack y Godfrey Newbold Hounsfield. Abajo: Equipo TAC o escáner. Composición a partir de imágenes de Wikimedia Commons

Imagen 5. Arriba: los premios Nobel de 1979 Allan McLeod Cormack y Godfrey Newbold Hounsfield. Abajo: Equipo TAC o escáner. Composición a partir de imágenes de Wikimedia Commons

En 2003 el premio Nobel de Medicina se concedió al físico británico Peter Mansfield y al químico estadounidense Paul Christian Lauterbur por la invención y desarrollo de la imagen por resonancia magnética nuclear, a la que coloquialmente llamamos resonancia magnética o imagen de resonancia magnética (MRI). Si sometemos los núcleos de los átomos a un intenso campo magnético, estos rotan alrededor de ese campo magnético con una frecuencia que depende del valor de la intensidad del campo. La energía de los núcleos puede aumentar (excitación nuclear) si absorben ondas de radio de la misma frecuencia de rotación. A este proceso se le conoce como resonancia nuclear. Cuando los núcleos se desexcitan, es decir, vuelven a su estado original o fundamental, emiten ondas de radio características del núcleo particular que lo identifican. De hecho, este fenómeno fue descubierto en 1946 para los núcleos de los átomos de Hidrogeno por los estadounidenses Felix Bloch y Edward Mills Purcell, que recibieron el premio Nobel de Física en 1952. Este fenómeno fue muy prolífico, ya que dio lugar a otros dos premios nobeles, de química estos, uno en 1991 y el otro en 2002.

Imagen 6. Los premios Nobel de 2003 Paul Christian Lauterbur y Peter Mansfield.

Imagen 6. Los premios Nobel de 2003 Paul Christian Lauterbur y Peter Mansfield.

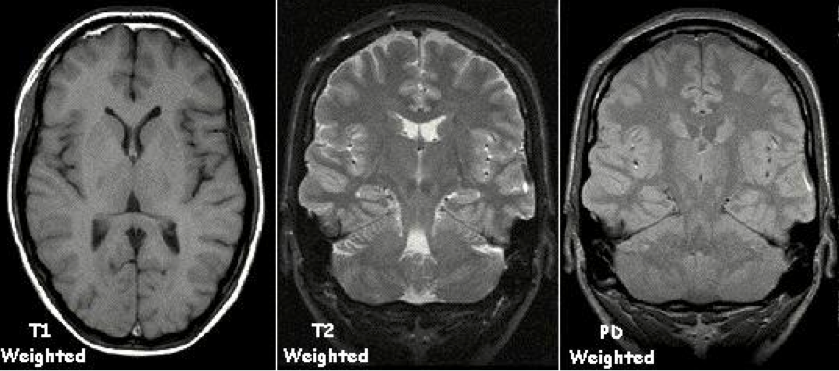

Mediante la detección de las ondas de radio siguiendo el procedimiento anterior es posible detectar el hidrógeno y su cantidad por unidad de volumen. El agua es una molécula compuesta de átomos de hidrógeno y oxígeno. Por lo tanto, al contener hidrogeno, el agua responde al fenómeno citado. Dos tercios del peso del cuerpo humano son agua y este elevado contenido en agua explica por qué las imágenes de resonancia magnética se han vuelto tan útiles en la medicina. Las pequeñas diferencias en las oscilaciones de los núcleos pueden detectarse y mediante un procesamiento informatizado complejo, es posible construir una detallada imagen de tejidos y órganos en el área del cuerpo investigada. De esta forma pueden documentarse los cambios patológicos.

Imagen 7. Ejemplos de MRI tomados con diferentes técnicas: ponderación T1 (spin-red), ponderación T2 (spin-spin) y ponderación en PD (densidad de protones). Fuente: Wikimedia Commons

Imagen 7. Ejemplos de MRI tomados con diferentes técnicas: ponderación T1 (spin-red), ponderación T2 (spin-spin) y ponderación en PD (densidad de protones). Fuente: Wikimedia Commons

Hoy día, la MRI se emplea para la exploración de casi todos los órganos del cuerpo. La técnica es especialmente valiosa para obtener imágenes detalladas del cerebro y la medula espinal. Sin embargo, el equipamiento para la MRI es caro, muy voluminoso, pesado y necesita de campos magnéticos elevados (como mínimo del orden de 1 Tesla, que en comparación al campo magnético terrestre es unas 10000 veces mayor), por lo que está localizado en lo que se vienen a llamar salas de resonancia de grandes hospitales.

Desarrollar equipamiento MRI portable sería una ventaja adicional, que posibilitaría su utilización en salas de urgencias, ambulatorios y ambulancias medicalizadas, con la consiguiente mejora en el servicio médico. En la Facultad de Ciencia y Tecnología se está trabajando en el desarrollo de equipamiento portable, y el primer prototipo del citado equipamiento está cerca [3].

Actualmente el desarrollo de una nueva terapia contra el cáncer (Hipertermia magnética), se está realizando por investigadores e investigadoras en Física y Química de la Facultad de Ciencia y Tecnología, investigadores de la Facultad de Medicina e investigadores en medicina clínica del Hospital de Galdakao. Esta nueva terapia necesita de los siguientes pasos: 1) sintetización de nanopartículas magnéticas apropiadas, 2) inoculación de las nanopartículas magnéticas de forma que estas se localicen en el tumor y 3) desarrollo de un aplicador electromagnético de radiofrecuencia que sea capaz de hacer que las nanopartículas magnéticas liberen calor suficiente para “quemar” los tumores en los que se han localizado las nanopartículas [4]. Cuando se consiga desarrollar completamente la terapia será posible “quemar” las células cancerosas, es decir, los tumores, sin dañar el tejido circundante. Si se consigue implementar esta terapia, los efectos secundarios serán mucho menores que los que producen la radioterapia y la quimioterapia, y su costo será mucho menor.

Para saber más:

[1] Ravin, James G. (1999). Gullstrand, Einstein, and the Nobel Prize. MD Arch Ophthalmol. 117(5):670-672. DOI:10.1001/archopht.117.5.670

[2] Angulo, Eduardo (2014). El caso de Rosalind Franklin. Mujeres con Ciencia.

[3] Alonso-Valdesueiro, J. et al., (2018). Design, Construction, and Characterization of a Magic Angle Field Spinning RF Magnet. IEEE Transactions on Instrumentation and Measurement, PP(99), 1-10. DOI:10.1109/TIM.2018.2884606

[4] Périgo, E.A. et al., (2015). Fundamentals and advances in magnetic hyperthermia. Applied Physics Reviews, 2(4), 041302. DOI:10.1063/1.4935688

Sobre el autor: Fernando Plazaola es catedrático en el Departamento de Eletricidad y Electrónica de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo ¿Puede la física resolver problemas en medicina? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las dos culturas de las matemáticas: construir teorías o resolver problemas

- El Nobel de Medicina de 2013: Logística de prefabricados de construcción (en las células)

- Dudas sobre las vacunas: problemas y soluciones

Los filtros solares llegan al torrente sanguíneo, dice la prensa

Fuente: Pixabay

Fuente: Pixabay

Recientemente se ha publicado un estudio preliminar sobre la absorción de algunos filtros ultravioleta empleados en los productos de protección solar [1]. Ha cundido el pánico, pero no en la comunidad científica, sino en los medios de comunicación. Tanto en la prensa española, como en la prensa extranjera [2] los titulares han sido alarmistas y no se corresponden ni con las conclusiones del estudio ni con la opinión de sus autores [3]. La realidad es que este estudio no ha aportado nuevas evidencias, y la recomendación sigue siendo el uso de protección solar, ya que los beneficios superan con creces a los posibles riesgos.

-

El origen del estudio

El estudio se realizó a petición de la FDA. La FDA es la agencia del gobierno de los Estados Unidos responsable de la regulación de alimentos, medicamentos, cosméticos, aparatos médicos, productos biológicos y derivados sanguíneos. Es el análogo as SCCS europeo.

La razón de este estudio es que la FDA ha cambiado los parámetros por los cuales un ingrediente usado en cosmética puede o no pasar a formar parte de su lista de ingredientes seguros (la lista GRASE, Generally Recognised as Safe and Effective).

Antiguamente, la seguridad de los filtros solares se evaluaba con ensayos en animales. Hace años que estos ensayos han de hacerse en personas. Todos los filtros solares que actualmente se usan en EEUU han superado con éxito los ensayos toxicológicos, pero con la nueva regulación [4] han de repetirse.

Para que se apruebe la entrada de un filtro solar en la lista GRASE, hay que presentar estudios de “prueba de uso máximo”. Estos estudios sirven para determinar si el ingrediente se absorbe, si pasa a la sangre y en qué cantidad [5]. Es la misma prueba que se exige en los medicamentos de uso tópico. Con esto, la definición de “cosmético” con respecto a la de “medicamento” está poco clara para la FDA.

- El estudio

El estudio es un estudio preliminar, o “estudio piloto”. En este caso significa que se ha hecho con muy pocos individuos, en poco tiempo y en unas condiciones que no son las normales de uso. Los estudios preliminares sirven para determinar si sería o no conveniente hacer un estudio más exhaustivo.

En el estudio participaron 24 voluntarios. Estos se dividieron en cuatro grupos de 6 personas. Cada uno de estos grupos estuvo utilizando un producto de protección solar concreto: dos aerosoles, una loción y una crema respectivamente. Durante 4 días cubrían el 75% de su cuerpo con estos productos a razón de 2 mg de producto por cada cm2 de piel, el doble del uso recomendado. Aplicaban esta cantidad de producto 4 veces al día. Durante este tiempo, los voluntarios no realizaban ninguna actividad: ni salían, ni iban a la playa, ni sudaban, ni se bañaban en el mar o la piscina. Es decir, las condiciones de uso fueron extremas, ya que solo se trataba de hacer un estudio preliminar. Luego, analizaron su sangre para detectar cuatro ingredientes activos: avobenzona, oxibenzona, octocrileno y ecamsule, que son cuatro filtros ultravioleta empleados en productos de protección solar.

Según la FDA, un filtro solar que presente una absorción sistémica de 0,5 ng/ml o inferior, no tiene que someterse a más ensayos toxicológicos y será directamente declarado como seguro, por lo que podrá formar parte de la lista GRASE. Esto no implica que una absorción superior vaya a tener efectos adversos en la salud, sino que habría que evaluar si es así o no.

Los autores del estudio encontraron evidencia de una absorción sistémica medible de los 4 filtros solares. Los productos que contienen avobenzona dieron como resultado concentraciones plasmáticas superiores a 0,5 ng/ml desde el primer día. La concentración aumentó desde el primer día al cuarto, por lo que existe acumulación. El séptimo día, la concentración de avobenzona decayó, hasta ser indetectable en sangre en el caso de la crema.

La aplicación de productos con oxibenzona y octocrileno dio lugar a niveles plasmáticos similares entre sí, muy por debajo de los niveles de la avobenzona, aunque con concentraciones también superiores a 0,5 ng/ml.

Entre los 6 participantes que usaron la crema con ecamsule, solo 5 tuvieron concentraciones plasmáticas superiores a 0.5 ng/mL el primer día. Los niveles plasmáticos fueron los más bajos de entre todos los filtros solares analizados.

No obstante, los coeficientes de variación del estudio están en su mayoría por encima del 20%, algunos por encima del 100%. Esto quiere decir que la absorción sistémica es heterogénea y difiere mucho de unos individuos a otros. Este es uno de los motivos por los cuales los autores del estudio reconocen que los resultados no son concluyentes.

-

Un estudio poco novedoso

Desde 1997 sabemos que los filtros solares llegan al torrente sanguíneo. Hace ya 22 años. También sabemos que son eliminados por medio de la orina [6]. Se han hecho decenas de estudios toxicológicos sobre todos los filtros ultravioleta utilizados en cosméticos de protección solar [7][8][9][10][11][12][13][14], así que el reciente estudio de la FDA no aporta información novedosa ni sorprendente para la comunidad científica.

No obstante, las autoridades sanitarias concluyen que las concentraciones plasmáticas detectadas están muy por debajo de los niveles tóxicos. El SCCS (el análogo a la FDA de la Unión Europea) ha estudiado los efectos en la salud de estos mismos ingredientes mucho más recientemente que la FDA, determinando que su uso es seguro [15][16][17].

-

Un estudio limitado

Al tratarse de un estudio preliminar es, casi por definición, un estudio limitado. La principal limitación la encontramos en el tamaño de muestra. Un estudio de este tipo debería realizarse con muchos más individuos. Tampoco se pueden tomar por válidos unos resultados con unos coeficientes de variación tan elevados.

Las condiciones del estudio también deberían asemejarse a las condiciones de uso normal de estos productos. Usando las cantidades recomendadas por el fabricante, no el doble, respetando los tiempos de reaplicación y manteniendo una actividad normal, acorde al uso para el que los cosméticos hayan sido diseñados: resistente al agua, al sudor, etc.

-

Conclusiones de los autores del estudio

Aunque el estudio es limitado, los resultados que arroja pueden resultar impactantes y pueden ser fácilmente malinterpretados y exagerados, como de he hecho ha ocurrido. Por ello, los autores del trabajo han declarado que “existen pruebas de alta calidad que demuestran que el uso de filtros ultravioleta previenen las quemaduras solares, la queratosis actínica precancerosa y el cáncer de células escamosas”, que “es importante continuar reforzando las recomendaciones clínicas con respecto a los efectos beneficiosos de la fotoprotección para la prevención del cáncer de piel que están enraizados en una sólida justificación biológica y en la evidencia clínica” y que “evitar el uso de los filtros ultravioleta del estudio, como cualquier filtro solar en general, podría tener importantes consecuencias negativas para la salud”.

-

Reflexiones finales

Un titular que diga “Los filtros solares llegan al torrente sanguíneo, dice un estudio” resulta muy jugoso. Se ganan más clics con la alarma que con la prudencia.

Lo desasosegante de este caso es que el estudio del que salieron tantos titulares alarmistas se trata de un estudio de libre acceso; cualquier medio de comunicación y cualquier persona puede acceder a él. Incluso los autores publicaron un resumen a modo de nota de prensa para tratar de evitar lo que finalmente sucedió. Incluso con solo leer el abstract del estudio, sabes que ni siquiera hay noticia. O se trabaja poco o se trabaja mal.

Si hubiese la más mínima sospecha de que un ingrediente cosmético es inseguro, se retiraría del mercado. La realidad es así de simple. Lo demás es una irresponsable batalla por el clic.

La presencia de una sustancia tóxica en los productos cosméticos no beneficia a nadie. Y esto, que es una obviedad, continuamente se pone en tela de juicio. Los embaucadores han convertido la desconfianza en un negocio.

Hay quien está constantemente ávido de conspiraciones, fraudes y malhacer. De tanto sospechar, le van a salir arrugas.

[1] https://jamanetwork.com/journals/jama/article-abstract/2733085

[2] https://labmuffin.com/sunscreens-in-your-blood-that-fda-study/

[3] https://jamanetwork.com/journals/jama/fullarticle/2733084

[5] https://www.reuters.com/article/us-fda-sunscreen-idUSKBN13H1RE

[6] https://www.thelancet.com/journals/lancet/article/PIIS0140-6736(05)62032-6/fulltext

[7] https://onlinelibrary.wiley.com/doi/abs/10.1046/j.1365-2230.2002.01095.x

[8] https://onlinelibrary.wiley.com/doi/abs/10.1111/j.1365-2133.2005.07007.x

[9] https://linkinghub.elsevier.com/retrieve/pii/S0731708505005595

[10] https://www.sciencedirect.com/science/article/pii/S0021967307013349?via%3Dihub

[11] https://www.sciencedirect.com/science/article/pii/S0013935115300505?via%3Dihub

[12] https://linkinghub.elsevier.com/retrieve/pii/S0022202X1530885X

[13] https://www.sciencedirect.com/science/article/pii/S157002320400008X?via%3Dihub

[14] https://ehp.niehs.nih.gov/doi/10.1289/ehp.11269

[15] https://ec.europa.eu/health/ph_risk/committees/04_sccp/docs/sccp_o_159.pdf

[16] https://ec.europa.eu/health/scientific_committees/consumer_safety/docs/sccs_o_055.pdf

[17] https://ec.europa.eu/health/scientific_committees/consumer_safety/docs/sccs_o_136.pdf

[18] https://jamanetwork.com/journals/jama/fullarticle/2733084

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Los filtros solares llegan al torrente sanguíneo, dice la prensa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Estimada OCU: recuerda que NO se pueden utilizar las cremas solares del año pasado

- Un ordenador químico que llega donde no llegan otros

- El flujo sanguíneo se reorganiza en respuesta a las necesidades

El poema de los números primos (2)

Con motivo de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… (del 5 de abril al 26 de mayo de 2019), de la artista donostiarra Esther Ferrer, en el Centro Internacional de Cultura Contemporánea Tabakalera, de Donostia/San Sebastián, en la anterior entrada del Cuaderno de Cultura Científica El poema de los números primos, estuvimos analizando las matemáticas que están detrás de algunas de sus obras de la serie Poema de los números primos: los números primos, la criba de Eratóstenes, la espiral de Ulam, los polinomios cuadráticos o las lagunas de números primos.

Portada y contraportada de la publicación Orriak del Centro Internacional de Cultura Contemporánea Tabakalera, sobre la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,…

Portada y contraportada de la publicación Orriak del Centro Internacional de Cultura Contemporánea Tabakalera, sobre la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,…

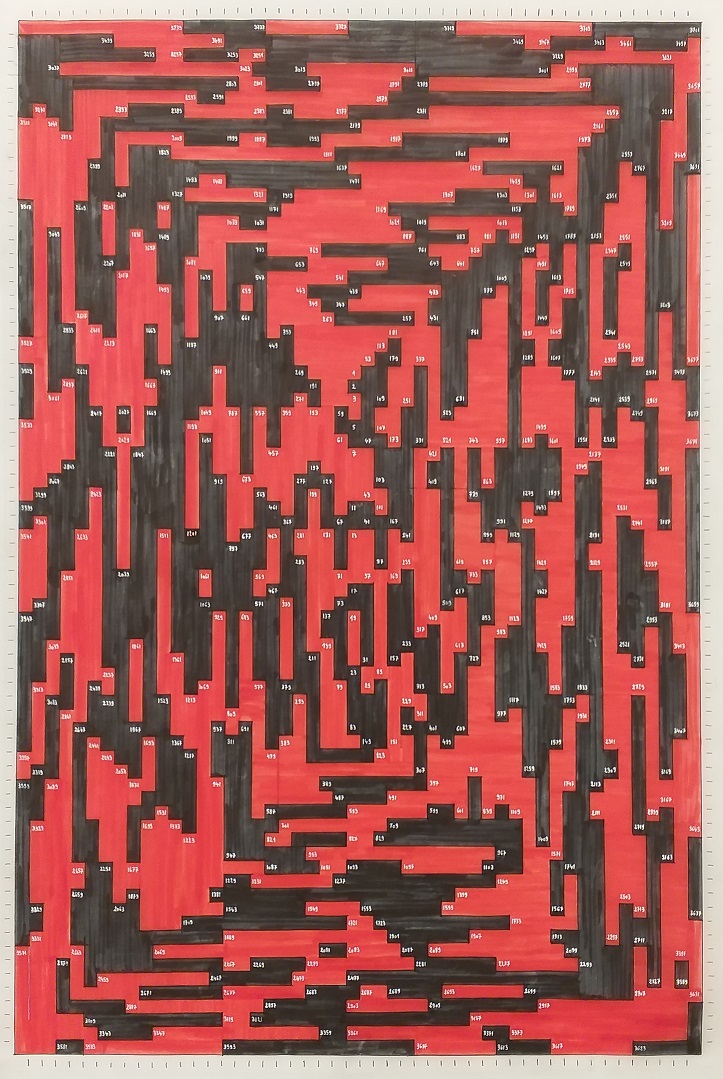

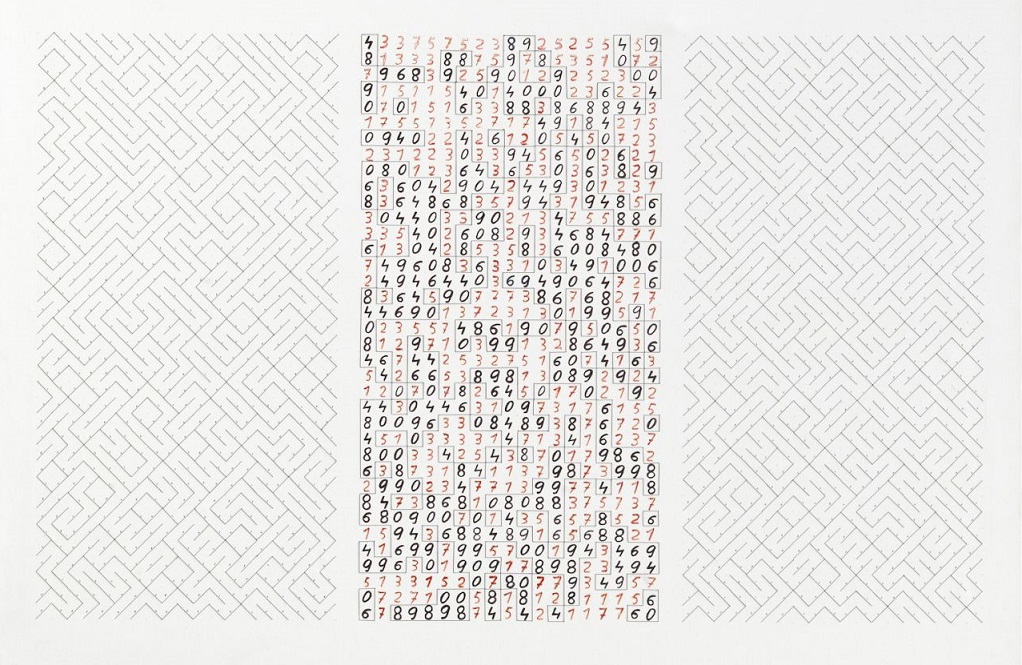

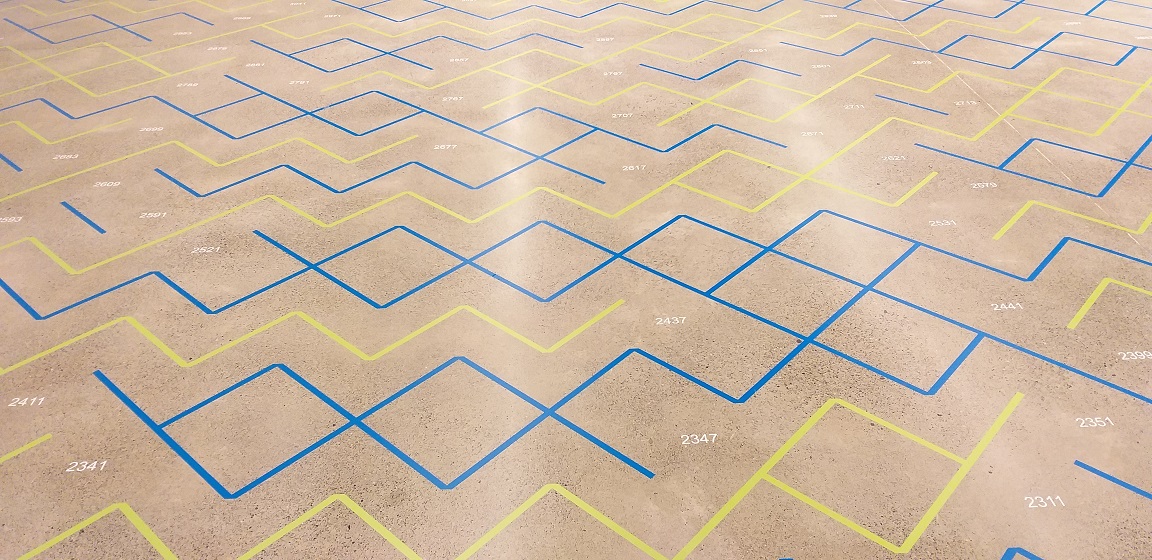

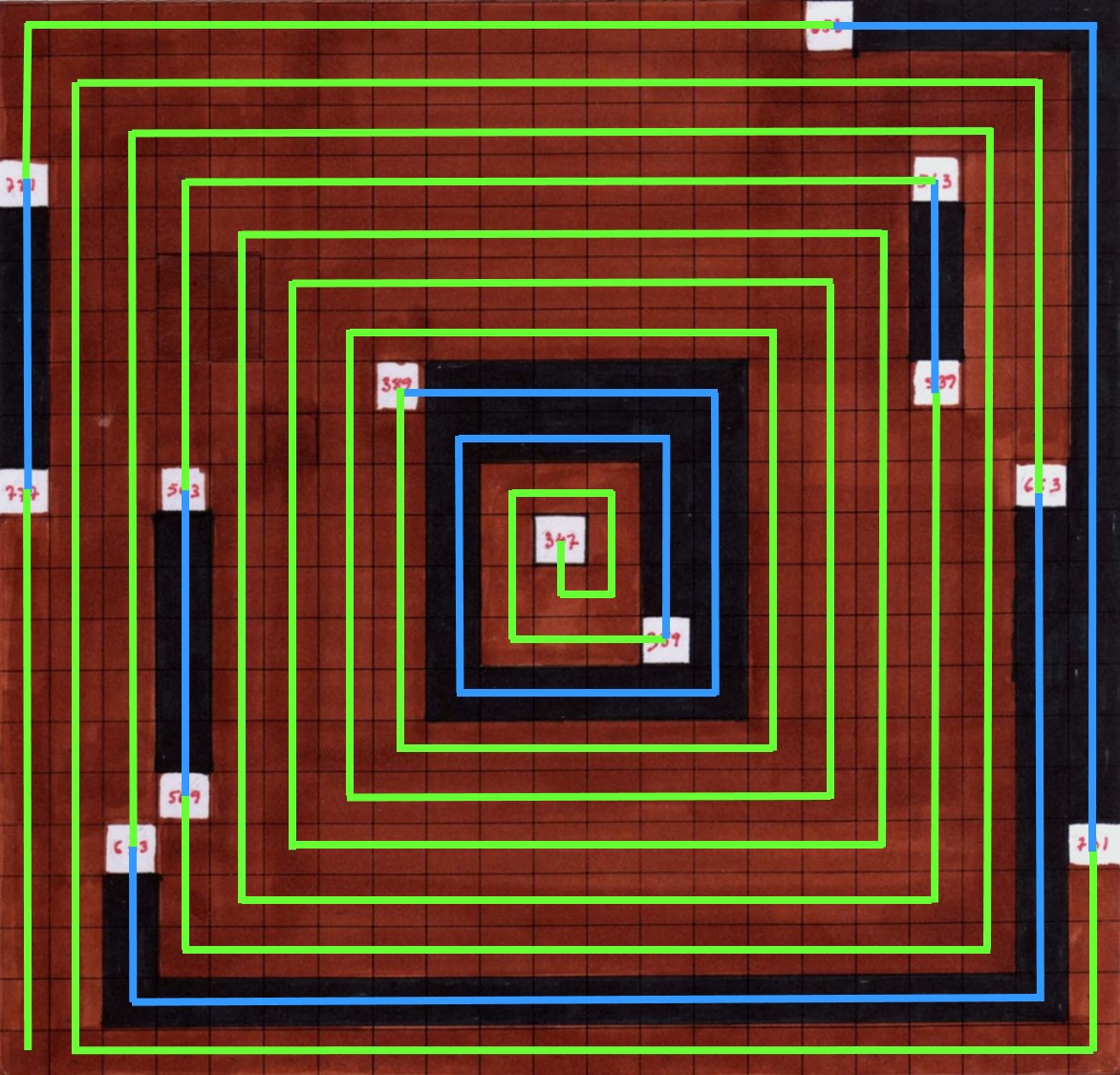

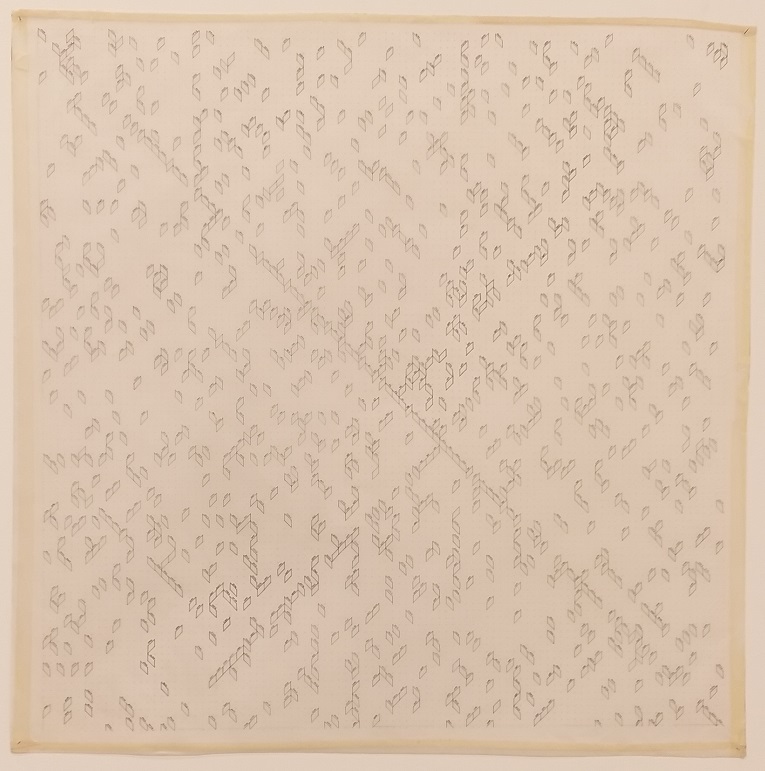

En esta entrada vamos a completar este pequeño paseo por la serie de obras Poema de los números primos de Esther Ferrer. Para empezar, mostraremos un grupo de dibujos para suelo de esta serie que utiliza una variación rectangular de la espiral de Ulam para generar diferentes estructuras geométricas planas

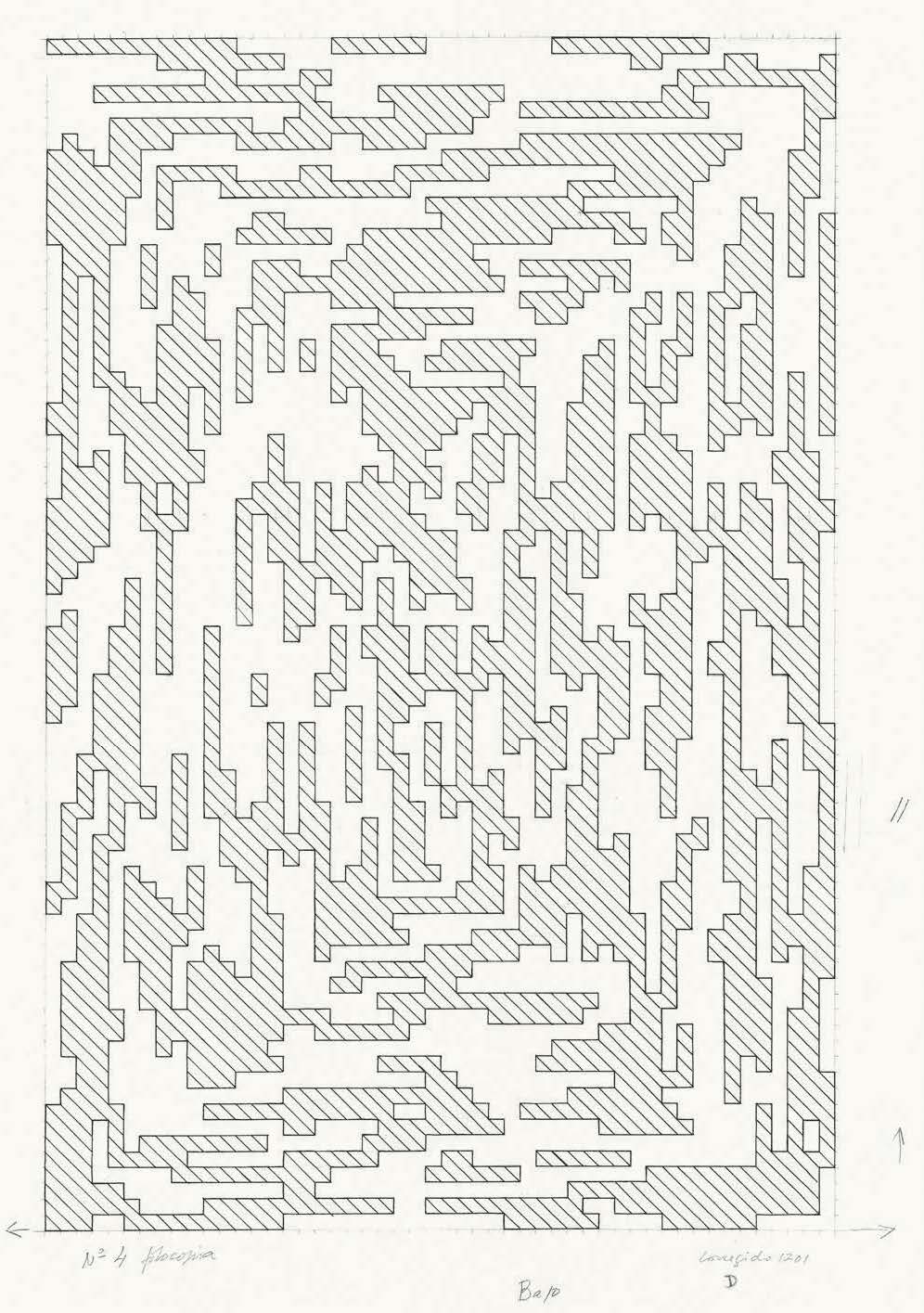

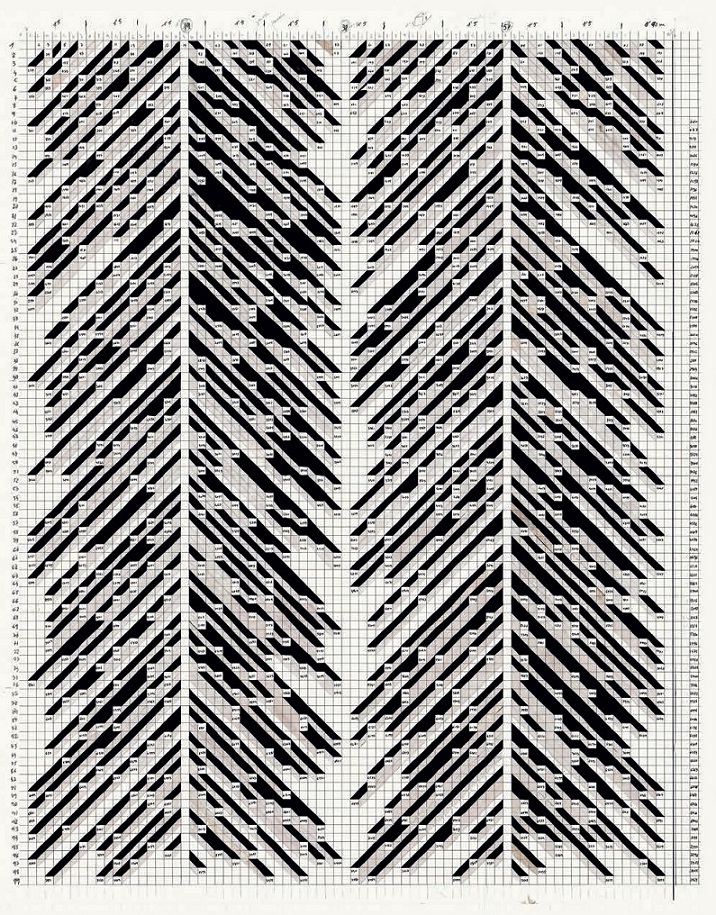

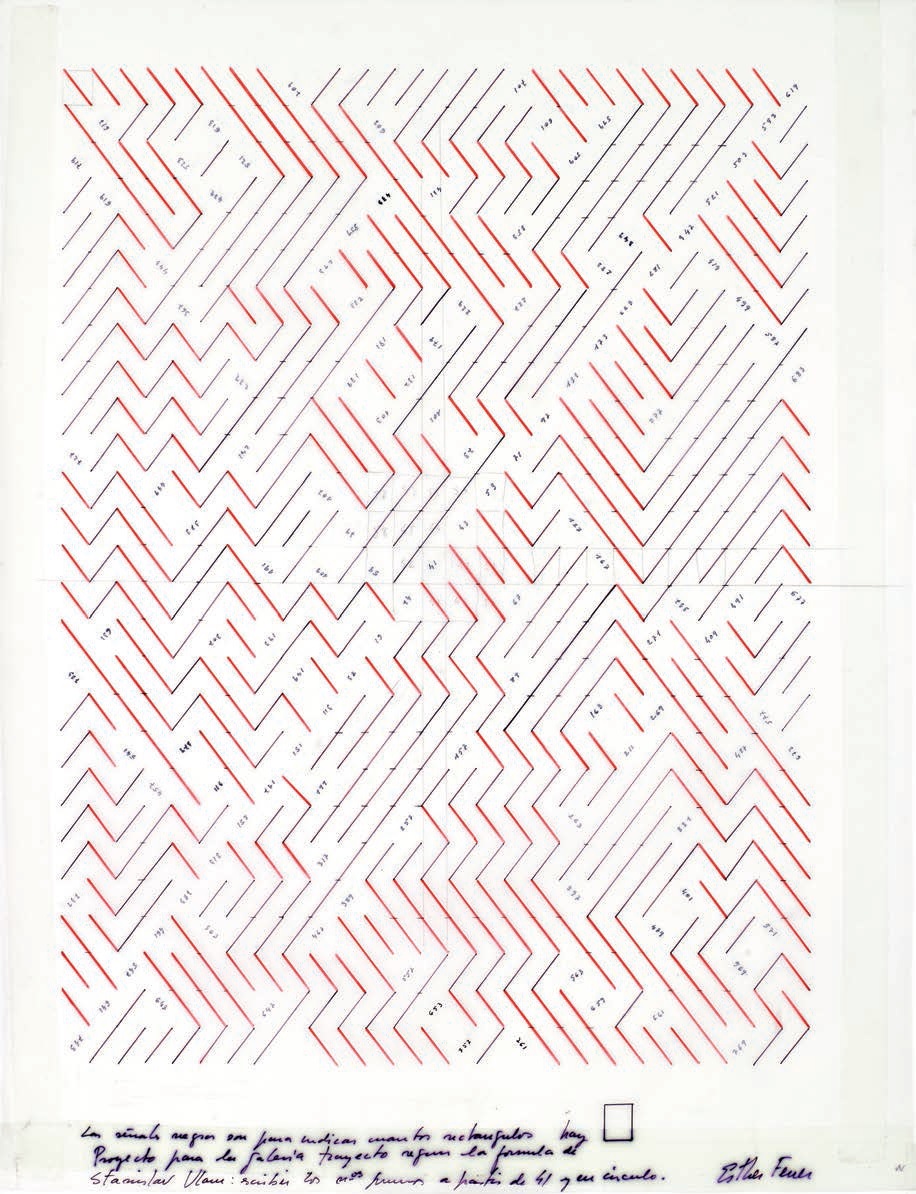

Dibujos para suelo de la serie Poema de los números primos (2016), de Esther Ferrer, realizados en tinta sobre papel, 83,5 x 59,5 cm, pertenecientes al archivo personal de la artista. Imagen del catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta, del Museo Nacional Centro de Arte Reina Sofía.

Dibujos para suelo de la serie Poema de los números primos (2016), de Esther Ferrer, realizados en tinta sobre papel, 83,5 x 59,5 cm, pertenecientes al archivo personal de la artista. Imagen del catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta, del Museo Nacional Centro de Arte Reina Sofía.

Estos dibujos para suelo, que son solo cuatro de un grupo más amplio realizado en 2016, nos recuerdan el objetivo de la artista Esther Ferrer al utilizar los números primos, que es hacer uso de las matemáticas como una herramienta objetiva, es decir, que sus preferencias estéticas jueguen un papel secundario en el proceso de creación artístico, para generar estructuras geométricas planas. La base matemática de las cuatro obras anteriores, como explicaremos a continuación, son la espiral de Ulam rectangular y las lagunas de números primos, que crean un patrón geométrico base que subyace a la serie de dibujos, pero que debido a la intervención de la artista cada uno de ellos adquiere un desarrollo estético propio, sorprendente y atractivo.

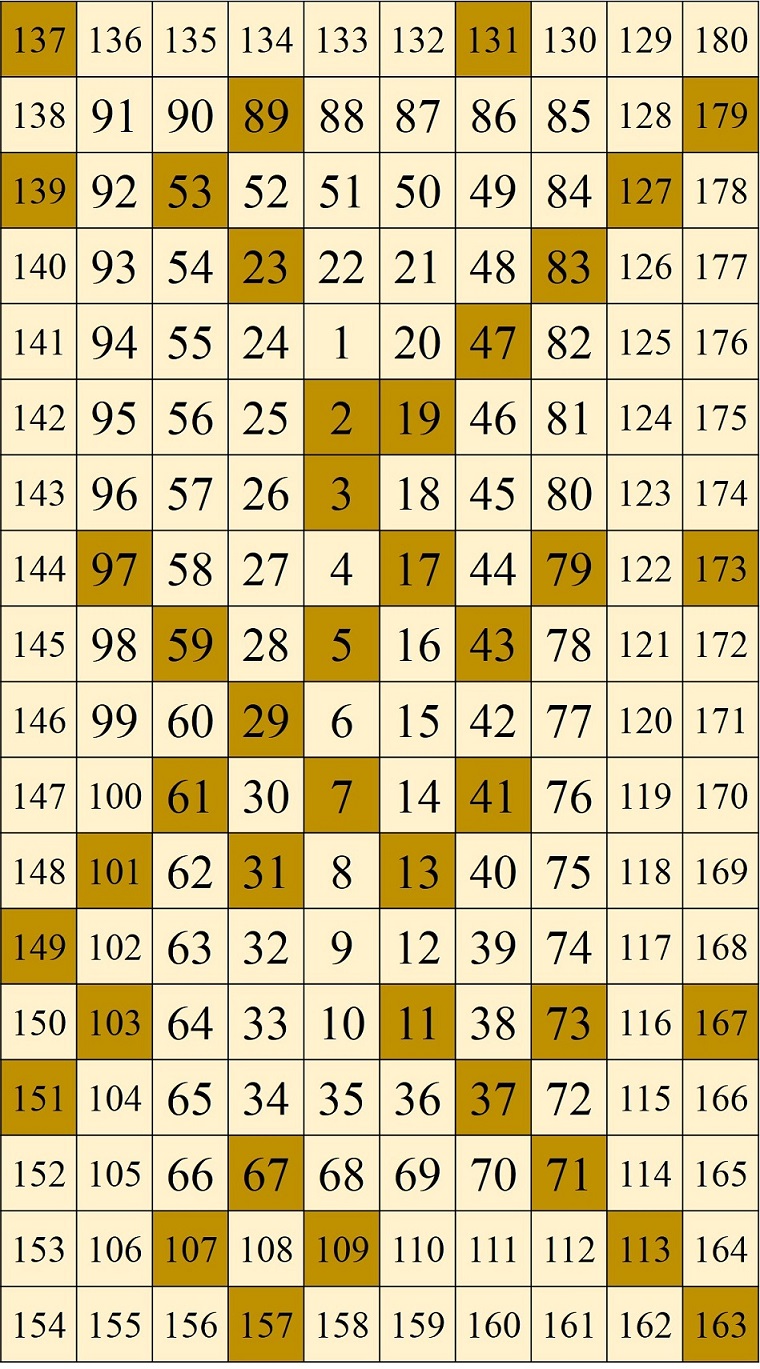

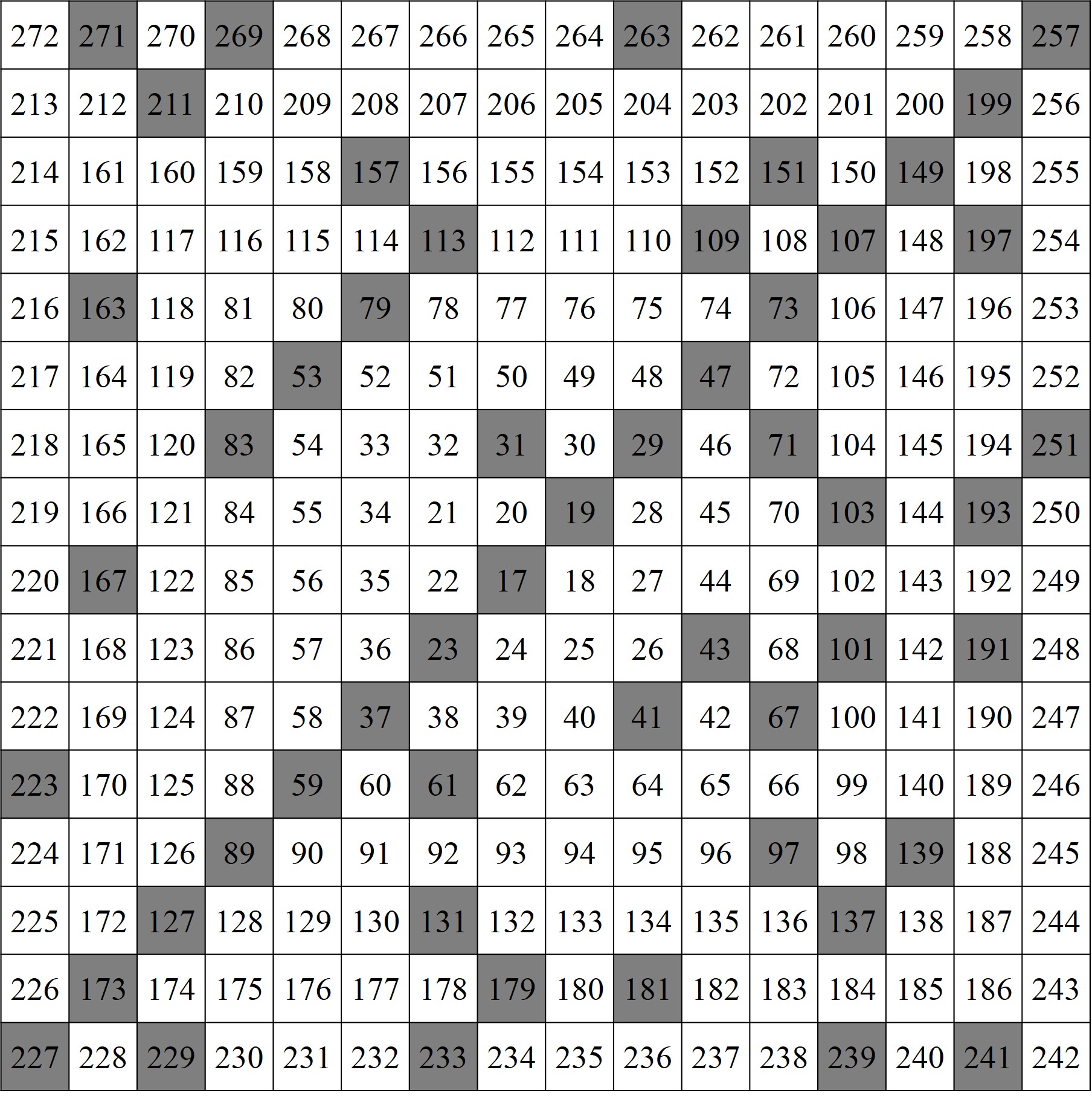

La base para esta serie de obras es similar a la espiral de Ulam. En ese caso, como puede verse en la entrada anterior, El poema de los números primos, se consideraba una cuadrícula cuadrada sobre la que se escribían los números naturales, empezando en 1 (aunque también podía empezarse en cualquier otro número, como el 17, el 41 o el 1.344.326.696.347) que se colocaba en la cuadrícula superior izquierda de la subcuadrícula central 2 x 2, de manera que los números eran escritos en orden creciente y distribuidos alrededor del 1 formando una espiral de números.

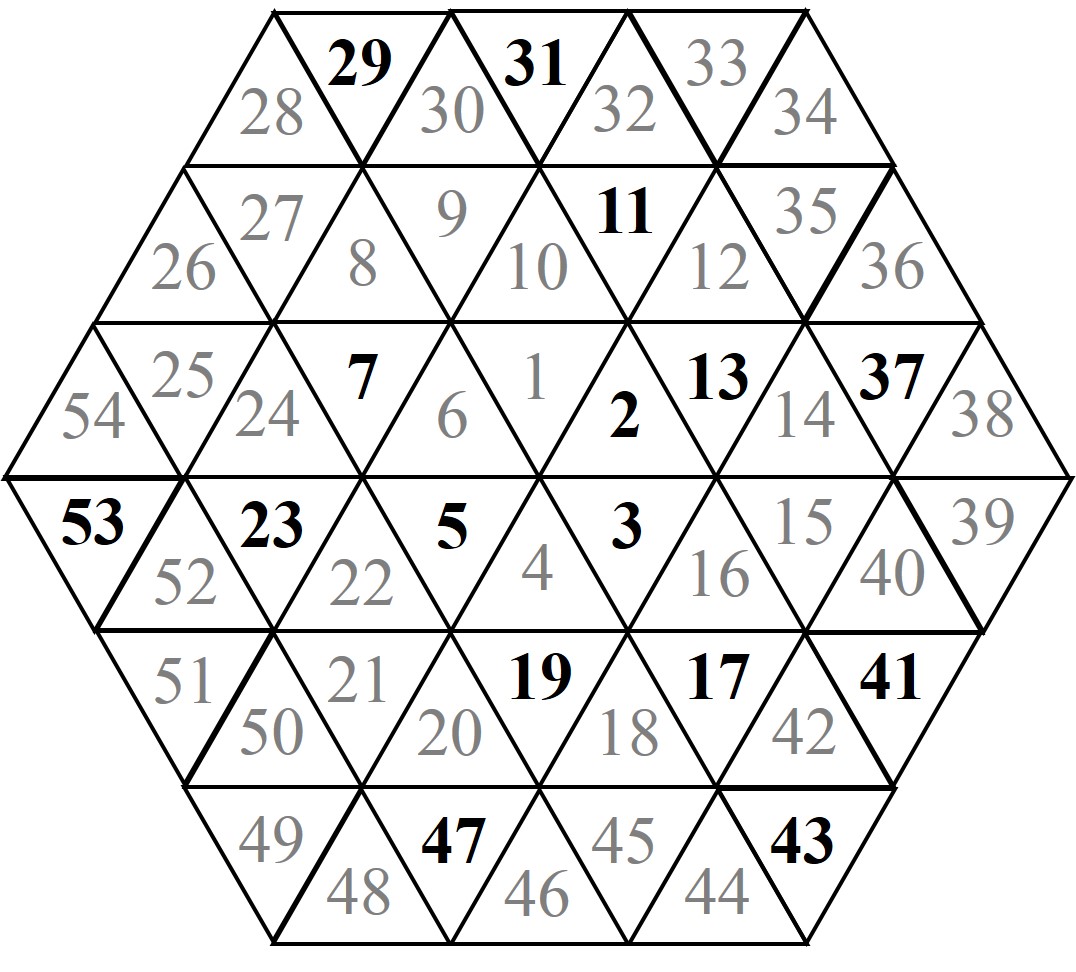

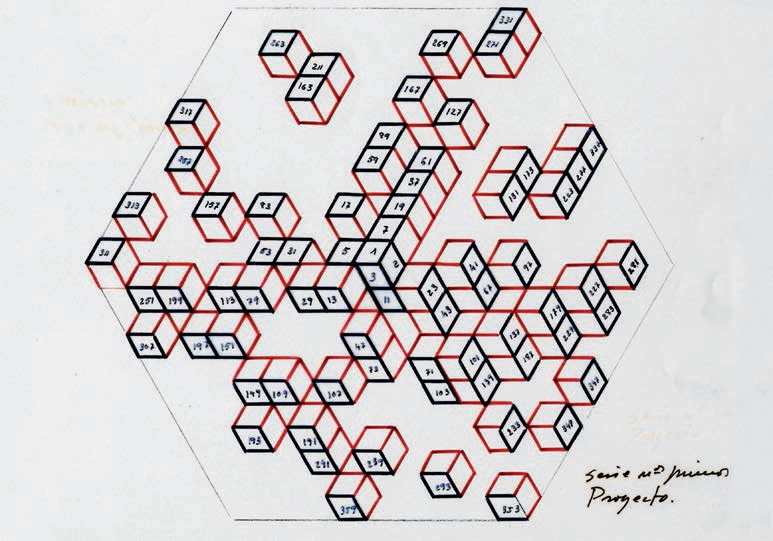

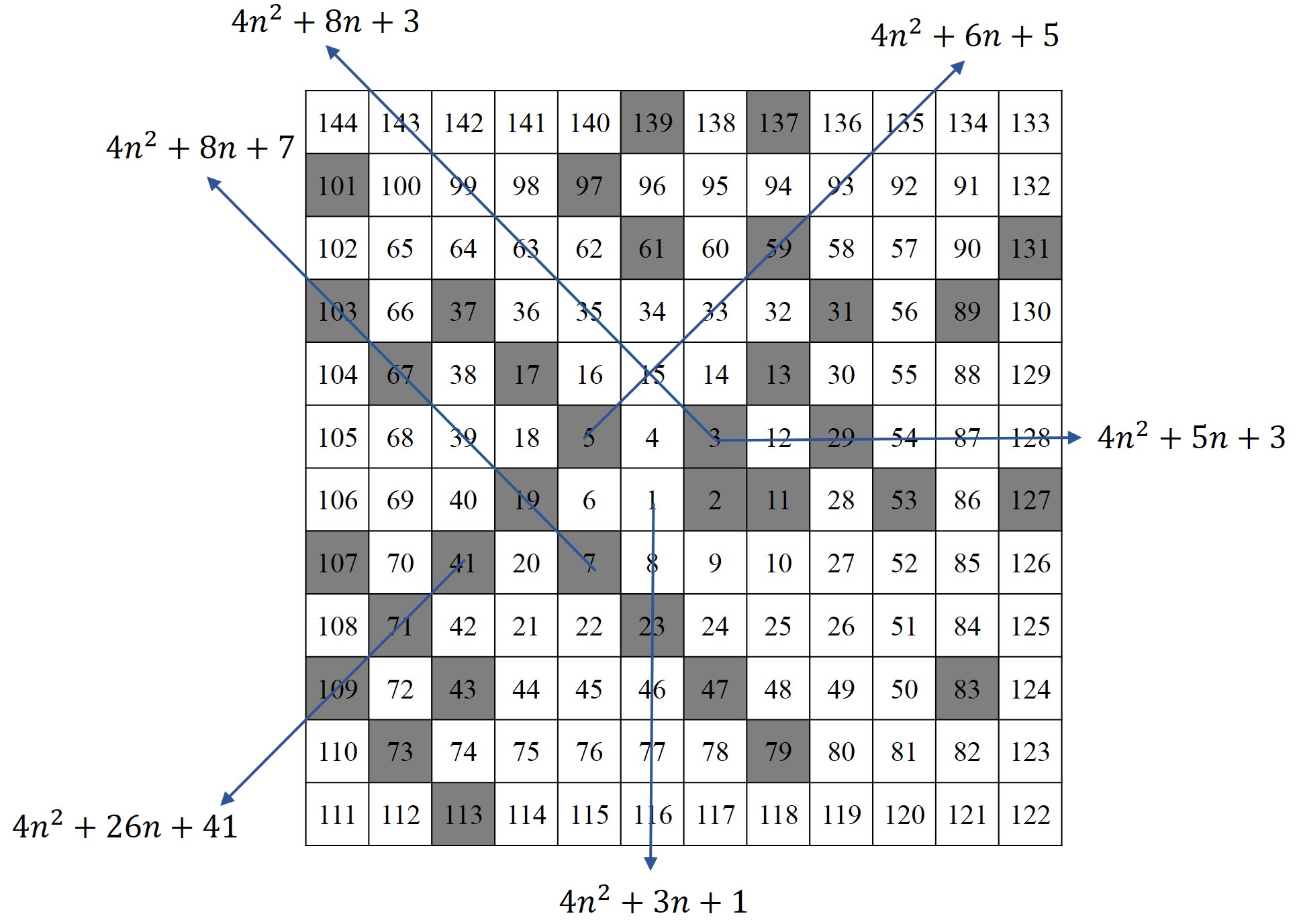

Para estas obras Esther Ferrer construye lo que podríamos llamar la espiral de Ulam rectangular, ya que en lugar de iniciar la espiral en la celda superior izquierda de la una subcuadrícula central 2 x 2, luego cuadrada, lo hace en la celda superior izquierda de la una subcuadrícula central 2 x 26, luego rectangular, de forma que al desarrollar la espiral alrededor queda un retículo rectangular, similar a la que vemos en la siguiente imagen.

Además, en este grupo de obras, otro elemento fundamental para crear los patrones geométricos planos son las lagunas de números primos, es decir, los grupos de números no primos o compuestos entre dos números primos (véase la entrada Buscando lagunas de números primos), con la diferencia, respecto a otras obras que hemos comentado, de que en este grupo de dibujos incluye al número primo anterior a la laguna como parte de la misma (que podríamos llamar laguna aumentada). Por ejemplo, entre los números primos 13 y 17 hay una laguna de tres números compuestos, de forma que Esther Ferrer considera la laguna aumentada formada por los números 13, 14, 15 y 16, después vendría la laguna aumentada 17 y 18, seguida de 19, 20, 21 y 22, y después, 23, 24, 25, 26, 27 y 28.

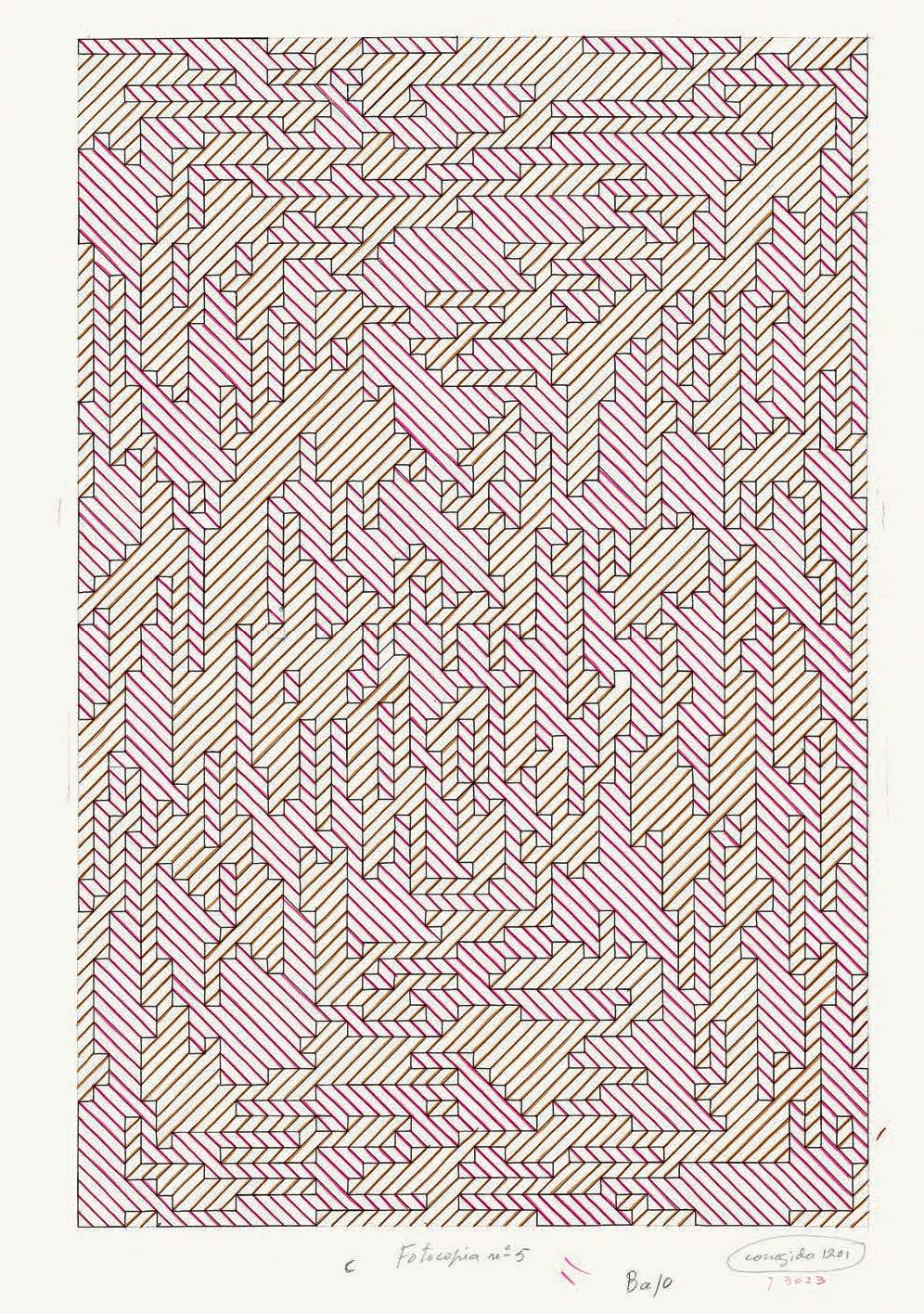

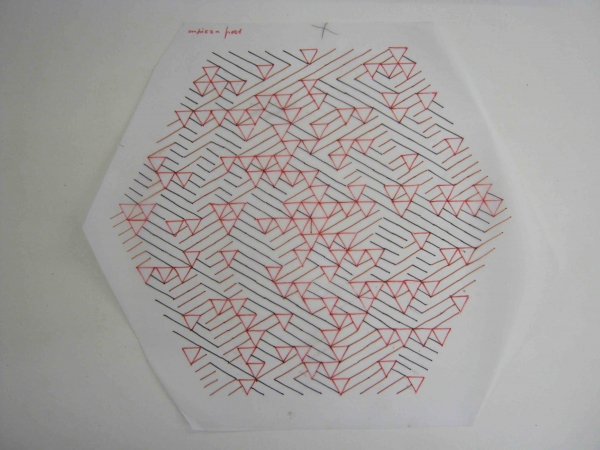

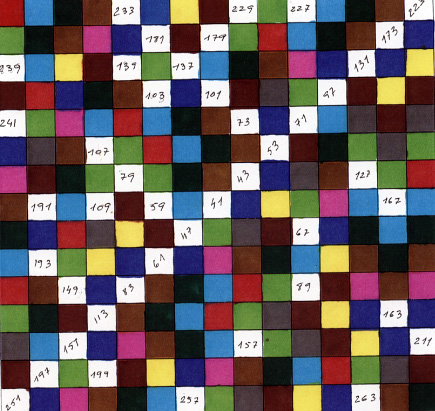

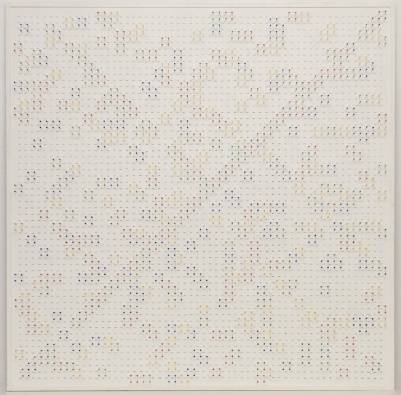

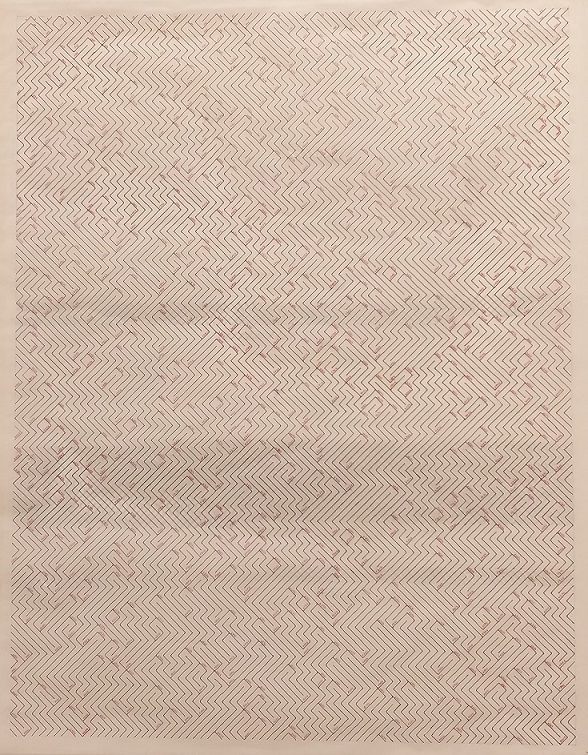

En esta serie de obras, las celdas de cada laguna aumentada de números primos son tratadas de una forma uniforme, cambiando el tratamiento de una laguna aumentada respecto a la siguiente, de forma alternada. Así, en la obra que se muestra a continuación, también de este grupo de dibujos para suelo que se ha podido ver en la exposición de Tabakalera, las celdas se pintan de rojo o negro en función de la laguna aumentada a la que pertenezcan y cambiando el color de una laguna a la siguiente. Por ejemplo, la celda 1 (que es una laguna de una sola celda) es roja, después la celda 2 (también una laguna solitaria) es negra, la laguna aumentada 3 – 4 tiene sus celdas rojas, mientras que son negras las casillas de la laguna aumentada 5 – 6 y de nuevo rojas las de 7 – 8 – 9 – 10, y así están pintadas de negro o rojo el resto de lagunas aumentadas. Trabajando de esta forma la artista, que ha sido galardonada con el Premio Nacional de Artes Plásticas en 2008 o el Premio Velázquez de Artes Plásticas en 2014, consigue la sorprendente e interesante creación artística que vemos en la siguiente imagen.

Dibujo para suelo de la serie Poema de los números primos (2016), de Esther Ferrer, realizados en tinta sobre papel cebolla, 83,5 x 59,5 cm, expuesto en Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23, … (Tabakalera, 2019) y perteneciente al archivo personal de la artista. Fotografía: Raúl Ibáñez

Dibujo para suelo de la serie Poema de los números primos (2016), de Esther Ferrer, realizados en tinta sobre papel cebolla, 83,5 x 59,5 cm, expuesto en Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23, … (Tabakalera, 2019) y perteneciente al archivo personal de la artista. Fotografía: Raúl Ibáñez

En cada una de las obras de este grupo particular dentro de la serie Poema de los números primos, Esther Ferrer interviene de forma diferente sobre las lagunas aumentadas de números primos, creando toda una serie de patrones geométricos planos, aunque con una base matemática común, que producen efectos visuales distintos, como puede observarse en las anteriores imágenes.

En la conversación entre Esther Ferrer, Laurence Rassel y Mar Villaespesa con motivo de la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta (Palacio de Velázquez, en el Parque del Retiro de Madrid, Museo Nacional Centro de Arte Reina Sofía, 2017), Laurence Rassel le pregunta a Esther Ferrer “¿Cómo es el proceso de trabajo con los números primos?”, a lo que la artista contesta:

“Primero decido el tipo de soporte y cómo voy a distribuir los números en el espacio, es la base. Luego decido el sistema que define la estructura de la obra, que tiene varios parámetros: si va a ser una obra única o una serie, para poder decidir a partir de qué número empieza, si los números en el espacio se reparten en círculo o en líneas horizontales o verticales, si se emplea color o no, y un largo etcétera. Finalmente decido la forma en que los voy a relacionar, y a partir de ahí me planteo las líneas y el color, si lo hay. Por ejemplo, puedo trabajar los números primos a partir de la espiral de Ulam. Al utilizarla se crea una línea ininterrumpida durante cierta cantidad de números. Me gustó la idea de escribirlos en espiral, como una galaxia, los números primos tienen algo que ver con la estructura del universo; a medida que progresas en la serie hay menos números, el espacio entre ellos se agranda, me gusta ese vacío, es como si la serie se expandiera, como el universo.”

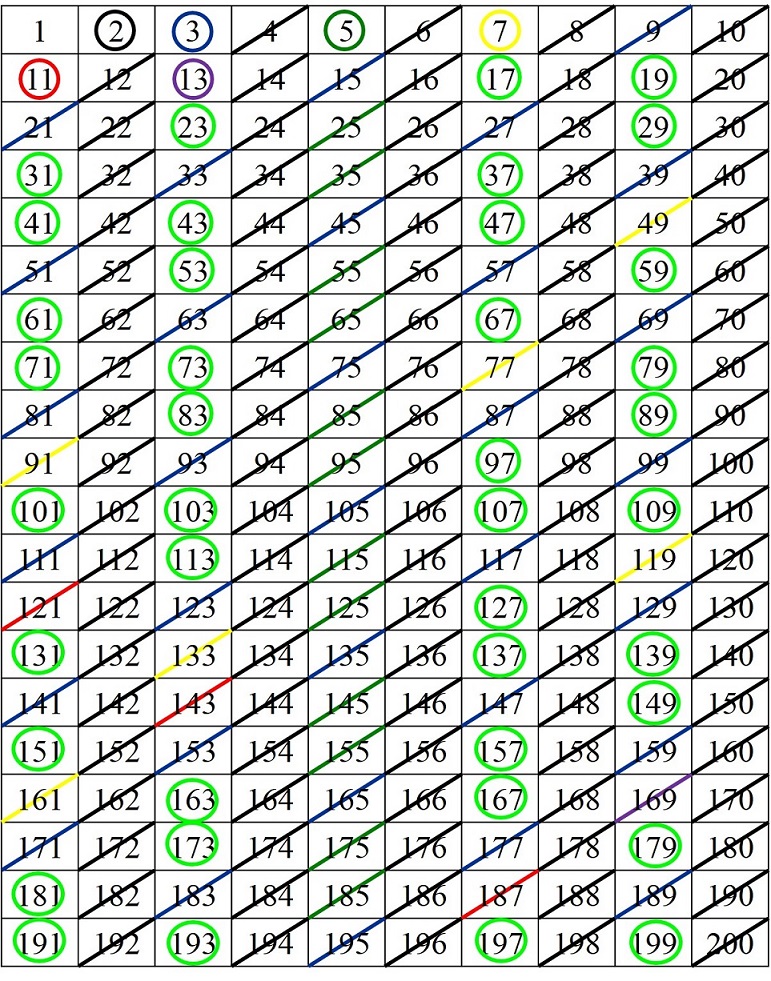

Existen algunas variantes de la distribución de la espiral de Ulam de los números primos de manera que la estructura general de la espiral de los números naturales genera una forma triangular, hexagonal o circular, en lugar de la forma cuadrada de la espiral de Ulam original, o la rectangular utilizada por Esther Ferrer en las obras. La autora de la serie Poema de los números primos se ha interesado por la espiral de Ulam hexagonal, generando toda una familia de obras basada en esta estructura.

Pero antes de hablar de estas obras, me gustaría mencionar lo que podríamos llamar una variante por anticipación, puesto que en el año 1932 (más de treinta años antes de que a Ulam se le ocurriese la idea de la espiral) el herpetólogo, es decir, zoólogo especializado en reptiles y anfibios, estadounidense Laurence Monroe Klauber (1883 – 1968) presentó en el congreso The March Meeting of the Southern California Section de la Asociación Americana de Matemáticas (MAA) una ponencia sobre un triángulo de números naturales en el que se destacaba la distribución de los números primos, y en particular, los generados por el polinomio de Euler n2 + n + 41.

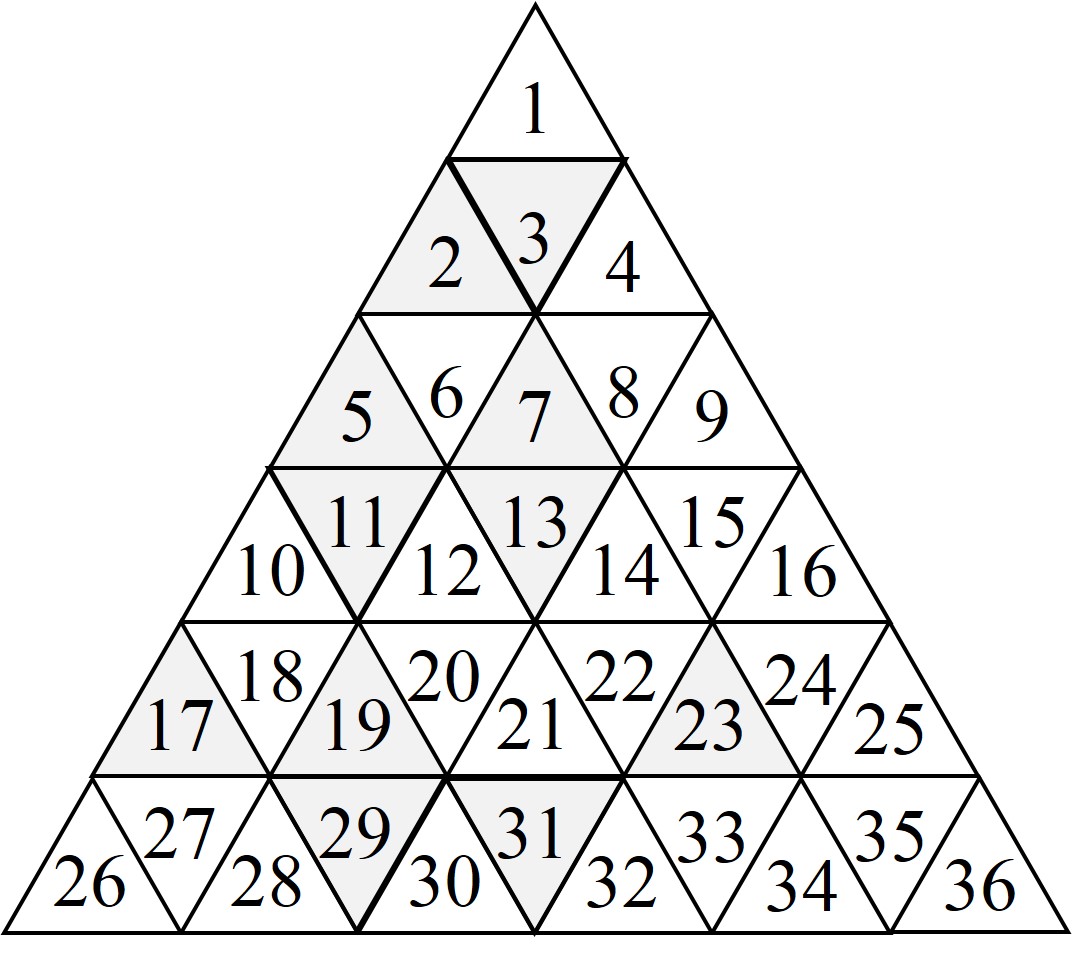

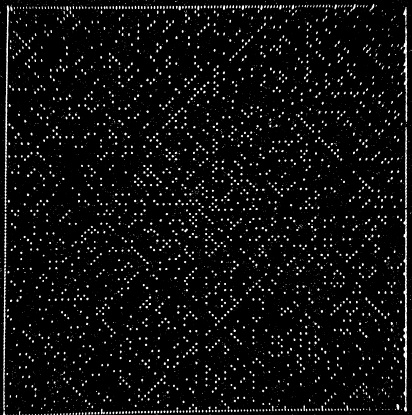

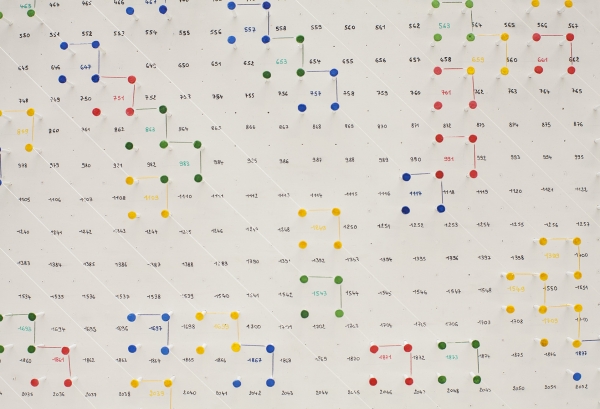

Este triángulo no está generado en espiral, sino distribuyendo los números en orden creciente desde el vértice de arriba y fila a fila, hacia abajo. Es decir, en la primera fila se coloca en 1, en la segunda los números 2, 3 y 4, en la tercera los números del 5 al 9, y así en la fila n-ésima están colocados los números del (n – 1)2 + 1 hasta n2, como en la siguiente imagen.

Sobre esa distribución triangular de los números se marcan los números primos. Por ejemplo, en la anterior imagen se ha pintado el triángulo correspondiente al número primo de gris. Al igual que ocurría con la espiral de Ulam, sobre el triángulo numérico de Klauber los polinomios cuadráticos generan números que descansan sobre líneas rectas. En particular, los polinomios de la forma n2 + n + a, para algún número a, son líneas verticales, un ejemplo es el polinomio de Euler.

Triángulo de números primos de Klauber, en el cual están marcados como puntos azules los números primos, como puntos naranjas los números primos generados por el polinomio de Euler, n2 + n + 41, y los números no primos no aparecen, están en blanco. Imagen: Will Orrick / Wikimedia Commons

Triángulo de números primos de Klauber, en el cual están marcados como puntos azules los números primos, como puntos naranjas los números primos generados por el polinomio de Euler, n2 + n + 41, y los números no primos no aparecen, están en blanco. Imagen: Will Orrick / Wikimedia Commons

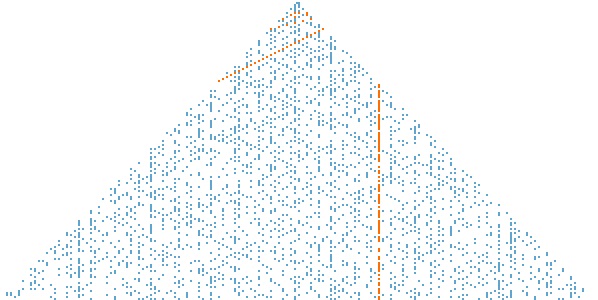

Pero volvamos a la obra artística de Esther Ferrer y a la espiral de Ulam hexagonal. Como en el caso de la espiral de Ulam clásica, en la espiral de Ulam hexagonal, se escriben los números naturales en orden creciente y formando una espiral, sobre una “colmena” o rejilla hexagonal (una especie de cuadrícula, pero formada por hexágonos y cuya forma general es también hexagonal), en cuyo centro hay un hexágono, para el número 1 (o el número inicial), y se van añadiendo filas de hexágonos alrededor del hexágono central, formando la rejilla hexagonal, como se muestra en la imagen de abajo.

Pequeña espiral de Ulam hexagonal, sobre una retícula hexagonal de lado 4, con los 37 primeros números, marcando en gris las casillas con números primos y señalada la espiral con una línea marrón discontinua

Pequeña espiral de Ulam hexagonal, sobre una retícula hexagonal de lado 4, con los 37 primeros números, marcando en gris las casillas con números primos y señalada la espiral con una línea marrón discontinua

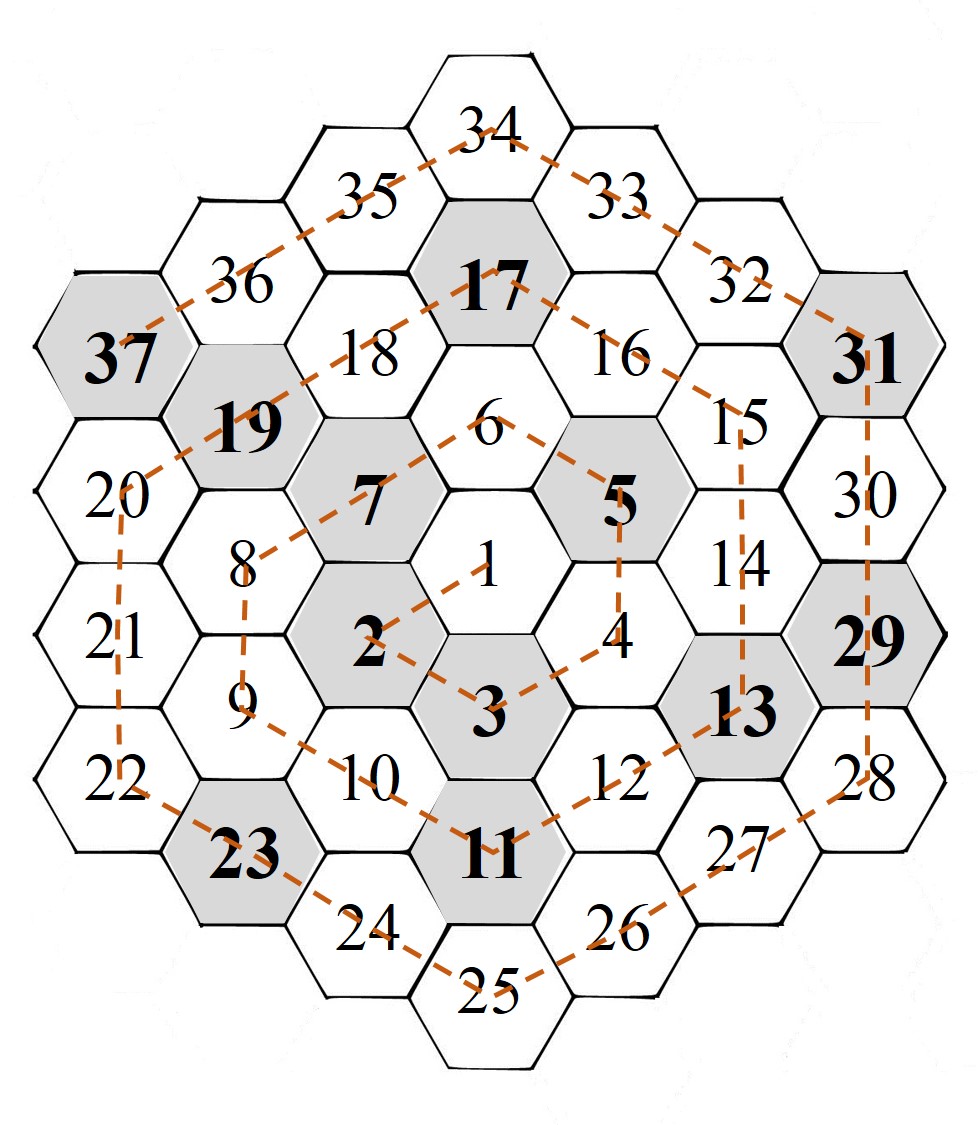

Sin embargo, no es esta la estructura hexagonal en espiral que considera la artista Esther Ferrer, quien trabaja, de hecho, con diferentes estructuras hexagonales en espiral. En la primera de ellas considera una rejilla triangular con forma hexagonal. Empieza en un hexágono central, que está dividido en seis triángulos equiláteros, sobre la que escribe los primeros seis números, y luego continúa escribiendo los números en orden creciente y en espiral sobre los triángulos equiláteros que están alrededor del hexágono central, y que van manteniendo la forma hexagonal del retículo, como se muestra en la imagen siguiente.

Ejemplo de espiral de tipo Ulam sobre una retícula triangular con forma hexagonal, sobre la que trabaja la artista Esther Ferrer, sobre la que se consideran los números naturales en orden creciente y en espiral, marcando de alguna forma los números primos

Ejemplo de espiral de tipo Ulam sobre una retícula triangular con forma hexagonal, sobre la que trabaja la artista Esther Ferrer, sobre la que se consideran los números naturales en orden creciente y en espiral, marcando de alguna forma los números primos

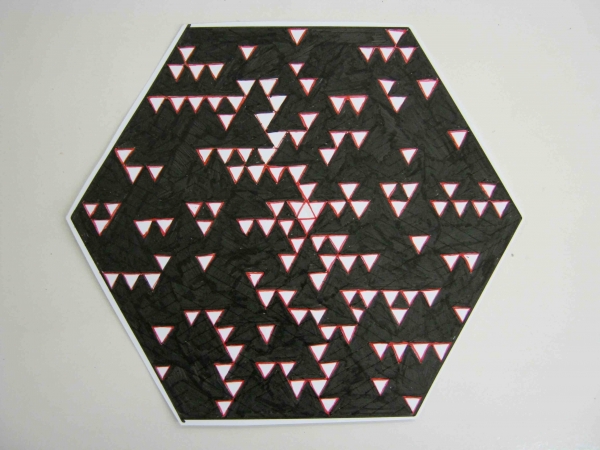

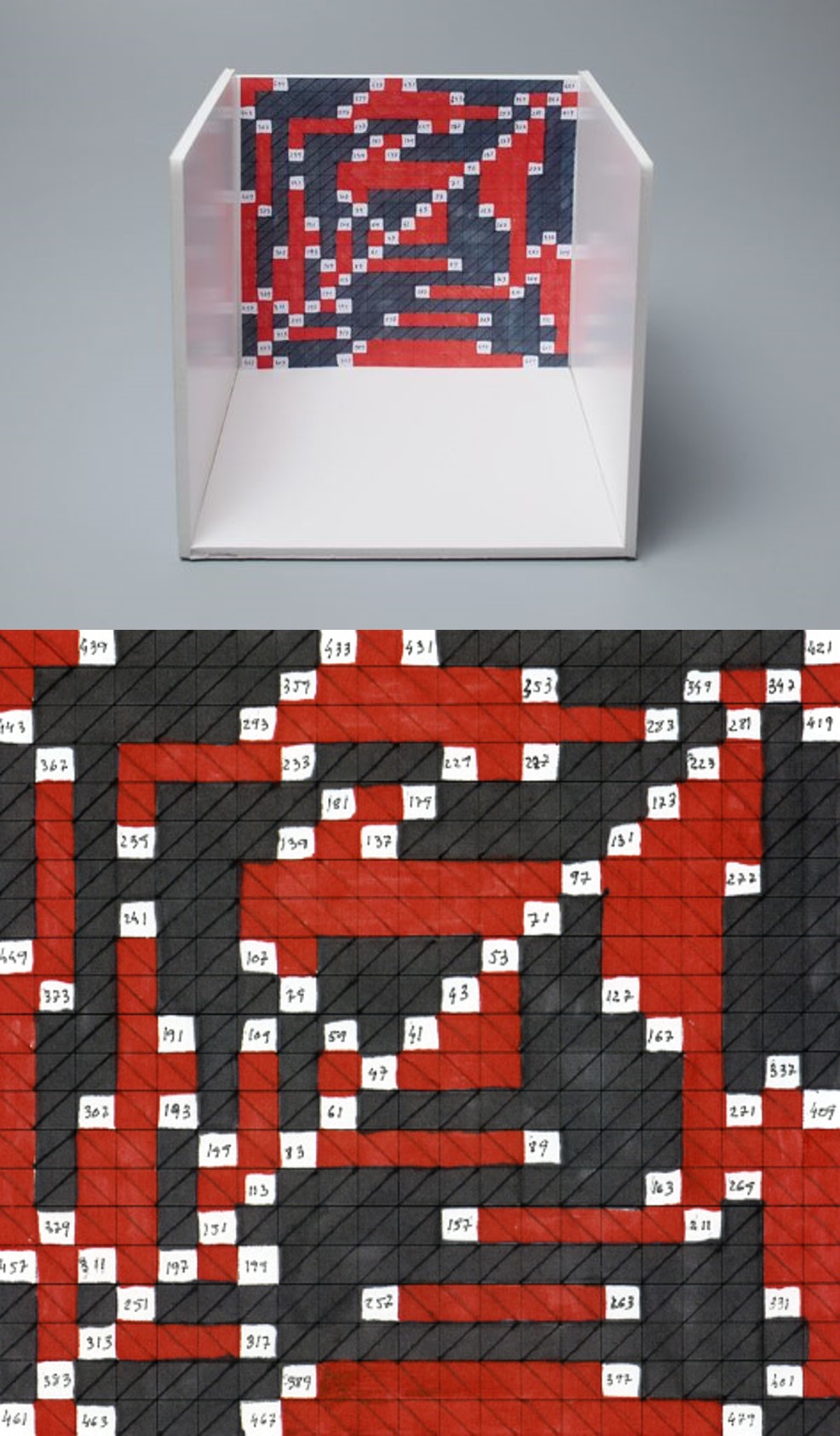

En la siguiente obra, en la cual se trabaja sobre la anterior estructura reticular, los triángulos se dividen en tres tipos, como ocurría en algunas de las obras que mostramos en la entrada El poema de los números primos, por una parte, están los triángulos que corresponden a números primos, que tienen color blanco y dibujado el correspondiente número primo (hay una excepción, que es la casilla del número 1, la cual se trata en esta obra como si fuese una casilla de un número primo, o podríamos decir como un no compuesto, en blanco y con el número escrito), y el resto de triángulos se corresponden con números no primos, o compuestos, luego en ellos no se dibuja su número y tendrán color rojo o negro en función de la laguna de números primos a la que pertenezca, coloreando las lagunas de rojo o negro de forma alternada, además, estos triángulos de números no primos, rojos o negros, tendrán espesor, altura, creando un relieve en la obra.

Maqueta de un proyecto de Esther Ferrer, basado en la serie Poema de los números primos (1989). Edición producida por ARTIUM, Centro-Museo Vasco de Arte Contemporáneo, en 2011. Cartón pluma blanco, pintado de rojo con acrílico y cartón pluma negro, ambos de diferentes espesores, cortados a mano en triángulos de 3 cm. y dispuestos sobre una base hexagonal de cartón de 71 x 62 cm aproximadamente

Maqueta de un proyecto de Esther Ferrer, basado en la serie Poema de los números primos (1989). Edición producida por ARTIUM, Centro-Museo Vasco de Arte Contemporáneo, en 2011. Cartón pluma blanco, pintado de rojo con acrílico y cartón pluma negro, ambos de diferentes espesores, cortados a mano en triángulos de 3 cm. y dispuestos sobre una base hexagonal de cartón de 71 x 62 cm aproximadamente

Como en otras obras, la intervención de la artista genera diferentes estructuras geométricas planas. A continuación, se muestran algunas obras que tienen como base la misma estructura espiral de tipo Ulam sobre la retícula triangular con forma hexagonal que acabamos de analizar.

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal de 22,5 cm. de lado a lado, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal de 22,5 cm. de lado a lado, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal de 23,5 cm. de lado a lado, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal de 23,5 cm. de lado a lado, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona

Como en las obras que hemos mostrado en la entrada anterior, El poema de los números primos, con base en la espiral de Ulam, se puede iniciar la espiral en un número distinto al 1, como ocurre en la siguiente obra.

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal de 27 cm. de lado a lado, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona.

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal de 27 cm. de lado a lado, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona.

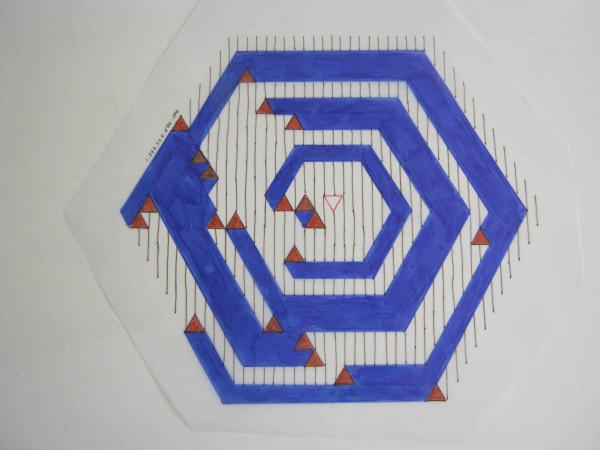

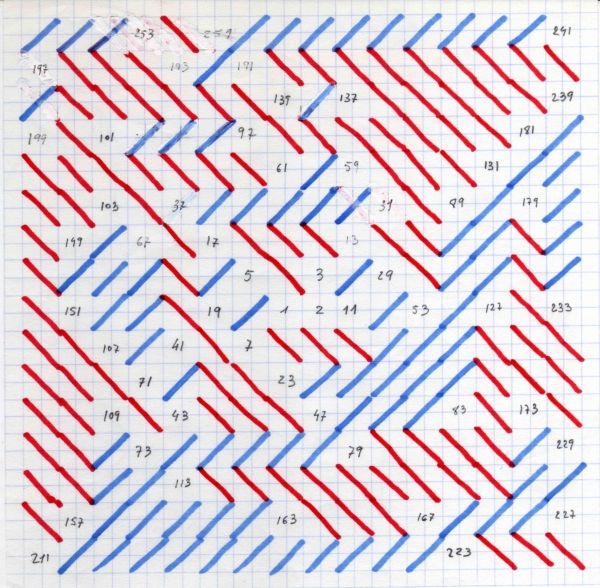

En otro grupo de obras, Esther Ferrer toma como base la retícula triangular con forma hexagonal descrita anteriormente, pero uniendo cada dos triángulos rectángulos para formar un rombo, creando así una retícula de rombos con forma hexagonal. Sobre esta estructura considera una espiral de tipo Ulam, al escribir los números naturales en orden creciente, cada número sobre un rombo y destacando los números primos. La intervención de la artista da lugar a toda una subfamilia de obras relacionadas con esta estructura, como la que se muestran a continuación.

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona y perteneciente al catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta.

Dibujo de la serie Poema de los números primos (1986 – 88), sobre una base hexagonal, de la artista Esther Ferrer, realizada con rotulador sobre papel cebolla. Obra expuesta en la Galería Angels Barcelona y perteneciente al catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta.

Pero dejemos estas estructuras geométricas hexagonales relacionadas con los números primos, para terminar con una obra relacionada con un tipo especial de números primos, los números primos gemelos. Recordemos que dos números primos son gemelos si están lo más cerca posible, es decir, con tan solo un número par entre ellos, como las parejas 11 y 13, 17 y 19, o 41 y 43. Esther Ferrer también se interesó por estos. De hecho, en la conversación de Esther Ferrer con Laurence Rassel y Mar Villaespesa con motivo de la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta, explica lo siguiente:

“En ese universo, de pronto, aparece un par de números primos gemelos, por ejemplo 11 y 13, 17 y 19, son como los cuerpos celestes que se descubren y no se sabe por qué están ahí. Un amigo ingeniero me envió el número gemelo más grande calculado al ordenador, que entonces tenía 703 dígitos, ahora tiene muchas más cifras. Hice dos cuadros poniéndolos de relieve. Lo curioso es que me interesé en estos números sin pensar en absoluto en mi situación personal: soy gemela, fue una amiga quien me lo señaló.”

Una de las conjeturas sobre los números primos gemelos es que existe un número infinito de parejas de números primos, aunque a día de hoy aún no ha sido posible demostrar esta conjetura. Por este motivo, dentro de la comunidad científica se siguen buscando parejas de números primos gemelos cada vez más grandes. En los años 1980 la pareja más grande conocida de números primos gemelos tenía 703 dígitos. De hecho, en la columna Mathematical Games de Martin Gardner en la revista Scientific American, en diciembre de 1980, menciona este dato y dice que esos dos primos empiezan por 4337 y terminan por 17759 y 17761.

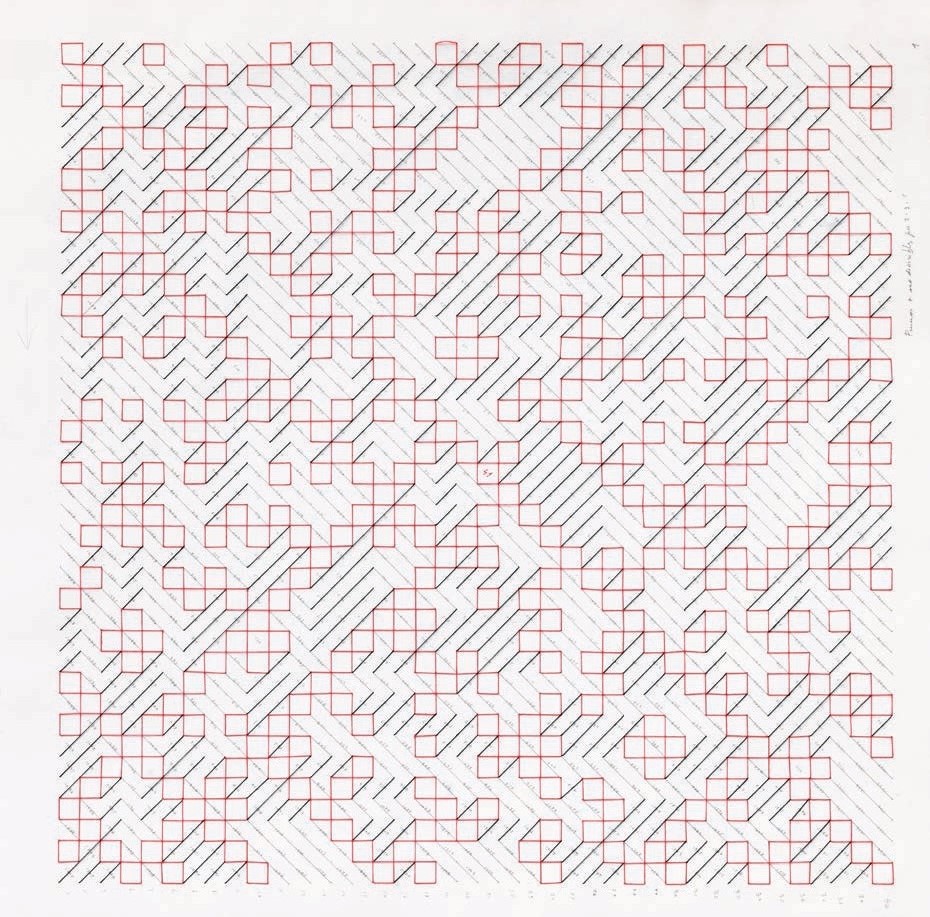

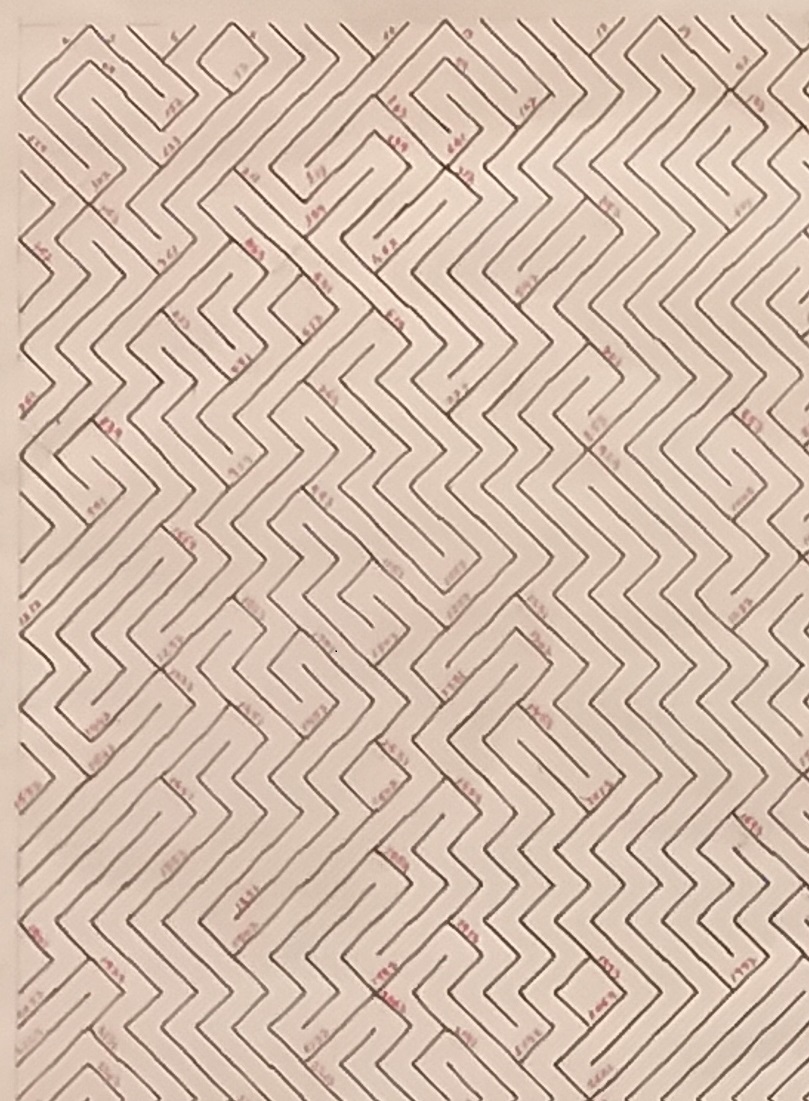

La siguiente obra de Esther Ferrer toma como base esta pareja de números primos gemelos. El número explícito que está en el medio sería el número no primo y par que está entre los dos primos gemelos y que termina en 17760, mientras que a cada lado del mismo están ciertas estructuras geométricas planas generadas a partir de esos dos números primos gemelos.

Poema de los números primos (años 1980), rotulador e hilo sobre lienzo, 97,5 x 130 cm. Archivo Esther Ferrer y perteneciente al catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta.

Poema de los números primos (años 1980), rotulador e hilo sobre lienzo, 97,5 x 130 cm. Archivo Esther Ferrer y perteneciente al catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta.

Se ha avanzado mucho en la obtención de parejas de números primos gemelos desde entonces. En la actualidad la pareja más grande conocida, descubierta en 2016, está formada por el número primo 2.996.863.034.895 · 21.290.000 – 1 y 2.996.863.034.895 · 21.290.000 + 1, que tienen 388.342 dígitos.

Por último, me gustaría finalizar esta entrada del Cuaderno de Cultura Científica con una frase de Esther Ferrer, que suele citar en muchas ocasiones, la última ha sido en la entrevista que le hicieron en el Diario Vasco con motivo de su exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera.

“Yo en el arte hago lo que quiero sin más límite que mi responsabilidad”

Así mismo, me gustaría expresar mi más sincero y profundo agradecimiento a Esther Ferrer por permitirme utilizar las imágenes de sus hermosas e interesantes obras en esta publicación, así como por las interesantes conversaciones que hemos mantenido sobre las matemáticas, y en particular, los números primos, en el conjunto de su obra artística.

Bibliografía

1.- Esther Ferrer, Maquetas y dibujos de instalaciones 1970/2011, Exit publicaciones, 2011.

2.- Rosa Olivares (comisaria), Esther Ferrer, Lau mugimenduan/En cuatro movimientos/In four movements, ARTIUM 08/10/2011 – 08/01/2012, Artium y Acción cultural española, 2011.

3.- Laurence Rassel y Mar Villaespesa (comisarias), Esther Ferrer, todas las variaciones son válidas, incluida esta, Palacio de Velázquez del Parque del Retiro 26/07/2017 – 25/02/2018, Museo Nacional Centro de Arte Reina Sofía, 2017.

4.- Página web de Esther Ferrer

5.- Página The Top Twenty: Twin Primes

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El poema de los números primos (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El concepto de estructura atómica

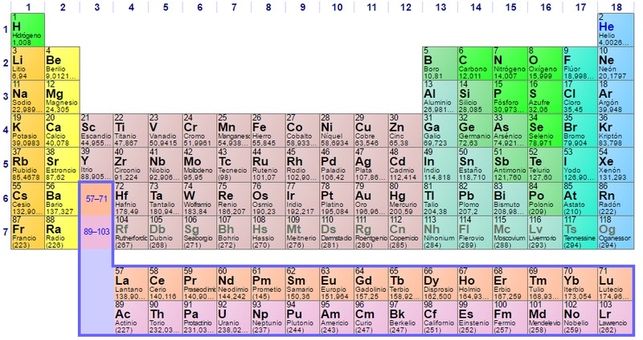

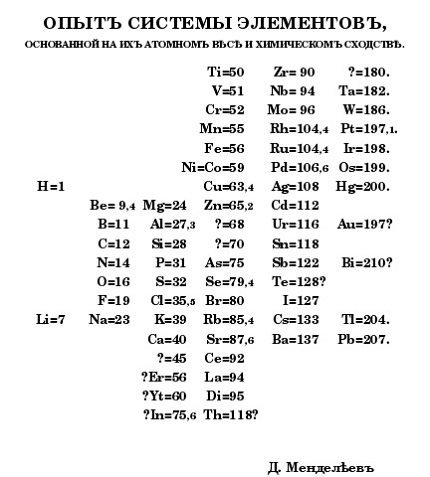

Decíamos al hablar del sistema de periodos que su regularidad, simetría y capacidad predictiva son indicios de que el modelo que explique la estructura de los átomos de los distintos elementos posee también estas características. Y, al hacerlo, dábamos por sentado que los átomos tienen estructura, algo que puede no parecer evidente. Merece la pena detenernos en este punto.

La química en el siglo diecinueve había tenido un éxito más que notable a la hora de explicar las proporciones de combinación de los distintos elementos y en la predicción de reacciones químicas. Tanto es así que buena parte de la revolución industrial fue la revolución químico-industrial. Este éxito terminó convenciendo a la mayoría de los científicos del último cuarto del siglo de que una hipótesis tan fructífera como la atómica indicaba claramente que la materia está compuesta en realidad de átomos. Pero este convencimiento suscitaba inmediatamente una pregunta relacionada: ¿Son los átomos realmente indivisibles, como se había supuesto, o consisten en partículas aún más pequeñas?

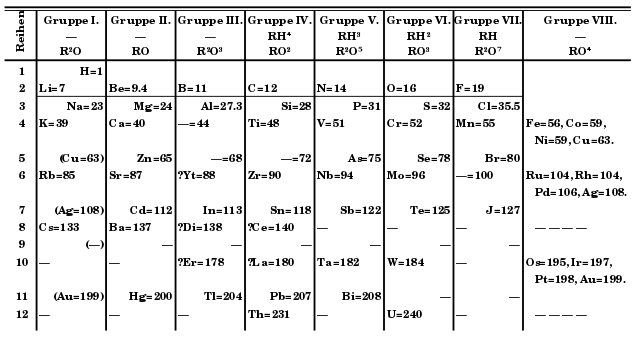

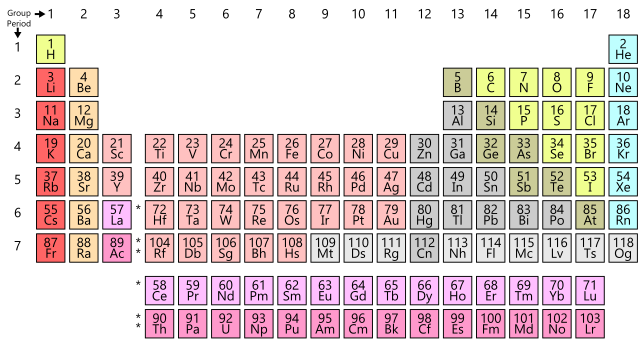

La pregunta surge de forma natural a poco que se piense un poco en el sistema de periodos. Recordemos que Mendeléyev había dispuesto los elementos siguiendo los criterios de masa atómica creciente y características químicas. Pero, y esto es importante, la única característica física del ordenamiento, las masas atómicas de los elementos, no pueden explicar las características químicas periódicas.

¿Por qué, por ejemplo, los elementos 3 (litio), 11 (socio), 19 (potasio), 37 (rubidio), 55 (cesio) y 87 (francio) [1], con masas atómicas muy diferentes, tienen propiedades químicas similares (por ejemplo, arden, esto es, reaccionan rápida y violentamente, cuando se exponen al aire)? ¿Por qué estas propiedades son algo diferentes de las de los elementos 4 (berilio), 12 (magnesio), 20 (calcio), 38 (estroncio), 56 (bario) y 88 (radio) [2] de la lista (que reaccionan lentamente con el aire o el agua), pero son muy diferentes de las propiedades de los 2 (helio), 10 (neón) ,18 (argón), 36 (kriptón), 54 (xenón) [3] y 86 (radón) (que rara vez se combinan con cualquier otro elemento)?

La periodicidad en las propiedades de los elementos llevó a especular con la idea de que los átomos podrían tener una estructura, que podrían estar formados por piezas más pequeñas. Las propiedades cambian gradualmente de grupo a grupo. Este hecho sugiere que se puede agregar alguna unidad de estructura atómica de un elemento al siguiente, hasta que se complete una cierta porción de la estructura. Esta porción se encontraría completada en el átomo de un gas noble (Grupo 18). En un átomo del siguiente elemento más pesado, se iniciará una nueva parte de la estructura, y así sucesivamente.

Los métodos y técnicas de la química clásica no pudieron proporcionar pruebas experimentales para tal estructura. En el siglo XIX, sin embargo, los descubrimientos y las nuevas técnicas en física abrieron el camino para probar que los átomos en realidad consisten de piezas más pequeñas. [5]

La evidencia se fue acumulando para apoyar la conclusión de que los átomos de diferentes elementos difieren en el número y la disposición de estas piezas.

Notas:

[1] Descubierto por Marguerite Perey en 1939, no estaba en la tabla original de Mendeléyev.

[2] La primera noticia de la existencia del radio es de 1898 y la dieron Marie y Pierre Curie. El aislamiento del elemento se produjo en 1910 por Marie Curie y André-Louis Debierne.

[3] Todos los descubrimientos de los gases nobles son posteriores a la primera publicación del sistema de periodos de Mendeléyev. El primero, el helio, fue descubierto en 1868 como una línea en el esptectro de la cromosfera del Sol. Su aislamiento se produjo en 1897. El resto de elementos del grupo se aislaron entre 1894 y 1910.

[5] La existencia del electrón como unidad de carga eléctrica definido como la carga de un ion monovalente la propuso George Stoney en 1874 (el lo llamó electrolión). Incluso antes Richard Laming, en 1851, ya especuló con que los átomos eran un núcleo de materia rodeado de cargas eléctricas. Pero estos hechos no deben interpretarse como avances en el conocimiento de la estructura de los átomos (véase el título del libro de Laming). Nada hacía prever que la especulación de Laming resultase teniendo base, ni que los electrones fuesen a ser tan importantes. Sería presentismo atribuirles más significación de la que realmente tuvieron. La lógica real se sustenta en el armazón del sistema de periodos, como iremos viendo.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El concepto de estructura atómica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ley de proporciones definidas y la unidad de masa atómica

- Un método para determinar la estructura átomo a átomo en un cristal

- Construcción de heteroestructuras de grafeno con precisión atómica

Restos de ensayos nucleares del siglo XX en lo más profundo del océano

Explosión de una bomba nuclear. Fuente: Pixabay

Explosión de una bomba nuclear. Fuente: Pixabay

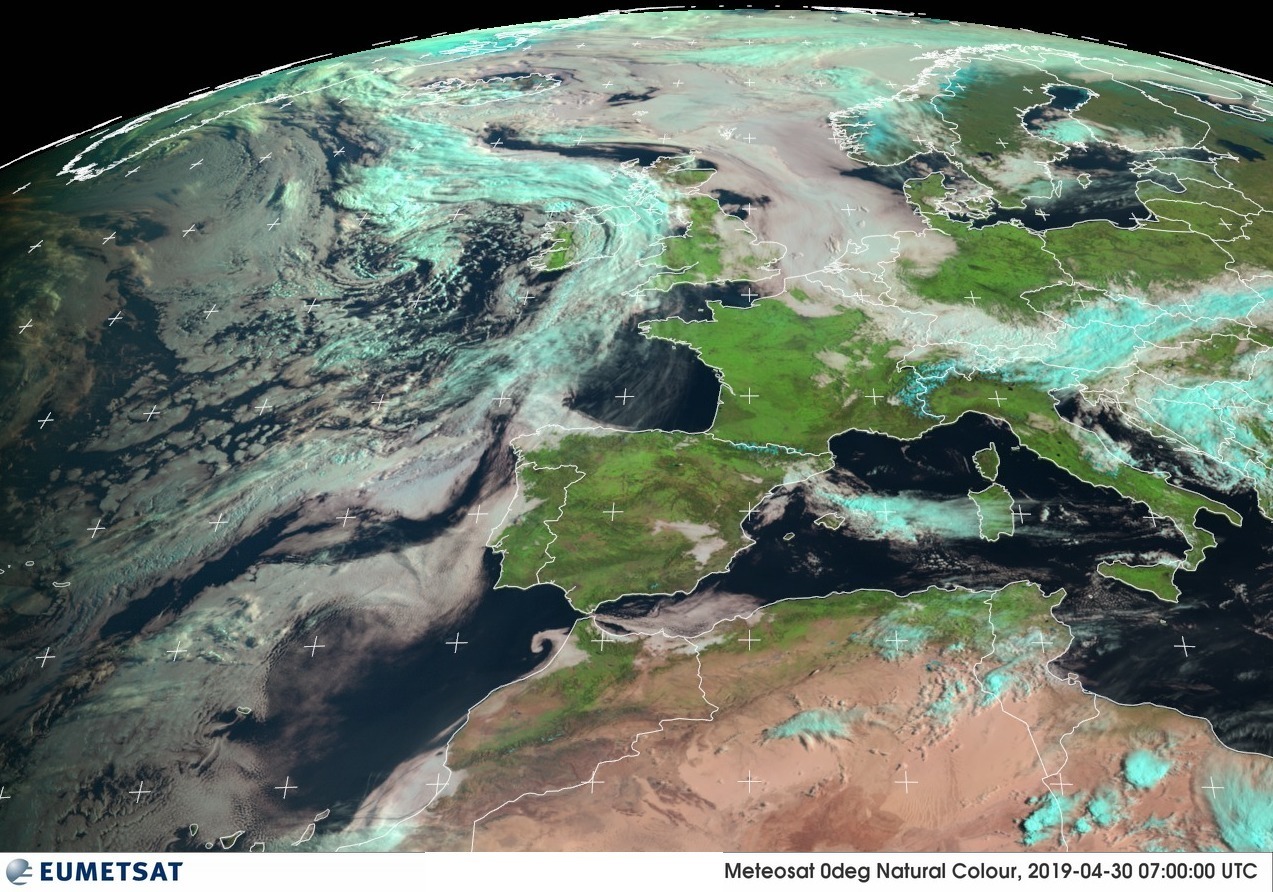

¿Quién vive en una piña en el fondo del mar? BOB-ES-PON-JA, dirán ustedes. Pues si es así, el pobre Bob y sus amigos están comiendo algunas cosas muy particulares. Entre otras, moléculas de carbono radiactivo liberado a la atmósfera durante algunos de los ensayos nucleares que el mundo vio con expectación y miedo a mediados del siglo XX. Un estudio ha desvelado que restos de aquellos experimentos han llegado ya a lo más profundo del mar, incluida la Fosa de las Marianas.

Que este carbono es parte de los organismos que pueblan la superficie del océano no es algo nuevo. Sabemos desde finales de los años 50 que estos organismos lo han ido incorporando a las moléculas de su cuerpo. Pero esta es la primera vez que se observa cómo crustáceos que viven en la base marina se están alimentando de materia orgánica de los seres vivos de la superficie, y repitiendo el proceso de incorporación del carbono radiactivo. “Las corrientes de circulación oceánicas necesitan cientos de años para conseguir que determinadas moléculas completen este recorrido. La cadena alimenticia lo hace mucho más rápido”, explica Ning Wang, geoquímico de a Academia China de las Ciencias e investigador principal del estudio, publicado en la revista Geophysical Research Letters.

Es un ejemplo de cómo la contaminación humana puede alcanzar casi cualquier punto del planeta, incluso aquellas que parecen más a salvo. “Existe una fuerte interacción biológica entre la superficie y las profundidades, y las actividades humanas pueden impactar incluso a 11.000 metros bajo el agua. Tenemos que tener cuidado con lo que hacemos”, dice otro de los autores, Weidong Sun, en el material publicado al respecto por la American Geophysical Union.

¿De dónde han salido estas partículas radiactivas?

El carbono 14 es un tipo de carbono radiactivo que se produce de forma natural cuando los rayos cósmicos provenientes del espacio interactúan con el nitrógeno de la atmósfera. Es un tipo de carbono menos abundante que el carbono no radiactivo, pero se puede encontrar en prácticamente todos los organismo vivos. De hecho, y puesto que conocemos la velocidad a la que se va descomponiendo, es uno de los métodos que se utiliza para datar muestras geológicas o arqueológicas que incluyan restos biológicos.

Hirondella gigas, un tipo de anfípodo hallado a 10.900 metros de profundidad en la fosa de las Marianas. Fuente: Wikimedia Commons

Hirondella gigas, un tipo de anfípodo hallado a 10.900 metros de profundidad en la fosa de las Marianas. Fuente: Wikimedia Commons

Las bombas termonucleares que se hicieron explotar en pruebas durante los años 50 y 60 del siglo XX hicieron que se multiplicase la cantidad de carbono 14 presente en la atmósfera cuando los neutrones que liberaron las explosiones reaccionaron con el nitrógeno del aire. Esos niveles alcanzaron su punto álgido a mitad de los años 60 y fueron descendiendo a medida que se terminaron las pruebas nucleares. En los años 90, los niveles en la atmósfera habían descendido hasta quedar en un 20% por encima de los niveles previos a estos ensayos.

¿A dónde fue todo ese carbono 14? Cayó rápidamente y se mezcló con la superficie del océano. Los organismos marinos han ido incorporando estas moléculas a sus células, por lo que los análisis realizados han permitido observar un aumento del carbono 14 en sus cuerpos desde poco después de que comenzasen las pruebas.

La dura vida en el fondo del mar

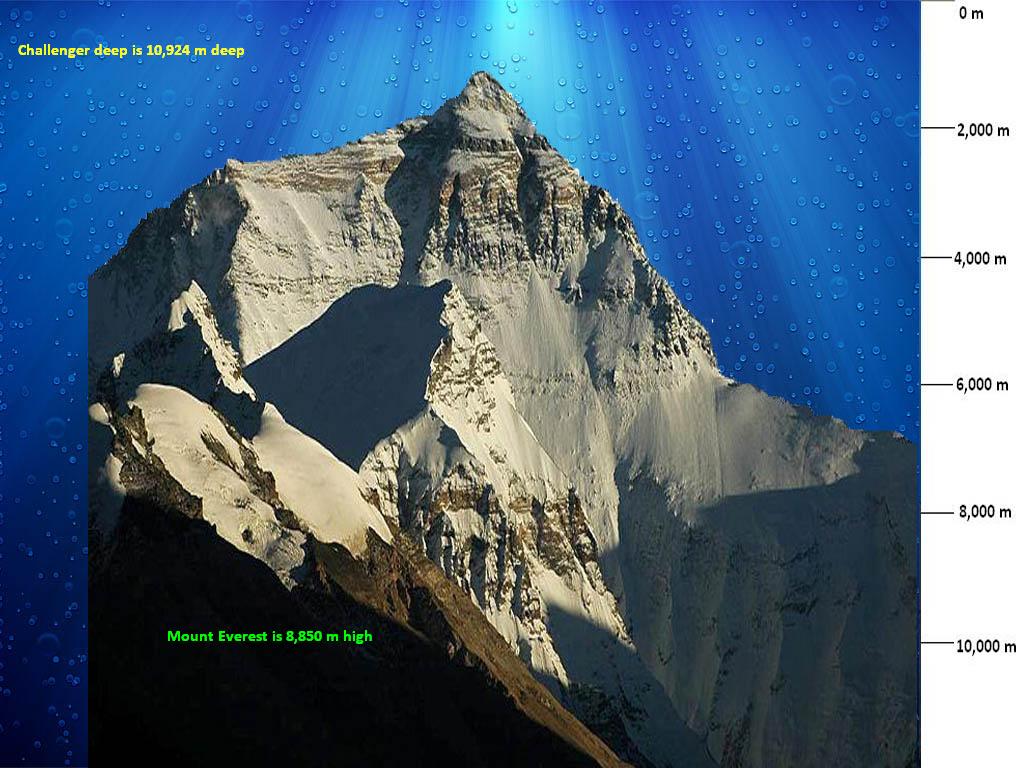

Vivir en el fondo del mar, en el fondo-fondo, no siempre es fácil. Estamos hablando de lugares a más de 6 kilómetros de profundidad, a menudo en puntos donde una placa tectónica se introduce bajo la de al lado. Hay poca luz, poca temperatura y poca comida y una intensa presión. Las criaturas que viven allí han tenido que adaptarse.

En este estudio, el carbono 14 ha servido para seguir el rastro de la materia orgánica que llega a estos lugares para entender mejor a los organismos que viven allí. Wang y sus colegas han analizado anfípodos (pequeños crustáceos que sobreviven a base de desechos y detritus marino) recogidos durante el año 2017 en la fosa de las Marianas, de Mussau o de New Britain, a profundidades de hasta 11 kilómetros.

Comparación de la profundidad de la Fosa de las Marianas con la altura del Monte Everest. Fuente: Wikimedia Commons

Comparación de la profundidad de la Fosa de las Marianas con la altura del Monte Everest. Fuente: Wikimedia Commons

Lo sorprendente fue hallar en su tejido muscular niveles de carbono 14 mucho más alto que en otros tipos de materia orgánica encontrada en esos niveles de profundidad bajo el mar. Al analizar después el contenido de su sistema digestivo, los niveles de carbono 14 hallados allí se correspondían con los hallados en muestras de materia orgánica de la superficie del océano. Esto sugiere que los anfípodos seleccionan para alimentarse el detritus y los restos que caen desde la superficie hasta las profundidades marinas.

Esto ayuda a entender mejor la longevidad de muchos de los organismos que viven en el fondo abisal, y cómo se han adaptado con éxito a sus condiciones extremas. Por ejemplo, es llamativo que los anfípodos de estos hábitats son más grandes y viven más tiempo que sus parientes que habitan en aguas menos profundas: de menos de dos años y 20 milímetros a más de 10 años y 91 milímetros.

Los autores sugieren que esta diferencia sea resultado de haber evolucionado exitosamente para vivir a poca temperatura, mucha presión y un aporte de alimento limitado. Para compensar, los animales tienen un metabolismo y un ciclo de renovación celular más lentos, lo que les permite almacenar energía y conservarla durante más tiempo. Por otro lado, al vivir más años, los contaminantes se acumulan en su cuerpo en mayores cantidades.

Pero también hay otro apunte interesante: la materia orgánica que los alimenta no proviene tanto de fuentes locales como serían otros seres vivos con los que conviven allí abajo, sino que parece venir principalmente de las superficie de mar.

Esto debería servir como toque de atención (otro más) a los seres humanos sobre el modo en que lo que hacemos repercute en todos los demás seres vivos del planeta, incluso aquellos que pueblan los lugares más remotos y en apariencia desconectados de nosotros. No lo están, ninguno lo está. Lo que lanzamos al aire hace ahora unos 60 años está alimentando a los pequeños crustáceos del lugar más profundo del mundo. Mucho cuidado con lo que tocamos.

Referencias:

Penetration of Bomb 14C into the Deepest Ocean Trench – Geophysycal Research Letter

Radioactive carbon from nuclear bomb tests found in deep ocean trenches – American Geophysisc Union

Carbono 14 – Wikipedia

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Restos de ensayos nucleares del siglo XX en lo más profundo del océano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los enigmas que nos cantan desde el fondo del océano

- Formas moleculares de excreción de restos nitrogenados

- Océanos nucleares. Cuando la basura llega antes que el ser humano

No hay raza blanca, tampoco negra

Foto: Alexandr Ivanov / Pixabay

Foto: Alexandr Ivanov / Pixabay

Al decir de alguien que es blanco o negro, es posible que pensemos que pertenece a una categoría biológica definida por su color. Mucha gente cree que la pigmentación de la piel refleja la pertenencia a una raza, entendiendo esta como la define la Real Academia Española en su segunda acepción: “cada uno de los grupos en que se subdividen algunas especies biológicas y cuyos caracteres diferenciales se perpetúan por herencia”. Y sin embargo, esa noción, en el caso de nuestra especie, carece de sentido. Porque desde un punto de vista biológico, las razas humanas no existen.

En la piel hay melanocitos, células que producen y contienen pigmentos. Hay dos tipos de pigmentos, llamados genéricamente melanina; uno es marrón parduzco (eumelanina) y el otro, rojo amarillento (feomelanina). El color de la piel depende de la cantidad y la proporción de ambos. Y se da la circunstancia de que ese rasgo depende de diferentes genes; unos inciden en la cantidad de pigmento en los melanocitos y otros sobre la proporción entre los dos tipos de melanina. Es más, colores muy similares puede ser el resultado de diferentes combinaciones de esos rasgos básicos y obedecer a configuraciones genéticas diferentes.

Los africanos, en general, son de piel oscura. Los Dinka, de África oriental, la tienen muy oscura, mientras que los San, del sur del continente, la tienen más clara. Los nativos del sur de la India, Nueva Guinea y Australia también son de piel oscura. En el centro de Asia y extremo oriente, así como en Europa, las pieles son, en general, claras. Y los nativos americanos las tienen de diferente color, aunque no tan oscuras como los africanos.

Si nos atenemos al color de la piel escondida bajo el grueso pelaje de los chimpancés, lo más probable es que nuestros antepasados homininos la tuviesen clara. En algún momento hace alrededor de dos millones de años, los miembros de nuestro linaje vieron reducido el grosor y consistencia del pelaje, hasta convertirse en una tenue capa de vello en gran parte de la superficie corporal. Pero esa transformación trajo consigo la exposición de la piel a la radiación solar ultravioleta, que podía causar cáncer y, además, eliminar una sustancia de gran importancia fisiológica, el ácido fólico. Seguramente por esa razón se seleccionaron variantes genéticas que oscurecían la piel, porque la melanina la protege evitando los daños citados.

Los seres humanos nos hemos expandido y llegado así a casi todas las latitudes. Esos movimientos han expuesto la piel de sus protagonistas a muy diferentes condiciones de radiación. Y al igual que un exceso de radiación ultravioleta puede ser muy dañino, su defecto también lo es, pues sin ella no se puede sintetizar vitamina D, cuyo déficit provoca raquitismo y otros problemas de salud. Por esa razón, sin descartar otras posibles, la piel humana se ha ido aclarando en diferentes zonas geográficas bajo la acción de la selección natural. Además, los movimientos de población han propiciado la mezcla de distintos linajes, cada uno con sus rasgos genéticos y características pigmentarias, para dar lugar a múltiples configuraciones.

El color de los seres humanos actuales es el resultado, por tanto, de una compleja secuencia de eventos biológicos y demográficos, y no es posible delimitar biológicamente unos grupos y otros. Las diferencias en el color de la piel no tienen correspondencia en innumerables otros rasgos que también varían y lo hacen según otros patrones y por efecto de otras presiones selectivas. No hay, pues, fundamento para invocar la existencia de razas. Como tampoco lo hay para justificar, sobre bases inexistentes, otras diferencias.

——————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo No hay raza blanca, tampoco negra se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- 11 años después de la marea negra

- Un punto cuántico emite luz blanca gracias a la aspirina

- Desvelado el misterio de la Gran Mancha Blanca de Saturno

¿Afecta el sexo a los síntomas de una enfermedad?

¿Afecta el sexo a los síntomas de una enfermedad? La Fundación Española del Corazón (FEC) afirma que “los síntomas del infarto agudo de miocardio y la percepción de estos se presentan de diferente modo dependiendo del sexo de la persona que lo sufra”. A pesar de que mujeres y hombres comparten los síntomas típicos, la enfermedad cardiovascular en la mujer es diferente en muchos aspectos respecto al hombre y puede cursar con síntomas distintos, los llamados atípicos, que en muchos casos tanto las propias mujeres como las y los profesionales médicos que las atienden no están acostumbrados a tener en cuenta. Esto es así debido a que, tradicionalmente, se han aceptado como propios y únicos en ambos sexos los síntomas comunes.

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Afecta el sexo a los síntomas de una enfermedad? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ecología de una enfermedad

- ¿Podría un humano vivir en el mar?

- Prevenir y tratar la enfermedad de Alzheimer: Una visión moderna

CSI Bilbao: entomología forense

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Foto: Strikers / Pixabay

Foto: Strikers / Pixabay

Desde que en 1235, el magistrado chino Sung Tz’u de la Dinastía Song incriminara por vez primera a un asesino gracias a la colaboración de moscardones, la entomología forense ha ido implantándose y perfeccionando sus técnicas en el mundo occidental. Pasarían siglos hasta que un médico militar francés Jean Pierre Mégnin registrara meticulosamente los artrópodos que encontraba en restos cadavéricos (Faune des Tombeaux, 1887) de forma ordenada y sistemática, organizados en lo que llamó “escuadrones de la muerte”. Así, en su obra La faune des cadavres. Application de l’entomologie à la médecine légale (Masson-Gauthier Villars Ed.,1894) nos muestra el primer modelo de sucesión ecológica aplicado a la investigación forense. En los albores de la Ecología como disciplina científica, el Dr. Mégnin demostró como un cadáver se comporta como una isla, con una fauna que le es propia y diferente de los ecosistemas circundantes. Por ello, aunque se intente ocultar un crimen o confundir a los inspectores trasladándolo a otro lugar, es posible demostrar el lugar donde ha sido asesinada una persona o cualquier otra especie animal, cuando se cometió el crimen, y realizar el seguimiento de mercancía que se introduce legal o ilegalmente en nuestro país.

Así, la entomología forense va más allá de lo que nos muestran series televisivas famosas como CSI o Bones y nos permite aplicar nuestros conocimientos para ayudar a empresas y a agentes a de aduanas a determinar el origen de la contaminación de una determinada mercancía, a diagnosticar comportamientos negligentes ante la presencia de larvas miásicas, piojos y otras especies en el cuerpo de pacientes y otras personas dependientes, etc. Incluso podemos demostrar si una persona sospechosa estuvo o no en un lugar donde se cometió el crimen dado que muscas especies de artrópodos se encuentran sólo en hábitats muy particulares y un pequeño ácaro, sus picaduras o fragmentos del cuerpo nos pueden permitir conectarle con un lugar específico. Para ello, necesitamos conocer en profundidad que especies de artrópodos habitan en nuestra región, como se distribuyen, que condiciones ambientales requieren, en que periodos del año están activos, como son sus ciclos, cuanto duran, etc. algo que resulta difícil de abordar sabiendo que más de las tres cuartas partes de los animales conocidos son artrópodos y que al igual que el resto de invertebrados dependen de la temperatura exterior para desarrollarse y factores como la duración de los días pueden condicionar su capacidad reproductora.

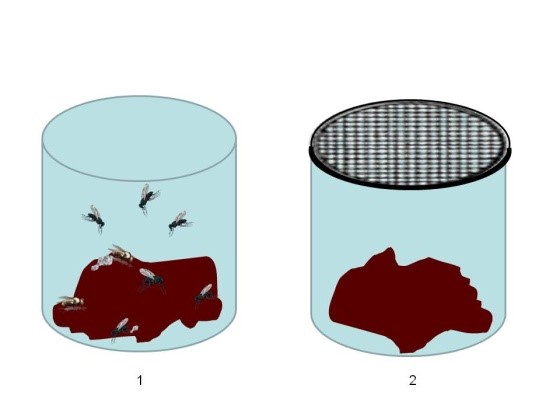

Figura 1. Experimento de Francesco Redi (1626-1697) donde se demuestra la falacia de la generación espontánea. A) Los botes sin tapar permiten el acceso de insectos que depositan sus huevos y, en pocas horas las larvas nacen y devoran los restos. B) Los botes debidamente tapados no permiten el acceso de los insectos y la carne permanece incorrupta.

Figura 1. Experimento de Francesco Redi (1626-1697) donde se demuestra la falacia de la generación espontánea. A) Los botes sin tapar permiten el acceso de insectos que depositan sus huevos y, en pocas horas las larvas nacen y devoran los restos. B) Los botes debidamente tapados no permiten el acceso de los insectos y la carne permanece incorrupta.

La relación entre los cadáveres y los insectos es conocido desde antiguo. De hecho, muchas culturas desarrollaron técnicas para impedir que los insectos deterioraran los restos de sus seres queridos o adorados. Es más, no sólo los egipcios embalsamaban los cuerpos de los muertos para evitar que otros organismos degradaran el cuerpo durante el viaje al más allá. También encontramos momias de culturas mayas, guanches y de pueblos asiáticos. Los vikingos incineraban los cuerpos y, con el tiempo, la gran mayoría de las culturas hemos enterrado los restos de nuestros seres queridos para evitar que los insectos los devoren. Aun así, no serán las mismas moscas necrófagas que llegaron a la hoz las que colonicen el cadáver sino otras especies capaces de detectar y hasta de descender varios metros bajo tierra hasta invadir cadáveres enterrados.

Concepto

La entomología forense es una disciplina que aplica el conocimiento adquirido sobre la biología, la estructura y la dinámica de las comunidades de artrópodos en la resolución de problemas civiles y casos criminales. Las muestras entomológicas recolectadas podrán ser empleadas como pruebas ante un Tribunal de Justicia, por lo que deberán ser adecuadamente conservadas y custodiadas hasta el requerimiento de la autoridad judicial competente.

Un error en la identificación, o una aplicación inadecuada de datos publicados, puede suponer un error en las conclusiones y, en consecuencia, la incriminación por error de una persona inocente. Por las consecuencias que derivan de una mala investigación, el trabajo debe ser llevado a cabo por personas competentes, debidamente formadas con adecuados conocimientos sobre la biología y dinámica de las especies involucradas. Por la complejidad de las comunidades de artrópodos, con frecuencia se requiere de la colaboración de diferentes expertos en los diversos grupos de artrópodos que sean recolectados durante la investigación pericial. Es más, sin un debido entrenamiento, determinados artrópodos o algunas de sus fases pueden pasar desapercibidos e incurrir en errores que irán acumulándose a lo largo de la investigación posterior. Por ello, es imprescindible el desarrollo de habilidades específicas para la adecuada aplicación de la entomología a la ciencia forense.

Método de trabajo

Uno de los aspectos fundamentales de toda investigación forense, es la relación indubitada entre la prueba y los hechos a investigar. Por ello, es fundamental establecer un protocolo minucioso de actuación que permita asociar sin ningún lugar a dudas la muestra del artrópodo con el caso a investigar. En el caso concreto de la entomología forense, existe el problema añadido de que la “prueba”, esto es el insecto, se ha podido ver naturalmente modificada a lo largo de la investigación dado que puede ser necesario criarla hasta alcanzar su estado adulto; por ejemplo, para estimar su edad con precisión, o para identificar la especie correctamente. Con frecuencia, la identificación específica sólo es posible con ejemplares adultos dado que éstos poseen las estructuras sexuales que permiten la identificación indubitada de la especie. Por ello, en el procedimiento a seguir es fundamental tener en consideración si va a ser necesario realizar cría en condiciones controladas de una parte de población para obtener ejemplares adultos que permitan una correcta identificación de la especie. Centraremos las explicaciones en casos de investigación criminal, dado que los métodos no difieren en los procedimientos civiles (tráfico de mercancías, mobiliario o inmuebles dañados, etc.) y requieren de mayor cuidado en el proceso, dadas las consecuencias que derivan de dicha investigación.

Los procedimientos a seguir difieren dependiendo del estado de descomposición del cadáver. En casos de fallecimiento reciente, el cadáver presentará abundancia de larvas en crecimiento que se alimentan de los restos cadavéricos hasta finalizar su desarrollo larvario. Corresponden a los huevos depositados por los primeros insectos en llegar al cadáver, habitualmente moscas califóridas, sarcofágidos o múscidos. Estas moscas son capaces de detectar el cadáver a varios kilómetros de distancia y, por su excelente capacidad de vuelo, llegar a éste en cuestión de minutos. Una vez lo localizan, si son hembras grávidas (ha habido cópula y los huevos están fecundados), depositarán inmediatamente huevos con clara preferencia por las cavidades naturales (boca, ojos, nariz, ano, etc). Sólo cuando las cavidades están saturadas, continúan depositando huevos sobre la piel, las prendas, el suelo, etc. De dichos huevos nacerán unas larvas diminutas que pueden pasar desapercibidas si no se inspecciona adecuadamente el cadáver. A lo largo de los días sucesivos irán comiendo y creciendo a velocidades vertiginosas si las condiciones ambientales son adecuadas, hasta alcanzar su máxima longitud en pocos días, momento en que abandonan la fuente de alimentación para pasar a la siguiente fase, la pupa, donde tiene lugar la metamorfosis y de la que emergerá una mosca que iniciará de nuevo el ciclo (fig. 2)

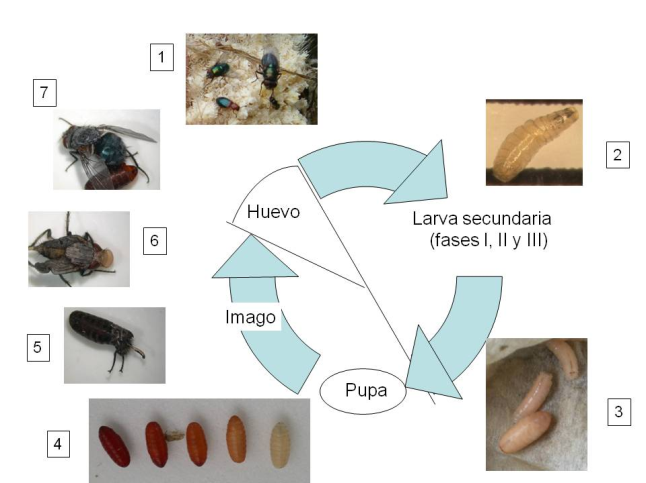

Figura 2. Ciclo biológico de una mosca caifórida. 1) masa de huevos sobre restos animales, con moscas y escarabajos depredadores de sus huevos. 2) Larva recién nacida en fase I de desarrollo. 3) Larvas migratorias junto a una prepupa. 4) prepupa y pupas de diferente edad. 5) imago intentando emerger del pupario; en ocasiones, hay dificultades para salir del pupario y el imago fallece o es inmediatamente depredado por un insectívoro; imago recién emergido donde se aprecia el ptilinum empleado para romper el pupario y salir de su escondite, y la ausencia de alas, las cuales se limitan a pequeños esbozos sobre el abdomen. Una vez extendidas las alas y endurecida la cutícula, la mosca habrá adquirido su color definitivo y podrá iniciar el desarrollo y maduración del aparato reproductor, alcanzando la categoría de adulto s.s. 7) Adulto debidamente conformado y apto para emprender el vuelo y localizar una pareja.

Figura 2. Ciclo biológico de una mosca caifórida. 1) masa de huevos sobre restos animales, con moscas y escarabajos depredadores de sus huevos. 2) Larva recién nacida en fase I de desarrollo. 3) Larvas migratorias junto a una prepupa. 4) prepupa y pupas de diferente edad. 5) imago intentando emerger del pupario; en ocasiones, hay dificultades para salir del pupario y el imago fallece o es inmediatamente depredado por un insectívoro; imago recién emergido donde se aprecia el ptilinum empleado para romper el pupario y salir de su escondite, y la ausencia de alas, las cuales se limitan a pequeños esbozos sobre el abdomen. Una vez extendidas las alas y endurecida la cutícula, la mosca habrá adquirido su color definitivo y podrá iniciar el desarrollo y maduración del aparato reproductor, alcanzando la categoría de adulto s.s. 7) Adulto debidamente conformado y apto para emprender el vuelo y localizar una pareja.

En cadáveres en avanzado estado de descomposición, cuando las primeras larvas finalizaron el desarrollo y abandonaron el cadáver, es fundamental fijar nuestra atención en otras especies de artrópodos que han ido llegando después de que las primeras moscas depositaran los primeros huevos. El proceso sigue un modelo similar a otras pautas de colonización de nuevos ambientes, donde especies pioneras modificaron el entorno permitiendo el asentamiento de nuevas especies que van definiendo un modelo específico de sucesión faunística. A los necrófagos les seguirán depredadores, parasitoides, etc. que nos permitirán realizar estimaciones muy precisas de la edad del entono cadavérico. Sólo una adecuada recogida de todos los artrópodos presentes en torno al cadáver y su correcta identificación específica aseguraran una estimación fiable del periodo de actividad de los insectos (PAI) que nos permitan adecuarlo a la estimación del intervalo postmortem (IPM).

Desde el año 2003, el grupo de investigación consolidado BIOMICS4 de la Universidad del País Vasco / Euskal Herriko Unibertsitatea (UPV/EHU) está sentando las bases para el correcto desarrollo de esta disciplina en la Comunidad Autónoma del País Vasco, elaborando mapas de distribución de las principales especies de califóridos5, sus patrones de desarrollo6 en presencia y ausencia de parasitoides, modelos de sucesión faunística7, caracterización molecular de insectos necrófagos y miásicos8,9, y colaborado en el esclarecimiento de diferentes casos10,11, tanto criminales como civiles12.

Referencias:

1Ci, S. (1247) The Washing Away of Wrongs. en B.E. en McKnight. (1981) The Washing Away of Wrongs: Forensic Medicine in Thirteenth-Century China. Science, medicine, and technology in East Asia, v. 1. Ann Arbor: Center for Chinese Studies, University of Michigan.

2Megnin, J.P. (1887) Faune des Tombeaux.Ed. Gauthier Villars.

3Megnin, J.P. (1894) La faune des cadavres application de l’entomologie à la médecine légale. Ed. Masson.

4Universidad del País Vasco / Euskal Herriko Unibertsitatea (UPV/EHU). Biomics Research group. http://www.biomics.es.

5M. Saloña, J. Moneo, B. Díaz. 2009. Estudio sobre la distribución de califóridos en la Comunidad Autónoma del País Vasco Boletín de la Asociación Española de Entomología, 33 (1-2): 63-89

6Diaz Martín B., A. López Rodríguez y M. I. Saloña Bordas. 2013. Primeros resultados sobre desarrollo de Calliphora vicina (Diptera, Calliphoridae) bajo condiciones controladas de temperatura. Ciencia Forense, 11-12 (en prensa)

7Morales Rayo J., G. San Martín Peral y M. I. Saloña Bordas. 2013. Primer estudio sobre la reducción cadavérica en condiciones sumergidas en la Península Ibérica, empleando un modelo de cerdo doméstico (Sus scrofa L., 1758) en el Río Manzanares (Comunidad Autónoma de Madrid). Ciencia Forense, 11-12 (en prensa)

8 Pancorbo M. M., A. Castro, I. Fernández-Fernández, N. Cuevas, M. Castillo, M. Saloña. 2004. Entomología molecular forense. Ciencia Forense 8: 107-130

9GilArriortua M, M.I. Saloña Bordas, L.M. Cainé, F. Pinheiro & M.M. de Pancorbo. 2013. Cytochrome b as a useful tool for the identification of blowflies of forensic interest (Diptera, Calliphoridae). Forensic Science International, 228(1–3): 132-136.

10Saloña M.I., Mª L. Moraza, M. Carles-Tolrá, V. Iraola, P. Bahillo, T. Yélamos, R. Outerelo y R. Alcaraz. Searching the soil. Report about the importance of the edaphic fauna after the removal of a corpse. Journal of Forensic Sciences 55(6): 1652-1655.

10Martínez-Sánchez A., C. Magaña, M. Saloña, & S. Rojo. First record of Hermetia illucens (Diptera: Stratiomyidae) on human corpses in Iberian Peninsula. Forensic Science International, 206 (1-3): e76-e78.

11Saloña M. 2005. Forensic Entomology besides corpses and morgues. 2 new cases reported from the Basque Country (N. Spain). 3d meeting of the European Association for Forensic Entomology EAFE, Laussanne.

Sobre la autora: Marta Saloña es profesora del departamento de Zoología y Biología Celular Animal de la Facultad de Ciencia y Tecnología y asesora científica del Servicio de Entomología Forense (SGIKER) de la UPV/EHU.