Ezjakintasunaren kartografia #247

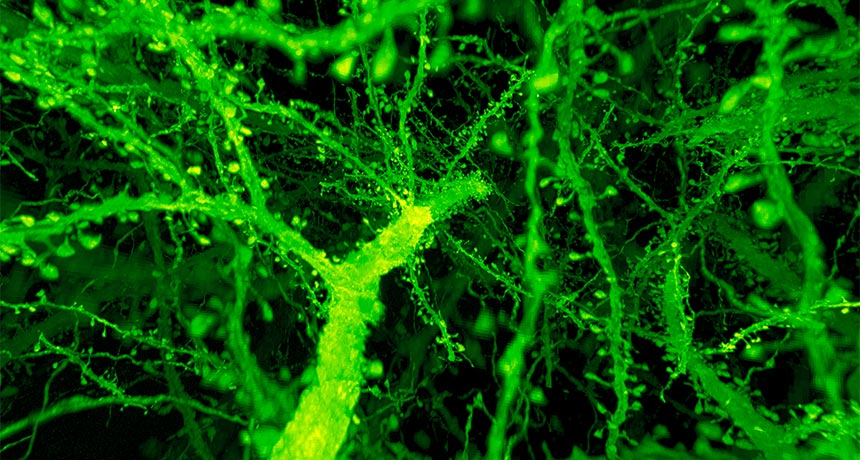

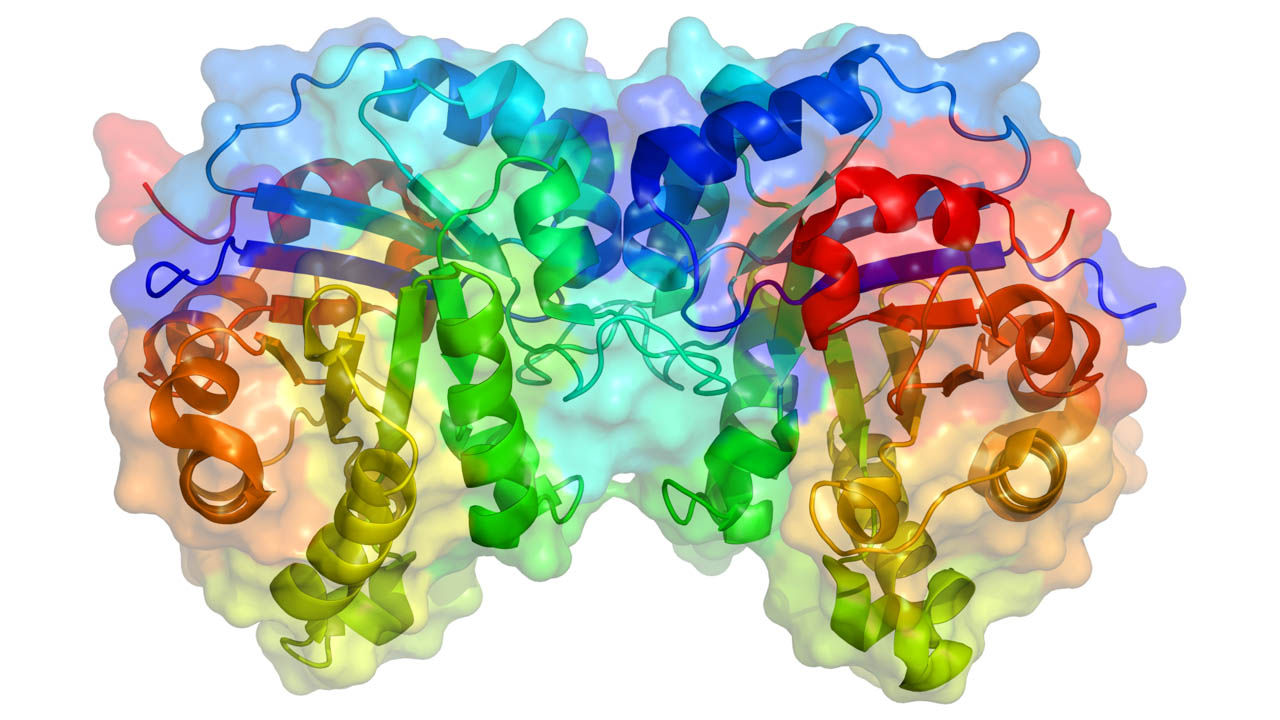

Irudia: Gao et al. Science 2019.

Innobazioa, edo horretaz hitz egitea, garaiaren ikurra da. Gaitz sozial eta ekonomiko guztien panazea da. Eta ekintzaileak bere apaizak. Ia nork konparatzen dituen Nietzscheren “supergizona” eta ekintzaile-innobatzailea. José Luis Granados-ek: En On the Genealogy of Innovation, or how to look for power with a hammer

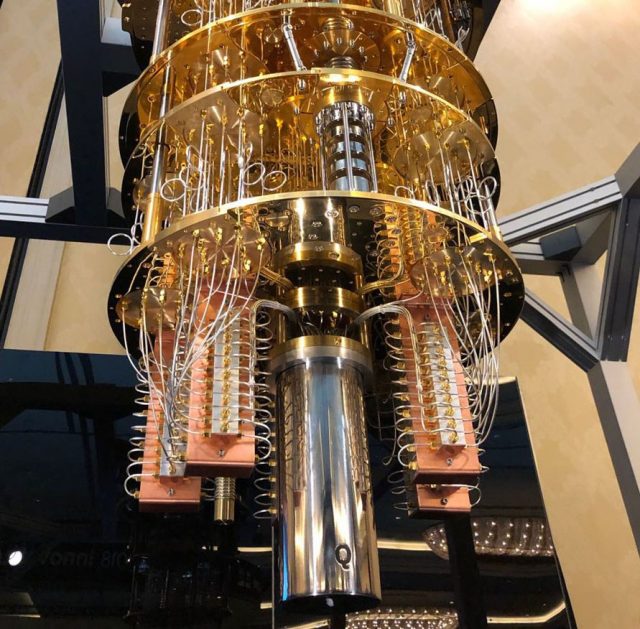

Aurrekaririk ez duen erresoluzioa duten irudiak, nerbio-sistemaren molekulenak, osatzen ditu teknika berri batek. Rosa García-Verdugokk azaltzen du When two forces join to make imaging brains more amazing than ever!

Ezpurutasun jakinaren kantitate txikia behar da batzuetan esperimentua hobeto atera dadin. DIPC-ren Methane and the determination of the Majorana nature of neutrinos

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #247 appeared first on Zientzia Kaiera.

A new hero is born: La espectrometría de masas al servicio de la justicia

Hace unos pocos años, apareció en algunos medios locales gallegos una noticia sobre la lucha judicial entre los herederos de un abuelo acaudalado. Este hombre falleció un año después de haber perdido su capacidad legal debido a un diagnóstico de alzhéimer. Uno de los nietos que había cuidado de él en sus últimos años alegaba ser el único heredero y, para ello, presentaba un testamento ológrafo (testamento que el testador formaliza por sí mismo, escribiéndolo y firmándolo de su puño y letra sin intervención de testigo alguno) a su favor fechado 3 años antes de su muerte. El resto de los herederos potenciales alegaban que este testamento era falso y se remitían al oficial realizado ante notario décadas antes en el que el abuelo repartía su fortuna de forma equitativa entre todos ellos. No cuestionaban el hecho que de que el testamento estuviera hecho por otra persona (había sido corroborado por peritos calígrafos), sino que cuestionaban la fecha de realización. Si se demostraba que el testamento ológrafo estaba realizado en la fecha descrita, le otorgaría vigencia y validez, ya que era posterior al realizado ante notario y anterior a que el abuelo perdiera sus facultades.

Hechos como este o algunos de naturaleza parecida, se repiten de forma recurrente en la sociedad en la que vivimos. Aunque avanzamos sin remedio hacia la sociedad del formato electrónico, la mayor parte de tratados o acuerdos con importantes consecuencias individuales, sociales y/o económicas aún siguen siendo certificados de forma manuscrita mediante útiles de escritura tipo bolígrafo. Por esa razón, el estudio forense documental sigue manteniendo aun vigencia. Por ejemplo, los datos recogidos por la policía científica en Finlandia en el año 2015 demuestran que el estudio forense fue determinante para llegar a una sentencia firme en el 40% de los casos judiciales relacionados con documentos.

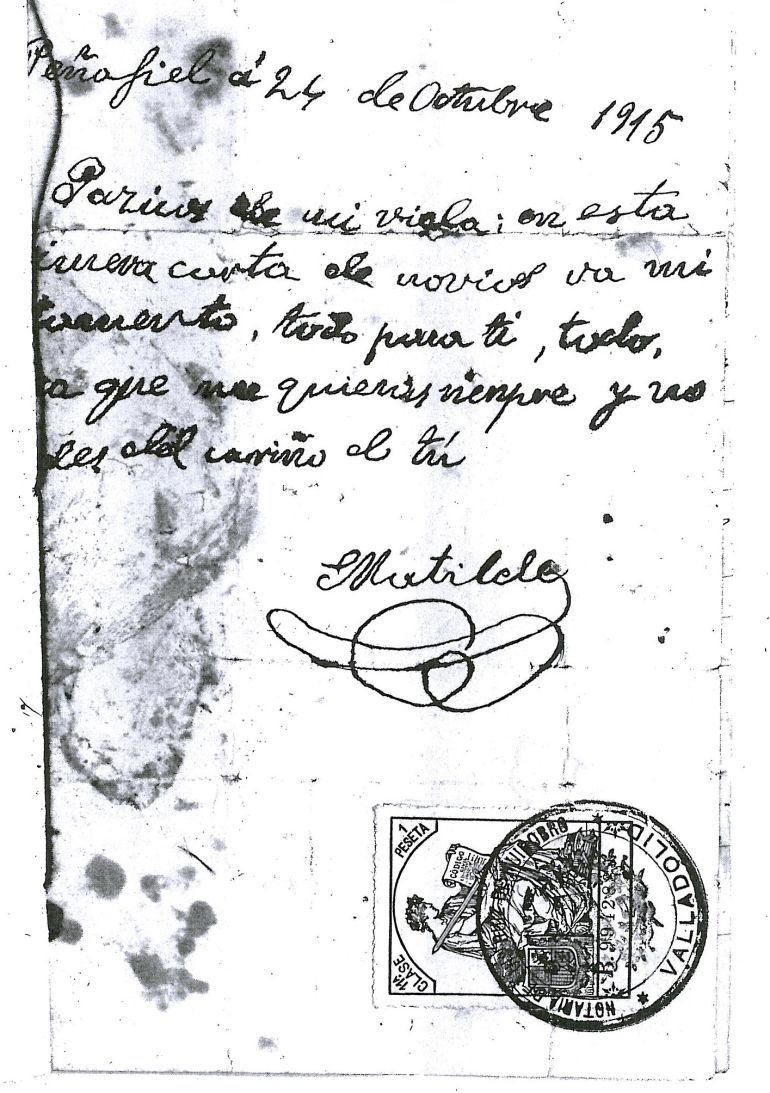

Imagen 1. Carta de amor de Matilde Corcho convertida en el primer testamento ológrafo después de la sentencia dictada por el Tribunal Supremo en 1918. Fuente: Archivo Histórico Provincial de Valladolid (vía cadena SER)

Imagen 1. Carta de amor de Matilde Corcho convertida en el primer testamento ológrafo después de la sentencia dictada por el Tribunal Supremo en 1918. Fuente: Archivo Histórico Provincial de Valladolid (vía cadena SER)Desde los años 90 existen distintas metodologías analíticas que posibilitan la datación de documentos. Para empezar por el principio debemos responder a estas preguntas: ¿En qué están basadas la mayor parte de las metodologías de datación de documentos? ¿Cómo podemos afirmar que un documento ha sido escrito en el momento en el que está fechado? Básicamente la mayor parte de las metodologías de datación directa tratan de observar los cambios ocurridos en la tinta con el tiempo. Como es fácil de imaginar, esto no es una tarea fácil ya que existen una gran variedad de tintas en el mercado internacional. Además, no sólo podemos asignar una única tinta a una marca de bolígrafo. La misma marca puede variar la composición de la tinta entre sus diferentes plantas de producción a lo largo del mundo o incluso entre lotes temporales con el propósito de ofertar útiles de escritura con distintas propiedades. Este hecho hace que nos encontremos ante una cantidad innumerable de tintas con diferentes componentes que haría imposible su estudio individual. En el ejemplo que nos concierne, nunca se supo qué bolígrafo utilizó el abuelo para realizar su testamento y mucho menos la marca o el lote. Para intentar solventar este problema, la mayor parte de las metodologías de datación se basan en el estudio de una familia de compuestos habituales en tinta de bolígrafo: los disolventes orgánicos. Estos compuestos, añadidos como vehículo para colorantes y resinas, sufren un proceso de evaporación desde el primer momento en el que se depositan en el trazo. Aunque hay algunas clases de bolígrafos que usan el agua como disolvente (bolígrafos tipo gel), el resto de útiles de escritura de uso común utilizan compuestos orgánicos volátiles como alcoholes, aldehídos o cetonas, siendo el 2-fenoxyetanol el compuesto más habitual (más del 80% de los bolígrafos de tinta viscosa lo contienen) y el más estudiado en su comportamiento cinético.

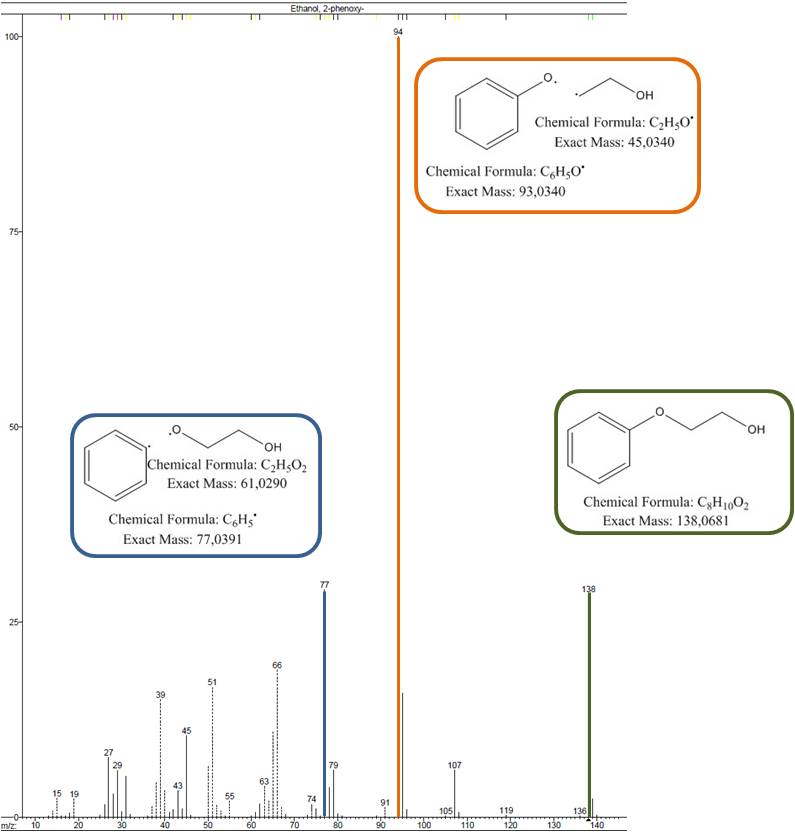

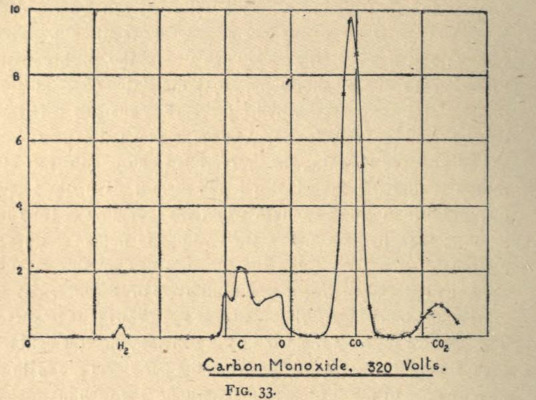

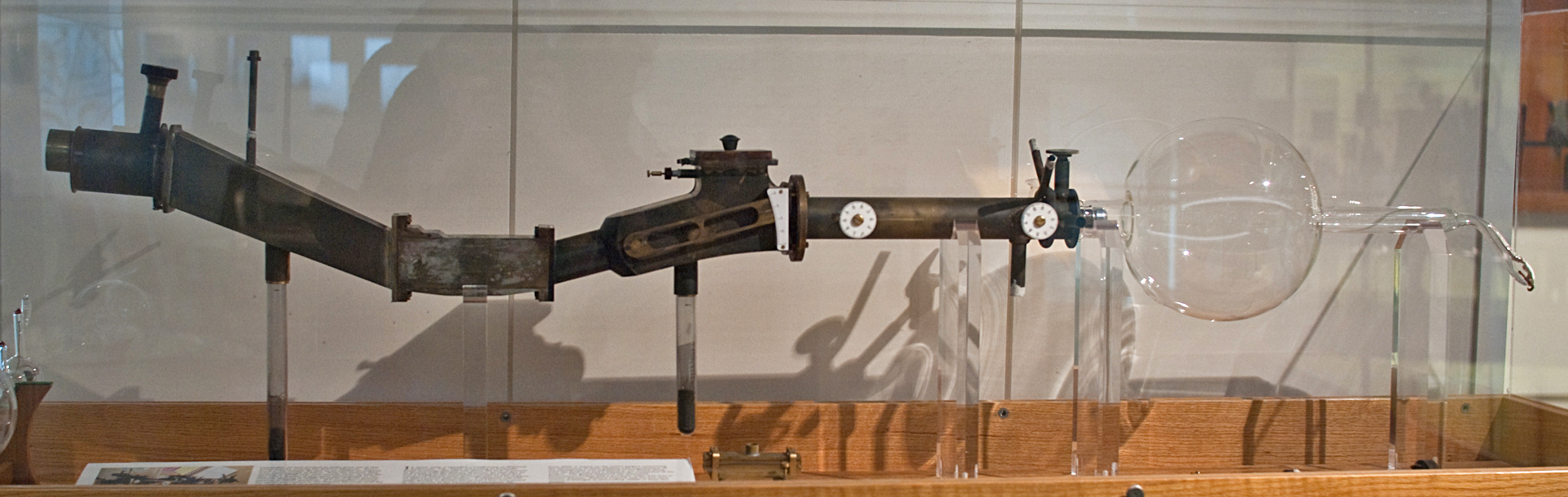

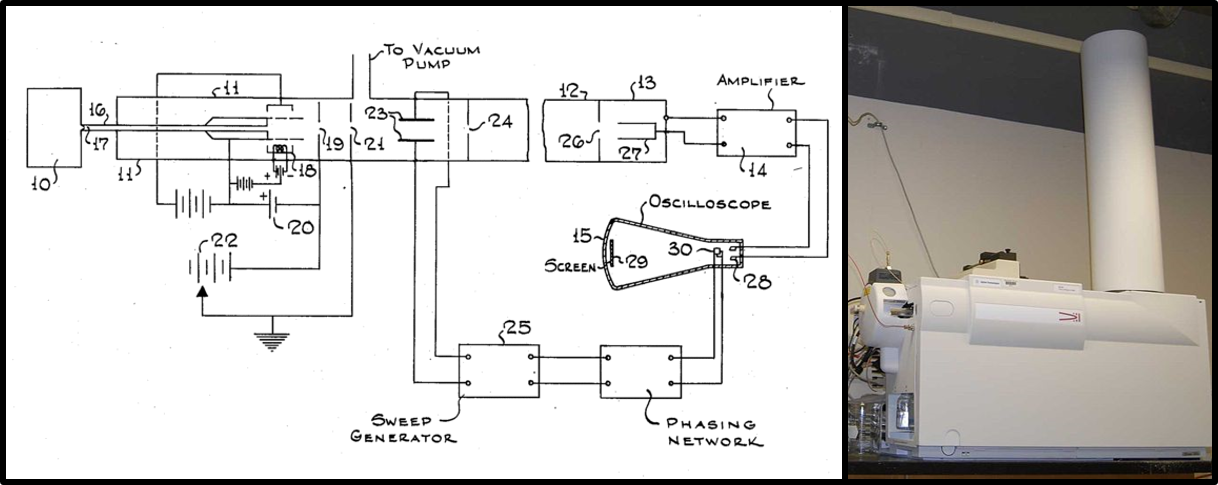

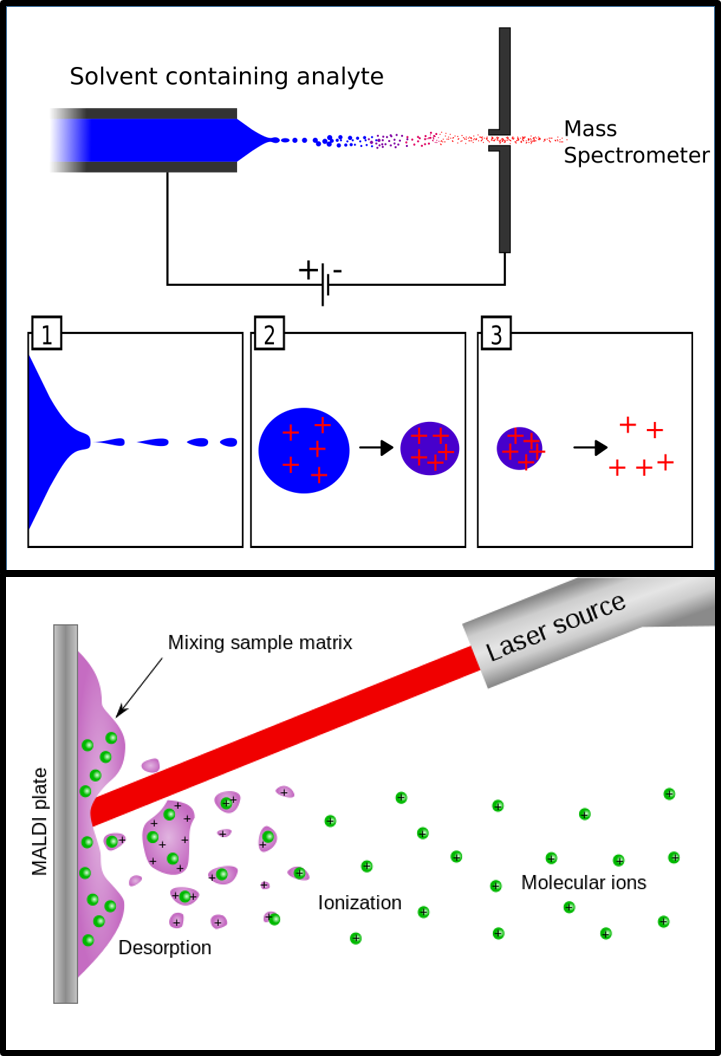

Y en este punto podemos preguntarnos, ¿En qué puede ayudar la espectrometría de masas en la datación de documentos? ¿Por qué se ha convertido en uno de los detectores más utilizados en las distintas metodologías de datación desarrolladas hasta el momento? La espectrometría de masas es una técnica relativamente reciente y ampliamente utilizada en distintas áreas de aplicación como análisis alimentario, industrial, farmacéutico y también forense. Su alta aplicabilidad reside, entre otras cosas, en la posibilidad de identificación de compuestos desconocidos a través de su contraste con una librería de espectros. El funcionamiento es relativamente sencillo: las moléculas orgánicas que llegan al espectrómetro de masas (MS) son “bombardeadas” por una gran cantidad de electrones al pasar bajo una diferencia de potencial controlada (70 eV). Este impacto electrónico provoca que el compuesto se rompa en fragmentos que serán siempre los mismos si no se cambia el potencial al que han sido sometidos (Imagen 2). Gracias a ello, la fragmentación controlada de sustancias puras nos permite poseer librerías de espectros de una gran cantidad de compuestos orgánicos (306 622 compuestos en la última versión del año 2017) con la que poder contrastar los espectros de moléculas que nos son desconocidas y así poder identificarlas. El contraste entre los espectros de compuestos puros y nuestros compuestos no identificados en la base de datos, nos devuelve una identificación con un porcentaje asociado de confianza. En este punto es donde la espectrometría de masas se convierte en una herramienta fundamental dentro de las distintas metodologías de datación de documentos. Y aún más si cabe si se combina previamente con una técnica de separación de sustancias orgánicas volátiles como es la Cromatografía de Gases (GC). Como cualquier otro detector químico de funcionamiento universal, el MS nos permite cuantificar la cantidad de compuesto que tenemos en nuestra muestra analizada (a niveles de pocos nanogramos) pero, además, es una herramienta fenomenal para determinar e identificar compuestos desconocidos.

Volviendo al ejemplo con el que hemos comenzado podríamos decir que, mediante un análisis de cromatografía de gases acoplado a espectrometría de masas (GC/MS), no sólo descubrimos la cantidad de disolvente remanente en los trazos de tinta de nuestro testamento ológrafo cuestionado, sino también qué tipo de compuestos la conforman. El conjunto de toda esta información es muy importante en la datación del documento: podemos identificar si ese trazo de escritura posee un disolvente orgánico cuya cinética esta estudiada y por otra parte podemos saber cuánto compuesto hay a partir de su medida cuantitativa. La combinación de estos dos datos puede servirnos para estimar la fecha en el que esta tinta fue depositada. Además, esa capacidad de identificar compuestos también nos permitiría datar de forma indirecta al encontrar algún tipo de anacronismo en la composición. Esto querría decir que, si logramos identificar algún compuesto que ha comenzado a formar parte de las composiciones comerciales en la actualidad, en ningún caso ese texto podía haber sido escrito con anterioridad.

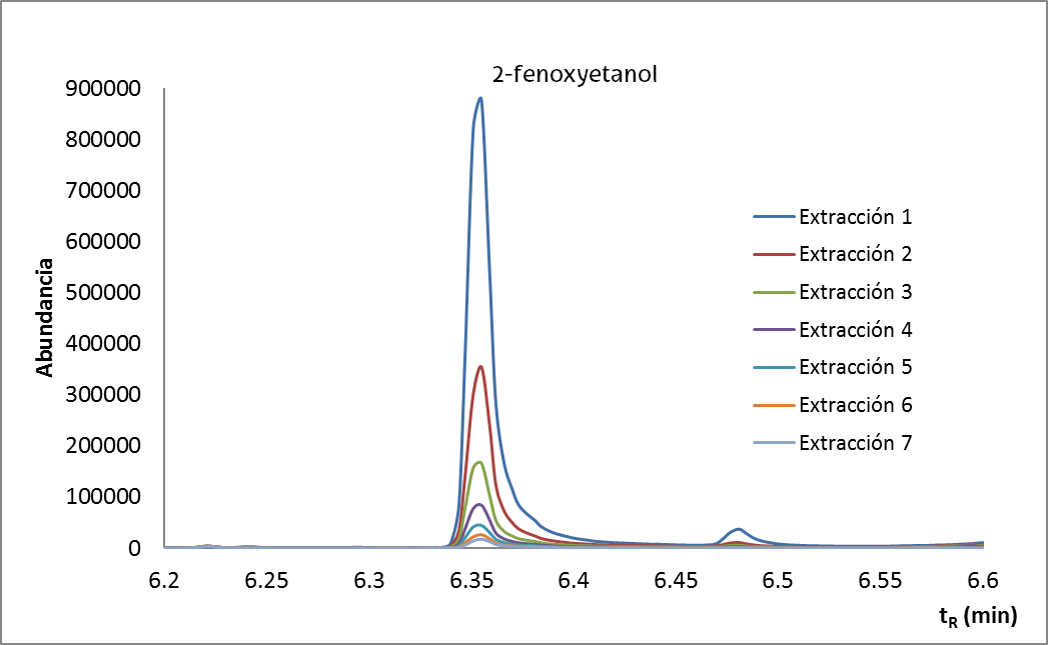

Imagen 2. Espectro de masa de la molécula 2-fenoxyetanol. En verde, su ion molecular y en naranja y azul distintos iones fragmento. Fuente: Luis Bartolomé.

Imagen 2. Espectro de masa de la molécula 2-fenoxyetanol. En verde, su ion molecular y en naranja y azul distintos iones fragmento. Fuente: Luis Bartolomé.A día de hoy, los métodos de datación todavía suscitan reparos en la comunidad científica y en la sociedad civil (peritos y jueces) debido a la gran cantidad de problemas e inconvenientes que los rodean. Algunos de los problemas más recurrentes son la influencia del soporte papel (densidad, composición…) sobre la evolución cinética de las tintas, la dependencia de la masa en la determinación de la edad de una tinta (hay que recordar que no todo el mundo deposita la misma cantidad de tinta en un trazo realizado en el mismo momento) o la influencia de la distinta conservación de los documentos (no es lo mismo la conservación de un documento en un cajón de un escritorio en condiciones controladas que en un coche en la playa). Además de estos problemas con solución compleja, existen otras problemáticas habituales como son la cantidad de muestra disponible (en algunos casos pocos milímetros de trazo escrito para analizar) o la incapacidad de poder datar documentos de más de 2 años de antigüedad. La Universidad del País Vasco (UPV/EHU) ha participado activamente en el desarrollo y evolución de nuevas metodologías de datación intentando minimizar estos problemas descritos. Desde el año 2015 un grupo de investigación del departamento de Química Analítica de la Facultad de Ciencia y Tecnología (FCT/ZTF) junto con el apoyo de los Servicios Generales de Investigación (SGIker) ha desarrollado un método de datación innovador denominado DATINK. Esta metodología que combina la potencialidad antes descrita de la espectrometría de masas junto con un proceso de micro-extracción en etapas sucesivas (Imagen 3) del 2-fenoxyetanol y un original modelado matemático, ha logrado rebajar la cantidad de muestra necesaria para poder realizar la datación (únicamente es necesario muestrear un trazo de 1.2 mm), así como aumentar el rango temporal de aplicación hasta los 5 años de antigüedad. Además, de forma completamente innovadora con respecto a las metodologías actuales, estima una fecha concreta (con un intervalo de error temporal del 20% aproximadamente). En el caso del testamento descrito como ejemplo, este hecho fue algo fundamental. Debía demostrarse que el documento cuestionado había sido realizado después del testamento ante notario pero antes de la incapacidad por enfermedad. Si habíais apostado por la ecuanimidad del abuelo con respecto a sus herederos, os diré que no habéis acertado.

Imagen 3. Señales cromatográficas en los que se basa el método DATINK. En cada extracción la cantidad de fenoxyetanol es menor. Fuente: Luis Bartolomé.

Imagen 3. Señales cromatográficas en los que se basa el método DATINK. En cada extracción la cantidad de fenoxyetanol es menor. Fuente: Luis Bartolomé.¿Es por tanto la espectrometría de masas la solución a nuestros problemas en el ámbito del estudio documental? ¿Ha nacido un héroe? Habría que ser un necio para afirmar que este tipo de herramientas no facilitan el desarrollo y la consecución de nuevos objetivos en la resolución de problemas analíticos. En el caso del estudio forense, la espectrometría de masas se ha convertido en una herramienta básica, no sólo en el desarrollo de nuevas metodologías para la datación de documentos, sino también en otras áreas de aplicación. De la misma manera, por otro lado, también se puede afirmar con rotundidad que este detector no es la panacea ni será la solución a todos nuestros males si no la ponemos al servicio de investigadores innovadores y creativos. Habitualmente, los investigadores caemos en la tentación de ceder la responsabilidad del desarrollo I+D+i a las capacidades de estos detectores y a sus continuos márgenes de mejora, olvidándonos que somos nosotros los que estamos al volante y que es la justa combinación de ambas facetas la que nos ofrece los mejores resultados. Ni que decir tiene que la UPV/EHU y la FCT/ZTF, como parte del entramado de formación de alta capacidad, ha tenido, tiene y debe seguir teniendo una responsabilidad muy alta en el hecho de obtener el máximo rendimiento en esta combinación.

Sobre el autor: Luis Bartolomé es técnico del Servicio Central de Análisis – SGIker en la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo A new hero is born: La espectrometría de masas al servicio de la justicia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Espectrometría de masas: de un isótopo de neón a elefantes que vuelan

- Curso de verano “Las dos culturas y más allá”: La ciencia al servicio de la salud humana, por Icíar Astiasarán

- Así en la Tierra como en Marte: espectrógrafos y espectrómetros de masas

Mirari Otxandorena, fisioterapian ikertzailea: “Nire bizitzako pasioa hori zela jabetu nintzen”

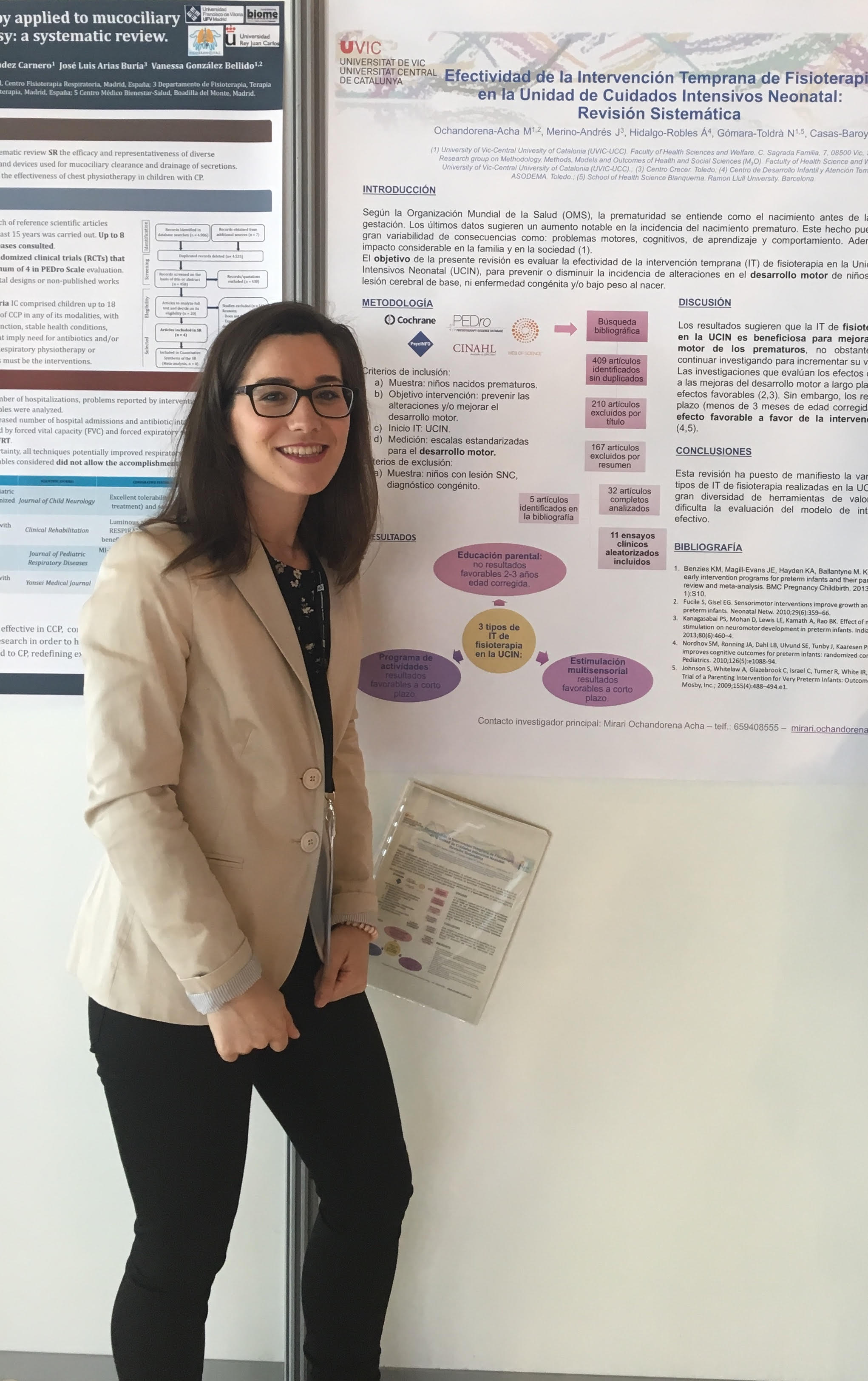

Otxandorenak horrela azaldu du nola iritsi den hara: “Duela urtebete hasi nintzen tesia egiten. Hasi aurretik, garbi nuen zer gai ikertu nahi nuen, eta, nazioartean arlo horretan erreferenteak bilatzen hasi nintzenean, Norvegiako ikertzaile baten lanak aurkitu nituen. Ikertzailearekin harremanetan jartzea erabaki nuen, eta, galdetu nionean ea haiekin ikertzera joan ote nintekeen, baietz erantzun zidan. Eta hala etorri nintzen”.

Irudia: Mirari Otxandorena Atxa, Fisioterapian ikertzailea.

Aitortu duenez, benetan pozik dago Norvegian: “Ate guztiak ireki dizkidate. Zentro publiko guzietara gonbidatu naute, lana nola egiten duten ikusteko, eta zainketa intentsiboen unitatera ere sartzeko aukera izango dut. Bestalde, diru-laguntza pribatu bat jasotzen dut, eta zortzi orduko lanaldia dut, ikertzeko. Bulego bat ere eman didate eta jende guztia oso abegikorra da…Espainian, berriz, tesia egiten dugunok ez dugu ordutegirik, ezta lan-baldintza egokirik ere. Nik, adibidez, nire denbora librean ikertu behar dut han. Sekulako aldea dago”.

Helduen fisioterapiatik neonatologiaraHain gustura dabilen arren, ikasketak aukeratzean ez zuen hain garbi bide hori hartuko zuenik. Haren lehengusu batek, kirol-fisioterapeuta, eta asko bidaiatzen zuen taldearekin, eta horrek erakartzen zuen. Ikasketak ere etxetik urrun egin nahi zituen; hala, Bartzelonan hasi zen Fisioterapia egiten. Bigarren urtean maitemindu zen Fisioterapiaz: “Neuroanatomiako ikasgaian izan zen. Irakaslea izugarri ona zen, eta orduan erabaki nuen neurologian espezializatuko nintzela”.

Hori bai, argi omen zuen ez zuela haurrekin lan egin nahi, ez baitzituen oso gustuko. “Edo hori uste nuen, garapen tipikoa duten haurrekin baino ez bainuen esperientzia”, aitortu du Otxandorenak.

Azken urtean neurologian espezializatu, eta Nafarroara itzuli zen. Aniztasun funtzionala dutenen elkarte batean lanean hasi zen, eta garun-paralisia zuen haur bat tratatzeko eskaintza jaso zuen. Erreparoekin bazen ere, eskaintza onartu zuen. “Mugarri bat izan zen; nire bizitzako pasioa hori zela jabetu nintzen”.

Haurrekin lan egiteko, pediatrian espezializatu behar zela erabaki zuen. Hala, asteburuetan, master bat egiten hasi nintzen Bartzelonan, eta, gainerako egunetan, lana egiten nuen Iruñean eta Nafarroako beste herri batzuetan. Halako batean, Bartzelonako hezkuntza bereziko eskola batetik deitu zioten lanerako, eta geroztik Bartzelonan aritu zen bai ikasten bai lanean.

Masterra amaitutakoan, irakasle hasi zen unibertsitatean, eta orduan hasi zen baita tesia egiten ere, pediatriaren barruan, neonatologian. Hain zuzen, haur goiztiarretan esku-hartze lasterrak izan dezakeen eragina ikertzen du: “Ikusi dugu haur goiztiarrek epe luzera atzerapena izaten dutela garapen psikomotorrean. Hortaz, ahalik eta lasterren tratatzen saiatzen ari gara, atzerapen hori ahalik eta txikiena izan dadin”.

Horrenbestez, haur horientzat eta haien familientzat tratamendu bat diseinatu du, eta proban jarri du, Bartzelonako Sant Joan de Déu ospitalean. Orain emaitzak biltzen ari da, eta ikerketa nagusi horren barruan joan da Tromsøko unibertsitatera ere. Laster izango dugu emaitzen berri.

Fitxa biografikoa:Mirari Otxandorena Atxa Almandozen jaioa da, 1992an. Gimbernat Unibersitate eskolan egin zuen Fisioterapiako gradua, eta, ondoren, Pediatriako masterra, Kataluniako Nazioarteko Unibertsitatean. Gaur egun, doktoretza egiten ari da Viceko Unibertsitatean, eta irakasle ere bada, unibertsitate berean.

———————————————————————————-

Egileaz: Ana Galarraga Aiestaran (@Anagalarraga1) zientzia-komunikatzailea da eta Elhuyar Zientzia eta Teknologia aldizkariko erredaktorea.

———————————————————————————-

Elhuyar Zientzia eta Teknologia aldizkariarekin lankidetzan egindako atala.

The post Mirari Otxandorena, fisioterapian ikertzailea: “Nire bizitzako pasioa hori zela jabetu nintzen” appeared first on Zientzia Kaiera.

Kosmetika onkologikoa: larruazalean efektu desiragaitzak eta tratatzeko konposatu naturaletan oinarritutako formulazio berriak

Irudia: Laborategi kosmetikoek, landare-jatorria duten konposatuak konbinatuz, paziente onkologikoen larruazala tratatzeko hainbat produktu kaleratu dituzte.

Orain arte, tratamendu onkologikoaren ondorioz sortutako larruazalaren efektu desiragaitzak tratatzeko formulazioek asaldurak sintomatikoki tratatzen zituzten, baina ez zuten ehun kaltetua erreparatzen ezta erregenerazio-prozesua azkartzen ere. Horiek administrazio topikoa duten antiseptiko, kortikoide, antihistaminiko edo analgesikoak dira.

Gaur egun, ordea, formulazio berrien joera aspaldidanik erabiltzen diren landare-jatorriko produktuen propietateaz baliatzea da, horiek baitituzte biologikoki aktiboak diren konposatu kimikoak.

Larruazalaren hidratazio-maila hobetzeko, fitozeramida eta gantz-azido esentzialetan aberatsak diren landare-estraktuak erabiltzen dira. Fitozeramidek barrera lipidikoaren egituran galdutako zeramidak ordezkatzen dituzte, horien jatorrizko funtzioa berreskuratuz: barnealdetik kanpo-ingurunera dagoen ur-transpirazioaren kontrola eta korneozitoek barnealdean dituzten Faktore Hidratatzaile Naturalen babesa. Bestalde, gantz-azido esentzialek, beste propietateez aparte, estratu korneoan funtzio bikoitza izango dute: alde batetik, barrera lipidikoaren egituraren berreskurapenean laguntzen dute ur-galera oztopatuz eta, beste aldetik, mintz zelularren erregenerazioan parte hartzen dute. Gehien erabilitakoak jojoba-olioa, kartamo-olioa edo mahats-hazi olioa dira, besteak beste.

Mina eta hantura arintzeko, landare-espezie batzuek badituzte aktibitate antiinflamatorio, analgesiko eta antioxidatzailea duten metabolito sekundarioak: fenolak, flabonoideak eta fitoesterolak. Horiek, ekintza mekanismo desberdinen bidez, hantura-, oxidazio- eta min-prozesuak kontrolatzen dituzte. Horien adibide kamamila edo Ginkgo biloba landareak dira.

Orbaintze- eta erregenerazio-propietateengatik ere landare-jatorria duten konposatuak betidanik erabili izan dira medikuntza tradizionalean. Aloe vera edo Centella asiatica-k, adibidez, kolageno-zuntzen sintesia estimulatzen dute. Badira bestelako ekintza mekanismo batzuk ere larruazalaren berriztatzea sustatzen dutenak, hala nola, mosketa-arrosa olioarena. Landare honen olioa gantz-azido esentzial poliinsaturatuen ehuneko handiagatik bereizten da, barrera lipidikoaren erregenerazioan parte hartuko duena.

Larruazal-osotasunaren galeraren ondorioz, mikroorganismoen sarrera faboratu egiten da. Antiseptiko tradizionalak albo batera uzteko asmoz, olio esentzialak erabiltzen hasi dira, izan ere, beren eragin farmakologikoetako bat funtzio antimikrobianoa da. Olio esentzialak mikroorganismoaren pareta zelularraren egitura lipidikoa eraldatzeko eta zeharkatzeko gai dira, mintz plasmatikoaren osotasuna galaraziz. Modu horretan, mintzaren iragazkortasuna handitzen da, zelularen suntsipena eragingo duena. Beren efektu antimikrobianoarengatik produktuetan gehien erabili izan diren olio esentzialak erromero-lorearen olioa, te-zuhaitzaren olioa eta eukalipto-olioa dira, besteak beste.

Laborategi kosmetikoek, landare-jatorria duten konposatuak konbinatuz, paziente onkologikoen larruazala tratatzeko hainbat produktu kaleratu dituzte, sintoma nagusiak arintzea eta erregenerazio-prozesua azkartzea helburu izango dutenak. María D’uol eta INOXDERM laborategiak horren adibide dira, landare-estraktuetan oinarritutako Cosmética Onco eta OnCosmetics produktu-lerroak garatu dituztenak, hurrenez hurren. Beacon Biomedicine laborategiek, landare-estraktuez gain, TECTUM Skincare produktu-lerroan hazkuntza faktoreak erabiltzen dituzte erregenerazio-prozesua azkartzeko. IFC laborategiek ere aurretik aipatutako laborategien joera jarraitzen dute, baina, kasu honetan, ez dituzte landare-jatorria duten konposatuak erabiltzen, baizik eta Cryptomphalus aspersa barraskilotik lortutako jariakina, izan ere, behatu izan da eskrezio glikoproteiko horrek berriztapen kutaneoa sustatzen duela.

OMSk aurreikusten du hurrengo bi hamarkadetan minbizi-kasu berrien agerpenak % 70 egingo duela gora mundu mailan eta, beraz, efektu desiragaitzak pairatuko dituzten pazienteen kopurua ere. Azken urteetan produktu naturalen erabilpenaren joera asko handitu da eta pentsa daiteke landare-jatorria duten produktu hauen erabilera handiagotuko dela.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 33

- Artikuluaren izena: Kosmetika onkologikoa: kimioterapiak eta erradioterapiak larruazalean eragindako efektu desiragaitzak eta horiek tratatzeko konposatu naturaletan oinarritutako formulazio berriak.

- Laburpena: Sarritan, tratamendu onkologikoek pazientearen bizi-kalitatea baldintzatu dezaketen efektu desiragaitzak sortzen dituzte, minbizi-zelulak kaltetzeaz gain, bestelako ehun osasuntsuak suntsitzen baitituzte. Lan honetan tratamendu onkologikoen ondorioz larruazalean sortutako gaitzak aztertuko dira (hala nola pruritoa, ezkatatzea edota ultzerazioa kasu larrienetan) eta baita arazo horiei aurre egiteko formulatu diren produktu berrien konposizioa ere. Orain arte erabili diren kortikoide, antihistaminiko edo lidokainadun kremak alde batera uzteko helburuarekin, laborategi dermokosmetikoek paziente onkologikoen larruazala tratatzeko bestelako produktu-lerroak merkaturatu dituzte, horien bizi-kalitatea hobetu eta eragin desiragaitz berantiarren agerpena oztopatzeko asmoz. Antzinatik erabili izan diren landare-estraktuez baliatuz, larruazalaren erreparaketa-prozesua bultzatzea helburu duten formulazioak diseinatu dituzte, Maria D’uol edota OnCosmetics laborategien produktu-lerroak bezala. Beste kasu batzuetan, landare-jatorriko konposatuez gain, bestelako molekula aktiboak erabili dituzte; hala nola, BEACON Biomedicine laborategien kasuan, hazkuntza-faktoreak eta Tectum 11 izeneko proteina-konplexuak erabiltzen dituzte, edota IFC laborategian, Cryptomphalus aspersa barraskilotik lortutako jariakinaz baliatzen dira tratamendu onkologikoen ondorioz sortutako larruazaleko gaitzak erreparatzeko.

- Egileak: Miren Izaguirre, Edorta Santos-Vizcaíno, Aiala Salvador, Amaia Esquisabel, José Luis Pedraz, Rosa María Hernández, Manoli Igartua.

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 35-53

- DOI: 10.1387/ekaia.17837

————————————————–

Egileez:

Edorta Santos-Vizcaíno, Aiala Salvador, Amaia Esquisabel, José Luis Pedraz, Rosa María Hernández eta Manoli Igartua UPV/EHUko NanoBioCel Taldean eta baita Biomaterial eta Nano-medikuntzako Ikerkuntza BiomedikokoZentro Sarea Bio-ingeniaritzan dabiltza.

————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Kosmetika onkologikoa: larruazalean efektu desiragaitzak eta tratatzeko konposatu naturaletan oinarritutako formulazio berriak appeared first on Zientzia Kaiera.

Ritmo, expectativas y Des… pa… cito.

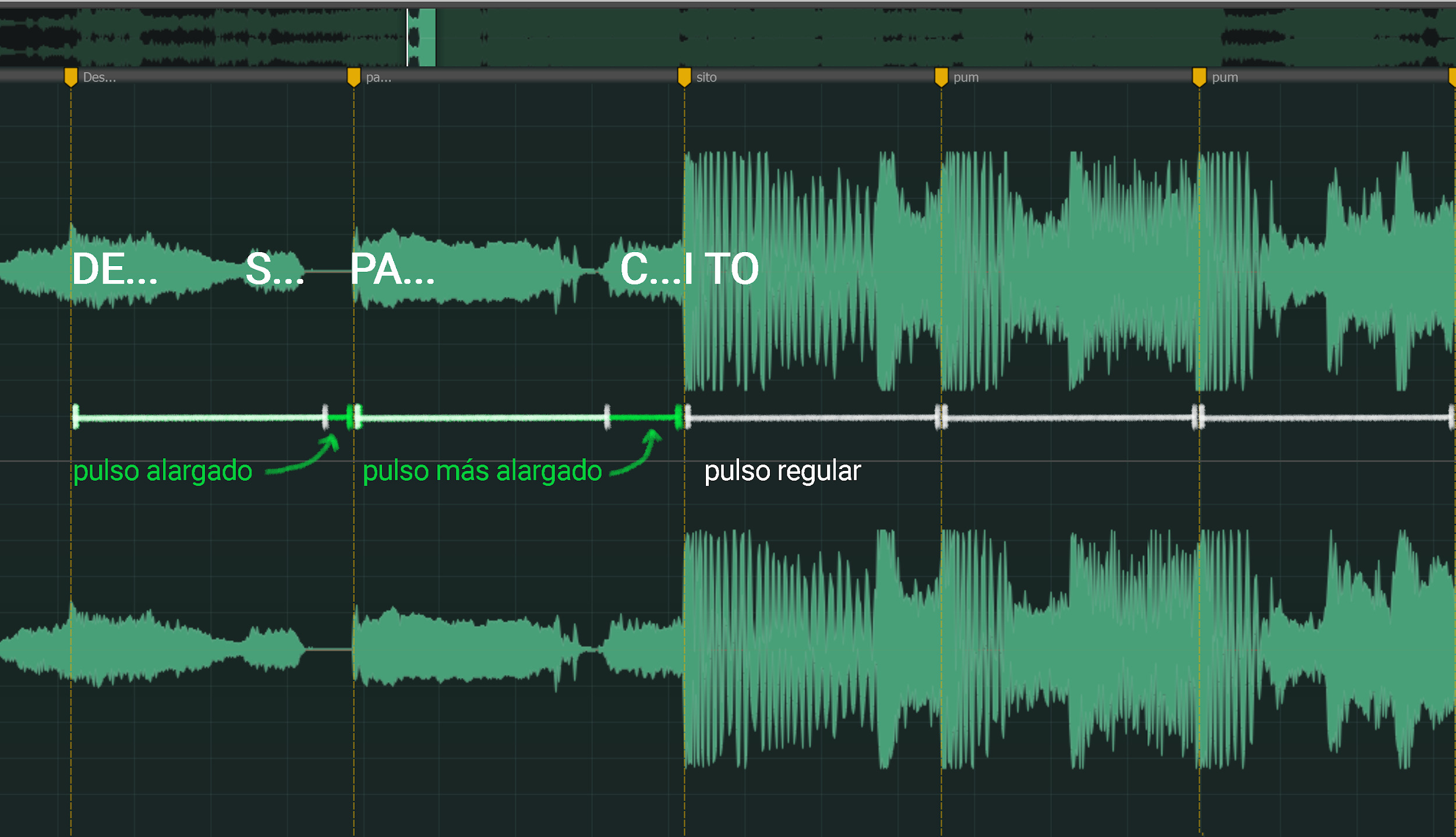

“Shave and a Haircut” es un patrón rítmico tan conocido que es imposible empezar a oírlo sin esperar su final. Pero además, es especialmente efectivo porque juega con nuestras expectativas rítmicas. En este caso, la gracia no está en qué notas van a sonar sino en el cuándo.

Lo normal sería que las dos últimas notas sonasen a tempo, dando continuidad al primer grupo de notas y cayendo sobre la parte fuerte del compás. Algo como esto:

Pero en lugar de esto, hay un “hueco”: como si, al ir a dar el siguiente paso, la música dejase el pie en el aire, por sorpresa. Nosotros ya sabemos que acaba sonando, no hay de qué preocuparse: la penúltima nota entra en una parte débil del compás y la última culmina, ya sí, a tempo. (Esto es lo que, en música, se conoce como síncopa). El pie acaba apoyándose en el suelo. Pero lo que consigue ese silencio previo es, justamente, aumentar la tensión de la caída, hacernos desearla con más fuerza.

Hace no tanto tiempo, un tema quizás aún más conocido, utilizó un recurso parecido (siento devolver este gusano a vuestros oídos):

Hay una ligerísima dilatación del tiempo en las dos primeras sílabas, una mínima pausa sobre la “c” justo antes de que suene la “i”, en la parte fuerte del siguiente compás. (Esto es lo que, en música, se conoce como fermata). Pero es justo esa pausa, el pie manteniéndose un instante más en el aire, la que hace el comienzo del estribillo aún más inevitable.

Pero volviendo a la premisa: ¿qué es eso de las expectativas rítmicas?, ¿qué nos esperamos, exactamente, de las duraciones de las notas en una canción?

Pues, para empezar, una obviedad, aunque no por ello poco interesante: de la música esperamos que haya cierto “pulso”, una repetición subyacente de duraciones de tiempo regulares. De hecho esto es uno de los rasgos universales de la música1 y es uno de los rasgos que, al menos a cierto nivel, la separan del lenguaje. Pero no cualquier duración regular vale y pongo un ejemplo: los semáforos de la calle se encienden y apagan a intervalos regulares y eso no basta para percibirlos como “rítmicos”. Tampoco nos sirve el batido de las alas de un colibrí. Existe un rango limitado de pulsos que somos capaces de apreciar como rítmicos y un rango aún más pequeño que podemos seguir con especial precisión: ese rango se sitúa, aproximadamente, entre 80 pulsos por minuto y 100 pulsos por minuto2. En ese intervalo, si nos piden anticipar las notas de una canción, ni nos aceleramos ni nos quedamos detrás, damos la palmada justo a tiempo y nuestras expectativas son especialmente precisas. Es nuestro “tempo ideal” por así decirlo. ¿Y qué hay del tempo de Despacito?: 89 pulsos por minuto. Bastante ajustadito, de hecho.

Además, dentro de una canción, no todos los pulsos (no todos los cuándos) son iguales, existe una jerarquía a varios niveles que suele ser binaria, especialmente en el caso de la música occidental. Es decir: las duraciones de las notas se suelen subdividir (un pulso de negra en dos corcheas, en 4 semicorcheas, etc. ) y agrupar (compases de 2/4 o de 4/4, semifrases de 4 compases, frases de 8, temas enteros de 32…) de dos en dos y esta agrupación está asociada, además, a que ciertos momentos se perciban como más importantes. En estos momentos es donde se producen los cambios armónicos, donde la música introduce nuevos materiales y donde es más probable que suene una nota que, además, será un poquito más fuerte que sus vecinas. El pie se apoya en el suelo y gracias a eso la música puede seguir avanzando.

Pero no se trata sólo de una construcción musical o de un capricho del lenguaje: la atención misma de los oyentes se focalizada de acuerdo con estas jerarquías. La profesora Mari Riess Jones ha estudiado especialmente este fenómeno: cuando escuchamos música, la atención se distribuye de forma desigual, dirigiéndose hacia los momentos donde es más probable que aparezca una nueva nota, lo cual nos permite percibirla mejor. De este modo, la jerarquía rítmica de la música se convierte, de hecho, en la estructura misma de nuestra atención.

¿Y Despacito? Una base rítmica del reggaetón en 2 pulsos que se repite 2 veces dentro de cada compás de 4/4, un estribillo de 4 compases que se repite 2 veces cada vez que suena, una estructura armónica de 4 acordes que se ha utilizado en otros cuatro cuatrillones de canciones antes… estábamos perdidos desde el principio.

Referencias:

1 Patrick E. Savage et al (2015) Statistical universals reveal the structures and functions of human music. 2015. . PNAS doi: 10.1073/pnas.1414495112

2 Dirk-Jan Povel and Peter Essens (1985) Perception of Temporal Patterns [PDF] (1985) Music Perception: An Interdisciplinary Journal Vol. 2, No. 4

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Ritmo, expectativas y Des… pa… cito. se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Qué son las expectativas musicales?

- Lo que tienen en común una red inalámbrica, el ritmo del corazón y la consciencia

- Formas ritmo-espacio

Entzimez

Irudia: Entzimak hain kopuru txikietan egoteak erabat zaildu zuten entzimak isolatzea.

Hartzigarriak antzinatetik ezagutzen ziren. Ogia altxarazten zuten agenteak ziren, mahats-zukua ardo eta malta-estraktuak garagardo bihurtzen zituztenak. Antoine-Laurent Lavoisier-ek, alkohol-hartzidura ekuazio kimiko gisa deskribatzean, eragile estatus berezia eman zien hartzigarriei, prozesuaren parte hutsa izan beharrean.

XIX. mendeko 30eko urteetan kimikariek hainbat erreakzio aurkitu zituzten, era berean aktibatzen zirenak substantzia baten kopuru oso txikietan; substantzia hori erreakzioan eraldatzen ziren erreaktiboak ez bezalakoa zen. Horrela, Anselme Payen-ek eta Jean-François Persoz-ek ernamuindutako hazietatik substantzia bat atera zuten, gai zena bere almidoi-pisua bi mila aldiz azukre bihurtzeko: diastasa deitu zioten. Eilhard Mitscherlich-ek frogatu zuen alkohola eter bihurtzen duen azido sulfurikoa ez zela erretzen prozesuan; kimikari horrexek beste prozesu asko identifikatu zituen, “kontaktu bidezko deskonposatze eta konbinatze” gisa sailkatu zituenak. 1835ean, Jöns Jacob Berzelius-ek katalisi deitu zion fenomeno orokorrari. Berzeliusek aurreikusi zuen diastasaren moduko eragile katalitiko organiko asko aurkituko zirela, eta milaka prozesu katalitiko gertatzen omen zirela landareen eta animalien ehun eta jariakinetan.

Urtebete geroago, Theodor Schwann-ek substantzia bat identifikatu zuen urdaileko urinetan, oso kopuru txikietan jokatzen zuena azidoen aurrean, albumina eta beste elikagai nitrogenodun batzuk digeritzeko. Substantzia hori ―pepsina izena eman zion― isolatzeko gai izan ez bazen ere, frogatu zuen haren propietate kimikoek beste edozein animalia-substantzia nitrogenodun ezagunetatik bereizi egiten zutela. Pepsinaren propietateak alkohol-entzimarekin arretaz alderatuta, Schwannek ondorioztatu zuen, jokatzeko moduan hain antzekoak zirenez, pentsa litekeela hartzigarri organikoen klase orokor batekoak zirela. Schwannen pepsinaren akzioaren analisiak digestio-entzima gehiagoren bilaketa erraztu zuen.

Louis Pasteur-ek esan zuenean alkohol, azido laktiko eta azido butirikorako hartzigarriek nahitaezkoa zutela organismo biziak izatea, behera etorri zen Schwannek pepsina alkohol-entzimarekin konparatuz sortua zuen definizioa, digestio-entzimek gorputzetik kanpo jokatu ahal zutelako. “Eratutako” hartzigarrietatik bereizteko ―legamiatik, adibidez―, organismoetatik beraietatik bereizezinak baitziruditen, hartzigarri “eragabeak” esan zitzaien Pasteurrenei, harik eta Willy Kühne-k entzima izena eman zien arte.

Eduard Buchner-ek 1900ean zelulen hartzidura askea frogatu ondoren, bereizketa hori ez zen beharrezkotzat jo. Entzima izena izendapen orokor gisa erabili zen alemanez mintzatzen ez ziren herrialdeetan, hartzigarri hitza lotuegi zegoelako hartzidura-prozesuekin, eta, beraz, agente katalitiko biokimikoez aritzeko ezin zen hitz orokorra izan. Alemanian bazen hitz ezberdin bat hartzidura izendatzeko (Gärung), eta, horregatik, hartzigarri hitza Bigarren Mundu Gerra ostera arte erabili zen.

Schwannek pepsina ezaugarritzeko erabili zituen erreaktiboek erakutsi zuten “albuminoide”en taldeko substantzia bat izan litekeela, geroago proteinak esango zitzaiena. Hala ere, entzimak hain kopuru txikietan egoteak erabat zaildu zuten entzimak isolatzea; hori zela eta, ezin zitzaizkien berariazko saiakuntzak aplikatu proteina gisa identifikatzeko. Egoera halakoa zen, ezen, artean XX. mendeko 20ko urteetan, Richard Willstäter biokimikari entzutetsuak ere esaten baitzuen entzimekin lotzen ziren proteinak molekula erreaktibo txikien garraiatzaile hutsak zirela, eta horiexek ematen zietela berariazkotasuna entzimei.

1930ean, John Northrop-ek pepsina kristaltzea lortu zuen; horrek iritzia azkar aldarazi eta entzimak proteinak zirela sinestea ekarri zuen. Harrezkero, ikertzeko ahalegin asko eskaini zaio frogatzeari molekula zinez konplexu horien hiru dimentsioko egitura dela beren akzioen berariazkotasun aparta dakarrena.

——————————————–

Egileaz: Cesár Tomé López (@EDocet) zientzia dibulgatzailea da eta Mapping Ignorance eta Cuaderno de Cultura Cientifica blogen editorea.

Itzulpena: Leire Martinez de Marigorta

Hizkuntza-begiralea: Gidor Bilbao

——————————————–

The post Entzimez appeared first on Zientzia Kaiera.

Gaston Julia y su ‘Grand Prix des sciences mathématiques’

En 1913, el gobierno francés aprobó la llamada loi des Trois ans por la que se aumentaba la duración del servicio militar de dos a tres años y se rebajaba a 19 años la edad la incorporación a ese servicio. Francia estaba preparando a su ejército para una eventual guerra con Alemania que comenzaría al año siguiente: la Primera Guerra Mundial.

Muchos alumnos de las Grandes Escuelas francesas fueron movilizados al estallar la guerra. Habitualmente se unían a la infantería como subtenientes, un grado que les colocaba delante de sus hombres en el momento del combate y les exponía especialmente. Si casi el 17% de los soldados franceses murieron en la Primera Guerra Mundial, ese porcentaje aumentaba al 30% en el caso de los oficiales de infantería y a un 41% para aquellos que procedían de la École normale supérieure. Se estima que un 40% de estudiantes universitarios franceses fallecieron o sufrieron mutilaciones en esa guerra: supuso el sacrificio de una generación de intelectuales, entre ellos muchos científicos.

Gaston Julia. Imagen: MacTutor History of Mathematics archive. University of St Andrews.

Gaston Julia. Imagen: MacTutor History of Mathematics archive. University of St Andrews.Tras una brillante carrera en la École normale supérieure, el joven Gaston Julia (1893-1978) fue llamado a filas en agosto de 1914. Se incorporó al 57 regimiento de infantería. Tras cinco meses de formación, fue enviado como subteniente al campo de batalla, al Chemin des Dames. Allí, en enero de 1915, fue gravemente herido en la cara: perdió la nariz, tuvo que someterse a diferentes operaciones y llevar durante toda su vida una máscara de cuero. Recordemos que Louis Antoine (1888-1971) fue un gran amigo de Julia. Durante la ofensiva de Nivelle, en abril de 1917, una bala le alcanzó la cara, perdió los dos ojos y el sentido del olfato. Julia y Antoine compartían habitación en el sanatorio en el que permanecieron para recuperarse de sus heridas.

Tras su largo periodo de convalecencia, Julia se dedicó a la investigación en matemáticas y a la docencia en diferentes centros superiores.

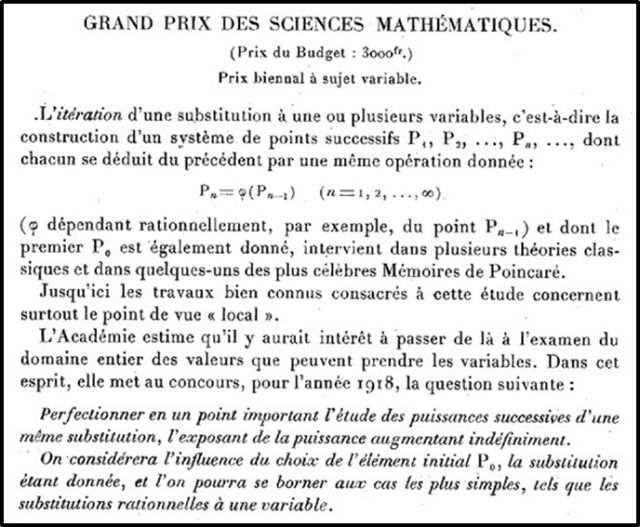

Anuncio del Grand Prix de 1918. Imagen: Repositorio Gallica.

Anuncio del Grand Prix de 1918. Imagen: Repositorio Gallica.El 29 diciembre de 1915 la Académie des sciences anunció que atribuiría un Grand Prix des sciences mathématiques en 1918 con el estudio de la iteración de funciones como tema propuesto.

Desde 1906, Pierre Fatou (1878-1929) investigaba sobre el problema de iteración de fracciones racionales. Animado por el premio de la Académie retomó con fuerza el tema en 1917. En mayo de 1917 publicó un primer artículo titulado Sur les substitutions rationnelles en el que decía que sabía resolver completamente el problema de la iteración (que calificaba de “muy difícil” en general) en el caso de fracciones racionales enviando un disco sobre sí mismo.

Simultáneamente, Gaston Julia comenzó a depositar en la Académie unos documentos confidenciales conteniendo resultados análogos.

El matemático, Paul Montel (1876-1975) publicó ese mismo año una nota titulada Sur la représentation conforme que inspiró a Fatou y Julia en sus trabajos de iteración. De hecho, les dio la clave para llegar a una solución satisfactoria del problema planteado en el Grand Prix en el caso de funciones racionales.

El 24 diciembre de 1917, la Académie des sciences recibió una carta de Gaston Julia en la que afirmaba que los resultados anunciados por Fatou en Sur les substitutions rationnelles estaban contenidos en sus documentos confidenciales y solicitó su apertura. Ese mismo día depositó su candidatura para el Grand Prix. Los expedientes se abrieron en la sesión de la Académie del 24 de diciembre de 1917: eran unas notas desordenadas, escritas sin demasiado cuidado, seguramente para adelantar a Fatou en una posible nueva publicación.

En la sesión del 2 diciembre 1918 la Académie des sciences concedió a Gaston Julia el Grand Prix anunciado en 1915.Fatou no se había presentado al premio. Pero el informe de la comisión que decidía el galardón prácticamente daba a entender la Académie tendría que haber dividido el premio en caso de que Fatou se hubiera postulado. Ambos matemáticos realizaron trabajos prácticamente equivalentes que publicaron posteriormente de manera extendida. No es extraño que diferentes personas lleguen a resultados similares trabajando de manera independiente.

El estudio de funciones iteradas se ralentizó en Francia tras la concesión del Grand Prix. Por un lado, aunque Julia era un matemático brillante y muy prolífico y tenía muchos estudiantes, parece que ninguno se interesó por el tema. Por otro lado, el trabajo como astrónomo de Fatou le impidió invertir mucho tiempo en las matemáticas, no tenía gente joven cerca que pudiera continuar con su trabajo y murió con solo 51 años.

El conjunto de Julia (en blaco) para la función f(z)=z²+c cuando la constante c cambia. Imagen: Wikimedia Commons.

El conjunto de Julia (en blaco) para la función f(z)=z²+c cuando la constante c cambia. Imagen: Wikimedia Commons.Hasta la década de los años 1980, el tema no se retomó con fuerza… pero esa es otra historia. Actualmente, en dinámica compleja, los conjuntos de Julia y de Fatou son dos conjuntos complementarios obtenidos al estudiar el comportamiento de números complejos al ser iterados por una función holomorfa. El conjunto de Julia J(f) de una función holomorfa f está formado por los puntos que bajo la iteración de f tienen un comportamiento ‘caótico’ (perturbaciones arbitrariamente pequeñas provocan cambios drásticos en la sucesión de funciones iteradas) y el conjunto de Fatou F(f) es el complementario, es decir, aquella familia de puntos que tiene un comportamiento ‘estable’ bajo iteración (bajo pequeñas iteraciones tiene pequeños cambios). Un pequeño homenaje que recuerda las aportaciones al tema de ambos matemáticos.

Referencias

-

Michèle Audin, Fatou, Julia, Montel, le Grand Prix des sciences mathématiques de 1918, et après…, Springer, 2009

-

Michèle Audin, Fatou, Julia, Montel. The Great Prize of Mathematical Sciences of 1918, and Beyond, Springer, 2011

-

J J O’Connor and E F Robertson, Gaston Julia, MacTutor History of Mathematics archive

-

Marta Macho Stadler, Pierre Fatou, un matemático poco (re)conocido, Cuaderno de Cultura Científica, 28 febrero 2018

-

Marta Macho Stadler, Louis Antoine: el destello en medio de una larga noche, Cuaderno de Cultura Científica, 19 diciembre 2018

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Gaston Julia y su ‘Grand Prix des sciences mathématiques’ se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Pierre Fatou, un matemático poco (re)conocido

- Louis Antoine: el destello en medio de una larga noche

- Homenaje de Google a Euler

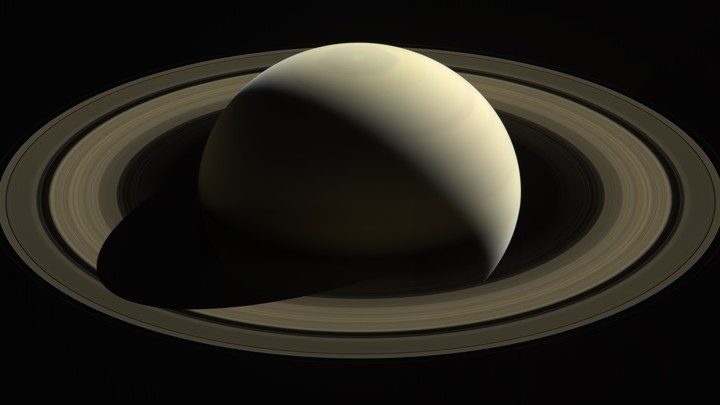

Cassiniren suizidioaren fruituak: uzta oparoa jasotzen hasia da

2017ko irailean izan zen Cassini zundaren Amaiera Handia. Zunda zaharra azken unera arte lanean arituko zela esan zuten orduan NASAko arduradunek. Zundak bere buruaz beste egin izanagatik, ilargiak kutsatzeko arriskua desagerrarazteaz gain, Cassini datu baliotsuak eskuratzeko eta bidaltzeko moduan egongo zela ere esan zuten. Ez dute hutsik egin: argi dago ez zela marketin kontua izan, edo, behintzat, hori baino askoz gehiago bazen.

1. irudia: Saturnoko eraztunek duten masa badakigu orain, eta, datu horri esker, ikertzaileek ondorioztatu dute haien adina zein den. (Argazkia: NASA/JPL-Caltech)

Orotara, Cassini 292 orbita egin zituen Saturnoren inguruan, eta horiei esker, eraztunen osaketari eta dinamikari buruzko datu andana eskuratu zituen. Bizitzaren amaierara hurbiltzen ari zela, misioaren kontrol gunetik gero eta maniobra ausartagoak egitera animatu ziren. Horietako maniobra bat izan zen planetaren eta haren eraztunen artean igarotzea: 2017ko apirilean Saturnoren eta haren eraztunen artean sartu zen Cassini. 22 aldiz egin zuen orbita hori, eta, horietatik, bostean posible izan zen doitasun handiarekin zundaren abiadura ezagutzea, irrati uhinen igorpenei esker.

Uneoro Cassiniren kokapen zehatza jakinda, planeta beraren eta eraztunen grabitazioa oso ondo neurtu ahal izan zen, bakoitza bere aldetik. Bestela, arras konplikatua lirateke bereiztea zein zen eraztunen grabitazio indarra eta zein planetarena, kontuan izanda pare-parean gasezko erraldoi baten grabitazio erraldoia dagoela.

Ohi bezala, kreatibitatea baliatu behar izan dute 1.400 milioi kilometrora dagoen mundu baten elementuak “pisatzeko” eta adina ezagutzeko. Gakoa partikuletan egon da (eraztunen %99 izotza da, eta silikatozko partikulak gainerako %1). Eraztunek sortzen duten grabitatea jakinda, 1,54 X 10^19 kg-ko masa ondorioztatu dute. Hori Mimas ilargiak duen masaren erdia baino txikiagoa da, gutxi gorabehera (%41). Masa jakinda, bertan dauden partikulen kopurua kalkulatu dute, eta horiek metatzeko beharrezkoa izan zen denbora kalkulatu dute ere. Eredu teorikoek aurreikusten dutenez, gero eta masiboagoak, orduan eta zaharragoak dira eraztunak. Horregatik, eraztunek 10-100 milioi urte bitarteko adina dutela uste dute, planetak 4.500 milioi urte dituen bitartean. Science aldizkarian jaso dituzte emaitzak.

Zientzialarientzat ez da erabateko ezustekoa izan. 1980ko hamarkadan Voyager zundei esker eskuratutako datuek norabide horretara jotzen zutelako ere. Baina orain datu berriek berretsi dute artean susmoa besterik ez zena.

2. irudia: 2017ko irailean gertatu zen Cassini zundaren Amaiera Handia, Saturnoren gainean amilduta. Bizitzaren azken hilabeteetan egin zituen orbitarik ausartenak. (Irudia: NASA/JPL-Caltech)

Ez dute argitu eraztunak nola sortu ziren, ezta bakoitzaren adina zein den. Eraztun horiek nola sortu ziren misterioa da oraindik. Zenbait proposamenaren arabera, planetarekin batera jaio ziren, baina, datu berrien argitara, aukera hori alboratutzat eman daiteke jada. Planetarekin batera sortu ez baziren, argi dago objektu batean edo objektu multzo batean izan behar dutela jatorria. Aukera bat da orain desagertu diren ilargi izoztu batzuk noizbait txikitu izana, talka baten ondorioz. Talka horren hondarrak lirateke egun ikusten diren eraztunak. Beste batzuek uste dute kanpotik etorritako kometa batean egon zitekeela jatorria: Saturnoren grabitazioak harrapatuta, kometa txikitu egin zen. Orain dakigunez, horixe izango da Marteko Phobos satelitearen patua: planetara gerturatzen ari denez, etorkizun urrun batean Marteren grabitateak, marea-indarren bitartez, satelitea birrinduko du, eraztun bihurtuta.

Biraketa eta barne estrukturaEraztunei dagokien informazioa da, zalantza barik, publiko zabalari atentzio gehien ematen diguna, baina planeta-zientzialariek beste irakaspen garrantzitsuak lortu dituzte datu hauetatik. Atera duten ondoriotako bat da planetaren barruan oso biraketa diferentzial handia dagoela: sakontasunaren araberakoa da biraketa hori. Ekuadorrera hurbildu ahala, errotazio hori handiagoa da. Horri esker, kalkulatu dute atmosferak gutxienez 9.000 kilometroko sakontasuna duela. Bestetik, Saturnoren barne nukleoaren masa ondorioztatu dute: Lurrak duen masa halako 15-18 da. Nukleo hori, Jupiterrena ez bezala, oso ondo bereizita dagoela iradoki dute zientzialariek.

Biraketa beraren inguruan beste emaitza bat atera dute. Harrigarria dirudien arren, 2019an plazaratutako datu hauei esker zientzialariak gai izan dira planeta erraldoiaren biraketa-periodo zehatza behin-betiko finkatzeko. Gasezko planeten kasuan, azaleran erreferentziazko punturik ez dagoenez, astrofisikariek eremu magnetikoaren igorpenak hartzen dituzte abiapuntutzat. Baina bide horretatik Voyager eta Cassini zunden bidez eskuratutako datuak ez zetozen bat. Orain datu horiek modu finagoan zehaztu ahal izan dira, eremu magnetikoa ez baizik eraztunak abiapuntu hartuta. Izan ere, planetaren eremu magnetikoak sortzen dituen bibrazioak eraztunetan “islatu” egiten dira, uhin baten modura, eta mugimendu horietan jarri du arreta berezia Cassinik. Horri esker, baieztatu ahal izan da zen den Saturnoko egun baten iraupena: 10 ordu, 33 minutu eta 38 segundo. Hortaz, esan liteke, estruktura liluragarria izateaz gain, erloju erraldoia ere badirela Saturnoko eraztunak.

Erreferentzia bibliografikoa:

Iess, L. et al., (2019). Measurement and implications of Saturn’s gravity field and ring mass. Science, 17, eaat2965. DOI: 10.1126/science.aat2965

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Cassiniren suizidioaren fruituak: uzta oparoa jasotzen hasia da appeared first on Zientzia Kaiera.

Refracción de ondas

Imagen: Pixabay

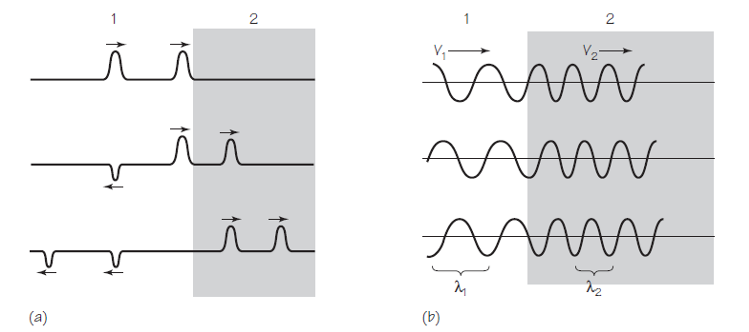

Imagen: Pixabay¿Qué sucede cuando una onda se propaga de un medio a otro en el que su velocidad de propagación es diferente? Fijémonos en la Figura 1(a). Dos pulsos unidimensionales se aproximan a un límite que separa dos medios. La velocidad de la propagación en el medio 1 es mayor que en el medio 2. Esta situación correspondería en el mundo real a pulsos en una cuerda ligera (medio 1) atada a una cuerda relativamente muy pesada (medio 2). Ya sabemos que podemos esperar que una parte de cada pulso se refleja en el límite. Esta componente reflejada se pone del revés en relación con el pulso original. ¿Pero qué pasa con esa parte de la onda que continúa en el segundo medio?

Figura 1. Fuente: Cassidy Physics Library

Figura 1. Fuente: Cassidy Physics LibraryComo vemos en la figura, los pulsos transmitidos están más juntos en el medio 2 que en el medio 1. La razón es que la velocidad de los pulsos es menor en la cuerda más pesada. Así que el segundo pulso, mientras todavía está en la cuerda ligera, está alcanzando al que ya está en la cuerda pesada. Por la misma razón, cada pulso se comprime en una forma más estrecha; es decir, cuando la parte frontal de un pulso ha entrado en la región de menor velocidad, la parte posterior sigue avanzando con mayor velocidad.

Con las ondas periódicas ocurre algo parecido. Lo tenemos en la Figura 1(b). Para simplificar suponemos que toda la onda se transmite y nada se refleja. Al igual que los dos pulsos se acercaron y cada pulso se apretó y se estrechó, el patrón de onda periódico también se comprime. Por lo tanto, la longitud de onda λ2 de la onda transmitida es más corta que la longitud de onda λ1 de la onda entrante o incidente.

Aunque la longitud de onda cambia cuando la onda pasa a través del límite, la frecuencia de la onda no puede cambiar. Si la cuerda no está rota, las trocitos de cuerda inmediatamente a ambos lados del límite deben subir y bajar juntos. Las frecuencias de las ondas incidentes y transmitidas deben, entonces, ser iguales. Podemos simplemente etiquetar ambas como f.

La relación entre longitud de onda, frecuencia y velocidad para las ondas incidentes y transmitidas se puede escribir por separado como λ1 f = v1 y λ2f = v2. Dividiendo una ecuación por la otra, eliminado f, obtenemos que

λ1 / λ2 = v1 / v2.

Esta ecuación nos dice que la razón entre las longitudes de onda en dos medios es igual a la razón entre las velocidades de propagación de las ondas en esos medios.

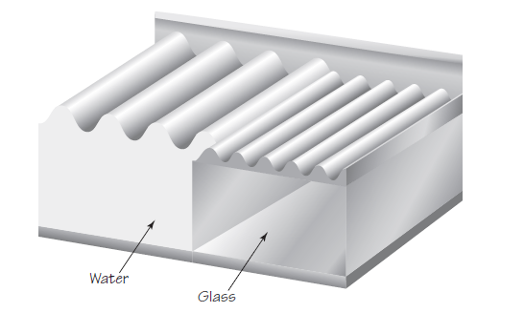

Figura 2. Fuente: Cassidy Physics Library

Figura 2. Fuente: Cassidy Physics LibraryLo mismo sucede cuando las ondulaciones del agua atraviesan un límite. Los experimentos muestran que las ondas se mueven más lentamente en aguas menos profundas. Si colocamos una pieza de vidrio en la parte inferior de un tanque de ondulación para hacer que el agua sea menos profunda estamos, de hecho, creando un límite entre la parte más profunda y la menos profunda (medio 1 y medio 2). La Figura 2 muestra el caso en que este límite es paralelo a las líneas de cresta de la onda incidente. Al igual que con las ondas en la cuerda, la longitud de onda de las ondas en el agua en un medio es proporcional a la velocidad en ese medio.

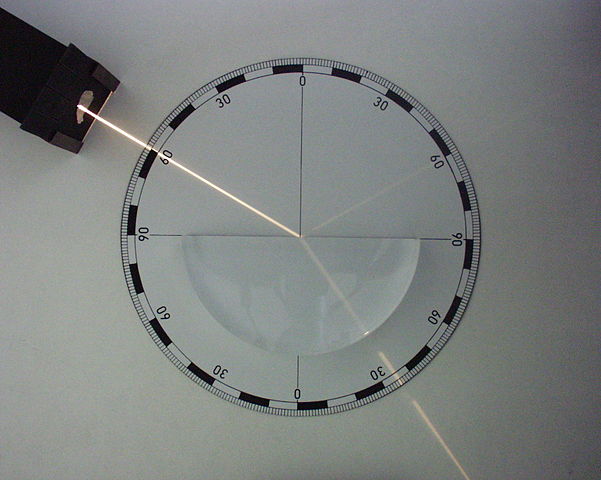

Figura 3. Fuente: Wikimedia Commons

Figura 3. Fuente: Wikimedia CommonsLas ondas en el agua ofrecen una posibilidad no presente en las ondas en la cuerda. El frente de onda puede acercarse al límite en cualquier ángulo, no solo de frente. La Figura 3 ilustra este caso. La longitud de onda y la velocidad, por supuesto, cambian a medida que la onda pasa a través del límite. La dirección de la propagación de la onda también cambia al pasar de un medio a otro con diferente velocidad de transmisión. A medida que cada parte de un frente de onda en el medio 1 entra en el medio 2, su velocidad disminuye y comienza a quedarse atrás. Con el tiempo, las direcciones de todo el conjunto de frentes de onda en el medio 2 tienen direcciones diferentes a las del medio 1. Este fenómeno se llama refracción. Los frentes de onda “giran” para hacerse más paralelos al límite entre los medios.

Figura 4. Un frente de onda muy estrecho llegando con un ángulo de 60º al límite; una parte es reflejada (también con un ángulo de 60º) y otra pasa al medio 2 con un cambio de dirección. Fuente: Wikimedia Commons

Figura 4. Un frente de onda muy estrecho llegando con un ángulo de 60º al límite; una parte es reflejada (también con un ángulo de 60º) y otra pasa al medio 2 con un cambio de dirección. Fuente: Wikimedia CommonsCombinando todo lo que hemos visto encontramos una explicación a un fenómeno que habrás observado en las playas de arena, esas en las que la profundidad del agua aumenta lentamente conforme te alejas de la orilla. Da igual la dirección de las olas mar adentro: cerca de la orilla son prácticamente paralelas a la orilla.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Refracción de ondas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cuando las ondas se encuentran

- Física de las ondas estacionarias: frecuencia fundamental y sobretonos

- Reflexión de ondas: rayos

Alkohola eta kafeina, eztanda egin arte

Esandako hori edan ondoren, gizonak ondoeza sentitu zuen eta handik pixka batera ziplo erori zen. Osasun-langileak saiatu baziren ere, suspertzea ezinezkoa izan zen eta bertan hilotz geratu zen. Kasu jakin honetatik haratago -autopsiak adieraziko du zein izan den heriotzaren arrazoia-, edari energetikoak geroz eta arruntagoak dira gazteen artean eta, gainera, edari alkoholdunekin nahasten direnean ondorio larriak eragin ditzakete.

1. irudia: Edari energetikoak eta alkohola nahastea oso arriskutsua da eta ondorio larriak ekar ditzake. (Argazkia: SocialButterflyMMG – domeinu publikoko irudia. Iturria: pixabay.com)

Ron botila bat eta edari energetiko baten bi lata edateak arrisku itzela du, eta horretarako nahikoa da zenbait kalkulu egitea. Tolosaldeko Ataria-n azaldu nuen moduan, organismoan sartzen diren etanol gramoak kalkulatzeko formula hau erabili behar dugu: etanol gramoak = (edandako mL-ak x edariaren graduazioa x 0,008). Estimazioak eginez, demagun ron botila baten bolumena 70 cL-koa dela eta bere alkohol-graduazioa 40º-koa. Horrek esan nahi du 224 gramo etanol puru irentsi direla.

Jarraian, etanol gramo horiek gorputzaren odolean izango duten kontzentrazioa kalkulatu beharko genuke. Horretarako, C (g/L-tan) = hartutako gramoak / (M x R) egingo dugu, non M gorputzaren masa den eta R, berriz, banaketa-faktore delakoa -0,7 gizonen kasuan eta 0,6 emakumeen kasuan-. 65 kg-ko gizon baten kasurako, ron botilak zuen etanolak 5,3 g/L kontzentrazioa emango luke odolean, teorikoki.

Arrisku tauletara jotzen badugu, 4-5 g/L kontzentraziotik gorakoak arrisku mailarik handienean kokatzen dira, alegia, koma arriskuan. Ibiltzeko ezintasuna, eutsi ezina, okadak, arnas-aparatuaren depresioa eta konorte galtzea dira espero behar diren ondorioak. 5 g/L kontzentraziotik gora shock kardiobaskularra, arnasketaren inhibizioa edo bihotz-biriken gelditzea gerta daiteke. Hortaz, ron botila bat edatea heriotza azaltzeko arrazoi nahikoa da, baina, arriskua are handiagoa da horrekin batera edari energetikoak hartzen badira.

Edari energetikoen atzean dagoenaEdari energetiko baten 500 mL-ko lata batek 160 mg kafeina edukitzera iritsi daiteke. Bi lata hartzen badira, egun batean segurtasunez kontsumitu daitekeen kafeina kantitatea gainditzen da. Haurren edo haurdun dauden emakumeen kasuan, esaterako, lata bat nahikoa litzateke. Bi lata hartzea jarraian bost kafe espreso hartzearen parekoa da. Horretaz gainera, bi latatan 30 bat azukre-koxkor daude -100-150 g azukre-, beraz, edari energetikoak kafeina eta azukre bonbak besterik ez dira. Lata bakar batek hirukoiztu egiten du OME Osasunaren Munduko Erakundeak egun batean kontsumitzea gomendatzen duen azukre kantitatea.

2. irudia: Edari energetikoak azukre eta kafeina bonbak dira. (Argazkia: Joenomias – domeinu publikoko irudia. Iturria: pixabay.com)

Beraz, edari energetikoen atzean azukrea eta kafeina besterik ez dago. Diabetesarekin eta gizentasun arazoekin lotzen dira eta bihotz taupadak azkartzen dituzte. Nerbio sistema bizkortzen dute eta bihotzeko asaldatzeak eragin ditzakete -takikardia, insomnioa, arterietako presioa handitzea eta gorputzaren koordinazioa zailtzea-. Esandakoarengatik, oso tarteka hartzeko edariak dira. Gainera, alkoholarekin batera nahasten direnean alkoholaren eta kafeinaren eragina handitu egin daiteke. Alkohola kontsumitzeak nerbio-sistema moteltzea dakar eta, horrek, lehenago edo beranduago kontsumitzez uztea dakar, baina, edari energetikoen kafeinarekin elkartzen bada, edaten jarraitzeko arriskua handiagoa da.

Edari energetiko askok aldarrikatzen dute nekea atzeratzeko edota kontzentrazioari eusteko balio dutela. Saltzaileen esanetan, karnitina, guarana, ginsenga, taurina eta edariei gehitzen zaizkien bestelako konposatuetan daude edari energetikoen ezaugarri apartak. Europar Batasuneko araudi berriak ez die uzten horrelako aldarrikapenak egitea; izan ere, ez dago frogatuta molekula miragarri horiek funtzio hori dutenik. Horrexegatik, edari energetikoetan B taldeko bitaminak gehitzen dituzte arazoa konpontzeko. Hala ere, esan behar da B bitamina edonon dagoela eta, hortaz, ez da beharrezkoa edari energetikoak kontsumitzea B taldeko bitaminak lortzeko.

Bitaminak onak izan badaitezke ere, edariak ezin dira aztertu haien osagaiak banan-banan aztertuta. Edaria bere osotasunean aztertu behar da onuragarria den edo ez erabakitzeko eta, hortaz, testuingurua edozein dela ere, onura gutxi daukate edari energetikoek. Ez dauka zentzurik kirola egin ondoren kafeina estimulatzaile bezala erabiltzea. Kirola egin ondoren gorputzak ura, gatz mineralak eta karbohidratoak galtzen ditu nagusiki eta horiek dira berreskuratu behar direnak. Zentzu horretan, aipatzekoa da 2015ean Kataluniako Elikagaien Segurtasunerako Zientzialarien Batzorde Aholkulariak egindako txostena, zeinetan edari energetikoak kontsumitzeko gomendioak eman zituzten. Adituen arabera, edari energetikoak ez dira inondik inora edari alkoholdunekin nahastu behar. Era berean, haurdun dauden zein bularra ematen duten emakumeek, haurrek, kafeinarekin sentiberak direnek eta bihotzeko zein arazo neurologikoak dituztenek ez lukete hartu behar. Kirola egin ondoren hartzea ere ez dute gomendatzen; izan ere, kafeinak eragin diuretikoa du eta, ondorioz, jarduera fisikoa egin ondoren ur gehiegi galtzeko arriskua handitzen dute edari energetikoek.

Laburtuz, edari energetikoek onetik ezer gutxi dute eta arrisku larriak ekar ditzakete kantitate handitan edaten badira. Zentzu horretan, garrantzitsua da kontsumitzaileek zehatz mehatz jakitea zein den edari bakoitzaren kafeina eta azukre edukia eta edari horien arriskuen jakitun izatea -adingabeen kasuan, bereziki-. Adingabeen kasuan, eskolako emaitzak kaltetu ditzakete eta haur-obesitatea handitzearen erantzuleak izan daitezke. Esandako guztiaren ondorioz, tabakoa eta alkoholaren kasuan egiten den bezala edari energetikoak adingabeei ez saltzea proposatu duenik ere bada. Aztertzekoa.

Informazio osagarria:

- Eztanda kafeinatan, G. Goikoetxea, berria.eus, 2014.

- Muere un joven en Murcia tras beberse una botella de ron y dos bebidas energéticas, elespanol.com, 2019.

- Bebidas energéticas: cafeína enlatada, ocu.org, 2016.

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea, irakaslea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

The post Alkohola eta kafeina, eztanda egin arte appeared first on Zientzia Kaiera.

Digestión estomacal (y II): regulación

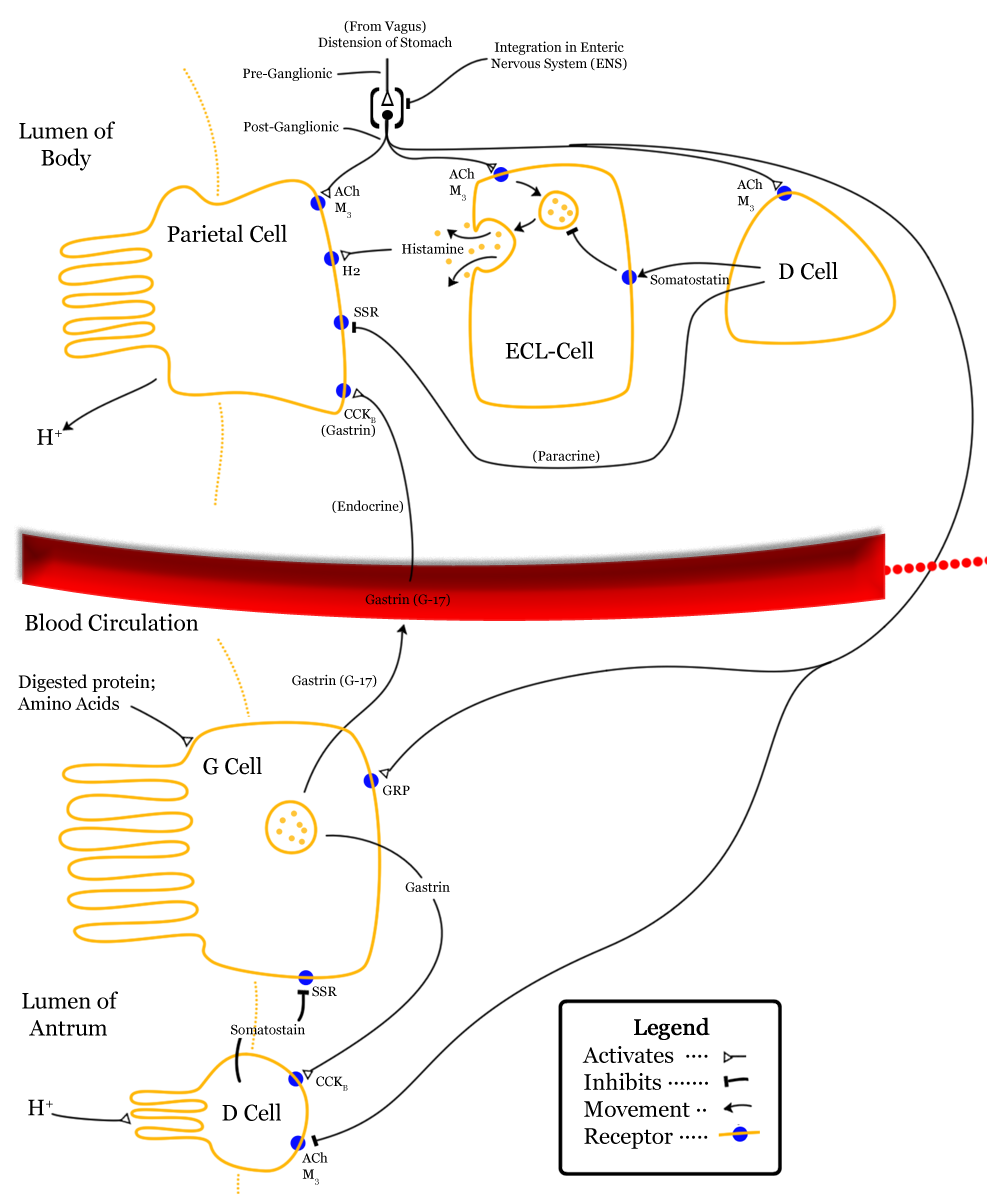

Además de las células propias de las glándulas de la mucosa oxíntica que se presentaron en la anotación anterior, en la mucosa gástrica hay otras que no liberan productos exocrinos, sino factores endocrinos (hormonas) o paracrinos con función reguladora. Son las siguientes:

(1) Las células enterocromafines se encuentran entre las células parietales y las células principales en las glándulas gástricas de la mucosa oxíntica. Secretan histamina.

(2) Las células G se encuentran en las glándulas del área de glándulas pilóricas. Son células endocrinas, que liberan la hormona gastrointestinal gastrina a la sangre.

(3) Las células D (o delta) se encuentran en número escaso en las glándulas de la zona pilórica pero son muy abundantes en el duodeno. Secretan somatostatina.

Imagen: Wikimedia Commons

Imagen: Wikimedia CommonsLa secreción de los jugos gástricos que vimos en la anotación anterior se produce mediante la intermediación de cuatro mensajeros químicos, para los que las células parietales cuentan con sus correspondientes receptores. Acetilcolina, gastrina e histamina ejercen efectos estimulantes al promover la inserción de las unidades de ATPasa de H+/K+ -que se encuentran almacenadas en vesículas intracelulares- en la membrana de las células parietales, elevando así la secreción de HCl a la luz gástrica. La somatostatina, sin embargo, tiene efectos inhibitorios. La gastrina y la acetilcolina estimulan también la secreción de pepsinógeno por las células principales. Veamos estos mensajeros con algún detalle.

La acetilcolina es un conocido neurotransmisor. Se libera en el plexo nervioso intrínseco en respuesta a la estimulación por el nervio vago, y estimula las células parietales, principales, células G y las enterocromafines.

Las células G secretan gastrina al torrente sanguíneo, en respuesta a la presencia de proteínas en el interior del estómago y por efecto de la acetilcolina. Cuando vuelve al cuerpo y al fundus del estómago, las células parietales y principales elevan la secreción de jugos gástricos. Además, promueve la liberación de histamina por parte de las células enterocromafines.

La histamina es un agente paracrino liberado por las células enterocromafines en respuesta a la gastrina y la acetilcolina. Ejerce efectos locales (por eso es paracrina) en las células parietales de su entorno, potenciando la acción, precisamente, de las sustancias que han estimulado su liberación.

La somatostatina es liberada por las células delta (o células D) en respuesta a la acidez y su efecto es inhibitorio dando lugar a una retroalimentación negativa. Actúa como agente paracrino también, sobre las células de su entorno, inhibiendo la secreción de células parietales, células G y células enterocromafines.

La regulación de la digestión estomacal se produce mediante un conjunto de actuaciones complementarias. Son varios los estímulos capaces de provocar un aumento de la secreción de jugos gástricos. Unos son anteriores a la llegada del alimento a estómago, otros actúan cuando el alimento ya se encuentra en su interior, y otros proceden del duodeno una vez el quimo ha abandonado el estómago. Por esa razón la secreción gástrica sigue una secuencia en tres fases:

Fase cefálica. Antes de que el estómago reciba el alimento, determinados estímulos sensoriales (visuales, olfativos o el acto de masticar) anticipan su llegada. En ese caso la secreción gástrica se eleva por la acción del nervio vago en respuesta a los citados estímulos, acción que surte dos efectos: (1) promueve el aumento en la secreción de acetilcolina por los plexos nerviosos intrínsecos, lo que, a su vez, eleva la secreción de HCl y de pepsinógeno; (2) estimula la secreción de gastrina por las células G, lo que a su vez promueve la secreción de HCl y pepsinógeno; además, la secreción de clorhídrico también se eleva debido a que la gastrina induce la liberación de histamina.

Fase gástrica. Esta comienza al llegar el alimento al estómago. Los estímulos que actúan a este nivel (proteínas y péptidos, por un lado, y distensión estomacal por el otro) elevan la secreción gástrica debido a la acción superpuesta de diferentes vías. La acción más potente se debe a la presencia de proteínas en el estómago, que estimulan los quimiorreceptores que activan los plexos nerviosos intrínsecos, con la consiguiente estimulación por estos (mediante la acetilcolina) de la células secretoras. La presencia de proteínas en el estómago también actúa a través de la vía vagal, reforzando la fase cefálica. La consecuencia de estas acciones es la elevación de la secreción de ácido clorhídrico y de pepsinógeno, acentuándose así la digestión ya iniciada.

Fase intestinal. Hay factores intestinales que inciden en la secreción de jugos gástricos, aunque en este caso pueden ser estimuladores o inhibidores. La presencia en el duodeno de los productos de la digestión parcial de las proteínas estimula la liberación de gastrina intestinal, que es transportada al estómago por la sangre, actuando de la misma forma que la gastrina estomacal. Ahora bien, cuando el quimo llega las zonas iniciales del intestino delgado la secreción gástrica se reduce debido a tres factores:

(1) Por un lado, al vaciarse el estómago, disminuye la presencia de proteínas en su interior, desapareciendo de esa forma el principal factor que había provocado la elevación de la secreción de jugos.

(2) Conforme se vacía el estómago, su pH se reduce mucho, pues el HCl ya no es neutralizado por las sustancias del quimo; esa reducción estimula la liberación de somatostatina que, como hemos visto, ejerce efecto inhibidor sobre la secreción gástrica.

(3) Los mismos estímulos que inhiben la motilidad estomacal, inhiben también la secreción gástrica. El reflejo enterogástrico y las enterogastronas suprimen la actividad de las células secretoras gástricas, a la vez que reducen la excitabilidad de las células musculares lisas.

Llegados a este punto, la digestión estomacal ha terminado y sus productos han ido pasando del antro estomacal al duodeno e intestino delgado, donde se completará la digestión de los péptidos, lípidos y carbohidratos que no han sido hidrolizados en las fases anteriores.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Digestión estomacal (y II): regulación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Digestión estomacal (I): el papel de las glándulas gástricas

- La motilidad estomacal

- Actividades digestivas y su regulación

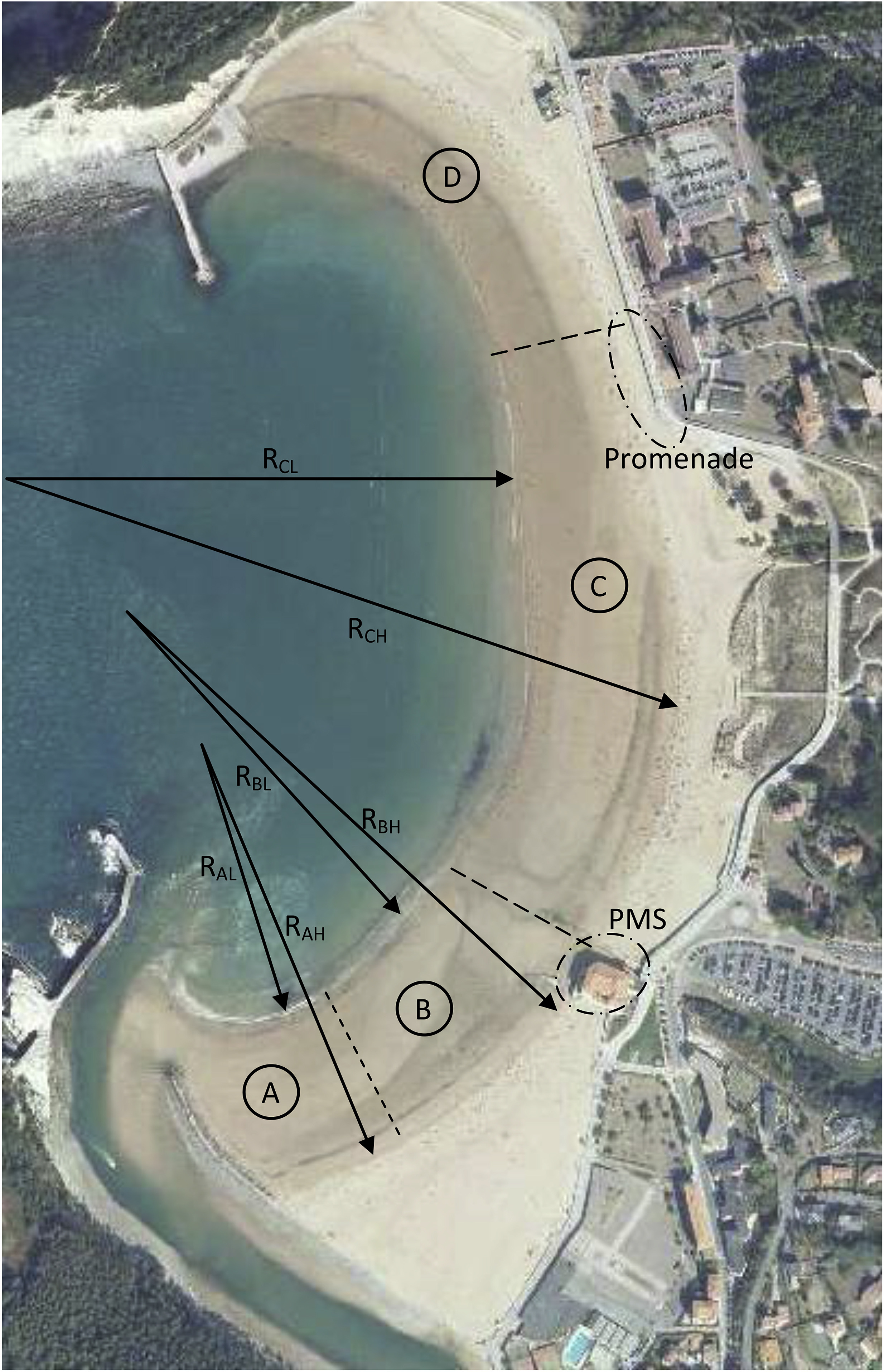

Hondartzaren bainulari gaitasuna kalkulatzen

1. irudia: Plentzia eta Gorliz hondartzetako bainulari gaitasuna kalkulatzeko tresna garatu dute. (Argazkia: Jatamendi)

Hondartzako ur-xaflak har ditzakeen bainulari kopurua kalkulatzeko tresna da garatu dena. Plentzia eta Gorlizko hondartzak izan dira ikerketan aztertu direnak eta bainu zonalde segurua kalkulatzeko eredua lortzea izan da ikerketaren helburua.

Plentzia eta Gorliz herriek 4304 eta 5669 biztanle dituzte hurrenez hurren, baina udan laukoiztu ere egiten dira kopuru horiek. Hondartzara doazen pertsonen %74k hiru aktibitate dituzte gogokoen: eguzkia hartu, paseatu eta bainatu. Bestelako erabiltzaileak ere badaude hondartzetan, hala ere.

Surfa, esaterako, gorantza doan aktibitatea da eta ikerketa egindako hondartzetan hamar surf eskolek eman zituzten kurtsoak ikerketa aldian.

Hondartzak har ditzakeen bainulari kopurua kalkulatzea erabilgarria izan daiteke hondartza erabiltzaile mota ezberdinei zona esleitzerako orduan, segurtasuna bermatuta.

Bainu zona seguruaHondartzak har ditzakeen bainulari kopurua kalkulatzeko korronteak, harkaitzak eta oztopoak bezalako arriskurik ez duen bainu eskualdea metro karratuetan kalkulatzen da lehenengo eta behin.

Horretarako, erabilgarria den ur-bazterra neurtzen da metrotan eta ur-bazterretik olatu-apurketa punturako distantzia kalkulatzen da. Bi hauekin, eta zuzenketak aplikatuta, bainu eskualde segurua kalkulatzen da metro karratuetan.

Legearen arabera bainu eremua ur bazterretik itsasoko 200 metrora doan ur xafla da hondartzetan. Ikerketan, baina, arriskurik gabeko bainu zona segurua da kalkulatu dena.

Ur-xaflaren bainu eskualde segurua bi faktore nagusiren menpekoa izango da: olatuen altuera eta marea. Mareak eragin zuzena du bainu zonaren tamainan, ura mugitzerakoan espazio ezberdinetan kokatzen baita eta arriskuen agerpena (arrokak eta oztopoak) ere eragin dezake mareak. Olatuen altuerari dagokionez, olatuak zenbat eta altuago, orduan eta indartsuago eta arriskutsuago.

Bi datu horiekin bainu zona segurua kalkulatu ostean, bainulari gaitasuna kalkulatu daiteke. 2016an egindako behaketetan oinarrituta, bainulari bakoitzari 9 metro karratuko espazioa esleitu zaio ikerketan.

Horrela, hondartzak duen bainulari gaitasuna ezagutu daiteke eta berau kudeatzea erraztu, bainularien, surflarien eta bestelako erabiltzaileentzako eremuak bereizterako orduan.

Datu aldagarriaKontuan izan behar da, hala ere, egunean zehar bainu zona segurua aldakorra dela, mareak gora eta behera egiten baitu eta olatuen indarra eta altuera ere aldakorrak baitira.

Ikerketa egiteko lau eremutan banatu zituzten Plentzia eta Gorlizko hondartzak. Berez, hondartza bakarra da, baina Gorlizek eta Plentziak zona ezberdinen kontrol administratiboa dute.

2. irudia: Lau zonaldetan banatu dituzte Plentzia eta Gorlizko hondartzak ikerketan (A, B, C eta D).

Esan bezala, marea eta olatuen altuera dira aldagai nagusiak eta eragin handiena dutenak. Ikerketan, hala ere, bestelako parametroak ere izan dituzte kontuan:

– Ur-bazterraren luzera. Marearen araberakoa da.

– Erradioa. Garrantzitsua da datua, izan ere, zenbat eta erradio txikiagoa, bainu eremu txikiagoa.

– Oztopoak. Plentzia eta Gorlizko hondartzan dauden eraikuntzek eta instalazioek eragina dute ur-bazterraren luzeran marea altua denean.

– Ur-bazterretik olatu-apurketa punturako distantzia. Sakonera kontuan izateko baliatu da datu hau, izan ere, sakonera 1.3 aldiz olatuaren altuera denean apurtzen dute olatuek. Hortaz, bainu eremu segurua mugatzeko muga gisa erabil daiteke.

– Korronteak eragina duen ur-bazterra. Itzulera korronteak (RIP current arriskua areagotzen du eta, beraz, erabilgarri den ur-bazterraren luzeran eragin zuzena du.

– Barneratzen koefizientea. Bainularien dentsitatea eta mugimenduak hartzen dira kontuan honen kalkulurako eta bainu zona seguruaren tamainan eragin zuzena du.

Bainulariek uretan ematen duten denbora ere kontuan hartu beharreko datua da. Gizonezkoen kasuan 19 minutu eta emakumeen kasuan 11 minutu egoten diren uretan bataz beste mota guztietako erabiltzaileek (bainulariak, paseatzaileak eta surflariak barne) Australian egindako ikerketen arabera. Eguraldiak ere eragin zuzena du uretan pasatzen den denboran.

2017 eta 2018ko tresna hau erabili izan da eta, datuen arabera, surflari eta bestelako erabiltzaileen arteko liskarrak zerora murriztu dira, uraren banaketa espazial egokiari esker.

Hortaz, uraren banaketa egiteko tresna da ikerketak garatu duena. Modu azkarrean kalkulatu daiteke bainu zona segurua eta eremuak banatu algoritmoari esker, baina kontuan izan behar da datuak aldakorrak direla.

Erreferentzia bibliografikoa

Basterretxea-Iribar, Imanol, et al., (2019). Managing bathers’ capacity at overcrowded beaches: A case on the Spanish North Atlantic coast. Tourism Management, 71, 453-465. DOI: https://doi.org/10.1016/j.tourman.2018.10.016

The post Hondartzaren bainulari gaitasuna kalkulatzen appeared first on Zientzia Kaiera.

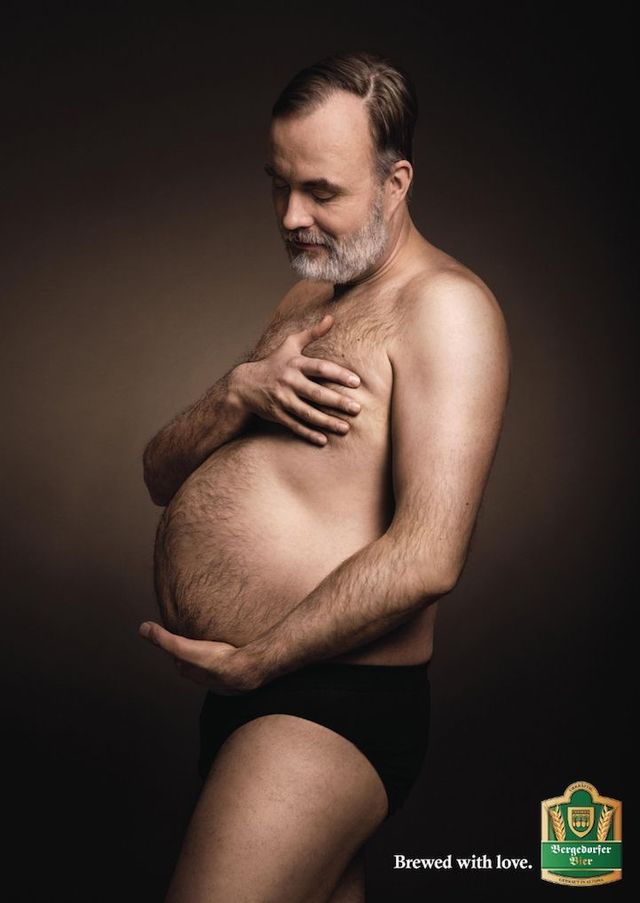

Desmitificando: La barriga cervecera

Una de las imágenes que la agencia Jung von Matt creó para Bergedorfer Bier en 2016

Una de las imágenes que la agencia Jung von Matt creó para Bergedorfer Bier en 2016Para empezar aquí van algunos ejemplos, de aquí y de allá, del consumo de cerveza. En Alemania y en 2006, era, por persona, de 112 litros al año y, también en Alemania y en 2011, más del 70% de los adolescentes y del 50% de las adolescentes había consumido cerveza en los 30 días anteriores a la encuesta. Cerca de Alemania, también en Europa central, en Chequia, el 79% de los hombres y el 55% de las mujeres consumen cerveza habitualmente. En España y en 2017, según el informe de Cerveceros de España, el consumo de esta bebida fue de 48.3 litros al año. Ese año, el consumo en Alemania fue de 104 litros al año.

Este consumo ha llevado a la extendida creencia popular de que el consumo de cerveza es la causa de la llamada barriga cervecera o, en términos más técnicos, la obesidad abdominal, tal como cuentan Schütze y sus colegas, del Instituto Alemán de Nutrición Humana de Nuthetal. Pero ya veremos como hay estudios que apoyan esta relación y otros que la niegan e, incluso, hay algunos que concluyen, y es sorprendente, que la relación es negativa, es decir, que la cerveza adelgaza.

En el trabajo de Schütze, con el método epidemiológico, participan 7876 hombres y 12749 mujeres, de 35 a 65 años, y con un seguimiento del peso, circunferencia en las caderas y consumo de cerveza en mililitros por día al inicio del estudio y a los seis años y a los ocho años y medio.

Los resultados muestran que en el 57% de los hombres y el 67% de las mujeres aumenta el peso durante los años que dura el estudio. En cuanto al consumo de cerveza, en el 57% de los hombres y el 69% de las mujeres se mantiene estable, y en el 30% de los hombres y el 22% de las mujeres, disminuye. Por tanto, en el 13% de los hombres y el 9% de las mujeres, el consumo de cerveza crece.

En los hombres con consumo alto, el peso y la circunferencia de las caderas crecen. El resultado es una curva en U: con el consumo moderado, de menos de medio litro al día, no cambian peso y circunferencia; y en los que más aumentan ambos parámetros es en los abstemios y en los que consumen más de un litro al día. En las mujeres, hay aumento de peso y circunferencia en consumidoras de poca cerveza y, en cambio, disminuyen con un consumo moderado, de unos 250 mililitros al día.

Los autores concluyen que hay relación entre el consumo de cerveza, si es elevado, y el peso, aunque dudan si el cambio detectado se debe más a los cambios en la distribución de grasas en el cuerpo habituales con la edad. Por tanto, la creencia popular de la relación entre la cerveza y la barriga cervecera no queda probada con este estudio.

En el estudio epidemiológico de Chequia, con 891 hombres y 1098 mujeres y edades de 25 a 64 años, la media semanal de toma de cerveza es de 3.1 litros en los hombres y de 0.31 litros en mujeres. Es en este estudio donde los autores detectan, en mujeres, una pequeña relación negativa entre el consumo de cerveza y el Índice de Masa Corporal, es decir, que la cerveza adelgaza, poco pero lo hace. En conclusión, en Chequia no existe relación entre la obesidad abdominal y la ingestión de cerveza.

Por el contrario, en Brasil, el estudio de Paula Aballo Nunes Machado y Rosery Sichieri, de la Universidad del Estado de Rio de Janeiro, encuentra relación entre la obesidad abdominal y la toma de cuatro o más copas al día, o sea, de casi litro y medio de cerveza. El estudio, epidemiológico, se hizo con 2441 voluntarios, el 57% mujeres, y edades de 20 a 60 años.

En un trabajo experimental, no epidemiológico, Javier Romeo y su grupo, del Instituto del Frío del CSIC, en Madrid, planificaron un experimento con 58 voluntarios, de ellos 27 mujeres, con una edad media de 36 años. Después de un mes de abstinencia alcohólica, los voluntarios consumieron, en el mes siguiente, 330 mililitros de cerveza al día las mujeres (lo que se llama un tercio o el contenido de una lata de cerveza) y 660 mililitros (dos latas) al día los hombres. Tras estudiar los datos, el grupo concluye que no hay relación entre el consumo de cerveza y cambios, ni positivos ni negativos, en el peso corporal, la circunferencia de las caderas o el Índice de Masa Corporal. Después de todo, una lata de cerveza supone unas 145 kilocalorías, algo más que un yogur con azúcar (o tres veces menos que una piña colada). No hay relación, en este estudio, entre cerveza y barriga cervecera.

En un meta-análisis sobre cerveza y obesidad publicado en 2013, Bendsen y sus colegas, de la Universidad de Copenhague, revisaron 35 estudios epidemiológicos con datos de peso y consumo de cerveza tomados de la población en general, con grupos de entre 317 y 44080 voluntarios y seguimientos de 3.7 a 10 años. También utilizaron doce estudios experimentales, con toma de cerveza y variaciones de peso. Consideraron que la ración estándar de cerveza es el tercio, o 330 mililitros, al día, y con 4.6 grados de alcohol.

Llegaron a varias conclusiones y, en primer lugar, los estudios epidemiológicos indican que consumir más de medio litro de cerveza al día está positivamente relacionado con la obesidad abdominal o, si se quiere decir así, con la barriga cervecera. En cambio, los estudios experimentales dan resultados diferentes. Seis de ellos indican que el consumo de cerveza por 21-126 días aumenta el peso una media de 0.73 kilogramos pero, sin embargo, otros cuatro estudios no demuestran aumentos de peso.

Según los autores y en general, aunque los datos publicados son de baja calidad, la conclusión final es que no hay evidencias de que el consumo moderado de cerveza, hasta medio litro al día, esté asociado a la obesidad abdominal. Pero el consumo por encima de estas cantidades parece que provoca la aparición de la barriga cervecera.

Por tanto, hay dudas sobre la existencia de la barriga cervecera, sobre todo para consumos moderados de cerveza, aunque, también es indiscutible, que la cerveza se bebe, a veces demasiada, y que la barriga, para muchos, existe, aunque, repito la relación entre ambas está en debate.

Referencias:

Bendsen, N.T. et al. 2013. Is beer consumption related to measures of abdominal and general obesity? A systematic review and meta-analysis. Nutrition Reviews 71: 67-87.

Bobak, M. et al. 2003. Beer and obesity: a cross-sectional study. European Journal of Clinical Nutrition 57: 1250-1253.

Cerveceros de España. 2018. Informe socioeconómico del sector de la cerveza en España. Ministerio de Agricultura, Pesca y Alimentación. Madrid. 56 pp.

Gaetano, C. de, et al. 2016. Effects of moderate beer consumption on health and disease: A consensus document. Nutrition, Metabolism & Cardiovascular Diseases doi: 10.1016/j.numecd.2016.03.007

Machado, P.A.N. & R. Sichieri. 2002. Relaçao cintura-quadril e fatores de dieta em adultos. Revista de Saùde Pública 36: 198-204.

Romeo, J. et al. 2007. ¿Influye la cerveza en el aumento de peso? Efectos de un consumo moderado de cerveza sobre la composición corporal. Nutrición Hospitalaria 22: 223-228.

Schütze, H. et al. 2009. Beer consumption and the “beer belly”: scientific basis or common belief? European Journal of Clinical Nutrition 63: 1143-1149.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Desmitificando: La barriga cervecera se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Desmitificando: Las rubias son “tontas”

- Desmitificando: Alguien me está mirando…

- Desmitificando: La vitamina C y el resfriado

Asteon zientzia begi-bistan #239

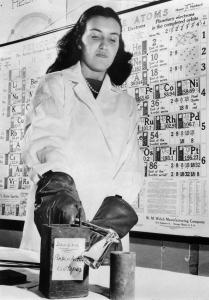

Rosalyn Yalow fisikariak lortu zuen Medikuntzako Nobel saria 1977an, erradioimmunosaio teknika (RIA ingelesez) garatzeagatik. Bere bizitzan zehar oztopo ugari izan zituen, gehienak emakumea izateagatik baina aurrera egin zuen. Yalowk Fisika Nuklearra doktoregoa lortu zuen 1945ean eta hortik aurrera lanean aritu zen Solomon Berson medikuarekin batera, 22 urteko lankidetza izan zen; biek lortu zuten erradioimmunosaio teknika garatzea. Metodo honek ahalbidetzen zuen, besteak beste, organismoan oso kantitate txikian zirkulatzen duten hormonak antzematea isotopo erradioaktiboak erabiliz. Azken batean, teknika honi esker zenbatu daitezke antigorputzen (Ac) eta antigenoen (Ag) kontzentrazioak modu oso espezifikoan.