La enseñanza multilingüe de las lenguas

Una investigación llevada a cabo en el Departamento de Teoría e Historia de la Educación por la profesora Elizabet Arocena, dirigida por el investigador Ikerbasque Durk Gorter y la catedrática de la UPV/EHU Jasone Cenoz, ha concluido que existen bases pedagógicas para poder implantar y extender el enfoque multilingüe en la enseñanza de las lenguas en las aulas.

Según explica la profesora e investigadora Arocena, “los hablantes multilingües no aíslan las lenguas en sus mentes. Es decir, no son una suma de hablantes monolingües. Rebasan los límites interlingüísticos, y, por ejemplo, utilizan en su lengua más débil lo aprendido en sus otras lenguas”. Actualmente, muchos investigadores internacionales ponen en tela de juicio la tendencia a enseñar idiomas por separado y defienden otro enfoque más generalizado, un enfoque multilingüe; es decir, proponen dotarlos de herramientas que les ayuden a utilizar en otras lenguas lo aprendido en una de ellas.

El objetivo de la investigación de Arocena ha sido analizar hasta qué punto está extendido el enfoque multilingüe en los centros de enseñanza vascos y si existen en ellos bases pedagógicas para poder implantarlo y extenderlo. Para ello, la investigadora ha llevado a cabo entrevistas entre el profesorado de distintas lenguas y ha observado sus clases, con el objetivo de recabar sus opiniones y analizar sus modos de impartir clase. Por otra parte, para analizar las tendencias del alumnado, ha solicitado a los y las alumnas cumplimentar una encuesta de información general (edad, lengua materna, qué uso hacen de las lenguas, cuándo…); además, la investigadora ha analizado tres redacciones de cada estudiante.

La investigadora ha recopilado diversas opiniones y creencias del profesorado. Entre otras conclusiones, el profesorado destaca que para la enseñanza de las lenguas consideran al alumnado monolingüe, y que persiguen el objetivo de conseguir el mismo nivel que las personas monolingües en ese idioma, aunque saben que es muy difícil conseguirlo en las tres lenguas por igual. Asimismo, creen que en las clases no se debe hacer referencia a otras lenguas como ayuda en la enseñanza, que no se debe dar una alternancia de código en clase. Sin embargo, Arocena ha constatado que la utilización de otras lenguas en la enseñanza lingüística es más frecuente de lo esperado, sobre todo para explicar vocabulario y conceptos difíciles.

Por otra parte, de los textos redactados por el alumnado, la investigadora ha concluido que los estudiantes rompen con las barreras inducidas por el enfoque monolingüista, ya que utilizan en una lengua recursos que han aprendido para otra. De hecho, “hemos constatado que además de transferir léxico, el alumnado es capaz de transferir recursos de puntuación, organización textual y contenidos”, añade Arocena. En opinión de la investigadora, las características de las redacciones ponen de manifiesto que “es necesario considerar al hablante como multilingüe, debido a que no escribe de diferente manera en uno u otro idioma. A menudo no tenemos en cuenta todo ello, y es muy importante contemplar las herramientas que los alumnos utilizan como multilingües que son: ¿Si saben utilizar un recurso en una lengua, por qué no les enseñamos cómo transferirlo a sus otras lenguas? ¿Por qué no utilizamos dicha transferencia en el proceso de aprendizaje de otra lengua?”.

Referencia:

E. Arocena-Egaña et al (2015) Teachers’ beliefs in multilingual education in the Basque country and in Friesland Journal of Immersion and Content-Based Language Education doi: 10.1075/jicb.3.2.01aro

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La enseñanza multilingüe de las lenguas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El oído absoluto y las lenguas tonales

- El aprendizaje del inglés es mejor si se usa para aprender otra cosa

- Los cuantificadores se aprenden en el mismo orden, sea cual sea la lengua

Relojes astronómicos

En una época en la que los dispositivos digitales nos permiten saber la hora con una precisión sin precedentes o en que las aplicaciones móviles pueden darnos datos astronómicos exactos, quizás no seamos capaces de entender en toda su amplitud el sentido de maravilla que suscitaba entre nuestros antepasados un artilugio capaz de dar esta información de antemano.

Durante muchos siglos, los relojes astronómicos fueron lo más parecido a los ordenadores actuales. No sólo permitían conocer la hora y la fecha del año, muchos de ellos daban además las horas de salida y puesta del Sol, las fases de la Luna o las posiciones de los planetas y las estrellas. Mediante engranajes cuidadosamente calculados y vinculados con los ritmos de los astros, estos mecanismos permitían reproducir ciclos astronómicos y determinar con antelación fenómenos tan complejos como los eclipses de Sol o de Luna.

Aunque hay quien considera al Mecanismo de Anticitera un precursor de estas calculadoras mecánicas, la edad dorada de los relojes astronómicos tiene lugar entre los siglos XIV y XVI. En esta época, las ciudades más prósperas comienzan a instalar estas prodigiosas maquinas. Si bien existen algunas variaciones importantes entre los distintos modelos, los relojes astronómicos se pueden clasificar en tres tipos principales.

Los primeros dos tipos se denominan “de astrolabio”, incluyen un círculo eclíptico giratorio y manecillas para indicar los movimientos del Sol y de la Luna, además de la hora. Este tipo de mecanismos permitía ofrecer todas las indicaciones propias de un astrolabio (Sol, Luna, estrellas brillantes, planetas). El primero de estos tipos engloba los relojes de astrolabio realizados en Lund, Doberan, Estrasburgo (reloj antiguo), Frankfurt y Praga, todos ellos anteriores a 1500.

Reloj astronómico de Lund (Suecia). Foto: © Paco Bellido

El segundo tipo de relojes de astrolabio engloba los realizados en Munster, Ulm, Lyon, Olomouc, Estrasburgo (reloj nuevo), posteriores al año 1500. La principal diferencia entre los dos tipos estriba en la proyección de la bóveda celeste utilizada, polo norte en el primer tipo y polo sur en el segundo.

Detalle del reloj astronómico de la Catedral de Estrasburgo. Foto: © Paco Bellido

El tercer tipo de reloj astronómico monumental tiene su origen en Italia, concretamente en el reloj construido en Padua por Jacopo Dondi. Este tipo de reloj consta de un cuadrante y varios círculos concéntricos que indican las horas, las 12 constelaciones zodiacales, la posición del Sol y de la Luna en el cielo y su fase correspondiente y, en el centro del reloj, el disco de la Tierra que porta las manecillas de las horas. En Italia se pueden ver relojes de este tipo en Venecia, Brescia y Cremona. También hay ejemplos en otros países, por ejemplo en Danzig (Polonia) y Rostock (Alemania) y en varias ciudades británicas: Hampton Court, Exeter, Ottery, Wells y Wimborne.

El reloj astronómico de Padua. Foto: © Paco Bellido

Los primeros relojes astronómicos representaban el sistema solar atendiendo al modelo geocéntrico. En el centro del dial se situaba un disco o esfera que representaba la Tierra, ubicada en el centro del Universo. El Sol, la luminaria mayor, solía aparecer representado por una esfera dorada que giraba alrededor de la Tierra. En este esquema la experiencia cotidiana iba de la mano de la visión cosmológica imperante en la Europa precopernicana.

El reloj astronómico del Torrazzo de Cremona. Foto: © Paco Bellido

Sobre la fachada sur del Ayuntamiento de la Ciudad Vieja de Praga se encuentra el más conocido de los relojes astronómicos. Está formado por tres componentes principales: un calendario perpetuo que indica el santo del día y la fecha; una esfera astronómica, que indica las posiciones del Sol y de la Luna en el cielo y, en la parte superior, el desfile de los apóstoles, una cabalgata mecánica que atrae a multitud de turistas cada hora.

La parte más antigua del reloj, el mecanismo y la esfera astronómica, datan de 1410 y son obra del relojero Mikuláš de Kadaň y del profesor Jan Šindel. Alrededor de 1490 se agregó el calendario perpetuo y se añadieron las esculturas góticas que decoran la fachada del reloj. En 1552 fue reparado por Jan Taborský y a partir de esta fecha funcionó intermitentemente.

Detalle del astrolabio del reloj astronómico de Praga. Foto: © Paco Bellido

El reloj astronómico reproduce la forma de un astrolabio mecánico. También se puede interpretar como un planetario primitivo que muestra el aspecto actual del universo.

Las catedrales y grandes templos son otro lugar habitual de estos ingeniosos mecanismos. Durante buena parte de la historia, las horas de la liturgia se determinaron mediante relojes de sol, clepsidras y relojes de arena, pero a finales del siglo XIII empiezan a aparecer relojes mecánicos en monasterios e iglesias que permiten calcular con exactitud la fecha de las fiestas religiosas móviles, en particular, la fecha de la Pascua. En ocasiones, como ocurre en Beauvais (Francia), el reloj encierra un mensaje espiritual de gran simbolismo religioso.

La ciudad alsaciana de Estrasburgo fue una de las primeras en disponer de un gran reloj monumental. La construcción del primer reloj de la catedral tuvo lugar entre 1352 y 1354. Algunas piezas del reloj original se pueden ver actualmente en un museo de la ciudad, pero la catedral cuenta con un nuevo reloj astronómico, el tercero que ha tenido. Una maravilla creada por el autodidacta Jean-Baptiste Schwilgué (1776-1856), quien dedicó su vida a la tarea de volver a poner en marcha el ingenio astronómico de la catedral.

Reloj astronómico de Estrasburgo. Foto: © Paco Bellido

Este reloj ha servido de inspiración a multitud de relojeros de todo el mundo. Por ejemplo, al danés Jens Olsen, uno de los fundadores de la Sociedad Astronómica Danesa, que en 1955 pudo cumplir su sueño de poner en marcha su reloj astronómico compuesto por 15.448 piezas individuales, aunque él no vivió para verlo. El reloj de Olsen se puede visitar en el Ayuntamiento de Copenhague y está considerado uno de los más precisos del mundo. La rueda dentada que se mueve más despacio da una vuelta cada 25.753 años.

El ingenio mecánico de Jens Olsen. Foto: © Paco Bellido

Algunos relojes astronómicos ofrecen una cantidad de información realmente asombrosa. La Torre Zimmer de Lier (Bélgica), por ejemplo, no solo indica con precisión la posición de los principales planetas, en su interior se encuentra el departamento de cálculos astronómicos donde encontramos toda una serie de diales que indican desde el período de Saros, hasta la ubicación de los cometas Encke y Halley, pasando por la posición de los radiantes de las principales lluvias de meteoros.

La Torre Zimmer de Lier (Bélgica) ideada en los años treinta del siglo pasado por Louis Zimmer. Foto: © Paco Bellido

Un buen número de estos relojes históricos están incluidos en la Lista del Patrimonio de la Humanidad de la UNESCO, no en vano son maravillas de la ingeniería mecánica y una muestra indiscutible del ingenio humano.

Este post ha sido realizado por Paco Bellido (@ElBesoenlaLuna) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Relojes astronómicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Relojes y cronómetros (I): la conexión astronómica

- Relojes y cronómetros (III): el problema de la longitud

- Relojes de ADN

El mecanismo de la vida, mejor vídeo de divulgación joven “On zientzia”

“El mecanismo de la vida” de Leonel Virosta Gutiérrez es el vídeo ganador del premio joven al mejor vídeo de divulgación de la 6ª edición de los premios On Zientzia. Leonel explica el funcionamiento de las células, como se forma un bebé, cómo infecta un virus y una cantidad increíble de cosas en tan solo 5 minutos.

¿Tienes una idea genial para explicar un concepto científico en un vídeo? ¿Quieres ver tu trabajo emitido en televisión? La Fundación Elhuyar y el Donostia International Physics Center (DIPC) han organizado la octava edición de On zientzia, un concurso de divulgación científica y tecnológica enmarcado en el programa Teknopolis, de ETB. Este certamen pretende impulsar la producción de vídeos cortos y originales que ayuden a popularizar el conocimiento científico.

On zientzia tendrá tres categorías. El mejor vídeo de divulgación recibirá un premio de 3.000 euros. Para impulsar la producción de piezas en euskera, existe un premio de 2.000 euros reservado a la mejor propuesta realizada en ese idioma. Por último, con el objetivo de impulsar la participación de los estudiantes de ESO y Bachillerato, hay un premio dotado con 1.000 euros para el mejor vídeo realizado por menores de 18 años.

Los vídeos han de tener una duración inferior a los 5 minutos, se pueden realizar en euskera, castellano o inglés y el tema es libre. Deben ser contenidos originales, no comerciales, que no se hayan emitido por televisión y que no hayan resultado premiados en otros concursos. El jurado valorará la capacidad divulgativa y el interés de los vídeos más que la excelencia técnica.

Las bases las encuentras aquí. Puedes participar desde ya hasta el 25 de abril de 2018.

Edición realizada por César Tomé López

El artículo El mecanismo de la vida, mejor vídeo de divulgación joven “On zientzia” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fallos científicos en el cine, mejor vídeo de divulgación joven “On zientzia”

- Soy esa bacteria que vive en tu intestino, mejor vídeo de divulgación “On zientzia”

- Keats vs Feynman, mejor vídeo de divulgación “On zientzia”

La tentación de la posesión

Por definición el conocimiento es compartido, ya que el saber que no se transmite es como si no existiera. Esto supone que la ciencia, como conocimiento del universo, es por necesidad de todos los humanos que quieren compartirla: no puede existir un trozo del saber que tenga dueño. Y sin embargo somos humanos y los científicos no son inmunes a la tentación de la posesión: la tendencia a apropiarse y hacer suyo un campo, un conocimiento o una técnica y a considerar un intruso o algo peor a quien pretende inmiscuirse y compartir. Con ser una querencia natural en la Humanidad cuando ocurre en ciencia trae malas consecuencias.

La cosa empieza simple, con el legítimo orgullo de haber encontrado una técnica potente, de haber realizado un importante avance en un campo muy especializado o de haber resuelto un problema especialmente enrevesado, pero pronto se convierte en una cuestión de propiedad: la técnica no puede retocarse, modificarse o aplicarse a otros problemas, el avance en la comprensión de un campo se puede extender a otros, la solución del enrevesado problema es la única solución posible de cualquier otro problema. Quien desea utilizar la técnica o la teoría es considerado un intruso, un advenedizo, alguien que en el fondo desea aprovecharse del trabajo ajeno; sólo el creador inicial se considera con derecho a explotar las consecuencias y derivaciones de sus avances. Así se crean escuelas cerradas de pensamiento compuestas por los discípulos del maestro original que funcionan como verdaderos clubes que tienen reservado el derecho de admisión.

Como consecuencia los avances se ralentizan, los conocimientos tienden a fosilizarse y las disciplinas o subdisciplinas empiezan a ser abandonadas por la gente más brillante, que no quiere quedar atrapada en un campo dominado por una única teoría o hipótesis defendida por una falange de discípulos celosos de cualquier recién llegado. El problema se complica aún más cuando el avance científico depende del acceso a piezas materiales concretas: especímenes particulares, fósiles o datos imposibles de replicar. Se conocen casos de fósiles humanos, por ejemplo, que han pasado años (o décadas) ocultos y sin que la profesión pudiese acceder a ellos porque el descubridor original estaba preparando una descripción inicial que jamás llegaba.

En según qué campos este tipo de ‘secuestro’ de evidencia física es imposible: todas las Arabidopsis thaliana o Drosophila melanogaster tienen los mismos genes, igual que todas las galaxias son analizables desde cualquier telescopio; por eso es mucho más difícil que un laboratorio, gran pope o escuela de seguidores se apropie de una ruta genética o de una teoría cosmológica, aunque tampoco se pueda considerar inimaginable. A veces una teoría, hipótesis o técnica puede ser para el científico que la crea casi como un hijo (intelectual) y generar el mismo tipo de reacciones de posesión y protección que crea un descendiente físico.

Porque no hay sensación más estimulante que comprender un pedacito del misterio que es el cosmos después de años de preguntas y un sinfín de ingeniosos y fallidos intentos de entenderlo; imagine dedicar décadas de su vida a resolver un intrincado rompecabezas sin tener la imagen de la caja y tras años de lento y doloroso avance descubrir la pieza que hace que todo tenga sentido, la clave que permite por fin contemplar el conjunto y entenderlo. Nuestro cableado interno responde ante esto con un subidón difícil de describir, tanto más intenso como que en realidad no hay ninguna garantía de que el esfuerzo y la dedicación vayan a dar resultado: cuando se compra un rompecabezas se sabe que es casi seguro que pueda resolverse, pero cuando se aborda un problema científico cabe la posibilidad de que nunca se alcance la solución. Cuando llega, si es que llega, es casi imposible transmitir la sensación a quien no se dedica a esto.

Y de ahí la tentación de la posesión, tan humana y por ello tan comprensible al mismo tiempo que tan problemática para el avance del conocimiento. Un riesgo real que sólo podría eliminarse si los científicos fuesen robots.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La tentación de la posesión se ha escrito en Cuaderno de Cultura Científica.

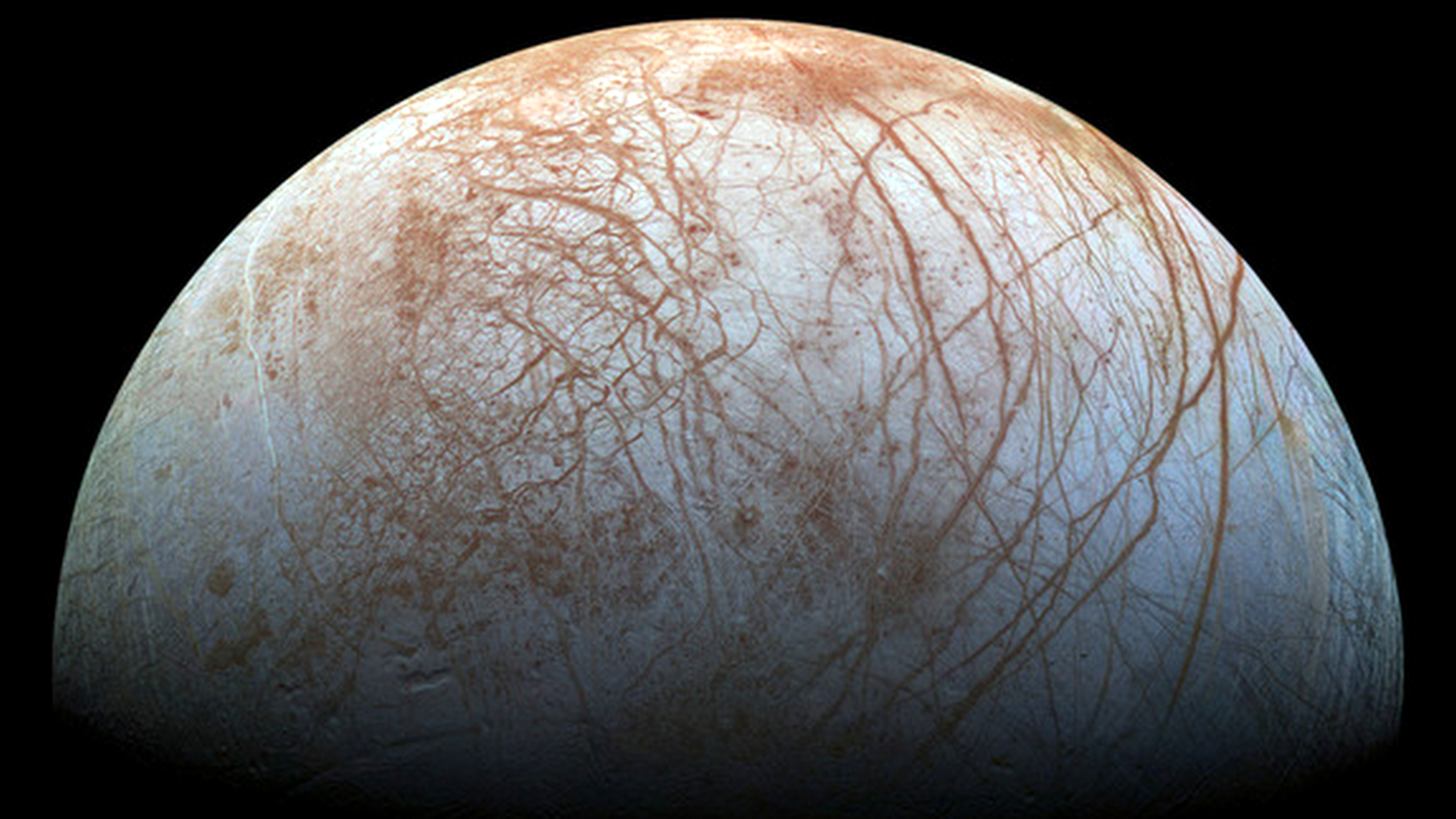

Entradas relacionadas:La presencia de sales podría hacer que exista una tectónica de placas en Europa

La capa helada de la luna de Júpiter, Europa, podría tener placas tectónicas similares a las de la Tierra. La presencia de actividad tectónica de placas podría tener implicaciones importantes para la posibilidad de que exista vida en el océano bajo la superficie de la luna.

El nuevo estudio, realizado por un equipo de investigadores encabezado por Brandon Johnson, de la Universidad Brown (Estados Unidos), usa modelos computacionales para demostrar que la subducción, esto es, el que una placa tectónica se deslice debajo de otra y se hunda profundamente en el interior de un planeta, es físicamente posible en la capa de hielo de Europa. Estos resultados refuerzan estudios anteriores de la geología de superficie de Europa que encontraron regiones donde la capa de hielo de la luna parece expandirse de una manera similar a las dorsales oceánicas de la Tierra. La posibilidad de subducción es otra pista más en el misterio tectónico.

Un aspecto añadido a la posibilidad de subducción que hace de este fenómeno algo especialmente relevante en Europa es que la corteza superficial está enriquecida con oxidantes y otras fuentes de energía química aprovechables por algún tipo de vida. La subducción proporciona un medio para que estos compuestos químicos entren en contacto con el océano líquido que los científicos creen que existe bajo el hielo de Europa.

En la Tierra, la subducción se debe principalmente a las diferencias de temperatura entre una placa descendente y el manto circundante. El material de la corteza es mucho más frío que el material del manto, y por lo tanto más denso. Esa mayor densidad proporciona la flotabilidad negativa necesaria para hundir una placa profundamente en el manto. Aunque estudios geológicos previos ya habían apuntado a que algo como la subducción podría estar sucediendo en Europa, no estaba claro exactamente cómo funcionaría ese proceso en un mundo helado.

El problema es el siguiente: hay pruebas de que la corteza de hielo de Europa tiene dos capas: una fina capa exterior de hielo muy frío que se encuentra sobre una capa de hielo convectivo ligeramente más cálido. Si una placa de la capa de hielo exterior se hunde en el hielo más caliente, su temperatura aumenta rápidamente hasta igualar a la del hielo circundante. En ese momento, la placa tendría la misma densidad del hielo circundante y, por lo tanto, dejaría de descender.

Pero el modelo desarrollado por Johnson y sus colegas presenta una forma en la que la subducción podría ocurrir en Europa, independientemente de las diferencias de temperatura. El modelo señala que, aparte de las posibles diferencias en porosidad, si hubiera cantidades variables de sales en la capa de hielo de la superficie, esto podría proporcionar las diferencias de densidad necesarias para que una placa se subdujera. Las sales la harían más densa y permitirían que se hundiese, independientemente de la temperatura.

La cuestión entonces es, ¿existe algo que nos permita sospechar de que existan esas diferencias en contenido en sales en Europa? La respuesta es sí.

Como si fuera el magma del manto que llega a la superficie a través de un volcán terrestre, dejando todo el territorio con una capa de roca volcánica fértil, ocasionalmente el agua del océano interior de Europa llega a la superfice y dejaría un alto contenido de sal en la corteza, ya que se cree que es salado.

Además de aumentar la probabilidad de un océano habitable en Europa, este estudio también apunta a un nuevo lugar en el sistema solar en el que estudiar un proceso que jugó un papel crucial en la evolución de nuestro propio planeta, la tectónica de placas.

Referencia:

Brandon C. Johnson (2017) Porosity and salt content determine if subduction can occur in Europa’s ice shell Journal of Geophysical Research: Planets doi: 10.1002/2017JE005370

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo La presencia de sales podría hacer que exista una tectónica de placas en Europa se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- De la tectónica de placas

- Ciencia Express: la tectónica de placas

- En Groenlandia el hielo recupera el agua que pierde por sublimación

La magia del teorema de Zeckendorf

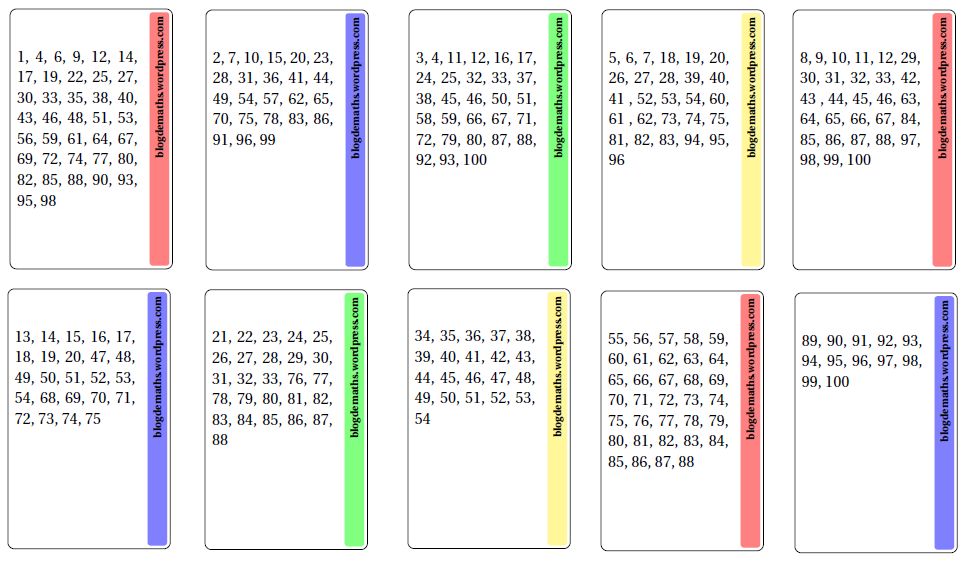

Hace unos años, en Blogdemaths, se presentaba un juego de cartas –de esos de adivinación que tanto desconciertan a la gente– que escondía una bella propiedad matemática. Vamos a explicar el juego.

Dispones de diez ‘cartas mágicas’ que puedes descargar en este enlace.

Ahora puedes ‘lucirte’ delante de un amigo o amiga, siguiendo siguientes pasos:

-

pide a tu colega que elija un número entre 1 y 100,

-

muéstrale cada una de las diez cartas anteriores y pregúntale en cuáles de ellas figura el número elegido,

- y ‘por arte de magia’… ¡aciertas el número!

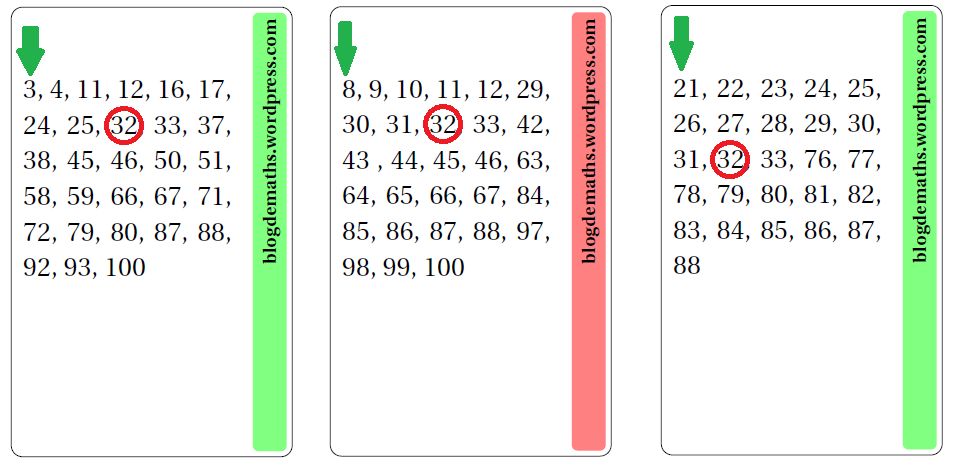

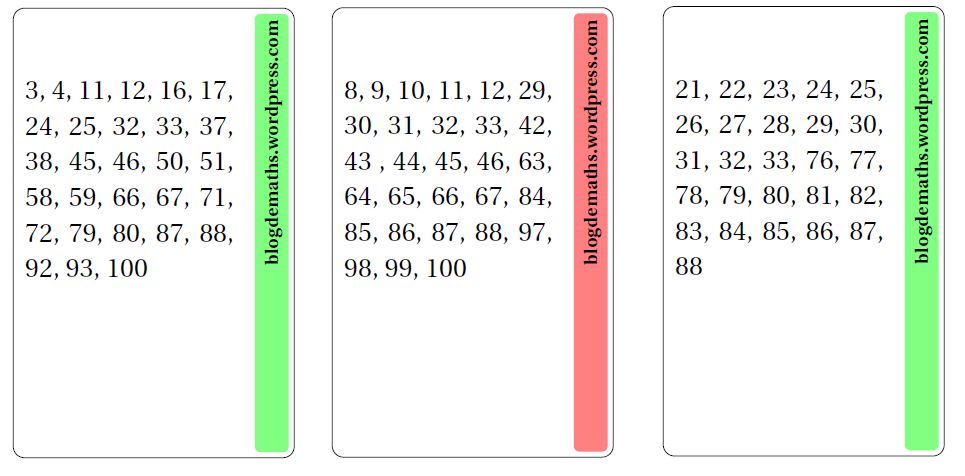

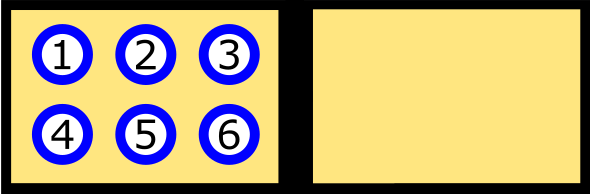

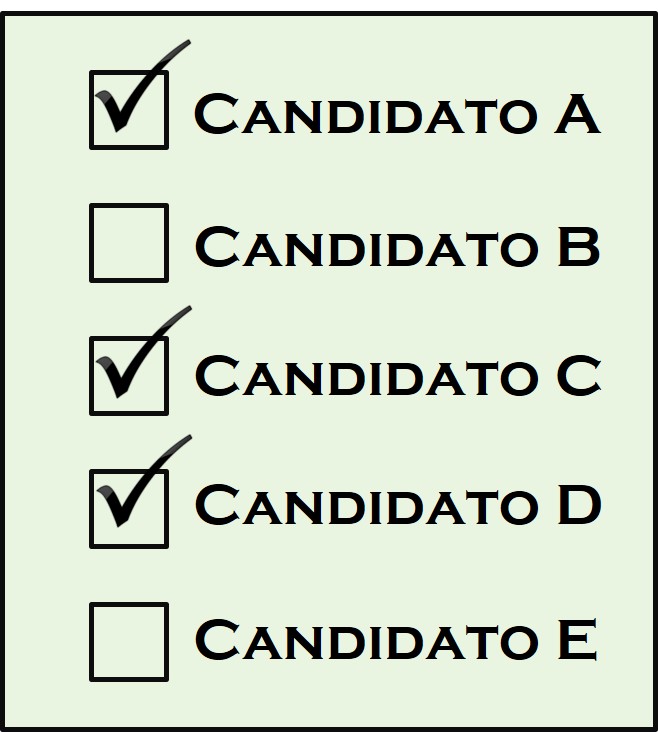

¿Cómo se ‘adivina’ el número? Imaginemos que tu colega ha elegido el número 32. Entre las diez cartas, estas tres son las que contienen el número 32:

Cartas que contienen el número 32.

Ahora basta con sumar los primeros números –los situados arriba y a la izquierda–. En este caso: 3+8+21, que suman ¡32!

Aunque hay que tener un poco de gracia para que el truco luzca –es decir, hay que aparentar que se tienen dotes mágicas–, en realidad todo depende de un teorema matemático, el que da nombre a esta entrada. Y, por supuesto, las cartas están preparadas para que esto suceda. La distribución de los números en estas cartas se basa en el teorema de Zeckendorf –que debe su nombre al matemático Édouard Zeckendorf (1901-1983)– y que afirma lo siguiente (ver la nota final):

Todo entero positivo se escribe, de manera única, como suma de números de Fibonacci no consecutivos. A esa escritura única se le llama la ‘descomposición de Zeckendorf’ del número en cuestión.

Recordar que los números de Fibonacci son los que aparecen en la sucesión de Fibonacci, que comienza con el 0 y el 1, y cada término se obtiene al sumar los dos anteriores (0, 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, 89, 144,…).

¿Cómo se elaboran entonces las diez cartas? Los primeros números de cada una de ellas corresponden a los diez primeros números de la sucesión de Fibonacci –tras haber eliminado los dos primeros términos, el 0 y el 1–:

1, 2, 3, 5, 8, 13, 21, 34, 55 y 89.

Como dice el teorema de Zeckendorf, cualquier número menor que 100 puede escribirse como una suma de estos números –deben ser sólo estos diez, ya que el siguiente número en la sucesión de Fibonacci es el 144–, y de manera única.

Así, cada número entero entre 1 y 100 sólo aparece en una única combinación de cartas, precisamente las que definen la descomposición de Zeckendorf. Por ejemplo, el número 32 es el único número que aparece en las cartas que comienzan por 3, 8 y 21 (ya que 3+8+21=32).

¿Y el resto de los números? Tras haber anotado el primer número de cada carta –1, 2, 3, 5, 8, 13, 21, 34, 55 y 89–, para cualquier número menor que 100, encontramos su descomposición de Zeckendorf –es decir, su expresión como suma de números de Fibonacci no consecutivos, que es única, como ya se ha comentado–, y entonces lo incorporamos en las cartas correspondientes a esos números de Fibonacci.

¿Te apetece probar el truco?

Nota: La descomposición de Zeckendorf

Vamos a calcular la del número 100. Para ello se toma el mayor número de Fibonacci que es menor o igual que 100, que es el 89; se hace la diferencia 100–89=11. El mayor número de Fibonacci que es menor o igual que 11 es 8; se hace la diferencia 11–8=3, que ya es un número de Fibonacci, con lo que la descomposición de Zeckendorf de 100 es: 100=89+8+3.

Es cierto que hay otras descomposiciones de 100 como sumas de números de Fibonacci (por ejemplo, una de ellas es 100=55+34+8+2+1), pero solo la anterior consta de números de Fibonacci no consecutivos. La prueba de este teorema puede hacerse por recurrencia, tanto la existencia como la unicidad de la descomposición.

Referencias

-

Un tour de magie mathématique…, Blogdemaths, 13 enero 2013

-

Marta Macho Stadler, Yo también quiero hacer magia… ¿o son matemáticas?, ZTFNews.org, 13 enero 2103

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo La magia del teorema de Zeckendorf se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La magia de los números (el teorema de Moessner)

- El teorema de Marion (Walter)

- El teorema de los cuatro colores (2): el error de Kempe y la clave de la prueba

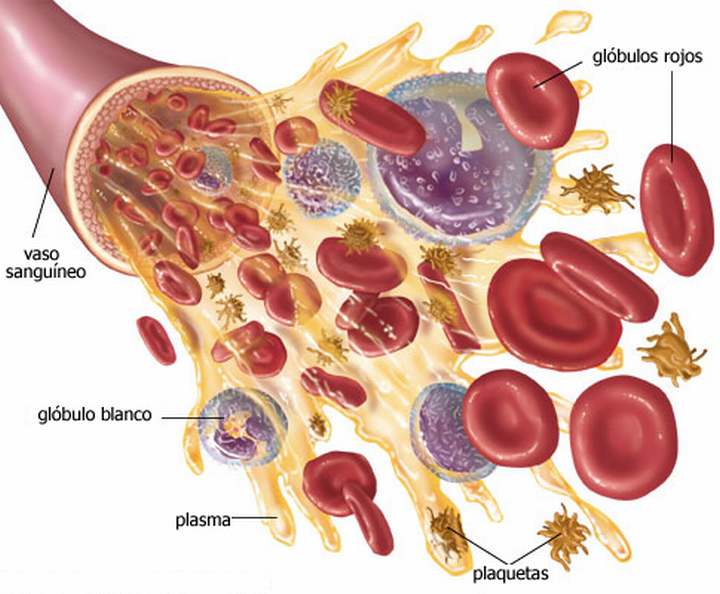

Sistemas circulatorios: células sanguíneas

Además de iones como Na+ o Cl–, gases disueltos como O2 y CO2, y moléculas orgánicas de diferentes tamaños como glucosa o lipoproteínas, en los fluidos de los sistemas circulatorios hay células. En vertebrados hay tres grandes familias: glóbulos rojos (o eritrocitos), glóbulos blancos (o leucocitos) y trombocitos. Y cada una de ellas cumple funciones diferentes.

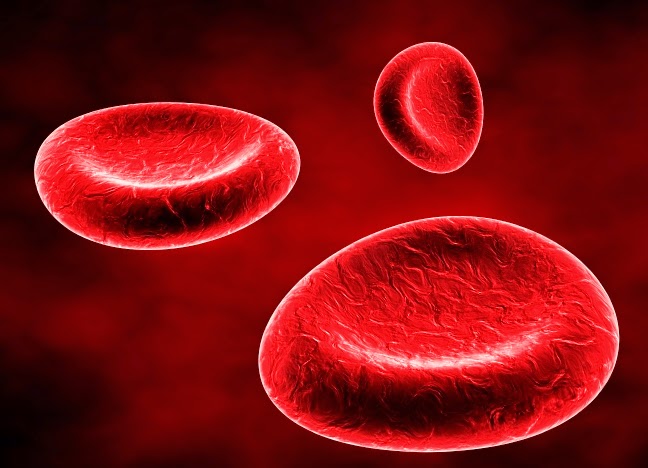

Eritrocitos

Estas son, con diferencia las células más abundantes en la sangre. En un solo mililitro de la de pollo hay tres mil millones, siete mil millones en la de vaca o cerdo, diez mil millones en la de caballo, y trece mil millones en la de cabra. Contienen en su interior hemoglobina, una proteína que se combina con O2 y con CO2 con facilidad y a la que, por ser de color, llamamos pigmento; el color rojo se lo debe al átomo de hierro que contiene. En invertebrados, como veremos en otra ocasión, hay pigmentos diferentes de la hemoglobina, y en unos pocos grupos se encuentran en el interior de corpúsculos en la hemolinfa; su color no tiene por qué ser rojo, pues depende del metal que contiene.

La principal función de estas células es respiratoria: transportan O2 de los órganos respiratorio a los tejidos y CO2 en sentido contrario. En la mayor parte de los vertebrados tienen forma oblonga oval, y los más grandes son los de los reptiles. Los de mamíferos son planos y con forma de disco en el que la parte externa es más gruesa que el centro: parecen donuts sin agujero central. Probablemente esas características facilitan, al aumentar la relación superficie:volumen, la difusión hacia y desde el interior del glóbulo rojo.

Los eritrocitos tienen una membrana muy flexible, por lo que pueden penetrar en capilares cuyo diámetro es inferior al suyo propio. El diámetro de los eritrocitos de mamíferos es de 8 µm, mientras que el de algunos capilares es de 3 µm.

Los eritrocitos de aves tienen un núcleo inactivo y los de mamíferos carecen de núcleo. Quizás por esa razón su vida es muy breve: entre 100 y 110 días los de mamíferos domésticos, y alrededor de un mes los de loros y pollos. Los eritrocitos no funcionales son eliminados por macrófagos, principalmente en el bazo. Este órgano sirve también de almacén. Los caballos, por ejemplo, duplican la concentración de eritrocitos en la sangre cuando empiezan a correr al expulsar, mediante contracciones, los que tiene almacenados en el bazo. Y algo muy similar hacen los mamíferos marinos antes de sumergirse; en estos los eritrocitos cumplen funciones de almacén de oxígeno.

La reposición de los glóbulos rojos se produce, de manera permanente, a partir de tejidos llamados hemopoiéticos. En los peces óseos esa función la cumplen el riñón y el bazo. En mamíferos y aves se producen en la médula de determinados huesos mediante un proceso denominado eritropoiesis. Los seres humanos producimos entre dos y tres millones de glóbulos rojos por segundo. Los eritrocitos proceden de células troncales pluripotentes, cuyas divisiones y diferenciación dan lugar a estas células (y también a leucocitos y trombocitos). Su generación está regulada, de manera que su cantidad se mantiene bastante constante, y en ella participa la hormona eritropoietina. La eritropoiesis se ajusta en respuesta a la pérdida, por hemorragia, de glóbulos rojos, o al transitar a un medio hipóxico.

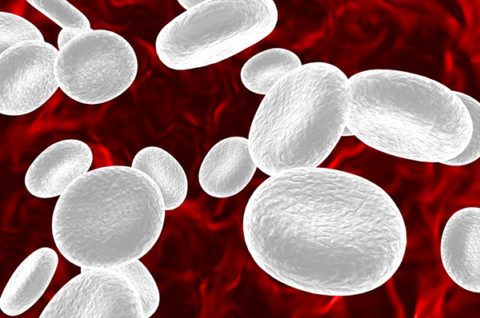

Leucocitos

Los leucocitos son las unidades móviles del sistema de defensa de los vertebrados. Los hay de diferentes tipos y el número o proporción en que se encuentran en la sangre depende del tipo de elemento patógeno al que han de hacer frente. Repasaremos a continuación las clases de leucocitos de los mamíferos, sin entrar en cuestiones propias del campo más específicamente inmunológico.

- Los neutrófilos son células fagocitarias de gran movilidad que incorporan y destruyen materiales indeseados; se los comen, literalmente. A menudo tienen la capacidad de reconocer agentes invasores y destruirlos sin que medie ningún otro elemento.

- Los eosinófilos secretan sustancias que destruyen gusanos parasitarios.

- Los basófilos liberan histamina, que provoca inflamación, y heparina, un anticoagulante. Facilitan así la llegada de sangre a una zona infectada y, con la sangre, otros leucocitos.

- Los monocitos se transforman en macrófagos, que son células fagocitarias de gran tamaño ligadas a tejidos. Una vez han fagocitado y digerido un invasor, despliegan fragmentos del invasor (antígenos) en su superficie, de manera que informa así a los linfocitos del ataque.

- Los linfocitos T citotóxicos destruyen células invadidas por virus o células mutantes sin fagocitarlas; también hay linfocitos T colaboradores, cuya función consiste en activar otras células inmunitarias. Los linfocitos B se transforman en plasmocitos, células que producen anticuerpos e inmunoglobulinas, que son glucoproteínas que reconocen de manera unívoca un antígeno específico y se adhieren a él.

- Las células asesinas naturales o linfocitos grandes son una clase especial de linfocitos que de forma espontánea y relativamente no específica lisan células infectadas con virus y células cancerosas.

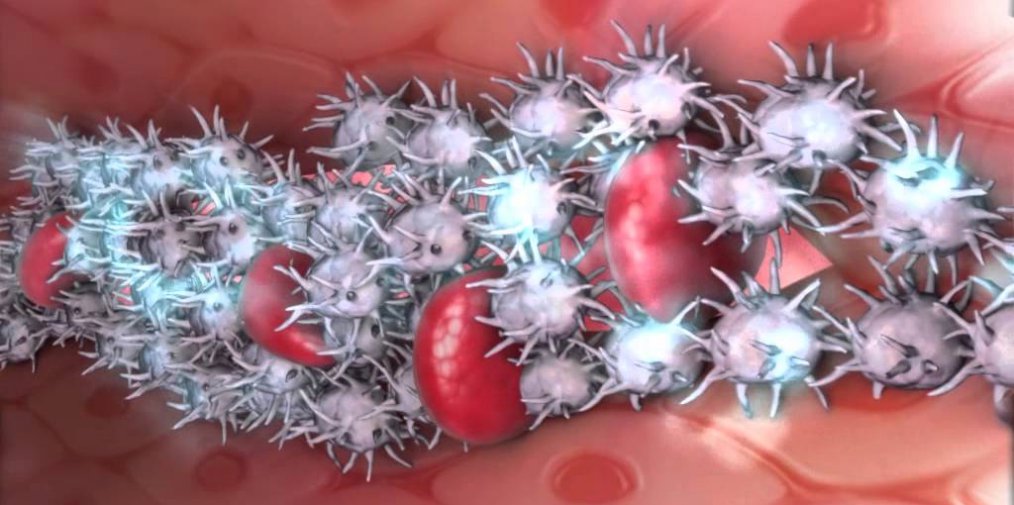

Trombocitos

Los trombocitos son células que se encuentran en la sangre de todos los vertebrados excepto la de mamíferos. Circulan en estado inactivo y se activan cuando en un tejido próximo se produce una herida. En ese momento se empiezan a romper en fragmentos o plaquetas, que son las que intervienen para que la sangre se coagule y se cicatrice la herida producida. En los mamíferos las cosas son algo diferentes, pues las plaquetas no proceden de eritrocitos circulantes, sino de megacariocitos, que son células que se encuentran en la médula ósea.

Los megacariocitos proceden de las misma células troncales que dan lugar a leucocitos y eritrocitos. Son, como su prefijo indica, de gran tamaño: su radio es de unas 30 µm. De la superficie de los megacariocitos se desprenden unas vesículas que se hallan envueltas por membrana celular, y que contienen citoplasma y algunos orgánulos celulares pero carecen de núcleo. Son las plaquetas. Un megacariocito puede llegar a producir unas mil unidades. Al cabo de un periodo que no llega a dos semanas, son retiradas de la circulación por macrófagos y repuestas por nuevas plaquetas. Una hormona, denominada trombopoietina es la responsable de activar el desarrollo de nuevos megacariocitos y de que los ya existentes eleven la producción de nuevas plaquetas. Como ocurre con los eritrocitos, el bazo actúa como almacén, pues una tercera parte de las plaquetas existentes se encuentra en ese órgano. Se liberan a la circulación, en función de las necesidades, mediante contracciones del bazo que son estimuladas por el sistema nervioso simpático.

Las plaquetas se encuentran en estado inactivo en el sistema circulatorio y su activación se produce en respuesta a una hemorragia en un tejido próximo. Como se ha señalado, carecen de núcleo pero contienen orgánulos y sistemas enzimáticos para la síntesis de productos de secreción, que son almacenados en gránulos dispersos por el citosol. Contienen, además, actina y miosina en altas concentraciones, lo que les permite contraerse. Tanto la secreción de sustancias diversas, como la posibilidad de contraerse son funcionalidades importantes para conseguir la hemostasia que es la función que desempeñan estos fragmentos celulares.

En los animales cuyo fluido circulatorio es la hemolinfa también existen sistemas de células que realizan la función de los trombocitos y las plaquetas. En insectos, por ejemplo, las heridas en el exoesqueleto provocan la coagulación de la hemolinfa. Hay en esta un conjunto de células (en una concentración de unos cincuenta millones por mililitro), que son denominados de forma colectiva hemocitos. Los denominados hemocitos hialinos secretan filamentos de proteína cuando se produce una herida. Esos filamentos interactúan con otras proteínas disueltas en la hemolinfa y forman una placa insoluble en el lugar donde se ha producido la herida.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas circulatorios: células sanguíneas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas circulatorios: proteínas plasmáticas

- Sistemas circulatorios: los compartimentos líquidos de los animales

- Sistemas respiratorios: el pulmón de los mamíferos

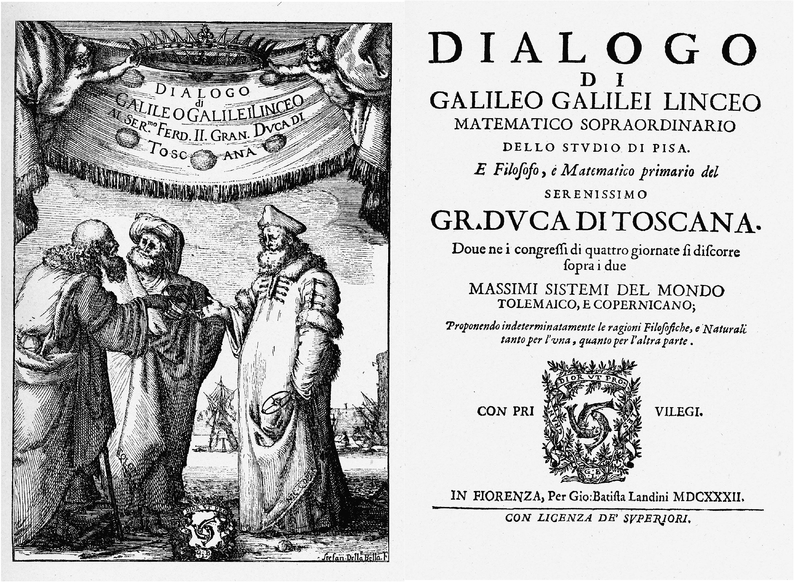

El principio de relatividad (3): la invariancia de Galileo

Experimento de física relativista galileana en Coria del Río (Sevilla, España)

Hemos visto que los experimentos mentales de Galileo con mariposas y pelotas de baloncesto en un barco nos permitían ver que para una persona en un marco de referencia, ya esté éste en reposo o en movimiento uniforme, no hay forma de determinar la velocidad de el marco de referencia en el que está haciendo experimentos mecánicos en ese marco de referencia. Todo lo que ocurre en el marco de referencia ocurre como si estuviese en reposo.

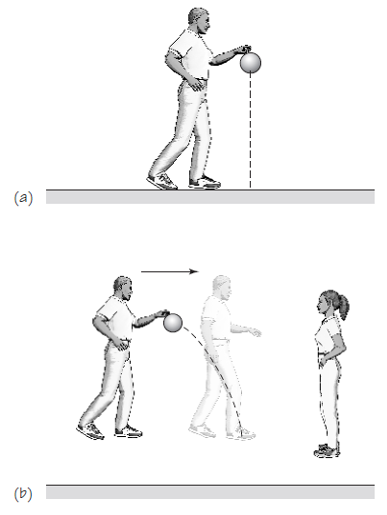

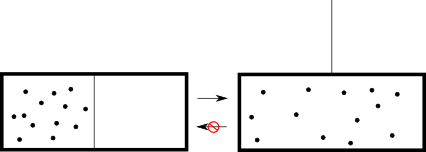

Pero, ¿cómo lo ve alguien fuera del marco de referencia? Supongamos que dejas caer una pelota en un marco móvil. Para ti, montado en el marco móvil, un barco que navega por un río tranquilo, por ejemplo, parece caer directamente al suelo. Pero, ¿cómo ve el movimiento de la pelota alguien que no se mueve contigo? ¿Cómo lo ve tu amiga que está en la orilla del río cuando pasa tu barco? Otra forma equivalente de realizar el experimento es que tu amiga esté quieta mientras tú caminas a velocidad uniforme botando la pelota. ¿Qué ves tú y qué ve ella?

El mismo hecho descrito por dos observadores en marcos de referencia en movimiento relativo uniforme. (a) Desde el marco de la persona que camina botando la pelota. (b) Desde el marco de la persona que la observa desde una posición estática.

Si nos fijamos, en ambos casos tu amiga notará que, desde su punto de vista, la pelota no cae y sube en línea recta. Por el contrario, la pelota sigue la trayectoria parabólica de un proyectil, con una velocidad uniforme en la dirección horizontal (la del barco o la tuya caminando), así como una aceleración uniforme en la dirección vertical.

Este experimento tan simple lleva al sorprendente resultado de que dos personas diferentes en dos marcos de referencia diferentes describen el mismo hecho de dos maneras diferentes. Mientras caminas o pasas navegando, estás en un marco de referencia con respecto al cual la pelota está en reposo antes de ser liberada. Cuando la sueltas, la ves cayendo en línea recta a tu lado y aterriza a tus pies. Pero la persona que te observa, en su propio marco de referencia, dirá que ve algo completamente diferente: una pelota que comienza contigo, no en reposo sino en movimiento uniforme, y al soltarla se mueve, no en línea recta, sino trazando una parábola hacia el suelo, impactando en el suelo a tus pies. Además, esto es exactamente lo que esperaría ver, ya que la bola comenzó moviéndose horizontalmente y luego debe trazar la trayectoria curva de un proyectil que cae por efecto de la gravedad.

Entonces, ¿quién tiene razón? ¿La bola cae directamente hacia abajo o sigue la trayectoria curva de un proyectil? La respuesta de Galileo fue: ambos tenéis razón. ¿Pero cómo puede ser eso? ¿Cómo puede haber dos observaciones diferentes y dos explicaciones diferentes para un mismo hecho físico, una pelota cayendo a los pies de alguien?

La respuesta es que observadores diferentes observan el mismo evento de manera diferente cuando están observando el evento desde diferentes marcos de referencia en movimiento relativo. La bola comienza estacionaria con respecto a un marco (el tuyo), mientras que, hasta su liberación, está en movimiento constante (uniforme) en relación con el otro marco de referencia (el de tu amiga). Ambos observadores ven que todo sucede como cabe esperar de las leyes de Newton aplicadas a su situación [1]. Pero lo que ven es diferente para cada observador. Dado que no existe un marco de referencia absoluto (ningún marco de referencia en velocidad uniforme es mejor o preferible a cualquier otro que se mueva con velocidad uniforme), no hay movimiento absoluto, y las observaciones hechas por ambos observadores son igualmente válidas.

Galileo se dio cuenta de que la persona que está en reposo con respecto a la pelota no puede determinar mediante ningún experimento mecánico que implique pelotas que caen, planos inclinados, etc., si está en reposo o en movimiento uniforme en relación con cualquier otra cosa, ya que todos estos experimentos ocurrirán como si simplemente estuviera en reposo. Una bola que cae desde una torre en la Tierra en movimiento golpeará la base de la torre como si la Tierra estuviera en reposo. Dado que nos movemos con la Tierra, siempre que se pueda considerar que la Tierra se mueve con velocidad uniforme [2], no hay ningún experimento mecánico que nos permita determinar si estamos o no realmente en reposo o en movimiento uniforme.

Notas:

[1] Las observaciones de los acontecimientos dependen de los marcos de referencia pero no así las leyes de la mecánica. Las leyes son las mismas (en otras palabras, son invarientes) en los marcos de referencia que están en movimiento uniforme relativo o en reposo. Todos los objetos que observamos que se mueven con respecto a nosotros siguen las mismas leyes de la mecánica. Por ello, de igual forma que esto se llama principio de relatividad de Galileo, podría llamarse principio de invariancia de Galileo.

[2] Descartamos por despreciable y a efectos del ejemplo el hecho de que durante el breve período de tiempo del experimento la Tierra en realidad gira, lo que es un cambio de dirección y, por tanto, un cambio en la velocidad o, lo que es lo mismo, una aceleración.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El principio de relatividad (3): la invariancia de Galileo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El principio de relatividad (2): la versión de Galileo

- El principio de relatividad (1): movimiento relativo

- La teoría de la invariancia

Historias de la malaria: Paul Müller, el DDT y Rachel Carson

“Sin una parte razonable de suerte, casi ningún descubrimiento se conseguiría. Pero los resultados no se basan completamente en la suerte. El descubrimiento del DDT se hizo durante un trabajo laborioso y, ciertamente, a veces monótono; el verdadero científico es aquel que posee la capacidad de comprender, interpretar y evaluar el significado de lo que a primera vista puede parecer un descubrimiento sin importancia.”

Profesor G. Fischer, del Karolinska Institutet, Estocolmo, en la entrega del Premio Nobel a Paul Müller en 1948.

DDT (1955)

Se llamaba Othmar Zeidler, había nacido en Viena en 1850 y se graduó como químico, aunque dedicó casi toda su vida a regentar una farmacia. El segundo protagonista de esta historia es Paul Hermann Müller, de Olten, en Suiza, nacido en 1899, químico y Premio Nobel de Medicina y Fisiología en 1948. Y nuestra tercera protagonista es Rachel Carson, de Homestead, en Estados Unidos, nacida en 1907, bióloga, especialista en biología marina, interesada por el medio ambiente, escritora y divulgadora. Todos están unidos por una molécula cuyos beneficios y daños a la humanidad y al ambiente todavía, después de siglo y medio de la primera vez que se sintetizó, siguen en debate. Es el dicloro difenil tricloroetano, conocido en todo el planeta como DDT.

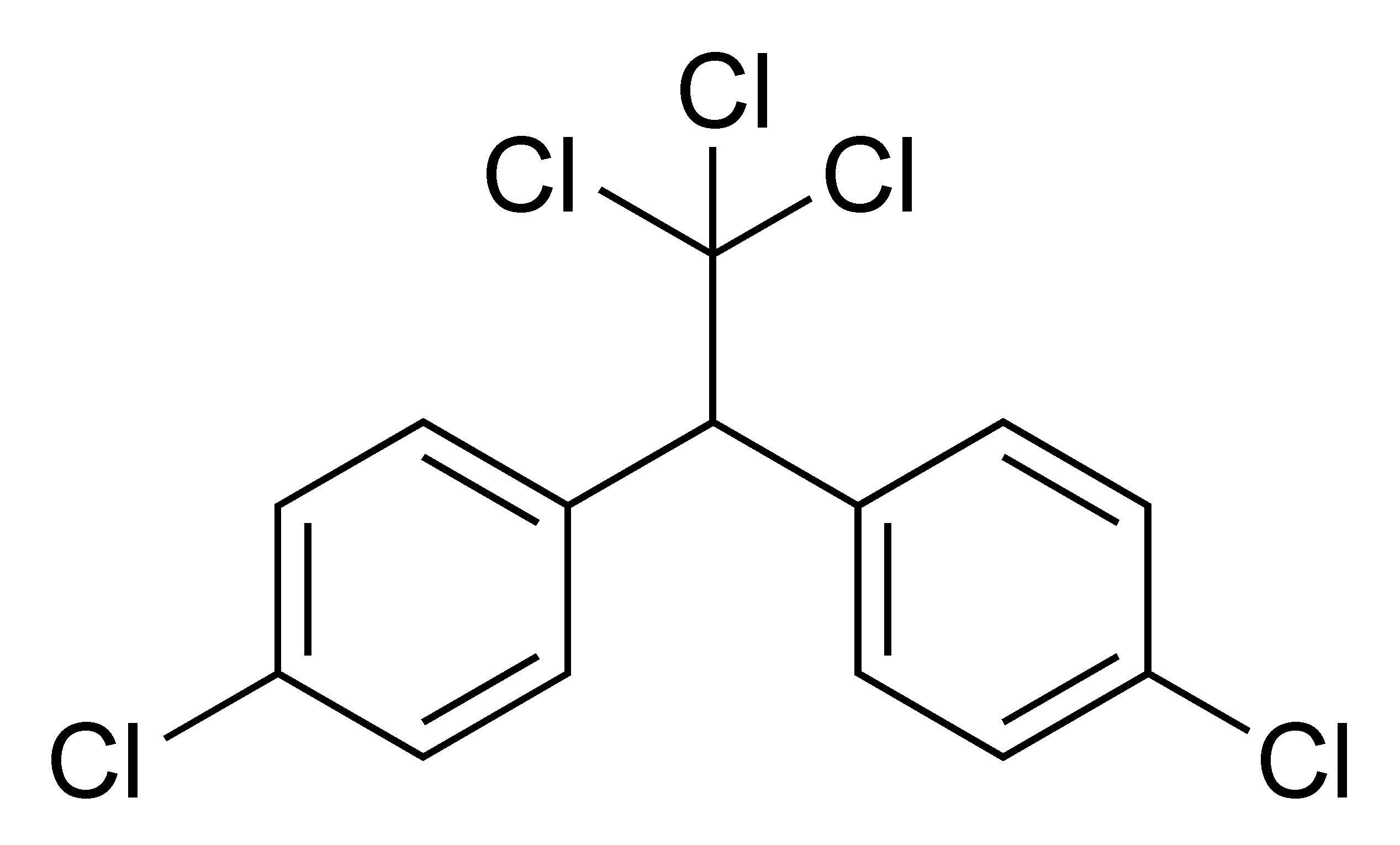

DDT

El primero de nuestros protagonistas tiene un papel corto pero esencial en esta historia. Othmar Zeidler estudió química y entró en el laboratorio de Adolf von Baeyer, en la Universidad de Estrasburgo, entonces en Alemania, y allí sintetizó el DDT en 1874, entre otros compuestos que incluyó en su tesis. El DDT quedó archivado y olvidado. Era, para ser exactos en su nomenclatura química, el 1,1,1-tricloro-2,2-bis(4-clorofenil)-etano, de fórmula (ClC6H4)2CH(CCl3). Es un compuesto soluble en grasas y disolventes orgánicos, casi insoluble en agua, y con 354 de peso molecular.

Zeidler volvió a Austria dos años más tarde, en 1876, y, como su padre, pasó a regentar una farmacia en Viena hasta su muerte en 1911.

Paul Hermann Müller

El segundo protagonista es Paul Hermann Müller, químico suizo que, en 1925, entró a trabajar en la planta de Basilea de la empresa de química y farmacia Geigy. Colaboró en la síntesis de colorantes para la industria textil y, en 1935, investigó y desarrolló protectores de plantas contra las bacterias. Entonces su empresa le asignó como objetivo conseguir productos con capacidad insecticida.

En aquellos años, los insecticidas o eran productos naturales escasos y caros o productos sintéticos poco efectivos. Algunos de los insecticidas más eficaces eran también tóxicos para las personas. Müller estableció como condiciones en su investigación, que luego detalló en su discurso de aceptación del Premio Nobel, que los productos resultantes fueran tóxicos y mataran, es obvio, el mayor número de insectos posible, por contacto y con rapidez, sin causar daños a las plantas o a las personas, no debían ser irritantes, con poco olor o inodoros y nunca con un olor desagradable. Además, debían ser estables y de bajo coste.

Como apuntan Walter Jarman y Karlheinz Ballschmiter, era signo de aquellos tiempos, hace varias décadas, que no se tuvieran en cuenta dos características que serían esenciales en la actualidad: degradación efectiva y no acumulación en el ambiente, y no acumulación en los organismos vivos.

Durante los estudios de Müller, antes y durante la Segunda Guerra Mundial, se produjo una escasez de alimentos en Suiza, en parte provocada por los daños que los insectos provocaban en los cultivos. Además, coincidió con una extensa y mortal epidemia de tifus en la Unión Soviética post revolucionaria. Ambos hechos empujaron a Geigy y, en concreto, a Müller a continuar la búsqueda de un insecticida sintético y eficaz.

Calliphora vomitoria

Müller comenzó a ensayar compuestos del archivo de la empresa y de otras fuentes y a medir su actividad insecticida. Los insectos que utilizaba para probar los compuestos eran moscas, de la especie Calliphora vomitoria, la conocida mosca de la carne. En septiembre de 1939, después de cuatro años y 349 compuestos ensayados, encontró uno que acababa en poco tiempo con sus moscas. Era el dicloro difenil tricloroetano, que pronto se haría popular como DDT.

Puso en una caja cerrada 100 moscas Calliphora y lo fumigó con DDT. Al principio, parecía que el compuesto no provocaba ningún efecto pero, después de una hora, todas las moscas habían muerto. Sacó Müller los cadáveres de la caja, la lavó con agua hirviendo y jabón, introdujo otras 100 moscas y, sin pulverizar más DDT, en una hora murieron todas. Era un producto con gran poder insecticida y, además, persistente.

Era el compuesto que había sintetizado Zeidler más de medio siglo antes y que había quedado olvidado. Probar su actividad como insecticida no había sido en absoluto el objetivo de la investigación del farmacéutico vienés. Pero sí lo era para Paul Müller.

Solo seis meses más tarde, Geigy patentó el DDT en Suiza en 1940, en Gran Bretaña en 1942, y en Estados Unidos y Australia en 1943. Fue en Gran Bretaña y en 1943 donde se empezó a utilizar y popularizar el nombre de DDT. Rápidamente sacó al mercado mezclas, con diferentes nombres comerciales, que contenían DDT en diferentes concentraciones.

El primer ensayo sistemático del DDT en agricultura se hizo en Suiza, en 1941, y contra el escarabajo de la patata. En 1943, en plena Segunda Guerra Mundial, Geigy mandó una muestra a Estados Unidos y el Departamento de Agricultura demostró la eficacia del DDT contra el escarabajo de la patata que era, en aquellos años, uno de los principales y más baratos alimentos. Más tarde se ensayó con el mismo éxito con piojos, pulgas y mosquitos. Se propuso la hipótesis de que enfermedades como la malaria, el tifus o la peste, transmitidas por insectos quizá, por fin, se podrían controlar.

Contra los insectos transmisores de enfermedades la primera campaña se hizo en Argelia, en 1943, contra el tifus. Italianos y alemanes, en Italia y en 1943, fueron los primeros en utilizar el DDT contra los mosquitos del género Anopheles transmisores de la malaria. Por la misma época, las tropas de Estados Unidos comenzaron a fumigar en la islas del Pacífico y otras zonas cercanas, con malaria endémica, para eliminar la malaria y ayudar en la guerra con Japón. Es curioso que entonces se sabía que el ejército de Estados Unidos utilizaba como insecticida un compuesto secreto muy eficaz. Ahora sabemos que era el DDT.

En las décadas entre los cincuenta y los setenta, el DDT ayudó a erradicar la malaria de muchos países, como ocurrió, por ejemplo, en España. Es el principal responsable de la eliminación de las especies de mosquito. del género Anopheles, vector del plasmodio de la malaria. La primera vez que se utilizó a gran escala el DDT contra el mosquito de la malaria fue en 1944, en Italia, contra el Anopheles labranchiae, transmisor de la malaria en las marismas del sur de la península. La campaña la hizo el ejército de Estados Unidos junto a la Fundación Rockefeller. Al sur de Roma abundan las marismas, de nuevo inundadas por el ejército alemán en retirada, y con la malaria como enfermedad endémica

La campaña comenzó en 1944 y 1945 en Castel Volturno, al norte de Nápoles, con gran éxito en la eliminación del mosquito y en la caída del número de enfermos. Un año más tarde, en 1945, se organizó una campaña similar cerca de Roma, en las marismas Pontinas. Terminó con un éxito parecido a la campaña de Nápoles, y el mosquito llegó a desaparecer de los alojamientos de las tropas. Fumigar los edificios era el método más eficaz y, además, justo después de la guerra había todavía minas y explosivos sobre el terreno y era peligroso fumigar a campo abierto.

El primer ensayo a gran escala lo organizó el ejército de Estados Unidos y la Fundación Rockefeller en la isla de Cerdeña entre 1946 y 1951. En 1946 los casos de malaria en la isla eran 75000 y en 1955 quedaban 9 pacientes de malaria.

A principios de los cincuenta, cuando el DDT empezaba su recorrido por el planeta, había 350 millones de enfermos y suponían 3.5 millones de muertes al año. En Europa, el insecticida consiguió eliminar la malaria en el Mediterráneo y, en concreto, además de en España, Italia, Grecia, Israel y Turquía. Por ejemplo, en Sri Lanka, los casos de malaria pasaron de 2800000 en 1948 a 17 en 1963, y para 1968, después de prohibir el DDT, ya había, de nuevo, un millón de enfermos. En la India bajaron de 100 millones a 300000 entre 1935 y 1969. Y en Bangladesh desapareció la enfermedad.

Era el resultado de la aplicación masiva de DDT, lo que entonces se empezó a llamar la dedetización. Para 1965, la malaria había sido erradicada de países que, en conjunto, sumaban 600 millones de habitantes.

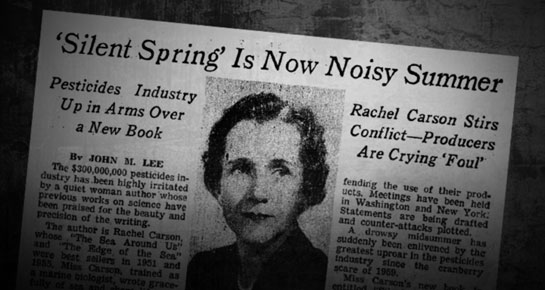

Rachel Carson

Sin embargo, pronto se empezó a sospechar que el DDT había perdido parte de su eficacia por la aparición de resistencias en insectos y, en concreto, en los mosquitos Anopheles trasmisores de la malaria. La primera publicación con un caso de resistencia de un Anopheles al DDT llegó de Grecia. Fue en 1953 aunque Rachel Carson, en su libro Primavera silenciosa menciona que las moscas del Valle Tennessee, en Estados Unidos, ya eran resistentes en 1948. En Grecia, se había detectado la resistencia al insecticida en 1951 en algunas zonas de fumigación en el Peloponeso.

Otro aviso sobre esa resistencia de los mosquitos apareció en 1958 y llegó desde Bombay, en la India, y trataba de la especie Anopheles culicifacies. Esta especie, para 2007, era resistente en 286 distritos de la India.

Para 1987, 57 especies del género Anopheles de 62 países eran resistentes a uno o a varios insecticidas. Volvió a crecer el número de enfermos junto con la resistencia de los mosquitos y la prohibición de su uso en muchos países. En la India había 100000 enfermos en 1965, 2.4 millones en 1974, y entre 50 y 70 millones en 1977. Ese año y en todo el planeta se calculó que había 150 millones de enfermos. De nuevo, la carga que suponía la malaria era uno de los mayores frenos para el crecimiento económico de los países en desarrollo. Además, la prohibición del DDT provocó, en pocos años, la muerte de 50 millones de personas.

Por su contribución al control de varias enfermedades transmitidas por insectos a través del hallazgo del DDT, Paul Müller recibió el Premio Nobel de Medicina y Fisiología en 1948. El texto de la concesión del premio decía que era por “su descubrimiento de la gran eficacia del DDT como veneno de contacto contra los artrópodos” y por “el uso del DDT en la evacuación de campos de concentración, de prisioneros y deportados. Sin ninguna duda… ha salvado la vida y la salud de miles de personas.”

La tercera protagonista de nuestra historia es la bióloga marina Rachel Carson. Trabajó para el Departamento de Pesca del Gobierno de Estados Unidos, a menudo para escribir textos y divulgar aspectos de la vida marina y, en concreto, de las pesquerías. En 1958 se mudó a Maryland por asuntos familiares y allí conoció el uso y los efectos del DDT por su uso en la agricultura. Se utilizaba fumigándolo con avionetas y en cantidades muy grandes, sin ningún control. Aquellos que les guste el cine recordarán la tantas veces repetida escena del ataque de la avioneta fumigadora a Cary Grant en la película de Alfred Hitchcock Con la muerte en los talones, de 1959, uno de los años con más uso del DDT. Podemos pensar que algo así experimentó Rachel Carson en los campos de Maryland.

Comenzó a reunir datos sobre el DDT y sus efectos y a escribir su libro más conocido e influyente, Primavera silenciosa, publicado en 1962. Rastreó el camino del DDT por la cadena alimenticia y demostró que, a medida que se acumulaba, exterminaba o alteraba la genética de muchas especies.

El DDT se convirtió en un símbolo de las interferencias de la especie humana con la naturaleza. Rachel Carson, con su libro, contribuyó a unir esfuerzos y objetivos a favor del ambiente y se le reconoce que ayudó a formar el movimiento ecologista. Para Rachel Carson, la naturaleza no nos pertenece pues nuestra especie es parte de ella aunque, sin duda, la modificamos a nuestra conveniencia.

Fue, por tanto, Rachel Carson, la que comenzó a reunir evidencias de los peligros del DDT aunque nunca propuso eliminar su uso sino, más bien, gestionarlo con precaución y más control que hasta aquellos años. También dio a conocer en su libro la posibilidad, ya con los primeros resultados, de utilizar el control biológico. Así comenzó la polémica, con estudios que demostraban los daños que provocaba y otros estudios no los encontraban. Además, fuertes intereses económicos y grupos de presión intentaban influir en el veredicto definitivo de las autoridades gubernamentales, en concreto, de la Agencia de Protección Ambiental (EPA) de Estados Unidos. Como hipótesis curiosa aparece que, detrás de los estudios que demostraban los peligros del DDT, estaban las empresas fabricantes de insecticidas que intentaban su prohibición para introducir sus propios productos, más caros y cuyas patentes controlaban.

Algunos expertos afirman que el DDT, a corto plazo y en envenenamientos con grandes dosis, puede dañar el sistema nervioso periférico y el hígado y, a largo plazo y con dosis menores, no hay datos que demuestren peligros para la especie humana aunque es carcinógeno para el hígado en ratones.

En el ambiente, el DDT provoca fallos en la reproducción y el desarrollo y la muerte en muchas especies de aves y después de fumigaciones masivas. Además, son sensibles al DDT el fitoplancton marino, los peces y los moluscos bivalvos. Es muy persistente y se transporta a grandes distancias en la atmósfera y, por ello, se encuentra, por ejemplo, en el Ártico.

No hay que olvidar, como hizo notar Paul Müller en su discurso de aceptación del Premio Nobel, que la acción del DDT en el envenenamiento de insectos está lejos de ser explicada con precisión. Sin embargo, era fácil sospechar que, si provocaba tanto daño en los insectos, se podía deducir que podían provocar parecidos daños al resto de seres vivos.

En Estados Unidos, después de grandes presiones de expertos y de ciudadanos en general, después del éxito del libro de Rachel Carson, en 1969 se prohibió el uso del DDT en el control de plagas agrícolas y para 1972 se prohibió su uso al aire libre. En muchos países ni siquiera se prohibió pero no se podía utilizar pues los países ricos y las instituciones no daban fondos a muchos proyectos de erradicación de la malaria simplemente porque utilizaban DDT. Daba mala imagen al donador de los fondos.

Era el DDT el protagonista de una historia que, entre 1945 y 1972, pasó de héroe a villano. Ilustra el cambio en los valores, en la ciencia y en la política y la sociedad, con la llegada del ecologismo, del cuidado del ambiente en el que la especie humana vive, del que forma parte y en el que influye y cambia.

Fue en mayo de 2001 cuando se firmó la Convención de Estocolmo sobre Contaminantes Orgánicos Persistentes que prohibía el uso de nueve grupos de productos químicos, sobre todo los organoclorados y, entre ellos, el DDT. Pero, unos años más tarde, el 15 de septiembre de 2006, la Organización Mundial de la Salud anunció que el DDT se podía usar de nuevo para erradicar la malaria con fumigaciones exclusivamente en el interior de las viviendas, método muy efectivo contra los mosquitos y no peligroso para el ambiente. Para muchos expertos es muy útil en la lucha contra esta enfermedad pues ahuyenta a los mosquitos antes de que piquen e impide su entrada en las viviendas. Además, dura dos veces más que otros insecticidas y es cuatro veces más barato. En situaciones concretas de salud pública, el DDT sigue siendo la elección más eficaz, sobre todo en África y en otras regiones tropicales con malaria endémica.

Como escribe George Davidson, de la Escuela de Higiene y Medicina Tropical de Londres, no es fácil decidir sobre el uso o la prohibición del DDT, un insecticida del que no hay evidencias claras de que haya matado a nadie y, sin embargo, hay muchas pruebas de que ha salvado miles de vidas. Según la ficha del DDT del Instituto Nacional de Seguridad e Higiene en el Trabajo, es “posiblemente carcinógeno para los seres humanos” y “la experimentación animal muestra que esta sustancia posiblemente cause efectos tóxicos en la reproducción humana”. Sobre su acción en el ambiente, la ficha dice que “la sustancia es muy tóxica para los organismos acuáticos. Esta sustancia puede ser peligrosa para el ambiente; debería prestarse atención especial a las aves. En la cadena alimentaria referida a los seres humanos tiene lugar bioacumulación, concretamente en la leche y organismos acuáticos. Se aconseja firmemente impedir que el producto químico se incorpore al ambiente”. Me vale como diagnóstico final.

Referencias:

Angulo, E. 2014. El caso de Rachel Carson. Cuaderno de Cultura Científica. 14 abril.

Bouwman, H. et al. DDT: fifty years since Silent Spring. European Environmental Agency. P: 240-259.

Brown, P.J. 1997. Malaria, miseria, and underpopulation in Sardinia: The “Malaria Blocks Development” cultural model. Medical Anthropology 17: 239-254.

Dash, A. et al. 2007. The biology and control of malaria vectors in India. Current Science 92: 1571-1578.

Dash, A.P. et al. 2007. Resurrection of DDT: A critical appraisal. Journal of Medical Research 126: 1-3.

Davidson, G. 1982. Who doesn’t want to eradicate malaria. New Scientist 96: 731-736.

Earle, D.P. 1979. A history of malaria and its ironies. Transactions of the American Clinical and Climatological Association 90: 1-26.

Edwards, J.G. 2004. DDT: A case study in scientific fraud. Journal of American Physicians and Surgeons 9: 83-88.

Franco, S. 1985. La apoteosis del DDT y el problema de la erradicación del paludismo en América latina. Nueva Antropología 7, 28: 129-152.

Hayes, W.J. 1955. Present status of our knowledge of DDT intoxication. American Journal of Public Health 45: 478-485.

Jarman, W.H. & K. Ballschmiter. 2012. From coal to DDT: the history of the development of the pesticide DDT from synthetic dyes till Silent Spring. Endeavour 36: 131-142.

Müller, P.H. 1948 (1964). Nobel Lectures in Physiology or Medicine 1942-1962. Nobel Foundation-Elsevier. Amsterdam. P. 221-239.

Panosian, C. 2006. Prevención y tratamiento de la malaria. Investigación y Ciencia febrero: 6-13.

Perkins, J.H. 1978. Reshaping technology in wartime: The effct of military goals in entomological research and insecto-control practices. Technology and Culture 19: 169-186.

Russell, E.P., II. 1999. The strange career of DDT. Experts, federal capacity, and environmentalism in World War II. Technology and Culture 40: 770-796.

Shah, S. 2010. The fever. How malaria has ruled humankind for 500000 years. Picador. New York. 309 pp.

Sharma, V.P. 2003. DDT: The fallen angel. Current Science 85: 1532-1537.

Shore, B. 2010. The imaginations of unreasonable men: inspiration, visión, and purpose in the quest to end malaria. Public Affairs. New York. 392 pp.

Snowden, F.M. 2006. The conquest of malaria: Italy, 1900-1962. Yale University Press. New Haven & London. 296 pp.

Stapleton, D.H. 2009. Historical perspectives on malaria: The Rockefeller Antimalaria Strategy in the 20th century. Mount Sinai Journal of Medicine 76: 468-473.

Tren, R. & R. Bate. 2001. Malaria and DDT story. The Institute of EConomic Affairs. London. 107 pp.

Wadhwa, V. et al. The history and progression of Malaria: A global and regional view. Advances in Asian Human-Environmental research DOI: 10.1007/978-90-481-3358-1_1

Wikipedia. 2017. Paul Hermann Müller. 14 June.

Yang, J. et al. 2017. Abuse of Rachel Carson and misuse of DDT science in the service of environmental deregulation. Angewandte Chemie International Edition 56: 10026-10032.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Historias de la malaria: Paul Müller, el DDT y Rachel Carson se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historias de la malaria: El mosquito

- Historias de la malaria: El charlatán y caballero Sir Robert Talbor

- Historias de la malaria: Charles Louis Alphonse Laveran y el protozoo

Adiós al yeti: las desventuras y tribulaciones de un criptozoólogo

Así imaginó Disney al Yeti (Fotograma de Monstruos S.A.)

Por si no se habían enterado, recientemente nos hemos quedado sin Yeti. Ocurrió la semana pasada cuando investigadores de la Universidad de Búfalo publicaron un estudio en el que habían analizado el ADN de muestras del supuesto Yeti dispersas por todo el mundo en museos y colecciones privadas: pelos, piel, dientes, huesos y hasta restos de excrementos recogidos en el Himalaya y el Tibet y que durante décadas se ha creído que pertenecían a la misteriosa criatura, un animal sin terminar de identificar, quizá medio hombre medio oso…

Bien, pues resulta que no es medio nada. Es un oso. U ocho osos diferentes, vaya. Pero ese es el animal al que pertenecen esas muestras. Todas excepto una, que resultó ser de un perro.

Supuesto cuero cabelludo de un yeti, en el monasterio Khumjung, en Nepal (Wikipedia)

Nuestro gozo en un pozo porque a la vez que nuestro lado racional nos dice que las probabilidades de que realmente existiese el Yeti tal y cómo lo describen las leyendas locales tibetanas y como ha pasado al imaginario global eran realmente pequeñas, esa parte de nosotros que se queda fascinada con los cuentos de criaturas imposibles y las películas de monstruos sufre una pequeña decepción cada vez que un científico, con su método empírico y sus evidencias, decide poner fin a una de esas pequeñas parcelas de misterio que aún nos quedan por resolver.

La pseudociencia de la criptozoología

Adiós al Yeti, pues, decíamos, que se suma a la cola de misterios resueltos para chasco de muchos. Y ya van quedando menos en la lista de los no resueltos, aunque alguno hay. Y aunque pocos han oído hablar de ella, son el material de estudio de su propia disciplina científica. O, más bien, pseudocientífica. Es la criptozoología.

La criptozoología se postula como el estudio científico de los animales y criaturas de cuya existencia no existen pruebas científicas, lo cual ya es un poco contradictorio. El Yeti, el monstruo del lago Ness, el chupacabras, los vampiros, el kraken, el leviatán o las sirenas son algunos de sus sujetos de estudio más conocidos.

Monstruo del lago Ness de Heikenwaelder Hugo (Wikipedia)

Los autodenominados criptozoólogos tratan de determinar y defienden la existencia de estos seres muchas veces conjeturados a partir de restos fósiles de animales extintos y otras veces a partir de leyendas, el folclore y la cultura local de distintas regiones del mundo. Aunque en general han recibido poca atención de la comunidad científica y se considera más bien un fenómeno cultural similar al fenómeno ovni, ellos defienden sus investigaciones y actividades basándose en algunos descubrimientos sorprendentes que ha hecho la zoología en los últimos siglos, como el calamar gigante (que habría dado pie a la leyenda del kraken) o el celacanto (un pez que se creía extinto desde hacía miles de años y que se descubrió vivo 1998).

Algunas obras fundacionales dieron luz a esta pseudodisciplina. En 1892, Andhonid Cornelis Oudemans publicaba La gran serpiente marina, que tuvo una gran. Entre 1941 y 1948, Willy Ley, escrito y científico, publicó The Lungfish, the Dodo and the Unicorn, que fue traducido a muchos idiomas, incluido al español varios años después.

Portada de ‘The Lungfish, the Dodo and the Unicorn’

Pero se considera a Bernard Heuvelmans, zoólogo, el creador del término criptozoología, y también de su descripción: “el estudio de los animales sobre cuya existencia solo poseemos evidencia circunstancial y testimonial, o bien evidencia material considerada insuficiente por la mayoría”. En 1955 publicó Tras la pista de animales desconocidos, considerado por muchos como la base de esta disciplina.

Según el autor, la criptozoología es una disciplina que debe ser ejercida con rigor científico, pero a su vez debe ser vista con una actitud abierta e interdisciplinaria, saliéndose del encorsetado método científico, digamos, tradicional. Además, es importante prestar atención y dedicar tiempo a estudiar las tradiciones y creencias populares, ya que, aunque suelen estar mezcladas con elementos fantásticos, pueden contener parte de verdad que ayude a guiar la investigación sobre estos animales aun desconocidos.

Para defender estos principios y proseguir estas investigaciones existen en el mundo numerosas asociaciones de criptozoólogos. La más conocida es la International Society of Cryptozoology, que estuvo en marcha hasta 2005, cuando desapareció por motivos económicos. El símbolo de la ISC era un okapi, un animal conocido por los pigmeos pero ignorado por los científicos hasta su descubrimiento oficial en 1901.

Símbolo de la International Society of Cryptozoology.

Por qué la criptozoología no puede ser una ciencia

A pesar de sus aspiraciones científicas, la criptozoología choca frontalmente con los principios científicos básicos continuamente. Un ejemplo es su negativa a aceptar que una hipótesis debe ser descartada cuando no se cumplan sus predicciones, porque los criptozoólogos parecen inasequibles al desaliento.

Numerosas pruebas en los últimos años han descartado, entre otros, la existencia de Nessie, el monstruo del lago Ness: imágenes por satélite, escáneres del fondo del lago… Igual que ahora con el Yeti y como ha ocurrido antes con otras , todas las supuestas pruebas de su existencia han sido rebatidas, pero esos resultados han sido ignorados y esas criaturas siguen en la lista de animales a descubrir.

Esta imagen captada por satélite es considerada por los criptozoólogos una prueba de la existencia del monstruo del lago Ness. Pruebas posteriores demostraron que un barco generaba esas estelas sobre el agua.

Otra contradicción con la que chocan a menudo los criptozoólogos tiene que ver con los principios básicos de la biología y la genética: que la existencia indefinida de un solo individuo es naturalmente imposible, y que hace falta una población mínima de ejemplares para que existan posibilidades de reproducción viable dentro de una especie. Eso quiere decir que, de existir Nessie o el Yeti, no existiría solo uno, sino unos cuantos, lo cual aumentaría lógicamente las probabilidades de un avistamiento fiable y con ello del descubrimiento oficial que reconociese científicamente su existencia. Y eso, hasta ahora, no ha ocurrido.

Por último, hay que reconocer que los criptozoólogos juegan en cierta desventaja. A menudo se señala como prueba en contra de su especialidad que la criptozoología nunca ha descubierto ni un solo ejemplar de las criaturas que estudia, mientras que los zoólogos descubren decenas de nuevas especies cada año.

Según estos estudiosos, se trata de una afirmación ignorante o hecha con mala fe. Después de todo, argumentan, la criptozoología es la única disciplina cuyos éxitos, en vez de aumentar su campo de estudio, lo disminuyen: si una criatura es descubierta y estudiada, saldrá de la criptozoología para entrar en la zoología.

No es el caso con el último estudio sobre el yeti, ya que no estamos hablando del descubrimiento de una nueva especie, pero existen otros ejemplos, como el del calamar gigante, que los criptozoólogos identifican con el kraken de las leyendas marinas.

Por todos estos motivos, la criptozoología es considerada por la mayoría una disciplina pseudocientífica. Como dirían aquellos que no deben ser nombrados: que estudien lo que quieran, pero que no lo llamen ciencia.

Referencia:

Lindqvist, Charlotte; Lan, Tianying; Gill, Stephanie; Bellemain, Eva; Bischof, Richard; Ali Nawaz, Muhammad (29 de Noviembre 2017). «Evolutionary history of enigmatic bears in the Tibetan Plateau–Himalaya region and the identity of the yeti». Proceedings of The Royal Society B. doi:10.1098/rspb.2017.1804.

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Adiós al yeti: las desventuras y tribulaciones de un criptozoólogo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Adiós a las microesferas de plástico en los cosméticos

- La menopausia… ¿para qué sirve? Seguimos sin respuesta

- Antes de que el león se hiciese con el trono de rey de la selva

No duermas, hay leones

Valoramos mucho el sueño continuo y prolongado. Los especialistas recomiendan dormir unas ocho horas o, si se trata de infantes, más incluso. Sin embargo, muchas personas son insomnes; tienen problemas para conciliar el sueño, despiertan en más de una ocasión durante la noche o lo hacen demasiado pronto. El insomnio tiene efectos adversos sobre diferentes facetas de la vida cotidiana: genera problemas de atención, provoca falta de concentración y somnolencia, aumenta la probabilidad de sufrir accidentes, y puede desencadenar la aparición de trastornos mentales, entre otros. Por esa razón los problemas de sueño han recibido atención científica y médica, y se ha desarrollado toda una batería de fármacos para tratarlos. El insomnio ha llegado a ser considerado un problema de salud pública por parte de algunos especialistas. Y sin embargo, no en todas partes se toman el sueño de la misma forma.

“No duermas, hay serpientes” es el título de un libro del lingüista Daniel Everett en el que cuenta sus experiencias y lo que ha aprendido tras varias décadas conviviendo con pirahas, un grupo humano que vive en una de las zonas más recónditas de la Amazonia brasileña. El título es el saludo con el que los pirahas se desean las buenas noches y hace mención a uno de los aspectos más llamativos de la vida en la selva: en todo momento había personas despiertas en el poblado. Fuese cual fuese la hora del día o de la noche, se oían conversaciones aquí o allá. Los piraha alternaban periodos de sueño y de vigilia durante la noche, y justificaban ese comportamiento por la necesidad de estar alerta ante el riesgo, muy real, de ser atacados por animales peligrosos, como anfibios y reptiles venenosos o, también, grandes depredadores, como panteras o anacondas.

Hace cincuenta años, el psicólogo Frederick Snyder propuso que los animales que viven en grupos se mantienen vigilantes durante la noche debido a que no todos los miembros del grupo duermen con el mismo horario. En términos más técnicos se diría que unos y otros miembros del grupo tienen diferentes cronotipos. Y lo cierto es que los horarios de sueño tienden a cambiar con el paso del tiempo. Los jóvenes suelen permanecer despiertos hasta tarde, mientras que los más mayores tienden a despertar muy pronto.

David Samson y colaboradores se propusieron contrastar la hipótesis de Snyder y estudiaron para ello un grupo de cazadores-recolectores Hadza, del norte de Tanzania. Cada grupo está formado por unos treinta adultos, y cada unidad familiar pasa la noche en una choza. Convencieron a 33 adultos pertenecientes a dos poblados próximos para que se pusieran sensores de movimiento de forma permanente. Y comprobaron que durante prácticamente todo el tiempo –el 99,8% del tiempo de sueño muestreado- al menos un individuo se encontraba despierto o durmiendo de forma ligera, y que una media de ocho adultos se encontraban despiertos en cualquier momento de la noche. Eso era debido, casi en su totalidad, a la estructura de edad de los grupos y al hecho de que el cronotipo varía con la edad.

Los autores del trabajo sostienen que la existencia, ligada a las diferencias de edad, de diferentes cronotipos en un mismo grupo humano favorece un comportamiento nocturno “de tipo centinela” (así se denomina) y ha podido cumplir un papel importante en las sociedades de cazadores-recolectores de zonas con peligrosos depredadores. Sugieren, por ello, que la tendencia a trasnochar de los jóvenes y los despertares tempranos de los mayores han podido proteger a nuestros antepasados de perecer en las fauces de algún gran felino africano durante parte importante de nuestro pasado.

Fuente: Samson et al (2017) Chronotype variation drives night-time sentinel-like behaviour in hunter-gatherers Proceedings of the Royal Society B

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 30 de julio de 2017.

El artículo No duermas, hay leones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Naukas Pro 2017: Amaia Zurutuza y el grafeno

El pasado 14 de septiembre de 2017 se celebró la primera edición de Naukas Pro, en el que Centros de Investigación, Laboratorios, científicos de renombre o equipos de trabajo contaron con 20 minutos para explicar a un público general en qué consiste su trabajo.

9ª conferencia: Amaia Zurutuza, directora científica de Graphenea

Amaia Zurutuza ha explicado al detalle lo que es el grafenoEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2017: Amaia Zurutuza y el grafeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro 2017: Leni Bascones y los superconductores

- Naukas Pro 2017: Lourdes Basabe y los microlaboratorios

- Naukas Pro 2017: Julián Estévez y la inteligencia computacional

Adolescencia, sexismo y publicidad

La mayoría de estudiantes de cuarto de ESO del País Vasco que participaron en un estudio sobre la percepción del sexismo en la publicidad se mostró insensible ante el uso sexista y el trato degradante de las mujeres. Así mismo, este colectivo asume muchos de los estereotipos femeninos publicitarios y de prejuicios propios de hace 40 años. El investigador Pablo Vidal ha analizado la respuesta de 528 estudiantes (266 chicos y 261 chicas, de entre 15 y 16 años) de ocho Institutos de Educación Secundaria de la Comunidad Autónoma Vasca al exponerles a siete anuncios con un marcado contenido sexista.

El trabajo de investigación analiza la influencia del sexismo presente en la publicidad en la adolescencia, una línea de investigación poco explorada y que persigue estudiar la imagen de las mujeres desde la perspectiva de las audiencias. En concreto, Pablo Vidal se centra en la perspectiva de género al estudiar el discurso publicitario “pues la imagen de las mujeres que proyecta la mayoría de los anuncios evidencia una clara tendenciosidad al ocultar los avances en igualdad logrados y no reflejar los nuevos roles que las mujeres desempeñan en la sociedad actual”.

En ese sentido, la mayoría de jóvenes adolescentes que ha participado en la investigación se ha mostrado incapaz o ha tenido muchas dificultades para percibir lo que es sexismo en publicidad. Solo un 34 % del alumnado (mayoritariamente femenino: 65% alumnas y 35% alumnos) ha demostrado tener esa capacidad, el resto lo confunde o no lo tiene claro. Ello es así porque considera que el sexismo es algo del pasado y no propio de una sociedad que consideran igualitaria, al tiempo que desconoce la manipulación y efectividad del lenguaje publicitario. “Lo que se ve en publicidad también ocurre en la realidad. La publicidad es así”, señalan en sus respuestas.

En palabras de Vidal, “la publicidad facilita que los estereotipos de género, roles de mujeres ya superados e imágenes simbólicas se asuman en la adolescencia como realidad de cómo son los hombres y las mujeres; y ha conseguido que los conceptos de masculinidad y feminidad, vivos hace 40 años, vuelvan a resurgir”.

El sexismo de baja y media intensidad

Para realizar la investigación se han diseñado dos cuestionarios ad hoc (uno de preguntas abiertas y otro de cerradas) y cuatro sesiones de grupos de discusión focalizados y se han utilizado siete anuncios de las marcas Lynx, Natan, Calvin Klein, Gucci, Axe, Cesare Paciotti y Ché Magazine. En cuanto a los análisis de los resultados se han tenido en cuenta las siguientes variables: sexo, ámbito residencial y país de origen.

En sus conclusiones, el investigador destaca que existen grandes diferencias entre alumnas y alumnos respecto a la aceptación del sexismo. “Lo que para una mayoría de chicos es permisible, normal y justificable, para muchas chicas es rechazable, inadecuado o machista. La aceptación del sexismo es algo natural en un 70% de los chicos y en un 30% de las chicas que conciben como habitual y propio de la sociedad que se presenten a las mujeres de forma sexista”.

Percibir el sexismo y distinguir su intensidad en la publicidad tampoco es sencillo para el alumnado adolescente. Una gran mayoría aceptó comportamientos claramente desiguales en anuncios que presentaban un sexismo de baja intensidad. Es decir, cuando las relaciones desiguales no son ofensivas o agresivas de manera explícita, el alumnado las acepta, no las considera sexistas, porque las admite como parte de nuestra realidad social legitimando los micromachismos. Y en todo caso, se entiende que esas proyecciones machistas no son para tanto, pues se consideran en clave humor, como una broma o una exageración graciosa.