Felinos líquidos

Cuando se estudia el movimiento de un cuerpo y sus reacciones ante la presencia de fuerzas se suele partir del supuesto de que tratamos con un objeto rígido. El motivo es que las fuerzas suelen hacer dos cosas: o aceleran los cuerpos o los deforman. En el primer caso aplicamos la segunda ley de Newton para el movimiento y ya está; en el segundo caso tenemos que estudiarlo como un material deformable, y si tiende a adoptar la forma del contenedor en que se encuentra lo llamamos fluido.

La física de fluidos se aplica a líquidos y gases, pero también a otros sistemas que en principio no consideramos que fluyen. Una carretera llena de vehículos es un sistema que podemos tratar cono un material fluido: nos permite hablar de velocidad media y densidad, estudiar el efecto de un estrechamiento o un ensanchamiento, variar el flujo de coches cambiando la velocidad.

¿Nunca se han preguntado por qué la zona de pago de una autopista de peaje es tan ancha? Estamos tan tranquilos conduciendo en un sistema de dos carriles y zas, de repente se convierten en seis u ocho. Esto puede explicarse mediante la ecuación de continuidad, una relación basada en que lo que entra por un lado tiene que salir por el otro; cuando la explico en clase suelo llamarla “el principio de José Mota” por aquello de las gallinas que entran por las que van saliendo. La ecuación de continuidad nos dice que el producto de la sección de la tubería (en este caso la autopista) por la densidad del fluido y su velocidad es constante: Aρv=cte. Para pagar el peaje tenemos que disminuir nuestra velocidad, así que una de dos: o aumentamos la sección o la densidad de vehículos aumenta (aumenta ρ) y tenemos un embotellamiento entre manos.

Aplicar las leyes de la mecánica de fluidos a sistemas como humanos o animales es arriesgado porque los seres vivos tienen tendencia a decidir por su cuenta, de modo que su comportamiento puede diferir del seguido por un sistema de objetos inertes. En los accidentes de autovía tenemos un ejemplo típico. Cuando se cierra uno de los carriles (por causa de obras o de accidente), la única posibilidad de que no se forme un tapón es aumentar la velocidad del fluido, es decir de los coches, pero eso es precisamente lo que nunca hacemos. No sólo nos arriesgamos a una multa sino que una zona de accidentes es el último lugar donde deberíamos conducir a alta velocidad, así que disminuimos la velocidad y el resultado es un aumento en la densidad del tráfico. Una molestia menor comparada con las posibles consecuencias, y en cualquier caso un efecto que la Guardia Civil de Tráfico puede y debe tener en cuenta.

La física de fluidos macroscópica se ha aplicado desde hace miles de años. Los constructores de las instalaciones recreativas donde entra y sale gran cantidad de personas han de tenerla en cuenta, como hicieron los antiguos romanos al diseñar el Coliseo. Aun cuando no conocieran la formulación de la ecuación de continuidad, sus vomitoria permitían la evacuación de miles de personas en pocos minutos. Cualquier experto en gestión de masas sabe lo peligroso que resulta dejar pasar grandes cantidades de personas por estrechamientos, como lo demostró el caso Madrid Arena hace algunos años.

Como profesor de Física suelo buscar ejemplos peculiares para mostrar a mis alumnos lo variado que pueden llegar a ser los sistemas a los que puede aplicarse la mecánica de fluidos. Hace poco encontré un caso que superó todas mis expectativas. Resulta que hay un galardón, llamado IgNobel, que premia resultados científicos particularmente hilarantes. Son trabajos de ciencia seria en cuanto a procedimiento y resultados pero cuyo objeto de estudio o resultado nos arranca una risa.

En la edición de 2017 el ganador en la modalidad de Física fue el francés Antoine Fardin, reólogo de Lyon (Francia), por un trabajo en el que intentaba determinar si un gato es un sólido o no. Un fluido adopta la forma del contenedor que lo alberga, un sólido deformable no, así que ¿a qué categoría pertenecen los gatos? Fardin se inspiró en una entrada de Bored Panda e intentó determinar la cuestión en un divertido artículo de tres páginas publicado en 2014.

Para determinar la naturaleza fluida del gato Fardin echó mano de sus conocimientos de reología (que, por cierto, es la ciencia que estudia la deformación de la materia, particularmente en sustancias fluidas) y utilizó un parámetro llamado número de Deborah De= τ/T, que es el cociente entre dos tiempos característicos, a saber: el llamado tiempo de relajación τ, que es lo que tarda el objeto en acomodarse a la forma del recipiente; y el tiempo de observación T. Si De es muy grande es porque el objeto, o es sólido, o es líquido pero tarda muchísimo tiempo en adoptar la forma del recipiente (como un bloque de mantequilla); si por el contrario De es pequeño, el objeto se acomoda enseguida a su recipiente y lo consideramos líquido.

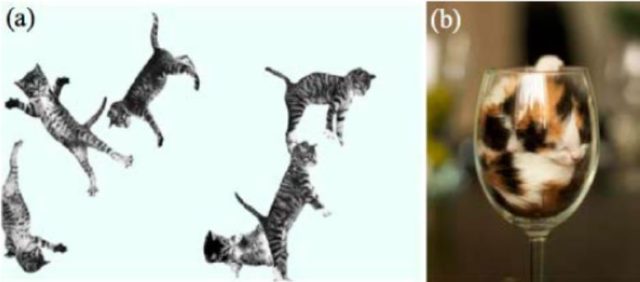

A partir de aquí usaré las ilustraciones del artículo de Fardin. Veamos, para empezar, algunos ejemplos de gatos sólidos y líquidos [Referencia (a), (b)]:

La figura (a) nos muestra un ejemplo de gato con número de Deborah muy alto, debido a que el tiempo de observación es muy pequeño, lo que nos indica solidez. Por el contrario, en (b) el gato ha tenido tiempo para asentarse y ha adoptado la forma de la copa, por lo que podemos considerarlo como un gato líquido.

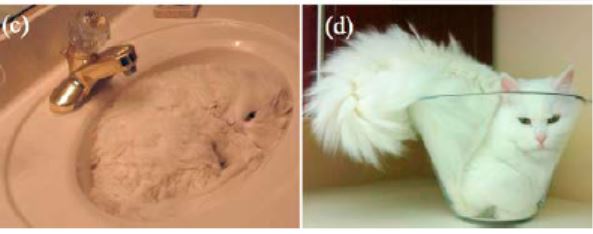

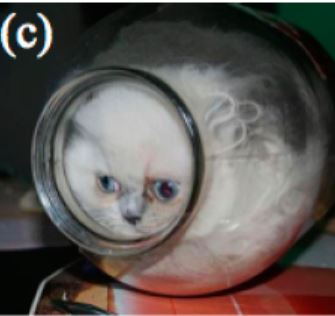

Los ejemplos anteriores correspondían a gatos jóvenes, con un tiempo de relajación de entre un segundo y un minuto. Es posible, afirmó el autor, que los gatos viejos tengan un tiempo de relajación menor, e incluso que no se encuentren en estado líquido sino gaseoso [Referencia (c), (d)]:

La reología de los gatos se presta al estudio de diversas propiedades de los fluidos tales como la ruptura capilar [Referencia desconocida]…

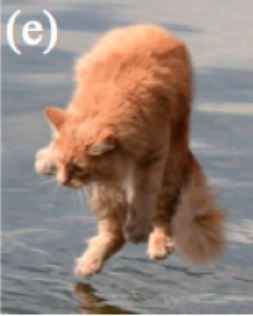

…el comportamiento de un gato sobre una superficie superhidrofóbica, o más bien supergatofóbica [Referencia desconocida]…

…la ausencia de movimiento fluido en determinadas circunstancias [Referencia]…

…la extensión del fluido gatuno en sustratos muy rugosos [Referencia]…

…la extremadamente baja afinidad entre gato y las superficies acuosas [Referencia desconocida]…

…y el sorprendente rango de valores para la interacción gato-superficie, que van desde un movimiento sin rozamientos sobre una superficie horizontal húmeda hasta la adhesión casi total en una pared vertical [Referencias (f), (g)]

Fardin se atrevió incluso a estudiar inestabilidades de flujo, que pueden aparecer cuando un gato encajado en un tarro comienza a girar. El problema es difícil porque, al parecer, los gatos son materiales activos, esto es, se mueven por sí solos, lo que dificulta su estudio. Queda mucho trabajo por hacer, como el estudio en tigres, cosa que estoy deseando ver como tema de tesis de algún valiente doctorando (no a título póstumo, espero). El autor acaba sugiriendo el estudio de gatos no como elementos aislados sino como sistemas capaces de absorber estrés, y afirmo que, según parece,hay cafés gatunos en Japón en los que los tensos clientes humanos pueden acariciar mascotas para eliminar el estrés. Como bien dice Francis Villatoro, la reología gatuna es un campo de estudio que dará mucho que hablar en el futuro.

Me hubiera encantado conocer la opinión de los revisores del artículo (los llamados referees), pero Rheology Bulletin no es realmente una publicación científica al uso sino más bien un boletín de la comunidad de reólogos de EEUU, así que dudo de que el proceso de peer review haya sido muy exigente en este caso. Ni siquiera incluye referencias bibliográficas, aunque al menos incluye los créditos de las fotografías gatunas. A pesar de todo ello, felicito al autor por su triunfo y le deseo lo mejor en sus investigaciones futuras.

Personalmente hubiera deseado poder contribuir al estudio de gatos para ampliar los conocimientos de la reología gatuna nacional, pero por desgracia no es algo que entre en mi campo de investigación habitual. A pesar de ello entré en contacto con mi hermana Belén, única persona de mi entorno que tiene gato. Su primera valoración le ha permitido determinar que PeekaBoo se comporta como líquido de forma indudable, adaptándose a los recipientes que la contiene con gran facilidad y adoptando, en general, un comportamiento cinemático bastante viscoso.

A partir de aquí, como suele decirse en la literatura científica, further reserach is needed.

Este post ha sido realizado por Arturo Quirantes (@Elprofedefisica) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Felinos líquidos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los riesgos de tratar químicamente los efluentes líquidos del fracking

- Cuántica y relatividad por todas partes

- La luz polarizada de la estrella más brillante de Leo

Catástrofe Ultravioleta #20 CÁPSULAS

Catástrofe Ultravioleta #20 CÁPSULAS

A finales de noviembre de 2009 el arqueólogo Daniel Pérez Vicente trabajaba en las obras de ampliación del parking de la plaza de las Cortes en Madrid cuando su equipo descubrió algo inesperado. “Lo que encontramos fue una caja rectangular de plomo“, recuerda Daniel. “Completamente lisa, negra, en muy buen estado. No se sabía lo que había dentro y estaba absolutamente sellada. Aquello no podía ser otra cosa que una cápsula del tiempo”, recuerda. En este capítulo hablaremos de los mensajes para el futuro que se encuentran bajo nuestras ciudades, en lugares que nunca habrías imaginado.

Agradecimientos: Museo Arqueológico Regional (MAR), Human File Project, Daniel Pérez Vicente, Javier Casado, Miguel Contreras, José María Jiménez, Instituto Cervantes, Patrick Tejedor. Y Murielle Lo, José Maria del Río y Noelia Lasso por las voces. El tema musical “Ha llegado de otra planeta” cuenta con la voz de Sr. Anido y los coros de Cris Blanco y Kimberley Tell. “Come on, Tutankamon” es una versión de “Streets of Cairo”, de Sol Bloom.

* Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #20 CÁPSULAS se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Preparados para una Catástrofe Ultravioleta

- Catástrofe Ultravioleta #01 Expedición

- Catástrofe Ultravioleta #03 Interferencias

¿Qué es y de quién es el conocimiento?

Existen dos tipos básicos de conocimiento: el objetivo y el subjetivo. Este último, por definición, es interno y no transmisible; una experiencia personal que se puede describir pero no compartir como una sensación, un sentimiento o un éxtasis. Por eso y por esencia el conocimiento científico del universo es únicamente el objetivo, el que se puede transmitir: aquello que permanece igual con independencia de quién es el que lo observa y que puede por tanto transmitirse entre personas sin deterioro. De esto se deduce que el conocimiento objetivo, y por tanto el científico, es en esencia compartido: de nada sirve un trozo de saber que no abandona la cabeza de alguien. Como el ruido que hace el árbol al caer en mitad del bosque si nadie lo recibe no se puede hablar de conocimiento; quizá de experiencia personal, pero desde luego jamás de ciencia. El conocimiento científico es por definición compartido: un proceso albergado en por lo menos dos mentes, algo dinámico y vivo en su misma esencia.

Y por tanto algo que no puede ser propiedad de nadie, porque no se puede encerrar o vallar. El conocimiento objetivo, y en especial el científico, no puede tener dueños por definición.

Existen, por supuesto, sistemas y métodos para controlar y sobre todo para rentabilizar parcelas concretas de conocimiento. Hemos inventado sofisticadas herramientas legales como la normativa de copyright o las leyes de propiedad intelectual e industrial con el objeto de favorecer la conversión en dinero de determinados tipos de ideas que consideramos socialmente deseables, y que han resultado útiles tanto para impulsar ciertos tipos de creación como, paradójicamente, para diseminar conocimiento. El Dominio Público, por ejemplo, permite a la sociedad recuperar de modo abierto tras cierto número de años el acceso abierto a productos del intelecto tras garantizar un cierto periodo de monopolio para recompensar el esfuerzo creativo original. Las patentes, por su parte, tienen fecha de caducidad con el mismo propósito. El hecho de que haya empresas e industrias que abusan de esos mecanismos para extender el periodo de monopolio temporal pactado no invalida su uso, aunque haga necesario discutir cómo se están iusando y de qué manera eliminar estos abusos.

Pero el hecho mismo de que haga falta una legislación propia y especializada demuestra que la ‘propiedad’ intelectual e industrial es diferente del resto de las propiedades como un coche o una casa, en virtud de que se multiplica al compartirla. Las propiedades materiales son exclusivas: si una persona las usa las demás no pueden usarla al mismo tiempo. Por eso en cuestiones como objetos la posesión y el control son sinónimos, y así se reconoce en las leyes. En el caso de las ideas o conocimientos y dado que el hecho de compartir es consustancial a su existencia y que por naturaleza se pueden usar de modo concurrente (varias personas pueden leer la misma novela, o escuchar la misma canción, o calcular la misma ecuación a la vez) este género de control es imposible. El conocimiento no puede ser de nadie; es, en realidad, de todos.

Esto es lo que hace posible proyectos como la Wikipedia: una encarnación del viejo sueño de recopilar todo el conocimiento humano, solo que esta vez sin dueños ni autores. El conocimiento disperso en las mentes de millones de personas en todo el mundo por virtud de la educación y la experiencia, la ciencia que por definición es libre porque se comunica se almacena ahora en un único depósito sin propietarios y de acceso completamente abierto. Por primera vez en la historia podemos disponer de un almacén de conocimiento que respeta la esencia de lo que es el saber: la apertura y la comunicación abierta y sin límites. Esta realidad va más allá de este proyecto concreto: hay muchos más depósitos de saber en Internet además de Wikipedia. No es la primera vez que se produce una revolución profunda en los modos de transmitir conocimiento, y por ello sabemos que tendrá consecuencias.

La última vez que ocurrió algo parecido se produjo cuando la tecnología de la imprenta y los ideales de la Ilustración se unieron para crear el proyecto de la L’Encyclopédie, que tuvo influencia en los cambios políticos posteriores con su idea básica de que el saber no era de nadie y por tanto pertenece a todos con independencia del estamento o nivel social al que se pertenezca. En este sentido el conocimiento es revolucionario, y por eso la actual era en la que el conocimiento se ha liberado aún más de las ataduras preexistentes será más igualitaria que la anterior. Porque el saber no es de nadie y por tanto es de todos, y en esto los humanos somos cada vez más iguales.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo ¿Qué es y de quién es el conocimiento? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Pozos de conocimiento: el problema de la profundidad

- #Naukas16 La transferencia de conocimiento, ¿nos lleva a la pobreza?

- Xurxo Mariño: “Nuestro sistema nervioso no es un máquina fiable para acceder al conocimiento”

Defectos moleculares explicarían el fondo cósmico infrarrojo no identificado

Zeta Ophiuchi es una estrella azul de tipo espectral O9V situada a 458 años luz del Sistema Solar y en está en el centro de la imagen. Es una de las estrellas conocidas como estrellas fugitivas, expulsadas de un sistema estelar por la explosión de la estrella acompañante. Debido a nubes de polvo interestelar, una de las cuales es iluminada por ella formando una nebulosa de emisión catalogada como S27, tiene una apariencia rojiza si se observa en el visible, ya que la luz azul es absorbida por el polvo. De hecho, si no fuera por las nubes, Zeta Ophiuchi sería una de las estrellas más luminosas del cielo. Esta es una imagen en infrarrojo tomada por Wide-field Infrared Survey Explorer (WISE). Los colores son falsos y representan distintas longitudes de onda del infrarrojo.

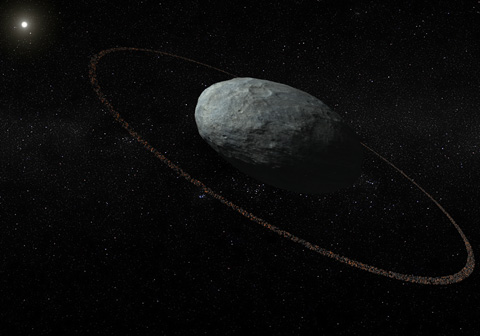

En el cielo nocturno existe un tenue fondo de radiación difusa que llega desde todas las direcciones del espacio y que abarca prácticamente todo el espectro electromagnético. La componente más conocida de ese fondo difuso es la que corresponde a la banda de microondas, el famoso fondo cósmico de microondas por ser la radiación fósil del Big Bang. Sin embargo, el cielo nocturno brilla también en otras frecuencias, como el óptico, el ultravioleta o el infrarrojo.

El llamado fondo cósmico infrarrojo (FCI) es una luz difusa que proviene fundamentalmente de galaxias ricas en polvo donde se están formando estrellas; eso polvo, a su vez, proviene de estrellas que explotan como supernovas o que expulsan al espacio sus capas más externas.

Para conocer el origen de los planetas, de las estrellas y de la propia vida es necesario conocer la composición química de este polvo interestelar. Por eso centenares de investigadores han dedicado décadas a tratar de identificar las sustancias químicas que producen los distintos picos del espectro infrarrojo del espacio. Muchos se han identificado, otros siguen siendo un misterio.

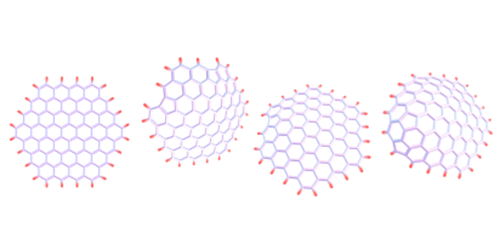

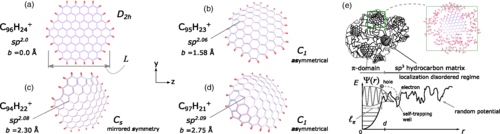

El trabajo teórico de dos investigadores mexicanos, Héctor Álvaro Galué de la Vrije Universiteit Amsterdam (Países Bajos) y Grisell Díaz Leines de la Ruhr-Universität Bochum (Alemania), puede que haya resuelto la llamada emisión cósmica infrarroja no identificada. El modelo desarrollado por los investigadores consolida la hipótesis de que esta emisión está producida por hidrocarburos con defectos estructurales.

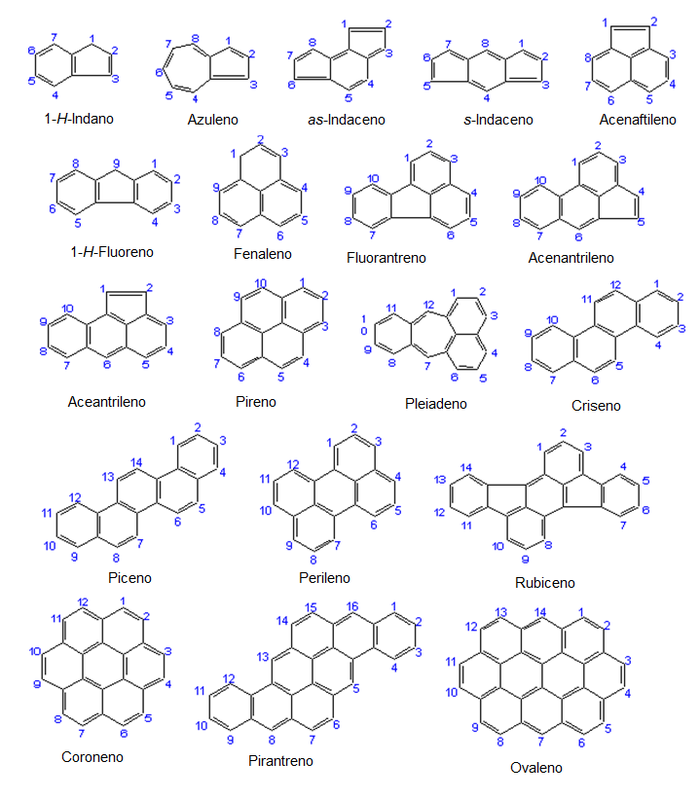

Algunos compuestos aromáticos policíclicos.

En los años ochenta del siglo pasado, algunos investigadores asociaron estos picos sin identificar del infrarrojo a unas moléculas llamadas hidrocarburos aromáticos policiclicos. Estas moléculas planas no son más que átomos de carbono e hidrógeno, con los átomos formando anillos de tal forma que parecen trozos de valla metálica. Cuando un hidrocarburo aromático se calienta comienza a vibrar y estas vibraciones emiten radiación a longitudes de onda que parecen coincidir con las de esos picos infrarrojos sin identificar. Sin embargo, las longitudes de onda exactas de los picos infrarrojos se sabe que se desplazan dependiendo del entorno astrofísico, es decir, no es lo mismo el pico en una nube planetaria que en la soledad del espacio interestelar. Esto es lo que el modelo de hidrocarburos aromáticos policíclicos no consigue explicar.

Hace algunos años Galué propuso que la emisión podría deberse a moléculas con una estructura en forma de anillos como la de los hidrocarburos aromáticos policíclicos pero con defectos estructurales que hacían que la molécula se curvase algo, dejando de ser plana. Los defectos los produciría la propia luz de las estrellas. Lo que Galué y Díaz Leines demuestran ahora usando varias técnicas teóricas es que la introducción de defectos permite que los electrones de las moléculas se redestribuyan en función del entorno. Este efecto desplaza los picos de emisión vibracional de las moléculas de tal manera que coinciden con los desplazamientos observados en la emisión infrarroja.

Referencia:

Héctor Álvaro Galué and Grisell Díaz Leines (2017) Origin of Spectral Band Patterns in the Cosmic Unidentified Infrared Emission Phys. Rev. Lett. doi: 10.1103/PhysRevLett.119.171102

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Defectos moleculares explicarían el fondo cósmico infrarrojo no identificado se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El fondo cósmico de microondas y el espejo de feria

- Viendo mejor en el infrarrojo

- La distribución de velocidades moleculares de Maxwell

Desenmascarando al autómata

Conviene señalar de paso que Poe había demostrado ya, en Charlottesville, una aptitud de las más notables para las ciencias físicas y matemáticas. Más tarde la empleará con frecuencia en sus extraños cuentos, y obtendrá de ella medios absolutamente inesperados.

Charles Baudelaire en [3]

Melville es un abeto marino, de sus ramas

nace una curva de carena, un brazo

de madera y navío. Whitman innumerable,

como los cereales, Poe, en su matemática

tiniebla, Dreiser, Wolfe,

frescas heridas de nuestra propia ausencia,

Lockridge reciente, atados a la profundidad,

cuántos otros, atados a la sombra:

sobre ellos la misma aurora del hemisferio arde

y de ellos está hecho lo que somos.

Pablo Neruda, fragmento del canto IX, Que despierte el leñador, en Canto General.

Eduardo Angulo habló en este blog de La ciencia de Edgar Allan Poe, y en Trigonometría para piratas comentamos un pequeño error de cálculo en su magnífico cuento El escarabajo de oro. Poe ‘coqueteaba’ con la ciencia en muchos de sus escritos, incluso en su faceta de crítico literario utilizaba las matemáticas para insistir en sus juicios. Su opinión sobre los escritores Cornelius Mathews y William Ellery Channing no tiene desperdicio:

To speak algebraically: Mr. M. is execrable but Mr. C. is (x+1)-ecrable.

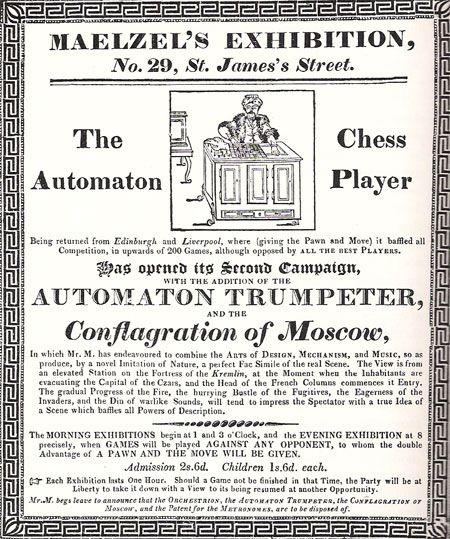

Hoy traemos un fragmento de uno de sus ensayos en el que habla sobre una máquina –El jugador de ajedrez de Maelzel–que existió realmente: la construyó en 1769 el inventor Wolfgang von Kempelen y se exhibió durante los siglos XVIII y XIX en ferias y teatros de París, Viena, Londres y Nueva York. Cuando von Kempelen murió, su hijo vendió la máquina a Nepomuk Maelzel, un violinista de Viena que construía aparatos musicales que funcionaban de forma autónoma.

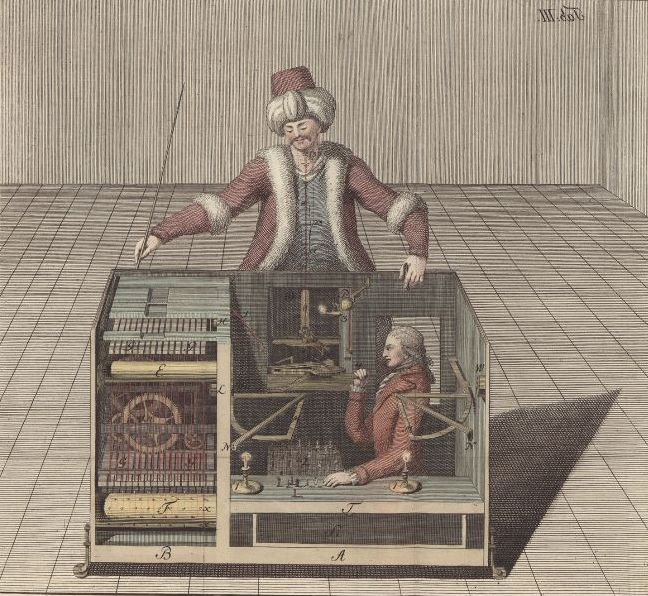

Ilustración de Joseph Racknitz, el secreto interior de “El turco”. Fuente

Edgar Allan Poe presenció una demostración del funcionamiento de esta máquina y escribió el ensayo El jugador de ajedrez de Maelzel (1836)para probar que se trataba de un fraude.

En efecto, no era la máquina la que jugaba al ajedrez; en su interior una persona –el ajedrecista francés Jacques Mouret– la controlaba realmente.

La minuciosidad con la que Poe explica el motivo del fraude es excepcional; Charles Babbage, la ciencia y las matemáticas, aparecen como ingredientes importantes en su razonamiento.

Anuncio de la demostración en 1819. Fuente

Tal vez ninguna exhibición de esta clase haya llamado tanto la atención general como el Jugador de Ajedrez de Maelzel. En cualquier parte donde haya sido visto ha sido objeto de gran curiosidad para todas las personas que piensan. Sin embargo, la cuestión de su modus operandiestá aún sin aclarar. No se ha escrito nada sobre este tema que pueda considerarse como decisivo; y, de hecho, encontramos en todas partes hombres dotados del genio mecánico, de una gran sutilidad general y de inteligencia discriminativa, que no tiene escrúpulos en afirmar que el autómata es une pure machine cuyos movimientos no tienen relación alguna con la actividad humana, y que, por consiguiente, es incomparablemente el más asombroso de los inventos de la humanidad. Y esto sería indudable si tuvieran razón en lo que suponen. Aceptando esta hipótesis, sería muy absurdo comparar el Jugador de Ajedrez con otra cosa cualquiera semejante, moderna o antigua. Sin embargo, han existido muchos y magníficos autómatas. […]

Si esas máquinas son tan ingeniosas, ¿qué podemos pensar de la máquina calculadora de míster Babbage? ¿Qué podemos pensar de un ingenio de madera y metal que, aparte de poder calcular las tablas astronómicas y de navegación, puede certificar la verdad matemática de sus operaciones y corregir sus posibles errores? ¿Qué podemos pensar de una máquina que no sólo puede realizar todo esto, sino que también imprime sus resultados, elaborados nada más que han sido obtenidos, y sin la menor intervención de la inteligencia de hombre? Tal vez se pueda decir que una máquina como la que hemos descrito sea mucho mejor que el Jugador de Ajedrez de Maelzel. Ni mucho menos; es completamente inferior, siempre que admitamos que el Jugador de Ajedrez es una pura máquina y que realiza sus operaciones sin ninguna intervención inmediata del hombre (cosa que sólo podría ser admitida por un instante). Los cálculos aritméticos y algebraicos, por su naturaleza, son fijos y determinados. Aceptados ciertos datos, se siguen ciertos resultados, necesaria e inevitablemente. Estos resultados son independientes, y no son influidos por nada excepto por sus datos originarios. Y la cuestión que hay que resolver procede o deberá proceder, hasta su última determinación, por una sucesión de pasos infalibles que no pueden cambiar ni ser objeto de modificación. […]

Pongamos el primer movimiento, en el juego de ajedrez, en justa posición con los datos de una cuestión algebraica, y percibiremos inmediatamente su enorme diferencia. En los datos, el segundo paso de la cuestión depende, absoluta e inevitablemente, del último. Es creado por los datos. Es necesario que sea el que es y no otro. Pero en una partida de ajedrez, del primer movimiento no se sigue necesariamente el segundo. En la cuestión algebraica, mientras avanza a su solución, la certeza de sus operaciones sigue siendo inalterable. Si el segundo paso ha sido una consecuencia de los datos, el tercero también es una consecuencia del segundo, el cuarto del tercero, y así hasta la solución, sin ninguna alteración posible. Pero en el juego del ajedrez, la certeza de la jugada siguiente está proporcionada al progreso de la partida. Se han hecho algunos movimientos, pero ningún paso es cierto. Diferentes espectadores podrán aconsejar diversos movimientos. Todo depende, por lo tanto, del juego variable de los jugadores. Ahora bien, aún concediendo (lo que no se puede conceder) que los movimientos del jugador autómata de ajedrez están determinados en sí mismos, se verían necesariamente interrumpidos y cambiados por la voluntad indeterminada de su adversario. Así, pues, no hay ninguna analogía entre las operaciones del Jugador de Ajedrez y las de la máquina calculadora de míster Babbage, y si queremos llamar al primero una pura máquina, estaremos obligados a admitir que, sin comparación posible, es el más maravilloso de todos los inventos humanos. […]

Es completamente cierto que las operaciones del autómata están reguladas por la mente y no por otra cosa. Incluso se puede afirmar que este asunto es susceptible de una demostración matemática a priori. La única cuestión, pues, que hay que resolver es el modo de producirse la intervención humana.

Referencias

[1] Edgar Allan Poe, Cuentos cortos completos (traducción de J. Cortázar), Alianza Editorial, Madrid, 2002

[2] Sergio E. Negri, Edgar Allan Poe y su diatriba que enriqueció al ajedrez, Ajedrez 12, 2016

[3] Georges Walter: Poe. Anaya & Mario Muchnik, Madrid, 1995

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Desenmascarando al autómata se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El juego del Sim

- El teorema de Morcom

- El teorema de los cuatro colores (y 4): ¿Podemos creer la prueba de la conjetura?

Sistemas respiratorios: los pulmones de reptiles y aves

Saurópsidos al sol

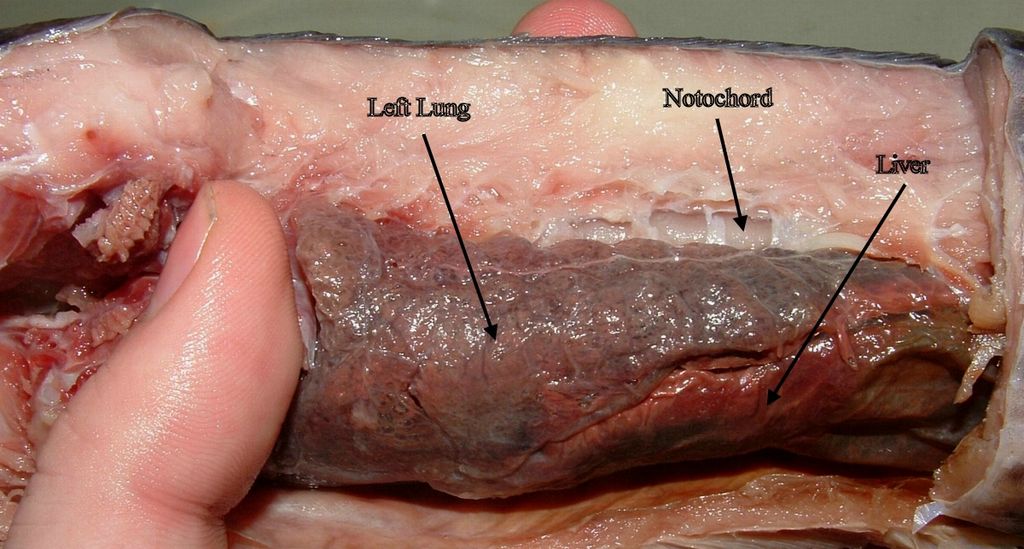

Esta anotación debería quizás llevar el nombre “saurópsidos1” en el título, pero entonces pocos habrían sabido de qué se trata. Por eso he optado por referirme a reptiles y aves. Hay gran variedad de pulmones en los saurópsidos. Los más sencillos son sacos simples en los que prácticamente no hay compartimentos. De hecho, se podría decir de un pulmón así que es como un único gran alveolo. También hay pulmones más complejos, con numerosos septos o paredes que se proyectan desde la superficie pulmonar hacia la luz. Los septos delimitan unos cubículos, unidades espaciales denominadas edículas. El intercambio de gases tiene lugar, principalmente, en los septos, aunque no están tan vascularizados como los alveolos de mamíferos. En otros casos los pulmones son multicamerales; están constituidos por diferentes cámaras dispuestas en paralelo. En estos, un bronquio intrapulmonar principal se va ramificando en bronquios secundarios que conectan el bronquio principal con cada cámara o saco aéreo.

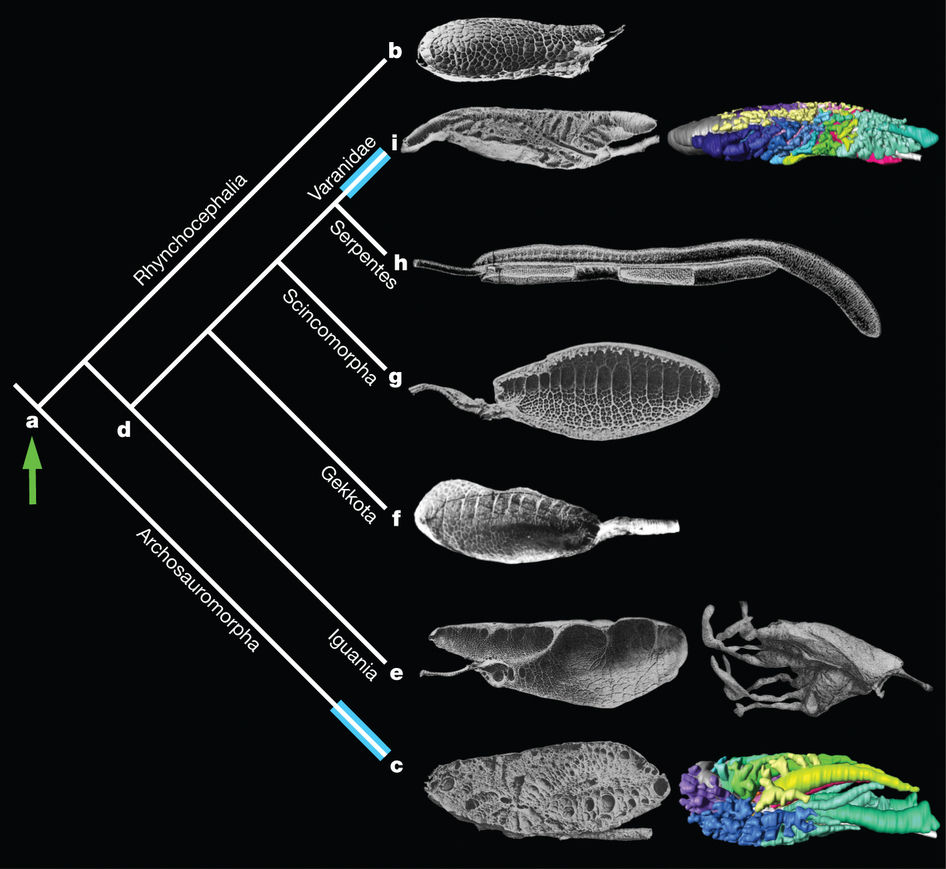

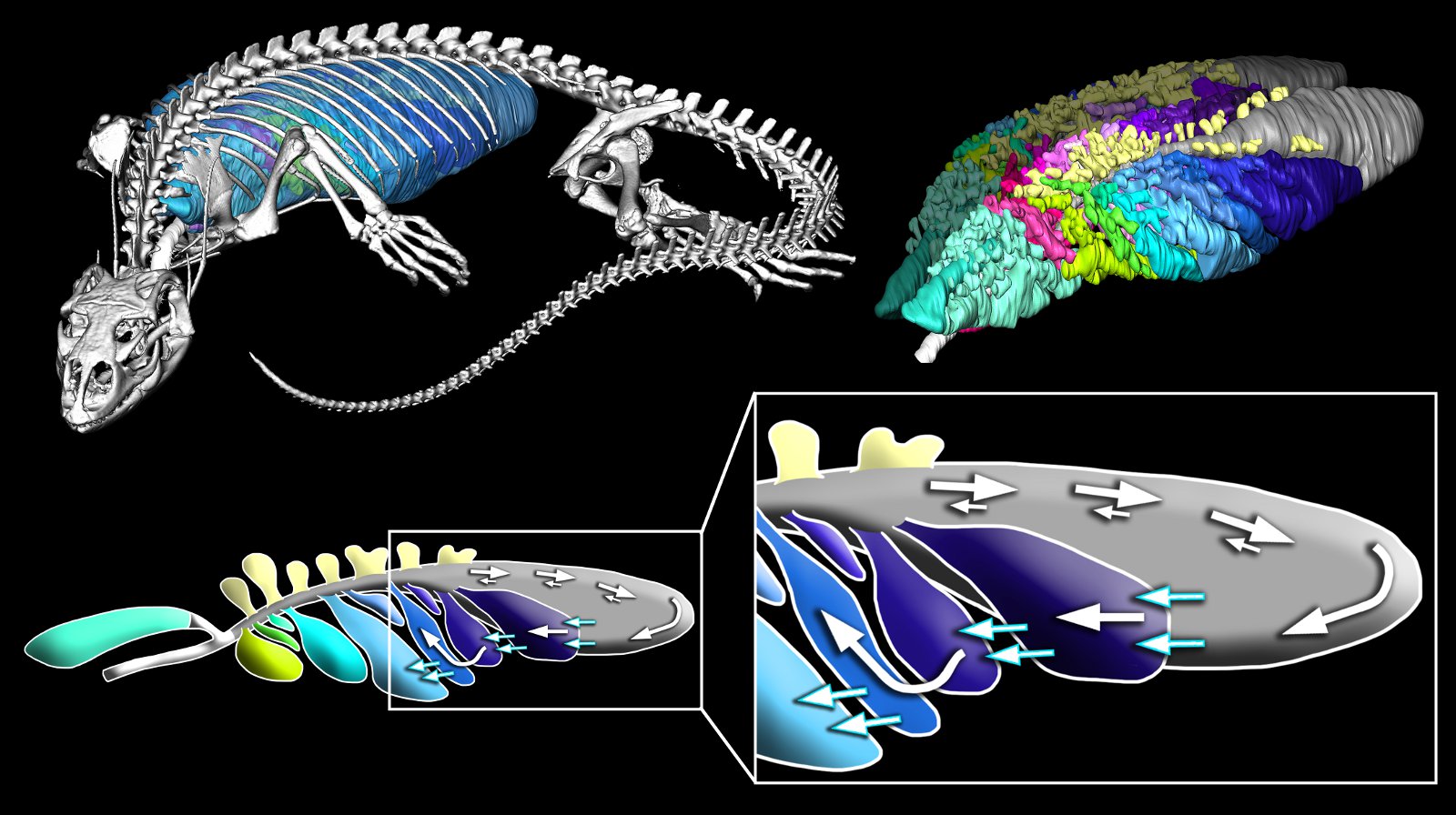

Pulmones de algunos reptiles. Filogenia de “Diapsida“.

En la gran mayoría de reptiles estudiados, la ventilación es mareal: se produce por flujo y reflujo del aire respirado, como si fuese impulsado por un fuelle. Una parte importante de muchos pulmones de reptiles no se dedica al intercambio respiratorio, sino que su función principal es ayudar a ventilar las porciones bien vascularizadas. Los mecanismos que participan en la impulsión del aire que entra y sale de los pulmones de los reptiles son variados, pero en general corren a cargo de la musculatura del tronco; como, en ocasiones, esa musculatura también participa en los movimientos de desplazamiento, ello puede representar una limitación. Quizás por esa razón algunos, como los varanos y otros lagartos, también utilizan la boca como bomba de impulsión del aire, como hacen las ranas. Otros reptiles poseen un diafragma o protodiafragma, cuyos desplazamientos arrastran el hígado hacia atrás y hacia adelante, dando lugar a la expansión y contracción de los pulmones en función del espacio que deja aquel.

Algunos reptiles, como es sabido, tienen un modo de vida acuático. Entre estos, unas especies han retenido la condición de respiradores aéreos, como los cocodrilos, algunas tortugas y las serpientes de mar, a pesar de lo cual pueden hacer inmersiones prolongadas. Hay serpientes de agua dulce capaces permanecer sumergidas hasta media hora; la tortuga verde marina llega a estar bajo el agua 50 minutos; y las serpientes marinas aguantan sin respirar una hora. Estas tienen un pulmón muy largo, que se extiende a lo largo de casi todo su cuerpo, por lo que es capaz de almacenar mucho oxígeno; además, reducen de forma considerable su metabolismo durante la inmersión. Y hay especies que tienen la capacidad, al sumergirse, de recurrir a vías metabólicas anaerobias para obtener ATP.

Otros reptiles son capaces de incorporar oxígeno del medio acuático de forma directa, como algunas culebras y tortugas. Las serpientes lo hacen a través de su superficie corporal, mientras que las tortugas recurren en mayor medida a captar O2 a través de las cavidades bucal y faríngea, e incluso, a través de la cloaca, que ha sufrido modificaciones que facilitan el intercambio de gases respiratorios. Ninguna de esas superficies es demasiado extensa, de manera que el intercambio gaseoso a su través es muy limitado, pero parece ser suficiente para cubrir las necesidades metabólicas de esos animales. Al fin y al cabo, dado que se trata de animales ectotermos, su metabolismo es relativamente bajo.

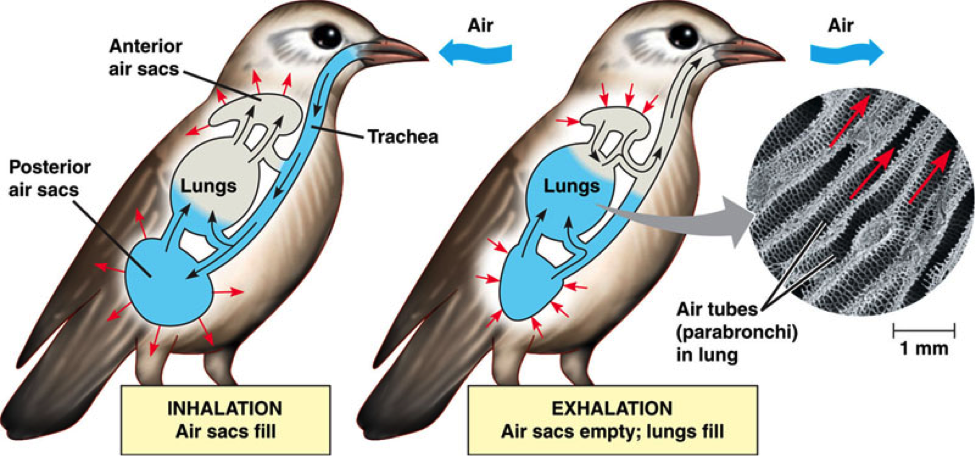

Los pulmones de las aves, aunque relativamente pequeños, son los más complejos. En cada pulmón, el bronquio principal se ramifica en varios bronquios secundarios, y estos están conectados entre sí por numerosos bronquios terciarios o parabronquios. Los parabronquios son cilíndricos y discurren en paralelo unos con otros. Los bronquios secundarios y los parabronquios forman una unidad integrada que permite que el aire circule a su través siempre en la misma dirección; el aire pasa de los llamados dorsobronquios a los ventrobronquios (denominaciones relativas a la posición que ocupan en el pulmón) a través de los parabronquios. La corriente inhalante entra por los dorsobronquios y la exhalante sale por los ventrobronquios. Al pasar por los parabronquios, el aire penetra en los capilares aéreos, un conjunto de canalículos interconectados que forman una tupida red y que aumentan de forma muy considerable la superficie para el intercambio gaseoso. Los capilares aéreos están a su vez íntimamente entrelazados con capilares sanguíneos en una disposición denominada de corriente cruzada (cross current), de manera que la sangre circula en una dirección que mantiene un ángulo de unos 90º, aproximadamente, con la dirección que sigue el aire respirado. Esa disposición permite una transferencia de O2 de altísima eficiencia.

Los pulmones de las aves están conectados con un conjunto de sacos aéreos, unos en disposición anterior y otros, posterior. Los sacos posteriores reciben el aire recién inhalado, de allí pasa a los pulmones y de estos, a los sacos anteriores, de donde es expulsado al exterior. Los sacos están dispuestos de manera que el aire inhalado no se mezcla con el que ya ha pasado por los parabronquios, por lo que todo el aire que llega al pulmón es aire fresco. El aire circula a través de ese sistema gracias, principalmente, a la contracción de los músculos de las costillas en asociación con el esternón.

Las pulmones de aves son, sin duda, los órganos respiratorios más eficaces de entre los metazoos. Ello se debe, como se ha señalado ya, a la circulación unidireccional de la corriente respiratoria y a la disposición en corriente cruzada de los parabronquios y los capilares sanguíneos. En esos rasgos las aves se diferencian de forma clara de la mayor parte del resto de saurópsidos. Sin embargo, es importante destacar que hay, al menos, tres especies de saurópsidos no aviares (un cocodrilo, un varano y una iguana) en cuyos pulmones hay flujo de aire unidireccional. Y es muy posible que otras especies también cuenten con esa ventaja, o que otras ya extinguidas también la tuviesen. Así pues, aunque el pulmón de las aves tiene características muy sofisticadas, todo hace indicar que hubo versiones previas, aunque quizás no fuesen tan eficaces.

Nota:

1 El clado Sauropsidae comprende todos los denominados reptiles, salvo los extinguidos “reptiles mamiferoides” (supuestos antecesores de los mamíferos) y las aves. La razón por la que quizás debería haber optado por ese nombre en el título es que los pulmones de las aves tienen seguramente antecedentes en otros saurópsidos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: los pulmones de reptiles y aves se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas respiratorios: peces capaces de respirar en aire y anfibios

- Sistemas respiratorios: invertebrados terrestres

- Sistemas respiratorios: los límites a la difusión de los gases

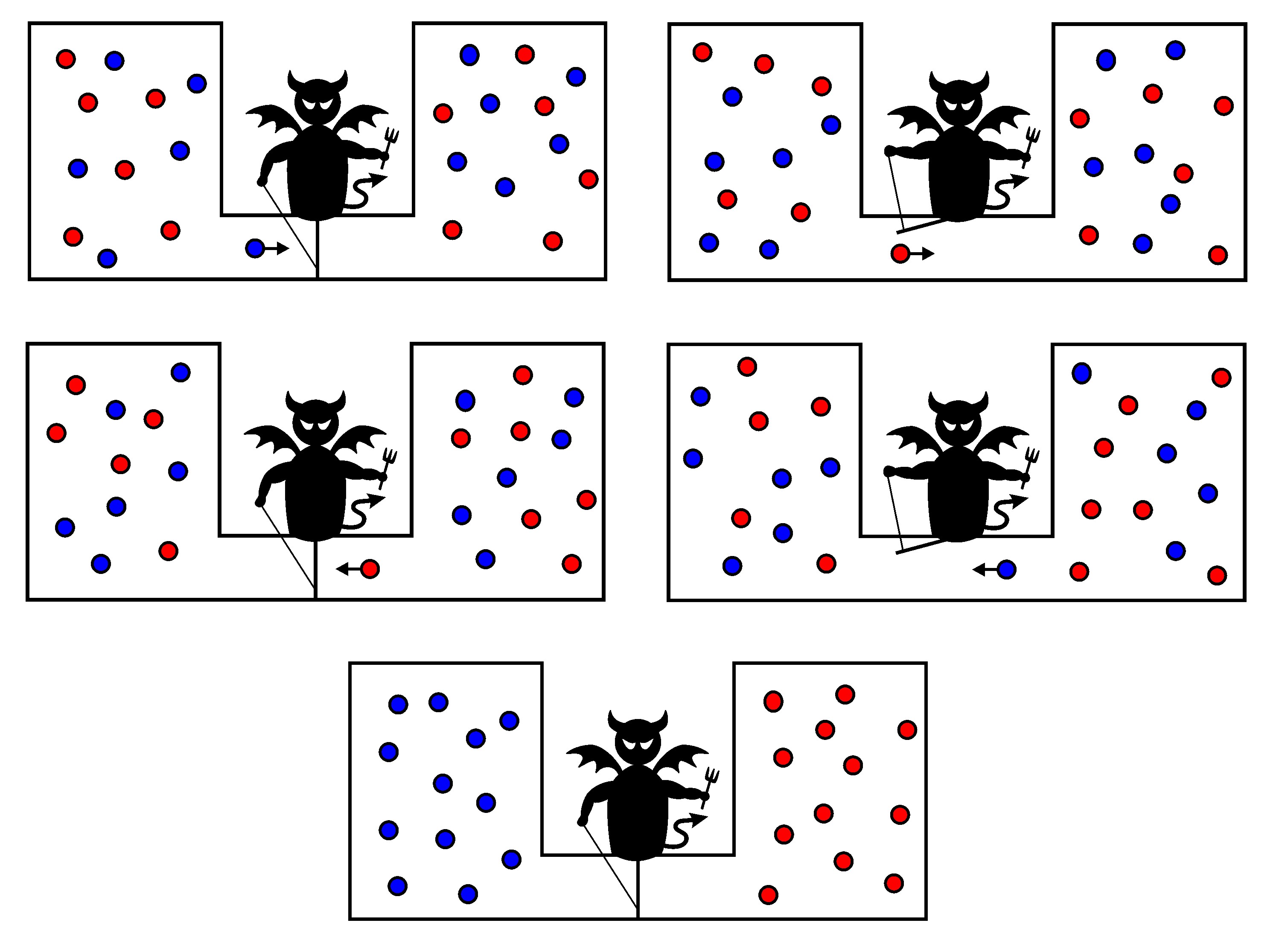

El demonio de Maxwell

Maxwell exploró los límites de una concepción estadística de la segunda ley mediante un “experimento mental” interesante. Supongamos que un recipiente de gas se divide por una membrana delgada en dos partes, el gas en una parte está más caliente que en la otra. “Ahora concibe un ser finito”, sugirió Maxwell, “que conoce las trayectorias y las velocidades de todas las moléculas, pero que no puede hacer otro trabajo que no sea abrir y cerrar un agujero en el diafragma”. Este “ser finito”, ahora conocido como El “demonio de Maxwell” puede calentar el gas caliente y enfriar el gas frío, permitiendo que las moléculas rápidas se muevan en una sola dirección a través del orificio (y las moléculas lentas en la otra), como se muestra en el diagrama, en el que, convencionalmente, el rojo representa moléculas de alta velocidad (y energía) y las azules de baja velocidad (y energía).

Por supuesto, no existe un demonio tan fantasioso (ni siquiera en forma de máquina) que pueda observar y seguir todas y cada una de las moléculas en un gas; por lo tanto, no existe ningún procedimiento como este para violar la segunda ley que puede realizarse en la práctica. De hecho, si de alguna manera se pudiera construir un “demonio”, podríamos encontrar que la propia entropía del demonio (que sería en sí mismo un sistema) se ve afectada por sus acciones. Así, su entropía podría aumentar lo suficiente como para compensar la disminución de la entropía del gas, con lo que la entropía neta aumenta, como dicta la segunda ley.

Esto es exactamente lo que sucede en otros sistemas donde se crea orden local, como en una bandeja de agua que se congela en cubos de hielo en un congelador; la entropía debe aumentar en algún otro lugar del universo, como en la habitación en la que está el congelador, donde se disipa el calor residual del motor del congelador.

Hay quien han sugerido que ciertas moléculas grandes, como las enzimas, pueden funcionar como “demonios de Maxwell”. Las moléculas grandes pueden influir en los movimientos de las moléculas más pequeñas para construir las estructuras ordenadas de los sistemas vivos. Esto es algo que no ocurre en los objetos inanimados y sería una aparente violación de la segunda ley de la termodinámica. Esta sugerencia, sin embargo, lo que demuestra es que no se ha entendido un aspecto fundamental de la segunda ley.

Efectivamente, la segunda ley no dice que el orden no pueda aumentar nunca en un sistema. Hace esa afirmación solo para sistemas aislados. Cualquier sistema “no aislado”, que pueda intercambiar energía con su entorno, puede aumentar su propio orden sin violar la segunda ley, ya que la entropía del entorno aumentará, compensando la disminución en el sistema abierto y aumentando la entropía del universo. Exactamente igual que un congelador, que es un sistema cerrado pero no aislado.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El demonio de Maxwell se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La distribución de velocidades moleculares de Maxwell

- La teoría cinética y la segunda ley de la termodinámica

- La segunda ley de la termodinámica

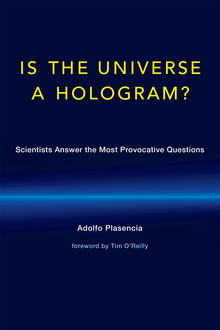

¿Es el universo un holograma?, y otras grandes preguntas de la ciencia actual

Javier Echeverría, lector y colaborador

Este libro ofrece un variado paisaje de la ciencia contemporánea, compuesto por 33 personas, algunas de las cuales son líderes mundiales de la ciencia y la tecnología actuales. Por orden alfabético: Hal Abelson, Ricardo Baeza-Yates, John Perry Barlow, Javier Benedicto, José Bernabéu, Michail Bletsas, Jose M. Carmena, David Casacuberta, Yung Ho Chang, Ignacio Cirac, Gianluigi Colalucci, Avelino Corma, Bernardo Cuenca Grau, Javier Echeverria, José Hernández-Orallo, Hiroshi Ishii, Pablo Jarillo-Herrero, Henry Jenkins, Anne Margulies, Mario J. Molina, Tim O’Reilly, John Ochsendorf, Paul Osterman, Alvaro Pascual-Leone, Rosalind W. Picard, Howard Rheingold, Alejandro W. Rodriguez, Israel Ruiz, Sara Seager, Richard Stallman, Antonio Torralba, Bebo White y José María Yturralde.

El libro ha sido escrito por Adolfo Plasencia, un veterano escritor valenciano, experto en la comunicación y difusión de la ciencia. El contenido del libro se fue originando a partir de la experiencia que co-fundó con Douglas Morgenstern el MITUPV Exchange, una iniciativa conjunta del MIT y la Universidad Politécnica de Valencia, que se extendió a lo largo de 12 años (1999-2011), gracias a la cual Plasencia pudo realizar y filmar diálogos con diversos investigadores y creadores de dicha universidad norteamericana y de otras muy destacadas. Posteriormente amplió el panorama a expertos de diversos países de todo el mundo. Esta es la razón por la que ocho de los colaboradores en el libro sean valencianos y, de manera todavía más notable, 17 de ellos sean hispano-parlantes, aunque el libro lo publique en inglés MIT Press. En conjunto, ofrece una excelente panorámica de los grandes desafíos que afronta la investigación científico-tecnológica de vanguardia, con la singularidad de vincular además las dos culturas, la científica y la humanística. Entre las numerosas preguntas que sustentan los diálogos persona a persona que Plasencia mantuvo con los participantes recién mencionados, algunas de las preguntas más humanísticas fueron dirigidas a los científicos, y viceversa.

El libro ha sido escrito por Adolfo Plasencia, un veterano escritor valenciano, experto en la comunicación y difusión de la ciencia. El contenido del libro se fue originando a partir de la experiencia que co-fundó con Douglas Morgenstern el MITUPV Exchange, una iniciativa conjunta del MIT y la Universidad Politécnica de Valencia, que se extendió a lo largo de 12 años (1999-2011), gracias a la cual Plasencia pudo realizar y filmar diálogos con diversos investigadores y creadores de dicha universidad norteamericana y de otras muy destacadas. Posteriormente amplió el panorama a expertos de diversos países de todo el mundo. Esta es la razón por la que ocho de los colaboradores en el libro sean valencianos y, de manera todavía más notable, 17 de ellos sean hispano-parlantes, aunque el libro lo publique en inglés MIT Press. En conjunto, ofrece una excelente panorámica de los grandes desafíos que afronta la investigación científico-tecnológica de vanguardia, con la singularidad de vincular además las dos culturas, la científica y la humanística. Entre las numerosas preguntas que sustentan los diálogos persona a persona que Plasencia mantuvo con los participantes recién mencionados, algunas de las preguntas más humanísticas fueron dirigidas a los científicos, y viceversa.

El libro muestra perfectamente hasta qué punto la tecnociencia contemporánea es ciencia, es cultura y, además, es humanidades. El proyecto de Plasencia asume y desarrolla una hipótesis muy clara: “cualquier observador curioso cuya capacidad de asombro goce de buena salud, sabe que la evolución, tanto de ciencia básica como aplicada en sus vanguardias; la evolución tecnológica y los nuevos descubrimientos, están siendo acaparados por disciplinas hibridas.”

Lo notable es que una editorial tan prestigiosa como MIT Press, cuya difusión es mundial, se haya animado a publicar un libro así, que ha debido incluir tanto en sus apartados de “Ciencia”, como de “Interés General”. Esa decisión la tomó la propia Directora Editorial de MIT Press, -y editora del libro-, Gita Devi Manaktala, quien tras su primer encuentro personal le dijo a Plasencia: “Nunca nos había presentado nadie algo así. Nos interesa. Lo vamos a estudiar”. Ella misma fue quien, de acuerdo con el autor, organizó cuatro secciones en el libro (El Mundo Físico; Información; Inteligencia y Epílogo), y aprobó los títulos de los diálogos presentados, (algunos ciertamente heterodoxos, p.ej.:”MIT Collaborative Innovation: It Takes >2 to Tango”), que Plasencia también consensuó con cada participante en la obra.

En suma: se trata de un libro atípico, incluido su título, elegido por la propia editorial. Dada la pregunta que aparece como título en portada, podría pensarse que estamos ante un libro de astrofísica. No es así. El ‘holograma’, de haberlo, radica en los treinta y tres diálogos, muchos de los cuales tienen puntos de convergencia que apuntan a algunas de las grandes preguntas de la ciencia actual. Quien quiera tener un panorama amplio y variado de la ciencia en 2017, lo obtendrá, y con múltiples puertas y ventanas, con sólo asomarse al listado de cincuenta y cinco preguntas que abre el libro, -con los nombres de qué participantes tratan en cada una de ellas-, que ilustran las cuestiones que en él se tratan. Esta lista la encabeza la frase de Pablo Picasso: “Los ordenadores no sirven para nada. Solo te pueden dar respuestas”, indicadora de que el volumen es un libro mucho más de preguntas que de respuestas. Aunque también hay respuestas, por supuesto. Pero lo importante son las preguntas, como el autor y varios de los participantes subrayan en sus respectivos textos.

No es posible resumir en pocas palabras el contenido del libro. Por eso, a título puramente informativo, terminaré esta nota enumerando algunas de esas preguntas, indicativas de la diversidad y relevancia de las múltiples cuestiones abordadas.

• ¿Qué es la inteligencia, cómo funciona, dónde radica y cómo se mide?

• ¿Habrá inteligencia no-biológica, (no basada en el homo sapiens)?

• ¿Qué va a pasar con el cambio climático?

• ¿Dónde radica la conciencia y como emerge? ¿Cómo funciona en realidad el cerebro?

• ¿Es en realidad el Universo un holograma? ¿Qué pasa con la materia oscura?

• ¿Qué origina la conducta en los humanos? ¿Y en los robots?

• ¿Qué va a pasar con el aprendizaje y las universidades, y su papel en la sociedad?

• ¿Vamos a convertirnos en biónicos? ¿Hasta qué grado?

• Nuestra relación con la tecnología, ¿está cambiando los ‘settings’ de nuestros sentidos?

• ¿Puede la ética combinada con el conocimiento abierto crear una economía de las ideas sostenible?

• ¿Veremos como parte de nuestras vidas al ordenador cuántico?

• ¿Habrá alguna vez “fin del trabajo”?

• ¿Por qué existe la masa? ¿Qué hay más allá del Bosón de Higgs?

• ¿Es posible gobernar la incertidumbre y convivir con sus efectos estocásticos? ¿Podemos planear lo imposible?

• ¿Es el paradigma del Software Libre y la Ética Hacker la solución?

• ¿Por qué la naturaleza es ‘cuántica’ y nuestra lógica normal no lo acepta?

• Las tecnologías de búsqueda, ¿nos permiten ahora recordar el futuro?

• ¿Es la expresión “Computación Afectiva” un oxímoron?

• ¿Es el “derecho a encriptar” un derecho humano?

• ¿Es cierta la ecuación: Belleza ≠ verdad? ¿Podemos contradecir a John Keats?

• ¿Cómo va a evolucionar representación del conocimiento en Internet?

• ¿En el arte, podemos ir al pasado y cambiarlo?

• ¿Es posible pintar el vacío?

Ficha:

Is the Universe a Hologram? Scientists Answer the most Provocative Questions (by Adolfo Plasencia, foreword by Tim O’Reilly). MIT Press 2017, 432 pp. ISBN: 9780262036016.

Más información:

A Dialogue about Dialogues: Adolfo Plasencia on Speaking with Scientists. (English). La entrevista, en español

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo ¿Es el universo un holograma?, y otras grandes preguntas de la ciencia actual se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La cara más emocionante, humana y filosófica de la ciencia

- Libros para enamorarse

- El arte de innovar, de Javier Echeverría

La menopausia… ¿para qué sirve? Seguimos sin respuesta

Hay una pregunta un poco extraña, quizá un poco fuera de lugar, pero que los biólogos evolutivos se hacen de vez en cuando y para la que nadie tiene respuesta todavía. Es la siguiente: la menopausia… ¿para qué sirve?

Me explico. Se supone que todos los caracteres de cualquier especie de ser vivo están de alguna forma orientados a aumentar las probabilidades de que los genes de un individuo pasen a la siguiente generación. La evolución consiste en sobrevivir, sino en reproducirse. Ese es el objetivo último de la evolución y la adaptación de las especies.

Por eso la existencia de la menopausia resulta intrigante: que las mujeres hayan desarrollado un mecanismo por el que llegado un determinado momento su sistema reproductor se apaga cuando aun les quedan años, incluso décadas, de vida es en principio contradictorio con el principio de favorecer el traspaso de los genes de generación en generación. Los hombres son fértiles prácticamente toda su vida, pero las mujeres viven hasta un tercio de ella sin poderse reproducir.

Puesto que es una cosa inevitable como la vida misma, muchos nunca se habrán parado a pensar en ello. Pero solo hay que mirar al resto de los mamíferos para darse cuenta de que la menopausia es, de hecho, una rareza: solo en un puñado de especies de cetáceos, por ejemplo las orcas, las hembras la tienen. En las demás, hembras y machos son capaces de reproducirse prácticamente hasta el final de sus vidas.

La hipótesis de la abuela

Esto hace que volvamos a la pregunta inicial: ¿para qué sirve la menopausia? ¿Qué sentido evolutivo? Pues creíamos tener las respuesta al alcance de la mano, pero de momento todo son teorías.

La más comúnmente aceptada es la hipótesis de la abuela. Esta hipótesis plantea que, puesto que a medida que la edad aumenta sacar adelante a las crías requiere más energía y conlleva un mayor riesgo, las hembras dejan de reproducirse y pasan a ayudar a sus hijas y sus crías, es decir, sus nietas. Esto supone una ventaja para todas: las crías están mejor cuidadas, las madres reciben una apreciada ayuda y las abuelas hacen aumentar la probabilidad de que sus genes salgan adelante a través de las siguientes generaciones.

En teoría tiene sentido, ¿no es verdad? Además se corresponde con la idea que todos tenemos de nuestras abuelas: mujeres amorosas que ayudaron a nuestros padres a criarnos (y a malcriarnos). Bien, ya tenemos explicación, ¿no? Pues no. Pero ahora llegamos a eso.

Otras teorías: la de la diferencia de edad y la de la conservación de la energía

La de la abuela es la única hipótesis. Otra, planteada en 2007, venía a complementarla bajo la premisa de que en el análisis de los cambios evolutivos de una especie no se podía tener en cuenta solo a uno de sus sexos. Según esta nueva teoría, la diferencia de edad en una pareja es beneficiosa en términos de fecundidad, y esta se da habitualmente entre mujeres jóvenes, que son más fértiles, y hombres mayores, que ya han demostrado su capacidad de engendrar hijos. Esto sería otra explicación añadida al hecho de que las mujeres tengan la menopausia cuando aun les quedan años de vida mientras que los hombres siguen siendo capaces de reproducirse prácticamente hasta su muerte.

Una tercera hipótesis plantea que, en las mujeres y en las hembras de otras especies de mamíferos, la expansión de la esperanza de vida y la expansión de la capacidad reproductiva ocurren a ritmos diferentes, ritmos determinados para maximizar la capacidad reproductiva y de supervivencia al principio de la vida adulta. Extender la capacidad de reproducción a partir de cierto momento, llegada la madurez, tiene un alto coste. Por eso, una vez que el número de ovocitos baja de cierto límite, eso desencadenaría el final de los ciclos menstruales normales, y con ello la llegada de la menopausia.

Sería por tanto, en resumen, una forma de asegurar que en los primeros años de vida adulta el cuerpo está en la situación óptima para sobrevivir y reproducirse, y que una vez pasado ese momento, la inversión de energía que requiere mantener el sistema funcionando ya no merece la pena, así que el cuerpo decide que ha llegado la hora de echar ese cierre.

Un estudio que ni confirma ni desmiente

Decíamos de todas formas que seguimos sin una explicación porque estas teorías son de difíciles de demostrar, ya que no hay una forma de que la evolución haya favorecido directamente caracteres que aparecen después de la reproducción, como ocurre con la menopausia. Un reciente intento por conseguirlo ha resultado en tablas: ni confirmo ni desmiento. No hay evidencias lo suficientemente sólidas para demostrar o descartar ninguna hipótesis sobre el modo en que la evolución favorece la esperanza de vida más allá de la época reproductiva en las mujeres.

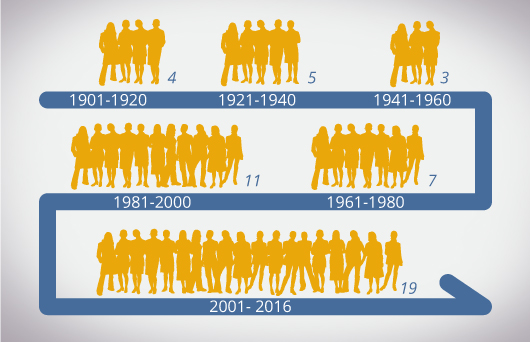

Jacob A. Moorad y Craig A. Walling son investigadores del Instituto de Biología Evolutiva de la Universidad de Edimburgo y el suyo es el primer intento por comprobar empíricamente cómo la menopausia se correspondería efectivamente con el aumento de la esperanza de vida en una población humana. Sus resultados se han publicado en la revista Nature Ecology&Evolution.

Para hacer esa comprobación, utilizaron los datos del censo de población de Utah a finales delo siglo XIX. Gracias la importancia que la fe mormona da a los registros genealógicos, los datos eran todo lo que un biólogo evolutivo podía desear.

A partir de ahí, realizaron un análisis detallado de todas los caminos genéticos que podrían haber tomado esos supuestos beneficios de la menopausia. No encontraron evidencias que sostuviesen ninguna de las tres teorías. El gozo de los investigadores en un pozo.

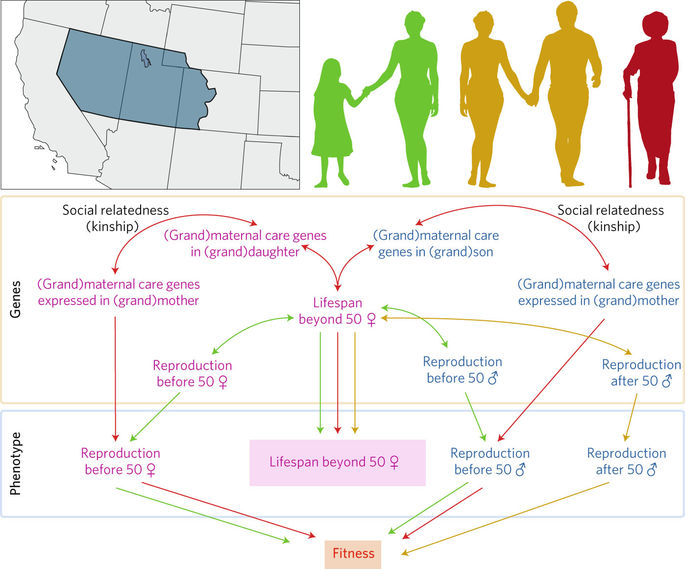

Las flechas entre fenotipos y “Fitness” con gradientes de selección. Las flechas entre genes y fenotipos son variaciones genéticas. Las flechas entre distintos genes son correlaciones genéticas. Puesto que la esperanza de vida postreproductiva de las mujeres no puede afectar directamente a un estado físico óptimo (“fitness”), la selección que influye en ello tiene que hacerlo de forma indirecta por otras vías. Estas vías se muestran aquí en los colores, de las que se han elegido tres: el rojo para la hipótesis de la abuela; el verde para la hipótesis de las diferencias de edad entre sexos; el amarillo para las diferencias de edad dentro del mismo sexo. En el mapa se muestra el Territorio de Utah tal y como era en 1851

¿Por qué? Para empezar, podría ser que no tengamos ni idea del asunto y ninguna de las hipótesis planteadas sea válida, aunque observaciones indirectas sugieren que alguna idea sí que tenemos.

Quizá ocurrieron, pero los movimientos migratorios entraron en escena

Los investigadores creen que una o más de estas hipótesis debió ser cierta en el pasado, pero se ha visto discontinuada por cambios en el ecosistema. Especialmente, y puesto que los datos se refieren al territorio de Utah a finales del siglo XIX, por la convulsión demográfica que supuso la migración masiva hacia el oeste americano, lo que conllevó en muchos casos la pérdida de apoyo y parentesco cuando los familiares se quedaron en sus lugares de origen, así como un alto índice de natalidad por la presión de poblar el territorio.

Esta explicación parece altamente probable, y a su vez es un ejemplo de por qué es tan difícil poner a prueba estas teorías. Existen grandes variaciones dentro de las distintas poblaciones de cada especie, y parece poco realista pensar que una foto fija de una población determinada pueda darnos una respuesta sobre cómo la selección natural ha favorecido o eliminado determinados rasgos de una especie.

Eso quiere decir, como explica Alan A. Cohen en su comentario sobre el estudio de Moorad y Walling, que probablemente si los autores hubiesen podido confirmar con sus resultados alguna de las tres hipótesis, esta hubiese sido cierta en el corto plazo, pero no hubiese sido del todo precisa para entender cómo la selección dio forma a la menopausia tal y cómo la conocemos.

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo La menopausia… ¿para qué sirve? Seguimos sin respuesta se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿La publicidad no sirve para nada?, ¡ja!

- El entrenamiento mental solo sirve para entretenerse un rato

- El flujo sanguíneo se reorganiza en respuesta a las necesidades

Árbol sagrado, árbol maldito

Los seres humanos hemos comido higos desde el origen de los tiempos. Quizás por ello aparece la higuera en varios relatos míticos de creación. En algunas religiones es sagrada y maldita en otras. El mismísimo Jesús de Nazaret, incluso, debió de maldecir una por no tener frutos: “¡Que nunca jamás coma nadie fruto de ti!” (Marcos 11: 12-14).

Ficus es el nombre en latín de la higuera y también del higo que, aunque lo parezca, no es un fruto sino un receptáculo de flores empaquetadas, una inflorescencia. Ficus es también el nombre científico del género -que agrupa a cerca de 800 especies- al que pertenece Ficus carica, nuestra higuera común. La mayor parte de sus especies comparten una característica: cada una de ellas ha coevolucionado con una especie de avispa de la familia Agaonidae. En virtud de la asociación -que comenzó hace al menos ochenta millones de años- entre la higuera y su correspondiente avispa, ésta poliniza las flores de la higuera a la vez que el higo proporciona a las avispas el cobijo en que reproducirse.

Una minúscula hembra de avispa (de unos dos milímetros de longitud) que va cargada de polen y transporta centenares de huevos fecundados, sale del higo en que ha nacido a través de una pequeña abertura llamada ostiolo. La hembra dispone de unas 48 horas para encontrar otra higuera de la misma especie que puede encontrarse a decenas de kilómetros de distancia, aunque –todo hay que decirlo- la higuera le facilita a la avispa la tarea, ya que emite un cóctel de sustancias químicas a la atmósfera cuyo rastro sigue aquélla con facilidad. Una vez alcanza el nuevo higo, penetra en su interior y avanza hasta la cavidad central distribuyendo el polen que lleva adherido. También deposita los huevos, uno en cada pequeña flor femenina; si la avispa es diligente puede llegar a poner más de doscientos huevos. Y después muere exhausta.

Los huevos fecundados crecen y completan su desarrollo alimentándose de las semillas. Los machos se desarrollan antes y perforan el higo en su interior en busca de las hembras para aparearse. Están dotados de fuertes mandíbulas, no tienen alas y son virtualmente ciegos. Tras fecundar a las hembras, mueren. Los pocos que llegan a salir del higo tienen una corta y miserable vida. Las hembras vuelan libres, presurosas, en busca de una nueva higuera donde todo volverá a empezar.

Los higos, una vez han sido abandonados por las avispas, aumentan de tamaño, adquieren un color rojizo y se llenan de azúcar. Se convierten así en un alimento atractivo. Dependiendo de la especie de Ficus, se alimentarán de ellos murciélagos, aves, monos u otros animales y después, al defecar, esparcirán las semillas, que podrán germinar y producir nuevas higueras.

En las zonas templadas las higueras dan dos o tres cosechas al año dependiendo del sexo de la planta. Pero en los trópicos hay higos “maduros” de manera permanente y sirven de alimento a más de un millar de especies de aves y mamíferos, a más que ninguna fruta. Juegan un papel ecológico crucial, pues sin higos muchas especies de animales se verían privadas de una importante fuente de alimento y podrían, incluso, llegar a desaparecer. Como consecuencia de ello, muchas otras plantas, cuyos frutos son también consumidos por esos animales, verían también disminuir sus posibilidades de dispersar las semillas.

La higuera es una rara planta, con un extraño -por falso- fruto. Pero ha proporcionado mucho alimento a los seres humanos y a una gran diversidad de otros animales. Por eso, sin higueras, muchas cosas en el Mundo serían diferentes.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 18 de junio de 2017.

El artículo Árbol sagrado, árbol maldito se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Naukas Pro 2017: Javier Burgos y el alzhéimer

El pasado 14 de septiembre de 2017 se celebró la primera edición de Naukas Pro, en el que Centros de Investigación, Laboratorios, científicos de renombre o equipos de trabajo contaron con 20 minutos para explicar a un público general en qué consiste su trabajo.

3ª Conferencia: Javier Burgos, director gerente de la Fundación de Investigación Biomédica de Andalucía Oriental (FIBAO)

Javier Burgos habla sobre el alzheimerEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2017: Javier Burgos y el alzhéimer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro, en directo

- Naukas Pro 2017: Carlos Briones y el origen de la vida

- Naukas Pro 2017: Leni Bascones y los superconductores

La luz polarizada de la estrella más brillante de Leo

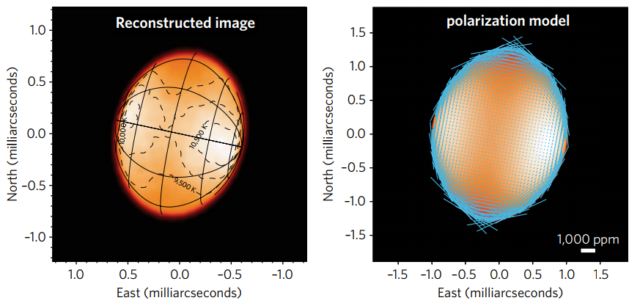

La estrella Régulo (α Leonis) es un sistema estelar cuádruple: Régulo A es una estrella blanco-azulada con una enana blanca como compañera, cuyo periodo orbital es de 40,11 días; les acompañan Régulo B, una enana naranja, y Régulo C, una enana roja. Régulo A es una estrella de la secuencia principal, como el Sol, pero rota sobre sí misma con un período de solo 15,9 horas —el Sol emplea más de 25,6 días—. Al rotar tan rápido, su forma está achatada en sus polos (figura 1, izquierda); en 1968 Harrington y Collins predijeron que su atmósfera tenía que emitir luz polarizada (figura 2, derecha). Se acaba de publicar en Nature Astronomy la confirmación de esta predicción [1].

Forma y brillo superficial de Régulo A determinado mediante interferometría (izquierda) y modelo teórico de la emisión polarizada de su atmósfera estelar con una longitud de onda de 400 nm (derecha). Fuente: Nature Astronomy [2].

Los electrones en la atmósfera de una estrella dispersan la radiación y la polarizan (igual que ocurre con el fondo cósmico de microondas) tanto de forma perpendicular como de forma paralela a la dirección radial (hacia a su centro), una predicción realizada por el genial físico Chandrasekhar en 1946. En una estrella (casi) esférica la emisión total no está polarizada porque se promedian en su disco ambas direcciones de polarización y resulta un valor casi nulo debido a su simetría (casi) esférica; la única forma de observar este fenómeno es con sistemas binarios donde se rompe la simetría. Esta idea podría permitir la búsqueda de exoplanetas de tipo Júpiter caliente; durante un tránsito estelar la estrella aparenta tener una forma achatada y se produciría una señal en el mapa de polarización. Sin embargo, este método de detección de exoplanetas todavía sin éxito requiere medidas de la polarización de las estrellas más allá de la precisión alcanzable en la actualidad.Hay otro caso en el que una estrella emite radiación polarizada, cuando realiza una rotación muy rápida; en dicho caso su superficie se achata y aparece un gradiente de temperatura entre los polos y el ecuador que rompe la simetría esférica, permitiendo una emisión polarizada cuya intensidad cambia con la longitud de onda. Harrington y Collins [4] predijeron este efecto en 1968. La razón por la que no ha sido observado hasta ahora (casi 50 años más tarde) es porque la intensidad de esta señal es demasiado débil para ser detectada salvo con polarímetros de alta precisión y en estrellas en rotación muy rápida. La estrella Régulo A en la constelación de Leo es ideal para este estudio.

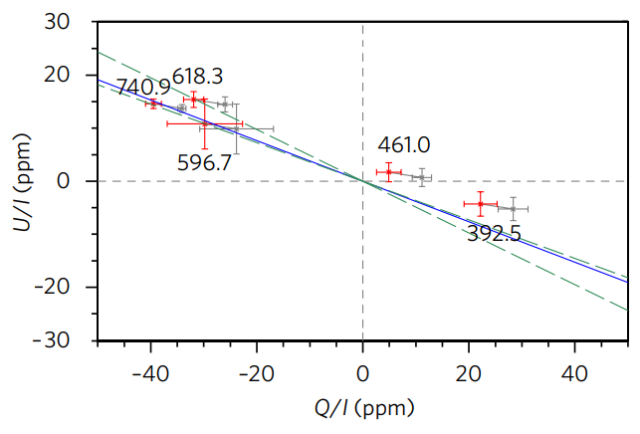

Diagrama Q/U para la polarización de Régulo A. Fuente: Nature Astronomy [1].

Daniel V. Cotton, de la Universidad de Nueva Gales del Sur, Sidney, Australia, y varios colegas han usado dos polarímetros de alta precisión, PlanetPol, instalado en el Telescopio William Herschel de 4,2 metros en La Palma, Islas Canarias, España —PlanetPol ya está fuera de servicio—, y HIPPI (siglas de High Precision Polarimetric Instrument, o Polarímetro de Alta Precisión), instalado en el Telescopio Angloaustraliano de 3,9 metros. La precisión de HIPPI alcanza las cuatro partes por millón (4 ppm) para estrellas brillantes. La polarización es una magnitud vectorial con dos componentes que se suelen describir mediante los parámetros de Stokes Q/I y U/I en el llamado diagrama Q/U.La figura 2 muestra el diagrama Q/U para la estrella Régulo A determinado para cinco longitudes de onda (el valor más impreciso —con la cruz en rojo más grande— es el de PlanetPol y los otros cuatro son de HIPPI). Se observa cómo la polarización cambia de forma casi lineal con la longitud de onda desde +42 ppm a 741 nm (color rojo) hasta −22 ppm a 395 nm (color azul), como muestra la figura 2; este cambio de signo conforme se pasa del rojo al azul se ha observado por primera vez, ya que medidas previas de la polarización solo se realizaron a una única longitud de onda. El cambio de signo está asociado al giro en la dirección del vector de polarización de noventa grados, confirmando el modelo de Harrington y Collins de 1968.

La polarización observada indica que Régulo A está rotando sobre sí misma el 96,5% de su velocidad angular máxima; esta velocidad angular crítica (también llamada de rotura) corresponde a la velocidad angular en el ecuador de la estrella tal que los módulos de la fuerza centrífuga y de la atracción gravitacional sean iguales. Más allá de esta velocidad la estrella se volvería inestable y se rompería en pedazos.

Por supuesto, confirmar una predicción teórica que estaba libre de controversias no parece una gran noticia. Sin embargo, considero todo un hito que se haya podido observar en varias frecuencias la polarización de una estrella; en los próximos años se logrará con muchas otras y quizás también se anuncie la primera detección de un exoplaneta de tipo Júpiter caliente con este método. Sin lugar a dudas la astronomía estelar basada en la polarización tiene un futuro muy prometedor.

Este post ha sido realizado por Francis Villatoro (@Emulenews) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias

[1] Daniel V. Cotton, Jeremy Bailey, …, J. H. Hough, “Polarization due to rotational distortion in the bright star Regulus,” Nature Astronomy (18 Sep 2017), doi: 10.1038/s41550-017-0238-6.

[2] J. Patrick Harrington, “Polarization from a spinning star,” Nature Astronomy (18 Sep 2017), doi: 10.1038/s41550-017-0267-1.

[3] S. Chandrasekhar, “On the radiative equilibrium of a stellar atmosphere. X,” Astrophysical Journal 103: 351–370 (1946), doi: 10.1086/144816.

[4] J. P. Harrington and G. W. Collins, “Intrinsic polarization of rapidly rotating early-type stars,” Astrophysical Journal 151: 1051–1056 (1968), doi: 10.1086/149504.

El artículo La luz polarizada de la estrella más brillante de Leo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- HR, la estrella de los diagramas en astrofísica

- #Naukas15 Fantasía en la divulgación: una estrella para Cervantes

- La cafeína y su renacimiento como ingrediente estrella de los productos funcionales

Prohibir los herbicidas con glifosato es anteponer la ideología a la evidencia científica

El glifosato fue sintetizado por primera vez en los años 50. En 1970, el químico John E. Franz, descubrió sus efectos herbicidas. Empezó a comercializarse por la compañía Monsanto en 1974 bajo el nombre de Roundup.

El éxito de Roundup llegó en los años noventa. Se utilizaba en cultivos de plantas genéticamente modificadas inmunes al efecto del glifosato. Esto permitía utilizar intensivamente el herbicida para eliminar las malas hierbas sin afectar al cultivo principal. La patente comercial de Monsanto acabó en el año 2000, con lo que desde entonces el glifosato comenzó a utilizarse libremente en herbicidas genéricos, popularizándose todavía más. Es barato y muy eficaz.

Hasta ese momento se usaban herbicidas específicos para cada planta. En cambio, el glifosato no es selectivo. Su aplicación es sencilla. Se pulveriza sobre las hojas y tallos, éste penetra en la planta y así la molécula comienza a circular por sus tejidos. El glifosato inhibe la ruta de biosíntesis de algunos aminoácidos esenciales para la vida de la planta. Esta ruta no existe en seres humanos y demás animales. Al ser una ruta exclusiva de las plantas, no tiene toxicidad apreciable en animales. Sustancias de uso común como la cafeína o el paracetamol tienen índices de toxicidad mayores que el glifosato.

Otra característica importante es que tiene una vida media muy corta, de tan solo 22 días antes de biodegradarse. Esto hace difícil que sus efectos acumulativos tengan un impacto significativo.

El glifosato nunca se ha llegado a prohibir. Durante años se ha estado cuestionando su seguridad, enfrentando a diferentes organismos. Algunos líderes de opinión y grupos ecologistas lo tienen en el punto de mira, convencidos de su supuesta acción cancerígena. Lo han convertido en un enemigo a combatir, emprendiendo campañas para su prohibición. Varias ciudades de España se han declarado libres de glifosato bajo lemas como «ciudad libre de herbicidas tóxicos», empleando en su lugar alternativas «naturales», como herbicidas que denominan «vinagre». Como el glifosato es un herbicida de uso legal, puede utilizarse en terrenos privados como explotaciones agrícolas. La medida sólo afecta a jardines, parques y vías públicas.

Al menos hasta diciembre de 2017 —fecha hasta la que se ha prorrogado la autorización—, el uso de glifosato en la Unión Europea está permitido, como lo ha estado siempre. Sin embargo, en 2015 se desató el conflicto. La Agencia Internacional para la Investigación del Cáncer (IARC) que depende de la OMS y la Autoridad Europea de Seguridad Alimentaria (EFSA) parecían haber llegado a conclusiones diferentes. Esta confrontación mediática ha hecho dudar de la independencia de los estudios presentados por ambas partes y de los supuestos intereses de unos y otros.

La EFSA publicó un metaestudio —un estudio que valoró las publicaciones científicas sobre el tema hasta la fecha— en el que se han tenido en cuenta más de 1500 estudios científicos sobre el glifosato. La conclusión del metaestudio es contundente: no hay evidencia científica de que el glifosato sea tóxico o potencialmente cancerígeno

Por su parte, la IARC incluyó el pesticida en el controvertido grupo 2A, es decir como «probable cancerígeno». Un dato que tener en cuenta es que esta lista del IARC se elabora según el nivel de evidencia que existe y no sobre los efectos o riesgos que tienen las sustancias. En esa misma categoría figura por ejemplo trabajar en una peluquería, en una freiduría, el consumo de hierba mate caliente o de carne roja. Ninguna de estas actividades se ha prohibido, precisamente porque no suponen un riesgo potencial. Realmente las conclusiones de la IARC y la EFSA no son tan diferentes como algunos se esfuerzan en mostrar.

A pesar de la evidencia científica, varias ciudades siguen en sus trece de prohibir el uso de glifosato. En su lugar dicen emplear «vinagre». Lo que emplean es una disolución de ácido acético —el vinagre contiene un 5% de esta sustancia—. El efecto del acético sobre las plantas es de quemadura. Si la planta es adulta las raíces pueden quedar intactas y la planta puede rebrotar, especialmente si es perenne. Por eso en un principio puede parecer que el acético funciona para eliminar las plantas no deseadas, pero normalmente es sólo en apariencia. También hay que tener en cuenta que las disoluciones de acético, además de resultar hediondas, por encima del 20% son irritantes para las personas y otros animales. Alteran el pH de la tierra y, en exceso, modifican la estructura del suelo. Es decir, llamarlo «vinagre» no lo convierte en la panacea de los herbicidas urbanos, responde a una cuestión estratégica: generar una falsa confianza atendiendo a un argumento de bajo calado intelectual, el que relaciona lo natural con lo bueno y lo sintético con lo malo.

Para algunos, Monsanto es algo así como el gran villano de la industria agrícola y cualquier invento suyo tiene, de serie, un halo de maldad. Ese fue el detonante de la farsa ecologista contra el glifosato que algunas ciudades lideran con ridículo orgullo. De ahí el título de este artículo. Prohibir los herbicidas con glifosato es anteponer la ideología a la evidencia científica, llevando las emociones por bandera. Eso tiene nombre.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Prohibir los herbicidas con glifosato es anteponer la ideología a la evidencia científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia, ideología y práctica política

- Azúcar moreno, ¿mejor que el azúcar blanco?

- Con los edulcorantes artificiales (casi) todo son ventajas

Cómo conseguir que la superhidrofobia dure

El CMA CGM Jules Verne puede transportar 16,000 contenedores

Los barcos, y no los automóviles y camiones, son los grandes contaminantes de nuestro planeta en lo que se refiere a transporte. Un solo barco de los grandes arroja tantas sustancias carcinogénicas a la atmósfera como 50 millones (sí has leído bien, millones) de coches. El transporte marítimo es responsable de hasta el 30 % de los óxidos de nitrógeno que los humanos emitimos.

Para cambiar eso en los laboratorios se buscan soluciones. Unas van en la dirección de cambiar el tipo de combustible que usan y otras en disminuir el consumo de combustible, sea este el que sea. Una de las vías para esto último es reducir la resistencia que el mar opone al avance del buque.

Recubrir el casco de un barco con un material fuertemente repelente al agua podría reducir la resistencia que al desplazamiento del barco ejerce el agua. Una forma conocida de este tipo de material superhidrofóbico funciona porque tiene una superficie áspera que atrapa un cojín de aire que hace de lubricante. Pero este tipo de material aún no se ha utilizado en los buques, ni tiene visos de que lo vaya a ser próximamente, ya que la capa de aire tiende a degradarse con el tiempo hasta desaparecer.

Ahora, investigadores de la Universidad de Peking (China) han identificado ciertas condiciones en el fluido que, de cumplirse, conducirían a una capa de aire más duradera. Aunque las condiciones podrían ser muy difíciles de cumplir para los buques, no dejan de tener mucho interés para otro tipo de aplicaciones.

Hoja de loto

La corta vida de la capa de aire es una dificultad muy conocida a la hora de encontrar uso comercial para los materiales superhidrofóbicos. Por ejemplo, cuando una hoja de loto, lo más de lo más en la superhidrofobia, se sumerge por debajo de 5 m de agua, la capa de aire se difunde y desaparece en menos de 2 min.

Los investigadores consideraron una superficie superhidrofóbica con un modelo termodinámico que explica la difusión del gas entre la capa de aire atrapado y el agua circundante. Encontraron que existe un estado de equilibrio en el que la cantidad total de aire en la capa no cambia, siempre que haya una cantidad suficiente de gas disuelto en el agua.

Controlar directamente la cantidad de gas disuelto en una masa de agua es complicado en el laboratorio, no digamos ya en el mar. Pero los experimentos del equipo con hojas de loto y superficies superhidrofóbicas artificiales muestran que este control se puede lograr indirectamente en sistemas sellados ajustando la presión del agua que actúa sobre la superficie. El equipo probó su idea en una hoja de loto, demostrando que podían extender la vida útil de la capa de aire a al menos cuatro horas, la duración máxima de sus experimentos.

Estos resultados indican que en la utilización de materiales hidrofóbicos habrá que tener muy presentes la presión del agua y las condiciones de flujo.

Referencia:

Yaolei Xiang et al (2017) Ultimate Stable Underwater Superhydrophobic State Phys Rev. Lett doi: 10.1103/PhysRevLett.119.134501

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Cómo conseguir que la superhidrofobia dure se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo fabricar hielo extraterrestre y verlo molécula a molécula

- La fusión nuclear como fuente de neutrones eficiente

- Cómo sintetizar casi cualquier biomaterial usando ADN

El problema de la plantación de árboles en filas

Existen dos matemáticos por los que siento cierta admiración y de los que hemos hablado en varias ocasiones en la sección Matemoción del Cuaderno de Cultura Científica, son los ingleses Arthur Cayley (1821-1895) y James J. Sylvester (1814-1897), que además tuvieron una profunda relación científica y de amistad.

El matemático británico James J. Sylvester (1814-1897)

Sobre el primero acabo de terminar una biografía, “Cayley, el origen del álgebra moderna” para la colección Genios de las matemáticas de la editorial RBA, con cuya escritura he aprendido y disfrutado mucho. Sin embargo, en esta entrada no vamos a hablar de Arthur Cayley, sino de su colega y amigo James J. Sylvester, y de un problema que formuló en 1893, en la revista Educational Times.

Problema 11851: Demostrar que no es posible colocar cualquier número finito de puntos (en el plano) de forma que cada recta que pase por dos de ellos también pase por un tercero, salvo que todos los puntos estén contenidos en la misma recta.

Este problema, conocido en ocasiones como el problema de la línea de Sylvester o simplemente el problema de Sylvester, estaba relacionado con un problema más general, que suele recibir diferentes nombres, entre ellos, el problema de la plantación de árboles en filas, el problema del huerto o el problema de los puntos y las líneas, sobre el que estuvo trabajando Sylvester desde la década de 1860 hasta su muerte. En su versión general el problema se puede plantear así.

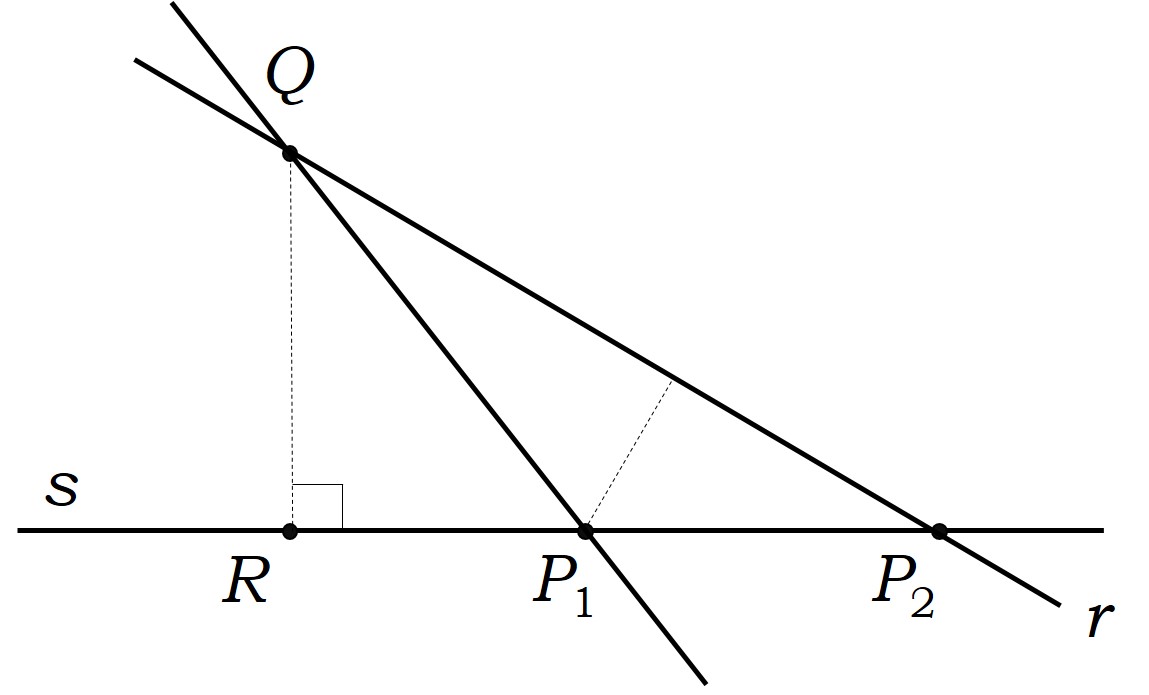

Problema: ¿Cómo pueden distribuirse n puntos en el plano (o quizás, n árboles en un huerto) formando filas, cada una de las cuales contiene exactamente k puntos (respectivamente, árboles), con el objetivo de obtener el mayor número de filas posibles? ¿Y cuál ese mayor número de filas posibles para cada n y k?

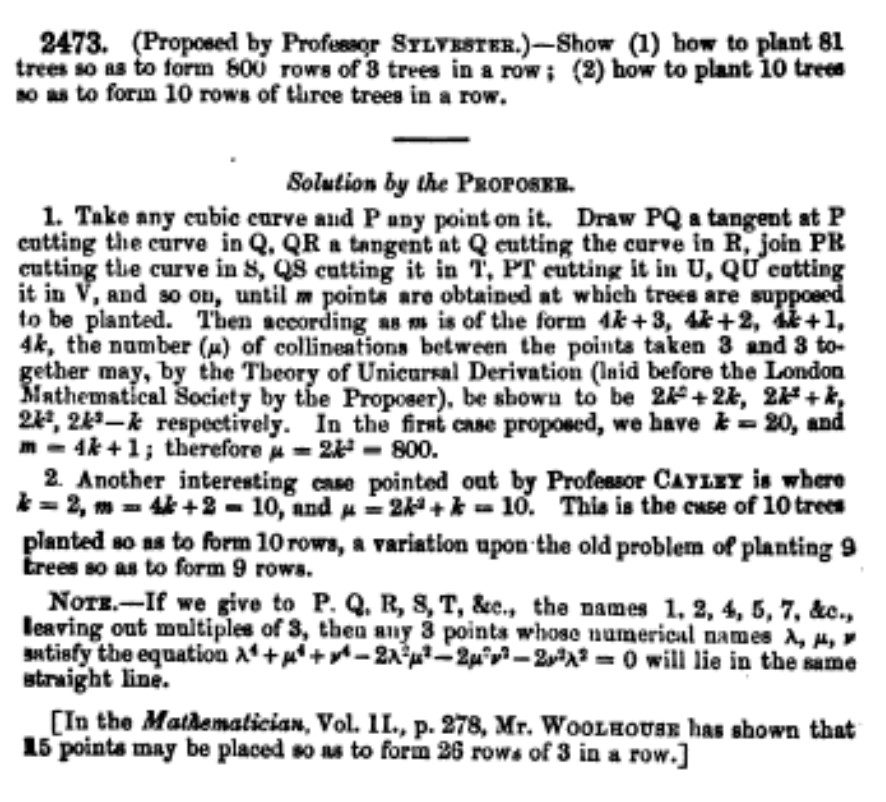

Sylvester había trabajado en la versión clásica en la cual las filas estaban formadas por tres árboles, es decir, el caso k = 3, como podemos observar en los problemas que planteó en Educational Times, en los años 1867 y 1886. Por ejemplo, en el problema 2473 (1867), que podéis ver en la imagen de abajo, planteó dos cuestiones: i) ¿Cómo plantar 81 árboles para que formen 800 filas con 3 árboles en cada fila?; ii) ¿Cómo plantar 10 árboles para que formen 10 filas con 3 árboles en cada fila?

“Problem 2473”, propuesto por J. J. Sylvester, en “Educational Times”, en 1867, con sus soluciones

Pero este era un problema que interesaba a más personas. Por ejemplo, como se menciona al final del problema 2473, el actuario inglés Wesley Woolhouse (1809-1893), editor de la famosa revista de matemática recreativa The Lady’s and Gentleman’s Diary, había publicado en la revista de problemas matemáticos The Mathematician que 15 puntos (árboles) podían ser colocados formando 26 filas, con 3 puntos (árboles) en cada fila.

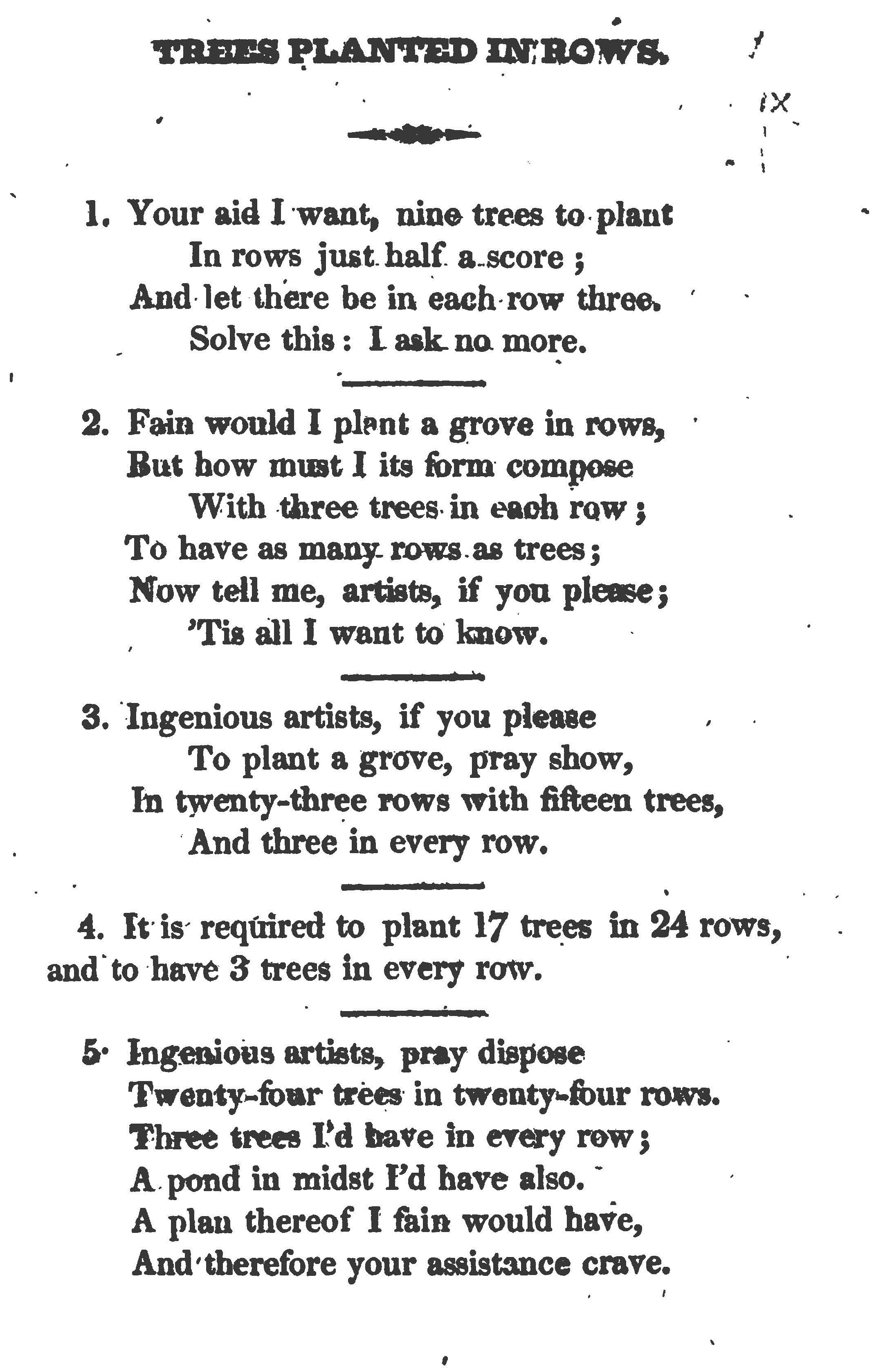

Aunque la primera publicación en la que se mencionan problemas de plantación de árboles en filas fue el libro Rational Amusement for Winter Evenings (1821), de John Jackson, en el que se dedica todo un “capítulo” precisamente a estos problemas, “árboles plantados en filas”.