La ‘reverosis’ de Pablo

En el texto que sigue hablaremos de una ‘enfermedad’–que claramente no existe– para ilustrar una paradoja de la teoría de la probabilidad –de la que ya se ha hablado en este blog–. Comenzamos con la historia ficticia de Pablo y su posible dolencia.

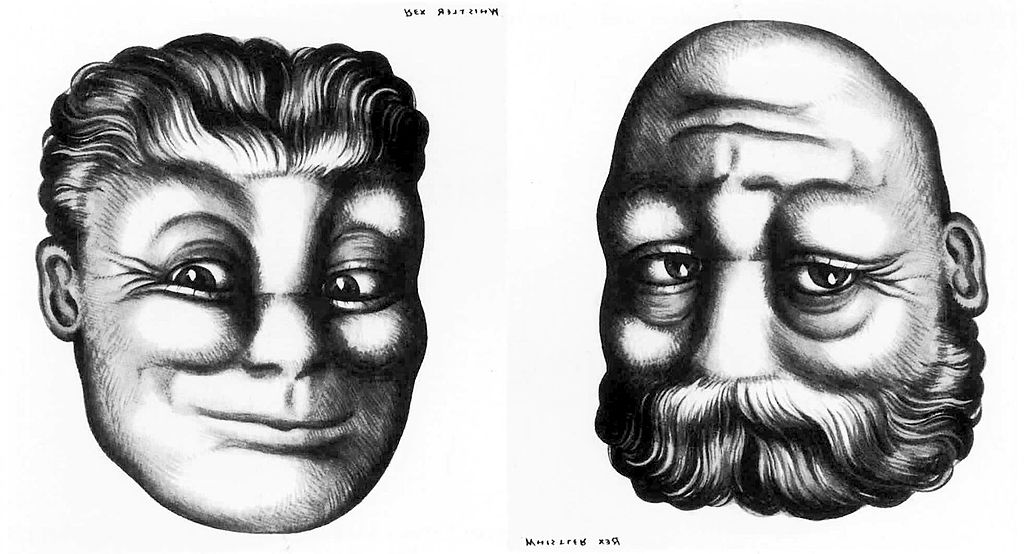

Rex Whistler: Hombre joven y hombre mayor (cabezas reversibles). Fuente Wikipedia.

Pablo es hipocondríaco. Pedro –que pretende burlarse de la obsesión de su amigo Pablo– le habla de una enfermedad genética recientemente descubierta –la reverosis–, que se manifiesta sólo a partir de los 40 años. Las personas que contraen esta enfermedad entienden al revés gran parte de lo que se les dice, aunque conservan el resto de sus facultades mentales intactas.

La reverosis es una enfermedad tremendamente rara: sólo la padece una persona entre un millón. Pedro comenta a su amigo que existe un test genético que permite averiguar a una persona si padecerá esta dolencia antes de contraerla. Lamentablemente, el test falla una vez de cada mil –es decir, acierta en el 99,9% de los casos–.

El aprensivo Pablo cumple en unos pocos días 40 años y no puede soportar la indecisión. Así que decide acudir a una consulta privada para realizar el test. Unos días más tarde, su médica le dice:

Su test de reverosis ha dado positivo. Pero no se preocupe, tiene sólo una posibilidad sobre mil de estar enfermo.

Pablo piensa que esto no tiene sentido, y reflexiona del siguiente modo:

Si el test se equivoca una vez de cada mil y mi test es positivo, la probabilidad de estar enfermo es del 99,9%… A lo mejor ya soy víctima de la reverosis, y aunque la médica me ha dicho “Su test de reverosis ha dado negativo”, yo he entendido “Su test de reverosis ha dado positivo”… y, entonces, probablemente no estaría enfermo… Pero, ¿cómo se ha invertido sólo su primera frase?

O a lo mejor esta enfermedad, que ya padezco, me ha hecho invertir sólo el sentido de la segunda frase, y en realidad la médica ha dicho: “Su test de reverosis ha dado positivo. Pero preocúpese, porque tiene una posibilidad sobre mil de no estar enfermo”.

Pablo se está dejando llevar por el pánico y está razonando mal. Lo que ha dicho su médica tiene sentido.

Para entenderlo mejor, supongamos que hacemos pasar el test a 100.000.000 personas: aproximadamente 100 de ellas estarán enfermas –recordar que una persona entre un millón padece la reverosis–. Para casi todas estas 100 personas, el test será positivo –recordar que la fiabilidad del test es del 99,9%– con lo que es muy probable que se equivoque para una o dos de esas 100 personas enfermas.

Para las 99.999.900 personas restantes –que están sanas– el test se equivocará aproximadamente 100.000 veces –es decir, una vez por cada mil–. Son los llamados falsos positivos, y la clave está en su gran cantidad. En efecto, a causa de los falsos positivos, entre las aproximadamente 100+100.000 personas para las que el test es positivo, no hay más que unas 100 personas realmente enfermas. Es decir, entre las personas con test positivo, hay aproximadamente 1/1.000 que realmente están enfermas.

Como bien dice su médica Pablo no debería preocuparse por el resultado de este test… Se ha topado con la paradoja del falso positivo, un problema de probabilidades condicionadas.

Nota 1: Como he comentado antes, de falsos positivos ya se ha hablado antes en este blog. Por ejemplo, en Falsos positivos, o la importancia de comprender la información de Raúl Ibáñez, To screen or not to screen de Naia Pereda, o Errar es humano de Juan Ignacio Pérez. Recomiendo cualquiera de ellos para aprender más.

Nota 2: Extraído y adaptado de Jean-Paul Delahaye, Au pays des paradoxes, Bélin, 2008.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo La ‘reverosis’ de Pablo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- “La saga Curie y las otras investigadoras” por Flora de Pablo

- Falsos positivos, o la importancia de comprender la información

- Desenmascarando al autómata

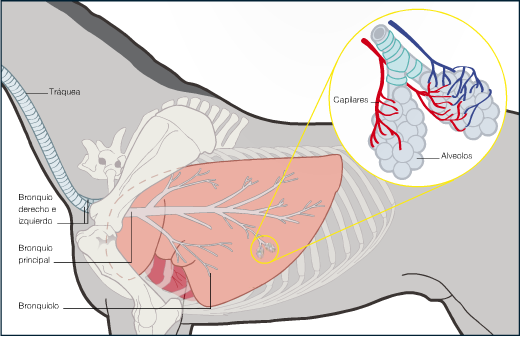

Sistemas respiratorios: la ventilación de los pulmones de mamíferos

La presión que ejerce un gas a una temperatura constante varía en función inversa del volumen que ocupa dicho gas. En otras palabras, si un número determinado de moléculas del gas pasa a ocupar mayor volumen del que tenía, la presión que ejerce disminuye. Y al contrario. En esa simplísima norma se basa el mecanismo que permite que fluya aire de la atmósfera a los pulmones y de estos al exterior. Me refiero a pulmones de mamíferos, aunque en realidad sirve para cualquier otro pulmón aunque las cosas ocurran de forma algo diferente.

En los pulmones de mamíferos el movimiento mareal (de entrada y salida) del medio respiratorio está provocado por cambios de volumen de la caja torácica. Ese volumen cambia debido a la contracción alterna de los músculos intercostales internos y externos, así como del diafragma y de los músculos abdominales. El aumento del volumen se produce como consecuencia de la contracción de los músculos intercostales externos y del diafragma; el esternón se eleva al separarse unas costillas de otras y, como consecuencia, se aleja de la columna vertebral. Al elevarse el volumen de la caja también lo hace el del interior pulmonar, por lo que la presión interna disminuye y, dado que la presión exterior no varía (760 mmHg a nivel del mar), el gradiente de presiones produce el flujo hacia el interior. La espiración se produce al relajarse el diafragma y contraerse los músculos intercostales internos y los abdominales. Se reduce así el volumen de la caja, con lo que aumenta la presión intra-alveolar y produce el flujo de aire hacia el exterior.

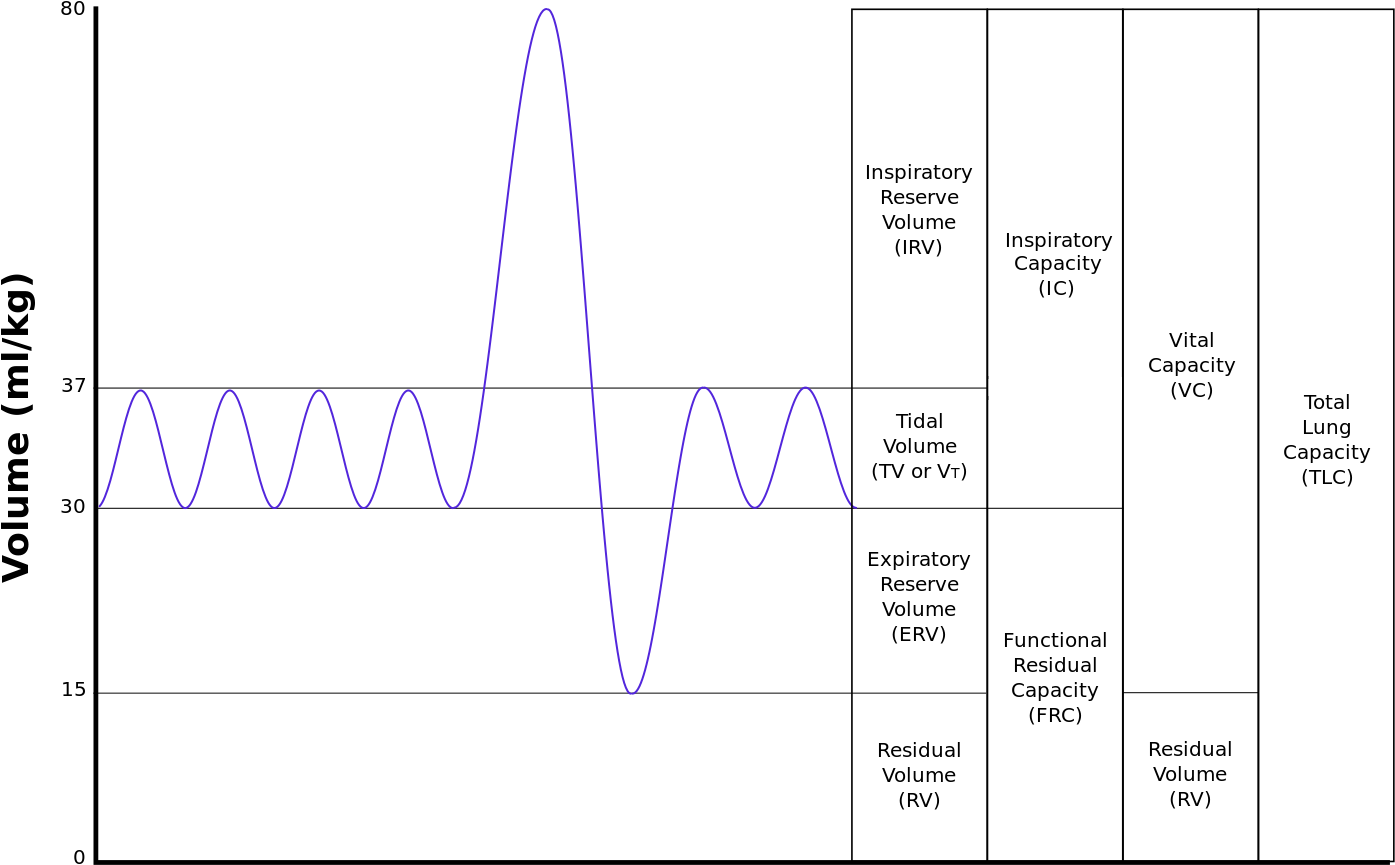

Los movimientos respiratorios en los pulmones de mamíferos definen una serie de volúmenes y capacidades que sirven para caracterizar el funcionamiento del órgano. La técnica que se utiliza para determinar esas magnitudes es la espirometría, realizada mediante un instrumento que mide el volumen de aire que es desplazado tras la ejecución de diferentes movimientos respiratorios. Se ofrecen a continuación esos indicadores junto con el valor de la media para un caballo y un hombre (las mujeres presentan valores algo más bajos):

- Volumen mareal (VM): es el volumen que entra o sale de los pulmones durante una única respiración. [6000 ml; 500 ml]

- Volumen inspiratorio de reserva (VIR): es el volumen extra de aire máximo que puede ser inspirado por encima del volumen mareal en condiciones de reposo. [12000 ml; 3000 ml]

- Capacidad inspiratoria (CI): es el máximo volumen de aire que puede ser inspirado al final de una espiración normal. CI = VM + VIR [18000 ml; 3500 ml]

- Volumen espiratorio de reserva (VER): es el volumen extra de aire que puede ser activamente espirado mediante la contracción máxima de los músculos espiratorios, en añadidura al que se espira normalmente de forma pasiva al final de una espiración normal típica. [12000 ml; 1000 ml].

- Volumen residual (VR): el volumen mínimo de aire que permanece en los pulmones tras una espiración máxima. [12000 ml; 1200 ml] Como es lógico, este volumen no puede establecerse por métodos espirométricos, puesto que ese aire no puede ser expulsado; se mide mediante técnicas de dilución con algún marcador gaseoso inocuo, como el Helio.

- Capacidad residual funcional (CRF): es el volumen de aire que queda en los pulmones al final de una respiración pasiva normal. CRF = VER + VR [24000 ml; 2200 ml]

- Capacidad vital (CV): es el máximo volumen de aire que puede desplazarse durante una única respiración tras una inspiración máxima. Se inspira y, a continuación, se espira todo lo que se puede. CV = VIR + VM + VER [30000 ml; 4500 ml]

- Capacidad pulmonar total (CPT): es el máximo volumen de aire que pueden albergar los pulmones. CPT = CV + VR [42000 ml; 5700 ml]

En resumen, en una respiración normal, tomamos y expulsamos 0,5 l de aire. En esas condiciones quedan en el interior de los pulmones 2,2 l. No obstante, estos pueden llegar a albergar 5,7 l; y dado que el máximo que pueden intercambiar en un único ciclo respiratorio es de 4,5 l, siempre quedarán dentro de los pulmones 1,2 l sin intercambiar. Prácticamente nunca se desplaza todo el volumen que podría intercambiarse como máximo en un único ciclo, por lo que, dependiendo de las necesidades, inspiramos entre 0,5 l y, en caso de gran necesidad, otros 4 l más.

De lo anterior se deriva que en los pulmones siempre hay un cierto volumen de aire con oxígeno (el volumen residual), por lo que incluso durante la espiración y antes de que vuelva a tomarse aire, la transferencia de oxígeno a la sangre no cesa por lo que solo se producen pequeñas variaciones en la concentración sanguínea de este gas al salir de los pulmones.

Por último, merece la pena reparar en la existencia de un volumen de aire que no es fisiológicamente útil. Me refiero al del espacio muerto, un volumen que no participa en el intercambio de gases respiratorios. Ese espacio da cuenta de unos 150 ml. Es el aire que permanece en los bronquios en zonas donde no se produce intercambio de gases o que accede a alveolos mal perfundidos. Para valorar las implicaciones de la existencia de ese espacio muerto, hagamos unas cuentas sencillas.

En condiciones normales respiramos con una frecuencia de 12 min-1 (doce movimientos inspiratorios y otros tantos espiratorios por minuto) y en cada uno intercambiamos 500 ml de aire. Por lo tanto, la ventilación pulmonar es de 6 l min-1. Sin embargo, no todos los 500 ml participan en el intercambio, ya que 150 ml corresponden al espacio muerto. Así pues, la ventilación alveolar –la efectiva a efectos respiratorios- es de 4,2 l min-1. Por ello, en una situación de necesidad es más rentable elevar el volumen mareal (volumen de intercambio) que la frecuencia respiratoria. Al subir el volumen mareal la importancia relativa del espacio muerto disminuye, pero al aumentar la frecuencia respiratoria no. Valoraré ahora tres supuestos al objeto de ilustrar esa afirmación.

El primer supuesto corresponde al ejemplo visto antes: una persona que respira con normalidad, con un volumen mareal de 500 ml y una frecuencia respiratoria de 12 min-1; su ventilación pulmonar es, como hemos visto, de 6 l min-1 y su ventilación alveolar de 4,2 l min-1. Si esa misma persona decide respirar muy rápidamente (40 min-1) y, por ello, hacerlo de forma superficial, podríamos encontrarnos con que su volumen mareal sea de 150 ml; en ese caso, su ventilación pulmonar sería igual que la anterior (6 l min-1), pero su ventilación alveolar sería nula (0 l min-1), pues el volumen mareal es igual al espacio muerto. En otras palabras, solo intercambiaría con el exterior el aire que se encuentra en las vías respiratorias donde no se produce intercambio de gases. Por el contrario, si optase por reducir su frecuencia respiratoria (a 5 min-1, por ejemplo), pero respirando profundamente (con un volumen mareal de 1,2 l, por ejemplo), la ventilación pulmonar seguiría siendo de 6 l min-1, pero la alveolar sería de 5,25 l min-1. Queda claro, por lo tanto, que la modalidad de respiración (somera, normal o profunda) ejerce un claro efecto sobre la ventilación alveolar que es lo que, a fin de cuentas, importa. Las aves, como vimos en otra ocasión, no tienen estos problemas, porque el aire circula de forma continua en un solo sentido y todo el que pasa por los bronquios participa en el intercambio de gases respiratorios. De ahí su extraordinaria eficacia.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: la ventilación de los pulmones de mamíferos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas respiratorios: el pulmón de los mamíferos

- Sistemas respiratorios: los pulmones de reptiles y aves

- Sistemas respiratorios: peces capaces de respirar en aire y anfibios

La paradoja de la recurrencia

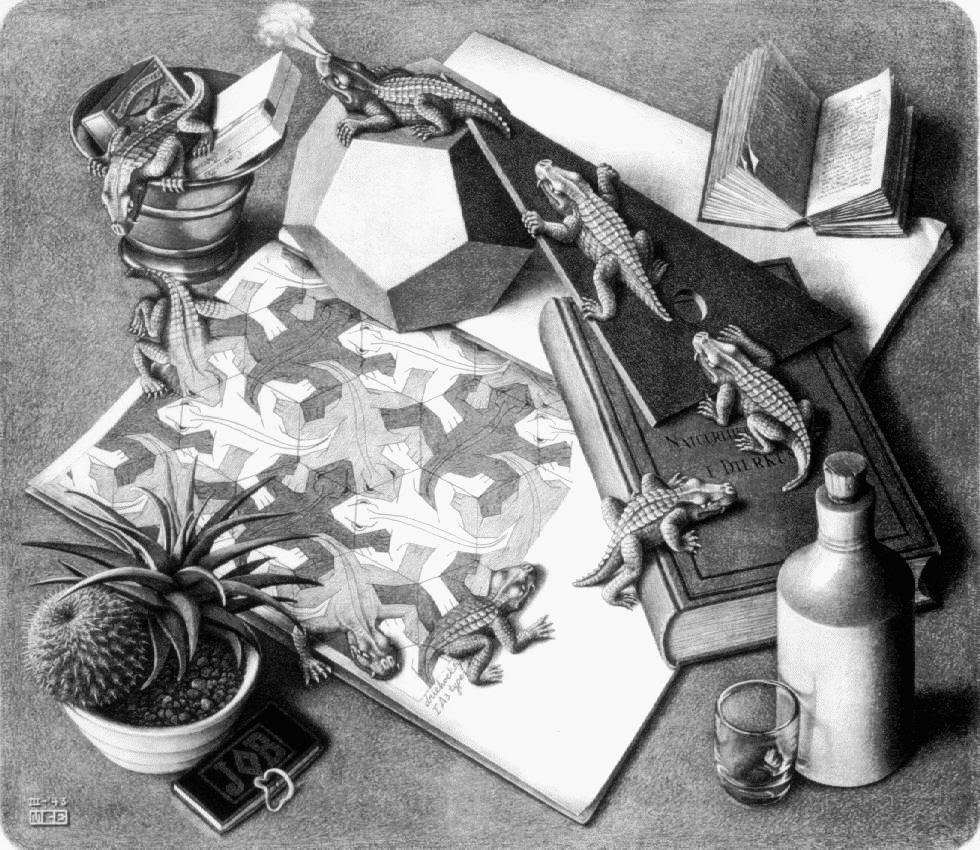

“Reptiles”, de M.C. Escher. Litografía 33.4 cm × 38.5 cm (1943)

Además de la paradoja de la reversibilidad, hay otra posibilidad permitida por la teoría cinética que conduce a una situación que parece contradecir inequívocamente la segunda ley. La que llamaremos paradoja de la recurrencia recuperó una idea que apareció con frecuencia en las filosofías antiguas y está presente también en la filosofía hindú actual: el mito del “eterno retorno”. Según este mito, la historia del mundo a largo plazo es cíclica. Todos los eventos históricos finalmente se repiten, quizás muchas veces, puede que infinitamente. Con tiempo suficiente, incluso la materia de la que las personas estamos hechas volverá a adoptar una forma concreta por casualidad. En ese momento una persona muerta podría nacer de nuevo y, tal vez con aún más tiempo, vivir una misma vida ya vivida. El filósofo alemán Friedrich Nietzsche estaba convencido de la verdad de esta idea.

La paradoja de recurrencia parte del hecho de que el número de moléculas en el mundo es finito, por lo tanto, solo hay un número finito de posibles disposiciones de moléculas. Por lo tanto, si el tiempo continúa infinitamente, la misma combinación de moléculas volverá a surgir. En algún momento, todas las moléculas en el universo volverían a tomar exactamente la misma disposición que tenían en algún momento anterior. Todos los eventos que siguen a este punto serían exactamente los mismos que los eventos que lo siguieron antes. Es decir, si cualquier instante único en la historia del Universo se repite exactamente, entonces la historia completa del Universo se repetirá desde ese instante. De hecho, a poco que reflexionemos nos daremos cuenta de que se repetiría una y otra vez hasta el infinito. Y esto contradice la segunda ley, ya que la energía no se disiparía sin fin. Nietzsche afirmó que esta visión del eterno retorno refutaba la teoría de la “muerte térmica” del universo.

Casi al mismo tiempo, en 1889, el matemático francés Henri Poincare publicó un teorema sobre la posibilidad de recurrencia en los sistemas mecánicos. Según Poincaré, a pesar de que el universo podría sufrir una muerte térmica, finalmente terminaría resucitando. En sus palabras:

Un mundo limitado, gobernado solo por las leyes de la mecánica, siempre pasará por un estado muy cercano a su estado inicial. Por otro lado, de acuerdo con las leyes experimentales aceptadas (si uno les atribuye validez absoluta, y si uno está dispuesto a llevar sus consecuencias al extremo), el universo tiende a un cierto estado final, que nunca abandonará. En este estado final, […], todos los cuerpos estarán en reposo a la misma temperatura.[…]. . . las teorías cinéticas pueden liberarse ellas mismas de esta contradicción.

El mundo, según éstas, tiende al principio hacia un estado en el que permanece durante mucho tiempo sin cambios aparentes; y esto es consistente con la experiencia; pero no permanece así para siempre; . . . simplemente permanece allí durante un tiempo enormemente largo, un tiempo que es más largo cuanto más numerosas son las moléculas. Este estado no será la muerte final del universo, sino una especie de letargo, del cual despertará después de millones de siglos.

De acuerdo con esta teoría, para ver pasar el calor de un cuerpo frío a uno caliente, no será necesario tener la visión aguda, la inteligencia y la destreza del demonio de Maxwell; bastará con tener un poco de paciencia.

Poincaré estaba dispuesto a aceptar la posibilidad de una violación de la segunda ley siempre hubiese transcurrido un tiempo lo suficientemente largo. Otros se negaron a admitir incluso esta posibilidad.

La teoría cinética es casi correcta

El resultado de la disputa entre los defensores y los críticos de la teoría cinética fue que ambas bandos tenían parte de razón. Mach y sus seguidores tenían razón al creer que las leyes mecánicas de Newton no pueden describir completamente los procesos moleculares y atómicos. Por ejemplo, solo es aproximadamente válido describir los gases en términos de colecciones de pequeñas bolas que se mueven a diferentes velocidades. Pero Boltzmann tenía razón al defender la utilidad del modelo molecular. La teoría cinética es casi correcta, excepto para aquellas propiedades de la materia que impliquen la propia estructura de las moléculas. Para avanzar en ese camino sería necesrio todo el desarrollo de la mecánica cuántica. E

El éxito de la teoría cinética con la explicación de Einstein del movimiento browniano, junto con los descubrimientos en radioactividad y física atómica, convencieron a casi todos los críticos de que, de hecho, átomos y moléculas existen. Pero los problemas de la irreversibilidad y de si las leyes de la física deben distinguir entre el pasado y el futuro aún siguen latentes. Por si fuera poco, los descubrimientos del siglo XX llevaron los estudios de la dinámica del calor por territorios cada vez más sutiles y fascinantes.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La paradoja de la recurrencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La paradoja de la reversibilidad

- El demonio de Maxwell

- La teoría cinética y la segunda ley de la termodinámica

Ingredientes para la receta: El kiwi

Plantación de kiwi en Neva Zelanda. Fuente

El kiwi es una planta trepadora semileñosa perteneciente al género Actinidia que incluye varias especies conocidas con este nombre. Según la revisión de Xu Honghua y su grupo, de la Universidad A&F Zhejiang, de China, este género se extiende desde Indonesia, al sur, hasta Siberia, al norte, y Nepal y el norte de la India, al oeste. La mayor variedad de especies se da en China, en el centro de su área de distribución, donde se encuentran 62 de las 66 especies catalogadas, hasta ahora, en el género Actinidia. En la provincia de Yunnan hay 59 tipos de Actinidia y, de ellos, 17 son endémicos. Revelan el centro Vavilov para el origen de este grupo, y, por ello, Ferguson y Huang afirman que esta región es, probablemente, el centro de la evolución del género.

Estas especies, y su fruto, tienen varios nombres en diferentes regiones de China pero, en el resto del mundo, se conoce como kiwi, término que recibió en Nueva Zelanda. El fruto que se comercializa tiene, en general, forma redondeada u ovalada, pelos en la piel y carne verde, amarilla o roja, y una hilera central de semillas oscuras. Las especies comercializadas más conocidas son la Actinidia deliciosa, con carne verde, y Actinidia chinensis, con carne amarilla. Son las más cultivadas y, en origen, endémicas en el centro de China. Tienen fruto grande, buena producción y conservación para el transporte y, por ello, con gran valor económico. La especie A. deliciosa se encuentra en la mitad oeste del centro de China, hacia el interior, y la A. chinensis en la mitad este, llegando a la costa del Mar de China.

Distintas variedades de Actinidia. A = A. arguta, C = A. chinensis, D = A. deliciosa, E = A. eriantha, I = A. indochinensis, P = A. polygama, S = A. setosa.

Las variedades más importantes de estas especies son la Hayward, para la A. deliciosa, y las Hort 16A y Gold 3, para la A. chinensis. La Hayward es una variedad con el fruto grande, alta calidad, buen sabor, capacidad para un almacenamiento prolongado y larga duración. Ya en los setenta se investigó en Italia para conseguir una variedad resistente a los nematodos del suelo.

En resumen , según la revisión de Xu Honghua, el kiwi es de sabor suave, jugoso, moderadamente dulce y algo ácido, delicioso y fragante. Lleva calcio, fósforo, hierro, carotenos y fibra y destaca, sobre todo, por tener una gran concentración de vitamina C.

Y, antes de seguir, por qué no abrir el apetito con una ensalada fresca y sencilla. Es una ensalada de naranjas, kiwi y fresas.

Pelamos un par de naranjas, un par de kiwis y lavamos unas fresas. Las naranjas y los kiwis los cortamos de través y con las fresas hacemos cuñas. Lo mezclamos todo, añadimos nueces o almendras y un chorrito de aceite. Y, si nos apetece, también sal y zumo de limón. Y a la mesa.

Los documentos escritos que describen el fruto de Actinidia en China tienen hasta 2700 años, con la dinastía Tang. No se cultivaba, excepto en la cercanía de las casas, y se recogía, sobre todo, de los árboles silvestres. Se comía fresco y se utilizaba para producir vino y para usos medicinales. Se mencionaban el árbol y los frutos en varios textos, pero el primer documento escrito que lo trata como un fruto comestible y lo describe como tal es de hace solo 800 años, con la dinastía Ming.

Isabel Fraser obtuvo un máster en física en 1889

En 1904, el kiwi o, mejor, la todavía Actinidia llegó a Nueva Zelanda. Fue Isabel Fraser, maestra y directora del colegio para chicas de Wanganui, en la costa este de la isla norte de Nueva Zelanda, la que regresó de China con semillas de A. deliciosa, tal como lo cuentan Juan Carlos García Rubio y sus colegas, del SEROA del Principado de Asturias. La Iglesia de Escocia abrió una iglesia y escuela para niñas en Yichang en 1878. En 1897 llegaron a la misión tres jóvenes misioneras desde Nueva Zelanda. Una de ellas era Katie Fraser, maestra, y su hermana Isabel, también maestra en Wanganui, la visitó, en 1903, durante un año de permiso en su trabajo. En febrero de 1904 regresó a Nueva Zelanda y, en su equipaje, llevaba unas semillas de kiwi.

Al llegar Isabel Fraser desde China, dio las semillas a Alexander Allison, horticultor, que las sembró en sus terrenos y para 1910 cosechó los primeros frutos. Se conocieron como la variedad Allison que todavía se cultiva. Hay quien asegura que, en aquellos primeros años de cultivo del kiwi en Nueva Zelanda, su principal utilidad era servir de munición en la peleas entre niños y adolescentes de la zona.

Todas las plantas de kiwi que se cultivan en el mundo, excepto algunas recientes aportaciones en China, provienen de estas semillas y de esquejes de los árboles plantados por Allison en 1905, tal como cuenta A. Ross Ferguson, del Instituto de Nueva Zelanda para la Horticultura y la Investigación de Alimentos de Auckland, y uno de los mayores expertos mundiales en el estudio del kiwi. Las semillas de Isabel Fraser fueron, por tanto, la base de una nueva industria en la horticultura mundial.

Hacia 1928, el científico y horticultor Hayward Wright obtuvo, mediante el método clásico de cruzamientos entre diferentes plantas, la variedad Hayward, el kiwi verde tan popular en la actualidad. Por tener un largo periodo de conservación se puede transportar a cualquier mercado del planeta.

El primer cultivo plenamente comercial y no solo para consumo personal y cercano, se inició en 1934. Fue el agricultor Jim MacLaughlin en la región de Te Puke, en la Bahía de Plenty, Nueva Zelanda. Distribuyó el fruto recolectado por los mercados locales, con gran éxito ayudado, además, porque el gobierno de Nueva Zelanda prohibió la importación de fruta fresca durante y después de la Segunda Guerra Mundial.

Fue el mismo MacLaughlin, casi veinte años después, en 1952, quien comenzó a exportar los kiwis. Envió veinte cajas a Inglaterra junto con un cargamento de cítricos. Se vendieron en el mercado de Covent Garden con un gran éxito. El mismo año MacLaughlin hizo el primer envío a Estados Unidos. La mejora en el transporte a larga distancia del kiwi la consiguió John Pilkinton Hudson, del Departamento de Agricultura de Wellington.

Kiwi

Y, finalmente, en 1959, el fruto conocido hasta entonces como grosella china o con su nombre original en chino yangtao o mihoutao, recibió el nombre de kiwi con el que ahora se conoce. Fue por su parecido con el ave nacional de Nueva Zelanda, el kiwi, y, también, porque de esta manera quedaba clara su procedencia. Lo utilizó, por vez primera, la empresa exportadora neozelandesa Turner & Growers en sus envíos a Estados Unidos. Según la historia oficial de Nueva Zelanda ocurrió exactamente el 15 de junio de 1959.

Las grosellas chinas no parecían populares en un mercado como el de Estados Unidos en aquellos años de la guerra fría y de Mao Tse Tung. Hubo otra propuesta, melonette, pero parecía rara y exótica e, incluso, difícil de pronunciar para un angloparlante. Se prefirió kiwi, término más sencillo y fácil de relacionar con el origen de la fruta.

En España, la primera plantación de kiwis fue en Gondomar, Pontevedra, en 1969, y, unos años más tarde, en 1975, en Asturias. En la década de los ochenta comenzó una fuerte expansión del cultivo del kiwi a más territorios y a incrementarse la comercialización. En los años 2000, el País Vasco es el tercer productor con Galicia en el primer lugar, seguida de Asturias. En 2015, el consumo es de más de dos kilos por habitante y año, el más alto de Europa.

Ahora se cultiva en más de veinte países y, entre ellos, está China. Era su lugar de origen y, en la década de los setenta, se empezó a cultivar en grandes extensiones. En 1983 se consumían entre 100000 y 150000 toneladas al año, en su mayoría procedentes de plantas silvestres. Es el país con la mayor producción, aunque casi en su totalidad para consumo interno debido a su gran población. Le siguen Italia y Nueva Zelanda. España, en 2001, estaba en los últimos puestos de los doce mayores productores, y en 2013 ocupaba el puesto doce. Nueva Zelanda exporta del 85% al 90% de la producción, Chile e Italia hasta el 75% y, en cambio, China solo del 1% al 2%. Pero, a pesar del éxito del kiwi en muchos mercados, solo supone el 0.22% del mercado mundial de frutas, todavía muy lejos de los cítricos, las bananas y las manzanas.

Para terminar y para despedirme deseándoles buen provecho, va una segunda receta con kiwi y, además, desde Nueva Zelanda y por internet. Es un tataki de atún con kiwi y wasabi. Sabroso y hace entrar en calor a quien la prueba.

Mezclamos salsa de soja, jengibre fresco cortado en rodajas finas y ajo picado con lomo de atún en filetes y sin piel. Lo dejamos marinar aparte, mejor la noche entera en la nevera.

Pelamos una zanahoria y un nabo y los fileteamos muy delgados. Reservamos para luego en agua con hielo. Pelamos el kiwi, lo cortamos en tacos, intentamos quitarle las semillas, lo secamos y lo dejamos para más tarde.

Sacamos los filetes de atún, los secamos con papel de cocina, pintamos con aceite de oliva y sellamos a la plancha con un vuelta y vuelta más o menos prolongado según como nos guste de rojo por dentro.

Mientras se hace, mezclamos polvo de wasabi con los trozos de kiwi y los machacamos hasta conseguir una pasta fresca, dulce y potente.

Sacamos la zanahoria y el nabo del agua con hielo, las secamos y emplatamos con el atún y la pasta de wasabi y kiwi. Se sirve con salsa de soja a gusto de cada uno.

Referencias:

Ferguson, A.R. 1983. E.H. Wilson, Yichang and the kiwifruit. Arnoldia 43: 24-35.

Ferguson, A.R. 2004. 1904 – the year that kiwifruit (Actinidia deliciosa) came to New Zealand. New Zealand Journal of Crop and Horticultural Science 32: 3-27.

Ferguson, A.R. & H. Huang. 2007. Genetic resources of kiwifruit: Domestication and breeding. Horticultural Reviews 33: 1-122.

García Rubio, J.C. et al. 2014. Variedades de kiwi. Tecnología Agroalimentaria 14: 2-7.

García Rubio, J.C. et al. 2015. El cultivo del kiwi. SEROA. Principado de Asturias. P. 13-19.

Honghua, X. et al. 2017. The wondrous kiwifruit – Origin, cultivation and utilization. International Journal of Horticulture 7: 1-6.

Huang, H. & A.R. Ferguson. 2001. Kiwifruit in China. New Zealand Journal of Crop and Horticultural Science 29: 1-14.

Testolin, R. & A.R. Ferguson. 2009. Kiwifruit (Actinidia spp.) production and marketing in Italy. New Zealand Journal of Crop and Horticultural Science 37: 1-32.

Wikipedia. 2017. Actinidia deliciosa. 17 febrero.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Ingredientes para la receta: El kiwi se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ingredientes para la receta: el ajo

- Ingredientes para la receta: El maíz

- Ingredientes para la receta: El conejo

Antes de que el león se hiciese con el trono de rey de la selva

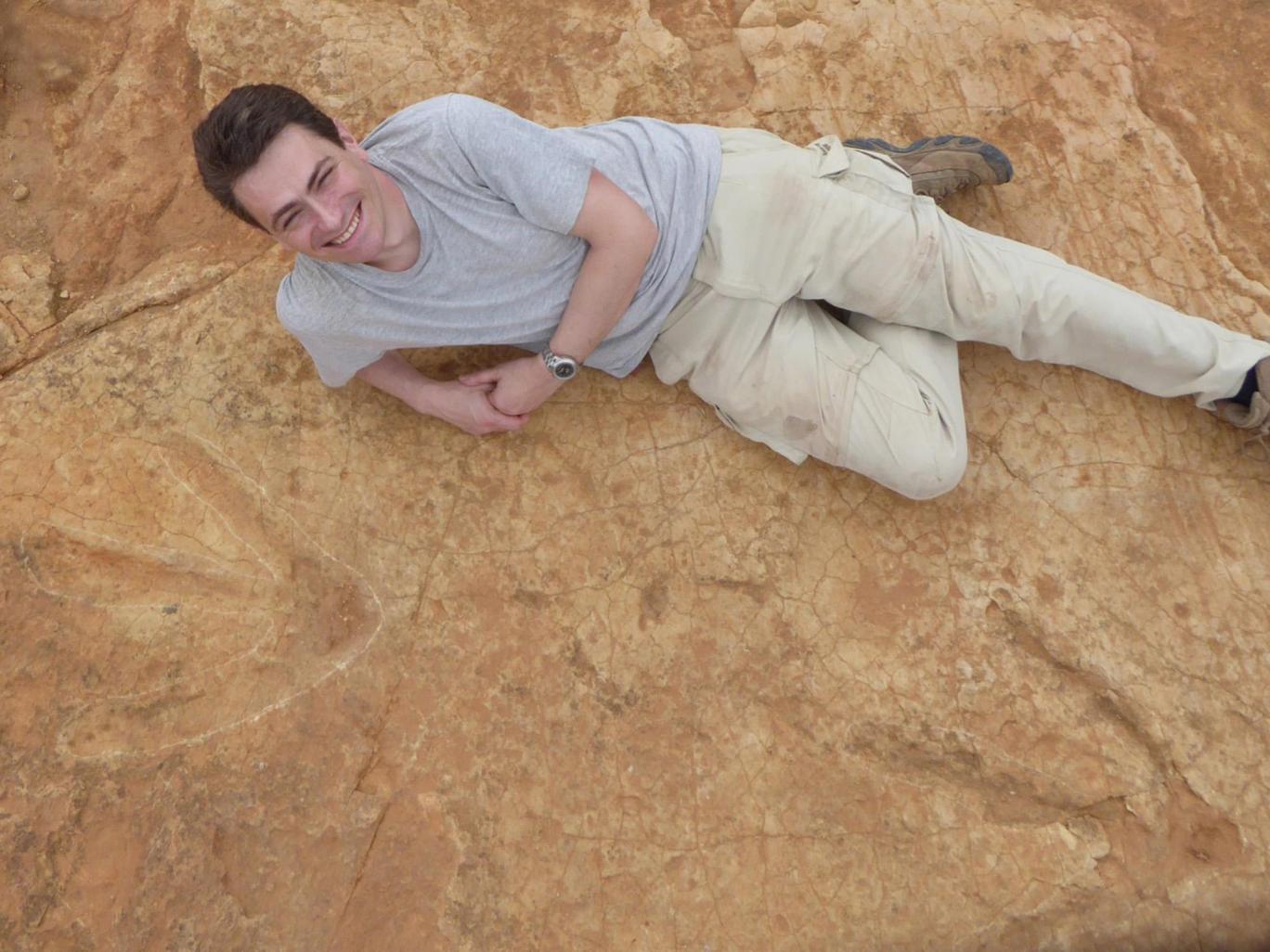

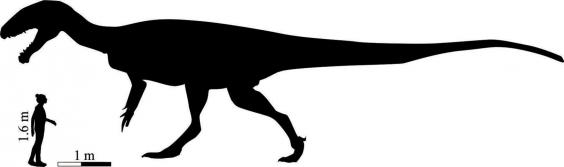

Son solo unas huellas grabadas hace millones de años en lo que entonces sería barro pero hoy es dura roca, en Sudáfrica. Ni siquiera son unas huellas muy complejas: tres líneas que convergen en un ángulo cerrado, como las que dejaría un pájaro sobre la arena húmeda de la playa.

Estas son algo más grandes. La línea central, la que correspondería al segundo dedo (o su equivalente) es más larga que la distancia entre el codo y la punta de los dedos de un hombre adulto, y también más ancha. Estamos ante el rastro dejado por un pájaro enorme. O un reptil. O ambas cosas.

Es un dinosaurio, y no uno cualquiera: el carnívoro más grande descubierto en el sur de África hasta la fecha. Donde hoy reina el león como el carnívoro más grande del lugar, un enorme felino en la cima de la cadena alimentaria, hubo durante el Jurásico un megaterópodo que lo cuadruplicaba en tamaño.

Saluden al Kayentapus ambrokholohali

Es un descubrimiento reciente,bautizado como Kayentapus ambrokholohali, y especialmente interesante por varios motivos. El primero, la aterradora fascinación de imaginarnos a un carnívoro que debió medir unos 9 metros de largo y hasta 3 de alto viviendo y cazando en un entorno en el que nadie podía hacerle sombra. Su hábitat estaría poblado por grandes herbívoros, pero ningún otro depredador que se acercase a su tamaño. Él era entonces el rey de la sabana.

Pero el más importante está relacionado con la época de la que datan las huellas, el principio del Jurásico, porque eso obliga a replantear todo lo que los científicos creían saber sobre los tiranosaurios y su familia.

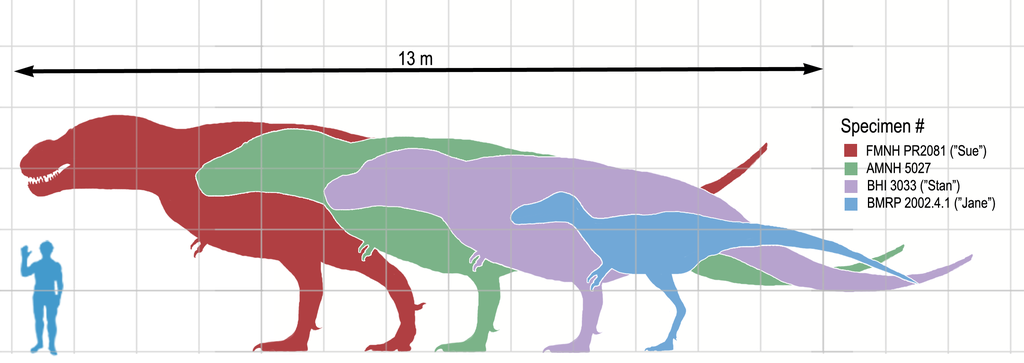

Tamaño relativo de terópodos

Hasta ahora se sabía que los terópodos, dinosaurios carnívoros que caminaban sobre dos patas, que vivieron en esta época eran relativamente pequeños. La mayoría medían entre tres y cinco metros de largo. Los más grandes podían alcanzar, como mucho, siete. El T-Rex, que sería uno de los mayores llegando a medir hasta 12,5 metros, no existiría hasta millones de años después y nunca poblaría esta zona.

El Tiranosauría tendría su cuerpo cubierto de protoplumas

Por eso los científicos creían que los terópodos se volvieron enormes a finales del Jurásico y durante el Cretácico, entre hace 145 millones de años y hace 65 millones de años, momento en el que estos animales se extinguieron y desaparecieron para siempre.

Por eso este último descubrimiento obliga a recomponer el mapa y la línea temporal de los terópodos. También ayuda a completar lo que sabemos de cómo era el paisaje africano millones de años antes de que el hombre poblase la Tierra. En lo que hoy son la selva y la sabana, donde viven leones, jirafas, gacelas, cocodrilos y rinocerontes, vivieron hace millones de años otros animales muy diferentes con sus propias relaciones entre depredadores y presas, con el Kayentapus ambrokholohali como amo y señor del lugar.

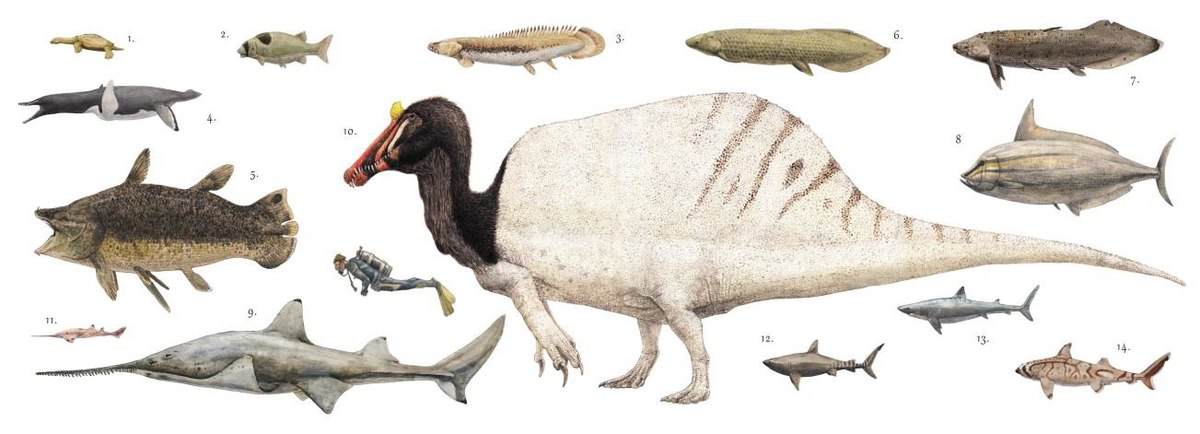

Spinosaurus, el rey de los carnívoros

Esqueleto de Spinosaurus expuesto en Japón

Aunque tanto él como el T-Rex se han quedado sin ocupar el lugar del dinosaurio carnívoro más grande de la historia porque el puesto ya está ocupado por el Spinosaurus, un gigantesco animal que vivió en el Cretácico, hace 100 millones de años, en la zona del norte de África, lo que hoy son Egipto y Marruecos.

Medía entre 15 y 18 metros de largo y estaba tocado por una gran aleta de espinas que le da nombre. Gracias a ella y a su cabeza, similar en su forma a la de los cocodrilos modernos, el Spinosaurus era un hábil pescador aunque también cazaba en tierra.

Spinosaurus comparado con animales actuales

A diferencia de la cómica imagen que tenemos de las patas delanteras de los tiranosaurios, cortas y débiles en comparación con sus poderosas patas traseras, algunos descubrimientos sugieren que las patas delanteras del Spinosaurus eran también fuertes, y que quizá no siempre era bípedo, sino que podía también caminar a cuatro patas.

Hoy de aquellos gigantes solo quedan huellas y huesos convertidos en piedra que nos ayudan a conocerles, aunque no es fácil. Los expertos en paleontología interpretan lo que encuentran y lo que no deben suponerlo, calcularlo o sugerirlo. Gracias a su trabajo podemos imaginar quiénes fueron los anteriores reyes de África.

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Antes de que el león se hiciese con el trono de rey de la selva se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: Casi me vuelvo a casa antes de las Galápagos

- ¿Y si los dinosaurios se hubieran extinguido antes de que se formaran los anillos de Saturno?

- El Rey León, la falsabilidad y los cuasicristales

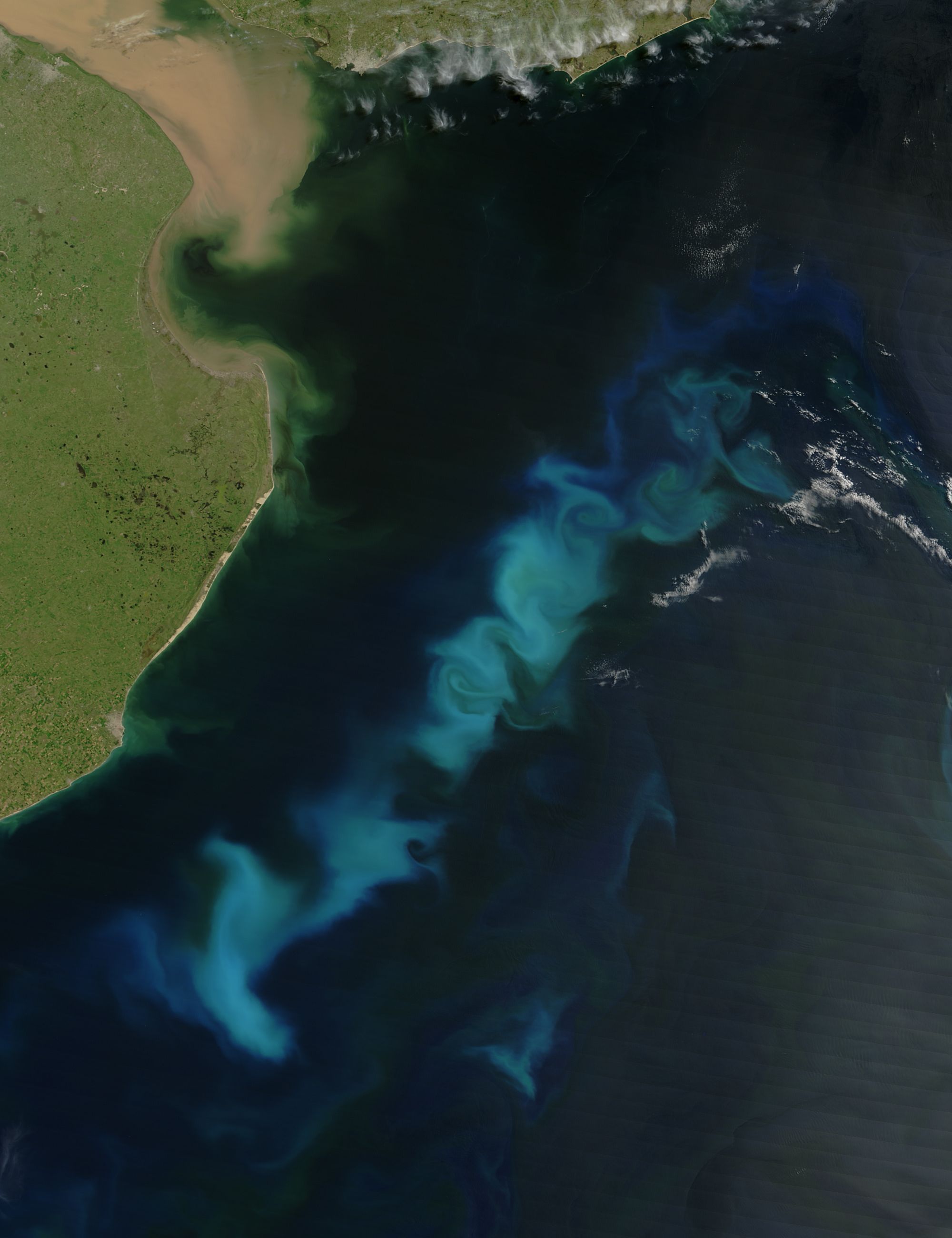

Abonar el mar para enfriar el planeta

Nube de cenizas del Pinatubo durante la erupción de 1991

El 15 de junio de 1991 la segunda mayor erupción volcánica del siglo XX, la del Monte Pinatubo en el norte de las Islas Filipinas, arrojó a los océanos 40.000 toneladas de polvo de hierro. Tras ese suceso el nivel atmosférico de CO2 descendió y subió el de O2. Aquella erupción es, seguramente, la mejor prueba a favor de una hipótesis formulada en 1988 por el científico John Gribbin, quien propuso que añadiendo grandes cantidades de hierro soluble al mar podría atenuarse el cambio climático.

La noción de que el hierro soluble puede revertir el calentamiento del planeta está basada en una idea formulada por primera vez en 1930 por el biólogo Joseph Hart. En el océano hay zonas ricas en nutrientes pero pobres en fitoplancton, que es como se llama al conjunto del material vegetal flotante, normalmente de tamaño microscópico. Hart pensaba que la razón de esa deficiencia era que en esas zonas había poco hierro, lo que impedía que creciera la materia vegetal. En los años ochenta el oceanógrafo John Martin, analizando los minerales disueltos presentes en esas zonas, retomó la idea de Hart. Y Gribbin sugirió que si se añadía al mar el nutriente que escaseaba –en este caso el hierro-, podría estimularse el crecimiento del fitoplancton y puesto que, para ello, las microalgas que lo forman han de captar CO2, podría así retirarse de la atmósfera ese compuesto. De ese modo disminuiría el efecto invernadero que provoca el CO2 y parte del calor que ahora queda retenido en la atmósfera se disiparía hacia el exterior. Poco después de que Gribbin hiciera la propuesta, Hart dijo, medio en serio medio en broma, “dadme medio barco cisterna de hierro y os daré otra edad de hielo”. Y desde entonces se empezó a considerar en serio la posibilidad de recurrir a ese procedimiento para atenuar o revertir el calentamiento global.

Fitoplancton oceánico floreciendo en el Océano Atlántico, cerca de las costas de Argentina cubriendo un área de aproximadamente 300 millas por 50 millas. Imagen: NASA. Moderate Resolution Imaging Spectroradiometer (MODIS) / Aqua satellite.

En el fitoplancton, por cada átomo de hierro hay mil átomos de fósforo, dieciséis mil de nitrógeno y ciento seis mil de carbono. Eso implica que por cada átomo de hierro utilizado por el fitoplancton se fijarían ciento seis mil átomos de carbono adicionales o, lo que es lo mismo, por cada kilogramo de hierro se fijarían ochenta y tres toneladas de CO2. Parte del dióxido de carbono fijado retornaría pronto a la atmósfera, debido al metabolismo de los organismos que lo consumen; por ello, una parte del CO2 pasaría al agua y después, quizás, a la atmósfera. Pero la fracción que permanecería en el océano sería mucho mayor, pues se acumularía a gran profundidad en detritos orgánicos o en forma de carbonatos. Pasarían centenares o miles de años antes de que retornase a aguas someras.

Desde que se propuso la idea se han hecho trece experimentos en mar abierto con resultados contradictorios, al parecer. Además, hay científicos preocupados acerca de los efectos indeseados que podrían tener intervenciones a gran escala. Temen que puedan producirse cambios en la composición de microalgas en las zonas afectadas, incluyendo la proliferación de fitoplancton tóxico, y también que los fondos marinos se queden sin oxígeno por un exceso de sedimentación de restos orgánicos. Por ello hay una moratoria sobre los proyectos de grandes fertilizaciones en alta mar en tanto no se hayan evaluado los experimentos hechos hasta ahora. De hecho, podría ocurrir que por evitar la hipotética aparición de mareas rojas a miles de millas de las costas se abandone la idea de tratar de revertir el calentamiento global secuestrando carbono en los océanos. Nos encontraríamos así ante una consecuencia paradójica del famoso principio de precaución.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 2 de julio de 2017.

El artículo Abonar el mar para enfriar el planeta se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Natacha Aguilar: “Necesitamos que el mar esté en equilibrio para que el planeta también lo esté”

- Un extraño planeta

- En lo más recóndito de nuestro planeta

Naukas Pro 2017: Manuel Collado y las células madre

El pasado 14 de septiembre de 2017 se celebró la primera edición de Naukas Pro, en el que Centros de Investigación, Laboratorios, científicos de renombre o equipos de trabajo contaron con 20 minutos para explicar a un público general en qué consiste su trabajo.

5ª Conferencia: Manuel Collado, Laboratorio de Células Madre en Cáncer y Envejecimiento (IDIS-CHUS)

Manuel Collado habla sobre las células madreEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2017: Manuel Collado y las células madre se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro 2017: Javier Burgos y el alzhéimer

- Naukas Pro 2017: Carlos Briones y el origen de la vida

- Naukas Pro 2017: Leni Bascones y los superconductores

El 70% de los varones del País Vasco desciende de un antepasado que vivió hace 4.500 años

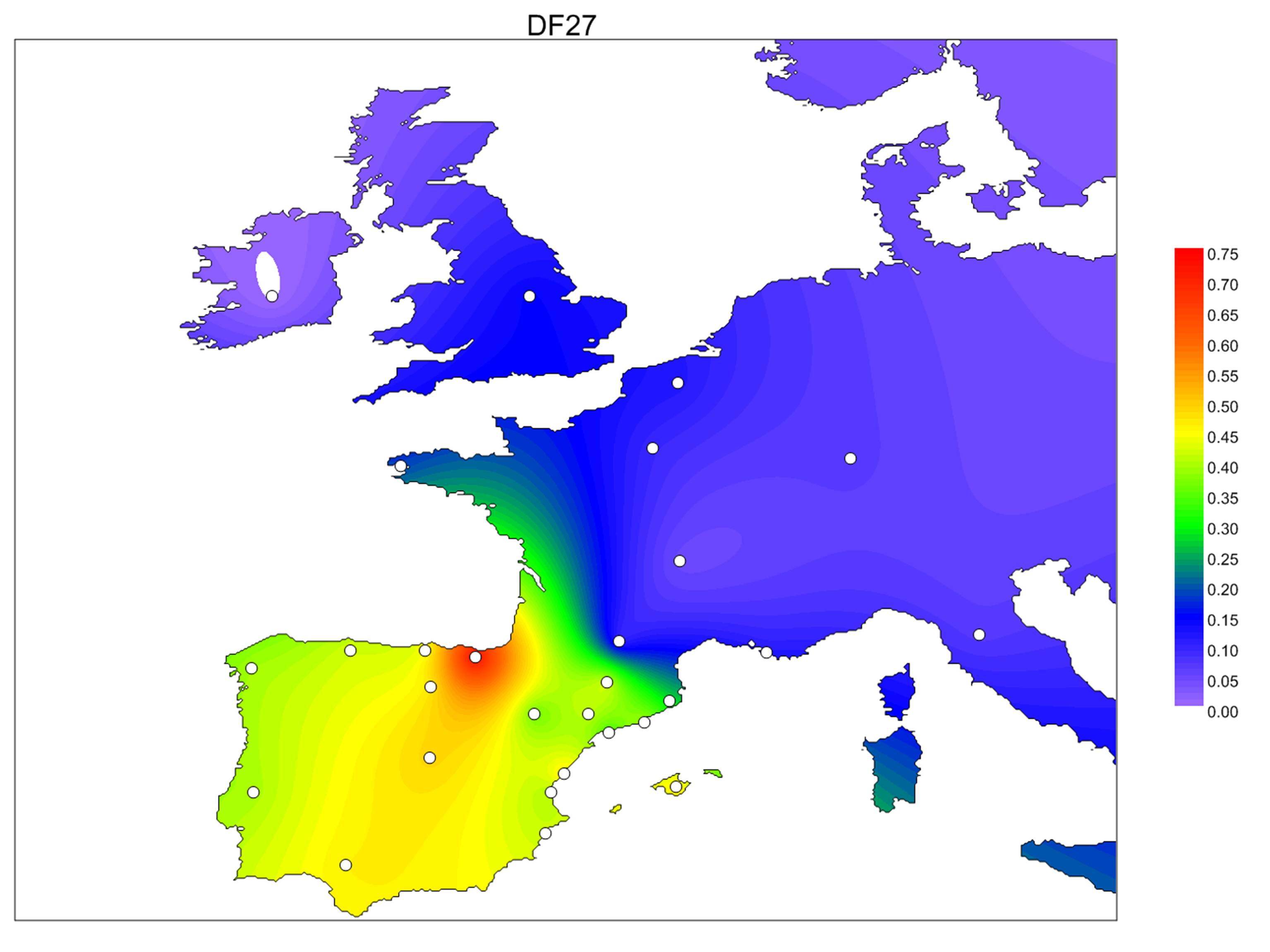

Tan sólo supone el 1% de todo el genoma masculino, pero es el responsable de que los hombres sean anatómicamente hombres. El cromosoma Y, encargado de impedir la formación de los ovarios en el feto y de permitir el desarrollo de los testículos, se transmite únicamente de padres a hijos varones. Desde el punto de vista evolutivo, esta característica facilita el rastreo de las distintas variantes existentes del cromosoma, y ya se conoce el origen, la dispersión y la distribución geográfica de muchas de ellas. Ahora, científicos del grupo de investigación en Genómica de la Individualidad de la UPF y del grupo BIOMICs de la UPV/EHU han estudiado la variante R1b-DF27, conocida en la comunidad científica por su elevada frecuencia en la Península Ibérica.

Mediante el análisis de muestras de ADN de casi 3.000 hombres de la Península Ibérica y Francia, el equipo científico ha revelado la presencia de esta variante en el 40% de los varones ibéricos, pero por debajo del 10% más allá de los Pirineos. La cifra asciende considerablemente en el País Vasco, donde el 70% de los varones muestran la variante R1b-DF27 del cromosoma Y.

Según los investigadores, “la historia evolutiva de los cromosomas Y humanos parece haber ocurrido en ráfagas, con aumentos en la frecuencia de ciertas variantes a raíz de cambios culturales o innovaciones tecnológicas”. En el caso de la variante R1b-DF27, los autores aseguran que se originó hace entre 4.000 y 4.500 años, y lo más probable es que apareciera en el noreste de la Península. “A pesar de su elevada frecuencia actual en el País Vasco, las medidas internas de diversidad y las estimaciones por edad son más bajas en los vascos que en cualquier otra población, lo que parece descartar esta región como punto de origen de la variante, si bien, todavía es pronto para asegurarlo”, comenta Marian Martínez de Pancorbo, investigadora principal del grupo de la UPV/EHU. Para los científicos, “un origen local en Iberia parece la hipótesis más plausible, puesto que muestra las mayores estimaciones de diversidad y edad para R1b-DF27”. Estas observaciones parecen coincidir con el movimiento de oriente a occidente que se produjo en Iberia en la Edad de Bronce, cuando los pueblos ibéricos no indoeuropeos se establecieron en la costa mediterránea y en el interior porque los pueblos celtas ocupaban el centro y el oeste de la Península Ibérica.

El estudio de R1b-DF27 puede ayudar a rastrear eventos migratorios que involucren a hombres españoles o portugueses. Un claro ejemplo se ha visto en las poblaciones latinoamericanas, donde la variante se halla en frecuencias del 40% en Colombia, 36% en Puerto Rico, 10% en México y 8% en Perú. La presencia de R1b-DF27 es notablemente inferior en las poblaciones con un componente indígena más fuerte, como México y Perú, evidenciando una menor mezcla de sus individuos con los colonos en el pasado. Incluso en Europa, las frecuencias de los subgrupos Y han sido utilizadas para detectar eventos de migración a corto plazo. Así, las huellas de la expansión medieval del reino de Aragón hacia el Mediterráneo durante los siglos XIV y XV o la ocupación castellana de Flandes en el siglo XVI pueden ser rastreadas a través de los linajes masculinos, en particular, a través de R1b-DF27.

Pero, además, una variante cromosómica con frecuencias relativamente altas en poblaciones ibéricas y rara en otras regiones puede tener aplicaciones en la genética forense. La presencia de R1b-DF27 en una muestra biológica recogida en la escena de un crimen puede ayudar a identificar el origen geográfico de quien la aportó.

Referencia:

Neus Solé-Morata, Patricia Villaescusa, Carla García-Fernández, Neus Font-Porterias, María José Illescas, Laura Valverde, Francesca Tassi, Silvia Ghirotto, Claude Férec, Karen Rouault, Susana Jiménez-Moreno, Begoña Martínez-Jarreta, Maria Fátima Pinheiro, María T. Zarrabeitia, Ángel Carracedo, Marian M. de Pancorbo, Francesc Calafell.. ‘Analysis of the R1b-DF27 haplogroup shows that a large fraction of Iberian Y-chromosome lineages originated recently in situ’. Scientific Reports. Agosto 2017. DOI: 10.1038/s41598-017-07710-x.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El 70% de los varones del País Vasco desciende de un antepasado que vivió hace 4.500 años se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Relaciones a distancia desde hace 16.000 años

- Técnicas artísticas de hace 40.000 años

- Los misterios que rodean al máximo térmico de hace 56 millones de años

Ecolocalización, la capacidad de ver a través del sonido

Murciélago Myotis myotis (Carlos González Revelles). PRINUM

¡Apaga la radio que no puedo aparcar!, ¿verdad que os ha pasado?. Es curiosos como el sentido del oído puede afectar directamente nuestras capacidades cognitivas e impedir que desarrollemos tareas de manera eficiente.

No obstante, no se trata de algo exclusivo de los humanos. Una investigación liderada por la Universidad de Exeter (Reino Unido) se centró en observar el comportamiento de los peces limpiadores, aquellos que retiran parásitos a otros peces (conocidos como ‘clientes’), cuando se les expone al ruido de las lanchas a motor.

Según su estudio, publicado en la revista Scientific Reports, mientras se les expone a este sonido los peces limpiadores son más propensos a ‘engañar’, mordisqueando la capa mucosa protectora de sus clientes en lugar de limpiarlos de parásitos. Por su parte, los clientes son más propensos a estarse quietos y dejar que esto suceda.

Aquí en España, Investigadores del Museo Nacional de Ciencias Naturales (MNCN-CSIC) pudieron comprobar cómo afecta la contaminación acústica del aeropuerto de Madrid al comportamiento de las poblaciones de carboneros comunes, Parus major. Con el ruido provocado por los aviones, las aves prolongan su estado de vigilancia en detrimento de su alimentación. En definitiva, los resultados muestran cómo las aves se sobreponen al ruido adaptando sus conductas.

Según los investigadores, “al no oír, los carboneros compensan esa pérdida aumentando la vigilancia visual”. Con esta investigación se registró cómo el tiempo de vigilancia visual de los carboneros comunes se dispara al despegar los aviones, al mismo tiempo que la actividad alimenticia se ve relegada ante este estado de alerta.

Un GPS en el oído

Y es que el sentido del oído todavía guarda algunos secretos. La posibilidad de desarrollar la ecolocalización es uno de ellos. No es ni más ni menos que un proceso que consiste en emitir un sonido que rebota al encontrar un obstáculo y analizar el eco recibido. Involucra la producción, elaboración, recepción y audición de los pulsos ultrasónicos para detectar obstáculos invisibles o rastrear presas y ha evolucionado por separado en diferentes grupos de murciélagos y cetáceos como los delfines.

Se trata de un sistema que permite a los animales que lo poseen medir la distancia hasta los objetos y es uno de los ejemplos más conocidos de evolución convergente, es decir, un desarrollo de rasgos similares en diferentes especies.

De hecho, un trabajo llevado a cabo en la Universidad Queen Mary de Londres con murciélagos y delfines, cuya ecolocación evolucionó independientemente, encontró patrones genéticos convergentes en casi 200 regiones genómicas diferentes concentrados en varios genes auditivos, o lo que es lo mismo, siendo especies totalmente diferentes cuentan con similitudes genéticas algo que los científicos creen que podría ser la punta del iceberg: “Cuando los genomas de más especies se secuencien y estudien, podremos ver otros casos notables de adaptaciones convergentes impulsados por cambios genéticos idénticos”.

Por otro lado, como si de un superpoder se tratase, se sabe que algunas personas invidentes tienen la capacidad de detectar la posición de algunos objetos mediante ese mismo sistema pero es que yendo un paso más allá, científicos de la Universidad Ludwig Maximilian, de Munich, han publicado un estudio en el Journal of Neuroscience, donde se recoge que los videntes también pueden conseguirlo, aunque su cerebro lo procese de un modo diferente.

Concretamente, estos científicos contaron con la colaboración de 12 personas (solo una de ellas era ciega) a las que introdujo en una habitación acolchada que impedía que se generara ningún tipo de eco. Una vez allí se les reproducían una serie de sonidos concretos y se les repetía, como si de ecos artificiales se tratase; asociando cada sonido a un tamaño de habitación diferente.

Posteriormente se les introducía en una máquina de resonancia magnética al mismo tiempo que se les conectaba a una reproducción virtual de un edificio cercano, con el objetivo de que si producían cualquier sonido, recibirían el eco a través de unos auriculares, como si realmente se encontraran en el interior del edificio.

Se podían dar dos tipos de ecolocalización: activa, si ellos mismos generaban el sonido a través de un chasquido de su lengua, o pasiva, si se aprovechaban del eco de un ruido externo, en este caso producido por la propia máquina.

Gracias a las clases previas que habían recibido, todos ellos acertaron con bastante precisión el tamaño de la habitación, aunque los resultados eran mucho mejores cuando eran ellos los que producían el sonido con sus lenguas.

El dato más llamativo fue que se detectaron diferencias entre las áreas del cerebro que procesaron la información de los individuos videntes y del ciego. En el caso de los primeros, fue la corteza motora, encargada de procesar el movimiento, la que se activó durante el procesamiento del eco, mientras que en el ciego se activó la corteza visual; que, lógicamente, normalmente se encuentra inactiva en personas de su condición.

Unos datos que ponen de manifiesto que aunque el cerebro se adapte a las condiciones de manera diferente, todos podemos desarrollar esa habilidad y es posible que, con el entrenamiento suficiente, cualquier otra que nos propongamos.

Este post ha sido realizado por Mariajo Moreno (@Mariajo_Moreno) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias científicas y más información:

Joe Parker, Georgia Tsagkogeorga,, James A. Cotton, Yuan Liu, Paolo Provero, Elia Stupkay Stephen J. Rossiter. ‘Genome-wide signatures of convergent evolution in echolocating mammals’ Nature, 4 de septiembre de 2013. doi:10.1038/nature12511

Klett-Mingo, J.I., Pavón, I., y Gil, D. (2016) ‘Great tits, Parus major, increase vigilance time and reduce feeding effort during peaks of aircraft noise’ Animal Behaviour, DOI: 10.1016/j.anbehav.2016.02.021

Virginia L. Flanagin, Sven Schörnich, Michael Schranner, Nadine Hummel, Ludwig Wallmeier, Magnus Wahlberg, Thomas Stephan and Lutz Wiegrebe. ‘Human exploration of enclosed spaces through echolocation’ Journal of Neuroscience 10 January 2017, 1566-12; DOI: https://doi.org/10.1523/JNEUROSCI.1566-12.2016

El artículo Ecolocalización, la capacidad de ver a través del sonido se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La física del sonido orquestal

- Las tres dimensiones del sonido

- Un viaje a través del sistema circulatorio humano

“Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso

Bence Nanay

Detalle de “Madame Jeantaud au miroir” de Edgar Degas (aprox. 1875). Cortesía de Wikipedia

Hay una frase que es igualmente probable que encuentres en un texto filosófico serio como en el libro de autoayuda más extravagante: “¡Conócete a ti mismo!” La frase tiene un pedigrí filosófico serio: en la época de Sócrates, era más o menos sabiduría tradicional (aparentemente cincelada en la explanada del Templo de Apolo en Delfos) aunque una variante de la frase se remonta al Antiguo Egipto. Y desde entonces, la mayoría de los filósofos han tenido algo que decir al respecto.

Pero “¡Conócete a ti mismo!” también tiene el atractivo de la autoayuda. ¿Tu objetivo es aceptarte a ti mismo? Bueno, necesitas conocerte primero. ¿O es tomar buenas decisiones, las decisiones que son adecuadas para ti? De nuevo, esto sería difícil a menos que te conocieras a ti mismo. El problema es que nada de esto se basa en una imagen realista del yo y de cómo tomamos decisiones. Todo este asunto de “conocerse a sí mismo” no es tan simple como parece. De hecho, podría ser un serio embrollo filosófico, por no decir un mal consejo.

Tomemos un ejemplo cotidiano. Vas a la cafetería de la esquina y pides un expreso. ¿Por qué? ¿Solo un capricho momentáneo? ¿Por probar algo nuevo? ¿Quizás sabes que la dueña es italiana y que te juzgaría si pidieses un capuchino después de las 11 de la mañana? ¿O simplemente eres una persona de expresos?

Sospecho que la última de estas opciones es la que refleja mejor tus elecciones. Haces gran parte de lo que haces porque crees que encaja con el tipo de persona que crees que eres. Pides tortilla con cebolla porque eres un tipo de persona de tortilla con cebolla. Es parte de lo que eres. Y esto se aplica a muchas de nuestras elecciones diarias. Vas a la sección de filosofía de la librería y a la sección de comercio justo del supermercado porque eres un filósofo que se preocupa por la justicia global, y eso es lo que hacen los filósofos que se preocupan por la justicia global.

Todos tenemos ideas bastante estables sobre qué tipo de personas somos. Y eso es lo mejor: no tenemos que pensar demasiado al pedir el café todas las mañanas. Estas ideas sobre qué tipo de persona somos también pueden ir acompañadas de ideas sobre qué tipo de persona no somos, no voy a comprar en Lidl*, no soy ese tipo de persona. (Esta forma de pensar acerca de uno mismo podría derivar fácilmente en moralizar nuestras preferencias, pero no abramos esa lata de gusanos aquí).

Sin embargo, existe un importante problema con esta disposición mental: las personas cambian. Hay períodos tumultuosos en los que cambiamos drásticamente, en los períodos de amor romántico, por ejemplo, o de divorcio o de tener hijos. A menudo somos conscientes de estos cambios. Después de haber tenido hijos, probablemente te hayas dado cuenta de que de repente te has convertido en una persona madrugadora.

Pero la mayoría de los cambios ocurren de forma gradual y por debajo del radar. Se comprenden bien algunos mecanismos de estos cambios, como el “mero efecto de exposición“: cuanto más estás expuesto a algo, más fácil es que te guste. Otro, más problemático, es que cuanto más se frustra tu deseo de algo, más fácil es que te desagrade. Estos cambios ocurren gradualmente, a menudo sin que notemos nada.

El problema es este: si cambiamos mientras nuestra imagen de nosotros mismos permanece igual, habrá un profundo abismo entre quiénes somos y quiénes pensamos que somos. Y esto lleva al conflicto.

Para empeorar las cosas, somos excepcionalmente buenos descartando incluso la posibilidad de que podamos cambiar. Los psicólogos le han dado a este fenómeno un nombre elegante: “la ilusión del final de la historia”. Todos pensamos que quienes somos ahora es el producto terminado: seremos iguales en cinco, 10 o 20 años. Pero, como descubrieron estos psicólogos, esto es completamente delirante: nuestras preferencias y nuestros valores serán muy diferentes en un futuro no muy lejano.

¿Por qué es esto un gran problema? Puede estar bien cuando se trata de pedir el expreso. Tal vez ahora prefieras casi mejor el capuchino, pero piensas que eres una persona de café expreso, por lo que sigues pidiendo expreso. Así que estás disfrutando de tu bebida matutina un poco menos; nada demasiado importante.

Pero lo que es cierto del expreso es cierto de otras preferencias y valores en la vida. Tal vez solías disfrutar realmente filosofando, pero ya no lo haces. Pero como ser filósofo es una característica tan estable de tu autoimagen, sigues haciéndolo. Hay una gran diferencia entre lo que te gusta y lo que haces. Lo que haces no está dictado por lo que te gusta, sino por el tipo de persona que crees que eres.

El verdadero perjuicio de esta situación no es solo que pasas gran parte de tu tiempo haciendo algo que no te gusta especialmente (y que a menudo te desagrada positivamente). En cambio, es que a la mente humana no le gustan las contradicciones flagrantes de este tipo. Hace todo lo posible para ocultar esta contradicción: un fenómeno conocido como disonancia cognitiva.

Ocultar una gran contradicción entre lo que nos gusta y lo que hacemos requiere un gran esfuerzo mental y esto deja poca energía para hacer cualquier otra cosa. Y si te queda poca energía mental, es mucho más difícil apagar el televisor o resistirse a pasar media hora mirando Facebook o Instagram.

¡Conócete a ti mismo!’, ¿verdad? Si tomamos en serio la importancia del cambio en nuestras vidas, esto simplemente no es una opción. Podrías saber lo que piensas de ti en este momento. Pero lo que piensas de ti es muy diferente de lo que eres y lo que realmente te gusta. Y en un par de días o semanas, todo esto podría cambiar de todos modos.

Conocerse a sí mismo es un obstáculo para reconocer y hacer las paces con valores constantemente cambiantes. Si sabes que eres tal y tal tipo de persona, esto limita considerablemente tu libertad. Puede ser que hayas sido la que elegió ser una persona de expreso o una persona que dona a la caridad, pero una vez que estas características se incorporan a tu propia imagen, tienes muy poco que decir en qué dirección va tu vida. Cualquier cambio sería o censurado o llevaría a una disonancia cognitiva. Como escribió André Gide en Autumn Leaves (1950): “Una oruga que busca conocerse a sí misma nunca se convertirá en mariposa”.

![]() Sobre el autor: Bence Nanay es catedrático de filosofía en la Universidad de Amberes (Bélgica) y Senior Research Associate de la Universidad de Cambridge (Reino Unido).

Sobre el autor: Bence Nanay es catedrático de filosofía en la Universidad de Amberes (Bélgica) y Senior Research Associate de la Universidad de Cambridge (Reino Unido).

Texto traducido y adaptado por César Tomé López a partir del original publicado por Aeon el 16 de octubre de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0).

Nota del traductor:

[*] “Costco” en el original. “Lidl” podría ser un equivalente en Europa continental.![]()

El artículo “Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Te tocó ayer la lotería? Da lo mismo, eres la persona más rica del mundo

- El crimen más estúpido

- El entrenamiento mental solo sirve para entretenerse un rato

Las mujeres poderosas se pintan los labios

Cleopatra se pintaba los labios con rojo rejalgar. En la época victoriana el pintalabios estaba repudiado, representaba la «inmoralidad femenina». Las sufragistas emplearon el pintalabios rojo como símbolo de la emancipación femenina. En la actualidad, pintarse los labios forma parte de una campaña de rechazo a las políticas machistas de Trump, e incluso es el estandarte de una nueva ola del feminismo.

Movimientos sociales con los labios pintados

El pintalabios ha estado vinculado a momentos sociales importantes como símbolo de protesta o de fortaleza de la mujer. En 1912, el movimiento sufragista utilizó el pintalabios rojo como símbolo de la emancipación femenina y de lucha en sus marchas por Nueva York.

Durante la Segunda Guerra Mundial, Elisabeth Arden creó un tono para las Fuerzas Armadas estadounidenses y Helena Rubinstein lanzó el color Regimental Red. El Gobierno de Estados Unidos puso en marcha una campaña bajo el lema Beauty as Duty («La belleza como deber»), que animaba a las mujeres a no descuidar su imagen para dar una apariencia de normalidad a pesar del conflicto bélico.

Unos de los labios más famosos del cine fueron los de Clara Bow, quien aparecía con ellos pintados en las películas de cine mudo de los años veinte. El pintalabios era un recurso para potenciar los labios de las actrices en las películas en blanco y negro. Su uso en el cine ayudó a popularizarlo, convirtiéndolo en un símbolo de cultura pop. El uso de pintalabios se normalizó en los años treinta, cuando comenzaron a comercializarse en los salones de belleza de Helena Rubinstein y Elisabeth Arden. Desde ese momento comienza a entenderse el pintalabios como un símbolo de la sexualidad adulta, sentido que se potenciará en la década de los 50 con estrellas del cine como Marilyn Monroe.

A partir de los años 70, el pintalabios dejó de ser algo exclusivo de las mujeres. La cultura punk tuvo mucho que ver. La subcultura gótica, con la música industrial y el post-punk, pusieron color a los labios de algunos hombres que se han convertido en iconos, como Robert Smith o Marilyn Manson.

La historia del pintalabios tiene su ciencia

La primera prueba arqueológica del uso de maquillajes se encontró en el Antiguo Egipto. Los ojos se delineaban con polvos de grafito (kohl), con mineral pirolusita o con negro de humo, que fabricaban quemando maderas resinosas. Los labios se pintaban con pigmentos de colores rojizos y violáceos mezclados con cera o grasas, a semejanza de las pinturas que se empleaban en arte. La mayoría de esos pigmentos eran de origen mineral, como piedras de colores molidas de ocre rojo y rejalgar.

A lo largo de la historia, las tendencias de maquillaje fueron variando. Tanto los colores como los aglutinantes empleados guardaban similitud con las técnicas pictóricas del momento.

La barra de labios que conocemos actualmente es un invento reciente. Los primeros pintalabios se vendían en pequeños botes o envueltos en papel y se aplicaban con pincel. A comienzos del siglo XX, en 1910, la marca Guerlain empezó a fabricar rudimentarias barras de labios. Las aristócratas francesas lo compraban envuelto en frágiles tubos de cartón. Posteriormente, en 1915, en la Socovill Manufacturing Company se fabricaron unos de los primeros tubos metálicos en los que se insertarían las barras de labios. Así fue más fácil comercializarlas y convertirlas en un producto más asequible. El primer pintalabios de esas características que se comercializó en España fue el Milady de la compañía Puig en 1922. En 1923, James Bruce Mason Jr inventó el sistema giratorio que permite subir y bajar la barra de labios, convirtiéndolo en el objeto fácil de aplicar y transportar que hoy conocemos.

El lápiz labial contiene una variedad de ceras, aceites, pigmentos y emolientes. La cera le da al lápiz labial su forma y facilidad de aplicación. Entre las ceras se encuentran cera de abeja, la cera de carnauba, que es un exudado de los poros de las hojas de palmeras de cera brasileñas, y la cera de candelilla, que se obtiene de la planta de candelilla propia de México.

Los aceites y las grasas que se utilizan en la barra de labios como emolientes incluyen aceite de oliva, manteca de cacao, lanolina, vaselina y aceite de ricino, que forma una película dura y brillante cuando se seca después de la aplicación.

En los últimos años, se han agregado al lápiz labial ingredientes hidratantes, vitaminas antioxidantes, humectantes y filtros solares, entre otros, con el fin de mantener los labios hidratados y protegidos.

Las barras de labios con acabado mate tienen mayor proporción de ceras y pigmentos que de emolientes, es decir, tienen más textura que brillo. Las de acabado cremoso guardan mayor equilibrio entre brillo y textura. Los gloss tienen alto brillo y poco pigmento. Los destellos de algunos pintalabios provienen de partículas de mica o sílice. Y los lápices labiales de larga duración contienen aceite de silicona, que sella el color.

El pintalabios como índice económico

El pintalabios se utiliza como medidor de consumo. En los años 40, Leonar Lauder, presidente de Estée Lauder, acuñó la expresión lipstick index (índice del pintalabios) para demostrar cómo en tiempos de crisis las ventas del rouge aumentan estrepitosamente. Durante la Gran Depresión, las ventas de lápices de labios aumentaron un 25%. Este índice también sirvió para describir el aumento de las ventas de cosméticos durante la recesión de principios de la década de 2000. Lauder hizo la afirmación de que las ventas de lápiz labial podrían ser un indicador económico, en el sentido de que las compras de cosméticos -en especial los lápices labiales- tienden a estar inversamente relacionados con la salud económica. La conjetura era que las mujeres sustituyen el lápiz labial por compras más caras, como vestidos y zapatos, en tiempos de dificultades económicas.

Sin embargo, el lipstick index ha sido desacreditado como indicador económico. El aumento de las ventas de cosméticos en 2001 se ha atribuido a un mayor interés en las marcas de cosméticos diseñadas por celebridades y no tanto a la recesión.

El esmalte de uñas, en la década de 2010, con el auge del nail art como moda, sobre todo en Japón y Reino Unido, ha reemplazado al lápiz labial. Podríamos empezar a hablar de nail polish index.

Feministas con los labios pintados de rosa

El llamado feminismo de tercera ola o de tercera generación comenzó a surgir en los años ochenta y noventa, en respuesta a un fracaso percibido por las feministas de la segunda ola. La primera ola del feminismo se enfocaba principalmente en la superación de los obstáculos legales a la igualdad (sufragio femenino, derechos de propiedad, etc.), la segunda ola tenía una amplia variedad de temas, como la desigualdad de facto, la sexualidad, la familia, el lugar de trabajo y quizá de forma más controvertida, los derechos en la reproducción. El feminismo de la segunda ola empoderó a muchas mujeres en los años sesenta y setenta, pero también generó una reacción violenta en algunas regiones, estimulando estereotipos sobre feministas, feminismo y lo que es ser feminista. Las feministas de la segunda ola, como reacción al paternalismo y cosificación de la mujer, señalaron al pintalabios como uno de los iconos de sometimiento al patriarcado.

Una parte del movimiento feminista actual de la tercera ola es el lipstick feminism (feminismo de pintalabios). Este feminismo lo encarnan mujeres tan populares como Madonna o Beyoncé a través del llamado «girl power». Este tipo de feminismo es en gran parte una reivindicación de la libertad femenina, en cuanto a independencia, poderío y no censura de la sexualidad. El pintalabios, así como otros adornos que se asocian al «cliché femenino», se utiliza como estandarte del empoderamiento de la mujer.

En el siglo XIX, la reina Victoria declaró públicamente que el maquillaje era descortés. Para ella el uso del pintalabios era característico de las mujeres «inmorales» y de las prostitutas. La palidez se puso de moda durante casi un siglo. También por eso el pintalabios se recupera como símbolo.

El feminismo del pintalabios es un tema que genera controversia. Algunos ven que las muestras de poder sexual en realidad siguen ahondando en un sistema patriarcal que cosifica el cuerpo femenino. En cambio, otros argumentan que están tomando el control de su sexualidad. Que las mujeres son libres para llevar faldas, escotes y maquillaje.

A principios de 2017, un pintalabios se convirtió en el símbolo de rechazo hacia las políticas de Donald Trump que atentan contra los derechos de la mujer. Tras la «Marcha de las Mujeres» en Washington y el movimiento de los «gorros rosas», ahora la protesta se hace visible con un lápiz de labios rosa.

Katie Sones, una universitaria californiana ha lanzado la marca Lipslut (que se traduciría como labios de zorra), que forma parte de la campaña «The Fuck Trump» (el jodido Trump), «un movimiento para dar poder a las mujeres y a las futuras generaciones». El 50% del total recaudado se destinará a la entidad benéfica relacionada con los derechos de la mujer que los clientes elijan por voto popular.

La historia del pintalabios es una historia de ciencia, de música, de política. Pero sobre todo es una historia que nos habla del poder de las mujeres.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Las mujeres poderosas se pintan los labios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La menor influencia de las mujeres en Internet

- La gestión de la salud y seguridad en el trabajo de las mujeres

- El altruismo en las mujeres se ve recompensado

El pulso láser más corto

Las moléculas están en continuo movimiento. No solo de traslación, como cuando un camión hormigonera se desplaza a una obra, también existen movimientos de vibración, como el que en la hormigonera producen el motor o las irregularidades de la carretera y de rotación, como el que efectúa la cuba de hormigón. Al igual que en la hormigonera, todos los movimiento se dan a la vez. Pero, a diferencia de ésta, en la que todos los movimientos se producen en la escala de segundos, en las moléculas la escala es muchísimo menor.

Las moléculas rotan en el rango de picosegundos (10-12 s), sus átomos vibran en el rango de femtosegundos (10-15 s) y los electrones se mueven en el rango de attosegundos (10-18 s). Esto significa que, si queremos estudiar las moléculas y sus transformaciones, necesitamos señales que operen en estos rangos de tiempo, algo en absoluto trivial.

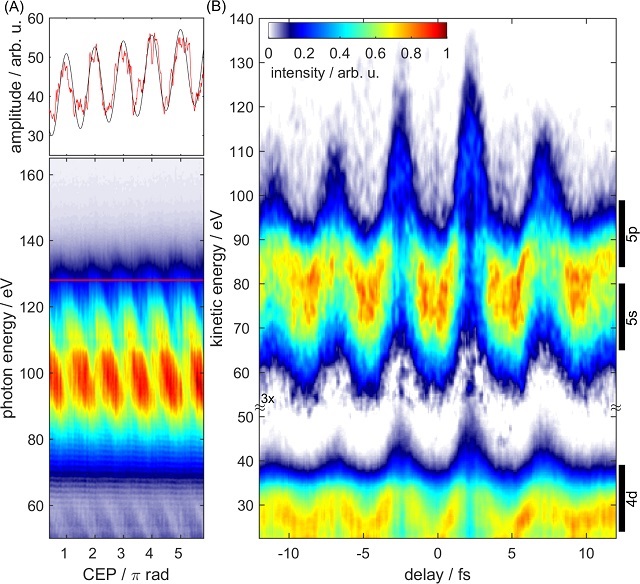

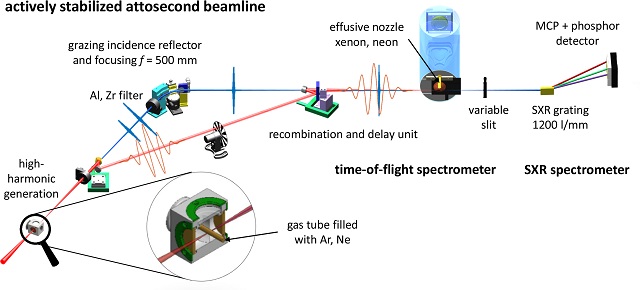

Un equipo de investigadores del Instituto Politécnico Federal de Zúrich (Suiza) encabezado por Thomas Gaumnitz ha logrado generar registrado con una duración de tan solo 43 attosegundos. Dicho de otra manera, este pulso de láser es el evento controlado más corto que jamás haya sido creado por humanos. Este pulso láser puede permitir observar con gran detalle cómo se mueven los electrones dentro de una molécula o cómo se forman los enlaces químicos.

Pero, ¿cuál es la ventaja de poder observar los pasos de las reacciones química con una resolución aún mayor? El ojo humano, por ejemplo, es muy eficiente cuando se trata de convertir fotones en señales nerviosas. En la rodopsina, un pigmento visual en la retina, la molécula fotosensible retinal se predispone de tal manera que su estructura puede cambiar extremadamente rápido mediante la absorción de un solo fotón. Esto permite que podamos ver incluso con poca luz. Una reacción mucho más lenta haría imposible la visión, porque la energía del fotón se convertiría en calor en solo unos pocos picosegundos. Esta eficiencia es algo que aún no tenemos en muchos sistemas industriales.

La espectroscopía en el rango de attosegundos podría contribuir al desarrollo de células solares más eficientes, ya que ahora sería posible por primera vez seguir el proceso desde la excitación por la luz solar hasta la generación de electricidad paso a paso. Una comprensión detallada de la vía de transferencia de carga podría ayudar a optimizar la eficiencia de la próxima generación de elementos fotosensibles.

La espectroscopía láser de attosegundos no solo sirve para observar. Las reacciones químicas también pueden ser manipuladas directamente: el uso de un pulso láser puede alterar el curso de una reacción; incluso los enlaces químicos se pueden romper al detener el cambio de carga en una determinada ubicación de la molécula. Intervenciones específicas como estas en reacciones químicas no han sido posibles hasta ahora, ya que nunca se había alcanzado la escala de tiempo del movimiento de electrones en las moléculas.

Si los químicos de síntesis tenían mucho de cirujano-barbero hace tan solo 50 años, esta herramienta una vez desarrollada los terminará de convertir en microcirujanos moleculares de alta precisión. ¡Quién sabe lo que lograrán entonces!

Referencia:

Thomas Gaumnitz et al (2017) Streaking of 43-attosecond soft-X-ray pulses generated by a passively CEP-stable mid-infrared driver Optical Express doi: 10.1364/OE.25.027506

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo El pulso láser más corto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo fabricar hielo extraterrestre y verlo molécula a molécula

- Cómo conseguir que la superhidrofobia dure

- El demonio de Maxwell

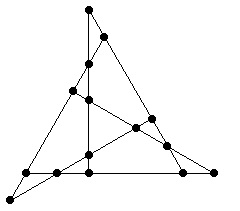

El problema de la plantación de árboles en filas (2)

Mi anterior entrada en el Cuaderno de Cultura Científica, El problema de la plantación de árboles en filas, terminaba con dos problemas de ingenio propuestos por el experto inglés en matemática recreativa Henry E. Dudeney (1857-1930), en su libro Amusements in mathematics –Diversiones matemáticas- (1917). Uno de ellos era el conocido como Rompecabezas de Newton.

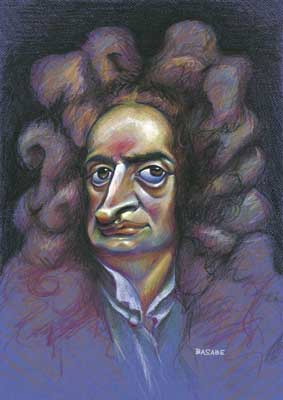

Rompecabezas de Newton: plantar 9 árboles de forma que formen 10 filas con 3 árboles en cada fila.

Os animo a quienes estáis leyendo esta entrada a que intentéis resolver el rompecabezas de Newton, antes de mirar la solución que mostraré más adelante.

Caricatura, realizada por Gerardo Basabe de Viñaspre, del matemático inglés Sir Isaac Newton (1642-1727), a quien se le atribuye la autoría del anterior juego de ingenio, perteneciente a la exposición El rostro humano de las matemáticas, de la Real Sociedad Matemática Española

Este problema de ingenio está relacionado con la familia de problemas de ingenio llamados de plantación de árboles en filas o problemas de puntos y líneas. La formulación general de estos problemas es la siguiente.

Problema: ¿Cómo pueden distribuirse n puntos en el plano (o quizás, n árboles en un huerto) formando filas, cada una de las cuales contiene exactamente k puntos (respectivamente, árboles), con el objetivo de obtener el mayor número de filas posibles? ¿Y cuál ese mayor número de filas posibles para cada n y k, que denotamos r(n,k)?

El matemático inglés James J. Sylvester (1814-1897) estuvo trabajando en este problema, para el caso clásico de filas formadas por tres árboles, es decir, el caso k = 3, desde la década de 1860 hasta su muerte. El problema de la línea de Sylvester del que hablamos en la anterior entrada formaba parte de esta investigación.

El problema general de determinar la mayor número de filas r(n, k) para n puntos y k puntos por fila no se ha resuelto todavía. Se ha obtenido la solución para algunos casos particulares y también algunas cotas inferiores para r(n, k). Por ejemplo, el propio Sylvester demostró la siguiente cota inferior:

![]()

x

es el número entero más grande que es menor o igual que x, por ejemplo,

5,2

= 5; ó

–3,2

= – 4.

Cuando k = 2 el problema es trivial, ya que cada par de puntos de los n dados forman una recta, luego el máximo número de rectas posibles es el número combinatorio “n sobre 2”, es decir, las formas de elegir dos objetos de un conjunto de n,

![]()

Para el caso clásico de filas de tres árboles, k = 3, la cuestión se complica ya mucho. Como comentaba Martin Gardner en su artículo Problemas de plantación de árboles, del libro Viajes en el tiempo y otras perplejidades matemáticas, este problema está relacionado con diferentes teorías matemáticas, como teoría del diseño, triples de Kirkman-Steiner, geometrías finitas, funciones elípticas de Weierstrass, curvas cúbicas, planos proyectivos, códigos de corrección de errores y muchas otras.

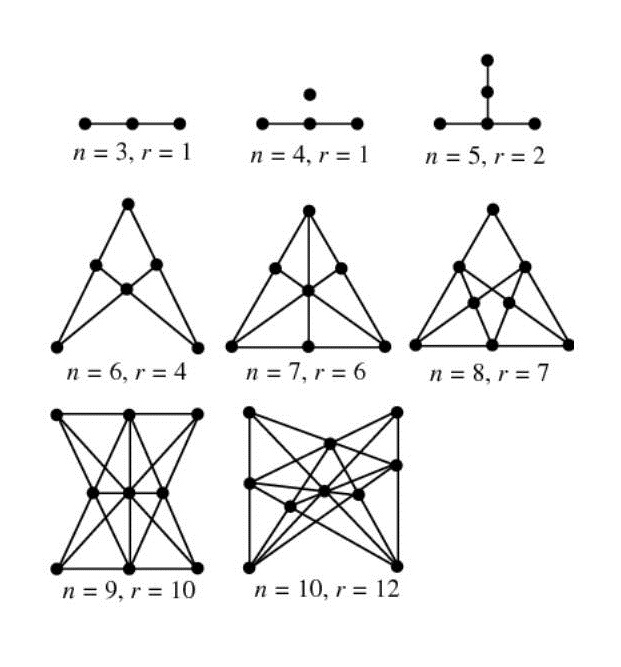

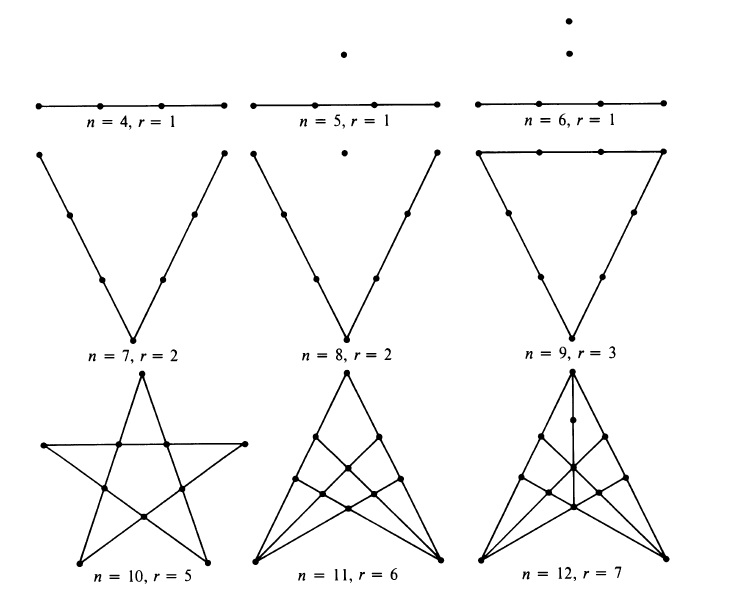

En la siguiente imagen vemos soluciones para un número bajo de puntos, es decir, distribuciones maximales de puntos (resp. árboles) en filas de tres puntos (resp. árboles) para una cantidad de puntos entre 3 y 10, muchos de los cuales aparecen en libros clásicos de problemas de ingenio.

En concreto, el diagrama para el caso de 9 puntos (abajo a la izquierda) es la solución al rompecabezas de Newton.

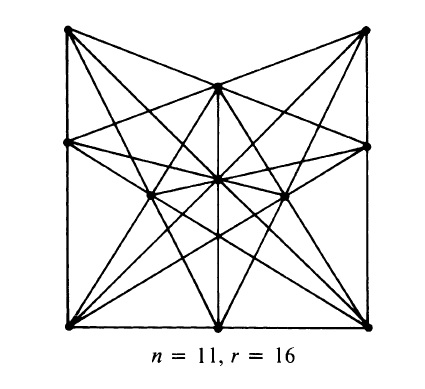

El diagrama que resuelve el caso de once puntos, es decir, la distribución maximal de 11 puntos, que permite obtener 16 rectas, es la solución del otro problema de ingenio de Henry E. Dudeney (1857-1930), de su libro Amusements in mathematics –Diversiones matemáticas-, que propusimos en la anterior entrada del Cuaderno de Cultura Científica, El problema de la plantación de árboles en filas.

Turcos y rusos (versión de N. J. A. Sloane): Durante una batalla de la Primera Guerra Mundial, 11 soldados turcos fueron rodeados por 16 soldados rusos. Cada ruso disparó una vez y cada bala pasó exactamente por la cabeza de tres turcos. ¿Cómo estaban colocados los soldados turcos?

Es el siguiente diagrama:

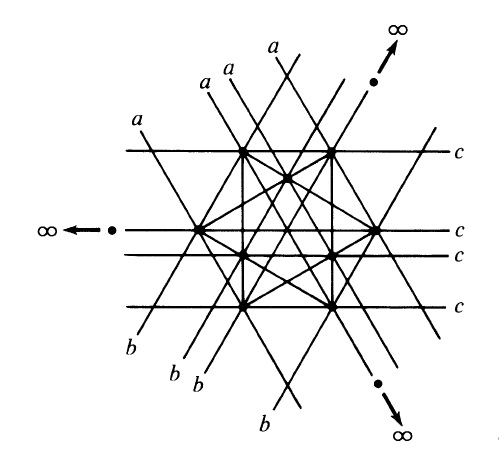

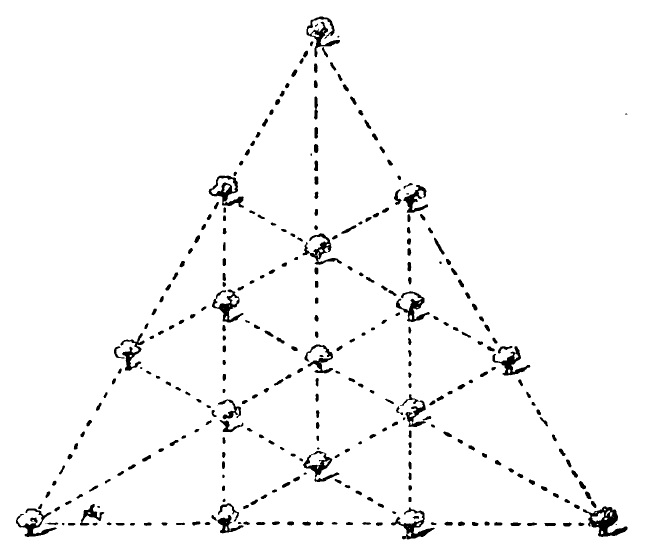

El ingeniero Robert H. Macmillan (1921-2015) que era un apasionado de la matemática recreativa, y colaborador habitual de la revista The mathematical Gazette anunció en esta revista en 1946 que se podía obtener una distribución de 12 puntos que permitía obtener 19 rectas. Después Stefan A. Burr, Branko Grunbaum, N. J. A. Sloane, en su artículo The Orchand Problem –el problema del huerto- (1974) demostraron que 19 era maximal, es decir, r(12, 3) = 19. A continuación mostramos la distribución maximal que aparece en el artículo de Burr, Grunbaum y Sloane. Esta distribución simétrica se ha realizado sobre el plano proyectivo, es decir, con puntos del infinito, de hecho, tres de los puntos están en el infinito y una de las rectas es la recta del infinito. Esta solución se puede trasladar al plano normal (euclídeo), pero no es tan sencilla de visualizar, por eso mostramos aquí la del plano proyectivo.

Aprovechemos para recordar que el plano proyectivo es una estructura geométrica que extiende el concepto de plano euclídeo ordinario. En el plano euclídeo dos rectas se intersecan en un punto o son paralelas. El plano proyectivo puede pensarse como el plano euclídeo al que se le añaden “puntos del infinito”, donde se intersecan las rectas paralelas. Por lo tanto, en el plano proyectivo cualesquiera dos rectas se cortan y lo hacen en un único punto. Además, todos los puntos del infinito forman la “recta del infinito”.

Stefan A. Burr, Branko Grunbaum, N. J. A. Sloane también obtuvieron en su artículo una nueva cota inferior para r(n, k), en concreto:

![]()

Así, por ejemplo, para las siguientes cantidades de puntos n = 13, 14, 15 y 16, se sabe que la cantidad de rectas, con tres puntos, maximal es mayor, o igual, que 22, 26, 31 y 35, respectivamente.

Recientemente, los matemáticos inglés Ben Green y australiano Terence Tao, han demostrado que la cota inferior para r(n, k) de Burr, Grunbaum y Sloane es también una cota superior, para valores suficientemente grandes de n, y por lo tanto, es el valor exacto de r(n, k), para dichos valores suficientemente grandes de n.

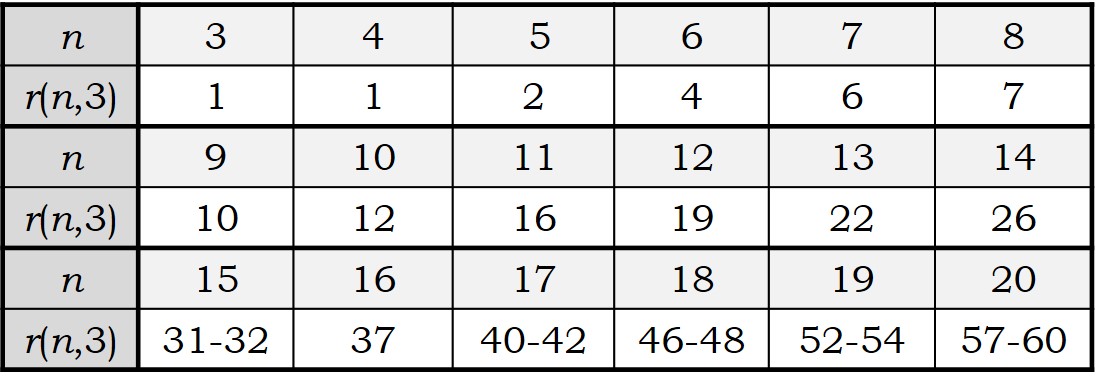

Los números r(n, 3) forman una sucesión de números enteros que aparece en la Enciclopedia On-line de Sucesiones de Números Enteros (The On-Line Encyclopedia of Integer Sequences) como la sucesión A003035.

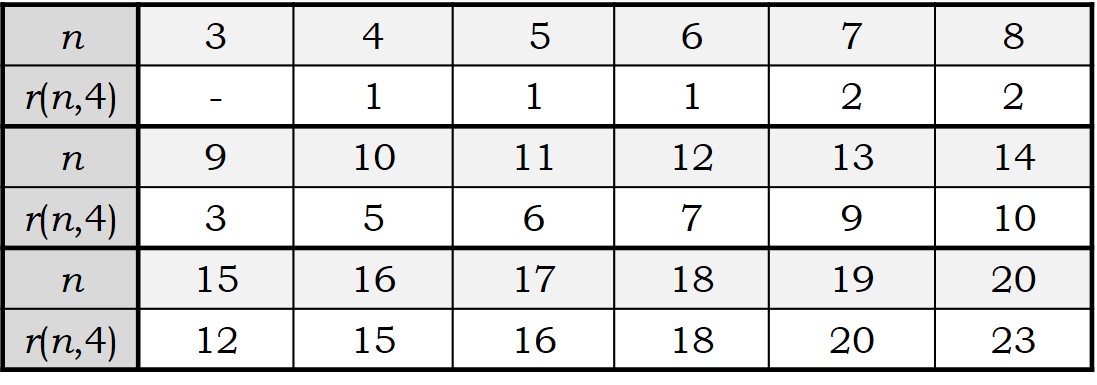

Los valores que se conocen de r(n, k), para n menor o igual que 20 son los siguientes:

Si aumentamos el número de puntos (o árboles) por línea a cuatro, k = 4, el problema de la plantación de árboles por filas, que ya era complicado para el caso clásico de 3 puntos por fila, se complica más aún.

En la actualidad se ha conseguido calcular el valor de r(n, 4) para n entre 4 y 20.

La sucesión de números r(n, 4) es la sucesión A006065 [https://oeis.org/A006065] en la Enciclopedia On-line de Sucesiones de Números Enteros (The On-Line Encyclopedia of Integer Sequences).

Los diseños maximales para valores bajos de n pueden verse en la siguiente ilustración del artículo de Martin Gardner, Problemas de plantación de árboles.

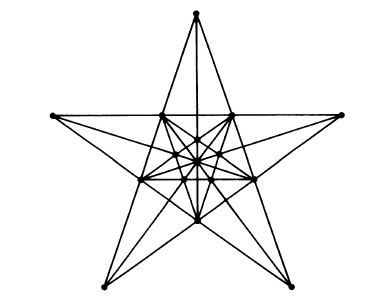

Este tipo de cuestiones han sido utilizadas por muchos expertos en matemática recreativa, como el mencionado Dudeney o el americano Sam Loyd (1841-1911), para crear problemas de ingenio. Por ejemplo, la solución óptima para 16 árboles (n = 16) fue utilizada por Dudeney en el “acertijo del Labrador” de su libro Los acertijos de Canterbury (RBA, 2007).