Jaime Escalante: “Ganas. Lo que necesitamos son ganas”

El profesor Jaime Escalante (1930-2010) fue un referente en la enseñanza de las matemáticas en Estados Unidos. A través de su singular y comprometida práctica docente consiguió que estudiantes de origen humilde y poco motivados destacaran en esta materia.

Este retrato alfabético es un pequeño homenaje a este poco convencional docente.

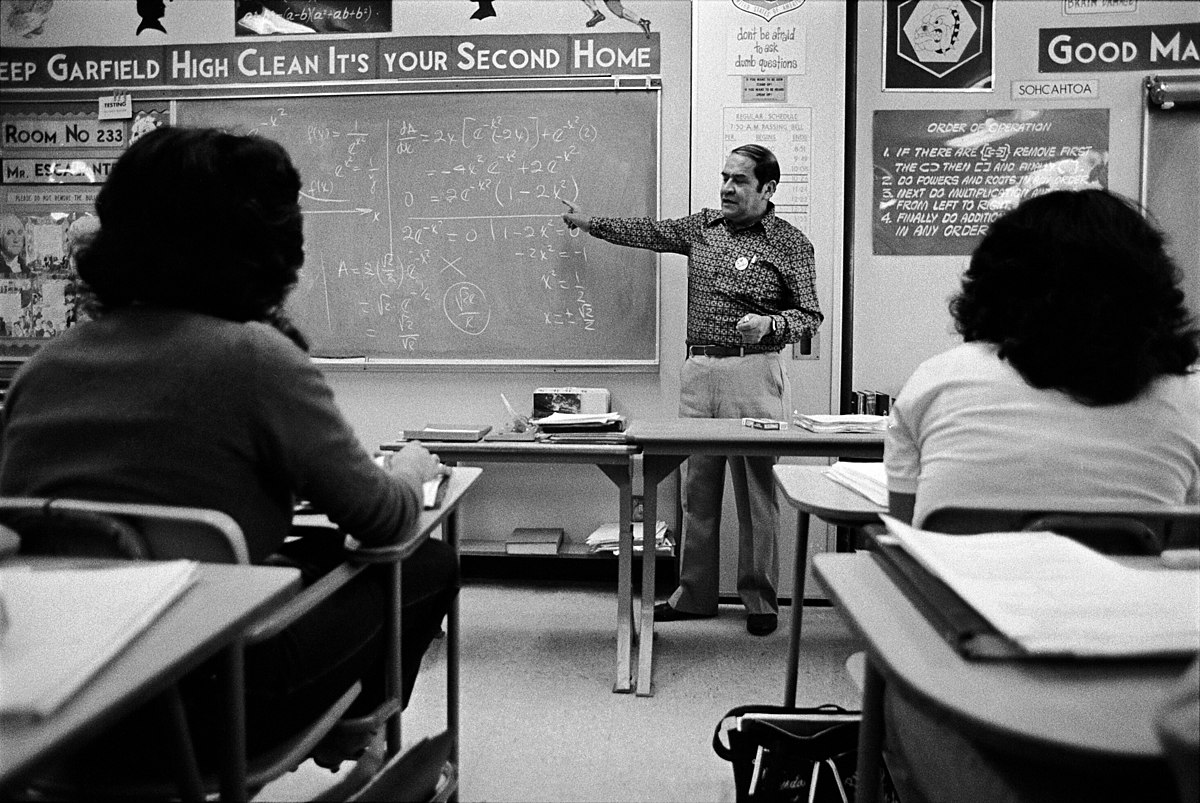

Jaime Escalante (1983), Garfield High School en Los Angeles. Fuente: Wikimedia Commons.

Jaime Escalante (1983), Garfield High School en Los Angeles. Fuente: Wikimedia Commons.

A. P. (EXAMEN)

Escalante consiguió que muchos de sus alumnos lograran superar con éxito la prueba a nivel avanzado de cálculo (A. P., Advanced Placement Examination in Mathematics: Calculus AB), requisito para ingresar a la universidad en Estados Unidos.

BOLIVIA

Es el país de origen de Jaime Escalante y donde regresó tras su jubilación en la escuela en la que trabajaba en Estados Unidos.

CERO (NO SE PUEDE DIVIDIR POR)

Escalante decía que para poder enseñar se necesitan tres cosas:

“Lo primero es el conocimiento del tema. Debes dominar lo que vas a enseñar. […] Lo segundo es motivar el concepto que voy a enseñar. Por ejemplo, presento el concepto de “defensa ilegal”: que en matemáticas no se puede dividir por cero. Entonces quiero que esto quede claro, le pongo un denominador cero y toda la clase grita “¡Defensa ilegal!” […] En tercer lugar, hay que entender las relaciones humanas, hay que mirar a los chicos como personas. Y respetarlos. Y de esa manera los motivas. Y desarrollas esa buena relación gradualmente durante todo un semestre o dos semanas o tres semanas. Y si haces eso, cuando tengas la retroalimentación del estudiante, matemáticamente hablando, entonces te responderá y sabrás que está aprendiendo”.

DOCENTE

Era el segundo de los cinco hijos e hijas de Zenobio Escalante Rodríguez y Sara Gutiérrez Valle, ambos maestros. Sus hermanas Olimpia y Bertha también fueron profesoras; la mayor de química y la menor de psicología. Sin duda, la profesión docente estaba muy arraigada en la familia.

EDNA (ESPECIAL)

“Edna especial” es un episodio de la decimocuarta temporada de la serie animada Los Simpson. Escalante aparece nombrado como “Julio Estudiante”, uno de los candidatos a ganar el premio de “Maestro del año”.

FAMILIA

Escalante nació en La Paz, Bolivia. Sus padres, Zenobio Escalante Rodríguez y Sara Gutiérrez Valle, eran maestros y fueron destinados a la provincia de Omasuyos. Jaime pasó su infancia en Achacachi, la capital. Su tía tenía algunas fincas en las que trabajaban los aimaras. El pequeño pasaba mucho tiempo con ellos; la lengua aimara fue su primera lengua; en esa época no hablaba español.

GARFIELD (ESCUELA PREPARATORIA)

Una vez calificado para enseñar en Estados Unidos, solicitó un puesto en el Distrito Escolar Unificado de Los Ángeles. Escalante deseaba enseñar en una escuela latina. En otoño de 1974 fue contratado por la Escuela Preparatoria Garfield, con alumnado en su mayoría hispano, como profesor de informática. Pero no había ordenadores, así que le asignaron la clase de matemáticas de nivel más bajo, con estudiantes sin interés por esta materia y con un mal comportamiento en general. Nadie esperaba nada de ellos.

HUMBERTO BILBAO

Cuando estaba en cuarto grado, uno de sus profesores era Humberto Bilbao, quien valoraba su talento a pesar de que hablaba mal español y no se portaba demasiado bien. Bilbao habló con la madre de Jaime y decidieron trasladarle a al Colegio La Salle donde el profesor estimaba que el pequeño podría desarrollar sus capacidades. Pero fue expulsado por su mal comportamiento con el profesor de matemáticas. Pasó por otros centros escolares, obteniendo malas notas y siendo conocido por su falta de disciplina.

Y volvería a encontrarse con Humberto Bilbao en 1950, cuando comenzó a estudiar en la Escuela Normal “Simón Bolívar” de La Paz en la que se formaba a futuros maestros. Jaime realizó el curso para acreditarse como profesor de matemáticas y física. Con Bilbao disfrutó aprendiendo a partir de experimentos. Y en esa escuela conoció a su futura esposa, Fabiola Tapia, con la que se casaría en 1954.

INGENIERÍA

Tras graduarse, su deseo hubiera sido matricularse en la Facultad de Ingeniería, pero su familia no podía costear sus estudios. Su padre había fallecido y Jaime tuvo que trabajar y emprender el servicio militar obligatorio a partir mediados de 1949.

JAIME

Jaime, el nombre del profesor. Y (Edward) James, el nombre del actor que le interpretó (ver la letra O).

KIMO

“Kimo” fue el apodo con el que le bautizó uno de sus alumnos en la década de 1970. Era la forma abreviada de “Kemo sabe” (amigo de confianza), la manera en la que el indio Toro llamaba a El Llanero Solitario.

LOUIS LEITHOLD

Escalante fue alumno del matemático Louis Leithold, autor del libro de texto “The Calculus 7”, que cambió los métodos de enseñanza del cálculo en las escuelas secundarias y universidades del todo el mundo.

MATEMÁTICAS

Emigró a Estados Unidos a finales de 1963. No sabía inglés y su título en Bolivia no tenía validez allí. Así que tuvo que realizar diferentes trabajos mientras aprendía el idioma; en 1973 consiguió finalmente su grado en matemáticas en la Universidad Estatal de California.

NARANJAS

Su abuelo materno, José Gutiérrez, le enseñó a leer y escribir con apenas seis años. Su madre le hablaba de geometría; utilizaba naranjas como ejemplo, para motivarle.

OLMOS

El actor Edward James Olmos, gran amigo de Escalante, interpretó al profesor en la película Stand and Deliver. Fue nominado en los Premios Óscar de 1988 como mejor actor por este papel.

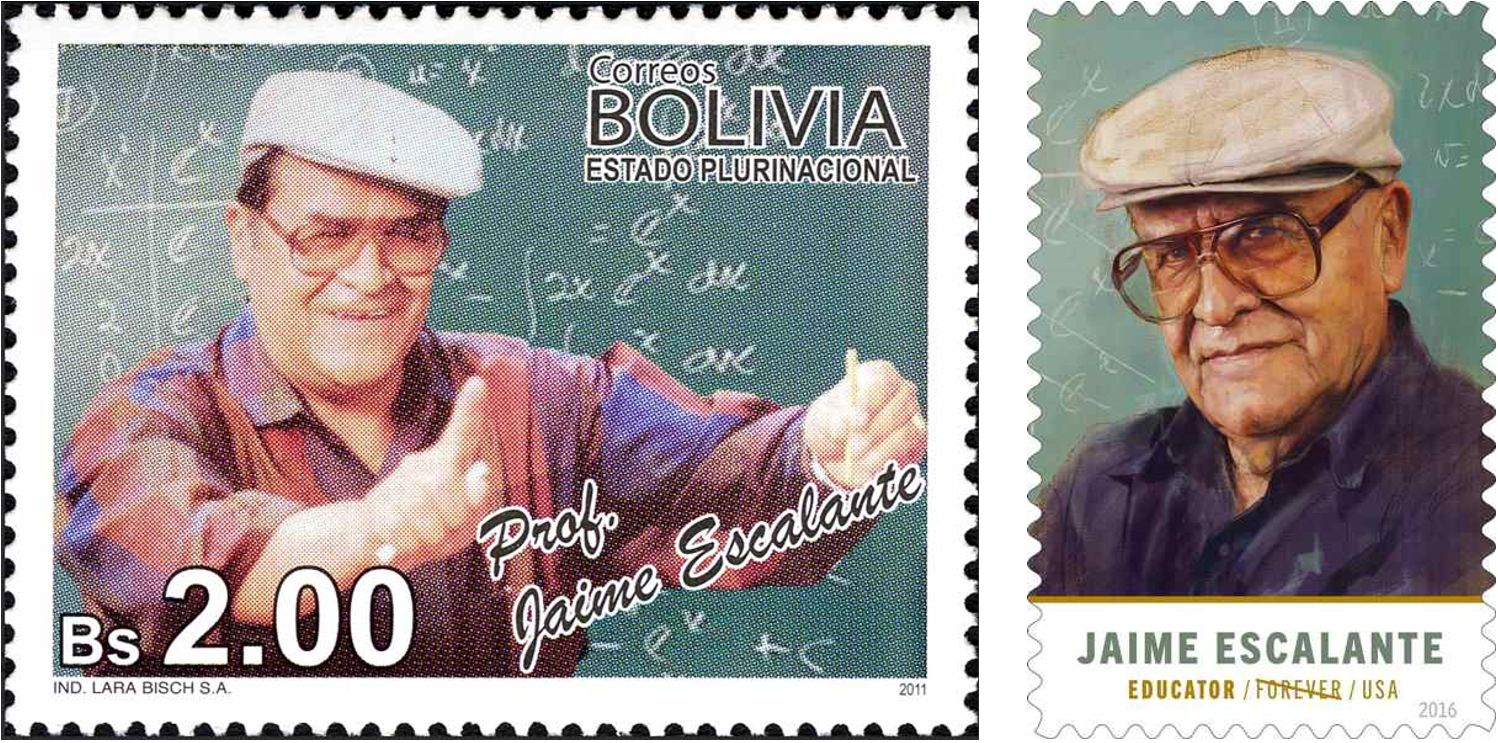

POSTAL (SELLO)

En 2011, el Servicio de Correos de Bolivia, su país de origen, emitió un sello postal en su honor. Y, en 2016, el Servicio Postal de los Estados Unidos le rindió homenaje a través de otro sello de uso postal.

Sellos postales emitidos en Bolivia y Estados Unidos en honor de Jaime Escalante. Fuente: MacTutor History of Mathematics archive.

Sellos postales emitidos en Bolivia y Estados Unidos en honor de Jaime Escalante. Fuente: MacTutor History of Mathematics archive.QUERER ES PODER

Stand and Deliver es un elogio al “querer es poder”. Como decía Escalante: “Ganas. Lo que necesitamos son ganas”.

RELACIONES HUMANAS

Ver la letra “C”, es parte de las tres cosas que se necesitan, según Escalante, para poder enseñar.

Stand and Deliver

Stand and Deliver (1988) es el título de una película estadounidense basada en la historia de este profesor de matemáticas.

THE BEST TEACHER IN AMERICA

La vida de Jaime Escalante inspiró al escritor Jay Mathews para escribir el libro “Escalante: The Best Teacher in America” (1988) en el que se basó posteriormente la película Stand and Deliver.

UNIÓN ASTRONÓMICA INTERNACIONAL

En 1993 Escalante fue honrado por la Unión Astronómica Internacional al nombrar al asteroide (5095) con su apellido.

VERDAD

Escalante afirmó que la película Stand and Deliver contenía “un 90 % de verdad y un 10 % de drama”. En particular, el profesor comentaba que transcurrieron muchos años para que su sistema de enseñanza de las matemáticas tuviera éxito, en contra de lo que parecía indicar el largometraje.

WITTENBERG

Entre otros muchos reconocimientos por su labor docente, Escalante recibió un Doctorado Honoris Causa de la Universidad de Wittenberg en 1998.

X, Y, Z (LAS INCÓGNITAS EN CÁLCULO)

Falleció el 30 de marzo de 2010 tras una larga enfermedad. Por expreso deseo, su ataúd fue colocado por un día en un aula de la Escuela Preparatoria Garfield donde había enseñado entre 1974 y 1991. En la pizarra escribieron una de las frases con la que este profesor animaba a sus estudiantes:

“No hay que hacer el cálculo fácil, ya es fácil”.

Referencias

- Alfonso Jesús Población Sáez, Las lecciones del profesor Escalante (PdM II), DivulgaMAT, Cine y Matemáticas, mayo 2009

- José María Sorando Muzás, De todo un poco, Suma 65 (2010) 119-124

- J J O’Connor and E F Robertson, Jaime Alfonso Escalante, MacTutor History of Mathematics archive, University of St Andrews

- «Ganas. Eso es todo lo que os hace falta. Ganas de aprender», Kindsein

- Jaime Escalante, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Jaime Escalante: “Ganas. Lo que necesitamos son ganas” se ha escrito en Cuaderno de Cultura Científica.

Los físicos finalmente encuentran un problema que solo los ordenadores cuánticos pueden resolver

Los investigadores han demostrado que resolver un problema sobre la energía de un sistema cuántico es fácil para los ordenadores cuánticos pero difícil para los clásicos.

Un artículo de Lakshmi Chandrasekaran. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Los ordenadores cuánticos están a punto de convertirse en superpotencias computacionales, pero los investigadores llevan mucho tiempo buscando un problema viable que confiera una ventaja cuántica, algo que solo un ordenador cuántico pueda resolver. Solo entonces, argumentan, la tecnología finalmente será vista como esencial.

Han estado buscando durante décadas. «Parte de la razón por la que es un desafío es que los ordenadores clásicos son bastante buenos en muchas de las cosas que hacen», explica John Preskill, físico teórico del Instituto de Tecnología de California.

En 1994 Peter Shor descubrió una posibilidad: un algoritmo cuántico para factorizar números grandes. El algoritmo de Shor es potente y se cree ampliamente que supera a todos los algoritmos clásicos; cuando se ejecute en un ordenador cuántico, tiene el potencial de romper gran parte de los sistemas de seguridad de Internet, que dependen de la dificultad de factorizar grandes números. Pero por muy impresionante que sea, el algoritmo solo es relevante para una pequeña porción de áreas de investigación, y es posible que mañana alguien encuentre una manera eficiente de factorizar números grandes en una máquina clásica, lo que haría que el algoritmo de Shor sea discutible. La limitada aplicabilidad de Shor ha llevado a la comunidad investigadora a buscar otros casos de uso de máquinas cuánticas que realmente podrían ayudar a realizar nuevos descubrimientos científicos.

«No queremos construir un ordenador solo para una tarea singular», afirma Soonwon Choi, físico del Instituto Tecnológico de Massachusetts. «Aparte del algoritmo de Shor, ¿qué más podemos hacer con un ordenador cuántico?»

Como dice Preskill: «Tenemos que encontrar aquellos problemas que sean difíciles clásicamente, pero entonces tendremos que [mostrar] que los métodos cuánticos serán realmente eficientes».

Ha habido unas pocas veces en las que los investigadores pensaron que lo habían logrado, descubriendo algoritmos cuánticos que podían resolver problemas más rápido que cualquier cosa que pudiera hacer un ordenador clásico. Solo para que luego alguien (a menudo el joven investigador Ewin Tang) ideara nuevos e inteligentes algoritmos clásicos que podían superar a los cuánticos.

Ahora, un equipo de físicos, que incluye a Preskill, podría haber encontrado el mejor candidato hasta ahora para la ventaja cuántica. Al estudiar la energía de ciertos sistemas cuánticos descubrieron una pregunta específica y útil que es fácil de responder para una máquina cuántica, pero difícil para una clásica. «Este es un gran avance en la teoría de los algoritmos cuánticos», comenta Sergey Bravyi, físico teórico e informático de IBM. «Su resultado es una ventaja cuántica para un problema relevante para la química y las ciencias de los materiales».

Los investigadores también están entusiasmados con que el nuevo trabajo explore nuevas áreas inesperadas de las ciencias físicas. «Esta nueva capacidad es cualitativamente diferente [a la de Shor] y potencialmente abre muchas oportunidades nuevas en el mundo de los algoritmos cuánticos», afirma Choi.

El problema tiene que ver con las propiedades de los sistemas cuánticos (típicamente átomos) en diversos estados energéticos. Cuando los átomos saltan entre estados, sus propiedades cambian. Podrían emitir un color de luz determinado, por ejemplo, o volverse magnéticos. Si queremos predecir mejor las propiedades del sistema en diversos estados de energía, es útil comprender el sistema cuando está en su estado menos excitado, al que los científicos se refieren como estado fundamental.

«Muchos químicos, científicos de materiales y físicos cuánticos están trabajando para encontrar estados fundamentales», explica Robert Huang, uno de los autores del nuevo artículo e investigador científico de Google Quantum AI. «Se sabe que es extremadamente difícil».

Es tan difícil que, después de más de un siglo de trabajo, los investigadores todavía no han encontrado un enfoque computacional eficaz para determinar el estado fundamental de un sistema a partir de primeros principios. Tampoco parece haber ninguna manera de que un ordenador cuántico lo haga. Los científicos han llegado a la conclusión de que encontrar el estado fundamental de un sistema es difícil tanto para los ordenadores clásicos como para los cuánticos.

Pero algunos sistemas físicos exhiben un panorama energético más complejo. Cuando se enfrían, estos sistemas complejos se contentan con asentarse no en su estado fundamental, sino más bien en un nivel de energía bajo cercano, conocido como nivel de energía mínimo local. (Parte del Premio Nobel de Física de 2021 se otorgó por el trabajo en uno de esos conjuntos de sistemas, conocidos como vídrios de espín). Los investigadores comenzaron a preguntarse si la cuestión de determinar el nivel mínimo de energía local de un sistema también era universalmente difícil.

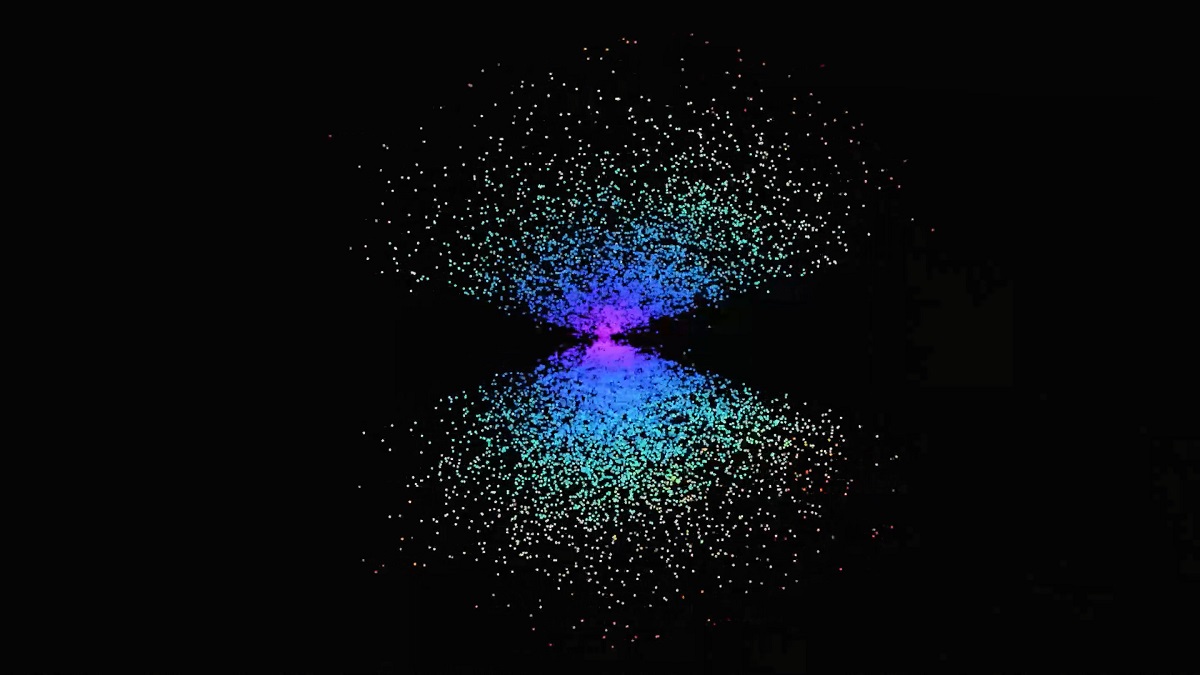

Las respuestas comenzaron a surgir el año pasado, cuando Chi-Fang (Anthony) Chen, otro autor del artículo reciente, ayudó a desarrollar un nuevo algoritmo cuántico que podría simular la termodinámica cuántica (que estudia el impacto del calor, la energía y el trabajo en un sistema cuántico). «Creo que mucha gente ha [investigado] la cuestión de qué aspecto tiene la superficie de energía potencial en los sistemas cuánticos, pero antes no existía ninguna herramienta para analizarlo», afirma Huang. El algoritmo de Chen ha ayudado a abrir una ventana a cómo funcionan estos sistemas.

Al ver lo potente que era la nueva herramienta, Huang y Leo Zhou, el cuarto y último autor del nuevo artículo, la utilizaron para diseñar una manera en la que los ordenadores cuánticos determinen el estado de energía mínimo local de un sistema, en lugar de perseguir el estado fundamental ideal; un enfoque que se centraba precisamente en el tipo de pregunta que estaban buscando los investigadores en computación cuántica. «Ahora tenemos un problema: encontrar una cantidad local de energía, lo que todavía es difícil desde el punto de vista clásico, pero que podemos decir que es cuánticamente fácil», afirma Preskill. «Así que eso nos coloca en el terreno donde queremos estar para lograr una ventaja cuántica».

Dirigidos por Preskill, los autores no sólo demostraron el poder de su nuevo enfoque para determinar el estado energético mínimo local de un sistema (un gran avance en el campo de la física cuántica), sino que también demostraron que éste era finalmente un problema en el que los ordenadores cuánticos podían demostrar su valor. «El problema de encontrar un mínimo local tiene una ventaja cuántica», concluye Huang.

Y a diferencia de los candidatos anteriores, éste probablemente no será destronado por ningún nuevo algoritmo clásico. «Es poco probable que se descuantifique», afirma Choi. El equipo de Preskill hizo suposiciones muy plausibles y tomó pocos riesgos lógicos; si un algoritmo clásico puede lograr los mismos resultados significa que los físicos deben estar equivocados en muchas otras cosas. «Ese será un resultado impactante», apunta Choi. «Me entusiasmará verlo, pero sería demasiado impactante para creerlo». El nuevo trabajo presenta un candidato viable y prometedor para demostrar la ventaja cuántica.

Para ser claros, el nuevo resultado sigue siendo de naturaleza teórica. Demostrar este nuevo enfoque en un ordenador cuántico real es hoy por hoy imposible. Llevará tiempo construir una máquina que pueda probar exhaustivamente la ventaja cuántica del problema. Por ello, para Bravyi, el trabajo acaba de empezar. «Si nos fijamos en lo que pasó hace cinco años, solo teníamos ordenadores cuánticos de unos pocos qubits, y ahora ya tenemos máquinas de cientos e incluso de 1.000 qubits», explica. “Es muy difícil predecir lo que sucederá dentro de cinco o diez años. Es un campo muy dinámico”.

El artículo original, Physicists Finally Find a Problem That Only Quantum Computers Can Do, se publicó el 12 de marzo de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo Los físicos finalmente encuentran un problema que solo los ordenadores cuánticos pueden resolver se ha escrito en Cuaderno de Cultura Científica.

No mezcles estos productos de limpieza

Productos de limpieza variados. Fuente: Freepick

Productos de limpieza variados. Fuente: Freepick

¿Puede matarte limpiar el váter? En la búsqueda de un hogar limpio y libre de gérmenes, a menudo recurrimos a una variedad de productos de limpieza. Sin embargo, ciertas combinaciones de productos químicos pueden generar vapores tóxicos y reacciones potencialmente peligrosas que pongan en peligro nuestra salud y seguridad.

Lee la etiqueta y ponte guantesUn accidente bastante frecuente consiste en limpiar una superficie con un producto e inmediatamente después aplicar otra sustancia. ¡Y no hablemos de echarlos juntos en el cubo de fregar! Al mezclar estos productos, lo menos grave que puede ocurrir es que sus propiedades se anulen, y lo más grave, que se liberen vapores tóxicos o exista riesgo de exposición.

Los productos de limpieza tienen composiciones muy variadas, por lo que se suelen catalogar en función de su uso y no tanto de sus ingredientes. Por ejemplo, hay desatascadores de tuberías formulados con oxidantes, otros con bases fuertes y otros con tensioactivos. Además, raramente contienen una única sustancia, de manera que hacer una lista general sobre las mezclas más peligrosas es prácticamente imposible.

Lo primero que hay que saber es que estos productos son seguros si se utilizan de acuerdo a las instrucciones. En términos generales, es importante evitar mezclar productos de limpieza entre sí, así como con sustancias domésticas comunes como el vinagre, el agua oxigenada, la laca o el bicarbonato, y tampoco es recomendable combinarlos con agua caliente.

Cuidado con estas mezclasLa lejía es una de las sustancias de limpieza más usadas en el hogar, pero también de las más peligrosas a la hora de mezclar con otros productos. La que tenemos en casa consiste por lo general en una disolución de hipoclorito de sodio (NaClO) al 5% en agua. Se trata de una sustancia oxidante, con excelentes propiedades blanqueantes y desinfectantes. Sin embargo, su mezcla con otros productos comunes como el amoníaco, el alcohol o el vinagre puede producir reacciones químicas potencialmente tóxicas.

-

Lejía y amoníaco. El amoníaco comercial contiene una disolución del 5-10% de hidróxido de amonio. La mezcla de estos dos productos habituales en el hogar genera vapores tóxicos de cloramina, que pueden irritar los ojos, la nariz, la garganta e incluso causar daño pulmonar grave. Además, la reacción entre el cloro y el amoniaco también puede generar gas cloruro de nitrógeno, un compuesto altamente tóxico y corrosivo que puede ser letal en altas concentraciones. En principio, no se trata de un peligro mortal, pero si a eso se suma una deficiente ventilación, se puede dar una intoxicación fatal.

“Un accidente bastante frecuente consiste en limpiar una superficie con un producto e inmediatamente después aplicar otra sustancia.”

Limpieza de superficies con guantes y productos de limpieza habituales. Fuente: Pexels

Limpieza de superficies con guantes y productos de limpieza habituales. Fuente: Pexels

-

Lejía y alcohol. La mezcla de lejía (cloro) con alcohol, como el alcohol etílico (etanol) o el alcohol isopropílico, puede generar cloroformo y otros compuestos cáusticos, como el ácido clorhídrico y la cloroacetona. Estos vapores pueden ser extremadamente irritantes para los ojos, la nariz y la garganta, y llegar a causar mareos, náuseas e incluso pérdida del conocimiento.

-

Lejía y vinagre. Al mezclar lejía con vinagre, que no es más que una disolución de ácido acético, se produce gas cloro. Este gas es altamente irritante para las vías respiratorias y puede causar tos, dificultad para respirar e incluso daño pulmonar. Además, tienen lugar reacciones que pueden producir cloruro sódico y oxígeno, desproporcionar a cloruro y clorato, o generar otros compuestos químicos potencialmente peligrosos.

La lejía tampoco debe mezclarse con otros productos de uso habitual, como el agua caliente o el agua oxigenada. En el primer caso, si se superan los 30ºC de temperatura, puede descomponerse y liberar gas cloro. En el caso del agua oxigenada, que es una disolución de peróxido de hidrógeno, el hipoclorito de la lejía puede reaccionar formando cloratos y percloratos, en una serie de reacciones químicas exotérmicas que desprenden calor y presentan un elevado riesgo de explosión.

Otras combinaciones peligrosasLa combinación de productos de limpieza como la sosa cáustica (hidróxido de sodio), el agua fuerte (ácido clorhídrico) y ciertos insecticidas puede generar mezclas extremadamente peligrosas. La sosa cáustica es altamente alcalina y puede reaccionar violentamente con ácidos fuertes como el agua fuerte, liberando calor y vapores corrosivos. Esta reacción puede causar quemaduras químicas graves en la piel y las vías respiratorias. Además, algunos insecticidas contienen compuestos químicos volátiles que pueden reaccionar de manera impredecible con otros productos químicos presentes en el ambiente, creando gases tóxicos o inflamables. Por lo tanto, es esencial evitar mezclar estos productos de limpieza con otros productos químicos para prevenir accidentes graves y proteger la salud y seguridad de las personas.

“La lejía tampoco debe mezclarse con otros productos de uso habitual, como el agua caliente o el agua oxigenada.”

Productos de limpieza variados. Fuente: Pexels

Productos de limpieza variados. Fuente: Pexels

Esta selección de combinaciones peligrosas es solo la punta del iceberg, ya que las posibles interacciones entre productos de limpieza podrían ser infinitas. La conclusión principal es que los productos de limpieza deben utilizarse exclusivamente para su propósito previsto, siguiendo siempre las indicaciones del fabricante y evitando en todo momento su mezcla con otras sustancias, por más inofensivas que puedan parecer, debido al riesgo de desencadenar reacciones químicas potencialmente mortales.

En caso de experimentar síntomas de intoxicación accidental, como irritación, tos, náuseas, escozor, mareos, dolor de cabeza, somnolencia, dificultad para respirar o dolor abdominal, es crucial llamar de inmediato a los servicios de emergencia al número 112 o contactar con el Servicio de Información Toxicológica.

Sobre la autora: Raquel Gómez Molina es química especialista en laboratorio clínico y comunicación científica

El artículo No mezcles estos productos de limpieza se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2023 – Toda su sangre en mis manos

El gran evento de divulgación organizado por Naukas y la Cátedra de Cultura Científica volvió a Bilbao para celebrar su decimotercera edición en el gran Palacio Euskalduna los pasados 15 y 16 de septiembre de 2023.

Alberto García Salido es un superhéroe auténtico. Pero no de los de capa y leotardos, sino de los de bata y estetoscopio. En esta charla nos cuenta una de sus primeras intervenciones como médico adjunto, que daría para una película.

Alberto García Salido (Madrid, 1981) es pediatra, escritor y divulgador. Trabaja actualmente en las unidades de Cuidados Intensivos y Cuidados Paliativos del Hospital Infantil Universitario Niño Jesús de Madrid.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2023 – Toda su sangre en mis manos se ha escrito en Cuaderno de Cultura Científica.

Raíces culturales de la transición demográfica

La opinión mayoritaria es que la transición demográfica obedece, fundamentalmente, a causas económicas. Sin embargo, sin descartar esas causas, hay datos que avalan la hipótesis de que el elemento determinante de ese fenómeno puede ser de naturaleza cultural, y tenga su origen en los valores e ideas predominantes en las sociedades avanzadas y en la forma en que esos valores e ideas son transmitidos.

Foto: Stéphane Juban / Unsplash

Foto: Stéphane Juban / UnsplashLa transición demográfica consiste en el descenso secuencial de las tasas de mortalidad y de las de natalidad. Tras un largo periodo –de siglos– durante el que ambas tasas se mantuvieron en valores relativamente altos y la población (cuando se daban las condiciones para ello) crecía muy lentamente, se ha pasado a una época de cambios en esas tasas que comenzó hace menos de 200 años.

Para que se produzca la transición demográfica debe reducirse, en primer lugar, la tasa de mortalidad. La mejora de las condiciones de alimentación, salud y vivienda hace que aumente la esperanza de vida, debido, fundamentalmente, a la reducción de la mortalidad infantil. Tras ese descenso en la mortalidad, y como consecuencia del mismo, la población crece de forma acelerada, porque aumenta mucho el número de niños que alcanzan la edad reproductora. Posteriormente, y tras un periodo de crecimiento poblacional fuerte, empieza a descender la tasa de natalidad, normalmente desde valores de entre seis y ocho hijos por mujer hasta niveles inferiores a dos. Una vez se ha reducido la tasa de natalidad hasta esos valores tan bajos, la población puede incluso llegar a descender.

La transición demográfica empezó a producirse en algunos países hace casi dos siglos y se está extendiendo al resto del mundo hasta alcanzar a prácticamente todos los países del planeta, con la notable excepción, hasta la fecha, de algunos africanos, principalmente. En este momento, la fecundidad ha descendido ya por debajo de los niveles necesarios para mantener la población mundial estable.

Lógicamente, la generalización de los métodos anticonceptivos, con el control que otorga a las mujeres sobre su propia reproducción, ha sido un elemento muy importante, dado que facilita que disminuyan los nacimientos.

La explicación económicaDe acuerdo con la explicación económica de la transición demográfica los factores responsables del fenómeno son las mejores condiciones de vida y una amplia oferta de bienes de consumo. La primera fase, la de la reducción de la mortalidad, está claramente vinculada a las condiciones de salud y alimentación. Y la segunda, la del descenso de la natalidad, se atribuye a una decisión consciente de criar a un pequeño número de hijos o hijas, y poderles ofrecer así las mejores condiciones posibles (de salud, formación, económicas), para su posterior trayectoria vital. Además, el disfrute de los bienes de consumo a que tenemos acceso es incompatible con las necesidades que se derivan de criar una amplia prole.

Desde un punto de vista evolutivo, la transición demográfica plantea un problema evidente. En principio, de acuerdo con lo que sabemos acerca de la evolución y sus mecanismos, lo lógico sería que los individuos tratásemos de tener una descendencia lo más numerosa posible. Y de hecho, la consecución de ese objetivo reproductivo debiera verse favorecida por la abundancia de recursos propia de nuestra época. Sin embargo, ocurre lo contrario.

A la explicación del descenso de la natalidad propio de la transición demográfica basada en factores puramente económicos, relacionados con la calidad de vida y el deseo de proporcionar la misma calidad a la descendencia, se ha venido a sumar una explicación alternativa que basa su argumentación en consideraciones de índole cultural.

La cultura como argumento alternativoAdquirir información es muy valioso y por eso tenemos mucha facilidad para hacerlo. El problema es que esa misma facilidad provoca que aumente la probabilidad de recibir ideas maladaptativas, que disminuyen la aptitud biológica (el fitness darwiniano).

La cultura minimiza el problema que conlleva el alto coste de evaluar la información. Gracias a ella, disponemos de un sistema de resolución de problemas de carácter general. La ciencia, por sí misma o a través de la tecnología, es el ejemplo más sofisticado de la capacidad de la cultura para resolver problemas diversos y de gran dificultad. Hasta tal punto es efectiva, que si existen las instituciones sociales adecuadas, intelectos individuales muy falibles –como los humanos– son capaces de revelar gradualmente los secretos más profundos del Universo. Pero a cambio pagamos un precio, y ese precio consiste en dar cobijo, en ocasiones, a variantes culturales patológicas en términos darwinianos.

La razón de que ocurra eso es que la posibilidad de difundir variantes culturales maladaptativas no se elimina fácilmente, porque evaluar una variante cultural es muy costoso. Si se eliminase fácilmente ese tipo de difusión de la información, también se perderían las ventajas que reporta, con carácter general, el contar con sistemas de transmisión cultural que se han demostrado muy útiles. Por esa razón, eso solo se hace en casos excepcionales; en la mayoría de los casos se recurre a heurísticos sencillos y rápidos.

Dos buenos ejemplos de heurísticos de gran utilidad son la conformidad y el sesgo de prestigio. El primero nos hace proclives a adoptar los comportamientos mayoritarios dentro del grupo, y el segundo, a imitar a las personas con prestigio. Estos sesgos se manifiestan con mucha claridad en los adolescentes, pero están presentes en el conjunto de la población.

Son, efectivamente, herramientas útiles, pero tienen efectos colaterales maladaptativos inevitables, pues cuando, por las razones que sea, la información o variante cultural que se transmite es maladaptativa, no es fácil que esa transmisión se elimine o limite. Además, la importancia relativa de este modo de transmisión es mayor cuanto mayor es el volumen de población, ya que son más las personas de las que se puede recibir información.

En las sociedades agrarias premodernas, el prestigio y el estatus lo daba la cuna, no el mérito, y la familia era la institución social más significativa. En esas sociedades la transmisión de información es vertical y tiende a favorecer variantes culturales que refuerzan la propia importancia de la familia, porque, al fin y al cabo, la prosperidad dependía del tamaño familiar, y una familia amplia era, a su vez, señal de éxito económico.

La formación en una sociedad complejaConforme los pueblos han accedido a mejores condiciones de vida, las sociedades se han hecho cada vez más complejas, y las economías, más y más dependientes del conocimiento avanzado. En esas sociedades se necesitan personas con un nivel de formación alto para ocuparse de la gestión y gobierno de entidades, tanto públicas como privadas, así como para desempeñar trabajos para los que se requieren conocimientos técnicos de alto nivel. Para formarse, esas personas necesitan dedicar un tiempo cada vez mayor, por lo que han de posponer el momento en que tendrán hijos.

Por otra parte, hay una fuerte competencia por esos puestos de trabajo cualificado, ya que quienes los ocupan tienen un mayor estatus social. Además, al posponerse la maternidad y extenderse a las mujeres las oportunidades de formación, éstas también participan de esas actividades.

Las vías de transmisión de las ideas han cambiado. La información se transmite de múltiples formas, y las vías “horizontales” –sobre todo basadas en medios de comunicación y sistemas educativos– han adquirido una importancia creciente. Cuando los modelos a imitar, en virtud del sesgo de prestigio, son profesionales de éxito, esas ideas y valores se extienden por la población, y a partir de ahí opera la conformidad, haciendo que muchas o todas las personas adopten los mismos comportamientos. El descenso en la natalidad es la consecuencia de todo ese proceso.

En definitiva, cierto grado de desarrollo económico es condición para que se pueda dar la transición demográfica, pero no está claro que sea el desencadenante, ni su factor más determinante. Un estudio realizado con 600 unidades administrativas europeas en el marco del Princeton European Fertility Project mostró un notable desajuste entre el desarrollo económico y los hitos de la transición demográfica. Esta comenzó en ciertas zonas de Francia alrededor de 1830, y sin embargo, en el Reino Unido, más desarrollado económicamente, no se produjo hasta 50 años después, a la vez que en algunas zonas de Alemania. En otras zonas de este último país, la transición se demoró hasta la segunda década del siglo XX, sin que esas diferencias tuvieran nada que ver con diferencias económicas. Igualmente, en la Bélgica francófona la transición demográfica se inició alrededor de 1870, pero no empezó hasta 1910 en la zona flamenca. Y hubo zonas de Francia, como Bretaña y Normandía, en las que el fenómeno se retrasó un siglo con respecto al resto del país. También en el que había sido el Imperio Austrohúngaro se produjeron grandes diferencias: Hungría se adelantó al resto del imperio. En todos los casos registrados, hay un elemento común: el acceso de las mujeres al mercado laboral es el factor que marca el inicio del descenso en la natalidad.

Pero hay excepcionesPara terminar, merece la pena presentar dos notables excepciones en Occidente a la tendencia general. Se trata de las dos comunidades articuladas en torno a sendas confesiones religiosas, la de los amish y la de los huteritas. Amish, en los Estados Unidos, y huteritas, en el Canadá, son los herederos de los anabaptistas que sufrieron persecución por motivos religiosos tras la reforma luterana en Europa. Los amish emigraron a los Estados Unidos en el siglo XVIII y los huteritas al Canadá en el XIX. En ambos casos mantuvieron sus tradiciones y modo de vida, basado fundamentalmente en la agricultura.

Ambas comunidades han mantenido un notable aislamiento cultural con respecto al resto de comunidades de sus países. Han rechazado el uso de los medios de comunicación propios de la era contemporánea, han renunciado a gran parte de los productos del desarrollo tecnológico, y cuentan con sistemas educativos propios para los niveles superiores. En definitiva, en estas comunidades se han preservado las vías de transmisión cultural propias de las sociedades premodernas.

Pues bien, tasas de natalidad de entre 6 y 8 hijos por mujer son la norma en estas comunidades. Durante el siglo XX los huteritas han duplicado su número cada 17 años, y los amish, que eran 5.000 a comienzo del siglo XX, han alcanzado la cifra de 150.000 a comienzos del siglo XXI. No son pobres. Unos y otros forman comunidades prósperas, que dedican sus recursos a sostener su crecimiento demográfico, para lo que necesitan extender sus posesiones de tierra. Solo el precio de esta última ha podido limitar en cierta medida su expansión, pero también han tenido la suficiente versatilidad como para dedicarse a otras actividades económicas sin perder los elementos esenciales de su modo de vida.

Fuente: Síntesis de algunas ideas tomadas del capítulo 4 (Culture is an adaptation) del libro de Peter J Richerson y Robert Boyd “Not by genes alone: How culture transformed human evolution” (The University of Chicago Press, 2006).

Nota: Our World in Data ofrece datos muy completos sobre fertilidad y un análisis detallado del posible efecto de diferentes factores sobre esta variable. En esos análisis el acceso de las mujeres a la educación recibe atención preferente, pero también se estudian las condiciones de crianza de la progenie, así como la influencia de factores culturales y otros.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Raíces culturales de la transición demográfica se ha escrito en Cuaderno de Cultura Científica.

El deterioro de los lagos de la montaña cantábrica

Una investigación en la que participan la Universidad Complutense de Madrid (UCM), la Universidad Politécnica de Madrid (UPM), la Universidad de Alcalá y la Universidad del País Vasco ha detectado que las aguas de los lagos de montaña de la Cordillera Cantábrica han perdido calidad en las últimas décadas. Detrás de esas variaciones estarían las condiciones climáticas y acciones humanas como los cambios de uso del suelo y la actividad ganadera de las últimas décadas.

El estudio detecta un aumento de la carga de nutrientes y la pérdida de oxígeno disuelto en esos lagos, lo que conlleva una pérdida de calidad de las aguas en esos valiosos ecosistemas. “Estos resultados permiten comparar la magnitud de los cambios ambientales que se han producido durante una época histórica en relación con el actual Cambio Global, sus causas y sus consecuencias en los ecosistemas acuáticos de montaña, lo que constituye un avance científico muy significativo”, destacan los investigadores.

La investigación, publicada en Anthropocene se ha llevado a cabo mediante el análisis de biomarcadores orgánicos en los sedimentos del fondo del Lago Isoba (León), que ha permitido identificar tanto su grado de preservación como el origen de los mismos.

A partir de ahí, se han reconstruido los principales cambios ambientales que se han producido en la región durante los últimos 550 años –que abarcan la Pequeña Edad de Hielo, periodo de enfriamiento global entre los siglos XVI y XIX- en respuesta a los cambios climáticos recientes y al impacto de las actividades humanas que se han desarrollado como ganadería, cambios en el uso del suelo y en la cubierta vegetal.

Entre la información extraída, por ejemplo, se sabe que durante la Pequeña Edad del Hielo se produjo un mayor aporte de plantas terrestres y poca degradación debido a las condiciones climáticas frías, o que desde 2006 la productividad del fitoplancton y la actividad microbiana han sido significativas, así como el aumento de estanoles de origen fecal -moléculas presentes en las heces de herbívoros-.

“Desde un punto de vista más aplicado, permiten evaluar el impacto de los cambios ligados a la actividad humana en los lagos de montaña, lo que proporciona criterios para una mejor ordenación del territorio y la conservación y restauración ecológica de estos emblemáticos lagos”, comentan sobre las aplicaciones de los resultados los investigadores.

Referencia:

José E. Ortiz, Yolanda Sánchez-Palencia, Ignacio López-Cilla, César Morales-Molino, Jon Gardoki, Trinidad Torres, Mario Morellón (2024) Lipid biomarkers in high mountain lakes from the Cantabrian range (Northern Spain): Coupling the interplay between natural and anthropogenic drivers Anthropocene doi: 10.1016/j.ancene.2024.100431

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El deterioro de los lagos de la montaña cantábrica se ha escrito en Cuaderno de Cultura Científica.

¿Un visitante de un mundo oceánico?

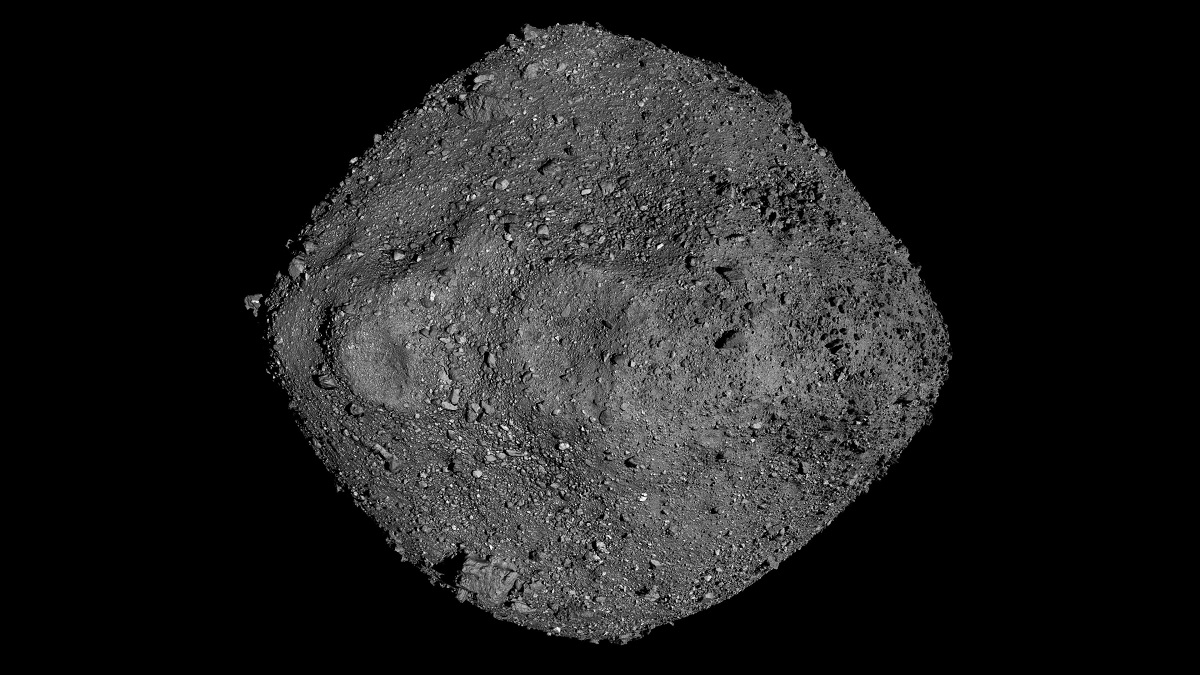

Siempre ha estado muy, muy cerca, en nuestro sistema solar, y lleva en él mucho más tiempo que nosotros, al menos, desde que este se originó hace unos 4500 millones de años, así que es posible que lo «viera» todo… y estamos deseando que nos lo cuente. Su nombre es Bennu, un asteroide cuya órbita se extiende entre el interior de la terrestre y el exterior de la marciana, y es uno de los pocos cuerpos celestes de los que hemos podido traer muestras a la Tierra hasta el momento ―los otros son la Luna, así como los asteroides Itokawa y Ryugu y material de la cola del cometa 81P/Wild.

Asteroide Bennu, antes 1999 RQ36. Bennu es una antigua ave mitológica egipcia, similar al ave fénix griego. El nombre lo eligió Michael Puzio, de 9 años, un niño de Carolina del Norte.

Asteroide Bennu, antes 1999 RQ36. Bennu es una antigua ave mitológica egipcia, similar al ave fénix griego. El nombre lo eligió Michael Puzio, de 9 años, un niño de Carolina del Norte.Fuente: NASA/Goddard/University of Arizona

El 24 de septiembre de 2023 aterrizó en el desierto de Utah una cápsula con los 70,3 gr que la misión de la NASA OSIRIS-Rex (Origins, Spectral Interpretation, Resource Identification, and Security – Regolith Explorer) había logrado obtener de la superficie de Bennu ―más de los 60 gr que se habían establecido como objetivo y la más abundante hasta el momento―. La sonda se lanzó el 8 de septiembre de 2016 y llegó a su destino dos años después: el 3 de diciembre de 2018. Las muestras se recogieron el 20 de octubre de 2020 y llegaron hasta nosotros tres años después. Ya hemos empezando a obtener los primeros resultados de su análisis.

La cápsula con las muestras del asteroide Bennu aterrizó en el desierto de Utah el 24 de septiembre de 2023. Se logró abrir, tras alguna dificultad, el 11 de octubre. Fuente: NASA/Keegan Barber

La cápsula con las muestras del asteroide Bennu aterrizó en el desierto de Utah el 24 de septiembre de 2023. Se logró abrir, tras alguna dificultad, el 11 de octubre. Fuente: NASA/Keegan Barber

Pero ¿qué tiene de especial Bennu? ¿Por qué esta inversión de recursos para analizarlo e incluso traer muestras de su superficie? Son varios los motivos que expone la NASA. El primero de ellos ya lo hemos mencionado: es muy antiguo, al menos tanto como el propio sistema solar, lo que ya podría darnos muchos datos sobre la manera en la que este se formó, pero es que, además, Bennu podría contener fragmentos de materiales más antiguos. Preservado durante tantos miles de millones de años gracias al vacío del espacio, podría considerarse una cápsula del tiempo de la historia de nuestros propios orígenes… y el de la vida en general debido a su composición, rica en moléculas orgánicas e incluso agua. Además, pero no menos importante, se encuentra bastante cerca de nosotros y su máxima aproximación a nosotros tiene lugar cada seis años, lo que facilita las labores de lanzamiento. También tiene el tamaño adecuado ―es más o menos como el Empire State Building, de Nueva York― como para que su velocidad de giro sobre sí mismo no sea tan grande como para haber complicado muchísimo las labores de aterrizaje.

Momento de recolección de muestras de la misión OSIRIS-REx en la zona de aterrizaje Nightingale, en el asteroide Bennu.

Momento de recolección de muestras de la misión OSIRIS-REx en la zona de aterrizaje Nightingale, en el asteroide Bennu.Créditos: NASA/Goddard/University of Arizona

Por si todo esto no fuera suficiente, aún hay más: Bennu podría tener algunas claves para averiguar cuál sería nuestra mejor estrategia de protección en el caso de que algún asteroide se aproximara demasiado a la Tierra, ya que se espera que en 2135 se acerque a nosotros a una distancia menor que la de la Luna. ¡¿Cómo?! ¿Hay peligro de colisión entonces? ¡Para nada! Pero esa cercanía nos permitirá calcular y estudiar su trayectoria, así como la acción del campo gravitatorio de la Tierra sobre cualquier cuerpo similar que se pueda aproximar e incluso suponer una amenaza, con mucha mayor precisión.

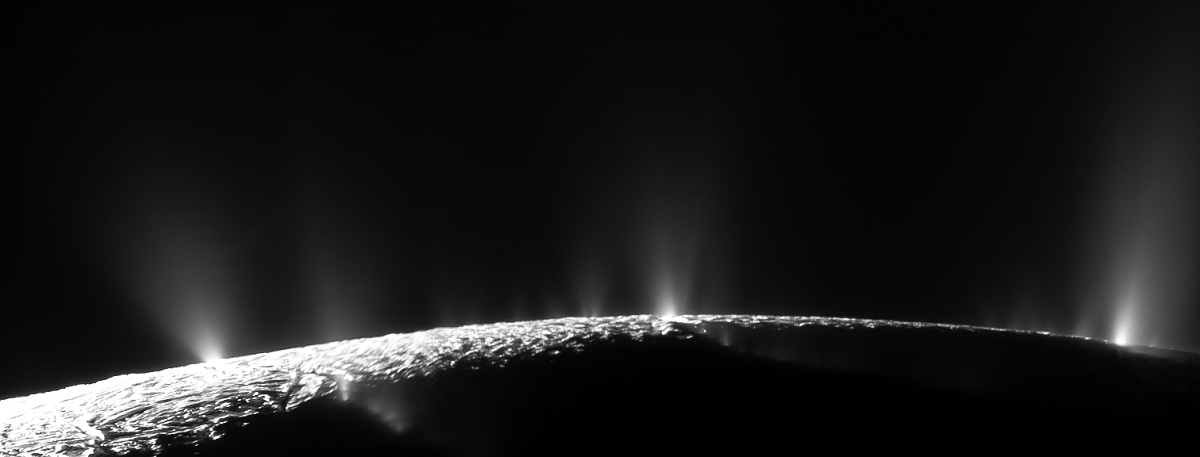

Las muestras de Bennu se están analizando el Laboratorio Lunar y Planetario de la Universidad de Arizona y el director del proyecto, Dante Lauretta, ya ha empezado a dar algunas pistas, aunque aún no se ha publicado ningún resultado. Lo que han encontrado son ciertos tipos de minerales compatibles con la presencia de agua y otros similares a los detectados en los géiseres de Encélado, uno de los satélites de Saturno, que, pensamos, oculta un vasto océano bajo su capa superficial de hielo. Así que, ¿es posible que Bennu venga de un lugar similar? Esa es, según Lauretta, la hipótesis con la que trabajan en este momento. No ha dado mucha información más, pero se espera que se publiquen muchos más detalles en algunas semanas que, según comenta el investigador son «muy interesantes».

Géiseres de Encélado fotografiados por la sonda Cassini en el año 2009. Fuente: NASA/JPL-Caltech/SSI/CICLOPS/Kevin M. Gill

Géiseres de Encélado fotografiados por la sonda Cassini en el año 2009. Fuente: NASA/JPL-Caltech/SSI/CICLOPS/Kevin M. Gill

En cualquier caso, puede que lo más bello de este tipo de misiones sea cómo nuestras ensoñaciones sobre otros mundos parecen hacerse realidad. En esta ocasión, nuestro visitante de las estrellas no es más que un pedazo de roca a la deriva, pero que, tal vez, venga de un mundo que hemos imaginado muchas veces: El mundo azul, de Jack Vance; Cachalot, de Alan Dean Foster; Terramar, de Ursula K. Le Guin; Hydros, de Robert Silverberg; El mundo de Roche, de Robert L. Forward; Solaris, de Stanislaw Lem, y tantos, tantos otros.

Fuente: Pixabay / NWimages by Sabrina Eickhoff

Fuente: Pixabay / NWimages by Sabrina Eickhoff

Estaremos muy atentos al mensaje que traiga consigo este pequeño asteroide.

Bibliografía

Howgego, Joshua (10 de febrero de 2024). Bennu may be from an ocean world, New Scientist.

NASA Science, OSIRIS-Rex.

Méndez Chazarra, Nahúm (8 de agosto de 2022). Meteoritos interestelares, muestreando otros sistemas planetarios, Cuaderno de Cultura Científica.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo ¿Un visitante de un mundo oceánico? se ha escrito en Cuaderno de Cultura Científica.

El árbol de Fibonacci

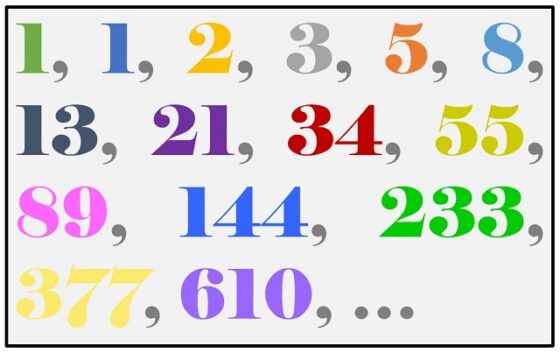

En esta entrada del Cuaderno de Cultura Científica recuperamos un tema clásico de la sección Matemoción, la conocida sucesión de Fibonacci. En concreto, vamos a mostrar que se puede construir un árbol relacionado con la sucesión de números en la que cada término es igual a la suma de los dos términos anteriores, siendo los dos primeros 1 y 1, esto es, la sucesión de Fibonacci:

La sucesión de Fibonacci fue introducida, al menos en Europa (en la entrada El origen poético de los números de Fibonacci puede leerse cómo surgió el conocimiento de esta sucesión en la India, en relación con la poesía en sánscrito), por el matemático italiano Leonardo de Pisa (1170-1241), a quien se le conocía como Fibonacci, esto es, hijo de Bonaccio, en su libro Liber Abaci / El libro del ábaco (1202), como solución a uno de los problemas de ingenio que se planteaban en el mismo.

Recordemos, una vez más, el problema en cuestión:

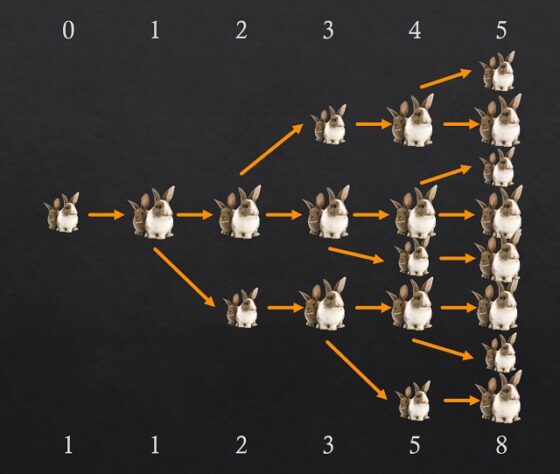

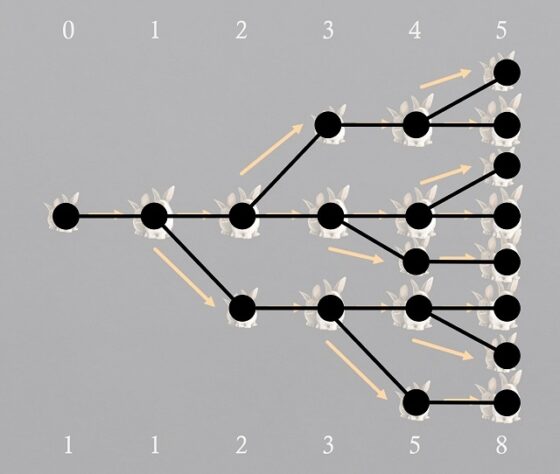

“Consideremos una familia de conejos con la característica de que tardan un mes en ser fértiles. Cuando han alcanzado la fertilidad, cada pareja se aparea teniendo al mes siguiente (cada hembra) una pareja de crías (un macho y una hembra) que de nuevo tardarán en ser fértiles un mes y entonces se aparearán. ¿Cuántas parejas de conejos habría al cabo de un tiempo dado, por ejemplo, un año?”

La respuesta a este problema se puede obtener estudiando qué es lo que ocurre durante los primeros meses, como se muestra en la siguiente imagen, e intentando deducir la respuesta general. En la parte de arriba se cuenta el paso del tiempo (cuántos meses van pasando, al finalizar cada mes) y en la parte de abajo la cantidad de parejas de conejos (asumiendo que no se muere ninguna y se reproducen como describe el problema, se aparean cada mes y tienen crías cada mes, cuando son fértiles claro). Imaginemos que partimos (0 arriba) de una pareja (1 abajo), como tarda un mes en ser fértil, al finalizar ese primer mes (1 arriba) sigue habiendo una pareja de conejos (1 abajo). Al finalizar el segundo mes (2 arriba) la pareja original habrá tenido su primera pareja de crías (un macho y una hembra, como reza el problema), luego hay 2 parejas de conejos (2 abajo). Al finalizar el siguiente mes, el tercero (3), estarán la pareja original, una nueva pareja de crías de la misma y la pareja de crías que había nacido el mes anterior, pero que aún son jóvenes para tener crías y no lo harán hasta el mes siguiente, luego 3 parejas de conejos.

Cantidad de parejas de conejos durante los cinco primeros meses

Cantidad de parejas de conejos durante los cinco primeros meses

Aunque el esquema es bastante claro, veamos qué ocurre al finalizar el cuarto mes. Como estamos asumiendo que las parejas de conejos no se mueren, seguirán las tres parejas que estaban el mes anterior (3), más las nuevas parejas de crías que nazcan ese mes, pero para saber cuántas son es necesario conocer cuántas son fértiles, que lo son la pareja original y la primera pareja de crías que tuvieron, es decir, las 2 parejas que estaban dos meses antes (2), en conclusión, 3 + 2 = 5 parejas de conejos. Otro tanto ocurre al término del quinto mes, que estarán 8 parejas de conejos, las del mes anterior (5), más las nuevas parejas de crías, cuya cantidad es igual a las parejas de conejos de dos meses antes (3), 8 = 5 + 3.

Está claro, por el razonamiento anterior, que la solución del problema de los conejos de Fibonacci es una sucesión de números en la que cada término Fn es la suma de los dos anteriores Fn – 1 + Fn – 2, siendo los dos primeros términos F1 = F2 = 1. Por lo tanto, al cabo de un año, doce meses, como pregunta el problema, la solución será F12, es decir, 144, si miramos a los primeros términos de la sucesión más arriba.

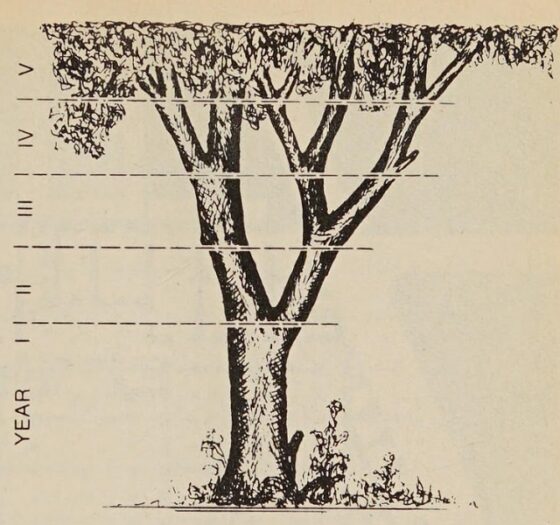

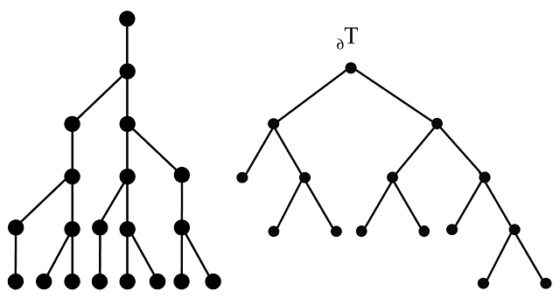

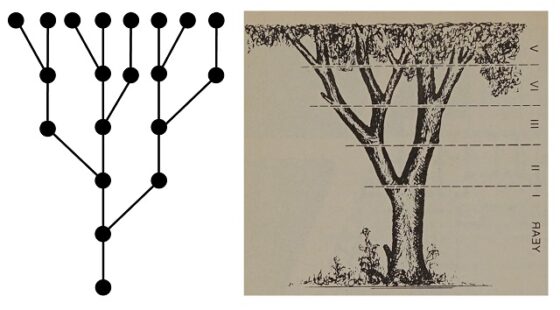

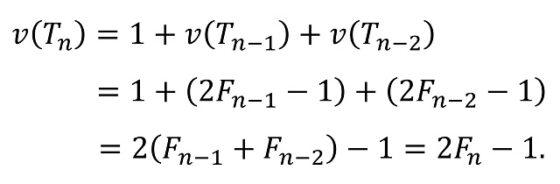

El matemático polaco Hugo Steinhaus (1887-1972), en su famoso libro de divulgación de las matemáticas Mathematical Snapshots / Instantáneas matemáticas (1938), introduce la sucesión de Fibonacci con la propiedad de que cada término es la suma de los dos anteriores y lo relaciona, a posteriori, con un problema sobre el crecimiento de las ramas de un árbol. En concreto, Steinhaus escribe

Si un árbol produce una nueva rama después de un año, y siempre descansa durante un año, produciendo otra nueva rama sólo en el año siguiente, y si la misma ley se aplica a cada rama, entonces, en el primer año deberíamos tener sólo el brote principal, en el segundo – dos ramas, en el tercero – tres, luego 5, 8, 13, etc…

Ilustración del libro Mathematical Snapshots / Instantáneas matemáticas (1938), del matemático polaco Hugo Steinhaus, sobre la relación de los números de Fibonacci con las ramas de un árbol

Ilustración del libro Mathematical Snapshots / Instantáneas matemáticas (1938), del matemático polaco Hugo Steinhaus, sobre la relación de los números de Fibonacci con las ramas de un árbolA este árbol que describe Steinhaus le podríamos denominar árbol de Fibonacci (biológico). Aunque volveremos al final de la entrada sobre el árbol de Fibonacci biológico, vamos a introducir, a continuación, el árbol de Fibonacci desde el punto de vista de la teoría de grafos.

Un árbol definido de forma recursivaAntes de definir el concepto de árbol de Fibonacci, desde el punto de vista de la teoría de grafos, recordemos algunos conceptos sencillos de la misma.

– Grafo. Un grafo está formado por un conjunto de puntos, llamados vértices, y un conjunto de aristas, cada una de las cuales une dos vértices (aunque los grafos pueden tener bucles, aristas que unen un vértice consigo mismo, en este contexto no nos interesa esta posibilidad). Salvo que se diga lo contrario un grafo tiene un número finito de vértices y aristas.

– Grado de un vértice. Se llama grado de un vértice al número de aristas que inciden en el mismo (si hubiese un bucle, esa arista se contaría como dos).

– Camino. Un camino es una sucesión de vértices y aristas, que se inicia en un vértice y se termina en otro.

– Camino simple y ciclo. Un camino en el que no se repite ningún vértice se llama camino simple, y si es cerrado, se dice que es un ciclo.

– Grafo conexo. Un grafo en el que cada par de vértices está conectado, al menos, por un camino simple, se dice que es conexo.

– Árbol. Un grafo en el que cualesquiera dos vértices están conectados exactamente por un camino es un árbol. Equivalentemente, es un grafo conexo que no posee ciclos.

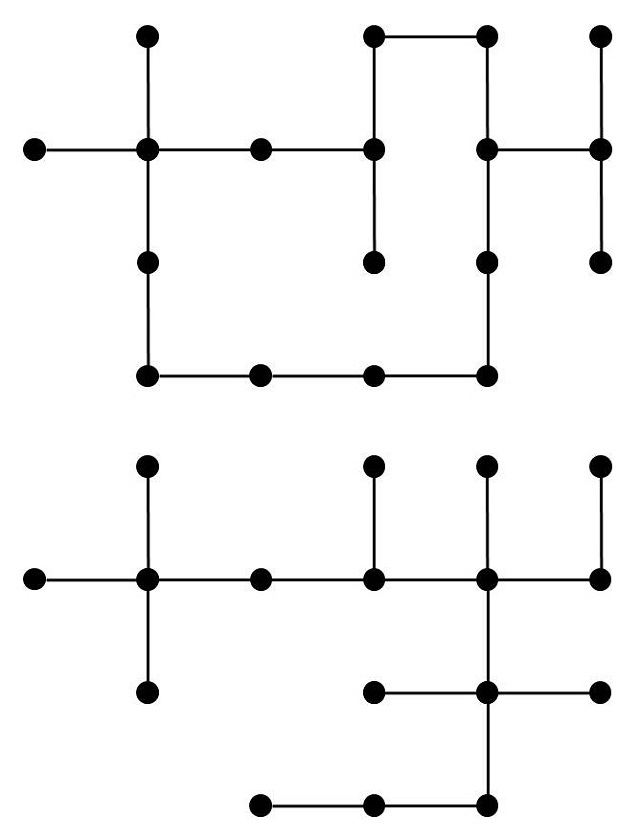

Un par de ejemplos, de un grafo, que no es árbol ya que contiene un ciclo, y de un árbol

Un par de ejemplos, de un grafo, que no es árbol ya que contiene un ciclo, y de un árbol

– Árbol con raíz. Si en un árbol se considera que uno de los vértices es especial, y se le denomina raíz, se dice que es un árbol con raíz, además, ese vértice (raíz) se suele considerar un punto inicial y las aristas se suelen considerar dirigidas alejándose de la raíz.

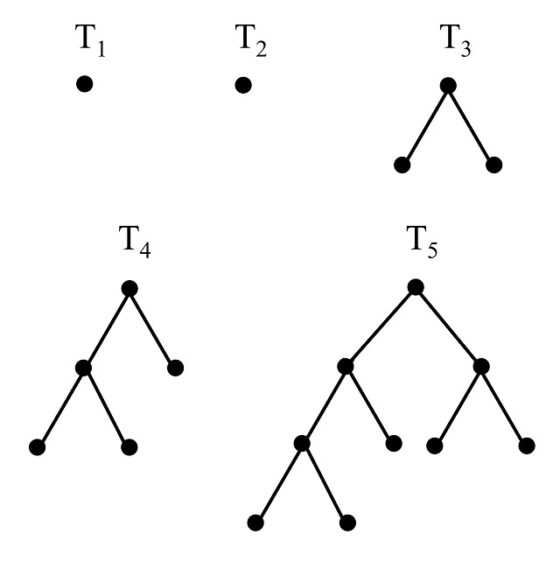

Ejemplo de árbol (binario) con raíz

Ejemplo de árbol (binario) con raíz

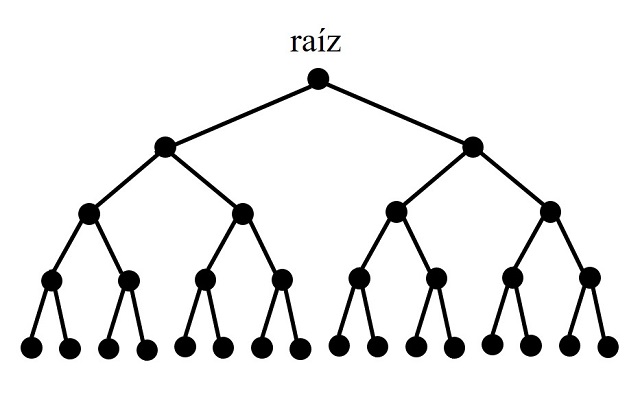

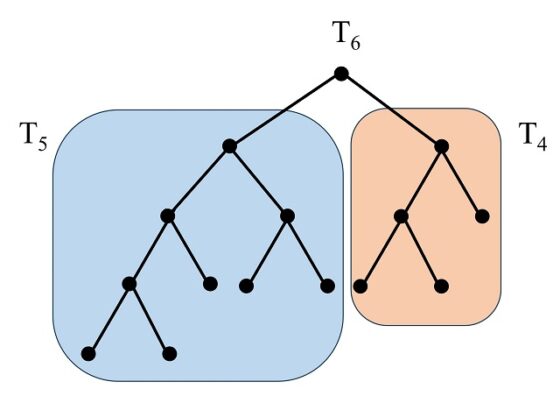

Ahora ya contamos con las definiciones pertinentes para definir el árbol de Fibonacci. Se definen, de forma recursiva, los árboles (con raíz) de Fibonacci, como los árboles Tn, tales que:

A. T1 y T2 son dos árboles con raíz que consisten solo en la raíz, es decir, un vértice;

B. Para n mayor que 2, Tn es el árbol con raíz que tiene a Tn – 1 como subárbol a izquierda y Tn – 2 como subárbol a derecha, es decir, se construye con una raíz, de la que salen dos aristas, una de ellas (la de la izquierda) va a la raíz del árbol Tn – 1, y se continua con el mismo, mientras que en la otra (la de la derecha) se coloca el árbol Tn – 2.

Veamos el proceso recursivo de construcción, que se muestra en la siguiente imagen para los primeros pasos, n = 1, 2, 3, 4, 5.

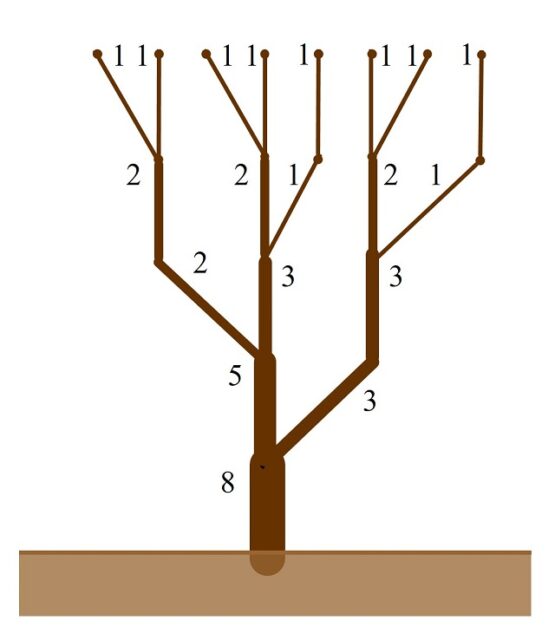

Árboles (con raíz) de Fibonacci T1, T2, T3, T4 y T5

Árboles (con raíz) de Fibonacci T1, T2, T3, T4 y T5

Veamos cómo se construiría ahora el árbol de Fibonacci T6. Como describe el proceso de construcción, se empieza con un vértice arriba (la raíz), del que salen dos aristas. En la de la izquierda se coloca el árbol T5, mientras que en la de la derecha el árbol T4, obteniendo así el árbol T6, que se muestra en la siguiente imagen.

Ahora, veamos la relación de estos árboles con la sucesión de Fibonacci. La principal es que si contamos los vértices que están en el extremo opuesto a la raíz de cada árbol de Fibonacci, es decir, los vértices finales del árbol con raíz (los que tienen grado 1), obtendremos los números de la sucesión de Fibonacci (la misma cantidad que si miramos las aristas finales). Si nos fijamos en las anteriores imágenes los vértices finales son 1, 1, 2, 3, 5 y 8. Es lógico que nos salgan los números de Fibonacci Fn, puesto que, por la construcción de cada árbol, a partir de los dos anteriores, los vértices finales del árbol Tn son igual a la unión de los vértices finales de Tn – 1 y Tn – 2, luego contando esos vértices, tenemos la relación Fn = Fn – 1 + Fn – 2, y empezamos con un solo vértice, las raíces, en los dos primeros pasos.

¿Está este árbol relacionado con el problema de los conejos de Fibonacci? La respuesta, como no podía ser de otra manera, es afirmativa. Si consideramos el esquema de la solución del problema planteado por Leonardo de Pisa (observemos la imagen de arriba), podemos construir para cada paso, es decir, para cada nuevo mes, un árbol (en el sentido de grafo), que consiste en considerar como vértices las parejas de conejos en el esquema y como aristas la unión de cada pareja de un cierto mes con ella misma en el mes siguiente y su nueva pareja de crías, si la han tenido, si no nada más, es decir, igual que las fechas del esquema.

Si comparamos los dos grafos, para un paso cualquiera, por ejemplo, n = 6, el árbol de Fibonacci y el árbol que acabamos de asociar a la solución experimental del problema de los conejos del Liber Abaci, observaremos que son iguales (en la siguiente imagen hemos volteado el árbol de Fibonacci, cambiando derecha e izquierda, para facilitar la comparación), salvo que en el árbol de la solución del problema aparecen un vértice y una arista iniciales (que se corresponde con el punto inicial, el mes 0).

Más aún, si colocamos el árbol asociado con la resolución del problema con el vértice inicial (raíz) abajo, observaremos que es esencialmente el árbol (biológico) de Fibonacci.

Ya hemos comentado que la cantidad de vértices, respectivamente, aristas, finales del árbol de Fibonacci Tn es el correspondiente número de Fibonacci Fn, pero contemos más elementos de ese grafo. Por ejemplo, ¿cuántos vértices tiene el árbol de Fibonacci? ¿cuántos son interiores y exteriores? ¿cuántas aristas tiene?.

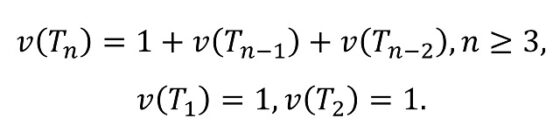

Si denotamos por v(Tn) el número de vértices del árbol Tn, entonces, por el proceso de construcción del árbol de Fibonacci Tn, que está formado por la nueva raíz junto con los árboles Tn – 1 y Tn – 2,es claro que

Si calculamos ahora los vértices para los primeros casos, n = 1, 2, 3, 4, 5, 6 (arriba podemos ver las imágenes de estos árboles de Fibonacci), tenemos que v(T1) = 1, v(T2) = 1, v(T3) = 3, v(T4) = 5, v(T5) = 9 y v(T6) = 15. Si los comparamos con los números de Fibonacci (F1 = 1, F2 = 1, F3 = 2, F4 = 3, F5 = 5, F6 = 8), podemos realizar la siguiente hipótesis:

![]()

Vamos a demostrar la anterior fórmula por inducción. En primer lugar, se cumple para los primeros casos, como acabamos de comprobar. En segundo lugar, vamos a asumir que se cumple para los árboles Tk, con k menor o igual que n – 1, y vamos a demostrarlo para el árbol Tn:

Por lo tanto, ya tenemos una fórmula general para el número de vértices del árbol de Fibonacci Tn, y su relación con el correspondiente número de Fibonacci Fn.

Los vértices del árbol Tn se pueden dividir en dos tipos, los exteriores (cuyo grado es 1, que son los que se llaman “hojas” del árbol, como grafo) y los interiores (cuyo grado es mayor que 1, llamados “nudos”, salvo la raíz, que tiene ya nombre asignado), v(Tn) = ve(Tn) + vi(Tn). Como sabemos que ve(Tn) = Fn y v(Tn) = 2 Fn – 1, entonces sabemos también la cantidad de vértices interiores, vi(Tn) = Fn – 1.

Respecto al número de aristas del árbol Tn, que podemos denotar e(Tn), es fácil darse cuenta de que es igual al número de vértices del árbol menos 1, es decir, e(Tn) = v(Tn) – 1. Por lo tanto, e(Tn) = 2Fn – 2.

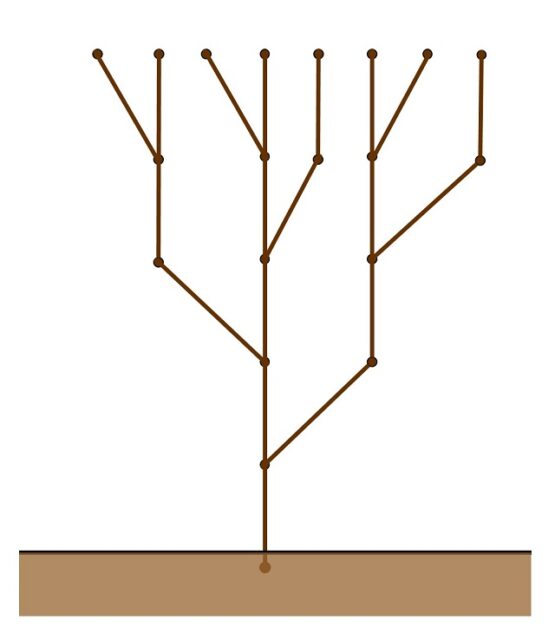

Retorno al árbol de Fibonacci biológicoSi consideramos el árbol de Fibonacci biológico, por ejemplo, como el árbol (grafo) asociado al problema de los conejos (véase la imagen siguiente, en la cual hemos disminuido el tamaño de los vértices y pintado vértices y aristas de marrón) observaremos que la propia construcción del árbol no nos proporciona un grosor para las ramas, que podrían considerarse, de hecho, todas del mismo grosor. En este último apartado vamos a ver cómo darle grosor a las mismas, utilizando la sucesión de Fibonacci, para crear un árbol de Fibonacci “más realista”, en el sentido de que, en cierta medida, las ramas más jóvenes son más delgadas que las ramas más viejas.

Para darle grosor a las ramas vamos a considerar que las ramas más jóvenes, las que se corresponden con aristas exteriores, las aristas que terminan en vértices exteriores (que sabemos que hay tantas ramas exteriores como el número de Fibonacci correspondiente, es decir, el árbol Tn tiene Fn ramas exteriores), tienen el grosor básico (de 1 unidad). A partir de ahí, hacia la raíz, cada rama tendrá un grosor que es igual a la suma de los grosores de las ramas más jóvenes, que surgen de la misma. En la siguiente imagen vemos cómo sería para el árbol de Fibonacci de cinco años, es decir, T6. Así, si dos ramas jóvenes (de grosor 1) vienen de una misma rama, esta tiene grosor 1 + 1 = 2; cuando dos ramas de grosores 1 y 2, respectivamente, vienen de una misma rama, esta tiene grosor 1 + 2 = 3; si dos ramas de grosores 2 y 3, respectivamente, vienen de una misma rama, esta tiene grosor 2 + 3 = 5; o si cada una de las dos ramas que vienen de una misma rama tienen grosores 3 y 5, la rama tiene grosor 8, como en la imagen.

Árbol de Fibonacci T6, luego que tienen una edad de 5 años, con ramas de grosores igual a los primeros números de Fibonacci 1, 2, 3, 5 y 8

Árbol de Fibonacci T6, luego que tienen una edad de 5 años, con ramas de grosores igual a los primeros números de Fibonacci 1, 2, 3, 5 y 8Como podemos observar todas las ramas tienen grosores iguales a números de Fibonacci, de hecho, los grosores de las ramas del árbol de Fibonacci Tn son alguno de los números de Fibonacci, de F2 (= 1) a Fn. Por otra parte, en cada nudo en el que se juntan dos ramas, estas tienen como grosores números de Fibonacci consecutivos, Fk y Fk + 1, para k entre 2 y n – 2. Además, como hemos comentado, hay tantas ramas exteriores como el número de Fibonacci correspondiente, las cuales tienen grosor 1, pero según vamos hacia abajo, hacia la raíz, en el árbol, lo que ocurre es que, al llegar al tronco inicial, el grosor es igual a ese número de Fibonacci. Es decir, el árbol de Fibonacci Tn tiene Fn ramas exteriores, de grosor 1, y su tronco tiene grosor Fn.

Por lo tanto, si tuviésemos el árbol de Fibonacci de 16 años, es decir, el árbol T17, tendríamos que posee F17 = 1.597 ramas jóvenes, de grosor 1, mientras que el tronco principal tendría un grosor igual a 1.597.

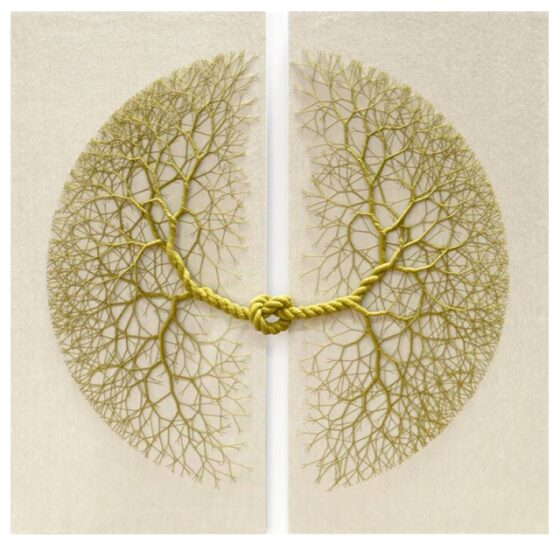

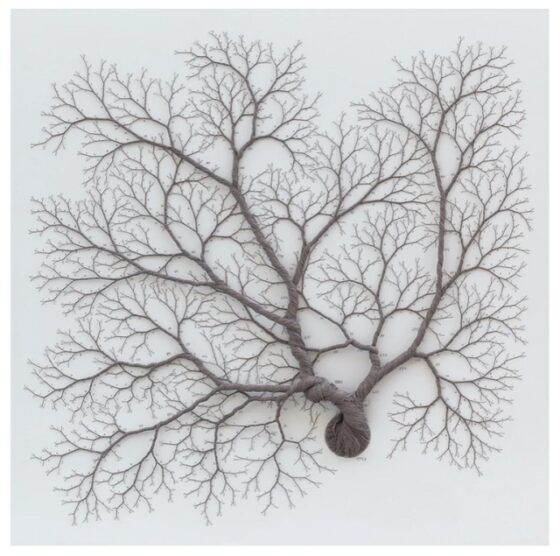

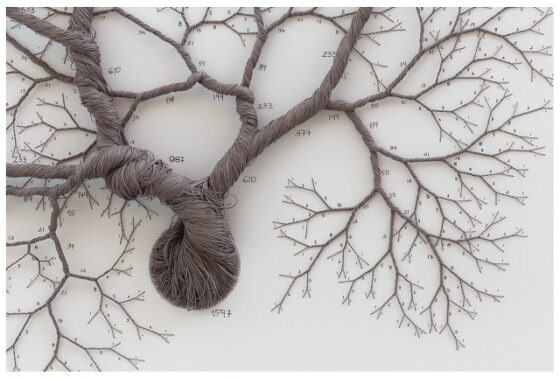

Diálogo artístico con FibonacciLa artista brasileña Janaina Mello Landini (1974) tiene unas series de obras que se enmarcan bajo el título ciclotramas y que consisten en instalaciones de estructuras arborescentes construidas con hilos y cuerdas que se entrelazan.

Instalación Ciclotrama 156 – palindrome (2019), de la artista brasileña Janaina Mello Landini, realizada con cuerda de algodón verde hecha a mano sobre lino, de tamaño 138cm x 138cm. Imagen de la página web de la artista Janaina Mello Landini

Instalación Ciclotrama 156 – palindrome (2019), de la artista brasileña Janaina Mello Landini, realizada con cuerda de algodón verde hecha a mano sobre lino, de tamaño 138cm x 138cm. Imagen de la página web de la artista Janaina Mello LandiniDos obras de la serie Ciclotrama Diálogos, en concreto, Ciclotrama 177 – Fibonacci (2020) y Ciclotrama 193 – Fibonacci (2020), que serían “diálogos con el matemático Fibonacci”, consisten en dos árboles de Fibonacci con 16 y 17 años, respectivamente.

Fijemos nuestra atención en la hermosa instalación Ciclotrama 177 – Fibonacci, que consiste en el árbol de Fibonacci T17, luego con una edad de 16 años. Como se puede observar en las siguientes imágenes, el hilo básico establece el grosor unidad (1) y sabemos que hay F17 = 1.597 ramas jóvenes, de grosor 1. Cuando dos ramas jóvenes se juntan, sus hilos se entrelazan formando una trenza de dos hilos, que es la rama de la que salen las dos jóvenes. En general, cuando se junten dos ramas con Fk y Fk + 1 hilos (para un cierto k entre 2 y 15), los Fk + 2 = Fk + Fk + 1 hilos en conjunto formarán la trenza de la rama de la que salen las otras dos. Y el tronco de esta instalación consiste en una trenza de 1.597 hilos.

Instalación Ciclotrama 177 – Fibonacci (2020), de la artista brasileña Janaina Mello Landini, realizada con hilos de algodón y rotulador acrílico sobre lienzo, de tamaño 170cm x 170cm. Imagen de la instalación y dos detalles de la misma, de la página web de la artista Janaina Mello Landini

Instalación Ciclotrama 177 – Fibonacci (2020), de la artista brasileña Janaina Mello Landini, realizada con hilos de algodón y rotulador acrílico sobre lienzo, de tamaño 170cm x 170cm. Imagen de la instalación y dos detalles de la misma, de la página web de la artista Janaina Mello LandiniEstas dos obras de la artista Janaina Mello Landini son artísticas y hermosas realizaciones de los árboles de Fibonacci (biológicos, con grosor de Fibonacci).

Bibliografía

1.- Raúl Ibáñez, Cayley, el origen del álgebra moderna, Genios de las Matemáticas, RBA, 2017.

2.- Hugo Steinhaus, Mathematical Snapshots, Dover, 1999.

3.- Ralph Grimaldi, Fibonacci and Catalan Numbers, Wiley, 2012.

4.- R. Ibáñez, Las matemáticas como herramienta de creación artística, Libros de la Catarata – FESPM, 2023.

5.- Página web de la artista Janaina Mello Landini

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El árbol de Fibonacci se ha escrito en Cuaderno de Cultura Científica.

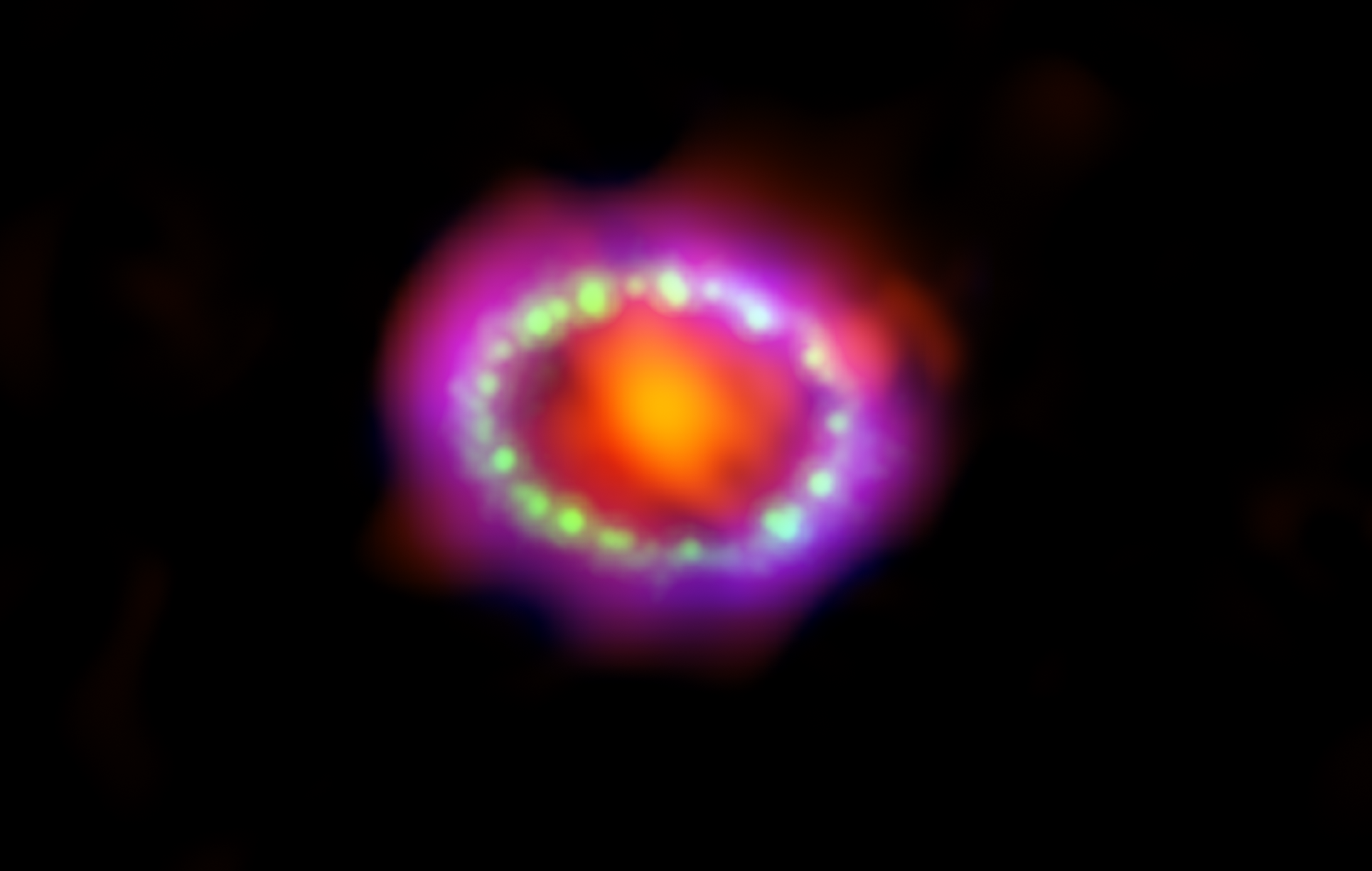

Así en la Tierra como en el cielo: la fluidodinámica de SN 1987A

SN 1987A. Fuente: Webb Space Telecope / NASA, ESA, A. Angelich (NRAO, AUI, NSF)

SN 1987A. Fuente: Webb Space Telecope / NASA, ESA, A. Angelich (NRAO, AUI, NSF)Hace unos 20.000 años, vista desde la Tierra, una estrella masiva en una de las galaxias satélite de la Vía Láctea expulsó un anillo de gas y polvo que luego se expandió hacia el espacio interestelar. Miles de años después, la estrella explotó. Cuando fue detectada por los terráqueos en 1987 la denominaron supernova (SN) 1987A. Como el flash de una cámara en una habitación oscura, SN 1987A iluminó su entorno, revelando el anillo de gas y polvo que la estrella había expulsado milenios antes.

Las imágenes de esa estructura mostraban que el material del anillo no se repartía uniformemente, sino que se agrupaba en parches discretos, algo que para lo que la comunidad astrofísica no tenía una explicación convincente.

Estelas de condensación de un Boeing 747. Fuente: Wikimedia Commons

Estelas de condensación de un Boeing 747. Fuente: Wikimedia CommonsAhora Michael Wadas y sus colegas de la Universidad de Michigan en Ann Arbor, han presentado una posible solución al problema basada en un fenómeno muy conocido en la Tierra. Proponen que los grumos se formaron a causa del mismo fenómeno fluidodinámico que hace que las estelas de condensación que deja un avión se rompan en pedazos.

Efectos de la inestabilidad de Crow en una estela de condensación. Fuente: Wikimedia Commons

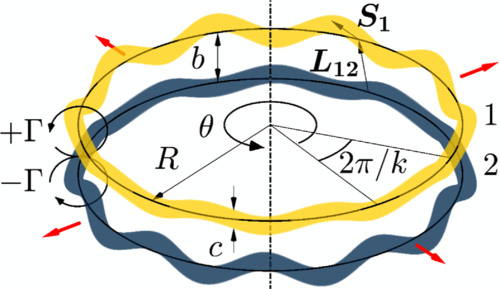

Efectos de la inestabilidad de Crow en una estela de condensación. Fuente: Wikimedia CommonsEl fenómeno en cuestión se comoce como inestabilidad de Crow y se desencadena por la interacción de dos vórtices que giran en sentido contrario. Wadas y sus colegas sugieren que el anillo de material expulsado por la progenitora de SN 1987A comenzó como un par de vórtices; imagina dos anillos de humo en expansión, uno encima del otro, que giran en direcciones opuestas.

Fuente: Wadas et al (2024)

Fuente: Wadas et al (2024)Los investigadores proponen que pequeñas ondas en los dos toroides crecieron a medida que los anillos se expandían, lo que finalmente habría provocado que las estructuras se tocaran en múltiples puntos. A lo largo del anillo, en lugares entre los puntos de contacto, un vórtice más pequeño «se desprendió», convirtiéndose en el núcleo de uno de los grumos del anillo. En simulaciones, los investigadores produjeron anillos con un número de grumos similar al que aparece en el anillo alrededor de SN 1987A.

Referencias:

Michael J. Wadas, William J. White, Heath J. LeFevre, Carolyn C. Kuranz, Aaron Towne, and Eric Johnsen (2024) Hydrodynamic Mechanism for Clumping along the Equatorial Rings of SN1987A and Other Stars Phys. Rev. Lett. doi: 10.1103/PhysRevLett.132.111201

Marric Stephens (2024) A Supernova Remnant Shaped by Vortices Physics 17, s31

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Así en la Tierra como en el cielo: la fluidodinámica de SN 1987A se ha escrito en Cuaderno de Cultura Científica.

La cuenca de Eridania y la complejidad de Marte

Creemos saber mucho sobre la geología marciana porque, al fin y al cabo, es uno de los lugares de nuestro Sistema Solar que más veces hemos visitado, tanto su órbita como su superficie. Pero si consideramos que la historia geológica de un planeta es como un libro, todavía nos faltan muchas páginas, incluso capítulos, por escribir.

Y si reconocemos nuestras limitaciones en este aspecto, muy probablemente la única manera de resolverlas será a través de misiones que, en su superficie, nos permitan estudiar su geología en detalle y tomar muestras que nos ayuden a extraer la mayor información posible en los laboratorios terrestres. Una empresa ambiciosa, sin duda, pero necesaria para seguir ampliando nuestro conocimiento y respondiendo a cuestiones como, por ejemplo, ¿por qué somos planetas tan diferentes?

De las cosas que más nos llama la atención del resto de planetas interiores es, si los comparamos con la Tierra, la ausencia de una tectónica de placas como la que tenemos aquí. Esto no quiere decir que estos otros cuerpos no hayan tenido procesos en los cuales su corteza -o partes de esta- hayan podido sufrir procesos de reciclaje importantes y que hayan tenido su repercusión en la geología que vemos hoy en día.

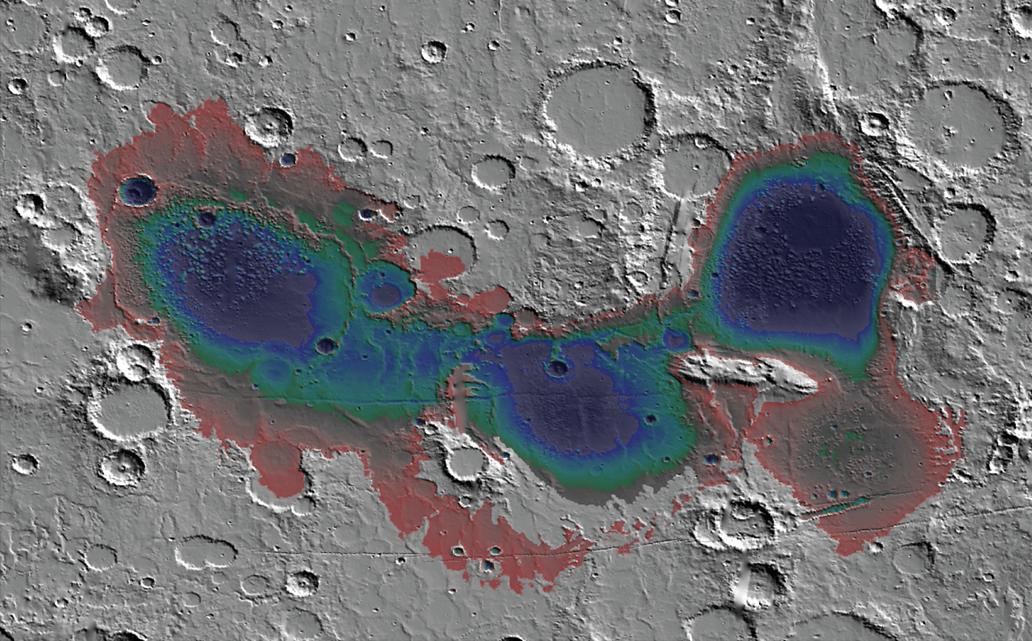

Mapa topográfico de la cuenca de Eridania. Los colores representan la profundidad de las aguas en lo que se piensa que fue un sistema de lagos -o mares, según se vea- que pudieron albergar nueve veces la cantidad de agua de los Grandes Lagos norteamericanos. Imagen cortesía de la NASA.

Mapa topográfico de la cuenca de Eridania. Los colores representan la profundidad de las aguas en lo que se piensa que fue un sistema de lagos -o mares, según se vea- que pudieron albergar nueve veces la cantidad de agua de los Grandes Lagos norteamericanos. Imagen cortesía de la NASA.Uno de los aspectos en los que se puede ver reflejada esta dinámica es a través del vulcanismo, ya que el reciclaje de los materiales de la corteza puede crear un rango de composiciones más variadas en los magmas que llegan a la superficie que si los magmas procediesen directamente de una fuente más primitiva.

Precisamente es en este punto donde llegan las novedades. Un nuevo artículo publicado en Nature Astronomy por Michalski et al. (2024) afirma que debemos cambiar la visión de un Marte donde la composición de las lavas era predominantemente basáltica por otro donde hay una mayor variabilidad composicional gracias a un sistema de reciclaje de su litosfera no horizontal como el de la tectónica de placas, sino vertical y que detallaremos más adelante.

En este nuevo artículo los autores se han centrado en la cuenca de Eridania, un lugar, por cierto, muy interesante para la búsqueda de vida pretérita en el planeta a causa de la presencia de antiguos lagos y actividad hidrotermal que, precisamente, podría haber estado relacionada con estos episodios de actividad volcánica. Pues bien, aquí se han descrito 63 volcanes -afirman que podría haber bastantes más- cuya forma y estructura nada tiene que ver con los magmas basálticos. Y es que en nuestro planeta la química de las lavas condiciona de manera fundamental la explosividad y el tipo de edificios volcánicos que se construyen, por lo que no es descabellado pensar que en Marte ocurra lo mismo.

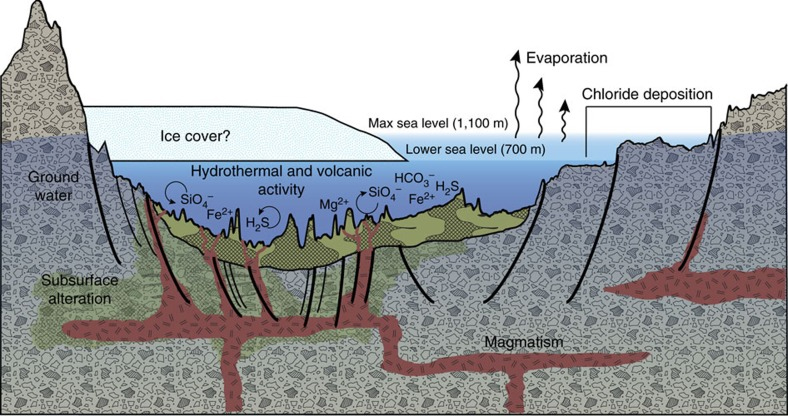

Funcionamiento de un sistema hidrotermal en la cuenca de Eridania, muy interesante desde la perspectiva astrobiológica. Imagen cortesía de la NASA.

Funcionamiento de un sistema hidrotermal en la cuenca de Eridania, muy interesante desde la perspectiva astrobiológica. Imagen cortesía de la NASA.Precisamente esta cuenca podría haber sido uno de los puntos donde en Marte pudo darse fenómenos de reciclaje de la corteza que permitieran el ascenso de magmas con composiciones diferentes, pero, ¿Cómo se reciclaría la corteza en este planeta sin que haya una tectónica de placas? Pues sería a través de procesos como la delaminación litosférica.

La litosfera es la capa más externa de los planetas rocosos, formada por la corteza y por la parte superior del manto. A grandes rasgos, por su comportamiento podemos considerarla como rígida y, en la Tierra, es la capa que está dividida en las distintas placas litosféricas o tectónicas que conocemos.

Pues la delaminación litosférica consiste en una serie de movimientos en los cuales parte de la litosfera se vuelve inestable -en el sentido gravitatorio- y se separa de la propia litosfera. Habitualmente esto puede ocurrir cuando esta parte inferior de la litosfera es más densa que la parte superior del manto y, por lo tanto, tiene esa facilidad para separarse y “hundirse” o bien por el ascenso de materiales calientes a través del manto y que sustituyen a parte de la litosfera.

Estos procesos de delaminación litosférica -y que en nuestro planeta siguen ocurriendo- probablemente serían los primeros sistemas de reciclaje de la corteza que existieron en la Tierra -antes de la tectónica de placas- y, probablemente, los que hayan existido también en planetas como Mercurio o Venus.

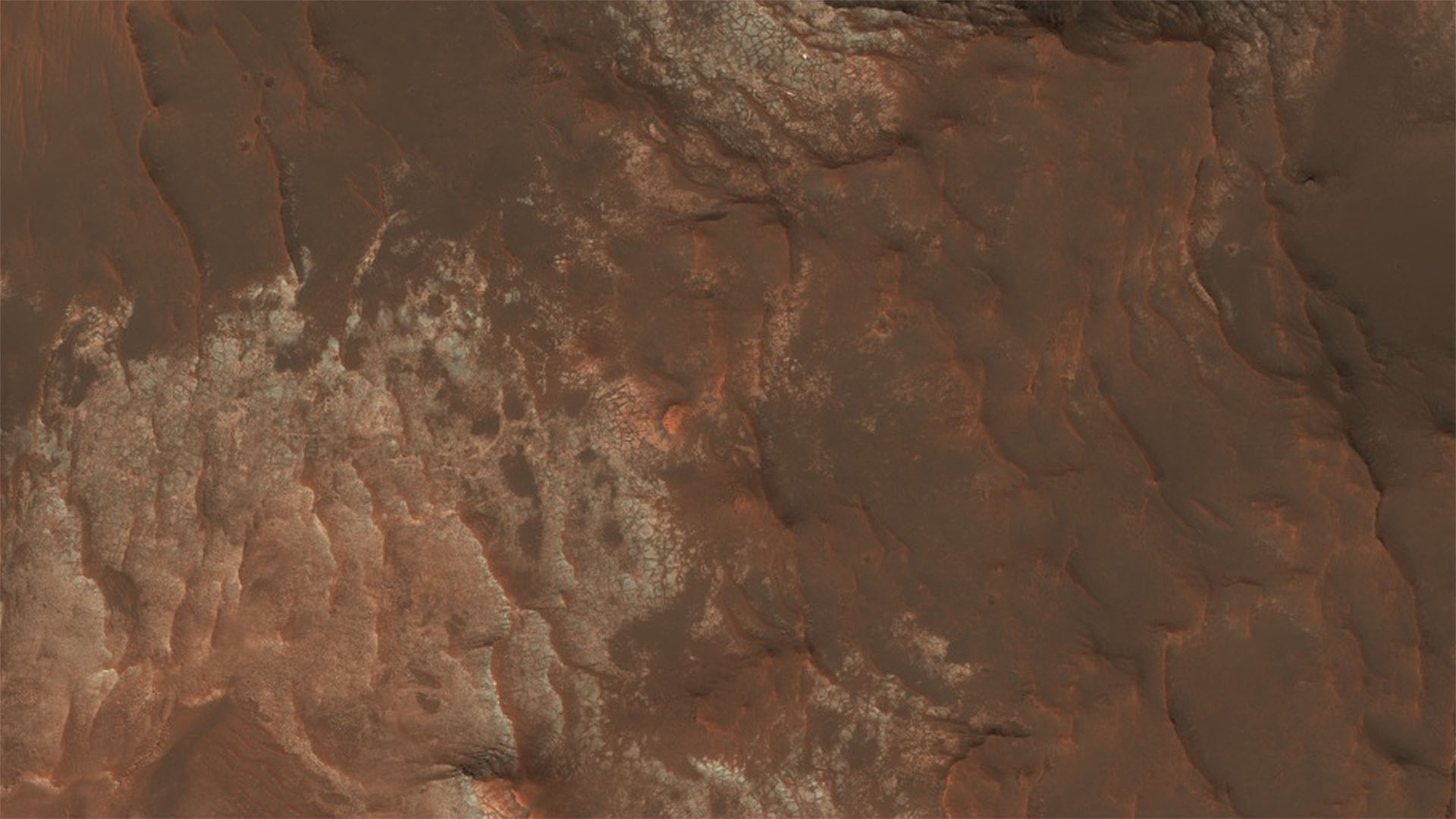

Detalle de la cuenca de Eridania, donde se aprecian unos materiales de tonos claros muy fracturados y que probablemente estén compuestos por minerales del grupo de las arcillas. Cortesía de NASA/JPL-Caltech/UArizona.

Detalle de la cuenca de Eridania, donde se aprecian unos materiales de tonos claros muy fracturados y que probablemente estén compuestos por minerales del grupo de las arcillas. Cortesía de NASA/JPL-Caltech/UArizona.En este proceso en el que se introducen materiales de la corteza hacia el manto estos se pueden acabar mezclando y provocando la evolución en las composiciones de los materiales del manto que posteriormente podrían llegar a la superficie a través de los volcanes, como parece que aquí ha ocurrido, y dando lugar a lavas con una composición diferente a la basáltica.

¿Qué interés puede tener este descubrimiento? Pues tenemos que pensar que en nuestro planeta quedan muy pocas rocas que nos remonten a los “primeros años”, por lo que este hallazgo en Marte podría poner a disposición de la ciencia rocas que proceden de un sistema de reciclaje de la corteza previo a la tectónica de placas, lo que a su vez nos podría ayudar a conocer mejor la dinámica no solo de nuestro planeta, sino también Venus y Mercurio.

Desde el punto de vista de la astrobiología, como comentábamos anteriormente, también es muy interesante, ya que esta cuenca albergaba lagos salpicados por la actividad hidrotermal que podrían ser análogos de los lugares donde se originó la vida en la Tierra y, por lo tanto, candidatos a buscar pistas sobre un posible origen de la vida en Marte.

Referencia:

Michalski, J.R., Deanne Rogers, A., Edwards, C.S. et al. (2024) Diverse volcanism and crustal recycling on early Mars. Nat Astron doi: 10.1038/s41550-023-02191-7

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo La cuenca de Eridania y la complejidad de Marte se ha escrito en Cuaderno de Cultura Científica.

Manipulación sonora, una cuestión evolutiva

José Manuel González Gamarro

La música es un concepto que se aborda en la inmensa mayoría de las investigaciones desde una perspectiva antropocéntrica, esto es, situando a los humanos en el centro del significado, el valor, el conocimiento y la acción. Sin embargo, existen otras orientaciones donde los animales no humanos, o todos los animales, humanos y no humanos, son el centro de las investigaciones en cuanto a la música o la musicalidad. Es lo que se conoce, sobre todo en el mundo anglosajón, como biomusicología. Ya en 1928, Henry Beston afirmaba en The Outermost House que necesitamos un concepto más sabio y más místico de los animales puesto que «no son hermanos, no son subordinados; son otras naciones, atrapadas con nosotros en la red de la vida y el tiempo».

Hablar de música o musicalidad en ciertas especies es controvertido por la dificultad de etiquetar algunas sucesiones de sonidos o ruidos como música. Esta polémica tampoco escapa al ser humano, puesto que hay muchas obras de renombrados compositores que el público en general podría no calificar como música. Sin irnos a ejemplos demasiado radicales, una muestra de esta difícil clasificación como música podría ser la conocida obra del compositor húngaro György Ligeti Artikulation, aunque la intención de este texto no sea polemizar con el límite de ciertos conceptos.

Foto: Dimitry B / Unsplash

Foto: Dimitry B / Unsplash284 especies con manipulación sonora

Volviendo al reino animal no humano, hay muchas especies que emiten sonidos con diversos fines, los cuales algunos se clasifican como cantos, llamadas, vocalizaciones, etc., dependiendo de la especie y las características sonoras de lo que se emite. Cuando se habla de música animal o música en la naturaleza, en lo primero que se piensa es en los pájaros, puesto que los sonidos que emiten se acercan bastante a la orientación antropocéntrica del concepto. En cualquier caso, producen sonidos y algunas especies usan deliberadamente algún tipo de objeto, estructura o instrumento para manipular este sonido y que eso le proporcione algún tipo de ventaja. De hecho, se conocen 284 especies que usan algún tipo de herramienta de manipulación sonora.1 Hay animales que pueden manipular el sonido, ya sea en frecuencia (hercios) o intensidad, con una intención bien definida. Conocer varios ejemplos nos da una visión más general de este fenómeno.

Uno de ellos es el caso de los grillos de árbol, que usan las hojas como membrana de un altavoz, haciendo un agujero en el centro2. Modifican el tamaño del agujero según su propio tamaño para amplificar el sonido. Los investigadores descubrieron que con el agujero en el centro la señal se amplifica hasta 4 veces más que si el grillo canta en el borde de la hoja. A la hora de aparearse, es esencial llegar al mayor público posible. Siguiendo con los grillos, el conocido como grillo topo también reajusta de alguna manera el lugar desde donde emite su sonido3. El macho construye su madriguera en forma de cuerno y modifica su estructura (tamaño y forma) para adecuarla a las frecuencias para atraer a las hembras. Si lo pensamos por un momento, este grillo es un lutier, puesto que la construcción de instrumentos musicales funciona de la misma manera, hacer objetos resonantes donde priman más unas frecuencias que otras. Su modus operandi es el ensayo y error, es decir, que mientras va construyendo la madriguera emite chirridos para ir adecuando el lugar. Gracias a esto consigue una señal más fuerte y con más intensidad en las frecuencias bajas, lo que atrae a más hembras, con la consiguiente ventaja evolutiva. Otros tipos de grillos, como el grillo subterráneo, seleccionan el sitio donde “cantan” aunque no lo construyen. Se suelen colocar cerca de muros o escaleras para amplificar su señal y también eligen la posición de su cuerpo para que la amplificación sea óptima.4