Bacterias magnetotácticas con funcionalidades mejoradas

El grupo de Magnetismo y Materiales Magnéticos de la UPV/EHU lleva más de una década trabajando con bacterias magnetotácticas, un grupo de bacterias acuáticas que en su entorno natural sintetizan cristales de magnetita (un mineral de hierro), que actúan como brújulas y posibilitan que estas bacterias se orienten y naveguen a lo largo de las líneas del campo magnético terrestre.

“Las funcionalidades intrínsecas de estas bacterias hacen que sean muy interesantes para el ámbito clínico, ya que tienen todas las características que se necesitan para ser utilizadas como nanorrobots. Además de poder guiarlas mediante campos magnéticos a la zona a tratar, numerosos trabajos han demostrado el potencial que las bacterias magnetotácticas tienen para ser utilizadas en diferentes prácticas, como la hipertermia magnética (una terapia contra el cáncer), como portadores de fármacos y como agentes de contraste para imágenes por resonancia magnética”, detalla Lucía Gandarias Albaina, investigadora del grupo de investigación y primera autora del presente estudio.

No obstante, estas bacterias presentan una dificultad: “No son fáciles de modificar; sus interesantes características las tienen de forma intrínseca, pero no resulta sencillo introducir nuevas funcionalidades”, señala la investigadora. Una de las estrategias que se sigue en este sentido reside en enriquecer el medio de cultivo con ciertas sustancias, y ver el efecto que esto tiene en las bacterias.

El equipo de investigación se propuso estudiar el efecto que tendría añadir terbio (Tb) y gadolinio (Gd) en el medio de cultivo de la bacteria Magnetospirillum gryphiswaldense, es decir, “cómo cambiaría el potencial de esta bacteria como agente biomédico al incorporar estos elementos”, precisa Gandarias.

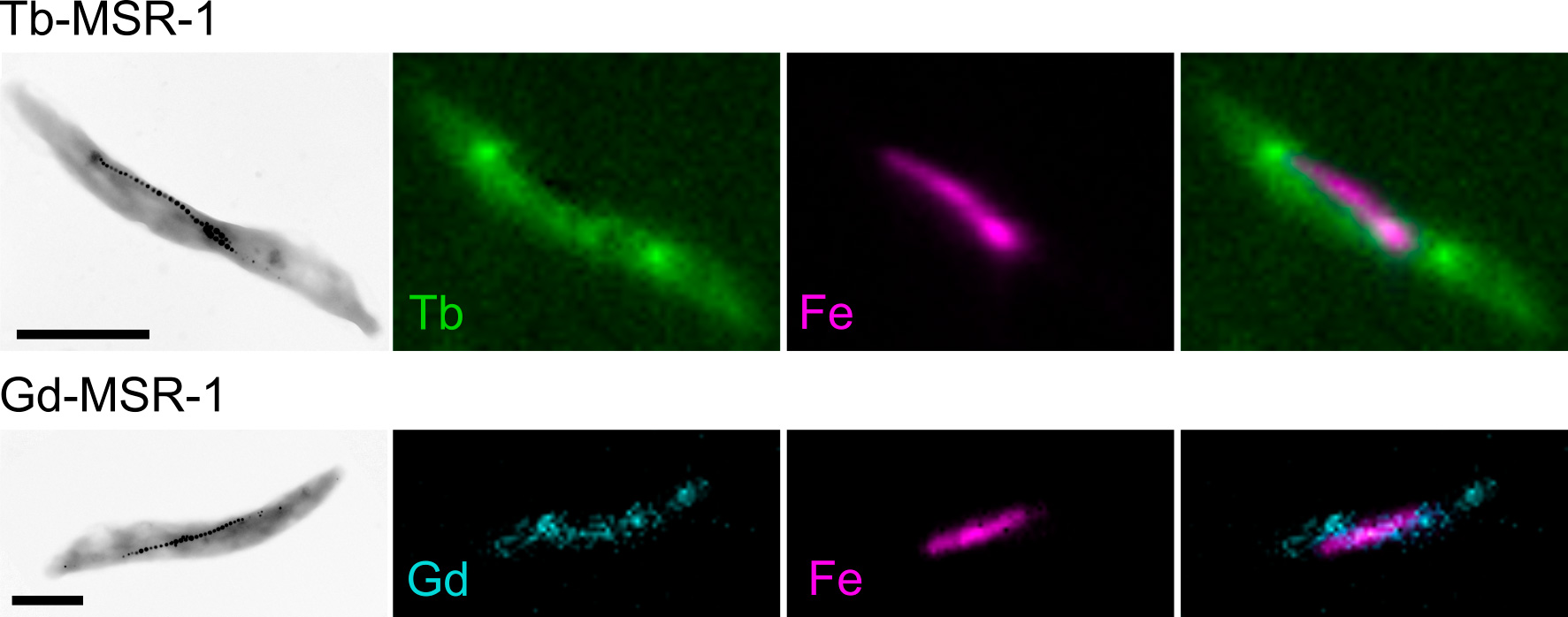

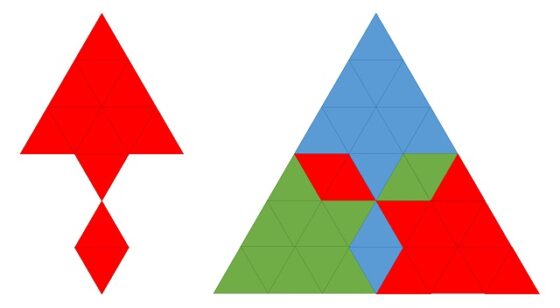

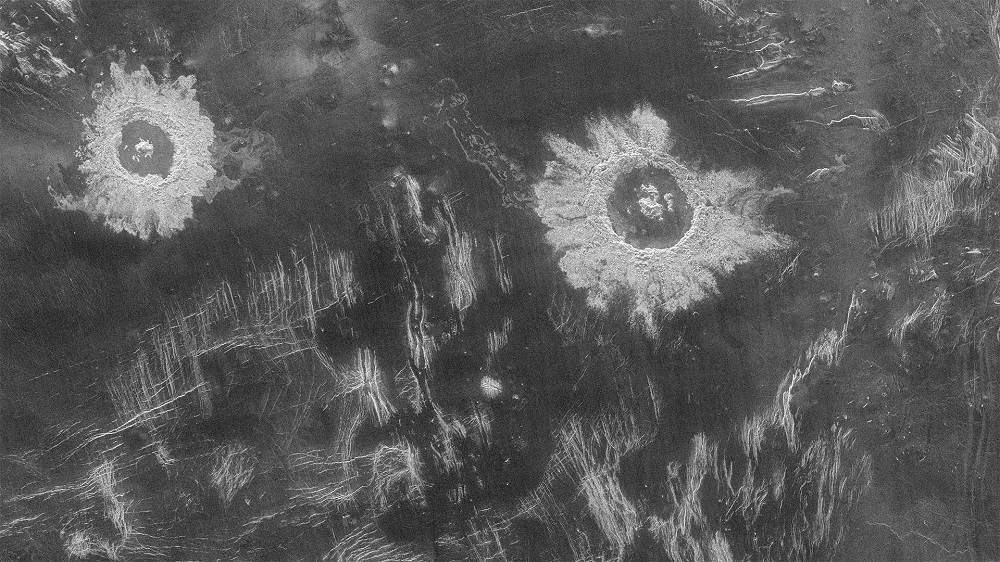

Imágenes de la bacteria Magnetospirillum gryphiswaldense (referida como MSR-1). Izquierda: imágenes obtenidas con microscopía electrónica de transmisión donde se puede ver en detalle de la cadena de magnetosomas dentro de la bacteria. Resto de imágenes: imágenes de microscopía de fluorescencia de rayos X donde se observa la localización del hierro (que coincide con la cadena de magnetosomas) y el terbio/gadolinio (que se distribuye por toda la bacteria). Estas imágenes fueron obtenidas en la línea I14 del sincrotrón Diamond Light Source (Didcot, Reino Unido).Agentes biomédicos con capacidades diagnósticas mejoradas

Imágenes de la bacteria Magnetospirillum gryphiswaldense (referida como MSR-1). Izquierda: imágenes obtenidas con microscopía electrónica de transmisión donde se puede ver en detalle de la cadena de magnetosomas dentro de la bacteria. Resto de imágenes: imágenes de microscopía de fluorescencia de rayos X donde se observa la localización del hierro (que coincide con la cadena de magnetosomas) y el terbio/gadolinio (que se distribuye por toda la bacteria). Estas imágenes fueron obtenidas en la línea I14 del sincrotrón Diamond Light Source (Didcot, Reino Unido).Agentes biomédicos con capacidades diagnósticas mejoradas

La internalización del terbio y el gadolinio por parte de las bacterias trajo la aparición de nuevas funcionalidades. Así lo describe la investigadora: “En nuestros análisis vimos, por un lado, que el terbio convierte las bacterias fluorescentes, por lo que podrían ser utilizadas como biomarcadores, ya que sería posible rastrear dónde se encuentran. Por otro lado, comprobamos que, al incorporar el gadolinio, las bacterias adquieren carácter de agentes de contraste duales para resonancias magnéticas, que es hacia donde se están dirigiendo las investigaciones en este campo de estudio”.

Es conocido que la resonancia magnética requiere que la persona que se va a someter a ella tome agentes de contraste, una clase de productos que mejoran la diferenciación por imagen entre el tejido normal y el dañado y facilitan el diagnóstico. Actualmente se utilizan dos tipos de contraste, los positivos, o T1, que son los más utilizados y están basados en compuestos de gadolinio, y los negativos, o T2, que son nanopartículas de óxido de hierro. “Dado que nuestras bacterias ya contaban con partículas de hierro como parte de sus partículas magnéticas y son capaces de integrar gadolinio del medio de cultivo, pueden funcionar como agentes de contraste duales”, explica Gandarias. Porque la aparición de las nuevas funcionalidades descritas no ha hecho desaparecer las que previamente tenían.

A la vista de estos resultados, la investigadora augura un futuro muy prometedor para el uso de bacterias en la práctica clínica: “Aunque estamos en los inicios, se está trabajando en el uso de bacterias para tratamientos contra el cáncer; hay muchos estudios en diferentes fases. En nuestro caso, en las pruebas in vitro realizadas hemos comprobado que las bacterias no son tóxicas para las células, lo cual nos permitirá continuar estudiando en esta línea”.

Referencia:

Lucía Gandarias, Elizabeth M. Jefremovas, David Gandia, Lourdes Marcano, Virginia Martínez-Martínez, Pedro Ramos-Cabrer, Daniel M. Chevrier, Sergio Valencia, Luis Fernández Barquín, M. Luisa Fdez-Gubieda, Javier Alonso, Ana García-Prieto & Alicia Muela (2023) Incorporation of Tb and Gd improves the diagnostic functionality of magnetotactic bacteria Materials Today Bio doi: 10.1016/j.mtbio.2023.100680

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Bacterias magnetotácticas con funcionalidades mejoradas se ha escrito en Cuaderno de Cultura Científica.

Europa entreabre la puerta a la edición genética en plantas

edición genética

Campo de algodón en Estados Unidos. Foto: Jordan Whitfield / Unsplash

Campo de algodón en Estados Unidos. Foto: Jordan Whitfield / UnsplashHace unos pocos meses publicaba un artículo en el que lamentaba el bloqueo que, en mi opinión y en la de muchos otros profesionales del sector, estaban sufriendo las nuevas técnicas genómicas (NGT en sus siglas en inglés) para su posible aplicación en las plantas. Las técnicas NGT incluyen los nuevos procedimientos de edición genética, en particular las herramientas de edición genética CRISPR, las más recientes, versátiles y poderosas, que han revolucionado la biología, la biomedicina y también la biotecnología tanto en animales como en plantas.

Una inexplicable sentencia del tribunal de justicia de la Unión Europea de julio de 2018 había equiparado los riesgos potenciales de las plantas modificadas genéticamente por la adición de un nuevo gen o fragmento de ADN (transgénicas) con los de las plantas editadas genéticamente con CRISPR. Sin embargo, en estas últimas no se suele añadir ningún transgén, sino que se inactivan o modifican genes con pequeñas variaciones genéticas (inserciones, deleciones o substituciones), similares o idénticas a las existentes en otras variedades naturales de esa misma planta.

La sentencia indicaba, sin aportar justificación científica, que toda planta editada genéticamente debía ser evaluada frente a los riesgos potenciales contra la salud humana y el medio ambiente. Eso implica la preparación de complejos y caros dossieres, tal y como recoge la Directiva 2001/18. Esta directiva se ha venido aplicando sobre todos los organismos modificados genéticamente (OMG) y ha provocado, de facto, la no aprobación para el cultivo de ninguna nueva variedad OMG desde entonces.

Este despropósito aisló Europa –y a Nueva Zelanda, aunque últimamente están reconsiderando su postura– del resto del mundo, que ha optado mayoritariamente por no regular a las plantas editadas genéticamente como OMG. Eso les permite favorecer la innovación tecnológica y aprovecharse de las ventajas productivas de incorporar estos métodos NGT en la agricultura.

Una nueva propuesta de la Comisión Europea para cambiar las cosasSin embargo, algo parece estar moviéndose en Europa en este tema. El pasado 5 de julio, la Comisión Europea publicó una propuesta para modificar la regulación de las plantas obtenidas mediante edición genética usando alguno de los métodos NGT, como las herramientas CRISPR.

El resumen de esta propuesta subraya varios aspectos. En primer lugar reconoce que las técnicas NGT no existían en 2001, cuando se adoptó la legislación actual europea que aplica sobre los OMG. Ciertamente parece cuando menos extraño que se intente aplicar los dictados de una directiva que se aprobó 12 años antes que apareciera la tecnología CRISPR (en 2013).

En segundo lugar, la propuesta incorpora una modificación largamente esperada por el sector: aquellas plantas obtenidas mediante alguna técnica NGT que podrían haberse también obtenido de forma natural o mediante cruces tradicionales serían sometidas a un proceso de verificación.

Aquellas que superaran este proceso serían tratadas como plantas convencionales y, por ello, estarían exentas de cumplir la Directiva 2001/18 de OMG. De hecho, no tendrían que ser identificadas como tales, aunque naturalmente deberían cumplir las normas de seguridad alimentaria, como cualquier otro producto destinado a la alimentación.

¿Y qué pasaría con las plantas NGT que no superen dicha verificación? Que seguirían considerándose OMG y seguirían teniendo que afrontar la citada directiva, aunque de una forma distinta, menos exhaustiva. Y esta es la tercera de las novedades importantes de la propuesta: no se les realizarán los mismos análisis que actualmente se aplican a las plantas transgénicas. La evaluación de riesgo debería estar justificada por una hipótesis de riesgo que se pudiera testar. O lo que es lo mismo, solamente se evaluarían aquellos riesgos para los que hubiera una hipótesis plausible.

No es lo mismo edición genética al azar que hacerla mediante CRISPRIncluir un proceso de verificación a las plantas obtenidas mediante NGT incorpora la flexibilidad que la comunidad científica venía reclamando desde hacía muchos años. No pueden tratarse todas las modificaciones o ediciones genéticas por igual.

Ese fue el error de la sentencia de julio de 2018: que equiparaba insertar al azar un gen de otro organismo (por ejemplo de una bacteria) en el genoma de una planta para generar una planta transgénica resistente a una plaga de insectos, a modificar mediante CRISPR, con precisión, algunas letras del ADN de una planta de forma que un gen deje de funcionar o adquiera una variante genética distinta, existente ya en la naturaleza, que le proporcione alguna característica distintiva aprovechable agroeconómicamente. Por ejemplo distinto sabor, mayor resistencia a la sequía, cambio en el contenido de compuestos metabólicos, resistencia a plagas, etcétera.

El nuevo (y gran) paso de la Comisión Europea acercaría el destino de la biotecnología vegetal en Europa al del resto del mundo, y terminaría con nuestro aislamiento. Algo que ya hizo en EE. UU. el Ministerio de Agricultura hace cinco años.

Aires de cambio que invitan al optimismoLa EPSO(la Organización Europea para la Ciencia de las Plantas) ya ha reconocido públicamente la voluntad de la Comisión Europea para modificar la legislación sobre OMG en la dirección adecuada. Y también ha dado la bienvenida a la propuesta el consejo científico asesor de ARRIGE, la Asociación para la Investigación Responsable e Innovación en Edición Genética.

Naturalmente esta propuesta no suscita el acuerdo de todos, y tanto los partidos Verdes europeos como Alemania y Austria ya se han posicionado en contra de la misma, reclamando mantener el principio de precaución que ha lastrado el progreso en Europa en este campo en los últimos años.

Algunos sinsentidosEn toda iniciativa, el diablo está en los detalles, y este caso no es una excepción. El procedimiento de verificación de las plantas NGT permite eximirlas de cumplir la Directiva 2001/18 solamente en determinadas situaciones, descritas en los anexos de la propuesta.

Concretamente, se propone que una planta obtenida por NGT se considerará equivalente a una planta convencional si el número de substituciones o inserciones de letras del genoma afectadas por la modificación es menor o igual a 20. Pero si se trata de eliminar letras (deleciones) o de invertir la dirección de un fragmento del ADN, este número es ilimitado. ¿Por qué diferenciamos entre inserciones/substituciones y deleciones/inversiones? ¿Por qué limitamos las primeras precisamente a 20 y no a 18, o a 25, o a 30? En plantas, de forma natural,existen inserciones y deleciones mucho mayores.

Son razones arbitrarias en las que, de nuevo, parece faltar la justificación científica correspondiente y pueden dejar fuera de esta propuesta a muchas plantas NGT que no cumplan con estas limitaciones.

Finalmente, las plantas NGT que se consideren equivalentes a las plantas convencionales no podrán, sin embargo, ser usadas en agricultura ecológica/orgánica. Otra contradicción.

Sea como fuere, esta propuesta de la Comisión Europea deberá ser debatida en el Parlamento Europeo y por el Consejo Europeo antes de su aprobación. Es posible que afronte nuevas modificaciones durante la negociación. Pero hay esperanza y algo se mueve –¡por fin!– en Europa.

Y por eso es tan importante contarlo, para que la sociedad europea conozca la existencia de esta propuesta y su previsible impacto en la biotecnología y en nuestra economía.![]()

Sobre el autor: Lluís Montoliu, Investigador científico del CSIC, Centro Nacional de Biotecnología (CNB – CSIC)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Europa entreabre la puerta a la edición genética en plantas se ha escrito en Cuaderno de Cultura Científica.

Los reptiles geométricos

Se acaba de anunciar que el lema del Día Internacional de las Matemáticas 2024 será Jugando con las matemáticas. Por este motivo, me ha parecido una buena idea dedicar esta entrada estival del Cuaderno de Cultura Científica a un curioso rompecabezas geométrico, el de las figuras geométricas conocidas como “rep-tiles”, bueno realmente su nombre es el de “repiteselas”, pero tiene su gracia utilizar en el título de esta entrada el término en inglés, “reptiles”.

El lema del Día Internacional de las Matemáticas 2024 será Playing with Math (inglés US), Playing with Maths (inglés UK), Jouons avec les maths (francés), Spiele mit Mathematik (alemán), Brincando com a matemática (portugués), Jugando con las matemáticas (español), Oyunla Matematik (turco)Un rompecabezas geométrico

El lema del Día Internacional de las Matemáticas 2024 será Playing with Math (inglés US), Playing with Maths (inglés UK), Jouons avec les maths (francés), Spiele mit Mathematik (alemán), Brincando com a matemática (portugués), Jugando con las matemáticas (español), Oyunla Matematik (turco)Un rompecabezas geométrico

El matemático escocés Charles Dudley Langford (1905-1969), a quien se le ocurrió también el conocido problema de los emparejamientos de Langford (véase la entrada Teselaciones rítmicas perfectas o el libro Del ajedrez a los grafos, la seriedad matemática de los juegos), en un artículo titulado Uses of a Geometric Puzzle (Usos de un rompecabezas geométrico) y publicado en la revista The Mathematical Gazette (La gaceta matemática) en 1940, se planteó la siguiente cuentión.

Problema: ¿Qué formas geométricas (formas poligonales) pueden ser diseccionadas en copias idénticas de ellas mismas?

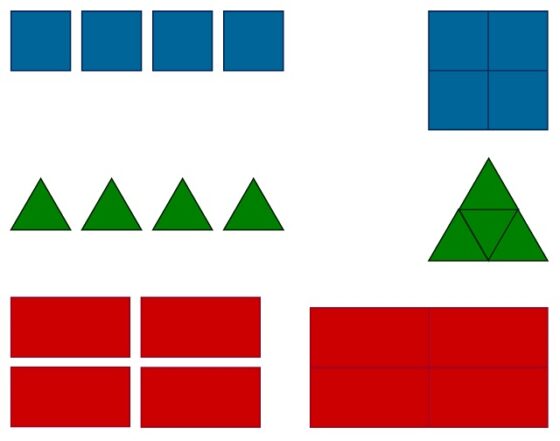

Aunque Langford lo plantea al revés, de la siguiente forma. Es trivial que, si tomamos cuatro cuadrados, triángulos o rectángulos, estos pueden juntarse para formar de nuevo un cuadrado, un triángulo o un rectángulo, es decir, la misma forma, pero de mayor tamaño.

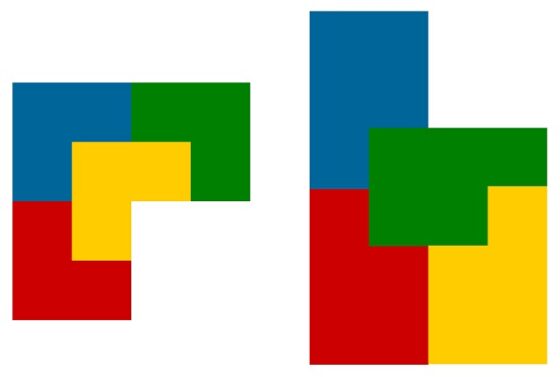

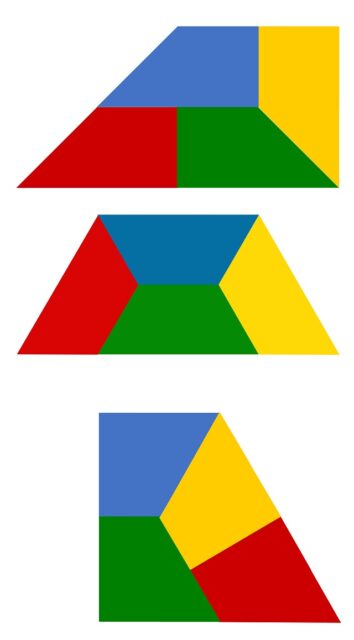

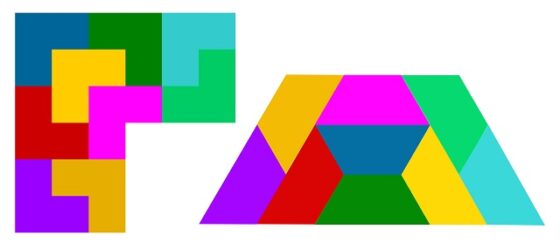

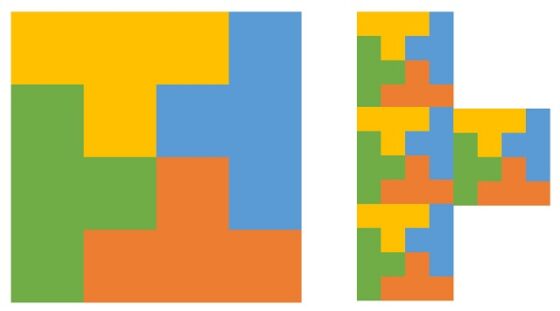

Langford propone buscar otras figuras geométricas que cumplan esta propiedad, algunas de las cuales, como las dos que aparecen en la siguiente imagen, ya eran conocidas por los creadores de rompecabezas geométricos.

Aunque el matemático ofrece algunos otros ejemplos, tres con forma de trapecio y otro con forma de L (los dos anteriores son también de este tipo). Los tres con forma de trapecio son los siguientes.

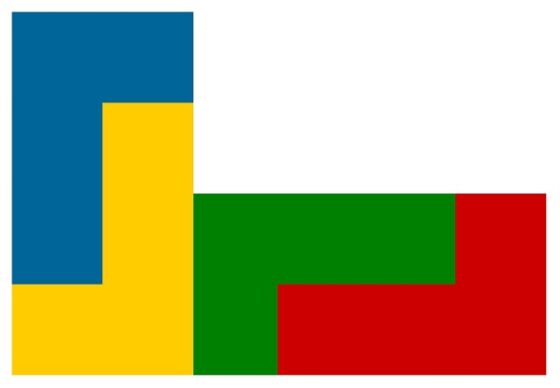

Mientras que el de la forma de L es esta sencilla forma.

En 1962 el matemático e ingeniero estadounidense Solomon W. Golomb (1932-2016), creador de los poliominós (véanse las entradas Embaldosando con L-triominós (Un ejemplo de demostración por inducción) y Tetris, embaldosados y demostraciones), recuperó la idea de los rompecabezas de Langford, a los que denominó “rep-tiles” (repiteselas), que venía de la expresión “self-replicating tiles” (teselas o baldosas auto-replicantes), haciendo un gracioso juego de palabras con el grupo de animales que reciben el nombre de reptiles. Las repiteselas fueron popularizadas por el divulgador de las matemáticas estadounidense Martin Gardner (1914-2010) en su columna Juegos matemáticos, de mayo de 1963, de la revista Scientific American.

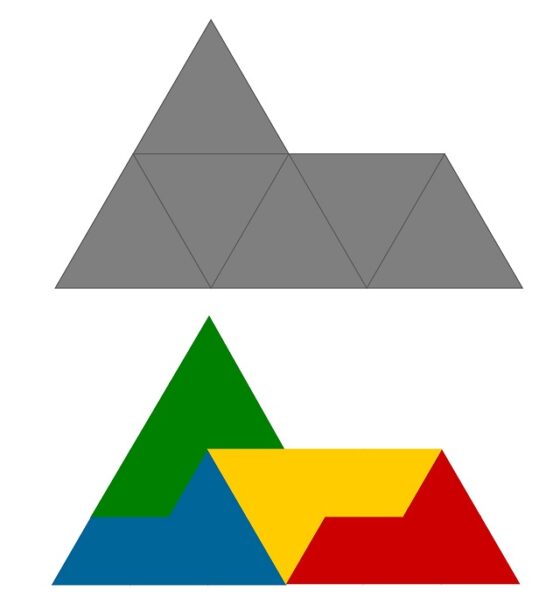

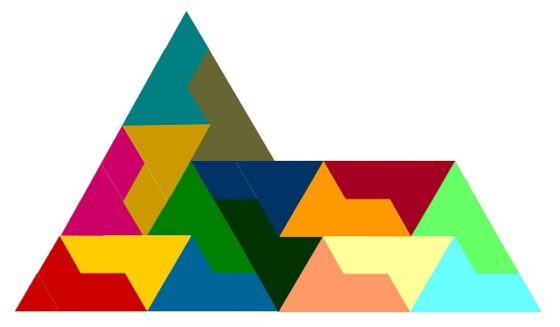

Por lo tanto, una repitesela (o un rep-tile geométrico, si queremos seguir el juego de palabras de Golomb) es una forma geométrica (poligonal) que puede ser diseccionada en copias idénticas de ella misma, como las formas que hemos mostrado más arriba o la figura “esfinge” introducida por Golomb y que mostramos a continuación.

La figura “esfinge” es un hexadiamante (es decir, un polidiamante -figura geométrica plana formada conectando dos o más triángulos equiláteros por alguno de sus lados; los triángulos se conectan lado con lado, pero no se pueden conectar ni por sus vértices, ni juntando solo parte de un lado de un triángulo con parte de un lado de otro- formado por seis triángulos equiláteros) que forma un pentágono irregular y que recuerda a la gran esfinge de Guiza (Egipto), motivo por el cual recibe su nombre.

La repitesela “esfinge”, que es un hexadiamante pentagonal, que puede ser diseccionada en cuatro copias de sí misma

La repitesela “esfinge”, que es un hexadiamante pentagonal, que puede ser diseccionada en cuatro copias de sí mismaPero se puede afinar un poco más la definición teniendo en cuenta el número de copias en las que se descompone la figura geométrica. Se dice que una figura geométrica es una repitesela (o un reptil geométrico) de orden k si puede ser diseccionada en k copias idénticas de ella misma. Todos los ejemplos que han sido mostrados en esta entrada hasta el momento son repiteselas de orden 4.

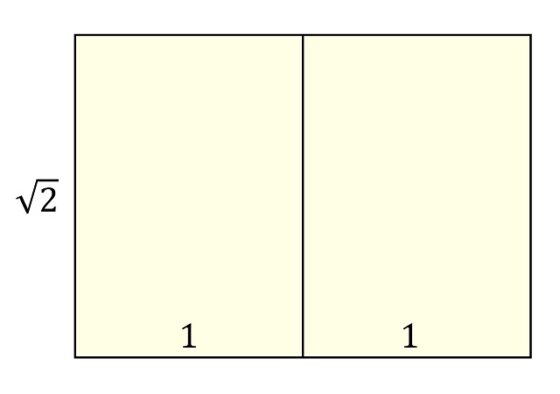

Veamos ejemplos de repiteselas de otros órdenes. Empecemos por el orden 2. Un ejemplo de reptil geométrico de orden 2 lo encontramos muy cerca de nosotros, de hecho, en las hojas de papel sobre las que escribimos, que tienen el formato denominado DINA (véase la entrada Visitad los museos, también en clave matemática). Si juntamos dos hojas de papel DIN A4 se obtiene una hoja de papel DIN A3 y ambas tienen la misma forma (el cociente entre el largo y el ancho en ambas es igual, la raíz de 2), es decir, se puede dividir la hoja DIN A3 en dos hojas DINA4, que tienen la misma forma que la hoja original (DIN A3). Por lo tanto, el rectángulo raíz cuadrada de dos, es decir, el rectángulo cuya proporción entre la altura y la base es la raíz cuadrada de 2, es una repitesela de orden 2.

El rectángulo raíz cuadrada de 2 es una repitesela de orden 2

El rectángulo raíz cuadrada de 2 es una repitesela de orden 2

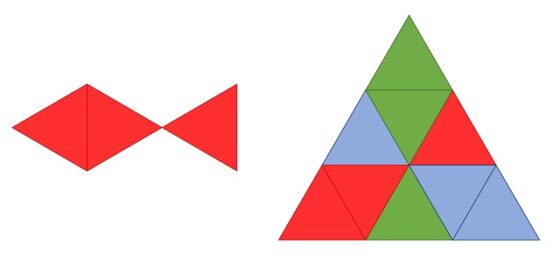

El triángulo rectángulo isósceles es también un ejemplo de reptil geométrico de orden 2.

El triángulo rectángulo isósceles es una repitesela de orden 2

El triángulo rectángulo isósceles es una repitesela de orden 2

El ejemplo del rectángulo anterior nos sirve para poder afirmar que para todo orden k existe siempre un reptil geométrico de ese orden, ya que el rectángulo cuya proporción entre la base y la altura es la raíz cuadrada de k, es una repitesela de orden k.

El rectángulo raíz cuadrada de 5 es una repitesela de orden 5

El rectángulo raíz cuadrada de 5 es una repitesela de orden 5

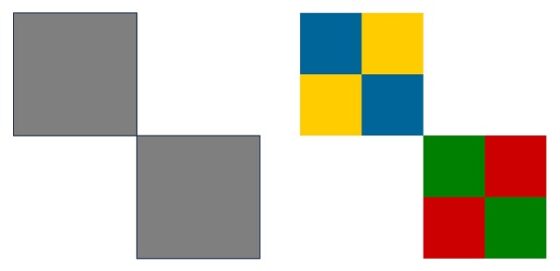

Todos los ejemplos de repiteselas que hemos mostrado son figuras convexas, sin embargo, Langford consideró también figuras no convexas. Recordemos que, en matemáticas, un conjunto es convexo si, dados dos puntos cualesquiera del conjunto, se verifica que los puntos del segmento que une esos dos puntos están también dentro del conjunto. El conjunto no convexo, mostrado por Langford en su artículo, que es una repitesela es la unión de dos cuadrados por su vértice, que se muestra en la siguiente imagen.

Repitesela (no convexa) de orden 4 y su disección en cuatro copias, más pequeñas, de ella mismaLos órdenes de un reptil geométrico

Repitesela (no convexa) de orden 4 y su disección en cuatro copias, más pequeñas, de ella mismaLos órdenes de un reptil geométrico

Teniendo en cuenta que una repitesela de orden k es una figura geométrica que puede ser diseccionada en k copias idénticas de ella misma, y que cada una de estas copias puede ser, a su vez, diseccionada en k pequeñas copias de sí misma, entonces la figura original quedará diseccionada en k2 copias, es decir, la figura geométrica es también una repitesela de orden k2. Y como este proceso de puede continuar hasta el infinito, se puede deducir el siguiente resultado.

Proposición: Una figura geométrica que es un reptil geométrico de orden k, es también un reptil geométrico de orden kn, para cualquier número natural n.

La esfinge es una repitesela de orden 4, pero también de orden 16, como se muestra en esta imagen

La esfinge es una repitesela de orden 4, pero también de orden 16, como se muestra en esta imagen

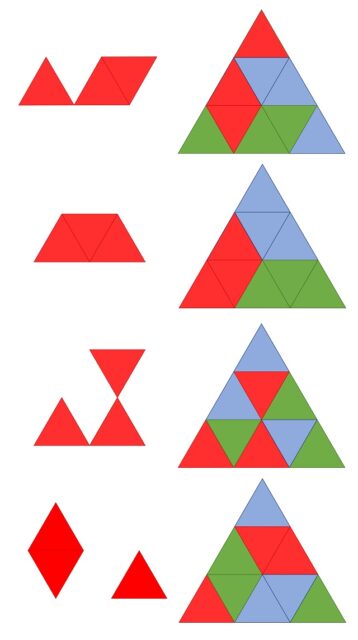

Pero los reptiles geométricos de un cierto orden k, es decir, que pueden ser diseccionados en k copias idénticas de ellos mismos, también pueden ser diseccionados en otras cantidades, distintas de k (o sus potencias), de copias de ellas mismas. Por ejemplo, el propio Langford muestra como dos de las repiteselas de orden 4 que ya hemos mostrado, también tienen orden 9, como queda de manifiesto en la siguiente imagen.

El triominó en forma de L y el segundo trapecio de los mostrados arriba son reptiles geométricos de orden 4, pero también de orden 9

El triominó en forma de L y el segundo trapecio de los mostrados arriba son reptiles geométricos de orden 4, pero también de orden 9

Existen diferentes investigaciones sobre los órdenes de las repiteselas, pero no abordaremos este tema en esta entrada del Cuaderno de Cultura Científica.

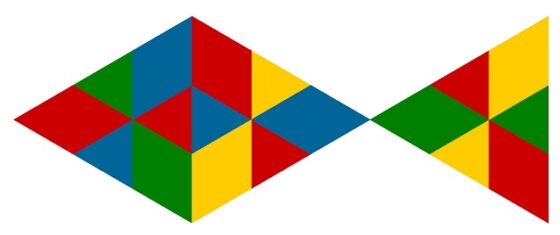

Construyendo reptiles geométricosVamos a terminar esta entrada con una sencilla técnica, desarrollada por Golomb, para construir reptiles geométricos. En particular, la que nos permite construir el siguiente pez como una repitesela de orden 9.

Figura geométrica em forma de pez que es una repitesela de orden 9

Figura geométrica em forma de pez que es una repitesela de orden 9

Si nos fijamos en la anterior imagen, la figura del pez es un polidiamante formado por tres triángulos (luego un tridiamante) que tesela el triángulo equilátero, es decir, con una cierta cantidad de copias del pez (en este caso tres) se forma un triángulo equilátero, luego el pez es un reptil geométrico.

El tridiamante con forma de pez tesela el triángulo equilátero, por lo que este pez es un reptil geométrico de orden 9

El tridiamante con forma de pez tesela el triángulo equilátero, por lo que este pez es un reptil geométrico de orden 9

De la misma forma, podemos buscar otros polidiamantes que teselen el triángulo equilátero. Empezando con los tridiamantes tales que juntando tres copias forman el triángulo equilátero, es decir, que teselan el triángulo equilátero, podemos observar que existen cinco ejemplares de estos tridiamantes (el pez y los cuatro que aparecen en la siguiente imagen).

Cuatro tridiamantes, el último formado por dos piezas desconectadas, que teselan el triángulo equilátero, luego que son reptiles geométricos de orden 9

Cuatro tridiamantes, el último formado por dos piezas desconectadas, que teselan el triángulo equilátero, luego que son reptiles geométricos de orden 9

Notemos que en los anteriores ejemplos el triángulo equilátero teselado tiene 9 pequeños triángulos equiláteros y efectivamente el 9 es divisible por 3. Si realizásemos un estudio general de esta construcción con polidiamantes que teselan un triángulo equilátero tendríamos que tener en cuenta cuantos pequeños triángulos equiláteros teselan un triángulo equilátero. El número de esos pequeños triángulos equiláteros es igual a la suma de los primeros números impares, 1 + 3 + 5 + … + (2n – 1), siendo n la cantidad de filas de triángulos que hay. Pero, como vimos en la entrada Matemáticas para ver y tocar la suma de los primeros números impares es igual a un número cuadrado, 1 + 3 + 5 + … + (2n – 1) = n2. Luego si buscamos otra teselación del triángulo equilátero con tres polidiamantes, el siguiente caso en el que buscar sería para n = 6 (seis filas) y un ejemplo es la figura del cohete siguiente.

Hexiadamente -o polidiamante formado por 12 triángulos equiláteros- con forma de cohete que tesela el triángulo equilátero con tres copias del mismo, por lo que es una repitesela de orden 36

Hexiadamente -o polidiamante formado por 12 triángulos equiláteros- con forma de cohete que tesela el triángulo equilátero con tres copias del mismo, por lo que es una repitesela de orden 36

Este tipo de construcción sirve también para otras poliformas, como por ejemplo los poliominós (recordemos que ahora se utilizan cuadrados en lugar de triángulos equiláteros). Terminamos la entrada con un ejemplo de esta construcción, que nos dice que el tetraminó (poliominó formado por cuatro cuadrados) con forma de T es un reptil geométrico de orden 16, ya que con cuatro tetraminós de esta forma se construye el cuadrado.

El tetraminó con forma de T es una repitesela de orden 16

El tetraminó con forma de T es una repitesela de orden 16

Bibliografía

1.- David Wells, The Penguin Dictionary of Curious and Interesting Geometry, Penguin, 1991.

2.- Charles Dudley Langford, Uses of a Geometric Puzzle, The Mathematical Gazette 24 (260), pp. 209–211, 1940.

3.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, El mundo es matemático, RBA, 2015.

4.- Solomon W. Golomb, Replicating figures in the plane, The Mathematical Gazette 48 (366), pp- 403–412, 1964.

5.- Martin Gardner, The Unexpected Hanging and Other Mathematical Diversions (capítulo 19: Rep-Tiles, Replicating Figures on the Plane), Chicago University Press, 1991.

6.- Wikipedia: Rep-tile

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Los reptiles geométricos se ha escrito en Cuaderno de Cultura Científica.

Fotones como neurotransmisores

Nuestro encéfalo está formado por miles de millones de neuronas que están conectadas entre sí formando redes complejas. Estas neuronas se comunican mayoritariamente mediante un proceso llamado transmisión sináptica, en el cual se envían señales eléctricas (potenciales de acción) y señales químicas (neurotransmisores).

Los neurotransmisores los libera una neurona, se difunden hacia las demás, y llegan a las células diana generando una señal que excita, inhibe o modula la actividad celular. El momento y la fuerza de estas señales son cruciales para que el cerebro procese e interprete la información sensorial, tome decisiones y genere comportamiento.

Controlar las conexiones entre las neuronas nos permitiría comprender y tratar mejor los trastornos neurológicos, reconfigurar o reparar los fallos en los circuitos neuronales tras haber sido dañados, mejorar nuestras capacidades de aprendizaje o expandir nuestro conjunto de comportamientos.

Existen varios métodos para controlar la actividad neuronal. El uso de fármacos es la alternativa más habitual, que permite alterar los niveles de los neurotransmisores presentes en el encéfalo y afectar la actividad de las neuronas. Otra opción es estimular eléctricamente zonas específicas para activar o inhibir las neuronas. Pero existe una tercera posibilidad: usar la luz.

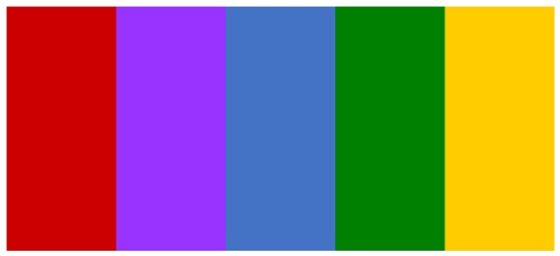

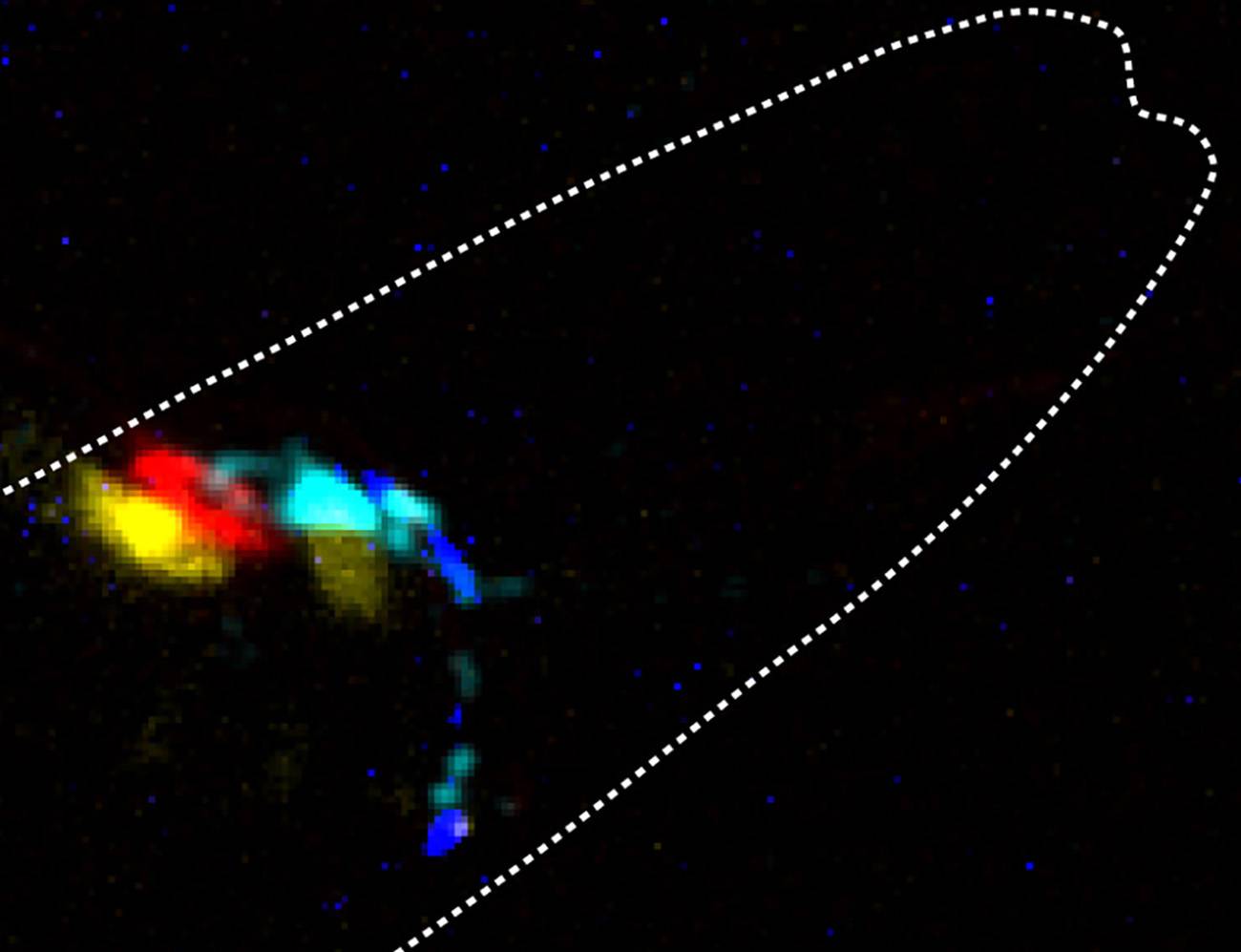

Los investigadores han utilizado el nemátodo Caenorhabditis elegans como modelo experimental. En la imagen, detalle donde el sabor de un neurotransmisor químico ha sido reemplazado por el color del fotón. La neurona de color azul cian es presináptica para el amarillo y el rojo y, por tanto, controla su actividad utilizando luz de ese color cian. Fuente: ICFO / Zeynep F. Altun

Los investigadores han utilizado el nemátodo Caenorhabditis elegans como modelo experimental. En la imagen, detalle donde el sabor de un neurotransmisor químico ha sido reemplazado por el color del fotón. La neurona de color azul cian es presináptica para el amarillo y el rojo y, por tanto, controla su actividad utilizando luz de ese color cian. Fuente: ICFO / Zeynep F. AltunLa manipulación de la actividad neuronal mediante la luz es una técnica, relativamente nueva, que se viene explorando desde hace tiempo. Esta técnica implica modificar genéticamente las neuronas para que expresen proteínas, canales iónicos, bombas de protones o enzimas específicas sensibles a la luz en las células diana.

Aunque este método permite a los investigadores controlar la actividad de grupos concretos de neuronas con mayor precisión, existen todavía algunas limitaciones. Como la luz se dispersa en el tejido cerebral, debe administrarse muy cerca de las neuronas para lograr una resolución suficiente a nivel de sinapsis. Esto implica usar técnicas a menudo invasivas, y requiere de intervenciones externas. Además, la intensidad que se necesita para llegar a las células diana puede ser potencialmente dañina para ellas.

Luz para controlar la actividad neuronalAhora, un equipo de investigadores ha desarrollado un nuevo sistema que utiliza fotones como neurotransmisores como estrategia para controlar la actividad neuronal. Este método permite conectar dos neuronas utilizando luciferasas (unas enzimas que emiten luz) y canales iónicos fotosensibles. El método, llamado PhAST, ha sido testado en el nemátodo Caenorhabditis elegans, un organismo modelo ampliamente utilizado para estudiar procesos biológicos.

Del mismo modo que los animales bioluminiscentes usan fotones para comunicarse, la idea era utilizar enzimas para enviar fotones, en lugar de sustancias químicas, como transmisores entre neuronas. Para comprobar si era posible, realmente, usar los fotones para codificar y transmitir el estado entre dos neuronas, el equipo primero modificó genéticamente los gusanos, alterando sus neurotransmisores de tal manera que fuesen insensibles a los estímulos mecánicos. El objetivo era ver si, con el sistema diseñado, se podían revertir estas alteraciones sensoriales.

En segundo lugar, los investigadores sintetizaron las luciferasas y seleccionaron los canales iónicos proteicos sensibles a la luz, denominados canalrodopsinas. Por último, desarrollaron un dispositivo que administraba estímulos mecánicos en la punta de la nariz de los gusanos, midiendo simultáneamente la actividad del calcio (uno de los iones y mensajeros intracelulares más importante) en las neuronas sensoriales. Esto les permitió seguir el flujo de la información.

Para poder ver los fotones y estudiar la bioluminiscencia, el equipo diseñó previamente un microscopio específico asistido con aprendizaje automático. Simplificaron un microscopio de fluorescencia quitando algunos elementos ópticos habituales como filtros, espejos, o el propio láser, y lo cubrieron por completo para eliminar la contaminación de luz externa.

Los investigadores diseñaron también varios experimentos que han conseguido establecer que los fotones sí pueden, de hecho, transmitir estados neuronales. En uno de ellos, se estableció una nueva comunicación entre dos neuronas no conectadas previamente, restaurando una conexión neuronal en un circuito defectuoso.

También suprimieron la respuesta del animal a estímulos dolorosos, cambiaron su comportamiento pasando de atracción a aversión en respuesta a un estímulo olfativo y estudiaron la dinámica del calcio durante la puesta de los huevos.

Los fotones pueden actuar como neurotransmisoresLos resultados demuestran que los fotones pueden actuar como neurotransmisores, permitiendo la comunicación entre las neuronas, y que el sistema PhAST permite la modificación sintética del comportamiento animal.

Como la luz puede usarse en más tipos de células y en más especies animales, ofrece un gran potencial para una amplia gama de aplicaciones, desde la investigación básica hasta aplicaciones clínicas en neurociencia.

Controlar y monitorear la actividad neuronal mediante luz puede ayudar a la comunidad científica a, por ejemplo, entender mejor los mecanismos subyacentes de la función cerebral y los comportamientos complejos o a determinar cómo distintas regiones del cerebro se comunican entre ellas.

También puede aportar nuevas maneras de escanear y mapear la actividad cerebral con mayor resolución espacial y temporal. Además, puede ser útil en el futuro para desarrollar nuevos tratamientos para reparar las conexiones neuronales dañadas sin necesidad de cirugías invasivas.

El camino a seguir en un futuro está orientado a mejorar la ingeniería de las enzimas bioluminiscentes, los canales iónicos o las moléculas diana, lo que permitiría controlar de manera óptica, no invasiva, y con una mayor especificidad y precisión la función neuronal.

Referencia:

Porta-de-la-Riva, M., Gonzalez, A.C., Sanfeliu-Cerdán, N. et al. (2023) Neural engineering with photons as synaptic transmitters. Nat Methods doi: 10.1038/s41592-023-01836-9

Edición realizada por César Tomé López a partir de materiales suministrados por ICFO.

El artículo Fotones como neurotransmisores se ha escrito en Cuaderno de Cultura Científica.

La juventud de la superficie de Venus

superficie de Venus

Quizás uno de los temas más candentes de la geología planetaria en los últimos años -y que probablemente lo seguirá siendo hasta bien entrada la próxima, cuando quizás podamos dar por sentada esta cuestión- ha sido el estudio de la posible actividad volcánica en Venus. Aquí, en este mismo espacio de Planeta B hemos hablado de los esfuerzos por cartografiar las estructuras volcánicas en Venus en “Un nuevo mapa del vulcanismo de Venus”, así como también de las que podrían ser las primeras imágenes que demuestran que es un planeta volcánicamente activo en “¿Es esta la prueba definitiva de que Venus tiene volcanes activos?”.

Pero lo cierto es que, a pesar de que nos cueste conocer el grado de actividad de Venus debido a la falta de misiones y a la escasa cobertura temporal -al menos con buena resolución-, si no es activo en la actualidad, lo ha sido muy recientemente, aunque desconozcamos exactamente que tipo de procesos son los encargados de rejuvenecer su superficie. En nuestro planeta tenemos la tectónica de placas, el vulcanismo o los agentes externos como la lluvia o el hielo, pero, ¿qué pasa en Venus?

Las cronologías más recientes muestran una gran horquilla de edades para la superficie de Venus que va desde los 1.000 a los 150 millones de años debido a las grandes limitaciones que tenemos para estudiar el planeta. De hecho, estas edades se han calculado estudiando la población de cráteres que hemos podido observar en las imágenes de radar que tenemos, ya que no hemos podido traer muestras de su superficie y que podamos datar en nuestros laboratorios, algo que de momento está lejos de nuestro alcance a nivel tecnológico.

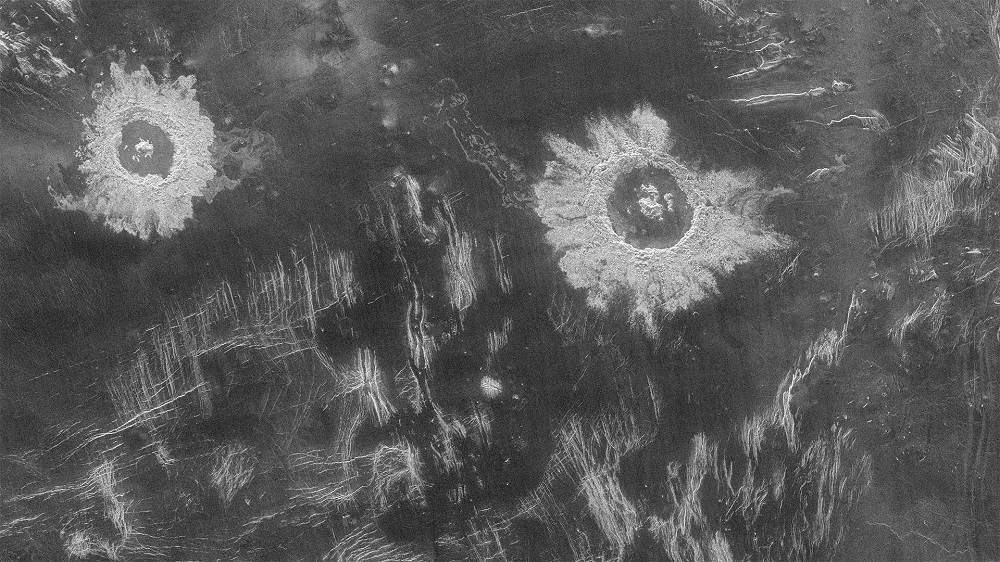

Cráteres en la región de Lavinia de Venus vistos por el radar de la sonda Magellan. Cortesía de NASA/JPL.

Cráteres en la región de Lavinia de Venus vistos por el radar de la sonda Magellan. Cortesía de NASA/JPL.Esta técnica de datación mediante el conteo de cráteres es muy habitual en los cuerpos del Sistema Solar de los que no podemos traer muestras pero de los que sí disponemos de imágenes, ya que nos permite estimar la edad contando los cráteres de una zona y por norma general, a mayor número de cráteres por unidad de superficie, más antigua es esta, aunque obviamente tiene sus limitaciones. Se basa en un principio básico que podríamos resumir en que si la superficie no cambia por algún tipo de proceso, cada vez tendrá más cráteres visibles. O dicho de una manera sencilla: los cráteres son las “arrugas” de los planetas.

Pero esta técnica tiene en Venus un inconveniente muy concreto: Y es que su densa atmósfera probablemente sirva de filtro para los cuerpos más pequeños y que, por lo tanto, podrían consumirse antes de tocar suelo, no llegando a dejar un cráter y por lo tanto, dificultando la tarea, dando como resultado una edad más reciente debido a este sesgo.

A pesar de este posible problema con las dataciones, si miramos la superficie de Venus parece muy joven, tanto es así que sería el único planeta interior (contando a Mercurio y Marte) cuya superficie tiene una edad de rejuvenecimiento de su superficie similar a la de la Tierra y, por lo tanto, procesos capaces de transformar el planeta activos o que han estado activos en el pasado reciente.

Cráteres en la región de Lavinia de Venus vistos por el radar de la sonda Magellan. Cortesía de NASA/JPL.

Cráteres en la región de Lavinia de Venus vistos por el radar de la sonda Magellan. Cortesía de NASA/JPL.¿Qué proceso o procesos podrían ser los responsables de este hecho? Un nuevo estudio (Marchi et al. (2023)) apunta directamente a la labor de la actividad volcánica en Venus. Sabemos por el último censo de edificios volcánicos en el planeta que hay en torno a unos 85.000 volcanes, una cifra que podría ser unas seis veces superior a todos los volcanes de nuestro planeta y, si hay un gran número de estos activos, las coladas de lava podrían ser las responsables de cubrir las superficies más viejas y de generar las nuevas.

Pero de nuevo, aquí hay otra diferencia con nuestro planeta: Si Venus tiene muchos más volcanes activos que la Tierra, a pesar de ser dos planetas similares en tamaño… ¿de dónde saca ese calor extra necesario para generar el elevado número de erupciones?.

El estudio apunta a que Venus pudo sufrir impactos mucho más energéticos contra su superficie al principio de su historia que la Tierra, aumentando el calor disponible en el planeta. Este hecho no es una extrañeza, ya que al encontrarse más cerca del Sol los cuerpos se mueven a mayor velocidad por la propia mecánica orbital, resultando en colisiones más violentas y un mayor grado de fusión en los materiales que forman Venus.

También es posible que las órbitas de estos cuerpos que podrían haber cochado contra Venus fuesen más excéntricas al provenir de zonas más alejadas del Sistema Solar, lo que de nuevo, serviría para añadir más energía al impacto.

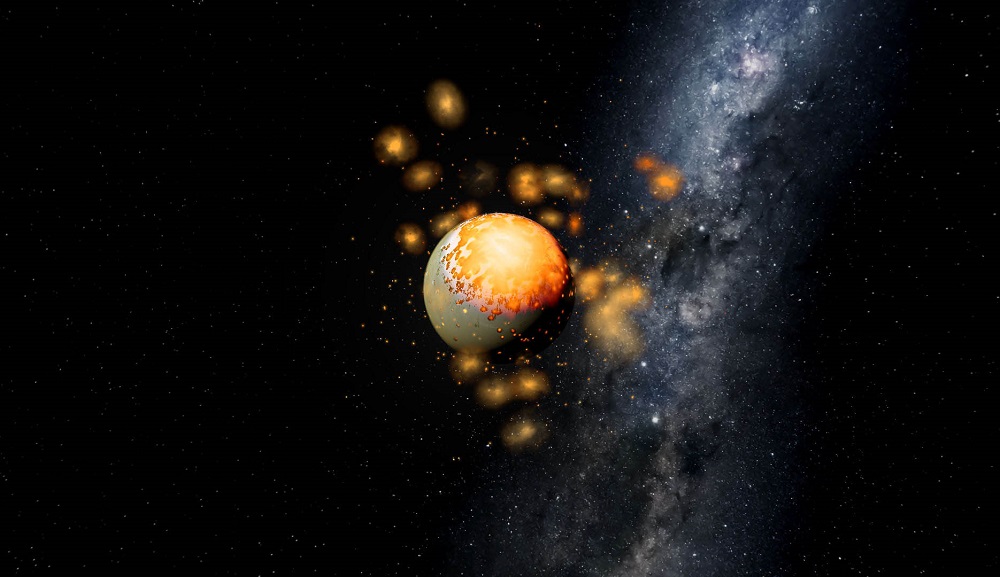

Reconstrucción de como habría lucido Venus durante la época de los impactos que añadieron ese calor “extra” al planeta y que permitiría una gran actividad volcánica, mayor que la de la Tierra. Imagen cortesía del Southwest Research Institute.

Reconstrucción de como habría lucido Venus durante la época de los impactos que añadieron ese calor “extra” al planeta y que permitiría una gran actividad volcánica, mayor que la de la Tierra. Imagen cortesía del Southwest Research Institute.Dicho esto, las condiciones generadas por estos impactos provocarían una evolución geodinámica muy diferente a Venus y la Tierra, llevando a Venus a tener un núcleo muy caliente que daría como resultado la gran actividad volcánica por esa transferencia de calor desde el interior del planeta hacia el exterior.

Pero hay una consecuencia más en este artículo: Venus tiene un campo magnético muy tenue y algunos estudios apuntaban a que la estructura de su núcleo sería la responsable de este hecho, puesto que los impactos podrían haber homogeneizado su composición. Y es posible incluso que Venus tuviese un campo magnético mucho más importante en el pasado ya que su núcleo probablemente tenía calor más que suficiente para iniciar una geodínamo, pero es posible que la magnetización de la corteza haya desparecido debido a su intenso vulcanismo.

Tendremos que esperar a las futuras misiones planeadas para Venus -a finales de esta década y principios de la siguiente- para poder resolver estas y muchas más cuestiones sobre Venus e incluso, quien sabe, si encontrar nuevas preguntas.

Referencias:

Herrick, Robert R., Evan T. Bjonnes, Lynn M. Carter, Taras Gerya, Richard C. Ghail, Cédric Gillmann, Martha Gilmore, et al. «Resurfacing History and Volcanic Activity of Venus». Space Science Reviews 219, n.º 4 (junio de 2023): 29. doi: 10.1007/s11214-023-00966-y.

Marchi, Simone, Raluca Rufu, y Jun Korenaga. «Long-Lived Volcanic Resurfacing of Venus Driven by Early Collisions». Nature Astronomy, 20 de julio de 2023. doi: 10.1038/s41550-023-02037-2.

Tian, Jiacheng, Paul J. Tackley, y Diogo L. Lourenço. «The Tectonics and Volcanism of Venus: New Modes Facilitated by Realistic Crustal Rheology and Intrusive Magmatism». Icarus 399 (julio de 2023): 115539. doi: 10.1016/j.icarus.2023.115539.

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo La juventud de la superficie de Venus se ha escrito en Cuaderno de Cultura Científica.

A qué hora comemos y en qué orden afecta a nuestros biorritmos

comemos

Foto: Farhad Ibrahimzade / Unsplash

Foto: Farhad Ibrahimzade / UnsplashGran parte de los procesos fisiológicos que ocurren en nuestro cuerpo están condicionados por el “sistema circadiano”. Por ejemplo, cuando sale el sol la síntesis de cortisol –la hormona de la vigilia– se dispara, mientras que la síntesis de melatonina –la hormona del sueño– llega a sus mínimos. Conforme llega la noche tiene lugar el proceso contrario.

La producción de estas dos hormonas consigue controlar, sin que nos demos cuenta y de manera repetitiva, muchos procesos que ocurren a diario en nuestro cuerpo, desde la regulación de la temperatura corporal al equilibrio de las concentraciones de glucosa en sangre. Pero ¿se ve afectado nuestro metabolismo si comemos más o menos tarde? ¿Es importante el orden en el que ingerimos los alimentos?

Relojes que marcan la vidaLa ritmicidad circadiana es generada por relojes internos que encontramos en la mayoría de mamíferos y que están sincronizados principalmente de acuerdo con el ciclo luz/oscuridad. Este sistema tiene una gran conexión con el metabolismo y produce ritmos cíclicos en procesos fisiológicos como la síntesis de proteínas y hormonas. Pero ¿puede nuestro estilo de vida afectar a esos biorritmos? Todo apunta a que sí.

Son muchos los factores ambientales que pueden afectar a la relación entre ritmos circadianos y metabolismo, entre ellos la luz artificial, el estrés, el trabajo por turnos y el desfase horario en los viajes. Se les conoce como “cronodisruptores”. Es decir, factores que pueden irrumpir en la correcta organización del sistema circadiano, afectando a los ritmos cíclicos de este sistema y contribuyendo al desarrollo de enfermedades crónicas como la obesidad y la diabetes.

¿Cómo afecta cuándo o cada cuánto comemos?En los últimos años se ha observado que la dieta es un factor importante en la sincronización de los relojes internos. Sin embargo, la compleja relación entre ambos factores todavía no está del todo descrita.

Una nueva disciplina denominada “crononutrición” se encarga de estudiar el impacto de los horarios de la alimentación en el bienestar de los seres vivos. Para ello tiene en cuenta tres dimensiones diferentes de la conducta alimentaria: el momento, la frecuencia y la regularidad de las ingestas.

Los relojes circadianos coordinan las variaciones del metabolismo energético y el comportamiento alimentario, de tal manera que durante la fase más activa del día se asegura de que reponemos las reservas energéticas. En la fase de sueño, por el contrario, promueve el ayuno y la movilización de las reservas de energía.

Sin embargo, el estilo de vida predominante en la sociedad actual se caracteriza cada vez más por seguir dietas poco saludables, no mantener un horario regular para las comidas, saltarse alguna de ellas y comer a altas horas de la noche. El resultado es la disrupción de los ritmos circadianos y, a su vez, una mayor prevalencia de obesidad en la población.

Varias investigaciones han señalado que mantenerse despierto y comer en horas fisiológicamente destinadas al sueño podría poner de alguna manera en riesgo un óptimo estado metabólico. No solo eso, sino que los horarios de alimentación inusuales se han relacionado con alteraciones en la cantidad de energía que se gasta a lo largo del día, cambios en el metabolismo de la glucosa y en la síntesis de hormonas estimulantes del apetito y, por ende, alteraciones de las conductas alimentarias.

Otros estudios sugieren que comer a horas tardías y no mantener horarios regulares de ingesta de alimentos, como ocurre en las personas que trabajan a turnos, altera los relojes biológicos y se asocia con una mayor dificultad para perder peso. Además, puede aumentar la prevalencia de diabetes y de enfermedades cardiovasculares.

¿Importa el orden en el que ingerimos los alimentos?Parece que sí. Estudios recientes han sugerido que priorizar el consumo de algunos grupos de alimentos antes que otros en la misma comida podría afectar a nuestra salud.

Se ha observado que consumir en primer lugar los alimentos ricos en fibra (verduras y frutas), seguido de alimentos proteicos (como carnes y pescados) y dejar para el final los hidratos de carbono (cereales), podría disminuir los picos de azúcar tras las comidas y reducir la concentración de glucosa en sangre. Esto ayudaría a prevenir el desarrollo de diabetes.

Es decir, si comemos un plato de verduras con un poco de arroz y de salmón, deberíamos comer en primer lugar las verduras y dejar para el final el arroz, porque así reduciríamos los aumentos bruscos de azúcar en sangre.

¿Qué podemos hacer para mantener los hábitos alimentarios en consonancia con nuestros relojes biológicos?Diversos estudios sugieren que restringir la ingesta de alimentos a espacios de tiempo concretos, es decir, a las horas del día en las que somos más activos, podría revertir los síntomas asociados a trastornos metabólicos. Esto aumentaría la tolerancia a la glucosa y reduciría la resistencia a la insulina. También podría traducirse en una manera eficaz de evitar la ganancia de peso.

Esto implica comer gran parte de la comida diaria durante el desayuno, almuerzo y comida. A medida que va entrando la noche hay que intentar que las comidas sean lo menos copiosas posible.

Existe evidencia científica de que ingerir la mayor parte de las calorías diarias y los alimentos ricos en hidratos de carbono a la hora del almuerzo y al comienzo de la tarde, evitando cenar tarde, contribuye a un mayor gasto energético a lo largo del día y es fundamental para una correcta sincronización de los relojes circadianos.

En consecuencia, restringir la ingesta de alimentos a las horas del día donde tenemos luz podría representar una estrategia interesante para mantener un correcto estado metabólico y promover la pérdida de peso. No obstante, a día de hoy todavía es escasa la evidencia existente acerca del efecto de horarios y frecuencias del consumo de alimentos en la salud metabólica, por lo que son necesarios más estudios.

Además, debemos tener en cuenta que, debido a que todos los procesos fisiológicos están relacionados entre sí, la mejor manera de seguir manteniendo nuestros relojes internos en hora es evitando hábitos o factores cronodisruptores y promoviendo los que ayudan a mantener la correcta organización de estos.

Así, podemos quedarnos con unos mensajes importantes para poner en práctica:

- Realizar actividad física frecuentemente.

- Mantener horarios regulares de sueño y evitar la exposición a luz artificial durante las horas nocturnas.

- Cambiar el hábito de cenar tarde y tener un horario regular para comer.

- Ingerir la mayoría de alimentos en las horas más activas del día.

- En las comidas, comer primero los alimentos con fibra, como las verduras y frutas, y dejar los hidratos de carbono para el final.

Por último, de nada sirve centrar nuestros esfuerzos en organizar nuestros horarios de comida si basamos nuestra dieta en alimentos poco nutritivos que ponen en riesgo nuestra salud. Es fundamental adquirir hábitos dietéticos adecuados y elaborar nuestra dieta en gran medida a partir de frutas, verduras, legumbres, cereales integrales, proteínas de alto valor biológico y alimentos que aporten grasas de buena calidad.![]()

Sobre los autores: Iker Gomez Garcia, Investigador predoctoral, UPV/EHU; Alfredo Fernández-Quintela, Profesor de Nutrición e Investigador de la UPV/EHU y del Centro de Investigación Biomédica en Red de la Fisiopatología de la Obesidad y Nutrición (CiberObn); Jenifer Trepiana Arin, Investigadora del grupo Nutrición y Obesidad de la UPV/EHU, del CiberObn y del Instituto de Investigación Sanitaria Bioaraba, y María Puy Portillo, Catedrática de Nutrición del UPV/EHU y del CIBERobn

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo A qué hora comemos y en qué orden afecta a nuestros biorritmos se ha escrito en Cuaderno de Cultura Científica.

Del calor al frío y tiro porque me lleva la corriente

Hace unos días apareció una noticia en los medios de comunicación y redes sociales que nos recordó a la trama de la película El Día de Mañana. Un artículo científico recientemente publicado predice un colapso de la AMOC en las próximas décadas, puede que años, que podría conducirnos a una nueva glaciación. Dicho así suena como algo muy serio, pero ¿qué es eso de la AMOC? ¿Y realmente podríamos congelarnos en un par de años?

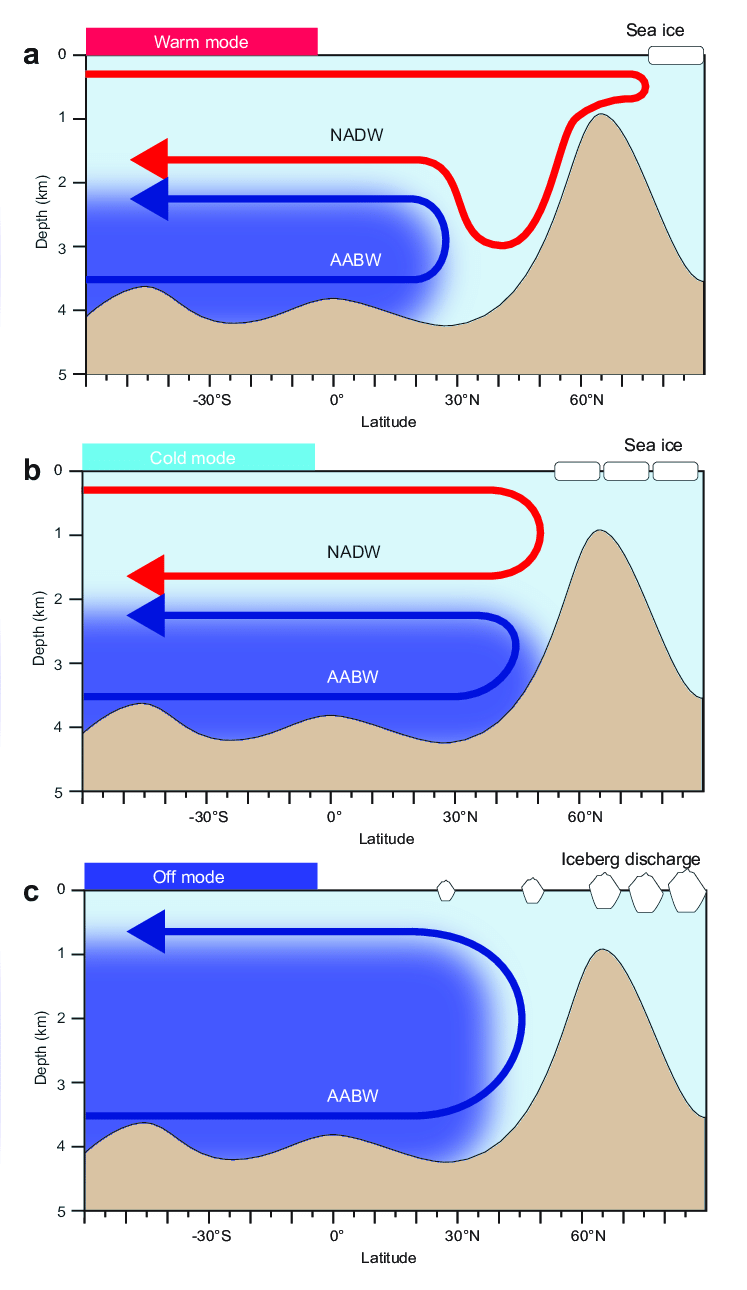

Para poder entender todo este lío, vamos a bucear un poco en el océano Atlántico. Según vamos profundizando en la columna de agua, descubriremos que las propiedades físico-químicas de esa agua van cambiando, sobre todo la temperatura y la salinidad, es decir, la densidad, formando una especie de capas superpuestas a las que llamamos masas de agua. Además, esas diferencias de densidad entre las masas de agua provocan que el agua fluya de un lado a otro formando las corrientes oceánicas. Así se genera una circulación convectiva global por densidad denominada Circulación Termohalina Oceánica (Oceanic Thermohaline Circulation, THC), nombre que procede de termo=temperatura y halina=salinidad. Esta THC, a grandes rasgos, consiste en corrientes superficiales cálidas que transportan calor desde zonas tropicales hacia los polos, donde se enfrían, se hunden y rehacen su camino como corrientes de fondo.

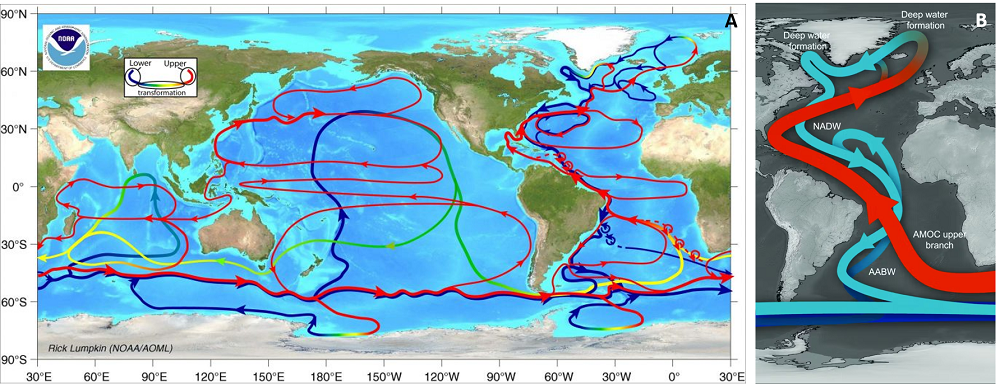

A) Imagen simplificada de la Circulación Termohalina Oceánica (THC). Propiedad de Rick Lumpkin, Atlantic Oceanographic and Meteorological Laboratory (AOML) de la National Oceanic and Atmospheric Administration (NOAA). B) Representación esquemática de los principales componentes de la Circulación de Vuelco Meridional Atlántica (AMOC), con las corrientes superficiales fluyendo hacia el Atlántico Norte, la formación del Agua Profunda del Atlántico Norte (NADW) en latitudes altas circulando hacia el sur y el Agua de Fondo Antártica (AABW) entrando hacia el norte por el fondo marino. Imagen tomada de: Crivellari, S. (2018). Effects of abrupt changes in the Atlantic meridional overturning circulation over the Amazon Basin: an isotopic and elemental approach. Tesis Doctoral, Universidad de São Paulo.

A) Imagen simplificada de la Circulación Termohalina Oceánica (THC). Propiedad de Rick Lumpkin, Atlantic Oceanographic and Meteorological Laboratory (AOML) de la National Oceanic and Atmospheric Administration (NOAA). B) Representación esquemática de los principales componentes de la Circulación de Vuelco Meridional Atlántica (AMOC), con las corrientes superficiales fluyendo hacia el Atlántico Norte, la formación del Agua Profunda del Atlántico Norte (NADW) en latitudes altas circulando hacia el sur y el Agua de Fondo Antártica (AABW) entrando hacia el norte por el fondo marino. Imagen tomada de: Crivellari, S. (2018). Effects of abrupt changes in the Atlantic meridional overturning circulation over the Amazon Basin: an isotopic and elemental approach. Tesis Doctoral, Universidad de São Paulo.Si hacemos un zoom de la THC sobre el Océano Atlántico, nos encontramos con la Circulación de Vuelco Meridional Atlántica (Atlantic Meridional Overturning Circulation, AMOC). Es decir, la AMOC es parte de la THC y se encarga de transportar calor por el Atlántico. Y si hacemos un nuevo zoom sobre la rama del Atlántico Norte de la AMOC, aparece la Corriente del Golfo (Gulf Stream) como parte de las corrientes cálidas superficiales que fluyen hacia el norte, en este caso desde el Golfo de México hasta el sur de Groenlandia, donde se enfrían y circulan hacia el sur como corrientes de fondo. Entre estas últimas destacan el Agua Profunda del Atlántico Norte (North Atlantic Deep Water, NADW), que fluye hacia el sur por debajo de 1.500m de profundidad, y el Agua de Fondo Antártica (Antarctic Bottom Water, AABW), que se llega a colar hacia el norte a más de 3.000m de profundidad.

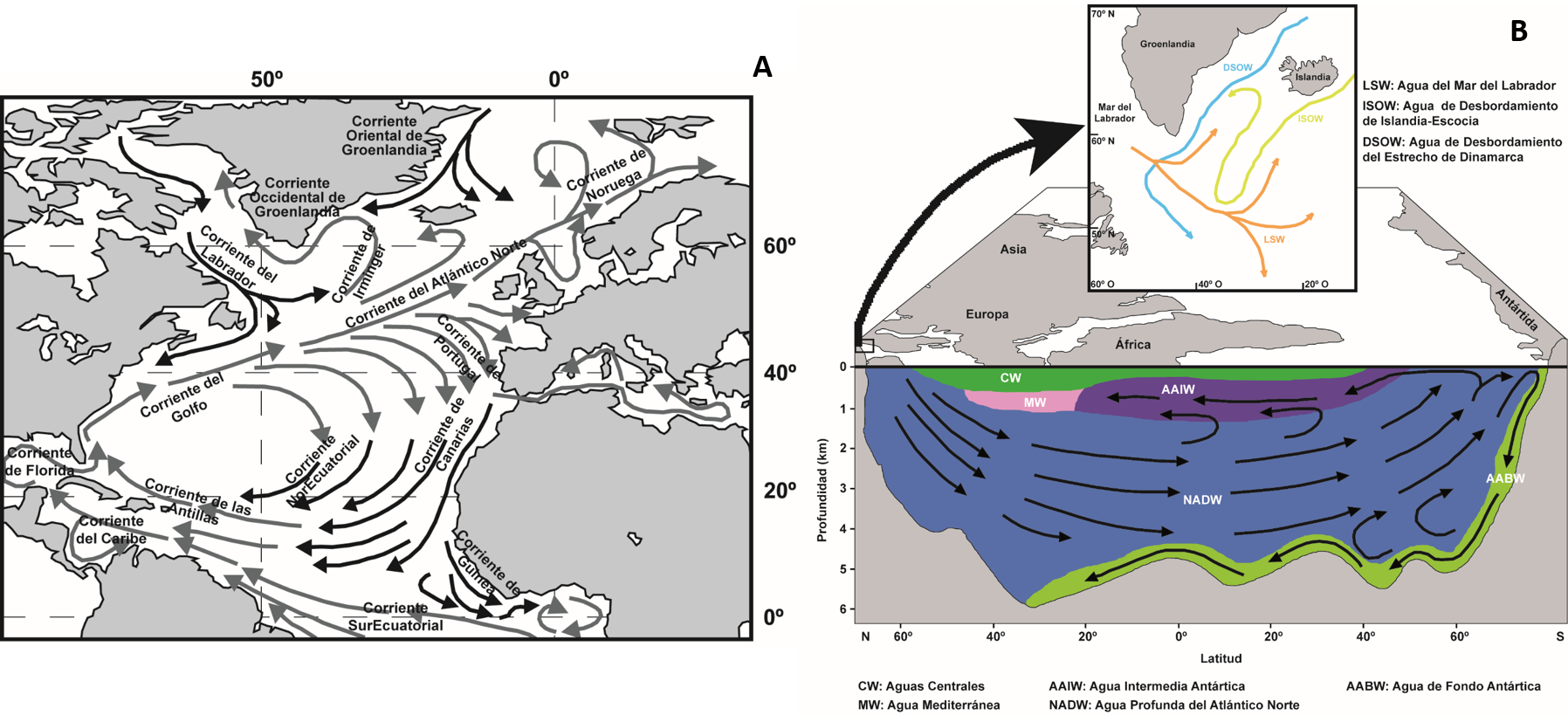

A) Esquema simplificado de las principales corrientes superficiales del Atlántico Norte (en gris se representan las corrientes cálidas y en negro las frías). B) Perfil latitudinal (simplificado) de la distribución, en profundidad, de las principales masas de agua del océano Atlántico (las flechas indican la dirección de las corrientes).

A) Esquema simplificado de las principales corrientes superficiales del Atlántico Norte (en gris se representan las corrientes cálidas y en negro las frías). B) Perfil latitudinal (simplificado) de la distribución, en profundidad, de las principales masas de agua del océano Atlántico (las flechas indican la dirección de las corrientes).Si la AMOC es la “culpable” de transportar calor a latitudes altas del Atlántico Norte, es factible pensar que su colapso nos llevaría de cabeza a una glaciación sin precedentes, de manera análoga a lo presentado en la citada película. Pero veamos qué nos dice la geología a esta suposición.

El Cuaternario, el último periodo de la historia de la Tierra, se caracteriza por la alternancia cíclica de momentos más fríos, llamados glaciales, y momentos más cálidos, o interglaciales. Y las causas de estos cambios climáticos abruptos están relacionadas con el giro del planeta sobre sí mismo y alrededor el sol, provocando variaciones en la radiación solar que actúan en periodicidades de 22.000, 40.000, 99.000 y 400.000 años. Vamos, que un cambio en la circulación oceánica no va a llevarnos a una glaciación en el sentido estricto de la palabra.

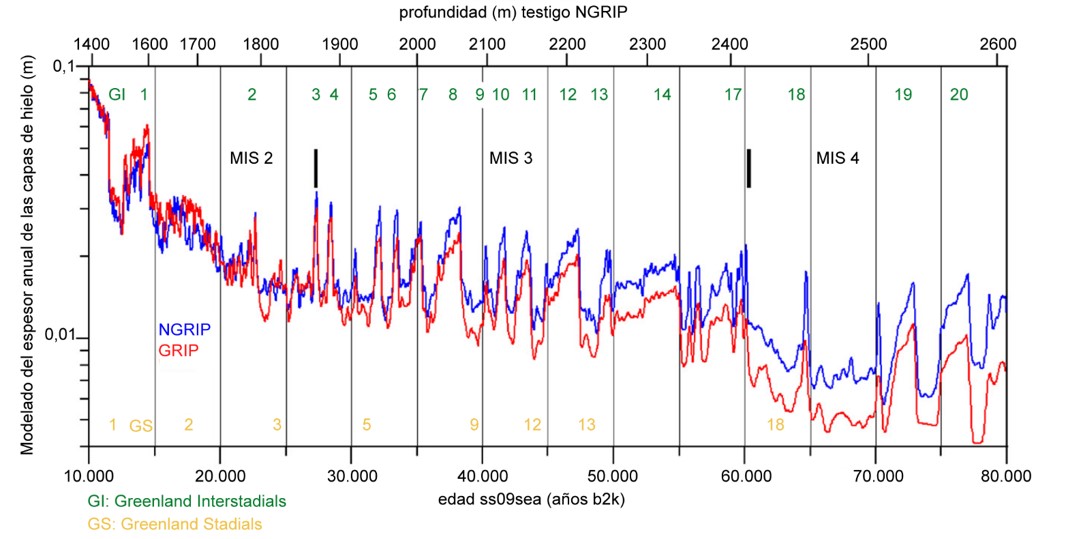

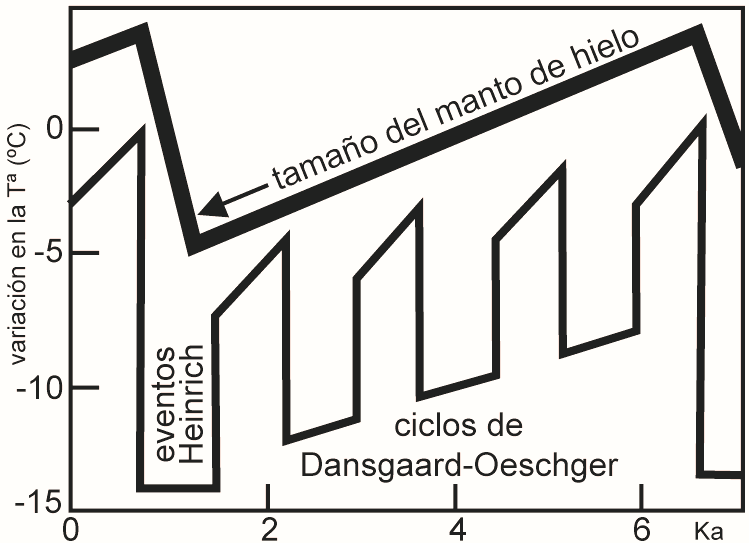

Pero vamos a hacer un último zoom, en esta ocasión en el clima terrestre de las últimas decenas de miles de años. En las reconstrucciones paleoclimáticas realizadas a partir de los sondeos de hielo extraídos en Groenlandia se observan variaciones climáticas en “dientes de sierra” dentro de los periodos glaciales e interglaciales, consistentes en transiciones abruptas desde condiciones frías o estadiales (Greenland Stadials, GS) a condiciones cálidas o interstadiales (Greenland Interstadials, GI), seguidas por un retorno a condiciones frías estadiales, denominadas ciclos de Dansgaard-Oeschger (D-O), con una periodicidad entre dos estadiales, o dos interestadiales, de unos 1.500 años. Además, se agrupan en secuencias de varios D-O cada vez más fríos que culminan con un evento frío extremo, conocido como evento Heinrich (HE), denominadas ciclos de Bond y que tienen una duración de unos 5.000 años.

Variación del clima en los últimos 80.000 años en el hemisferio norte basado en el espesor de las capas de hielo de dos sondeos extraídos en Groenlandia (sondeo NGRIP en azul y sondeo GRIP en rojo), donde los picos positivos de la gráfica se corresponden con momentos cálidos y los picos negativos con eventos fríos. Se indican los interestadiales cálidos (GI) en color verde y los estadiales fríos (GS) en color amarillo.

Variación del clima en los últimos 80.000 años en el hemisferio norte basado en el espesor de las capas de hielo de dos sondeos extraídos en Groenlandia (sondeo NGRIP en azul y sondeo GRIP en rojo), donde los picos positivos de la gráfica se corresponden con momentos cálidos y los picos negativos con eventos fríos. Se indican los interestadiales cálidos (GI) en color verde y los estadiales fríos (GS) en color amarillo.Las reconstrucciones de los cambios de temperatura en la transición entre dos ciclos de Bond en Groenlandia sugieren un rápido aumento de la temperatura superficial media anual de hasta 15ºC en unas pocas décadas. Ahora falta buscar la causa de estas oscilaciones tan bruscas. Y aquí viene lo complicado, porque la relación atmósfera-criosfera-océano es tan compleja, que ninguna de ellas sería una causa aislada de los ciclos climáticos.

El movimiento de las masas de aire es el principal proceso que provoca la circulación de las masas de agua superficiales. Incluso, el efecto del viento genera el movimiento de las capas oceánicas más profundas hacia superficie debido a la mezcla de aguas con diferentes propiedades en profundidad. Y estos movimientos atmosféricos están condicionados por la cantidad de insolación que llega a la superficie terrestre, la distribución diferencial de esa energía solar con la latitud y la rotación de la Tierra. La variabilidad en los ciclos de actividad solar a escala centenaria podría causar cambios en el clima y la circulación oceánica de escala multi-centenaria.

Por otro lado, la fusión de los icebergs y los mantos de hielo continentales en periodos climáticos cálidos provoca una descarga de agua dulce y, por tanto, menos densa en latitudes altas. Esta entrada de agua dulce frena el ascenso de la AMOC hacia el norte de Europa, disminuyendo el transporte de calor, detiene la formación de la NADW al sur de Groenlandia, favorece el ascenso de la AABW hacia el norte y provoca el descenso de las temperaturas que caracteriza los GS y HE registrados en los sondeos de hielo. La disminución del flujo de agua de deshielo, junto con una disipación de la cubierta de agua dulce, podría restablecer la circulación termohalina previa, causando el calentamiento abrupto que cierra los ciclos de Bond y los ciclos D-O.

Esquema idealizado de los cambios en la extensión de los mantos de hielo y la temperatura atmosférica entre dos eventos Heinrich (HE) consecutivos que representan un ciclo de Bond completo. Ka se refiere a miles de años.

Esquema idealizado de los cambios en la extensión de los mantos de hielo y la temperatura atmosférica entre dos eventos Heinrich (HE) consecutivos que representan un ciclo de Bond completo. Ka se refiere a miles de años.Es decir, que el calor conduce al frío, y el frío conduce al calor. El aumento actual de las temperaturas podría producir un colapso de la AMOC que llevaría a un enfriamiento generalizado en el Atlántico Norte. Pero ¿qué tipo de enfriamiento? Pues una glaciación no. Y, probablemente, tampoco un GS ni un HE, porque todo tiene sus ciclos temporales y todavía no les toca. El propio Grupo Intergubernamental de Expertos sobre el Cambio Climático (IPCC) ya ha confirmado que es muy improbable que este tipo de eventos se produzcan este siglo. Pero es que hemos visto que la AMOC depende de las condiciones atmosféricas, por lo que, a pequeña escala, su zona de hundimiento en el Atlántico Norte está variando continuamente. Hace una década sufrió un pequeño retroceso, que apenas duró un año y produjo un par de inviernos más duros de lo normal, y ni nos enteramos. Así que hablar de “ralentización de la AMOC” es muy relativo, lo que importa saber es cuánto debilitamiento se puede producir más que cuándo se producirá, antes de empezar a asustarnos.

Representación esquemática de la Circulación de Vuelco Meridional Atlántica (AMOC) en diferentes estados climáticos. A) En un momento cálido similar al actual, con escaso desarrollo del manto de hielo continental que favorece una fuerte producción del Agua Profunda del Atlántico Norte (NADW) en latitudes altas y una escasa penetración del Agua de Fondo Antártica (AABW). B) Momento frío similar a los estadiales (GS), con un avance de los mantos de hielo que provoca una situación de AMOC débil, con un hundimiento a latitudes más bajas, una reducción de la formación de la NADW y una mayor penetración de la AABW desde el sur. C) Momento muy frío similar a un evento Heinrich (HE), donde la AMOC es muy débil o está prácticamente detenida, se liberan grandes cantidades de icebergs en latitudes altas, no se produce la formación de la NADW y la AABW penetra por completo en el fondo del Atlántico Norte. Imagen tomada de: Crivellari, S. (2018). Effects of abrupt changes in the Atlantic meridional overturning circulation over the Amazon Basin: an isotopic and elemental approach. Tesis Doctoral, Universidad de São Paulo.

Representación esquemática de la Circulación de Vuelco Meridional Atlántica (AMOC) en diferentes estados climáticos. A) En un momento cálido similar al actual, con escaso desarrollo del manto de hielo continental que favorece una fuerte producción del Agua Profunda del Atlántico Norte (NADW) en latitudes altas y una escasa penetración del Agua de Fondo Antártica (AABW). B) Momento frío similar a los estadiales (GS), con un avance de los mantos de hielo que provoca una situación de AMOC débil, con un hundimiento a latitudes más bajas, una reducción de la formación de la NADW y una mayor penetración de la AABW desde el sur. C) Momento muy frío similar a un evento Heinrich (HE), donde la AMOC es muy débil o está prácticamente detenida, se liberan grandes cantidades de icebergs en latitudes altas, no se produce la formación de la NADW y la AABW penetra por completo en el fondo del Atlántico Norte. Imagen tomada de: Crivellari, S. (2018). Effects of abrupt changes in the Atlantic meridional overturning circulation over the Amazon Basin: an isotopic and elemental approach. Tesis Doctoral, Universidad de São Paulo.El comportamiento de nuestro planeta es mucho más complejo de lo que imaginamos. Se trata de un sistema no lineal donde se interrelacionan numerosos factores que condicionan la variabilidad climática en periodicidades muy distintas. Creo que esto ha quedado evidenciado en este texto, repleto de nombres, ciclos y procesos a cuál más complicado. Y eso que lo he resumido, y simplificado, lo máximo que he podido. Pero quería dejar constancia de que una publicación modelizando el posible comportamiento de una de las variables, sin considerar el efecto, sumatorio o contrario, del resto, simplemente es eso, una modelización ideal de algo caótico y que todavía no entendemos en su totalidad. Así que, aunque los títulos de las publicaciones puedan ser muy llamativos, no hay que juzgar nunca un libro por su portada. Y tampoco alarmar sin motivos, la influencia humana en el cambio climático es innegable y debemos evitarla lo máximo posible, porque no podremos pronosticar el comportamiento de nuestro planeta al añadir una nueva variable que no teníamos anteriormente, pero sin exagerar las posibles consecuencias. Si algo nos enseñó una antigua fábula, gritar “que viene el lobo” sin necesidad es bastante contraproducente, porque podríamos conseguir el efecto contrario al que queríamos.

Referencia:

Ditlevsen, P. y Ditlevsen, S. (2023) Warning of a forthcoming collapse of the Atlantic meridional overturning circulation. Nat Commun doi: 10.1038/s41467-023-39810-w

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Del calor al frío y tiro porque me lleva la corriente se ha escrito en Cuaderno de Cultura Científica.

La investigación en matemáticas evoluciona como las estaciones del año

La gran aventura del conocimiento. Un paseo con las matemáticas en cuatro estaciones (Editorial Planeta Chilena S.A., 2023) es el título de una original propuesta divulgativa de las matemáticas Leslie Jiménez Palma y Constanza Rojas-Molina.

Fuente: Editorial Planeta Chilena S.A.

Fuente: Editorial Planeta Chilena S.A.El libro se estructura en cuatro capítulos que corresponden a las cuatro estaciones del año en el hemisferio sur; cada capítulo se divide en tres secciones que corresponden a los meses de la estación protagonista, y cada una de esas secciones en otros cuatro apartados.

Cada estación del año simboliza un momento del proceso creativo en la investigación matemática: descubrimiento de un problema matemático (otoño), pensamiento profundo para comprender las “dobleces” del problema (invierno), colaboración y puesta en común de ideas (primavera) y final del proceso con la solución (o la falta de ella) del problema planteado (verano).

Del otoño al verano (australes)El libro comienza en otoño, “Es un momento de reflexión y descubrimiento, es el momento de mirar un problema con ojos matemáticos […] Es también el momento donde nos hacemos preguntas, donde tratamos de responderlas […]”, dicen las autoras. Y recorren los meses otoñales, desde marzo a mayo, dando algunas claves sobre la relación entre las matemáticas y el arte, hablando del papel de las matemáticas en la comprensión de nuestro entorno por medio del modelamiento y, finalmente, revindicando a algunas matemáticas chilenas que “crearon comunidad y redefinieron el quehacer matemático con sus aportes”: Guacolda Antoine, Irene Mikenberg, Salomé Martínez y el colectivo de mujeres matemáticas en Chile.

Tras el otoño llega el invierno, la época en la que la meteorología nos trae frío, los días son más cortos, y no apetece salir a la calle como en otros momentos del año. Para Leslie y Constanza, “Es un momento de pensamiento profundo con el que buscamos revelar los secretos que esconde nuestro problema matemático y donde buscamos desencriptarlo […] para luego poder solucionarlo usando las reglas matemáticas”. En la sección correspondiente al mes de junio las autoras nos invitan a conocer mejor las matemáticas de los códigos secretos; julio está dedicado a los fractales de Sierpinski, de Mandelbrot, de Koch y en la naturaleza, es decir, a las replicaciones infinitas; y agosto se centra en las matemáticas y el lenguaje, desde los símbolos a las metáforas, pasando por la programación.

Para Constanza y Leslie, la primavera “es el momento donde salimos de nuestros pensamientos solitarios a buscar la ayuda de nuestros nuevos colaboradores. […] el regreso de la luz y el calor nos hacen salir y conversar, comunicarnos y buscar ideas en común con otras disciplinas”. La física es el área a la que se dedica esta estación del año, una disciplina profundamente conectada con las matemáticas. En septiembre y octubre se pasa del suelo al cielo a través de la física y las matemáticas: los movimientos sísmicos, las leyes de Newton, la mecánica celeste o el espacio-tiempo son algunos de los temas elegidos. Noviembre se dedica a la matemática Emmy Noether, cuyo trabajo ayudó a entender la conexión fundamental entre la simetría en física y las leyes de conservación.

El libro finaliza festejando el verano austral, para las autoras “el momento en el que hemos logrado describir matemáticamente nuestro problema, lo hemos investigado y llegamos a un resultado”. El mes de diciembre se centra en algunos ejemplos de cómo la biología es una disciplina que, en nuestros días, avanza en parte gracias a la utilización de variadas técnicas matemáticas. La sección dedicada al mes de enero repasa algunos de los grandes problemas matemáticos, con un especial recuerdo a la segunda mujer que ha obtenido una medalla Fields (tras la matemática iraní Maryam Mirzakhani (1977-2017): Maryna Viazovska. Finalmente, el mes de febrero introduce algunos desafíos relacionados con la sociedad: la igualdad de género, la diversidad, la educación matemática y la comunicación de las matemáticas para públicos diversos.

Las autoras y el formato del libroLas autoras, Leslie Jiménez Palma y Constanza Rojas-Molina, son matemáticas chilenas. Las dos son profesoras, investigadoras, divulgadoras y están profundamente preocupadas por la situación de las mujeres en el entorno matemático, en particular en Chile.

Leslie Jiménez Palma trabaja en la Universidad de Chile y, además de su docencia y su investigación, se dedica a la comunicación de las matemáticas.

Constanza Rojas-Molina es matemática e ilustradora; trabaja en la CY Cergy Paris Université. En este Cuaderno de Cultura Científica ya conocíamos su faceta artística al haber ilustrado la sección Historias que cuentan a cargo de Alberto Mercado Saucedo. Y también conocíamos su precioso proyecto #Noethember dedicado a la genial matemática Emmy Noether. Este libro también se nutre de sus ilustraciones en forma de sketchnotes, notas visuales usadas como herramienta para resumir los contenidos del texto.

La gran aventura del conocimiento es una propuesta singular, estimulante y atractiva para entender cómo trabajan las personas que hacen investigación en matemáticas y para conocer algunos hermosos resultados matemáticos y a sus protagonistas. Es una joya.

Referencias

- Leslie Jiménez Palma y Constanza Rojas-Molina, La gran aventura del conocimiento. Un paseo con las matemáticas en cuatro estaciones, Editorial Planeta Chilena S.A., 2023

- Diana Porras, “Un paseo con las matemáticas”: libro revela la aventura del conocimiento y el desafío de la comunicación científica, Diario UChile, 20 marzo 2023

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo La investigación en matemáticas evoluciona como las estaciones del año se ha escrito en Cuaderno de Cultura Científica.

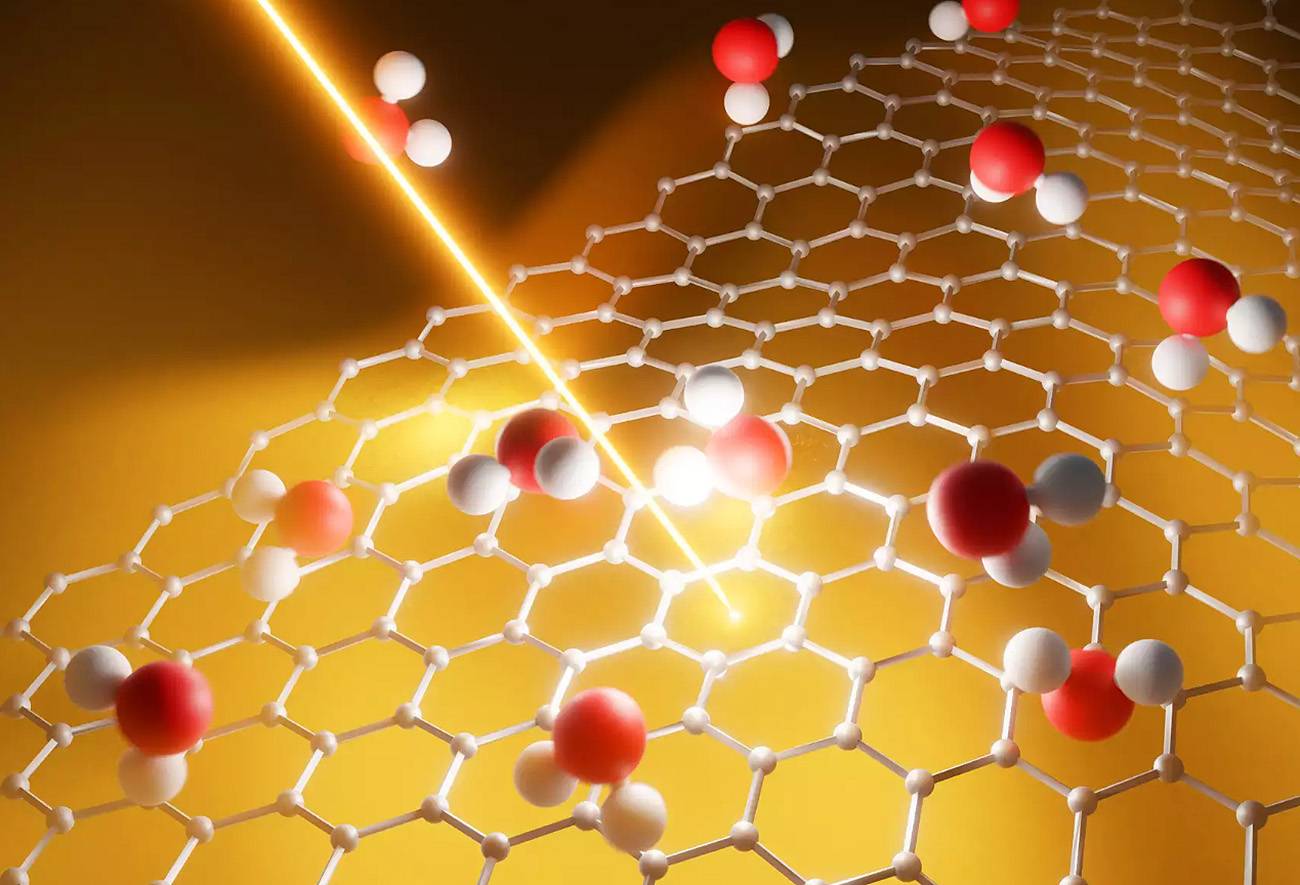

El ruido, un aliado para la computación cuántica

Los ordenadores cuánticos se distinguen por el uso de cúbits en lugar de bits. Esto les permite almacenar y procesar mucha más información a una velocidad mucho mayor, mediante el aprovechamiento de propiedades cuánticas como la superposición y el entrelazamiento. No obstante, existe una importante limitación para el desarrollo pleno de estos ordenadores: el ruido. Este provoca la aparición de errores que se propagan cuando se ejecutan algoritmos complejos, lo cual limita el potencial de la computación cuántica para revolucionar muchos campos de la ciencia y la tecnología. Equipos de todo el mundo llevan años trabajando intensamente para superar esta barrera, concentrando sus esfuerzos principalmente en técnicas para la corrección o mitigación de errores, y en el diseño de algoritmos más sencillos que se adapten a las limitaciones.

Foto: WrongTog / UnsplashEl ruido puede mejorar la calidad…

Foto: WrongTog / UnsplashEl ruido puede mejorar la calidad…

Ahora, un equipo de investigación ha dado una vuelta de tuerca a la cuestión. Proponen una solución alternativa: usar el ruido para mejorar los resultados de algoritmos cuánticos. El equipo ha demostrado que la presencia de ruido en los ordenadores cuánticos puede ser beneficioso para los resultados de un importante algoritmo conocido como quantum reservoir computing.

Este algoritmo realiza predicciones de aprendizaje automático usando sistemas cuánticos con parámetros aleatorios para extraer información útil del sistema estudiado. De este modo, puede resolver problemas muy diversos, como cálculos químico-cuánticos o predicciones de series temporales, así como ayudar en el descubrimiento de nuevos fármacos.

“La idea detrás del quantum reservoir computing es utilizar el espacio de Hilbert, donde viven los estados cuánticos, para extraer propiedades esenciales de los datos estudiados. Así, usando propiedades cuánticas como superposición y entrelazamiento, podemos obtener información útil de los datos y proporcionarla a un modelo de aprendizaje automático, el cual hace la predicción final”, explican los autores.

El estudio concluye que algunos tipos de ruido, como el llamado amplitude damping noise, mejoran la calidad de los resultados del quantum reservoir computing. Por lo tanto, no solo es innecesario corregir este tipo de ruido, sino que podría ser beneficioso para los cálculos cuánticos.

…pero no todos los ruidos son igualesSin embargo, otras fuentes de errores, como el denominado depolarizing noise, pueden degradar los resultados en todos los casos, por lo que es primordial priorizar su corrección en los ordenadores cuánticos.

El estudio también proporciona una demostración teórica que ayuda a explicar este fenómeno. A través del formalismo matemático de las matrices de densidad y los canales cuánticos, los autores ilustran cómo el ruido amplitude damping permite explorar de manera más efectiva el espacio de operadores cuánticos. Esto facilita la extracción de propiedades más complejas y valiosas de los datos, que luego se utilizan para predecir la variable objetivo.

El hallazgo ofrece una nueva perspectiva sobre los mecanismos físicos inherentes en los dispositivos cuánticos. Además, proporciona sólidas pautas prácticas para facilitar una implementación con éxito del procesamiento de información cuántico en la tecnología actual.

Referencia:

Domingo, L., Carlo, G. & Borondo, F. (2023) Taking advantage of noise in quantum reservoir computing. Sci Rep doi: 10.1038/s41598-023-35461-5

Para saber más:

Cómo la aleatoriedad mejora los algoritmos

Edición realizada por César Tomé López a partir de materiales suministrados por la Universidad Autónoma de Madrid

El artículo El ruido, un aliado para la computación cuántica se ha escrito en Cuaderno de Cultura Científica.

La crisis climática potencia a los vectores transmisores de enfermedades infecciosas exóticas

El calentamiento global representa uno de los mayores peligros para la humanidad y su amenaza será cada vez mayor con el paso del tiempo. De hecho, la Organización Mundial de la Salud (OMS) estima que la crisis climática causará unos 250.000 fallecimientos adicionales cada año debido a la malnutrición, el paludismo, la diarrea y el estrés calórico entre los años 2030 y 2050. Por un lado, las catástrofes naturales (sequías, inundaciones, incendios…) serán más frecuentes como consecuencia de fenómenos meteorológicos extremos. Por otro, las olas de calor serán más intensas, frecuentes y duraderas. Ambos fenómenos provocarán, de forma directa o indirecta, más fallecimientos y dolencias en un futuro próximo.

Sin embargo, no es necesario esperar a para comprobar las consecuencias que ya tiene la crisis climática sobre la salud humana. Un estudio epidemiológico publicado recientemente en la revista Nature Medicine calcula que durante el verano de 2022 se produjeron más de 61.000 muertes en Europa (11.000 en España) como consecuencia de las olas de calor. Estas cifras suponen un 41 % más de muertes como consecuencia de las altas temperaturas que las ocurridas de media en los veranos de entre 2015 y 2021. Los autores sugieren que, de seguir esta tendencia, en Europa se producirán un promedio de más de 68.000 muertes prematuras cada verano hacia 2030 y más de 94.000 hacia 2040.

Más allá de las enfermedades y las muertes causadas por estos fenómenos meteorológicos extremos, el calentamiento global afecta también a la salud humana de forma indirecta al alterar la distribución mundial de diversos vectores de enfermedades infecciosas. En ese sentido, el pasado 22 de junio el Centro Europeo para el Control y Prevención de Enfermedades (ECDC) anunció que la extensión de diferentes especies de mosquito del género Aedes por Europa está aumentando el riesgo de diversas enfermedades infecciosas de las que este insecto es vector.

La institución científica explica que las inundaciones y las olas de calor cada vez más frecuentes y graves en el continente europeo, junto con unos veranos más cálidos y largos, crean unas condiciones más favorables para la expansión de los mosquitos invasores Aedes albopictus (más conocido como «mosquito tigre») y Aedes aegypti, que no son propios de esta zona del planeta. Hace 10 años, en 2013, ambas especies se encontraban en solo ocho países de la Unión Europea, afectando a 114 regiones. Ahora estas se encuentran en 13 países y 337 regiones, al invadir dichos vectores el norte y el oeste del continente. España atestigua la gran capacidad que tiene el mosquito tigre para extenderse: la primera vez que se detectó su presencia fue en Sant Cugat del Vallés en el verano de 2004, desde entonces este vector ha conseguido expandirse ya por casi todo el país.

Ambas especies de mosquito (A. albopictus y A. aegypti) pueden transmitir enfermedades infecciosas tropicales o típicas de otros países como el dengue, el Zika, la fiebre amarilla, el chikungunya o la fiebre del Nilo Occidental. El director de la ECDC, Andrea Ammon, sostiene que si la tendencia actual continúa se espera que, con el tiempo, aparezcan más casos y posiblemente más muertes por las citadas enfermedades infecciosas entre los ciudadanos europeos. Solo en 2022 se produjeron los mismos casos autóctonos de dengue (71) en la UE que el total de los que aparecieron entre los años 2010 y 2021. Seis casos de dengue ocurrieron en España. Además, en 2022 aparecieron 1.122 casos de infecciones por el virus del Nilo Occidental en Europa, con 92 muertes, la mayor cifra desde la epidemia de 2018.

Vectores conocidosEspaña conoce de primera mano los estragos que la extensión de los vectores puede provocar en la Salud Pública de su población. Tanto la fiebre del Nilo Occidental (transmitida por mosquitos), como la fiebre hemorrágica de Crimea-Congo (transmitida por garrapatas) preocupan cada vez más a los especialistas por su mayor incidencia en nuestro territorio. En 2020 se produjo el mayor brote registrado de fiebre del Nilo Occidental en el país, con decenas de casos confirmados y siete fallecidos. Anteriormente, ni en 2017 ni en 2019 se detectaron casos de esta enfermedad en humanos, y solo un caso en 2018. Las últimas cifras oficiales, de 2022, han registrado cuatro casos.

Diferentes especies de garrapata están también bajo el punto de mira de los expertos en Salud Pública. Estos arácnidos son vectores de más de cincuenta enfermedades diferentes y la crisis climática está ayudando de forma significativa a su expansión por territorios de mayor altitud y latitudes más elevadas, donde no estaban presente antes.