¿Qué salió mal en el primer trasplante de un corazón de cerdo a un humano?

Foto: Ben Mater / Unsplash

Foto: Ben Mater / UnsplashCada año se realizan en el mundo más de 120.000 trasplantes que dan otra oportunidad a decenas de miles de personas para seguir viviendo. Sin embargo, muchas otras mueren en las listas de espera porque la demanda de órganos es muy superior al número de donaciones. Este problema se está acentuando con los años, debido al envejecimiento progresivo de las poblaciones de multitud de países, que incrementa aún más la necesidad de órganos.

Con el objetivo de solucionar este grave problema sanitario, los científicos están investigando otras opciones alternativas a la donación de órganos humanos. En la última década, el campo de los xenotrasplantes (trasplante de células, tejidos u órganos entre diferentes especies) ha experimentado grandes avances gracias a la ingeniería genética y a los avances en el conocimiento y uso de las células madre. En enero de 2022 se dio un hito histórico en ese sentido: por primera vez, se trasplantó con éxito el corazón de un cerdo a una persona y esta siguió viviendo. El animal había sido modificado genéticamente para que no produjera ciertas moléculas en sus células que se consideran extrañas por el sistema inmunitario humano, lo que minimizó el rechazo.

El paciente, David Bennet, recibió el preciado órgano procedente de un cerdo en el Centro Médico de la Universidad de Maryland. Era su única opción, pues no cumplía los requisitos para acceder a la lista de espera de un corazón humano. Parecía que todo iba bien: la función cardíaca era normal y no había signos de rechazo inmunitario agudo. No obstante, a los 47 días del trasplante, Bennet falleció de forma fulminante debido a un fallo cardíaco (el corazón dejó de bombear la sangre necesaria para mantenerle con vida). Antes de ese fatídico día, los estudios de ecocardiografía y otras pruebas mostraban que el corazón funcionaba sin problemas.

En un primer momento, los investigadores no fueron capaces identificar la causa que llevó al trágico desenlace, pero pusieron en marcha diferentes estudios para analizar cada paso tras el trasplante y conocer qué factores estaban involucrados, ya que estos podrían ser obstáculos también en futuros xenotrasplantes. Se espera que en los próximos años aparezcan ensayos clínicos en los que se trasplanten órganos de animales a personas y toda la información que se pueda obtener de casos como el de Bennet resulta esencial.

En ese sentido, un artículo publicado hace unos meses en la revista médica The Lancet aclara con detalle qué pasó para que el paciente falleciera por un fallo cardíaco. Lejos de ser una única causa la responsable del evento, los datos indican que múltiples factores contribuyeron a un deterioro funcional del corazón porcino trasplantado.

Una de las razones que se barajaban inicialmente como causa del fallo cardíaco era el rechazo hiperagudo. Este suele suceder dentro de los primeros días tras el trasplante por la acción de los anticuerpos contra el órgano donado, lo que lleva a la formación de coágulos que llegan a bloquear a vasos sanguíneos pequeños y, como consecuencia, provocan el infarto del tejido por la falta de oxígeno y nutrientes. No obstante, este tipo de rechazo inmunitario no llegó a aparecer. Los investigadores creen que el delicado estado de salud de Bennet, ya antes del trasplante, fue el desencadenante inicial de una serie de eventos que terminó por provocar su fallecimiento.

El paciente tenía una inmunodepresión muy grave, por lo que el uso estándar de inmunosupresores tuvo que restringirse bastante para que no sufriera infecciones fatales. Sin embargo, esto tenía un precio: también aumentaba el riesgo de rechazo inmunitario hacia el órgano recibido, que fue lo que terminó ocurriendo. Otro factor que pudo haber contribuido a la muerte de Bennet fueron las dos veces que se le administró por vía intravenosa inmunoglobulinas (anticuerpos) durante el segundo mes para prevenir infecciones y el intercambio de plasma sanguíneo. Se cree que esto terminó por desencadenar la respuesta inmunitaria de rechazo frente al corazón recibido, porque se detectó un aumento de anticuerpos (sobre todo de IgG) contra moléculas porcinas tras la administración de las inmunoglobulinas y, además, se observó también la unión de estas moléculas a la superficie interna (endotelio) de los vasos sanguíneos del corazón de cerdo.

Los científicos encontraron pruebas indirectas del ataque de anticuerpos hacia células y tejidos del corazón porcino mediante su análisis a través de diferentes técnicas de laboratorio. Por ejemplo, detectaron lesiones generalizadas en el endotelio de los vasos de dicho órgano. Por otro lado, también se identificó la reactivación y la replicación de virus porcinos (en concreto, de citomegalovirus y roseolovirus porcinos) que habían estado sin mostrar señales de actividad hasta ese momento y que probablemente desencadenaron una respuesta inflamatoria que también contribuyó a dañar al órgano donado. Es posible que la atenuación del tratamiento antiviral del paciente como consecuencia de su estado de salud terminase por activar estos virus.

Como resultado de todo lo anterior, el músculo cardíaco fue desarrollando cicatrices (fibrosis) que terminaron por incapacitar al corazón para contraerse con normalidad y bombear la sangre necesaria para mantener a Bennet con vida. Una trágica cadena de desafortunados eventos biológicos que los científicos tratarán de evitar en los próximos pacientes que reciban corazones de cerdo. Ahora están más preparados: cuentan con técnicas novedosas para monitorizar con más detalle a aquellos que reciban un xenotrasplante y así detectar de forma temprana las primeras señales de rechazo inmunitario. Los próximos ensayos clínicos determinarán si los problemas que sufrió Bennet se debieron principalmente a su delicado estado de salud o si, por el contrario, estos aparecerán también en otros pacientes y si será posible evitarlos.

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo ¿Qué salió mal en el primer trasplante de un corazón de cerdo a un humano? se ha escrito en Cuaderno de Cultura Científica.

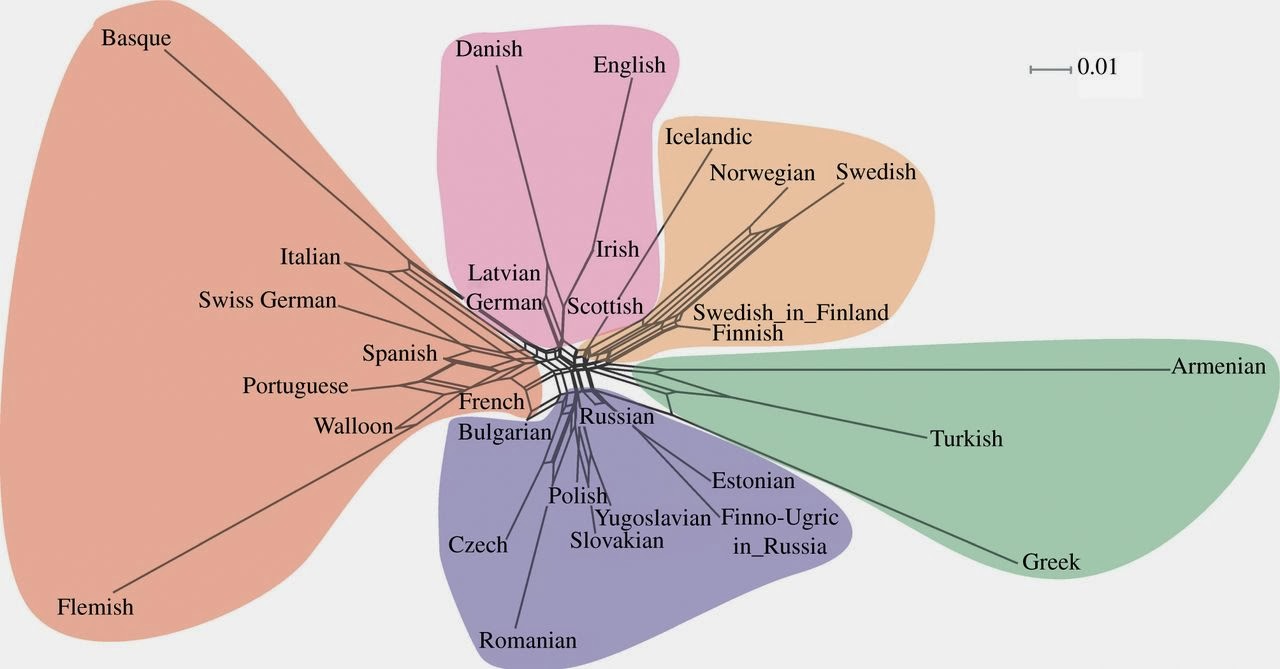

Más que la genética, es la cultura la que configura los grupos humanos

cultura

Foto: Eddi Aguirre / Unsplash

Foto: Eddi Aguirre / UnsplashLos cantos populares son verdaderos registros del pasado de las poblaciones humanas. Sus diferencias reflejan las distintas trayectorias que han seguido aquellas a lo largo del tiempo. Junto con la lengua y otros elementos culturales, pueden aportar un complemento valioso a los estudios genéticos como herramienta para conocer el pasado.

Conforme los seres humanos nos dispersamos por el planeta, no sólo se diferenciaron nuestros genomas, también se diversificaron las lenguas y otros rasgos culturales. De hecho, es posible, y no demasiado difícil, establecer correspondencias entre grupos genéticos y familias o variedades lingüísticas. No obstante, en numerosas ocasiones, y por varios posibles motivos, los grupos humanos han perdido la que era su lengua para adquirir otra diferente. Por ello, la correspondencia original entre grupos genéticos y grupos lingüísticos se difumina, lo que dificulta el análisis conjunto de esos rasgos de cara, por ejemplo, a caracterizar la historia y relaciones entre unos grupos humanos y otros.

Además de la lengua, la música tradicional se ha diferenciado también entre grupos humanos conforme éstos se han desgajado unos de otros y se han diversificado genéticamente. El genetista de poblaciones Floyd Reed presentó, en la reunión anual de 2007 de la American Anthropological Association, un estudio realizado con 39 grupos humanos de África que mostraba una estrecha conexión entre su genética y las canciones que cantaban. Esos resultados venían a apoyar la idea de que la música puede ayudar a identificar las profundas relaciones entre diferentes poblaciones humanas. Al parecer, la música es mucho más resistente al cambio que otros rasgos culturales; puede serlo más incluso que la lengua.

El procedimiento utilizado para caracterizar las canciones que sirvieron de base al estudio de Floyd fue desarrollado por los musicólogos y etnógrafos Alan Lomax y Victor Grauer. Lomax, quien había dado a conocer a Woodie Guthrie y Lead Belly al gran público, creó un archivo de unas 5.500 canciones tomadas de 857 culturas. El sistema, denominado “Cantométrica”, diseñado por los dos etnomusicólogos clasifica las canciones basándose en una escala de 37 rasgos relacionados con ciertas características de la melodía.

Floyd desarrolló un método que permitía determinar la distancia entre pares de culturas musicales, y comprobó que, efectivamente, existía una correlación significativa entre las distancias musicales y las genéticas. Observó que los pueblos que se agrupaban musicalmente, tendían a compartir marcadores genéticos. El método empleado suscitó alguna reserva, ya que la cuantificación de los rasgos utilizados en la clasificación es subjetiva, y eso limita su aplicabilidad universal. No obstante, sus defensores señalan que los resultados avalan su validez.

En esa misma línea, en 2014 se publicaron los resultados de una investigación en Taiwán en la que se estudiaron nueve poblaciones indígenas, cuya genética era conocida, y de las que se contaba con abundantes registros de canciones populares de géneros diversos, principalmente de carácter ritual. Los autores de la investigación trabajaron con una muestra de 220 canciones. Las codificaron combinando Cantométrica (para reflejar estilo vocal, ornamentación y dinámica) y un método desarrollado por ellos mismos, CantoCore (para reflejar ritmo, tono, texto, textura y forma). En total trabajaron con 41 caracteres (15 de Cantométrica y 26 de CantoCore) que han servido para codificar los rasgos de cada canción.

Calcularon la distancia, dos a dos, entre las nueve poblaciones, tanto para la genética (ADN mitocondrial) como para los cantos. Estimaron también las distancias entre las lenguas, a partir de cognados lexicales del vocabulario básico de las culturas incluidas en el estudio. Dado que se analizaron nueve poblaciones, contaron con 36 pares, por lo que obtuvieron 36 distancias para cada aspecto estudiado (genética, lengua y canciones). El análisis estadístico consistió, en lo esencial, en análisis de la varianza –para valorar la variabilidad en y entre culturas– y en correlaciones entre las distancias estimadas a partir de cada uno de los tres rasgos –para establecer el grado de correspondencia entre rasgos genéticos y culturales.

La correlación entre distancias musicales y distancias genéticas fue significativa (r = 0,417; p = 0,015), y lo siguió siendo (r = 0,385; p = 0,032) incluso después de descontar el efecto de la distancia geográfica entre las poblaciones. También era significativa la correlación entre distancias genéticas y lingüísticas (r = 0,492; p = 0,006), pero en este caso la significación se esfumó (r = 0,321; p = 0,071) al introducir las distancias geográficas en el análisis. Eso indica que probablemente las distancias entre las canciones están más firmemente relacionadas con las distancias genéticas que éstas con las lingüísticas. Los autores de la investigación concluyeron que es muy probable que se haya producido una covariación de la música y del genoma mitocondrial de los taiwaneses mediante una ramificación a partir de un ancestro común, de manera que las diferencias, genéticas y musicales no serían mera consecuencia de una separación geográfica relativamente reciente de esas poblaciones.

Los valores de correlación que obtuvieron fueron similares, lo que indica, a mi entender, que tanto las distancias lingüísticas como la musicales reflejan, en una medida similar, el grado de diferenciación de los grupos humanos. Es muy interesante, sin embargo, que la correlación entre las distancias musicales y las lingüísticas sea relativamente débil (r = 0,411; p = 0,085), lo que sugiere que la diferenciación de uno y otro elemento cultural no ha seguido el mismo proceso. Así pues, música, por un lado, y lengua, por el otro, retienen aspectos diferentes de la historia de los grupos humanos analizados.

De todos los elementos contemplados en el estudio, el que más me ha llamado la atención es el de la magnitud relativa de las diferencias entre unos elementos y otros. Porque resulta que, utilizando la misma metodología para analizar distancias, las existentes entre las canciones populares y las lenguas son mayores que las genéticas. En todos los casos –lengua, canciones populares y genoma– la variación dentro de cada población es mayor que la variación entre poblaciones, pero, en términos relativos, hay más variación entre poblaciones en canciones populares y lengua que en los genomas mitocondriales.

En conclusión, los grupos humanos se diferencian en mayor medida en los rasgos culturales que en los rasgos genéticos. Y de aquí se extrae una interesante consecuencia: los grupos humanos se constituyen y diferencian unos de otros sobre la base de elementos culturales. O lo que es lo mismo, a los efectos de la configuración de los pueblos, la cultura es lo que nos hace miembros de uno u otro grupo, no los genes que codifican las proteínas que dan forma y función a nuestro organismo.

Fuente: S Brown S, P E Savage, AM-S Ko, M Stoneking, Y-C Ko, J-H Loo, J A Trejaut (2014): Correlations in the population structure of music, genes and language. Proc. R. Soc. B 281.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Más que la genética, es la cultura la que configura los grupos humanos se ha escrito en Cuaderno de Cultura Científica.

La ceguera a las plantas

A pesar de la importancia que tienen las plantas en nuestro entorno, el conocimiento sobre ellas es escaso, convirtiéndolas en elementos que muchas veces pasan inadvertidos o que, como mucho, quedan como telón de fondo. ¿Por qué generan tan poco interés las plantas? ¿Es el color de las plantas y los paisajes casi monocromáticos los elementos que provocan esa reacción?

En el año 1999 los botánicos James H. Wandersee y Elisabeth Schussler bautizaron este fenómeno como “ceguera a las plantas” o «ceguera vegetal» y, desde entonces, varias investigaciones han intentado entender las razones del mismo.

Entre los motivos que explicarían la ceguera a las plantas se mencionan los factores biológicos y socioculturales. El ser humano cuenta con un sistema visual que no se siente cómodo al no poder fijar la mirada en un punto concreto de un paisaje que, a primera vista, puede parecer monótono. Además, el sistema visual y el cerebro humano habrían evolucionado para detectar con más facilidad a los animales que a las plantas.

La ceguera a las plantas tiene consecuencias y por ejemplo, como muestra el estudio realizado por la Universidad del País Vasco y Aranzadi, mientras hoy en día los y las jóvenes son capaces de nombrar 10 animales, solo el 7% es capaz de nombrar 10 plantas.

La investigadora Ainara Achurra habló sobre este fenómeno en la charla “La ceguera a las plantas: un fenómeno que sufrimos la mayoría” dentro del ciclo Bidebarrieta Científica organizado por la Cátedra de Cultura Científica de la Universidad del País Vasco y la Biblioteca Bidebarrieta.

Ainara Achurra es doctora en Biología y profesora en la Facultad de Educación y Deporte de la Universidad del País Vasco en Vitoria-Gasteiz.

Edición realizada por César Tomé López

El artículo La ceguera a las plantas se ha escrito en Cuaderno de Cultura Científica.

Los cambios en el glaciar de Aneto

El glaciar de Aneto, aunque se considera un glaciar muy pequeño, es el glaciar más grande de los Pirineos y también el más grande del sur de Europa. Sin embargo, el cambio climático ha acelerado su desaparición, al igual que en el resto de los glaciares de la cordillera. La evolución de las técnicas de teledetección de corto alcance posibilita observar la superficie del glaciar con un nivel de detalle muy alto, lo que permite la comparación entre la superficie del glaciar de diferentes años y la evaluación de sus cambios.

Glaciar del Aneto y vista de la Cresta de los Portillones desde la cima en 2007. Fuente: Faras / Wikimedia Commons

Glaciar del Aneto y vista de la Cresta de los Portillones desde la cima en 2007. Fuente: Faras / Wikimedia CommonsLos glaciares de montaña son excelentes indicadores de la variabilidad y el cambio climático porque su evolución depende del equilibrio entre la acumulación de nieve durante el período frío y la fusión de hielo y nieve durante la estación más cálida. El glaciar del Aneto es uno de los glaciares más meridionales de Europa y, a pesar de ser un glaciar muy pequeño (<0,5 km2), es el más grande de los Pirineos.

Un reciente estudio liderado por el Instituto Pirenaico de Ecología (IPE-CSIC) ha encontrado que, para el periodo 1981-2022, la superficie del glaciar de Aneto ha disminuido un 64,7 % (de 135,7 ha (1,36 km2) a 48,1 ha (0,48 km2)), y su frente ha pasado de 2.828 a 3.026 metros.

El objetivo del estudio era analizar la evolución reciente del glaciar más grande y alto de los Pirineos utilizando el conjunto de datos temporales más largo de pérdida de espesor de los glaciares en los Pirineos. Además, el trabajo ha permitido evaluar el impacto de una única temporada extremadamente cálida y seca (2022) en la evolución de los glaciares. “Hemos realizado el estudio del glaciar de Aneto más detallado (modelos tridimensionales del glaciar de muy alta resolución) y longevo (41 años) hasta el momento. Para ello, hemos reconstruido las superficies del glaciar entre 1981 y 2022 a partir del uso de imágenes aéreas de muy alta resolución que han sido obtenidas, por un lado, por el Instituto Geográfico Nacional para el año 1981 y mediante vuelos LIDAR para el año 2011 y, por otro, por vehículos aéreos no tripulados (drones) para los años 2020, 2021 y 2022 -explica Eñaut Izagirre Estibaritz, profesor del Departamento de Geografía, Prehistoria y Arqueología de la Universidad del País Vasco y participante en la investigación-. Todo ello se complementó con una amplia campaña de georadar en el año 2020, donde a partir de la realización de diferentes transectos (más de 7 km recorridos sobre el glaciar), pudimos conocer el grosor que tenía el glaciar en ese año”.

Desaparición de los glaciaresLa pérdida de superficie glaciar en los Pirineos es notable: había más de 100 glaciares en 1850, 39 en 1984, 21 en 2020 y 18 en 2022, correspondientes a una superficie de 2.060 ha (20,6 km2) en 1850, 810 ha (8,1 km2) en 1984, 232 ha (2,3 km2) en 2020 y 170 ha (1,7 km2) en 2022, lo que representa una pérdida del 92 % del área glaciar desde el final de la Pequeña Edad de Hielo.

Los investigadores midiendo el grosor del glaciar. Fuente: campusa

Los investigadores midiendo el grosor del glaciar. Fuente: campusaEn el Aneto, durante los últimos 41 años, la superficie glaciar se ha reducido un 64,7 % y el espesor del hielo ha disminuido, en promedio, 30,5 m. “El espesor medio del hielo restante en el otoño de 2022 fue de 11,9 m, frente al espesor medio de 32,9, 19,2 y 15,0 m reconstruido para 1981 y 2011 y observado en 2020, respectivamente. Los resultados demuestran la crítica situación del glaciar, con una inminente segmentación en tres cuerpos de hielo más pequeños y sin evidencia de una zona de acumulación. También encontramos que la influencia de un año extremadamente caluroso y seco, como se observó en la temporada 2021-2022, conduce a una degradación drástica del glaciar, lo que representa un alto riesgo para la persistencia del glaciar de Aneto, situación que podría extenderse al resto de glaciares pirenaicos en un tiempo relativamente corto”, detallan los investigadores.

Los datos de la investigación señalan que la distribución del espesor del hielo muestra zonas alrededor de los glaciares con muy poco espesor (<2 m), por lo que esas zonas están muy cerca de desglaciarse durante los próximos veranos. Las pérdidas de superficie y espesor del glaciar de Aneto indican la situación crítica de esa masa de hielo. Se encuentra en su etapa terminal, mostrando fragmentación en cuerpos de hielo más pequeños y presencia de cubierta de derrubios en algunas áreas. “Las tasas de adelgazamiento del glaciar, que estaban en torno a 1 m por año, se han triplicado en el último año de estudio (entre 2021 y 2022), lo cual demuestra la afección de un año bastante seco y, sobre todo, extremadamente cálido como 2022 sobre la fusión de la nieve y el hielo en el glaciar de Aneto”, concluye el profesor de la UPV/EHU.

Referencia:

Vidaller, I., Izagirre, E., del Rio, L. M., Alonso-González, E., Rojas-Heredia, F., Serrano, E., Moreno, A., López-Moreno, J. I., Revuelto, J. (2023) The Aneto glacier’s (Central Pyrenees) evolution from 1981 to 2022: ice loss observed from historic aerial image photogrammetry and remote sensing techniques The Cryosphere doi: 10.5194/tc-17-3177-2023

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Los cambios en el glaciar de Aneto se ha escrito en Cuaderno de Cultura Científica.

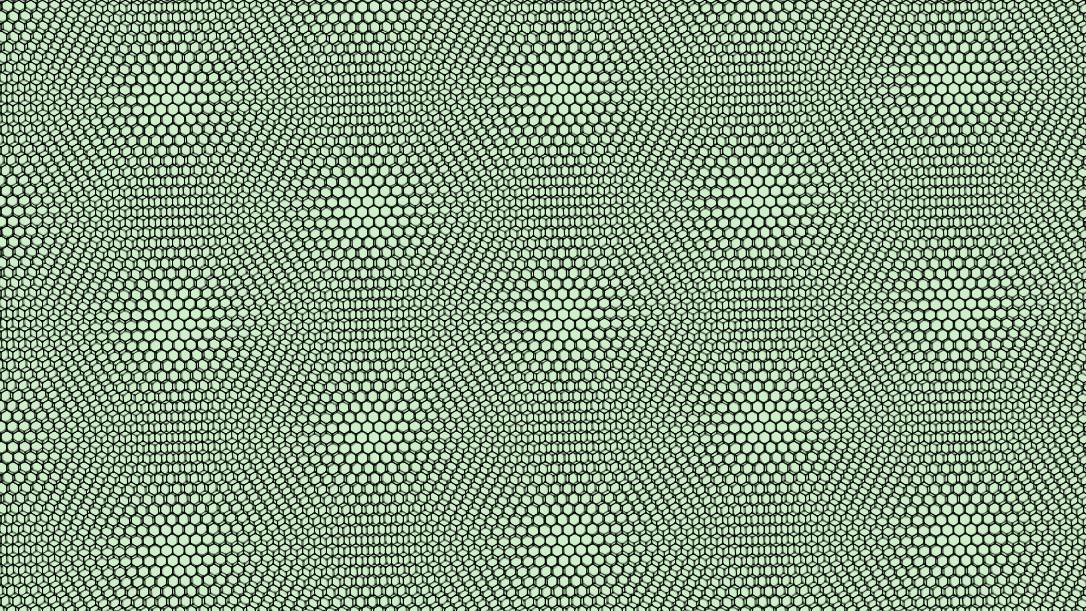

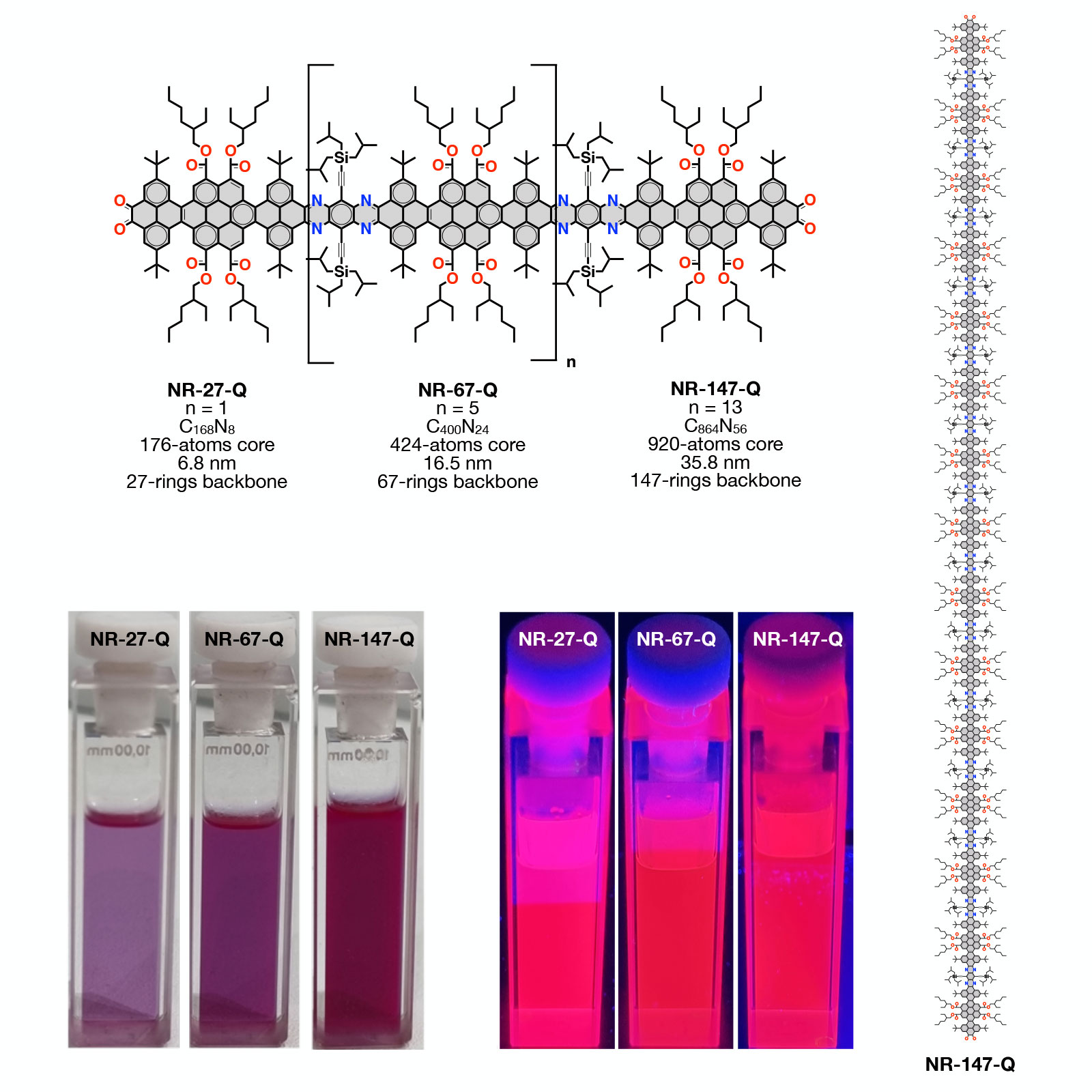

Cómo editar una imagen con matemáticas

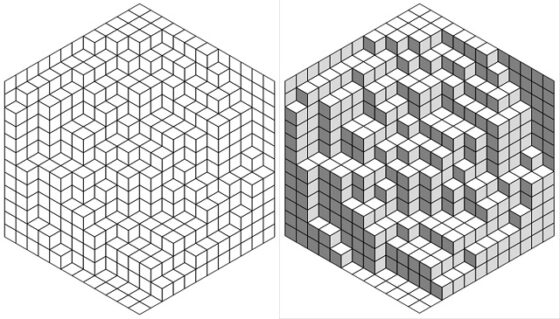

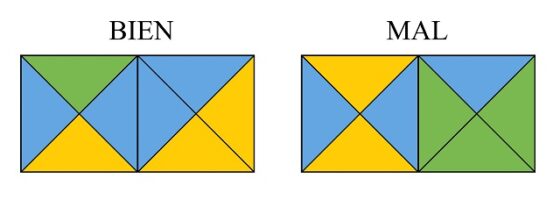

En Coordenadas polares os hablé de mi afición por las fotografías con simetría circular. Pero no os conté toda la historia. No solo saco “fotos redondas”. Además, las “despolarizo”, por así decirlo. O, dicho de manera más precisa: utilizo un programa para mapear los píxeles de sus coordenadas polares, sobre los ejes cartesianos de una segunda imagen. Y además de eso, aplico una transformación exponencial sobre el radio, de manera que se conservan las proporciones de cada región en toda la imagen.

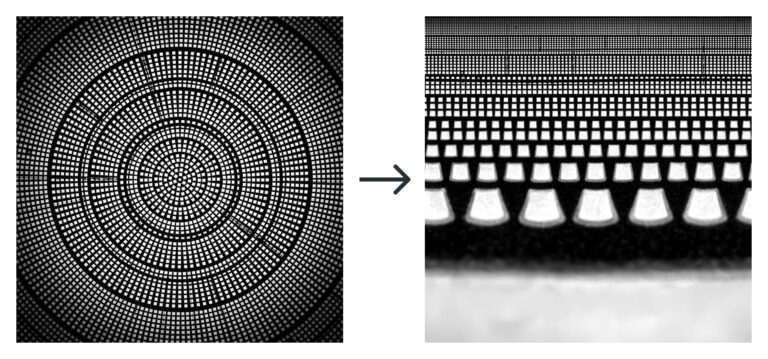

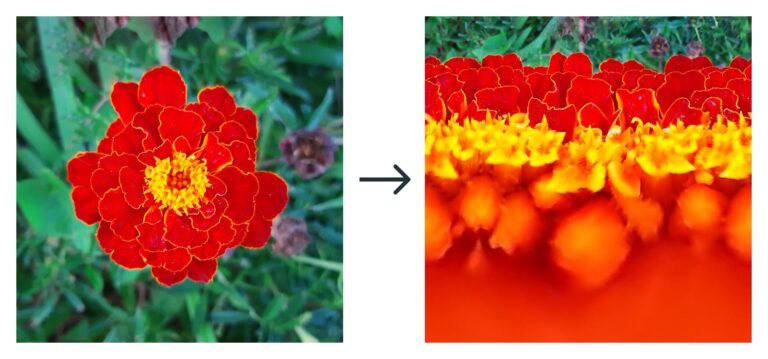

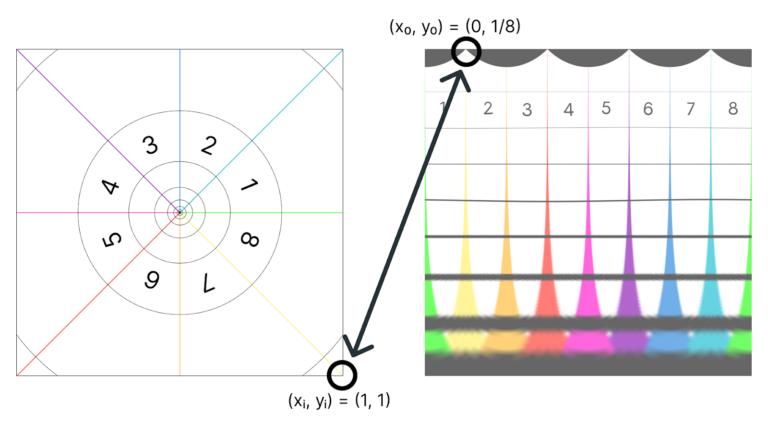

Pero… dicho así, creo que suena más complicado de lo que realmente es. Se entiende mucho más fácilmente con un par de imágenes. La idea es convertir la foto de la izquierda en la imagen de la derecha:

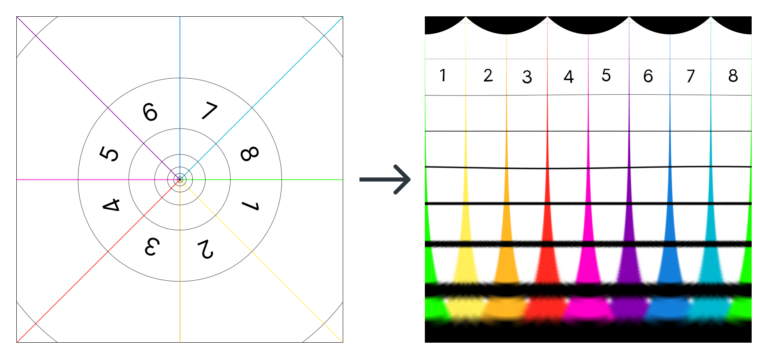

O, lo que es lo mismo (quizás con un esquema se entienda mejor):

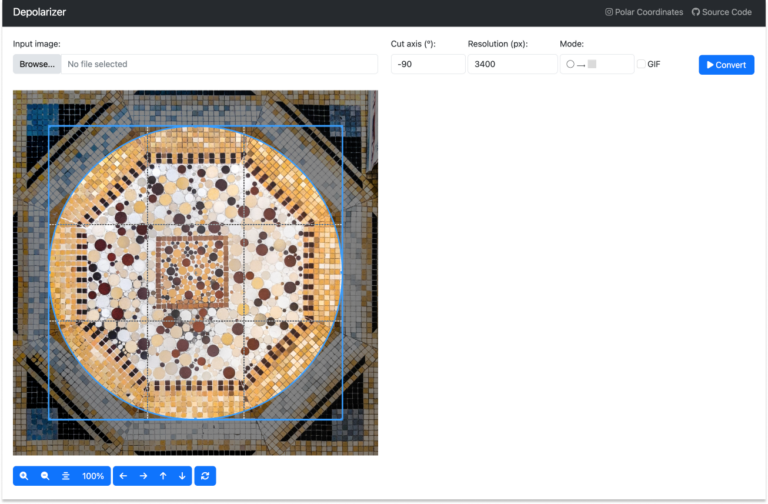

La transformación no se logra con un truco de Photoshop, ni con un filtro de ningún tipo. Es una aplicación de código abierto llamada depolarizer.

¿Qué es depolarizer?Depolarizer es una aplicación de R creada por Iñaki Úcar y una servidora. El proyecto nació como un pequeño código de java que escribí para poder ejecutarlo desde FIJI. Pero Iñaki lo mejoró infinitamente y añadió una interfaz gráfica para que cualquier persona lo pueda instalar, y jugar con él fácilmente. Si queréis probarlo, solo tenéis que ir al repositorio de GitHub, descargar el código, y abrir la aplicación con RStudio. Una vez la ejecutéis, deberíais ver en vuestro navegador aparece una interfaz parecida a esta:

La interfaz está construida con ayuda de la librería shiny de R. Pero el alma de la aplicación vive en este archivito de Python, depolarizer.py. Es ahí donde se puede donde la imagen de entrada se transforma en su versión “despolarizada”. En concreto, en la función “to_polar”.

Voy a intentar a explicar cómo funciona. Pero no te preocupes: no hace falta saber programar para interpretar su código. Y si se te hace bola, siempre puedes saltar hasta la siguiente sección.

¿Cómo funciona el código?La idea es más o menos como sigue:

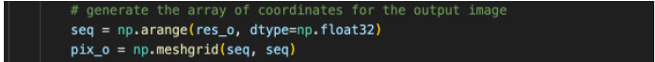

1- Generamos una imagen de salida (pix0), con la resolución la elegida (res0).

Una imagen, en este contexto, no es más que una matriz, una estructura donde vamos a guardar los valores RGB de los pixeles de la nueva imagen. Las coordenadas de la imagen son los índices de cada elemento de la matriz.

En adelante utilizaremos los subíndices “i” de “input” y “o” de “output” para identificar las variables referidas a la imagen de entrada y de salida respectivamente.

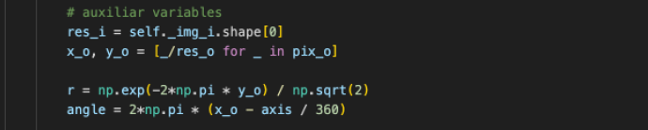

2- Definimos algunas variables auxiliares de utilidad.

- La resolución de la imagen de entrada es resi.

- Las variables x0 e y0 son las coordenadas de la imagen de salida normalizadas (dividimos sus valores entre la resolución de la imagen, para que vayan de 0 a 1).

Y aquí viene lo más interesante:

- Las coordenadas polares, r y Θ (angle), están definidas directamente sobre las coordenadas cartesianas de la imagen de salida, x0 e y0 . Es decir, cuando el programa “pinte” la imagen de salida (pix0), en la dirección horizontal (x0) veremos el ángulo (angle), y en la vertical (y0), veremos el radio (r).

- En el caso de r, utilizamos una transformación exponencial. Y eso por qué, os preguntaréis, pues eso se merece su propio apartado, más abajo.

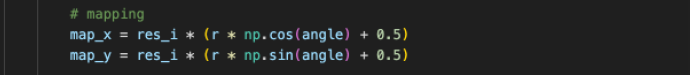

3- Definimos la función de mapeo, que es una transformación de coordenadas polares a cartesianas.

Lo que hará este mapeo es lo siguiente: el programa intentará rellenar los píxeles de la imagen de salida de uno en uno. Para saber “qué pintar” en cada pixel, buscará las coordenadas del pixel correspondiente en la imagen de entrada según diga el mapa.

¿Y qué es el mapa? ¡No es más que una función! La entrada de esa función son las coordenadas del pixel que queremos rellenar en la imagen final (x0 , y0) y la salida son las coordenadas correspondientes de la imagen inicial (xi , yi).

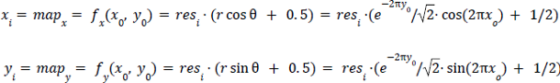

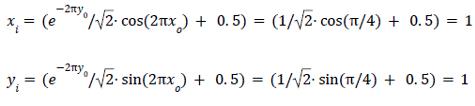

Si escribimos este código de manera más matemática, y obviamos la resolución (resi = 1) quedaría algo así:

Pongamos, por ejemplo, que queremos rellenar el pixel situado en (x0 , y0) = (1/8, 0) . El programa utilizará estas coordenadas como input de las funciones mapx y mapy y encontrará las coordenadas del pixel correspondiente en la imagen de entrada. En este caso serían:

La idea de “desenroscar” las imágenes mediante un cambio de coordenadas resulta más o menos intuitiva después de ver unos cuantos ejemplos. Pero puede que sea más difícil ver qué es lo que hace esa función exponencial sobre el radio. Quizás se entiende mejor si usamos el esquema anterior y representamos el cambio de coordenadas sin la función exponencial. El resultado sería este:

Fíjate en que todas las circunferencias de la imagen de entrada pasan a medir lo mismo en la de salida (son las líneas negras que van de izquierda a derecha). Pero, por eso mismo, el área entre las dos circunferencias más pequeñas queda mucho más “alargada” que la de la circunferencia mayor.

Mira lo que sucede, por ejemplo, con los dos “quesitos” subrayados en color negro. En la imagen de la izquierda los dos son muy parecidos: salvo por un factor de escala, tienen la misma forma. En la imagen de la derecha, en cambio, son muy distintos entre sí. La única manera de preservar las proporciones de todos los quesitos y evitar que distintos puntos de la superficie se deformen es utilizar una función exponencial, la misma que se oculta tras los sucesivos giros de la espiral maravillosa de Bernoulli.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Cómo editar una imagen con matemáticas se ha escrito en Cuaderno de Cultura Científica.

El problema de los calissons

Este verano he pasado unos días visitando la región francesa de la Provenza. Mi visita empezó en la hermosa ciudad de Aix-en-Provence, donde compré una caja de los famosos calissons.

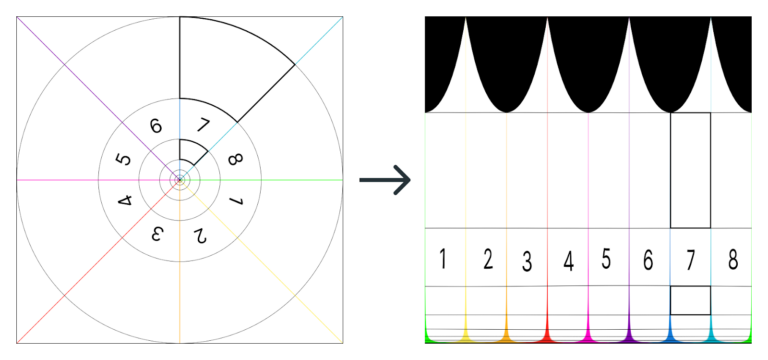

Fotografía de mi visita a la Fundación Vasarely, en Aix-en-Provence, Francia. Fotografía: Marian Espinosa

Fotografía de mi visita a la Fundación Vasarely, en Aix-en-Provence, Francia. Fotografía: Marian EspinosaCalissons

El calisson es un dulce típico de la región francesa de la Provenza, asociado especialmente con la ciudad de Aix-en-Provence. Está elaborado a partir de una pasta formada por almendras molidas y melón confitado (u otras frutas confitadas), con un glaseado blanco por encima, que se cuece a fuego lento. La forma del calisson es, más o menos, la de un rombo formado por dos triángulos equiláteros (similar a la de la forma de la caja que mostramos en la siguiente imagen).

Fotografía de una caja de calissons, con forma de rombo (como la forma de los propios calissons), que me compré en la ciudad francesa de Aix-en-Provence. Fotografía: Marian Espinosa

Fotografía de una caja de calissons, con forma de rombo (como la forma de los propios calissons), que me compré en la ciudad francesa de Aix-en-Provence. Fotografía: Marian Espinosa

No está muy claro el origen de este dulce, que parece ser originario de Italia. Como se comenta en la correspondiente entrada de la Wikipedia (en francés), “una de sus primeras referencias se remonta al siglo XII, en un texto medieval italiano en latín que utiliza el término calisone para referirse a un pastel de almendra y harina similar al mazapán moderno”. Y existe otra referencia posterior, el texto Chronique des Vénitiens / Crónica de los venecianos (1275), del italiano Martino Canal, en la que se menciona un dulce, a base de pasta de almendras y nueces a la que se añadían diversas especias (canela y clavo), de nombre “calissons”.

Tampoco está claro cuando llegan estos dulces a la Provenza. Según algunas versiones podría haber sido importado por uno de los cocineros del príncipe francés René d’Anjou / Renato de Anjou (1409-1480), que entre otros títulos fue rey de Nápoles, Sicilia, Aragón y Mallorca. Se cuenta que durante el segundo matrimonio de Renato de Anjou con Jeanne de Laval / Juana de Laval, en 1454, el jefe de la confitería del rey sirvió algunos de estos dulces a la futura reina, que dijo entonces en provenzal “Di calin soun” (que no sé bien cómo traducir, pero para darle cierta gracia me aventuro a traducirlo como “estos son besos”). Por otra parte, en la Wikipedia se cita que el término calisson, con el significado actual, ya aparece en la Provenza en el año 1503. De hecho, la almendra, elemento principal de los calissons, se introdujo en la Provenza en el siglo XVI, por lo que es posible que la introducción del dulce en esta región sea paralela al desarrollo de la producción y comercialización de las almendras.

Fotografía de los calissons dentro de su caja, que me compré en mi reciente visita a Aix-en-Provence. Aunque como vemos la forma de estos calissons es más bien como una vesica piscis y no como un diamante formado por dos triángulos equiláteros. Fotografía: Marian Espinosa

Fotografía de los calissons dentro de su caja, que me compré en mi reciente visita a Aix-en-Provence. Aunque como vemos la forma de estos calissons es más bien como una vesica piscis y no como un diamante formado por dos triángulos equiláteros. Fotografía: Marian EspinosaPero dejemos las cuestiones históricas aparte y vayamos a la cuestión matemática relacionada con estos dulces provenzales. Aunque si os animáis a prepararlos vosotros mismos, podéis encontrar la receta en muchos blogs de postres, o de recetas de cocina, en general.

Fotografía de un plato con calissons, cuya forma es la de un rombo o diamante formado por dos triángulos equiláteros, que hemos tomado de una página francesa de recetas, en la que podéis leer cómo se hacen los calissons. La página de recetas es Odelices.Demostraciones sin palabras

Fotografía de un plato con calissons, cuya forma es la de un rombo o diamante formado por dos triángulos equiláteros, que hemos tomado de una página francesa de recetas, en la que podéis leer cómo se hacen los calissons. La página de recetas es Odelices.Demostraciones sin palabras

La primera vez que leí sobre el problema de los calissons fue en el magnífico libro Proofs without words / Demostraciones sin palabras, de Roger B. Nelsen. Este es un tema, el de las demostraciones sin palabras, al que le hemos dedicado varias entradas en el Cuaderno de Cultura Científica, entre ellas:

* Matemáticas para ver y tocar

* Más matemáticas para ver y tocar

* Teoremas geométricos sin palabras: Viviani

* Teoremas geométricos sin palabras: Conway

* Teoremas geométricos sin palabras: Herón

* Teoremas geométricos sin palabras: Snover

Las demostraciones sin palabras, como comenta el matemático Roger B. Nelsen –autor del libro Proofs without words / Demostraciones sin Palabras (publicado por la MAA, Mathematical Association of America, en 1993) –, se fueron haciendo populares en la comunidad matemática a raíz de su publicación en las revistas de la MAA, Mathematics Magazine y The College Mathematical Journal, en las que empezaron a aparecer hacia 1975, primero como imágenes de relleno entre artículos y posteriormente como secciones fijas de las revistas. Las demostraciones sin palabras no son realmente demostraciones matemáticas en sí mismas, son más bien diagramas, esquemas o dibujos que nos ayudan a comprender por qué un teorema es cierto o que encierran la idea de la verdadera demostración matemática. Son sugerentes, atractivas y todo un ejercicio de estímulo del pensamiento.

El origen del problema de los calissons y su demostración visual, tema que nos ocupa en esta entrada del Cuaderno de Cultura Científica, es el artículo The problem of calissons, de los matemáticos Guy David y Carlos Tomei, publicado en 1989 en la revista The American Mathematical Monthly (que también es una revista de la MAA, creada en 1894).

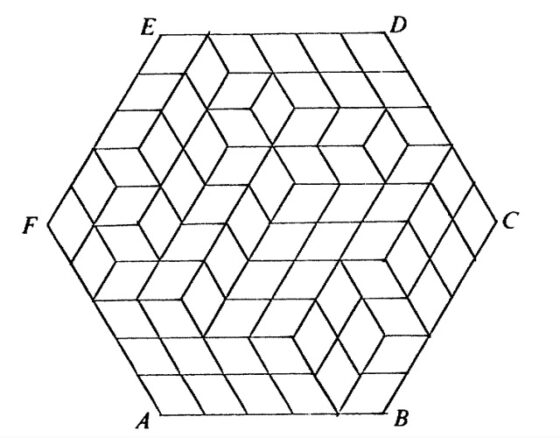

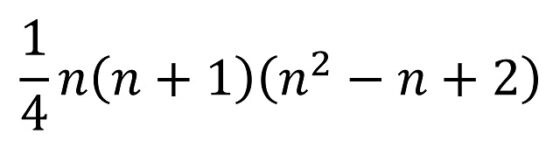

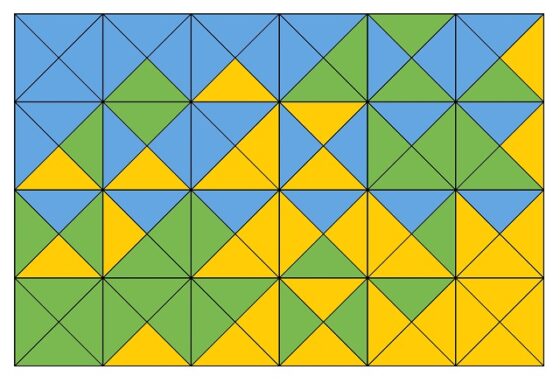

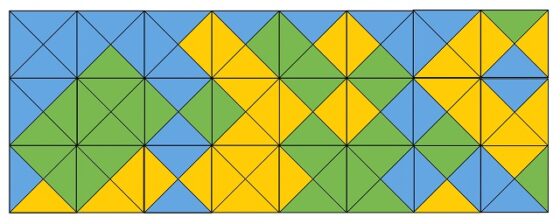

El problema de los calissonsTomando las mismas palabras que utilizaron David y Tomei en su artículo de la revista The American Mathematical Monthly,

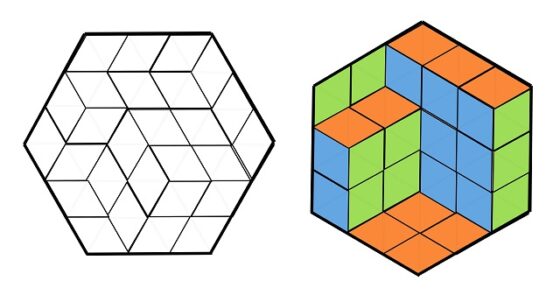

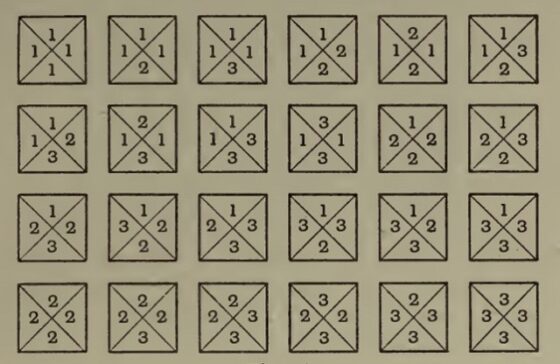

“Un calisson es un dulce francés con la forma de dos triángulos rectángulos pegados por uno de sus lados. Los calissons podrían guardarse en una caja con la forma de un hexágono regular, y su empaquetado sugeriría un interesante problema de combinatoria. Supongamos una caja (hexagonal) cuyos lados tienen longitud n que se llena con calissons cuyos lados tienen longitud 1. La diagonal larga de cada calisson en la caja tiene tres posibles orientaciones, como en la imagen.

Las tres posibles orientaciones de los calissons en una caja hexagonal

Las tres posibles orientaciones de los calissons en una caja hexagonal

Nuestro resultado principal es que el número de calissons de cada una de las tres orientaciones es un tercio del número de calissons que entran en la caja (hexagonal).”

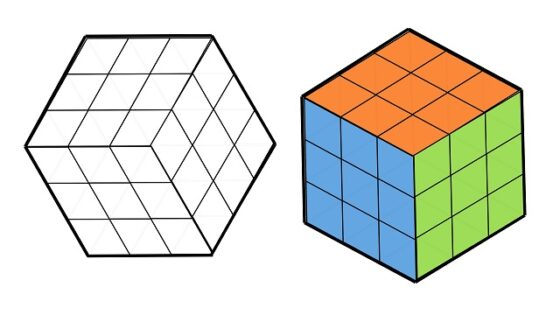

El problema de los calissons consiste en cómo demostrar esa afirmación, es decir, que el número de calissons de cada orientación es el mismo, un tercio del total de los calissons que entran en la caja hexagonal. Y lo hermoso de la demostración es que consiste en un argumento intuitivo y visual relacionado con el espacio tridimensional.

Los matemáticos David y Tomei, en su artículo The problem of calissons, toman una caja hexagonal cuyo lado tiene longitud 5 (es decir, n = 5), considerando que los lados del calisson son de longitud 1, que es la imagen que mostramos a continuación, con el objetivo de mostrar que hay la misma cantidad de calissons en cada una de las tres direcciones posibles.

Distribución aleatoria de los 75 calissons que entran en una caja hexagonal cuyo lado tiene longitud 5, considerando que los lados del calisson son de longitud 1, que es la considerada por los matemáticos David y Tomei en su artículo The problem of calissons

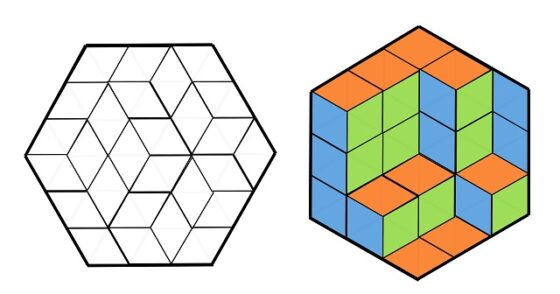

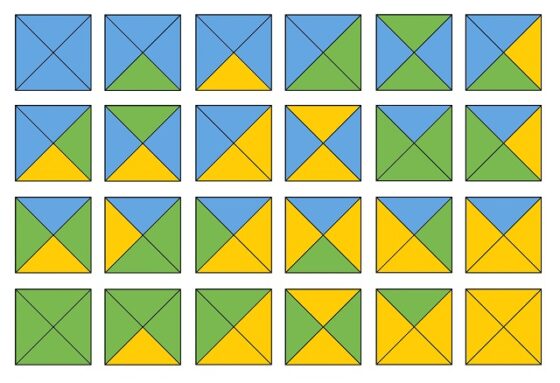

Distribución aleatoria de los 75 calissons que entran en una caja hexagonal cuyo lado tiene longitud 5, considerando que los lados del calisson son de longitud 1, que es la considerada por los matemáticos David y Tomei en su artículo The problem of calissonsLa solución consiste en rotar un poco la caja hexagonal para que un vértice quede arriba y colorear cada calisson en función de la orientación que tiene, es decir, los pintamos de tres colores distintos (por ejemplo, en el artículo se utiliza blanco, gris y negro). De esta forma, nuestra imagen de una caja hexagonal rellena con calissons (luego, una imagen esencialmente plana) se convierte en una imagen tridimensional que representa una serie de pequeños cubos apoyados entre tres paredes cuadradas perpendiculares (de tamaño 5 x 5, en el ejemplo de David y Tomei, luego con una superficie de 25 cuadrados, pero en general serán paredes cuadradas con n2 cuadrados), una abajo, otra a la derecha y una tercera a la izquierda. En esta representación tridimensional de pequeños cubos (se verán algunos ejemplos a continuación) puede verse que cada calisson es una cara visible de un pequeño cubo, de manera que todas las caras de un mismo color (que provienen de calissons con la misma orientación) miran en la misma dirección, paralelas a una de las tres paredes sobre las que se apoyan los pequeños cubos. Resulta que todas las caras de pequeños cubos (incluyendo los cuadrados de las paredes de apoyo que no se han cubierto) que miran en una misma dirección son las mismas que todos los cuadrados de la pared de apoyo, por lo tanto, 25 en este caso y n2, en general.

Veámoslo con algunos ejemplos de distribuciones de calissons en una caja hexagonal de tamaño n = 3 (como la que vemos en la siguiente imagen), por lo tanto, que se rellena con 27 dulces con forma de diamante.

Caja hexagonal, cuyo lado mide 3, siendo la medida de los lados de los calissons 1, y los 27 calissons con los que se rellena la caja

Caja hexagonal, cuyo lado mide 3, siendo la medida de los lados de los calissons 1, y los 27 calissons con los que se rellena la caja

A continuación, vamos a rellenar la caja hexagonal (de lado 3) con los 27 calissons, de tres formas distintas y vamos a utilizar el procedimiento anterior (girar ligeramente y pintar con tres colores distintos los calissons en función de su orientación en la caja) para comprobar que en los tres casos la cantidad de calissons en cada orientación es igual a 9.

Ejemplo 1, con los calissons agrupados

Ejemplo 2

Ejemplo 3

Este argumento visual nos sirve para cualquier tamaño n de la caja hexagonal, en la que introduciremos 3n2 calissons.

En esta misma línea, la imagen que ilustraba la demostración de David y Tomei, con la distribución mostrada arriba, para una caja de tamaño 5, es la siguiente (utilizando blanco, gris y negro).

En consecuencia, se ha demostrado el resultado buscado.

Teorema: En todo empaquetamiento de calissons (con forma de diamante) en una caja hexagonal, la cantidad de ellos con una orientación dada es igual a la tercera parte del total de calissons que se incluyen en la caja.

Distribución de 432 calissons en una caja hexagonal de lado igual a 12, junto con su transformación en una imagen tridimensional, mediante el coloreado –blanco, gris claro y gris oscuro- de los calissons en función de su orientación, y en la que se comprueba que hay la misma cantidad de dulces en cada orientación, en concreto, 144. Imagen del blog Possibly wrong

Distribución de 432 calissons en una caja hexagonal de lado igual a 12, junto con su transformación en una imagen tridimensional, mediante el coloreado –blanco, gris claro y gris oscuro- de los calissons en función de su orientación, y en la que se comprueba que hay la misma cantidad de dulces en cada orientación, en concreto, 144. Imagen del blog Possibly wrongLa demostración que aparece en el artículo de David y Tomei, y que después incluye Nelsen en su libro, es una demostración sin palabras, luego visual e intuitiva, pero no una demostración matemáticamente rigurosa. Sin embargo, sí es posible dar demostraciones más matemáticas de este resultado, y de alguna generalización del mismo, para la cual, además, no es válido el razonamiento visual anterior. Para quienes estéis interesados en la misma (solo se necesita un poco de álgebra de vectores) podéis leerla en el blog Symmetry de Gábor Damásdi.

Bibliografía

1.- Roger B. Nelsen, Demostraciones sin palabras (ejercicios de pensamiento visual), Proyecto Sur, 2001.

2.- Guy David, Carlos Tomei, The problem of the Calissons, American Mathematical Monthly, vol. 96, n. 5, pp. 429-430, 1989.

3.- Gábor Damásdi, Symmetry (blog): Problem of calissons

4.- Wikipedia: Calisson

El artículo El problema de los calissons se ha escrito en Cuaderno de Cultura Científica.

Alan Turing y el poder del pensamiento negativo

Las pruebas matemáticas basadas en una técnica llamada diagonalización pueden ser implacablemente contrarias, pero ayudan a revelar los límites de los algoritmos.

Un artículo de Ben Brubaker. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

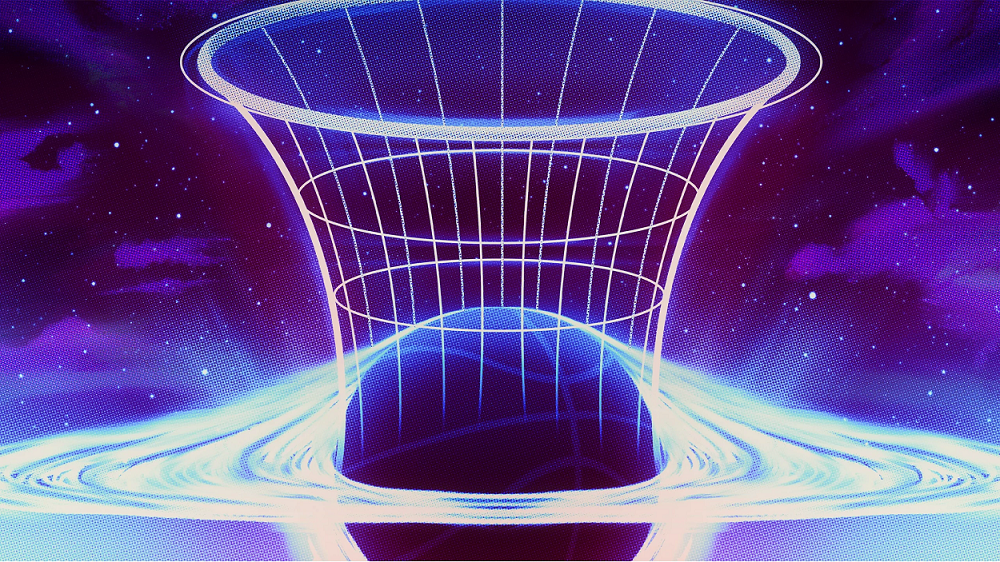

Ilustración Kristina Armitage / Quanta Magazine

Ilustración Kristina Armitage / Quanta MagazineLos algoritmos se han vuelto omnipresentes. Optimizan nuestros viajes, procesan pagos y coordinan el flujo del tráfico en Internet. Parece que para cada problema que puede articularse en términos matemáticos precisos, hay un algoritmo que puede resolverlo, al menos en principio.

Pero ese no es el caso: algunos problemas aparentemente simples nunca pueden resolverse algorítmicamente. El científico informático pionero Alan Turing demostró la existencia de estos problemas “incomputables” hace casi un siglo, en el mismo artículo en el que formuló el modelo matemático de computación que lanzó la informática moderna.

Turing demostró este resultado innovador utilizando una estrategia contraria a la intuición: definió un problema que simplemente rechaza todo intento de resolverlo.

«Te pregunto qué estás haciendo y luego digo: ‘No, voy a hacer algo diferente'», explica Rahul Ilango, un estudiante de posgrado en el Instituto de Tecnología de Massachusetts que estudia informática teórica.

La estrategia de Turing se basa en una técnica matemática llamada diagonalización que tiene una historia ilustre. He aquí una explicación simplificada de la lógica de su prueba.

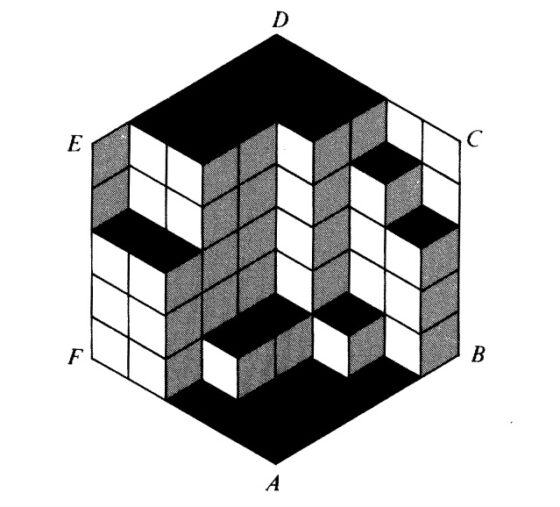

Teoría de cadenasLa diagonalización surge de un truco inteligente para resolver un problema rutinario que involucra cadenas de bits, cada uno de los cuales puede ser 0 o 1. Dada una lista de estas cadenas, todas igualmente largas, ¿se puede generar una nueva cadena que no esté en la lista?

La estrategia más sencilla es considerar cada cadena posible por turno. Supongamos que tienes cinco cadenas, cada una de cinco bits de longitud. Comienza repasando la lista en busca de 00000. Si no está, puedes parar; si está, pasa a 00001 y repite el proceso. Esto es bastante simple, pero lento para listas largas de cadenas largas.

La diagonalización es un enfoque alternativo que construye poco a poco una cadena nueva. Comienza con el primer bit de la primera cadena de la lista e inviértelo; ese será el primer bit de tu nueva cadena. Luego invierte el segundo bit de la segunda cadena y utilízalo como el segundo bit de la nueva cadena, y repite hasta llegar al final de la lista. Los bits que inviertes garantizan que la nueva cadena difiera de cada cadena de la lista original en al menos un lugar. (También forman una línea diagonal a través de la lista de cadenas, lo que da nombre a la técnica).

Ilustración: Merrill Sherman / Quanta Magazine

Ilustración: Merrill Sherman / Quanta MagazineLa diagonalización sólo necesita examinar un bit de cada cadena de la lista, por lo que suele ser mucho más rápido que otros métodos. Pero su verdadero poder reside en lo bien que se comporta con el infinito.

“Las cadenas ahora pueden ser infinitas; la lista puede ser infinita; todavía funciona”, afirma Ryan Williams, científico informático teórico del MIT.

La primera persona en aprovechar este poder fue Georg Cantor, el fundador del subcampo matemático de la teoría de conjuntos. En 1873, Cantor utilizó la diagonalización para demostrar que algunos infinitos son más grandes que otros. Seis décadas después, Turing adaptó la versión de Cantor de la diagonalización a la teoría de la computación, dándole un tono claramente a contracorriente.

El juego de la limitación [*]Turing quería demostrar la existencia de problemas matemáticos que ningún algoritmo puede resolver, es decir, problemas con entradas y salidas bien definidas pero sin un procedimiento infalible para pasar de la entrada a la salida. Hizo que esta vaga tarea fuera más manejable al centrarse exclusivamente en problemas de decisión, donde la entrada puede ser cualquier cadena de ceros y unos y la salida es 0 o 1.

Determinar si un número es primo (divisible sólo por 1 y por sí mismo) es un ejemplo de un problema de decisión: dada una cadena de entrada que representa un número, la salida correcta es 1 si el número es primo y 0 si no lo es. Otro ejemplo es comprobar los programas informáticos en busca de errores de sintaxis (el equivalente a errores gramaticales). Aquí, las cadenas de entrada representan código para diferentes programas (todos los programas se pueden representar de esta manera, ya que así es como se almacenan y ejecutan en los ordenadores) y el objetivo es generar 1 si el código contiene un error de sintaxis y 0 si no lo contiene.

Un algoritmo resuelve un problema sólo si produce la salida correcta para cada entrada posible; si falla aunque sea una vez, no es un algoritmo generalista para ese problema. Normalmente, primero especificarías el problema que deseas resolver y luego intentarías encontrar un algoritmo que lo resuelva. Turing, en busca de problemas irresolubles, le dio la vuelta a esta lógica: imaginó una lista infinita de todos los algoritmos posibles y utilizó la diagonalización para construir un problema pertinaz que frustraría todos los algoritmos de la lista.

Imagina un juego amañado de ’20 preguntas’ [**], donde en lugar de comenzar con un objeto particular en mente, quien responde inventa una excusa para decir no a cada pregunta. Al final del juego, han descrito un objeto definido completamente por las cualidades que le faltan.

La prueba de diagonalización de Turing es una versión de este juego en el que las preguntas recorren la lista infinita de algoritmos posibles, preguntando repetidamente: «¿Puede este algoritmo resolver el problema que nos gustaría demostrar que es incomputable?»

«Es una especie de ‘preguntas infinitas'», comenta Williams.

Para ganar el juego Turing necesitaba elaborar un problema en el que la respuesta fuera no para cada algoritmo. Eso significaba identificar una entrada particular que hiciese que el primer algoritmo generase una respuesta incorrecta, otra entrada que hiciese que el segundo fallase, y así sucesivamente. Encontró esas entradas especiales utilizando un truco similar al que Kurt Gödel había utilizado recientemente para demostrar que afirmaciones autorreferenciales como “esta afirmación no es demostrable” significaban problemas para los fundamentos de las matemáticas.

La idea clave fue que cada algoritmo (o programa) se puede representar como una cadena de ceros y unos. Eso significa, como en el ejemplo del programa de comprobación de errores, que un algoritmo puede tomar el código de otro algoritmo como entrada. En principio, un algoritmo puede incluso tomar su propio código como entrada.

Con esta idea, podemos definir un problema no computable como el de la prueba de Turing: “Dada una cadena de entrada que representa el código de un algoritmo, genera 1 si ese algoritmo genera 0 cuando su propio código es la entrada; de lo contrario, la salida es 0”. Cada algoritmo que intente resolver este problema producirá una salida incorrecta en al menos una entrada, es decir, la entrada correspondiente a su propio código. Eso significa que este perverso problema no puede resolverse mediante ningún algoritmo.

Lo que la negación no puede hacerLos informáticos aún no habían terminado con la diagonalización. En 1965, Juris Hartmanis y Richard Stearns adaptaron el argumento de Turing para demostrar que no todos los problemas computables son iguales: algunos son intrínsecamente más difíciles que otros. Este resultado lanzó el campo de la teoría de la complejidad computacional, que estudia la dificultad de los problemas computacionales.

Pero la teoría de la complejidad también reveló los límites del método a la contra de Turing. En 1975, Theodore Baker, John Gill y Robert Solovay demostraron que muchas cuestiones abiertas en la teoría de la complejidad nunca pueden resolverse únicamente mediante la diagonalización. La principal de ellas es el famoso problema de las clases de complejidad P y NP, que pregunta si todos los problemas con soluciones fácilmente comprobables también son fáciles de resolver con el algoritmo adecuado.

Los puntos ciegos de la diagonalización son una consecuencia directa del alto nivel de abstracción que la hace tan poderosa. La demostración de Turing no implicaba ningún problema incomputable que pudiera surgir en la práctica; en cambio, inventó un problema de ese tipo sobre la marcha. Otras pruebas de diagonalización están igualmente alejadas del mundo real, por lo que no pueden resolver cuestiones en las que los detalles del mundo real importan.

«Manejan la computación a distancia», explica Williams. «Me imagino a un tipo que se enfrenta a un virus y accede a él a través de una caja de guantes».

El fracaso de la diagonalización fue una indicación temprana de que resolver el problema de las categorías P y NP iba a ser un largo camino. Pero a pesar de sus limitaciones, la diagonalización sigue siendo una de las herramientas clave en el arsenal de los teóricos de la complejidad. En 2011, Williams lo utilizó junto con una serie de otras técnicas para demostrar que cierto modelo restringido de computación no podía resolver algunos problemas extraordinariamente difíciles, un resultado que había eludido a los investigadores durante 25 años. Estaba muy lejos de resolver el problema de las categorías P y NP, pero aun así representó un avance importante.

Si quieres demostrar que algo no es posible, no subestimes el poder de simplemente decir no.

Notas del traductor:

[*] El original en inglés “The limitation game” es un juego de palabras con el título de la película “The Imitation Game” basada en aspectos de la vida y obra de Alan Turing.

[**] En el juego tradicional de ’20 preguntas’ la persona que responde (la “respondedora”) elige algo que las demás jugadoras, las «interrogadoras», deben adivinar. Se turnan para hacer una pregunta a la que la respondedora debe responder «sí» o «no». Ejemplos de preguntas podrían ser: «¿Es más grande que un móvil?», «¿Está vivo?» y, finalmente, «¿Es este bolígrafo?». No se permite mentir. Si una interrogadora adivina la respuesta correcta, gana y se convierte en la respondedora en la siguiente ronda. Si se hacen 20 preguntas sin una respuesta correcta, entonces la respondedora gana y vuelve a ser la persona que responde en otra ronda.

El artículo original, Alan Turing and the Power of Negative Thinking, se publicó el 5 de septiembre de 2023 en Quanta Magazine.

Traducido por César Tomé López

El artículo Alan Turing y el poder del pensamiento negativo se ha escrito en Cuaderno de Cultura Científica.

La diversidad mineral en Marte

Nuestro planeta tiene una gran diversidad mineralógica. Tanta que hasta el momento hay reconocidas casi siete mil especies minerales y una de las preguntas que a menudo nos surgen cuando estudiamos otros planetas es: ¿Habrá un número similar en otros planetas o cuerpos del Sistema Solar? ¿O quizás es la Tierra un caso extremo dentro del mundo de los minerales?

Pero antes de continuar, ¿tenemos claro qué es un mineral? Llamamos minerales a sustancias sólidas, que tienen una composición química definida, de origen natural y con una estructura cristalina ordenada. Aunque esta definición nos pueda parecer un poco laxa, lo cierto es que en las últimas dos décadas sigue habiendo algo de debate, ya que se sigue discutiendo si los compuestos orgánicos -los de origen biológico o los que aparecen de manera espontánea- se deben considerar minerales.

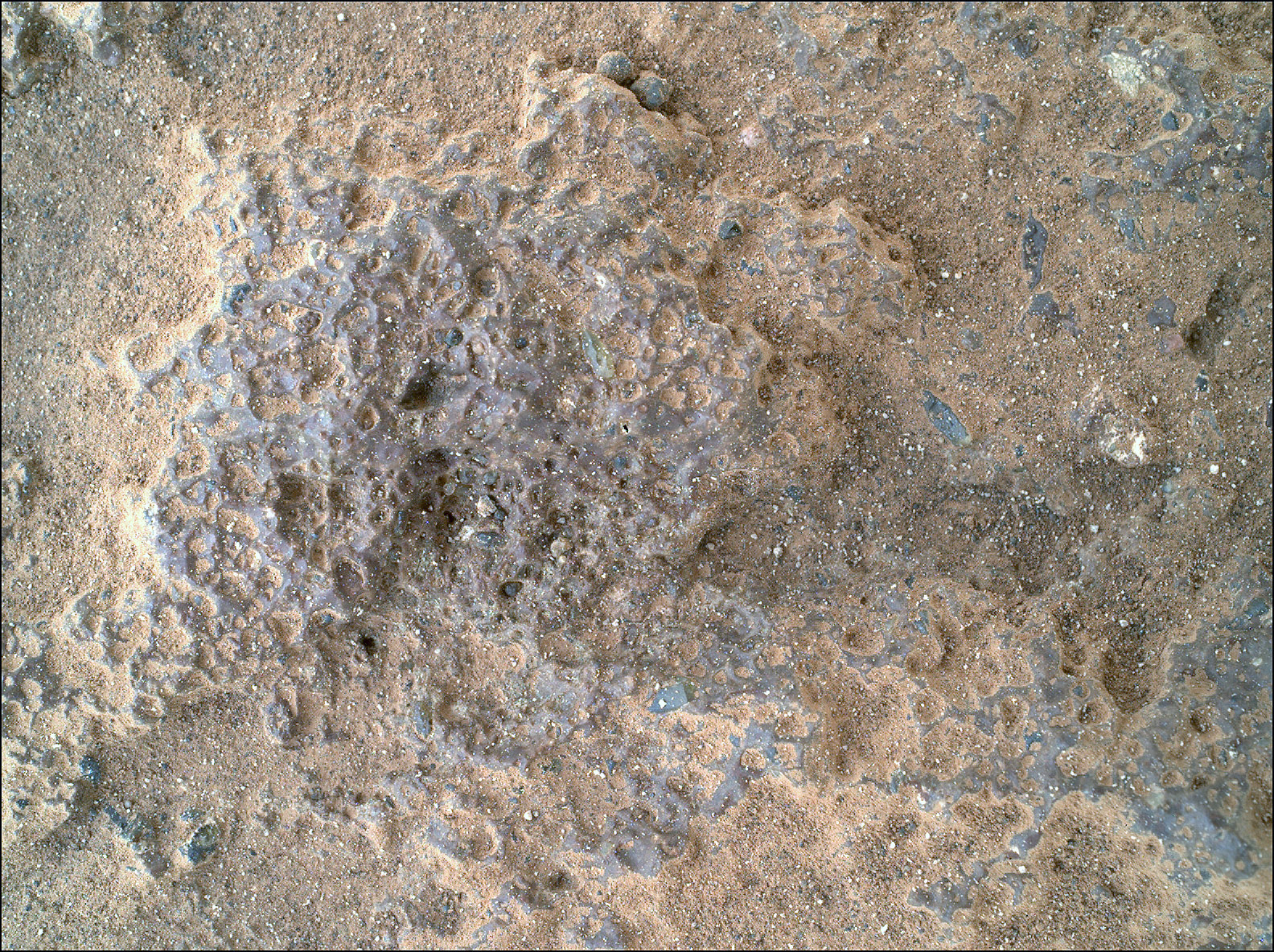

La cámara WATSON del Perseverance toma una imagen de cerca de una roca en Marte de la que posteriormente realizará análisis para conocer su composición. En la imagen se pueden ver distintos minerales, entre ellos uno traslúcido que ha llamado la atención de los científicos. Imagen cortesía de NASA/JPL-Caltech.

La cámara WATSON del Perseverance toma una imagen de cerca de una roca en Marte de la que posteriormente realizará análisis para conocer su composición. En la imagen se pueden ver distintos minerales, entre ellos uno traslúcido que ha llamado la atención de los científicos. Imagen cortesía de NASA/JPL-Caltech.Para los geólogos, los minerales son más que una curiosidad o un elemento de coleccionista, ya que nos pueden ayudar a conocer aquellos procesos que han tenido lugar en los planetas a lo largo de los 4500 millones de historia. Muy probablemente los planetas terrestres, de Mercurio a Marte, tuvieron una evolución mineralógica muy similar durante su infancia, pero que poco a poco fue divergiendo debido a las particularidades de cada uno.

Los planetas interiores partíamos con una serie de elementos y minerales similares por nuestra posición en el disco protoplanetario a partir del cual nos formamos. Una vez acabaron todos los procesos que dieron lugar a la formación de los planetas, muy probablemente los primeros minerales existentes en estos cuatro planetas podrían haber sido muy similares en número y composición, ya que se habrían formado a partir de la cristalización del océano de magma existente en estas primeras etapas de infancia planetaria.

Pero tras esa etapa comenzó un proceso evolutivo que nos ha hecho muy diferentes: la presencia o no de atmósfera, de una tectónica de placas o la aparición de la vida son algunos de los eventos que han podido marcar la mayor o menor diversidad mineral de los planetas.

Y aquí viene el segundo término que quería introducir en el artículo de hoy: los modos paragenéticos. Esta palabra engloba los procesos a partir los minerales se forman, es decir, como un conjunto de átomos en forma sólida o líquida son capaces de reconfigurarse dando lugar a una o más formas minerales. Estos modos son una gran cantidad de procesos naturales que llevan a la formación de nuevos minerales.

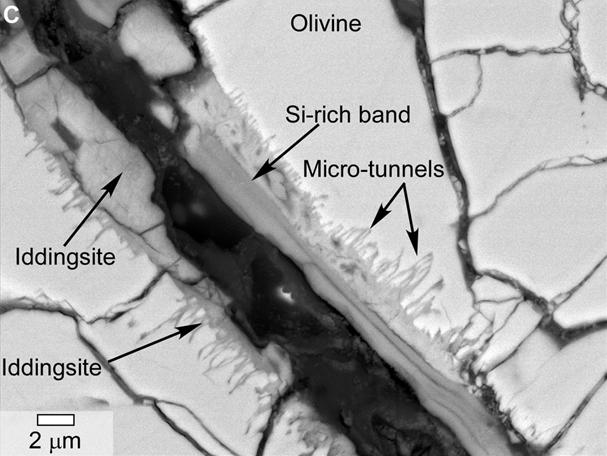

Imagen de microscopio electrónico de un meteorito marciano donde podemos ver algunos de los minerales anotados. Imagen cortesía de la NASA.

Imagen de microscopio electrónico de un meteorito marciano donde podemos ver algunos de los minerales anotados. Imagen cortesía de la NASA.Algunos ejemplos de los modos paragenéticos son la formación a partir de un gas o un líquido -por condensación, precipitación…-, transformaciones físicas a partir de eventos como la caída de rayos, impactos de meteoritos o fenómenos de metamorfismo regional, interacción del agua y las rocas o incluso la formación de minerales por efecto de la vida, como las biomineralizaciones-.

Marte es uno de los planetas que mejor conocemos debido a dos cuestiones principalmente: la primera de ellas son las misiones espaciales con capacidad de observación y análisis que nos han permitido conocer los minerales de su superficie, incluso desde la órbita, sin contacto. La segunda, gracias a los meteoritos que han caído a nuestro planeta y cuyo estudio podemos hacer con mucho detalle en los laboratorios terrestres. A pesar de esto, solo se han podido identificar un total de 161 minerales.

Una nueva investigación (Hazen et al. (2023)) sugiere que esta ausencia de minerales se podría deber a la existencia de un menor número de modos paragenéticos en Marte que los que hay en la Tierra… ¿Por qué? Pues porque nuestro planeta es algo especial con respecto al resto, al menos por lo que sabemos de momento.

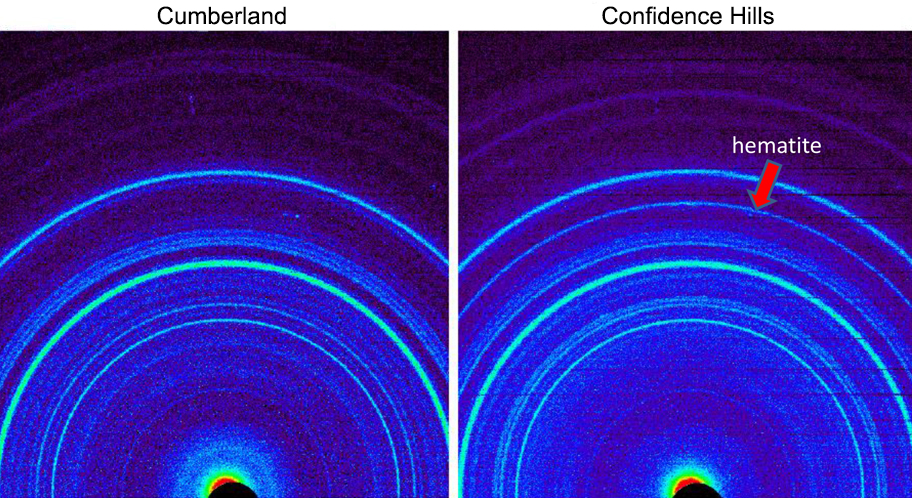

Patrón de difracción de rayos X capturado por el Curiosity en Marte. Gracias a instrumentos como el que permite tomar esta imagen, podemos conocer la composición de las rocas y el suelo de Marte con misiones de superficie. Imagen cortesía de NASA/JPL-Caltech.

Patrón de difracción de rayos X capturado por el Curiosity en Marte. Gracias a instrumentos como el que permite tomar esta imagen, podemos conocer la composición de las rocas y el suelo de Marte con misiones de superficie. Imagen cortesía de NASA/JPL-Caltech.En primer lugar, las interacciones entre los fluidos -como el agua- y las rocas en nuestro planeta tiene una mayor escala que en Marte gracias a la tectónica de placas, que a través de la subducción y de los procesos de fracturación de las rocas hace que nuestro planeta sea más permeable a este tipo de interacciones.

También la existencia de un metamorfismo de altas presiones como el que ocurre durante procesos de colisión continental algo que solo puede ocurrir bajo el régimen de tectónica de placas y, por supuesto, el efecto de la vida en la generación de minerales.

Estos tres procesos de los que hemos hablado podrían ser, según los autores del artículo, los responsables del 80% de la diversidad mineral de nuestro planeta, y precisamente estos modos paragenéticos son de momento exclusivos en la Tierra o podrían tener un ámbito mucho más restringido en el resto de los planetas.

¿Quiere esto decir que en Marte solo existen 161 minerales? No, todavía podrían existir más, ya que apenas hemos podido arañar la superficie y podríamos estar perdiéndonos los minerales existentes en zonas más profundas o inaccesibles debido a procesos hidrotermales o a fenómenos de metamorfismo de contacto, como el que podría haberse dado en las zonas volcánicas, pero a pesar de esto los investigadores sugieren que el número de minerales seguiría siendo un orden de magnitud inferior que en la Tierra.

No cabe la menor duda que los minerales pueden ayudarnos a comprender mejor la historia de los planetas y otros cuerpos, pero todavía nos queda por recorrer un largo camino hasta que podamos estudiar con detalle la composición de estos. Solo entonces podremos decir… ¿realmente somos tan diferentes?

Referencia:

Hazen, R. M., Downs, R. T., Morrison, S. M., Tutolo, B. M., Blake, D. F., Bristow, T. F., Chipera, S. J., McSween, H. Y., Ming, D., Morris, R. V., Rampe, E. B., Thorpe, M. T., Treiman, A. H., Tu, V. M., & Vaniman, D. T. (2023). On the diversity and formation modes of martian minerals. Journal of Geophysical Research: Planets, 128(9). doi: 10.1029/2023je007865

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo La diversidad mineral en Marte se ha escrito en Cuaderno de Cultura Científica.

ZientZinema 5: Los herederos del viento

Scopes

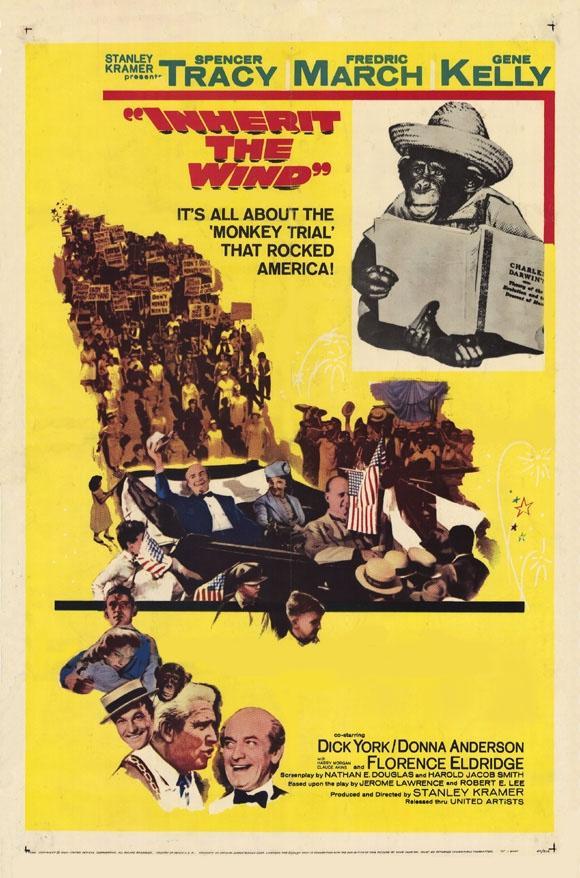

Título original: Inherit the Wind. En las adaptaciones se ha titulado como La herencia del viento o Heredarás el viento. 1960, blanco y negro, 128 minutos. Dir.: Stanley Kramer. Guion: Nedrick Young, Harold Jacob Smith, según la obra de teatro de Jerome Lawrence y Robert Edwin Lee. Música: Ernest Gold. Fotografía: Ernest Laszlo. Montaje: Frederic Knudtson. Intérpretes. Spencer Tracy, Fredric March, Gene Kelly, Dick York, Harry Morgan.

El que perturba su propia casa heredará viento, y el necio será esclavo del sabio.

Proverbios, 11: 29.

Llamar a un hombre mamífero, al parecer, era también ignorar una revelación divina. El efecto de esta doctrina sería destruir la moralidad y promover la infidelidad.

H.L. Mencken sobre el juicio Scopes, The Baltimore Evening Sun, 17 julio 1925.

En 1925, John Thomas Scopes fue juzgado por violar la ley del Estado de Tennessee que prohibía enseñar la teoría de la evolución en las escuelas públicas. El darwinismo se enfrentaba al creacionismo en una batalla judicial en la que participaron Spencer Tracy, en el papel de Henry Drummond (nombre supuesto de Clarence Darrow para el film); Fredric March en el papel de Matthew Harrison Brady (nombre supuesto para William Jennings Bryan); Gene Kelly en el papel del periodista progresista E. K. Hornbeck (nombre que en la película a H. L. Mencken); Dick York como Bertram T. Cates (nombre supuesto para John Scopes) y Claude Atkins como el reverendo fundamentalista que denuncia al profesor Cates.

Posteriormente se rodaron para televisión otras tres versiones del juicio Scopes: en 1965 con Melvyn Douglas y Ed Begley, en 1988 con Jason Robards y Kirk Douglas, y en 1999 con Jack Lemmon y George C. Scott.

Cuando Estados Unidos salió de la Primera Guerra Mundial, una nostalgia colectiva recorrió el país por la simplicidad y normalidad anterior a la guerra. En las áreas rurales, particularmente en el sur y el medio oeste, los estadounidenses recurrieron a la fe para recuperar de la estabilidad, y la religión creció en popularidad. Los fundamentalistas, que creían en una interpretación literal de la Biblia, encontraron en Darwin y la teoría de la evolución la amenaza más evidente a la verdad que estaban seguros de que solo ellos poseían. Con la evolución como enemiga, se propusieron erradicarla de su sociedad, comenzando por el sistema educativo.

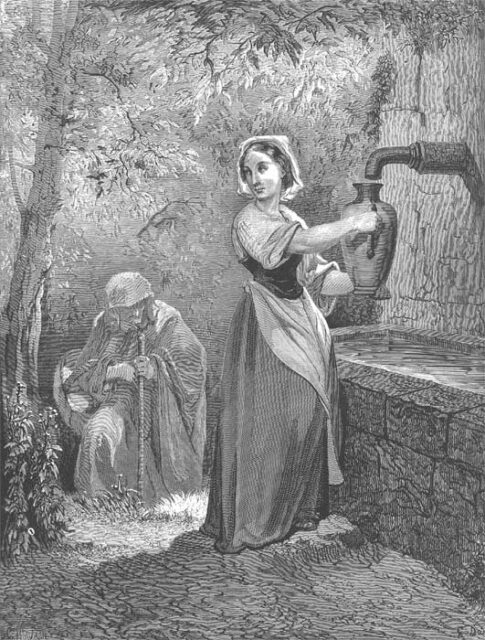

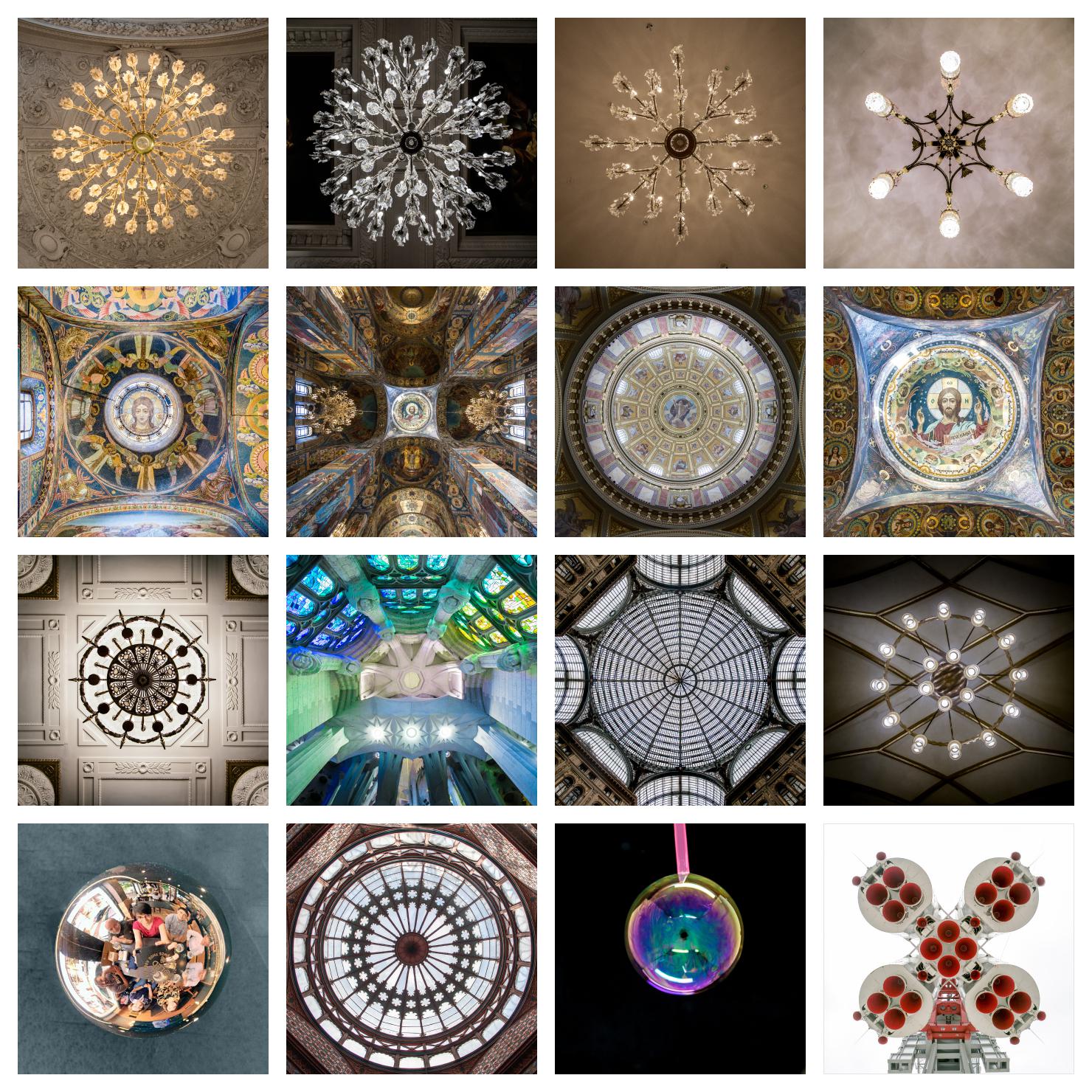

Debido al excesivo calor el 20 de julio de 1925 el presidente del tribunal decidió que la sesión se trasladase al exterior del juzgado. En la imagen Bryan (de pie) interroga a Darrow (sentado a la izquierda). Fuente: Wikimedia Commons

Debido al excesivo calor el 20 de julio de 1925 el presidente del tribunal decidió que la sesión se trasladase al exterior del juzgado. En la imagen Bryan (de pie) interroga a Darrow (sentado a la izquierda). Fuente: Wikimedia CommonsPara 1925, varios estados del sur habían aprobado leyes que prohibían la enseñanza de la evolución. Oklahoma, Florida y Mississippi tenían esas leyes, e influían en las de Carolina del Norte y Kentucky. En Tennessee, la Ley Butler se aprobó en 1925, y aunque el gobernador no era fundamentalista, muchos de sus electores lo eran. Y la Unión Estadounidense de Libertades Civiles de Nueva York, cada vez más cautelosa, y declararon la prohibición de la evolución como una infracción de sus derechos constitucionales. Con la vista puesta en Tennessee, la ACLU se dispuso a iniciar un caso judicial para probar si era constitucional la Ley Butler.

A los pocos días de la decisión de la ACLU de poner a prueba la Ley Butler, se publicó un comunicado de prensa en un periódico de Tennessee que ofrecía apoyo legal a cualquier maestro que desafiara la ley. El 5 de mayo, varios líderes locales se reunieron y acordaron los detalles de su plan. Necesitaban un maestro para probar la ley, y lo encontraron en John T. Scopes, un profesor de ciencias y entrenador de fútbol de 24 años. Cuando se le preguntó acerca de su enseñanza de la evolución como parte de la enseñanza de la biología, Scopes respondió que lo mismo haría cualquier otro maestro.

La película se adaptó en Hollywood en 1960, cinco años después del estreno de la obra de teatro en Broadway. Entonces el Movimiento por los Derechos Civiles iniciaba sus acciones, el macartismo había terminado y el país recibía a un nuevo presidente, John F. Kennedy, que pronto sería elegido. El asunto de las leyes contra la teoría de la evolución no parecía interesar. Ese año, el New York Times publicó pocas noticias sobre el juicio de Scopes. En uno de ellos presentaron las declaraciones de un profesor de ciencias adventista del séptimo día que advirtió sobre los peligros de enseñar la evolución a los estudiantes. Sin embargo, el segundo de los dos artículos más largos sugería que la obra de teatro y su contenido ocupaban un lugar importante en la memoria del público.

La versión de Hollywood era muy diferente de la que Lawrence y Lee habían escrito para el teatro. Aunque la película era entretenida y hábil, muchos de debates de Lawrence y Lee se distorsionaron en la película de 1960.

En julio de ese año, en Dayton, Tennessee, donde se celebró el juicio a Scopes en 1925, se declaró el 21 de julio, Día del Juicio Scopes. La ciudad había aprovechado el juicio como una bendición comercial para Dayton, y en 1960 buscaba revivir el legado, trayendo más visitantes a Dayton. Donde antes había carteles que proclamaban «Lea su Biblia«, ahora, treinta y cinco años después, una pancarta decía «Bienvenido a Dayton, día del juicio de Scopes, 21 de julio«. En realidad, la ciudad había cambiado muy poco y el palacio de justicia seguía como siempre, como medio siglo atrás. Para la gente de Dayton, el juicio todavía se vivía no tanto como un conflicto cultural sino como un evento publicitario que honraba a este pequeño pueblo olvidado.

En resumen, el juicio a Scopes se convirtió en un objetivo para la lucha por las libertades civiles y en un exponente del conflicto entre la ciencia y el cristianismo fundamentalista en auge en Estados Unidos. Scopes fue declarado culpable y condenado a pagar la multa mínima de 100$. Pero, aparte del veredicto concreto, en la opinión pública vencieron los proevolucionistas. Sin embargo, como escriben Judith Grabiner y Peter Miller desde California y Ohio en 1974, los partidarios de la teoría de la evolución fallaron en la continuidad de su defensa y, por ello, los debates continúan incluso en la actualidad.

Referencias:

Grabiner, J.V. & P.D. Miller. 1974. Effects of the Scopes Trial. Was it a victory for evolutionists? Science 185: 832- 837.

Martínez-Salanova Sánchez. E. s.f. La herencia del viento. Libertad de pensamiento y tolerancia religiosa en las aulas. Cine y educación. 9 pp.

Mencken, H.L. 2007. El juicio Scopes. La acusación del fundamentalismo cristiano (The Baltimore Evening Sun 17-20 julio 1925). Letras Libres 71: 38-43.

Wikipedia. 2022. Inherit the wind (película). 22 diciembre.

Wikipedia. 2023. Scopes trial. 9 July.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo ZientZinema 5: Los herederos del viento se ha escrito en Cuaderno de Cultura Científica.

Naukas Bilbao 2023 en directo

El gran evento de divulgación organizado por Naukas y la Cátedra de Cultura Científica vuelve a Bilbao para celebrar su decimotercera edición que tendrá lugar nuevamente en el gran Palacio Euskalduna. Las sesiones del acto central durante los días 15 y 16 de septiembre, Naukas Bilbao 2023, pueden seguirse por streaming aquí o en la web de Naukas.

El programa es el siguiente (horas GMT+2):

Viernes 15 septiembre – Sesión de Mañana10:00 a 10:10 – José Miguel Viñas: ¡Leed a Verne, malditos!

10:10 a 10:30 – Javier S. Burgos y Luisma Escudero: Ciencia ochentera (20 minutos)

10:30 a 10:40 – Juan Francisco Hernández: Recreo Naukas, un nuevo espacio de divulgación

10:40 a 10:50 – Sara Barja: Vamos a mover átomos

10:50 a 11:00 – Teresa Valdés-Solís: Ilustradas y aventureras

11:00 a 11:10 – Iván Rivera: El ancho de banda de la Stasi

11:10 a 11:20 – José A. Prado-Bassas: Series a lo Grandi

11:20 a 11:30 – Juan Ignacio Pérez: Una taxonomía de los saberes

11:30 a 12:00 – Descanso de 30 minutos

12:00 a 12:10 – Raúl Ibáñez: Las matemáticas como herramientas de creación artística

12:10 a 12:20 – Carlos Lobato: Archaea, las pequeñas grandes desconocidas

12:20 a 12:30 – Anabel Forte: Entre datos y lámparas

12:30 a 12:40 – Lorena Pérez Hernández: Anna Wierzbicka y la tabla periódica del pensamiento

12:40 a 12:50 – Laura Morrón: La revolución newtoniana… a pesar de Newton

12:50 a 13:00 – Pablo Rodríguez: Las charlas de mis pesadillas

Viernes 15 septiembre – Sesión de Tarde17:00 a 17:10 – Ignacio López Goñi: Andeuineris

17:10 a 17:20 – Eva Caballero: Nuestras madres nos alteran

17:20 a 17:30 – Ángel López Sánchez: El cielo es tu laboratorio

17:30 a 17:40 – Naiara Barrado: Júpiter ¿Héroe o villano?

17:40 a 17:50 – Miguel A. Delgado: ¿Y si resulta que la revolución científica la inició España?

17:50 a 18:00 – Gaby Jorquera: Sombras largas

18:00 a 18:10 – Isabel Moreno: Que llueva, que llueva

18:10 a 18:20 – Francis Villatoro: Lo que sabemos que no sabemos

18:20 a 18:30 – Sergio P. Acebrón: Explorando los límites de la vida

18:30 a 19:00 – Descanso (30 minutos)

19:00 a 19:20 – Gemma del Caño y Conchi Lillo: Comer con los ojos (20 minutos)

19:20 a 19:30 – Susana Escudero: Granjas de cadáveres

19:30 a 19:40 – Guillermo Peris: La expresión de la muerte

19:40 a 19:50 – José Ramón Alonso: La lección de anatomía

19:50 a 20:00 – Miguel Santander: Dear Doctor,

Sábado 16 septiembre – Sesión de Mañana10:00 a 10:10 – Ambrosio Liceaga: ¿Es Bilbao el mejor lugar para una civilización tecnológica en expansión?

10:10 a 10:20 – Paula Serras : En la cresta de la ola

10:20 a 10:30 – Helena Matute: Experimentos con humanos e IAs

10:30 a 10:40 – Javier Pedreira Wicho: IA: no es inteligencia todo lo que reluce

10:40 a 10:50 – Onintze Salazar: Sobre perturbaciones y no precisamente de la atmósfera

10:50 a 11:00 – Gemma Marfany: Ni tuyo ni mío, de todos

11:00 a 11:10 – Gisela Baños: Cuando la ciencia ficción puso en jaque a Seguridad Nacional

11:10 a 11:20 – Alberto García Salido: Toda su sangre en mis manos

11:20 a 11:30 – Lluís Montoliu: Millones de raras

11:30 a 12:00 – Descanso de 30 minutos

12:00 a 12:10 – Javier Fdez. Panadero: Ilusiones cacharrísticas

12:10 a 12:30 – Luis Martínez Otero: FESTIVAL JA (20 minutos)

12:30 a 12:40 – Julián Estévez: Drones y Ramstein

12:40 a 12:50 – Fernando Frías: Benidorm y la Tierra

12:50 a 13:00 – Laura Toribio: Ese huequito entre Marte y Júpiter

Sábado 16 septiembre – Sesión de Tarde17:00 a 17:10 – Laura Morán: La erótica del fregao

17:10 a 17:20 – César Tomé: La desviación de Einstein

17:20 a 17:30 – Sara Cazzoli: Feo, fuerte y formal

17:30 a 17:40 – Álvaro Bayón: Nuestra vida por unas monedas

17:40 a 17:50 – Ricardo Moure: Seguro dental, Lisa necesita un aparato

17:50 a 18:00 – Txema Campillo: De Guttemberg a Marilyn

18:00 a 18:10 – Pablo José Barrecheguren: La paradoja del sueño lúcido

18:10 a 18:20 – Virginia Arechavala: Los vulgares exploradores del laberinto.

18:20 a 18:30 – Juan Carlos Gil: Vuela, gaviota… ¡Vuela!

18:30 a 19:00 – Descanso (30 minutos)

19:00 a 19:10 – Carlos Briones: Invisible a los ojos

19:10 a 19:20 – Álvaro Carmona: El borde del espejo

19:20 a 19:30 – Elisabete Alberdi: Las matemáticas del glioma

19:30 a 19:40 – Joaquín Sevilla: Una mañana de verano

19:40 a 19:50 – Antonio Martínez Ron: Etiquetar el asombro

19:50 a 20:00 – Oskar González: La última de Vermeer

20:00 a 20:10 – Entrega de los Premios Tesla 2023 y despedida del evento.

El artículo Naukas Bilbao 2023 en directo se ha escrito en Cuaderno de Cultura Científica.

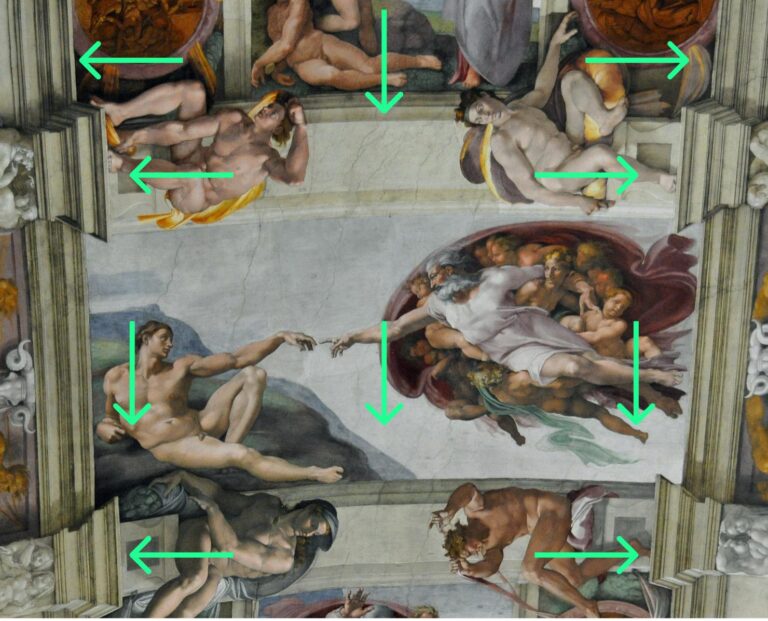

Fantasías de colores microscópicos

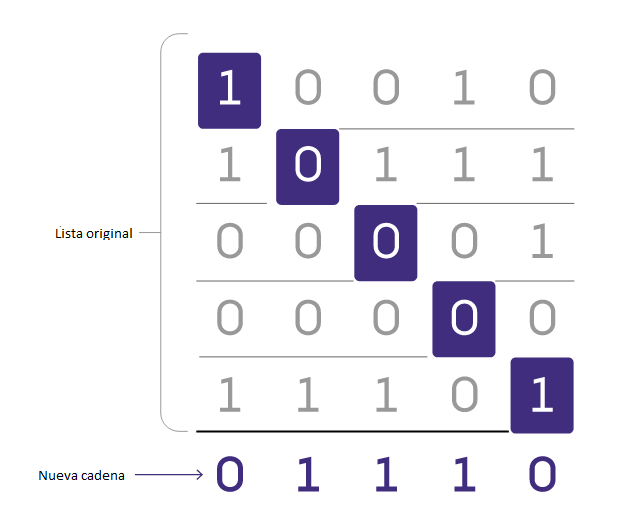

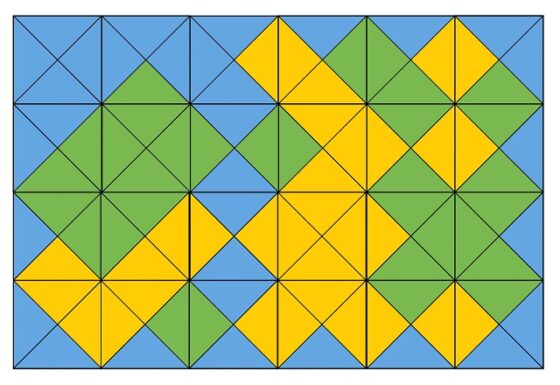

En Geología, al igual que en otras disciplinas científicas como la Biología o la Medicina, cuando queremos hacer un estudio detallado de cualquier roca para conocer de manera precisa su composición y sus propiedades internas, debemos utilizar un microscopio de luz transmitida. Pero, en nuestro caso, se trata de un microscopio un poco particular, al que llamamos microscopio petrográfico.

Microscopio petrográfico modelo Olympus BHT utilizado para las prácticas de petrología en el Departamento de Geología de la Universidad del País Vasco (UPV/EHU). Imagen: UPV/EHU

Microscopio petrográfico modelo Olympus BHT utilizado para las prácticas de petrología en el Departamento de Geología de la Universidad del País Vasco (UPV/EHU). Imagen: UPV/EHULa principal diferencia con los microscopios biológicos es que tiene un sistema de luz polarizada formado por dos filtros (o nícoles): el primero se encuentra situado en el foco de luz, por debajo de la muestra, y el segundo está posicionado entre la muestra y el ocular. El primer filtro, que generalmente está fijo, hace que las ondas lumínicas se muevan en una sola dirección para que puedan atravesar la muestra sin desviarse. Pero el segundo filtro, que podemos sacar y meter del microscopio a nuestra voluntad, se coloca de manera perpendicular al primero, de tal manera que, cuando lo activamos, o, para ser más exacta, lo cruzamos, hace de barrera e impide el paso de la luz. Es decir, si miramos por el ocular de un microscopio petrográfico sin colocar ninguna muestra y lo encendemos con el segundo filtro sacado, veremos la luz incidiendo sobre nuestros ojos. Pero si metemos, o cruzamos, el segundo polarizador, lo veremos todo negro.

Seguro que os estaréis preguntando que, entonces, para qué sirve ese segundo polarizador si no nos permite ver nada. Pues la respuesta está en las propiedades ópticas de los minerales. Si ponemos una muestra en el microscopio que sea capaz de cambiar la dirección de la luz polarizada a medida que la atraviesa (esta propiedad se denomina birrefringencia), cuando cruzamos el segundo filtro surgirá la magia, porque entonces la luz no incidirá de manera perpendicular, sino que tendrá un ángulo que se verá reflejado en la aparición de una serie de colores ante nuestros ojos, denominados colores de interferencia. Y esta propiedad óptica es un criterio de identificación de los minerales.

La segunda diferencia más importante con el resto de microscopios es que el petrográfico dispone de una platina, es decir, de una superficie donde se coloca la muestra que puede girarse 360º. Y, aunque parezcamos DJs intentando sacar una buena base musical de la muestra que estamos analizando cuando nos ponemos a girar adelante y atrás la platina, lo que estamos haciendo es comprobar cómo cambian los colores de interferencia de los minerales al modificar el ángulo de incidencia de la luz. En algunos casos, apenas varían y nos encontramos con tonos similares del mismo color. Pero en otras ocasiones parece una imagen psicodélica de los años sesenta del siglo pasado, encontrando variaciones extremas en los colores de interferencia de un mismo mineral. Este rango de variación de los colores de interferencia también es un criterio identificativo de los minerales.

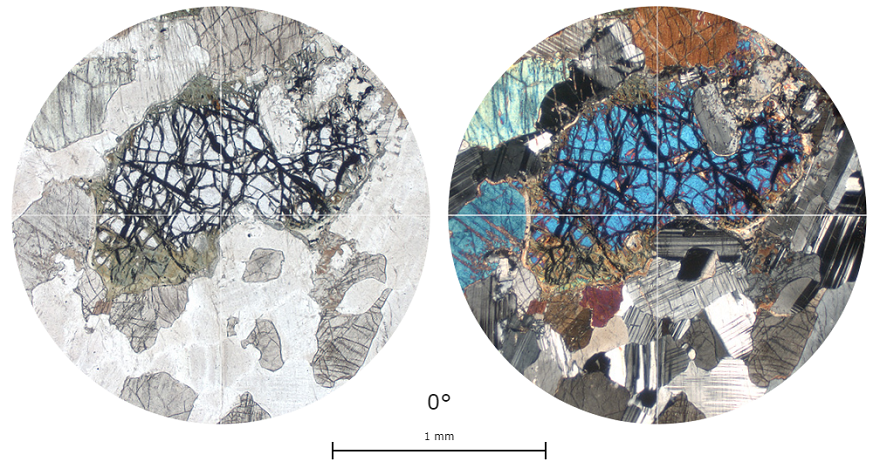

Aspecto de una roca ígnea (gabro) vista al microscopio petrográfico. La imagen de la izquierda se ha obtenido con el segundo polarizador no activado, mientras que la imagen de la derecha se obtiene al cruzar el segundo polarizador, revelando los colores de interferencia de los minerales que componen la muestra analizada. Imagen: Open University / OpenLearn

Aspecto de una roca ígnea (gabro) vista al microscopio petrográfico. La imagen de la izquierda se ha obtenido con el segundo polarizador no activado, mientras que la imagen de la derecha se obtiene al cruzar el segundo polarizador, revelando los colores de interferencia de los minerales que componen la muestra analizada. Imagen: Open University / OpenLearnPero el estudio de las rocas al microscopio petrográfico no solo nos permite identificar la composición mineral de la misma. También podemos observar estructuras microscópicas de la muestra, como la existencia de fracturas o de poros internos, o la presencia de microfósiles que nos informen sobre la edad de la roca o el ambiente en el que se formó. Características que no podíamos apreciar a simple vista y que son necesarias a la hora de describir el material con el que estamos trabajando.

Vídeo: Variación de los colores de interferencia en varios minerales, principalmente feldespatos, al girar la platina del microscopio petrográfico con los dos polarizadores cruzadosAhora es cuando nos surge otra cuestión: ¿Cómo podemos hacer que la luz atraviese una roca, si estamos trabajando con una sustancia sólida y, por tanto, opaca? Pues exactamente igual que en Biología o Medicina, cortando una rodaja muy fina de nuestra muestra hasta conseguir transformarla en algo transparente. Para ello usamos una cortadora de rocas, que tiene un disco de diamante, con la que preparamos un pequeño taco con forma de prisma de base rectangular, de unos 2,5 cm de ancho por unos 4 cm de largo, que se pega a un portamuestras de vidrio. Este taco de roca se va puliendo con diferentes abrasivos, también de polvo de diamante, hasta que alcanza un grosor de 0,03 mm, tras lo que se tapa con un cubreobjetos de vidrio. Así se transforma en lo que en Geología denominamos una lámina delgada, o sección pulida de roca si queremos usar un término un poco más serio. Ahora ya podemos poner la muestra sobre el microscopio permitiendo que la luz la atraviese sin problemas.

Proceso de preparación de una lámina delgada desde la muestra de roca hasta que se obtiene la sección pulida que permite el paso de la luz a través de la misma. Imagen: Instituto de Geología de la Universidad Nacional Autónoma de México

Proceso de preparación de una lámina delgada desde la muestra de roca hasta que se obtiene la sección pulida que permite el paso de la luz a través de la misma. Imagen: Instituto de Geología de la Universidad Nacional Autónoma de MéxicoEl microscopio petrográfico lleva usándose más de un siglo para hacer estudios geológicos a lo largo de todo el mundo, pero la técnica se va perfeccionando año tras año. Los aparatos que usé durante la carrera hace un par de décadas están a años luz, nunca mejor dicho, que los que pueden emplear ahora mismo las nuevas hornadas de profesionales de la Geología que se están cocinando a fuego lento en las facultades españolas. Y esto es una buena noticia, porque, aunque las propiedades ópticas de los minerales sigan siendo las mismas, cualquier avance tecnológico va a permitir que sea mucho más fácil determinarlas, pudiendo así afinar cada vez más y mejor en la identificación de los componentes de las rocas que estemos estudiando, lo cual se agradece mucho durante los exámenes. Aunque lo que tampoco va a cambiar será la impresión que sufrirán estas futuras generaciones cuando vean por primera vez una lámina delgada al microscopio y descubran el maravilloso juego de colores que se oculta en el interior de una oscura y simple roca.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Fantasías de colores microscópicos se ha escrito en Cuaderno de Cultura Científica.

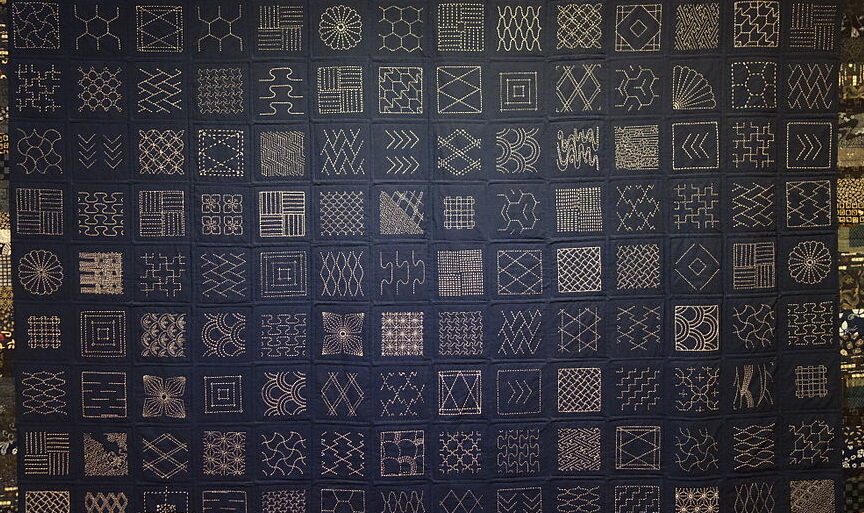

Las matemáticas del bordado sashiko

Las matemáticas definen el sashiko a través de la geometría de los patrones. […] El sashiko y el proceso de coser patrones ejemplifican la relación entre las matemáticas y los textiles.

La palabra sashiko viene del japonés 刺し子, que significa “pequeñas puntadas”. Este nombre alude al acto de ir empujando la aguja verticalmente a través de gruesas capas de tela.

Historia del sashikoDesde el periodo Edo, esta técnica de bordado se utilizaba para reforzar la ropa de trabajo de la población rural japonesa. Las piezas así obtenidas eran más resistentes y aislaban mejor del frío. Gracias al sashiko, los agricultores con escasos recursos podíanhacer durar más tiempo su ropa, remendándola o juntando varias capas de telas viejas con esta técnica.