P4K 2023: Un triángulo. Mucha ciencia

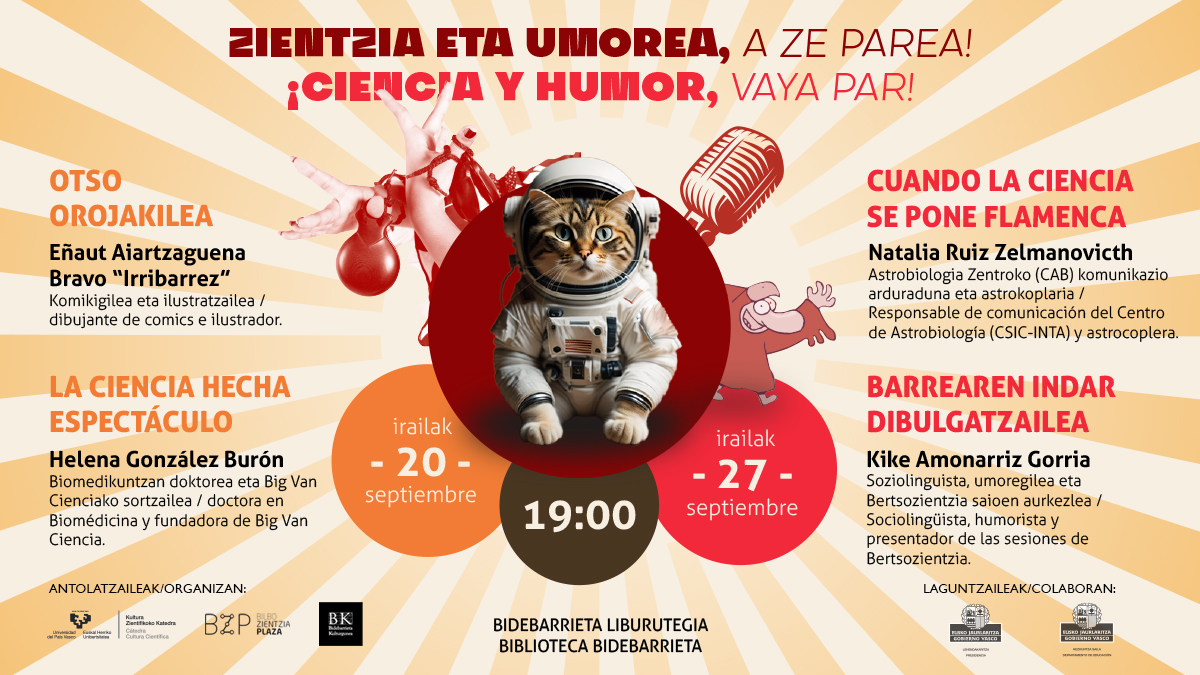

Passion for Knowledge (P4K) es un festival internacional de ciencia abierto a toda la ciudadanía organizado por el centro de investigación Donostia International Physics Center. Bajo un enfoque innovador y un amplio programa de actividades, el festival ofrece un punto de encuentro entre la comunidad científica y la sociedad.

La sede principal del festival es el Teatro Victoria Eugenia de San Sebastián, extendiéndose a diferentes puntos del País Vasco con actividades en Bilbao y otras localidades. La quinta edición tuvo lugar del 2 al 7 de octubre de 2023.

El objetivo de Passion for Knowledge es promocionar la ciencia como actividad cultural clave para contribuir al bienestar de las generaciones venideras y destacar el conocimiento como motor del progreso científico, tecnológico y cultural.

El festival cuenta con la participación de prestigiosos científicos y científicas internacionales que han sido protagonistas de algunos de los descubrimientos científicos más relevantes de las últimas décadas. En estas charlas magistrales, conoceremos cómo los y las científicas invitadas han logrado expandir las fronteras del conocimiento y contribuir al progreso y el bienestar de la sociedad en su conjunto.

El extenso programa tiene como actividad principal las conferencias plenarias de nuestros científicos y científicas invitadas, que se complementa con toda una serie de actividades dirigidas a diferentes públicos.

En este marco tuvo lugar la conferencia de José Luis Crespo (@quantumfracture), conocido físico youtuber con más de 3 millones de suscriptores, va de algo tan aparentemente simple como son los triángulos. Simple hasta que haces las preguntas correctas, claro.

Edición realizada por César Tomé López

El artículo P4K 2023: Un triángulo. Mucha ciencia se ha escrito en Cuaderno de Cultura Científica.

El cambio climático no afectará negativamente a las energías renovables marinas

El cambio climático no afectará significativamente a la producción de energías renovables marinas, al menos, hasta el año 2100. Todo ello a pesar del aumento de emisiones de gases de efecto invernadero. La explotación eficiente de los recursos energéticos renovables en nuestras costas y océanos podrá continuar desarrollándose de manera fiable contribuyendo así al objetivo de disminución de emisiones y la descarbonización de la economía.

Foto: Bob Brewer / Unsplash

Foto: Bob Brewer / UnsplashEspaña y el Parlamento Europeo realizaban en 2019 sendas declaraciones en las que advertían de la situación de emergencia climática en que nos encontramos, un anuncio que se extendió posteriormente a todo el mundo. Estas declaraciones analizaban las proyecciones climáticas a largo plazo. Se hacían eco, así, del consenso científico que alerta sobre un aumento de las temperaturas en las próximas décadas como consecuencia de las emisiones de gases de efecto invernadero. De ahí los esfuerzos internacionales para alcanzar una menor dependencia de los combustibles fósiles y, por tanto, desarrollar energías renovables marinas puede contribuir significativamente al cumplimiento de los objetivos globales de descarbonización.

Sin embargo, además de la temperatura, el incremento de las concentraciones de gases de efecto invernadero altera el comportamiento de la atmósfera y del océano. Por ello, en un contexto calificado como emergencia climática, es necesario determinar cuáles serán a finales de siglo los efectos esperables del calentamiento global sobre la disponibilidad de viento y olas para su explotación como fuente renovable de energía. En otras palabras, ¿puede el propio cambio climático disminuir su disponibilidad cortocuitando así una de sus más importantes vías de solución como es el desarrollo de las energías renovables?

En un intento de dar una respuesta científica, el grupo de investigación EOLO ha publicado el primer estudio sobre el impacto que tendrán los distintos escenarios climáticos sobre la disponibilidad de recursos renovables marinos hasta 2100. Para ello ha analizado la evolución esperada de la electricidad extraíble del viento y las olas en aquellas zonas marinas donde es posible la instalación de dispositivos para su aprovechamiento. Para la investigación han incluido las proyecciones más recientes de los distintos escenarios climáticos previstos (CMIP6), que han publicadas por el Panel Internacional de Cambio Climático (IPCC), la institución dependiente de la ONU que se encarga de coordinar los esfuerzos científicos internacionales en este ámbito.

Los resultados de este estudio indican que la electricidad obtenible del viento y olas marinas apenas experimentaría cambios y que estos serían perceptibles solo en unas pocas áreas marinas, incluso si llegara a producirse el escenario más desfavorable; esto es, que no se redujeran las emisiones comprometidas por los acuerdos internacionales de aquí a 2100. Según esta investigación, la foto de España hasta final de siglo es plenamente estática, sin cambios previsibles en el potencial extraíble de las zonas marinas donde instalaciones renovables pueden ser técnicamente viables.

Pocos cambios y de reducida magnitudLos pocos entornos geográficos donde se han detectado cambios a nivel global se corresponden con áreas donde ya existen parques eólicos marinos plenamente funcionales, como el Norte de Europa o el Mar de China. Un denominador común en este pequeño número de zonas es que, además, los cambios esperables son pequeños.

Según explican los investigadores, en un escenario de importantes reducciones en las inversiones necesarias en la industria eólica marina, estos pequeños cambios no comprometerán su viabilidad tecno-económica. Por el contrario, añaden, es esperable que en las próximas décadas veamos un notable incremento de este tipo de instalaciones. Es más, de la investigación se ha podido deducir que zonas costeras que actualmente no cuentan con instalaciones eólicas marinas como el Mar de Arabia o el Golfo de Bengala, podrían llegar a atraer notables inversiones, dado el elevado potencial de esta industria y el incremento que se prevé de la misma que se prevé.

Los autores del estudio advierten que el desarrollo tecnológico de la energía obtenida de las olas es aún notablemente inferior al de la energía eólica marina; sin embargo, la investigación presenta una fotografía global prácticamente estática, con cambios del oleaje en pocos lugares y de magnitud reducida, como ocurre con el potencial de la energía eólica. Esto supone, a entender de este equipo de investigación, que habrá un escenario estable en el mar, donde desarrollar futuros prototipos que permitan una explotación eficiente de la energía proveniente de las olas. Ello permitirá una mejor estimación a largo plazo de los costes de investigación e inversión requeridos y contribuirá a un desarrollo más predecible y seguro.

Los autores, que ya en su día hicieron una investigación sobre la eficacia energética de la planta de olas de Mutriku, sugieren también para esta instalación un escenario de oleaje estable, lo cual ayudará a mantener su explotación y mejora por medio de nuevos tipos de dispositivos a instalar. Cabe recordar que esta planta es la única instalación en el mundo que lleva inyectando electricidad originada por las olas a la red durante más de 10 años.

Referencia:

Gabriel Ibarra-Berastegui, Jon Sáenz, Alain Ulazia, Aitor Sáenz-Aguirre & Ganix Esnaola (2023) CMIP6 projections for global offshore wind and wave energy production (2015–2100)

Scientific Reports doi: 10.1038/s41598-023-45450-3

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El cambio climático no afectará negativamente a las energías renovables marinas se ha escrito en Cuaderno de Cultura Científica.

Neuronas para las emociones

Juan Ignacio Pérez Iglesias, lector

Charles Darwin fue probablemente uno de los primeros científicos que estudiaron las emociones, tanto en los seres humanos como en otras especies animales. Lo hizo observando las expresiones que mostramos al exterior, y publicó los resultados de sus observaciones en La expresión de las emociones en el ser humano y en los animales, en 1871.

Ha pasado siglo y medio desde entonces y, aunque con esfuerzo, ahora sabemos bastante más de las emociones. Son materia de estudio de varias disciplinas, y en especial de la psicología y las neurociencias. Y son el tema de Neuronas para la emoción (Shackleton Books, 2023), de Xurxo Mariño.

El libro está estructurado en tres partes. En la primera, tras la «Introducción», se presentan las emociones básicas, se explica en qué consisten y se ofrecen sus características más importantes. La caracterización que se ofrece de las emociones incluye lo que se sabe hoy acerca de los circuitos neuronales y áreas del encéfalo que las procesan.

Las emociones cumplen funciones esenciales y son resultado de millones de años de evolución. En gran medida son innatas, automáticas y a menudo inconscientes. Facilitan la toma de decisiones y nos ayudan a comunicarnos con los demás, porque mediante sus expresiones transmitimos estados mentales.

Hasta hace relativamente poco tiempo yo era de los que pensaba que emoción y sentimiento venían a ser casi sinónimos. Por esa razón cuando experimentaba la sensación de alegría, pensaba que ese era mi estado emocional, que mi sentimiento de alegría tenía su origen, precisamente, en esa emoción. Y, por lo tanto, que había una correspondencia clara, bien definida, entre ambas cosas, por no decir que eran lo mismo. Pero las cosas no son tan sencillas.

Las emociones no son experiencias subjetivas y conscientesLas emociones consisten en comportamientos, cambios fisiológicos o actividades neuronales. No son las experiencias subjetivas, conscientes, que popularmente se conocen como emociones. Uno puede pensar que, aunque no sean la misma cosa, la distinción entre esas experiencias subjetivas –los sentimientos– y las emociones –la actividad neuronal y sus correlatos fisiológicos y de comportamiento– es ociosa y, por lo tanto, que tal distinción carece de importancia.

Sin embargo, es una distinción importante. Lo cierto es que no hay forma de asegurar que lo que se mide experimentalmente –la actividad neuronal, los cambios fisiológicos, etc.– corresponde a, o está directamente relacionado con, las experiencias subjetivas, los sentimientos. Menos aún se puede asegurar que esas experiencias subjetivas o sentimientos sean causados por esas actividades neuronales o cambios fisiológicos.

Los mamíferos y los seres humanos compartimos emociones, pero no podemos afirmar que compartamos sentimientos. Ni siquiera podemos saber si los animales no humanos experimentan sentimientos; desconocemos si tienen una experiencia consciente de sus estados emocionales.

Desconocía gran parte de lo que he comentado en las líneas precedentes, pero he disfrutado recordando nociones de neurociencia tan importantes como que no es posible deslindar la esfera de lo emocional de la de lo racional, porque ambas están profundamente imbricadas e inciden en nuestro comportamiento de forma conjunta. O que en la toma de decisiones que consideramos racionales los estados emocionales tienen una influencia decisiva.

En Neuronas para la emoción también he aprendido que el encéfalo pone en marcha paquetes de acción para ellas; y que la emoción aparece antes que el sentimiento mediante el que la experimentamos de forma consciente y la categorizamos. Y que una vez se experimenta de forma consciente un sentimiento, se producen pensamientos acordes a él.

Xurxo aborda asuntos tan interesantes como el del carácter innato –o no– de ciertos miedos, como el que muchos experimentan hacia las serpientes o, como en mi caso, hacia los roedores. Y resulta que no, no nacemos con esos miedos instalados, pero estamos predispuestos genéticamente a experimentarlos. No los taremos de serie, sino que hace falta alguna “mala experiencia” para que este se desencadene.

También trata de la forma en que las emociones se ven condicionadas por las experiencias y la forma en que aquellas influyen en los recuerdos. La emoción condiciona la intensidad y el detalle con que se recuerdan los episodios que guardamos en la memoria.

Emociones muy básicasEn la segunda parte, Xurxo Mariño se ocupa de forma pormenorizada de un conjunto de emociones básicas o, incluso, muy básicas. Esa distinción puede parecer ociosa pero quizás no lo sea tanto. Porque resulta, por ejemplo, que una emoción –probablemente la más básica de todas– no ha sido categorizada como tal hasta hace relativamente poco tiempo.

Se trata de la de “búsqueda y anticipación”. En palabras de Xurxo, “es una especie de sistema afectivo que está detrás de los demás y que crea la necesidad de involucrarse activamente en el mundo, esa motivación que pone en marcha el resto de emociones y que promueve la curiosidad y el aprendizaje”. Es posible que la razón por la que esta emoción solo se haya identificado como tal muy recientemente, es el hecho de tener ese carácter tan global.

El libro se ocupa también del deseo sexual, una emoción que, más que básica, algunos consideran primordial y equivalente, en cierto modo, al hambre o la sed, debido a su enorme importancia biológica.

Otras emociones básicas incluidas en el recorrido del autor son la tristeza, el miedo, la alegría y la ira. Y he de advertir que el texto depara alguna sorpresa que otra en ese repaso.

La tercera parte incluye dos asuntos especiales, el primero es el de las emociones en la adolescencia, un aspecto fascinante de nuestra biología. Es la época de la vida en la que pasamos a integrarnos en el grupo social. En ese proceso de integración los y las adolescentes construyen su propia identidad; y lo hacen, precisamente, en el marco de las relaciones que se establecen dentro del grupo. Es una fase especial de la vida, el control de los impulsos es imperfecto, por lo que se asumen más riesgos, y no se valoran de forma correcta las consecuencias de los actos. Y concluye el libro con un capítulo dedicado a estudiar la relación que existe entre la música y las emociones.

Me gusta cómo escribe Xurxo Mariño. Lo hace con claridad, sin sacrificar el rigor científico de lo que cuenta. Tiene un estilo identificable; creo que nada más empezar a leer uno de sus textos identificaría su autoría. Neuronas para la emoción está, además, salpicado de anécdotas, vivencias personales, episodios de la investigación en neurociencia que contribuyen a elaborar un texto muy ameno. Xurxo disfruta jugando con las palabras; por eso abunda en hallazgos lingüísticos y metáforas originales.

Eso sí, me quedo con ganas de saber de otras emociones; las que subyacen a los sentimientos de envidia, de vergüenza, de culpa o de celos tienen que ser apasionantes… Pero es un texto relativamente breve, algo que supongo deliberado, por lo que entiendo que se ha optado por abarcar menos para apretar algo más. Es una opción, por supuesto.

Vaya desde aquí mi enhorabuena y agradecimiento al autor, mi felicitación a la editorial, por el fichaje, y mi recomendación de este libro a todas las personas mínimamente interesadas en los vericuetos de la mente humana.

Ficha:

Título: Neuronas para la emoción. Cómo la neurociencia comienza a descifrar los circuitos de tus emociones.

Autor: Xurxo Mariño

Editorial: Shackleton Books (2023), 206 pp.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

Una versión de este texto apareció anteriormente en Lecturas y Conjeturas (Substack).

El artículo Neuronas para las emociones se ha escrito en Cuaderno de Cultura Científica.

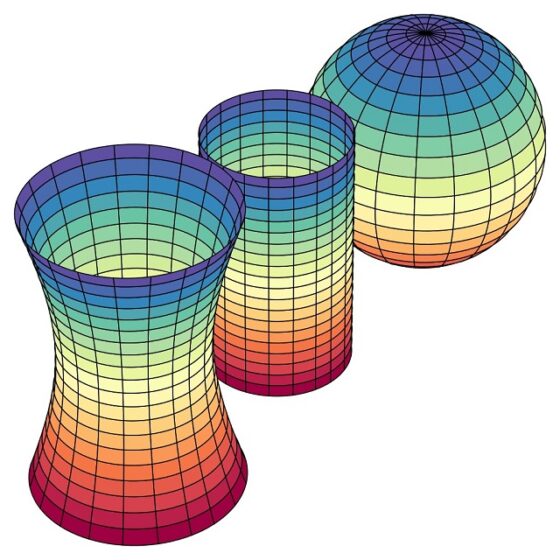

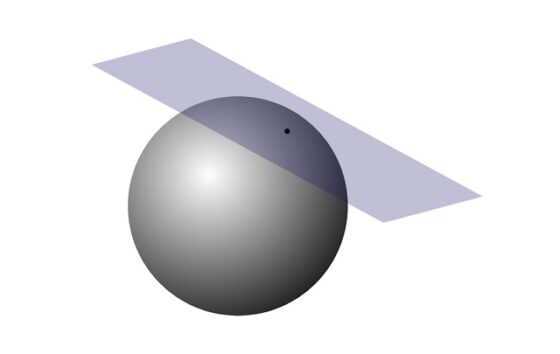

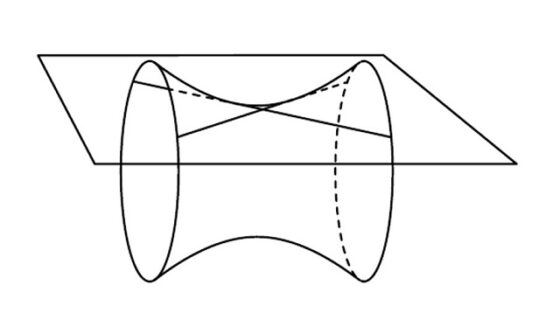

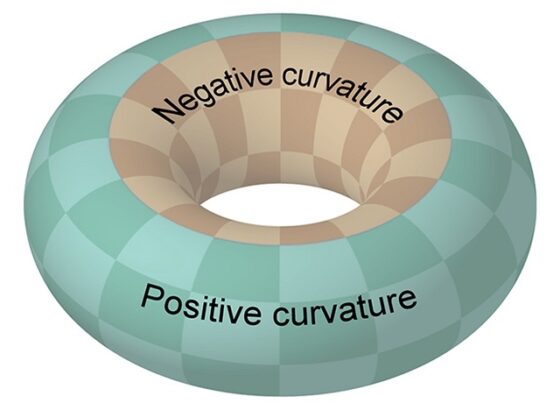

Una banda de Moebius de chocolate

En mi última entrada del Cuaderno de Cultura Científica, titulada El toro, la botella de Klein y el plano proyectivo real (I), he iniciado una serie dedicada a la superficie del toro, la botella de Klein y el plano proyectivo real, y a su utilización en el arte contemporáneo. Sin embargo, la entrada en escena de un delicioso postre de chocolate con la forma de una banda de Moebius, de mi amigo el cocinero y escritor donostiarra Xabier Gutiérrez, me obliga a interrumpir esta serie para dedicar esta entrada al mismo.

Escultura Estudio del toro #2 (2023), del artista sudafricano Paul Stein. Fotografía de la página web de Paul SteinMatemáticas gastronómicas

Escultura Estudio del toro #2 (2023), del artista sudafricano Paul Stein. Fotografía de la página web de Paul SteinMatemáticas gastronómicas

Desde la publicación de mi último libro Las matemáticas como herramienta de creación artística (catarata) en marzo de 2023, he estado dándole difusión en las redes sociales y presentándolo en algunas librerías y bibliotecas. Para mi última presentación, hasta la fecha, en la librería Zubieta-TROA (Donostia/San Sebastián) invité a mi amigo Xabier Gutiérrez, para que me acompañara en la misma.

Fotografía, realizada por Iñaki Von Früchte, de la presentación del libro Las matemáticas como herramienta de creación artística (catarata, 2023) en la librería Zubieta-TROA (Donostia/San Sebastián), con el cocinero y escritor Xabier Gutierrez acompañando al autor del libro, Raúl Ibáñez, en la misma

Fotografía, realizada por Iñaki Von Früchte, de la presentación del libro Las matemáticas como herramienta de creación artística (catarata, 2023) en la librería Zubieta-TROA (Donostia/San Sebastián), con el cocinero y escritor Xabier Gutierrez acompañando al autor del libro, Raúl Ibáñez, en la mismaXabier Gutiérrez (1960) es cocinero, escritor y sicólogo. Ha dirigido el departamento de innovación del Restaurante Arzak en San Sebastián desde 1990 hasta 2022, ha escrito y publicado más de 20 libros, tanto de cocina como novelas negras (la tetralogía Los aromas del crimen y su última novela El refugio de las mariposas dentro de lo que se ha bautizado como noir gastronómico), y en su página web podéis encontrar muchísimas recetas sobre sus maravillosas creaciones culinarias.

Xabier y yo formamos parte del equipo que realizó la primera temporada (yo estuve también durante la segunda) del late night show de divulgación científica y humor emitido en el canal de televisión La 2 de RTVE, Orbita Laika, que creó José Antonio Pérez Ledo para la Fundación Española para la Ciencia y la Tecnología (FECyT) y que acaba de cumplir 100 programas (¡Felicidades!). Por cierto, desde 2019 lo presenta el matemático riojano Eduardo Sáenz de Cabezón. Ambos, Xabier y yo, realizamos una sección de videos, la suya era la sección titulada “Ciencia en la cocina”, junto al bioquímico José Manuel López Nicolás, y la mía tenía el nombre de “Una de mates” (los videos de estas secciones los podéis encontrar en la página de RTVE o en YouTube, pero también, todos los videos de “Ciencia en la Cocina” y los videos de la segunda temporada de “Una de mates”, en el Cuaderno de Cultura Científica).

Sin embargo, no llegamos a conocernos entonces. Nos conocimos un año después, en la Feria del Libro de Bilbao, a la que vino a firmar ejemplares de su primera novela negra Los aromas del crimen (Destino, 2015), que yo, aficionado a la novela negra, me compré y le pedí que me firmara.

Yo soy una persona a la que le gustan los “diálogos en la frontera”, por este motivo invitamos a Xabier al curso de verano de la UPV/EHU Cultura con “M” de matemáticas: una visión matemática del arte y la cultura, que organizábamos Pedro Alegría, Marta Macho y yo mismo, para hablar de las matemáticas como herramienta de creación en el arte culinario. Tras la sorpresa inicial, Xabier, que es una persona muy creativa, decidió que no se trataba de hablar de recetas ya conocidas, sino de crear nuevas recetas inspiradas en las matemáticas para ese curso de verano. Para ello le propuso a Mikel Olaizola, entonces alumno en prácticas en el restaurante y en la actualidad profesor del Basque Culinary Center, realizar un Trabajo Fin de Grado sobre este tema, bajo su dirección. Y se pusieron manos a la obra, junto al equipo del Laboratorio del Restaurante Arzak, que dirigía Xabier Gutiérrez. Se crearon platos muy interesantes, inspirados en ideas matemáticas como las proporciones, el tangram, los fractales o las figuras geométricas, algunos de los cuales pudieron comerse en el Restaurante Arzak. Sobre algunos de ellos podéis leer en la entrada Gastronomía y matemáticas del blog de Xabier Gutiérrez.

Una de las creaciones culinarias fruto de este trabajo fue la titulada Percepción de la proporción, que se basaba en la idea del rectángulo áureo. Por una parte, se creó el recipiente, con dos materiales, policarbonato y bambú, cuya forma era la de un rectángulo áureo (véanse las entradas Visitad los museos, también en clave matemática, ¿Es áureo el Aston Martin de James Bond? o Crímenes áureos). Por otra parte, las mousses, de chocolate, de avellana y de coriandro, iban en su interior, que era una pirámide invertida de rectángulos áureos. El plato se completaba con una serie de crocantes triangulares.

Fotografía del recipiente puesto en pie, con forma de rectángulo áureo, para el plato Percepción de la proporción, creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del recipiente puesto en pie, con forma de rectángulo áureo, para el plato Percepción de la proporción, creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos Fotografía del plato Percepción de la proporción, con las mousses de chocolate, de avellana y de coriandro en el interior del recipiente y acompañado con los crocantes triangulares, creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del plato Percepción de la proporción, con las mousses de chocolate, de avellana y de coriandro en el interior del recipiente y acompañado con los crocantes triangulares, creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara SantosOtro de los platos estaba relacionado con los fractales (véanse las entradas Fractus, arte y matemáticas o Guía matemática para el cómic ‘Promethea’). Para crear este fractal, que podéis observar en la siguiente imagen, utilizaron “guisantes lágrima, agua de tomate, xixas (Calocibe gambosa) y albahacas”. Los fractales eran creados delante del cliente que iba a disfrutar después de ese plato.

Fotografía del fractal creado con guisantes lágrima, agua de tomate, xixas (Calocibe gambosa) y albahacas para el plato creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del fractal creado con guisantes lágrima, agua de tomate, xixas (Calocibe gambosa) y albahacas para el plato creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del momento en el que se está creando el fractal para el plato creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del momento en el que se está creando el fractal para el plato creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del plato realizado con pequeños fractales para el plato creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

Fotografía del plato realizado con pequeños fractales para el plato creado por Xabier Gutiérrez, Mikel Olaizola y el equipo del Laboratorio Arzak. Fotografía de Sara Santos

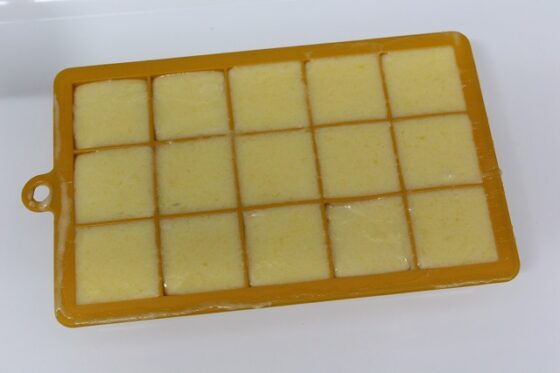

Chocolate desorientado

Pero vayamos al postre que ha motivado esta entrada, cuyo nombre es “chocolate desorientado”, y que se inspira en la banda de Moebius. Podéis leer la receta y la explicación de su creador, Xabier Gutiérrez, en su blog: Chocolate desorientado, el concepto de Moebius en la cocina.

Fotografía del postre Chocolate desorientado, de mi amigo el cocinero Xabier Gutiérrez

Fotografía del postre Chocolate desorientado, de mi amigo el cocinero Xabier Gutiérrez

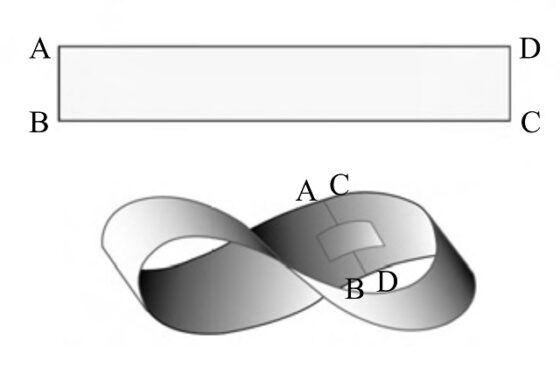

Aunque hemos hablado en muchas ocasiones de la banda de Moebius en el Cuaderno de Cultura Científica (por ejemplo, en las entradas Arte Moebius (I), Arte Moebius (II), En busca de la banda de Moebius más corta posible o Dibujando grafos sobre la banda de Moebius) volvamos a explicar, una vez más, qué es y cómo se construye esta superficie tan especial.

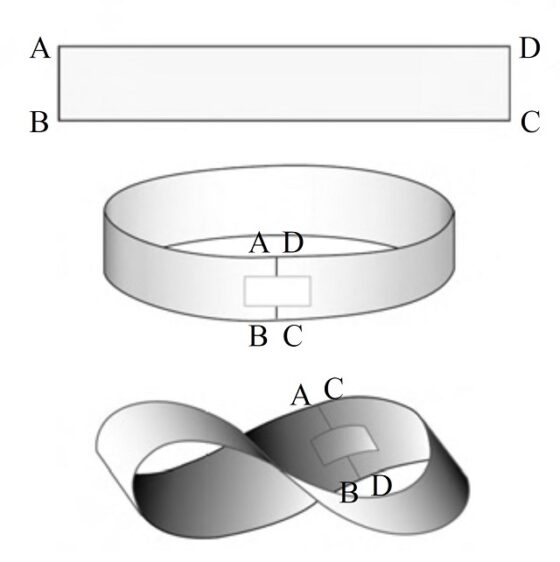

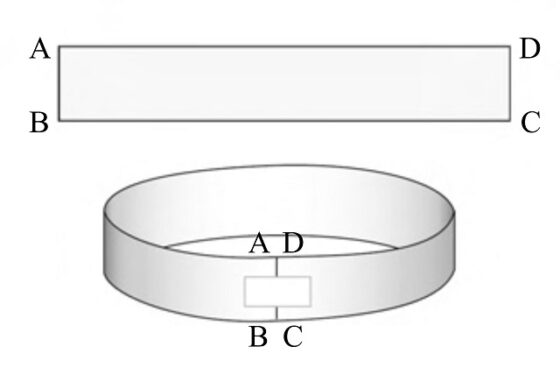

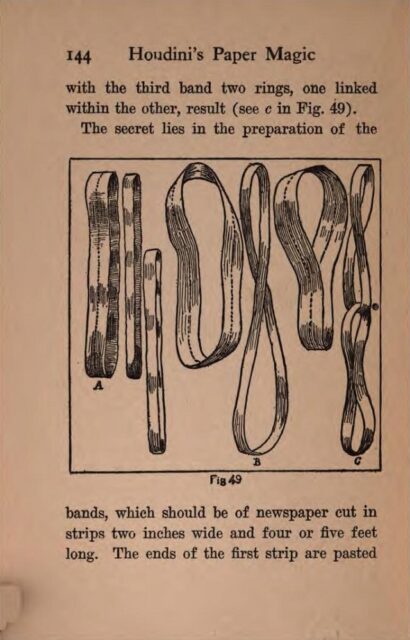

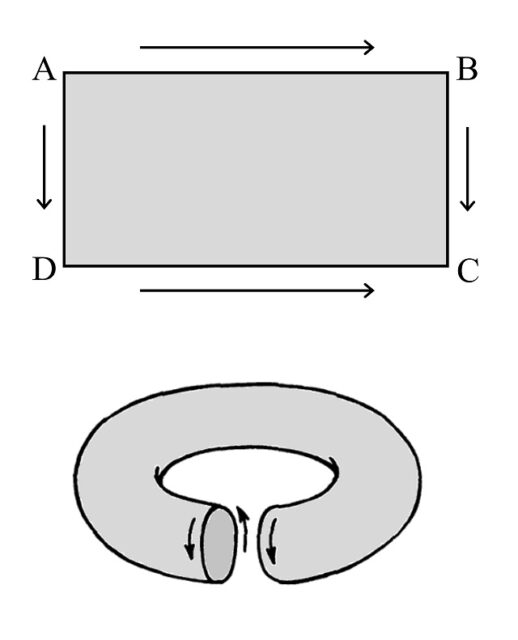

Una banda de Moebius es una banda retorcida que podemos construir de forma sencilla de la siguiente forma. Si tomamos una tira de papel y pegamos los extremos se obtiene una banda normal, con dos caras y dos bordes, pero si primero giramos uno de los extremos del papel media vuelta y después juntamos los extremos se obtiene la banda de Moebius, una superficie que solo tiene una cara y un solo borde (como se observa en la siguiente imagen), y propiedades mágicas.

Para preparar su postre, Xabier realizó una banda de Moebius con acetato, que utilizaría para darle la forma adecuada al chocolate. En la siguiente imagen mostramos la banda de Moebius en acetato.

Banda de Moebius realizada por Xabier Gutiérrez con una lámina de acetato de 25 cm por 3 cm

Banda de Moebius realizada por Xabier Gutiérrez con una lámina de acetato de 25 cm por 3 cmLo bonito de la creación de este postre es que, a su creador, el cocinero Xabier Gutiérrez, le vino la inspiración para realizarlo mientras leía mi libro Las matemáticas como herramienta de creación artística, en concreto, el segundo capítulo titulado Topología: la banda de Moebius. Como dice Xabier en la entrada de su blog: “Las ideas salen de los lugares más insospechados”. Es un ejemplo más de lo maravilloso de los “diálogos en la frontera”.

La receta de Xabier GutiérrezEn su blog tenéis la receta para realizar el postre chocolate desorientado, así como una gran cantidad de fotografías para facilitar su comprensión. Aunque, para todas las personas que estéis interesadas en realizar este postre, os facilito aquí su receta.

Ingredientes (chocolate desorientado):

200 g de chocolate de 70%

280 g de puré de mango

200 g de nata líquida

60 g de azúcar.

3 hojas de gelatina

Cacao en polvo

La realización del postre es la siguiente:

“Preparar una lámina de acetato de 25 cm por 3 cm.

Fundir el chocolate a 32 °C. Esparcir sobre la lámina de acetato dando un grosor fino, pero sin pasarse que después se rompen. Dejar reposar unos minutos y cuando esté un poco seco, pero que se pueda manejar, cerrar la banda dando media vuelta a uno de los extremos. Sujetar con dos pinzas y dejar enfriar por lo menos 6 horas. Trascurrido este tiempo retirar con extremo cuidado el acetato y ya tendremos la banda de Moebius de chocolate. Espolvorear con cacao en polvo. Reservar.

Pelar el mango y triturarlo hasta hacerlo puré. Pesar 280 g y calentarlo con una hoja de gelatina previamente remojada en agua muy fría. Remover y dejar templar e ir mezclando con la nata semimontada y el azúcar que hemos preparado aparte. Porcionar en cubitos y dejar enfriar. Puedes congelar y comerlo también como si fuera un sorbete.

Presentar ambas preparaciones. El chocolate y el mango.”

A continuación, se muestran un par de presentaciones del postre incluidas en la entrada de la receta en el blog de Xabier Gutiérrez.

¡Muchas gracias Xabier por tu imaginación, tu sabiduría y tu creatividad artística!

El artículo Una banda de Moebius de chocolate se ha escrito en Cuaderno de Cultura Científica.

Los púlsares imponen un nuevo límite a la materia oscura ultraligera

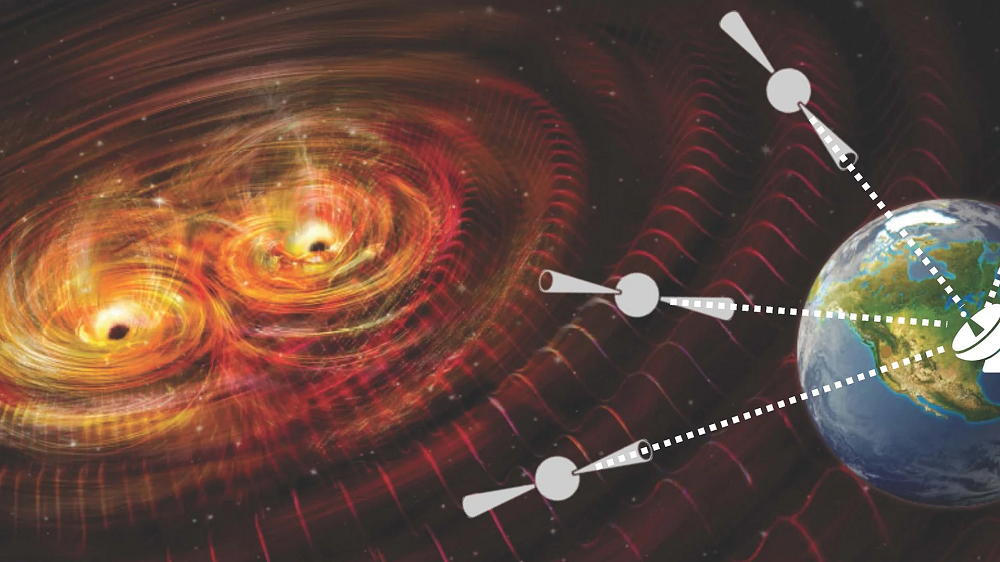

Con objeto de comprender la materia oscura la comunidad científica está buscando hasta debajo de las piedras hasta que encuentre (o descarte) todos los lugares donde pueda estar escondida. La colaboración European Pulsar Timing Array (EPTA) ha eliminado de la lista un rincón previamente inexplorado de las posibilidades de la fase materia oscura mediante el seguimiento de los púlsares de la Vía Láctea.

Fuente: EPTA

Fuente: EPTALos púlsares son estrellas de neutrones que giran rápidamente y emiten hasta varios cientos de destellos electromagnéticos por segundo, como si fueran los tics de un reloj. La regularidad de estos destellos rivaliza con la precisión de los mejores relojes atómicos, lo que convierte a los púlsares en cronómetros cósmicos ideales.

Sin embargo, las distorsiones del espacio-tiempo causadas por las ondas gravitacionales que pasan entre los púlsares y la Tierra afectan a la regularidad de estos tics, permitiendo que una red de púlsares seleccionados pueda actuar como un detector de ondas gravitacionales; un detector del tamaño de una galaxia. La viabilidad de esta técnica se ha demostrado recientemente, capturando la señal de fondo de ondas gravitacionales del Universo utilizando una serie de 67 púlsares de la Vía Láctea.

La colaboración EPTA decidió comprobar la posibilidad de que los púlsares también puedan actuar como detectores de materia oscura. Específicamente, los investigadores buscaron materia oscura ultraligera, la candidata a materia oscura de menos masa, de la que se predice que estaría distribuida de manera no uniforme en toda nuestra galaxia.

Las acumulaciones de partículas crean pozos de potencial gravitacional locales que oscilan en profundidad con un período que depende de las masas de las partículas. Para acumulaciones de materia oscura lo suficientemente grandes, esta oscilación induciría variaciones pequeñas, pero mensurables, en los tiempos de llegada de los pulsos electromagnéticos, imprimiendo un patrón periódico secundario encima de la señal del púlsar.

Al no encontrar un patrón así en los datos de 25 púlsares, la colaboración EPTA ha establecido un límite superior a la posible densidad de materia oscura ultraligera con masas de partículas de 10-24,0 a 10-23,3 eV. Si bien los resultados dejan abierta la posibilidad de que existan partículas de materia oscura ultraligeras de mayor masa en la Vía Láctea, dichas partículas podrían constituir, como máximo, entre el 60% y el 70% de la materia oscura de nuestra galaxia, según el análisis de la colaboración.

Referencia:

Clemente Smarra et al. (European Pulsar Timing Array) (2023) Second Data Release from the European Pulsar Timing Array: Challenging the Ultralight Dark Matter Paradigm Phys. Rev. Lett. 131, 171001 doi: 10.1103/PhysRevLett.131.171001

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Los púlsares imponen un nuevo límite a la materia oscura ultraligera se ha escrito en Cuaderno de Cultura Científica.

La causa de los terremotos marcianos

terremotos marcianos

De todas las misiones que han llegado a la superficie Marte, solo tres han llevado entre su carga científica unos sismómetros: Las Viking Lander 1 y 2 en la década de los 70 y la InSight a finales de la década pasada. Y, desgraciadamente, los datos de las dos primeras podríamos decir que no fueron muy útiles más allá que para descartar una elevada sismicidad global.

Por eso podríamos decir que la primera misión que de verdad nos ha proporcionado una instantánea -sensu lato- de la actividad sísmica en Marte ha sido la InSight durante sus cuatro años de vida, una ventana temporal muy corta, pero que nos ha permitido conocer con más detalle el interior del planeta y testear nuestras hipótesis sobre la actividad geológica del planeta.

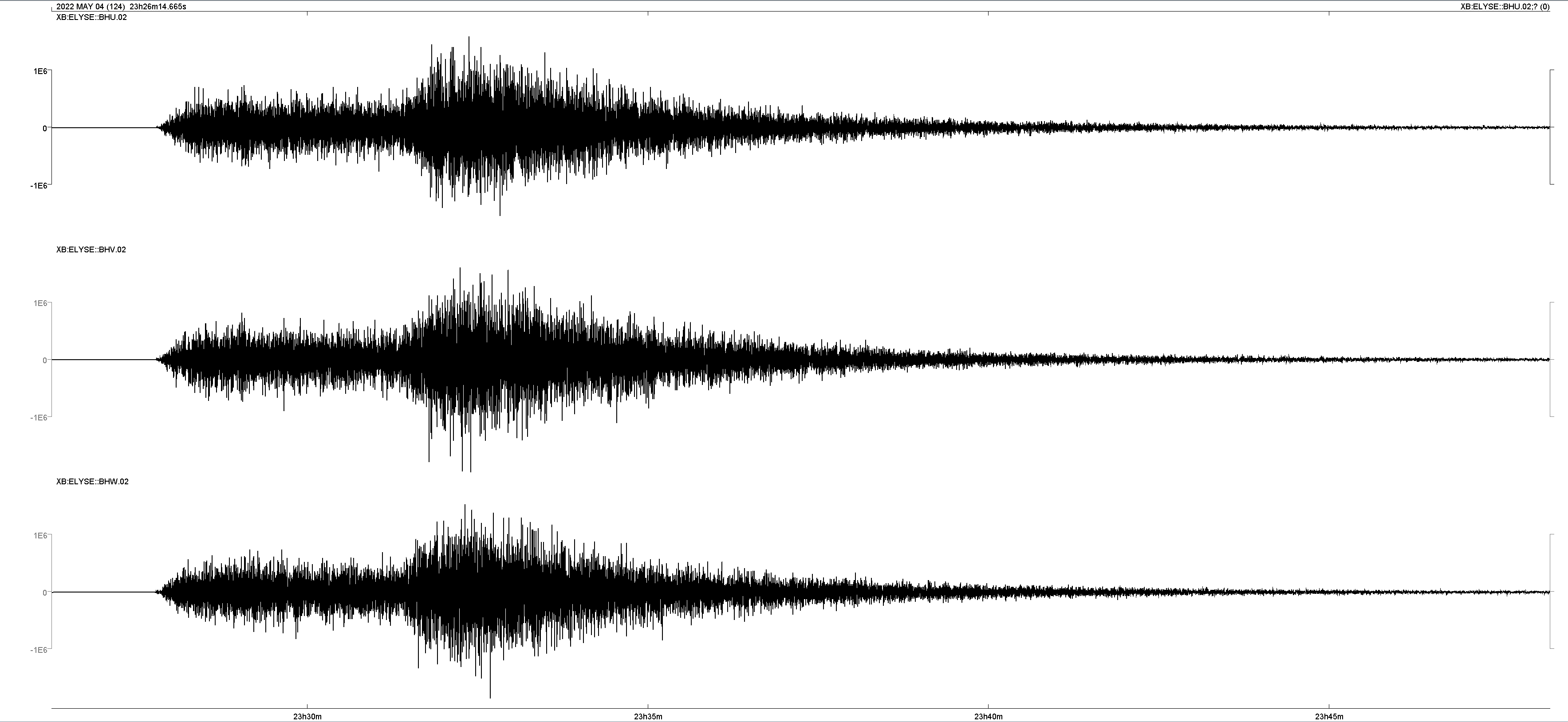

A lo largo de los 1440 días de misión, el sismómetro de la InSight detectó más de 1300 terremotos, algunos de origen tectónico y otros causados por los impactos sobre la superficie del planeta. El 4 de mayo de 2022, un evento sísmico de magnitud 4.7 se ponía en la primera posición de los terremotos de mayor magnitud detectados en el planeta.

Este terremoto hizo vibrar, de una manera perceptible para la InSight, la superficie de Marte durante seis horas. Pero, ¿cuál era su origen? Al ver la forma de las ondas sísmicas recogidas por el sismómetro, los científicos pensaron que estas eran similares a las que se observan cuando algo choca con la superficie de Marte. Un nuevo estudio por Fernando et al. (2023) descartan el origen del impacto como causante del evento sísmico.

Sismograma del evento S1222a. Datos cortesía de InSight Mars SEIS Data Service.

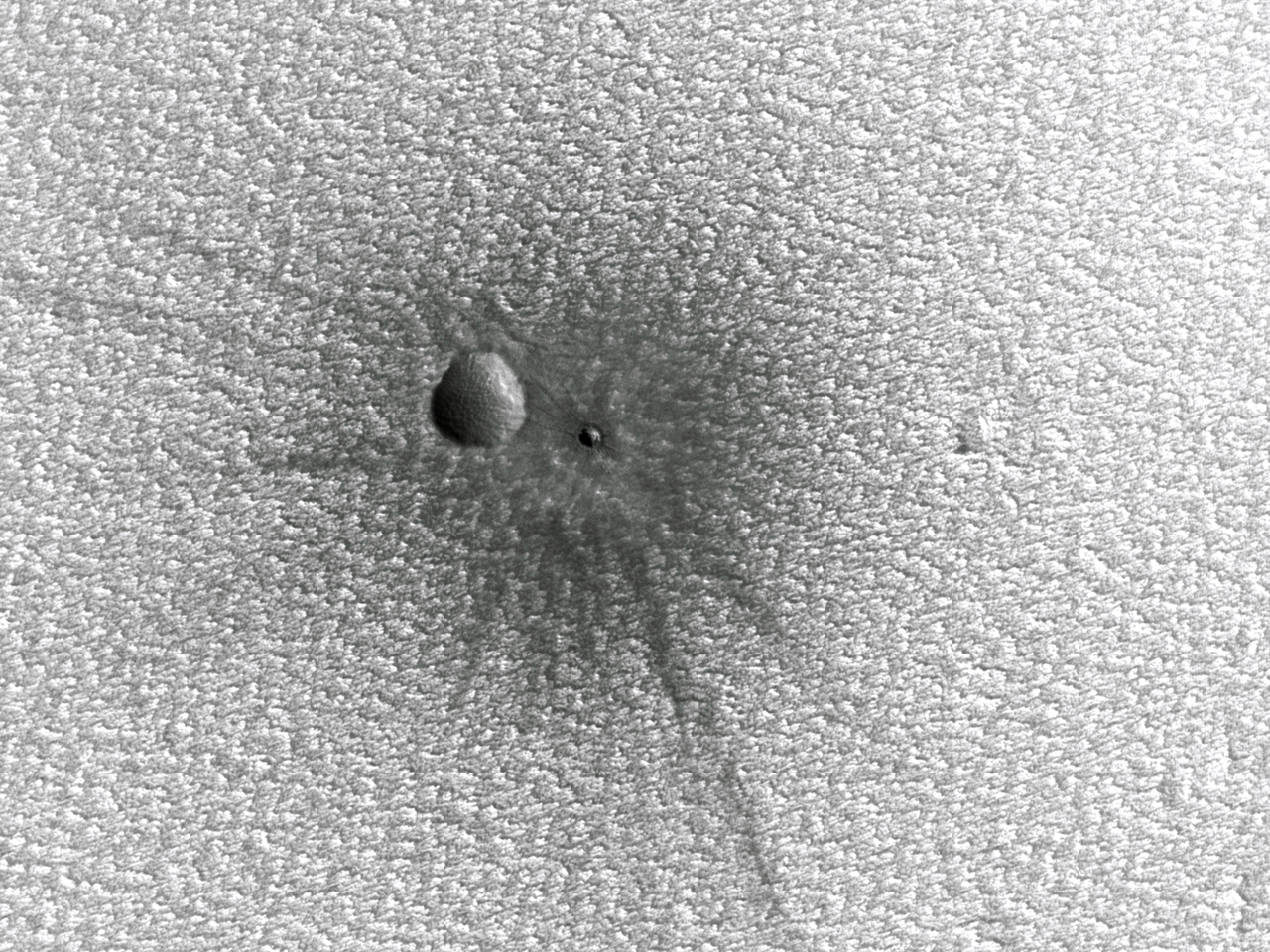

Sismograma del evento S1222a. Datos cortesía de InSight Mars SEIS Data Service.De haber sido el caso de un impacto, el cráter, a la vista de los datos sísmicos, habría medido en torno a unos 300 metros de diámetro y probablemente levantado parte del polvo que tiñe de rojo la superficie de Marte a más de 100 kilómetros de distancia. Dadas las dimensiones, este era un objetivo relativamente fácil para detectar con las misiones que están en órbita alrededor de Marte y puesto que de los datos sísmicos se puede establecer una posición aproximada, también se sabe dónde apuntar las cámaras.

Y digo relativamente fácil porque hay algunas restricciones para fotografiar la superficie: En primer lugar, que los satélites no pasan todos los días por el mismo punto de la superficie. En segundo lugar, hay que solicitar la toma de las imágenes, que normalmente tienen ya un plan preestablecido, ya que en ocasiones no se toman imágenes de la superficie de una manera continua a causa del espacio de almacenamiento en la propia sonda y el ancho de banda disponible para comunicarse y transferirlas a la Tierra.

Un cráter de impacto muy reciente en Marte, algo que se ve claramente por los rayos de eyecta que salen hacia afuera de este. Su diámetro es aproximadamente de 10 metros. Cortesía de NASA/JPL-Caltech/UArizona.

Un cráter de impacto muy reciente en Marte, algo que se ve claramente por los rayos de eyecta que salen hacia afuera de este. Su diámetro es aproximadamente de 10 metros. Cortesía de NASA/JPL-Caltech/UArizona.La búsqueda del posible cráter fue infructuosa, pero tampoco se han encontrado pruebas de que hubiese sido una explosión de un pequeño asteroide en la atmósfera -algo parecido al evento de Chelíabinsk-, ya que tampoco se han detectado en las imágenes tomadas alrededor de esa hora la existencia de cualquier tipo de fenómeno atmosférico relacionado, como podrían ser la presencia de algunas nubes.

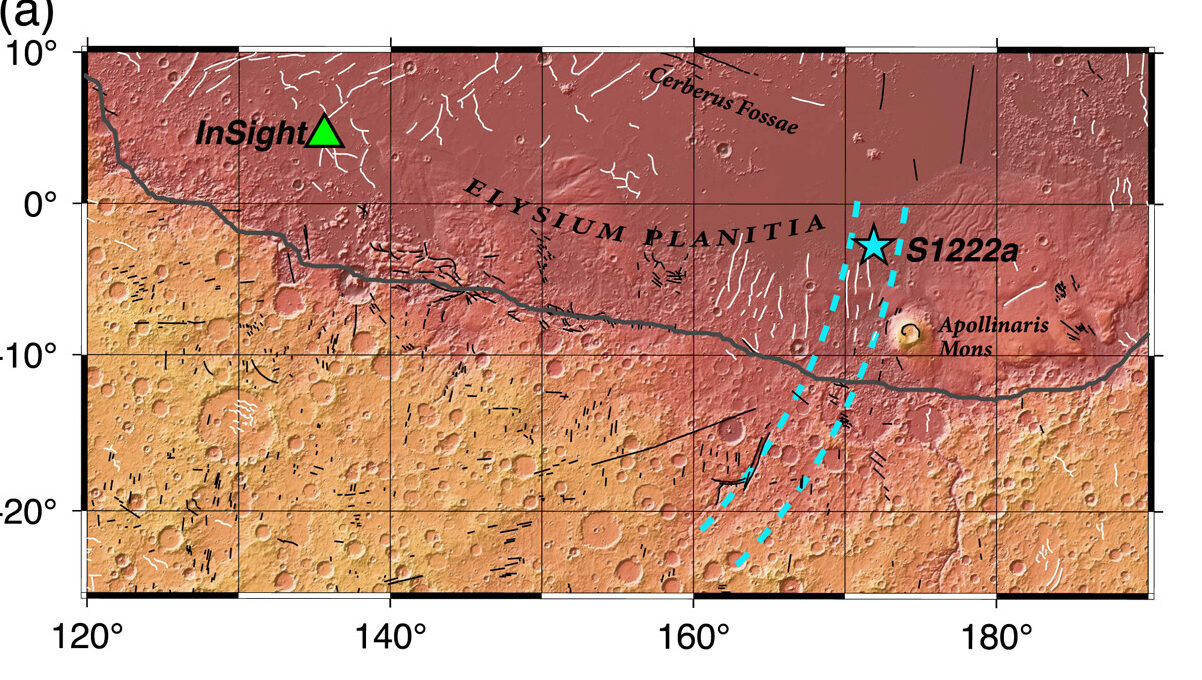

Un estudio ya publicado en agosto de este mismo año por Maguire et al. (2023) sugería que el evento en realidad tuvo un origen tectónico, es decir, en este caso producido por una falla inversa en el entorno de Elysium Planitia y cerca de fallas ya cartografiadas con anterioridad. Estas fallas se formarían por la contracción térmica del planeta y podrían ser uno de los mecanismos más importantes a la hora de producir los terremotos marcianos. Pero tampoco descarta que el terremoto se hubiese producido en las tierras altas marcianas, y que su mecanismo fuese de falla normal, es decir, extensional.

Aunque pueda parecer una tontería el hecho de discriminar si ha sido un terremoto en el sentido más estricto de la palabra o un impacto, lo cierto es que un impacto nos puede también aportar muchas pistas, ya que mientras que un terremoto podemos localizarlo de una peor manera con tan solo una estación sísmica, un impacto -y más si fuese de esta escala- nos permitiría con una gran precisión saber el punto de origen de las ondas sísmicas y con ello, reconstruir mejor la trayectoria de las ondas hasta el sismómetro.

La estrella de color azul muestra el epicentro del evento sísmico S1222a, y las líneas discontinuas en azul muestran la incertidumbre en la posición, de ahí que pueda estar más al norte o más al sur, cambiando la interpretación del mecanismo. Las líneas negras finas se corresponden con las fallas cartografiadas en la zona. Imagen cortesía de Maguire et al. (2023).

La estrella de color azul muestra el epicentro del evento sísmico S1222a, y las líneas discontinuas en azul muestran la incertidumbre en la posición, de ahí que pueda estar más al norte o más al sur, cambiando la interpretación del mecanismo. Las líneas negras finas se corresponden con las fallas cartografiadas en la zona. Imagen cortesía de Maguire et al. (2023).No obstante, este tipo de estudios que nos permiten adscribir una causa a los terremotos detectados son fundamentales: si son por impactos, nos permiten hacernos a la idea de lo habituales que son en la superficie de Marte no solo a escala temporal, sino también en que rango de tamaños nos movemos.

Y si es por la actividad sísmica del planeta, no únicamente nos valen para saber cuánto de “vivo” está Marte, sino que también podemos calibrar la peligrosidad sísmica en el planeta… ¿Y para qué sirve esto?

Más allá de la ciencia básica, que es un pilar fundamental del conocimiento, si en algún momento del futuro establecemos bases con presencia humana en Marte, conocer los riesgos a los que nos enfrentamos y cuáles son los sitios más favorables para situarnos probablemente estos estudios jueguen un papel fundamental en las decisiones que tomemos de cara a la seguridad de estas misiones.

Al mismo tiempo, el desarrollo de nuevos algoritmos de análisis de datos sísmicos aplicados a Marte también podría tener su uso en la Tierra mejorando, por lo tanto, nuestras capacidad de aprovechamiento de los datos sísmicos, así como servir para futuras misiones marcianas y a otros lugares -como Venus- que pudiesen en algún momento tener un sismómetro en su superficie.

Referencias:

-

Fernando, Benjamin, Ingrid J. Daubar, Constantinos Charalambous, Peter M. Grindrod, Alexander Stott, Abdullah Al Ateqi, Dimitra Atri, et al. «A Tectonic Origin for the Largest Marsquake Observed by InSight». Geophysical Research Letters 50, n.º 20 (28 de octubre de 2023): e2023GL103619. doi: 10.1029/2023GL103619.

-

Kawamura, Taichi, John F. Clinton, Géraldine Zenhäusern, Savas Ceylan, Anna C. Horleston, Nikolaj L. Dahmen, Cecilia Duran, et al. «S1222a—The Largest Marsquake Detected by InSight». Geophysical Research Letters 50, n.º 5 (16 de marzo de 2023): e2022GL101543. doi: 10.1029/2022GL101543.

-

Maguire, R., V. Lekić, D. Kim, N. Schmerr, J. Li, C. Beghein, Q. Huang, et al. «Focal Mechanism Determination of Event S1222a and Implications for Tectonics Near the Dichotomy Boundary in Southern Elysium Planitia, Mars». Journal of Geophysical Research: Planets 128, n.º 9 (septiembre de 2023): e2023JE007793. doi: 10.1029/2023JE007793.

-

InSight Mars SEIS Data Service. SEIS raw data, Insight Mission (2016-2022). IPGP, JPL, CNES, ETHZ, ICL, MPS, ISAE-Supaero, LPG, MFSC. doi: 10.18715/seis.insight.xb_2016

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo La causa de los terremotos marcianos se ha escrito en Cuaderno de Cultura Científica.

Moral y mercados

La producción y el comercio de bienes genera a menudo lo que se denominan externalidades negativas, o sea, consecuencias negativas para terceras personas. Entre esas consecuencias, se suelen citar las condiciones laborales peligrosas o insanas, el trabajo infantil, el sufrimiento de animales, o el daño ambiental. Y según algunas interpretaciones, eso ocurre porque, al participar en los mercados, estamos dispuestos a rebajar nuestros estándares morales, dando por buenas situaciones que no aceptaríamos en otros contextos.

Fuente: Ingrid Moen et al (2012) Gene expression in tumor cells and stroma in dsRed 4T1 tumors in eGFP-expressing mice with and without enhanced oxygenation. BMC Cancer. doi:10.1186/1471-2407-12-21

Fuente: Ingrid Moen et al (2012) Gene expression in tumor cells and stroma in dsRed 4T1 tumors in eGFP-expressing mice with and without enhanced oxygenation. BMC Cancer. doi:10.1186/1471-2407-12-21Cuando se crían ratones de laboratorio con alguna característica especial (transgénicos, mutantes en algún gen, o cualquier otra) y si, por las razones que fuere, no son después utilizados, se sacrifican. Salvo por el rasgo que los distingue y que es el motivo por el que fueron criados, son ratones normales y sanos. Se sacrifican porque se considera que no hay razón que justifique el gasto que supondría el mantenerlos con vida.

Veremos a continuación los resultados de cinco experimentos, los más significativos de un estudio que comprendía nueve. Los otros cuatro se hicieron principalmente para dilucidar cuestiones colaterales o de índole metodológica que no afectan al núcleo de las conclusiones. No los he incluido por no alargar en exceso esta anotación.

En un primer experimento a los participantes se les dio a elegir: o permitir que uno de esos ratones sobrantes de los estudios científicos viviese el resto de su vida (unos dos años más) en condiciones cómodas y saludables, o recibir 10€ si estaban dispuestos a que el ratón fuese sacrificado. El 46% de los participantes optaron por los 10 €.

En un segundo experimento, en vez de realizar ofertas individuales, se organizaron mercados bilaterales, formados por parejas en las que al vendedor se le encomendaba la vida del ratón y, tras una serie de regateos o negociaciones (se estableció un máximo de diez rondas de oferta y contraoferta), podía acordar con el comprador la forma de repartirse 20€ a cambio de la vida del ratón. Una vez alcanzado un acuerdo, el vendedor recibiría el precio estipulado y el comprador el resto del dinero hasta los 20 €. Si alguno de los dos no aceptaba participar, ninguno recibía nada. En este experimento, el 72% de los vendedores estuvieron dispuestos a que se sacrificase el ratón a cambio de una cantidad igual o inferior a 10 €.

El tercer experimento era igual que el anterior, pero los mercados eran multilaterales, formados por nueve vendedores y siete compradores. También a lo largo de diez rondas podían hacer ofertas unos a los otros; los precios ofertados eran visibles para todos los participantes pues se proyectaban en una pantalla de manera continua. En este experimento el 76% de los vendedores estuvieron dispuestos a que se sacrificase el ratón a cambio de una cantidad igual o inferior a 10 €.

En el cuarto experimento se ofrecieron a los participantes cantidades crecientes de dinero (con incrementos sucesivos de 2,5 €) a cambio de la vida del ratón. El 43% de los participantes estuvieron dispuestos a aceptar cantidades iguales o inferiores a 10 € a cambio de permitir su sacrificio. Adicionalmente, en este experimento se comprobó que para que un 72% de los participantes aceptasen que el ratón fuese sacrificado (porcentaje que aceptó en el experimento N.º 2 cantidades de 10 € o inferiores), la oferta tuvo que llegar a los 47,5 €. Y para que ese porcentaje fuese del 76% (porcentaje que aceptó en el experimento N.º 3 cantidades de 10 € o inferiores), la oferta debía llegar a 50 €.

En el quinto experimento se reprodujo el N.º 3, solo que en este no era la vida del ratón la que estaba en juego, sino un cupón para adquirir bienes en la tienda de la universidad. Esto es, lo que estaba en juego no era un valor moral, sino un valor material. Este experimento permitió comprobar que mientras la vida del ratón iba perdiendo valor de una ronda a la siguiente (de las 10 en las que se regateaba), el valor del cupón se mantuvo constante. La vida del ratón empezó valiendo 6’4 € y acabó en 4,5 €.

Llegados a este punto habrá quien objete que el comportamiento de las personas dependería mucho de su situación económica particular. Y seguramente así es, pero en estos experimentos, las personas que participan se encuentran en situaciones similares, por lo que ese posible efecto está descartado a priori.

Otros objetarán que la vida de un ratón no tiene ningún valor en términos morales. Pero tanto si la tiene como si no, lo que se hace en estos experimentos es comparar. En principio cabe suponer que la consideración moral de la muerte o el mantenimiento con vida de un ratón es algo que no debería variar entre unas condiciones experimentales y otras. O sea, si la vida de un ratón es o no un bien moral que debe preservarse, no debería depender de que la persona concernida actúe en privado o lo haga en un mercado.

Sin embargo, estos resultados confirman que, al menos bajo las condiciones utilizadas en este trabajo y por comparación con las decisiones que se toman en la esfera individual, el mercado tiende a erosionar valores morales. Los autores del trabajo proponen que hay tres tipos de razones para que esa erosión ocurra. En primer lugar, para cerrar un trato, en los mercados se requiere el concurso de, al menos, dos personas, por lo que la responsabilidad y los posibles sentimientos de culpa se pueden compartir y, por lo tanto, pueden perder intensidad. En segundo lugar, la interacción en el mercado proporciona información acerca de las normas que prevalecen en la sociedad. Al fin y al cabo, el observar a otros comerciar e ignorar los estándares morales puede hacer que la búsqueda en exclusiva del interés propio se considere éticamente permisible. Y en tercer lugar, los mercados hacen que se ponga el foco en aspectos tales como el regateo, la negociación y la competencia, lo que puede distraer la atención de las posibles consecuencias adversas y de las implicaciones morales del comercio.

Así pues, si estas conclusiones son extrapolables al mundo real, al de la producción e intercambios de bienes y servicios en la vida real, sería cierto que el mercado, por comparación con las acciones individuales, rebaja los estándares morales.

Referencia

Armin Falk, Nora Szech, Morals and Markets. Science 340, 707-711 (2013). DOI:10.1126/science.1231566

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Moral y mercados se ha escrito en Cuaderno de Cultura Científica.

¡Ups! La fusión fría

fusión fría

En la práctica científica también existe lo que se denomina «ciencia patológica». Es aquella que se realiza por personas que creen que lo están haciendo bien, pero que se están autoengañando. Un ejemplo de ello es el ocurrido el 23 de marzo de 1989, cuando los estadounidenses Stanley Pons y Martin Fleischmann, en una rueda de prensa anunciaron que habían conseguido reacciones nucleares de fusión a temperatura ambiente («fusión fría») después de años trabajando en ello en secreto. El anuncio dio la vuelta al mundo. Aquel invento podía solucionar los problemas energéticos del mundo entero, de manera económica y sostenible. Pero cuando científicos de todo el mundo se pusieron a replicar el experimento, ni uno solo obtuvo una fusión nuclear.

Los vídeos de ¡UPS¡ presentan de forma breve y amena errores de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se han emitido en el programa de ciencia Órbita Laika (@orbitalaika_tve), en la 2 de RTVE.

Producción ejecutiva: Blanca Baena

Guion: José Antonio Pérez Ledo

Grafismo: Cristina Serrano

Música: Israel Santamaría

Producción: Olatz Vitorica

Doblaje: K 2000

Locución: José Antonio Pérez Ledo

Edición realizada por César Tomé López

El artículo ¡Ups! La fusión fría se ha escrito en Cuaderno de Cultura Científica.

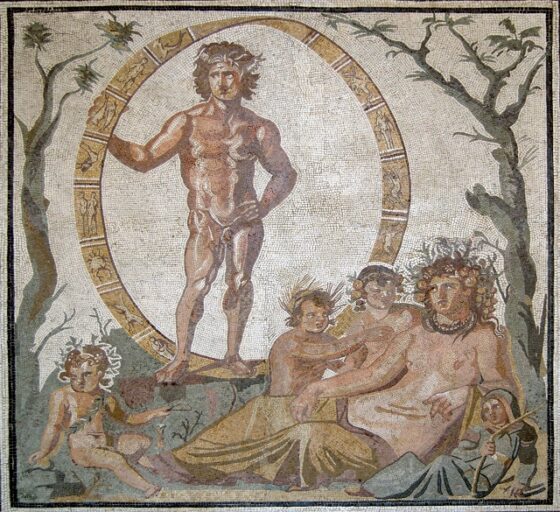

El Imperio romano en el que (se supone) piensan los hombres

Imperio romano

Foto: Ilona Frey / Unsplash

Foto: Ilona Frey / UnsplashPienso a diario en el Imperio romano. Puede que algún día concreto haya conseguido no hacerlo, pero temo que haya sido una extraña excepción. Conozco, además, a un número considerable de mujeres que también piensan en ello, probablemente tan a menudo o más.

Esto no trata de ser un alegato machirulo con la típica coletilla de “ellas también lo hacen…”. Hay una explicación más simple: como historiador de la Antigüedad he tenido la oportunidad de conocer a un buen número de historiadoras, clasicistas, arqueólogas, investigadoras y divulgadoras expertas en la antigua Roma. Si algo sabemos quienes nos dedicamos a reflexionar sobre ello a nivel profesional es que se trata de uno de los periodos históricos que más interés suscita entre las sociedades occidentales.

Viralidad romana en TikTokCuando hace un año la influencer sueca Saskia Cort planteaba en Instagram la pregunta “¿qué comen y en qué piensan los hombres heterosexuales?” no podía imaginar que doce meses después desembocaría en una tendencia viral de TikTok de alcance global.

Una de sus seguidoras dio una respuesta ciertamente inesperada: “Le pregunté a mi novio. Dice que o piensa en nada o piensa en el Imperio romano”. El tema tuvo cierto tirón en redes y medios suecos en septiembre de 2022, pero no alcanzaría el impacto global hasta después del pasado agosto.

Entonces, el recreacionista sueco “Gaius Flavius” publicó un vídeo en el que podía leerse en inglés: “Señoras, muchas de ustedes no se dan cuenta de la frecuencia con la que los hombres piensan en el Imperio romano. Pregunten a su marido/novio/padre/hermano: ¡les sorprenderán sus respuestas!”.

Con el paso de los días TikTok se convirtió en un hervidero de vídeos de mujeres preguntando a sus allegados varones por la cuestión. Las sorprendentes respuestas que daban acabaron por convertir la etiqueta #RomanEmpire en la tendencia del momento.

Tras publicarse la noticia en The Washington Post, replicada por medios diversos como Time, Cosmopolitan o Financial Times, y con la participación “estelar” de Elon Musk admitiendo pensar cada día en el Imperio romano, la polémica ha sido vox populi durante la segunda quincena de septiembre.

Viñetas, reels, memes y vídeos parodiando la cuestión o ganchos publicitarios han inundado las redes. El fenómeno se ha generalizado de tal manera que “este es mi Imperio romano” se ha convertido en una expresión común y reconocible para señalar algo en lo que se piensa de forma constante.

La Antigüedad hoy en díaEsta frenética tendencia puede parecer una moda banal y pasajera (y en buena medida así es), pero al mismo tiempo es un material de trabajo muy interesante desde el punto de vista de los estudios de género y de recepción de la Antigüedad.

Estos últimos son una de las líneas más actuales e innovadoras de investigación dentro de las denominadas Ciencias de la Antigüedad. Actualmente ya no solo investigamos para entender e interpretar ese pasado a partir de los restos conservados (textos, restos arqueológicos, etc.). También hemos comenzado a prestar una atención considerable a cómo y por qué las sociedades “postclásicas”, desde la Edad Media hasta el presente, han imaginado, recreado y reinventado la Antigüedad.

Fotograma de la serie Roma de HBO.

Fotograma de la serie Roma de HBO.HBO

Proyectos de investigación como ANIHO, ANTIMO, IMAGINES o Marginalia Classica se están dedicando a analizar el impacto que han tenido y siguen teniendo en nuestra percepción del pasado romano medios como la pintura histórica, la ópera, las novelas, el cine y la televisión, el cómic o los videojuegos. En este ejercicio de reflexión está la clave para comprender esta polémica y las dinámicas de las redes sociales son sin duda un novedoso objeto de estudio.

En concreto, películas tan influyentes como Gladiator, y series como Roma o Spartacus han popularizado una imagen de la antigua Roma totalmente estereotipada y reduccionista.

La guerra es un elemento central y omnipresente en esas producciones, junto con los espectáculos violentos como las luchas de gladiadores. No es casualidad que buena parte de las noticias sobre la tendencia viral hayan sido ilustradas con imágenes de estos filmes. El legionario y el gladiador son las dos figuras más icónicas y el merchandising turístico y las tiendas de souvenires en la Roma actual confirmarían esta percepción popular. Asimismo, el poder desmedido de los emperadores, la corrupción o las orgías serían otros de los grandes tópicos sobre ese periodo histórico.

¿Era Roma tan masculina como creemos?La polémica ha permitido a historiadoras como Mary Beard, Patricia González Gutiérrez, Casey Haughin-Scasny o Paloma Martín-Esperanza, entre otras, exponer algunas de las razones profundas que se esconden detrás de una idea “hipermasculinizada” de la Antigüedad romana y del afán por imaginar ese pasado como un espacio seguro de la machoesfera.

Por un lado, todas coinciden en la importancia de medios populares como el cine en la conformación de esta imagen. Por otro, subrayan que, si bien Roma era una sociedad eminentemente patriarcal, fue igualmente una sociedad en constante evolución, compleja y diversa, con unos parámetros sobre el género, la sexualidad o las dinámicas de poder que no serían tan familiares ni monolíticos como se ha podido pensar. El arqueólogo y divulgador Mikel Herrán resumía está idea de una forma muy directa y accesible: “ese Imperio romano en el que piensan los bros es una versión muy limitada de lo que fue la antigua Roma”.

Coinciden igualmente en que esta imagen prototípica es solo la forma actual de una larga “cadena de recepciones”. Es decir, hunde sus raíces en toda una serie de momentos de la historia en los que diversas sociedades han puesto sus ojos en el pasado romano en busca de inspiración, con afán de emular su supuesta grandeza y sus logros civilizatorios, pero también para encontrar precedentes a los males de su tiempo.

Se ha hablado de momentos clave como el Renacimiento, la Ilustración, el fascismo italiano o el “Imperio estadounidense”, pero lo cierto es que mirar a la antigua Roma como espejo del presente puede rastrearse prácticamente a lo largo de toda la historia de Occidente. También en contextos trascendentales tan recientes como la crisis del coronavirus, el asalto al Capitolio en enero de 2021 o la guerra entre Rusia y Ucrania.

Un aspecto central en los estudios de recepción es atender al contexto socio-cultural y político que explique un determinado acercamiento a la Antigüedad. En el caso de la tendencia actual nos encontramos ante unas sociedades occidentales que observan el declive de su hegemonía en un mundo globalizado y cada vez más multipolar. Una sociedad en la que la lucha feminista transinclusiva ha logrado avances considerables en los últimos años, mientras que la reacción machista está siendo visceral.

En este sentido, un debate sexista del estilo “pensamientos de hombres vs. pensamientos de mujeres” simplificaría la compleja diversidad que plantean las cuestiones de género. Este es el caldo de cultivo para apelar a una idea nostálgica de un supuesto pasado glorioso, un mundo clásico como cuna de Occidente, en el que los hombres (blancos y heterosexuales) eran machos alfa y las mujeres no cuestionaban su papel en la sociedad. Una apropiación interesada del pasado que la extrema derecha de muchos países, aunque no en exclusiva, está explotando con asiduidad.

No sabemos cuál será la próxima “gran polémica” en la que la antigua Roma volverá a estar en el centro de la atención mediática. Creo no equivocarme si auguro dos certezas. En primer lugar, no será la última. Y en segundo, independientemente de la forma que adopte, dirá más sobre nuestras inquietudes del presente que sobre las complejas realidades del pasado.![]()

Sobre el autor: Oskar Aguado-Cantabrana, Investigador posdoctoral Departamento de Estudios Clásicos, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo El Imperio romano en el que (se supone) piensan los hombres se ha escrito en Cuaderno de Cultura Científica.

¿Géiser urbano?

En situaciones de lluvias muy intensas o tormentas con abundantes descargas de agua en breves periodos de tiempo sobre zonas urbanas, donde los sistemas de alcantarillado ya no pueden recibir más volumen de agua o, incluso, se rompen las canalizaciones y el agua sale a presión a superficie como un gran chorro sobre las aceras o el asfalto, la primera frase que nos viene a la mente a todo el mundo es “se ha formado un géiser en mitad de la ciudad”. Pero, ¿realmente esto es un géiser? Pues, como en otras ocasiones, vengo aquí con el manual de Geología debajo del brazo para desmentir esta afirmación.

Salida de agua caliente a presión en el géiser Old Faithful del Parque Nacional de Yellowstone, Estados Unidos. Fotografía de Jacob W. Frank, National Park Service, tomada de www.usgs.gov

Salida de agua caliente a presión en el géiser Old Faithful del Parque Nacional de Yellowstone, Estados Unidos. Fotografía de Jacob W. Frank, National Park Service, tomada de www.usgs.govEn pocas palabras, un géiser es una abertura del terreno por la que surge un chorro de aguas subterráneas en estado líquido a mucha presión y muy calientes, con una temperatura cercana al punto de ebullición, así que también es frecuente que se produzca la salida de agua en estado gaseoso (vapor). El foco de calor que provoca este calentamiento del agua es una cámara magmática situada en el subsuelo a poca profundidad, por lo que los géiser aparecen en zonas volcánicas. Su funcionamiento es sencillo: el agua subterránea circula por el subsuelo pasando cerca de una cámara magmática que va a provocar que aumente su temperatura; esta agua caliente, al disminuir su densidad, va a tender a ascender hacia la superficie; cuando encuentra una chimenea o tubo volcánico, es decir, una especie de tubería cilíndrica formada por la erupción de antiguos magnas que tenga salida al exterior, el agua caliente circulará por ella con mucha presión y velocidad; finalmente, esa agua saldrá a la superficie en forma de una enorme surgencia o chorro que puede alcanzar varios metros de altura. Como curiosidad final, decir que géiser procede de la palabra islandesa geysa, que significa emanar, y que da nombre a una de estas surgencias de agua caliente, la fuente Geysir, que se encuentra en el Valle de Haukadalur, al sur de Islandia.

Piscina de aguas termales del balneario de Solares, Cantabria. Imagen tomada de Castilla termal

Piscina de aguas termales del balneario de Solares, Cantabria. Imagen tomada de Castilla termalLos géiseres no son los únicos eventos geológicos por los que se produce la salida de aguas subterráneas calientes al exterior. De hecho, las más comunes son las fuentes, surgencias o manantiales de aguas termales. En este caso, no es necesaria la presencia de una fuente de calor, como una cámara magmática, para elevar la temperatura del agua subterránea, sino que este calentamiento se produce debido al gradiente geotérmico. Con este término se conoce a una propiedad de nuestro planeta por la cual, a medida que aumentamos en profundidad en el interior de la Tierra, se incrementa la temperatura, en un promedio de unos 30 °C cada kilómetro. Por este motivo, las aguas subterráneas que circulan a cierta profundidad se calentarán de forma natural, saliendo al exterior en esta ocasión a través de fracturas del terreno. Para que un agua se considere termal, su temperatura tiene que ser de entre 10 °C y 15 °C superior a la de otras surgencias de agua superficial que haya en esa zona y que no se hayan calentado en profundidad. Es decir, que si tenemos varias fuentes de agua en un lugar que salen al exterior a 10 °C, para que una de ellas fuese considerada un agua termal debería hacerlo, al menos, a 20-25°C. En nuestras latitudes, las surgencias termales suelen alcanzar los 30-40 °C de temperatura, por lo que han sido empleadas desde la antigüedad como aguas medicinales mediante el baño en termas y balnearios.

Fumarolas del volcán Tajogaite durante su erupción a finales de 2021 estudiadas sobre el terreno por personal del Instituto Geológico y Minero de España (IGME-CSIC)De manera general, existe un último tipo de surgencias de aguas termales que son las fumarolas. En este caso volvemos a encontrarnos en un ambiente volcánico con cámaras magmáticas como focos caloríficos, pero, en esta ocasión, las aguas subterráneas alcanzan una temperatura superior al punto de fusión, debido a lo cual lo que sale al exterior a través de los tubos volcánicos es vapor de agua, muchas veces acompañado de otros gases formados por la actividad magmática. Estas fumarolas no sólo se producen en tierra firme, también aparecen en los fondos oceánicos debido a la actividad volcánica submarina. Entonces las denominamos fumarolas o chimeneas hidrotermales y son muy comunes en áreas profundas de los océanos cercanas a zonas tectónicamente activas como las dorsales oceánicas.

Chimeneas hidrotermales en los fondos marinos del Pacífico, en la fosa de las Marianas, grabadas durante una exploración oceanográfica de la Oficina Nacional de Administración Oceánica y Atmosférica de los Estados Unidos de América (National Oceanic and Atmospheric Administration, NOAA)La importancia de estas fuentes de aguas termales no solo radica en su curiosidad científica que nos permite conocer, de manera indirecta, el comportamiento interno de nuestro planeta o en su llamativa belleza, en especial la de los géiser, que puede fomentar el turismo en las zonas donde se producen, sino también en sus aplicaciones directas para la sociedad. Ya he comentado el aprovechamiento de estas surgencias como aguas medicinales en termas o balnearios, pero no es la única. La más importante es la utilización de estas aguas termales de zonas volcánicas como generadoras de energía geotérmica, una nueva fuente de energía sostenible, renovable y siempre disponible basada en el aprovechamiento del calor interno del planeta para generar electricidad utilizando fluidos calientes que circulen por turbinas.

Otra aplicación muy interesante es la búsqueda de zonas de surgencias hidrotermales como posibles fuentes de recursos minerales críticos para el desarrollo tecnológico actual. El agua subterránea caliente es capaz de capturar los elementos químicos presentes en las rocas por las que circula en profundidad, transportándolos en disolución. Cuando estas aguas salen al exterior, ya sea en tierra firme o en los fondos marinos, al disminuir su temperatura bruscamente pierden esa capacidad de transportar elementos, provocando su precipitación en zonas cercanas a donde se producen las surgencias. Así se generan acumulaciones de minerales ricos en calcio, silicio, cobre, hierro, azufre, manganeso y un largo etcétera, incluidas las tierras raras. Además, estas zonas tienen un importante interés biológico, ya que suelen ser el hábitat perfecto para el desarrollo de organismos extremófilos, principalmente de los tipos termófilos y quimiosintéticos, lo que ha llevado a considerar las fuentes hidrotermales submarinas como uno de los posibles escenarios en los que surgió la vida en nuestro planeta.

Así que, la próxima vez que veamos saltar la tapa de una alcantarilla en la calle y salir un enorme chorro de agua, mejor decimos “se ha formado una bonita surgencia de agua a presión en mitad de la ciudad” ahorrándonos llamarla géiser. Salvo que estemos en una localidad con actividad volcánica subterránea y esa agua expulsada tenga una temperatura cercana a los 100°C, donde ya tendríamos que discutir si es un evento natural o si se ha reventado una tubería de agua caliente.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo ¿Géiser urbano? se ha escrito en Cuaderno de Cultura Científica.

Évariste Galois, el ‘Rimbaud’ de las matemáticas

Évariste Galois (1811-1832) nació un 25 de octubre, hace 212 años. Le rendimos homenaje a través del siguiente retrato alfabético escrito solo con veinte letras, aludiendo a los años que tenía el matemático cuando falleció.

Évariste Galois hacia 1826. Fuente: Wikimedia Commons.

Évariste Galois hacia 1826. Fuente: Wikimedia Commons.

Álgebra

Galois fue el primero en usar la palabra groupe (grupo) en un sentido cercano al actual. Por ello se le considera uno de los fundadores de la rama del álgebra conocida como teoría de grupos.

Billette, Geneviève

La dramaturga Geneviève Billette estrenó en 2011 su obra Contre le temps (Contra el tiempo), precisamente en el año en el que se conmemoraba el centenario del nacimiento de Évariste Galois. Puede leerse una breve reseña en este mismo blog.

Clase de álgebra

Falto de recursos, Galois ofertó un curso público de álgebra superior el 13 de enero de 1831. Lo anunciaba de esta manera:

Ce cours aura lieu tous les jeudis, à une heure et quart ; il est destiné aux jeunes gens qui, sentant combien est incomplète l’étude de l’algèbre dans les collèges, désirent approfondir cette science. Le cours se composera de théories dont quelques-unes sont neuves et dont aucune n’a jamais été exposée dans les cours publics. [Este curso tendrá lugar todos los jueves, a la una y cuarto; está destinado a jóvenes que, sintiendo lo incompleto que resulta el estudio del álgebra en la universidad, deseen profundizar en esta ciencia. El curso constará de teorías, algunas de las cuales son nuevas y ninguna de las cuales ha sido presentada en cursos públicos].

La primera lección reunió a una treintena personas interesadas; el curso duró unas pocas sesiones.

Duelo

Galois falleció el 31 de mayo de 1832. El día anterior, a primera hora de la mañana, el matemático fue alcanzado por una bala en un duelo de pistolas eventualmente provocado por una breve aventura amorosa.

Ecuación (algebraica)

Galois demostró que la solución algebraica de una ecuación polinómica está relacionada con la estructura de un grupo de permutaciones asociado a las raíces del polinomio, el grupo de Galois de dicho polinomio.

Fourier, Joseph

Galois redactó los resultados de su investigación y los presentó en febrero de 1830 a la Académie des sciences para optar al gran premio de matemáticas. Joseph Fourier, Secretario Permanente de Matemáticas, se llevó el manuscrito a casa para examinarlo. Pero falleció el 16 de mayo y el manuscrito se perdió. Niels Henrik Abel (a título póstumo) y Carl Gustav Jakob Jacobi se llevaron el premio ese año.

Gérard (de Nerval)

El poeta Gérard de Nerval (1808-1855) estuvo brevemente encarcelado en la prisión de Sainte-Pélagie junto a algunos de sus colegas del grupo Bouzingo al ser tomados por conspiradores durante una manifestación. Fue encarcelado en febrero de 1832 y puesto en libertad a principios de abril de 1832.

El 14 de julio de 1831, Galois fue detenido durante una manifestación contra el recién coronado Luis Felipe I y encarcelado en la prisión de Sainte-Pélagie hasta el 29 de abril de 1832.

Así, Nerval y Galois coincidieron durante un tiempo en este centro penitenciario. En Mes Prisons (1841), el escritor hablaba de su salida de la cárcel:

Il était cinq heures. L’un des convives me reconduisit jusqu’à la porte, et m’embrassa, me promettant de venir me voir en sortant de prison. Il avait, lui, deux ou trois mois à faire encore. C’était le malheureux Gallois, que je ne revis plus, car il fut tué en duel le lendemain de sa mise en liberté. [Eran las cinco. Uno de los comensales me acompañó hasta la puerta, y me abrazó, prometiéndome venir a visitarme al salir de la cárcel. A él le quedaban dos o tres meses por cumplir aún. Es al desdichado Galois al que no volví a ver, ya que murió en un duelo al día siguiente de su puesta en libertad].

Humor

Con un fino sentido del humor, el 1 de abril de 2011, Aurélien Alvarez y Michèle Audin publicaron en el sitio Images des mathématiques el artículo titulado Il y a cent quarante ans : la mort de Galois (Hace ciento cuarenta años: la muerte de Galois). En él explicaban que, el día 3 de abril de 1871, Galois salía de su casa tras haber finalizado la demostración de un teorema, y caía abatido por una bala durante las revueltas de la Comuna de París. Galois fallecía así con 60 años. Por supuesto, se trataba de una broma para celebrar Le Poisson d’Avril.

Integrales (abelianas)

Galois realizó algunas contribuciones a la teoría de integrales abelianas y las fracciones continuas.

Je (n’ai pas le temps)

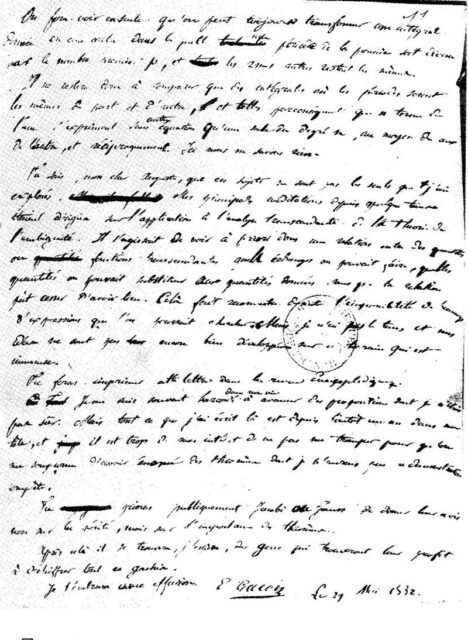

Intuyendo su muerte, el 29 de marzo de 1832, Galois escribió una carta a su amigo Auguste Chevalier. En ella intentaba transmitir un resumen de su trabajo científico. Ese testamento en forma de carta terminaba así:

… je n’ai pas le temps et mes idées ne sont pas encore bien développées sur ce terrain qui est immense. [… no tengo tiempo y mis ideas no están aún bien desarrolladas en este terreno que es inmenso].

Última página de la carta de Galois a Auguste Chevalier. Fuente: Wikimedia Commons.

Última página de la carta de Galois a Auguste Chevalier. Fuente: Wikimedia Commons.

Liouville, Joseph

El 4 de septiembre de 1843 Joseph Liouville anunció a la Académie des sciences que acababa de encontrar en los trabajos de Galois transmitidos por Auguste Chevalier (ver [J]) una solución tan exacta como profunda al problema de la resolución de ecuaciones por radicales.

Memoria

El académico Siméon Denis Poisson aconsejó a Galois que escribiera una nueva versión de la memoria presentada (y perdida) a Fourier en 1930 [ver F]. El 4 de julio de 1931, Poisson y Sylvestre François Lacroix publicaron su informe:

… Nous avons fait tous nos efforts pour comprendre la démonstration de Galois. Ses raisonnements ne sont ni assez clairs ni assez développés pour que nous ayons pu juger de leur exactitude… On peut attendre que l’auteur ait publié en entier son travail pour se former une opinion définitive… ; pour le moment nous ne pouvons pas vous proposer d’y donner votre approbation. [… Hemos hecho todo lo posible para comprender la demostración de Galois. Su razonamiento no es lo suficientemente claro ni lo suficientemente desarrollado para que podamos juzgar su exactitud… Podemos esperar hasta que el autor haya publicado su obra íntegramente para formarnos una opinión definitiva…; Por el momento no podemos ofrecerle su aprobación].

No llores…

Ne pleure pas, j’ai besoin de tout mon courage pour mourir à vingt ans. [No llores, necesito todo mi coraje para morir a los veinte años].

Estas fueron las palabras que le dijo a su hermano menor Alfred poco antes de fallecer.

Fue enterrado en la fosa común del cementerio de Montparnasse el 2 de junio de 1832, sin su familia presente.

Oculta (cara)

Galois es el nombre de un gran cráter de impacto situado en la cara oculta de la Luna.

Profesores

El 2 de enero de 1831, en la Gazette des écoles, se publicó una carta de Galois titulada Sur l’enseignement des sciences, sous-titrée Des professeurs. Des ouvrages. Des examinateurs [Sobre la enseñanza de las ciencias, subtitulada Profesores. Libros. Examinadores]. En ella el matemático denunciaba la mediocridad de la enseñanza a los estudiantes:

Quand leur laissera-t-on du temps pour méditer cet amas de connaissances… pourquoi les examinateurs ne posent-ils les questions aux candidats que d’une manière entortillée ? Il semblerait qu’ils craignissent d’être compris de ceux qu’ils interrogent… Croit-on donc la science trop facile ? [¿Cuándo se les dejará tiempo para meditar sobre este montón de conocimientos?… ¿por qué los examinadores sólo hacen preguntas a los candidatos de manera enredada? Parece que temen ser comprendidos por aquellos a quienes examinan… ¿Creemos por lo tanto que la ciencia es demasiado fácil?].

Richard, Louis Paul Emile

El profesor Louis Paul Émile Richard (1795-1849) enseñó matemáticas en diferentes centros, ganándose una gran reputación por sus cursos y por la buena tasa de éxito de sus estudiantes en el examen de ingreso en la prestigiosa École polytechnique. Galois fue uno de sus alumnos durante el curso 1828-1829. Richard dijo de él a finales de 1828, en uno de sus informes trimestrales:

Cet élève a une supériorité marquée sur tous ses condisciples. [Este estudiante posee una marcada superioridad sobre todos sus compañeros de clase].

Société des Amis du Peuple

El 10 de noviembre de 1830 Galois ingresó en la asociación republicana Société des Amis du Peuple.

Teoría (de Galois)

La teoría de Galois relaciona la teoría de cuerpos con la teoría de grupos.

Veintiséis

Galois nació tal día como hoy hace 212 años. Además, 212 es la suma de los 26 primeros valores de la función φ de Euler.

Weil, Hermann

Hermann Weyl dijo sobre la carta de Galois a su amigo Auguste Chevalier (ver [J]):

This letter, if judged by the novelty and profundity of ideas it contains, is perhaps the most substantial piece of writing in the whole literature of mankind. [Esta carta, si se juzga por la novedad y profundidad de las ideas que contiene, es quizás el escrito más sustancial de toda la literatura de la humanidad].

Referencias

- J.-P. Escofier, Biographie d’Évariste Galois, Bicentenaire de la naissance d’Évariste Galois, IHP

- John J. O’Connor and Edmund F. Robertson, Évariste Galois, MacTutor History of Mathematics Archive, University of St Andrews

- Évariste Galois, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Évariste Galois, el ‘Rimbaud’ de las matemáticas se ha escrito en Cuaderno de Cultura Científica.

Estas células generan electricidad en el encéfalo. No son neuronas.

Durante décadas los investigadores han debatido si las células encefálicas llamadas astrocitos pueden emitir señales como las neuronas. Se ha publicado recientemente la mejor evidencia hasta el momento de que algunos astrocitos son parte de la conversación eléctrica.

Un artículo de Laura Dattaro. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

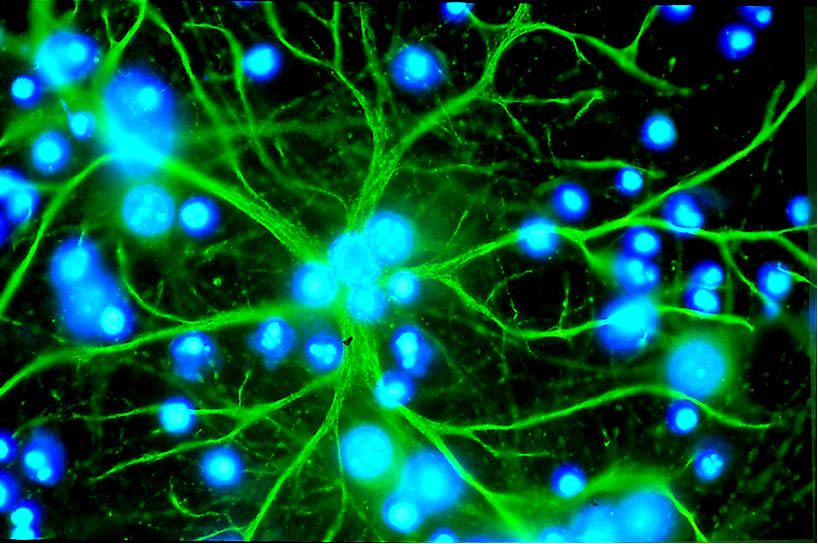

Nuevas pruebas sugieren que algunos astrocitos pueden estimular señales eléctricas tal como lo hacen las neuronas. Fuente: : Alliance Européenne Dana pour le Cerveau / Wikimedia Commons

Nuevas pruebas sugieren que algunos astrocitos pueden estimular señales eléctricas tal como lo hacen las neuronas. Fuente: : Alliance Européenne Dana pour le Cerveau / Wikimedia CommonsUn encéfalo no es nada si no es comunicativo. Las neuronas son las parlanchinas de este órgano conversacional y se comunican entre sí intercambiando pulsos de electricidad utilizando mensajeros químicos llamados neurotransmisores. Al repetir este proceso miles de millones de veces por segundo, el cerebro convierte grupos de sustancias químicas en acciones coordinadas, recuerdos y pensamientos.

Los investigadores estudian cómo funciona el cerebro poniendo la oreja en esa conversación química. Pero las neuronas hablan tan alto y con tanta frecuencia que si hay otras voces más bajas puede resultar difícil escucharlas.

Durante la mayor parte del siglo XX, los neurocientíficos coincidieron en gran medida en que las neuronas son las únicas células encefálicas que propagan señales eléctricas. Se pensaba que todas las demás células encefálicas, llamadas glía, cumplían funciones puramente de apoyo. Entonces, en 1990, surgió un fenómeno curioso: los investigadores observaron un astrocito, un subtipo de célula glíal, que respondía al glutamato, el principal neurotransmisor que genera actividad eléctrica.

En las décadas posteriores, los equipos de investigación han presentado pruebas contradictorias: algunos informando que los astrocitos envían señales y otros replicando que definitivamente no lo hacen. El desacuerdo se manifestó en conferencias y en una revisión tras otra de la evidencia. Las dos partes parecían irreconciliables.

Un nuevo artículo publicado en Nature en septiembre presenta la mejor prueba hasta ahora de que los astrocitos pueden emitir señales, recopilada durante ocho años por un equipo codirigido por Andrea Volterra, profesor visitante en el Centro Wyss de Bio y Neuro Ingeniería en Ginebra, Suiza. El estudio incluye dos pruebas clave: imágenes de glutamato fluyendo desde los astrocitos y datos genéticos que sugieren que estas células, denominadas astrocitos glutamatérgicos, tienen la maquinaria celular para utilizar el glutamato como lo hacen las neuronas.

El artículo también ayuda a explicar las décadas de hallazgos contradictorios. Debido a que sólo algunos astrocitos pueden realizar esta señalización, ambos lados de la controversia tienen, en cierto sentido, razón: los resultados de un investigador dependen de qué astrocitos muestrea.

«Este estudio es genial porque proporciona una explicación de por qué ambos conjuntos de datos existían y eran contradictorios», comenta Christopher Dulla, profesor de neurociencia en la Universidad Tufts que estudia la señalización astrocítica y que no ha participado en el nuevo trabajo. «Tiendo a comprarlo».

El descubrimiento abre la posibilidad de que algunos astrocitos formen una parte esencial de los circuitos del encéfalo. «Cada vez llegamos más a la idea de que todos los tipos de células participan en el funcionamiento del encéfalo», afirma Volterra. «Está mucho más integrado de lo que se pensaba antes».

Una red comunicativaEl nombre generalista «glía» (de la palabra griega que significa «pegamento») para todas las células encefálicas que no son neuronas, como los astrocitos, transmite la opinión inicial de los científicos de que su objetivo principal era mantener unidas a las neuronas. Sin embargo, desde la primera descripción de los astrocitos en 1865, los investigadores han descubierto que pueden hacer mucho más. De entrada tienen receptores de glutamato, que utilizan para detectar y limpiar el exceso de neurotransmisores en los espacios alrededor de las neuronas.

Lo que ha estado menos claro es si pueden utilizar el glutamato para generar una señal eléctrica por sí mismas. En 1994, los investigadores estimularon astrocitos en una placa y observaron que las neuronas cercanas parecían responder preparándose para enviar una señal. Y en 1997 Volterra y sus colegas observaron la inversa: los astrocitos de rata respondían a las llamadas de las neuronas con ondas oscilantes de la molécula de señalización calcio. Entre 2000 y 2012, los investigadores publicaron más de 100 artículos que presentaban evidencia a favor de la capacidad de los astrocitos para comunicarse a través de sinapsis.

Más de 25 años después de observar por primera vez los astrocitos respondiendo a señales en una placa, el neurocientífico Andrea Volterra del Centro Wyss de Bio y Neuro Ingeniería en Ginebra, Suiza, ha regresado con nueva evidencia de que algunos astrocitos participan activamente en la conversación eléctrica del encéfalo. Foto cortesía de Andrea Volterra