¿Que puede aportar (y qué no) la neurociencia a la educación?

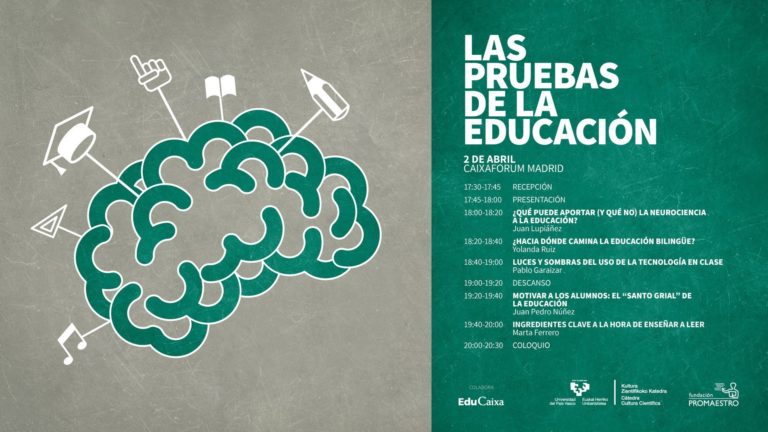

Érase una vez… en el País Vasco, un congreso tan oportuno y tan útil, y tan bien recibido en Bilbao y en Donostia-San Sebastián, que muchos pensaron que tenía que viajar a más lugares. Así que la Cátedra de Cultura Científica y la Fundación Promaestro se pusiron de acuerdo y, con la ayuda de EduCaixa, lo llevaron a Madrid: casi un centenar de personas con espíritu crítico y bien informadas llenaron el pasado 2 de abril la modesta y acogedora sala de CaixaForum en la que se celebró.

Así como toda (buena) historia tiene un (buen) principio, toda (buena) práctica tiene un (buen) fundamento. Un fundamento, una justificación, una razón, una prueba. Lo más importante es que nuestras prácticas educativas estén sostenidas por evidencias científicas. Su nombre da igual. Da igual, ¿o no?

“Que algo lleve el prefijo «neuro» no significa que contenga más verdad, pero –apostilla el profesor Juan Lupiáñez en su ponencia– la neurociencia le presta estatus a la psicología”. Sorprendentemente, aportaciones teóricas ya clásicas de la psicología son tenidas más en cuenta por el público cuando provienen de la neurociencia. El catedrático de la Universidad de Granada presenta estudios que demuestran que la gente comprende y recuerda mejor aquellos datos y teorías en los que aparecen términos e imágenes relacionadas con el cerebro.

Es decir, que las palabras también importan y, precisamente por eso, tenemos que ser especialmente cuidadosos con ellas y evitar que nos obnubilen: ¿Cuántos siguen creyendo en neuromitos, en el brain gym y en la teoría del cerebro derecho e izquierdo, por ejemplo? ¿Cuántos hablan de educar al cerebro y olvidan que el objetivo de la escuela es educar a la persona? Entender el cerebro, repite el ponente, “es mucho más complicado que entender el comportamiento, que ya es complicado”, y además “éste no es una máquina: no podemos cambiar sus conexiones como cambiamos las bujías de un coche”.

Es muy recomendable escuchar a los neurocientíficos –afirma en su conclusión Lupiáñez– pero, en lo que se refiere a evidencias educativas, “siempre es mejor ampliar su búsqueda más allá de un solo campo”.

Edición realizada por César Tomé López a partir de materiales suministrados por Fundación Promaestro

El artículo ¿Que puede aportar (y qué no) la neurociencia a la educación? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones

- Autismo y educación: problemas y pautas en el aula

- Educación basada en la evidencia: retos y propuestas de mejora

Cómo conservar mejor los alimentos con una iluminación inteligente

![]()

Raquel Esteban, José Ignacio García Plazaola y Víctor Resco de Dios

Ernest Brillo / Unsplash

Ernest Brillo / UnsplashEl otoño ha dejado paso al invierno. Y con él, se van los colores propios de la estación que hemos despedido: el verde que cubría a los árboles de hoja caduca se transforma en un abanico de colores, que va desde el ocre hasta el naranja.

Los pigmentos responsables de estos colores son imprescindibles para la salud humana. Además, la calidad de los alimentos está relacionada con la preservación de estos compuestos y, por lo tanto, conocer su funcionamiento ayuda a disminuir el desperdicio de alimentos.

A través de las nuevas tecnologías podemos lograr mejoras sustanciales en dos aspectos: la calidad nutricional y la preservación de los vegetales vegetales.

Los pigmentos de las plantas, nuestras vitaminas

Tanto el color verde como la gama de colores típicamente otoñales se deben a las propiedades físico-químicas de los pigmentos de las hojas:

- Las clorofilas son los pigmentos responsables de los tonos verdes.

- Los carotenoides de los colores amarillo-naranja.

Estos pigmentos son clave en el funcionamiento y la supervivencia vegetal. Participan en procesos tan importantes como la fotosíntesis y la tolerancia a las condiciones adversas.

¿Recuerda cuando su abuela le decía que comiera zanahorias para preservar la vista? Pues llevaba parte de razón. Los carotenoides son imprescindibles para la vista.

El beta caroteno, el mayoritario de la zanahoria, es la provitamina A, que forma parte de la retina de los ojos. Los amarillos como la luteína y la zeaxantina están en la mácula y son los responsables de disipar las especies reactivas de oxigeno de nuestros ojos

Además, debido a sus propiedades antioxidantes, estos pigmentos aportan otros beneficios a la salud, como la mejora de la capacidad cognitiva y la prevención de enfermedades degenerativas.

Al ser los humanos incapaces de sintetizar carotenoides, los debemos incorporar en la dieta mediante la ingesta de frutas, verduras y legumbres, principalmente. Forman parte de las vitaminas.

Las zanahorias contienen carotenoides beneficiosos para la vista.

Las zanahorias contienen carotenoides beneficiosos para la vista.Voltamax/Pixabay

Así cambia el valor nutritivo de los vegetales

Una cualidad que define a las plantas es que, aunque las cosechemos, siguen vivas. Es decir, continúan realizando procesos fisiológicos como la fotosíntesis y la respiración.

Todos los vegetales que vemos en los expositores de los supermercados están vivos. Esto se debe a la característica modular de sus órganos y a su habilidad para mantener una autonomía fisiológica.

Aunque aparentemente estén inactivos, en realidad su maquinaria está completamente activa. Responden a las condiciones ambientales que se dan desde que se recolectan hasta que acaban en la nevera de nuestros hogares.

El contenido de carotenoides y, por lo tanto, de las vitaminas o compuestos antioxidantes, es muy variable. Va a responder a las condiciones a las que están expuestos los productos, aumentando o disminuyendo su concentración.

Dicho de otra forma: el contenido nutricional de un vegetal (basándonos en el contenido de carotenoides) varía a lo largo del día.

Por ejemplo, el carotenoide zeaxantina –relacionado, junto con la luteína, con la disminución del riesgo de padecer degeneración macular asociada a la edad– presenta valores máximos durante el día y mínimos por la noche.

El papel de los frigoríficos

Los frigoríficos, ya sea en nuestra casa, o en un supermercado, suelen mantener los alimentos bajo condiciones de oscuridad continua o de luz continua.

En los hogares, por ejemplo, suele suceder lo primero: el vegetal no ve la luz, salvo por los pocos segundos en los que abrimos la puerta. En muchos supermercados, sin embargo, la iluminación es continua y el producto en el expositor nunca experimenta la oscuridad.

En los supermercados, los vegetales se conservan en condiciones de luz.

En los supermercados, los vegetales se conservan en condiciones de luz.Matheus Cenali/Pexels

Nuestros estudios indican que guardar las verduras bajo estas condiciones tan extremas de luz acorta su vida.

Los carotenoides y demás pigmentos foliares se degradan más rápidamente bajo estos ritmos de luz artificial, lo que provoca cambios visuales (cambios de color en las hojas de verde a amarillento). Disminuye la calidad de los alimentos y hace que se desperdicien con más facilidad.

Si incorporamos ciclos de luz/oscuridad en los sistemas de refrigeración, de forma que reproduzcamos los ciclos de día/noche que el vegetal experimenta cuando crece en el campo, lograremos mejoras sustanciales en la preservación de los alimentos.

Medir los contenidos de carotenoides

Para entender mejor el valor nutricional de los vegetales, y para mejorar su preservación, necesitamos cuantificar cuántos carotenoides y clorofilas tienen los alimentos que comemos.

La técnica más precisa, pero a la vez costosa, de cuantificación es el análisis mediante cromatografía en un laboratorio. Este es un procedimiento caro y complejo.

Una alternativa mucho más sencilla es el uso de técnicas basadas en al análisis de la reflectancia de la luz. Consisten en evaluar la cantidad de cada tipo de luz reflejada por la superficie del alimento en cuestión, es decir, en cuantificar el color. Este será proporcional a su contenido de pigmentos.

Estos métodos no son tan precisos, pero sí más económicos. Solo se necesita el aparato de medición y generalmente existe en versión portátil.

En una investigación reciente, hemos aplicado estas técnicas en una simulación de un ambiente de supermercado. Hemos conseguido determinar el contenido aproximado de los carotenoides a partir de la medida de sus características ópticas. Este hecho abre una interesante línea para el futuro y nos dirige hacia los supermercados 2.0.

En un futuro cercano será posible medir los antioxidantes de nuestros alimentos tan solo apretando un botón. Incluso, la tecnología de los supermercados podría incluir drones con sensores que nos indiquen el valor aproximado de esos compuestos.![]()

Sobre los autores: Raquel Esteban y José Ignacio García Plazaola son profesores de fisiología vegetal en la Universidad del País Vasco / Euskal Herriko Unibertsitatea y Víctor Resco de Dios es profesor de incendios forestales y cambio global en la Universitat de Lleida.

Este artículo fue publicado originalmente en The Conversation. Artículo Original.

El artículo Cómo conservar mejor los alimentos con una iluminación inteligente se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un espectrómetro Raman portátil mide el punto óptimo de maduración del tomate

- ¿Cómo llegan bacterias resistentes y residuos de antibióticos a los alimentos?

- El azúcar oculto en los alimentos

¿Y si la bolsa de plástico fuese más sostenible que las de papel o algodón?

Foto: Karina Tess / Unsplash

Foto: Karina Tess / UnsplashLas bolsas de plástico son las que peor reputación tienen. Esto sucede porque a menudo se juzga la sostenibilidad de las bolsas y su impacto medioambiental solo en función de si el material es fácilmente biodegradable. Sale ganando la bolsa de papel porque imaginamos que, si la tirásemos en el monte o al mar, se biodegradaría en poco tiempo. Sin embargo, este análisis es superficial e incompleto. No se está teniendo el cuenta el ciclo de vida de la bolsa: qué impacto medioambiental tiene su fabricación, cuánta energía se usa en su producción y transporte, cómo se conserva, si se reutiliza, cuánto tiempo de vida útil tiene…

Todos estos parámetros se han analizado científicamente y, para sorpresa de muchos, las bolsas de algodón y de papel no salen mejor paradas que las de plástico.

El análisis de ciclo de vida, ACV (LCA en inglés) es un balance ecológico con el que se evalúa el impacto ambiental de un producto durante todas las etapas de su existencia, desde la extracción de materias primas, la producción, la distribución, el uso, la posible reutilización, el reciclaje, la valorización y la gestión de residuos.

Las bolsas de plástico de polietileno surgieron en los años 60 como una alternativa sostenible a las bolsas de papel que se usaban tradicionalmente. El coste energético de fabricación es irrisorio en comparación con el papel, se usa una fracción residual de petróleo que no es útil como combustible, no implica tala de árboles, es más resistente y pesa diez veces menos que el papel, por lo que la huella de carbono derivada del transporte también se reduce diez veces. Todo parecían ventajas. Lo que no se esperaba es que se usasen de forma tan irresponsable.

Cada persona gasta de media 180 bolsas de plástico al año. En 2008 la media en España era de 300 bolsas por habitante y año, dato que se ha reducido más del 60% gracias a la reutilización, principalmente animada por campañas de concienciación medioambiental y por el cobro obligatorio de las bolsas.

El plástico es un material inerte y duradero, lo que en principio es ventajoso. Pero la realidad es que el 80% de los residuos que llegan al mar son plásticos. Cada año llegan al mar unos ocho millones de toneladas de plástico. China, Indonesia y Filipinas encabezan la clasificación de los países que más cantidad arrojan, y los 20 primeros –todos en Asia y África, excepto Estados Unidos y Brasil– son responsables del 83% del plástico mal gestionado que puede acabar en el mar. De todo el plástico que llega al mar, el 1,5% se ha convertido en microplásticos, se ha ido fragmentando hasta transformarse en pedazos tan pequeños que son muy difíciles de eliminar.

El plástico llega al mar porque no se está reciclando ni destruyendo como es debido. En España solo el 66,5% del plástico se recicla y el 12% se incinera para obtener energía.

Con respecto al la influencia sobre el cambio climático podemos hacer un cálculo que nos permite saber la cantidad de CO2 emitido por el uso de bolsas de plástico, incluyendo su incineración. Una bolsa de plástico tiene una masa de entre 4 y 8 g. Cada persona gasta unas 180 bolsas de plástico al año, mayoritariamente de polietileno. Haciendo los cálculos estequiométricos, el uso de bolsas de plástico supone un aporte de 340 g de CO2 al año por individuo. En comparación con el transporte esto es muy poco: desplazarse en coche sólo 3 o 4 km (dependiendo del modelo) también produce 340 g de CO2.

Fábrica de pasta de celulosa en Finlandia. Fuente: Wikimedia Commons

Fábrica de pasta de celulosa en Finlandia. Fuente: Wikimedia CommonsHaciendo el análisis del ciclo de vida (ACV) de las bolsas de plástico convencionales comparadas con las de papel, sale ganado ampliamente la bolsa de plástico. La producción y consumo de papel tienen un fuerte impacto ambiental y social sobre el planeta. La industria papelera y de celulosa ocupa el quinto lugar del sector industrial en consumo mundial de energía, y utiliza más agua por cada tonelada producida que cualquier otra industria. También, la industria papelera se encuentra entre los mayores generadores de contaminantes del aire y del agua, así como gases de efecto invernadero responsables del cambio climático. Tendríamos que reutilizar la bolsa de papel tres veces para que su impacto medioambiental sea equivalente al de una bolsa de plástico convencional. Es decir, usar y tirar una bolsa de plástico tiene un impacto medioambiental tres veces menor que hacerlo con una de papel. Si además reutilizamos la bolsa de plástico una sola vez, aunque solo sea para contener basura, el impacto será 6 veces menor que el de la bolsa de papel.

Si analizamos el ciclo de vida (ACV) de las bolsas de algodón, su impacto medioambiental es el más dañino de todos. El algodón se cultiva de forma intensiva, necesita de mucho terreno, un importante gasto energético y su transformación en tejido emite, entre otras sustancias nocivas, gases de efecto invernadero. Producir 1 kg de tejido de algodón requiere más de 40.000 litros de agua en promedio, una sed mucho mayor que la de cualquier vegetal e incluso la mayoría de las carnes. A diferencia del papel, también hay que tener en cuenta que el algodón no se recicla en la mayoría de los países.

Cosecha y empaquetamiento sobre el terreno de algodón en Texas (EE.UU.). Fuente: Wikimedia Commons

Cosecha y empaquetamiento sobre el terreno de algodón en Texas (EE.UU.). Fuente: Wikimedia CommonsA esto hay que añadir que las bolsas de algodón son la opción menos higiénica. El algodón es un material que puede ser colonizado por microorganismos patógenos, por lo que no debería ponerse en contacto directo con alimentos, y debería lavarse con la misma asiduidad y a la misma temperatura que los trapos de cocina. El gasto energético y el impacto medioambiental derivado de su uso es sustancial.

En comparación, una bolsa de algodón habría que utilizarla 131 veces para que su impacto medioambiental fuese equiparable al de la bolsa de plástico convencional.

La única forma en la que una bolsa de tela es más sostenible que una de papel es usándola muchas veces a lo largo de mucho tiempo. Y tener dos o tres bolsas de algodón, no decenas. Lo mismo podría decirse de las bolsas de papel. Sin embargo, las bolsas de papel no resisten tantas reutilizaciones, principalmente porque se contaminan, no son lavables y se descomponen con la humedad.

Analizando toda la evidencia científica de la que disponemos, las bolsas de plástico son la opción más sostenible. Si además las reutilizamos y las llevamos al contenedor adecuado (en España es el contenedor amarillo), el impacto medioambiental será todavía menor. En la actualidad ya hay superficies comerciales en las que ofrecen bolsas reutilizables de plástico de poliéster para frutas y verduras, más sostenibles que las habituales de polietileno de baja densidad.

Bolsa de plástico de poliéster. Foto: Deborah García Bello

Bolsa de plástico de poliéster. Foto: Deborah García Bello

La opción más sostenible de todas es la que engloba las bondades del plástico y las del uso responsable que solemos hacer con las de algodón, que se prestan a un mayor número de reutilizaciones. Las bolsas de rafia, por ejemplo, que son un tejido de plástico de polietileno y propileno, son muy resistentes, estéticas e higiénicas. También lo son las de poliéster, como la «puto plástico» de la foto que, irónicamente también es de plástico.

Fuentes:

Lewis, H., Verghese, K., & Fitzpatrick, L. (2010). Evaluating the sustainability impacts of packaging: the plastic carry bag dilemma. Packaging Technology and Science: An International Journal, 23(3), 145-160.

Edwards, C., & Fry, J. M. (2011). Life cycle assessment of supermarket carrier bags. Environment Agency, Horizon House, Deanery Road, Bristol, BS1 5AH.

Bell, K., & Cave, S. (2015). Comparison of Environmental Impact of Plastic, Paper and Cloth Bags. Research and Library Service Briefing Note, Northern Ireland Assembly

Interim Review os the Plastic Shopping Bags Ban. ACT Government. 2012.

Hyder Consulting, LCA of shopping bag alternatives: Final report, Zero Waste South Australia, August 2009, p.3

Daniel Montoya. Plastic bags: an update. NSW Parliamentary Research Service April 2013

The Danish Environmental Protection Agency (2018). Life Cycle Assessment of grocery carrier bags.

Brian Halweil y Lisa Mastny. Informe anual del Worldwatch Institute sobre progreso hacia una sociedad sostenible. Ed. Icaria, Noruega, 2004.

Advancing Sustainable Materials Management: 25Fact Sheet Assessing Trends in Material Generation, Recycling, Composting, Combustion with Energy Recovery and Landfilling in the United States July 2018

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo ¿Y si la bolsa de plástico fuese más sostenible que las de papel o algodón? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Adiós a las microesferas de plástico en los cosméticos

- Si hacer fármacos fuese como jugar a Lego, la pieza más guay se llamaría carbino

- Corales, ciencia y plástico.

Composición nº1, la historia de X gobernada por el azar

Una tirada de dados jamás abolirá el azar.

Stéphane Mallarmé

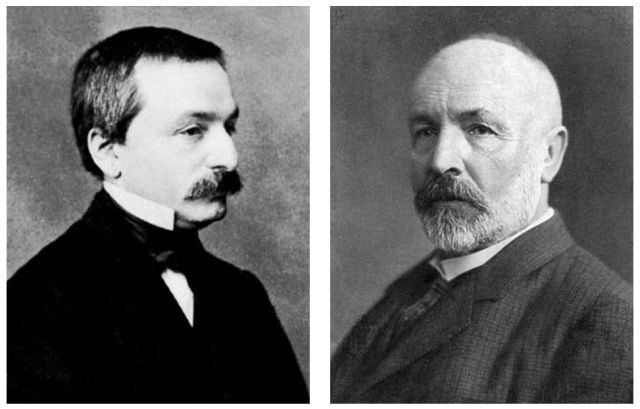

Un Coup de Dés jamais n’abolira le Hasard –Una tirada de dados jamás abolirá el azar– es el título de un poema de Stéphane Mallarmé (1842-1898) publicado en 1897. Compuesto en forma de versos libres, es uno de los primeros poemas tipográficos de la literatura francesa.

El título de este poema, junto a su autor, aparece en el colofón del libro Composición n01 de Marc Saporta (1923-2009) en su traducción al castellano publicada por la editorial Capitán Swing en 2012. La primera versión, en francés, fue publicada en 1962 por la editorial Le Seuil.

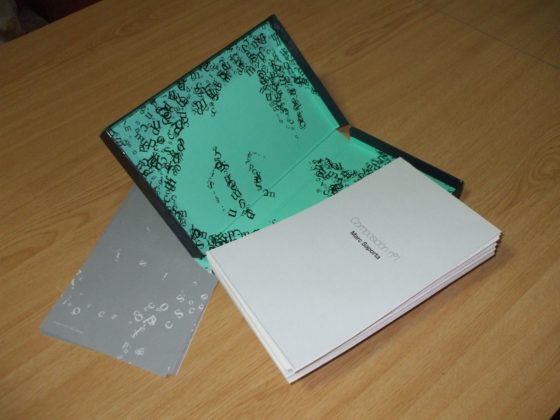

Composición n01 es una novela compuesta por 150 hojas no encuadernadas, no numeradas, escritas por una única cara e introducidas al azar en una caja.

Foto: Marta Macho Stadler.

Foto: Marta Macho Stadler.

En el prefacio, el autor explica las ‘instrucciones de uso’ de su novela y proporciona algunas claves sobre la lectura:

Se ruega al lector que mezcle estas páginas como una baraja. Que las corte, si lo desea, con la mano izquierda, igual que una echadora de cartas. El orden en el que salgan las hojas después de hacerlo orientará el destino de X.

Porque el tiempo y el orden de los acontecimientos regulan la vida más que la naturaleza de estos acontecimientos. Sin duda, la Historia impone un marco: la pertenencia de un hombre al maquis y su paso por las tropas de ocupación en Alemania pertenecen a una época determinada. Asimismo, los hechos que marcaron su infancia no pueden presentarse como vividos en la edad adulta.

No obstante, no es indiferente saber si conoció a su amante, Dagmar, antes o después de su matrimonio; si abusó de la pequeña Helga durante su adolescencia o su madurez; si el robo que cometió tuvo lugar bajo el abrigo de la Resistencia o en tiempos menos turbulentos; si el accidente del que fue víctima carece de relación con el robo (o la violación) o si tuvo lugar durante la huida.

Del encadenamiento de las circunstancias depende que la historia acabe bien o mal. Una vida se compone de elementos múltiples. Pero el número de composiciones posibles es infinito.

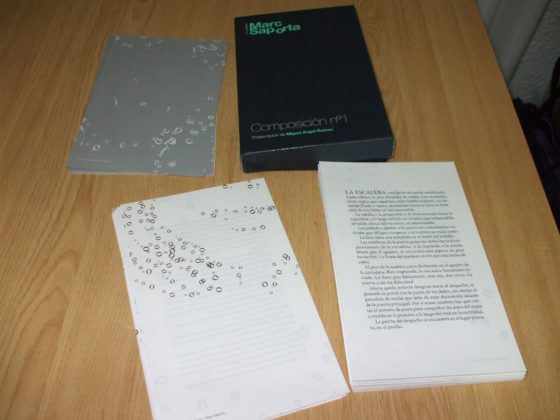

El libro de Saporta ‘cuenta’ una historia de un personaje misterioso. Una, y no la historia, porque el relato transcurre dependiendo del orden en el que se colocan las hojas tras barajarlas, como indica el autor en el prefacio. Cada página corresponde a un episodio procedente de los recuerdos del personaje X. Este narrador aparece como un ladrón y un violador. De hecho, dos de las páginas de Composición n01 se dedican a citar algunos artículos –entiendo que eran los que estaban vigentes en Francia cuando Saporta publicó su texto, en 1962– relativos a los delitos de robo y violación.

Al recorrer las páginas de esta singular novela, la historia va incorporando diferentes personajes, algunos de los cuales son recurrentes: Marianne –la esposa de X–, Dagmar –su amante– o Helga –una joven a la que X viola– aparecen en numerosas ocasiones, mientras que otros personajes solo son citados en una de las páginas. Cada una de las hojas corresponde a un marco espacio-temporal que cambia continuamente. El lugar elegido –una ciudad ocupada por el ejército alemán, el patio de una escuela o el apartamento de alguno de los personajes– depende de lo que el azar dispone tras barajar las páginas del libro.

Aunque pienses que estoy intentando ‘destripar’ la versión de Composición n01 que he leído, no pasa nada; es bastante improbable que, tras barajar las páginas del libro, la versión que tú vas a leer sea la misma que la mía…

Foto: Marta Macho Stadler.

Foto: Marta Macho Stadler.

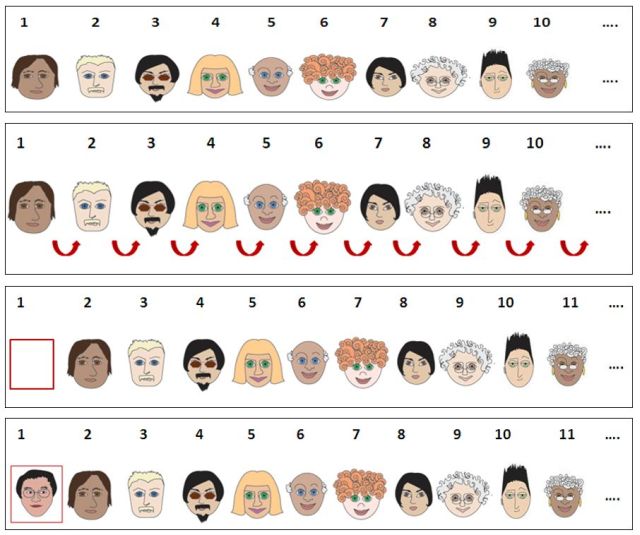

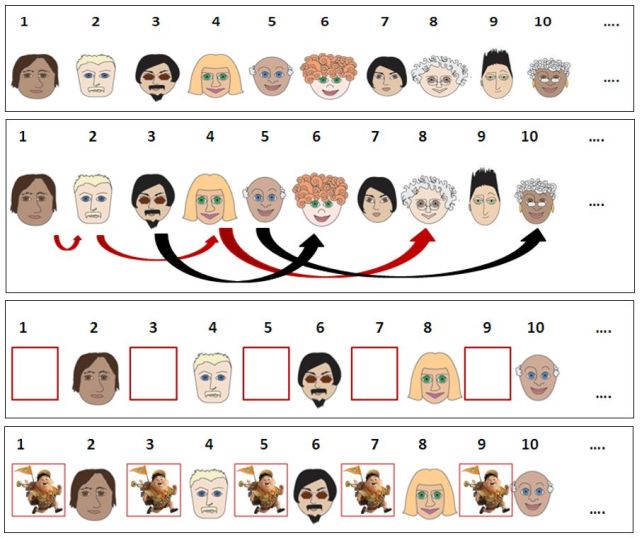

El prefacio de Marc Saporta termina con la frase: Pero el número de composiciones posibles es infinito. En realidad, Composición n01 no contiene infinitas versiones de la historia de X. Aunque es cierto que contiene muchas. De hecho, al haber 150 páginas que pueden ordenarse de manera aleatoria, el número de novelas distintas que podemos leer es la factorial de 150 –son las permutaciones sin repetición de 150 elementos–.

Para hacernos una idea de esa cantidad de versiones, el factorial de 150 es el número:

57133839564458545904789328652610540031895535786011264182548375833179829124845398393126574488675311145377107878746854204162666250198684504466355949195922066574942592095735778929325357290444962472405416790722118445437122269675520000000000000000000000000000000000000,

número que está formado por 263 cifras y finaliza con 37 ceros. Redondeando, el factorial de 150 es aproximadamente 5,7 x 10262. Y, efectivamente, es un número muy, muy grande… pero no infinito.

Referencias

-

Una tirada de dados jamás abolirá el azar de Stéphane Mallarmé (Una propuesta estético-filosófica de Juan David García Bacca, incluida en su obra «Necesidad y Azar. Parménides y Mallarmé», Editorial Antrophos, Barcelona, 1985), Revista aesthethika 12 (2), septiembre 2016. Caos e invención, pág. 53-54

-

Marc Saporta, Composición no1, Capitán Swing, 2012

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Composición nº1, la historia de X gobernada por el azar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ‘La Historia es la ciencia de la desgracia de los hombres’

- El teorema de los cuatro colores (1): una historia que comienza en 1852

- Ciegos ante el azar

El comportamiento ondulatorio de los electrones

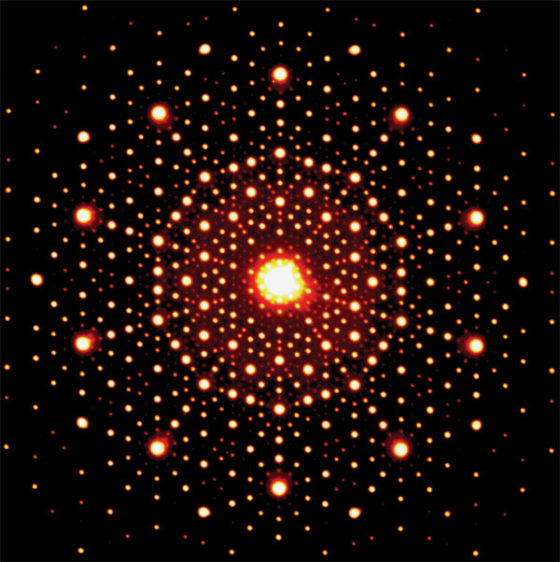

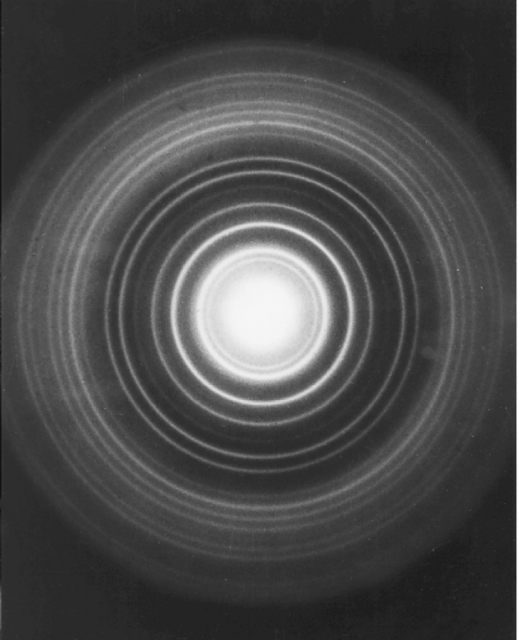

Una imagen por difracción de electrones parecida a esta pero tomada en 1982 terminó dándole el premio Nobel de química a Dan Shechtman en 2011 por el descubrimiento de los cuasicristales. Fuente: Wikimedia Commons

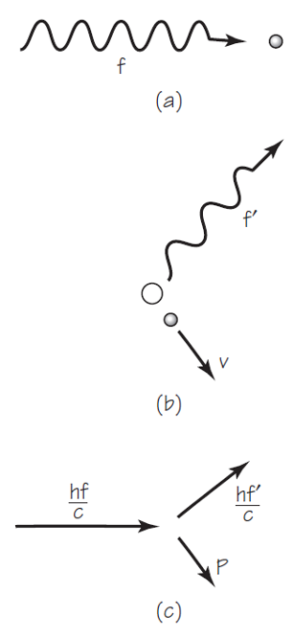

Una imagen por difracción de electrones parecida a esta pero tomada en 1982 terminó dándole el premio Nobel de química a Dan Shechtman en 2011 por el descubrimiento de los cuasicristales. Fuente: Wikimedia CommonsEn 1923, Louis de Broglie sugirió que la dualidad onda-corpúsculo que se aplica a los fotones, a la radiación electromagnética, también podría aplicarse a los electrones y otras partículas atómicas. Quizás, dijo, la dualidad onda-corpúsculo es una propiedad fundamental de todos los procesos cuánticos. Si es así, las partículas que siempre se consideraron corpúsculos materiales pueden, en algunas circunstancias, actuar como ondas. De Broglie buscó una expresión para la longitud de onda que podría estar asociada con el comportamiento ondulatorio de un electrón. Encontró la expresión con un argumento muy simple.

El momento lineal de un fotón de longitud de onda λ es p = h/λ o, dicho de otra forma, la longitud de onda del fotón es λ = h/p. De Broglie pensó que esta relación también podría aplicarse a los electrones que se mueven con velocidad v y, por tanto, con un momento lineal p = mv. Sugirió audazmente que la longitud de onda de un electrón es λ = h/mv, donde m es la masa del electrón y v su velocidad.

Pero, ¿qué significa decir que un electrón tiene una longitud de onda igual a la constante de Planck dividida por su mometo lineal? Como hemos visto, si esta afirmación tiene algún significado físico debe ser posible comprobarla mediante algún tipo de experimento. En este caso, se debería poder medir alguna propiedad ondulatoria del electrón. La primera de esas propiedades que se pudo medir fue la difracción.

De la relación λ = h/mv se deduce que las longitudes de onda asociadas a los electrones serán muy cortas, incluso para electrones bastante lentos. Un electrón acelerado a través de una diferencia de potencial de solo 100 V tendría una longitud de onda de solo 10-10 m. Una longitud de onda tan pequeña no daría efectos de difracción mensurables al encontrar incluso un objeto microscópicamente pequeño (digamos, de una micra, 10-6 m). No podía manipularse un objeto así en la época. Había que buscar algo del tamaño de la longitud de onda que pudiese usarse.

En 1920 estaba bien establecido que los cristales tienen una estructura reticular regular. La distancia entre los planos de átomos en un cristal es de aproximadamente 10-10 m. Tras proponer De Broglie que los electrones podían tener propiedades de onda, varios físicos sugirieron que la existencia de ondas de electrones podría mostrarse usando cristales como rejillas de difracción. Los experimentos iniciados en 1923 por C.J. Davisson y L.H. Germer encontraron patrones de difracción similares a los obtenidos anteriormente para los rayos X.

El experimento de Davisson-Germer demostraba dos cosas. Primero, los electrones tienen propiedades de onda, de lo contrario no podrían mostrar el patrón de difracción de las ondas. Se podría decir que un electrón se mueve siguiendo el camino que toma la onda de Broglie que está asociada al electrón. En segundo lugar, las longitudes de onda de los electrones están dadas correctamente por la relación de de Broglie, λ = h/mv .

Patrón de difracción obtenido al hacer incidir un haz de electrones en aluminio policristalino (una masa de aluminio compuesta de multitud de cristales diminutos orientados al azar). G.P. Thomson encontró un patrón similar usando una lámina de oro. Fuente: Cassidy Physics Library.

Patrón de difracción obtenido al hacer incidir un haz de electrones en aluminio policristalino (una masa de aluminio compuesta de multitud de cristales diminutos orientados al azar). G.P. Thomson encontró un patrón similar usando una lámina de oro. Fuente: Cassidy Physics Library.Estos resultados fueron confirmados en 1927 cuando G.P. Thomson [1] hizo pasar un haz de electrones a través de una delgada lámina de oro. Thomson encontró un patrón como el que se muestra en la imagen 1. Se asemeja a los patrones de difracción producidos por los haces de luz que atraviesan hojas finas de materiales. Para 1930 la difracción que se producía en los cristales había permitido demostrar el comportamiento ondulatorio incluso de los átomos de helio y de las moléculas de hidrógeno. [2]

Los experimentos que confirmaban la hipótesis de De Broglie indicaban que la dualidad onda-corpúsculo es una propiedad general no solo de la radiación sino también de la materia.

Notas:

[1] Sí, el hijo de J.J. Thomson.

[2] Se puede decir que Joseph John Thomson demostró que el electrón es una partícula y que su hijo George Paget Thomson que es una onda. J.J. recibió el Nobel en 1906 y G.P. en 1937.

El artículo El comportamiento ondulatorio de los electrones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El comportamiento corpuscular de la luz: el efecto Compton

- El comportamiento corpuscular de la luz: momento lineal del fotón

- La realidad de los estados estacionarios

El ethos de la ciencia

Lise Meitner con unas estudiantes estadounidenses (Sue Jones Swisher, Rosalie Hoyt y Danna Pearson McDonough) en las escaleras del edificio de química del Bryn Mawr College (Pennsylvania, EE.UU.) en abril de 1959. Meitner, de origen judío, nació en Austria, trabajó en Alemania y finalmente se refugió en Suecia debido a la persecución nazi. Participó notablemente en el descubrimiento de la fisión nuclear. Su compañero de equipo Otto Hahn recibió el premio Nobel (1944), pero no ella cuando era igualmente merecedora, si no más.

Lise Meitner con unas estudiantes estadounidenses (Sue Jones Swisher, Rosalie Hoyt y Danna Pearson McDonough) en las escaleras del edificio de química del Bryn Mawr College (Pennsylvania, EE.UU.) en abril de 1959. Meitner, de origen judío, nació en Austria, trabajó en Alemania y finalmente se refugió en Suecia debido a la persecución nazi. Participó notablemente en el descubrimiento de la fisión nuclear. Su compañero de equipo Otto Hahn recibió el premio Nobel (1944), pero no ella cuando era igualmente merecedora, si no más.Dado que lo que aquí nos interesa es la cuestión de los males que afligen a la empresa científica, nos parece conveniente partir de una exposición de los valores de la ciencia, puesto que, en general, los males son rasgos que se oponen a aquellos. Empezaremos por los valores o normas enunciadas por el sociólogo Robert K. Merton en la primera mitad del siglo pasado, para pasar, en la anotación siguiente, a otras visiones de esta misma cuestión.

Las consideraciones éticas no son ajenas al desempeño científico. La investigación se rige por un código de comportamiento que asumimos como propio quienes nos dedicamos a esa actividad. En 1942, el sociólogo Robert K. Merton postuló la existencia de un “ethos científico”, un conjunto de valores que deben impregnar o inspirar la actividad científica. Sin ellos la ciencia, como empresa colectiva, perdería su misma esencia. Según él, la palabra «ciencia» hace referencia a diferentes cosas, aunque relacionadas entre sí. Normalmente se utiliza para denotar: (1) un conjunto de métodos característicos mediante los cuales se certifica el conocimiento; (2) un acervo de conocimiento acumulado que surge de la aplicación de estos métodos; (3) un conjunto de valores y normas culturales que gobiernan las actividades científicas; (4) cualquier combinación de los elementos anteriores.

En expresión de Merton (1942), “el ethos de la ciencia es ese complejo, con resonancias afectivas, de valores y normas que se consideran obligatorios para el hombre de ciencia. Las normas se expresan en forma de prescripciones, proscripciones, preferencias y permisos. Se las legitima sobre la base de valores institucionales. Estos imperativos, trasmitidos por el precepto y el ejemplo, y reforzados por sanciones, son internalizados en grados diversos por el científico, moldeando su conciencia científica. Aunque el ethos de la ciencia no ha sido codificado, se lo puede inferir del consenso moral de los científicos tal como se expresa en el uso y la costumbre, en innumerables escritos sobre el espíritu científico y en la indignación moral dirigida contra las violaciones del ethos”.

Para Merton (1942), el fin institucional de la ciencia es el crecimiento del conocimiento certificado. Y los métodos empleados para alcanzar ese fin proporcionan la definición de conocimiento apropiada: enunciados de regularidades empíricamente confirmados y lógicamente coherentes (que son, en efecto, predicciones). Los imperativos institucionales (normas) derivan del objetivo y los métodos. Toda la estructura de normas técnicas y morales conducen al objetivo final. La norma técnica de la prueba empírica adecuada y confiable es un requisito para la constante predicción verdadera; la norma técnica de la coherencia lógica es un requisito para la predicción sistemática y válida. Las normas de la ciencia poseen una justificación metodológica, pero son obligatorias, no solo porque constituyen un procedimiento eficiente, sino también porque se las cree correctas y buenas. Son prescripciones morales tanto como técnicas.

Merton (1942) propuso cuatro conjuntos de imperativos institucionales: el universalismo, el comunalismo, el desinterés y el escepticismo organizado, como componentes del ethos de la ciencia moderna.

Si la comunidad científica comparte un proyecto común –la construcción de un cuerpo de conocimiento certificado o fiable acerca del mundo y de cómo funciona-, las normas que Merton (1942) identificó son algo parecido a los valores compartidos por esa comunidad, valores que son considerados esenciales. Una interpretación actualizada de las normas mertonianas, es la que propone el físico John Ziman (2000), y que se presenta a continuación.

- Lo importante en la ciencia no es quién la practica, sino su contenido, los conocimientos que adquirimos acerca del mundo y de los fenómenos que ocurren en él. Todos pueden contribuir a la ciencia con independencia de su raza, nacionalidad, cultura o sexo.

- El conocimiento certificado debería ser compartido por el conjunto de la comunidad científica, con independencia de qué parte de los descubrimientos ha sido hecha por unos u otros científicos. Así pues, todos deberían tener el mismo acceso a los bienes científicos y debería haber un sentido de propiedad común al objeto de promover la colaboración. El secretismo es lo opuesto a esta norma, puesto que el conocimiento que se oculta, que no se hace público, no es de ninguna ayuda en el cumplimiento del objetivo de la comunidad, que el conocimiento certificado crezca.

- Desinterés. Se supone que los científicos actúan en beneficio de una empresa común, más que por interés personal. No obstante, no debe confundirse este “desinterés” con altruismo. De lo que se trata es de que el beneficio que pueda reportar los descubrimientos científicos, sin dejar de resultar beneficiosos para quien los realice, no entorpezca o dificulte la consecución del objetivo institucional de la ciencia: la extensión del conocimiento científico.

- Escepticismo organizado El escepticismo quiere decir que las declaraciones o pretensiones científicas deben ser expuestas al escrutinio crítico antes de ser aceptadas. Este es el valor que compensa el universalismo. Todos los miembros de la comunidad científica pueden formular hipótesis o teorías científicas, pero cada una de ellas debe ser evaluada, sometida al filtro de la prueba o la refutación para comprobar si se sostiene. Las propuestas que superan esa prueba con éxito pasan a formar parte del bagaje universal de conocimiento científico. El escepticismo es el valor que permite que funcione el del desinterés, porque sin escepticismo es más fácil caer en la tentación de anteponer el interés personal al del conjunto de la comunidad científica.

A los científicos no se nos da un manual con esas normas. Se supone que las adquirimos prestando atención a lo que hacen otros científicos en nuestra comunidad, los comportamientos que se castigan y los que se premian. En otras palabras, no es necesariamente lo que los científicos hacemos habitualmente; porque a veces lo que hacemos no satisface lo que pensamos que deberíamos hacer.

Hace unos años MacFarland & Cheng (2008) analizaron en qué medida los miembros de la academia hacen suyas en la actualidad las normas mertonianas y comprobaron que la norma que menos apoyo recibe es el desinterés. Interpretan ese menor apoyo como una consecuencia de la tendencia creciente a alinear los intereses de investigación con las oportunidades de financiación. Y cabe plantearse si el menor apoyo al ideal del desinterés constituye una disfunción del sistema científico o, por el contrario, es simplemente muestra de una concepción de la empresa científica diferente de la que en su día concibió Robert Merton.

No obstante, creo que el conjunto de valores aquí expuesto sería suscrito como deseable por la mayoría de científicos, por lo que me parece un buen punto de partida para evaluar la medida en que esos valores impregnan la práctica de la investigación científica que realmente se hace. Por esa razón, me ha parecido adecuado denominar “males de la ciencia” a aquellos comportamientos que no se ajustan a esos principios o aquellas formas de funcionar del sistema científico que impiden o dificultan su cumplimiento.

Fuentes:

Merton, R K (1942): “Science and Technology in a Democratic Order” Journal of Legal and Political Sociology1: 115-126. [Traducción al español como “La estructura normativa de la ciencia” en el volumen II de “La Sociología de la Ciencia” Alianza Editorial 1977, traducción de The Sociology of Science – Theoretical and Empirical Investigations, 1973]

Ziman, J (2000): Real Science: What It Is and What It Means. Cambridge University Press.

Este artículo se publicó originalmente en el blog de Jakiunde. Artículo original.

Sobre los autores: Juan Ignacio Perez Iglesias es Director de la Cátedra de Cultura Científica de la UPV/EHU y Joaquín Sevilla Moroder es Director de Cultura y Divulgación de la UPNA.

El artículo El ethos de la ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El ethos de la ciencia y las normas de Merton

- La ciencia no tiene valores… ¿o sí los tiene?

- La hostilidad a la ciencia

Ha llegado el frío

Foto: Talgat Baizrahmanov / Unsplash

Foto: Talgat Baizrahmanov / UnsplashPara mantener la temperatura corporal constante cuando llega el frío, un animal homeotermo necesita reponer mediante el metabolismo el calor que pierde. Esa pérdida depende de la diferencia entre la temperatura del organismo y la del ambiente, por un lado, y del grado de aislamiento, por el otro. Por esa razón y si dejamos al margen a los hibernantes, el modo en que los mamíferos responden a la bajada invernal de temperatura tiene dos componentes principales. Por un lado, aumentan el grado de aislamiento con el exterior. Y por el otro, si la temperatura ambiental baja mucho, también elevan la actividad metabólica; producen así más calor y compensan la mayor pérdida.

El aislamiento se puede modificar de varias formas: cambiando la postura corporal para exponer una menor o mayor superficie al exterior, limitando la circulación sanguínea por la periferia de las extremidades y dejando que se enfríen, o actuando sobre el pelaje para cambiar el grosor de la capa de aire que aísla la superficie del cuerpo del exterior. Pero por debajo de cierta temperatura esas respuestas no bastan y hay que gastar más energía, como se ha dicho, elevando el metabolismo. Por eso es importante contar con alimento abundante cuando llega el frío o, en su defecto, con depósitos de reservas.

Pero los seres humanos somos especiales. Somos homeotermos, sí, pero nuestra especie surgió en África y nuestro linaje homínido es africano. Evolucionamos en la sabana y muchas de nuestras características son claro reflejo de nuestra procedencia. Durante esa evolución nos quedamos prácticamente desnudos y desarrollamos una gran capacidad para sudar y refrigerarnos de una manera muy eficiente evaporando el sudor sobre la superficie corporal. De hecho, el desplazamiento a zonas frías nos obligó a vestir ropas con una capacidad de aislamiento adecuado a la temperatura de cada zona. Y a pesar de todo, la vida en lugares verdaderamente fríos nos ha exigido esfuerzos considerables para disponer de habitación confortable (gastando en calefacción), vestir ropas de abrigo y conseguir el alimento necesario para comer más.

Cuando los sensores de temperatura que tenemos repartidos por diferentes lugares del cuerpo detectan la bajada térmica, informan al hipotálamo, una estructura nerviosa en el interior del encéfalo. Y este responde dando las órdenes debidas, tanto al sistema endocrino como al nervioso. Ciertas órdenes provocan cambios en la circulación sanguínea periférica y en la disposición del pelaje, de manera que se aumenta el grado de aislamiento. Y otras elevan la actividad metabólica. En esos ajustes intervienen hormonas tales como la adrenalina, la noradrenalina y las tiroideas, que provocan un aumento del metabolismo. Quienes tienen grasa parda llevan ventaja, porque es un tejido cuya única función es producir calor. Y llegado el caso, tiritamos también.

Los mamíferos de zonas frías están, lógicamente, bien adaptados a la vida en entornos helados. Una cría de oso polar mantiene su metabolismo constante hasta 0ºC, y se estima que solo llegaría a multiplicarlo por tres a 60ºC bajo cero. Los zorros árticos, perros esquimales y demás grandes mamíferos árticos prácticamente no necesitan elevar su metabolismo salvo a temperaturas verdaderamente extremas, como 25 o 30ºC bajo cero. Pero a los seres humanos, como no hemos dejado de ser primates de sabana, todo eso nos sale muy caro. Un individuo desnudo empieza a elevar su metabolismo al descender la temperatura de 26ºC, aproximadamente, y a 8ºC lo triplica.

De lo anterior se extrae una triste conclusión. El frío es especialmente cruel con los pobres de solemnidad: no solo no tienen recursos para calentar el entorno en el que viven, tampoco los tienen para calentar su propio interior.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Ha llegado el frío se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:1969: el año en el que llegamos a la Luna e inventamos Internet

El año 1969 marcó un antes y un después. Fue el año en el que el ser humano pisó por primera vez un astro distinto al que nos vio nacer: la Luna. Fue, sin ninguna duda, un momento histórico. Pero, pocos meses después sucedería algo que cambiaría nuestro mundo por completo: un grupo de ingenieros en los Estados Unidos consiguió que dos ordenadores de distintos fabricantes se hablaran entre ellos, estableciendo así el germen de lo que sería Internet. Ese hecho pasó desapercibido en esos momentos, pero para muchos fue un hito mucho más relevante que lo que supuso nuestra llegada a la Luna.

Javier Pedreira, divulgador científico en el blog Microsiervos donde firma como Wicho, repasa en esta charla cómo fueron y que significaron estos dos hitos históricos.

Pedreira es responsable de Informática de los Museos Científicos Coruñeses desde hace ya casi 15 años y cofundador Microsiervos, uno de los blogs sobre ciencia y tecnologías más leídos en español en el mundo. Además, es colaborador habitual en varios medios de comunicación.

Esta charla se enmarca en el ciclo “Bidebarrieta Científica”, una iniciativa que organiza todos los meses la Cátedra de Cultura Científica de la UPV/EHU y la Biblioteca Bidebarrieta para divulgar asuntos científicos de actualidad.

Edición realizada por César Tomé López

El artículo 1969: el año en el que llegamos a la Luna e inventamos Internet se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

- Naukas Bilbao 2017 – Ángel Gómez Roldán: Tras la sombra de la Luna

- Coloquios escépticos: ¿Fuimos a la Luna?, con Eugenio Manuel Fernández Aguilar

Un aislante topológico intrínsecamente magnético

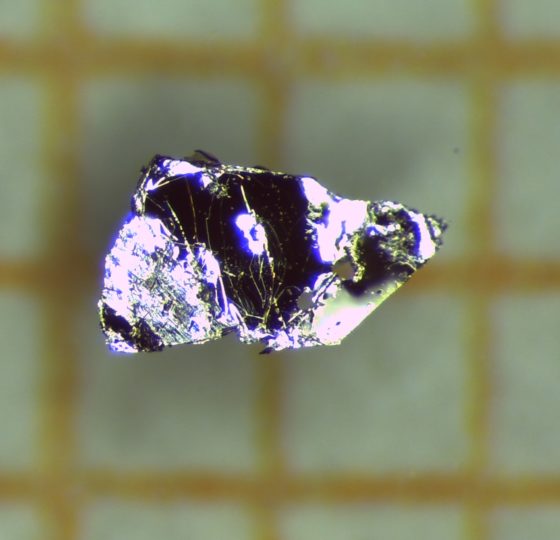

Un cristal de telururo de bismuto y manganeso, el primer aislante topológico magnético predicho y confirmado. Foto: A. Isaeva, TU Dresden/IFW Dresden

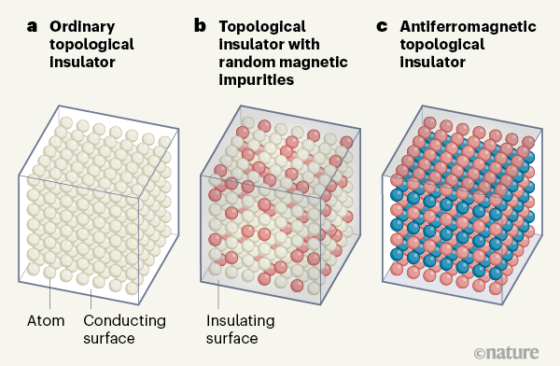

Un cristal de telururo de bismuto y manganeso, el primer aislante topológico magnético predicho y confirmado. Foto: A. Isaeva, TU Dresden/IFW DresdenLos materiales llamados aislantes topológicos son aquéllos que no dejan pasar la corriente eléctrica en su volumen, pero sí sobre su superficie. A diferencia de los conductores habituales, como los metales, la corriente no sufre ninguna pérdida de energía al circular en la superficie de un aislante topológico. Esta propiedad abre grandes posibilidades de aplicación en electrónica, pues facilitaría la fabricación de dispositivos más eficientes y rápidos, propiedades muy deseables habida cuenta del rápido avance de la demanda energética mundial asociada a la electrónica. No es de extrañar, por tanto, que el descubrimiento de los aislantes topológicos hace aproximadamente una década causase que la investigación en nanotecnología y en física de la materia condensada dedicase buena parte de sus recursos a ellos.

Uno de los retos durante estos años de intensa investigación, por las aplicaciones tecnológicas que podría tener en las tecnologías de la información, por ejemplo, ha sido la creación de un aislante topológico magnético. Hasta hace poco el magnetismo se introducía en los aislantes topológicos no-magnéticos exclusivamente por la llamada vía extrínseca, que consiste en añadir átomos que confieren propiedades magnéticas. Sin embargo, gracias al esfuerzo de un grupo de investigadores del Centro de Física de Materiales (CFM, centro mixto CSIC-UPV/EHU), el Donostia International Physics Center (DIPC) y la Universidad del País Vasco (UPV/EHU) ahora ya es posible fabricar un aislante topológico magnético intrínseco, esto es, que tiene propiedades magnéticas por su propia naturaleza. Los resultados se han publicado en Nature y han merecido un análisis en News & Views.

Fuente: Nature

Fuente: NatureEl equipo formado por los investigadores Mikhail Otrokov, Evgueni Chulkov, María Blanco Rey y Pedro M. Etxenike, ha logrado predecir teóricamente el primer aislante topológico magnético, el telururo de bismuto y manganeso, de fórmula química MnBi2Te4. El investigador Ikerbasque y líder del estudio, Mikhail Otrokov, afirma que «el trabajo previo desde diferentes enfoques nos llevó a la conclusión de que la ruta intrínseca era la única viable hoy en día. Entonces dirigimos nuestros esfuerzos a encontrar un aislante topológico magnético intrínseco basándonos en experiencias previas, gracias a las cuales supimos qué estructura cristalina y composición atómica debía tener tal material».

La confirmación experimental de la predicción ha sido un trabajo que ha involucrado a investigadores expertos en distintas áreas de centros de investigación de referencia de Rusia, Azerbaiyán, Alemania, Austria, Japón, Italia y los EE.UU, coordinados por los investigadores de los centros vascos. Otrokov ha explicado que para la confirmación experimental la primera tarea fue la síntesis de los cristales del compuesto por parte de los expertos en síntesis química. Una vez sintetizadas, las muestras fueron sometidas a multitud de experimentos de caracterización estructural, magnética, electrónica, de transporte, de composición atómica, etc. que han permitido verificar las características predichas.

«El MnBi2Te4 además de ser un aislante topológico con propiedades magnéticas intrínsecas, ha resultado ser un material antiferromagnético, tal y como habíamos calculado», explica Blanco. El antiferromagnetismo consiste en un orden magnético a escala atómica tal que el material carece de magnetización neta. Por ello estos materiales son mucho más robustos frente a perturbaciones por imanes.

El telururo de bismuto y manganeso tiene un gran potencial tanto a nivel fundamental como a nivel tecnológico. Es extraordinariamente rico en propiedades exóticas, como, por ejemplo, varios efectos de Hall, incluido el efecto Hall cuántico, algunos de los cuales se utilizan en la calibración de constantes físicas por su excepcional precisión. El MnBi2Te4 también se puede usar para la creación de los llamados fermiones de Majorana. Un tipo de partícula que se ha llegado a considerar la piedra angular de la computación cuántica. Asimismo, el MnBi2Te4 es el primer material intrínseco para el que se predice una respuesta electromagnética muy similar a la de un axión, una hipotética partícula postulada en el marco de la cromodinámica cuántica, que es buena candidata para resolver el problema de la materia oscura. Por ello se están diseñado muchos experimentos dirigidos precisamente a la detección de señales de un comportamiento de tipo axión en la familia de este compuesto.

Los resultados del estudio, que ya habían sido publicados en arXiv y difundidos en charlas impartidas por los autores en congresos internacionales, han sido bien recibidos por la comunidad científica internacional. A día de hoy el MnBi2Te4 y otros materiales basados en él se están estudiando en decenas de centros de investigación, siendo los radicados en EE.UU. y China los que muestran una actividad más intensa.

Ya se han patentado ya varios dispositivos basados en los aislantes topológicos magnéticos. Así, el MnBi2Te4 puede ser utilizado en las interconexiones quirales de los circuitos integrados, que prometen un rendimiento superior a las conexiones de cobre ordinarias que se emplean actualmente en los circuitos disponibles comercialmente. Otras aplicaciones incluyen moduladores ópticos, sensores de campo magnético y elementos de memoria.

Los investigadores, junto a su red de colaboradores internacionales, esperan poder observar en el MnBi2Te4 algunas de las exóticas propiedades mencionadas y descubrir nuevos aislantes topológicos magnéticos intrínsecos con características incluso superiores que las del propio MnBi2Te4.

Referencia:

M. M. Otrokov, I. I. Klimovskikh, H. Bentmann, D. Estyunin, A. Zeugner, Z. S. Aliev, S. Gaß, A. U. B. Wolter, A. V. Koroleva, A. M. Shikin, M. Blanco-Rey, M. Hoffmann, I. P. Rusinov, A. Yu. Vyazovskaya, S. V. Eremeev, Yu. M. Koroteev, V. M. Kuznetsov, F. Freyse, J. Sánchez-Barriga, I. R. Amiraslanov, M. B. Babanly, N. T. Mamedov, N. A. Abdullayev, V. N. Zverev, A. Alfonsov, V. Kataev, B. Büchner, E. F. Schwier, S. Kumar, A. Kimura, L. Petaccia, G. Di Santo, R. C. Vidal, S. Schatz, K. Kißner, M. Ünzelmann, C. H. Min, Simon Moser, T. R. F. Peixoto, F. Reinert, A. Ernst, P. M. Echenique, A. Isaeva and E. V. Chulkov.(2019) Prediction and observation of an antiferromagnetic topological insulator. Nature doi: 10.1038/s41586-019-1840-9

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un aislante topológico intrínsecamente magnético se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La teoría de bandas de los sólidos se hace topológica

- Superelasticidad nanométrica

- Trayectorias de las partículas cargadas en un campo magnético

La ciencia de llorar a gusto

Composers have a gift, as Barber did, for confirming with music what we already know—sad music intensifies sadness, and in that intensity, solace is somehow provided. [*]

The saddest music ever written, Thomas Larson, 2010.

Los humanos somos unos monos muy raros. A veces, cuando nos duele algo, goteamos. Pongamos que se nos ha muerto un cactus, que nuestro gato nos deja, que nos pillamos un dedo con la puerta. Entonces, una glándula de la región externa del ojo empieza a liberar un líquido salado lleno de proteínas, agua, moco y grasa. Este líquido, más conocido como lágrimas, fluye por la superficie del ojo y se desprende desde las pestañas hasta que, además de goteras, tenemos la cara roja, la nariz congestionada, el rímel como si lo hubiese aplicado Jackson Pollock…

A priori, no parece una reacción especialmente provechosa y, para colmo, los humanos somos la única especie que produce las llamadas lágrimas psíquicas o emocionales1. En su tercer libro sobre teoría evolutiva, La Expresión de las Emociones en el Hombre y los Animales (1872), Charles Darwin llegó a afirmar que este tipo de lágrimas son “inútiles”. Por suerte, algo hemos aprendido desde entonces.

Para empezar, hoy sabemos que no todas las lágrimas son iguales. Las lágrimas emocionales son solo un tipo. Las producimos cuando sentimos emociones intensas, principalmente dolor, pero también con la risa y la felicidad. Existen además lágrimas reflejas o irritativas, que son las que derramamos al ver sufrir a una cebolla o si se nos mete algo en el ojo. Y aunque desde fuera puedan parecer iguales, al microscopio las diferencias se vuelven evidentes. Si bien todas contienen lípidos, metabolitos, electrolitos y enzimas, las lágrimas emocionales tienen además una mayor cantidad de proteínas y hormonas que no se encuentran en el caso de las reflejas. En concreto, se encuentran sustancias relacionadas con la respuesta al estrés y al dolor, como la Encefalina (un anestésico natural) y la Adrenocorticotropa (un trabador de lenguas artificial), que podrían tener un efecto autorregulador. Eso explicaría por qué a veces uno se encuentra mejor después de una buena llorera.

Y para el profesor David Huron explicaría también, por qué disfrutamos de la música triste2: “Cuando una persona está en un estado triste, esta hormona llamada prolactina se libera y tiene un efecto psicológico de consuelo”. Es como si nuestro cuerpo tuviese un mecanismo para que la tristeza y el dolor no se agudicen demasiado, no alcancen ciertos límites que nos incapaciten. Ahora bien, es posible sentir esta sensación de alivio incluso en situaciones donde no existe ningún duelo real. Y una de esas situaciones se da cuando escuchamos música. “La música triste nos pone en un estado de duelo. Pero al final del día, ¡nada terrible ha sucedido!”, no se nos ha muerto el cactus, no nos ha dejado el gato, no hay restos de dedo en ninguna puerta. Por ello, afirma Huron, “sí es posible llorar a gusto, gracias a la música”.

Sin embargo, esta hipótesis sobre el llanto no es la única ni tampoco la más explicativa3. Si bien las lágrimas desencadenan una respuesta fisiológica, su función principal es actuar como señal. Los ojos con goteras, la nariz congestionada, la cara hinchada y salpicada como un Pollock… todos estos síntomas combinados comunican a otros Sapiens un mensaje claro y directo: “Socorro, necesito ayuda”.

En ese sentido, el llanto es muy distinto de la apacible tristeza. Mientras la tristeza deja ver indicios que pueden llegar a confundirse con otros estados fisiológicos (como el cansancio), el llanto es una señal explícita, su función es comunicar y por ello se vale de varios canales, para resultar más evidente e inequívoca. Cuando lloramos, no sólo goteamos; también vocalizamos de una manera muy peculiar: nuestra garganta se tensa, nuestra voz se agudiza, emitimos sonidos vibrantes y ruidosos, a veces sostenidos en el tiempo —notas largas que languidecen y se rinden hacia el grave—, otras veces, entrecortados en forma de sollozo. Nada que ver con los sonidos de la tristeza.

Algunos estudios muestran que, cuando vemos a alguien llorar, se activa en nosotros automáticamente una respuesta de empatía y compasión por los demás. ¿Quizás sucede lo mismo cuando oímos a un violín llorar?

Referencias:

1Asmir Gračanin, Lauren M. Bylsma, Ad J. J. M. Vingerhoets. “Why Only Humans Shed Emotional Tears”. Humane Nature, 2018.

2David Huron. “Why is sad music pleasurable? A possible role for prolactin”. Musicae Scientiae, 2011.

3Michael Trimble. “Why humans like to cry: Tragedy, evolution and the brain”. 2012

Nota:

[*] Los compositores tienen un don, como lo tenía Barber, para confirmar con música lo que ya sabemos; la música triste intensifica la tristeza, y en esa intensidad, de alguna manera, se proporciona consuelo. [Traducción de César Tomé López]

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo La ciencia de llorar a gusto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El arte contemporáneo que mira al Tangram

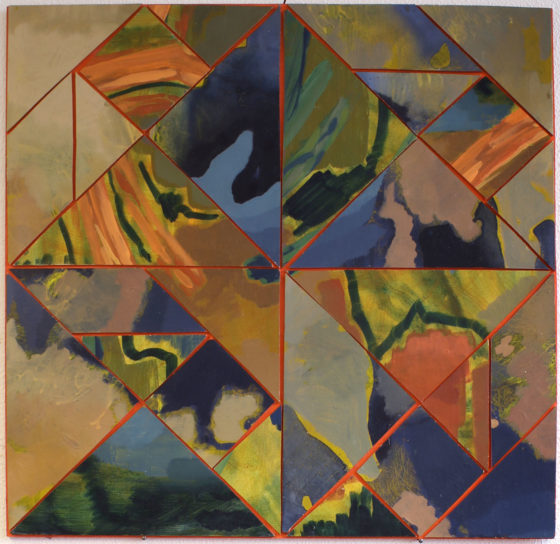

En la octava edición del FIG Bilbao, Festival Internacional de Grabado y Arte sobre Papel, que tuvo lugar el pasado mes de noviembre en Bilbao, descubrí una serie de interesantes grabados del artista madrileño Javier Abad Alonso, co-fundador del estudio de grabado y galería Arco Tijera, relacionada con el Tangram, el clásico rompecabezas de tipo geométrico.

Fotografía de la mesa de la galería Arco Tijera durante la celebración del festival FIG Bilbao, en la que podemos ver dos fotolitografías del artista Javier Abad Alonso de la serie que relaciona el rompecabezas Tangram con el cosmos. Imagen de la página de Facebook de Arco Tijera

Fotografía de la mesa de la galería Arco Tijera durante la celebración del festival FIG Bilbao, en la que podemos ver dos fotolitografías del artista Javier Abad Alonso de la serie que relaciona el rompecabezas Tangram con el cosmos. Imagen de la página de Facebook de Arco Tijera

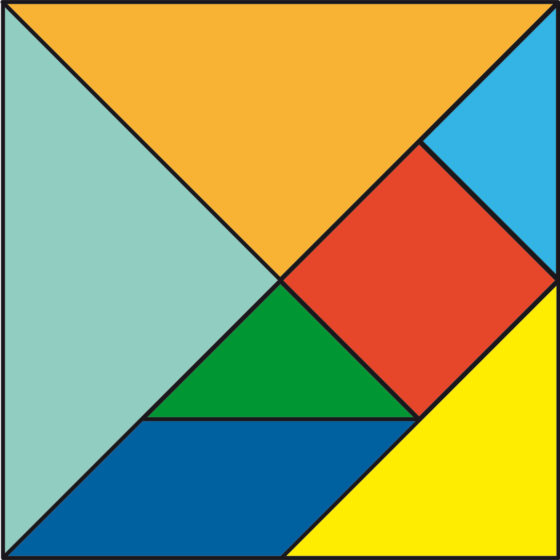

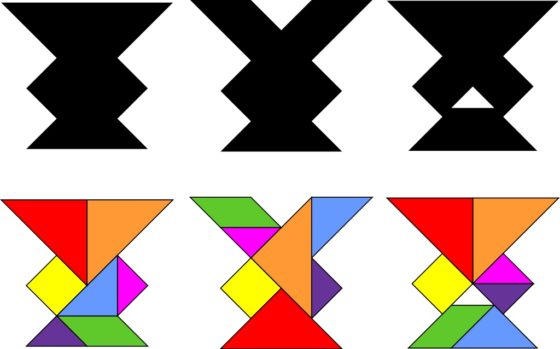

El Tangram es un rompecabezas geométrico de origen chino, aunque de antigüedad desconocida (véase más sobre su historia en la entrada Tangram), formado por 7 piezas poligonales –5 triángulos, 1 cuadrado y 1 paralelogramo de tipo romboide (que pueden verse en la siguiente imagen) – con las cuales se puede formar la figura básica, que es un cuadrado, o una enorme familia de figuras, tanto figurativas (animales, personas, objetos, números, letras, etc), como geométricas (figuras poligonales convexas, etc), además de poder ser utilizado de forma didáctica para aprender matemáticas (teorema de Pitágoras, áreas, ángulos, etc).

Las siete piezas del Tangram formando la figura básica del cuadrado

Las siete piezas del Tangram formando la figura básica del cuadradoEste rompecabezas geométrico nos permite incluso jugar con algunas paradojas, es decir, dos figuras formadas por las siete piezas del Tangram, de igual aspecto, salvo que aparentemente una de ellas es una “extensión” (tiene un añadido) de la otra. La paradoja más conocida es la que consiste en dos monjes y que aparece en el libro Amusements in Mathematics (1917), del matemático recreativo Henry Dudeney (1857-1930). Otras dos conocidas paradojas pertenecen a la persona que popularizó el Tangram, el jugador de ajedrez y matemático recreativo Sam Loyd (1841-1911), que las incluye en su libro The Eighth Book of Tan (1903). En la siguiente imagen mostramos la paradoja de la taza mágica.

Paradoja de la taza mágica, de Sam Loyd, que consiste en tres tazas similares, aparentemente una de ellas con más superficie que las otras dos. Imagen de Wikimedia Commons

Paradoja de la taza mágica, de Sam Loyd, que consiste en tres tazas similares, aparentemente una de ellas con más superficie que las otras dos. Imagen de Wikimedia Commons

Pero regresemos a la serie de grabados de Javier Abad Alonso, que recibe el nombre “Supremus, el cerebro del hombre también es el cosmos”. Este artista toma como punto de partida las ideas del movimiento artístico Suprematismo y en particular de su cofundador Kazimir Malevich (1879-1935), recogiendo además la idea de imitar la naturaleza utilizando módulos geométricos, como explica el propio artista en el texto del proyecto. Así mismo, explica que una referencia fundamental en su trabajo es la pintura icónica de Kazimir Malevich Cuadrado negro (1915-1930):

“El espíritu revolucionario del cuadro de Malévich más de un siglo después de ser exhibido por primera vez sigue manteniendo intacto su espíritu transgresor y aún resulta controvertida para la mayor parte de la sociedad actual, el debate que genera, es algo que aún no ha sido superado y su vigencia es mi punto de partida. Modificar el color negro por paisajes extraídos de un observatorio astronómico e ir deconstruyendo el cuadrado con la ayuda de un juego geométrico siguiendo las reglas suprematistas expuestas de su manifiesto.”

Para esta serie de fotolitografías (como se explica en el Diccionario de Historia del Arte, la fotolitografía es un proceso de impresión litográfico que utiliza una imagen formada a través de medios fotográficos), este artista del grabado utilizada por una parte fotografías del cielo estrellado, tomadas con el telescopio de un observatorio astronómico, y el rompecabezas geométrico más conocido, el Tangram.

A través de una serie de ejemplos concretos de sus fotolitografías, que mostraremos a continuación, podemos observar el uso que hace este artista del grabado de este versátil rompecabezas geométrico.

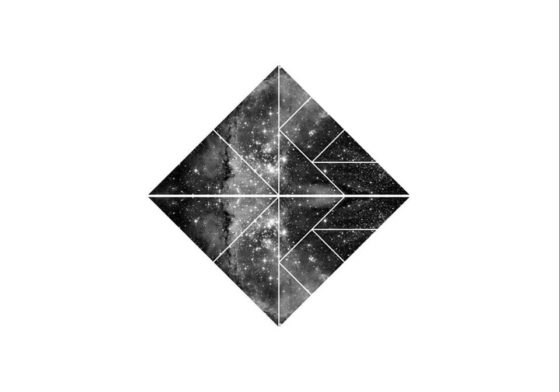

En el primer grabado, que forma parte de un grupo de cinco fotolitografías de la serie Supremus, El cráneo del hombre también es el cosmos con las que este artista ganó el primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019), podemos observar la imagen de un trozo de cielo estrellado dividida en siete zonas poligonales, en concreto con la forma de las siete piezas del Tangram. Además, la imagen que configuran las siete piezas, que es la imagen del cielo estrellado, tiene la forma de una figura poligonal convexa, un hexágono irregular, que es una de las 13 configuraciones poligonales convexas (un polígono convexo es un polígono cuyos ángulos interiores miden menos de 180º, es decir, no hay zonas que externas metidas hacia dentro) que puedes realizarse con las piezas del Tangram.

Fotolitografía de la serie “El cráneo del hombre también es el cosmos”, de Javier Abad Alonso, serie ganadora del primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019). Imagen de la página de Facebook de Arco Tijera

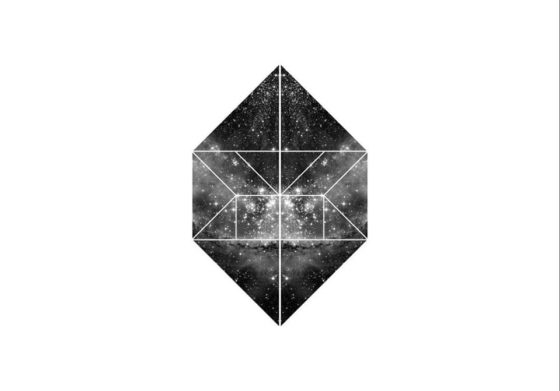

Fotolitografía de la serie “El cráneo del hombre también es el cosmos”, de Javier Abad Alonso, serie ganadora del primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019). Imagen de la página de Facebook de Arco TijeraEn los dos siguientes grabados, pertenecientes al tríptico que este artista madrileño ha expuesto durante la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019), vemos dos fotolitografías, cuyas imágenes son cuadradas, del cielo estrellado y divididas, de nuevo, en las piezas de un rompecabezas geométrico.

Si nos fijamos bien, en la primera litografía la mitad superior es la imagen de una fotografía recortada por las siete piezas del Tangram formando un rectángulo (de proporciones 1:2), mientras que el rectángulo de la mitad inferior es un giro de 180 grados de la pieza de arriba alrededor del centro de la imagen global. Por lo tanto, en esta composición las piezas de arriba y abajo son las mismas en forma e imagen.

Sin embargo, en la segunda litografía la mitad superior está formada por la imagen de una fotografía recortada por las siete piezas del Tangram formando un triángulo (también de proporciones, 1:2), pero ahora el triángulo de abajo es la imagen especular (de tipo espejo) del triángulo de arriba. Por lo cual, ahora las piezas de abajo y arriba son las mismas en forma, las siete piezas del Tangram (bueno, la pieza romboide volteada), pero realmente no en imagen, ya que la imagen de cada pieza de abajo la imagen de espejo respecto de la de arriba.

Fotolitografía 1 del tríptico de Javier Abad Alonso expuesto en la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019). Imagen de la página de Facebook de Arco Tijera

Fotolitografía 1 del tríptico de Javier Abad Alonso expuesto en la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019). Imagen de la página de Facebook de Arco Tijera

Fotolitografía 2 del tríptico de Javier Abad Alonso expuesto en la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019). Imagen de la página de Facebook de Arco Tijera

Fotolitografía 2 del tríptico de Javier Abad Alonso expuesto en la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019). Imagen de la página de Facebook de Arco Tijera

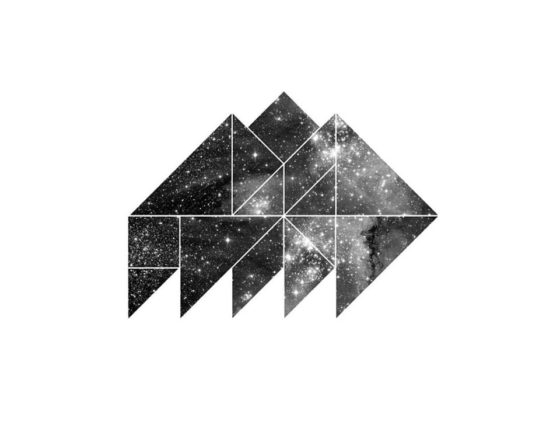

En los ejemplos que hemos comentado hasta ahora podemos observar como Javier Abad utiliza configuraciones convexas del Tangram, distintas del cuadrado básico, como son el hexágono irregular, el rectángulo 1:2 y el triángulo 1:2. En la siguiente fotolitografía utiliza un trapecio isósceles, en las partes derecha e izquierda de la imagen, que son una la imagen especular de la otra.

Fotolitografía 3 del tríptico de Javier Abad Alonso expuesto en la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019). Imagen de la página de Facebook de Arco Tijera

Fotolitografía 3 del tríptico de Javier Abad Alonso expuesto en la VIII Bienal Iberoamericana de obra gráfica ciudad de Cáceres (2019). Imagen de la página de Facebook de Arco Tijera

Y en la siguiente obra utiliza la configuración convexa de un trapecio rectangular. Sin embargo, en esta fotolitografía, aunque las piezas que aparecen se corresponden también con dos juegos enteros del rompecabezas Tangram, no ocurre, como en los ejemplos anteriores, que una parte es simétrica a la otra, sino que las dos configuraciones (derecha e izquierda) son dos imágenes celestes distintas.

Fotolitografía de la serie “El cráneo del hombre también es el cosmos”, de Javier Abad Alonso, serie ganadora del primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019). Imagen de la página de Facebook de Arco Tijera

Fotolitografía de la serie “El cráneo del hombre también es el cosmos”, de Javier Abad Alonso, serie ganadora del primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019). Imagen de la página de Facebook de Arco TijeraAunque Javier Abad no siempre utiliza configuraciones convexas como puede verse en alguna de las obras que hay en la página de Facebook de Arco Tijera, o incluso maneja las piezas de dos juegos completos del rompecabezas Tangram creando una nueva configuración con las 14 piezas, como en la siguiente fotolitografía, donde además ya no se trata de una imagen del cielo “duplicada”, sino una única imagen.

Fotolitografía de la serie “El cráneo del hombre también es el cosmos”, de Javier Abad Alonso, serie ganadora del primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019). Imagen de la página de Facebook de Arco Tijera

Fotolitografía de la serie “El cráneo del hombre también es el cosmos”, de Javier Abad Alonso, serie ganadora del primer premio de la 17 Edición «Gran Canaria Series de Obra Gráfica» (2019). Imagen de la página de Facebook de Arco TijeraSin embargo, Javier Abad Alonso no es el único artista contemporáneo que ha utilizado, o utiliza, el rompecabezas geométrico Tangram, como se mostrará a lo largo de esta entrada del Cuaderno de Cultura Científica.

Vamos a continuar este pequeño paseo por el arte contemporáneo que mira al Tangram por el artista italiano, aunque en la actualidad reside en Grecia, Francesco Moretti, quien cultiva varios formatos, como la pintura, la escultura, el video, el diseño interior o los libros artísticos (como puede verse en su página web), pero también el grabado. De hecho, tiene varias series de maravillosos grabados en los que hace uso del rompecabezas Tangram y algunas de las configuraciones que pueden realizarse con sus piezas.

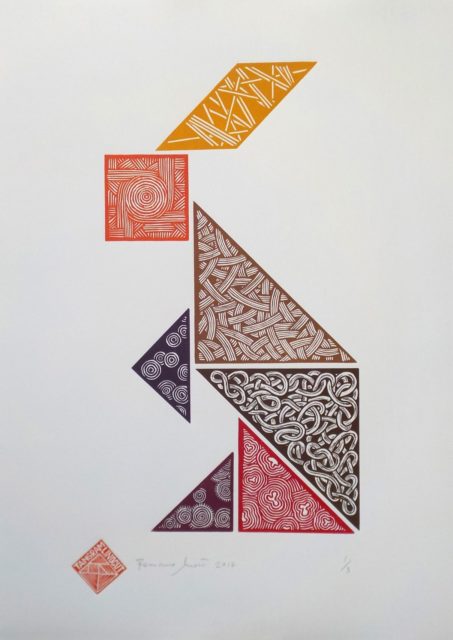

La primera serie de grabados de Francesco Moretti lleva el título de Tangram game. Estas obras son algunas de las configuraciones conocidas del Tangram (hombre cayendo, avión, pez, cisne, caballo, gato, flecha o conejo). Cada pieza del Tangram tiene un diseño geométrico diferente. Además, en cada grabado todas las piezas son del mismo color o cada una tiene un color distinto.

Conejo (2018), de Francesco Moretti. Linograbado con 7 colores, de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti

Conejo (2018), de Francesco Moretti. Linograbado con 7 colores, de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti Gato (2018), de Francesco Moretti. Linograbado con 7 colores, de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti

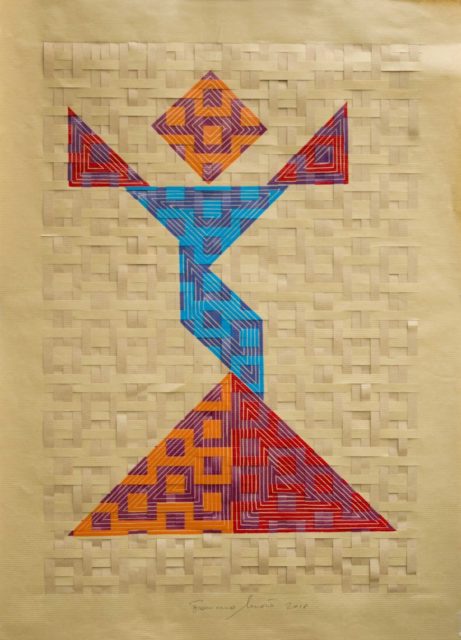

Gato (2018), de Francesco Moretti. Linograbado con 7 colores, de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco MorettiTiene una segunda serie dedicada a las mujeres, titulada Tangram Ladies, en la cual utiliza para cada obra dos impresiones en color de la imagen que ha diseñado, las cuales son cortadas en tiras y “entrelazadas como si fueran hilos de lana en un tejido”. Las configuraciones del Tangram utilizadas son, por supuesto, de figuras femeninas. El resultado es de una gran belleza.

Mujer Tangram 01 (2018), de Francesco Moretti. Linograbado con 2 impresiones, de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti

Mujer Tangram 01 (2018), de Francesco Moretti. Linograbado con 2 impresiones, de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti

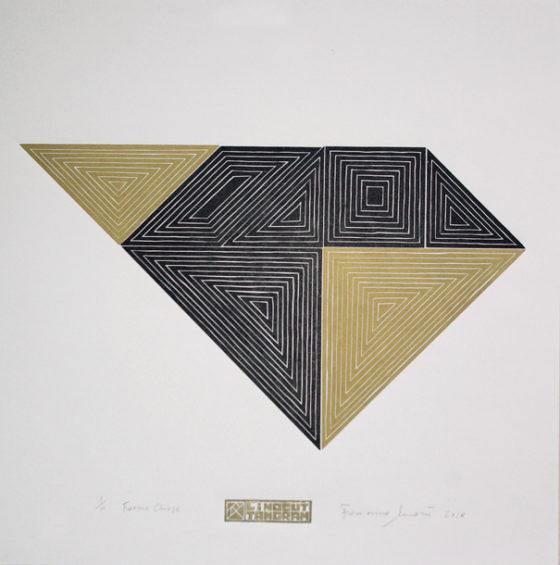

La siguiente serie de grabados, denominada Closed forms (formas cerradas), está formada por algunas de las 13 configuraciones convexas que existen para este rompecabezas geométrico. Además, en cada figura incluye líneas paralelas con la forma de la misma figura, que nos recuerdan a algunas de las obras del artista abstracto y minimalista norteamericano Frank Stella (véase la entrada Frank Stella, la forma del lienzo).

Forma cerrada 03 (2018), de Francesco Moretti. Linograbado en 2 colores, de tamaño 50 x 50 cm. Imagen extraída de la página del artista Francesco Moretti

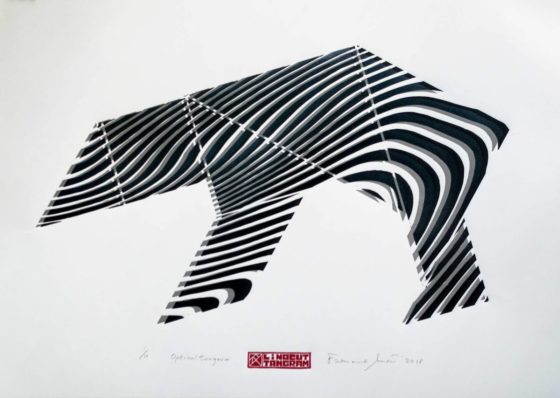

Forma cerrada 03 (2018), de Francesco Moretti. Linograbado en 2 colores, de tamaño 50 x 50 cm. Imagen extraída de la página del artista Francesco MorettiEn la última serie de grabados en los que utiliza este rompecabezas geométrico, que recibe el nombre de Tangram óptico, utiliza diferentes configuraciones de animales del Tangram (camello, gallina, oso, ardilla y tejón). Por otra parte, sobre las piezas diseña una serie de líneas que crean cierto efecto óptico y a que, a diferencia de los anteriores diseños, las líneas se continúan de unas piezas a otras ya dentro de la configuración realizada.

Oso (2018), de Francesco Moretti. Linograbado de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti

Oso (2018), de Francesco Moretti. Linograbado de tamaño 50 x 70 cm. Imagen extraída de la página del artista Francesco Moretti

Pero la utilización del Tangram que realiza este artista italiano no se limita al grabado, sino que también realiza una serie de potentes esculturas inspiradas en el rompecabezas, realizadas tanto en madera, como en acero.

Cisne (2018), de Francesco Moretti. Madera. Tamaño 43 x 19 x 45 cm. Imagen extraída de la página del artista Francesco Moretti

Cisne (2018), de Francesco Moretti. Madera. Tamaño 43 x 19 x 45 cm. Imagen extraída de la página del artista Francesco Moretti

En el año 2016, la galería Espacio Líquido de Gijón en su nueva propuesta por difundir la obra de artistas del entorno organizó una muestra titulada Estructura primitiva, que unía el trabajo de dos creadores como Jorge Nava (Gijón, 1980) y Job Sánchez (A Coruña, 1979). La propuesta del artista gallego Job Sánchez fue su serie Tangram, en la que se utilizaban algunas configuraciones convexas del rompecabezas. Por ejemplo, en cuatro collages de papel y vinilo sobre papel (con los títulos Tangram 1, 2, 3, 4) se utilizaban cuatro de estas configuraciones. Aunque quizás la propuesta más impactante fue el mural, de acrílico y grafico sobre la pared, de un tamaño de 135 x 180 cm, que vemos a la derecha en la siguiente imagen.

Imagen de la exposición Estructura Primitiva en la Galería Espacio Líquido, en 2016. A la derecha, Sin título (2016), del artista Job Sánchez, perteneciente a la serie Tangram. Acrílico y grafico sobre la pared, de un tamaño de 135 x 180 cm. Imagen de la página de la revista cultural online LaEscena

Imagen de la exposición Estructura Primitiva en la Galería Espacio Líquido, en 2016. A la derecha, Sin título (2016), del artista Job Sánchez, perteneciente a la serie Tangram. Acrílico y grafico sobre la pared, de un tamaño de 135 x 180 cm. Imagen de la página de la revista cultural online LaEscena

Imagen de la exposición Estructura Primitiva en la Galería Espacio Líquido, en 2016. Tangram 1, 2, 3, 4 (2016), collage de papeles y vinilo sobre papel, y Sin título (2016), tangram de madera pegado y pintado, con vinilo en la pared, del artista Job Sánchez, perteneciente a la serie Tangram. Imagen de la página de la revista cultural online LaEscena

Imagen de la exposición Estructura Primitiva en la Galería Espacio Líquido, en 2016. Tangram 1, 2, 3, 4 (2016), collage de papeles y vinilo sobre papel, y Sin título (2016), tangram de madera pegado y pintado, con vinilo en la pared, del artista Job Sánchez, perteneciente a la serie Tangram. Imagen de la página de la revista cultural online LaEscena

Otra artista que utiliza el Tangram es la artista francesa, afincada en Aarhus (Dinamarca), Lucie Payoux. Tiene dos obras en las que utiliza la configuración básica del cuadrado, del Tangram, en las cuatro posiciones obtenidas al rotar 90 grados esa configuración básica. Y cada pieza tiene su propio diseño.

Tangram (2019), de la artista Lucie Payoux. Acrílico y óleo sobre madera. Tamaño de 55 x 55 cm. Imagen de la página web de la artista

Tangram (2019), de la artista Lucie Payoux. Acrílico y óleo sobre madera. Tamaño de 55 x 55 cm. Imagen de la página web de la artistaEl artista holandés Daan Roukens también utiliza las cuatro rotaciones de 90 grados de la configuración básica del cuadrado en su graffiti sobre madera On the Wall / Sobre el muro (2010), que realizó para el Artpie 2010, en Ámsterdam, en el que se van repitiendo las cuatro imágenes de forma periódica.

On the Wall / Sobre el muro (2010), del artista Daan Roukens, para el Artpie 2010, en Ámsterdam. Grafitti sobre madera. Tamaño de 1 x 16 metros. Imagen de la página web del artista

On the Wall / Sobre el muro (2010), del artista Daan Roukens, para el Artpie 2010, en Ámsterdam. Grafitti sobre madera. Tamaño de 1 x 16 metros. Imagen de la página web del artistaLa francesa Françoise Bergaglia ha desarrollado un interesante trabajo como ceramista en los últimos años. Como ella misma ha comentado en su página La galerie des Tangram, este rompecabezas geométrico le fascina, sus siete piezas y la infinidad de configuraciones posibles que existen. En La galerie des Tangram tiene más de 50 piezas, de diferentes tamaños, realizadas en terracota sobre configuraciones del Tangram.

Variaciones rojo y azul sobre fondo pintado, de Françoise Bergaglia. Imagen de su página La galerie des Tangram

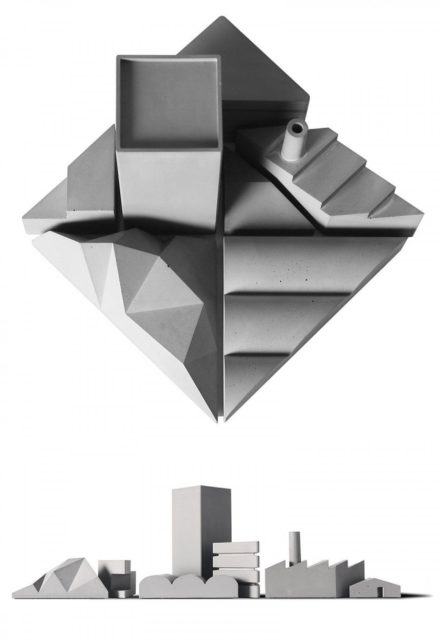

Variaciones rojo y azul sobre fondo pintado, de Françoise Bergaglia. Imagen de su página La galerie des TangramSigamos con el diseño. La compañía de diseño 22 Studio Room de Taipei (Taiwan) realizó la escultura Ciudad Tangram que vemos en la siguiente imagen tomando como base la configuración cuadrada del Tangram.

Escultura Ciudad Tangram, diseñada por la compañía 22 Studio Room de Taipei (Taiwan). Imagen de la página The Journal Shop

Escultura Ciudad Tangram, diseñada por la compañía 22 Studio Room de Taipei (Taiwan). Imagen de la página The Journal ShopTambién podemos encontrar ejemplos dentro de la arquitectura. El estudio de arquitectura de Barcelona del arquitecto Carlos Ferrater, OAB – Office of Architecture in Barcelona, diseño en el año 2013 el proyecto de Casa Tangram, de Borja Ferrater y Carlos Ferrater, para ser construida en Angelo Drive, Beverly Hills.

El estudio OAB explica así la relación del rompecabezas geométrico con su diseño arquitectónico:

“La relación entre el rompecabezas y nuestro proyecto se ha vuelto casual pero con un alcance muy significativo. Nuestro propósito de simplificar el proyecto destacando sus aspectos más importantes nos llevó a relacionar el proyecto con esta brillante, pero a la vez simple idea del juego de rompecabezas, que nos permite representar múltiples formas desde el punto de partida.

Tangram utiliza siete figuras geométricas y con cada una de ellas podemos crear múltiples posibilidades. Nuestro proyecto comenzó con unas premisas muy claras desde el primer día, tales como la relación natural con el paisaje existente, una perfecta organización del programa arquitectónico y un objeto bellamente terminado diseñado para ser visto desde diferentes lugares.

Siempre hemos querido convertir estos tres temas principales en una solución muy clara y potente, tomando como creencia fundamental la fuerza de abstracción en la arquitectura.

Queríamos simplificar la forma mientras transmitíamos estos conceptos importantes con formas geométricas. Este tipo de lógica y pensamiento está bien relacionado con la abstracción, rigor y austeridad que se han utilizado en la arquitectura moderna a lo largo del siglo XX, teniendo California como un magnifico epicentro.”

En la página web del estudio OAB puede encontrarse la descripción completa del proyecto.

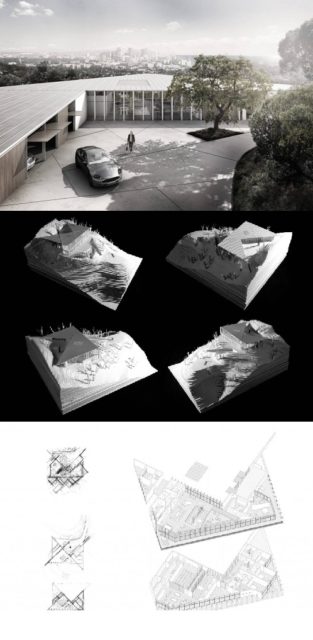

Imágenes del proyecto Casa Tangram, de Borja Ferrater y Carlos Ferrater, para ser construida en Angelo Drive, Beverly Hills

Imágenes del proyecto Casa Tangram, de Borja Ferrater y Carlos Ferrater, para ser construida en Angelo Drive, Beverly Hills

Y vamos a terminar este pequeño paseo con una hermosa obra del diseñador gráfico e ilustrador Hugo Giner.

Ilustración de Hugo Giner. Imagen de su Instagram, a través de su página web

Ilustración de Hugo Giner. Imagen de su Instagram, a través de su página web

Bibliografía

1.- Página web del artista Javier Abad Alonso

2.- Javier Abada Alonso, Supremus, el cerebro del hombre también es el cosmos [comunicación personal]

3.- Diccionario de Historia del Arte: fotolitografía

4.- Página web del artista Francesco Moretti

5.- Página web del artista Job Sánchez

6.- Página web de la artista Lucie Payoux