Las cárcavas marcianas y los ciclos de oblicuidad

Hay términos que a priori pueden parecer poco relacionados con la geología -al menos en un sentido estricto- pero que son capaces de condicionar, por ejemplo, el clima de un planeta, y con ello su dinámica externa, dejando una impronta en procesos erosivos y deposicionales, hasta el punto de que podemos aproximarnos a la historia climática de un planeta como puede ser la Tierra o Marte a través de su geomorfología o de su sedimentología. La palabra en cuestión que hoy nos trae aquí es oblicuidad, o lo que es lo mismo, la inclinación del eje de rotación de un planeta con respecto al plano orbital, y de la que podemos decir que cuanto mayor sea el ángulo, más extremas serán las estaciones, aunque con sus particularidades para cada zona del planeta.

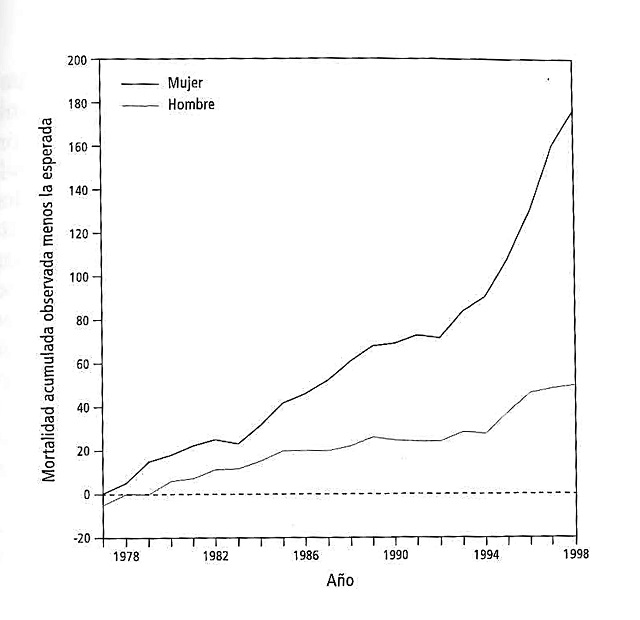

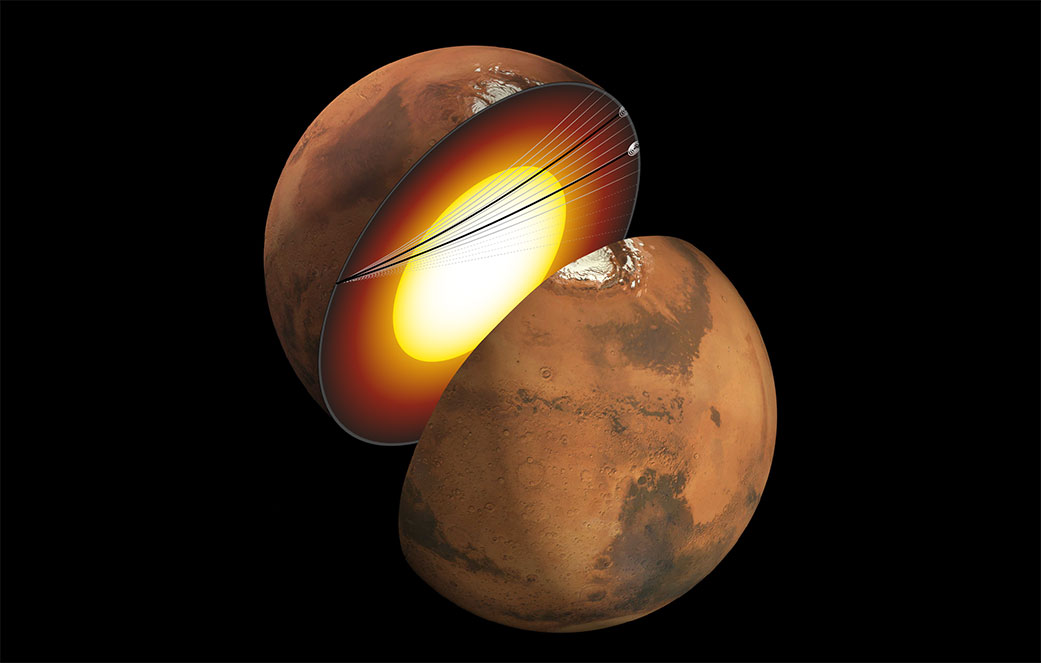

Podríamos pensar que los planetas mantienen estable a lo largo del tiempo esta inclinación del eje de rotación, pero lo cierto es que no es así, sino que hay ciclos en los cuales este valor va cambiando entre momentos de mayor y menor oblicuidad. En nuestro planeta estos cambios son relativamente pequeños -entre 22,1º y 24,5º -, pero en Marte su oblicuidad puede oscilar en ocasiones entre valores cercanos a los 10º, periodos de baja oblicuidad, a otros en los que su eje se inclina por encima de los 40º.

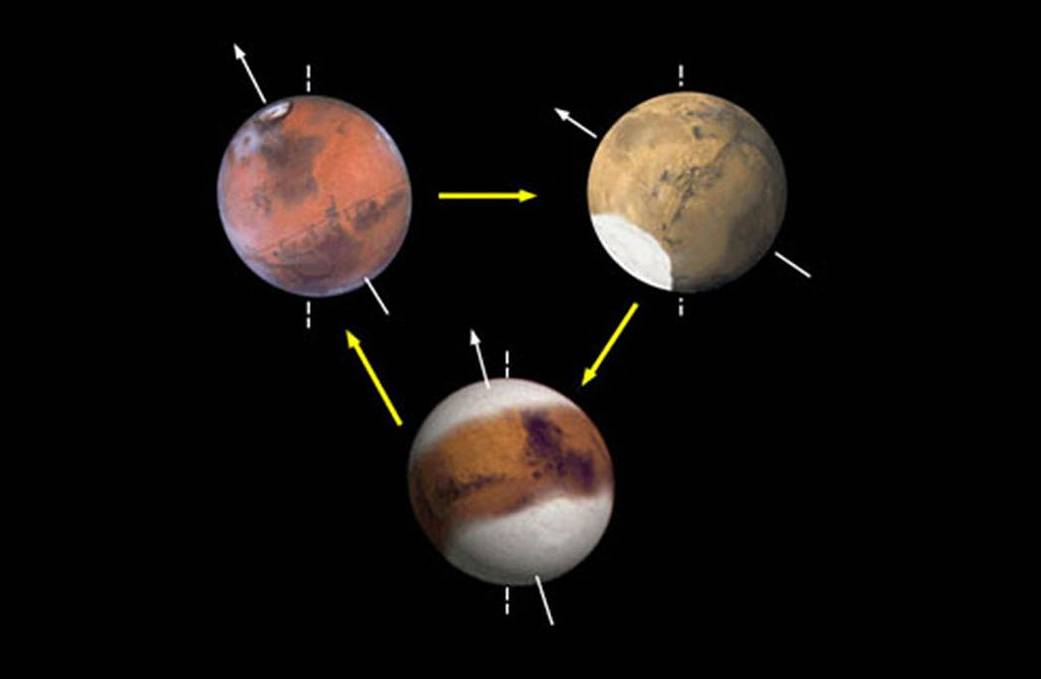

Recreación de como podrían ser de extremos los ciclos de oblicuidad en Marte. En la actualidad estaría en una situación similar a la de la imagen superior izquierda. Cortesía de la NASA/JPL-Caltech.

Recreación de como podrían ser de extremos los ciclos de oblicuidad en Marte. En la actualidad estaría en una situación similar a la de la imagen superior izquierda. Cortesía de la NASA/JPL-Caltech.Los momentos en los que Marte tuviese una mayor oblicuidad serían perfectos para que hubiese una transferencia importante de masa de los polos a la atmósfera, es decir, que una parte del dióxido de carbono que se encuentra formando hielo en estos depósitos polares, acabase sublimándose y permitiese un aumento de la presión atmosférica, pudiendo llegar a valores que duplican la actual presión atmosférica, algo que facilitaría alcanzar mayores temperaturas así como unas condiciones de mayor estabilidad para la presencia de agua líquida en la superficie.

Pero regresemos a la geología. En Marte aparecen una serie de pequeños barrancos que en nuestro planeta conocemos como cárcavas y que en la Tierra suelen estar formados por la erosión fluvial en zonas con pendiente, donde la fuerza del agua y a veces la poca competencia de los materiales -o incluso una baja proporción de materiales consolidados- permite que se produzca una incisión y el transporte de materiales ladera abajo.

Cárcavas en la Tierra, en este caso en la provincia de Guadalajara. Imagen cortesía del Centro Nacional de Información Geográfica (CNIG)

Cárcavas en la Tierra, en este caso en la provincia de Guadalajara. Imagen cortesía del Centro Nacional de Información Geográfica (CNIG)Además, algunas de estas cárcavas observadas en Marte parecen relativamente recientes en tiempo geológico, algo que se aprecia porque conservan todavía muy bien su forma y no han sido alteradas en gran medida por otros procesos y porque no acumulan una gran cantidad de cráteres de impacto. Pero, si las condiciones actuales no permiten la presencia de agua líquida en la superficie -al menos no en los lugares ni en la cantidad para generar las poblaciones más recientes de cárcavas-, ¿cómo han podido formarse?.

Algunos estudios sugerían que estas estarían formadas por el hielo de dióxido de carbono, que durante su sublimación -el paso de sólido a gaseoso sin pasar por el líquido- provocaría que los materiales sobre -o debajo- de los que se encuentra se desestabilicen y caigan ladera abajo, a veces ayudados por el propio dióxido de carbono en estado gaseoso que serviría como una especie “lubricante” que facilitaría su transporte. Este mecanismo podría ser incluso funcional en la actualidad, especialmente durante la primavera y el verano marcianos en laderas iluminadas por el Sol.

Este proceso repetido a lo largo del tiempo daría lugar las cárcavas que observamos, como por ejemplo se describe en Pilorget et al. (2016). De algún modo podríamos decir que esta erosión sería “en seco”, ya que no necesita agua para explicar la formación de las cárcavas. Pero lo cierto es que hoy día, al menos en el tiempo que hemos podido observar el planeta rojo y estudiar los cambios que se producen en su superficie, las cárcavas no muestran una gran actividad, por lo que podrían ser una herencia de otros momentos de la historia de Marte más que representar una forma del modelado actual.

En este artículo nos referimos únicamente a las cárcavas que aparecen en las laderas de algunas montañas y cráteres, que parecen tener un origen diferente a aquellas que se forman en las dunas de zonas polares y donde parece que el agente erosivo es exclusivamente el dióxido de carbono a causa de los ciclos estacionales y que son más representativas del clima actual.

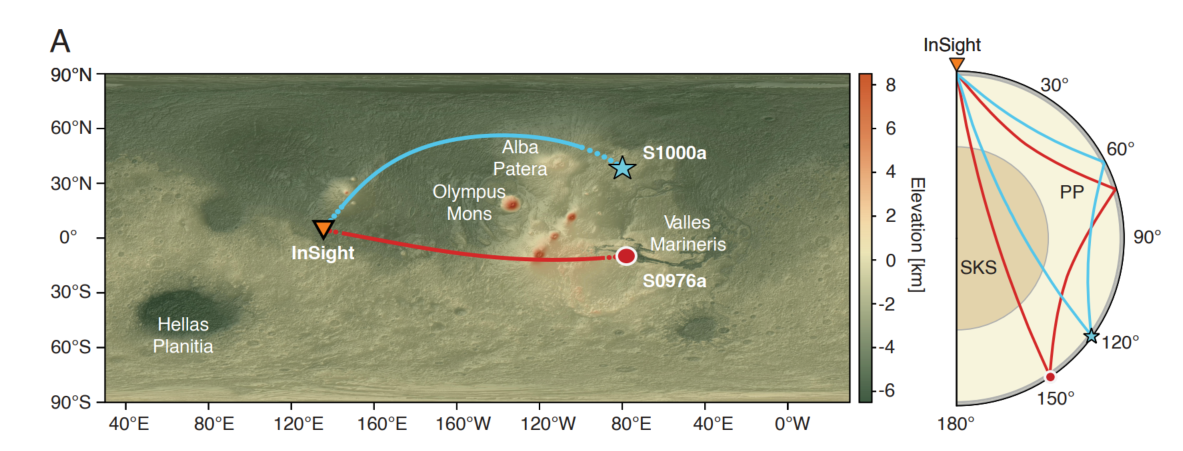

Un nuevo estudio publicado en la revista Science por Dickson et al. (2023) vuelve a poner en el punto de mira al agua como agente formador de las cárcavas. Hoy día, con la actual inclinación del eje de rotación de Marte, los lugares donde existen estas cárcavas no cumplen las condiciones de presión y temperaturas necesarias para que el hielo de agua que existe en el regolito u otros almacenes geológicos cercanos a la superficie pueda derretirse y permitir al agua bajar ladera abajo, pero cuando la oblicuidad del planeta se encuentra alrededor de los 35º, las condiciones serían favorables para la fusión del hielo y para que el agua se mantuviese estable en la superficie el tiempo suficiente de generar los procesos erosivos y el depósito de los sedimentos que observamos.

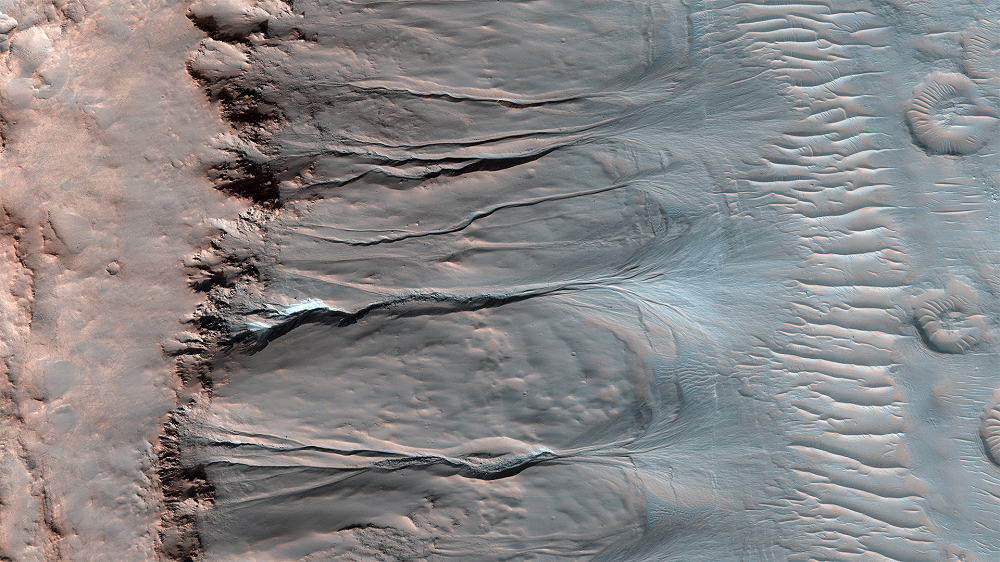

Cárcavas en Marte capturadas por el instrumento HiRISE. La pendiente de la imagen iría de izquierda -más alto- a derecha -más bajo-. Además, se puede apreciar como al final de las cárcavas aparecen una serie de “abanicos” como consecuencia de los materiales arrastrados por el agua. Cortesía de NASA/JPL-Caltech/UArizona.

Cárcavas en Marte capturadas por el instrumento HiRISE. La pendiente de la imagen iría de izquierda -más alto- a derecha -más bajo-. Además, se puede apreciar como al final de las cárcavas aparecen una serie de “abanicos” como consecuencia de los materiales arrastrados por el agua. Cortesía de NASA/JPL-Caltech/UArizona.Para llegar a esta conclusión, los científicos han desarrollado un modelo climático en el cual han podido marcar las localizaciones de las poblaciones de cárcavas más recientes y ver en que momentos y bajo que condiciones la formación de estas podría darse de una manera más o menos simultánea, algo que parece explicarse muy bien mediante los ciclos de oblicuidad marcianos. De hecho, estos procesos formadores de las cárcavas podrían haberse repetido en los últimos millones de años, siendo la última vez hace aproximadamente unos 630.000 años.

Este descubrimiento tiene muchas repercusiones. El primero de cara a la exploración planetaria, ya que nos permitiría acceder a depósitos de hielo para su estudio, pero también de cara a la astrobiología, porque la presencia de agua líquida -aunque sea en momentos más o menos efímeros- podría ser importante para la vida en Marte si esta existiese, suponiendo estos intervalos de tiempo en los que hay agua líquida en superficie una especie de puente entre las condiciones frías y secas y otras que amplíen el rango de espacios habitables en el planeta.

Pero, sin lugar a dudas, estudios como estos ponen de manifiesto lo difícil que es a veces la interpretación de la geología en otros lugares diferentes a la Tierra. Es por ello que se necesitan aproximaciones multidisciplinares que nos permitan comprender un poco mejor la historia de los planetas y otros cuerpos del Sistema Solar.

Referencias:

Dickson, J. L., A. M. Palumbo, J. W. Head, L. Kerber, C. I. Fassett, y M. A. Kreslavsky. «Gullies on Mars Could Have Formed by Melting of Water Ice during Periods of High Obliquity». Science 380, n.º 6652 (30 de junio de 2023): 1363-67. https://doi.org/10.1126/science.abk2464.

Dickson, James L., y James W. Head. «The Formation and Evolution of Youthful Gullies on Mars: Gullies as the Late-Stage Phase of Mars’ Most Recent Ice Age». Icarus 204, n.º 1 (noviembre de 2009): 63-86. https://doi.org/10.1016/j.icarus.2009.06.018.

Dundas, Colin M., Serina Diniega, Candice J. Hansen, Shane Byrne, y Alfred S. McEwen. «Seasonal Activity and Morphological Changes in Martian Gullies». Icarus 220, n.º 1 (julio de 2012): 124-43. https://doi.org/10.1016/j.icarus.2012.04.005.

Dundas, Colin M., Alfred S. McEwen, Serina Diniega, Candice J. Hansen, Shane Byrne, y Jim N. McElwaine. «The Formation of Gullies on Mars Today». Geological Society, London, Special Publications 467, n.º 1 (enero de 2019): 67-94. https://doi.org/10.1144/SP467.5.

Treiman, Allan H. «Geologic Settings of Martian Gullies: Implications for Their Origins». Journal of Geophysical Research 108, n.º E4 (2003): 8031. https://doi.org/10.1029/2002JE001900.

Pilorget, C., y F. Forget. «Formation of Gullies on Mars by Debris Flows Triggered by CO2 Sublimation». Nature Geoscience 9, n.º 1 (enero de 2016): 65-69. https://doi.org/10.1038/ngeo2619.

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Las cárcavas marcianas y los ciclos de oblicuidad se ha escrito en Cuaderno de Cultura Científica.

Por qué los humanos tenemos un extra inesperado de energía (y para qué sirve)

energía

Foto: Jordan McQueen / Unsplash

Foto: Jordan McQueen / UnsplashEl metabolismo es el conjunto de transformaciones mediante las cuales, a partir de materia orgánica (la comida), agua y oxígeno, construimos nuestro cuerpo y generamos energía para todo proceso vital. Gastamos energía cuando hacemos ejercicio. Pero también al dormir, manteniendo y reparando el cuerpo. O pasando una agradable tarde de lectura: no olvidemos que mantener el cerebro “le cuesta” a un adulto el 20 % de toda su energía diaria.

El modo en que obtenemos y gastamos energía los humanos ha sido objeto de discusión en las ciencias y las humanidades. Más aún desde que se ha descubierto que contamos con un extra de energía inesperado. Comparados con otros primates, empleamos más energía de la que podría parecer necesaria por nuestras características físicas.

¿Por qué necesitamos los humanos ese extra de energía? Y ¿cómo la conseguimos?

Una de las respuestas más apasionantes a ambas preguntas tiene que ver con nuestra naturaleza biocultural.

La paradoja energética humanaDurante nuestra evolución hemos desarrollado rasgos que nos diferencian de nuestros parientes vivos más cercanos: crecemos más lentamente, desarrollamos un cerebro más grande, nos reproducimos más, vivimos más años y somos más resistentes en el ejercicio físico que chimpancés, bonobos y gorilas.

Estos rasgos son energéticamente caros, y hacerlos posibles a lo largo de nuestra vida es lo que se ha llamado la paradoja energética humana.

Hasta hace unos años, sorprendentemente nadie había comparado el gasto energético total entre humanos y grandes simios. El primero en hacerlo fue el biólogo experimental Herman Pontzer, que propuso que los humanos estamos metabolicamente “acelerados”. Esto significa que el linaje humano ha experimentado una aceleración en la tasa metabólica a lo largo de la evolución, proporcionando energía para cerebros más grandes y una reproducción más rápida sin sacrificar el mantenimiento del organismo y la longevidad. Pontzer lo describió como el extra inesperado de energía humana: gastamos más energía por unidad de masa que nuestros parientes más cercanos. Y eso se acompaña de un metabolismo particularmente acelerado.

La energía la distribuye el corazónSi seguimos el rastro del gasto energético, el camino nos lleva directos al corazón, el órgano que ha encarnado la esencia de la vida a lo largo y ancho de nuestra historia. Siempre ha sido protagonista, desde la representación prehistórica en la Cueva del Pindal en Asturias hasta el énfasis actual en una buena salud cardiaca, pasando por su pesaje en el viaje al más allá en el antiguo Egipto, o su transformación en jaguar tras la muerte para los Waorani amazónicos.

El corazón provee a todo el cuerpo de la energía necesaria para toda la actividad fisiológica. Podemos cuantificar este suministro con el gasto cardiaco, que es el producto de la cantidad de sangre que bombeamos en un latido por el número de latidos por minuto.

Este flujo tiene un valor medio aproximado de cinco litros por minuto. Así mantenemos la circulación de materias primas (oxígeno y nutrientes) y de deshecho (dióxido de carbono, agua) de nuestro metabolismo, lo que nos lleva a la paradoja energética humana. Si comparados con otros grandes simios estamos metabólicamente acelerados (empleamos más energía por unidad de masa), podemos esperar que nuestro gasto cardiaco por unidad de masa también sea mayor.

Una manera de estudiarlo es midiendo el diámetro de la “tubería” por la cual sale del corazón toda la sangre de un latido. A partir de ecocardiografías en grandes simios vivos observamos que nuestra aorta es similar a la de los gorilas, que nos pueden duplicar en tamaño. De hecho, controlando por el peso tenemos una aorta mayor por unidad de masa que los gorilas. Para alimentar nuestro metabolismo acelerado tenemos un gasto cardiaco mayor por unidad de masa: una aorta de gorila en un cuerpo de humano.

Reproducción biocultural¿Y bien? ¿Cómo sostenemos el sistema? ¿Cómo logramos esa energía extra que permite desarrollar un cerebro voraz o parir más que cualquier otro primate?

Una respuesta a estas preguntas la encontramos en nuestra naturaleza biocultural.

Pensemos en un ingrediente de la paradoja: nuestro gran cerebro. Termina de crecer en volumen aproximadamente a los seis años de edad, en un proceso tan costoso que frena el crecimiento corporal y emplea nada menos que el 40 % de la energía total diaria de los niños (y más del 65 % de la energía en reposo). De hecho, en la infancia tenemos un gasto cardiaco y quemamos más energía por unidad de masa que de adultos.

Pensemos ahora en otro ingrediente de la paradoja: nos reproducimos más. Las madres humanas tienen la capacidad de tener bebes a un ritmo mayor que otros grandes simios. Las humanas destetan a la cría para quedarse embarazada de nuevo cuando aquella todavía es dependiente y quema energía a una tasa muy elevada. Esto sólo es posible gracias a la provisión de cuidados y de comida nutritiva y procesada que proporciona la comunidad, una característica exclusivamente humana: no criamos solas.

Como sugiere el biólogo humano Barry Bogin, una clave es que los humanos practicamos una reproducción biocultural. En nuestra especie, el cuidado y provisión de las crías no es solo asunto de los progenitores. En esa tarea es fundamental el papel de abuelas, abuelos, hermanos y hermanas mayores, y otros familiares. Pero también el papel de otras personas del grupo cuyo vínculo se define culturalmente, más allá de la genética (las “tías” y “tíos” de la infancia, en realidad amigos cercanos de nuestros padres). Otra característica exclusivamente humana.

Siguiendo esta senda energética biocultural, se ha propuesto que, durante nuestra evolución, una de las soluciones para la búsqueda de alimento nutritivo fue el desarrollo de la caza y recolección y de la horticultura. Estas habilidades sociales, de grupo, nos permitieron mejorar nuestra tasa de retorno energético.

Mediante un proceso social complejo, intenso y costoso pero rentable, obtenemos más calorías en menos tiempo que los demás grandes simios. Así alimentamos la máquina.

La supervivencia del más amistosoLa reproducción biocultural y el aumento del retorno energético no se explican sin un aumento continuado de nuestra sociabilidad a lo largo de la evolución. Un aumento que seguramente se produjo en una retroalimentación que incluyó a otros hitos como el fuego, el lenguaje y el cocinado de los alimentos.

Tan llamativa es nuestra sociabilidad que se ha sugerido que nuestra evolución es un proceso de autodomesticación, de “supervivencia del más amistoso”.

Regresando a la perspectiva fundamental de los ciclos de materia y energía, los corazones y cerebros forman parte de metabolismos individuales entretejidos en un grupo social. Al fin y al cabo, forman parte de una matriz biocultural evolutiva capaz de costear nuestra paradoja energética.

El ensayo del recientemente fallecido Nuccio Ordine La utilidad de lo inútil expresa la profundidad de estos vínculos. En él, Ordine escribe: “La necesidad de imaginar, de crear, es tan fundamental como lo es respirar”. Así, según Ordine: “Esta respiración […] expresa el excedente de la vida respecto de la vida misma […], energía que circula de forma invisible y que va más allá de la vida, aún siendo inmanente a ella”.

Una evocadora reflexión para dar respuesta al inesperado extra de energía humana.![]()

Sobre el autor: Luis Ríos Frutos es Profesor de Antropología en la Universidad Complutense de Madrid

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Por qué los humanos tenemos un extra inesperado de energía (y para qué sirve) se ha escrito en Cuaderno de Cultura Científica.

El mono que desafió la sincronía

Cómo influyen los parásitos en el comportamiento de los animales, cómo se modifica la conducta de las madres mamífero o cuáles son las enfermedades que nos afectan y desde cuándo hemos desarrollado comportamientos funerarios ante la muerte son algunos de los aspectos que se analizarán en la V Jornada Nacional sobre Evolución y Neurociencias.

Especialistas en ambas materias se reunieron el 11 y 12 de mayo en una nueva edición conducida por Eva Garnica y Pablo Malo, psiquiatras y miembros de la Red de Salud Mental de Bizkaia, y organizada por esa misma entidad y la Cátedra de Cultura Científica de la UPV/EHU.

La jornada, cuya primera edición se celebró en 2017, se ha convertido en una cita imprescindible para las y los expertos en ámbitos como la psiquiatría, la psicología o la biología. Una jornada que sirve para analizar el comportamiento humano desde un punto de vista evolucionista y divulgar de un modo accesible para todos los públicos.

A la hora de entender las psicopatologías y su tratamiento el conocimiento del hecho evolutivo tiene mucho que aportar, especialmente para asumir que no somos más que primates enamorados de los símbolos que nos alegramos con lo bueno u odiamos al otro en sincronía.

Julio Sanjuán Arias es coordinador de la Unidad de Primeros Episodios Psicóticos del Hospital Clínico Universitario de Valencia, investigador principal de la línea de Psiquiatría y enfermedades Neurodegenerativas del INCLIVA y profesor Titular de Psiquiatría en la Universidad de Valencia.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo El mono que desafió la sincronía se ha escrito en Cuaderno de Cultura Científica.

La natalidad es solo un número

Foto: Luana Azevedo / Unsplash

Foto: Luana Azevedo / UnsplashLa demografía es una ciencia de sumas y restas, pero si queremos entender su lógica matemática es preciso incorporar la dimensión temporal y analizar los efectos que ejerce la estructura demográfica en su propia dinámica. Cifras de nacimientos como las recientemente publicadas por Eustat deben, por tanto, contextualizarse. Destacar las bajas cifras de nacimientos sin ponerlas en su contexto es quedarse en una visión muy simplificada de la realidad. El número total de nacimientos es cada vez más bajo, pero es solo un número. Si no lo relativizamos, no podremos interpretarlo. Si lo comparamos con la población total, a través de la tasa bruta de natalidad, el resultado son valores cada vez más bajos. Pero, como también se está reduciendo el número de mujeres en edad fértil, si lo medimos a través del índice sintético de fecundidad, nos da valores que superan los de hace tres décadas1.

La natalidad no es el único factor demográficoAdemás, gozamos de mayor eficiencia reproductiva que en el pasado. Lo que MacInnes y Pérez Díaz (2009)2 denominan la revolución reproductiva nos ha conducido a que menores índices de fecundidad por mujer deriven en mayores volúmenes de población. Un menor número de hijos, pero con más medios para su cuidado y educación, lleva a una supervivencia mucho mayor y a un incremento notable de la esperanza de vida. Una sociedad con mayores niveles educativos será también más productiva, por lo que el volumen de población activa necesario para garantizar la sostenibilidad de las pensiones será menor. Asimismo, si se alarga la esperanza de vida, se llega con mejor salud a la vejez y se retrasan el resto de las etapas vitales, no resulta tampoco tan insensato retrasar la edad de jubilación y mantener activo un capital humano que puede aportar experiencia y know-how.

Por otro lado, ¿cómo establecer el número óptimo de nacimientos, tratándose de una decisión individual, un proyecto de vida que cada cual puede o debería poder elegir? Porque, aunque tradicionalmente la demografía ha situado en 2,1 el número de hijos por mujer necesario para que se produzca el reemplazo generacional, esa cifra no incorpora el impacto de las migraciones ni del incremento de la longevidad ni de los nuevos modelos familiares. Es, por tanto, un valor discutible, como lo es considerar que una pérdida de población sea siempre negativa y, por ende, preocuparse más por la cantidad de habitantes que por la calidad de vida de dichos habitantes.

El mayor logro demográfico de los países desarrolladosNo nos percatamos de que gozamos de mejor calidad de vida que nuestros antepasados y que convertirse en sociedades envejecidas es el mayor logro demográfico de los países desarrollados. La pirámide de población de amplia base de los países en vías de desarrollo recoge su pujante natalidad, pero también es el reflejo de una mortalidad por edades relativamente alta y de un marcado descenso de individuos entre una cohorte de edad y la siguiente. Nuestras pirámides, bastante más alargadas y que han perdido hace tiempo su característica forma triangular, indican, por el contrario, un continuo incremento de la esperanza de vida. Sin embargo, en lugar de destacar que los índices de supervivencia de las sucesivas generaciones son cada vez más positivos, los titulares periodísticos se centran en los efectos negativos del envejecimiento de la población y en la baja natalidad.

Aunque ampliamente compartida, presentar el bajo número de nacimientos como algo negativo no deja de ser una valoración subjetiva. Además, gran parte de las alarmas demográficas no se sostienen en fundamentos científicos, sino que se impregnan de ideologías políticas o religiosas que ponen a la familia como núcleo central de organización de la sociedad y otorgan a la mujer el rol de garante de la natalidad. Nos enfrentamos a un cambio en el modelo reproductivo, no solo a nivel individual, sino también como sociedad, que consigue que la población siga creciendo a pesar de que la natalidad se reduzca.

Esa reducción se puede explicar en base al coste de oportunidad que supone tener hijos. En el pasado, tener una prole abundante significaba una probabilidad más alta de que sobreviviesen a la infancia en mayor número y pudiesen contribuir a edades tempranas a la economía familiar e, incluso, garantizasen el cuidado de los padres en la vejez. En la actualidad, las familias que deciden tener hijos se enfrentan a altos costes tanto económicos como medidos en términos de tiempo, lo que lleva a muchas de ellas a replantearse esa decisión.

La maternidad pasa facturaEspecialmente en el caso de las mujeres, la maternidad pasa factura. Son ellas quienes disfrutan en mayor medida de reducciones de la jornada laboral o de excedencias por cuidado de hijos o familiares. A medida que el número de hijos aumenta, presentan mayor probabilidad de abandonar el mercado laboral3, reduciendo también su empleabilidad futura. Por esos y otros motivos, se retrasa la edad de la maternidad y con frecuencia no se tienen los hijos que se desean.

Ese hecho sí debería ser objeto de preocupación por parte de las políticas públicas. Políticas de igualdad que garanticen una sociedad más equitativa, políticas laborales que reduzcan la precariedad laboral y permitan la conciliación de la vida personal y laboral o políticas de vivienda que faciliten el acceso a la misma y favorezcan la emancipación temprana de los jóvenes tendrán una incidencia importante en la decisión de abordar la maternidad/paternidad.

En cambio, las políticas pronatalistas, que hacen un uso ideológico de las estadísticas demográficas, se muestran ineficientes en el fomento de la natalidad. Ayudas coyunturales y no progresivas como son los cheques bebé universales, aunque mejoren la situación de familias en situación de vulnerabilidad, no serán tampoco relevantes en la decisión reproductiva. Probablemente, patrones de parentalidad compartida y una corresponsabilidad real contribuirán en mucha mayor medida a reducir la distancia existente entre expectativas y realidad reproductiva.

Notas y Referencias:

1 Según los Indicadores para el análisis de los fenómenos demográficos (Eustat, 2022), en 1990/1991, el índice sintético de fecundidad de Euskadi era de 0,97 hijos por mujer mientras que en 2020/2021, se sitúa en 1,25 hijos por mujer. En ese mismo periodo, según las Estadísticas de nacimientos, la tasa bruta de natalidad se ha reducido, pasando de 7,7 a 6,5 nacimientos por cada mil habitantes, mientras que el número total de nacimientos ha disminuido también en algo menos de 2.000.

2 MacInnes, J., y Pérez Díaz, J. (2009). ‘The Reproductive Revolution’. The Sociological Review, vol. 57, nº. 2, págs. 262–284. https://doi.org/10.1111/j.1467-954X.2009.01829.x

3 En España, según datos de la Encuesta de Población Activa (INE, 2022), en el caso de los hombres entre 25 y 49 años, presentan una mayor tasa de empleo si tienen hijos que si no tienen hijos (89,7 frente a 83,6), mientras que en las mujeres de esa misma edad se reduce la empleabilidad (en el caso de ser madres, 69,7 frente a 74,7 si no tienen hijos). Pero llama especialmente la atención la distancia existente en el caso de que el número de hijos sea superior a 3, ya que en los hombres la tasa de empleo alcanza el 84,2 (superior incluso a la que presentan cuando no tienen hijos), y en las mujeres es de 53,4 (más de 20 puntos inferior a la que presentan si no son madres).

Sobre la autora: Itziar Aguado es Profesora del Área de Geografía Humana en la Facultad de Letras de la UPV/EHU

Una versión de este texto apareció originalmente en campusa.

El artículo La natalidad es solo un número se ha escrito en Cuaderno de Cultura Científica.

Geología en el Tour

arqueas

Reconozco que, de siempre, me ha encantado seguir las grandes vueltas ciclistas veraniegas, pero no por el deporte en sí, sino por la gran oportunidad de ver unos paisajes increíbles que caracterizan los países por los que pasa la serpiente multicolor. Y el Tour de Francia de este año me está encantando, porque no paran de subir unas montañas míticas. Así que esta semana os voy a hablar de la geología del Tour de Francia, pero no como os lo estáis imaginando.

Maillot del equipo ciclista Arkéa Samsic en el Tour de Francia 2023. Imagen tomada de www.letour.fr

Maillot del equipo ciclista Arkéa Samsic en el Tour de Francia 2023. Imagen tomada de www.letour.frSi estáis siguiendo la ronda gala, os habréis encontrado con un equipo francés llamado Arkéa Samsic. Pues cada vez que veo las letras Arkéa bien grandes en los maillots, lo que menos pienso es en una empresa de finanzas o en un grupo ciclista. Lo que me viene a la mente es en el origen de la vida en nuestro planeta.

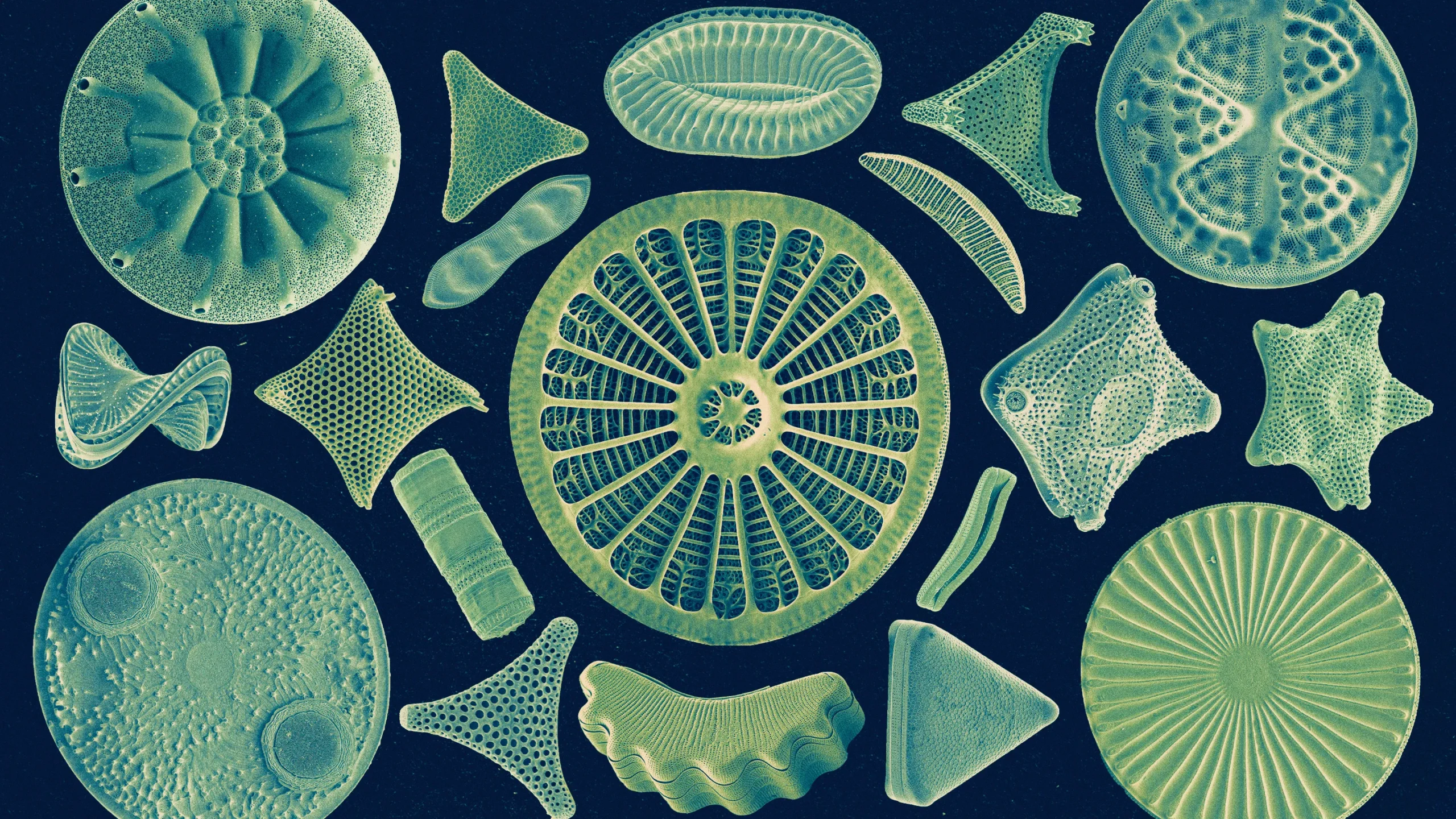

Hoy en día, toda la vida del planeta se puede dividir en tres grandes grupos, llamados Dominios: Archaea (más conocidas en el argot popular como arqueas), Bacteria (creo que estas no necesitan traducción) y Eucarya (o células eucariotas). Los dos primeros grupos son organismos unicelulares sin núcleo diferenciado (lo que en mi época de estudiante se llamaban procariotas y formaban el Reino Monera), mientras que el último está compuesto por organismos con células que tienen un núcleo verdadero.

Arquea es una palabra de origen griego que significa “antiguo”, ya que, hasta no hace mucho, a estos organismos se les consideraba como las formas de vida más antiguas de nuestro planeta. Además, se creía que eran todos extremófilos, es decir, que habitaban ambientes considerados actualmente como muy extremos para la vida: unas arqueas se alimentaban de metano, otras se desarrollaban en medios de alta salinidad y un tercer grupo vivían en condiciones de temperaturas muy elevadas.

Pero todo esto ha cambiado en los últimos años. Recientemente, se han descubierto arqueas en ambientes muy normalitos, por decirlo de alguna manera, como el agua del mar o el fango del suelo continental. Incluso, se pone en duda que realmente sean los organismos vivos más primitivos de la Tierra. Así que vamos a viajar en el tiempo, a ver si nos situamos un poco en toda esta historia… Aunque no va a ser tan fácil como os podéis imaginar, porque la ausencia de un registro fósil tan antiguo nos obliga a trabajar con edades estimadas a partir del estudio genético de actuales grupos de arqueas, bacterias y eucariotas.

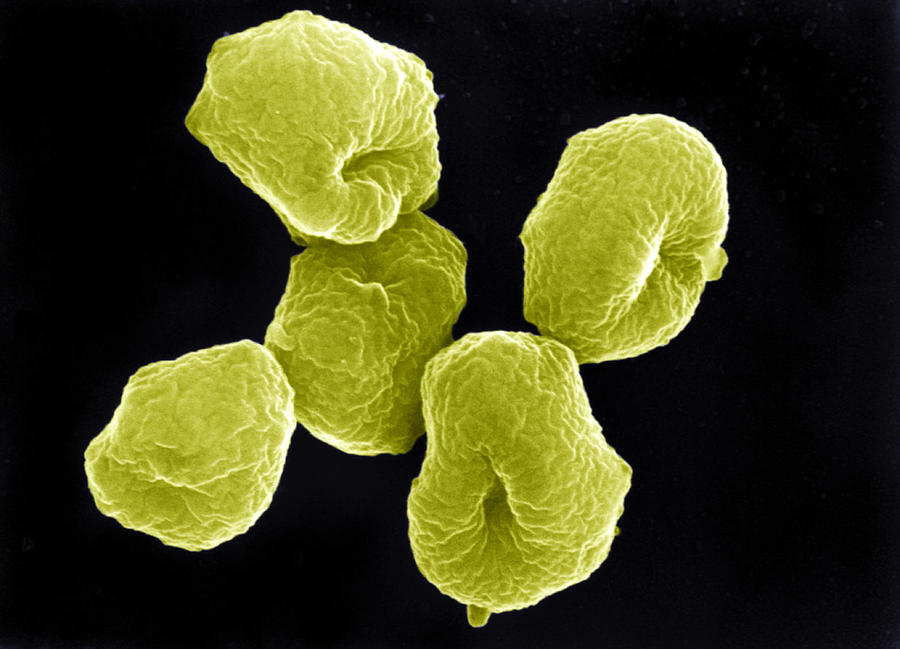

Fotografía coloreada de Microscopio Electrónico de Barrido (SEM) de una arquea Sulfolobus, un grupo de organismos extremófilos que habita en medios acuáticos de agua caliente con abundante azufre disuelto. Cada célula mide, aproximadamente, 0,002 mm. Imagen de Oliver Meckes EYE OF SCIENCE /Pixels

Fotografía coloreada de Microscopio Electrónico de Barrido (SEM) de una arquea Sulfolobus, un grupo de organismos extremófilos que habita en medios acuáticos de agua caliente con abundante azufre disuelto. Cada célula mide, aproximadamente, 0,002 mm. Imagen de Oliver Meckes EYE OF SCIENCE /PixelsHoy en día se acepta que nuestro planeta tiene unos 4570 millones de años de edad, millón de años arriba, millón de años abajo. Pues se considera que las primeras formas de vida verdaderas, es decir, células sin núcleo que incluían moléculas de ADN en su interior, aparecieron hace unos 4350 millones de años. Como dice el grupo de música heavy Nightwish en su canción Greatest Show on Earth, que entre LUCA. Estas siglas significan Last Universal Common Ancestor, que se puede traducir como el Último Ancestro Común Universal. Lo primero, no era un organismo en singular, sino un grupo de organismos evolucionados a partir de la unión de los ladrillos de la vida, moléculas de ARN libres que se combinaron para secuenciar ADN.

Pero, ¿qué tipo de organismos eran LUCA? Hasta no hace mucho se consideraban como las primeras arqueas. Actualmente, se ha llegado al consenso de que se trata de un grupo primitivo de bacterias. Por tanto, los organismos más antiguos de nuestro planeta no son el grupo cuyo nombre significa, precisamente, antiguo, sino que lo son las bacterias. Aunque la diferenciación entre los dos dominios pudo producirse muy rápido, hace entre 3800 y 4100 millones de años, dando lugar a dos clados muy diferenciados.

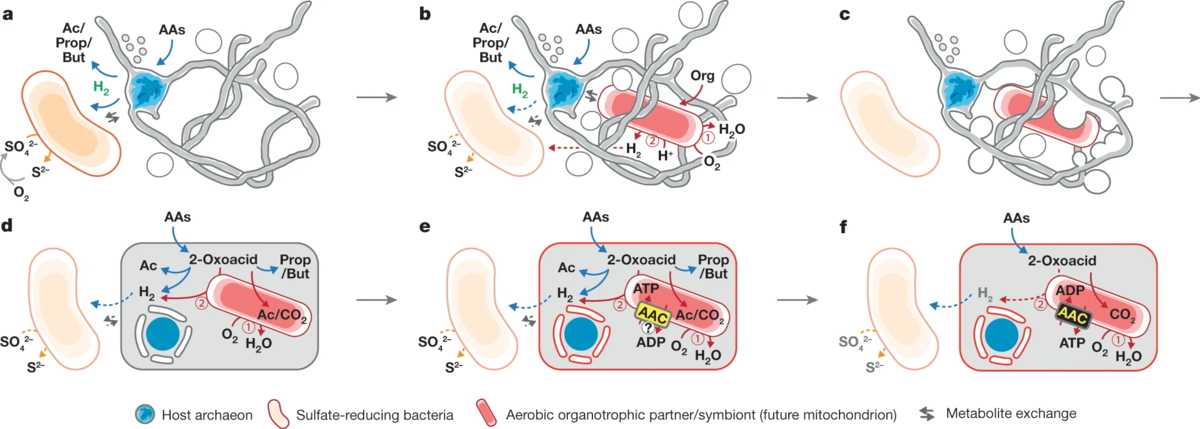

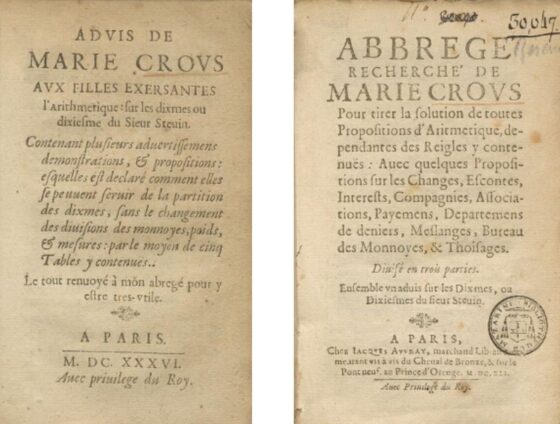

Mecanismo simbiótico propuesto entre las arqueas y las bacterias para dar origen a los organismos eucariotas. Imagen tomada de Imachi et al. (2020) Isolation of an archaeon at the prokaryote–eukaryote interface. Nature volume 577, pages 519–525

Mecanismo simbiótico propuesto entre las arqueas y las bacterias para dar origen a los organismos eucariotas. Imagen tomada de Imachi et al. (2020) Isolation of an archaeon at the prokaryote–eukaryote interface. Nature volume 577, pages 519–525¿Y los eucariotas? Pues parece que tardaron un poquito más en aparecer, estimándose su presencia más antigua hace unos 2300 millones de años. Estudios recientes han llegado a la conclusión de que este último dominio surgió de un grupo de arqueas primitivas que pudieron hacer simbiosis con bacterias más evolucionadas. Estos primeros eucariotas debieron ser unicelulares, pero rápidamente evolucionaron, dando lugar a organismos pluricelulares hace entre 1900 y 2100 millones de años. Es decir, que los dos grupos primigenios unieron fuerzas para generar la vida compleja en nuestro planeta.

Todo esto que os he contado parecen simples curiosidades biológicas, pero es algo mucho más complejo, porque tanto la aparición como la evolución de las primeras formas de vida provocaron cambios en nuestro planeta que lo condicionaron todo. Los primeros seres vivos aparecieron en un mundo sometido al bombardeo continuo de cuerpos extraterrestres, con una atmósfera reductora y mares repletos de hierro disuelto en el agua. La evolución de estos organismos primitivos dio lugar a las cianobacterias hace entre 3400 y 3700 millones de años, los seres fotosintéticos más antiguos, que llegaron a provocar un cambio desde una atmósfera reductora a una débilmente oxidante. Llegando hace unos 2400 millones de años a producirse el Gran Evento Oxidativo, a partir del cual disfrutamos de una atmósfera totalmente oxidante, lo que aceleró aún más la evolución biótica. Unos cambios ambientales radicales gracias a los cuales los seres humanos estamos aquí hoy.

Espero que, a partir de ahora, sigáis las etapas ciclistas de otra manera. Y cuando algún miembro del equipo Arkéa tome protagonismo con una escapada, os acordéis de la importancia evolutiva de estos pequeños organismos. Incluso, que veáis a un eucarionte con arqueas y bacterias en simbiosis con su organismo para permitirle hacer esos titánicos esfuerzos subiendo esas preciosas montañas, fruto de millones de años de evolución de nuestro planeta.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Geología en el Tour se ha escrito en Cuaderno de Cultura Científica.

Martha Betz Shapley, la “Primera Dama del Observatorio de Harvard”

En mi tercer año [en la Universidad de Missouri] conocí a una morena llamada Martha Betz, de Kansas City, y nunca me separé de ella, ni quise hacerlo. Nos conocimos en una clase de matemáticas: ella se sentaba en primera fila y conocía todas las respuestas. Era una mujer inteligente… Hizo cinco cursos completos y obtuvo las mejores calificaciones en todos ellos.

Martha Betz Shapley. Fuente: MacTutor.

Martha Betz Shapley. Fuente: MacTutor.

Martha Betz nació el 3 de agosto de 1890 en Kansas City, Missouri (Estados Unidos). Era la tercera de las siete hijas e hijos de Carl Betz y Louise Wittig Betz. El abuelo paterno de Martha, John G. Betz había nacido en Hannover (Alemania) y emigrado a Estados Unidos junto a su esposa en 1863. Contó a su nieta que había visto una vez en las calles de Hannover a la astrónoma Caroline Lucretia Herschel (1750-1848). Aunque ella recordaba esta anécdota de su abuelo, en aquel momento, Martha no sospechaba que dedicaría toda su vida a estudiar las estrellas.

Carl Betz era maestro de música en varias escuelas de Kansas City y transmitió su pasión por la música a su prole; tocar música fue uno de los mayores pasatiempos de Martha a lo largo de su vida.

De maestra a astrónomaComo su madre y dos de sus hermanas, y con solo 15 años, Martha se convirtió en maestra de escuela primaria tras completar su formación secundaria. A los 18 comenzó sus estudios en la Universidad de Missouri, donde obtuvo una licenciatura en educación, y se convirtió en profesora de matemáticas de secundaria en 1912. En 1914, se casó con el astrónomo Harlow Shapley (1885-1972) al que había conocido durante sus estudios en la universidad. Lo hicieron después de que Shapley finalizara su tesis doctoral en Princeton. De hecho, según confirma su nieta Deborah Shapley, Martha ayudó a Harlow realizando algunos cálculos para su tesis que trataba sobre sistemas binarios eclipsantes.

El matrimonio se trasladó al Observatorio Mount Wilson donde comenzaron a trabajar como astrónomos profesionales. Mientras él estudiaba las estrellas variables cefeidas, Martha se centró en el análisis de las binarias eclipsantes que, como ya hemos comentado, habían sido el tema de investigación doctoral de su marido. Redactó una serie de artículos dedicados al cálculo de los elementos y la variación de los períodos de los sistemas eclipsantes que fueron contribuciones destacadas en su época. Entre estos trabajos destacan The period of U Cephei(1916) o The Light Curve and Orbital Elements of the Eclipsing Binary Y Leonis (1918).

También colaboró varias veces en la investigación de Shapley, algunas ocasiones como coautora. Algunos de esos trabajos son The Light Curve of XX Cygni(1915) o Studies Based on the colors and magnitudes in stellar clusters (1919).

En 1921 Harlow Shapley fue nombrado director del Observatorio de Harvard. Martha lo acompañó en su nuevo puesto y continuó su trabajo sobre binarias eclipsantes durante un tiempo, aunque pronto su familia de cinco hijos (Mildred, Willis, Alan Horace, Lloyd Stowell y Carl Betz) se convirtió en el centro de su atención.

Durante la Segunda Guerra Mundial, los Shapley participaron en actividades humanitarias, encontrando hogar para muchas familias judías que habían huido de Europa. Además, Martha se unió a Zdeněk Kopal (1914-1993) y otros astrónomos de Harvard que estaban trabajando para la División de Cooperación Industrial en el Instituto Tecnológico de Massachusetts. Sus habilidades matemáticas fueron esenciales para calcular trayectorias de proyectiles para la Armada y las Fuerzas Aéreas. Tras finalizar la contienda, continuó colaborando con el mismo grupo, midiendo posiciones y calculando órbitas de meteoros.

Cuando sus hijos e hija abandonaron el hogar familiar, Martha Shapley regresó a sus investigaciones astronómicas. Su última contribución a la astronomía fue Catalogue of the Elements of Eclipsing Binaries (1956) en colaboración con Zdeněk Kopal.

Primera Dama del Observatorio de HarvardDurante los 32 años en los que Harlow Shapley fue director del Observatorio de la Universidad de Harvard, a Martha se la conocía como la Primera Dama del Observatorio. El matrimonio era muy apreciado por su hospitalidad con “la familia astronómica de Harvard” (personal fijo y personas que trabajaban temporalmente o visitaban el Observatorio), y Martha era una anfitriona entregada en las reuniones que organizaban en su casa.

Tres de sus hijos también se dedicaron a la astronomía y las matemáticas: Mildred Shapley Matthews (1915-2016) se convirtió en una destacada astrónoma; Willis Shapley (1917-2005) trabajó como administrador de la NASA; y Lloyd Shapley (1923-2016) fue un brillante matemático que recibió el Premio Nobel de Economía el año 2012 junto a Alvin E. Roth (citamos a estos dos investigadores en Matemática discreta y trasplantes cruzados de riñones).

Martha Shapley falleció el 24 de enero de 1981, a los 90 años de edad.

La Sra. Shapley lamenta no haber hecho más por su cuenta. No es el tipo de mujer que se conforma con el mérito de haber ayudado a su marido. Cree que una mujer nacida con aptitudes, y ella evidentemente las tenía, tiene la obligación de utilizarlas, y no sólo en su calidad de esposa y madre.

Referencias

-

John J O’Connor and Edmund F. Robertson, Martha Betz Shapley, MacTutor History of Mathematics Archive, University of St Andrews

-

Barbara L. Welther, Guilt by Association: How Mrs. Harlow Shapley Lost Her Job, Bulletin of the American Astronomical Society 18 (1986) 1055

-

Zdeněk Kopal, Obituary – Shapley, Martha-Betz 1890-1981, Astrophysics and Space Science 79 (1981) 261-264

-

Deborah Shapley, Martha Shapley – Astronomer, Harlow Shapley Project, 8 marzo 2023

-

Martha Betz Shapley, Wikipedia

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Martha Betz Shapley, la “Primera Dama del Observatorio de Harvard” se ha escrito en Cuaderno de Cultura Científica.

Los invasores: Los hipopótamos del narco Escobar

Es la especie animal invasora más grande del mundo, tal como titulan su artículo Jonathan Shurin y sus colegas, de la Universidad de California San Diego de La Jolla. Mide entre tres y cinco metros de la cabeza a la punta de la cola, con metro y medio de altura hasta los hombros. El peso medio es de 1500 a 1800 kilos, aunque puede llegar a los 3000. Es el hipopótamo común, de nombre científico Hippopotamus amphibius. Habita el África subsahariana hasta Sudáfrica y es una especie invasora en Colombia por los caprichos de un célebre narcotraficante, Pablo Escobar.

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsLa portada y el primer capítulo de Historia de las especies invasoras, del biólogo Ángel León Panal, libro publicado en 2021, están dedicados a los hipopótamos de Colombia y al narco Pablo Escobar. Dirigía en 1978 el Cártel de Medellín. Visitaba el curso medio del valle del río Magdalena, en el centro de Colombia. En la zona compró varias fincas con selva, agua y montaña y fundó la Hacienda Nápoles, en el municipio de Puerto Triunfo, Departamento de Antioquía, así llamada en homenaje a su admirado Al Capone, nacido en Napolés.

En la finca mostraba su colección de automóviles y practicaba varios deportes, entre ellos el tenis. Pero el mayor atractivo era el Zoológico. Se informó de las especies que se adaptarían al clima de aquella zona de Colombia y, por medio de intermediarios de Estados Unidos, compró, por ejemplo, cebras, elefantes, rinocerontes, jirafas, hipopótamos y más especies que, poco a poco, iban llegando a la hacienda. En total llegaron a ser unos mil doscientos animales.

Los hipopótamos primero fueron cuatro, tres hembras y un macho, en 1981, y pronto llegaron a seis con la compra de otros ejemplares (quizá, no está claro, eran entre dos y seis los ejemplares del grupo inicial). Tras la muerte de Pablo Escobar a los 44 años, en 1993 y acribillado a balazos por la policía colombiana, los hipopótamos y otros animales quedaron en la Hacienda Nápoles. Eran muchos hipopótamos y en 2016 llegaban a 30 ejemplares y, para 2020, se calculó que había entre 60 y 80 individuos. Viven, de media, unos 40 años en estado silvestre y las hembras tienen unas 25 crías. Las proyecciones para el futuro hablan de 800-1400 individuos en Colombia para 2040.

Las últimas previsiones publicadas hace unas semanas por Amanda Subalusky y sus colegas, de la Universidad de Florida en Gainesville, estiman que el crecimiento de la población de hipopótamos es del 9.6% al año, lo que supone 230 individuos para 2032. Incluso el cálculo de crecimiento de la población, según D.N. Castelblanco-Martínez y su grupo, del Consejo Nacional de Ciencia y Tecnología de Ciudad de México, podría llegar a los 800 individuos en 2034. Todos estos datos suponen que, según la estrategia de control que adopte el Gobierno de Colombia, hay hipopótamos en el país por unos 50-100 años.

En conclusión, es el único grupo de hipopótamos en estado salvaje y viable que se puede encontrar fuera de África.

Algunos ejemplares abandonaron la Hacienda Nápoles y siguieron el curso del río Magdalena hacia el norte hasta, por ahora y con datos confirmados, unos 150 kilómetros de la finca, aunque las citas más al norte parecen que están a unos 400 kilómetros. Para los habitantes de los márgenes del río es un asunto difícil pues los hipopótamos son agresivos y peligrosos. En África causan más muertes al año que leones, elefantes, búfalos y rinocerontes juntos, como escribe Ángel León Panal. Además, pueden transmitir enfermedades como la tuberculosis, la brucelosis, la leptospirosis, el ántrax y la salmonelosis.

Ingenieros de ecosistemasSon los hipopótamos lo que se denomina ingenieros de ecosistemas, pues pueden modificar los hábitats en que se encuentran. Es un herbívoro que transporta nutrientes desde las plantas de las que se alimenta hasta las zonas acuáticas donde libera sus heces. Algo así como una tonelada de carbono y otros compuestos al año y por individuo. En los ecosistemas acuáticos en que vive puede provocar la eutrofización por exceso de nutrientes por la acumulación de los componentes de las heces. Según el resumen de Jonathan Shurin y sus colegas, los hipopótamos importan al hábitat acuático materia orgánica y nutrientes con un impacto apreciable en el metabolismo del ecosistema y en la estructura de la comunidad.

Por cierto, desde 2012 y por orden judicial está prohibida la caza de hipopótamos en Colombia. Y en 2014, el Gobierno optó por la conservación de los hipopótamos, controló su reproducción y exportó algunos ejemplares a zoológicos de otros países como Ecuador y Uruguay. Sin embargo, en 2021, la Unión Internacional para la Conservación de la Naturaleza envió una carta de intervención al Gobierno de Colombia recomendando iniciar un programa para eliminar la población de hipopótamos. Y en sentido opuesto, el hipopótamo fue declarado legalmente como especie invasora hace poco más de un año, el 24 de marzo de 2022.

El control de la población de hipopótamos en Colombia ha planteado varios problemas. En 2018 revisaron los métodos Santiago Monsalve, de la Corporación Universitaria Lasallista, y Alejandro Ramírez, de la Universidad de Durham. Se han propuesto los anticonceptivos para las hembras y la castración química en los machos. Pero faltan datos sobre su eficacia. Ninguno de estos métodos parece funcionar con ella tal y como se propone su aplicación según D.N. Castelblanco-Martínez y su grupo. Para la aplicación de estas técnicas se necesita controlar la agresividad de los hipopótamos, también poco estudiada y difícil de evitar por su tamaño y peso. También la población ha crecido en tal cantidad que la captura y entrega a zoológicos ya no es posible. La caza y eliminación de individuos ha provocado un gran debate con ONGs y la sociedad en general por lo que, por ahora, se ha abandonado.

La conservación compasiva de los hipopótamos no es una opciónComo resumen final valen los comentarios de Amanda Subalusky y sus colegas, de la Universidad de Yale, publicados en 2021. El hipopótamo es un ingeniero de ecosistemas que puede tener efectos profundos en los entornos terrestre y acuático y afectar la biodiversidad original de la cuenca del río Magdalena. Los hipopótamos también son agresivos y representan una amenaza para los habitantes de la región del río Magdalena aunque, por otra parte, también podrían generar beneficios económicos por el turismo. Sin embargo, se necesita más investigación para cuantificar el tamaño y la distribución de la población de hipopótamos y para predecir los efectos ecológicos, sociales y económicos que pueden provocar. Pero el conocimiento debe equilibrarse con la consideración de las preocupaciones sociales y culturales al desarrollar estrategias de manejo apropiadas para la introducción de una especie invasora.

Además, en este debate sobre cómo manejar una especie invasora, Colombia depende en gran medida del negacionismo científico: varios participantes en debates públicos tergiversan el trabajo y las opiniones de los científicos y cuestionan su ética y motivos. Destacan la necesidad y la confianza en la acción basada en la ciencia, proponen participar en discusiones sobre las preocupaciones éticas, y deben superar falsos dilemas, a menudo poco argumentados. La “conservación compasiva”, que valora los derechos e intereses de los individuos de una especie exótica carismática, no puede prevalecer sobre (1) los derechos e intereses de los individuos de las especies nativas y (2) la conservación de poblaciones, ecosistemas y servicios que suponen las especies nativas. Como proponen Sebastián Restrepo y Carlos Daniel Cadenas, de las universidades Javeriana y de los Andes, de Bogotá, sin una acción decisiva por parte de las autoridades ambientales de Colombia, con una variedad de medidas que incluyen la matanza selectiva bajo estándares humanitarios de bienestar animal, las poblaciones de hipopótamos continuarán expandiéndose a expensas de los ecosistemas que sustentan a comunidades humanas vulnerables y las especies nativas.

Referencias:

Castaño, J.A. 2008. Dos hipopótamos tristes. Letras Libres junio: 22-25.

Castelblanco-Martínez, D.N.et al. 2021. A hippo in the room: Predicting the persistence and dispersion of an invasive mega-vertebrate in Colombia, South America. Biological Conservation 253: 108923.

Dembitzer, J. 2018. The case for hippos in Colombia. Israel Journal of Ecology & Evolution doi: 10.1163/22244662-06303002.

León Panal, A.L. 2021. Historia de las especies invasoras. Guadalmazán. Córdoba. 425 pp.

Monsalve Buriticá, S. & A. Ramírez Guerra. 2018. Estado actual de los hipopótamos (Hippopotamus amphibius) en Colombia: 2018. Revista CES Medicina Veterinaria y Zootecnia 13: 338-346.

Resolución nº 0346, de 24 marzo 2022, Por la cual se modifica el artículo 1º de la Resolución Nº 848 de 2008, adicionando la especie Hippopotamus amphibius (Hipopótamo común) y se toman otras determinaciones. El Ministro de Ambiente y Desarrollo Sostenible. Colombia.

Restrepo, S. & C.D. Cadena. 2021. Science denialism limits management of invasive hippos in Colombia. Frontiers in Ecology and the Environment 19: 323-325.

Shurin, J.B. et al. 2020. Ecosystem effects of the world’s largest invasive animal. Ecology e02991.

Subalusky, A.L. et al. 2021. Potential ecological and socio-economic effects of a novel megaherbivore introduction: the hippopotamus in Colombia. Oryx 55: 105-113.

Subalusky, A.L. et al. 2023. Rapid population growth and high management costs have created a narrow window for control of introduced hippos in Colombia. Scientific Reports 13: 6193.

Wikipedia. 2023. Hippopotamus amphibius. 12 mayo.

Para saber más:

Catástrofe Ultravioleta #18 INVASORES

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Los invasores: Los hipopótamos del narco Escobar se ha escrito en Cuaderno de Cultura Científica.

ChatGPT puede inventarse artículos médicos y hacerte creer que son auténticos

Los chatbots generados por inteligencia artificial (IA) han experimentado una auténtica revolución entre la población general en el último año, con ChatGPT como su máximo exponente. Centenares de millones de personas alrededor del mundo usan, con más o menos frecuencia, estas tecnologías para diversos fines como resolver dudas o como complemento en el trabajo para redactar textos o para programar. Sin embargo, esta herramienta, que usa el procesamiento del lenguaje natural para generar textos equivalentes a los escritos por los humanos, puede ser tan convincente a la hora de dar información cierta como cuando arroja otra que es totalmente falsa.

Foto: Levart_Photographer / Unsplash

Foto: Levart_Photographer / UnsplashUn equipo de investigadores de la Universidad Carolina de Praga ha puesto a prueba la capacidad de ChatGPT, desarrollado por la empresa OpenAI, para crear un artículo médico falso, desde cero. Los resultados de su experimento, que se han publicado en la revista Journal of Medical Internet Research, son preocupantes. En tan solo una hora y sin ninguna formación previa del usuario, esta tecnología generó un artículo científico sobre neurocirugía que parecía verídico para los no expertos en la materia. Los autores crearon el documento mediante una serie de preguntas e indicaciones a la IA para ir mejorando progresivamente la calidad de sus respuestas. Posteriormente, expertos en el campo de la neurocirugía, de la psiquiatría y de la estadística evaluaron el artículo falso comparándolo con artículos reales similares.

En apariencia, el artículo científico generado por ChatGPT es idéntico a uno convencional. Reúne los diferentes apartados propios de estos documentos (resumen, introducción, métodos, resultados y discusión), muestra datos y tablas y utiliza las palabras apropiadas con una estructura coherente y lógica. No obstante, las personas expertas podían detectar múltiples errores como imprecisiones en el uso de ciertas palabras o en la redacción de referencias científicas: algunas presentaban detalles incorrectos, mientras que otras directamente eran inventadas. En cualquier caso, el profesor de neurocirugía encargado de evaluarlo explica que «en general, el artículo generado mostró un gran nivel de competencia técnica y autenticidad».

La creación de artículos científicos falsos no es un problema nuevo. En el mundo académico existe una gran presión para que los investigadores sean prolíficos a la hora de publicar si desean avanzar profesionalmente o incluso sobrevivir, un fenómeno conocido en el mundillo como «Publica o muere». Esto lleva a que algunos científicos, escasos de ética, publiquen a toda costa, aunque sea mediante artículos falsos. La demanda de artículos inventados ha llegado a tal nivel que existen empresas, conocidas como «fábricas de artículos», que se encargan de generar artículos falsos por encargo de científicos para así inflar su curriculum y progresar en su carrera. Se estima que casi el 22 % de los artículos retirados de revistas científicas en 2021 fueron por este tipo de engaño.

Las revistas depredadoras añaden más leña al fuego del fraude científico. Estas publicaciones basan su modelo de negocio en cobrar por publicar artículos, pero sin contar con los procesos adecuados de revisión por pares que caracterizan a las revistas científicas. El resultado es que resulta muy fácil colar artículos inventados o de muy poca calidad en este tipo de revistas. Se estima que existen unas 8.000 revistas depredadoras que, en su conjunto, publican cada año 420.000 papers con escasa o nula garantía de calidad. , lo que supone el 20 % de la publicación científica anual mundial, que gira en torno a los 2,5 millones de artículos.

La irrupción de la IA como generadora de artículos falsos, en medio de este panorama, complica aún más la situación porque facilita en gran medida todo el proceso de fraude para las personas sin escrúpulos. Además, dada la capacidad que tiene esta tecnología de perfeccionarse a sí misma, es posible que en un futuro próximo la redacción automática de artículos inventados y creíbles sea una cuestión de minutos sin apenas esfuerzo por parte de una persona. Quizás, la IA podría llegar a un nivel de refinamiento que hiciera difícil incluso para los expertos en la materia distinguir los artículos científicos reales de los falsos.

La tentación de usar la IA para tomar el camino fácil y progresar en el mundo académico puede ser demasiado poderosa para algunos científicos. Por esta razón, los autores sostienen que se necesita mayor vigilancia y mejores métodos de detección para luchar contra la IA en la investigación científica. No obstante, esta herramienta puede aportar valor, al ayudar en la preparación del manuscrito, el análisis de los resultados y la edición del texto de un artículo científico genuino.

En el estudio se recalca la importancia de desarrollar e implantar guías éticas y de buenas prácticas para el uso de esta herramienta en la investigación y en la escritura científica. Por otro lado, obligar a los investigadores a ser transparentes en cuanto al uso de la IA (para que declaren cuánto de su texto se ha generado por esta tecnología) podría echar para atrás a aquellos que contemplen utilizarla para inventarse parcial o totalmente un artículo científico.

Sea como sea, la IA ha llegado para quedarse. Al igual que un cuchillo, esta herramienta se puede usar tanto para el bien como para el mal. Será necesario detectar, desincentivar y castigar a aquellos que tengan la tentación de usar la IA con malos propósitos para evitar que el fraude en la ciencia se convierta en un problema mucho mayor en un futuro próximo.

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo ChatGPT puede inventarse artículos médicos y hacerte creer que son auténticos se ha escrito en Cuaderno de Cultura Científica.

La buena literatura ayuda a ponernos en el lugar de los otros

Foto: Matias North / Unsplash

Foto: Matias North / UnsplashLeer buena literatura mejora nuestra capacidad para empatizar con los otros y para entenderlos, para interpretar mejor su comportamiento; en definitiva, para ponernos en su lugar. Expresado en términos algo más técnicos y con pocas palabras, mejora nuestra «teoría de la mente» (TM), que es la capacidad para asignar pensamientos, intenciones y emociones a otras personas. Dentro de ella se diferencia la afectiva (TMa), que es la que se refiere a las emociones, y la cognitiva (TMc), que es la relativa a los pensamientos e intenciones.

La conclusión general presentada en el párrafo anterior ha sido obtenida a partir de experimentos diseñados para valorar el posible efecto que tienen diferentes tipos de lectura sobre la capacidad para ponernos en el lugar de los demás. Proporcionaron a grupos formados por diferentes personas textos breves tomados de libros seleccionados y, tras su lectura, a las personas de cada grupo les pasaron test para evaluar diferentes indicadores de TM. En todos los experimentos se valoró también el grado de familiaridad de los participantes con la literatura, para lo que se utilizó un test de reconocimiento de autores. En el primer experimento compararon el efecto de leer ficción literaria con el de leer lo que se denomina no ficción. Y a continuación, en una serie de otros cuatro experimentos, compararon el efecto de leer ficción literaria con el de leer lo que ellos denominan ficción popular que, a los efectos de esta anotación, podemos llamar “superventas” (best sellers).[1]

Citaré, a modo de ejemplo, dos de los test utilizados. En el denominado de “lectura de la mente en los ojos”, considerado el test prototípico de TM afectiva, se pedía a los participantes que asignasen estados emocionales a las expresiones faciales que se les mostraban en imágenes centradas en los ojos. Y en el denominado “test de Yoni”, debían deducir estados emocionales (para TMa) o pensamientos (para TMc) a partir de claves lingüísticas y visuales mínimas. Aunque los autores también utilizaron un test de falsa suposición –del tipo de Sally & Anne–[2] para valorar la teoría de la mente cognitiva, no dio ningún resultado.

El primer experimento mostró que la lectura de ficción literaria mejora la teoría de la mente afectiva por comparación con la lectura de textos de no ficción. De los siguientes experimentos se concluyó que el efecto es específico de la ficción literaria, y que, por lo tanto, no se extiende a la ficción popular. Como el test de falsa suposición no funcionó, lo autores recurrieron al test de Yoni al que me he referido antes, que es bastante más exigente que el de falsa suposición y que, como hemos visto, sirve para determinar ambas modalidades de TM, la afectiva y la cognitiva. Los resultados de los experimentos en que se utilizó este test mostraron que el efecto de la lectura de ficción literaria no se limitaba a la TM afectiva, sino que se extienden también a la TM cognitiva.

De acuerdo con tres de los cinco experimentos, la familiaridad con la literatura sí ejerce efectos positivos sobre la TM, pero ese efecto no se verificó en los otros dos experimentos. Los investigadores sugieren que ese aspecto debe ser investigado de forma más específica, pues las referencias anteriores indicaban que, en efecto, la familiaridad con la literatura de ficción es un factor que afecta de forma positiva a la teoría de la mente. Y lo cierto es que hay razones para que así ocurra, ya que la ficción amplía nuestro conocimiento de las vidas de otros y nos ayuda a reconocer nuestras semejanzas y diferencias con ellos.

Sin embargo, los autores, sin descartar que eso sea así, creen que la relación entre la teoría de la mente y la familiaridad con la literatura puede deberse a características del texto más sutiles que la simple caracterización de los personajes. Ellos proponen que la ficción puede cambiar no sólo lo que pensamos de los demás, sino lo que pensamos de uno mismo. Según su planteamiento, la ficción afecta a los procesos propios de la TM al obligarnos a implicarnos en la lectura de la mente de los personajes. Y eso es algo que no valdría para cualquier forma de ficción. Solo la literaria llevaría al lector a implicarse en los procesos propios de la teoría de la mente.

Sostienen que la ficción literaria es más polifónica y más rica tras la interpretación del lector que reelabora lo leído y que, por ello, le permite adquirir las claves necesarias para comprender a los personajes. En ese sentido, se parecería más a la vida real que la ficción popular, pues está llena de personajes complejos cuyas vidas no son fácilmente discernibles. Por comparación con la vida real, la ventaja de la ficción es que en ésta no se corre ningún peligro personal por implicarse en la trama. Es más, mientras que muchas de nuestras relaciones sociales habituales están gobernadas por estereotipos y convenciones, las que se presentan en las obras de ficción literaria no se ajustan a nuestras expectativas en muchas ocasiones. Por eso, los lectores de ficción literaria deben hacer uso de recursos interpretativos más flexibles para poder inferir los sentimientos y pensamientos de los personajes. O lo que es lo mismo, deben recurrir a los procesos mentales propios de la teoría de la mente. La llamada «ficción popular», por el contrario, tiende a describir el mundo y las personas de una forma mucho más coherente y predecible; de esa forma, reafirma las expectativas de los lectores y no tiene por qué mejorar la teoría de la mente.

Los resultados de los experimentos confirman, según los autores, lo anterior, y sugieren que las explicaciones que se basan en el contenido concreto de la ficción no podrían dar cuenta de aquellos. De hecho, los textos utilizados trataban asuntos muy diferentes. Además, no les parece verosímil que los lectores pudiesen aprender mucho acerca de los demás leyendo unos textos tan breves. Por otro lado, era específicamente la ficción literaria la que ejercía efecto sobre la TM. Por todo ello, los investigadores proponen que es la adopción de un papel activo para representar los estados subjetivos de los personajes la que hace que la lectura de ficción literaria promueva la teoría de la mente.

En otro orden de cosas, y a pesar de que los resultados relativos al efecto de la familiaridad con la literatura no fueron concluyentes, sostienen que es muy probable que leer ficción literaria de manera frecuente conduzca a mejoras estables en la teoría de la mente. Por otra parte, no creen que los efectos benéficos de la buena literatura se limiten a los procesos de la TM, sino que seguramente produzca también beneficios de otro tipo, tanto de índole cognitiva como afectiva, y es muy posible que dichos efectos sean generalizables a la ficción en general, no sólo a la literaria.

Fuente:

David Comer Kidd y Emanuele Castano (2013): «Reading Literary Fiction Improves Theory of Mind» Science 342: 377-380.

Notas:

[1] Las obras de ficción literaria seleccionadas por los autores de este trabajo habían recibido algún tipo de galardón literario de prestigio, y los superventas fueron tomados de la lista de libros más vendidos de Amazon.

[2] En su versión original, en este test se muestra al sujeto una escena en la que hay dos muñecas, Sally y Anne. Sally coge una canica (o cualquier otro objeto de pequeño tamaño) y lo coloca en su cesta. A continuación sale de la escena. Entonces, Anne coge la canica de la cesta de Sally y la pone en su propia cesta. Regresa Sally a la escena y se le hace al sujeto la pregunta clave: “¿Dónde buscará Sally la canica?” El sujeto supera el test si responde que en la cesta de Sally, pues de esa forma aplicará la misma lógica que aplicaría Sally. Ello quiere decir que se pone en el lugar de Sally, que adopta su perspectiva. Los sujetos incapaces de ponerse en el lugar del otro y anticipar sus actos, responden de acuerdo con la información con que cuentan, esto es, que la canica se encuentra en la cesta de Anne, donde ella la ha puesto. Quienes superan el test entienden que Sally tiene sus propias suposiciones que pueden no corresponder a la realidad, y ese es precisamente el requerimiento nuclear de la teoría de la mente.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La buena literatura ayuda a ponernos en el lugar de los otros se ha escrito en Cuaderno de Cultura Científica.

El origen de la cultura de la muerte en el linaje humano

Cómo influyen los parásitos en el comportamiento de los animales, cómo se modifica la conducta de las madres mamífero o cuáles son las enfermedades que nos afectan y desde cuándo hemos desarrollado comportamientos funerarios ante la muerte son algunos de los aspectos que se analizarán en la V Jornada Nacional sobre Evolución y Neurociencias.

Especialistas en ambas materias se reunirán el 11 y 12 de mayo en una nueva edición conducida por Eva Garnica y Pablo Malo, psiquiatras y miembros de la Red de Salud Mental de Bizkaia, y organizada por esa misma entidad y la Cátedra de Cultura Científica de la UPV/EHU.

La jornada, cuya primera edición se celebró en 2017, se ha convertido en una cita imprescindible para las y los expertos en ámbitos como la psiquiatría, la psicología o la biología. Una jornada que sirve para analizar el comportamiento humano desde un punto de vista evolucionista y divulgar de un modo accesible para todos los públicos.

Por muy diferentes que puedan parecer las diferentes poblaciones humanas en el mundo hay algo que comparten a nivel fundamental: la cultura funeraria o cultura de la muerte. ¿Cómo se desentraña el origen de esta cultura de la muerte del registro arqueológico? Esto es lo que nos explica Nohemí Sala en esta charla.

Nohemí Sala es investigadora del CENIEH. Geóloga de formación y doctora en Paleontología por la Universidad Complutense de Madrid, su investigación está enfocada en los procesos de formación de los yacimientos paleontológicos y arqueológicos, desde un punto de vista geológico y tafonómico (la tafonomía es la parte de la paleontología que estudia los procesos de fosilización y la formación de los yacimientos de fósiles).

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo El origen de la cultura de la muerte en el linaje humano se ha escrito en Cuaderno de Cultura Científica.

Hogares en fosa en un yacimiento mesolítico ibérico

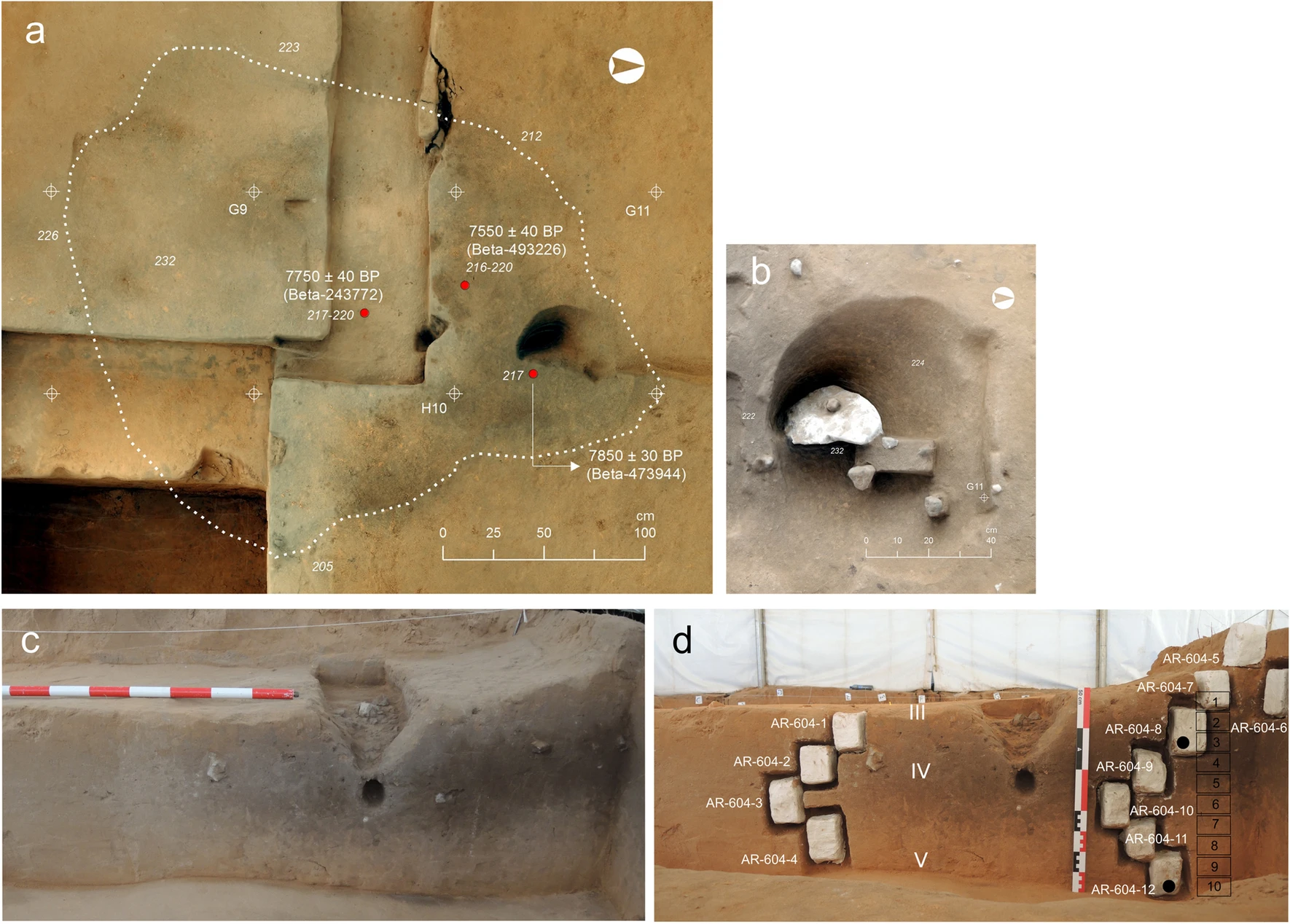

Un estudio sobre los sedimentos arqueológicos del Arenal de la Virgen, un yacimiento al aire libre situado en un sistema dunar junto a la Laguna de Villena (Alicante), revela la existencia de campamentos con hogares durante el Mesolítico. El objetivo de este trabajo era aclarar el origen antrópico (producido o modificado por la actividad humana) de un tipo de evidencia arqueológica común pero poco estudiada en yacimientos mesolíticos de principios del Holoceno localizada en contextos dunares semiáridos de Europa: los conocidos como hogares en fosa o ‘hearth-pits’.

“En la Península Ibérica es la primera vez que se estudia este tipo de estructuras de manera detallada aplicando una metodología sistemática con el fin de determinar su formación, comprender mejor su función específica y evaluar las alteraciones sufridas tras la ocupación y el abandono del yacimiento”, señala Ana Polo-Díaz, investigadora del Departamento de Geografía, Prehistoria y Arqueología de la Universidad del País Vasco, miembro del Grupo de Investigación en Prehistoria de la UPV/EHU (Gizapre) y primera firmante del artículo.

Como novedad, para llevar a cabo ese trabajo, los investigadores han aplicado una novedosa metodología de arqueología científica interdisciplinar que integra el análisis estratigráfico y textural, la química del suelo, la micromorfología, la petrografía y la luminiscencia ópticamente estimulada y termoluminiscencia .

“Los resultados obtenidos permiten confirmar el origen antrópico de las estructuras investigadas, cuya cronología se asocia dos fases de ocupación diferentes: la más lejana, con una antigüedad de entre 9.300 y 9.100 años, mientras que la más reciente tiene una antigüedad de entre 8.700 y 8.400 años”, explica Javier Fernández López de Pablo.

En cuanto a la fase más antigua de ocupación se han descubierto restos de estructuras correspondientes a un posible horno en cubeta, así como a una zona anexa dedicada a la acumulación de residuos de combustión procedentes de dicho horno y con un uso puntual. Por lo que respecta a la fase más reciente, se han identificado áreas de actividad de mayor extensión en superficie respecto a la fase más antigua, en las que además de evidencia de fuego, se han documentado residuos de la ocupación de un asentamiento que se extendió entre 200 y 400 años.

Los datos obtenidos evidencian condiciones climáticas favorables de habitabilidad durante el periodo de tiempo específico en el que tuvo lugar el asentamiento en el Arenal de Virgen, durante el Holoceno Antiguo. “Esas condiciones ambientales se caracterizaron por un incremento en la humedad ambiental, la temperatura y la cubierta vegetal, en contraste a una significativa mayor aridez detectada en los momentos anteriores y posteriores a la ocupación del sitio durante el Pleistoceno y el Holoceno Medio, respectivamente”, indican los autores del artículo.

Los resultados de esta investigación abren nuevas perspectivas para la investigación de los asentamientos al aire libre de los últimos grupos de cazadores-recolectores de la Prehistoria en la Península Ibérica, en un momento crucial en la evolución humana, tras el final de la última gran glaciación y el comienzo del periodo climático en el que nos encontramos en la actualidad, el Holoceno.

Referencia:

Ana Polo-Díaz, Jose Ramón Rabuñal, Guillaume Guérin & Javier Fernández-López de Pablo (2023) Mesolithic hearth-pits and formation processes: a geoarchaeological investigation of sediments from El Arenal de la Virgen site (SE Iberia) Archaeological and Anthropological Sciences doi: 10.1007/s12520-023-01794-5

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Hogares en fosa en un yacimiento mesolítico ibérico se ha escrito en Cuaderno de Cultura Científica.

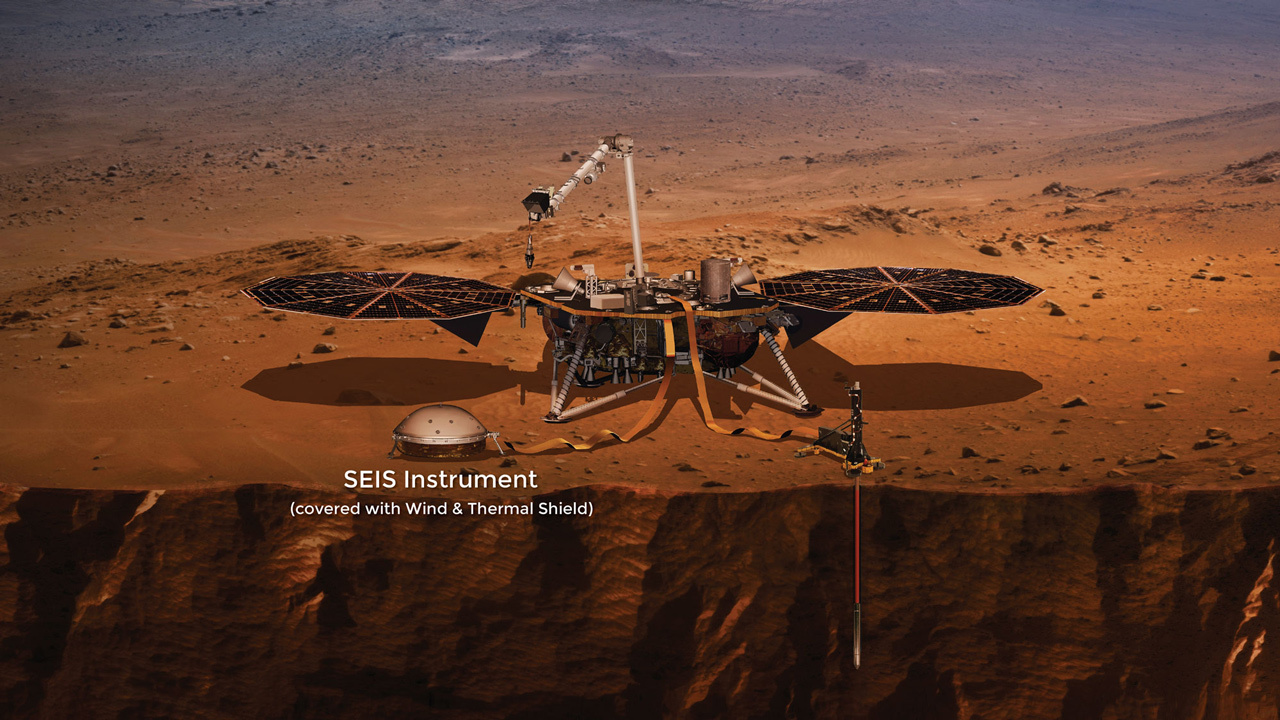

La catenaria: sensores (3/4)

Desde los años sesenta, la tecnología ferroviaria ha desarrollado multitud de sensores que ayudan, de una forma u otra, a la operación. Sensores de cajas calientes para determinar la temperatura de los ejes de un tren y evitar roturas y descarrilamientos. Detectores de caída o arrastre de objetos por la vía. Medidores de viento lateral, cruciales en los grandes viaductos. Detectores de incendios en túneles. La alimentación eléctrica en sí misma está controlada en los puntos donde se toma de la red de alta tensión de propósito general y se transforma para la alimentación óptima de los trenes. En estas ubicaciones, llamadas subestaciones de tracción, no faltan dispositivos capaces de cortar la corriente en milisegundos en caso de detectar cualquier problema.

Sin embargo, la propia integridad y desempeño mecánico de la catenaria ha tardado mucho más en disponer de sensores propios que los demás elementos de la infraestructura ferroviaria. Esto ha sido así por la particular dificultad que reviste instalar electrónica sensible en un entorno de alta tensión. Las elevadas corrientes, y por tanto los intensos campos electromagnéticos, pueden dañar cualquier circuitería que no esté muy protegida o suficientemente alejada.

Vías de salida de la estación Madrid-Puerta de Atocha-Almudena Grandes. Foto: Iván RiveraSensores para la catenaria

Vías de salida de la estación Madrid-Puerta de Atocha-Almudena Grandes. Foto: Iván RiveraSensores para la catenaria

¿Qué es lo más interesante a la hora de monitorizar el comportamiento de la catenaria? La integridad de los aisladores, el movimiento de los contrapesos que regulan la tensión mecánica de los hilos o la respuesta dinámica del hilo de contacto al paso de un pantógrafo son todas ellas posibles respuestas. Esta última, la respuesta dinámica del hilo de contacto al paso del pantógrafo de un tren en marcha, es particularmente compleja de dilucidar. Los pantógrafos son sistemas mecánicos con suspensiones taradas para ejercer cierta fuerza vertical contra el hilo de contacto. Pero esta fuerza no puede ser, como en la historia de Ricitos de Oro, ni muy pequeña ni muy grande. Si la fuerza es demasiado leve, existe el riesgo de que el pantógrafo se despegue por momentos del hilo de contacto ante cualquier mínima irregularidad. La elevada corriente eléctrica que fluye entre este hilo y los frotadores montados sobre la mesilla del pantógrafo no se interrumpe inmediatamente. Antes bien, la aparición de un pequeño hueco provoca la descarga de un arco voltaico: un pequeño rayo que ioniza el aire circundante y eleva las temperaturas tanto del hilo como del material del frotador (habitualmente grafito, por sus especiales características conductoras y autolubricantes).

Arcos voltaicos en el contacto pantógrafo-catenaria. Fuente: [Zhou 2022]Este flash térmico, reiterado, provoca un desgaste temprano de los frotadores y del hilo. En casos extremos, tanto el hilo como el propio pantógrafo pueden romperse, provocando un fenómeno conocido como enganchón. En este caso, el pantógrafo dañado arrastra el hilo de contacto, provocando daños ulteriores en el tren y en la infraestructura. Si el tren circulaba a una velocidad elevada, puede destruir varios kilómetros de hilos antes de detenerse por completo. El tráfico ferroviario queda cortado durante horas o días en tanto se repara la catenaria y se hace necesario remolcar el tren afectado.

Arcos voltaicos en el contacto pantógrafo-catenaria. Fuente: [Zhou 2022]Este flash térmico, reiterado, provoca un desgaste temprano de los frotadores y del hilo. En casos extremos, tanto el hilo como el propio pantógrafo pueden romperse, provocando un fenómeno conocido como enganchón. En este caso, el pantógrafo dañado arrastra el hilo de contacto, provocando daños ulteriores en el tren y en la infraestructura. Si el tren circulaba a una velocidad elevada, puede destruir varios kilómetros de hilos antes de detenerse por completo. El tráfico ferroviario queda cortado durante horas o días en tanto se repara la catenaria y se hace necesario remolcar el tren afectado.

Incidente de arrastre de hilo de contacto en Cetina, línea Madrid-Barcelona-Frontera francesa. (Autor desconocido)

Incidente de arrastre de hilo de contacto en Cetina, línea Madrid-Barcelona-Frontera francesa. (Autor desconocido)El caso contrario, el de un exceso de fuerza de empuje por parte del pantógrafo, también es susceptible de dañar la instalación, por un procedimiento inicialmente distinto. La fuerza de empuje para un pantógrafo extendido se ajusta en el taller, y por tanto en condiciones estáticas. Circular a velocidades elevadas, sin embargo, puede alterar esta fuerza debido a fenómenos de sustentación: la mesilla del pantógrafo se comporta como un alerón y, en función de pequeñas variaciones de su ángulo de ataque respecto de la dirección de avance, puede sufrir un empuje extra hacia arriba o hacia abajo.

El conjunto de efectos que aparecen en la práctica sobre la interfaz pantógrafo-catenaria hace muy deseable el registro de lo que ocurre en condiciones dinámicas. Tal es así, que tanto la fuerza ejercida por los pantógrafos como un parámetro relacionado y de medida más sencilla, el desplazamiento vertical del hilo de contacto, están limitados por una normativa específica. Sin embargo, realizar la medida necesaria para asegurar su cumplimiento de un modo comercialmente práctico ha estado fuera de las capacidades de la tecnología ferroviaria hasta hace relativamente poco tiempo. ¿Y cuál es el reto? Nada menos que registrar cambios en la altura del hilo de contacto de pocos centímetros que pueden suceder tan rápido como un milisegundo. Naturalmente, mientras fluyen por él intensas corrientes eléctricas y sin que el tren, que pasa justo por debajo, ni su pantógrafo, que está por definición rozando el hilo, perturben la medida o dañen el equipo.

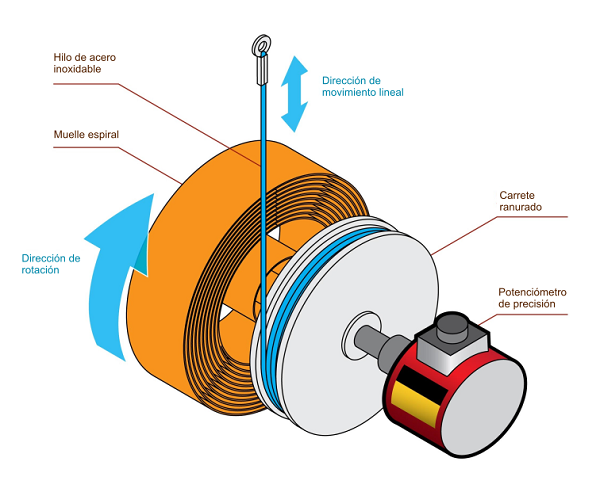

Medida potenciométricaLa primera tecnología que se aplicó a la medida dinámica del comportamiento del hilo fue la de los sensores potenciométricos lineales. Estos dispositivos transforman una distancia en una diferencia de potencial eléctrico mediante una resistencia variable giratoria conectada a un circuito divisor de tensión; en la jerga técnica, decimos que son un tipo de transductor. El giro del potenciómetro cambia el valor de su resistencia eléctrica, de modo que, si se alimenta la entrada del circuito con una tensión constante, la salida es proporcional al ángulo total girado (por ejemplo, dos vueltas serían 720 grados).

El potenciómetro, montado en un bastidor fijo, se acopla por su eje de giro solidariamente con un carrete que aloja un cable flexible enrollado en una ranura helicoidal. El cable sale del dispositivo por una abertura. En su extremo, se acopla al elemento móvil cuya distancia se desee medir: el cambio en la longitud se traslada al giro del potenciómetro y, por tanto, a la tensión eléctrica de salida del equipo. Por último, todo el conjunto se acopla por su eje a un resorte espiral para que el sistema tienda a volver a su posición inicial. El funcionamiento mecánico es algo similar, así, al de un flexómetro, una cinta métrica de las que todos tenemos en casa.

Sensor potenciométrico lineal. Adaptado de [FUTEK 2023])

Sensor potenciométrico lineal. Adaptado de [FUTEK 2023])