La gran infraestructura europea de investigación en biotecnologías azules es ya una realidad

La gran infraestructura europea de investigación European Marine Biological Resource Centre (EMBRC-ERIC) es ya una realidad, y la Estación Marina de Plentzia (PiE) de la UPV/EHU es uno de los dos centros seleccionados por el Estado español para participar en la misma. El EMBRC-ERIC es el resultado de unión de 24 centros de investigación de 9 países, que aunando sus recursos y know-how y ofertando servicios de investigación trabajarán para resolver cuestiones fundamentales sobre la salud de los ecosistemas marinos en un medioambiente cambiante, promover nuevas tecnologías científicas en esta área, impulsar descubrimientos en el campo de la salud mediante el uso de modelos biológicos marinos y mantener a largo plazo la monitorización del estado de los mares.

Como indican las siglas ERIC (European Research Infrastructure Consortium), esta infraestructura se ha constituido legalmente como un Consorcio Europeo Infraestructuras de Investigación, siendo la decimoctava infraestructura europea de este tipo. Según Ibon Cancio, profesor de Biología Celular de la UPV/EHU y responsable de la adscripción de la Estación Marina de Plentzia al EMBRC-ERIC. “Es muy importante participar en una organización de este nivel y dimensión. ¿Quién no conoce el CERN? Nuestra infraestructura será del mismo nivel. Ellos se dedican al campo de la física, mientras que nosotros trabajaremos en el área de la salud y alimentación (‘Health and Food‘). El CERN tiene una única sede. Nosotros tenemos 24 sedes en 9 países, si bien tenemos un presupuesto mucho más modesto y mucho para demostrar”.

Los estatutos de la infraestructura de investigación paneuropea EMBRC acaban de publicarse en el Diario Oficial de la Unión Europea. “Somos oficialmente uno de los centro de investigación que conforman EMBRC-ERIC, y la única infraestructura de este tipo en el País Vasco”, señala Cancio. Los nueve países en los que se encuentran los 24 centros de investigación que constituyen el EMBRC-ERIC son Bélgica, Francia, Grecia, Israel, Italia, Noruega, Reino Unido, Portugal y España. En el nodo español participa, además de la Estación Marina de Plentzia de la UPV/EHU, la Estación de Ciencias Marinas de Toralla (ECIMAT) de la Universidad de Vigo.

Biotecnología azulEl EMBRC-ERIC proporcionará acceso a información y recursos los ecosistemas de todos los mares de Europa. “El objetivo es que cualquier investigador o investigadora o empresa tenga a su disposición los recursos biológicos marinos necesarios para su labor de investigación, y asimismo tenga acceso a todo el know-how en biología molecular y genómica, de manera que puedan explotarlos de un modo sostenible”.

Los primeros trabajos para constituir el EMBRC empezaron en 2008, una vez que la Comisión Europea introdujo esta iniciativa en su segunda hoja de ruta. En 2011 los promotores del EMBRC pusieron en marcha su primer proyecto, y para 2014 todos los países participantes habían suscrito un memorandum de entendimiento para iniciar el proceso de formalización legal de la infraestructura. A mediados de noviembre se aprobaron los estatutos y el presupuesto de lo que será el EMBRC-ERIC, que en el caso del nodo español contará con financiación del Gobierno Vasco y la Xunta de Galicia. Posteriormente todos los países han ratificado su compromiso con el EMBRC-ERIC, que en el caso de España se produjo en el Consejo de Ministros el 15 de diciembre de 2017. La sede principal del EMBRC-ERIC se encuentra en París.

El EMBRC es, además, una de las grandes infraestructuras promovidas por la Comisión Europea dentro del foro estratégico ESFRI (European Strategy Forum on Research Infrastructures- ESFRI) para impulsar la investigación de calidad en la Unión Europea. En total cuenta con 50 infraestructuras o proyectos de infraestructuras.

Estación Marina de PlentziaLa Estación Marina de Plentzia (PIE) es un centro de investigación y enseñanza de alto nivel de la UPV/EHU. Situada en el antiguo sanatorio de Plentzia, estudia la salud del medio ambiente marino y su influencia en la salud humana. En concreto, promueve la investigación y formación en materias relacionadas con la salud de los ecosistemas marinos, los efectos de las alteraciones medioambientales sobre la salud humana y los biorrecursos marinos. La Estación Marina imparte tres másteres, dos de los cuales cuentan con la máxima distinción de calidad que otorga la Unión Europea, el sello Erasmus Mundus: Erasmus Mundus Master in Marine Environment and Resources (MER); Erasmus Mundus Master in Marine Biological Resources (IMBRSEa) y Environmental Contamination and Toxicology, Asimismo, cuenta con programas de doctorado. Una veintena de científicos y científicas y una treintena de doctorandos y doctorandas trabajan en el centro.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La gran infraestructura europea de investigación en biotecnologías azules es ya una realidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Lado oscuro del genoma y leucemia: aspectos éticos y legales de una investigación

- La pubertad está comenzando antes para muchos niños; la educación sexual debería afrontar esta realidad

- Equilibrio tautomérico en un sistema modelo de gran interés biológico

Científicos, animalistas y el uso de animales para investigación

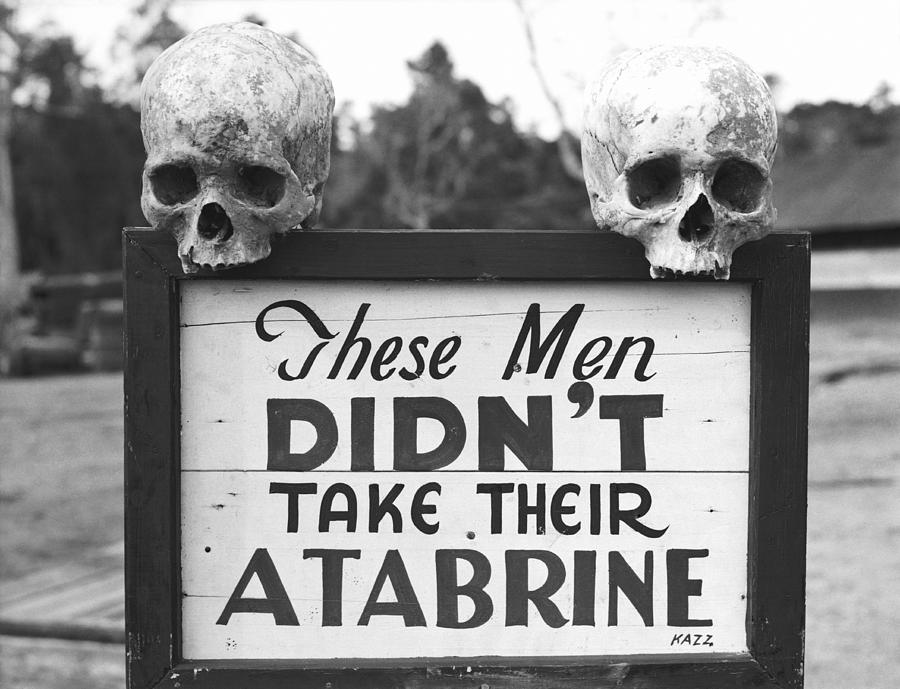

Mucho se ha hablado de los animales utilizados en investigación. Valga como ejemplo esta estupenda revisión sobre el tema realizada por el investigador Lluís Montoliu o el informe Confederación de Sociedades Científicas de España (COSCE). El tema del uso de animales para fines científicos salta a la palestra periódicamente por presiones del lobby animalista, el cual, sin lugar a dudas, ha influido en las leyes y normas vigentes. Por parte de la razón, es decir, de la ciencia, existe una defensa férrea del uso de animales para investigación, ya que, sin su utilización, no podríamos acometer las nuevas aproximaciones terapéuticas y diagnósticas que necesitamos para poder combatir las enfermedades que todavía hoy no tienen solución y que necesitamos para mejorar la vida de los enfermos. Así que existe un enconado desencuentro entre científicos y animalistas sobre el uso de animales para fines científicos. Sin embargo, hay una entidad, o grupo de entidades, en los que no cabe debate alguno.

Anuncio de PACMA contra la experimentación animal

La talidomida fue prescrita y utilizada entre los años 1957 y 1963 en Europa. Hasta ese momento ningún país europeo contaba con regulación alguna sobre el uso de medicamentos, por lo que la tragedia de este fármaco produjo un verdadero terremoto en el desarrollo de medicamentos en el viejo continente. Alemania, un país particularmente afectado por el caso de la talidomida, tuvo que aprobar con urgencia en el año 1961 la primera ley que regulaba el uso de medicamentos.

Hasta ese momento la responsabilidad de evaluar los medicamentos recaía sobre los propios fabricantes. Aunque su distribuidor, Grünenthal, realizó algunos experimentos de seguridad, estos no fueron suficientes para detectar los efectos secundarios del fármaco, y en ninguno de los casos se evaluó el fármaco en animales gestantes. En aquellos años tampoco era obligatorio evaluar los medicamentos en animales en periodo de gestación en el Reino Unido, pero de nuevo la catástrofe de la talidomida propició que se formara en 1964 el Comité de Seguridad de Medicamentos y que, cuatro años más tarde, se promulgara la primera Ley del Medicamento británica.

Niña afectada por la talidomida

Hoy en día todos los países de primer orden cuentan con agencias para el control del desarrollo, liberación y evaluación de nuevos medicamentos. Es el caso de la European Medicines Agency (EMA) en Europa o la Food and Drug Administration (FDA) en los Estados Unidos. Dichas organizaciones se encargan de velar por la seguridad de los fármacos que se prueban en humanos. La única obsesión de dichas agencias es que no se vuelva a dar un “caso talidomida”. Así que solicitan que se realice un estudio completo y pormenorizado de la toxicidad de los fármacos bajo estudio, y siempre antes de autorizarlos para su uso en humanos. La eficacia del medicamento se supone; de lo que se encargan las correspondientes agencias es de que los fármacos sean suficientemente inocuos.

Sede de la EMA en Londres, que será trasladada a Amsterdam y no a Barcelona.

Las agencias reguladoras obligan a la industria farmacéutica a realizar una exhaustiva batería de estudios para conocer cómo los fármacos afectan a diferentes sistemas del organismo y a procesos patológicos críticos, determinando sus rangos de su seguridad en el mejor de los casos (en el peor y más habitual el desarrollo de los nuevos fármacos es interrumpido por estas cuestiones).

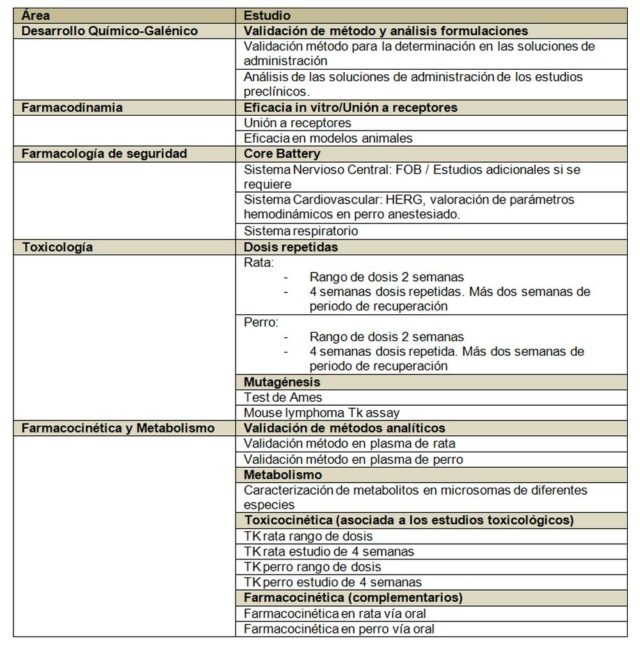

Veamos un ejemplo concreto de los estudios requeridos por las autoridades:

Podemos observar en la tabla anterior, grosso modo, los estudios que las agencias exigen. Hagamos algunas apreciaciones al respecto:

- La tabla refleja los estudios mínimos necesarios, los cuales pueden no ser suficientes si se encuentra algún hallazgo patológico inesperado, cosa que suele ocurrir ya que se fuerzan las dosis hasta encontrar efectos secundarios, lo cual permite definir las dosis de trabajo. Aquí es necesario recordar a Paracelso, que ya explicó la importancia de las dosis hace casi 500 años.

- El paquete básico de estudio está por encima del medio millón de euros en prácticamente todos los casos y los estudios tienen una duración de un año al menos. Esto si las cosas van bien, claro. En muchas ocasiones los tiempos y los costes se incrementan.

- Los laboratorios que realizan este tipo de estudios deben estar certificados en Buenas Prácticas de Laboratorio (BPL; o GLP en inglés), por lo que lo realizan exclusivamente empresas especializadas llamadas Contract Research Organizations (CRO). Todos los protocolos de estudios están normalizados y acordados, y hay que seguirlos estrictamente, registrando cualquier desviación detectada.

- Se estudian los principales sistemas del organismo, tales como el sistema respiratorio, cardíaco o nervioso, así como procesos que puedan afectar a la seguridad, tales como la mutagénesis o los estudios de interacción con receptores.

- Se estudian dos especies animales siempre; una de roedores y otra de no roedores. Por cuestiones históricas la especie de roedor mayoritaria es la rata (el ratón no se usa para estudios regulatorios normalmente). Las agencias tienen un amplio recorrido de estudios realizados en rata y pueden comparar expedientes. La especie no roedora suele ser el perro, aunque se pueden utilizar otros no roedores con su justificación pertinente. Sólo en contadas ocasiones las agencias autorizan el uso de primates. El perro habitualmente usado para estos estudios es de la variedad Beagle; los monos suelen ser macacos.

- Toda la información extraída de los estudios regulatorios preclínicos es utilizada para diseñar los estudios en humanos First-in-human, y las primeras dosis de estudio vienen definidas por la dosis anterior a la más baja que produce algún efecto en cualquiera de las dos especies animales utilizadas en los estudios. A esta dosis se le conoce como NOAEL (de non-observed adverse effect level).

- Previamente a los estudios en humanos se aplicará un factor de dilución a la dosis elegida como medida adicional de seguridad. La dosis final que será utilizada para iniciar los estudios en humanos es lo que se conoce como MRSD (del inglés máximum recommended starting dose).

A grandes rasgos, para todo lo anteriormente expuesto, es necesario el uso de animales. Y en este caso el factor limitante no son los comités de ética, que los hay, si no la cuantía económica de los estudios y la duración de los mismos (para la empresa farmacéutica, tiempo y dinero son parámetros esencialmente equivalentes).

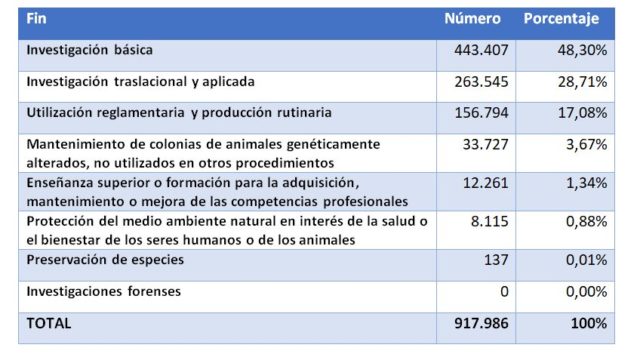

La pregunta ahora es: ¿Cuántos animales se usan para este tipo de estudios en nuestro país? Si analizamos el último informe oficial publicado por el Ministerio de Agricultura, Pesca, Alimentación y Medio Ambiente (MAPAMA), el número de animales utilizados en 2016 para fines científicos fueron los siguientes:

Es decir, que la mayoría de animales fueron usados para investigación (básica o traslacional/aplicada, en un 77%). La siguiente partida en importancia es la utilización reglamentaria y producción rutinaria. Si atendemos sólo al uso reglamentario los datos indican que se utilizaron 49.640 animales para este fin repartidos de la siguiente forma:

Es decir, de cada 100 animales utilizados para fines científicos aproximadamente 5 fueron sacrificados por cuestiones regulatorias, por los 75 que fueron usados en las diferentes fases de investigación. Tal vez 50.000 animales al año para estudiar la seguridad de los fármacos pueda parecer mucho, tal vez no parezca tanto si lo comparamos con las incontables personas que sufrieron el efecto de la talidomida en nuestro país.

Si salimos de nuestra zona de confort y atendemos, por ejemplo, al uso de animales para la alimentación, según Eurostat sólo en 2015 se sacrificaron más de 46 millones de cerdos en España. O lo que es lo mismo, un cerdo por español. Por el contrario, en 2015 por cada español tan sólo se usaron 0,018 animales con fines regulatorios. Juzguen ustedes mismos.

Este post ha sido realizado por Javier Burgos (@Javisburgos) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias y más información

- Lluís Montoliu (2018) ¿Cuántos animales se usan en España para experimentación? Cuaderno de Cultura Científica

- Informe COSCE sobre el uso de animales de investigación.

- Informe 2016 de uso de animales para investigación del MAPAMA. [PDF]

- Guía de desarrollos preclínicos. Genoma España. [PDF]

El artículo Científicos, animalistas y el uso de animales para investigación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Cuántos animales se usan en España para experimentación?

- #Naukas15 ¿Es necesario usar animales en investigación?

- Una nueva investigación muestra que explicar cosas a la gente “normal” puede ayudar a los científicos a ser mejores en su trabajo

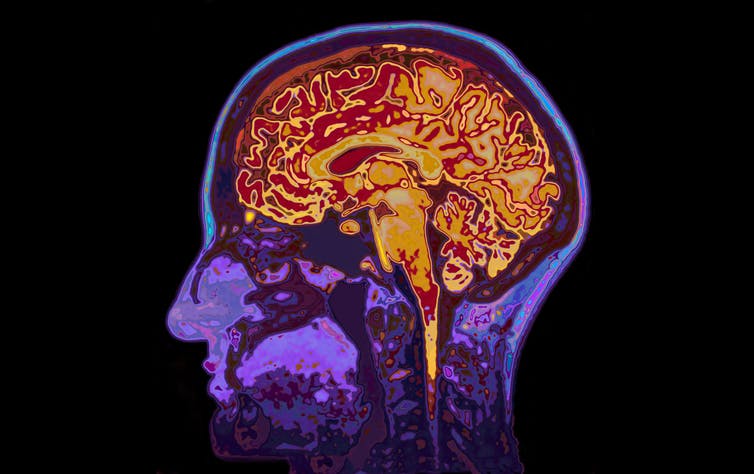

La neurociencia está desentrañando los misterios del encéfalo adolescente

Lucy Foulkes

![]()

¿Cómo describirías al adolescente medio? A la mayoría las siguientes características pueden venirnos a la mente: temperamental, impulsivo, arriesgado, propenso a sucumbir a la presión de grupo.

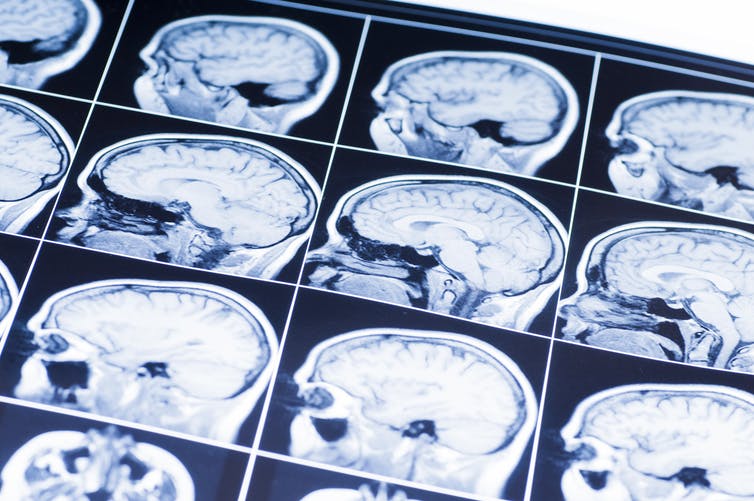

Si bien está claro que la adolescencia es un período de la vida que está plagado de estereotipos, hay algo de verdad en los clichés. Muchos estudios neurocientíficos han establecido que ocurren cambios significativos en el encéfalo durante la adolescencia. Y las cosas por las que a menudo se ridiculiza a los adolescentes, como su asunción de riesgos y la vulnerabilidad a la presión de los compañeros, en realidad están enraizadas en los cambios que ocurren en sus encéfalos. Solo hay un problema con esto: muchos adolescentes no se ajustan a los estereotipos.

Todos sabemos por experiencia personal que la forma en la que los adolescentes piensan y actúan puede variar ampliamente según el adolescente del que se trate. Pero, a pesar de esto, la gran mayoría de los estudios hasta la fecha se han centrado en las medias: ¿qué ocurre de media con el encéfalo durante la adolescencia o cómo se comportan y sienten los adolescentes de media?

Depender de las medias de esta manera tiene un beneficio estadístico importante, ya que es más probable que los investigadores sean capaces de detectar un efecto genuino si promedian sus hallazgos entre muchos participantes. Pero el coste obvio es que estos hallazgos generales no se aplican a todos y cada uno.

Comprender las diferencias individuales

En un artículo reciente, mis colegas y yo argumentamos que esto debe cambiar. A partir de ahora, la investigación del encéfalo de los adolescentes necesita prestar más atención a estas importantes variaciones entre adolescentes, lo que se conoce en el campo como “diferencias individuales”.

Además de documentar que todos los adolescentes son diferentes, también debemos comenzar a entender por qué esto es así. Los estudios que ya están investigando esto han demostrado que tanto la genética, como la nutrición, la crianza de los hijos o las enfermedades mentales afectan a la forma en la que se desarrolla nuestro encéfalo y la manera en la que nos comportamos durante la adolescencia. Y en nuestro último artículo, analizamos otros tres factores que podrían afectar el desarrollo del encéfalo: el estatus socioeconómico, las relaciones con los compañeros y la cultura.

No útil para retrato robot. Imagen: Shutterstock

El estatus socioeconómico es una medida de la posición social y financiera de una persona en la sociedad, y a menudo se mide por el nivel de educación de sus padres y por los ingresos familiares totales. La investigación ya ha descubierto que tu encéfalo se desarrolla de manera diferente en la adolescencia dependiendo de tu nivel socioeconómico. Pero lo que aún no entendemos del todo es por qué. Podría ser, por ejemplo, que criarse en un ambiente de bajos ingresos es más estresante o que esté relacionado con diferentes tipos de nutrición, y que esto a su vez afecte el desarrollo del encéfalo, pero se necesitan más estudios sobre este tema.

Compañeros de clase y cultura

El tipo de relación que los adolescentes tienen con sus compañeros también afecta la actividad encefálica. Los adolescentes con una historia de acoso, por ejemplo, muestran diferentes patrones de activación encefálica ante ciertas informaciones sociales: sus encéfalos parecen ser más sensibles a la experiencia de ser excluidos. Por la misma razón, tener muchos amigos y un historial de ser querido por los compañeros de clase también afecta a la activación encefálica, y puede hacerte más resistente al desarrollo de problemas de salud mental.

En todo el mundo, los adolescentes también crecen en culturas muy diferentes, lo que afecta muchos aspectos de sus vidas: desde cuántos años pasan estudiando hasta cuándo se casan e incluso cuánto tiempo pasan con sus familias.

Recientemente, los científicos se han interesado en cómo esto se podría reflejar en las diferencias en los encéfalos adolescentes. Ya sabemos que los adultos de diferentes culturas muestran diferencias interesantes en su actividad y estructura encefálicas, y esto ahora está empezando a investigarse en adolescentes.

Solo tu adolescente medio

La razón por la que la mayoría de las investigaciones sobre el encéfalo de adolescentes aún no consideran las diferencias individuales se debe en parte a que el campo tiene solo 20 años de edad, y las nuevas áreas de investigación deben comenzar con lo básico, las medias, antes de intentar comprender los matices.

La investigación del encéfalo adolescente es un campo relativamente nuevo. Imagen: Shutterstock

También hay razones prácticas. La tecnología de imágenes encefálicas hasta la fecha no ha sido lo suficientemente buena como para cartografiar exactamente cómo los factores específicos, como las relaciones entre iguales, podrían afectar el desarrollo del encéfalo. Luego también está el hecho de que para tener suficiente capacidad para detectar hallazgos fiables, se necesitan grandes tamaños de muestra.

Esto significa cientos, a veces miles, de adolescentes. Por el momento, un escáner cerebral cuesta alrededor de 600 € por hora, por lo que el tamaño de las muestras a menudo está limitado por el coste. Una forma de resolver este problema es que los científicos compartan sus datos entre ellos, y esto ya está comenzando a suceder .

Todos los encéfalos son diferentes

Reconocer que todos los adolescentes son diferentes tiene implicaciones realmente importantes para cosas como la educación o la publicidad. Si, por ejemplo, la forma en que los adolescentes aprenden depende de su patrón específico de desarrollo encefálico, entonces las estrategias educativas basadas en medias solo tendrán una utilidad limitada.

Del mismo modo, las campañas publicitarias para temas como la salud sexual, si se basan en los estudios que promedian entre los participantes, funcionarán para algunos adolescentes, pero no para otros.

Cuanto antes entendamos la diferencia entre los adolescentes, más pronto podremos integrar esta información en las escuelas y las políticas. Esto es importante porque, después de todo, no existe un adolescente medio, y debemos recordar esto a medida que continuamos refinando nuestra comprensión del encéfalo adolescente.

Nota del traductor sobre las referencias bibliográficas: Todos los artículos científicos están enlazados en el texto en sus contextos apropiados, basta pulsar en las palabras azules.

Sobre el autor:

Lucy Foulkes es profesora de de psicología de la educación en la Universidad de York (Reino Unido)

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 23 de abril de 2018 bajo una licencia Creative Commons (CC BY-ND 4.0)

El artículo La neurociencia está desentrañando los misterios del encéfalo adolescente se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran encéfalo humano es un “encéfalo social”

- La pubertad está comenzando antes para muchos niños; la educación sexual debería afrontar esta realidad

- El encéfalo bilingüe: por qué no existe un modelo único

La humildad como virtud científica

Linus Pauling (1901-1994). Ganador de dos premios Nobel. Uno de los padres de la química cuántica y de la biología molecular. Pacifista y activista. Pero también padre de la medicina ortomolecular (sin base científica; una teoría inventada en un sillón, como el psicoanálisis de Freud o la homeopatía de Hahnemann) y perseguidor arrogante, hostil e incansable de Dan Shechtman, los cuasicristales y de cualquiera que trabajase en ellos desde su descubrimiento en 1984 hasta su muerte en 1994 (Shechtman recibiría el Nobel en 2011 por el descubrimiento de los cuasicristales).

Gente que practica ciencia desde la arrogancia hay, ya lo creo; incluso en según qué disciplinas o instituciones abundan. Personas de teoría única que acertaron una vez en algo importante y desde entonces mantienen su hipótesis favorita como única aceptable; científicos que sólo se relacionan con discípulos de su secta, que rechazan a quien tiene ideas diferentes, que son incapaces de imaginar que sus ideas puedan ser insuficientes o mucho menos erróneas. Abundan los jefes de laboratorio, directores de centro, catedráticos eminentes, editores de revistas u organizadores de congresos que en cualquier disciplina, de cualquier sexo (aunque más a menudo, ay, varones), con variado acierto y casi siempre con temibles consecuencias practicas la ciencia desde la más absoluta arrogancia intelectual y a menudo social. Todos los que practica ciencia los conocen o los sufren, tratando siempre de sobrevivirlos.

Porque un científico arrogante, especialmente cuando esa arrogancia se manifiesta en su producción intelectual, es un mal científico. No porque su trato sea muy desagradable, que lo es; no porque suponga un obstáculo al avance del conocimiento al dificultar la adopción de nuevas ideas, que lo hace; sino porque su ciencia es mala por definición.

La buena ciencia sólo puede ser humilde, porque errar es humano y porque al universo le importan poco nuestros sentimientos y aunque no hace trampas para engañarnos tampoco nos pone las cosa fáciles: comprender como funciona es complicado y está lleno de trampas. Malinterpretar, crear hipótesis bellas (pero erradas), teorizar en ausencia de datos o con datos equivocados o desconocer factores relevantes son certezas con las que tenemos que lidiar a la hora de establecer nuestras hipótesis y explicaciones. Y cuando esas hipótesis bellas pero erróneas se enfrentan a la comparación con el cosmos real éste es inmisericorde, y las tumba sin remedio.

Cuando esto ocurre podemos refugiarnos en la ceguera desde la arrogancia: ese factor no es relevante porque YO no lo considero así, porque MI experimento no lo tiene en cuenta, porque NUESTRA hipótesis no lo incluye. Al hacer esto estamos intentando imponer nuestras formas de pensar y nuestros límites al universo, forzando sobre el funcionamiento de cosmos nuestra interpretación limitada. Si tenemos bastante poder terrenal conseguiremos que esto funcione, durante un tiempo; si controlamos las carreras de los científicos que vienen después mediante tribunales o consejos editoriales de revistas, si somos determinantes al escribir los libros de texto, si empujamos y apartamos a las voces discrepantes e impedimos que se les escuche. Con arrogancia y poder es posible mentir a todo el mundo, durante algún tiempo.

Pero no hay arrogancia capaz de forzar la mano del universo, así que a la larga todos nuestros esfuerzos serán en vano. Quizá tengamos una larga y poderosa carrera, quizá incluso muramos pensando que lo hemos logrado, pero tarde o temprano (y será temprano) la realidad se impondrá y nuestras teorías e hipótesis pasarán al basurero de la historia. No será siquiera recicladas como parte de teorías mejores, como ocurre con los avances correctos pero siempre (ay) insuficientes, sino que serán descartadas y quedarán como notas a pie de página en la historia de la ciencia, asociando para siempre nuestro nombre con el fracaso.

Los mejores científicos son humildes, no por vocación propia, sino por experiencia duramente ganada. Por errores cometidos, hipótesis rechazadas, experimentos fallidos, dificultades no superadas; por meteduras de pata risibles, confusiones involuntarias, complejidades experimentales o de campo no tenidas en cuenta. Es cierto que la naturaleza no nos miente de modo malicioso, pero a veces puede ser puñeteramente sutil y esconder fuentes de error en los rincones más inverosímiles; uno puede estar al borde del Nobel y descubrir de repente que sus datos están contaminados y no dicen lo que uno pensaba que decían, perdiendo cualquier posibilidad de alcanzar la gloria.

Y eso duele, pero sólo se convierte en una catástrofe si se le suma una buena dosis de arrogancia. En presencia de humildad el error se desarrolla y se acaba convirtiendo en el germen de nuevas ideas, nuevas hipótesis, nuevos avances. Por eso los buenos practicantes de ciencia comparten como rasgo común la humildad intelectual; no porque eso les haga mejores personas o les convierta en practicantes de la filosofía Zen, sino porque eso les hace mejores científicos. Ante el maravilloso, complejo y sutil universo que hay ahí fuera pensar que una mente humana pueda contener toda la verdad no sólo es arrogante: es estúpido. La humildad, pues, es una virtud científica, porque nos ayuda a entender mejor.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La humildad como virtud científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo leer una noticia científica

- Las matemáticas como herramienta (II): La Revolución Científica y el cálculo

- Ellen Richards: la economía doméstica como cultura científica

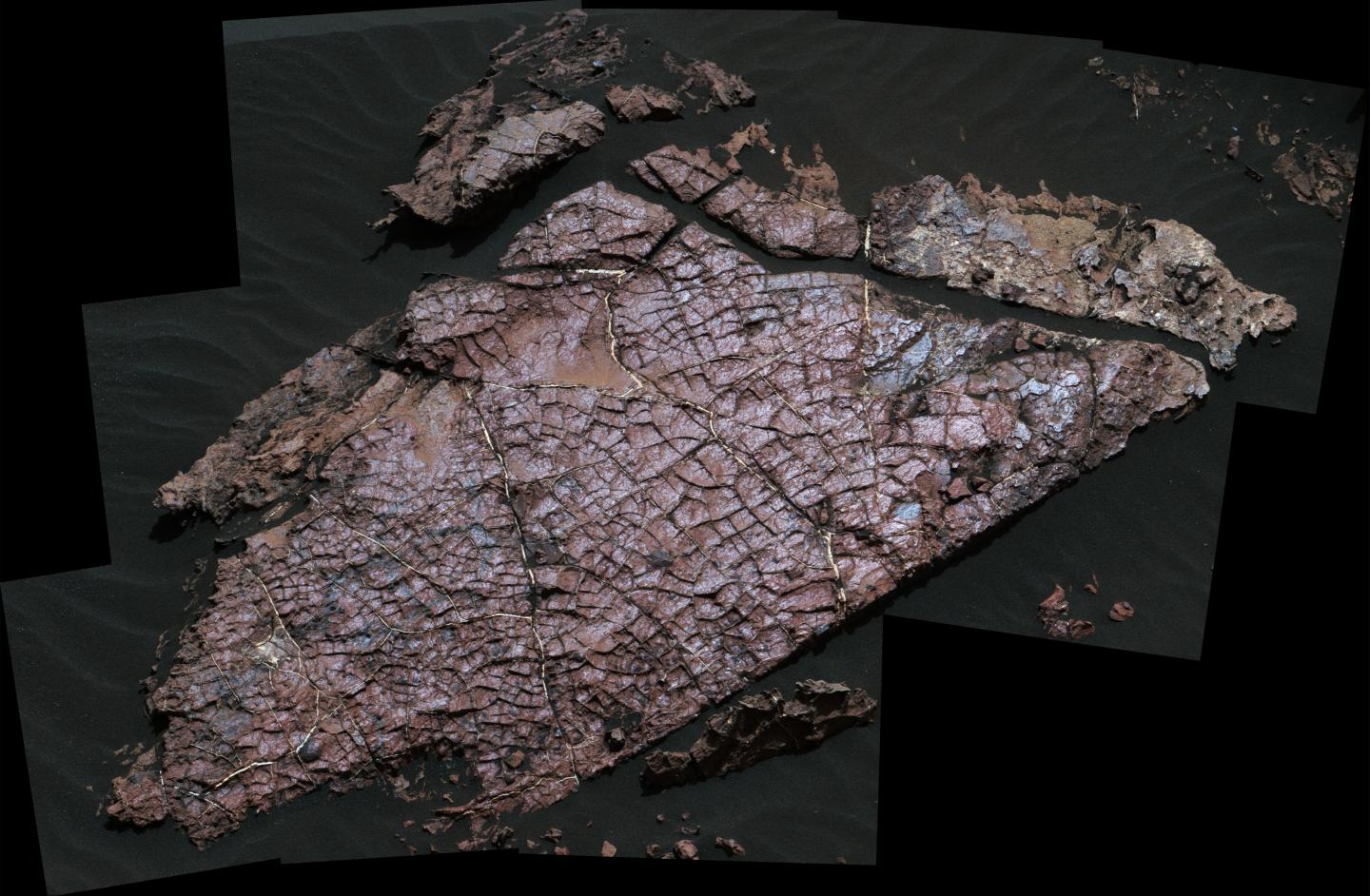

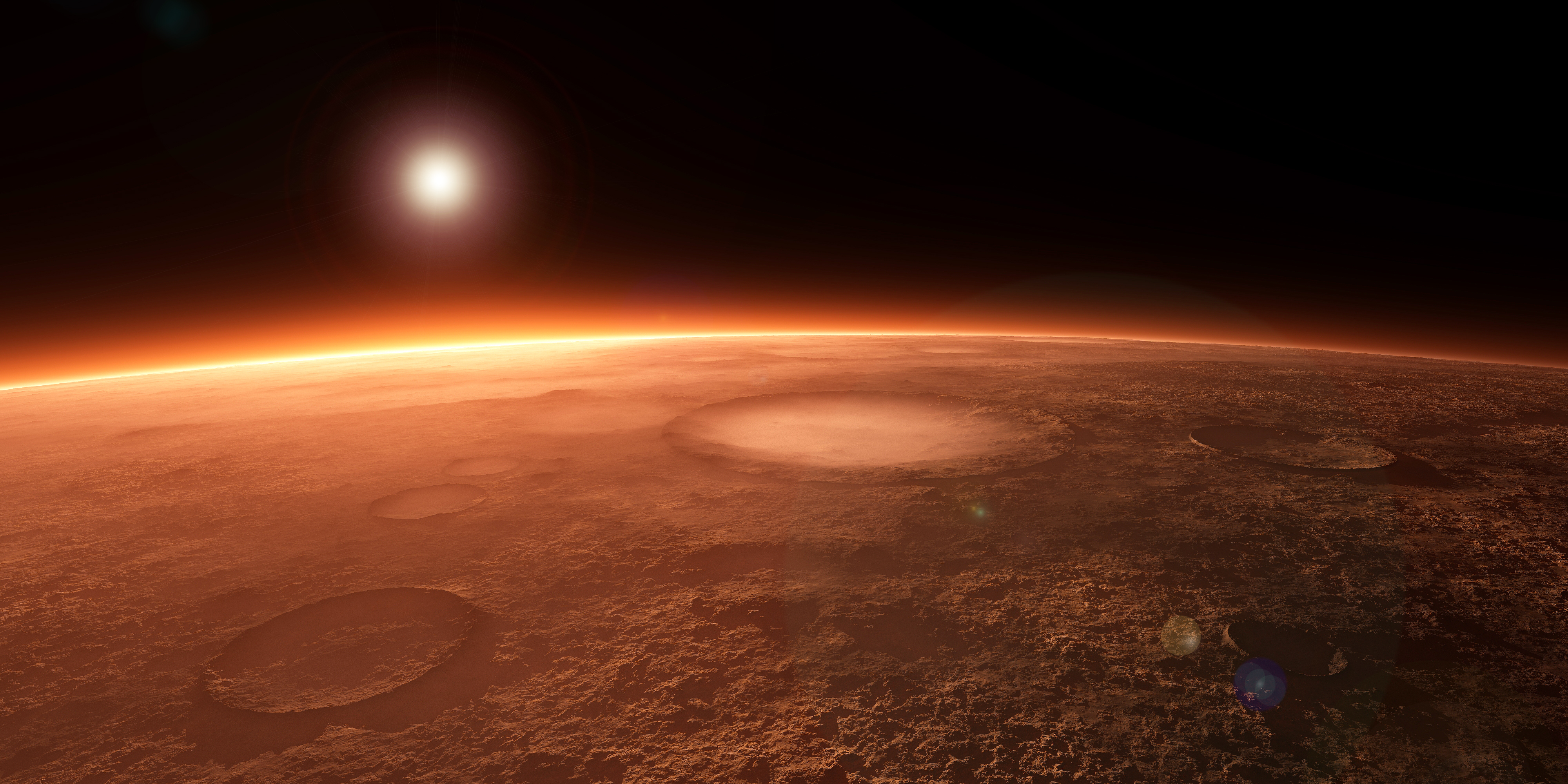

Grietas de desecación marcianas

Imagen que Curiosity tomó de “Old Soaker” durante el sol 1555. La losa tiene unos 80 cm de longitud. Foto: NASA.

A principios de 2017, y a partir de imágenes recopiladas por el róver Curiosity, los científicos anunciaron el descubrimiento de posibles grietas de desecación en el cráter Gale, que habría estado lleno de lagos hace 3.500 millones de años. Ahora, un nuevo estudio ha confirmado que son realmente grietas de desecación, lo que revela nuevos detalles sobre el antiguo clima de Marte.

Dado que las grietas de desecación se forman solo cuando el sedimento húmedo está expuesto a la atmósfera, su posición más cercana al centro del antiguo lecho del lago que al borde también sugiere que los niveles del lago aumentaron y disminuyeron drásticamente con el tiempo. Esto es, los lagos del cráter Gale habrían pasado por el mismo tipo de ciclos que vemos en la Tierra

Los investigadores se centraron en una losa de roca del tamaño de una mesa de café apodada “Old Soaker”. Old Soaker está atravesado por polígonos idénticos en apariencia a los característicos de los procesos de desecación terráqueos. El equipo analizó los aspectos físicos y químicos de los polígonos utilizando todo el despliegue de medios de análisis de Curiosity. Hay que recordar en este punto que Curiosity es un potentísimo laboratorio geoquímico autopropulsado.

Este escrutinio puso de manifiesto que los polígonos, confinados a una sola capa de roca y con sedimentos llenando las grietas entre ellos, se formaron por la exposición a la atmósfera, y no por otros mecanismos como la fracturación térmica o hidráulica. Y si bien los científicos sabían casi desde el momento en que Curiosity aterrizó en 2012 que el cráter Gale alguna vez contuvo lagos, la confirmación de la existencia de grietas de desecación añade un contexto a nuestra comprensión de este antiguo sistema lacustre.

Hallazgo tras hallazgo, Curiosity está transformando continua y completamente nuestra visión del presente y del pasado de Marte.

Referencia:

N. Stein et al (2018) Desiccation cracks provide evidence of lake drying on Mars, Sutton Island member, Murray formation, Gale Crater Geology doi: 10.1130/G40005.1

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Grietas de desecación marcianas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- En Marte el viento crea montañas

- Cómo se formaron las columnas hexagonales de la Calzada del Gigante

- Ox Bel Ha, un ecosistema tropical alimentado por metano

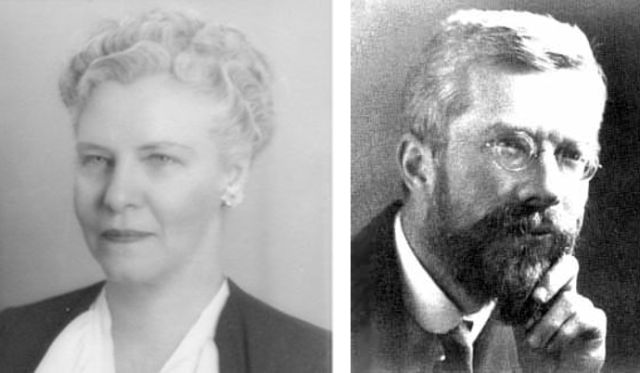

Muriel Bristol, la gran catadora de té

Estamos en Rothamsted (Harpenden, Reino Unido). Son las cuatro de la tarde, la ‘sagrada’ hora del té. Un grupo de personas hace una pausa en su trabajo para tomarse su infusión. Entre ellas están Muriel y Ronald. Ronald ofrece a su amiga una taza de té. Ella, tras tomar un sorbo, la rechaza. A Muriel le gusta el té, pero solo si la leche se ha servido en la taza en primer lugar. Ronald cree que se trata de una broma, e insiste con vehemencia; piensa que es lo mismo el orden en el que se vierten los líquidos, y se burla de su colega. Pero Muriel, enfadada, la rechaza de nuevo… no le gusta el sabor. William, otro de los miembros del grupo, intenta mediar y pide a Ronald que deje demostrar a Muriel que efectivamente es capaz de distinguir el momento en el que se ha servido la leche en la taza. Rápidamente, se organiza el experimento: Muriel debe distinguir entre ocho tazas de té, cuatro de cada tipo (leche antes del té o té antes de la leche) colocadas de manera aleatoria ante ella. Tras una pausada cata –en la que se permite a Muriel comparar el sabor de dos tazas–, y ante el asombro de sus compañeros, Muriel distingue con precisión el orden en el que se ha servido la leche de cada taza. ¿Ha sido pura suerte? ¿O quizás Muriel es una experta catadora capaz de distinguir esos detalles? Ronald tuvo que admitir la “victoria” de Muriel y se puso a reflexionar mucho sobre el tema…

Por cierto, Muriel y William se casaron poco tiempo después.

La anterior historia –me he permitido alguna pequeña licencia– es una historia real. Sus protagonistas son la bióloga Muriel Bristol (1888-1950) –que trabajó en la estación experimental de Rothamsted (Harpenden, Reino Unido) desde 1919 y era especialista en algas–, el biólogo y estadístico Ronald Fisher (1890-1962) y William Roach –con el que es cierto que Muriel se casó–.

Muriel Bristol y Ronald Fisher.

El experimento se realizó realmente, fue diseñado por el propio Fisher y dio lugar a un experimento aleatorizado que el estadístico presentó en su libro The Design of Experiments (1935) –llamado The lady tasting tea, la catadora de té–, en el que la prueba de significación estadística usada fue el test exacto de Fisher.

En este experimento, Fisher introdujo el concepto de hipótesis nula, unaafirmación que no se demuestra o establece, y no se rechaza excepto si durante el curso de la prueba parece demostrarse su falsedad. En el caso de la catadora de té la hipótesis nula suponía que Muriel no tenía la capacidad de distinguir las tazas.

Fisher eligió ocho tazas porque le pareció una cantidad suficiente para que la suerte no fuera un factor determinante. Observar que, efectivamente, existen 70 maneras de colocar las ocho tazas, con cuatro de cada tipo, y parece difícil acertar solo por azar.

Muriel aclaró –una explicación muy científica, desde su condición de bióloga– que, si se añadía leche fría al té caliente, las proteínas de la leche coagulaban y cambiaba el sabor, y ella lo percibía como desagradable.

Por cierto, el escritor George Orwell (1903-1950) no coincide con Muriel… en 1946 publicó el texto A nice cup of tea en el que describía con detalle el procedimiento a seguir para preparar una taza de té perfecta. Entre las instrucciones decía (traducción extraída de [3]):

En décimo lugar se debe verter el té en la taza antes que la leche. Este es uno de los puntos más polémicos, de hecho en todas las familias de Gran Bretaña probablemente hay dos escuelas de pensamiento sobre el tema. La escuela que echa primero la leche (que puede tener argumentos contundentes) y la escuela que la echa después. Yo sostengo que mi teoría es irrefutable. Al poner el té primero se puede regular exactamente la cantidad de leche, mientras que si se hace al revés se puede poner demasiada leche y no tendrá arreglo.

A lo mejor, para saber quién lleva la razón, es mejor leer lo que dice la norma ISO 3103 respecto al método estándar de preparar el té…

Referencias

[1] Sturdivant, Lt. Col. Rod., Lady Tasting Tea, 2004

[2] Jesús Ortiz, La ciencia y el té de las cinco, El Diario, 23 noviembre 2016

[3] Las onces reglas de George Orwell para ‘Una buena taza de té’, Territorio gastronómico

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Muriel Bristol, la gran catadora de té se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran cuatro, o los números siguen estando locos

- Artistas que miran a las matemáticas

- ¡Es la Aritmética!

Las relaciones hídricas, osmóticas y salinas de los condrictios

Los condrictios (tiburones y rayas, principalmente) son una clase de vertebrados mandibulados a los que se les suele llamar peces cartilaginosos. La mayoría pertenecen a la subclase de los elasmobranquios1, aunque en la misma clase se encuentran también las quimeras, únicos representantes vivos de la subclase de los holocéfalos. Hay menos especies de condrictios que de osteíctios, o peces óseos (la mayoría de cuyas especies son teleósteos).

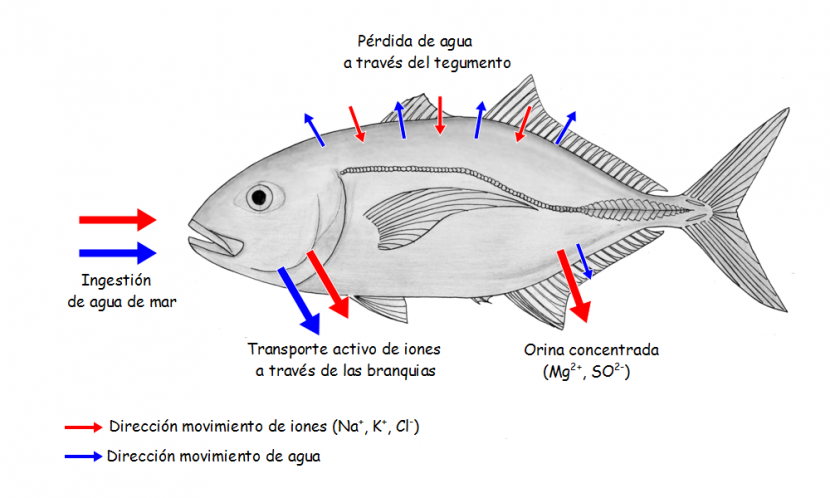

Los condrictios son muy interesantes pues algunos rasgos de su biología los diferencian claramente de los osteíctios. En concreto, la forma de resolver los problemas hídricos y osmóticos es radicalmente diferente en ambos grupos. De hecho, tal y como adelantamos aquí, en el medio interno de elasmobranquios y celacantos (Latimeria) determinadas sustancias orgánicas alcanzan concentraciones muy elevadas, pudiendo representar hasta un 40% de la concentración total de solutos. Ningún otro grupo tiene representantes con ese extraño rasgo.

La concentración de iones inorgánicos en la sangre de los elasmobranquios marinos es muy similar a la de los teleósteos, pero la concentración osmótica de la sangre de aquellos es ligeramente superior a la del agua de mar. La diferencia obedece a la presencia de urea y, en menor medida, de óxido de trimetilamina (TMAO). Aunque similares, la concentración osmótica del medio interno es lo suficientemente más alta que la del externo como para generar un pequeño flujo de agua hacia el interior del organismo.

Los condrictios son capaces de sintetizar urea y esta es la molécula que utilizan para eliminar los restos nitrogenados del catabolismo de proteínas y otras sustancias2. Pero aunque es la molécula de excreción del nitrógeno, también la retienen en la sangre, lo que consiguen reabsorbiéndola de la orina recién formada en los riñones y evitando su pérdida a través de los epitelios branquiales, que son muy impermeables para con esta sustancia.

La razón por la que, además de urea, la sangre de los elasmobranquios contiene también TMAO es que esta ejerce una función protectora frente a los efectos potencialmente tóxicos de aquella. En efecto, aunque menos que el amonio, la urea también es una sustancia tóxica pues ejerce efectos desestabilizadores sobre proteínas y otras macromoléculas, como consecuencia de lo cual inhibe la acción de las enzimas. Pero hay otras sustancias, como TMAO, glicín betaína y sarcosina, que tienen el efecto contrario, estabilizan macromoléculas y, por lo tanto, activan enzimas. Por esa razón, esas sustancias contrarrestan los efectos de la urea y suelen estar presentes cuando la urea también lo está a altas concentraciones. En humanos, por ejemplo, la concentración de urea se mantiene en el intervalo 2-7 mM, pero en los elasmobranquios marinos esa concentración se encuentra entre 300 y 400 mM. En la sangre del tiburón Squalus acanthias la urea una concentración 351 mM y el TMAO 71 mM (la concentración osmótica total es de 1018 mOsm y la del agua de mar en que vive, de 930 mOsm).

Una consecuencia interesante del hecho de que los elasmobranquios sean ligeramente hiperosmóticos con relación al agua de mar es que el flujo de agua hacia el interior les proporciona toda el agua que necesitan para eliminar las sustancias nitrogenadas de deshecho. No necesitan beber. Por esa razón, no adquieren una cantidad excesiva de sales inorgánicas, como les ocurre a los teleósteos. No obstante, las sales que se introducen con el agua de mar las eliminan a través de la glándula salina rectal, agrupación de miles de túbulos secretores que evacua al recto una solución isosmótica con la sangre aunque sin apenas urea. Por ello, la concentración de Na+ y de Cl– en la secreción salina rectal duplica la concentración sanguínea de esos iones.

Modelo del celacanto “Latimeria chalumnae” que muestra sus colores reales cuando está vivo que se conserva en el Oxford University Museum of Natural History. Foto: Ballista / Wikimedia Commons

Como se ha dicho antes, además de condrictios (elasmobranquios y quimeras), los celacantos también tienen una elevada concentración de urea y TMAO en su medio interno. La concentración de urea en Latimeria chalumnae es de 377 mM y la de TMAO, de 122 mM. El dato es interesante, porque los celacantos son los únicos representantes vivos del grupo de los sarcopterigios, del que suponemos que proceden todos los tetrápodos, muchos de los cuales también recurren a la urea como molécula de excreción de restos nitrogenados.

Hay elasmobranquios que son capaces de penetrar en aguas salobres de estuarios y otros ecosistemas costeros y algunos también han llegado a colonizar los ríos. El tiburón Carcharhinus leucas, tristemente conocido por sus ataques a bañistas, es una de esas especies eurihalinas. En estas especies la concentración sanguínea de urea y TMAO se reduce de forma significativa cuando se encuentran en aguas más diluidas. El citado C. leucas, por ejemplo, pasa de 293 mM (urea) y 47 mM (TMAO) en la sangre cuando está en agua de mar, a 151 mM (urea) y 19 mM (TMAO) en agua dulce. Esa reducción se produce dejando de reabsorber urea en los riñones. No obstante, esa reducción no es suficiente para evitar una intensa entrada de agua en el organismo a favor de gradiente osmótico. Por ello, han de aumentar la producción de orina y, por otro lado, la reabsorción renal y branquial de sales.

Rayas de río “Potamotrygon motoro” en el zoo de Duisburg (Alemania). Foto: Raimond Spekking / Wikimedia Commons

Las rayas de la familia Potamotrygonidae (menos una que es marina) y algunas especies de la familia Dasyatidae son de agua dulce. Al menos algunas de esas especies han llegado a perder incluso la capacidad para sintetizar y retener urea y TMAO, por lo que eliminan sus restos nitrogenados en forma de amonio. Y como no podía ser menos, producen orina abundante y diluida. La fisiología de estas rayas es, de hecho, muy similar a la de los teleósteos de agua dulce en lo que a la regulación hídrica, osmótica y salina se refiere.

Aunque los de agua dulce recurren a mecanismos muy similares, la forma en que los condrictios marinos resuelven sus problemas hídricos y salinos reviste, como hemos visto, características muy diferentes a la de los osteíctios. Esas diferencias son interesantes, porque ponen de manifiesto que la historia evolutiva de unos y otros linajes da lugar a diferentes adaptaciones fisiológicas. En otras palabras, en el funcionamiento de los animales no hay soluciones obligadas para resolver los problemas que plantean los medios a los que se adaptan. Es el azar el que decanta la adopción de una u otra estrategia de entre las disponibles.

Notas:

1 Aunque, como se ha visto, no todos los condrictios son elasmobranquios, en este texto utilizaremos indistintamente ambas denominaciones para referirnos a los peces cartilaginosos. Igualmente, utilizaremos indistintamente las denominaciones osteíctios y teleósteos para referirnos a los llamados peces óseos, aunque no todos los osteíctios sean teleósteos.

2 La inmensa mayoría de las especies de teleósteos eliminan amonio. No llegan a diez las especies que recurren a la urea con ese propósito.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Las relaciones hídricas, osmóticas y salinas de los condrictios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Relaciones hídricas y salinas de los animales

- La distribución del agua animal y el curioso caso del potasio

- Efectores osmóticos

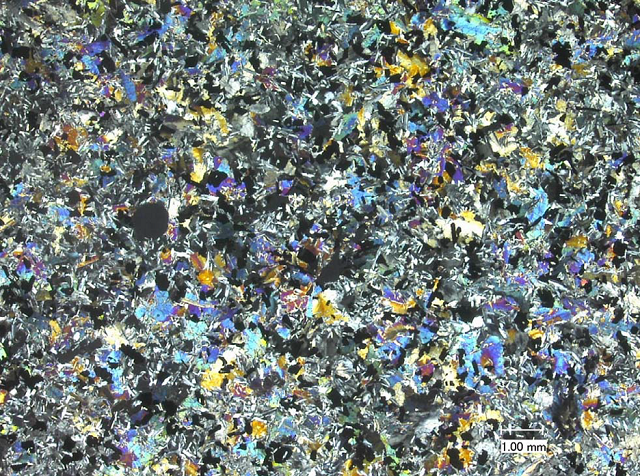

Esa pesadilla científica llamada mineralogía

Muestra de aragonito procedente de Pantoja (Toledo, España). Imagen: Quebul Fine Minerals

La mineralogía es la ciencia que estudia la estructura y propiedades químicas y físicas de los minerales y cuerpos mineralizados. En lo que sigue la consideraremos como una ciencia en sí misma, aunque es posible que haya quien se apresure a decir que es una rama de las geociencias, lo que, como veremos en su momento, es una apropiación moderna y, aunque cómoda, no deja de ser discutible.

Hay quien describe la mineralogía como una pesadilla científica y, si bien realmente esta podría ser su etiqueta más adecuada, intentaremos en lo que sigue exponer por qué es una ciencia; es posible que se entienda también el por qué lo de llamarla pesadilla. Nuestro objetivo es introducir algunas de las ideas fundamentales de la mineralogía de la forma más intuitiva: estudiando su historia.

Fotografía de la muestra 10003 recogida de la superficie lunar por la misión Apolo XI. Aunque tiene toda la pinta de un basalto con presencia de ilmenita, olivino y otros minerales, según el DRAE no lo son. El informe completo de análisis puede obtenerse aquí [PDF] como separata del Lunar Sample Compendium.

Pero empecemos por lo más básico: ¿qué es un mineral?Si hubiera que hacer caso de eso que la Real Academia Española llama diccionario, podríamos entender por mineral una “Sustancia inorgánica que se halla en la superficie o en las diversas capas de la corteza terrestre”. Si esta definición fuese válida las sustancias inorgánicas en la superficie de la Luna, Mercurio, Venus, Marte o cualquier otro cuerpo del universo distinto de la Tierra no serían minerales; el agua líquida sería un mineral si está en la Tierra pero no en cualquier exoplaneta; y los silicatos, siendo inorgánicos y terrestres no serían minerales si están en el manto terrestre y no en la corteza. Es manifiesto que se impone, pues, dar una definición formal de mineral.

Las columnas coloreadas son erbaita, una forma de turmalina. La fórmula genérica de las turmalinas dista mucho de ser una fórmula química al uso: (Na,Ca)(Mg,Li,Al,Fe2+,Fe3+)3(Al,Mg)6(BO3)3Si6O18(OH,O,F)4. Los otros minerales presentes en la imagen son cuarzo, lepidolita y cleavelandita (una variedad de albita). Imagen: Rob Labinsky / Wikimedia Commons

Un mineral es una sustancia que:

a) existe en la naturaleza (esto incluye cualquier parte del universo) naturalmente, esto es, sin intervención humana;

b) tiene una composición química característica, aunque no tiene por qué tener una fórmula química exacta;

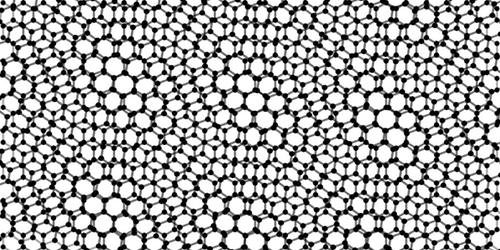

c) posee una estructura generalmente cristalina. Esta afirmación implica que los minerales son, en principio, sólidos, que la estructura cristalina puede tener alteraciones debido a impurezas, y que además se usa la definición actualizada de cristal (sólido con un patrón de difracción definido) lo que incluye a los cuasicristales.

Si nos fijamos no hemos incluido esa distinción arbitraria tan del siglo pasado: inorgánico/orgánico. Cualquier sustancia que cumpla lo anterior es un mineral. A las mezclas estables de minerales las llamaremos rocas.

Roca basáltica con fenocristales de olivino. Un fenocristal es un cristal de tamaño considerable respecto al resto de los componentes de una roca; es el resultado de un enfriamiento lento en el proceso de cristalización del magma. La muestra de la imagen procede de la isla de La Palma (Canarias, España y, a efectos del DRAE, planeta Tierra) y pertenece a la Universidad de Tartu (Estonia). Fuente: Wikimedia Commons

Probablemente no exista rama del conocimiento con más cambios de estatus que el estudio de los minerales, pero podemos reducirlos a tres principales. Desde el siglo XVI hasta comienzos del XIX fue un nexo entre la química y lo que se conocía como historia natural. Empleaba las técnicas de laboratorio de la primera y los principios de clasificación de la segunda para estudiar la totalidad del “reino mineral”. En esta época la mineralogía era una disciplina a la que los eruditos dedican buena parte de su tiempo habida cuenta de su trascendencia económica y alquímica.

Durante el siglo XIX la mineralogía dejó de tener esta posición de privilegio intelectual para convertirse en una subdisciplina de la geología. Es de esta época la definición de mineral como “sustancia química que ocurre naturalmente en la corteza terrestre” y su estudio se separa del de las rocas, “agrupaciones definidas de minerales”, lo que lleva a finales de sigloa distinguir entre mineralogía y petrología.

Tras la Segunda Guerra Mundial la geología pasa a formar parte de las geociencias, y las sub-sub-ramas de la mineralogía y la petrología se ven transformadas por la teoría de la tectónica de placas y por la nueva instrumentación disponible.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Esa pesadilla científica llamada mineralogía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ellen Richards: la economía doméstica como cultura científica

- De cañones, cátedras y espías

- Una ventana llamada Rosetta

Colonialismo científico: los investigadores africanos se rebelan contra el expolio de datos genéticos

Fuente: Universidad de Boston. Centro de Estudios Africanos

Desde que en el año 2001 se descodificó el primer genoma humano, miles de ellos han pasado por el mismo proceso y poco a poco estamos creando una enorme base de datos mundial que refleja nuestra diversidad como especie. El continente africano está siendo escenario de gran parte de esa recolección de datos: en África, el lugar donde aparecieron los primeros de nuestros antepasados, los distintos grupos de población contienen interesantes variaciones para entender los cruces genéticos que nos dieron forma, cómo nos movemos y alimentamos y las enfermedades que todavía hoy sufrimos.

Hay grandes beneficios en juego para la población africana a cambio de aportar esta valiosa información al campo de la genómica a nivel global. Conocer las variaciones genéticas de un grupo puede ayudar a mejorar su atención médica. En muchas regiones de África eso puede significar una mejora de la calidad de vida incalculable.

El expolio de los datos

Pero a medida que la genómica avanza y despega, los científicos africanos temen (y están observando ya) como las viejas dinámicas del colonialismo vuelven a hacer de las suyas y las grandes potencias mundiales se dedican a explotar sus recursos y ofrecer nada a cambio. A causa de la falta de recursos, hay pocas instituciones científicas en África que puedan llevar a cabo en solitario investigaciones de este tipo, que en muchos casos requieren complejos equipos informáticos capaces de procesar miles de datos con velocidad. Por eso, los equipos que tienen interés en investigar en este campo a menudo tienen que asociarse y aceptar las condiciones de grupos de otros países. Y esas condiciones muchas veces dejan muy poco margen y resultado para los científicos locales.

Investigación alimentaria en África. Fuente: Wikipedia Commons

Lo llaman ‘investigación helicóptero’, una práctica por la que los investigadores de países desarrollados acuden a los países en desarrollo, recogen sus datos y se marchan de allí sin contar con los científicos locales. A veces incluso pueden compartir a posteriori esos datos con otros grupos que no estuvieron involucrados en su recogida, lo cual crea una indignante contradicción en la que la información recabada y los resultados derivados de ella benefician a todo el mundo excepto a la población de la que se extrajo.

Una guía de buenas prácticas

Conocedores de cómo puede terminar esta historia (los países del continente expoliados de sus datos genéticos, que estarán dando réditos a miles de kilómetros donde sus habitantes apenas llegarán a olerlos, ¿no les suena esto de algo?), los científicos africanos han decidido tomar cartas en el asunto y han publicado una guía de buenas prácticas a exigir para desarrollar investigaciones genéticas en África. Detrás del documento está la Human Heredity and Health in Africa (H3Africa) Initiative, un consorcio que apoya y promueve investigaciones biomédicas en el continente.

“El hecho de compartir [datos] para contribuir al bienestar de otros sería algo ampliamente respaldado en África. Pero eso siempre debe ir unido a la reciprocidad, debe hacerse de una forma responsable, con la aportación de todos los involucrados y con mecanismos que obliguen a los equipos de investigación a hacerse responsables y a dar explicaciones de sus actos”, explican los autores del documento, que aseguran que así los africanos podrán participar y contribuir al avance en este campo de innovación, “algo que, aunque caro por el momento, tiene un enorme potencial para retornar en forma de menores costes sanitarios cuando conozcamos los determinantes genómicos de muchas enfermedades”.

Fuente: Wellcome UK

El documento establece algunos principios básicos. Para empezar, las investigaciones genómicas que se lleven a cabo en África deben ser sensibles y respetuosas con las culturas y valores de los africanos, así como establecer los beneficios para ellos como uno de sus objetivos primordiales. Además, estos proyectos y la publicación y publicitación de sus resultados deben contar con la aportación y participación de científicos africanos. “Teniendo en cuenta que el objetivo principal de la investigación genómica en África debería ser el beneficio de los africanos, la contribución de los científicos que trabajan en instituciones africanas debería ser significativa y sustanciosa, incluyendo el liderazgo o coliderazgo intelectual efectivo”.

La ciencia que reduzca desigualdades y no las aumente

La idea es que esta guía dé ideas y estrategias a los científicos africanos a la hora de negociar con sus socios extranjeros. Los marcos temporales son especialmente críticos debido al desequilibrio en capacidad de computación de unos y de otros, así que una forma de evitar el saqueo de datos podría ser, por ejemplo, exigir periodos de embargo durante los cuales investigadores que no hayan participado en la recogida de datos no puedan publicar resultados basándose en ellos.

A nadie se le escapa que no será fácil conseguir que estas reglas sean respetadas. Los científicos africanos juegan en desventaja económica, lo cual puede mermar su capacidad para imponer condiciones a la hora de pactar las condiciones de futuras colaboraciones científicas.

Pero si hemos aprendido algo de nuestra propia historia, si tenemos claro qué actitudes e injusticias del pasado terminaron conformando el mundo desigual en el que vivimos hoy, si de verdad el avance de la ciencia tiene como objetivo mejorar el bienestar de toda la humanidad… Entonces no dejaremos que la investigación se convierta en otra palanca para seguir ampliando la brecha que separa a ricos y pobres hasta desgajarnos.

Referencias

Ethics and Governance Framework for Best Practice in Genomic Research and Biobanking in Africa – Human Heredity and Health in Africa (H3Africa) Initiative

African scientists call for more control of their continent’s genomic data – Nature

How the genomics revolution could finally help Africa – Nature

‘Helicopter’ researchers – issues with research being conducted on mining impact in North Western Province Zambia – Australian National University

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Colonialismo científico: los investigadores africanos se rebelan contra el expolio de datos genéticos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Pena de muerte contra el fraude científico

- Contra el furtivismo, genética molecular

- Ciencia aplicada (1): Quibim, los datos ocultos tras una imagen

El organismo humano es una estufa de unos pocos vatios

El organismo humano es un agregado de millones de células en las que tienen lugar innumerables reacciones químicas de forma permanente, y en su interior se llevan de un lado para otro sustancias de lo más diverso. Gracias a ello se mantiene vivo. Además, suele dedicar parte de su tiempo a desarrollar algunas actividades físicas. Todo ello da lugar a una cierta producción de calor que acaba por disiparse. El calor disipado constituye una pérdida de energía y lo llamamos gasto metabólico porque, en última instancia, tiene su origen en el metabolismo del organismo, que es el conjunto de procesos que intermedian en las actividades citadas.

En promedio, un kilogramo de ser humano en reposo gasta 22 kilocalorías al día (valor promediado para hombres y mujeres adultas de diferentes edades). Pero no todos los kilogramos gastan lo mismo. Corazón y riñones gastan 440 kilocalorías por kilo y día. No está nada mal; aunque la masa de cada uno representa el 0,4% de la del organismo, dan cuenta del 8% (corazón) y 8,5% (riñones) del gasto total. Del corazón sabemos que late unas ochenta veces por minuto sin descanso, noche y día, y como vemos, a un alto coste relativo. No imaginábamos, sin embargo, que los riñones se esforzasen tanto, pero lo hacen. Trasiegan con brío agua y otras sustancias, y gracias a ese gran trabajo llevándolas de aquí para allá, fabrican una orina llena de productos de deshecho pero a la que le han quitado las sustancias que necesita el organismo, para que no se pierdan.

Sin llegar al nivel de los anteriores, el hígado y el encéfalo son también verdaderos campeones metabólicos. La masa de cada uno de ellos no supera el 2% de la de todo el organismo, pero con un gasto de 200 (hígado) y 240 (encéfalo) kilocalorías por kilo y día, su actividad da cuenta de una producción de calor que representa, respectivamente, el 17% y el 20% de la producción total del organismo. Tampoco está mal.

Mucho menos activa es la musculatura (recordemos que el organismo del que hablamos está en reposo), que representa el 36% de la masa total pero solo gasta el 21% de la energía. Y muy parecido es el nivel metabólico del resto de órganos (excluido el tejido graso) que suponen el 19% de la masa y el 34% del gasto energético. La tasa metabólica de músculos y otros tejidos es, respectivamente, de 13 y 12 kilocalorías por kilo y día. Finalmente nos queda la grasa corporal. Un kilo de tejido adiposo gasta unas ridículas 4,5 kilocalorías diarias; por eso, aunque la grasa representa una cuarta parte de la masa corporal, solo gasta el 5,5%. O sea, cuando el organismo acumula grasa, no solo engorda, sino que, además, produce un tejido que prácticamente no gasta energía.

Aunque lo hacen en diferente grado, todos los órganos contribuyen al gasto energético total del organismo en reposo, que se acerca a las 1600 kilocalorías diarias. Esa cifra representa aproximadamente el 75% del gasto diario total de individuos poco o nada activos. Habría que añadirle las 160 kilocalorías que se gastan en la digestión y absorción del alimento. Y si el sujeto en cuestión desarrolla una gran actividad física, el gasto energético diario podría llegar a ser un 50% mayor. Para que nos hagamos una idea, en reposo y sin comer, gastaríamos a diario una cantidad de energía equivalente al calor que produce una estufita de 75 vatios, pero si hiciésemos una actividad física relativamente intensa de forma cotidiana, la estufita podría llegar a ser de casi 150 vatios.

Fuente: Zi Mian Wang, Zhiliang Ying, Ania Bosy-Westphal, Junvi Zhang, Britta Schautz, Wiebke Later, Steven B Heymsfield & Manfred J Müller (2010): Specific metabolic rates of major organs and tissues across adulthood: evaluation by mechanistic model of resting energy expenditure. Am J Clin Nutr 92 (6): 1369-1377 doi: 10.3945/ajcn.2010.29885

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 31 de diciembre de 2017.

El artículo El organismo humano es una estufa de unos pocos vatios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El neerlandés que subirá unos pocos metros pero bajará una montaña

- ¿Cuántas células hay en el cuerpo humano?

- El encéfalo humano

Naukas Bilbao 2017 – Pepe Cervera: Despegue: cuando la Inteligencia Artificial supera a la humana

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Si no sabemos definir adecuadamente la inteligencia en humanos, ¿sabremos reconocer una inteligencia artificial? Pepe Cervera tiene claro que sí.

Pepe Cervera: Despegue:cuando la Inteligencia Artificial supera a la humanaEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Pepe Cervera: Despegue: cuando la Inteligencia Artificial supera a la humana se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Daniel Marín: Algo se muere en el alma cuando una sonda se va

- Naukas Bilbao 2017 – Guillermo Peris: Los trapecistas del genoma

- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

Consumo de carnes rojas y ubicación del cáncer en mujeres

Al comparar el efecto que tienen cuatro tipos de dieta —que incluyen regularmente carnes rojas, aves, pescado o las dietas vegetarianas— en el desarrollo de cáncer en secciones específicas del colon, se ha encontrado que quienes comen carne roja con regularidad, en comparación con quien sigue una dieta sin carne roja, tenían mayores tasas de cáncer de colon distal, un tipo de cáncer situado en la sección descendente del colon, donde se almacenan las heces.

“El impacto de los diferentes tipos de carne roja y de los patrones dietéticos en la ubicación del cáncer es uno de los mayores desafíos en el estudio de la dieta y el cáncer colorrectal. Nuestra investigación es uno de los pocos estudios que analizan esta relación y, si bien se necesitan análisis adicionales en un estudio más amplio, podría proporcionar información valiosa para aquellas personas que tienen antecedentes familiares de cáncer colorrectal y quienes trabajan en el ámbito de la prevención y la salud pública”, señala Diego Rada Fernández de Jáuregui, miembro del Departamento de Medicina Preventiva y Salud Pública de la Facultad de Farmacia de la UPV/EHU y del Grupo de Epidemiología Nutricional (NEG) en la Universidad de Leeds (Reino Unido) y autor principal de este trabajo.

Se espera que para el año 2030 se diagnostiquen más de 2,2 millones de nuevos casos de cáncer colorrectal, también conocido como cáncer de intestino, en todo el mundo. Es el tercer tipo de cáncer más frecuentemente diagnosticado en las mujeres del Reino Unido. Estudios previos han sugerido que comer mucha carne roja y procesada aumenta el riesgo de desarrollar cáncer colorrectal y se estima que alrededor de 1 de cada 5 cánceres intestinales en el Reino Unido están relacionados con el consumo de este tipo de carne. Sin embargo, hay información limitada disponible sobre los patrones dietéticos específicos y el lugar de aparición del cáncer en el intestino.

En el estudio, utilizaron datos del Estudio de Cohortes de Mujeres del Reino Unido (UKWCS). Esta cohorte incluyó un total de 32.147 mujeres de Inglaterra, Gales y Escocia. Fueron reclutadas y encuestadas por el Fondo Mundial de Investigación del Cáncer entre 1995 y 1998 y fueron monitorizadas durante 17 años de promedio.

Además de registrar sus hábitos dietéticos, se documentaron un total de 462 casos de cáncer colorrectal, y de los 335 cánceres de colon, 119 casos fueron casos de cáncer de colon distal. El análisis del estudio, publicado recientemente en la revista International Journal of Cancer, exploró la relación entre los cuatro patrones dietéticos y el cáncer colorrectal; un análisis exploratorio posterior examinó, asimismo, la asociación entre la dieta y las subsecciones del colon donde apareció el cáncer.

Janet Cade, coautora del trabajo y jefa del NEG, y profesora de Epidemiología Nutricional y Salud Pública en la Facultad de Ciencias de la Alimentación y Nutrición de Leeds, comenta que “nuestro estudio no solo ayuda a arrojar luz sobre cómo el consumo de carne puede afectar de manera diferente a las secciones del colon y recto; pone de manifiesto la importancia de contar con información dietética fiable de grandes grupos de personas. El contar con acceso al Estudio de Cohorte de Mujeres del Reino Unido nos permite descubrir tendencias en la salud pública y analizar cómo la dieta puede influir en la prevención del cáncer. Los informes dietéticos precisos ofrecen al personal investigador la información necesaria para vincular estos dos aspectos”.

Referencia:

Diego Rada Fernández de Jáuregui, Charlotte E. L. Evans, Petra Jones, Darren C. Greenwood, Neil Hancock, Janet E. Cade (2018) Common dietary patterns and risk of cancers of the colon and rectum: Analysis from the United Kingdom Women’s Cohort Study (UKWCS) International Journal of Cancer doi: 10.1002/ijc.31362

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Consumo de carnes rojas y ubicación del cáncer en mujeres se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Seguridad diagnóstica en el cáncer de colon y tratamiento del de páncreas

- Nanopartículas para reducir la metástasis hepática del cáncer de colon

- Detección precoz del cáncer de colon por métodos no invasivos

Antonio de Ulloa, el marino que leía a Newton

El 25 de marzo de 1726 se publica en Londres la tercera edición de Philosophiæ naturalis principia mathematica (los Principia), de Isaac Newton, una de las obras más importantes, revolucionarias e influyentes de la historia de la ciencia. Se imprimieron 1250 copias cuidadosamente encuadernadas en piel de Marruecos. Una de ellas llegó veinte años después a las manos de un joven marino español, apresado por corsarios ingleses cuando participaba en una expedición científica, y que acabó siendo nombrado miembro de pleno derecho de la Real Sociedad de Londres para el Avance de la Ciencia Natural, la Royal Society.

Tercera edición de los Principia

Antonio de Ulloa y de la Torre-Giralt (Sevilla, 1716 – San Fernando, 1795) fue una de las figuras más destacadas de la Ilustración española como escritor, científico y naturalista. Hijo del aristócrata Bernardo de Ulloa, con solo catorce años se embarcó en el galeón San Luis hacia las Antillas para regresar dos años más tarde al puerto de Cádiz. Ingresa unos meses después en la recién creada Real Academia de Guardias Marinas y en 1735 fue destinado, con diecinueve años y el rango de teniente de fragata, como representante de la corona española junto a Jorge Juan y Santacilia en la Misión geodésica francesa, una ambiciosa expedición científica que pretendía medir un grado del arco de meridiano en el ecuador terrestre.

Antonio de Ulloa

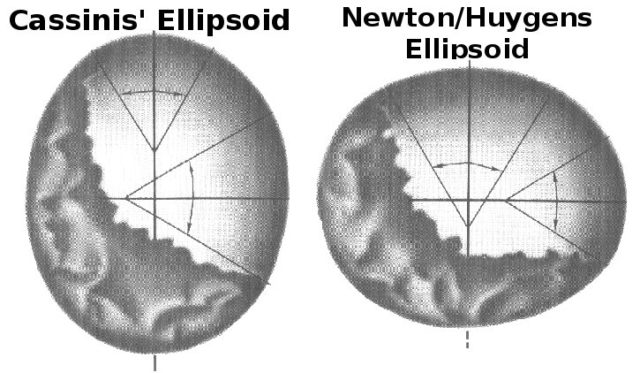

El fin último de esta expedición era zanjar la discusión por la forma de la Tierra que enfrentaba a la comunidad científica entre los newtonianos, que sostenían la forma achatada por los polos, y los cartesianos (como los franceses Piccard, La Hire y Cassini), que decían que lo estaba por el ecuador. ¿Tenía la Tierra forma de calabaza o de melón? En paralelo, se envió otra expedición a Laponia encabezada por el astrónomo Pierre Louis Maupertuis y en la que participó activamente el sueco Anders Celsius, creador de la escala de temperatura centígrada que lleva su nombre. Y fue esta segunda expedición en las frías regiones del Ártico la que demostró que la Tierra está achatada en los polos, dando la razón a los newtonianos. El filósofo francés Voltaire, que estuvo muy atento al desarrollo de estas misiones por el alcance científico y político, escribió: «Han confirmado con mucha transpiración lo que Newton descubrió sin salir de su habitación».

Cassini vs Newton

Durante la expedición francesa en Perú de 1735, un marinero galo descubrió casualmente unos nódulos de arcilla grisácea mientras caminaba por un estuario y se lo entregó a Ulloa. En la arcilla se encontraban unos trozos de un extraño metal plateado que ya era conocido desde tiempo atrás en América del Sur. Ulloa se dio cuenta inmediatamente de que se encontraba delante de un nuevo elemento metálico, el platino, y se le considera su descubridor, pero no sin cierta polémica porque no llegó a aislarlo o a estudiar sus propiedades. El joven teniente de fragata bautizó al metal como platina del Pinto («plata pequeña del río Pinto»), o simplemente platina, y fue posteriormente el insigne químico británico Humphrey Davy el que le dio el nombre definitivo con el que lo conocemos en la actualidad.

Pese al adelanto y el éxito de la misión en Laponia, los resultados científicos de la expedición en Perú y Ecuador fueron muy importantes y productivos para la ciencia del siglo XVIII. Se midió con más exactitud el arco del meridiano, se hicieron medidas de la gravedad a varias altitudes y se realizaron valiosas medidas de la velocidad del sonido.

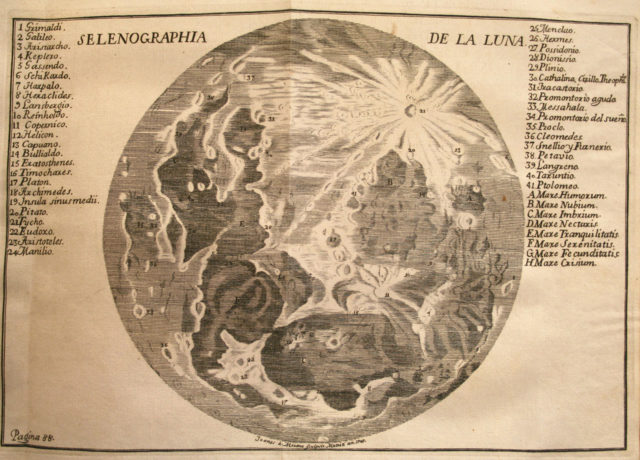

Como curiosidad añadida, podemos destacar las observaciones y cartografía de la Luna, que con la ayuda de un pequeño telescopio, Ulloa y Jorge Juan recogieron en la obra Observaciones astronómicas y físicas hechas de orden de Su Majestad en los Reinos de Perú.

Selenographia de la luna

En agosto de 1745, durante el viaje de regreso a España a bordo de la fragata Délivrance, Antonio de Ulloa fue capturado por un navío británico y enviado preso a Inglaterra. Se le incautó toda la documentación científica que traía de su expedición y se la remitió a la Royal Society. Varios miembros se interesaron por el trabajo de Ulloa, entre ellos se encontraba el entonces presidente Martin Folkes, un brillante matemático que fue nombrado vicepresidente por el mismísimo Isaac Newton en 1923. Folkes entabló amistad con Ulloa en el proceso de recuperación de su trabajo requisado y quedó asombrado con la recopilación de datos científicos en su década de investigación en las Américas. Tanto es así, que Ulloa fue nombrado miembro de la Royal Society en diciembre de 1746 en justicia con su trabajo y sus descubrimientos. Un poco antes, a mitad de ese año de 1746, Martin Folkes le regaló a su amigo sevillano un ejemplar de los Principia de Newton, en su tercera edición, con la siguiente dedicatoria en un latín poco ortodoxo: «Viro doctrina simul et moribus spectabili Dº Antonio de Ulloa, Hispalensi, auspicatum in patriam reditum omniaque dein felicia ex animo precatur. Martinus Folker, Regalis Societatis Londini Praeses, et Regia Scientiarum Academiae Parisiensis Socies. 3º Eid. May Anno salutis reparatae M.DCCC.XLVI».

Ese ejemplar de los Principia se encuentra en la actualidad en la Biblioteca de la Universidad de Sevilla y era uno de los seis libros de Isaac Newton de la fabulosa biblioteca personal del gran Antonio de Ulloa y de la Torre-Giralt, el marino que leía a Newton.

Este post ha sido realizado por Daniel Torregrosa (@DaniEpap) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias y más información:

- Antonio de Ulloa. La biblioteca de un ilustrado, AA., 2015.

- El secreto de Prometeo y otras historias sobre la tabla periódica de los elementos, Alejandro Navarro Yañez, 2015.

- Observaciones astronomicas y phisicas hechas de orden de S. M. en los Reynos del Perú, Jorge Juan y Antonio de Ulloa, 1748.

- La misión geodésica francesa, Bernard Francou, 2015.

- El mapa lunar de Jorge Juan y Antonio de Ulloa, Paco Bellido, 2010.

El artículo Antonio de Ulloa, el marino que leía a Newton se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los institutos Isaac Newton y Oberwolfach, dos curiosas instituciones de investigación matemática

- “Comunicar la ciencia, menuda historia” por Xurxo Mariño

- Arte & Ciencia: Imaginario marino

No dejarás de comer pescado por culpa del mercurio

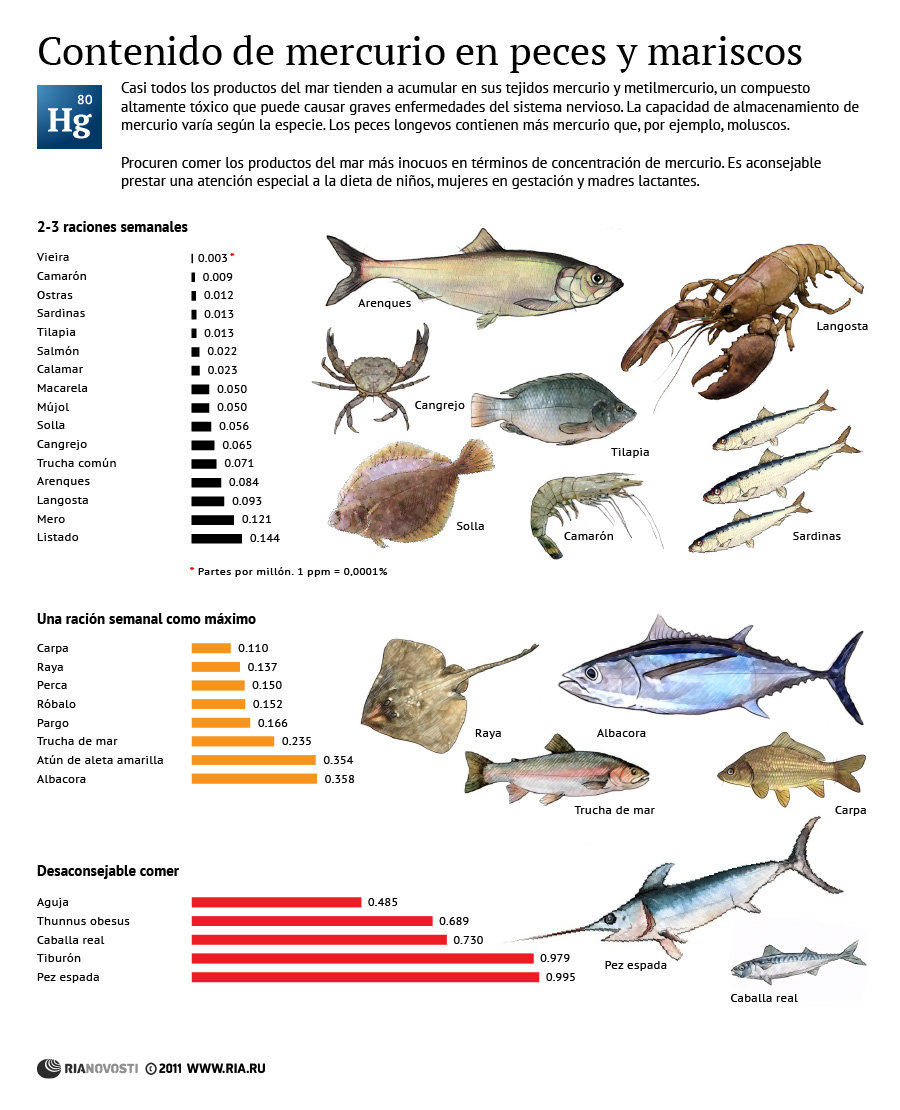

Una duda frecuente es si el pescado que consumimos tiene mercurio y si éste supone un riesgo para la salud.

El mercurio entra dentro de la categoría de metal pesado. Aunque desde la comunidad científica no hay un consenso sobre esta denominación, comúnmente se emplea para referirnos a los metales que se bioacumulan, es decir, que se introducen en los organismos vivos de forma casi permanente y pueden llegar a producir efectos tóxicos. Además del mercurio se consideran metales pesados el cadmio, el plomo y el cobalto, entre otros.

La forma más peligrosa del mercurio se llama metilmercurio

El mercurio lo encontramos principalmente en dos formas químicas, como mercurio inorgánico y como metilmercurio, siendo ésta la forma que presenta mayor toxicidad. Esto es así porque el metilmercurio es liposoluble, es decir, tiene la capacidad de acumularse en la grasa de los animales. Afecta especialmente al sistema nervioso central y a los riñones, por eso se considera neurotóxico y nefrotóxico.

El proceso de transformación del mercurio inorgánico en metilmercurio no se conoce con total exactitud, pero sí sabemos que se necesita la participación de determinadas bacterias una vez el mercurio ha llegado al agua. Los pescados y los mariscos son capaces de acumularlo en sus tejidos.

Mercurio metal (inorgánico)

Los depredadores acumulan el mercurio de sus presas

Si un animal ingiere mercurio, éste permanece indefinidamente en su organismo. Si un segundo animal se alimenta de este primero, el mercurio pasará automáticamente al depredador. Esa es la manera que tiene el mercurio de introducirse y permanecer en la cadena alimentaria. Esta cadena se inicia en el momento en que un animal ingiere mercurio.

En el océano, el metilmercurio es ingerido tanto por los succionadores de los fondos como por las formas del plancton que se alimentan de las bacterias. El plancton sirve de alimento a numerosas especies de peces y crustáceos, de modo que el metilmercurio pasa al siguiente nivel de la cadena alimentaria.

En el siguiente escalón de la cadena hay peces como la merluza, que se alimentan de los peces pequeños y crustáceos y, por tanto, acumulan el metilmercurio que estos contenían. Lo mismo sucede con los atunes, que también son carnívoros. Sin embargo, a diferencia de la merluza, algunas especies de túnidos alcanzan gran tamaño y peso, con lo que su tasa de alimento necesaria diaria es mucho mayor, por lo que van acumulando cantidades cada vez más significativas de metilmercurio.

Como el metilmercurio es soluble en la grasa, se acumula principalmente en los peces más grasos, es decir, en el pescado azul. La mayor concentración la encontraremos en las vísceras, las partes más grasas de estos pescados.

Dado que los peces son menos eficientes en la depuración que en la acumulación de metilmercurio, la concentración en los tejidos aumenta con el tiempo. Así, las especies que ocupan un nivel superior en la cadena alimentaria acumulan una carga corporal de mercurio que puede ser diez veces mayor que la de las especies que consumen. Este proceso se denomina biomagnificación.

Por estos motivos, la lista de pescados con más probabilidad de contener mercurio la encabezan los grandes túnidos: pez espada y ciertas variedades de atún, como el atún rojo. Le siguen el cazón, el marrajo, la tintorera y otros tiburones pequeños. El pescado que más quebraderos informativos nos ha traído es el salmón, sin embargo, no hay que preocuparse demasiado por él. Si procede de acuicultura o de aguas vírgenes como las de Alaska, el riesgo de contaminación por mercurio del salmón es muy bajo.

El bonito del norte y el atún claro, al no ser tan grandes como el atún rojo, entrañan menos riesgo. Ambos son los más frecuentes en las conservas y por tanto en el consumo cotidiano. No hay razón para preocuparse por ellos.

Con respecto al marisco, las recomendaciones de AECOSAN se limitan a advertir que no ingiramos las cabezas de las cigalas, gambas o langostinos, cuyo principal contaminante podría ser el cadmio, más que el mercurio. Del mismo modo, convendría no abusar de bivalvos como mejillones, almejas o berberechos. Estas recomendaciones hay que tomarlas con cierta cautela, ya que se refieren a una advertencia sobre el consumo excesivo de marisco y lo cierto es que solemos consumirlos de forma ocasional, con lo que no acarrean un verdadero problema.

La Autoridad Europea de Seguridad Alimentaria (EFSA) recomienda limitar la ingesta de atún rojo, emperador, tiburones o lucio, aunque dictamina que la limitación debe ir en función de la procedencia de la carne, ya que hay aguas más contaminadas que otras. Por ejemplo, el mediterráneo se considera altamente contaminado, pero no así el atlántico, que incluye zonas del cantábrico alejadas de la costa.

Cómo se produce la contaminación por mercurio

Los animales entran en contacto con el mercurio por varios motivos. Uno de ellos es de forma natural. El mercurio forma parte de ciertos minerales como el cinabrio, y estos pueden acabar arrastrados por corrientes de agua en la que habiten animales acuáticos y plantas, y también como consecuencia de la actividad volcánica.

No obstante, la principal vía de contaminación acuática por mercurio es de origen industrial. Puede darse como consecuencia de la actividad minera, por vertidos industriales con alto contenido en mercurio o como resultado de procesos industriales de combustión. Si las chimeneas de las incineradoras, las centrales térmicas que usan carbón con altos niveles de metales pesados o las industrias del cloro, no cuentan con filtros eficientes, las partículas contaminadas con mercurio pueden liberarse al aire. La lluvia se encargará de introducirlas en el subsuelo, donde contaminarán los acuíferos iniciando su camino hacia el mar.

Los niveles de mercurio del pescado se controlan

En la sección 3 del anexo del Reglamento (CE) Nº 1881/2006 (UE, 2006) se toma como contenido máximo para el mercurio en productos de la pesca entre 0,5 y 1 mg/kg de pescado fresco, dependiendo de la especie. Esta cantidad se ha fijado en función de los límites de ingesta que se ha comprobado que son tolerables, es decir, que no suponen un riesgo para nuestra salud, habida cuenta del consumo prolongado en el tiempo y siguiendo una dieta normal.

Para garantizar que los niveles se encuentran dentro de los límites permitidos, se hacen controles periódicos del pescado que llega al mercado, así que, salvo pautas de consumo fuera de lo habitual, no hay que preocuparse del mercurio que contiene el pescado.

La recomendación de AESAN para grupos especialmente sensibles, como niños menores de doce años, mujeres embarazadas o en período de lactancia, es que no consuman más de 50 g de grandes túnidos a la semana, o más de 100 g cada dos semanas. Desaconsejan el consumo de estos pescados a menores de tres años.

No dejes de comer pescado, hay más beneficios que riesgos

Aunque las autoridades sanitarias recomiendan limitar el consumo de determinados pescados en grupos de riesgo, animan al resto a consumirlo con frecuencia para mantener una dieta saludable. Esto es así porque el pescado azul contiene una proporción de grasas beneficiosas muy superior al pescado blanco, en especial los ácidos grasos omega-3. Hay abundante evidencia científica sobre los beneficios de estos ácidos grasos en el buen funcionamiento del sistema cardiovascular y el mantenimiento de los niveles de colesterol.

Lo ideal sería consumir solo un par de veces al mes los pescados que entrañan mayor riesgo y acudir cada semana a alternativas como el atún claro, el bonito, la caballa o el salmón, con el mismo aporte de ácidos omega-3 pero con menor concentración de metilmercurio.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo No dejarás de comer pescado por culpa del mercurio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Vas a freir pescado? Usa aceite de oliva virgen extra

- Esperma de pescado para extraer tierras raras

- Cómo los olores nos incitan a comer

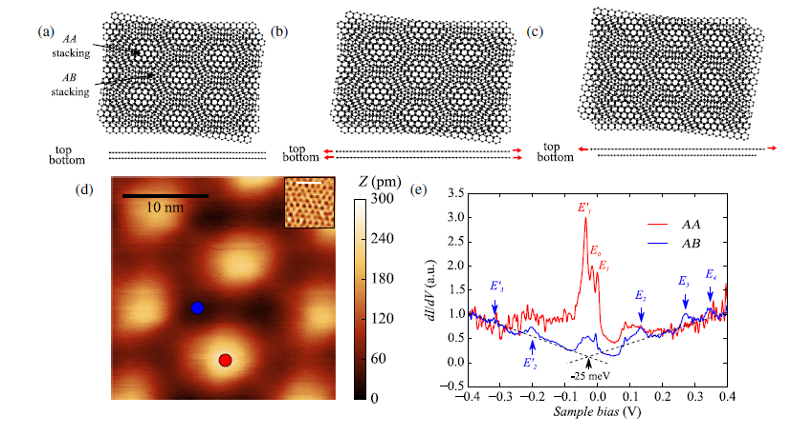

Lo que la tensión puede hacer en dos capas de grafeno