El problema de la plantación de árboles en filas

Existen dos matemáticos por los que siento cierta admiración y de los que hemos hablado en varias ocasiones en la sección Matemoción del Cuaderno de Cultura Científica, son los ingleses Arthur Cayley (1821-1895) y James J. Sylvester (1814-1897), que además tuvieron una profunda relación científica y de amistad.

El matemático británico James J. Sylvester (1814-1897)

Sobre el primero acabo de terminar una biografía, “Cayley, el origen del álgebra moderna” para la colección Genios de las matemáticas de la editorial RBA, con cuya escritura he aprendido y disfrutado mucho. Sin embargo, en esta entrada no vamos a hablar de Arthur Cayley, sino de su colega y amigo James J. Sylvester, y de un problema que formuló en 1893, en la revista Educational Times.

Problema 11851: Demostrar que no es posible colocar cualquier número finito de puntos (en el plano) de forma que cada recta que pase por dos de ellos también pase por un tercero, salvo que todos los puntos estén contenidos en la misma recta.

Este problema, conocido en ocasiones como el problema de la línea de Sylvester o simplemente el problema de Sylvester, estaba relacionado con un problema más general, que suele recibir diferentes nombres, entre ellos, el problema de la plantación de árboles en filas, el problema del huerto o el problema de los puntos y las líneas, sobre el que estuvo trabajando Sylvester desde la década de 1860 hasta su muerte. En su versión general el problema se puede plantear así.

Problema: ¿Cómo pueden distribuirse n puntos en el plano (o quizás, n árboles en un huerto) formando filas, cada una de las cuales contiene exactamente k puntos (respectivamente, árboles), con el objetivo de obtener el mayor número de filas posibles? ¿Y cuál ese mayor número de filas posibles para cada n y k?

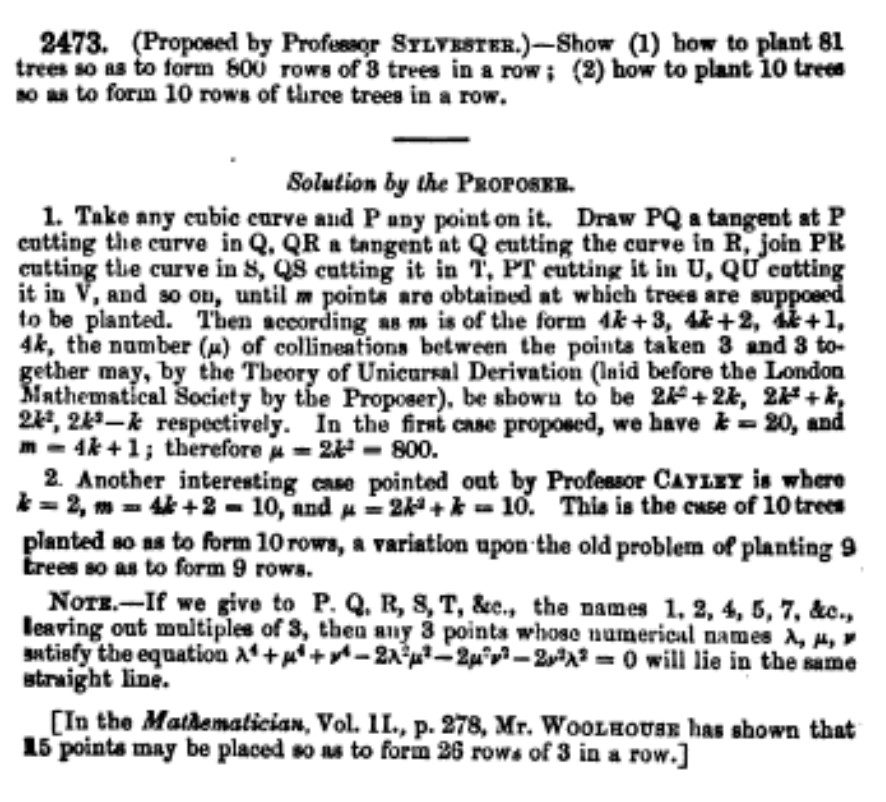

Sylvester había trabajado en la versión clásica en la cual las filas estaban formadas por tres árboles, es decir, el caso k = 3, como podemos observar en los problemas que planteó en Educational Times, en los años 1867 y 1886. Por ejemplo, en el problema 2473 (1867), que podéis ver en la imagen de abajo, planteó dos cuestiones: i) ¿Cómo plantar 81 árboles para que formen 800 filas con 3 árboles en cada fila?; ii) ¿Cómo plantar 10 árboles para que formen 10 filas con 3 árboles en cada fila?

“Problem 2473”, propuesto por J. J. Sylvester, en “Educational Times”, en 1867, con sus soluciones

Pero este era un problema que interesaba a más personas. Por ejemplo, como se menciona al final del problema 2473, el actuario inglés Wesley Woolhouse (1809-1893), editor de la famosa revista de matemática recreativa The Lady’s and Gentleman’s Diary, había publicado en la revista de problemas matemáticos The Mathematician que 15 puntos (árboles) podían ser colocados formando 26 filas, con 3 puntos (árboles) en cada fila.

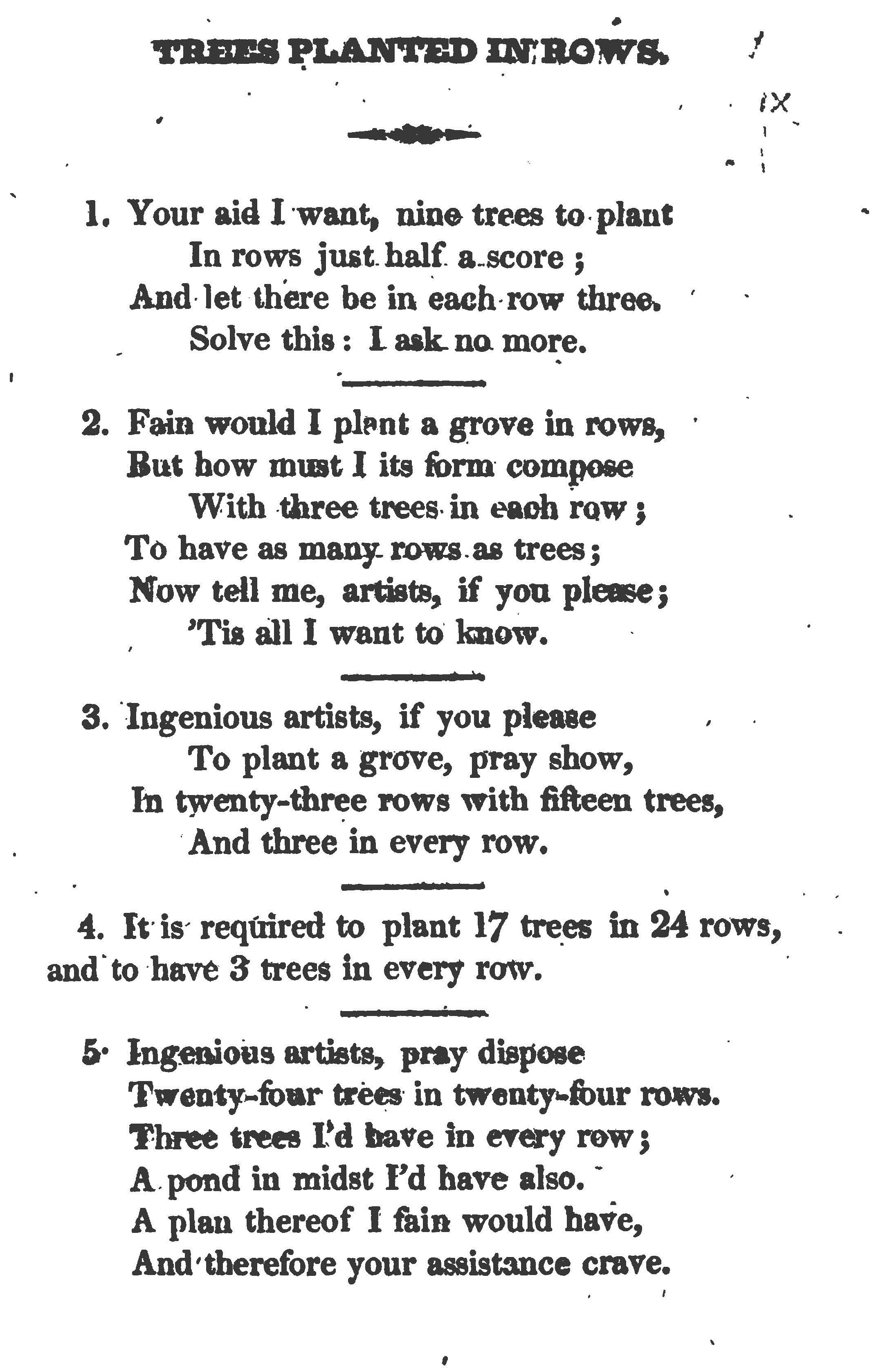

Aunque la primera publicación en la que se mencionan problemas de plantación de árboles en filas fue el libro Rational Amusement for Winter Evenings (1821), de John Jackson, en el que se dedica todo un “capítulo” precisamente a estos problemas, “árboles plantados en filas”.

Página del libro “Rational Amusement for Winter Evenings” (1821), de John Jackson, con algunos problemas de “árboles plantados en filas”

Pero volvamos al problema de la línea de Sylvester (problema 11851 de Educational Times). Ni Sylvester, ni sus contemporáneos, consiguieron demostrar que no es posible colocar cualquier número finito de puntos en el plano de forma que cada recta que pase por dos de ellos también pase por un tercero, salvo que todos los puntos estén contenidos en la misma recta.

Cuarenta años después de la formulación del problema en Educational Times, aunque sin ser consciente de la existencia del mismo, el matemático húngaro Paul Erdös (1913-1996) conjeturó que el resultado era cierto, y lo publicó después en forma de problema en la revista American Mathematical Monthly (1943), formulado de la siguiente forma.

Problema de la línea de Sylvester (versión Erdös): Demostrar que si un conjunto finito de puntos del plano no están todos sobre la misma recta, entonces existe una recta con exactamente dos de los puntos.

La solución llegó rápidamente. En 1944 se publicaron dos demostraciones en la revista American Mathematical Monthly. Una de ellas, la del colega y amigo de Erdös, el matemático húngaro Tibor Grünwald, que posteriormente se cambiaría el nombre a Tibor Gallai, (1912-1992). Aunque no fue la primera en publicarse, parece ser que era previa a la publicación del enunciado del problema en la revista por parte de Erdös. La otra prueba era del matemático Robert Steinberg (1922-2014), por aquel entonces estudiante en la Universidad de Toronto (Canada). De esos años debía de ser también la demostración del matemático estadounidense Leroy M. Kelly (1914-2002), que es la que vamos a mostrar en esta entrada.

La demostración de Leroy M. Kelly del problema de Sylvester aparece recogida en El Libro de las demostraciones (Nivola, 2005), de los matemáticos Martin Aigner y Günter M. Ziegler, y de la que escriben que puede considerarse “simplemente la mejor”.

Recordemos que el matemático Paul Erdös solía hablar de EL LIBRO en el que Dios había escrito las demostraciones más bellas de entre todos los teoremas. Esta idea llevó a los matemáticos Martin Aigner y Günter M. Ziegler a escribir El libro de las demostraciones (Proofs from the BOOK) con el objetivo de incluir algunas de esas bellas demostraciones de las que hablaba Paul Erdös.

Dos entradas del Cuaderno de Cultura Científica en la que se recogen otras demostraciones de El libro de las demostraciones son:

A. Teorema de la galería de arte

B. Una bella demostración del Libro

Pero vayamos con la demostración de Kelly del problema de la línea de Sylvester. Es decir, vamos a demostrar que si un conjunto finito de puntos del plano no están todos sobre la misma recta, entonces existe una recta con exactamente dos de los puntos.

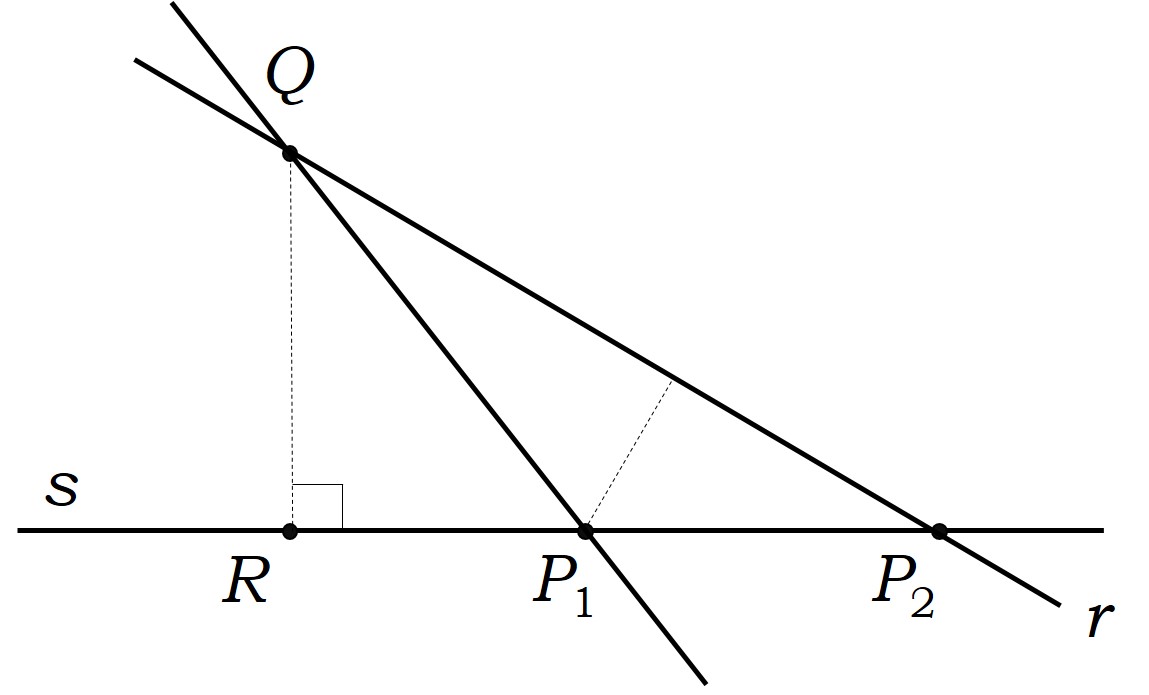

Demostración: Llamemos Ω al conjunto finito de los puntos del plano dados y Σ al conjunto de todas las rectas que pasan por al menos dos puntos de Ω. A continuación, consideramos todos los pares (P, r), donde P es un punto de Ω que no está en la recta r, de Σ, y todas las distancias de los puntos P a las rectas r, d(P, r), de todos esos pares. Y consideramos el par (Q, s) que nos da la distancia más pequeña de todas ellas. Ahora, llamemos R a la proyección ortogonal de Q sobre s, es decir, al punto de s más cercano a Q.

Vamos a demostrar que la recta s es la que verifica el resultado, es decir, que tiene exactamente dos puntos de Ω.

Supongamos que no es así y que la recta s tiene al menos tres puntos de Ω. Entonces existirán dos puntos P1 y P2 que están en el mismo lado de la recta s respecto de R y supongamos que P1 es el que está más cerca de R (como se muestra en la imagen), incluido el caso en el que P1 sea el propio R.

En tal caso, vamos a demostrar que la distancia del punto P1 a la recta r (que es la recta de Σ que pasa por Q y P2) es menor que la distancia de Q a s. Fijémonos en el triángulo QP1P2. Podemos afirmar que:

1. d(P1, P2) < d(Q, P2), ya que el ángulo que tiene como vértice P1 es obtuso (o recto);

2. calculando el área del triángulo desde dos puntos de vista distintos, obtenemos que

![]()

En consecuencia, de 1. y 2. se deduce que d(Q, s) = d(Q, R) > d(P1, r), como habíamos afirmado.

Que la distancia del punto P1, que pertenece a Ω, a la recta r, que pertenece a Σ, sea menor que la distancia de Q a s, es una contradicción con respecto a la elección del par (Q, s). En consecuencia, en la recta s no puede haber nada más que un punto de Ω a cada lado del punto R, es decir, hay dos puntos de Ω en total, como queríamos demostrar. QED

En una siguiente entrega de la sección Matemoción del Cuaderno de Cultura Científica abordaremos la historia de la solución del problema de la plantación de árboles en filas.

Pero vamos a terminar esta entrada con un par de problemas de ingenio del experto inglés en matemática recreativa Henry E. Dudeney (1857-1930). En sus libros, en particular, en Amusements in mathematics (1917), que fue publicado en castellano en tres partes, con el nombre conjunto de Diversiones Matemáticas (El acertijo del mandarín, Los gatos del hechicero y El misterio del muelle), también incluyó problemas de plantaciones de árboles en fila, que él llamó problemas de puntos y líneas.

En Diversiones matemáticas menciona un rompecabezas de este tipo atribuido al matemático inglés Sir Isaac Newton (1643-1727).

Rompecabezas de Newton: plantar 9 árboles de forma que formen 10 filas con 3 árboles en cada fila.

Y el segundo problema de este estilo, que incluimos aquí, lo planteó Dudeney como un problema militar, con una narrativa del problema no muy acertada en mi opinión. Es el problema Turcos y rusos (problema 213 de Amusement in Mathematics), que trasladamos aquí en la versión más simplificada de N. J. A. Sloane, que se recoge en el libro Viajes en el tiempo y otras perplejidades matemáticas, de Martin Gardner.

Turcos y rusos (versión de N. J. A. Sloane): Durante una batalla de la Primera Guerra Mundial, 11 soldados turcos fueron rodeados por 16 soldados rusos. Cada ruso disparó una vez y cada bala pasó exactamente por la cabeza de tres turcos. ¿Cómo estaban colocados los soldados turcos?

Martin Gardner (1914-2010), uno de los más grandes divulgadores de las matemáticas

Bibliografía

1.- Miodrag S. Petkovic, Famous puzzles of Great Mathematicians, AMS, 2009.

2.- James J. Sylvester, Problem 2473, Mathematical Questions from Educational Times 8, 1867, 106-107.

3.- James J. Sylvester, Problem 2572, Mathematical Questions from Educational Times 45, 1886, 133-134.

4.- James J. Sylvester, Problem 3019, Mathematical Questions from Educational Times 45, 1886, 134.

5.- James J. Sylvester, Problem 11851, Mathematical Questions from Educational Times 59, 1893, 98-99.

6.- John Jackson, Rational Amusement for Winter Evenings, Longman, Hurst, Rees, Orme and Brown, 1821.

7.- H. S. M.Coxeter, A Problem of Collinear Points, The American Mathematical Monthly, Vol. 55, No. 1, 1948, 26-28.

8.- L. M. Kelly, W. O. J. Moser, On the Number of ordinary lines determined by n points, Canad. J. Math. 10, 1958, 210-219.

9.- Martin Aigner, Günter M. Ziegler, El libro de las demostraciones, Nivola, 2005.

10.- Jiri Herman, Radan Kucera, Jaromir Simsa, Counting and Configurations, Canadian Mathematical Society, Springer, 2003.

11.- Henry E. Dudeney, El misterio del muelle (Diversiones matemáticas III), Biblioteca Desafíos Matemáticos, RBA, 2008.

12.- Martin Gardner, Viajes en el tiempo y otras perplejidades matemáticas, Biblioteca Desafíos Matemáticos, RBA, 2007.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El problema de la plantación de árboles en filas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El problema de Malfatti

- El problema de las estudiantes de Kirkman

- El problema de los McNuggets de pollo

Sistemas respiratorios: peces capaces de respirar en aire y anfibios

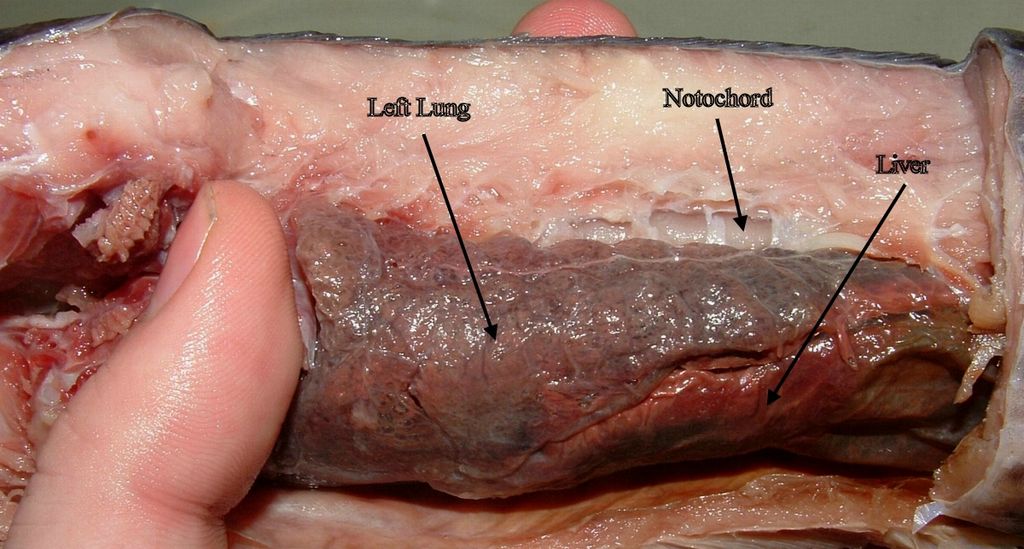

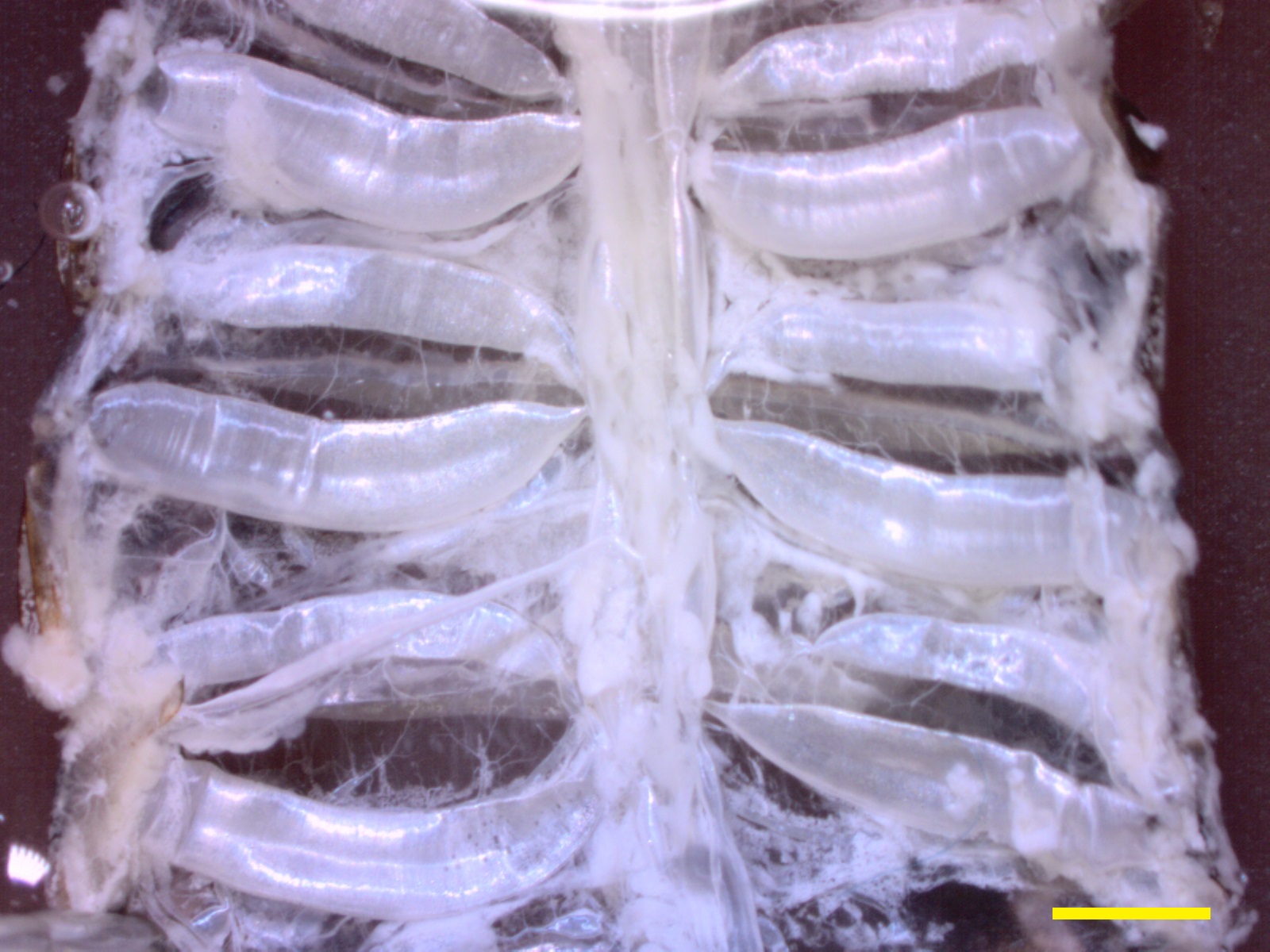

Pulmón izquierdo (“Left Lung”) de un ejemplar diseccionado de Protopterus dolloi, un sarcopterigio dipnoo (véase el texto)

Numerosos vertebrados respiran en aire. Lo hacen aves y mamíferos, la mayor parte de los reptiles y buen número de anfibios. La gran mayoría de los peces respiran en agua, si bien unos cuantos son también capaces de hacerlo en aire y unos pocos, como algunos dipnoos, solo pueden respirar en aire. Precisamente, los primeros vertebrados que respiraron en aire fueron peces, y se cree que esa capacidad la desarrollaron especies cuyos ejemplares colonizaron masas de agua que experimentaban una intensa evaporación estacional. Bajo esas circunstancias, la gran evaporación conllevaba una fuerte reducción de la concentración de oxígeno, dando lugar a condiciones de hipoxia o, directamente, a la pérdida total de la masa de agua por desecación. Tanto en condiciones de hipoxia como en ausencia de agua, la respiración a través de branquias resulta insuficiente para proveer los volúmenes de oxígeno necesarios para sostener el metabolismo mediante las vías aerobias.

Los peces que desarrollaron la capacidad para respirar en aire eran seguramente bimodales, no perdieron la respiración acuática. En la actualidad hay varias especies con respiración bimodal. Algunas anguilas, por ejemplo, son capaces de respirar en aire a través del tegumento; eso les permite, además, transitar entre cauces de agua reptando por el suelo, si este se encuentra húmedo, para desplazarse. Los cláridos tienen branquias modificadas, dotadas de una estructura -el órgano laberinto- que surge de unos arcos branquiales reforzados de manera que evitan su colapso cuando se encuentran expuestos al aire; los llamados bagres andarines son capaces de realizar cortos desplazamientos en tierra gracias a esa modificación branquial. Otras especies recurren al intercambio gaseoso a través de ciertas partes del aparato digestivo, como la pared de la boca, la faringe o el estómago. Y otras, finalmente, presentan sacos aéreos independientes, o sea, verdaderos pulmones, como los de los dipnoos.

Las especies de la familia Chaniidae están obligadas a respirar en aire, y lo hacen a través de un órgano laberinto primitivo. Y lo mismo ocurre con algunos dipnoos, aunque estos respiran a través de pulmones.

Los primeros pulmones surgieron en los peces a partir de la faringe. En algunos el saco aéreo original se duplicó y los dos pulmones adoptaron una disposición ventral. Ese es el origen de los pulmones de anfibios, reptiles, aves y mamíferos. Los anfibios fueron la primera clase de vertebrados que surgió de peces pulmonados, en concreto de peces sarcopterigios. En los anfibios se combinan de formas diversas la respiración a través de la piel, las branquias y los pulmones. La salamandra Siren lacertina, por ejemplo, combina las tres modalidades, y si se considera el ciclo de vida completo, casi todos los anfibios también lo hacen: en la fase larvaria respiran a través de las branquias y tras sufrir la metamorfosis pasan a combinar la respiración cutánea y la pulmonar.

No obstante, hay excepciones. El ajolote retiene las branquias propias de la fase larvaria durante toda su vida y respira a través de ellas. Otras salamandras, sin embargo, carecen de branquias y de pulmones; respiran solo por la piel gracias a que se encuentra muy vascularizada y a que viven en cauces de agua muy oxigenada. No son los únicos anfibios con respiración exclusivamente cutánea: la rana del lago Titicaca y la rana de cabeza aplanada también son acuáticas y solo respiran por la piel. Hay también unas salamandras terrestres de muy pequeño tamaño que carecen de pulmones y solo respiran a través de la piel.

Sin embargo, como ya se ha señalado, la mayor parte de los anfibios respiran a través de las branquias durante la fase larvaria acuática y tras la metamorfosis pasan a respirar a través de los pulmones y de la piel. Los pulmones de los anfibios son muy primitivos. Comparados con los de los amniotas (reptiles, aves y mamíferos) tienen pocos septos y grandes alveolos, por lo que cuentan con una superficie para el intercambio de gases relativamente pequeña. La tasa difusión es, por ello, baja. La excepción la constituyen las cecilias, un grupo de anfibios tropicales que viven dentro del suelo o de la hojarasca y cuyas especies carecen de extremidades. Tienen un único pulmón muy largo (recorre el 70% de la longitud corporal) con un alto grado de compartimentación y, por lo tanto, con numerosos alveolos.

En la mayoría de las especies con respiración pulmonar la ventilación se realiza bombeando aire desde la boca a los pulmones. El animal inspira el aire a través de los orificios nasales y lo alberga en su cavidad bucal, a continuación cierra los orificios nasales, abre la glotis y eleva el suelo de la boca, impulsando el aire hacia los pulmones; debe repetir esta operación varias veces para llenar los pulmones. Y a continuación expulsa en aire contrayendo los músculos de la pared corporal próximos a los pulmones de manera que el volumen de estos se reduce. Normalmente el aire utilizado es expulsado de una sola vez.

Como hemos podido ver aquí, la ocupación parcial del medio terrestre por parte de ciertos grupos de peces, así como la diversidad de situaciones en que se pueden encontrar los anfibios ha propiciado una variedad de dispositivos y comportamientos respiratorios en estos grupos. No son muchas especies, pero su anatomía y fisiología respiratoria reviste interés por tratarse de los grupos de vertebrados que protagonizaron la colonización del medio terrestre y por ello, la adaptación a un nuevo medio respiratorio.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: peces capaces de respirar en aire y anfibios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas respiratorios: animales que respiran en agua

- Sistemas respiratorios: invertebrados terrestres

- Sistemas respiratorios: los límites a la difusión de los gases

La naturaleza estadística de la segunda ley de la termodinámica

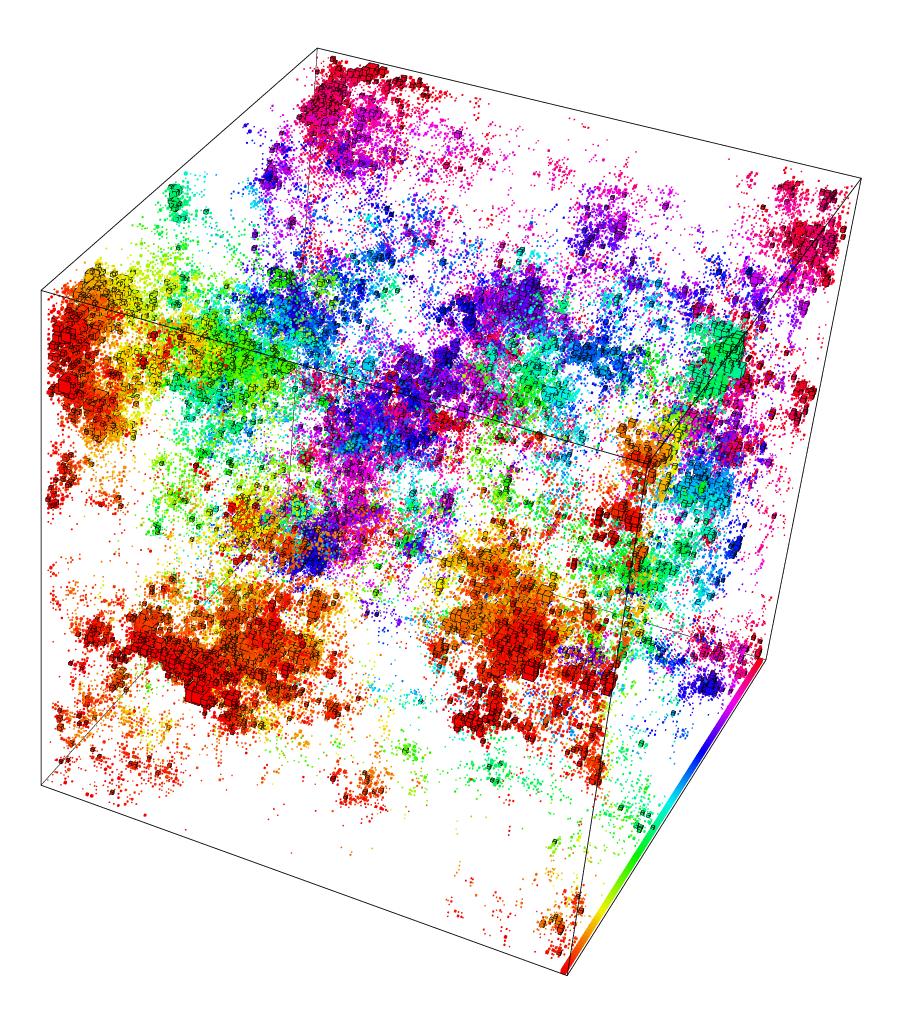

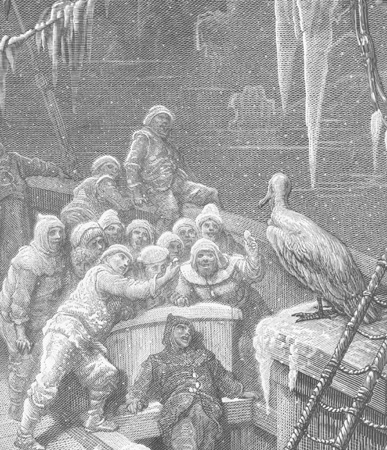

Si te preguntas qué pinta aquí un encéfalo en la mitad del espacio interestelar, lee el artículo completo y la nota final.

El físico austríaco Ludwig Boltzmann, dándole vueltas al concepto de fenómeno “irreversible”, detectó una escapatoria a la imagen fatalista de un Universo que se agota a medida que aumenta la entropía. Concluyó que la tendencia hacia la disipación de la energía no es una ley absoluta de la física que aplique en cualquier situación. Por el contrario, cuando se refiere al comportamiento de muchas partículas, es solo una ley estadística. Esta idea, que le apartaba del determinismo newtoniano, le costó hacerse muchos enemigos.

Piensa en un globo lleno de aire que contiene billones de moléculas. Boltzmann diría que, de todos las disposiciones concebibles de las moléculas de gas en un instante dado, su movimiento casi siempre estaría completamente “desordenado”, en el sentido que definíamos anteriormente. Sin embargo, es igualmente concebible que en algún momento ocurra que la mayoría de las moléculas, por casualidad, se muevan en la misma dirección. En cualquier disposición al azar habrá fluctuaciones del desorden completo o, dicho de otra manera, si llamamos homogeneidad a este desorden completo, habrá momentos en los que existan heterogeneidades. Pero cuanto mayor es la fluctuación hacia el orden, menos probable es que ocurra. Para colecciones de partículas tan grandes como el número de Avogadro, la posibilidad de que una fluctuación sea lo suficientemente grande como para ser mensurable es extremadamente pequeña, pero no nula.

Con el mismo argumento, es por tanto concebible que una olla con agua fría se caliente por sí sola después de que la golpeen solo las moléculas más energéticas del aire circundante. También es concebible que, por un breve momento, las moléculas de aire “se agrupen” y golpeen solo un lado de una piedra, empujándola cuesta arriba. Estos acontecimientos son concebibles, técnicamente no imposibles pero absolutamente improbables.

Para pequeñas colecciones de partículas, sin embargo, es una historia diferente. Así como es bastante probable que la altura promedio de las personas en un autobús en concreto sea considerablemente mayor (si viaja la selección absoluta de baloncesto) o menor (si lleva de excursión a niños de primaria) que el promedio del país, es probable de la misma manera que más moléculas golpeen un lado que otro de una partícula microscópica. Eso es precisamente lo que causa el movimiento browniano observable de partículas microscópicas en un gas o líquido. Las fluctuaciones, prácticamente indetectables para cualquier colección de moléculas grandes que nos encontramos diariamente en nuestra vida cotidiana, como ollas o piedras, son un aspecto importante del mundo de las partículas muy pequeñas.

Una consecuencia de estas consideraciones es que la segunda ley de la termodinámica tiene un carácter diferente a todas las otras leyes fundamentales de la física conocidas a finales del siglo XIX. La diferencia estriba en que trata con probabilidades, no con certezas. Por ejemplo, dice que es muy probable que cuando se mete un cubito de hielo en agua caliente, la estructura ordenada del cubito se rompa y se derrita, formando agua. Pero esta ley no descarta la posibilidad extremadamente improbable de que las moléculas más lentas de agua caliente se unan por un instante para formar un cubo de hielo*. Una cosa así o se ha observado nunca, y probablemente nunca lo será, pero en principio es posible.

La segunda ley es, por lo tanto, una ley estadística, que da el resultado estadístico de un gran número de eventos individuales (colisiones de moléculas).

Nota:

*O, ya puestos, que surja en medio del espacio un ente autoconsciente. Esto se conoce como paradoja del cerebro de Boltzmann.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La naturaleza estadística de la segunda ley de la termodinámica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La teoría cinética y la segunda ley de la termodinámica

- El estatus de la segunda ley de la termodinámica

- La segunda ley de la termodinámica

Sobre igualdad, excelencia, ejemplaridad y responsabilidad en los premios Nobel

Mikel Mancisidor

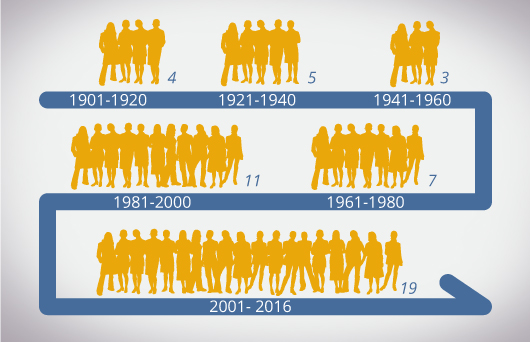

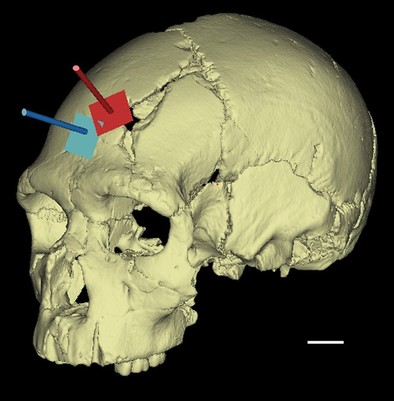

Según datos proporcionados por nobelprize.org el premio Nobel se ha concedido (entre 1901 y 2016) 579 veces. De esas, 48 veces a mujeres, un 8,3 %. Los números incluyen cualquier modalidad del premio, no solo las científicas. En la imagen, número de mujeres galardonadas por períodos de 15 años.

Ya se han anunciado todos los Premios Nobel de este año 2017.

El Premio Nobel de Física ha ido a parar a tres norteamericanos. El Premio Nobel de Medicina ha sido otorgado a otros tres norteamericanos. Por fin, lo ganadores del Premio Nobel de Química han sido un suizo, un escocés y un norteamericano de origen alemán. Son 9 hombres y cero mujeres.

Si sumamos el Nobel de Literatura para Kazuo Ishiguro (británico que escribe en inglés), el de la Paz para la red ICAN (Campaña Internacional para la Abolición de las Armas Nucleares) y el de Economía para el norteamericano Richard Thaler, son 11 hombres, una institución y cero mujeres. 10 norteamericanos o británicos.

El año pasado sucedió lo mismo. Se otorgó el Nobel de Física a tres físicos; el de Química a tres químicos; el de Medicina a un biólogo; el de Economía a dos economistas; el de la Paz a un político y el de Literatura a un cantante. Todos hombres. El mismo resultado: 11 a 0.

De modo que por dos años consecutivos la imagen mundial de la máxima excelencia científica, intelectual, investigadora y creativa corresponderá a un pleno de hombres, quizá ligeramente disimulado si ICAN opta por una mujer para recoger el galardón.

Creo que se trata de un error muy grave, de lamentables consecuencias y que lo sadministradores del Premio demuestran no sólo falta de sensibilidad, sino incluso me atrevo a decir que falta de responsabilidad.

Sí, ya sé que muchos de quienes han tenido la amabilidad de leerme hasta aquí estarán pensando que antepongo mis deseos políticamente correctos a la realidad. Tal vez piensen ustedes que olvido que los Premios Nobel son un reconocimientos a los mayores logros de la humanidad, vengan de donde vengan, sin atender a su nacionalidad, raza, lengua o género. Que no puede haber cuotas ni porcentajes. Que sólo se puede atender a los méritos más objetivos tras un estudio neutro sin prejuicios ni ideas preconcebidas. ¿Saben qué? Estoy de acuerdo con todo ello. Pero precisamente por eso creo que los Premios Nobel se equivocan y se traicionan.

Alfed Nobel buscó reconocer los mayores logros para toda humanidad, quiso premiarlos y de esa forma ponerlos en valor, hacerlos visibles, fomentar en la sociedad su aprecio y generalizar el espíritu de emulación. A todo ello deberían hoy deberse estos premios. Explícitamente dejó constancia Alfred Nobel de su deseo de universalidad, si bien en aquel momento histórico la universalidad se formulaba de un forma un tanto estrecha: “es mi expreso deseo que, al otorgar estos premios, no se tenga en consideración la nacionalidad de los candidatos, sino que sean los más merecedores los que reciban el premio, sean escandinavos o no.”

Es obvio que los méritos científicos, como los literarios o cualquiera otros del ámbito del conocimiento y la cultura, no se pueden medir en una clasificación indisputable de puntos objetivos como podría hacerse en una prueba tipo test para las oposiciones de una administración pública (afortunadamente), ni como en la clasificación de una liga deportiva donde a fin de temporada un equipo tiene 67 puntos y otro 66 y por lo tanto el primero se lleva la copa. Los méritos científicos están sometidos a una valoración que incluye muchos elementos intangibles o cualitativos de imposible cuantificación. Se incluye el mérito, la originalidad, el impacto, la espectacularidad, la belleza, la contribución a la mejora de la vida de las personas y otros mil factores en los que además hay que decidir, cada año de forma distinta, cómo equilibrar los juicios de corto con los de largo plazo. La combinación de estos factores, dependiendo de cada momento puede variar y se pueden dar distintos resultados de equivalente mérito e igual legitimidad. Es ahí donde hay que decidir por un modelo de premio entre distintas opciones igualmente excelentes.

Con esto quiero decir que el premio Nobel de Química de un año no corresponde necesaria o indiscutiblemente al mejor químico de ese año, si tal calificación pudiera existir, sino una persona eminente que está entre los mejores de su especialidad, en una minoría de excelencia mundial junto a otras pocas docenas de personas, quizá, si ustedes quieren, por poner una cifra, un centenar. La selección final de entre ese grupo de potenciales merecedores del Premio está sometida a factores que incluyen la oportunidad, la comunicación y que deben incorporar la ejemplaridad y el efecto social.

No dudo de los méritos de cada premiado por separado (carezco de conocimientos para juzgarlo: simplemente me fío plenamente del tribunal), pero sí puedo afirmar que en su conjunto el resultado está desequilibrado y da una imagen distorsionada de la excelencia global. No es cierto que la excelencia científica en el mundo esté en una relación de 8 a 0 (año 2016) o 9 a 0 (2017) entre hombres y mujeres. No es cierto que la excelencia cultural esté en una relación de 11 a 0 en ambos años. De la misma forma que no es cierto que más del 80% de la excelencia global tenga el inglés como lengua materna.

Que los premios Nobel nos regalen una imagen falsa de la ciencia y la cultura en el siglo XXI no sólo es producto de esos prejuicios que pretende no tener. Eso no sería lo peor. Esta decisión tiene además graves efectos en perpetuar esos mismos prejuicios y estereotipos, que todavía limitan hoy que el acceso y participación de las mujeres en determinadas especialidades científicas en todo el mundo o dificultan su desarrollo y éxito profesional. No hace falta más que ver las cifras de la UNESCO al respecto.

Es cierto, digámoslo por ser justos, que los Premios Nobel van incrementando -poco a poco, década a década- el reconocimiento de la labor de las mujeres en la sociedad en general y en la ciencia en particular. O lo que es casi lo mismo, pero mucho más positivo: los premios dejan traslucir un mundo en que cada vez la mujer tiene más presencia en la ciencia, en la política y en la vida cultural pública. Pero lo cierto es que este progreso es lento y que por segundo año en Estocolmo han hecho un innecesario paréntesis en ese camino por la igualdad.

No, no quiero cuotas. No pido porcentajes. Me conformo con que Estocolomo reconozca la pluralidad de los aportes a la humanidad en nuestro mundo contemporáneo y así, reconociéndolos, haciéndolos visibles con equidad y sin prejuicios, promueva la igualdad de oportunidades. Estoy seguro de que es ésta la interpretación a día de hoy leal con aquel deseo de Alfred Nobel en su contexto histórico: cuando quiso incluir no solo escandinavos, podría entenderse hoy como incluyendo no sólo blancos, no sólo hombres, no sólo angloparlantes.

Tengo una hija de 12 años. El año pasado no le quise enseñar una foto de 11 hombres como ejemplo de excelencia universal, como lo más elevado del conocimiento, de la creatividad, de la cultura y de los valores a los que ella debería aspirar. Difícilmente podría verse llamada por ese camino, reconocida en esa aspiración, si comprueba que está absolutamente copada por hombres. Este año creo que le enseñaré esa foto, pero tendremos que debatir, por desgracia, otras cosas que también tiene que aprender: que no se deje nunca limitar por quienes le digan que la excelencia es sólo masculina, sea cuando lo escucha en el patio de un colegio, en un machista comentario de bar, en un tonto programa de la tele o sea, y esto es mucho más grave, en los fallos de unos sabios en Estocolmo que deberían por el contrario estimularnos a todos y a todas.

Sobre el autor: Mikel Mancisidor (@MMancisidor) es miembro del Comité de Derechos Económicos, Sociales y Culturales de la ONU y Adjunct Professor of International Human Rights Law, Washington College of Law, American University (Washington D. C.)

El artículo Sobre igualdad, excelencia, ejemplaridad y responsabilidad en los premios Nobel se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Premios Nobel y transferencia tecnológica

- Electroforesis, premios Nobel y laboratorios de criminalística

- El Nobel de Química 2013: Bailando con proteínas

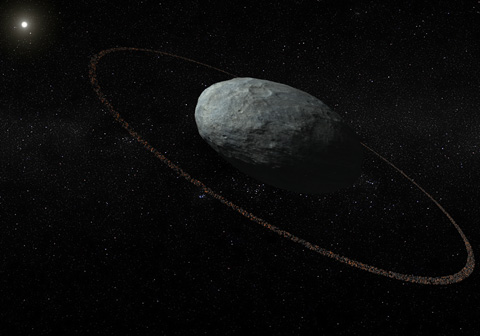

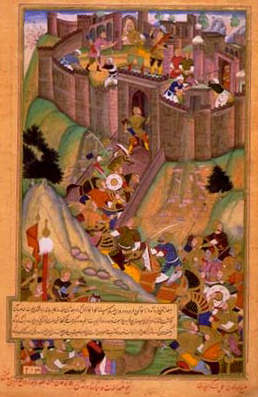

El planeta enano Haumea tiene anillo

“Predijimos que Haumea pasaría delante de una estrella el 21 de enero del 2017, y doce telescopios de diez observatorios europeos observaron el fenómeno. Gracias a este despliegue de medios hemos podido reconstruir con mucha precisión la forma y tamaño del planeta enano Haumea, con el sorprendente resultado de que es bastante más grande y menos reflectante de lo que se pensaba. También es mucho menos denso de lo que se creía con anterioridad y esto soluciona algunas incógnitas que estaban pendientes de resolver para este objeto”. José Luis Ortiz, Instituto de Astrofísica de Andalucía (IAA-CSIC)

En los confines del Sistema Solar, más allá de la órbita de Neptuno, existe un cinturón de objetos compuestos de hielos y rocas entre los que destacan cuatro planetas enanos: Plutón, Eris, Makemake y Haumea. Este último, el más desconocido de todos, ha sido objeto de una campaña internacional de observación que ha permitido determinar sus principales características físicas. El estudio, encabezado por astrónomos del Instituto de Astrofísica de Andalucía (IAA-CSIC) y en el que colaboran investigadores de la UPV/EHU, desvela la presencia de un anillo en torno al planeta enano Haumea.

Los objetos transneptunianos resultan muy difíciles de estudiar debido a su reducido tamaño, a su bajo brillo y a las enormes distancias que nos separan de ellos. Un método muy eficaz pero complejo reside en estudiar las ocultaciones estelares, que consisten en la observación del paso de estos objetos por delante de las estrellas de fondo (una especie de pequeño eclipse). Este método permite determinar sus características físicas principales (tamaño, forma, densidad) y ha sido también empleado con los planetas enanos Eris y Makemake con excelentes resultados.

Haumea es un objeto curioso: gira alrededor del Sol en una órbita elíptica que tarda 248 años en completar (en la actualidad se halla a unas cincuenta veces la distancia entre la Tierra y el Sol de nosotros), y su velocidad de rotación es de 3.9 horas, mucho más rápido que cualquier otro cuerpo de más de cien kilómetros de todo el Sistema Solar. Esta velocidad provoca que Haumea se deforme, adquiriendo una forma elipsoidal similar a un balón de rugby. Gracias a los datos recién publicados, se conoce que Haumea mide unos 2.320 kilómetros en su lado más largo, casi igual que Plutón, pero que carece de una atmósfera global similar a la de Plutón.

“Uno de los hallazgos más interesantes e inesperados ha sido el descubrimiento de un anillo alrededor de Haumea. Hasta hace apenas unos años solo conocíamos la existencia de anillos alrededor de los planetas gigantes y, hace muy poco tiempo, nuestro equipo también descubrió que dos pequeños cuerpos situados entre Júpiter y Neptuno, pertenecientes a la familia de objetos denominados centauros, tienen anillos densos, lo que fue una gran sorpresa.

Según los datos obtenidos de la ocultación de Haumea, el anillo se halla en el plano ecuatorial del planeta enano, al igual que su satélite más grande, Hi’iaka, y muestra una resonancia 3:1 con respecto a la rotación de Haumea, lo que significa que las partículas heladas que componen el anillo completan un giro en torno al planeta en el tiempo en que este rota tres veces.

“Hay varias explicaciones posibles para la formación del anillo, por ejemplo, pudo haberse originado tras una colisión con otro objeto, o por la liberación de parte del material superficial debido a la rápida rotación de Haumea”, apunta Ortiz (IAA-CSIC). Se trata del primer hallazgo de un anillo alrededor de un objeto transneptuniano, y muestra que la presencia de anillos podría ser mucho más común de lo que se creía, tanto en nuestro Sistema Solar como en otros sistemas planetarios.

En esta investigación han participado Agustín Sánchez Lavega, Ricardo Hueso y Santiago Pérez Hoyos del Grupo de Ciencias Planetarias de la UPV/EHU. La colaboración se centra en el uso de la instrumentación del grupo (telescopios del Aula EspaZio Gela y cámara PlanetCam montada en los telescopios del Observatorio de Calar Alto) para el seguimiento y observación de ocultaciones de estrellas por los cuerpos del sistema solar con el fin de deducir sus propiedades físicas.

Referencia:

J. L. Ortiz et al. (2017) The size, shape, density and ring of the dwarf planet Haumea from a stellar occultation” Nature DOI: 10.1038/nature24051.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El planeta enano Haumea tiene anillo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un lirón enano del Cuaternario en la Península Ibérica y lo que eso significa para la paleoecografía

- La nebulosa del Bicho* y el anillo no único

- Planeta X, en busca del inquilino invisible del sistema solar

Mujeres que hablan de Ciencia, mujeres que hablan de Arte

La luz sobre cuya naturaleza Newton y Huygens contrapusieron teorías, la misma con la que Caravaggio elevó el claroscuro a su máximo exponente. La luz de la dualidad onda-partícula de Einstein y de Broglie que Turner y Sorolla tan magníficamente plasmaron en sus cuadros. Esa luz es la protagonista de la segunda entrega de los episodios “Arte y Ciencia” de La Aventura del Saber (TVE2), una iniciativa del FECYT en la que algunas de las personas más relevantes del panorama científico estatal explican de modo ameno su labor investigadora valiéndose de obras del Museo del Prado.

Al igual que el año pasado, arrancamos este curso de #KimikArte con un repaso a dicha iniciativa, dedicada por completo al año de la luz, celebrado en 2015. En esta ocasión, como modo de visualizar el papel de la mujer en el ámbito científico, el programa está protagonizado en su totalidad por investigadoras. Veamos a continuación que obra del Prado ha elegido cada una de ellas. Y cuando acabéis, os propongo un pequeño juego, si os dedicáis a la investigación contad en twitter con que obra de arte asociaríais vuestro trabajo.

Caterina Biscari: “La Anunciación”, de Fra Angelico

“La luz de sincrotrón es como un verdadero pintor de la materia que busca el detalle y la minuciosidad para alcanzar los puntos que nuestros ojos no pueden ver. Hay un paralelismo entre el sincrotrón ALBA y el cuadro de Fra Angelico”

Caterina Biscari, doctora en física, es la directora del Sincrotrón ALBA, una de las instalaciones científicas más punteras de Europa. Ahí, en un anillo de 270 metros de perímetro, se aceleran electrones a una velocidad cercana a la de la luz que, al pasar por campos magnéticos, producen finísimos haces de rayos X. Esa idea del haz de luz es la que emplea Caterina para elegir su obra: La Anunciación de Fra Angelico, donde la luz se manifiesta como un personaje más de la composición, atravesando la escena desde la esquina superior izquierda hasta alcanzar el cuerpo de la Virgen María.

Imagen 1. La Anunciación (194×194 cm), de Fra Angelico (1425-28).

La científica nos explica que la luz de sincrotrón permite estudiar la materia de forma excepcional, bien sea para explorar el interior de una célula, investigar el comportamiento de los fármacos o, incluso, mejorar la calidad de pigmentos sintéticos como el azul ultramar, cuya versión natural empleó el artista en el manto de la Virgen de la obra que nos ocupa.

Y ahora, permitidme que me recree un momento con la interpretación iconográfica de la Anunciación. A la izquierda de la composición podemos observar a Adán y Eva, ya vestidos, lo que significa que han cometido el pecado original y de ahí que un arcángel les invite “amablemente” a dejar el paraíso que, por cierto, es un auténtico compendio de botánica. Esta escena no es elegida por casualidad, sino como contrapunto a la escena principal. Por una parte, la mujer que trajo el pecado al mundo y, por otro, la que había de redimir a la humanidad. María recibe la noticia del arcángel Gabriel mientras se consuma el “acto”: el Espíritu Santo, en forma de paloma (entre el arcángel y la columna), viaja en el haz de luz que sale de las manos de Dios Padre para entrar por el oído de la Virgen. Aclaremos, llegado a este punto, que Fra Angelico era monje dominico y que creó esta obra hacia 1425 para el convento de Santo Domingo de Fiesole. Quizás por eso incluyó una golondrina, con la que estos monjes compartían el color de sus hábitos. La obra es de carácter renacentista, como apreciamos en el pórtico y en el uso de la perspectiva, que encuentra el punto de fuga en ese vano abierto por el que se ve una habitación con un banco y un ventanuco. En cualquier caso, al tratarse de una época de transición, todavía se aprecian reminiscencias del gótico, véase el abundante uso de los dorados y las bóvedas de crucería. Y, dentro del estilo artístico, no podemos dejar de destacar el delicioso uso de los colores pastel en las túnicas de San Gabriel y de la Virgen, que contrastan con el ya mencionado azul ultramarino del manto.

Y, antes de dejar paso a la siguiente científica, me gustaría destacar una parte de la obra que suele pasar desapercibida: la prevela. Esa parte inferior con 5 imágenes. En el credo cristiano el mayor mérito de María es ser la madre de Cristo y, como tal, la representación más habitual es la de La Anunciación. Según parece, el dominico quiso dedicarle una parte de la pintura en la que fuese protagonista absoluta y aprovecha esa parte inferior para contarnos su vida, desde su nacimiento (recordemos que es sin pecado concebida) hasta su tránsito (que no muerte), pasando por los desposorios, la visitación a Santa Isabel, la Epifanía y la visita al templo.

Belén Mate: “El Invierno”, de Goya

“La combinación de observaciones astrofísicas con experimentos de laboratorio permite conocer, por ejemplo, la composición de los mantos de hielo de las nubes densas del medio interestelar, tan gélidos como este invierno de Goya”

Belén Mate es la directora del laboratorio de Hielos de Interés Atmosférico y Astrofísico del Instituto de la Estructura de la Materia (CSIC). Sí, eso existe. Y la verdad es que en boca de la protagonista resulta un área fascinante, ya que el estudio de las moléculas interestelares no sólo permite explorar la riqueza del Universo, sino su relación con el origen de la vida en nuestro planeta. Ahí es nada. En el cuadro elegido no podía faltar, obviamente, el hielo. Hablamos de El Invierno, de Goya.

Imagen 2. El Invierno (275×293 cm), de Goya (1786).

También conocida como La Nevada, esta obra es parte de una serie de cartones que incluye El Verano, La Primavera y El Otoño, además de otras escenas campestres. Y, cuando decimos cartón, no nos referimos a que ese sea el material empleado. Su nombre proviene de su función, que no era otra que servir de modelo para elaborar tapices en La Real Fábrica, en este caso para el palacio del Pardo. El que nos ocupa es un ejemplo de cómo el arte puede incluso cambiar la sensación ambiental. La nieve, la ventisca, los árboles combados y los personajes abrigados nos hacen sentir la crudeza del invierno, en una escena que, al parecer, refleja la detención de tres hombres que pretendían meter un cerdo en Madrid sin pasar impuestos. Pero Belén Mate no se centra en la nieve y apunta más allá. A ese cielo que se ve blanco por la interacción de la luz con la materia. Así nos explica la dispersión, el efecto Rayleigh y el porqué de los colores. Ah, y que la sombra del perro nos dice que es mediodía. Es esta interacción de la luz con la materia la que, mediante técnicas espectroscópicas, nos permite saber la composición química de objetos increíblemente distantes. Belén Mate y su grupo tratan de obtener la huella dactilar de diferentes hielos espaciales, en las condiciones adecuadas, unos -250 °C y una cienmilmillonesima de atmósfera. Es decir, mucho frío y muy poca presión. Todo ello para comprender mejor la composición del basto espacio que nos rodea y, quién sabe, si alguna vez descubrir cómo surgió la vida en este punto azul pálido.

Mònica López: “Recuerdos de Granada”, de Antonio Muñoz Degrain

“Encontrarnos con días de tormenta en Granada como la que vemos en el cuadro de Muñoz Degrain resultará cada vez más extraño”

Mònica López, licenciada en Física con la especialidad de Tierra y Cosmos, a la que posiblemente conozcáis por ser presentadora de “El tiempo” en la edición noche de TVE1, espacio que dirige desde 2008. Lleva casi 20 años comunicando información meteorológica y le presta atención a las condiciones climáticas severas, así que, si alguien esperaba un panorama soleado va por mal camino. A los del Norte no nos dan ese placer ni en el arte. La obra elegida es Recuerdos de Granada, de Muñoz Degrain.

Imagen 3. Recuerdos de Granada (97×144 cm), de Antonio Muñoz Degrain (1881)

Menos mal que se trata de un paisaje hermoso pese a las inclemencias del tiempo. Como la propia meteoróloga explica, se trata de una desapacible tarde de tormenta, sin un alma en la calle y con ramas que se retuercen. Especial mención para el agua que cae por los canalones azotada por el viento y la cortina de lluvia que cuelga de las nubes. Pensamos que es una tarde de primavera o verano por la luz amarillenta y los claros que se abren en el cielo. Y es que el artista cuidó hasta el más mínimo detalle: desde las salpicaduras hasta el pequeño farolillo en el callejón. Ahora bien, que nadie intente buscar ese rincón, porque es una recreación transformada fruto de la imaginación de Muñoz Degrain, quien gustaba de evocar su pasado nazarí. Su otro gran amor era Venecia, así que no sale mal parada la ciudad andaluza.

La obra, también conocida como Chubasco en Granada, le sirve a Mònica López para llamar la atención sobre el calentamiento global, del que la ciudad en cuestión es buena prueba. En 2015 se alcanzaron los 43,1 ºC y se calcula que en 2050 en una ola de calor se alcanzarían los 47 ºC. Una obra llena de melancolía la de Muñoz Degrain que, por desgracia, nos tendremos que acostumbrar a ver en cuadro porque cada vez será menos habitual.

Susana Marcos: “San Jerónimo leyendo una carta”, de Georges De la Tour

“Entender cómo vemos ha fascinado al hombre desde la antigüedad que también ha intentado plasmar lo que vemos mediante la pintura”

Susana Marcos, directora del Laboratorio de Óptica Visual y Biofotónica del CSIC, explica cómo se dedica a desarrollar nuevas tecnologías para el diagnóstico y corrección de la visión y a investigar la estructura y la calidad óptica de la córnea y del cristalino, así como su impacto en la percepción neuronal. Los avances que su grupo ha conseguido ya están llegando a los oftalmólogos, contribuyendo al aumento de la calidad de vida de la población. Y, si de corregir la visión se trata, no podía faltar un cuadro con gafas, o algo parecido: San Jerónimo leyendo una carta, de George de La Tour.

Imagen 4. San Jerónimo leyendo una carta (79×65 cm) de George de La Tour (1620).

Artísticamente es una obra con una gran cantidad de cosas que comentar. Guarda una verticalidad muy llamativa que arranca de la cabeza del santo, pasa por los botones del hábito y continua en el pliegue central de la carta para acabar de nuevo en los botones, esta vez sin abrochar. Como gran maestro de la iluminación, de La Tour usa un foco de luz que crea sombras en la carta, cuidada al detalle, con su sello y el texto que se transparenta. Ese anciano ensimismado es, obviamente, San Jerónimo, quien según la leyenda arrancó una astilla de la pata de un león y que acostumbramos a ver acompañado de una calavera o leyendo (es uno de los doctores de la iglesia y por lo tanto se le supone un sabio). En la obra destaca el rojo bermellón por encima de cualquier otro color, pese a que el cargo de cardenal que se le suele atribuir es un anacronismo, ya que a su muerte (420 E.C.) todavía no existía el cardenalato.

Por último, y como hace Susana Marcos, fijémonos en las lentes que sujeta en la mano: unos quevedos para poder leer la carta. En ellos el artista aplica conocimientos de óptica y aumenta el tamaño del botón que observa el espectador. Queda claro que el protagonista sufría presbicia (vista cansada), defecto en la visión por la que el cristalino pierde su capacidad para enfocar objetos. Según nos explica la física, este problema visual aparece en los mayores de 45 años, aunque, afortunadamente, se puede corregir. Tradicionalmente se ha logrado con gafas “de cerca” (como los quevedos) o lentes progresivas pero, gracias a la investigación, van apareciendo nuevas soluciones como lentes multifocales o la monovisión (un ojo para ver de cerca y otro de lejos). En el futuro se espera que las lentes devuelvan la capacidad al cristalino natural joven para cambiar dinámicamente entre objetos cercanos y lejanos.

Dicho todo esto, lo más fascinante de este óleo no es el manejo de la luz, los pliegues o la óptica, sino su intrahistoria. Este San Jerónimo descansó en el despacho del administrador del Instituto Cervantes durante años sin que nadie sospechase quien era su ilustre creador.

Josefa Yzuel: “La vista”, de Jan Brueghel el Viejo y Rubens

“El año internacional de la luz ha sido una iniciativa global para comunicar a la sociedad la importancia de la luz y de las tecnologías basadas en la luz en campos como la energía, las comunicaciones, el arte y la educación”

María Josefa Yzuel tiene el gran mérito de ser la primera mujer en lograr el puesto de Profesor(a) agregado en física (1971) del estado. Estudió física porque esta disciplina le permitía explicar la naturaleza aplicando las matemáticas que tanto le apasionaban. Y lo hizo en una época en la que no era una “carrera de mujeres” (a decir verdad, lo sigue sin ser: quien les escribe apenas tiene un tercio de alumnas en el grado de Física mientras que en la totalidad de la Facultad el número de alumnas y alumnos se iguala). Josefa Yzuel también fue pionera en realizar estudios postdoctorales en el extranjero y ha impartido clase en tres universidades españolas. A día de hoy es catedrática emérita de la Universidad Autónoma de Barcelona y ostenta numerosos cargos nacionales e internacionales. Entre ellos uno que debemos destacar por su relación con este artículo: fue la presidenta del Comité Español del Año Internacional de la luz. Sus investigaciones se centran en estudios de calidad de imagen y, por esa razón, su obra escogida ha sido un hermosa alegoría: La vista, de Brueghel y Rubens, porque el arte, como la ciencia, también puede ser colaborativo. El primero se encargó de dibujar el exuberante escenario y el segundo de dar vida a los personajes. Y no solo lo hicieron para este cuadro sino para toda una serie sobre los cinco sentidos.

Imagen 5. La vista (65x110cm), de Brueghel el viejo y Rubens (1617).

En La vista observamos una cámara de las maravillas (una especie de museo privado) en la que aparecen conocidas obras artísticas de la época. Pero llamemos la atención sobre la cantidad de objetos científicos que se pueden observar, en especial relacionados con la visión: anteojos (buscad a un simpático monito), lupas y hasta un telescopio. Esto demuestra el aprecio por la ciencia de los mecenas, los gobernadores de Flandes, retratados en el cuadro que descansa sobre la mesa y cuyo palacio vemos al fondo. Las dos figuras centrales son Venus y su hijo Cupido, quien sujeta un cuadro relacionado con la visión: el milagro de la curación de un ciego.

Nos cuenta Josefa Yzuel que percibimos el 75% de la información por la vista, de ahí que sea sumamente importante que esta información sea correcta. Cuando se usan instrumentos ópticos las imágenes sufren defectos debido al paso de la luz por las lentes, la reflexión en los espejos o por fenómenos de difracción asociados a su naturaleza ondulatoria. La corrección de esas aberraciones ha ocupado la trayectoria investigadora de esta científica que ha visto como la óptica ha contribuido al avance de infinidad de campos. Gracias a trabajos como éste, hoy somos capaces de emplear microscopios con una resolución del orden del nanómetro y telescopios de una potencia hace poco inimaginable.

Teresa Rodrigo: “Los tres viajeros aéreos favoritos”, de John-Francis Rigaud

“La invención del globo aerostático, a la que se hacer referencia en esta obra, no solo sirvió como una atracción o un medio de transporte, sino que abrió una nueva ventana al conocimiento científico”

[El video se corta en el minuto 2:51, en cuanto esté la grabación completa, la cambiaremos. Puede verse el video completo en el programa La aventura del saber (10 de octubre de 2016) a partir del minuto 48.]

Teresa Rodrigo, la última protagonista de la serie, es, al igual que la primera, especialista en física de las partículas. Catedrática de la Universidad de Cantabria y directora del instituto de Física de esa comunidad es, además, miembro del comité científico del CERN. Como veis, los aceleradores de partículas están en la cresta de la ola. La obra que ha elegido es realmente curiosa, ya que a priori es difícil encontrarle una relación con su área de investigación. Se trata de los tres viajeros aéreos favoritos, de John-Francis Rigaud. Veamos que tiene que ver un globo con la física de partículas.

Imagen 6. Los tres viajeros aéreos favoritos (50×36 cm), de John-Francis Rigaud (1785)]

La obra que nos ocupa es un óleo sobre lámina de cobre con una peculiar forma ovalada. En él se recoge un momento histórico: el segundo vuelo aerostático realizado en Inglaterra, el 29 de junio de 1785. El primero lo había organizado el año anterior Vicenzo Lunardi, el mismo diplomático italiano que en esta obra vemos con una casaca roja. El otro caballero es su ayudante, George Biggin, que es el único hombre que finalmente se subió en ese globo, ya que por exceso de peso Lunardi tuvo que quedarse en tierra. Vemos pues que el artista se tomó una licencia al hacer su crónica pictórica. La que sí fue en ese vuelo fue Leticia Sage, actriz de la alta sociedad, que se convirtió así en la primera mujer en montar en globo.

Teresa Rodrigo hace referencia al importante motor que es la curiosidad para lograr el conocimiento y compara aquel viaje en plena Ilustración con la investigación de hoy en día. Pero no acaba ahí la cosa. Nos habla de Victor Hess, un científico que en 1912 ascendió hasta los 5300 metros de altitud equipado con un rudimentario medidor de radiación. Observó que la radiación aumentaba cuanto más alto volaba y dedujo que debía haber una forma de energía que entraba por la atmosfera. Había descubierto los rayos cósmicos, lo que le valió el Nobel en 1936. Gracias a su descubrimiento se abrió una nueva ventana para el estudio de la materia y, de hecho, también de la antimateria, ya que el positrón fue descubierto en 1932 al fotografiar rayos cósmicos (había sido predicho con anterioridad).

Hoy en día sabemos que la materia visible se forma de 12 partículas elementales (quarks y leptones) y sus correspondientes antipartículas. Del mismo modo también conocemos la existencia de los bosones (seguro que os suena el de Higgs). Todo ello es posible gracias a los aceleradores de partículas que aparecieron en los años 50, pero no debemos olvidar que antes fueron los rayos cósmicos los que nos ofrecieron información sobre la materia y su interacción.

Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

N. del A. No hace falta decir que cada uno de estos vídeos ha aparecido ya en el blog “hermano”, Mujeres con Ciencia, editado por Marta Macho Stadler.

El artículo Mujeres que hablan de Ciencia, mujeres que hablan de Arte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arte & Ciencia: La importancia de la ciencia para la conservación del arte

- Arte & Ciencia: Analogías entre el arte y la ciencia como formas de conocimiento

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

Naukas Pro 2017: Leni Bascones y los superconductores

El pasado 14 de septiembre de 2017 se celebró la primera edición de Naukas Pro, en el que Centros de Investigación, Laboratorios, científicos de renombre o equipos de trabajo contaron con 20 minutos para explicar a un público general en qué consiste su trabajo.

2ª Conferencia: Elena “Leni” Bascones, investigadora del Instituto de Ciencia de Materiales de Madrid (ICMM-CSIC)

Leni Bascones presebnta una charla sobre la materia de superconductores.Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Pro 2017: Leni Bascones y los superconductores se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro 2017: Carlos Briones y el origen de la vida

- #Naukas15 Superconductores

- Naukas Pro, en directo

Meridianas

Meridiana de Cassini en la basílica de San Petronio de Bolonia. Fotografía: Paco Bellido

A pesar de la idea extendida de que la Iglesia Católica impidió el avance de la Astronomía durante buena parte de los siglos anteriores a la Ilustración, lo cierto es que pocas instituciones invirtieron tanto en el estudio de los movimientos del Sol. El objetivo era eminentemente práctico, la determinación de la fecha de Pascua con varios años de antelación demostró ser un problema complejo debido a las particularidades de los movimientos de los cuerpos celestes. En el primer concilio de Nicea (año 325) se estableció que la Pascua de Resurrección, fiesta central del cristianismo, tendría lugar el primer domingo posterior a la primera Luna llena ocurrida después del equinoccio de primavera. Por tanto, determinar la correcta fecha de los equinoccios revestía una importancia crucial para el culto.

La meridiana es un sencillo instrumento que consta de un agujero (foro gnomónico) situado en el techo o en la pared de un edificio por donde entra la luz del Sol y una línea marcada en el suelo y orientada en dirección N-S donde se puede medir la altura del Sol al mediodía local, lo que permite determinar la época del año. En varias catedrales europeas se conservan meridianas astronómicas que desempeñaron un importante papel en el avance del conocimiento astronómico, en particular en el cálculo preciso de la duración del año trópico, el que transcurre desde un equinoccio vernal al siguiente.

La primera meridiana instalada en una iglesia fue obra de Paolo dal Pozzo Toscanelli, quien en 1468 desarrolló un sencillo instrumento que registraba el momento del solsticio de verano en el suelo de la catedral de Florencia. Algunos autores consideran que dicho gnomon ha sido uno de los mayores instrumentos solares de la época moderna hasta la construcción del telescopio McMath del observatorio de Kitt Peak en Arizona.

La primera meridiana monumental instalada en una basílica fue la que Giovanni Domenico Cassini diseñó e instaló en San Petronio (Bolonia) en 1655. Con sus 66,8 metros de longitud se trata de la meridiana más larga del mundo. Cassini pretendía medir con este instrumento, al que llamó “heliómetro”, la duración del año solar y, de esta manera, verificar la exactitud de la reforma gregoriana del calendario.

Meridiana de Piazzi en la catedral de Palermo. Fotografía: Paco Bellido

Otro de los objetivos de Cassini era solucionar la controversia entre los modelos geocéntrico y heliocéntrico. El Sol parece moverse en el cielo más lentamente en verano que en invierno. Para los antiguos este fenómeno obedecía a que en verano el Sol está más lejos de la Tierra y por tanto parece moverse más despacio. No obstante, la segunda ley de Kepler, demostrada a finales del siglo XVII por Newton, establece que la Tierra tiene una velocidad mayor cuando está más cerca del Sol y se mueve más lentamente cuando está más lejos del astro rey, es decir, que la línea que une el planeta y el Sol describe áreas iguales en períodos iguales.

Cassini logró comprobar con su meridiana que el diámetro del Sol no se reducía en el transcurso del año en la misma proporción en la que lo hacía su velocidad. Por tanto la disminución de velocidad del Sol no era aparente como pensaban los antiguos, sino real. Este hecho fue la primera confirmación de la segunda ley de Kepler obtenida mediante la observación.

Cassini también midió la inclinación de la eclíptica con una exactitud sin precedentes, gracias a la precisa corrección que aplicó para la refracción atmosférica.

Meridiana de Santa María de los Ángeles y Mártires (Roma). Fotografía: Wikimedia Commons

La catedral de Milán también cuenta con una meridiana. El instrumento fue construido en 1786 por los astrónomos del observatorio de Brera, Giovanni Cesaris y Francesco Reggio, que acometieron el montaje de la meridiana siguiendo los consejos del prestigioso astrónomo jesuita Roger Boscovich. La catedral de Milán tiene su eje principal orientado perfectamente en la dirección este-oeste, así que en este caso la meridiana se sitúa paralelamente a la fachada.

El 1976 una comisión formada por arquitectos y astrónomos de Brera determinó que el error máximo en azimut de la meridiana de Cesaris es de 7 milímetros, con lo que el error de determinación del mediodía local sólo era de apenas un segundo.

Órbita de la estrella Polar en la meridiana de Santa María de los Ángeles y Mártires (Roma). Fotografía: Paco Bellido

Pero el uso de las meridianas no siempre ha sido el de estudiar los movimientos del Sol, en ocasiones las meridianas tenían como objetivo servir de guía para poner en hora los relojes, como fue el caso de las dos líneas meridianas iguales construidas por el jesuita bohemio Johan Wendlingen, Profesor de la Cátedra de Matemáticas del Colegio Imperial, en el Monasterio de El Escorial a petición del rey y hoy tristemente cegadas. O la ideada por Giuseppe Piazzi, descubridor del primer asteroide, para la Catedral de Palermo a fin de racionalizar la medida del tiempo en Sicilia que hasta bien entrado el siglo XIX se regía por la hora itálica.

En la basílica de Santa María de los Ángeles y los Mártires de Roma encontramos otra de las grandes meridianas monumentales. Fue un encargo del papa Clemente XI al polifacético matemático Francesco Bianchini. La meridiana, completada en 1702, tenía un triple objetivo: comprobar la exactitud de la reforma gregoriana del calendario, disponer de una herramienta fiable para la determinación de la Pascua y finalmente, no menos importante, que Roma dispusiera de una meridiana tan importante como la que Cassini había construido en Bolonia con el detalle adicional de que la meridiana se encuentra sobre los baños de Diocleciano y transmite el mensaje simbólico del triunfo del calendario cristiano (gregoriano) sobre el romano (juliano).

Placa solsticial de la meridiana de San Sulpicio de París. Fotografía: Paco Bellido

En la iglesia de San Sulpicio de París se encuentra una meridiana solar instalada en 1743 por el relojero inglés Henry de Sully a petición del párroco Jean-Baptiste Languet de Gergy. El cura deseaba un instrumento preciso para hacer sonar las campanas a la hora exacta, pero Sully falleció antes de terminar el proyecto y finalmente fueron astrónomos del Observatorio de París quienes se encargaron de la instalación de la meridiana.

Las meridianas monumentales son lugar de visita obligada para cualquier interesado en la Ciencia y conviene recordar que forman parte del patrimonio científico de los países y, por ello, merece la pena conservarlas en buen estado.

Este post ha sido realizado por Paco Bellido (@ElBesoenlaLuna) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Meridianas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La astronomía transformada en arte

- Cómo fabricar hielo extraterrestre y verlo molécula a molécula

- El valle de la evaporación de planetas

El Universo y los límites

En las últimas décadas una plaga se ha extendido por los pasillos de departamentos y centros de investigación; un término que es ya casi ubicuo en proyectos, solicitudes de becas e incluso nombres de instituciones: pluridisciplinariedad, o multidisciplinariedad, da igual. Como cualquier moda nadie sabe muy bien cómo ha aparecido, pero su progresión ha sido rápida y extensa hasta colonizar todos los rincones de la investigación científica. Hoy sin un atisbo de multidisciplinariedad ningún proyecto tiene posibilidades de progresar o recibir financiación, hasta tal punto que para algunos tipos de solicitudes es directamente obligatorio incluirlo. Y aunque pueda parecer que como cualquier concepto de moda su esencia es pasar de moda y por tanto acabará por desaparecer, lo cierto es que su aparición se debe a un accidente de la historia de las ciencias y refleja una realidad que no va a desaparecer: el universo mismo no tiene límites entre disciplinas y es, por tanto, esencialmente multidisciplinar. Es la ciencia la que no lo es.

Dividimos el estudio del Cosmos en diferentes campos, que tienen metodologías, paradigmas, libros de texto y facultades diferentes. Quienes estudian el universo son químicos, físicos, astrónomos, biólogos o matemáticos; sus titulaciones y carreras profesionales son diferentes, así como su forma de trabajar, su tradición intelectual y los puestos de trabajo a los que pueden aspirar. Incluso su lugar físico de trabajo está determinado por el campo de estudio que han escogido, al igual que la reputación e imagen social de que disfrutan (o padecen). Algunas áreas del conocimiento, como la filosofía, pertenecen incluso a regiones culturales consideradas diferentes e incluso incompatibles al otro lado de la famosa frontera ciencias/letras. Y sin embargo la realidad es tozuda y no reconoce campos separados de estudio. El universo carece de límites entre disciplinas, de modo que la multidisciplinariedad es una característica esencial del conocimiento.

Sin matemáticas la física de lo ingente y lo pequeño no puede ser estudiada. La biología a escalas lo suficientemente reducidas se convierte en química, que no es más que la física de los elementos y compuestos. La geología entiende de minerales y rocas, pero linda con la astronomía cuando se trata de otros cuerpos celestes y con la química y la física cuando quiere entender sus propiedades. La radioastronomía necesita la física nuclear al mismo tiempo que la mecánica clásica y relativista para trabajar con galaxias y cúmulos de ellas, y de la química para entender las nubes moleculares. Y por si fuera poco no hay hoy un solo campo de conocimiento que pueda avanzar sin usar sofisticadas herramientas tecnológicas. Ya no hay ‘ciencias puras’, y en rigor jamás las ha habido. Las divisiones entre las disciplinas no son más que artefactos del pasado; accidentes que tienen más que ver con las sociedades del siglo XVIII y sus particularidades que con ninguna división racional de ‘espacios de conocimiento’.

En el universo los límites no existen, y una buena parte de nuestros mayores avances en su comprensión han venido precisamente cuando nos hemos saltado esas fronteras artificiales aplicando ideas, métodos y conocimientos de una ciencia para resolver los problemas de otra. Para entender las reacciones químicas en detalle o para explicar el funcionamiento de las biomoléculas es necesario usar la mecánica cuántica, como hace falta la química si se aspira a comprender los mecanismos que hacen brillar a una estrella o crean un sistema solar a partir de polvo estelar. Las propiedades mecánicas de los minerales que forman las placas tectónicas dependen de su estructura cristalográfica, que viene determinada por las propiedades químicas y físicas de los compuestos que los forman y su historia. La evolución de los seres vivos está decisivamente influenciada por los límites de la mutación, a su vez intrínsecamente ligados a las propiedades químicas del ADN y del interior de la célula. Nada está separado: el cosmos es un gran sistema integrado. Y si queremos aspirar a conocerlo tendremos que estudiarlo sin límites entre disciplinas.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo El Universo y los límites se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La verdadera composición última del universo (III): La desmaterialización del universo

- En los límites del frío

- Sistemas respiratorios: los límites a la difusión de los gases

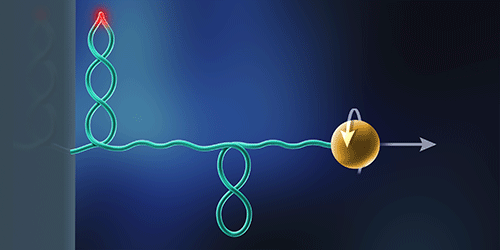

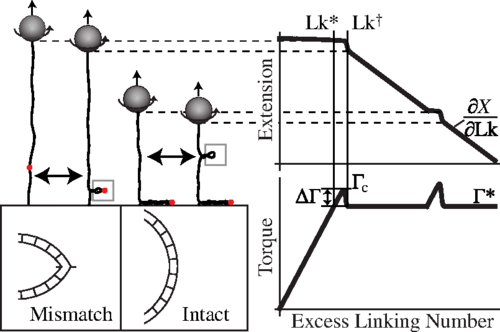

Cómo detectar un defecto en el ADN viendo cómo se retuerce

Imagen: E. Tyler/NIH

Toma el extremo de una cuerda y empieza a darle vueltas como si le estuvieras dando cuerda a un reloj. Llega un momento, más allá de cierto límite de vueltas, en el que se deformará, retorciéndose sobre sí misma hasta formar un bucle enrollado. El mismo tipo de deformación ocurre cuando se pasa de vueltas el ADN (al fin y al cabo es una cuerda biológica). Ahora, un grupo de investigadores ha demostrado que este comportamiento puede usarse para localizar con precisión una sola base desemparejada en la hebra de ADN. Especulan además con que este proceso podría estar ocurriendo en el interior de las células.

Los investigadores dieron vueltas a hebras de ADN con una técnica muy conocida para manipular biomoléculas. Es tan simple, dentro de lo simple que puede ser manejar una sola macromolécula, como sujetar un extremo de la hebra de ADN a una superficie sólida, mientras que el otro extremo se “amarra” a una canica magnética. En estas condiciones la aplicación de campos magnéticos adecuados hace girar la canica sobre sí misma haciendo que el ADN gire sobre sí mismo. Con el tiempo el ADN llega a un punto en el que se retuerce haciendo que la distancia que separa inicialmente la pared y la canica disminuya.

Para comprobar la eficacia de la técnica para localizar los puntos en los que había un defecto de pares de bases, el equipo diseñó una serie de cadenas de ADN con errores colocados con precisión. El número de errores podía ir de 1 a 16 bases adyacentes.

Al realizar los experimentos el ADN se retorcía dos veces. Primero, se doblaba y formaba un bucle en el defecto, lo que tenía como consecuencia una caída repentina de la longitud de la hebra. A partir de ahí la hebra continuaba acortándose conforme cada vez más parte de ella pasaba a formar parte del bucle, mientras que el bucle se desplazaba hacia la superficie sólida. Finalmente, una vez que el bucle tocaba la superficie, se doblaba una segunda vez y aparecía un nuevo bucle.

Los investigadores comprobaron que la disminución de la longitud del ADN entre la formación del primer y el segundo bucle se correspondía con la distancia original entre las bases desemparejadas y la superficie. Demostraron que, incluso en el caso de un único defecto, su técnica podía localizar siempre la posición del defecto.

Este descubrimiento permite descubrir la localización de defectos por medios físicos, sin necesidad de atacar químicamente la molécula de ADN, lo uq epodría ser muy útil para buscar daños en el ADN in vivo.

Referencia:

Andrew Dittmore, Sumitabha Brahmachari, Yasuharu Takagi, John F. Marko, and Keir C. Neuman (2017) Supercoiling DNA Locates Mismatches Phys. Rev. Lett. doi: 10.1103/PhysRevLett.119.147801

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Cómo detectar un defecto en el ADN viendo cómo se retuerce se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La fusión nuclear como fuente de neutrones eficiente

- Viendo mejor en el infrarrojo

- Comprimiendo la luz para detectar mejor ondas gravitacionales

Algunas observaciones someras relativas a las propiedades aerodinámicas de la suma

No es la primera vez que hablamos en este blog de alguna de las propuestas del magnífico escritor Raymond Queneau. Creador del grupo OuLiPo –Ouvroir de Littérature Potentielle, Obrador de Literatura Potencial– junto al ingeniero François Le Lionnais, jugó en muchos de sus escritos, de manera más o menos evidente, con las matemáticas.

El libro Cuentos y declaraciones recoge diferentes textos de este autor, todos ellos marcados con un toque de ‘absurdidad’. Debajo reproduzco uno de ellos, bellísimo, en el que es posible percibir que a nuestras profesoras y profesores se les olvidó enseñarnos algunas de las propiedades más importantes de la suma…

En la traducción del texto (del original en francés) he intentado conservar –¡qué atrevida!– el estilo de Queneau, a veces coloquial, a veces burlón,…

Algunas observaciones someras relativas a las propiedades aerodinámicas de la suma (Quelques remarques sommaires relatives aux propriétés aérodynamiques de l’addition, 1950)

En todos los intentos realizados hasta nuestros días para demostrar que 2 + 2 = 4, nunca se ha tenido en cuenta la velocidad del viento.

La suma de números enteros no es, en efecto, posible más que con un tiempo bastante tranquilo para que, una vez puesto el primer 2, se quede en su sitio hasta que se pueda poner la pequeña cruz, después el segundo 2, y después el pequeño muro sobre el que sentarse para reflexionar y por fin el resultado. El viento puede soplar después: dos y dos son cuatro.

Si el viento empieza a elevarse, he aquí el primer número que cae. Si continúa, ocurre lo mismo con el segundo. ¿Cuál es entonces el valor de ![]() ? Las matemáticas actuales no están en la medida de respondernos.

? Las matemáticas actuales no están en la medida de respondernos.

Si el viento sopla fuerte, entonces la primera cifra sale volando, después la crucecita, y así sucesivamente. Pero supongamos que cae tras la desaparición de la cruz, entonces podríamos estar abocados a escribir la absurdidad 2 = 4.

El viento no sólo lleva, también trae. La unidad, número particularmente ligero y que una simple brisa basta para desplazar, puede caer en una suma donde no tiene nada que hacer, a espaldas incluso del calculador. Es esta la intuición que había tenido el matemático ruso Dostoievski cuando osó declarar que tenía una debilidad por 2 + 2 = 5.

Las reglas de la numeración decimal prueban igualmente que los hindúes han debido probablemente formular más o menos de modo inconsciente nuestro axioma. El cero rueda con facilidad, es sensible al mínimo soplido. Tampoco se le tiene en cuenta cuando está situado a la izquierda de un número: 02 = 2, ya que el cero ‘se larga’ siempre antes del final de la operación. No es significativo más que a la derecha, pues entonces las cifras precedentes pueden también retenerlo e impedirle salir volando. También se tiene 20 ≠ 2, mientras el viento no supere algunos metros por segundo.

Deduciremos ahora algunas consecuencias prácticas de estas consideraciones; en cuanto se pronostican perturbaciones atmosféricas, es bueno dar a la suma una forma aerodinámica. También se aconseja escribir de derecha a izquierda y comenzar lo más cerca posible del borde de la hoja de papel. Si el viento hace deslizar la operación en curso se puede, casi siempre, recogerla antes de que llegue al margen. Se obtendrá así, aún con una tormenta de equinoccio, resultados como éste:

![]() = 5.

= 5.

Referencias

Raymond Queneau, Contes et propos, Gallimard, 1981

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Algunas observaciones someras relativas a las propiedades aerodinámicas de la suma se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una de mates: La suma de Gauss

- Galileo vs. Iglesia Católica redux (III): Observaciones

- Amelia quiere explorar el desierto

Sistemas respiratorios: invertebrados terrestres

Sistema de tráqueas en una cucaracha “Nauphoeta cinerea” (disección)

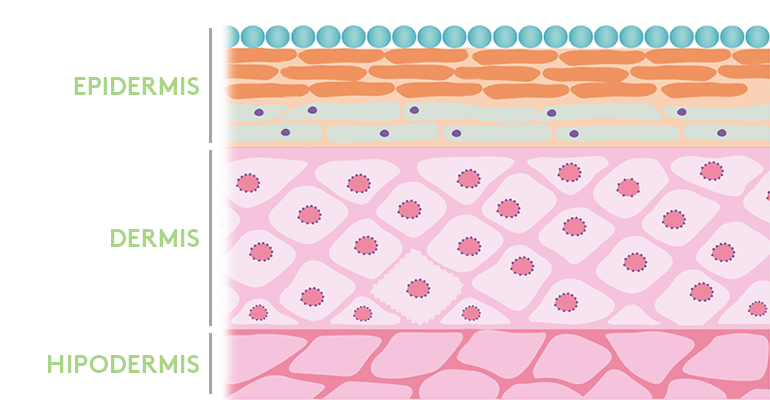

Aunque el medio respiratorio de los animales terrestres es aire, todos los epitelios respiratorios están recubiertos por una fina película de agua, razón por la cual el intercambio de gases siempre se produce a su través. Los animales terrestres, por ello, han de mantener húmedas las superficies respiratorias. En algunos casos ello obliga a permanecer en medios húmedos, como ocurre con algunos anélidos. Aunque en la mayoría de las especies, la solución ha consistido en disponer de superficies respiratorias internas o cubiertas por alguna estructura protectora, a la vez que el epitelio se mantiene húmedo por medio de alguna secreción. Los principales órganos respiratorios de animales terrestres son (1) el sistema de tubos aéreos internos denominados tráqueas, característicos de insectos y de algunas arañas, (2) los pulmones en libro, que se asemejan a branquias, de escorpiones y algunas arañas, (3) la cavidad del manto de algunos gasterópodos, y (4) los pulmones, que son sacos internos muy vascularizados, propios de algunos caracoles y de los vertebrados.

Gasterópodos terrestres

Los bivalvos y los cefalópodos son animales casi exclusivamente acuáticos. Si acaso, de los bivalvos intermareales podría decirse que tienen un modo de vida anfibio, pues algunos llegan a permanecer durante largos periodos de tiempo expuestos al aire en la bajamar. Lo normal es que en ese periodo cierren sus valvas y se aíslen del exterior para evitar la desecación, por lo que pueden verse obligados a recurrir a vías anaerobias del metabolismo. Los gasterópodos, sin embargo, tienen numerosos representantes terrestres. Nos referimos a caracoles y babosas.

Las babosas intercambian los gases a través del tegumento, razón por la cual lo mantienen húmedo de forma permanente. Ese factor condiciona su modo de vida, ya que necesitan ambientes húmedos. Algunos caracoles terrestres –los prosobranquios- utilizan el manto que recubre la concha por su interior para intercambiar los gases respiratorios. Otros –los pulmonados- han desarrollado verdaderos pulmones a partir de la cavidad del manto, con un pequeño orificio que conecta al pulmón con el exterior.

Insectos y miriápodos

Estos animales utilizan tráqueas para respirar. Se trata de tubos llenos de aire que se abren al exterior a través de unos orificios en el exoesqueleto denominados espiráculos y que se ramifican hacia el interior de manera que las proyecciones de una misma tráquea –las traqueolas, de unos 0,2 µm de diámetro- alcanzan varios puntos en el tejido. Los tubos están llenos de aire salvo al final de las traqueolas, donde mantienen un fluido. Muchas tráqueas están reforzadas con quitina, por lo que son estructuras con una cierta rigidez. Las tráqueas pueden disponer de un mecanismo de cierre, al que recurren para evitar una excesiva pérdida de agua por evaporación del fluido de las traqueolas. El tejido nervioso y el muscular son los que reciben un mayor número de traqueolas, debido a su alta actividad metabólica.

Es importante reparar en el hecho de que el aparato circulatorio de los animales con un sistema traqueal no tiene la función de transportar gases respiratorios, pues estos van directamente del exterior a las células (O2) y de las células al exterior (CO2); de hecho, la apertura de las tráqueas se produce en respuesta a una disminución de la concentración de O2 en las células o a un aumento de la concentración de CO2. El sistema circulatorio transporta muchas otras sustancias, principalemene alimenticias, pero no cumple funciones respiratorias.

Los insectos sedentarios y los muy pequeños intercambian gases por pura difusión, pero los activos, especialmente los voladores impulsan los gases a través del sistema traqueal, para lo que disponen de sacos aéreos, que son regiones expandidas de las tráqueas, que se abren y cierran por la acción de músculos ad hoc o por efecto de la contracción de otros músculos.

Dado el enorme número de especies de insectos y miriápodos, así como el gran número de ejemplares de algunas especies, especialmente de insectos sociales, el sistema traqueal es, con diferencia, en sistema respiratorio más abundante en metazoos.

Arácnidos

Aunque algunas arañas tienen tráqueas para respirar, el órgano respiratorio de los escorpiones y las arañas más primitivas es el pulmón en libro. Se trata de una estructura similar a una branquia, en la que un conjunto de lamelas (láminas) apiladas penetran desde la cutícula hacia el interior del abdomen.

Las arañas de aparición más recuente han desarrollado un sistema de tubos –o sea, de tráqueas- que, curiosamente, es independiente del de los insectos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: invertebrados terrestres se ha escrito en Cuaderno de Cultura Científica.