Alegato por el árbol

Mertxe de Renobales Scheifler, lectora

Para la mayoría de las personas, sobre todo las que vivimos en ciudades, los árboles son objetos decorativos que embellecen el paisaje urbano y rompen la monotonía de los edificios y el cemento de las calles. En días soleados veraniegos apreciamos su sombra, pudiendo ser difícil encontrar un hueco en un banco protegido del sol para leer tranquilamente un libro, o el periódico. Y ya está. A lo largo de sus 336 páginas, Alegato por el Árbol (primera edición en español) me ha hecho apreciar los árboles como seres vivos sorprendentes e impresionantes, y me ha proporcionado muchos ratos buenos e interesantes paseando por parques urbanos, fijándome en los árboles y tratando de identificar algunas de las estructuras que describe este libro (no es tan difícil!). Me ha enseñado a mirar los árboles de otra manera, a darme cuenta de aspectos y detalles que antes nunca había visto a pesar de «haber visto» muchos árboles, en las ciudades y en la naturaleza. Pero no sabía cómo mirarlos para realmente verlos. Y también a apreciar su influencia en las culturas de diferentes pueblos. Las fotos que acompañan esta reseña están sacadas en ambientes urbanos del País Vasco.

Francis Hallé, su autor, es botánico, profesor emérito de la Universidad de Montpellier, y experto reconocido internacionalmente en ecología forestal de regiones tropicales. Dicho de otra manera, sabe de lo que está hablando. Y, además, lo hace en un lenguaje sencillo, ágil y fácil de entender para el público en general, sin perder rigor científico. Las explicaciones escritas, concisas y claras, se acompañan de 95 excelentes dibujos, la gran mayoría hechos por el propio autor, en los que resalta los detalles botánicos mencionados en el texto, y de 19 fotografías en color. Todo ello se completa con un glosario de los conceptos científicos utilizados para que los lectores legos en la materia vayamos adquiriendo un vocabulario correcto.

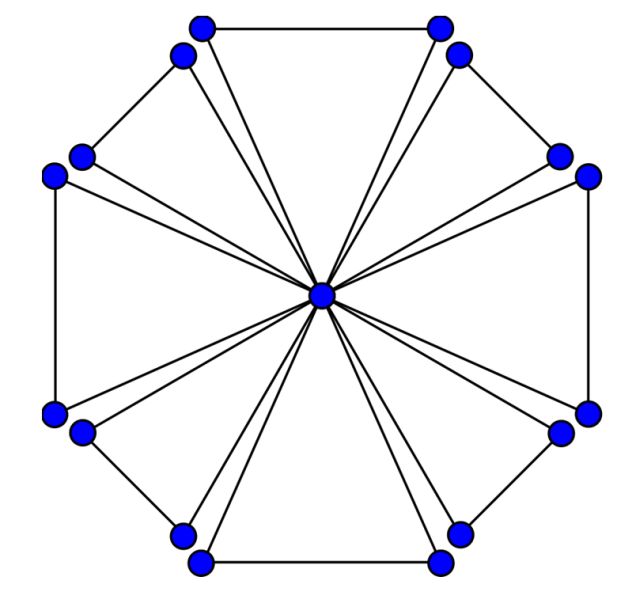

El libro consta de 3 partes que se pueden leer en cualquier orden, aunque creo que es mejor seguir el orden propuesto para adentrarnos en el inesperado mundo del árbol. El título del capítulo 1 «¿Puede definirse el árbol?» ya nos indica que quizá el concepto de árbol no está tan consolidado, aunque hasta ahora hubiéramos pensado que estábamos seguros de lo que es un árbol! ¿Cómo se es árbol? El Profesor Hallé es muy conocido, entre otras contribuciones científicas, por proponer (junto con otros dos expertos botánicos) los modelos arquitectónicos que describen el modo de crecimiento y la forma de los árboles atendiendo a: si tienen ramas o no; si el crecimiento del eje principal del árbol es continuo o rítmico; si las ramificaciones son homogéneas o no; la disposición de los órganos sexuales (flores, inflorescencias, conos, etc) con respecto al eje principal (tronco) y sus ramificaciones. En total ha descrito 24 modelos arquitectónicos existentes en la naturaleza. Sorprende leer que «hay muy pocos árboles que se mantienen durante toda su vida en una misma unidad arquitectónica que, simplemente, crece con el tiempo» (es lo que se llama un «árbol unitario»). Nos explica el autor que esto se debe a que la mayoría de los árboles son seres coloniales, es decir, formados por repeticiones de la unidad arquitectónica principal («unidades reiteradas). Es como si dijéramos que al árbol original «le sale» otro árbol! (ver Figura 1).

Figura 1. Ejemplos de «unidades reiteradas» Las «ramas» de la izquierda de estos árboles son Unidades Reiteradas. Al fondo de la imagen de la derecha, hay un árbol cuyo eje (tronco) principal está tumbado y del que emerge otra unidad reiterada vertical. En la imagen de la derecha, el árbol en primer plano también tiene por lo menos 1 unidad reiterada, si no 2. Fotos suministradas por la autora.

Figura 1. Ejemplos de «unidades reiteradas» Las «ramas» de la izquierda de estos árboles son Unidades Reiteradas. Al fondo de la imagen de la derecha, hay un árbol cuyo eje (tronco) principal está tumbado y del que emerge otra unidad reiterada vertical. En la imagen de la derecha, el árbol en primer plano también tiene por lo menos 1 unidad reiterada, si no 2. Fotos suministradas por la autora.El hecho de ser colonial le permite al árbol llegar a alcanzar longevidades prácticamente indefinidas. ¿Indefinidas? El autor describe cómo muchos árboles forman «renuevos» que en realidad son unidades reiteradas producidas a partir de la raíz. Un análisis genético nos indica si un pequeño árbol que está creciendo en las inmediaciones de otro es un renuevo o ha brotado de una semilla: en el primer caso mantiene el genotipo del árbol crecido, y en el segundo no. Muchos árboles tienen una gran tendencia a formar clones (organismos que tiene el mismo genotipo que el organismo original) unidos por redes de raíces. Aparentemente son individuos diferentes, pero el análisis genético ha revelado en varias ocasiones que son el mismo individuo con decenas de miles de reiteraciones, como ya se ha comprobado en algunos bosques de álamos en Estados Unidos a los que se les ha calculado una edad superior a los 10.000 años. Por eso se pregunta el autor «el árbol, ¿es un individuo o una colonia?» la respuesta no es sencilla.

Las otras dos partes del libro inciden en la relación que los seres humanos hemos tenido, y seguimos teniendo, con los árboles, su influencia en diferentes culturas, en sus economías y hasta en el desarrollo del moderno sector del automóvil. En nuestra sociedad, altamente tecnificada, podríamos aprender mucho de las prácticas agronómicas de bajo coste que muchos pueblos indígenas han puesto a punto para mejorar la productividad de sus árboles y aprovechar sus escasos recursos naturales, sobre todo el agua. El último capítulo es un sugerente estudio de lo que la especie humana podría deber a nuestros antepasados arborícolas.

Como sucede en todos los campos científicos, no todos los expertos están de acuerdo en la interpretación de las razones que explican lo que observamos. Los temas que trata el presente libro no son una excepción. A lo largo del texto, con abundantes referencias a publicaciones científicas, el profesor Hallé señala las diferentes posturas e hipótesis junto a la que él considera más adecuada, lo que nos amplía la visión del tema en cuestión.

La cuidada edición de este libro en todos sus aspectos es una constante de la alta calidad a la que ya nos tiene acostumbrados la editorial Libros del Jata. Se lee muy fácilmente, por una parte gracias la pluma ágil del autor, y por otra a la exquisita traducción, como si el libro hubiera estado originalmente escrito en español, sin esas frases forzadas, resultado de una traducción literal que, aunque se entiendan, disminuye mucho la calidad del texto. No he encontrado una sola errata en todo el texto, ni una coma fuera de lugar! La portada, los dibujos del autor y la calidad de las fotografías están a la altura de las excelentes descripciones científicas del texto. Este libro proporciona una visión de los árboles que le marcarán a Ud., lector o lectora, un antes y un después en su manera de verlos y considerarlos. Estoy segura de que lo disfrutará y ya no volverá a ver un árbol de la misma manera que antes.

Ficha:

Autor: Francis Hallé

Editorial: Libros del Jata, S.L.,

Año: 2019. Primera edición en español (título original: Paidoyer pour l’arbre).

Colección: La Mirada Atenta.

ISBN: 978-84-16443-10-9. EAN: 9788416443109

Sobre la autora de la reseña: Mertxe de Renobales Scheifler es catedrática de bioquímica en la Facultad de Farmacia de la UPV/EHU.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo Alegato por el árbol se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Árbol sagrado, árbol maldito

- Historias de la malaria: El árbol de la quina

- I, Mammal. The Story of What Makes Us Mammals

Leonardo Torres Quevedo en Bilbao, 1919-2019: Naútica, Aeronáutica y Computación

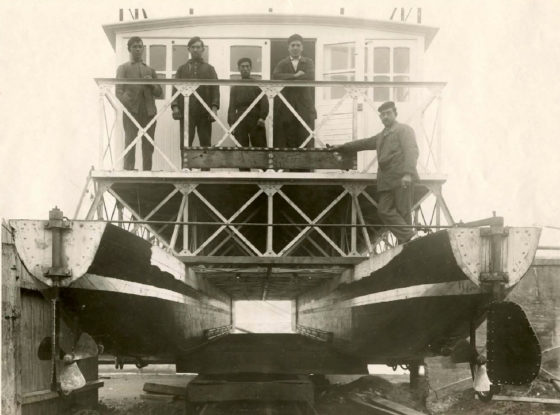

El catamarán que Leonardo Torres Quevedo diseñó y se construyó en los astilleros de Euskalduna en Bilbao. Conocido como «binave» se probó en la ría de Bilbao en 1918 por primera vez. Fotografía: Francisco Gonzalez Redondo – Museo Torres Quevedo

El catamarán que Leonardo Torres Quevedo diseñó y se construyó en los astilleros de Euskalduna en Bilbao. Conocido como «binave» se probó en la ría de Bilbao en 1918 por primera vez. Fotografía: Francisco Gonzalez Redondo – Museo Torres QuevedoEl ingeniero Leonardo Torres Quevedo (1852-1939) fue el protagonista de importantes sucesos ocurridos en Bilbao hace cien años. Por un lado, completó en la ría de la capital vizcaína las pruebas de su “Binave”, el primer catamarán moderno construido en los astilleros Euskalduna. Por otro, hacía público en el Teatro Arriaga el proyecto del dirigible trasatlántico “Hispania”, culminación de su obra aeronáutica.

Otro de los grandes logros del ingeniero de origen vasco fue su “aritmómetro electromecánico”, aparato que puede considerarse el primer ordenador de la historia en el sentido actual del término y que fue presentado en la Exposición de Material Científico.

Todos estos grandes inventos, entre otros, hicieron que fuera calificado en 1930 como el más prodigioso inventor de su tiempo, por lo que ocupa un importante lugar en la historia universal de la ciencia y la técnica. Francisco A. González Redondo, profesor de la Universidad Complutense de Madrid (UCM), analizó las grandes obras del ingeniero el pasado 18 de septiembre en la Biblioteca Bidebarrieta de Bilbao.

Francisco A. González Redondo es profesor en la Universidad Complutense de Madrid (UCM) en el Departamento de Didáctica de las Ciencias Experimentales, Sociales y Matemáticas, además de ser uno de los grandes especialistas en la vida y obra de Leonardo Torres Quevedo. Sobre él ha escrito una biografía y numerosos artículos, además de organizar numerosos congresos y exposiciones.

Edición realizada por César Tomé López

El artículo Leonardo Torres Quevedo en Bilbao, 1919-2019: Naútica, Aeronáutica y Computación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- «Leonardo Torres Quevedo, el más prodigioso inventor de su tiempo» por F.A. González Redondo

- Neandertales ¿crónica de una muerte anunciada?, por María Martinón-Torres

- Francisco Ayala en Bilbao

¿Quiere que coman fruta y verdura? Conviértalos en pequeños artistas

«Vertumnus» (1590/1591) de Gisussepe Arcimboldo

«Vertumnus» (1590/1591) de Gisussepe ArcimboldoLas tasas de sobrepeso y obesidad infantil son preocupantes a nivel mundial. Por ello, se han llevado a cabo programas para promover hábitos alimentarios saludables. La mayoría se ha centrado fundamentalmente en la educación nutricional, pero esta no es la única estrategia posible. Nosotros hemos optado por una aproximación diferente a este problema.

Es habitual que niños y niñas rechacen probar nuevos alimentos, sobre todo frutas y verduras. Este comportamiento se denomina neofobia alimentaria y se considera como característico del desarrollo evolutivo entre los 2 y 6 años. Sin embargo, si no se gestiona adecuadamente puede prolongarse hasta la edad adulta.

Frutas y verduras son, además, una fuente de minerales y vitaminas. Por todo ello es sumamente importante explorar nuevas estrategias para fomentar el consumo de estos alimentos entre la población infantil.

El papel de los sentidos

La simple exposición ha sido una de las estrategias más utilizadas para inducir el consumo de nuevas frutas y verduras. De esta manera, el niño se familiariza con el alimento. Además, durante un tiempo se consideró que en su aceptación era decisivo el sentido del gusto y, por eso, había que probar y saborear estos alimentos.

No obstante, otros autores observaron que la información de los sentidos del tacto, de la vista y del olfato también eran importantes para probar nuevas verduras.

Centrémonos en el sentido de la vista. En un estudio donde se presentaron los vegetales con diferentes formas (enteros, a rebanadas, en palitos y con figuras de estrella), los resultados mostraron que los pequeños preferían mucho más las verduras con figura de estrella.

De manera similar, otros autores encontraron que los niños comieron el doble de fruta cuando esta se presentaba decorada con palillos para cócteles y dentro de una sandía que cuando se mostraba de manera habitual. Los elementos divertidos siempre han resultado atractivos para los más pequeños: un claro ejemplo de ello es la variedad de colores y formas que presentan la mayoría de golosinas.

Efecto ‘Ikea’

Hasta el momento, varios estudios han identificado una relación entre la participación de los niños en la preparación de los alimentos (concretamente, en la compra y el cocinado) y el aumento de su disposición a probar cosas nuevas.

Este tipo de actividades prácticas son muy valoradas entre los pequeños, y se ha demostrado que aportan una sensación de responsabilidad y orgullo. Dichas emociones han sido explicadas a través del denominado “Efecto Ikea” o, más específicamente en relación a la comida, “lo cocino para mí”.

Este fenómeno explica cómo los consumidores aprecian más (por tanto, les gusta más e ingieren mayor cantidad) aquellas comidas que han preparado ellos mismos, comparadas con las elaborados por otras personas. Además, crear experiencias positivas con nuevos alimentos es también interesante, ya que la aceptación de nuevos sabores puede generalizarse y aumentar así la de otros diferentes.

Preparar platos artísticos

En un estudio, llevado a cabo en el departamento de I+D del Basque Culinary Center de Donostia-San Sebastián analizamos los efectos en el consumo y el agrado de nuevas frutas y verduras al involucrar a los niños en la creación de una merienda artística.

Uno de los platos artísticos preparados para el experimento.

Uno de los platos artísticos preparados para el experimento.Para ello, se crearon tres grupos:

- El grupo ART, en el que los pequeños elaboraron ellos mismos el plato artístico y luego lo comieron para merendar.

- El grupo VISUAL, donde los niños participaron en una actividad creativa de tipo collage con imágenes de frutas y verduras. A continuación merendaron el mismo plato artístico que el grupo anterior, pero elaborado por los investigadores.

- El grupo CONTROL, en el que los niños participaron en la misma actividad creativa que el grupo anterior y merendaron los mismos alimentos que el resto, pero presentados de la manera habitual (simplemente cortados).

Los resultados mostraron que tanto el grupo ART como el VISUAL aumentaron su disposición a probar y comer nuevos alimentos. Esto indica que tanto la creación como la presentación del plato artístico pueden ser dos estrategias válidas para fomentar el consumo de nuevas frutas y verduras.

Proceso de elaboración del plato.

Proceso de elaboración del plato.Este experimento ha demostrado, además, que los niños también “comen primero con la vista”.

No obstante, el grupo que elaboró el plato por ellos mismos (ART) mostró un estado de ánimo más positivo, así como una mayor dominancia. Esto prueba que participar en la elaboración tiene un mayor impacto en el estado emocional que el simple hecho de comer algo elaborado por otro.

También es importante recalcar la importancia de jugar con los alimentos, tocándolos con las manos e implicando diferentes sentidos. Al final, crear comidas artísticas es una nueva forma de jugar y divertirse en familia.![]()

Sobre la autora: Edurne Maiz Aldalur es profesora adjunta de la Facultad de Psicología, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Quiere que coman fruta y verdura? Conviértalos en pequeños artistas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Acumuladores térmicos domésticos más pequeños usando parafinas

- Artistas científicos

- Artistas que miran a las matemáticas

A la sombra de un Adagio

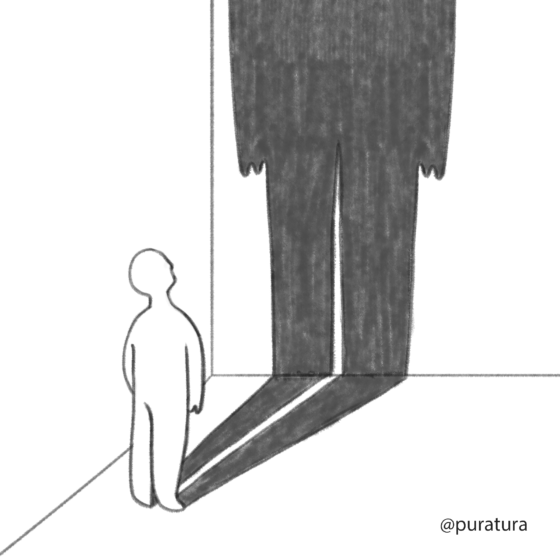

Imagen de Almudena M. Castro (@puratura)

Imagen de Almudena M. Castro (@puratura)El Adagio de Barber ha sonado en cientos de funerales, exequias y homenajes. Pero hubo uno donde su ausencia se hizo notar: el funeral de su propio compositor, Samuel Barber. Él mismo lo vetó poco antes de su muerte, cansado del que fue simultáneamente su mayor éxito y un espejo asfixiante durante toda su carrera.

Barber copuso su famoso Adagio en 1936, cuando apenas tenía 26 años. Pocos años antes, había conocido a Arturo Toscanini, uno de los compositores más célebres de su tiempo, quien le había animado a enviarle alguna de sus obras. Barber, un compositor joven y deseoso de darse a conocer, arregló rápidamente el movimiento lento de un cuarteto de cuerda que había compuesto poco antes y así nació su famoso Adagio para cuerdas.

La obra se estrenó el 5 de noviembre de 1938. Un selecto grupo de melómanos fue invitado al Estudio 8H del Rockefeller Center para ver a Toscanini dirigir la premier al frente de la Orquesta Sinfónica de la NBC. La obra además se grabó y emitió en directo para todos los oyentes de la Radio Nacional. Hasta la fecha, pocas obras del repertorio clásico se habían estrenado ante una audiencia tan inmensa y un público tan pequeño.

Desde entonces, y a partir de las primeras críticas positivas, su fama no dejó de crecer. Funerales, elegías, películas, televisión… durante el s. XX, no hubo lugar triste donde no sonase el Adagio. A día de hoy, algunas orquestas aún lo ensayan periódicamente, por si a alguna celebridad le da por estirar la pata.

Sin embargo, el compositor acabó lamentando este éxito tan temprano. Por un lado, su tremenda intensidad emocional fijó un estándar que Barber se sentía presionado a replicar en cada un de sus obras, condenado a destilar, una y otra vez, la fórmula que le había llevado al éxito. Pero además, sucedió que esta ópera prima eclipsó por completo el resto de su obra (y lo sigue haciendo a día de hoy, basta con buscar Samuel Barber en Spotify, por ejemplo).

Barber estaba convencido de haber escrito obras al menos igual de buenas que el Adagio, como sus conciertos para violín y para piano. Por eso no entendía que estas no llenasen los escenarios. Su irritación se volvía evidente, cada vez que alguien le comentaba cuánto admiraba su (dichoso) Adagio. En una entrevista de 1949, un periodista de la CBS le interpela, admirado, explicando que el Adagio fue la primera composición de Barber que él conoció. El compositor le contesta, “ojalá hubieses escuchado alguna de las nuevas” y añade con desdén “todo el mundo toca esa”. Hacia 1979, la acidez parece haber ido in crescendo: “A veces me aburro escuchando el Adagio. Pero me divierto durante las representaciones porque sé que siempre va a haber un error en alguna parte; simplemente espero que suceda. Es una obra tan sencilla, que ni siquiera se molestan en ensayarla”. A pesar del paso de los años, su Adagio lo seguía y ocultaba como una sombra, un espejo plano y oscuro en el que el compositor ya no se reconocía y que otros se empeñaban en mostrar.

No es de extrañar, por tanto, que Barber pidiese excluirlo de su propio funeral. Carlo Menotti, su pareja de toda la vida, se aseguró de que así fuera: durante la ceremonia sonaron corales de Bach, otras obras de música vocal de Barber, un madrigal del propio Menotti… ni resto del Adagio. Sin embargo, no logró silenciarlo durante la agonía del pobre Barber, atrapado en el hospital a causa del cancer: poco antes de su muerte, el director Lukas Foss dirigió su propia interpretación al frente de la Orquesta Filarmónica de Brooklyn y se la dedicó al compositor convaleciente. También Bernstein lo dirigió como homenage, poco tiempo después. Los amigos de Barber fueron a visitarle al hospital y le tocaron el Adagio en directo con todo su amor (y para aburrimiento mortal del compositor, segúnel testimonio de Menotti)… no falta comedia en esta pequeña tragedia, si uno la quiere ver.

Referencia:

Thomas Larson (2012) «The Saddest Music Ever Written: The Story of Samuel Barber’s Adagio for Strings»

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo A la sombra de un Adagio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Ángel Gómez Roldán: Tras la sombra de la Luna

- Tema y variaciones

- El último puzle de Bach

42, la respuesta definitiva a la vida, el universo y todo lo demás

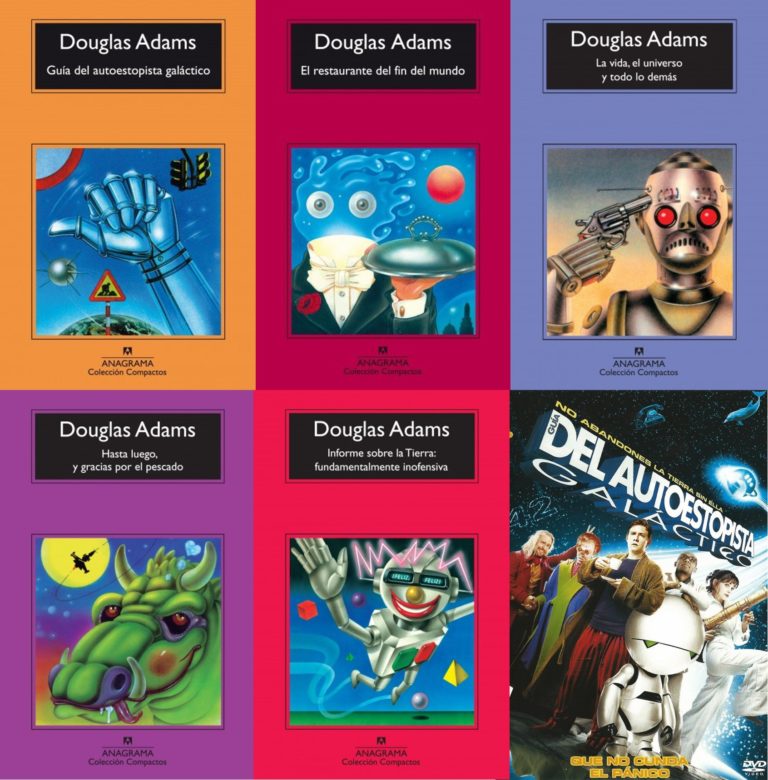

Una serie clásica de novelas de ciencia ficción de la década de los años 1980 es La guía del autoestopista galáctico, del escritor inglés Douglas Adams (1952 – 2001). Originalmente fue una serie para la radio, de 1978, con ese mismo nombre. La serie literaria se compone de cinco libros, el primero que da título a toda la serie, La guía del autoestopista galáctico, fue publicado en 1979, al que siguieron El restaurante del fin del mundo; La vida, el universo y todo lo demás; Hasta luego, y gracias por el pescado e Informe sobre la Tierra.

Portadas de las novelas de la serie de ciencia ficción La guía del autoestopista galáctico, publicadas por la editorial Anagrama, y cartel de la película

Portadas de las novelas de la serie de ciencia ficción La guía del autoestopista galáctico, publicadas por la editorial Anagrama, y cartel de la películaEn la novela aparece un superordenador, llamado Pensamiento Profundo y que es el segundo ordenador más grande del universo del espacio y del tiempo, que ha sido construido por una raza de seres “pan-dimensionales” que buscan el sentido de la vida. Cuando le preguntan al superordenador cuál es la “respuesta definitiva a la vida, el universo y todo lo demás”, éste contesta, después de siete millones y medio de años haciendo cálculos, que “cuarenta y dos”.

– Buenos días –dijo al fin Pensamiento Profundo.

– Hmmm… Buenos días, Pensamiento Profundo –dijo nerviosamente Loonquawl–, ¿tienes… hmmm, es decir…?

– ¿Una respuesta que daros? –le interrumpió Pensamiento Profundo en tono majestuoso–. Sí, la tengo.

Los dos hombres temblaron de expectación. Su espera no había sido en vano.

– ¿De veras existe? –jadeó Phouchg.

– Existe de veras –le confirmó Pensamiento Profundo.

– ¿A todo? ¿A la gran pregunta de la Vida, del Universo y del Todo?

– Sí.

Los dos hombres estaban listos para aquel momento, se habían preparado durante toda la vida; se les escogió al nacer para que presenciaran la respuesta, pero aun así jadeaban y se retorcían como criaturas nerviosas.

[…] Los dos hombres se agitaron inquietos. La tensión era insoportable.

– En serio, no os va a gustar –observó Pensamiento Profundo.

– ¡Dínosla!

– De acuerdo –dijo Pensamiento Profundo–. La Respuesta a la Gran Pregunta…

– ¡Sí…!

– … de la Vida, del Universo y de Todo… –dijo Pensamiento Profundo.

– ¡Sí…!

– Es… –dijo Pensamiento Profundo, haciendo una pausa.

– ¡Sí…!

– Es…

– ¡¡¡¿Sí…?!!!

– Cuarenta y dos –dijo Pensamiento Profundo, con calma y majestad infinitas.

Ante el asombro de sus creadores, el supercomputador les plantea que tienen que buscar cuál es la “pregunta definitiva”. Y como ese ordenador no puede contestar a esa pregunta construyen el superordenador más grande del universo, llamado Tierra, que es destruido antes de responder a la cuestión de cuál es la “pregunta definitiva” y se pierde la posibilidad de conocer esa información de vital importancia.

Esta historia de La guía del autoestopista galáctico es el motivo por el cual cuando hace unas semanas se pudo leer en la prensa que los matemáticos habían resuelto un problema relacionado con el número 42, a muchas personas nos vino a la cabeza la “respuesta definitiva a la vida, el universo y todo lo demás”.

El número 42 era el último número de la conocida sucesión de números 4, 8, 15, 16, 23, 42 de la serie de televisión Lost. Aquí vemos el billete de lotería que, en la serie, tocó a uno de los personajes, Hurley

El número 42 era el último número de la conocida sucesión de números 4, 8, 15, 16, 23, 42 de la serie de televisión Lost. Aquí vemos el billete de lotería que, en la serie, tocó a uno de los personajes, Hurley

Algunos de los titulares de prensa que pudieron leerse hace unas semanas fueron

“Matemáticos resuelven el diabólico acertijo del número 42, sin solución durante 65 años” (ABC Ciencia)

“Un viejo problema sobre el 42, resuelto” (Investigación y Ciencia)

“Resuelven por fin un misterioso problema matemático que lo puede cambiar todo” (El Confidencial)

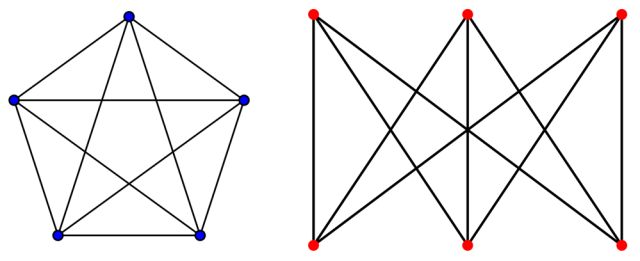

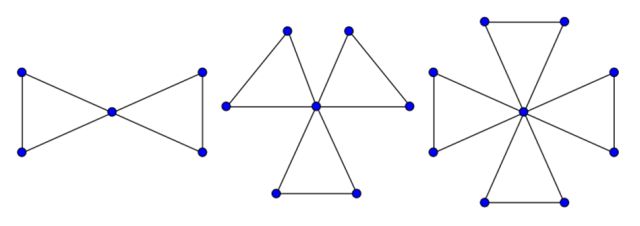

Dejando la ciencia ficción a un lado, expliquemos cuál es el problema matemático al que se estaban refiriendo los titulares de la prensa. El problema es el siguiente.

Problema: ¿cómo expresar los números naturales del 1 al 100 como suma de tres cubos de números enteros?

Si lo escribimos de forma algebraica sería lo siguiente. Dado un número natural k, entre 1 y 100, buscar los números enteros x, y, z tales que verifican la ecuación diofántica:

x3 + y3 + z3 = k.

Empecemos explicando qué es una ecuación diofántica. Estas son ecuaciones polinómicas de dos o más variables x, y, z, etc, para las que se estudian las soluciones con números enteros (los naturales, el cero y los negativos).

Por ejemplo, se puede considerar la ecuación, en las variables x, y, z, relacionada con el teorema de Pitágoras x2 + y2 = z2 y estudiar sus soluciones enteras. Una solución de esta ecuación es la clásica (3, 4, 5), ya que 32 + 42 = 52. Estas soluciones enteras se conocen con el nombre de ternas pitagóricas. Otras ternas pitagóricas son (5, 12, 13) o (8, 15, 17). Los griegos se dedicaron a investigar la existencia de diferentes ternas pitagóricas. El matemático griego Diofanto, que vivió en Alejandría en el siglo III, escribió un libro sobre ecuaciones algebraicas de título Arithmetica. En particular, Diofanto elaboró una regla general para encontrar todas las ternas pitagóricas, y se interesó por el estudio de lo que hoy llamamos ecuaciones diofánticas.

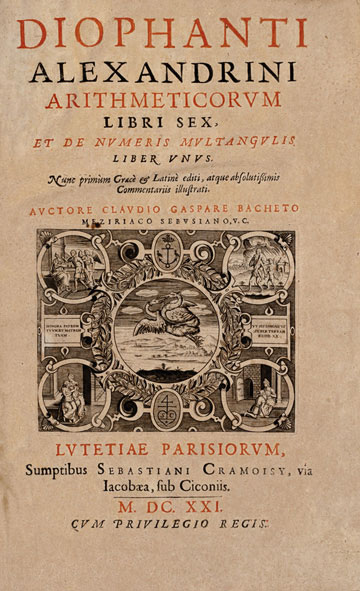

Portada de la edición de 1621 de la Arithmetica de Diofanto. Imagen de Wikimedia Commons

Portada de la edición de 1621 de la Arithmetica de Diofanto. Imagen de Wikimedia CommonsPero volviendo a nuestro problema, a la ecuación diofántica concreta x3 + y3 + z3 = k, o cómo expresar los números naturales del 1 al 100 como suma de tres cubos de números enteros, esta cuestión fue planteada de forma explícita y extensamente estudiada en un artículo publicado en 1955, en la revista Journal of the London Mathematical Society, por los matemáticos ingleses, J. C. P. Miller y M. F. C. Woollett, con el explícito título Solutions of the Diophantine Equation x3 + y3 + z3 = k.

Estos matemáticos se interesaron por este problema a raíz de un comentario del matemático inglés L. J. Mordell en otro artículo anterior, de 1953, en la misma revista:

“No sé absolutamente nada sobre las soluciones enteras de x3 + y3 + z3 = 3, más allá de la existencia de (1, 1, 1) y (4, 4, – 5); y tiene que ser realmente muy difícil descubrir algo sobre otras soluciones”.

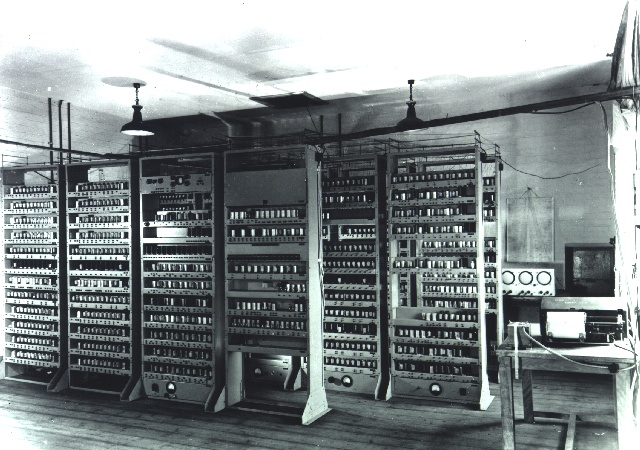

Además, Mordell sugirió a sus colegas Miller y Woollett que utilicen el ordenador ERSAC, de la Universidad de Cambridge, para obtener soluciones de la ecuación diofántica x3 + y3 + z3 = k, para valores de k menores, o iguales, a 100. Fruto de ese trabajo es el mencionado artículo.

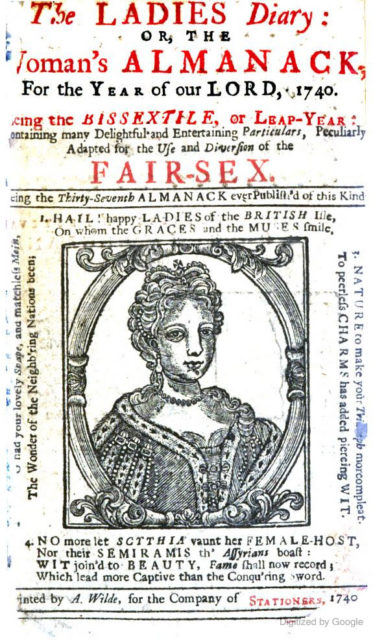

Aunque ya con anterioridad de había estudiado la ecuación x3 + y3 + z3 = k. En la revista inglesa de matemática recreativa The Ladies’ Diary se publicó en 1825, por S. Ryley, una familia de soluciones racionales, no enteras, de esa ecuación. Y las primeras soluciones enteras fueron obtenidas para las ecuaciones diofánticas x3 + y3 + z3 = 1 y x3 + y3 + z3 = 2 (k = 1, 2), en 1908 y 1936, respectivamente.

Portada de 1740 de la revista The Ladies’ Diary, en la que aparece un retrato de Carolina de Brandeburgo-Ansbach, reina consorte del rey Jorge II de Gran Bretaña [*]. Desde el inicio de la revista se incluían en la portada retratos de mujeres prominentes británicas, para atraer a las mujeres a leer la revista. Imagen de la Princeton University Library, a través de Google Books

Portada de 1740 de la revista The Ladies’ Diary, en la que aparece un retrato de Carolina de Brandeburgo-Ansbach, reina consorte del rey Jorge II de Gran Bretaña [*]. Desde el inicio de la revista se incluían en la portada retratos de mujeres prominentes británicas, para atraer a las mujeres a leer la revista. Imagen de la Princeton University Library, a través de Google Books

Pero volvamos a la ecuación diofántica x3 + y3 + z3 = k y al estudio de sus soluciones enteras.Veamos algunos ejemplos que nos permitan entender mejor la cuestión. Podríamos incluso plantearnos primero la ecuación x3 + y3 + z3 = 0, la cual por el último teorema de Fermat (véase la entrada Euler y el último teorema de Fermat) no tiene soluciones más allá de las triviales, del tipo (a)3 + (– a)3 + 03 = 0.

Para k = 1, además de la solución trivial 13 + 03 + 03 =1, se pueden encontrar otras soluciones, como 93 + (–8)3 + (–6)3 = 729 – 512 – 216 = 1 o (– 12)3 + 103 + 93 = –1728 + 1000 + 729 = 1. De hecho, en 1908 se demostró que existen infinitas formas de obtener 1 como suma de cubos, como aparece en el artículo de Miller y Woollett:

(9 t4)3 + (3 t – 9 t4)3 + (1 – 9 t3)3 = 1.

Este resultado se extiende, de forma natural, a los números que son cubos, a3. Luego, para números menores de 100 serían 8, 27 y 64.

También se probó, en 1936, que para k = 2, algunas de cuyas soluciones son 13 + 13 + 03 = 2 y 73 + (– 5)3 + (–6)3 = 2, existen, de nuevo, infinitas soluciones:

(6 t3 + 1)3 + (– 6 t3 + 1)3 + (– 6 t2)3 = 2,

que se extiende a los números que son el doble de un cubo, 2 a3. Para menores de 100 serían 16 y 54.

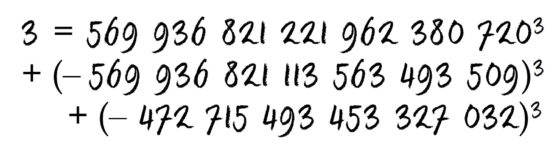

Para el 3, como menciona Mordell, se conocían solo las soluciones 13 + 13 + 13 = (– 5)3 + 43 + 43 = 3. A pesar de los intentos computacionales de encontrar más soluciones a esta ecuación diofántica x3 + y3 + z3 = 3, no se produjo ningún avance. Solo, en 1985, se demostró que una condición necesaria para que una terna de números enteros (x, y, z) fuese solución de esa ecuación debía de cumplir que x, y y z fuesen congruentes entre sí, módulo 9. Es decir, que el resto al dividirlos por 9 fuese el mismo. Pero ninguna solución particular fue encontrada.

Ahora tocaría el turno a los números 4 y 5. Aunque os recomiendo que no lo intentéis, puesto que no es posible. De hecho, el resultado es más general.

Proposición: No existen soluciones de la ecuación diofántica x3 + y3 + z3 = k, para valores de k “congruentes con 4 o 5, módulo 9”, es decir, que al dividirlos por 9 el resto de la división es 4 o 5, como los números 4, 5, 13, 14, 22, 23, 31, 32, 40, 41, 49, 50, 58, 59, 67, 68, 76, 77, 85, 86, 94 y 95.

Esto se debe a que cualquier número elevado al cubo a3 es congruente con 0, 1 u 8, módulo 9, es decir, el resto de dividir a3 entre 9 solo puede ser 0, 1 u 8. Por lo tanto, la suma de tres cubos no puede ser congruente con 4 o 5, módulo 9, puesto que no hay forma de sumar tres valores (pueden ser repetidos) de 0, 1 u 8 para que quede un resultado congruente con 4 o 5, módulo 9. Por ejemplo, los siguientes cubos 23 = 8, 33 = 27, 53 = 125, son congruentes con 8, 0 y 8, módulo 9, respectivamente, luego su suma es congruente con 8 + 0 + 8 = 16, es decir, congruente con 7, módulo 9. Efectivamente, 8 + 27 + 125 = 160 es congruente con 7, módulo 9, ya que al dividir 160 entre 9 nos queda 17 y de resto 7.

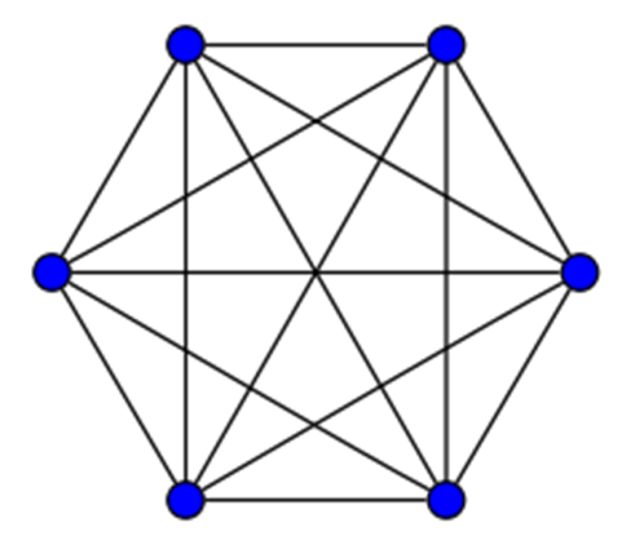

Ordenador británico Electronic delay storage automatic calculator (EDSAC), de la Universidad de Cambridge, fue utilizado por los matemáticos Miller y Woollett para encontrar soluciones a las ecuaciones diofánticas. Las primeras tareas de EDSAC, en 1947, fueron el cálculo de una tabla de cuadrados de números y un listado de números primos. Imagen de la Universidad de Cambridge

Ordenador británico Electronic delay storage automatic calculator (EDSAC), de la Universidad de Cambridge, fue utilizado por los matemáticos Miller y Woollett para encontrar soluciones a las ecuaciones diofánticas. Las primeras tareas de EDSAC, en 1947, fueron el cálculo de una tabla de cuadrados de números y un listado de números primos. Imagen de la Universidad de CambridgeLos matemáticos británicos Miller y Woollett, utilizando el ordenador EDSAC, encontraron soluciones particulares para 69 valores de k entre 1 y 100, buscando en un rango de valores de x, y, z comprendidos entre – 3.164 y 3.164. Si tenemos en cuenta que además había 22 valores, menores que 100, para los que no existen soluciones, quedaron sin resolver las ecuaciones diofánticas correspondientes a nueve valores, a saber, 30, 33, 39, 42, 52, 74, 75, 84 y 87.

Llegados a este punto de esta entrada del Cuaderno de Cultura Científica, os animo a que os enfrentéis vosotros mismos a la búsqueda de soluciones particulares al problema de expresar los números naturales del 1 al 100 (evitad los nueve valores que no consiguieron resolver Miller y Woollett, así como los 22 valores que no tienen solución) como suma de tres cubos de números enteros. Para algunos valores de k no es difícil encontrar soluciones, mientras que para otros no es tan sencillo, aunque para la mayoría existen soluciones con x, y, z menores, en valor absoluto, que 25 (esto es, entre – 25 y 25). En particular, para k = 16 la solución de Miller y Woollett es complicada,

16263 + (– 1609)3 + (– 511)3 = 16.

Bueno, pues si os animáis, disfrutad del problema/juego… divertíos… pero no os olvidéis de seguir leyendo esta entrada.

A partir del artículo Solutions of the Diophantine Equation x3 + y3 + z3 = k, de J. C. P. Miller y M. F. C. Woollett, se empezó a trabajar en la solución de estos nueve números menores que 100 que quedaban pendientes, pero también se estudió la ecuación diofántica x3 + y3 + z3 = k, para valores de k mayores que 100, en particular, se puso mucho énfasis en los menores que 1.000. Para resolver estas ecuaciones diofánticas se desarrollaron nuevos algoritmos computacionales y se amplió el rango de valores para x, y, z.

Hasta el año 2001 se había resuelto el problema para todos los números menores que 100, salvo 33, 42 y 74, para los cuales se sabía que no existían soluciones para x, y, z menores (en valor absoluto) que 1011. Así mismo, se habían encontrado soluciones para las ecuaciones diofánticas de todos los valores menores de 1000, salvo veinte, además de los tres anteriores.

Hubo que esperar a 2016 para obtener una solución para el número 74 y al inicio de este año 2019, aún quedaban por resolver los números 33 y 42.

En abril de este año, 2019, el matemático británico Andrew Booker, de la Universidad de Bristol, empezó a trabajar en el problema de escribir el número 33 como suma de tres cubos a raíz del video The uncracked problem with 33 [https://www.youtube.com/watch?v=wymmCdLdPvM] del canal de Youtube Numberphile.

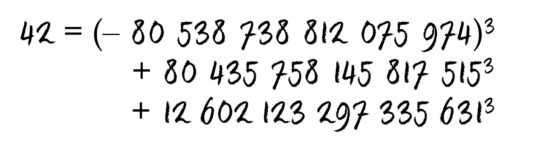

Booker desarrolló un nuevo algoritmo que le permitiera buscar soluciones enteras con números de 16 dígitos de la ecuación diofántica x3 + y3 + z3 = 33. Y, con ayuda de este algoritmo, encontró la buscada solución. Como cuenta el propio Andrew Booker en una entrevista para Numberphile, saltó de alegría en su despacho cuando encontró esa solución.

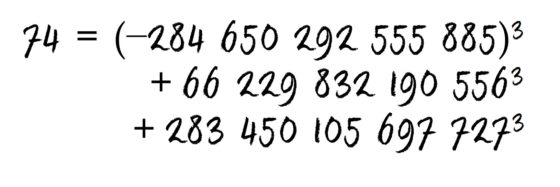

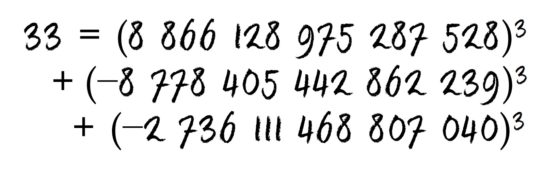

Y a principios del pasado mes de septiembre (de 2019) Andrew Brooker, junto con el matemático estadounidense Andrew Sutherland del MIT, han conseguido la solución del número que faltaba, el 42. Para ello han tenido que subir el rango de las posibles soluciones x, y, z a números de 17 dígitos. En concreto, el 42 se puede expresar como suma de tres cubos de la siguiente forma

Booker y Sutherland también encontraron algunas soluciones para números menores que 1000, como 165, 795 y 906. De esta forma ha quedado resuelto el problema, hasta los 100 primeros números, aunque hasta 1.000 aún quedan unos pocos… 114, 390, 579, 627, 633, 732, 921 y 975, sobre los que se seguirá trabajando en el diseño de algoritmos que los resuelvan.

Pero, ¡sorpresa! Solo diez días más tarde del anuncio de que habían conseguido resolver el problema de expresar el 42 como suma de tres cubos, Booker y Sutherland volvieron a hacer otro importante anuncio, relacionado con este problema. Por fin, habían encontrado una nueva solución de la ecuación diofántica citada por el matemático británico L. J. Mordell en 1953, x3 + y3 + z3 = 3, más allá de las ya conocidas (1, 1, 1) y (4, 4, – 5). Los números de esta solución no trivial tienen 21 dígitos.

Para resolver estos complicados problemas de computación, asociados a la solución de la ecuación diofántica, los matemáticos Andrew Booker y Andrew Sutherland utilizaron la aplicación Charity Engine, que conecta más de 500.000 ordenadores personales de todo el planeta, creando una red planetaria de ordenadores.

Existen muchos otros problemas que implican la suma de cubos de números, por ejemplo, el problema de ver qué números, en progresión aritmética, verifican que la suma de sus cubos es, de nuevo, un cubo. Por ejemplo, 33 + 43 + 53 = 63 (por cierto, que a este número, 63, se le conoce como el número de Platón) o 113 + 123 + 133 + 143 = 203, pero eso es otra historia que será contada en otra ocasión.

Floating cubes, an essay in superrealism (1962), del artista irlandés Harry Kernoff (1900 – 1974). Imagen de la galería WHYTE’S

Floating cubes, an essay in superrealism (1962), del artista irlandés Harry Kernoff (1900 – 1974). Imagen de la galería WHYTE’S

Bibliografía

1.- University of Bristol: Sum of three cubes for 42 finally solved

2.- Andrew R. Booker, Cracking the problem with 33, Res. Number Theory vol. 5, n. 29, 2019.

3.- John Pavlus, Sum-of-Three-Cubes Problem Solved for “Stubborn” number 33, Quanta Magazine, March, 2019.

4.- J. C. P. Miller y M. F. C. Woollett, Solutions of the Diophantine Equation x3 + y3 + z3 = k, Journal of the London Mathematical Society, vol. 30, pp. 101 – 110, 1955.

5.- L. J. Mordell, On the integer solutions of the equation x2+y2+z2+2xyz = n, Journal London Math. Soc, vol. 28, pp. 500-510, 1953.

6.- Armen Avagyan, Gurgen Dallakyan, A New Method in the Problem of Three Cubes, Universal Journal of Computational Mathematics vol. 5, n. 3, pp. 45-56, 2017.

7.- J. W. S. Cassels, A Note on the Diophantine Equation x3 + y3 + z3 = 3, Mathematics of Computation, vol. 44, n. 169, pp. 265-266, 1985.

8.- University of Bristol: Almost imposible 66-years-old maths puzzle solved

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

Nota del editor: Como es costumbre en España se traduce el nombre del rey o la reina y su correspondiente consorte. También es correcto su título como «rey de Gran Bretaña»; la denominación «Gran Bretaña» para el estado duró desde el 1 de mayo de 1707 al 1 de enero de 1801, momento en el que pasó a ser «Reino Unido de la Gran Bretaña e Irlanda» («…Irlanda del Norte» desde 1927).

El artículo 42, la respuesta definitiva a la vida, el universo y todo lo demás se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- 1 = 0, la prueba definitiva

- Cuando todo tu universo es un sólido

- El universo en un día: El origen de la vida, por Carlos Briones

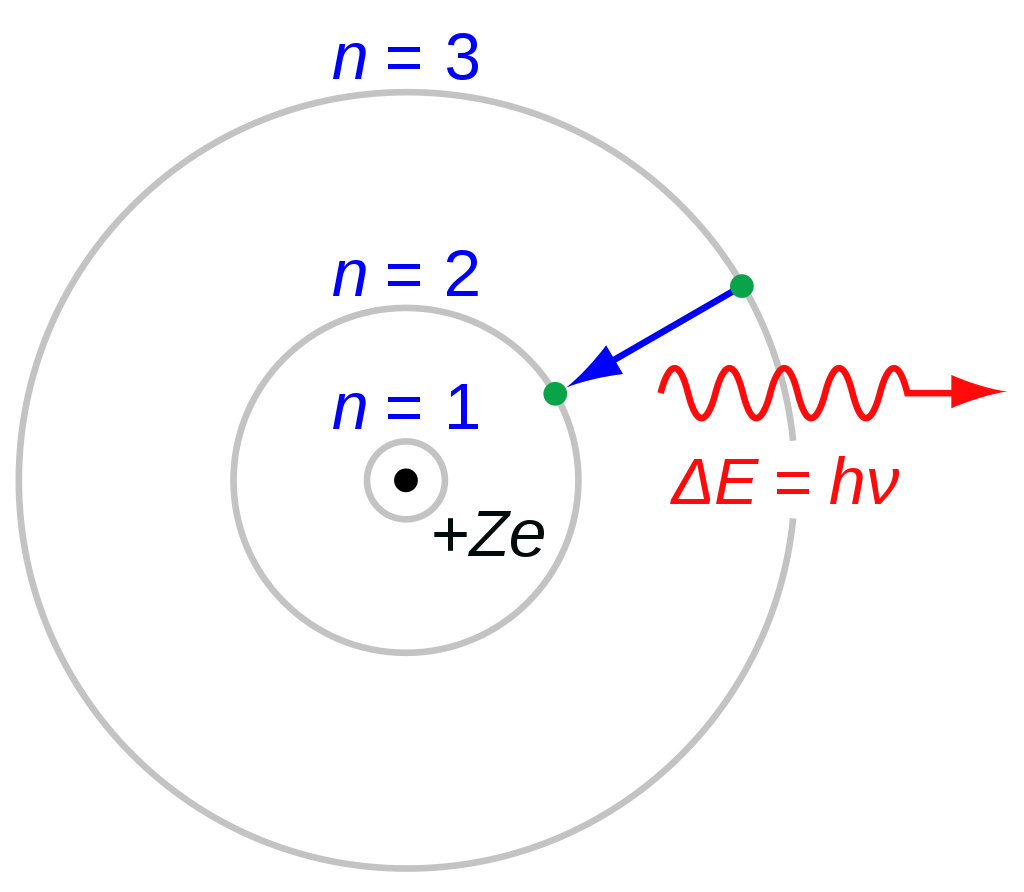

El tamaño del átomo de hidrógeno

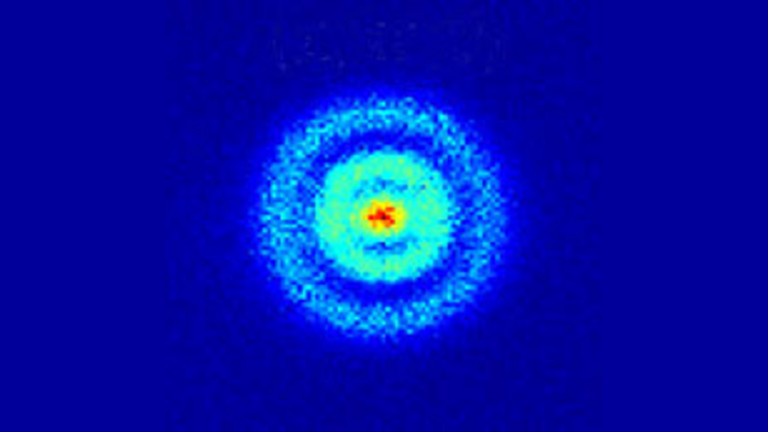

Visualización real de los estados de Stark de un átomo de hidrógeno. Fuente: A. S. Stodolna et al (2013) Hydrogen Atoms under Magnification: Direct Observation of the Nodal Structure of Stark States Phys. Rev. Lett. 110, 213001

Visualización real de los estados de Stark de un átomo de hidrógeno. Fuente: A. S. Stodolna et al (2013) Hydrogen Atoms under Magnification: Direct Observation of the Nodal Structure of Stark States Phys. Rev. Lett. 110, 213001Sin duda, una prueba de fuego para el modelo de Bohr tendría que ser explicar los espectros de los elementos, empezando por el del hidrógeno. Pero antes tenía que pasar una prueba cuantitativa básica: el tamaño del átomo derivado del modelo tenía que ser compatible con los datos ya conocidos.

De entrada estaban los órdenes de magnitud impuestos por los resultados de dispersión obtenidos por el laboratorio de Rutherford. De ellos se podían deducir algunas cosas interesantes. Para empezar, el tamaño aproximado del núcleo atómico. Supongamos que una partícula α se mueve directamente hacia un núcleo. Su energía cinética se transforma en energía eléctrica potencial: se ralentiza y finalmente se detiene, como una pelota rodando cuesta arriba. Lo más cerca que la partícula estará del núcleo puede calcularse a partir de la energía cinética original de la partícula y las cargas de la partícula y el núcleo. El valor calculado resulta ser de unos 3·10-14 m.

Si la partícula no penetra en el núcleo, esta distancia debe ser, al menos, la suma de los radios de las partículas y el núcleo; de aquí, el radio del núcleo no podría ser mayor que aproximadamente 10-14 m. Pero 10-14 m es solo aproximadamente 1/1000 del radio que establece la teoría cinética para un átomo. Como el volumen total del átomo es proporcional al cubo de su radio, eso quiere decir que el átomo está mayormente vacío, con el núcleo ocupando solo una milmillonésima parte del espacio. Esto explica cómo las partículas o los electrones pueden penetrar miles de capas de átomos en láminas de metal o en gases, con solo una desviación grande ocasional de la trayectoria y muy pocos rebotes.

Con estas condiciones de contorno veamos la aplicación del modelo de Bohr al átomo más sencillo, el hidrógeno que, recordemos, tiene un solo electrón alrededor del núcleo. Bohr supuso que las posibles órbitas de los electrones son circulares por simplicidad. El resultado de Bohr para los radios de las posibles órbitas estables rn fue rn = a·n2, donde a es una constante (a = h2 / 4π2mkqe2) [1] que se puede calcular a partir de valores físicos conocidos, y n representa cualquier número entero, n = 1, 2, 3… .

El resultado de Bohr es muy llamativo. En los átomos de hidrógeno los posibles radios orbitales de los electrones son múltiplos enteros de una constante que se puede calcular fácilmente; es decir, n2 adquiere valores de 12, 22, 32,. . . , y todos los factores a la izquierda de n2 en rn = a·n2 son cantidades conocidas previa e independientemente.

El valor de a es aproximadamente de 5,3·10-11 m. Por lo tanto, según el modelo de Bohr, los radios de las órbitas estables tenía que se n2 veces 5,3·10-11 m. Es decir, para n = 1, la primera órbita permitida el radio era, precisamente, 5,3·10-11 m, 4 veces esta cantidad la segunda y 9 veces la tercera. Entre ellas, simple y llanamente, no podía estar el electrón.

En resumen, las distintas órbitas electrónicas están espaciadas alrededor del núcleo de manera regular, con los radios permitidos cuantificados de manera regular. Por lo tanto, la emisión y absorción de luz debe corresponder a la transición del electrón de una órbita permitida a otra. La emisión de luz ocurre cuando el electrón «cae» de un estado de energía más alto a un estado más bajo; la absorción de luz ocurre cuando el electrón «salta» desde un estado de baja energía hasta un estado de mayor energía. Un resultado muy bonito que indica qué radios son posibles y dónde se encuentran. Pero hasta ahora, todo esto es la construcción de un modelo. ¿Soporta la comparación con los datos conocidos?

En su primer artículo de 1913, Bohr pudo dar al menos un «sí» parcial como respuesta. Hacía tiempo que se sabía que el átomo de hidrógeno normal «no excitado» tenía un radio de aproximadamente 5·10-11 m (es decir, el tamaño del átomo obtenido, por ejemplo, al interpretar las características medidas de los gases en términos de la teoría cinética) [2]. Este valor conocido de aproximadamente 5·10-11 m se corresponde mejor que bien con la predicción de la ecuación para el radio orbital r si n tiene el valor más bajo, es decir 1. El modelo proporcionaba un mecanismo para entender el tamaño del átomo de hidrógeno neutro y no excitado. Para cada átomo, el tamaño corresponde al tamaño de la órbita electrónica más interna permitida.

Nota:

[1] Esta constante, llamada radio de Bohr, comparte el honor con la constante de Boltzman o la constante de Avogadro, de haber sido descritas en realidad por otras personas (respectivamente, Haas, Planck y Cannizaro). Pero esto es otra historia…

[2] Este valor de 5·10-11 m para un átomo de hidrógeno no es más que la mitad del 10-10 m que proporcionaba la teoría cinética para la molécula de hidrógeno.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El tamaño del átomo de hidrógeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las regularidades en el espectro del hidrógeno

- La carga del núcleo y el sistema de periodos

- Un átomo con un centro masivo diminuto

¿Es contagiosa la enfermedad de Alzheimer?

![]()

Foto: Simon Wijers / Unsplash

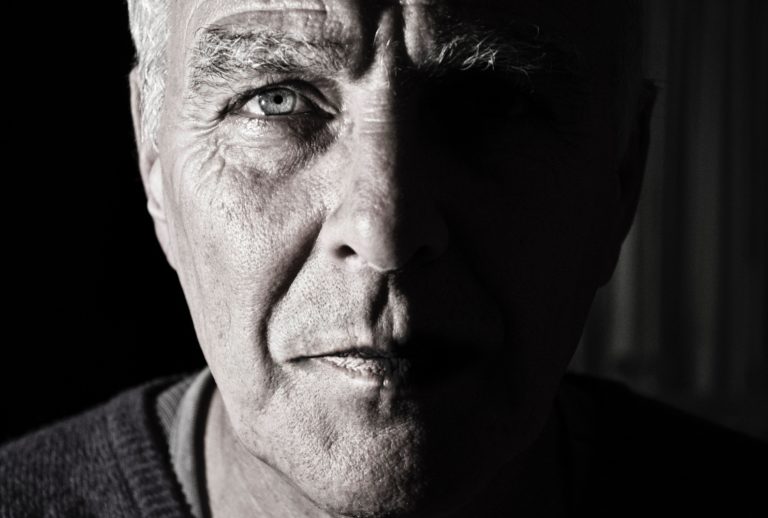

Foto: Simon Wijers / UnsplashEn la actualidad se conocen más de cincuenta demencias resultantes de enfermedades neurodegenerativas, y la enfermedad de Alzheimer es la más extendida. Se estima que cerca de 35 millones de personas la sufren en el mundo, y que el número de enfermos podría alcanzar los 115 millones de personas en los próximos 30 años.

Aunque en algunos casos —pocos— el alzhéimer puede deberse a un problema genético, el factor de riesgo principal es el envejecimiento. Así pues, es lógico que la prevalencia de estas enfermedades guarde relación con el aumento de la esperanza de vida.

No obstante, recientemente se han llevado a cabo trabajos que también apuntan a que, en determinadas condiciones, la enfermedad de Alzheimer podría transmitirse entre personas. Es cierto que su mecanismo recuerda el de las enfermedades producidas por priones, como la enfermedad de Creutzfeldt-Jakob, de la que se produjeron decenas de casos como consecuencia de la crisis de las vacas locas. A continuación ofrecemos algunas explicaciones.

La enfermedad de Alzheimer, un problema de proteínas

Desde un punto de vista sintomático, el alzhéimer se caracteriza por un deterioro drástico de las facultades psíquicas y físicas debido a la muerte de las neuronas cerebrales. Cuando se analizan los cerebros de los pacientes fallecidos, se observa la presencia de dos tipos de depósitos de proteínas.

Las proteínas son moléculas de gran tamaño constituidas por una secuencia de moléculas más pequeñas denominadas aminoácidos. Se trata de componentes esenciales de la vida: las células y los tejidos de los seres vivos contienen miles de proteínas, que cumplen funciones variadas y específicas (hormonas, enzimas, proteínas de estructura como el colágeno, la tubulina, que constituye el “esqueleto” de las células y les da su forma, etc.). En la enfermedad de Alzheimer, algunas de estas proteínas se vuelven anormales y se acumulan.

El primer tipo de depósitos proteicos encontrados en el cerebro de pacientes con esta demencia contiene una proteína denominada “Tau” (del inglés Tubulin-associated unit). En condiciones normales, una de sus funciones es estabilizar la estructura de las neuronas. En la enfermedad de Alzheimer, Tau se modifica y deja de cumplir su función. Las neuronas se degeneran, mientras que las proteínas anormales se agregan unas a otras y se acumulan en las células nerviosas.

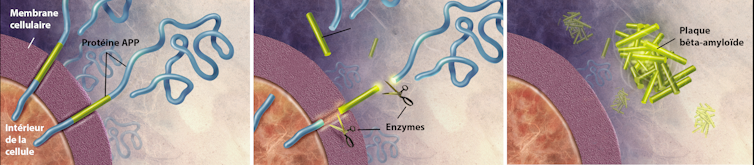

El péptido Aβ se produce a partir de un corte en la secuencia de aminoácidos de una gran proteína denominada APP o precursor proteico amiloide. Esta proteína se sitúa en la superficie de las neuronas e interviene sobre todo en su crecimiento, su supervivencia y su reparación.

En condiciones normales, los péptidos Aβ se eliminan, pero en la enfermedad de Alzheimer se acumulan en el exterior de las células nerviosas, en forma de placas amiloides, también denominadas placas seniles. Estos depósitos se encuentran, asimismo, alrededor de los capilares sanguíneos del cerebro y pueden ser causa de microhemorragias cerebrales denominadas angiopatías amiloides cerebrales.

Formación de las placas amiloides.

Formación de las placas amiloides.Wikimedia, CC BY

Proteínas capaces de contaminar otras

El aspecto más destacable de los mecanismos que dan lugar al alzhéimer es que la neurodegenerescencia no se deriva de una simple acumulación pasiva de proteínas.

En realidad, las proteínas implicadas cambian de forma, lo que modifica su acción a escala celular. Cabe señalar que la función de una proteína depende generalmente de su forma (que, a su vez, depende en gran medida de la secuencia de los aminoácidos que la compone). Este cambio de morfología es lo que confiere al péptido Aβ propiedades totalmente diferentes de las de su forma normal. Al ser capaz de autoagregarse, puede formar los depósitos de fibras amiloides que, probablemente, causan la muerte de las neuronas.

Pero aún hay más: los investigadores han demostrado que las formas tóxicas son capaces de obligar a sus álter ego normales a imitarlas y a adoptar a su vez una forma patógena. Este fenómeno, denominado “autorreplicativo”, explica cómo una célula enferma que produce la forma tóxica del péptido puede “contaminar” la célula vecina.

Este contagio de una célula a otra también explica por qué, durante la evolución de la enfermedad de Alzheimer, la propagación de las lesiones cerebrales se extiende de forma progresiva a todo el cerebro siguiendo un esquema bien determinado que se observa en todos los pacientes.

¿Qué es la enfermedad de Alzheimer?Mecanismos similares a los de los priones

Este proceso autorreplicativo es similar al que se observa en el caso de otra enfermedad neurodegenerativa, la enfermedad de Creutzfeldt-Jakob. Esta se debe a la propagación en el seno del cerebro de un agente patógeno muy particular: el prion.

Aunque no es una bacteria, ni un parásito, ni un virus, ni un hongo, el prion es, sin embargo, transmisible. El descubrimiento de estas “partículas proteicas infecciosas” (el acrónimo prion procede del inglés proteinacious infectious particule) ha sido objeto de un amplio debate y ha obligado a los investigadores a crear un nuevo concepto, el de “agentes transmisibles no convencionales”. Al contrario de lo que ocurre con los otros agentes patógenos, los priones están desprovistos de genoma (no tienen ADN ni ARN) y se componen exclusivamente de una única proteína.

Como sucede con las proteínas implicadas en la enfermedad de Alzheimer, las células producen de forma natural una versión “normal” del prion. Esta versión cumpliría numerosas funciones biológicas, pero todavía no se conocen bien sus diversas utilidades. También posee la propiedad de replegarse y agregarse para formar partículas infecciosas. En su forma infecciosa, los priones son capaces de infectar a un nuevo individuo tras la ingesta de determinados tejidos contaminados, o a través de la sangre, por ejemplo.

La gran resistencia de los priones a los procesos de destrucción clásicos ha dado lugar a varias crisis económico-sanitarias de gran alcance, como la crisis de las vacas locas en los años ochenta y noventa o el escándalo de la hormona del crecimiento contaminada.

¿Es contagiosa?

Los procesos de agregación del péptido Aβ y de la proteína Tau presentan semejanzas con el proceso observado en los priones. Así pues, ¿es posible que la enfermedad pueda transmitirse entre personas, según un mecanismo idéntico al del prion? Diversos grupos de científicos han intentado responder a esta pregunta.

De forma experimental, varios equipos de investigadores han podido inducir la proliferación de agregados de péptidos Aβ en animales de laboratorio. Por otra parte, más recientemente, se han llevado a cabo diferentes trabajos que apuntan a la existencia de casos de transmisión iatrogénica del péptido Aβ patógeno, lo que ha dado lugar a angiopatías amiloides cerebrales. Las hormonas de crecimiento producidas, en particular, antes de 1977 no solo habrían estado contaminadas por el prion, sino también por el péptido Aβ, y habrían podido intervenir en el desarrollo de la enfermedad de Alzheimer.

Paralelamente a la publicación de estos trabajos, se ha detallado de manera especial otra población llamada “de riesgo”, la de los pacientes que han recibido un trasplante de duramadre. Esta fina membrana fibrosa que protege el cerebro podía extraerse de cadáveres y utilizarse como “gasa” tras la realización de operaciones neuroquirúrgicas invasivas. Esta práctica se prohibió en Francia en 1994, pues los trasplantes de duramadre dieron lugar a casos de transmisión iatrogénica del prion humano.

Se llevaron a cabo tres estudios (suizo, japonés e internacional) que mostraron respectivamente que el 71,4%, el 81% y el 61,5% de los pacientes que recibieron este tipo de trasplante desarrollaron posteriormente angiopatías amiloides cerebrales. Aunque no es posible aportar la prueba formal de la contaminación por causa de los trasplantes, la localización de las lesiones y de los depósitos proteicos indica con claridad que el trasplante es la causa del cambio de forma y de la agregación de los péptidos Aβ del receptor.

Un estudio también ha señalado que los instrumentos quirúrgicos utilizados en neurocirugía tal vez podrían constituir a veces una fuente de contaminación, aunque el riesgo es probablemente muy bajo. No obstante, los autores de estos trabajos proponen que se mejoren los procedimientos de esterilización.

¿Es una enfermedad producida por priones?

Desde un punto de vista mecanístico, queda claro que la enfermedad de Alzheimer se parece a las enfermedades producidas por priones. Si nos atenemos a la definición estricta de la palabra prion —partícula proteica infecciosa—, la enfermedad de Alzheimer debería estar incluida, puesto que ha quedado demostrado el carácter transmisible de los ensamblajes proteicos tóxicos que la causan, al menos de forma experimental.

No obstante, de acuerdo con los resultados de investigación, el concepto de prion se ha ampliado: se ha revelado la existencia de diferentes cepas de priones así como su capacidad para “mutar” y adaptarse a su nuevo huésped. En este aspecto, las enfermedades producidas por priones se diferencian de la enfermedad de Alzheimer. Así pues, de acuerdo con el nivel de conocimientos actual, parece más justo calificar esta última como “enfermedad de tipo prion” o “de amiloides infecciosos”. O ampliar el término de agente transmisible no convencional a los ensamblajes proteicos causantes de la enfermedad de Alzheimer.![]()

Sobre la autora: Angélique Igel-Egalon es ingeniera de investigación del grupo de macroagregados proteicos y enfermedades priónicas del Inra

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Es contagiosa la enfermedad de Alzheimer? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Prevenir y tratar la enfermedad de Alzheimer: Una visión moderna

- El papel de la insulina en la enfermedad de Alzheimer

- El citoesqueleto de las neuronas y el alzhéimer

Sin intimidad genética

Fuente: Pixabay

Fuente: PixabayMadonna, la conocida cantante, contrata equipos para que limpien de manera concienzuda las habitaciones de hotel en que se ha alojado. Pretende evitar así que alguien consiga muestras biológicas de las que extraer material que pueda ser utilizado para secuenciar su genoma. Puede ser prudencia exagerada, pero no es ninguna extravagancia.

Al lado de la información genética que pueda extraerse de una muestra biológica mínima y, sobre todo, de la forma en que esa información sea transmitida al gran público, las imágenes que capturan hoy los paparazzi de las celebridades serían juegos de patio de colegio. ¿Se lo imaginan?

Angelina Jollie se sometió a sendas operaciones quirúrgicas para extirparse las mamas y los ovarios porque tenía, por causas genéticas, un 87 y un 50% de probabilidades de sufrir cáncer de mama y cáncer de ovario respectivamente. Hizo públicas esas decisiones porque quiso. Pero lo que teme Madonna es que otros, sin que ella pueda ejercer control alguno, puedan hacer pública alguna información de ese estilo relativa a su persona.

¿Se imaginan lo que harían ciertos medios o algunos políticos con información genética relativa a un adversario? Un candidato a ocupar un alto cargo podría ser presentado a la opinión pública como alguien predispuesto genéticamente a adoptar comportamientos de riesgo, por ejemplo. Incluso suponiendo que hubiera algo de verdad en esa supuesta propensión, ¿cómo lo presentaría un medio sensacionalista? ¿cómo se haría alusión a ello en las tertulias de radio o televisión? ¿cómo lo entendería el máximo responsable de su partido? ¿qué pensaráin los votantes de ese partido? Presumo que esas prácticas no serían legales, pero ¿supodría ello una diferencia importante en la práctica?

Análisis genéticos comerciales han servido ya en los Estados Unidos para localizar a la madre de un donante de semen. Cuando esa práctica se generalice, los donantes dejarán de ser anónimos, lo que introducirá cambios importantes en las reglas o podría, incluso, conducir a la desaparición de esa modalidad de donación.

Pero la pérdida del anonimato no se limita al ámbito de los donantes de semen. Solo en Estados Unidos hay del orden de 90 empresas que hacen análisis de ADN para rastrear los ancestros de quienes recurren a sus servicios. Pues bien, el acceso a un porcentaje muy pequeño de la población es suficiente para poder trazar la ascendencia de la gran mayoría. Eso, que resulta sorprendente, es consecuencia de la tupida red de relaciones familiares que tiene cada persona. En los Estados Unidos, por ejemplo, desde el 2% se puede acceder, a traves de primos terceros, a la información genética del 99% de la población.

En esa progresiva pérdida de intimidad, el rizo lo ha rizado Ancestry, una conocida compañía norteamericana de genealogía que comercializa tests genéticos. Tras aliarse con Spotify la conocida firma de música on-line, ofrece, además del correspondiente test de ADN, la lista de música inspirada, supuestamente, en los orígenes del cliente. Nada hay en el ADN de una persona que pueda servir a tal fin. Por mucho que el gusto genérico por la música pueda de alguna forma estar codificado en el genoma, no hay manera de saber qué música escuchaban nuestros ancestros, si es que escuchaban alguna, a partir de su análisis. Porque la particular forma que adquiere la expresión musical es un rasgo cultural y se transmite, por ello, mediante aprendizaje y contagio social.

Envoltorio musical aparte ¿a nadie se le ha ocurrido pensar el uso que una red social como Spotify podría hacer de la información genética de miles de usuarios? Recuerden lo que ha hecho Facebook con información igualmente sensible pero de otra naturaleza.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sin intimidad genética se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Poca influencia genética en el desempeño educativo

- Contra el furtivismo, genética molecular

- Genética en las aulas

Materiales inteligentes y multifuncionales para impulsar el desarrollo tecnológico

Los materiales inteligentes, también denominados activos o multifuncionales, son estructuras capaces de modificar sus propiedades como respuesta a estímulos físicos o químicos externos, como la presión, la temperatura o la humedad del entorno.

Por sus características, estos componentes ofrecen un elevado potencial de aplicación en sectores como el transporte, la energía o la biomedicina. Combinados con técnicas de fabricación avanzada como la fabricación aditiva o las nuevas tecnologías de impresión, estos materiales resultan particularmente relevantes en ámbitos como la Industria 4.0 o el denominado “Internet de las cosas”, con importantes implicaciones sociales, económicas y laborales, entre otras.

El físico Senentxu Lanceros-Mendez, actual director científico del BCMaterials (Basque Center for Materials, Applications and Nanostructures), analizó la relevancia de estos elementos en la conferencia titulada “Importancia de los materiales inteligentes y multifuncionales en el desarrollo tecnológico actual”, que se celebró el pasado 27 de febrero en la Biblioteca Bidebarrieta de Bilbao. El investigador Ikerbasque explica en ella no solo los aspectos más destacados de los nuevos materiales inteligentes, sino también las aplicaciones hasta hace poco inimaginables que estos permiten y sus implicaciones económicas y sociales.

Senentxu Lanceros-Mendez es licenciado en Física por la UPV/EHU y doctorado por la Universidad Julius-Maximilians-Universität Würzburg (Alemania). Su investigación está centrada en el desarrollo de nuevos materiales inteligentes y multifuncionales para su aplicación en sensores, actuadores, energía y biomedicina.

La charla se enmarca dentro del ciclo “Bidebarrieta Científica” una iniciativa que organiza todos los meses la Cátedra de Cultura Científica de la UPV/EHU y la Biblioteca Bidebarrieta para divulgar asuntos científicos de actualidad.

Edición realizada por César Tomé López

El artículo Materiales inteligentes y multifuncionales para impulsar el desarrollo tecnológico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un atlas para materiales 2D

- Ciencia, arte y cultura callejera: materiales y obra artística

- Un algoritmo genético para buscar materiales 2D

¿Son evitables los ataques con drones?

La respuesta corta a la pregunta del título es: ahora mismo, no.

Si algún lector quiere seguir leyendo, desarrollaré un poco más la explicación. Al hilo de los ataques sufridos en las instalaciones de Saudi Aramco, muchas personas se preguntan si el ataque se pudo evitar. O incluso, pensando en el futuro, si se podrá evitar cuando vuelva a pasar. La respuesta es que no será nada fácil. No hay un sistema de contramedidas 100 % fiable.

¿Se acuerdan los lectores de que el año pasado unos drones obligaron a cerrar el aeropuerto de Gatwick? Fíjense en el caos y en la dificultad para tratar estas emergencias, que incluso las autoridades llegaron a pensar que quizás esos drones nunca habían existido. Había tal confusión que, meses más tarde, la policía en uno de sus informes finales recogió más de 100 visiones de estos multirrotores.

Unos drones domésticos paralizaron el aeropuerto de Gatwick.

Unos drones domésticos paralizaron el aeropuerto de Gatwick.El caso de Gatwick es diferente del de Aramco, ya que no se emplearon los drones para el ataque. Estas máquinas se llevan usando para hacer daño al enemigo desde hace bastante tiempo. Ya en el siglo XIII a.C. la dinastia china Song usaba cometas para sobrevolar por encima de sus enemigos, a las que entonces prendía fuego. Ese episodio representa el primer vestigio de la guerra con drones.

Si viajamos a tiempos más recientes, en 2003 la OTAN lanzó un programa que duraría 10 años para el estudio de contramedidas contra esta tecnología. Este informe no ha sido abierto al público. En 2008, el think tank RAND Corporation publicó un informe sobre la amenaza que los robots voladores suponían para la seguridad de Estados Unidos. El ISIS usó con gran éxito estos aparatos en sus ataques. Una de las maniobras más sonadas fue la de enero de 2018, cuando este grupo terrorista coordinó una docena de estos ingenios contra dos instalaciones militares en Rusia.

Además, a los responsables de seguridad les pone los pelos como escarpias la aparente naturalidad con la que los vehículos aéreos no tripulados se acercan a objetivos muy sensibles. Como Pedro por su casa, que dirían. En 2013, por ejemplo, el Partido Pirata alemán voló un drone muy cerca de Angela Merkel, sin ningún peligro, pero dejando muchas dudas sobre la preparación de la seguridad ante estas eventualidades. Incluso en 2015, un hombre estrelló su juguete en los terrenos de la Casa Blanca.

Medidas de defensa

Conviene aclarar que las medidas antiaéreas tradicionales no sirven de nada contra estos aparatos. En 2016, un sencillo drone que sobrevoló el cielo de Israel procedente de Siria no sucumbió ante el ataque de dos misiles Patriot ni de un misil aire-aire lanzado desde un avión israelí. Las medidas antidrones son más sutiles.

Actualmente, los sistemas para combatir a los vehículos aéreos no tripulados los podemos clasificar en los siguientes tipos:

Detección

Los drones son tan pequeños que no son fáciles de detectar con un radar. Se emplean otras tecnologías como sensores de radiofrecuencia, acústicos y ópticos. Estas medidas tienen la desventaja de que necesitan tener línea directa de visión con la máquina voladora. Para solventarlo, existen sensores acústicos, que se valen de grandes librerías que intentan detectar el sonido característico de estos aparatos. Pero la incorporación al mercado de estos drones es muy rápida, y la librería no siempre es fácil de mantener actualizada. Todas estas imprecisiones llevan a que haya un gran número de falsos positivos, lo cual no es nada deseable.

Interceptación

Estas medidas consisten en interrumpir las comunicaciones del drone. Ya sea con el operador que lo maneje, con una estación o con un satélite. Esto tampoco es 100 % efectivo, ya que muchos están programados para navegar de manera autónoma.

Por otro lado, también se contempla la idea de lanzar redes para atascar los rotores del drone. Hay espectaculares vídeos comerciales sobre estas iniciativas de derribo de UAVs con unas armas bastante aparatosas que normalmente requieren un espacio aéreo totalmente despejado.

Vídeo promocional de SkyWall 100, una bazuca anti drones.En esta línea encontramos también el famoso caso de las águilas usadas por la policía holandesa, aunque esta idea se rechazó finalmente.

Algunos fabricantes de drones tienen la opción de configurar en qué área geográfica pueden operar sus productos, tal y como lo demostró la empresa DJI en el conflicto de Siria. Esta medida parece fácilmente salvable por unos terroristas.

Aunque el mayor problema de atacar un drone que transporta una bomba es: ¿qué hacer cuando caiga? Por lo tanto, vuelve a quedar claro que no existen medidas 100 % efectivas de interceptación.

Conclusión

El número y el mercado de contramedidas se ha multiplicado en los últimos años y la amenaza hace tiempo que está detectada. Muchas medidas que he presentado aquí no se pueden usar directamente en un aeropuerto, ya que podría interferir en la comunicación con los aviones, así que un caso como el de Gatwick podría repetirse.

Sin embargo, tanto pero no significa que evitar este tipo de ataques sea imposible. Aunque no sean tan mediáticos, ya existen casos de interceptación de drones, como en el aeropuerto de Londres hace unos pocos días. El interés de las fuerzas de seguridad y los ejércitos en este ámbito va en aumento.![]()

Sobre el autor: Julián Estévez Sanz es profesor ayudante de Robótica e Inteligencia Artificial en el Departamento de Ingeniería Mecánica de la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Son evitables los ataques con drones? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Adulterar los cigarrillos electrónicos te puede matar

Foto de Austin Lawrence

Foto de Austin Lawrence

-

805 afectados y 12 muertos

El New York Times alertaba a principios de septiembre de una nueva muerte consecuencia del vapeo en el estado de Oregón. Es la segunda muerte registrada después de la acontecida en Illinois hace casi dos meses.

Cuando el número de afectados ingresados llegó a 53, el Departamento de Salud Pública de Illinois elaboró un informe acerca de las similitudes de estos pacientes. Todos ellos presentaban infiltraciones pulmonares, es decir, tenían sustancias adheridas a los pulmones que dificultaban su normal funcionamiento, provocando inflamación e impidiendo la respiración. Fueron tratados con esteroides para frenar la inflamación, coma inducido, lavado broncoalveolar, antibióticos para tratar las neumonías y con respiración asistida. Los expertos se enfrentan a un nuevo síndrome cuyas causas, aseguran en el informe, requieren un estudio urgente.

Según los CDC (Centros para el Control y la Prevención de Enfermedades de Estados Unidos) los casos de enfermedad pulmonar asociados al mal uso de cigarrillos electrónicos aumentaron un 52% en la última semana. Hay 805 afectados y 12 muertos. En su mayoría adolescentes. En todos los casos parece que los consumidores manipularon los vapeadores para fumar otro tipo de sustancias, diferentes a las que contienen los cigarrillos electrónicos convencionales, y utilizaron cartuchos del mercado negro. La inhalación de sustancias tóxicas es el origen del misterioso síndrome pulmonar.

-

La “epidemia” no es por vapear. Hay algo más.

Lo más importante de este suceso es que los afectados no fumaban con vapeadores normales, sino que los manipularon y usaron cargas irregulares.

Mas del 90% de los afectados reconoció haber utilizado vapeadores cargados con aceites que contenían cannabinoides, como el THC (tetrahidrocannabinol) y el CBD (cannabidiol). Es decir, alteraron las cargas originales de estos dispositivos.

Se están estudiando otros posibles contaminantes como hidrocarburos aromáticos policíclicos, compuestos liposolubles como la vitamina E, nitrosaminas, productos químicos orgánicos volátiles como el formaldehído y productos químicos inorgánicos como metales. También se han detectado endotoxinas y compuestos aromatizantes como el diacetilo y la 2,3-pentanodiona.

En busca de respuestas, NBC News encargó a CannaSafe, un laboratorio experto en análisis de cartuchos de vapeadores, el análisis de 18 cartuchos, 3 comprados en dispensadores legales de California y 15 del mercado ilegal. De los tres comprados en dispensarios legales, la compañía de pruebas CannaSafe no encontró metales pesados, pesticidas o disolventes residuales como la vitamina E. Pero 13 de las otras 15 muestras de cartuchos de THC del mercado negro sí contenían vitamina E.

La vitamina E es una sustancia liposoluble, es decir, en los pulmones puede comportarse como un aceite que se va adhiriendo al árbol respiratorio. El organismo se defiende intentando eliminar ese cuerpo extraño y para ello utiliza las células expertas en ello: los eosinófilos. El resultado de esto puede derivar en neumonía eosinófila aguda.

CannaSafe también probó pesticidas en 10 de los cartuchos no regulados. Los 10 dieron positivo. Todos los productos contenían el fungicida myclobutanil, una sustancia que puede transformarse en cianuro de hidrógeno cuando se quema. El cianuro es tóxico por inhalación, ya que inhibe la respiración celular. Es mortal a partir de 300 ppm de concentración.

Los jóvenes afectados por esta “epidemia” no habían utilizado cápsulas comerciales, sino que las habían adulterado para poder fumar otras drogas o ahorrar dinero.

La razón por la que llevamos meses preguntándonos si el origen de este misterioso síndrome pulmonar está en los cigarrillos electrónicos, es que muchos de los jóvenes afectados ocultaron la información. Los médicos no sabían qué estaban fumando. Esto obstaculiza el tratamiento y el diagnóstico.

-

Composición de los cigarrillos electrónicos convencionales

Los principales componentes de los cigarrillos electrónicos convencionales a base de nicotina incluyen propilenglicol y glicerina, además de la nicotina. También algún aromatizante. En ningún caso contienen aceites.

A excepción de la nicotina, inhalar estas sustancias no supone ningún peligro. Sin embargo, aunque en estos dispositivos no se producen reacciones de combustión, tal y como ocurre con el tabaco convencional, sí se produce calentamiento. El calentamiento sí puede dar lugar a la formación de otras sustancias que están en el punto de mira. Se sigue estudiando la formación de sustancias peligrosas como el formaldehído y las acroleínas como subproducto de reacción en algunos de estos dispositivos. Sea como fuere, los niveles de estas sustancias potencialmente tóxicas que se pueden formar en los cigarrillos electrónicos estarán muy por debajo de las que se forman en el tabaco. Desde el punto de vista exclusivamente bioquímico, atendiendo a las sustancias presentes en el humo y su impacto en la salud, los cigarrillos electrónicos no son totalmente inocuos, pero sí son más seguros que fumar tabaco convencional.

-

Pros de los cigarrillos electrónicos

Durante la combustión del tabaco convencional se producen sustancias relacionadas con el cáncer, como bencenos, alquitrán y amoniaco. Sustancias que no se producen en los vapeadores.

Un estudio de Sigma Dos asegura que el 96,3% de los españoles recurren al cigarrillo electrónico como sustituto del tabaco. De ellos, el 69,8% ha logrado cambiar el humo por el vapor; reemplazar por completo el tabaco por los nuevos dispositivos electrónicos de liberación controlada de nicotina consiguiendo así no volver a fumar tabaco convencional.

Sin embargo, los estudios realizados hasta la fecha no son muy prometedores con respecto al abandono del tabaquismo. Aunque fumar es significativamente más insalubre que vapear, no hay evidencias sobre que el vapeo sea una estrategia útil para dejar de fumar. Al menos no parece ofrecer una tasa de éxito mayor que otras estrategias.

No obstante, en 2015 el Gobierno del Reino Unido decidió autorizar a los médicos de su sistema público de salud a prescribir los vaporizadores como tratamiento alternativo para dejar de fumar, igual que ocurre en España con las terapias de reemplazo de nicotina, como los parches o chicles de nicotina. Una decisión avalada por un informe del Real Colegio de Médicos británicos que asegura que el uso de vaporizadores es «un 95% menos dañino» que el tabaco.

Aunque los autores del trabajo en el que se citaba este dato fueron acusados de conflicto de interés, la evidencia científica nos dice que los cigarrillos electrónicos ofrecen niveles mucho más bajos de carcinógenos que los cigarrillos convencionales. No son inocuos, pero sí suponen una mejora significativa.

Con respecto a la salud cardiovascular, el cigarrillo electrónico no parece ofrecer ventajas frente al tabaco convencional. El riesgo de infarto de miocardio e ictus es prácticamente el mismo.

-

Contras de los cigarrillos electrónicos

Aunque la evidencia científica es escasa, con respecto a enfermedades pulmonares, todo apunta a que el cigarrillo electrónico podría aumentar el riesgo de bronquitis y asma. Pero este no es el contra más importante.

Austin Lawrence retratado por Matt Martin para GQ

Austin Lawrence retratado por Matt Martin para GQEste tipo de dispositivos se han introducido en el mercado como sustitutos del tabaco, como una transición plácida hasta dejar definitivamente de fumar. Aparentemente es un win-win. Los consumidores van dejando de fumar y esto sigue reportando beneficios a la industria del tabaco. British American Tobacco (BAT), Philip Morris, Japan Tobacco International (JTI) y Altadis, las cuatro grandes del sector, comercializan distintas modalidades de cigarrillos electrónicos.

Pero a su vez, estos dispositivos que se presentaban como una alternativa para dejar de fumar, se han colado en el mercado como un caballo de Troya capaz de persuadir a nuevos clientes. Vapear se ha convertido en una moda que arrasa en las redes sociales. Uno de los más famosos es Austin Lawrence, que cuenta con más de 3 millones de seguidores en Intagram y en Youtube.

Los adolescentes son atraídos mediante técnicas de marketing que van desde el «esto que fumas no hace daño» hasta el «te ofrezco sabores como el de pepino«, claramente dirigidas a los más jóvenes. Las campañas publicitarias son del tipo “glamur y libertad”. Nos recuerdan a las que en su día se hacían con el tabaco convencional. Quienes comienzan a fumar utilizando cigarrillos electrónicos con nicotina no deberían olvidarse de que la nicotina es una sustancia adictiva, y la adicción es contraria a la libertad.

-

Los jóvenes fuman menos y empiezan más tarde, pero vapean más

En la encuesta Estudes sobre consumo de drogas entre estudiantes se muestra que el 20,1% de los alumnos ha utilizado cigarrillos electrónicos alguna vez en su vida, observándose una mayor extensión entre los chicos. Entre los que admiten haber vapeado en alguna ocasión, el 52,6% utilizó cartuchos sin nicotina, el 22,4% con nicotina y el 24,9% admitieron haber utilizado ambos tipos. La proporción de usuarios de cigarrillos electrónicos es considerablemente más alta ente los que fuman tabaco a diario que entre los que no lo hacen.

El 34,7% (31,4 en 2014) de los alumnos ha fumado tabaco en el último año. El consumo diario se sitúa en el 8,8% (8,9% en 2014), cifra mínima de la serie histórica de Estudes. En 2004, el 21,5% de este sector de la población fumaba a diario. Por término medio, el primer consumo de tabaco se produce a los 14,1 años; por primera vez a lo largo de toda la serie histórica de Estudes se supera la frontera de los 14 años. La adquisición del hábito de fumar diariamente, igual que ocurría en 2014, comienza a los 14,6 años de media, apenas medio año después de haberlo probado por primera vez. Parece que la irrupción del cigarrillo electrónico no ha aumentado el número de fumadores adolescentes ni la edad a la que empiezan a fumar. Parece que un hábito ha reemplazado en parte al otro.

Meme creado por Adam Padilla

Meme creado por Adam Padilla

Aunque el juguete mi primer vapeador no existe, fue un meme creado por Adam Padilla, sí se comercializaron cigarrillos de chocolate, que vienen a ser lo mismo. Los cigarrillos de chocolate fueron creados por Milton Snavely Hershey en 1906 y se popularizaron en España en la década de los 80, cuando un tercio de la población era fumadora. En 2005 fueron retirados del mercado español debido a la aprobación de la Ley Antitabaco, que especifica: «En particular, se prohíbe la venta de dulces, refrigerios, juguetes y otros objetos que tengan forma de productos del tabaco y puedan resultar atractivos para los menores».