Sobre la superficie de Dios

Gestes et opinions du docteur Faustroll, pataphysicien. Roman Néo-Scientifique –Gestas y opiniones del doctor Faustroll, patafísico: novela neo-científica– es una obra del dramaturgo y novelista Alfred Jarry (1873-1907).

El libro describe las aventuras del patafísicoi Doctor Faustroll, de su babuino hidrocéfalo Bosse-de-Nage y del oficial de justicia René-Isidore Panmuphle, que aparece en la historia para embargar los bienes de Faustroll.

Esta novela es ‘la biblia’ del Colegio de Patafísicaii, que le ha dedicado diferentes exégesis. El texto está plagado de referencias filosóficas, e incluso matemáticas, en muchas ocasiones usando un lenguaje incoherente.

El Doctor Faustroll es un científico verdaderamente singular. Nacido en Circasia a la edad de 63 años –y fallecido ese mismo año– es pionero de la patafísica y curador perpetuo del Colegio de Patafísica desde 1947.

La historia comienza con el desalojo del Doctor Faustrollde su residencia. Junto a Bosse-de-Nage y René-Isidore Panmuphle, el científico realiza un ‘viaje de París a París por mar’, viaje que le conduce a la muerte. Proyectado dentro de la ‘Ethernidad’, Faustroll transmite –a través de una carta telepática– a Lord Kelvin diferentes reglas sobre el tiempo, el Sol, el espacio, etc. También traduce al matemático y astrónomo Hipócrates de Quíos –al que Jarry atribuye el origen de la patafísica– y, para finalizar, calcula la superficie de Dios, concluyendo el libro con la contundente sentencia ‘La Patafísica es la ciencia’.

El libro está dividido en cuarenta y un capítulos distribuidos en ocho ‘libros’:

-

Procédure (Introducción)

-

Éléments de pataphysique (Elementos de patafísica)

-

De Paris à Paris par mer, ou le Robinson belge (De París a París por mar, o el Robinson belga)

-

Céphalorgie (Cefalorgia)

-

Officiellement (Oficialmente)

-

Chez Lucullus (En casa de Lúculo)

-

Khurmookum

-

Éthernité (Ethernidad)

Se reproduce debajo el último capítulo –traducido por la autora de esta anotación– en el que se calcula la ‘superficie de Dios’.

XLI

SOBRE LA SUPERFICIE DE DIOS

Por definición, Dios no posee extensión pero nos permitimos, por la claridad de nuestro enunciado, suponerle un número cualquiera, mayor que cero, de dimensiones, aunque no tenga ninguna si estas dimensiones desaparecen en los dos miembros de nuestras identidades. Nos conformaremos con dos dimensiones, para poder representar fácilmente figuras de geometría plana sobre una hoja de papel.

Simbólicamente se representa a Dios por un triángulo, pero las tres Personas no deben considerarse como los vértices o las aristas. Son las tres alturas de otro triángulo equilátero circunscrito en el tradicional. Esta hipótesis concuerda con las revelaciones de Anne-Catherine Emmerick, quien vio la cruz (que consideramos como símbolo del Verbo de Dios) en forma de Y, y sólo lo explica por esta razón física: ningún brazo de longitud humana podría extenderse hasta los clavos de las ramas de una tau.

Por lo tanto, POSTULADO:

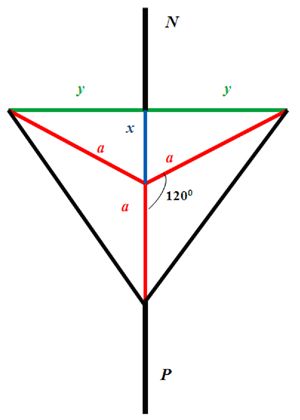

Hasta tener más información y por nuestra comodidad provisional, suponemos a Dios en un plano y bajo la figura simbólica de tres rectas iguales, de longitud a, pasando por un mismo punto y formando entre ellas ángulos de 120 grados. Es del espacio comprendido entre ellas, o del triángulo obtenido uniendo los tres puntos más alejados de estas rectas, del que nos proponemos calcular el área.

Sea x la mediana prolongación de una de las Personas a, 2y el lado del triángulo al que es perpendicular, N y P las prolongaciones de la recta (a+x) en los dos sentidos hacia el infinito.

Esta figura –realizada por la autora de la anotación– no aparece en el libro de Jarry: se inserta solo para aclarar las notaciones.

Esta figura –realizada por la autora de la anotación– no aparece en el libro de Jarry: se inserta solo para aclarar las notaciones.Tenemos:

x=∞−N−a−P.

Ahora bien

N=∞−0.

y

P=0.

De donde

x=∞−(∞−0)−a−0=∞−∞+0−a−0

x=−a.

Por otro lado, el triángulo rectángulo cuyos lados son a, x e y nos da:

a²=x²+y².

Así, sustituyendo x por su valor (−a)

a²=(−a²)+y²=a²+y².

De donde

y²=a²−a²=0

e

y=√0.

Así la superficie del triángulo equilátero que tiene por bisectrices de sus ángulos las tres rectas a será:

S=y(x+a)=√0(−a+a)

S=0√0.

COROLARIO.- A primera vista del radical √0, podemos afirmar que el área calculada es a lo más una línea; en segundo lugar, si construimos la figura según los valores obtenidos para x e y, observamos:

Que la recta 2y, que ahora sabemos que va a ser 2√0, tiene su punto de intersección sobre una de las rectas aen sentido inverso de nuestra primera hipótesis, ya que x=−a; y que la base de nuestro triángulo coincide con su vértice;

Que las dos rectas a forman con la primera ángulos menores al menos de 60°, y más aún no pueden encontrar 2√0 más que coincidiendo con la primera recta a.

Esto concuerda con el dogma de equivalencia de las tres Personas entre ellas y a su suma.

Podemos decir que a es una recta que une 0 con ∞, y definir Dios:

DEFINICIÓN.- Dios es el camino más corto entre cero e infinito.

¿En qué sentido?, nos preguntaremos.

– Responderemos que Su nombre no es Julio, sino Más-y-Menos. Y debe decirse:

± Dios es el camino más corto de 0 a ∞, en un sentido o en el otro.

Esto concuerda con la creencia en los dos principios; pero es más exacto atribuir el signo + al de la creencia del sujeto.

Pero como Dios no posee extensión, no es una línea.

– Observemos en efecto que, según la identidad

∞−0−a+a+0=∞

la longitud a es nula, a no es una línea, sino un punto.

Así, definitivamente:

DIOS ES EL PUNTO TANGENTE DE CERO Y DEL INFINITO.

La Patafísica es la ciencia…

Alfred Jarry en bicicleta. Imagen: Wikimedia Commons.

Alfred Jarry en bicicleta. Imagen: Wikimedia Commons.

Parece que este singular cálculo se inspira en el último capítulo del último libro de Pantagruel de François Rabelais. Allí se afirma que: ‘Esa esfera intelectual, cuyo centro está en todas partes y la circunferencia en ninguna, que llamamos Dios’.

Nota:

Por si alguien se encuentra un tanto confundido, los cálculos realizados no se basan en las matemáticas, sino en la patafísica… ‘la ciencia’…

Más información:

-

La obra completa en el repositorio Gallica

i La patafísica –contracción de epí ta metá ta physiká, es decir, «lo que está alrededor de lo que está más allá de la física»– es un movimiento cultural francés de la segunda mitad del siglo XX vinculado al surrealismo. Toma su nombre de las Gestas y opiniones del doctor Faustroll, patafísico, de Alfred Jarry. Basándose en esta novela, algunas personas comenzaron a practicar la ciencia paródica denominada patafísica que se dedicaba «al estudio de las soluciones imaginarias y las leyes que regulan las excepciones».

ii El Colegio de Patafísica fue fundado en París en 1948 como contraposición caricaturesca a Academias de Arte y Ciencias como el Collège de France y en honor al doctor Faustroll.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Sobre la superficie de Dios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Blaise Pascal, Dios y la cicloide

- La característica de Euler de una superficie: un invariante topológico

- Coloquios escépticos: ¿hijos de dios?, con Francisco Mora

El modelo de Bohr-Sommerfeld y las propiedades químicas de los elementos

Foto: Joel Filipe / Unsplash

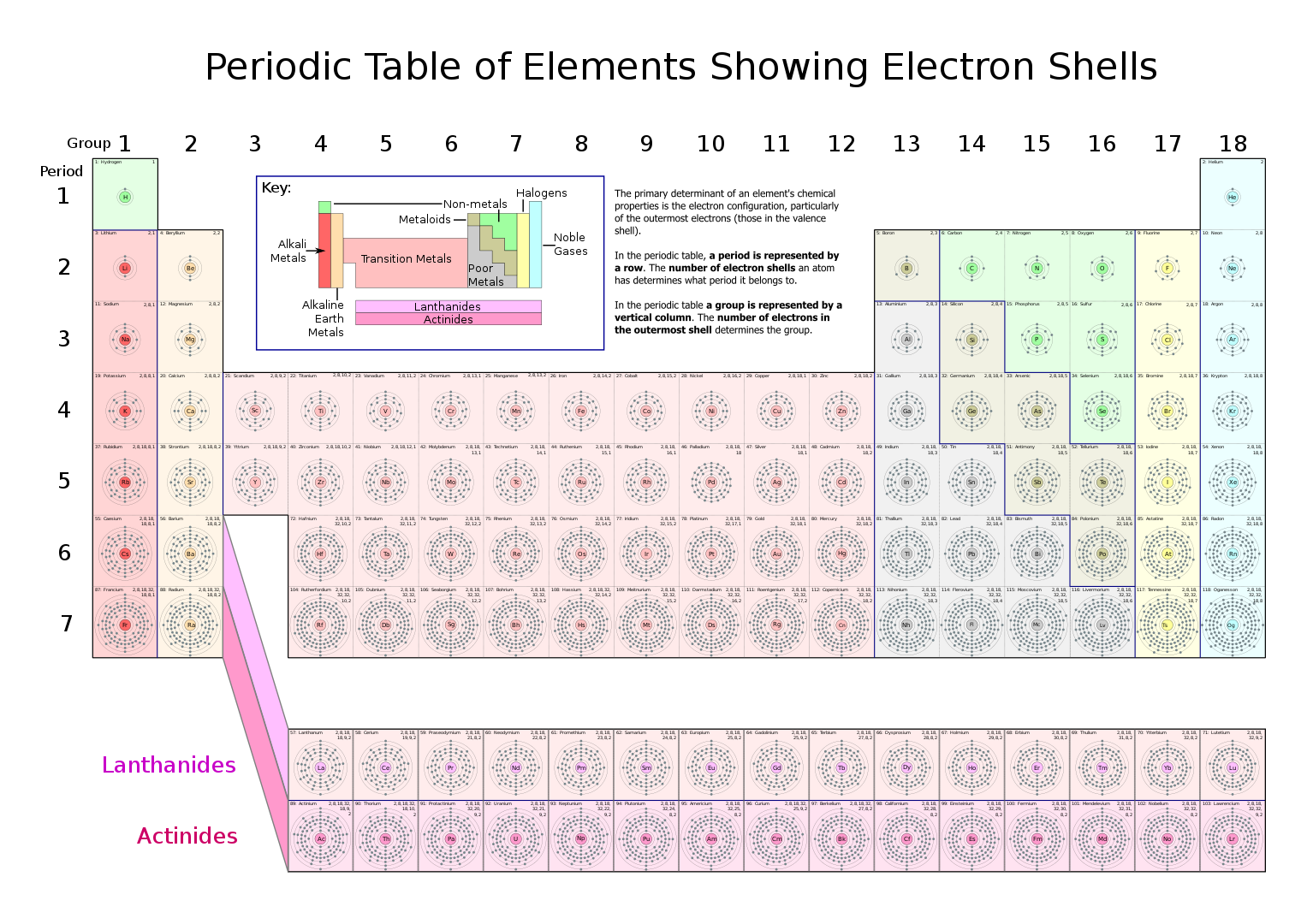

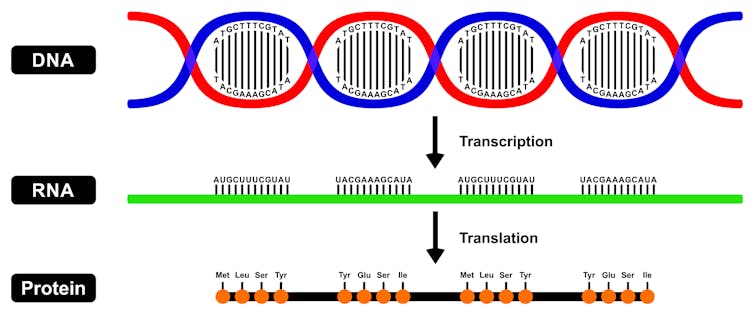

Foto: Joel Filipe / UnsplashEn el modelo de Bohr (1913) los átomos de los diferentes elementos difieren en la carga y la masa de sus núcleos y en el número y disposición de los electrones. En 1916 Arnold Sommerfeld generalizó el modelo modificando las órbitas electrónicas [1]: ahora ya no eran solo circulares, también podían ser elípticas; y ya no eran como una serie de anillos concéntricos en un plano, sino figuras geométricas en tres dimensiones. ¿Cómo explica este modelo de Bohr-Sommerfeld las propiedades químicas de los elementos?

Los elementos hidrógeno (número atómico Z = 1) y litio (Z = 3) son algo similares químicamente. Ambos tienen valencia 1. Ambos entran en compuestos de estructura similar, por ejemplo, cloruro de hidrógeno (HCl) y cloruro de litio (LiCl). También hay algunas similitudes en sus espectros. Todo esto sugiere que el átomo de litio se parece al átomo de hidrógeno en algunos aspectos importantes. Bohr especuló que dos de los tres electrones del átomo de litio están relativamente cerca del núcleo, en órbitas que se asemejan a las del átomo de helio (Z = 2), formando lo que se puede describir como una «capa» alrededor del núcleo. Pero el tercer electrón está en una órbita circular o elíptica fuera del sistema interno. Dado que este sistema interno consiste en un núcleo de carga +3e y dos electrones, cada uno de los cuales tiene carga –e, su carga neta es +e. Por lo tanto, el átomo de litio puede representarse aproximadamente con un núcleo central de carga +e. Alrededor de este núcleo gira un electrón, algo así como si fuera un átomo de hidrógeno. Esta estructura física similar sería entonces la razón del comportamiento químico similar de hidrógeno y litio.

Tabla periódica de Werner-Paneth en la que aparece infográficamente la estructura de capas. Una infografía es una representación inteligible de la información, no la realidad. Fuente: Wikimedia Commons

Tabla periódica de Werner-Paneth en la que aparece infográficamente la estructura de capas. Una infografía es una representación inteligible de la información, no la realidad. Fuente: Wikimedia CommonsEl helio (Z = 2) es un gas noble, químicamente inerte [2]. Estas propiedades indican que el átomo de helio debe ser altamente estable y que tiene sus dos electrones estrechamente unidos al núcleo [3]. Parece sensato, entonces, considerar que ambos electrones se mueven en la misma «capa» más interna cuando el átomo no está excitado. Además, debido a que el átomo de helio es tan estable y químicamente inerte, podemos suponer razonablemente que esta capa no puede contener más de dos electrones. Esta capa se llama K [4]. El único electrón del hidrógeno también está en la capa K cuando el átomo no está excitado. El litio tiene dos electrones en la capa K, llenándola completamente; el tercer electrón inicia una nueva capa, llamada L [4]. Este único electrón externo y débilmente ligado es la razón por la cual el litio se combina tan fácilmente con el oxígeno, el cloro y muchos otros elementos.

El sodio (Z = 11) es el siguiente elemento en la tabla periódica que tiene propiedades químicas similares a las del hidrógeno y el litio. Esta similitud sugiere que el átomo de sodio también es similar al hidrógeno al tener un núcleo central sobre el que gira un electrón. Además, así como el litio sigue al helio en la tabla periódica, el sodio sigue al gas noble neón (Z = 10). Podemos suponer que dos de los diez electrones del neón están en la primera capa (K), mientras que los ocho electrones restantes están en la segunda capa (L). Debido a que es químicamente inerte [2] y la estabilidad del neón, podemos suponer además que estos ocho electrones llenan la capa L hasta su capacidad. Para el sodio, entonces, el undécimo electrón debe estar en una tercera capa, llamada la capa M [4].

Si pasamos al potasio (Z = 19), el siguiente elemento del mismo grupo de la tabla periódica, podemos volver a imaginar un núcleo interno y un solo electrón fuera de él. El núcleo consta de un núcleo con carga +19e. Hay dos, ocho y ocho electrones que ocupan las capas K, L y M, respectivamente. El decimonoveno electrón gira alrededor del núcleo en una cuarta capa, llamada N. El átomo del gas noble argón, con Z = 18, aparece justo antes del potasio en la tabla periódica. El argón nuevamente tiene una estructura de electrones firme y estable, con dos en la capa K, ocho en la capa L y ocho en la capa M.

Parece que tenemos un patrón y que la cosa funciona. ¿Podremos construir todo el sistema de periodos usando solo el modelo de Bohr-Sommerfeld?

Notas:

[1] También introdujo velocidades relativistas para el electrón y determinó que las capas posteriores a la primera pueden tener subcapas, lo que introduciría un nuevo número cuántico. Pero esto ya lo contaremos en otra parte.

[2] A todos los efectos prácticos que nos interesan aquí.

[3] Ya que la química depende del intercambio de electrones. Si el átomo no reacciona químicamente es porque no intercambia sus electrones y esto se debe a que el núcleo los agarra con fuerza. Esto es una sobresimplificación, pero, por ahora, nos sirve.

[4] Los nombres de las capas vienen de la espectroscopía. No les busques lógica porque no la tienen más allá del orden alfabético. Tienen historia, pero es irrelevante ahora.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El modelo de Bohr-Sommerfeld y las propiedades químicas de los elementos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El modelo de Bohr explica las regularidades en el espectro del hidrógeno

- El modelo de Bohr explica la fórmula de Balmer

- El tamaño del átomo de hidrógeno

La evolución nos dice que es probable que seamos la única vida inteligente del universo

NASA

NASA¿Estamos solos en el universo? La pregunta que se plantea es si la inteligencia es un resultado probable de la selección natural o un improbable golpe de suerte. Por definición, los acontecimientos probables se producen con frecuencia, mientras que los sucesos improbables tienen lugar pocas veces o una sola vez. La historia de nuestra evolución muestra que muchas adaptaciones de carácter crucial –no solo la inteligencia, sino también los animales y las células complejas, la fotosíntesis y la propia vida– fueron sucesos únicos y excepcionales y, por tanto, muy improbables. Nuestra evolución tal vez haya sido como ganar la lotería… solo que con una probabilidad mucho menor.

El universo es inmensamente grande. La Vía Láctea tiene más de 100 000 millones de estrellas, y en el universo observable, es decir, en la diminuta fracción de universo que podemos ver, hay más de un billón de galaxias. Aunque los mundos habitables son escasos, el número por sí solo —existen tantos planetas como estrellas, puede que más— invita a pensar que hay mucha vida ahí fuera. Si es así, ¿dónde se ha metido? Esta es la paradoja de Fermi. El universo es inmenso y viejo, y dispone de tiempo y espacio suficiente para que la inteligencia evolucione; sin embargo, no hay pruebas de que tal cosa ocurra.

¿Cabría pensar, sencillamente, que a lo mejor es poco probable que la inteligencia evolucione? Por desgracia, no podemos estudiar la vida extraterrestre para responder a esta pregunta. Pero sí podemos estudiar los casi 4 500 millones de años de historia que tiene la Tierra y observar cuándo se repite –o no– la propia evolución.

A veces la evolución se repite, de tal forma que pueden observarse especies diferentes que evolucionan de manera convergente hacia resultados similares. Si la propia evolución se repite con frecuencia, nuestra evolución podría ser un acontecimiento probable, incluso inevitable.

El tilacino, parecido al lobo.

El tilacino, parecido al lobo.Wikipedia

De hecho, existen ejemplos notables de convergencias evolutivas. El tilacino de Australia, también conocido como lobo marsupial o tigre de Tasmania, hoy extinguido, tenía una bolsa semejante a la de los canguros, pero, por lo demás, parecía un lobo, a pesar de que evolucionó a partir de un linaje de mamíferos diferente. También hay topos marsupiales, marsupiales hormigueros y ardillas planeadoras marsupiales. Es sorprendente comprobar cómo toda la historia evolutiva de Australia, con la diversificación que experimentaron sus mamíferos tras la extinción de los dinosaurios, es paralela a la de otros continentes.

Otros casos llamativos de convergencia son el delfín y el extinto ictiosaurio, que evolucionaron de forma similar para deslizarse por el agua, así como las aves, los murciélagos y los pterosaurios, que evolucionaron de manera convergente para volar.

Ojo de calamar.

Ojo de calamar.PLoS Biology

También se observan convergencias en órganos independientes. Los ojos evolucionaron no solo en los vertebrados, sino también en los artrópodos, los pulpos, los gusanos y las medusas. Los vertebrados, los artrópodos, los pulpos y los gusanos, cada uno por su cuenta, desarrollaron mandíbulas. Por su parte, las patas evolucionaron de forma convergente en los artrópodos, los pulpos y cuatro tipos de peces (tetrápodos, peces sapo, rájidos, peces del fango).

Aquí está la trampa. Toda esta convergencia tuvo lugar dentro de un mismo linaje, los eumetazoos, que son animales complejos dotados de simetría, boca, tubo digestivo, músculos y un sistema nervioso. Hubo eumetazoos diferentes que desarrollaron soluciones similares a problemas similares, pero la compleja estructura corporal que lo hizo posible es única. Los animales complejos evolucionaron una sola vez en la historia de la vida, lo que da a entender que son improbables.

Sorprende constatar que muchos acontecimientos fundamentales de la historia de nuestra evolución son únicos y, seguramente, improbables. Uno es el esqueleto óseo de los vertebrados, que permitió que los animales grandes se desplazaran hacia la tierra. Las complejas células eucariotas de las que están compuestos todos los animales y plantas, y que contienen núcleos y mitocondrias, evolucionaron una sola vez. El sexo evolucionó una única vez. La fotosíntesis, que aumentaba la energía disponible para la vida y producía oxígeno, es un acontecimiento único. A este respecto, también lo es la inteligencia humana. Existen lobos y topos marsupiales, pero no hay humanos marsupiales.

El esqueleto de los vertebrados es único.

El esqueleto de los vertebrados es único.Smithsonian Institution

Hay lugares donde la evolución se repite y otros donde no. Si solo nos fijamos en la convergencia, se crea un sesgo de confirmación. La convergencia parece ser la norma y nuestra evolución se presenta como algo probable. Sin embargo, cuando se presta atención a la no convergencia, se observa que está en todas partes, y las adaptaciones decisivas y complejas parecen ser las que menos se repiten, por lo que adquieren carácter improbable.

Además, estos acontecimientos dependían unos de otros. Los seres humanos no pudieron evolucionar hasta que los peces desarrollaron huesos que les permitieron arrastrarse hasta la tierra. Los huesos no pudieron evolucionar hasta que aparecieron los animales complejos. Los animales complejos necesitaban células complejas, y las células complejas necesitaban oxígeno, producido por la fotosíntesis. Nada de esto sucede sin la evolución de la vida, un acontecimiento singular entre acontecimientos singulares. Todos los organismos provienen de un solo antepasado; por lo que sabemos, la vida ocurrió una sola vez.

Es curioso observar que todo este proceso requiere un tiempo sorprendentemente largo. La fotosíntesis evolucionó 1 500 millones de años después de la formación de la Tierra; las células complejas, tras 2 700 millones de años; los animales complejos, al cabo de 4 000 millones de años; y la inteligencia humana, 4 500 millones de años después de que se formara la Tierra. El hecho de que estas innovaciones sean tan útiles pero tardaran tanto en evolucionar implica que son increíblemente improbables.

Una sucesión improbable de acontecimientos

Es posible que estas innovaciones puntuales, casualidades de importancia crucial, crearan una cadena de obstáculos o filtros evolutivos. De ser así, nuestra evolución no fue como ganar la lotería; fue como ganar la lotería una vez y otra y otra y otra. En otros mundos, es posible que estas adaptaciones decisivas hubieran evolucionado demasiado tarde para que la inteligencia apareciera antes de que sus soles se convirtieran en novas, o que no hubieran evolucionado en absoluto.

Supongamos que la inteligencia depende de una cadena de siete innovaciones improbables –el origen de la vida, la fotosíntesis, las células complejas, el sexo, los animales complejos, los esqueletos y la propia inteligencia–, y que cada una tiene un 10 % de posibilidades de evolucionar. Las probabilidades de que la inteligencia evolucione pasan a ser 1 entre 10 millones.

La fotosíntesis, otra adaptación única.

La fotosíntesis, otra adaptación única.Nick Longrich

Pero las adaptaciones complejas podrían ser incluso menos probables. La fotosíntesis necesitó una serie de adaptaciones en cuanto a proteínas, pigmentos y membranas. Los animales eumetazoos requirieron de múltiples innovaciones anatómicas (nervios, músculos, boca). Por tanto, es posible que cada una de estas siete innovaciones cruciales evolucione solo el 1 % de las veces. En tal caso, la inteligencia evolucionará solamente en 1 de cada 100 billones de mundos habitables. Teniendo en cuenta que los mundos habitables son escasos, podríamos ser la única vida inteligente de la galaxia, o incluso del universo observable.

Así y todo, estamos aquí, y este hecho tiene que valer para algo, ¿no? Si la evolución tiene suerte 1 de cada 100 billones de veces, ¿cuáles son las probabilidades de que nos hallemos en un planeta donde la evolución tuvo lugar? En realidad, las probabilidades de estar en ese mundo improbable son del 100 %, porque no podríamos tener esta conversación en un mundo donde la fotosíntesis, las células complejas o los animales no evolucionaran. Es el principio antrópico. La historia de la Tierra tiene que haber permitido que la vida inteligente evolucionara, pues, de lo contrario, no estaríamos aquí para plantearnos estas cuestiones.

La inteligencia depende, al parecer, de una cadena de acontecimientos improbables. Pero teniendo en cuenta la enorme cantidad de planetas, e igual que un número infinito de monos que golpean un número infinito de máquinas de escribir para redactar Hamlet, está destinada a evolucionar hacia alguna parte. El resultado improbable fuimos nosotros.![]()

Sobre el autor: Nick Longrich es profesor titular (senior lecturer) en el departamento de paleontología y biología evolutiva de la University of Bath

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo La evolución nos dice que es probable que seamos la única vida inteligente del universo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La evolución de la vida inteligente: ¿Azar o necesidad?

- Vida alienígena inteligente, una historia terráquea

- El universo en un día: Vida y diversidad, por Carlos Chordá

Breve historia de las ciencias del clima

Imagen de Arek Socha / Pixabay

Imagen de Arek Socha / Pixabay

La climatología es una ciencia peculiar: no hay que confundirla con la meteorología. Por una parte, se considera una rama de las ciencias atmosféricas, y por tanto perteneciente a las ciencias físicas. Por otro lado, se trata de un subcampo de la geografía perteneciente a las llamadas Ciencias de la Tierra. Sin embargo, la climatología también incluye aspectos de la oceanografía y la biogeoquimica, al igual que de otras ciencias como la geofísica, la glaciología, ecología, ciencias computacionales, meteorología, la economía y… también la historia. Y es que el clima, como es natural, está presente en nuestro planeta mucho antes que la especie humana. Es a lo que se dedica la paleoclimatología, que entre otras cosas trata de hacer arqueología de fósiles u otros signos que permitan comprender cómo fueron los climas a lo largo de la historia de la Tierra.

Hoy en día, la ciencia climática utiliza modelos computacionales que permiten estudiar la evolución del clima e, incluso, realizar proyecciones de cómo será en el futuro. No hay duda de que esta ciencia ha cobrado una gran relevancia social, especialmente desde que la concienciación medioambiental se hizo presente en el debate público durante la segunda mitad del siglo XX. De hecho, la historia que tiene detrás muestra que, en realidad, nunca ha sido una disciplina bien definida y que probablemente no existiría de no ser por los aspectos sociales, culturales y tecnológicos que contingentemente la han llevado a coronarse como una de las ciencias de mayor impacto en la vida diaria actual de muchas personas.

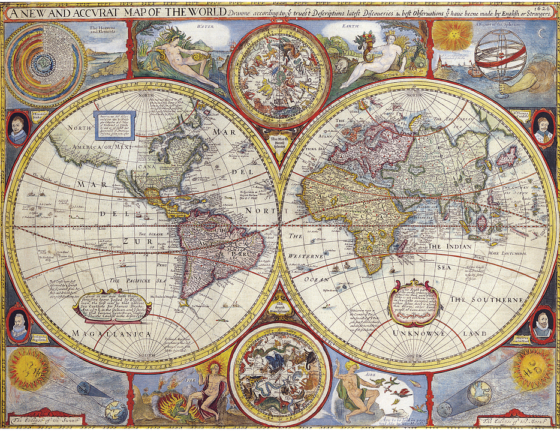

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsEn la época clásica, por “clima” se entendía una cosa bien distinta a lo que hoy conciben los climatólogos. Su significado estaba acotado a cuestiones de geografía, un invento de los trabajos de cartografía del siglo III a.C en la Grecia Antigua. No tenía prácticamente nada que ver con la meteorología o la atmósfera, pues hablar del “clima” de un lugar era equivalente a dar sus coordenadas geográficas más que explicar si hacía frío o calor, su humedad o la frencuencia con que llovía en la zona. De hecho, el término “clima” proviene del griego (κλίμα) y significa “zona” o “lugar”.

El concepto “clima” tuvo que esperar hasta el siglo XVIII, momento en el que fue definido como la media de los estados meteorológicos en un lugar a lo largo del tiempo. Sin embargo, sólo se volvió un objeto de la práctica científica cuando los servicios meteorológicos nacionales pudieron proveerse de grandes cantidades de datos para hacer estadística con ellos, lo cual no ocurrió hasta mediados del siglo XIX.

Esta concepción física del clima vino, además, de la mano de la hipótesis científicas del cambio climático. Antes, los colonos del siglo XVII ya auguraban variaciones antropogénicas en el tiempo, cuando en sus observaciones metereológicas se daban cuenta de cambios en zonas particulares. Ellos los atribuían a sus esfuerzos en el cultivo de la tierra, para lo cual tenían que transformar los ecosistemas y, de algún modo, sospechaban que eso tenía su impacto en la meteorología. No obstante, no era una discusión científica, sino más bien una preocupación por la prosperidad de sus cultivos.

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsFue con la entrada de la segunda mitad del siglo XVIII cuando empezaron a emerger los debates científicos acerca de si realmente existía un cambio climático y, de existir, cuáles podrían ser las causas de este. La emergencia y desarrollo de la climatología moderna, en sintonía con las nuevas ciencias surgidas con la Revolución Científica, había empezado a aplicar la metodología y formalismos propias de la nueva forma de conocimiento. La matematización y la experimentación eran piezas claves a la hora de comprender científicamente el mundo, y ello llegó al estudio del clima a través de las nuevas teorías de la distribución del calor y la humedad, que reemplazaron a la antigua astrometeorología. El clima empezó a ser estudiado en dimensiones más extensas y escalas temporales más amplias, especialmente cuando descubrieron las eras glaciares pasadas y la discusión de sus causas empezó a cobrar importancia.

Todas esas investigaciones que llevaron científicos como Fourier, Tyundall o Arrhenius, se vieron radicalmente aceleradas a lo largo del siglo XX, sobre todo en su segunda mitad. Hasta entonces, el imperalismo europeo y estadounidense hizo que la climatología se centrara en las geografías pendientes de exploración y zonas concretas de interés, aparte de que la instrumentación disponible no permitía grandes avances ante un objeto tan inmenso y complejo. Sin embargo, entrado el siglo XX el clima se empieza a poder concebir como una entidad global, como una entidad planetaria. Ello vino de la mano de los primeros modelos computacionales, junto con la aparición de otras tecnologías como los satélites artificiales, el radar, los espectómetros, las radiosondas y, en general, la tecnología computacional. Las nuevas capacidades instrumentales permitieron investigar las capas más altas de la atmósfera y mejorar el entendimiento de la física de los procesos atmosféricos. Junto a la información proporcionada por satélites artificiales y la red distribuida de centros meteorológicos, los climatólogos empezaron a tener una visión de conjunto y el clima pasó a convertirse en un objeto científico de escala planetaria.

La actividad climatológica también se transformó por influencia de los cambiantes contextos políticos y culturales durante las guerras mundiales y la guerra fría y, a partir de 1970, por el medioambientalismo y la emergencia de los intereses medioambientales. No sólo apareció una nueva ciencia del clima, sino que también acontenció un nuevo problema político, social y cultural en todas las dimensiones de su práctica. Aparecieron instituciones sin precedentes, como el IPCC, encargada de informar con conocimiento científico a las políticas medioambientales. Así, el consenso científico sobre el calentamiento global antropogénico empezó a consolidarse y los intereses y objetivos de la climatología pasaron a tener un uso político y anticipatorio a problemas medioambientales, marginando los enfoques y preocupaciones de esa misma ciencia durante la preguerra.

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsAlgunos autores han denominado a este tipo de ciencia como ciencia posnormal, una modalidad de ciencia en la que hay valores en disputa, altos riesgos y decisiones urgentes. Una etapa de la ciencia donde se cuestiona su metodología, su producción y su uso. La compleja relación entre ciencia y política, la comunicación de la incertidumbre o la evaluación de la calidad son nuevos elementos que hacen tan particular a esta actividad científica, que no ha de confundirse con la meteorología. Una estudia el tiempo a corto plazo. La otra cuánto plazo queda para que se nos acabe el tiempo.

Referencias:

Heymann, M., G. Gramelsberger, M. Mahony (Eds.) (2017): Cultures of Prediction in Atmospheric and Climate Sciecne: Epistemic and Cultural Shifts in Computer-based Modelling and Simulation, New York: Routledge.

Funtowicz, S., J. Ravetz (1993): “Science for the post-normal age”, Futures, Vol 25, Issue 7, pp. 739-755.

White, S., C. Pfister, F. Mauelshagen (Eds.) (2018): The Palgrave Handbook of Climate History, London: Palgrave McMillan.

Winsberg, E. (2018): Philosophy and Climate Science, Cambridge (UK): Cambridge University Press.

Sobre el autor: José Luis Granados Mateo (@JoisDo) desarrolla una tesis doctoral en Historia y Filosofía de la Ciencia en la UPV/EHU, becado por la Dirección de Medio Ambiente de la Diputación Foral de Gipuzkoa.

El artículo Breve historia de las ciencias del clima se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una breve historia del método de la hipótesis

- Una breve historia del concepto de trastorno bipolar

- Breve historia del trastorno bipolar (II): neurobiología y tratamiento

La letra pequeña de algunos métodos de aprendizaje

Vitoria-Gasteiz acogió por primera vez el pasado 18 de octubre el evento Las pruebas de la educación, una jornada que abordó diversos temas educativos desde la evidencia científica. El acto, organizado por el Consejo Escolar de Euskadi y la Cátedra de Cultura Científica de la UPV/EHU, tuvo lugar en el Salón de Actos del Centro de Investigación Micaela Portilla, ubicado en el Campus de la capital alavesa de la UPV/EHU.

La jornada consta de un total de cinco charlas que tratan temas como el rendimiento académico, los métodos de aprendizaje y la innovación educativa, entre otros. La dirección del seminario corre a cargo de la doctora en psicología Marta Ferrero.

En esta primera charla es precisamente Marta Ferrero quien aborda algunas ideas erróneas que existen sobre la educación en el profesorado y revisa los estudios existentes sobre la eficacia de diferentes métodos educativos. En este sentido, el objetivo de la ponencia es “leer detenidamente la letra pequeña” de dos métodos actualmente muy extendidos en las aulas: el aprendizaje basado en proyectos y la aplicación de intervenciones inspiradas en la teoría de las inteligencias múltiples para la adquisición de nuevos aprendizajes.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo La letra pequeña de algunos métodos de aprendizaje se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El error como ocasión de aprendizaje

- Del mito al hecho: hemisferios, gimnasia cerebral y estilos de aprendizaje

- Educación basada en la evidencia: retos y propuestas de mejora

Alcanzada la escala atómica en la detección magnética

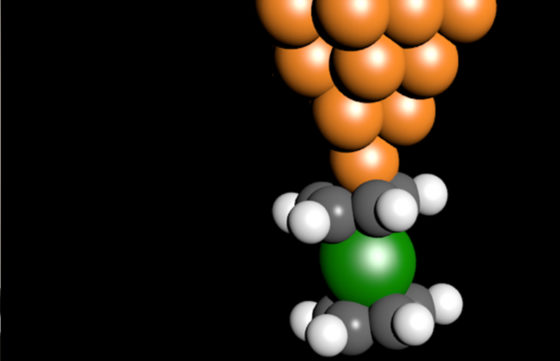

Los resultados, publicados en Science, abren un nuevo camino para obtener información crucial para la comprensión fundamental de las estructuras a escala atómica y para el diseño de futuros dispositivos a escala atómica así como de almacenamiento a nanoescala, o simuladores cuánticos entre otros. Nicolás Lorente, investigador del Centro de Física de Materiales (CFM, centro mixto UPV/EHU–CSIC) y del Donostia International Physics Center (DIPC), y Roberto Robles, también del CFM, son parte del equipo internacional que ha llevado a cabo el trabajo, junto a miembros de las Universidades de Estrasburgo (Francia), y Jülich (Alemania).

Los clásicos microscopios ópticos que utilizan un rayo de luz o de electrones son ciegos e inútiles en la exploración del mundo de los átomos y de las moléculas individuales. En su lugar, se utilizan otras técnicas que pueden ser vistas como una versión diminuta y ultraprecisa de un tocadiscos. Estos instrumentos llamados microscopios de sonda de barrido utilizan el extremo de una aguja afilada como punta para «leer» los surcos creados por los átomos y las moléculas en la superficie de apoyo.

“Para sentir la proximidad entre la punta y la superficie, los científicos utilizamos una pequeña corriente eléctrica que comienza a fluir cuando ambas están separadas por una fracción de millones de milímetros, es decir, un nanómetro. La regulación de la punta para mantener esta distancia permite la obtención de imágenes topográficas mediante el escaneado de la superficie” comenta el Dr. Lorente.

Mientras que los principios básicos de tales microscopios se desarrollaron ya en 1980, solo durante la última década la comunidad científica ha aprendido a ampliar las capacidades de estos microscopios elaborando diseños inteligentes del extremo de su punta de sondeo. Por ejemplo, uniendo una pequeña molécula, como el monóxido de carbono (CO) o el hidrógeno (H2), se logra un aumento sin precedentes en la resolución espacial, en el que la flexibilidad de la molécula hace visibles incluso los enlaces químicos.

De manera similar, los autores de la reciente publicación en Science, presentan un diseño de la afilada punta que aporta una función novedosa: la hace sensible a los momentos magnéticos. Esto se consigue mediante la colocación de un imán molecular que contiene un único átomo de níquel en el ápice. Esta molécula puede ser llevada eléctricamente a diferentes estados magnéticos que tienen en cuenta la dirección en la que señala el imán molecular. La dirección del imán se puede determinar midiendo la conductancia electrónica en el microscopio. Al modo de una pequeña brújula, la punta molecular reaccionará a la presencia de pequeños campos magnéticos en la superficie medida, cambiando la conductancia del microscopio.

“Es la magnitud del dipolo magnético (del imán) de forma que si los dos dipolos se miran con sus lados norte, se repelen con una fuerza proporcional al producto de los momentos magnéticos, y si se miran con polos opuestos se atraen con la misma magnitud”

La importancia de este logro es triple. En primer lugar, el uso de una molécula como sensor activo hace que sea muy reproducible y fácil de implementar en instrumentos utilizados por otros grupos de todo el mundo que trabajan en este campo. En segundo lugar, la técnica no es destructiva ya que las interacciones son muy débiles. En tercer lugar, el esquema de detección se basa únicamente en propiedades fácilmente observables en la punta del sensor de forma que pequeñísimos imanes atómicos que normalmente son difíciles de medir, se vuelven accesibles.

Con este trabajo los científicos han ampliado su caja de herramientas a nanoescala con una nueva técnica sensible a las propiedades magnéticas que será importante para futuras aplicaciones que van desde dispositivos de memoria a nanoescala hasta nuevos materiales o aplicaciones en el campo de la simulación cuántica y la computación.

Referencia:

B. Verlhac, N. Bachellier, L. Garnier, M. Ormaza, P. Abufager, R. Robles, M.-L. Bocquet, M. Ternes, N. Lorente, L. Limot (2019) Atomic-scale spin sensing with a single molecule at the apex of a scanning tunneling microscope Science doi: 10.1126/science.aax8222

El artículo Alcanzada la escala atómica en la detección magnética se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La óptica se hace atómica: la lente más pequeña del mundo

- Construcción de heteroestructuras de grafeno con precisión atómica

- Biomarcadores para la detección precoz del melanoma

A más datos, mejor servicio público

Foto: Jacek Dylag / Unsplash

Foto: Jacek Dylag / UnsplashLa digitalización es un aspecto imparable de nuestras sociedades modernas. Cada vez más datos personales acaban en manos de grandes empresas tecnológicas que, en contraprestación, nos ofrecen cada vez nuevos y mejores servicios. Esto, no obstante, conlleva unos riesgos para la privacidad y una preocupación creciente de la ciudadanía, que ya ha visto saltar a los medios diversos escándalos por una gestión poco ética, o directamente ilegal, de esos datos. Leyes como la nueva GDPR europea responden a esa preocupación, y tratan de asegurar que la explotación de nuestros datos se realice con las máximas garantías, aunque todavía queda mucho por hacer.

Recientemente, saltaba la polémica ante la noticia de que diversos organismos públicos, como el INE o el Ministerio de Fomento, están llevando a cabo proyectos para estudiar la viabilidad de obtener un beneficio público de datos procedentes de operadoras de telefonía, ya sea subcontratando estudios o mediante la compra de datos anónimos. En este caso, se trataba de una alarma injustificada provocada por titulares de medios más preocupados por las visitas que por el interés de la ciudadanía. Efectivamente, como muestran muchos estudios científicos, existe un enorme potencial para que la explotación de estos y otros datos mejore la función pública al mismo tiempo que reduzca los costes. Pero además, estos recientes estudios se llevan a cabo con las máximas garantías para preservar nuestro derecho a la privacidad.

El caso del Censo

Un censo es un procedimiento sistemático para adquirir información de una población. Antiguamente, el objetivo era exclusivamente contar a la población. Hoy en día, el registro del Padrón tiene un recuento permanentemente actualizado, y el objetivo de los censos es el de conocer las características de esa población. Se trata de una herramienta de gran tradición (se remonta al siglo XVIII) que aporta una información estadística fundamental para fines no solo gubernamentales, de planificación económica y social, sino también para el tejido empresarial y económico de los países. Tanto es así que su realización es obligatoria por normativa comunitaria, y el ciudadano tiene la obligación por ley de aportar información veraz cuando es encuestado.

En España, el Instituto Nacional de Estadística (INE) es el organismo público encargado de los Censos de Población y Viviendas, que se realizan cada 10 años. La última edición, de 2011, incorporaba una novedad con respecto a la anterior, de 2001: se realizaron encuestas a una muestra representativa (el 10% de la población, unos 4 millones de personas), en lugar de enviar cuestionarios a todas las viviendas del país. Se partía de muy pocos datos por habitante empadronado (tan solo cuatro variables administrativas), y se ideó un procedimiento para inferir todos los demás datos (sociales, familiares, económicos) a partir de la encuesta a esta muestra. Como resultará evidente, se trata de un procedimiento muy complejo y muy costoso.

Los nuevos Censos 2021, en cambio, vendrán cargados de novedades dirigidas a mejorar estas estadísticas y la eficiencia con la que se compilan. El objetivo principal del INE desde 2014, cuando se finalizaron los trabajos de los Censos 2011, es el de aumentar las variables de partida (el INE estima que llegarán hasta el 90%) para disminuir el número de preguntas de la encuesta, haciéndole la vida más fácil al ciudadano, reduciendo el trabajo de procesar todos esos cuestionarios y aumentando la calidad de la información recopilada. Para ello, no solo se cuenta en la actualidad con muchos más registros administrativos (tributarios, seguridad social), aparte del Padrón, sino que se estudia la viabilidad de conseguir parte de esas variables mediante el análisis de datos en manos de compañías privadas.

En concreto, recientemente se ha materializado un acuerdo pionero en Europa entre el INE y tres de las mayores operadoras de telefonía en España. En próximas fechas, se realizará un estudio piloto en el que estas operadoras reportarán al INE recuentos de la presencia de teléfonos móviles para ciertas franjas horarias en una serie de “áreas INE” en las que han dividido el país. Estas áreas se han definido bajo el criterio de que contengan un mínimo de 5000 habitantes para ofrecer las máximas garantías en cuanto a anonimidad de los datos, y el INE ha desarrollado una metodología para su aprovechamiento con tres objetivos fundamentales: obtener 1) dónde vive la población, 2) adónde se mueve diariamente (principalmente por motivos de trabajo), y 3) con qué otras zonas está vinculada (por ejemplo, viaje al pueblo en Navidad). Los dos últimos objetivos están relacionadas con dos preguntas referentes a movilidad que ya estaban presentes en los dos últimos censos, mientras que el primero es una estimación complementaria de la población que servirá para cuantificar y corregir posibles sesgos.

El caso de la movilidad

Otro aspecto tanto o más importante para las políticas públicas que las características de la población es cómo nos movemos. Muchos investigadores estamos convencidos de que la cantidad masiva de datos que generamos con nuestra actividad diaria puede analizarse de forma ética para obtener grandes beneficios sociales en este aspecto. No en vano, la mayor parte del conocimiento que tenemos de nuestras ciudades se basa en estos censos que se realizan cada 10 años y contienen información estática. Investigaciones como el Atlas de la Desigualdad, del profesor Esteban Moro (Universidad Carlos III de Madrid, profesor visitante en el MIT Media Lab), tratan de ir un paso más allá y combinar la información censal con datos de geoposicionamiento para tener una visión más granular de los problemas de las ciudades modernas.

El Ministerio de Fomento también empieza a ser consciente del potencial de este tipo de datos en beneficio de todos, y en concreto para estudiar la movilidad de los ciudadanos y planificar las infraestructuras y sistemas de transportes. Al igual que con el censo, hasta ahora la fuente principal de información también eran encuestas. La última gran encuesta, Movilia 2006/2007, nos costó 5 millones de euros. Sin embargo, en 2018 se contrató un estudio con objetivos similares a partir de datos telefónicos, cuyo coste fue de tan solo 150 mil euros, aunque todavía no son públicos sus resultados.

Datos para el bien social

Toda esta información estadística es un bien público necesario para el buen funcionamiento de un país, para el diseño, evaluación y mejora de las políticas públicas. La empresa privada ya hace tiempo que se subió al carro de la digitalización, y hace cada vez un mayor uso de la ciencia de datos para optimizar sus procesos internos y tomar decisiones basadas en datos, para crecer y aumentar su competitividad en el mercado. Es el momento de que la administración pública tome el mismo camino y se modernice en beneficio de todos.

Como ciudadanos, no solo deberíamos alegrarnos de que por fin se tomen estas iniciativas, sino que deberíamos exigir activamente que nuestros datos se usen para el bien social; eso sí: siempre con las máximas garantías y transparencia, de forma ética y respetuosa con nuestro derecho a la privacidad. Es el momento de exigir políticas y una gestión basadas en datos.

Sobre el autor: Iñaki Úcar es doctor en telemática por la Universidad Carlos III de Madrid e investigador postdoctoral del UC3M-Santander Big Data Institute.

El artículo A más datos, mejor servicio público se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Datos que entran por los ojos

- Los orígenes de la visualización de datos

- Humildemente, el mundo es mejor gracias a mí

El puzzle Stomachion y el palimpsesto de Arquímedes (2)

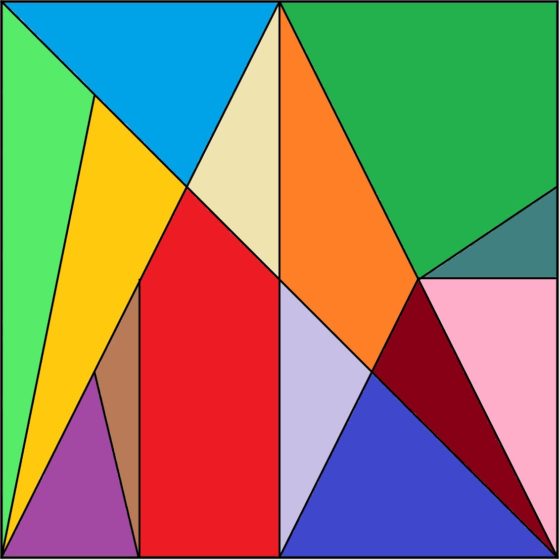

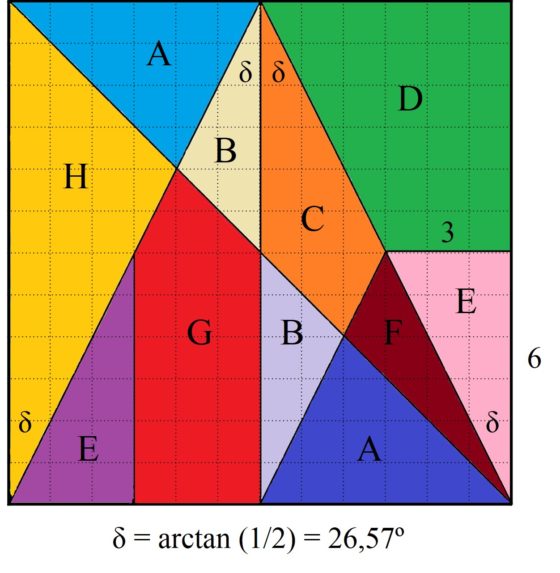

En la primera entrada de esta mini-serie de la sección Matemoción del Cuaderno de Cultura Científica, El puzzle Stomachion y el palimpsesto de Arquímedes (1), habíamos descrito el rompecabezas conocido como Stomachion, o caja de Arquímedes, e incluso analizado las áreas de las piezas que lo componen, pero, sobre todo, habíamos contado la sorprendente historia del palimpsesto de Arquímedes, que incluye la copia más extensa de la obra Stomachion del gran matemático griego Arquímedes de Siracusa (aprox. 287 – 212 a.n.e.). Por otra parte, en la presente entrada vamos a centrarnos en algunos aspectos matemáticos del Stomachion.

Rompecabezas Stomachion, también llamado Ostomachio o caja de Arquímedes

Rompecabezas Stomachion, también llamado Ostomachio o caja de Arquímedes

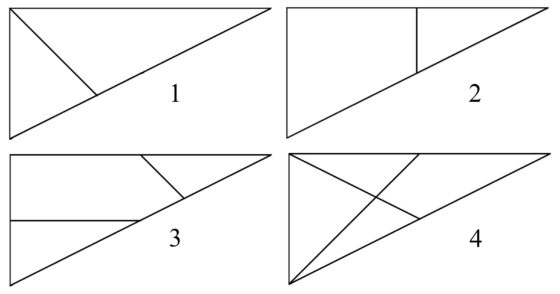

Empecemos recordando que el Stomachion es un rompecabezas de tipo Tangram formado por 14 piezas, en concreto, 11 triángulos, 2 cuadriláteros y 1 pentágono, que podemos ver en la imagen anterior.

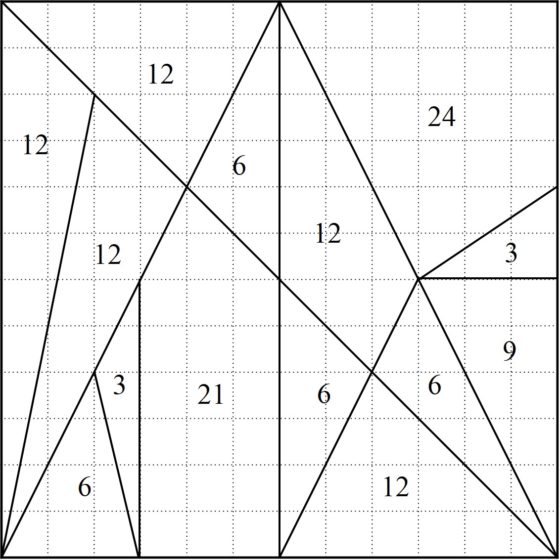

Si consideramos que el cuadrado generador tiene unas dimensiones de 12 unidades de longitud (por ejemplo, centímetros) de lado y trazamos la cuadrícula 12 x 12 sobre el mismo, como hicimos en la entrada anterior, se puede observar que todos los vértices de las piezas descansan sobre los puntos de intersección de la cuadrícula. Notemos además que, en la cuadrícula, la distancia entre un punto de la misma y el siguiente, en horizontal o vertical, es una unidad de longitud. Esto, además de dejar claro que esta descomposición del cuadrado no es caprichosa, nos permite calcular fácilmente las áreas de las 14 piezas del rompecabezas, todas con valores enteros (desde arriba a la izquierda, siguiendo el orden de las agujas del reloj, más o menos): 12, 6, 12, 24, 3, 9, 6, 12, 6, 21, 3, 6, 12 y 12.

Áreas de las 14 piezas del puzle de Arquímedes, Stomachion

Áreas de las 14 piezas del puzle de Arquímedes, Stomachion

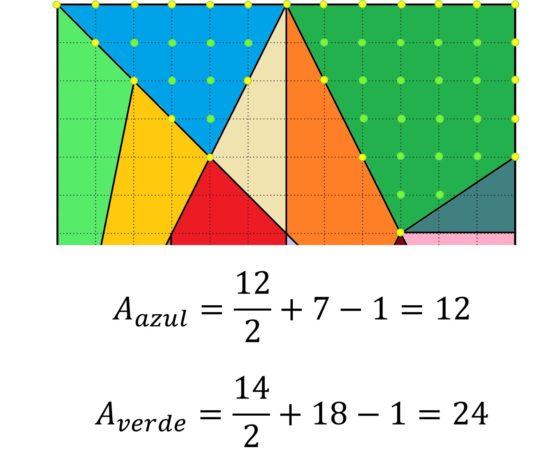

El cálculo de las áreas es sencillo y puede ser un interesante problema para el aula de matemáticas, pero aún le podemos sacar un poco más de partido al tema de las superficies, comprobando que los anteriores resultados son correctos mediante el teorema de Pick, como nos sugiere el grupo Alquerque de Sevilla en su artículo sobre el Stomachion en la revista Suma.

Teorema de Pick (1899): si un polinomio P tiene sus vértices sobre una cuadrícula, entonces su área es igual a

![]()

donde B es un número de puntos de la cuadrícula que están en el borde del polígono e I los que están en el interior del mismo.

En la siguiente imagen podemos ver la comprobación del teorema de Pick para las piezas verde y azul. Hemos pintado los puntos del borde de los polígonos (cuyo número es B) de amarillo y los del interior de verde (cuyo número es I).

El teorema de Pick aplicado al cálculo de las áreas de las piezas verde y azul del Stomachion

El teorema de Pick aplicado al cálculo de las áreas de las piezas verde y azul del Stomachion

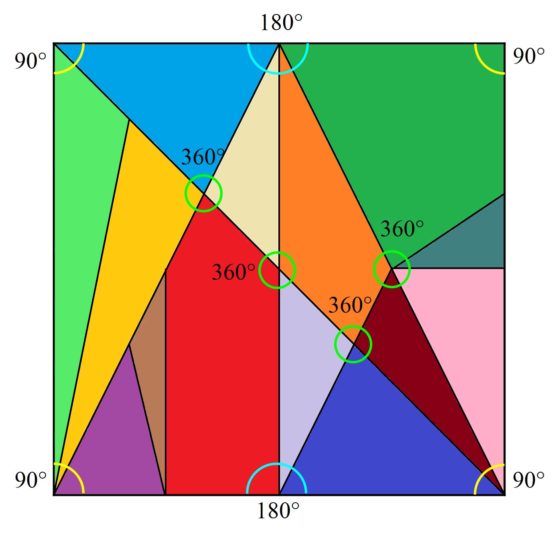

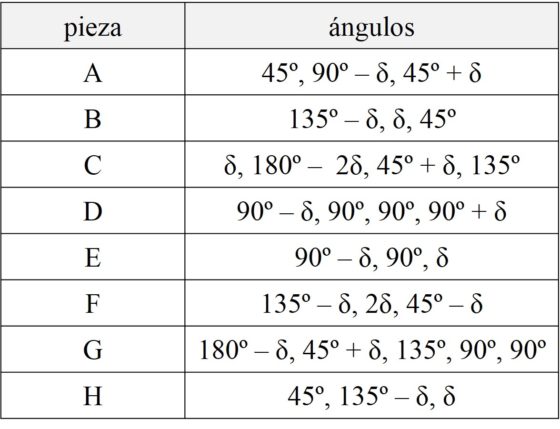

A continuación, vamos a analizar los ángulos de las piezas de la caja de Arquímedes. Esta es una cuestión importante también, puesto que cuando se trabaja la resolución de puzzles geométricos como el Tangram, los rompecabezas de letras, como T y M, u otros similares, el razonamiento sobre los ángulos es fundamental para la resolución de los mismos. Por ejemplo, en estos puzzles cuadrados, en las esquinas debe ir una pieza rectangular o la suma de los ángulos de las piezas que tocan la esquina debe ser 90º, los ángulos en los vértices que están en los lados del cuadrado deben sumar 180º, mientras que en los vértices interiores deben sumar 360º (véase en la imagen algunos ejemplos).

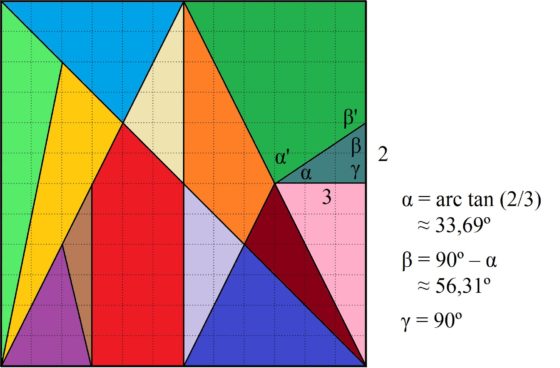

Para empezar, fijémonos en la pieza que es un triángulo rectángulo, de área 3 en la cuadrícula 12 x 12, que está en la parte derecha de la imagen anterior del puzzle (de color azul grisáceo en la imagen coloreada). Si estudiamos los ángulos de esta figura, uno es 90º (ángulo recto), pero los otros son alpha = arctan (2/3) = 33,69º (aprox.) y beta = 90º – alpha = 90º – 33,69º = 56,31º (aprox.). Como veremos más adelante, la mayoría de los ángulos de las piezas del Stomachion están relacionados con el ángulo delta = arctan (1/2) = 26,57º (aprox.) y los ángulos alpha y beta de este pequeño triángulo rectángulo solo encajan con los ángulos alpha’ y beta’ de la pieza que es un cuadrilátero con un ángulo recto (la pieza verde oscuro en la imagen coloreada). Como consecuencia de esto las dos piezas anteriores, el cuadrilátero con un ángulo recto y el pequeño triángulo rectángulo, siempre irán juntas en cualquier solución del juego original, es decir, colocar las piezas del rompecabezas para montar un cuadrado.

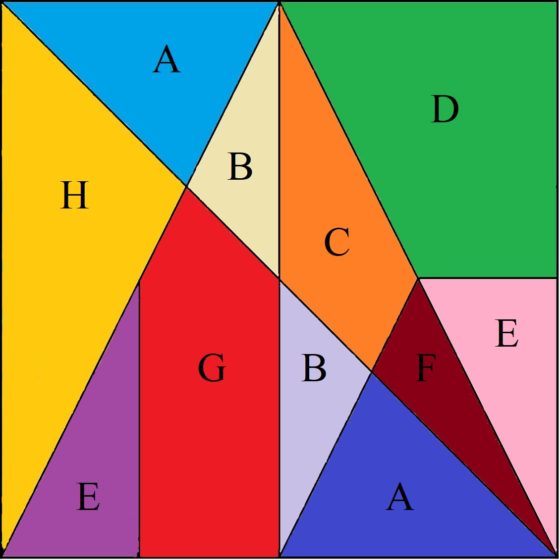

Un análisis similar puede realizarse con las piezas verde claro y naranja, que irán juntas en cualquier solución de la caja de Arquímedes. Y lo mismo las piezas morada y marrón. Por este motivo, en los análisis matemáticos de este juego geométrico se suele juntar cada una de estas parejas de piezas para formar una pieza común. De hecho, la matemática estadounidense nacida en Taiwán Fan Chung y el matemático estadounidense Ron Graham llaman a este nuevo puzzle el Stomach (le han quitado tres letras al nombre, al igual que el nuevo rompecabezas ahora tiene tres piezas menos), y veremos más adelante el análisis que hacen del mismo.

Rompecabezas Stomach, formado por 11 piezas, 8 triángulos, dos cuadriláteros y un pentágono. Las piezas han sido nombradas con una letra, de forma que las piezas que tienen la misma forma tengan la misma letra, como ocurre con A, B y E

Rompecabezas Stomach, formado por 11 piezas, 8 triángulos, dos cuadriláteros y un pentágono. Las piezas han sido nombradas con una letra, de forma que las piezas que tienen la misma forma tengan la misma letra, como ocurre con A, B y E

Ahora, de nuevo con un poco de trigonometría básica (de hecho, basta la definición geométrica de la tangente de un ángulo y que la suma de los ángulos de un triángulo es 180º) se pueden calcular los ángulos de las piezas del Stomach (en general, del Stomachion), que como hemos comentado están la mayoría expresados en función del ángulo delta = arctan (1/2) = 26,57º (en la imagen siguiente puede verse, por ejemplo, en el triángulo rosa que el ángulo delta es aquel cuya tangente vale 3/6 = 1/2).

A continuación, mostramos en una tabla los valores de los ángulos de las piezas del Stomach (que son las del Stomachion, con la salvedad de las tres uniones que hemos realizado). Empezamos por las piezas de arriba a la derecha, desde la pieza A, y enumeramos los ángulos desde la derecha y en el sentido de las agujas del reloj.

Pero volvamos a la obra Stomachion de Arquímedes, dedicada al rompecabezas homónimo. Como comentamos en la anterior entrada El puzzle Stomachion y el palimpsesto de Arquímedes (1), el mayor fragmento conservado de esta obra, aunque es solamente una página y además la parte introductoria de la misma, apareció en el palimpsesto de Arquímedes. Esta obra despistó completamente a los expertos, ya que aparentemente trataba sobre un juego infantil sin ningún interés científico, lo cual no se correspondía con la profundidad científica de sus demás obras.

El historiador de las matemáticas israelí Reviel Netz, profesor de la Universidad de Stanford en California, después de investigar el Stomachion concluyó que, en su opinión, no era simplemente una sencilla obra sobre un juego infantil, sino que se trataba realmente de un tratado de combinatoria.

La combinatoria es una rama de las matemáticas, que entre otras cuestiones incluye el estudio de métodos para contar las estructuras o configuraciones de un conjunto de un determinado tipo o tamaño. Por ejemplo, son problemas de la combinatoria el contar cuántos cuadrados latinos existen de un orden dado (véase la entrada Cuadrados latinos, arte y matemáticas), cuántas soluciones tiene una ecuación lineal (véase Aprendiendo técnicas de contar: lotería primitiva y bombones), cómo se pueden distribuir una serie de elementos con unas ciertas condiciones (véase El problema matemático de las cartas extraviadas o El problema de las estudiantes de Kirkman), o cuántas soluciones tiene un juego o puzzle (véase Cubo soma: diseño, arte y matemáticas o el libro Del ajedrez a los grafos).

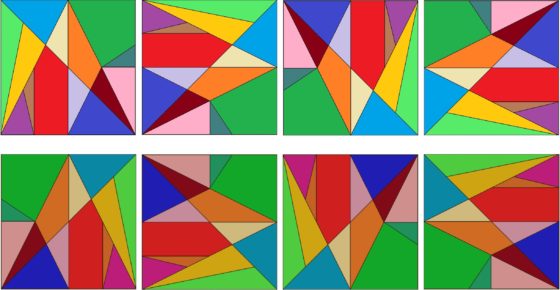

En opinión de Reviel Netz la cuestión que le interesaba a Arquímedes en relación al rompecabezas era cuántas soluciones existen del mismo, es decir, de cuántas formas distintas se pueden colocar las 14 piezas para formar un cuadrado. Mientras que para el Tangram solo hay una manera de construir el cuadrado, es decir, solo existe una solución, más allá de rotaciones (girar el cuadrado), reflexiones (darle la vuelta) o cambiar las piezas de igual forma entre sí, las piezas geométricas del Stomachion se pueden combinar de diferentes formas para dar lugar al cuadrado, esto es, tiene muchas soluciones. Este era el problema combinatorio del tratado de Arquímedes, por lo tanto, de una profundidad mayor de la que aparentaba.

Por lo tanto, el problema combinatorio quedaba abierto, ¿de cuántas formas distintas se puede resolver la caja de Arquímedes? El profesor Netz no sabía cómo de difícil podía ser este problema y si Arquímedes pudo resolverlo en su tratado, por lo que se lo planteó a algunos colegas de su universidad, la profesora de estadística Susan Holmes y el matemático Persi Diaconis, conocido por su trabajo en magia y matemáticas. Como explica la propia Susan Holmes: “al principio pensamos que podíamos sentarnos y resolver en un día cuántas soluciones tenía. Entonces nos dimos cuenta de que eran muchas más de las que podíamos haber imaginado”. Entonces, junto con la pareja de profesores de la Universidad de California, Ron Howard y Fan Chung, dedicaron varios meses a resolver esta cuestión combinatoria. Finalmente, obtuvieron la respuesta buscada, hay 17.152 configuraciones distintas de todas las piezas del Stomachion que forman un cuadrado, que se reducen a 536, si no tenemos en cuenta rotaciones, reflexiones o el intercambio de las piezas que son iguales (las piezas A y B en la imagen del Stomach), 536 x 32 = 17.152.

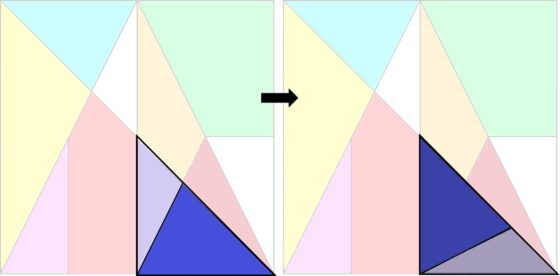

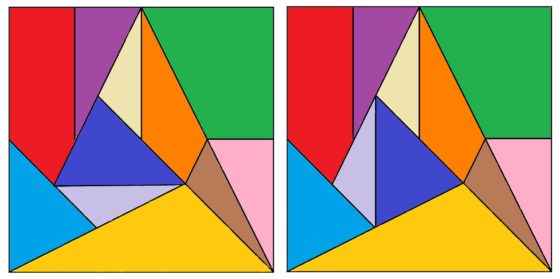

Cada solución del Stomachion, como la original de la construcción, da lugar a 8 soluciones mediante rotaciones y reflexiones, como se muestra en la imagen. Además, cada una de estas da lugar, a su vez, a 4 soluciones intercambiando de lugar las piezas de igual forma, A y B. Por este motivo, 536 x 8 x 4 = 17.152 soluciones

Cada solución del Stomachion, como la original de la construcción, da lugar a 8 soluciones mediante rotaciones y reflexiones, como se muestra en la imagen. Además, cada una de estas da lugar, a su vez, a 4 soluciones intercambiando de lugar las piezas de igual forma, A y B. Por este motivo, 536 x 8 x 4 = 17.152 soluciones

Aunque un poco antes, en noviembre de 2003, el informático Guillermo H. Cutler, que había diseñado un programa informático para resolver el problema, encontró las 536 formas distintas de combinar las 14 piezas del rompecabezas para formar el cuadrado.

536 soluciones del Stomachion obtenidas por Guillermo H. Cutler

536 soluciones del Stomachion obtenidas por Guillermo H. Cutler

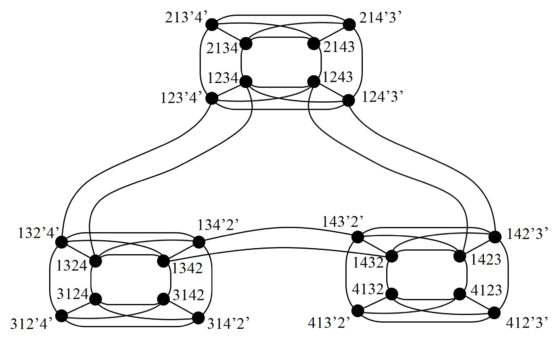

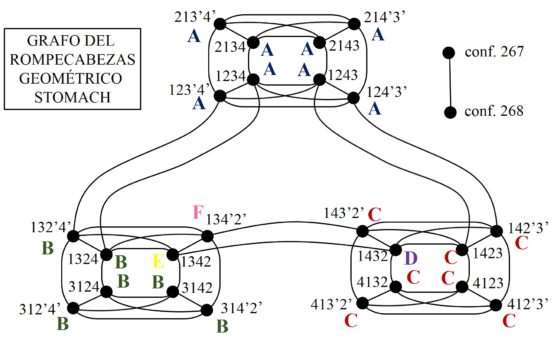

Por otra parte, la profesora Chung y el profesor Graham visualizaron las soluciones de la caja de Arquímenes, y las relaciones entre las mismas, a través de un grafo, que vamos a explicar brevemente en lo que queda de entrada. La construcción es delicada, pero de una gran profundidad y belleza.

Para empezar, Fan Chung y Ron Howard no estudiaron directamente las soluciones del Stomachion, sino de un nuevo rompecabezas que llamaron Stomach y que hemos mostrado más arriba. Las soluciones son prácticamente las mismas. De hecho, cada solución del Stomach da lugar a dos soluciones del Stomachion ya que la pieza E rosa, se puede intercambiar con la pieza E morada, la cual está formada por dos piezas del Stomachion original. De hecho, el Stomach tiene 268 configuraciones básicas, que dan lugar a las 268 x 2 = 536 configuraciones básicas del Stomachion.

Para visualizar las soluciones del Stomach, Chung y Howard construyeron un grafo. Recordemos que un grafo está formado simplemente por puntos –llamados vértices del grafo- y líneas que unen algunos de esos puntos –llamadas aristas del grafo- (véase, por ejemplo, El problema de los tres caballeros y los tres criados [https://culturacientifica.com/2016/05/04/problema-los-tres-caballeros-los-tres-criados/], El grafo de Marion (gray) [https://culturacientifica.com/2019/07/31/el-grafo-de-marion-gray/] o El juego de Sim [https://culturacientifica.com/2017/04/19/juego-del-sim/], entre otros), y que es una estructura matemática muy sencilla, pero a la vez muy versátil.

En el grafo introducido por Chung y Howard, asociado al rompecabezas geométrico, cada vértice es una de las configuraciones de las piezas formando el cuadrado, es decir, una de las 268 soluciones del rompecabezas, mientras que dos vértices están unidos por una arista si existe un movimiento, local o global (cuyo significado explicaremos un poco más adelante), que transforma una configuración en otra.

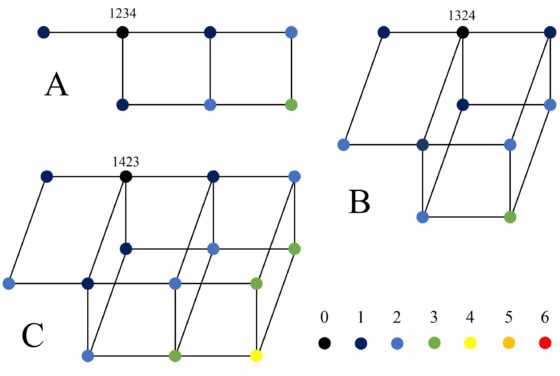

Para empezar, describamos lo que esta pareja de matemáticos denomina “núcleo” del grafo, que está formado por 24 configuraciones particulares y los movimientos entre ellas.

Si se consideran las 11 piezas del Stomach, solo existe una forma de dividirlas en cuatro grupos para formar cuatro triángulos rectángulos básicos, que juntos dan lugar al cuadrado del rompecabezas, que llamaremos triángulos básicos 1, 2, 3, 4, siguiendo la notación de Chung y Howard. Estos triángulos son:

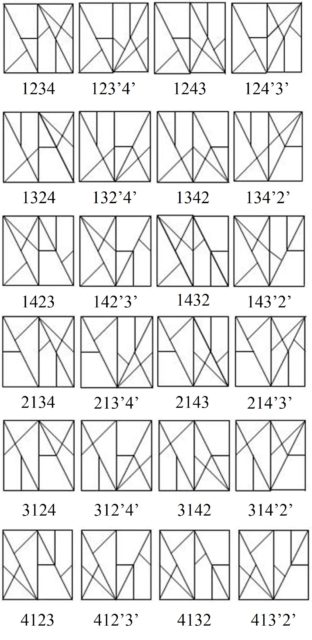

El núcleo del grafo está formado por las 24 soluciones básicas que se obtienen juntando estos cuatro triángulos, tomados tal cual están, salvo que los rotemos, o volteados. La notación que vamos a utilizar es la siguiente. Cada configuración básica estará nombrada por los cuatro números de los cuatro triángulos básicos en el orden que están colocados desde la izquierda a la derecha, y si un triángulo está volteado utilizamos un signo prima para marcarlo. Por ejemplo, la solución inicial del Stomach que está más arriba, coloreada, sería 1’ 2’ 3 4, ya que la pieza 1 está a la izquierda, pero volteada, lo mismo que la siguiente, que es la 2, mientras que luego van, sin voltear, las piezas 3 y 4.

A continuación, mostramos la imagen con las 24 configuraciones del núcleo, con la correspondiente notación.

Además, estas configuraciones del núcleo están conectadas por movimientos globales (que van a ser las aristas del grafo) que consisten en intercambiar dos de los cuatro triángulos básicos (la pieza 1 la podemos mantener sin dar la vuelta y siempre en la parte de la izquierda, respecto al centro).

Por ejemplo, la configuración 1234 está conectada, con una arista, a las configuraciones 1324, 1243, 124’3’, 123’4’ y 2134, puesto que se puede llegar a ellas intercambiando dos de los triángulos básicos de 1234, como se ve fácilmente. En teoría de grafos se dice que el vértice 1234 tiene grado 5, ya que hay 5 aristas conectadas con el mismo (por ahora).

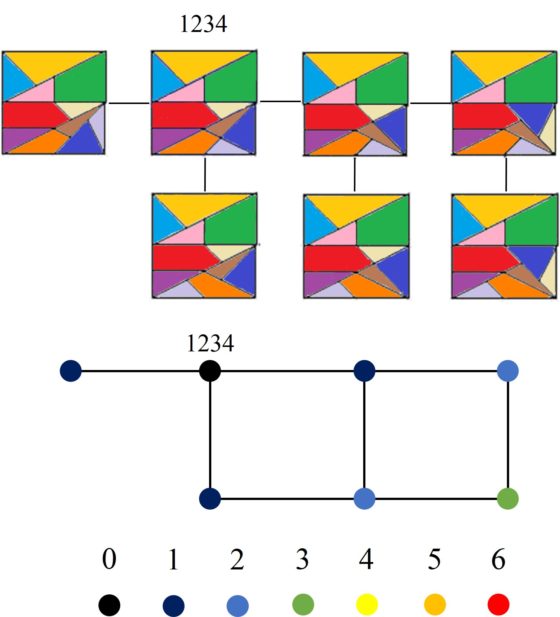

Podemos formar ahora la parte de este grafo que es el núcleo, cuyos vértices son las 24 configuraciones anteriores y las aristas están dadas por los movimientos globales que acabamos de describir. El resultado sería el siguiente.

Por otro lado, cada una de esas 24 configuraciones básicas está conectada, mediante aristas que vienen de movimientos locales, con otras configuraciones del cuadrado. Un movimiento local de una configuración consiste en rotar o voltear una subregión simétrica del cuadrado formada por un grupo de piezas contiguas. Por ejemplo, en la imagen de abajo el grupo de piezas formado por los dos triángulos azules, que es un triángulo isósceles, ha sido volteado para dar lugar a otra solución distinta del rompecabezas, otra configuración.

Dada una de las 24 configuraciones básicas, llamémosle B, la estructura de las configuraciones que se pueden alcanzar a partir de ella, mediante movimientos locales, es denominada por Chung y Howard el “cluster” de B. En la siguiente imagen vemos el cluster de la configuración básica 1234, con el grafo asociado al mismo, que es un grafo con 7 vértices/representaciones (podéis descubrir en la imagen el movimiento local que se produce entre una configuración y otra conectada). Notemos que se han coloreado los vértices en función de la distancia a la configuración básica del núcleo (cada arista recorrida aumenta una unidad la distancia), en este ejemplo, la distancia a 1234.

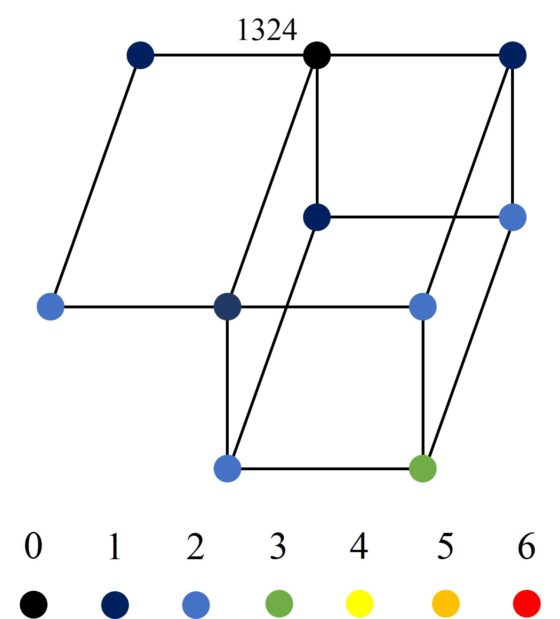

Los clusters de las configuraciones básicas no son siempre iguales. Por ejemplo, el cluster de la configuración 1324 tiene diez vértices, como vemos en la siguiente imagen.

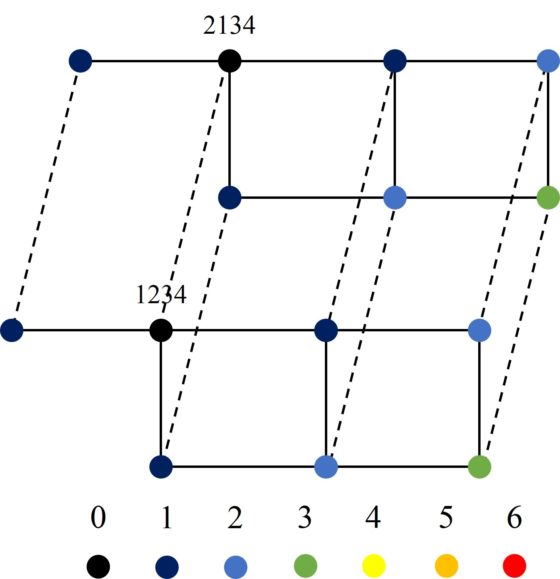

Además, la arista entre dos vértices del núcleo, es decir, entre dos configuraciones básicas, se extiende a aristas entre los vértices de sus clusters. Si los clusters tienen la misma estructura, como los de los vértices 1234 y 2134, las aristas se extienden de forma paralela, como se ve en la siguiente imagen.

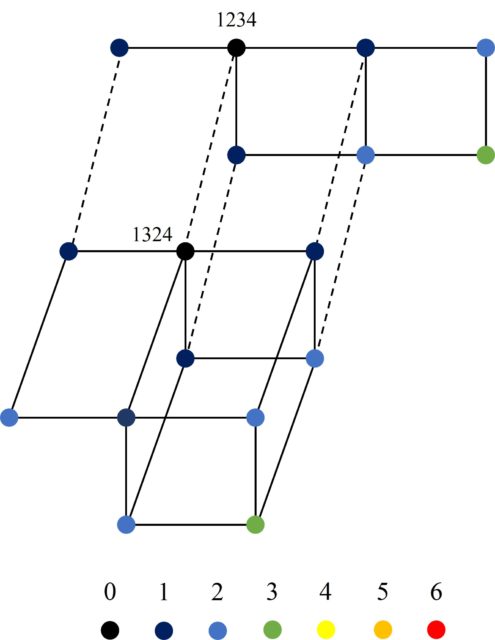

Mientras que, si los clusters tienen distintas estructuras, entonces las aristas que unen vértices de los dos clusters son más particulares, como entre los vértices 1234 y 1324.

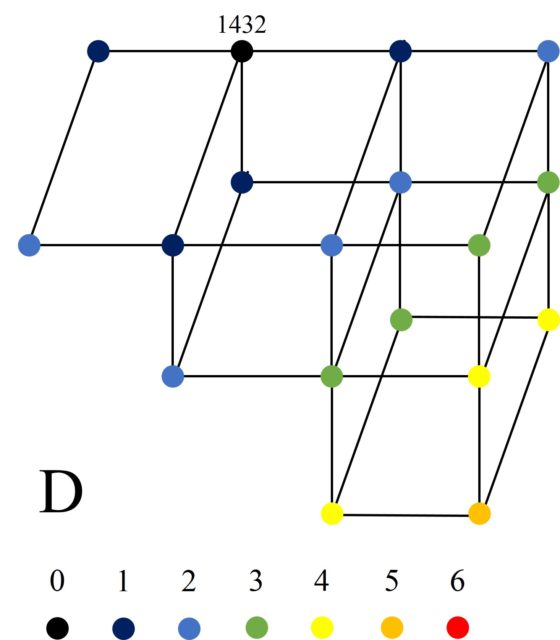

Existen seis estructuras diferentes de clusters, aunque la mayoría de las configuraciones básicas están relacionadas con tres de ellos. La estructura del cluster de las ocho configuraciones básicas que están en la parte superior de la imagen del grafo del núcleo (1234, 1243, 2143, 2134, 213’4’, 123’4’, 124’3’, 214’3’) es la misma. La llamaremos “estructura de cluster A” y tiene 7 vértices. También comparten estructura de cluster seis de las ocho configuraciones básicas que están en la parte izquierda de la imagen del grafo del núcleo (1324, 3124, 3142, 132’4’, 312’4’, 314’2’). La llamaremos “estructura de cluster B” y tiene 10 vértices. Y la otra estructura de cluster repetida, que llamaremos “estructura de cluster C”, tiene 14 vértices y es compartida por 7 de las ocho configuraciones básicas que están en la parte derecha de la imagen del grafo del núcleo (1423, 4123, 4132, 143’2’, 142’3’, 412’3’, 413’2’). Estas tres estructuras de clusters son las que aparecen en la siguiente imagen.

Mientras que hay tres configuraciones básicas, cada una de las cuales tiene su propia estructura particular de cluster. La configuración 1432 tiene la siguiente estructura de cluster, que llamaremos D, con 18 vértices.

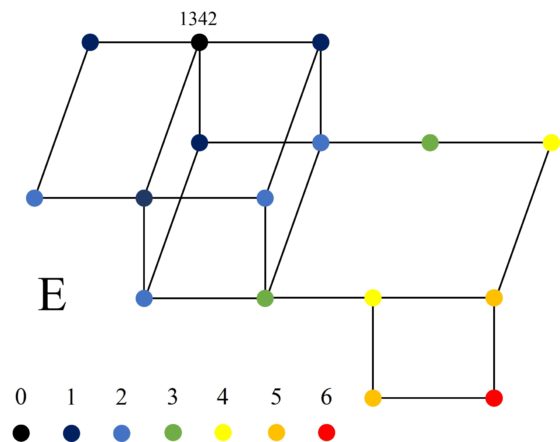

La configuración 1342 tiene la estructura de cluster que llamaremos E, con 16 vértices.

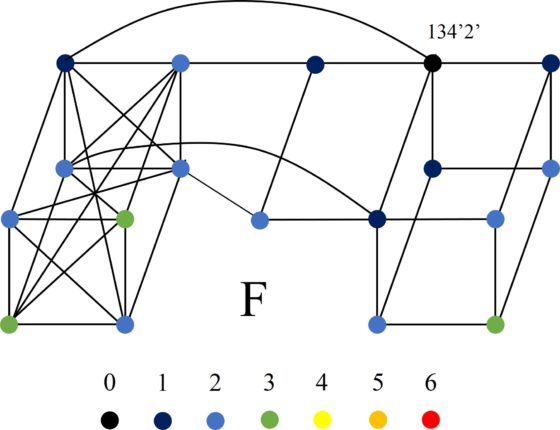

Y la configuración 134’2’ tiene la estructura de cluster más raras de todas, también con 18 vértices, que llamaremos F.

En resumen, el grafo gigante que hemos generado con soluciones/configuraciones del Stomach posee 266 vértices (que recordemos que son las soluciones del rompecabezas geométrico) y 936 aristas (que recordemos que están generadas a partir de movimientos locales y globales sobre las soluciones del Stomach). Pero resulta que hemos generado un grafo (conexo, es decir, no hay grupos de vértices desconectados, mediante las aristas, del resto) con 266 vértices, pero recordemos que el número de soluciones básicas del Stomach son 268. ¿Qué ocurre con las otras dos soluciones/configuraciones del puzzle? Resulta que esas dos configuraciones, están conectadas entre ellas mediante un movimiento local, es decir, son dos vértices con una arista entre ellas, pero están desconectadas del resto de soluciones del rompecabezas. Estas configuraciones son las que aparecen en la imagen siguiente.

En la siguiente imagen, para comprender un poco mejor la estructura de este enorme grafo asociado con el puzzle geométrico Stomach, hemos vuelto a dibujar el núcleo, indicando en cada configuración básica cual es la estructura de cluster que se agrega a la misma, así como las dos configuraciones aisladas, que no están en el núcleo o conectadas con el mismo, que hemos denominado “configuración 267” y “configuración 268”.

Todos los detalles de esta construcción, incluidas las aristas entre clusters de diferente estructura que no hemos incluido aquí, pueden encontrarse en la página A tour of Archimedes’ Stomachion, de la matemática Fan Chung y el matemático Ron Graham. Además, se incluyen interesantes propiedades matemáticas del grafo, como las dos con las que concluimos esta entrada.

Si consideramos la componente más grande del grafo del Stomach, con 266 vértices y 936 aristas, esta tiene un diámetro de 11, es decir, la distancia más grande entre dos vértices del grafo es de 11 aristas. Además, este subgrafo es un grafo de los llamados hamiltonianos, es decir, existe un camino (sucesión de vértices y aristas) que pasa por todos los vértices y en el que no se repite ningún vértice. Uno de esos caminos se muestra en la página A tour of Archimedes’ Stomachion, para quien esté interesado.

Y, para terminar, una escultura relacionada con los caminos hamiltonianos.

Escultura Hamilton cycle on football, del matemático y artista holandés Koos Verhoeff, en el exterior del edificio de Matemáticas de la Universidad de Heidelberg

Escultura Hamilton cycle on football, del matemático y artista holandés Koos Verhoeff, en el exterior del edificio de Matemáticas de la Universidad de Heidelberg

Bibliografía

1.- Reviel Netz, Fabio Acerbi, Nigel Wilson, Towards a Reconstruction of Archimedes’ Stomachion, SCIAMV 5, pp. 67-99, 2004.

2.- Grupo Alquerque de Sevilla (Juan Antonio Hans, José Muñoz, Antonio Fernández-Aliseda), Stomachion, el cuadrado de Arquímedes, SUMA, n. 50, pp. 79 – 84, 2005.

3.- Fan Chung, Ron Graham, A tour of Archimedes’ Stomachion

4.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, colección El mundo es matemático, RBA, 2015.

5.- Erica Klarreich, Glimpses of genius, Science News, n. 15, vol. 165, 2004.

6.- Wolfram Mathworld: Stomachion

7.- Tom Verhoeff, Koos Verhoeff, Three Mathematical Sculptures for the Mathematikon, Proceedings of Bridges 2016: Mathematics, Music, Art, Architecture, Education, Culture, pp. 105-110, 2016.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El puzzle Stomachion y el palimpsesto de Arquímedes (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El puzzle Stomachion y el palimpsesto de Arquímedes (1)

- Un delicioso puzzle de chocolate

- Un puzzle sencillo

El modelo de Bohr explica las regularidades en el espectro del hidrógeno

Foto: Tyler Lastovich / Unsplash

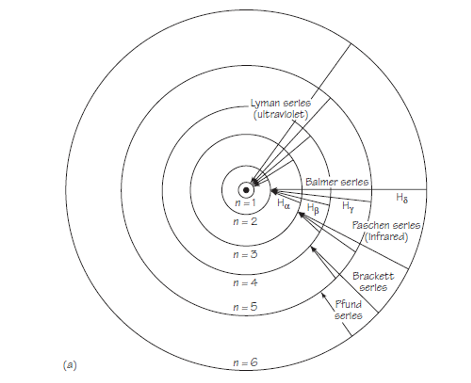

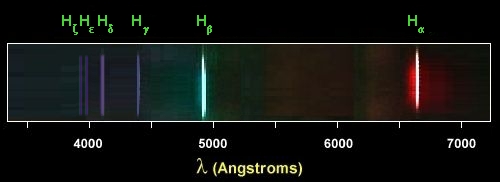

Foto: Tyler Lastovich / UnsplashCuando Bohr propuso su modelo en 1913, solo se conocían las líneas de emisión del hidrógeno en las series Balmer y Paschen. Balmer había sugerido, y el modelo de Bohr concordaba con ello, que deberían existir series adicionales.

Experimentos contemporáneos y posteriores descubrieron la serie de Lyman en la porción ultravioleta del espectro (1904–1914), la serie de Brackett (1922) y la serie de Pfund (1924), estando estas últimas en la región infrarroja del espectro. En cada serie se encontró que las frecuencias medidas de cada una de las líneas eran las predichas por el modelo de Bohr y, lo que es más importante, no aparecían líneas que no se correspondiesen con el modelo. Del mismo modo, el modelo de Bohr podía explicar la fórmula general que Balmer supuso que podría aplicarse a todas las líneas espectrales de hidrógeno. Descritas términos empíricos, las líneas de la serie de Lyman corresponden a transiciones de varios estados iniciales al estado final nf =1; las líneas de la serie Paschen corresponden a transiciones de varios estados iniciales al estado final nf = 3; y así sucesivamente, como lo indica la expresión derivada a partir del modelo de Bohr:

1/λ = RH (1/nf2 – 1/ni2)

El esquema general de posibles transiciones entre las primeras seis órbitas se muestra en la figura 1.

Fuente: Cassidy Physics Library

Fuente: Cassidy Physics LibraryPor lo tanto, el modelo no solo relacionó información conocida sobre el espectro de hidrógeno, sino que también predijo correctamente las longitudes de onda de series de líneas previamente desconocidas en el espectro. Además, proporcionó un modelo físico razonable; la fórmula general de Balmer no había proporcionado ninguna razón física para la relación empírica entre las líneas de cada serie.

El diagrama de la figura 1 es útil como ayuda para la imaginación. Pero tiene el peligro de ser demasiado específico. Por ejemplo, puede llevar a pensar en la emisión de radiación como «saltos» reales de electrones entre órbitas. [*]

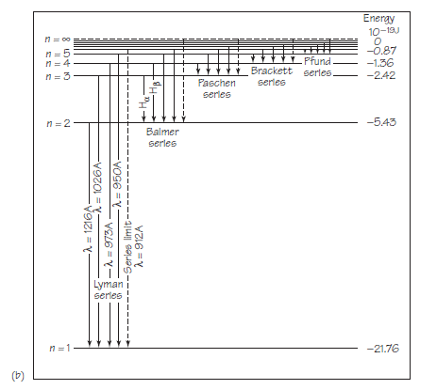

Existe otra forma de presentar los resultados de la teoría de Bohr que produce los mismos resultados pero no se adhiere tan estrechamente a una imagen de órbitas. Este nuevo esquema se muestra en la figura 2. No se centra en las órbitas sino en los estados de energía posibles correspondientes. Todos estos estados de energía vienen dados por la expresión para la energía del estado estacionario, En = 1/n2 ·E1 .

Fuente: Cassidy Physics Library

Fuente: Cassidy Physics LibraryEn términos de este modelo matemático, el átomo normalmente no está excitado, con una energía E1 de aproximadamente 13,6 eV (o 22 1019 J). La absorción de energía puede colocar a los átomos en un estado excitado, con una energía correspondientemente más alta. El átomo excitado está entonces listo para emitir radiación, con la consiguiente reducción de energía. La energía absorbida o emitida siempre cambia la energía total del átomo a uno de los valores especificados por la fórmula para En. Por lo tanto, el átomo de hidrógeno también puede representarse, no por órbitas, sino por medio de un diagrama de niveles de energía.

Nota:

[*] Es necesario profundizar un poco más en la cuántica para comprender que esto no es posible, porque no podemos, de entrada, localizar un electrón. Lo veremos en una próxima serie.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El modelo de Bohr explica las regularidades en el espectro del hidrógeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El modelo de Bohr explica la fórmula de Balmer

- Las regularidades en el espectro del hidrógeno

- El tamaño del átomo de hidrógeno

Desmitificando: Vacunas peligrosas

Imagen de Ria Sopala / Pixabay

Imagen de Ria Sopala / PixabayLos datos son de Estados Unidos. Antes de las vacunas algo más de 21000 personas tuvieron difteria; en la era de las vacunas, el número bajó a cero. Para la varicela, el porcentaje de caída del número de enfermos fue del 89%. Para la polio, el 100%, la viruela, el 100%; el tétanos, el 98%. Y así podemos seguir, enfermedad tras enfermedad. Los males que ahora padece nuestra especie, en general, son aquellos para los que no hay vacuna, y, en cambio, muchos con vacuna han sido prácticamente erradicados. Males que diezmaban generaciones hace no muchos años. La OMS, en 2018, resume que las vacunas protegen al 86% de la población mundial, y evitan la muerte de dos millones de personas cada año.

En 1980 se declaró desaparecida la viruela y, ahora, se debate si hay que destruir los pocos cultivos de virus de la viruela que se conservan en algunos laboratorios de alta seguridad. En 2016 solo se registraron 42 casos de polio en todo el mundo y todos ellos en cuatro países: Pakistán, Afganistán, Laos y Nigeria. La enfermedad infectó a unas pocas personas por razones religiosas y sociales, no por causas médicas. Fue en la década de los cincuenta del siglo pasado cuando, primero Jonas Salk y, poco después, Albert Sabin, desarrollaron vacunas contra la polio. Ahora, 60 años después, la vacuna ha eliminado la enfermedad de casi todo el planeta. Jonas Salk renunció a la patente de su vacuna y proclamó que “no se puede patentar el sol”.

Vista la historia de las vacunas, parece que la confianza en ellas debía ser total. Sin embargo, la confianza en su eficacia se ha convertido en un asunto de salud pública global de importancia creciente. La caída en la confianza en las vacunas lleva a la vuelta de enfermedades casi olvidadas y casi erradicadas o a impedir que otras desaparezcan, como ocurre con la polio o las paperas, y a múltiples debates sociales y políticos en muchos países, sean ricos o en desarrollo. El grupo de Heidi Larson, de la Escuela de Higiene y Medicina Tropical de Londres, ha estudiado la confianza en las vacunas en 67 países, con datos de 65810 voluntarios.

El sentimiento de confianza en las vacunas es general en todos los países estudiados, aunque hay mucha variabilidad en las respuestas a la encuesta de los autores. Es de destacar que la menor confianza se observa en Europa, con siete países europeos entre los diez que encabezan la lista de los que no se fían de las vacunas. En Francia, la desconfianza alcanza al 41% de los encuestados, seguida de Bosnia con el 36%. Los países con más confianza son Bangladesh, Ecuador e Irán y los más escépticos son Azerbaiyán, Rusia e Italia. La media de los 67 países es del 13% de falta de confianza en las vacunas. En España, el 28% no considera seguras las vacunas, y el 27% no cree que sean efectivas.

Los voluntarios con más confianza en las vacunas son los mayores de 65 años y los católicos. Y los que menos confianza tienen son de los países con más educación, mejor acceso a los servicios de salud y mayor estatus socioeconómico.

Todo este asunto de la falta de confianza, incluso del temor a las vacunas, comenzó en 1998 cuando Andrew Wakefield y su equipo, entonces en la Escuela de Medicina de Londres, publicaron un artículo que relacionaba la vacuna triple vírica, contra el sarampión, las paperas y la rubeola, con el autismo. Los resultados de este estudio provocaron miedo en los padres y un intenso debate público sobre la seguridad de la vacuna. Unos años, después, en 2010, se reunieron suficientes evidencias que demostraban que la publicación de Wakefield era un fraude e instituciones públicas y privadas la rechazaron. Incluso todos los firmantes del artículo original menos dos retiraron su apoyo al estudio. En 2017, Paul Offit, del Hospital Infantil de Philadelphia, escribe que el 85% de los padres de hijos autistas no creen que la vacuna sea la causa.

La revista The Lancet,que había publicado el artículo original de Wakefield en 1998, se retractó en 2017, y retiró el estudio de sus archivos. Y en 2011, la revista British Medical Journal publicó el relato de cómo se había gestado el fraude y el engaño de Wakefield.

Fue en 2014 cuando se publicó un meta análisis sobre lo conocido hasta esa fecha de la relación entre la vacuna triple vírica y el autismo, tal como Wakefield aseguraba en 1998. Fue el grupo de Luke Taylor, de la Universidad de Sydney, en Australia, quien revisó los trabajos publicados hasta abril de 2014. El total de la muestra son 1256407 niños y, además, se examinan otros cinco estudios con 9920 niños como control. Otra revisión, publicada en 2019, por el grupo de Anders Hviid, del Instituto Estatal del Suero de Copenhague, basada en el seguimiento de 657000 niños daneses, nacidos entre 1999 y 2010 y con un seguimiento hasta 2013, encuentra, también, que no hay relación entre la triple vacuna y el autismo.

Los resultados son claros: no hay relación entre la vacuna triple vírica y el autismo o con desórdenes que se asocian al autismo.

Andrew Wakefield perdió su licencia para ejercer la medicina. Pero el mito, en esos años, llegó a los medios y a las redes sociales y se extendió y, hoy en día, sigue vigente para muchas personas que siguen sin creer en las vacunas. En encuestas publicadas en Australia por el equipo de Stephan Lewandowsky, de la Universidad de Australia Occidental en Crawley, se encuentra que, en 2002, del 20% al 25% de la población cree en la relación entre la vacuna y el autismo, y del 39% al 53% considera que las evidencias a favor y en contra de esa relación están igualadas. Incluso un número relevante de profesionales sanitarios aceptan la relación.

Es interesante conocer las razones que llevan los antivacunas a seguir una conducta que el consenso científico afirma que puede ser peligrosa para la salud e, incluso, la vida de quien la sigue. El estudio de Beth Hoffman y su grupo, de la Universidad de Pittsburgh, utiliza datos que tienen un origen curioso, casi de serendipia. Este grupo de médicos publicó, en 2015, un video en Facebook recomendando el uso de la vacuna contra el virus del papiloma humano. En poco tiempo se convirtió en viral y recibió unas 10000 opiniones de 800 comentaristas de ocho países. La mayoría de los comentarios eran de contenido antivacunas, y los autores eligieron 197 comentaristas de los más activos.

El estudio de los textos permitió al grupo de Hoffman conocer las razones que apoyaban su ideología contra las vacunas. En primer lugar, está la desconfianza respecto a la comunidad científica. Después, aparecen los seguidores de terapias alternativas. En tercer lugar, los que aceptan las exageraciones del riesgo de las vacunas. Y, finalmente, están los conspiranoicos que acusan a gobiernos, instituciones y grandes empresas.