Las regularidades en el espectro del hidrógeno

Foto: Adam Kring / Unsplash

Foto: Adam Kring / UnsplashLas ideas de Balmer sobre el espectro del hidrógeno tuvieron un éxito enorme. Veámoslo.

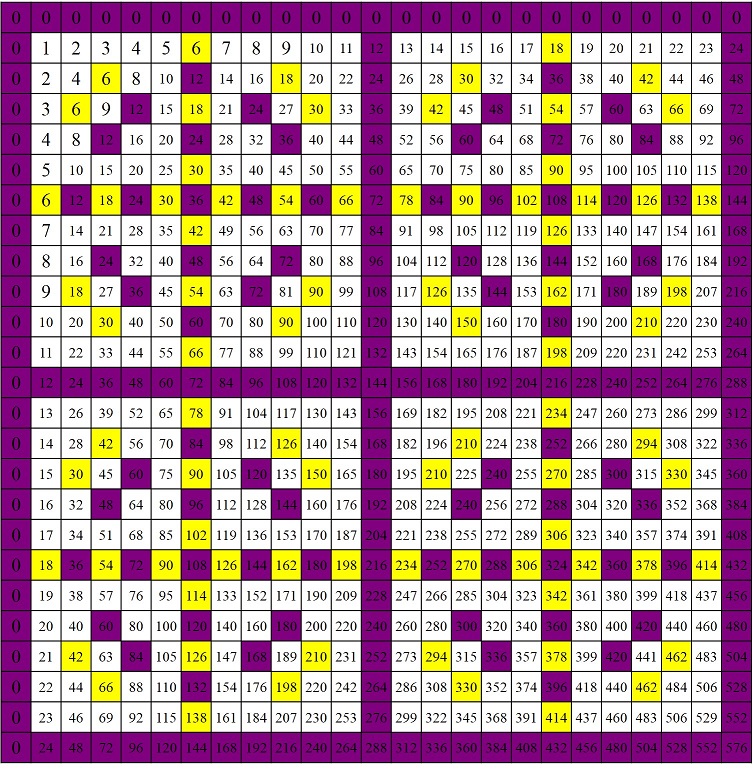

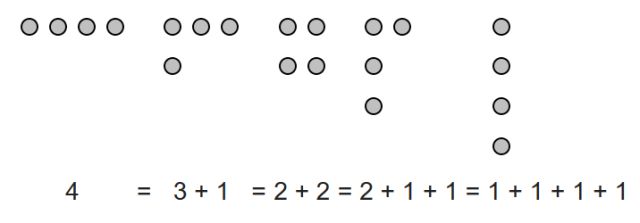

Para usar la notación moderna, reescribimos la fórmula de Balmer λ = b [n2/(n2-22)] en una forma que nos será más útil:

1/λ = RH (1/22 – 1/n2)

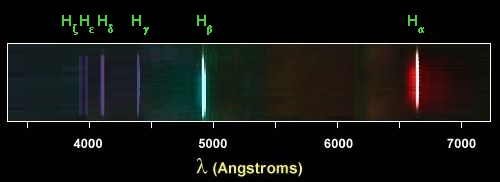

En esta ecuación que, como decimos, puede derivarse de la anterior, RH es una constante, igual a 4 / b. Se llama constante de Rydberg para el hidrógeno, en honor del espectroscopista J.R. Rydberg. Continuando el trabajo de Balmer, Rydberg hizo un gran progreso en la búsqueda de varias series espectrales. La serie de líneas descritas por la fórmula de Balmer se llama la serie de Balmer. Balmer construyó su fórmula a partir de las longitudes de onda conocidas de solo cuatro líneas en la parte visible del espectro. Esta fórmula de Balmer predice correctamente cada una de estas cuatro líneas con una precisión considerable. La fórmula, sin embargo, parecía indicar que podrían existir muchas más líneas en la misma serie [1]. Además,

La sugerencia especulativa [2] de Balmer de reemplazar 22 por otros números ofrece las siguientes posibilidades:

1/λ = RH (1/12 – 1/n2)

1/λ = RH (1/32 – 1/n2)

1/λ = RH (1/42 – 1/n2)

…

Cada una de estas ecuaciones describe una posible serie de líneas de emisión. Todas estas series hipotéticas de líneas pueden resumirse en una fórmula general

1/λ = RH (1/nf2 – 1/ni2)

donde nf sería un número entero que es fijo para cada serie para la que se encuentren longitudes de onda (por ejemplo, nf = 2 para todas las líneas de la serie Balmer). Por otro lado ni representa enteros que toman los valores nf + 1, nf + 2, nf + 3,. . . para las sucesivas líneas individuales en una serie dada (las cuatro primeras líneas de la serie de Balmer, ni toma por tanto los valores 3, 4, 5, y 6) La constante RH debe tener el mismo valor para todas las series del hidrógeno.

Reiteremos que todo esto es pura especulación [2]. No hay nada que indique que deba existir ninguna otra serie, ninguna línea que se ajuste a la fórmula general, excepto la serie de Balmer observada experimentalmente, donde nf = 2. Pero resultó que, cuando la comunidad científica se puso a buscar estas líneas hipotéticas con buenos espectrómetros descubrió que, de hecho, ¡existen!

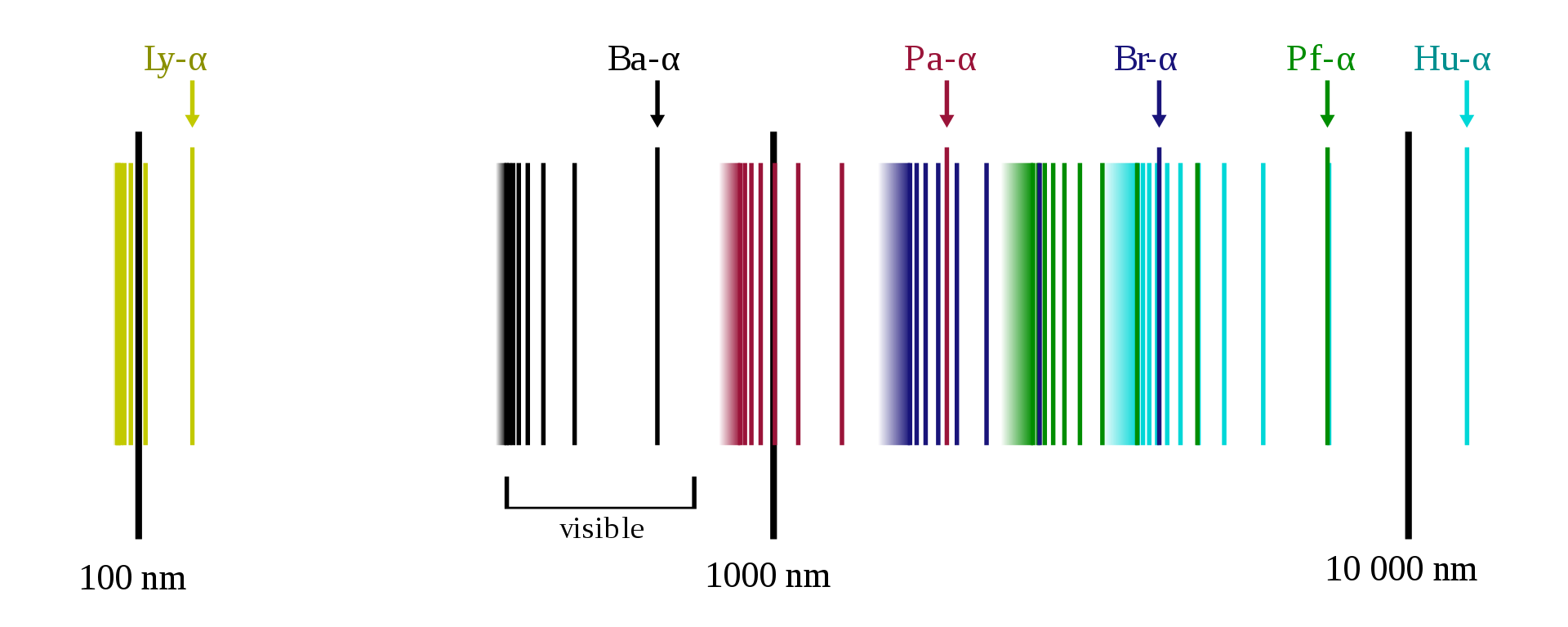

En 1908, F. Paschen encontró dos líneas del hidrógeno en el infrarrojo. Sus longitudes de onda se correspondían con notable precisión a la fórmula general estableciendo nf = 3 y ni = 4 y 5. Desde entonces, se han identificado muchas otras líneas en esta «serie de Paschen». Con técnicas y aparatos experimentales mejorados, se pudieron explorar nuevas regiones del espectro. Así, se fueron agregando gradualmente otras series a las series de Balmer y de Paschen. Las series del espectro del hidrógeno descubiertas son las siguientes (entre paréntesis año de descubrimiento):

Lyman (1906–1914) nf =1, ni = 2, 3, 4, . . . en el ultravioleta;

Balmer (1885) nf = 2, ni = 3, 4, 5, . . . en el ultravioleta-visible;

Paschen (1908) nf = 3, ni = 4, 5, 6, . . . en el infrarrojo;

Brackett (1922) nf = 4, ni = 5, 6, 7, . . . en el infrarrojo;

Pfund (1924) nf = 5, ni = 6, 7, 8, . . . en el infrarrojo;

Humphreys (1953) nf = 6, ni = 7, 8, 9, . . .en el infrarrojo.

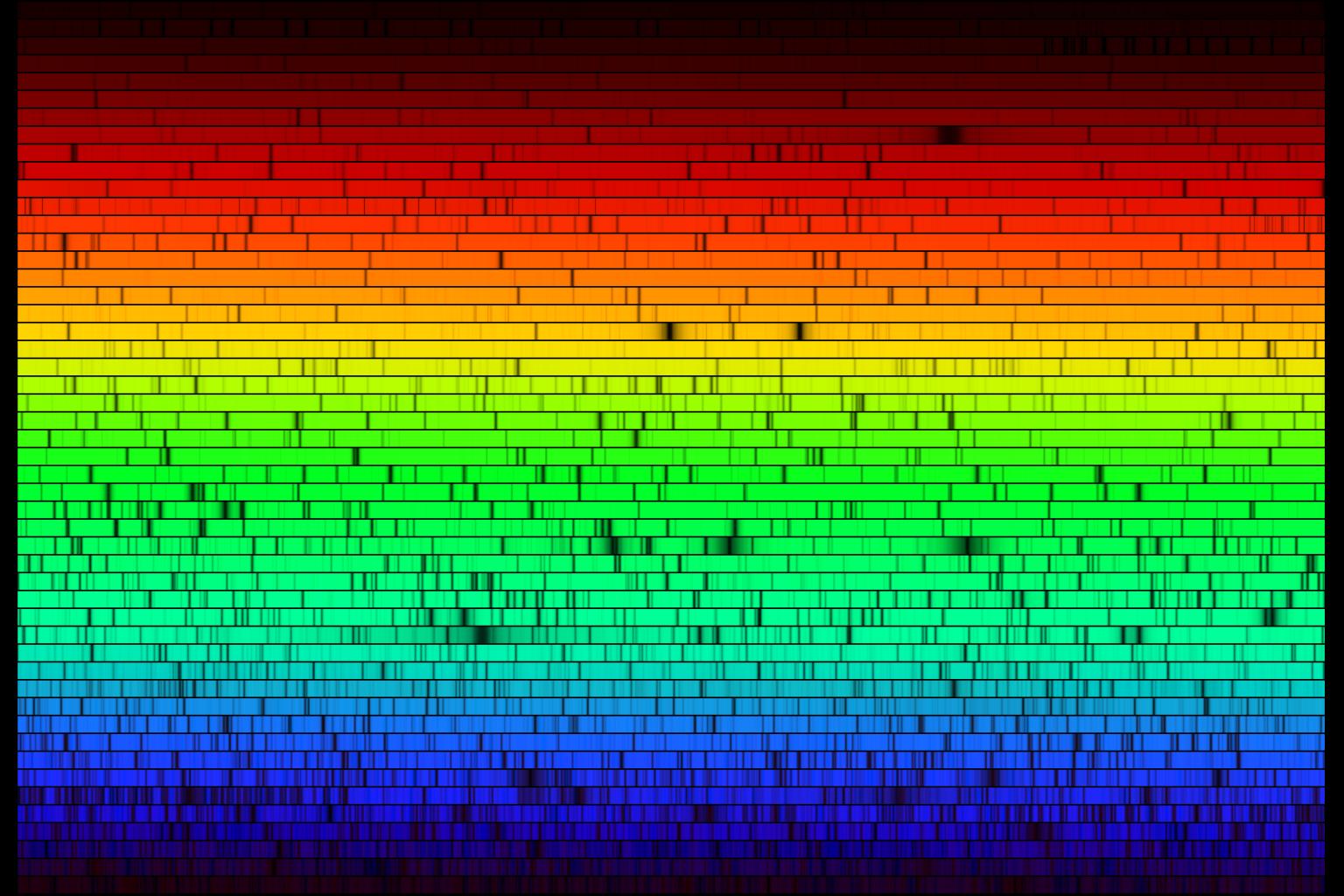

Líneas espectrales del hidrógeno en escala logarítmica. Se señala la primera línea (α) de cada una de las series. Imagen: Wikimedia Commons

Líneas espectrales del hidrógeno en escala logarítmica. Se señala la primera línea (α) de cada una de las series. Imagen: Wikimedia CommonsBalmer también especuló con la idea de que su fórmula para el espectro del hidrógeno pudiera ser un patrón para encontrar relaciones en los espectros de otros gases. Esta sugerencia también dio fruto. La fórmula de Balmer en sí misma no funcionó directamente para describir espectros de gases distintos al hidrógeno. Pero sí inspiró fórmulas de forma matemática similar que describieron con éxito el orden en porciones de muchos espectros complejos [3].

Para sorpresa de muchos y desesperación de otros no se podía construir ningún modelo basado en la mecánica clásica y el electromagnetismo que explicara los espectros descritos por estas fórmulas.

Lo que ya hemos visto sobre la teoría cuántica sugería una línea de ataque. Obviamente, la emisión y absorción de luz de un átomo debe corresponder a una disminución y un aumento de la energía del átomo. Si los átomos de un elemento emiten luz de solo ciertas frecuencias, entonces la energía de los átomos debe poder cambiar solo en ciertas cantidades. Estos cambios de energía deben implicar la reorganización de las partes del átomo. Se hacía imprescindible cambiar radicalmente el enfoque a la hora de construir un modelo de átomo viable. Pero era necesario un ingrediente fundamental adicional antes de que se construyese un modelo atómico que pudiese tener éxito: el descubrimiento de que el átomo es, básicamente, espacio vacío.

Notas:

[1] De hecho, infinitas, ya que n = 3, 4, 5, 6, 7, 8,… ∞

[2] Y numerológica. Es por pura simetría matemática. Funciona porque funciona, pero recordemos que tras la sugerencia de Balmer no hay ninguna base física a priori.

[3] La constante de Rydberg RH también reapareció en estas fórmulas empíricas.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Las regularidades en el espectro del hidrógeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las líneas de Balmer

- El hidrógeno en el Universo (I): La emisión del hidrógeno neutro a 21 cm.

- La ley del gas ideal y la tercera ley de la termodinámica

Los límites del ferrocarril

Iván Rivera

Foto:Konstantin Planinski / Unsplash

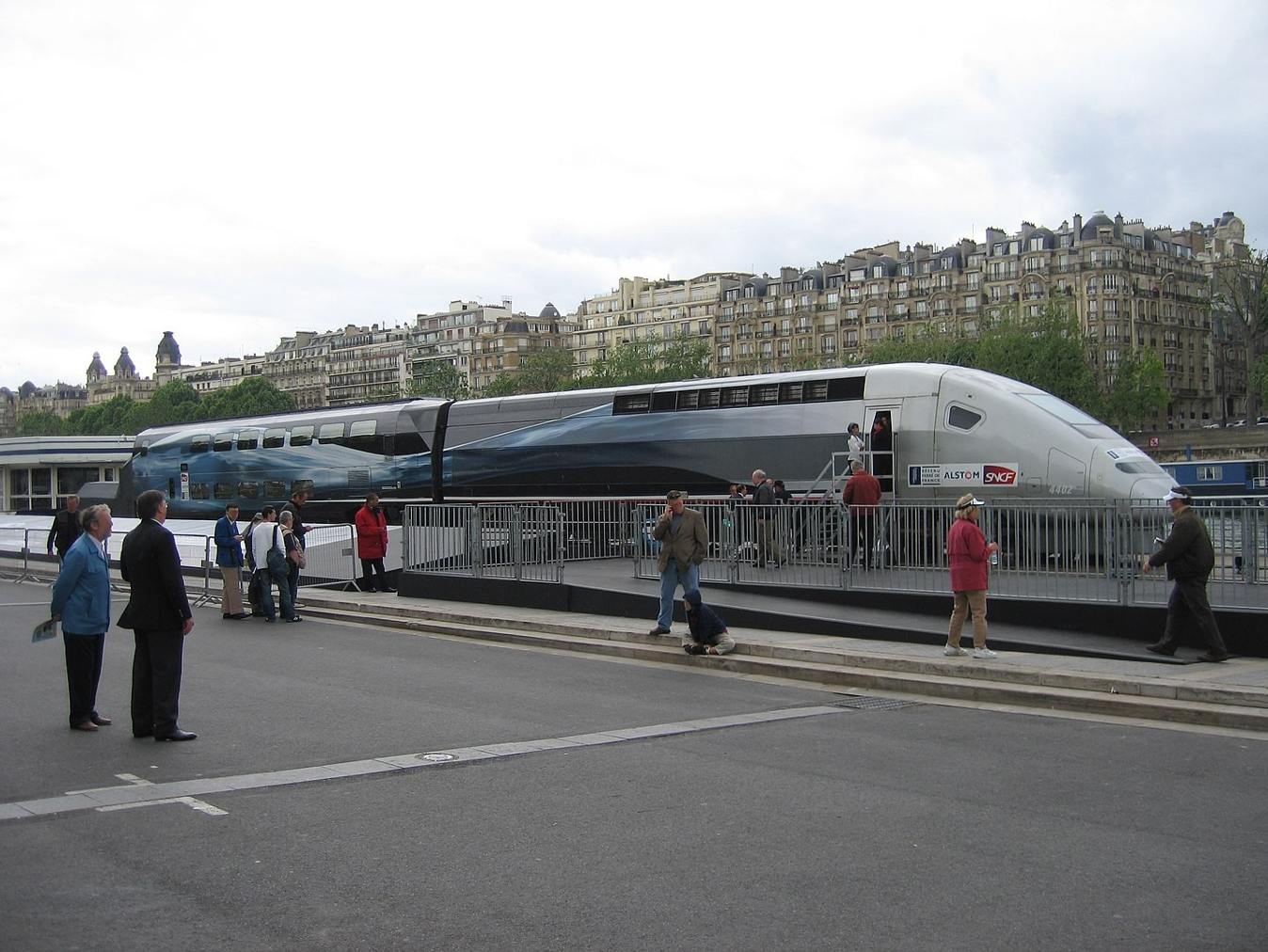

Foto:Konstantin Planinski / UnsplashYa han pasado doce años desde que se logró el récord del mundo de velocidad en ferrocarril. La que se dio en llamar «Operación V150» por la velocidad objetivo, 150 metros por segundo o 540 kilómetros por hora, ocupó desde enero de 2007 hasta abril del mismo año a un equipo formado por la operadora SNCF, el gestor de infraestructuras Réseau Ferré de France y el fabricante de material móvil Alstom. El 3 de abril, a las 13 horas, 13 minutos y 40 segundos, el TGV V150 construido para la ocasión por esta última empresa alcanzó los 574,8 km/h en el punto kilométrico 194 de la línea TGV-Est entre las estaciones de Prény y Champagne-Ardennes, cerca de la localidad de Éclaires —quizá en un giro involuntariamente poético para los ingenieros a cargo: éclaires significa en español «(tú) iluminas».

Con un gasto de 30 millones de euros, la Operación V150 no fue solo un ardid publicitario para cementar el prestigio nacional de una industria ante la dura competencia alemana y, cada vez más, china. Durante los múltiples recorridos de prueba en los que el anterior récord de 1990 (515,3 km/h) fue superado extraoficialmente en varias ocasiones, los ingenieros del proyecto monitorizaron en detalle el comportamiento del vehículo, la vía y la catenaria para determinar en cada caso sus límites operativos.

Más de una década después, ¿qué conclusiones pueden extraerse de este experimento para el ferrocarril? ¿Por qué la velocidad máxima de los trenes ha parecido estancarse en los 350 kilómetros por hora desde hace décadas? Para entenderlo, hagamos un repaso por el sistema ferroviario prestando especial atención a los factores susceptibles de limitar su rendimiento.

El contacto rueda-carril

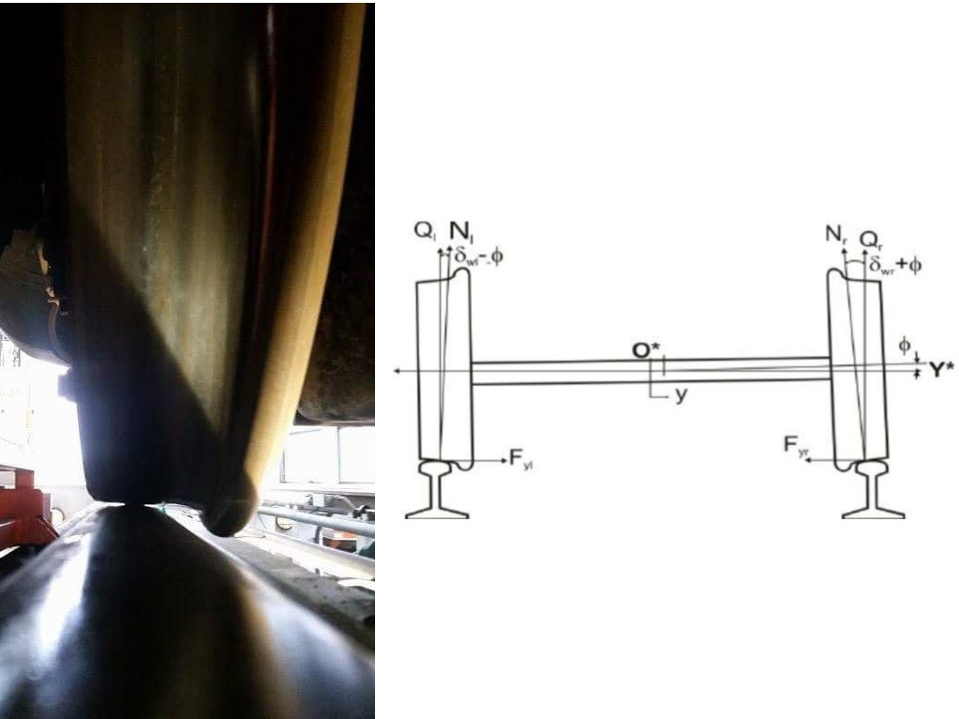

El tren es un medio de transporte terrestre guiado, lo que significa que solo puede moverse a lo largo de una estructura —la vía— formada por raíles paralelos entre sí, mantenidos en su sitio mediante sujeciones a unas piezas usualmente de hormigón denominadas traviesas. La vía no está anclada a su plataforma: solo descansa sobre ella. Su estabilidad está asegurada por su propio peso. Las ruedas del tren, de acero como los raíles, tienen un perfil ligeramente cónico rematado por una pestaña por el lado interior que asegura que los ejes se mantengan centrados sobre la vía sin descarrilamientos [Casanueva, 2014]. El perfil de las ruedas garantiza el centrado durante la mayor parte de los trayectos apoyándose sobre la cabeza del raíl, mientras que las pestañas sujetan al tren en caso de desplazamientos laterales excesivos.

Imagen1. Rueda y carril. Foto: CAF.

Imagen1. Rueda y carril. Foto: CAF.

Cuando la vía no se bifurca, presenta una estructura geométrica formada por secuencias de rectas y arcos de circunferencia unidos entre sí mediante curvas de acuerdo para evitar discontinuidades en el radio de curvatura —infinito en una recta, finito en plena curva— y, por tanto, eliminando así posibles saltos en la aceleración radial experimentada por los trenes a lo largo de su trayecto. Para limitar aún más esta aceleración y tolerar radios de curvatura más pequeños, las vías van peraltadas: el plano de rodadura se inclina hacia el lado interior de la curva con un ángulo que depende de la velocidad esperada de los trenes y su peso por eje.

Sin duda, el contacto rueda-carril es uno de los grandes inventos de la humanidad a la hora de reducir la energía necesaria para transportar grandes cantidades de pasajeros y carga. La superficie de contacto por rueda sobre la cabeza del carril apenas es de 250 mm², garantizando unas fuerzas de rozamiento mínimas —el coeficiente de resistencia a la rodadura del acero sobre acero es, en el peor de los casos, 30 veces menor que el del caucho sobre asfalto.

Imagen 2. Contacto rueda-carril: detalle y diagrama. Fuente: TER Pays de la Loire / Anyakwo, Pislaru, Ball, & Gu, 2011.

Imagen 2. Contacto rueda-carril: detalle y diagrama. Fuente: TER Pays de la Loire / Anyakwo, Pislaru, Ball, & Gu, 2011.Sin embargo, en Física nunca se obtiene nada sin sacrificar otra cosa a cambio: la capacidad de mover centenares de toneladas con una fuerza de tracción moderada solo se obtiene a cambio de perder la capacidad de frenar en espacios cortos o de superar pendientes pronunciadas. Es totalmente intuitivo si pensamos en cómo se comporta un automóvil sobre asfalto frente a su respuesta sobre hielo. Si, además, reducimos la anchura de las ruedas y las fabricamos en un material de menor coeficiente de rozamiento («más liso»), no debería resultar extraño que un tren ligero de viajeros requiera algún centenar de metros para detenerse, mientras que un mercante pesado necesite uno o dos kilómetros de vías.

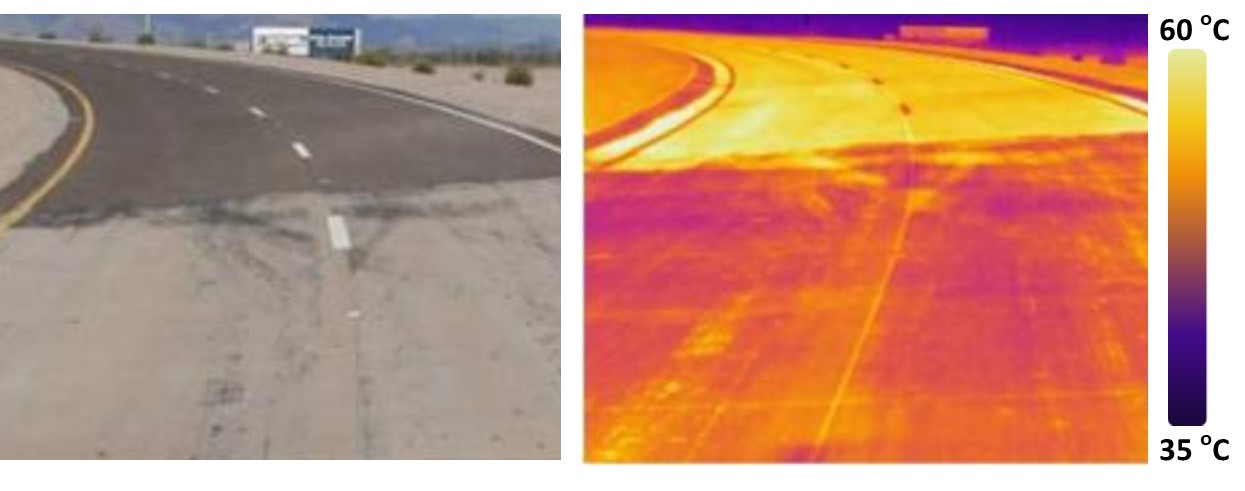

La aerodinámica

Tiempo atrás los trenes tenían testeros —la denominación en jerga ferroviaria del frontal— completamente rectangulares. La velocidad que alcanzaban no era suficiente para que los ingenieros debieran preocuparse por la resistencia que opusiera el aire al avance de un vehículo tan pesado. Sin embargo, el advenimiento de plantas motrices más capaces trajo consigo la preocupación por encontrar formas que permitieran «penetrar» el aire más fácilmente. Hay que buscar el origen de todo ello en la relativamente sencilla ecuación de la fuerza de arrastre aerodinámico, que establece que la resistencia al avance debida al aire es directamente proporcional al cuadrado de la velocidad [1].

Imagen 3. Locomotora de vapor Mallard en el National Railway Museum, York. Foto: PTG Dudva.

Imagen 3. Locomotora de vapor Mallard en el National Railway Museum, York. Foto: PTG Dudva.La lucha por reducir al mínimo el coeficiente de arrastre aerodinámico, en principio empírica y realizada en túneles de viento, y más adelante numérica y ejecutada mediante simulaciones llevadas a cabo en ordenadores de gran potencia de cálculo, tiene límites. Un carenado con un buen coeficiente puede mejorarse mediante faldones específicos para los pantógrafos, sistemas de enganche escamoteables o reduciendo la separación entre coches (vagones, una vez más en jerga ferroviaria). Sin embargo, es fácil ver que rápidamente es necesario llegar a compromisos con la mantenibilidad del sistema o su propia durabilidad. En particular, la separación entre coches debe ser la suficiente como para acomodar sus conexiones flexibles durante la inscripción del tren en las curvas. Cómo un tren formado por elementos fundamentalmente rígidos toma curvas con facilidad es materia para otro artículo.

El contacto pantógrafo-catenaria

La interfaz rueda-carril es la más evidente para quien no haya prestado demasiada atención a la disposición física del sistema ferroviario. Es, además, la única interfaz mecánica que presentan los trenes de propulsión diésel. Sin embargo, las plantas motrices diésel tienen limitaciones intrínsecas que no afectan a los trenes eléctricos y que se resumen en que el rendimiento de los motores de combustión interna tiene un límite impuesto por el segundo teorema de Carnot y la temperatura (fija) de la combustión de la mezcla diésel-aire. Ningún motor diésel presenta rendimientos superiores al 48%, por lo que disponer de más potencia —y a la postre más velocidad— es cuestión, únicamente, de aumentar el número de cilindros. Aumenta así también el consumo de combustible, que debe ser además transportado en depósitos específicos.

El conjunto de compromisos de ingeniería en los que se incurre deriva en que el récord mundial de velocidad de un tren con planta motriz diésel está fijado desde 1987 en 238 km/h, aunque no sin cierta polémica: el prototipo Talgo XXI (actualmente al servicio del gestor de infraestructuras Adif como tren laboratorio) alcanzó los 256,38 km/h entre Olmedo y Medina del Campo en 2002, aunque no se aceptó oficialmente el registro por la falta de una verificación independiente.

Imagen 4. Talgo XXI «Virgen del Pilar» en 2002. Foto: Photocapy

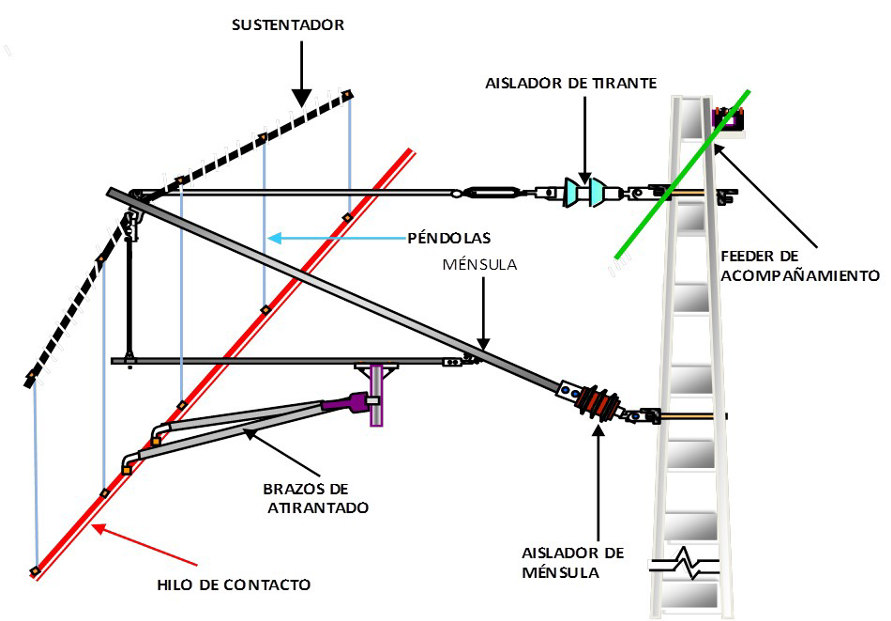

Imagen 4. Talgo XXI «Virgen del Pilar» en 2002. Foto: PhotocapyLos trenes eléctricos presentan una segunda interfaz mecánica. Al no transportar su propia fuente de energía, un tren eléctrico debe avanzar gracias a la corriente eléctrica que toma gracias a un contacto móvil con una estructura conductora ubicada sobre las vías. El contacto móvil se efectúa mediante el pantógrafo: un brazo articulado que mantiene una mesilla con una banda frotadora presionando contra el hilo de contacto, un hilo en aleación de cobre con plata con una resistencia muy baja al paso de la corriente, un coeficiente de rozamiento por fricción muy bajo y una alta resistencia al desgaste.

El hilo de contacto está sujeto —abusando un poco de la terminología— a dos tensiones. Por un lado, la tensión eléctrica que establece (dada la resistencia constante del metal empleado) la máxima corriente que puede solicitar el motor del tren. Por otro, la tensión mecánica que lo mantiene lo más horizontal posible, ya que la mejor calidad del contacto se obtendrá cuanto más regular sea. Naturalmente, el peso propio del hilo provoca una flecha: una diferencia de alturas entre los apoyos del sistema y el centro del vano. La flecha se reduce aumentando la tensión mecánica, que se consigue gracias a sistemas denominados de compensación automática: equipos compuestos por polipastos y contrapesos que mantienen constante la tensión mecánica del hilo de contacto ante los cambios de temperatura diarios y estacionales.

Imagen 5. Poleas del sistema de compensación automática de tensión en

Imagen 5. Poleas del sistema de compensación automática de tensión encatenaria de alta velocidad. Foto: Electrén, S.A.

Las fuerzas involucradas en el contacto pantógrafo-catenaria son despreciables a la hora de calcular la resistencia al avance de un tren, pero deben ser tenidas en cuenta para determinar la durabilidad de la propia catenaria. Al tratarse de una estructura ligera mantenida en tensión mecánica y atravesada por un flujo de corriente eléctrica, la catenaria puede resultar dañada tanto por causas mecánicas como eléctricas. Estos daños pueden ser nominales, provocando desgastes esperables en la estructura, o catastróficos, provocando cortes del hilo o enganchones en el pantógrafo.

La Operación V150

Los trabajos de la Operación V150 se desarrollaron en un doble sentido. Por un lado, se procedió a la construcción de una unidad laboratorio capaz de superar la velocidad de 150 m/s (540 km/h) —de ahí el nombre del proyecto, TGV V150 (Train à Grande Vitesse, tren de alta velocidad). Por el otro, se acondicionó un tramo de 94 kilómetros especialmente escogido de la línea TGV Est con una ligera pendiente descendiente uniforme y radios de curvatura suficientemente amplios para acomodar sin problemas el conjunto de pruebas a realizar. Las circulaciones del proyecto comenzaron en enero de 2007 y terminaron en abril, aumentando paulatinamente la velocidad. Se registraron un total de casi 1000 kilómetros a velocidades superiores a los 500 km/h.

La unidad V150 estaba formada por una inusual composición de dos cabezas motrices situadas entre tres coches remolque: dos unidades de doble cubierta y un coche cafetería central, especialmente construido para la ocasión y habilitado como laboratorio. Además, disponía de una serie de modificaciones especialmente concebidas para el intento de récord.

Imagen 6. Cabeza tractora y coche de la composición, expuestas en París tras la campaña del récord. Foto: Gonioul.

Imagen 6. Cabeza tractora y coche de la composición, expuestas en París tras la campaña del récord. Foto: Gonioul.La propulsión estaba garantizada por las dos cabezas motrices («locomotoras», traduciendo una vez más de la jerga profesional) y por dos bogies motores [2] articulados AGV montados en los extremos del coche cafetería. Los motores asíncronos de las cabezas habían sido potenciados un 56% por encima del valor habitual en su clase, hasta llegar a los 1950 kW. Los motores síncronos de imanes permanentes de los bogies fueron ajustados igualmente hasta alcanzar los 1000 kW (un 39% por encima de su potencia nominal). El conjunto podía desarrollar así una potencia total de 19,6 MW.

Se recurrió a un «viejo truco» empleado en las locomotoras de vapor para mejorar la velocidad a expensas del par motor —lo que afecta, fundamentalmente, a la capacidad de arranque: usar ruedas de un diámetro mayor. Se montaron ruedas de 1092 mm frente a las habituales de 920 mm. El ligero incremento de la altura del conjunto fue compensado, para mejorar sus prestaciones aerodinámicas, con mayores faldones en todo su contorno.

Además de éste, las modificaciones destinadas a enfrentar el flujo de aire a velocidades superiores a los 150 m/s fueron muy numerosas. Se sustituyó el carenado retráctil de dos piezas que protege el sistema de enganche automático de los testeros con una sola pieza continua. Se montó un parabrisas especial enrasado con la carrocería, y se desmontó el limpiaparabrisas. Toda la superficie inferior del conjunto fue panelada para reducir la resistencia aerodinámica y proteger los componentes expuestos al fenómeno de vuelo de balasto que producen las turbulencias propias de la circulación a altas velocidades.

Además, los pantógrafos de corriente continua que permiten la operación de las cabezas motrices en vías alimentadas de esta forma fueron retirados, y sus huecos panelados y enrasados. Las separaciones entre coches fueron protegidas con juntas flexibles superficiales. Incluso llegaron a diseñarse faldones específicos para los bogies, que finalmente no fueron utilizados durante la prueba del récord.

Las modificaciones de la infraestructura

El ferrocarril es un sistema de transporte en el que los vehículos y su infraestructura correspondiente están fuertemente acoplados. Por este motivo, era de esperar que la vía y la catenaria del programa V150 también sufrieran una serie de ajustes y modificaciones destinadas a garantizar un resultado final exitoso.

Los acuerdos entre rectas y arcos de circunferencia del trayecto fueron exhaustivamente revisados y ajustados para garantizar una transición completamente suave en la aceleración normal. Los peraltes de todas las curvas, así como sus correspondientes acuerdos de peralte, fueron aumentados hasta en 130 mm para evitar que el tren pudiera rodar bajo la condición conocida como «insuficiencia de peralte», que provoca que las pestañas de las ruedas del lado exterior de la curva rocen la cabeza del carril, provocando el desgaste prematuro tanto de éste como de las ruedas.

Se utilizó un balasto especialmente perfilado para reducir el impacto del ya citado efecto de vuelo. Finalmente en lo que respecta a la vía, todas las agujas existentes en el trayecto de prueba (del tipo conocido como corazón móvil) fueron enclavadas manualmente en la posición de vía directa, reduciendo así al mínimo toda posible discontinuidad física en los carriles.

Imagen 7. Tramo de ensayos de aerotraviesas —resultado de un desarrollo de Adif y SENER para minimizar el vuelo de balasto. Foto: Adif.

Imagen 7. Tramo de ensayos de aerotraviesas —resultado de un desarrollo de Adif y SENER para minimizar el vuelo de balasto. Foto: Adif.Por lo que respecta a la catenaria, se realizaron cambios tanto de la alimentación eléctrica como mecánicos. Los grupos de subestaciones y autotransformadores destinados a mantener un voltaje constante sin carga de 25 kV de corriente alterna en todo el trayecto fueron alterados para suministrar voltajes máximos de 31,7 kV. Se añadieron bancos de condensadores especialmente diseñados para apoyar a los autotransformadores y absorber la potencia reactiva extra generada por las mayores cargas inductivas de los motores de la unidad V150.

El factor clave para la circulación a muy alta velocidad, sin embargo, es la respuesta mecánica de la catenaria. Su comportamiento es sencillo de entender si imaginamos un dedo pulsando una cuerda de guitarra. El «dedo» representa el pantógrafo de un tren. Al desplazarse longitudinalmente por la catenaria aplicando una fuerza vertical para garantizar la continuidad del contacto eléctrico, el pantógrafo crea una onda que se desplaza en ambos sentidos a lo largo de cada cantón (tramo) de compensación automática de la tensión mecánica de la catenaria.

La frecuencia de la onda generada aumenta con la tensión mecánica —y por ese motivo las cuerdas más tensas de una guitarra suenan más agudas. Pero si el dedo se desplaza presionando la cuerda en vez de pulsarla, la onda deja de ser estática para pasar a desplazarse con una velocidad proporcional a la tensión mecánica e inversamente proporcional a la masa por unidad de longitud del material [3].

Esta situación ideal se ve modificada por la existencia de masas fijas en la catenaria, necesarias para su sujeción mecánica. Las péndolas y los brazos de atirantado, que permiten mantener la forma del hilo de contacto anclándolo al hilo sustentador y a los postes respectivamente, provocan ondas reflejadas que alteran el comportamiento del conjunto. A velocidades elevadas la interacción dinámica entre el pantógrafo y la catenaria se complica aún más debido al efecto Doppler que acorta las ondas en el sentido de avance (y las alarga en el sentido contrario).

Imagen 8. Diagrama descriptivo de una catenaria de alta velocidad.

Imagen 8. Diagrama descriptivo de una catenaria de alta velocidad.Fuente: Adif.

Dado que el hilo de contacto usado durante las pruebas del récord es el mismo que se utiliza en producción, el único parámetro que podía alterarse era su tensión mecánica: de los 25 kN nominales se aumentó hasta 40 kN —la tensión equivalente a colgar del hilo una masa de 4 toneladas, aproximadamente. La velocidad estimada para la perturbación ondulatoria resultante sería de 610 km/h, dejando suficiente margen de seguridad respecto de la velocidad finalmente alcanzada por el tren.

El récord

A las 13 horas exactas del día 3 de abril, Daniel Beylot, jefe de la Operación V150, dio la orden de arranque. Reconoce la orden Eric Pieczak, el maquinista designado para conducir el tren durante el intento de récord. En la cabina le acompañan Georges Pinquié, inspector de tracción y Claude Maro, director del departamento correspondiente. A bordo del tren, y mostrando la confianza absoluta de los ingenieros en la seguridad de la prueba, se encuentran 105 personas, incluyendo a la presidenta de la SNCF, Anne-Marie Idrac, su director general, Guillaume Pépy, el presidente de RFF, Hubert du Mesnil y el comisario europeo de Transportes, Jacques Barrot, junto con un nutrido complemento de invitados y periodistas.

Tres cámaras de televisión de gran formato y diez minicámaras adicionales montadas en diferentes puntos del tren transmitían imágenes en directo a los informativos nacionales. Junto a la vía, siete cámaras adicionales capturarían imágenes del tren —una en el lugar de partida y otra en el de llegada, con cinco más dispuestas en la zona en la que se esperaba conseguir el récord de velocidad. Una cámara adicional a bordo de un avión reactor Aérospatiale Corvette seguiría la totalidad del trayecto. Los alrededores de la vía, y muy en particular todos los pasos superiores y la estación de Meuse, a mitad del trayecto, están abarrotados de espectadores.

El tren sale de Prény y rápidamente alcanza la zona neutra de la catenaria que separa la alimentación convencional de 25 kV de alta velocidad de la especial a 31 kV, proporcionada desde la subestación especialmente preparada de Trois Domaines. Siguiendo el protocolo habitual en el cambio de alimentación, Pieczak baja el pantógrafo al entrar en la zona neutra, y vuelve a elevarlo a la salida. Son las 13 horas y cinco minutos.

Al alcanzar los 500 km/h la cámara que muestra la situación del pantógrafo muestra ya un arco continuo. Los arcos, provocados por pequeños despegues del pantógrafo y el hilo de contacto, son uno de los factores fundamentales que reduce la durabilidad de ambos elementos. A las 13 horas y 10 la estación de Meuse pasa ante los ojos de los pasajeros como una exhalación. El tren levanta a su paso una nube de polvo proveniente del balasto sobre el que descansa la vía. La velocidad es de 535 km/h.

Imagen 9. El TGV V150 en el momento del récord. Foto: Alain Stoll.

Imagen 9. El TGV V150 en el momento del récord. Foto: Alain Stoll.El objetivo oficial del intento de récord son los 540 km/h, que se superan entre aplausos. También se superan en breve los 550. Finalmente, el tren supera los 574 km/h antes de comenzar su deceleración. A las 13:30 ya está deteniéndose en el andén de la estación de Champagne-Ardenne. El tour de force publicitario se ha conseguido.

¿El cielo es el límite?

Los ingenieros de Alstom parecieron confiados en que la prueba no sujetó a su tren a ninguna condición límite. Creían posible superar los 600 km/h, aunque esa velocidad hubiera puesto al pantógrafo peligrosamente cerca de la de la perturbación ondulatoria de la catenaria. De superarla, el tren adelantaría a su propia onda generada en un efecto similar al que sufre un avión al rebasar la velocidad del sonido. El régimen de contacto entre el pantógrafo y la catenaria cambiaría abruptamente, pudiendo provocar incluso la destrucción de la catenaria por enganchón en el pantógrafo.

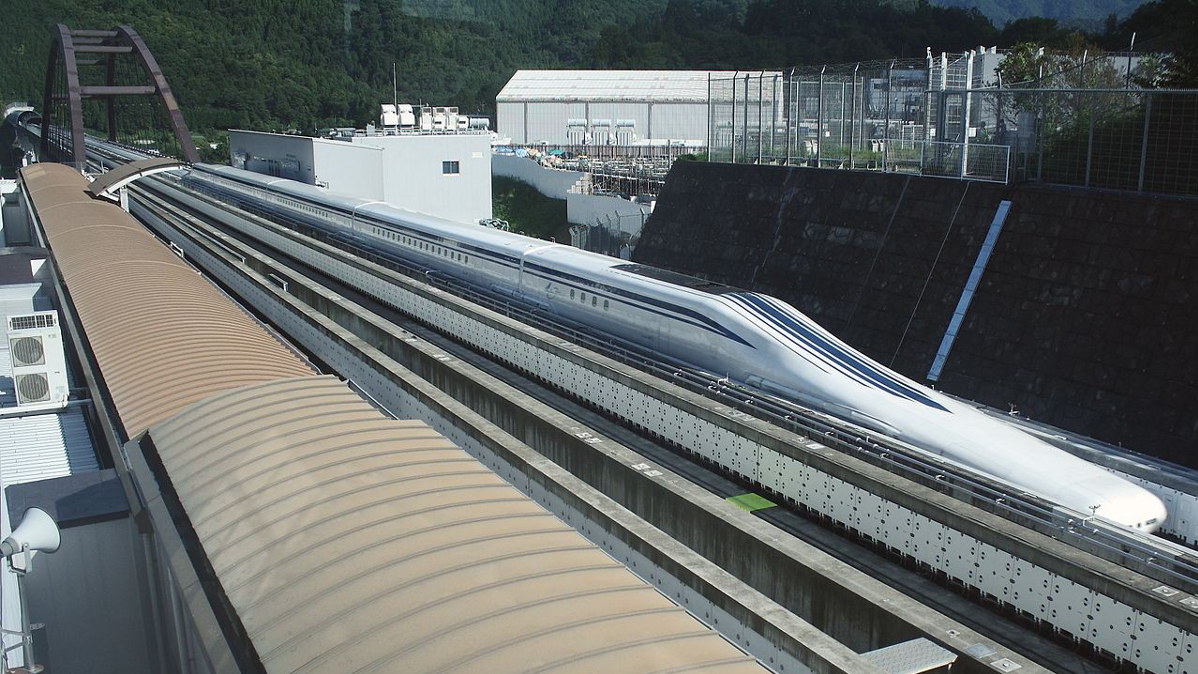

Existía, además, un límite «diplomático»: cinco años antes, un maglev japonés había establecido un récord de velocidad a 581 km/h. Los gestores franceses consideraron poco útil, a la vez que prudente, forzar el experimento para rebasar esa velocidad, ya que podrían haber entrado en una especie de «carrera internacional» que no tenían demasiadas probabilidades de ganar. El tiempo les daría la razón: en 2015, otro maglev de la serie L0 alcanzó los 603 km/h en la línea de pruebas de Yamanashi. Toda la comunicación relacionada con la Operación V150 hizo hincapié en que los resultados obtenidos solo tendrían relevancia para la tecnología de contacto rueda-carril y alimentación eléctrica mediante hilo de contacto.

Imagen 10. Maglev Serie L0 de Mitsubishi Heavy Industries en la línea de pruebas de Yamanashi. Foto: Saruno Hirobano.

Imagen 10. Maglev Serie L0 de Mitsubishi Heavy Industries en la línea de pruebas de Yamanashi. Foto: Saruno Hirobano.Parece claro que el límite práctico con la tecnología ferroviaria actual se alcanzaría antes de llegar a los 600 km/h. Resolver los problemas técnicos del contacto pantógrafo-catenaria a tales velocidades implica aumentar la tensión mecánica del hilo, lo que comprometería su resistencia y obligaría a usar mayores secciones. Esto, a su vez, tendría efectos en cascada en todo el sistema, aumentando los valores de las masas fijas y complicando la integridad del contacto.

Un pie en la tierra

La tecnología actual parece marcar el entorno de los 600 km/h como una cota superior de velocidad para el ferrocarril. Sin embargo, las condiciones de explotación habituales, en las que las composiciones de material rodante realizan rutinariamente millones de kilómetros, son necesariamente más conservadoras que las de un proyecto como la Operación V150. Tanto desde el punto de vista de la seguridad como del consumo energético y de las necesidades de un mantenimiento controlado en costes, es preciso poner un pie (al menos) en la tierra y volver a examinar la situación de la tecnología comercialmente disponible para comprender por qué la velocidad punta no evoluciona por encima de los 350 km/h, así como cuáles son sus posibilidades en el largo plazo.

Las condiciones de la operación de un trayecto de alta velocidad se revelan rápidamente como factores limitantes. La Operación V150 reveló que los fenómenos aerodinámicos son dominantes en el comportamiento del tren por encima de los 500 km/h, pero por motivos evidentes las pruebas no incluyeron algunos de los efectos de este tipo con más peso en la explotación comercial: la interacción con la infraestructura en túneles, la afectación debida al cruce de circulaciones y el efecto del viento cruzado en zonas vulnerables como viaductos. Solo por esto es razonable suponer que ningún tren actual podría alcanzar comercialmente los 500 km/h sin modificaciones extensivas. Además, la señalización más avanzada en uso en las líneas de alta velocidad (ETCS/ERTMS) llega a su límite precisamente en esa cota.

Esta suposición encaja a la perfección con los récords de velocidad registrados por trenes comerciales. El CRH380BL chino, una variante de 16 coches y gálibo ampliado del Velaro de Siemens (conocido en España como S-103, en servicio en la línea Madrid-Barcelona-frontera francesa), alcanzó los 487,3 km/h en enero de 2011 en un tramo de la línea Beijing-Shanghai. Más cerca y sin preparación especial, Renfe alcanzó en julio de 2006 los 403,7 km/h entre Guadalajara y Calatayud con una unidad S-103 —durante un breve tiempo estableció el récord del mundo de velocidad para trenes comerciales.

Los límites prácticos

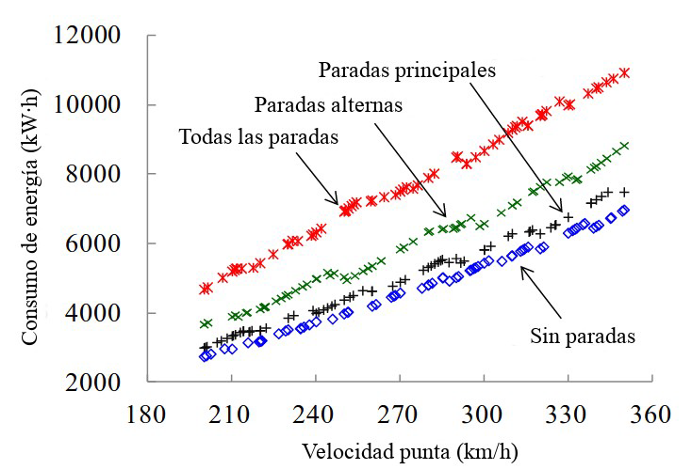

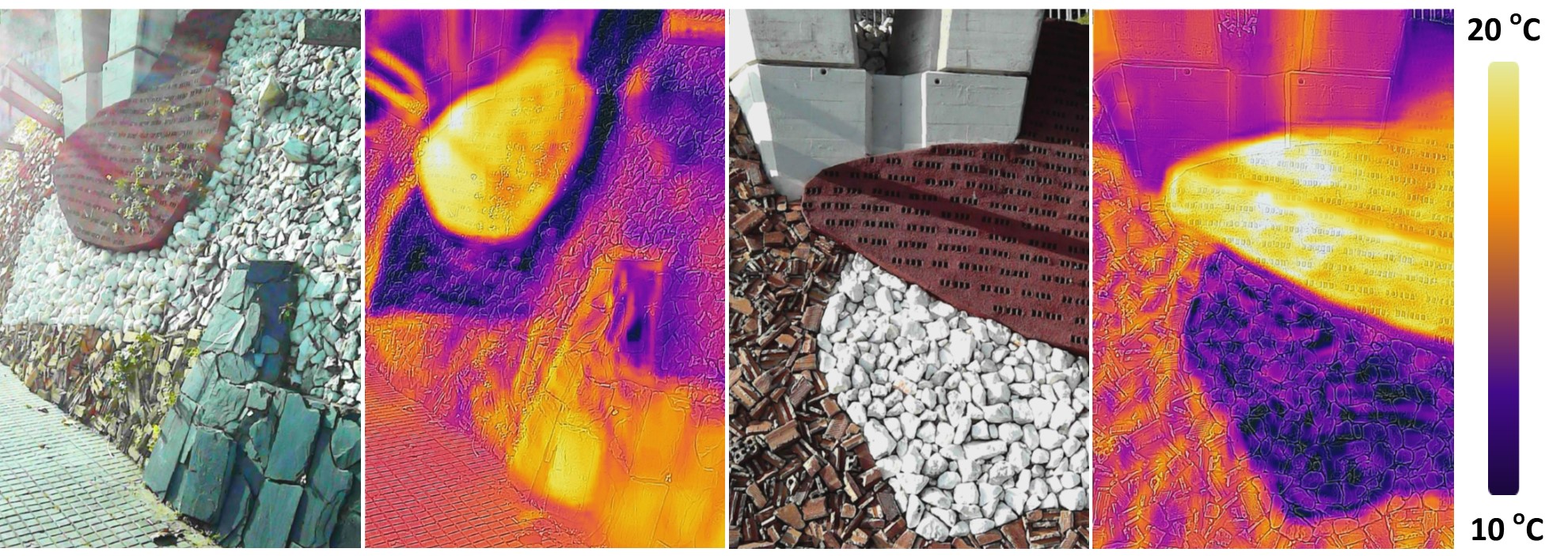

En Feng, Sun, Liu, & Li (2014) se propone un modelo para la estimación del consumo energético de un tren de alta velocidad en función de la velocidad punta en un determinado trayecto. Un ejemplo numérico para la línea Shanghai-Hangzhou arroja el siguiente resultado:

Imagen 11. Consumo de energía estimado frente a velocidad punta. Ejemplo numérico. Adaptado de Feng, Sun, Liu, & Li (2014).

Imagen 11. Consumo de energía estimado frente a velocidad punta. Ejemplo numérico. Adaptado de Feng, Sun, Liu, & Li (2014).La línea del ejemplo tiene 169 km de longitud y nueve posibles paradas incluyendo las estaciones inicial y final, que se usan para establecer cuatro estrategias de explotación: con todas las paradas, con paradas alternas, con una parada intermedia y sin paradas. Debido a la alta concentración de la población en España, ninguna de las líneas de tren existentes dispone de semejante concentración de estaciones intermedias. Aun así, es interesante observar cómo un tren sin paradas con velocidad punta objetivo de 300 km/h arroja un consumo de energía total idéntico al de otro con tres paradas intermedias (estrategia de paradas alternas) y velocidad punta de 250 km/h. Al contrario: si fijamos la velocidad punta en 300 km/h, el tren con la estrategia de paradas alternas consume casi un 30% más de energía que el que realiza la circulación directa.

Este resultado nos sirve para darnos cuenta de que el modo de operación es crítico para determinar la viabilidad de un sistema de alta velocidad, ya que es el número de paradas intermedias y no tanto la velocidad punta objetivo, en los rangos estudiados, lo que determina el consumo final de energía. Al mismo tiempo, es posible realizar una extrapolación razonable por encima del rango de velocidades cubiertas por el modelo para ver cómo a 400 km/h de velocidad punta los consumos para la estrategia directa son equivalentes a los de paradas alternas con punta de 350 km/h.

La cuestión a resolver queda así mucho más clara. La explotación comercial del ferrocarril de alta velocidad debe buscar tanto una rentabilidad económica como un control de la huella medioambiental. Lo segundo es teóricamente posible gracias a la flexibilidad ofrecida por la fuente energética utilizada, y depende del mix de generación eléctrica particular del entorno de la línea, algo que queda fuera del ámbito de este artículo. Por su parte, la rentabilidad económica depende de si somos capaces de compensar el consumo energético realizado con la productividad de transporte del tren, medido en pasajeros-kilómetro [4].

Imagen 12. Interior de un coche de clase turista del futuro Talgo AVRIL, con

Imagen 12. Interior de un coche de clase turista del futuro Talgo AVRIL, conasientos en disposición 3+2. Foto: Talgo.

Es posible entonces que, simplemente aumentando la capacidad bruta de transporte de un tren (y manteniendo su ocupación alta, naturalmente), un aumento de la velocidad punta pueda ser compensado, tanto desde el punto de vista de consumo energético como del de gasto de mantenimiento —más complejo de modelar— con una productividad mayor. Las estrategias ferroviarias para conseguir esto sin aumentar el número de trenes circulando son conocidas: desde aumentar ligeramente los gálibos para admitir coches con disposición de asientos por fila de 3+2 (como en el caso de China), pasando por una reducción del espacio disponible por pasajero con este mismo objeto (como ocurrirá en el tren Talgo Avril), utilizar trenes de doble cubierta (Alstom es líder en este tipo de coches, muy frecuentes en la red de alta velocidad francesa con sus TGV Duplex), prescindir de coches-cafetería o primeras clases (como se plantea en el futuro servicio «EVA» de Renfe Operadora) o, directamente, operar los trenes en doble composición —dos trenes unidos—, opción que se caracteriza por doblar el número de pasajeros sin consumir el doble de energía.

El tren de alta velocidad del futuro puede alcanzar los 400 kilómetros por hora si realiza pocas paradas y transporta a un gran número de personas a la vez. Ahora es nuestro turno, no solo como ingenieros, sino también como gestores y creadores de políticas de transporte, decidir si esto es deseable, cuáles son las alternativas y cómo es el sistema de transporte con el que queremos enfrentarnos a los retos que nos plantea el futuro.

Notas:

1. La fuerza de arrastre aerodinámico puede expresarse de este modo: D = 1/2 Cd ρ A V2 , donde D es la fuerza que se opone al avance, Cd el coeficiente de arrastre aerodinámico (viene dado por la forma del objeto en movimiento), ρ la densidad del aire (a nivel del mar, en condiciones normales, es de alrededor de 1,2 kg/m²), A el área de la sección transversal del tren (en el caso del ferrocarril es prácticamente constante para todos los vehículos y corresponde con el área del gálibo cinemático, es decir, el hueco más pequeño por el que pasa un tren sin chocar con elementos de la infraestructura) y V la velocidad en la dirección de avance.

2. Un bogie (normalmente pronunciado como se escribe) es un conjunto rígido habitualmente formado por dos ejes —y por tanto cuatro ruedas— que contiene los elementos fundamentales para asegurar la inscripción en curva de los coches, el frenado, la suspensión y, en algunos casos, también la propulsión del tren. Los bogies se montan en los extremos de los coches o, si son articulados, entre dos coches. No todos los trenes los llevan: el ejemplo más característico de composición con ejes sencillos es la del sistema Talgo.

3. La velocidad de propagación de la onda inducida por el pantógrafo es: Cp = √ (T/m)

4. El pasajero-kilómetro (y no «pasajeros partido por kilómetro»), o p·km, es una unidad de medida de la capacidad de transporte que permite comparar trenes individuales o líneas completas con varios trenes entre sí sin necesidad de tener en cuenta diferencias de capacidad bruta o distancias recorridas.

Bibliografía:

Anyakwo, A., Pislaru, C., Ball, A., & Gu, F. (2011). Modeling the dynamic behaviour of the wheel rail interface using a novel 3D wheel-rail contact model. 5th IET Conference on Railway Condition Monitoring and Non-Destructive Testing (RCM 2011). doi:10.1049/cp.2011.0616

Casanueva, C. (29/10/2014). Los trenes no se van por la tangente. Visitado el 18 de agosto de 2019, en https://ccasanueva.wordpress.com/2014/10/26/los-trenes-no-se-van-por-la-tangente/.

DVV Media International Ltd. (01/05/2007). V150: Power-packed train proves AGV technology in record sprint. Visitado el 18 de agosto de 2019, en https://www.railwaygazette.com/news/single-view/view/v150-power-packed-train-proves-agv-technology-in-record-sprint.html.

DVV Media International Ltd. (01/05/2007). V150: 574·8 km/h eclipses the 1990 world record. Visitado el 18 de agosto 2019, en https://www.railwaygazette.com/news/single-view/view/v150-5748-kmh-eclipses-the-1990-world-record.html.

Feng, X., Sun, Q., Liu, L., & Li, M. (2014). Assessing Energy Consumption of High-speed Trains based on Mechanical Energy. Procedia – Social and Behavioral Sciences, 138, 783-790. doi:10.1016/j.sbspro.2014.07.260.

Liu, Z. (2017). Measures to Enhance the Dynamic Performance of Raiway Catenaries. Stockholm: KTH Royal Institute of Technology.

Researching the train of the future. Colonia: Deutsches Zentrum für Luft- und Raumfahrt, Institute of Vehicle Concepts. Visitado el 18 de agosto de 2019, en https://www.dlr.de/dlr/en/desktopdefault.aspx/tabid-10467/740_read-916/#/gallery/2043.

Wu, J. (2018). Dynamic Interaction Between Pantograph and Contact Line. In Chapter 4: Pantograph and contact line system (pp. 130-131). London: Academic Press.

Sobre el autor: Iván Rivera (@brucknerite) es ingeniero especializado en proyectos de innovación de productos y servicios para ferrocarriles.

El artículo Los límites del ferrocarril se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La tabla periódica en el arte: Titanio

El titanio es el noveno elemento químico más abundante en la corteza terrestre y está presente en decenas y decenas de minerales. Sin embargo, no se tuvo constancia de su existencia hasta finales del s. XVIII. En 1795 Martin Heinrich Klaproth lo bautizó inspirándose en los titanes, antiguos dioses de la mitología griega e hijos de Gea (Tierra). Pese a no ser un metal de uso histórico, el titanio cobró gran importancia en las diferentes artes plásticas a lo largo del s. XX hasta convertirse en un elemento de gran transcendencia.

Imagen 1. El museo Guggenheim de Bilbao. Fuente: Mariordo / Wikimedia Commons

Imagen 1. El museo Guggenheim de Bilbao. Fuente: Mariordo / Wikimedia CommonsUna nueva arquitectura

Cualquier persona que viva en Bilbao o alrededores asociará automáticamente el titanio con el museo Guggenheim. Para que luego se diga que los materiales artísticos no tienen importancia. Cuando Frank Gehry diseñó un gigantesco barco metálico junto a la ría del Nervión inició una pequeña revolución arquitectónica. Es cierto que desde los años 70 ya se venía empleando el titanio con ese fin, pero su uso en un edificio tan singular y de dimensiones colosales supuso un antes y un después.

La decisión de emplear titanio para forrar el museo no fue sencilla. Uno de los grandes inconvenientes era su precio: más del doble que el del acero de uso tradicional. Si tenemos en cuenta que se emplearon 42 875 paneles (o 33 000 según otras fuentes), estamos hablando de un auténtico dineral. Eso sí, con el titanio se pueden hacer planchas de la mitad de grosor, así que tampoco fue un drama. A partir de ahí todo fueron ventajas: es un material ligero, pero con una elevadísima resistencia mecánica, aguanta bien frente a la corrosión gracias a la capa de óxido que lo cubre y ofrece una estética insuperable en la que el color varía en función de las condiciones ambientales.

Así el Guggenheim se convirtió en el primer gran icono arquitectónico de titanio, lo que no quiere decir que sea el único. Por citar algunos casos repartidos por todo el orbe, tenemos: el Museo de la Ciencia de Glasgow, el Gran Teatro Nacional de Pekín, la Biblioteca Cerritos Millenium de California o la sede de Fuji en Japón. En la mayoría de los casos el titanio se combina con el vidrio, en lo que resulta una de las parejas de materiales más exitosas de este siglo.

Imagen 2. Sede de Fuji en Odaiba (Japón) y Cerritos Millenium Library en California. Fuente: Mark J. Nelson y Cerritos disaster / Wikimedia Commons

Imagen 2. Sede de Fuji en Odaiba (Japón) y Cerritos Millenium Library en California. Fuente: Mark J. Nelson y Cerritos disaster / Wikimedia CommonsArcoíris metálico

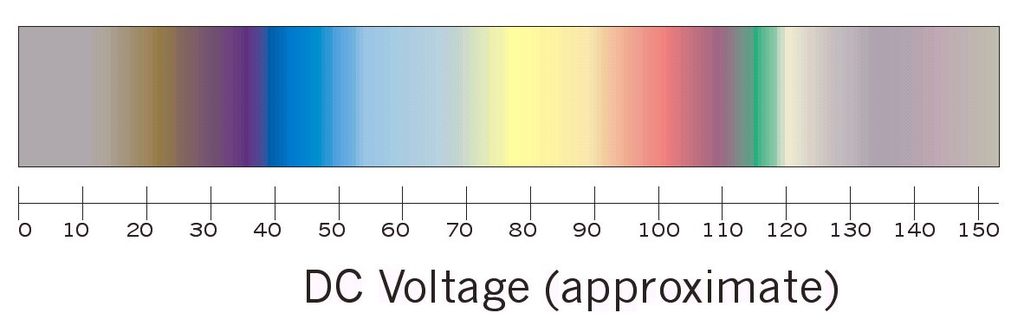

Pese a los edificios que acabamos de mencionar y el nombre del elemento que nos ocupa, no siempre se ha usado el titanio para obras de grandes dimensiones. El titanio en forma metálica también se puede emplear en esculturas y en joyería. En estos casos resulta de gran interés una propiedad bastante peculiar del metal: puede ofrecer diferente color en función del grosor de la capa de óxido que lo cubre.

Imagen 3. A Parliament of some things, de Mark Hagen (2014) hecho con titanio anodizado. Fuente: Wall Street International

Imagen 3. A Parliament of some things, de Mark Hagen (2014) hecho con titanio anodizado. Fuente: Wall Street InternationalSobre la superficie del titanio se crea una delgadísima capa de óxido (de menos de una micra) que interactuará con la luz y provocará que veamos un color u otro. Seguro que en alguna ocasión has visto una especie de arcoíris en un charco con restos de aceite o en una pompa de jabón. Pues este mecanismo es similar: la luz blanca se dispersa al entrar en contacto con la superficie del óxido y se generan interferencias que varían con el grosor, permitiendo que sólo se observen ciertas longitudes de onda, es decir, ciertos colores. Para lograr diferentes colores se puede alterar el grosor del óxido mediante un proceso que se conoce como anodización en el que el titanio se conecta a una fuente de alimentación. Jugando con el voltaje que se aplica se provocan reacciones de oxidación-reducción y se logra una capa más o menos delgada en función del color que deseemos lograr (Imagen 4).

Imagen 4. Color obtenido en el titanio anodizado en función del voltaje aplicado. Fuente: Instructables

Imagen 4. Color obtenido en el titanio anodizado en función del voltaje aplicado. Fuente: InstructablesEl blanco de nuestros tiempos

La pintura blanca no puede faltar en la paleta del artista. No sólo para pintar con ese color, sino para variar las tonalidades del resto de los colores. Históricamente el pigmento blanco más importante ha sido el albayalde o blanco de plomo, pero tiene algunos inconvenientes, entre ellos que te puede matar debido a la toxicidad del plomo. Ante esa perspectiva era necesaria la aparición de otros blancos. Así, en el s. XIX se comercializó el blanco de zinc, pero en el siglo siguiente fue desbancado por el blanco más empleado hoy en día: el blanco de titanio (TiO2).

Imagen 5. Number 1A, 1948 (173×264 cm), de Jackson Pollock (1948) contiene blanco de titanio. Fuente: MOMA

Imagen 5. Number 1A, 1948 (173×264 cm), de Jackson Pollock (1948) contiene blanco de titanio. Fuente: MOMAPara que os hagáis una idea de la importancia del blanco de titanio, tened en cuenta que la industria de los pigmentos y los colorantes mueve alrededor de 30 billones (americanos) de dólares al año y unos 13,2 corresponden a este blanco. Claro que no sólo se usa en pintura de caballete, sino en pintura industrial, esmaltes, plásticos, opacificador de papel, etc. Todo ello gracias a que es un blanco con un excelente poder cubriente, relativamente barato y no tóxico (aunque recientemente la Unión Europea ha alertado sobre su posible efecto cancerígeno).

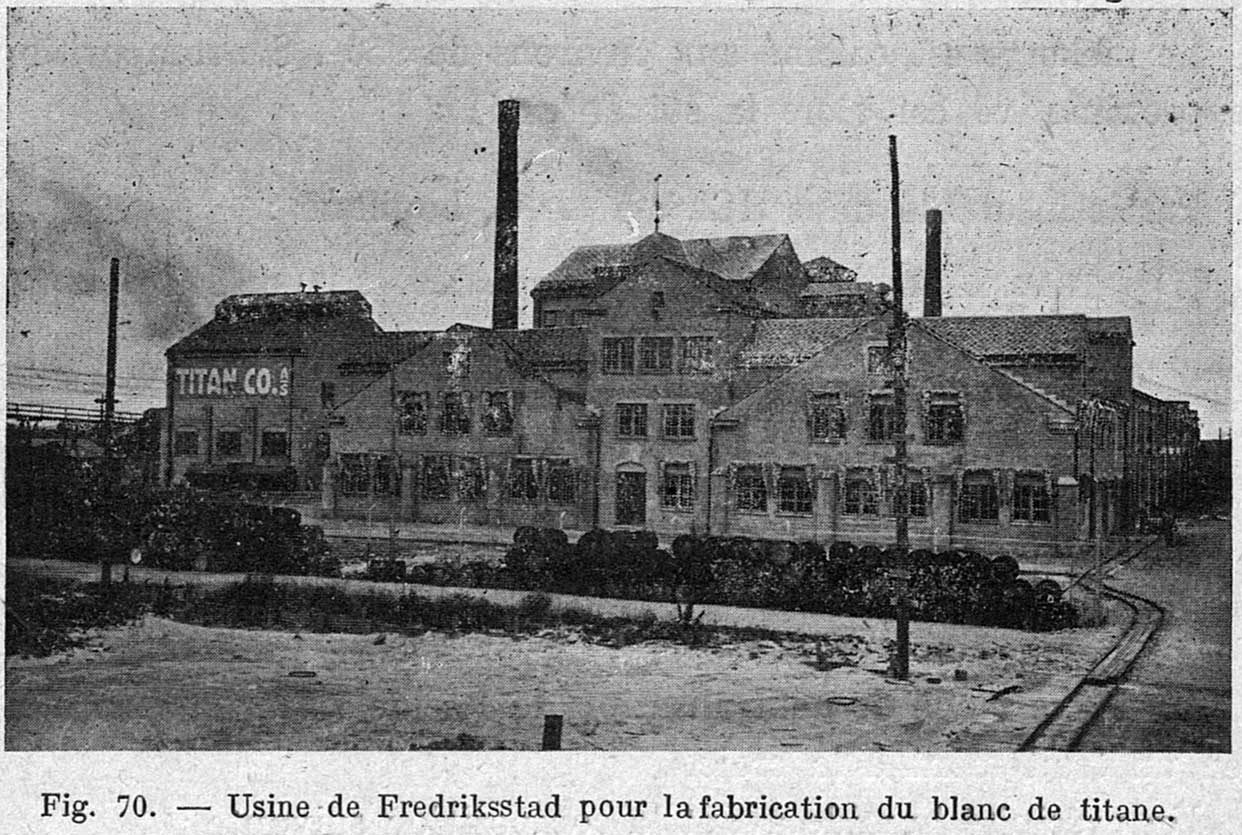

El óxido de titanio (IV) se puede encontrar en la naturaleza formando tres minerales: rutilo, anatasa y brookita. Se sabe que durante el s. XIX se empleó rutilo natural en pintura, pero su calidad es mucho menor que el sintético, por lo que no llegó a ser un pigmento trascendental como este último. Pese a que en 1821 ya se había sintetizado blanco de titanio, no fue hasta 1916 cuando se empezó a comercializar, casi simultáneamente en Noruega y Estados Unidos.

Imagen 6. Primera fábrica de blanco de titanio. Fredrikstad (Noruega). Fuente: Painter’s Palettes

Imagen 6. Primera fábrica de blanco de titanio. Fredrikstad (Noruega). Fuente: Painter’s PalettesLa síntesis del blanco de titanio ha ido evolucionando desde aquel momento. Al principio se partía del mineral ilmenita (FeTiO3) para lograr anatasa sobre un substrato de sulfato de bario o de calcio, pero ya en los años 30 se descubrió cómo lograr rutilo sintético, forma que hoy en día sigue siendo la más popular. El siguiente gran hito fue el desarrollo de un método de síntesis, empleando cloro, que resultó ser mucho más eficiente que el empleado hasta la fecha y que se basaba en el uso de sulfatos.

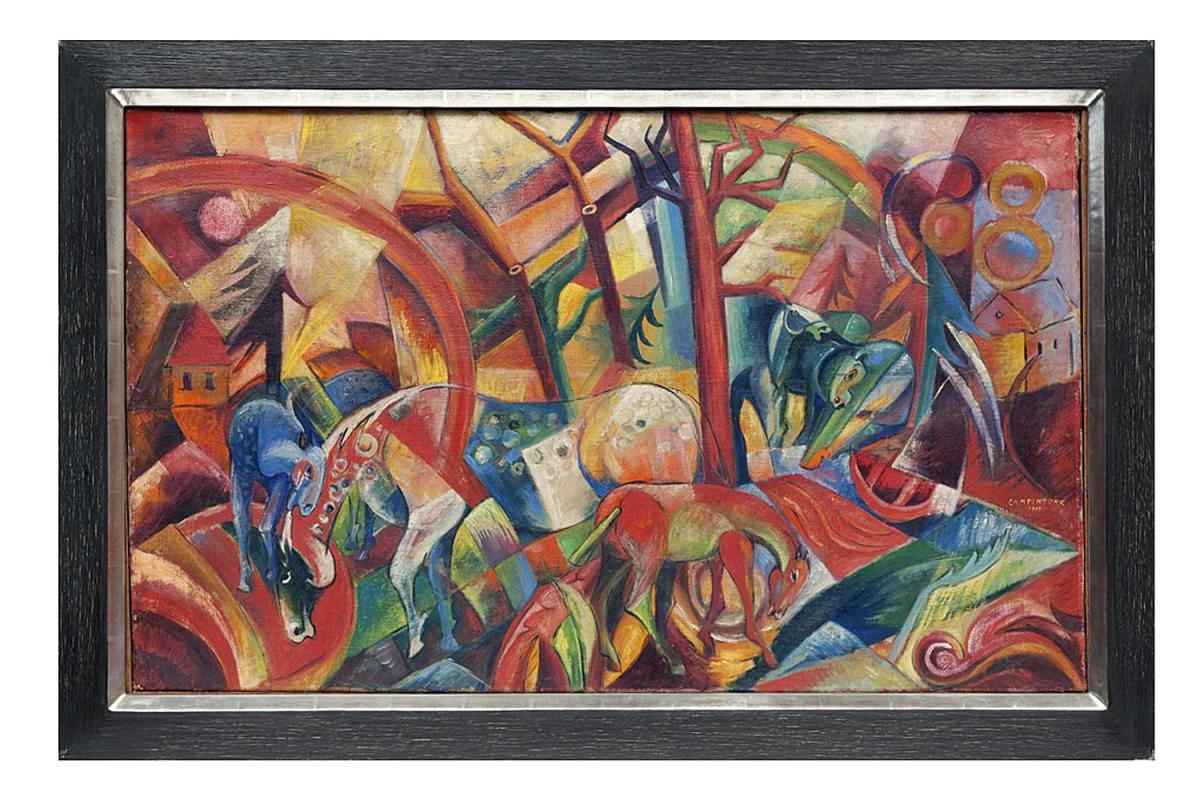

Como os podéis imaginar, el blanco de titanio sólo aparece en obras de arte a partir del s. XX, algo que resulta muy útil para detectar falsificaciones. Ya contamos en su momento que en un estudio realizado en la Universidad Politécnica de Catalunya se detectó rutilo y azul de ftalocianina en una obra inicialmente atribuida al pintor valenciano Cecilio Pla y Gallardo, fallecido antes de que esos productos se comercializasen. Mucho más espectacular es sin duda el caso de Wolfgang y Helene Beltracchi, una pareja de falsificadores que la lio parda, como podéis aprender en este hilo de Luis Pastor. Tras vender obras por varios millones de euros se descubrió su estafa porque en un supuesto Campendonk de 1914 había blanco de titanio (Imagen 7). Como ya os habréis dado cuenta, dicho pigmento no estaba disponible en el mercado. No penséis que Wolfgang no era consciente de ello (o por lo menos, eso declaró en el Spiegel). Él empleó un tubo de blanco de zinc, pero no se dio cuenta de que también contenía blanco de titanio. Maldita química.

Imagen 7. Pintura roja con caballos. El supuesto Campendonk por el que atraparon a los Beltracchi. Fuente: The Times

Imagen 7. Pintura roja con caballos. El supuesto Campendonk por el que atraparon a los Beltracchi. Fuente: The TimesPara saber más:

Nippon Steel Corporation. Features of Titanium Building Materials (2019).

A. Mendelsohn How Analog and Digital Came Together in the 1990s Creation of the Guggenheim Museum Bilbao en Guggenheim.org (2017).

E. West FitzHugh. Artist’s Pigments: A Handbook of Their History and Characteristics. (Volume 3). National Gallery of Art (1998).

B.A. van Driel et al. The white of the 20th century: an explorative survey into Dutch modern art collections. Heritage Science 6(16) (2018).

Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

El artículo La tabla periódica en el arte: Titanio se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La tabla periódica en el arte: Cobre

- La tabla periódica en el arte: Arsénico

- La tabla periódica en el arte: Cobalto

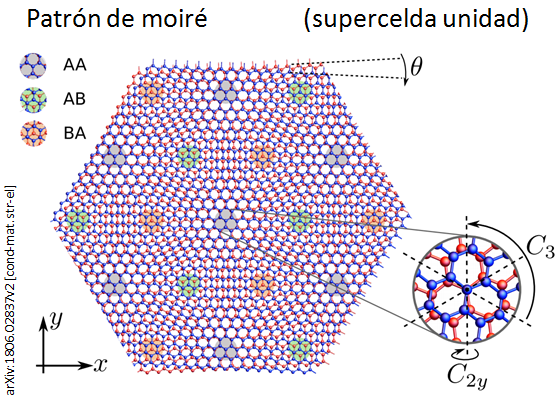

Francisco R. Villatoro – Naukas Bilbao 2018: El ángulo mágico del grafeno

La gran noticia científica de 2018 fue que el grafeno bicapa rotado con ángulo mágico es un superconductor no convencional (y un aislante Mott cuando deja de serlo). Este material “mágico” promete revolucionar nuestro conocimiento sobre la superconductividad de alta temperatura. Francisco R. Villatoro presentó el descubrimiento durante Naukas Bilbao 2018 en una charla impecable, con una densidad de conocimientos difícilmente superable. No es una charla fácil de seguir sin fundamentos de física del estado sólido, pero merece muy mucho la pena el esfuerzo. Francis publicó una transcripción de la misma para que se pueda estudiar con mayor profundidad aquí.

Francis Villatoro: ''El ángulo mágico del grafeno''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Francisco R. Villatoro – Naukas Bilbao 2018: El ángulo mágico del grafeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Francisco R. Villatoro: El espín para irreductibles

- Carlos Briones – Naukas Bilbao 2018: Os voy a contar una historia (en imágenes)

- Lo que la tensión puede hacer en dos capas de grafeno

La química analítica como base para el estudio de las prácticas pastoriles prehistóricas

Servicio Central de Análisis de Araba (SGIker – UPV/EHU)

La arqueología actual pretende reconstruir eventos del pasado desde sus restos y determinar la experiencia humana del pasado, es decir, cómo se organizaban socialmente y por qué cambiaban sus sociedades, cómo explotaban sus recursos, qué comían, qué creían, cómo se comunicaban… [1]. El desarrollo de nuevas técnicas analíticas permite al arqueólogo pasar de preguntarse de qué material están hechos los utensilios encontrados en las excavaciones a preguntarse sobre la procedencia, origen de lo encontrado y costumbres/actividades humanas [2].

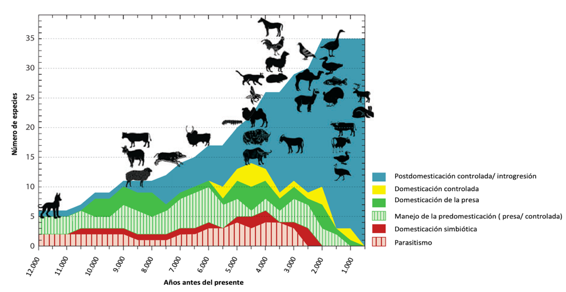

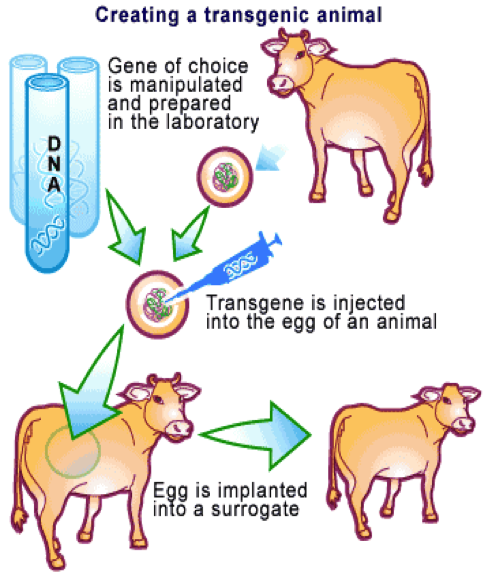

Hace unos 10.500-10.000 años, en el oeste de Euroasia, fueron domesticadas las cabras Capra aegagrus, ovejas Ovis orietalis y vacas Bos primisgenius. Con la domesticación, el ser humano logró ampliar los recursos obtenidos de de los animales y pasar de ser una fuente exclusiva de aporte proteico a través de su carne, a ser también fuente de leche y lana [3].

Figura 1. Cronología de la domesticación animal. Fuente: [3]

Figura 1. Cronología de la domesticación animal. Fuente: [3]

El desarrollo y proliferación de la domesticación obligó a los pastores a buscar refugio para sus reses y mantenerlas a salvo. El uso de cuevas o abrigos refugio como establos fue una práctica habitual a lo largo y ancho del mediterráneo desde el Neolítico a la Edad de Hierro [4]. El principal rasgo común de los yacimientos encontrados en dichos refugios son sus sedimentos, que se presentan como espacios con depósitos de apariencia arcillosa originados por grandes cantidades de estiércol generado por presencia continuada de ganado, principalmente ovicaprino [5]. Los animales estabulados provocan el incremento de los residuos del establo, constituidos por la acumulación del estiércol junto con productos aportados por ellos mismos, hierbas, tierra y piedras.

Con el objeto de mantener limpio y libre de parásitos el establo, frecuentemente se reducía el volumen de estiércol mediante su quema, siendo una práctica que se estima que duró hasta la Edad de Bronce, ya que a partir de entonces se generaliza el uso del estiércol generado en las estabulaciones como abono para los campos [6].

La quema continuada de este estiércol a lo largo de los años genera unos depósitos que están constituidos por diferentes capas de sedimentos, generadas por la sucesión de unidades de combustión, que son denominadas de forma genérica como fumier (estiércol en francés) [7], que en general están formadas por una capa blanca o gris (combustión total), otra negra (combustión parcial) y finalmente una marrón (sin combustión). Estas capas, sobre todo las negras y las marrones, poseen una buena conservación, lo que permite la caracterización de compuestos orgánicos que nos pueden ayudar a identificar especies de animales estabulados y costumbres pastoriles.

Uno de los yacimientos más destacados donde se utilizó esta estrategia de eliminación de excremento animal es el de San Cristóbal, situado en la Sierra de Cantabria (Araba/Álava)

Figura 2. Excavación de San Cristobal.

Figura 2. Excavación de San Cristobal.

Los estudios comenzaron por el interés del Prof. Fernández Eraso del Dpto. de Geografía, Prehistoria y Arqueología de la UPV/EHU y su grupo High Yield Research Group of Prehistory (IT 622-13), que abrió la posibilidad de establecer una línea de investigación que permitiera relacionar la naturaleza de los animales estabulados con la presencia de ciertas sustancias orgánicas en los estratos excavados de los abrigos de la Sierra Cantabria.

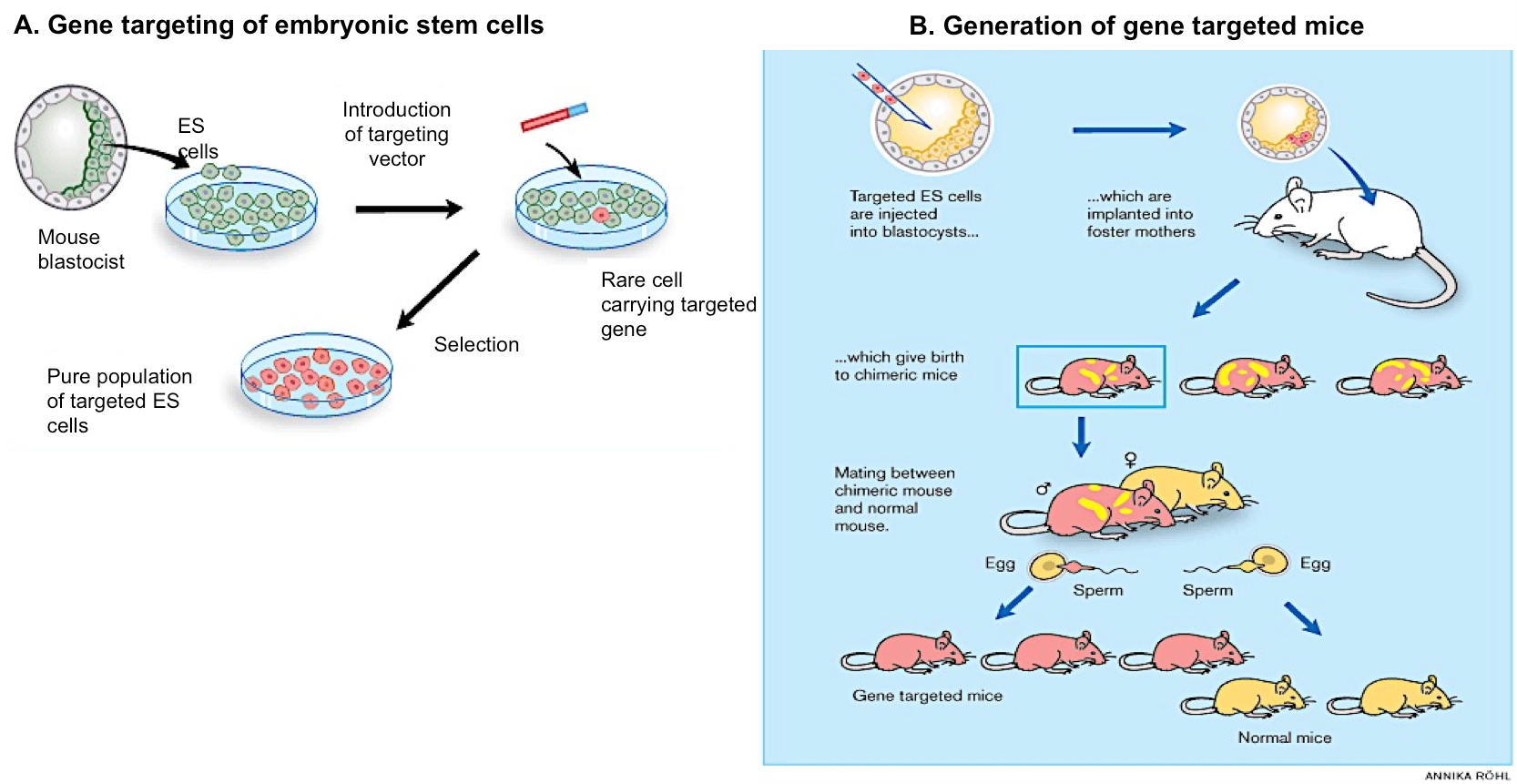

En este yacimiento no se encuentran restos óseos de los animales allí estabulados y es necesario realizar análisis de biomarcadores de especie para determinar que tipo de animal ha sido estabulado. Este estudio, llevado a cabo en el Servicio Central de Análisis de Álava, se focalizó en el análisis cuantitativo de ácidos biliares, esteroles y fitoesteroles en los residuos/sedimentos orgánicos (capas blancas, negras y marrones) del yacimento de San Crístobal usando como técnica de medida la cromatografía de gases acoplada a espectrometría de masas (GC-MS) .

Figura 3. Yacimiento San Cristobal, Sierra de Cantabria (Araba/Álava). Estructura del fumier. Fotografía: Javier Fernández Eraso

Figura 3. Yacimiento San Cristobal, Sierra de Cantabria (Araba/Álava). Estructura del fumier. Fotografía: Javier Fernández Eraso

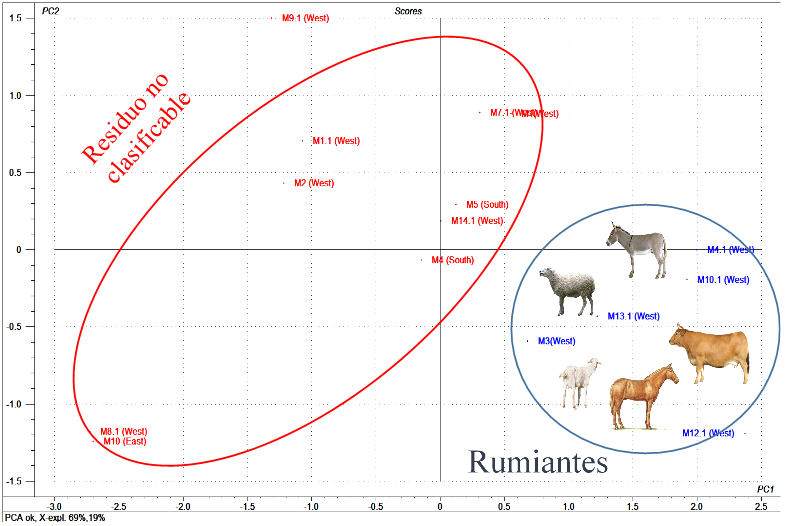

Los compuestos orgánicos de los sedimentos seleccionados como biomarcadores para este estudio, fueron sometidos a una etapa de extracción asistida por microondas, a una etapa de limpieza y finalmente el extracto fue derivatizado y analizado por GC-MS. Los resultados del análisis de los biomarcados fueron procesados utilizando herramientas quimométricas (ver figura 2), que facilitan la clasificación de los residuos/sedimentos orgánicos prehistóricos, permitiendo diferenciar el origen de los restos y la actividad pastoril.

Figura 2. Análisis de componentes principales para muestras de rumiantes y residuos no clasificables. Fuente: Journal of separation Science (2017, 40, 4549-4562)

Figura 2. Análisis de componentes principales para muestras de rumiantes y residuos no clasificables. Fuente: Journal of separation Science (2017, 40, 4549-4562)

La capas marrones y negras clasifican los restos como restos de animales rumiantes mientras que el resto no se pueden usar para la clasificar el tipo de animal estabulado debido a que no se conservan los compuestos de interés. Además, se observan actividad pastoril en desde 6010±30 BP (Neolítico temprano) hasta 4030±30 BP (Calcolítico) lo que corrobora estudios anteriores y además no hay indicios de estabulación de otros animales no rumiantes.

Este estudio forma parte del trabajo de la tesis doctoral de Jaime Gea del Río del grupo METABOLOMIPs de la Facultad de Farmacia de la UPV/EHU.

Referencias bibliográficas:

[1] .M. Pollard, C. Batt, B. Stern, S. Young, Analytical Chemistry in Archaeology, 2006.

[2] .B.T. Nigra, K.F. Faull, H. Barnard, Analytical Chemistry in Archaeological Research, Anal. Chem. 87 (2014) 3–18

[3].Larson, G. & Fuller, D. Q. The Evolution of Animal Domestication. Annual Review of Ecology, Evolution, and Systematics 45, 115–136 (2014).

[4]. Fernández-Eraso, J. et al. Beginnings, settlement and consolidation of the production economy in the Basque region. Quaternary International 364, 162–171 (2015).

[5]. Angelucci. Shepherds and karst: the use of caves and rock- shelters in the Mediterranean region during the Neolithic Diego. 191–214 (1999).

[6]. Boschian, G. and Miracle, P. T. 2008. Shepherds and caves in the Karst of Istria (Croatia). In Proceedings of the 2nd International Conference on Soils and Archaeology (ed. G. Boschian). Atti Società toscana Scienze naturali, Mem., Serie A, 112(2007), pp. 173–80. (2008)

[7]. Fernández Eraso, J. U. D. P. V. (España) & Polo Díaz, A. U. D. P. V. (España). Establos en abrigos bajo roca de la Prehistoria Reciente: su formación, caracterización y proceso de estudio. Los casos de Los Husos y de San Cristóbal. 2008.pp39-51. Krei 10, 39–51 (2008).

El artículo La química analítica como base para el estudio de las prácticas pastoriles prehistóricas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El metanol es clave para entender cómo se forman las estrellas

- Técnicas «low cost» para el estudio de obras de arte

- Por qué España es un modelo para el estudio de la economía

Por qué la langosta es el emoji del lujo

Lobster Telephone 1936 Salvador Dal? 1904-1989 Purchased 1981 http://www.tate.org.uk/art/work/T03257

Lobster Telephone 1936 Salvador Dal? 1904-1989 Purchased 1981 http://www.tate.org.uk/art/work/T03257La langosta ha sido objeto de representación artística por sus cualidades simbólicas como alimento de lujo y signo de opulencia. También por sus cualidades plásticas, sobre todo en los estudios de color y formas de los bodegones. La langosta está presente en obras de Albrecht Dürer, Antonio Viladomat, Zacarias González Velázquez, Adriaen van Utrecht, José María Corchón, José Serra y Porson, Eugene Delacroix, Utagawa Kuniyoshi, Pablo Picasso, Salvador Dalí y Jeff Koons, entre muchos otros.

No obstante, la langosta no siempre ha sido un alimento de ricos. El lujo está sujeto a la abundancia relativa y a los vaivenes de la moda, a veces caprichosos. Hasta mediados del siglo XIX la langosta era considerada una especie de cucaracha marina. En las costas atlánticas de Canadá y Nueva Inglaterra eran tan abundantes que los colonos las consideraban un estorbo para la pesca. En las playas de Massachusetts Bay las langostas se acumulaban a montones. Tanto es así que las utilizaban para fertilizar suelos, para dar de comer a cerdos y vacas, y también para alimentar a los sirvientes.

A finales del siglo XIX el ferrocarril y la incipiente industria conservera cambiaron el estatus de la langosta. Una de las primeras conserveras estadounidense fue la de Maine, fundada en 1841. Uno de sus productos estrella era la langosta enlatada. Este producto se servía a los turistas que viajaban en tren como si se tratase de un alimento exótico y exquisito. La ceremonia tenía la suficiente pompa como para que les pareciese un alimento de lujo. De hecho, la llegada de los ferrocarriles refrigerados permitió la exportación de la langosta a Inglaterra, donde se vendía por diez veces su precio original. Una estrategia de marketing muy efectiva. En los años 20 la langosta alcanzó su precio máximo, convirtiéndose en el alimento más caro del momento.

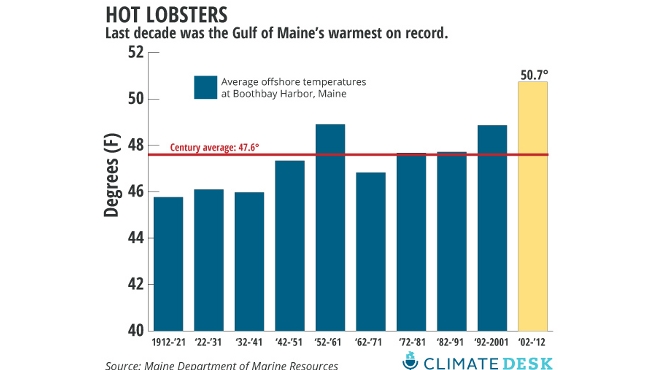

La cantidad de langosta ha ido variando a lo largo del tiempo, sobre todo en función de la temperatura de las aguas. En los mares de Maine se recogieron 56 millones de kilos de carne de langosta en 2013, seis veces más que en 1986. El calentamiento de las aguas hace que las langostas sean más grandes y produzcan más descendencia. Además, el calentamiento también ha afectado a su depredador natural, el bacalao.

En Estados Unidos se está viviendo tal bonanza de langosta que su precio ha caído lo suficiente como para que el consumo se esté volviendo masivo. Tanto es así que McDonald’s ofrece menús con langosta en algunas regiones durante la temporada de verano. Eso sí, el McDonald’s lobster roll es el menú más caro de la cadena. El lujo se paga, incluso el que se sirve en plato de cartón.

Para Dalí la langosta era uno de sus animales preferidos «porque además de ser inteligente por llevar el esqueleto por fuera y no por dentro como los cretinos». En su Autorretrato anecdótico Dalí escribió: «Me gusta sólo comer cosas de forma bien definida, detesto la espinaca por su carácter absolutamente amorfo. Lo directamente opuesto a la espinaca es la armadura, he aquí porqué me gusta tanto comer armadura y especialmente las pequeñas variedades, esto es los mariscos, estos son una organización material de la originalísima e inteligente idea de llevar los propios huesos fuera más bien que dentro. El crustáceo puede con las armas de su anatomía proteger el blando y nutritivo delirio de su interior cobijado contra toda profanación y encerrado como un hermético y virginal vaso que lo deja vulnerable sólo a la más alta forma de conquista imperial en la noble guerra del descortezamiento: la del paladar».

En varias de sus obras, Dalí asocia las langostas con el deseo carnal, con lo sexual. Frecuentemente muestra a la langosta adherida a la mujer, como si ambos compartiesen la cualidad de ser eróticamente apetecibles, «pues tienen ambos el interior exquisito y se enrojecen cuando se las quiere hacer comestibles».

La langosta se enrojece al cocinarse a causa de la astaxantina, que es un pigmento soluble que en su forma libre es de color bermellón. Cuando este crustáceo está vivo, el carotenoide permanece oculto porque está ligado a una proteína, la crustacianina, causante del color pardo azulado. Esta coloración resulta muy útil para pasar desapercibidos ante los depredadores. Cuando la langosta se cocina, la proteína se desnaturaliza perdiendo su estructura y liberando la astaxantina de color bermellón. En la astaxantina ocurre un cambio químico durante este proceso en el que el compuesto pasa de ser un enolato a una hidroxicetona neutra.

Tanto la langosta como el teléfono tenían para Dalí una fuerte connotación sexual. En su autobiografía, La vida secreta de Salvador Dalí, aparece un dibujo de un teléfono langosta con la siguiente anotación: «No entiendo por qué, cuando pido una langosta asada en un restaurante, nunca se me sirve un teléfono asado; no entiendo por qué el champán siempre se sirve frío mientras que, sin embargo, los teléfonos, que son a menudo excepcionalmente cálidos y desagradablemente pegajosos al tacto, no son servidos en cubos plateados con hielo triturado».

El teléfono langosta de Dalí es completamente funcional y cuatro de ellos fueron utilizados por su mecenas Edward James en su vivienda vacacional. Dalí realizó un total de once Teléfonos langosta, cuatro de color rojo y siete en blanco. Como parte del discurso artístico daliniano, resulta interesante que estos teléfonos fuesen funcionales, ya que el propio sistema del arte se encargaría de convertirlos en objetos inútiles. Los teléfonos langosta fueron concebidos como futuros readymades, objetos cotidianos reconvertidos en objetos artísticos y por tanto inútiles, o bien a través del contexto en el que se exponen (un museo, una vitrina, una peana…) o bien a través de una manipulación que los inutiliza o los transforma en otra cosa. Hacer una llamada con el teléfono langosta, además de ser una extravagancia, sería una performance. La seducción comienza en la llamada con la que conciertas la cita.

Los materiales del teléfono langosta son materiales innobles. La langosta es de yeso y el teléfono es un teléfono de rueda de baquelita. El yeso es un sulfato de calcio, uno de los materiales más empleados en construcción. Y la baquelita es un polímero sintético del tipo plástico termoestable: al solidificarse y darle forma no puede volver a ablandarse con calor. Por su resistencia térmica se empleaba para fabricar las carcasas de aparatos ordinarios como teléfonos y radios.

En los años 30 tanto la langosta como el teléfono representaban el lujo. Esa idea de lujo cambiante, reconocible y suficientemente accesible. Solo las clases acomodadas tenían teléfono en sus viviendas, y la langosta era un alimento reservado para las celebraciones. Para Dalí, el placer del lujo, por lo exclusivo, era un placer semejante al de la conquista y el sexo.

Wallis Simpson posando para Vogue con un vestido de Elsa Schiaparelli y Salvador Dalí. Fotografía de Cecil Beaton, 1937.

Wallis Simpson posando para Vogue con un vestido de Elsa Schiaparelli y Salvador Dalí. Fotografía de Cecil Beaton, 1937.

En 1937, Salvador Dalí y la legendaria diseñadora de moda italiana, Elsa Schiaparelli, se unieron para crear un vestido de noche de verano de seda. El vestido tenía impresa una langosta creada por Dalí localizada sobre la zona genital. Este vestido fue el que lució Wallis Simpson en un reportaje para Vogue cuando había anunciado su compromiso con el príncipe Eduardo. Wallis Simpson fue una socialite estadounidense que, después de haberse divorciado dos veces, se casó con el príncipe Eduardo, duque de Windsor, quien antes de su matrimonio había sido Eduardo VIII, rey del Reino Unido de Gran Bretaña e Irlanda del Norte y emperador de la India. Al comprometerse con Wallis Simpson, Eduardo fue obligado a renunciar a su título. En aquellos años, casarse con una mujer divorciada era algo moralmente inadmisible, así que no tuvo más remedio que abdicar. Por este motivo, que Wallis Simpson decidiese posar para la prensa con el vestido langosta fue toda una provocación.

En 1989, la firma de moda Moschino, sacó varias prendas en las que empleaba la langosta como símbolo de opulencia. Entre ellas destacó una icónica chaqueta cuya botonadura estaba decorada con langostas bordadas con hilo de oro.

Por aquel entonces, el diseñador y director de arte de Moschino era Franco Moschino, quien definió las bases de lo que siempre sería Moschino. Hoy en día, la dirección de arte corre a cargo del extraordinario diseñador Jeremy Scott, que con maestría continúa reavivando la fricción entre lo lujoso y lo hortera.

A la izquierda Gigi Hadid camina en el show Moschino de febrero de 2015 en Milán. A la derecha Katy Perry luce el mismo vestido en la Gala Met de 2015 con el bolso de la colección inspirado en los espráis Krylon de los 80.

A la izquierda Gigi Hadid camina en el show Moschino de febrero de 2015 en Milán. A la derecha Katy Perry luce el mismo vestido en la Gala Met de 2015 con el bolso de la colección inspirado en los espráis Krylon de los 80.

Esto lo logra poniendo en cuestión el propio sistema de la moda, la elección a veces arbitraria del valor de las cosas y elevando lo ordinario a categoría de moda. Así, hay colecciones de Moschino inspiradas en el graffiti, en los útiles de limpieza, en la construcción o en la comida basura. Como colecciones que rinden tributo a iconos pop contemporáneos como Barbie o McDonald’s. Prendas y accesorios de lujo ejecutados con exquisitez que representan lo que comúnmente llamamos baja cultura. Por este motivo Moschino es a la moda lo que Jeff Koons es al arte.

Langosta. Jeff Koons, 2003

Langosta. Jeff Koons, 2003

La langosta es una de las esculturas más icónicas del artista Jeff Koons. Se trata de una langosta colchoneta de aluminio policromado colgada del techo con una cadena de acero. La langosta además de ser una obra de arte mayúscula es una virguería técnica. Si uno no se fija en la ficha técnica, estaría convencido de que se trata de una colchoneta auténtica.

La escultura Langosta pertenece a la serie Popeye. Este personaje es un icono popular y símbolo proletario del triunfo sobre la adversidad. Con la escultura Langosta, Koons reflexiona acerca del concepto del triunfo proletario y acerca de la noción de readymade. La colchoneta langosta es un objeto ordinario al que cualquiera puede acceder. Además, en sí mismo es una representación de un símbolo de lujo, la langosta, reconvertido en un objeto de plástico hortera y divertido. Puede entenderse como una suerte de readymade porque se trata de un objeto transformado en arte a través de un cambio de contexto (de la piscina a estar colgado en un museo) y de una manipulación. En lugar de ser de plástico, la colchoneta langosta de Koons es de aluminio policromado. Tanto el material como el objeto que representa, la colchoneta, son innobles. Además, existen tres copias y la prueba de artista, con lo cual la exclusividad se comparte, aunque de forma limitada, se comparte. Con todo esto Koons logra interpelar acerca de la noción de lujo y por supuesto, de mercado. La langosta simboliza ambas cosas.

La obra de Koons es en apariencia frívola, pero esconde un profundo recorrido intelectual. Igual que el provocador título de este trabajo, «Por qué la langosta es el emoji del lujo», es un disfraz frívolo e insultantemente contemporáneo. Como una escultura de bronce que parece de plástico.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Por qué la langosta es el emoji del lujo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un lujo asiático cultivado en aguas del Mediterráneo

- Si hacer fármacos fuese como jugar a Lego, la pieza más guay se llamaría carbino

- En The Big Bang Theory no hay químicos, sin embargo…

Las simetrías ocultas de la tabla de multiplicar

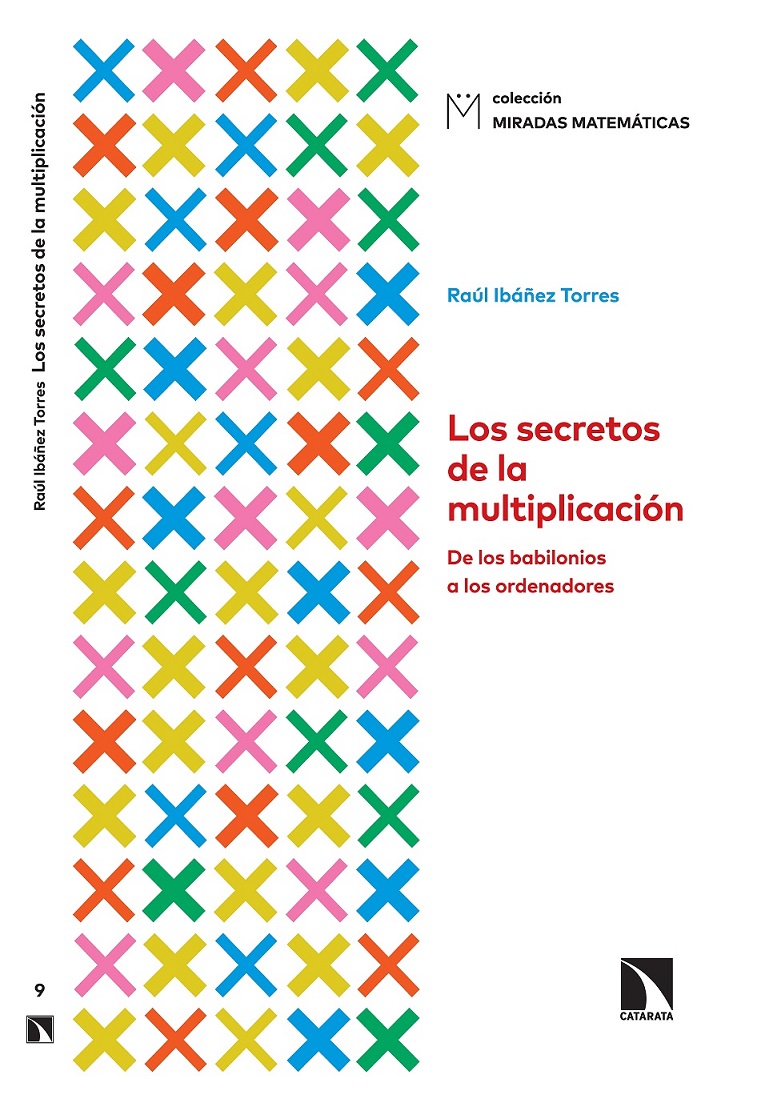

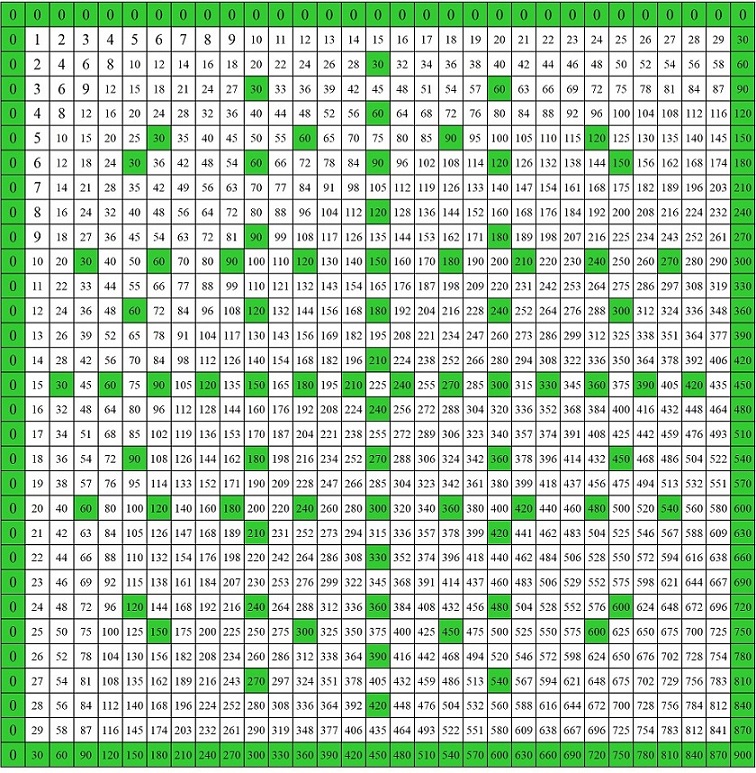

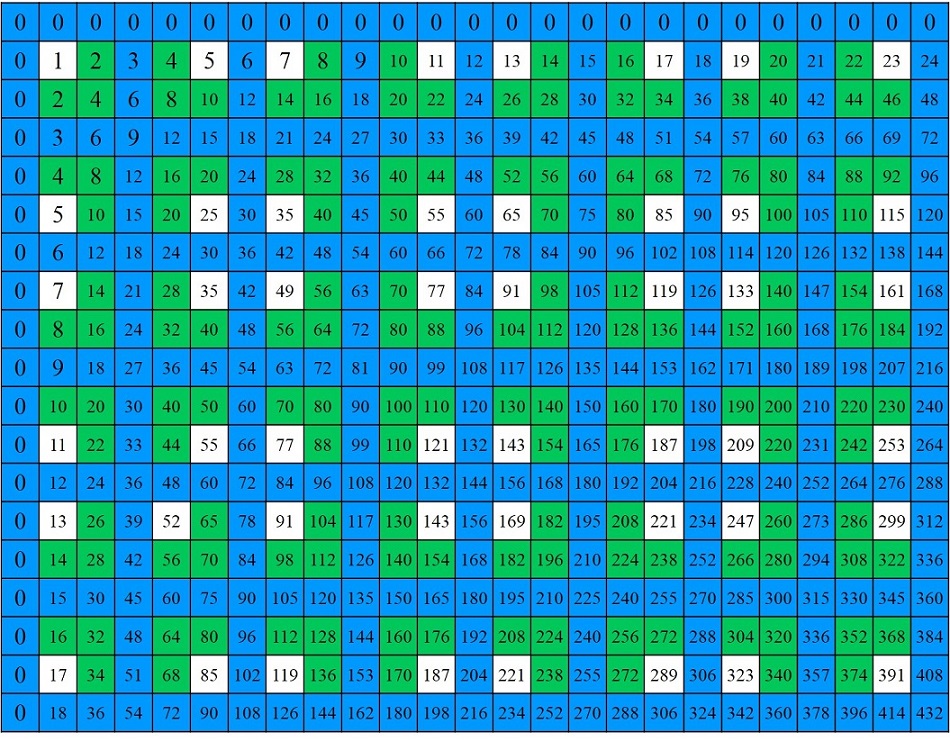

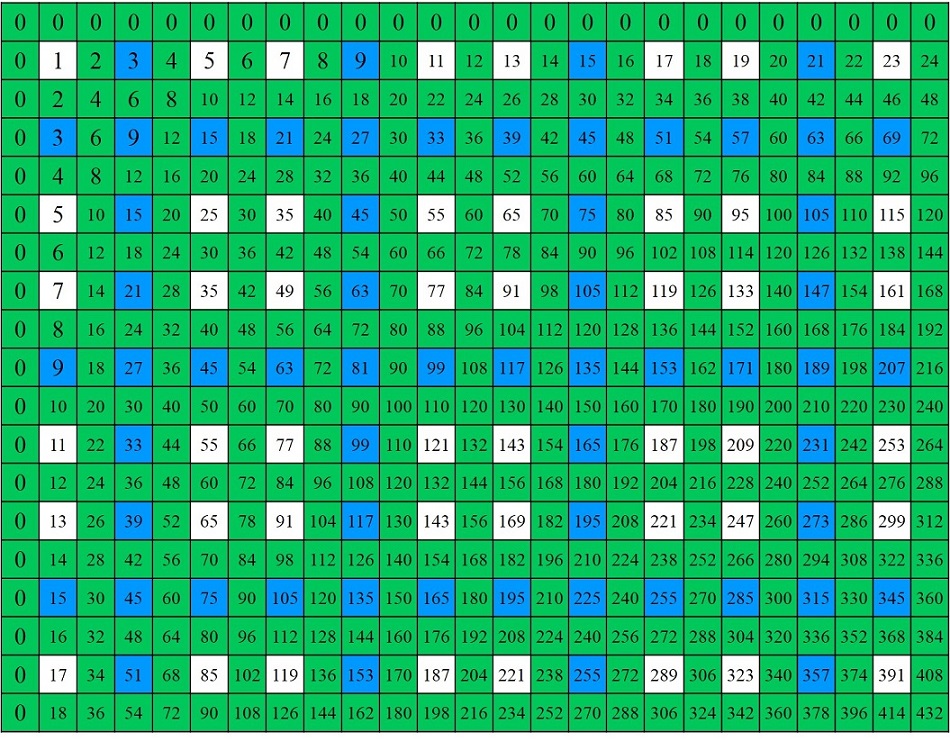

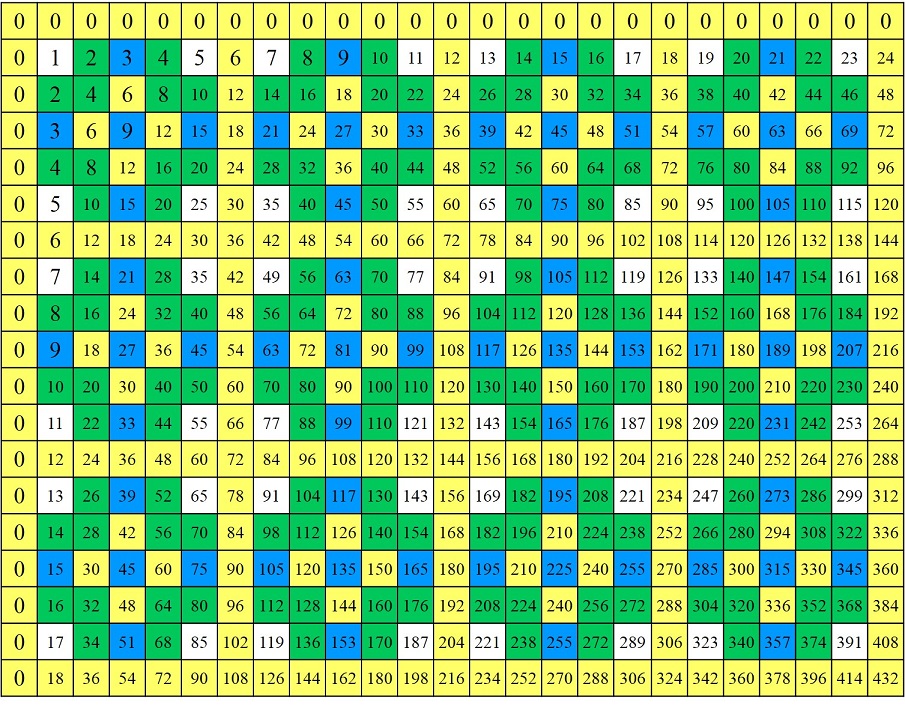

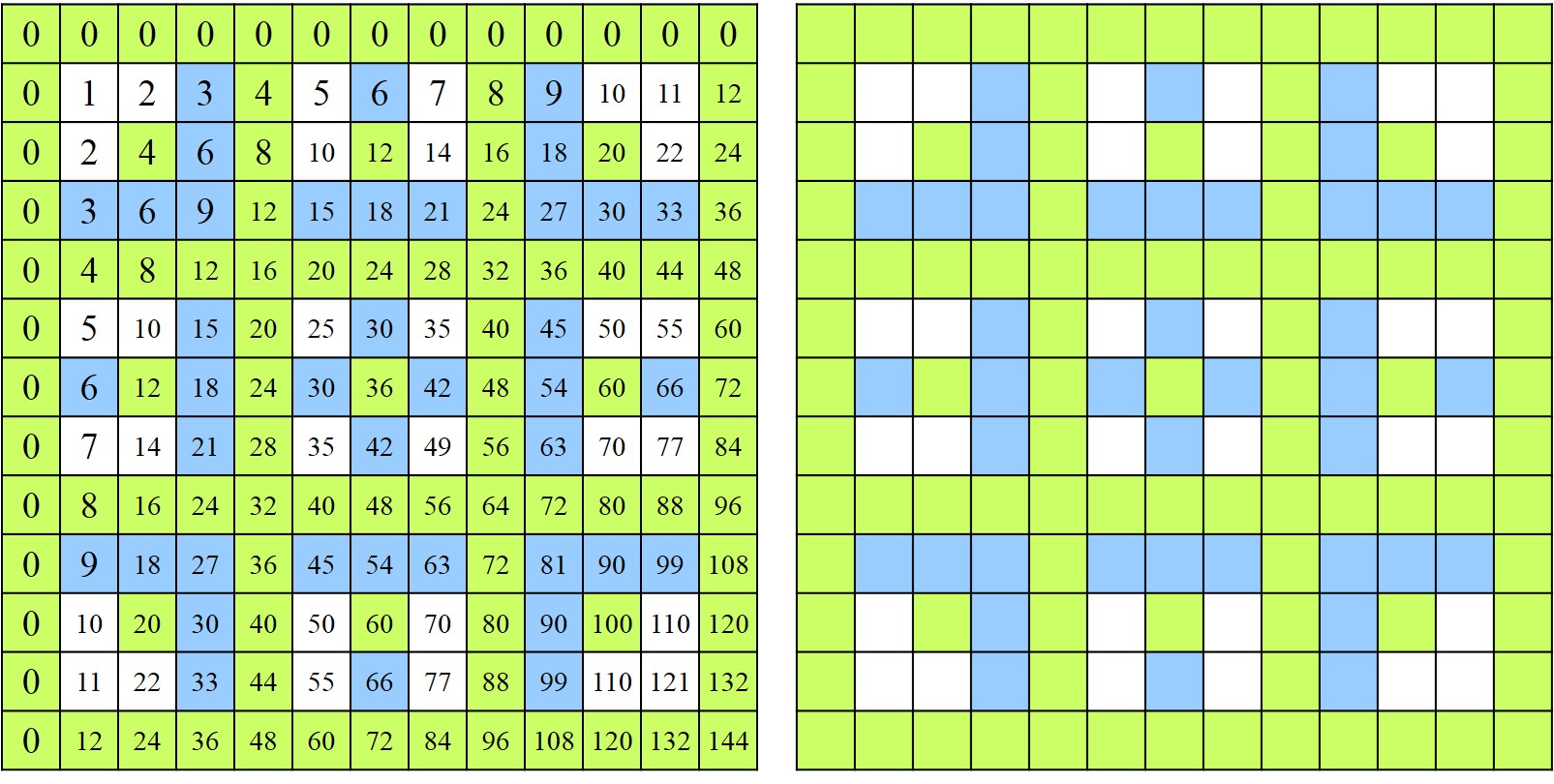

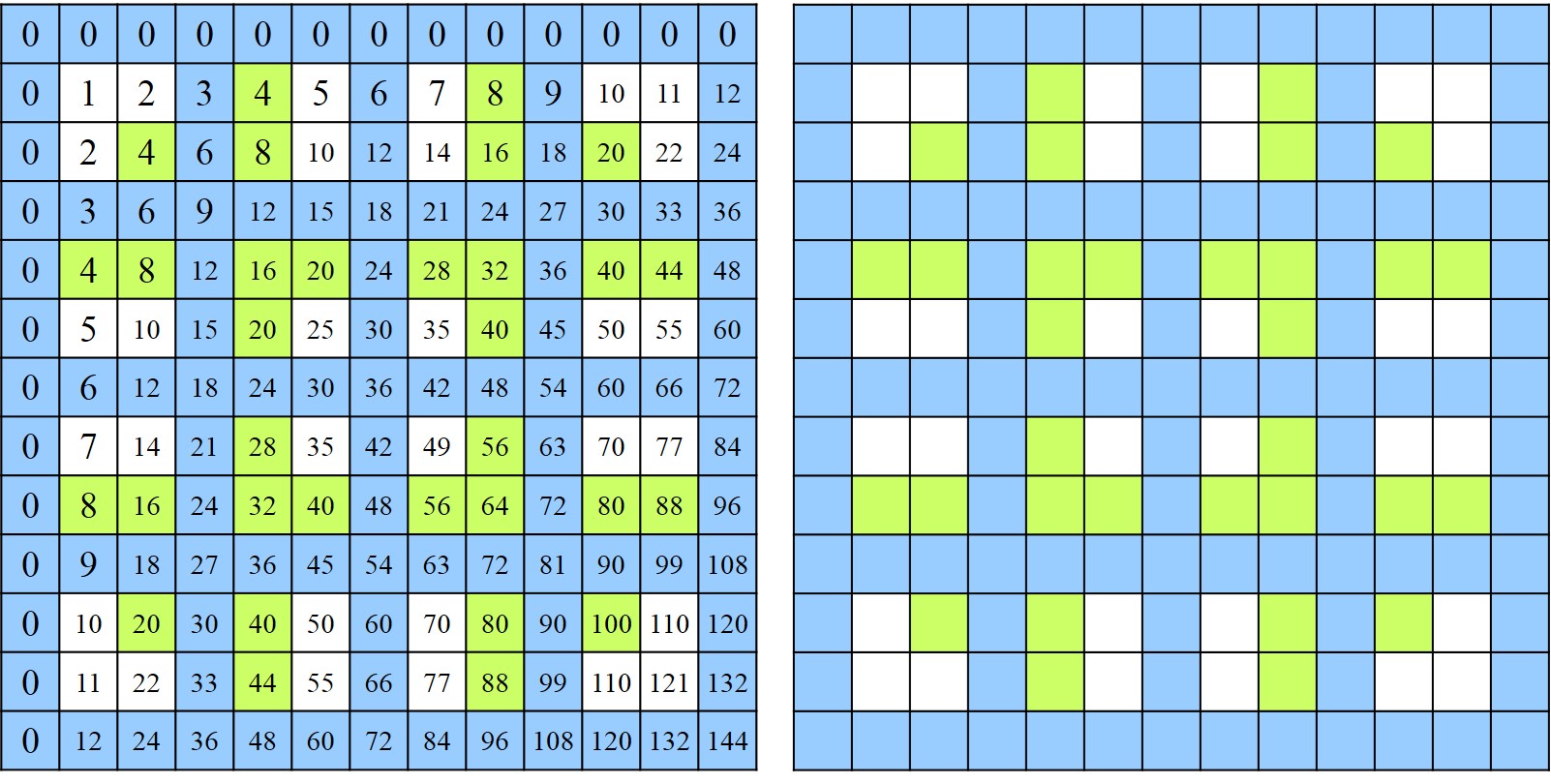

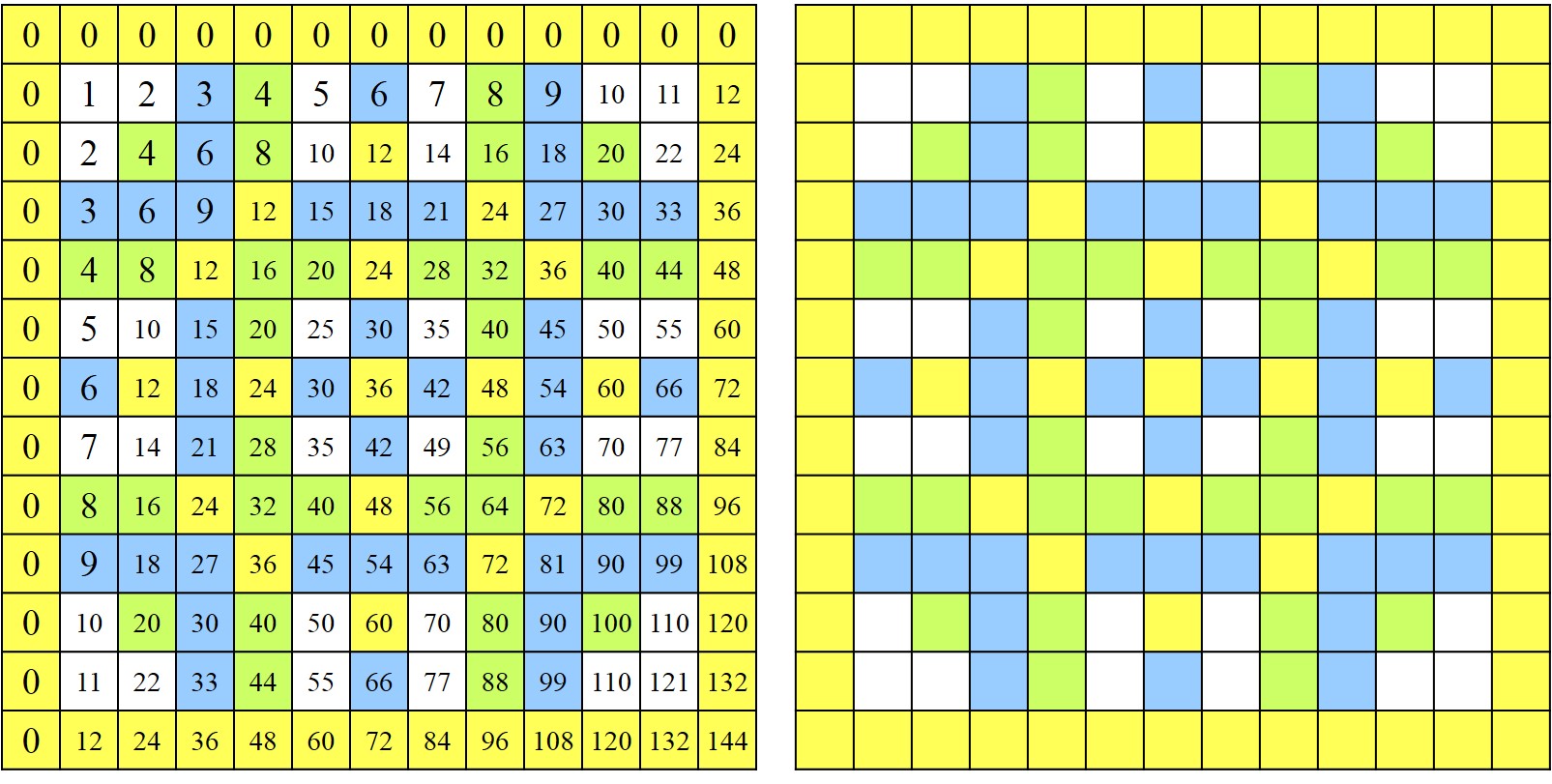

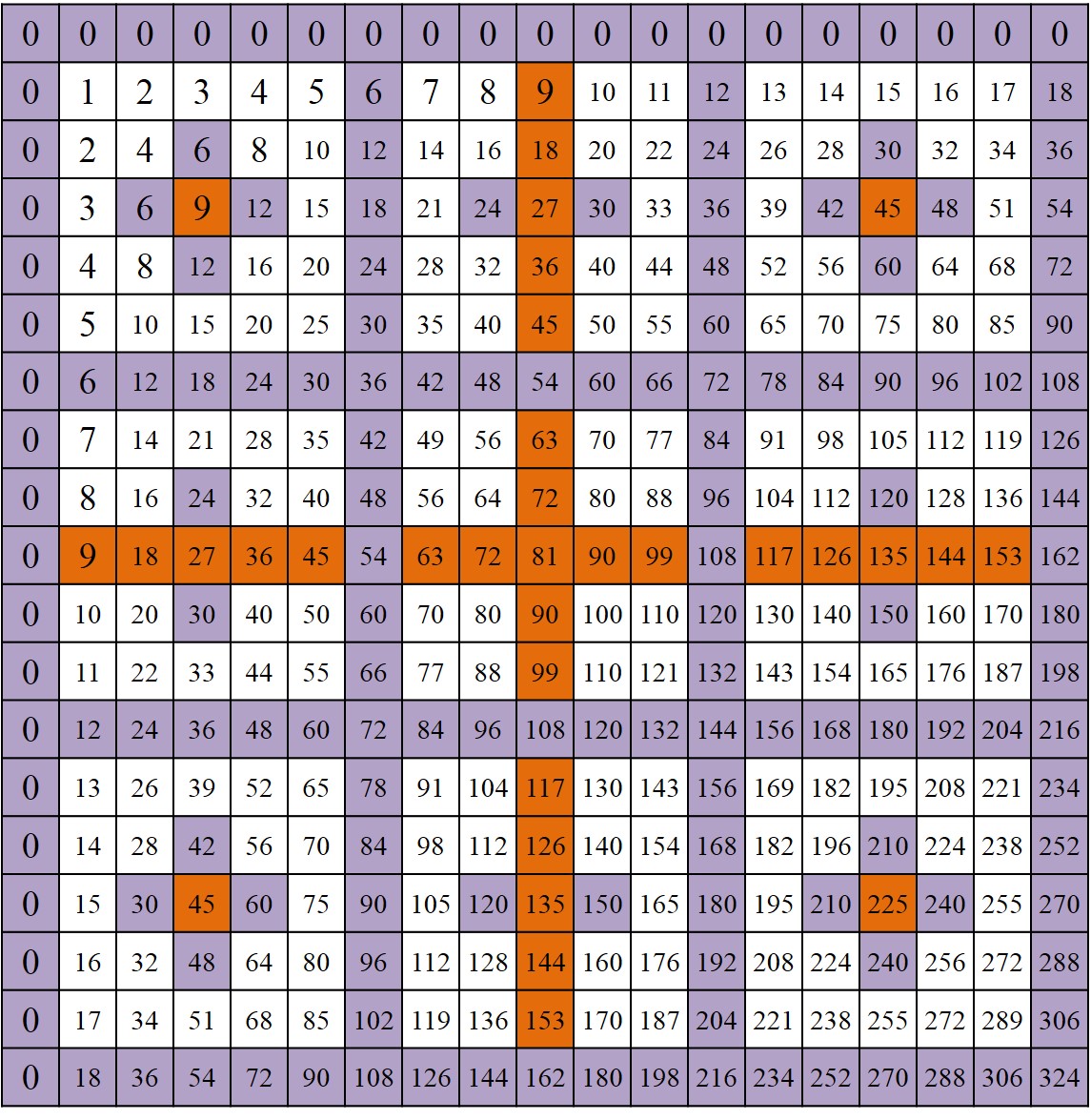

Hace unos meses, buscando material para mi libro Los secretos de la multiplicación (Catarata, 2019), que estará en las librerías el 2 de septiembre, encontré un interesante artículo del profesor de francés argelino Zoheir Barka, que es un apasionado de las matemáticas, titulado The Hidden Symmetries of the Multiplication Table (Las simetrías ocultas de la tabla de multiplicar). En esta entrada veraniega de la sección Matemoción del Cuaderno de Cultura Científica vamos a iniciar un pequeño paseo por algunas de esas simetrías ocultas en las tablas de multplicar.

Portada del libro Los secretos de la multiplicación, de los babilonios a los ordenadores, colección Miradas Matemáticas, Catarata, 2019

Portada del libro Los secretos de la multiplicación, de los babilonios a los ordenadores, colección Miradas Matemáticas, Catarata, 2019

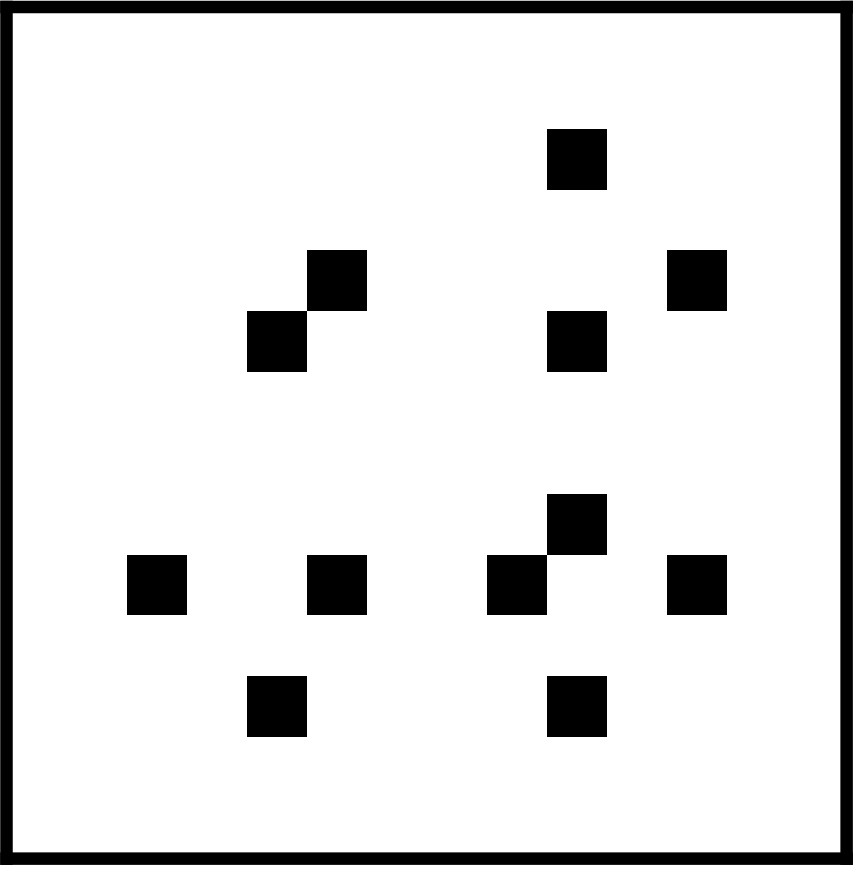

La idea de Zoheir Barka es crear diferentes patrones geométricos planos de color sobre la tabla de multiplicar, de tamaños variables, asociando colores a los múltiplos de algunos números. Por lo tanto, el punto de partida es una tabla de multiplicar cuadrada o rectangular, con un cierto número de filas y columnas, en función de las necesidades estéticas del patrón que se quiere realizar.

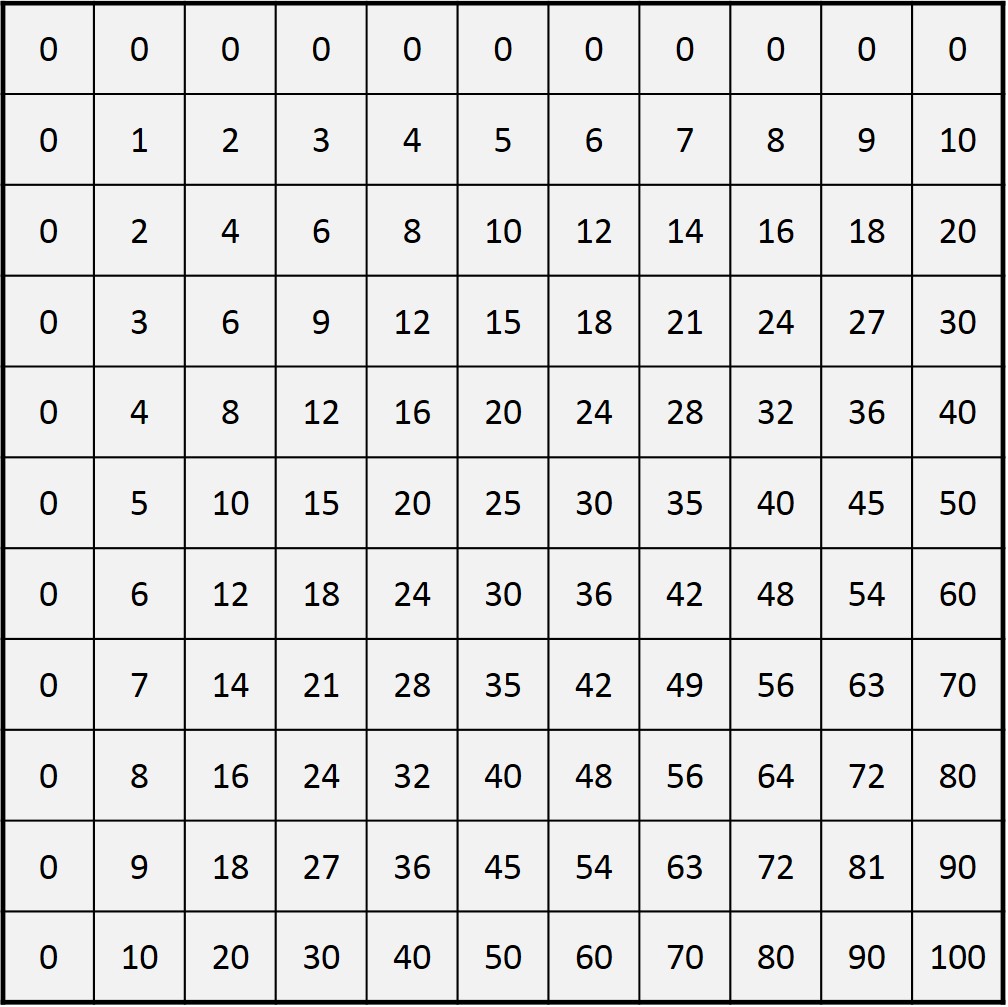

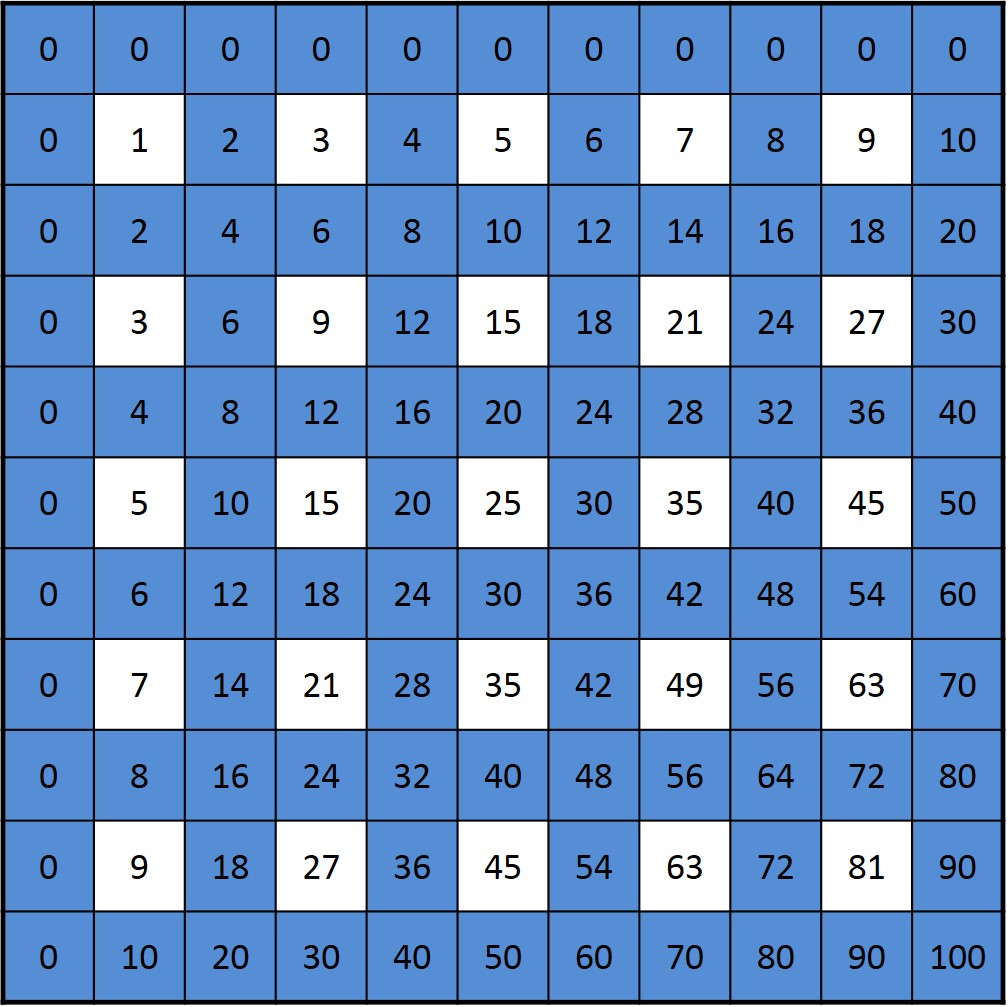

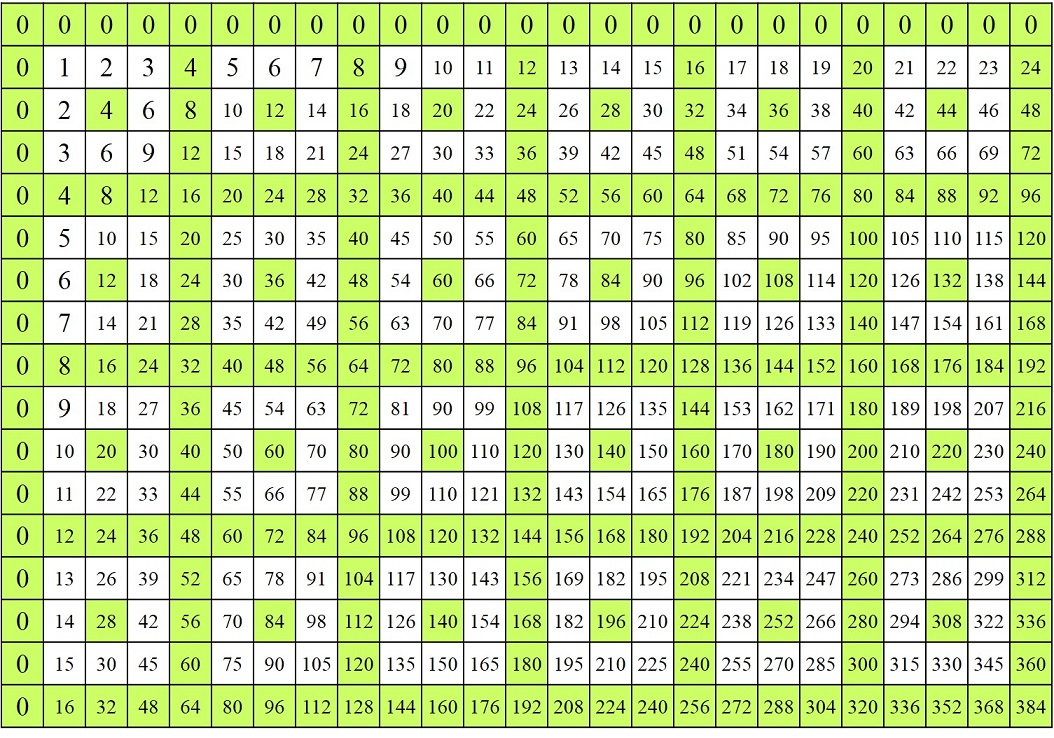

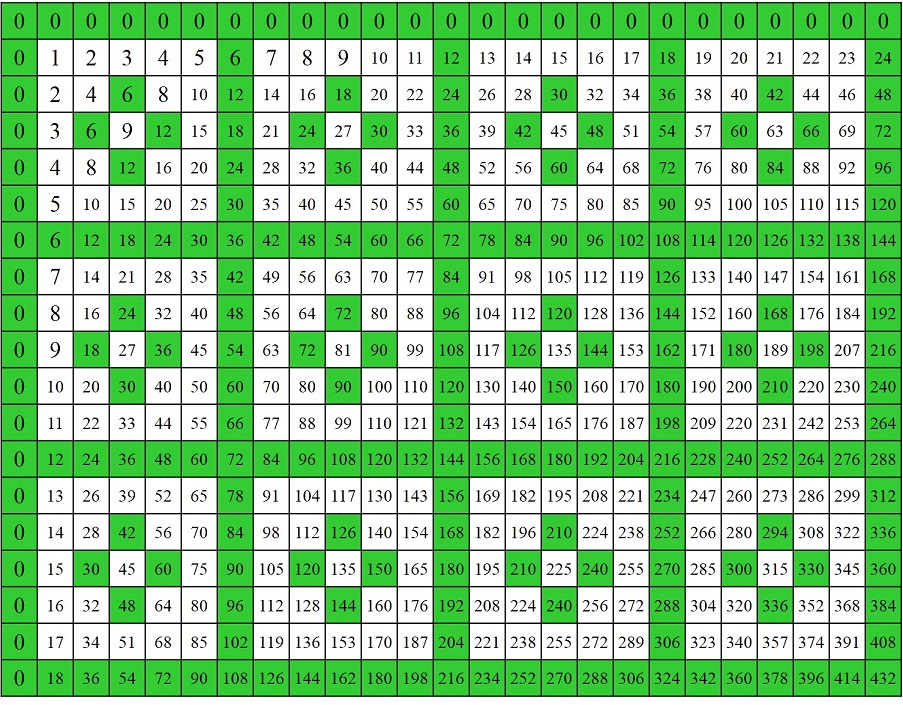

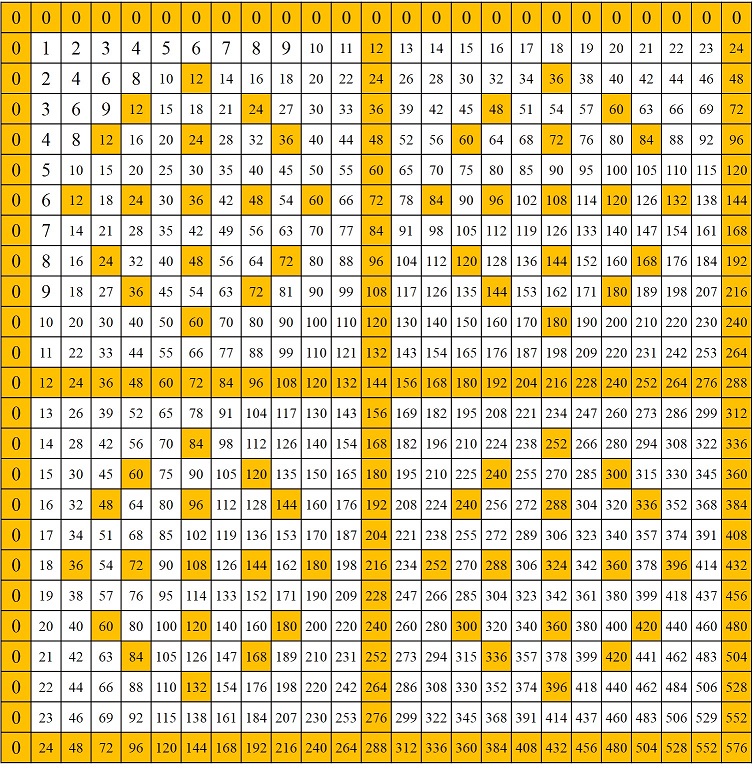

La siguiente imagen es una tabla de multiplicar normal, con los productos de los diez primeros números, del 1 al 10, a la que se ha añadido además los productos por cero, es decir, todo ceros, por lo que resulta una retícula cuadrada con 11 filas y 11 columnas.

Una vez que disponemos de la tabla de multiplicar, del tamaño que se considere oportuno, se trata de colorear cada celda de la misma en función de si el número de la celda es, o no, múltiplo de un número o de alguno de los números seleccionados. El caso más sencillo sería dar color a los múltiplos de un número, por ejemplo, el 2 y dejar sin color, o utilizar otro distinto, para los que no son múltiplos de 2, obteniendo así el siguiente patrón, que es muy sencillo.

Es evidente que, si tomamos los múltiplos de un número primo, como el 2, pero también el 3, el 5 o el 7, por ejemplo, los patrones serán sencillos enrejados, como el anterior, pero con zonas cuadradas blancas, o sin colorear, más grandes aún. Para el 2 las zonas blancas eran sencillas celdas, para el 3 serían cuadrados de 2 x 2 celdas, para el 5 cuadrados de 4 x 4 celdas, y así para el resto de los números primos. Es decir, se crea un patrón simétrico en el que se están repitiendo, en horizontal y vertical, bloques básicos de tamaño igual al número cuyos múltiplos se están considerando. A continuación, vemos los bloques básicos para 2, 3 y 5.

Pero si consideramos los múltiplos de números no primos, como el número 4, cuyo divisor no trivial es 2 (4 = 2 x 2), o el número 6, cuyos divisores no triviales son el 2 y el 3 (6 = 2 x 3), la estructura se complica un poco más, como vemos a continuación.

Por motivos estéticos, podríamos llamar la “zona básica” de cada ejemplo a la cuadrícula de tamaño (n + 1) x (n + 1), si estamos considerando los múltiplos del número n, que consiste en añadir al bloque básico la siguientes fila y columna, cuyas celdas tienen color (ya que son los primeros múltiplos del número n) y que cierran los bloques básicos.

Así las zonas básicas de los casos en los que se consideran los múltiplos de los números 4, 6 y 10, que son producto de dos primos (iguales o distintos), son las siguientes.

Y si el número considerado es múltiplo de más números primos (iguales o distintos), como el 12, que es igual al producto 2 x 2 x 3, se complica un poco más el entramado. Veámoslo.

Otro ejemplo es el siguiente, en el que se muestra la zona básica del número 30, que es igual al producto 2 x 3 x 5.

Como vemos la estructura se enriquece en función de la cantidad de números primos que generan el número cuyos múltiplos se están coloreando.

El siguiente paso natural, que es el que considera también Zoheir Barka en su artículo, es considerar los múltiplos de dos o más números, utilizando tantos colores como números. Empecemos con los múltiplos de 2 y de 3, los números más pequeños posibles para los que esto tiene sentido, y coloreemos los múltiplos de 2 en verde y los múltiplos de 3 en azul. Aquí se nos plantea una duda, qué hacer con los números que son múltiplos de los dos, luego múltiplos de 6. Tendríamos tres opciones, que se mantenga el color del múltiplo mayor, que en este caso es el 3 (azul),

que se mantenga el color del múltiplo menor, que en este ejemplo es el 2 (verde),

o incluso, utilizar otro color para los múltiplos de 6 = 2 x 3, que en la siguiente imagen utilizamos el amarillo.

Y veamos ahora un ejemplo en el que uno de los dos números no es primo, por ejemplo, 4 = 2 x 2, pero los números primos que lo componen, 2 (dos veces), no son el otro número primo, 3. En este caso, las zonas básicas que se repiten en las tres opciones son las de las siguientes imágenes. En cada uno de los casos hemos añadido a la versión con números, una sin números, que nos permite apreciar mejor el patrón geométrico que se genera.

El siguiente es un ejemplo de dos números que comparten un número primo, como los números 6 y 9, para los que el 3 es divisor de ambos. Mostramos las zonas básicas en los casos en los que prima, en el primero, el color del número 9 y, en el segundo, el color del número 6.

Y, para terminar, tomamos un ejemplo en el que uno de los números es múltiplo del otro, por ejemplo, los números 6 y 12.

En la segunda parte de esta entrada del Cuaderno de Cultura Científica continuaremos con más patrones geométricos planos sobre la tabla de multiplicar.

Maqueta para una futura pintura, Raúl Ibáñez

Maqueta para una futura pintura, Raúl Ibáñez

Bibliografía

1.- Raúl Ibáñez, Los secretos de la multiplicación, de los babilonios a los ordenadores, colección Miradas Matemáticas, Catarata, 2019.

2.- Zoheir Barka, The Hidden Symmetries of the Multiplication Table, Journal of Humanistic Mathematics, vol. 6, n. 1, pp. 189-203, 2016.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Las simetrías ocultas de la tabla de multiplicar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Multiplicar con las manos

- Multiplicar no es difícil: de los egipcios a los campesinos rusos

- Uno, dos, muchos

Las líneas de Balmer

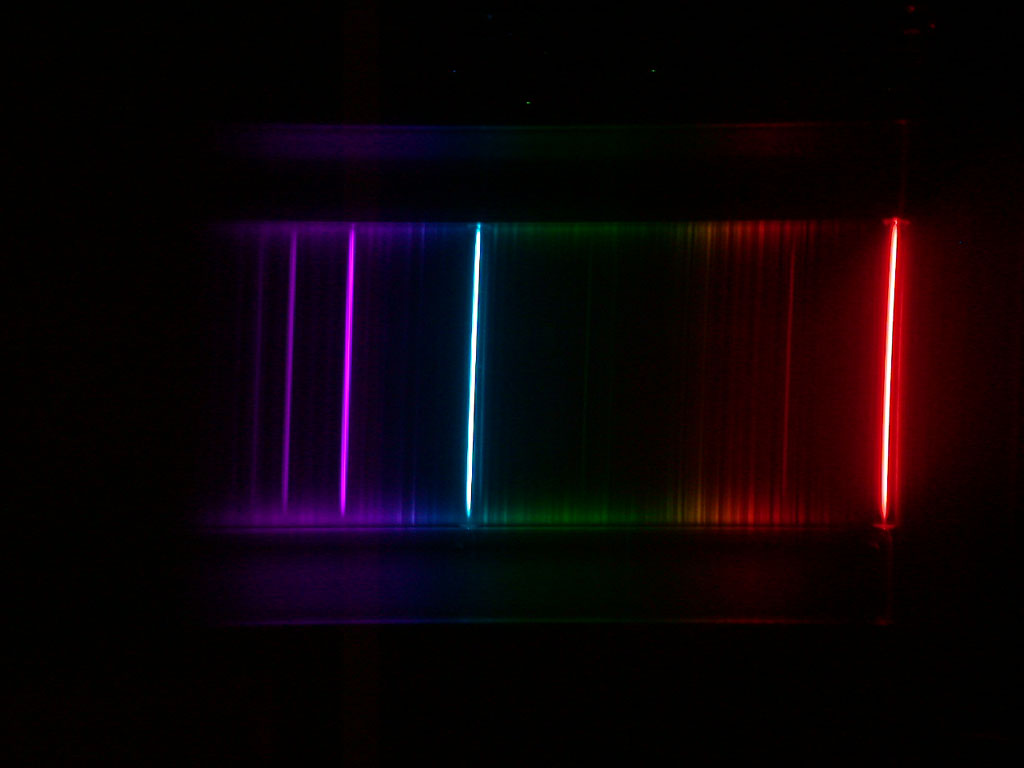

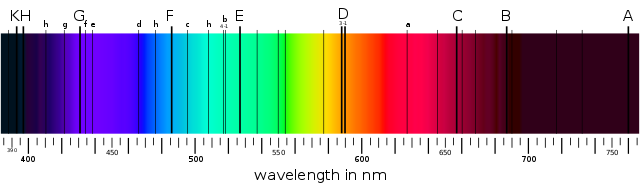

De todos los espectros, el espectro de emisión del hidrógeno es especialmente interesante por razones históricas y teóricas. En las regiones visible y casi ultravioleta, el espectro de emisión consiste en una serie de líneas en las que aparentemente hay cierto orden.

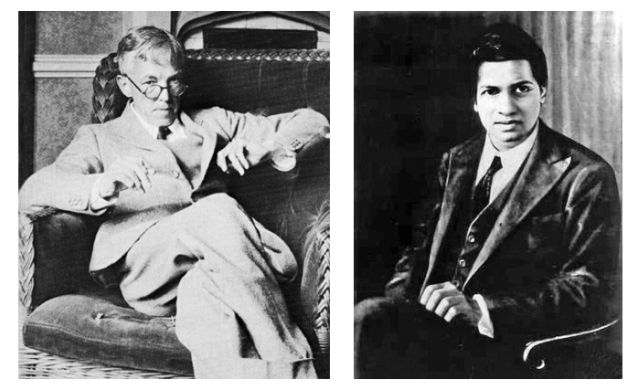

En 1885, Johann Jakob Balmer (1825-1898), un profesor de una escuela femenina Suiza, interesado en los acertijos numéricos y la numerología, encontró una fórmula simple [1] que daba las longitudes de onda de las líneas conocidas en el hora. La formula es λ = b [n2/(n2-22)].

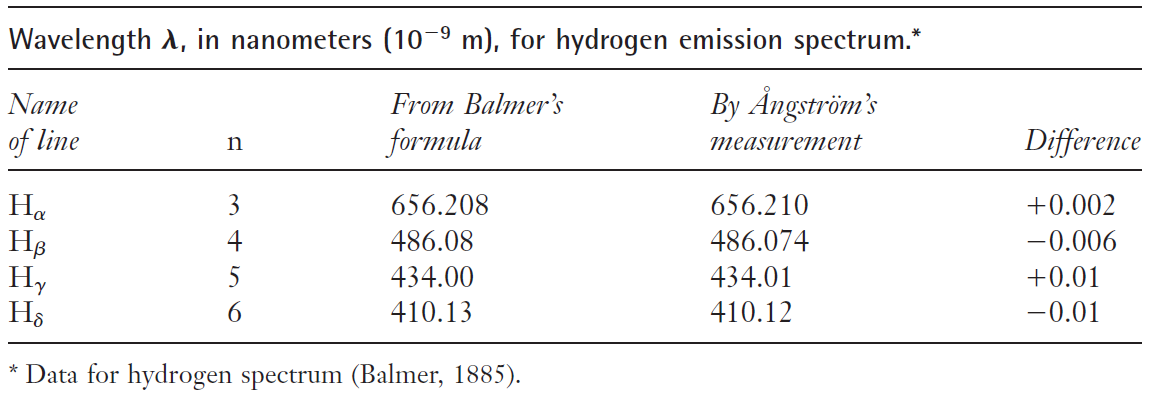

En esta fórmula b es una constante que Balmer determinó empíricamente y encontró que era igual a 364,56·10-9 m; n es un número entero, diferente para cada línea. Específicamente, para que la ecuación produzca el valor observado para las longitudes de onda respectivas, n debe ser 3 para la primera línea visible (roja) del espectro de emisión de hidrógeno (denominada Hα); n = 4 para la segunda línea (verde) (Hβ); n = 5 para la tercera línea (azul) (Hγ); y n = 6 para la cuarta (violeta) (Hδ). [2]

Fueron necesarios 30 años más para comprender cómo era posible que la fórmula de Balmer funcionase tan bien, el por qué el hidrógeno emitía en longitudes de onda con esa regularidad tan simple.

Balmer fue un paso más allá. Se planteó si no sería posible que existiesen otras series de líneas hasta ese momento desconocidas en el espectro del hidrógeno. Sus longitudes de onda, en la mejor lógica numerológica, podrían obtenerse simplemente cambiando el 22 de su fórmula por 12, 32, 42… Esta idea llevó a muchos científicos a buscar estas líneas. Con éxito, como veremos.

Notas:

[1] Se trata de una relación puramente empírica sin ninguna base teórica física. En otras palabras, la ecuación se ajusta a los datos, sin ninguna explicación de por qué.

[2] En esta tabla podemos apreciar el nivel de precisión de la fórmula al compararla con las mediciones efectuadas por Ångström:

Más detalles, aquí.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Las líneas de Balmer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La mágica fórmula de Balmer

- Los espectros de absorción de los gases

- Los espectros de emisión de los gases

Una historia de mosquitos, escoceses, esclavos y nazis

Foto: Wikimedia Commons

Foto: Wikimedia CommonsPara la mayoría de nosotros, pensar en mosquitos es pensar en picores y picaduras, pero no más. Son una anécdota molesta asociada al verano. Pero en la mayoría del mundo y durante la mayor parte de la historia, los mosquitos han sido más que eso, forman una de las grandes amenazas para la población humana a causa de su efecto transmisor de enfermedades contagiosas como la malaria, el dengue o el zika. Se considera, de hecho, el animal más peligroso para el ser humano, por encima de grandes depredadores terrestres o marinos.

Eso significa que su impacto va más allá de una incomodidad veraniega semejante al sudor o la música de chiringuito. Los mosquitos han influido en los movimientos de población y en los resultados bélicos durante siglos. Así lo explica el libro The Mosquito: A Human History of Our Deadliest Predator del historiador Timothy Winegard, que retrata a estos insectos como una fuerza de la naturaleza modeladora de la historia humana.

Los mosquitos panameños y la independencia escocesa

Foto: Wikimedia Commons