Ezjakintasunaren kartografia #213

Eboluzioak topatutako irtenbideetan oinarritzen dela ingeniaritza ez da berria. Gure aparailuen pisua arintzeko txoriengandik ikas dezakeguna, ordea, harrigarria da oraindik ere. Silvia Románen Lightweighting strategies inspired by birds.

Neurogenesia, neurona berrien sorrera, dago helduengan? Batzuen arabera, bai; besteen arabera, ez. No neurogenesis in adult primate hippocampal formation idatzi du JR Alonsok.

Solido, likido eta gas hiru materiaren egoera klasikoak baino gehiago daudela jakin beharko genuke jada. Harrigarria izan daiteke, dena den, inguru tenperaturan materia kondentsatuaren 7 egoera gutxienez daudela jakitea. DIPCko jendea, The 7 states of condensed matter at room temperature.

–—–

Mapping Ignorance bloga lanean diharduten ikertzaileek eta hainbat arlotako profesionalek lantzen dute. Zientziaren edozein arlotako ikerketen azken emaitzen berri ematen duen gunea da. UPV/EHUko Kultura Zientifikoko Katedraren eta Nazioarteko Bikaintasun Campusaren ekimena da eta bertan parte hartu nahi izanez gero, idatzi iezaguzu.

The post Ezjakintasunaren kartografia #213 appeared first on Zientzia Kaiera.

La gran infraestructura europea de investigación en biotecnologías azules es ya una realidad

La gran infraestructura europea de investigación European Marine Biological Resource Centre (EMBRC-ERIC) es ya una realidad, y la Estación Marina de Plentzia (PiE) de la UPV/EHU es uno de los dos centros seleccionados por el Estado español para participar en la misma. El EMBRC-ERIC es el resultado de unión de 24 centros de investigación de 9 países, que aunando sus recursos y know-how y ofertando servicios de investigación trabajarán para resolver cuestiones fundamentales sobre la salud de los ecosistemas marinos en un medioambiente cambiante, promover nuevas tecnologías científicas en esta área, impulsar descubrimientos en el campo de la salud mediante el uso de modelos biológicos marinos y mantener a largo plazo la monitorización del estado de los mares.

Como indican las siglas ERIC (European Research Infrastructure Consortium), esta infraestructura se ha constituido legalmente como un Consorcio Europeo Infraestructuras de Investigación, siendo la decimoctava infraestructura europea de este tipo. Según Ibon Cancio, profesor de Biología Celular de la UPV/EHU y responsable de la adscripción de la Estación Marina de Plentzia al EMBRC-ERIC. “Es muy importante participar en una organización de este nivel y dimensión. ¿Quién no conoce el CERN? Nuestra infraestructura será del mismo nivel. Ellos se dedican al campo de la física, mientras que nosotros trabajaremos en el área de la salud y alimentación (‘Health and Food‘). El CERN tiene una única sede. Nosotros tenemos 24 sedes en 9 países, si bien tenemos un presupuesto mucho más modesto y mucho para demostrar”.

Los estatutos de la infraestructura de investigación paneuropea EMBRC acaban de publicarse en el Diario Oficial de la Unión Europea. “Somos oficialmente uno de los centro de investigación que conforman EMBRC-ERIC, y la única infraestructura de este tipo en el País Vasco”, señala Cancio. Los nueve países en los que se encuentran los 24 centros de investigación que constituyen el EMBRC-ERIC son Bélgica, Francia, Grecia, Israel, Italia, Noruega, Reino Unido, Portugal y España. En el nodo español participa, además de la Estación Marina de Plentzia de la UPV/EHU, la Estación de Ciencias Marinas de Toralla (ECIMAT) de la Universidad de Vigo.

Biotecnología azulEl EMBRC-ERIC proporcionará acceso a información y recursos los ecosistemas de todos los mares de Europa. “El objetivo es que cualquier investigador o investigadora o empresa tenga a su disposición los recursos biológicos marinos necesarios para su labor de investigación, y asimismo tenga acceso a todo el know-how en biología molecular y genómica, de manera que puedan explotarlos de un modo sostenible”.

Los primeros trabajos para constituir el EMBRC empezaron en 2008, una vez que la Comisión Europea introdujo esta iniciativa en su segunda hoja de ruta. En 2011 los promotores del EMBRC pusieron en marcha su primer proyecto, y para 2014 todos los países participantes habían suscrito un memorandum de entendimiento para iniciar el proceso de formalización legal de la infraestructura. A mediados de noviembre se aprobaron los estatutos y el presupuesto de lo que será el EMBRC-ERIC, que en el caso del nodo español contará con financiación del Gobierno Vasco y la Xunta de Galicia. Posteriormente todos los países han ratificado su compromiso con el EMBRC-ERIC, que en el caso de España se produjo en el Consejo de Ministros el 15 de diciembre de 2017. La sede principal del EMBRC-ERIC se encuentra en París.

El EMBRC es, además, una de las grandes infraestructuras promovidas por la Comisión Europea dentro del foro estratégico ESFRI (European Strategy Forum on Research Infrastructures- ESFRI) para impulsar la investigación de calidad en la Unión Europea. En total cuenta con 50 infraestructuras o proyectos de infraestructuras.

Estación Marina de PlentziaLa Estación Marina de Plentzia (PIE) es un centro de investigación y enseñanza de alto nivel de la UPV/EHU. Situada en el antiguo sanatorio de Plentzia, estudia la salud del medio ambiente marino y su influencia en la salud humana. En concreto, promueve la investigación y formación en materias relacionadas con la salud de los ecosistemas marinos, los efectos de las alteraciones medioambientales sobre la salud humana y los biorrecursos marinos. La Estación Marina imparte tres másteres, dos de los cuales cuentan con la máxima distinción de calidad que otorga la Unión Europea, el sello Erasmus Mundus: Erasmus Mundus Master in Marine Environment and Resources (MER); Erasmus Mundus Master in Marine Biological Resources (IMBRSEa) y Environmental Contamination and Toxicology, Asimismo, cuenta con programas de doctorado. Una veintena de científicos y científicas y una treintena de doctorandos y doctorandas trabajan en el centro.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La gran infraestructura europea de investigación en biotecnologías azules es ya una realidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Lado oscuro del genoma y leucemia: aspectos éticos y legales de una investigación

- La pubertad está comenzando antes para muchos niños; la educación sexual debería afrontar esta realidad

- Equilibrio tautomérico en un sistema modelo de gran interés biológico

Científicos, animalistas y el uso de animales para investigación

Mucho se ha hablado de los animales utilizados en investigación. Valga como ejemplo esta estupenda revisión sobre el tema realizada por el investigador Lluís Montoliu o el informe Confederación de Sociedades Científicas de España (COSCE). El tema del uso de animales para fines científicos salta a la palestra periódicamente por presiones del lobby animalista, el cual, sin lugar a dudas, ha influido en las leyes y normas vigentes. Por parte de la razón, es decir, de la ciencia, existe una defensa férrea del uso de animales para investigación, ya que, sin su utilización, no podríamos acometer las nuevas aproximaciones terapéuticas y diagnósticas que necesitamos para poder combatir las enfermedades que todavía hoy no tienen solución y que necesitamos para mejorar la vida de los enfermos. Así que existe un enconado desencuentro entre científicos y animalistas sobre el uso de animales para fines científicos. Sin embargo, hay una entidad, o grupo de entidades, en los que no cabe debate alguno.

Anuncio de PACMA contra la experimentación animal

La talidomida fue prescrita y utilizada entre los años 1957 y 1963 en Europa. Hasta ese momento ningún país europeo contaba con regulación alguna sobre el uso de medicamentos, por lo que la tragedia de este fármaco produjo un verdadero terremoto en el desarrollo de medicamentos en el viejo continente. Alemania, un país particularmente afectado por el caso de la talidomida, tuvo que aprobar con urgencia en el año 1961 la primera ley que regulaba el uso de medicamentos.

Hasta ese momento la responsabilidad de evaluar los medicamentos recaía sobre los propios fabricantes. Aunque su distribuidor, Grünenthal, realizó algunos experimentos de seguridad, estos no fueron suficientes para detectar los efectos secundarios del fármaco, y en ninguno de los casos se evaluó el fármaco en animales gestantes. En aquellos años tampoco era obligatorio evaluar los medicamentos en animales en periodo de gestación en el Reino Unido, pero de nuevo la catástrofe de la talidomida propició que se formara en 1964 el Comité de Seguridad de Medicamentos y que, cuatro años más tarde, se promulgara la primera Ley del Medicamento británica.

Niña afectada por la talidomida

Hoy en día todos los países de primer orden cuentan con agencias para el control del desarrollo, liberación y evaluación de nuevos medicamentos. Es el caso de la European Medicines Agency (EMA) en Europa o la Food and Drug Administration (FDA) en los Estados Unidos. Dichas organizaciones se encargan de velar por la seguridad de los fármacos que se prueban en humanos. La única obsesión de dichas agencias es que no se vuelva a dar un “caso talidomida”. Así que solicitan que se realice un estudio completo y pormenorizado de la toxicidad de los fármacos bajo estudio, y siempre antes de autorizarlos para su uso en humanos. La eficacia del medicamento se supone; de lo que se encargan las correspondientes agencias es de que los fármacos sean suficientemente inocuos.

Sede de la EMA en Londres, que será trasladada a Amsterdam y no a Barcelona.

Las agencias reguladoras obligan a la industria farmacéutica a realizar una exhaustiva batería de estudios para conocer cómo los fármacos afectan a diferentes sistemas del organismo y a procesos patológicos críticos, determinando sus rangos de su seguridad en el mejor de los casos (en el peor y más habitual el desarrollo de los nuevos fármacos es interrumpido por estas cuestiones).

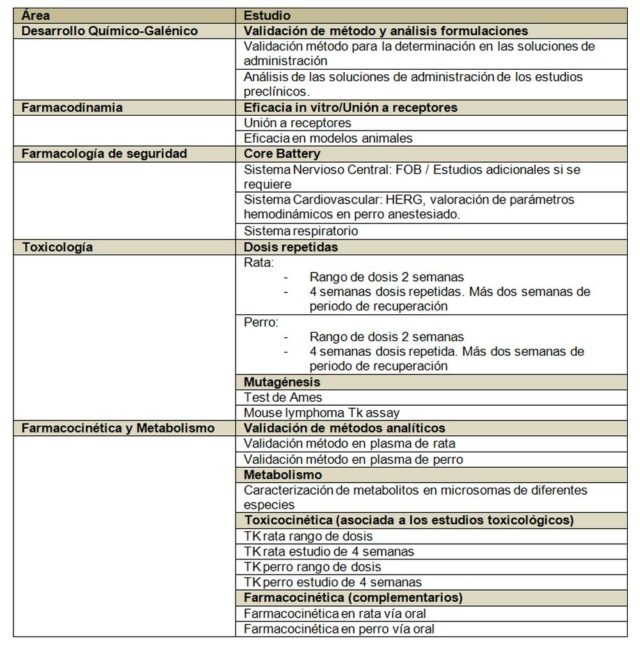

Veamos un ejemplo concreto de los estudios requeridos por las autoridades:

Podemos observar en la tabla anterior, grosso modo, los estudios que las agencias exigen. Hagamos algunas apreciaciones al respecto:

- La tabla refleja los estudios mínimos necesarios, los cuales pueden no ser suficientes si se encuentra algún hallazgo patológico inesperado, cosa que suele ocurrir ya que se fuerzan las dosis hasta encontrar efectos secundarios, lo cual permite definir las dosis de trabajo. Aquí es necesario recordar a Paracelso, que ya explicó la importancia de las dosis hace casi 500 años.

- El paquete básico de estudio está por encima del medio millón de euros en prácticamente todos los casos y los estudios tienen una duración de un año al menos. Esto si las cosas van bien, claro. En muchas ocasiones los tiempos y los costes se incrementan.

- Los laboratorios que realizan este tipo de estudios deben estar certificados en Buenas Prácticas de Laboratorio (BPL; o GLP en inglés), por lo que lo realizan exclusivamente empresas especializadas llamadas Contract Research Organizations (CRO). Todos los protocolos de estudios están normalizados y acordados, y hay que seguirlos estrictamente, registrando cualquier desviación detectada.

- Se estudian los principales sistemas del organismo, tales como el sistema respiratorio, cardíaco o nervioso, así como procesos que puedan afectar a la seguridad, tales como la mutagénesis o los estudios de interacción con receptores.

- Se estudian dos especies animales siempre; una de roedores y otra de no roedores. Por cuestiones históricas la especie de roedor mayoritaria es la rata (el ratón no se usa para estudios regulatorios normalmente). Las agencias tienen un amplio recorrido de estudios realizados en rata y pueden comparar expedientes. La especie no roedora suele ser el perro, aunque se pueden utilizar otros no roedores con su justificación pertinente. Sólo en contadas ocasiones las agencias autorizan el uso de primates. El perro habitualmente usado para estos estudios es de la variedad Beagle; los monos suelen ser macacos.

- Toda la información extraída de los estudios regulatorios preclínicos es utilizada para diseñar los estudios en humanos First-in-human, y las primeras dosis de estudio vienen definidas por la dosis anterior a la más baja que produce algún efecto en cualquiera de las dos especies animales utilizadas en los estudios. A esta dosis se le conoce como NOAEL (de non-observed adverse effect level).

- Previamente a los estudios en humanos se aplicará un factor de dilución a la dosis elegida como medida adicional de seguridad. La dosis final que será utilizada para iniciar los estudios en humanos es lo que se conoce como MRSD (del inglés máximum recommended starting dose).

A grandes rasgos, para todo lo anteriormente expuesto, es necesario el uso de animales. Y en este caso el factor limitante no son los comités de ética, que los hay, si no la cuantía económica de los estudios y la duración de los mismos (para la empresa farmacéutica, tiempo y dinero son parámetros esencialmente equivalentes).

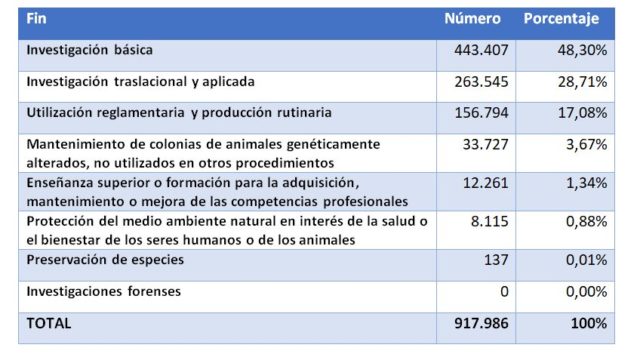

La pregunta ahora es: ¿Cuántos animales se usan para este tipo de estudios en nuestro país? Si analizamos el último informe oficial publicado por el Ministerio de Agricultura, Pesca, Alimentación y Medio Ambiente (MAPAMA), el número de animales utilizados en 2016 para fines científicos fueron los siguientes:

Es decir, que la mayoría de animales fueron usados para investigación (básica o traslacional/aplicada, en un 77%). La siguiente partida en importancia es la utilización reglamentaria y producción rutinaria. Si atendemos sólo al uso reglamentario los datos indican que se utilizaron 49.640 animales para este fin repartidos de la siguiente forma:

Es decir, de cada 100 animales utilizados para fines científicos aproximadamente 5 fueron sacrificados por cuestiones regulatorias, por los 75 que fueron usados en las diferentes fases de investigación. Tal vez 50.000 animales al año para estudiar la seguridad de los fármacos pueda parecer mucho, tal vez no parezca tanto si lo comparamos con las incontables personas que sufrieron el efecto de la talidomida en nuestro país.

Si salimos de nuestra zona de confort y atendemos, por ejemplo, al uso de animales para la alimentación, según Eurostat sólo en 2015 se sacrificaron más de 46 millones de cerdos en España. O lo que es lo mismo, un cerdo por español. Por el contrario, en 2015 por cada español tan sólo se usaron 0,018 animales con fines regulatorios. Juzguen ustedes mismos.

Este post ha sido realizado por Javier Burgos (@Javisburgos) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias y más información

- Lluís Montoliu (2018) ¿Cuántos animales se usan en España para experimentación? Cuaderno de Cultura Científica

- Informe COSCE sobre el uso de animales de investigación.

- Informe 2016 de uso de animales para investigación del MAPAMA. [PDF]

- Guía de desarrollos preclínicos. Genoma España. [PDF]

El artículo Científicos, animalistas y el uso de animales para investigación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Cuántos animales se usan en España para experimentación?

- #Naukas15 ¿Es necesario usar animales en investigación?

- Una nueva investigación muestra que explicar cosas a la gente “normal” puede ayudar a los científicos a ser mejores en su trabajo

Gorka Kobeaga: “Ibilbideen optimizazioa arlo zabala da eta aplikazioak oso anitzak dira” #Zientzialari (93)

Orientazio Problema (Orienteering Problem, OP) matematikaren arloan aztertzen den ibilbideen optimizazio problema bat da. Saltzaile ibiltariaren problema (TSP) ospetsuaren aldaera den ibilbide-problema honen helburu nagusia da, ibilbidearen gehienezko luzera errespetatuz, bisitatutako herrietan jasotako sarien batura maximizatzen duen ibilbidea aurkitzea.

Ibilbide-problema honen aplikazioak anitzak dira gaur egun. Izan ere, teknologia berriek eskainitako aukerak aurrera egin ahala, Orientazio Problemaren aplikazioak ugaritu egin dira.

Baina, zeintzuk dira zehazki aplikazio hauek? Nola aplikatzen dira algoritmoak ibilbideen optimizazioan? Galdera hauei erantzuteko, Gorka Kobeaga BCAM zentroko ikertzailearekin izan gara.

‘Zientzialari‘ izeneko atal honen bitartez zientziaren oinarrizko kontzeptuak azaldu nahi ditugu euskal ikertzaileen laguntzarekin.

The post Gorka Kobeaga: “Ibilbideen optimizazioa arlo zabala da eta aplikazioak oso anitzak dira” #Zientzialari (93) appeared first on Zientzia Kaiera.

La neurociencia está desentrañando los misterios del encéfalo adolescente

Lucy Foulkes

![]()

¿Cómo describirías al adolescente medio? A la mayoría las siguientes características pueden venirnos a la mente: temperamental, impulsivo, arriesgado, propenso a sucumbir a la presión de grupo.

Si bien está claro que la adolescencia es un período de la vida que está plagado de estereotipos, hay algo de verdad en los clichés. Muchos estudios neurocientíficos han establecido que ocurren cambios significativos en el encéfalo durante la adolescencia. Y las cosas por las que a menudo se ridiculiza a los adolescentes, como su asunción de riesgos y la vulnerabilidad a la presión de los compañeros, en realidad están enraizadas en los cambios que ocurren en sus encéfalos. Solo hay un problema con esto: muchos adolescentes no se ajustan a los estereotipos.

Todos sabemos por experiencia personal que la forma en la que los adolescentes piensan y actúan puede variar ampliamente según el adolescente del que se trate. Pero, a pesar de esto, la gran mayoría de los estudios hasta la fecha se han centrado en las medias: ¿qué ocurre de media con el encéfalo durante la adolescencia o cómo se comportan y sienten los adolescentes de media?

Depender de las medias de esta manera tiene un beneficio estadístico importante, ya que es más probable que los investigadores sean capaces de detectar un efecto genuino si promedian sus hallazgos entre muchos participantes. Pero el coste obvio es que estos hallazgos generales no se aplican a todos y cada uno.

Comprender las diferencias individuales

En un artículo reciente, mis colegas y yo argumentamos que esto debe cambiar. A partir de ahora, la investigación del encéfalo de los adolescentes necesita prestar más atención a estas importantes variaciones entre adolescentes, lo que se conoce en el campo como “diferencias individuales”.

Además de documentar que todos los adolescentes son diferentes, también debemos comenzar a entender por qué esto es así. Los estudios que ya están investigando esto han demostrado que tanto la genética, como la nutrición, la crianza de los hijos o las enfermedades mentales afectan a la forma en la que se desarrolla nuestro encéfalo y la manera en la que nos comportamos durante la adolescencia. Y en nuestro último artículo, analizamos otros tres factores que podrían afectar el desarrollo del encéfalo: el estatus socioeconómico, las relaciones con los compañeros y la cultura.

No útil para retrato robot. Imagen: Shutterstock

El estatus socioeconómico es una medida de la posición social y financiera de una persona en la sociedad, y a menudo se mide por el nivel de educación de sus padres y por los ingresos familiares totales. La investigación ya ha descubierto que tu encéfalo se desarrolla de manera diferente en la adolescencia dependiendo de tu nivel socioeconómico. Pero lo que aún no entendemos del todo es por qué. Podría ser, por ejemplo, que criarse en un ambiente de bajos ingresos es más estresante o que esté relacionado con diferentes tipos de nutrición, y que esto a su vez afecte el desarrollo del encéfalo, pero se necesitan más estudios sobre este tema.

Compañeros de clase y cultura

El tipo de relación que los adolescentes tienen con sus compañeros también afecta la actividad encefálica. Los adolescentes con una historia de acoso, por ejemplo, muestran diferentes patrones de activación encefálica ante ciertas informaciones sociales: sus encéfalos parecen ser más sensibles a la experiencia de ser excluidos. Por la misma razón, tener muchos amigos y un historial de ser querido por los compañeros de clase también afecta a la activación encefálica, y puede hacerte más resistente al desarrollo de problemas de salud mental.

En todo el mundo, los adolescentes también crecen en culturas muy diferentes, lo que afecta muchos aspectos de sus vidas: desde cuántos años pasan estudiando hasta cuándo se casan e incluso cuánto tiempo pasan con sus familias.

Recientemente, los científicos se han interesado en cómo esto se podría reflejar en las diferencias en los encéfalos adolescentes. Ya sabemos que los adultos de diferentes culturas muestran diferencias interesantes en su actividad y estructura encefálicas, y esto ahora está empezando a investigarse en adolescentes.

Solo tu adolescente medio

La razón por la que la mayoría de las investigaciones sobre el encéfalo de adolescentes aún no consideran las diferencias individuales se debe en parte a que el campo tiene solo 20 años de edad, y las nuevas áreas de investigación deben comenzar con lo básico, las medias, antes de intentar comprender los matices.

La investigación del encéfalo adolescente es un campo relativamente nuevo. Imagen: Shutterstock

También hay razones prácticas. La tecnología de imágenes encefálicas hasta la fecha no ha sido lo suficientemente buena como para cartografiar exactamente cómo los factores específicos, como las relaciones entre iguales, podrían afectar el desarrollo del encéfalo. Luego también está el hecho de que para tener suficiente capacidad para detectar hallazgos fiables, se necesitan grandes tamaños de muestra.

Esto significa cientos, a veces miles, de adolescentes. Por el momento, un escáner cerebral cuesta alrededor de 600 € por hora, por lo que el tamaño de las muestras a menudo está limitado por el coste. Una forma de resolver este problema es que los científicos compartan sus datos entre ellos, y esto ya está comenzando a suceder .

Todos los encéfalos son diferentes

Reconocer que todos los adolescentes son diferentes tiene implicaciones realmente importantes para cosas como la educación o la publicidad. Si, por ejemplo, la forma en que los adolescentes aprenden depende de su patrón específico de desarrollo encefálico, entonces las estrategias educativas basadas en medias solo tendrán una utilidad limitada.

Del mismo modo, las campañas publicitarias para temas como la salud sexual, si se basan en los estudios que promedian entre los participantes, funcionarán para algunos adolescentes, pero no para otros.

Cuanto antes entendamos la diferencia entre los adolescentes, más pronto podremos integrar esta información en las escuelas y las políticas. Esto es importante porque, después de todo, no existe un adolescente medio, y debemos recordar esto a medida que continuamos refinando nuestra comprensión del encéfalo adolescente.

Nota del traductor sobre las referencias bibliográficas: Todos los artículos científicos están enlazados en el texto en sus contextos apropiados, basta pulsar en las palabras azules.

Sobre el autor:

Lucy Foulkes es profesora de de psicología de la educación en la Universidad de York (Reino Unido)

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 23 de abril de 2018 bajo una licencia Creative Commons (CC BY-ND 4.0)

El artículo La neurociencia está desentrañando los misterios del encéfalo adolescente se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran encéfalo humano es un “encéfalo social”

- La pubertad está comenzando antes para muchos niños; la educación sexual debería afrontar esta realidad

- El encéfalo bilingüe: por qué no existe un modelo único

Laser bidezko ablazioaren egungo egoera eta aplikazioak

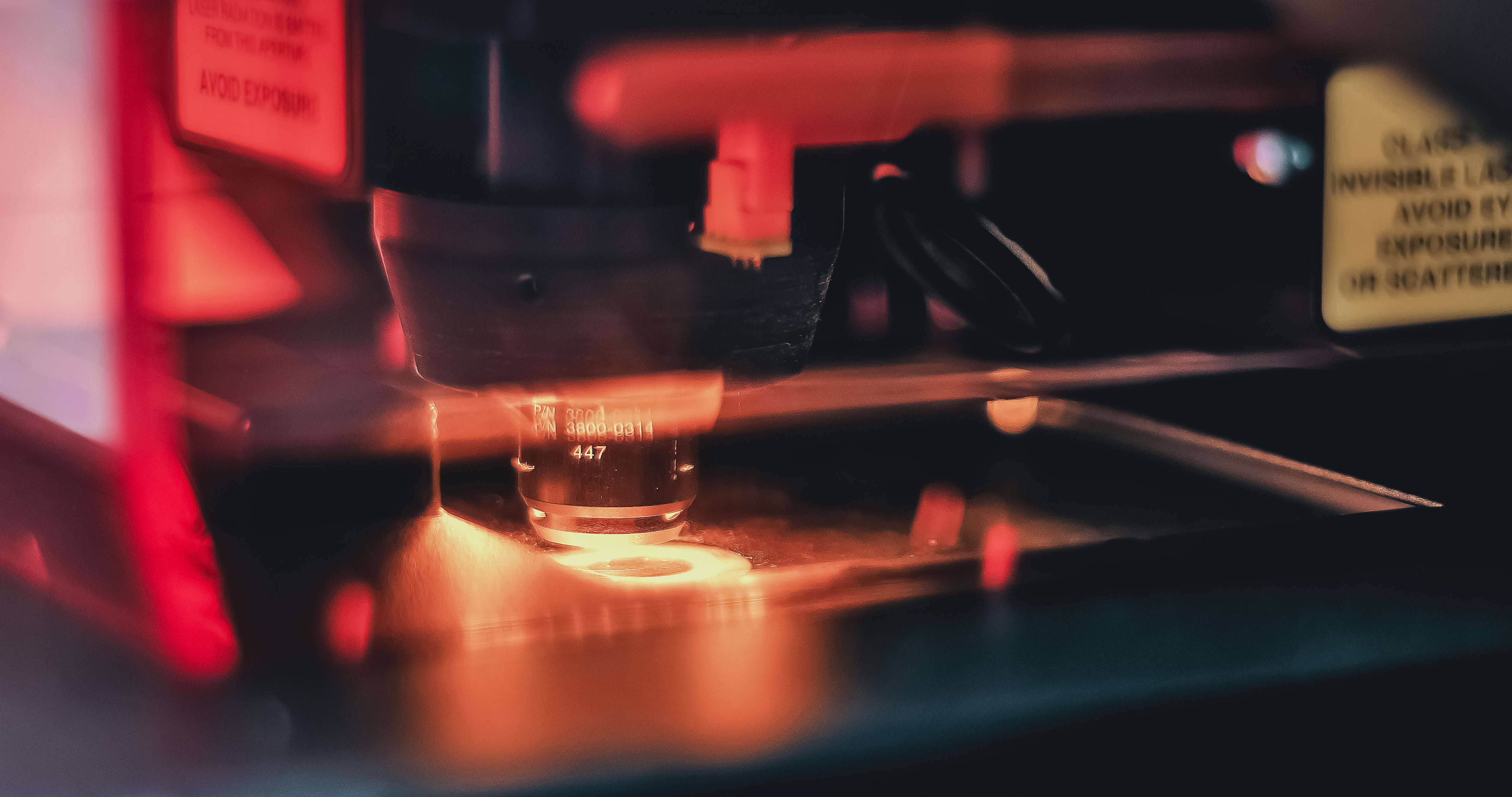

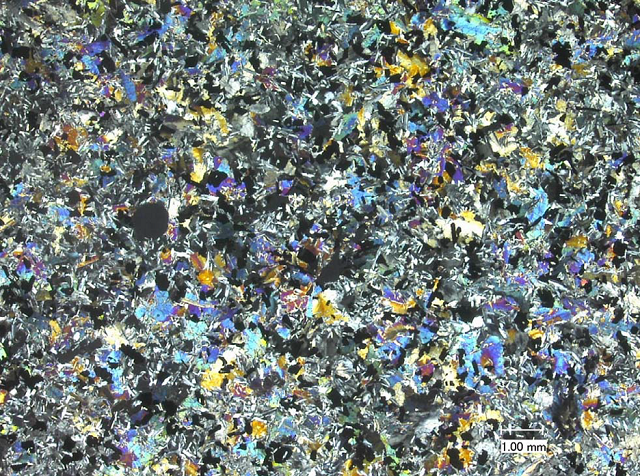

Irudia: Alan Gray-ek, 1985. urtean, laser bidezko ablazioa garatu zuenetik teknikaren oinarriak ez dira asko aldatu.

Teknikaren funtsa sinplea da: lagina hermetikoki itxita dagoen gelaxka batetan kokatzen da. Pultsu laburreko eta energia handiko laser izpi bat laginaren gainazalean fokatu eta partikulak, atomoak, ioiak eta elektroiak erauzten ditu. Gas inerte batek (He edo Ar) gelaxka zeharkatu eta ICPMS-era garraiatzen ditu. Bertan, aerosola lurrundu, atomizatu eta ionizatu ondoren sortzen diren ioi positiboak masa espektrometroan analizatzen dira.

Hortaz, laserrak lagin solidoaren analisi zuzena ahalbidetzen du, aurretratamendurik gabe eta analisi denbora nabarmenki murrizten da. Ezaugarri bereizgarrienak hauexek dira: erabilpen erraza, analisi denbora laburra, laginari eragindako kalte urriak, sentsibilitate handia eta elementu nagusi zein minoritarioen eta ratio isotopikoen aldibereko neurketa ahalbidetzen duen tarte dinamiko zabala.

Hala ere, teknika honek zehaztasunean eragina duten desabantailak ditu. Alde batetik, laginak oso homogeneoak ez badira, analisiaren adierazgarritasuna bermatzeko sakonera edota gainazal handiagoak analizatu behar dira laserraren diametroa, energia eta abiadura areagotuz. Bestalde, zatikatze elementala (edo elemental fractionation) laginaren matrizearen izaeraren arabera gertatu daiteke (matrize efektua, hain zuzen) eta honek kuantifikazioan eragina izan dezake. Horregatik, laginak berak kuantifikazioan eragin ditzakeen desbiderapenak zuzentzeko laginaren antzerako konposizioa duten erreferentziazko materialak erabiltzen dira (matrix-matching).

Alan Gray-ek, 1985. urtean, laser bidezko ablazioa garatu zuenetik teknikaren oinarriak ez dira asko aldatu. Hala ere, burututako hobekuntzek (laser pultsuen iraupenean eta egonkortasunean, uhin-luzeran, laser izpiaren bide optikoan eta aerosolaren garraioan eragina dutenak, batez ere) teknikaren aplikazioak ugaritu dituzte eta gaur egun laser bidezko ablazioa erreferentziazko teknika bilakatu da kimika analitikoaren esparruan lagin konplexuen (material geokimikoak, geruza anizkoitzeko laginak, ingurune-laginak eta lagin biologikoak, artelanak, arkeologia piezak eta harribitxiak, esaterako) analisi mikroskopikoa egiteko.

Teknika honen egungo egoeraz jabetzeko ondorengo puntako aplikazioak bereiz daitezke bai biologian eta ingurumenean, osasunean, geokimikan zein auzitegi zientzien alorretan:

i) Arrain espezieen populazioaren kontrola eta habitaten kalitatearen neurketa otolitoen eta hegats-hezurren analisiaren bidez.

ii) Psikiatriako, neurologiako eta onkologiako medikuntzaren adarretan egindako aurrerapenak zenbait gaixotasunetan eragiten duten metalen identifikazioaren bidez.

iii) Petrolio gordinaren jatorriaren ziurtapena eta kalitatearen ebaluazioa.

iv) Tiro aztarnen dudarik gabeko identifikazio azkarra.

v) Material nuklearraren legez kanpoko trafikoaren aurkako borroka.

Artikuluaren fitxa:- Aldizkaria: Ekaia

- Zenbakia: Ekaia 31

- Artikuluaren izena: Laser bidezko ablazioaren egungo egoera eta aplikazioak.

- Laburpena: 80ko hamarkadaz geroztik, laser bidezko ablazioa eta akoplamendu induktibozko plasma-masa espektrometria (LA-ICPMS) konbinatzen dituen teknika analitikoa sakonki ikertu eta garatu da, eta, gaur egun, lagin solidoen analisi elemental zein isotopiko zuzena egiteko erreferentziazko teknika bilakatu da. Ezaugarri bereizgarrienak hauexek dira: erabilpen erraza, analisi-denbora laburra, laginari eragindako kalte urriak, sentsibilitate handia eta elementu nagusi zein minoritarioen eta ratio isotopikoen aldibereko neurketa ahalbidetzen duen tarte dinamiko zabala. Lan honetan, LA-ICPMS teknikaren oinarriak eta konfigurazio orokorra azaldu eta femtosegundo/ nanosegundo laser bidezko ablazioaren erabileraren arteko desberdintasun nagusiak nabarmentzen dira. Azkenik, teknika honen egungo egoeraz jabetzeko, jatorri askotariko laginen analisi elementala laburbildu eta berrikusten da biologian eta ingurumenean, osasunean, geokimikan zein auzitegi zientzien alorretan.

- Egileak: Nagore Grijalba, Fanny Claverie, Ariane Donard, Hélène Tabouret, Christophe Pecheyran, Nora Unceta, Mª Aránzazu Goicolea, Ramón J. Barrio

- Argitaletxea: UPV/EHUko argitalpen zerbitzua

- ISSN: 0214-9001

- Orrialdeak: 45-65

- DOI: 10.1387/ekaia.16332

—————————————————–

Egileez: Fanny Claverie, Ariane Donard, Hélène Tabouret, Christophe Pecheyran Laboratoire de Chimie Analytique Bio-inorganique et Environnement (IPREM-UMR UPPA/CNRS 5254)koak dira; Nora Unceta, Mª Aránzazu Goicolea, Ramón J. Barrio UPV/EHUko Farmazia Fakultateko Kimika Analitikoa Sailekoak dira eta Nagore Grijalba bietakoa.

————————————————–

Ekaia aldizkariarekin lankidetzan egindako atala.

The post Laser bidezko ablazioaren egungo egoera eta aplikazioak appeared first on Zientzia Kaiera.

La humildad como virtud científica

Linus Pauling (1901-1994). Ganador de dos premios Nobel. Uno de los padres de la química cuántica y de la biología molecular. Pacifista y activista. Pero también padre de la medicina ortomolecular (sin base científica; una teoría inventada en un sillón, como el psicoanálisis de Freud o la homeopatía de Hahnemann) y perseguidor arrogante, hostil e incansable de Dan Shechtman, los cuasicristales y de cualquiera que trabajase en ellos desde su descubrimiento en 1984 hasta su muerte en 1994 (Shechtman recibiría el Nobel en 2011 por el descubrimiento de los cuasicristales).

Gente que practica ciencia desde la arrogancia hay, ya lo creo; incluso en según qué disciplinas o instituciones abundan. Personas de teoría única que acertaron una vez en algo importante y desde entonces mantienen su hipótesis favorita como única aceptable; científicos que sólo se relacionan con discípulos de su secta, que rechazan a quien tiene ideas diferentes, que son incapaces de imaginar que sus ideas puedan ser insuficientes o mucho menos erróneas. Abundan los jefes de laboratorio, directores de centro, catedráticos eminentes, editores de revistas u organizadores de congresos que en cualquier disciplina, de cualquier sexo (aunque más a menudo, ay, varones), con variado acierto y casi siempre con temibles consecuencias practicas la ciencia desde la más absoluta arrogancia intelectual y a menudo social. Todos los que practica ciencia los conocen o los sufren, tratando siempre de sobrevivirlos.

Porque un científico arrogante, especialmente cuando esa arrogancia se manifiesta en su producción intelectual, es un mal científico. No porque su trato sea muy desagradable, que lo es; no porque suponga un obstáculo al avance del conocimiento al dificultar la adopción de nuevas ideas, que lo hace; sino porque su ciencia es mala por definición.

La buena ciencia sólo puede ser humilde, porque errar es humano y porque al universo le importan poco nuestros sentimientos y aunque no hace trampas para engañarnos tampoco nos pone las cosa fáciles: comprender como funciona es complicado y está lleno de trampas. Malinterpretar, crear hipótesis bellas (pero erradas), teorizar en ausencia de datos o con datos equivocados o desconocer factores relevantes son certezas con las que tenemos que lidiar a la hora de establecer nuestras hipótesis y explicaciones. Y cuando esas hipótesis bellas pero erróneas se enfrentan a la comparación con el cosmos real éste es inmisericorde, y las tumba sin remedio.

Cuando esto ocurre podemos refugiarnos en la ceguera desde la arrogancia: ese factor no es relevante porque YO no lo considero así, porque MI experimento no lo tiene en cuenta, porque NUESTRA hipótesis no lo incluye. Al hacer esto estamos intentando imponer nuestras formas de pensar y nuestros límites al universo, forzando sobre el funcionamiento de cosmos nuestra interpretación limitada. Si tenemos bastante poder terrenal conseguiremos que esto funcione, durante un tiempo; si controlamos las carreras de los científicos que vienen después mediante tribunales o consejos editoriales de revistas, si somos determinantes al escribir los libros de texto, si empujamos y apartamos a las voces discrepantes e impedimos que se les escuche. Con arrogancia y poder es posible mentir a todo el mundo, durante algún tiempo.

Pero no hay arrogancia capaz de forzar la mano del universo, así que a la larga todos nuestros esfuerzos serán en vano. Quizá tengamos una larga y poderosa carrera, quizá incluso muramos pensando que lo hemos logrado, pero tarde o temprano (y será temprano) la realidad se impondrá y nuestras teorías e hipótesis pasarán al basurero de la historia. No será siquiera recicladas como parte de teorías mejores, como ocurre con los avances correctos pero siempre (ay) insuficientes, sino que serán descartadas y quedarán como notas a pie de página en la historia de la ciencia, asociando para siempre nuestro nombre con el fracaso.

Los mejores científicos son humildes, no por vocación propia, sino por experiencia duramente ganada. Por errores cometidos, hipótesis rechazadas, experimentos fallidos, dificultades no superadas; por meteduras de pata risibles, confusiones involuntarias, complejidades experimentales o de campo no tenidas en cuenta. Es cierto que la naturaleza no nos miente de modo malicioso, pero a veces puede ser puñeteramente sutil y esconder fuentes de error en los rincones más inverosímiles; uno puede estar al borde del Nobel y descubrir de repente que sus datos están contaminados y no dicen lo que uno pensaba que decían, perdiendo cualquier posibilidad de alcanzar la gloria.

Y eso duele, pero sólo se convierte en una catástrofe si se le suma una buena dosis de arrogancia. En presencia de humildad el error se desarrolla y se acaba convirtiendo en el germen de nuevas ideas, nuevas hipótesis, nuevos avances. Por eso los buenos practicantes de ciencia comparten como rasgo común la humildad intelectual; no porque eso les haga mejores personas o les convierta en practicantes de la filosofía Zen, sino porque eso les hace mejores científicos. Ante el maravilloso, complejo y sutil universo que hay ahí fuera pensar que una mente humana pueda contener toda la verdad no sólo es arrogante: es estúpido. La humildad, pues, es una virtud científica, porque nos ayuda a entender mejor.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La humildad como virtud científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo leer una noticia científica

- Las matemáticas como herramienta (II): La Revolución Científica y el cálculo

- Ellen Richards: la economía doméstica como cultura científica

Thomson gazelaren beroaldia

Juan Ignacio Pérez eta Miren Bego Urrutia Igeri egiten, lasterka egiten, hegan egiten

Juan Ignacio Pérez eta Miren Bego Urrutia Igeri egiten, lasterka egiten, hegan egiten ———————————————————————————————————–

Ezaguna denez, jarduera fisiko altuak energia-eskari altuagoak sortzen ditu. Giharrek lan gehiago egitean, uzkurketa-zikloak gauzatzeko beharrezkoa den gainerako energia (ATPa) sortzeko oxigeno gehiago garraiatu behar da gihar-zeluletako mitokondrioetaraino.

Irudia: Ohiko 39 °C-ko tenperaturatik 44 °C-raino hel daiteke odol arterialaren tenperatura Thomson gazelaren kasuan.

Bai zirkulazio-sistemak eta bai arnas aparatuak hartzen dute parte oxigeno gehigarri hori helarazten, lankidetzan: batetik, arnas hartzea azkartu egiten da oxigeno gehiago hel dadin difusioz arnas organoa irrigatzen duen odolerantz, eta bestetik, bihotzaren taupada-maiztasuna emendatu egiten da; sarriago uzkurtuz, denbora-unitateko odol gehiago ponpatzen da beharrizan metaboliko altuagoa duten ehunetarantz.

Beraz, animalia asko hatsankatu egiten dira ariketaren ondorioz. Hatsankatzea, baina, xede anitzeko jokabidea dugu. Goraxeago esan denez, arnasketa-zikloa azkartzeko mekanismoa da, baina ariketak eragindako beroa barreiatzeko ere erabiltzen da zenbait animaliaren kasuan, batez ere izerdirik botatzen ez dutenetan (ikus «Munduko gauza hotzenetako bat» izenburuko atala). Hala ere, batzuetan ariketak sortutako beroa xahutzeko zailtasunak daudenean, hatsankatzeak ba omen du hirugarren betebehar garrantzitsu bat: garuneko tenperaturari balio seguruetan eustea.

Azter dezagun aukera hori adibide baten bidez: Thomson gazela izenaz ezaguna den Afrikako ekialdeko gazela txikiak 15-20 kg inguru pisatzen du. Harrapari baten presiopean, 40 km/h-ko abiaduran 5 minutuz korrika aritu ondoren, jarduera metaboliko emendatuak eragindako ezohiko bero-ekoizpenak animaliaren gorputz guztia berotzen du. Ohiko 39 °C-ko tenperaturatik aldenduz, 44 °C-raino heltzen da odol arterialaren tenperatura. Ariketa gogorraren ondorioz, beraz, animalia homeotermo honek, aldi baterako bada ere, galdu egiten du gorputzeko tenperaturari konstante eusteko gaitasuna.

Zergatik gertatzen da tenperatura-emendio hori? Harrapariaren mehatxupean korrika bizian doala, 40 aldiz emendatzen da gazelaren gastu metabolikoa. Aipatu behar da gainera, lasterketa hori ingurune-tenperatura altuetan burutzen dela. Beraz, Thomson gazelak ariketaren ondorioz ekoitzitako beroa galtzeko zailtasun handiak ditu. Ondorioz, odolaren tenperatura nabarmen igotzen da, beroa galtzeko aukerak mugatuta baitaude. Izan ere, tenperatura-emendio horrek baliteke animaliaren gihar sistemaren funtzionamendua azkartzen laguntzea, eta ondorioz korrikaldiaren etekina hobetzea.

Gazelaren gorputzeko tenperaturaren emendioa ez da gertatzen beroa barreiatzeko mekanismoek huts egiten dutelako, animaliak maiztasun altuko hatsankatzera jotzen baitu, bai freskatzeko, eta baita oxigeno gehiago lortu ahal izateko ere. «Munduko bi gauza hotzenetako bat» izenburuko atalean txakurretarako azaldu dugunez, izerdirik botatzen ez duten animalia askok erabiltzen dute hatsankatzea beroa xahutzeko. Arnas sisteman oinarritutako mekanismo horiek oso eraginkorrak badira ere, ohiko egoeran behintzat, hain da handia gazelaren ihesaldia bezalako larrialdi-egoeretan gertatutako bero-ekoizpenaren zama, ezen tenperaturak gora egiten baitu, ezin baitaiteke sortzen den bezainbeste bero barreiatu.

Baina ariketak eragindako tenperatura-igoera ez da gorputz osoan modu berean gertatzen, hatsankatzeari esker Thomson gazelaren garuna gainerako gorputz guztia baino hotzago mantzentzea lortzen baita. Gorputzeko tenperatura 44 °C-ra dagoen artean, garuneko tenperatura ez da 41 °C-ra heltzen. Balio seguruetan mantentzen da, beraz; jakina denez, garuna osatzen duten zelulentzat oso kaltegarriak dira 41-42 °C-tik gorako tenperaturak.

Nola lor daiteke baina hatsankatzearen bitartez horrelako hozte-prozesu selektiboa? Arteria karotideotik garunerantz bideratzen den odola kaskezurreraino iritsi orduko ehunka arteria txikitan banatzen da; gero, garunera heldu baino lehen, batu egiten dira berriro, bero-trukatzaile modura jokatzen duen rete mirabile bat osatuz. Sare miragarria osatzen duten arteria txiki horiek, zain-odolak osaturiko sinu bat zeharkatzen dute. Zainetako odol hori hotzago dago, hatsankatzen ari den gazelaren sudurretik igaro ondoren heltzen baita sinu horretara. Horrela, hoztu egiten da arteriatxoetan zehar doan odol arteriala, beroaren zati bat zain-odolerantz galtzen baitu, eta garunera heltzen denerako odol hau arteria karotideoko odola baino 2-3 °C freskoago dago. «Atunen berogailua eta sare miragarria» izenburuko artikuluan ikusi dugu sare miragarriaren bero-trukerako sistema hau, justu kontrara jokatzen: atunen giharraren kasuan, odola muskulura heldu orduko berotzeko erabiltzen zen sistema bera.

Hortaz, oro har, bero-galerarako mekanismoa izateaz gain, hatsankatzeak ingelesez «selective brain cooling» deritzon prozesuan ere hartzen du parte. Thomson gazela adibidetzat hartu badugu ere, artiodaktilo hori ez da hozte selektibo hau baliatzen duen animalia bakarra, etxe-abere ungulatu askok ere mekanismo bera erabiltzen baitute. Animalia hauei buruz esan daiteke, bai, «burua hotz» mantentzen dutela!

—————————————————–

Egileez: Juan Ignacio Pérez Iglesias (@Uhandrea) eta Miren Bego Urrutia Biologian doktoreak dira eta UPV/EHUko Animalien Fisiologiako irakasleak.

—————————————————–

Artikulua UPV/EHUren ZIO (Zientzia irakurle ororentzat) bildumako Animalien aferak liburutik jaso du.

The post Thomson gazelaren beroaldia appeared first on Zientzia Kaiera.

Grietas de desecación marcianas

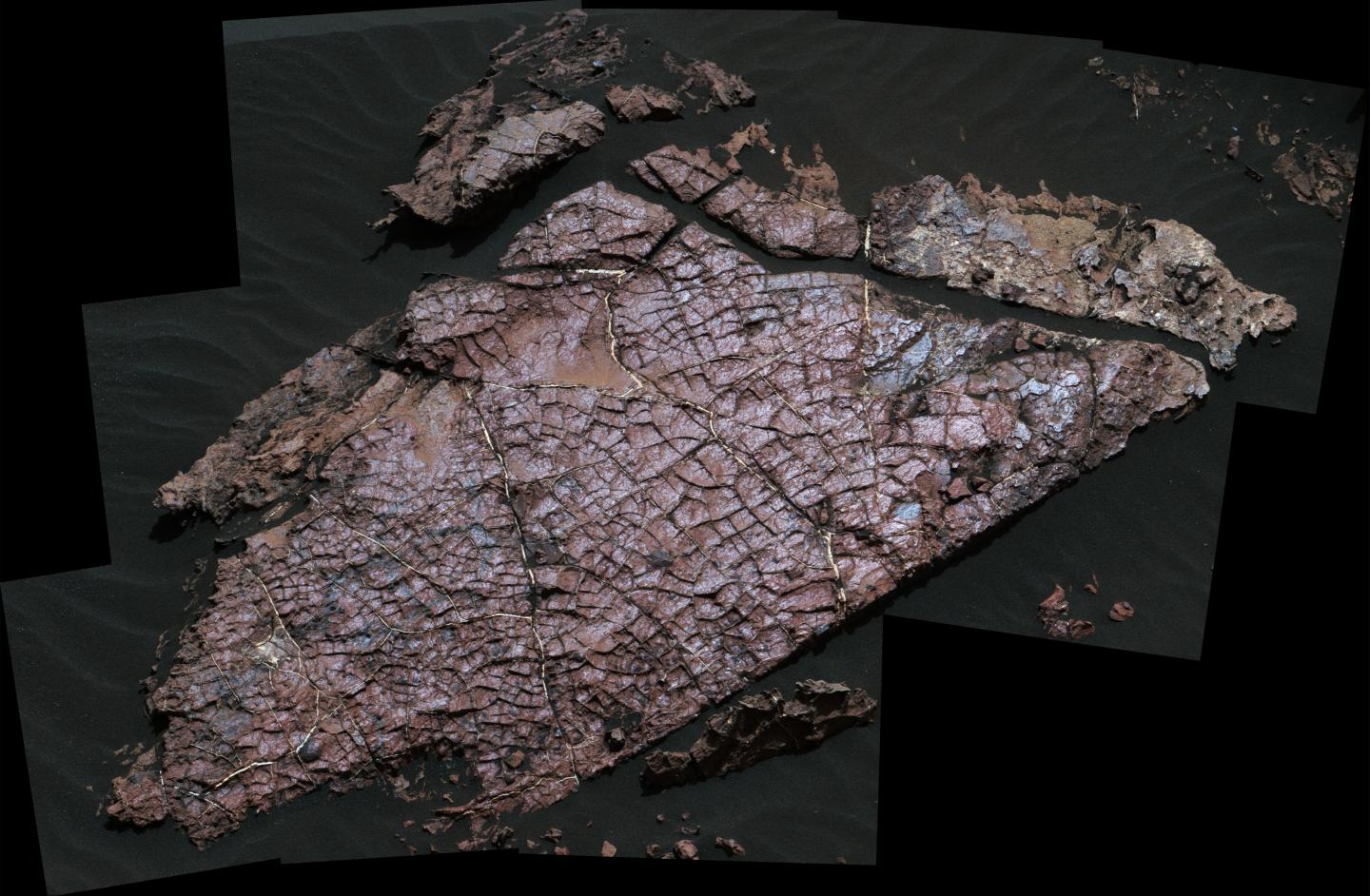

Imagen que Curiosity tomó de “Old Soaker” durante el sol 1555. La losa tiene unos 80 cm de longitud. Foto: NASA.

A principios de 2017, y a partir de imágenes recopiladas por el róver Curiosity, los científicos anunciaron el descubrimiento de posibles grietas de desecación en el cráter Gale, que habría estado lleno de lagos hace 3.500 millones de años. Ahora, un nuevo estudio ha confirmado que son realmente grietas de desecación, lo que revela nuevos detalles sobre el antiguo clima de Marte.

Dado que las grietas de desecación se forman solo cuando el sedimento húmedo está expuesto a la atmósfera, su posición más cercana al centro del antiguo lecho del lago que al borde también sugiere que los niveles del lago aumentaron y disminuyeron drásticamente con el tiempo. Esto es, los lagos del cráter Gale habrían pasado por el mismo tipo de ciclos que vemos en la Tierra

Los investigadores se centraron en una losa de roca del tamaño de una mesa de café apodada “Old Soaker”. Old Soaker está atravesado por polígonos idénticos en apariencia a los característicos de los procesos de desecación terráqueos. El equipo analizó los aspectos físicos y químicos de los polígonos utilizando todo el despliegue de medios de análisis de Curiosity. Hay que recordar en este punto que Curiosity es un potentísimo laboratorio geoquímico autopropulsado.

Este escrutinio puso de manifiesto que los polígonos, confinados a una sola capa de roca y con sedimentos llenando las grietas entre ellos, se formaron por la exposición a la atmósfera, y no por otros mecanismos como la fracturación térmica o hidráulica. Y si bien los científicos sabían casi desde el momento en que Curiosity aterrizó en 2012 que el cráter Gale alguna vez contuvo lagos, la confirmación de la existencia de grietas de desecación añade un contexto a nuestra comprensión de este antiguo sistema lacustre.

Hallazgo tras hallazgo, Curiosity está transformando continua y completamente nuestra visión del presente y del pasado de Marte.

Referencia:

N. Stein et al (2018) Desiccation cracks provide evidence of lake drying on Mars, Sutton Island member, Murray formation, Gale Crater Geology doi: 10.1130/G40005.1

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Grietas de desecación marcianas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- En Marte el viento crea montañas

- Cómo se formaron las columnas hexagonales de la Calzada del Gigante

- Ox Bel Ha, un ecosistema tropical alimentado por metano

Muriel Bristol, la gran catadora de té

Estamos en Rothamsted (Harpenden, Reino Unido). Son las cuatro de la tarde, la ‘sagrada’ hora del té. Un grupo de personas hace una pausa en su trabajo para tomarse su infusión. Entre ellas están Muriel y Ronald. Ronald ofrece a su amiga una taza de té. Ella, tras tomar un sorbo, la rechaza. A Muriel le gusta el té, pero solo si la leche se ha servido en la taza en primer lugar. Ronald cree que se trata de una broma, e insiste con vehemencia; piensa que es lo mismo el orden en el que se vierten los líquidos, y se burla de su colega. Pero Muriel, enfadada, la rechaza de nuevo… no le gusta el sabor. William, otro de los miembros del grupo, intenta mediar y pide a Ronald que deje demostrar a Muriel que efectivamente es capaz de distinguir el momento en el que se ha servido la leche en la taza. Rápidamente, se organiza el experimento: Muriel debe distinguir entre ocho tazas de té, cuatro de cada tipo (leche antes del té o té antes de la leche) colocadas de manera aleatoria ante ella. Tras una pausada cata –en la que se permite a Muriel comparar el sabor de dos tazas–, y ante el asombro de sus compañeros, Muriel distingue con precisión el orden en el que se ha servido la leche de cada taza. ¿Ha sido pura suerte? ¿O quizás Muriel es una experta catadora capaz de distinguir esos detalles? Ronald tuvo que admitir la “victoria” de Muriel y se puso a reflexionar mucho sobre el tema…

Por cierto, Muriel y William se casaron poco tiempo después.

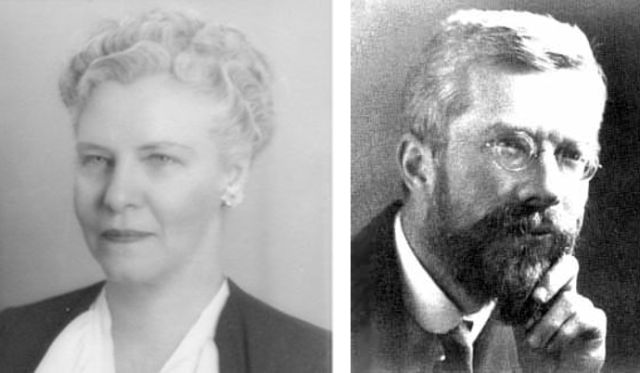

La anterior historia –me he permitido alguna pequeña licencia– es una historia real. Sus protagonistas son la bióloga Muriel Bristol (1888-1950) –que trabajó en la estación experimental de Rothamsted (Harpenden, Reino Unido) desde 1919 y era especialista en algas–, el biólogo y estadístico Ronald Fisher (1890-1962) y William Roach –con el que es cierto que Muriel se casó–.

Muriel Bristol y Ronald Fisher.

El experimento se realizó realmente, fue diseñado por el propio Fisher y dio lugar a un experimento aleatorizado que el estadístico presentó en su libro The Design of Experiments (1935) –llamado The lady tasting tea, la catadora de té–, en el que la prueba de significación estadística usada fue el test exacto de Fisher.

En este experimento, Fisher introdujo el concepto de hipótesis nula, unaafirmación que no se demuestra o establece, y no se rechaza excepto si durante el curso de la prueba parece demostrarse su falsedad. En el caso de la catadora de té la hipótesis nula suponía que Muriel no tenía la capacidad de distinguir las tazas.

Fisher eligió ocho tazas porque le pareció una cantidad suficiente para que la suerte no fuera un factor determinante. Observar que, efectivamente, existen 70 maneras de colocar las ocho tazas, con cuatro de cada tipo, y parece difícil acertar solo por azar.

Muriel aclaró –una explicación muy científica, desde su condición de bióloga– que, si se añadía leche fría al té caliente, las proteínas de la leche coagulaban y cambiaba el sabor, y ella lo percibía como desagradable.

Por cierto, el escritor George Orwell (1903-1950) no coincide con Muriel… en 1946 publicó el texto A nice cup of tea en el que describía con detalle el procedimiento a seguir para preparar una taza de té perfecta. Entre las instrucciones decía (traducción extraída de [3]):

En décimo lugar se debe verter el té en la taza antes que la leche. Este es uno de los puntos más polémicos, de hecho en todas las familias de Gran Bretaña probablemente hay dos escuelas de pensamiento sobre el tema. La escuela que echa primero la leche (que puede tener argumentos contundentes) y la escuela que la echa después. Yo sostengo que mi teoría es irrefutable. Al poner el té primero se puede regular exactamente la cantidad de leche, mientras que si se hace al revés se puede poner demasiada leche y no tendrá arreglo.

A lo mejor, para saber quién lleva la razón, es mejor leer lo que dice la norma ISO 3103 respecto al método estándar de preparar el té…

Referencias

[1] Sturdivant, Lt. Col. Rod., Lady Tasting Tea, 2004

[2] Jesús Ortiz, La ciencia y el té de las cinco, El Diario, 23 noviembre 2016

[3] Las onces reglas de George Orwell para ‘Una buena taza de té’, Territorio gastronómico

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Muriel Bristol, la gran catadora de té se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran cuatro, o los números siguen estando locos

- Artistas que miran a las matemáticas

- ¡Es la Aritmética!

Urpekaritzarako egokitzapen genetikoa identifikatu dute, aurrenekoz

Klasiko bat da. Gizakiak genetikaren inguruan gero eta ezagutza gehiago izan, orduan eta argiago geratzen da geneek, hein handi batean, gizakia baldintzatzen dutela. Determinismoa barra-barra dabil, honezkero. Kontua ez da, baina, hain sinplea. Izan ere, azken urteetan, gero eta argiago dago oharkabean gizakia ere geneak baldintzatzeko gai dela. Ez gaude, bada, transgenikoei buruz hizketan, kulturak kode genetikoan eragindako aldaketei buruz baizik.

1. irudia: Modu tradizionalean egiten dute urpekaritza bajauarrek, eta mila urte inguru eman dute horrela. (Argazkia: Melissa Ilardo /University of Cambridge)

Adibide asko daude: altuera handira bizitzera egokitu diren populazioak, omega-3 azidoen kontsumoa errazteko entzima zehatz bat garatu duten herriak edo laktosa onartzeko Neolitoaren geroztik Europan eta mendebaldeko populazioetan garatu den egokitzapena. Horietan guztietan, gizakiek egindako hautespen kulturalek norabidea “erakutsi” diote eboluzioari, eta baldintza berrietara hoberen egokitutako aldaerak nagusitu dira.

Hemendik aurrera, beste adibide bat gehitu ahal izango da pixkanaka hazten den zerrenda horri: uraren barruan eusteko gaitasuna, alegia. Gizakiak lurraren gainean bizi behar badu ere, itsasoarekiko kontaktua gero eta handiagoa da, eta bereziki zenbait kulturatan garrantzitsuagoa izan da lotura hori. Oraingoan, berariaz itsaspean denbora gehiago ematera bideratutako egokitzapen bat azaleratu dute zientzialariek.

Cell aldizkarian argitaratutako ikerketa batean ezagutzera eman dute: Indonesian bizi den Bajau herriko kideek ohi baino bare handiagoak dituzte, eta horrek aukera ematen die itsasoaren azpian 70 metroko sakonerara iristeko.

Aurretik ere zientzialariek susmatzen zuten bare handia edukitzeak eta urpekaritzan hain ondo moldatzeak lotuta egon behar zutela, baina harreman hori ikerketa genetiko baten bitartez berresten den lehenengo aldia da oraingoa.

Tradizionalki, Bajau herria nomada izan da. Azken milurtekoan leku batetik bestera ibili da, Asiako hego-ekialdeko itsasoetan zehar; baina, gehienbat, Indonesian bizi dira bajauarrak. Bertan, nahiko ezagunak dira urpekaritza egiteko daukaten abilezia dela eta. Arrantza da haien ogibide nagusia, batez ere itsas luzokerrak eskuratzen dituztelarik. Holothuroidea familiako animalia hauek itsas hondoan bizi dira. Asiarrek estimu handian duten jakia da, eta, horregatik, bajauarrek baliabide hori ustiatu dute mendeetan zehar, erraztasun handiz saltzen dutelako. Lantokitik gertu bizi dira bajauar asko, etxe flotagarrietan, hain zuzen.

2. irudia: Gizakiek egindako hautespen kulturalek norabidea “erakutsi” diote eboluzioari. Oraingoan, urpekaritzara egokitzeko gaitasuna da azaleratu dutena. (Argazkia: Melissa Ilardo /University of Cambridge)

Horregatik, orain ikerketa aurkeztu duten zientzialariek susmoa zuten uraren azpian hain ondo moldatu izanaren atzean abiapuntu genetiko bat egon ote zitekeen. Izan ere, gizakien kasuan halako gaiaren inguruan informazio gutxi bazegoen ere, animalietan horrelako kasuak ezagunak ziren. Bereziki, sakonera handian arrantza egiten duten fokak aipatu dituzte; horien artean, Weddellgo fokak omen dira uraren pean ederki moldatzeko bare oso handia duten animaliak.

Hipotesia berresteko, hainbat hilabete eman ditu Jaya Bakti (Brunei) izeneko herrian artikuluaren egile nagusi Melissa Ilardok. Ikerketa genetikoa burutzeko laginak hartzeaz gain, urpekarien bareetako tamainak ere neurtu ditu, ekografien bitartez.

Laginketa berdina egin du bajauarren auzokide diren Saluan herrikoekin. Horrek aukera eman die ikertzaileei alderatzeko antzeko ingurunean bizi diren baina praktika kultural desberdinak dituzten populazioak alderatzeko.

Emaitzen arabera, barearen tamainari dagokionean, batez bestean, bajauarren barearen tamaina saluandarrena baino %50 handiagoa da. Arlo genetikoari dagokionez, desberdintasuna PDE10A izeneko genean aurkitu dute. Gene honek T4 hormona tiroideoa arautzen du.

Emaitzek hipotesia oinarritzeko nahikoa froga eman dutela diote. “Uste dugu bajauarrek egokitzapen bat garatu dutela. Horren bidez, hormona tiroidearen mailak handitu dira, eta horrek haien barearen tamaina handitu du”, adierazi du Ilardok, prentsa ohar batean.

Bajau arrantzale bat, 20 metroko sakoneran arrantza egiten. (Bideoa: BBC One)

Globulu gorrien askatzeaOrganismoa urpean dagoenean, bihotzeko taupadak mantsotu egiten dira, eta, ondorioz, barea uzkurtzen da. Horri esker, oxigenoa daramaten globulu gorriak isurtzen dira odol-fluxura, eta horrek urpean denbora gehiago egotea ahalbidetzen du.

Ez da ondo ezagutzen urpekari hauek uraren azpian mantentzeko gaitasuna noraino iristen den, baina, prentsa oharrean diotenez, hauetako batek behin esan zion Melissa Ilardori 13 minutuz egondakoa dela uraren azpian.

Bestalde, nabaritu dute ere medikuntzaren arloan irakaspenak atera daitezkeela ikerketatik. Hipoxia aipatu dute. Organismoa oxigenorik gabe geratzen denean gertatzen da hori. Izan ere, urpekaritza egiten denean hipoxia akutua suertatzean izaten diren antzeko baldintzetan dago organismoa, oxigenorik gabe.

Erreferentzia bibliografikoa:

Ilardo et al. Physiological and Genetic Adaptations to Diving in Sea Nomads. Cell 173, 1–12 April 19, 2018. DOI: doi.org/10.1016/j.cell.2018.03.054

———————————————————————————-

Egileaz: Juanma Gallego (@juanmagallego) zientzia kazetaria da.

———————————————————————————-

The post Urpekaritzarako egokitzapen genetikoa identifikatu dute, aurrenekoz appeared first on Zientzia Kaiera.

Las relaciones hídricas, osmóticas y salinas de los condrictios

Los condrictios (tiburones y rayas, principalmente) son una clase de vertebrados mandibulados a los que se les suele llamar peces cartilaginosos. La mayoría pertenecen a la subclase de los elasmobranquios1, aunque en la misma clase se encuentran también las quimeras, únicos representantes vivos de la subclase de los holocéfalos. Hay menos especies de condrictios que de osteíctios, o peces óseos (la mayoría de cuyas especies son teleósteos).

Los condrictios son muy interesantes pues algunos rasgos de su biología los diferencian claramente de los osteíctios. En concreto, la forma de resolver los problemas hídricos y osmóticos es radicalmente diferente en ambos grupos. De hecho, tal y como adelantamos aquí, en el medio interno de elasmobranquios y celacantos (Latimeria) determinadas sustancias orgánicas alcanzan concentraciones muy elevadas, pudiendo representar hasta un 40% de la concentración total de solutos. Ningún otro grupo tiene representantes con ese extraño rasgo.

La concentración de iones inorgánicos en la sangre de los elasmobranquios marinos es muy similar a la de los teleósteos, pero la concentración osmótica de la sangre de aquellos es ligeramente superior a la del agua de mar. La diferencia obedece a la presencia de urea y, en menor medida, de óxido de trimetilamina (TMAO). Aunque similares, la concentración osmótica del medio interno es lo suficientemente más alta que la del externo como para generar un pequeño flujo de agua hacia el interior del organismo.

Los condrictios son capaces de sintetizar urea y esta es la molécula que utilizan para eliminar los restos nitrogenados del catabolismo de proteínas y otras sustancias2. Pero aunque es la molécula de excreción del nitrógeno, también la retienen en la sangre, lo que consiguen reabsorbiéndola de la orina recién formada en los riñones y evitando su pérdida a través de los epitelios branquiales, que son muy impermeables para con esta sustancia.

La razón por la que, además de urea, la sangre de los elasmobranquios contiene también TMAO es que esta ejerce una función protectora frente a los efectos potencialmente tóxicos de aquella. En efecto, aunque menos que el amonio, la urea también es una sustancia tóxica pues ejerce efectos desestabilizadores sobre proteínas y otras macromoléculas, como consecuencia de lo cual inhibe la acción de las enzimas. Pero hay otras sustancias, como TMAO, glicín betaína y sarcosina, que tienen el efecto contrario, estabilizan macromoléculas y, por lo tanto, activan enzimas. Por esa razón, esas sustancias contrarrestan los efectos de la urea y suelen estar presentes cuando la urea también lo está a altas concentraciones. En humanos, por ejemplo, la concentración de urea se mantiene en el intervalo 2-7 mM, pero en los elasmobranquios marinos esa concentración se encuentra entre 300 y 400 mM. En la sangre del tiburón Squalus acanthias la urea una concentración 351 mM y el TMAO 71 mM (la concentración osmótica total es de 1018 mOsm y la del agua de mar en que vive, de 930 mOsm).

Una consecuencia interesante del hecho de que los elasmobranquios sean ligeramente hiperosmóticos con relación al agua de mar es que el flujo de agua hacia el interior les proporciona toda el agua que necesitan para eliminar las sustancias nitrogenadas de deshecho. No necesitan beber. Por esa razón, no adquieren una cantidad excesiva de sales inorgánicas, como les ocurre a los teleósteos. No obstante, las sales que se introducen con el agua de mar las eliminan a través de la glándula salina rectal, agrupación de miles de túbulos secretores que evacua al recto una solución isosmótica con la sangre aunque sin apenas urea. Por ello, la concentración de Na+ y de Cl– en la secreción salina rectal duplica la concentración sanguínea de esos iones.

Modelo del celacanto “Latimeria chalumnae” que muestra sus colores reales cuando está vivo que se conserva en el Oxford University Museum of Natural History. Foto: Ballista / Wikimedia Commons

Como se ha dicho antes, además de condrictios (elasmobranquios y quimeras), los celacantos también tienen una elevada concentración de urea y TMAO en su medio interno. La concentración de urea en Latimeria chalumnae es de 377 mM y la de TMAO, de 122 mM. El dato es interesante, porque los celacantos son los únicos representantes vivos del grupo de los sarcopterigios, del que suponemos que proceden todos los tetrápodos, muchos de los cuales también recurren a la urea como molécula de excreción de restos nitrogenados.

Hay elasmobranquios que son capaces de penetrar en aguas salobres de estuarios y otros ecosistemas costeros y algunos también han llegado a colonizar los ríos. El tiburón Carcharhinus leucas, tristemente conocido por sus ataques a bañistas, es una de esas especies eurihalinas. En estas especies la concentración sanguínea de urea y TMAO se reduce de forma significativa cuando se encuentran en aguas más diluidas. El citado C. leucas, por ejemplo, pasa de 293 mM (urea) y 47 mM (TMAO) en la sangre cuando está en agua de mar, a 151 mM (urea) y 19 mM (TMAO) en agua dulce. Esa reducción se produce dejando de reabsorber urea en los riñones. No obstante, esa reducción no es suficiente para evitar una intensa entrada de agua en el organismo a favor de gradiente osmótico. Por ello, han de aumentar la producción de orina y, por otro lado, la reabsorción renal y branquial de sales.

Rayas de río “Potamotrygon motoro” en el zoo de Duisburg (Alemania). Foto: Raimond Spekking / Wikimedia Commons

Las rayas de la familia Potamotrygonidae (menos una que es marina) y algunas especies de la familia Dasyatidae son de agua dulce. Al menos algunas de esas especies han llegado a perder incluso la capacidad para sintetizar y retener urea y TMAO, por lo que eliminan sus restos nitrogenados en forma de amonio. Y como no podía ser menos, producen orina abundante y diluida. La fisiología de estas rayas es, de hecho, muy similar a la de los teleósteos de agua dulce en lo que a la regulación hídrica, osmótica y salina se refiere.

Aunque los de agua dulce recurren a mecanismos muy similares, la forma en que los condrictios marinos resuelven sus problemas hídricos y salinos reviste, como hemos visto, características muy diferentes a la de los osteíctios. Esas diferencias son interesantes, porque ponen de manifiesto que la historia evolutiva de unos y otros linajes da lugar a diferentes adaptaciones fisiológicas. En otras palabras, en el funcionamiento de los animales no hay soluciones obligadas para resolver los problemas que plantean los medios a los que se adaptan. Es el azar el que decanta la adopción de una u otra estrategia de entre las disponibles.

Notas:

1 Aunque, como se ha visto, no todos los condrictios son elasmobranquios, en este texto utilizaremos indistintamente ambas denominaciones para referirnos a los peces cartilaginosos. Igualmente, utilizaremos indistintamente las denominaciones osteíctios y teleósteos para referirnos a los llamados peces óseos, aunque no todos los osteíctios sean teleósteos.

2 La inmensa mayoría de las especies de teleósteos eliminan amonio. No llegan a diez las especies que recurren a la urea con ese propósito.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Las relaciones hídricas, osmóticas y salinas de los condrictios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Relaciones hídricas y salinas de los animales

- La distribución del agua animal y el curioso caso del potasio

- Efectores osmóticos

Esa pesadilla científica llamada mineralogía

Muestra de aragonito procedente de Pantoja (Toledo, España). Imagen: Quebul Fine Minerals

La mineralogía es la ciencia que estudia la estructura y propiedades químicas y físicas de los minerales y cuerpos mineralizados. En lo que sigue la consideraremos como una ciencia en sí misma, aunque es posible que haya quien se apresure a decir que es una rama de las geociencias, lo que, como veremos en su momento, es una apropiación moderna y, aunque cómoda, no deja de ser discutible.

Hay quien describe la mineralogía como una pesadilla científica y, si bien realmente esta podría ser su etiqueta más adecuada, intentaremos en lo que sigue exponer por qué es una ciencia; es posible que se entienda también el por qué lo de llamarla pesadilla. Nuestro objetivo es introducir algunas de las ideas fundamentales de la mineralogía de la forma más intuitiva: estudiando su historia.

Fotografía de la muestra 10003 recogida de la superficie lunar por la misión Apolo XI. Aunque tiene toda la pinta de un basalto con presencia de ilmenita, olivino y otros minerales, según el DRAE no lo son. El informe completo de análisis puede obtenerse aquí [PDF] como separata del Lunar Sample Compendium.

Pero empecemos por lo más básico: ¿qué es un mineral?Si hubiera que hacer caso de eso que la Real Academia Española llama diccionario, podríamos entender por mineral una “Sustancia inorgánica que se halla en la superficie o en las diversas capas de la corteza terrestre”. Si esta definición fuese válida las sustancias inorgánicas en la superficie de la Luna, Mercurio, Venus, Marte o cualquier otro cuerpo del universo distinto de la Tierra no serían minerales; el agua líquida sería un mineral si está en la Tierra pero no en cualquier exoplaneta; y los silicatos, siendo inorgánicos y terrestres no serían minerales si están en el manto terrestre y no en la corteza. Es manifiesto que se impone, pues, dar una definición formal de mineral.

Las columnas coloreadas son erbaita, una forma de turmalina. La fórmula genérica de las turmalinas dista mucho de ser una fórmula química al uso: (Na,Ca)(Mg,Li,Al,Fe2+,Fe3+)3(Al,Mg)6(BO3)3Si6O18(OH,O,F)4. Los otros minerales presentes en la imagen son cuarzo, lepidolita y cleavelandita (una variedad de albita). Imagen: Rob Labinsky / Wikimedia Commons

Un mineral es una sustancia que:

a) existe en la naturaleza (esto incluye cualquier parte del universo) naturalmente, esto es, sin intervención humana;

b) tiene una composición química característica, aunque no tiene por qué tener una fórmula química exacta;

c) posee una estructura generalmente cristalina. Esta afirmación implica que los minerales son, en principio, sólidos, que la estructura cristalina puede tener alteraciones debido a impurezas, y que además se usa la definición actualizada de cristal (sólido con un patrón de difracción definido) lo que incluye a los cuasicristales.

Si nos fijamos no hemos incluido esa distinción arbitraria tan del siglo pasado: inorgánico/orgánico. Cualquier sustancia que cumpla lo anterior es un mineral. A las mezclas estables de minerales las llamaremos rocas.

Roca basáltica con fenocristales de olivino. Un fenocristal es un cristal de tamaño considerable respecto al resto de los componentes de una roca; es el resultado de un enfriamiento lento en el proceso de cristalización del magma. La muestra de la imagen procede de la isla de La Palma (Canarias, España y, a efectos del DRAE, planeta Tierra) y pertenece a la Universidad de Tartu (Estonia). Fuente: Wikimedia Commons

Probablemente no exista rama del conocimiento con más cambios de estatus que el estudio de los minerales, pero podemos reducirlos a tres principales. Desde el siglo XVI hasta comienzos del XIX fue un nexo entre la química y lo que se conocía como historia natural. Empleaba las técnicas de laboratorio de la primera y los principios de clasificación de la segunda para estudiar la totalidad del “reino mineral”. En esta época la mineralogía era una disciplina a la que los eruditos dedican buena parte de su tiempo habida cuenta de su trascendencia económica y alquímica.

Durante el siglo XIX la mineralogía dejó de tener esta posición de privilegio intelectual para convertirse en una subdisciplina de la geología. Es de esta época la definición de mineral como “sustancia química que ocurre naturalmente en la corteza terrestre” y su estudio se separa del de las rocas, “agrupaciones definidas de minerales”, lo que lleva a finales de sigloa distinguir entre mineralogía y petrología.

Tras la Segunda Guerra Mundial la geología pasa a formar parte de las geociencias, y las sub-sub-ramas de la mineralogía y la petrología se ven transformadas por la teoría de la tectónica de placas y por la nueva instrumentación disponible.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Esa pesadilla científica llamada mineralogía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ellen Richards: la economía doméstica como cultura científica

- De cañones, cátedras y espías

- Una ventana llamada Rosetta

Patata frijituak akrilamida pixka batekin, mesedez

Hedabideetan akrilamida pil-pilean dago egunotan; izan ere, apirilaren 11n elikagaien akrilamida edukia kontrolatzea helburu duen Europar Batasuneko araudia indarrean sartu zen. Albistea horixe izan behar zen, alegia, toxikoa den konposatu bat kontrolatzeko araudi berri bat indarrean sartu dela, baina, akrilamidaren toxikotasuna ez da albiste. Hortaz, ezer berririk ez dago udaberriko eguzkiaren azpian, baina, momentu aproposa da akrilamidari buruz hitz egiteko eta akrilamidak kezkatu behar gaituen hausnartzeko.

1. irudia: Patata frijituek akrilamida konposatu minbizi-sortzailea dute. (Argazkia: 31 images. Iturria: pixabay.com)

Lehenik eta behin, esan behar da indarrean jarri berri den Europar Batasuneko araudiak ez dituela gehienezko mugak ezartzen, erreferentziako mailak gomendatu baizik. Izan ere, ezinezkoa -edo ia ezinezkoa- da akrilamida guztiz kentzea elikagaietatik eta, bestalde, akrilamida prozesaketa unean bertan eratzen denez, zaila da akrilamida kontzentrazioa kontrolatzea. Alabaina, araudiak akrilamida kontzentrazioa murrizteko gomendioak ematen ditu eta patata frijituak, ogia, gosarirako zerealak, kafea, gailetak eta opilak dira ikusmiran dauden elikagaietako batzuk. Oraingoz ez gara iritsi Kaliforniako arauen kasura: kafea saltzen duten saltokiek akrilamida minbizi eragilea dela ohartarazi beharko dute

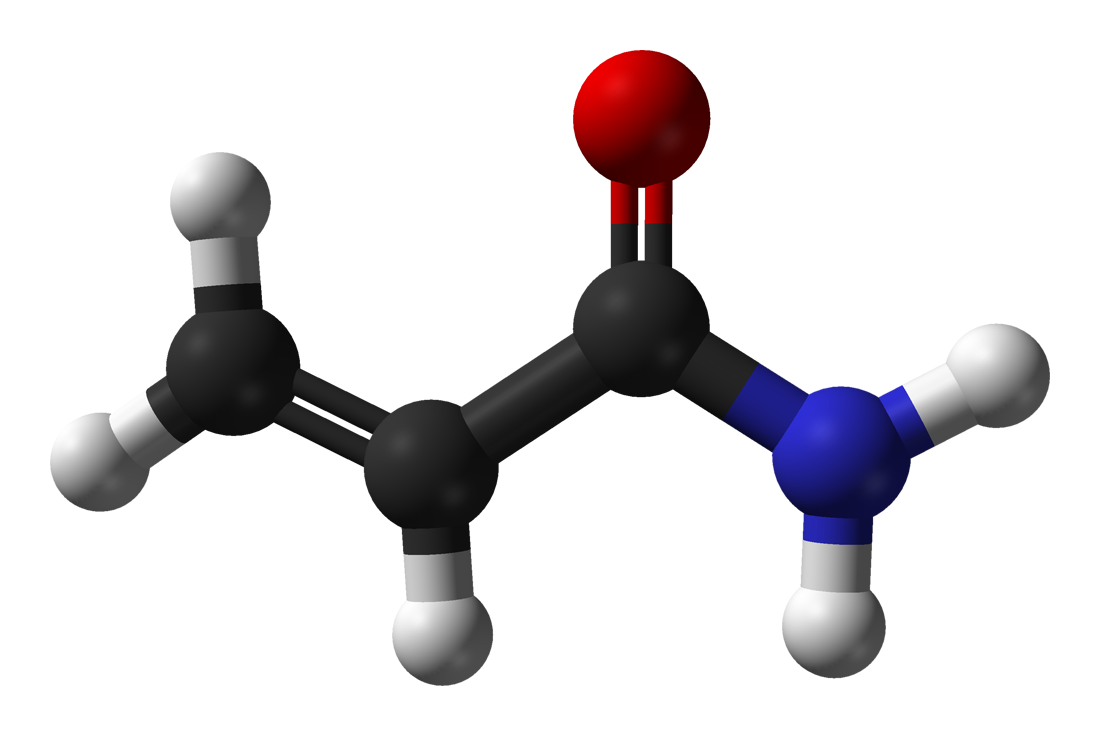

Zer da akrilamida eta nola iritsi da patata frijituetara?Akrilamida C3H5NO formula duen konposatua da eta almidoia duten eta beroketa prozesuak jasan dituzten elikagaietan aurki daiteke. Oro har, 120 ºC-tik gorako tenperaturan berotu behar dira jakiak -frijitu, egosi edo erre ondoren, adibidez-. Industria aplikazioak ere baditu eta akrilamida poliakrilamidazko kopolimeroak egiteko erabiltzen da, esaterako. Toxikotasunari dagokionez, ezaguna da akrilamidak minbizia eragin dezakeela. MOE Mundiko Osasun Erakundearen menpekoa den IARC Minbizia Ikertzeko Nazioarteko Agentziaren arabera, arriskuaren eskalaren 2A mailan dago akrilamida, alegia, gizakiontzat minbizi-sortzaile probablea da eta animalietan frogatuta dago minbizia eragin dezakeela.

Etxean patatak frijitzen direnean Maillard erreakzioen kausaz eratzen da akrilamida. Maillard erreakzioak erreakzio-multzo izugarria dira, elikagaien arretze-prozesuetan gertatzen direnak. Louis Camille Maillard kimikari eta fisikari frantziarrak ikertu zituen lehen aldiz, 1912an, eta hortik erreakzio-multzoaren izena. Aminoazidoak eta azukreak -horien artean, almidoia- dira akrilamidaren aitzindariak, eta arretzearekin batera areagotzen da akrilamida edukia. Zenbat eta tenperatura altuagoan eta zenbat eta denbora luzeagoan berotu, orduan eta akrilamida gehiago metatzen da. Hala ere, Maillard erreakzioek ez dute arretzean bakarrik eragiten; izan ere, jakien zaporean eta usainean ere funtsezko garrantzia dute. Akrilamida kontzentraziorik altuenak lortzeko, azukreen eta asparagina aminoazidoaren arteko Maillard erreakzioa gertatu behar da eta 160 ºC – 180 ºC artean mantendu behar dira elikagaiak. Patataren kasuan, hain justu, hori da normalean erabiltzen den frijitze tenperatura eta, gainera, patatak duen aminoazidorik ugariena asparagina da. Horregatik, patata frijituak dira akrilamidaren toxikotasunagatik ikusmiran gehien jarri diren jakiak.

2. irudia: Akrilamida molekula. (Argazkia: Ben Mills – domeinu publikoko irudia. Iturria: wikipedia.org)

Akrilamida gutxiagoEuropar Batasuneko araudian erreferentziako kontzentrazioak ematen dira elikagaien arabera sailkatuta, baina, oro har, zaila da egunean jan daitekeen akrilamida kantitate segurua finkatzea. Kontua da minbizi-sortzaileak diren substantzien kasuan nekeza dela determinatzea zenbateko esposizioak eragin ditzakeen arazo genotoxikoak. Hala ere, ikertzaileak gai izan dira erreferentziako dosiaren konfiantzazko gutxieneko muga ezartzea -BMDL deritzona-, eta horren arabera, gutxi gorabehera egunean 150 g patata frijitu nahikoak dira egunean har daitekeen akrilamida-kantitate segurua gainditzeko. Gainera, kontuan hartu behar da helduen akrilamida-esposizioaren %49 patata eta patataren deribatuak jatearen ondorio dela, %34 kafearen ondorioa eta %23 ogiarena. Hortaz, elikagai horietan egin beharko litzateke akrilamida murrizteko saiakerarik handiena. Zentzu horretan, Europar Batasunaren araudi berriaren saiakera nagusia akrilamida kantitatea murrizteko prozesaketa moduak gomendatzea da.

Pataten kasuan, Europar Batasunak gomendatzen du fruktosa, glukosa eta asparagina eduki baxuko patata motak erabiltzea, horiek baitira akrilamida sortzen dutenak. Patatak modu egokian mantendu behar dira -patatak tenperatura altutxoagoan gordetzen badira akrilamida kontzentrazio handiagoak lortzen dira frijitu ondoren-, eta frijitzeko erabili den olioaren tenperatura kontrolatzea garrantzitsua da. Hortaz, prozesaketa termikoak birplanteatzea eskatzen du araudiak, eta baita lehengaiak aztertzea ere. Askotarikoak dira araudian zerrendatzen diren gomendioak eta betebeharrak eta elikagai motaren arabera desberdinak dira. Gaileta eta opilen kasuan, gasifikatzaile moduan amonio bikarbonatoa ez erabiltzea gomendatzen da, eta fruktosa eta eztia saihestea ere gomendatzen da.

3. irudia: Patata frijituen ondoren, kafea da helduen akrilamida esposizio handienaren erantzulea. (Argazkia: cocoparisienne – domeinu publikoko irudia. Iturria: pixabay.com)

Nolanahi ere, eta lehenago esan bezala, zenbait elikagaik akrilamida dutela ezaguna zen duela urte asko, alegia, hedabideetan argitaratu diren albisteetan ez dago ezer berria akrilamidaren edukiari edo toxikotasunari dagokionez. Bestalde, garrantzitsua da azpimarratzea jakiek akrilamida izatea ez dela prozesatze desegoki baten ondorioa; izan ere, akrilamida berez agertzen da almidoia duten elikagaiak tenperatura altuan kozinatzen direnean. Hortaz, argi izan behar dugu etxean frijitutako patatek ere akrilamida kontzentrazio altuak izan ditzaketela, agian patata komertzialena baino altuagoa izan daitekeena.

OCU kontsumitzaileen elkartearen arabera indarrean jarri berri den araudia ez da nahikoa eta, diotenez, gehiegizko mugak ezarri beharko lirateke. Araudiaren arabera, erreferentziazko kontzentrazioak gainditzen badira elikagaia ez da merkaturik atera behar, prozesaketa berraztertu baizik. Hortaz, ezarritako muga horiek gainditzea posible da akrilamida kantitatea murrizteko balizko modurik ez badago. Nolanahi ere, gehiegizko alarma eragin daiteke horrelako neurriekin; izan ere, patata frijituen gehiegizko kontsumoa arriskutsua da, bai, baina ez bakarrik akrilamida edukiarengatik. Gehiegizko erregulazioak eta mugen ezarpenak zentzurik gabeko beldurra eragin dezake eta eragingo lukeen kaltea handiagoa da ekarriko dituen onurak baino. Izan ere, ia edozein elikagaitan aurkitu daitezke minbizi-sortzaileak diren substantziak -kontzentrazio oso txikitan izanik ere-. Gainera, jakina da patatak moztu ondoren giro tenperaturan dagoen uretan murgiltzen badira 2 orduz, akrilamida kontzentrazioa erdira jaitsi daitekeela, baina, nork ez ditu nahiago txigortutako patata frijitu kurruskariak?

Informazio osagarria:

- Europar Batasuneko 2017/2158 Araudia, eur-lex.europa.eu

- Egunero jaten dituzun pozoiak (I). J. Lopez-Gazpio, Tolosaldeko Ataria, 2015

- El cuadrilátero de la acrilamida. Juan J. Iruin, Naukas.com, 2013

- Acrylamide french fries. Juan J. Iruin, elblogdebuhogris.blogspot.com, 2008

- Acrilamida, AECOSAN, aecosan.msssi.gob.es, 2018

- Acrilamida, NIH, cancer.gov, 2018

—————————————————–

Egileaz: Josu Lopez-Gazpio (@Josu_lg) Kimikan doktorea eta zientzia dibulgatzailea da. Tolosaldeko Atarian Zientziaren Talaia atalean idazten du eta UEUko Kimika sailburua da.

—————————————————–

The post Patata frijituak akrilamida pixka batekin, mesedez appeared first on Zientzia Kaiera.

Colonialismo científico: los investigadores africanos se rebelan contra el expolio de datos genéticos

Fuente: Universidad de Boston. Centro de Estudios Africanos

Desde que en el año 2001 se descodificó el primer genoma humano, miles de ellos han pasado por el mismo proceso y poco a poco estamos creando una enorme base de datos mundial que refleja nuestra diversidad como especie. El continente africano está siendo escenario de gran parte de esa recolección de datos: en África, el lugar donde aparecieron los primeros de nuestros antepasados, los distintos grupos de población contienen interesantes variaciones para entender los cruces genéticos que nos dieron forma, cómo nos movemos y alimentamos y las enfermedades que todavía hoy sufrimos.

Hay grandes beneficios en juego para la población africana a cambio de aportar esta valiosa información al campo de la genómica a nivel global. Conocer las variaciones genéticas de un grupo puede ayudar a mejorar su atención médica. En muchas regiones de África eso puede significar una mejora de la calidad de vida incalculable.

El expolio de los datos

Pero a medida que la genómica avanza y despega, los científicos africanos temen (y están observando ya) como las viejas dinámicas del colonialismo vuelven a hacer de las suyas y las grandes potencias mundiales se dedican a explotar sus recursos y ofrecer nada a cambio. A causa de la falta de recursos, hay pocas instituciones científicas en África que puedan llevar a cabo en solitario investigaciones de este tipo, que en muchos casos requieren complejos equipos informáticos capaces de procesar miles de datos con velocidad. Por eso, los equipos que tienen interés en investigar en este campo a menudo tienen que asociarse y aceptar las condiciones de grupos de otros países. Y esas condiciones muchas veces dejan muy poco margen y resultado para los científicos locales.

Investigación alimentaria en África. Fuente: Wikipedia Commons

Lo llaman ‘investigación helicóptero’, una práctica por la que los investigadores de países desarrollados acuden a los países en desarrollo, recogen sus datos y se marchan de allí sin contar con los científicos locales. A veces incluso pueden compartir a posteriori esos datos con otros grupos que no estuvieron involucrados en su recogida, lo cual crea una indignante contradicción en la que la información recabada y los resultados derivados de ella benefician a todo el mundo excepto a la población de la que se extrajo.

Una guía de buenas prácticas

Conocedores de cómo puede terminar esta historia (los países del continente expoliados de sus datos genéticos, que estarán dando réditos a miles de kilómetros donde sus habitantes apenas llegarán a olerlos, ¿no les suena esto de algo?), los científicos africanos han decidido tomar cartas en el asunto y han publicado una guía de buenas prácticas a exigir para desarrollar investigaciones genéticas en África. Detrás del documento está la Human Heredity and Health in Africa (H3Africa) Initiative, un consorcio que apoya y promueve investigaciones biomédicas en el continente.

“El hecho de compartir [datos] para contribuir al bienestar de otros sería algo ampliamente respaldado en África. Pero eso siempre debe ir unido a la reciprocidad, debe hacerse de una forma responsable, con la aportación de todos los involucrados y con mecanismos que obliguen a los equipos de investigación a hacerse responsables y a dar explicaciones de sus actos”, explican los autores del documento, que aseguran que así los africanos podrán participar y contribuir al avance en este campo de innovación, “algo que, aunque caro por el momento, tiene un enorme potencial para retornar en forma de menores costes sanitarios cuando conozcamos los determinantes genómicos de muchas enfermedades”.

Fuente: Wellcome UK

El documento establece algunos principios básicos. Para empezar, las investigaciones genómicas que se lleven a cabo en África deben ser sensibles y respetuosas con las culturas y valores de los africanos, así como establecer los beneficios para ellos como uno de sus objetivos primordiales. Además, estos proyectos y la publicación y publicitación de sus resultados deben contar con la aportación y participación de científicos africanos. “Teniendo en cuenta que el objetivo principal de la investigación genómica en África debería ser el beneficio de los africanos, la contribución de los científicos que trabajan en instituciones africanas debería ser significativa y sustanciosa, incluyendo el liderazgo o coliderazgo intelectual efectivo”.

La ciencia que reduzca desigualdades y no las aumente