Verdín, eucaliptos y cambio climático

Un estudio del Departamento de Biología Vegetal y Ecología de la UPV/EHU evidencia que los efectos del cambio climático, en este caso la escasez de agua en los sistemas acuáticos junto con la presencia de plantaciones de eucaliptos, están cambiando el metabolismo de dichos sistemas. Se trata, según Aingeru Martínez, uno de los autores del estudio, de otra evidencia de la alteración de los ciclos de nutrientes a nivel global.

El aumento de temperatura es, normalmente, el aspecto más destacado del cambio climático; sin embargo, no es el único. Las variaciones en el nivel de agua constituyen otro aspecto a tener en cuenta. Según Martínez, “se está observando que existen periodos cada vez más pronunciados y prolongados de escasez de agua en los sistemas acuáticos, lo cual es normal en regímenes áridos y mediterráneos; pero se está dando también en zonas de ambiente templado como la nuestra. Es importante saber qué impacto tiene eso sobre los ecosistemas acuáticos”.

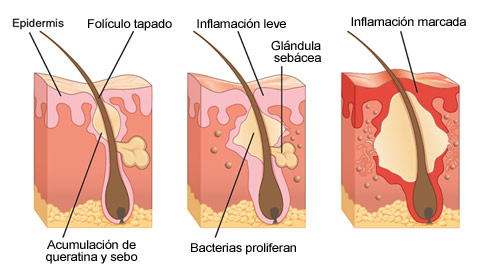

El estudio contempla, además, el efecto que producen las plantaciones de monocultivo de Eucalyptus grandis, una de las especies de árboles más plantadas del mundo, en los ecosistemas acuáticos. Y es que las hojas de eucalipto, una vez sumergidas, transfieren al agua materia orgánica disuelta, “algo similar a lo que ocurre cuando hacemos una infusión”, aclara. Así es como se crean los lixiviados de hojarasca que, en el caso del eucalipto, “son muy recalcitrantes, ricos en compuestos secundarios complejos y aceites que son difícilmente metabolizables por las comunidades biológicas; incluso llegan a ser tóxicos”, explica Martínez. “Nos parecía importante unir estos dos aspectos: por una parte, el modo en el que puede afectar la escasez de agua, y por otra parte, el hecho de que los sistemas acuáticos estén rodeados de plantaciones de eucalipto”, añade.

La investigación se ha centrado en el análisis de los citados efectos en el biofilm, “el verdín que vemos en las piedras de ríos y embalses”, aclara Martínez. El biofilm es uno de los componentes básicos de las cadenas tróficas, y “juega un papel fundamental tanto en el ciclo biogeoquímico de la materia orgánica disuelta como en la transferencia de materia, nutrientes y energía a niveles tróficos superiores. Así, alteraciones en el metabolismo del biofilm podrían generar una reacción en cascada, y afectar al funcionamiento de los ecosistemas de agua dulce”, afirma Aingeru Martínez.

Para poder conocer los efectos de los lixiviados de hojarasca en el biofilm, han llevado a cabo un experimento en el que han sumergido sustratos artificiales colonizados por biofilm en cinco diferentes concentraciones de lixiviados de E. grandis, “a fin de simular las concentraciones que se pueden encontrar en los sistemas naturales según el grado de escasez de agua”. Han medido los efectos sobre el crecimiento, la respiración, la producción primaria, la concentración de nutrientes y la actividad exoenzimática. “Los efectos más significativos se observaron sobre la respiración y la producción primaria. Esto altera el metabolismo de la comunidad, ya que se vuelve más heterótrofa, es decir, existe un mayor consumo de oxígeno y liberación de CO2 al medio”.

Por lo tanto, debido a la importancia del biofilm sobre el funcionamiento de los sistemas de agua dulce, “se podría decir que los periodos de escasez de agua, junto con la presencia de plantaciones extensivas de eucaliptos, alteran el metabolismo y, por tanto, el funcionamiento de los sistemas de agua dulce a nivel mundial. Teniendo en cuenta la importancia de los sistemas acuáticos de agua dulce en el ciclo del carbono, a nivel global, se trataría de una evidencia más de que nuestras actividades están produciendo cambios en los ciclos de nutrientes a nivel global”.

Referencia:

Martínez A, Kominoski JS & Larrañaga A, (2017) “Leaf-litter leachate concentration promotes heterotrophy in freshwater biofilms: Understanding consequences of water scarcity”.. Science of the Total Environment. Vol. 599–600. Pages 1677–1684.. DOI: 10.1016/j.scitotenv.2017.05.043.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Verdín, eucaliptos y cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El declive de las praderas de algas por el cambio climático

- Del cambio climático

- “El cambio climático: ciencia, política y moral” por José Manuel Sánchez Ron

Retrodiagnósticos

Goya atendido por el doctor Arrieta (Francisco de Goya, 1820). La cartela de abajo reza (sic): “Goya agradecido, á su amigo Arrieta: por el acierto y esmero con qe le salvo la vida en su aguda y / peligrosa enfermedad, padecida á fines del año 1819, a los setenta y tres de su edad. Lo pintó en 1820” . Cuadro del Instituto de Arte de Mineápolis.

Acertar con los pronósticos o, lo que viene a ser lo mismo, predecir con éxito lo que ocurrirá no es fácil. Y en muchas ocasiones, tampoco lo es acertar con los diagnósticos. La dificultad aumenta cuando de lo que se trata es de indagar acerca de las enfermedades de personas desaparecidas hace tiempo. Eso es lo que intentan hacer en la Historical Clinicopathological Conference, que se celebra todos los años en la Facultad de Medicina de la Universidad de Maryland (EEUU), con personalidades de las que se sabe que sufrieron alguna enfermedad y se dispone de alguna información acerca de sus síntomas.

Cada año se escoge una figura histórica y se propone a un especialista que realice un diagnóstico a partir de la información disponible. Este año le ha tocado a Goya, y la especialista que ha tratado de diagnosticar su enfermedad ha sido Ronna Hertzano, experta en audición. Goya cayó enfermo de “cólico” en 1792 a la edad de 46 años. Un año más tarde una enfermedad misteriosa le obligó a guardar cama. Tenía dificultades de visión, pérdida de equilibrio, fuertes dolores de cabeza y pérdida de audición. Necesitó dos años para recuperarse, al cabo de los cuales quedó sordo para el resto de su vida.

La doctora Hertzano barajó la posibilidad de que se tratase de una intoxicación con plomo, pues lo utilizó con abundancia para pintar, pero en ese caso, los síntomas se hubieran prolongado en el tiempo, como le ocurrió con la sordera. Más probable que haberse intoxicado con plomo, Goya pudo haber contraído la sífilis, pero esta enfermedad muestra síntomas de deterioro neurológico progresivo a lo largo de muchos años, y no hay datos que avalen ese deterioro. Ronna Hertzano se ha inclinado finalmente por una enfermedad autoinmune, el síndrome de Susac. Se trata de una enfermedad muy rara que se caracteriza porque el paciente sufre alucinaciones, parálisis y pérdida de audición. El sistema inmune ataca pequeños vasos sanguíneos encefálicos y el daño puede extenderse a ojos y oídos. No suele durar más de tres años.

En la Historical Clinicopathological Conference se han diagnosticado otros personajes célebres. Lenin pudo haber muerto a causa de una ateroesclerosis cerebral acelerada. Darwin, quien padeció durante buena parte de su vida una molesta enfermedad gastrointestinal, pudo haber sufrido el denominado síndrome de vómitos cíclicos; se trata de una enfermedad de causa desconocida aunque con una cierta componente genética y que no tiene cura, pero cuyos síntomas pueden ser tratados en la actualidad. Poe pudo haber muerto de rabia o, quizás, de delirium tremens. Es probable que la enfermera Florence Nightingale sufriese un trastorno bipolar con rasgos psicóticos o, alternativamente, síndrome de estrés postraumático; la enfermedad se le declaró con 35 años cuando se encontraba en Turquía trabajando como enfermera del ejército británico en condiciones terribles. Mozart quizás falleció por culpa de una fiebre reumática aguda. Es muy posible que Beethoven sufriera sífilis, aunque también pudo haberse envenenado con plomo. Y Pericles pudo haber muerto de tifus. Estos son algunos de los personajes retrodiagnosticados en Maryland.

Tratar de diagnosticar una enfermedad de forma retrospectiva, como se hace en este congreso no deja de ser un divertimiento. Pero tiene su interés. Por un lado, puede arrojar luz acerca de las causas de la muerte de personajes históricos relevantes, lo que en algunos casos tiene importancia histórica. Pero tiene también interés científico, ya que se trata de un ejercicio sometido al escrutinio del resto de especialistas y, muy probablemente, sirve para mejorar las técnicas de diagnóstico que se aplican a los enfermos de hoy. Es, cuando menos, un espléndido ejercicio docente.

—————————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 4 de junio de 2017.

El artículo Retrodiagnósticos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Ciencia a presión: Científicos que avalan patrañas

La expresión publish or perish (publica o perece) es de sobra conocida en el ámbito científico. Quiere expresar la importancia que tienen las publicaciones en los currículos del personal investigador. En ciencia no basta con hacer observaciones, obtener unos resultados y derivar conclusiones. Hay, además, que hacerlo público y, a poder ser, en medios de la máxima difusión internacional. La ciencia que no se da a conocer, que no se publica, no existe. El problema es que de eso, precisamente, depende el éxito profesional de los investigadores, sus posibilidades de estabilización y de promoción. De ahí la conocida expresión del principio.

El mundo de la comunicación tiene también sus normas. En comunicación se trata de que lo que se publica sea consumido. De la misma forma que la ciencia que no se publica no existe, en comunicación tampoco existen los contenidos que no se consumen: o sea, no existen los artículos que no se leen, los programas de radio que no se oyen, los de televisión que no se ven o los sitios web que no se visitan. En comunicación valdría decir “sé visto, oído o leído, o perece”.

Ambas esferas tienen ahí un interesante punto en común. Y por supuesto, en comunicación o difusión científica el ámbito de confluencia se aprecia en mayor medida aún. Confluyen aquí ambas necesidades, la de hacer públicos los resultados de investigación y, además, conseguir que lleguen a cuantas más personas mejor.

El problema es que la presión por publicar y por tener impacto comunicativo puede conducir tanto a unos como a otros profesionales, a adoptar comportamientos deshonestos, contrarios a la ética profesional e, incluso, a desvirtuar completamente el fin de la ciencia y de su traslación al conjunto del cuerpo social. Y también puede conducir, y de hecho ha conducido, a que se haya configurado un sistema de publicaciones científicas con patologías.

De todo esto se trató el pasado 31 de marzo en “Producir o perecer: ciencia a presión”, el seminario que organizarono conjuntamente la Asociación Española de Comunicación Científica y la Cátedra de Cultura Científica de la UPV/EHU.

1ª Conferencia

José Manuel López Nicolás, profesor de la Universidad de Murcia y divulgador científico: Científicos que avalan patrañas

Científicos que avalan patrañasEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Ciencia a presión: Científicos que avalan patrañas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Curso de verano “La ciencia de nuestras vidas”: Cuando la música era ciencia, por Almudena M. Castro

- Curso de verano “La ciencia de nuestras vidas”: Arte, literatura y ciencia, por Gustavo A. Schwartz

- Curso de verano “La ciencia de nuestras vidas”: La ciencia del habla, por Manuel Carreiras

Los límites del Hyperloop

Durante el pasado mes de julio hemos asistido a las primeras pruebas integradas de un sistema hyperloop en las instalaciones de Hyperloop One —la empresa más destacada de las que compiten por poner en marcha este sistema— en Las Vegas, Nevada. Pero ¿qué es un hyperloop? Es difícil no estar al menos vagamente familiarizado con la propuesta de un «quinto modo de transporte» realizada por el magnate Elon Musk, conocido por SpaceX y Tesla, en un white paper de 2013 [1] dado el tratamiento masivo que cualquier avance técnico o propuesta relacionada con el asunto tiene en todos los medios de comunicación.

En breve: un hyperloop es un sistema de cápsulas de transporte que se desplazan sin contacto a velocidades cercanas a la del sonido a través de un tubo en el que se ha evacuado el aire hasta llegar a condiciones de casi vacío, y que aceleran mediante motores de inducción lineales ubicados a intervalos regulares dentro de los tubos. Un sistema así puede sorprender por lo atrevido de la propuesta, pero una lectura rápida de las especificaciones técnicas y las estimaciones de costes avanzadas por Musk levanta, legítimamente, más de una ceja en la comunidad de expertos en transporte [2][3]. Más allá de análisis teóricos, los propios progresos de la empresa que más ha avanzado en la implementación física del concepto desvelan cuáles serán los problemas a los que tendrá que enfrentarse en un futuro inmediato y que tienen el potencial de dar al traste con todo el proyecto.

Durante la madrugada del sábado 29 de julio, Hyperloop One realizó su primera prueba de «fase 2» [4]. La cápsula de prueba denominada XP-1 recorrió un total de 437 metros en un tubo evacuado a una presión inferior a 100 Pa (la milésima parte de la presión atmosférica), alcanzando en el proceso una velocidad máxima de 310 km/h. El motor de inducción lineal utilizó para ello un estátor de 300 metros de longitud, de donde podemos deducir algún parámetro más de la prueba aplicando algo de cinemática elemental.

Suponiendo que la cápsula partió del reposo y que la aceleración impartida fue constante, resulta que debió estar sujeta a 12,36 m/s², unos 1,26 g. La frenada debió ser algo más intensa, de 2,76 g: afortunadamente, la XP-1 no es más que un chasis cubierto con una estructura hueca de fibra de vidrio [5]. Unos potenciales pasajeros habrían encontrado el viaje extremadamente poco confortable. No hay que olvidar, sin embargo, que la limitación de longitud que presenta el tramo de pruebas de Hyperloop One en Las Vegas prácticamente obliga a sostener aceleraciones y frenadas de semejante intensidad si se desea probar el sistema a cualquier velocidad significativa.

Vista frontal de la sección del tubo de pruebas de Hyperloop One. Fuente: Hyperloop One

Hyperloop One es un tanto parca ofreciendo datos técnicos relacionados con sus pruebas, aunque un poco más de estudio sobre el vídeo y los materiales de prensa publicados deberían permitir hacer alguna inferencia más allá de la cinemática del sistema. Será importante conocer con alguna precisión las dimensiones de la cápsula: en la documentación disponible se afirma que mide 8,69 metros de longitud y 2,71 metros de altura. Examinando las imágenes disponibles esta altura parece excesiva; además, el parámetro fundamental de la anchura de la cápsula, necesario para calcular su sección y sus características aerodinámicas, no aparece por ninguna parte. Un pequeño trabajo de estimación sobre el vídeo de la prueba permite conjeturar que el diámetro interior del tubo debe rondar los 4 metros, mientras que la cápsula misma debería tener una anchura de alrededor de 3 metros.

La altura del carenado parece no superar los 1,80 metros a la vista de las fotografías. Tomemos una altura de 2 metros para arrojar una sección transversal aproximada de 6 m²; el tubo mismo tendría una sección interior de 12,67 m². Estos datos son consistentes con la intención de Hyperloop One de centrarse en el segundo de los diseños propuestos por Musk: el hyperloop de mercancías —aunque Musk lo concibió como un medio mixto de viajeros y carga que podría transportar vehículos como (naturalmente) un Tesla S. El primer diseño, de menor sección y supuestamente de construcción más barata, sería prácticamente un homoducto [6] que lanzaría a un pequeño grupo de personas reclinadas en el interior de un tubo de 1,35 por 1,10 metros como si fueran fajos de billetes en un supermercado. En cualquier caso, la incertidumbre propia de las medidas nos permite estimar que la cápsula ocupa alrededor de la mitad de la superficie disponible en su desplazamiento. ¿Por qué es esto importante?

El límite de Kantrowitz

El mismo equipo de Elon Musk, en la redacción del artículo original que sirvió como pistoletazo de salida para la definición del hyperloop, resaltó un parámetro clave de dinámica de gases que resulta limitante en el diseño de un sistema de transporte que debe alcanzar velocidades transónicas —cercanas a las del sonido— en el interior de un tubo, por analogía con el flujo de aire a través de la boca de una turbina en un motor a reacción. Se trata del llamado «límite de Kantrowitz», por Arthur Kantrowitz, ingeniero estadounidense que derivó la expresión de un límite en el flujo de un gas a velocidades transónicas cuando atraviesa una zona en la que se fuerza una reducción en su sección [7]. Como el flujo del gas debe ser continuo, un estrechamiento supone un aumento correspondiente de su velocidad hasta alcanzar la velocidad local del sonido; en este momento el flujo de gas resulta obstruido.

En el hyperloop el límite de Kantrowitz puede visualizarse como un «efecto jeringa». En una jeringa, si se impide el flujo de aire a través de su boquilla, el émbolo no puede seguir avanzando si no es comprimiendo el aire que haya en su interior realizando un esfuerzo inconmensurable con el necesario para hacerlo avanzar en condiciones de flujo normal —es decir, con la boquilla sin tapar. El límite de Kantrowitz es, entonces, la velocidad a la que la sección mínima del hueco entre la cápsula y el tubo provoca un aumento súbito en la resistencia del aire, por poco que sea. De hecho, la ecuación del límite relaciona la razón entre el hueco citado y la sección interna del tubo con la velocidad, y ni siquiera tiene en cuenta la presión local del aire [8].

Las estimaciones que hemos realizado antes sobre las dimensiones de la cápsula XP-1 permiten averiguar la velocidad a la que el sistema debería encontrarse con el límite de Kantrowitz: ocurrirá alrededor de Mach 0,55, o suponiendo una temperatura interior del tubo de 20 °C, a 188 m/s², es decir, 677 kilómetros por hora. Una cifra algo decepcionante teniendo en cuenta que el relato de Hyperloop One de la prueba incluye la siguiente cita textual, un tanto fanfarronesca dadas las condiciones actuales de las instalaciones de ensayo:

With an additional 2000 meters of stator, we would have hit 1100 km per hour […]

Es decir, 2 kilómetros adicionales de aceleración habrían permitido alcanzar los 1100 km/h. Esto, simplemente, no es cierto salvo que el sistema disponga de potencia suficiente para arrastrar la cápsula más allá del pico de resistencia impuesto por la dinámica de gases, algo que sin duda dispararía el consumo energético de todo el conjunto mucho más allá de lo previsto, afectando de forma crítica a su viabilidad.

El artículo original de Musk discutió —correctamente— la pertinencia del límite de Kantrowitz en el sistema del hyperloop. Las velocidades previstas tanto por Musk como por Hyperloop One para el sistema se encuentran en el entorno de Mach 0,9 (aproximadamente 1100 km/h), lo que arroja una relación de sección libre frente a total de 0,99. Es decir, un hyperloop solo podría funcionar a la velocidad objetivo en el interior de un tubo gigantesco respecto a su propia sección transversal, eliminando así toda posible ventaja que la existencia del tubo pudiera conllevar. Pero Musk abordó el problema proponiendo una solución decididamente ingeniosa: ¿por qué no incorporar en el frontal de la cápsula un compresor axial similar al de los turborreactores? De esta forma, sería la propia cápsula la que evacuaría el aire que se fuera encontrando, aumentando así la sección libre en función de la tasa de compresión que proporcionara el sistema. Yendo un paso más allá, Musk y su equipo calcularon que el compresor debería ofrecer una relación de compresión de 20 a 1, y realizaron los cálculos necesarios para aprovechar parte del aire para los sistemas de soporte vital de la cápsula, a la vez que tenía en cuenta el resultado impuesto por la termodinámica para un gas que se comprime: un aumento de su temperatura.

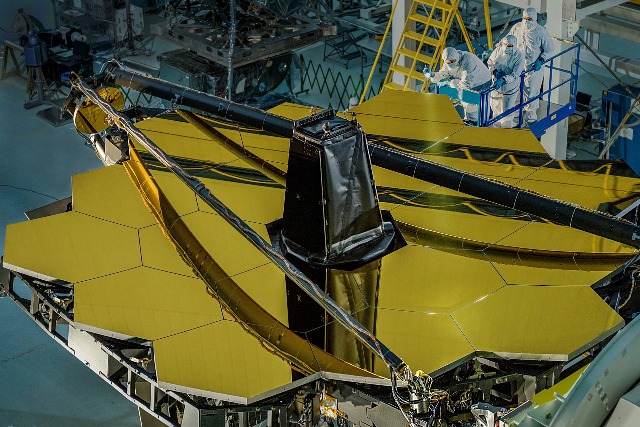

Frontal de la cápsula de Hyperloop One. Obsérvese la ausencia de ningún tipo de estructura. En la fotografía, de izquierda a derecha, Josh Giegel y Shervin Pishevar, cofundadores de Hyperloop One. Fuente: Hyperloop One.

Sin embargo, una simple inspección de la cápsula XP-1 permite descartar que disponga de compresor axial alguno montado en su frontal —mostrado, por otro lado, en prácticamente todas las recreaciones artísticas de la cápsula del hyperloop como la que encabeza este artículo, realizada por Hyperloop One (aunque ya no puede encontrarse en su web). Esta falta de compresor es la que permite calcular con tanta seguridad a qué velocidad encontrará el límite de Kantrowitz; ahora bien, ¿no bastará con instalar un compresor en el frontal para solventar el problema? Después de todo, según afirmó a principios de año el Dirk Ahlborn, director de Hyperloop Transportation Technologies (y competencia de Hyperloop One en la carrera por traer a la realidad los tubos), «la tecnología [para construir un hyperloop] no es la cuestión —ya existe» [9].

Pues bien, esta afirmación es falsa. Hoy por hoy no existe un compresor axial con las características necesarias para equipar una cápsula de hyperloop como la que Hyperloop One está proponiendo, ni de hecho como ningún otro diseño. Los compresores de las turbinas utilizadas en aviación superan con frecuencia las relaciones de compresión de 20:1, pero funcionan con keroseno. Sin duda no es imposible desarrollar una turbina eléctrica que realice esa función, aunque la incógnita sobre su desarrollo obligaría a ser más prudente con los plazos y no realizar afirmaciones como las que acostumbran a hacer los participantes en la «carrera del hyperloop» —y a difundir, sin crítica ni comentario, los medios de comunicación. El consumo eléctrico de este teórico compresor eléctrico es también una incógnita, por más que simples cálculos termodinámicos permitan establecer un límite inferior.

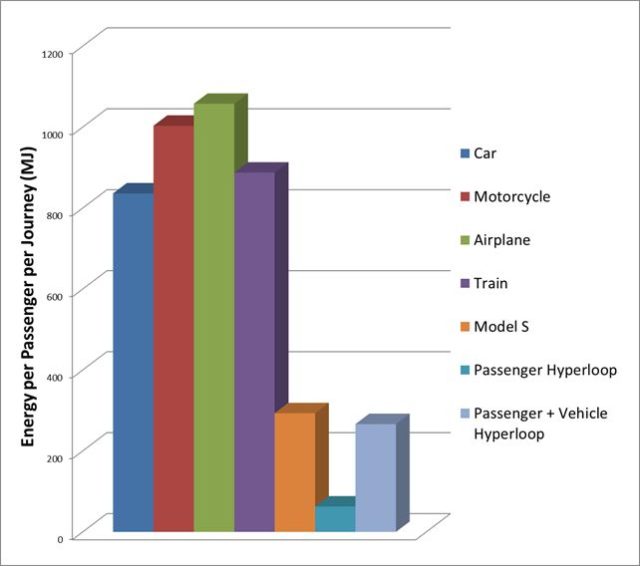

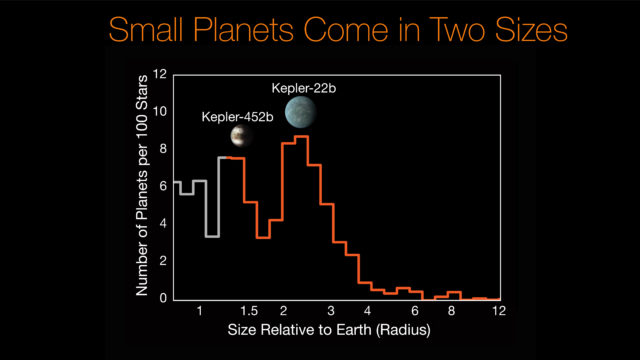

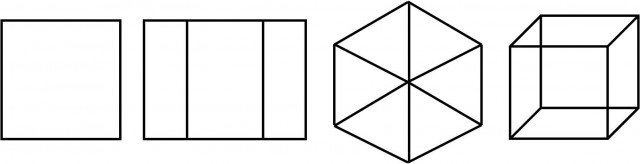

Por esto, el balance energético total del sistema citado por Musk debe ser puesto claramente en duda. Si además tenemos en cuenta que el gasto energético mostrado para los diferentes medios de transporte en la primera figura del paper es clara ¿e intencionadamente? erróneo —en lo que respecta, al menos, al ferrocarril— no es ninguna insensatez dudar, como muchos llevamos tiempo haciéndolo, de la viabilidad del sistema en su conjunto.

Gastos energéticos por trayecto citados por Musk en su paper. Los valores «por pasajero y trayecto» y no por pasajero-kilómetro hacen la gráfica ambigua, aunque suponiendo que se refiere al proyecto de alta velocidad Los Ángeles-San Francisco, un valor más razonable basado en cálculos realistas [10] es al menos cuatro veces inferior (!) al reportado por Musk

¿Tener compresor o no tener compresor?

Llegados a este punto nos encontramos con una disyuntiva: o bien se desarrolla el compresor axial eléctrico necesario para el funcionamiento del sistema tal y como fue diseñado, o no. En el primer caso podríamos, teóricamente, incrementar la velocidad punta del sistema de transporte hasta un régimen cuasi-transónico. Nos encontraríamos entonces con una limitación termodinámica por la que pasa de puntillas el diseño original: como quiera que un gas sujeto a compresión incrementará fuertemente su temperatura, es necesario hacer algo con la energía adicional si no deseamos que la cápsula se transforme en una especie de horno de aire —un horno de aire es un artefacto ideal para hacer patatas fritas con muy poca grasa, pero no muy indicado para transportar personas o mercancías. Musk concibe un sistema de refrigeración basado en agua, un par de intercambiadores térmicos (intercoolers) y varios tanques dispuestos para almacenar agua y vapor, y los dimensiona de acuerdo con sus cálculos.

Un poco más adelante, en una sola línea de la descripción del sistema compresor y como pretendiendo que pase inadvertido (apartado 4.1.3) se afirma lo siguiente:

Water and steam tanks are changed automatically at each stop.

Es decir, «los tanques de agua y vapor son intercambiados [por otros frescos] automáticamente en cada parada». Este curioso y poco reportado (¿por trivial?) paso tiene una cierta reminiscencia a los depósitos de agua de las antiguas locomotoras de vapor. Tiene también el defecto de complicar la logística de la gestión de las cápsulas, algo que para mantener el flujo previsto de pasajeros del sistema tiene que realizarse con total precisión y a gran velocidad al objeto de mantener el flujo de pasajeros previsto que da sentido al sistema en su conjunto. Es, además, una complejidad a añadir al previsto cambio de batería tras cada viaje: como quiera que la cápsula no obtiene energía de la infraestructura como lo haría un tren eléctrico, toda la operación interna del sistema (compresor, intercambiadores de calor, válvulas y sistemas de soporte vital, entre otros) tiene que sustentarse con baterías.

El mismo Musk, a través de Tesla, su empresa automovilística, lleva ya años preconizando la creación de una infraestructura de intercambio rápido de baterías para sus coches eléctricos. Esto tendría la ventaja obvia de sustituir los potenciales largos tiempos de carga de las baterías de los vehículos por un futurista y automático intercambio robotizado. Sin embargo, la creciente disponibilidad de sistemas de carga rápida (y, potencialmente, la introducción de un punto clave de fallo en una conexión eléctrica fundamental en los vehículos, con el consiguiente y previsible descenso en la fiabilidad) ha impedido que esta tecnología se desarrolle [11]. Ni siquiera hay prototipos que puedan adaptarse para su uso en las cápsulas del hyperloop: cuánto menos los habrá si se trata de intercambiar baterías junto con tanques de aire y vapor de agua a presión y sobrecalentado, que deben conectarse no ya mediante un contacto eléctrico, sino mediante válvulas robustas.

La otra opción en la disyuntiva de diseño es olvidar el compresor frontal y operar el sistema a velocidades subsónicas por debajo de Mach 0,5. Un hyperloop que opere a una velocidad punta en el entorno de los 600 km/h podría ser factible, aunque está mucho menos claro que el sistema de transporte resultante sea atractivo en costes de construcción por km, costes de mantenimiento, consumo energético y confort respecto de su competencia más obvia, el tren de alta velocidad. Décadas de desarrollo por parte de empresas y organismos públicos en los EE.UU., Alemania, Japón y China han llevado al despliegue comercial de un sistema presentado por muchos expertos como «el transporte del futuro»: el tren de levitación magnética o maglev.

Hoy hay una línea en el mundo funcionando comercialmente como un tren de levitación magnética de alta velocidad: el Transrapid de Shanghai que cubre una distancia de 30,5 kilómetros en 8 minutos a una velocidad máxima récord de 430 km/h. El resto de los trenes de levitación magnética existentes en el mundo son líneas automáticas de baja o media velocidad, concebidas según el modelo people mover propio de grandes aeropuertos. En el futuro la Chūō Shinkansen [12][13], una línea de mayor alcance y más similar al perfil de transporte al que aspira hyperloop, deberá cubrir el trayecto Tokio-Nagoya-Osaka en algo más de una hora, alcanzando una velocidad punta de 505 kilómetros por hora. Según la planificación actual esta línea —una auténtica maravilla de la ingeniería, con más del 86% del trayecto en su primer tramo ejecutado en túnel— debería poner en servicio su primer tramo (Tokio-Nagoya) en 2027 y el segundo (Nagoya-Osaka) en 2045. No puedo dejar pasar la oportunidad de que estos y no otros son plazos realistas para una infraestructura de transporte puntera; en ningún caso lo son los que se están divulgando desde el entorno de hyperloop y Elon Musk.

De todos modos, la mayoría de expertos en sistemas de transporte opinan que los grandes proyectos de trenes de levitación magnética son «elefantes blancos» [14]: obras realizadas más como forma de señalar el prestigio de un país que como forma práctica de mover grandes flujos de personas entre ubicaciones populosas. El potencial incremento en la velocidad comercial de un sistema maglev requiere de unos costes por kilómetro consecuentemente elevados, que solo se justifican con una demanda de transporte extremadamente intensa. A falta de tales condiciones y con un riesgo tecnológico inexistente, el tren de alta velocidad se erige como la alternativa al transporte privado. Fiable [15] y maduro aunque todavía con margen de mejora, permite conectar entre sí centros urbanos separados por centenares de kilómetros con mínimo impacto ambiental y costes conocidos.

El concepto del hyperloop plantea, además de las aquí reseñadas, muchas otras dudas y limitaciones técnicas no menos importantes desde puntos de vista tecnológicos, operativos y de seguridad. Es por todo esto que puede afirmarse con rotundidad que hyperloop no ocurrirá. Desde luego no en cuatro años, como afirma Hyperloop One. Tampoco en veinte años —el mínimo razonable para un proyecto con tanta tecnología en el aire. Y quizá nunca.

Este post ha sido realizado por Iván Rivera (@Brucknerite) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU

Para saber más

[1] Musk, E. R. et al. (12/08/2013). Hyperloop Alpha. Visitado el 14/08/2017 en http://www.spacex.com/sites/spacex/files/hyperloop_alpha-20130812.pdf.

[2] Bradley, R. (10/05/2016). The Unbelievable Reality of the Impossible Hyperloop, MIT Technology Review. Visitado el 14/08/2017 en https://www.technologyreview.com/s/601417/the-unbelievable-reality-of-the-impossible-hyperloop/.

[3] Konrad, A. (18/11/2016). Leaked Hyperloop One Docs Reveal The Startup Thirsty For Cash As Costs Will Stretch Into Billions, Forbes. Visitado el 14/08/2017 en https://www.forbes.com/sites/alexkonrad/2016/10/25/hyperloop-one-seeks-new-cash-amid-high-costs/#4f78547d125c.

[4] Giegel, J., Pishevar, S. (02/08/2017). Hyperloop Gets More Real Every Time We Test, Hyperloop One. Visitado el 14/08/2017 en https://hyperloop-one.com/blog/hyperloop-gets-more-real-every-time-we-test.

[5] Hyperloop One. (10/08/2017). What Testing Has Taught Us. Visitado el 14/08/2017 en https://hyperloop-one.com/blog/what-testing-has-taught-us.

[6] «Homoducto», del latín homo (ser humano) y ductus (conducto), palabra acuñada por @Mssr_Pecqueux en conversación de Twitter https://twitter.com/brucknerite/status/733684888033984512.

[7] Kantrowitz, A., Coleman, duP. (05/1945). Preliminary Investigation of Supersonic Diffusers. Advance Confidential Report L5D20, National Advisory Committee for Aeronautics. Visitado el 14/08/2017 en http://www.dtic.mil/dtic/tr/fulltext/u2/b184216.pdf.

[8] Una expresión apropiada para el límite de Kantrowitz según se aplica al Hyperloop es:![]()

Donde Abypass es la sección libre, Atube la sección interna total, γ el factor de expansión isentrópica y M el número de Mach del flujo de aire (equivalente a la velocidad de avance de la cápsula).

[9] Carlström, V. (26/01/2017). HTT’s CEO says a hyperloop line will be up and running within three years: “The technology is not the issue – it already exists”, Business Insider Nordic. Visitado el 14/08/2017 en http://nordic.businessinsider.com/htts-ceo-says-a-hyperloop-line-will-be-up-and-running-within-three-years-the-technology-is-not-the-issue–it-already-exists-2017-1/

[10] García Álvarez, A. (01/2008). Consumo de energía y emisiones del tren de alta velocidad en comparación con otros modos. Vía Libre, (515). Visitado el 14/08/2017 en https://www.vialibre-ffe.com/PDF/Comparacion_consumo_AV_otros_modos_VE_1_08.pdf

[11] Korosec, K. (10/06/2015). Tesla’s battery swap program is pretty much dead, Fortune. Visitado el 14/08/2017 en http://fortune.com/2015/06/10/teslas-battery-swap-is-dead/

[12] Chuo Shinkansen Maglev Line. Railway Technology. Visitado el 14/08/2017 en http://www.railway-technology.com/projects/chuo-shinkansen-maglev-line/.

[13] JR Central (2012). The Chuo Shinkansen using the Superconducting Maglev System. JR Central Annual Report. Visitado el 14/08/2017 en http://english.jr-central.co.jp/company/ir/annualreport/_pdf/annualreport2012-05.pdf

[14] Binning, D. (11/02/2008). Maglev – the Great Debate, Railway Technology. Visitado el 14/08/2017 en http://www.railway-technology.com/features/feature1606/

[15] European Commision. (10/02/2017). Rail accident fatalities in the EU. Visitado el 14/08/2017 en http://ec.europa.eu/eurostat/statistics-explained/index.php/Rail_accident_fatalities_in_the_EU

El artículo Los límites del Hyperloop se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- En los límites del frío

- Cuántica y relatividad por todas partes

- ¿Por qué el Rover Curiosity es más lento que un caracol?

Más allá de los experimentos

Un error muy extendido, usado también como argumento a favor de algunas pseudociencias y en contra de ciertas teorías como la de la Evolución por Selección Natural, es postular que sólo puede ser conocimiento científico aquel que surge de un experimento. Según esta idea la ‘verdadera ciencia’ es la que sale de los laboratorios, de la comprobación de hipótesis en un entorno controlado con estricta determinación de variables sistemáticamente bien controladas para evitar la interacción. Todas las fuentes de error son localizadas y eliminadas, todas las fuentes de ruido minimizadas y cada variable independiente es determinada y su influencia sobre el fenómeno estudiado es medida; la ciencia es o debe ser como la física o la química, un ejercicio de extrapolación controlada a partir de casos limitados estudiados en laboratorio, porque el único conocimiento real es el que tiene base experimental.

En ocasiones se llega a discutir incluso la posibilidad de generalizar y se intenta argumentar que ninguna ley puede ser considerada verdaderamente científica a no ser que se pueda demostrar que se cumple en todos y cada uno de los casos; es el origen del ‘amimefuncionismo’ tan típico para defender pseudociencias como la homeopatía. En el fondo, y dada la imposibilidad práctica de cumplir esta condición, se trata de negar la existencia misma de la ciencia o el conocimiento: si es imposible generalizar es imposible saber, dado que cada caso concreto es independiente de todos los demás y cualquier abstracción es imposible. Si cada caso es un caso particular nunca podemos saber nada en general y el conocimiento es imposible: nihilismo epistemológico, o la ignorancia disfrazada de escepticismo extremo.

Igual ocurre con la exigencia de que todo conocimiento científico provenga de un experimento, que para empezar niega la consideración de ciencia a cualquier proceso histórico: como no podemos hacer un experimento que repita la historia de la Tierra la Evolución por Selección Natural no es una teoría científica. Como tampoco puede serlo el Big Bang, la tectónica de placas o la secuencia principal de la evolución estelar. En su interpretación más extrema hasta la historia humana sería imposible de conocer, ya que el Imperio Romano, las sociedades paleolíticas o el Siglo de Oro español son imposibles de reproducir experimentalmente. El pasado sería por tanto incognoscible.

Muchos de quienes usan este tipo de argumentos para defender las bondades de una pseudoterapia o como garrota contra Darwin no son conscientes de que en realidad están rechazando la existencia de cualquier posibilidad de conocimiento al hacerlo; tampoco es que a la mayoría de ellos les moleste demasiado. Llevado al extremo el nihilismo epistemológico haría también imposible cosas como perseguir a un criminal: en ausencia de testigos directos o grabaciones no habría ninguna forma de demostrar la comisión de un crimen, ya que ninguna pista sería suficiente prueba. No sólo el conocimiento, sino la misma sociedad dejaría de funcionar si nuestros criterios de confirmación fuesen tan estrictos. La exigencia de experimentación y de estudio caso por caso son formas de rechazo del intelecto mismo; incluso de los elementos clave de la Humanidad, una especie de auto odio en versión intelectual.

El universo que hay ahí fuera es cognoscible; las leyes existen, las generalizaciones son posibles y el experimento es una herramienta más a disposición de quien busca el conocimiento. A partir de casos concretos se pueden crear conclusiones generales que pueden ser útiles en presencia de nuevos casos. Lo ocurrido en el pasado deja pistas en el presente que pueden ser utilizadas para reconstruir lo ocurrido. Las leyes científicas existen y se pueden usar, aunque pocas sean inmutables y eternas. El cosmos es sutil, pero no malicioso, lo que nos permite usar la razón y fiarnos de las conclusiones obtenidas con ella incluso cuando se refieren a un pasado remoto. El avance de la ciencia nos demuestra que podemos conocer el universo y los intentos de rechazar esta idea para defender absurdas teorías no muestran más que la bancarrota intelectual de quienes están dispuestos a rechazar la idea misma de conocimiento sólo por no dar su brazo a torcer.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Más allá de los experimentos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Curso de verano “Las dos culturas y más allá”: El caso de la lingüística y las ciencias cognitivas

- Curso de verano “Las dos culturas y más allá”: Ciencia, Sociedad y Desarrollo

- Curso de verano “Las dos culturas y más allá”: Ciencia y Poder

Amelia quiere explorar el desierto

Sí, Amelia quiere explorar el desierto. Ha conseguido el patrocinio de una millonaria que le impone unas cuantas reglas para que agudice su ingenio. Las explicamos a continuación.

Amelia tiene a su disposición una cantidad ilimitada de gasolina almacenada en el lugar de salida, en el límite del desierto.

Para realizar su viaje, dispone de un jeep en el que puede transportar como máximo, en cada momento, una unidad de combustible. Con cada unidad de gasolina puede viajar una unidad de distancia; se supone que el consumo de combustible es constante.

En cualquier momento del viaje, Amelia puede dejar cualquier cantidad de combustible en un depósito para poder recogerlo más tarde al volver a pasar por allí. La mecenas le exige, además, que siempre que el jeep comience a salir del desierto debe regresar necesariamente al punto de partida.

Con todas estas normas impuestas, la pregunta es: ¿hasta dónde puede llegar Amelia en su paseo por el desierto?

Vamos a intentar ver que puede llegar tan lejos como quiera, solo con un poco de estrategia por su parte. Para ello, vamos a explicar lo lejos llegaría realizando tres viajes –saliendo tres veces del punto de partida– para describir después el caso general.

La estrategia de Amelia si realiza tres salidas

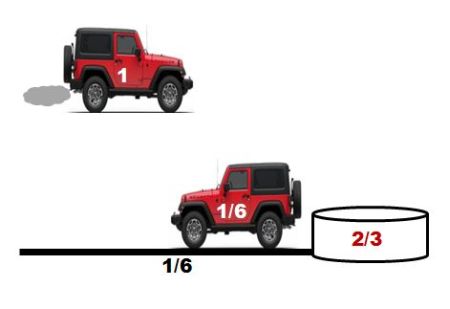

Amelia sale de la base una unidad de gasolina en el depósito del jeep y conduce 1/6 de unidades de distancia. Es decir, ha consumido la sexta parte del combustible. Deja 2/3 de unidades de combustible en un depósito, y regresa al punto de partida con el 1/6 de combustible que le queda.

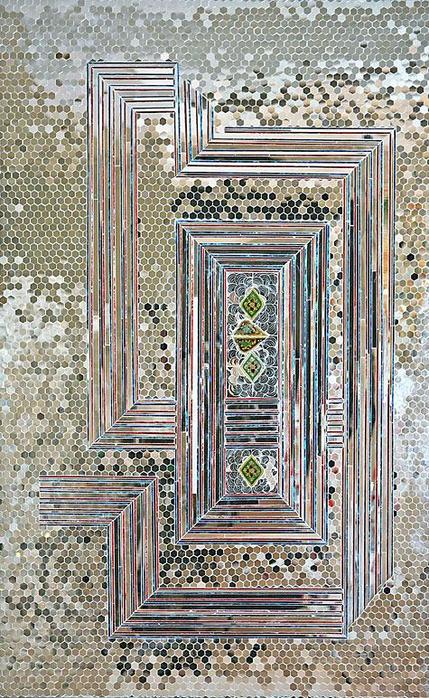

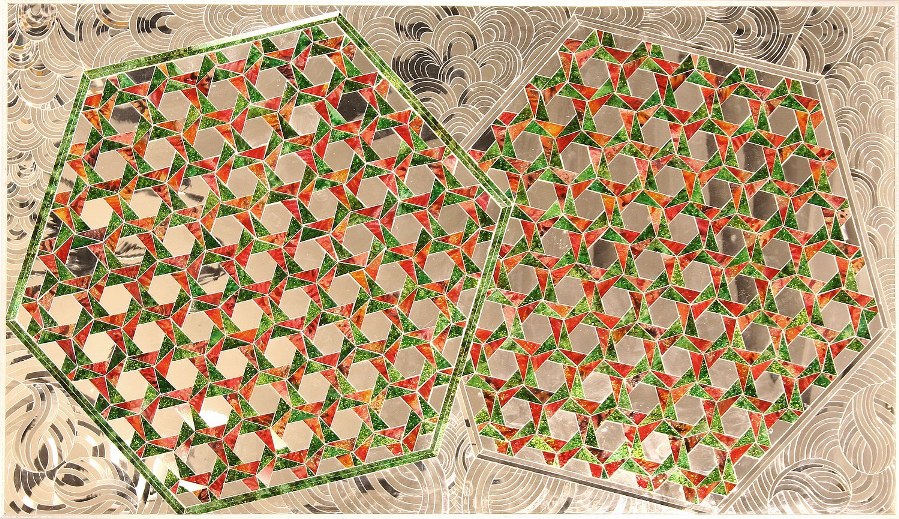

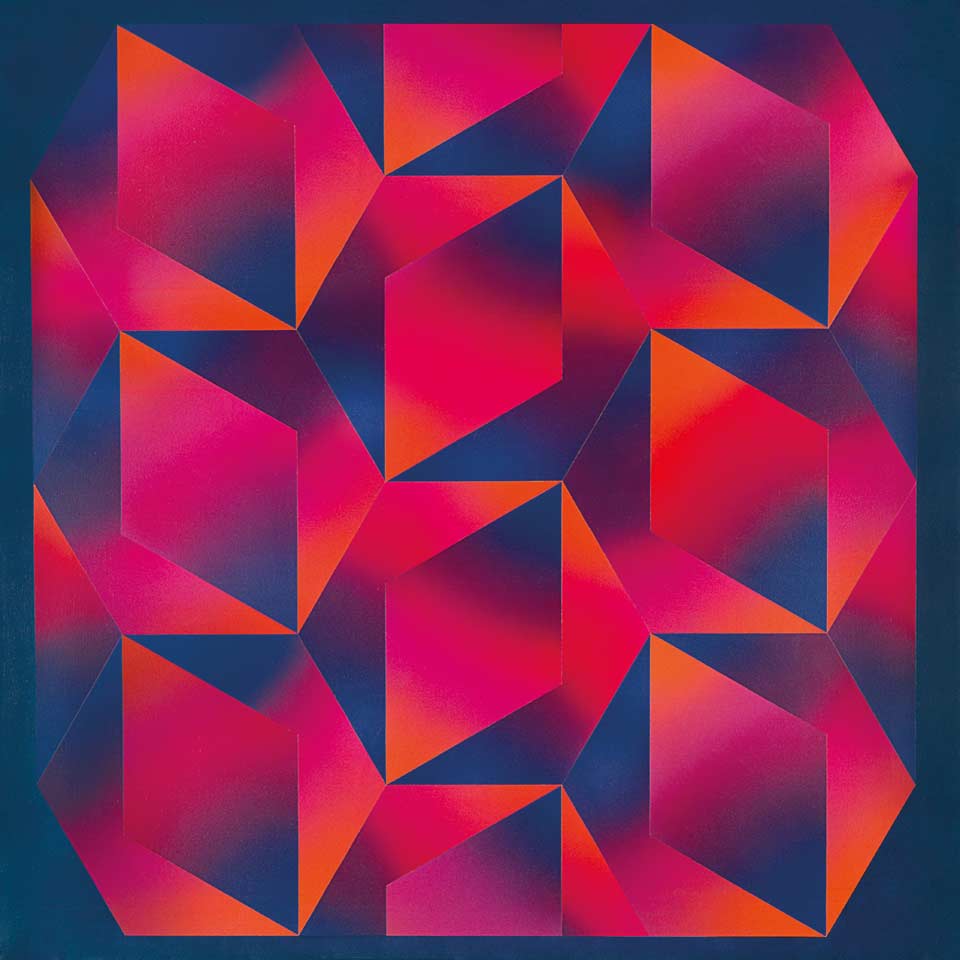

Figura 1: Sobre el coche, en blanco aparecen las unidades de gasolina en el depósito, y en los bidones, en rojo, la cantidad de combustible almacenada. Fuente: Marta Macho Stadler

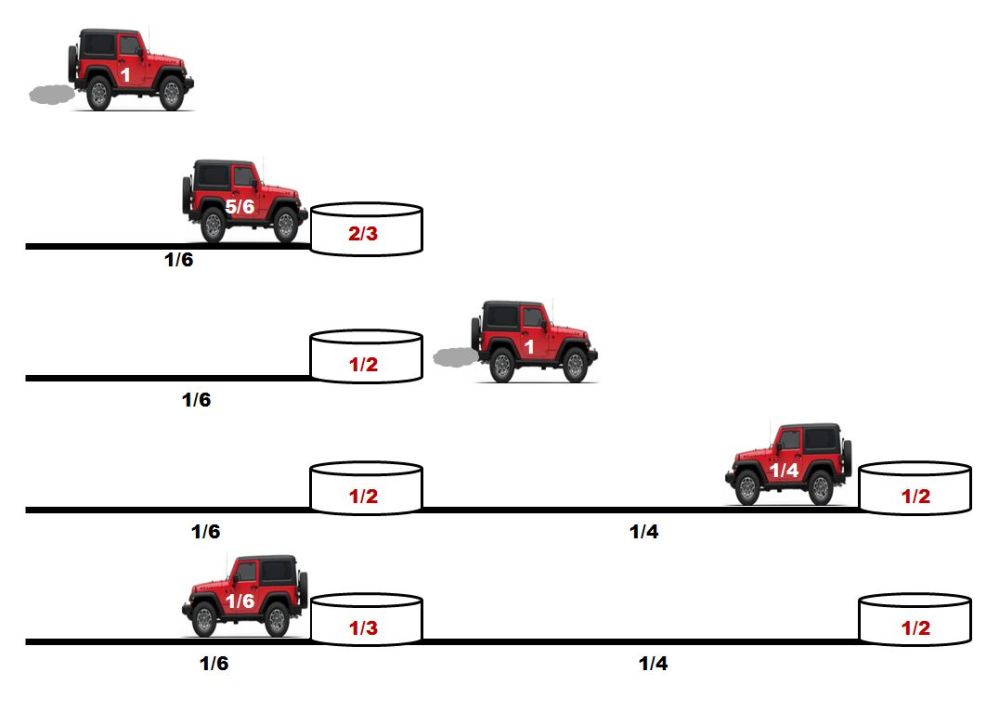

Amelia vuelve a cargar el depósito del jeep al máximo –es decir con una unidad de combustible– y conduce 1/6 de unidades de distancia. Ha gastado 1/6 de unidades de gasolina; llena el depósito del coche con 1/6 de combustible tomado del depósito, y vuelve a adentrarse en el desierto, dejando en el primer depósito 1/2 de unidades de fuel. Desde ese punto conduce 1/4 de unidades de distancia y deposita 1/2 unidad de gasolina en un segundo recipiente. Le quedan 1/4 de unidades de fuel, lo justo para llegar al primer bidón. De ese recipiente toma 1/6 de unidades de combustible –es decir, deja el primer bidón con 1/3 de unidades de fuel– y llega a la base con el depósito del coche vacío.

Figura 2 : Sobre el coche, en blanco aparecen las unidades de gasolina en el depósito, y en los bidones, en rojo, la cantidad de combustible almacenada. Fuente: Marta Macho Stadler

Amelia carga el coche con el máximo de gasolina, llega al primer bidón y utiliza 1/6 de combustible para volver a llenar el depósito del jeep –así, en el primer depósito, deja 1/6 de unidades de gasolina–. Llega al segundo recipiente tras recorrer 1/4 de unidades de distancia, y allí vuelve a llenar el vehículo con fuel, dejando en el segundo depósito 1/4 de unidades de combustible, y continúa su viaje hacia el interior del desierto. Tras recorrer 1/2 unidad de distancia, da la vuelta, llega al segundo recipiente gastando todo el combustible que le queda, usa el fuel del segundo recipiente para llegar al primero y de nuevo toma la gasolina del primer bidón para regresar al punto de partida.

Figura 3: Sobre el coche, en blanco aparecen las unidades de gasolina en el depósito, y en los bidones, en rojo, la cantidad de combustible almacenada. Fuente: Marta Macho Stadler

Así, con estas tres idas y vueltas, Amelia se ha adentrado en el desierto 11/12 de unidades de distancia.

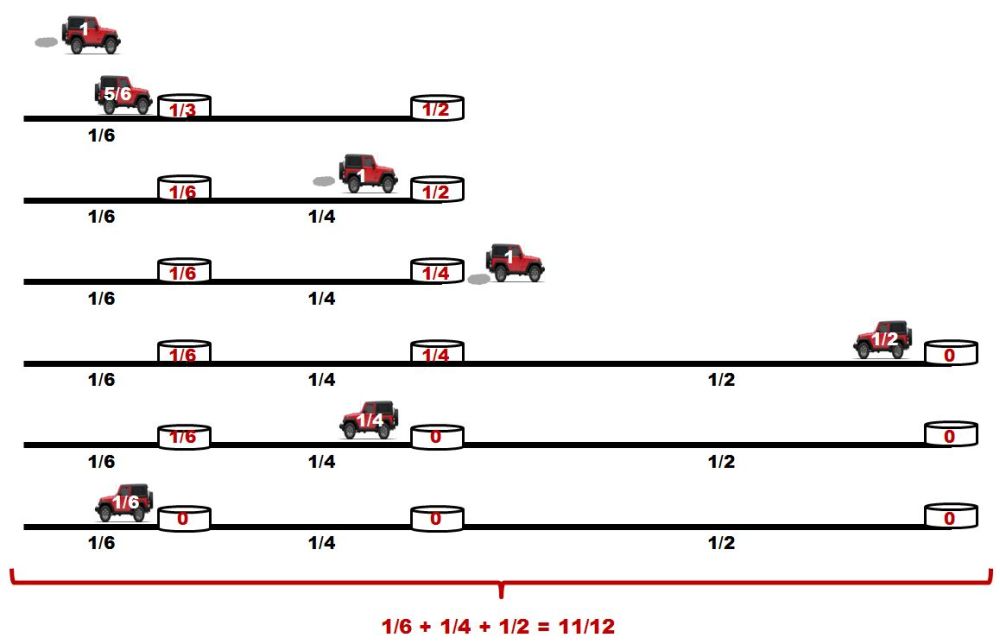

Entendiendo el caso general

La estrategia utilizada por Amelia con tres salidas desde el límite del desierto puede generalizarse para cualquier n:

-

El jeep realiza n viajes de ida y vuelta.

-

En la primera salida, viaja 1/(2n) de unidades de distancia, deja (n − 1)/n unidades de gasolina en el primer depósito, quedándose con el combustible justo para llegar a la base.

-

En cada una de las n − 1 siguientes salidas, y en dirección hacia el interior del desierto, Amelia va tomando de cada depósito el combustible necesario para llenar al máximo el jeep y llegar al siguiente depósito. Y al regresar, va tomando solo la gasolina suficiente para llegar al depósito anterior.

-

Esta operación la puede realizar n veces, dejando en su último viaje todos los bidones vacíos, y habiendo recorrido en la dirección del desierto

1/2 + 1/4 + 1/6 + … + 1/(2n) = 1/2 (1 + 1/2 + 1/3 + … + 1/n)

de unidades de distancia.

Recordemos que 1 + 1/2 + 1/3 + … + 1/n es el n-ésimo número armónico,la suma parcial n-ésima de la serie armónica, que es una serie divergente.

¿Y que tiene esto que ver con el viaje de Amelia? Si la exploradora utiliza la estrategia anteriormente descrita, podrá adentrarse en el desierto todo lo que desee, porque para n suficientemente avanzado,

1/2 (1 + 1/2 + 1/3 + … + 1/n)

es tan grande como se desee… Como el desierto, sea cual sea el que ha elegido Amelia, tiene dimensiones finitas, la exploradora puede recorrerlo por completo. Solo necesita suficiente tiempo –que no sobrepase su tiempo de vida–: Amelia completará su aventura. Aunque es probable que arruine a su mecenas y, sobre todo, que desperdicie un combustible precioso de manera un tanto caprichosa…

Más información:

-

Jeep problem, Wikipedia

-

Jeep problem, Wolfram Math World

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Amelia quiere explorar el desierto se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Mestizajes: ¿Cómo sabe una metáfora? Poética y ciencia, por Amelia Gamoneda

- ¿Quién quiere vivir para siempre?

- El diablo y Simon Flagg, una lectura ligera para el verano

Sistemas nerviosos: el cerebro de vertebrados

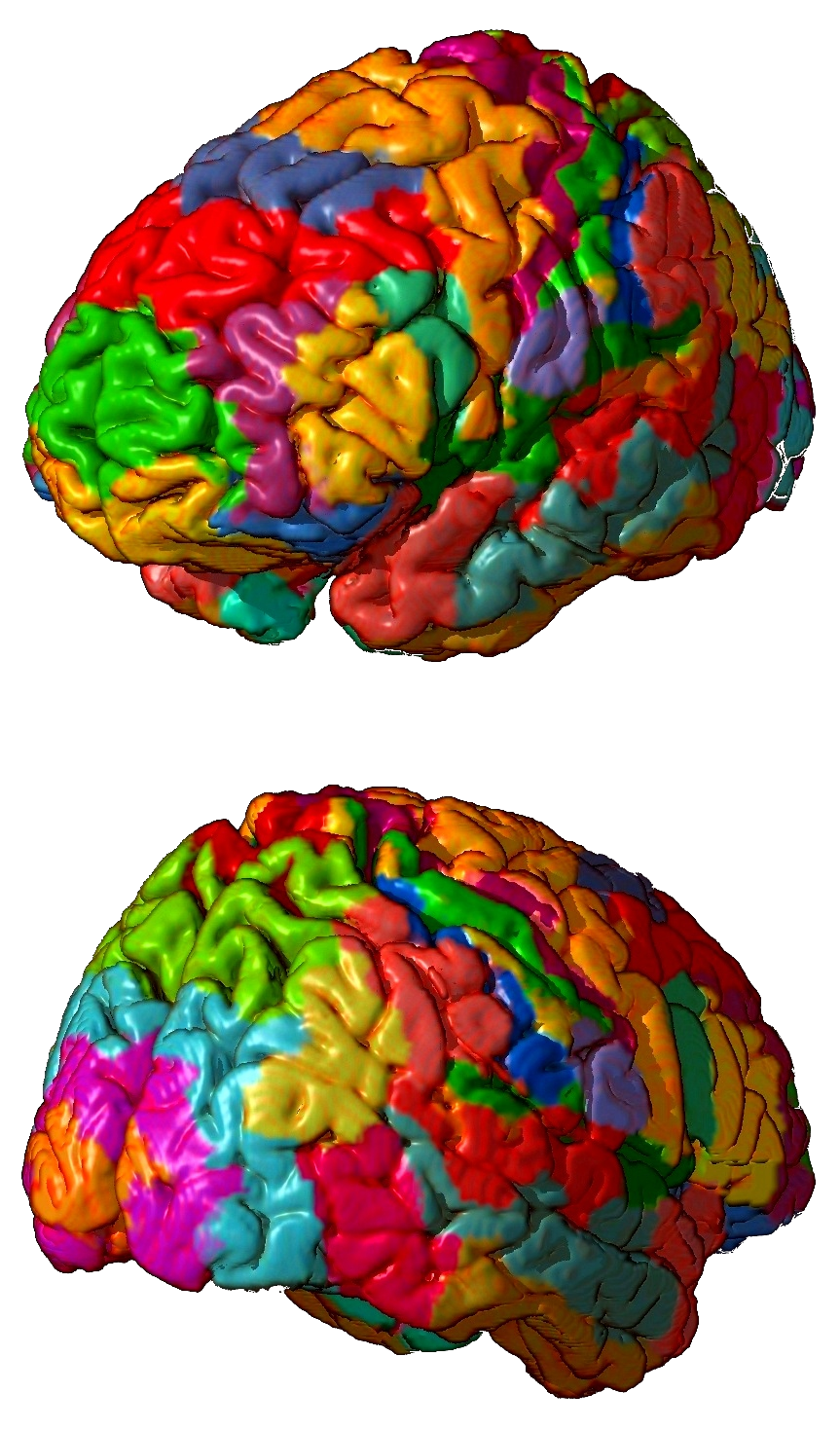

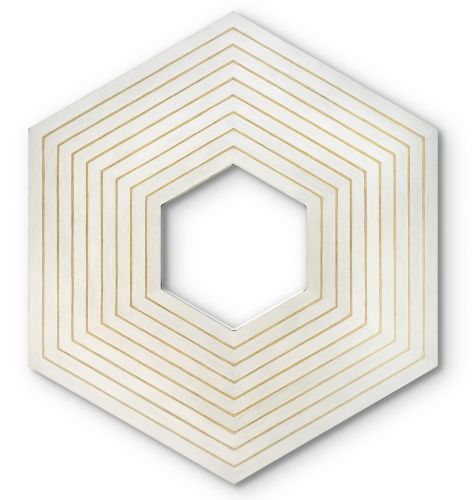

Áreas de Brodman en un cerebro de primate

El cerebro, que se desarrolla a partir del telencéfalo embrionario, es la estructura encefálica de vertebrados que ha alcanzado en mamíferos su máximo desarrollo. Contiene, a su vez, el bulbo olfatorio, los ganglios basales, el hipocampo y la corteza cerebral.

El prosencéfalo de todos los vertebrados posee una estructura en láminas denominada pallium. El pallium de agnatos (lampreas), peces condrictios (tiburones) y anfibios obedece a un esquema básico general, consistente en dos hemisferios unidos por una región denominada septum. Cada uno de los hemisferios asemeja un cilindro formado por tres capas, en cuyo interior quedan cavidades llenas de líquido denominadas ventrículos. La capa que da al ventrículo y la que da al exterior son de materia blanca, y la que queda entre ellas, de materia gris. En el resto de los grupos (peces teleósteos, reptiles, aves y mamíferos) se produce una fuerte modificación del esquema básico, debido al crecimiento diferencial de diferentes zonas del pallium original en cada uno de ellos. En mamíferos se diferencian cuatro zonas en el contorno de la forma cilíndrica antes mencionada, que se denominan pallium dorsal, medio, ventral y lateral, cuyo desarrollo daría lugar, respectivamente, al neocortex, el hipocampo, la amígdala y la corteza olfativa. El neocortex es la región que alcanza un mayor desarrollo de todas ellas.

El cerebro es un órgano con simetría bilateral y su desarrollo en mamíferos da forma a dos mitades o hemisferios cerebrales que, en los placentarios, se encuentran conectadas por el corpus callosum, una especie de “autopista de información” por la que se estima atraviesan unos 300 millones de axones neuronales. Cada hemisferio cerebral consiste en una fina capa de materia gris (corteza o córtex cerebral) que cubre una capa gruesa interna de materia blanca (médula cerebral). En el interior de la materia blanca se encuentra otra región de materia gris, los ganglios basales. La materia gris está formada por cuerpos neuronales empaquetados, sus dendritas y células gliales. La materia blanca está formada por ramos o fascículos de axones cubiertos de vainas de mielina. El color blanco se debe a la vaina de mielina, que está formada por lípidos.

Simplificando, se puede decir que la materia gris procesa la información, o sea, integra inputs de diferentes procedencias y elabora nuevas señales, mientras que la blanca la conduce, esto es, envía las señales a otros destinos. Las fibras de la materia blanca transmiten información de una zona a otra de la corteza o, también, a zonas que no se encuentran en ella. Es así como se produce la integración que permite el procesamiento de las señales que se reciben y la consiguiente elaboración de respuestas.

En los grupos de mamíferos en que alcanza su máximo desarrollo, la corteza cerebral presenta múltiples hendiduras o pliegues, lo que permite que aumente de forma considerable el número de neuronas que alberga. En lo que a su configuración tisular se refiere, es una estructura dispuesta en seis capas (procedentes del pallium dorsal), y se organiza en columnas verticales que se extienden perpendicularmente hasta la materia blanca, a dos milímetros de profundidad desde la superficie de la corteza. Se cree que cada una de esas columnas constituye un “equipo” formado por las neuronas contenidas en ella, cada una de las cuales desempeñaría una función en la tarea propia de la columna. Las diferencias funcionales entre unas y otras columnas tienen su reflejo en diferentes grosores de alguna de las seis capas.

Cada mitad de la corteza cerebral se divide en cuatro lóbulos: occipital, temporal, parietal y frontal, nombres que hacen referencia a los correspondientes huesos del cráneo. Los lóbulos occipitales, que se encuentran en la parte posterior, son los responsables del procesamiento inicial de las señales visuales. La información sonora se recibe, en primera instancia, en los lóbulos temporales, que tienen una disposición lateral a ambos lados de la cabeza. Los lóbulos parietales y frontales se encuentran en la parte superior del encéfalo y están separados por el denominado surco central del cerebro, un pliegue o invaginación profunda que discurre de arriba abajo hacia la mitad de la superficie lateral de cada hemisferio. Los lóbulos parietales quedan en la parte posterior, detrás del surco central, mientras los frontales quedan por delante. Los parietales reciben y procesan la información sensorial. Los frontales desempeñan varias tareas: (1) actividad motora de carácter voluntario; (2) producción vocal en los mamíferos que poseen esta capacidad; y (3) funciones superiores, como planificación y otras.

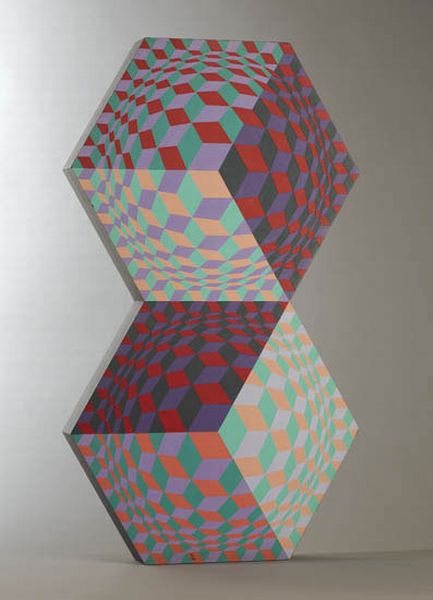

Si bien la descripción de la anatomía cortical por lóbulos resulta útil en una primera aproximación, suele recurrirse a las denominadas “áreas de Brodmann” para una caracterización más precisa. Un área de Brodmann es una región de la corteza del cerebro de primates definida por su estructura histológica, organización celular y citoarquitectura. Hay 52 áreas de Brodmann, aunque alguna está, a su vez, subdividida en dos áreas, y alguna de ellas sólo se halla presente en primates no humanos.

Fuentes:

Eric R. Kandel, James H. Schwartz, Thomas M. Jessell, Steven A. Siegelbaum & A. J. Hudspeth (2012): Principles of Neural Science, Mc Graw Hill, New York

Lauralee Sherwood, Hillar Klandorf & Paul H. Yancey (2005): Animal Physiology: from genes to organisms. Brooks/Cole, Belmont.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas nerviosos: el cerebro de vertebrados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: el sistema central de vertebrados

- Sistemas nerviosos: el sistema periférico de vertebrados

- Sistemas nerviosos: el tálamo y el hipotálamo

Presión y volumen de un gas

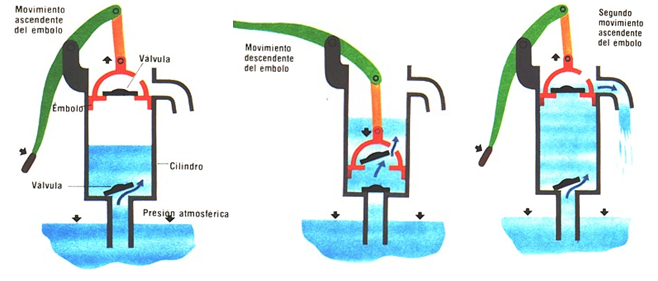

Terminábamos la entrega anterior preguntándonos por qué las bombas de pistón manuales, también llamadas bombas de elevación o aspirantes, no pueden elevar el agua más de 10 metros y cuestionándonos por qué funcionaban. Estas preguntas se resolvieron a lo largo del siglo XVII gracias al trabajo experimental de varios investigadores, entre ellos, Torricelli (un alumno de Galileo), Guericke, Pascal, y Boyle.

Para 1660, estaba bastante claro que el funcionamiento de una bomba de aspirante depende de la presión del aire. Al eliminar un poco de aire por encima del agua por la acción de la bomba, simplemente se reduce la presión en la parte superior del agua que está dentro del tubo sumergido en el pozo. Como inicialmente la presión es la atmosférica, eso quiere decir que la acción de la bomba consigue que ahora haya una presión inferior a la atmosférica por encima de la columna de agua que está en el tubo. Es entonces la presión que ejerce la atmósfera en la masa de agua del pozo la que fuerza a que el agua suba por el tubo hasta que se igualan las presiones (la presión dentro del tubo es ahora la de la columna de agua que está por encima del nivel de la superficie del agua del pozo más lo que quede de presión atmosférica). Una buena bomba puede reducir la presión en la parte superior del tubo a casi cero. La presión atmosférica puede, por tanto, forzar el agua del tubo a elevarse considerablemente por encima del nivel del agua del pozo.

Pero ocurre que la presión atmosférica al nivel del mar no es lo suficientemente grande como para soportar una columna de agua de más de 10 m de altura. Como el mercurio es casi 14 veces más denso que el agua, la misma presión atmosférica solo podría soportar una columna 14 veces más pequeña, esto es, de aproximadamente 0.76 m (760 mm). Resulta que esta altura está muy bien para construir un instrumento con el que medir la presión atmosférica.

Por lo tanto, gran parte de la investigación del siglo XVII sobre la presión atmosférica se realizó con una columna de mercurio, un barómetro de mercurio. Torricelli diseñó el primero de estos barómetros. La altura de la columna de mercurio que puede ser soportada por la presión del aire no depende del diámetro del tubo, es decir, no depende de la cantidad total de mercurio, sino sólo de su altura. Esto puede parecer extraño al principio. Para entenderlo, debemos considerar la diferencia que existe entre presión y fuerza. La presión se define como la magnitud de la fuerza (F) que actúa perpendicularmente (esto lo indicamos con el símbolo ┴ como subíndice) sobre una superficie dividida por el área (A) de esa superficie, P = F┴ / A , y se mide, por tanto, en N/m2.

Por lo tanto, una fuerza grande puede producir una presión pequeña si se distribuye por un área muy grande. Por ejemplo, se puede caminar sobre la nieve sin hundirse en ella si se emplean raquetas de nieve Por otra parte, una pequeña fuerza puede producir una gran presión si se concentra en un área pequeña. El tacón de los zapatos de tacón de aguja puede producir una presión enorme, mayor que la hay debajo de la pata de un elefante; de hecho, pueden perforar suelos de madera y alfombras con mucha facilidad.

En definitiva, la medida de la presión no se ve afectada por el área de la sección transversal del tubo del barómetro ni por el peso (que es una fuerza) de la masa de mercurio en la columna, porque la presión es precisamente el cociente entre las dos. En una columna de mercurio que pese el doble que otra porque el tubo sea el doble habrá la misma presión porque el área será también el doble.

Este tipo de variables que no dependen de la masa se llaman intensivas. Existe otro tipo de variables, las llamadas extensivas que si dependen de la cantidad de materia, como el volumen. Pero sabemos que si aumentamos la presión, por ejemplo soplando más en un globo, el volumen puede aumentar. Es muy interesante esta relación de propiedades intensivas y extensivas.

En 1661, dos científicos ingleses, Richard Towneley y Henry Power, descubrieron una importante relación básica. Encontraron que en un globo de paredes delgadas, la presión ejercida por un gas es inversamente proporcional al volumen ocupado por ese gas. Duplicar la presión (al dejar entrar más gas) duplicará el volumen del globo. Usando P para la presión y V para el volumen, esta relación es P = a /V, donde a es una constante de proporcionalidad; también lo podemos escribir, P·V = a .

Si el volumen de una cantidad dada de aire en un globo es reducido a la mitad (por ejemplo, comprimiéndolo), la presión ejercida por el gas en el interior se duplica. Por otro lado, si se dobla el volumen del recipiente cerrado con una cierta cantidad de aire dentro, la presión interior se reduce a la mitad. Robert Boyle confirmó esta relación mediante multitud de experimentos. Es una regla empírica, ahora generalmente conocida como la ley de Boyle. Sin embargo, la ley se aplica exactamente sólo bajo condiciones especiales, como veremos.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Presión y volumen de un gas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El encéfalo humano

El encéfalo de un ser humano adulto tiene una masa de entre 1,2 kg y 1,4 Kg, lo que representa alrededor de un 2% de la masa corporal total. Su volumen viene a ser de 1260 cm3 en los hombres y 1130 cm3 en las mujeres, aunque hay una gran variabilidad entre individuos. A pesar de representar un 2% de la masa corporal, consume alrededor de un 20% de la energía que gasta todo el organismo.

Ese gasto energético tan alto tiene su origen en la frenética actividad que desarrollan las aproximadamente noventa mil millones de neuronas que posee. Cada neurona mantiene con las vecinas del orden de cinco mil conexiones sinápticas. El número total de tales conexiones se encuentra, quizás, entre 2 x 1014 y 3 x 1014. Un encéfalo normal puede establecer y deshacer un millón de conexiones por segundo.

Hace uso de un conjunto de sensores capaces de recibir información en forma de variaciones de presión, radiaciones electromagnéticas y sustancias químicas. Los propios sensores convierten esa información en señales bioeléctricas que consisten en despolarizaciones transitorias, de magnitud constante, que se desplazan con frecuencias variables a lo largo de las membrana de las neuronas que conectan los sensores con el encéfalo. Éste, una vez recibidas, filtra y prioriza las señales en función del interés de la información que contienen o del peligro que indican. Y a partir de esa información y de la que posee almacenada en sus circuitos, reconstruye –o recrea- el entorno en el que se encuentra. Siempre que el cuerpo aguante, puede almacenar información durante un siglo, catalogándola automáticamente y editándola cuando se necesita. De hecho, modifica esa información cualitativa y cuantitativamente cada vez que accede a ella, y construye a partir de ella un “yo” cada vez que se hace consciente al despertar.

Gobierna un sistema de mensajería química de gran complejidad y coordina la actividad de al menos sesicientos músculos. Mediante esas herramientas se ocupa de organizar el procesamiento de energía, de gobernar las actividades conducentes a la reproducción del organismo en el que se encuentra y, por supuesto, de preservar su misma existencia, aunque a esta último fin dedica normalmente un esfuerzo mínimo.

El resto de su capacidad la dedica a relacionarse con otros encéfalos, valorar el sentido de la existencia y aprender de la experiencia y de semejantes a los que ni siquiera ha llegado a conocer.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El encéfalo humano se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Cuando en Venus es de noche el caos atmosférico aumenta

Venus, considerado durante mucho tiempo el planeta gemelo de la Tierra, es, sin embargo, un infierno comparado con nuestro planeta, con temperaturas en la superficie superiores a los 450ºC, una atmósfera aplastante y densas nubes de ácido sulfúrico que cubren todo el planeta.

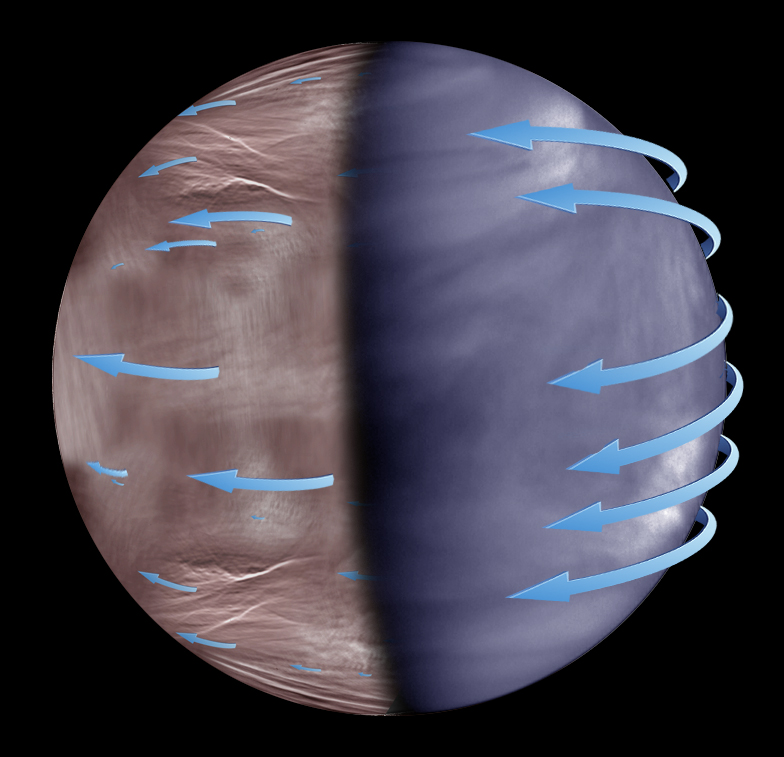

Esquema de la superrotación atmosférica de Venus en las nubes superiores. Mientras que la superrotación es más uniforme en el lado diurno de Venus (imagen tomada por la nave Akatsuki, derecha), en la noche esta se vuelve más caótica e impredecible (imagen tomada por Venus Express, izquierda). CRÉDITOS: ESA-NASA-JAXA-UPV/EHU.

En los años 60, observaciones en luz ultravioleta permitieron medir con precisión los movimientos de las nubes en el lado diurno de Venus, resultando en vientos de más de 360 km/h. Esto fue toda una sorpresa porque tanto en la Tierra como en otros planetas semejantes como Marte, la atmósfera rota a un ritmo parecido al del planeta. En Venus, sin embargo, la atmósfera completa una vuelta alrededor del planeta en apenas 4 días mientras que el planeta –mucho más lento– tarda 243 días en girar sobre sí mismo. A esta rotación rápida de la atmósfera se le conoce como “superrotación” y los mecanismos físicos que la generan son todavía desconocidos. Hasta el momento no se sabía cómo se comportaba esta circulación atmosférica en el lado nocturno del planeta. Ahora, un trabajo encabezado por astrónomos españoles en el que participan la Agencia Aeroespacial Japonesa (JAXA), la Universidad del País Vasco (UPV/EHU), el Instituto de Astrofísica y Planetología Espacial (IAPS, Italia), el Instituto Nacional Japonés de Ciencia y Tecnología Industrial Avanzada (AIST), y la Universidad Técnica de Berlín, entre otros, desvela que el comportamiento de los vientos en la noche de Venus es marcadamente diferente al del que se encuentra de día.

“Saber de dónde saca la energía la atmósfera de Venus para tener esta ‘superrotación’ continúa siendo un misterio, y los modelos numéricos siguen sin lograr simulaciones realistas del planeta”, señala Javier Peralta, miembro de la misión espacial japonesa Akatsuki en JAXA y doctorado en la UPV/EHU que lidera este estudio publicado en Nature Astronomy y destacado por la revista en su sección News & Views. “El problema es que habíamos asumido, erróneamente, que en la noche de Venus ocurre lo mismo que en el día, ya que hasta ahora no éramos capaces de ver claramente cómo era la superrotación atmosférica en el lado nocturno del planeta.”

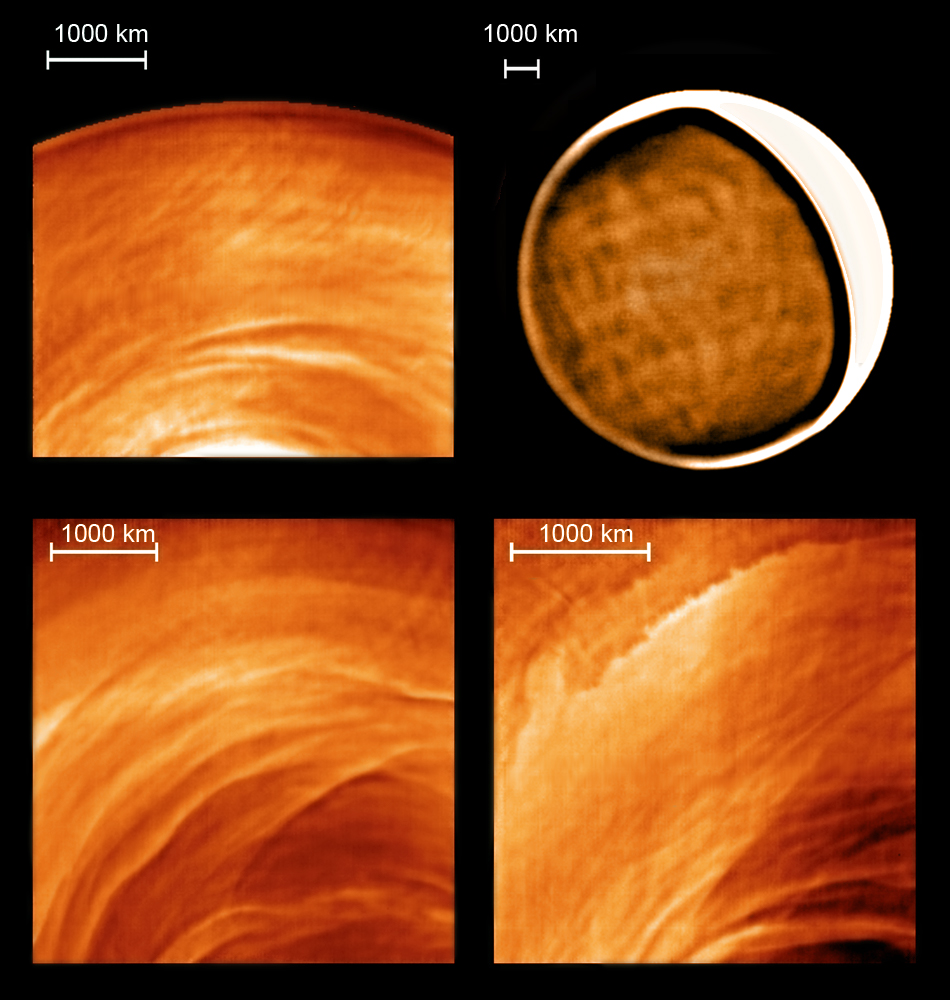

Ejemplos de los tipos de nubes observados en la noche de Venus en imágenes térmicas tomadas por Venus Express y con el telescopio IRTF de NASA en Hawaii: ondas estacionarias (Venus Express, arriba izquierda), patrones de “red” (IRTF, arriba derecha), misteriosos filamentos (Venus Express, abajo izquierda) e inestabilidades de origen dinámico (Venus Express, abajo, derecha). (Fotos: ESA-NASA-JAXA-UPV/EHU)

“A unos 70 km de altura se encuentran las nubes más altas de Venus, precisamente donde la superrotación es más intensa. Estas nubes pueden observarse por la noche, gracias a su emisión térmica, pero las imágenes de misiones espaciales anteriores apenas mostraban detalles en ellas”, comenta Ricardo Hueso, investigador de la UPV/EHU. Gracias a nuevas técnicas de procesado de imágenes este equipo internacional de investigadores de España, Japón, Alemania e Italia ha descubierto que tanto las nubes nocturnas como sus movimientos se diferencian de las observadas durante el día. El estudio se basa en el análisis de observaciones efectuadas por el instrumento VIRTIS a bordo de la misión espacial Venus Express de la agencia espacial europea ESA, que orbitó el planeta desde 2006 hasta el año 2014, con el apoyo de observaciones independientes efectuadas en 2015 por un equipo japonés usando el telescopio IRTF de NASA en Hawaii, que han permitido observar también el hemisferio norte del planeta.

“Si bien la superrotación se mantiene en la noche, esta parece mucho menos ‘uniforme’ que durante el día, con una rica variedad de movimientos y con tipos de nubes que nunca habíamos visto que sufren cambios drásticos e impredecibles de un día para otro”, apunta Agustín Sánchez Lavega director del Grupo de Ciencias Planetarias de la UPV/EHU.

Imagen de gran campo del lado nocturno de Venus mostrando emisiones térmicas de la atmósfera superior del planeta (Venus Express). CRÉDITOS: ESA-UPV/EHU

Pero la mayor sorpresa fue encontrar abundante estructuras en las nubes que no se mueven, lo que ha sido interpretado por el equipo como un tipo de ondas atmosféricas llamadas “estacionarias”. Estas ondas son semejantes a otro fenómeno ondulatorio en la atmósfera de Venus encontrado recientemente por la misión espacial japonesa Akatsuki, una onda estacionaria de miles de kilómetros que se localiza encima de las tierras altas de “Aphrodita Terra”. En este nuevo estudio las ondas estacionarias tienen tamaños muchos más pequeños, de centenares de kilómetros, y se localizan también en las posiciones geográficas donde hay zonas elevadas de la superficie. Dado que estas ondas se suelen formar cuando el viento en superficie encuentra obstáculos como una montaña, verlas constantemente es paradójico, pues la superficie de Venus es muy poco accidentada.

Se espera que con las observaciones que la nave Akatsuki está realizando en órbita alrededor de Venus, junto con el apoyo de observaciones desde Tierra, se pueda arrojar luz sobre un desafío que dura ya más de 60 años: el misterio de la superrotación en la atmósfera de Venus.

Referencia bibliográfica

J. Peralta, R. Hueso, A. Sánchez-Lavega, Y. J. Lee, A. García-Muñoz, T. Kouyama, H. Sawada, T. M. Sato, G. Piccioni, S. Tellmann, T. Imamura, T. Satoh. “Stationary waves and slowly moving features in the night upper clouds of Venus”. Nature Astronomy. DOI: 10.1038/s41550-017-0187.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU KomunikazioaEl artículo Cuando en Venus es de noche el caos atmosférico aumenta se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sorpresas en la atmósfera del polo sur de Venus

- NASA, ¿cuándo vas a llevarnos a Venus en un barco (o en lo que sea)?

- Los volcanes de Venus

El caso de Julius Lederer (y del agua que bebemos)

Julius Lederer

Esta es la historia de Julius Lederer. Había nacido en Bornheim, Alemania, en 1980 y llegó a España, a A Coruña, en 2006. Estaba en contacto con su familia en Alemania y le pasaban una pensión pero pronto comenzó a vivir en la calle, siempre con su mochila y bien vestido. Poco a poco lo perdió todo, la mochila y la ropa y se cubría solo con una manta y unas bolsas de basura. Su olor era espantoso, pedía en la calle y, con el dinero que obtenía, compraba comida en los supermercados. Era tranquilo, pacífico y poco hablador; no quería tratos con nadie. Años más tarde, en 2011, y tras pasar por varios pueblos y ciudades de A Coruña y de la costa de Lugo, fue ingresado por orden judicial en el Área de Psiquiatría del Hospital de Lugo. A pesar del tratamiento, a los dos meses y con solo 31 años, murió.

No hay constancia oficial pero parece que falleció de potomanía, es decir, de consumo excesivo de agua. Los que le conocían de su vida en la calle no habían notado que bebiese agua en exceso. Sus familiares declararon que odiaba los fármacos y creen que, para eliminar de su organismo la medicación que le administraban en el hospital, bebía hasta diez litros de agua al día. Con tanta agua quizá eliminó los medicamentos pero también diluyó su medio interno, quizá provocó hiponatremia, o sea, un concentración en sangre de sodio demasiado baja, y esa fue la causa de su muerte.

Para conocer más la historia de Julius les recomiendo el documental “El mundo tras Julius”.

El mundo tras Julius (Documental completo en castellano) from FlyingRatProductions on Vimeo.

Pasemos ahora a la bibliografía científica sobre el consumo de agua. Hay que beber ocho vasos de agua al día. Esta es la recomendación que aparece todos los años en cuanto arrecia el calor. Dicen que es bueno o, más bien, indispensable para nuestra salud. Y, sin embargo, es un mito de esos tan habituales que tardan mucho tiempo, y mucha tinta, en desaparecer. O que parece no desaparecer nunca. Nos cuenta Aaron Carroll, de la Universidad de Indiana en Indianápolis, en un artículo en el British Medical Journal y en el diario El País, que todo comenzó en 1945 en una publicación del Consejo de Alimentación y Nutrición de Estados Unidos. Allí se decía que

“Water. A suitable allowance of water for adults is 2.5 liters daily in most instances. An ordinary standard for diverse persons is one milliliter for each calorie of food. Most of this quantity is contained in prepared foods… Water should be allowed ad libitum, since sensations of thirst usually serve as adequated guides to intake except for infants and sick persons.”

Por tanto, “las personas necesitan unos 2.5 litros de agua al día”. Pero a la cita nunca se le añade el párrafo que seguía y que precisaba que “la mayor parte de esta cantidad está en los alimentos”. O sea, que no hay que traducir los 2.5 litros de agua en ocho vasos de unos 250 mililitros puesto que ya tomamos el líquido necesario con los alimentos. Beba cuando tenga sed, pero no exceso pues, como veremos ahora, demasiada agua es peligrosa. En fin, beba con sed y deje de beber cuando se le quite la sed.

El control de la sed viene del mecanismo que la evolución ha seleccionado para controlar el volumen de los fluidos internos y, sobre todo, de la concentración de iones y, más en concreto, del sodio. Si hay poco sodio se provoca la hiponatremia, y pueden aparecer síntomas como letargia, náuseas, convulsiones e, incluso, el coma y la muerte.

En febrero de 2015 se reunieron en Carlsbad, California, un grupo de 17 expertos en hiponatremia provocada por la toma excesiva de agua, sobre todo por la sed provocada por un intenso ejercicio físico. Entre los participantes en carreras de fondo, sea atletismo o ciclismo, la pérdida de fluidos provoca sed y, habitualmente, se toma mucho agua, casi siempre con iones, para reponer líquidos y iones. Pero se debe controlar la cantidad del líquido ingerido pues es frecuente que, al final de estas carreras, puede ocurrir que la mitad de los participantes presenten síntomas de hiponatremia por toma excesiva de agua. Así, los expertos recomiendan que, en carreras largas, los espacios habilitados para proporcionar líquidos a los atletas queden lo suficientemente espaciados como para evitar el consumo excesivo de agua.

Sin embargo, como cuentan Pascal Saker y sus colegas, de la Universidad de Melbourne, no conocemos con exactitud el mecanismo de ajuste entre la desaparición de la sed después de haber bebido y la cantidad de agua ingerida. En algún momento, al beber, la sed es reemplazada por la saciedad y, entonces, se deja de beber. Incluso se ha medido que el líquido que se toma se ajusta a la cantidad perdida que ha provocado la sed. Pero, repito, no se conoce el mecanismo que hace que nos sintamos saciados y ya no tengamos sed.

La sed la provocan señales de deshidratación en las células, los cambios en las concentraciones de diversas moléculas en la sangre y la pérdida de líquidos en el exterior de las células. Son varios mecanismos que, a su vez, provocan el funcionamiento de un sistema de hormonas con renina y angiotensina que controla la cantidad de fluidos corporales. Así se provoca la sed y es un mecanismos relativamente conocido y, por el contrario y como ya he mencionado, el proceso por el que desaparece la sed no lo es tanto. Parece que se relaciona con la sensación de sequedad en la boca y con los cambios que provoca en esa sensación el beber agua. Para estudiar si hay otros mecanismos, el grupo de Pascal Saker obtiene imágenes de resonancia del cerebro de voluntarios con sensación de sed cuando beben agua.

Las áreas del cerebro que se activan tienen que ver con la inhibición del proceso de tragar y con los músculos de la boca y la faringe que actúan para tragar. Trabajan con 20 voluntarios, con 7 mujeres, una edad media de 30 años y un rango de 25 a 45 años. Los investigadores provocan la sed en los voluntarios con una hora de ejercicio físico intenso en bicicleta estática y, después, se auto puntúan la sed que sienten de 0 a 10. A continuación, beben agua y se les hace la resonancia del cerebro.

La inhibición de tragar activa la corteza motora, la corteza prefrontal, la zona parietal posterior y el tálamo. Sobre todo se activa la corteza prefrontal del hemisferio derecho. Y cuando se bebe en exceso, por encima de la sensación de sed, la respuesta cerebral para inhibir el tragar es tres veces más fuerte que la respuesta habitual. El cerebro avisa de que tanto líquido no es necesario y que hasta puede ser un riesgo.

En conclusión, cuando se tiene sed y se bebe agua para quitar esa sensación incómoda, una de las primeras respuestas es inhibir la acción de tragar con lo que, en consecuencia, se deja de beber. Esta acción se localiza con más potencia en la corteza prefrontal del hemisferio derecho. Así se evita la toma excesiva de líquido que puede provocar la potomanía y la hiponatremia.

Y, ahora, veamos cómo, a menudo, cuesta tiempo y energía conseguir agua para aplacar la sed. A pesar de los progresos de las últimas décadas para conseguir el acceso de la población al agua potable, todavía 4000 millones de personas, más o menos dos tercios de la población mundial, sufren escasez de agua. En 2015 se estimó que más de 600 millones seguían sin disponer de agua limpia. Muchos hogares con acceso al agua deben ir a buscarla al pozo, la fuente, el río o cualquier otro lugar que proporcione agua potable o, por lo menos, que se pueda considerar más o menos limpia. Para aceptar que existe un acceso básico al agua, Jay Graham y su grupo, de la Universidad George Washington, en Estados Unidos, proponen que la condición es que se pueda ir a por agua y volver con ella al hogar en menos de media hora. Pero, añaden, muchos hogares necesitan dedicar más tiempo a buscar agua. Lo analizan en 24 países africanos del sur del Sáhara y estudian cómo se organizan en el hogar para traer el agua. Toman los datos de varias encuestas internacionales hechas sobre el terreno en los años 2005 y 2012.

En todos los países analizados, son mayoría las mujeres adultas que tiene que ir a por el agua para el hogar, con el mínimo en Liberia con el 46% de las mujeres y el máximo en Costa de Marfil con el 90%. Detrás se sitúan las niñas que, también en todos los países, superan a los niños, con una media del 62% para las niñas y el 38% para los niños. Hay seis países en que son los niños y niñas los que van a por el agua más que los adultos: Burundi, Camerún, Etiopía, Mozambique, Níger y Nigeria.

La escasez de agua en el hogar, la dificultad para conseguirla y la distancia a recorrer provocan inseguridad y estrés. Lo han medido Edward Stevenson y su grupo, del Colegio Universitario de Londres, en tres aldeas de Etiopía en las que una ONG ha construido aljibes para almacenar agua en la estación de lluvias y poder utilizarla en la estación seca. El estudio se hizo en marzo y abril de 2013 y de 2014. Otras tres aldeas cercanas, sin aljibes construidos, sirvieron como control.

Los resultados demuestran que el estrés en las mujeres, las encargadas de buscar el agua, es la mitad si disponen de agua en los aljibes respecto a las mujeres de las aldeas sin aljibes. Además, aumenta la cosecha y su calidad, otro posible factor estresante para estas mujeres, pues da seguridad tener alimentos para la familia e, incluso, la calidad y cantidad de la cosecha mejora su estatus socioeconómico.

En muchos países con dificultades para tener agua para el hogar, como hemos visto, son las mujeres las encargadas de conseguirla y su lucha para mejorar esa disponibilidad viene de hace tiempo. Por ejemplo, en 1991 Brinda Rao, de la Universidad de California en Santa Cruz, publicó un resumen de lo que había ocurrido en Maharashtra, en la India.

Cuenta que años antes, en 1972, un miembro del gobierno declaró que los 230000 pueblos del país sin agua potable ya la tendrían si fueran los hombres los encargados de llevarla a casa. En la India, como en África, el agua para el hogar es “cosa de mujeres”. Así es, y sobre todo en las zonas rurales, agua y mujeres son asuntos relacionados. Es en el norte de África, pero está muy bien contado en la película “La fuente de las mujeres”. Merece la pena verla.

Lo habitual es que las mujeres, de media, dediquen de tres a cinco horas al día para acarrear agua hasta el hogar aunque, además, y con las estadísticas de aquellos años, las mujeres hagan el 46% de todo el trabajo de la unidad familiar rural. Aunque, y es costumbre habitual, todo ello es el trabajo invisible de las mujeres. No se refleja en las estadísticas oficiales y, por tanto, es un problema sin visibilidad y no existe y, en consecuencia, no necesita soluciones.

En aquellas décadas de los setenta y ochenta, las soluciones no tenían en cuenta a las mujeres. La experiencia más innovadora en relación con el abastecimiento de agua fue la creación de cooperativas que se encargaban de su suministro y distribución. En la dirección de estas cooperativas había un consejo con un representante por cada hogar que era, por supuesto, un hombre. A pesar de esta falta de participación de las mujeres, Brinda Rao explica que en las aldeas con cooperativa, las mujeres se veían liberadas, en gran parte, del acarreo del agua hasta el hogar, lo que implica más tiempo para otras cosas, más seguridad, menos estrés y menos subordinación a las labores diarias.

Referencias:

Carroll, A.E. 2015. No, no tienes que beber ocho vasos de agua al día. El País, 28 agosto.

Graham, J.P. et al. 2016. An analysisis of water collection albor among women and children in 24 sub-Saharian African countries. PLOS ONE 11: e155981

Hew-Butler, T. et al. 2015. Statements of the 3rd International Exercise-Associated Hyponatremia Consensus Development Conference, Carlsbad, California, 2015. British Journal of Sports Medicine 49: 1432-1446.

National Research Council. 1945. Recommended dietary allowances. Revised 1945. Reprint and Circular Series 122, August 1945. Washington DC. 19 pp.

Rao, B. 1991. Las lucha por las condiciones de producción y la producción de las condiciones para la emancipación: las mujeres y el agua en Maharashtra, India. Ecología Política 1: 32-32.

Saker, P. et al. 2016. Over drinking, swallowing inhibition, and regional brain responses prior to swallowing. Proceedings of the National Academy of Scioences USA 113: 12274-12279.

Stevenson, E.G.J. et al. 2016. Community wáter improvement, household water insecurity, and women’s psychological distress: An interpretation and control study in Ethiopia. PLOS ONE 11: e153432

Vázquez Taín, J.A. 2015. Matar no es fácil. Espasa. Madrid. 288 pp.

Vreeman, R.C. & A.E. Carroll. 2007. Medical myths. British Medical Journal 335: 1288-1289.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo El caso de Julius Lederer (y del agua que bebemos) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La distribución del agua animal y el curioso caso del potasio

- El caso de Rin Tin Tin y sus amigos

- El caso de la mujer barbuda

Arte & Ciencia: ¿Qué interés puede tener para los artistas el trabajo de un científico?

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Jornada 4. 3ª conferencia.