La carrera de obstáculos para el diagnóstico de la endometriosis

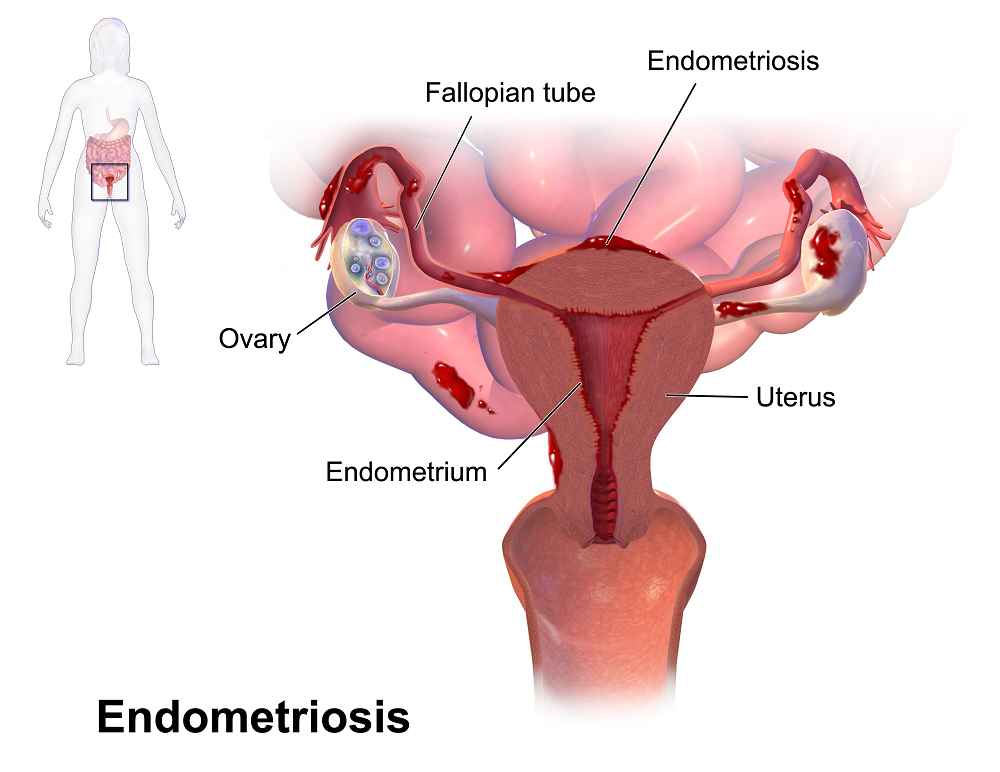

La endometriosis es una dolencia crónica muy frecuente en las mujeres. Se estima que una de cada diez está afectada por ella, lo que supone un total de más de 2 millones de casos en España. En todo el mundo, se estiman alrededor de 190 millones de mujeres afectadas. No obstante, su causa es desconocida: ¿por qué el tejido endometrial, que normalmente recubre el interior de la superficie del útero, empieza a crecer en lugares tan extraños como la vejiga, el ovario o el recto? A día de hoy, la respuesta es todo un misterio y la limitada investigación científica que se ha realizado sobre esta dolencia no ayuda a resolverlo.

Fuente: Wikimedia Commons8 años para el diagnóstico

Fuente: Wikimedia Commons8 años para el diagnóstico

A pesar de que la endometriosis es muy frecuente, se puede tardar más años en diagnosticar esta dolencia que una enfermedad rara. Tanto es así que las pacientes que sufren endometriosis tienen que esperar una media de 7- 8 años para la identificación de su enfermedad, según datos del Ministerio de Sanidad . Este gran retraso en el diagnóstico no es un fenómeno aislado en nuestro país, sino generalizado a lo largo del mundo.

La larga espera para recibir un diagnóstico implica consecuencias para las mujeres, que pueden sufrir incomprensión y estigmatización durante años por una afectación sin etiqueta médica. Durante todo ese tiempo, aquellas que no reciben tratamiento deben soportar diversos síntomas (especialmente dolor, fatiga y dificultades para conseguir un embarazo) que, en los casos más graves, pueden afectar de forma importante a su calidad de vida, al trabajo y a las relaciones sociales. Además, la enfermedad puede progresar a lo largo de dicho periodo. Las causas que están detrás de este retraso diagnóstico son múltiples y no se comprende bien en qué medida contribuyen a ello. Recientemente, científicos de la Universidad de Aston (Inglaterra) han publicado en la revista Obstetrics & Gynaecology los resultados de su investigación sobre cómo diferentes factores contribuyen en retrasar el diagnóstico de la endometriosis.

El estudio, que consiste en una revisión sistemática y un análisis cualitativo del asunto, examinó un total de 13 artículos científicos realizados en los últimos 20 años en países ricos (con asistencia sanitaria universal en su mayoría). Los factores que contribuyen al retraso del diagnóstico de la endometriosis se relacionan con las características del sistema sanitario y de la endometriosis, así como también por las influencias interpersonales y los rasgos individuales. Los autores clasificaron en 4 grupos las barreras que impiden un diagnóstico temprano de dicha dolencia:

- La dificultad para distinguir los síntomas patológicos de la menstruación normal y el uso de técnicas de autocuidado.

- El estigma de la menstruación y la normalización del dolor menstrual.

- Ciertas actitudes y falta de conocimiento de los profesionales sanitarios, retraso en la derivación a los especialistas y explicaciones deficientes sobre el uso de las pastillas anticonceptivas orales en el proceso diagnóstico.

- Variabilidad en la presentación de los síntomas, que se solapan con otras dolencias, la ausencia de un método no invasivo de diagnóstico de la endometriosis y preocupaciones sobre la importancia del diagnóstico.

Un hallazgo llamativo fue que muchos médicos de familia, en varios de los estudios analizados, reconocían saber poco sobre la endometriosis. Esto, unido a los síntomas variables, poco específicos, que pueden aparecer por esta dolencia (diarrea, estreñimiento, reglas intensas, fatiga crónica, dolor durante el sexo, urgencia para orinar…) complica su diagnóstico. Por otro lado, muchas mujeres que padecían endometriosis y un porcentaje importante de los médicos de familia normalizaban el dolor por esta enfermedad, achacándolo a la regla y no a un problema de salud, lo que impedía investigar en profundidad el origen de este. En su lugar, las mujeres recurrían a medidas de autocuidado para aliviar el dolor, asumiendo que este sufrimiento era inherente a la regla y algo que debían soportar.

Identificar los diferentes factores que contribuyen al retraso diagnóstico de la endometriosis es un primer paso para tomar medidas al respecto. Además, difundir información sobre la endometriosis, derribando sus mitos, al público general puede contribuir a minimizar dicho retraso por una mejor comprensión del problema. En ese sentido, Sophie Davenport, responsable principal del estudio, explica que «la sociedad ha normalizado tradicionalmente el dolor menstrual, así que tenemos que repensar qué significan menstruaciones anormales. Si los síntomas afectan a la vida diaria, y la mujer no acude al trabajo o a la escuela, o es incapaz de continuar con su vida social, eso es un claro signo de que se necesita intervención médica». La experta espera que el artículo científico «anime a las pacientes a buscar ayuda si sienten que sus reglas son anormales o que les provocan un dolor o un sufrimiento importante, y que anime a los clínicos a tomar en serio sus preocupaciones y a derivar al especialista de forma temprana».

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo La carrera de obstáculos para el diagnóstico de la endometriosis se ha escrito en Cuaderno de Cultura Científica.

Salud Global

Las enfermedades tienen su ecología. El de la borreliosis de Lyme es un ejemplo magnífico. El aumento de la temperatura hace las delicias de las garrapatas, ya que su supervivencia y velocidad de desarrollo son más altas a temperaturas elevadas. A estos ácaros hematófagos se les da bien parasitar ratones de campo; al alimentarse de su sangre les inoculan bacterias del género Borrelia. Además, las bellotas también abundan más en años de inviernos suaves y primaveras benignas, de manera que las poblaciones de roedores también progresan; ambos fenómenos –crecimiento rápido de garrapatas y mayor abundancia de bellotas– facilitan que las garrapatas se multipliquen y expandan. Y, con ellas, las bacterias.

De esa forma, los años de bonanza para los ratones, también lo son para las garrapatas y para las bacterias. Pero son años malos para las personas que frecuentan los bosques y campos de las zonas templadas. A las garrapatas no solo les gusta la sangre de los ratones, también les gusta la sangre de otros mamíferos, incluida la humana, por lo que en los años de invierno suave y primavera benigna, al haber más ratones (porque han comido más bellotas) y más garrapatas (porque han sobrevivido al invierno en mayor número), es más probable que les pique uno de esos detestables ácaros y les transmita la bacteria que provoca una enfermedad –borreliosis de Lyme– que puede revestir cierta gravedad.

Otro magnífico ejemplo de ecología de una enfermedad es el de la cadena que forman cinco especies pertenecientes a taxones de lo más diversos. El hongo Batrachochytrium dendrobatidis provoca a los anfibios una quitridiomicosis que diezma sus poblaciones. Como consecuencia de la menor abundancia de anfibios, disminuye la presión sobre los mosquitos del género Anopheles. Estos son el vector que transmite el protozoo del género Plasmodium a los seres humanos y les provocan la malaria. Por tanto, cualquier factor que favorezca la expansión del hongo en una zona donde la malaria sea endémica, provocará, automáticamente, una aumento de la prevalencia de esta enfermedad. Hay condiciones ambientales sobre las que no se puede actuar, pero sobre otras si es posible. Por ejemplo, cualquier medida que se revele eficaz para dificultar la expansión del hongo, redundará en una menor incidencia de la malaria.

Estos no son más que dos casos que ejemplifican la forma en que interactúan diferentes organismos de manera que dan lugar a que exista una relación íntima entre la salud de los ecosistemas, la de los seres vivos que los pueblan y la de los seres humanos. Y es por esa imbricación por lo que durante los últimos años ha venido ganando peso la noción “Salud Global” (“One Health”).

Salud GlobalMediante la expresión “One Health” se quiere expresar, precisamente, que no es posible tratar de resolver de manera duradera algunos de los más importantes problemas de salud cuya resolución afronta la humanidad sin tener en cuenta la intrincada red de relaciones que hay entre los seres vivos y el modo en que la salud humana depende de la de aquellos y de un normal y saludable funcionamiento de los ecosistemas.

Y ese es, precisamente el tema que han decidido desarrollar el microbiólogo Ignacio López-Goñi, la viróloga veterinaria Elisa Pérez-Ramírez y el farmacólogo Gorka Orive en su libro “Salud Global”.

Tras presentar el tema en su primer capítulo, los autores abordan, en el segundo, la relación entre el clima y la salud humana a través, principalmente, de los efectos de aquel sobre las posibilidades de expansión de las enfermedades infecciosas. Al fin y al cabo, la humedad y la temperatura tienen claros efectos sobre los seres vivos, por lo que el clima, a través de esas dos variables, ejerce una influencia intensa sobre la biología de las especies y las relaciones entre ellas.

Por otro lado, es muy significativo –y de importancia crucial– que un 60% de las enfermedades infecciosas humanas que se conocen tengan origen animal; y ese porcentaje se eleva a un 75% en el caso de las enfermedades emergentes. Por esa razón es importante no perder de vista que las actuaciones humanas que modifican el patrón de comportamiento de otras especies –cambios en las rutas migratorias de aves, alteraciones en la densidad de poblaciones de roedores, reducción de la distancia de los seres humanos a otros animales, salvajes o domésticos, y otras– también cambian las condiciones para que se produzca la transmisión de patógenos entre ellas.

Amenaza para la salud humanaEn los capítulos que siguen, los autores repasan la situación de las enfermedades infecciosas y los patógenos que las provocan que suponen una mayor amenaza para la salud humana: el VIH, la malaria, la viruela del mono, las que se transmiten a través del agua o el aire, la gripe aviar y las que provocan los coronavirus. De cada una de ellas se ofrece información muy actual acerca de su extensión de su forma de transmisión, de su prevención y de su tratamiento.

También se analiza el papel de los vectores que transmiten y propagan enfermedades; el papel de otras especies animales como fuente de los patógenos que amenazan nuestra salud (roedores, insectos y otros), así como la forma en que nosotros mismos –los seres humanos– podemos transmitir patógenos a otras especies. Finalmente, se aborda la espinosa cuestión de la resistencia a los antibióticos, así como el papel de las vacunas –cuando se dispone de ellas– como mecanismo efectivo para prevenir las enfermedades infecciosas.

En resumen, el lector o lectora de este libro se encontrará con un repaso muy completo de la compleja relación entre el medio ambiente, los microorganismos patógenos y la salud humana. El libro expone con claridad y profusión de datos la gran importancia de abordar estas relaciones de forma holística, porque no es realista pensar que la solución a los grandes retos de salud que se nos presentan pueden ser abordados fuera de su contexto ambiental global.

Nota final: Si tiene usted interés en información adicional, la puede encontrar en este artículo firmado por los tres coautores del libro.

Título: Salud Global. La nueva estrategia frente a la amenaza medioambiental.

Autores: Ignacio López-Goñi, Elisa Pérez-Ramírez y Gorka Orive

Ed. B, Penguin Random House, 2023.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

Una versión de este texto de Juan Ignacio Pérez Iglesias apareció anteriormente en Lecturas y Conjeturas (Substack).

El artículo Salud Global se ha escrito en Cuaderno de Cultura Científica.

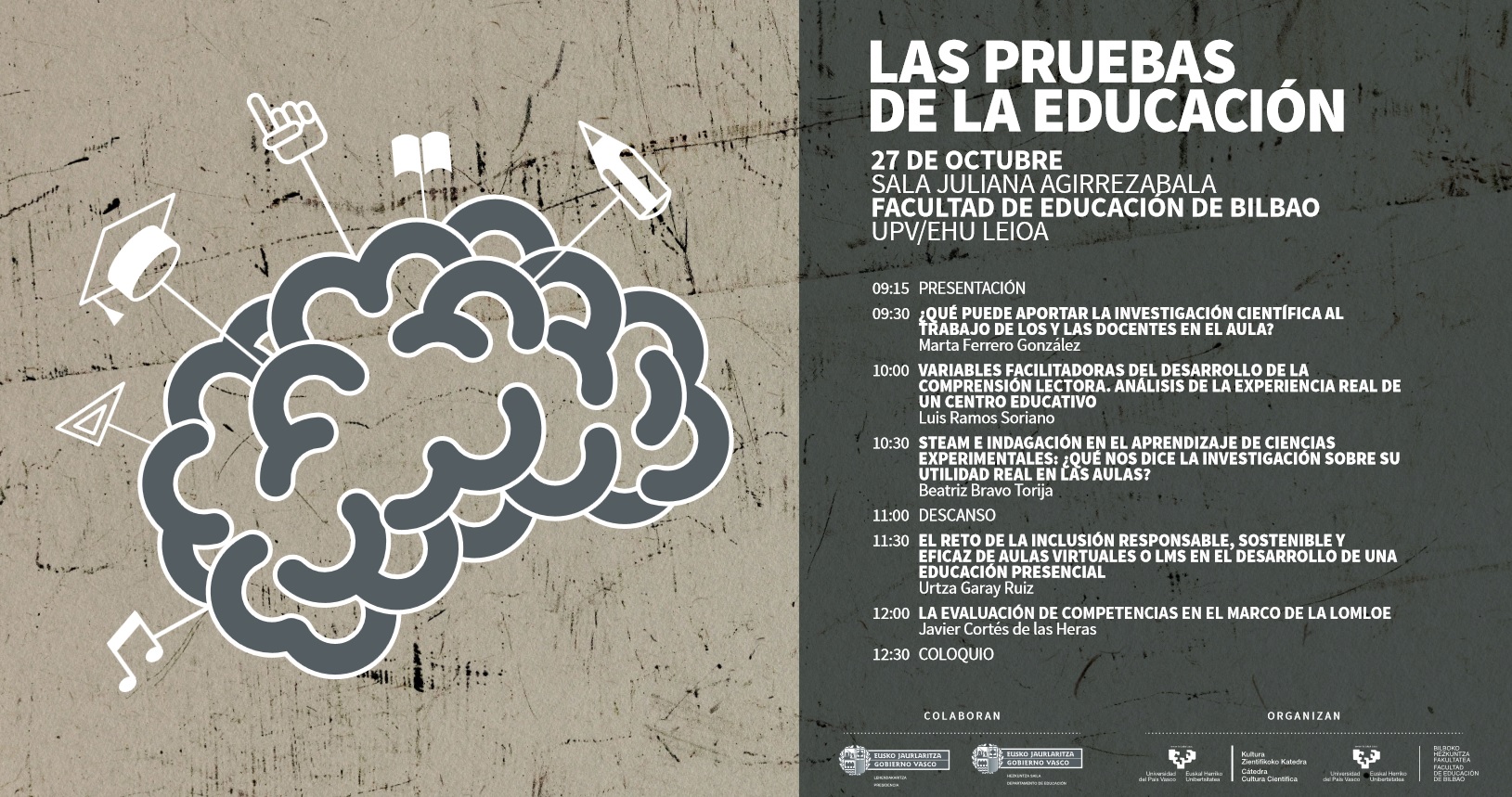

La evaluación de competencias en el marco de la LOMLOE

La jornada Las Pruebas de la Educación tuvo lugar con el objetivo de analizar la validez de las estrategias educativas puestas en marcha durante los últimos años. El enfoque STEAM o las clases virtuales fueron analizados desde la evidencia científica por un grupo de expertos y expertas que se reunió en la Facultad de Educación de Bilbao de la Universidad del País Vasco. La jornada, fruto de la colaboración entre la Cátedra de Cultura Científica de la Universidad del País Vasco y la facultad de Educación de Bilbao, tuvo lugar el 27 de octubre pasado.

Esta sexta edición volvió a estar dirigida a profesionales del ámbito de la educación y a quienes, en un futuro, formarán parte de este colectivo. Su objetivo ha sido reflexionar, desde la evidencia científica, sobre la validez de las estrategias utilizadas hoy en día. El seminario ha contado, una vez más, con la dirección académica de la vicedecana de Investigación y Transferencia de la Universidad Autónoma de Madrid, Marta Ferrero González.

Javier Cortés de las Heras, doctor en Educación y profesor asociado de la Universidad de Valencia, explica en esta charla cómo se supone que han de evaluarse las competencias según la Ley Orgánica por la que se modifica la LOE de 2006 (LOMLOE).

Edición realizada por César Tomé López

El artículo La evaluación de competencias en el marco de la LOMLOE se ha escrito en Cuaderno de Cultura Científica.

La historia genómica del primer milenio de la península balcánica

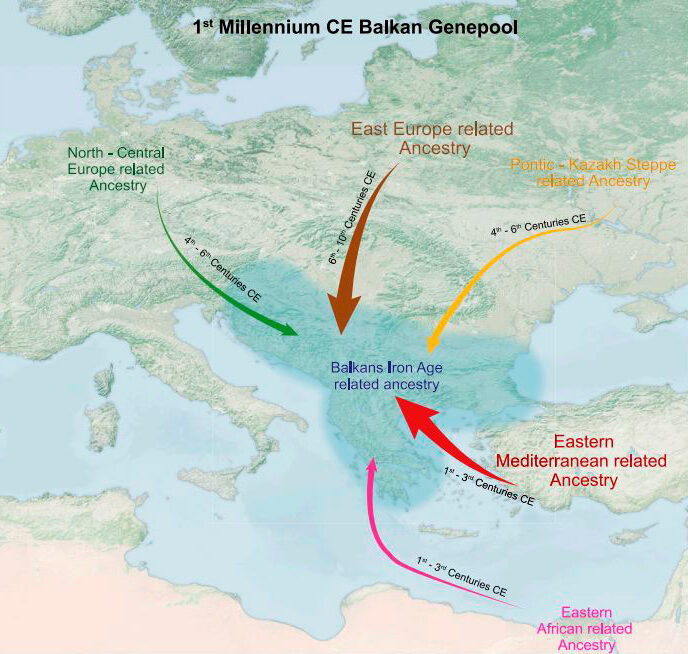

Los Balcanes fueron una región fronteriza de la antigua Roma tan cosmopolita como el centro imperial; la migración eslava que llegó a los Balcanes a partir del siglo VI representa entre el 30 % y el 60 % de la ascendencia de los pueblos balcánicos en la actualidad. Estas son dos de las conclusiones de la primera reconstrucción de la historia genómica del primer milenio de la península balcánica.

Cráneo de un individuo de origen subsahariano encontrado en Viminacium. La lámpara legionaria fue encontrada en su tumba. Foto: Miodrag Grbic

Cráneo de un individuo de origen subsahariano encontrado en Viminacium. La lámpara legionaria fue encontrada en su tumba. Foto: Miodrag GrbicIñigo Olalde, investigador Ikerbasque y Ramón y Cajal de la Universidad del País Vasco, ha liderado junto con el Instituto de Biología Evolutiva (IBE: CSIC-UPF) y la Universidad de Harvard, un estudio en el que han reconstruido por primera vez la historia genómica del primer milenio de la península balcánica. Para ello, el equipo ha recuperado y analizado el genoma antiguo de 146 personas que habitaron las actuales Croacia y Serbia durante ese período. El trabajo, publicado en la prestigiosa revista Cell, desvela los Balcanes como una frontera global y cosmopolita del Imperio Romano y reconstruye la llegada de los pueblos eslavos a esta región.

Por primera vez, el equipo ha identificado tres individuos de origen africano que vivieron en los Balcanes bajo el dominio imperial de Roma. Por otro lado, la investigación corrobora que la migración de los pueblos eslavos a partir del siglo VI representó uno de los mayores cambios demográficos permanentes en toda Europa, cuya influencia cultural perdura hasta nuestros días.

El Imperio Romano transformó los Balcanes en una región globalLa República Romana primero y el Imperio Romano después incorporaron los Balcanes y convirtieron esta región fronteriza en una encrucijada de comunicaciones y un crisol de culturas. Así lo confirma el estudio, que desvela que la vitalidad económica del imperio atrajo a inmigrantes de lugares lejanos hasta esta región.

Grupos genéticos de la península balcánica durante el primer milenio de la era común. Imagen: Pablo Carrión e Íñigo Olalde

Grupos genéticos de la península balcánica durante el primer milenio de la era común. Imagen: Pablo Carrión e Íñigo OlaldeA través del análisis de ADN antiguo, el equipo ha podido identificar que, durante el dominio romano de la región, hubo un gran aporte demográfico proveniente de la península anatólica (localizada en la actual Turquía) que dejó huella genética en las poblaciones balcánicas. Sin embargo, no se observa rastro de ascendencia itálica en los genomas analizados. “Estas poblaciones venidas del este se integraron totalmente en la sociedad local de los Balcanes. En Viminacium, por ejemplo (una de las principales ciudades de los romanos, localizada en la actual Serbia), encontramos un sarcófago excepcionalmente rico en el que fueron enterrados un hombre de ascendencia local y una mujer de ascendencia anatólica”, comenta Olalde.

Sarcófago de Viminacium. Foto: Ilija Mikić

Sarcófago de Viminacium. Foto: Ilija MikićEl equipo también ha revelado la movilidad esporádica de larga distancia de tres individuos de ascendencia africana a la península balcánica durante su dominio imperial. Uno de ellos era un adolescente cuyo origen genético radica en la región del actual Sudán, fuera de los límites del antiguo Imperio. “De acuerdo con el análisis isotópico de las raíces de sus dientes, en su niñez tuvo una dieta marina muy distinta a la del resto de individuos analizados”, comenta Carles Lalueza-Fox, investigador principal del Instituto de Biología Evolutiva (IBE) y director del Museo de Ciencias Naturales de Barcelona (MCNB).

Además, fue enterrado con una lámpara de aceite que representa una iconografía del águila relacionada con Júpiter, uno de los dioses más importantes para los romanos. “El análisis arqueológico de su entierro revela que pudo formar parte de las fuerzas militares romanas, por lo que estaríamos hablando de un inmigrante que viajó desde muy lejos a los Balcanes del siglo II d.C.”, apunta Lalueza-Fox. “Esto nos muestra un Imperio Romano diverso y cosmopolita, que acogía poblaciones mucho más allá del continente europeo”.

El Imperio Romano acogió a poblaciones bárbaras mucho antes de su caídaEl estudio ha identificado algunos individuos de ascendencia del Norte de Europa y de las estepas que habitaron la península balcánica durante el siglo III, en plena ocupación romana. El análisis antropológico de sus cráneos revela que algunos de ellos fueron artificialmente deformados, una costumbre propia de algunas poblaciones de las estepas y de los hunos, a menudo denominados como “bárbaros”.

Cráneo deformado del siglo IV de la era común, atribuido a un individuo de las estepas. Posible gépido o godo, si bien los hunos también practicaban la deformación craneal. Foto: Carles Lalueza-Fox

Cráneo deformado del siglo IV de la era común, atribuido a un individuo de las estepas. Posible gépido o godo, si bien los hunos también practicaban la deformación craneal. Foto: Carles Lalueza-FoxEstos resultados apoyan las investigaciones históricas y arqueológicas y muestran la presencia de individuos provenientes de fuera de las fronteras del Imperio, más allá del Danubio, mucho tiempo antes de la caída del Imperio occidental. “Las fronteras del Imperio eran mucho más difusas que las fronteras de los estados nación actuales. El Danubio servía como límite geográfico del Imperio, pero actuaba como vía de comunicación y era muy permeable al movimiento de personas”, comenta Pablo Carrión, investigador del IBE y co-primer autor del estudio.

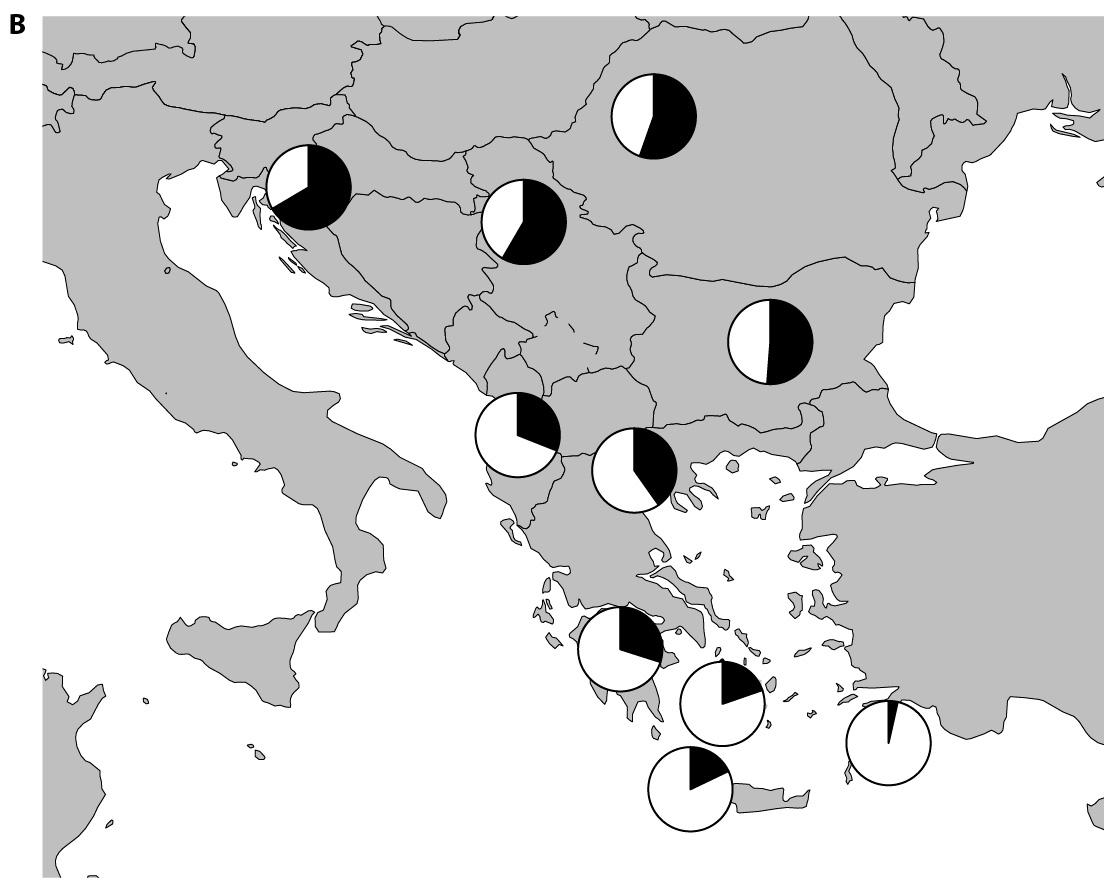

Las poblaciones eslavas cambiaron la demografía de la península balcánicaTras la caída del Imperio Romano de Occidente, y especialmente a partir del siglo VI, el estudio revela la llegada a gran escala a los Balcanes de individuos genéticamente similares a las poblaciones modernas de habla eslava de Europa del Este. Su huella genética representa entre el 30 y el 60 % de la ascendencia de los pueblos balcánicos actuales, lo que supone uno de los mayores cambios demográficos permanentes en cualquier lugar de Europa durante el período de las Grandes Migraciones.

Aunque el estudio detecta la llegada esporádica de individuos procedentes del Este de Europa en periodos anteriores, es a partir del siglo VI cuando se observa una fuerte oleada migratoria. “Según nuestros análisis de ADN antiguo, esta llegada de poblaciones de habla eslava a los Balcanes tuvo lugar a lo largo de varias generaciones e involucró a grupos familiares completos que incluían hombres y mujeres”, explica Carrión.

Proporciones de poblaciones de ascendencia eslava, en negro, en los países actuales de la península balcánica y el Egeo. Imagen: Íñigo Olalde y Pablo Carrión

Proporciones de poblaciones de ascendencia eslava, en negro, en los países actuales de la península balcánica y el Egeo. Imagen: Íñigo Olalde y Pablo CarriónEl estudio también identifica que el establecimiento de las poblaciones eslavas en los Balcanes fue mayor en el norte, con una contribución genética de entre el 50 % y el 60 % en la actual Serbia, y gradualmente menor hacia el sur, con entre un 30 y un 40 % de representación genética en la Grecia continental y hasta un 20 % en las islas del Egeo. “Su legado genético es visible no solo en poblaciones balcánicas actuales de habla eslava, sino también en otros grupos que incluyen regiones donde actualmente no se habla lenguas eslavas, como Rumanía y Grecia», puntualiza David Reich, investigador de la Universidad de Harvard en cuyo laboratorio se llevó a cabo la recuperación y secuenciación del ADN antiguo.

Coordinación y cooperación para reescribir la historia de los BalcanesLa guerra de Yugoslavia en 1991 provocó la separación de los pueblos balcánicos en los distintos países que conforman la región hoy en día y sus consecuencias perduran en la actualidad. Sin embargo, investigadores de toda la región han colaborado en el estudio. «En el estudio han estado colaborando investigadores croatas y serbios. Se trata de un gran ejemplo de cooperación, teniendo en cuenta la historia reciente de la península balcánica. Al mismo tiempo, este tipo de trabajos son un ejemplo de cómo datos genómicos objetivos pueden contribuir a dejar atrás problemas sociales y políticos ligados a identidades colectivas que han estado basadas en narraciones épicas del pasado», comenta Lalueza-Fox.

El equipo elaboró una base de datos genética de la población Serbia de novo, con el fin de poder reconstruir la historia de los Balcanes. «Nos encontramos con la situación de que no existía una base de datos genómica de la población serbia actual. Para construirla y utilizarla como referencia comparativa en este estudio, tuvimos que buscar a personas que se autodenominaban como serbias en base a determinados rasgos culturales compartidos, aunque vivieran en otros países como Montenegro o Macedonia del Norte”, comenta Miodrag Grbic, profesor de la Universidad de Western Ontario y profesor visitante en la Universidad de La Rioja.

Pese a la cuestión identitaria, marcada por la historia más reciente de los Balcanes, los genomas de los croatas y serbios analizados hablan de una herencia compartida en igual medida entre las poblaciones eslavas y las poblaciones del mediterráneo.

“Creemos que el análisis del ADN antiguo puede contribuir, junto con los datos arqueológicos y los registros históricos, a la reconstrucción de la historia de los pueblos balcánicos y la formación de los denominados pueblos eslavos del sur de Europa”, apunta Lalueza-Fox.

«La imagen que surge no es de división, sino de historia compartida. Las personas que en la Edad del Hierro habitaban la región de los Balcanes se vieron afectadas de manera similar por las migraciones durante la época del Imperio Romano y por las migraciones eslavas más tarde. Juntas, estas influencias dieron como resultado el perfil genético de los Balcanes modernos, independientemente de las fronteras nacionales», concluye Grbic.

Referencia:

Olalde, I., Carrión, P., Mikić. I. et al. (2023) A genetic history of the Balkans from Roman frontier to Slavic migrations Cell doi: 10.1016/j.cell.2023.10.018

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La historia genómica del primer milenio de la península balcánica se ha escrito en Cuaderno de Cultura Científica.

Estrellas de mar: de no tener cabeza a tener solo cabeza

Las estrellas y los erizos de mar forman parte de uno de los grupos más enigmáticos de seres vivos: los equinodermos. Un estudio publicado recientemente los convierte en criaturas todavía más enigmáticas. Al menos, si las contemplamos con nuestros ojos humanos.

Foto: Adrian Pingstone / Wikimedia Commons

Foto: Adrian Pingstone / Wikimedia CommonsLa inmensa mayoría de los animales, nosotros incluidos, somos bilaterales: nuestra simetría divide el cuerpo en dos mitades casi idénticas. En otras palabras, estamos organizados sobre la base de un eje anteroposterior y otro dorsoventral. Hacia finales del siglo pasado se descubrió que los genes que controlan la formación de estos ejes durante el desarrollo son los mismos en todos los animales bilaterales. Es decir, el mecanismo que determina qué región va a ser anterior, media o posterior es el mismo en una mosca y en un ser humano.

Una organización bilateral parece la más lógica en animales que tienen un tubo digestivo y se desplazan en una dirección determinada. Lo razonable es que alrededor del extremo anterior, donde está la boca, se concentren los órganos de los sentidos y los centros nerviosos. En pocas palabras, que se desarrolle una cabeza.

Esta es la razón por la que nos resultan fascinantes los equinodermos. Sus ancestros eran bilaterales con todas sus ventajas, cabeza incluida. Sin embargo, en algún momento de su evolución perdieron esta característica y desarrollaron una organización pentámera. Dejaron de tener un único plano de simetría para contar con nada menos que cinco, dispuestos alrededor de un eje oral-aboral, el eje que pasa por la boca y por el lado opuesto del cuerpo.

Esta innovación evolutiva se refleja en el desarrollo de los equinodermos: su larva es bilateral, pero tras una metamorfosis compleja adquiere la simetría pentámera.

La organización pentámera, sin eje anteroposterior ni centros nerviosos, implica la ausencia de una cabeza. O, al menos, esto se creía hasta ahora. Un artículo recientemente publicado en la revista Nature sugiere lo contrario de lo que se pensaba. Los equinodermos no solo tienen cabeza, sino que no tienen nada más. Son cabezas sin cuerpo.

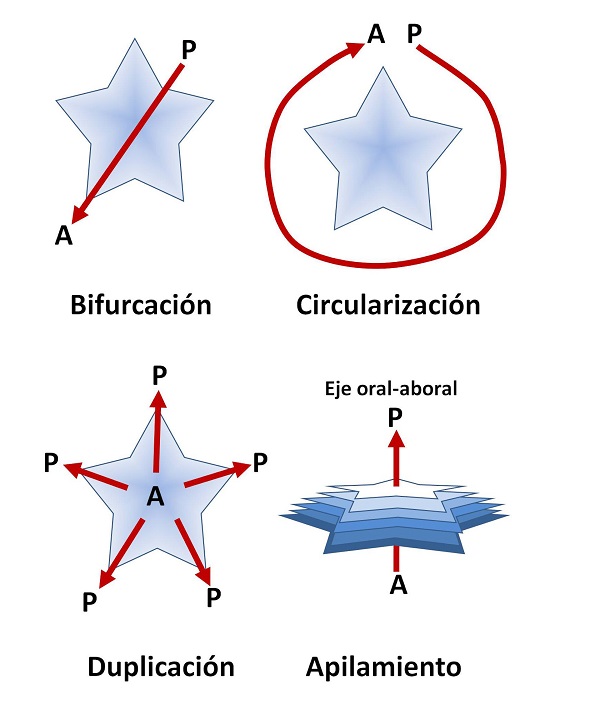

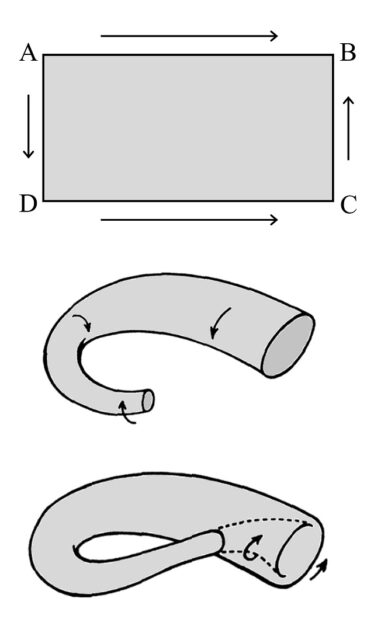

Cuatro hipótesis, todas inválidasHasta ahora se habían formulado cuatro hipótesis para explicar cómo el eje presente en todos los animales bilaterales pudo transformarse en los cinco planos de simetría de los equinodermos. Estos modelos eran la bifurcación, circularización, duplicación y el apilamiento.

Las cuatro hipótesis formuladas sobre la transición de un eje anteroposterior (A-P) a una simetría pentámera en los Equinodermos.

Las cuatro hipótesis formuladas sobre la transición de un eje anteroposterior (A-P) a una simetría pentámera en los Equinodermos.Un equipo de biólogos de la Universidad de Stanford (EE UU) propone en su artículo un modelo nuevo y diferente, que supone una nueva concepción de cómo evolucionaron los equinodermos.

Su estrategia consistió en seleccionar una serie de marcadores genéticos típicos del eje anteroposterior de los bilaterales. Estos han sido conservados a lo largo de la evolución, por lo que es interesante saber dónde se expresan en un animal pentámero. Entre los 36 marcadores seleccionados los había de la región más anterior del cuerpo, de la media y de la posterior. También se incluyeron los genes del complejo Hox, que son fundamentales en la organización del eje de todos los animales bilaterales.

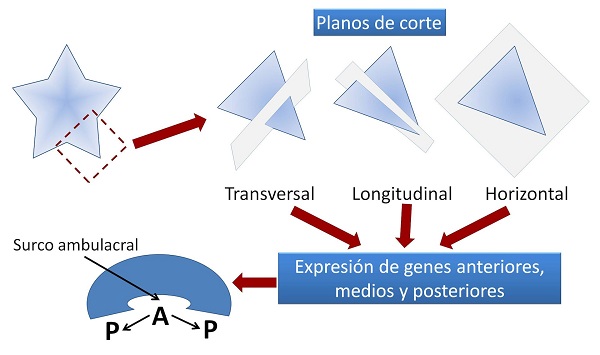

La técnica utilizada fue la tomografía de ARN aplicada a los pequeños estados juveniles de una estrella de mar abundante en la costa de California, Patiria miniata. Esta avanzada técnica molecular consiste en seccionar brazos de la estrella en tres planos diferentes: a lo largo del eje del brazo, en un plano horizontal y de forma transversal. En las distintas secciones fue detectada la expresión de los diferentes marcadores.

El sorprendente resultado obtenido fue que los genes más anteriores se expresaban en la línea media de los brazos, y los más posteriores en sus márgenes laterales. Como la línea media de los brazos está ocupada por los surcos ambulacrales, en los que se localizan los pequeños pies con los que las estrellas de mar se desplazan, este nuevo modelo de organización se ha denominado ambulacral-anterior.

La estrategia consistió en seccionar los brazos de la estrella en tres planos y comprobar la expresión de genes anteriores, medios y posteriores en animales bilaterales. Los más anteriores se expresaban en la línea media de los brazos y los posteriores en sus márgenes.Un resultado inesperado

La estrategia consistió en seccionar los brazos de la estrella en tres planos y comprobar la expresión de genes anteriores, medios y posteriores en animales bilaterales. Los más anteriores se expresaban en la línea media de los brazos y los posteriores en sus márgenes.Un resultado inesperado

Que el centro de los brazos corresponda a la parte anterior de los demás animales y los márgenes a la posterior, no era un resultado esperado. Pero menos todavía lo fue la ausencia de marcadores típicos del tronco de los animales bilaterales.

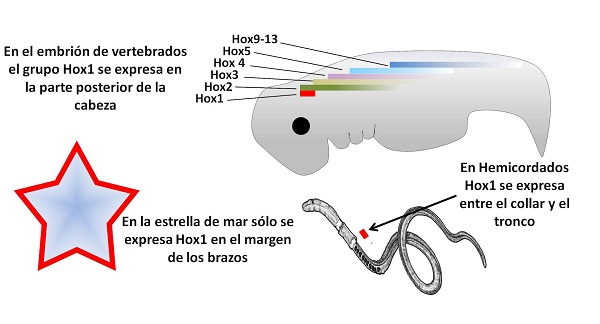

En el ectodermo de la estrella de mar solo se expresa uno de los trece genes del complejo Hox, Hox1, y lo hace en el margen de los brazos, lo que corresponde a la zona posterior de su cuerpo. Dicho de otra forma, lo más posterior que encontramos en el cuerpo de la estrella corresponde al límite posterior de la cabeza de los vertebrados. El cuerpo de la estrella de mar se corresponde con nuestra cabeza, pero no hay evidencia molecular de que haya nada semejante a un tronco.

Los genes Hox se expresan ordenadamente a lo largo del cuerpo de los animales bilaterales. En el ectodermo de la estrella de mar sólo se expresa el más anterior, Hox1, y lo hace en el margen de los brazos. Vertebrados y hemicordados sirven como comparación.

Los genes Hox se expresan ordenadamente a lo largo del cuerpo de los animales bilaterales. En el ectodermo de la estrella de mar sólo se expresa el más anterior, Hox1, y lo hace en el margen de los brazos. Vertebrados y hemicordados sirven como comparación.Queda por comprobar si estos resultados son exclusivos de las estrellas de mar o, como parece muy probable, son aplicables a todos los equinodermos. Si se confirma esto, se trataría de una concepción completamente novedosa de la forma en que los equinodermos reorganizaron su eje bilateral y construyeron su cuerpo. Una constatación final que nos confirma este estudio: la biología, y en particular la evolución, mantiene intacta su capacidad de asombrarnos.![]()

Sobre el autor: Ramón Muñoz-Chápuli Oriol, Catedrático de Biología Animal (jubilado), Universidad de Málaga

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Estrellas de mar: de no tener cabeza a tener solo cabeza se ha escrito en Cuaderno de Cultura Científica.

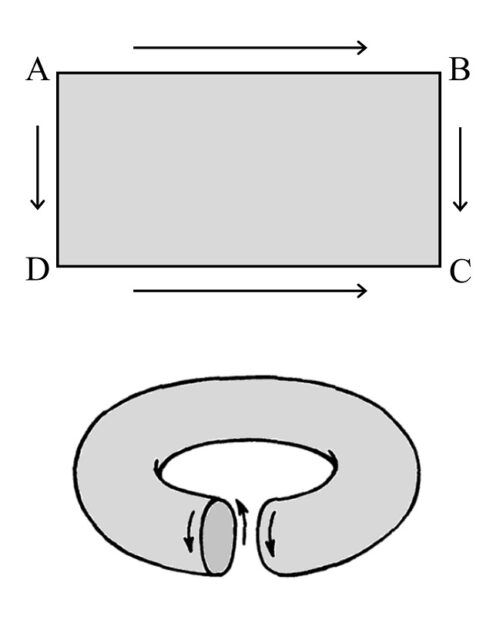

El cuento de la ruleta rusa

Cuando presento alguno de mis libros en una librería, aunque la verdad es que esto no ocurre tantas veces como uno desearía, me gusta pedir a las personas que trabajan en la misma que me recomienden algunos libros, principalmente, novelas. En octubre (de 2023) presenté mi último libro “Las matemáticas como herramienta de creación artística” (Catarata / FESPM, 2023) en la librería Zubieta-TROA, de Donostia/San Sebastián. El responsable de esta librería, Adolfo López Chocarro, me recomendó varios libros, entre los cuales estaba el cuento El Ruletista (Impedimenta), del escritor rumano Mircea Cartarescu (Bucarest, 1956), en el cual se menciona, de pasada, la probabilidad de morir jugando a la ruleta rusa, en su versión en solitario. Y es de esto precisamente de lo que vamos a hablar en esta entrada del Cuaderno de Cultura Científica.

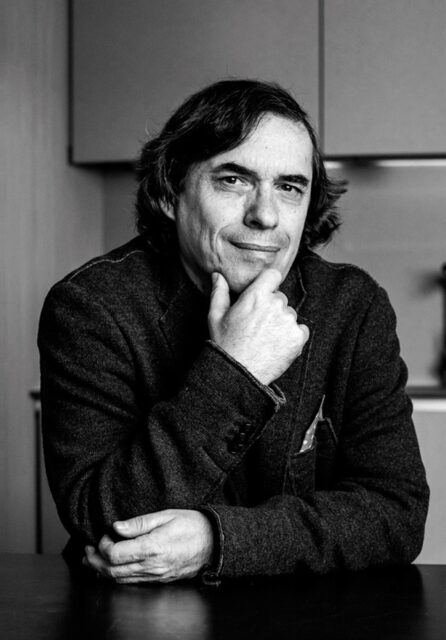

Portada del cuento El Ruletista (Impedimenta, 2010), del escritor rumano Mircea CartarescuMircea Cartarescu

Portada del cuento El Ruletista (Impedimenta, 2010), del escritor rumano Mircea CartarescuMircea Cartarescu

El escritor y crítico literario Mircea Cartarescu está considerado el mejor escritor rumano de la actualidad y uno de los grandes escritores de la literatura europea contemporánea. La editorial Impedimenta ha traducido al español y publicado muchos de sus libros, como El Levante (Impedimenta, 2015), una epopeya heroico-cómica, que es también una aventura a través de la historia de la literatura rumana; el libro de relatos Nostalgia (Impedimenta, 2012), que se habría precisamente con el cuento El ruletista, y que consagró a Cartarescu como uno de los grandes escritores actuales de Rumanía; la novela Solenoide (Impedimenta, 2017), incluida en el listado de los mejores libros de ese año por la prensa cultural española e iberoamericana (que es parte de mi “tsundoku”, es decir, descansa en mi mesilla a la espera de ser leída); o Poesía esencial (Impedimental 2021), una recopilación de poemas escritos durante sus primeros años creativos. Para describir su filosofía como escritor, podemos acudir a una de sus citas, “Escribo porque quiero entender mi situación en el mundo”.

Fotografía del escritor rumano Mircea Cartarescu, en la editorial ImpedimentaEl Ruletista, un cuento de Cartarescu

Fotografía del escritor rumano Mircea Cartarescu, en la editorial ImpedimentaEl Ruletista, un cuento de Cartarescu

Aprovechemos la contraportada de la publicación en español, por parte de la editorial Impedimenta, para introducir brevemente el cuento del que vamos a escribir en esta entrada del Cuaderno de Cultura Científica.

Prohibido durante años en Rumanía por lo explícito de su argumento, El Ruletista constituye uno de los más brillantes hitos narrativos de la reciente literatura europea. Esta pieza, tan breve como intensa, narra la improbable historia de un hombre al que nunca le ha sonreído la suerte, un desarraigado que sorprendentemente hace fortuna participando en letales sesiones de ruleta rusa. Multitudes enfervorecidas, presas del morbo, guardan cola para participar en las ceremonias de muerte y redención en que se convierten sus apariciones, y que dan paso a la histeria colectiva. Un escritor moribundo que conoció al Ruletista en su juventud intenta explicar cómo ese hombre insulso termina convirtiéndose en alguien inmortal y aparentemente inexpugnable, cuando en realidad en él solo anida el más desesperado espíritu de la autodestrucción.

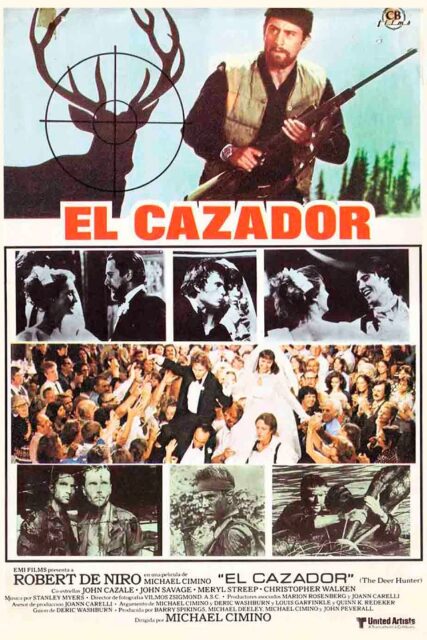

Expliquemos en primer lugar en qué consiste el macabro juego de la ruleta rusa que es un elemento principal de este cuento. Mientras que en la ruleta rusa que hemos visto en duras películas como El cazador (1978), dirigida por Michael Cimino e interpretada por Robert de Niro, Christopher Walken, Meryl Streep, John Savage y John Cazale, se juega entre dos, o más jugadores, en el cuento El ruletista es una ruleta rusa solitaria, de un solo jugador.

Cartel de la película El cazador (1978), dirigida por el director estadounidense Michael Cimino

Cartel de la película El cazador (1978), dirigida por el director estadounidense Michael CiminoLos principales protagonistas de la ruleta rusa de este relato son los siguientes. Por un lado, la persona que se juega la vida en la ruleta rusa, el ruletista, que en el cuento se explica que suele ser alguna persona que por diferentes circunstancias vitales no le importa jugarse la vida a cambio de dinero, normalmente, algún borracho, vagabundo o expresidiario, como se menciona más arriba “un desarraigado”. Luego está el patrón, que es quien contrata, o convence, al ruletista y que va a apostar a su favor, es decir, va a apostar a que esa persona que se juega la vida a la ruleta rusa va a sobrevivir a la misma. Y finalmente están los accionistas que son quienes apuestan en contra del patrón, esto es, ganan si muere el ruletista.

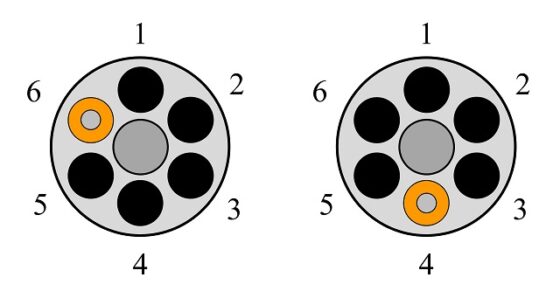

El juego consiste en lo siguiente. Primero se introduce una bala en el tambor de un revólver, que tiene capacidad para alojar seis balas (aunque hay revólveres que admiten otra cantidad de balas, cinco, seis, siete, ocho o diez balas), luego se gira el tambor y se cierra rápidamente para que la bala quede colocada en una posición al azar, entonces el ruletista coge el revólver, se apunta a la sien y dispara. Si tiene la suerte de que no salga la bala (lo cual ocurre en 5 de las 6 posiciones posibles del tambor, es decir, la probabilidad de que sea un disparo fallido es de 5 de cada 6 veces, el 83,33 %) el patrón gana, se queda con el dinero de los accionistas y le da al ruletista un diez por ciento de las ganancias. Por otra parte, si se dispara la bala (lo cual ocurre 1 de cada 6 veces, esto es, una probabilidad del 16,66 %), el ruletista muere y el patrón debe pagar a los accionistas entre diez y veinte veces la cantidad apostada por ellos, según hayan acordado. Es cierto, que el peso de la bala modifica algo estas probabilidades, pero no vamos a tenerlo en cuenta en esta entrada.

En el cuento hay dos protagonistas, el viejo escritor que escribe la historia del Ruletista y este, que se ha ganado el derecho a ser nombrado con la inicial mayúscula, ya que, como escribe el viejo escritor, “ha sido el único hombre al que fue concedido vislumbrar al infinito Dios matemático y luchar cuerpo a cuerpo con él”, refiriéndose a que este hombre ha jugado muchísimas veces a la ruleta rusa solitaria y siempre ha salido indemne, saltándose la “alta” probabilidad de morir. Como escribe el viejo escritor, referente a esto último:

“… el ruletista solo tenía cinco posibilidades entre seis de salvarse en la primera partida. Según el cálculo de probabilidades, si volvía a llevarse la pistola a la sien, sus posibilidades disminuían. En el sexto intento, esas posibilidades se reducían a cero. De hecho, hasta que mi amigo entró en el mundo de la ruleta, en el que llegaría a convertirse en el Ruletista con mayúscula, no se conocían casos de supervivencia ni siquiera tras cuatro intentos. La mayoría de los ruletistas lo eran, por supuesto, de forma ocasional, y no volverían a repetir esa terrible experiencia por nada del mundo…”

Y continuaba:

“… supongo que los accionistas apenas se fijaron en él cuando escapó con vida la primera o la segunda vez, puede que incluso la tercera. Fue considerado, como mucho, un ruletista afortunado. Pero después de la cuarta y de la quinta, se convirtió en la figura central del juego, un verdadero mito llamado a alcanzar proporciones gigantescas en los años posteriores. Durante dos años, hasta nuestro reencuentro en el restaurante, el Ruletista se había llevado el revólver a la sien en ocho ocasiones…”

Antes de entrar en el tema de las probabilidades, al que dedicaremos la siguiente sección de esta entrada, presentemos brevemente al Ruletista, a quien el viejo escritor conocía desde que eran niños. Desde siempre este perdía a todos los juegos, de pequeño a las canicas o el lanzamiento de herradura, cuando estuvo en la cárcel siempre perdía al póquer y cuando al salir de la misma se dedicó a la bebida e iba mendigando un trago de cerveza de mesa en mesa por las tabernas, los parroquianos de las mismas se lo jugaban con él al palillo más largo y, de nuevo, siempre perdía. El Ruletista era un candidato ideal para ser jugador de la ruleta rusa, pero, además, su malísima suerte en todo tipo de juegos hacía que en el caso de la ruleta rusa jugase a su favor, ya que podríamos decir que nunca “acertaba” con la bala en la posición de disparo y salía ileso del juego.

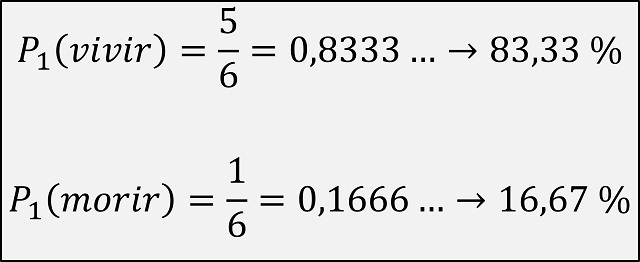

Un poco de probabilidadRealmente hay diferentes cuestiones de probabilidad que se pueden analizar relacionadas con la ruleta rusa, pero vayamos exactamente a la situación descrita en este cuento. Empecemos por lo que ya sabemos y es evidente. Si un ruletista solo juega una vez a la ruleta rusa de un solo jugador, la probabilidad de sobrevivir es del 83,33 %, esto es, 5 de cada 6, mientras que la probabilidad de morir durante el juego es, la complementaria de la anterior, es decir, el 16,67 %, solo 1 de cada 6.

La probabilidad de que el ruletista viva o muera si juega solo una vez a la ruleta rusa

La probabilidad de que el ruletista viva o muera si juega solo una vez a la ruleta rusa

La siguiente cuestión que nos planteamos, siguiendo lo escrito en este pequeño relato, en extensión, no en calidad literaria, es la siguiente. Si el ruletista juega dos veces a la ruleta rusa, ¿cuál será la probabilidad de que muera o viva?

Pero cuidado, cada vez que se juega a la ruleta rusa la probabilidad es la misma que hemos comentado arriba, no cambia, ya que el juego, o el revólver, no tiene memoria. Lo que queremos conocer es la probabilidad de salir indemne, o respectivamente, morir, si se arriesga a jugar dos veces. Aunque no es necesario, podéis pensar en que ha decidido previamente jugarse la vida a la ruleta rusa solitaria en dos ocasiones. Calculemos esta probabilidad.

Recordemos brevemente, aunque realmente ya lo hemos utilizado, que la probabilidad de un evento es igual al número de casos favorables (del evento) dividido el número de casos posibles (del evento). Por ejemplo, si queremos conocer cual es la probabilidad de que salga un múltiplo de 3 si tiramos un dado, el número de casos favorables sería dos -que salga 3 o 6-, mientras que hay seis casos posibles -los seis valores del dado 1, 2, 3, 4, 5, 6-. Por lo tanto, la probabilidad de que salga un múltiplo de tres (3 o 6) al tirar el dado es 2 / 6 = 0,3333…, esto es, una probabilidad del 33,33 %.

Volvamos a la probabilidad de que el ruletista viva o muera si juega dos veces a la ruleta rusa. Primero veamos los casos posibles. Como en el primer disparo tenemos seis posibles posiciones del tambor del revólver o, dicho de otra forma, seis agujeros para disparar (que en la siguiente imagen hemos numerado como 1, 2, 3, 4, 5, 6) y en el segundo disparo tenemos otros seis posibles agujeros (de nuevo del 1 al 6 en la imagen), entonces el número de posiciones posibles de los tambores en los dos disparos o, mejor dicho, parejas de agujeros sobre los que disparamos son 6 x 6 = 36 (que podemos pensarlos como parejas de números, desde el (1, 1), (1, 2), (1, 3), hasta el (6,6)).

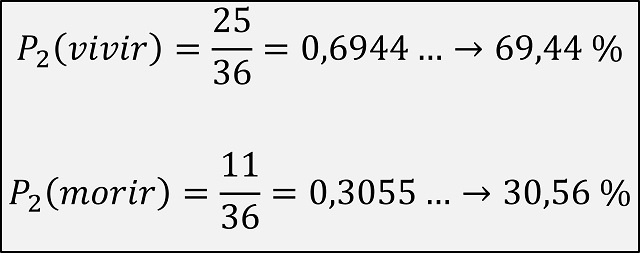

Ahora contemos cuántas parejas de agujeros serían favorables, si queremos calcular la probabilidad de que el ruletista salga indemne de las dos sesiones de la ruleta rusa. Como en el primer revolver hay 5 agujeros para los que el jugador vive, serán estos los que hay que tener en cuenta en la primera posición de la pareja de agujeros (en el ejemplo de la anterior imagen son los agujeros 1, 2, 3, 4, 5) y para cada uno de esos 5 agujeros, tenemos otros 5 agujeros en la segunda pistola que no contienen la bala de la muerte. Por lo tanto, el número de casos favorables, es decir, parejas de agujeros para los que el ruletista no muere, son 5 x 5 = 25. Por lo tanto, la probabilidad de que el ruletista quede con vida si juega dos veces a la ruleta rusa es 25/36 = 0,6944, es decir, una probabilidad del 69,44 %, mientras que la probabilidad de que muera es su complementario, 11/36 = 0,3056, esto es, el 30,56%.

La probabilidad de que el ruletista viva o muera si juega dos veces a la ruleta rusa

La probabilidad de que el ruletista viva o muera si juega dos veces a la ruleta rusa

Aunque, si lo pensamos un poco, la probabilidad de salir indemne de las dos partidas de la ruleta rusa es la probabilidad de vivir en la primera partida (5/6) por la probabilidad de vivir en la segunda partida (5/6), es decir, (5/6)2 = 25 / 36.

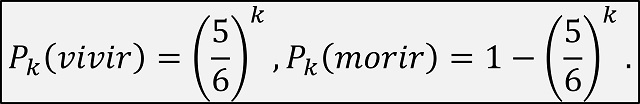

Esta forma de entenderlo nos permite obtener fácilmente la respuesta a la cuestión de qué probabilidades tiene el ruletista de vivir, o morir, si juega k veces a la ruleta rusa (para k = 1, 2, 3, 4, 5, …). De hecho, podemos obtener una fórmula en función del número k de partidas jugadas a la ruleta rusa por el ruletista.

La probabilidad de que el ruletista viva o muera si juega un número k de veces a la ruleta rusa

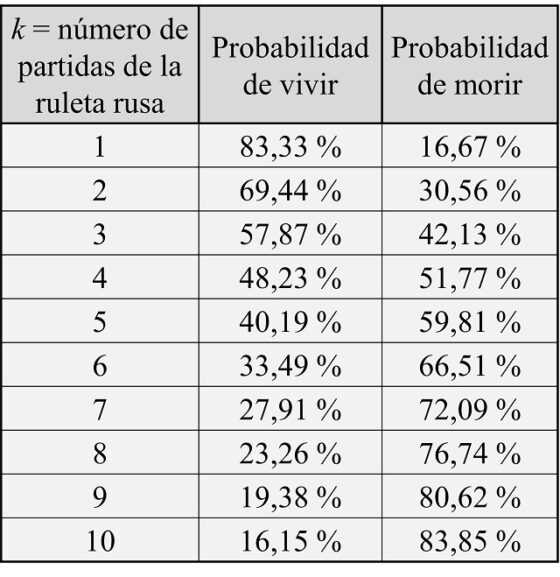

La probabilidad de que el ruletista viva o muera si juega un número k de veces a la ruleta rusaAhora es fácil ir calculando la probabilidad de vivir o morir en función de cuantas veces juegue el ruletista a la ruleta rusa solitaria, que precisamente es de lo que habla, sin calcular probabilidades, el viejo profesor en los párrafos que hemos incluido más arriba. A continuación, incluimos una tabla con estas probabilidades para los casos en los que el ruletista juega entre una y diez veces, en la cual podemos apreciar la velocidad a la que la probabilidad de que el ruletista salga vivo va disminuyendo, y creciendo la probabilidad de morir.

Tabla con las probabilidades de que el ruletista viva o muera si juega k veces a la ruleta rusa, para k = 1, 2, 3, …, 9, 10

Tabla con las probabilidades de que el ruletista viva o muera si juega k veces a la ruleta rusa, para k = 1, 2, 3, …, 9, 10Podemos sacar entonces algunas conclusiones. Para empezar la probabilidad de morir es menor que el 50 % para los casos de una sola partida de la ruleta rusa (16,67 %), dos partidas (30,56 %) e incluso tres partidas (42,13 %). Luego en esos casos hay más probabilidades de ganar que de perder. El problema es que, si el jugador pierde, ha perdido algo tan importante e irrecuperable como es su propia vida. Además, cuando se dice que después de la tercera partida era considerado un ruletista afortunado, aun estando de acuerdo -ya que se está jugando la vida- podemos decir que no era tan excepcional, ya que la probabilidad de salir con vida seguía siendo, como hemos comentado, menor que el 50 %.

Justo se supera la probabilidad del 50 %, es decir, la misma que de sacar cara, o cruz, al tirar una moneda al aire, cuando se juegan cuatro partidas a la ruleta rusa. En concreto, hay una probabilidad del 51,77 % de morir y una probabilidad del 48,23 % de vivir. De hecho, cuando en el relato se escribe que “no se conocían casos de supervivencia ni siquiera tras cuatro intentos”, esto podríamos explicarlo como que los ruletistas no se atrevían a arriesgarse con la cuarta partida, porque lo que nos dicen los fríos números es que, a la larga, entre todos los jugadores que jugasen cuatro partidas, más o menos la mitad de los mismos vivirían y la otra mitad moriría.

Si continuamos, cuando se juegan seis partidas, la probabilidad de vivir no es cero, de hecho, es todavía relativamente alta, ya que es, más o menos, uno de cada tres casos. Aunque, como hemos dicho antes, el jugador no se juega dinero, sino su propia vida, por lo que la apuesta es demasiado arriesgada para él.

Por otra parte, el viejo escritor cuenta que cuando él se encontró con el Ruletista ya había superado 8 partidas de la ruleta rusa solitaria. Salir con vida de ocho partidas, como se ve en la anterior tabla es, más o menos, del 25 %, es decir, uno de cada cuatro casos. Luego, aun siendo algo excepcional, no es tan raro. Dicho de otra forma, si jugasen muchas personas a la ruleta rusa solitaria en ocho ocasiones, de media, una de cada cuatro viviría, aunque eso sí, tres de cada cuatro, moriría. A partir de ahí la probabilidad continúa cayendo cada vez más y más.

Por otra parte, en cierto momento del relato, el Ruletista empieza a incluir más balas en el revólver, aunque el cálculo de las probabilidades, para una cantidad de balas entre 1 y 6, es similar al realizado previamente, lo dejamos como diversión para las personas que están leyendo esto, si así lo desean.

Para terminar, me gustaría comentar que el objetivo de escribir esta entrada del Cuaderno de Cultura Científica no es corregir el cuento de Mircea Cartarescu, que es un cuento de una calidad excepcional, sino de aprovechar la mención a la probabilidad para hablar de la misma y calcular con exactitud cuál es esa probabilidad mencionada. De hecho, mi recomendación es que, si no lo habéis hecho ya, leáis este magnífico cuento.

Terminaremos con un poco de humor negro de la mano de El Mundo Today y la noticia en clave de humor cuyo titular es: Uno de cada ocho jugadores de la ruleta rusa no llega a fin de mes; así como con el cortometraje, también en clave de humor, Ruleta (2015), de Álvaro Carmona, que podéis ver aquí.

Fotograma del corto Ruleta (2015), dirigido por Álvaro Carmona

Fotograma del corto Ruleta (2015), dirigido por Álvaro CarmonaBibliografía

1.- Mircea Cartarescu, El ruletista, Impedimenta, 2010.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El cuento de la ruleta rusa se ha escrito en Cuaderno de Cultura Científica.

La comprobación experimental de la teoría postcuántica de la gravedad clásica

El pasado 4 de diciembre se publicaron un par de artículos científicos en los que se introducía el concepto de teoría postcuántica para referirse a la gravedad clásica. Un titular típico en la prensa para recoger estas publicaciones podría ser el de Xataka: Esta teoría reconcilia la relatividad general y la mecánica cuántica. Y lo que propone es revolucionario. Los científicos proponen un experimento para comprobar la nueva teoría consistente en “medir la masa de un objeto con muchísima precisión para determinar si su peso fluctúa con el tiempo.” Pero esa no es la única posibilidad, hay una más radical.

Pesando una masa. Ilustración: Isaac Young

Pesando una masa. Ilustración: Isaac YoungLa mejor teoría de la materia que tenemos es la mecánica cuántica, que describe el comportamiento discreto (cuantizado) de las partículas microscópicas mediante ecuaciones de ondas. La mejor teoría de la gravedad es la relatividad general, que describe el movimiento continuo (clásico) de los cuerpos con masa a través de la curvatura del espaciotiempo. Estas dos teorías de gran éxito chocan a la hora de describir la naturaleza del espacio-tiempo: las ecuaciones de ondas cuánticas se definen en un espacio-tiempo fijo, pero la relatividad general dice que el espacio-tiempo es dinámico y se curva en respuesta a la distribución de la materia.

La mayoría de los intentos de resolver este conflicto se han centrado en la cuantificación de la gravedad, siendo las dos propuestas principales la teoría de cuerdas y la gravedad cuántica de bucles. El nuevo trabajo teórico de Jonathan Oppenheim y sus colaboradores lo que hace es dejar la gravedad como una teoría clásica y acoplarla a la teoría cuántica mediante un mecanismo probabilístico. Esta estrategia híbrida ha sido considera tradicionalmente como estéril, ya que llevaría a inconsistencias. Oppenheim las evita a costa de tener que insertar la probabilidad –una “tirada de dados”– en la evolución del espacio-tiempo.

Comprobando la teoría postcuánticaUna forma de ir delimitando qué modelo es más adecuado es lo que proponen los investigadores, medir las fluctuaciones de la masa de un objeto. Esto supone en realidad medir el tiempo de coherencia de un objeto masivo en una superposición cuántica, ya que el tiempo de coherencia puede relacionarse con la evolución de la métrica del espacio-tiempo. Los datos de tiempo de coherencia existentes ya se han utilizado para descartar ciertos rangos de parámetros para modelos híbridos clásico-cuánticos como el de Oppenheim. Pero, como decimos, estos experimentos no descartarían, solo limitarían.

Es mucho más radical y, por tanto, mucho más interesante, contestar a la pregunta fundamental: ¿la gravedad es cuántica o no? Una forma de hacerlo es detectando gravitones directamente, otra sería entrelazar dos objetos masivos solo con su interacción gravitacional. Esto que se resume así de fácil en una frase, tiene una complejidad enorme.

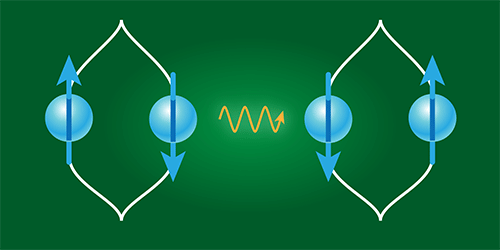

Ilustración: G. W. Morley/University of Warwick and APS/Alan Stonebraker

Ilustración: G. W. Morley/University of Warwick and APS/Alan StonebrakerSin embargo, ha habido avances significativos en la segunda idea. En 2017 se hicieron dos propuestas en este sentido que, si bien difieren en los detalles, se basan en el mismo concepto: dos masas (microesferas, por ejemplo) interactúan solo a través de su atracción gravitacional mutua. Si estas masas se entrelazan mecanocuánticamente, entonces la gravedad debe ser la culpable. Para quedar entrelazadas por la gravedad, las masas deben estar en una superposición de estados cuánticos.

Si cada masa se coloca en uno de dos interferómetros próximos, que crearían la superposición. Si las masas están entrelazadas cuando salen de los interferómetros, esto implicaría que la gravedad es inherentemente cuántica, ya que solo un campo cuántico puede inducir el entrelazamiento.

Los experimentos están plagados de obstáculos técnicos, entre ellos cómo garantizar que la gravedad sea la única forma en que las masas interactúen. Pero están más cerca de realizarse que otros métodos propuestos, como la detección directa de gravitones. Para que estos experimentos se realicen, los investigadores deben descubrir cómo crear y mantener superposiciones cuánticas de objetos relativamente masivos y cómo reducir los efectos de fuerzas distintas a la gravedad.

Referencias:

Oppenheim, J. (2023) A Postquantum Theory of Classical Gravity? Physical Review X doi: 10.1103/PhysRevX.13.041040

Oppenheim, J., Sparaciari, C., Šoda, B. et al. (2023) Gravitationally induced decoherence vs space-time diffusion: testing the quantum nature of gravity. Nat Commun doi: 10.1038/s41467-023-43348-2

Marletto, C. and Vedral, V. (2017) Gravitationally Induced Entanglement between Two Massive Particles is Sufficient Evidence of Quantum Effects in Gravity Phys. Rev. Lett. doi: 10.1103/PhysRevLett.119.240402

Bose, S. et al. (2017) Spin Entanglement Witness for Quantum Gravity Phys. Rev. Lett. doi: 10.1103/PhysRevLett.119.240401

Galley, T. (2023) Might There Be No Quantum Gravity After All? Physics 16, 203

Para saber más:

Teoría de la invariancia (serie)

Incompletitud y medida en física cuántica (serie)

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La comprobación experimental de la teoría postcuántica de la gravedad clásica se ha escrito en Cuaderno de Cultura Científica.

Eris, de planeta enano a planeta “blandito”

Aunque un gran desconocido para el público, Eris es el segundo planeta enano más grande de nuestro Sistema Solar, solo por detrás de Plutón. Fue descubierto en 2005, trayendo la discordia y un fuerte debate al mundo de la astronomía que obligó a repensar a que llamábamos planeta.

Esta disputa concluiría con la aparición de una nueva categoría -la de planeta enano- que nos devolvió a un Sistema Solar de ocho planetas… pero en el que ya hay nueve planetas enanos de los cuales -salvo en los casos de Ceres y Plutón- hemos podido ver muy poco debido a las enormes distancias que nos separan y el exiguo número de misiones dedicadas a estos cuerpos.

A pesar de las dificultades que impone la distancia y el tamaño de estos cuerpos, las observaciones de Eris realizadas desde los mejores telescopios nos permiten conocer algunos detalles interesantes que nos dan una idea sobre como podía ser este planeta enano.

Secuencia de imágenes donde se descubrió Eris en 2005 tomadas desde el observatorio del Monte Palomar, en California. Imagen Cortesía de NASA/JPL/Caltech.

Secuencia de imágenes donde se descubrió Eris en 2005 tomadas desde el observatorio del Monte Palomar, en California. Imagen Cortesía de NASA/JPL/Caltech.Estos datos apuntan a una superficie muy blanca y reflectante -refleja el 96% de la luz solar- algo que contrasta con la de Plutón, que refleja mucha menos luz y que -a grandes rasgos-es de un color bastante rojizo, algo que podría indicar que el hielo que cubre Eris se renueva -ahora mismo sería difícil de saber si por procesos internos o externos- y que, por lo tanto, existe cierta dinámica activa en el planeta.

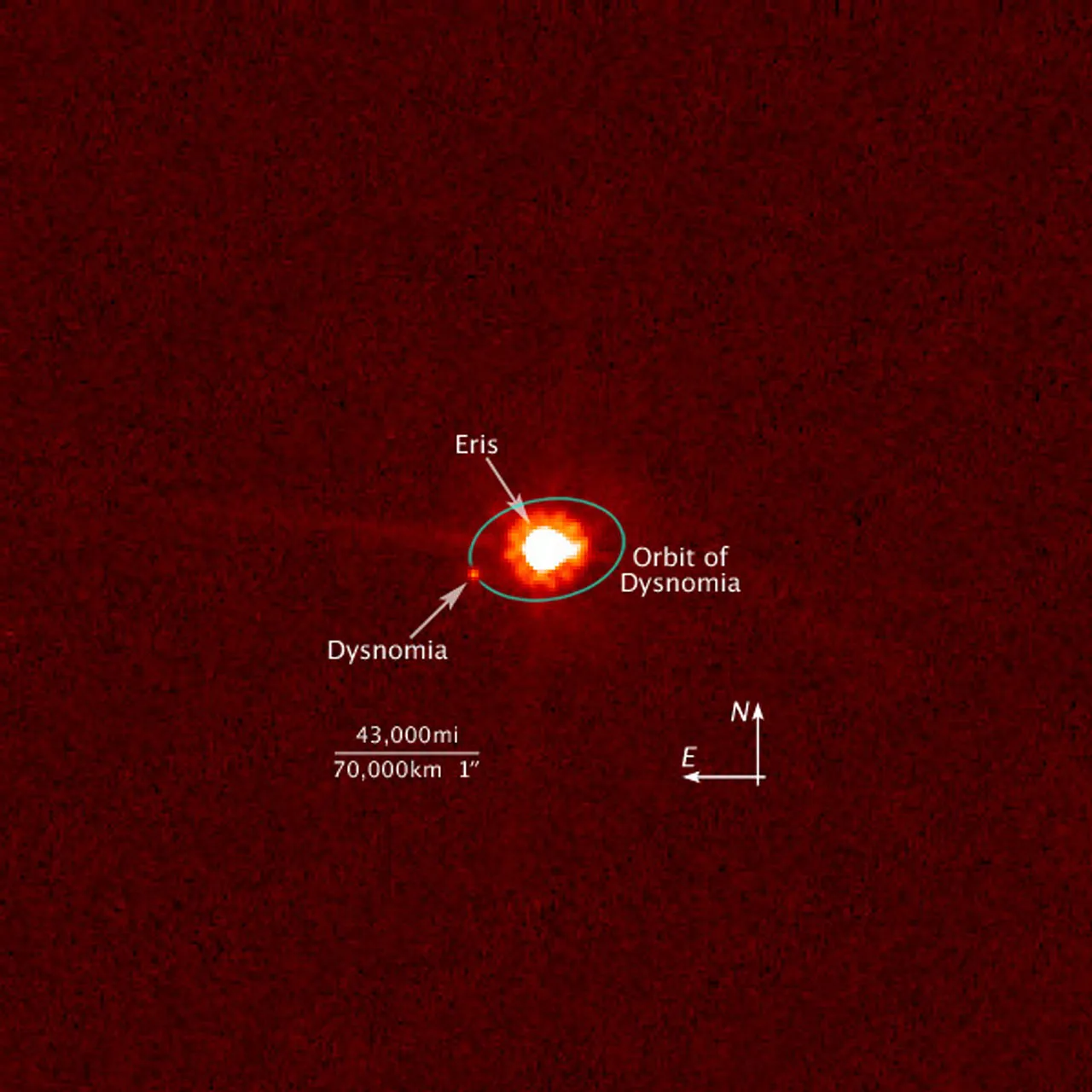

Eris tiene un satélite llamado Disnomia, con un diámetro aproximado de 615 kilómetros, lo que viene a ser una cuarta parte del de Eris, y que orbita a una distancia de este de unos 37.000 kilómetros. La existencia de este satélite fue la que permitió a los científicos calcular la masa de Eris con gran precisión y empezar a hacer asunciones sobre su composición y estructura interna.

Pues bien, un nuevo estudio publicado en la revista Science Advances ha analizado la relación orbital entre Eris y Disnomia para arrojar algo de luz sobre la estructura interna de Eris o, al menos, para construir una serie de modelos muy interesantes que nos permitan conocer más detalles sobre su interior y evolución, algo que a su vez nos daría pistas sobre una posible dinámica interna.

Para hablar de las conclusiones de este estudio, tenemos que remontarnos prácticamente a la formación del Sistema Solar, hace unos 4500 millones de años. En esta infancia de nuestro sistema planetario, Eris habría sufrido un gran impacto, bien arrebatándole una gran cantidad de materia de su manto -en torno a un 15%- o bien, debido al enorme calor generado por el impacto, se podría haber perdido un porcentaje importante de los elementos volátiles que lo componían. Este impacto resultaría en la formación de Disnomia.

Imagen tomada por el telescopio espacial Hubble donde se puede apreciar a Eris y a Disnomia, junto con una escala para hacernos a la idea de la distancia. Cortesía de NASA, ESA y M. Brown.

Imagen tomada por el telescopio espacial Hubble donde se puede apreciar a Eris y a Disnomia, junto con una escala para hacernos a la idea de la distancia. Cortesía de NASA, ESA y M. Brown.La consecuencia más inmediata para Eris sería el haberse convertido en un planeta enano más denso y que destaca tanto con respecto a Plutón, por ejemplo, y otros objetos, ya que ese calor habría sublimado o evaporado un gran volumen de elementos volátiles y alterado la proporción hielo/roca del planeta.

Pero hay más: Disnomia se habría formado mucho más cerca de Eris de lo que lo está ahora, provocando importantes mareas sobre Eris (y viceversa). Esta energía generada por las mareas se transformaría, en primer lugar, en calor, pudiendo alimentar fenómenos criovolcánicos y el rejuvenecimiento de la superficie e incluso, quién sabe, si la formación de un océano de agua líquida debajo de su corteza al poder mantener unas temperaturas más elevadas que las que podría haber hoy en día.

Pero esta disipación de la energía generada por las mareas también tendría un componente digamos que… astronómico, capaz de alterar, por un lado, la órbita de Disnomia, que progresivamente se ha ido alejando de Eris y, por otro, provocando el acoplamiento de mareas entre ambos cuerpos.

Este acoplamiento provoca que Eris y Disnomia siempre se “vean” la misma cara, ya que el periodo de rotación de ambos cuerpos y el de traslación de Disnomia están sincronizados, como ocurre con nuestra Tierra y la Luna. Aunque nos parezca algo extraño, es bastante común en nuestro sistema planetario.

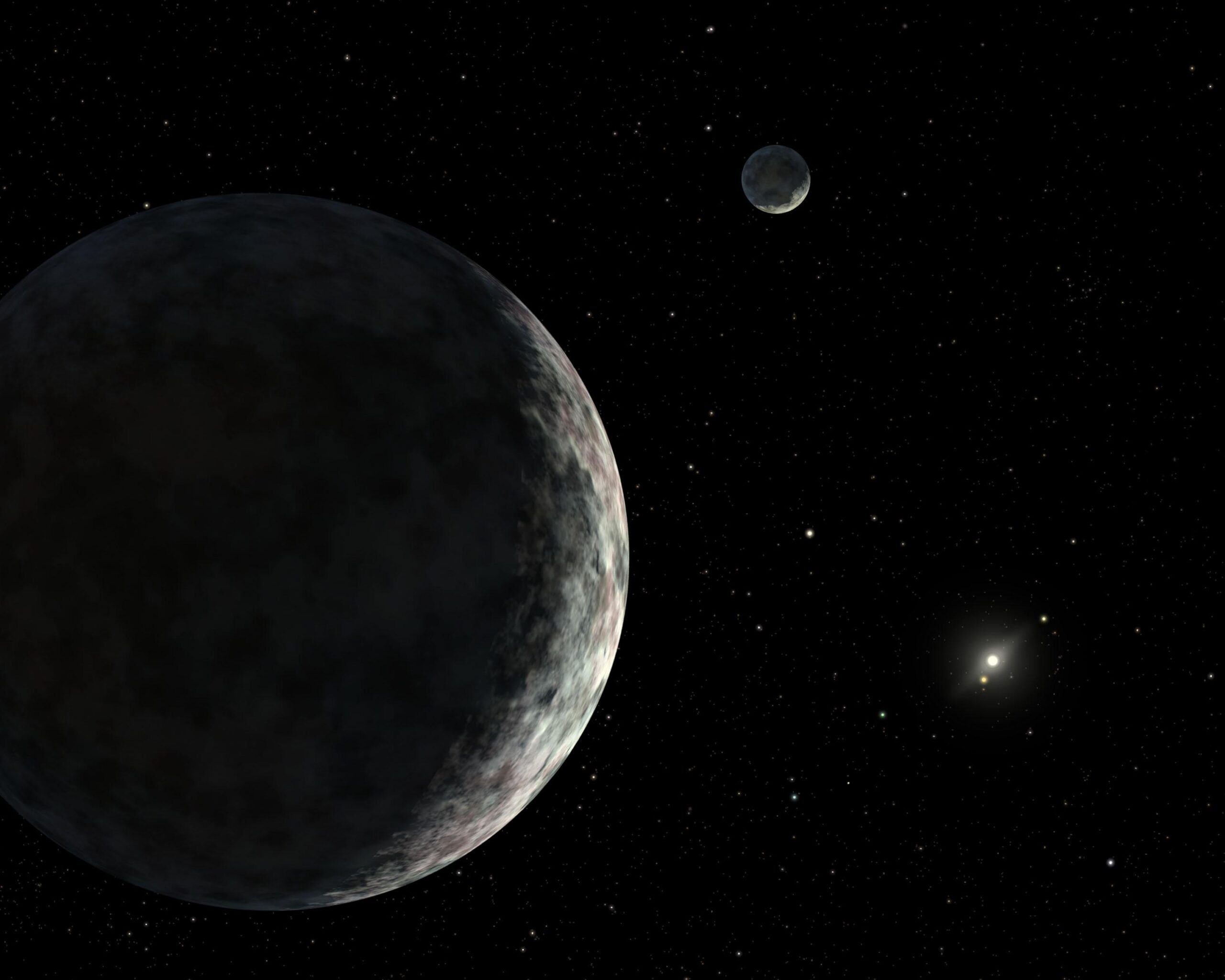

Impresión artística del sistema Eris-Disnomia. Cortesía de NASA/JPL-Caltech.

Impresión artística del sistema Eris-Disnomia. Cortesía de NASA/JPL-Caltech.Este detalle sugiere que el sistema ha alcanzado una configuración estable a lo largo de millones -probablemente miles de millones- de años y que Eris es un cuerpo que es capaz de disipar una gran cantidad de energía generada por su interacción con Disnomia, lo que hace pensar a los científicos que no es un cuerpo totalmente rígido, sino que todavía podría sufrir cierta convección en su capa intermedia de hielo gracias al calor de generado por la disipación de la energía de mareas y también de la desintegración de elementos radioactivos que todavía podrían quedar en su núcleo rocoso, que transferiría ese calor hacia la superficie. De aquí la broma del título de planeta “blandito”.

Precisamente, esta mayor disipación también apuntaría a que Eris sería un cuerpo totalmente diferenciado, es decir, formado por distintas capas -en este caso probablemente una corteza más rígida de hielo en la superficie, un manto de hielo en estado viscoso y en convección y por último un núcleo rocoso- como ocurre en nuestro planeta, en vez de ser una mezcla más o menos homogénea de roca y de hielo como se piensa que podrían ser otros planetas enanos.

Conocer la estructura de estos cuerpos podría ayudarnos en el futuro a estudiar detalles sobre su habitabilidad -presente y pasada- o a reconstruir su historia, algo muy valioso de cara a comprender la compleja dinámica de nuestro Sistema Solar, especialmente durante sus primeras etapas.

Referencias:

Nimmo, F. and Brown, M.E. (2023) The internal structure of Eris inferred from its spin and Orbit Evolution Science Advances doi: 10.1126/sciadv.adi9201

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo Eris, de planeta enano a planeta “blandito” se ha escrito en Cuaderno de Cultura Científica.

Comunismo originario en la prehistoria ibérica

Al leer el libro que les traigo hoy, he tenido la impresión de estar ante un (breve y muy bien escrito) tratado de arqueología de la Prehistoria Reciente.

El tratado comienza con unas consideraciones acerca de la naturaleza de la historia como disciplina. El autor quiere indagar acerca del origen de las desigualdades y las relaciones de dominación. Le interesan las sociedades en las que no habían surgido estados y en las que las relaciones entre sus miembros no eran de dominación. Y se remite –para glosar brevemente sus obras– a los autores de los siglos XVII, XVIII y XIX, aunque sus aportaciones no sean hoy consideradas fuentes fidedignas, sino que han de ser valoradas por las preguntas que se hicieron, las ideas que empezaron a hacer circular y por seguir siendo fuente de inspiración.

Dominación y desigualdadEn una de sus primeras aseveraciones, el autor, Rodrigo Villalobos García, sostiene que la dominación y la desigualdad no son relaciones sociales necesarias, eternas o inevitables, sino consecuencia de circunstancias históricas concretas. La afirmación me llamó la atención porque hacía unos pocos años había leído Against the grain: A Deep History of the Earlier States, de James C. Scott, y hace unos meses, The Dawn of Everything: A New History of Humanity, de David Graeber y David Wengrow. En ambos libros se sostienen, expresadas de forma diferente, tesis similares.

Si se me permite un inciso, la obra de Scott, aunque menos conocida en España que la de Graeber y Wengrow, y no tan extensa, me pareció más profunda y mejor documentada. Creo que no está traducida al español (la de los dos David, sí lo está). Scott estudia los albores del sedentarismo y las primeras aldeas en el Creciente Fértil, sobre todo en Mesopotamia.

Su conclusión es que lo que conocemos como neolitización no fue algo lineal, que hubiese obedecido a una trayectoria preestablecida (como se nos enseñó en la escuela), sino que fue un proceso irregular, con idas y vueltas, en el que las sociedades cambiaron de unas formas de vida a otras. Los cereales, su cultivo y las posibilidades de ser almacenados, generando excedentes, fue lo que, según el autor, acabó conduciendo a la aparición de las desigualdades estructurales y los estados.

Graeber y Wengrow no difieren demasiado –al menos para las entendederas de un humilde fisiólogo de animales– de lo que sostiene Scott, pero basan su análisis, sobre todo, en los pueblos originarios de Norteamérica y, en especial, de la costa Oeste. Me pareció que incurrieron en un cierto cherry picking. Sea como fuere, todos ellos, Scott, Graeber y Wengrow, y Villalobos García, vienen a coincidir en esa idea fundamental. Hasta aquí el inciso.

Comunismo originario en la PrehistoriaTras la introducción de las nociones fundamentales, Villalobos García aborda la noción del comunismo originario (que califica de esquiva) y caracteriza los diferentes tipos de sociedades sin gobierno: igualitarias, de rango y estratificadas, que no deben entenderse como peldaños en una escalera que conduce a sociedades con estados. A continuación se ocupa de los orígenes de la familia (el patriarcado), la propiedad privada y el estado. Sostiene que los estados arcaicos han sido menos poderosos, jerarquizados, desiguales y patriarcales que muchos otros estados desarrollados con posterioridad, aunque las semillas de esas desigualdades ya se encontraban en aquellos.

En ciertas sociedades sin estado los recursos se gestionan de forma colectiva, el trabajo se desempeña mediante asociación libre, hay democracia directa y aplican el principio «de cada uno según sus capacidades y a cada cual según sus necesidades»; esto es, se cumplen los requisitos para ser consideradas sociedades comunistas, aunque haya gran diversidad entre ellas. Pero, por otro lado, otras sociedades sin estado son patriarcales, explotan a parte de sus integrantes y practican la conquista. En otras palabras, la ausencia del estado no conlleva ausencia de opresión.

No hay sociedades naturalesConcluye el autor el capítulo dedicado al comunismo originario con una idea muy poderosa: no hay sociedades naturales. Añade: «Nunca las ha habido. Si acaso habrá una base de instintos biológicos que se pueden manifestar de distintas maneras en distintas personas de una sociedad y que, según el caso, pueden ser fomentados o desincentivados por condicionantes medioambientales varios, así como, también, por la propia cultura o subcultura en cada caso.»

Este aspecto me interesa especialmente porque, en efecto, los seres humanos no estamos dotados de serie con unos rasgos que nos hacen comportarnos de una u otra forma. Y, por lo tanto, las sociedades que conformamos no son consecuencia de decisiones o actuaciones condicionadas por esos rasgos. La falacia naturalista, también en aspectos como este, ha sido fuente de inspiración para estudiosos (y para muchos amateurs). No hay una sociedad natural. Y si la hubiera, no tendría por qué ser la buena.

Bipolos como generosidad/egoísmo, belicosidad/pacifismo, individualismo/colectivismo, y cualesquiera otros que se nos puedan ocurrir se encuentran en diferente grado en todas o casi todas las personas. Y si bien es cierto que hay personas más inclinadas a la compasión que a la indiferencia, por ejemplo, también lo es que la situación en que nos encontramos es el factor que más suele influir en nuestro comportamiento y, por tanto, el que inclina el bipolo hacia uno de los componentes. Las sociedades son, en consecuencia, una amalgama diversa de las interacciones entre personas entre las que suele haber bastante diversidad.

No hay una sociedad natural. Aunque también podría decirse que todas las sociedades humanas lo son. En otras palabras, la naturaleza no aboca a un único modelo social.

La observación manchada de teoríaLa arqueología, durante las últimas décadas, ha actualizado su arsenal metodológico, incorporando técnicas propias de las ciencias naturales. Esa transición, no obstante, no ha modificado el carácter básico de la disciplina. Sus practicantes, en función de su particular visión de la realidad, formulan modelos explicativos que pretenden dar cuenta de las observaciones (hallazgos) poniéndolas en un contexto narrativo coherente. En otras palabras, en arqueología hacen algo muy parecido a lo que hacemos en ciencias experimentales y naturales.

En estas disciplinas, en muchas ocasiones, hacemos experimentos en los que controlamos las condiciones y fijamos potenciales fuentes de variación para determinar la existencia e intensidad de los efectos cuya existencia pretendemos establecer, pero en otras ocasiones trabajamos como la haría un historiador. De hecho, hay disciplinas –en geología y biología, principalmente–que son intrínsecamente históricas.

Por otro lado, en determinadas ciencias experimentales y naturales, la visión de la realidad, las teorías en que se enmarcan los estudios, las hipótesis de las que parten las investigaciones, también influyen en los modelos que proponemos para explicar las observaciones. Esto extrañará a más de uno de mis colegas, pero es así. La observación (prácticamente) siempre está manchada de teoría.

Interpretando la PrehistoriaEn el cuarto capítulo se describen las principales líneas de pensamiento que durante el siglo XX han interpretado la Prehistoria reciente –en especial la de Occidente–, a cargo de autores como Childe, Renfrew, Gimbutas y Sherratt. Me ha alegrado ver el nombre de Colin Renfrew entre los autores de referencia, porque siendo estudiante universitario (a caballo entre los setenta y los ochenta del pasado siglo) leí un artículo suyo en Investigación y Ciencia que no he olvidado: trataba de la expansión simultánea, de carácter démico, de las lenguas indoeuropeas y el Neolítico por Europa.

Por fin en el último capítulo, cuyo título es el del libro, se presentan y discuten los hallazgos arqueológicos más relevantes y lo que de ellos cabe inferir sobre las relaciones de poder entre hombres y mujeres, entre clases sociales y entre grupos humanos, en la península Ibérica durante la Prehistoria Reciente.

Finaliza el autor remarcando la idea de que no hay trayectorias históricas prefijadas, y que, dado que en el pasado el futuro estuvo abierto, igualmente abierto lo está en la actualidad. En otras palabras, las sociedades no están condenadas a transitar por cauces preestablecidos. El autor deja clara su posición ideológica –lo que es de agradecer–, sin que esa posición sesgue el contenido de un texto que me ha parecido muy interesante.

Ficha:

Título: Comunismo originario y lucha de clases en la Iberia prehistórica. Arqueología social del neolítico, Calcolítico y Bronce Antiguo

Autor: Rodrigo Villalobos García

Ed. Sabotabby Press, 2022.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

Una versión de este texto apareció anteriormente en Lecturas y Conjeturas (Substack).

El artículo Comunismo originario en la prehistoria ibérica se ha escrito en Cuaderno de Cultura Científica.

Aulas virtuales o LMS en la educación presencial

La jornada Las Pruebas de la Educación tuvo lugar con el objetivo de analizar la validez de las estrategias educativas puestas en marcha durante los últimos años. El enfoque STEAM o las clases virtuales fueron analizados desde la evidencia científica por un grupo de expertos y expertas que se reunió en la Facultad de Educación de Bilbao de la Universidad del País Vasco. La jornada, fruto de la colaboración entre la Cátedra de Cultura Científica de la Universidad del País Vasco y la facultad de Educación de Bilbao, tuvo lugar el 27 de octubre pasado.

Esta sexta edición volvió a estar dirigida a profesionales del ámbito de la educación y a quienes, en un futuro, formarán parte de este colectivo. Su objetivo ha sido reflexionar, desde la evidencia científica, sobre la validez de las estrategias utilizadas hoy en día. El seminario ha contado, una vez más, con la dirección académica de la vicedecana de Investigación y Transferencia de la Universidad Autónoma de Madrid, Marta Ferrero González.

La decana de la facultad de Educación de Bilbao de la UPV/EHU, Urtza Garay Ruiz, doctora en psicodidáctica e investigadora en tecnología educativa, habla en esta charla de cómo usar de forma responsable y eficaz las aulas virtuales cuando la educación es presencial.

Edición realizada por César Tomé López

El artículo Aulas virtuales o LMS en la educación presencial se ha escrito en Cuaderno de Cultura Científica.

¿Las tecnologías digitales están corrompiendo la educación obligatoria?

Desde que el mundo es mundo, la tecnología ha estado presente en nuestro día a día. En el paleolítico inferior el Homo habilis empezó a utilizar herramientas de piedra: a partir de ahí, la humanidad no ha parado de generar nuevos objetos a base de los elementos que iba encontrando en su entorno más cercano. No debemos olvidar que la tecnología es todo aquello creado por el hombre, que no se puede encontrar por sí mismo en la naturaleza.

Esos elementos han supuesto un cambio en la manera en que hacemos las cosas, mejorando notablemente nuestra calidad de vida. Pero no todo ha sido de color de rosa. Toda innovación tecnológica ha tenido detractores. La época actual no iba a ser diferente y existe una corriente, cada vez más generalizada, dispuesta a achacar a los avances tecnológicos todos los males de esta sociedad. En el terreno educativo, el foco del debate se ha puesto en la siguiente pregunta dicotómica, a mi juicio, tendenciosa: ¿debemos usar los ordenadores en el aula?

Toda tecnología tiene implícitas unas ventajas y unos inconvenientes. En Educación, se traducen en ayudas y en riesgos para enseñar, para aprender y para la salud. No existe estudio que niegue rotundamente esa cuestión, ni lo habrá. Por lo tanto, la pregunta inicial no debiera ser esa. El debate no gira en usar o no usar tecnología digital en las aulas.

Foto: Tianyi Ma / UnsplashLas tecnologías no van a desaparecer

Foto: Tianyi Ma / UnsplashLas tecnologías no van a desaparecer

Los avances tecnológicos vienen para quedarse y posicionarnos a favor o en contra no aporta nada a la educación. Además, algunas personas lo plantean como un versus entre lo digital y lo analógico, una pelea en la que debe ganar una de las dos tecnologías. Olvidan que el libro de texto impreso también es una tecnología, sujeta a ventajas e inconvenientes, igual que esos ordenadores, pantallas, móviles y demás aparatos digitales que demonizan.

Vivimos tiempos convulsos, un periodo de grandes transformaciones sociales que influyen constantemente en las nuevas políticas educativas. Eso genera confusión, tanto en los docentes como en los estudiantes y las familias, respecto a la formación del ciudadano del siglo XXI que deseamos fomentar en nuestras escuelas. Sin embargo, la importancia de desarrollar la competencia digital en nuestro alumnado sigue siendo una constante inalterable.

En España, desde la promulgación de la Ley Orgánica de Educación en 2006 hasta la más reciente Ley Orgánica de Mejora de la Ley Orgánica de Educación en 2020, el foco de la formación en la etapa obligatoria ha sido promover un alumnado “multialfabetizado”.

Esa visión implica que, además de adquirir habilidades en lectoescritura, matemáticas y un conocimiento básico en áreas como idiomas, ciencias sociales, naturales, artísticas y culturales, los estudiantes deben ser capaces de enfrentarse a los retos de la sociedad de la información y la comunicación.

Cinco áreas claveLa iniciativa DigComp (Digital Competence Framework), impulsada por la Comisión Europea en 2013 y actualizada de forma continua desde entonces, ha obligado a los sistemas educativos a nivel nacional y autonómico a tomar diversas medidas para asegurar, entre su alumnado, múltiples competencias en cinco áreas clave.

Se busca que el ciudadano que salga de la escuela sea capaz de:

- Buscar, evaluar y organizar información.

- Comunicarse, colaborar y participar en entornos digitales.

- Crear, editar y publicar contenido digital.

- Protegerse de los riesgos asociados al uso de la tecnología y garantizar su privacidad.

- Identificar, analizar y resolver problemas típicos relacionados con el uso de las herramientas tecnológicas.

Lamentablemente, la práctica común de algunos sistemas educativos ha sido tomar medidas para la consecución de la multialfabetización de su alumnado mediante una implementación irreflexiva e indiscriminada de tecnología en las escuelas. En ese modo de actuar subyace una idea errónea basada en las bondades per se de la tecnología digital en los procesos educativos, no respaldada por evidencia alguna.

La literatura científica no ha aceptado la hipótesis de que a más tecnología en el aula se produzcan mejores resultados académicos. Por lo tanto, no se puede afirmar que exista una relación directa, lineal y automática entre esas dos variables, más allá del efecto causal hacia la mejora de la competencia digital del alumnado.

En el campo de la tecnología educativa destinada a estudiar el uso de diferentes herramientas y recursos tecnológicos para mejorar los procesos de enseñanza-aprendizaje existe una máxima que todos los investigadores asumen: la cuestión no es tecnológica, sino pedagógica. Cualquier herramienta o recurso que integrar en educación debe ser analizado desde el prisma del objetivo a lograr. Por lo tanto, la pregunta que nos tenemos que hacer es qué queremos conseguir.

El discente medio no existeSi hablamos de la educación obligatoria, debemos tener en cuenta la necesidad de responder a la diversidad del alumnado existente en nuestras aulas. Los últimos avances en neurociencias derivados por estudios científicos nos informan de esa variabilidad en la manera de aprender.

No obstante, se puede simplificar el aprendizaje a través de un modelo denominado Diseño Universal para el Aprendizaje basado en tres redes neuronales interdependientes:

- Una red afectiva que regula la implicación del alumnado en su aprendizaje.

- Una red de reconocimiento que permite procesar la información que se requiere.

- Una red estratégica que garantiza la acción y la expresión de lo aprendido.

Ese modelo propugna la utilización de diferentes opciones, estrategias y recursos. Y es en esa diversidad de soportes donde podemos encontrar la respuesta a nuestro dilema. Las pantallas, los ordenadores e internet tienen cabida junto a una gran diversidad de otras herramientas sobre la base de una reflexión previa y un diseño que acepte la variabilidad de nuestro alumnado y no intente buscar lo imposible, una planificación para un discente medio que no existe.

Lo importante en nuestras escuelas de educación obligatoria es programar actividades que utilicen una selección variada de herramientas, incluidas las digitales, que garantice a todo el alumnado, sin excepción e independientemente de sus características individuales, su motivación y compromiso, un procesamiento propio de la información y una puesta en práctica de lo aprendido.

A modo de conclusión, es importante subrayar que las tecnologías digitales no están corrompiendo la educación, pero tampoco podemos decir que la estén mejorando por el simple hecho de que se hayan naturalizado en nuestras aulas. Solo con una planificación sosegada hacia una escuela para todos nos puede llevar a un desenlace positivo en su integración.

Sobre el autor : Daniel Losada es Profesor Titular de Universidad en el Departamento de Didáctica y Organización Escolar. Facultad de Educación, Filosofía y Antropología, UPV/EHU

Una versión de este texto apareció originalmente en campusa.

El artículo ¿Las tecnologías digitales están corrompiendo la educación obligatoria? se ha escrito en Cuaderno de Cultura Científica.

I lava (que no magma) you

Foto: Martin Sanchez / Unsplash