Más allá de las neuronas

Al hablar de las células del sistema nervioso todo el mundo piensa inmediatamente en las neuronas, unidades de importancia capital porque están especializadas en recibir, procesar y transmitir información a través de señales químicas y eléctricas y sirven, entre otras funciones, para pensar y recordar. Pero las neuronas no están solas en el cerebro, sino que hay otras células que las acompañan y se encargan de tareas tan relevantes como la respuesta inmune o la eliminación de los residuos que se generan en el sistema nervioso central. Estas últimas células han sido las protagonistas de la charla que la doctora en Neurobiología Amanda Sierra ha ofrecido en el programa de conferencias Naukas Pro, que tienen lugar en el marco del evento de divulgación científica Bizkaia Zientzia Plaza, que se celebra en Bilbao del 18 al 25 de septiembre.

Imagen: Amanda Sierra, neurocientífica y profesora investigadora Ikerbasque en la Universidad del País Vasco y el Centro Vasco de Neurociencia Achucarro durante su charla en Naukas PRO 2019. (Fotografía: Iñigo Sierra)

Imagen: Amanda Sierra, neurocientífica y profesora investigadora Ikerbasque en la Universidad del País Vasco y el Centro Vasco de Neurociencia Achucarro durante su charla en Naukas PRO 2019. (Fotografía: Iñigo Sierra)En concreto la investigadora Ikerbasque se ha centrado en la microglía, un tipo de célula “muy pequeña que está constantemente escaneando el cerebro” en busca de estructuras dañadas, células muertas o residuos con la intención de eliminarlos.

Según la experta, el cerebro es como una sabana en la que habitan diferentes especies. Si un ejemplar muere, los animales carroñeros eliminan los residuos que se generan, llevando a cabo una función esencial para el equilibrio de ese ecosistema.

En el sistema nervioso ocurre algo parecido. Cuando las células mueren la microglía se encarga de encontrar y fagocitar esos residuos. Pero ¿cómo lo hacen? Lo cierto es que las células muertas emiten señales para llamar la atención de la microglía, se trata de “señales encuéntrame, como la galleta de Alicia en el País de las Maravillas que decía: cómeme”. Esta señal es la que permite que la microglía localice el tejido dañado y lance sus prolongaciones alrededor de la célula muerta formando un bolsillo tridimensional que la envuelve completamente y la atrae hacia sí para poder fagocitarla.

“Una de las preguntas que nos hacemos es qué le ocurre a la microglía después de llevar a cabo ese proceso. Estamos intentando responderla, ya que comerse una célula muerta implica una serie de cambios metabólicos en la microglía, modifica su función”, asegura la experta.

Este tipo de trabajos, que Sierra desarrolla en el laboratorio del Achucarro Basque Center for Neuroscience en el que trabaja, tienen relevancia para descubrir, por ejemplo, cómo se desenvuelven estas células en las situaciones en las que aparecen enfermedades neurodegenerativas. Lamentablemente, en algunos casos como el infarto cerebral o la epilepsia ya se ha detectado que no cumplen correctamente su función, por lo que los residuos se acumulan en el cerebro y se aumenta el daño todavía más.

Imagen: La investigadora Amanda Sierra explicó las líneas de investigación que desarrolla en Achucarro Center for Neuroscience, que se centra en las células microgliales y la interacción entre la fagocitosis y la inflamación en el cerebro enfermo. (Imagen: Iñigo Sierra)

Imagen: La investigadora Amanda Sierra explicó las líneas de investigación que desarrolla en Achucarro Center for Neuroscience, que se centra en las células microgliales y la interacción entre la fagocitosis y la inflamación en el cerebro enfermo. (Imagen: Iñigo Sierra)Las investigaciones de Sierra buscan generar conocimiento para abrir nuevas vías que permitan influir en el proceso de fagocitosis de la microglía, mejorar su eficiencia y acelerar las tareas de limpieza.

La experta aprovechó asimismo la cita para rendir homenaje al investigador Pío del Río Hortega, discípulo del científico vasco Nicolás Achúcarro, que murió en el exilio y fue una figura clave en el descubrimiento y estudio de la microglía hace aproximadamente 100 años. Aunque no lo logró, Río Hortega estuvo nominado al premio Nobel de Medicina en dos ocasiones por su contribución a la ciencia. Sus restos mortales descansan desde 1986 en el Panteón de Hombres Ilustres del cementerio de Valladolid, de donde era oriundo.

Sobre la autora: Marta Berard, es periodista, responsable de contenidos de la agencia de comunicación GUK y colaboradora de la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Más allá de las neuronas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La hiperactividad neuronal impide que las microglías realicen su trabajo

- El citoesqueleto de las neuronas y el alzhéimer

- Las dos culturas y más allá: Ciencia, Sociedad y Desarrollo (curso de verano)

¿Y si el futuro de la refrigeración estuviera en Galicia? Caliente, caliente

Si jugáramos a asociar un concepto a un topónimo y para empezar la partida escogiéramos el término frío, seguramente mucha gente contestaría Siberia. Lo cierto es que es una muy buena respuesta, porque el clima siberiano se caracteriza por unas temperaturas extraordinariamente bajas. Pero cuando hablamos del frío generado artificialmente hay otro territorio geográfico que está emergiendo con fuerza: se trata de Galicia, y muy particularmente del Centro de Investigaciones Científicas Avanzadas (CICA) de la Universidad de A Coruña, porque es allí donde un equipo de investigadores ha descubierto las perovskiñas, una nueva familia de materiales sólidos con potencial para revolucionar el futuro de la refrigeración.

Imagen: Juan M Manuel Bermúdez, doctor en Química Ambiental y Fundamental por la Universidade da Coruña e investigador que desarrolla su labor en el ámbito de la química del estado sólido y ciencia de materiales, durante su charla en Naukas PRO 2019. (Fotografía: Iñigo Sierra) (Fotografía: Iñigo Sierra)

Imagen: Juan M Manuel Bermúdez, doctor en Química Ambiental y Fundamental por la Universidade da Coruña e investigador que desarrolla su labor en el ámbito de la química del estado sólido y ciencia de materiales, durante su charla en Naukas PRO 2019. (Fotografía: Iñigo Sierra) (Fotografía: Iñigo Sierra)“Es una investigación realizada por un equipo formado íntegramente por miembros de la Universidad de A Coruña”, asegura uno de los padres de las perovskiñas, el doctor en Química Ambiental y Fundamental Juan Manuel Bermúdez. El científico ha presentado los resultados de su estudio y sus posibles aplicaciones dentro del programa de conferencias Naukas Pro, que tienen lugar en el marco del evento de divulgación científica Bizkaia Zientzia Plaza, que se celebra en Bilbao del 18 al 25 de septiembre.

Pero para entender el hallazgo un poco mejor hay que volver al punto de partida. Según los datos que maneja Bermúdez, el 10% del consumo eléctrico mundial se destina a dispositivos de aire acondicionado. Si a este dato le sumamos el consumo de neveras domésticas, frigoríficos y cámaras industriales el porcentaje se sitúa en el 20% del total. Generar frío de forma artificial es necesario para conservar los alimentos, garantizar el buen estado de muchos medicamentos y mejorar la calidad de vida de las personas, pero, para conseguirlo, se emplean diversos tipos de fluidos refrigerantes que tienen impacto en el medioambiente. Por este motivo resulta imperativo investigar en el descubrimiento de nuevas fórmulas de enfriar más respetuosas con el medio natural. Eso es exactamente lo que Bermúdez ha compartido en una charla en la que se ha valido de imágenes térmicas de objetos cotidianos tomadas con cámaras de infrarrojos, que se pueden consultar en el perfil de Instagram @thermogramer.

El experto ha hecho un repaso por los principales inconvenientes que presentan para el medio ambiente los actuales sistemas de refrigeración y ha presentado a la audiencia las ventajas de las perovskiñas, una familia de materiales barocáloricos muy flexibles que tienen la capacidad de producir efectos de refrigeración si se les aplica presión.

Imagen: Juan Manuel Bermúdez presentó un nuevo material en Naukas PRO 2019, la perovskiña. La perovskiña es un nuevo material sólido que responde a aplicación de bajas presiones enfriándose con facilidad. (Fotografía: Iñigo Sierra)

Imagen: Juan Manuel Bermúdez presentó un nuevo material en Naukas PRO 2019, la perovskiña. La perovskiña es un nuevo material sólido que responde a aplicación de bajas presiones enfriándose con facilidad. (Fotografía: Iñigo Sierra) Pero ¿por qué se llaman perovskiñas? El término constituye la versión gallega del sustantivo perovskita, que abarca los compuestos que presentan una estructura reticular en forma de cubos que alojan iones en su interior. De hecho la perovskita es un mineral poco frecuente que fue descubierto a inicios del siglo XIX en los Montes Urales. ¡Tachán! Al hablar de frío tarde o temprano tenía que aparecer Rusia.

Además de servir para enfriar neveras y aparatos de aire acondicionado, las perovskiñas presentan, según Bermúdez, un enorme potencial de aplicación. Por ejemplo, como plantillas de calzado para que los deportistas puedan evitar el sobrecalentamiento del pie y autorrefrigerarse a través de sus propias pisadas (hay que recordar que las perovskiñas despliegan sus efectos refrigerantes mediante presión).

También podrían ser útiles para concebir colchones que dieran fresquito en verano, evitar el sobrecalentamiento de teléfonos móviles e incluso contribuir a la refrigeración de un gran equipamiento como un aeropuerto o una estación si se aplican al suelo y se aprovecha la presión ejercida por las personas que lo recorren. Nada de esto existe en este momento, pero hay un universo de posibilidades por explorar. Seguramente por eso la investigación ha sido publicada en Nature Communications y ha recibido reconocimientos como el Premio de Investigación Ernesto Viéitez de la Real Academia Galega de Ciencias.

Sobre la autora: Marta Berard, es periodista, responsable de contenidos de la agencia de comunicación GUK y colaboradora de la Cátedra de Cultura Científica de la UPV/EHU.

El artículo ¿Y si el futuro de la refrigeración estuviera en Galicia? Caliente, caliente se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Recomiendan el antibiótico Eridosis para el acné en sus redes sociales, pero no son médicos

Foto: Deborah García Bello

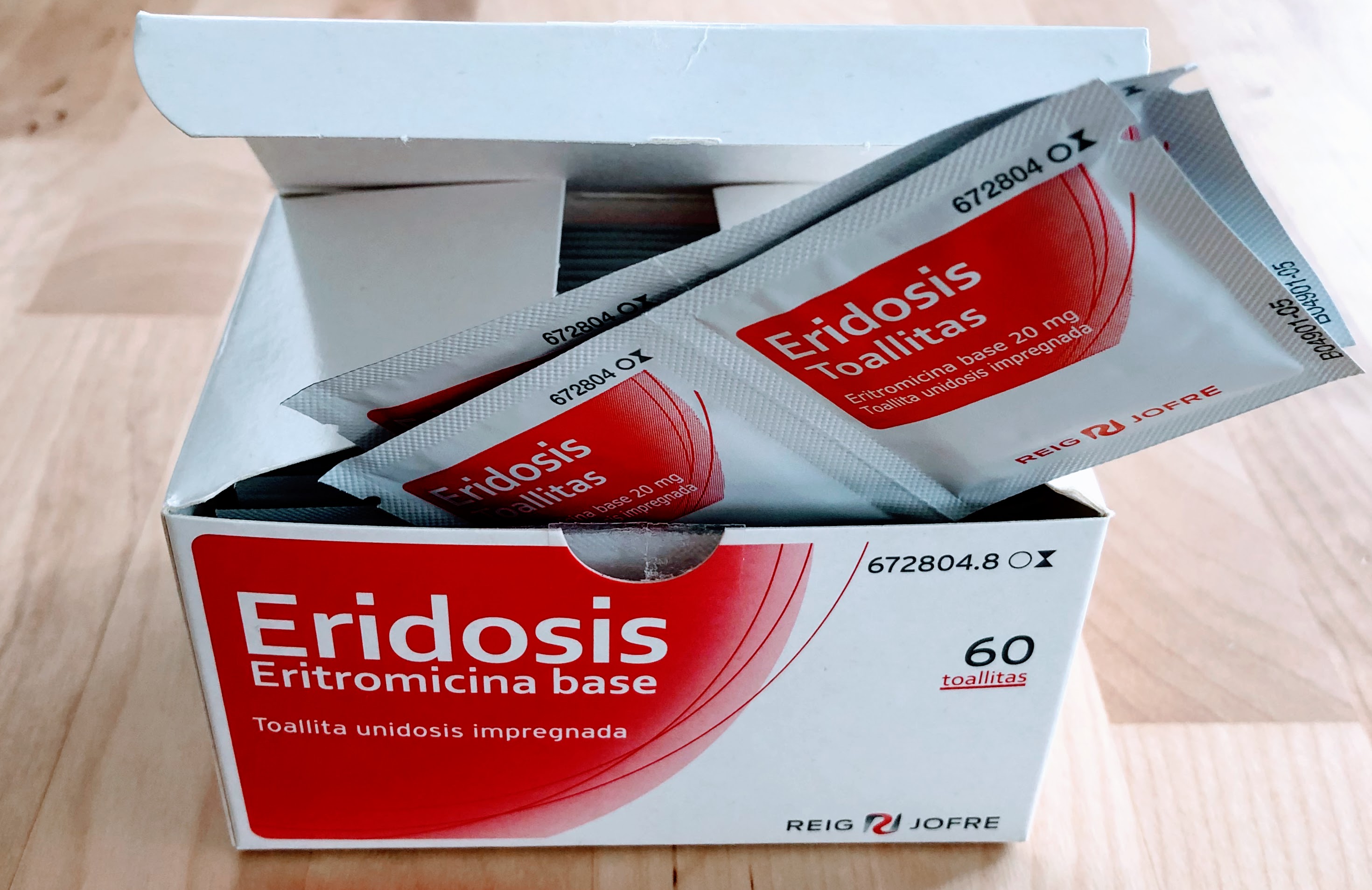

Foto: Deborah García BelloEn las redes sociales hay personas con miles de seguidores que enseñan cuáles son sus remedios para luchar contra el acné. Personas sin formación científica ni vínculo alguno con la profesión sanitaria recomiendan mascarillas de yogur, miel, bicarbonato o limón. Estas mascarillas, además de ser ineficaces contra el acné, pueden causar graves daños en la piel. Desde hace poco nos enfrentamos a una nueva recomendación por parte de algunos influencers cuyo daño es de mayor envergadura. Se trata de las toallitas Eridosis. Las toallitas Eridosis son un medicamento sujeto a prescripción médica cuyo principio activo es un antibiótico. En las redes hay quien recomienda este medicamento con ligereza, como si se tratase de una simple toallita desmaquillante. Este es el origen del problema, pero no termina ahí. Hay farmacias que dispensan este medicamento sin pedir la receta médica y sin dar ningún tipo de información.

-

Las toallitas Eridosis son un medicamento, no un cosmético.

La diferencia entre un medicamento de uso tópico y un cosmético es la actividad farmacológica. Mientras que en un cosmético ningún principio activo puede penetrar más allá de la dermis, en un medicamento de uso tópico el principio activo sí puede penetrar y tener actividad farmacológica más allá de la barrera cutánea. Las bases reguladoras para su fabricación y distribución también son diferentes. Los medicamentos solo se venden en farmacia; mientras que los cosméticos son de venta libre. El laboratorio cosmético es quien decide en qué canal vende sus productos.

Las toallitas Eridosis son un medicamento. Pertenecen a los laboratorios Reig Jofre y son un preparado anti-acné para uso tópico. Es uno de los tratamientos más prescritos por médicos ante casos de acné leve y moderado.

El principio activo que contiene es la eritromicina. Cada toallita está impregnada con un mililitro de una disolución de eritromicina al 2% de concentración (20 mg de eritromicina por cada ml de preparado).

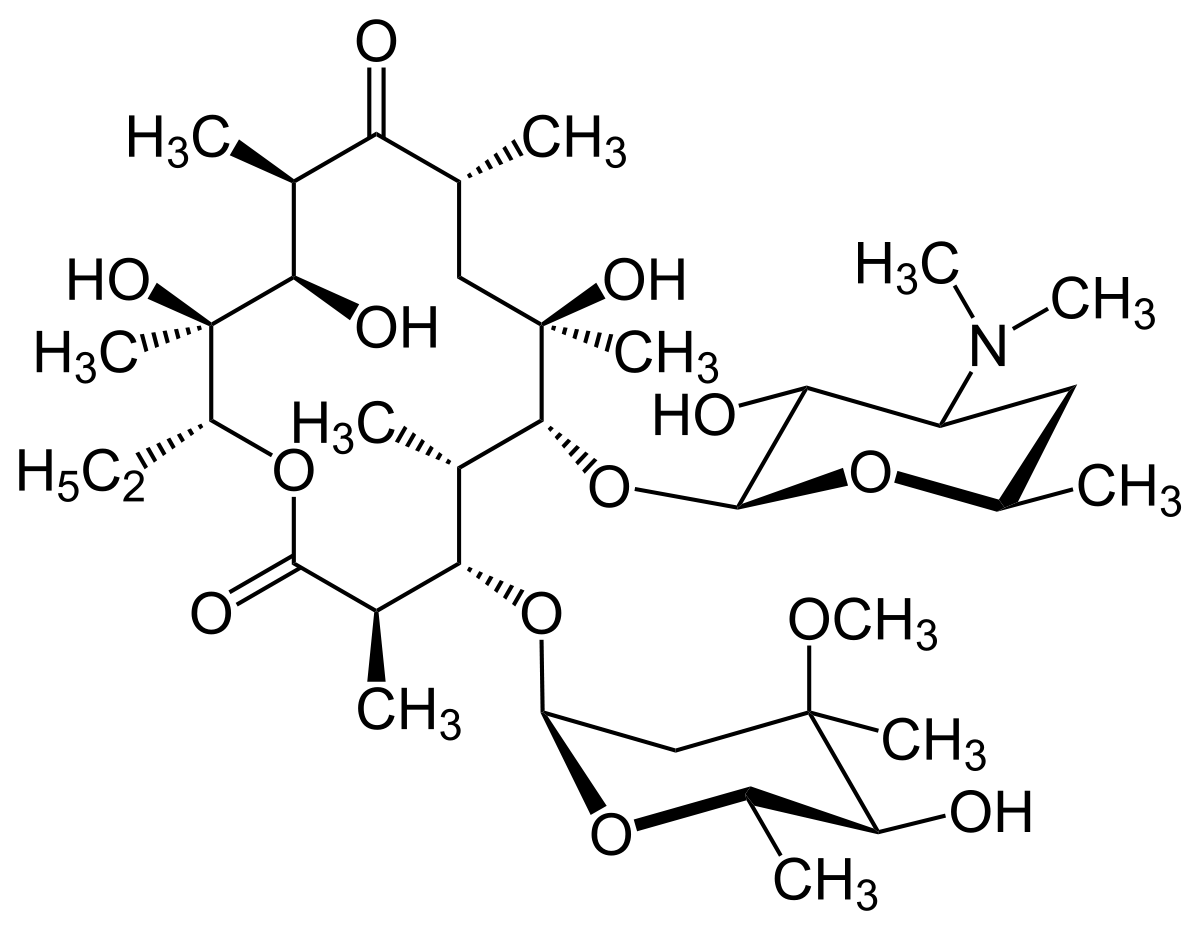

Eritromicina. Fuente: Wikimedia Commons

Eritromicina. Fuente: Wikimedia Commons

La eritromicina es un antibiótico del grupo de los macrólidos, con acción bacteriostática. Aunque es un antibiótico de espectro antibacteriano moderadamente amplio, es especialmente activo frente al Propionibacterium acnes, la bacteria responsable del acné.

El mecanismo exacto por el cual la eritromicina reduce el acné vulgar no es bien conocido. Sin embargo, se sabe que la eritromicina actúa por inhibición de la síntesis de proteínas en microorganismos sensibles y de esa forma se explica su actividad antibacteriana.

-

Contraindicaciones y advertencias de Eridosis.

Como en cualquier otro medicamento, en el prospecto de Eridosis figuran una serie de contraindicaciones, precauciones, advertencias y reacciones adversas. Es un medicamento y, como tal, puede producir ciertos efectos secundarios.

Hay que tener especial precaución durante el embarazo y la lactancia con el uso de eritromicina tópica. La razón es que la eritromicina atraviesa la placenta, alcanzando concentraciones bajas en el feto, pero no despreciables. La seguridad de su uso durante el embarazo no ha sido establecida, por eso se aconseja que este medicamento se utilice solo cuando se estime imprescindible y siempre que el beneficio supere el posible riesgo.

Con respecto a la lactancia se desconoce si la eritromicina se excreta con la leche materna tras la administración tópica. Sin embargo, es sabido que la eritromicina administrada por vía sistémica se excreta con la leche materna, por ese motivo se aconseja administrar este medicamento con precaución a madres lactantes.

No obstante, en el prospecto de Eridosis se indica que «los resultados de los estudios realizados con Eridosis al 2% demostraron que no aparecen niveles detectables de eritromicina en el suero sanguíneo de los pacientes acneicos tratados».

Los efectos adversos de este medicamento son, en general, leves y transitorios. Los efectos secundarios que se manifiestan más frecuentemente son alteraciones dermatológicas como eritema, sequedad de la piel, piel escamosa, prurito, irritación, sensación de quemazón cutánea y ampollas (pustulosis exantemática). El uso tópico de este medicamento, concomitante con otras terapias contra el acné, deben realizarse con precaución y bajo supervisión médica debido a la posibilidad de acumulación de efectos irritantes.

En el prospecto de Eridosis también se advierte que «la utilización de agentes antimicrobianos (especialmente en terapias prolongadas) puede estar asociada con la proliferación de gérmenes resistentes a los antibióticos». La resistencia a los antibióticos es la pandemia más grave que se nos viene encima en este siglo.

-

Los influencers recomiendan y las farmacias dispensan

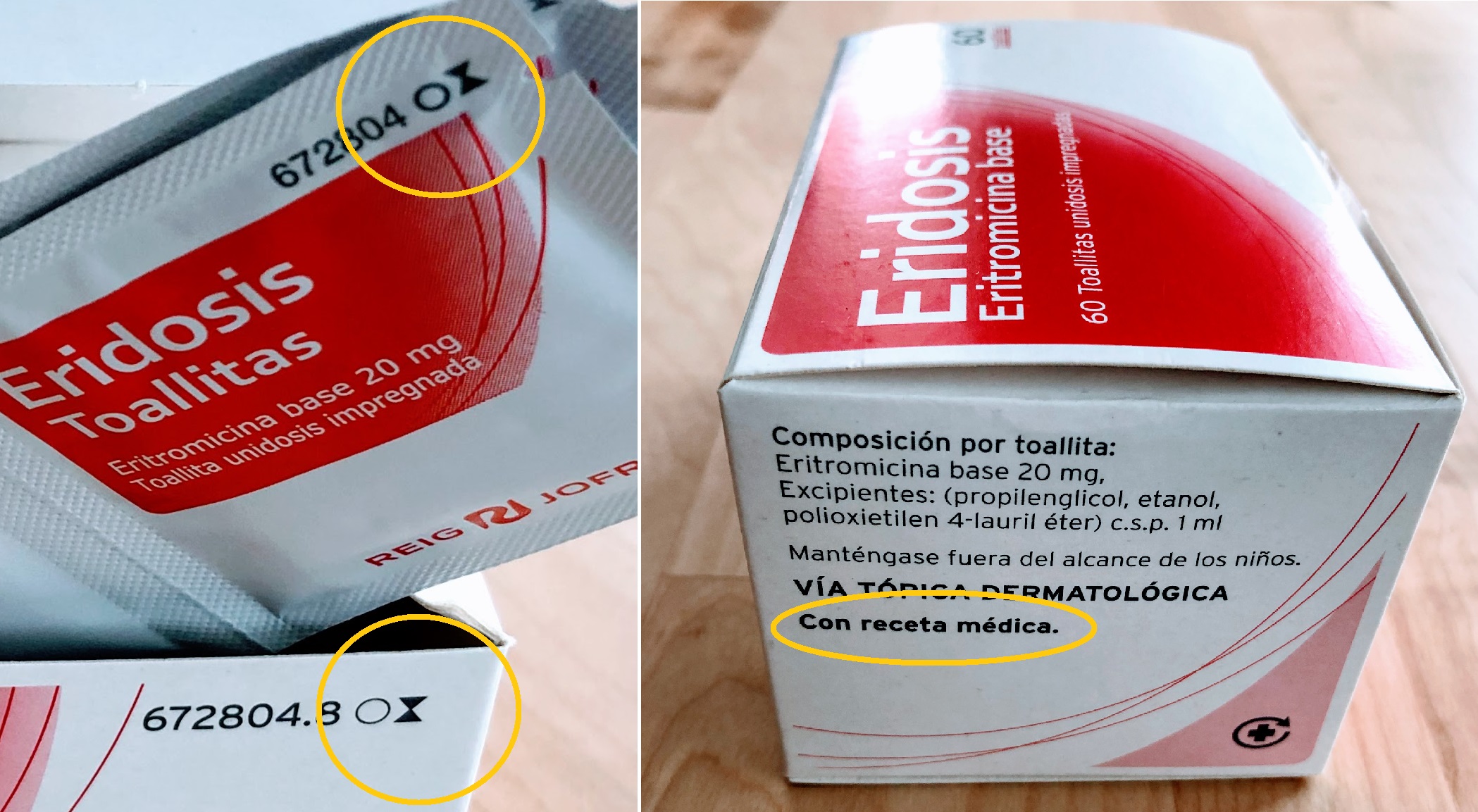

Para documentarme para este artículo visité seis farmacias españolas. En todas ellas pedí “las toallitas Eridosis”. Solo en una de las seis farmacias me indicaron que se trataba de un medicamento sujeto a prescripción médica y que no lo dispensarían sin receta. Allí me explicaron que se trata de un antibiótico, me hablaron del problema de la resistencia a los antibióticos y de los posibles efectos adversos y contraindicaciones. En las otras cinco farmacias no habría tenido ningún problema en llevarme el medicamento. No me hicieron ninguna pregunta. Son tres euros veinte. Nada más. Compré el medicamento en una de ellas para ver el prospecto actual y escribir este artículo.

Foto: Deborah García Bello

Foto: Deborah García BelloEn el lateral de la caja de Eridosis aparece escrito en negrita «Con receta médica». En el frontal, al lado del código nacional del medicamento, aparece un círculo. También aparece en cada sobre. Ese círculo es el símbolo que indica «dispensación sujeta a prescripción médica».

-

A modo de cierre

Las redes sociales son muy útiles a la hora de difundir información, también desinformación. Y aunque las recomendaciones sanitarias de un influencer sin formación científica tendrían que parecer un chiste para cualquiera, la realidad es que no es así, y hay personas que siguen sus consejos. Unos y otros por ignorancia.

Compañías como Google han empezado a tomar medidas relacionadas con esto, como prohibir los anuncios de tratamientos médicos especulativos y sin evidencia científica suficiente. Sería conveniente que las redes sociales filtrasen los contenidos con implicaciones sanitarias. Se censuran los pezones femeninos, pero no se controlan los anuncios de antibióticos. Al teclear “eridosis” en el buscador de cualquier red social aparecen decenas de publicaciones en las que personas sin formación recomiendan su uso.

No obstante, la responsabilidad final recae en el personal sanitario. Las farmacias no deberían dispensar medicamentos sujetos a prescripción médica sin solicitar receta y sin orientar al paciente.

A modo de cierre. Si tienes la sospecha de padecer acné, no busques el remedio en las redes sociales. Pide consejo en la farmacia y acude al médico.

Para saber más:

Ni mitos ni remedios caseros: así me libré del acné.

Sobre la autora: Déborah García Bello es química y divulgadora científica

Nota de la autora: Deliberadamente en este artículo no se ha enlazado ninguna publicación de influencers que hayan recomendado el uso de Eridosis. Una de las razones es no fomentar más su difusión. Otra de las razones es no inducir linchamientos en las redes sociales. Por educación y por elegancia, elijo criticar el hecho y no la persona. Y porque para brillar es mejor echarse purpurina.

El artículo Recomiendan el antibiótico Eridosis para el acné en sus redes sociales, pero no son médicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La confianza en las redes sociales y el uso de electrodomésticos inteligentes

- Ni mitos ni remedios caseros: así me libré del acné

- Las redes 5G no afectan a la salud… pero podrían hacer que el hombre del tiempo acierte menos

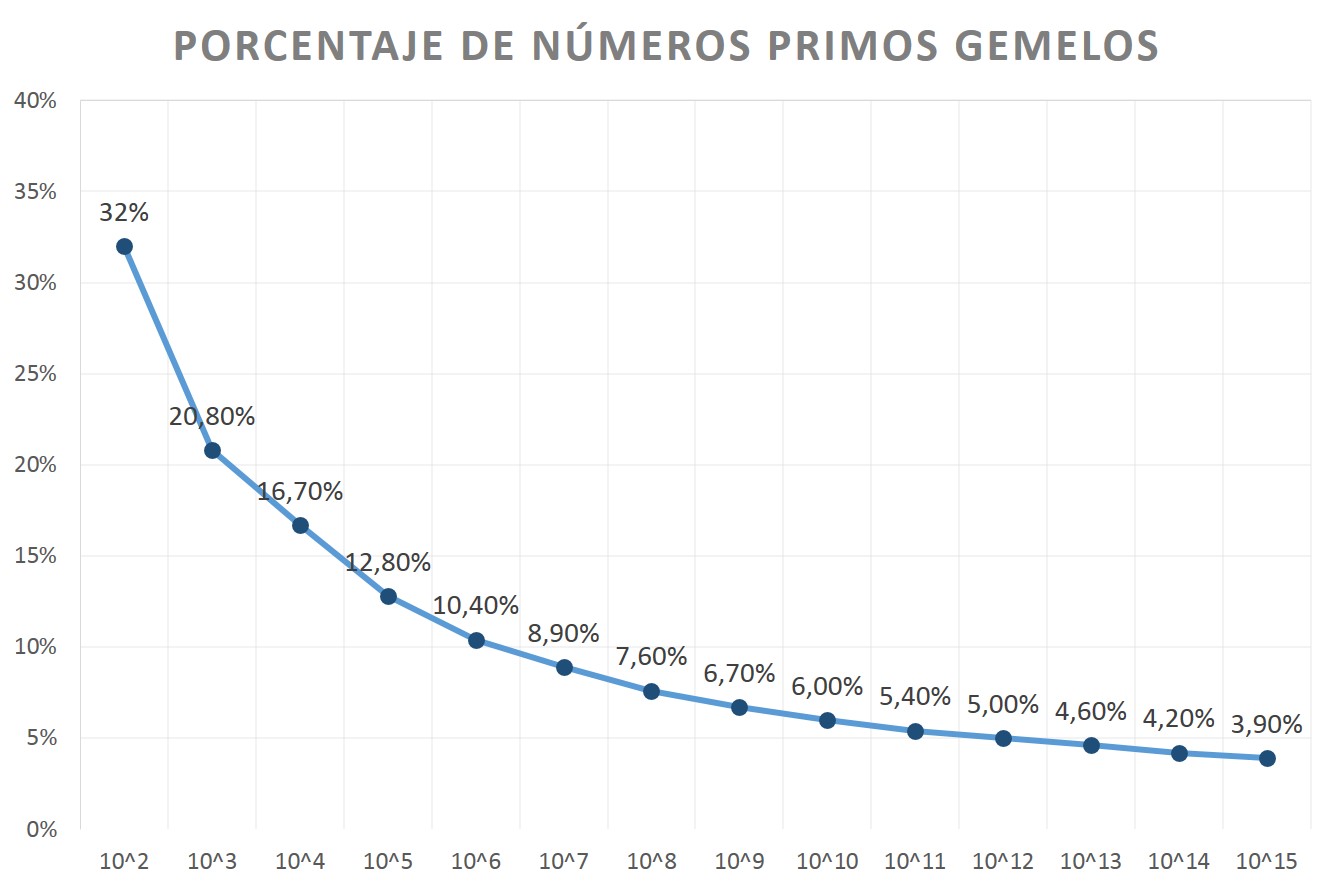

Números primos gemelos, parientes y sexis (2)

En mi anterior entrada de la sección Matemoción de Cuaderno de Cultura Científica, titulada Números primos gemelos, parientes y sexis (1), estuvimos hablando de los números primos gemelos, que son aquellas parejas de números primos que están lo más cerca que pueden estar dos números primos, excepto el 2 y el 3, con solo un número par entre ellos, (p, p + 2), así como de algunas familias de números primos relacionadas con los gemelos, como son los trillizos, cuatrillizos, quintillizos, etc.

En esta entrada, vamos a considerar otras familias de números primos, que también generalizan, en otro sentido, a los números primos gemelos, como son los números primos parientes y sexis.

Escena de la primera cita entre el profesor de matemáticas de la Universidad de Columbia (Jeff Bridges) y la profesora de literatura inglesa de la misma universidad (Barbra Streisand), en la película El amor tiene dos caras (1996), dirigida por Barbra Streisand. El profesor de matemáticas explica en la misma qué son los números primos gemelos

Escena de la primera cita entre el profesor de matemáticas de la Universidad de Columbia (Jeff Bridges) y la profesora de literatura inglesa de la misma universidad (Barbra Streisand), en la película El amor tiene dos caras (1996), dirigida por Barbra Streisand. El profesor de matemáticas explica en la misma qué son los números primos gemelosPero primero vayamos con un poquito de historia. Como puede leerse en el artículo A note on the Origin of the Twin Prime Conjecture (Nota sobre el origen de la conjetura de los números primos gemelos), del historiador de las matemáticas estadounidense William Dunham, en 1849 el matemático francés y oficial de artillería Alphonse de Polignac (1826–1863), un personaje prácticamente desconocido, publicó el artículo Recherches Nouvelles sur les Nombres Premiers ( Nuevas investigaciones sobre números primos), en la revista Comptes rendus de la Academia de Ciencia Francesa, en la que afirmaba lo siguiente (aunque lo presentó como un teorema, era más bien una conjetura).

Conjetura de Polignac: para cada número natural k, existen infinitos números primos p, tales que (p + 2k) también es primo.

Observemos que para k = 1, es la conjetura de los números primos gemelos.

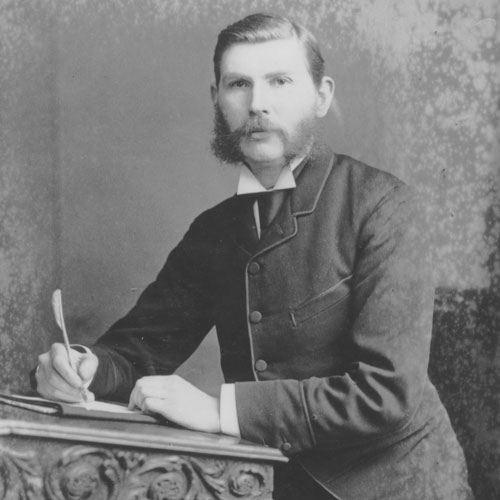

El siguiente protagonista de esta historia es el matemático inglés James Whitbread Lee Glaisher (1848 – 1928), profesor del Trinity College de Cambridge y que tuvo una reconocida carrera dentro de la matemática y la ciencia británicas. En 1879, publicó en la revista Messenger of Mathematics, de la que fue editor durante 56 años, el artículo An Enumeration of Prime-Pairs (Enumeración de pares primos), en la que estudiaba lo que llamó “pares primos”, que eran números primos “separados por un solo número” (lo que conocemos como números primos gemelos). Contó la cantidad de “pares primos” que había hasta un millón, dos millones, etcétera, con el objetivo de analizar la distribución de estos. Y afirmó “Hay poca o ninguna duda de que el número de pares primos es ilimitado; pero sería interesante, aunque probablemente no sencillo, demostrarlo”. Es decir, la conjetura de los números primos gemelos.

Aunque fue el matemático alemán Paul Stäckel (1862 – 1919), quien acuñó el término “números primos gemelos”, en alemán Primzahl-Zwillinge, en un artículo de 1916. Poco después el matemático francés Viggo Brun, utilizaría ese mismo término en francés, en su artículo de 1919 (véase a entrada Números primos gemelos, parientes y sexis (1)), y acabó convirtiéndose en el término utilizado para ese concepto.

Fotografía de 1908 del matemático de Trinity College, Cambridge, James Whitbread Lee Glaisher (1848-1928)

Fotografía de 1908 del matemático de Trinity College, Cambridge, James Whitbread Lee Glaisher (1848-1928)

Sobre la conjetura de los números primos gemelos ya estuvimos hablando en la primera parte de esta serie, Números primos gemelos, parientes y sexis (primera parte) [https://culturacientifica.com/2019/09/04/numeros-primos-gemelos-parientes-y-sexis-1/]. En esta entrada vamos a analizar las otras parejas de números primos que aborda la conjetura de Polignac, en particular, los números primos parientes (k = 2) y sexis (k = 3).

Si los números primos gemelos son aquellas parejas de números primos tales que la diferencia entre ellos es 2 (k = 1), es decir, parejas de primos (p, p + 2), se van a llamar números primos parientes (“cousin” en inglés) a las parejas de números primos con una diferencia entre ellos de 4 (k = 2), luego de la forma (p, p + 4), como (3, 7), (7, 11) o (13, 17).

Las parejas de números primos parientes menores de 500 son (véase la sucesión A023200 de la enciclopedia online de números enteros):

(3, 7), (7, 11), (13, 17), (19, 23), (37, 41), (43, 47), (67, 71), (79, 83), (97, 101), (103, 107), (109, 113), (127, 131), (163, 167), (193, 197), (223, 227), (229, 233), (277, 281), (307, 311), (313, 317), (349, 353), (379, 383), (397, 401), (439, 443), (457, 461), (463, 467), (487, 491), (499, 503).

La pareja de números primos parientes más grande conocida, a día de hoy, fue obtenida en 2009, y está formada por los números (p, p + 4), tal que

p = [311.778.476 x N x (N + 1) + 210] x [N – 1] / 35 + 1,

para N = 587.502 x 9.001#, donde 9.001# denota el primorial de 9.001, que definiremos a continuación, que tiene 11.594 dígitos.

El primorial de un número n, que se denota n#, es una especie de factorial del número (véase Buscando lagunas de números no primos) que se define como el producto de todos los números primos menores, o iguales, que ese número n. Así, si tomamos el número primo 23, entonces 23# = 2 x 3 x 5 x 7 x 11 x 13 x 17 x 19 x 23 = 223.092.870 o para el número 39 se tiene que 39# = 2 x 3 x 5 x 7 x 11 x 13 x 17 x 19 x 23 x 29 x 31 x 37 = 7.420.738.134.810.

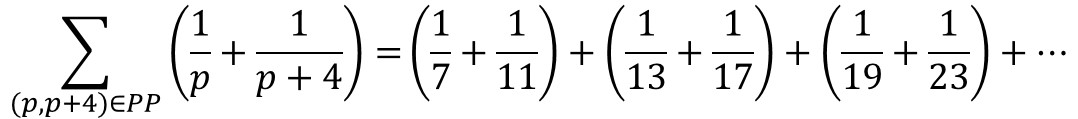

Para los números primos parientes existe un resultado análogo al teorema de Brun para números primos gemelos, es decir, la suma de los recíprocos de los números primos parientes (salvo la pareja 3 y 7)

también es convergente, y su límite es el número B4, conocido como constante de Brun para números primos parientes, que tiene un valor aproximado de 1,1970449 (véase el artículo On the Twin and Cousin Primes, de Marek Wolf).

Nos podemos interesar ahora por las ternas de números primos parientes, como (3, 7, 11). Pero resulta que esa es la única terna de números primos parientes que existe, puesto que si tenemos una terna de números primos de la forma (p, p + 4, p + 8), necesariamente uno de ellos es divisible por 3. Esto es fácil de probar. Si escribimos p de la forma p = 3 n + r, donde r = 0, 1 ó 2, entonces la terna anterior es de la forma (p = 3 n + r, p + 4 = 3 (n + 1) + r + 1, p + 8 = 3 (n + 2) + r + 2), luego si r = 0, el primer número de la terna es divisible por 3, si r = 1, lo es el tercero y si r = 2, lo es el segundo.

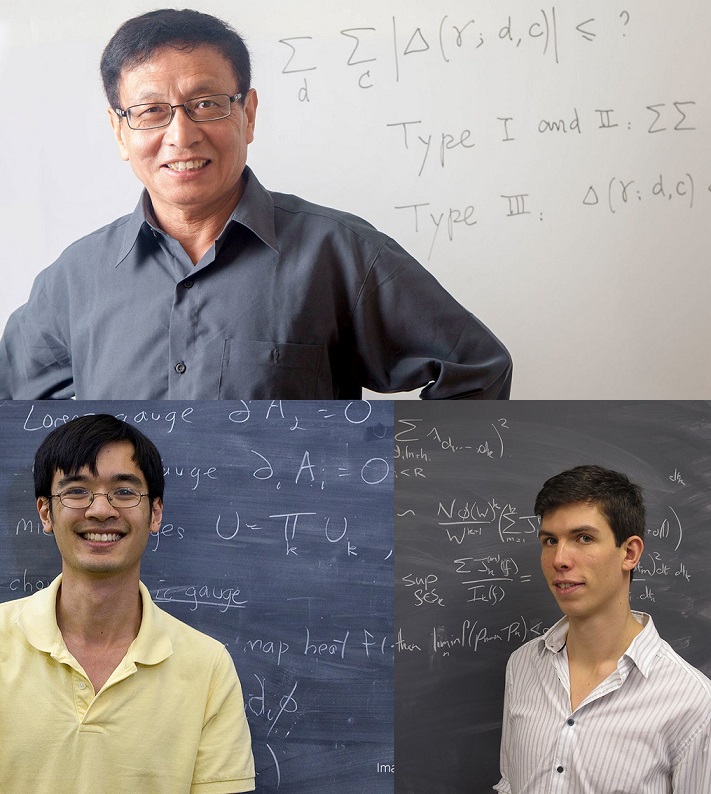

La investigación de los matemáticos Yitang Zhang, Terence Tao y James Maynard sobre la conjetura de los números primos gemelos, ha conseguido grandes avances en los últimos años. Véase la entrada Números primos gemelos, parientes y sexis (1)

La investigación de los matemáticos Yitang Zhang, Terence Tao y James Maynard sobre la conjetura de los números primos gemelos, ha conseguido grandes avances en los últimos años. Véase la entrada Números primos gemelos, parientes y sexis (1)La siguiente familia de números primos, relacionada con la conjetura de Polignac, que nos interesa, son los números primos sexis. Estos son parejas de números primos de la forma (p, p + 6), es decir, la diferencia entre ellos es 6 (k = 3), como (5, 11), (7, 13) o (11, 17). Su nombre se debe a que la palabra en latín para el número “seis” es “sex” (de hecho, los diez primeros números, en latín, son unus, duo, tres, quattuor, quinque, sex, septem, octo, novem, decem).

Las parejas de números primos sexis menores de 500 son (véase la sucesión A023201):

(5, 11), (7, 13), (11, 17), (13, 19), (17, 23), (23, 29), (31, 37), (37, 43), (41, 47), (47, 53), (53, 59), (61, 67), (67, 73), (73, 79), (83, 89), (97, 103), (101, 107), (103, 109), (107, 113), (131, 137), (151, 157), (157, 163), (167, 173), (173, 179), (191, 197), (193, 199), (223, 229), (227, 233), (233, 239), (251, 257), (257, 263), (263, 269), (271, 277), (277, 283), (307, 313), (311, 317), (331, 337), (347, 353), (353, 359), (367, 373), (373, 379), (383, 389), (433, 439), (443, 449), (457, 463) y (461, 467).

Además, la pareja de números primos sexis más grande conocida, a día de hoy, es la pareja (p, p + 6), tal que

p = (187.983.281 x 251.478 + 4) x (5 x 251.478 – 1) – 1,

con 31.002 dígitos, que fue encontrada por S. Batalov, en abril de 2019.

Algunas parejas de números primos sexis forman parte de grupos de tres primos muy próximos, como (5, 7, 11) o (7, 11, 13), lo que en la anterior entrada denominados números primos trillizos, los cuales son de la forma (p, p + 2, p + 6) o (p, p + 4, p + 6). Por lo tanto, en cada terna de números primos trillizos, hay una pareja de números primos gemelos, (p, p + 2) o (p + 4, p + 6), una pareja de números primos parientes, (p +2, p + 6) o (p, p + 4), y una pareja de números primos sexis, (p, p + 6). Por ejemplo, en la terna de números primos trillizos (67, 71, 73), 71 y 73 son gemelos, 67 y 71 parientes, y 67 y 73 sexis.

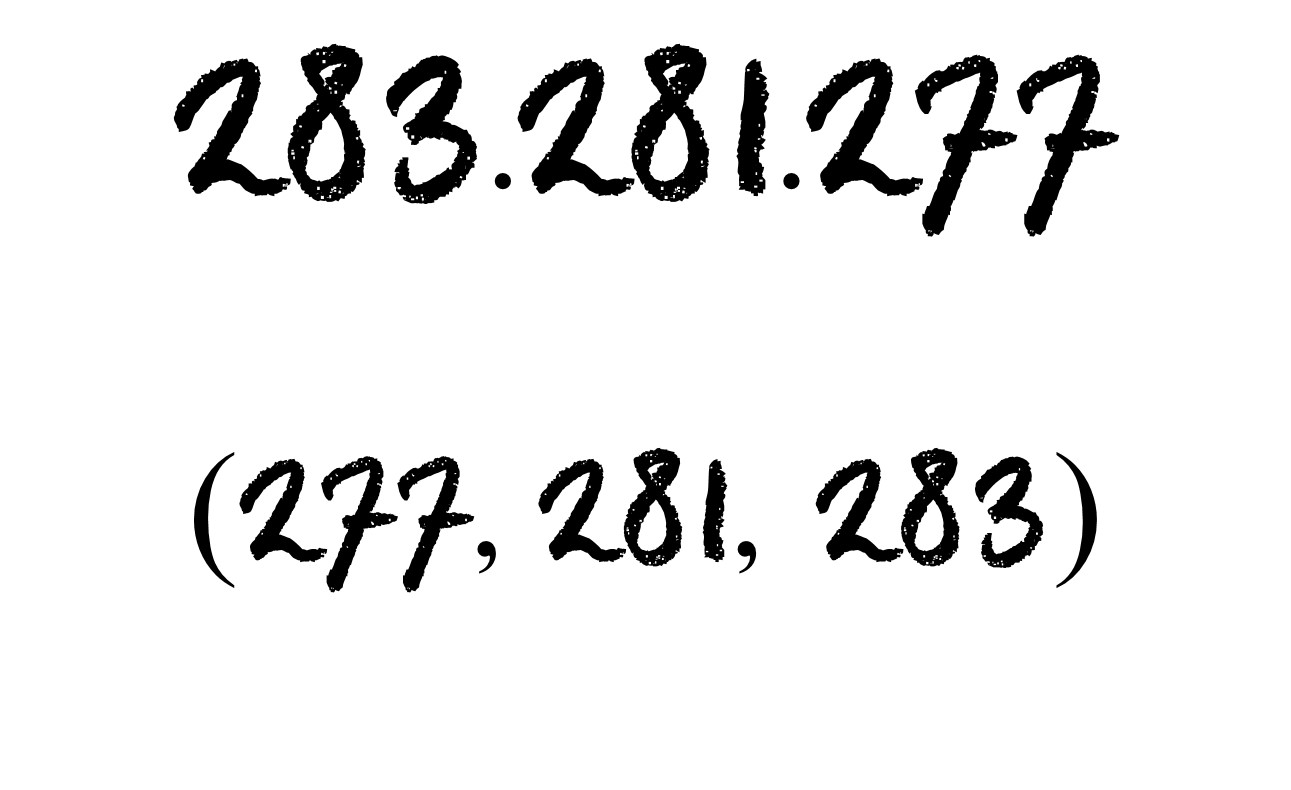

El número 283.281.277 es el número primo más pequeño formado por los tres miembros, en sentido inverso, de una terna de números primos trillizos (277, 281, 283). Visto en The Prime pages

El número 283.281.277 es el número primo más pequeño formado por los tres miembros, en sentido inverso, de una terna de números primos trillizos (277, 281, 283). Visto en The Prime pages

A diferencia de lo que ocurría con los números primos parientes, que no pueden ir en grupos de tres, ahora se pueden considerar ternas de números primos sexis como (7, 13, 19), (17, 23, 29) o (31, 37, 43), formadas por tres números primos sexis consecutivos, (p, p + 6, p + 12), tal que el siguiente p + 18 no es primo, pero podría serlo el anterior p – 6, y que llamaremos tripletes, o tríos, de números primos sexis.

Más aún, se pueden considerar cuartetos de números primos sexis, formados por cuatro números primos sexis consecutivos, de la forma (p, p + 6, p + 12, p + 18), como (5, 11, 17, 23), (11, 17, 23, 29) o (41, 47, 53, 59). Curiosamente, salvo para el primer cuarteto, el primer número primo de cualquier cuarteto de números primos sexis termina en 1, como podemos observar en los primeros términos de la sucesión A023271, que está formada por los primeros primos de los cuartetos de números primos sexis: 5, 11, 41, 61, 251, 601, 641, 1091, 1481, 1601, 1741, 1861, 2371, 2671, 3301, 3911, 4001, 5101, …

Sin embargo, no existen quintetos de números primos sexis, salvo (5, 11, 17, 23, 29), puesto que dados cinco números con una deferencia de seis entre ellos (p, p + 6, p + 12, p + 18, p + 24), entonces uno de ellos debe ser divisible por 5, para lo cual basta escribir p de la forma p = 5 n + r, para r = 0, 1, 2, 3 ó 4.

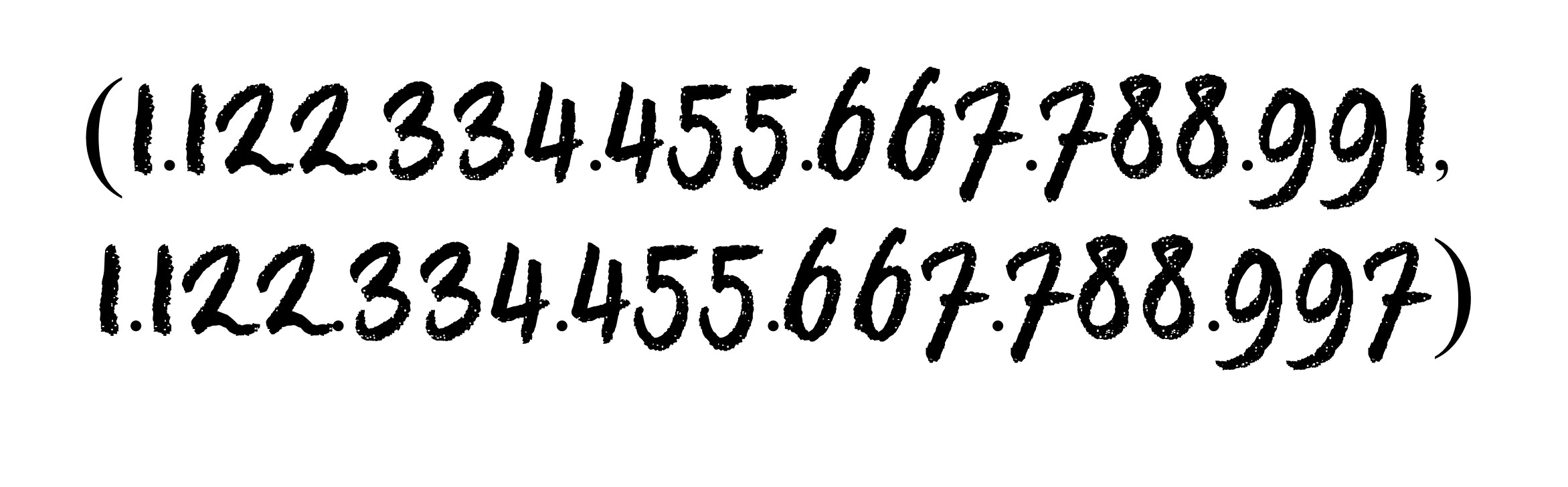

Curiosa pareja de números primos sexis, formada por los nueves dígitos, del 1 al 9, pero duplicados, pero terminados luego en 1 y 7. Visto en The Prime pages

Curiosa pareja de números primos sexis, formada por los nueves dígitos, del 1 al 9, pero duplicados, pero terminados luego en 1 y 7. Visto en The Prime pagesAdemás de las parejas de números primos gemelos, parientes y sexis, se pueden estudiar otras parejas de números primos (p, p + 2k), para k mayor que 3, relacionadas con la conjetura de Polignac. Parejas de números primos cuya distancia entre ellos sea 8 (k = 4), como (3, 11), (5, 13), (11, 17), (23, 31) o (29, 37), cuya distancia sea 10 (k = 5), como (3, 13), (7, 17), (13, 23), (19, 29) o (31, 41), cuya distancia sea 12 (k = 6), como (5, 17), (7, 19), (11, 23), (17, 29) o (19, 31), o mayores distancias aún.

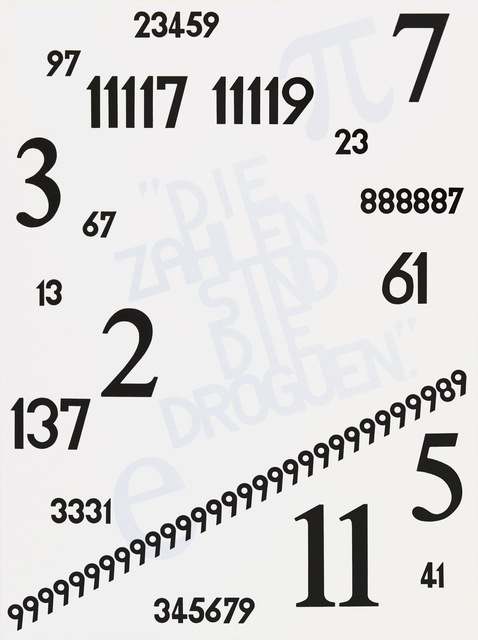

Die Droguen /Las drogas –Novalis– (2011), 150 × 110 cm, de la artista alemana Rune Mields. Los números que aparecen en esta obra son números primos. Imagen de ART SY

Die Droguen /Las drogas –Novalis– (2011), 150 × 110 cm, de la artista alemana Rune Mields. Los números que aparecen en esta obra son números primos. Imagen de ART SY

Bibliografía

1.- William Dunham, A Note on the Origin of the Twin Prime Conjecture, Notices of the ICCM, vol. 1, n. 1, pp. 63-65, 2013.

2.- Wolfram Mathworld: Cousin Primes

3.- Wikipedia: Cousin prime

4.- The Prime pages

5.- Wolfram Mathworld: Sexy Primes

6.- Wikipedia: Sexy prime

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Números primos gemelos, parientes y sexis (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Números primos gemelos, parientes y sexis (1)

- Buscando lagunas de números no primos

- Los ritmos primos de Anthony Hill

La carga del núcleo y el sistema de periodos

Foto: vubp / Pixabay

Foto: vubp / PixabayA pesar del éxito del modelo atómico de Rutherford a la hora de explicar los resultados de los experimentos de dispersión de partículas α, seguía habiendo un problema sin resolver. Todavía no había forma de medir la carga Q en el núcleo de forma independiente. Sin embargo, los experimentos de dispersión habían confirmado las predicciones de Rutherford sobre el efecto de la velocidad de la partícula y el grosor de la lámina sobre el ángulo de dispersión. Como sucede a menudo cuando se confirma parte de una hipótesis, es razonable proceder temporalmente como si toda la hipótesis estuviera justificada; es decir, hasta que no hubiese más resultados, se podría suponer que el valor de Q necesario para explicar los datos de dispersión observados fuese el valor correcto de Q para el núcleo real, determinado por la ley de Coulomb y el movimiento de las partículas α.

Sobre esta base, el laboratorio de Rutherford compiló datos de dispersión para varios elementos diferentes, entre ellos carbono, aluminio y oro. De estos experimetos resultaba que las siguientes cargas positivas para el núcleo eran las que cuadraban mejor: para el carbono, Q = 6e ; para el aluminio dos valores parecían funcionar, Q = 13e o 14e; y para el oro, Q = 78e o 79e [1]. Del mismo modo, se encontraron valores para el resto de elementos.

La magnitud de la carga positiva del núcleo fue un dato de trascendental importancia para entender cómo era un átomo. Como el átomo en su conjunto es eléctricamente neutro, se sigue que, si el núcleo tiene una carga positiva de 6e, 13e, 14e, etc., el número de electrones cargados negativamente que rodean el núcleo debe ser 6 para el carbono, 13 o 14 para el aluminio, etc. Por lo tanto, por primera vez, la comunidad científica tenía idea de cuántos electrones puede tener un átomo.

Pero un hecho más importante si cabe resultó rápidamente evidente. Para cada elemento, el valor de la carga nuclear, en múltiplos de e, estaba cerca del número atómico Z, ¡el número de lugar de ese elemento en la tabla periódica! Los resultados de los experimentos de dispersión con partículas α aún no eran lo suficientemente precisos como para llegar afirmarlo con certeza, pero todo apuntaba a que cada núcleo tiene una carga positiva Q numéricamente igual a Ze.

Esta posibilidad hacía la imagen del átomo nuclear mucho más clara y simple. Sobre esta base, el átomo de hidrógeno (Z = 1) tiene un electrón en algún lugar que no es el núcleo. Un átomo de helio (Z = 2) tiene en su estado neutro dos electrones en algún lugar que no es el núcleo. Un átomo de uranio (Z = 92) tiene 92 electrones en algún lugar que no es el núcleo. Experimentos adicionales respaldaron aún más este sencillo esquema. Los experimentos demostraban que era posible producir átomos de hidrógeno ionizados con una carga, H+, y átomos de helio ionizados con dos cargas, He2+, pero no había forma de conseguir H2+ ni He3+. Evidentemente, un átomo de hidrógeno tiene solo un electrón que perder, y un átomo de helio solo dos. Inesperadamente, el concepto de átomo nuclear proporcionaba una nueva visión completamente nueva de la tabla periódica de los elementos. El átomo nuclear sugiere que la tabla periódica es realmente una lista de los elementos de acuerdo con el número de electrones alrededor del núcleo, o lo que es lo mismo, con el número de unidades de carga positiva en el núcleo.

Estos resultados aclaraban algunas de las problemas en el sistema de periodos de Mendeléyev. Por ejemplo, a los elementos teluro y yodo se les habían asignado las posiciones Z = 52 y Z = 53 en función de sus propiedades químicas. Este posicionamiento contradecía el orden de sus pesos atómicos. Pero ahora se veía que Z correspondía a un hecho fundamental sobre el núcleo. Por lo tanto, lo que se pensaba que era una carencia del sistema de Mendeléyev en realidad no lo era. [2]

Notas:

[1] Donde e es la magnitud de la carga de un electrón (e = −1,602·10−19 C ). Para una explicación de cómo se determina e véase La carga más pequeña.

[2] Esto es algo a lo que no se le da tanta importancia como a las predicciones de nuevos elementos que hizo Mendeléyev, pero es algo del mismo calibre. A toro pasado parece obvio, pero cuando Mendeléyev presenta el sistema de periodos es toda una expresión de rigor químico.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La carga del núcleo y el sistema de periodos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El Antropoceno: cuando ciencias y letras convergen

Foto: Dominik Vanyi / Unsplash

Foto: Dominik Vanyi / UnsplashEstamos presenciando una época sin precedentes, o al menos eso es lo que postulan muchos miembros de la comunidad científica. En términos geológicos, vivimos oficialmente en el “Holoceno”, época perteneciente al período Cuaternario de la historia de la Tierra. Sin embargo, en las últimas dos décadas ha emergido con fuerza una idea alternativa, la cual no está dejando indiferente a ningún geólogo ni tampoco – esta vez no – a intelectuales de ciencias sociales y humanidades.

El que fue galardonado con Premio Nobel de Química en 1995 por sus investigaciones acerca de la incidencia atmosférica del ozono, Paul J. Crutzen, introdujo la nueva noción en el año 2000:

“Yo estaba en una conferencia en la que alguien comentaba algo sobre el Holoceno. En ese momento pensé que tal término era incorrecto, porque el mundo ha cambiado demasiado. Así que le dije: ¡No, estamos en el Antropoceno!, creando en el ardor de ese momento la palabra. Todo el mundo estaba sorprendido, pero parece haber persistido”

El término lo había publicado junto al biólogo Eugene F. Stoermer en un boletín del Organismo Internacional de la Geosfera y la Biosfera (IGBP), y hacía hincapié en el impacto significativo que las actividades humanas han tenido sobre los ecosistemas terrestres, una de cuyas principales manifestaciones es el cambio climático. No la única: la disminución de la naturaleza virgen, la urbanización, la agricultura industrial, la infraestructura del transporte, las actividades mineras, la pérdida de biodiversidad, la modificación genética de organismos, los avances tecnológicos, la acidificación de los océanos o la creciente hibridación socionatural son otras muestras de que algo está pasando. Ello implicaría la adopción de la nueva unidad geológica y aceptar que los cambios cuantitativos han cobrado tales dimensiones que han devenido en un cambio cualitativo global propiciado por la acción humana. De ahí su denominación como Antropoceno, que está compuesto por Antropos, “ser humano”, y Kainos, “nuevo”.

Crutzen plantó una semilla que empezó a germinar poco tiempo después. En 2002 publica en solitario un artículo en la revista Nature, y en 2008 Zalasiewicz sugiere en un artículo que el nuevo término es el apropiado para el período en el que vivimos. Y desde entonces, el concepto ha ido ganando popularidad. Nature pidió el reconocimiento científico y público del Antropoceno en un editorial de 2011, mismo año en el que aparece en portada de la revista The Economist. A pesar de que no se haya admitido como paradigma compartido dentro de la comunidad científica, su aprobación oficial por parte de la International Commision on Stratigraphy (ICS) y la International Union of Geological Sciences (IUGS) parece inminente. Y todo apunta a que sea así.

Vale, pero… ¿Qué pintan aquí las “letras”?

Sea o no aceptado finalmente, no parece que el término “Antropoceno” vaya a desaparecer de la cultura popular. Se trata de un concepto que no sólo trasciende las fronteras de la geología, sino también las de las ciencias naturales ligadas al estudio del ecosistema terrestre. Un concepto que nos recuerda que la naturaleza se encuentra dentro de la sociedad y la sociedad se encuentra dentro de la naturaleza. Por ello, ciencias naturales y ciencias sociales se encuentran íntimamente imbricadas.

Por ejemplo, algunos críticos temen que el nombramiento de una nueva época geológica que hace referencia a los seres humanos proporcione un estímulo más para el generalizado antropocentrismo imperante. Otros argumentan que hacer referencia al ser humano en general tiene al menos una consecuencia no deseada: se oculta qué grupos o qué personas en concreto son los verdaderos agentes de dichas acciones transformadoras. Y de haber una transformación, ¿cuándo se ha iniciado?

Algunos científicos consideran el comienzo de esta a partir de la Revolución Industrial, otros a la Revolución Agrícola y otros a partir de 1945, año de la detonación de la primera bomba atómica. Sin embargo, cada una de las propuestas exige de un análisis profundo por parte de los historiadores. Filósofos, sociólogos, climatólogos, biólogos, antropólogos, geólogos y una larga lista de disciplinas se dan encuentro bajo un mismo pero polifacético problema. Hay quienes incluso han propuesto otras variantes al Antropoceno, como Econoceno, Capitaloceno o Tecnoceno, que avivan la reflexión sobre las responsabilidades diferenciadas relativas a la acumulación de las emisiones de gases de efecto invernadero.

Cada una de las opciones se encuentra repleta de implicaciones políticas y simbólicas. Por ello, aunque la recopilación y análisis de pruebas empíricas es una labor genuinamente científica, se trata de un problema que también atañe a las denominadas “humanidades”. Así, los hechos científicos son reelaborados por “los de letras”, que aportan significados adicionales, colaboran en la matización de conceptos y en la comprensión global de un mismo fenómeno. La buena noticia es que aquella división a la que C.P. Snow se refirió con “las dos culturas” se ve, al menos por el momento, unida por una causa común: el ser humano.

Referencia:

Arias-Maldonado, M. (2018): Antropoceno: la política en la era humana. Madrid: Taurus.

Sobre el autor: José Luis Granados Mateo (@JoisDo) desarrolla una tesis doctoral en Historia y Filosofía de la Ciencia en la UPV/EHU, becado por la Dirección de Medio Ambiente de la Diputación Foral de Gipuzkoa.

El artículo El Antropoceno: cuando ciencias y letras convergen se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las letras que son de ciencias, y viceversa

- El Antropoceno: ¿estamos en un nuevo tiempo geológico?

- Activa tu neurona – Antropoceno. El comienzo de “la era de los hombres”

El cobalto, un metal escaso y muy necesario

Plataformas petrolíferas en desuso en Cromarty Firth (Escocia, Reino Unido). Foto: Michael Elleray / flickr

Plataformas petrolíferas en desuso en Cromarty Firth (Escocia, Reino Unido). Foto: Michael Elleray / flickrEl cobalto es un elemento cuyo atributo más conocido es el color que proporcionan ciertos compuestos de los que forma parte a piezas de vidrio, esmaltes y cerámicas. El azul cobalto, que es como se denomina ese color, es propio de los pigmentos minerales elaborados con aluminatos y silicatos de cobalto, y con mezclas de fosfato de cobalto y alúmina.

El cobalto es también el centro activo de la vitamina B12 -denominada también cobalamina-, una coenzima que participa en el metabolismo celular. Interviene, por ejemplo, en la síntesis de ADN, y en el metabolismo de ácidos grasos y aminoácidos. Es especialmente importante para el sistema nervioso, debido al papel que juega en la producción de la cubierta de lípidos que envuelve los axones de las neuronas y en la maduración de los glóbulos rojos en la médula ósea.

Además de su uso decorativo y su papel biológico a través de la vitamina B12, el cobalto tiene numerosas aplicaciones industriales. Hay una gran demanda de este elemento para su uso en los electrodos de las baterías eléctricas. Por esa razón, como la producción de vehículos eléctricos está aumentando rápidamente, su demanda está creciendo a gran ritmo. Se estima, de hecho, que el año que viene no pueda extraerse todo el cobalto que necesitará la industria del automóvil, lo que podría suponer un obstáculo importante para aumentar la producción de coches eléctricos.

El cobalto representa el 0,003% de la corteza terrestre. Se extrae mediante minería, generalmente asociada a la extracción de cobre y níquel. Se calcula que las reservas mineras totales de este metal ascienden a algo más de siete millones de toneladas, de las que aproximadamente la mitad se encuentra en la República Democrática del Congo.

Así las cosas, no es de extrañar que se busquen afanosamente alternativas a la minería como método de obtención de tan escaso metal. Se da la circunstancia de que en los océanos hay una cantidad enorme de cobalto, tanto como quinientos millones de toneladas. O sea, hay setenta veces más cobalto en los mares que en la corteza terrestre, por lo que ya hay quien se ha puesto a pensar en cómo extraerlo. Maha Haji y Alexander Slocum, del Instituto tecnológico de Massachusetts (MIT), han propuesto para ello recurrir a tecnologías de adsorción pasiva; son tecnologías basadas en la propiedad de muchos materiales para atrapar de forma pasiva (sin gasto energético) determinadas sustancias.

Al parecer el cobalto se adhiere con facilidad a materiales como algas y otros productos orgánicos abundantes. Y los investigadores del MIT proponen utilizar torres de perforación de petróleo en desuso para amarrar a ellas cordones de los que colgarían esferas de plástico del tamaño de balones de playa. Las esferas estarían convenientemente perforadas y en su interior se dispondrían los materiales adsorbentes más adecuados. Cada pocas semanas se recogerían los balones, se les retiraría el cobalto y se volverían a colocar colgando de los cordones. De acuerdo con sus estimaciones, reutilizando setenta y seis plataformas petroleras hoy en desuso, podría obtenerse el cobalto necesario para fabricar medio millón de baterías de coches eléctricos cada año. Sus cálculos se basan en experimentos de laboratorio en los que se ha utilizado un procedimiento similar para obtener uranio. El problema es que en el agua de mar hay ocho veces menos cobalto que uranio y este procedimiento tendría, por ahora, un coste muy alto. Pero puede que sea asumible, dependiendo, entre otras cosas, de lo que represente en el coste total de las baterías y del interés que tenga la gente en adquirir coches eléctricos.

Fuente: Haji, Maha N. & Slocum, Alexander H. (2019): An offshore solution to cobalt shortages via adsorption-based harvesting from seawater. Renewable and Sustainable Energy Reviews 105(C): 301-309.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El cobalto, un metal escaso y muy necesario se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La tabla periódica en el arte: Cobalto

- Un aerogel metal-orgánico cataliza una nueva empresa

- Una batería de metal líquido y el futuro de las energías renovables

Gemma Del Caño y Marián García – Naukas Bilbao 2018: Sandwich mixto en tres actos

Foto: Steven Depolo / flickr

Foto: Steven Depolo / flickrNaukas es sinónimo de ciencia divertida. Y en ocasiones la ciencia divertida se convierte en todo un espectáculo. Tras ver este vídeo nunca verás un sandwich mixto igual.

Por cierto, Naukas Bilbao 2019 se celebra a partir del próximo día 18 de septiembre (programa completo) dentro del festival Bizkaia Zientzia Plaza (programa de actividades completo). Por si te animas a que te sorprendan aprendiendo.

Gemma Del Caño y Marián García: ''Sandwich mixto en tres actos''Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Gemma Del Caño y Marián García – Naukas Bilbao 2018: Sandwich mixto en tres actos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao está en marcha

- Francisco R. Villatoro – Naukas Bilbao 2018: El ángulo mágico del grafeno

- Naukas Bilbao 2017 – Déborah García Bello: Saboer

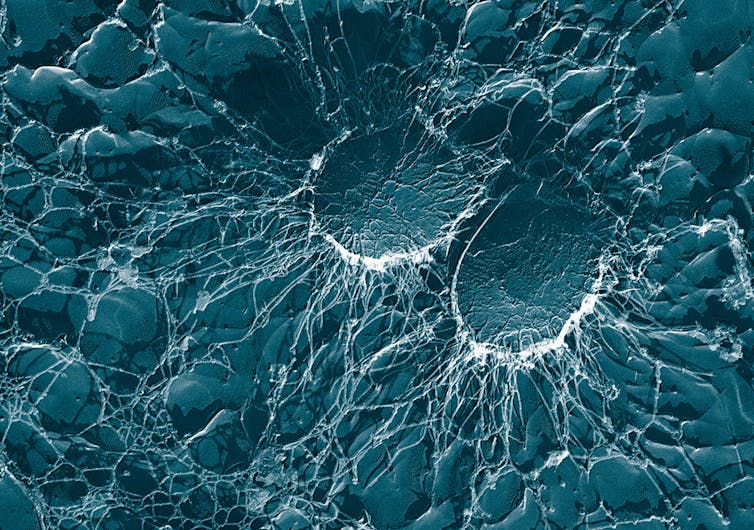

Nuevos biomarcadores en niños con enfermedad renal crónica

Servicio Central de Análisis de Araba (SGIker – UPV/EHU)

Imagen: Tareq Salahuddin / flickr

Imagen: Tareq Salahuddin / flickrLa enfermedad renal crónica (ERC) se define como una condición en la que los riñones se encuentran dañados y no son capaces de filtrar la sangre adecuadamente. Como consecuencia, se produce la acumulación de desechos en la sangre y en el organismo, que puede originar serios problemas de salud[1].

Los últimos avances en nuevas terapias médicas han permitido un mejor control y pronóstico de estos pacientes. Sin embargo, aún no se logra prevenir el retraso en el crecimiento, la anemia, los problemas cardiovasculares asociados y otras consecuencias de la enfermedad en niños con ERC, alcanzando elevadas tasas de morbimortalidad en este grupo de población[2].

En la actualidad, la creatinina sérica se utiliza como biomarcador clásico para evaluar la función renal. No obstante, la creatinina tiene una sensibilidad bastante limitada y revela el daño renal cuando ya se ha producido una importante pérdida de nefronas, las unidades funcionales de los riñones. Por ello, la búsqueda de nuevos biomarcadores de diagnóstico o de la evolución de la patología y su aplicación en la ERC pediátrica podría contribuir a su diagnóstico, seguimiento y a una mejor comprensión de la fisiopatología de la enfermedad[3].

La metabolómica es una herramienta que tiene como finalidad la búsqueda e identificación de biomarcadores atendiendo al perfil metabólico de un conjunto de muestras biológicas. Estudia las moléculas pequeñas, típicamente por debajo de los 1500 Da, en un sistema biológico, comparando los conjuntos de moléculas o metabolitos entre un grupo control y un grupo testado[4].

Existen dos tipos de metabolómica, la metabolómica dirigida y la metabolómica no dirigida. En el primero de los casos, se buscan diferencias en cuanto a moléculas o grupos de moléculas pertenecientes a distintas rutas metabólicas que son seleccionadas por los investigadores. Por el contrario, en la metabolómica no dirigida se comparan los perfiles de moléculas presentes en las poblaciones objeto de estudio sin que exista ningún tipo de selección de éstas, lo que implica que no haya ningún sesgo previo[5].

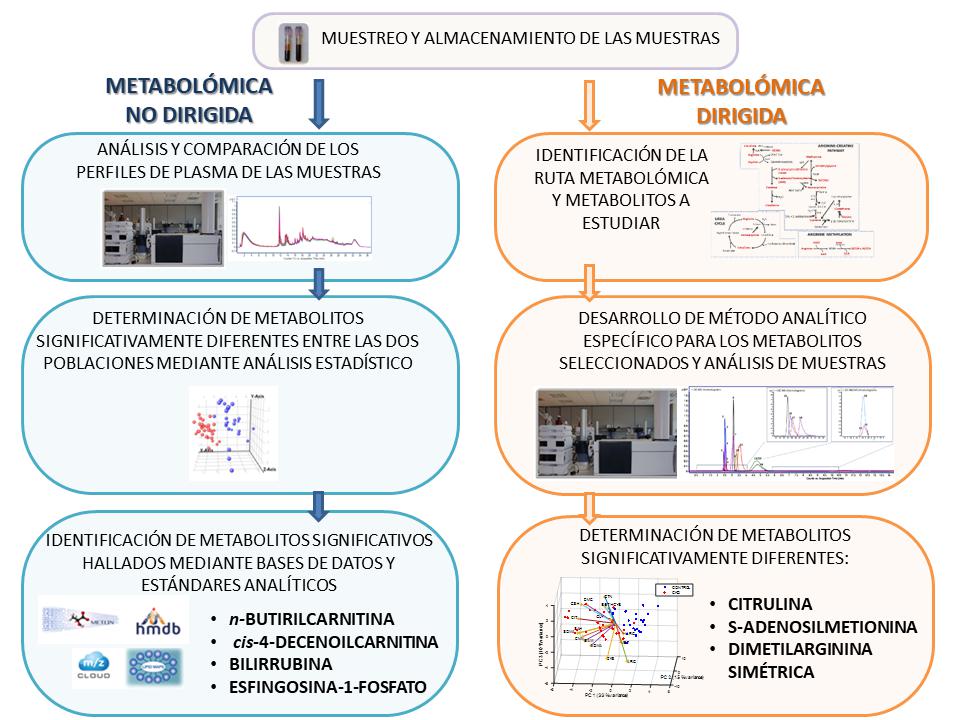

Figura 1. Comparativa de los estudios metabolómicos para la búsqueda de biomarcadores de la ERC pediátrica. Elaboración del SCAA.

Figura 1. Comparativa de los estudios metabolómicos para la búsqueda de biomarcadores de la ERC pediátrica. Elaboración del SCAA.En el SCAA, se han desarrollado dos métodos diferentes basados en la cromatografía líquida acoplada a espectrometría de masas, técnica de análisis que permite la separación, detección y cuantificación de moléculas de una muestra (Figura 1). Los métodos propuestos se han aplicado a muestras de plasma recogidas por el Servicio de Nefrología Pediátrica del Hospital de Cruces en Barakaldo de pacientes pediátricos con ERC y controles de la misma edad del País Vasco.

El primer método (metabolómica dirigida) permitió la identificación de tres moléculas que podrían actuar como biomarcadores potenciales, además de la creatinina: citrulina, S-adenosilmetionina y dimetilarginina simétrica. En un estudio estadístico llevado a cabo para evaluar la calidad de los posibles nuevos biomarcadores, la utilización de la creatinina sérica como único biomarcador permitía la clasificación correcta del 71 % de los pacientes, mientras que la incorporación de las concentraciones plasmáticas de estas tres nuevas moléculas logró alcanzar una correcta clasificación en un 89 % de los pacientes mejorando el diagnóstico[6,7].

Por su parte, de la aplicación del otro método (metabolómica no dirigida) se obtuvieron cinco señales, de las que posteriormente fue posible identificar cuatro como las siguientes moléculas: n-butirilcarnitina, cis-4-decenoilcarnitina, bilirrubina y esfingosina-1-fosfato. Del mismo modo, se evaluó la capacidad de estas moléculas que podrían proponerse como biomarcadores de la ERC, obteniéndose una correcta discriminación entre enfermos y controles en un 96 % de los casos[8].

Referencias:

Este trabajo de investigación ha formado parte de la Tesis Doctoral de Sandra Benito y ha dado lugar a cuatro publicaciones científicas.

[1] LEVEY, A.S., ATKINS, R., CORESH, J., COHEN, E.P., COLLINS, A.J., ECKARDT, K.U., NAHAS, M.E., JABER, B.L., JADOUL, M., LEVIN, A., POWE, N.R., ROSSERT, J., WHEELER, D.C., LAMEIRE, N. eta EKNOYAN, G., 2007. «Chronic kidney disease as a global public health problem: approaches and initiatives – a position statement from Kidney Disease Improving Global Outcomes». Kidney International, 72, 247-59.

[2] HARAMBAT, J., VAN STRALEN, K.J., KIM, J.J. eta TIZARD, E.J., 2012. «Epidemiology of chronic kidney disease in children». Pediatric Nephrology, 27, 363-73.

[3] ZHAO, Y.Y., 2013. «Metabolomics in chronic kidney disease». Clin. Chim. Acta, 422, 59-69.

[4] FIEHN, O., 2002. «Metabolomics – the link between genotypes and phenotypes». Plant Mol. Biol., 48, 155-171.

[5] PATTI, G.J., YANES, O. eta SIUZDAK, G., 2012. «Innovation Metabolomics: the apogee of the omics trilogy». Nat. Rev. Mol. Cell Biol., 13, 263-269.

[6] BENITO, S., SANCHEZ, A., UNCETA, N., ANDRADE, F., ALDAMIZ-ECHEVARRIA, L., GOICOLEA, M.A. eta BARRIO, R.J., 2016. «LC-QTOF-MS-based targeted metabolomics of arginine-creatine metabolic pathway-related compounds in plasma: application to identify potential biomarkers in pediatric chronic kidney disease». Anal. Bioanal. Chem., 408, 747-760.

[7] BENITO, S., SANCHEZ-ORTEGA, A., UNCETA, N., JANSEN, J.J., POSTMA, G., ANDRADE, F., ALDAMIZ-ECHEVARRIA, L., BUYDENS, L.M.C., GOICOLEA, M.A. eta BARRIO, R.J., 2018. «Plasma biomarker discovery for early chronic kidney disease diagnosis based on chemometric approaches using LC-QTOF targeted metabolomics data». J. Pharm. Biomed. Anal., 149, 46-56.

[8] BENITO, S., SANCHEZ, A., UNCETA, N., ANDRADE, F., ALDAMIZ-ECHEVARRIA, L., GOICOLEA, M.A. eta BARRIO, R.J., 2018. «Untargeted metabolomics for plasma biomarker discovery for early chronic kidney disease diagnosis in pediatric patients using LC-QTOF-MS». Analyst (Cambridge, U. K.), Ahead of Print.

El artículo Nuevos biomarcadores en niños con enfermedad renal crónica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Posibles biomarcadores para el ictus

- Tres historias italianas: vacunas, homeopatía, niños y derechos humanos

- La ecología de una enfermedad

El sonido del viento (2)

Mientras que los instrumentos de cuerda necesitan transmitir su vibración al aire (mediante una superficie o caja de resonancia), en los instrumentos de viento es el propio aire el que se mueve desde el principio. La función del tubo, por tanto no es producir sonido, sino dar forma y contener la onda sonora. Ahora bien, como contenedor tiene una función fundamental ya que define el tono del sonido.

De manera general, cuanto más larga sea la onda sonora, más grave será su sonido y viceversa. Por eso, los instrumentos más grandes de la orquesta (como el contrabajo) son aquellos que producen sonidos más graves y viceversa. Además, bajo el nombre de cada instrumento, suele agruparse una familia entera, de distintos tamaños, que cubren rangos de sonidos diferentes (lo que en música se conoce como tesitura).

Cada instrumento de viento tendrá, por tanto, un tono asociado a su longitud, la frecuencia natural de su tubo, que diría un físico. Ahora bien, suele ser deseable que un solo instrumento pueda producir varios tonos distintos. Y “cortar” el tubo en cuestión no suele ser una opción (aunque en algunos instrumentos se puede probar algo parecido). Por ello, los ingeniosos inventores de máquinas de hacer sonidos (i.e. instrumentos) han ideado varios mecanismos que permiten variar la longitud de un tubo sin romperlo. Aquí van algunas.

1- Agujeros.

El tubo define la frecuencia de la onda sonora que contiene porque es capaz de imponer unas condiciones de contorno sobre ella. Pero vamos a explicar qué significa esto. Pongamos por ejemplo, un tubo cilíndrico abierto por los dos lados (i.e. flauta). Lo que nos dice la física es que, dentro de ese tubo, va a suceder todo lo que pueda suceder y nada que no pueda suceder. A veces la física se pone un poco tautológica, yo lo sé, pero esto tiene su importancia porque una de las cosas que no pueden suceder es que en los extremos del tubo se den cambios bruscos de presión o de velocidad en el aire.

Esto implica que la onda sonora, dentro de nuestro imaginario tubo cilíndrico, debe tener al menos dos puntos donde la presión del aire no varía (dos nodos): la entrada y la salida. Aquí, el aire del tubo entra en contacto con el exterior que se encuentra, invariablemente, a presión atmosférica.

Este es el mecanismo por el que la longitud del tubo define la longitud de la onda sonora. Pero podemos utilizarlo también para “acortar” el tubo sin cortarlo. Si abrimos agujeros y los destapamos sucesivamente, cada agujero forzará un nuevo nodo en la onda sonora. La onda se formará entonces entre la entrada del tubo y el primer agujero abierto. Cuanto más cerca este agujero de la embocadura, más agudo será el sonido (más corta su longitud de onda). Por eso los instrumentistas van retirando dedos, según se acercan al agudo, fijaos por ejemplo, en el solo inicial del clarinete de Rhapsody in Blue.

2- Armónicos.

Ahora bien, existen algunos instrumentos de viento que no tienen agujeros, ni uno solo. Este es el caso, en general, de los instrumentos de viento metal. Las “teclas” de trompetas, trompas y demás activan distintos pistones sin dejar que el aire de su interior entre en contacto en ningún momento con el exterior.

La trompa es un caso especialmente sorprendente, dado que alcanza los 3 metros de longitud. El origen de las trompas son son los míticos cuernos o cornos que se llevaban a la batalla. Pero este corno fue creciendo… y está claro que en algún momento a alguien se le fue de las manos. En su versión orquestal, el tubo se encuentra enrollado y quizás no impresiona tanto, pero la trompa alpina, un instrumento típico de Suiza, permite apreciar la verdadera magnitud del instrumento.

Ahora bien, la trompa no tiene ni un agujero. Es un único tubo continuo… y aún así, sirve para entonar melodías como esta:

¿Cómo es esto posible? La clave está en que las condiciones de contorno imponen que la onda tenga al menos dos nodos en los extremos del tubo (en el caso de la trompa, un nodo y un antinodo, ya que uno de los extremos está tapado por la boca del instrumentista). Pero esta condición se cumple también para sonidos que tienen más nodos dentro del propio tubo, sonidos cuya longitud es una fracción racional de la longitud del tubo, también conocidos como armónicos. Para conseguir tocar estos armónicos, el trompista debe variar la vibración de sus labios con una gran precisión. Con una trompa moderna, un profesional es capaz de hacer sonar hasta 10 armónicos de una mismo tono fundamental.

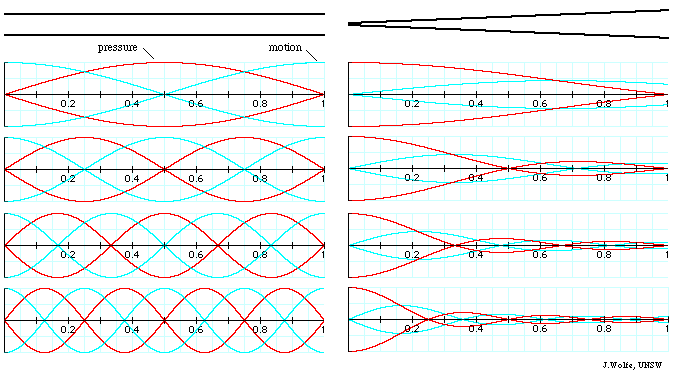

Esquema de los armónicos de un abierto por ambos extremos y un tubo cónico cerrado por un lado, como la trompa. Fuente: University of New South Wales

Esquema de los armónicos de un abierto por ambos extremos y un tubo cónico cerrado por un lado, como la trompa. Fuente: University of New South Wales3- Pistones.

Hasta el s. XIX, las trompas de las orquestas solían ser, como las alpinas, un simple tubo enrollado, sin ningún tipo de apertura ni pistón. Sin embargo, su dependencia de los armónicos, limitaba su posible repertorio a aquellas piezas compuestas en la tonalidad de su frecuencia fundamental.

Con un lenguaje musical cada vez más flexible y con más cambios de tonalidad, esto suponía una fuerte restricción. En el s. XVIII, empezaron a usarse tubos de distinta longitud, que se colocaban entre la boquilla y el cuerpo del instrumento para extender su longitud y variar así su tono. Estos fueron los precursores del sistema de pistones y válvulas que se utiliza hoy en día: el “elija su propia aventura” de los instrumentos de viento metal.

Los pistones son mecanismos que habilitan distintos recorridos del aire dentro del instrumento, dando lugar a tubos de distinta longitud con sólo pulsar una tecla. Fueron ideados a principios del s. XIX (alrededor de 1815) pero no llegaron a popularizarse hasta bastante tiempo después debido, por un lado, a la falta de madurez del invento y, por otro, al recelo de algunos músicos que seguían prefiriendo la trompa natural. Hoy, en cambio, este mecanismo está plenamente aceptado y no sólo dota de mayor flexibilidad a este tipo de instrumentos, sino que les da ese aspecto intrincado, tan característico y tan bonito.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El sonido del viento (2) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Évariste Galois: contra el tiempo

«Lejos de cualquier lirismo, Billette ha sabido crear un universo históricamente anclado, pero moderno por su lenguaje y su intención, por la explosión cronológica del relato, así como por el humor y un toque fantástico».

Raymond Bertin, « Combat pour un nouveau monde / Contre le temps », Cahiers de théâtre Jeu, 2012

Libreto de Contre le temps.

Libreto de Contre le temps.

Contre le temps –Contra el tiempo– (2011) es una obra de teatro de la dramaturga Geneviève Billette. Se estrenó en Montreal (Canadá) el 8 de noviembre de 2011, año en el que se conmemoraba el centenario del nacimiento de Évariste Galois. En la imagen posterior aparecen los personajes de la obra; de izquierda a derecha:

-

Stéphanie, la amada de Galois.

-

El poeta Gérard de Nerval, encarcelado en la prisión de Sainte-Pélagie en febrero de 1832 por un alboroto nocturno. Allí conoce a Galois y entablan amistad.

-

Évariste Galois, protagonista de la historia.

-

Gabriel, el padre de Galois.

-

Adélaïde, la madre de Galois que se siente culpable por haber perdido el contacto con su hijo durante su estancia en prisión.

-

Alfred, el hermano pequeño de Galois, que sólo desea pasar tiempo con Évariste.

-

Augustin, el amigo de Galois que no entiende la razón de sus matemáticas.

-

El espectro del matemático Jean-Baptiste Fourier, que anhela que Galois redacte su legado científico. Se siente culpable por haber fallecido sin terminar la evaluación de un documento de Galois. Junto a Gérard de Nerval, aporta la nota cómica a una obra de claro corte dramático.

Los personajes de la obra. Fotografía de producción.

Los personajes de la obra. Fotografía de producción.

A continuación resumimos el guion y compartimos algunas citas (traducidas por la autora de esta anotación).

Estamos en 1832, en París. Évariste Galois acaba de abandonar la prisión en la que ha permanecido encarcelado durante ocho meses por motivos políticos. Activo republicano, había sido arrestado, por segunda vez, por un acto de sedición contra el rey Luis Felipe de Orleans. Es un joven apasionado y comprometido; vive por la democracia y la investigación científica.

El matemático intenta terminar su tratado de álgebra porque sospecha que va a morir; lucha contra el tiempo. La noche anterior al duelo que le lleva a la muerte, Galois escribe en el margen de la memoria que está intentando terminar:

Hay algo a completar en esta demostración. No tengo tiempo.

Su madre –con la que ha perdido el contacto desde hace meses– corre a buscarlo para abrazarle y transmitirle su cariño. Un curioso personaje impide a Adélaïde acercarse a Galois: es el fantasma de Jean-Baptiste Fourier, que se siente culpable por haber fallecido –en mayo de 1830– unos días después de haber recibido un manuscrito de Galois para –como secretario vitalicio de la académie des Sciences– evaluar. Sin haber sido revisado, este documento se perdió. Fourier sabe que Galois va a morir y no quiere que nadie le entretenga para que finalice la redacción de su legado matemático.

Galois redacta con gran excitación. Se detiene en algunos momentos para recordar detalles de su vida. Se acuerda afligido de su padre –alcalde de Bourg-la-Reine, de ideas liberales– que se suicida en 1829 no pudiendo soportar el descrédito ante sus conciudadanos promovido por el párroco de la ciudad. Galois lamenta no haber percibido el mal momento anímico por el que pasaba Gabriel. Pero sigue escribiendo, con pasión, con un arrebato cercano a la locura. Recuerda a su amada Stéphanie, a su hermano pequeño, a su madre…

Galois encarna al genio romántico, apasionado por la vida y por intentar cambiar el orden del mundo. Sus ansias por aprender se habían visto frenadas por las autoridades académicas; fue expulsado de la École Polytechnique que apoyaba a una monarquía repudiada por Galois.

Adélaïde: La dirección de la École se declara monárquica, ¿y qué? Eso no te impedirá pensar, trabajar, ¡el álgebra no tiene banderas!

Évariste: El álgebra es también una visión del mundo.

En una conversación con su amigo Augustin, explica la razón por la que sus matemáticas son revolucionarias:

¿Por qué crees que nadie antes de mí había conseguido resolver el problema? Los otros matemáticos no carecen de inteligencia. Conozco sus trabajos de memoria, sé exactamente cómo piensan […]. Uno a uno, han fracasado con la ecuación de grado 5, porque aislaban el problema. […] La única manera de resolverlo era con otra perspectiva. Mi método de resolución general, Augustin, […] era la única solución.

Al definir la estructura de grupo, Galois establece un nuevo territorio a explorar, un territorio con inmensas posibilidades:

Augustin: Comprendo el principio, pero ¿para qué sirve?

Évariste: Para pensar de manera amplia. […] También para ir más allá. Permite anticiparse.

Augustin: ¿Pero a qué se dedica?

Évariste: No te entiendo…

Augustin: Las aplicaciones concretas.

Évariste: Ah eso… Ninguna. […]

Augustin: Vamos… Cuando vayas donde un mecenas, ¿qué le dirás? ¿A quién beneficiarán tus grupos de inmediato?

Évariste: A nadie. Por ahora, a nadie. No… no es para nosotros. Los químicos se apropiarán de ello. Los físicos también. Pero las aplicaciones concretas, como dices, creo que no serán visibles más que dentro de doscientos años. […]

Augustin: Esto es serio, Évariste. No has podido pasarte noches enteras de trabajo sin conocer la utilidad de tus investigaciones… Es imposible. ¡Imposible!

Évariste: Lo que dices es estúpido. ¿Cómo quieres inventar si sabes exactamente lo que estás buscando? Me he obsesionado con la ecuación de grado 5, esto es lo que me ha permitido progresar, noche a noche, hasta la idea de grupo. No se puede investigar, Augustin, realmente investigar, conociendo con antelación el paisaje final.

Augustin: Doscientos años… nadie se beneficiará. Me refiero a que ninguno de nosotros estará…

Évariste: Es cierto, es lo que más me fascina. Hacer posible un mundo que nunca conoceré.

Por cierto, el tiempo le ha dado la razón. Sus teorías matemáticas permiten estudiar objetos complejos en términos de simetrías y de permutaciones y, hoy en día, se aplican a áreas tan variadas como la informática, la química, la física o la criptografía.

Contre le temps finaliza con la aprobación por parte de Fourier de los trabajos de Galois. Cuando el matemático yace ya herido de muerte tras su duelo, Fourier le tranquiliza:

Está todo. (Pausa) Está todo, Galois.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Évariste Galois: contra el tiempo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Estudiar más que conocer, buscar más que encontrar la verdad

- Contra la meritocracia

- El rostro humano de las matemáticas

El modelo atómico de Rutherford

El oro se emplea en las naves espaciales como protector contra la radiación. Pero básicamente radiación térmica (infrarrojo), visible y, combinado con otros materiales, ultravioleta. Tras leer esta anotación sabrás que el espesor de oro necesario para proteger contra una fuente de radiación alfa a una nave espacial o a una astronauta haría las misiones espaciales prohibitivamente caras. Fuente: NASA

El oro se emplea en las naves espaciales como protector contra la radiación. Pero básicamente radiación térmica (infrarrojo), visible y, combinado con otros materiales, ultravioleta. Tras leer esta anotación sabrás que el espesor de oro necesario para proteger contra una fuente de radiación alfa a una nave espacial o a una astronauta haría las misiones espaciales prohibitivamente caras. Fuente: NASA¿Cómo llega Rutherford a la conclusión de que el átomo debía tener una concentración de masa y carga, esto es, un núcleo a partir de los primeros experimentos de Geiger y Marsden? Veámoslo con algo más de detalle partiendo de la base de que el modelo imperante en ese momento es el modelo atómico de Thomson.

Lo primero que parecía evidente es que debía existir algo (los núcleos) que tenía que ser mucho más densos que cualquier cosa en los átomos de Thomson. Simplemente, porque una partícula α que se mueve directamente hacia uno de ellos se ve detenida y devuelta. Una analogía sería que una pelota de tenis rebota si impacta con una roca, pero no si lo que se encuentra delante es una nube de partículas de polvo de la misma masa que esa misma roca.

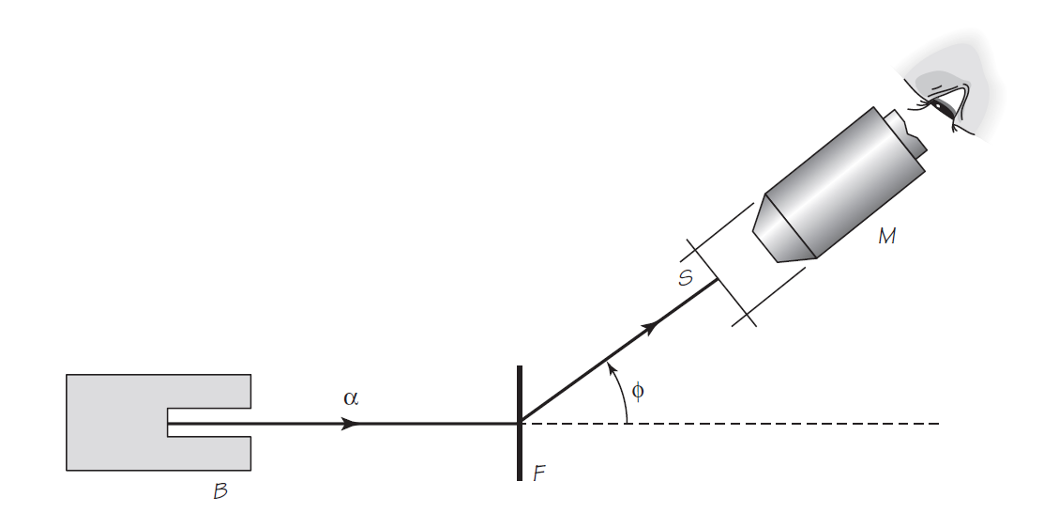

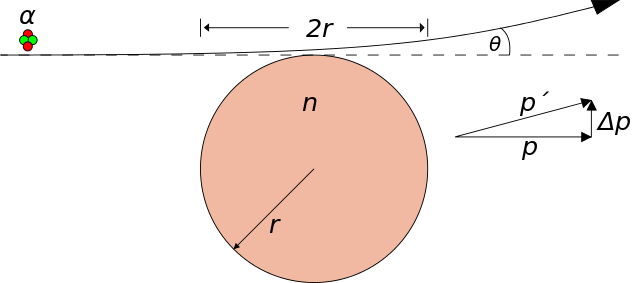

Figura 1. Fuente: Cassidy Physics Library

Figura 1. Fuente: Cassidy Physics LibraryEl esquema de la Figura 1 se basa en uno de los diagramas de Rutherford en su artículo de 1911 [1], que sentó las bases de la teoría moderna de la estructura atómica. Muestra dos partículas α cargadas positivamente, A y A’. La partícula α A se dirige directamente hacia un núcleo masivo N. Si el núcleo tiene una carga eléctrica positiva, repelerá la partícula α, que tiene carga positiva. Debido a esta fuerza eléctrica repulsiva, A frenará hasta detenerse a cierta distancia r de N y luego cambiará el sentido de su movimiento, volverá hacia atrás. A’ es una partícula α que no se dirige directamente hacia el núcleo N. Es rechazada por N de tal forma que sigue una trayectoria que se puede demostrar matemáticamente que debe ser una hipérbola. La desviación de A’ de su trayectoria original está indicada por el ángulo ϕ.

Rutherford consideró los efectos en la trayectoria de la partícula α de las variables importantes: la velocidad de la partícula, el grosor de la lámina y la cantidad de carga Q en cada núcleo. Según el modelo de Rutherford, la mayoría de las partículas deberían dispersarse en ángulos pequeños, porque la posibilidad de acercarse a un núcleo muy pequeño directamente es muy pequeña. Pero un número significativo de partículas α debería dispersarse en ángulos grandes. Eran necesarios nuevos experimentos.

Figura 2. Fuente: Cassidy Physics Library

Figura 2. Fuente: Cassidy Physics LibraryGeiger y Marsden comprobaron [2] estas predicciones con el dispositivo esquematizado en la Figura 2. La caja de plomo B contiene una sustancia radiactiva (radón) que emite partículas α. Las partículas que emergen del pequeño orificio en la caja se desvían en diversos ángulos al pasar pasan a través de una fina capa de metal F. El número de partículas desviadas en cada ángulo ϕ se encuentra dejando que las partículas golpeen una pantalla de sulfuro de zinc S. Cada partícula que golpea la pantalla produce un centelleo (un punto de fluorescencia momentáneo). Estos centelleos se pueden observar y contar mirando a través del microscopio M. El microscopio y la pantalla se pueden mover conjuntamente a lo largo de toda la circunferencia, cubriendo de esta manera todos los ángulos ϕ.

Geiger y Marsden descubrieron que el número de partículas α contadas dependía del ángulo ϕ de dispersión, de la velocidad de las partículas y del grosor de la lámina. Estos hallazgos coincidieron con las predicciones de Rutherford y respaldaron un nuevo modelo atómico, en el cual la mayor parte de la masa y toda la carga positiva ocupan una región muy pequeña en el centro del átomo.[3][4]

Notas:

[1] E. Rutherford (1911) «The Scattering of α and β Particles by Matter and the Structure of the Atom», Philosophical Magazine. Series 6, vol. 21.

[2] H. Geiger, Hans & E. Marsden (1913). «The Laws of Deflexion of α Particles through Large Angles», Philosophical Magazine. Series 6. vol. 25

[3] Lo que implica que la mayor parte del átomo es espacio vacío.

[4] Curiosamente y desde el punto de vista electrostático el átomo de Rutherford es un caso particular del átomo de Thomson. Esto permitió que el primer modelo cuántico del átomo se desarrollase basándose en el modelo de Thomson. Lo hizo Arthur E. Hass en 1910. Esta historia, bastante desconocida, la conté en este video.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El modelo atómico de Rutherford se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Rutherford: la radiactividad y el descubrimiento del núcleo atómico, por El zombi de Schrödinger

- El modelo atómico de Thomson

- 1913-2013: del modelo atómico de Bohr al Higgs

Todos los rojos son chillones

Foto: Janke Laskowski / Unsplash

Foto: Janke Laskowski / UnsplashUn vestido rojo destaca en cualquier fiesta, terraza o sarao. La prenda roja atrae nuestra atención pero, ¿alguna vez se ha preguntado por qué?

Blanco, negro y rojo

Lingüísticamente, “rojo” es el primerizo, la primera palabra cromática, el hermano mayor de todos los demás colores.

No todas las culturas humanas desarrollan palabras para nombrar los colores, como “amarillo”, “rosa” o “marrón”. En cambio, todas distinguen entre el día y la noche. Entre lo visible y lo que no se puede ver. De alguna manera, todas las lenguas humanas son capaces de distinguir su “blanco” de su “negro”, su claro de su oscuro. Pero a partir de ahí, no todas las culturas han necesitado desplegar palabras para describir colores particulares.

La evolución lingüística, no obstante, suele conducir a un punto en el que las sociedades humanas comienzan a nombrar las cosas por su apariencia externa, los colores. Y curiosamente, casi siempre la primera palabra que emerge para cumplir esa función, después de blanco y negro, suele ser el rojo.

Henry & Co. / Unsplash

Henry & Co. / UnsplashGracias a la antropología lingüística sabemos que si una lengua humana solo cuenta con tres palabras para designar la apariencia externa de las cosas, esas tres palabras serán “claro”, “oscuro” y “rojo”. Evidentemente, eso llama la atención de cualquier psicólogo cognitivo. De todos los colores, el rojo debe ser especial porque, lingüísticamente al menos, es casi siempre el primer color. O, dicho al revés, algo tendrá, alguna vivacidad especial, para que siempre le toque ser el primerizo, el hermano mayor.

Se puso colorado

Al ser el primer color, es normal que en algunas lenguas rojo todavía signifique “todos los colores” o “cualquier color”. En lengua comanche, por ejemplo, rojo es sinónimo de color. Incluso en griego clásico, la raíz de “chroma” es “chros”, que también representa la piel humana o, en general, la presencia exterior. Además, está presente en la palabra ocre, un rojo primigenio.

Aunque tampoco hay que irse tan lejos. En español, ¿qué significa la expresión “ponerse colorado”, sino sonrojarse?

También es el color que ha tenido más margen temporal para evolucionar. Siempre se menciona que los esquimales tienen decenas de palabras para designar el blanco; pero no es tan conocido que los maoríes, por ejemplo, tienen tantas o incluso más variedad de palabras para designar el complejo universo del rojo.

Los frutos rojos, las hojas verdes

Todos los rojos son chillones pero, ¿de dónde le viene esa vivacidad especial?

“Le regaló una rosa roja y él, tímido, se puso colorado”. El pincel de la literatura romántica colorea de rojo el amor, la pasión, la atracción y el placer. Es el pigmento de las flores y de la piel. Pero, pero, pero… la naturaleza no es tan romántica. Biológicamente, el rojo no nació del amor y las flores, sino del hambre y los frutos.

Ser el primer color tiene una preciosa explicación evolutiva. En comparación con otras funciones biológicas del cuerpo humano, nuestra visión tricromática es relativamente reciente, se conformó hace unos 30 o 40 millones de años. Se conoce como ‘tricromática’ porque se configura sobre 3 ejes: el eje blanco/negro, el eje azul/amarillo y, por último, el eje el rojo/verde. Este tercer eje, el último en evolucionar, lo compartimos con otros simios tricromáticos. Los demás animales (los pájaros, los peces, los insectos…) han desarrollado otro tipo de espectros cromáticos.

¿Cuál es la razón evolutiva que llevó a ciertos simios a desarrollar ese tercer eje rojo/verde? La explicación simplificada es que éramos recolectores. Poder ver el color rojo, contrastándolo con el verde, supuso un fenomenal avance evolutivo porque nos permitió poder resaltar en un solo golpe de vista el jugoso y deseable fruto rojo frente a las desabridas hojas verdes de fondo.

Foto: Xiaokang Zhang / Unsplash

Foto: Xiaokang Zhang / UnsplashEl color rojo es el resultado evolutivo de la tecnología visual desarrollada por los monos recolectores para distinguir la fruta madura de las hojas. Por eso es el color que se distingue desde más lejos, a primera vista y sin esfuerzo.

Evolutivamente, rojo significa comida, significa jugoso, el fruto que se esconde tras las hojas de los arbustos. Significa también caza, el animal sobre la hierba. Significa, en definitiva, que ha llegado poderosa la primavera.

Siempre forma, nunca fondo

Por esa razón, el color rojo fuerza la distinción entre la forma y el fondo. El rojo es siempre forma; nunca es fondo.

En una original exposición sobre el color rojo que acogió en Mayo el Campus de Gipuzkoa (UPV/EHU), el pintor Manuel Bocanegra presentó una obra paradójica. Se trata de un marco vacío pintado de rojo.

‘Pausa’, obra de Manuel Bocanegra.

‘Pausa’, obra de Manuel Bocanegra.Ekai Txapartegi, Author provided

¿Por qué no se pintan de rojo los marcos de los cuadros? Porque un marco rojo empujaría la pintura al fondo y convertiría la pared en su propio marco. Manuel Bocanegra ha dejado vacío, intencionadamente, el espacio enmarcado porque, se ponga lo que se ponga, pasaría a ser paisaje, al igual que la pared que la sostiene.

Lo rojo viene al frente y arrastra al fondo todo lo demás. Como cuando va recogiendo grosellas una a una por los matorrales, mecánicamente, en una coordinación espontánea entre el ojo y la mano. Todo lo demás es fondo, que ni se ve. Simplemente, la mano se abalanza a por el objeto rojo que la vista trae al frente.

¡Mírame, estoy aquí!