Rayos X, ¿ondas o partículas?

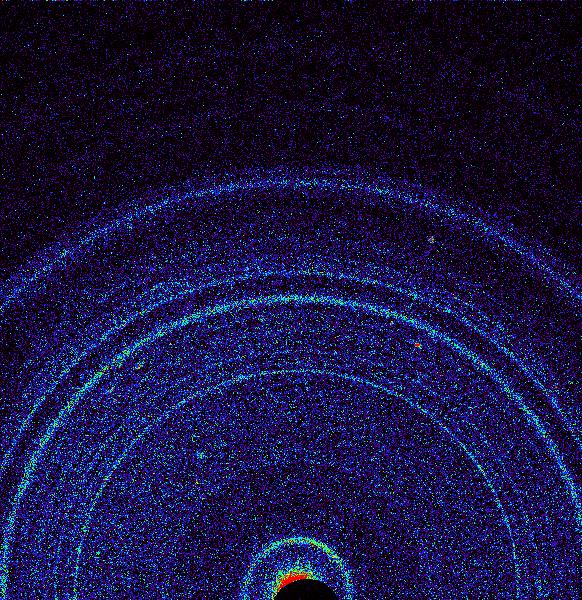

Primera difracción de rayos X efectuada por el CheMin (rover Curiosity) del suelo marciano. Fuente: NASA/JPL-Caltech/Ames

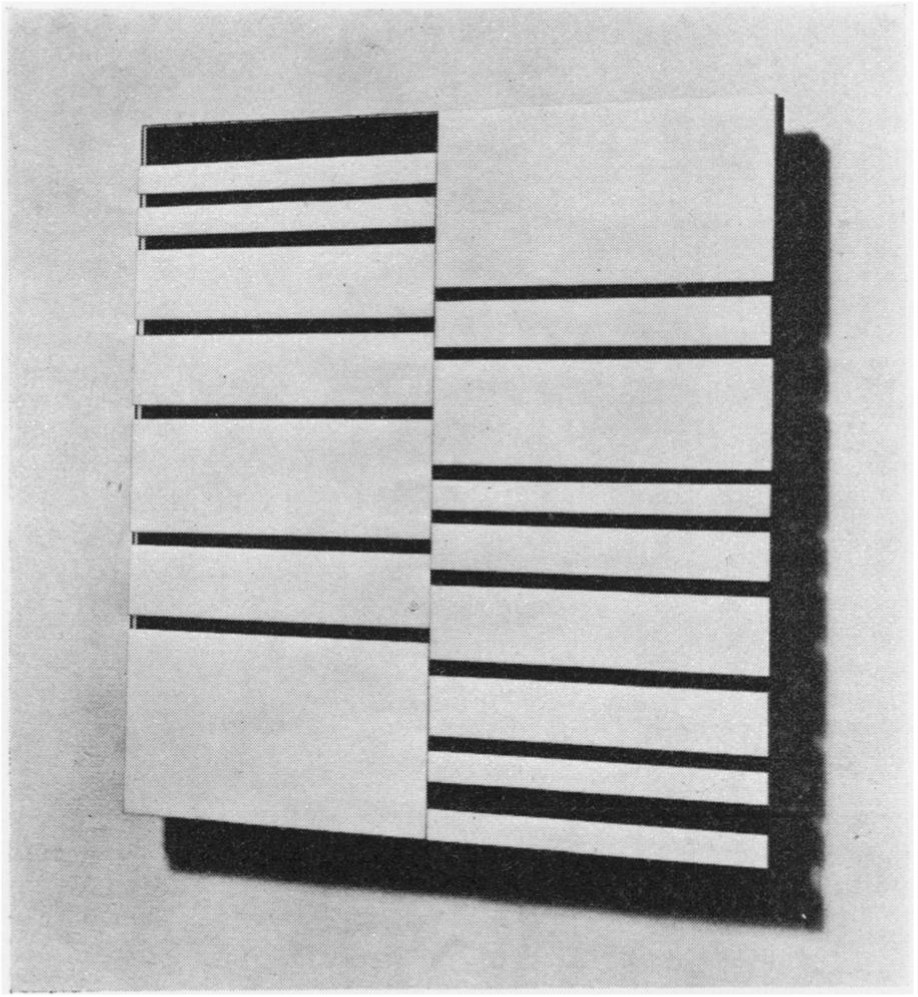

Primera difracción de rayos X efectuada por el CheMin (rover Curiosity) del suelo marciano. Fuente: NASA/JPL-Caltech/AmesUn problema que despertó un gran interés tras el descubrimiento de los rayos X se refería a la naturaleza de estos rayos misteriosos. A diferencia de las partículas cargadas (electrones, por ejemplo), no se desviaban por los campos magnéticos o eléctricos. Por lo tanto, parecía que tenían que ser partículas neutras u ondas electromagnéticas.

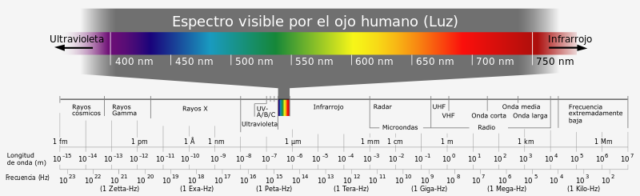

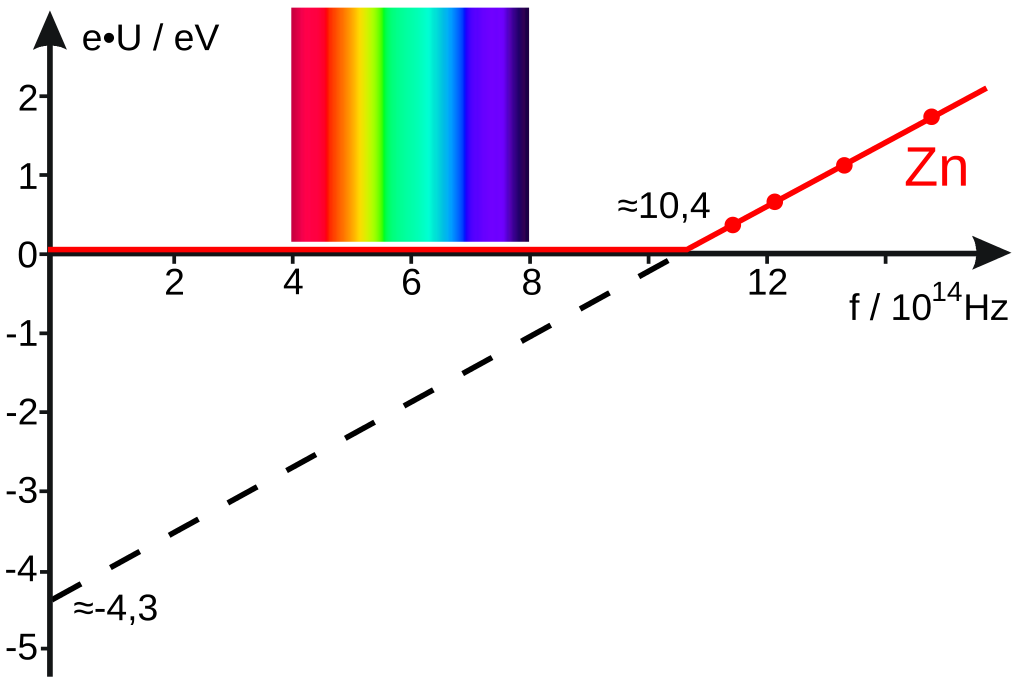

Era difícil elegir entre estas dos posibilidades. Por una parte, no se conocían partículas neutras de tamaño atómico (o más pequeñas) que tuvieran el poder de penetración de los rayos X. La existencia de unas partículas así sería extremadamente difícil de probar, porque no había manera de interactuar con ellas [1]. Sin embargo, se encontró que los rayos X tenían propiedades cuánticas, lo que significaba que también exhibían un comportamiento similar a las partículas. Por ejemplo, pueden causar la emisión de electrones de los metales. Estos electrones tienen mayores energías cinéticas que los producidos por la luz ultravioleta [2]. Por lo tanto, los rayos X también requieren de la teoría cuántica para explicar algunos de sus efectos.

Por otro lado, si los rayos X eran ondas electromagnéticas, tendrían que tener longitudes de onda extremadamente cortas porque solo en este caso, según la teoría, podrían tener un alto poder de penetración y no mostrar efectos de refracción o interferencia con aparatos ópticos ordinarios como era el caso. Como vimos al hablar de ondas, las propiedades claramente ondulatorias se hacen evidentes solo cuando las ondas interactúan con objetos, como las rendijas en una barrera, que son más pequeños que varias longitudes de onda. Las longitudes de onda hipotéticas para los rayos X tendrían que ser del orden de 10-10 m. Por lo tanto, para demostrar de su comportamiento como onda requeriría una rejilla de difracción con hendiduras separadas aproximadamente 10-10 m. La teoría cinética y la química del XIX apuntaban a que os átomos tenían precisamente del orden de 10-10 m de diámetro. Parecía razonable, por tanto, que los rayos X pueden ser difractados de forma medible por cristales en los cuales los átomos forman capas ordenadas separadas 10-10 m.

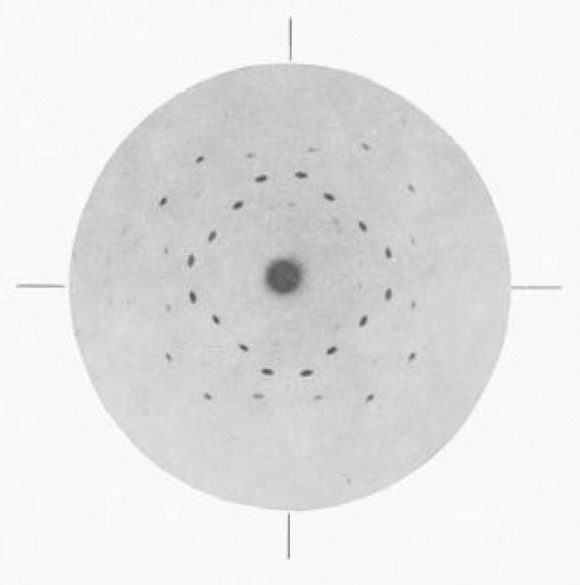

Estos experimentos tuvieron éxito en 1912. Las capas de átomos actuaron como redes de difracción, y los rayos X sí actuaron como cabía esperar de una radiación electromagnéticas de longitud de onda muy corta (como la luz ultravioleta). Estos experimentos son más complicados de interpretar que la difracción de un haz de luz mediante una rejilla óptica bidimensional única. El efecto de difracción se produce en tres dimensiones en lugar de dos. Por lo tanto, los patrones de difracción son mucho más elaborados [3].

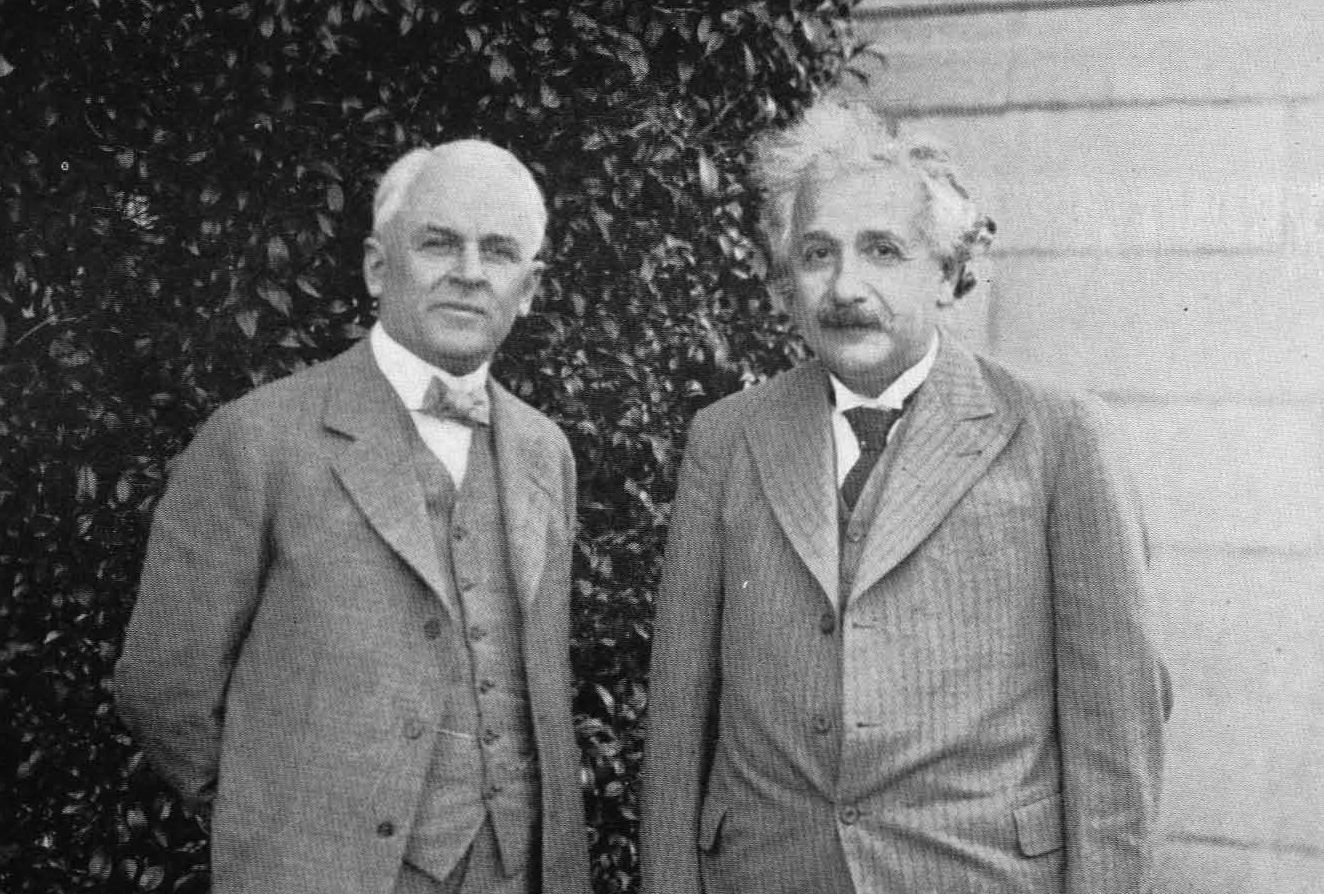

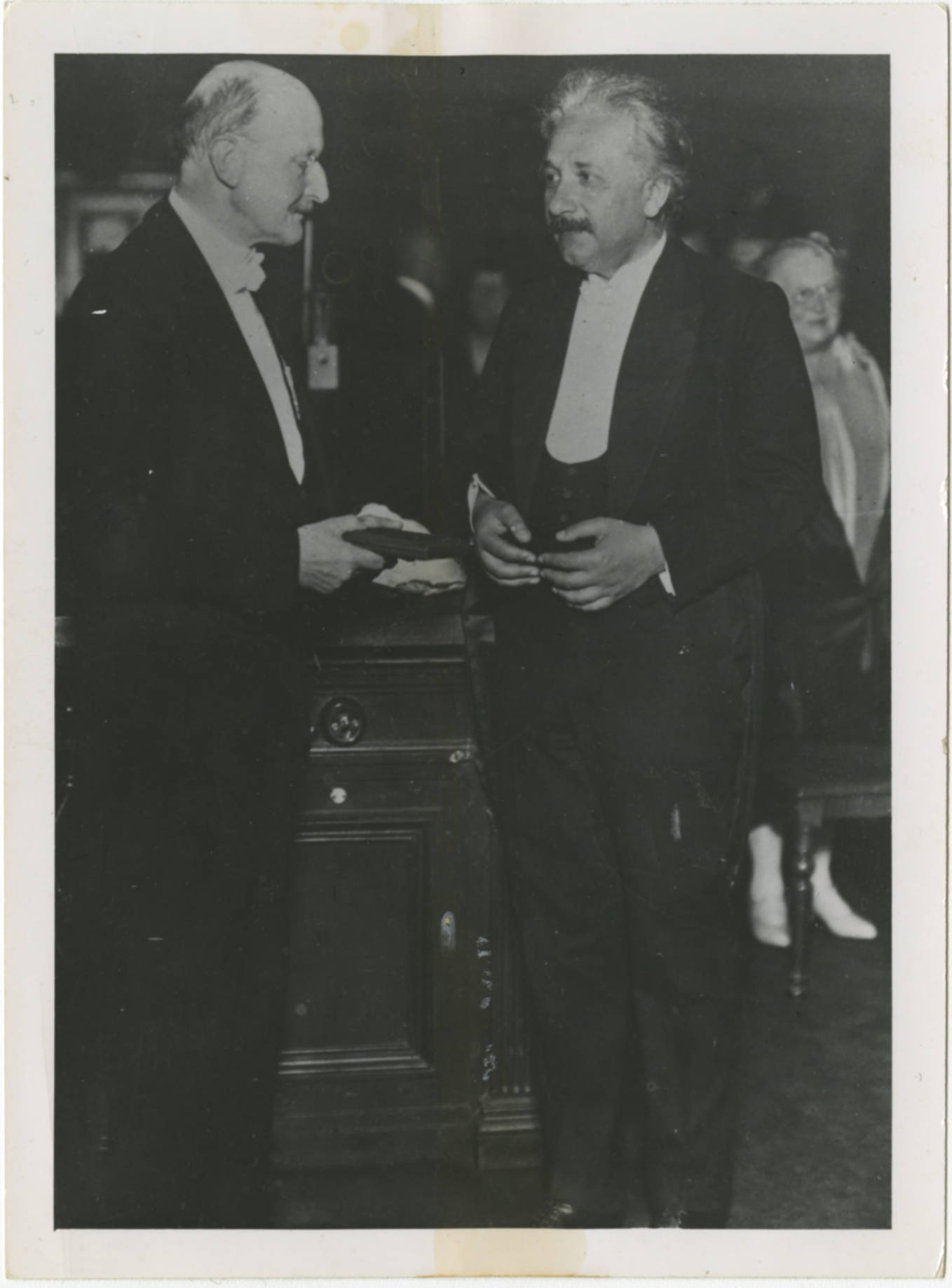

Walter Friedrich y Paul Knipping (del departamento de Arnold Sommerfeld en la Universidad de Munich), comprobaron la existencia de un patrón de difracción de rayos X en un cristal de sulfuro de cinc (ZnS). La explicación de este hallazgo llevaría a que un jovenzuelo llamado William Lawrence Bragg ganase el premio Nobel de física con solo 25 años.

Walter Friedrich y Paul Knipping (del departamento de Arnold Sommerfeld en la Universidad de Munich), comprobaron la existencia de un patrón de difracción de rayos X en un cristal de sulfuro de cinc (ZnS). La explicación de este hallazgo llevaría a que un jovenzuelo llamado William Lawrence Bragg ganase el premio Nobel de física con solo 25 años.La comunidad científica estaba ante otro hecho sorprendente: como le ocurre a la luz, los rayos X tienen propiedades de onda y de partícula.

Notas:

[1] Un problema parecido formalmente al que existe en la actualidad con la naturaleza de la materia oscura, que no interactúa con la radiación electromagnética y de la que solo se detectan efectos gravitatorios.

[2] La ionización de los gases por rayos X es también un ejemplo del efecto fotoeléctrico. En este caso, los electrones se liberan de los átomos y las moléculas del gas.

[3] Aunque tampoco es para tanto. En Generación X dimos una introduccion muy simple a la idea.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Rayos X, ¿ondas o partículas? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Por qué es tan difícil investigar la depresión en modelos animales

Foto: Pixabay

Foto: PixabayExiste una prueba muy común en la investigación sobre procesos depresivos y medicamentos antidepresivos llamada el test de natación forzada. En esta prueba se suelta a un ratón del laboratorio en una cubeta con agua dos veces en días cercanos y se mide cuanto tiempo tarda en rendirse y dejar de nadar en ambas ocasiones. Se considera que una reducción de ese tiempo de un experimento al siguiente está relacionada con un mayor riesgo de síntomas depresivos, una suerte de desesperanza vital, de apatía y sentimientos negativos que se relacionaría con el riesgo de depresión en seres humanos.

Como decimos, es un test común en las investigaciones que tratan de encontrar y mejorar terapias para tratar la depresión y otras enfermedades mentales relacionadas. Se ha empleado con resultados eficaces, por ejemplo, en el desarrollo de un tipo de medicamentos antidepresivos llamados ISRS (inhibidores selectivos de la recaptación de serotonina): los ratones que recibían estos compuestos luchaban por mantenerse a flote más tiempo que los que no los tomaban.

Foto: Wikimedia Commons

Foto: Wikimedia Commons¿Y si los ratones dejan de nadar por otros motivos?

Sin embargo, esta prueba está en el centro de un debate más amplio, que cuenta aquí la revista Nature, que se cuestiona si realmente sirven estos modelos animales a la hora de tratar enfermedades mentales tan complejas como la depresión.

Las dudas sobre la prueba de la natación forzada comienzan con la propia naturaleza de la prueba. Algunos críticos señalan que si el animal se rinde pronto en la segunda zambullida quizá no sea tanto por una mayor presencia de síntomas depresivos sino por mero aprendizaje: después de la primera experiencia sabe que cuando deje de nadar el investigador le sacará del agua antes de ahogarse y, por tanto, para qué invertir tanta energía. En ese caso, las diferencias entre uno y otro bañito no se deberían tanto a los efectos de tal o cual medicación sino a una posible adaptación al entorno.

Esto lleva aparejado el debate ético ya clásico sobre lo oportuno de la investigación biomédica con animales, porque si resulta que esta prueba ofrece resultados cuestionables, ¿qué necesidad hay de hacer pasar a los ratones por ella? Incluso aunque no sufran daño ni dolor (en la prueba correctamente realizada no se deja que se ahoguen), sí deben superar un momento de angustia y estrés que algunos activistas en contra de la experimentación animal, y también algunos científicos del área consideran innecesario si no se obtienen con ello datos fiables.

La depresión, una enfermedad compleja que no todos sufren igual

Pero el debate va más allá de la posible adaptación de los ratones y entra en el terreno de la propia salud mental, al plantear la cuestión de cómo crear un modelo que represente de forma adecuada y eficaz qué es realmente la depresión y cómo evoluciona, mejora o empeora. ¿Es posible y útil pretender que un modelo animal puede representar la complejidad de una enfermedad de este tipo, como lo sería un test que trata de medir su “desesperanza” o su “tendencia a los sentimientos negativos”? ¿O sería más realista fijarse en síntomas más específicos, como por ejemplo la pérdida de apetito hacia su alimento preferido, algo que a menudo padecen los pacientes con depresión?

Quizá esta segunda alternativa tendría más sentido si tenemos en cuenta que la depresión no tiene siempre el mismo aspecto en humanos y que los mismos tratamientos no funcionan para todo el mundo.

¿Cómo modelizar el componente social de la depresión?

Pero hay algo más que eso. Cada vez hay menos deudas de que la salud mental tiene un importante componente social difícil de trasladar a un modelo animal, y que tomar medidas que reduzcan la precariedad y la desigualdad a nivel colectivo tendría un impacto mayor sobre la salud mental de los individuos que poner el énfasis en la medicación y la terapia como principales soluciones como se lleva haciendo en las últimas décadas.

Esa era la principal conclusión de un informe elaborado por Dainius Pūras, psiquiatra y Relator Especial para la salud física y mental de la ONU. Según sus palabras, recogidas aquí por el periódico The Guardian, hacer frente a la discriminación y la desigualdad “sería la mejor vacuna contra la enfermedad mental, y desde luego sería mucho mejor que el uso excesivo de medicación psicotrópica que estamos viendo”.

En cualquier caso, Pūras no pide sacar de la ecuación la medicación, sino dejar de darle el papel único y central en el tratamiento de estos problemas. “La mejor forma de invertir en la salud mental de los individuos es crear un entorno de apoyo en los distintos ámbitos, tanto familiar como laboral. Después, los servicios terapéuticos pueden ser necesarios, por supuesto, pero no deberían estar basados de forma excesiva en el modelo biomédico”.

En su opinión, se ha puesto hasta ahora demasiado énfasis en curar las enfermedades mentales, como la depresión, igual que las enfermedades físicas, a través de la medicina pura, sin pensar en los factores sociales que causan o intervienen en muchas de esas enfermedades, y señala como ejemplo el recetado de antidepresivos que se ha disparado en el mundo desarrollado en los últimos 20 años.

Ante este enfoque más social de la salud mental, de nuevo el debate sobre los modelos animales para tratar la depresión quizá necesite ser reenfocado, más allá de la prueba de la natación forzada en concreto. No porque no sea necesario encontrar nuevos y mejores tratamientos químicos para la depresión y sus síntomas, así como para otras enfermedades mentales, que pueden ayudar a las personas que las padecen, sino porque parece que estas enfermedades son, por decirlo de alguna forma, especialmente humanas, con una dimensión colectiva y social difícil de trasladar a los ratones del laboratorio.

Referencias

Depression researchers rethink popular mouse swim tests – Nature

Right of everyone to the enjoyment of the highest attainable standard of physical and mental health – Organización para las Naciones Unidas

Austerity and inequality fuelling mental illness, says top UN envoy – The Guardian

Animal models of depression – Wikipedia

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Por qué es tan difícil investigar la depresión en modelos animales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Quién llorará por los animales feos cuando desaparezcan?

- ¿Cuánto cuesta realmente investigar en biomedicina?

- La difícil tarea de persuadir

Nivel formativo y transición demográfica

Foto: Jonny McLaren / Unsplash

Foto: Jonny McLaren / UnsplashLa fecundidad ha descendido o está descendiendo rápidamente en la mayoría de países del mundo. Como consecuencia, la población humana crece cada vez menos y es muy posible que a partir de un determinado momento llegue a disminuir. A ese cambio en la fecundidad y sus consecuencias poblacionales se denomina “transición demográfica”. Desde un punto de vista estrictamente evolutivo es un fenómeno difícil de entender porque, en principio, cuanto mayor es la cantidad de recursos de que dispone una pareja, mayor es la descendencia que puede sacar adelante. Pero las cosas no ocurren de acuerdo con ese esquema.

En Europa, la transición demográfica se inició en algunas regiones de Francia hace casi dos siglos, alrededor de 1830, pero en Normandía y Bretaña no llegó hasta casi un siglo después. En Valonia empezó alrededor de 1870, pero en Flandes lo hizo cuatro décadas más tarde. En Gran Bretaña y algunas regiones de Alemania llegó en 1880, pero en otras de este mismo país se inició en 1910 y tan tarde como en 1930 en las demás. Esas disparidades, sobre todo las que se observan en diferentes zonas de un mismo país, sugieren que en el fenómeno pueden influir factores de naturaleza cultural. De hecho, el descenso de la fecundidad suele ir ligado al acceso de las mujeres a la educación y a trabajos económica y socialmente valorados.

Un estudio realizado en una zona de Polonia en plena transición demográfica puso de manifiesto que, efectivamente, cuanto mayor es el nivel de estudios de una mujer, menor tiende a ser el número de hijos que tiene. Pero el dato más interesante de ese estudio fue que, tanto o más que del nivel de cada mujer de forma individual, la fecundidad depende del nivel de formación de las mujeres de su entorno social. O sea, las mujeres de bajo nivel educativo que se relacionan con otras de nivel alto tienden a copiar el comportamiento reproductivo de estas, generalizándose de esa forma al conjunto del entorno social.

En un principio, las mujeres con un alto nivel de formación tienden a posponer la maternidad porque pueden así dedicar más tiempo y esfuerzo a adquirir los conocimientos y capacidades que facilitan el progreso profesional y proporcionan un estatus más elevado; y el retraso de la maternidad conlleva un descenso en la fecundidad. Como esas mujeres y sus parejas suelen tener un nivel socio-económico más elevado, son imitadas por el resto de mujeres o parejas de su entorno. La imitación puede implicar el dedicar más tiempo a adquirir formación y empleos socialmente deseables; en ese caso, la fecundidad también disminuye. Pero puede ocurrir que lo que se imita sean simplemente las decisiones reproductivas. Se trata de un fenómeno bien conocido de tranmisión cultural que se basa en dos sesgos psicológicos muy poderosos, el de prestigio y el de conformidad.

En virtud del sesgo de prestigio tendemos a imitar el comportamiento de los individuos de mayor éxito. Y en virtud del de conformidad, tendemos a hacer lo que hace la mayoría del grupo al que pertenecemos. El efecto combinado de ambos sesgos provoca la transmisión rápida de normas culturales que propician el descenso de la fecundidad. Es un fenómeno que se autoalimenta y que conduce a tasas de natalidad muy bajas en periodos de tiempo relativamente breves.

En la transición demográfica seguramente actúan otros factores también, pero si se quieren revertir sus efectos más indeseados, seguramente ha de tenerse en cuenta la forma en que el nivel formativo de la población y las expectativas profesionales de las jóvenes parejas ejercen sobre las decisiones reproductivas.

Fuente: H. Colleran, G. Jasienska, I. Nenko, A. Galbarczyk y R. Mace (2014): “Community-level education accelerates the cultural evolution of fertility decline.” Proc. R. Soc. B 281: 20132732.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Nivel formativo y transición demográfica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Tener hijos o no tenerlos?

- La compleja transición de cazador-recolector a agricultor

- Una consecuencia inesperada de la longevidad

Pizza y terraplanistas

Es razonable pensar que la Tierra tiene forma de pizza. Y puede ser muy complicado convencer a una persona que crea que esto es así de lo contrario. Salvo que intervengan las matemáticas y la definición de curvatura. Alberto Márquez, de la Universidad de Sevilla, lo explica.

Quizás sea el número más famoso de la historia. Lo cierto es que el número Pi, representado por la letra griega π, es una de las constantes matemáticas más importantes que existen en el mundo, estudiada por el ser humano desde hace más de 4.000 años. La fascinación que ha suscitado durante siglos es tal que el popular número cuenta con su propio día en el calendario, así el mes de marzo se celebra el Día de Pi en todo el planeta.

Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien lanzó en 1988 la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática. (3-14 martxoaren 14 en euskara / 3-14 march, 14th en inglés) y además, la celebración coincide con la fecha del nacimiento de Albert Einstein. En 2009, el congreso de EEUU declaró oficialmente el 14 de marzo como el Día Nacional de Pi.

Actualmente, el Día de Pi es una celebración mundialmente conocida que sobrepasa el ámbito de las matemáticas. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

Este 2019 nos unimos de nuevo al festejo con el evento BCAM–NAUKAS, que se desarrolló a lo largo del 13 de marzo en el Bizkaia Aretoa de UPV/EHU. BCAM-NAUKAS contó durante la mañana con talleres matemáticos para estudiantes de primaria y secundaria y durante la tarde con una serie de conferencias cortas dirigidas al público en general.

Este evento es una iniciativa del Basque Center for Applied Mathematics -BCAM, enmarcada en la celebración de su décimo aniversario, y de la Cátedra de Cultura Científica de la Universidad el País Vasco.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Pizza y terraplanistas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sigue al conejo blanco

- Matemáticas modernas

- Diagnóstico de enfermedades: una cuestión de probabilidades

Barbacoas, ciencia y salud

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Foto: Victoria Shes / Unsplash

Foto: Victoria Shes / UnsplashQue Bilbao fuera galardonada como la mejor ciudad gastronómica del mundo no sorprendería a muchos, máxime cuando ha sido elegida como la mejor ciudad europea en 2018. Y como las ciudades las hacemos los ciudadanos pues nos congratulamos por la parte que nos toca. Ciertamente es Bilbao cuna de la ‘fine cuisine’ vasca, europea y mundial, con grandes maestros de los fogones y una elevada concentración de restaurantes en la Guía Michelín.

Sin embargo, no todo en la cocina debería orientarse a la obtención de nuevos y sofisticados sabores para alegrarnos el paladar. Alimentos muy dorados, flambeados o incluso parcialmente quemados realzan su sabor y por ello se utilizan con frecuencia en las recetas más sofisticadas de los mejores restaurantes. Pero esta ganancia en sabor tiene su precio. Una gran parte de las propiedades nutritivas de los alimentos tratados de esta manera se pierden, al mismo tiempo que se generan moléculas no deseadas, a menudo tóxicas para el organismo.

Los alimentos muy cocinados (a temperaturas de 120 º C o superiores), sobre todo los que requieren contacto directo con la llama, a la brasa o cocinados sobre planchas metálicas cambian sus características químicas (organolépticas) convirtiéndose en serias amenazas para la salud. Vamos con algunos ejemplos…

Cada vez son más típicas las barbacoas entre amigos, o los asados de carne, o pescados a la plancha en nuestras mesas. Y uno podría pensar que si esto fuera acompañado de un buen arroz socarrado, formado por los granos de arroz caramelizados en el fondo de la paella, sería el acompañamiento perfecto de una comida ideal. Exquisito sabor sin duda alguna, pero con toda seguridad estaríamos introduciendo una cantidad muy elevada de moléculas perjudiciales para la salud.

Concretamente, el almidón del arroz y el de todos los alimentos ricos en este tipo de polisacárido vegetal (fécula de pata, pan simple…), está formado por unidades de glucosa enlazadas y son muy susceptibles de formar acrilamida cuando se calientan a temperaturas relativamente elevadas (120 °C o superiores). Lo mismo ocurriría con el polisacárido de reserva animal, el glucógeno, el cual también está formado por unidades de glucosa. Muchos estudios realizados con animales de laboratorio han demostrado que la acrilamida es altamente cancerígena. La acrilamida se forma al reaccionar las unidades de glucosa de los polisacáridos con el aminoácido asparragina, el cual está presente en las proteínas tanto vegetales como animales.

Sin duda alguna la manera de cocinar los alimentos tiene un impacto muy importante sobre los niveles de acrilamida que pueden generarse. Los alimentos poco cocinados (poco dorados) o sometidos a temperaturas más bajas que las indicadas anteriormente tendrán mucha menor concentración de acrilamida que los alimentos muy cocinados o sometidos a temperaturas elevadas. Dado que la acrilamida es altamente carcinogénica, los científicos no se atreven a establecer un nivel ‘tolerable’ de esta sustancia en nuestra dieta. Por otra parte, hay que tener en cuenta que los niños son más vulnerables a los efectos de la acrilamida debido a su menor peso corporal.

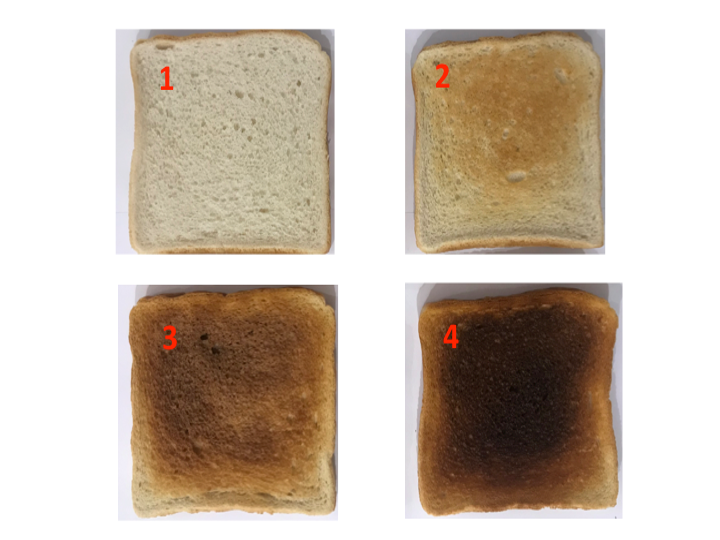

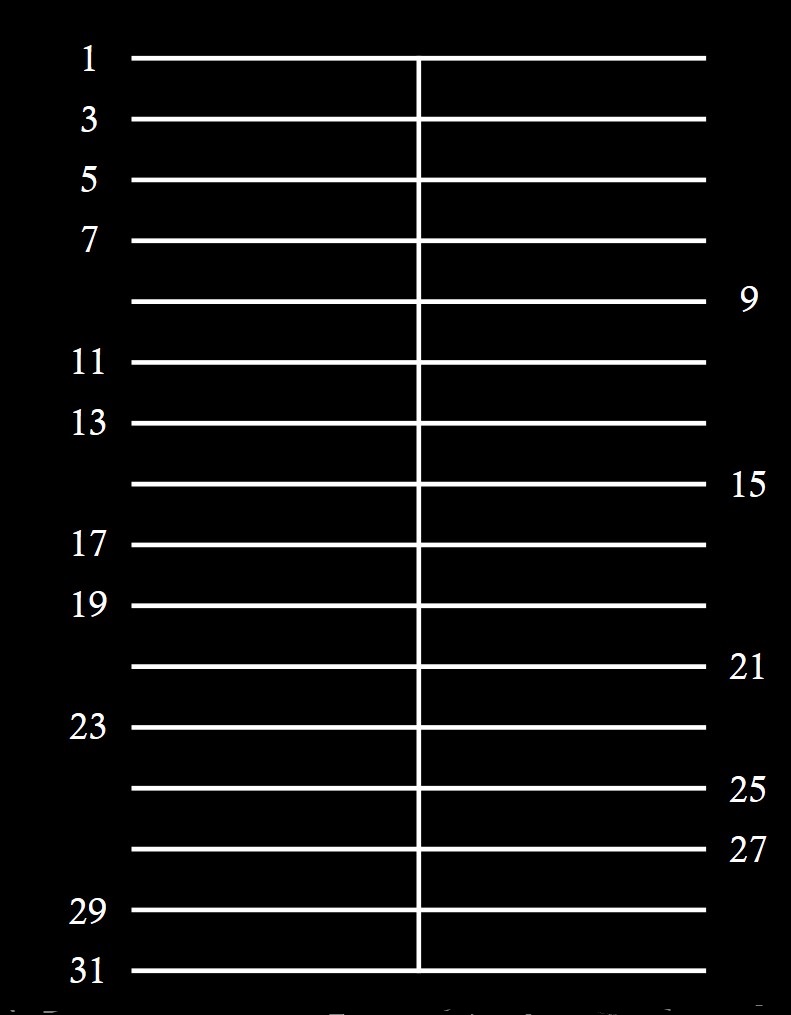

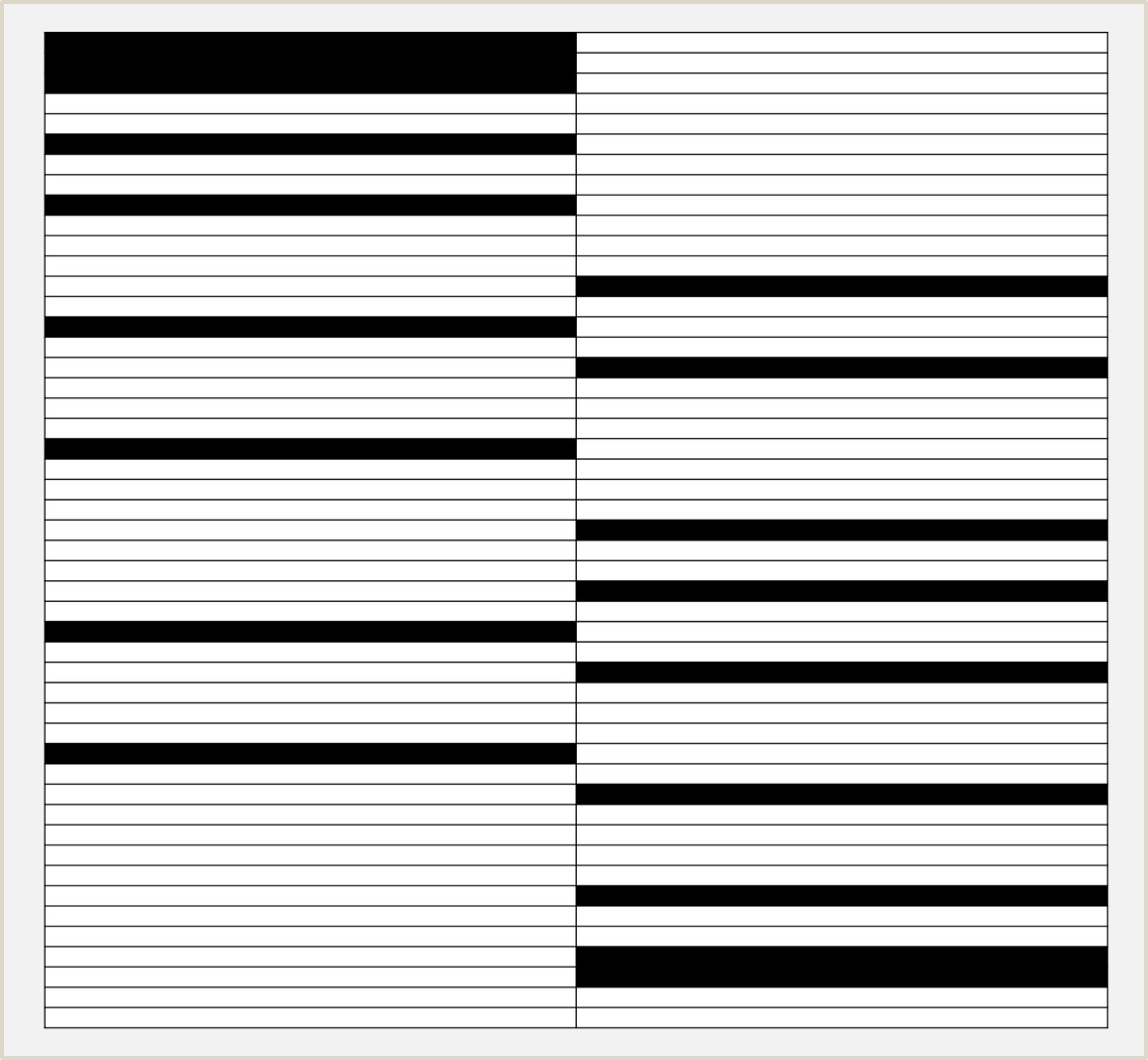

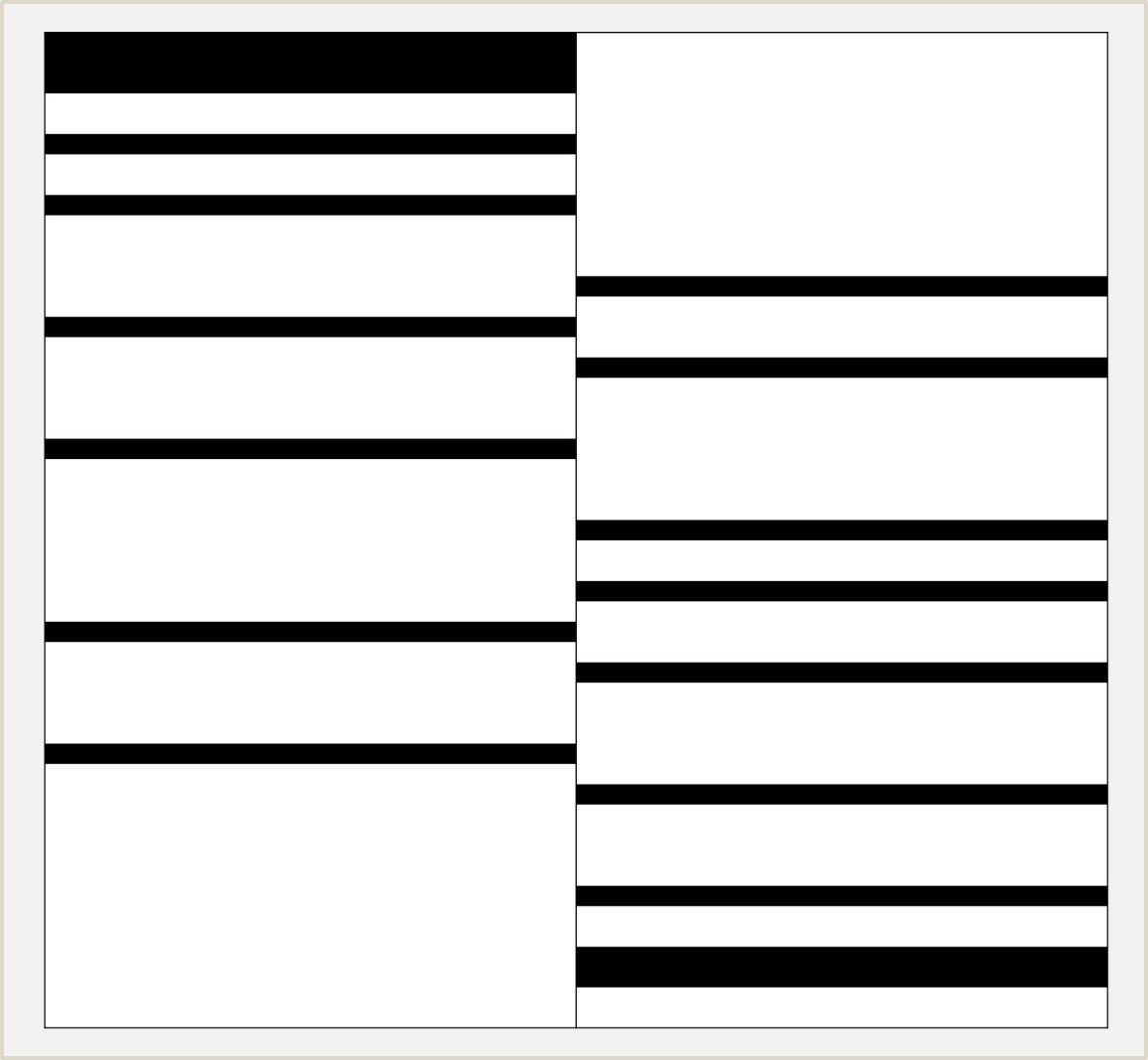

No obstante, a día de hoy, todos los estudios realizados sobre la toxicidad de la acrilamida se han llevado a cabo utilizando animales de laboratorio y no existen estudios epidemiológicos exhaustivos en humanos. A título simplemente orientativo la Figura 1 muestra cuatro niveles de tostado que van desde un nivel recomendable al no recomendable para el consumo. Nivel 1: recomendable; nivel 2: aceptable; nivel 3: poco recomendable; nivel 4: no recomendable.

Figura 1. Cuando cocines alimentos piensa siempre en blanco o en dorado, nunca en negro o marrón. Así se reducirá la formación de sustancias tóxicas para la salud.

Figura 1. Cuando cocines alimentos piensa siempre en blanco o en dorado, nunca en negro o marrón. Así se reducirá la formación de sustancias tóxicas para la salud.Al igual que los alimentos ricos en hidratos de carbono, las carnes, los pescados y las verduras cocinadas a elevadas temperaturas también dan lugar a la formación de sustancias tóxicas para el organismo. Concretamente, la carne demasiado hecha puede contener dos tipos de sustancias químicas carcinogénicas: hidrocarburos aromáticos policíclicos (HAPs) y aminas aromáticas heterocíclicas (AAHs). Los HAPs se generan, por ejemplo, por contacto directo de la carne o el pescado con la llama o cuando la carne o el pescado a la parrilla gotean sobre el fuego o sobre el dispositivo de calentamiento. Muchas de estas toxinas son volátiles y pueden ser transportadas por el humo acabando de nuevo sobre la carne o el pescado que nos vamos a comer, agravando así el problema. Igualmente, los alimentos ahumados pueden poseer cantidades importantes de este tipo de moléculas tóxicas.

Tanto los HAPs como las AAHs son sustancias mutagénicas, es decir, que producen cambios químicos importantes en el ácido desoxirribonucleico (ADN) de las células contribuyendo así al desarrollo de diferentes tipos de cáncer. En cuanto a los vegetales, tampoco conviene cocinarlos a temperaturas altas, ya que esto daría lugar a la formación de benzopireno, otro potente agente carcinogénico perteneciente a la familia de los HAPs. Al igual que para la acrilamida, no se pueden establecer límites de tolerancia de estos compuestos en la dieta debido a su elevado potencial carcinogénico.

Algunos consejos para reducir la formación de sustancias nocivas cuando cocinamos

1. Cocinar los alimentos en presencia de diferentes tipos de especias (albahaca, ajo, jenjibre, pimienta, tomillo, romero, salvia, orégano) o marinados en vinagre, lima, limón, vino o cerveza. Las especias se conocen desde muy antiguo. Ya en el siglo I las utilizaban griegos y romanos en sus recetas culinarias, como se describe en el tratado de botánica ‘Dioscórides’. Las especias no solo realzan el sabor de los alimentos o se suman a sus características organolépticas sino que resultan indispensables para proteger a los alimentos contra la formación de moléculas tóxicas que afectan seriamente a nuestra salud.

2. Cocinar carne magra, evitando las carnes grasas para prevenir el goteo sobre la fuente de calor.

3. Cuando cocines piensa en dorado, nunca en negro ni en marrón. Asegúrate siempre de que los alimentos no sobrepasen los límites de color por la acción del calor. Y si te pasas, siempre puedes rascar o eliminar las partes más quemadas.

Sobre el autor: Antonio Gómez Muñoz es catedrático en el Departamento de Bioquímica y Biología Molecular de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Barbacoas, ciencia y salud se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Salud: ciencia y comunicación (seminario)

- Curso de verano “Las dos culturas y más allá”: La ciencia al servicio de la salud humana, por Icíar Astiasarán

- Ciencia para todos a través del cine y la literatura de ciencia ficción

El sonido del viento

Cuando se habla de los orígenes del arte, o de “Arte Prehistórico”, la primera imagen que se nos viene a la cabeza se suele parecerse mucho a una pintura: las Cuevas de Altamira por ejemplo, de 18 mil años de antigüedad, ocupan un lugar privilegiado en el imaginario colectivo. En algunos casos, habrá también quienes piensen en esculturas paleolíticas, como la Venus de Willendorf de 28 mil años de antigüedad. Es mucho menos habitual pensar en otras formas artísticas y, sin embargo, se han encontrado flautas de hueso de hace 43 mil años que sitúan a la música en los orígenes mismos del pensamiento simbólico humano en Europa.

La cifra resulta apabullante y aún así se piensa que la primera música que hicieron los humanos debe de ser todavía más antigua. Lo más probable es que los primeros músicos no fuesen flautistas, sino cantantes. Para producir melodías, los humanos comenzamos por controlar nuestra voz y luego, probablemente, añadimos algo de percusión (como palmadas, o golpes contra cualquier objeto). Pero estas voces y estas palmadas, evidentemente, no se ha conservado, así que hoy la primera evidencia que tenemos de la música son huesos perforados: huesos de buitre o de oso que, con toda probabilidad funcionaron como flautas.

Esto nos da una pista de por qué son precisamente los instrumentos de viento los más antiguos conservados. Para empezar, pueden fabricarse usando materiales rígidos, no perecederos (al contrario que las cuerdas, por ejemplo, que suelen estar hechas con tripas o pelo de animal). Pero además, son muy fáciles de construir. Para fabricar un instrumento de viento sólo se necesita viento (claro) y un tubo. El viento lo llevamos todos de serie en los pulmones y para conseguir un tubo, basta con encontrar un hueso de animal o alguna caña hueca y rígida. En realidad, la única función de este tubo es la de “contener” el aire, dando cabida a ciertas longitudes de onda, su material y forma exacta son poco cruciales. Toda la magia de los instrumentos de viento tiene lugar más allá del tubo, en uno de sus extremos: el lugar donde el aire se “excita” y comienza a vibrar.

Existen distintas maneras de poner en marcha esta vibración y cada una de ellas da lugar a un timbre característico. Por eso, la forma en que se excita el aire es el verdadero criterio que distingue a las familias de instrumentos de viento. Es muy probable que todos hayáis oído hablar de instrumentos de viento madera y viento metal. La paradoja de estas etiquetas es que poco tienen que ver con el material de que están hechos los instrumentos. Las flautas traveseras de las orquestas contemporáneas, por ejemplo, suelen estar hechas de plata u oro incluso y, sin embargo, la flauta pertenece a la familia del viento madera. Por su parte, dentro del viento metal, encontramos instrumentos tan poco dúctiles o brillantes como las caracolas o las vuvuzelas.

Steve Turre tocando un instrumento de viento metal… poco convencional.

Steve Turre tocando un instrumento de viento metal… poco convencional.Lo que caracteriza en realidad a los instrumentos de viento metal es que el sonido procede de la vibración de los labios del instrumentista. La presión procedente de la boca fuerza al aire a pasar por un mínimo hueco que se abre y cierra constantemente gracias a la elasticidad de los labios. Lo que viene siendo una pedorreta. O lo que sucede cuando dejamos escapar el aire de un globo mientras estiramos la goma junto a la salida: la membrana flexible lucha por recuperar su posición mientras el aire sale intermitentemente. Esa intermitencia puede ser más rápida o más lenta, según lo tensa que esté la goma. Por eso, cuanto más estiramos el globo, más agudo es el sonido resultante (mayor es la frecuencia de las oscilaciones de la presión). Del mismo modo: los trompetistas, trompistas y demás instrumentistas de viento metal, pueden modificar la tensión de sus labios para obtener distintas notas.

Dentro del viento madera, por su parte, encontramos distintas maneras de romper el aire. La flauta, por ejemplo, funciona mediante un bisel: una pieza rígida y afilada que fuerza al aire a desviarse en un sentido u otro, generando nuevamente una oscilación periódica de la presión más comúnmente conocida como sonido.

También son instrumentos de viento madera los que utilizan lengüetas para sonar. La lengüeta (o caña) es una pieza semirígida que interrumpe el paso del aire de manera intermitente gracias al principio de Bernoulli: cuando el aire fluye junto a ella, la presión disminuye y atrae a la lengüeta. Al ser esta flexible, se curva en la dirección del flujo e interrumpe su paso, la velocidad del aire disminuye y la presión vuelve a aumentar. Esto devuelve la lengüeta a su posición inicial y así el ciclo vuelve a empezar.

Existen distintos tipos de cañas y lengüetas, pero generalmente se clasifican como simples, dobles o libres, dependiendo de si se apoyan contra una superficie rígida, contra una segunda caña o si oscilan libremente obstruyendo por sí mismas el flujo del aire. Algunos instrumentos dentro de este grupo son el saxofón (lengüeta simple), la gaita (lengüeta doble) o la armónica (lengüeta libre). Los timbres, como puede verse, son enormemente diferentes pero si he de elegir uno, yo me quedo con la dulzura y la enorme versatilidad del clarinete.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El sonido del viento se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La física del sonido orquestal

- Máquinas inteligentes (I): Del molino de viento al test de Turing

- En Marte el viento crea montañas

Kaisa-talo, geometría en la biblioteca

Esa fuerza interior se transmite de forma brillante hacia fuera en las dos fachadas, especialmente en la que da a la calle Kaisaniemenkatu. Una trama de pequeñas ventanas cuadradas dan una luz muy tamizada interrumpida por unos grandes ventanales de formas parabólicas por la que se introduce la luz hacia el espacio central.

Alberto Corral

La biblioteca de la Universidad de Helsinki es la biblioteca universitaria multidisciplinaria más grande de Finlandia. Funciona como un instituto independiente e incluye la Biblioteca Central –llamada Kaisa-talo, es decir, casa Kaisa en finés– y las bibliotecas de los campus de Kumpula, de Meilahti y de Viikki.

Fachada principal (este) de Kaisa-talo. Fotografía: Inés Macho Stadler.

Fachada principal (este) de Kaisa-talo. Fotografía: Inés Macho Stadler.Kaisa-talo reúne las colecciones de libros y documentos de las facultades de arte, derecho, teología y ciencias sociales de la Universidad de Helsinki; está situada en el centro del campus. El solar que alberga esta biblioteca estaba antes ocupado por un centro comercial –construido en dos fases en 1973 y 1984 y posteriormente demolido– que era poco respetuoso con el paisaje urbano debido a su fachada de cemento. Los niveles subterráneos, antes ocupados por los aparcamientos, han sido conservados y forman parte de la biblioteca como zona de mantenimiento y almacenaje.

La firma de arquitectos Anttinen Oiva de Helsinki se presentó en 2007 a un concurso para diseñar el nuevo edificio que iba a alojar la biblioteca central de la universidad de esta ciudad, y lo ganó. En 2011 la propuesta de Anttinen Oiva comenzó a construirse como parte de La Capital de Diseño Mundial, un proyecto de promoción de ciudades patrocinado por el Consejo Internacional de Sociedades de Diseño Industrial (International Council of Societies of Industrial Design, World Design Organization) en el que la ciudad elegida – en el año 2012 fue Helsinki– tiene la oportunidad mostrar sus logros de innovación en diseño y sus estrategias urbanas. Kaisa-talo fue inaugurada el 3 de septiembre de 2012.

Fachada oeste de Kaisa-talo. Fotografía: Inés Macho Stadler

Fachada oeste de Kaisa-talo. Fotografía: Inés Macho StadlerEl exterior del edificio es de ladrillo rojo –caracteriza el modernismo finlandés– y respeta la altura de los edificios colindantes, lo que le ayuda a integrarse en su entorno. Situado en una cuesta, Kaisa-talo tiene forma de L y siete pisos. Su entrada principal está en el lado este, dos pisos por encima de los accesos a las tiendas situadas en la fachada opuesta. La fachada este posee un arco catenario que ocupa cuatro pisos y otro similar invertido aparece en la fachada oeste. Las paredes exteriores albergan grandes ventanales curvos y también numerosas ventanas pequeñas y cuadradas que forman una retícula uniforme que contrasta con la zona curvilínea.

Small Worlds (2012). Imagen: Wikimedia Commons.

Small Worlds (2012). Imagen: Wikimedia Commons.Ya en el interior del edificio, en el hall de entrada se sitúa un mural de 18 metros, donado por el Consejo de Arte del Estado: Small Worlds realizado por las artistas Terhi Ekebom y Jenni Rope. Esos Pequeños mundos, algunos de ellos enlazados mediantes estrechos caminos, quizás aludan a los muchos espacios interconectados en la biblioteca.

Una impresionante escalera en forma de espiral comunica los pisos principales de la biblioteca, exceptuando el centro logístico y las instalaciones de mantenimiento bajo tierra a los que se accede fundamentalmente por ascensor.

Escalera interior en forma de espiral. Fotografía: Inés Macho Stadler

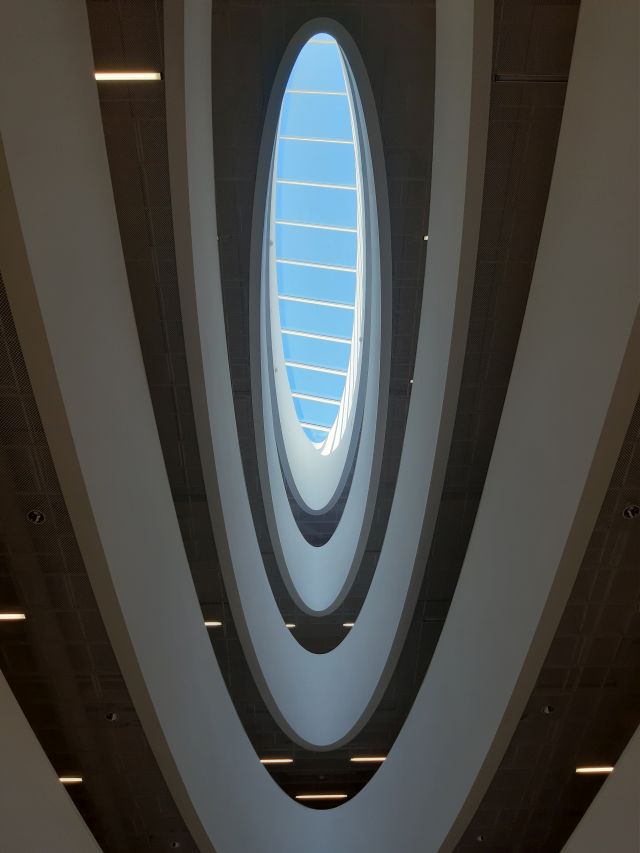

Escalera interior en forma de espiral. Fotografía: Inés Macho StadlerEn la entrada principal, se observan dos grandes vacíos: unos en forma de elipse –que van disminuyendo su tamaño al subir de piso en piso– y otros en forma de parábola e hipérbola –que van aumentando a medida que se sube en el edificio–. Ambos proporcionan luz natural además de comunicar las diferentes alturas del edificio.

Vacío interior en forma de elipse. Fotografía: Inés Macho Stadler

Vacío interior en forma de elipse. Fotografía: Inés Macho StadlerEn las referencias pueden verse numerosas fotografías en las que se aprecian los detalles descritos anteriormente. El siguiente video del arquitecto Alberto Corral realiza un buen recorrido por el interior del edificio.

Nota: Un especial agradecimiento a mi hermana Inés por hablarme de Kaisa-talo y cederme las fotografías utilizadas en esta anotación.

Referencias

-

Sinikara, K. & Lukkari, A-M., A case study on a post-occupancy evaluation of the new Helsinki University Main Library en Post-Occupancy Evaluation of Library Buildings, Latimer, K. & Sommer, D. (eds.). IFLA Publications Series 169 (2015) 175-191

-

Alberto Corral, Kaisa-talo, un edificio único en Helsinki, Blog, 23 febrero 2014

-

Mara Corradi, Anttinen Oiva y la Helsinki University Main Library (Kaisa house), Floornature, 29 julio 2015

-

Amy Frearson, Curving voids pierce the floors of Anttinen Oiva Architects’ Helsinki library, DeZeen, 13 noviembre 2014

-

Manuela Londoño Laserna y Juliana Marroquín DeCastro, Biblioteca Universidad de Helsinki. Sede Centro, Unidad taller de Cartagena, 2013

-

Imágenes para prensa, Universidad de Helsinki

-

Kaisa-talo, Wikipedia (consultado el 14 julio 2019)

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Kaisa-talo, geometría en la biblioteca se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La geometría de la obsesión

- El tamaño sí importa, que se lo pregunten a Colón (o de la geometría griega para medir el diámetro de la Tierra)

- Quad: pura geometría

El descubrimiento de los rayos X

Fuente: Wikimedia Commons.

Fuente: Wikimedia Commons.En 1895, Wilhelm Konrad Röntgen hizo un descubrimiento que lo sorprendió primero a él y luego a todo el mundo. Al igual que el efecto fotoeléctrico, no encajaba con las ideas aceptadas sobre las ondas electromagnéticas y, finalmente, también requirió la introducción de los cuantos para una explicación completa. Las consecuencias del descubrimiento de los rayos X para la física atómica, la medicina y la tecnología fueron enormes.

El 8 de noviembre de 1895, Rontgen estaba experimentando con los nuevos rayos catódicos, al igual que muchos físicos de todo el mundo. Según un biógrafo [*]:

. . . había cubierto el tubo de cristal en forma de pera [un tubo de Crookes] con trozos de cartón negro, y había oscurecido la habitación para probar la opacidad de la cubierta de papel negro. De repente, a aproximadamente un metro del tubo, vio una débil luz que brillaba en un pequeño banco que sabía que estaba cerca. Muy emocionado, Rontgen encendió una cerilla y, para su sorpresa, descubrió que la fuente de la misteriosa luz era una pequeña pantalla de platino-cianuro de bario depositada en el banco.

El platino-cianuro de bario, un mineral, es uno de los muchos productos químicos que se sabe que producen fluorescencia (emiten luz visible cuando se ilumina con luz ultravioleta). Pero no había ninguna fuente de luz ultravioleta en el experimento de Röntgen. Se sabía además que los rayos catódicos viajan solo unos pocos centímetros en el aire. Por lo tanto, ni la luz ultravioleta ni los propios rayos catódicos podrían haber causado la fluorescencia. Röntgen dedujo que la fluorescencia involucraba la presencia de rayos de un nuevo tipo. Los llamó rayos X, ya que los rayos eran de naturaleza desconocida.

En una intensa serie de experimentos sistemáticos durante las siguientes 7 semanas Röntgen determinó las propiedades de esta nueva radiación. Informó de sus resultados el 28 de diciembre de 1895 en un artículo cuyo título (traducido) es «Sobre un nuevo tipo de rayos». El artículo de Röntgen describía casi todas las propiedades de los rayos X que se conocen.

Hand mit Ringen (mano con anillos). Impresión de la primera radiografía médica tomada por Wilhelm Röntgen usando rayos X. Corresponde a la mano de su mujer y fue tomada el 22 de diciembre de 1895. Röntgen se la regaló a Ludwig Zehnder del Physik Institut de la Freiburg Universität el 1 de enero de 1896.

Hand mit Ringen (mano con anillos). Impresión de la primera radiografía médica tomada por Wilhelm Röntgen usando rayos X. Corresponde a la mano de su mujer y fue tomada el 22 de diciembre de 1895. Röntgen se la regaló a Ludwig Zehnder del Physik Institut de la Freiburg Universität el 1 de enero de 1896.Röntgen describió el método para producir los rayos y probó que se originan en la pared de vidrio del tubo, donde los rayos catódicos lo golpean. Demostró que los rayos X viajan en línea recta desde su lugar de origen y que oscurecen una placa fotográfica. Informó detalladamente de la capacidad variable de los rayos X para penetrar en diversas sustancias como el papel, la madera, el aluminio, el platino y el plomo. Su poder de penetración era mayor en los materiales “ligeros” (papel, madera, carne) que en los materiales “densos” (platino, plomo, hueso). Describió y exhibió fotografías que mostraban «las sombras de los huesos de la mano, de un conjunto de pesas dentro de una pequeña caja, y de un pedazo de metal cuya inhomogeneidad se hace evidente con los rayos X.» Dio una descripción clara de las sombras proyectadas por los huesos de la mano sobre la pantalla fluorescente. Röntgen también informó que los rayos X no se desviaban por la presencia de un campo magnético. Tampoco constató reflexión, refracción o interferencia usando aparatos ópticos ordinarios.

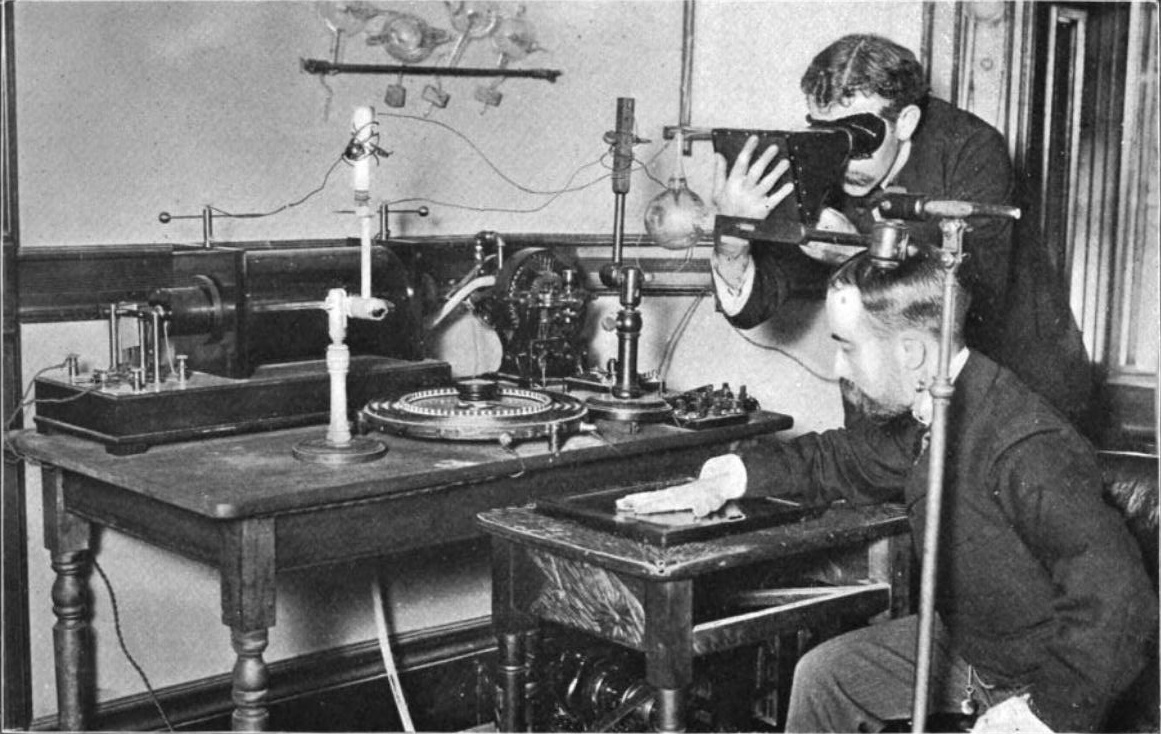

Experimentando con rayos X. Fuente: William J. Morton & Edwin W. Hammer (1896) «The X-ray, or Photography of the Invisible and its value in Surgery», American Technical Book Co., New York, fig. 54 / Wikimedia Commons

Experimentando con rayos X. Fuente: William J. Morton & Edwin W. Hammer (1896) «The X-ray, or Photography of the Invisible and its value in Surgery», American Technical Book Co., New York, fig. 54 / Wikimedia CommonsJ.J. Thomson descubrió una de las propiedades más importantes de los rayos X uno o dos meses después de que los rayos se diesen a conocer. Encontró que cuando los rayos pasan a través de un gas, lo convierten en un conductor de electricidad. Thomson atribuyó este efecto a «una especie de electrólisis, la molécula se divide o casi se divide por los rayos de Röntgen». Hoy sabemos que los rayos X, al pasar a través del gas, liberan electrones de algunos de los átomos o moléculas del gas. Los átomos o moléculas que pierden estos electrones se cargan positivamente. Siguiendo con el símil electrolítico a estas moléculas cargadas se las llamó iones porque se parecen a los iones positivos de la electrólisis, y de ahí que se diga que el gas está “ionizado”. Además, los electrones liberados pueden unirse a átomos o moléculas previamente neutros, cargándolos negativamente.

Röntgen y Thomson descubrieron, independientemente que los cuerpos electrificados pierden sus cargas cuando el aire a su alrededor se ionizado por los rayos X. (Ahora es fácil ver por qué: el cuerpo electrificado atrae iones de la carga opuesta presentes en el aire ionizado). La velocidad de descarga depende de la intensidad de los rayos (ya que de ella depende la cantidad de ionización). Por lo tanto, esta propiedad se usó, y se sigue usando, como un medio cuantitativo conveniente para medir la intensidad de un haz de rayos X. Este descubrimiento implicaba, pues, que se podían realizar mediciones cuantitativas cuidadosas de las propiedades y efectos de los rayos X.

Nota:

* Hay varias versiones del descubrimiento. Incluso existe una de consenso que no es más válida que la que ofrecemos. Lo cierto es que la única persona presente era Röntgen, él no lo contó a nadie que tomase notas de ello de forma fidedigna y fiable y dejó dicho que sus notas de laboratorio, que podrían haber arrojado algo de luz [nótese el ingeniosísimo juego de palabras], se destruyesen a su muerte. La cuestión es que los elementos fundamentales de todas las narraciones (tubo de Crookes, cartón negro y pantalla de platino-cianuro de bario) están presentes.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo El descubrimiento de los rayos X se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La luz se propaga en línea recta pero los rayos de luz no existen

- Rayos X y gamma

- El tubo de rayos catódicos, auge y caída de una pieza clave del siglo XX

La certeza de la incertidumbre en los informes del IPCC

El año 2018 fue el más caluroso de la historia moderna de la Tierra. Batió el récord de temperatura media global desbancando al año 2017, el cual había superado la espectacular marca del año 2016. El listón de temperaturas elevadas en nuestro planeta está llegando a límites, paradójicamente, escalofriantes. Los que seguimos – con preocupación – la evolución del clima global hemos observado cómo la Organización Meteorológica Mundial (OMM) ha ido informando que durante los últimos 22 años se han batido 20 récords de temperatura media. Y que esta tendencia va en aumento: la Tierra acumula 400 meses seguidos de temperaturas superiores a la media histórica, sumando más de 33 años consecutivos por encima de la referencia del siglo XX.

El cambio climático puede considerarse una certeza y ello supone una verdadera amenaza para el mundo que conocemos. Una amenaza que, además, todo indica que ha sido generada principalmente por la actividad industrial humana. El informe especial “Global Warming of 1,5 ºC” del IPCC, publicado a finales de 2018, no da lugar a dudas: estima que esta actividad ha aumentado la temperatura del planeta en aproximadamente 1ºC con respecto a los niveles preindustriales. En unos pocos decenios, la concentración de CO2 en la atmósfera ha aumentado más del 30%, superando los 400 ppm y batiendo el récord datado hace 3 millones de años. No se trata de una evolución natural del clima: la evidencia es abrumadora y el consenso de la comunidad científica es prácticamente unánime.

Sin embargo, así como el cambio climático pasado es avalado por el histórico de datos recogidos a lo largo del último siglo, para conocer el futuro de este no hay observación posible. Si queremos estimar los posibles escenarios a los que se enfrenta nuestro planeta, dependemos casi exclusivamente de modelos de simulación compleja, los cuales están compuestos por un conjunto de submodelos en continuo desarrollo por centros como la NASA, la UK Met Office, o el Beijing Climate Center.

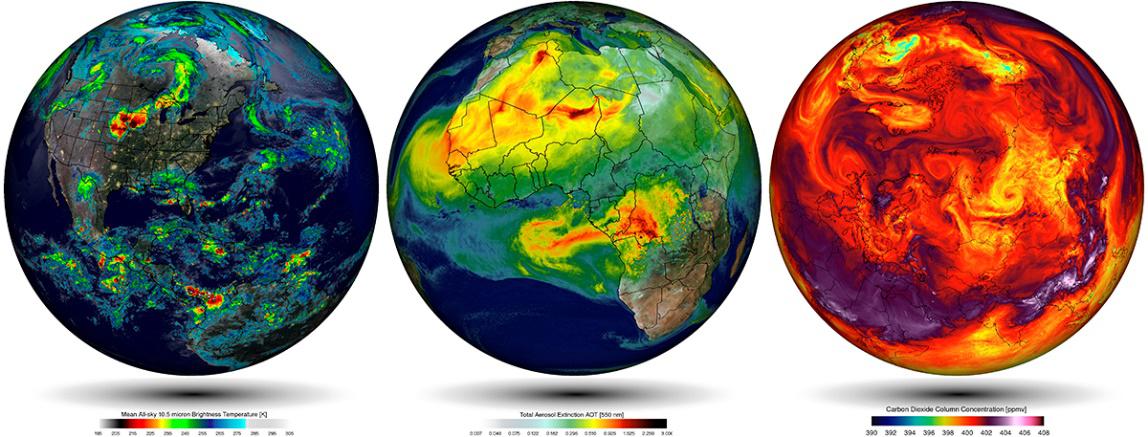

Simulaciones empleando el modelo climático del Goddard Earth Observing System (GEOS-5) de la NASA. Fuente: William Putman, NASA/Goddard

Simulaciones empleando el modelo climático del Goddard Earth Observing System (GEOS-5) de la NASA. Fuente: William Putman, NASA/GoddardEstas simulaciones se rigen por un corpus teórico introducido previamente. Por ejemplo, en el caso de las simulaciones atmosféricas este corpus es construido con (i) las leyes de movimiento de Newton aplicadas en elementos finitos de fluidos, (ii) la ley de la conservación de la masa, y (iii) ecuaciones termodinámicas que permiten calcular el efecto calorífico en cada parcela de aire a través de valores parametrizados de la radiación solar. Estas tres componentes se traducen en ecuaciones diferenciales parciales no-lineales de solución analítica irresoluble, por lo que se aplican métodos numéricos que discretizan las ecuaciones continuas y permiten determinar una aproximación a la solución de estas a través técnicas de modelización y simulación computacional.

En conjunto con otros submodelos, como la simulación del ciclo del carbono o el movimiento tectónico, estas simulaciones se utilizan para construir posibles escenarios futuros, que son una herramienta utilizada para la toma de decisiones en política de mitigación o de adaptación medioambiental, ya sea en forma de monetización del carbón o de aplicación de estrategias de geoingeniería, por ejemplo. Sin embargo, a pesar de que los mecanismos que gobiernan el cambio climático antropogénico son bien entendidos, estas proyecciones presentan incertidumbre en la precisión de sus resultados. Su cuantificación es, precisamente, la principal herramienta para comunicar el (des)conocimiento de expertos a políticos.

La literatura especializada establece hasta siete fuentes de inseguridad epistémica que determinan el grado de incertidumbre: (a) la estructura de los modelos que sólo permiten describir un subconjunto de componentes e interacciones existentes, (b) aproximaciones numéricas, (c) resolución limitada que implica que los procesos de microescala tengan que ser parametrizados y, por tanto, tengan que describir su efecto − sin resolver realmente el proceso− en términos de cuantificaciones disponibles a gran escala, (d) variabilidad natural interna, (e) observación de datos, (f) condiciones iniciales y de contorno, y (g) escenario económico futuro. Todas estas fuentes de incertidumbre se derivan de la existencia de diferentes representaciones del clima para cada uno de los distintos modelos.

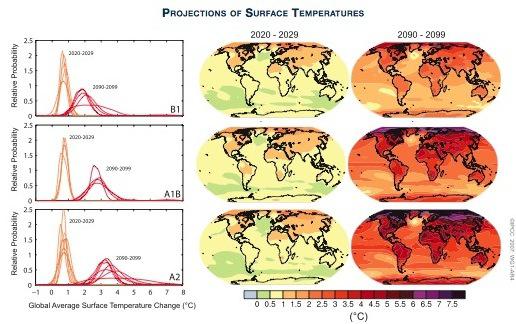

Fuente: Policymaker Summary of The Phisical Science Basis (4th IPCC Report)

Fuente: Policymaker Summary of The Phisical Science Basis (4th IPCC Report)

La primera impresión que genera esta incertidumbre en el público general es que el cambio climático es una hipótesis, de algún modo, incierta. Sin embargo, los modelos de incertidumbre presentados en los sucesivos informes del Grupo I del IPCC no se presentan para dilucidar si el cambio climático es incierto o no, sino para informar de la calidad de los modelos obtenidos y trasladar la toma de decisiones políticas fuera del proceso de obtención de resultados por parte de decenas de miles de científicos.

Parece claro que el futuro no podemos conocerlo a ciencia cierta y, como diría Zygmunt Bauman, la única certeza que tenemos es la incertidumbre. Ello no impide, sin embargo, que podamos estimar de forma más o menos robusta el futuro plausible que nos espera. Por ello, acompañar los resultados de las simulaciones con modelos probabilísticos de incertidumbre no es una muestra de debilidad, sino un instrumento que permite comunicar esas estimaciones de manera transparente, sin comprometer la investigación científica con cuestiones políticas, sociales o éticas. Se trata de una actividad que los científicos y el IPCC consideran como un ejemplo de rigor, a pesar de que haya mercaderes de la duda que la exploten como una debilidad. Y es que la certeza de la incertidumbre en los informes del IPCC consiste, paradójicamente, en que es la única forma disponible para hacer que las proyecciones del clima que nos espera sean lo más certeras posible.

Para saber más:

Winsberg, Eric (2018), Philosophy and Climate Science, New York: Cambridge University Press.

Sobre el autor: José Luis Granados Mateo es investigador predoctoral en Historia y Filosofía de la Ciencia en UPV/EHU.

El artículo La certeza de la incertidumbre en los informes del IPCC se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El clima, los informes y la política

- Migraciones…¿vegetales?

- ¿Una charla? ¿de ciencia?, prefiero el bar…

La enfermedad del hígado graso no alcohólico, una gran desconocida

Jenifer Trepiana, Saioa Gómez-Zorita, María P. Portillo, Maitane González-Arceo

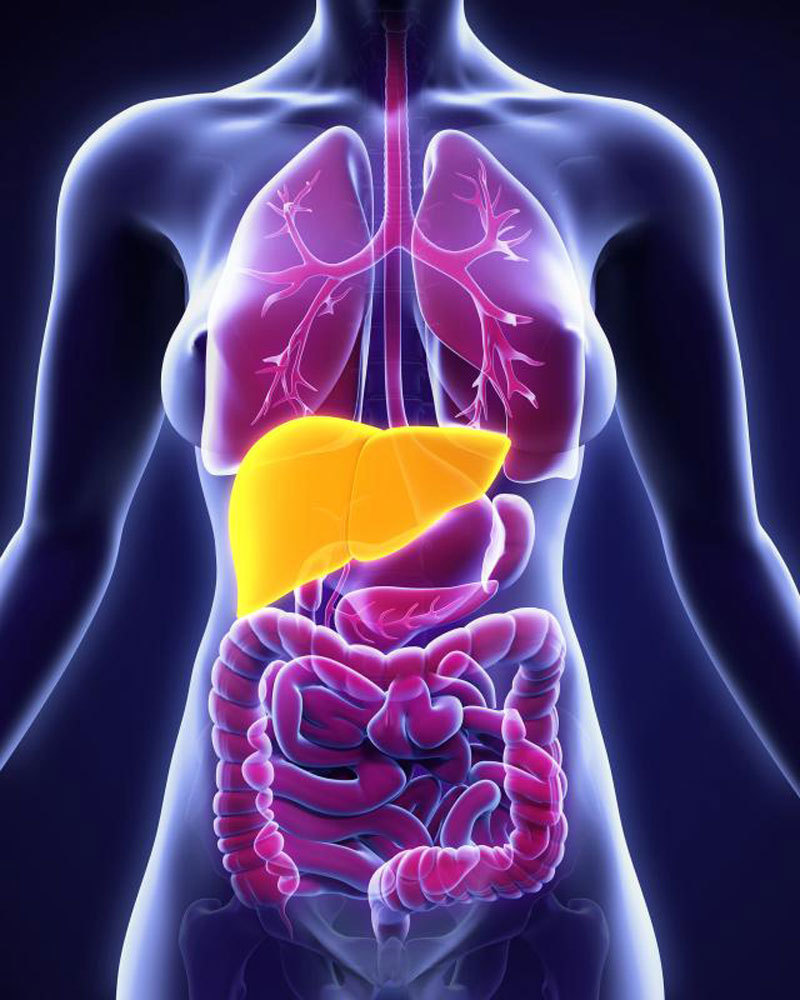

La enfermedad del hígado graso no alcohólico (EHGNA) consiste en una acumulación excesiva de grasa en las células del hígado o hepatocitos (más del 5% del peso del hígado sería grasa) sin un consumo excesivo de alcohol, siendo en la actualidad la causa más frecuente de enfermedad hepática (Ahmed, 2015). Puede presentarse como esteatosis (acumulación de grasa) simple o como esteatohepatitis, situación de mayor gravedad que comporta ya inflamación y un inicio de fibrosis.

La prevalencia de la esteatosis simple oscila entre un 14% y un 30% en la sociedad occidental, aunque es probable que sea mayor ya que como muchos pacientes son asintomáticos, en ocasiones no son diagnosticados (Abd El-Kader SM y El-Den Ashmawy EM, 2015).

¿Cómo se desarrolla la EHGNA?

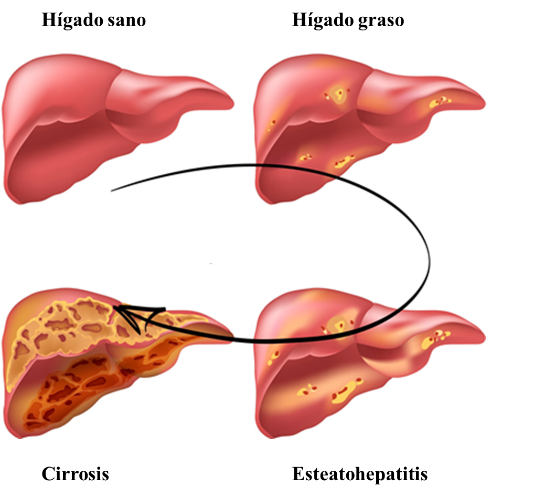

El hígado graso no alcohólico comprende numerosas lesiones hepáticas, comenzando con la esteatosis simple, que supone el 80-90% de los casos. Hay que destacar que el hígado graso no alcohólico se desarrolla de una manera progresiva y lenta, siendo la esteatosis simple reversible, y pudiendo dejar de progresar. Sin embargo, en el 10-20% de los pacientes avanza hasta la siguiente etapa llamada esteatohepatitis o inflamación del hígado. De la misma manera, la esteatohepatitis puede no seguir progresando o, por el contrario, puede evolucionar mediante la aparición de fibrosis a su etapa final, llamada cirrosis, con riesgo de desarrollar carcinoma de hígado en el peor de los casos (Hashimoto et al., 2013).

Lo que ocurre en la esteatosis simple, es que la excesiva acumulación de lípidos en el hígado lo hace vulnerable a otras agresiones como el estrés oxidativo, provocado por un desequilibrio entre los radicales libres y la disponibilidad de antioxidantes, además de promover la liberación de moléculas que producen inflamación provocando esteatohepatitis. En la esteatohepatitis, aparece inflamación y daño en las células de manera crónica que puede cursar con fibrosis (formación excesiva de un tejido llamado tejido conectivo para intentar reparar la víscera). Según estudios científicos, un 41% de los pacientes que sufren la EHGNA desarrollan fibrosis (Ekstedt et al., 2006). Por otra parte, el riesgo de padecer hepatocarcinoma en los pacientes con EHGNA que no sufren cirrosis es mínimo (de 0-3% en 20 años), mientras que en pacientes con cirrosis el riesgo asciende a 12,8% en 3 años (White et al., 2012).

Figura 1. Esquema de los estadios de la enfermedad del hígado graso. Modificado de: Non Alcoholic Fatty Liver Disease NAFLD. Preventicum (2016).

Figura 1. Esquema de los estadios de la enfermedad del hígado graso. Modificado de: Non Alcoholic Fatty Liver Disease NAFLD. Preventicum (2016).Al analizar la morfología del hígado de pacientes que sufren EHGNA tras una biopsia, se observa una acumulación de grasa en las células del hígado (hepatocitos) en forma de triglicéridos. Se ha aceptado que el criterio mínimo para diagnosticar la EHGNA mediante el estudio con microscopía de este órgano, es que el hígado contenga una cantidad mayor al 5% de hepatocitos esteatóticos (Neuschwander-Tetri y Caldwell, 2003), es decir que más de un 5% de las células del hígado contengan una gran cantidad de grasa en su interior. Así, mediante estas técnicas de imagen, se puede clasificar la EHGNA en diferentes tipos, desde una esteatosis simple, hasta esteatohepatitis con o sin fibrosis.

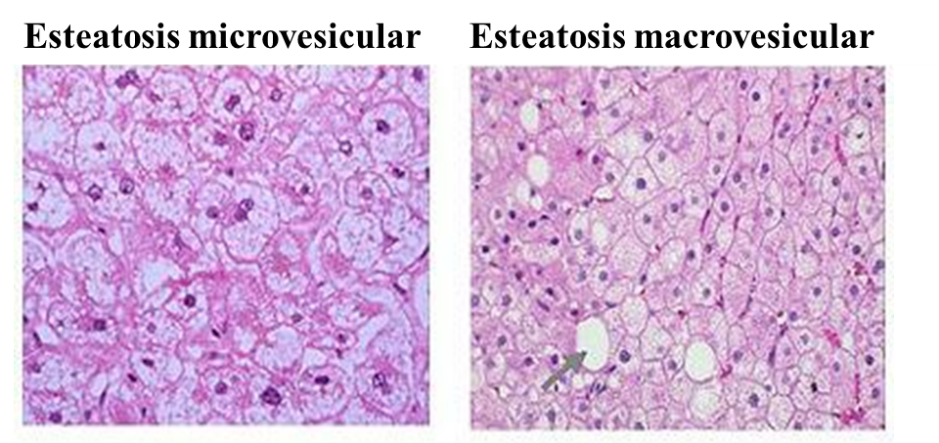

Centrándonos más en lo que le ocurre al hepatocito, podemos decir que normalmente, la esteatosis en el hígado graso no alcohólico, es de tipo macrovesicular. Esto es, que el hepatocito contiene una única gota grande de grasa, o varias gotas de grasa algo más pequeñas, lo que provoca el desplazamiento del núcleo de la célula a la periferia (extremos) del hepatocito. Sin embargo, en la esteatosis de tipo microvesicular, el núcleo se mantiene en el centro del hepatocito con diminutas gotículas de grasa presentes en la célula (Brunt y Tiniakos, 2010). Este último tipo, no suele ser la forma más típica de esteatosis, encontrándose sobre todo en los hepatocitos más pequeños o en los que no se encuentran en las zonas donde la esteatosis es más prominente. Cuando se da esta situación, el paciente suele tener peor pronóstico. En alguna ocasión, también puede ocurrir que se produzca una esteatosis mixta, donde se encuentran hepatocitos con una esteatosis macrovesicular, a la vez que encontramos grupos de hepatocitos con esteatosis microvesicular.

Figura 2. Esteatosis microvesicular y macrovesicular. Análisis mediante técnicas de imagen. Mofrad P, Sanyal, A. Nonalcoholic Fatty Liver Disease. Medscape (2003).

Figura 2. Esteatosis microvesicular y macrovesicular. Análisis mediante técnicas de imagen. Mofrad P, Sanyal, A. Nonalcoholic Fatty Liver Disease. Medscape (2003).

¿Qué factores influyen en el desarrollo de esta enfermedad?

El origen de la EHGNA no está claro, aunque probablemente sea la resistencia a la insulina la causa principal. Otros factores de riesgo asociados con el hígado graso son el sobrepeso y la obesidad, la dislipemia (altos niveles de colesterol y/o triglicéridos en sangre), y la diabetes mellitus tipo 2. Hay que tener en cuenta que la EHGNA afecta a todos los segmentos de la población, no solo a los adultos, y también a la mayoría de los grupos raciales. Se estima que entre el 74% y el 80% de los individuos obesos presentan hígado graso. Además de la obesidad, la presencia de diabetes mellitus tipo 2 incrementa no solo el riesgo, sino también la severidad de la EHGNA (Angulo, 2002). Esto quiere decir, que la diabetes mellitus tipo 2 constituye un perfil metabólicamente desfavorable para los pacientes que presentan EHGNA, aumentando el riesgo de sufrir enfermedades cardiovasculares.

¿Cómo se detecta la EHGNA?

Como hemos indicado al inicio, con mucha frecuencia, la EHGNA cursa de manera asintomática, y cuando produce síntomas estos son bastante inespecíficos. Por ello, muchas veces pasa desapercibida, tanto para los médicos como para los pacientes. El síntoma más frecuente es dolor en la zona abdominal derecha y fatiga.

Para la detección de la EHGNA, primeramente se suelen valorar las transaminasas hepáticas (AST, aspartatoaminotransferasa y ALT, alaninaaminotransferasa), que se suelen encontrar aumentadas. No obstante, aunque los niveles de transaminasas son lo primero que se analiza mediante una extracción de sangre del paciente, no son consideradas buenos marcadores ya que en algunos individuos con esteatosis los niveles de transaminasas en sangre no están elevados, incluso en algunos pacientes con cirrosis tampoco lo están. Además, solo pueden indicar daño hepático en general, no siempre teniendo que ir asociado a la EHGNA. Por otro lado, la AST aparece en otros tejidos como el corazón o el músculo esquelético, por lo que en caso de que se eleve, también puede deberse a una alteración en otros órganos o tejidos. También se recurre a técnicas de imagen para ayudar en el diagnóstico de la enfermedad o para la detección de hepatomegalia (hígado más grande de lo normal), como son la ecografía, TAC (Tomografía Axial Computarizada) o RMN (Resonancia Magnética), siendo esta última la más eficaz en su diagnóstico. Estas pruebas de imagen son útiles para saber si hay infiltración de grasa en el hígado, pero presentan la limitación de que no muestran si el hígado presenta inflamación o fibrosis.

Por ello, el mejor método de diagnóstico es la biopsia, que además permite conocer el grado de EHGNA del paciente. No obstante, dado que se trata de una técnica invasiva, únicamente se suele realizar en aquellos pacientes que muestran signos de estar en un estadio avanzado de enfermedad hepática (por ejemplo, cirrosis) o en aquellos pacientes que presentan mayor probabilidad de esteatohepatitis. Una limitación de esta técnica es que las lesiones hepáticas sufridas no son uniformes en todo el hígado, lo que dificulta el análisis de las biopsias. Es decir, según de qué zona del hígado se tome la muestra, el diagnóstico puede variar.

Ante la necesidad de detectar la EHGNA sin tener que recurrir a la biopsia hepática, se está profundizando en el estudio de biomarcadores para analizar la función hepática de una manera no agresiva para el organismo. Entre ellos encontramos marcadores específicos para la fibrosis, como la medición de concentraciones de proteínas implicadas en la fibrolisis o rotura del tejido fibrótico (colagenasas, α2-macoglobulina, MMPs, C3M) o de proteínas que participan en la fibrogénesis o generación del tejido fibrótico (colágeno tipo IV, pro-C3/C5). En la práctica clínica se suelen utilizar diversos test como el SteatoTest que calcula el grado de esteatosis hepática en pacientes con riesgo metabólico elevado, el FibroTest que valora los niveles de fibrosis y cirrosis, así como el grado de inflamación del hígado, y el NashTest que predice la presencia o ausencia de esteatohepatitis. Los marcadores que se analizan mediante estos tests son la α2-macroglobulina, haptoglobina, apolipoproteína A1, bilirrubina total, ALT, GGT, glucosa en ayunas, triglicéridos, y colesterol. Estos parámetros se ajustan a la edad, sexo, peso y tamaño del paciente. Estos índices y biomarcadores pueden ser útiles no solo para el diagnóstico de la enfermedad, sino también para estudiar la evolución de esta y los efectos del tratamiento.

¿Qué se puede hacer para prevenir la EHGNA?

Es importante remarcar que para la prevención de la EHGNA la principal medida es evitar los factores de riesgo asociados a la enfermedad (obesidad, dislipemia, resistencia a la insulina). Para ello son esenciales una rutina de ejercicio físico en nuestro día a día y llevar una dieta equilibrada.

Tratamientos en la actualidad

Actualmente, no existe un tratamiento específico para la EHGNA. Por ello, lo que se suele hacer es tratar los factores causales, es decir, la obesidad, y otros componentes del síndrome metabólico, como son la hipertensión (mediante el tratamiento farmacológico con estatinas), la diabetes mellitus y la dislipemia. Al igual que en el caso de la prevención, una dieta equilibrada y la actividad física serán los pilares básicos para tratar el hígado graso no alcohólico.

Además, se ha comprobado que seguir un patrón de alimentación mediterráneo se asocia con una menor probabilidad de presentar esteatosis y esteatohepatitis (Aller et al., 2015).

Recomendaciones en el estilo de vida

-

Pérdida de peso: 3-5% en la esteatosis simple y 7-10% en la esteatohepatitis (Jeznach-Steinhagen et al., 2019).

-

Reducción del consumo de hidratos de carbono simples (

-

Reducción de la grasa saturada de la dieta. Una dieta rica en grasas saturadas, intensifica el estrés oxidativo en el organismo, aumentando la inflamación en la zona afectada por la esteatosis. Sin embargo, el consumo de ácidos grasos poliinsaturados del grupo n-3 (omega 3) mejora la esteatosis hepática (Dasarathy et al., 2015).

-

Aumento del consumo de antioxidantes, presentes en altas cantidades en frutas y verduras.

-

Evitar la cantidad de alcohol ingerida. Dado que un abuso del alcohol provoca un desarrollo rápido de la enfermedad, se recomienda la abstinencia del alcohol.

Tratamientos farmacológicos

Como se ha mencionado anteriormente, algunos tratamientos farmacológicos están dirigidos a reducir las enfermedades asociadas al hígado graso, como son la diabetes, obesidad, y desordenes lipídicos.

-

Suplementación con vitaminas, especialmente aquellas que son antioxidantes como la vitamina E (precaución con las dosis elevadas ya que pueden tener efectos secundarios graves). Debido a la dosis empleada la vitamina E o α-tocoferol se incluye dentro de los tratamientos farmacológicos para tratar esta enfermedad.

-

Fármacos antidiabéticos: pioglitazone, rosiglitazona, liraglutide, metformina, etc. (al igual que en el caso anterior pueden tener efectos secundarios).

En la actualidad están siendo probados en diversos ensayos clínicos fármacos novedosos como el agonista del receptor Farnesoil X, o el agonista de PPARα y PPARδ (estudios en fase 2).

Referencias bibliográficas

Ahmed M. Non-alcoholic fatty liver disease in 2015. World J Hepatol. 18;7(11):1450-9 (2015).

Abd El-Kader SM, El-Den Ashmawy EM. Non-alcoholic fatty liver disease: The diagnosis and management. World J Hepatol. 28;7 (6):846-58 (2015).

Hashimoto E, Taniai M, Tokushige K. Characteristics and diagnosis of NAFLD/NASH. J Gastroenterol Hepatol. 28 Suppl 4:64-70 (2013).

Non Alcoholic Fatty Liver Disease NAFLD. Preventicum (2016).

Ekstedt M, Franzén LE, Mathiesen UL, Thorelius L, Holmqvist M, Bodemar G, Kechagias S. Long-term follow-up of patients with NAFLD and elevated liver enzymes. Hepatology. 44(4):865-73 (2006).

White DL, Kanwal F, El-Serag HB. Association between nonalcoholic fatty liver disease and risk for hepatocellular cancer, based on systematic review. Clin Gastroenterol Hepatol. 10(12):1342-1359 (2012).

Neuschwander-Tetri BA, Caldwell SH. Nonalcoholic steatohepatitis: summary of an AASLD Single Topic Conference. Hepatology. 37(5):1202-19 (2003).

Brunt EM, Tiniakos, DG. Histopathology of nonalcoholic fatty liver disease. World J Gastroenterol. 14;16(42):5286-96 (2010).

Mofrad P, Sanyal, A. Nonalcoholic Fatty Liver Disease. Medscape (2003).

Angulo P. Nonalcoholic fatty liver disease. New Engl. J. Med. 346:1221-1231 (2002).

Aller R, Izaola O, Luis DD. La dieta mediterránea se asocia con la histología hepática en pacientes con enfermedad del hígado graso no alcohólico. Nutrición Hospitalaria, 32: 2518-2524 (2015).

Jeznach-Steinhagen A, Ostrowska J, Czerwonogrodzka-Senczyna A, Boniecka I, Shahnazaryan U, Kuryłowicz A. Dietary and Pharmacological Treatment of Nonalcoholic Fatty Liver Disease. Medicina 55, 166 (2019).

Mager D, Iñiguez I, Gilmour S, Yap J, The effect of a low fructose and low glycemic index/load (FRAGILE) dietary intervention on indices of liver function, cardiometabolic risk factors, and body composition in children and adolescents with nonalcoholic fatty liver disease (NAFLD). J. Parenter. Enteral. Nutr. 39, 73–84 (2015).

Dasarathy S, Dasarathy J, Khiyami A, Yerian L, Hawkins C, Sargent R, McCullough A.J. Double-blind randomized placebo-controlled clinical trial of omega 3 fatty acids for the treatment of diabetic patients with nonalcoholic steatohepatitis. J. Clin. Gastroenterol. 49, 137–144 (2015).

Sobre las autoras:

Jenifer Trepiana1, Saioa Gómez-Zorita1,2, María P. Portillo1,2, Maitane González-Arceo1

1 Grupo de Nutrición y Obesidad. Departamento de Farmacia y Ciencias de los Alimentos. Facultad de Farmacia. Universidad del País Vasco (UPV/EHU)

2 Centro de Investigación Biomédica en Red de la Fisiopatología de la Obesidad y Nutrición (CiberObn)

El artículo La enfermedad del hígado graso no alcohólico, una gran desconocida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Avances contra la enfermedad de hígado graso no alcohólica

- Una ecuación para determinar la grasa en el hígado a partir de una resonancia

- Consolider-Gran Telescopio Canarias: Cómo comunicar Astrofísica

El problema de Josefo o cómo las matemáticas pueden salvarte la vida

Imagina que sois 41 soldados, que estáis rodeados y que todo el mundo menos el jefe quiere suicidarse antes que rendirse. En esta tesitura se encontraba Josefo cuando se le ocurrió una forma matemática de salvar su vida. La Ikerbasque Research Fellow Luz Roncal, del BCAM, te lo explica usando magia.

Quizás sea el número más famoso de la historia. Lo cierto es que el número Pi, representado por la letra griega π, es una de las constantes matemáticas más importantes que existen en el mundo, estudiada por el ser humano desde hace más de 4.000 años. La fascinación que ha suscitado durante siglos es tal que el popular número cuenta con su propio día en el calendario, así el mes de marzo se celebra el Día de Pi en todo el planeta.

Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien lanzó en 1988 la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática. (3-14 martxoaren 14 en euskara / 3-14 march, 14th en inglés) y además, la celebración coincide con la fecha del nacimiento de Albert Einstein. En 2009, el congreso de EEUU declaró oficialmente el 14 de marzo como el Día Nacional de Pi.

Actualmente, el Día de Pi es una celebración mundialmente conocida que sobrepasa el ámbito de las matemáticas. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

Este 2019 nos unimos de nuevo al festejo con el evento BCAM–NAUKAS, que se desarrolló a lo largo del 13 de marzo en el Bizkaia Aretoa de UPV/EHU. BCAM-NAUKAS contó durante la mañana con talleres matemáticos para estudiantes de primaria y secundaria y durante la tarde con una serie de conferencias cortas dirigidas al público en general.

Este evento es una iniciativa del Basque Center for Applied Mathematics -BCAM, enmarcada en la celebración de su décimo aniversario, y de la Cátedra de Cultura Científica de la Universidad el País Vasco.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo El problema de Josefo o cómo las matemáticas pueden salvarte la vida se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Dinosaurios

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Imagen: Pixabay

Imagen: PixabayLos dinosaurios son un grupo natural de organismos ( o clado), lo que significa que todos ellos comparten un antecesor común. Poseen un conjunto de caracteres anatómicos que permite reconocerlos y diferenciarlos de otros grupos de vertebrados. Por ejemplo, los dinosaurios se caracterizan por presentar un acetábulo perforado, es decir, una cavidad en la pelvis donde se articula la cabeza del fémur (hueso del muslo).

A diferencia de los reptiles actuales, como cocodrilos y lagartos, los dinosaurios no reptaban. Sus miembros estaban dispuestos en posición vertical, de manera similar a los mamíferos. Esto les confería una locomoción más eficaz. Además, poseían un metabolismo elevado y eran animales adaptados a un modo de vida activo.

Gracias a los fósiles conservados en las rocas sabemos que los primeros dinosaurios aparecieron hace unos 230 millones de años, durante el Triásico. A inicios del Jurásico, los dinosaurios pasaron a ser los reptiles dominantes sobre la tierra firme. Se diversificaron durante el Jurásico y el Cretácico [Triásico, Jurásico y Cretácico son las tres divisiones o periodos geológicos que componen la Era Secundaria o Mesozoico]. A finales del Cretácico, hace 66 millones de años, los dinosaurios se extinguieron, junto con otros organismos tanto terrestres como marinos, durante una de las mayores crisis biológicas que ha sufrido la vida en la Tierra. Solo las aves sobrevivieron a la extinción en masa de finales del Cretácico.

Tyrannosaurus, Triceratops, Stegosaurus y Diplodocus son algunos de los dinosaurios más conocidos. Todos ellos eran terrestres. Ningún dinosaurio vivió en el mar. Sólo las aves, que son dinosaurios muy especializados, han adquirido la capacidad de volar. Los dinosaurios desarrollaron una sorprendente diversidad de tamaños, así como una gran disparidad morfológica. Los dinosaurios terrestres más pequeños eran del tamaño de una paloma, mientras que algunos de los saurópodos más grandes medían 30 metros de longitud y se estima que su masa corporal superaba las 50 toneladas, lo que los convierte en los mayores animales que han existido sobre la tierra firme. Había dinosaurios carnívoros, vegetarianos, omnívoros, e incluso insectívoros. Muchos de ellos eran bípedos, otros cuadrúpedos, y algunos podían incluso adoptar ambos tipos de locomoción.

Sin contar las aves, se han descrito más de mil especies de dinosaurios en el registro fósil (conjunto de evidencias conservadas en las rocas) del Mesozoico. Gracias a la labor que realizan los paleontólogos (trabajos de campo, laboratorio y gabinete), cada año se describen de 30 a 40 especies nuevas. Es probable que aún no conozcamos ni la mitad de las especies de dinosaurios que realmente existieron.

Desde que se definieron los primeros dinosaurios hace casi dos siglos hasta la actualidad, su imagen científica ha ido evolucionando con el tiempo. En un principio fueron considerados lagartos gigantescos, más tarde reptiles cuadrúpedos similares a grandes mamíferos, y a finales del siglo XIX se los imaginaba como reptiles-canguros saltadores. Este cambio conceptual en el conocimiento científico sobre los dinosaurios ha tenido reflejo en la iconografía paleontología, así como en la literatura y el cine. Durante mucho tiempo se pensó que eran animales lentos, torpes y estúpidos condenados a extinguirse. El renovado interés por los dinosaurios (“Dinosaur Rennaissance” en inglés), que se inició a finales de la década de 1960 y continúa en nuestros días, se ha materializado en profundos cambios en las ideas sobre su biología, léase anatomía, metabolismo, comportamiento, relaciones de parentesco y pseudoextinción a finales del Cretácico.

Jurassic Park, saga cinematográfica iniciada en 1993, supone el punto álgido de lo que se ha dado en llamar “dinomanía” o pasión popular por los dinosaurios. La película aumentó el interés por los dinosaurios y su investigación científica, despertando muchas vocaciones paleontológicas entre los niños que la vieron, por lo que cabe hablar de una generación “Parque Jurásico”. Hoy en día, la paleontología de los dinosaurios es una disciplina en pleno desarrollo, con muchos especialistas trabajando en el tema, y donde se aplican nuevas tecnologías (por ejemplo, escaneado y modelización en tres dimensiones) que permiten abordar aspectos novedosos de la biología de los dinosaurios. Cabe destacar el carácter multidisciplinar de la investigación actual y la presencia cada vez mayor de mujeres paleontólogas, particularmente en áreas que están experimentando un rápido crecimiento, como la paleohistología (estudio de la microestructura ósea de los organismos del pasado) o la paleontología molecular (estudio de restos orgánicos fósiles). Los resultados de la investigación paleontológica sobre los dinosaurios están a la orden del día. Los debates científicos sobre su origen, su apariencia, el color de su piel o sus plumas, su termofisiología, la causa o causas de su extinción (con excepción de las aves), el origen del vuelo, etc., son temas fascinantes que interesan al público y tienen amplio eco en los medios de comunicación.

Los dinosaurios no solo tuvieron un tremendo éxito evolutivo durante el Jurásico y el Cretácico, sino que algunas formas adaptadas al vuelo como las aves son, con algo más de 10.000 especies, el grupo más diversificado de tetrápodos en la naturaleza actual.

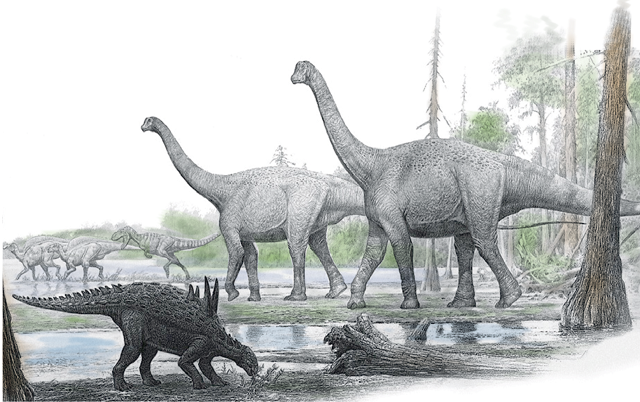

Reconstrucción de un paisaje de finales del Cretácico con la fauna de dinosaurios de Laño (Condado de Treviño). En primer plano, el anquilosaurio enano Struthiosaurus. Detrás, una pareja de Lirainosaurus, titanosaurio definido a partir de los fósiles hallados en este yacimiento. Al fondo, un terópodo persigue a dos ornitópodos. Esta asociación es típica de los yacimientos de dinosaurios del sur de Europa de hace unos 70 millones de años. Ilustración original del paleoartista Raúl Martín coloreada por Gonzalo De las Heras (Diario El Correo), usada con permiso.

Reconstrucción de un paisaje de finales del Cretácico con la fauna de dinosaurios de Laño (Condado de Treviño). En primer plano, el anquilosaurio enano Struthiosaurus. Detrás, una pareja de Lirainosaurus, titanosaurio definido a partir de los fósiles hallados en este yacimiento. Al fondo, un terópodo persigue a dos ornitópodos. Esta asociación es típica de los yacimientos de dinosaurios del sur de Europa de hace unos 70 millones de años. Ilustración original del paleoartista Raúl Martín coloreada por Gonzalo De las Heras (Diario El Correo), usada con permiso.Por último, solemos pensar que el descubrimiento de dinosaurios solo se da en tierras exóticas, cuando en nuestro entorno cercano hay yacimientos paleontológicos de gran relevancia, como es el caso de la cantera de Laño (Condado de Treviño). Este yacimiento es una ventana abierta al mundo de finales del Cretácico, cuando Europa era un archipiélago formado por islas de diferentes tamaños separadas por mares cálidos poco profundos. En Laño se han hallado fósiles pertenecientes a una decena de especies de dinosaurios (incluyendo un nuevo titanosaurio: Lirainosaurus astibiae), junto con otros vertebrados continentales, como peces óseos, anfibios, lagartos, serpientes, tortugas, cocodrilos, pterosaurios y mamíferos. El estudio del yacimiento ofrece información de primera mano sobre cómo eran las faunas de dinosaurios y otros vertebrados continentales hace aproximadamente 70 millones de años.

Para saber más:

S.L. Brusatte, “Dinosaur Paleobiology”, Wiley-Blackwell (2012).

X. Pereda Suberbiola (2018) “Dinosaurios y otros vertebrados continentales del Cretácico final de la Región Vasco-Cantábrica: cambios faunísticos previos a la extinción finicretácica”, en A. Badiola, A, Gómez-Olivencia & X. Pereda Suberbiola, “Registro fósil de los Pirineos occidentales. Bienes de interés paleontológico y geológico. Proyección social”, Servicio Central de Publicaciones del Gobierno Vasco, Vitoria-Gasteiz, pp. 83-98.

Sobre el autor: Xabier Pereda Suberbiola es Doctor en Ciencias Geológicas e investigador del Departamento de Estratigrafía y Paleontología de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Dinosaurios se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Dinosaurios quijotescos o con nombre de princesa

- Las plumas estaban en los dinosaurios desde el principio

- ¿Se podrían recuperar los dinosaurios como en Parque Jurásico?

Ha llegado el final de la cosmética «sin»

Foto: Pixabay

Foto: PixabayDesde el 1 de julio de 2019 ha entrado en vigor una nueva normativa en cosmética que se ha propuesto acabar con la desafortunada estrategia del «sin».

Hay consumidores que no saben qué son los parabenos, pero no los quieren. Desconocen la historia que ha llevado a algunos laboratorios cosméticos a utilizar como reclamo el ‘sin parabenos’, y la consecuencia de esto es que estas sustancias cuyo uso está permitido y es seguro, se perciben como sustancias perjudiciales para la salud. Esto ocurre también con las sales de aluminio de los desodorantes, los sulfatos o con los conservantes, entre otros.

La estrategia publicitaria del «sin» se fundamenta en el miedo. Es lo que los científicos hemos convenido en denominar ‘quimiofobia’, miedo a la química. Funciona porque se sirve de grandes males de la sociedad: la desinformación y la incultura.

La libertad de elegir solo nos la garantiza el conocimiento. Pero cuando el conocimiento requerido es suficientemente profundo, y el caso que nos ocupa lo es, la mejor forma de afrontarlo es tomando medidas que faciliten las elecciones. O al menos, que garanticen que estas elecciones se basan en criterios acertados.

Esa es la razón por la que se ha decidido regular las reivindicaciones de los productos cosméticos. Una historia de reglamentos, informes y documentos técnicos que comenzó en 2009 y que ha llegado hasta nuestros días.

- La historia de cómo se regulan las reivindicaciones de los productos cosméticos