¿Es posible el arte sin ciencia?

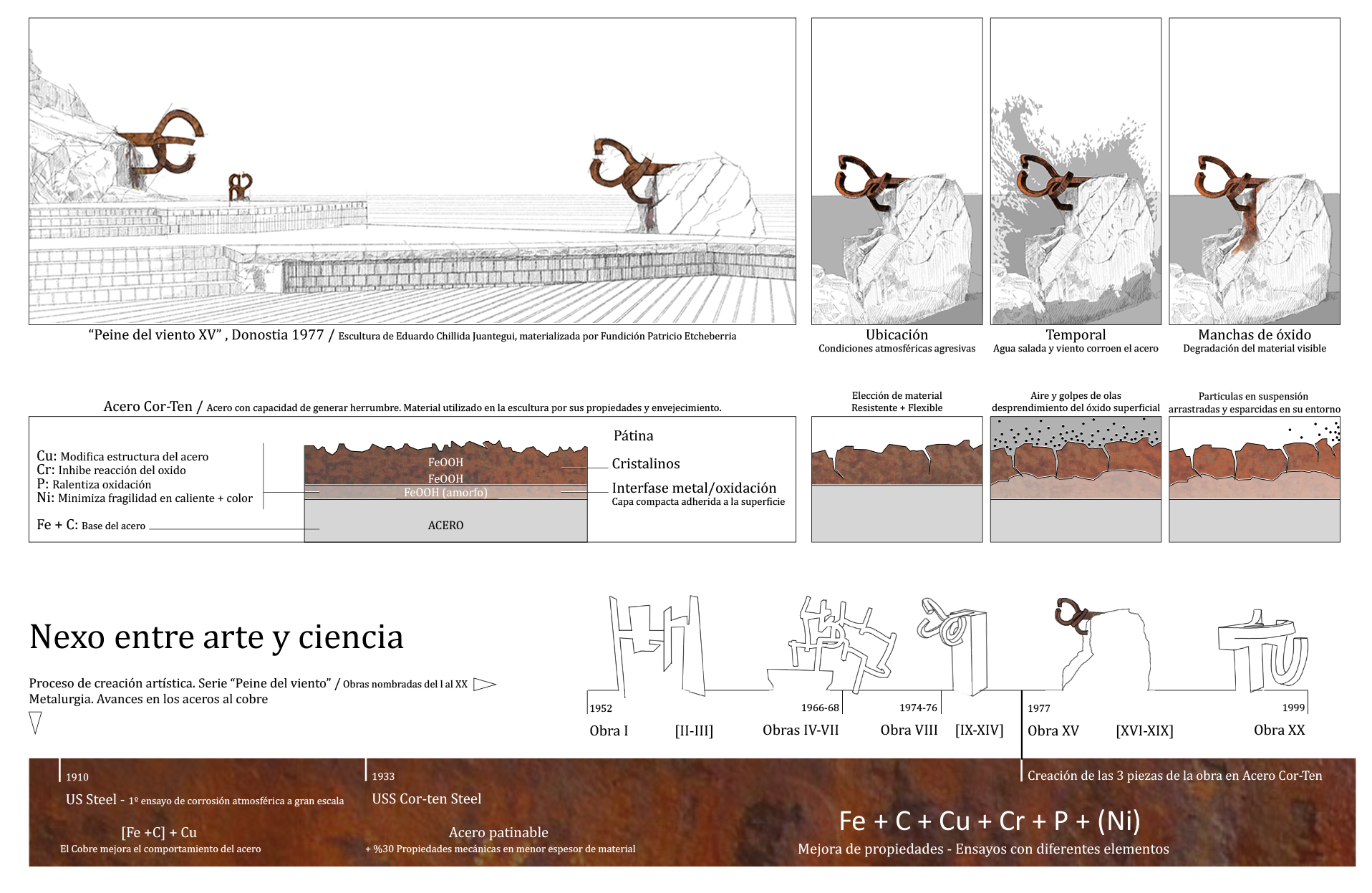

En un rincón del litoral donostiarra donde los estratos de la corteza terrestre descienden y se ocultan bajo el mar Cantábrico, para emerger de nuevo sobre la isla Santa Clara, se narra una historia de tierra, mar y viento. “El Origen”, fascinación del escultor Eduardo Chillida Juantegui.

El “Peine del Viento”, es la XV obra de un dilatado proceso creativo fruto de la reflexión, ensayos con formas y materiales, y aquel “Origen” como lugar condicionante. Su trabajo evolucionó, desde diseños rígidos y estáticos hacia figuras más orgánicas, y su posterior simplificación.

Influenciado tanto por movimientos artísticos, como por los avances científicos en el campo de la metalurgia, el artista se valió de las propiedades del acero Cor-ten, que contiene aditivos mejorando así su tenacidad y resistencia a la corrosión. El material genera una barrera protectora de herrumbre en la superficie, optimizándolo ante la corrosión atmosférica. Su característico color rojizo y meteorización paulatina visibiliza el inevitable “bagaje del tiempo” en su piel. Idea que el artista plasmó integrando el proceso de degradación material en el conjunto, realzado por manchas en las bases rocosas.

Imagen: Arte y ciencia. Interacción entre el proceso creativo del escultor Eduardo Chillida Juantegui y los avances científicos en el acero al cobre, aplicados en la creación del conjunto escultórico “Peine del viento XV”. Se justifica la elección del acero Cor-Ten por sus propiedades materiales y el modo en el que se degrada a causa de las condiciones atmosféricas adversas de su ubicación. (Ilustración: Amaia Torres Piñeiro)

Imagen: Arte y ciencia. Interacción entre el proceso creativo del escultor Eduardo Chillida Juantegui y los avances científicos en el acero al cobre, aplicados en la creación del conjunto escultórico “Peine del viento XV”. Se justifica la elección del acero Cor-Ten por sus propiedades materiales y el modo en el que se degrada a causa de las condiciones atmosféricas adversas de su ubicación. (Ilustración: Amaia Torres Piñeiro)

El arte y la ciencia convergen en este lugar donostiarra, donde la historia y la naturaleza son protagonistas.

Referencias consultadas:- Díaz Ocaña, Iván (2013). Corrosión atmosférica de aceros patinables de nueva generación. Tesis doctoral. Universidad Complutense de Madrid, Facultad de Ciencias Químicas, Departamento de Ciencia de los Materiales e Ingeniería Metalúrgica.

- Elósegui Itxaso, José María (1977). El Peine del Viento de Eduardo Chillida en San Sebastián. Ingeniería de su colocación. Donostia – San Sebastián. Fundación Kutxa.

Autora: Amaia Torres Piñeiro (@amaia_torres), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2018/19

Artículo original: El Peine del Viento de Chillida: materia, forma y lugar. Déborah García, Cuaderno de Cultura Científica, 28 de octubre de 2016.

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo ¿Es posible el arte sin ciencia? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 La cultura

- Arte & Ciencia: Cómo descubrir secretos que esconden las obras de arte

- Arte & Ciencia: Química y Arte, reacciones creativas

La explicación de Einstein del efecto fotoeléctrico

Si conocemos la función de trabajo de los materiales y las frecuencias de la luz incidente podríamos determinar qué materiales emiten electrones al ser expuestos a la luz, como el titanio de colores de las cubiertas del Hotel Marqués de Riscal. Foto: Wikimedia Commons

Si conocemos la función de trabajo de los materiales y las frecuencias de la luz incidente podríamos determinar qué materiales emiten electrones al ser expuestos a la luz, como el titanio de colores de las cubiertas del Hotel Marqués de Riscal. Foto: Wikimedia Commons

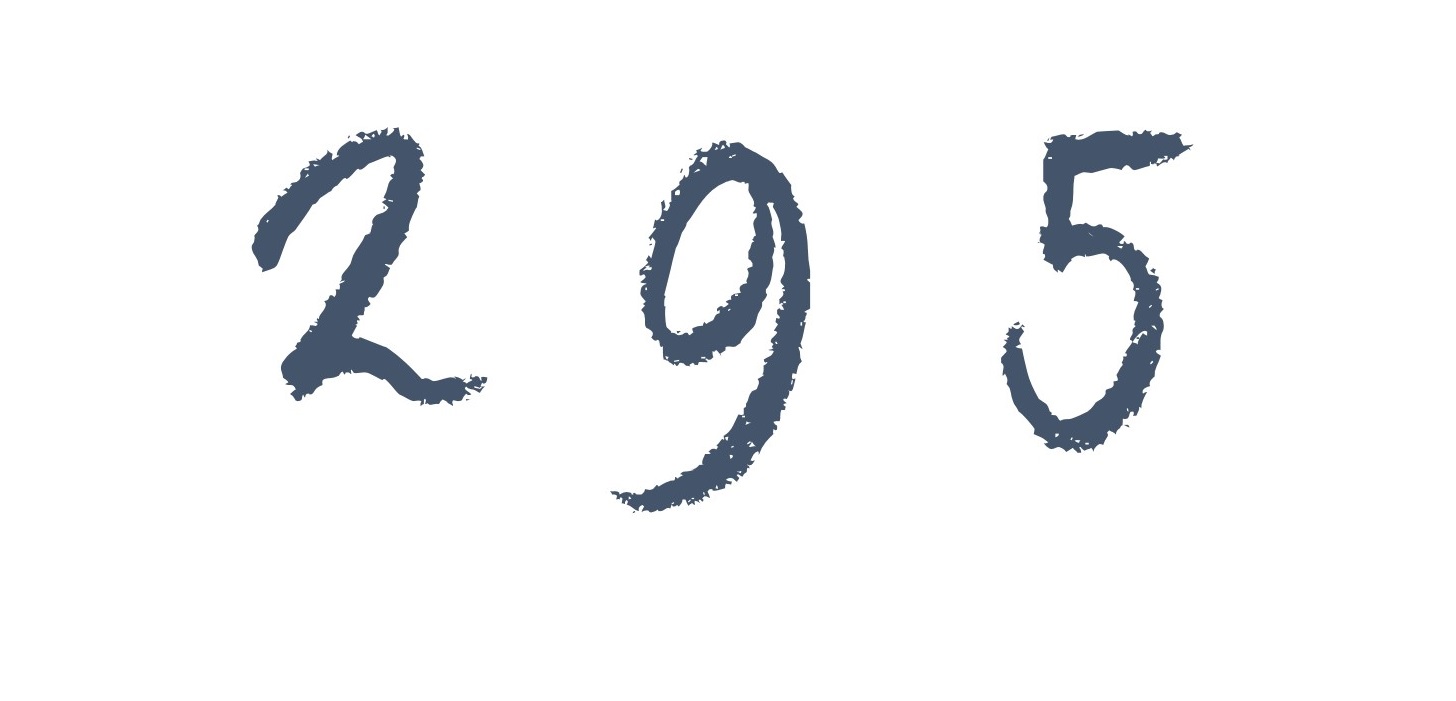

La explicación del efecto fotoeléctrico fue el trabajo principal citado en cuando se le concedió el premio Nobel de Física en 1921 a Albert Einstein. La explicación de Einstein, propuesta en 1905, desempeñó un papel importante en el desarrollo de la física atómica. Basó su teoría en una hipótesis muy atrevida, ya que pocos de los detalles experimentales se conocían en 1905. Además, el punto clave de la explicación de Einstein contradecía las ideas clásicas de la época.

Einstein asumió que la energía de la luz no estaba distribuida uniformemente en todo el frente de onda en expansión (como suponía la teoría clásica). En cambio, la energía de la luz se concentraría en «paquetes» separados. Además, la cantidad de energía en cada una de estas regiones no sería una cantidad cualquiera, sino una cantidad definida de energía que es proporcional a la frecuencia f de la onda luminosa. El factor de proporcionalidad sería una constante (símbolo h); se llama constante de Planck por razones que veremos más adelante.

Por lo tanto, en el modelo que propone Einstein, la energía luminosa en un haz de frecuencia viene en paquetes, cada uno cona energía E = hf, donde h = 6,626·10-34 J / s. La cantidad de energía radiante de cada paquete se llama cuanto de luz o cuanto de energía luminosa. Como cuanto de energía luminosa es muy largo, más tarde se le daría un nombre, fotón.

No hay una explicación más clara o más directa que la del propio Einstein en al artículo original de 1905 [1]. Presentamos a continuación una cita del mismo, en traducción libre y con la notación adaptada a la que venimos utilizando:

[…]De acuerdo con la idea de que la luz incidente se compone de cuantos con energía hf, la expulsión de los rayos catódicos [fotoelectrones] por luz se puede entender de la siguiente manera. Los cuantos de energía penetran en la capa superficial del cuerpo y su energía se convierte, al menos en parte, en energía cinética de electrones. La imagen más simple es que un cuanto de luz cede toda su energía a un solo electrón; Asumiremos que esto sucede[…]. Un electrón provisto de energía cinética dentro del cuerpo puede haber perdido parte de su energía cinética en el momento en que llega a la superficie. Además, se debe suponer que cada electrón, al abandonar el cuerpo, tiene que realizar una cantidad de trabajo W (que es característica del cuerpo). Los electrones expulsados directamente desde la superficie y en ángulos rectos tendrán las mayores velocidades perpendiculares a la superficie. La energía cinética máxima de uno de estos electrones es

Ecmax = hf – W

Si la placa C se carga a un potencial positivo, Vp , lo suficientemente grande para evitar que el cuerpo pierda carga eléctrica, debemos tener que

Ecmax = hf – W = eVp ,

donde e es la magnitud de la carga electrónica[…]

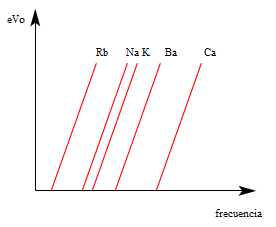

Si la fórmula derivada es correcta, entonces Vp , cuando se representa gráficamente en función de la frecuencia de la luz incidente, debe producir una línea recta cuya pendiente debe ser independiente de la naturaleza de la sustancia iluminada. […]

A la primera ecuación en la cita anterior se la suele conocer como ecuación fotoeléctrica de Einstein. Veamos si esta ecuación y el modelo fotónico de Einstein pueden explicar los resultados experimentales que la física clásica no puede:

1. De acuerdo con la ecuación fotoeléctrica, la energía cinética de los fotoelectrones es mayor que cero solo cuando la energía del fotón hf es mayor que el trabajo W, que es el trabajo que debe realizar el electrón contra las fuerzas de atracción del material del cátodo en el que se encuentra para escapar de él. La energía requerida para escapar del metal se conoce como la función de trabajo. Por lo tanto, solo se puede emitir un electrón cuando la frecuencia de la luz incidente es mayor que un cierto valor mínimo que corresponde al trabajo requerido para escapar del metal. Usando símbolos, la frecuencia mínima o umbral f0 viene definida para cada material por la igualdad h f0 = W.

2. Según el modelo fotónico de la luz de Einstein, es un fotón individual de frecuencia f el que expulsa a un electrón si f > f0 . Como la intensidad de la luz es proporcional al número de fotones en el haz de luz y el número de fotoelectrones expulsados es proporcional al número de fotones incidentes en la superficie, la cantidad de electrones expulsados (y con ella la corriente fotoeléctrica) es proporcional a la intensidad de la luz incidente. [2]

3. En el modelo de Einstein, la energía luminosa se concentra en una serie de cuantos de luz (fotones). Por tanto no se necesita tiempo para que el electrón acumule energía luminosa. En efecto, los cuantos transfieren su energía inmediatamente a los fotoelectrones, que escapan de la superficie casi inmediatamente.

4. Finalmente, la ecuación fotoeléctrica predice que cuanto mayor sea la frecuencia de la luz incidente mayor será la energía cinética máxima de los electrones expulsados. Esto es así porque la energía del fotón es directamente proporcional a la frecuencia de la luz. La energía mínima necesaria para expulsar un electrón es la energía requerida para que el electrón escape de la superficie del metal. Esto explica por qué la luz de una frecuencia menor que la frecuencia f0 no puede expulsar ningún electrón. La energía cinética del electrón que se escapa es la diferencia entre la energía del fotón absorbido y la energía perdida por el electrón al escapar de la superficie: si la priemera no compensa a la segunda el electrón se queda donde está

Notas:

[1] Einstein, A. (1905) Über einen die Erzeugung und Verwandlung des Lichtes betreffenden heuristischen Gesichtspunkt Annalen der Physik 17, 132-149

[2] Ojo, no todos los fotones en un haz de luz incidente golpean un electrón haciendo así que se emita desde el metal. Solo del orden de 1 de cada 50 fotones lo consigue. Esto es muy importante para la ingeniería y el diseño de experimentos, pero para lo que a nosotros nos interesa no es necesario que pase de nota a pie de página.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La explicación de Einstein del efecto fotoeléctrico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La incompatibilidad del efecto fotoeléctrico con la física clásica

- El desconcertante efecto fotoeléctrico

- El principio de relatividad (y 4): la versión de Einstein

Azul… ¿Serendipia?

Berlín, año 1704. El químico e inventor de pinturas suizo Johann Jacob Diesbach se encuentra trabajando en el laboratorio. ¿Su objetivo? Elaborar una laca rojiza a partir de cochinillas. Sin embargo, el destino es caprichoso, por lo menos para algunos. Tras un tiempo trabajando en la elaboración del pigmento rojizo, casi había conseguido su meta cuando al pobre Diesbach se le truncó el experimento. Se le acabó la ceniza que tenía que emplear para finalizar su labor.

No obstante, no todo acaba ahí. Como en toda buena historia llegó la salvación, con nombre de Johann Conrad Dippel. Dippel, compañero de trabajo, o más bien jefe de Diesbach, le prestó un material de sustitución denominado aceite Dippel, un aceite obtenido mediante la destilación destructiva de huesos. Y funcionó. Bueno, no exactamente.

Aunque su propósito final fuera una laca rojiza, de la mezcla realizada salió un azul excepcional, lo que hoy en día conocemos como el azul de Prusia (Fe7N18C18). Y fue así como nació, por un caso de serendipia, una sustancia azul que ha inspirado a diversidad de artistas en la creación de obras de arte muy conocidas. ¿Sabríais decirme cuáles?

https://culturacientifica.com/app/uploads/2019/06/Johann-Jacob-Diesbach-y-el-azul-prusia.mp4Imagen: Johann Jacob Diesbach y el azul de Prusia (1704). (Animación: Ainhoa Caporossi Esteibar)

Referencias consultadas:- Bartoll, Jens (2008). The early use of Prussian Blue in paintings. 9th International Conference on NDT of Art, Jerusalem Israel, 25-30 Mayo 2008.

- Wikipedia: Azul de Prusia (fecha de consulta: 01/2019).

————————————

Autora: Ainhoa Caporossi Esteibar (@laveceria), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2018/19

Artículo original: Ensayo sobre el azul. Oskar González, Cuaderno de Cultura Científica, 23 de septiembre de 2017.

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo Azul… ¿Serendipia? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Nacionalismo, ideología y religión

“Nada mejor para explicar una cosa problemática que inventar otra tan problemática y darla como indiscutible. Es el procedimiento de todas las sectas religiosas”.

Pío Baroja. En «El mundo es ansí», 1912.

“Cuando se trata de controlar a los seres humanos no hay mejor instrumento que las mentiras. Porque los humanos viven según sus creencias y las creencias pueden ser manipuladas.”

Michael Ende.

“La gente se radicaliza porque prefiere sentir a razonar.”

Anna Rosling, 2018.

Creer en algo, sea lo que sea. Lo más popular y extendido en sociedades y culturas es la religión. Juan Ignacio Pérez escribió hace un tiempo en el Cuaderno de Cultura Científica que, a esta necesidad de creer, la ciencia responde con dos hipótesis. La primera afirma que nuestra especie está predispuesta a creer en otros mundos, en seres sobrenaturales, en dioses, en la vida después de la muerte, en todo aquello que las religiones sistematizan y ofrecen a sus seguidores en forma, que conocemos bien, de credo indiscutible.

La religión sería una consecuencia de la habilidad de la especie humana para concretar la relación entre causa y efecto. Y, por ello, si buscamos respuestas a los enigmas que hemos planteado en el párrafo anterior, encontramos la respuesta en milagros, fantasmas o, si se quiere, en la religión. como dice Juan Ignacio Pérez, “las creencias religiosas serían un subproducto del modo en que funciona nuestro cerebro”.

Actuación de la Orquesta y Coro del Tabernáculo Mormón en Temple Square en el Centro de Conferencias de los Santos de los Últimos Días (Salt Lake City, Utah, Estados Unidos). Fuente: Wikimedia Commons

Actuación de la Orquesta y Coro del Tabernáculo Mormón en Temple Square en el Centro de Conferencias de los Santos de los Últimos Días (Salt Lake City, Utah, Estados Unidos). Fuente: Wikimedia Commons

En consecuencia, Dimitrios Kapogiannis y sus colegas, del Instituto Nacional del Envejecimiento de Baltimore, han buscado en el cerebro las redes neuronales relacionadas con las creencias religiosas. Estas redes se integran en las áreas cerebrales relacionadas con la cognición social, el lenguaje y el razonamiento lógico, y no son específicas solo de la religión.

Obtienen más detalle cuando investigan, con resonancia magnética, el cerebro de voluntarios que se declaran creyentes o no creyentes. Localizan la relación íntima con Dios en la corteza del lóbulo temporal medio, el miedo a Dios en la corteza orbitofrontal, y las dudas sobre la existencia de Dios en el pecuneus del lóbulo parietal. La doctrina religiosa activa las áreas del lenguaje como, por ejemplo, la muy conocida área de Broca.

Para conocer el detalle de esta relación entre cerebro y religión, Michael Ferguson y su grupo, de la Universidad de Utah, lo han estudiado en un caso muy concreto, los mormones. Han escaneado el cerebro de 19 voluntarios que se declaran mormones devotos. Han encontrado que, cuando practican su religión asistiendo a actos de la congregación, se activan el núcleo accumbens, la corteza prefrontal ventromedial, y las regiones frontales relacionadas con la atención.

Algo parecido han encontrado Mario Beauregard y Vincent Paquette, de la Universidad de Montreal, en los cambios del electroencefalograma en monjas carmelitas cuando rezan y alcanzan lo que denominan una experiencia mística. Parece que la devoción activa una asociación entre ideas abstractas, el sistema de recompensa del cerebro y los procesos de atención de emociones. La doctrina motiva la conducta del devoto y la recompensa.

En conclusión, como proponía Juan Ignacio Pérez, las creencias religiosas activan en el cerebro redes de neuronas que ya existían y que provocan atención, cognición, emoción y recompensa que, sabemos, se activan también con otros estímulos diferentes a la religión.

Vamos a por la segunda propuesta del texto de Juan Ignacio Pérez: las creencias religiosas han contribuido a la cohesión de los grupos humanos y, por ello, han ayudado a su supervivencia y, en último término, al éxito evolutivo. Tienen, por tanto, las religiones o, en general, las ideologías un gran valor adaptativo. Hay ejemplos muy antiguos sobre la utilización de la religión para cohesionar grupos o, si se quiere, de pueblos y países enteros. Por ejemplo, Jorg Wagner contaba en 2018 la historia del rey Antíoco I del reino Comagene, ahora en el centro sur de Turquía, que hace más de 2000 años se autoproclamó como dios para mantener unido a su pueblo. Los habitantes tenían dos orígenes, persa y griego, y dos religiones y Antíoco los unió nombrándose dios y creando toda una religión alrededor de su persona.

Judíos ortodoxos en Jerusalén (Israel). Foto: Blake Campbell / Unsplash

Judíos ortodoxos en Jerusalén (Israel). Foto: Blake Campbell / Unsplash

Incluso, como proponen Jesse Graham y Jonathan Haidt, de la Universidad de Virginia, las personas religiosas se sienten felices y lo son por sentir que pertenecen a una congregación, a un grupo social cohesionado por la religión y su práctica. En resumen, los que siguen una religión forman parte de comunidades organizadas que cooperan y se mantienen en torno a seres sobrenaturales. Veamos algunos ejemplos que ilustran esta segunda propuesta.

La religión simplifica el control aquellos que no cumplen con las reglas de la moralidad en una sociedad. Tanto los incumplimientos, o pecados, como los castigos, infiernos y demás, vienen de dioses sobrenaturales y todopoderosos que se encuentran por encima de todos y de todo. Según Andra Craciun, de la Universidad de Bucarest, las personas religiosas pertenecen a grupos que organizan actividades conjuntas como reuniones donde se pasea, desfila, canta o baila. Estas actividades provocan en quien participa confianza, cooperación y sacrificio. Y también recompensa como encontró Uffe Schjodt, de la Universidad de Aarhus, en Dinamarca, cuando escaneó el cerebro de los que rezan, con la repetición de unos textos ya establecidos. El cerebro lo premia con secreción de dopamina y con bienestar a quienes practican su religión. O a quienes repiten eslóganes en una manifestación o en un partido de fútbol.

Además de supervivencia, para conseguir el éxito evolutivo se necesita una reproducción eficaz, y Ara Norentayan y su grupo, de la Universidad de La Columbia Británica en Vancouver, han comparado los ateos y el número de hijos que tienen con quienes se declaran religiosos. Después de revisar los datos de 82 países han encontrado que, de media, los que asisten a un culto religioso una vez por semana tienen 2.5 hijos mientras que los que no van nunca tienen 1.7 hijos. O, también, en Suiza y en el censo de 2000, los cristianos, hindúes, musulmanes y judíos tienen, de media, 3 hijos, y los judíos ateos tienen 1.5 hijos. Incluso los judíos Haredim, de Israel y más ortodoxos, tienen 6-8 hijos de media.

Lo habitual es que los hijos tengan, en principio, la misma religión que sus padres y, por tanto, los devotos de alguna religión, al tener más hijos que los que no siguen ningún culto, la transmiten a más individuos de la siguiente generación.

Ayuda al éxito en la reproducción, en nuestra cultura, una buena situación económica que lleva a tener más recursos para criar a los hijos. En un repaso en 81 países, las personas que consiguen con rapidez prosperidad económica son los que muestran una creencia más fuerte en el cielo y en el infierno. Sobre todo cuenta la creencia en el infierno. Y, además, rechazan más el fraude fiscal, el soborno, el adulterio y la mentira.

Una de las características psicológicas más interesantes de las personas religiosas es que consideran que sus creencias no se pueden probar por medio de la ciencia, no son falsables en el sentido de Popper. La religión solo se debe basar en la fe de sus seguidores, no en evidencias externas. Lo estudiaron Justin Friesen y sus colegas, de la Universidad de Waterloo, en Canadá, y encontraron que la religión, y también las ideologías políticas, se basan en otros motivos y, sobre todo, en que mantienen una determinada imagen del mundo y son el soporte de una identidad de grupo concreta. Friesen comenta que, cuando se dice que unas creencias religiosas o políticas no son demostrables por la ciencia, no se disgusta a sus seguidores sino que, incluso, se refuerza su aceptación de esas creencias.

Además, de la religión, la ideología también sirve para compactar un grupo. Una de las ideologías políticas más debatidas en estos días es el nacionalismo, por lo que supone en relación con los estados nación actuales como por su fuerza en crear sentimientos y reforzar el grupo de pertenencia. Sin embargo, la definición de nacionalismo no es fácil. Por ejemplo, el Diccionario de la Lengua da dos acepciones: 1. Sentimiento fervoroso de pertenencia a una nación y de identificación con su realidad y con su historia. 2. Ideología de un pueblo que, afirmando su naturaleza de nación, aspira a constituirse como Estado. O en el Diccionario Espasa de Sinónimos y Antónimos de 1997: Nacionalismo: Patriotismo, regionalismo, tradicionalismo, civismo, chauvinismo, patriotería, xenofobia, fanatismo. O, también, en Wikipedia, donde, y según Ernest Gellner, “el nacionalismo es un principio político que sostiene que debe haber congruencia entre la unidad nacional y la política”, o, si se quiere, “el nacionalismo es una teoría de legitimidad política que prescribe que los límites étnicos no deben contraponerse a los políticos”.

Eugène Delacroix «La libertad guiando al pueblo» (1830). Óleo sobre lienzo, 260 x 325 cm. Sobre esta obra Delacroix escribió: «He emprendido un tema moderno, una barricada, y si no he luchado por la patria, al menos pintaré para ella.» La lucha a la que se refiere es el alzamiento del pueblo de París el 28 de julio de 1830 contra la supresión del parlamento por parte de Carlos X. Fuente: Wikimedia Commons

Eugène Delacroix «La libertad guiando al pueblo» (1830). Óleo sobre lienzo, 260 x 325 cm. Sobre esta obra Delacroix escribió: «He emprendido un tema moderno, una barricada, y si no he luchado por la patria, al menos pintaré para ella.» La lucha a la que se refiere es el alzamiento del pueblo de París el 28 de julio de 1830 contra la supresión del parlamento por parte de Carlos X. Fuente: Wikimedia Commons

Algo parecido define Bert Bonikowsky, de la Universidad de Harvard, con un enfoque más personal: nacionalismo es un grupo de significados subjetivos y de orientaciones afectivas que dan a los individuos un sentido de sí mismos y guían sus interacciones sociales y sus elecciones en política. Para Bonikowsky, el nacionalismo en política y para políticos es, como ideología, un principio político que propone que las unidades nacional y política deben ser congruentes. El mundo debe estar dividido en naciones identificables, que cada persona pertenezca a una nación, y que la nacionalidad del individuo influya en cómo piensa y actúa y siente. En la práctica política, el nacionalismo es una llamada a la lealtad, a la atención y solidaridad del pueblo para cambiar como se ven a sí mismos, movilizar lealtades, promover energías y articular demandas. Para el resto de los ciudadanos, los que no se sienten nacionalistas, el nacionalismo como política crea, a menudo, una percepción de superioridad nacional y una orientación hacia la dominación y, por tanto, el rechazo. Como práctica es un conjunto heterogéneo de prácticas y posibilidades que están disponibles en la vida cultural y política moderna.

Sobre este asunto escribía Javier Elzo en el Deia en 2018: No acabo de ver la distinción entre algo dado, la nación, y un sentimiento, la patria. También la Constitución une ambos conceptos en el mismo artículo: “Artículo 2. La Constitución se fundamenta en la indisoluble unidad de la nación española, patria común e indivisible de todos los españoles”. Como ven, aparecen patria y nación en el mismo párrafo.

Hace unos meses, en noviembre de 2018, en los actos del centenario de la Primera Guerra Mundial, el presidente francés Emmanuel Macron reabrió el debate. Proclamó que “el patriotismo es el exacto contrario al nacionalismo. El nacionalismo es su traición… Diciendo que nuestros intereses primero y qué importan los de otros, se borra lo que una nación tiene de más precioso, lo que la hace vivir, lo que la lleva a ser grande, los más importante: sus valores morales”. También George Orwell avisó, en 1945, que no hay que confundir nacionalismo y patriotismo. En su texto Orwell se refiere, es obvio por el tiempo y lugar en que lo escribe, al nacionalismo supremacista nazi recién derrotado en la Segunda Guerra Mundial al que une, por su experiencia vital, a los comunistas soviéticos. Su definición de nacionalismo lo deja muy claro: “Cuando digo nacionalismo me refiero antes que nada al hábito de pensar que los seres humanos se pueden clasificar como si fueran insectos y que masas enteras integradas por millones o decenas de millones de personas se pueden etiquetar sin problema alguno como “buenas” o “malas”.

Pero, en segundo lugar –y esto es mucho más importante-, me refiero al hábito de identificarse con una única nación o entidad, situando a esta por encima del bien o del mal, y negando que exista cualquier otro deber que no sea favorecer sus intereses.”

Todo lo escrito hasta aquí sobre el nacionalismo quizá ayude a comprender por qué es una ideología que provoca sentimientos tan profundos que, a la vez, ayudan a aumentar la cohesión del grupo social. Sin embargo, tanto la ideología política como la religión pueden llegar al fanatismo y, como escribió Gilbert K. Chesterton en 1910, se llega a “la incapacidad de concebir seriamente la alternativa de una proposición” y, por tanto, “es fanático solamente cuando no puede comprender que su dogma es un dogma, aunque sea verdad”. Así, la ideología, en la práctica, llena el día a día con charlas con y sobre dogmas, rituales simbólicos, compromisos con las instituciones y prácticas a cumplir. Con el nacionalismo como forma civil de religión puede pasar que coloque la nación por encima de otras afiliaciones colectivas.

Fue a principios del siglo XIX, hacia 1830, tal como lo cuenta Karen Armstrong, cuando los nuevos Estados nación provocaron bajo una profunda contradicción: por una parte, eran laicos, pero las nuevas naciones despertaban emociones casi religiosas. En último término, la patria era una manifestación divina, el depósito de la esencia del pueblo y, por tanto, eterna. Daba a los seres humanos la inmortalidad que buscaban porque, la patria, existía desde el inicio del tiempo y continuaría tras su muerte Además, el Estado se había creado para contener la violencia pero la nación se utilizó como argumento para desencadenarla. En fin, si podemos definir lo sagrado como aquello por lo que se está dispuesto a morir, la nación era el valor supremo, lo divino en la tierra.

En ese momento, en el siglo XIX, en el entorno de la aparición del Estado nación que describe Karen Armstrong, cuando Ernest Renan escribió que ni la raza, ni la lengua, ni la religión, ni la geografía bastan para explicar una nación, como resume Marc Bassets en El País, sino que debe suponer un hecho tangible y cotidiano, que los ciudadanos expresen que quieren seguir una vida en común. O, si se quiere, que esa ideología contribuye a la cohesión de las personas en el grupo. O, como de nuevo nos dice Renan, que “existencia de una nación es un plebiscito cotidiano”, aunque se refería a su tiempo, es decir, al Estado nación.

Así, la aceptación de, por ejemplo, la Primera Guerra mundial fue aceptada con entusiasmo. Demuestra lo difícil que es resistirse a las emociones de la religión y, ya hace un siglo, a las del nacionalismo, la nueva fe laica. Es obvio que el nacionalismo llega con facilidad a un fervor casi religioso, especialmente en momentos tensos y emocionales.

Quizá la obsesión, religiosa o política, tenga relación con la química del cerebro. Hay algunas personas que tienden a aceptar creencias sin fundamentos como manías conspiranoicas, lo paranormal o las pseudociencias. Según Katharina Schmack y sus colegas, de la Universidad Médica Charité de Berlín, hay una relación entre la concentración de dopamina, neurotransmisor cerebral, y el apoyo a creencias sin fundamentos científicos.

Trabajan con 102 voluntarios, de ellos 53 son mujeres, y la edad media es de 25 años. A la vez que estudian los genes COMT, que regulan la degradación de la dopamina, les hacen encuestas sobre sus creencias. Los resultados muestran que, cuanto más alta es la concentración de dopamina, mayor es la tendencia a aceptar creencias sin apoyo científico.

Sala del órgano de la Cueva de Neptuno (Cerdeña, Italia). ¿Qué ves? Fuente: Wikimedia Commons

Sala del órgano de la Cueva de Neptuno (Cerdeña, Italia). ¿Qué ves? Fuente: Wikimedia Commons

Todos tendemos, como cuentan Philipp Sterzet y sus colegas, del Colegio Universitario de Londres, a ver lo que esperamos ver, lo que buscábamos es lo que, a menudo, encontramos. Hay, por tanto, que preguntarse si nuestro sistema de creencias y opiniones se ve sesgado por lo que esperamos, incluso por estados patológicos o por mentiras y engaños de otros. Así, por ejemplo, varios factores influyen en hechos o creencias que nos interesan o nos dejan más o menos indiferentes. Geoffrey Goodwin y John Dailey, de las universidades de Pennsylvania y Princeton, respectivamente, han encontrado que se aceptan con facilidad sucesos negativos como orinar sobre monumentos, mentir o hacer el saludo nazi. Tienen menos aceptación los hechos positivos como salvar a alguien que se ahoga o donar fondos a una ONG. Y todavía menos se puntúa lo que está en debate en la actualidad como el aborto o la eutanasia. Por ello, hay personas que piensan que sus creencias morales son objetivas y, por tanto, hechos verdaderos del mundo real. Y, en cambio, otras aceptan que sus creencias pueden ser, simplemente, preferencias morales personales.

En los debates sobre creencias se interviene para ganarlos o para aprender. En los debates para aprender, una elección personal y subjetiva, se escucha y, a menudo, se llega a un acuerdo. En los debates para ganar, lo importante son los objetivos, los hechos que nos son opiniones ni opinables, se escucha menos y no se consiguen acuerdos. Incluso, en los debates para ganar se tiende a parecer muy objetivo en las argumentaciones ya que, como solo hay una respuesta correcta, las demás están equivocadas. Uno se pregunta si los asuntos políticos en debate tienen una respuesta correcta o si todo es relativo. Estamos en el tiempo del tribalismo creciente.

El mejor debate es el cooperativo, con intención de llegar a un acuerdo, pero no siempre debe ser así. Es inútil el debate cooperativo sobre la homeopatía, o sobre las pseudociencias en general, o sobre el cambio climático o, si se quiere, sobre la existencia del cielo y el infierno. En los debates se debe ser cooperativo pero no equidistante sobre asuntos claramente falsos o indebatibles. En el debate cooperativo o para aprender, más parece que puede haber otras respuestas correctas y que no existe una verdad objetiva.

Es fácil de entender lo que revelan los estudios de Justin Friesen y sus colegas, de la Universidad de Waterloo, en Canadá, cuando aseguran que, muchas personas con una ideología interiorizada, consideran que sus creencias no se pueden, ni quizá deben, probar por la ciencia, con la falsabilidad en el sentido de Popper. En sus encuestas, Friesen y su equipo obtuvieron, para las ideologías, los mismos resultados que para la religión: las personas solo se deben basar en la fe y no en la realidad externa. Las personas con ideología establecida buscan, como la religión, una determinada imagen del mundo, la estabilidad en su modo de vida y, también, el soporte de una identidad concreta para sentirse integradas en un grupo. Cuando se afirma que una religión o una ideología no se pueden demostrar por la ciencia, no se disgusta a sus seguidores sino que, por el contrario, se refuerza su aceptación de esa creencia, sea religión o ideología.

Este rechazo al método científico se basa en lo que Geoffrey Munro, de la Universidad Towson, de Inglaterra, denomina la “excusa de la impotencia científica”. Es el rechazo de cualquier argumento científico en contra de la propia creencia y, además, el rechazo es previo, antes de analizarlo o debatirlo. Y, en último término, provoca la pérdida de credibilidad en el método científico y en la ciencia. Munro propone su hipótesis después de trabajar con 84 universitarios voluntarios y plantearles un debate sobre la homosexualidad en un estudio que, en general, trata de enjuiciar la calidad de la información basada en la ciencia. Así, las propias creencias provocan el rechazo a la ciencia.

Por tanto, hay quien afirma que sus opiniones son las únicas correctas y, además, sienten que lo son porque ellos son los mejor informados sobre ese asunto, sea el que sea, tal como han estudiado Michael Hall y Kaithin Raimi, de la Universidad de Michigan en Ann Arbor. Es curioso que, para los que piensan que sus ideas no son superiores a las de otros, también subestiman sus conocimientos sobre ese asunto. Sin embargo, los que se sienten superiores y que saben mucho, tienden a perder la oportunidad de aprender más. En general, los que sienten que sus creencias son objetivas, o sea, hechos, no debaten pues no ven la necesidad ya que consideran que su opinión es la correcta.

En resumen, quien piensa que su opinión es única y la mejor, pierde oportunidades de aprender más sobre ese tema, es fácil que se convierta en un obstáculo para conseguir que se debata en asuntos políticos.

Y, es evidente, que la interacción social cambia lo que se siente sobre la certeza de las opiniones propias. Los experimentos del grupo de Matthew Fisher, de la Universidad de Yale, muestran que las opiniones debatidas en un grupo que coopera se consideran menos objetivas que si en el grupo se compite por demostrar la verdad. O sea, quien coopera, acepta argumentos sin mayores problemas, y quien compite y no coopera quiere la verdad absoluta para apropiarse de ella.

Nos podemos acercar a la relación entre la religión y la ideología política con los estudios de Paola Bressan y su grupo, de la Universidad de Padua, en Italia, y que comenta Julio Rodríguez en su blog La bitácora del Beagle. Tanto la religiosidad como las ideas conservadoras presentan una dificultad en interpretar lo que se sale de lo habitual o, si se quiere, el azar en el entorno. Las investigaciones de este grupo llevaron a David Amodio y sus colegas, de la Universidad de Nueva York, a estudiar el funcionamiento del cerebro en liberales y conservadores y a concluir que los liberales tienen una onda de potenciales cerebrales que revela mayor sensibilidad para responder a conflictos. Por supuesto, es una propuesta en debate y queda mucho por conocer sobre las diferencias en la neurocognición según la ideología.

Creencias, religión e ideología están relacionadas, por lo menos en el principio de su desarrollo, tal como propone Joseph Henrich, de la Universidad de la Columbia Británica en Canadá. Lo explica Juan Ignacio Pérez en el Cuaderno de Cultura Científica. Una persona con prestigio difunde con más facilidad sus ideas en su grupo. Si, además, está dispuesto a sufrir por sus creencias. Incluso a llegar al martirio, lo conseguirá con más eficacia y difusión. Por ello, al principio de las religiones y de las ideologías con éxito suele haber una persona de prestigio que sufre. A través del sufrimiento, las creencias, la ideología y la religión llegan mejor al grupo. Las derrotas llegan mejor al imaginario popular que las victorias. Como escribe Francisco Javier Caspistegui en un texto sobre la ciudad, el campo y el tradicionalismo español, “la moral de la derrota es un elemento necesario para conseguir el objetivo último, que no es otro que la recuperación de aquello que se juzga más positivo de los buenos viejos tiempos”.

Referencias:

Alonso, J.R. 2019. Religiosidad y teoría de la mente. Neurociencia Blog 2 febrero.

Amodio, D.M. et al. 2007. Neurocognitive correlates of liberalism and conservatism. Nature Neuroscience 10: 1246-1247.

Anónimo. 2019. Nacionalismo. Wikipedia 16 junio.

Armstrong, K. 2015. Campos de sangre. La religión y la historia de la violencia. Paidós. Barcelona. 575 pp.

Atkinson, Q.D. & P. Bourrat. 2011. Beliefs about God, the afterlife and morality support the role of supernatural policing in human cooperation. Evolution and Human Behavior 32: 41-49.

Bassets, M. 2018. Patriotismo, nacionalismo y todo lo contrario. El País 20 noviembre.

Beauregard, M. & V. Paquette. 2008. EEG activity in Carmelite nuns during a mystical experience. Neuroscience Letters 444: 1-4.

Bonikowski, B. 2016. Nationalism in settled times. Annual Review of Sociology 42: 427-449.

Boyer, P. & B. Bergstrom. 2008. Evolutionary perspectives on religión. Annual Review of Anthropology 17: 111-130.

Bressan, P. et al. 2008. Visual attentional capture predicts belief in a meaningful worl. Cortex 44: 1299-1306.

Caspistegui Gorasurreta, F.J. 2002. “Esa ciudad maldita, cuna del centralismo, la burocracia y el liberalismo”: La ciudad como enemigo en el tradicionalismo español. En “Actas del Congreso Internacional Arquitectura, Ciudad e Ideología Antiurbana”, p. 71-86. Escuela Técnica Superior de Arquitectura Universidad de Navarra. Pamplona.

Craciun, A. 2014. Research review regarding religious beliefs and their role in one’s psychological life. Romanian Journal of Experimental Applied Psychology 5: 65-72.

Dawkins, R. 2007. El espejismo de Dios. Ed. Espasa Calpe. Madrid.

Ferguson, M.A. et al. 2018. Reward, salience, and attentional networks are activated by religious experience in devout Mormons. Social Neuroscience 13: 104-116.

Fisher, M. et al. 2016. The influence of social interaction on intuitions of objectivity and subjectivity. Cognitive Science DOI: 10.1111/cogs.12380

Fisher, M. et al. 2018. El tribalismo de la verdad. Investigación y Ciencia mayo: 74-77.

Friesen, J.P. et al. 2014. The psychological advantage of unfalsifiability: The appeal of untestable religious and political ideologies. Journal of Personality and Social Psychology doi: 10.1037/pspp0000018

Gilead, M. et al. 2018. That’s my truth: Evidence for involuntary opinion confirmation. Social Psychological and Personality Science DOI: 10.1177/194855018762300

Goodwin, G.P. & J.M. Darley. 2012. Why are some moral beliefs perceived to be more objective tan others? Journal of Experimental Social Psychology 48: 250-256.

Graham, J. & J. Heidt. 2010. Beyond beliefs: Religions bind individuals into moral communities. Personality and Social Psychology Review 10: 140-150.

Hall, M.P. & K.T. Raimi. 2018. Is belief superiority justified by superior knowledge? Journal of Experimental Social Psychology 76: 290-306.

Henrich, J. 2009. The evolution of costly displays, cooperation and religión: credibility enhancing displays and their implications for cultural evolution. Evolution and Human Behavior 30: 244-260.

Kapogiannis, D. et al. 2009. Cognitive and neural foundations of religión belief. Proceedings of the National Academy of Sciences USA 106: 4876-4881.

Kapogiannis. D. et al. 2009. Neuroanatomical variability of religiosity. PLOS ONE 4: e7180.

Kapogiannis, D. et al. 2014. Brain networks shaping religious belief. Brain Connectivity 4: 70-79.

Kramer, P. et al. 2011. Belief in God and in strong government as accidental cognitive by-products. Behavioral and Brain Sciences 34: 31-32.

Munro, G.D. 2010. The scientific impotence excuse: Discounting belief-threatening scientific abstracts. Journal of Applied Social Psychology 40: 579-600.

Norenzayan, A. et al. 2016. The cultural evolution of prosocial religions. Behavioral and Brain Sciences 39: 1-65.

Orwell, G. 1945. Notas sobre el nacionalismo. Polemic: A Magazine of Philosophy, Psychology & Aesthetics 1: octubre.

Pérez, J.I. 2017. El terrorismo como sacerdocio. Cuaderno de Cultura Científica 15 mayo.

Pérez, J.I. 2017. ¿Nacidos para creer? Cuaderno de Cultura Científica 29 mayo.

Purzycki, B.G. et al. 2016. Moralistic gods, supernatural punishment and the expansion of human sociality. Nature doi: 10.1038/nature16980

Rodríguez, J. 2018. Una unión psicológica entre religión y política. La bitácora del Beagle Blog SciLogs 11 diciembre.

Schjodt, U. et al. 2008. Rewarding prayers. Neuroscience Letters 443: 165-168.

Schmack, K. et al. 2015. Linking unfounded beliefs to genetic dopamine availability. Frontiers in Human Neuroscience 9: 521.

Sterzer, P. et al. 2008. Believing is seeing: expectations alter visual awareness. Current Biology 18: R697-R698.

Wagner, J. 2018. Antíoco I: la religión como instrumento de cohesión social. Investigación y Ciencia abril: 68-74.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Nacionalismo, ideología y religión se ha escrito en Cuaderno de Cultura Científica.

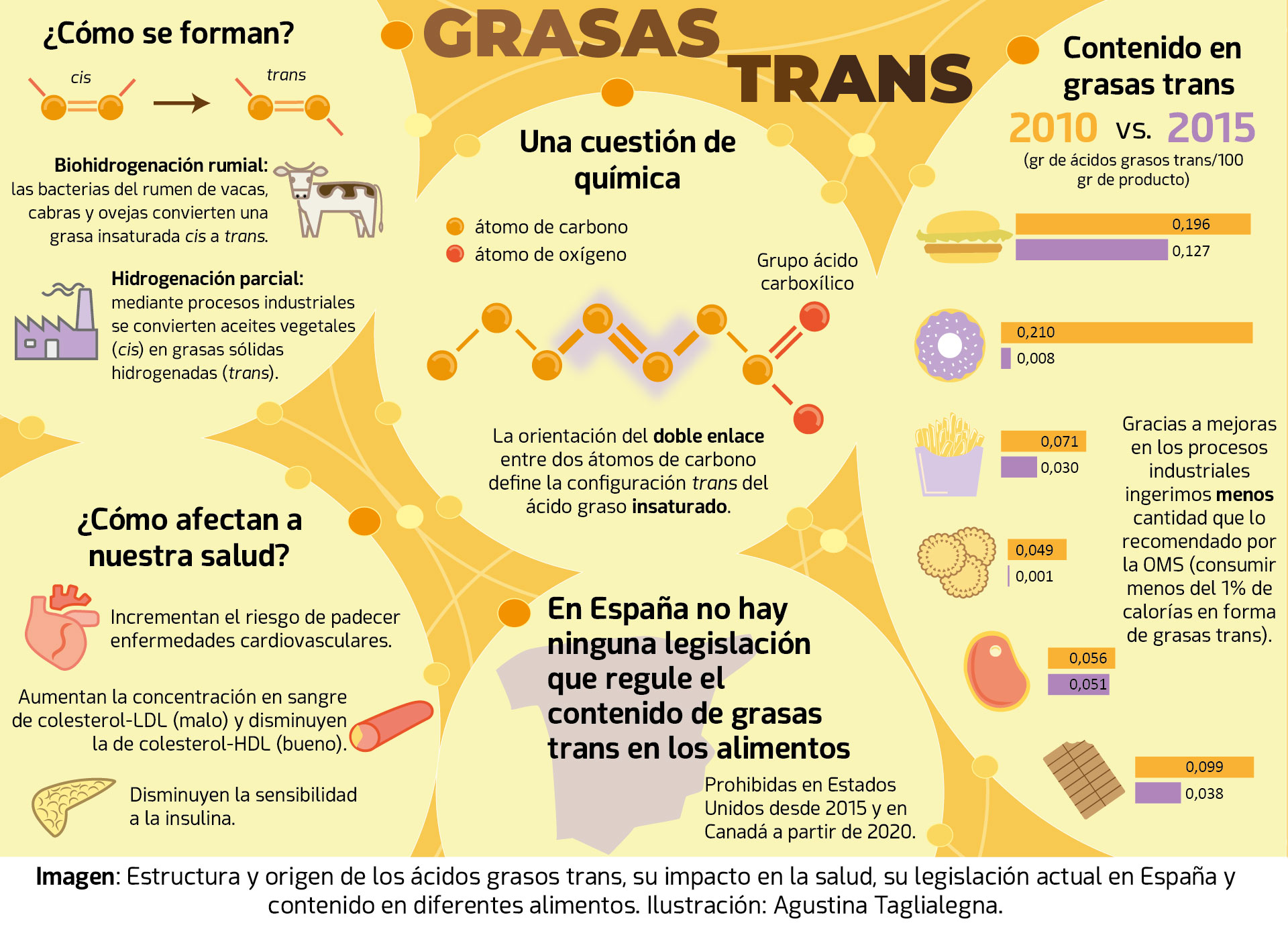

Entradas relacionadas:Adiós a las grasas trans

Querido lector, si estás comiendo algo mientras lees este artículo, lamento informarte que probablemente estés ingiriendo grasas trans. ¿Que no sabes qué son? Para empezar, estas grasas no tienen nada de transgénico. Su nombre y el porqué se consideran “malas” radica en su estructura molecular, en cómo están orientados los átomos de carbono al interaccionar entre sí mediante un doble enlace químico.

Estas grasas pueden perjudicar tu salud favoreciendo el desarrollo de enfermedades cardiovasculares. Están presentes en alimentos como la leche y la carne de rumiantes, pero sobretodo se obtienen como productos no deseados durante procesos industriales como la hidrogenación de aceites vegetales. Están por todas partes, hasta en la sopa (¡y no es broma!).

Como si todo esto fuera poco, en numerosos países europeos, entre ellos España, no existe una legislación que regule la cantidad permitida de grasas trans en los alimentos. Pero que no cunda el pánico. Lo cierto es que en realidad consumimos mucha menos grasas trans de lo que creemos. Los procesos industriales por los cuales se obtienen han mejorado tanto que la ingesta de este tipo de grasas suele ser inferior al límite aconsejado por la OMS.

Así que tranquilo/a, sigue disfrutando sin culpa de lo que estés comiendo, porque las grasas trans son cosa del pasado.

Referencias consultadas:- Riobó, Pilar y Breton, Irene (2014). Ingesta de grasas trans; situación en España. Nutrición Hospitalaria, 29(4), 704-711. DOI:10.3305/nh.2014.29.4.7337.

———————————-

Autora: Agustina Taglialegna (@AgustinaTaglia), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2018/19

Artículo original: A nadie le preocupan las grasas trans. Déborah García Bello, Cuaderno de Cultura Científica, 4 de octubre de 2018.

———————————-

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo Adiós a las grasas trans se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- A nadie le preocupan las grasas trans

- Adiós a las microesferas de plástico en los cosméticos

- ¿Azúcar moreno o azúcar milagro?

¿El escudo del Capitán América? A mí tráeme un casco de obra

Imagina que estás en una obra y se suelta un pedrolo bien gordo que comienza a caer y va directo a tu cabeza, ¿qué eliges para cubrirte? ¿El escudo del Capitán América…

Imagen: Wikimedia Commons

Imagen: Wikimedia Commons

… o el típico casco de obra?

Imagen: Wikimedia Commons

Imagen: Wikimedia Commons

Unos millones de obreros y yo nos decantamos por el casco, te explicaré por qué.

El primer motivo es que el escudo no existe, pero no es el principal.

Para entenderlo bien tenemos que precisar qué es la fuerza.

No es infrecuente definir las magnitudes físicas según alguna fórmula en las que participan. Por ejemplo, la fuerza es aquello capaz de cambiar el estado de movimiento de un sistema. Simplificando podría decirse que bien aumentando/disminuyendo su velocidad o bien cambiándola de dirección, lo que implica generar una aceleración. Recuerda la segunda ley de Newton: F = m·a

Aquí se suele obviar que hay otro fenómeno en el que se manifiestan las fuerzas, cuando se producen deformaciones.

(En realidad es trabajo hecho contra las fuerzas que mantenían las partes del sistema en sus posiciones relativas)

Pero, para verlo bien claro, nos quedamos con que las fuerzas producen cambios en el estado de movimiento o deformaciones.

Y volvamos a nuestros superhéroes, esos que se ponen cotas de mithril y escudos de vibranium, materiales tremendamente resistentes y que no se romperán cuando se les aplique una fuerza, por intensa que sea.

Muy bien, te lo compro, pero tú estás detrás, querido amigo… Y para mostrarte lo que te pasará si confías ciegamente en los Vengadores o en tu tío Bilbo, recordemos un conocido juguete, el péndulo de Newton (Newton’s cradle).

Imagen: Wikimedia Commons

Imagen: Wikimedia Commons

Si piensas en que la bola de la izquierda es el objeto que te golpea; las del centro, tu cobertura, y la de la derecha, tu cabeza… creo que verás que te llevas el impacto completo, con toda su energía.

Eso es lo que pasará si te cubres con un elemento rígido en contacto contigo. El impacto te llegará con toda su fuerza. La única ventaja que puedes obtener sería que si el objeto es puntiagudo, su fuerza se repartirá por todo el “protector” que uses y la presión será menor (se clavará menos), pero la energía del golpe será la misma.

Por lo tanto, si te tiras de un edificio con la mejor armadura de vibranium el golpe va a ser equivalente al que te darías si fueras desnudo, sólo que, en lugar de chocar contra el suelo, chocarás contra la armadura.

Puedes comprobarlo por ti mismo con monedas sobre una mesa. Mira este vídeo.

Estarás pensando: “Vale, quizá el truco sea, no estar en contacto con la armadura, dejar hueco. Así no me llegará el impacto.” Si es así, es que has olvidado la primera ley Newton, la ley de la inercia.

Si sobre un cuerpo la fuerza neta es cero, este seguirá con su estado de movimiento constante. Bien parado o con movimiento rectilíneo y uniforme.

Ponte la armadura de nuevo, ahora usaremos una de una talla más, y saltemos desde lo alto de un edificio. Cuando la armadura toque el suelo no te pasará la fuerza (¡Bien!), pero la armadura se parará… y tú seguirás cayendo el trocito que te faltaba y te darás el tortazo que te mereces por no estudiar física (¡MAL!).

Esto es justo lo que les pasa al cerebros cuando la cabeza sufre un movimiento brusco en un accidente de coche o al recibir un puñetazo. El cráneo se mueve, pero el cerebro que está suspendido en medio no, al final es el propio cráneo el que le golpea en su movimiento.

Y, entonces, ¿por qué es mejor el caso frente al escudo? Si cuando el objeto golpee el casco me pasará toda la fuerza y energía, ¿qué ventaja me ofrece?

El secreto, claro, está en el interior.

Imagen: Wikimedia Commons

Imagen: Wikimedia Commons

El casco de seguridad no va apoyado sobre el cráneo, va sujeto a la cabeza con una estructura de plástico que, por un lado nos separa del casco y por otro… es FLEXIBLE.

Recuerda que dijimos que las fuerzas también podían producir una deformación, como cuando espachurramos una lata de refresco. En este caso, el entramado de plástico hace de amortiguador, deformádose un poco, sin que el casco toque la cabeza), absorbiendo la energía del golpe y salvándonos esta mollera que tantos años ha costado educar. Por supuesto, después vuelve a estirarse y en ese proceso disipa la energía en forma de calor y todos contentos.

Ya sólo me queda pedirte perdón por estropearte el 90% de las películas de ciencia ficción y fantasía, pero es que el universo de verdad es más fascinante aún.

Sobre el autor: Javier Fernández Panadero es físico y profesor de secundaria además de escritor de libros de divulgación.

El artículo ¿El escudo del Capitán América? A mí tráeme un casco de obra se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las cartas de Darwin: El capitán y el filósofo

- #Naukas14: Con casco a la ducha

- Una brecha en nuestro escudo

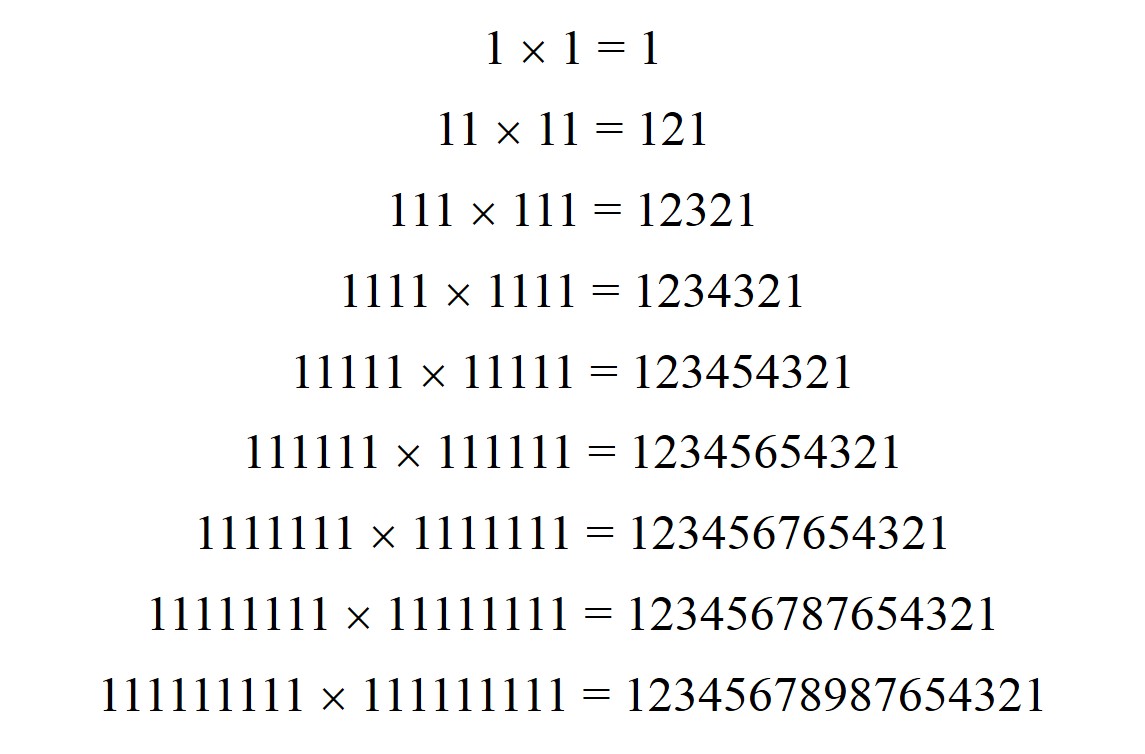

Placer y geometría

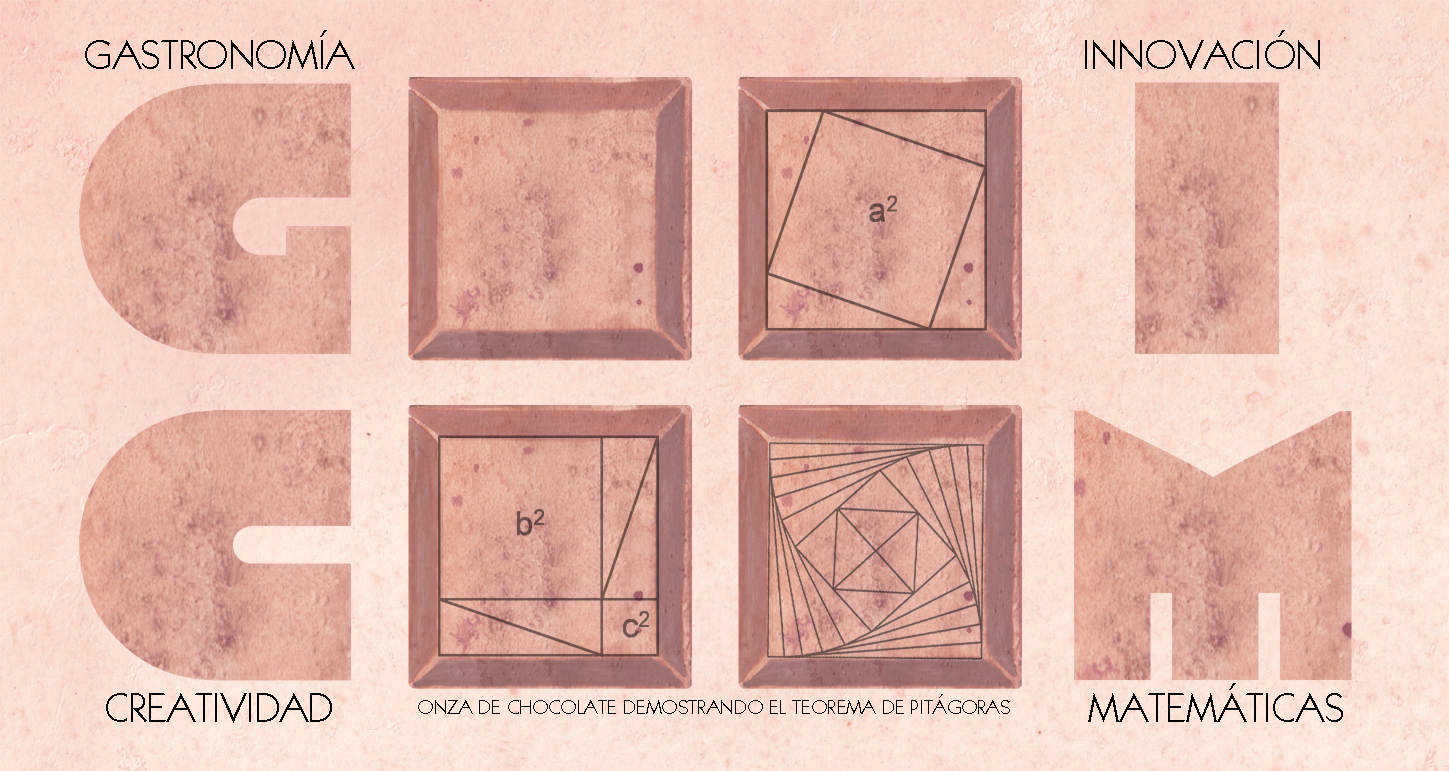

Cuando pensamos en chocolate nuestro cerebro activa las sensaciones y recuerdos de placer, pero ¿y si nos abre las puertas a degustar algo tan en principio alejado como las matemáticas?

Imagen: Diseño de tableta que demuestra visualmente el teorema de Pitágoras: girando el cuadrado típico de la onza de chocolate hacia el interior crea triángulos de diferentes medidas, pero que mantienen la misma superficie. (Ilustración: Olga Carmona Peral)

Imagen: Diseño de tableta que demuestra visualmente el teorema de Pitágoras: girando el cuadrado típico de la onza de chocolate hacia el interior crea triángulos de diferentes medidas, pero que mantienen la misma superficie. (Ilustración: Olga Carmona Peral)

La gastronomía va mucho más allá de cubrir una necesidad primaria, y se considera un arte con relaciones íntimas con nuestro mundo, nuestra cultura e incluso la ciencia. El gourmet busca en la alta cocina dar un valor añadido a sus platos y que actúen como elemento de distinción y atractivo.

Un buen ejemplo es el maestro chocolatero barcelonés Enric Rovira que viene desarrollando desde hace 25 años propuestas rompedoras que unen lógica con placer, sensaciones con geometría. Parecen mundos muy distantes pero, ¿y si no lo son tanto?

Ya la tradicional tableta de chocolate es un ejemplo maestro de geometría de gran sencillez y sentido práctico, pero él va un paso más allá. Mediante la innovación y la creatividad nos propone diseños de tabletas que nos remiten a la arquitectura modernista o a medidas armónicas y orgánicas más propias de Le Corbusier, incluso una tableta realizada junto al diseñador Santos Bregaña y el matemático Enrique Zuazua, que demuestra visualmente el teorema de Pitágoras.

Son propuestas que unen lógica con placer, sensaciones con geometría, matemáticas con gastronomía, así ambos mundos nos enriquecen cuando damos un delicioso bocado a ese chocolate.

———————————-

Autora: Olga Carmona Peral (@olga_CPeral), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2018/19

Artículo original: Diseños geométricos de chocolate. Raúl Ibáñez, Cuaderno de Cultura Científica, 8 de octubre de 2014.

———————————-

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo Placer y geometría se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cálculo y geometría analítica, de George F. Simmons

- La geometría de la obsesión

- Arte y geometría del triángulo rectángulo: Broken Lights

Matemáticas modernas

Las matemáticas son el lenguaje en el que está escrito el univero y eso hace que el grado en matemáticas sirva para muchas más cosas que para dar clases. Lo ilustra Paz Morillo de la Universitat Politècnica de Catalunya con 6 casos de chicas que aplican las matemáticas en ámbitos muy distintos.

Quizás sea el número más famoso de la historia. Lo cierto es que el número Pi, representado por la letra griega π, es una de las constantes matemáticas más importantes que existen en el mundo, estudiada por el ser humano desde hace más de 4.000 años. La fascinación que ha suscitado durante siglos es tal que el popular número cuenta con su propio día en el calendario, así el mes de marzo se celebra el Día de Pi en todo el planeta.

Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien lanzó en 1988 la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática. (3-14 martxoaren 14 en euskara / 3-14 march, 14th en inglés) y además, la celebración coincide con la fecha del nacimiento de Albert Einstein. En 2009, el congreso de EEUU declaró oficialmente el 14 de marzo como el Día Nacional de Pi.

Actualmente, el Día de Pi es una celebración mundialmente conocida que sobrepasa el ámbito de las matemáticas. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

Este 2019 nos unimos de nuevo al festejo con el evento BCAM–NAUKAS, que se desarrolló a lo largo del 13 de marzo en el Bizkaia Aretoa de UPV/EHU. BCAM-NAUKAS contó durante la mañana con talleres matemáticos para estudiantes de primaria y secundaria y durante la tarde con una serie de conferencias cortas dirigidas al público en general.

Este evento es una iniciativa del Basque Center for Applied Mathematics -BCAM, enmarcada en la celebración de su décimo aniversario, y de la Cátedra de Cultura Científica de la Universidad el País Vasco.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Matemáticas modernas se ha escrito en Cuaderno de Cultura Científica.

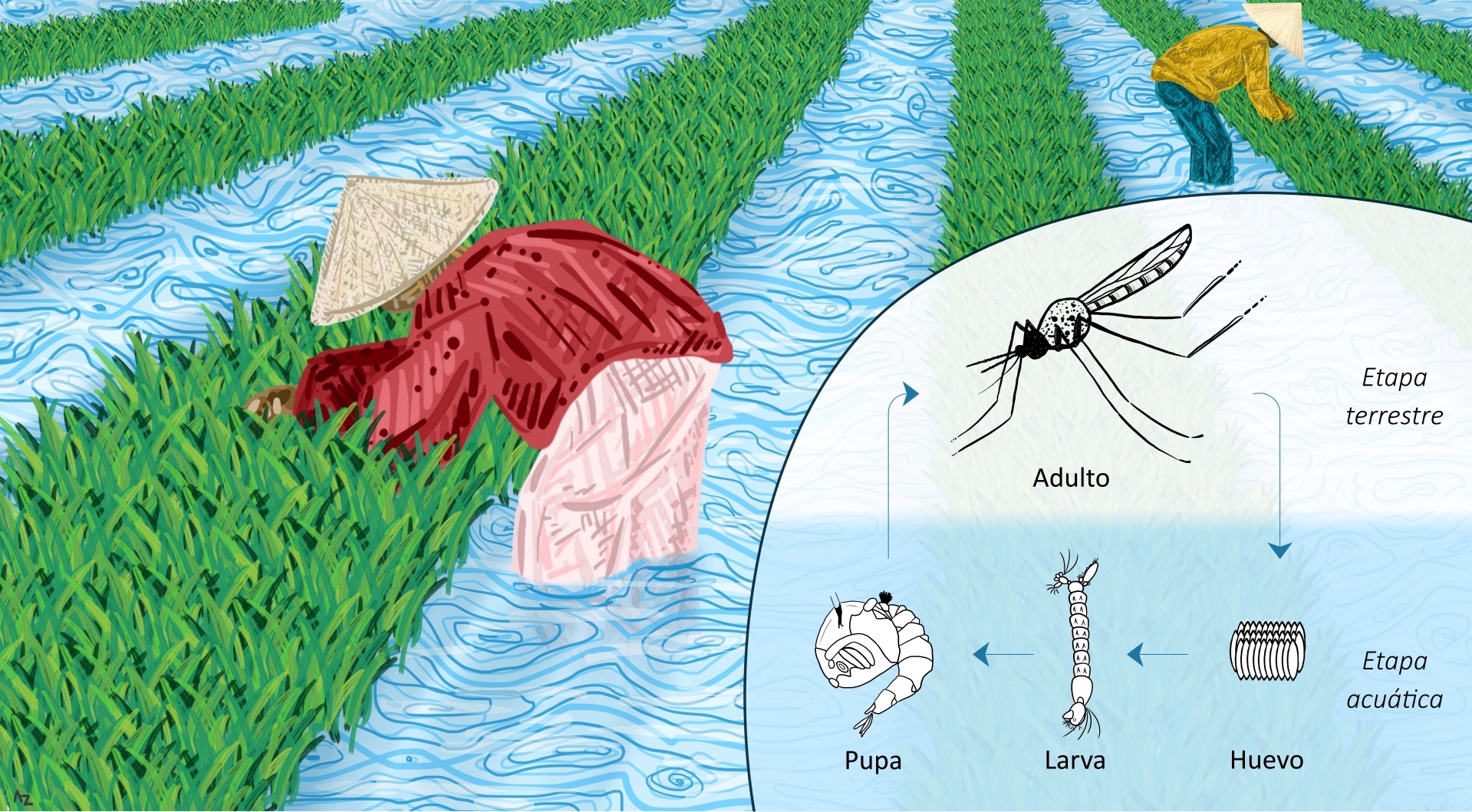

Entradas relacionadas:Historia y peligros del cultivo de arroz

En la actualidad, muchas regiones del mundo consumen alimentos que no se producen en el propio país. Este es el caso del arroz (Oryza sativa). Se calcula que en el sur-sudeste de Asia se produce entorno al 90% del arroz consumido en el mundo.

Análisis arqueológicos y genéticos indican que el arroz se domesticó hace 14.000-10.000 años en China. Tardó alrededor de 10.000-8.000 años en llegar a India y otros 2.000 en expandirse por Japón, Oriente Medio, Egipto, Grecia y Roma. Hace 1.300 años se introdujo en la Península Ibérica, gracias a los árabes. 500 años después se consumía en el norte de Europa y fue hace 300 años cuando se introdujo en Norteamérica, mediante esclavos africanos.

No hay que olvidar que el cultivo del arroz es complicado y peligroso ya que se necesita mucha agua y los lodazales de siembra son lugares idóneos para la cría de mosquitos Anopheles, puesto que sus huevos y el crecimiento de la larva y pupa se desarrolla en un medio acuático. En su etapa adulta, mediante sus picaduras, transmiten enfermedades como el paludismo o malaria.

En un estudio psicológico se comparó el comportamiento de los cultivadores de arroz con los de trigo. Los resultados mostraron que los primeros eran más interdependientes y holistas que los segundos. Esto ocurre porque la siembra del arroz, a diferencia del trigo, requiere cooperación.

Imagen: Ilustración del cultivo del arroz en un lodazal de siembra y la relación que muestra con el ciclo de vida del mosquito Anopheles. (Ilustración: Aida Zuriñe Campos Vivanco)

Imagen: Ilustración del cultivo del arroz en un lodazal de siembra y la relación que muestra con el ciclo de vida del mosquito Anopheles. (Ilustración: Aida Zuriñe Campos Vivanco)

En conclusión, el cultivo del arroz es una actividad que puede ser complicada y peligrosa, que lleva tras de sí miles de años de historia y expansión.

———————————-

Autora: Aida Zuriñe Campos Vivanco (@az_ciencia), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2018/19

Artículo original: Ingredientes para la receta: El arroz. Eduardo Angulo, Cuaderno de Cultura Científica, 5 de diciembre de 2018.

———————————-

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo Historia y peligros del cultivo de arroz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Desde cuándo nos repite el ajo?

- Ingredientes para la receta: El arroz

- En el mar, allí donde todo comienza

Parque cretácico

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Algunas producciones cinematográficas y su despliegue mediático han permitido que nuestra sociedad esté familiarizada con el Jurásico, ese periodo de la historia de la Tierra de hace entre 201 y 145 millones de años (ma a partir de aquí). Y yo, como geólogo, agradezco esta difusión, pero nuestro planeta presenta una gran historia de 4500 ma que podríamos considerar plenamente fascinante. La Geología, con la ayuda de las otras ciencias básicas, ha permitido conocer esta dilatada historia. Y de ella, voy a destacar la del periodo Cretácico (145-100 ma)… y os preguntaréis por qué…

Las montañas y valles de nuestro entorno, que tan acostumbrados estamos a pisar fruto de nuestra fusión ancestral con el territorio, están formadas principalmente por rocas sedimentarias que se originaron en el mar, y precisamente, las del Cretácico son las que mayor extensión presentan en el paisaje… ¡Las que más pisamos!

Geológicamente, nuestro entorno forma la región que denominamos vasco-cantábrica, donde localizamos Euskal Herria y zonas aledañas (Cantabria, Burgos,…). Este territorio se formó por el plegamiento de sedimentos y rocas que dio origen a los Pirineos; de hecho, también podemos denominarla Pirineo Occidental. Entre los periodos Triásico (hace aproximadamente 200 ma) y Paleógeno (hace aprox. 35 ma) esta región no era como la conocemos sino una amplia zona de sedimentación continental y marina comprendida entre el Macizo de Asturias al Oeste, la Sierra de la Demanda al Sur, y el Macizo de Bortziri-Aldude, al Este: la conocida por los geólogos como Cuenca (de sedimentación) Vasco-Cantábrica. Podemos imaginarla como un mar alimentado por ríos que nacían en las áreas continentales mencionadas (imagen 1).

Imagen 1. La región Vasco-Cantábrica hace 100 millones de años (edad Albiense). La imagen se presenta como si estuviera tomada desde el aire mirando hacia el sureste. Modificada de una imagen del mapa geológico del País Vasco (EVE. Ente Vasco de la Energia / Energiaren Euskal Erakundea).

Imagen 1. La región Vasco-Cantábrica hace 100 millones de años (edad Albiense). La imagen se presenta como si estuviera tomada desde el aire mirando hacia el sureste. Modificada de una imagen del mapa geológico del País Vasco (EVE. Ente Vasco de la Energia / Energiaren Euskal Erakundea).

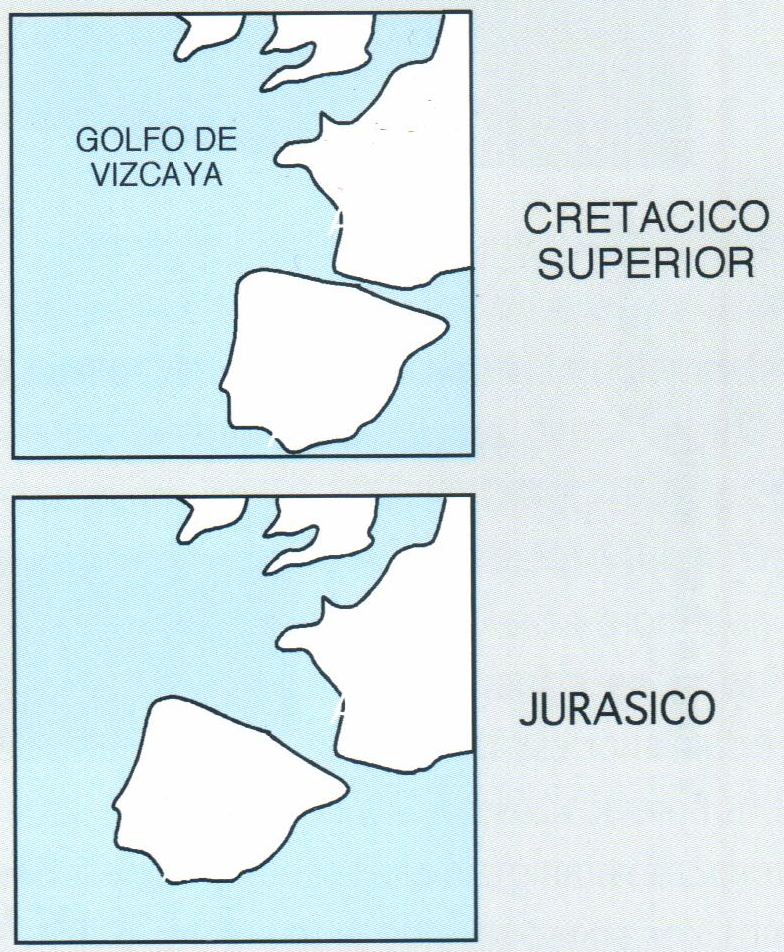

Pero esta imagen no era estática sino que iba cambiando a lo largo del tiempo: conforme se movía la placa de Iberia respecto de la de Europa y se iba abriendo el Golfo de Bizkaia (imagen 2), el mar iba ganando extensión y profundidad progresivamente hasta el momento en el que comienza la formación de los Pirineos, elevándose la topografía y pasando a ser una zona montañosa en erosión (imagen 3).

Imagen 2. Posición relativa de las placas de Iberia y de Europa en el Jurásico y en el Cretácico superior, donde se observa la apertura del Golfo de Bizkaia como consecuencia del movimiento relativo de ambas placas. Tomada del libro de Bodego et al. Eds. (ISBN 978-84-9860-991-2).

Imagen 2. Posición relativa de las placas de Iberia y de Europa en el Jurásico y en el Cretácico superior, donde se observa la apertura del Golfo de Bizkaia como consecuencia del movimiento relativo de ambas placas. Tomada del libro de Bodego et al. Eds. (ISBN 978-84-9860-991-2).

Así, durante el Cretácico, en nuestra región, además de mares y ríos que llevaban sus sedimentos hacia zonas costeras, había deltas, playas, estuarios…, los cuales son ejemplos de lo que denominamos medios sedimentarios. En ellos vivían comunidades de seres vivos que florecieron y se extinguieron, pero que dejaron su carácter en los sedimentos y rocas. El estudio de los organismos fósiles nos ayuda a entender mejor cómo era el medio sedimentario y viceversa, ya que los condicionantes físicos (p. ej. el oleaje) y químicos (p. ej. la salinidad del agua) influyen en el desarrollo de los seres vivos y en la distribución y depósito de sedimento.

Imagen 3. Mapa geológico actual de los Pirineos. La Región Vasco-Cantábrica es la parte occidental de esta cadena montañosa. Los colores verdes indican rocas sedimentarias plegadas. Con color amarillo se representan las zonas actuales con sedimentación continental. Tomada del libro de Bodego et al. Eds. (ISBN 978-84-9860-991-2).

Imagen 3. Mapa geológico actual de los Pirineos. La Región Vasco-Cantábrica es la parte occidental de esta cadena montañosa. Los colores verdes indican rocas sedimentarias plegadas. Con color amarillo se representan las zonas actuales con sedimentación continental. Tomada del libro de Bodego et al. Eds. (ISBN 978-84-9860-991-2).

La Cuenca Vasco-Cantábrica estuvo influenciada por procesos geológicos tales como actividad de fallas, vulcanismo, expansión de las áreas marinas, entre otros. El estudio de las rocas cretácicas de nuestra región ha permitido y permite conocer como han actuado estos procesos en un periodo con muchos cambios ambientales e influenciado por una climatología subtropical.

El Cretácico se divide en intervalos de tiempo Inferior y Superior y a su vez, en intervalos menores llamados edades, los cuales usaremos para ilustrar los principales ambientes y fósiles de nuestra región.

Así, al comienzo del Cretácico Inferior (edad Berriasiense a Barremiense; hace 145-125 ma) los ríos principales drenaban las zonas de Asturias y llevaban sus sedimentos arenoso-arcillosos a un mar de poca profundidad. En las zonas costeras se desarrollaron comunidades piscícolas de teleósteos primitivos, los antepasados directos de la mayoría de las especies actuales de peces (imagen 4).

Imagen 4. Pez fósil llamado Ezkutuberezi carmeni. Es un teleósteo primitivo que tiene el honor de ser el primer vertebrado fósil en conexión anatómica encontrado y descrito en nuestra Región. Longitud aproximada: 10 cm. Cretácico inferior. Foto: Mikel A. López-Horgue.

Imagen 4. Pez fósil llamado Ezkutuberezi carmeni. Es un teleósteo primitivo que tiene el honor de ser el primer vertebrado fósil en conexión anatómica encontrado y descrito en nuestra Región. Longitud aproximada: 10 cm. Cretácico inferior. Foto: Mikel A. López-Horgue.

Poco después, geológicamente hablando (Aptiense y Albiense; hace 125-100 ma), el mar ocupó mayor superficie y ganó en profundidad. La actividad de las fallas aumentó de tal manera, que sobre los bloques de falla hundidos el mar presentó profundidades mayores (>200m) mientras que sobre los bloques elevados no se pasaron de 40-50 m de columna de agua. En estas zonas de menor profundidad y con menor aporte de arenas y arcillas, las asociaciones de corales, bivalvos rudistas, algas y bacterias, entre otros, indujeron una sedimentación de carbonato cálcico que hoy día forman las calizas (arrecifales y de plataforma) tan abundantes y que configuran los principales relieves en nuestra geografía: Karrantza, Anboto, Aitzgorri, Aralar, entre otros. En las zonas con mayor profundidad proliferaban los ammonites, cefalópodos de concha tabicada, que ocupaban distintos hábitats pelágicos. El vulcanismo submarino del Albiense es un fenómeno que influyó en el medio marino, con procesos tales como la introducción de metales (p. ej. hierro) y la variación de la temperatura del entorno. La abundancia de calizas con microbios (bacterias, algas,…) y la diversificación de ciertos grupos (p. ej. crustáceos decápodos-cangrejos, langostas- y ammonites; imagen 5) son hitos evolutivos que suceden en el Albiense vasco-cantábrico, aunque no se ha demostrado todavía si hubo relación con el vulcanismo.

Imagen 5. A la izquierda una langosta fósil de edad Albiense. Habitaba en las zonas alejadas de la costa de un mar somero. Longitud aproximada: 10 cm. (Foto: Patxi Rosales Espizua). A la derecha un ammonite de gran tamaño. Edad Albiense. Habitaba un medio marino de mayor profundidad y alejado de la costa. Diámetro del fósil: 45 cm. Foto: Mikel A. López-Horgue.

Imagen 5. A la izquierda una langosta fósil de edad Albiense. Habitaba en las zonas alejadas de la costa de un mar somero. Longitud aproximada: 10 cm. (Foto: Patxi Rosales Espizua). A la derecha un ammonite de gran tamaño. Edad Albiense. Habitaba un medio marino de mayor profundidad y alejado de la costa. Diámetro del fósil: 45 cm. Foto: Mikel A. López-Horgue.

Un gran cambio ambiental ocurre al comienzo del Cretácico Superior (Cenomaniense; hace 100-93 ma): una subida del nivel del mar permitió que éste ocupara progresivamente amplias zonas continentales en toda la región (este fenómeno se conoce como transgresión marina), llegando la línea de costa hasta más al sur de la actual Soria, y desarrollándose una sedimentación de carbonato cálcico aportado principalmente por organismos unicelulares planctónicos (algas calcáreas, foraminíferos). En las zona de Bilbao-Plencia se llegó a un máximo de profundidad del mar, que según autores, alcanzaría los 1500-2000 m durante el Coniaciense (hace 86 ma). Esta transgresión es un proceso rápido geológicamente (aprox. 15 ma) que dificultó que los seres vivos respondieran a unas nuevas condiciones con áreas marinas más extensas, cambio en las corrientes oceánicas y en la profundidad, entre otros efectos, aunque también supuso oportunidades para nuevos grupos emergentes. Como ejemplo, la mayoría de los grupos de ammonites del Cretácico inferior desparecieron al final del Albiense (99 ma), diversificándose rápidamente a partir de pocos grupos con las nuevas condiciones. Asimismo, los peces teleósteos primitivos dejaron paso a los nuevos peces óseos. Los “constructores” de arrecifes y plataformas carbonatadas (corales, rudistas) se redujeron a algunas zonas de menor profundidad hacia el sur de la región. Una nueva fase de vulcanismo tuvo lugar durante el Santoniense (86-83 ma) en las zonas de mayor profundidad.

En el Campaniense-Maastrichtiense (83-66 ma), los ríos avanzaron sustancialmente hacia el norte, posibilitando un nuevo cambio en los ambientes. En estuarios y zonas costeras con sedimentación de arenas y arcillas proliferaron los tiburones y rayas, presentando una alta biodiversidad en la región. Asimismo, en sedimentos fluviales de este tiempo se ha encontrado una diversa asociación con más de 40 especies de vertebrados continentales, entre dinosaurios, pterosaurios, cocodrilos, tortugas, serpientes, lagartos, anfibios, mamíferos y peces, constituyendo uno de los yacimientos de vertebrados del Cretácico superior más importante de Europa.

El impacto de un meteorito en Yucatán marca el final del Cretácico (66 ma) y con ello se produce una de las llamadas extinciones masivas (en la historia de la Tierra se han diferenciado al menos 7), donde desaparecieron un 76% de las especies. Este fenómeno quedó registrado en los sedimentos arcillosos de mar profundo de Sopela, Zumaia y Bidart como una fina capa de entre 1 y 7 cm de espesor con un alto contenido en Iridio que supera cien veces la concentración de la corteza terrestre; este hecho se toma como evidencia directa del impacto de un meteorito, ya que éstos presentan igualmente concentraciones muy altas.

La vida volvió a abrirse camino después del Cretácico, y también volvió a sufrir cambios. La geología nos enseña una Tierra dinámica con procesos geológicos que controlan los cambios ambientales y el desarrollo de los seres vivos. El Cretácico es una pequeño pero apasionante capítulo de la historia de la Tierra, y su registro es especialmente importante en nuestra región vasco-cantábrica. ¿A que ahora podemos “pisar” nuestro paisaje de otra manera?

Para saber más:

- Bodego, A., López-Horgue, M. A., (2018). “Geología de los Pirineos occidentales: evolución ambiental a través de sus rocas y fósiles”. Registro fósil de los Pirineos occidentales, Eds.: Badiola et al., p.35-52. Vitoria-Gasteiz. Eusko Jaurlaritza.

- López-Horgue, M. A., Agirrezabala, L. M., Burgos, J., (2018). “Los ammonoideos de Mutriku: patrimonio único a preservar”. Registro fósil de los Pirineos occidentales, Eds.: Badiola et al., p.269-271. Vitoria-Gasteiz. Eusko Jaurlaritza.

- Bodego, A., López-Horgue, M. A., (2018). “Grandes desconocidos del registro fósil: los crustáceos decápodos del Mesozoico y Cenozoico de los Pirineos occidentales”. Registro fósil de los Pirineos occidentales, Eds.: Badiola et al., p.109-116. Vitoria-Gasteiz. Eusko Jaurlaritza.

Sobre el autor: Mikel López-Horgue es profesor en el Departamento de Estatigrafía y Paleontología de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo Parque cretácico se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arrecifes fósiles, una paradoja geológica

- Geología, Antropoceno y cambio climático

- La regla de los números intermedios y el parque automovilístico de Bilbao

¿Azúcar moreno o azúcar milagro?

Seguro que alguna vez habéis observado a gente echar azúcar moreno al café alegando que es más sano y contiene menos calorías que el blanco. No obstante, esto no es cierto.

Imagen: Proceso de obtención del azúcar blanco y moreno. Este comienza con la recolección de la caña o la remolacha azucarera, las cuales son troceadas y mezcladas con agua para poder extraer el jugo. Posteriormente se realiza un proceso de decantación química para eliminar las sustancias no deseadas, así como la evaporación del agua, de forma que parte de la sacarosa cristaliza y otra parte carameliza formando la melaza. Finalmente, la sacarosa se mezcla con la melaza en cantidades controladas para obtener el azúcar moreno. (Ilustración: Ledicia Prieto Vázquez)

Imagen: Proceso de obtención del azúcar blanco y moreno. Este comienza con la recolección de la caña o la remolacha azucarera, las cuales son troceadas y mezcladas con agua para poder extraer el jugo. Posteriormente se realiza un proceso de decantación química para eliminar las sustancias no deseadas, así como la evaporación del agua, de forma que parte de la sacarosa cristaliza y otra parte carameliza formando la melaza. Finalmente, la sacarosa se mezcla con la melaza en cantidades controladas para obtener el azúcar moreno. (Ilustración: Ledicia Prieto Vázquez)

Partimos de que estos dos tipos de azúcar salen de la caña o remolacha y al principio sufren un proceso de transformación idéntico. ¿Entonces, dónde difieren? Básicamente lo hacen en que el azúcar moreno lleva la propia sacarosa cristalizada junto con la melaza (sacarosa caramelizada, de color parduzco), mientras que el azúcar blanco solo lleva la primera. Es decir, el azúcar moreno, al igual que el blanco, está compuesto por sacarosa y por lo tanto no hay diferencia a nivel de calorías; aunque sí en la cantidad de minerales (ínfima) y en el sabor.

El azúcar moreno, debido a la melaza, es más amargo que el blanco. Así que si sumamos las creencias de que el azúcar moreno es más sano y más amargo, ¿qué se obtiene? Que se echará mayor cantidad de azúcar en la comida o bebida y se consumirán más calorías aún.

———————————-

Autora: Ledicia Prieto Vázquez (@araliart_l), alumna del Postgrado de Ilustración Científica de la UPV/EHU – curso 2018/19

Artículo original: Azúcar moreno, ¿mejor que el azúcar blanco? Déborah García Bello, Cuaderno de Cultura Científica, 3 de diciembre de 2018.

———————————-

“Ilustrando ciencia” es uno de los proyectos integrados dentro de la asignatura Comunicación Científica del Postgrado de Ilustración Científica de la Universidad del País Vasco. Tomando como referencia un artículo de divulgación, los ilustradores confeccionan una nueva versión con un eje central, la ilustración.

El artículo ¿Azúcar moreno o azúcar milagro? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Azúcar moreno, ¿mejor que el azúcar blanco?

- Miel y siropes, ¿son mejores que el azúcar?

- El azúcar oculto en los alimentos

Puedes llamarlo responsabilidad, pero es censura

Hay hechos que pueden hacer que ciertas ideologías se tambaleen. Hay hechos cuya difusión puede causar una importante repercusión social, sanitaria, incluso moral. Podemos optar por negarlos, por divulgarlos, o por ocultarlos. La oscuridad (en contraposición etimológica a ilustración) acostumbra a presentarse como un acto de responsabilidad. La posmodernidad y su disfraz lingüístico. En ocasiones llamamos responsabilidad a lo que realmente es censura.

Para ponernos en situación imaginemos que un hecho disparatado es cierto. Por ejemplo, se ha comprobado científicamente que las personas de color son intelectualmente inferiores a las blancas. (Obviamente esto no es así, pero sirve de ejemplo). ¿Qué hacemos con este hecho? ¿Es posible divulgar este hecho de forma responsable? ¿Lo responsable sería ocultarlo? Si optásemos por censurarlo, la razón a la que se apelaría es la responsabilidad social. Se ocultaría para prevenir un mal mayor, como dotar de argumentos a los movimientos xenófobos. No obstante, si un hecho así fuese cierto, no tendría porqué hacer peligrar la igualdad de derechos y oportunidades. Un estado de derecho debería garantizarlos igualmente, sean cuales sean las capacidades intelectuales de los individuos de esa sociedad. De la misma manera, el estado procura que las personas con algún tipo de discapacidad intelectual no sean discriminadas por ello. Sí, pero. Vaya dilema. ¿Lo divulgamos o lo censuramos?

Cuando un hecho contradice aquello en lo que se sustentan nuestras ideologías y nuestros valores, nos coloca ante el espejo. Siguiendo con el ejemplo. Si el hecho probado fuese el contrario, que las personas de color son intelectualmente superiores a las blancas, con toda seguridad este hecho se divulgaría sin problemas y sin tanto dilema moral de por medio. Esto nos lleva a una reflexión que esconde una realidad todavía más incómoda: la condescendencia y el paternalismo por el que decidimos qué hechos científicos divulgamos. También revela algo peor.

La realidad es que este tipo de situaciones se dan con cierta frecuencia, sobre todo en la actualidad y, sobre todo en ciencias. Hay hechos científicos que generan acalorados debates sobre la idoneidad de su divulgación. No hay debate sobre su veracidad, sino sobre la conveniencia de sacarlos a la luz.

Fuente: CDC

Fuente: CDC

Por ejemplo, es un hecho conocido por la comunidad científica que la eficacia de la vacuna de la gripe es baja. Algunos años fue solo del 10%, y otros alcanzó máximos del 60%. Para una vacuna, es una efectividad baja. La divulgación de este hecho es controvertida porque hay quien opina que puede disuadir a grupos de riesgo de vacunarse, puede poner en entredicho la efectividad de las vacunas en su conjunto o puede usarse como argumento antivacunas. Quien defiende su divulgación argumenta que la información debe estar a disposición de todos y que ocultar estos datos es una forma de censura. También se puede llamar responsabilidad social. O condescendencia. Al fin y al cabo, ocultar esta información nos da la medida de lo poco preparada que pensamos que está la sociedad para asumir este hecho y actuar igualmente de forma responsable. También nos da la medida de cómo creemos que algunos medios de comunicación podrían informar de este hecho o alarmar sobre él.

Con respecto a temas sanitarios hay otros muchos hechos cuya divulgación está sujeta a controversia, como la insuficiente efectividad del cribado o diagnóstico precoz en algunos tipos de cáncer, o el uso deliberado de placebos como método terapéutico efectivo. Hechos cuya divulgación podría hacerse de forma tendenciosa e irresponsable a fin de desprestigiar el sistema sanitario.

Ilustración: César Mejías para El Definido

Ilustración: César Mejías para El Definido

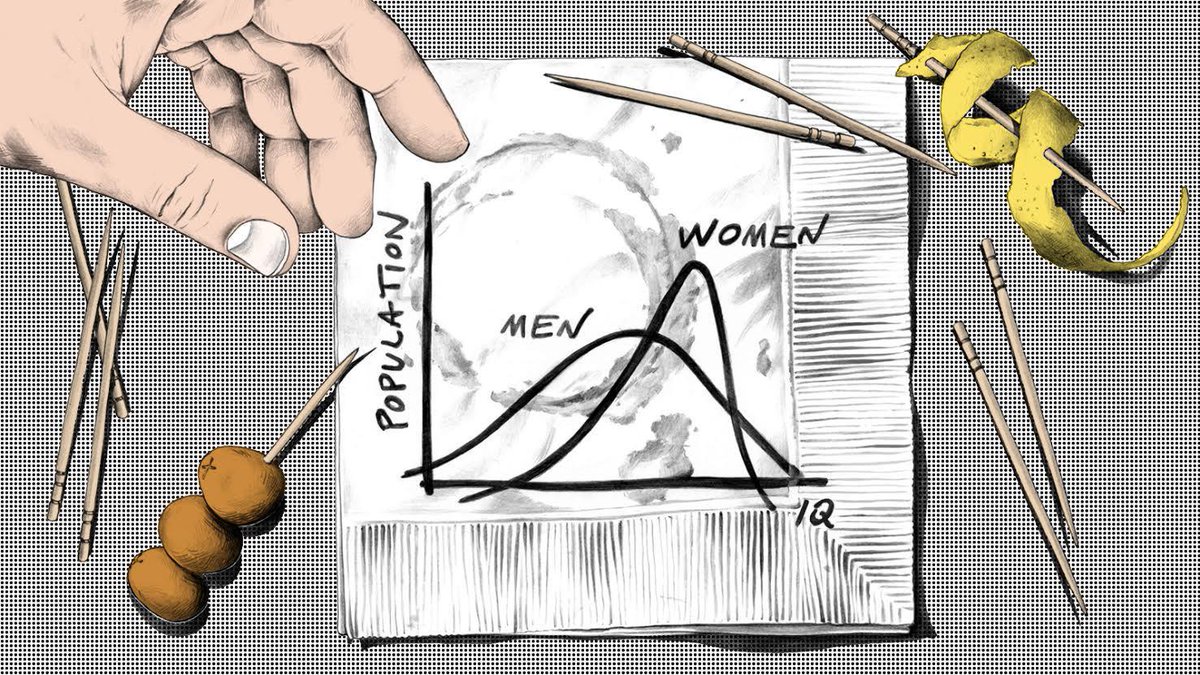

La divulgación de hechos biológicos también suscita apasionadas discusiones. Las diferencias halladas entre los cerebros de hombres y mujeres resultan inconvenientes para los creyentes en ciertas ideologías, que consideran estos hechos como un ataque que podría hacer peligrar la igualdad de género. También hay quien los niega tildándolos de neurosexismo, es decir, negando que sean hechos y defendiendo que solo se trata de la lectura estereotipada de los datos.

La realidad es que las diferencias entre los cerebros masculino y femenino tienen interés científico. De igual manera que ha resultado muy esclarecedor el estudio de las diferencias metabólicas, hormonales o de las de cualquier órgano entre hombres y mujeres, incluido el cerebro. Tanto es así, que la inclusión de las mujeres en estudios clínicos supuso un gran adelanto en medicina, pudiendo ofrecer tratamientos más adaptados a las necesidades de unos y otros.