¿Podría un humano vivir en el mar?

Los bajau laut viven en torno a las costas de Filipinas, Indonesia, Malasia y Brunéi y son mundialmente conocidos como «los nómadas del mar». Esta denominación es debida a que el pueblo bajau vive literalmente en el mar desde hace, como mínimo, 1.000 años. Pero, ¿cómo es eso de que viven en el mar?

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Podría un humano vivir en el mar? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Qué tienen en común Einstein y una zanahoria?

- ¿Hemos intentando contactar con extraterrestres?

- ¿Qué pasa en tu cuerpo cuando te enamoras?

El pico petrolero

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Fotografía: Pixabay

Fotografía: Pixabay

¿Qué es el pico del petróleo (peak oil)?

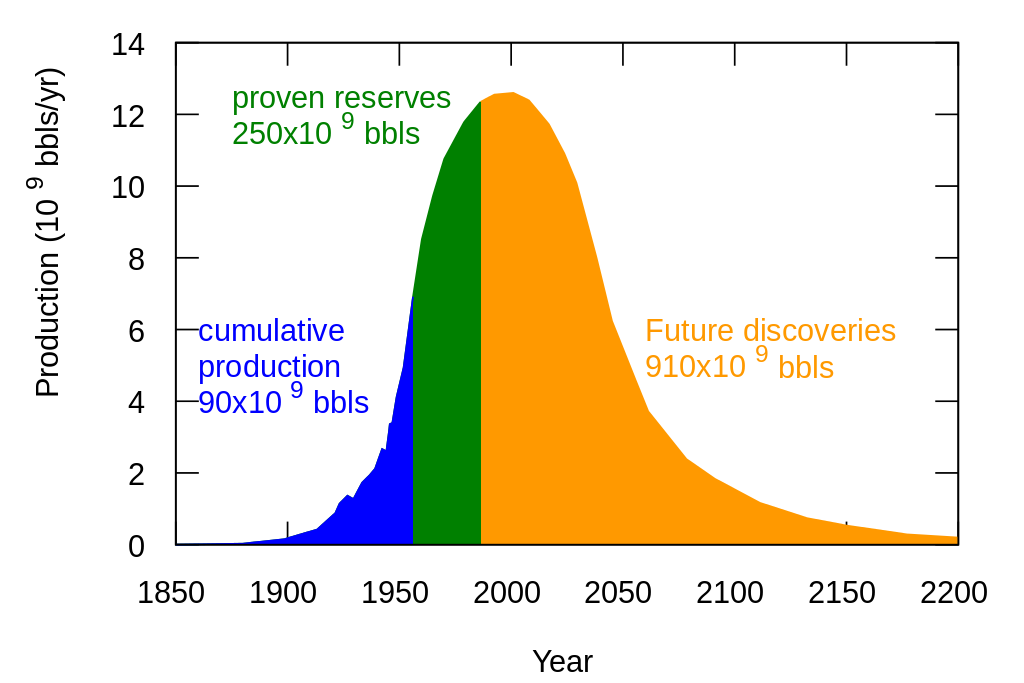

El pico (o cénit) petrolero es el momento de máxima tasa de extracción del petróleo. Es un momento teórico a partir del cual se espera que la cantidad de petróleo disponible decline de manera irreversible. El concepto de pico del petróleo se atribuye a Marion King Hubbert (1903-1989) geólogo y geofísico estadounidense, quien en 1956 lo presentó por primera vez de manera formal (Figura 1). Este concepto se basa en extrapolar la historia conocida de yacimientos en explotación o que han sido explotados al total mundial. Los yacimientos de petróleo alcanzan muy rápido su pico de producción, para pasar después a una meseta, en la que la producción se mantiene más o menos constante, seguida de un largo declive. De hecho, la mayor parte del petróleo de un yacimiento se extrae en esta última fase.

Figura 1. Propuesta M. King Hubbert de 1956 en la que se muestra la producción acumulada (en azul), así como una proyección hacia el futuro en base a las reservas probadas (en verde) y descubrimientos futuros. Este geólogo proponía el pico del petróleo en el año 2000 con una producción máxima de alrededor de la mitad que se produjo en 2016 (29.400 millones de barriles al año). Esta predicción fue realizada casi una década antes de que se produjera el máximo de descubrimientos de petróleo, en la década de los 60 (Figura 2). Licencia Creative Commons.

Figura 1. Propuesta M. King Hubbert de 1956 en la que se muestra la producción acumulada (en azul), así como una proyección hacia el futuro en base a las reservas probadas (en verde) y descubrimientos futuros. Este geólogo proponía el pico del petróleo en el año 2000 con una producción máxima de alrededor de la mitad que se produjo en 2016 (29.400 millones de barriles al año). Esta predicción fue realizada casi una década antes de que se produjera el máximo de descubrimientos de petróleo, en la década de los 60 (Figura 2). Licencia Creative Commons.

¿Qué es la tasa de retorno energético (TRE)?

El TRE se calcula dividiendo la cantidad de energía total que es capaz de producir una fuente de energía y la cantidad de energía que es necesaria “invertir” para explotar esta fuente. Un TRE alto indica una fuente de energía “rentable” (en términos energéticos), un TRE de 1 indica la cantidad de energía “invertida” y producida es la misma, por lo cual no aportaría energía extra al sistema, mientras que un TRE menor de uno indicaría que se trata de un sumidero energético, una fuente que aporta menos energía neta que la que es necesario invertir.

Si aplicamos el concepto de TRE a los yacimientos de petróleo vemos que cada yacimiento tiene un TRE distinto, y que, en promedio, el TRE de los yacimientos descubiertos ha ido disminuyendo a lo largo del tiempo. Los yacimientos con un petróleo de más calidad y cercanos a la superficie y, por tanto, más fácilmente explotables, fueron los primeros en explotarse. Posteriormente se han ido explotando yacimientos de más difícil acceso, y que, por lo tanto, tienen menores TREs. En el cómputo global, por tanto, a partir del cénit de extracción no sólo hay cada vez menos petróleo, sino que además se explotan yacimientos con cada vez menor TRE.

¿Hemos llegado al pico del petróleo?

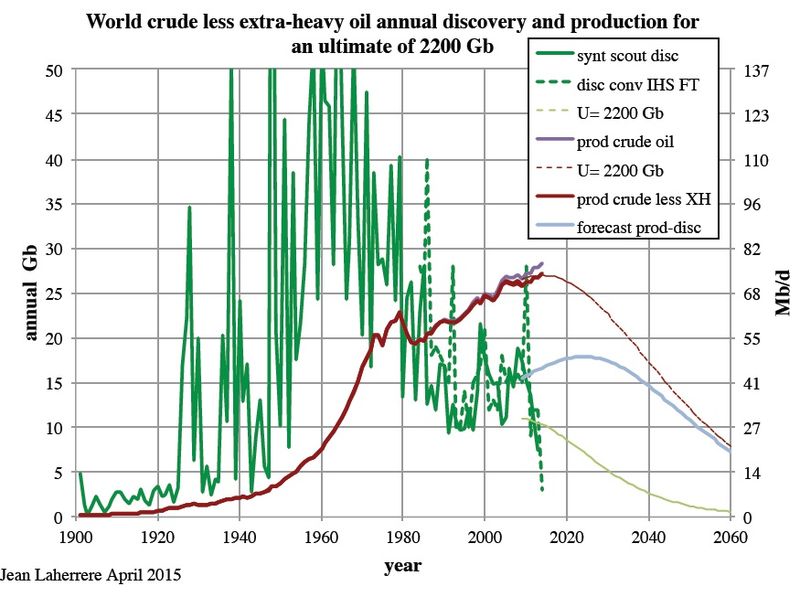

Ésta es una pregunta complicada, por varios motivos. Por un lado, porque certificar con seguridad el pico petrolero solo puede hacerse una vez éste ha pasado y actualmente sólo podemos intentar estimar el mismo en base a las tendencias en la producción y descubrimiento de yacimientos. Por otro lado, lo que habitualmente llamamos petróleo en realidad engloba varias categorías de hidrocarburos líquidos: petróleo crudo convencional, crudo extra-pesado, arenas bituminosas, petróleo ligero de roca, etc, cuyo cénit de producción debería calcularse por separado. Aunque el número de descubrimientos se mantiene estable desde finales del s. XX, después de haber tenido su máximo en la década de los 60 del pasado siglo (Figura 2), el TRE de estos yacimientos es menor. Esto no debe sorprendernos, ya que se trata de un recurso finito, no-renovable, y es razonable pensar que los yacimientos más grandes y más ricos fueron los primeros en ser descubiertos. Algunas estimaciones indican que es probable que estemos viviendo actualmente el pico del petróleo crudo convencional.

Figura 2. Descubrimiento de petróleo (en verde) junto con la producción (en rojo). En esta gráfica se puede ver que el máximo de descubrimientos se realizó en la década de los 60. La producción creció muy rápidamente a partir del fin de la segunda guerra mundial para alcanzar un primer máximo en 1979, con un crecimiento posterior más lento. Fuente: Figura por Jean Laherrere (Creative Commons).

Figura 2. Descubrimiento de petróleo (en verde) junto con la producción (en rojo). En esta gráfica se puede ver que el máximo de descubrimientos se realizó en la década de los 60. La producción creció muy rápidamente a partir del fin de la segunda guerra mundial para alcanzar un primer máximo en 1979, con un crecimiento posterior más lento. Fuente: Figura por Jean Laherrere (Creative Commons).

¿Cuáles son las implicaciones del pico petrolero?

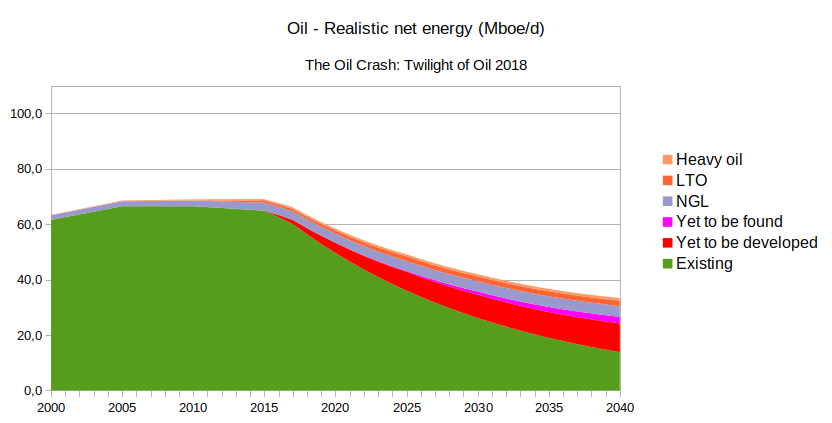

La primera, implícita en la propia definición del pico petrolero es la disminución progresiva del petróleo y de la energía que puede ser extraída del mismo. La Agencia Internacional de la Energía (AIE; o IEA en sus siglas en inglés) publica cada año un informe sobre la situación energética internacional (World Energy Outlook; WEO), tratando distintos apartados, entre ellos el petróleo. El último informe indica una previsión de crecimiento de la demanda mundial de petróleo debido al creciente transporte por carretera, aviación y de las petroquímicas, que se cifra en más de 10 millones de barriles diarios para 2025. Por otro lado, la AIE realiza una predicción de la producción del petróleo y prevé que para el año 2025 faltarán al menos 13 millones de barriles de petróleo para satisfacer las demandas. En base a los datos publicados por la AIE, Antonio Turiel, científico titular del CSIC, ha calculado la energía neta que de manera realista ofrece el petróleo actualmente y que ofrecerá en el futuro. Esos cálculos indican una disminución de más del 50% en los próximos 25 años, pasando de 69 millones de barriles equivalentes diarios a 33 millones en el año 2040 (Figura 3).

Figura 3. Estimación de la energía neta a partir del petróleo hasta el año 2040. Se ha usado la predicción de producción proporcionada por la Agencia Internacional de la Energía, aplicándole la tasa de retorno energético. Gráfica realizada por Antonio Turiel.

Figura 3. Estimación de la energía neta a partir del petróleo hasta el año 2040. Se ha usado la predicción de producción proporcionada por la Agencia Internacional de la Energía, aplicándole la tasa de retorno energético. Gráfica realizada por Antonio Turiel.

El cénit de producción es un concepto que se puede aplicar a todo recurso no renovable. De hecho, además del cénit de producción del petróleo también se habla de otros cénits de recursos energéticos como el carbón, el uranio o el gas natural, algunos de los cuales (los combustibles fósiles) podrían estar también próximos en el tiempo ( menos de 20 años). En definitiva, la perspectiva de una disminución de la energía neta disponible es real.

Los intentos de mejora de la eficiencia energética podrían ayudar a la disminución de la energía por persona. Por desgracia, parece probado que la mejora de la eficiencia en la que se usa un recurso debido al desarrollo tecnológico, más que disminuir el consumo de dicho recurso, hace más probable un aumento en el consumo del mismo (paradoja de Jevons). Por otro lado, la sustitución del petróleo y otros combustibles fósiles por otras fuentes de energía, no es un asunto sencillo, ya que hay ciertos sectores (p.ej., transporte aéreo, transporte pesado por mar y carretera) cuya electrificación no es viable. Además, estos intentos de sustitución necesitarían en su desarrollo ingentes cantidades de energía y/o de materias primas raras y escasas.

Existe una correlación entre la economía real y la cantidad de energía disponible, y el petróleo está muy imbricado en todos los sectores económicos. Por ello, la disminución de la cantidad disponible de petróleo y otros combustibles fósiles, y por ende, de la energía disponible, tiene implicaciones a muchos niveles en el sistema económico mundial. Además, el control de recursos energéticos y minerales son los condicionantes principales de las agendas geoestratégicas de las grandes potencias.

El cénit de la producción de petróleo, al igual que el cénit de producción de otros combustibles fósiles, son parte y consecuencia del cambio global; es decir, del conjunto de cambios que tiene un origen antropogénico y que están teniendo repercusiones a escala geológica. Las consecuencias de las actividades humanas, incluyendo el cambio climático y la pérdida masiva de biodiversidad, son los grandes desafíos a los que se debería estar enfrentando nuestra especie actualmente.

Para saber más:

Miller Richard, G., Sorrell Steven, R., 2014. The future of oil supply. Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences 372, 20130179.

A. Turiel (2019).

M. Mediavialla et al. (2019).

G. Tverberg (2019).

Sobre el autor: Asier Gómez es investigador Ramón y Cajal en el Departamento de Estratigrafía y Paleontología de la Facultad de Ciencia y Tecnología de la UPV/EHU.

El artículo El pico petrolero se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Energía oscura

- Espectrometría de masas: de un isótopo de neón a elefantes que vuelan

- Proteómica: cuando las proteínas y la espectrometría de masas van de la mano

El progreso nos salvará del ecologismo

Clausura (2014) de Santiago Talavera. Acuarela, tinta, lápiz de color y collage sobre papel. 180 x 152 cm

Clausura (2014) de Santiago Talavera. Acuarela, tinta, lápiz de color y collage sobre papel. 180 x 152 cm

El ecologismo surgió en la década de 1960 como consecuencia de, primero, el conocimiento científico resultado de la ecología, las ciencias de la Tierra, la meteorología, la zoología, la botánica, etc. Y, segundo, de la romantización de la naturaleza. Esto tiene como origen la definición presocrática de la naturaleza, es decir, que la naturaleza es la totalidad de las cosas a excepción del hombre y de las cosas del hombre.

En esencia, el ecologismo podría entenderse como una forma de progreso, ya que su prioridad es la salud del planeta. El planeta es nuestra casa, así que su mantenimiento es, a fin de cuentas, una garantía de evolución y bienestar humanos. Sin embargo, el movimiento ecologista tradicional se desmarca del progreso, precisamente por cómo define la naturaleza. Tanto es así, que para el ecologismo el progreso es una suerte de reiterados pecados contra la naturaleza. Así es el movimiento ecologista gestado en la década de 1970, esa ideología verde de activistas como Al Gore, el papa Francisco o Greenpeace.

El ecologismo verde o ecologismo tradicional anhela una naturaleza prístina. Como si esa naturaleza hubiese sido mancillada por la humanidad. Es una visión infantilizada de la naturaleza. Esta idealización tiene sus consecuencias, en primer lugar intelectuales, que son las más graves, y en segundo lugar prácticas, que afectan a la economía, la política, la ciencia y la tecnología, entre otras.

Algunas de las consecuencias intelectuales del ecologismo tradicional son el pesimismo y el nihilismo. El ecologismo es un movimiento apocalíptico: agotamiento de recursos, superpoblación, pobreza, enfermedad… Y, como la mayoría de movimientos apocalípticos, es misántropo. Culpa a la humanidad de la inevitable catástrofe, definiendo así a la humanidad como el cristianismo se refiere al pecado. Y no solo culpa a la humanidad, sino que solicita su retirada. Con frecuencia aluden a la humanidad como al cáncer de la naturaleza, y como tal, hay que combatir la enfermedad siguiendo una estrategia radical. La fantasía última es un planeta despoblado. Por lo de pronto pretenden el retroceso de las actividades humanas: la desindustrialización y el rechazo al progreso, a la ciencia y a la tecnología. Esto lo vemos en el ecologismo que rechaza la ingeniería genética, la síntesis química, la radiación wifi o la energía nuclear. Un movimiento que nació en parte como consecuencia del conocimiento científico, ahora lo contradice.

El ecologismo tradicional incurre en una serie de errores precisamente por tratarse de un movimiento anticientífico, o contrailustrado, como quiera llamarse. Por ejemplo, la idealización de las reservas naturales. Este es un fenómeno curioso, ya que las llamadas reservas naturales no son santuarios naturales, sino producto de la civilización. Son espacios protegidos y controlados. Lo mismo ocurre con la llamada agricultura ecológica. Agricultura ecológica es un oxímoron. La agricultura, por definición, contradice a la ecología tradicional. La agricultura es una de las prácticas humanas que produce un mayor impacto medioambiental y supone un desequilibrio dirigido de los ecosistemas. No hay más que ver la parcelación del paisaje. Destrozamos el suelo, lo allanamos, lo inundamos y lo plagamos de monocultivos. Cultivos que, por cierto, son engendros genéticos que ni siquiera sobrevivirían sin el cuidado permanente que hacemos de ellos.

La llamada agricultura ecológica genera más impacto que la llamada agricultura tradicional precisamente porque la agricultura ecológica rechaza el progreso científico y tecnológico. Necesita más terreno para producir la misma cantidad de alimento, tiene menor rendimiento, con lo cual es menos sostenible. Por ejemplo, la agricultura ecológica no contempla los cultivos hidropónicos, que ni siquiera necesitan suelo. Ni el uso de transgénicos, aunque ello suponga dejar de emplear pesticidas. Es como si la agricultura ecológica respondiese a una idealización nostálgica de lo que fue la agricultura hasta un momento concreto, congelado en el tiempo de forma arbitraria. Esa es la idea, aunque en la práctica ni siquiera es así de romántica. Los cultivos ecológicos a menudo se encuentran bajo invernadero y apenas se diferencian de la agricultura tradicional que simplemente se ha quedado anclada unas décadas atrás.

El ecologismo tradicional se está convirtiendo en un movimiento meramente cosmético. Resulta muy ilustrativa la preocupación y el malestar que nos provoca encontrarnos con pequeños trozos de plástico en la playa, en contraposición con la indiferencia que nos producen los cantos de vidrio, cemento o ladrillo. Por si hay dudas, el impacto medioambiental de los materiales cerámicos es mayor que el de los plásticos. Otro ejemplo. Nos parece idílica y consecuente la vida en el campo, las casas antiguas con paredes de piedra. Efectivamente tienen un valor estético y arquitectónico, pero no ecológico. La vida en las ciudades, en edificios, además de dejar más espacio al campo, si se quiere, para las anheladas reservas naturales, necesita menos recursos para el desplazamiento, construcción y calefacción. El techo de uno es el suelo del otro. Otro ejemplo. Las cascadas artificiales de la energía hidráulica, los paneles solares de la energía fotovoltaica, los molinos de la energía eólica que abarcan inmensas extensiones de terreno. No los contemplamos como las perturbaciones del paisaje que de hecho son, sino como parte de la lucha contra el calentamiento global. Hemos aprendido a contemplar esas monstruosidades como ecologismo. Sin embargo, una central nuclear, que es más sostenible, genera mucha más energía a partir de menos recursos, con un menor impacto medioambiental, la apreciamos como lo contrario al ecologismo. Efectivamente el ecologismo es un movimiento cosmético.

Por estas razones, otro tipo de ecologismo es posible. El ecologismo ilustrado. Se trata de un ecologismo que permanece ligado al conocimiento científico y, por tanto, entiende que los problemas medioambientales a los que nos enfrentamos sí tienen solución y esta vendrá de la mano del progreso. No es un movimiento apocalíptico, sino optimista y realista. No define a la naturaleza al estilo presocrático, sino que la humanidad entra dentro de la definición de la naturaleza que se pretende preservar. Por tanto, el bienestar humano es crucial.

Las soluciones que propone el ecologismo ilustrado a los problemas medioambientales pasan por el uso de todo el conocimiento científico y tecnológico que hemos generado hasta ahora. De la ingeniería genética a la física nuclear.

Escapar de la pobreza requiere energía y alimentos en abundancia. Escapar de la pobreza intelectual requiere ilustración. Escapar de la pobreza requiere progreso.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo El progreso nos salvará del ecologismo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sin ciencia no hay progreso

- #Naukas14: La fragilidad del progreso

- El falso pan integral tiene los días contados

El poema de los números primos

El Centro Internacional de Cultura Contemporánea TABAKALERA, de Donostia/San Sebastián nos ha regalado estos días una maravillosa exposición de la artista donostiarra Esther Ferrer, comisariada por Laurence Rassel y Mar Villaespesa. Bajo el título Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… (del 5 de abril al 26 de mayo de 2019), la exposición recoge, en cuatro espacios conectados de Tabakalera, cuatro grupos de obras emblemáticas de la artista Esther Ferrer: proyectos espaciales, una visión general de las performances más significativas de su carrera (con realizaciones de las performances cada viernes), obras de la serie Poema de los números primos, y cuadros de la obra Pi.

Cartel de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… (del 5 de abril al 26 de mayo de 2019), en el Centro Internacional de Cultura Contemporánea TABAKALERA, de Donostia/San Sebastián. Imagen de Tabakalera

Cartel de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… (del 5 de abril al 26 de mayo de 2019), en el Centro Internacional de Cultura Contemporánea TABAKALERA, de Donostia/San Sebastián. Imagen de Tabakalera

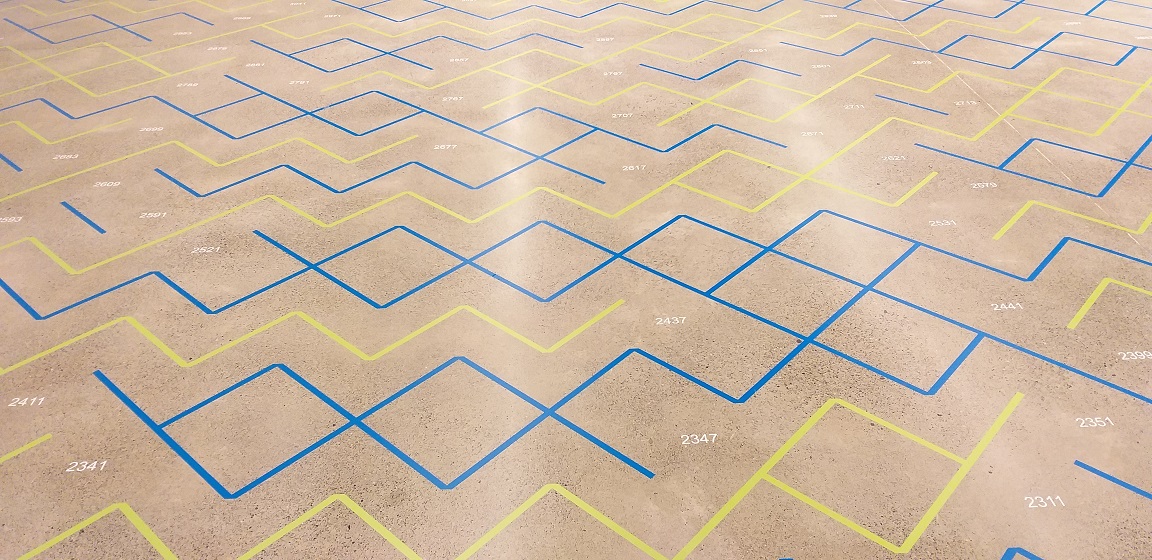

Vista parcial del suelo de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera, mostrándonos un “mar de números primos” generado por la artista Esther Ferrer, para esta obra de la serie Poema de los números primos diseñada expresamente para la exposición. Fotografía: Raúl Ibáñez

Vista parcial del suelo de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera, mostrándonos un “mar de números primos” generado por la artista Esther Ferrer, para esta obra de la serie Poema de los números primos diseñada expresamente para la exposición. Fotografía: Raúl Ibáñez

Los números primos constituyen un elemento fundamental en la obra artística de Esther Ferrer, que ella ha utilizado desde las décadas de los años 1970 y 1980, a través de diferentes estructuras espaciales planas, como la conocida espiral de Ulam.

La propia artista, con motivo de su exposición en Artium en 2011, explica el origen de su trabajo con representaciones espaciales de los números primos:

“Tras algunos años, en la década de los 70, realizando proyectos con estructuras geométricas definidas únicamente en función de mis propios criterios, sentí la necesidad de pensar otras en las cuales mis preferencias estéticas jugaran un papel secundario. Estructuras libres que pudieran evolucionar por sí mismas, según su lógica interna…

Durante algún tiempo no conseguí un resultado que me satisficiera hasta que una noche soñé con los números primos, así empecé la serie, EL POEMA DE LOS NÚMEROS PRIMOS.”

Además, el título de la serie juega con la similitud de las palabras poema y teorema (recordemos que un teorema es una verdad matemática demostrable), “poema = teorema – ter + p”, así mismo este título nos habla de la poesía que está detrás de los números, en particular, de los números primos.

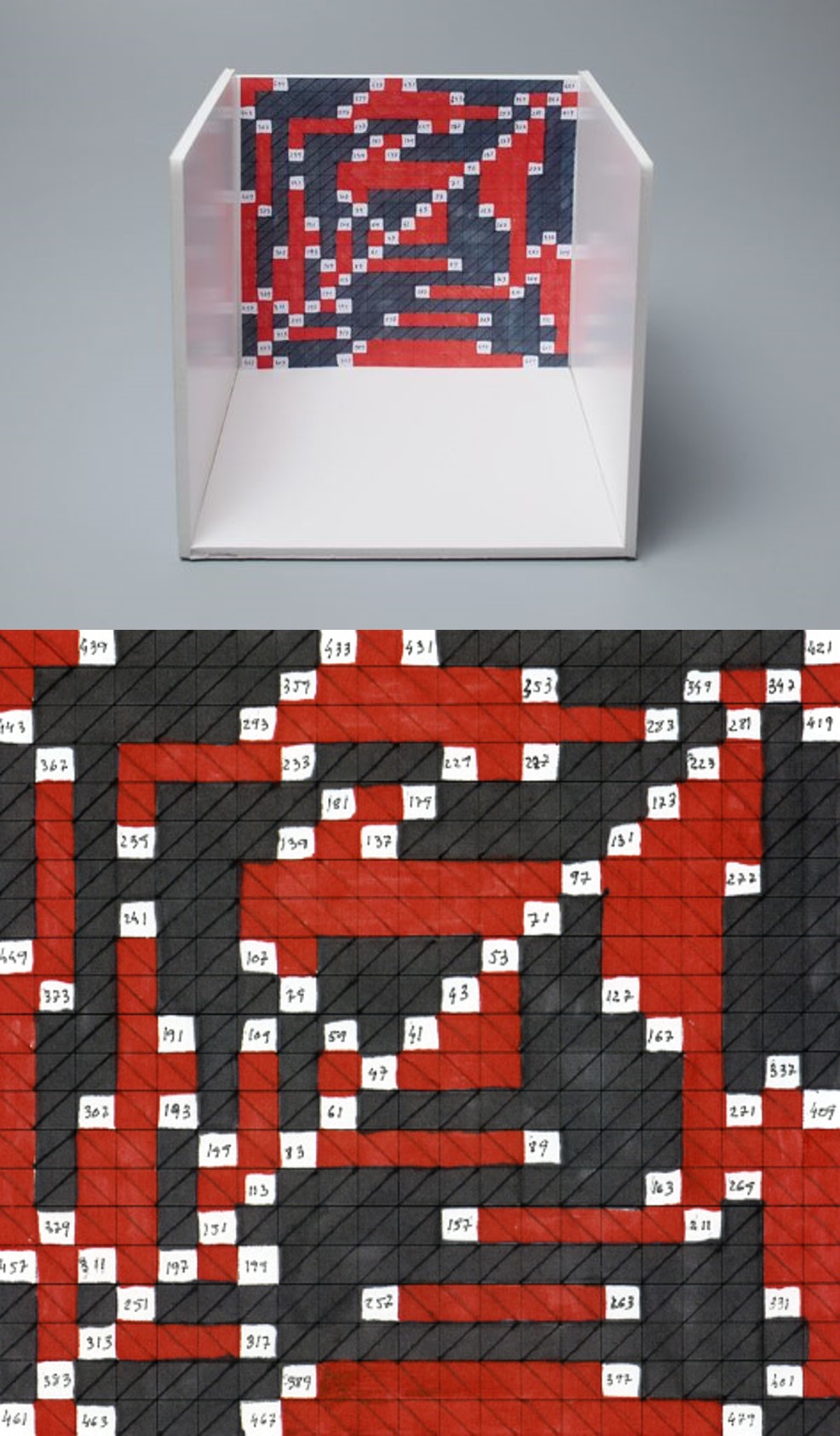

Maqueta de un proyecto de números primos hexagonales, de la serie Poema de los números primos (1989), de la artista Esther Ferrer. Edición especial producida por ARTIUM, Centro-Museo Vasco de Arte Contemporáneo, en 2011

Maqueta de un proyecto de números primos hexagonales, de la serie Poema de los números primos (1989), de la artista Esther Ferrer. Edición especial producida por ARTIUM, Centro-Museo Vasco de Arte Contemporáneo, en 2011

Pero vayamos con los objetos matemáticos utilizados por la artista donostiarra, los números primos, la espiral de Ulam y otras estructuras geométricas planas formadas por números.

Aunque seguramente todas las personas que estáis leyendo esta entrada del Cuaderno de Cultura Científica conocéis el concepto de número primo, siempre es conveniente empezar por el principio. Los números primos son aquellos números que solamente se pueden dividir por 1 y por ellos mismos. Así, por ejemplo, el número 25 no es un número primo ya que se puede dividir por 5, además de por 1 y 25, o tampoco el 33, divisible por 3 y 11, mientras que el número 17 sí es primo, ya que solamente es divisible por el 1 y el mismo, al igual que los números 2, 3, 5, 7, 11, 13 o 19.

El teorema fundamental de la aritmética, que ya aparece en el libro Los Elementos, de Euclides de Alejandría (aprox. 325 -265 a.n.e.), y que nos dice que todo número puede expresarse, de forma única, como producto de números primos, por ejemplo, el número 924 es igual al producto de 2 x 2 x 3 x 7 x 11, pone de manifiesto la importancia de esta familia de números. Además, este resultado es el motivo por el cual el número 1 no se considera un número primo, puesto que en ese caso no se daría la unicidad.

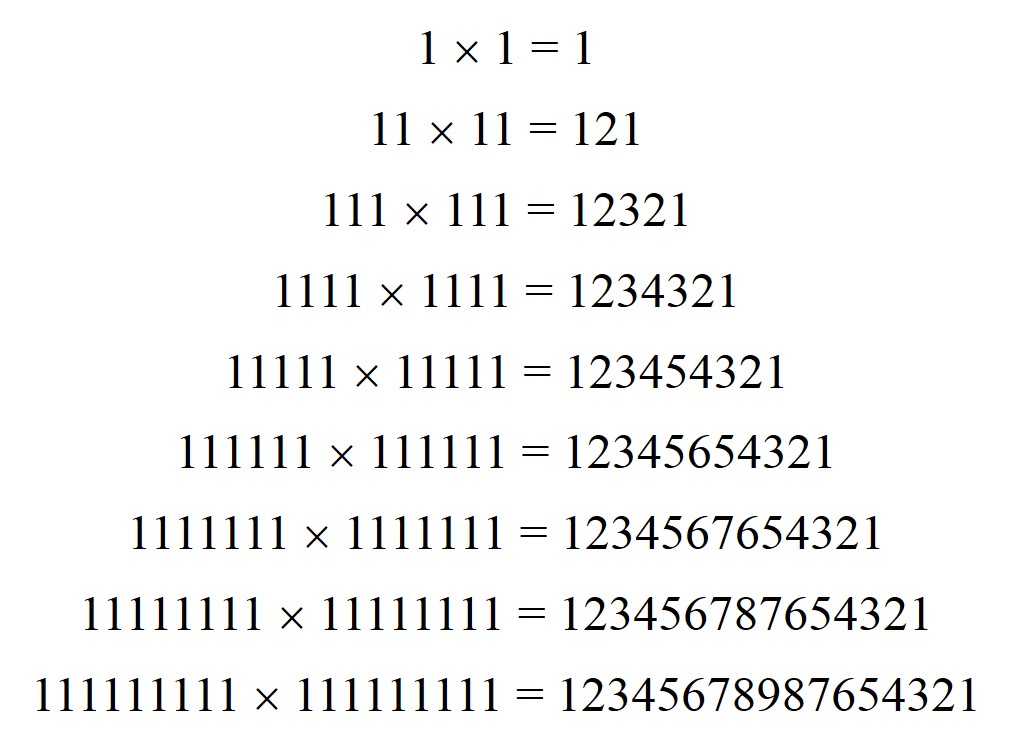

En la Antigua Grecia ya conocían también un método para obtener números primos, conocido como la criba de Eratóstenes. Este método aparece descrito en el texto Introducción a la Aritmética, del filósofo y matemático Nicómaco de Gerasa (aprox. 60 – 120 n.e.), quien atribuye su autoría al sabio polifacético griego Eratóstenes de Cirene (276-194 a.n.e.), aquel que también estimó de forma muy certera el diámetro de la esfera terrestre (véase El tamaño sí importa, que se lo pregunten a Colón (o de la geometría griega para medir el diámetro de la Tierra)).

El método de la criba de Eratóstenes consiste en lo siguiente. Consideremos todos los números naturales hasta uno dado, por ejemplo, tomemos uno bajo para ilustrar el concepto, el 25. En primer lugar, escribimos todos los números hasta ese número:

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24 y 25.

El 1 no es primo, luego lo tachamos, es decir, lo eliminamos como número primo. Después tenemos el 2, que sí es primo, lo marcamos (nosotros lo hemos puesto en negrita) y tachamos todos los múltiplos de 2, los números pares, que no serán números primos, puesto que los podemos dividir por 2.

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24 y 25.

El siguiente número que aparece es el 3, que es primo, lo marcamos y tachamos todos los múltiplos de 3, puesto que no son primos.

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24 y 25.

El siguiente número que aparece es el 5, que, puesto que no está tachado (esto nos expresa que no es divisible por ningún número anterior), es un número primo, luego lo marcamos y tachamos sus múltiplos, los que aún no estén tachados.

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24 y 25.

El siguiente número no tachado es el 7, luego es un número primo, y debemos de tachar sus múltiplos, así hasta recorrer toda la lista hasta el número final, en este caso el 25. En este sencillo caso nos quedaría:

1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24 y 25.

Luego, los números primos menores que 25 son 2, 3, 5, 7, 11, 13, 17, 19 y 23.

Este es un método sencillo que nos permite ir obteniendo números primos hasta un número dado, aunque es un método con muchas limitaciones, ya que no permite conocer si un número en concreto, por ejemplo, el número 76.243, es primo o no, para saberlo la criba debe de llegar hasta ese número (en este caso, sí es primo), ni generar números primos, ni conocer sencillas propiedades de estos números, como, por ejemplo, si existen infinitos números primos.

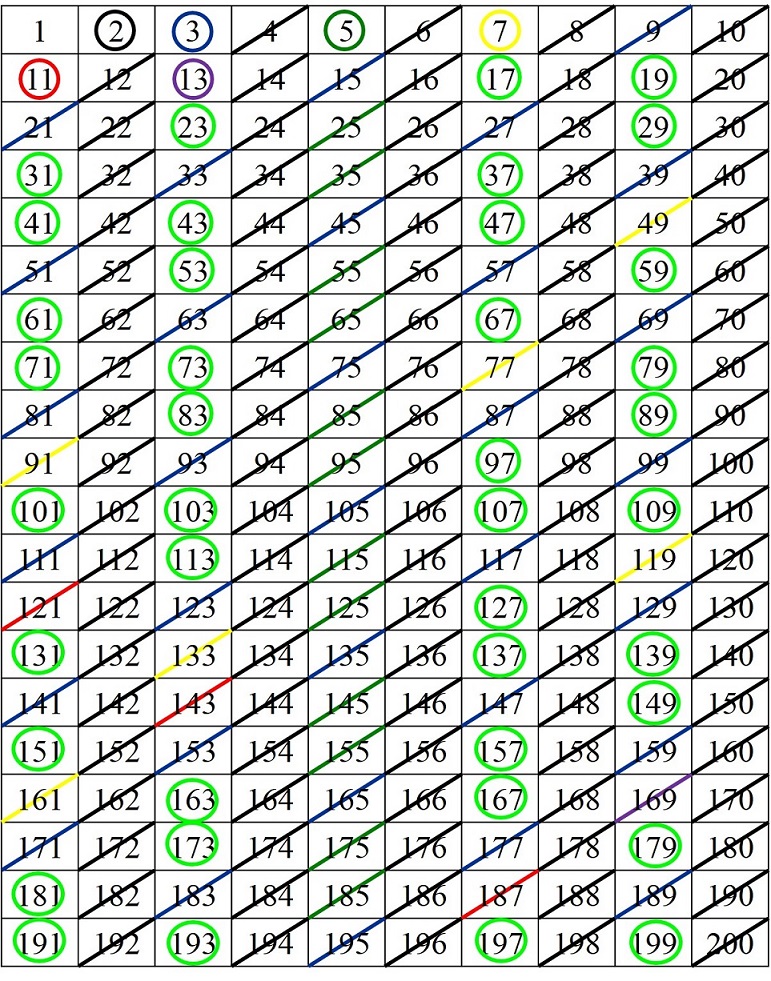

Puesto que nuestros elementos de escritura, como una hoja de papel, son rectangulares, y además una línea continua de números se nos extendería mucho, lo normal es representar los números, hasta el número considerado, en un rectángulo de números, como el que aparece abajo y aplicar sobre el mismo el método de la criba de Eratóstenes.

Así, los números primos hasta el 200 son: 2, 3, 5, 7, 11, 13, 17, 19, 23, 29, 31, 37, 41, 43, 47, 53, 59, 61, 67, 71, 73, 79, 83, 89, 97, 101, 103, 107, 109, 113, 127, 131, 137, 139, 149, 151, 157, 163, 167, 173, 179, 181, 191, 193, 197, 199.

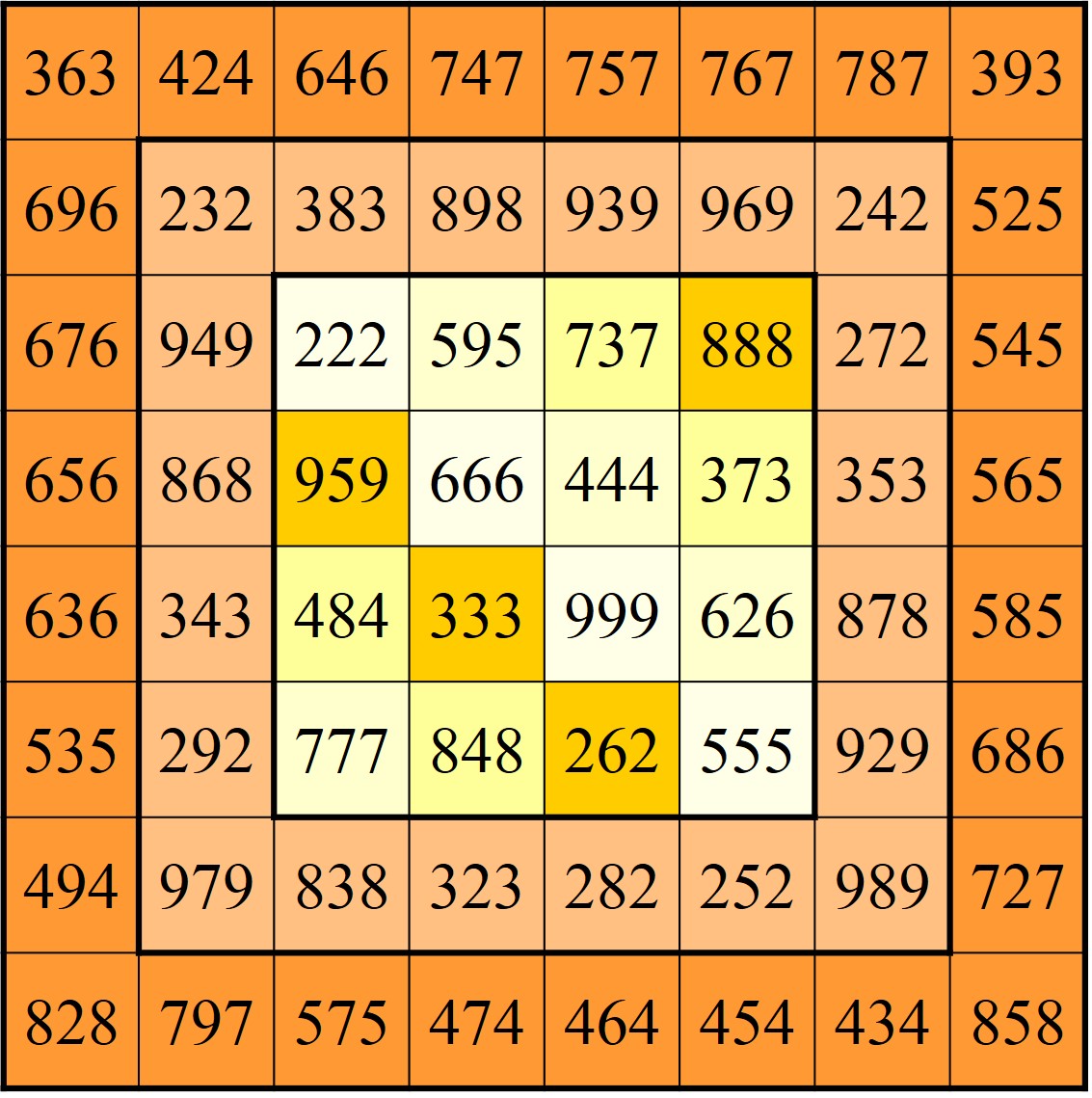

La criba de Eratóstenes, expresada de esta forma, ya es una estructura geométrica plana, rectangular, que nos puede permitir buscar información de la estructura de la familia de números primos, como patrones visuales que puedan producirse a partir de los cuales obtener dicha información. Por ejemplo, aunque esto es evidente sin necesidad de la criba de Eratóstenes, podemos observar que todos los primos están en cuatro columnas, que se corresponden a los números que terminan en 1, 3, 7 y 9. Y nos permite ver que hay muchas parejas de números primos gemelos, que son aquellos números primos que están lo más cerca posible, es decir, con tan solo un número par entre ellos, como las parejas 11 y 13, 17 y 19, 41 y 43, 59 y 61, 71 y 73, 101 y 103, 107 y 109, 137 y 139, 149 y 151, 179 y 181, 191 y 193, 197 y 199, que se corresponden con las terminaciones (1, 3), (7, 9) o (9, 1). Estas parejas de números primos gemelos también han interesado a la artista Esther Ferrer.

Antes de continuar con la espiral de Ulam, remarquemos dos hechos muy importantes relacionados con los números primos, que juegan un papel central en la serie Poema de los números primos de la artista donostiarra y de los que ya hablamos en la entrada del Cuaderno de Cultura Científica Buscando lagunas de números primos, que existen infinitos números primos y que cada vez existen menos números primos en la recta de los números naturales, es decir, la densidad de números primos según vamos avanzando en los números naturales es cada vez menor.

“Un día soñé que nadaba en un mar de números y después del sueño todos los que se me venían a la cabeza eran primos. Así fue como empecé a trabajar en la serie Poema de los números primos, y a plantearme la cuestión del infinito, que trabajé más tarde recurriendo a Pi, sin duda un número infinito.”

(Conversación entre Esther Ferrer, Laurence Rassel y Mar Villaespesa en Esther Ferrer, todas las variaciones son válidas, incluida esta, 2017)

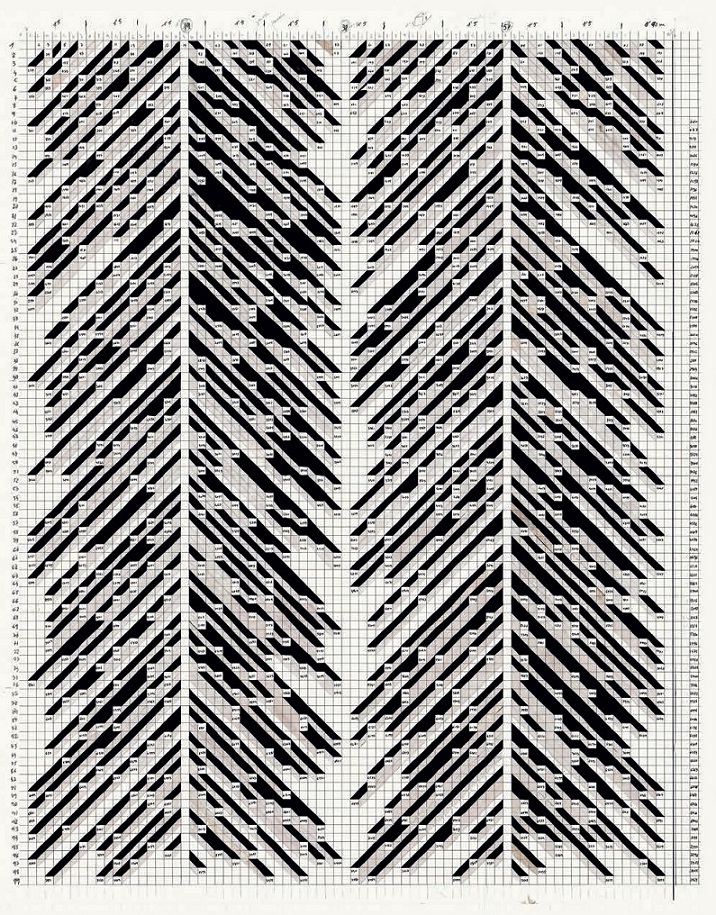

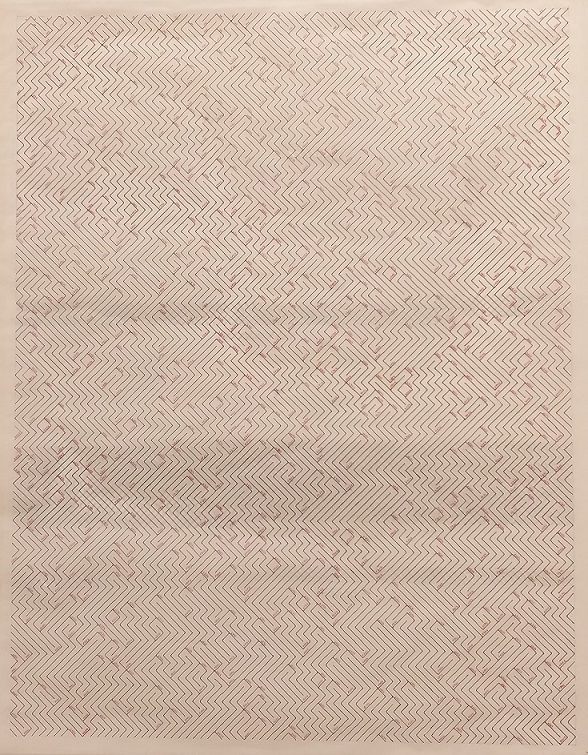

Poema de los números primos (2016), de Esther Ferrer, dibujo para suelo, realizado en tita sobre papel cuadriculado, 104,5 cm x 83,5 cm, del Archivo de Esther Ferrer. Imagen del catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta, del Museo Nacional Centro de Arte Reina Sofía

Poema de los números primos (2016), de Esther Ferrer, dibujo para suelo, realizado en tita sobre papel cuadriculado, 104,5 cm x 83,5 cm, del Archivo de Esther Ferrer. Imagen del catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta, del Museo Nacional Centro de Arte Reina Sofía

La anterior obra tiene como base una criba de Eratóstenes rectangular de 76 columnas, es decir, la primera fila son los números del 1 al 76, y 99 columnas, luego nos determina los números primos hasta el número 7.524 (76 x 99). Esther Ferrer construye esta criba de Eratóstenes en la que se producen cuatro columnas vacías de números primos (la de la derecha, debajo del cero, es un añadido para dar simetría a la estructura), correspondientes a las columnas debajo del 19, 38, 57 y 76, múltiplos de 19.

Esther Ferrer genera, a través de su mirada personal, una determinada estructura espacial que subyace a la distribución real de los números primos dentro de la recta de los números naturales, que es una realidad del universo de los números, pero que observamos a través de la mirada creativa de la artista. Esta hermosa obra ha sido realizada en el suelo del Palacio de Velázquez, en el Parque del Retiro de Madrid, para la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta (2017). Además, al realizarla a un tamaño grande, dispuesta en el suelo y sobre la que pasear, cautiva a las personas que pasean sobre ella y realza aún más el impacto de la estructura de los números primos.

Realización de la obra Poema de los números primos (2016), de Esther Ferrer, en el suelo del Palacio de Velázquez, para la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta (2017). Imagen de ZAS Madrid

Realización de la obra Poema de los números primos (2016), de Esther Ferrer, en el suelo del Palacio de Velázquez, para la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta (2017). Imagen de ZAS Madrid

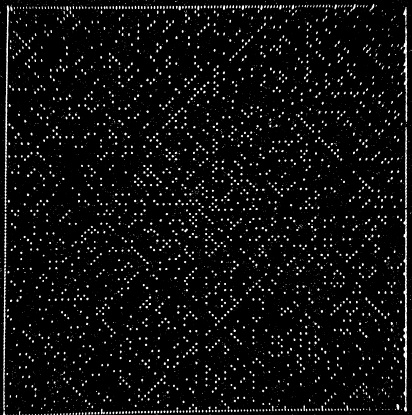

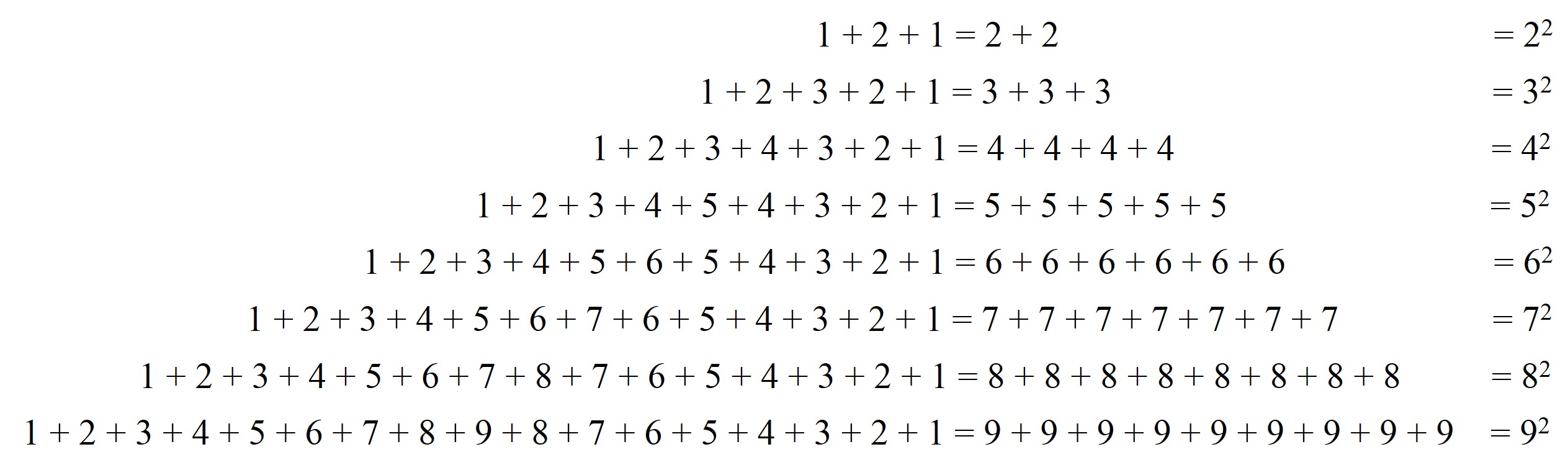

Martin Gardner en su artículo The remarkable lore of the prime numbers cuenta que el matemático polaco Stanislaw Ulam (1909 – 1984), quien participó en el proyecto Manhattan y desarrollo junto con el matemático húngaro John Von Newmann (1903 – 1957) el método de Montecarlo, estaba escuchando una conferencia en el Laboratorio Científico de Los Álamos, que el propio Ulam describió como “un artículo largo y muy aburrido”, y empezó a hacer garabatos en una hoja, en concreto, empezó a escribir los números en espiral, empezando en el 1 y en el sentido contrario a las agujas del reloj, e hizo un círculo alrededor de los números primos. Entonces se dio cuenta de que los números primos se concentraban en líneas rectas, especialmente en diagonales, así mismo, había algunas diagonales, como las formadas solo por números pares, en las que no había ningún número primo.

En Los Álamos disponían del ordenador MANIAC II, que tenía guardados en su memoria los primeros 90 millones de números primos, por lo que junto a Myron L. Stein y Mark B. Wells programaron el ordenador para que realizara una espiral de números, con los números naturales desde el 1 hasta el 65.000, en la que se marcaran solamente los números primos. La imagen que obtuvieron (que hemos incluido más abajo y que aparece en el artículo de Ulam, Stein y Wells, A visual display of some properties of the distribution of primes, 1964) confirmaba lo que había visto Ulam, que los números primos aparecen alineados en rectas horizontales, verticales y, sobre todo, diagonales.

A esta estructura geométrica plana en la que los números naturales son escritos en espiral, empezando en el 1 y en el sentido contrario a las agujas del reloj, destacando los números primos, es lo que se conoce como la espiral de Ulam (dos imágenes más abajo puede verse con más claridad).

Espiral de números primos representada por Stanislaw Ulam, Myron Stein y Mark Wells, con el ordenador Maniac II de Los Álamos, en 1964, en la que se observa que los números primos están alineados en rectas diagonales, verticales y horizontales

Espiral de números primos representada por Stanislaw Ulam, Myron Stein y Mark Wells, con el ordenador Maniac II de Los Álamos, en 1964, en la que se observa que los números primos están alineados en rectas diagonales, verticales y horizontales

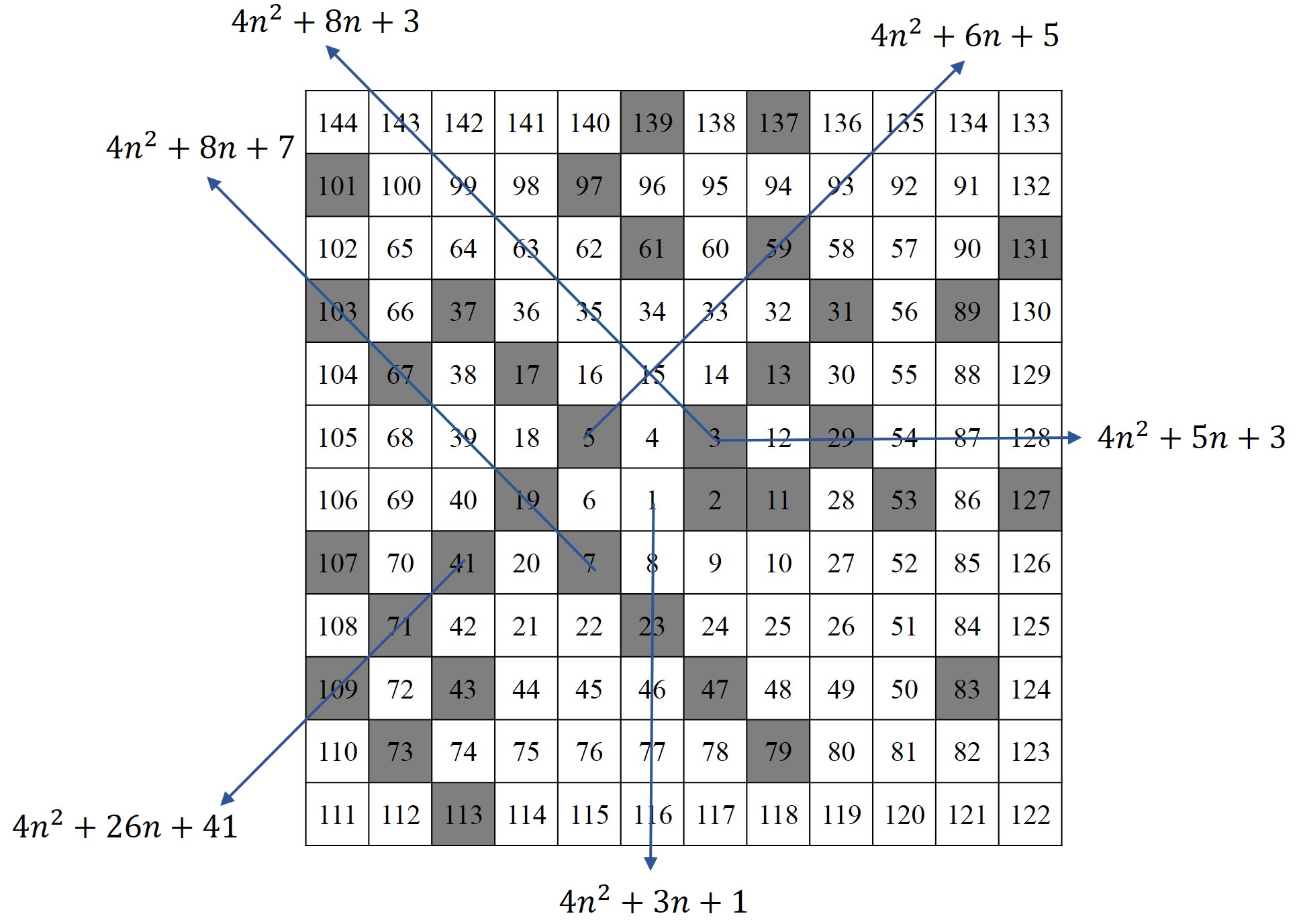

Detrás de esta observación de Stanislaw Ulam está el hecho de que los números de las líneas verticales, horizontales y diagonales se corresponden con los valores de los polinomios cuadráticos de la forma 4n2 + bn + c, como puede verse en la siguiente imagen. En función de los valores de b y c se generan diferentes líneas que tendrán más o menos números primos. Por ejemplo, si b y c son pares, solo se producen números pares y no habrá números primos en dichas líneas, salvo quizás el 2. El polinomio de la imagen siguiente, 4n2 + 8n + 3, es igual a (2n + 1)(2n + 3), luego no genera números primos, salvo el 3, para n = 0. Mientras que otras líneas, como la diagonal 4n2 + 26n + 41, sí genera números primos, como 41, 71, 109 o 271, y no primos, como 155 y 209. Dos polinomios cuadráticos que generan muchos números primos son 4n2 – 2n + 41, que a partir de un cierto valor de n genera la línea diagonal de puntos blancos en la parte de arriba de la imagen de Ulam, Stein y Wells (la imagen anterior), y 4n2 + 2n + 41, que es la línea de abajo.

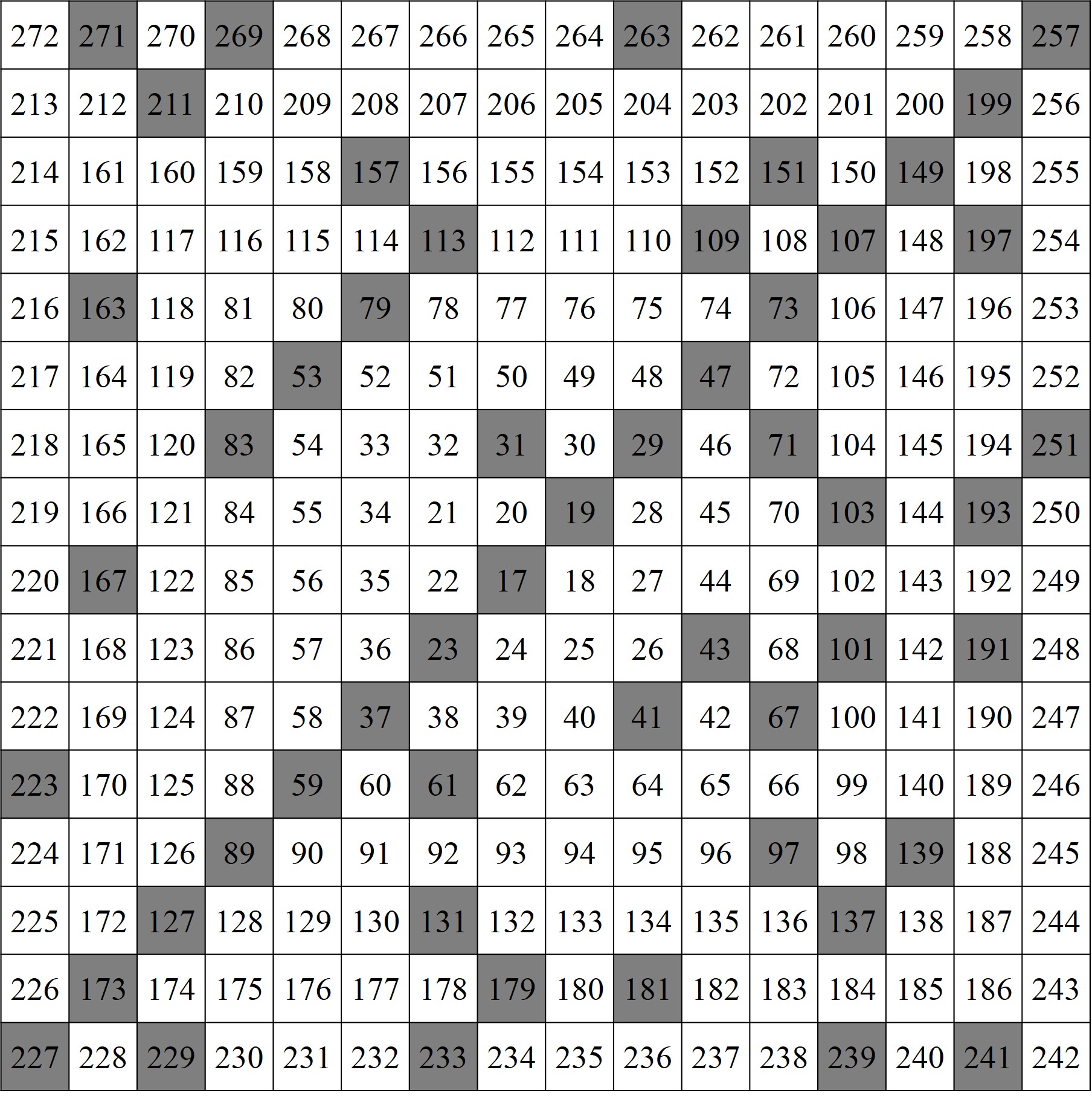

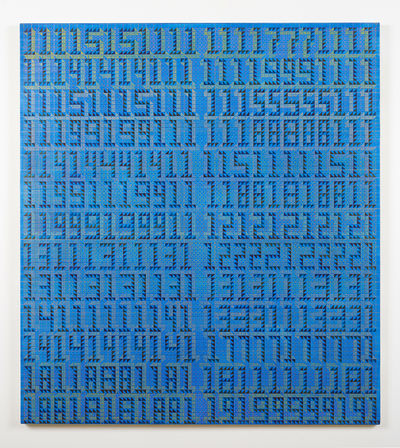

Espiral de Ulam, en una cuadrícula 12 x 12, y algunas líneas de números con los polinomios cuadráticos que las generan

Espiral de Ulam, en una cuadrícula 12 x 12, y algunas líneas de números con los polinomios cuadráticos que las generan

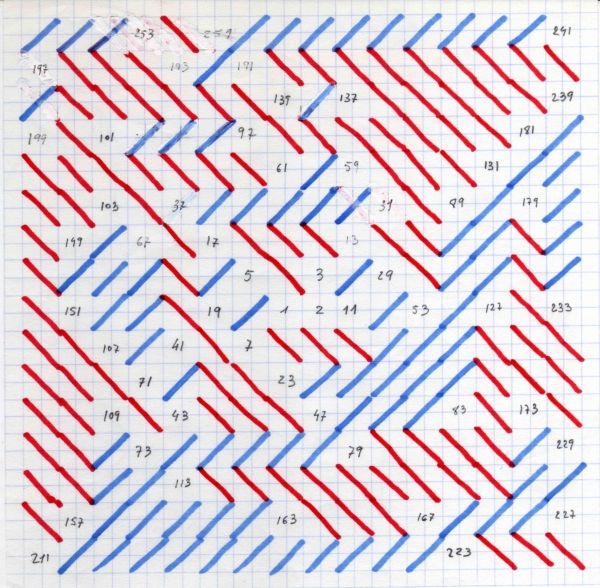

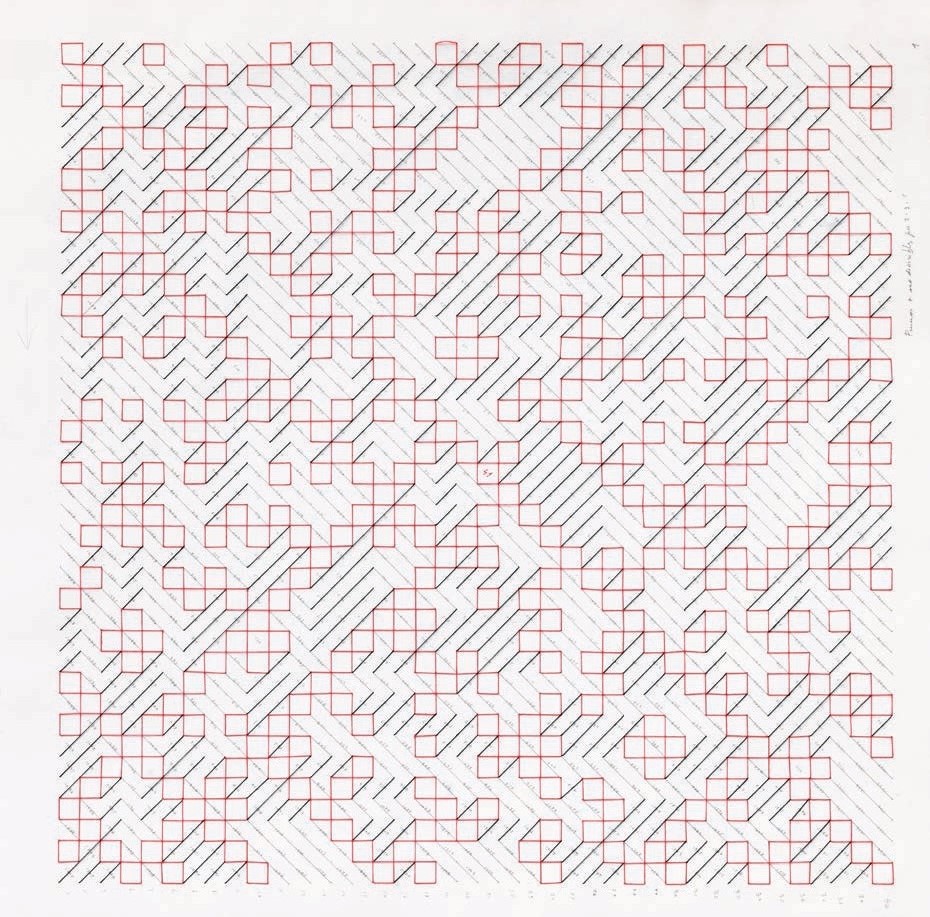

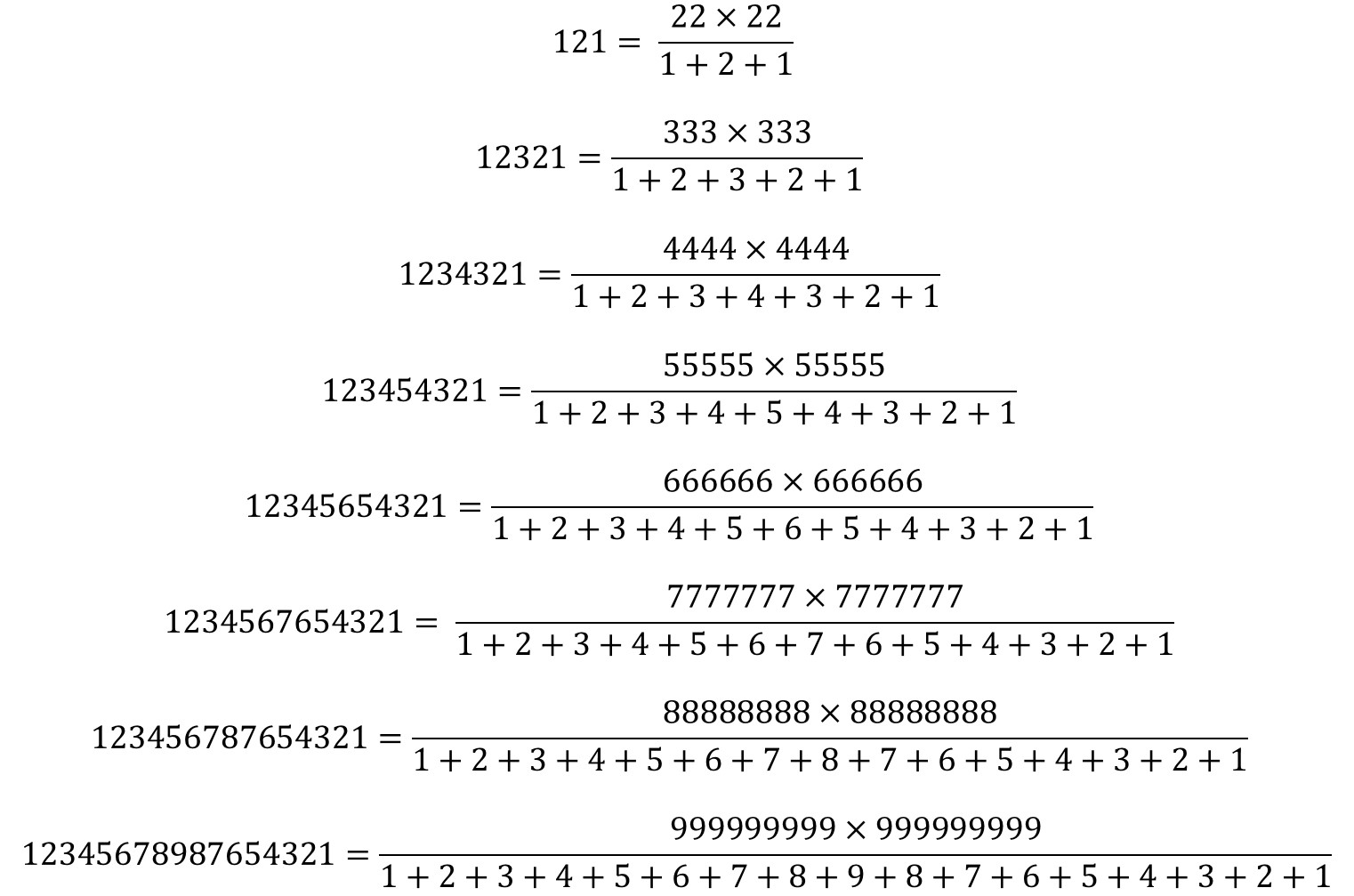

El siguiente dibujo de Esther Ferrer, de entre los años 1983 y 1985, nos da algunas claves de la forma en la que la artista trabaja con la espiral de Ulam. Para empezar el dibujo contiene la espiral de Ulam en una cuadrícula 16 x 16, luego con los números desde 1 hasta 256. Además, solo están escritos los números primos en la espiral y en las posiciones que corresponden a números compuestos, es decir, los números no primos, está dibujado un segmento diagonal “tachando” ese número, pero sin el número. En este dibujo, las diagonales tienen dos posiciones y dos colores posibles. El sentido de la diagonal y el color cambian cada vez que aparece un número primo, de forma que entre un primo y el siguiente, es decir, lo que conocemos como una laguna de números compuestos entre números primos (véase la entrada Buscando lagunas de números primos), las diagonales que aparecen tienen un mismo sentido y color. La confluencia de la construcción de la espiral de Ulam, junto con las diagonales inclinadas y de colores, confiere al conjunto de una estructura geométrica particular, casi laberíntica en este caso, que es el objetivo buscado por la artista.

Dibujo de la serie Poema de los números primos (1983 – 1985), de Esther Ferrer, expuesto en la Galería Angels Barcelona, que reproduce la espiral de Ulam en una cuadrícula 16 x 16

Dibujo de la serie Poema de los números primos (1983 – 1985), de Esther Ferrer, expuesto en la Galería Angels Barcelona, que reproduce la espiral de Ulam en una cuadrícula 16 x 16

Stanislaw Ulam también realizó una espiral similar, pero empezando con el número 17, de forma que los números de una de las dos diagonales principales se correspondían con los valores, desde n = 0 hasta 15, del polinomio n2 + n + 17, eran números primos (17, 19, 23, 29, 37, …, 257), lo cual fallaba para el siguiente valor, n = 16, que es un número compuesto, 162 + 16 + 17 = 172. Este polinomio ya era conocido por el matemático suizo Leonhard Euler (1707 – 1783), como un polinomio que generaba muchos números primos.

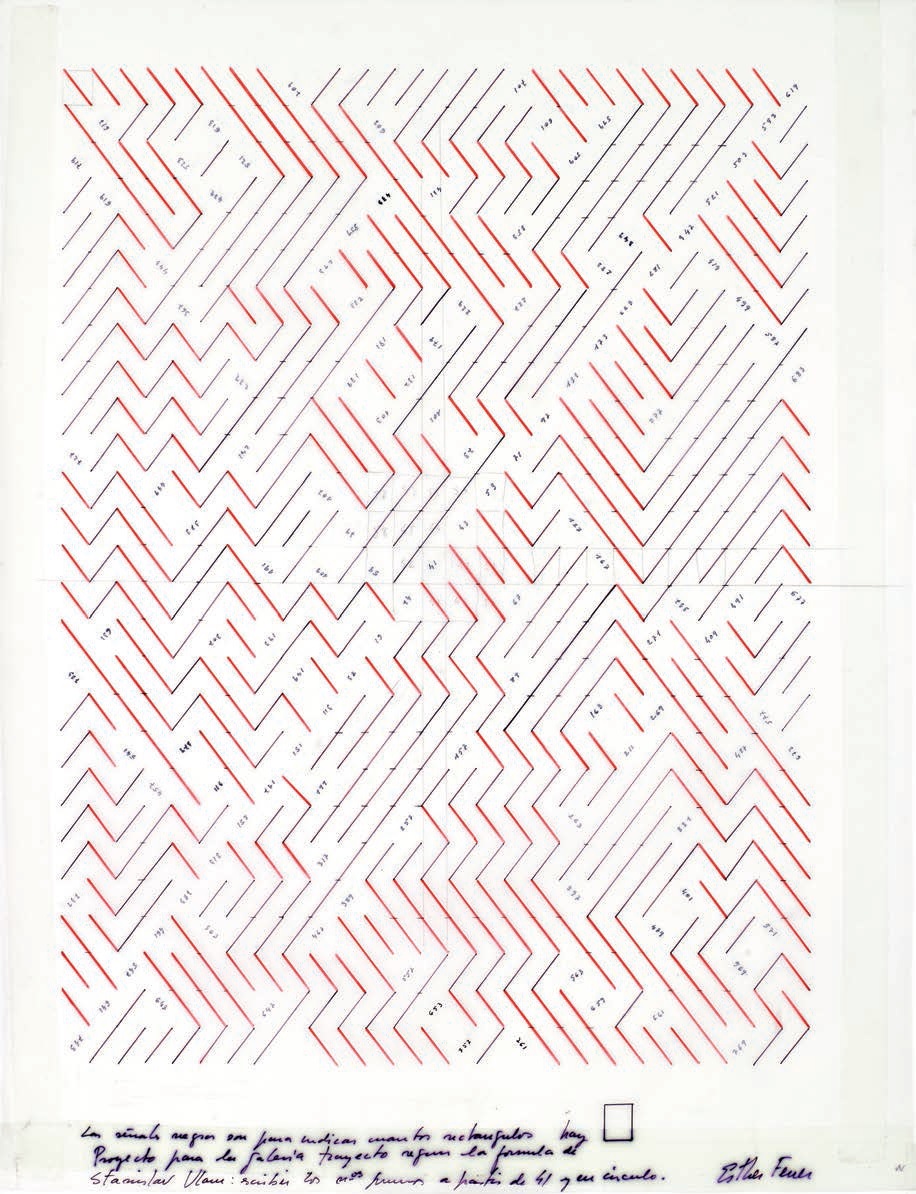

Espiral de Ulam empezando en el número 17, cuyos números de la diagonal son valores del polinomio n2 + n + 17, y son números primos para n = 0, …, 15, es decir, entre el 227 de abajo a la izquierda y el 257 de arriba a la derecha

Espiral de Ulam empezando en el número 17, cuyos números de la diagonal son valores del polinomio n2 + n + 17, y son números primos para n = 0, …, 15, es decir, entre el 227 de abajo a la izquierda y el 257 de arriba a la derecha

Un polinomio que genera muchos números primos y que también era conocido por el matemático Leonhard Euler (1772) es n2 + n + 41. Si se inicia la espiral de Ulam en el número 41, los números de la diagonal principal son valores de este polinomio generador de primos de Euler y para los valores entre n = 0 y n = 39, se genera un segmento continuo en esa diagonal de 40 números primos, que durante más de dos siglos fue el segmento más grande conocido de este tipo. Ulam, Stein y Wells encontraron que, para valores de n entre 0 y 10.000.000, el polinomio n2 + n + 41 genera un 47,5% de números primos, casi uno de cada dos (aunque en esta entrada no vamos a dedicarnos a este tema, en matemáticas se han continuado estudiando polinomios que generan muchos números primos). Los valores de este polinomio n2 + n + 41 son, en la espiral de Ulam empezando en 1, los valores del polinomio es 4m2 + 170m + 1847, haciendo el cambio n = 2m + 42.

La espiral de Ulam empezando en el número 41 alcanzó cierta notoriedad por esa diagonal principal con un segmento de 40 primos seguidos, con el 41 en el medio, 19 primos hacia abajo en la diagonal, hasta el número 1523, y 20 primos hacia arriba, hasta el número 1601.

Dibujo de la serie Poema de los números primos (años 1970 – 1980), de Esther Ferrer, basado en la espiral de Ulam que empieza en el número 41, y con los 40 números primos en la diagonal principal. Imagen del catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta

Dibujo de la serie Poema de los números primos (años 1970 – 1980), de Esther Ferrer, basado en la espiral de Ulam que empieza en el número 41, y con los 40 números primos en la diagonal principal. Imagen del catálogo Esther Ferrer, todas las variaciones son válidas, incluida esta

El anterior dibujo fue la base para la realización de una obra de la serie Poema de los números primos en el parque del Prado en Vitoria-Gasteiz, en 2003. Es una espiral de Ulam de 100 x 100 = 10.000 “números”, que empieza en el número 41 y cuyo último número primo es 10.039. Está realizada con baldosas de cerámica, de tamaño 20 x 20 cm cada una, en las que aparece una diagonal roja, una diagonal azul o un número primo. Luego el tamaño de la obra es de 20 x 20 metros.

Instalación Poema de los números primos (2003), de la artista Esther Ferrer, en el parque del Prado (Vitoria-Gasteiz). Imagen de la web de ARTIUM

Instalación Poema de los números primos (2003), de la artista Esther Ferrer, en el parque del Prado (Vitoria-Gasteiz). Imagen de la web de ARTIUM

Esther Ferrer explica así el objetivo de elegir esa obra para el parque del Prado de Vitoria-Gasteiz:

“– es una obra que incita a la reflexión puesto que no corresponde exactamente a los cánones más o menos establecidos sobre lo que es o no es una obra de arte,

– es una obra dinámica, con posibilidades de interactividad libre y espontánea, sin normas,

– además de su belleza intrínseca, esta pieza aporta un elemento lúdico, puesto que los niños que frecuenten el parque jugarán sobre ella y quizás inventarán a partir de la misma sus propios juegos,

– podrán también empezar a comprender que las matemáticas no son forzosamente aburridas, y que con ellas puede hacerse incluso arte,

– por último, podrán aprender, iniciarse, sin prácticamente darse cuenta, en el universo de los números primos, esos números tan particulares, casi mágicos, conocidos desde la más remota antigüedad y que actualmente presentan una gran utilidad en diferentes campos, tanto científicos, como técnicos.”

Dibujo-maqueta Poema de los números primos (años 1980-1990), de Esther Ferrer. Imagen de la página de Esther Ferrer

Dibujo-maqueta Poema de los números primos (años 1980-1990), de Esther Ferrer. Imagen de la página de Esther Ferrer

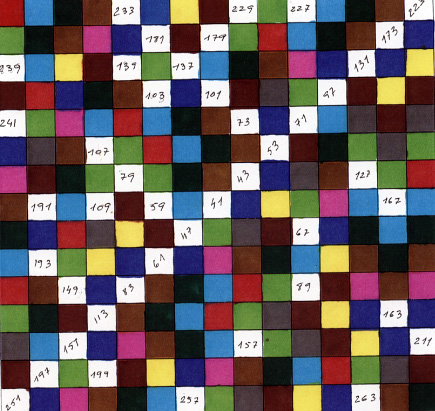

Como bien explica Esther Ferrer en su libro Maquetas y dibujos de instalaciones 1970/2011, para toda una serie de dibujos-maquetas de números primos, estos están “pensados para suelos, alfombras, murales por lo que pueden realizarse en materiales diversos (azulejo, lana, seda, hormigón,…). En los cuadrangulares o rectangulares se hace una cuadrícula y cada cuadrado es un número. Se marcan en esa enumeración los primos y luego se unen con hilos, o se dejan en blanco y el resto se colorea … según la variación elegida”.

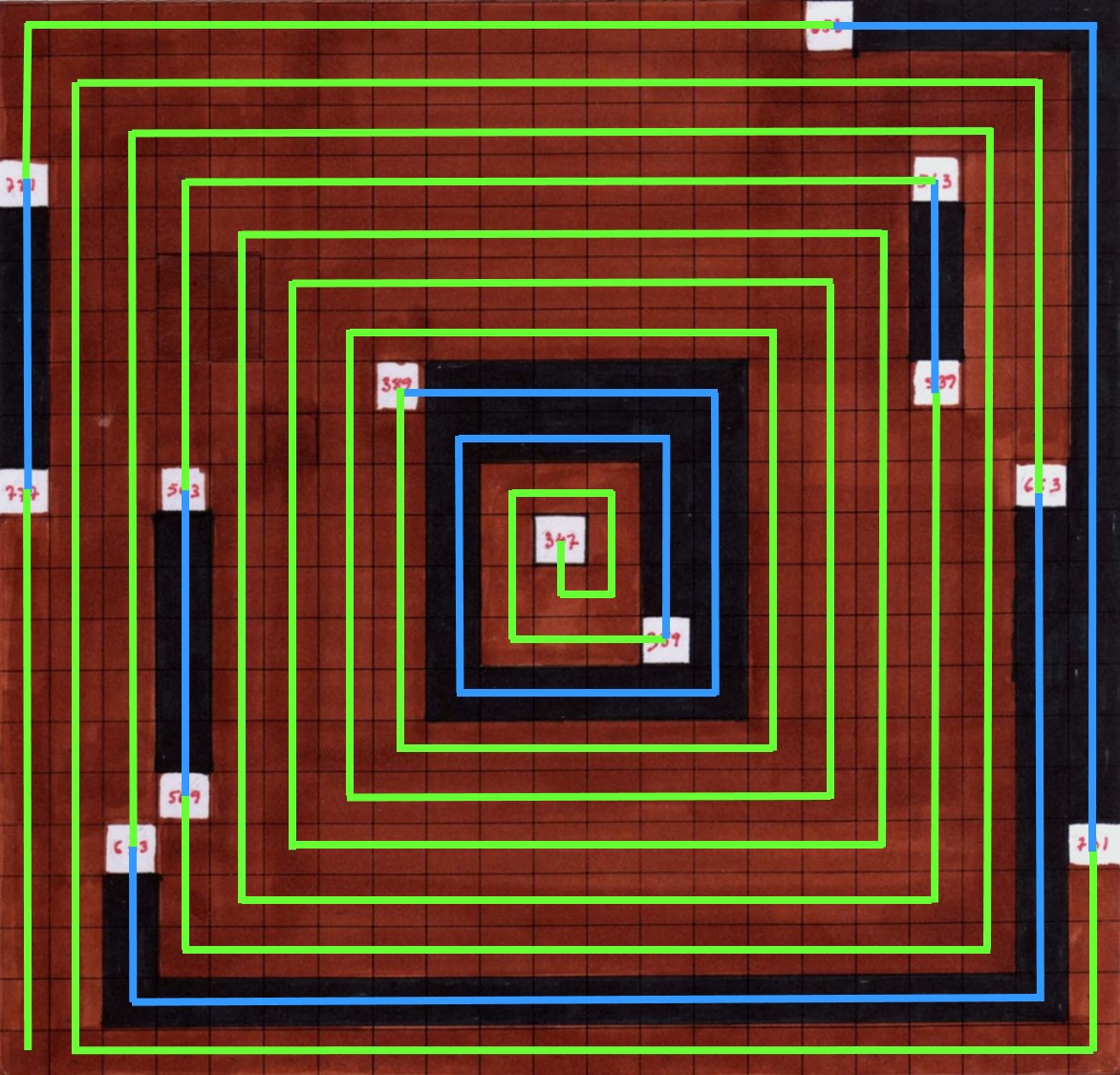

Dibujo-maqueta Poema de los números primos (años 1980-1990), de Esther Ferrer. Imagen de la página de Esther Ferrer

Dibujo-maqueta Poema de los números primos (años 1980-1990), de Esther Ferrer. Imagen de la página de Esther Ferrer

En este dibujo podemos observar de nuevo, que uno de los elementos importantes en la reflexión artística de Esther Ferrer son las lagunas de números primos, es decir, las zonas de números compuestos, no primos, entre dos números primos. Así, en esta obra, la artista ha coloreado los cuadrados de los números compuestos de los colores negro o rojo en función de la laguna a la que pertenezca el número natural. Por ejemplo, entre los números primos 257 y 263 (abajo en la espiral) aparecen, en la espiral, cuadrados de color rojo correspondientes a los números compuestos entre ellos, 258, 259, 260, 261 y 262, mientras que los cuadrados de la siguiente laguna, entre los números primos 263 y 269, están pintados de negro, 264, 265, 266, 267, 268.

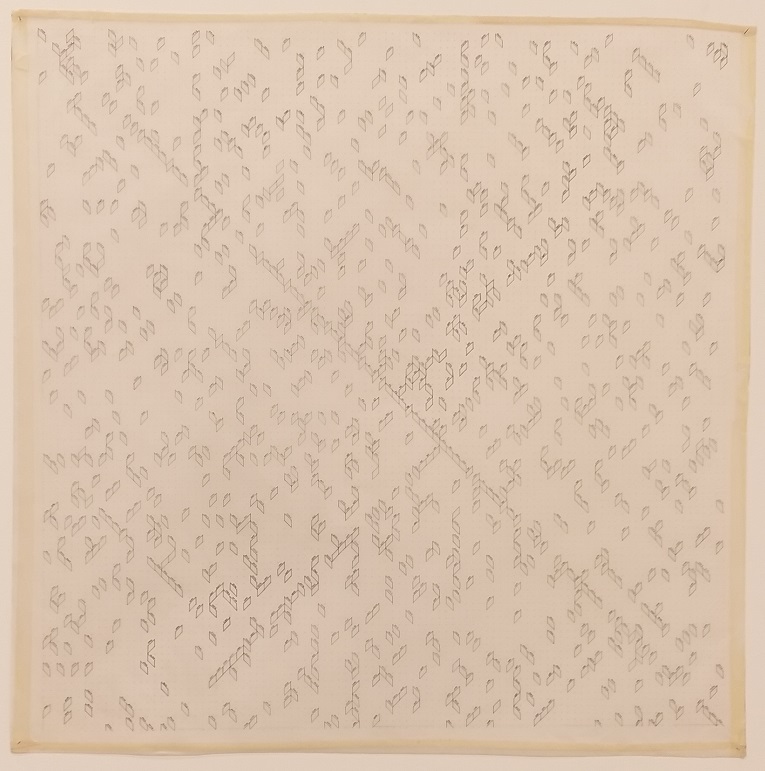

Según vamos avanzando en los números naturales hay una menor cantidad de números primos, una menor densidad dentro de los números naturales, y las lagunas entre números primos son cada vez mayores, como se puede observan en el siguiente dibujo, en el que la artista Esther Ferrer construye una espiral de Ulam empezando en el número 1.344.326.696.347. Como en el dibujo-maqueta anterior, se trata de una cuadrícula 21 x 21, es decir, la correspondiente espiral en ambos casos está formada por 441 números, aunque en este segundo caso hay muchos menos números primos y las lagunas de números primos (los números compuestos entre dos números primos consecutivos) son mayores.

Dibujo-maqueta Poema de los números primos (años 1980-1990), de Esther Ferrer. Expuesto en la Galería Àngels Barcelona y en la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta, del Palacio Velázquez (2017). Imagen del catálogo

Dibujo-maqueta Poema de los números primos (años 1980-1990), de Esther Ferrer. Expuesto en la Galería Àngels Barcelona y en la exposición Esther Ferrer, todas las variaciones son válidas, incluida esta, del Palacio Velázquez (2017). Imagen del catálogo

A continuación, he repintado la estructura de la espiral de Ulam del anterior dibujo-maqueta, en colores azul y verde, para recuperar la espiral que subyace debajo de la obra, y para observar mejor las lagunas de números primos que existen.

Dialogando con Laurence Rassel y Mar Villaespesa en Esther Ferrer, todas las variaciones son válidas, incluida esta (2017), la artista explica así su trabajo con la espiral de Ulam:

“… puedo trabajar los números primos a partir de la espiral de Ulam. Al utilizarla se crea una línea ininterrumpida durante cierta cantidad de números. Me gustó la idea de escribirlos en espiral, como una galaxia, los números primos tienen algo que ver con la estructura del universo; a medida que progresas en la serie hay menos números, el espacio entre ellos se agranda, me gusta ese vacío, es como si la serie se expandiera, como el universo.”

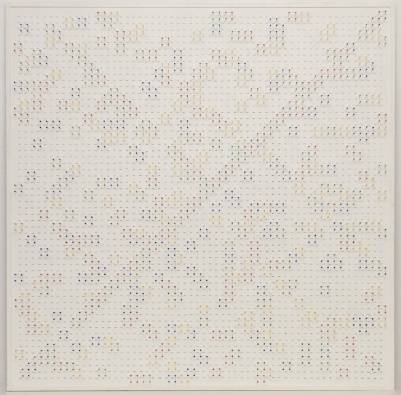

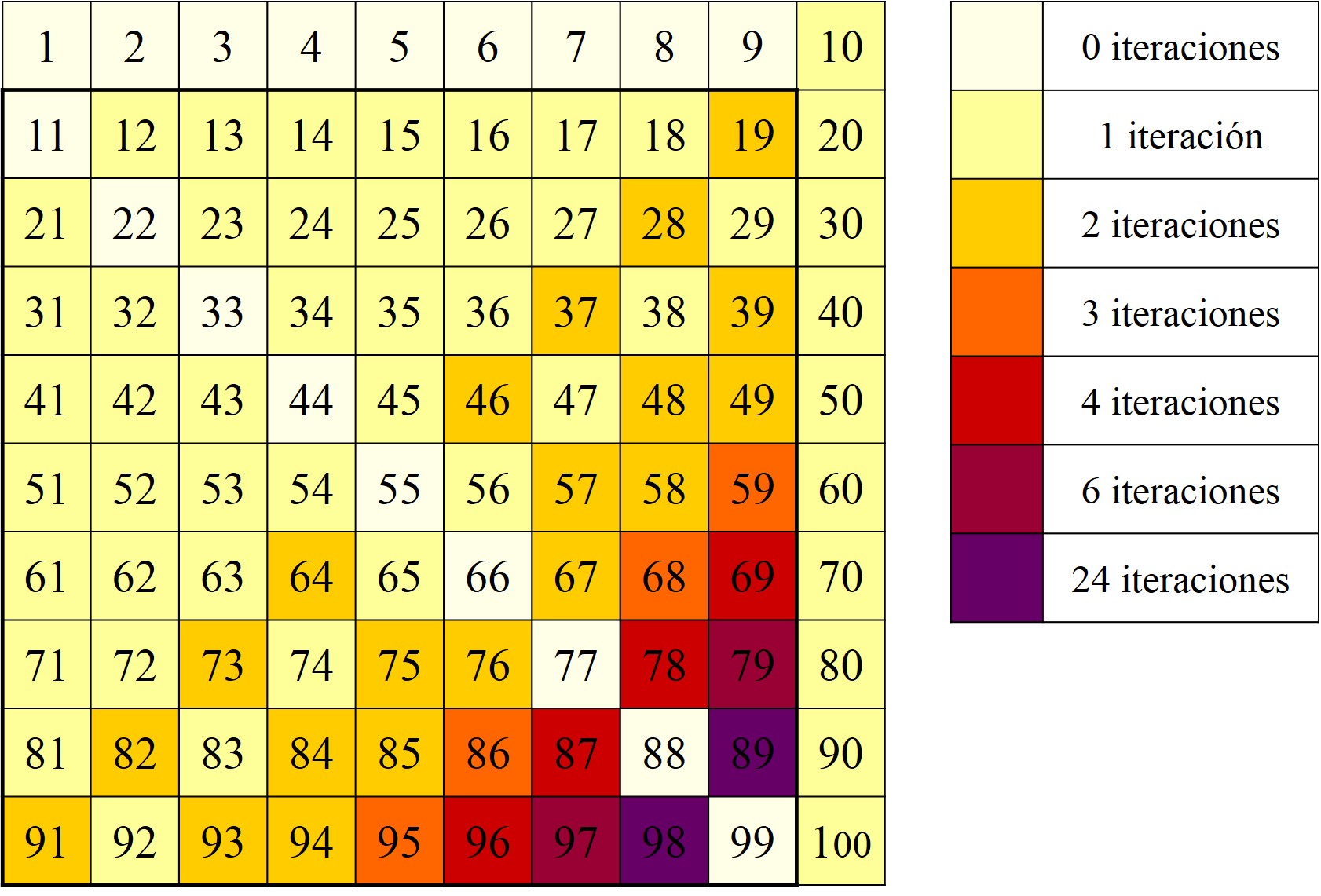

Existe toda una serie de obras de Esther Ferrer, pertenecientes a la serie Poema de los números primos, que tienen como punto de partida la espiral de Ulam, empezando en el número 41. A continuación, mostramos algunos ejemplos, que además nos muestran como la intervención creativa de la artista da lugar a diferentes resultados. La primera está realizada con hilos, alfileres de colores y tinta sobre lienzo, en la cual los colores están asociados con los números primos, de hecho, con la terminación en 1 (rojo), 3 (verde), 7 (azul) o 9 (amarillo) del número primo.

Poema de los números primos (1980), de Esther Ferrer, realizada con hilos, alfileres y tinta sobre lienzo, de 122 x 120 cm. Obra expuesta en la Galería Àngels Barcelona.

Poema de los números primos (1980), de Esther Ferrer, realizada con hilos, alfileres y tinta sobre lienzo, de 122 x 120 cm. Obra expuesta en la Galería Àngels Barcelona.

Detalle de la obra Poema de los números primos (1980), de Esther Ferrer, realizada con hilos, alfileres y rotulador sobre lienzo, de 122 x 120 cm. Obra expuesta en la Galería Àngels Barcelona

Detalle de la obra Poema de los números primos (1980), de Esther Ferrer, realizada con hilos, alfileres y rotulador sobre lienzo, de 122 x 120 cm. Obra expuesta en la Galería Àngels Barcelona

Las diferentes intervenciones artísticas de Esther Ferrer, sobre la misma base de la espiral de Ulam, generan diferentes patrones geométricos planos, como se pone de manifiesto con estas obras.

Una de las tres partes de un tríptico de la serie Poema de los números primos (años 1980), de Esther Ferrer, realizada con rotulador e hilos sobre papel, de 68 x 67 cm

Una de las tres partes de un tríptico de la serie Poema de los números primos (años 1980), de Esther Ferrer, realizada con rotulador e hilos sobre papel, de 68 x 67 cm

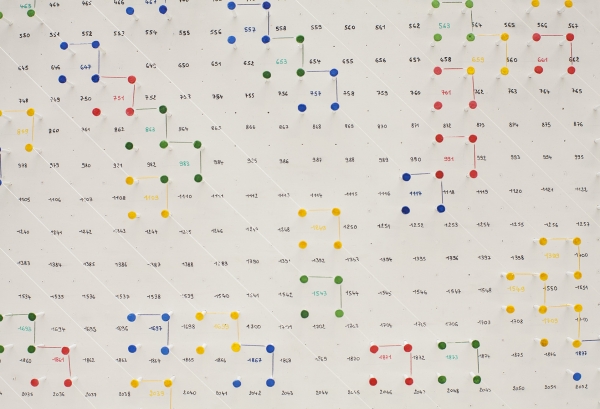

En la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… de Tabakalera también nos encontramos obras que surgen del mismo punto que las anteriores, la espiral de Ulam empezando en el número 41, pero, una vez más, con sus propias características fruto de la acción de la artista.

Obra de la serie Poema de los números primos, de Esther Ferrer, que ha formado parte de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera. Fotografía Raúl Ibáñez

Obra de la serie Poema de los números primos, de Esther Ferrer, que ha formado parte de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera. Fotografía Raúl Ibáñez

Y terminemos esta entrada, con unas palabras de la creadora donostiarra, con motivo de su exposición en Artium en 2011, en relación a su trabajo con los números primos:

“Lo primero que sorprende cuando se comienza a trabajar con la serie de los números primos es que – cualquiera que sea el sistema utilizado – el resultado es siempre equilibrado, hermoso, y lo segundo es que cuanto más grande es la obra, es decir, cuantos más números la forman, más interesante es la estructura, nunca simétrica, siempre en movimiento, por ello siempre he pensado en realizar obras monumentales como suelos, muros, tapicerías etc.

Al penetrar el universo de los números primos se tiene la sensación de que son la traducción, el reflejo, de un caos universal, magnífico, continuamente en evolución, que no se repite jamás, pero que, pese a ello, es siempre el mismo. Un caos en cuyo interior parece existir un orden, un orden extraño, curioso.”

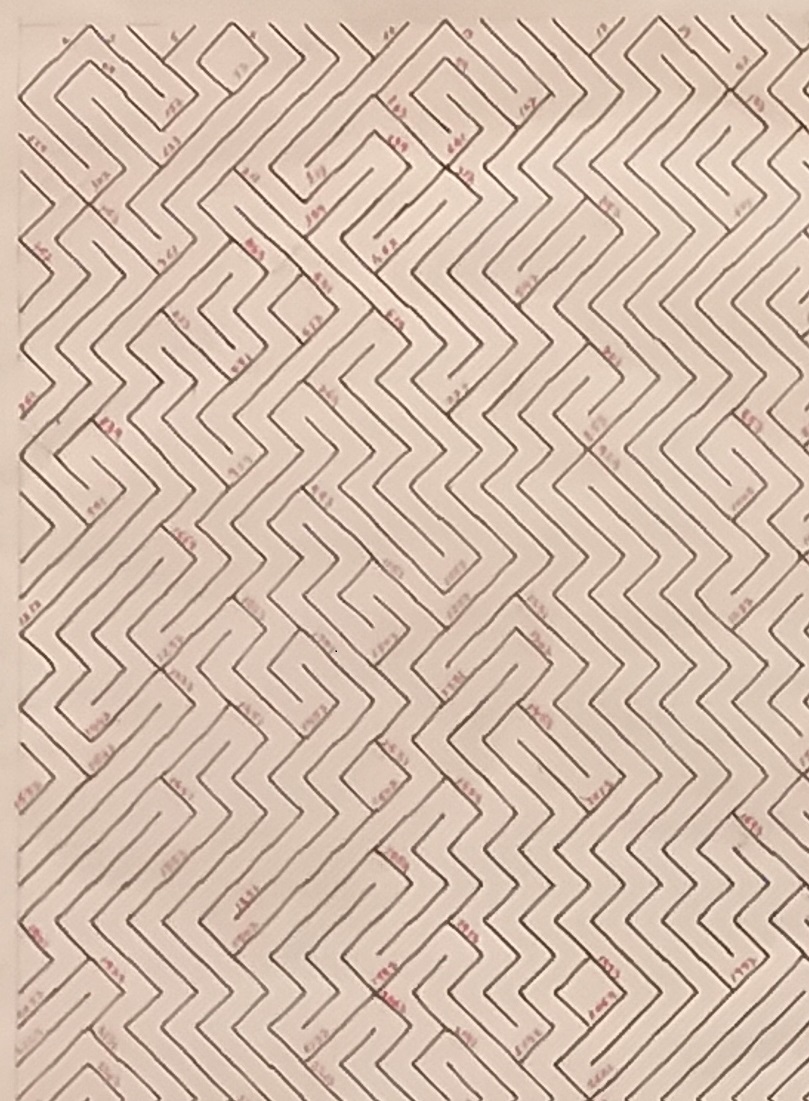

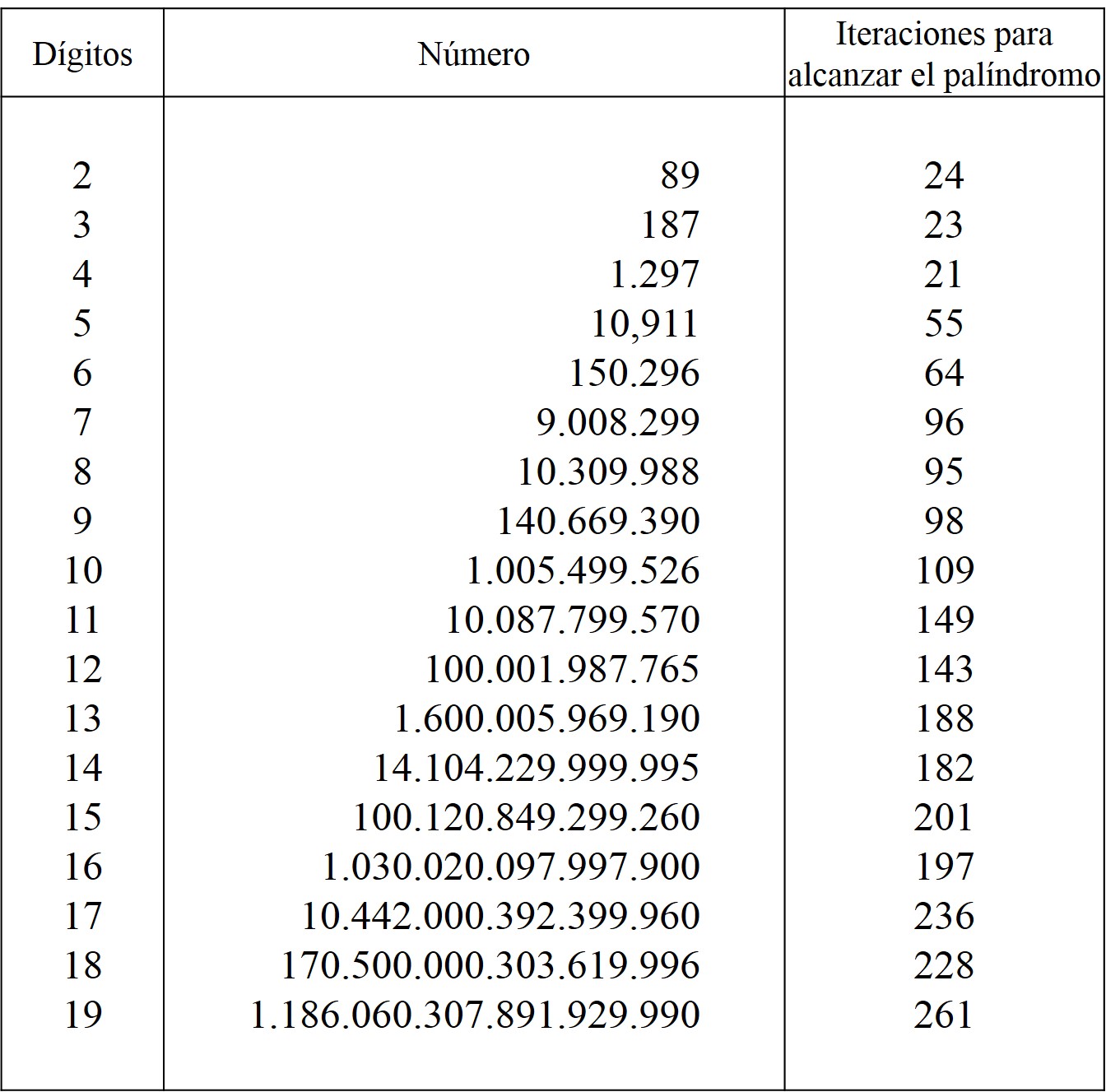

Obra de la serie Poema de los números primos, de Esther Ferrer, que ha formado parte de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera. La obra tiene como base la criba de Esratóstenes, donde la inclinación de las diagonales en los lugares de los números compuestos está dada en función de las lagunas de números primos, lo cual genera una curiosa estructura laberíntica. Fotografía de Raúl Ibáñez

Obra de la serie Poema de los números primos, de Esther Ferrer, que ha formado parte de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera. La obra tiene como base la criba de Esratóstenes, donde la inclinación de las diagonales en los lugares de los números compuestos está dada en función de las lagunas de números primos, lo cual genera una curiosa estructura laberíntica. Fotografía de Raúl Ibáñez

Detalle de la anterior obra de la serie Poema de los números primos, de Esther Ferrer, que ha formado parte de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera

Detalle de la anterior obra de la serie Poema de los números primos, de Esther Ferrer, que ha formado parte de la exposición Esther Ferrer 2, 3, 5, 7, 11, 13, 17, 19, 23,… en Tabakalera

Para concluir esta entrada, me gustaría expresar mi más sincero y profundo agradecimiento a Esther Ferrer por permitirme utilizar las imágenes de sus hermosas e interesantes obras en esta publicación, así como por las interesantes conversaciones que hemos mantenido sobre las matemáticas, y en particular, los números primos, en el conjunto de su obra artística.

Bibliografía

1.- Esther Ferrer, Maquetas y dibujos de instalaciones 1970/2011, Exit publicaciones, 2011.

2.- Rosa Olivares (comisaria), Esther Ferrer, Lau mugimenduan/En cuatro movimientos/In four movements, ARTIUM 08/10/2011 – 08/01/2012, Artium y Acción cultural española, 2011.

3.- Laurence Rassel y Mar Villaespesa (comisarias), Esther Ferrer, todas las variaciones son válidas, incluida esta, Palacio de Velázquez del Parque del Retiro 26/07/2017 – 25/02/2018, Museo Nacional Centro de Arte Reina Sofía, 2017.

4.- Martin Gardner, The remarkable lore of the prime numbers, Scientific American 210, n.3, 120 – 129, 1964.

5.- M. L. Stein, S. M. Ulam, M. B. Wells, A Visual Display of Some Properties of the Distribution of Primes, American Mathematical Monthly 71, p. 516 – 520, 1964.

6.- Paul Hoffman, El hombre que sólo amaba los números, la historia der Paul Erdös y la búsqueda de la verdad matemática, Granica, 2000.

7.- Wikipedia: Ulam spiral

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El poema de los números primos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Buscando lagunas de números no primos

- Una conjetura sobre ciertos números en el ‘sistema Shadok’

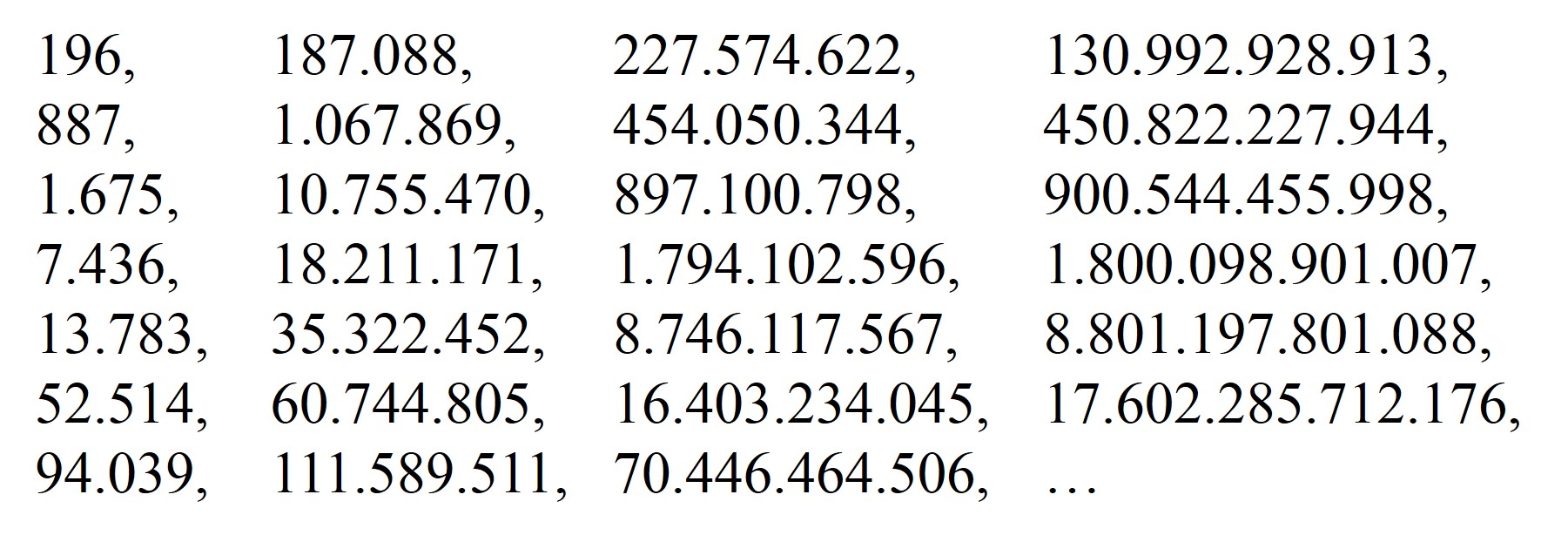

- El secreto de los números que no querían ser simétricos

Las redes 5G no afectan a la salud… pero podrían hacer que el hombre del tiempo acierte menos

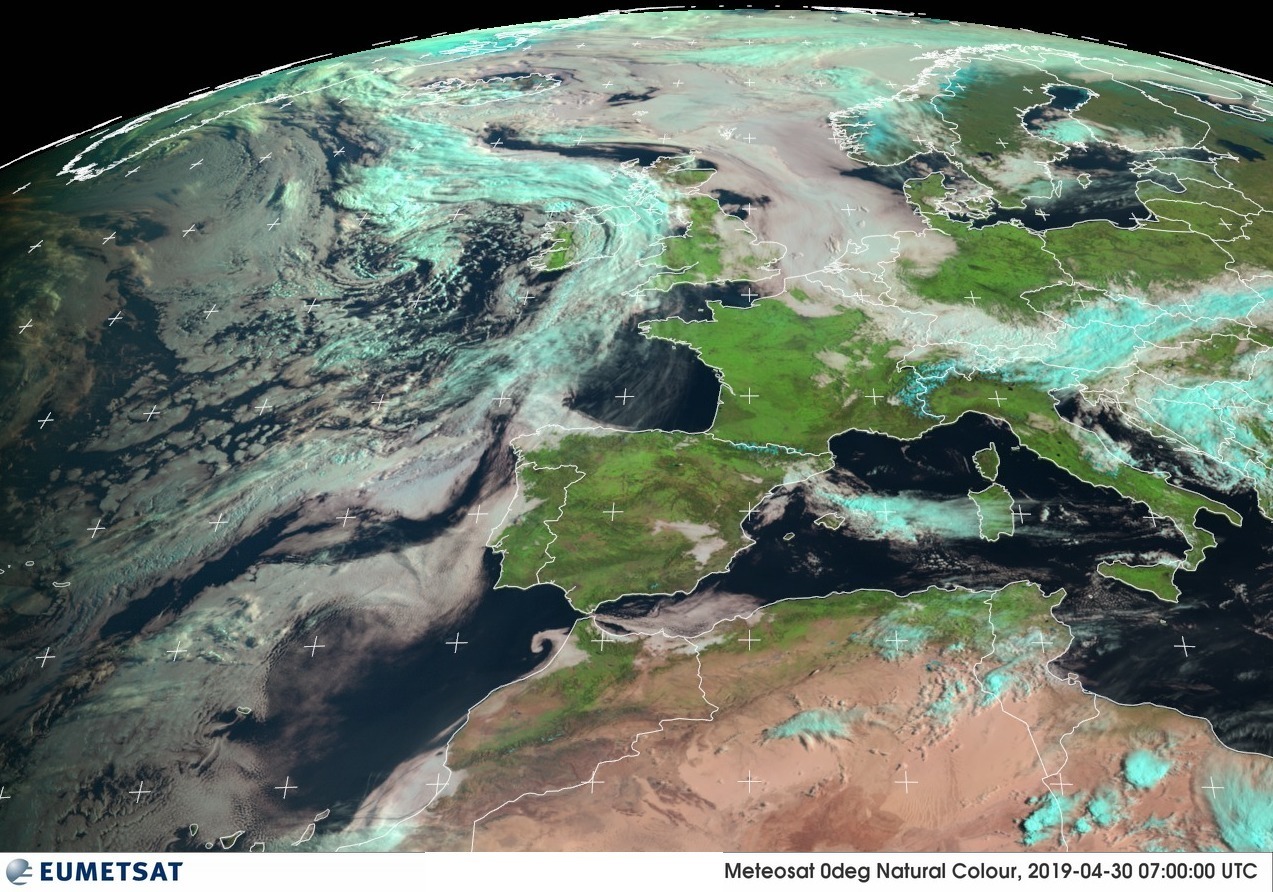

Imagen: EUMETSAT

Imagen: EUMETSAT

Igual que la radio en su momento, la televisión después, internet, el wifi o cualquier tecnología inalámbrica, hay gente a la que el 5G le pone nervioso. Esta evolución del 4G promete una forma más rápida y eficaz de transmitir la información y los datos que alimentan nuestros móviles y dispositivos, pero para muchos es una amenaza para la salud por el efecto que sus ondas podrían tener sobre los tejidos de nuestro cuerpo.

Lo cierto es que, igual que ocurre con el wifi, no hay evidencias de que el 5G cause ningún problema en realidad. Esta radiación no ionizante no tiene energía suficiente como para causar ningún efecto sobre nuestros tejidos, más allá de calentarnos levemente la oreja si nos pasamos mucho tiempo con el teléfono pegado a ella. Estudios epidemiológicos han tratado de encontrar una correlación entre la expansión de los teléfonos móviles, y después del wifi, y el número de cánceres y tumores. Si bien correlación no implica causalidad, podría ser la primera señal de que algo pasa. La búsqueda no ha tenido éxito.

Esto no ha impedido que mucha gente se oponga a la implementación de las redes 5G apelando al principio de precaución. En Bruselas, donde la legislación que limita las radiaciones es especialmente estricta, se estaba fraguando una excepción para permitir el desarrollo de un programa piloto de redes 5G que de otra forma sería imposible, pero el gobierno de la ciudad finalmente se ha echado atrás poniendo como motivo la precaución en el cuidado de la salud de sus ciudadanos.

Sí podría afectar a cómo estudiamos la meteorología

Otro grupo está empezando a alzar la voz respecto a los riesgos del 5G, estos parece que con una base un poco mas sólida para sus advertencias. Claro que aquí la salud no tiene nada que ver. Son los meteorólogos.

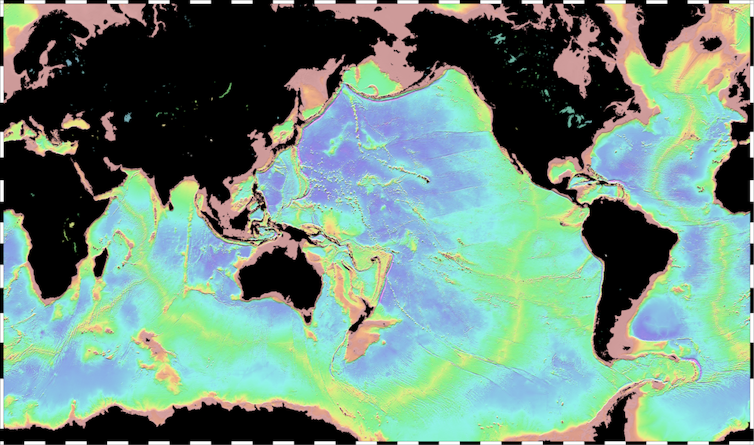

Según un artículo publicado recientemente en la revista Nature, advierten de que las redes 5G podrían interferir con las observaciones vía satélite que les permiten hacer su trabajo, observar la evolución del clima y hacer sus seguimientos de los fenómenos meteorológicos. En concreto, creen que esto les impedirá detectar y medir con precisión las masas de vapor de agua en la atmósfera. Temen que eso repercuta en peores predicciones meteorológicas en todo el mundo.

Por eso, en Estados Unidos la Administración Nacional para el Océano y la Atmósfera (NOAA) y la NASA están actualmente negociando con la Comisión Federal de Comunicaciones (FCC), que es la que controla las redes inalámbricas en este país. La NOAA y la NASA han pedido a la FCC que les ayude a proteger las frecuencias que se utilizan para las observaciones terrestres y atmosféricas para que el desarrollo de las redes 5G no interfieran con ellos. Pero la FCC sacó recientemente a subasta el primer paquete del espectro 5G sin tener en cuenta esas peticiones.

Un acuerdo global para que no haya interferencias

El debate no ha llegado aun a Europa, pero teniendo en cuenta el liderazgo en telecomunicaciones que ejerce Estados Unidos, sus decisiones seguro que influirán en cómo se trata el tema en otros países. En otoño de este año está previsto que se reúnan legisladores de todo el mundo en Egipto para llegar a acuerdos que permitan desarrollar esta tecnología a nivel global. Allí se debatirá qué frecuencias podrán utilizar estas empresas y cómo asegurar que la protección a las redes meteorológicas está garantizada.

Astrónomos y meteorólogos llevan mucho tiempo asegurándose de que compartir sus espectros de observación con otros usuarios no les causa problemas o interferencias en sus observaciones. Pero ahora, dicen, es la primera vez que ven amenazada su “joya de la corona”, esas frecuencias que consideran que deben ser solo suyas “y que debemos defender pase lo que pase”, explica en Nature Stephen English, meteorólogo del Centro para Predicciones Meteorológicas de Medio Alcance en Reading, Reino Unido.

Dentro de esa joya de la corona estaría la frecuencia de 23,8 GHz a la que el vapor de agua emite una débil señal. Algunos satélites, como el European MetOp, monitorizan constantemente la energía que emite la Tierra a través de esta frecuencia para medir la humedad que hay en la atmósfera justo bajo el satélite. La ventaja de esta medición es que se puede hacer con el cielo despejado o nublado de día o de noche. Los meteorólogos utilizan estos datos para alimentar los modelos que predicen cómo evolucionarán las tormentas y otros elementos climáticos en los días y horas siguientes.

¿Cómo lidiar con los vecinos ruidosos?

El problema con el 5G, dicen, es que una estación emitiendo en la misma frecuencia produciría una señal muy parecida a la de ese vapor de agua, lo cual impediría saber si es de origen natural o no. Incorporar esos datos dudosos haría los modelos mucho menos precisos. Es como tener un vecino ruidoso al otro lado de la pared: si pone la música muy alta, parte de su ruido te llegará a ti; si mantiene el volumen controlado, probablemente te libres del escándalo.

La NOAA y la NASA quieren que la FCC obligue a los vecinos a poner un aislamiento entre ellos y, si eso no es posible, a mantener el volumen a niveles que no les impidan trabajar. El problema es que los niveles que la FCC pide no les parecen suficientemente bajos como para no molestarles: -20 dBW, mientras que la Comisión Europea fija el máximo de ruido en -42 dBW y la Organización Meteorológica Mundial recomienda -55 dBW.

No está muy claro cuánto pueden empeorar las predicciones si las interferencias afectan a los 23,8 GHz y otras frecuencias necesarias para estas observaciones. Un informe de 2010 de las Academias Nacionales de Ciencias, Ingeniería y Medicina concluía que perder el acceso a la señal de los 23,8 GHz supondría eliminar un 30% de los datos útiles en las frecuencias de microondas, que contribuyen significativamente a las predicciones globales.

Referencias:

La tecnología 5G no tiene por qué preocuparte – Maldita Ciencia

Sí, Bruselas ha detenido la implantación de la tecnología 5G, pero no por “amenazar la salud de la humanidad” – Maldita Ciencia

Global 5G wireless networks threaten weather forecasts – Nature

Spectrum Management for Science in the 21st Century – National Academies of Sciences, Engineering and Medicine

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Las redes 5G no afectan a la salud… pero podrían hacer que el hombre del tiempo acierte menos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Menos felices y menos insatisfechos a medida que envejecemos

- Redes y arpones para cazar basura zombie en el espacio

- Hacia las redes 5G

La ley de proporciones definidas y la unidad de masa atómica

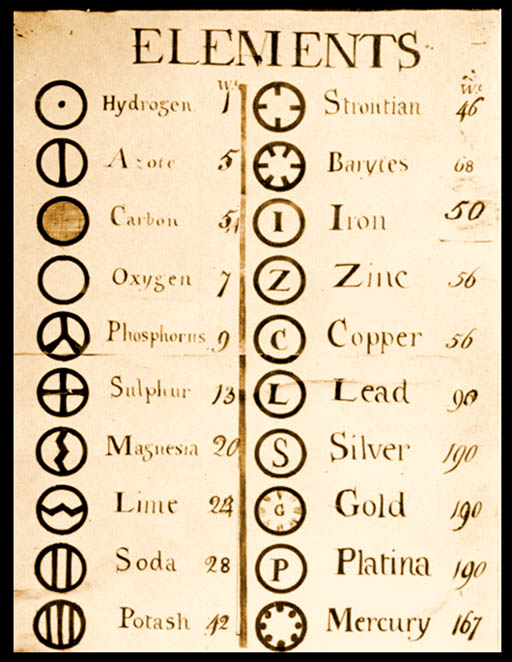

Símbolos químicos de Dalton (1803). Fuente: Wikimedia Commons

Símbolos químicos de Dalton (1803). Fuente: Wikimedia Commons

Durante milenios la idea de que toda la materia está hecha de pequeños e indivisibles trozos llamados átomos ha rondado por la cabeza de los investigadores de la naturaleza. Sin embargo hubo que esperar al siglo XX para obtener una confirmación experimental sin ningún género de dudas. Durante el siglo XIX se habían logrado grandes avances al atribuir las leyes termodinámicas y algunas de las propiedades de la materia, especialmente de los gases, a la teoría cinético-molecular; fue a partir de esta teoría que Einstein en 1905 propuso un modelo del movimiento browniano que Jean Perrin confirmó experimentalmente en 1908, probando más allá de toda duda la existencia de los átomos.

Por otra parte, durante siglos se supo que existen diferentes tipos de los llamados “elementos” fundamentales en la naturaleza: oro, plata, cobre, sodio, etc. Eran los componentes más simples en los que se pueden dividir las sustancias por medios químicos. Finalmente, se encontró útil dar a los elementos símbolos especiales: se empezó usando grafías elaboradas de distinta especie hasta acabar, por motivos puramente operativos, con simples letras, por ejemplo, “C” para el carbono, “O” para el oxígeno, “H” para el hidrógeno, etc.

Para muchas personas, aunque nadie lo expresó tan explícitamente como John Dalton, estos diferentes elementos indicaban que la naturaleza también está formada por diferentes tipos de átomos, un tipo de átomo para cada elemento. Cada elemento no sería más que una colección de átomos idénticos e indestructibles químicamente, una idea que se confirmó en durante todo el desarrollo de la química durante el siglo XIX.

Cuando dos o más átomos se unen, forman una molécula. La molécula puede ser un elemento en sí mismo si ambos átomos son iguales, como en el oxígeno, O2, o puede ser un compuesto si los átomos son diferentes, como el agua, H2O. Dado que los átomos no son divisibles, la idea de unir dos átomos de hidrógeno a, digamos, átomo y medio de oxígeno en lugar de exactamente un átomo de oxígeno no tiene sentido [1].

La ley de las proporciones definidas establecida por Joseph Proust en 1794 es una consecuencia natural de la idea de que los elementos están formados por átomos idénticos e indestructibles. De hecho, Dalton postula su teoría atómica en 1808 en un intento de explicar esta ley (su primera propuesta atómica, mucho más simple, es de 1803). Cuando los elementos se combinan para formar compuestos siempre es necesaria la misma proporción de masas de los constituyentes para hacer un compuesto en concreto. Por ejemplo, 23,0 g de sodio siempre se combinan con 35,5 g de cloro para producir 58,5 g de cloruro sódico (NaCl, sal común). Si tenemos 25,0 g de sodio y 35,5 g de cloro, seguiremos obteniendo solo 58,5 g de sal, y sobrarán 2,0 g de sodio. Esta regla, la ley de proporciones definidas, se aplica a todos los compuestos [2][3].

De la ley de proporciones definidas se deduce que los átomos de los elementos que se combinan para formar compuestos como el NaCl no tienen la misma masa. Dado que solo 23,0 g de sodio se combinan con 35,5 g de cloro para formar 58,5 g de NaCl, los átomos de cloro deben tener más masa que los átomos de sodio. Así, si un átomo de sodio tiene 23,0 “unidades” de masa, entonces un átomo de cloro tendría 35,5 unidades de masa. Las unidades de masa pueden ser gramos, kilogramos, libras o lo que sea. Por conveniencia, se denominan unidades de masa atómica, para las cuales el símbolo estándar es u.[4]

Ahora sabemos que solo existen 94 [5] elementos diferentes que ocurren naturalmente en toda la naturaleza y, de hecho, en todo el Universo. Los átomos de cada elemento tienen una masa concreta expresada en unidades de masa atómica . Hoy en día, las unidades de masa atómica se miden en relación con un tipo, o isótopo [6], del carbono conocido como carbono-12 (12C), que se define como una masa atómica de 12,0000 u. Las masas atómicas de todos los demás elementos se dan en relación con el carbono-12. Por ejemplo, en relación con el carbono-12, el sodio natural tiene una masa atómica de 22,990 u, el hidrógeno tiene una masa atómica de 1,008 u, el oxígeno tiene una masa atómica de 15,999 u, el uranio tiene una masa de 238,029 u, y así todos los demás [7].

Algunos de estos elementos tienen propiedades similares: algunos son gases a temperatura ambiente; otros son metales sólidos. Existen diferencias en las densidades, los puntos de fusión y ebullición, la conductividad eléctrica, etc. Estas propiedades parecen seguir ciertas pautas. Para entender por qué son las que son y cómo varían iniciamos aquí un viaje al interior de los átomos. [8]

Notas:

[1] De la misma forma no tiene sentido diluir una sustancia por debajo de una concentración en la que haya menos de un átomo en la unidad de volumen considerado. Así de simple se demuestra que la homeopatía y sus diluciones cuasi infinitas es falsa. Dicho de otra forma: si los átomos existen, y existen, entonces la homeopatía es falsa. De aquí se sigue, primero, que cualquiera que quiera venderte o recomendarte homeopatía es o un ignorante o un estafador; segundo, que cualquier dinero empleado en demostrar una imposibilidad manifiesta es dinero tirado a la basura.

[2] La ley establece que para un compuesto dado las proporciones están definidas. Eso no quiere decir que dos elementos no puedan formar compuestos diferentes.

[3] Hoy sabemos que la ley de proporciones definidas no es estrictamente cierta. Si bien el argumento que exponemos es plenamente válido, la química de precisión actual sabe que existen proporciones variables en los compuestos debido a pequeñas impurezas (naturales o artificiales, como el dopado) y las características de las redes cristalinas.

[4] La unidad de masa atómica no forma parte del Sistema Internacional de unidades.

[5] Habrá lugares en los que leas 92. Depende de la antigüedad de la fuente.

[6] A lo largo del siglo XX se descubrió que todos los átomos de un elemento son iguales en sus características pero que pueden existir varios valores de la masa. Cada uno de los valores de masa corresponde a un isótopo. Ya llegaremos a esto más avanzada esta serie. Paso a paso.

[7] Aquí tienes la última tabla oficial publicada por la IUPAC (2013).

[8] Será un viaje largo pero muy entretenido, en el que, como siempre, solo emplearemos matemáticas elementales.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La ley de proporciones definidas y la unidad de masa atómica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La relatividad de la masa

- Equivalencia entre masa y energía

- La óptica se hace atómica: la lente más pequeña del mundo

El selenio, esencial y peligroso

La Luna en el De Astronomia (Libri X) de Guido Bonatti (1550), representada por Selene

La Luna en el De Astronomia (Libri X) de Guido Bonatti (1550), representada por Selene

Ciertos elementos químicos, como el oxígeno o el hierro, por ejemplo, nos resultan familiares. Los nombres que los designan son de uso cotidiano. Pero lo normal es que de la mayoría no hayamos tenido noticia, salvo en las aulas. El selenio (Se), por ejemplo, es un gran desconocido. Quizás hemos visto su nombre en la formulación de alguna loción o champú, o hemos sabido de su uso en electrónica para hacer rectificadores de corriente en el pasado. Y poco más.

Fue descubierto en 1817 por el barón sueco Jakob Berzelius, considerado uno de los padres de la química moderna, y su colega y socio Joseph Gottlieg Gahn. Producían ácido sulfúrico en la fábrica de la que eran propietarios, y utilizaban para ello pirita procedente de la mina de Falun. La mina es muy conocida porque se comenzó a explotar alrededor del año 1000 y desde entonces ha proporcionado el 75% del cobre consumido en Europa hasta 1998, año en que se clausuró al dejar de ser rentable. Tres años después la UNESCO la declaró Patrimonio de la Humanidad.

El proceso de producción del sulfúrico dejaba lo que se denomina un precipitado (restos sólidos) de color rojo del que, al principio, Berzelius pensó que era un compuesto de arsénico. Pero su olor recordaba, más bien, a otro elemento, el telurio, que había sido descubierto en 1782 y con el que tiene cierta semejanza. Por esa razón, y porque al elemento descubierto 35 años antes se le nombró haciendo referencia al nombre latino de Tellus (Tierra), al nuevo elemento Berzelius lo denominó Selenium, por referencia a Selene, nombre griego de la diosa que personificaba a la Luna.

Según cuenta Daniel Torregrosa en su recomendable libro “Del mito al laboratorio”, Selene se enamoró del joven Endimión, un mortal de ilustre estirpe, pero mortal al fin y al cabo. Pidió por ello a Zeus que hiciese inmortal a su amado y Zeus, que tenía esas cosas, le concedió el deseo pero con la condición de que Endimión durmiese para siempre. Su estado de eterno durmiente no fue obstáculo, empero, para que Selene lo visitase cada noche y yaciese con él. Fruto del trajín llegó a concebir, al parecer, nada menos que cincuenta hijas. Sorprende que, siquiera por tal proeza, no fuese entronizada diosa de la fertilidad, honor que sin duda merecía. Quiere la casualidad, además, que haya una forma de infertilidad masculina, caracterizada por una movilidad espermática reducida, que se debe a la carencia de selenio.

El selenio es esencial para la vida. Aunque en concentraciones altas es muy dañino y puede ser letal, en concentraciones adecuadas (bajas) es necesario para el normal desarrollo de las funciones vitales. Por eso se suele incluir en complejos multivitamínicos y suplementos dietéticos.

Ese estrecho rango de concentraciones en que se requiere para un desarrollo óptimo de las funciones vitales tiene y ha tenido consecuencias curiosas e importantes. Por exceso de incorporación con la comida o el agua, el selenio ha sido causa de envenenamientos en animales y seres humanos. Hay lagos, ríos y bahías en los que se encuentra en concentraciones tóxicas a causa de la contaminación de origen industrial.

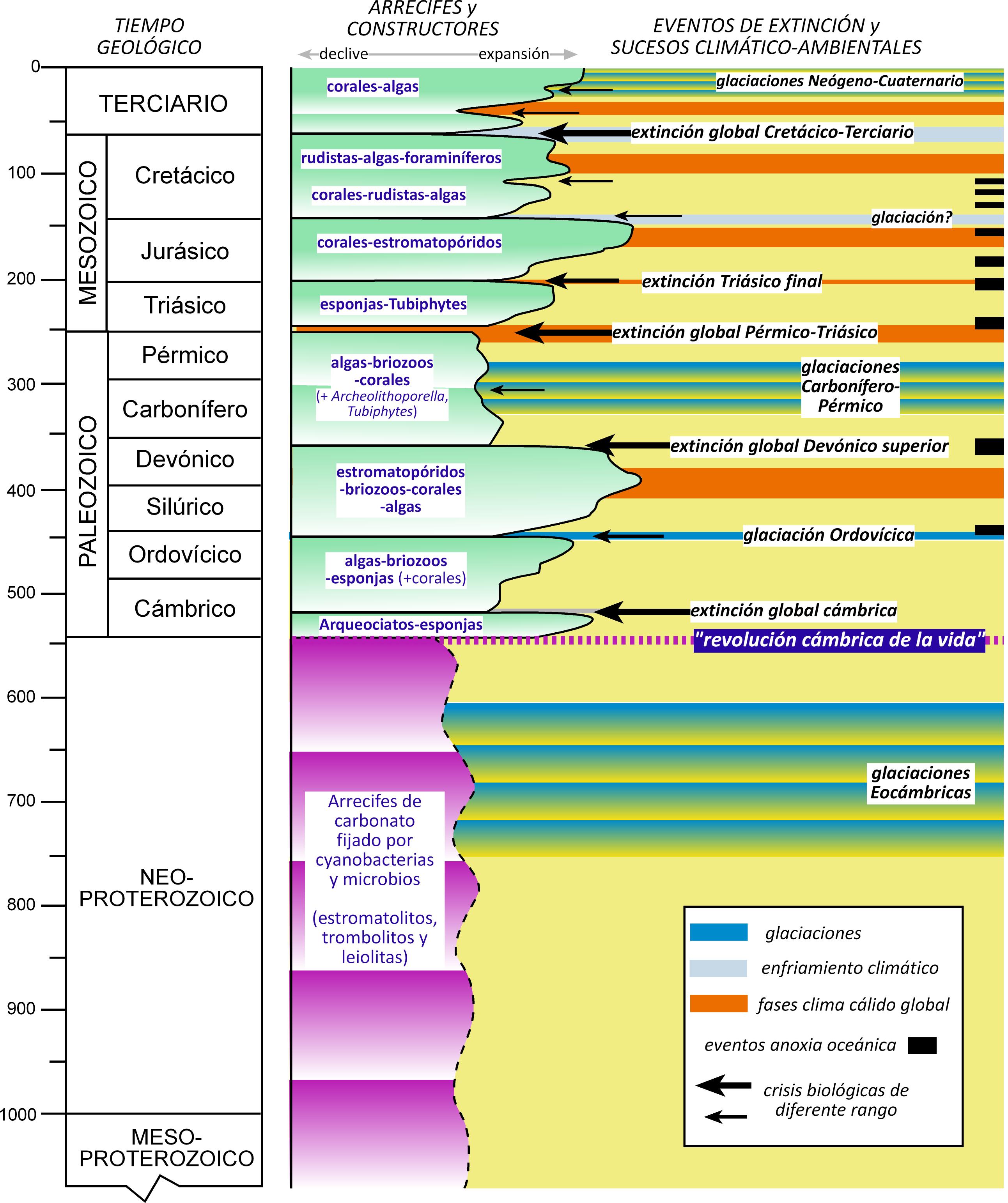

Pero su baja concentración en el medio es también perjudicial. Tres grandes extinciones de especies en la historia de la vida –las ocurridas al final de los periodos Ordovícico, Devónico y Triásico- han sido vinculadas con fuertes reducciones de la concentración de selenio en los océanos. Por el contrario, también se cree que favoreció la explosión del Cámbrico de hace quinientos millones de años, cuando surgió la mayoría de los grupos animales.

——————-

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El selenio, esencial y peligroso se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un cóctel peligroso

- “Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso

- Sangre de dragón

¿Qué comes cuando comes comida basura?

Hay quien lo denomina “comida rápida” y quien lo llama “comida basura”. Llamemosle de una u otra manera, si la comemos dos veces por semana y mantenemos ese ritmo, en una década ganaremos entre 4 y 5 kg más que alguien que coma este tipo de comida solo una vez por semana.

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Qué comes cuando comes comida basura? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Qué pasa en tu cuerpo cuando te enamoras?

- ¿Qué pasa en tu cerebro cuando duermes?

- La comida en la basura

50 años de secretos: la era de la criptografía moderna

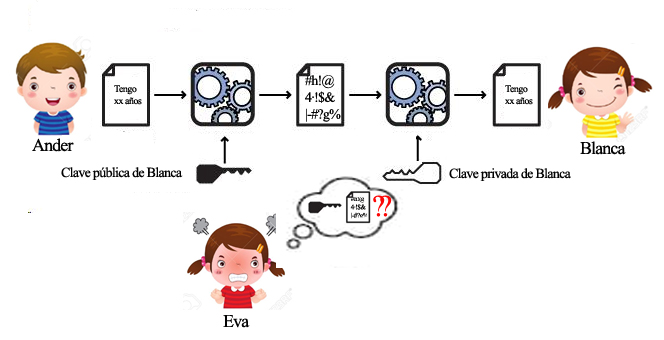

Tres personas que no se conocen, Ander, Blanca y Eva, se encuentran aisladas en una habitación. Blanca necesita saber la edad de Ander, que Eva no debe conocer bajo ningún concepto. ¿Hay alguna forma de que Ander pueda responder a Blanca sin revelar la información a Eva? Todo lo que cada uno diga o haga lo escucharán o verán los otros dos.

El sentido común dice que no: Blanca y Eva ven y oyen exactamente lo mismo, si en un momento dado una de ellas tiene información suficiente para deducir la edad de Ander, la otra la tendrá igualmente. Este problema, de haberse planteado hace cincuenta años, habría tenido seguramente la misma respuesta escéptica, sin embargo, en aquella época las cosas estaban cambiando.

Comenzaba una revolución, silenciosa para el ciudadano de a pie, cuyas consecuencias pocos podían prever. Se vivía el inicio de la revolución digital. Pesadas máquinas que llenaban habitaciones enteras eran capaces de efectuar cálculos y almacenar datos con una rapidez y un volumen desconocidos hasta entonces (que hoy nos haría sonreír) y poco a poco abandonaban los laboratorios de los centros de investigación para hacerse presentes en bancos y grandes industrias. Incluso con sus limitaciones, el manejo de grandes cantidades de datos trajo consigo nuevos retos a los que dar solución. Entre otros, establecer procedimientos para asegurar que la información se procesaba y transmitía libre de errores y protegerla de quien pudiera hacer uso malintencionado de ella.

No se puede decir que estos problemas fueran nuevos, pero sí lo era la escala de los potenciales afectados. En la era pre-digital la información que de verdad requería protección era relativamente poca, limitada esencialmente a ámbitos militares o de la burocracia gubernamental y en esos casos el coste que suponía mantener el nivel adecuado de seguridad era alto pero asumible.

La información es especialmente vulnerable mientras se transmite, antes o después de este momento su custodia no presenta grandes dificultades, pero ¿cómo puede protegerse mientras viaja a su destinatario por un canal que casi siempre escapa a nuestro control? La herramienta es el cifrado. En la era analógica, por llamar así a toda la historia de la humanidad salvo los aproximadamente últimos cincuenta años, la solución no dejaba de ser más o menos simple. Digamos que al espía o diplomático se le proveía de un “libro de claves” del que el receptor mantenía una copia.

En su versión más simple (pero también la más perfecta) un libro de claves no es más que una larguísima secuencia aleatoria de bits, es decir ceros y unos. Para cifrar un mensaje, que ya suponemos transcrito al lenguaje binario, el emisor suma simplemente los bits del mensaje, uno a uno, con los del libro empezando por el primero (emplea la suma binaria en la que 1+1=0). Así el mensaje cifrado resulta ser una cadena de bits tan aleatoria como la del libro y el enemigo que eventualmente capture el mensaje cifrado no tendrá absolutamente ninguna posibilidad de recuperar el mensaje original. Sin embargo, el receptor del mensaje, poseedor de una copia del libro de claves, no tiene ninguna dificultad puesto que si hace exactamente lo mismo que hizo el emisor descifrará el mensaje. Este es el esquema de la criptografia clásica, conocido y utilizado por la humanidad desde las civilizaciones más antiguas.

¿Pero por qué no sirve la criptografía clásica en el mundo digital? Pues porque exige algo que parece fácil a simple vista pero que en el mundo virtual es inviable por su coste: acordar cuál es el libro de claves. No es aceptable que cada vez que queramos comunicarnos con alguien, sea una persona de carne y hueso, una entidad bancaria, un comercio o una administración, estemos obligados a contactar previamente con ella, físicamente o mediante otro medio no digital, para establecer nuestra contraseña. Necesitamos hacerlo a través del mismo canal digital inseguro por el que se transmite toda la información. Estamos justamente enfrentados al problema de Ander, Blanca y Eva.

No está claro a quién atribuir la solución a este acertijo, sin la cual gran parte del mundo actual no podría funcionar. En 1976 los investigadores de la universidad de Stanford W. Diffie y M. Hellman publicaron un artículo que se considera el nacimiento oficial de la criptografía moderna, aunque, según parece, agencias de seguridad de algunos países ya habían desarrollado ideas similares poco antes. El fechar este suceso hace cincuenta años ha sido simplemente una pequeña licencia al hilo de la celebración del nacimiento de nuestra facultad.

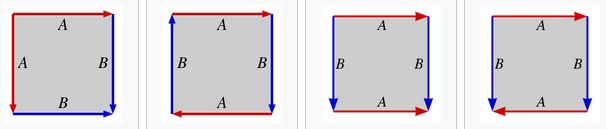

Intentemos explicar en qué consiste eso de la criptografía moderna con un símil. Cifrar un mensaje no es más que meterlo en una caja que cerramos con un candado. En la criptografía clásica, como en la vida real, la “llave” que encripta y desencripta, esto es, la que cierra y abre el candado, es la misma, por eso no le sirve a Blanca, porque si le dice a Ander cómo tiene que encriptar, Eva, que está atenta, se da cuenta inmediatamente, no sólo de cómo encriptar, lo cual es inocuo, sino también, y esto es lo que queremos evitar a toda costa, de cómo desencriptar. Al dar la llave de cerrar a Ander, Blanca le está dando también la de abrir a Eva, puesto que es la misma (es decir, al dar la regla para encriptar a Ander le está dando sin querer la regla para desencriptar a Eva).

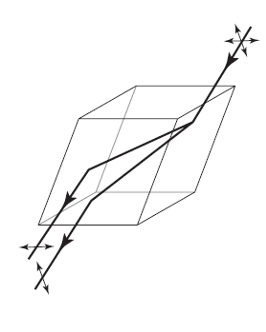

Lo que los descubridores (o inventores, cada cual que elija el término que considere más adecuado) de la criptografía moderna plantearon es que todo sería muy distinto si hubiera dos llaves diferentes, una para cerrar y otra para abrir. Entonces no habría ningún problema, Blanca podría dar con total tranquilidad una copia de la llave de cerrar a Ander (y también a Eva o a cualquiera) pero sólo ella retendría la llave de abrir. Así Eva vería pasar ante sus ojos la caja cerrada pero no podría hacer nada porque la llave que tiene sólo sirve para cerrar, es inútil para abrir.

Fuente: elaboración propia a partir de Public Key Private Key Cryptography

Fuente: elaboración propia a partir de Public Key Private Key Cryptography

Lo anterior puede sonar convincente, pero sucede que las acciones de encriptar y desencriptar están inexorablemente ligadas, una no es más que el proceso inverso de la otra (como en el mundo real: cerramos girando la llave en un sentido y abrimos girándola en el sentido contrario). Sin embargo, es un hecho bastante común, al menos en el mundo matemático, que cuando dos procesos son inversos uno del otro, uno de ellos es mucho más costoso que su recíproco (así, es más difícil restar que sumar, dividir que multiplicar, extraer la raíz cuadrada que elevar al cuadrado… o recomponer los añicos de un jarrón chino que estrellarlo contra el suelo). Pero sucede que esto que nos protege de Eva, también afecta a Blanca, es decir para que nuestro esquema tenga sentido el proceso inverso (desencriptar) debe ser de una dificultad insuperable para Eva pero no para Blanca, que necesita saber cómo hacerlo para recuperar el mensaje original de Ander.

Las matemáticas están llenas de problemas difíciles, algunos con cientos o incluso miles de años de antigüedad, y que en ocasiones tienen enunciados arcanos sólo al alcance de iniciados. Afortunadamente éste no es el caso del que vamos a comentar ahora y que encaja en la tipología de los problemas inversos de los que hablábamos en el párrafo anterior. En la escuela todos aprendimos a multiplicar, primero los números de una cifra (un ejercicio de memorización) y luego los de dos o más. Ningún lector tendrá dificultad en realizar 17×71 o cualquier otra multiplicación que se quiera plantear, incluso aunque los factores tengan muchas más cifras. Es verdad que, si fueran dos números de, digamos, cien cifras, seguramente no tendríamos la paciencia suficiente para terminar (y, además, ¿qué interés puede haber en semejante operación?), sin embargo, con tiempo y motivación sería factible. Ni que decir tiene que un ordenador puede hacer este cálculo prácticamente al instante.