La forma fractal de mapas y pulmones

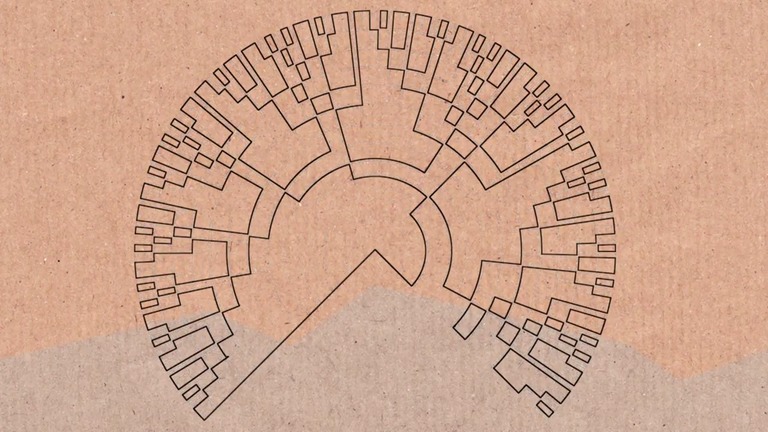

Los mapas isócronos son mapas que representan tiempos: en general, el tiempo que se tarda en llegar de un lugar a otro. Distintos tonos de color corresponden a distintos valores de tiempo y, en consecuencia, dos puntos del mapa del mismo color están a la misma “distancia temporal” de otro que se haya tomado como origen.

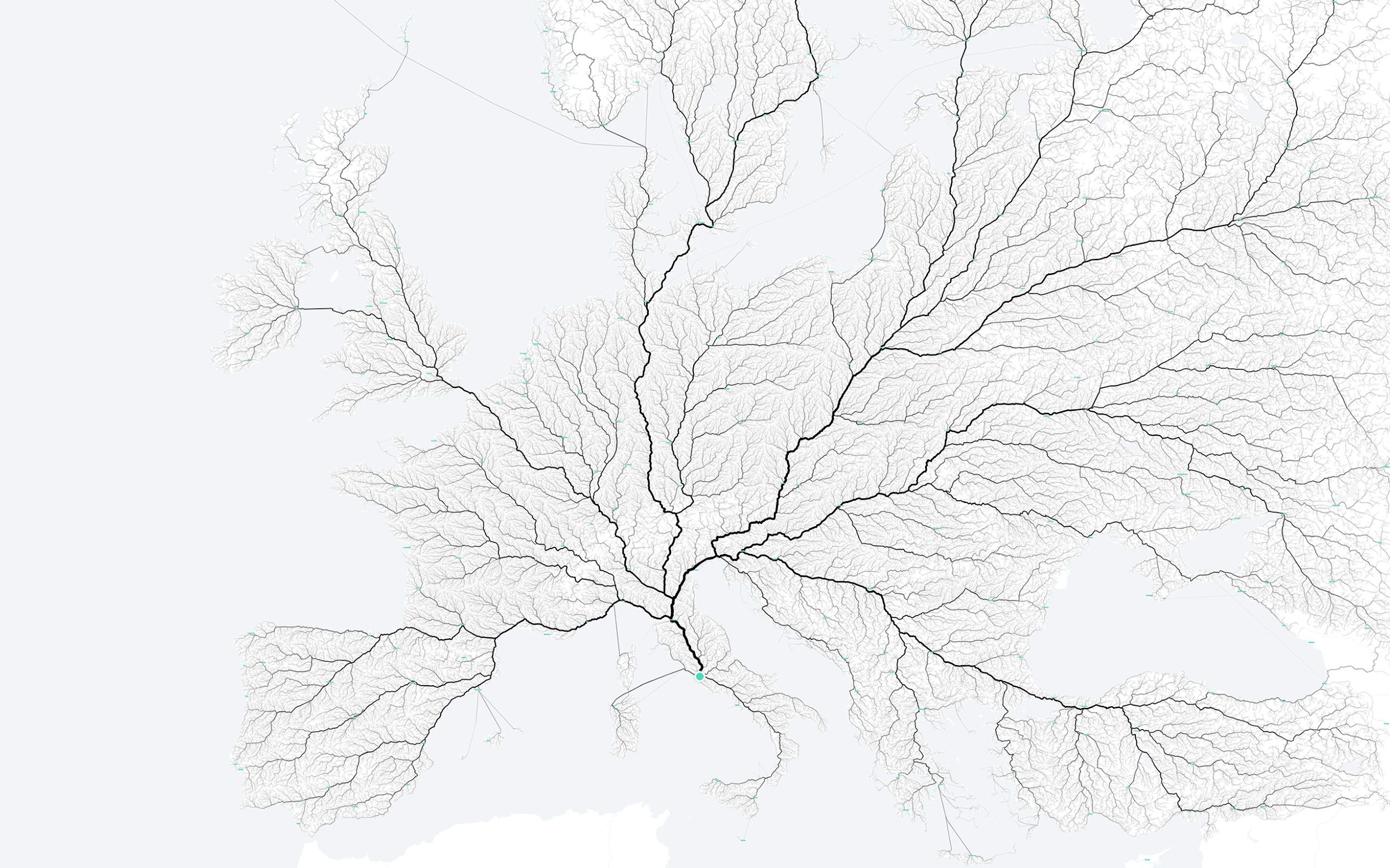

Si la superficie representada en el mapa fuese la de un terreno liso, igualmente transitable en todas las direcciones, podríamos esperar que un mapa isócrono fuese, sencillamente, una especie de diana: círculos concéntricos trazados a partir del origen elegido. En lugar de eso, el patrón que nos encontramos es este:

El vídeo, publicado por Alberto Hernando de Castro, muestra un mapa isócrono de España con origen en la Plaza Mayor de Madrid, creado con herramientas de software libre (el autor explica cómo aquí, por si queréis jugar). Pero existe una galería completa de mapas isócronos que podéis consultar: Estados Unidos, Japón, Brasil… y todos ellos tienen la misma forma. Una forma que recuerda poderosamente a la de un fractal.

No es casualidad, claro. Esta es la forma que tienen, en general, los caminos construidos por humanos mirados desde un único punto de origen (o de destino). Pero también; la forma que adopta nuestro sistema circulatorio. O las ramificaciones de nuestros pulmones. O las raíces de un árbol… Todos estos sistemas se parecen porque todos dan solución a un problema muy concreto: el problema del transporte, o de cómo cubrir una superficie (léase, un objeto de dimensión n) usando sólo líneas (de dimensión n-1).

Todos los caminos llevan a Roma… formando un precioso fractal. Fuente: Moovel Lab

Todos los caminos llevan a Roma… formando un precioso fractal. Fuente: Moovel LabLos fractales son, quizás, una de las estrellas pop de la matemática moderna y, francamente, no me extraña. Presentan un equilibrio intrigante de sencillez y complejidad, como los mejores puzzles de lógica: una premisa aparentemente fácil va escalando poco a poco y da lugar a una trama mucho más rica y minuciosa. Puede que su atractivo visual algo que ver con esto. O puede que nos hechice saber que ninguna de sus líneas se debe al capricho: cada una obedece un camino preciso, exacto, sin que ningún diseñador haya tenido que trazarlo, sin que ningún espectador vaya a poder recorrerlo por completo jamás.

A pesar de su encanto y su fama, los fractales son también grandes incomprendidos: la idea popular los pinta como objetos idénticos a sí mismos a distintas escalas. Sin embargo, esta no es una característica compartida por todos los fractales, sólo por los llamados autosimilares. Como definición, resultaría demasiado restrictiva, demasiado “ideal”. Los fractales, en cambio, nacieron en los años 70 con la ambición de describir objetos muy reales de la naturaleza, que no podían ser delimitados por las líneas suaves a las que nos tenía acostumbrado el cálculo, o la geometría. Lo que Mandelbrot tenía en mente era capturar la idea de rugosidad: como la de la costa de Gran Bretaña o, sí, como el contorno de una carretera. Para representar esta idea matemáticamente, podemos utilizar el concepto de dimensión fractal.

Fácil y divertido. O… no tanto. Veamos qué es esto: ¿qué es una dimensión?

A todos nos suena más o menos, aunque sólo sea como salmodia, que “un punto no tiene dimensiones”, que una línea recta es un objeto unidimensional, una superficie tiene dos dimensiones y los volúmenes que nos rodean ocupan un espacio de tres dimensiones (4 si consideramos el tiempo). De manera intuitiva, podemos decir que una dimensión es un parámetro de cambio que puede ser fijado mediante una coordenada. Por lo tanto, el número de dimensiones de un objeto será igual al número de coordenadas necesarias para definir un punto sobre el mismo.

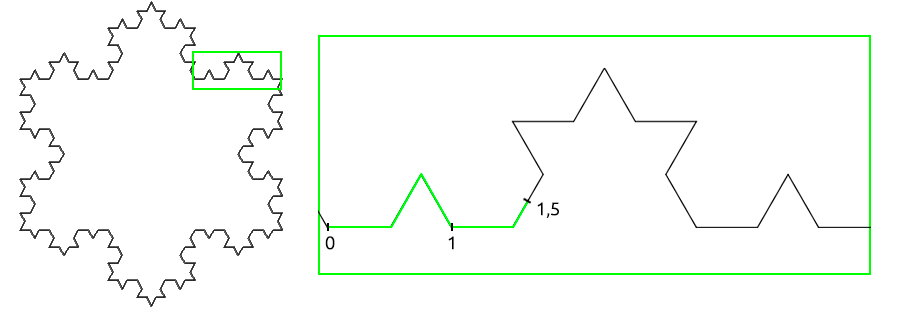

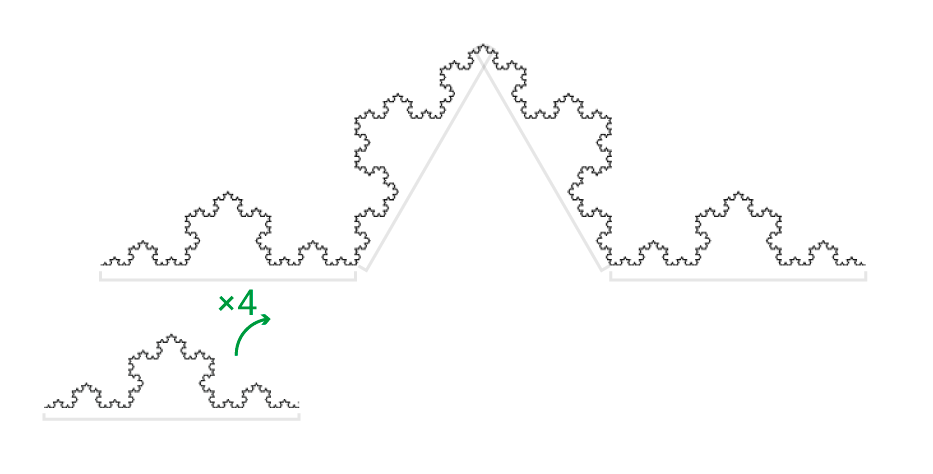

Ahora bien, tomemos un fractal e intentemos poner a prueba esta idea: por simplicidad, elegiremos un fractal de los más populares, autosimilar, como el copo de nieve de Koch. A primera vista, parece ser una línea (unidimensional), por lo que debería bastar una única coordenada para definir un punto sobre ella. En este caso, claro, al no estar sobre una línea recta, nuestra coordenada será una especie de “punto kilométrico” sobre la curva.

Bien, imaginemos que buscamos el punto “1,5” de la curva, siendo sus segmentos rectos de longitud 1. Para ello, hacemos zoom y nos quedamos con un fragmento lo más sencillo posible del copo de nieve. Algo como esto:

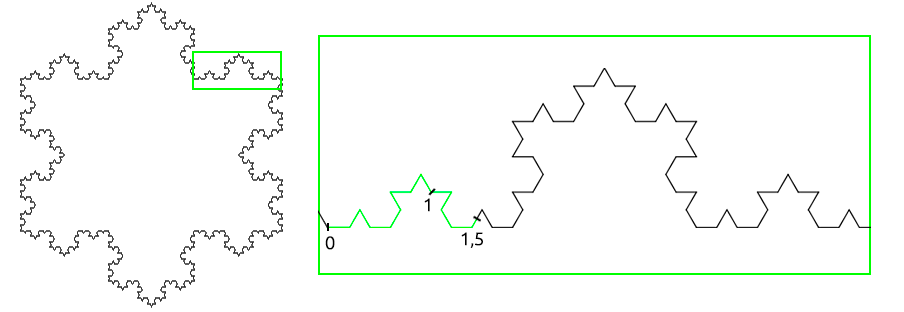

Lo dicho ¡fácil y divertido! O… no tanto. En realidad, al intentar simplificar el problema, hemos hecho una pequeña trampa. Hemos eliminado, precisamente, la rugosidad del fractal. De hecho, si nos fijamos un poco mejor y añadimos más detalle a la curva de Koch, nos encontramos con que el punto 1,5 ya no donde lo habíamos encontrado:

Y con una tercera iteración, el punto se desplaza todavía más:

Supongo que veis adónde va a parar esto. Realmente, no es posible localizar nuestro punto de esta manera porque la longitud un fragmento cualquiera de la curva de Koch es infinito.

Como lo sería (figuradamente) el contorno de Gran Bretaña medido alrededor de cada grano de arena de su costa (o del peinado de Boris Johnson). El detalle de nuestra medida, la “escala” elegida, altera la medida misma. Esto es lo que se conoce como el efecto Richardson.

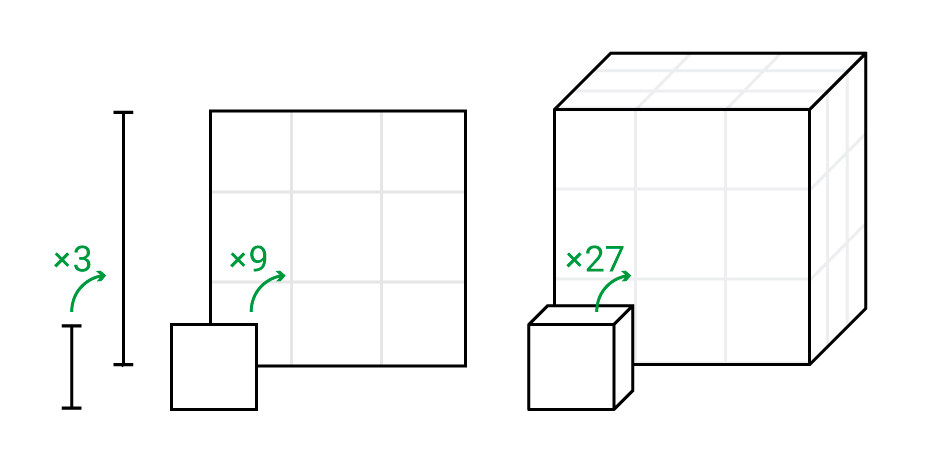

Nuestro primer intento, por tanto, no ha funcionado. Pensemos en otra manera de entender la dimensión de un objeto. Partamos, de nuevo, ejemplos conocidos: un fragmento de recta, un cuadrado, un cubo e imaginemos que queremos “pesarlos”. En este caso, se tratará de un peso imaginario, intuitivo. Podemos usar una báscula matemática de masas platónicas para medirlo, si queréis. En concreto, nos interesa saber cómo cambia la masa de estos objetos al cambiar su escala y multiplicarla por 3.

Bien: si tomamos la recta y multiplicamos su tamaño por 3, su masa se multiplicará también por 3. En el caso del cuadrado, al triplicar su escala, obtendremos un peso 9 veces mayor (dicho de otro modo: el cuadrado original cabe 9 veces en el ampliado). El cubo, pasará a pesar 27 veces más… Supongo el patrón es fácil de ver: 3=31, 9=32, 27=33. La dimensión de cada objeto nos indica a qué número debemos elevar el cambio de escala (3) para obtener el valor de la nueva masa.

¿Qué sucede entonces con la curva de Koch? Bien, en este caso, si ampliamos un fragmento de nuestro copo por 3, obtenemos un fragmento que contiene 4 veces al fragmento original. Es decir: su peso se multiplicará por 4.

Siguiendo el razonamiento del párrafo anterior, podemos calcular cuánto vale la dimensión del fractal, encontrando el valor de este exponente (x): 3x=4

¿A cuánto hay que elevar el factor de escala (3) para que el peso se multiplique por 4? La solución de la ecuación, x = log4 / log3 nos indica que la dimensión fractal de la curva de Koch no es ni 1 ni 2: es, aproximadamente, 1,26.

Esta es la magia de los fractales: su dimensión puede ser un número no entero. El infinito que llevan en su ADN (infinitas torsiones, infinitas ramificaciones) los coloca a mitad de camino entre líneas y superficies, o superficies y volúmenes. Existen, incluso, curvas ¡de dimensión fractal 2! capaces de llenar el plano. Este es el caso de la curva de Hilbert, por ejemplo, pero existen muchas otras.

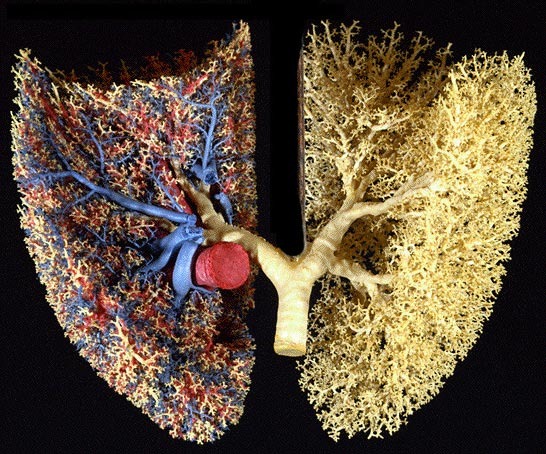

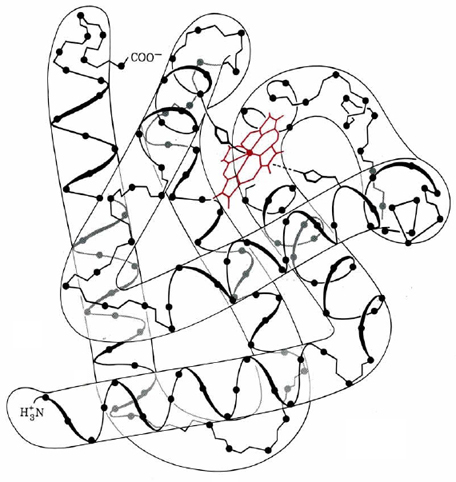

Pero volvamos a los ejemplos reales. Ciertamente, nuestros pulmones no se ramifican de manera infinita ni tienen una masa platónica. Sin embargo, es precisamente su parecido con un fractal lo que les permite maximizar su superficie siguiendo un patrón de crecimiento relativamente sencillo (similar a distintas escalas). Los pulmones, como árboles invertidos (y los árboles, como pulmones invertidos), intercambian gases en la punta de cada rama, donde se encuentran los alvéolos (las hojas). La cantidad de gases que consiguen aprovechar es directamente proporcional a su superficie total. Y aquí es donde viene el dato sorprendente: aunque el volumen de los pulmones humanos es apenas de unos 4 a 6 litros, su superficie ronda los 140 metros cuadrados1, algo más de media cancha de tenis. En esto consiste, precisamente, la idea de rugosidad. Para cuantificarla, eso sí, pueden tomarse distintas aproximaciones: en el caso de los pulmones, la dimensión fractal varía, según distintos autores, entre 2,26 y 2,882.

Pulmones humanos (con sistema circulatorio a la derecha). Fotografía de Ewald Weibel, Institute of Anantomy, University of Berne.

Pulmones humanos (con sistema circulatorio a la derecha). Fotografía de Ewald Weibel, Institute of Anantomy, University of Berne.Volviendo a las líneas del precioso mapa isócrono que, sin quererlo, se han ramificado hasta dar forma a esta digresión: se ha estimado que podrían tener una dimensión de 1,83. Resulta difícil asegurar si la fractalidad de estas carreteras se debe, quizás, a la rugosidad del propio terreno sobre el que se construyen. O si el truco radica en tomar un punto de origen sobre una red mucho más compleja. En cualquier caso, es bonito pensar que nuestros caminos son, de hecho, equivalentes a pulmones, o al sistema circulatorio de un organismo inmenso del que, sin saberlo, formamos parte. Un organismo vivo que nosotros mismos hemos ido construyendo.

Bonus track: Este es el aspecto de los ríos y sus afluentes

Referencias:

1 E.N. Marieb, K.N. Hoehn. Human anatomy and physiology.

2 K. Lamrini Uahabi and M. Atounti. New approach to the calculation of fractal dimension of the lungs

3 P. Pavón et al. Multifractal approach for comparing road transport network geometry: The case of Spain

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo La forma fractal de mapas y pulmones se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia en la cocina: Fractal de cochinilla

- Frank Stella, la forma del lienzo

- La nueva forma de enfriar que lo cambiará todo

La misteriosa sucesión de Kolakoski

William Kolakoski (1944-1997) fue un artista que se dedicó también a la matemática recreativa. Es conocido –fuera del ámbito artístico– por la sucesión que lleva su nombre y que él mismo introdujo en 1965 en la revista American Mathematical Monthly:

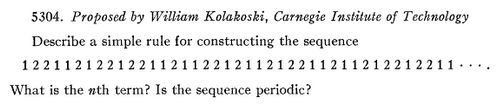

Imagen 1: Captura de pantalla del problema planteado en la referencia [1].

Imagen 1: Captura de pantalla del problema planteado en la referencia [1].

El matemático Rufus Oldenburger ya había descrito esta sucesión en 1939, aunque parece en ese momento no llamó la atención de la comunidad científica.

En este ‘problema 5304’ planteado en la American Mathematical Monthly, Kolakoski escribía los primeros términos de la sucesión, proponía describir una regla para construirla, encontrar su n-ésimo término y decidir si se trata de una sucesión periódica.

Para describirla se puede recurrir a la llamada ‘sucesión contadora’ de una dada, es decir, la sucesión formada por aquellos enteros positivos que indican el número de bloques de símbolos consecutivos iguales en la sucesión. Por ejemplo, la sucesión contadora de:

a, b, b, a, a, b, b, b, a, b, a, a, b, b,…,

es 1, 2, 2, 3, 1, 1, 2, 2…; porque el término a aparece una vez, la b dos veces, la a dos veces, la b tres veces, la a una vez, la b una vez, la a dos veces, la b dos veces,…

La sucesión de Kolakoski posee bloques de uno o dos dígitos de ‘1’ y ‘2’; los primeros son:

1, 2, 2, 1, 1, 2, 1, 2, 2, 1, 2, 2, 1, 1, 2, 1, 1, 2, 2, 1, 2, 1, 1, 2, 1, 2, 2, 1, 1,…

Su sucesión contadora es:

1, 2, 2, 1, 1, 2, 1, 2, 2, 1, 2, 2, 1, 1, 2, 1, 1, 2, 2,…,

ya que los bloques de dígitos van agrupados de la siguiente manera:

1, 2, 2, 1, 1, 2, 1, 2, 2, 1, 2, 2, 1, 1, 2, 1, 1, 2, 2, 1, 2, 1, 1, 2, 1, 2, 2, 1, 1,…

Es decir, la sucesión contadora de la de Kolakoski… ¡vuelve a ser la de Kolakoski!

Cada término de la sucesión de Kolakoski genera un ‘camino’ de uno o dos términos ‘futuros’. ¿Cómo? El primer 1 de la sucesión genera un camino de “1”, es decir, a sí mismo. El primer 2 genera el camino “2, 2” (que se incluye a sí mismo) y el segundo 2 genera un camino “1, 1” y así sucesivamente.

En [5] se demuestra que la sucesión de Kolakoski no es periódica. En [6] el autor proporciona una fórmula recursiva para la sucesión… Pero muchos otros problemas relativos a esta sucesión quedan aún abiertos, como los siguientes:

-

dada una cadena de dígitos en la sucesión, ¿vuelve a aparecer en algún otro lugar de la sucesión?

-

dada una cadena de dígitos en la sucesión, ¿la cadena inversa también aparece en algún otro lugar de la sucesión?

-

¿aparecen los dígitos 1 y 2 con la misma frecuencia en la sucesión de Kolakoski?

En este video del canal de YouTube de Numberphile, el divulgador Alex Bellos explica algunas de las curiosidades sobre la misteriosa sucesión de Kolakoski…

Existen numerosas variaciones –incorporando más cifras a la sucesión, o cifras diferentes, etc. (ver [4])– que añaden dificultad al tema y hacen surgir otro tipo de preguntas, muchas de ellas aún sin solución. Así avanzan las matemáticas… aumentando la dificultad de los retos y buscando nuevas ideas y diferentes técnicas que puedan ayudar a resolverlos.

Referencias

[1] William Kolakoski (1965). Problem 5304, The American Mathematical Monthly 72: 674.

[2] The Kolakoski Sequence, Futility Closet, 5 octubre 2018

[3] N. J. A. Sloane, A000002 Kolakoski sequence, The On-Line Encyclopedia of Integer Sequences (y los 10 500 primeros términos de la sucesión).

[4] Kolakoski Sequence, Wikipedia (consultado: 6 octubre 2018)

[5] Necdet Üçoluk (1966). Problem 5304, The American Mathematical Monthly 73, 681-682.

[6] Steinsky, Bertran (2006). A recursive formula for the Kolakoski sequence A000002. Journal of Integer Sequences. 9 (3).

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo La misteriosa sucesión de Kolakoski se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- John Rainwater no existe

- Los números (y los inversos) de Fibonacci

- El teorema de los cuatro colores (y 4): ¿Podemos creer la prueba de la conjetura?

La clasificación actual de los minerales

En Esa pesadilla científica llamada mineralogía dábamos una definición de mineral que nos ha servido suficientemente bien por el recorrido que hemos hecho por la historia de esta ciencia. Y, sin embargo, esa definición no es del todo correcta. Y no es exactamente correcta porque la historia tiene cosas que decir.

En los listados existen algunos minerales que, según las reglas actuales, no podrían considerarse minerales y sin embargo lo son oficialmente. Esas reglas las establece una comisión específica de la Asociación Mineralógica Internacional (IMA, por sus siglas en inglés), un organismo fundado en Madrid en 1958 y que agrupa actualmente a 40 sociedades nacionales. La AMI publica regularmente el listado de especies minerales reconocidas, listado que se ha actualizado en septiembre de 2018 y que puede ser descargado aquí. Pero vayamos por orden y veamos el origen de la clasificación actual de los minerales reconocida oficialmente.

La clasificación actual de los minerales, la 10ª Edición de la Nickel-Strunz, tiene su origen en el trabajo de Karl Hugo Strunz.

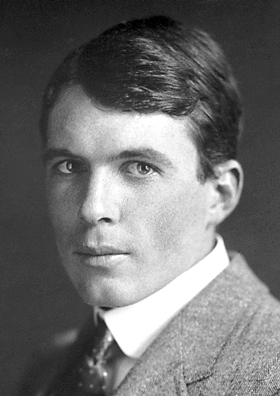

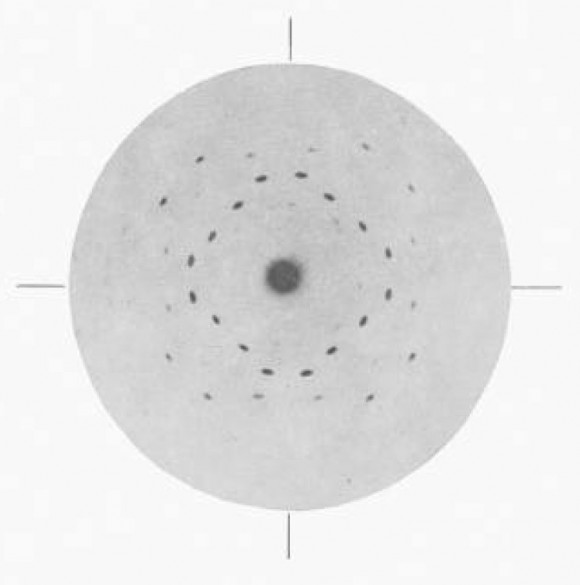

Strunz nació en Weiden (Baviera, Alemania) en 1910 y estudió ciencias naturales en la Universidad de Múnich, especializándose en mineralogía. Obtuvo una beca de investigación en la Universidad Victoria en Manchester (Reino Unido), donde trabajó con el físico y cristalógrafo William Lawrence Bragg, quien en 1912 descubrió lo que hoy se conoce como la ley de difracción de rayos X de Bragg, la base para a determinación de la estructura cristalina. Posteriormente, Strunz ocupó puestos de investigación con Paul Niggli en Zurich y Paul Ramdohr en Berlín. Ocupó cargos de profesor en la Universidad Friedrich-Wilhelm, ahora Universidad Humboldt en Berlín, en la Universidad de Ratisbona y en el Instituto de Tecnología de Berlín.

Strunz desarrolló una clasificación de los minerales que se basaba tanto en su composición química como en su estructura cristalina. Su trabajo reagrupó las categorías de James Dwight Dana en un sistema más útil, pero también más complejo.

Edición original de las “Mineralogische Tabellen” (1941) conservada en la Universidad Humboldt de Berlín. Tiene los sellos de la biblioteca con la nueva denomincación de la universidad y el de cuando entró en ella bajo el régimen nazi. Fuente: Humboldt Universität zu Berlin

Edición original de las “Mineralogische Tabellen” (1941) conservada en la Universidad Humboldt de Berlín. Tiene los sellos de la biblioteca con la nueva denomincación de la universidad y el de cuando entró en ella bajo el régimen nazi. Fuente: Humboldt Universität zu BerlinLas Mineralogische Tabellen de Strunz se publicaron por primera vez en 1941, cuando era curador del Museo de Mineralogía de la Universidad Friedrich-Wilhelm. Strunz había estado clasificando la colección del museo de acuerdo con las propiedades cristalinas y químicas.

Strunz fue miembro fundador y luego presidente de la Asociación Mineralógica Internacional. Él mismo descubrió 14 nuevos minerales, y la strunzita lleva su nombre.

El sistema de Strunz se sometió a una revisión importante en 1966 y tras la colaboración con Ernest Henry Nickel para la novena edición, publicada en 2001, el sistema pasó a conocerse como la clasificación Nickel-Strunz. Actalmente está en vigor la décima edición.

La clasificación de Strunz dividía los minerales en nueve clases que se dividen aún más según la composición y la estructura del cristal. La décima edición establece 10 categorías. Estas categorías son (pueden verse con algo más de detalle aquí):

1 – Minerales elementos

2 – Minerales sulfuros y sulfosales

3 – Minerales haluros

4 – Minerales óxidos e hidróxidos

5 – Minerales carbonatos y nitratos

6 – Minerales boratos

7 – Minerales sulfatos

8 – Minerales fosfatos

9 – Minerales silicatos

10 – Compuestos orgánicos

Decíamos al comienzo que nuestra definición no es del todo correcta porque la historia tiene cosas que decir. Recordemos: Un mineral es una sustancia que:

a) existe en la naturaleza (esto incluye cualquier parte del universo) naturalmente, esto es, sin intervención humana;

b) tiene una composición química característica, aunque no tiene por qué tener una fórmula química exacta;

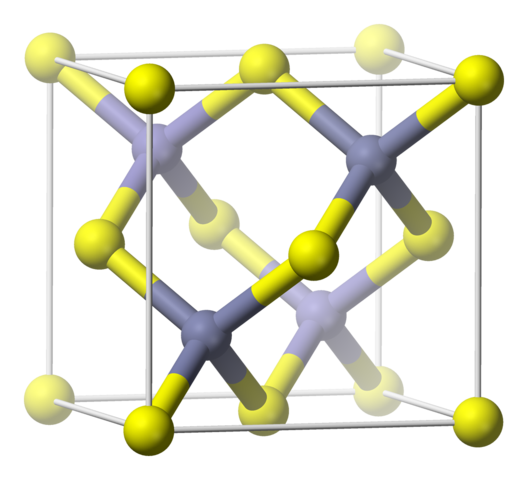

c) posee una estructura generalmente cristalina. Esta afirmación implica que los minerales son, en principio, sólidos, que la estructura cristalina puede tener alteraciones debido a impurezas, y que además se usa la definición actualizada de cristal (sólido con un patrón de difracción definido) lo que incluye a los cuasicristales.

Pero, si la definición incluye a los cuasicristales y los minerales extraterrestres, ¿que es lo que la clasificación de Nickel-Strunz admite que no cumple con la definición? La clave está en la condición de cristalinidad.

Existe un mineral aprobado actualmente que es un líquido a temperatura ambiente, el mercurio, que, al ser un líquido, no tiene estructura cristalina y no puede producir un patrón de difracción. De hecho existe una familia del mercurio y sus amalgamas (la 1.AD de Strunz).

También existe todo un conjunto minerales amorfos. El ópalo es, quizás, el más conocido. Ello se debe a que cuando la composición se define con precisión mediante un análisis cuidadoso, se demuestra que la sustancia es única, está en una sola fase y, a pesar de ello, se comprueba que no existe un patrón de difracción, la CNMNC (la comisión de la IMA encargada) puede considerar incluir en los listados una sustancia amorfa. Esto se hace siempre caso por caso. El ópalo, sílice hidratada (SiO2·nH2O), sin embargo, es otra de estas excepciones históricas que nunca se aprobarían como mineral bajo las normas actuales (la n indica que la composición es variable). De momento el ópalo aparece clasificado como óxido: 4.DA.10 de Strunz, pero es muy posible que en una futura edición tanto el ópalo como el mercurio pierdan su estatus.

Ya lo dijimos, la mineralogía es una pesadilla científica. Pero fascinante.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La clasificación actual de los minerales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Modalidades de alimentación

Los animales necesitan obtener de su entorno ciertas moléculas orgánicas para construir y renovar sus propias estructuras. Además también necesitan un suministro de energía que les permita desarrollar las actividades que les son propias. Esa energía la obtienen también de moléculas orgánicas, algunas de ellas coincidentes o muy similares a las que se utilizan como sillares de construcción de sus estructuras. Las moléculas que obtienen los animales de su entorno son, principalmente, carbohidratos, grasas y proteínas. Una vez adquiridas, las fragmentan hasta disponer de ellas en forma de sus unidades constitutivas, que son azúcares simples, ácidos grasos y aminoácidos, que es la forma en que serán utilizadas bien para renovar y construir las estructuras corporales propias, bien para degradarlas metabólicamente para sintetizar moléculas utilizables como moneda de intercambio energético; se trata, principalmente, de trifosfato de adenosina (ATP), molécula cuyos enlaces fosfato contienen la energía que se utiliza en las células para desarrollar trabajo biológico cuando es necesario. Además de componentes estructurales y sustratos para la obtención de energía, los animales han de ingerir ciertas vitaminas y oligoelementos que son esenciales para el normal funcionamiento del organismo.

Se denomina alimento al conjunto de sustancias que se adquieren con los fines dichos. Y el procesamiento para la posterior utilización incluye su adquisición, su digestión y la absorción de los productos de la digestión.

Los primeros animales realizaban la digestión dentro de las células, pero esa forma de proceder está limitada por el pequeñísimo tamaño que han de tener las partículas de alimento para su introducción en el interior celular. Esa limitación se pudo salvar cuando aparecieron estructuras específicas en forma de saco o de tubo y abiertas al exterior, en cuyo interior pudieron digerirse los alimentos. Los cnidarios, por ejemplo, tienen una cavidad general tapizada por un endodermo interno llamado gastrodermis, que se abre al exterior por un orificio (que hace funciones de boca) en cuyo perímetro se disponen una serie de tentáculos de los que se sirve el animal para atrapar el alimento y llevarlo a la boca.

En otros grupos de posterior aparición, el fondo del saco se abrió al exterior dando lugar a un tubo y un segundo orificio. El orificio inicial era la boca y el segundo, el ano. El tubo resultante era un aparato digestivo cuyas células epiteliales fueron evolucionando y dando lugar a áreas especializadas en diversas funciones. Así, las células especializadas en la digestión ácida quedaron en un compartimento separado de la zona en que quedaron las células especializadas en la digestión alcalina. Además, otras áreas se dedicaron a la recepción y almacenamiento inicial del alimento, y otras al procesamiento de los residuos. De esta forma, no todo el alimento ingerido tiene por qué ingresar en las células digestivas, quedando el material indigerible fuera de ellas.

Se han desarrollado formas muy diversas de adquirir el alimento, formas que están relacionadas, a su vez, con las características del mismo. Aunque como ocurre con muchas otras clasificaciones, también en lo relativo a la alimentación las categorías tienen fronteras no muy bien definidas, los modos de alimentación pueden clasificarse de acuerdo con las categorías que se presentan a continuación.

Comedores de fluidos. Entran en este grupo todos aquellos que succionan fluidos de plantas o animales de mayor tamaño que ellos mismos. Aquellos que permanecen unidos durante largos periodos de tiempo al organismo del que se alimentan son considerados parásitos. Moscas blancas, cochinillas y pulgones se alimentan de la savia de las plantas; vampiros, mosquitos, y sanguijuelas, de la sangre de animales; y luego están los que, como las tenias y otros parásitos intestinales, se alimentan de jugos intestinales.

Filtradores (o suspensívoros). Son aquellos cuyo alimento se encuentra en suspensión en una masa de agua; lo atrapan haciendo pasar el agua por un cedazo en ingiriendo lo que queda retenido en él. El alimento pueden consistir en bacterias, microalgas unicelulares, partículas detríticas, protozoos, y hasta pequeños animales, como los crustáceos eufasiáceos (krill) que sirve de alimento a las ballenas. Entre la macrofauna, los filtradores más abundantes son los bivalvos, que se alimentan de todo tipo de partículas de materia orgánica en suspensión. A este grupo pertenecen, entre otros, esponjas, copépodos, poliquetos, bivalvos y ballenas.

Sedimentívoros. Son los que se alimentan de partículas de sedimento en el que abunda la materia orgánica, normalmente de carácter detrítico. De hecho, en ocasiones se utiliza la denominación “detritívoro” para referirse a los sedimentívoros. La mayor parte de los sedimentívoros son, como la mayoría de los suspensívoros, micrófagos, porque ingieren partículas microscópicas. En este grupo se encuentran los gusanos de tierra (oligoquetos, por ejemplo), o algunos bivalvos y holoturias.

Herbívoros. Se consideran parte de este grupo a aquellos animales macrófagos (que capturan trozos macroscópicos de alimento) que se alimentan de materia vegetal predominantemente (algas, plantas, frutas o semillas, sobre todo). Dado que una parte importante de los materiales que sirven de alimento a los herbívoros es difícil de digerir, no es extraño que muchos herbívoros hayan desarrollado modalidades de digestión en las que intervienen microorganismos simbiontes. Los rumiantes, como las vacas, han recurrido a una fermentación pregrástrica a cargo de diferentes microbios que ponen a disposición del animal sustancias que de otra forman no estarían a su alcance. Otros, como caballos y conejos, cuentan con un dispositivo para la digestión microbiana simbióntica que se encuentra en el intestino posterior, ya sea el colon del animal, ya en sacos intestinales ciegos.

Carnívoros. Como los anteriores, también estos son macrófagos. Capturan presas animales y las ingieren, a veces troceándola, como el león, y en otras ocasiones introduciéndola entera en su aparato digestivo, como la serpiente pitón.

Omnívoros. Los omnívoros son los que consumen indistintamente material vegetal o animal, aunque su sistema digestivo se asemeja más al de los carnívoros que al de los herbívoros. Los cerdos y los seres humanos entramos dentro de esta categoría.

Animales con simbiontes autótrofos en sus tejidos. Algunos ejemplos son los cnidarios (corales) con dinoflagelados simbiontes (fotosintetizadores) en su interior que proporcionan al hospedador parte de su alimento; o los anélidos siboglínidos que habitan los entornos de fuentes hidrotermales sulfurosas en fondos oceánicos, y que contienen bacterias quimiolitotrofas que proporcionan al gusano todo el alimento que necesita.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Modalidades de alimentación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Los ‘Lugares de Encuentro’ de Chillida y la importancia de la restauración.

Preámbulo:

Desde el celebérrimo Ecce Homo de Borja hemos visto cómo, de tanto en tanto, desastrosas intervenciones realizadas sobre obras de arte de gran valor se convierten en noticia. Son tan sólo una muestra más del descuido al que se ve sometido parte de nuestro patrimonio cultural que debería ser atendido exclusivamente por profesionales de la Conservación-Restauración. Con el fin de aumentar la visibilidad de esta profesión, ACRE (Asociación Profesional de Conservadores Restauradores de España) ha impulsado una serie de eventos que se realizarán a lo largo de esta semana con motivo del Día Europeo de la Conservación-Restauración a celebrarse el próximo 14 de octubre. No dudéis en visitar la página web para consultar si hay alguna actividad programada en vuestra ciudad. Desde KimikArte nos queremos unir a esta iniciativa dando a conocer uno de los muchos trabajos que realizó el Departamento de Conservación y Restauración del Museo de Bellas Artes de Bilbao durante el 2017. Porque aunque las intervenciones que no acaban arruinando obras de arte rara vez aparecen en los medios son las que realmente deberíamos visibilizar.

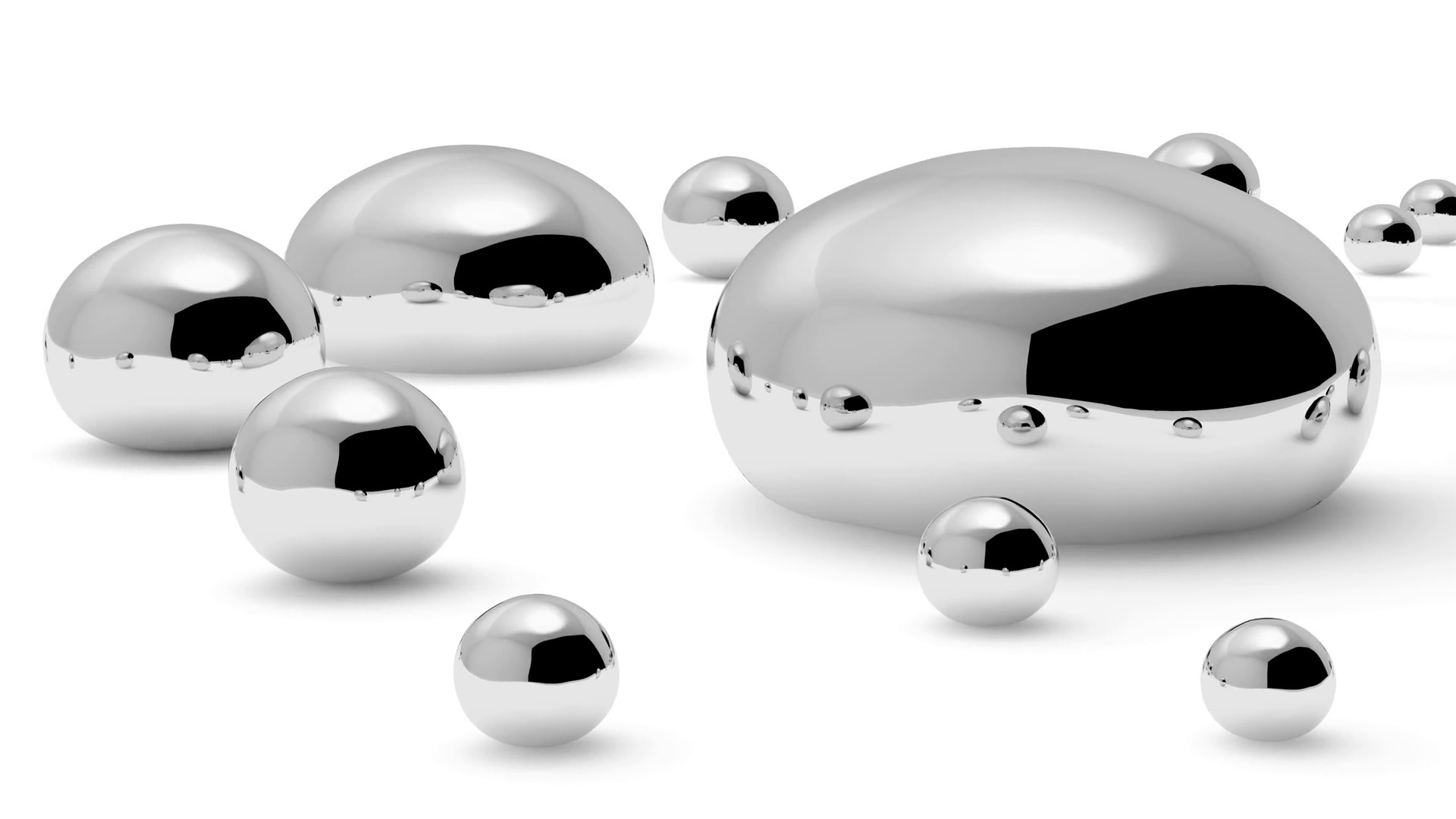

Imagen 1. Eduardo Chillida y su obra. Fuente: Foto Archivo Eduardo Chillida Copyright Zabalaga-Leku, VEGAP, Madrid (2018). Courtesy of The Estate of Eduardo Chillida and Hauser & Wirth.

Imagen 1. Eduardo Chillida y su obra. Fuente: Foto Archivo Eduardo Chillida Copyright Zabalaga-Leku, VEGAP, Madrid (2018). Courtesy of The Estate of Eduardo Chillida and Hauser & Wirth.

Se suele pensar que los museos son edificios impasibles al paso del tiempo, quizás porque su función habitual es albergar obras de arte que pretenden perdurar eternamente. Pero lo cierto es que son lugares en constante cambio, cambios que van mucho más allá que la inauguración de una exposición temporal o la adquisición de una nueva obra. Si no, que se lo pregunten al Museo de Bellas Artes de Bilbao cuyo edificio antiguo fue construido en 1945 con un claro porte clásico. En los 70 se realizó una ampliación en la que se añadió un edificio de estilo mucho más moderno. La última ampliación llegó con el cambio de milenio y sirvió para integrar mejor ambos edificios. Tiene mérito que con 55 años de diferencia entre construcciones se mantenga una cohesión arquitectónica. Sin embargo, alguien que visitase el museo en 1999 difícilmente reconocería el espacio que alberga el hall hoy en día. Uno de los principales motivos sería que una gran pieza de hormigón que habitaba en ese lugar desapareció para crear un espacio mucho más diáfano (Imagen 2). Pero dicha obra no ha abandonado el museo o, por lo menos, no del todo. Ahora flanquea una de sus dos entradas, sirviendo de perfecto contrapunto a Euterpe, la musa que se encarga de guardar la otra. Hablamos de Lugar de Encuentros IV, una creación del inconfundible Eduardo Chillida. Por supuesto, el cambio de hábitat expuso la pieza a unos cambios de temperatura más bruscos y la privó de abrigo contra las constantes lluvias. Teniendo en cuenta esas nuevas condiciones el equipo de Conservación y Restauración del museo bilbaíno prestó especial atención al cuidado de la obra, hasta que en 2017 se tomó la decisión de llevar a cabo un proceso de restauración.

Imagen 2. “Lugar de Encuentros IV” en la primera planta del Museo de Bellas Artes antes de la reforma del edificio (1989).] Fuente: El Correo Digital

Imagen 2. “Lugar de Encuentros IV” en la primera planta del Museo de Bellas Artes antes de la reforma del edificio (1989).] Fuente: El Correo Digital

La obra

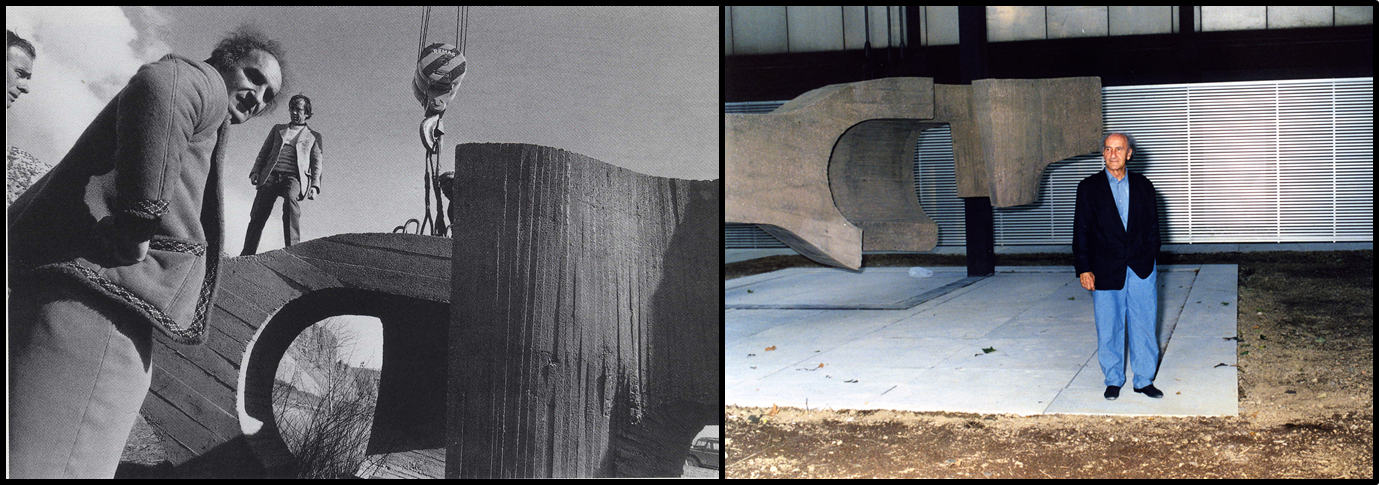

Como ya habréis intuido, si nuestra protagonista se llama Lugar de Encuentros IV es porque no es única en su especie. El escultor donostiarra concibió una serie de obras como “espacios para el diálogo y la convivencia”. La primera de ellas la elaboró en 1964 en madera de roble y se expuso en Nueva York, aunque ahora es propiedad del Museo Peggy Guggenheim de Venecia. La segunda escultura la creó en acero en 1971 y decora la Plaza del Rey de Madrid. En la misma ciudad encontramos Lugar de Encuentros III (1972), también conocida como La Sirena Varada, que cuelga de un puente que atraviesa la Castellana y es parte del Museo de Arte Público. Con esa obra, que no estuvo exenta de polémica, Chillida inicia la construcción de esculturas de hormigón de gran tamaño. Así, en 1973 nace nuestra protagonista de hoy, junto con Lugar de Encuentros V que se puede disfrutar en Toledo. Ambas se fabricaron con el mismo encofrado, pero la “gemela” castellana reposa sobre una base cilíndrica en posición inversa. Chillida todavía realizaría una obra más para la Fundación Juan March en Madrid (1974) y remataría su serie con Lugar de Encuentros VII (1974) en Palma de Mallorca. Como podéis ver en la Imagen 3, todas estas obras son un juego de curvas y rectas con las que el artista genera un espacio interior. En sus propias palabras: “Para definir esos espacios interiores es necesario envolverlos, haciéndolos casi inaccesibles para el espectador situado al exterior… yo aspiro a definir lo tridimensional hueco por medio de lo tridimensional lleno, estableciendo al mismo tiempo una especie de diálogo entre ellos”.

Imagen 3. Los siete “Lugares de Encuentro”. Fuentes: I: Fundación Peggy Guggenheim; II: Arte de Madrid; III: Luís Garcia, IV: Museo de Bellas Artes de Bilbao; V: Arantxa Castaño; VI: Tnarik Innael; VII: Panoramio.

Imagen 3. Los siete “Lugares de Encuentro”. Fuentes: I: Fundación Peggy Guggenheim; II: Arte de Madrid; III: Luís Garcia, IV: Museo de Bellas Artes de Bilbao; V: Arantxa Castaño; VI: Tnarik Innael; VII: Panoramio.

Pero centrémonos ahora en Lugar de Encuentros IV. Chillida sigue el camino que había iniciado con su predecesora, donde debemos de destacar dos aspectos. Primero, desde un punto de vista artístico, la idea de que la escultura esté sujeta por cables que permiten que levite a 60 centímetros del suelo, logrando sensación de ingravidez. Segundo, desde una perspectiva técnica, el uso del hormigón como material artístico que sería recurrente en otras obras del donostiarra. Como siempre, el material empleado es de especial importancia, sobre todo a la hora de abordar un proceso de restauración, como veremos a continuación. Se podría hablar largo y tendido sobre el hormigón en el arte, pero quedémonos con lo esencial: es una mezcla de cemento (el aglomerante) y áridos que tras mezclarse con agua se fragua (gracias al cemento) para formar un material pétreo. Para más información os recomiendo encarecidamente visitar la entrada de Deborah García Bello que tiene como protagonista otra obra de Chillida: El Elogio del Horizonte.

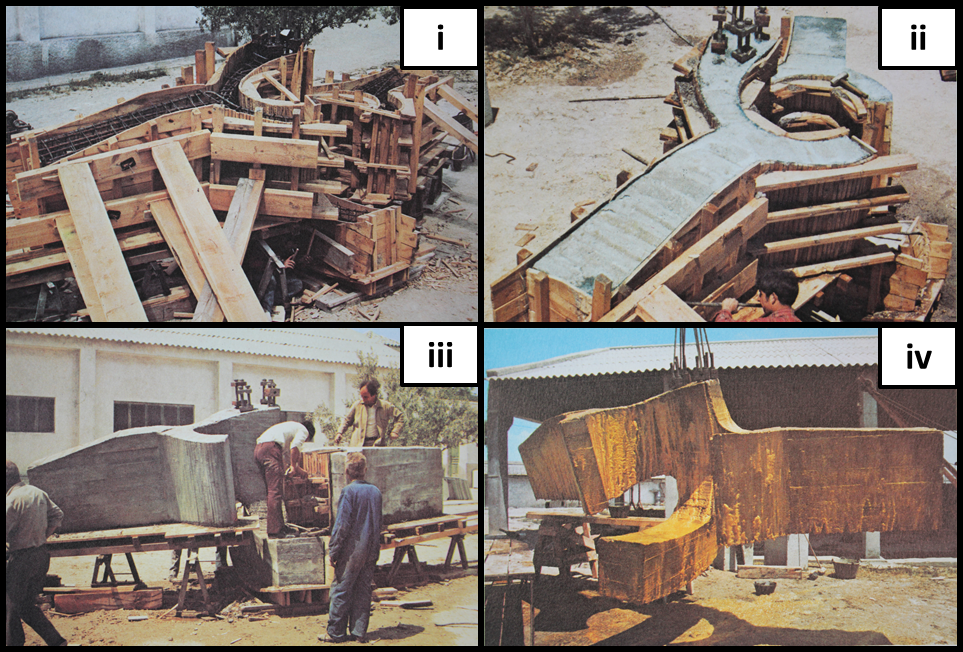

Lugar de Encuentros IV tiene unas dimensiones de 215 x 475 x 408 cm y pesa más de 16 toneladas. Para crear una obra de tan espectaculares dimensiones Chillida contó con la colaboración del ingeniero José Antonio Fernández Ordoñez. A la escultura se le dio forma mediante un encofrado de madera permitiendo que el hormigón fraguara alrededor de una armadura metálica. Tras el fraguado Chillida aplicó ácido sobre el hormigón con lo que cambió la textura y matizó el color. El resultado final es una obra llena de contrastes: es de rudo hormigón, pero delicada; su peso es dantesco, pero levita y su masa es grande, pero crea vacío. La escultura lleva en el museo desde que el artista la donase en 1982. Entonces se colocó en la planta baja (lo que hoy es el hall de entrada), para moverse, como ya hemos dicho antes, al exterior en el año 2000, en ambos casos bajo la atenta supervisión del escultor.

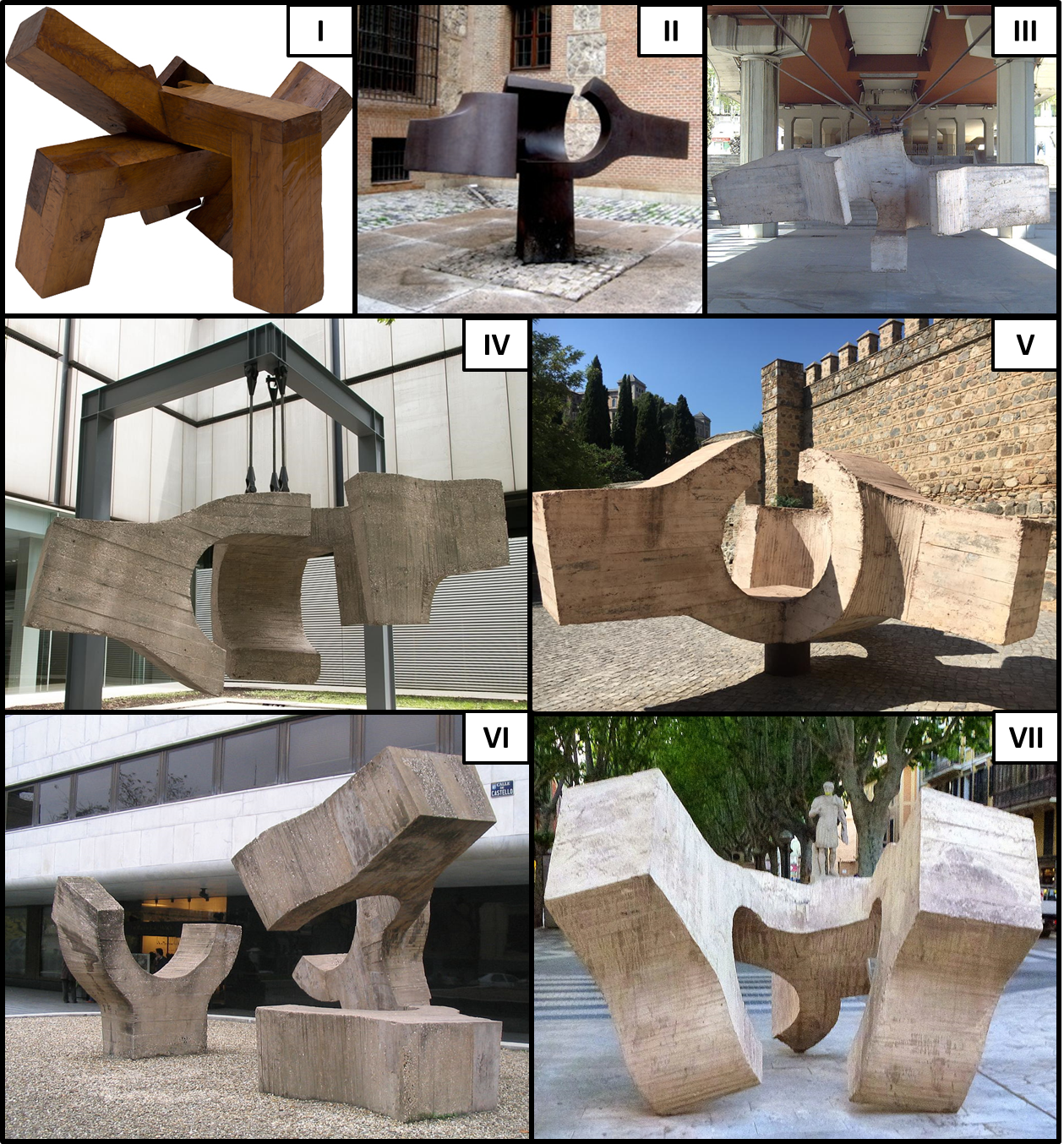

Imagen 4. Fotografías del proceso de elaboración de “Lugar de Encuentros”: Encofrado y armadura (i). Proceso de desencofrado (ii y iii). Aplicación del ácido sobre el hormigón (iv).] Fuente: Foto Archivo Eduardo Chillida Copyright Zabalaga-Leku, VEGAP, Madrid (2018). Courtesy of The Estate of Eduardo Chillida and Hauser & Wirth.

Imagen 4. Fotografías del proceso de elaboración de “Lugar de Encuentros”: Encofrado y armadura (i). Proceso de desencofrado (ii y iii). Aplicación del ácido sobre el hormigón (iv).] Fuente: Foto Archivo Eduardo Chillida Copyright Zabalaga-Leku, VEGAP, Madrid (2018). Courtesy of The Estate of Eduardo Chillida and Hauser & Wirth.

El deterioro y el estudio previo

Lugar de Encuentros IV sobrepasaba ya los 40 años cuando el museo decidió someterlo a un proceso de restauración. Pero, antes de afrontar intervenciones de este, lo primero que nos debemos preguntar es: ¿por qué se está produciendo el deterioro? Para contestar tenemos que entender la composición química de la obra de arte y su interacción con los factores externos. En el caso de la estructura de Chillida, dos son las principales causas: la colonización biológica y, por encima de todo, la carbonatación del hormigón. Una vez producida la hidratación y fraguado del cemento que sirve de aglomerante en el hormigón, el producto resultante tiene un elevado pH debido a la gran cantidad de hidróxido cálcico. Cuando este compuesto entra en contacto con el dióxido de carbono (proceso que sucede en disolución) se forma carbonato cálcico. Esta reacción química tiene dos consecuencias que pueden resultar nefastas. Por una parte aumenta la porosidad del hormigón, lo que facilita la penetración del agua y, por otra, disminuye el pH, lo que permite que el hierro de la armadura se oxide. Debido a esta oxidación la armadura aumenta su tamaño y provoca grietas en la estructura que pueden ocasionar las pérdidas que alguna vez habréis observado en alguna construcción de hormigón.

Imagen 5. Crecimiento biológico sobre el hormigón (izquierda) y armadura visible tras retirar una reposición inhábil de hormigón (derecha). Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Imagen 5. Crecimiento biológico sobre el hormigón (izquierda) y armadura visible tras retirar una reposición inhábil de hormigón (derecha). Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Para conocer mejor las propiedades físicoquímicas de la obra y su estado de deterioro se sometió a diversos análisis técnicos, siempre sobre trozos que se habían desprendido, para no perjudicar a la escultura El estudio petrográfico sirvió para saber que el árido que forma el hormigón se podía dividir en dos fracciones: una gruesa compuesta por material calcáreo (gran cantidad de carbonato cálcico) y una más fina que contenía principalmente silicatos y rocas metamórficas. Además, mediante difracción de rayos X se obtuvo información valiosísima sobre la composición química del hormigón. Así, se detectaron compuestos silíceos del árido y aluminosilicatos que apuntan al uso de cemento portland y aluminoso. Además, se observó que la temida carbonatación del cemento se había producido, por lo menos en la muestra analizada.

La restauración

Una vez se conocía perfectamente la obra, era el momento de comenzar con la intervención. Para ello el museo contó con la ayuda de Instituciones y expertos en el campo; a destacar la colaboración con Javier Chillida, especialista en la conservación y restauración de este tipo de materiales y con amplia experiencia en obras de Eduardo Chillida. Como estáis viendo, el trabajo que lleva restaurar una sola obra es más complejo de lo que podríamos pensar, y eso que todavía no le hemos puesto la mano encima. Vamos allá.

El primer paso fue colocar un andamio alrededor de la escultura, ya que si no sería imposible llegar a todos los puntos en los que hay que intervenir. A continuación, con sumo cuidado y la ayuda de brochas o pequeños aspiradores, se realizó una limpieza superficial en la que se quitaron desde hojas a excrementos de aves. Así, la obra estaba lista para recibir el primer tratamiento químico: la aplicación de un biocida que serviría para eliminar esa capa verdosa que podemos apreciar en tantos superficies (formada por musgos y líquenes). Se dejó actuar al biocida durante un día cubriendo la obra con polietileno y posteriormente se procedió a la limpieza.

Imagen 6. Antes y después de la aplicación del biocida. Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Imagen 6. Antes y después de la aplicación del biocida. Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

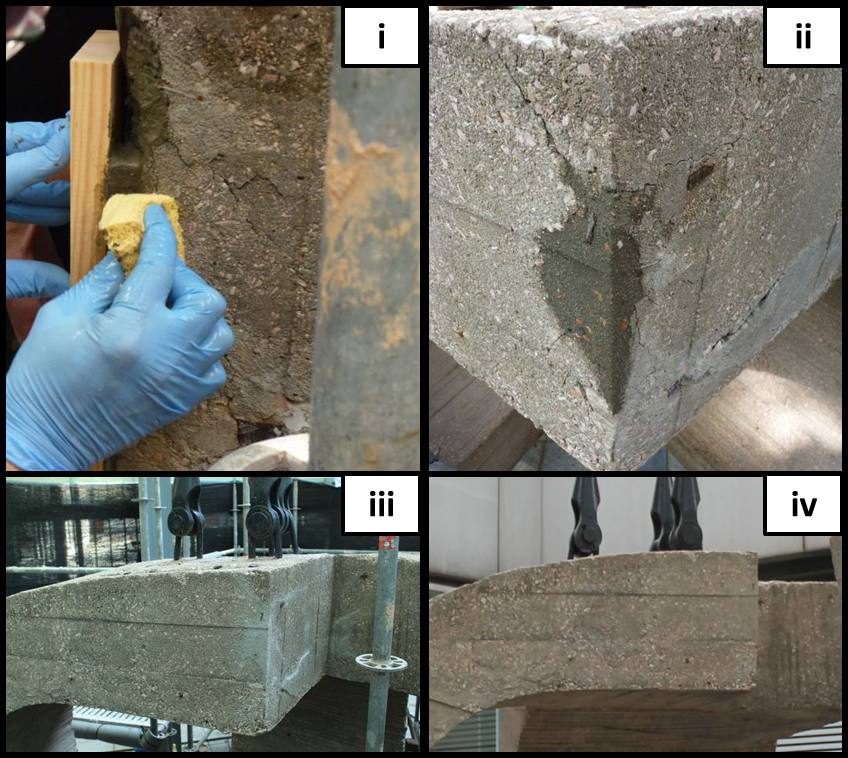

Como la obra ya había sido sometida a otras intervenciones, antes de proceder con la restauración se decidió eliminar reintegraciones anteriores. Es decir, se quitaron adiciones que se habían realizado para sustituir a las pérdidas de hormigón. A continuación se eliminó el óxido que se había creado sobre todas las partes de la estructura de hierro que quedaban al descubierto. Para ello se empleó una herramienta rotativa equipada con cepillos de acero, siempre dejando una pequeña capa de óxido para que hiciera las veces de protector. Los trozos de metal se limpiaron con etanol y se les aplicó una disolución que contenía ácido tánico. Quizás os preguntéis cómo puede un ácido evitar la corrosión si antes hemos dicho que el descenso del pH era perjudicial para la armadura interior. Pues bien, en este caso no tenemos que centrarnos en ese parámetro. En algunos metales la aparición de óxidos forma una capa sobre la superficie del metal que impide que siga en contacto con el oxígeno. En esa situación hablamos de pasivación, ya que el metal no seguirá oxidandose. En el caso del hierro, dicha capa no es homogénea y no cumple una misión protectora frente al agua y el oxígeno. Sin embargo, el compuesto que se forma entre los iones de hierro y los taninos sí que crea una película protectora, de ahí que se emplee como agente pasivante. El uso de esta reacción entre hierro y taninos quizás os suene por su papel en la tinta ferrogálica.

Pero no nos vayamos por las ramas y sigamos con la intervención sobre Lugar de Encuentros. Ya tenemos la obra limpia, libre de plagas biológicas y reintegraciones anteriores y el hierro visible está pasivado. A todos aquellas partes metálicas que no iban a ser tapadas posteriormente se les puso una protección más: una resina acrílica que se aplicó con pincel. La obra estaba en este punto lista para el proceso de consolidación y reintegración. Las grietas y fisuras se rellenaron con una mezcla de cemento y agua (lechada) que contenía una pequeña cantidad de resina acrílica. Por supuesto, antes de aplicar esa lechada se estudió si podría haber pérdidas durante la aplicación. Si no, podría haber sido como intentar llenar una botella agujereada. Dicho proceso se realizó con una disolución de agua y alcohol, y allí donde se observaron fugas se taparon con un mortero especialmente elaborado para tal propósito.

Imagen 7. Aplicación de la lechada mediante una jeringuilla. Fuente: Cortesía del Museo de Bellas Artes de Bilbao

Imagen 7. Aplicación de la lechada mediante una jeringuilla. Fuente: Cortesía del Museo de Bellas Artes de Bilbao

Además de fisuras y grietas, la escultura tenía una pérdida de un tamaño destacable que supuso un desafío mayor. Se decidió realizar una reintegración empleando un hormigón lo más parecido posible al original. Para ello se realizaron varias pruebas y finalmente se empleó un mortero que contenía, entre otros áridos, mármol rojo de Alicante como el que usara Chillida. Por último, se realizó una reintegración cromática o, en otras palabras, se homogenizó el color del mortero aplicado con el de la obra aplicando con pincel una pintura acrílica con pigmentos.

Imagen 8. Aplicación del mortero sobre la pérdida (i). Reposición antes de secarse (ii). Reposición seca (iii). Reposición reintegrada (iv). Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Imagen 8. Aplicación del mortero sobre la pérdida (i). Reposición antes de secarse (ii). Reposición seca (iii). Reposición reintegrada (iv). Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Tras la reintegración cromática la intervención estaba prácticamente completada, pero como es mejor prevenir que curar (o conservar que restaurar), se aplicó sobre la superficie un hidrofugante. Es decir, un producto que servirá de impermeable a la obra y que, en este caso, es un producto nanotecnológico. También se aplicó biocida nuevamente para retrasar el crecimiento de hongos y líquenes y se dieron los últimos retoques de color con acuarela y pintura acrílica.

Y hasta aquí el proceso de restauración de Lugar de Encuentros IV que, como habéis visto, va mucho más allá de preparar un poco de cemento y ponerlo de mala manera sobre los agujeros. Es un proceso que ha implicado a un gran número de profesionales que han trabajado con rigurosidad y cuyas indagaciones servirán sin duda para futuras intervenciones en otras obras de Chillida. Como colofón os dejo un video en el que podéis ver cada uno de los pasos que he tratado de explicar.

Imagen 9. “Lugar de Encuentros IV” en su emplazamiento actual. Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Imagen 9. “Lugar de Encuentros IV” en su emplazamiento actual. Fuente: Cortesía del Museo de Bellas Artes de Bilbao.

Agradecimientos

Me gustaría agradecer a todos los miembros del Departamento de Conservación y Restauración del Museo de Bellas Artes de Bilbao su total predisposición a compartir el trabajo que realizan, especialmente a Maria José Ruíz-Ozaita y a Sandra Rodríguez por el tiempo empleado en las explicaciones. Del mismo modo quiero agradecer al Museo y a la Sucesión Chillida su gentileza al darnos permiso para emplear las imágenes que aparecen en este artículo.

Sobre el autor: Oskar González es profesor en la facultad de Ciencia y Tecnología y en la facultad de Bellas Artes de la UPV/EHU.

Nota: Si se pretende republicar este artículo se debe solicitar permiso expreso de los titulares del copyright de cada una las imágenes antes de reproducirlas.

El artículo Los ‘Lugares de Encuentro’ de Chillida y la importancia de la restauración. se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Helena Matute: “Los algoritmos nos ganan en cualquier partida que juguemos contra ellos”

La catedrática de Psicología Experimental Helena Matute explica cómo las grandes empresas de internet utilizan los conocimientos sobre la conducta humana y el aprendizaje para influir en los usuarios

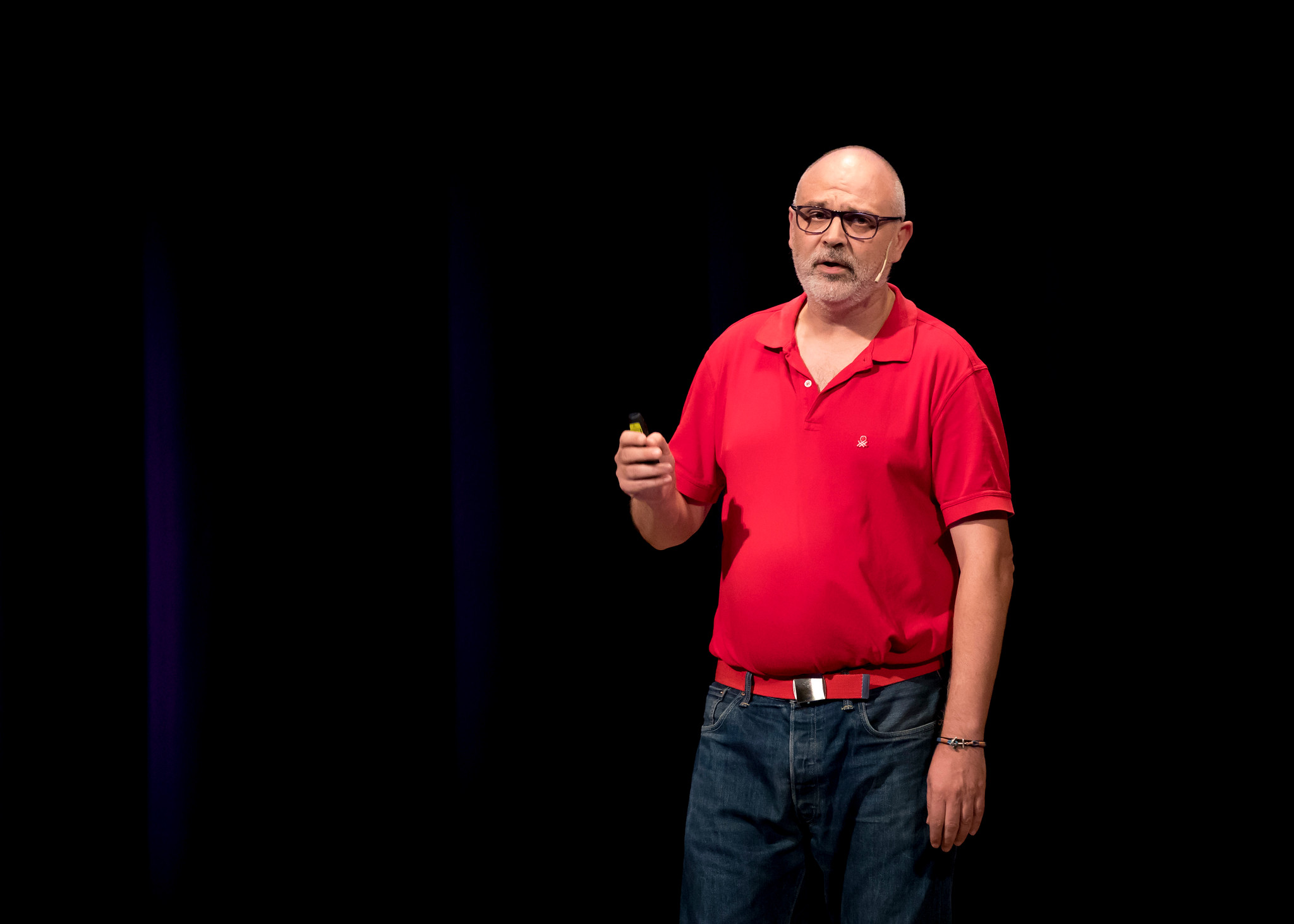

Qué difícil es explicar las leyes del condicionamiento instrumental y su relación con los algoritmos de internet en apenas diez minutos, pero la catedrática de Psicología Experimental en la Universidad de Deusto Helena Matute no ha temido el desafío.

El escenario escogido fue la octava edición de Naukas, el evento de divulgación científica que llenó Bilbao de conocimiento del 13 al 16 de septiembre en el Palacio Euskalduna de la capital vizcaína.

En la charla “Humanos, algoritmos y otros bichos”, Matute relató cómo los psicólogos Edward Thorndike y B.F. Skinner hicieron una contribución capital a la ciencia en el siglo XX. Así sus experimentos y ensayos culminaron en las leyes del aprendizaje humano y del condicionamiento instrumental. Esas teorías, para las que se usaron gatos que tenían que conseguir salir de una caja a cambio de un premio, llegaban a la conclusión de que el proceso de aprendizaje está relacionado con las consecuencias derivadas de nuestras acciones, por lo que una conducta que desencadena un resultado positivo o consigue una recompensa se repetirá y, ¡ojo!, también al revés.

Imagen: Helena Matute, catedrática de Psicología Experimental en la Universidad de Deusto, durante su charla en Naukas Bilbao 2018. (Fotografía: Iñigo Sierra)

Imagen: Helena Matute, catedrática de Psicología Experimental en la Universidad de Deusto, durante su charla en Naukas Bilbao 2018. (Fotografía: Iñigo Sierra)“Toda conducta que va seguida de consecuencias agradables tenderá a repetirse. Toda conducta que no vaya seguida de consecuencias agradables tenderá a extinguirse. Es como la evolución, pero en comportamiento”, explicó la experta.

Pero ¿qué relación guardan estas teorías con los mecanismos de aprendizaje de la inteligencia artificial y los algoritmos de internet?

En la actualidad los grandes gigantes de la red como Amazon, Google o Facebook emplean los frutos de esas investigaciones psicológicas para afinar sus algoritmos y mejorar las funciones de los motores de búsqueda, pero también para influir en el usuario y motivar comportamientos.

“Todos los principios de modificación de conducta se están aplicando a día de hoy. Cosas que hemos estudiado los psicólogos creyendo que eran para el beneficio de la humanidad, investigaciones que hemos desarrollado para contribuir al progreso, se están utilizando para meternos dentro de esa caja de Skinner gigantesca”, alertó.

La experta relató cómo las compañías más influyentes en la red disponen de equipos formados por grandes profesionales que están volcando todo el conocimiento atesorado durante décadas sobre la psicología de la personalidad, de la persuasión y de las emociones, así como las teorías de modificación de la conducta y de sesgo cognitivo, con objetivos de los que no hemos sido debidamente informados.

“Lo que están haciendo los psicólogos y los ingenieros (que trabajan para los gigantes de internet) es desarrollar algoritmos que exploten nuestros sesgos, que exploten nuestras debilidades”, razonó.

Imagen: Helena Matute en otro momento de su charla en Naukas Bilbao 2018. (Fotografía: Iñigo Sierra)

Imagen: Helena Matute en otro momento de su charla en Naukas Bilbao 2018. (Fotografía: Iñigo Sierra)En opinión de Matute se trata de un círculo vicioso, porque el algoritmo aprende de los humanos y aprovecha ese aprendizaje para influir posteriormente sobre sus actos.

“Decimos al algoritmo lo que nos gusta continuamente, lo reforzamos y nos da más. Nos ponen un titular loco y lo retuiteamos. El siguiente que nos ponen es todavía más loco. Da igual lo que haya detrás o si refleja una realidad verdadera”, añadió la catedrática, quien advirtió: “Los algoritmos aprenden, recordad que nos ganan en cualquier partida que juguemos contra ellos porque han aprendido de nosotros”.

Sin embargo, Matute, que dejó claro que el problema nunca es la tecnología, sino el mal uso que pueda derivarse de los avances científicos y tecnológicos, se mostró esperanzada con el futuro.

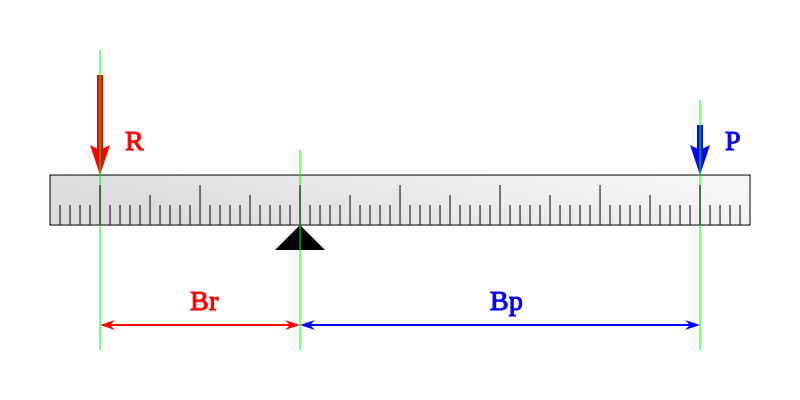

“Esto acaba de empezar, no vengamos con eso de que ya no podemos hacer nada. Estamos empezando. Tenemos que hacer algo, tenemos que volver a equilibrar la balanza. Tenemos que conseguir, entre todos, que toda esa inteligencia artificial que se ha desarrollado para el progreso humano (…) se reoriente y vuelva a tener interés para la especie humana”, concluyó.

Sobre la autora: Marta Berard, es periodista, responsable de contenidos de la agencia de comunicación GUK y colaboradora de la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Helena Matute: “Los algoritmos nos ganan en cualquier partida que juguemos contra ellos” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La paleodieta de una aldea visigoda

El equipo encabezado por Maite Iris García Collado, de la UPV/EHU, ha reconstruido la dieta de la población que habitaba la aldea de Boadilla, un asentamiento de campesinos de época visigoda (siglos VI-VIII e.c.) situado a las afueras del actual municipio de Illescas, en Toledo. El análisis biomolecular ha permitido no sólo reconstruir cómo se alimentaba un grupo de población, sino que ha demostrado ser una alternativa real para historiar conjuntos antropológicos que tendrían escaso potencial si sólo se estudiaran mediante métodos tradicionales.

Maite Iris García Collado. Foto: Nuria González – UPV/EHU

Maite Iris García Collado. Foto: Nuria González – UPV/EHU El objetivo de la investigación era comprobar hasta qué punto las técnicas de arqueología biomolecular pueden ser una alternativa útil para obtener nuevos datos sobre diversos aspectos sociales y económicos de las sociedades rurales de la Península Ibérica en la Alta Edad Media y así devolver el valor histórico a esos conjuntos antropológicos.

Para ello, por un lado, se realizó un estudio antropológico tradicional para determinar el tamaño de la población enterrada en Boadilla y su perfil demográfico (edad y sexo), lo cual determinó que se trataba de una población estable en la que estaban representadas todas las categorías de edad. Por otro lado, se llevaron a cabo los análisis de isótopos estables de carbono y nitrógeno de una parte de la población seleccionada aleatoriamente. “Esta técnica se basa en la premisa de que la composición química de los alimentos que tomamos queda reflejada en la composición química de los tejidos de nuestro organismo. Por lo tanto, analizando la composición de los restos antropológicos de una población arqueológica, podemos conocer su dieta”, explica García Collado.

Se sabe poco sobre los hábitats rurales de esa época porque las fuentes escritas apenas cuentan nada sobre ellos y los restos arqueológicos que dejaron son escasos y poco visibles. “En ese tipo de contextos son frecuentes los cementerios que ocupan grandes extensiones, con tumbas que forman hiladas irregulares, en las que se inhumaban una o varias personas sucesivamente, a menudo acompañadas de distintos tipos de objetos”, comenta la investigadora. Sin embargo, el material antropológico procedente de esos cementerios, es decir, los huesos y los dientes de las personas que habitaron esas aldeas, no han recibido mucha atención, porque frecuentemente están fragmentados y mal conservados. Eso ha sido un obstáculo para el conocimiento de esas poblaciones, ya que se asumía que la información que se podía sacar de sus restos antropológicos era muy escasa. Ahora, con esta investigación, se demuestra que la aplicación de ese tipo de análisis permite no sólo reconstruir la dieta de un grupo de población, sino que constituye una alternativa real para historiar conjuntos antropológicos que tendrían escaso potencial si sólo se estudiaran mediante métodos tradicionales.

La alimentación de la población enterrada en Boadilla, según los datos aportados por el análisis de los isótopos de carbono, estaba basada en cereales de invierno, una categoría que incluye el trigo, la cebada, el centeno o la avena. No obstante, los cereales de ciclo corto, que en esta cronología están restringidos al mijo y el panizo, también formaban parte importante de la dieta de esa comunidad. “Esto es relevante porque este y otros estudios anteriores apuntan a que la producción y el consumo de esos cereales menores podría ser un rasgo característico de grupos de campesinos con cierta autonomía y control sobre su producción. Los mijos son cereales muy nutritivos y eficientes ecológicamente, pero que tradicionalmente han sido poco apreciados. Por eso no responden a las lógicas en las que un poder superior controla los productos que se cultivan, sino que tienen más sentido en contextos en los que los propios campesinos pueden decidir diversificar sus cosechas”, destaca García Collado.

En cuanto a las proteínas de origen animal (carne, huevos, leche, lácteos) que se han podido detectar a través de los isótopos de nitrógeno, su consumo sería limitado y ocasional. Asimismo, se ha podido descartar el consumo de pescado.

A partir de ahí, se analizó la variabilidad en la dieta dentro de la población. “No detectamos ninguna diferencia en cuanto al consumo de cereales a lo largo de las diferentes categorías de edad. Sin embargo, sí que identificamos una pauta en lo que respecta al consumo de proteínas de origen animal”, comenta la investigadora de la UPV/EHU.

Según los resultados de los isótopos de nitrógeno, los individuos más jóvenes (entre 2 y 8 años) eran los que menos productos de origen animal consumían. El consumo de carne, huevos, lácteos y otros productos derivados se incrementaba ligeramente entre los 8 y los 14 años, para ponerse a la misma altura que los adultos durante la adolescencia (a partir de los 14 años). “Eso quiere decir que el acceso a ese tipo de productos estaba condicionado por la edad y que los individuos más jóvenes tenían un acceso muy restringido a ellos. Además, nos indica que era a partir de los 14 años aproximadamente cuando los adolescentes empezaban a ser tratados como adultos”, puntualiza.

Otra cuestión interesante investigada fue la existencia de diferencias en la alimentación entre los individuos enterrados con objetos de adorno personal o herramientas de uso cotidiano y los que se enterraron sin nada de ello. “A menudo, se ha considerado que esos objetos, que en ocasiones se depositaban junto a los cuerpos, podrían denotar la posición social del individuo. No obstante, de ser así, no habría habido diferencias significativas entre la dieta de los individuos más y menos relevantes”, concluye García Collado. Además, se pudo comprobar que las dietas de los individuos enterrados dentro de la misma tumba tendían a ser similares, un argumento a favor de la hipótesis de que esas estructuras funerarias se usasen como panteones de grupos familiares extensos.

Por último, también se analizó un conjunto de muestras de animales domésticos, ya que determinar las pautas alimenticias de esos animales es útil para caracterizar la ganadería que se practicaba en esa aldea. “El resultado más interesante es que se practicaban diferentes estrategias para cada especie. Las vacas, las ovejas y las cabras probablemente pastaban en tierras cercanas a la aldea, lo cual contribuía al abonado de los campos de cultivo. En cambio, seguramente los caballos eran enviados a pastos abiertos más alejados del asentamiento”, explica la investigadora.

Referencia:

Maite I. García-Collado, Paola Ricci, Raúl Catalán Ramos, Simona Altieri, Carmine Lubritto, Juan Antonio Quirós Castillo (2018) Palaeodietary reconstruction as an alternative approach to poorly preserved early medieval human bone assemblages: the case of Boadilla (Toledo, Spain) Archaeological and Anthropological Sciences (Julio 2018) doi: 10.1007/s12520-018-0672-0

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La paleodieta de una aldea visigoda se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:A nadie le preocupan las grasas trans

Hemos encontrado evidencia científica suficiente como para afirmar que el consumo de grasas trans afecta a nuestra salud, sobre todo a lo relativo a nuestra salud cardiovascular. Es por eso que en 2020 no podrán comercializarse alimentos con grasas trans en Canadá[1]. En 2015 se prohibieron en EEUU, con un plazo de retirada que finaliza en 2018. En Dinamarca, Austria, Letonia y Hungría, solo se permite una cantidad muy limitada. En cambio, en la mayoría de los países de la Unión Europea, incluida España, no existe ninguna ley que lo regule.

La Organización Mundial de la Salud recomienda que el consumo de grasas trans no supere el 1% de las calorías ingeridas. La Food and Drug Administration (FDA) recomienda una ingesta tan baja como sea posible. En Europa, algunos países, como los nórdicos, han dictado sus propias normas y recomendaciones, sin embargo, la European Food Safety Authority (EFSA) solamente indica que el consumo debe ser lo más bajo posible.

A pesar de la limitada regulación, la presencia de grasas trans en los alimentos es cada vez más pequeña y consumimos menos del 1% que establece la OMS, por eso no tendríamos que preocuparnos por ellas.

-

Efecto sobre la salud de las grasas trans

Las primeras evidencias de los efectos adversos de las grasas trans sobre la salud se publicaron en la década de los 90, cuando diversos estudios realizados en humanos mostraron que su ingesta aumentaba el riesgo de padecer alteraciones cardiacas tanto o más que las grasas saturadas. Desde entonces, se han publicado múltiples estudios científicos llegando a las mismas conclusiones: un aumento de un 2% de la energía a partir de grasas trans incrementa significativamente el riesgo de sufrir enfermedades cardiovasculares hasta en un 23 %. [2][3][4]

El efecto negativo de las grasas trans sobre la salud cardiovascular se debe a que producen alteraciones en el metabolismo de las lipoproteínas: su ingesta está relacionada con el aumento de la concentración de colesterol total y colesterol LDL en sangre (el malo) y con la disminución del colesterol HDL (el bueno).

Se continúan haciendo estudios sobre la posible implicación del consumo de grasas trans en el desarrollo de otras enfermedades, como la diabetes tipo 2, entre otras. Aunque todavía se desconocen los mecanismos por los cuales las grasas trans disminuyen la sensibilidad a la insulina. [5]

-

Qué son las grasas trans

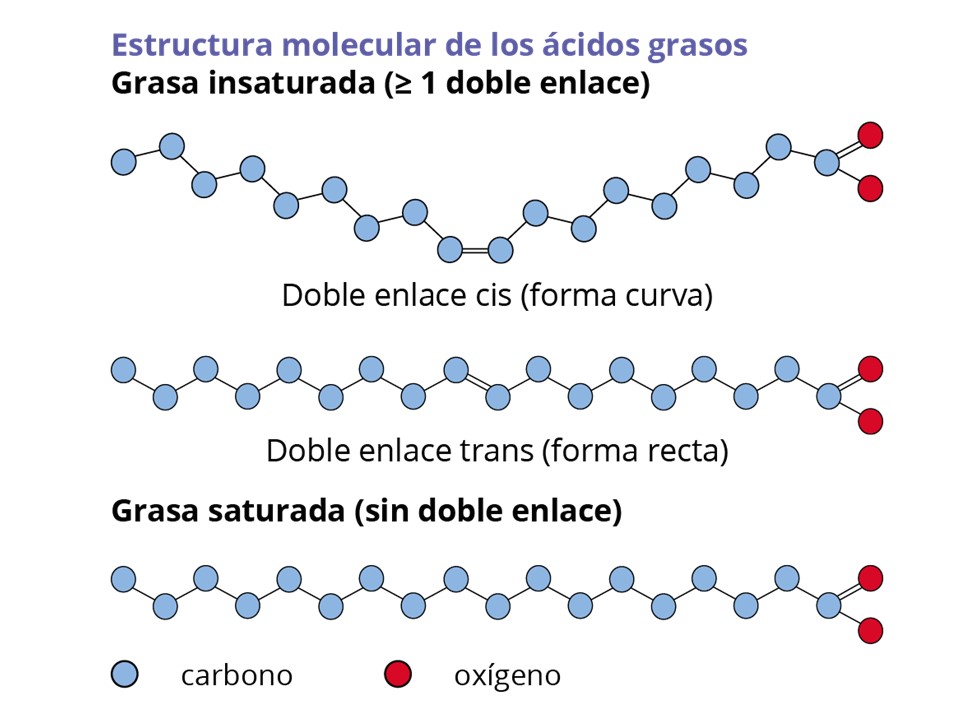

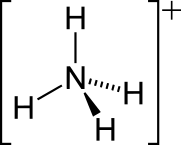

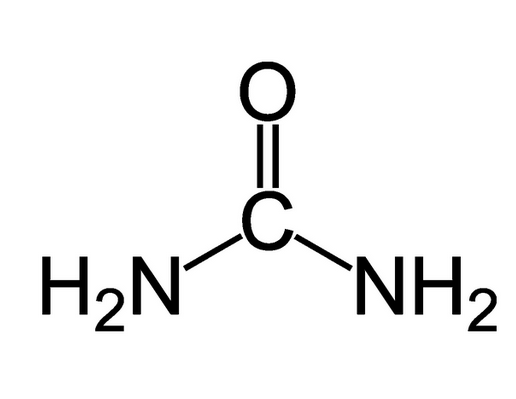

La denominación trans no tiene nada que ver con los transgénicos, sino que se corresponde con la nomenclatura que utilizamos los químicos para un tipo de enlace.

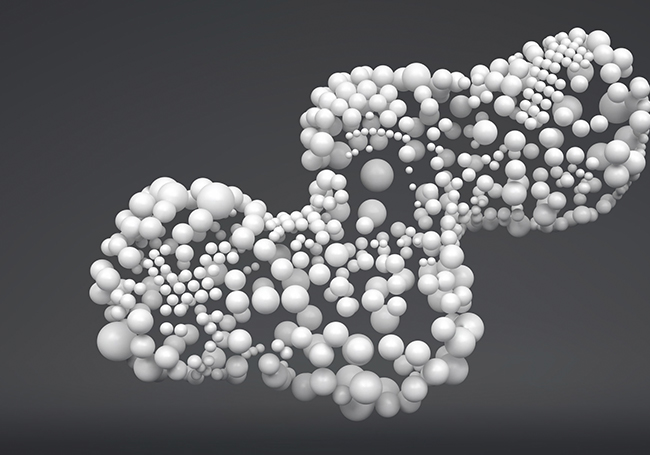

Los ácidos grasos (coloquialmente denominados grasas) son moléculas formadas por una cadena hidrocarbonada (carbonos unidos entre sí como las cuentas de un collar) y un extremo denominado ácido carboxílico. La cadena hidrocarbonada es la que hace que unos ácidos grasos sean diferentes a otros: puede ser más larga o más corta, y puede presentar carbonos unidos por un enlace simple o por un enlace doble.

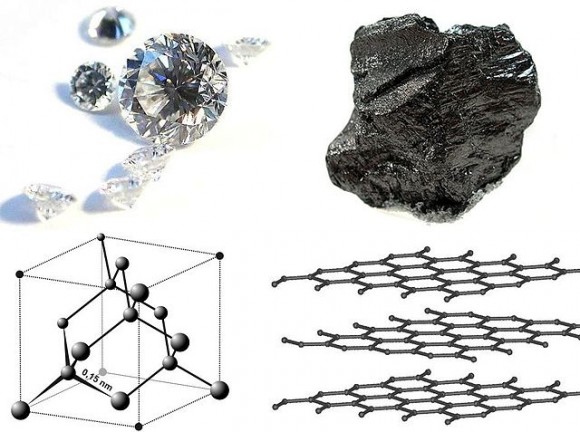

Si el ácido graso presenta algún enlace doble, estaremos ante una grasa insaturada. Si no hay ningún enlace doble (si son todos simples) estaremos ante una grasa saturada.

Por norma general, las grasas saturadas son las que debemos evitar en la dieta, puesto que son las que hemos relacionado con ciertas cardiopatías. Y las grasas insaturadas son las saludables. Pero esta norma tiene una excepción, y es que las grasas insaturadas no son todas iguales. Esos dobles enlaces pueden estar orientados de diferente manera. Si la orientación es cis, significa que el ácido graso adquiere forma curva. Pero si es trans, significa que el ácido graso adquiere forma recta (ver imagen anterior).

Puede parecer una diferencia muy sutil, pero ese cambio en la orientación y la forma que adquiere el ácido graso insaturado hace que pase de ser saludable (cis) a no serlo (trans).

Tanto las grasas saturadas, como las grasas insaturadas trans, presentan algo en común. Ambas tienen forma recta, y esto les confiere una característica: funden a temperaturas más altas o, lo que es lo mismo, pueden ser sólidas o más viscosas a temperatura ambiente. La razón de esto es, precisamente esa forma recta. Si nos las imaginamos como piezas, son fácilmente apilables. Podemos hacer coincidir los carbonos unos sobre otros, sin dejar huecos entre sí (ver imagen inferior). Si alguna de esas piezas fuese curva, nos complicaría la tarea. Pero si todos son rectos, se podrían apilar perfectamente, lo que se traduce en que entre ellos surgen unos enlaces débiles. El resultado macroscópico de esto es que tendremos una grasa más sólida y con un mayor punto de fusión.

Las grasas saturadas y las grasas trans tienen más facilidad para enlazar débilmente entre sí.

Las grasas saturadas y las grasas trans tienen más facilidad para enlazar débilmente entre sí.

Las grasas insaturadas cis son las que presentan un mayor impedimento para enlazar sus cadenas hidrocarbonadas entre sí. Esto se traduce en puntos de fusión más bajos, es decir, cuantas más grasas insaturadas cis, mayor es la tendencia a mantenerse líquidas a temperatura ambiente.

Las grasas insaturadas tienen más dificultad para enlazar débilmente entre sí.

Las grasas insaturadas tienen más dificultad para enlazar débilmente entre sí.

-

Por qué hay alimentos con grasas trans

La industria alimentaria no produce grasas trans de forma deliberada, sino que estas grasas se producen como consecuencia de otros procesos, sobre todo durante la síntesis de grasas saturadas.

Desde hace años sabemos que la mayoría de las grasas saturadas no son saludables. Sin embargo, las encontramos en algunos alimentos. La razón de que estén ahí es que las grasas saturadas presentan ciertas ventajas tecnológicas. Hacen que algunos alimentos tarden más tiempo en echarse a perder, ofrecen texturas más cremosas, evitan que los alimentos se reblandezcan y los hacen permanecer crujientes más tiempo. Mejoran la experiencia de consumo y son responsables del efecto “derretirse en la boca”. Esto se debe a su estructura y cómo ésta afecta al punto de fusión. Nos gustan por muchas razones.

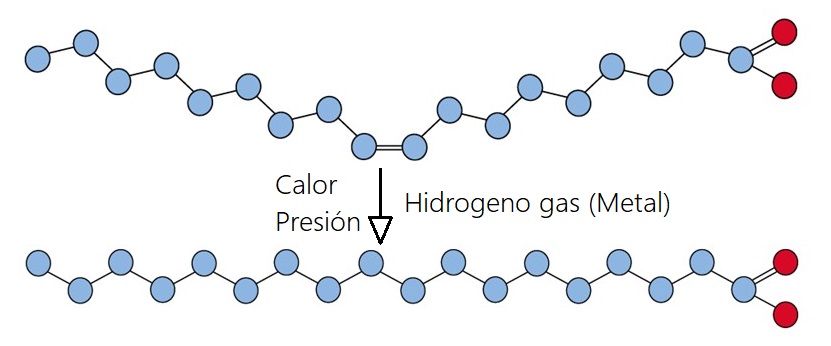

En el proceso de conversión de grasas insaturadas en grasas saturadas o parcialmente insaturadas es donde se pueden producir grasas trans. Este proceso suele hacerse con grasas de origen vegetal para que ganen consistencia. Estas grasas vegetales, en gran medida insaturadas, se someten a un proceso de hidrogenación. Esto consiste en hacerlas reaccionar con gas hidrógeno en presencia de un catalizador metálico a una presión y temperatura controladas. El resultado es que el hidrógeno pasa a formar parte de la grasa rompiendo los enlaces dobles. Es decir, el hidrógeno destruye las insaturaciones. Y si la reacción se lleva a cabo hasta su término, obtendríamos grasas completamente saturadas. Por ese motivo llamamos “grasas totalmente hidrogenadas” a las grasas saturadas y “grasas parcialmente hidrogenadas” a las grasas que han perdido alguno de sus enlaces dobles.

Durante estas reacciones se producen, de forma indeseada, las grasas trans. Es decir, algunos enlaces se acaban transformando en enlaces dobles trans. Actualmente conocemos mucho mejor los mecanismos de la reacción, y ajustando las condiciones de la reacción somos capaces de evitar que se produzcan grasas trans durante la hidrogenación.

Los tratamientos térmicos en los procesos de desodorización, en el refinado de aceites vegetales o de pescado, o el calentamiento y fritura de los aceites a altas temperaturas, también generan grasas trans. Por este motivo, algunos países europeos han establecido que la temperatura de fritura no debe superar los 180 oC. [5]

También hay alimentos que de forma natural presentan grasas trans. Pero ojo, no podemos catalogar a un producto de sano o insano solo por eso, sino que hay que contemplar el alimento en su conjunto. Por ejemplo, en los productos lácteos y en las carnes los rumiantes (vacas, corderos y ovejas), las grasas trans se encuentran de manera natural en una concentración del 3% al 6% porque las bacterias que se encuentran en el rumen de estos animales cambian la configuración de los ácidos grasos insaturados de cis a trans.

Las grasas trans producidas por efecto del metabolismo ruminal se absorben en el intestino, se distribuyen en el tejido mamario, entre otros, y se excretan finalmente a través de la leche. Más del 70% del contenido en ácidos linoleicos conjugados (CLA) de la leche se corresponden ácido ruménico, al que se le atribuyen la mayoría de sus propiedades beneficiosas [6]. Así que no hay que dejar de consumir leche por esto.

La evidencia científica apunta a que el consumo de cantidades moderadas de grasas trans procedentes de la leche no contribuye a aumentar el riesgo cardiovascular. La ingesta de ácidos grasos contenidos en los productos lácteos se asocia al descenso de partículas de colesterol LDL (el malo)[7].

-

Consumes menos grasas trans de las que crees

A comienzos de los 90 se estimaba que en Europa consumíamos entre 2 y 17 g al día de grasas trans. Para conocer con precisión la ingesta de grasas saturadas en los distintos países europeos, la Comisión Europea financió el proyecto TRANSFAIR [8]. Su objetivo fue valorar el consumo de grasas trans en 14 países europeos occidentales durante los años 1995 y 1996. Los valores de la ingesta media diaria obtenida en el estudio variaron entre los distintos países. Los valores más elevados, 5,4 g al día (2% de las calorías de la dieta) se encontraron en Islandia y los más bajos 1,5 g al día (0,5%) en Grecia e Italia. En el caso de España, la ingesta media se situaba en 2,1 g al día (0,7%). El estudio concluía que, en general, el consumo de grasas trans en Europa occidental no era preocupante. En cambio, en Estados Unidos, la ingesta diaria estimada mediante un cuestionario de frecuencias de consumo fue de 3-4 g al día.

Desde la publicación de los resultados del proyecto TRANSFAIR, muchos países han realizado estudios sobre los contenidos de grasas trans en los alimentos de uso habitual y la industria ha comenzado a utilizar nuevas tecnologías que disminuyen su formación. La ingesta en la mayor parte de los países europeos ha descendido a niveles inferiores al 1%[9], debido fundamentalmente a la reformulación de los productos que las contenían. En países como Reino Unido o Francia, la ingesta oscila entre el 0,8-1%, siendo proporcionalmente mayor la ingesta de grasas trans de origen natural.

La Agencia Española de Seguridad Alimentaria y Nutrición (AESAN), elaboró un Informe Científico [10] sobre el riesgo asociado a la presencia de grasas trans en los alimentos en 2010, en el que se llegaba a la conclusión de que la ingesta estaba por debajo del 0,7%. En el informe publicado en 2015 [11] se llegó a la conclusión de que la presencia de grasas trans en los alimentos había disminuido todavía más, llegando a ser indetectables en muchos de ellos. La implicación de la industria alimentaria fue clave en este descenso. Lo consiguieron reformulando sus productos y desarrollando nuevas técnicas de evitación de formación de grasas trans. Estos datos hacen que sea prácticamente imposible superar la recomendación de la OMS de consumir menos del 1% de calorías en forma de grasas trans.

-

En España no hay una ley que regule las grasas trans

La Ley 17/2011 del 5 de julio de seguridad alimentaria y nutrición establece en relación a las grasas trans que «en las escuelas infantiles y en los centros escolares no se permitirá la venta de alimentos y bebidas con un alto contenido en ácidos grasos saturados, ácidos grasos trans, sal y azúcares». Sabemos que esta ley nos la saltamos alegremente. También «está limitado el contenido de grasas trans en fórmulas infantiles (han de contener menos del 4% del total de ácidos grasos)». Este artículo de la ley sí que lo respetamos. Con respecto a los demás alimentos no existe ningún tipo de reglamento, ni siquiera se establecen unos valores mínimos.

Sin embargo, a pesar de la falta de regulación, la presencia de grasas trans en los alimentos es mínima, y según la AESAN no representa un problema de salud [11].

-

Qué alimentos contienen grasas trans

Los aportes más altos de grasas trans en la dieta se corresponden a los alimentos elaborados con grasas hidrogenadas (margarinas, shortening -término genérico utilizado para describir grasas y aceites usados en la preparación de alimentos-, productos comerciales de pastelería, platos precocinados, hamburguesas, patatas fritas de bolsa, aperitivos o snacks, sopas deshidratadas entre otros) y los aportes dietéticos más bajos a la carne y productos lácteos (leche, queso y yogur).

En el caso concreto de las margarinas[5], en España, el contenido en grasas trans ha ido disminuyendo en los últimos años, pasando de más del 10% en los años 80, a cero o prácticamente cero en la actualidad.

Así que de los únicos alimentos de los que podríamos preocuparnos son, como siempre, los ultraprocesados. En esta ocasión el problema no está en la presencia de grasas trans, que como hemos visto, es muy limitada, sino en el alimento en su conjunto. Un ultraprocesado con azúcares, altos niveles de sal, harinas refinadas y grasas en general de baja calidad, no se va a convertir en un alimento saludable por carecer de grasas trans.

-

Conclusiones

Las grasas trans son perjudiciales para la salud. Se producen como subproductos indeseables durante la fabricación de alimentos ultraprocesados. Actualmente la industria ha mejorado tanto estos procesos que la ingesta de grasas trans está por debajo de lo que aconseja la Organización Mundial de la Salud.

Aunque en muchos países, entre ellos España, no existe ninguna normativa que regule cuánta cantidad puede haber en los alimentos, lo cierto es que no encontramos grasas trans que debieran alarmarnos dentro de los parámetros de una dieta normal. Así que la conclusión es clara: afortunadamente ya nadie tiene que preocuparse por las grasas trans.

Fuentes:

[1] Canadá prohíbe el uso de grasas trans en los productos alimenticios.

[2] Mozaffarian, D., Katan, M.B., Ascherio, A., Stampfer, M.J. y Willett, W.C. Trans fatty acids and cardiovascular disease. N Engl J Med 2006; 354, pp: 1601-1613. Mozaffarian, D., Katan, M.B., Ascherio, A., Stampfer, M.J. y Willett, W.C. Trans fatty acids and cardiovascular disease. N Engl J Med 2006; 354, pp: 1601-1613.

[3] Clifton PM, Keogh JB, Noakes M. Trans fatty acids in adipose tissue and the food supply are associated with myocardial infarction. J Nutr 2004; 134: 874- 879.

[4]Bendsen NT, Christensen R, Bartels EM, Astrup A. Consumption of industrial and ruminant trans fatty acids and risk of coronary heart disease: a systematic review and meta-analysis of cohort studies. Eur J Clin Nutr. 2011;65:773-83.

[5]Informe FESNAD sobre la ingesta de grasas trans. Situación es España. 2013.

[6] Cruz-Hernández, C., Kramer, J.K.G., Kraft, J., Santercole, V., Or-Rashid, M., Deng, Z., Dugan, M.E.R., Delmonte, P. y Yurawecz, M.P. (2006). Systematic analysis of trans and conjugated linoleic acids in the milk and meat of ruminants. Advances in CLA Research. 2006; 3:45-93.

[7] Sjogren, P., Rosell, M., Skoglund-Andersson, C., Zdravkovic, S., Vessby, B., De, F.U., Hamsten, A., Hellenius, M.L. y Fisher, R.M. Milk-derived fatty acids are associated with a more favourable LDL particle size distribution in healthy men. J Nutr 2004; 134: 1729-1735.

[9] EFSA Panel on Dietetic Products, Nutrition, and Allergies (NDA). Scientific Opinion on Dietary Reference Values for fats, including saturated fatty acids, polyunsaturated fatty acids, monounsaturated fatty acids, trans fatty acids, and cholesterol. The EFSA Journal, 2010; 8, 1461.

[10] Informe del Comité Científico de la Agencia Española de Seguridad Alimentaria y Nutrición (AESAN) sobre el riesgo asociado a la presencia de ácidos grasos trans en alimentos. Revista del Comité Científico de la AESAN nº 12, Madrid 2010.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo A nadie le preocupan las grasas trans se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:El tamaño sí importa, que se lo pregunten a Colón (o de la geometría griega para medir el diámetro de la Tierra)

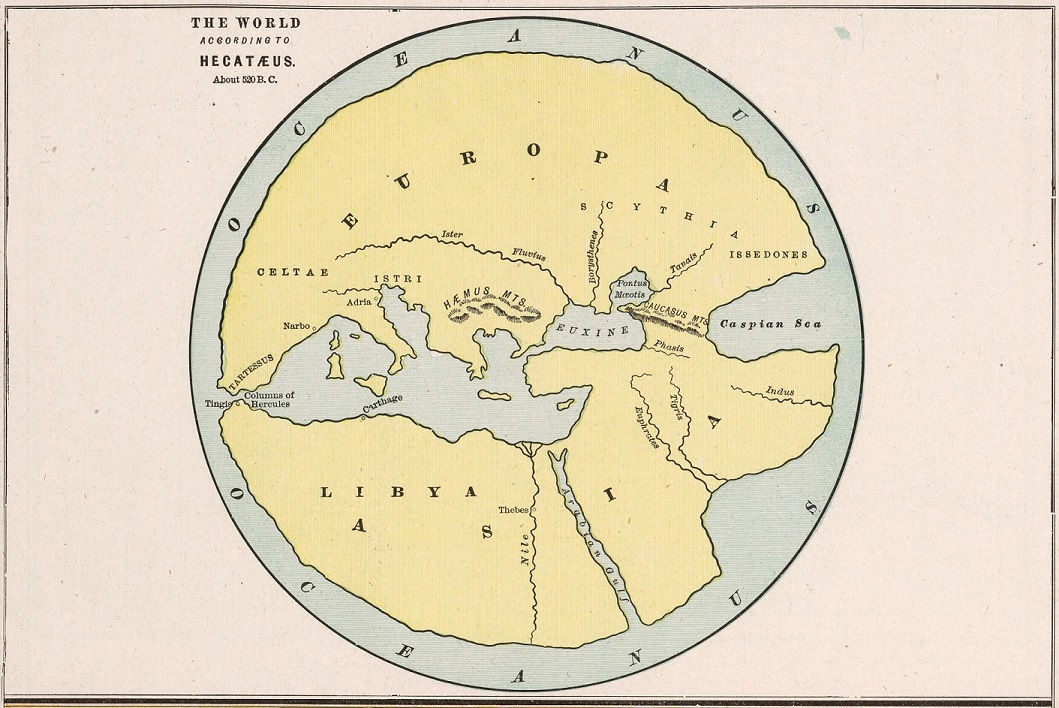

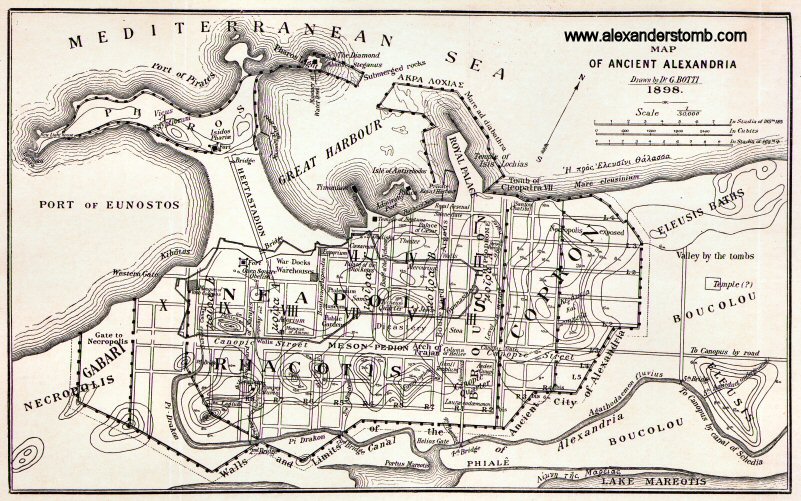

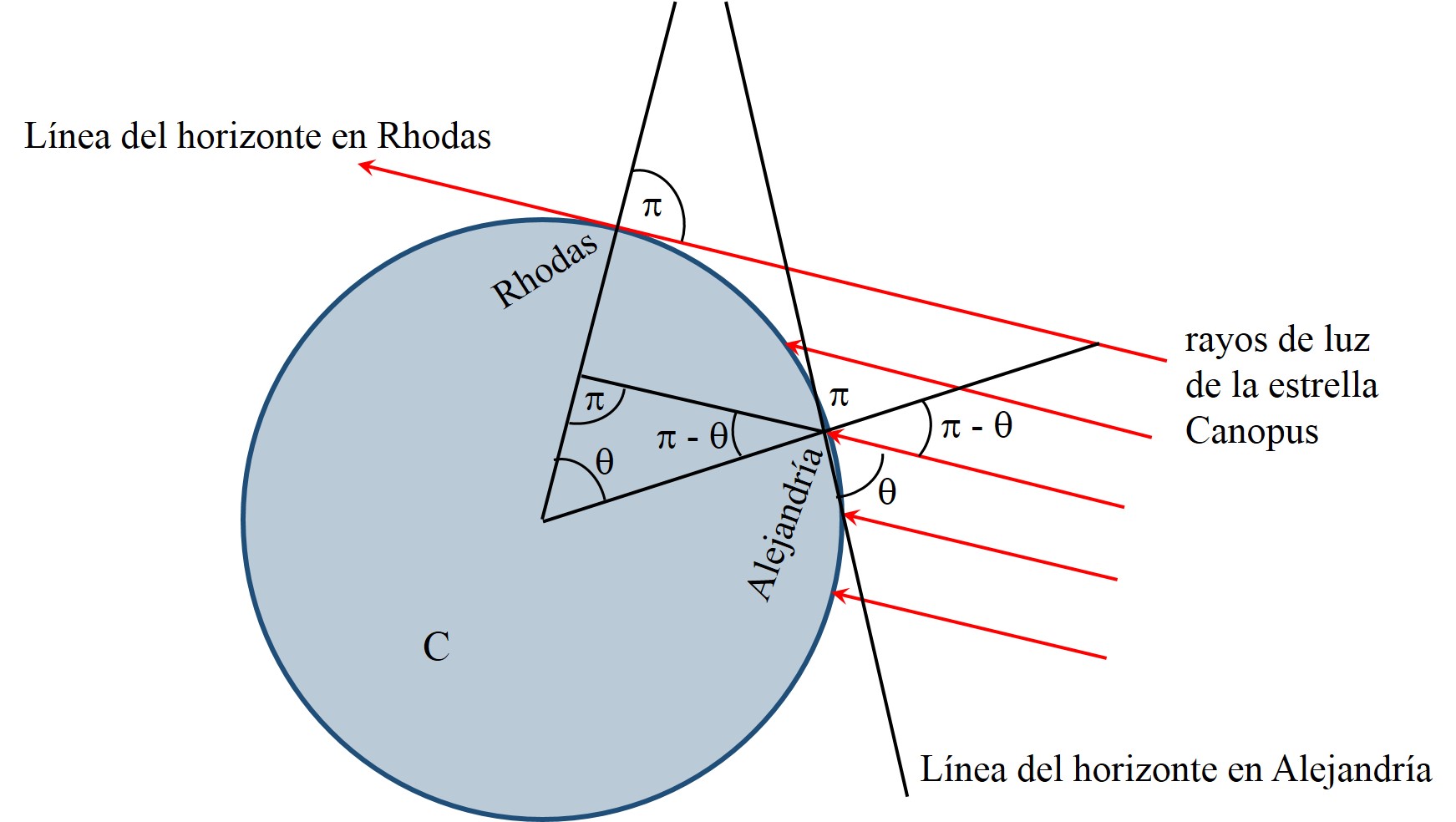

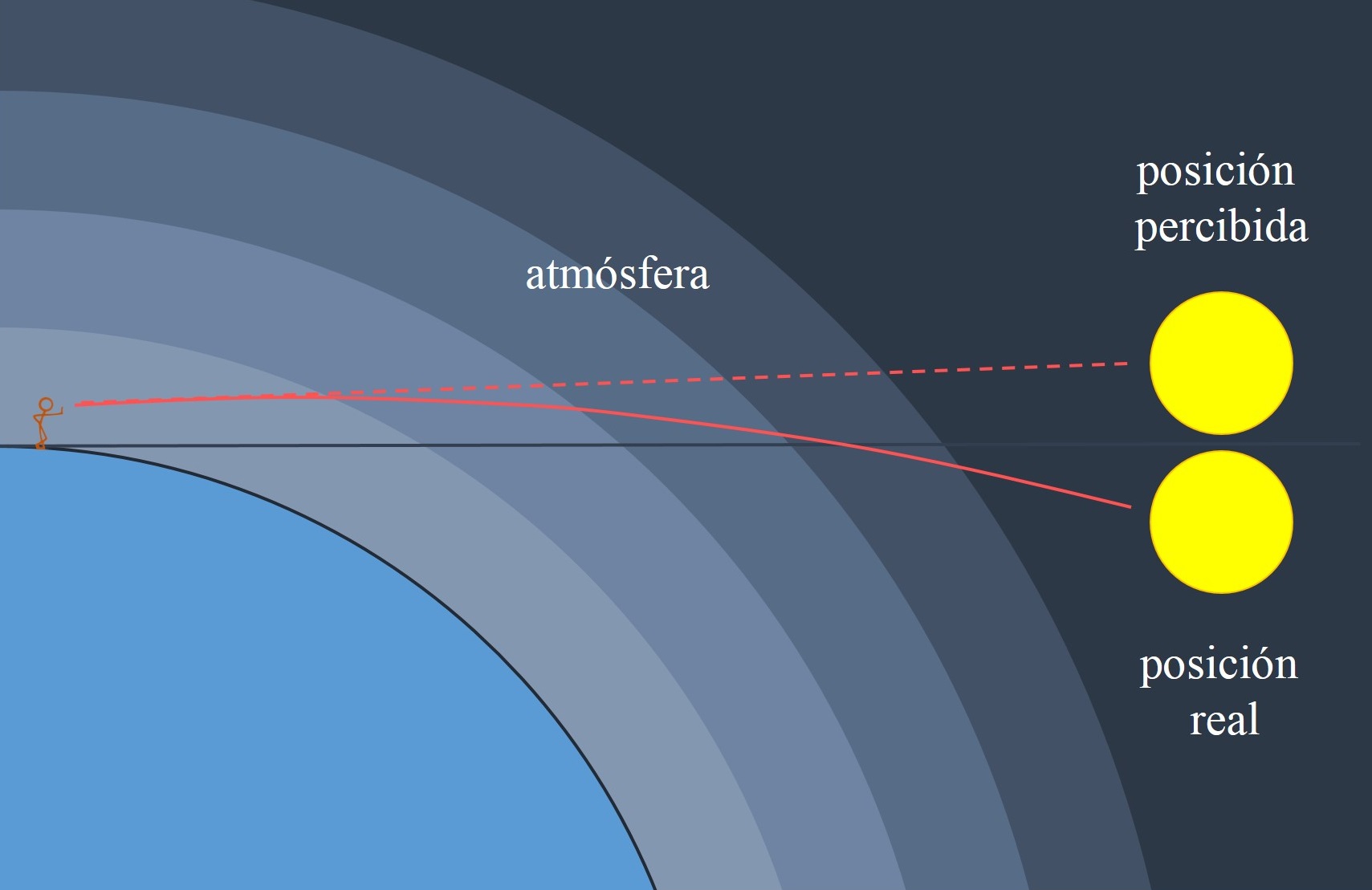

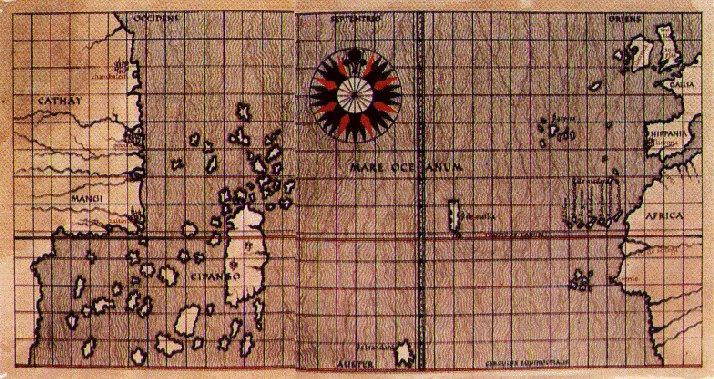

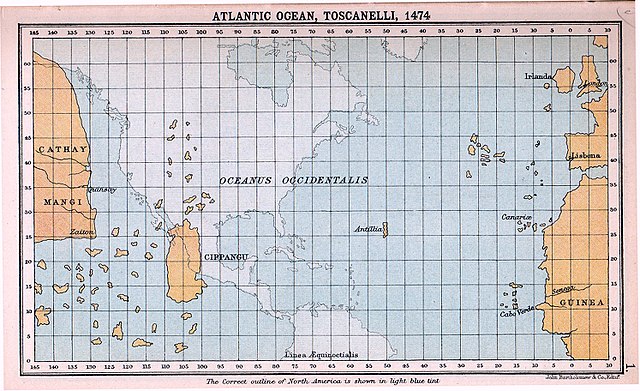

Si miramos a nuestro alrededor, puede dar la impresión de que vivimos en un planeta plano, como así lo creyeron muchos pueblos en la antigüedad. Babilonios, egipcios, chinos, incas, nativos americanos, o incluso los primeros griegos, pensaron que la Tierra era plana. Según el filósofo y matemático griego Tales de Mileto (aprox. 624-547 a.n.e.), la Tierra es un disco flotando en un mar de agua, mientras que, para su discípulo Anaximandro (aprox. 610-545 a.n.e.), es un cilindro, con la ecúmene (el mundo habitado) en una de sus tapas planas. Precisamente, el mapa de la ecúmene de Anaximandro está considerado uno de los primeros mapas geográficos del mundo.

Reconstrucción del mapa de Hecateo, basado en el mapa de Anaximandro, perteneciente al “Cram’s atlas of the world, ancient and modern” (1901), de G. F. Cram. Imagen de la David Rumsey Map Collection [2] Sin embargo, también fueron los antiguos griegos quienes pronto descubrirían que la Tierra tiene forma esférica, como aparece recogido en el diálogo del filósofo griego Platón (aprox. 427-347 a.n.e.) Fedón o la inmortalidad del alma o en el Tratado del Cielo de su discípulo Aristóteles (384-322 a.n.e.), este último con argumentos físicos y lógicos que lo demostraban.

Reconstrucción del mapa de Hecateo, basado en el mapa de Anaximandro, perteneciente al “Cram’s atlas of the world, ancient and modern” (1901), de G. F. Cram. Imagen de la David Rumsey Map Collection [2] Sin embargo, también fueron los antiguos griegos quienes pronto descubrirían que la Tierra tiene forma esférica, como aparece recogido en el diálogo del filósofo griego Platón (aprox. 427-347 a.n.e.) Fedón o la inmortalidad del alma o en el Tratado del Cielo de su discípulo Aristóteles (384-322 a.n.e.), este último con argumentos físicos y lógicos que lo demostraban.

El siguiente pasaje es del diálogo Fedón o la inmortalidad del alma (Platón, Diálogos, Espasa-Calpe, 1984):

Primeramente, repuso Sócrates, estoy convencido de que, si la Tierra está en medio del cielo, y es de forma esférica, no tiene necesidad ni del aire ni de ningún otro apoyo que la impida caer…

Además, estoy convencido de que la Tierra es muy grande y que no habitamos en ella más que esta parte que se extiende desde Fasis hasta las columnas de Hércules, repartidos alrededor del mar como las hormigas y las ranas alrededor de un pantano…

Se dice, mi querido Simmias, que si se mira esta Tierra desde un punto elevado, se parece a uno de esos balones de cuero…

Por otra parte, los argumentos de la esfericidad terrestre que aparecen en la obra de Aristóteles son sencillos y contundentes, como puede leerse en el libro El sueño del mapa perfecto (RBA, 2010), la posición de las estrellas en el firmamento, la existencia de usos horarios o la existencia y forma del horizonte.

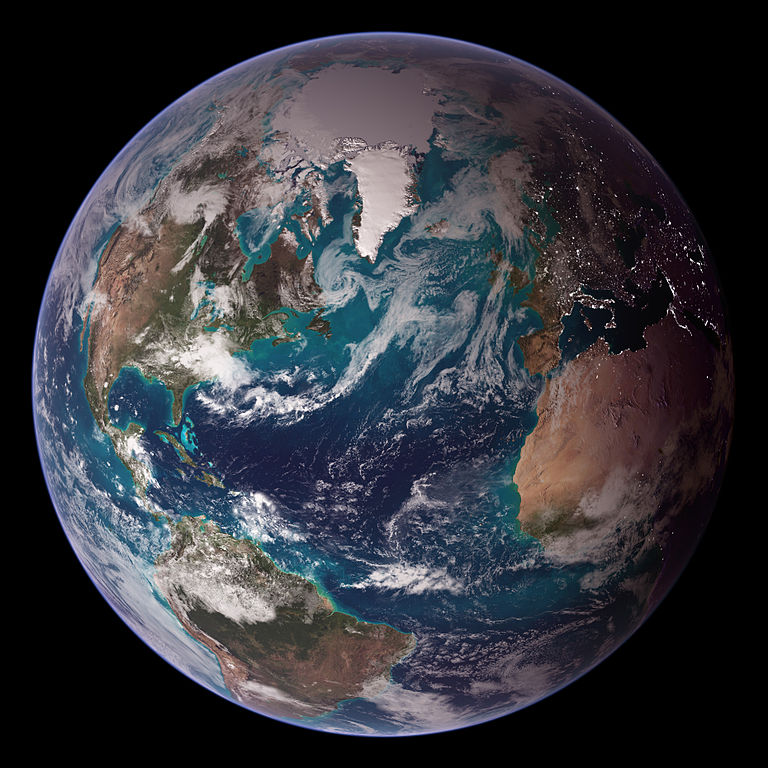

Representación de la Tierra vista desde el espacio utilizando datos obtenidos por la NASA y NOAA. Imagen de la NASA realizada por Reto Stöckli

Representación de la Tierra vista desde el espacio utilizando datos obtenidos por la NASA y NOAA. Imagen de la NASA realizada por Reto StöckliUna vez conocida la forma del planeta en el que vivimos, surge la cuestión de conocer cuál es su tamaño. De nuevo, fue la ciencia griega la que se puso manos a la obra, y realizó algunas estimaciones, utilizando la geometría, del perímetro terrestre.

Ya Aristóteles, en el mencionado Tratado del cielo, escribía que los “matemáticos” habían calculado la longitud de la circunferencia del globo terráqueo, estableciéndola en 400.000 estadios (más adelante, discutiremos el valor de esta unidad de longitud). Según parece la estimación citada por Aristóteles se debía al matemático y astrónomo griego Eudoxo de Cnido (aprox. 400-347 a.n.e.), considerado el fundador de la astronomía matemática.

La siguiente estimación del tamaño de la Tierra aparece en la obra El Arenario de uno de los más grandes científicos griegos, Arquímedes de Siracusa (aprox. 287-212 a.n.e.), quien en el transcurso de la discusión sobre la cantidad de granos de arena que se necesitarían para llenar todo el universo, y, por tanto, sobre el tamaño del universo, afirma que “el perímetro de la Tierra es de 3.000.000 de estadios y no más”, aunque también reconoce que hay quienes afirman que es de 300.000 estadios, que a él le parece demasiado pequeña.

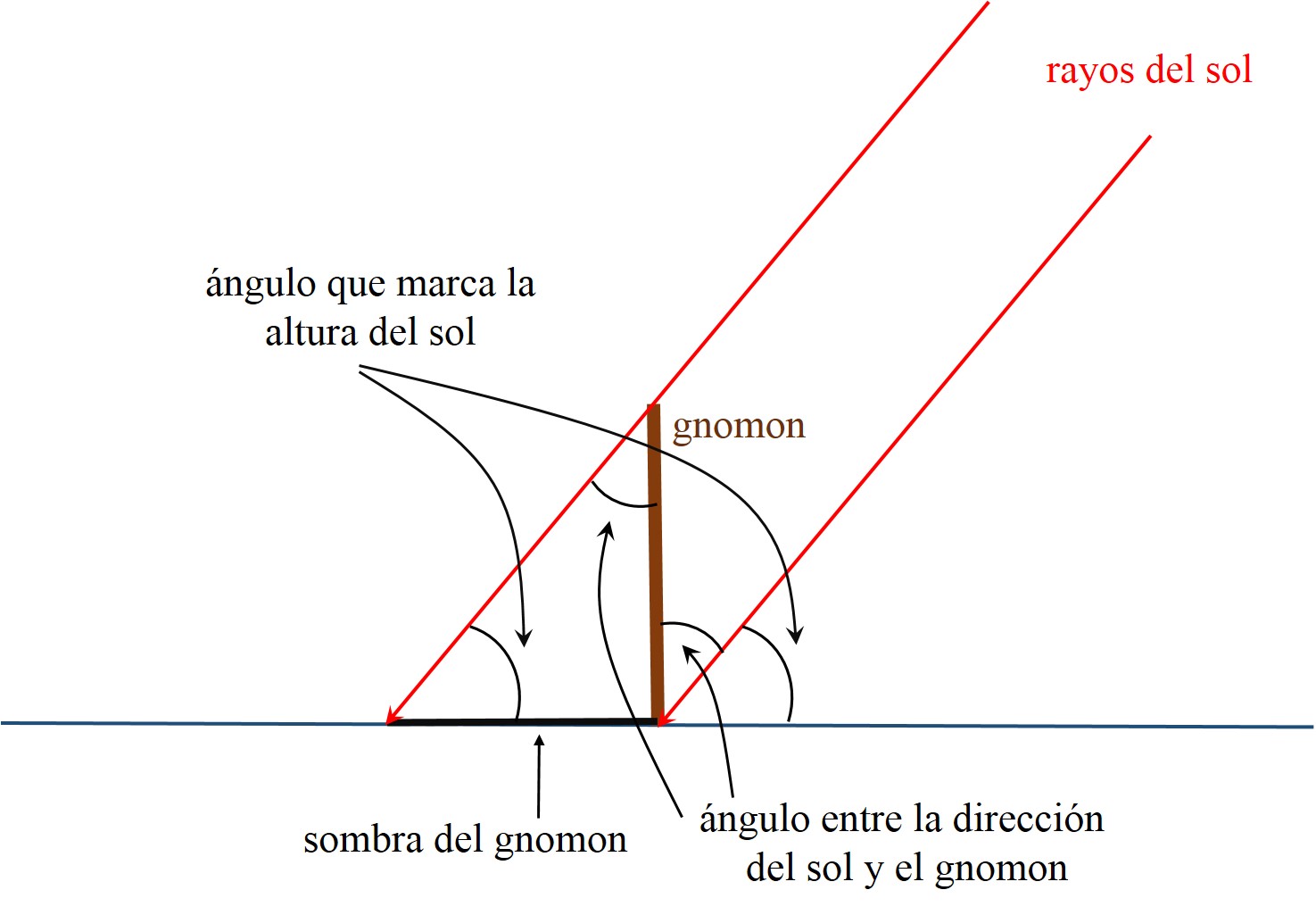

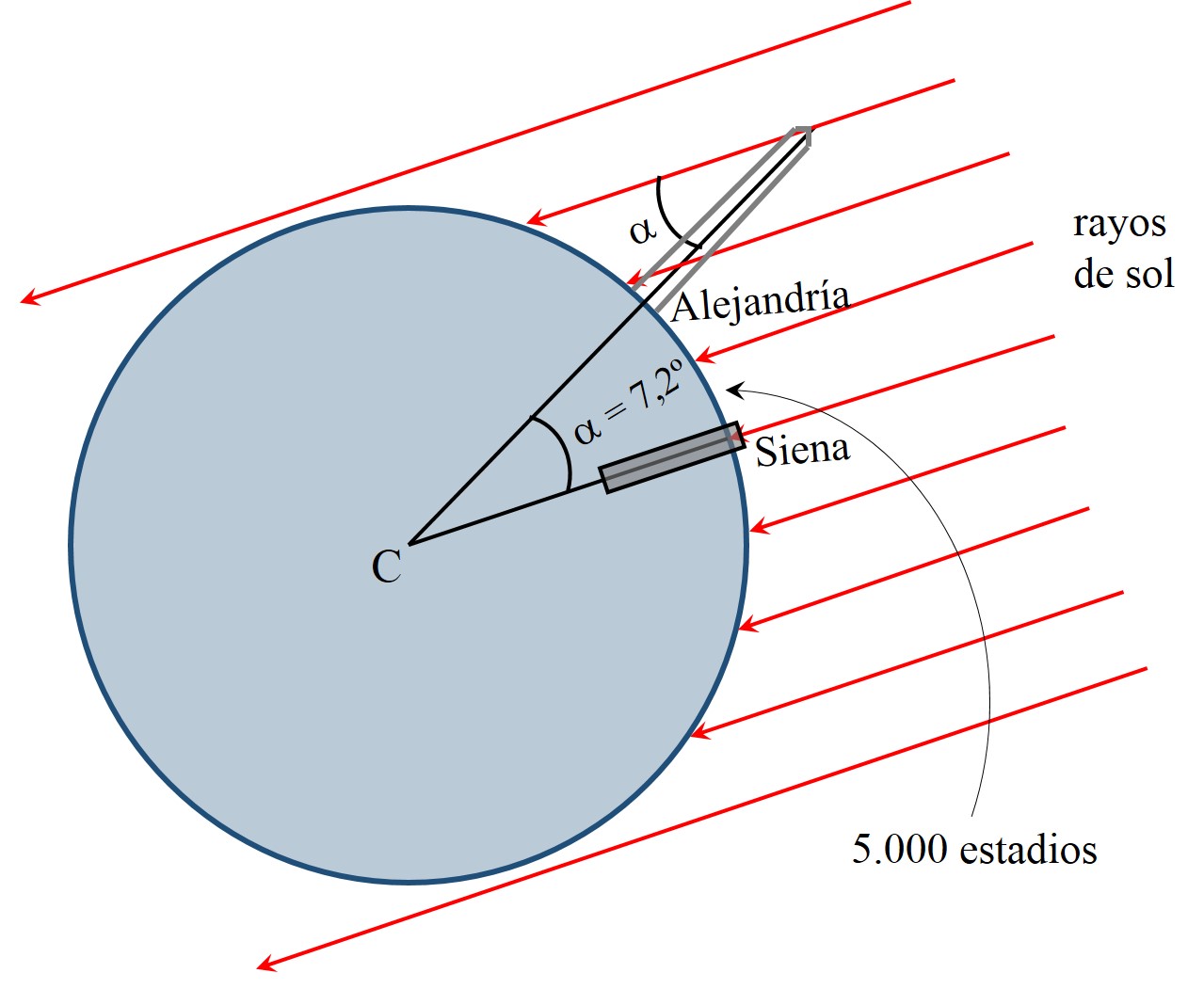

“Muerte de Arquímedes”, del pintor francés Edouard Vimont (1846-1930)