Desmitificando: Las rubias son “tontas”

“Solo porque soy rubia no creo ser una tonta, porque esta rubia tonta no es ninguna idiota.”

Dolly Parton, cantante y actriz.

“No soy ni tonta ni rubia.”

Marta Sánchez, cantante y actriz.

“Una chica con seso debe hacer algo más que pensar con su seso.”

Anita Loos, “Los caballeros las prefieren rubias”, 1926.

Retrato oficial de sus tiempos como subdirectora general de la NASA de Dava Newman, catedrática de aeronáutica, astronáutica e ingeniería de sistemas en el MIT.

Ya ven, para empezar, una rubia “tonta” puede no ser ni rubia ni “tonta”, con lo cual la propia descripción de la, digamos, “tontera” de las rubias, está, evidentemente, equivocada. Y todo ello a pesar de que conocemos, según Jay Zagorsky, de la Universidad Estatal de Ohio, que la belleza, sobre todo si es rubia, ayuda a triunfar en política, sacar mejores notas, aumenta los ingresos de la prostitución, lleva al éxito en el golf, da ventaja para ser un gran criminal o una celebridad, y sube el sueldo de los agentes inmobiliarios. En fin, según Zagorsky, todo esto está demostrado.

Y todo ello se debe a que, a menudo, juzgamos la personalidad de una persona según su aspecto externo. Como cuenta Zagorsky, juzgamos a las rubias como incompetentes, o a las pelirrojas como con mal genio y temperamento fogoso. Estos prejuicios se refuerzan en la cultura popular con películas (no olvidar a Marilyn), libros o cómics. Zagorsky se pregunta si las rubias son realmente “tontas” y para aclararlo compara el color del pelo de las mujeres con su cociente de inteligencia (CI).

Obtienen los datos de 5827 personas, con el 51.4% de mujeres y, entre ellas, con el 20.7% de rubias. Por cierto, se declaran rubios el 17.1% de los hombres, lo que supone que, quizá, el 3.5% de las mujeres no lo son si consideramos que el porcentaje para ambos sexos debería ser parecido.

El CI medio de las rubias es de 103.2, seguido de 102.2 de las de pelo castaño, 101.2 de las pelirrojas y 100.5 de las de pelo negro. Las diferencias entre los CIs no son importantes pero, es evidente, en este grupo las rubias, podemos afirmar, que no son “las más tontas”.

Lisa Randall, catedrática de física teórica de la Universidad de Harvard

O sea, que se supone que las rubias son “tontas” y, en cambio, son listas y, quien sabe si es por ello que saben sacar algunas ventajas del color de su pelo. Así, David Johnston, de la Universidad Tecnológica de Queensland, en Australia, ha encontrado, después de estudiar los datos de 13000 mujeres, que las rubias, ocupando el mismo puesto de trabajo, cobran hasta un 7% que las mujeres con el pelo de otro colora. Esto supone que, para un salario medio de 22000 libras, las rubias ganan unas 1300 libras más al año, unos 1700 euros. Y hay más, pues Johnston descubre que los maridos de estas rubias también ganan más que otros hombres en el mismo puesto de trabajo. El autor no aclara si estos maridos también tienen que ser rubios.

Desde luego y como decía antes, todo esto tiene que ver con nuestra cultura y, en último término, con la información que llega a los ciudadanos y los forma. Por ejemplo, Melissa Rich y Thomas Cash, de la Universidad Old Dominion de Norfolk, en Estados Unidos, cuentan que en la revista Playboy han aparecido, de la década de los cincuenta a los ochenta, un 41% de rubias, cuando en Estados Unidos las rubias son el 5% de la población. Es más, el récord de portadas en el Playboy lo tiene la actriz, por supuesto rubia, Pamela Anderson, con 13 portadas.

De esta manera se fomenta la imagen y se construye el estereotipo de las rubias como bellas y algo “tontas” pues solo se preocupan de la belleza de su cuerpo y muchos acaban pensando, en realidad, que no necesitan nada más.

Referencias:

Johnston, D.W. 2010. Physical appearance and wages: Do blondes have more fun? Economics Letters 108: 10-12.

Rich, M.K. & T.F. Cash. 1993. The American images of beauty: Media representations of hair color for four decades. SexRoles 29: 113-124.

Tejedor Pardo, D. 2014. La realidad sobre las rubias. Verdades y mitos. PsicoWisdom Blog 30 marzo.

Zagorsky, J.L. 2016. Are blondes realty dumb? Economics Bulletin 36: 401-410.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Desmitificando: Las rubias son “tontas” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Desmitificando: La vitamina C y el resfriado

- Desmitificando: Alguien me está mirando…

- Ingredientes para la receta: el ajo

Naukas Bilbao 2017 – Javier Fernández Panadero: Si tú supieras

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

El cacharrista mayor del reino vuelve a hacer de las suyas. Si tú supieras lo que él sabe podrías sacar mucho provecho en tu vida cotidiana.

Javier Fdez Panadero: Si tú supierasEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Javier Fernández Panadero: Si tú supieras se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Javier de la Cueva: Proyecto Richfields, un ejemplo de proyecto 2020

- Naukas Bilbao 2017 – Mónica Lalanda: Una muerte de cómic

- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

La contribución global de los ríos intermitentes al ciclo del carbono

Un trabajo de investigación en el que ha participado Daniel von Schiller del Departamento de Biología Vegetal y Ecología de la UPV/EHU ha estudiado por primera vez cómo afectan los ríos intermitentes a las emisiones fluviales de CO2 a nivel global. Los resultados se han publicado en Nature Geoscience.

Cauce seco del río Guadalmedina a su paso por Málaga. Imagen: Juan Martín Martín

En los últimos años, varios estudios han demostrado que los ríos tienen una contribución importante en las emisiones de CO2. Este trabajo se ha centrado en los ríos intermitentes, ya que hasta ahora no se ha profundizado en su estudio. Tal como explica von Schiller, “aunque son mucho menos estudiados que los ríos permanentes, podrían representar la mitad de la red fluvial del mundo, y en respuesta al cambio climático y las crecientes demandas de agua, podrían llegar a dominar el paisaje en algunas regiones”.

Cuando un río deja de fluir, la hojarasca terrestre, en su mayoría hojas y madera de la zona adyacente, cae y se acumula en los lechos de los ríos secos. El tipo y cantidad de hojarasca varía dependiendo del clima, la vegetación, el ancho del cauce del río, la duración del período seco y el régimen de flujo del río. En este trabajo, “hemos analizado la hojarasca depositada a lo largo de los lechos secos de 212 ríos distribuidos por todo el mundo y hemos medido la respiración, traducida a emisiones de CO2, cuando el agua vuelve a fluir en esos ríos, y en consecuencia se rehumedece toda la hojarasca”, explica el investigador de la UPV/EHU. “Ese momento de rehumedecimiento es un momento caliente en el cual se reactivan muchos de los mecanismos biológicos que estaban latentes en el río. El agua reactiva las comunidades biológicas, sobre todo las bacterias pero también los hongos, que como llevan un tiempo en la fase latente, se reactivan de forma muy acelerada y empiezan a respirar con tasas muy elevadas. Por eso se llama un momento caliente. Es un momento de actividad desproporcionada, de gran actividad biológica”, continua.

“Hemos medido la respiración, que se puede traducir a CO2, simulando un rehumedecimiento en el laboratorio DYNAM de IRSTEA (Francia), ya que hacerlo in situ resulta muy complicado porque es difícil saber cuándo vuelve el agua a un río intermitente”, apunta Daniel von Schiller. “Las altas tasas de respiración medidas reflejan la reactivación de las comunidades microbianas, que a su vez liberan cantidades sustanciales de CO2 a la atmosfera”, afirma el investigador.

“Los resultados obtenidos indican, que las estimaciones de las emisiones diarias de CO2 podrían aumentar entre un 7 y un 152 % si se sumaran los datos de emisiones de los ríos intermitentes a los datos ya existentes de ríos permanentes”, detalla von Schiller. Y por otro lado, “hemos observado que el pulso de emisión de CO2 que se produce en un solo momento de rehumedecimiento podría contribuir hasta un 10 % de ese incremento”.

Referencia:

Datry T, Foulquier A, Corti R, von Schiller D, Tockner k et al. (2018) A global analysis of terrestrial plant litter dynamics in non-perennial waterways Nature Geoscience doi: 10.1038/s41561-018-0134-4

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La contribución global de los ríos intermitentes al ciclo del carbono se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Todo lo que se puede medir en un río

- Cartografiando automáticamente áreas quemadas a nivel global

- Hidrógeno a partir de composites de fibra de carbono

Por qué España es un modelo para el estudio de la economía

Viajemos mentalmente hasta el San Sebastián de 1886, “una ciudad moderna, con edificios esbeltos, elegantes, cómodos; preparados algunos con el refinamiento de lujo y confort que exigen los adelantos de la época; obras de gusto, solidez y esmero, edificios en una palabra, de gran valor, por el crecimiento adquirido por la propiedad, escasa de terrenos”, tal y como se lee en uno de los capítulos del libro ‘Tierra Euskara’ de Alfredo de Laffitte Obineta, en que se describía el San Sebastián de mediados del XIX. .

Aquel año, en enero, se añadieron a la tradicional Tamborrada los barriles, que vienen a simbolizar a los habitantes locales de la ciudad que tocaban el barril o los cubos de agua mientras esperaban en su turno en las fuentes y replicaban con esos instrumentos los tambores de los militares y en agosto, se estaba empezando a construir el tranvía de la ciudad, el primero que consiguió electrificar todas sus líneas en España.

Una España que en abril de ese año había acogido unas elecciones generales, tras la muerte de Alfonso XII en noviembre del 1885, y en las que solamente hizo uso de su derecho a voto el 4’5% de la población total, claro que las mujeres no contaban pues el sufragio femenino no se reconoció en España hasta la firma de la Constitución de 1931 de la II República.

En ese marco, Josefa Martina Otaegui, una joven soltera de San Sebastián, se aventuró a abrir su propio negocio: la chocolatería artesana Pastelería Otaegui. Tras casarse con un maestro en el oficio, se trasladó a Elizondo (Navarra) y allí fundó con su marido, sin perder su papel activo como dueña, la Pastelería Malkorra.

Hoy, ambos negocios siguen abiertos y son regentados con éxito por mujeres descendientes de Otaegui, una de las pioneras a las que la implantación de la Sociedad de Responsabilidad Limitada (S.R.L.) en España les facilitó el arduo propósito de atreverse a ser empresaria en el siglo XIX.

Es solo un ejemplo de los muchos que han usado en un estudio internacional, llevado a cabo por la Universidad de Murcia y la Universidad de Yale sobre el impacto de las S.R.L. (más conocidas como Sociedades Limitadas) en España y Europa entre los años 1886 y 1936. En concreto, el proyecto, liderado por Susana Martínez, profesora de la UMU, analiza los datos de las sociedades mercantiles creadas en España durante esos 50 años.

Entre los resultados obtenidos, destaca el hecho de que la S.R.L. catapultara a la mujer como empresaria. Han encontrado que entre el 10% y el 15% de las sociedades mercantiles que se fundan en la etapa 1886 -1936 tiene al menos una socia fundadora. Se ha comprobado que hay más mujeres a medida que nos acercamos al presente y también en provincias donde el régimen hereditario es igualitario; es decir, cuando todos los hijos tienen acceso a una parte más o menos igual de la herencia con independencia de su sexo.

Además, en España, como en otros países por la comunidad de bienes, cada uno de los esposos era dueño al 50% de todo lo adquirido durante la duración del matrimonio. Por este motivo, sumado a la mayor esperanza de vida de las mujeres, la ‘viuda de’ era una figura fundamental en los negocios. Pero también había casadas con permiso de su marido, y solteras, aunque en menor proporción.

España como modelo

Por otro lado, uno de los resultados más novedosos del estudio demuestra que los lazos familiares de los socios seguían una pauta clara: los empresarios se decantaban por la Sociedad Limitada (S.L.) cuando en la empresa participaban individuos que no estaban ligados a los demás por vínculos familiares. Un negocio con miembros de una sola familia solía adoptar la forma de Sociedad Colectiva y tenía otros rasgos característicos como que el capital estaba dividido en partes iguales. Encontrar que una sociedad está formada por algunos miembros de una misma familia y otros socios ajenos es indicativo de que habían necesitado la inversión de terceros para su constitución. Para evitar conflictos de intereses, al estar mezclados socios que eran de la familia y los que no lo eran, lo más sencillo era acudir a un tipo de sociedad donde la responsabilidad asumida estaba limitada al capital aportado.

Para determinar si en las empresas analizadas los socios eran o no familia/familiares, los investigadores se han apoyado en el Registro Mercantil Español como principal fuente. De hecho, los investigadores extranjeros alaban la enorme cantidad de datos que ofrece y su continuidad a lo largo de tantos años.

Por poner un ejemplo, en el caso de las sociedades limitadas en España, lo excepcional es que cuando aparecen, desde el primer momento en el que las autoridades permiten su funcionamiento, queda constancia de ella en el Registro Mercantil. Es posible, por tanto, mapear dónde surgen en primer lugar estas sociedades, que será en ciudades antes que en zonas rurales, en negocios medianos y con preferencia por empresas donde existe personal cualificado (agencias de viajes, negocios relacionados con el automóvil, con los profesionales liberales). Ese mapeo no es posible en otros países, solo existe en España.

Del mismo modo, para determinar si en las empresas analizadas los socios eran o no familia/familiares, los investigadores destacan la calidad de las fuentes registrales españolas. Para ellos ha sido fundamental, para investigar el parentesco entre los socios, contar con la práctica española de que los apellidos de cada individuo son dos: el del padre y el de la madre, por este orden. En otros países, donde solo se usa un apellido y es el del padre, se está eliminando mucha información sobre las familias. En España, gracias a esta práctica se puede analizar en parentesco con mucho más detalle.

Continuidad

En definitiva, la conclusión fundamental del estudio es que éste acredita el papel determinante que ha jugado la S.R.L. en la actual composición del tejido empresarial nacional y, por ende, en la creación de riqueza en España. La Sociedad de Responsabilidad Limitada se popularizó entre las empresas porque evitaba poner en riesgo el capital familiar, por lo que fue una figura clave para el desarrollo económico.

A tenor de estos hallazgos, los analistas de la Facultad de Economía y Empresa de la Universidad de Murcia, en colaboración con el equipo de Yale, en el que se encuentra Timothy Guinnane, quieren iniciar un proyecto de investigación más ambicioso con el que poder desarrollar una serie de recomendaciones útiles en cuanto a programas legislativos mercantiles en beneficio del despegue económico.

Este post ha sido realizado por Mariajo Moreno (@Mariajo_Moreno) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Por qué España es un modelo para el estudio de la economía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Cuántos animales se usan en España para experimentación?

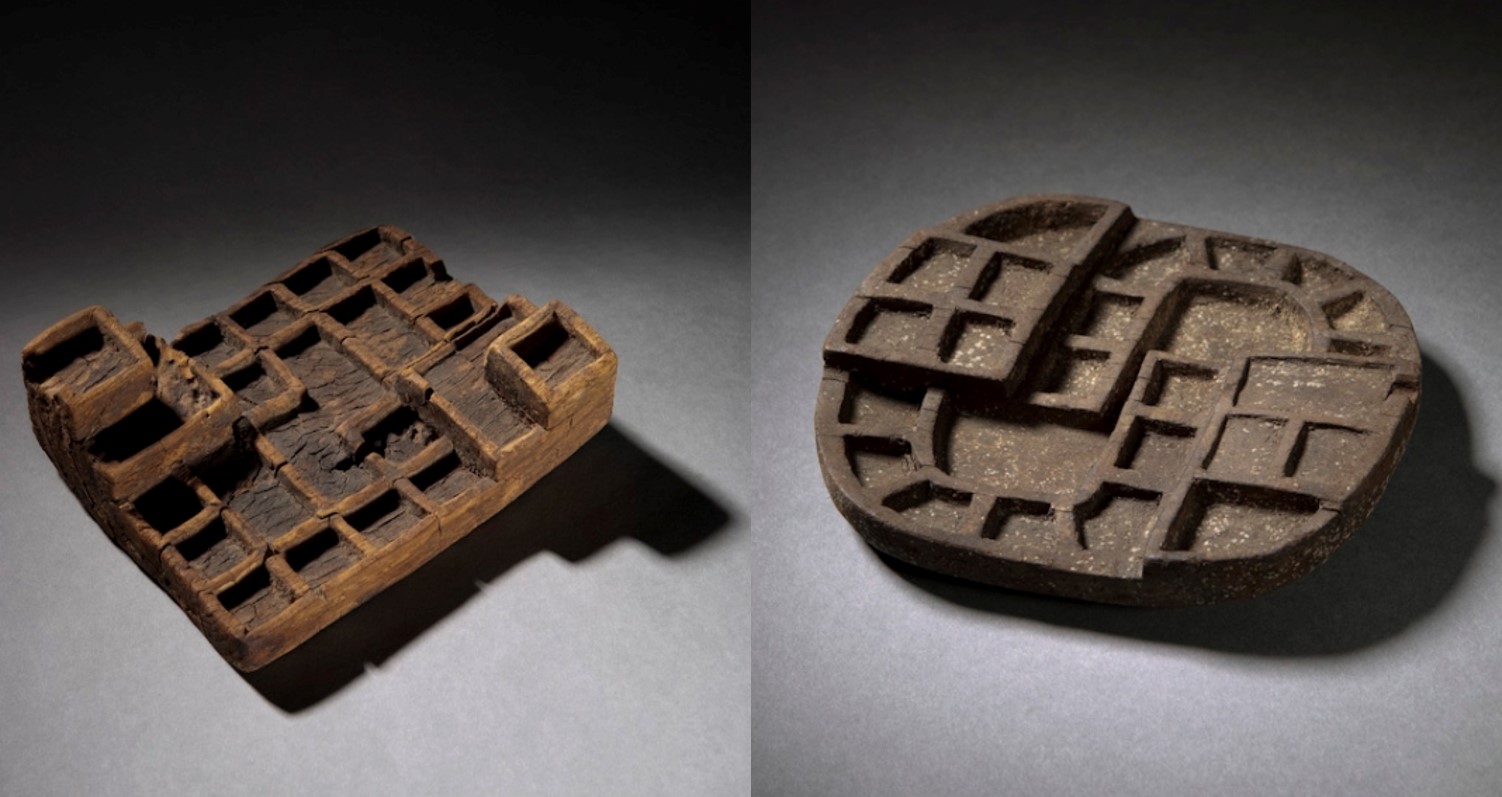

- Técnicas “low cost” para el estudio de obras de arte

- Dando valor a los residuos marinos para cuadrar la economía circular

La ciencia y el egoísmo nacional

Niels Bohr y Albert Einstein invirtiendo en el desarrollo económico y tecnológico de la humanidad sin ser conscientes de ello. Foto: Paul Ehrenfest / Wikiemedia Commons

A pesar de lo que solemos leer en los medios la verdad es que la mayoría de los científicos profesionales no trabajan en ciencia para mejorar el bienestar de la Humanidad. Hay investigadores biomédicos cuya vocación es acabar con determinadas enfermedades, o ingenieros que trabajan para que tengamos mejor y más barata tecnología con la que resolver nuestros problemas, pero el móvil de la mayoría de los científicos no es mejorar la vida de la gente, sino el conocimiento; la pura y dura curiosidad. Esto, y la ignorancia de algunos, lleva a que se pueda encontrar críticas a los presupuestos dedicados a la ciencia en plan ¿por qué debe el estado subvencionar sus aficiones a los de las batas blancas en sus torres de marfil? Si el objetivo de la ciencia no es en sí mismo mejorar la vida de la gente, ¿por qué debe la gente pagar por ella?

Es cierto que la ciencia puede parecer cara, aunque sus presupuestos palidecen ante otros gastos (defensa, infraestructuras) típicos de las entidades nacionales. Y es cierto que la ciencia pura y dura no sólo parece inútil, sino enrevesada, abstrusa y a veces incluso absurda. Políticos populistas de toda laya han sacado partido a la burla de determinados estudios científicos financiados con fondos públicos convenientemente retorcidos para hacerlos parecer ridículos. Resulta complicado explicar a veces por qué se deben dedicar dineros del estado a la investigación, si a cambio no se obtiene nada de provecho.

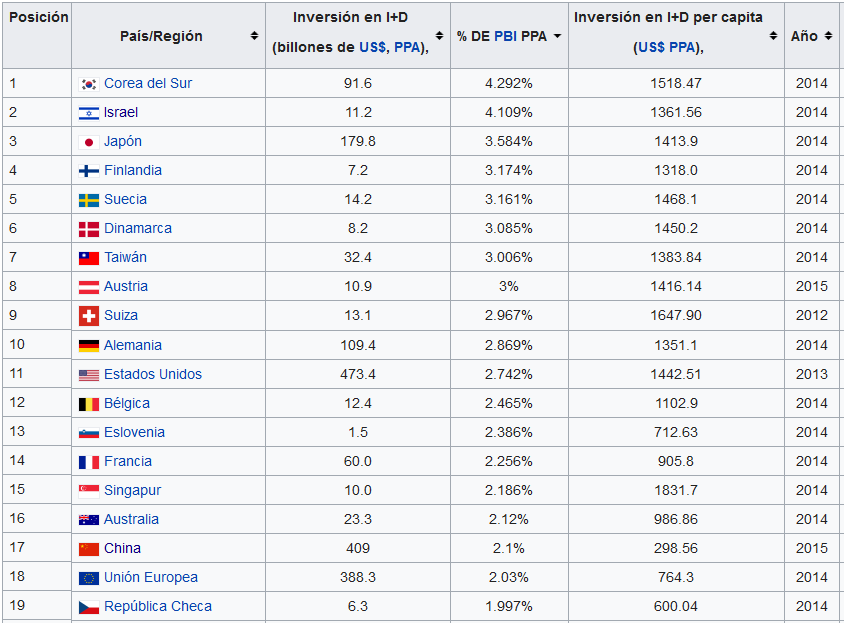

Y sin embargo el egoísmo nacional es precisamente la razón más importante que puede justificar que un país dedique dinero público a la ciencia y la tecnología; no por amor al conocimiento o por el prestigio de sus instituciones, sino para obtener a cambio mejoras e su situación económica. La lista de los países más ricos y poderosos del mundo coincide con la lista de los países que más invierten en ciencia, no sólo en términos absolutos, sino también en relativos; y no es una coincidencia. Los países más ricos y poderosos invierten en ciencia porque esta inversión ayuda a hacerlos más ricos y más poderosos, no por la bondad de sus estatales corazones; existe una clara correlación entre inversión en ciencia básica y aplicada y bienestar económico y poderío nacional.

Tabla con los países que invierten al menos un 2,00 % de su PIB en I+D según los últimos datos disponibles. España ocuparía un lugar 31, con el 1,22 % según datos de 2014 (en la actualidad puede que sea significativamente menos). Fuente: Wikimedia Commons

Aunque pueda parecer mentira censar las garcetas de un lago, estudiar la microbiología de una playa, analizar la dispersión de rayos cósmicos o determinar los intríngulis de una reacción química acaba teniendo un impacto sobre la vida de la gente, si no directa sí indirectamente. Cuando un estado dispone de un aparato de investigación científica pura genera conocimientos nuevos que se acaban derramando sobre la industria de ese país convertidos en técnicas útiles; el disponer de gente entrenada y formada ayuda cuando es necesario resolver un problema de producción en una empresa o cuando se trata de crear nuevos productos. Y esto sin contar con las veces en las que un recóndito detalle de un remoto rincón especializado de una ciencia se transforma en la base de una industria multimillonaria completa, como ocurrió con los sistemas de defensa antivirus de las halobacterias de Santa Pola y el CRISPR/CAS.

La ciencia no se practica por el bien de la humanidad, no más que la carnicería, la construcción de edificios o la conducción de autobuses. Pero lo cierto ers que tenemos pruebas de que la práctica de la ciencia mejora la vida en las sociedades que le dedican cariño, presupuestos y atención: su economía mejora, su industria se fortalece, su lugar en el mundo crece. Es por eso que por puro y duro egoísmo cabe reclamar a políticos y administradores que le dediquen la atención que necesita al sistema de ciencia e innovación. Por egoísmo nacional, si no por cariño verdadero.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La ciencia y el egoísmo nacional se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia, poder y comercio

- Ciencia grande, ciencia pequeña

- Héroes de la ciencia, héroes de la humanidad

Apocalipsis alienígena: ¿puede alguna civilización sobrevivir a un cambio climático?

Ante el cambio climático, la deforestación y la pérdida de biodiversidad, crear una versión sostenible de la civilización es una de las tareas más urgentes de la humanidad. Pero cuando nos plateamos este inmenso desafío rara vez nos preguntamos la que puede ser la pregunta más apremiante de todas: ¿cómo sabemos si la sostenibilidad es posible?

Sabemos que existen infinidad de estrellas, galaxias y agujeros negros del universo. El número de planetas podría ser incluso superior a la suma de los anteriores objetos astronómicos, pero, ¿existen los planetas con civilizaciones sostenibles? ¿O todas las civilizaciones que pueden haber surgido en el universo duran solo unos pocos milenios antes de desaparecer a consecuencia del cambio climático que desencadenan?

Isla de Pascua alienígena. Imagen: University of Rochester illustration / Michael Osadciw

Un grupo de investigadores encabezado por Adam Frank,de la Universidad de Rochester (EE.UU.), ha abordado estas cuestiones desde una perspectiva “astrobiológica”, es decir, desde el punto de vista del estudio de la vida y sus posibilidades en un contexto planetario. Las suposiciones de partida son muy simples. La primera es que si no somos la primera civilización del universo eso significa que es probable que haya reglas sobre cómo evoluciona una civilización joven como la nuestra. La segunda es que, a medida que la población de una civilización crece, usa más y más de los recursos de su planeta y, al hacerlo, cambia las condiciones del planeta. Por tanto, las civilizaciones y los planetas no evolucionan por separado sino interdependientemente.

Para ilustrar cómo los sistemas civilización-planeta co-evolucionan, Frank y sus colaboradores desarrollaron un modelo matemático para mostrar las formas en las que una población tecnológicamente avanzada y su planeta podrían desarrollarse juntos. Usando su modelo matemático, los investigadores encontraron cuatro posibles escenarios que podrían ocurrir en un sistema civilización-planeta:

-

Gran mortandad: la población y el estado del planeta (indicado por algo así como su temperatura promedio) aumentan muy rápidamente. Finalmente la población alcanza un pico y luego disminuye rápidamente a medida que la temperatura planetaria en aumento hace que las condiciones hagan la supervivencia muy difícil. Se alcanza un nivel de población estable, pero es solo una fracción del pico de población (quizás un 30 % del pico). No está claro si una civilización tecnológica compleja podría sobrevivir a ese tipo de cambio.

-

Sostenibilidad: la población y la temperatura aumentan, pero finalmente ambos alcanzan valores estables sin ningún efecto catastrófico. Este situación aparece en los modelos cuando la población reconoce que está teniendo un efecto negativo en el planeta y pasa de usar recursos de alto impacto, como el petróleo, a recursos de bajo impacto, como la energía solar.

-

Colapso sin cambio en el uso de recursos: la población y la temperatura aumentan rápidamente hasta que la población alcanza un pico y cae precipitadamente. En estos modelos, la civilización colapsa, aunque no está claro si la especie misma muere completamente.

-

Colapso con cambio en el uso de recursos: la población y la temperatura aumentan, pero la población reconoce que está causando un problema y cambia de recursos de alto impacto a recursos de bajo impacto. Las cosas parecen nivelarse por un tiempo, pero la respuesta llega demasiado tarde y la población se derrumba de todos modos.

Los investigadores crearon sus modelos basados en parte en estudios de casos de civilizaciones extintas, como los habitantes de la Isla de Pascua. Los humanos comenzaron a colonizar la isla entre 400 y 700 e.c. y creció hasta alcanzar una una población máxima de 10,000 habitantes en algún momento entre 1200 y 1500 e.c.. En el siglo XVIII, sin embargo, los habitantes habían agotado sus recursos y la población se redujo drásticamente a unas 2.000 personas.

La mortandad de la población de la Isla de Pascua se relaciona con un concepto llamado capacidad de carga, el tamaño máximo de población que el ambiente puede soportar indefinidamente en un periodo determinado, teniendo en cuenta el alimento, agua, hábitat, y otros elementos necesarios disponibles en ese ambiente . Un cambio climático importante supone que la capacidad de carga para distintas especies, incluida la humana, puede disminuir, porque, por ejemplo, la agricultura a gran escala podría verse fuertemente alterada.

Los investigadores no pueden predecir con seguridad cual será el futuro de la Tierra, son demasiadas variables desconocidas en un sistema endiabladamente complejo. Pero este estudio pone de relieve la existencia de una posibilidad aterradora: si cambiamos lo suficiente el clima de la Tierra, puede que no podamos hacer nada para salvarnos. ¿Habremos llegado ya a ese punto?

Referencia:

Adam Frank et al (2018) The Anthropocene Generalized: Evolution of Exo-Civilizations and Their Planetary Feedback Astrobiology doi: 10.1089/ast.2017.1671

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Apocalipsis alienígena: ¿puede alguna civilización sobrevivir a un cambio climático? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Del cambio climático

- Dani y Fiti sobre el cambio climático

- ¿Y si el cambio climático nos termina haciendo a todos más simpáticos?

Zorn, su lema y el axioma de elección

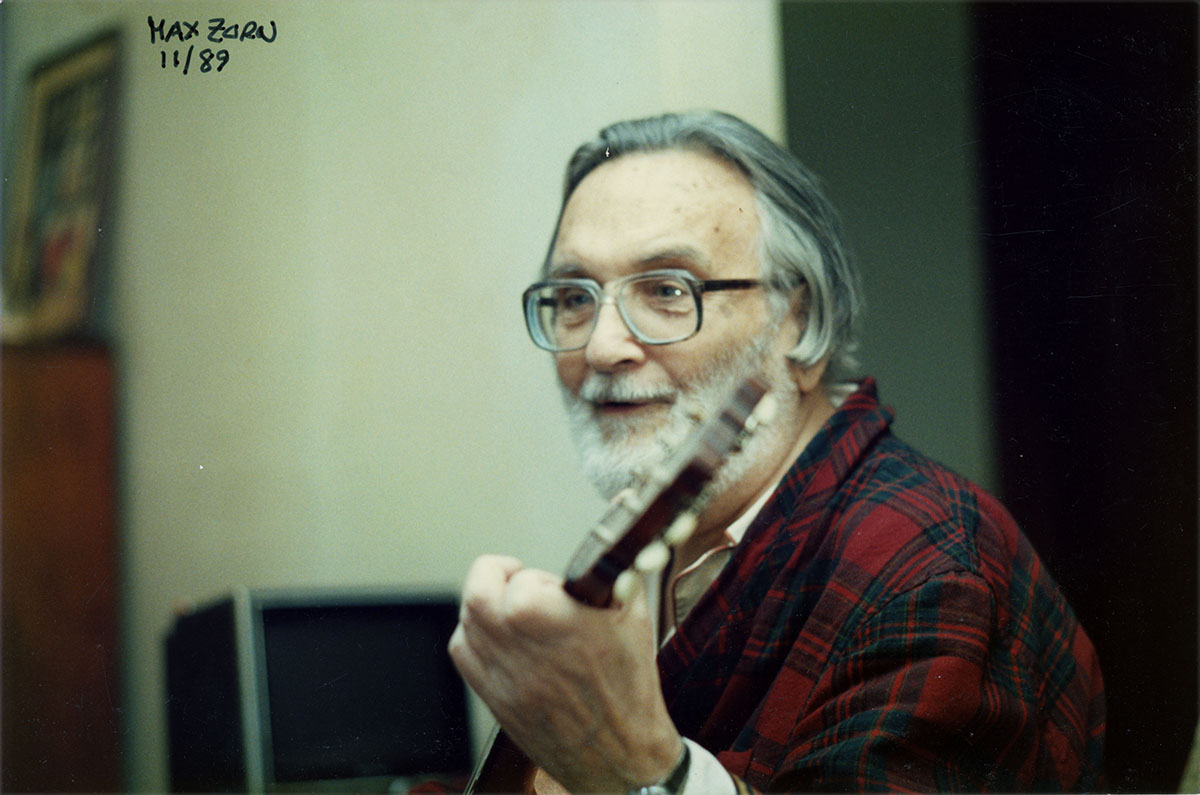

El matemático Max August Zorn (1906-1993) nació un 6 de junio.

Max Zorn en una fotografía de 1989 realizada por Paul Halmos (imagen tomada de la MAA)

Trabajó en diferentes áreas de las matemáticas; el álgebra abstracta, la teoría de grupos y el análisis numérico fueron sus principales temas de investigación. Zorn nació y se formó en Alemania; su tesis doctoral Theorie Der Alternativen Ringe –Teoría de anillos alternativos– fue dirigida por el conocido algebrista austriaco Emil Artin (1898-1962) y defendida en 1930 en la Universidad de Hamburgo. Poco después, Zorn emigró a Estados Unidos, y continuó allí con su vida y su carrera.

Cualquier persona que haya cursado una licenciatura o un grado de matemáticas –y de algunas otras carreras científicas– ha oído hablar del famosísimo lema de Zorn. De hecho no solo ha oído hablar de él, lo ha utilizado en múltiples ocasiones. ¿Y qué dice lema de Zorn? Vamos a escribir su enunciado, aunque no es nada ‘intuitivo’ al involucrar muchos conceptos sobre conjuntos ordenados. Aunque no es necesario leerlo para seguir esta anotación, puede servir de ‘repaso’ para aquellas personas que lo hayan estudiado alguna vez. Por cierto, además, es precioso, y dice así:

Si X es un conjunto parcialmente ordenado (no vacío) en el que toda cadena (subconjunto totalmente ordenado de X) posee una cota superior, entonces X contiene, al menos, un elemento maximal.

Es una herramienta muy útil en teoría de conjuntos, y es muy valioso para demostrar resultados en prácticamente todas las áreas de las matemáticas. Es un teorema de existencia, es decir, el lema de Zorn no proporciona una manera de encontrar ese ‘elemento maximal’ aludido… solo afirma que existe.

Como decíamos, se usa en casi todas las áreas de las matemáticas, como en la demostración de importantes resultados de análisis funcional (el teorema de Hahn-Banach o el teorema de Krein-Milman, por citar algunos), de topología (el teorema de Tychonoff que afirma que el producto de espacios compactos es compacto), de espacios vectoriales, de álgebra, etc.

Se puede demostrar que el lema de Zorn es equivalente al axioma de elección, que forma parte de los axiomas de Zermelo-Fraenkel, el sistema axiomático aceptado mayoritariamente para formular la teoría de conjuntos. La paradoja de Banach-Tarski –de la que hablamos en la anotación El guisante y el Sol: una extraña equivalencia–es una de las más sorprendentes consecuencias del axioma de elección. Este resultado tan contrario a la intuición –dada una bola (sólida) de dimensión 3, es posible recortarla en un número finito de trozos, y reagruparlos para obtener dos copias idénticas de la bola original– no agrada a algunos matemáticos que optan por evitar usar el axioma de elección en sus argumentaciones… aunque esa decisión les lleva a no poder demostrar muchos resultados clásicos de las matemáticas.

Como suele pasar a veces con las propiedades que llevan nombre, el lema de Zorn fue descubierto por otra persona, seguramente por varias que estaban trabajando en estos mismos temas. El matemático y lógico Kazimierz Kuratowski (1896-1980) dio una prueba de este resultado en 1922, y Zorn lo hizo, de manera independiente, en 1935. Ahora, en muchos libros y artículos se cita como lema de Kuratowski-Zorn.

Por cierto, el lema de Zorn aparece en el episodio El nuevo amigo de Bart de los Simpson (ver [3]). En este capítulo, la familia visita un parque de atracciones. En la carpa del ‘maestro hipnotizador Sven Golly’, Cleto, que está en trance, cree que es un gran matemático, y ante una pizarra afirma:

De esta manera se demuestra el lema de Zorn.

La escena aludida aparece en el minuto 2 del siguiente video:

También aparece este resultado matemático en el libro Los Simpsons y las matemáticas de Simon Singh (ver [3]). Un par de retos cómicos se plantean y responden así:

-

¿Qué es marrón, peludo, corre hacia el mar y es equivalente al axioma de elección? (respuesta: El lemming de Zorn).

-

¿Qué es amarillo y equivalente al axioma de elección? (respuesta: El limón de Zorn).

La película de cine experimental Zorns Lemma (1970) de Hollis Frampton también alude a este conocido resultado…

Por cierto, también llevan el apellido de Max August Zorn el teorema de Artin-Zorn y los anillos de Zorn, ambos relacionados con el tema de su tesis doctoral.

Referencias:

[1] O’Connor, John J.; Robertson, Edmund F., Max August Zorn, MacTutor History of Mathematics archive, University of St Andrews

[2] Max August Zorn, Wikipedia (consultado el 3 de junio de 2018)

[3] Simon Singh. Zorn’s Lemma. The Simpsons and their Mathematical Secrets

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Zorn, su lema y el axioma de elección se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El teorema de los cuatro colores (1): una historia que comienza en 1852

- El teorema de Marion (Walter)

- El teorema de los cuatro colores (y 4): ¿Podemos creer la prueba de la conjetura?

Así forman la orina los animales

El metabolismo de las moléculas nitrogenadas (proteínas, principalmente, pero también ácidos nucleicos) conduce a la producción de amonio (NH4+) como producto terminal, que ha de ser expulsado al exterior por su alta toxicidad. No obstante, el amonio puede ser transformado en otra molécula –urea o ácido úrico, principalmente- para su eliminación. Aunque algunas especies lo hacen a través de la pared del cuerpo, la mayor parte de los animales eliminan los restos nitrogenados por medio de la orina, que es evacuada al exterior a través de estructuras anatómicas específicas basadas en tubos. Esa es la razón por la que se denominan genéricamente tubos excretores.

La denominación anterior hace alusión, lógicamente, a la función excretora, pero esos tubos cumplen también un papel muy importante como órganos de regulación osmótica e iónica. La razón de esa duplicidad funcional es que participan de forma intensa en procesos implicados en el mantenimiento del balance de agua y electrolitos. Como vimos en las correspondientes anotaciones, los animales que ejercen algún tipo de regulación osmótica someten a control fisiológico tanto el volumen como la concentración osmótica de la orina. Y es lógico que así sea dado que, en principio, la eliminación de los restos nitrogenados se hace en forma de solución acuosa (aunque las excretas pueden llegar a ser semisólidas en algunos grupos), con lo que ello implica a efectos del balance hídrico y salino global.

En la zona proximal del tubo (o túbulo1) excretor se genera, en primera instancia, un flujo de solución acuosa a la que llamamos orina primaria. Hay dos mecanismos de producción de esa orina. Uno es la filtración (o ultrafiltración), y el otro es la secreción de un soluto al que acompaña el movimiento de un cierto volumen de agua. Más adelante se suele modificar la composición de esa solución o su concentración osmótica mediante la reabsorción o secreción de ciertas sustancias y la reabsorción de agua en zonas posteriores, más distales, del túbulo. La concentración osmótica e iónica de la orina, así como su volumen final, depende de la magnitud relativa y sentido de la reabsorción o secreción de las sustancias citadas y también de la proporción de agua reabsorbida.

La filtración se produce entre un enclave en el que se encuentra el medio interno -ya sea medio intersticial, líquido celómico, hemolinfa o sangre- y otro donde se forma la orina primaria. El filtro consiste en un epitelio que separa ambos compartimentos y entre cuyas células existen poros de pequeño tamaño a través de los cuales pueden pasar el agua y pequeñas moléculas (como glucosa, aminoácidos, urea y ciertos polímeros de dimensiones reducidas), pero no macromoléculas o células sanguíneas. Para que se produzca la filtración, ha de haber un gradiente de presión hidrostática entre los dos compartimentos citados. Gracias a ese gradiente fluye la solución acuosa hacia la luz del tubo excretor. En ciertos animales el medio interno no está sometido a presión, por lo que para que pueda generarse el necesario gradiente ha de producirse una presión negativa en el interior del túbulo renal. En los animales cuyo medio interno o sangre sí está sometido a cierta presión eso no es necesario, pues es esa presión interna la que genera el gradiente. Cuando la orina se produce por filtración, su concentración y composición inicial reflejan fielmente las del líquido de la que procede, salvo por lo que se refiere a proteínas plasmáticas u otras moléculas grandes, así como a los corpúsculos sanguíneos.

No en todos los animales se forma la orina primaria por filtración. La secreción de cierta o ciertas sustancias es el mecanismo que da lugar a la producción de orina. Como en la filtración, también aquí hay un epitelio que separa dos compartimentos líquidos. La diferencia es que en el caso de la filtración el responsable del movimiento de líquido de uno al otro era un gradiente de presión hidrostática, mientras que en este caso el gradiente es de presión osmótica, y por otro lado, entre los dos enclaves o compartimentos hay un epitelio de transporte. El epitelio en cuestión transporta (activamente) ciertos iones (K+ principalmente). Ese movimiento se ve acompañado por un cierto flujo de agua, que pasa desprovista de las sustancias que se encuentran disueltas en el medio interno del que procede. El gradiente es, en este caso, osmótico porque el transporte del soluto (o solutos) provoca que aumente la concentración osmótica del líquido en la luz del túbulo renal y sea superior a la del medio interno. La molécula de excreción también es transportada de forma activa en este caso.

La orina primaria, una vez formada, fluye a lo largo del túbulo renal y puede ser sometida a cambios en su composición mediantes posteriores procesos de transporte activo, ya sea para reabsorber ciertas sustancias y recuperarlas así, ya para eliminar otras. Y, como se ha dicho, la orina puede sufrir cambios en su concentración osmótica, bien porque los provoquen la retirada o adición de sustancias que se acaban de citar, o bien porque se reabsorba agua del túbulo renal al medio intersticial.

Nota:

1La denominación túbulo denota, si es el caso, pequeñas dimensiones

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Así forman la orina los animales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La regulación osmótica de los animales de agua dulce

- Animales en equilibrio osmótico: invertebrados marinos y peces bruja

- Animales eurihalinos

Datos vs. ideología: ¿Es la asignación de una renta básica universal la forma más eficiente de reducir la pobreza?

Foto de Niels Steeman via Unsplash

El actual estado del bienestar instaurado en países como España es un sistema levantado tras el desastre socioeconómico de la Gran Depresión y la Segunda Guerra Mundial. A medida que los países occidentales iban recomponiendo sus economías comenzaron a diseñar métodos para cuidar de sus ciudadanos más pobres a través de becas, servicios y subvenciones destinados a propósitos concretos, como alimentos o vivienda.

Es innegable que este sistema ha mejorado la calidad de vida general, y en especial la de los ciudadanos que reciben esas ayudas. Pero no lo ha tenido fácil: hace falta una burocracia nutrida y compleja para administrar los fondos y para asegurarse de que los ciudadanos que los reciben cumplen con los criterios establecidos.

Así que hay voces que defienden un sistema diferente, el de la renta básica universal (RBU), según el cual se reparte directamente una cantidad de dinero determinada a los ciudadanos más pobres sin imponer en qué deben gastarlo. Para los progresistas, esta podría ser una forma más eficaz de erradicar la pobreza; para los conservadores, se trata de una versión del estado del bienestar que resultaría mucho más sencilla y barata de implementar.

Los experimentos que han puesto a prueba la RBU

Pero, ¿es esto verdad? Hacen falta experimentos que nos den datos empíricos sobre los que sostener estas afirmaciones y posibles variaciones en políticas económicas y sociales que llevan décadas en pie. La revista Nature ha publicado recientemente un artículo en el que recoge y detalla algunos de los experimentos que se están llevando a cabo en todo el mundo en la materia.

Como por ejemplo, el que se realizó entre 1974 y 1978 en la ciudad canadiense de Dauphin. A los ciudadanos más pobres de Dauphin se les entregó un cheque mensual durante esos años sin indicarles en qué debían gastarlo. Mientras tanto se analizaron los cambios en distintos indicadores sociolaborales. Problemas de financiación confinaron todos esos datos en un despacho hasta que fueron rescatados y publicados en 2011 y revelaron, entre otras cosas, que los adolescentes de las familias incluidas en este programa completaron un año más de escolarización en comparación con otras familias en circunstancias parecidas, y que las hospitalizaciones se redujeron un 8,5% durante ese periodo, especialmente aquellas relacionadas con accidentes, heridas y problemas de salud mental. Y para los que temiesen que la RBU fuese a llevar a los participantes a abandonar sus trabajos, un dato interesante: las tasas de empleo se mantuvieron estables durante todo el experimento.

Foto de Lucas Favre en Unsplash

Basándose en esos datos y experiencias actualmente se están realizando estudios más amplios y profundos. Uno de los mayores se lleva a cabo en el oeste de Kenia. Allí, cada mes 21.000 adultos reciben 2.250 chelines keniatas (unos 19 euros, entre un cuarto y la mitad de los ingresos de un hogar medio en la zona más pobre del país) provenientes de la organización GiveDirectly, y lo harán algunos durante dos años, y otros durante 12. Otras personas no recibirán renta y servirán como grupo de control. Se trata del experimento más amplío y prolongado sobre esta materia hecho hasta ahora.

¿Qué se consideraría un éxito?

Su éxito es algo fácil de evaluar. Para empezar, porque no está del todo claro qué se podría considerar un éxito en la aplicación de la RBU: puede que haga mejorar unos indicadores (salud, educación) y disminuir otros (empleo y, paradójicamente, también educación). Además, es importante observar los efectos no solo individuales sino de toda la comunidad al completo y no solo a corto plazo sino de forma sostenible en el tiempo.

En el artículo de Nature, la economista del MIT Tavneet Suri, una de las principales investigadoras del estudio en Kenia, describe cuál sería el ciclo de mejoras que supondría el mejor resultado de la aplicación de la RBU: mujeres mejores alimentadas tendrán hijos más sanos que las madres desnutridas, que podrán atender más años a sus estudios (por salud y porque su familia no requerirá sus ingresos para subsistir), lo cual les dará mayores y mejores oportunidades laborales y a la vez retrasará la edad de matrimonio y maternidad, que también significa madres y bebés más sanos.

Para medir todo esto, los investigadores planean medir todos los indicadores posibles, del emprendimiento en la región hasta la salud, la educación y el estado nutricional. Harán entrevistas puerta a puerta, seguimiento telefónico y tendrán reuniones en profundidad con las personas más mayores para tener un panorama general del efecto de la RBU.

Foto de Didier Weemaels en Unsplash

El intento fallido en Finlandia

Recientemente, otro experimento relacionado con la RBU ha tenido problemas en Finlandia. En marzo de 2016 el gobierno anunció que, en colaboración con una ONG, iban a entregar 560 euros mensuales a 2.000 personas que en ese momento recibían un subsidio de desempleo durante dos años. A ese dinero se aplicaría una fiscalidad más leve que al subsidio y no estarían obligados a buscar empleo activamente para seguir recibiéndolo. Tampoco lo perderían si empezaban a trabajar.

Aunque al principio tuvo una buena acogida, la opinión pública terminó resentida con este sistema por sus costes. Además, esos ingresos no eran ni mucho menos suficientes para cubrir las necesidades básicas y no había un grupo de control para evaluar los resultados. En abril de 2018 el parlamento finlandés se negó a otorgar fondos para un año más del experimentos. Los fallos de procedimiento desvirtuaron el experimento y se han convertido en una barrera para poner en marcha otros programas parecidos.

La política (y no solo los datos) es lo que cuenta

Pero incluso aunque se pongan en marcha, como se ha puesto el estudio keniata, ¿cómo de fiables serán esos datos, sean positivos o negativos? Teniendo en cuenta que siguen siendo muestras relativamente pequeñas en comparación con la población de un país, y que los fondos vienen de iniciativas privadas, es difícil predecir, aun en caso de éxito, si un país podría sostener un sistema así o si sus habitantes tendrían la voluntad de financiarlo con sus impuestos.

Un recordatorio de que en la mayoría de los casos será la política, y no los resultados empíricos, los que determinen que la RBU se convierta en un sistema generalizado. Algo que, por supuesto es inevitable: si la política es la asignación y gestión de los recursos públicos según las prioridades de cada persona, grupo o ideología, ¿es la asignación de dinero sin obligaciones la mejor forma de reducir la pobreza, mejorar la salud y aumentar la calidad de vida?

Referencias:

Money for nothing: the truth about universal basic income – Nature

The Town with No Poverty: The Health Effects of a Canadian Guaranteed Annual Income Field Experiment – Canadian Public Policy

This Kenyan village is a laboratory for the biggest basic income experiment ever – Vox

Finland to end basic income trial after two years – The Guardian

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Datos vs. ideología: ¿Es la asignación de una renta básica universal la forma más eficiente de reducir la pobreza? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Colonialismo científico: los investigadores africanos se rebelan contra el expolio de datos genéticos

- La reacción de las madres al llanto de los bebés es universal

- Una simulación más eficiente de la evolución del Sistema Solar

Neptunistas y plutonistas

Las capas se corresponden con distintos periodos de actividad del volcán Chimborazo (Ecuador)

El debate entre neptunistas y plutonistas acerca del origen de las rocas de la corteza terrestre se desarrolló a finales del siglo XVIII y comienzos del XIX.

Los neptunistas (llamados así por el dios oceánico romano, Neptuno) creían que, desde un punto de vista fundamental, todas las rocas se habían formado en el agua. Según el neptunista más pominente, Abraham Gottlob Werner (1749-1817), profesor en la Academia de Minería de Freiberg en Sajonia desde 1775 [1], originalmente la superficie de la Tierra estaba cubierta por un caldo espeso, caliente y acuoso. Conforme este caldo se iba enfriando comenzaron a cristalizar los minerales que formaron las rocas que constituyen la base de las cadenas montañosas. Más tarde las rocas “no cristalinas” [2] se depositarion como capas de estratos sobre las rocas primarias [3] cristalinas.

Pero la mera observación de la naturaleza planteaba problemas a esta hipótesis. Probablemente el más obvio se podía plantear como una pregunta muy simple: “¿Y los volcanes?” Los neptunistas respondían con toda tranquilidad que los volcanes eran consecuencia de que se estabn quemando restos de plantas y, por lo tanto, eran intrascendentes.

La tradición neptunista tiene una componente teológico-metafísica en su epistemología, es decir, parte de la base de que puedo conocer de forma válida el mundo pensando, más que observando. Podemos encontrar antecedentes de cosmogonías químicas, como las de los protoquímicos del siglo XVII Joachim Becher y Georg Ernst Stahl, basadas en la asunción de que los procesos que se observan en el laboratorio pueden ser la base de las hipótesis acerca de la formación de los minerales que se encuentran en la naturaleza.

Humboldt y Aimé Bonpland en el volcan Chimborazo. Óleo de Friedrich Georg Weitsch (1810)

Este tipo de afirmaciones chocaban de frente frente con los vulcanistas (llamados así por el dios volcánico romano, Vulcano). Por ejemplo, Rudolph Eric Raspe o Nicolas Desmarest afirmaban que los basaltos , encontrados a menudo entre los estratos, habían fluido desde los volcanes. Los estudios de campo en el Massif Central francés confirmaban esta idea. Curiosamente uno de los primeros centros en abrazar esta idea fue precisamente la llamada Escuela de Freiberg, algunos de cuyos miembros, como Leopold von Buch y Alexander von Humboldt, llevaron a cabo importantes estudios de volcanes sobre el terreno durante la primera mitad del siglo XIX.

Sin embargo, el vulcanista más prominente e influyente había que encontrarlo en la empírica isla de Gran Bretaña. James Hutton, muy influido por las ideas newtonianas, fue quien mejor y más completamente formuló las ideas que terminaron llamándose plutonistas (por el dios inframundano romano, Plutón). Según Hutton el calor era responsible tanto de la consolidación de las rocas del fondo del océano como de su elevación para formar la tierra seca.

En abierto contraste con la aproximación racionalista/continental neptunista, John Playfair escribió Illustrations of the Huttonian Theory of the Earth (1802) en la mejor tradición empirista/británica, concentrándose en las pruebas que apoyaban la teoría neptunista de Hutton y apenas mencionando consideraciones naturalfilosóficas o químicas.

James Hall llevó a cabo experimentos en Estados Unidos, que hoy serían inconcebibles por si peligrosidad, sometiendo piedra caliza a calor y presión enormes, y vivió de chiripa para informar sobre sus resultados: efectivamente la roca se consolidaba eb esas circunstancias. Sin embargo, ni Playfair ni Hall consiguieron convencer a la comunidad geológica de que los estratos se consolidaban por el calor.

Para los años veinte del siglo XIX la mayoía de los geólogos estabn de acuerdo en que los estratos se formaban bajo el aguay que el basalto y otras rocas ígneas eran expulsadas por los volcanes. Esa era la parte fácil. El origen de las rocas duras y cristalinas [2] como los granitos y los gneises eran el verdadero problema. A finales del XIX los mineralogistas aún andaban peleando por el origen de los granitos, en una reedición del debate neptunista-plutonista.

Si la primera fase del debate tuvo una componente filosófica. Esta segunda parte tuvo una componente, digamos, “contrarreformista” [4], en el sentido de que se apreciaban aún más componentes claramente no científicos en el debate. Fue Charles Lyell en la introducción histórica a su muy influyente Principles of Geology (1830) el primero en alertar sobre ello. De hecho, el debate, planteado en los términos en los que se hacía era completamente estéril, como el debate contemporáneo entre defensores y detractores de la teoría de la evolución por selección natural de Darwin. Puede argumentarse que se percibe una clara influencia en la tesis neptunista de la Biblia, en concreto de la idea del diluvio universal, mientras que los plutonistas eran, innegablemente, magníficos geólogos de campo.

En cualquier caso, la evolución posterior de la mineralogía, petrología y geología ha demostrado que ambos bandos aportaron ideas y datos empíricos que contribuyeron a desarrollar las teorías modernas sobre el origen de minerales y rocas.

Notas:

[1] Con él estudiaron minería, entre otros, Alexander von Humboldt y Andrés Manuel del Río en 1791/92.

[2] A simple vista diríamos hoy. Recordemos las definiciones de roca y mineral que vimos aquí.

[3] Sobre la distinción entre rocas primarias y secundarias véase esto.

[4] La Contrareforma fue un movimiento en la Europa católica como reacción a la Reforma de Lutero

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Neptunistas y plutonistas se ha escrito en Cuaderno de Cultura Científica.

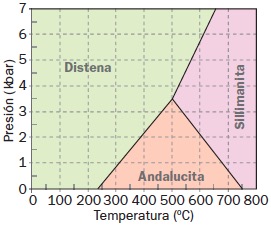

Entradas relacionadas:- Montañeros, espeleólogos y mineros

- Diagramas de fases, migmatistas y magmatistas

- Microscopios petrográficos y libros de geoquímica

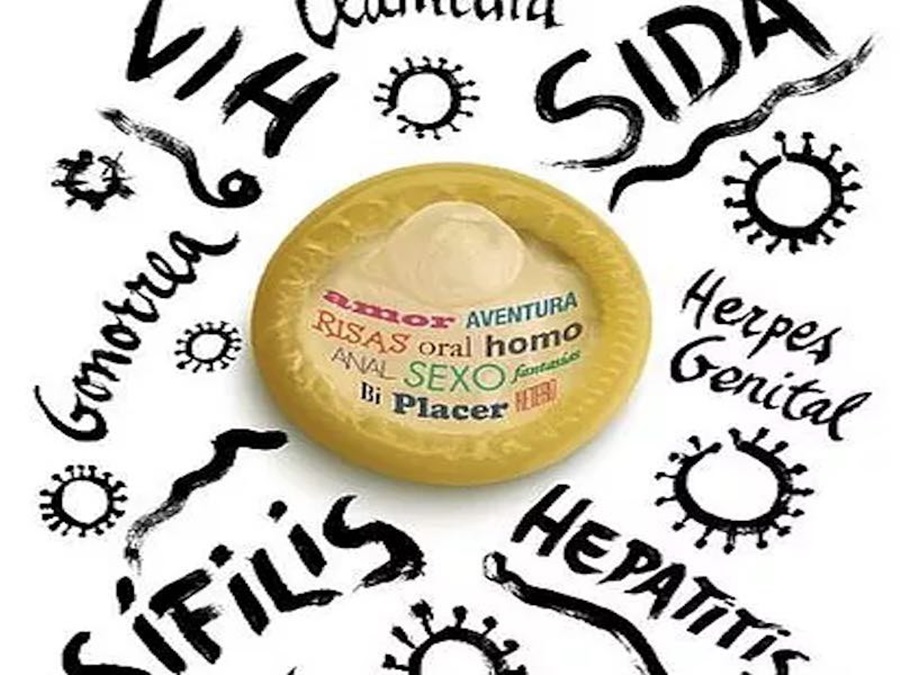

Un cóctel peligroso

Hace unos lustros llegamos a olvidarnos de ellas, aunque en realidad no habían desaparecido; sólo retrocedido. Los tratamientos farmacológicos, por un lado, y una mayor prevención, por el otro, habían conseguido mantener a raya a las enfermedades de transmisión sexual. La penicilina fue efectiva en los años cuarenta del pasado siglo para curar la sífilis; muchos soldados que habían combatido en la segunda guerra mundial se beneficiaron del tratamiento antibiótico. Y la emergencia del SIDA a comienzos de los ochenta condujo a muchas personas a practicar sexo de forma segura, recurriendo al uso de preservativos como nunca antes se había hecho. Pero las cosas parecen haber cambiado.

En varios países occidentales se viene observando un aumento continuado de la incidencia de la sífilis, gonorrea y clamidiasis durante los últimos años. En España, en concreto, los casos de sífilis y gonorrea han aumentado desde comienzos de este siglo. Y es posible que el mismo fenómeno haya ocurrido también en otros países.

Los especialistas atribuyen el repunte de la incidencia de estas enfermedades al hecho de haberse perdido el miedo al SIDA con la consiguiente relajación de las medidas profilácticas. Los más mayores quizás han abandonado las prácticas seguras, pero muchos jóvenes posiblemente ni siquiera han llegado a adoptarlas. Se perdió el miedo al SIDA como consecuencia de los grandes avances en antirretrovirales, que han conseguido aumentar de forma impresionante la esperanza de vida de las personas seropositivas. Además, desde 2012 se dispone de las denominadas medicinas profilácticas pre-exposición, que son fármacos antirretrovirales que se toman de forma preventiva con objeto de evitar el contagio del VIH. El uso creciente de estos fármacos ha venido acompañado por una disminución del uso de preservativos. Y el problema es que los condones protegen frente a todas las enfermedades de transmisión sexual, pero los antirretrovirales solo lo hacen frente a virus como el VIH.

A la pérdida del miedo parece haberse unido en los últimos años un segundo factor. Las aplicaciones para citas –dating apps– han experimentado un auge enorme. Estas aplicaciones facilitan una mayor promiscuidad, pues pueden poner en contacto a mucha gente con suma facilidad. Eso, en principio, no debería ser un problema. Pero en la práctica lo es porque, al parecer, quienes conciertan citas para practicar sexo de ese modo utilizan menos los condones que el resto. Se desconoce si hay relación causal entre esos dos comportamientos y, de haberla, en qué dirección se produce. Esto es, no está claro si el uso de las dating apps conduce per se a la adopción de pautas de riesgo en las relaciones sexuales o si quienes hacen un mayor uso de las apps en cuestión son quienes, de suyo, tienden a “relajar” las precauciones con mayor frecuencia. Sea una cosa o la otra, la combinación de los dos factores –mayor promiscuidad y menos precauciones- es un peligroso cóctel.

La gonorrea, la sífilis y la clamidiasis son enfermedades provocadas por bacterias y por esa razón mucha gente no les tiene miedo. Confían en que, de contraer cualquiera de ellas, podrán curarse tratándose con antibióticos. Sin embargo, de la misma forma que está ocurriendo con otras bacterias patógenas, también estas están desarrollando resistencias frente a los antibióticos habituales y si aumenta la prevalencia de estas enfermedades, cabe esperar que también aumenten las resistencias, con lo que el problema podría alcanzar proporciones preocupantes.

Solo la prevención puede evitar contagios. Y dado que en este momento no se dispone de vacunas para estas enfermedades, la alternativa sensata al cóctel peligroso consiste en practicar sexo tomando las debidas precauciones; o sea, pasa por ponerse el condón.

—————————————————————–

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

————————

Una versión anterior de este artículo fue publicada en el diario Deia el 25 de marzo de 2018.

El artículo Un cóctel peligroso se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- “Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso

- Mapa genético al nacer

- El bisturí que opera ADN

Naukas Bilbao 2017 – Aberrón entrevista a María Martinón y a José Mª Bermúdez de Castro

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Dos de los grandes especialistas en paleoantropología a nivel mundial explican en esta entrevista, entre otras cosas, por qué su disciplina se parece cada vez más a Juego de Tronos.

Entrevista a JM Bermúdez de Castro y María MartinónEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Aberrón entrevista a María Martinón y a José Mª Bermúdez de Castro se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – María José Calderón y Belén Valenzuela: Esta física es la leche

- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

Andamios con aplicaciones biomédicas a partir subproductos alimentarios ricos en quitina

Scaffolds obtenidos por bioimpresión de proteína de pescado. Foto: Biomat

Partiendo de subproductos alimentarios ricos en quitina, y tras un tratamiento específico basado en los principios de la química verde, es posible obtener biomateriales que pueden ser procesados por técnicas empleadas actualmente por la industria. La quitina es el segundo polímero natural más abundante después de la celulosa y constituye el exoesqueleto de insectos, arácnidos y crustáceos, entre otros.

El grupo BIOMAT de la UPV/EHU trabaja en la obtención de quitina a partir de fuentes alternativas. Las materias primas que utiliza el grupo son residuos de la industria conservera, a partir de las cuales esperan desarrollar un proceso optimizado de obtención de quitina y proteína, que podrían ser utilizadas en una amplia gama de aplicaciones, ya que poseen propiedades de gran interés, entre las que destacan su biocompatibilidad y biodegradabilidad. Además, se pueden obtener materiales en una gran variedad de formatos (polvo, pellet, film, hidrogel).

Asimismo, la quitina se puede utilizar como refuerzo en la obtención de hidrogeles para aplicaciones biomédicas basados en proteínas. Los hidrogeles son materiales porosos con alto contenido en agua, formados por entramados moleculares que les confieren gran elasticidad y resistencia, y que cumplen una serie de requisitos específicos relativos a biocompatibilidad, biodegradabilidad y citotoxicidad necesarios para las aplicaciones biomédicas. Precisamente, el grupo de investigación ha obtenido muy buenos resultados al usar quitina obtenida de las plumas de calamar como refuerzo en la fabricación de hidrogeles de proteína.

“Imagina un producto hecho de proteína, que sea muy ligero, muy resistente y en el que se adhieran y crezcan las células. Suena complicado, pero en los últimos años hemos investigado cómo desnaturalizar las proteínas para poder modificarlas en función de las propiedades requeridas para cada aplicación específica y, una vez renaturalizadas, siguen siendo biocompatibles y no generan rechazo”, subraya Pedro Guerrero, investigador del grupo BIOMAT.

Hidrogel de proteína reforzado con quitina de calamar. Foto: Biomat

“Uno de nuestros objetivos consiste en desarrollar nuevos materiales para formular hidrogeles similares a los tejidos biológicos, por tanto, estos hidrogeles deben tener unas propiedades específicas para poder interactuar con células o fármacos, por ejemplo”, explica el investigador.

El grupo BIOMAT pretende desarrollar un nuevo material basado en proteína y quitina para fabricar “andamios” (scaffolds) innovadores y que este material sea, además, apto para la fabricación aditiva mediante tecnología Fused Deposition Modeling (FDM), bioimpresión por inyección y bioimpresión por extrusión. “Existe la necesidad de desarrollar nuevos materiales para fabricar estructuras 3D, examinando no sólo las características del material sino también su viabilidad para emplearlo utilizando las técnicas industriales de diseño asistido por ordenador. El reto no está solo en la tecnología de las impresoras, sino también en los materiales que se utilizan para alimentar dichas impresoras”, añade el Dr. Guerrero.

Esta estrategia consiste en modular y controlar las propiedades químicas, físicas y biológicas bajo condiciones de reacción moderadas para fabricar scaffolds para ingeniería de tejidos, depositando una capa de proteína termoplástica sobre otra de forma sucesiva hasta completar el scaffold. Como ventaja de partida, los materiales basados en proteínas son biocompatibles y biodegradables y, por tanto, aptos para la ingeniería tisular.

Una vez obtenidos los materiales basados en proteínas, estos deben cumplir una serie de requerimientos para su utilización en ingeniería de tejidos: ser biocompatibles con los tejidos; mostrar una biodegradabilidad controlada para ser sustituidos por el tejido una vez que éste se haya regenerado; no ser citotóxicos, para evitar respuestas adversas en el organismo; tener las propiedades mecánicas requeridas para cada tipo de aplicación, en función de la localización del scaffold; y poseer una porosidad y una morfología apropiadas para favorecer el crecimiento celular y el transporte de metabolitos, nutrientes y moléculas bioactivas, tanto dentro del scaffold como entre este y el medio circundante. Los resultados de los análisis, llevados a cabo en colaboración con el grupo de la Dra. Rosa Hernández en la Facultad de Farmacia de la UPV/EHU, muestran la viabilidad de los materiales desarrollados para aplicaciones biomédicas.

Referencia:

Tania Garrido, Alaitz Etxabide, Koro de la Caba, Pedro Guerrero (2017) Versatile soy protein films and hydrogels by the incorporation of β-chitin from squid pens (Loligo sp.) Green Chem. DOI: 10.1039/C7GC02982A

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Andamios con aplicaciones biomédicas a partir subproductos alimentarios ricos en quitina se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Dando valor a los residuos marinos para cuadrar la economía circular

- Hidrógeno a partir de composites de fibra de carbono

- Subproductos agrícolas para mantener la calidad nutricional de los lácteos

Killifish, una vida acelerada

La posibilidad de tratar de manera efectiva el envejecimiento con fármacos como si de una enfermedad más se tratase era tenido por una quimera irreal, cuando no directamente producto de la charlatanería de feria (como las que desgraciadamente frecuentan nuestras ciudades hoy en día), hasta hace pocos años. La primera pista de que quizás el envejecimiento no era ese proceso inexorable, designio de los dioses, consecuencia del paso del tiempo que no admitía siquiera el atrevimiento de ser estudiado con la pretensión de buscar una solución vino de la mano de un gusano.

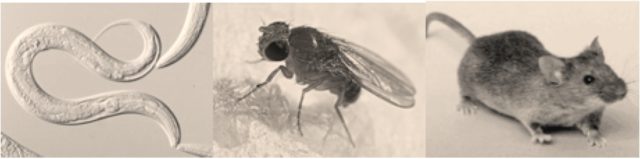

En concreto de individuos de la especie Caenorhabditis elegans, un gusano sencillo de aproximadamente 1 mm de longitud que vive en ambientes templados y que desde los años 70 del siglo pasado comenzó a habitar los laboratorios de investigación genética.

Pero, ¿cuál es el organismo modelo idóneo para estudiar envejecimiento?

Existe un gran número de descubrimientos relacionados con la biología del envejecimiento que se realizaron en seres unicelulares como la levadura, Saccharomyces cerevisiae. Por ejemplo, en esta levadura se descubrió el gen Sir2, iniciador de toda la saga relacionada con las sirtuínas y el popular resveratrol. Y la mosca, Drosophila melanogaster, también ha aportado lo suyo. Pero es obvio que la levadura y la mosca, pese a su utilidad, son organismos bastante alejados de los humanos.

En los laboratorios de investigación biomédica la especie predominante con mucha diferencia es el Mus musculus, el ratón, y, como no puede ser menos, también se estudia envejecimiento en este animal. Un modelo en auge es el del pez cebra, Danio rerio, cuyos embriones son transparentes, fácilmente manipulable genéticamente, poseedor de espectaculares capacidades regenerativas y que comparte gran parte de su genoma con los humanos, entre muchas características que hacen de él un gran modelo de estudio. Pero la esperanza de vida de un ratón ronda los 3 años y en el caso del pez cebra se acerca a los 5 años. Demasiado tiempo para los investigadores (y las agencias financiadoras).

Por ello, unos pocos investigadores han apostado establecer un modelo de envejecimiento rápido. Ese es el caso del Nothobranchius furzeri, conocido en inglés como el “african turquoise killifish” o killifish en corto. El killifish es un pequeño pez de agua dulce que vive en las charcas estacionales de Zimbabue y Mozambique. Una vez pasada la época de lluvias las charcas que son hogar de estos peces se secan y desaparecen. El killifish es capaz de producir y fecundar unos huevos que son resistentes a la sequedad y que entierra entre el barro seco para que, con la llegada de la nueva temporada de lluvias, la especie continúe adelante.

Todo el periodo de vida del killifish se desarrolla en esos 4-5 meses que duran los charcos estacionales en los que vive, resultado de una adaptación de su longevidad a las condiciones de vida extrema. Estos peces fueron en los últimos años llevados al laboratorio desde sus charcas en Zimbabue y Mozambique. Allí se han conseguido adaptar, reproducir y mantener con el objetivo de servir para el estudio del envejecimiento y de las enfermedades humanas, haciendo de este pez el vertebrado con el periodo de vida más breve que se puede crecer en cautividad. En el laboratorio también muestran un periodo de vida corto de pocos meses. Pero lo resaltable es que estos animales envejecen, es decir, muestran un periodo de vida que va desde el crecimiento y maduración sexual, hasta el declive funcional típico del envejecimiento y hasta la muerte. Es una vida completa comprimida en poco tiempo. Una vida acelerada.

Se ha realizado además un esfuerzo ingente que ha permitido en muy poco tiempo tener disponible la secuencia del genoma completo, la generación de herramientas moleculares que permiten la manipulación del genoma durante el desarrollo embrionario (y con ello la obtención de peces modificados genéticamente), el análisis de los patrones de expresión de genes …, en resumen, todo el kit básico que permite a un laboratorio moderno realizar investigación biomédica. Y como “prueba de concepto” se han eliminado genes clave en el control de la longevidad identificados hace años en otras especies y que son comunes al killifish, lo que ha permitido demostrar su utilidad en investigación del envejecimiento. Se han generado y estudiado peces que carecen de la enzima telomerasa (responsable del mantenimiento de la longitud de los telómeros), de genes clave en la estabilidad genómica, en el control de las células madre adultas, en la senescencia celular, en la regulación de la ingesta de nutrientes, etc. En todas aquellas vías que la investigación en este campo ha revelado en los últimos años como cruciales en el control de la longevidad, validando este nuevo organismo modelo.

En el último año el killifish nadó entre los medios de comunicación de medio mundo debido a un curioso estudio que generó llamativos titulares del tipo “la caca joven rejuvenece a los peces viejos”. En él se demostraba que la microbiota intestinal puede tener un papel importantísimo en el estado de salud de un organismo relacionado con la edad. Aunque la aplicación inmediata de este descubrimiento aún esté lejos (yo al menos no lo adoptaría del modo como se identificó), este ejemplo nos ilustra las posibilidades derivadas del estudio del envejecimiento con este nuevo modelo animal.

Suele ocurrir que esos nuevos organismos modelo surgen del esfuerzo individual de uno o unos pocos laboratorios que trabajan arduamente para establecer una nueva especie como animal de laboratorio y que desarrollan la mayoría de los reactivos y herramientas para su estudio. Ese es el caso del laboratorio que dirige Anne Brunet, investigadora del envejecimiento en cuyo laboratorio de la Universidad de Stanford, en California, EEUU, jóvenes investigadores como Itamar Harel (ahora con su propio grupo en la Universidad Hebrea de Jerusalén, Israel), Bérénice Benayoun (que dirige su laboratorio en la Universidad del Sur de California, EEUU) y sobre todo Dario Valenzano (líder de laboratorio en el Instituto Max Planck de Envejecimiento de Colonia, Alemania), han sido responsables en gran medida del desarrollo del killifish como modelo animal para el estudio del envejecimiento.

Lograr establecer un nuevo organismo modelo para la investigación biomédica supone un tremendo esfuerzo, una gran confianza en una idea y el apoyo de un sistema que no mira a corto plazo y cree en la originalidad e intuición de grandes científicos, prestándoles un decidido apoyo.

Este post ha sido realizado por Manuel Collado(@Mcollado_CHUS) y es una colaboración de Naukas.com con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Killifish, una vida acelerada se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- De cómo un sistema estelar allana el camino a la vida

- Vida alienígena inteligente, una historia terráquea

- Lo que más quiero en la vida es a mi pez cebra

Los brackets de zafiro, ¿son realmente de zafiro?

Una de las formas más estéticas de pasar por un tratamiento de ortodoncia es utilizar brackets transparentes, los denominados brackets de zafiro. Existen otros métodos todavía más discretos, como el Invisaling, aunque no es válido para todos los casos y en algunas situaciones el tiempo del tratamiento podría dilatarse.

Sabemos que el zafiro es una piedra preciosa de gran valor. Una piedra del tamaño de un guisante costaría unos 1.500 €. Entonces, ¿cómo es posible que los brackets se fabriquen con este material y aun así la ortodoncia no alcance precios astronómicos? ¿Realmente llevamos zafiros pegados a nuestros dientes?

Qué es el zafiro

El zafiro es un mineral de tipo corindón. Esto quiere decir que está compuesto por óxido de aluminio. El óxido de aluminio es transparente como el vidrio, en cambio el zafiro presenta diferentes coloraciones, especialmente azuladas. Estos colores se deben a la presencia de impurezas de cromo, hierro o titanio.

Tanto el rubí como el zafiro son corindones. A estas piedras las denominamos rubí o zafiro por una clasificación arbitraria en función del color: se le llama rubí a los corindones de colores cálidos (a excepción de la variedad amarilla, que es considerada zafiro) y zafiro a los colores fríos (a excepción de las variedades blanca y gris que son rubíes).

Estas piedras preciosas tardan miles de años en formarse a partir de rocas metamórficas, y precisan alta temperatura y presión. Es uno de los motivos por los que son tan escasas y, por tanto, tan valiosas. Otra de las virtudes del zafiro es que es extremadamente duro (resistente al rayado). Le corresponde una dureza de 9 en la escala de Mohs, lo que le convierte en el mineral más duro tras el diamante.

La evolución de los brackets transparentes

Los primeros brackets estéticos aparecieron alrededor de la década de los 70. Estos brackets se fabricaban inyectando policarbonato en un molde. El policarbonato es un polímero (coloquialmente denominado plástico) de tipo termoplástico, es decir, que se puede moldear aplicando calor. Es un material transparente y resistente al impacto, lo que podría hacer suponer que sería un buen sustituto de los brackets metálicos. La realidad es que este material no tuvo el buen resultado que se esperaba. Aparecían manchas y coloraciones debidas al consumo de colorantes alimenticios, café, té, zumos y tabaco. Además, no era lo suficientemente duro, con lo que terminaba deformándose por presión del arco metálico que une los brackets entre sí.

A mediados de los 80 se desarrollaron los primeros brackets cerámicos. Estos se fabrican de dos maneras, o bien esculpiendo piedra de cristal zafiro empleando herramientas con punta de diamante, o bien a través de un aglutinado térmico de alúmina. El primero se denomina alúmina monocristalina, y el segundo alúmina policristalina, por presentar el óxido de aluminio formando diferentes tipos de cristales (diferentes ordenamientos) en lugar de uno.

Ambos materiales resisten la tinción, la ranura no se distorsiona por presión del arco y además son químicamente inertes, con lo que el paciente puede ingerir cualquier líquido y comida sin miedo al desgaste.

El arco metálico se fija a los brackets a través de gomas, con lo que estas sí terminan tiñéndose con la comida. Pero como se cambian al menos una vez al mes, no son un verdadero problema estético.

Tampoco presentan grandes problemas de fricción con el arco, obteniéndose resultados similares a los que se obtienen con los brackets metálicos convencionales. También hay brackets cerámicos que resuelven estos problemas incorporando metal a la ranura o un sistema de autoligado que evita el uso de gomas.

Cómo se pegan los brackets a los dientes

Para pegar los brackets primero se limpian los dientes con un cepillo y una pasta de pulir de polvo de piedra pómez. Luego se aplica un gel con ácido ortofosfórico, que no daña el diente y abre los poros superficiales del esmalte para ganar retención. Además, este ácido elimina completamente la placa bacteriana. Los restos se eliminan con agua.

Una vez terminada la limpieza se procede a la colocación de los brackets, para ello se utilizan composites adhesivos de secado rápido, también transparentes. Químicamente son acrilatos (como el metilmetacrilato, los poliácidos acrílicos y los diacrilatos). Para sellar el composite se aplica aire y luz ultravioleta.

Cómo se hace el zafiro de los brackets

El zafiro de los brackets de zafiro no es el mismo que el de las piedras preciosas de las joyas. Si fuese así, el precio de la ortodoncia sería desorbitado. Para la ortodoncia se fabrica el zafiro de forma sintética, de modo que obtenemos la misma estructura química y la misma composición: óxido de aluminio. Al no contener impurezas de otros metales, este zafiro será completamente transparente.

La composición del zafiro es óxido de aluminio (Al2O3), también denominado alúmina. Este compuesto se extrae de las minas de bauxita. La bauxita es una roca con alto contenido en óxido de aluminio hidratado. Este mineral se pulveriza finamente. Es el que se utiliza para fabricar aluminio. Y tiene la propiedad de que si lo calentamos lo suficiente es capaz de formar cristales de zafiro.

Para fabricarlo se parte de pequeños cristales de alúmina que se calientan en un crisol en un horno a 2.200 oC, la mitad de la temperatura de la superficie del sol, que logra fundir la alúmina. A continuación se introduce en el crisol una varilla con una minúscula porción de zafiro. Y se deja caer la temperatura para que la alúmina comience a solidificar. La porción de zafiro actúa como semilla. Alrededor de ella empezará a cristalizar la alúmina siguiendo la misma estructura cristalina que el zafiro. Este proceso de crecimiento del cristal puede tardar hasta un par de semanas. Así suelen fabricarse piedras de zafiro sintético de hasta 200 kg.

Estas piedras de zafiro sintético son tan duras como el zafiro natural. Para tallarlas es necesario emplear un mineral más duro que el zafiro: el diamante. También hay técnicas que permiten el tallado por medio de corte ultrasónico o por combinación de ambas. Así se talla el zafiro que se emplea para los brackets, para los láseres, para las esferas de los relojes o los protectores de sensores y cámaras militares.

Conclusión

Los brackets de zafiro son realmente de zafiro. En lugar del valioso zafiro natural se emplea o bien alúmina policristalina, o bien zafiro sintético. Este último es un cristal de alúmina, igual que lo es el zafiro natural, compuesto por los mismos elementos en la misma disposición.

Si llevas brackets de zafiro, llevas zafiro pegado a tus dientes. Sonríe con glamur.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Los brackets de zafiro, ¿son realmente de zafiro? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Cuánto cuesta realmente investigar en biomedicina?

- “Conócete a ti mismo” no solo es un consejo estúpido, es realmente peligroso

- Si hacer fármacos fuese como jugar a Lego, la pieza más guay se llamaría carbino

Con qué calcular ondas gravitacionales en superordenadores a exaescala

Incluso después de la medición directa de sus ondas gravitacionales, aún hay muchas preguntas sin resolver sobre los agujeros negros. ¿Qué sucede cuando dos agujeros negros se fusionan, o cuando las estrellas chocan con un agujero negro? Esto es lo que pretende contribuir a resolver un nuevo método numérico desarrollado por un equipo internacional de investigadores encabezado por Michael Dumbser, de la Universidad de Trieste (Italia). El código de simulación “ExaHyPE” está diseñado de tal manera que será capaz de calcular ondas gravitacionales en la próxima generación de superordenadores a exascala.

La dificultad de simular agujeros negros reside en la necesidad de resolver el complejo sistema de ecuaciones de Einstein. No existe una solución analítica, por lo que debe realizarse usando la fuerza bruta, numéricamente, usando para ello la potencia los superordenadores. La precisión y la rapidez con la que se puede aproximar una solución dependen del algoritmo utilizado. En este sentido ExaHyPE podría ser un hito. A largo plazo, este trabajo teórico podría ampliar las posibilidades experimentales para detectar ondas gravitacionales de otros cuerpos astronómicos además de los agujeros negros.

Esta aproximación es, esencialmente, un método Galerkin, es decir, transforma una relación continua, como una ecuación diferencial, en un operador discreto (no continuo) lo que permite optimizar los cálculos de ondas gravitacionales en superordenadores, tanto en precisión como en velocidad.

ExaHyPE ha sido diseñado para explotar las posibilidades de cálculo de los superordenadores a exaescala. Aunque aún no se han construido, los científicos de todo el mundo ya están estudiando cómo hacer uso de esta próxima generación de máquinas. Estos superordenadores representan la evolución futura de los superordenadores a petascala actuales. Para entender qué significa esto pensemos que el ordenador en el que se ha escrito este texto tiene un procesador que opera a 3 gigahertz, lo que supone que es capaz de procesar unos pocos gigaflops u operaciones de coma flotante por segundo; un superordenador como el MareNostrum del Barcelona Supercomputing Center – Centro Nacional de Supercomputación puede alcanzar los 11,15 petaflops, es decir, hace más de 10 millones de veces el número de cálculos por segundo que hace este ordenador. De esta unidad, el petaflop, es de donde viene el nombre de la generación actual de superordenadores. La próxima trabajará con exaflops, 1000 veces más rápido, del orden de un millón de billones (1018) de cálculos por segundo.