Crímenes áureos

Me gusta leer. Me gusta todo tipo de literatura, pero, en especial, leo muchas novelas. De todos los estilos. En estos momentos estoy terminando de leer la magnífica, aunque dura, novela Manual para mujeres de la limpieza (Alfaguara, 2016) de Lucia Berlin, antes de este libro he leído la excelente novela gráfica de Paco Roca, Las calles de arena (Astiberri, 2015) y Las normas de la casa (Temas de Hoy, 2012), de Jodi Picoult, y mis dos siguientes lecturas, salvo que se cruce alguna otra en el camino, serán Solenoide (Impedimenta, 2017), de Mircea Catarescu, cuyas primeras páginas te enganchan y es difícil dejar de leer (aunque antes tenía que terminar el magnífico libro de Lucia Berlin), y La torre de Babel (Alfaguara, 2011), de A. S. Byatt, un interesante descubrimiento que hice mientras preparaba una conferencia sobre la sucesión de Fibonacci.

Portada del libro “Manual para mujeres de la limpieza” (Alfaguara, 2016), de Lucia Berlin

Pero, en especial, me gusta la novela policiaca. Desde las clásicas novelas de raciocinio, como los relatos de Edgar Allan Poe, las historias de Sherlock Holmes, de Arthur Conan Doyle, o las sencillas novelas de Agatha Christie, hasta la novela negra actual, que es mucho más realista y social. Y si estas novelas tienen alguna referencia matemática, entonces mi interés y disfrute es mucho mayor aún.

En esta entrada del Cuaderno de Cultura Científica vamos a ver un pequeño ejemplo de presencia de las matemáticas en una novela negra. No es un caso aislado, existen muchos ejemplos, como la novela La chica que soñaba con una cerilla y un bidón de gasolina, del escritor sueco Stieg Larsson (Destino, 2008), de la que ya hablamos en la entrada La chica que soñaba con una cerilla y un bidón de gasolina. En esta ocasión, se trata de la novela La mano del diablo (Plaza & Janés, 2005), de los escritores Douglas Preston y Lincoln Child.

Portada de la novela “La mano del diablo” de Douglas Preston y Lincoln Child, publicada por Plaza & Janés en 2005, un año después de su publicación en inglés

Los escritores estadounidenses Douglas Preston y Lincoln Child suelen escribir juntos, a cuatro manos, novelas policiacas, de misterio y de aventuras. Son dos escritores de éxito, aunque tengo que confesar que no están entre mis escritores preferidos. Su primer éxito fue El ídolo perdido (1995), novela en la cual se inspiró la película The Relic (Peter Hyams, 1997). Esta novela, como muchas de las que han escrito juntos, está protagonizada por el agente del FBI, Aloysius Pendergast, acompañado del teniente de la policía, Vicent D’Agosta.

La novela La mano del diablo es la primera novela de la trilogía de Diogenes, el hermano de Aloysius. En esta historia, el agente del FBI Aloysius Pendergast y el teniente de la policía Vicent D’Agosta investigan una serie de asesinatos que parecen implicar al propio Lucifer.

En la novela aparece un periodista del Post, Bryce Harriman, que investiga también estas misteriosas muertes. El periodista decide entrevistar, para recabar información sobre esta serie de asesinatos relacionados con el diablo, al profesor Friedrich Von Menck, doctor en filosofía por la Universidad de Heidelberg (Alemania), en medicina por la Universidad de Harvard (EE.UU.) y en teología por la Universidad de Canterbury (Nueva Zelanda), pero que siempre se había interesado por el misticismo, lo paranormal y lo inexplicable, lo cual le hace un candidato ideal, según el periodista, para hablar de los “asesinatos del diablo”. Una mezcla de científico y apasionado de los temas esotéricos.

Leamos la parte de la novela en la que el periodista Harriman está en casa de Von Menck preguntándole por los “asesinatos del diablo”.

“—Lo de menos son las personas y la manera. Lo decisivo es el momento.

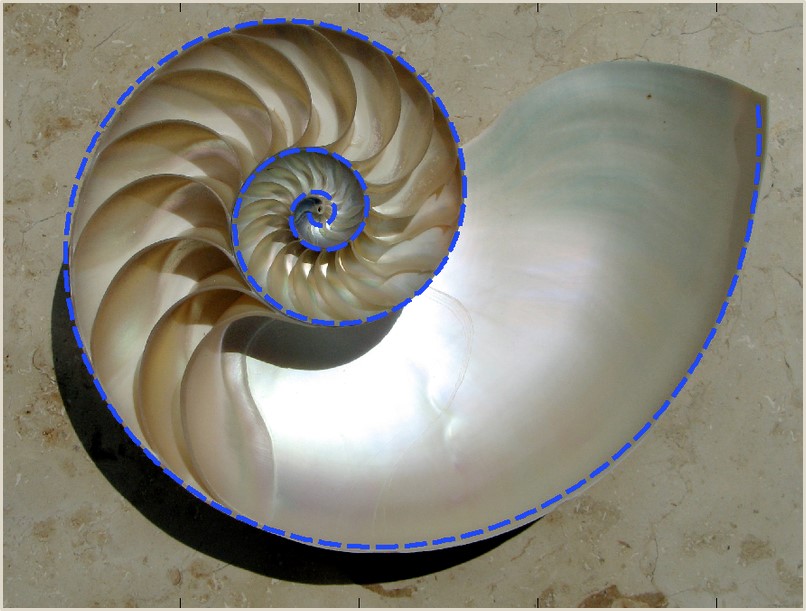

Von Menck se levantó para abrir una de las vitrinas y sacar algo, Lo trajo y lo dejó sobre la mesa, delante de Harriman. Era una sección de concha de nautilo, con sus celdas de crecimiento formando una espiral de hermosa regularidad.

—Señor Harriman, ¿sabe qué hay en común entre esta cocha, el Partenón, los pétalos de una flor y las pinturas de Leonardo da Vinci?

Harriman negó con la cabeza.

—Que encarna la proporción más perfecta de la naturaleza, la proporción áurea.

—No sé si le entiendo.

—Es la proporción que se obtiene al dividir una línea de modo que el segmento más corto sea al segmento más largo, lo mismo que el segmento más largo a la línea entera.

Harriman lo anotó con la esperanza de entenderlo más tarde.

—El segmento más largo es 1,618054 veces más largo que el segmento más corto. El segmento más corto representa el 0,618054 por ciento del más largo. Son dos números exactamente recíprocos, que solo se diferencian en el primer dígito. Se trata de los dos únicos números que presentan esta propiedad.

—Ah, claro.

Las matemáticas nunca habían sido su fuerte.

—Y tienen otras propiedades muy notables. Se considera que un rectángulo construido con lados de estas longitudes es la forma más agradable a la vista. Recibe el nombre de rectángulo áureo. La planta del Partenón se construyó según esta figura. Y en ella se basan catedrales y pinturas. Estos rectángulos tienen otra propiedad destacable: si se recorta un cuadrado en cada lado se obtiene un rectángulo áureo de menor tamaño, pero con las mismas proporciones. Se pueden recortar cuadrados y obtener rectángulos dorados más pequeños hasta el infinito.

—Comprendo.

—Bueno, pues si parte de un rectángulo grande y lo reduce a una serie infinita de rectángulos áureos más pequeños, y si después conecta todos los centros de los rectángulos, obtendrá una espiral logarítmica natural perfecta. Es la espiral que está viendo en la cocha del nautilo, la misma que forman las semillas en la cabeza del girasol, y de la armonía musical. La proporción áurea es una característica básica del mundo natural.

—Ajá.

—Es una proporción que forma parte de la estructura del universo.”

Paremos un momento en este punto, en el cual el periodista Harriman piensa que ha perdido el tiempo al ir a entrevistar al profesor Von Menck. No entiende nada y no cree que las personas que van a leer el Post entiendan tampoco nada. Paremos un momento para recordar algunos de los conceptos matemáticos que aparecen citados.

Para empezar, recordemos que es el número áureo, que ya hemos introducido en el Cuaderno de Cultura Científica, por ejemplo, en la entrada Visitad los museos, también en clave matemática y en la entrada ¿Es áureo el Aston Martin de James Bond?. La proporción áurea es un concepto matemático muy antiguo, que ya fue estudiado por los griegos, en particular, por los pitagóricos. La definición de esta proporción aparece recogida en el gran texto matemático, Los Elementos de Euclides (aprox. 325-265 a.c.). Y dice así:

“Se dice que un segmento está dividido en media y extrema razón cuando la longitud del segmento total es a la parte mayor, como la de esta parte mayor es a la menor”.

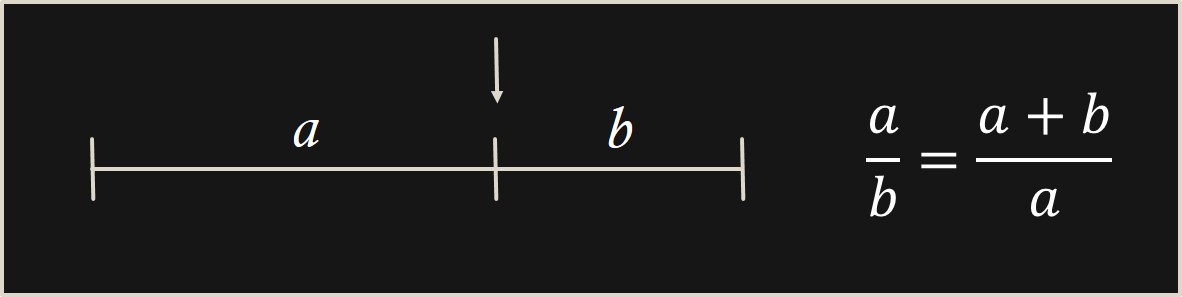

Es decir, si tenemos un segmento como el que aparece en la siguiente imagen, buscamos el punto del mismo que divide al segmento en dos partes, de longitudes a y b, de forma que la proporción o razón (división) entre la parte mayor y la menor, a/b es igual a la proporción entre la longitud del segmento y la parte mayor (a + b)/a.

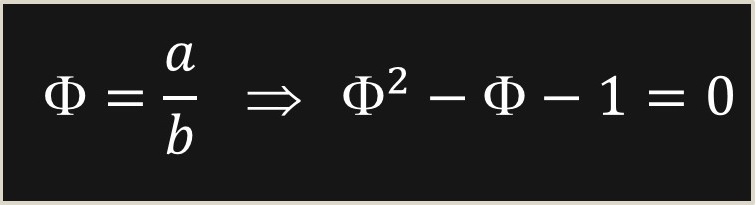

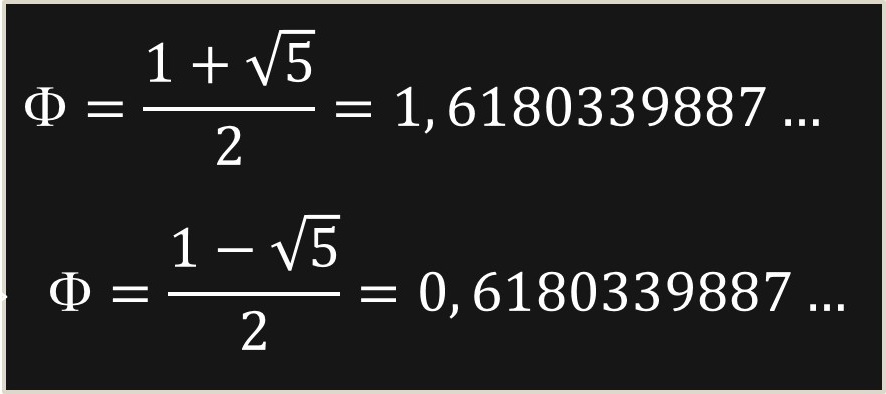

Ahora, si llamamos Φ al cociente a/b, la condición anterior se puede escribir como la ecuación algebraica siguiente:

Esta es una ecuación algebraica de segundo grado, cuyas soluciones, sin más que utilizar la conocida fórmula de resolución de la ecuación de segundo grado que estudiamos en el instituto, son:

Si tenemos en cuenta que la inversa de Φ, es decir, Φ-1, es b/a, entonces la propia expresión de la definición nos dice que

Φ = 1 + Φ-1,

es decir, que ambas soluciones se diferencian en 1, como se comenta en la novela. Aunque el número que aparece citado en la misma, “1,618054”, no es exactamente el número áureo, que más bien, por aproximación sería “1,618034”, ahí se ha colado un 5, en lugar de un 3.

Un pequeño error. Cuando se dice que “El segmento más corto representa el 0,618054 por ciento del más largo”, lo correcto sería que “El segmento más corto representa el 0,618054 del más largo”, sin la expresión “por ciento”.

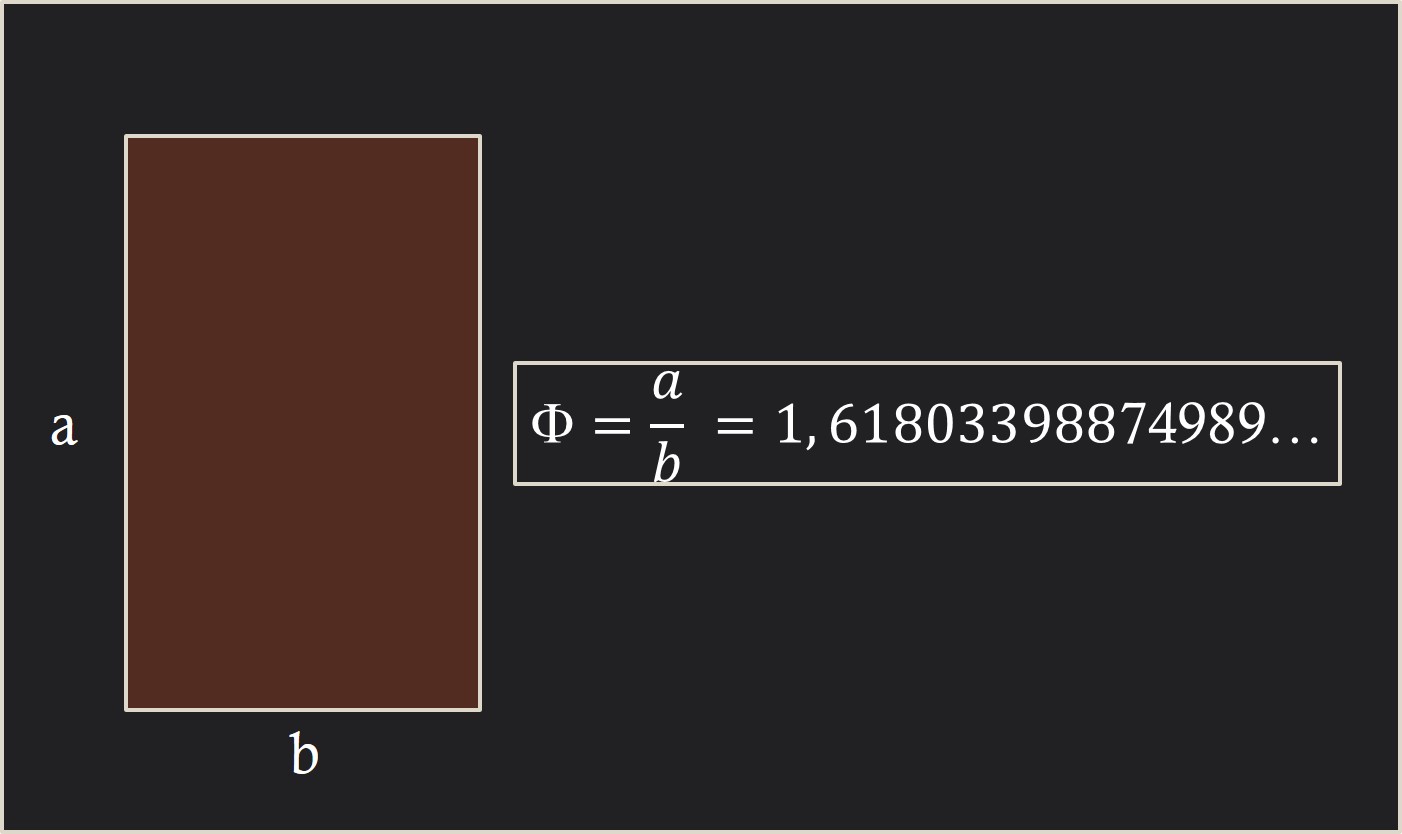

Sigamos. Un rectángulo áureo es un rectángulo de dimensiones a (alto) y b (ancho), tal que la proporción entre ambas, a/b, es el número áureo, Φ = 1,618033…, como aparece en la siguiente imagen y no como está escrito en la novela, es decir, que los lados del rectángulo sean “1,618034” (Φ) y “0,618034” (Φ-1),… “Se considera que un rectángulo construido con lados de estas longitudes es la forma más agradable a la vista. Recibe el nombre de rectángulo áureo”. En cuanto a que sea el rectángulo más bello que existe, esa es una creencia basada en la supuesta demostración estadística del sicólogo alemán Gustav Fechner (1801-1887).

Una interesante reflexión sobre las supuestas relaciones del rectángulo áureo con la belleza, el Partenón, el arte de Leonardo da Vinci y algunas otras cuestiones, la encontramos en el artículo Misconceptions about the Golden Ratio (Ideas erróneas sobre la proporción áurea), del matemático, de la Universidad de Harvard, George Markowsky.

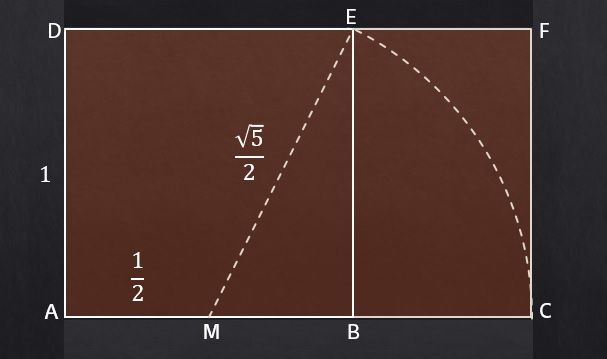

Una propiedad interesante de los rectángulos áureos es que se pueden construir fácilmente a partir de un cuadrado, como se muestra en la siguiente imagen. Se parte de un cuadrado ABDE (en la imagen se ha considerado de lado 1) y se traza un arco de circunferencia, con centro el medio M del lado del cuadrado AB y de radio igual al segmento ME, determinando así el punto C (la intersección de la recta que pasa por A y B, con el arco de circunferencia), de forma que el rectángulo generado ACDF resulta ser un rectángulo áureo.

Esta es una forma sencilla de construir rectángulos áureos, que puede ser desarrollada por personas dedicadas, por ejemplo, al arte o la jardinería.

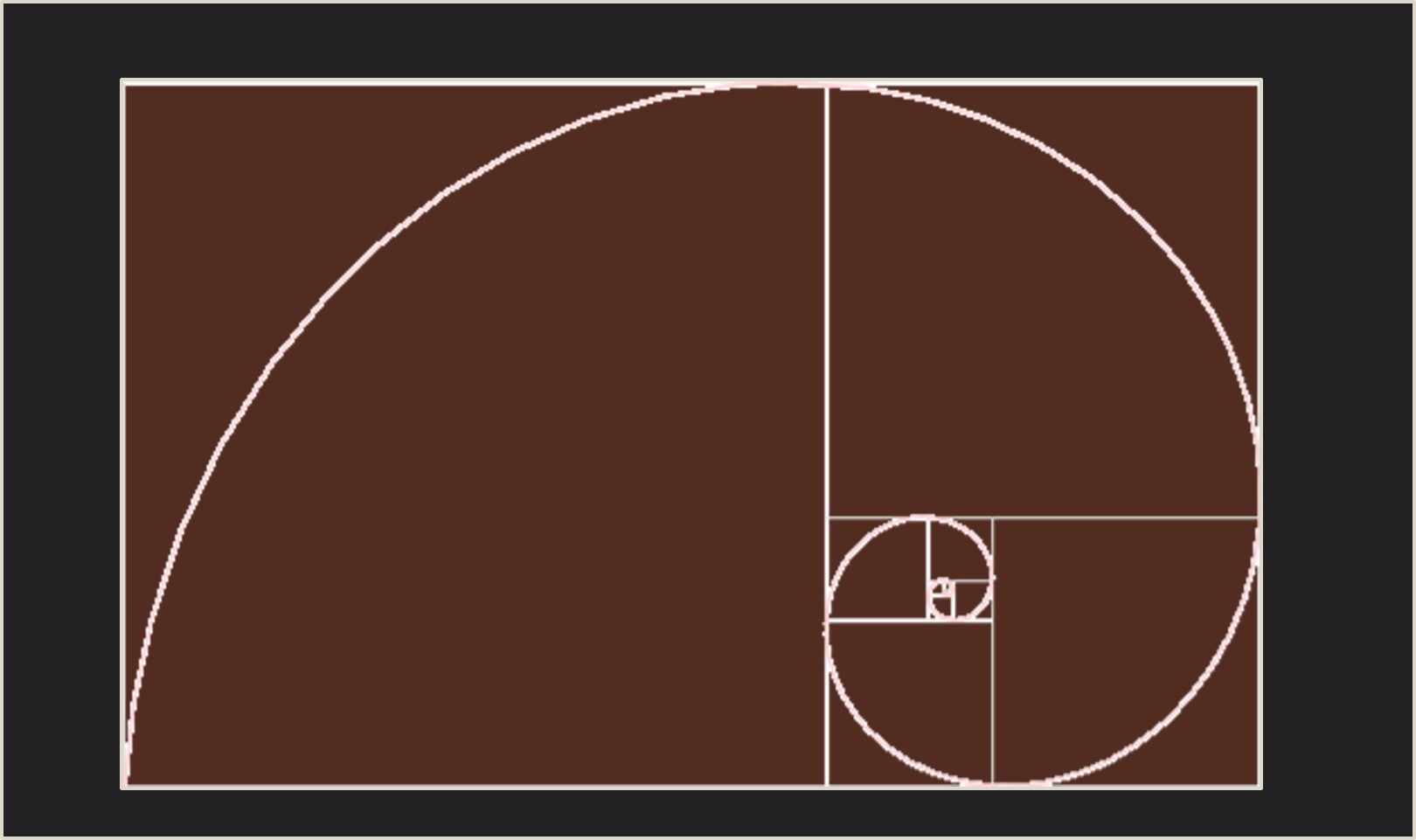

Pero esta propiedad pone de manifiesto, como se expresa en la cita anterior (aunque de una forma un poco confusa), que un rectángulo áureo puede descomponerse en un cuadrado y un rectángulo más pequeño, con la sorprendente propiedad de que resulta ser también un rectángulo áureo. Ahora, con este rectángulo áureo más pequeño podríamos, a su vez, descomponerlo en un cuadrado y un rectángulo áureo, así hasta el infinito.

Si se considera un trozo de circunferencia en cada uno de los cuadrados de la descomposición, como aparece en la siguiente imagen, se construye lo que se conoce como “espiral áurea”.

A pesar de lo que se suele leer en muchos sitios, ni esta espiral, ni la construida con segmentos rectos, al unir los centros de los cuadrados, según la novela, son la espiral logarítmica o espiral del crecimiento que aparece en el nautilus.

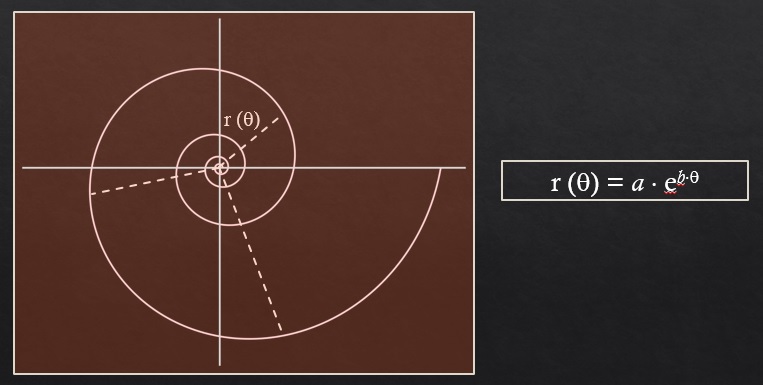

La espiral logarítmica, que aparece en la siguiente imagen, se define como aquella espiral cuyo radio aumenta de forma exponencial según va creciendo el ángulo de giro (θ en la imagen), es decir, matemáticamente la longitud del radio es igual a r(θ) = a ebθ.

Y esta espiral sí modeliza la sección de la concha del nautilus.

Disculpad que me haya entretenido un poco con estos conceptos iniciales y algunas cuestiones relacionadas. Volvamos a la novela La mano del diablo, de la pareja de escritores Preston y Child. La persona que este leyendo la novela se preguntará en el punto en el que habíamos dejado la cita, al igual que el periodista del Post, … ¿todo esto para qué? ¿qué tiene que ver con los “asesinatos del diablo”? Para dar respuesta a esta cuestión volvamos a la novela, puesto que toda la cita anterior es una introducción a lo que es el asunto principal, que explica el profesor Von Meck a continuación.

“—Se lo voy a explicar. He dedicado toda mi vida a estudiar lo misterioso y lo inexplicable. En muchos casos, la solución del misterio me ha satisfecho del todo. Otros misterios, casi siempre los de mayor importancia, se me siguen resistiendo.

Von Menck cogió un papel de la mesa, hizo unas anotaciones y se lo puso delante de Harriman: 3243, 1239. Dio un golpecito en la hoja.

—Para mí, estos números siempre han representado el mayor de los misterios. ¿Los reconoce?

Harriman negó con la cabeza.

—Identifican los dos mayores cataclismos que ha sufrido la civilización humana. En 3243 a.C., la explosión de la isla Santorini produjo un maremoto que barrió la gran civilización minoica de Creta y devastó todo el Mediterráneo. Es la fuente tanto de la leyenda de la Atlántida como de la del Diluvio Universal. En 1239 a.C., las ciudades gemelas de Sodoma y Gomorra fueron reducidas a cenizas por una lluvia de fuego.

—¿La Atlántida? ¿Sodoma y Gomorra?

La cosa empeoraba.”

Tras una larga explicación sobre la Atlántida y Sodoma y Gomorra, el profesor Von Menck continúa con su teoría, para lo cual es necesario saber que la novela transcurre en el año 2004, luego ese es el año de los “asesinatos del diablo”.

“Von Menck cogió la hoja de papel y escribió otro número debajo de los dos primeros: 3243, 1239, 2004

—2004 d.C., señor Harriman. Constituye el término de la proporción áurea. Han pasado exactamente 5246 años desde 3243 a.C.: la proporción áurea. La siguiente fecha de la serie es 2004 d.C. Resulta que también es el número exacto de años que separan los desastres anteriores. ¿Una coincidencia?

Harriman se quedó mirando el papel. “¿Está diciendo lo que creo?”, pensó. Parecía increíble, una locura.”

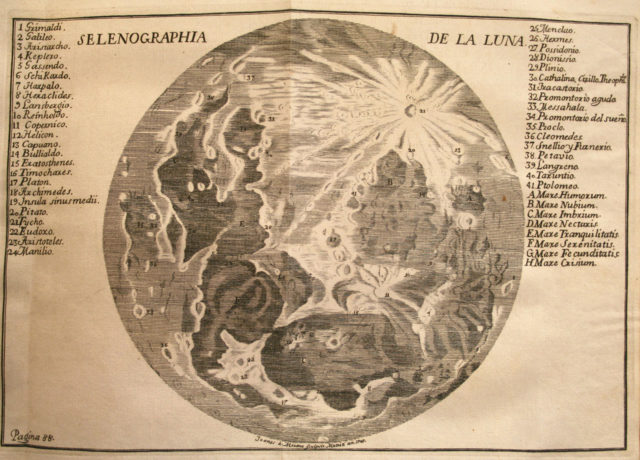

Lo que está diciendo Von Menck, entre otras cosas, es que si se toma el segmento de tiempo que va desde el año 3243 a.C. hasta el año 2004 d.C., el punto que está en “media y extrema razón”, es decir, el que produce la proporción áurea, es el año 1239 a.C., como se muestra en la siguiente imagen.

Continuemos leyendo.

“Se acercó a otra vitrina y sacó una cartulina blanca que tenía dibujada una espiral de grandes dimensiones, como la concha de un nautilo. En la parte inferior había una anotación en lápiz rojo: “3243 a.C. – Santorini/Atlántida”. A dos tercios de la curva, otra anotación en rojo: “1239 a.C. – Sodoma/Gomorra”. En otros puntos de la espiral, una serie de marcas en negro componían una lista de decenas de fechas y lugares:

79 d.C. – La erupción del Vesuvio destruye Pompeya/Herculano.

426 d.C. – Caída de Roma, saqueada y destruida por los bárbaros.

1321 d.C. – La peste azota Venecia. Mueren dos tercios de la población.

1665 d.C. – Gran incendio de Londres.

Y justo en el centro, donde la espiral se cerraba sobre si misma y terminaba en un gran punto negro, había otra anotación en rojo, la tercera: 2004 d.C. ¿…?

Von Menck dejó la cartulina en equilibrio sobre la mesa.

Como ve, he levantado acta de muchos desastres y todos coinciden con puntos exactos de la espiral logarítmica natural. Todos están perfectamente alineados en proporciones áureas.”

Lo importante del anterior comentario es que las fechas de los desastres “están perfectamente alineados en proporciones áureas” y la continua mención a la “espiral logarítmica natural” es más bien metafórica, salvo por la idea de que esas fechas de desastres van aproximándose a la fecha límite, la fecha final, el año 2004, que es cuando se desarrolla la historia de la novela.

Mientras que las tres primeras fechas mencionadas por el profesor 3243 a.C., 1239 a.C. y 2004 d.C. efectivamente están situadas en proporción áurea, en el sentido explicado arriba, no sucede lo mismo cuando se consideran las nuevas fechas de desastres presentadas por Von Menck. Contrariamente a lo expresado por el profesor, las cuentas no salen, no están en proporción áurea.

Los autores de la novela, Preston y Child, son conscientes de ello, solamente quieren darle un aire de misterio satánico a los acontecimientos que se desarrollan en la novela, a los “asesinatos del diablo”. Y que los autores son conscientes de que las cuentas no salen para las demás fechas lo sabemos leyendo los agradecimientos, en los que han escrito:

“Para acabar, queremos pedir disculpas […] de la aplicación incorrecta de la proporción áurea del profesor Von Menck.”

La razón áurea, divina proporción o número de oro aparece en muchas novelas policiacas y de misterio, como la famosa El código Da Vinci (Umbriel, 2004), de Dan Brown.

“Canto de espigas” (1929), de Maruja Mallo. Toda la estructura de esta obra está realizada mediante la razón áurea

Bibliografía

1.- Douglas Preston, Lincold Child, La mano del diablo, Plaza & Janés, 2005.

2.- Mario Livio, La proporción áurea, La historia de phi, el número más sorprendente del mundo, Ariel, 2006.

3.- George Markowsky, Misconceptions about the Golden Ratio, The College Mathematical Journal 23, n. 1, 1992.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Crímenes áureos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El diablo y Simon Flagg, una lectura ligera para el verano

- Las vacas de Narayana, la versión hindú de los conejos de Fibonacci

- ¿Es normal el número pi?

Animales eurihalinos

Tiburón toro (“Carcharius taurus”). Foto: Jeff Kubina / Wikimedia Commons

La mayor parte de los animales acuáticos son estenohalinos, no toleran cambios en la concentración de sales del medio externo y están, por lo tanto, obligados a vivir en un medio osmóticamente estable, ya sea el mar o las aguas dulces. En ese grupo se encuentran tanto animales osmoconcordantes (u osmoconformadores) como osmorreguladores. De los primeros ya nos ocupamos aquí; baste recordar que se encuentran en equilibrio hídrico y osmótico con el medio externo; son, de hecho, isosmóticos con el agua de mar. Pero han de realizar una cierta regulación iónica, porque las concentraciones de solutos inorgánicos no son las mismas dentro y fuera del organismo. Y de los segundos hemos tratado aquí (de agua dulce) y aquí (de agua de mar).

Pero aunque son una minoría, también hay animales acuáticos eurihalinos. Algunos son peces elasmobranquios, como el tiburón toro y otros de su mismo grupo, de los que nos ocupamos aquí. Pero también hay invertebrados y teleósteos eurihalinos. Y los mecanismos que ponen en juego para poder hacer frente a los cambios ambientales de salinidad o para poder vivir en medios de concentración muy diferente (aunque en la práctica esa concentración no varíe) son muy distintos dependiendo, principalmente, de si son osmoconcordantes (poiquilosmóticos) u osmorreguladores (homeosmóticos).

Aunque la mayor parte de los invertebrados marinos osmoconcordantes son estenohalinos, hay unas pocas especies que toleran cambios en la salinidad ambiental. Los mejor estudiados son, quizás, los bivalvos. Numerosos miembros de este grupo viven en zonas costeras sometidas a la influencia de los ríos (bahías, ensenadas, lagunas costeras) o penetran, incluso, en los estuarios. Muchas especies de mejillones, berberechos, almejas u ostras, se encuentran en ese grupo. Estos animales permiten que su medio interno se diluya cuando lo hace el externo, y por ello, también el medio intracelular se diluye en la misma medida. Pero esa dilución no es pasiva; no es consecuencia de una invasión de agua de sus células, ya que si ello ocurriera podrían llegar a estallar o, cuando menos, a ver alterados gravemente todos los procesos que dependen de la estructura de la membrana celular. Además, también la concentración intracelular de potasio se reduciría, con los consiguientes daños al funcionamiento de las proteínas celulares, cuya integridad funcional depende precisamente de la concentración del principal catión intracelular. La dilución del medio intracelular se produce mediante una reducción activa de la concentración de solutos orgánicos como aminoácidos, taurina y otros, los denominados efectores osmóticos, sustancias gracias a las cuales las células de los invertebrados marinos pueden mantenerse isosmóticas con el medio interno, sin que el K+ tenga por qué alcanzar concentraciones intracelulares inconvenientes.

Y luego tenemos animales eurihalinos que regulan activamente la concentración osmótica de su medio interno, aunque lo suelen hacer en rangos limitados de salinidad. Estos suelen asignarse, a su vez, a dos grandes categorías, los reguladores hiper-isosmóticos y los reguladores hiper-hiposmóticos.

Los del primer grupo mantienen su concentración interna por encima de la ambiental, aunque la diferencia se reduce conforme aumenta la concentración osmótica exterior. A este grupo pertenecen especies predominantemente dulceacuícolas que tienen la capacidad para adentrarse en aguas salobres, como algunos peces de la familia Cyprinidae, y otras propias de zonas costeras y estuarinas, como algunos anfípodos y crustáceos. La adaptación a aguas de diferente concentración, pero siempre igual o inferior a la interna, se basa en la capacidad para modificar la intensidad con que funcionan los mecanismos propios de la regulación hiperosmótica (grado de dilución y tasa de producción de orina, así como tasas de recuperación de solutos a través de las branquias).

Los reguladores hiper-hiposmóticos son animales que mantienen su concentración interna constante en condiciones tanto hiper como hiposmóticas. En otras palabras, a bajas concentraciones ambientales, su concentración interna se encuentra por encima de la externa, y lo contrario ocurre a altas concentraciones ambientales. Esta forma de regulación es característica de ciertos crustáceos que habitan zonas intermareales, como algunos cangrejos violinistas y especies próximas.

Por último tenemos a los peces diádromos, pero de esos nos ocuparemos en una próxima anotación, porque es dudoso que deban ser considerados eurihalinos.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Animales eurihalinos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Animales en equilibrio osmótico: invertebrados marinos y peces bruja

- La regulación osmótica de los animales de agua dulce

- Relaciones hídricas y salinas de los animales

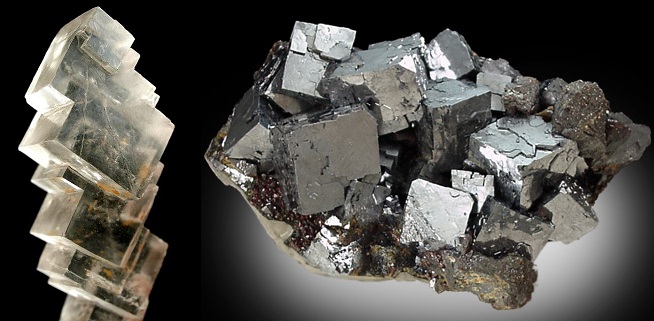

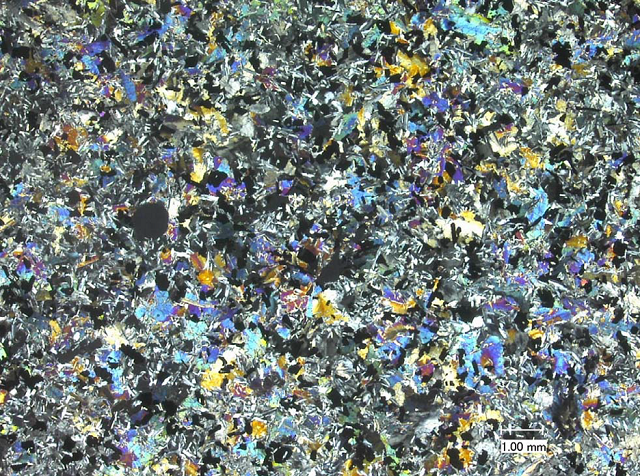

Clasificación y origen, los dos problemas de la mineralogía

Fluorita. Fluoruro cálcico, CaF2; sistema cúbico; color violeta; raya blanca; dureza de Mohs 4; peso específico 3,1; brillo vítreo; opaco; fractura lisa a concoidea; exfoliación perfecta; en macla; fluorescente.

A pesar de los cambios en estatus como disciplina desde el siglo XVIII hasta la actualidad la mineralogía se ha concentrado en dos problemas principales: la clasificación y el origen de los minerales.

El primero, la clasificación, aunque pueda parecer un tecnicismo, es fundamental tanto para la teoría geológica como para los aspectos más prácticos y económicamente relevantes de la ingeniería de minas: encontrar vetas rentables.

Por su importancia se han dedicado a lo largo de los siglos importantes esfuerzos a desarrollar clasificaciones coherentes, relevantes y útiles, lo que ha probado ser de todo menos fácil. Digámoslo claramente, las clasificaciones minerales han sido tan numerosas como arbitrarias.

Clasificar algo depende de la capacidad de hacer distinciones claras a distintos niveles de organización. En el caso de los animales y plantas distinguir entre especies no es tan difícil y siempre existe un criterio último que dirime la cuestión de si un especimen es de la especie A o B: la capacidad de reproducirse con A o B.

En el siglo XVIII Carl Nilsson Linnæus (castellanizado, Linneo) se atrevió osadamente a aplicar los principios de clasificación que con tanto éxito había aplicado a animales y plantas a los minerales. Todo ese esfuerzo para fracasar estrepitosamente: aparecían tantas categorías casi como minerales conocidos, tantas excepciones había.

Isomorfismo. tanto la halita (NaCl) a la izquierda y la galena (PbS) a la derecha cristalizan en el sistema cúbico, sin embargo, a pesar de compartir sistema cristalino sus composciones difieren completamente.

Tras ese escarmiento los mineralogistas han oscilado principalmente entre el uso de la composición química y la forma cristalográfica. Para complicar la cosa hay que decir que estos dos tipos de clasificaciones no casan entre sí, ya que dos minerales con la misma composición pueden tener distinta forma cristalina y al revés, dos minerales con la misma forma cristalina pueden tener composiciones completamente dispares. Para añadir más dificultad, la composición química de un mineral no corresponde necesariamente a una fórmula exacta. De hecho, la mayoría de los minerales tienen un rango de variación en la composición.

Polimorfismo. Calcita (izquierda) y aragonito (derecha) tienen la misma composición, carbonato cálcico (CaCO3), sin embargo, la primera cristaliza en el sistema trigonal y el segundo en el ortorrómbico.

Esto ha llevado a ingenieros, geólogos y aficionados ha desarrollar suplementos a la clasificacón que se esté usando en forma de características macroscópicas para poder decidir más o menos rápidamente y con cierta seguridad ante que se está. Así en una guía moderna siguen apareciendo criteros de identificación como el color (aunque no sirva de mucho), la raya [1], la dureza de Mohs [2], el peso específico, el brillo [3], la brillantez (que no es lo mismo que el brillo), irisaciones (que tampoco hay que confundir con el brillo ni con la brillantez) [4], transparencia, fractura [5], exfoliación (si el mineral se rompe en hojas planas) y muchas más.

Sistema portátil para determinar la dureza en la escala de Mohs [2].

El segundo problema mineralógico clave es cómo se originaron los minerales y las rocas. Como aparecen mezclados unos con otros, desde el siglo XVII lo mineralogistas asumieron que se originaban a partir de fluidos y que se endurecían en las posiciones y localizaciones en las que se encontraban. El estado de de fluidez podía deberse al calor, al agua o a alguna combinación de ambos.Los mineralogistas han librado batallas recurrentes en lo que parece una guerra interminable sobre la importancia relativa de todos estos factores. En cualquier caso, siempre han mantenido la esperanza de que serían capaces de usar sus conocimientos de química para reconstruir una narración de la génesis histórica de las rocas: una geogonía basada en una invariable secuencia de reacciones químicas a partir de un estado inicial. Buena parte de esos relatos están más próximos a la leyenda que a la realidad, que se ha mostrado exasperantemente tozuda.

Notas:

[1] La raya es el color “propio” de mineral que aparece al rayar una porcelana sin vidriar

[2] La escala de Mohs es una relación de diez minerales ordenados por su dureza, de menor a mayor. Se utiliza como referencia de la dureza de un material dado. Es necesario, por tanto, poseer una caja con minerales de referencia para poder determinar el valor de dureza.

[3] El ojo entrenado distingue entre vítreo, sedoso, nacarado, adamantino, graso y metálico

[4] Hay expertos que a simple vista disciernen entre ojo de gato, adularescencia, irisación propiamente dicha, labradorescencia y opalescencia

[5] O cómo se rompe un mineral; la fractura puede ser concoidea, astillosa, fibrosa, desigual y terrosa

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Clasificación y origen, los dos problemas de la mineralogía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Esa pesadilla científica llamada mineralogía

- ¿Y si la Gran Oxidación tuvo un origen geológico?

- Los amiloides y el origen de la vida

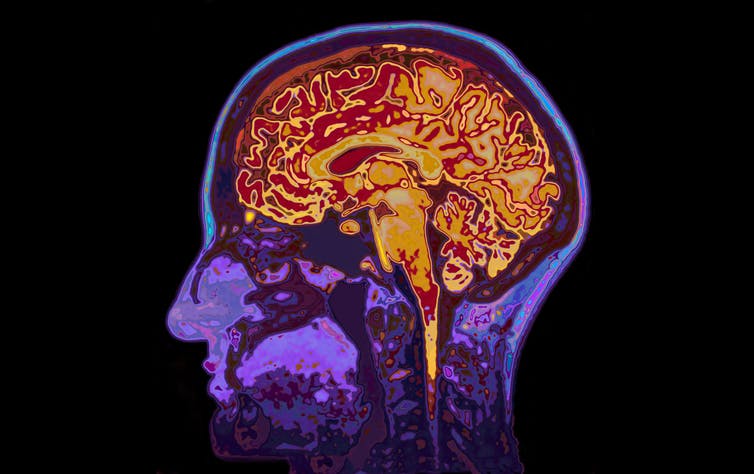

El nivel socioeconómico familiar influye en el desarrollo del encéfalo infantil

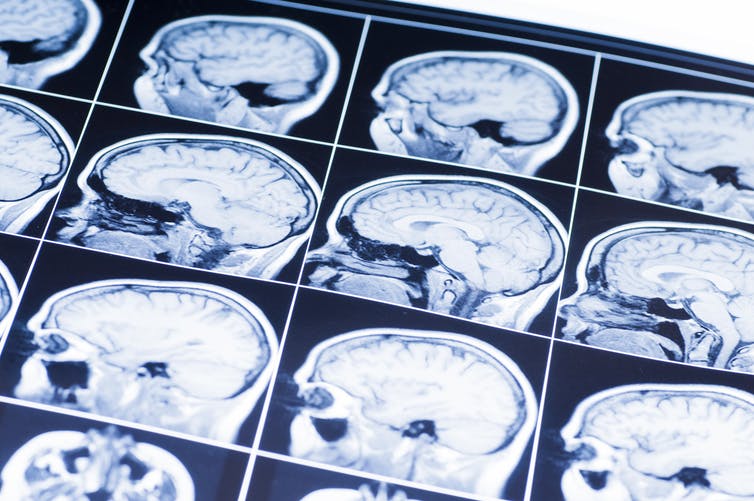

El entorno familiar influye de forma marcada en el desarrollo del encéfalo infantil. Los bebés tienen similares volúmenes de materia gris al nacer y en su más temprana infancia, pero al cabo de unos pocos meses de vida los que pertenecen a familias de bajo estatus socio-económico tienen menos que los de nivel medio o alto. Las diferencias no tienen relación con el peso al nacer, con la salud en las primeras semanas de vida o con diferencias en el tamaño de la cabeza en el momento del nacimiento. Y sabemos, por otro lado, que las diferencias en la cantidad de materia gris están relacionadas con problemas de comportamiento en los años anteriores a la escolarización.

Esas son las principales conclusiones de un estudio en el que se compararon los volúmenes de materia gris en varias áreas encefálicas de bebés y niños y niñas de edades preescolares procedentes de diferentes familias de los Estados Unidos. En el estudio se utilizaron imágenes obtenidas por resonancia magnética de encéfalos de bebés a los que se les siguió a lo largo de su desarrollo hasta los tres años edad, aproximadamente. Los análisis de imagen se hicieron con niños y niñas de los que se conocía su historial médico, no habían sido adoptados, no habían estado expuestos a sustancias nocivas durante el embarazo de la madre, el parto había sido normal, habían tenido un desarrollo normal y en la familia no había antecedentes psiquiátricos.

Las diferencias observadas se localizaron específicamente en las áreas frontal y parietal del cerebro, con menores volúmenes de estas áreas en los niños de familias de menores recursos. El lóbulo frontal está implicado en funciones ejecutivas, tales como planificación, control de impulsos y atención. El lóbulo parietal participa en la integración de señales sensoriales y aspectos relativos a la atención visual. Además, el desarrollo del lóbulo parietal parece ser importante para la conectividad entre diferentes áreas encefálicas.

No son los primeros resultados que ponen de manifiesto la relación entre las condiciones en que se desenvuelve el desarrollo temprano ligadas al nivel socioeconómico familiar y la posterior salud y capacidad de adaptación de los niños. Y al parecer, que el volumen de determinadas áreas dependa de las circunstancias ambientales experimentadas por los individuos tiene que ver con el establecimiento en ellas de diferente número de conexiones sinápticas, así como con diferencias en la producción de tejido de soporte (capilares sanguíneos y glía).

La variable de referencia utilizada para determinar el estatus socioeconómico fue el volumen de ingresos con relación al “nivel de pobreza federal”, que varió desde un 4% de dicho nivel hasta valores que lo cuadriplicaban. En los Estados Unidos, un 19% de las personas viven por debajo de esa línea. Los autores del trabajo descartan establecer relaciones causales concretas, porque el estatus socioeconómico lleva emparejado muchas otras condiciones ambientales, como el nivel cultural o educativo de los padres, el estilo de vida, la calidad de la alimentación, el ruido, la incidencia de enfermedades infecciosas, el ambiente familiar u otros. Y es muy posible que sea alguno de esos factores o determinada combinación de ellos lo que dé lugar a los efectos observados.

Conviene tener en cuenta que los criterios utilizados para seleccionar a los niños y niñas incluidos en los análisis conducen, de hecho, a atenuar las diferencias que cabría esperar encontrar, pues es sabido que los factores de exclusión (del estudio) están sobrerrepresentados en las personas de bajos recursos económicos. Por lo tanto, las conclusiones obtenidas en este trabajo deben considerarse conservadoras. Las diferencias reales son, con toda seguridad, de una magnitud muy superior.

Los resultados obtenidos en este y otros trabajos son importantes por lo que aportan al conocimiento de la naturaleza humana y, más concretamente, a la forma en que el desarrollo neurocognitivo se puede ver condicionado por factores ambientales. Pero a nadie se le escapa que pueden, también, tener implicaciones en términos de políticas públicas, principalmente con las iniciativas orientadas a mejorar el capital humano.

Fuente:

Jamie L. Hanson, Nicole Hair, Dinggang G. Shen, Feng Shi, John H. Gilmore, Barbara L. Wolfe, Seth D. Pollak (2013): Family Poverty Affects the Rate of Human Infant Brain Growth. PLoS ONE 8(12): e80954. doi:10.1371/journal.pone.0080954

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo El nivel socioeconómico familiar influye en el desarrollo del encéfalo infantil se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran encéfalo humano es un “encéfalo social”

- La sensibilidad medioambiental se desarrolla a nivel inconsciente

- Juguetes y hormonas sexuales

Los 40 Radikales

Oficina de comunicación de la UPV/EHU

David Mota Zurdo (Barakaldo, 1985), doctor internacional en Historia Contemporánea por la IPV/EHU, ha publicado recientemente el libro ‘Los 40 Radikales. La música contestataria vasca y otras escenas musicales: origen, estabilización y dificultades (1980-2015)’. La obra analiza la evolución de la música contestataria vasca desde 1980 hasta la actualidad, centrándose fundamentalmente en los géneros del punk, hardcore y hip-hop.

Siguiendo las corrientes historiográficas que están en plena batalla por el relato, en ‘Los 40 Radikales’ se analiza, por un lado, la estrategia de instrumentalización de la música underground que llevó a cabo la izquierda nacionalista vasca para transmitir y expandir su ideario entre la juventud durante las décadas de 1980 y 1990; y, por otro, se estudian los cambios, las sinergias y las dificultades que desde entonces ha padecido ese tipo de música contestataria. Se trata, sin duda, de una interpretación novedosa sobre la música política de nuestro país, donde se recopilan diferentes trabajos inéditos y artículos ya publicados en revistas especializadas de difícil acceso, que han sido actualizados y ampliados.

El libro se divide en dos grandes partes. En la primera, se analiza el origen y evolución del movimiento musical underground vasco. En la segunda se presta atención a la situación de este género en la actualidad, atendiendo a sus problemas legales, y se cruza a fin de establecer comparativas entre la situación de la música underground durante la Transición y la actualidad, haciendo especial hincapié en las obstaculizaciones que sufrió este género contestatario. “He examinado las divergencias existentes entre los grupos, sus problemas, sus lugares de sociabilidad y su imagen durante las tres grandes etapas de nuestra historia reciente: la Transición, la consolidación de la democracia y la actualidad”, explica el autor.

Además, se dedica un amplio espacio para la historia de ese movimiento, atendiendo a su inspiración filosófico-política, sus dificultades de expansión, sus críticas y sus obstáculos. Para concluir con los problemas judiciales que han tenido algunos de los protagonistas. “Los últimos acontecimientos en torno al 15-M y la Ley Mordaza están produciendo un repunte de la politización de la música. Este contexto de ultraderechización de la sociedad y el constreñimiento de la libertad de expresión está provocando de manera generalizada un repunte de la música antisistema”, llega a comentar David Mota en su libro.

Para el periplo de presentaciones de su nueva obra, Mota ha contado con la colaboración de un importante elenco de historiadores y representantes de la cultura que, además, han vivido en primera persona muchos de los acontecimientos que en ella se relatan.

Para Santiago Burutxaga, promotor cultural y presidente de Cultura Abierta, no es frecuente que, para investigar una época, un historiador ponga la música en su punto de mira y que, además, se fije en las bandas que al comienzo de ese tiempo eran poco menos que subterráneas y malditas para el establishment cultural. “Lo interesante y singular del libro es que va más allá de hacer un recorrido por los temas y los grupos de lo que el autor llama la escena underground vasca: el punk, heavy metal y otras corrientes musicales que en los años 80 se englobaron bajo la etiqueta de Rock Radical Vasco. David Mota se detiene a estudiar los lazos que se tejieron entre los grupos políticos radicales y aquellos chavales de garaje, tugurio y barriada que escupían sus frustraciones y mala leche en sus canciones y que estaban, quizás sin saberlo, abriendo nuevos caminos a la música vasca de la época. En definitiva, es un libro tanto para rockeros como para los que no siéndolo especialmente, quieran conocer o recordar sin nostalgia, -como es mi caso-, aquellos años “alegres y combativos”, pero también violentos y oscuros”.

Mikel Toral, exdirector de Cultura del Gobierno Vasco y miembro del Consejo Vasco de la Cultura, que prologa el libro, cree que es una buena oportunidad para repasar de manera solvente y amena la difícil relación entre la música contestataria y los poderes establecidos y los contrapoderes que aspiran a sustituir a estos. “En un mundo de autocomplacencia y aduladores, sorprende gratamente la valentía con la que David Mota se enfrenta al periodo más reciente de nuestra historia musical desde la objetividad del historiador y desde la crítica “sin paños calientes”, ya sea a la IA o al PP. Creo que la mayoría de los lectores que se acerquen al libro confirmarán sus sospechas y vivencias de la maldad del poder respecto a la música contestataria. Es así en un 90%, y más en los últimos tiempos. Pero también pienso que es un libro que sirve para que los más jóvenes desarrollen su espíritu crítico y reflexionen, tal y como constantemente se invita a lo largo de la obra”.

En la presentación del libro en Bilbao también participó Joseba Martín, doctor en Periodismo, profesor de la UPV/EHU y director del programa ‘La Jungla Sonora’ de Radio Euskadi, a quien le ha llamado la atención la cantidad y la calidad de las fuentes consultadas a la hora de dar contexto al conjunto, sobre todo desde una visión sociopolítica. “Si bien es cierto que en los años 80 y en los primeros 90 la escena vasca más contestataria estaba fagocitada por la izquierda abertzale, no es menos cierto que en la actualidad la música que se hace en Euskal Herria, salvo contadas excepciones, es mucho más acomodaticia, con un perfil más mainstream que busca un éxito que se pueda convertir en numerosos conciertos”, comenta. Para Joseba Martín, el acierto del libro, además de esa revisión del contexto histórico de los 80, reside en la constatación de que la libertad de expresión está, en los últimos años, bajo sospecha. “En el caso vasco se ha traducido en una cierta persecución (algunas denuncias, suspensión de conciertos…), lejos aún del ensañamiento actual de la derecha y su caverna mediática, capaz de calentar el ambiente para que, leyes restrictivas mediante, un rockero, un rapero o un grupo acabe con penas de cárcel por esta o aquella letra”, afirma.

Para Antonio Rivera, catedrático de Historia Contemporánea de la UPV/EHU, el libro proporciona gran cantidad de información sobre la relación que mantuvo la múltiple variante vasca del punk-rock, sobre todo de los ochenta y noventa, con culturas políticas como la de la izquierda abertzale. “Da muchos datos y analiza con inteligencia la doble influencia e instrumentalización que se produjo entre esos dos ámbitos y cómo uno y otro se vieron modificados con esa relación. Un sector de la izquierda abertzale se modernizó haciendo propios mensajes y formas que en origen le resultaban ajenas, y el llamado RRV se contagió de discurso nacionalista, aunque siguiera primando en él unas letras contra el sistema democrático que se instalaba en nuestro país en los ochenta, muchas veces justificando la violencia política y el terrorismo, y denunciando situaciones de injusticia producidas en una sociedad muy crispada y crítica como fue la vasca de los ochenta”, destaca.

En ese sentido, como se expone en la obra, el RRV fue más político y reivindicativo que la Movida madrileña (o viguesa) porque respondían a dos sociedades distintas. “En la vasca de los ochenta –explica Rivera-, la ciudadanía no había abandonado las calles para dejar que las instituciones condujeran la política cotidiana. La calle estuvo agitada todavía durante algunos años por reivindicaciones de diverso género: sociolaboral (son los años de la reconversión industrial), antirrepresivo, antisistémico, nacionalista, en el combate por “liberar” espacios respecto de las nuevas instituciones que se iban asentando… Aunque la Transición tuvo los mismos efectos que en el resto de España, la consolidación institucional estuvo cuestionada hasta más tarde. En el resto del país ese proceso no se produjo y sí el del llamado “desencanto”, una vuelta al territorio de lo privado después de la intensa politización de las vidas de las gentes que se produjo durante el tardofranquismo y la Transición. Unas letras menos precisamente políticas, más preocupadas por la vida privada, más lúdicas que sacrificadas, algo desencantadas o, lo que el autor llama, “metafísicas” son expresión de “esa radical diferencia entre esos dos territorios en ese tiempo”.

David Mota. Foto: Nuria González. UPV/EHU.

Otro joven doctor en Historia y profesor en la UPV/EHU, Aritza Sáenz del Castillo, también ha intervenido en las presentaciones del libro. “A diferencia de otras publicaciones que han tratado el tema, que podríamos catalogar como crónicas o anecdotarios de tinte autobiográfico de una época, el autor se suma a la corriente de las Ciencias Sociales –New Popular Music Studies- que ha analizado esta época y esta materia con el rigor científico que merece”, opina.

Para este historiador, el autor consigue despertar el interés del lector al introducirse y analizar de forma exhaustiva las relaciones existentes entre los diferentes movimientos musicales underground y el poder hegemónico y no tan hegemónico a lo largo de estos casi cuarenta años. “Muchas de sus reflexiones coinciden con ideas que ya manifestaron los protagonistas de aquella primigenia escena punk que eclosionó a finales de los 70 y primeros 80, y que puso el País Vasco patas arriba. Otros, por la juventud que poseemos y asumiendo muy a nuestro pesar aquello que coreaba La Polla Records – “no soy joven, yo soy muy viejo, ríete de mí que soy tu espejo”- no contemplamos aquellos primeros acordes y desacuerdos, pero sí fuimos testigos del eco o, mejor dicho, reflujo de aquello que llamaron Rock Radical Vasco y que dejó su impronta en la cultura musical vasca décadas después, para bien y para mal”, destaca.

En Logroño o Lleida también se han realizado presentaciones de ‘Los 40 Radikales’, actos en los que han intervenido académicos como Sergio Cañas, doctor en Historia Contemporánea e investigador de la Universidad de La Rioja. Para este historiador, el libro es necesario para comprender una parte importante de la historia reciente del País Vasco y está escrito con habilidad para analizar la parte más salvaje, rompedora e internacional de la cultura popular desde las ciencias sociales, pero carente de la inocencia de quien simplemente ve en el rock radical surgido en los años 80 una representación marginal de una tribu urbana. “Su mayor aportación –incide-, es explicar los mecanismos de instrumentalización que la izquierda nacionalista vasca hizo de una contracultura que vino para quedarse, y su relación con los dispositivos de censura y marginación que sufrió por parte del resto del espectro político más interesados en promocionar la Movida Madrileña o el folclore vasco tradicional”.

Sergio Cañas, además, ha formado parte de diversos grupos musicales, si bien al margen de su instrumentalización nacionalista y desde un prisma anarcopunk. “Al entrar en la universidad, me sumergí de lleno en su vertiente intelectual y comencé a utilizarla como fuente para la historia, releyendo lo anterior y descubriendo nuevos autores y estilos diferentes, al tiempo en que continuaba siendo miembro de nuevas bandas musicales. Pero ya era tarde para cambiar y sólo podía evolucionar. Tal vez por eso cada capítulo que he ido leyendo del libro me ha obligado a buscar mis cintas, vinilos y cedés para volverlos a escuchar”, relata.

En Lleida participó en la presentación Carles Feixa, catedrático de Antropología Social de la Universidad Pompeu Fabra, que tuvo un personal acercamiento a ese movimiento musical y destaca de la obra que va mucho más allá de la superficie política en la que se le ha querido encasillar. “Mi encuentro con la música rock-punk/hardcore vasca tuvo lugar en la ciudad de México en 1991. Al haber paseado por el mercado callejero de El Chopo (un tianguis que cada sábado reúne desde los 80s a todas las tribus urbanas de una de las mayores metrópolis del planeta), conocía a la banda de los Mierdas Punks, que se sabían de memoria las letras de Kortatu y Eskorbuto (además de las de LPR, claro), cuyos discos se vendían en casetes autograbados en varios puestos del mercado. De todos ellos destacaba el de un vasco transterrado en el que también se podían comprar camisetas, gadgets y literatura contracultural. Mis cuates punks de ciudad Nezahualcóyotl me contaron las míticas visitas de esos grupos al DF. Cuando regresé a Cataluña me interesé por esa historia subterránea. Luego estuve en la tesis doctoral de Huan Porrah, un andaluz pionero en bucear en ella, pero hasta que leí el libro de David Mota no acabé de entender lo sumergido, lo emergente y lo visible de uno de los movimientos músico-culturales más interesantes que durante el último medio siglo ha surgido al sur de los Pirineos”.

Ficha:

Autor: David Mota Zurdo

Título: Los 40 Radikales. La música contestataria vasca y otras escenas musicales: origen, estabilización y dificultades (1980-2015)

Año: 2017

Editorial: Ediciones Beta

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo Los 40 Radikales se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- I, Mammal. The Story of What Makes Us Mammals

- Cálculo y geometría analítica, de George F. Simmons

- El filósofo que baila con las sepias

Naukas Bilbao 2017 – Clara Grima & Enrique F. Borja: Matemáticas, epidemias y vacunas

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Cuando aplicamos las matemáticas a la salud se obtienen datos muy interesantes. En el caso de las vacunaciones deberían hacer reflexionar a más de una persona; más que nada para evitar la tercera variable de la ecuación: las epidemias.

Clara Grima y Enrique Borja: Matemáticas, epidemias y vacunasEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Clara Grima & Enrique F. Borja: Matemáticas, epidemias y vacunas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Francisco R. Villatoro: El espín para irreductibles

- Naukas Bilbao 2017 – Álex Méndez: Luz de luna

- Naukas Bilbao 2017 – Ignacio López-Goñi: Las bacterias también se vacunan

La gran infraestructura europea de investigación en biotecnologías azules es ya una realidad

La gran infraestructura europea de investigación European Marine Biological Resource Centre (EMBRC-ERIC) es ya una realidad, y la Estación Marina de Plentzia (PiE) de la UPV/EHU es uno de los dos centros seleccionados por el Estado español para participar en la misma. El EMBRC-ERIC es el resultado de unión de 24 centros de investigación de 9 países, que aunando sus recursos y know-how y ofertando servicios de investigación trabajarán para resolver cuestiones fundamentales sobre la salud de los ecosistemas marinos en un medioambiente cambiante, promover nuevas tecnologías científicas en esta área, impulsar descubrimientos en el campo de la salud mediante el uso de modelos biológicos marinos y mantener a largo plazo la monitorización del estado de los mares.

Como indican las siglas ERIC (European Research Infrastructure Consortium), esta infraestructura se ha constituido legalmente como un Consorcio Europeo Infraestructuras de Investigación, siendo la decimoctava infraestructura europea de este tipo. Según Ibon Cancio, profesor de Biología Celular de la UPV/EHU y responsable de la adscripción de la Estación Marina de Plentzia al EMBRC-ERIC. “Es muy importante participar en una organización de este nivel y dimensión. ¿Quién no conoce el CERN? Nuestra infraestructura será del mismo nivel. Ellos se dedican al campo de la física, mientras que nosotros trabajaremos en el área de la salud y alimentación (‘Health and Food‘). El CERN tiene una única sede. Nosotros tenemos 24 sedes en 9 países, si bien tenemos un presupuesto mucho más modesto y mucho para demostrar”.

Los estatutos de la infraestructura de investigación paneuropea EMBRC acaban de publicarse en el Diario Oficial de la Unión Europea. “Somos oficialmente uno de los centro de investigación que conforman EMBRC-ERIC, y la única infraestructura de este tipo en el País Vasco”, señala Cancio. Los nueve países en los que se encuentran los 24 centros de investigación que constituyen el EMBRC-ERIC son Bélgica, Francia, Grecia, Israel, Italia, Noruega, Reino Unido, Portugal y España. En el nodo español participa, además de la Estación Marina de Plentzia de la UPV/EHU, la Estación de Ciencias Marinas de Toralla (ECIMAT) de la Universidad de Vigo.

Biotecnología azulEl EMBRC-ERIC proporcionará acceso a información y recursos los ecosistemas de todos los mares de Europa. “El objetivo es que cualquier investigador o investigadora o empresa tenga a su disposición los recursos biológicos marinos necesarios para su labor de investigación, y asimismo tenga acceso a todo el know-how en biología molecular y genómica, de manera que puedan explotarlos de un modo sostenible”.

Los primeros trabajos para constituir el EMBRC empezaron en 2008, una vez que la Comisión Europea introdujo esta iniciativa en su segunda hoja de ruta. En 2011 los promotores del EMBRC pusieron en marcha su primer proyecto, y para 2014 todos los países participantes habían suscrito un memorandum de entendimiento para iniciar el proceso de formalización legal de la infraestructura. A mediados de noviembre se aprobaron los estatutos y el presupuesto de lo que será el EMBRC-ERIC, que en el caso del nodo español contará con financiación del Gobierno Vasco y la Xunta de Galicia. Posteriormente todos los países han ratificado su compromiso con el EMBRC-ERIC, que en el caso de España se produjo en el Consejo de Ministros el 15 de diciembre de 2017. La sede principal del EMBRC-ERIC se encuentra en París.

El EMBRC es, además, una de las grandes infraestructuras promovidas por la Comisión Europea dentro del foro estratégico ESFRI (European Strategy Forum on Research Infrastructures- ESFRI) para impulsar la investigación de calidad en la Unión Europea. En total cuenta con 50 infraestructuras o proyectos de infraestructuras.

Estación Marina de PlentziaLa Estación Marina de Plentzia (PIE) es un centro de investigación y enseñanza de alto nivel de la UPV/EHU. Situada en el antiguo sanatorio de Plentzia, estudia la salud del medio ambiente marino y su influencia en la salud humana. En concreto, promueve la investigación y formación en materias relacionadas con la salud de los ecosistemas marinos, los efectos de las alteraciones medioambientales sobre la salud humana y los biorrecursos marinos. La Estación Marina imparte tres másteres, dos de los cuales cuentan con la máxima distinción de calidad que otorga la Unión Europea, el sello Erasmus Mundus: Erasmus Mundus Master in Marine Environment and Resources (MER); Erasmus Mundus Master in Marine Biological Resources (IMBRSEa) y Environmental Contamination and Toxicology, Asimismo, cuenta con programas de doctorado. Una veintena de científicos y científicas y una treintena de doctorandos y doctorandas trabajan en el centro.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo La gran infraestructura europea de investigación en biotecnologías azules es ya una realidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Lado oscuro del genoma y leucemia: aspectos éticos y legales de una investigación

- La pubertad está comenzando antes para muchos niños; la educación sexual debería afrontar esta realidad

- Equilibrio tautomérico en un sistema modelo de gran interés biológico

Científicos, animalistas y el uso de animales para investigación

Mucho se ha hablado de los animales utilizados en investigación. Valga como ejemplo esta estupenda revisión sobre el tema realizada por el investigador Lluís Montoliu o el informe Confederación de Sociedades Científicas de España (COSCE). El tema del uso de animales para fines científicos salta a la palestra periódicamente por presiones del lobby animalista, el cual, sin lugar a dudas, ha influido en las leyes y normas vigentes. Por parte de la razón, es decir, de la ciencia, existe una defensa férrea del uso de animales para investigación, ya que, sin su utilización, no podríamos acometer las nuevas aproximaciones terapéuticas y diagnósticas que necesitamos para poder combatir las enfermedades que todavía hoy no tienen solución y que necesitamos para mejorar la vida de los enfermos. Así que existe un enconado desencuentro entre científicos y animalistas sobre el uso de animales para fines científicos. Sin embargo, hay una entidad, o grupo de entidades, en los que no cabe debate alguno.

Anuncio de PACMA contra la experimentación animal

La talidomida fue prescrita y utilizada entre los años 1957 y 1963 en Europa. Hasta ese momento ningún país europeo contaba con regulación alguna sobre el uso de medicamentos, por lo que la tragedia de este fármaco produjo un verdadero terremoto en el desarrollo de medicamentos en el viejo continente. Alemania, un país particularmente afectado por el caso de la talidomida, tuvo que aprobar con urgencia en el año 1961 la primera ley que regulaba el uso de medicamentos.

Hasta ese momento la responsabilidad de evaluar los medicamentos recaía sobre los propios fabricantes. Aunque su distribuidor, Grünenthal, realizó algunos experimentos de seguridad, estos no fueron suficientes para detectar los efectos secundarios del fármaco, y en ninguno de los casos se evaluó el fármaco en animales gestantes. En aquellos años tampoco era obligatorio evaluar los medicamentos en animales en periodo de gestación en el Reino Unido, pero de nuevo la catástrofe de la talidomida propició que se formara en 1964 el Comité de Seguridad de Medicamentos y que, cuatro años más tarde, se promulgara la primera Ley del Medicamento británica.

Niña afectada por la talidomida

Hoy en día todos los países de primer orden cuentan con agencias para el control del desarrollo, liberación y evaluación de nuevos medicamentos. Es el caso de la European Medicines Agency (EMA) en Europa o la Food and Drug Administration (FDA) en los Estados Unidos. Dichas organizaciones se encargan de velar por la seguridad de los fármacos que se prueban en humanos. La única obsesión de dichas agencias es que no se vuelva a dar un “caso talidomida”. Así que solicitan que se realice un estudio completo y pormenorizado de la toxicidad de los fármacos bajo estudio, y siempre antes de autorizarlos para su uso en humanos. La eficacia del medicamento se supone; de lo que se encargan las correspondientes agencias es de que los fármacos sean suficientemente inocuos.

Sede de la EMA en Londres, que será trasladada a Amsterdam y no a Barcelona.

Las agencias reguladoras obligan a la industria farmacéutica a realizar una exhaustiva batería de estudios para conocer cómo los fármacos afectan a diferentes sistemas del organismo y a procesos patológicos críticos, determinando sus rangos de su seguridad en el mejor de los casos (en el peor y más habitual el desarrollo de los nuevos fármacos es interrumpido por estas cuestiones).

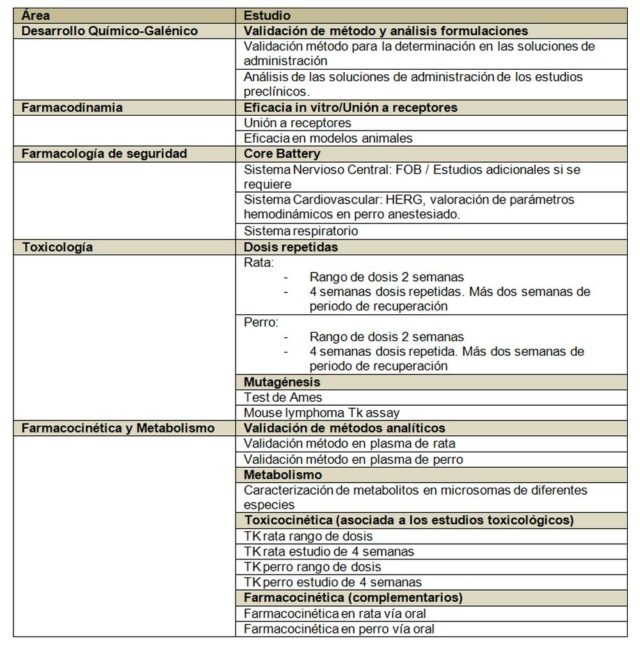

Veamos un ejemplo concreto de los estudios requeridos por las autoridades:

Podemos observar en la tabla anterior, grosso modo, los estudios que las agencias exigen. Hagamos algunas apreciaciones al respecto:

- La tabla refleja los estudios mínimos necesarios, los cuales pueden no ser suficientes si se encuentra algún hallazgo patológico inesperado, cosa que suele ocurrir ya que se fuerzan las dosis hasta encontrar efectos secundarios, lo cual permite definir las dosis de trabajo. Aquí es necesario recordar a Paracelso, que ya explicó la importancia de las dosis hace casi 500 años.

- El paquete básico de estudio está por encima del medio millón de euros en prácticamente todos los casos y los estudios tienen una duración de un año al menos. Esto si las cosas van bien, claro. En muchas ocasiones los tiempos y los costes se incrementan.

- Los laboratorios que realizan este tipo de estudios deben estar certificados en Buenas Prácticas de Laboratorio (BPL; o GLP en inglés), por lo que lo realizan exclusivamente empresas especializadas llamadas Contract Research Organizations (CRO). Todos los protocolos de estudios están normalizados y acordados, y hay que seguirlos estrictamente, registrando cualquier desviación detectada.

- Se estudian los principales sistemas del organismo, tales como el sistema respiratorio, cardíaco o nervioso, así como procesos que puedan afectar a la seguridad, tales como la mutagénesis o los estudios de interacción con receptores.

- Se estudian dos especies animales siempre; una de roedores y otra de no roedores. Por cuestiones históricas la especie de roedor mayoritaria es la rata (el ratón no se usa para estudios regulatorios normalmente). Las agencias tienen un amplio recorrido de estudios realizados en rata y pueden comparar expedientes. La especie no roedora suele ser el perro, aunque se pueden utilizar otros no roedores con su justificación pertinente. Sólo en contadas ocasiones las agencias autorizan el uso de primates. El perro habitualmente usado para estos estudios es de la variedad Beagle; los monos suelen ser macacos.

- Toda la información extraída de los estudios regulatorios preclínicos es utilizada para diseñar los estudios en humanos First-in-human, y las primeras dosis de estudio vienen definidas por la dosis anterior a la más baja que produce algún efecto en cualquiera de las dos especies animales utilizadas en los estudios. A esta dosis se le conoce como NOAEL (de non-observed adverse effect level).

- Previamente a los estudios en humanos se aplicará un factor de dilución a la dosis elegida como medida adicional de seguridad. La dosis final que será utilizada para iniciar los estudios en humanos es lo que se conoce como MRSD (del inglés máximum recommended starting dose).

A grandes rasgos, para todo lo anteriormente expuesto, es necesario el uso de animales. Y en este caso el factor limitante no son los comités de ética, que los hay, si no la cuantía económica de los estudios y la duración de los mismos (para la empresa farmacéutica, tiempo y dinero son parámetros esencialmente equivalentes).

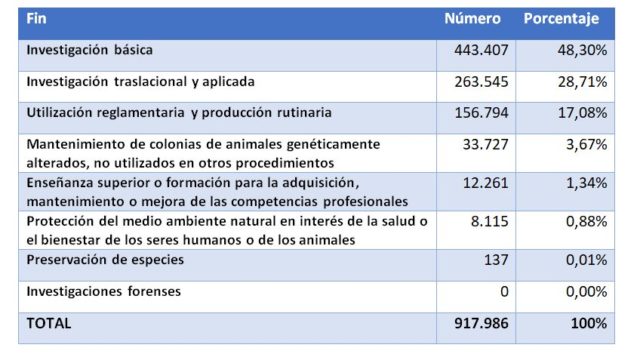

La pregunta ahora es: ¿Cuántos animales se usan para este tipo de estudios en nuestro país? Si analizamos el último informe oficial publicado por el Ministerio de Agricultura, Pesca, Alimentación y Medio Ambiente (MAPAMA), el número de animales utilizados en 2016 para fines científicos fueron los siguientes:

Es decir, que la mayoría de animales fueron usados para investigación (básica o traslacional/aplicada, en un 77%). La siguiente partida en importancia es la utilización reglamentaria y producción rutinaria. Si atendemos sólo al uso reglamentario los datos indican que se utilizaron 49.640 animales para este fin repartidos de la siguiente forma:

Es decir, de cada 100 animales utilizados para fines científicos aproximadamente 5 fueron sacrificados por cuestiones regulatorias, por los 75 que fueron usados en las diferentes fases de investigación. Tal vez 50.000 animales al año para estudiar la seguridad de los fármacos pueda parecer mucho, tal vez no parezca tanto si lo comparamos con las incontables personas que sufrieron el efecto de la talidomida en nuestro país.

Si salimos de nuestra zona de confort y atendemos, por ejemplo, al uso de animales para la alimentación, según Eurostat sólo en 2015 se sacrificaron más de 46 millones de cerdos en España. O lo que es lo mismo, un cerdo por español. Por el contrario, en 2015 por cada español tan sólo se usaron 0,018 animales con fines regulatorios. Juzguen ustedes mismos.

Este post ha sido realizado por Javier Burgos (@Javisburgos) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Referencias y más información

- Lluís Montoliu (2018) ¿Cuántos animales se usan en España para experimentación? Cuaderno de Cultura Científica

- Informe COSCE sobre el uso de animales de investigación.

- Informe 2016 de uso de animales para investigación del MAPAMA. [PDF]

- Guía de desarrollos preclínicos. Genoma España. [PDF]

El artículo Científicos, animalistas y el uso de animales para investigación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Cuántos animales se usan en España para experimentación?

- #Naukas15 ¿Es necesario usar animales en investigación?

- Una nueva investigación muestra que explicar cosas a la gente “normal” puede ayudar a los científicos a ser mejores en su trabajo

La neurociencia está desentrañando los misterios del encéfalo adolescente

Lucy Foulkes

![]()

¿Cómo describirías al adolescente medio? A la mayoría las siguientes características pueden venirnos a la mente: temperamental, impulsivo, arriesgado, propenso a sucumbir a la presión de grupo.

Si bien está claro que la adolescencia es un período de la vida que está plagado de estereotipos, hay algo de verdad en los clichés. Muchos estudios neurocientíficos han establecido que ocurren cambios significativos en el encéfalo durante la adolescencia. Y las cosas por las que a menudo se ridiculiza a los adolescentes, como su asunción de riesgos y la vulnerabilidad a la presión de los compañeros, en realidad están enraizadas en los cambios que ocurren en sus encéfalos. Solo hay un problema con esto: muchos adolescentes no se ajustan a los estereotipos.

Todos sabemos por experiencia personal que la forma en la que los adolescentes piensan y actúan puede variar ampliamente según el adolescente del que se trate. Pero, a pesar de esto, la gran mayoría de los estudios hasta la fecha se han centrado en las medias: ¿qué ocurre de media con el encéfalo durante la adolescencia o cómo se comportan y sienten los adolescentes de media?

Depender de las medias de esta manera tiene un beneficio estadístico importante, ya que es más probable que los investigadores sean capaces de detectar un efecto genuino si promedian sus hallazgos entre muchos participantes. Pero el coste obvio es que estos hallazgos generales no se aplican a todos y cada uno.

Comprender las diferencias individuales

En un artículo reciente, mis colegas y yo argumentamos que esto debe cambiar. A partir de ahora, la investigación del encéfalo de los adolescentes necesita prestar más atención a estas importantes variaciones entre adolescentes, lo que se conoce en el campo como “diferencias individuales”.

Además de documentar que todos los adolescentes son diferentes, también debemos comenzar a entender por qué esto es así. Los estudios que ya están investigando esto han demostrado que tanto la genética, como la nutrición, la crianza de los hijos o las enfermedades mentales afectan a la forma en la que se desarrolla nuestro encéfalo y la manera en la que nos comportamos durante la adolescencia. Y en nuestro último artículo, analizamos otros tres factores que podrían afectar el desarrollo del encéfalo: el estatus socioeconómico, las relaciones con los compañeros y la cultura.

No útil para retrato robot. Imagen: Shutterstock

El estatus socioeconómico es una medida de la posición social y financiera de una persona en la sociedad, y a menudo se mide por el nivel de educación de sus padres y por los ingresos familiares totales. La investigación ya ha descubierto que tu encéfalo se desarrolla de manera diferente en la adolescencia dependiendo de tu nivel socioeconómico. Pero lo que aún no entendemos del todo es por qué. Podría ser, por ejemplo, que criarse en un ambiente de bajos ingresos es más estresante o que esté relacionado con diferentes tipos de nutrición, y que esto a su vez afecte el desarrollo del encéfalo, pero se necesitan más estudios sobre este tema.

Compañeros de clase y cultura

El tipo de relación que los adolescentes tienen con sus compañeros también afecta la actividad encefálica. Los adolescentes con una historia de acoso, por ejemplo, muestran diferentes patrones de activación encefálica ante ciertas informaciones sociales: sus encéfalos parecen ser más sensibles a la experiencia de ser excluidos. Por la misma razón, tener muchos amigos y un historial de ser querido por los compañeros de clase también afecta a la activación encefálica, y puede hacerte más resistente al desarrollo de problemas de salud mental.

En todo el mundo, los adolescentes también crecen en culturas muy diferentes, lo que afecta muchos aspectos de sus vidas: desde cuántos años pasan estudiando hasta cuándo se casan e incluso cuánto tiempo pasan con sus familias.

Recientemente, los científicos se han interesado en cómo esto se podría reflejar en las diferencias en los encéfalos adolescentes. Ya sabemos que los adultos de diferentes culturas muestran diferencias interesantes en su actividad y estructura encefálicas, y esto ahora está empezando a investigarse en adolescentes.

Solo tu adolescente medio

La razón por la que la mayoría de las investigaciones sobre el encéfalo de adolescentes aún no consideran las diferencias individuales se debe en parte a que el campo tiene solo 20 años de edad, y las nuevas áreas de investigación deben comenzar con lo básico, las medias, antes de intentar comprender los matices.

La investigación del encéfalo adolescente es un campo relativamente nuevo. Imagen: Shutterstock

También hay razones prácticas. La tecnología de imágenes encefálicas hasta la fecha no ha sido lo suficientemente buena como para cartografiar exactamente cómo los factores específicos, como las relaciones entre iguales, podrían afectar el desarrollo del encéfalo. Luego también está el hecho de que para tener suficiente capacidad para detectar hallazgos fiables, se necesitan grandes tamaños de muestra.

Esto significa cientos, a veces miles, de adolescentes. Por el momento, un escáner cerebral cuesta alrededor de 600 € por hora, por lo que el tamaño de las muestras a menudo está limitado por el coste. Una forma de resolver este problema es que los científicos compartan sus datos entre ellos, y esto ya está comenzando a suceder .

Todos los encéfalos son diferentes

Reconocer que todos los adolescentes son diferentes tiene implicaciones realmente importantes para cosas como la educación o la publicidad. Si, por ejemplo, la forma en que los adolescentes aprenden depende de su patrón específico de desarrollo encefálico, entonces las estrategias educativas basadas en medias solo tendrán una utilidad limitada.

Del mismo modo, las campañas publicitarias para temas como la salud sexual, si se basan en los estudios que promedian entre los participantes, funcionarán para algunos adolescentes, pero no para otros.

Cuanto antes entendamos la diferencia entre los adolescentes, más pronto podremos integrar esta información en las escuelas y las políticas. Esto es importante porque, después de todo, no existe un adolescente medio, y debemos recordar esto a medida que continuamos refinando nuestra comprensión del encéfalo adolescente.

Nota del traductor sobre las referencias bibliográficas: Todos los artículos científicos están enlazados en el texto en sus contextos apropiados, basta pulsar en las palabras azules.

Sobre el autor:

Lucy Foulkes es profesora de de psicología de la educación en la Universidad de York (Reino Unido)

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 23 de abril de 2018 bajo una licencia Creative Commons (CC BY-ND 4.0)

El artículo La neurociencia está desentrañando los misterios del encéfalo adolescente se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El gran encéfalo humano es un “encéfalo social”

- La pubertad está comenzando antes para muchos niños; la educación sexual debería afrontar esta realidad

- El encéfalo bilingüe: por qué no existe un modelo único

La humildad como virtud científica

Linus Pauling (1901-1994). Ganador de dos premios Nobel. Uno de los padres de la química cuántica y de la biología molecular. Pacifista y activista. Pero también padre de la medicina ortomolecular (sin base científica; una teoría inventada en un sillón, como el psicoanálisis de Freud o la homeopatía de Hahnemann) y perseguidor arrogante, hostil e incansable de Dan Shechtman, los cuasicristales y de cualquiera que trabajase en ellos desde su descubrimiento en 1984 hasta su muerte en 1994 (Shechtman recibiría el Nobel en 2011 por el descubrimiento de los cuasicristales).

Gente que practica ciencia desde la arrogancia hay, ya lo creo; incluso en según qué disciplinas o instituciones abundan. Personas de teoría única que acertaron una vez en algo importante y desde entonces mantienen su hipótesis favorita como única aceptable; científicos que sólo se relacionan con discípulos de su secta, que rechazan a quien tiene ideas diferentes, que son incapaces de imaginar que sus ideas puedan ser insuficientes o mucho menos erróneas. Abundan los jefes de laboratorio, directores de centro, catedráticos eminentes, editores de revistas u organizadores de congresos que en cualquier disciplina, de cualquier sexo (aunque más a menudo, ay, varones), con variado acierto y casi siempre con temibles consecuencias practicas la ciencia desde la más absoluta arrogancia intelectual y a menudo social. Todos los que practica ciencia los conocen o los sufren, tratando siempre de sobrevivirlos.

Porque un científico arrogante, especialmente cuando esa arrogancia se manifiesta en su producción intelectual, es un mal científico. No porque su trato sea muy desagradable, que lo es; no porque suponga un obstáculo al avance del conocimiento al dificultar la adopción de nuevas ideas, que lo hace; sino porque su ciencia es mala por definición.

La buena ciencia sólo puede ser humilde, porque errar es humano y porque al universo le importan poco nuestros sentimientos y aunque no hace trampas para engañarnos tampoco nos pone las cosa fáciles: comprender como funciona es complicado y está lleno de trampas. Malinterpretar, crear hipótesis bellas (pero erradas), teorizar en ausencia de datos o con datos equivocados o desconocer factores relevantes son certezas con las que tenemos que lidiar a la hora de establecer nuestras hipótesis y explicaciones. Y cuando esas hipótesis bellas pero erróneas se enfrentan a la comparación con el cosmos real éste es inmisericorde, y las tumba sin remedio.

Cuando esto ocurre podemos refugiarnos en la ceguera desde la arrogancia: ese factor no es relevante porque YO no lo considero así, porque MI experimento no lo tiene en cuenta, porque NUESTRA hipótesis no lo incluye. Al hacer esto estamos intentando imponer nuestras formas de pensar y nuestros límites al universo, forzando sobre el funcionamiento de cosmos nuestra interpretación limitada. Si tenemos bastante poder terrenal conseguiremos que esto funcione, durante un tiempo; si controlamos las carreras de los científicos que vienen después mediante tribunales o consejos editoriales de revistas, si somos determinantes al escribir los libros de texto, si empujamos y apartamos a las voces discrepantes e impedimos que se les escuche. Con arrogancia y poder es posible mentir a todo el mundo, durante algún tiempo.

Pero no hay arrogancia capaz de forzar la mano del universo, así que a la larga todos nuestros esfuerzos serán en vano. Quizá tengamos una larga y poderosa carrera, quizá incluso muramos pensando que lo hemos logrado, pero tarde o temprano (y será temprano) la realidad se impondrá y nuestras teorías e hipótesis pasarán al basurero de la historia. No será siquiera recicladas como parte de teorías mejores, como ocurre con los avances correctos pero siempre (ay) insuficientes, sino que serán descartadas y quedarán como notas a pie de página en la historia de la ciencia, asociando para siempre nuestro nombre con el fracaso.

Los mejores científicos son humildes, no por vocación propia, sino por experiencia duramente ganada. Por errores cometidos, hipótesis rechazadas, experimentos fallidos, dificultades no superadas; por meteduras de pata risibles, confusiones involuntarias, complejidades experimentales o de campo no tenidas en cuenta. Es cierto que la naturaleza no nos miente de modo malicioso, pero a veces puede ser puñeteramente sutil y esconder fuentes de error en los rincones más inverosímiles; uno puede estar al borde del Nobel y descubrir de repente que sus datos están contaminados y no dicen lo que uno pensaba que decían, perdiendo cualquier posibilidad de alcanzar la gloria.

Y eso duele, pero sólo se convierte en una catástrofe si se le suma una buena dosis de arrogancia. En presencia de humildad el error se desarrolla y se acaba convirtiendo en el germen de nuevas ideas, nuevas hipótesis, nuevos avances. Por eso los buenos practicantes de ciencia comparten como rasgo común la humildad intelectual; no porque eso les haga mejores personas o les convierta en practicantes de la filosofía Zen, sino porque eso les hace mejores científicos. Ante el maravilloso, complejo y sutil universo que hay ahí fuera pensar que una mente humana pueda contener toda la verdad no sólo es arrogante: es estúpido. La humildad, pues, es una virtud científica, porque nos ayuda a entender mejor.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo La humildad como virtud científica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo leer una noticia científica

- Las matemáticas como herramienta (II): La Revolución Científica y el cálculo

- Ellen Richards: la economía doméstica como cultura científica

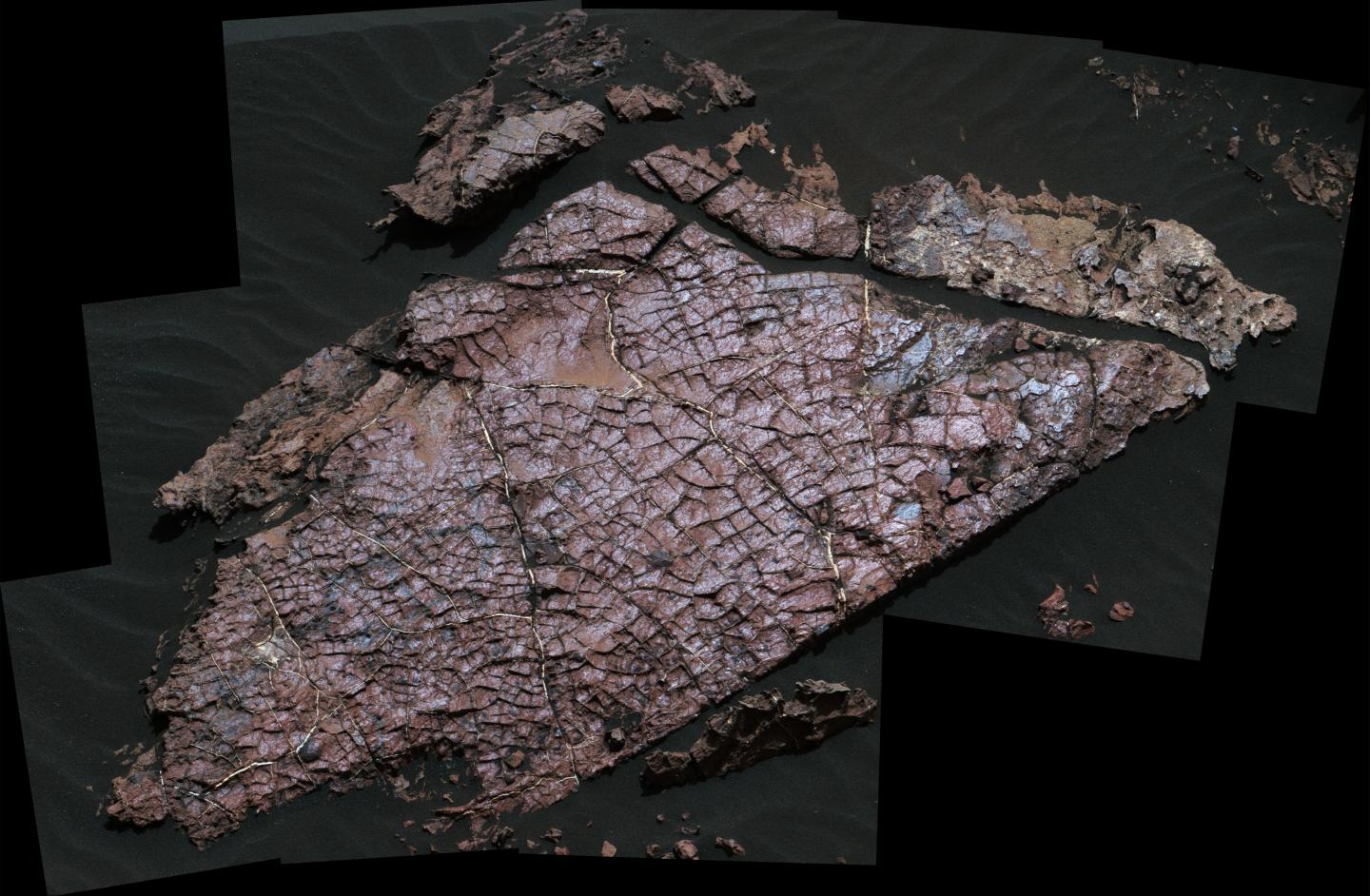

Grietas de desecación marcianas

Imagen que Curiosity tomó de “Old Soaker” durante el sol 1555. La losa tiene unos 80 cm de longitud. Foto: NASA.

A principios de 2017, y a partir de imágenes recopiladas por el róver Curiosity, los científicos anunciaron el descubrimiento de posibles grietas de desecación en el cráter Gale, que habría estado lleno de lagos hace 3.500 millones de años. Ahora, un nuevo estudio ha confirmado que son realmente grietas de desecación, lo que revela nuevos detalles sobre el antiguo clima de Marte.

Dado que las grietas de desecación se forman solo cuando el sedimento húmedo está expuesto a la atmósfera, su posición más cercana al centro del antiguo lecho del lago que al borde también sugiere que los niveles del lago aumentaron y disminuyeron drásticamente con el tiempo. Esto es, los lagos del cráter Gale habrían pasado por el mismo tipo de ciclos que vemos en la Tierra

Los investigadores se centraron en una losa de roca del tamaño de una mesa de café apodada “Old Soaker”. Old Soaker está atravesado por polígonos idénticos en apariencia a los característicos de los procesos de desecación terráqueos. El equipo analizó los aspectos físicos y químicos de los polígonos utilizando todo el despliegue de medios de análisis de Curiosity. Hay que recordar en este punto que Curiosity es un potentísimo laboratorio geoquímico autopropulsado.

Este escrutinio puso de manifiesto que los polígonos, confinados a una sola capa de roca y con sedimentos llenando las grietas entre ellos, se formaron por la exposición a la atmósfera, y no por otros mecanismos como la fracturación térmica o hidráulica. Y si bien los científicos sabían casi desde el momento en que Curiosity aterrizó en 2012 que el cráter Gale alguna vez contuvo lagos, la confirmación de la existencia de grietas de desecación añade un contexto a nuestra comprensión de este antiguo sistema lacustre.

Hallazgo tras hallazgo, Curiosity está transformando continua y completamente nuestra visión del presente y del pasado de Marte.

Referencia:

N. Stein et al (2018) Desiccation cracks provide evidence of lake drying on Mars, Sutton Island member, Murray formation, Gale Crater Geology doi: 10.1130/G40005.1

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Grietas de desecación marcianas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- En Marte el viento crea montañas

- Cómo se formaron las columnas hexagonales de la Calzada del Gigante

- Ox Bel Ha, un ecosistema tropical alimentado por metano

Muriel Bristol, la gran catadora de té

Estamos en Rothamsted (Harpenden, Reino Unido). Son las cuatro de la tarde, la ‘sagrada’ hora del té. Un grupo de personas hace una pausa en su trabajo para tomarse su infusión. Entre ellas están Muriel y Ronald. Ronald ofrece a su amiga una taza de té. Ella, tras tomar un sorbo, la rechaza. A Muriel le gusta el té, pero solo si la leche se ha servido en la taza en primer lugar. Ronald cree que se trata de una broma, e insiste con vehemencia; piensa que es lo mismo el orden en el que se vierten los líquidos, y se burla de su colega. Pero Muriel, enfadada, la rechaza de nuevo… no le gusta el sabor. William, otro de los miembros del grupo, intenta mediar y pide a Ronald que deje demostrar a Muriel que efectivamente es capaz de distinguir el momento en el que se ha servido la leche en la taza. Rápidamente, se organiza el experimento: Muriel debe distinguir entre ocho tazas de té, cuatro de cada tipo (leche antes del té o té antes de la leche) colocadas de manera aleatoria ante ella. Tras una pausada cata –en la que se permite a Muriel comparar el sabor de dos tazas–, y ante el asombro de sus compañeros, Muriel distingue con precisión el orden en el que se ha servido la leche de cada taza. ¿Ha sido pura suerte? ¿O quizás Muriel es una experta catadora capaz de distinguir esos detalles? Ronald tuvo que admitir la “victoria” de Muriel y se puso a reflexionar mucho sobre el tema…

Por cierto, Muriel y William se casaron poco tiempo después.