Lo que la tensión puede hacer en dos capas de grafeno

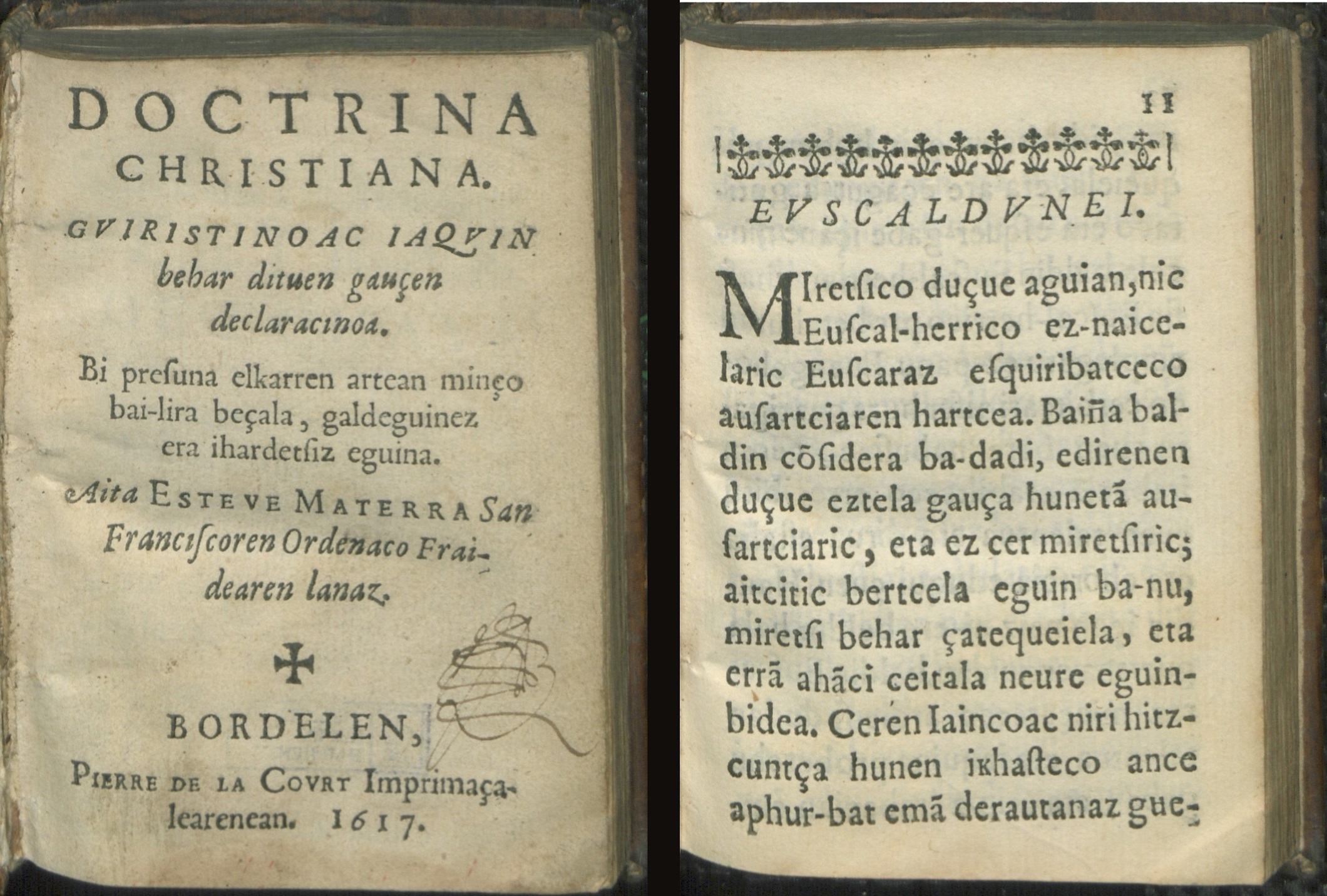

El grafeno, una lámina de un átomo de grosor de átomos de carbono, no deja de sorprendernos. Si el mes pasado el equipo de Pablo Jarillo-Herrero sorprendía a la comunidad científica que trabaja en física de la materia condensada con su descubrimiento de que si las láminas forman determinado ángulo se vuelven superconductoras, lo que puede revolucionar nuestro conocimiento de este fenómeno, ahora un equipo encabezado por Loïc Huder, de la Univesité Grenoble Alpes (Francia) ha encontrado que si las láminas del par están sometidas a tensiones ligeramente diferentes las propiedades eléctricas cambian completamente.

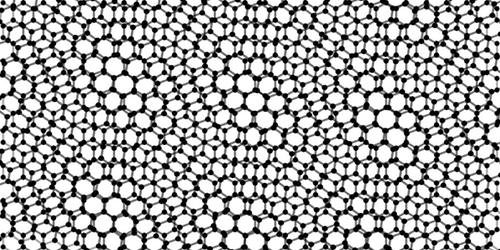

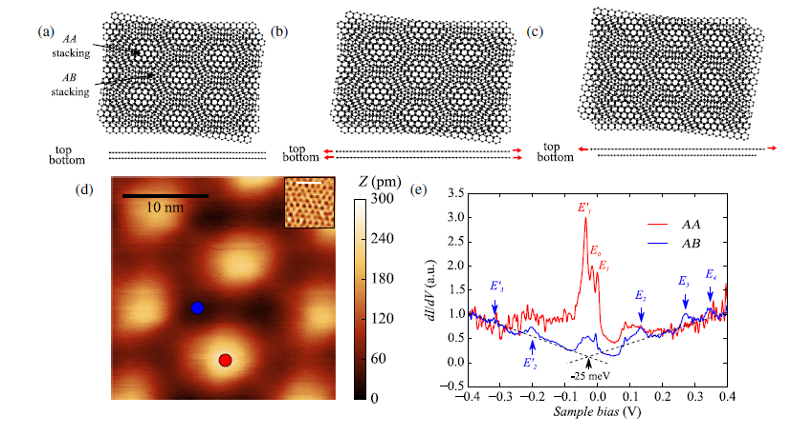

Los investigadores crearon sus bicapas haciendo crecer una lámina de grafeno encima de otra. Este proceso introdujo de forma natural diferentes tensiones en las dos láminas y una determinada rotación de una lámina respecto a la otra. Como resultado, en posiciones periódicas a través de la bicapa, las láminas se alinean, con sus patrones de átomos hexagonales perfectamente superpuestos. Entre estas posiciones los patrones de las láminas se desplazan una distancia equivalente a la mitad de un hexágono. El equipo utilizó un microscopio de efecto túnel (STM) para analizar cómo se comportan los electrones en las áreas alineadas y en las no alineadas.

En las áreas alineadas el equipo observó grandes picos en la cantidad de estados electrónicos disponibles. Estos picos eran significativamente más pequeños en las no alineadas. Las regiones con un gran número de estados electrónicos tienen acumulaciones de electrones atrapados, lo que puede llevar a comportamientos superconductores o magnéticos en la bicapa.

Si bien este hallazgo es sorprendente, lo que en ciencia ya es importante de por sí, también es cierto que ajustar las propiedades eléctricas del grafeno estirando y rotando las láminas aún no ofrece ventajas prácticas concretas frente a otros enfoques, pero tampoco el tren de alta velocidad ofrecía en su momento ventajas frente al avión.

Referencia:

Loïc Huder, Alexandre Artaud, Toai Le Quang, Guy Trambly de Laissardière, Aloysius G. M. Jansen, Gérard Lapertot, Claude Chapelier, and Vincent T. Renard (2018) Electronic Spectrum of Twisted Graphene Layers under Heterostrain Physical Review Letters doi: 10.1103/PhysRevLett.120.156405

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Lo que la tensión puede hacer en dos capas de grafeno se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ajustando la adsorción sobre grafeno

- El estaño beta es como el grafeno pero en 3D

- La esponja de grafeno como propulsor espacial

Poemas Fibonacci

[Nota del editor: advertimos a quien acceda a este texto desde dispositivos móviles que es probable que no pueda apreciar adecuadamente la expresión gráfica del mismo y, por lo tanto, pueden carecer aparentemente de sentido algunos de los comentarios del autor.]

Uno, uno, dos, tres, cinco, ocho, trece, veintiuno, … la sucesión de Fibonacci, una sucesión de números que ha superado la frontera de las matemáticas, de la ciencia, para colarse en el mundo de las artes, y en particular, de la literatura.

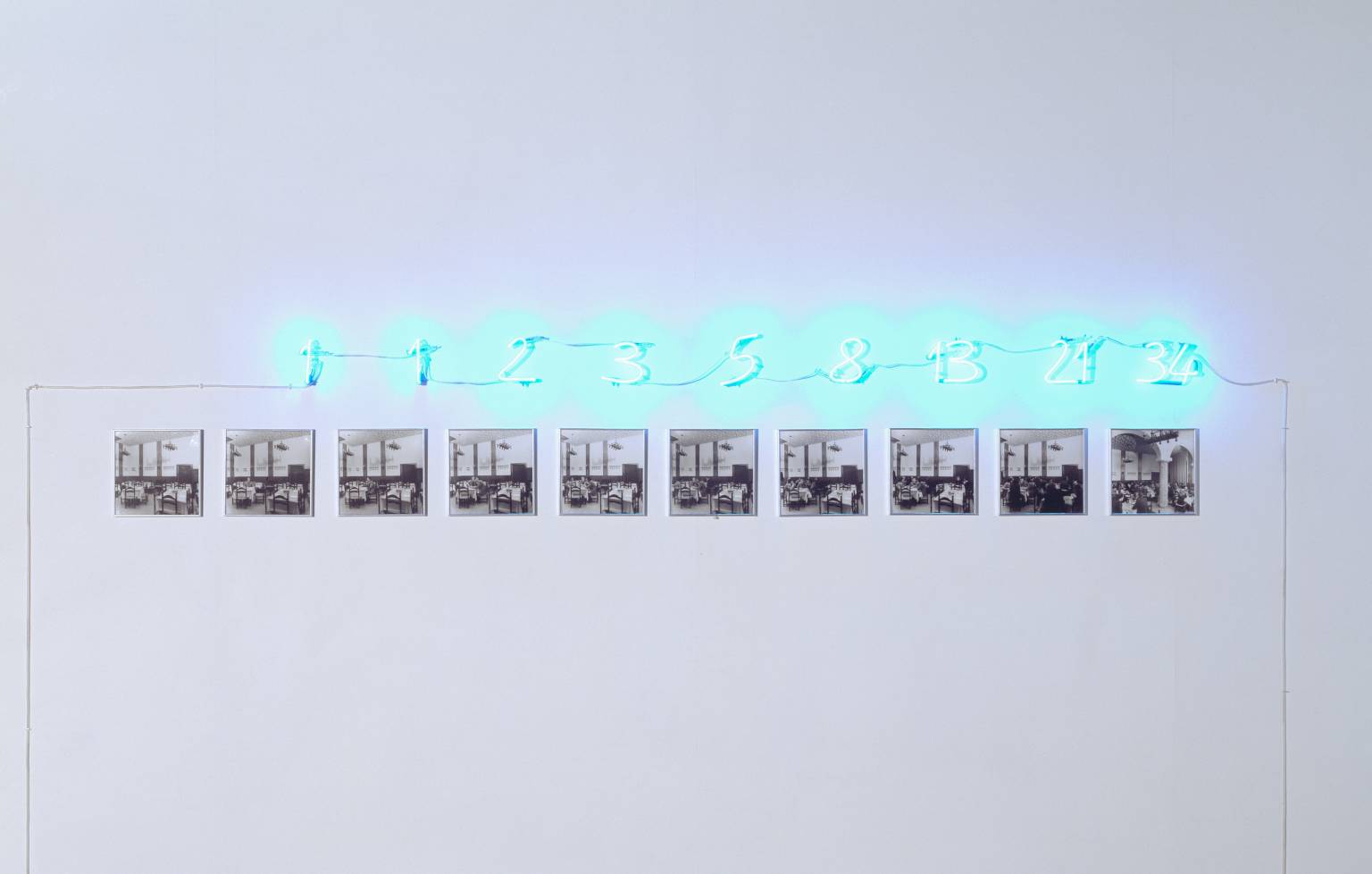

Obra “Fibonacci 42” de la artista estadounidense Cagney King

En esta entrada del Cuaderno de Cultura Científica vamos a mostrar algunos ejemplos de la relación de la sucesión de Fibonacci con la poesía. Esta relación es fundamentalmente de dos tipos, como suele ocurrir con otros conceptos matemáticos, estructural o temática. Aunque en la entrada de hoy vamos a realizar un breve paseo por ejemplos del primer tipo, es decir, cuando los números de la sucesión de Fibonacci son utilizados como regla o estructura para construir poemas.

El ejemplo más conocido de poesía en la cual se utiliza la sucesión de Fibonacci para dotar de estructura al poema es la obra Alfabeto (1981), de la escritora danesa Inger Christensen (1935-2009). Esta obra poética está formada por 14 poemas, cada uno de los cuales tiene tantos versos como el número correspondiente de la sucesión de Fibonacci (1-610) y su primer verso empieza por la letra correspondiente del alfabeto (A-N). Os dejamos un par de sitios, de Marta Macho, donde podéis leer más sobre esta conocida obra: Alfabeto, de Inger Christensen, en divulgamat e Inger Christensen: letras abrazando a Fibonacci, en Mujeres con Ciencia.

Portada de la edición en castellano del poemario “Alfabeto” (1981), de Inger Christensen, de la editorial Sexto Piso, edición bilingüe danés-español, 2014, traducida por Francisco J. Uriz

Como nos cuenta Sarah Glaz en su artículo Poems structured by integer sequences, existen otros poemas cuya estructura se apoya en esta sucesión numérica. Un ejemplo, de 1981, es el poema en prosa Tjanting, del poeta norteamericano Ron Silliman, en el cual cada número de Fibonacci determina el número de frases de cada párrafo. El poema tiene 200 páginas y termina con el número de Fibonacci 4181.

Otro ejemplo es el poema Fibonacci de la poeta de Nueva York Judith Baumel, perteneciente a su libro The Weight of Numbers – El peso de los números (1988). Cada uno de las estrofas del poema tiene número de versos igual a un número de Fibonacci, 1, 1, 2, 3, 5, 8 y 13. Así mismo, la temática del poema está relacionado con nuestra sucesión y algunas de sus propiedades.

Fibonacci

Call it windfall

finding your calculation

come, finally,

to the last decimal point of pi.

In the silence of January snow

a ladybug survives the frost

and appears on the window pane.

She drawls a tiny space.

Hesitant. Reverses. Forward,

like a random-number generator,

the walking computer frog

who entertains mathematicians.

Think of the complexity

of temperature, quantification

of that elusive quality “heat.”

Tonight, for instance,

your hands are colder than mine.

Someone could measure

more precisely than we

the nature of this relationship.

Learn the particular strength

of the Fibonacci series,

a balanced spiraling

outward of shapes,

those golden numbers

which describe dimensions

of sea shells, rams’ horns,

collections of petals

and generations of bees.

A formula to build

your house on,

the proportion most pleasing

to the human eye.

También podemos encontrar ejemplos de poemas similares en lengua castellana. Un ejemplo similar a la obra Alfabeto de Inger Christensen es el poemario Las razones del agua, del escritor Francisco Javier Guerrero (Adeshoras, 2017), de quien también Marta Macho nos habló en ¡Nos encanta Fibonacci!.

Obra “23220” del artista Harold Edwards, quien descompone los elementos de cada obra relacionándolos con los números de la sucesión de Fibonacci. Por ejemplo, esta obra mide 13 x 21 pulgadas, hay obras en las que utiliza 13 colores y la obra se divide en 13 zonas, otras donde utiliza triángulos –de 3 lados- o estrellas pentagonales –de 5 puntas-, etc.

Otro ejemplo de estructuras poéticas determinadas por la sucesión de Fibonacci (uno, uno, dos, tres, cinco, ocho, trece, veintiuno, …) son los conocidos como “poemas Fibonacci”, “Fibs” u otros nombres similares para estas formas poéticas. La idea de esta estructura poética es que cada verso del poema tenga tantas palabras (respectivamente, sílabas, o incluso letras) como el correspondiente número de Fibonacci. Veamos un par de ejemplos para ilustrar esta forma poética.

El primer ejemplo, que está en inglés, es un divertido e ilustrativo poema de Brian Bilston, titulado Word crunching. En el poema cada verso tiene tantas palabras como los números de Fibonacci, del 1 al 21 (al final de cada verso, yo he incluido el número de Fibonacci que le corresponde, para que sea más ilustrativo el ejemplo).

Word crunching

I (1)

wrote (1)

a poem (2)

on a page (3)

but then each line grew (5)

by the word sum of the previuos two (8)

until I started to worry at all these words coming with such frecuency (13)

because, as you can see, it can be easy to run out of space when a poem gets all Fibonacci sequency (21)

Como segundo ejemplo traemos un poema de la serie Las torres de Fibonacci del joven poeta mexicano Esteban López Arciga, en el cual cada verso tiene tantas sílabas como los números de Fibonacci, de 1 a 34 (al final de cada verso, yo he incluido el número de Fibonacci que le corresponde, para que sea más ilustrativo el ejemplo). Aunque el poeta se salta en algunos casos la regla de las sílabas, siendo en ocasiones un número cercano al de la sucesión.

III

Creo (1+1)

que (1)

debo (2)

confesar (3)

las ocasiones (5)

en las que yo también lloré (8)

al saberme mortal, saber que moriría (13)

en penumbra, tan ignorante como al principio de mi existencia. (21)

No comprendo lo que mis ojos ven próximo o a lontananza, ni los sollozos de soledad que mi mente susurra. (34+2)

Veamos otro ejemplo, de Luis Alvaz, en el cual el número de sílabas crece y luego vuelve a decrecer.

[…]

si (1)

es (1)

el sol (2)

un río (3)

cantando mares (5)

y los fervientes planetas (8)

que rondan en el espacio como saetas (13)

son el comienzo en que las estrellas parecen retroceder del tiempo (21)

como el caracol que arremete siendo espectro silente en las comisuras de la tierra cuando parece dormitar (37/34)

y el arduo dilatar de los mares se transfigura en torrente sanguíneo (24/21)

como en los latidos superfluos de nostalgia (14/13)

cuando aparece un murmullo (10/8)

en las orillas (5)

que ciega (3)

al sol (2)

si (1)

es (1)

[…]

En este poema, da la impresión de que no está cumpliendo la propiedad de que el número de sílabas sean los números de la sucesión de Fibonacci, sin embargo, como vamos a ver, sí lo cumple. ¿Cómo es posible?

Según el diccionario de la RAE una “sinalefa” es “la unión en una única sílaba de dos o más vocales contiguas pertenecientes a distintas palabras, por ejemplo, mu-tuoin-te-rés por mu-tuo-in-te-rés”. En el anterior poema, si se tienen en cuenta las sinalefas sí se obtiene el número de sílabas que debería aparecer siguiendo la sucesión de Fibonacci. Por ejemplo, el verso “cuando aparece un murmullo” se divide en sílabas, teniendo en cuenta las sinalefas, de la siguiente forma “cuan-doa-pa-re-ceun-mur-mu-llo”, es decir, 8 sílabas, y no 10.

Existen páginas, con el objetivo de poder analizar poesías y textos literarios, en las que se pueden consultar el número de sílabas, de forma normal o teniendo en cuenta las sinalefas. Como, por ejemplo, la página Separar en silabas.

“Untitled (A Real Sum is a Sum of People) – Sin título (Una suma real es una suma de personas)”, 1972, del artista italiano Mario Merz, en la Tate Gallery

Varios colectivos de poetas que se han animado, o retado, a componer “poemas de Fibonacci”. Un ejemplo bastante conocido es Gregory K. Fincus, quien en 2006 propuso en internet la composición de Fibs, composiciones poéticas cortas, similares a los haikus, cuyo número de silabas por verso fuese 1/1/2/3/5/8 (números de la sucesión de Fibonacci), aunque no era la primera vez que se proponía algo de este estilo, este llamamiento tuvo mucha repercursión en las redes. Un ejemplo de Fib de Gregory K. Fincus es…

One

Small,

Precise,

Poetic,

Spiraling mixture:

Math plus poetry yields the Fib.

Si navegamos por internet descubriremos muchos ejemplos de fibs, o haikus de Fibonacci, incluso algunos libros. Por ejemplo, en la web Templo de elegías incluyen alguno como este…

Es

tu

amor

lo que me

mantiene firme

en esta dulce espera.

Y se sigue animando a la creación de este tipo de poemas cortos. Por ejemplo, en la página de la clase de Géneros Literarios del Colegio San José Superior de Caguas. Donde se incluyen algunos ejemplos y animan a las personas a enviar sus propias creaciones…

Luz

ruin.

Huyes

del día

acompasada

en tu andar hacia la noche.

Hay quien propone variaciones, como la octava de Fibonacci (en Mundo poesía), con ocho versos de 1, 1, 2, 3, 5, 8, 13 y 21 sílabas, con una posible rima dada (o no), como, por ejemplo, 1 1 2 3a 5a 8b 13b 21A. Un ejemplo…

Si

te

siembro

yacente

donde el poniente

esparce su ocaso adusto,

no esperaré los frutos en el tiempo justo.

Mas si así te complace, he aquí mi esfuerzo vano y el sudor de mi frente.

Para terminar con este tipo de poemas de Fibonacci, volvamos a otro ejemplo en el que el número de palabras va creciendo como en esta sucesión numérica (con alguna licencia). Es el poema en prosa Sucesión, del libro Hondura, del joven poeta Pedro José Morillas Rosa…

Si. Claro. Las puertas. Dios las abre. Contemos

una historia sin verso. A él lo operaban del

corazón hecho vendimia. Fue en Tegucigalpa

la primera vez, lo abrieron y cerraron sin hacer

hada. Eso le dijeron en los Estados adonde

llego después de la recaudación del relajo de

lempiras y el apoyo de amigos. Al poco de

conocerlo fue una de las pocas veces que he

visto un corazón con su hombre aparte y por

eso las tazas de café con su latido y la ventana

hecha venas. Ella tenía charcos en las cuencas,

relato que de repente había llaves para todas

las soldadas cerraduras y fue un éxito la

operación a pesar de lo delicado, le dieron seis

meses de ida y ahora que salían bien las cosas,

puesto el anillo en Time Square parecía que la

alegría estaba a la veleta. A falta de sístole no

hay nada como la pestaña estetoscopio de la

mujer que te quiere, ella estuvo a su lado

cuando empezaba a sonreír el endotelio,

entonces nunca se sabe la barbaridad que

puede haber al otro lado del teléfono: ha

muerto su padre de ni se sabe la de discaros, y

ella como una bestia que se alimenta de alarido

se trago la noticia y tenso Dios el tendedero de

su risorio, puestos a secar en ella los añicos: ha

caído algo enfermo tu papa. Lo cierto es que

era demasiado el impuesto de yerra y entonces

el día dieciocho sale de la casa para ir a la

venta de zapatos y ese día le toca irse de los

pies de la vida porque así deciden los seres sin

llama de la muerte sin ojos y el pésame

estanco. Durante varios días ella se calla la

roca, a veces el de arriba hace exagerado de

ventrílocuo y nos anuda pero luego son

inevitables los indicios, se entera, lo mira en

los periódicos. Hermano, Dios es grande, pero

uno nunca sabe sus delirios, en mi casa hacen

luto hasta los quecos y nadie atalanta. Muchas

gracias por el rezo, todo pasa por galgo, caza el

viento resoles. Se dan la mano, juntos son un

nido. Hay que prestar mucha aleación. El

corazón bate. Hay ritmo. Pum. Pum.

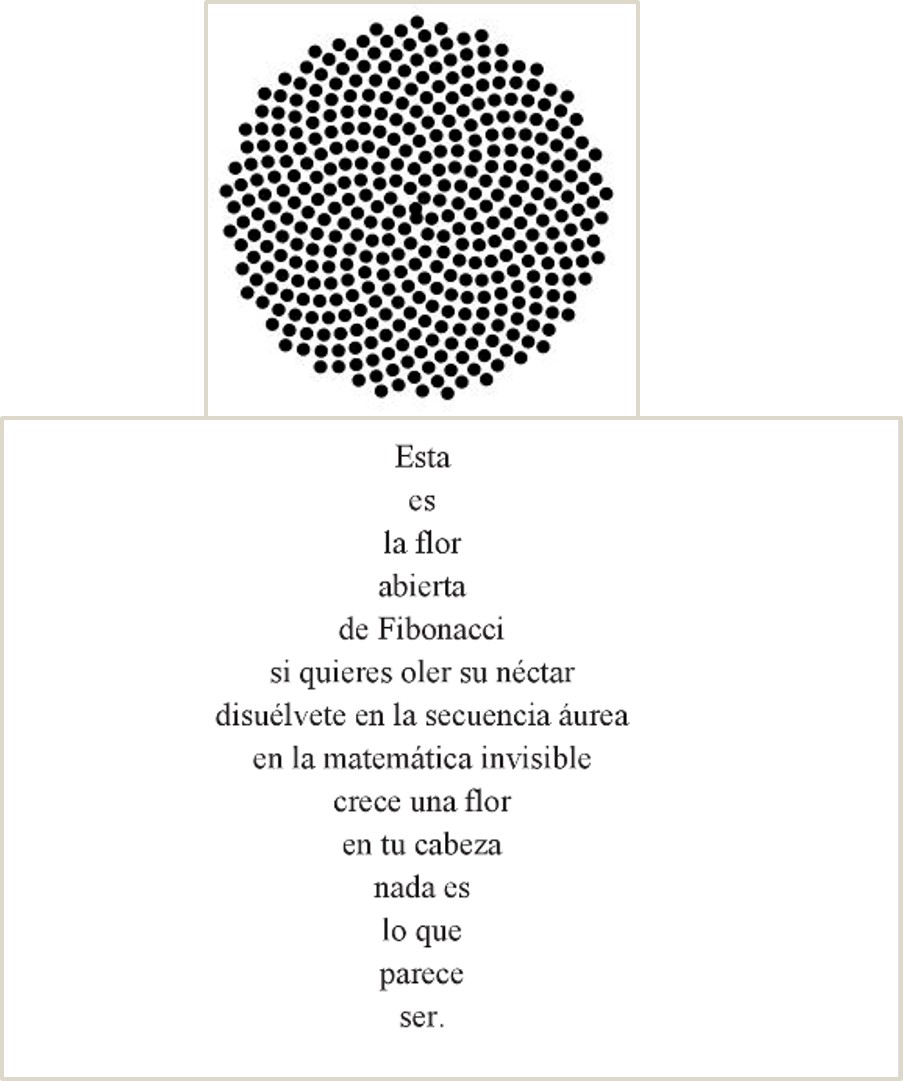

Pero, dejemos aquí estas interesantes composiciones poéticas, y terminemos con una poesía diferente. Este ejemplo es en gran medida temático, aunque la imagen del poema está relacionada con la aplicación de los números de Fibonacci a la naturaleza. El poema se titula Flor de Fibonacci y pertenece al libro Hachís (Poesía 2005-2011) del profesor de filosofía, guionista de comics y poeta barcelonés Ramón Pereira.

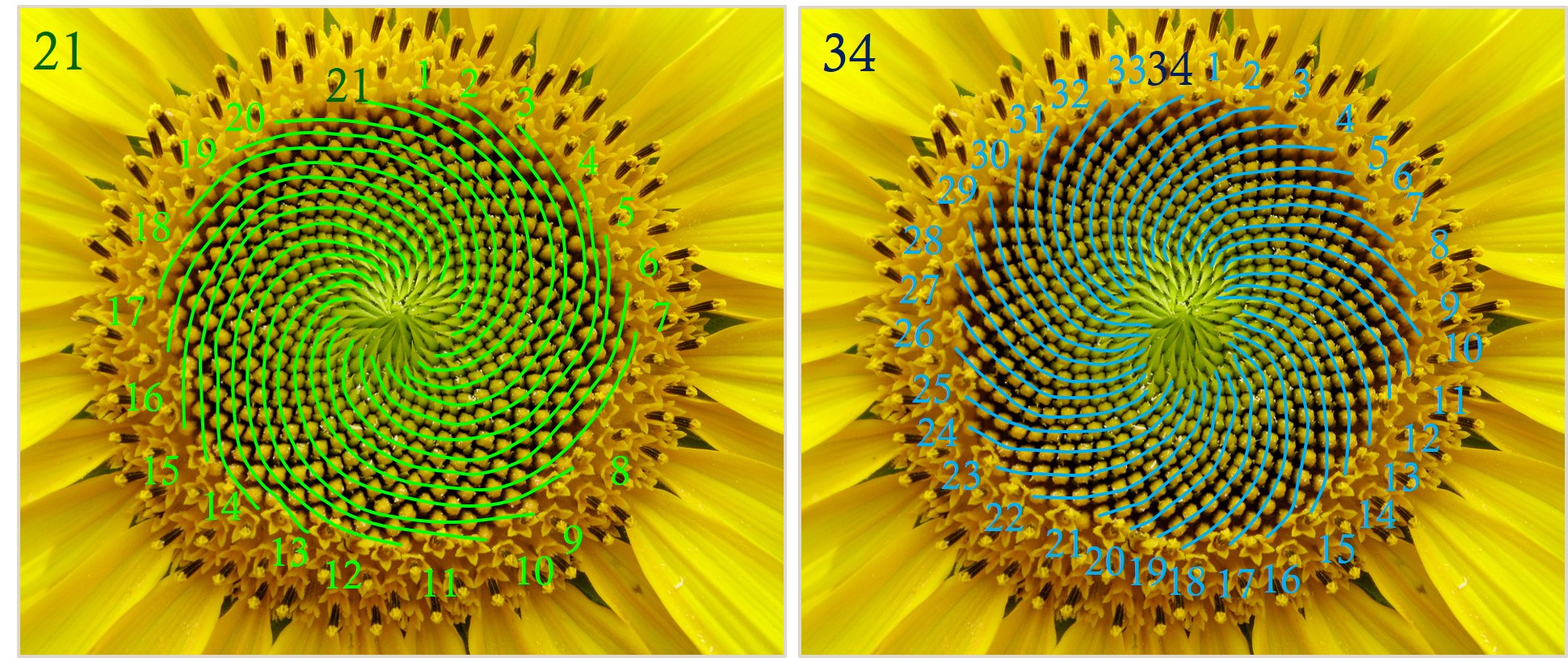

La imagen de esta poesía nos recuerda a una flor, e incluso un girasol. El motivo es que, como es conocido, si contamos la cantidad de espirales, en el sentido de las agujas del reloj y en el contrario, en la cabeza de un girasol, se obtienen dos números de Fibonacci consecutivos, de la misma forma que para otras flores, plantas y frutos.

El número de espirales, en ambos sentidos, de esta cabeza de girasol es 21 y 34, dos números consecutivos de Fibonacci

Obra “Fibonacci 116” del artista Jylian Gustin

Bibliografía

1.- Mario Livio, La proporción áurea, La historia de phi, el número más sorprendente del mundo, Ariel, 2006.

2.- Página web de la artista Cagney King

3.- Inger Christensen, Alfabeto (1981), editorial Sexto Piso, edición bilingüe danés-español, traducida por Francisco J. Uriz, 2014.

4.- Marta Macho, Alfabeto, de Inger Christensen, literatura y matemáticas, divulgamat, marzo, 2015.

5.- Marta Macho, Inger Christensen: letras abrazando a Fibonacci, mujeresconciencia, enero, 2016.

6.- Sarah Glaz, Poems structured by integer sequences, Journal of Mathematics and the Arts, vol. 10, p. 44-52, 2016.

7.- Página web de la poeta Judith Baumel

8.- Francisco Javier Guerrero, Las razones del agua, Adeshoras, 2017.

9.- Marta Macho, ¡Nos encanta Fibonacci! Cuaderno de Cultura Científica, 2018.

10.- Brian Bilston’s poetry Laboetry

11.- Esteban López Arciga, Las torres de Fibonacci, Revista colectiva El Fractalario, julio, 2014.

12.- Luis Alvaz, El rincón del Poeta

13.- Página web del escritor Greg Pincus

14.- Página web de la clase de Géneros Literarios del Colegio San José Superior de Caguas

15.- Mundo poesía

16.- Pedro José Morillas Rosa, Hondura, Lulu, 2016.

17.- Ramón Pereira, Hachís (Poesía 2005-2011), Lulu, 2012.

18.- Página web del artista Jylian Gustin.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Poemas Fibonacci se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¡Nos encanta Fibonacci!

- Los números (y los inversos) de Fibonacci

- El origen poético de los números de Fibonacci

La regulación osmótica e iónica en los teleósteos marinos

Algunos peces teleósteos en una ilustración de “Expédition dans les parties centrales de l’Amérique du Sud, de Rio de Janeiro à Lima et de Lima au Para sous la direction du Comte Francis de Castelnau” (1856)

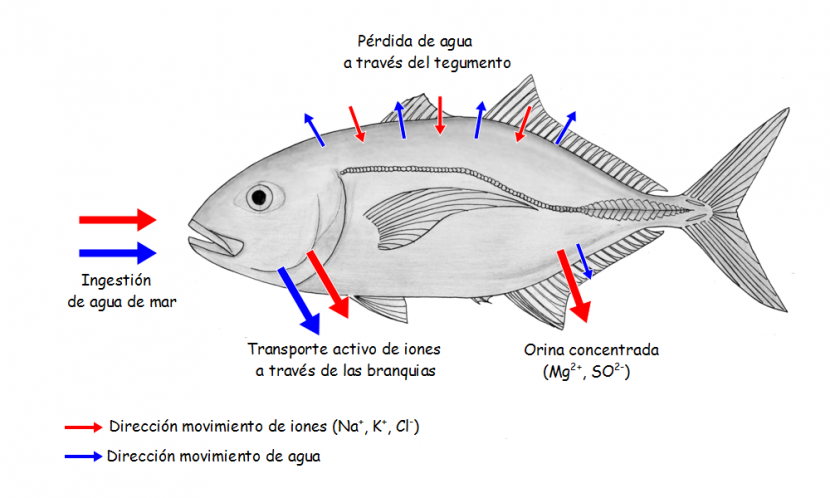

La concentración osmótica del medio interno de los teleósteos marinos está muy por debajo de la concentración del medio en el que viven. El agua de mar tiene una osmolaridad de unos 1000 mOsm (miliosmolar) y la de los peces óseos se encuentra normalmente entre 300 y 400 mOsm, aunque en algunos casos puede ser algo mayor. La diferencia, como se puede apreciar, es muy importante. De hecho, son valores muy próximos a los de los teleósteos de agua dulce (entre 250 y 350 mOsm), proximidad que refleja el común origen dulceacuícola de todos ellos.

Los teleósteos marinos son, por lo tanto reguladores osmóticos, como lo son los de agua duce; lo que ocurre es que estos son reguladores hiposmóticos, puesto que mantienen la concentración interna por debajo de la exterior. Dada su condición hiposmótica con respecto al medio en el que se encuentran, han de hacer frente al riesgo de desecación que tal condición comporta. En estos animales el agua tiende a salir del medio interno a favor del gradiente de concentración. Lo curioso, sin embargo, es que el flujo osmótico de agua hacia el exterior no es tan intenso como cabría esperar de un gradiente tan fuerte (de unos 600 mOsm l-1). En principio podría pensarse que en los peces marinos el flujo de agua hacia el exterior del organismo es mucho mayor que el que experimentan los peces de río en sentido opuesto (hacia el interior), dado que en estos el gradiente osmótico con el medio externo es muy inferior (de unos 300 mOsm l-1). Sin embargo, ambos flujos son de magnitudes no muy diferentes si bien, como es lógico, de sentido contrario. La razón de que el flujo de salida de agua de los teleósteos marinos no sea demasiado intenso es que sus tegumentos han alcanzado un mayor grado de impermeabilización que los de los teleósteos de río y de esa forma compensan el efecto del mayor gradiente osmótico. Nos encontramos, por lo tanto, con que la impermeabilización del tegumento opera en los teleósteos marinos como barrera frente a la desecación, de la misma forma que operaba en los de agua dulce frente a la dilución.

El otro riesgo que han de conjurar los reguladores hiposmóticos es el de la entrada de sales en su organismo por difusión, dado que Na+ y Cl–, principalmente, y demás iones inorgánicos propios del agua de mar se encuentran mucho más concentrados en el medio externo que en el interno. El Na+, no obstante, tiene escasa tendencia a entrar o puede no tenerla, puesto que la cara interna del epitelio branquial –principal enclave por el que podría producirse su difusión- está cargada positivamente, por lo que el gradiente electroquímico no favorece la entrada. Ocurre lo contrario con el ión Cl–, dado que no solo el gradiente de concentración es favorable; también lo es el gradiente eléctrico. Existe, por lo tanto, una fuerte tendencia del Cl– a difundir hacia el interior.

El principal mecanismo que ponen en juego los teleósteos marinos para contrarrestar las pérdidas de agua consiste en beber. Al contrario que los de agua dulce, los marinos sí beben. En general, beben diariamente un volumen de agua que representa entre un 10% y un 20% de su masa corporal, aunque algunos no llegan al 1% diario y otros llegan al 50%. Ahora bien, de la misma forma que en los de agua dulce la producción de una orina copiosa generaba un problema de economía de iones inorgánicos (porque tienden a perderlos a través de la orina), en los marinos beber conlleva también serias complicaciones en lo relativo a la regulación de los flujos de sales, como veremos a continuación.

Al ingerir agua con alta concentración de sales inorgánicas, como la de mar, lo lógico es que esa agua no solo no sea absorbida, sino que, de hecho, el flujo osmótico se produzca en sentido contrario. Esto es, dado que la concentración salina y la osmótica total es muy superior en el contenido digestivo que en el plasma sanguíneo, cabe esperar que el agua fluya a favor de gradiente osmótico del medio interno a la luz intestinal. Y de hecho, eso es lo que ocurre durante buena parte del recorrido que sigue la ingesta a lo largo del sistema digestivo. Llega un momento, no obstante, en que el contenido intestinal aumenta y se diluye hasta que su concentración osmótica se iguala con la de la sangre. Bajo esas circunstancias se produce la absorción de agua. El agua se absorbe gracias a un proceso denominado transporte cuasi-isosmótico de fluidos que propicia su paso a la sangre, aun cuando los fluidos intestinales y el plasma son prácticamente isosmóticos. El movimiento de agua es posible gracias a la generación, mediante la absorción activa de iones monovalentes, de gradientes osmóticos locales en ciertas áreas del epitelio; parece ser que las acuaporinas del epitelio intestinal juegan un papel importante en ese proceso. De esa forma se puede llegar a absorber hasta un 85% (un 50% mínimo) del agua ingerida, aunque a cambio, casi todo el NaCl presente en ese agua es también absorbido, con lo que el problema que representa la regulación de las concentraciones iónicas se agrava. Los iones divalentes (SO4-2 y Mg+2, principalmente) se absorben en mucha menor medida que los monovalentes y son, en gran parte, eliminados con las heces.

Como hemos señalado antes y se ha podido comprobar, la regulación del contenido hídrico dificulta la regulación del contenido en sales de la sangre, puesto que para mantener el volumen de agua es necesario incorporar iones monovalentes. Es preciso, por lo tanto, eliminar esas sales. Los pocos iones divalentes absorbidos se eliminan en la orina que, en los teleósteos marinos, es isosmótica con el plasma y muy escasa (entre un 0,5 y un 3,5% del peso corporal por día). Hay dos poderosas razones para producir poca orina: (1) se pierde así poca agua por esa vía, y (2) dado que el agua que entra en estos peces está mucho más concentrada que el medio interno, si produjesen mucha orina, se retendría una cantidad excesiva de solutos en el plasma, solutos que habría que eliminar de otra forma.

Los iones monovalentes Na+ y Cl–, que han entrado del exterior a través del tegumento y desde el fluido intestinal, han de ser expulsados. Ya hemos visto que eso no ocurre a través de la orina. Son las branquias las encargadas de cumplir esa función. En concreto, son las células ricas en mitocondrias, también llamadas células de cloruro, las responsables de transportar el exceso de iones monovalentes al exterior. En aproximadamente la mitad de especies de teleósteos marinos, el transporte es exclusivamente de Cl–, porque el Na+ difunde al exterior a favor del gradiente eléctrico que genera el movimiento del anión. En otras especies ambos iones son transportados activamente. En los teleósteos marinos la eliminación de NaCl se produce, por lo tanto, de forma extrarrenal y es un proceso de gran relevancia cuantitativa, hasta el punto de que se puede afirmar que las branquias son el principal órgano osmorregulador de estos peces.

Los procesos de transporte activo de sales a que se ha hecho mención aquí son energéticamente costosos. La osmorregulación representa en los teleósteos marinos entre un 8% y un 17% del gasto metabólico basal. Eso es mucho. En los de agua dulce ese gasto es aproximadamente la mitad porque, como se dijo al comienzo, el gradiente osmótico es muy superior en los peces marinos, el doble aproximadamente que en los de agua dulce.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La regulación osmótica e iónica en los teleósteos marinos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La regulación osmótica de los animales de agua dulce

- Animales en equilibrio osmótico: invertebrados marinos y peces bruja

- Regulación de la circulación (1): control del sistema cardiovascular

Reflexiones sobre la gravedad

Hemos visto que la luz viaja siguiendo el camino más corto disponible. En relatividad general los cuerpos que no están sometidos a fuerzas también siguen el camino más corto, esto es, los cuerpos en general se mueven siguiendo geodésicas.

Pero, si lo anterior es cierto, de ahí se sigue que un planeta, que es un cuerpo, no se mueve como lo hace porque exista una fuerza atractiva mutua, simplificando, con la estrella que orbita. Marte, por ejemplo, no se mueve en una órbita elíptica alrededor del Sol debido a nada que tenga que ver con una fuerza de atracción mutua, una “fuerza de la gravedad”, entre Marte y el Sol. Marte, como todo cuerpo en movimiento, se estaría moviendo en una línea recta en un espaciotiempo curvo.

Una línea recta en un espaciotiempo curvo es una geodésica. Según la relatividad general, la masa del Sol provoca una curvatura del espaciotiempo. Y según las ecuaciones de la relatividad general, esta curvatura es tal que la geodésica según la cual debería moverse Marte sería lo que nosotros interpretamos como una elipse con el Sol posicionado en uno de sus focos.

En otras palabras, en relatividad general no existe una “fuerza” atractiva entre los cuerpos con masa como Marte y el Sol. En vez de eso, Marte simplemente se mueve en una línea recta, pero debido a la curvatura del espaciotiempo, esta “línea recta” tiene la apariencia de ser una elipse alrededor del Sol. Esto es una desviación significativa de las ideas de Newton…o tal vez no.

En el cuadro que pinta Newton la gravedad sería una fuerza atractiva entre objetos con masa. Pero, si esta fuerza se toma en sentido realista [*], estamos ante un caso de una acción a distancia. La mera idea de la acción a distancia era inadmisible para Newton y, como resultado, el no afirma que la gravedad sea una fuerza atractiva, sino que una fórmula que lo asume describe lo que se observa. Ni siquiera hacía hipótesis para explicar por qué funciona. Esto es, la actitud de Newton es perfectamente compatible con la de los calculistas de órbitas de una agencia espacial que emplean las fórmulas de Newton porque funcionan, aún a sabiendas de que la teoría general de la relatividad da otra descripción de la realidad, más fidedigna, pero mucho más prolija matemáticamente.

Sin embargo, y a pesar de las afirmaciones del propio Newton sobre la materia, la mayor parte de la gente que ha crecido en la cosmovisión newtoniana tiende a tomar una actitud realista frente a la llamada fuerza de la gravedad. Si pregunto, por ejemplo, ¿por qué cae la manzana? La respuesta automática es “por la fuerza de la gravedad”; si ahora pregunto si esta fuerza es real, lo más normal es recibir una mirada extrañada y un “por supuesto que sí”. Esto es, mucha gente eleva la aproximación instrumentalista de Newton a descripción precisa de la realidad.

Por lo tanto, siendo la teoría general de la relatividad (que incluye la especial como caso particular) una teoría sólidamente confirmada, supone un reto para la cosmovisión de la mayoría, obligando a adoptar una actitud instrumentalista ante lo que hasta ese momento es nuestra descripción por defecto de la realidad. Quizás por eso todavía sean legión los que intentan negarla (a ella y a su autor), no por ciencia, sino por ideología.

Nota:

[*] Más sobre realismo e instrumentalismo en nuestros Incompletitud y medida en física cuántica: esperando a Didinberg, donde se trata de las diferencias filosóficas entre Hawking (instrumentalista à la Newton) y Penrose (realista à la Einstein), y Galileo vs. Iglesia Católica redux: Reconvención donde la primera adopta una actitud instrumentalista frente a la teoría heliocéntrica mientras que la de Galileo es realista.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Reflexiones sobre la gravedad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La relatividad de la masa

- Generalización de la invariancia: principios de covariancia y equivalencia

- Espaciotiempo

Historias de la malaria: Las drogas sintéticas

En 1941, en Estados Unidos y al comienzo de la Segunda Guerra Mundial para este país, una orden presidencial inició las investigaciones sobre la malaria como objetivo de guerra. Fue el llamado “Proyecto Manhattan Biológico”. Entre otros objetivos, uno de los más importantes era la producción de drogas antimalaria pues las plantaciones de árbol de la quina en la Indonesia holandesa, que suponían el 97% del comercio mundial de este fármaco, estaban en peligro de caer en manos japonesas, lo que ocurrió poco después del Pearl Harbor.

El programa incluía el ensayo de compuestos químicos con posible actividad antimalárica. Con la cooperación de compañías farmacéuticas y de sus programas de síntesis de nuevos compuestos, para el final del programa, en 1945, se habían ensayado más de 16000 compuestos.

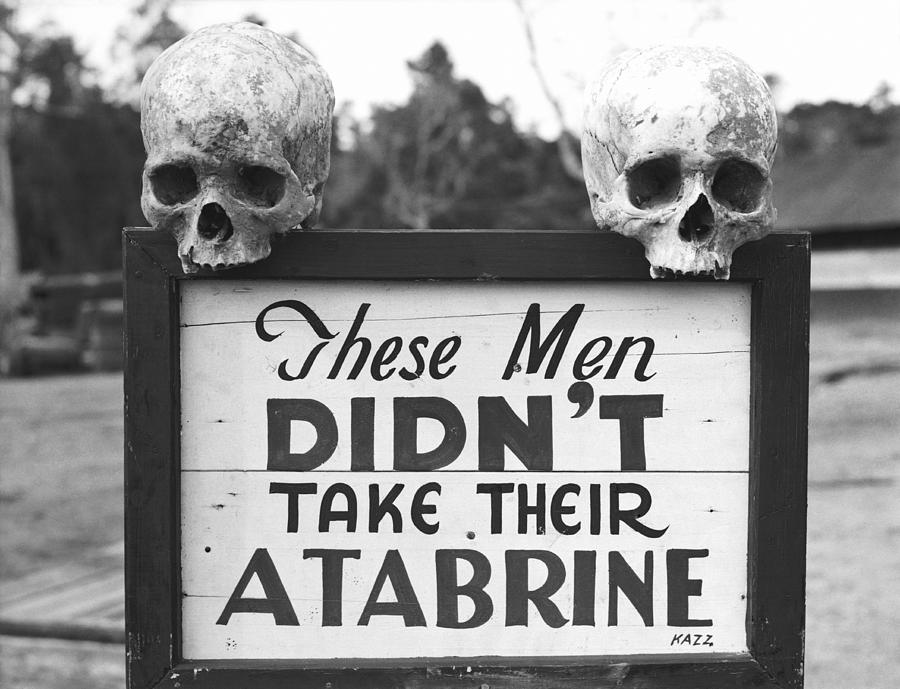

“Estos hombres no tomaron su Atabrina”. Cartel en un campamento del ejército de los Estados Unidos en el Pacífico durante la Segunda Guerra Mundial.

Cuando comenzó la guerra, solo la quinina y la quinacrina o Atebrina eran drogas antimaláricas eficaces. Pero, como decía, la producción de quinina cayó bajo el empuje japonés y, además, la Atebrina se fabricaba en la Alemania de Hitler. Se racionó el uso de quinina para civiles y se aceleró la plantación de árboles de la quina en Centro y Sudamérica, en concreto en Costa Rica, Perú, Ecuador y otros países. Pero las necesidades militares de drogas contra la malaria eran mucho mayores que el suministro posible de quinina. Gran parte de la guerra tenía lugar en áreas geográficas con malaria endémica. Y así comenzó el programa de ensayos de fármacos con posible acción contra la malaria.

Buscaban drogas que atacaran al plasmodio, tal como lo hacía la quinina, o sea, en la fase de su ciclo vital en que se encuentra en los glóbulos rojos del paciente. Con sucesivas dosis en el tiempo se conseguía eliminar el plasmodio, siempre teniendo en cuenta la especie de plasmodio de que se trate: el falciparum en semanas, el vivax en meses, y el malariae en años. Por tanto, las especies del plasmodio respondían de manera diferente a los fármacos ensayados.

Los primeros ensayos se hicieron con la plasmoquina a partir de 1925, y con la Atebrina, en 1929, buscando las dosis y los tiempos más adecuados. Se demostró que eran más eficaces y menos tóxicos que la quinina, sobre todo la Atebrina. Ambos fármacos se descubrieron en los laboratorios de Eberfeld de la empresa Bayer. Era el primer programa sistemático de investigación sobre compuestos sintéticos antimaláricos. Se inició al final de la Primera Guerra Mundial. Cuenta David Greenwood, del Instituto Wellcome de Historia de la Medicina de Londres, que, durante la Primera Guerra Mundial, en Alemania, sin el suministro de quinina de las plantaciones de las colonias holandesas de Indonesia, con la enorme extensión de la guerra por todo el planeta, incluyendo zonas tropicales y subtropicales, llevaba a soldados europeos a zonas con malaria endémica. Eran muy necesarias las drogas antimaláricas sintéticas. Además, al perder la guerra, Alemania se vio fuera de los centros mundiales de comercio de la quinina.

Para entonces ya ya se habían elaborado protocolos muy precisos para la quinina y la Atebrina. Había llegado el momento de seguir el mismo método con los fármacos nuevos que se estaban ensayando y que mostraban actividad antimalárica en una prueba previa, rápida y sencilla, con aves de laboratorio contagiadas con el plasmodio. Ochenta compuestos llegaron a los ensayos clínicos y, aunque ninguno llegó a tiempo de utilizarse en la Segunda Guerra Mundial, uno de ellos, la cloroquina, demostró una gran eficacia contra la malaria.

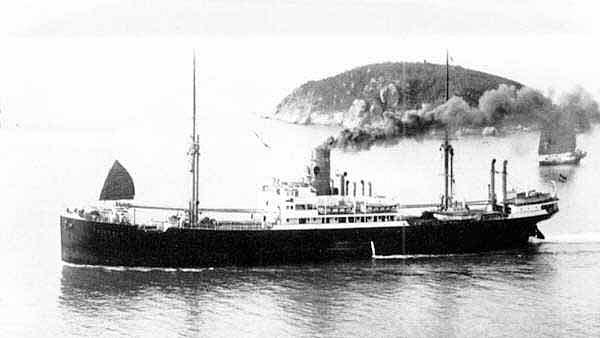

El “Friederun”

Pero ahora volvamos atrás en el tiempo, a Alemania en 1925. Allí se sintetizó la plasmoquina, que fue el primer compuesto sintético antimalaria que se ensayó con un grupo amplio y con tiempo suficiente para sacar conclusiones precisas. Se trató la tripulación del vapor Friderun de la compañía Hamburg-Bremer Afrikanlinie. Llegó a los mercados en 1927, aunque solo era medianamente eficaz en el tratamiento a los enfermos. Es interesante conocer que uno de los primeros ensayos de la plasmoquina lo hizo Wilhelm Roehl, uno de sus descubridores, en Talavera de la Reina, con gran éxito y mayor eficacia que la quinina.

Más potente era la quinacrina, y conocida como Atebrina, se sintetizó en 1930 y se comercializó en 1932. Se ensayó México y Venezuela y demostró ser más eficaz que la quinina pero, como derivaba de la química de los colorantes artificiales, teñía de amarillo la piel y los ojos de los pacientes y, por ello, no era muy popular.

Y en 1934, Hans Andersag, de la Bayer, sintetizó en Eberfeld una nueva droga, muy eficaz, y a la que llamó Resochin, y se reconoció su eficacia en 1940. Parecía algo tóxica para los enfermos, algo más que la Atebrina en animales de laboratorio y los alemanes la descartaron. Años después todo el mundo la conocería como cloroquina cuando se estudió en Estados Unidos durante y después de la Segunda Guerra Mundial. Su descarte en Alemania se debió a una equivocación en el archivo de las pruebas de laboratorio que se le hicieron. Desde entonces, esta historia se conoce como el “Error Resochin”.

Con estas confusiones en la evaluación de la droga que, años más tarde, sería la cloroquina y con las peticiones ingentes de los ejércitos, sobre todo en el Pacífico y la India y Birmania, en Estados Unidos se sintetizó Atebrina a partir de 1942, en aquel momento el fármaco más eficaz y asequible contra la malaria, aunque tiñera de amarillo la piel de los soldados.

En 1936, de nuevo Hans Andersag y su grupo sintetizaron una variante del Resochin, muy eficaz y menos tóxica, que llamaron Santochin y, en este caso, menos tóxica que la Atebrina. Ensayaron el Santochin, en1939, en el Instituto de Enfermedades Tropicales de Hamburgo con resultados excelentes y prometedores. Con todos estos estudios, la I.G. Farben patentó en 1939 hasta 23 compuestos con una fórmula muy parecida y, entre ellos, estaban el Resochin y el Santochin.

Las filiales o empresas colaboradoras de I.G. Farben en Francia y Estados Unidos prepararon y ensayaron el Santochin . La empresa francesa, Spezia, sintetizó el Santochin y, por ello, la ensayó Schneider en el norte de África, en concreto en Túnez. Y cuando llegaron las muestras de este fármaco a Estados Unidos, después de la invasión del norte de África, la filial de Estados Unidos, la empresa Winthrop, ya la había sintetizado y archivado.

La Winthrop fabricó una pequeña cantidad en 1940 y la envió a Nueva York para que se ensayara su eficacia contra la malaria. Funcionó bien y los datos del ensayo volvieron a la Winthrop que no los difundió hasta dos años después. En realidad, la empresa esperó hasta conseguir un acuerdo con el gobierno para que se respetara su patente. En detalle, ocurrió que en octubre de 1940, una pequeña cantidad de cloroquina se sintetizó en la Winthrop, filial de la I.G. Farben alemana en Estados Unidos, y se envió a Nueva York para su ensayo. Dos años más tarde, en 1942, se informó de su eficacia y, en enero de 1943, se ordenó continuar los ensayos con el compuesto que, por entonces, se clasificó y nombró como SN-183.

Sin embargo, por un error todavía no muy claro, se archivó como sustancia tóxica y se dejaron los ensayos. Parece ser que se rechazaron todos los compuestos del grupo llamado 8-aminoquinoleínas, y se incluyó el SN-183 que, en realidad, era una 4-aminoquinoleína.

En 1942 los aliados invaden el norte de África y un médico militar francés, el doctor Schneider, organiza ensayos clínicos con una droga antimalaria capturada a los alemanes. Se llama Santochin, es eficaz contra la malaria, y Schneider entrega un informe con los resultados y 5000 pastillas a los norteamericanos que, con rapidez y en 1943, envían todo ello a Washington. Pero hay algún error burocrático y pastillas e informe se separan durante el traslado y, además, se tarda en traducir el informe del francés al inglés.

Pasan seis meses antes del análisis del Santochin y, entonces, se descubre, con sorpresa y, quizá, con enfado y algo de histeria por el error, que es el mismo compuesto rechazado y que está archivado como SN-183. Por si fuera poca la confusión, existe una escasa y difícil de encontrar bibliografía que indica que los mismos compuestos se están ensayando en la URSS y se ha demostrado su eficacia contra la malaria.

De inmediato se borra este número, el SN 183, de los archivos y se sustituye con el SN-6911 que servirá para el antiguo SN-183 y para el Santochin puesto que ahora se sabe que son el mismo compuesto. Cuando se reanudan los ensayos con el antiguo SN-183 y los compuestos cercanos, se encuentra uno más eficaz que la Atebrina, el SN-7618. Se le elige como droga antimalaria oficial para las fuerzas armadas y, en 1946, se la nombra oficialmente como cloroquina cuando llegó a los pacientes. Los ensayos habían comenzado en 1944; se ensayó en 5000 personas y se consiguió un protocolo de dosis adecuado para evitar daños tóxicos secundarios.

También hay que citar como fármaco eficaz el Proguanil, sintetizado por ICI en Inglaterra en 1944.

En Estados Unidos, el interés por las drogas antimalaria reapareció con las guerras de Corea y Vietnam. En Corea se ensayó la primaquina, con buenos resultados y baja toxicidad, y, en Vietnam, se detectó la resistencia del Plasmodium falciparum a la cloroquina. Entonces se reactivó el programa de ensayos de nuevos compuestos que había funcionado durante la Segunda Guerra Mundial. Entre 1963 y 1976, se habían probado más de 300000 y 1600 tenían efecto sobre la malaria, con siete nuevas drogas muy eficaces y solo cinco de ellas llegaron a la práctica clínica, entre ellas la mefloquina y la halofantrina. También en este programa se concluyó que eran muy eficaces contra la enfermedad las mezclas de drogas incluyendo antibióticos en algunos casos, aunque, también, eran tratamientos de 10 a 20 veces más caras que los fármacos habituales. Sin embargo, todos estos fármacos tan caros son un problema para muchos países con malaria endémica y, además, pueden provocar la aparición de resistencia en el plasmodio. Pronto fue evidente que todas las drogas, excepto la quinina, provocaban la resistencia en los plasmodios y, por ello, la continua búsqueda de nuevos compuestos no tiene fin.

Las primeras evidencias de estas resistencias se conocieron en la década de los sesenta. En 1959 en Colombia y en 1960 en Thailandia ya había cepas de falciparum resistentes a la cloroquina, pero en 1987 había cepas en 25 países de Asia sudoriental y norte de Sudamérica y en otros 18 países de África. Ahora, en los países con malaria endémica no funciona la cloroquina. Doce años se necesitaron para que apareciera la resistencia a la cloroquina pero, para el proguanil, solo un año. Hay expertos que aseguran que, de media, se necesita un fármaco nuevo cada siete años. Y para la quinina, utilizada desde hace 400 años, casi no ha aparecido resistencia.

Artemisia annua

En la década de los setenta, aunque veremos que todo empezó años antes, aparece una nueva droga en China, la artesiminina, que se aisló en 1971 y deriva de la planta Artemisia annua. En la medicina tradicional china se utilizaba esta planta en infusión contra la fiebre. Es eficaz contra el plasmodio y, además, bloquea la trasmisión de humanos a mosquitos.

La historia de este fármaco comenzó en los años de Mao Tse Tung y la Revolución Cultural. En la guerra de Vietnam, la malaria provocada por el falciparum resistente a la cloroquina, la droga más utilizada desde 20 años antes en todo el mundo, provocó muchas bajas entre los combatientes. Los Estados Unidos, con su potente estructura científica, consiguió la mefloquina que, en los setenta y con una sola dosis, eliminaba el plasmodio. Pero Vietnam del Norte, sin infraestructura científica, pidió ayuda a China.

Por orden del Presidente Mao, se celebró en Pekín una reunión en 1967 para debatir sobre la malaria provocada por la resistencia del plasmodio. Así se inició el programa llamado proyecto 523, tal como cuentan Louis Miller y Xinzhuan Su, de los Institutos Nacionales de la Salud. Contaba el proyecto con unos 500 científicos de 60 centros de investigación. Para 1969 ya tenían tres tratamientos en ensayo pero, a medio y largo plazo, se marcaron otros dos objetivos: probar la capacidad antimalaria de productos químicos sintéticos y estudiar las prácticas y las recetas de la medicina tradicional china.

Tu Youyou en su época de estudiante, en los primeros años cincuenta. Ella no llegaría a obtener el doctorado porque en aquella epoca no existían los estudios de posgrado en China.

Era un proyecto militar y secreto y nunca se publicó ninguno de los resultados que se obtuvieron. Nadie de fuera del proyecto 523 conocía lo que allí se investigaba. Por tanto, nadie sabe con exactitud cómo se descubrió la artemisinina. Por lo que sabemos, el equipo de Tu Youyou, del Instituto de Malaria Médica China, fue el que, en enero de 1969, comenzó una revisión de la literatura escrita y oral y de las recetas de la medicina tradicional china. Los resultados se empezaron a conocer en el resto del mundo en 1979 con noticias, firmadas por todo el grupo del proyecto 523, y publicadas en el Chinese Medical Journal. Y fue Tu Youyou quien presentó en octubre de 1981 y en Pekín, los hallazgos del proyecto 523 a la Organización Mundial de la Salud.

El grupo de Tu Youyou investigó más de 2000 recetas de la medicina tradicional china y seleccionaron 640 con posible actividad antimalaria. Ensayaron 200 recetas y 380 extractos de plantas con animales de laboratorio y, entre ellas, estaba la Artemisia annua conocida en China como Quinghao. El grupo, con esta planta, siguió una receta escrita 2000 años atrás: “Tome un racimo de Quinghao y póngalo a remojo en medio litro de agua, agítelo hasta obtener su jugo y tómelo hasta terminarlo”.

El resultado era prometedor pero algo escaso en cuanto a la efectividad contra la malaria. Obtenían el jugo calentando en los disolventes habituales para la extracción química de compuestos de plantas. Tu Youyou planteó la hipótesis de que, según la receta tradicional, quizá había que extraer el componente a baja temperatura y que el calor lo destruía. Y así obtuvieron la artesiminina a baja temperatura con etanol y éter.

El extracto era algo tóxico pero el grupo consiguió atenuar la toxicidad. El ensayo de su capacidad antimalaria llegó al 100% en octubre de 1971. Era el extracto número 191. Estos resultados se presentaron en una reunión del grupo celebrada en Nanjing en 1972. Pronto otros equipos del proyecto 523 consiguieron artemisinina cristalizada. Se ensayó en clínica y se demostró eficaz contra la malaria. Y en los ochenta comenzó a utilizarse en áreas geográficas con malaria endémica. En 2008 se detectaron los primeros casos de resistencia en Camboya.

Por estos estudios sobre la artemisinina, Tu Youyou recibió el Premio Nobel de Medicina en 2015.

Sin embargo, preparar la artesiminina supone casi año y medio desde que se planta la Artemisia annua hasta que se recolecta, procesa y purifica la droga. Es cara y poco disponible. Se disuelve mal en agua y se mantiene poco tiempo en el plasma sanguíneo. Necesita, por tanto, tratamientos prolongados.

Se comenzó a cultivar la planta en cantidad en 1987 en China, Vietnam y zonas de África. Se comercializó en 1992 y se han conseguido derivados semisintéticos igualmente eficaces. Ahora se ensayan otras variantes en la producción como la inserción de los genes implicados de la planta en bacterias, cultivar estas y que produzcan en cantidad y con rapidez el fármaco.

En la actualidad, Osakidetza – Servicio Vasco de Salud y el Servicio de Sanidad Exterior del Ministerio de Sanidad, Servicios Sociales e Igualdad español, recomiendan a los que viajan a países con malaria endémica el uso de diferentes fármacos aunque declaran que “ningún régimen farmacológico actual garantiza una protección completa frente a la malaria”. Detrás de esta precisión están las resistencias del plasmodio que aparecen y cambian sin cesar. Los fármacos que recomiendan son la cloroquina (Resochin), cloroquina más proguanil, mefloquina y mezclas que incluyen antibióticos.

No hay que olvidar que, a pesar de las resistencias, la cloroquina sigue siendo el antimalárico más utilizado. Por ejemplo, en una revisión publicada en 1987 por Leonard Jan Bruce-Chwatt, del Instituto Tropical Wellcome de Londres, se enumeran hasta seis grupos de fármacos antimalaria aunque sigue considerando la cloroquina como el más eficaz y la quinina como el que menos resistencia ha provocado en el plasmodio de la malaria. Todavía en 2006 y, a pesar del desarrollo de resistencias, la cloroquina sigue siendo, en África, el fármaco antimalaria más utilizado, tal como cuenta Claire Panosian Dunavan, de la Universidad de California en Los Angeles.

Referencias:

Achan, J. et al. 2011. Quinine, an old anti-malarial drug in a modern world: role in the treatment of malaria. Malaria Journal 10: 144.

Amaro Lasheras, J. 1955. Los últimos años del paludismo en Marruecos. Instituto de Estudios Africanos,. CSIC. Madrid. 111 pp.

Bohle, F.J. & R. Alstaedter. 1988. 100 años de investigación y progreso. Bayer-Pharma 1988. Bayer AG. Leverkusen.

Bruce-Chwatt, L.J. 1987. Malaria and its control: Present situation and future prospects. Annual Review of Public Health 8: 75-110.

Clavero del Campo, G. 1950. La lucha antipalúdica en España. Revista de Sanidad e Higiene Pública 24: 149-177.

Coatney, G.R. 1963. Pitfalls in a discovery: The chronicle of chloroquine. American Journal of Tropical Medicine and Hygiene 12: 121-128.

Earle, D.P. 1979. A historical of malaria and its ironies. Transactions of the American Clinical and Climatological Association 90: 1-26.

Greenwood, D. 1995. Historical pespective. Conflicts of interest: the genesis of synthetic antimalarial agents in peace and war. Journal of Antimicrobial Chemotherapy 36: 858-872.

Haberkorn, A. et al. 2001. Milestones of protozoan research at Bayer. Parasitology Research 170: 1693-1702.

Maher, B.A. 2004. Fever Pitch. The Scientist May 24.

Mesa Vanegas, A.M. 2017. Perspectiva histórica de antimaláricos de origen natural. Anales de la Real Academia Nacional de Farmacia 83: 167-174.

Miller, L.H. & X. Su. 2011. Artemisinin: Discovery from the Chinese herbal garden. Cell 146: 855-858.

Padmanaban, G. et al. 2007. Drugs and drug targets against malaria. Current Science 92: 1545-1555.

Palacios, C. 1984. La lucha contra la malaria. Algo noviembre: 58-61.

Panosian Dunavan, C. 2006. Prevención y tratamiento de la malaria. Investigación y Ciencia febrero: 6-13.

Quinghaosu Antimalaria Coordinating Rsearch Group. 1979. Antimalaria studies on Quinghaosu. Chinese Medical Journal 92: 811-816.

Shah, S. 2010. The fever. How malaria has ruled humankind for 500000 years. Picador. New York. 309 pp.

Suh, K.N. et al. 2004. Malaria. Canadian Medical Association Journal 170: 1693-1702.

Wadhwa, V. et al. 2010. The history and progression of malaria: A global and regional view. En “Malaria in South Asia”, p.1-27. Ed. por R. Akhtar et al. Springer Science + Business Media.

Wikipedia. 2017. Artemisisa annua. 29 noviembre.

Wikipedia. 2017. Artemisinina. 1 diciembre.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Historias de la malaria: Las drogas sintéticas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historias de la malaria: El mosquito

- Historias de la malaria: Charles Louis Alphonse Laveran y el protozoo

- Historias de la malaria: El charlatán y caballero Sir Robert Talbor

Modernos gracias a las más viejas

El ciclo de vida de los seres humanos tiene algunos rasgos que nos diferencian claramente de nuestros parientes los grandes simios: maduramos más tarde, crecemos más lentamente, somos más fecundos y vivimos bastantes más años. En las mujeres, además, la mayor longevidad supone la superación, con la menopausia, del periodo de fertilidad.

De acuerdo con la “hipótesis de la abuela” la gran explosión demográfica y el éxito de nuestra especie en la colonización de muy diversos hábitats en la Tierra no hubiera sido posible sin la contribución de las personas adultas que sobrepasan con creces el periodo fértil. Según esta hipótesis, la longevidad fue necesaria para la acumulación intergeneracional y la transferencia de la información sin la cual los seres humanos no hubiesen dispuesto del volumen de conocimiento ecológico necesario para sobrevivir en casi todo tipo de entornos y tampoco hubiera sido posible mantener las complejas estructuras sociales que hacen única a nuestra especie.

La antropóloga Rachel Caspari, de la Universidad de Michigan en Ann Arbor y su colega Sang-Hee Lee de la Universidad de California en Riverside, se propusieron analizar en qué medida se había modificado la longevidad a lo largo de la historia evolutiva reciente de nuestra especie. Para ello estudiaron 768 cráneos de individuos adultos de distintas especies correspondientes a los anteriores 3 millones de años de historia del linaje humano. En el estudio determinaron si los cráneos correspondían a adultos jóvenes o a adultos viejos, estableciendo para distintos momentos o especies, la proporción entre unos y otros. Y se comprobó que, efectivamente, a lo largo del tiempo se ha producido un aumento importante en la longevidad, pero sobre todo, que ese aumento ha sido espectacular en el caso de Homo sapiens, nuestra especie.

Considerados en conjunto, tan solo un 10% de los cráneos de los australopitecinos estudiados correspondían a adultos viejos; el porcentaje subía a un 20% en los primeros representantes del género Homo, y a un 33% en los Neandertales. Pero el gran salto se produce con Homo sapiens: en el Paleolítico Superior temprano, un 68% de los individuos analizados eran adultos viejos.

Según Rachel Caspari y Sang-Hee Lee, “lo que nos hace modernos es la contribución de los individuos más viejos”. Es una bonita paradoja.

Fuente:

Rachel Caspari y Sang-Hee Lee (2004): Older age becomes common late in human evolution. Proceedings of the National Academy of Sciences 101: 10895-10900; DOI: 10.1073/pnas. 0402857101

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Modernos gracias a las más viejas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Pezqueñiñes no, gracias… ¿o sí?

- Estalactitas y estalagmitas, unas viejas chivatas

- Rincones del sistema solar para geógrafos modernos

La Cátedra de Cultura Científica en 2017

Se presenta a continuación la actividad de la Cátedra de Cultura Científica de la UPV/EHU en 2017. Las actividades se han ordenado en función de su naturaleza. Las colaboraciones con otras entidades y las presentaciones (conferencias, mesas redondas, coloquios u otras) en que ha participado el director de la Cátedra también se han presentado de manera separada.

Mapping Ignorance publica artículos de divulgación científica de alto nivel en inglés; se dirige, por lo tanto, a un público minoritario, principalmente profesionales de la ciencia. En 2017 ha publicado 202 artículos (223 en 2016), recibió 197.773 visitas (171.346 en 2016) y se han consumido 251.375 páginas (231.387 en 2016). La cuenta @MapIgnorance ha incorporado 500 nuevos seguidores durante 2017 (con un total de 3.545). Casi cuatro de cada cinco (el 78%) lectores del blog y seguidores de la cuenta de Twitter son extranjeros. El blog cuenta con un total de 500 suscripciones que siguen su contenido a través de correo electrónico.

Mujeres con ciencia publica artículos sobre mujeres científicas y sobre temas relacionados con la situación de las mujeres en el mundo de la ciencia. En mayo de 2017 cumplió su tercer año. En 2017 ha publicado un total de 791 anotaciones (524 en 2016), de las que 354 han sido artículos o vídeos (366 en 2016), y 437 eran efemérides (158 en 2016) que recuerdan el nacimiento y la labor de las científicas en los distintos ámbitos de la ciencia y la tecnología. Ha tenido 654.409 visitas (368.379 en 2016) y se han servido 955.757 páginas (516.408 en 2016). El número de visitantes ha sido de 450.502 (257.125 en 2016). Su seguimiento en Twitter, a través de la cuenta @mujerconciencia, ha aumentado de forma sensible: 23.400 a finales de 2017 (12.506 en diciembre de 2016). El 40% de las visitas al blog procede de países extranjeros (37% en 2016).

Cuaderno de Cultura Científica publica en español artículos divulgativos de carácter general todos los días del año. Durante 2017 publicó un total de 626 anotaciones, de las que 576 fueron artículos (535 en 2016) y 50 textos informativos sobre conferencias, jornadas, cursos, etc. (49 en 2016). También creció el consumo: 1.834.926 visitas (999.328 en 2016), 2.392.528 páginas vistas (1.370.352 en 2016) 1.331.818 usuarios (720.784 en 2016). La cuenta @CCCientifica de Twitter contabilizaba 21.571 seguidores (5.760 nuevos). El 54,34 % de las visitas al Cuaderno proceden de países extranjeros (53,20% en 2016). 2.000 usuarios siguen el contenido del blog a través de la suscripción por correo electrónico.

Zientzia Kaiera publica en lengua vasca artículos divulgativos de carácter general. En 2017 publicó un total de 447 anotaciones: 400 artículos (397 en 2016) y 47 textos informativos anunciando jornadas, cursos, conferencias… (40 en 2016). El número de usuarios ha sido de 30.000 (28.900 en 2016). Ha recibido un total de 50.792 visitas (45.000 en 2016) que han consumido 91.839 páginas (82.226 en 2016). El 80% de las visitas proceden de la CAV, el 11% de otras comunidades autónomas, y el 9% del extranjero. La audiencia en Twitter de la cuenta @zientzia_k ha alcanzado los 1.557 seguidores a finales de 2017 (410 más que en diciembre de 2016). Un total de 200 lectores siguen los artículos editados en Zientzia Kaiera a través del correo electrónico, vía suscripción.

Zientzia.info, es el portal que recoge las novedades relativas a la actividad que desarrolla la Cátedra y ofrece información de actualidad científica en castellano, vasco e inglés. Constituye por ello una plataforma mediante la que acceder a la mejor información científica de actualidad, pues selecciona las informaciones de cada día a partir de un conjunto de medios digitales de calidad contrastada (diariamente, de lunes a viernes, se editan de media 5 artículos). El acceso a la información científica se completa con dos suplementos de artículos científicos que se recopilan semanalmente gracias a dos agregadores de blogs de ciencia Science Seeker, en inglés, y Cienciasfera, en español y a la anotación semanal en Zientzia Kaiera que recoge todas las publicaciones sobre ciencia en lengua vasca en la red. Y por otro lado, da acceso a los cuatro blogs de la Cátedra, así como a sus canales de vídeos en Youtube y Vimeo. El 58 % de los usuarios de Zientzia.info provienen del estado español y el 42 % restantes del extranjero.

Matemáticas para mentes inquietasEste programa se realiza en colaboración con Aupatuz, asociación de familiares de menores con altas capacidades intelectuales del País Vasco y Basque Center for Applied Mathematics (BCAM). Consiste en una serie de diálogos, conferencias y sesiones de taller dirigidas a niños y niñas de hasta 15 años de edad. Estas actividades se han desarrollado en cinco sesiones en las siguientes fechas:

- Taller para toda la familia: Curvas con rectas, hiloramas matemáticos (con materiales caseros) con Aida Inmaculada Conejo (Colegio Brains). 25 de febrero, Bizkaia Aretoa UPV/EHU.

- Taller para jóvenes de entre 9-11 años: Lógica-mente. Problemas y acertijos matemáticos para poner a prueba tu capacidad de pensamiento lógico, con Pedro Alegría y Raúl Ibáñez (UPV/EHU). 18 de marzo, Institute of Technology Eurepe-Bilbao (Digipen).

- Taller para estudiantes de 12-15 años: Dibujando videojuegos con funciones matemáticas, con Naiara Espejo (Digipen). 18 de marzo, Institute of Technology Eurepe-Bilbao (Digipen).

- Taller para jóvenes de entre 9-11 años: La calculadora, tu pequeña gran aliada, con Goyo Lekuona (Colegio La Salle Zumarraga). 1 de abril, Institute of Technology Eurepe-Bilbao (Digipen).

- Taller para estudiantes de 12-15 años: Simulación de físicas elementales aplicadas en los videojuegos, con Naiara Espejo (Digipen). 1 de abril, Institute of Technology Eurepe-Bilbao (Digipen).

- Taller para jóvenes de entre 9-11 años: Nuevo taller de Estadística y Probabilidad, con Alex Aginagalde (IES Laudio). 29 de abril, Bizkaia Aretoa UPV/EHU.

- Taller para estudiantes de 12-15 años: La calculadora, tu pequeña gran aliada, con Irantzu Barrio y Jone Lázaro (UPV/EHU). 29 de abril, Bizkaia Aretoa, UPV/EHU.

- Taller para jóvenes de entre 9-11 años: La criptografía en casa, con Alex Aginagalde (IES Laudio). 20 de mayo, Bizkaia Aretoa UPV/EHU.

- Taller para estudiantes de 12-15 años: Nuevo taller de Estadística y Probabilidad, con Irantzu Barrio y Jone Lázaro (UPV/EHU). 20 de mayo, Bizkaia Aretoa, UPV/EHU.

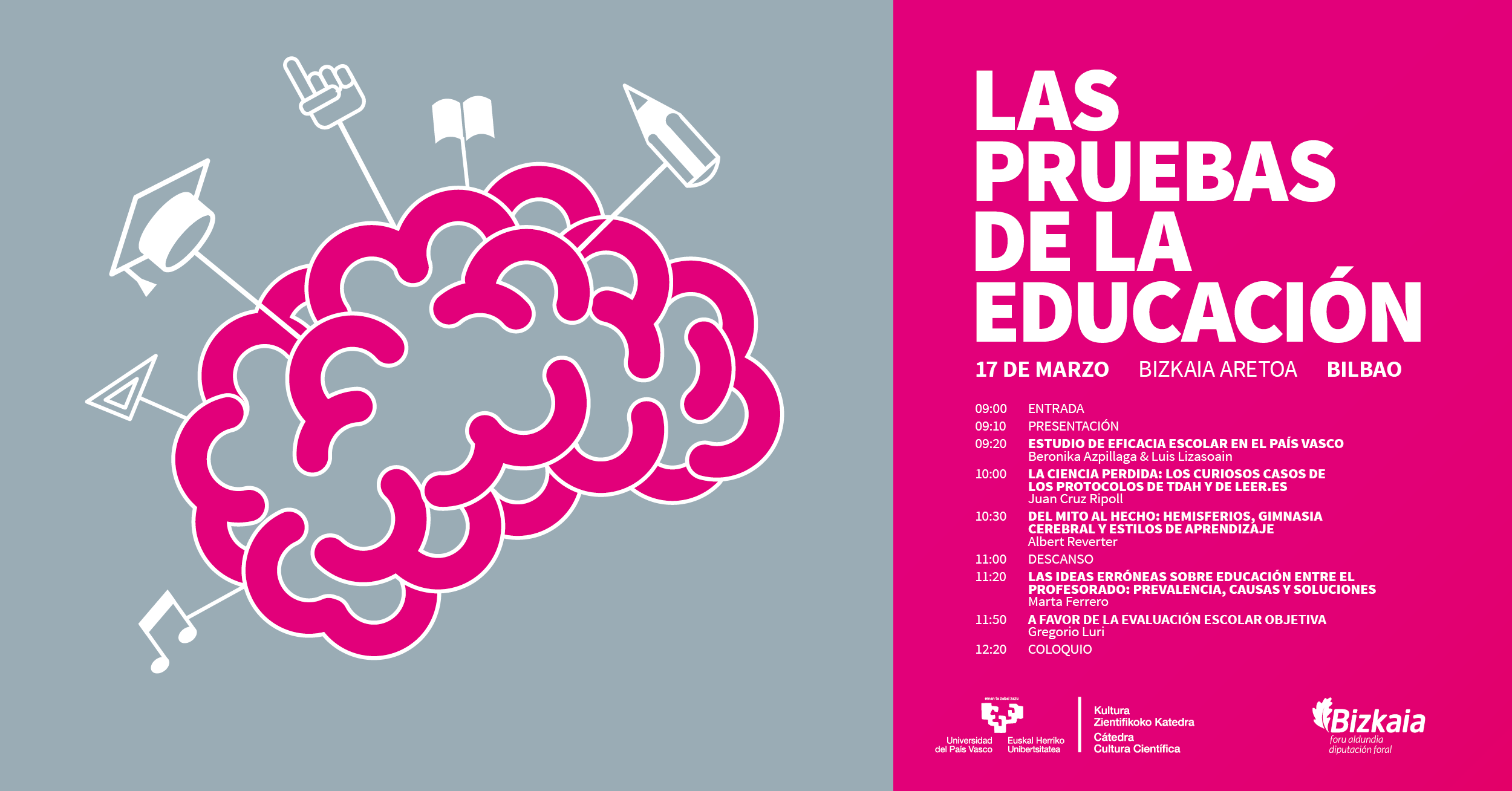

El seminario (17 de marzo; sala Baroja, Bizkaia Aretoa) y tuvo como objetivo analizar las pruebas (o su ausencia) que avalan prácticas que se ponen de moda en el ámbito educativo de forma recurrente. La dirección del seminario corrió a cargo de la doctora en Psicología y experta en educación Marta Ferrero, y se desarrolló con arreglo al siguiente programa:

- Beronika Azpillaga y Luis Lizasoain: Estudio de eficacia escolar en el País Vasco

- Juan Cruz Ripoll: La ciencia perdida: los curiosos casos de los protocolos de TDAH y de leer.es

- Albert Reverter: Del mito al hecho: Hemisferios, Gimnasia Cerebral y Estilos de Aprendizaje

- Marta Ferrero: Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones

- Gregorio Luri: A favor de la evaluación escolar objetiva

Se celebró el 31 de marzo a lo largo de una jornada completa de mañana y tarde. Se abordaron los problemas que se derivan de la presión a que están sometidos los científicos por publicar y los profesionales de la comunicación (específicamente los de la comunicación científica) por obtener impacto mediático. Se analizó, muy especialmente, el riesgo de que tanto unos como otros profesionales adopten comportamientos deshonestos, contrarios a la ética profesional e, incluso, desvirtúen el fin de la ciencia y de su traslación al conjunto del cuerpo social.

Este seminario se organizó conjuntamente con la Asociación Española de Comunicación Científica, y colaboraron el Campus de Bizkaia de la UPV/EHU y la Facultad de Ciencias Sociales y de la Comunicación. Se desarrolló con arreglo al siguiente programa:

- José M. López Nicolás (Universidad de Murcia): Científicos que avalan patrañas.

- Mesa redonda: Los propietarios del conocimiento, con Julián de Juan (Estrategia π), Ignasi Labastida i Juan (Universitat de Barcelona) y Javier de la Cueva, abogado. Moderadora: Elena Lázaro (UCC+i de la Universidad de Córdoba).

- José A. Pérez Ledo (escritor, guionista, director rtv): Periodistas que avalan patrañas.

- Mesa redonda: Todo por el clic y por la audiencia, con Eva Caballero (Radio Euskadi), Antonio Martínez Ron (Vozpópuli); Luis Alfonso Gámez (El Correo). Moderador: Alex Fernández Muerza.

- Joaquín Sevilla (Universidad Pública de Navarra): Ciencia patológica y patología editorial.

- Eva Méndez (Universidad Carlos III de Madrid): Ciencia abierta vs. Ciencia cerrada.

- Ángela Bernardo (Hipertextual): ¿Periodismo científico o periodismo de “papers”?

- Ana Victoria Pérez Rodríguez (Agencia DiCYT): Darwin en la redacción: Evolución de la imagen de la ciencia en la prensa española.

El seminario (13 de junio; sala Baroja, Bizkaia Aretoa). Tuvo como objetivo reflexionar acerca de las nociones de post-verdad y hechos alternativos, expresiones mediante las que se pretende describir una situación en la que las apelaciones emocionales y las creencias personales tienen más influencia a la hora de crear la opinión pública que los hechos objetivos y las informaciones contrastadas. Participaron expertos de varios ámbitos académicos como la biología, la filosofía, las ciencias políticas o la sociología, entre otros.

El seminario fue organizado conjuntamente por ehuGune y Cátedra de Cultura Científica, y se desarrolló de acuerdo con el siguiente programa:

- Apertura: Nekane Balluerka, rectora de la UPV/EHU

- Joseba Agirreazkuenaga (UPV/EHU): Historian barrena: Pirrón (Elis, s. III a.C.), things and speech (Hobbes, s. XVII) y la skepsis en la era digital.

- Mesa redonda: Fundamentos, moderada por Xabier Aierdi (ehuGune, UPV/EHU).

- Juan Ignacio Pérez (Cátedra de Cultura Científica, UPV/EHU): Cada ideología genera sus hechos alternativos

- César Tomé López (Fundación Euskampus): Contra quién estamos perdiendo la guerra

- Helena Matute (Universidad de Deusto): Dando sentido a la apariencia

- Javier Echeverria (Ikerbasque): Las falsedades de la postverdad

- Mesa redonda: Post-verdad y corrección política, moderada por Joxerramon Bengoetxea (ehuGune)

- Pedro Ibarra (UPV/EHU): Las verdades de la post-política

- Daniele Conversi (Ikerbasque, UPV/EHU): Nacionalismo y post-verdad en la era de Internet

- Uxune Martinez (Euskampus Fundazioa): Las redes sociales reafirman tus creencias, incluso las erróneas

- Xabier Aierdi (ehuGune): Pre- y post-verdad

- Mesa redonda: Hechos y relatos, moderada por Luis Mendizabal (colaborador de ehuGune)

- Juan Igartua (UPV/EHU): La verosimilitud: un insidioso disfraz de la post-verdad

- Mari Luz Esteban (UPV/EHU): Hechos, relatos múltiples y reconceptualizaciones

- Noe Cornago (UPV/EHU): Relaciones Internacionales/Relaciones Intertextuales

- Esti León (Innobasque): Post-verdad: una nueva etapa para las Relaciones Públicas

El día de Darwin se organiza en colaboración con la asociación Círculo Escéptico y la Biblioteca de Bidebarrieta cada año desde 2007. Se celebró el 12 de febrero en la Biblioteca de Bidebarrieta, Bilbao, con las siguientes conferencias:

- Jesús Zamora Bonilla (Facultad de Filosofía, UNED): The survival of the loveliest: amor en perspectiva darwiniana.

- Ana Aguirre Escobal (Facultad de Ciencia y Tecnología, UPV/EHU): Las mil y una caras de la epigenética

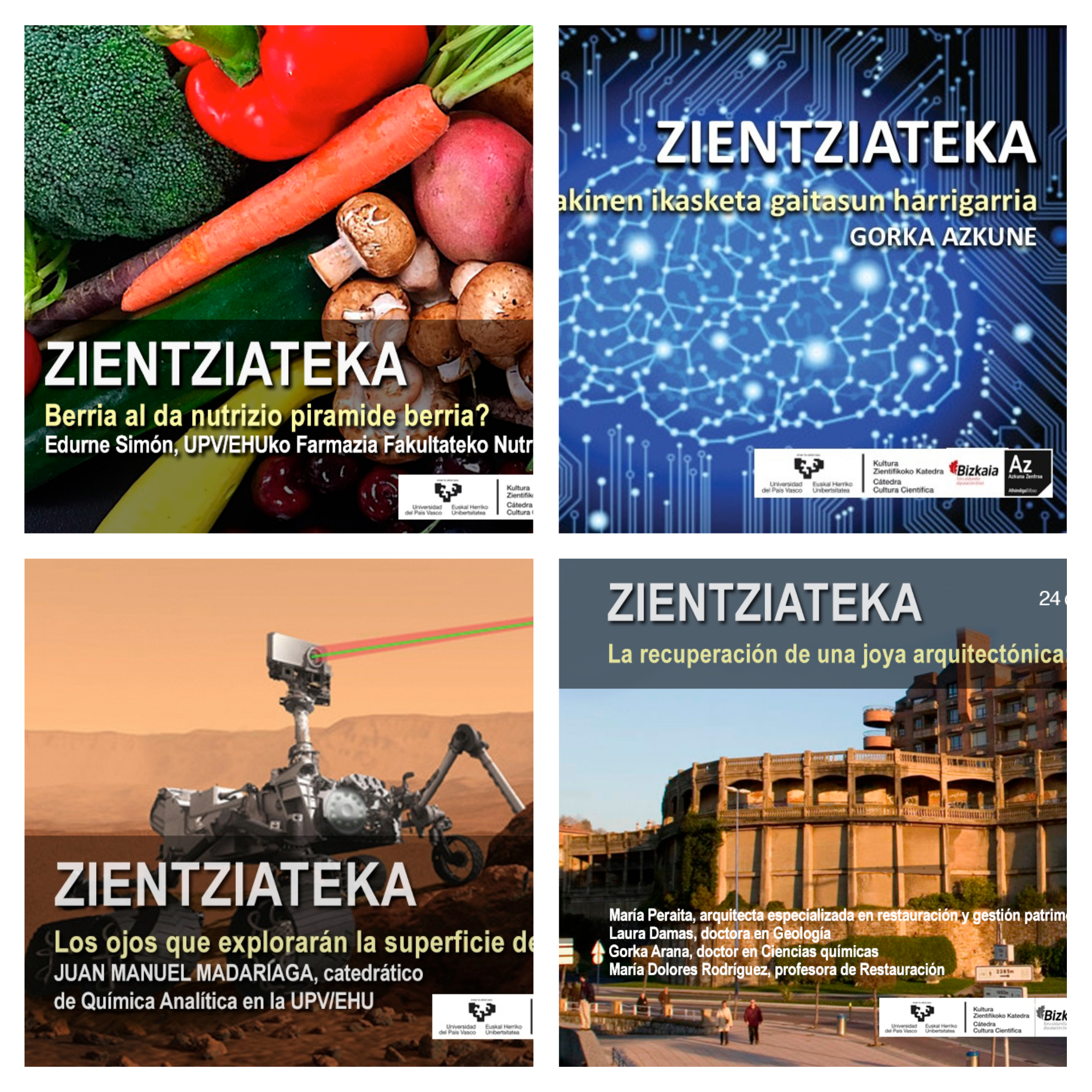

El programa Zientziateka consiste en una serie de conferencias-coloquio que se imparten en la sala Bastida (lengua vasca) y el Auditorium (castellano) del centro cultural Azkuna Zentroa, en Bilbao. Normalmente corren a cargo de personal investigador de la UPV/EHU. Este programa se realiza en colaboración con Azkuna Zentroa.

- Gorka Azkune (grupo Morelab, U Deusto): Makinen ikasketa gaitasun harrigarria (17 de enero)

- Jon Andoni Duñabeitia (Basque Center on Cognition, Brain and Language): ¿Cómo sienten y piensan los bilingües? (25 de enero)

- Maialen Garmendia, (grupo EU KIDS Online; UPV/EHU): Erabiltzaile goiztiarrak? Internet arakatzen 7 urtetik aurrera (7 de febrero)

- Juanma Madariaga (Facultad de Ciencia y Tecnología; UPV/EHU): Los ojos que explorarán la superficie de Marte (22 de febrero)

- Itziar Alkorta (Basque Centre for Biophysics, Biofisika y UPV/EHU): ‘Superbakterioen’ kontrako borrokaren estrategia berriak (7 de marzo)

- Guillermo Quindós (Facultad de Enfermería y Medicina, UPV/EHU): Candida auris, el hongo que ha causado una alerta sanitaria internacional (4 de abril)

- Edurne Simón (Facultad de Farmacia; UPV/EHU): Berria al da nutrizio piramide berria? (9 de mayo)

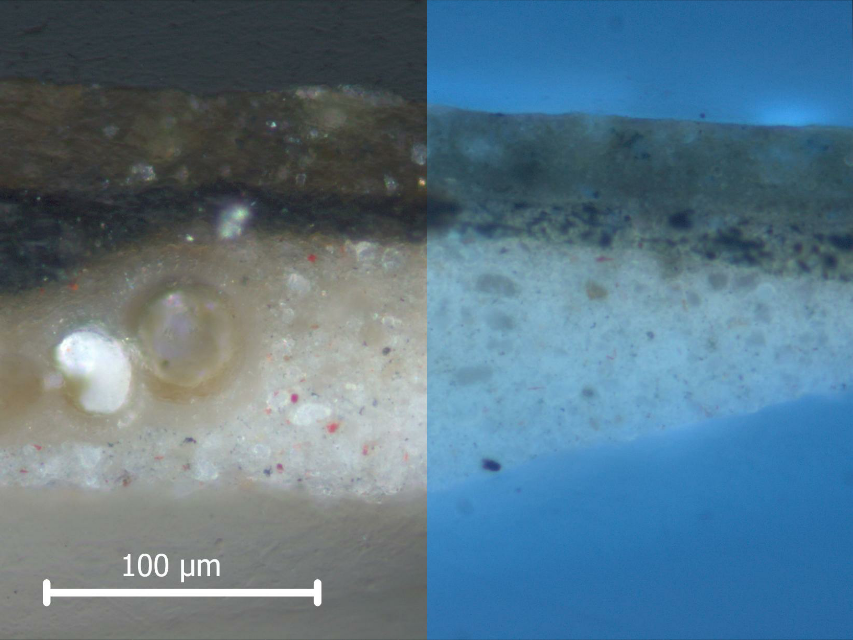

- 24 de mayo: Gorka Arana, María Peraite, Mª Dolores Rodríguez, Laura Damas (grupos IBEA, de restauración BB.AA. y GPAC UPV/EHU): La recuperación de una joya arquitectónica: las Galerías Punta Begoña (9 de mayo)

- Asier Fullaondo (Facultad de Enfermería y Medicina; UPV/EHU): Minbiziaren mutazioak aztertzeko software berria (6 de junio)

- Gorka Orive (Facultad de Farmacia, UPV/EHU): “Microfábricas” de insulina para tratar la diabetes (14 de junio)

Ciencia y Arte es la denominación genérica de un ciclo de cuatro sesiones vespertinas celebradas en el marco de TopArte, programa desarrollado por el Museo Guggenheim Bilbao para celebrar su vigésimo aniversario y para el que contó con la colaboración de diferentes entidades culturales de la villa de Bilbao.

En Ciencia y Arte destacados profesionales –de las artes plásticas, la ilustración, la filosofía y las ciencias- abordaron, cada uno desde su particular punto de vista y adscripción disciplinar, las variadas y complejas relaciones que hay entre dos formas de conocimiento en apariencia tan alejadas entre sí como son las artes plásticas y las ciencias naturales.

Ciencia & Arte se desarrolló bajo la dirección de la química y divulgadora Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los días 6 y 27 de abril, y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggenheim Bilbao. El programa de sesiones fue el siguiente:

- La ciencia que atesora y revela nuestro legado artístico, con Oskar González, Ainhoa Sanz López de Heredia y Aitziber Velasco (6 de abril).

- Conocimiento y representación de los fenómenos naturales, con Xavier Durán, Clara Cerviño y José Ramón Marcaida (27 de abril).

- Analogías entre el arte y la ciencia como formas de conocimiento, con Pau Alsina y Juan Luis Moraza (11 de mayo).

- La ciencia como herramienta del arte, con Jacobo Castellano, Deborah García Bello y Sergio Prego (25 de mayo).

En la primavera de 2017 se inició un programa de charlas en colaboración con Goienagusi, Asociación de Jubilados del Alto Deba (Gipuzkoa). El objetivo de esta iniciativa es dar a conocer temas de actualidad científica y contribuir al fomento de la cultura científica entre la población de más edad. Las conferencias se imparten en horario de mañana (10:00-12:00) en sede alterna, Bergara y Arrasate. Durante 2017 se han organizado un total de 6 conferencias:

- Aitor Bergara (UPV/EHU): Grafeno, el material del futuro. 15 de marzo; Bergara.

- Arantza Aranburu y Arturo Apraiz (UPV/EHU): Euskal Herriko paisaia: zergatik ditugu lautada zabalak eta lurralde aldapatsuak? 22 de marzo; Arrasate.

- Carmen Manzano (UPV/EHU): Nondik dator gizakia? Afrikako tximino arraro batzuk baino ez gara. 16 de octubre; Arrasate.

- Pablo Martínez-Lage (Fundación CITA Alzheimer): Prevenir y tratar la enfermedad de Alzheimer: una visión moderna. 25 de octubre; Bergara

- Juan José Iruin (UPV/EHU): Desmitificando lo “natural”: el caso de los aditivos alimentarios (números E). 6 de noviembre; Arrasate

- Oskar González (UPV/EHU): Arteak ezkutatzen duen zientzia. 13 de noviembre; Bergara.

Del 26 al 28 de junio se celebró en la sede cántabra de la UIMP (Palacio de la Magdalena, Santander) el encuentro Divulgación y cultura científica: diálogo Universidad-Sociedad. El encuentro mostró experiencias exitosas de divulgación y cultura científica en las universidades. Se trató el uso de diversos recursos y estrategias para la divulgación: blogs, redes sociales, monólogos, libros, podcast, eventos de ciencia ciudadana, la divulgación en los centros educativos, etc. Se analizaron también las necesidades sociales en esta materia y el papel de ésta en la promoción de vocaciones científicas entre la juventud.

El encuentro estuvo dirigido al público universitario en general, responsables de las Unidades de Cultura y Científica e Innovación de universidades y centros de investigación y a profesionales de la comunicación científica. El curso fue organizado conjuntamente por la UIMP, la Cátedra de Cultura Científica de la UPV/EHU y la Fundación Española para la Ciencia y la Tecnología (FECYT), y contó con el apoyo de la Fundación Lilly.Fue dirigido por Ignacio López-Goñi, catedrático de microbiología de la Universidad de Navarra y por Juan Ignacio Pérez, catedrático de fisiología de la UPV/EHU y director de la Cátedra de Cultura Científica.

El programa fue el siguiente:

Lunes 26

- Pedro Miguel Etxenike (DIPC; UPV/EHU): Ciencia: cultura y progreso.

- Juan Ignacio Pérez (CCC; UPV/EHU): Cátedras de divulgación y cultura científica en la Universidad.

Experiencias de cultura científica en la Universidad

- Nora González (DIPC): Passion for knowledge

- Gema Revuelta (U Pompeu i Fabra): La formación universitaria en comunicación científica.

- Joaquín Sevilla (U Pública Navarra): Divulgación y docencia en la Universidad.

- José Miguel Mulet (U Politécnica Valencia): Estrategias de divulgación científica en la Universidad.

- Mesa redonda: ¿Por qué divulgar ciencia en la universidad?

Martes 27

Ciencia y divulgación 2.0

- José M López Nicolás (U Murcia): ¿Por qué un profesor universitario tiene un blog de ciencia?

- Ignacio López-Goñi (U Navarra): ¿Se pueden usar las redes sociales para divulgar ciencia?

Otras experiencias sobre divulgación científica

- Clara Grima (U Sevilla): Ciencia en tu barrio y en tu cole.

- José Ramón Alonso (U Salamanca): Escribir en el país de los sabios ágrafos.

- Helena Matute (U Deusto): El escepticismo como materia de investigación

Cuéntalo en 10 minutos: Monólogos de ciencia a cargo de José Ramón Alonso, Joaquín Sevilla, José Manuel López Nicolás, José Miguel Mulet, Clara Grima, Helena Matute, Juan Ignacio Pérez e Ignacio López-Goñi.

Miércoles 28

Las Unidades de Cultura Científica en las Universidades

- César López (FECyT): Nacimiento, evolución y principales características y modalidades.

- Elena Lázaro (UCC+i, U Córdoba): UCC+i que realizan actividades de divulgación.

- Francisco Javier Alonso (UCC+i, U Carlos III Madrid): UCC+i que realizan comunicación de resultados de investigación

Ciencia, Universidad y sociedad

- Gonzalo Remiro (FECyT): Presentación de resultados de la Encuesta de Percepción Social de la Ciencia 2016.

- Digna Couso (U Autónoma Barcelona): Herramienta para la evaluación del impacto de la actividades de divulgación de la cultura científica.

- Miguel Ángel Quintanilla (U Salamanca): De la divulgación de la ciencia a las “3Os” (Open Innovation, Open Science, Open World).

- Mesa redonda: ¿Cómo valorar la actividad de divulgación y promoción de la ciencia en la carrera docente e investigadora?

Este curso se desarrolló en el Palacio Miramar de San Sebastián entre el 10 y el 12 de julio. En el mismo se siguió una aproximación multidisciplinar para analizar los procesos implicados en la adquisición y formación de conocimiento, y a partir de ahí, identificar sus límites. Para ello, se caracterizó el sistema cognitivo humano con sus sistemas receptores y el dispositivo central, el encéfalo. Seguimos la trayectoria que siguen las señales que recibimos del exterior, repasando los mecanismos de transducción, transmisión y procesamiento neuronal de las mismas, hasta el modo en que el encéfalo construye imágenes, sonidos, sensaciones, emociones y conocimientos.

El curso, promovido por la Cátedra de Cultura Científica de la UPV/EHU y la Fundación Ikerbasque, se desarrolló de acuerdo con el siguiente programa:

10 de julio

- Fernando Cossío (Facultad de Química, UPV/EHU): Presentación: un viaje a través de la materia

- Joaquín Sevilla (U Pública de Navarra): La naturaleza de la luz y del sonido

- Xabier López (DIPC y Facultad de Química, UPV/EHU): La luz de tus ojos: la molécula receptora

- Miren Bego Urrutia (Facultad de Ciencia y Tecnología, UPV/EHU): De los sentidos al cerebro: transductores

11 de julio

- Antonio Martínez Ron (Next, Vozpópuli): El viaje de la luz

- José Ramón Alonso (Facultad de Biología, U de Salamanca): De moléculas flotantes a emociones incontroladas

- Almudena Martín Castro (Facultad de Ciencias, UNED; StyleSage): Música, física y significado

- Clara Martin (BCBL, Ikerbasque): El cerebro eléctrico percibe el lenguaje

12 de julio

- Itziar Laka (Facultad de Letras, UPV/EHU): Condenados al sentido

- Deborah García Bello (Dimetilsulfuro): Significancia de materiales en el arte contemporáneo

- Luís Martínez (Instituto de Neurociencias de Alicante, CSIC-Universidad Miguel Hernández): La mente recreadora

- Juan Ignacio Pérez (Facultad de Ciencia y Tecnología, UPV/EHU): Los límites del conocimiento

Bizkaia Zientzia Plaza es un gran festival de divulgación científica para todos los públicos que se celebró entre los días 14 y 24 de septiembre en el Palacio Euskalduna y en el Bizkaia Aretoa de la UPV/EHU, en Bilbao, y que también se extendió a varios municipios del territorio de Bizkaia. Contó con el patrocinio de Bilbao Ekintza (Ayuntamiento de Bilbao). Se ofreció un amplio programa conformado por un total de siete eventos, todos ellos gratuitos y abiertos al público en general, en los que se acercó la actividad científica desde infinidad de registros y formatos como conferencias, espectáculos, monólogos y talleres. El programa contó con los siguientes actos:

Final de Ciencia ShowLa sala Barria del Palacio Euskalduna acogió el 14 de septiembre la gran final de Ciencia Show, un concurso de monólogos científicos realizados por jóvenes estudiantes de los cursos comprendidos entre 3º de ESO y 2º de Bachillerato.

Los cinco finalistas presentaron sus monólogos ante las miembros del jurado, que valoraron su contenido, la claridad de las presentaciones y el carisma de los monologuistas. Obtuvo el premio Asier Fernández, estudiante de 3 de la ESO de la Ikastola Lauaxeta, por su monólogo Límites tiene el que se los pone.

Más adelante se ofrece más información acerca de este certamen.

Naukas PROEl 14 de septiembre se celebró la primera edición de Naukas PRO donde se presentó el trabajo de centros de investigación, laboratorios, empresas o equipos de trabajo. 300 personas escucharon durante más de tres horas los pormenores de la labor desarrollada por los conferenciantes, donde dieron a conocer el camino que siguen los productos; desde su concepción en el laboratorio hasta su comercialización. Mostrando de esta manera el impacto que la ciencia tiene en la sociedad, incluso desde el punto de vista socioeconómico.

Los ponentes fueron Carlos Briones (Centro de Astrobiología: CAB-INTA/CSIC), Leni Bascones (Instituto de Ciencia de Materiales de Madrid, CSIC). Javier Burgos (Fundación de Investigación Biomédica de Andalucía Oriental, FIBAO), Julián Estévez (Grupo de inteligencia computacional de la UPV/EHU), Manuel Collado (Laboratorio de Células Madre en Cáncer y Envejecimiento; IDIS-CHUS), Inma Estévez (Ikerbasque, Neiker-Tecnalia), Lluis Montoliu (Centro Nacional de Biotecnología, CNB-CSIC), Lourdes Basabe Desmonts (Ikerbasque. Cluster de Microfluidica UPV/EHU) y Amaia Zurutuza (Graphenea).

Naukas BilbaoLos días 15 y 16 de septiembre se celebró Naukas Bilbao, acto de divulgación dirigido a un público general, compuesto por charlas sencillas e informales de 10 minutos de duración, entrevistas con personajes relevantes del mundo de la ciencia, monólogos humorísticos, experimentos en directo y representaciones musicales. Naukas Bilbao trata de acercar la ciencia a la sociedad desde un enfoque cercano y divertido, a la vez que trata de fomentar el escepticismo y el pensamiento crítico.

La edición de 2017 ha hecho frente al reto de dar el salto al Auditorio del Palacio Euskalduna de Bilbao, donde congregó a 2.000 personas en cada una de las dos sesiones consecutivas, triplicando la asistencia a Naukas Bilbao de años anteriores, realizado en el auditorio del Bizkaia Aretoa de la UPV/EHU.

Naukas Kids (17 de septiembre por la mañana; Palacio Euskalduna) consistió en una serie de actividades y charlas dirigidas a los más jóvenes. Se desarrollaron talleres donde los asistentes aprendieron ciencia haciendo ciencia. Con el aforo completo (800 asistentes), los chicos y chicas, divididos en dos grupos de edad (3-10 y 13-16 años), experimentaron, entre otros, con flotabilidad, densidad, pigmentos y huellas dactilares.

Después de los talleres fue el turno de los espectáculos. También divididos por grupos de edad (8-12 y 13-17 años) hubo dos actos simultáneos. Por un lado, el grupo Big Van trajo su espectáculo científico para enseñar ciencia a los más pequeños. Y por el otro, los estudiantes de secundaria tuvieron oportunidad de hacer preguntas a cinco científicos de distintas disciplinas en el marco de Somos Científicos; pudieron así conocer de primera mano su día a día y premiar al científico o científica asistente que dio las mejores respuestas a las preguntas del público.