Cosmogonías y química

Una espectacular combinación de rodocrosita (rosa), calcopirita (amarillo latón y negro), cuarzo (blancuzco-incoloro), esfalerita (grisáceo) y pirita (amarillo oro, abajo a la derecha). Foto: Quebul Fine Minerals

A la hora de clasificar las rocas en primarias y secundarias los mineralogistas encontraron que los dos grandes problemas de la mineralogía, clasificación y origen, teníanmucho en común. De hecho, era muy difícil hallar una justificación para esta clasificación si no se tenía en cuenta la cosmogonía, esto es, el estudio del origen del planeta y los cambios que se habían producido en él desde entonces.

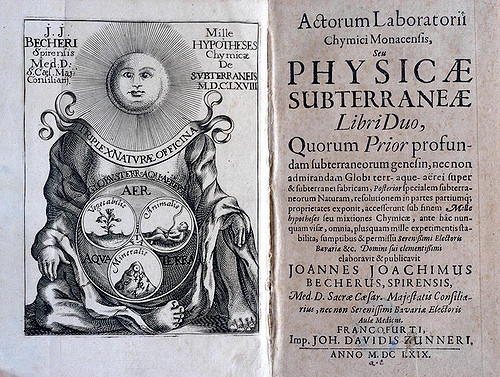

Desde el siglo XVII los cosmogonistas habían asumido, apartir de la forma globular del planeta, que en el algún momento del pasado había tenido que ser un fluido. En el motivo de esta fluidez ya se podían apreciar dos campos. Estaban los que afirmaban que la fluidez había sido debida al calor, pero eran minoría. La mayoría, los que se dedicaban a la mineralogía, precisamente, preferían el agua, como dejó por escrito Johann Joachim Becher en su Physicae subterraneae (1669).

Physicae subterraneae (1669)

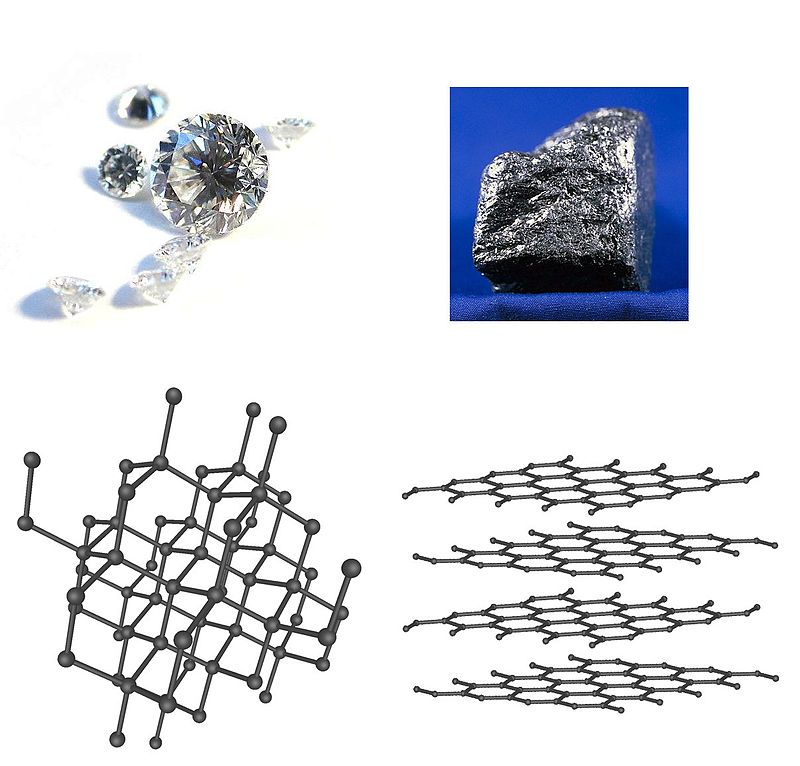

Los mineralogistas de finales del XVII y del XVIII llegaron al convencimiento de que en algún momento del pasado la superficie de la Tierra estuvo cubierta por un océano muy rico en sustancias químicas. Las rocas primarias habrían sido las primeras en precipitar y cristalizar a partir de este océano formando las grandes cadenas montañosas. Esta conclusión venía soportada por el hecho de que los químicos de la época estuviesen convencidos de que los cristales solo podían formarse a partir de disoluciones acuosas y no a partir de sustancias fundidas.

Conforme el agua veía disminuir la concentración de sustancias y comenzaban a funcionar los mecanismos de la erosión, olas, lluvias, ríos, en las nuevas cadenas montañosas, el océano comenzó a decantar cieno que terminaba solidificándose y formando las rocas secundarias, estratificadas. Esta teoría, conocida como neptunismo, alcanzó su apogeo con Abraham Gottlob Werner. [1]

Edición de 2011 del libro de Rose.

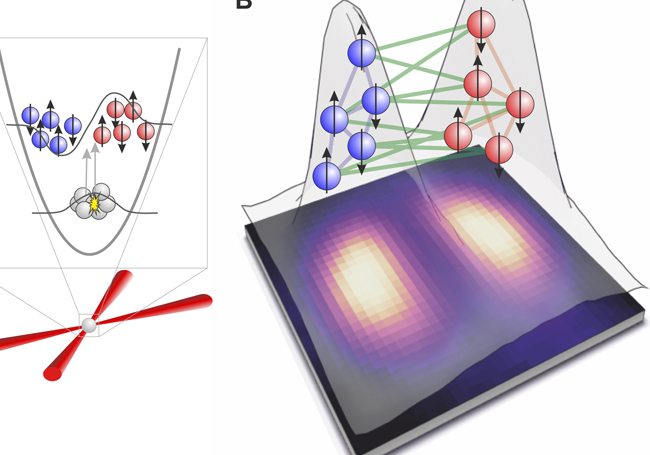

Desde alrededor de 1830 a 1873 [2] los mineralogistas se vieron arrastrados por los desarrollos de la química moderna, lo que marcó la forma en la que miraban y clasificaban los minerales. Notablemente, sería Jöns Jacob Berzelius, un químico sueco, la persona que distinguió por primera vez entre silicatos y aluminatos, las dos grandes clases de compuestos más abundantes en la corteza terrestre. Como consecuencia de esta influencia química Gustav Rose publicó la clasificación de minerales más exhaustiva y amplia jamás publicada en su Das Krystallo-chemische Mineralsystem (1852). El libro de Rose es un hito de la ciencia y es tan completo que aún se reedita en lengua alemana.

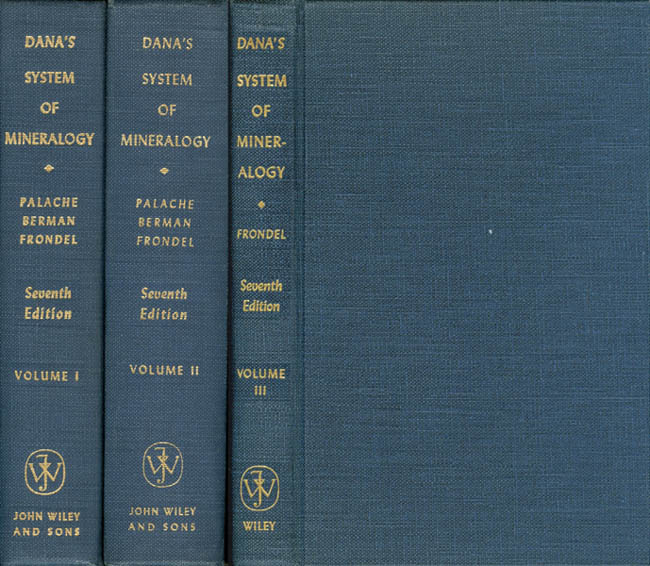

La última edición del Dana, en 3 volúmenes (1962)

Sin embargo, en su día a día y por motivos prácticos, lo mineralogistas continuaron usando características externas. Friedrich Mohs, conocido por la escala de dureza, desarrolló toda una sistemática de identificación. Pero sería su adaptación a una audiencia americana por parte de James Dwight Dana la que terminaría triunfando. Tanto es así que su System of Mineralogy, publicado originalmente en 1837, no es que fuese un libro de consulta casi obligada como el de Rose, sino libro de texto de refrencia, con continuas actualizaciones hasta 1962 [3].

Notas:

[1] Por su interés, dedicaremos un capítulo completo a esta teoría y su alternativa, el plutonismo, más adelante.

[2] Si bien la primera fecha es groseramente aproximada y un tanto arbitraria, la segunda corresponde con la publicación del texto de microscopía mineral de Rosenbusch, que veremos en la siguiente entrega de la serie.

[3] Tanto es así, que cuando hablemos de clasificación mineral contemporánea ésta no será más que la de Dana actualizada.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Cosmogonías y química se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- De la materia a la vida: ¿Química? ¡Química!, por Jean-Marie Lehn

- Montañeros, espeleólogos y mineros

- #Naukas14 La química del arte…pero bien

Marcas de agua digitales, qué son y para qué sirven

Juanjo Unzilla

Las facilidades que ofrece Internet para el acceso y la transmisión de forma sencilla e inmediata de información han supuesto la aparición de nuevos escenarios para negocios y mercados tradicionales. En unos segundos se pueden hacer compras de materiales digitales o de productos físicos desde cualquier lugar donde se disponga de una conexión y un terminal con unas mínimas capacidades de procesamiento y conectividad. Ello ha acentuado la necesidad de analizar y hacer propuestas diferentes para el entorno digital, el entorno de los bits, de las que han servido para el comercio y el intercambio en el mundo físico, en el mundo de los átomos.

Uno de los escenarios que ha suscitado amplios debates y ha promovido grandes desarrollos de tecnología es el del comercio de contenidos digitales y la gestión de los derechos de propiedad intelectual asociados. Después de varios años debatiendo sobre ello, sigue sin existir una solución sencilla y aceptada por todas las partes implicadas. El marcado del material digital, ya sea en formato de texto, audio, imágenes o vídeo es una de las tecnologías que pretende ofrecer herramientas para hacer realidad esa solución sencilla, al menos en su uso.

Como todos comprobamos a diario, Internet es un magnífico instrumento para la difusión de contenidos digitales y ello es una gran ventaja para quien quiera difundir sus creaciones, ya sean canciones, videos, fotos o textos. Sin embargo, esta facilidad para la difusión y el acceso supone una debilidad en lo que respecta al control de los datos, en la medida que se facilita la obtención y copia de información, en muchos casos sin una adecuada gestión de los derechos de autor de la misma. A una persona que crea un contenido puede estar interesada darle la mayor difusión y llegar al mayor número de espectadores posible, pero a la vez evitar la falsificación, la apropiación por una tercera persona de su obra o la utilización ilegal de la misma. Para conseguirlo, necesita alguna forma de marcar sus trabajos para acreditar su autoría y sus derechos ante terceros, de forma que pueda demostrar que es el creador del material en cuestión. Las marcas de agua pueden ser una herramienta útil para ello.

Imagen: Wikimedia Commons

Marcas de agua digitales

Una marca de agua digital es una información o señal que se inserta en un contenido digital que puede ser utilizada para determinar la propiedad del mismo, saber quién lo ha creado y quién lo ha vendido o para asegurar su integridad. El término marca de agua procede de una analogía con las imágenes que se graban en los billetes para garantizar su autenticidad, muy difíciles y costosas de reproducir y que generalmente no son perceptibles a simple vista, pudiéndose observar al trasluz. En inglés se utiliza la palabra watermark, cuya equivalencia en español es filigrana, sin embargo, lo habitual es usar la traducción literal: water (agua) – mark (marca).

La utilización de marcas en distintos soportes, generalmente en papel o similares, es una técnica empleada desde la antigüedad. Los griegos ya la utilizaron, pero fue con la aparición de la imprenta cuando su uso se hizo más habitual. Su principal objetivo era la acreditación de la calidad del material así como la originalidad y autenticidad del mismo.

Al ser una marca de agua digital un conjunto de datos que se insertan directamente sobre el material multimedia, esto significa que la marca implica una modificación del propio contenido. La señal digital es modificada y algunos de los bits que representan el contenido son parcial o totalmente cambiados. En ningún caso estas modificaciones deben suponer una degradación de la calidad del material ni alterar las condiciones en las que éste va a ser leído, escuchado o visto.

Antes de pasar a explicar los diferentes tipos de marcas de agua y sus aplicaciones, voy a tratar de exponer de una forma sencilla los fundamentos científicos que se utilizan en esta tecnología.

El mundo en el que vivimos y en el que actúan nuestros sentidos es un mundo analógico. ¿Pero qué es eso de “analógico”? La palabra analógico procede de análogo, y ésta del griego (ana, reiteración o comparación y logos, razón) y según la RAE significa en su segunda acepción “Dicho de un aparato o de un instrumento de medida: Que la representa mediante variables continuas, análogas a las magnitudes correspondientes”, es decir, aquello que representa o mide una magnitud física mediante una función matemática continua. Una señal analógica, es según la Wikipedia, un tipo de señal generada por algún tipo de fenómeno electromagnético y que es representable por una función matemática continua en la que es variable su amplitud y periodo (representando un dato de información) en función del tiempo. Algunas magnitudes físicas comúnmente portadoras de una señal de este tipo son eléctricas como la intensidad, la tensión y la potencia, pero también pueden ser hidráulicas como la presión, térmicas como la temperatura o mecánicas como la fuerza.

En la naturaleza, el conjunto de señales que percibimos son analógicas, así la luz, el sonido, la energía etc, son señales que tienen una variación continua. Incluso la descomposición de la luz en el arco iris vemos como se realiza de una forma suave y continua.

Una onda sinusoidal es una señal analógica de una sola frecuencia. Los voltajes de la voz y del video son señales analógicas que varían de acuerdo con el sonido o variaciones de la luz que corresponden a la información que se está transmitiendo.

Desde hace varias décadas la información se almacena en formato digital por su mayor calidad, su mayor facilidad de procesado, compresión, transmisión, corrección de errores y regeneración y por su mejor respuesta al tratamiento del ruido y otras interferencias. Para ello es necesario convertir la señal analógica en digital, en una sucesión de ceros y unos. Y esto se hace con conversores analógico-digitales. Y para poder oír una canción, leer un texto o ver una foto o un video, dado que nuestros sentidos funcionan de forma analógica, es preciso realizar la conversión inversa. Para ello tenemos altavoces y pantallas que transforman los ceros y unos en sonidos e imágenes.

Nuestros sentidos tienen un rango limitado dentro del cual son capaces de percibir las señales que nos llegan: el oído sano sólo es capaz de oir aquellos sonidos que se encuentra entre los 20 Hz y los 20 KHz, lo que equivale a unas 10 octavas completas. Por debajo de 20 Hz, infrasonidos, o por encima de 20 KHz, ultrasonidos, nuestros oídos no perciben la señal. Lo mismo ocurre con la vista. El espectro visible, entre 400 y 700 nm de longitud de onda, se denomina así precisamente porque es lo que una persona puede ver. Longitudes de onda inferiores a 400 nm, ultravioleta, o superiores a 700 nm, infrarrojo, resultan invisibles para el ojo humano medio.

Pero el hecho de que no podamos ver u oír una señal no quiere decir que no pueda formar parte de la información que se envía o se almacena. Y es precisamente en estos límites donde podemos jugar para introducir información en forma de marca de agua digital.

Para el caso de imágenes, la marca de agua puede definirse como una imagen digital que se introduce en la imagen original y posteriormente puede ser recuperada y analizada de una forma u otra en función del tipo de marcado y de su finalidad. De igual forma se puede insertar un sonido no audible en una canción o ambas cosas a la vez, una imagen y un sonido, en el caso de un video. En el caso del vídeo se puede utilizar también la variable tiempo, es decir, en qué instante o instantes de tiempo de la secuencia se introduce la marca, o si en unos se modifica sólo el audio y en otros la imagen o se realiza una combinación más o menos compleja de ambas operaciones.

El principal problema planteado radica en la propia naturaleza del material creado digitalmente, ya que una vez producido el original, la realización de copias es un proceso sumamente sencillo, las copias son idénticas al original e indistinguibles de éste y entre sí. Es por ello que el valor añadido del material se produce exclusivamente en la creación del original, de forma similar a lo que sucede en la creación de software.

Las primeras aplicaciones de las marcas de agua fueron las destinadas a la identificación del autor y por ello, los requerimientos que debían satisfacer los métodos de marcado eran los siguientes:

- Debe ser invisible a la percepción humana y no debe afectar a la calidad del material digital.

- La marca recuperada debe identificar de forma no ambigua a la persona propietaria.

- No debe ser detectada mediante pruebas estadísticas.

- Debe ser difícil de eliminar, es decir, la marca debe ser robusta a los diferentes algoritmos de procesado de señal como pueden ser los filtros, compresiones, reescalados, etc..

- Debe ser difícil de falsificar.

En el caso de imágenes, los métodos y esquemas propuestos para el marcado digital se definen generalmente dos tipos de marcas, las visibles y las invisibles. De forma análoga podemos hablar de marcas audibles o inaudibles en el caso del audio. Así, los logotipos que aparecen en la transmisión de televisión pueden ser un ejemplo de marcas visibles. Sin embargo, las marcas invisibles se diseñan para ser lo más discretas e imperceptibles posible. Si se consideran otras aplicaciones como la garantía de posesión de un original o de no modificación, existen otras formas de clasificar las marcas teniendo en cuenta la técnica de procesado de la señal que se usa para insertar la marca, el método de extracción o el tipo de información que se incluye en el material digital cuando se produce el marcado.

Aunque el uso más extendido para las marcas de agua digitales es el de la protección de la propiedad intelectual, existen otras aplicaciones que además pueden requerir el uso de otras tecnologías como el cifrado o el uso de certificados digitales. En el siguiente artículo estudiaremos en mayor detalle las diferentes clasificaciones de marcas de agua digital propuestas, así como su nivel de adecuación a cada tipo de uso.

Sobre el autor: Juanjo Unzilla es ingeniero industrial, doctor en ingeniería de comunicaciones y profesor titular de telemática en el departamento de comunicaciones de la Escuela de Ingenieros de Bilbao (UPV/EHU). Ha trabajado extensamente en protección de derechos de autor en Internet.

El artículo Marcas de agua digitales, qué son y para qué sirven se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una proteína humana para potabilizar agua

- ¿Para qué sirven las matemáticas?

- Identificando paleococineros por las marcas en los huesos

La cultura no protege de la selección natural

Todavía hay quien piensa que, en cierto modo, la cultura o la tecnología nos protege de determinadas presiones selectivas. La ropa nos protege del frío, la medicina de las enfermedades, la agricultura del hambre, etc. Desde ese punto de vista, la cultura humana estaría actuando contra la selección natural que es, como es bien sabido, el principal motor de la evolución de las especies.

Sin embargo, la cultura ejerce un papel muy diferente en la evolución humana. Dado que la cultura puede definirse, de forma amplia, como cualquier comportamiento aprendido, si alguno de esos comportamientos aprendidos se convierte, por las razones que fuese, en un factor selectivo, tendríamos que concluir que incide en la evolución de la especie humana, no sólo porque neutraliza ciertas presiones selectivas, sino también porque genera otras. Kevin N. Laland (St. Andrews, RU), John Odling-Smee (Oxford, RU) y Sean Myles (Cornell, EEUU y Acadia, Canadá), entre otros, desarrollaron esa noción de forma brillante en un artículo publicado hace unos años y que se ha convertido ya en un clásico. Laland, Odling-Smee y Myles hicieron referencia a dos aproximaciones diferentes a la interacción entre cultura y selección natural. Una es la conocida como hipótesis de la construcción del nicho, según la cual los organismos tienen una cierta capacidad para, modificando las condiciones físicas del entorno, incidir en la selección natural; actuarían de esa forma como codirectores de su propia evolución y de la de otras especies.

Y la otra aproximación es la de la coevolución genético-cultural, para la que los estudios antropológicos han proporcionado cierto respaldo. Los genetistas son capaces de identificar los genes que se encuentran sometidos a mayor presión selectiva en la actualidad. Calculan que son unos 2.000 genes (el 10%) los que muestran alguna evidencia de estar sometidos a presión selectiva, y el periodo de tiempo durante el que se viene ejerciendo esa presión es de entre 10.000 y 20.000 años. Muchos de esos genes se encuentran bajo presión “convencional”, como pueden ser los responsables de codificar el sistema inmune, o como los responsables del color de la piel, relacionada, quizás, con el clima y la geografía.

De entre los casos en los que una práctica cultural ha afectado al genoma, el ejemplo mejor conocido es el de la ganadería para producción de leche y el gen de la lactasa. La mayor parte de los individuos de nuestra especie “apaga” el gen de la lactasa poco tiempo después de ser destetados, pero los europeos del norte, que descienden de un grupo de pastores de ganado de hace unos 7.000 años, mantienen el gen “encendido” durante toda la vida. Gracias a ello, pueden consumir leche, ya que la lactasa es el enzima que digiere la lactosa, el azúcar de la leche. Sin ese enzima no se puede digerir y ello causa problemas digestivos que pueden llegar a ser muy severos. Pero resulta que la tolerancia a la lactosa no sólo ha aparecido en europeos del norte; en tres pueblos africanos de pastores también se ha producido y lo más curioso es que la mutación que lo permite es diferente en cada uno de los cuatro casos. La ventaja derivada de esa mutación debió de ser muy importante, ya que se ha extendido de forma considerable en un tiempo relativamente breve.

Además del de la lactasa, hay otros genes que están siendo afectados por cambios en la dieta y en el metabolismo. Se trata de comportamientos culturales que, muy probablemente, reflejan el gran cambio que se produjo hace 10.000 años en la dieta humana durante la transición al Neolítico y la aparición de la agricultura y la ganadería. Las gentes que viven en sociedades agrarias consumen más almidón y tienen copias extra del gen que codifica la síntesis de la amilasa (la enzima que digiere el almidón) que quienes dependen más de la caza o de la pesca.

Muchos genes relacionados con el gusto y el olfato también dan muestras de estar sometidos a fuerte presión selectiva, lo que quizás refleja un cambio de dieta de gran importancia. Y finalmente, también los genes que afectan al crecimiento óseo se encuentran sometidos a presión, debido seguramente a la pérdida de peso que ha experimentado el esqueleto humano al pasar de la vida nómada a la vida sedentaria.

Referencia:

Kevin N. Laland, John Odling-Smee y Sean Myles (2010): “How culture shaped the human genome: bringing genetics and the human sciences together”, Nature Reviews Genetics 11: 137-148 doi: 10.1038/nrg2734

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La cultura no protege de la selección natural se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La unidad de selección en la evolución y el origen del altruismo (6): La crítica de Godfrey-Smith a la selección centrada en el gen

- La unidad de selección en la evolución y el origen del altruismo (7): La selección multinivel

- La unidad de selección en la evolución y el origen del altruismo (8): Selección de parentesco y altruismo recíproco

Historia del bolígrafo

“El mundo está lleno de cosas obvias a las que nadie observa ni por casualidad.”

Sherlock Holmes, en El sabueso de los Barkerville, según Sir Arthur Conan Doyle, 1902.

“BiC naranja escribe fino, BiC cristal escribe normal.

BiC naranja, BiC cristal,

dos escrituras a elegir.

BiC, BiC,… BiC, BiC, BiC.”

“Yo tengo en mi mano un cetro.

Mi cetro dice, habla, canta

con su punta luminosa:

en medio del papel planta

una luminosa rosa.

Entre mis dedos se mueve,

lo deslizo entre mis dedos

como una espada de nieve

en el centro de los ruedos.”

Blas de Otero, Bolígrafos, publicado en El Correo el 2 de abril de 2018.

La azada y el arado para el labrador, el yunque y el martillo para el herrero, el estetoscopio para el médico, la paleta y la grúa en la construcción y, en nuestro trabajo, por lo menos para mí, el bolígrafo, la pluma, el lápiz y, ahora, el teclado. Son las herramientas de trabajo para el que escribe. Me quedo con el bolígrafo pues es, sin duda, la herramienta que más utilizo. Contaré su historia.

El bolígrafo que ahora conocemos empezó a utilizarse en la década de los cuarenta del siglo pasado, hace casi 80 años, pero, como ocurre con todos los adelantos, tuvo precursores que hemos olvidado. Después de siglos de usar diferentes tipos de tinta para escribir, tinta que había tomar de un recipiente, la idea de ponerla en un tubo y colocar una bolita en un extremo cuya única función sea extenderla sobre la superficie en la que se quiere escribir, viene del siglo XIX. Sin embargo, presentaba muchas dificultades técnicas: fabricar bolas suficientemente pequeñas, colocar la bola en el cilindro con tinta, la propia tinta en exceso líquida o viscosa,… Todo ello se ha ido resolviendo con tiempo y mucho ingenio.

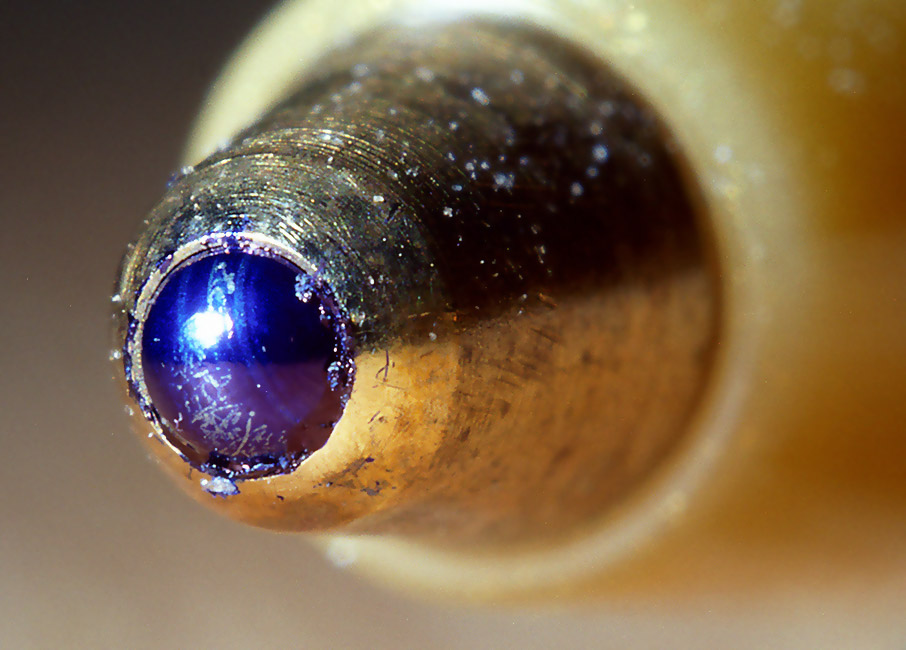

Casi todos los expertos nos recuerdan a John Loud, de Weymouth, Massachusetts, como el inventor del bolígrafo. Por lo menos recibió la primera patente de un cilindro con tinta y una bola en un extremo para escribir. Fue la patente número 392046 de Estados Unidos, de 30 de octubre de 1888. En el texto de la patente, Loud explica que su “invención consiste en un depósito de tinta mejorado, especialmente útil entre otros propósitos, para marcar superficies ásperas –como madera, papel rugoso, y otros artículos- que una pluma no lo puede hacer”. Loud trabajaba con pieles y necesitaba un instrumento de escritura para marcarlas.

Loud utilizaba un cilindro con la tinta, una bola metálica gruesa en el extremo para escribir y otras dos bolas de menor diámetro para que, junto a la grande, se deslizaran y no se atascaran. A estas últimas bolas las llamaba “anti-fricción”. Era difícil fabricar estas bolas y Loud fabricó algunos ejemplares de su invento pero nunca lo comercializó.

En los años siguientes, a finales del siglo XIX y principios del siglo XX, se presentaron varias patentes con el mismo sistema de bolas e, incluso, se fabricaron algunos de estos instrumentos de escritura, pero todos ellos tuvieron poco éxito. Las patentes se presentaron en Estados Unidos, Inglaterra, Francia, Alemania, Checoslovaquia y otros países.

Además, para los primeros bolígrafos se exigían características adecuadas para la manera en que se escribía entonces en los centros de trabajo. Por ejemplo, el sistema de bolas debía de ser lo suficientemente fuerte como para permitir una gran presión sobre el papel para la escritura simultánea de siete u ocho copias superpuestas en papel carbón.

En los años treinta se empieza a conocer al húngaro Laszlo Jozsef Biro, nacido en Budapest en 1899 y un verdadero “hombre del Renacimiento” tal como lo considera Henry Gostony, experto norteamericano en bolígrafos. Había estudiado medicina, era escultor, practicaba la hipnosis, pintaba, y era escritor y periodista y, además, inventor, que es lo que aquí nos interesa. Habían desarrollado una lavadora, un cambio automático para coches, la levitación magnética para trenes, un explosivo inflamable que luego sería el napalm, un método de separación de isótopos,… y, así, hasta 32 patentes.

Lazslo y su hermano György, químico, inventaron un instrumento de escritura con la bola en el extremo del cilindro para la tinta. Al diseño de Loud, con su bola central grande y las pequeñas alrededor para evitar una fricción excesiva, añadió un conducto de muy poco diámetro para llevar la tinta desde el depósito hasta la bola central. Así, consiguió que la tinta llegara a la bola por la gravedad y, además, por capilaridad al ser el conducto muy estrecho. La tinta, mejorada por György, el hermano químico, era muy viscosa para evitar los derrames y la evaporación pero, también, debía secarse lo más rápidamente posible en el papel.

Sin embargo, no consiguió que su invento interesara a financieros y fabricantes. Por casualidad, en un viaje por vacaciones en el Lago Balaton, en Hungría, o, según otros autores, en una estancia en los Balcanes, en Yugoeslavia, por su trabajo como periodista (era editor de un periódico con una tirada muy baja), una persona se interesó por aquel extraño instrumento de escritura que Biro utilizaba. Era el Presidente de Argentina Agustín Justo que le invitó a trasladarse a su país y, allí, montar una fábrica y comercializar su invento.

Era 1938 y, en principio, a los hermanos Biro no les interesó el viaje a Argentina, pero se veía venir la guerra en Europa y eran judíos. Huyeron a París en 1940 pero, cuando los nazis llegaron a la ciudad decidieron marchar a Argentina. En París habían conocido a un financiero, también húngaro, Johann Georg Meyne, dedicado a negocios de importación y exportación, que les ayudó a escapar y les acompañó a Argentina. Trabajaron juntos en el desarrollo del invento de Biro y se convirtió en uno de sus mejores amigos.

En Buenos Aires, Laszlo Jozsef Biro se convirtió en Ladislao José Biro, su hermano György fue Jorge Biro, y a Johann Georg Meyne se le conoció como Juan Jorge Meyne. Ladislao José Biro fundó la empresa Biro-Mayne-Biro, con su socio y su hermano.

Para 1943 ya tenían un modelo que funcionaba y al que llamaron Eterpen. Los hermanos presentaron la patente en Estados Unidos y se les concedió la certificación el 11 de diciembre de 1945 con el número 2390636. Antes, desde Hungría, habían patentado el invento en su país y en Suiza en 1938, en Francia en 1939, y, más tarde, desde Argentina, en ese país en 1940 y 1947.

Para 1943 ya tenían un modelo que funcionaba y al que llamaron Eterpen. Los hermanos presentaron la patente en Estados Unidos y se les concedió la certificación el 11 de diciembre de 1945 con el número 2390636. Antes, desde Hungría, habían patentado el invento en su país y en Suiza en 1938, en Francia en 1939, y, más tarde, desde Argentina, en ese país en 1940 y 1947.

Los hermanos Biro lo llamaron “esferográfica” pero se popularizó, sobre todo en Argentina pero también en muchos otros países, como biro, por el apellido de su fabricante. Poco después apareció el término bolígrafo que, por lo que sé hasta ahora, llegó desde España. El industrial catalán Amadeo Arboles registró en 1946 la marca “bolígrafo” a nombre de su madre Antonia. Al principio se le conoció como “pluma atómica” pero, en 1960, el término “bolígrafo” y el instrumento habían sido aceptados por el público y eran de uso común. Y pronto fue incluido como genérico en el “Diccionario de la lengua española”, que dice:

“Bolígrafo. Instrumento para escribir que tiene en su interior un tubo de tinta especial y, en la punta, una bolita metálica que gira libremente.”

Amadeo Arboles era dueño de la empresa “Estilográfica Nacional” y fabricante de plumas y, en pocos años, también de bolígrafos con la marca Arpen. La empresa todavía sigue funcionando hoy con el nombre Molin.

Pero volvamos a 1943, en plena guerra mundial. Henry Martin, que había ayudado en la financiación del invento de Biro, le compró los derechos y contrató la venta de miles de bolígrafos a la RAF, la Real Fuerza Aérea inglesa, para usarlos en sus bombarderos. Funcionaban bien en altura, no les afectaban los cambios del clima y llevaban tinta que no se secaba y duraba mucho tiempo. Eran evidentes sus ventajas para el uso militar.

Llegó la noticia al Departamento de Guerra de Estados Unidos y, después de probarlo, se lo ofrecieron a las compañías Eversharp, Parker y Sheaffer y, aseguraron que, si los fabricaban, se los comprarían. En agosto de 1944, comenzó la fabricación en la Sheaffer.

Entonces entra en nuestra historia Milton Reynolds, de Chicago. Unos seis meses después de la decisión del Departamento de Guerra, Reynolds se interesó por el invento. Era un empresario, nacido en Minnesota, que había invertido en muchos negocios e inventos, y se había hecho millonario y, también, se había arruinado unas cuantas veces. Por ejemplo, fue uno de los primeros inversores en Syntex, la empresa pionera en la píldora anticonceptiva.

Mientras tanto, en Argentina y en 1944, Biro había cedido los derechos del bolígrafo o, mejor, del biro, para Estados Unidos a las compañías Eversharp y Eberhard Faber por dos millones de dólares. Comercializaron el invento con la marca Birome, de Biro y Meyne, y lo llamaron esferográfica.

Reynolds vio, en un comercio de Chicago, unos de los escasos bolígrafos de Biro. Era uno de los fabricados en Inglaterra por la compañía Miles-Martin para la RAF. Reynolds creyó en la importancia del producto y pensó que tendría unas grandes ventas al acabar la guerra. Declaró que era el sueño de los inversores. Viajó a Buenos Aires para conocer a Biro e investigar el origen de aquel producto tan sugestivo y que veía con un gran futuro. Allí se encontró con que los derechos ya eran de Eversharp y Eberhard Faber y volvió a Chicago dispuesto a fabricar su propio bolígrafo.

Contrató a un par de expertos ingenieros mecánicos y fabricó un prototipo de bolígrafo que no era exactamente igual al que vendía Biro. Este tenía la patente en Estados Unidos y Reynolds no lo podía copiar. En el bolígrafo de Biro, la tinta llegaba a la bola por gravedad y capilaridad pero, en el de Reynolds, solo lo hacía por gravedad. Y Reynolds era un genio de las ventas y lo anunció por todas partes. Decía, entre otras cosas, que “escribe bajo el agua”. Además, en años anteriores, Reynolds había vendido otros productos a muchas tiendas y grandes almacenes y, por ello, tenía una buena lista de posibles clientes con sus encargados de compras. Contactó con Gimble, unos grandes almacenes de Manhattan, firmó con ellos una exclusiva y les vendió 50000 bolígrafos que todavía no había fabricado. Volvió a Chicago y buscó una empresa para fabricarlos. La producción comenzó el 6 de octubre de 1945 y, solo 23 días después, los primeros bolígrafos Reynolds se vendía en Gimbel, en la tienda de la calle 32 de Manhattan con fecha 29 de octubre de 1945. El precio era de $12.50, aunque solo costaba 80 centavos fabricar cada unidad. Se convirtió en el perfecto regalo de Navidad de aquel año. Hacía mes y medio se había rendido Japón y había terminado la Segunda Guerra Mundial.

Para fabricar su bolígrafo Reynolds fundó la Reynolds International Pen Company. Consiguió, después del estreno del 29 de octubre, vender ocho millones de bolígrafos en seis semanas y por valor de $5.3 millones en tres meses. La compañía Eversharp, que tenía los derechos de la patente de Biro, denunció a Reynolds por copias su producto, y Reynolds contraatacó con una denuncia contra Eversharp por restringir la libertad de comercio. No he encontrado datos exactos de quien ganó todos estos juicios pero, está claro, todos se beneficiaron de la publicidad que despertaron. Era lo que se llamó la “guerra de los bolígrafos”. Fue cuando Eversharp fundó Parker, y un socio de Reynolds, Paul Fisher, creó Fisher, compañías que compitieron con Reynolds y todavía se mantienen en el mercado.

Cuando Eversharp empezó a vender sus bolígrafos con licencia Biro, era mediados de 1946 y el mercado ya era de Reynolds. Además, llegaron al mercado más de 150 firmas vendiendo cada una sus propios bolígrafos. Los compradores pronto detectaron que los bolígrafos Biro de Eversharp no eran tan buenos como los de Reynolds. Lo mismo pasaba con muchos de los bolígrafos de otras marcas: eran malos, las ventas cayeron y el precio comenzó a bajar desde aquellos extraordinarios $12.50 del primero de Reynolds. Sin embargo, las ventas, en número de bolígrafos vendidos crecían vertiginosamente: casi nada en 1949, 50 millones en 1951, 300 millones en 1957, 475 millones en 1958, 650 millones en 1959, 900 millones en 1061, y 1000 millones en 1962.

Pronto Reynolds comenzó a exportar sus bolígrafos a todo el mundo y, sobre todo, a Europa donde había dinero para comprarlos. Pero fue en Francia, en concreto, donde apareció el que conseguiría colocar un bolígrafo en el bolsillo de casi todos los habitantes de nuestro planeta. Se llamaba Marcel Bich y, con Edouard Buffard, fundó en Clichy, Francia, una empresa que fabricó un bolígrafo de plástico en 1948. Lo comenzaron a vender en Francia en 1953 con la marca, ahora famosa, de BiC, pensada solo con quitar la h del final del apellido del fundador. Era de plástico transparente y de sección hexagonal, lo que facilitaba el agarre y escribir con precisión por el usuario. La bola es de tungsteno según una patente sueca. Las bolas del bolígrafo de Biro eran de acero inoxidable y se fabricaban según técnicas de los relojeros suizos. El BiC escribe entre tres y cinco kilómetros de tinta.

En 1958 compró Waterman y entró en el mercado de Estados Unidos. Fue el modelo Cristal el primero que se vendió en aquel país. En la actualidad, BiC vende 20 millones de bolígrafos al día, unos 57 por segundo, y la empresa ha declarado que, en toda su historia, habían vendido 100000 millones de bolígrafos.

Referencias:

Anónimo. 2013. Estilográfica Nacional, la marca pionera de bolígrafos en España. La Vanguardia 26 abril.

Brachmann, S. 2014. The evolution of modern ballpoint pen: A patent history. IPWatchdog Blog. December 10.

Gostony, H. & S. Schneider. 1998. The incredible ball point pen. A comprehensive history & price guide. Schiffer Publ. Ltd. Atglen, Pennsylvania. 160 pp.

Hilton, O. 1957. Characteristics of the ball point pen and its influence on handwriting identification. Journal of Criminal Law and Criminology 47: 606-613.

Jiménez Cano, A. 2018. Historia del bolígrafo. Bolígrafos con Propaganda Blog. 21 febrero.

U.S. Patent nº 392046, October 30, 1888. John J. Loud.

Wikipedia. 2017. Ladislao José Biro. 6 noviembre.

Wikipedia. 2017. Marcel Bich. 13 noviembre.

Wikipedia. 2018. Milton Reynolds. 31 enero.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Historia del bolígrafo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La poliomielitis: una historia sin final

- La historia de la humanidad en una isla

- #Naukas16 La verdadera historia de la penicilina

Naukas Bilbao 2017 – Carmen Agustín: La hormona del amor no existe

En #Naukas17 nadie tuvo que hacer cola desde el día anterior para poder conseguir asiento. Ni nadie se quedó fuera… 2017 fue el año de la mudanza al gran Auditorium del Palacio Euskalduna, con más de 2000 plazas. Los días 15 y 16 de septiembre la gente lo llenó para un maratón de ciencia y humor.

Una hormona es una molécula que puede hacer multitud de cosas, dependiendo de multitud de factores. Por eso no existe una relación directa como “la hormona del amor”. Establecido eso, Carmen nos habla de la neurobiología del comportamiento maternal (y del paternal) como solo ella puede hacerlo.

Carmen Agustín: La hormona del amor no existeEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Naukas Bilbao 2017 – Carmen Agustín: La hormona del amor no existe se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – Ignacio López-Goñi: Las bacterias también se vacunan

- Naukas Bilbao 2017 – Francisco R. Villatoro: El espín para irreductibles

- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

Cómo sabemos que el oro del Tesoro de El Carambolo era local

Piezas de oro del Tesoro de El Carambolo. Imagen: © Consejería de Cultura de la Junta de Andalucía / J. Morón.

El Tesoro de El Carambolo es una colección de piezas de oro del primer milenio antes de de la era común, cuyo origen ha sido durante unos 50 años el epicentro de un controvertido debate. Nuevos análisis químicos e isotópicos llevados a cabo por el Servicio de Geocronología y Geoquímica Isotópica – Ibercron de la UPV/EHU, por encargo de la Universidad de Huelva y del Museo Arqueológico de Sevilla, sugieren que el origen de ese oro no está a miles de kilómetros de donde se encontró dicho tesoro sino en un yacimiento situado a tan solo 2 km del lugar.

El elevado valor museístico de esta colección de piezas de oro limita drásticamente la posibilidad de usar técnicas clásicas de análisis de muestras disueltas, por lo que se ha utilizado de forma complementaria “un tipo de ablación láser que hace un pequeño orificio de tan solo unas 100 micras o 0,1 mm”, explica la doctora Sonia García de Madinabeitia, una de las encargadas de llevar a cabo los análisis. El citado servicio posee uno de los pocos laboratorios existentes en el contexto internacional que realiza análisis de isótopos de plomo para investigaciones arqueológicas. El laboratorio combina un sistema de ablación láser con la espectrometría de masas con fuente de plasma “con el que hacemos tanto los análisis de isótopos como los análisis elementales directamente sobre muestras sólidas y con la mínima afección posible”.

El grupo de investigación de la UPV/EHU determina las relaciones isotópicas en objetos arqueológicos, así como en los materiales relacionados con la manufactura de dichos objetos y en los potenciales minerales utilizados en su elaboración, a fin de establecer la procedencia de las materias primas. Según explica García de Madinabeitia, “estamos estableciendo una base de datos de los distintos yacimientos mineros antiguos, con los que establecer la relación que hay entre el resto arqueológico y la posible mina de la cual procede”.

“Nos basamos en una especie de huella dactilar del plomo —explica la investigadora—. Las relaciones isotópicas del plomo son diferentes en función de los materiales utilizados y de la edad de esos materiales, y nosotros determinamos la relación isotópica que tiene ese plomo. Porque hay notables diferencias de unos yacimientos minerales a otros”. Además de ello, los investigadores del laboratorio realizan análisis elementales, es decir, cuantifican los elementos traza y ultratraza que tienen los materiales, “porque sabemos que una mina por mucho que sea una mina de oro o de plata, los materiales nunca son puros, sino que tienen una serie de trazas y ultratrazas que permiten luego establecer relaciones entre los materiales arqueológicos y los materiales geológicos”, añade García de Madinabeitia.

Son muchos los grupos de investigación de centros e instituciones tanto de España (universidades, diputaciones, museos, CSIC, etc.) como de otros países (Reino Unido, Italia, Portugal, Francia, Estados Unidos, Australia) que han utilizado los datos obtenidos en el laboratorio de la UPV/EHU para investigar la procedencia de los metales en objetos arqueológicos de la más variada índole: desde pendientes de bronce etruscos, pasando por brazaletes y anillos de plata, lingotes y urnas funerarias de cobre o plomo, armas y útiles diversos de bronce, metalurgia nurágica de Cerdeña y otros muchos restos cuya antigüedad oscila entre 1.000 y 5.000 años.

A través de los numerosos estudios llevados a cabo por el grupo de investigación de la UPV/EHU, se han puesto de manifiesto hechos sumamente interesantes para el conocimiento de la antigüedad, como, por ejemplo, el abastecimiento local y el comercio de metales en el sur de la Península Ibérica mucho antes de la llegada de los primeros pueblos del Mediterráneo Oriental; el reciclaje del oro por las culturas del bajo Guadalquivir desde 3000 años antes de Cristo; o bien, el uso durante la Edad de Bronce de materias primas procedentes de áreas alejadas miles de km de distancia.

Referencia:

F, Nocete, R. Sáez, A.D. Navarro, C. San Martin, J.I. Gil-Ibarguchi (2018) The gold of the Carambolo Treasure: New data on its origin by elemental (LA-ICP-MS) and lead isotope (MC-ICP-MS) analysis Journal of Archaeological Science doi: 10.1016/j.jas.2018.02.011

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Cómo sabemos que el oro del Tesoro de El Carambolo era local se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo regular la velocidad de disolución de los biometales de las prótesis

- Si son tan buenos escondiéndose, ¿cómo sabemos que existen los camaleones?

- Artazu VII, una trampa mortal del Pleistoceno que es un tesoro

El sucesor del Hubble: el telescopio espacial James Webb

Parte del equipo del telescopio espacial James Webb posa delante de un modelo a tamaño natural del telescopio, para apreciar sus enormes dimensiones. (NASA/GSFC)

Casi treinta años de operación ininterrumpida para una máquina de cierta complejidad suelen ser un periodo bastante largo, y a pesar de reparaciones y mejoras que se le puedan realizar, tras cerca de tres décadas ya no contará ni con la tecnología ni las prestaciones más avanzadas que una máquina más moderna sí tiene. Da lo mismo que hablemos de una lavadora, un coche, o, en este caso, de un telescopio.

El pasado mes de abril, el más famoso del mundo, el telescopio espacial Hubble, cumplía nada menos que veintiocho años en órbita. Veamos unas cuantas cifras a modo de resumen de su carrera: en todo ese tiempo desde su lanzamiento el 24 de abril de 1990, y moviéndose a 28 000 km/h a casi 600 km de altura sobre la Tierra, el Hubble ha realizado un millón largo de observaciones de decenas de miles de objetos celestes distintos. Los más de diez mil astrónomos que han utilizado el Hubble han publicado unos quince mil artículos de investigación, lo que le convierte en uno de los instrumentos científicos más productivos nunca construidos.

Sin duda, el Hubble ha supuesto para la astronomía una auténtica revolución, gracias en especial a su capacidad de ser reparado y mejorado por astronautas, y que ha permitido que su vida útil se haya prolongado todos estos años. Sin embargo, tras la última de estas misiones de mantenimiento en mayo de 2009, ya hace tiempo que se viene trabajando a fondo en el que será su «sustituto»: el telescopio espacial James Webb.

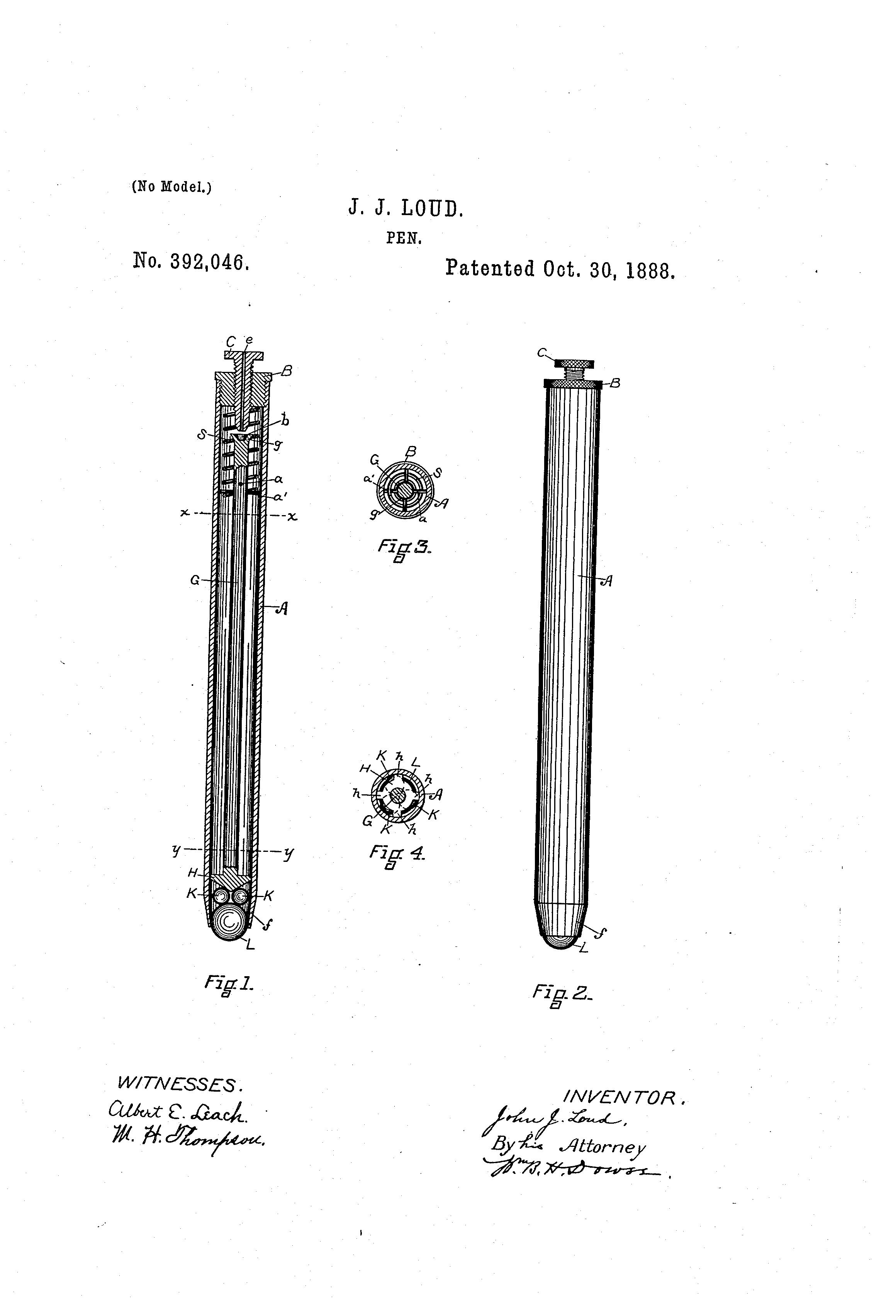

¿Cómo será este nuevo telescopio espacial? Si el parámetro que suele determinar la diferencia fundamental en cualquier telescopio es el diámetro de su espejo primario, y, por ende, su capacidad colectora de luz, comparemos los del Hubble y el James Webb. Mientras que el veterano Hubble tiene un único espejo monolítico de 2,4 metros, el James Webb tendrá 18 segmentos de forma hexagonal que conformarán un primario equivalente de 6,5 metros de abertura; es decir, su superficie colectora será unas cinco veces mayor que la del Hubble.

Comparación de tamaños de los espejos del Hubble (a la izquierda, con 2,4 metros de diámetro) y el James Webb, de 6,5 metros de abertura. (NASA)

En el origen del proyecto del que se llamó en un principio el Telescopio Espacial de Nueva Generación, hará ya veinte años, se pretendía que el diámetro del espejo fuese de 10 metros, pero complicaciones tecnológicas y especialmente, económicas, hicieron que se rebajase el tamaño del telescopio hasta los 6,5 metros actuales. A fecha de hoy, su coste ya se acerca a los 9000 millones de dólares (más o menos lo que cuesta un portaviones nuclear, por comparar). Proyecto conjunto de la NASA y las Agencias Espaciales Europea y Canadiense, el telescopio fue renombrado como James Webb en septiembre de 2002 en honor a uno de los administradores de la NASA en los años dorados del proyecto Apollo.

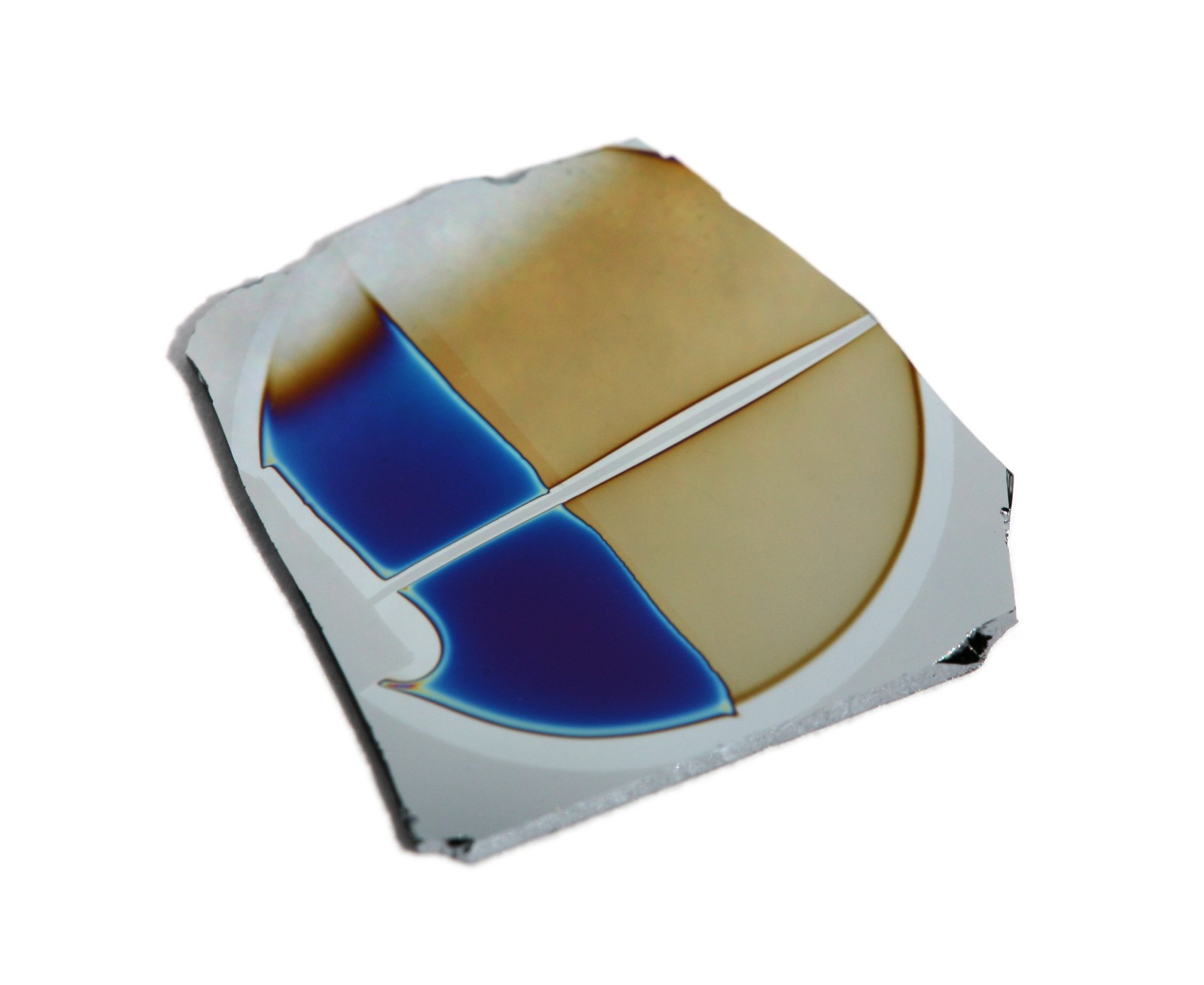

Muchos y novedosos son los desarrollos tecnológicos que se han hecho para el James Webb. Por subrayar solo algunos de ellos, mencionar su espejo primario segmentado, que se lanza plegado en tres partes que se montan en el espacio tras su despegue; óptica fabricada en berilio, un material ultra ligero y resistente; o enfriadores criogénicos que permitirán bajar la temperatura de los detectores del telescopio hasta solo 7 Kelvin y optimizar así su observación en el infrarrojo, la zona del espectro donde observará el James Webb.

Tras casi ocho de construcción, prácticamente todos los elementos del telescopio están ya listos, destacando los segmentos hexagonales del espejo primario recubiertos de una capa micrométrica de oro –especialmente reflectante en el infrarrojo– y los cuatro instrumentos científicos que se colocarán a bordo. Estos serán una cámara en el infrarrojo cercano, un espectrógrafo multiobjeto también en el infrarrojo cercano, otro instrumento para el infrarrojo medio, y una cámara con filtros sintonizables. El rango espectral de trabajo del James Webb estará entre los 0,6 y los 27 nanómetros, con cierta capacidad para observar también en el visible.

Este interesante vídeo muestra cómo se desplegarán el telescopio James Webb y su pantalla protectora, del tamaño de un campo de tenis (que tapa la luz del Sol y la Tierra para que no incida en las ópticas), hasta adquirir la configuración de trabajo. (NASA)

Se han definido cuatro áreas científicas principales para el telescopio, y que han recibido estos inspiradores títulos: El Final de las Eras Oscuras: Primera Luz y la Reionización; El Ensamblaje de las Galaxias; El Nacimiento de las Estrellas y los Sistemas Protoplanetarios; y Sistemas Planetarios y los Orígenes de la Vida. Así, estudiará todas las etapas de la historia del universo, desde los primeros destellos luminosos tras el Big Bang, hasta la formación de sistemas planetarios capaces de albergar vida en mundos como la Tierra, pasando por la evolución de nuestro propio Sistema Solar.

El James Webb, poco antes de entrar en la cámara de vacío donde se le somete a temperaturas criogénicas para comprobar su funcionamiento en las condiciones extremas del espacio. Los segmentos del espejo primario están recubiertos con una película reflectante de oro. (NASA)

Otra de las innovaciones de este telescopio espacial respecto del Hubble es que, a diferencia de este, no orbitará próximo a la Tierra, a apenas unos centenares de kilómetros de la superficie, sino que en su lugar se ubicará a 1,5 millones de kilómetros de nuestro planeta en dirección contraria al Sol, en un punto donde las atracciones gravitatorias del Sol, la Tierra y la Luna se equilibran –conocido como Lagrange 2, o L2– y las condiciones de observación son mucho mejores que en una órbita baja como la del Hubble. Eso sí, no serán posibles las visitas de mantenimiento de los astronautas, por lo que deberá ser mucho más robusto y fiable que el Hubble. Su enorme tamaño (6500 kg de peso) hace también que el cohete capaz de ponerlo en órbita sea la versión más potente del Ariane 5 ECA europeo. Tras numerosos retrasos debidos, por un lado, a la enorme complejidad el telescopio, y por otro, a las restricciones presupuestarias de la agencia espacial estadounidense, la última fecha prevista de lanzamiento es mayo de 2020, desde el puerto espacial de Kourou en la Guayana francesa.

Por último, la vida de trabajo prevista para el James Webb es de un mínimo de cinco años, llevando combustible suficiente para sus maniobras en L2 hasta diez años. Si todo va bien, durará hasta 2030, complementándose perfectamente con los telescopios gigantes de 30 y 40 metros en tierra que se están construyendo en la actualidad, y que empezarán a estar operativos a finales de la próxima década. ¿Qué maravillas nos descubrirá este digno sucesor del Hubble? Como siempre suele pasar en ciencia, las mayores no las podemos ni sospechar.

Este post ha sido realizado por Ángel Gómez Roldán (@AGomezRoldan) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

Para más información: http://jwst.nasa.gov

El artículo El sucesor del Hubble: el telescopio espacial James Webb se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La misión espacial Rosetta, por Agustín Sánchez Lavega

- Hola a todos, me llamo Bond, James Bond… y soy un alcohólico

- La estrella individual más lejana jamás vista

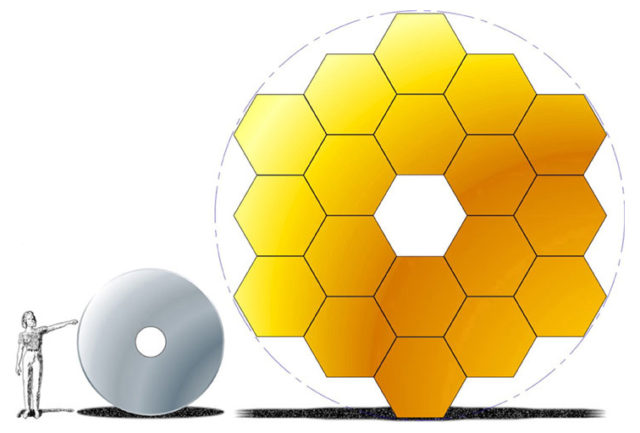

Catástrofe Ultravioleta #24 DISONANCIA

Catástrofe Ultravioleta #24 DISONANCIA

En este último capítulo de la segunda temporada nos proponemos descubrir las razones por las que a nuestro cerebro le gustan determinados sonidos y le desagradan otros. ¿Todos encontramos armónicos los mismos sonidos o existen diferencias culturales repartidas por todo el mundo? Os invitamos a una experiencia sonora donde viajaremos de la mano de la armonía y la disonancia para conocer los mecanismos por los que nuestra mente disfruta o rechaza sonidos.

Agradecimientos: Almudena M. Castro, Iñaki Úcar, Lucas Sánchez, Luis Delgado y su museo de instrumentos en Urueña, Ray Jaén, Lucía Perlado, Don Rogelio J, Jose María del Río, Stephen Hughes y la familia Cuéllar.

La edición, músicas originales y ambientación son obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo. En esta ocasión, además de la banda sonora original, ha hecho versiones de BWV 529 Sonata a trio nº 5 (J.S. Bach), Gran étude de Paganini Nº 1 (Liszt), Le Carnaval des Animaux – Aquarium (Saint-Saëns), Naima (John Coltrane) y Rumble (Link Wray).

Colaboran Cris Blanco (voz en la canción de apertura) y Quique Gallo (batería en el tema de cierre).

** Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #24 DISONANCIA se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Catástrofe Ultravioleta #14 VULCANO

- Catástrofe Ultravioleta #13 LEVIATÁN

- Catástrofe Ultravioleta #21 PHARMA

Héroes de la ciencia, héroes de la humanidad

Juan Francisco Martínez Mojica, investigador de la Universidad de Alicante. Foto: Pepe Olivares / El País

Honramos en el recuerdo, y con razón, a gente como Norman Borlaug, Jonas Salk, Maurice R. Hilleman, Alexander Fleming o Howard Florey; gentes que a través de su trabajo científico consiguieron avances que han salvado la vida y permitido vivir literalmente a miles de millones de humanos. Gracias a las variedades enanas de cereal de Borlaug, las vacunas de Salk (polio) o Hilleman (hasta 40 vacunas diferentes) y la penicilina (descubierta por Fleming, desarrollada como producto farmacéutico gracias a Florey) hoy hay vivas muchas más personas de las que jamás ha habido en la historia del planeta. Gentes como ellos son, con toda justicia, reconocidos como la causa de que estemos aquí muchos de nosotros. Y sin embargo tratándose sin duda de científicos héroes de la Humanidad no representan realmente lo que la ciencia es y por qué se hace.

Mucha gente cree, en parte por la merecida gloria de pioneros como los citados, que el papel de la ciencia es crear nuevas herramientas para el progreso de la Humanidad. Es la razón principal que aducen los políticos cuando dicen que van a dedicar presupuestos a la ciencia (casi siempre torticeramente), o la que usan muchos defensores de la divulgación y la educación científica. Es necesario apoyar esta actividad por su utilidad social, que es el objetivo que sustenta los esfuerzos de los científicos: curar el cáncer, crear nuevas tecnologías con potencial económico, mejorar la vida de la gente. Lo importante de la ciencia, por tanto, son sus aplicaciones. los usos que de ella se puedan derivar que redunden en mejoras de la calidad de vida e impulso económico: las patentes, las empresas derivadas de laboratorios, los megaproyectos creadores de nuevos paradigmas como Internet. La ciencia se debe hacer, así, para que sea útil.

Y nadie vivo hoy (y honesto intelectualmente) puede dudar de la utilidad del conocimiento científico. Los avances en medicina, sanidad e higiene, agricultura, infraestructuras y tecnologías múltiples son obvios y han contribuido a aumentos en la calidad y cantidad de vida humana que hubiesen sido impensables siglos atrás. Hoy el modo de vida de casi cualquier habitante de un país desarrollado y de un creciente número de quienes viven en países más pobres es objetivamente mejor y más larga que la de los más poderosos regentes y ricos del pasado. Gracias a nuestros conocimientos de ciencia cada vez mueren menos niños, estamos menos enfermos, vivimos mucho más tiempo y lo hacemos con niveles de comodidad y libertad que hubiesen provocado la envidia de los Césares de Roma.

Pero reconozcámoslo: lo que mueve a la mayor parte de los científicos del mundo no es este noble empeño por mejorar la vida de la Humanidad, sino la simple, pura y dura curiosidad: el querer conocer cómo funciona el Universo. La necesidad de rascarse ese picor cortical que nos acecha cuando somos incapaces de resolver un rompecabezas; la sensación de irritación, casi de ofensa, que tenemos cuando estamos al borde de comprender pero todavía no lo conseguimos. La búsqueda incesante del destello de placer que ilumina el cerebro en ese clásico Momento Ahá. Confesémoslo: la ciencia, en sí misma, es una actividad egoísta que se lleva a cabo mayoritariamente por el placer propio de conocer.

A partir de ese conocimiento luego pueden llegar las aplicaciones, a veces espectaculares y de tal alcance que pueden cambiar la vida de la humanidad entera. Así es como un sistema bacteriano de protección contra infecciones víricas se está convirtiendo en una herramienta que va a cambiar con carácter inmediato la medicina o la agricultura, revolucionando por completo el futuro de nuestros descendientes. En laboratorios de todo el mundo hay una verdadera carrera en estos momentos para usar CRISPR en multitud de funciones de enorme utilidad; el potencial económico de su impacto es tal que a la vez hay una feroz guerra de patentes por el control financiero de la tecnología. Los creadores de estas herramientas serán son duda héroes de la humanidad que contribuirán a salvar innumerables vidas y a mejorar las economías de sus países y del mundo.

Pero cuando Francis Mojica estudiaba en su laboratorio de Alicante el genoma de arqueas como Haloferax y Haloarcula no estaba haciéndolo para esto. Su motivación no era descubrir una técnica revolucionaria de edición genética, sino comprender un misterio encerrado en el ADN de algunos de las más recónditos organismos de la Tierra. Su móvil no era salvar a la humanidad, sino comprender. Y en ese sentido se trata de un verdadero héroe de la ciencia, no solo de la Humanidad.

La distinción puede parecer pueril, pero es importante, porque muchas veces no podemos saber de antemano qué descubrimientos sobre como pera el Cosmos nos van a resultar útiles después. Si nos limitamos a apoyar aquella ciencia que puede tener aplicación visible estamos limitando nuestra propia visión del futuro, porque descubrimientos como el de Mojica no serán financiados ni obtendrán respeto y respaldo, con lo que futuros CRISPR jamás serán descubiertos. Si comprendemos que el motor de la ciencia es la curiosidad, y que ese motor debe ser alimentado no sólo porque los resultados de la ciencia sean útiles sino porque la curiosidad es un rasgo humano que debemos fomentar. La ciencia básica necesita respeto por sí misma, también (pero no solo) porque los héroes de la humanidad llegan a serlo gracias a la existencia previa de héroes de la ciencia. Por lo cual incluso por razones practicas conviene apoyar la ciencia teórica.

Sobre el autor: José Cervera (@Retiario) es periodista especializado en ciencia y tecnología y da clases de periodismo digital.

El artículo Héroes de la ciencia, héroes de la humanidad se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- De los héroes de la ciencia y sus frágiles teorías

- Los enemigos de la humanidad

- La historia de la humanidad en una isla

Cómo deshacer un nudo en el ADN

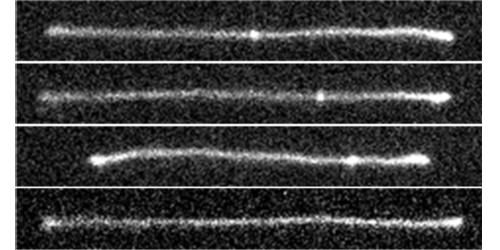

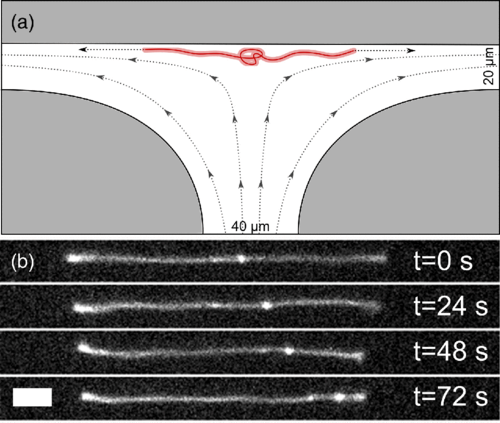

Como la mayoría de las cuerdas y cables, los biopolímeros (que no dejan de ser cuerdas moleculares, ya que son cadenas de unidades que se repiten) pueden enredarse y anudarse. Alexander Klotz y sus colegas del Instituto de Tecnología de Massachusetts (EE.UU.) han desarrollado experimentalmente una técnica para deshacer los nudos que puedan existir en un biopolímero, en este caso el ADN, mediante el estiramiento de la cadena. El equipo dice que su técnica podría usarse para crear cadenas de ADN sin nudos para mejorar los estudios genéticos, en los que los nudos pueden llevar a una lectura errónea de los genes.

Una cadena de ADN se comporta de forma similar a una serpiente que se mueve hacia adelante y hacia atrás en un tubo estrecho, impulsada por energía térmica. Las simulaciones muestran que si la cadena se estira, este movimiento hacia adelante y hacia atrás hace que el nudo se mueva a lo largo de la cadena hasta que llega a un extremo y se deshace. Bajo ciertas condiciones, las simulaciones también indican que los nudos pueden viajar más rápido de lo que lo harían por difusión. Pero no hasta ahora no existía ninguna confirmación experimental de estas predicciones.

Para comprobar estas ideas, los investigadores diseñaron una configuración que utiliza un campo eléctrico para atrapar y estirar una cadena de ADN que contiene un nudo. Como el ADN está cargado eléctricamente un campo eléctrico homogéneo externo podría arrastrar al filamento en una dirección. El campo diseñado para la trampa de ADN vale cero en el centro y tiene sendos máximos en los extremos. Esto es equivalente, eléctricamente, a tirar de los dos extremos de la cadena de ADN.

Utilizando microscopía de fluorescencia, el equipo de investigadores confirmó que el nudo, inicialmente localizado cerca del centro del filamento, viaja hacia un extremo antes de deshacerse. El nudo se acelera mientras se mueve, influenciado por el campo eléctrico cada vez mayor conforme se acerca a uno de los extremos.

Curiosamente, existe un valor umbral del campo, por encima del cual el nudo se detiene. El equipo sugiere que esta inmovilización del nudo surge de una mayor fricción en el nudo resultado de que la tensión de la cadena supera la necesaria para simplemente mover el nudo.

Referencia:

Alexander R. Klotz et al (2018) Motion of Knots in DNA Stretched by Elongational Fields Physical Review Letters doi: 10.1103/PhysRevLett.120.188003

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Cómo deshacer un nudo en el ADN se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Del nudo gordiano al nudo de los enamorados, por territorio matemático

- Cómo detectar un defecto en el ADN viendo cómo se retuerce

- Cómo cargar el móvil a partir del ruido magnético ambiente

¡Préstame cincuenta dólares!

Bud Abbott y Lou Costello. Fuente: Wikimedia Commons.

Bud Abbott (BA): Hazme un favor, ¡préstame 50 dólares!

Lou Costello (LC): Bud, no puedo. No puedo prestarte 50 dólares.

BA: Oh, sí, puedes.

LC: No, no puedo. Solo tengo 40 dólares.

BA: De acuerdo, dame los 40 dólares y me debes 10.

LC: De acuerdo, te debo 10.

BA: Está bien.

LC: ¿Cómo es que te debo 10?

BA: ¿Cuánto te he pedido?

LC: 50.

BA: ¿Cuánto me has dado?

LC: 40.

BA: Entonces me debes 10 dólares.

LC: Es verdad. [Pausa] Pero me debes 40.

BA: No cambies de tema.

LC: No estoy cambiando de tema; estás tratando de cambiar mis finanzas. Vamos, Abbott dame mis 40 dólares.

BA: De acuerdo, ten tus 40 dólares, ahora dame los 10 que me debes.

LC: Te pago a cuenta.

BA: ¿A cuenta?

LC: A cuenta, no sé cómo te debo eso.

BA: Esa es la forma en que te sientes al respecto, es la última vez que te pido un préstamo de 50 dólares.

LC: ¿Pero cómo voy a prestarte 50 dólares ahora? Solo tengo 30.

BA: Bueno, dame los 30 y me debes 20.

LC: De acuerdo. Esto está empeorando cada vez más. [Mira a la audiencia]. Al principio le debía 10, ahora le debo 20.

BA: Bueno, ¿por qué te metes en deudas?

LC: No me estoy metiendo, ¡me estás empujando!

BA: No puedo ayudarte si no eres capaz de manejar tus finanzas. Me va bien con mi dinero.

LC: Y también te va bien con mi dinero.

BA: Bueno, te he pedido un préstamo de 50 dólares. Me has dado 30, entonces me debes 20. 20 más 30 son 50.

LC: No. No. No. ¡25 más 25 son 50!

BA: Muy bien, aquí tienes tus 30 dólares, ahora dame los 20 que me debes. Buen tipo… que no presta a un amigo 50 dólares.

LC: ¿Cómo puedo prestarte 50, si ahora solo tengo 10?

BA: Espera un minuto, para mostrarte que soy tu amigo, ¿quieres duplicar eso?

LC: Adelante [Da a Abbott 10 billetes]. Nos vemos luego.

BA: Espera un minuto. No quiero esa clase de dinero. Lo haremos honesta y respetablemente. Elije un número entre 1 y 10.

LC: Bien.

BA: ¿Es par o impar?

LC: Par.

BA: ¿Es el número entre 1 y 3?

LC: No.

BA: ¿Entre 3 y 5?

LC: No. Creo que lo tengo.

BA: ¡Entre 5 y 7!

LC: Sí.

BA: número 6

LC: ¡Cierto! … ¿Cómo has hecho eso? [Pausa] Oye…

Esta conversación entre los cómicos Abbott y Costello (ver 2.) es una versión del enigma del dólar perdido, una paradoja elemental de matemáticas consecuencia de una falacia informal. Lo enunciamos en su forma habitual:

Tres amigos cenan en un restaurante. Al finalizar la comida, el camarero les lleva la cuenta que asciende a 30 dólares; cada comensal pone 10 dólares. El camarero lleva el dinero al dueño del restaurante, quien percibe un error en la factura: la comida costaba en realidad 25 dólares, es decir, los tres amigos han pagado 5 dólares de más. El dueño da cinco billetes de dólar al camarero para que los haga llegar a los clientes. El camarero, queriendo ganar un poco más de dinero, devuelve tres dólares a los invitados (fácil de repartir, porque como ya sabemos, Muchos adultos son incapaces de realizar operaciones financieras básicas), y se queda con los otros dos.

El problema que se plantea es el siguiente: cada invitado ha pagado 9 dólares, lo que hace un total de 27 dólares, y el camarero se ha embolsado 2. Pero 27+2=29 y no 30. ¿Dónde ha quedado el dólar que falta?

Cinco dólares. Fuente Wikimedia Commons.

En realidad, la solución es sencilla: no hay ninguna razón, en el ‘convincente’ argumento anterior, para sumar los 27 dólares pagados por los clientes a los 2 que se queda el camarero. Los clientes han pagado 30 dólares y han recibido 3 de vuelta, es decir, han pagado 27, que corresponden a los 25 pagados al dueño del restaurante y los 2 que se ha quedado el camarero. Así pues, las únicas operaciones pertinentes son 30-3=27 y 27=2+25… En el anterior argumento, las operaciones matemáticas realizadas son elementales, pero una de ellas… ¡no tiene ningún sentido!

Referencias

-

Missing dollar riddle, Wikipedia

-

Loan me 50 dollars, Abbott and Costello

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo ¡Préstame cincuenta dólares! se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El diablo y Simon Flagg, una lectura ligera para el verano

- Variaciones artísticas del teorema de Napoleón

- 666, el número de la Bestia (y 2)

La regulación osmótica de los peces diádromos

Ejemplar macho maduro de salmón del pacífico (“Oncorhynchus kisutch”). Imagen tomada en un arroyo de Alaska.

Vimos en la anotación anterior que hay animales eurihalinos, capaces de tolerar cambios en la concentración salina del medio en el que viven. Y hay también un grupo de animales –peces, para ser precisos- que cambian de medio en determinados momentos de su vida, son los peces diádromos. Los hay, además, de dos tipos: anádromos (van hacia arriba) y catádromos (van hacia abajo). Los anádromos, como los salmones, nacen en los ríos y en ellos inician su desarrollo y adquieren un cierto tamaño; más adelante migran al mar, donde alcanzan un tamaño mayor y se proveen de abundantes reservas que les servirán para disponer de energía para hacer el viaje de vuelta al río del que salieron y producir gametos; una vez en el río, lo remontan y desovan. Los catádromos, como las anguilas, hacen lo contrario: nacen en el mar y viajan al río, donde crecen y se dotan de reservas; vuelven más tarde a la zona del océano en que nacieron para desovar.

Es evidente que en esas transiciones se producen cambios en la salinidad ambiental y, por lo tanto, han de ajustar en cada caso los mecanismos de osmorregulación a la nueva situación. Cuando se encuentran en agua dulce son reguladores hiperosmóticos y en agua de mar, reguladores hiposmóticos. La concentración de su medio interno experimenta un cierto cambio, aunque pequeño, lo que sirve para que el gradiente osmótico entre el interior y el exterior del organismo sea de menor entidad. El medio interno del salmón Oncorhynchus tshawytscha, por ejemplo, tiene una concentración 410 mOsm (miliosmolar) cuando se encuentra en agua marina y 360 mOsm, en agua dulce.

La gran impermeabilización del tegumento es un rasgo valioso en ambos medios; eso no han de cambiarlo al migrar. Elevan la producción de orina –y la diluyen- al pasar del mar al río, y la disminuyen –a la vez que la concentran- cuando transitan en sentido contrario. Si pasan del río al mar empiezan a beber agua, y dejan de hacerlo cuando migran del mar al río. En ambas condiciones se produce transporte activo de NaCl en las branquias, pero el sentido de ese trasvase es opuesto: incorporan sales en el río y las expulsan en el mar. Cuando van al mar procedentes del río, ponen en marcha los mecanismos de incorporación de NaCl en el epitelio intestinal, a la vez que aumenta la densidad de acuaporinas.

Esas transformaciones se producen bajo el gobierno de ciertas hormonas. En concreto, sabemos que la prolactina juega un papel clave en la transición del agua de mar al agua dulce, al reducir la permeabilidad del epitelio branquial al sodio y al elevar el flujo de orina. Y también otras hormonas, como el cortisol, la hormona del crecimiento y el factor de crecimiento insulínico y las hormonas tiroideas, tienen importantes funciones en estas transiciones.

La especie acerca de cuyos mecanismos de osmorregulación más se sabe es el salmón atlántico, Salmo salar, dado el gran desarrollo que ha alcanzado el cultivo de esta especie. A los salmones que todavía no han viajado al mar se les denomina parr. Los cambios fisiológicos necesarios para poder vivir en agua de mar han de darse inmediatamente antes de que la migración se produzca y a los salmones que se encuentran en condiciones fisiológicas para la transición se les denomina smolt. Por esa razón, al proceso de cambio se le denomina smoltificación.

En la actualidad se dispone de conocimiento preciso acerca de todas estas cuestiones. Antes, cuando se desconocían las particularidades de la fisiología de los salmones ocurrían cada cierto tiempo episodios de alta mortalidad en las factorías en las que se cultivaban. En el cultivo intensivo de salmones ha de reproducirse el ciclo de vida en su totalidad, razón por la que debe ejercerse un control estricto de la transición de agua dulce a agua salada en los estanques. Cuando no se conocía bien la biología de la especie, en ocasiones se cambiaba la salinidad demasiado pronto, cuando los salmones todavía no se encontraban preparados para la transición, por lo que los jóvenes parr morían en grandes cantidades. Fue necesario identificar con precisión los hitos y características de la transición parr-smolt para que el cultivo de salmones alcanzase las dimensiones de que goza hoy.

El hecho de que las especies anádromas no puedan cambiar de salinidad en cualquier momento de sus vidas las diferencias de las especies eurihalinas que vimos en la anotación anterior. En ese sentido, los peces diádromos tienen un estatus equívoco con relación a su tolerancia al cambio de salinidad: existe tal tolerancia, aunque restringida a periodos concretos y limitados. No serían verdaderas especies eurihalinas.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La regulación osmótica de los peces diádromos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La regulación osmótica e iónica en los teleósteos marinos

- La regulación osmótica de los animales de agua dulce

- Peces capaces de respirar en aire y anfibios

Montañeros, espeleólogos y mineros

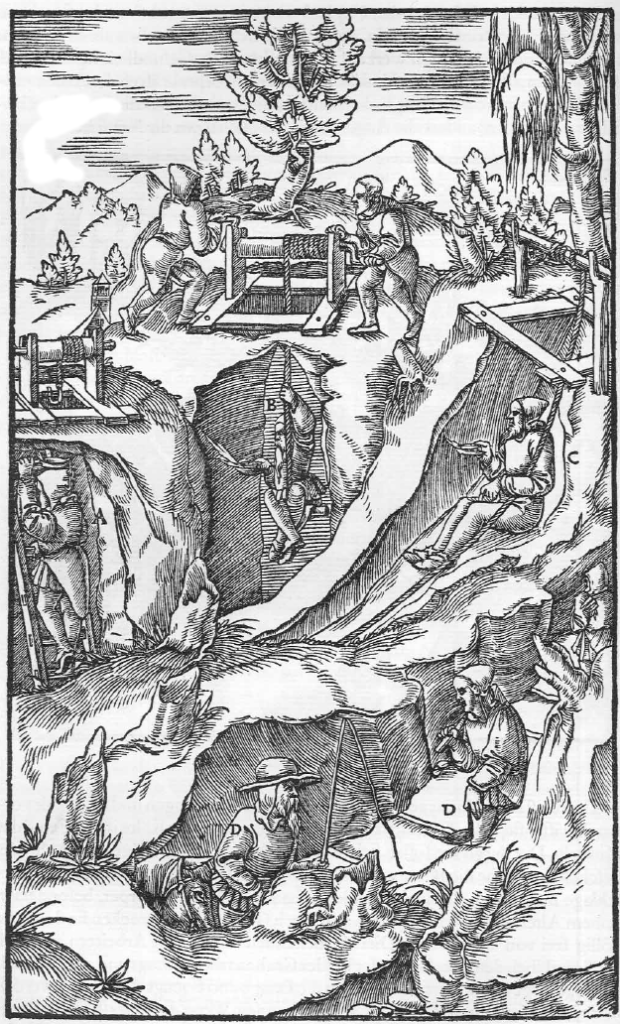

Ilustración del libro XII de “De re metallica” (1556) de Georg Bauer “Agricola”

Desde el Renacimiento has el siglo XVIII produjeron clasificaciones de minerales y rocas una tras otra. Entre las más importantes cabe mencionar la del ingeniero de minas y alquimista alemán Georg Pawer (también Bauer), más conocido como Agricola, la del químico sueco Johan G. Wallerius (considerado el padre de la química agrícola, por cierto) o la del geólogo alemán Abraham Gottlob Werner (otro padre, en este caso del neptunismo, algo de lo que nos ocuparemos más adelante).

Todas estas clasificaciones tenían un trasfondo alquímico y todas tenían en común la clasificación general en cuatro grupos en función de sus “químicas”, más concretamente en su relación con el calor y los fluidos: tierras, metales, sales y combustibles. Así, las tierras resistían el calor y el agua, los metales se volvían fluidos al calentarse, las sales se disolvían en los fluidos y los combustibles (como el carbón, por ejemplo) generaban calor al arder.

Como la química era la base de la clasificación de las rocas y minerales, los aprendices y estudiantes pasaban más tiempo en talleres, fundiciones, gabinetes y laboratorios trabajando con sustancias y aparataje químicos que sobre el terreno.

La Calzada del Gigante (Irlanda) está formada por duras columnas de basalto.

Después de siglos de clasificaciones minerales, Werner sería el primero en expresar la frustración que producía el estudio de minerales y rocas desde el punto de vista científico a principios del siglo XIX, concluyendo que no existían y, por tanto, no podían encontrarse, principios teóricos consistentes para la clasificación de los minerales. Una consecuencia de este convencimiento es que Werner empieza a dar instrucciones a sus estudiantes de clasificar las rocas en función del tiempo de su formación (lo que se enmarca en lo que se conoce como estratigrafía, que también veremos más avanzada la serie) y los minerales aparte de la clasificación general se asocian al tipo y antigüedad de las rocas en las que aparecen, algo que estrá relacionado con el origen mismo de esas rocas.

La creciente industrialización junto a la aparición de estados nacionales ilustrados lleva a que los gobiernos comiencen a contratar inspectores de minas, especialistas en sondeos mineros y mineralogistas para que estudien el territorio nacional concienzudamente en busca de riquezas y recursos. Los mineralogistas abandonan sus cubículos para convertirse en montañeros, espeleólogos y mineros.

La blanda piedra arenisca del Cañón del Antílope (Arizona, Estados Unidos) está formada por arena (cuarzo, blanco); los colores los porporcionan mayoritariamente los minerales hematites (rojo), goetita (pardo / amarillo ocre) y limonita (pardo / amarillento claro).

En la segunda mitad del siglo XVIII, estos mineralogistas de aire libre, entre ellos, Lazzaro Moro y Giovanni Arduino en Italia, Johann Lehmann en Alemania o Guillaume-François Rouelle en Francia, encuentran conveniente clasificar las rocas en dos tipos fundamentales: primarias y secundarias.

Las rocas primarias eran duras, a menudo cristalinas, y la matriz en la que se encontraban los metales y minerales preciosos; constituían el núcleo de las cadenas montañosas.

Las rocas secundarias eran relativamente blandas y granulares, a menudo formaban capas o estratos en las laderas de las montañas cuyos núcleos eran las rocas primarias. A menudo, las rocas secundarias contenían fósiles, que ya entonces los mineralogistas consideraban restos endurecidos de animales y plantas.

Esta clasificación tenía que ver con la cosmogonía: el estudio del desarrollo del planeta.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Montañeros, espeleólogos y mineros se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Clasificación y origen, los dos problemas de la mineralogía

- Esa pesadilla científica llamada mineralogía

- Potencia y eficiencia de una máquina

La polilla que se parecía a Donald Trump: más allá del chascarrillo

La polilla bautizada en honor a Donald Trump. Imagen: Wikimedia Commons

Con todos ustedes, bajo estas líneas, el escarabajo acuático Grouvellinus leonardodicaprioi, bautizado como habrán podido deducir mis avezados lectores, en honor del actor Leonardo DiCaprio como homenaje a su activismo en favor de la conservación del medio ambiente y para conmemorar el 20 aniversario de la Leonardo DiCaprio Foundation, creada por el actor con este fin.

Leonardo DiCaprio junto al escarabajo que lleva su nombre. Imagen: Wikimedia Commons

Este recién descubierto escarabajo fue encontrado en la cascada en la remota zona de Maliau Basin, en el Borneo Malasio, y su descubrimiento es un logro de la llamada ciencia ciudadana: fue un grupo de excursionistas aficionados el que encontró el espécimen nunca antes descrito. En total descubrieron tres nuevas especies de escarabajos acuáticos, y uno de ellos quisieron dedicarlo a DiCaprio, que ha dedicado sus esfuerzos a proteger el medio ambiente, y en concreto los hábitats vírgenes e inexplorados, como el propio lugar donde su escarabajo vive. “Pequeño y negro, este nuevo escarabajo nunca ganará un Oscar por su carisma, pero en la conservación de la biodiversidad, todas las criaturas cuentan”, ha dicho la entomóloga Iva Njunjic.

Permítanme que les presente a otra amiga. Pueden verla al comienzo de este texto y si se fijan bien en su aspecto quizá puedan adivinar su nombre. Presten atención sobre todo a esas escamas pálidas sobre su cabeza y a su parecido con el proceloso flequillo del hombre a su lado: están ustedes ante un ejemplar de Neopalpa donaldtrumpi bautizada, como no podía ser de otra manera, en recuerdo del actual presidente de Estados Unidos, Donald Trump.

Shakira y sus movimientos de cadera dan nombre a esta avispa. Imagen: Wikimedia Commons

Pero esperen, que traigo más amigos a esta pequeña reunión nuestra. Esta curiosa avispa se llama Aleiodes shakirae en honor a la cantante colombiana Shakira. No es porque se le parezca, o porque Shakira haya hecho nada concreto por ella y su entorno. No, en este caso el homenaje se debe a que “el parasitismo por esta especie causa que la oruga anfitriona doble y retuerza su abdomen de forma muy particular, y Shakira también es famosa por su habilidad en la danza del vientre”, explicaban los bautizadores del insecto.

La tarántula bautizada en honor a Johnny Cash. Imagen: Wikimedia Commons

Y aquí está la araña Aphonopelma johnnycashi. Dado que se puede encontrar en los alrededores de la prisión Folsom, en California, y que los machos a partir de determinada edad son de color negro completamente, sus descubridores decidieron que no había nombre más apropiado para esta especie que un homenaje al cantante Johnny Cash. Y yo coincido en ese juicio.

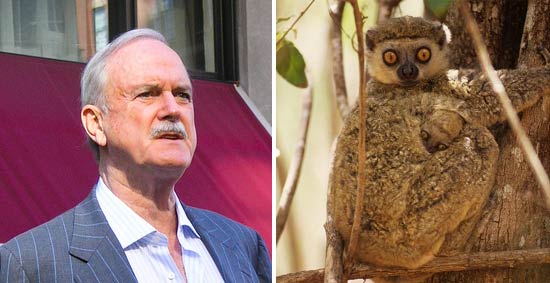

Jonh Cleese y ‘su’ lemur. Imagen: Wikimedia Commons

En 2005 este simpático lemur fue descrito por primera vez y bautizado como Avahi cleesei en honor al actor inglés John Cleese, que en la película Criaturas feroces interpretaba a un cuidador de lemures y que después dio voz y presentó a un afamado documental sobre estos animales.

Para no extenderme, pero no queriendo dejar a nadie atrás, dejad simplemente que mencione a los trilobites Avalanchurus simoni y Avalanchurus garfunkeli (en homenaje a Simon y Garfunkel), al escarabajo Cheguevaria (que recuerda al Che Guevara), al pterosaurio Coloborhynchus spielbergi (bautizada en honor al director Steven Spielbergh), la araña Filistata maguirei (para recordar a Tobey Maguire, actor en tres películas de Spiderman), el mamífero extinto Gagadón (que homenajea a Lady Gaga), la polilla Hellinsia pizarroi (que recuerda al conquistador Francisco Pizarro) o la rana Hyloscirtus princecharlesi (en honor al príncipe Carlos de Inglaterra).

¿Cómo se bautiza a una especie?

Imaginarse a una polilla con un pelucón a lo Donald Trump tiene su gracia. ¿Cómo se convierte eso en el nombre oficial de una nueva especie?

Lo primero que hace falta es asegurarse de que lo que tenemos entre manos es efectivamente una nueva especie lista para ser bautizada. Para eso hace falta designar un holotipo, esto es, un ejemplar que sirva como identificación de esa nueva especie descubierta. También son de ayuda los paratipos, ejemplares complementarios, por ejemplo un macho si el holotipo es una hembra, o una cría de la misma especie, de forma que se puedan reunir y observar todas las características distintivas de la especie descubierta.

Esta rana recibe su nombre del Príncipe Carlos, ya que este siempre utiliza una rana como símbolo en sus campañas para la conservación tropical. Imagen: Wikimedia Commons

Normalmente estos especímenes se conservan en un lugar donde puedan ser examinados por otros científicos, a fin de determinar con seguridad si se trata de una especie nueva o no. La taxonomía es una disciplina en constante discusión y reexaminación, y no son pocas las veces que un ejemplar ha obtenido y perdido después el estatus de especie independiente.