Carnot y los comienzos de la termodinámica (1)

Carnot fue uno de de los ingenieros franceses que se propusieron estudiar los principios científicos subyacentes al funcionamiento de la máquina de vapor con el objetivo de lograr la máxima potencia de salida con la máxima eficiencia. Como resultado de sus estudios, Carnot y otros ayudaron a establecer la física del calor, lo que se conoce como termodinámica.

Nicolas Léonard Sadi Carnot (1796-1832), en este imagen vistiendo el uniforme de estudiante de L’École polytechnique, fue hijo de Lazare Carnot, uno de los generales de confianza de Napoléon. Murió a los 36 años como conseuencia de la epidemia de cólera que se extendió por Europa en la época.

Carnot comenzó con la observación experimental de que el calor no fluye por sí solo de un cuerpo frío a uno caliente. Se deduce entonces que si, en una situación dada, se hace fluir calor de lo frío a lo caliente, debe tener lugar algún otro cambio en otra parte. Es decir, debe realizarse algún trabajo. Por ejemplo, un refrigerador o un acondicionador de aire son también “máquinas térmicas”, pero su ciclo funciona de manera inversa a una máquina de vapor o un motor de automóvil. Hace falta trabajo (en forma de energía eléctrica o mecánica) para bombear el calor de un cuerpo frío (desde el interior del compartimento o la habitación fríos) a uno más caliente (la habitación donde está el refrigerador o el aire exterior). Utilizando una argumentación muy elegante1 Carnot demostró que ninguna máquina puede ser más eficiente que una máquina ideal y reversible, y que todas las máquinas de este tipo tienen la misma eficiencia.

¿Y que es una máquina ideal y reversible? De entrada algo que no existe en el mundo real (por eso se llama ideal), pero que es extremadamente útil para entender los límites de las máquinas reales. Íntimamente ligado a la idealidad está el concepto de reversibilidad. Una máquina reversible es aquella en la que el ciclo desde la energía de entrada al trabajo de salida más la energía residual, y vuelta a la energía de entrada, se puede ejecutar en sentido inverso sin ninguna pérdida o ganancia adicional de calor u otras formas de energía.

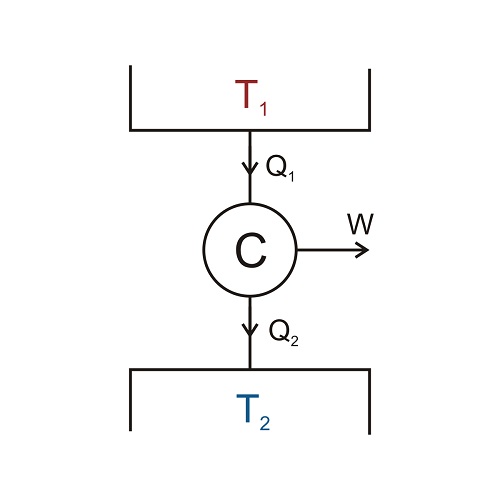

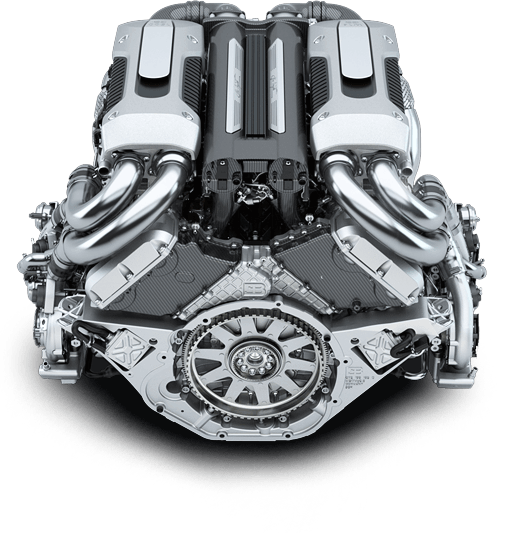

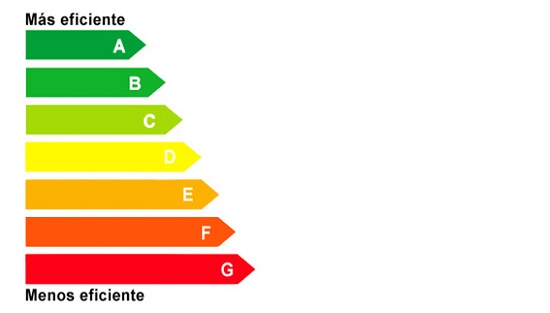

Como todas las máquinas reversibles tienen la misma eficiencia, sólo se tiene que elegir una versión simple de una máquina reversible y calcular su eficiencia para un ciclo para encontrar un límite superior a la eficiencia de cualquier máquina. Esta máquina simple se representa esquemáticamente en el siguiente diagrama. Durante un ciclo de funcionamiento, la máquina, representada por la C de Carnot, absorbe la energía térmica Q1 del cuerpo caliente a temperatura T1, produce un trabajo útil W, y descarga una cierta cantidad de energía térmica Q2 al cuerpo frío a temperatura T2. El ciclo puede repetirse muchas veces.

Observando el diagrama y empleando la ley de conservación de la energía vemos que se tiene que cumplir que Q2 = Q1 – W; o, dicho en términos coloquiales, el calor que sale es la diferencia entre el que entra menos el trabajo que realiza la máquina. Pero, como la eficiencia vimos que era la proporción entre la energía de salida (ahora añadimos “útil”, esto es, el trabajo) y la energía de entrada, tenemos que ef = W/Q1.

Carnot calculó la eficiencia de este ciclo esquemático y encontró que las proporciones de calor y trabajo en una máquina reversible dependen solamente de la temperatura2 de la sustancia caliente desde la cual la máquina obtiene el calor y la temperatura2 de la sustancia fría que extrae el calor residual de la máquina.

La expresión que encontró Carnot para la eficiencia de las máquinas reversibles es, escrita con nomenclatura actual, ef = W/Q1 = 1 – T2/T1

Démonos cuenta de que la única forma de obtener una eficiencia del 100%, es decir ef = 1, es si hacemos que T2, la temperatura de la sustancia que recibe el calor residual, sea el cero absoluto, algo físicamente imposible, como veremos. Esto significa, de nuevo en términos coloquiales, que toda máquina debe liberar algo de calor residual al exterior antes de volver a tomar más energía del cuerpo caliente. Y esto, tan simple, es de una importancia enorme.

Notas:

1 Una argumentación a la que, por su simplicidad, importancia y valor formativo, dedicaremos una anotación específica.

2 Las temperaturas usadas en este caso se llaman temperaturas absolutas (T), o Kelvin, (por el señor Kelvin que fue el primero en introducir esta escala). En la escala absoluta, las mediciones de temperatura son iguales a las temperaturas (t) en la escala Celsius (°C) más 273. No se usa signo de grado, °, para grados Kelvin, el símbolo utilizado es K. Por tanto, el agua se congela a T = 273 K y cuando T = 0 K hablamos de cero absoluto. Ya explicaremos el origen de esta escala más adelante en la serie.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Carnot y los comienzos de la termodinámica (1) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Historias de la malaria: Charles Louis Alphonse Laveran y el protozoo

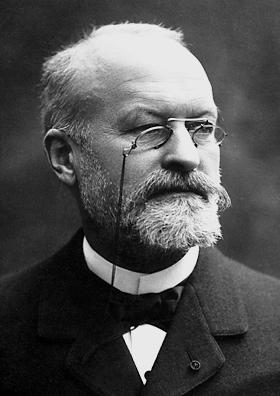

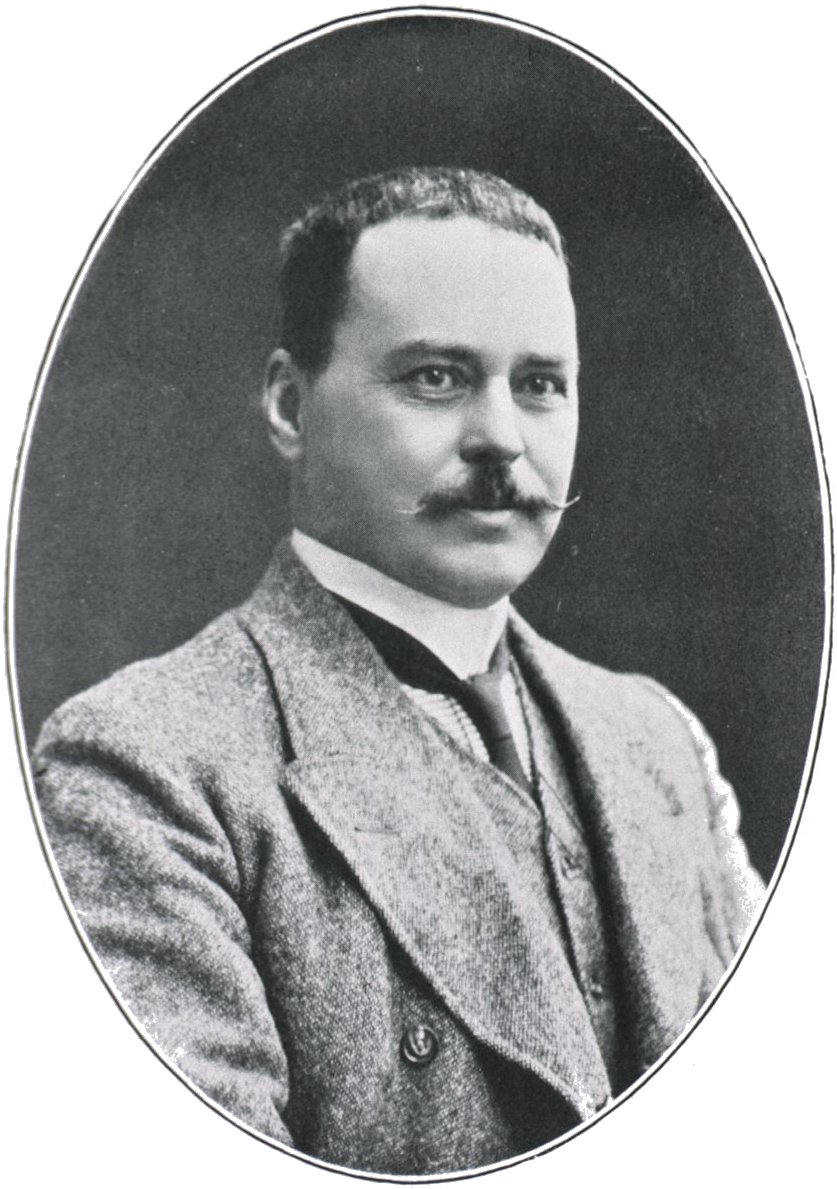

Charles Louis Alphonse Laveran

Fue Alphonse Laveran quien en 1880 identificó correctamente que era un protozoo, al que llamó Oscillaria, el agente causante de la malaria. Nació en 1845 y se licenció en Medicina en 1867. Sirvió como médico militar en la guerra con Prusia en 1870 y en 1874 fue nombrado Director de Enfermedades y Epidemiología en la Escuela de Val de Grâce. En 1878 fue destinado a Argelia donde inició sus estudios sobre la malaria, una de las enfermedades más incapacitantes y extendidas entre los soldados franceses que servían en aquella colonia.

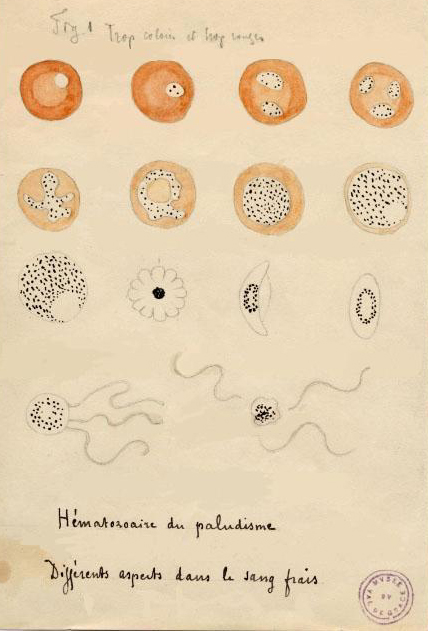

No se conocía su causa y, para aliviar los síntomas, sobre todo los accesos de fiebre, solo era eficaz la quinina. En Bona, Laveran practicó la autopsia a soldados fallecidos por las fiebres, y encontró que padecían anemia y que su sangre tenía un color marrón oscuro por la presencia de un pigmento negro. Todo ello le llevó a estudiar al microscopio muestras de sangre de soldados enfermos, sin preparar la muestra para facilitar el examen como era habitual entonces, algo que no habían probado otros investigadores antes que él.

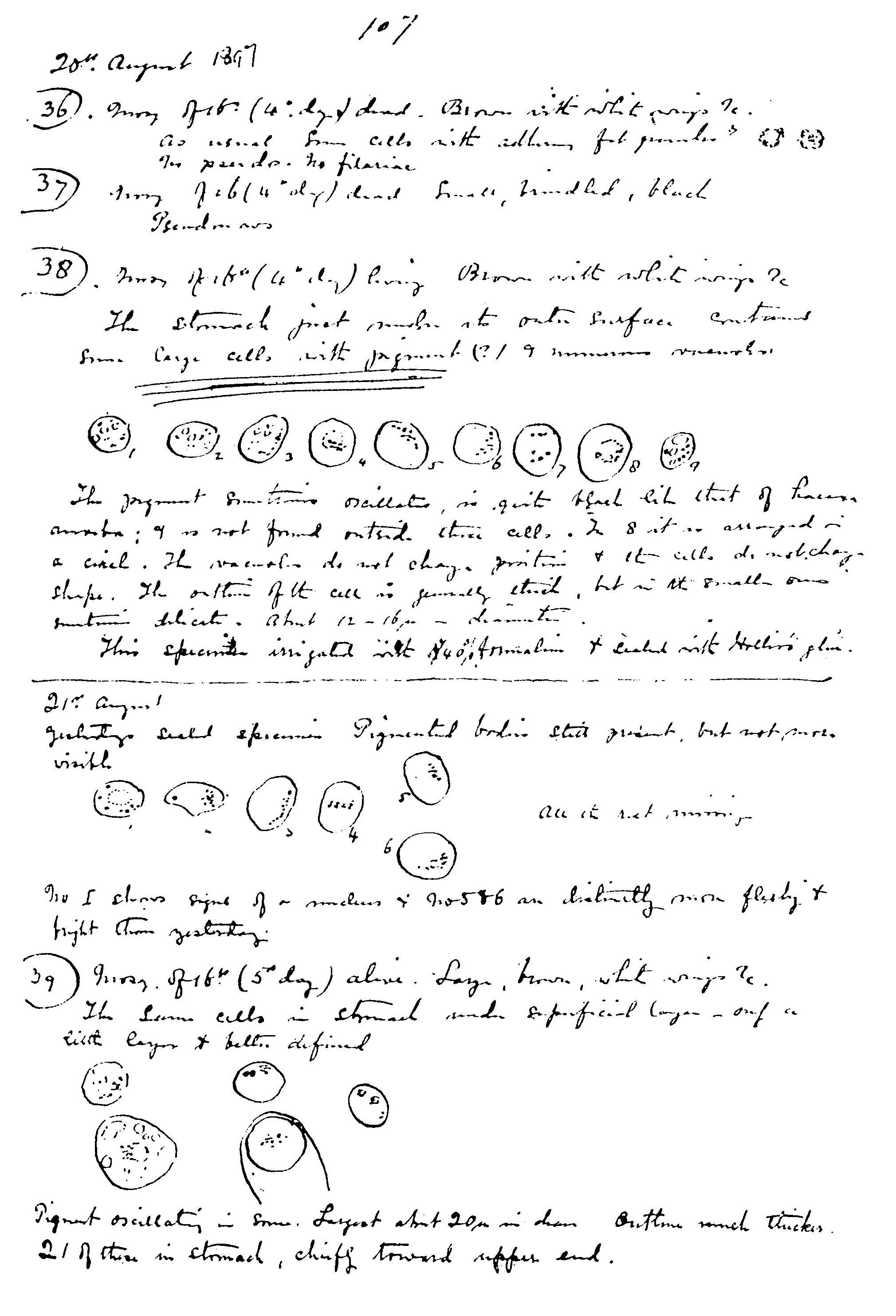

Ilustración de Laveran de 1880 con sus observaciones del parásito de la malaria en sangre fresca.

En su destino en Bona y, más tarde, en Constantina, detectó que los glóbulos rojos de los enfermos llevaban unos gránulos pigmentados. Poco después descubrió en la sangre fresca de esos enfermos, que, a veces, de esos glóbulos rojos se desprendían partículas de menor tamaño con cilios o flagelos móviles. Fue, según lo relata el propio Laveran, el 6 de noviembre de 1880 y en el Hospital Militar de Constantina, cuando observó “unos filamentos móviles o flagelos, con movimientos muy rápidos y variados que no dejaban duda de su naturaleza”. Dos días después observó lo mismo en la sangre de otro enfermo. De inmediato redactó y envió una nota, de fecha 23 de noviembre, comunicando su descubrimiento a la Academia de Medicina de París.

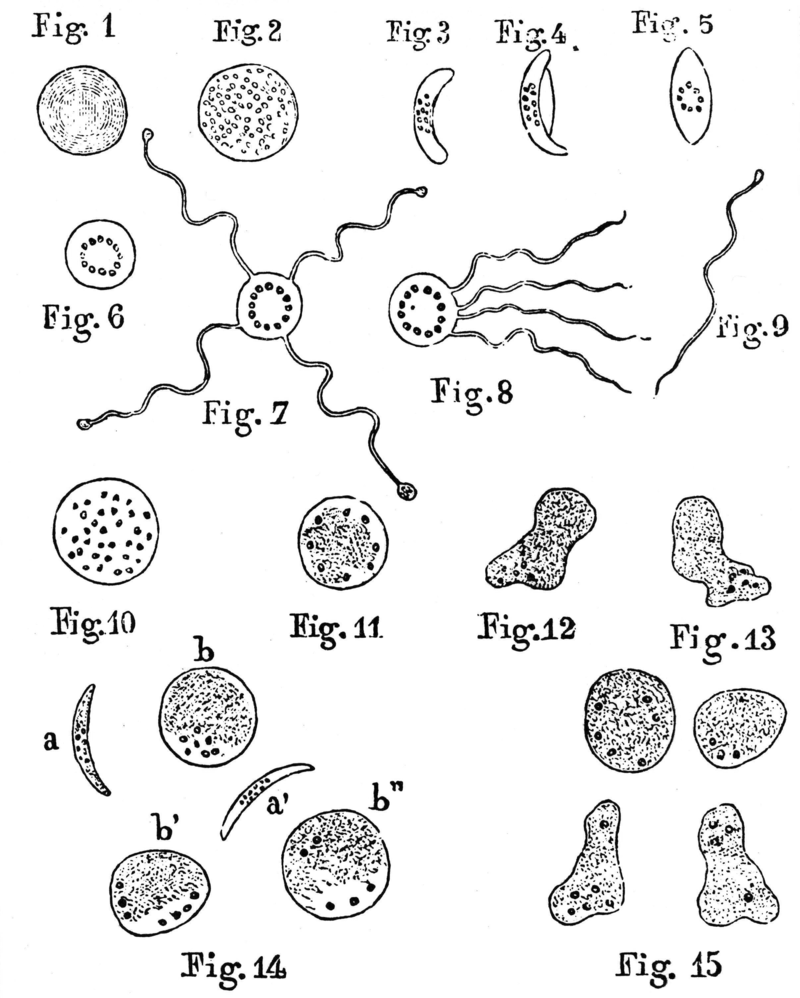

Ilustración de Laveran C.L.A., “Note sur un nouveau parasite trouvé dans le sang de plusieurs malades atteints de fièvre palustres”. Bull Acad Med 1880; 9: 1235-1236.

En 1881, publicó la revista The Lancet, de Estados Unidos, la confirmación del hallazgo de Laveran. En los meses siguientes, Laveran encontró los mismos organismos en la sangre de 148 de 192 enfermos examinados, incluidos algunos de las marismas de Roma y de otros lugares de Italia.

Viajó a París y convenció a Louis Pasteur y a su colaborador Emile Roux, otro prestigioso microbiólogo de la época, de que era un protozoo el parásito que causaba la malaria. Laveran era un médico militar, fuera de los círculos académicos y destinado en una colonia al otro lado del Mediterráneo, lejos de la capital, y sin contactos con los grupos de investigación de la malaria de finales del siglo XIX. Pero también los italianos Ettore Marchiafava y Angelo Celli, con un microscopio más potente, confirmaron el hallazgo de Laveran y le agradecieron expresamente el descubrimiento del protozoo. Pertenecían a la prestigiosa escuela italiana de estudios de la malaria, encargada de las investigaciones sobre esta enfermedad en las numerosas marismas de Italia. De allí nos llega el término malaria, del italiano “mal aria”, o “mal aire” en traducción directa.

Cuatro años más tarde, en 1884, Laveran ya había estudiado 480 casos y concluyó que el parásito de la malaria penetraba y se desarrollaba en los glóbulos rojos, provocaba su ruptura y liberaba esporas al torrente sanguíneo que, a su vez, invadían otros glóbulos rojos. Lo llamó Oscillaria malariae, nombre que, posteriormente, la escuela italiana cambió a Plasmodium, tal como ahora se conoce.

Era la época de la Microbiología y Pasteur, Koch y otros habían demostrado que la causa de las infecciones y de muchas enfermedades eran las bacterias. Así se había confirmado para, entre otras, el ántrax, la tuberculosis, el tifus o el cólera. Aceptar que había otros organismos causantes de enfermedades, como el protozoo descrito por Laveran, costó que lo aceptaran muchos investigadores. Pero las evidencias eran abrumadoras y Laveran recibió el Premio Nobel en 1907.

Ronald Ross

Uno de los expertos en malaria más críticos, en principio, con los trabajos de Laveran fue el médico militar inglés, de servicio en la India, Ronald Ross. Llevaba años estudiando la malaria y, en 1893, estaba convencido, según lo habitual en la época, de que era una enfermedad intestinal provocada por la toma de agua no potable. Escribió un informe para la revista Medical Reporter en que afirmaba que no era necesario otro parásito, un protozoo según Laveran, como causa de la malaria.

Consideraba que la enfermedad era compleja en síntomas y diagnóstico y, por ello, terminaba su informa con una frase llena de ironía, oculta en el típico lenguaje científico:

“Para la solución de la cuestión de la fiebre india, lo que queremos es una definición clara de las ideas, un escrutinio cuidadoso de todas las suposiciones y una interpretación de sentido común de los fenómenos que tenemos ante nosotros; y están muy equivocados quienes se imaginan que un problema siempre tan grande y variado será resuelto por un solo ‘coup de microscope’.”

Por “un vistazo al microscopio” y, además, en francés, o sea, lo que había propuesto Laveran, en francés, años antes de este escrito de Ross.

Página del cuaderno de notas de Ross en la que identifica en parásito de la malaria

Dos años más tarde, en 1895, y después de los consejos de otro médico inglés, Patrick Manson, Ross observó el “denostado” protozoo en el estómago del mosquito Anopheles y demostró que era el parásito y el vector de la malaria. Y, por estos hallazgos, Ronald Ross recibió el Premio Nobel en 1902.

Además de los conocimientos de Microbiología, típicos de su época, a Laveran le permitieron su descubrimiento y los estudios posteriores sobre el protozoo de la malaria otras mejoras en los métodos de investigación. Por ejemplo, los microscopios cambiaron en la segunda mitad del siglo XIX, con adelantos sustanciales en óptica y en la fabricación de lentes. Eran los años de Ernst Abbe, el especialista en óptica que resolvió los problemas teóricos de la fabricación de lentes. Y Carl Zeiss y Otto Schott, que formaron la empresa Carl Zeiss Inc., que todavía fabrica microscopios de gran calidad. A partir de 1884, junto con la fábrica Nachet, de París, ya comercializaban microscopios que mejoraban sustancialmente el material disponible hasta entonces. Fue sorprendente que, cuando Laveran, en 1880, encontró por vez primera el parásito de la malaria, su microscopio no era precisamente de los mejores y no tenía los aumentos, solo llegaba a 400, que después se consideraron necesarios para describir el protozoo. Pero, a pesar de ello, lo hizo con una precisión que se confirmó en años posteriores y con mejor instrumental. Como diría Pablo Picasso, la inspiración le encontró trabajando, o sea, en este caso mirando por el microscopio.

Otro de los adelantos técnicos que permitió la observación del protozoo de la malaria fue el desarrollo de las técnicas de tinción. No eran fáciles los estudios al microscopio tal como hizo Laveran, con sangre fresca y sin teñir. Fue Dimitri Leonidovich Romanowsky, en 1891, quien publicó una tinción que permitió las observaciones en frotis de sangre sobre portaobjetos que, incluso, permitían guardar las muestras y repetir el estudio al microscopio. Además, utilizaba dos colorantes, eosina y azul de metileno, que teñían diferente al protozoo según la fase de su ciclo vital.

En aquellos años, Wilhelm von Drigalski nos cuenta que en Italia llevaban mucho tiempo estudiando las causas de la malaria, sobre todo en las marismas que rodeaban la capital, Roma. Fueron Camillo Golgi, Marchiafava o Celli quienes completaron el ciclo vital del Plasmodium en la sangre de los enfermos, con buenos microscopios y la tinción de Romanowsky. El primero, Golgi, identificó con precisión los parásitos de la malaria y clasificó el Plasmodium vivax y el P.malariae. Y en 1890, Marchiafava y Celli identificaron el P. falciparum. Así quedó establecido que la malaria no era una enfermedad provocada por un solo parásito sino por cuatro (el P. ovale se identificó en 1922) que, a veces, hasta provocaban las fiebres actuando en conjunto.

Fue en la India donde el también médico militar Ronald Ross planteó la hipótesis, y la demostró en aves, de que el parásito llegaba a la sangre de los enfermos por la picadura de mosquitos.

Giovanni Battista Grassi

Y, finalmente, el italiano Giovanni Battista Grassi mostró todo el ciclo de desarrollo del protozoo, con su paso por el mosquito y el hombre como huéspedes.

La historia del protozoo de la malaria está llena de intensos debates, rencillas personales y amargura. Varios de los científicos dedicaron mucho tiempo a reclamar la prioridad de sus descubrimientos, un aspecto importante en la cultura de la ciencia de la época y hoy, en cambio, un debate casi olvidado. Investigadores franceses, alemanes, ingleses e italianos contribuyeron a los descubrimientos sobre la malaria y, también, polemizaron interminablemente sobre muchos aspectos de lo que se iba encontrando.

Además, todos los estudios de finales del siglo XIX sobre la malaria coinciden, en los grandes países europeos, con las aventuras y las exploraciones de otros continentes, con las colonias y los imperios. En ese momento histórico, la malaria era una enfermedad importante para el control europeo de esas colonias y la explotación de sus recursos naturales y, por tanto, era un asunto prioritario para los gobiernos y para la opinión pública.

En cambio, en Italia la malaria era algo muy cercano y, por ello, su investigación era esencial para la salud pública y como problema social. Era una enfermedad de siempre que mantenía empobrecidas extensas regiones del país. Para ingleses y franceses, la malaria es un problema colonial y, para los italianos, era un asunto interno, sobre todo para el centro y sur del país.

Y, por si fuera poco este sustrato político en la investigación sobre la malaria, estamos en la era de los nacionalismos y, también, son habituales en la ciencia. Parte de la polémica entre Grassi, Ross y Laveran, o del rechazo de ingleses e italianos a los descubrimientos del médico militar francés en Argelia, viene de esta competición patriótica entre científicos. Como ejemplo nos sirve lo que Santiago Ramón y Cajal publicó en aquellos años en sus “Reglas y consejos de investigación científica”, pues entre las “cualidades de orden moral” de un investigador está el patriotismo. Inicia el texto afirmando que

“entre los sentimientos que deben animar al hombre de ciencia merece particular mención el patriotismo. Este sentimiento tiene en el sabio signo exclusivamente positivo: ansía elevar el prestigio de su patria, pero sin denigrar a los demás.”

Es oportuno citar que la cualidad que Ramón y Cajal menciona antes del patriotismo es la “pasión por la gloria” y, de ello se derivan las polémicas sobre la prioridad en los descubrimientos. Hoy, quizá, solo se discute por las patentes derivadas de esos hallazgos.

En mayo de 1922, Alphonse Laveran murió en París a los 76 años. Está enterrado en el Cementerio de Montparnasse, junto a celebridades como el filósofo Jean Paul Sartre, o el líder anarquista Pierre-Joseph Proudhon, el poeta Charles Baudelaire o el escritor Julio Cortázar.

Referencias:

Capanna, E. 2006. Grassi versus Ross: who solved the riddle of malaria? International Microbiology 9: 69-74.

Chernin, E. 1984. The malariatherapy of neurosyphilis. Journal of Parasitology 70: 611-617.

Coleman-Jones, E. 1999. Ronald Ross and the great malaria problem: historical reference in the biological sciences. Journal of Biological Education 33: 181-184.

Earle, D.P. 1979. A history of malaria and its ironies. Transactions of the American Clinical and Climatological Association 90: 1-26.

Hommel, M. 2007. Morphologie, biologie et cycle des Plasmodium parasites de l’homme. Bulletin de l’Academie nationale de medicine 191: 1235-1246.

Laverdant, C. 2007. Le context scientifique contemporain de la découverte de Laveran. Bulletin de l’Academie nationale de medicine 191: 1227-1234.

Ledermann, W. 2008. Laveran, Marchiafava y el paludismo. Revista Chilena de Infectiología 25: 216-221.

Macchi, G. 1999. Camillo Golgi: A clinical pathologist. Journal of History of Neurosciences 8: 141-150.

Ramón y Cajal, S. 1940 (1899). Reglas y consejos sobre investigación científica (Los tónicos de la voluntad). 8ª ed. Librería Beltrán. Madrid. 302 pp.

Ross, R. 1893. Some objections to hematozoic theories of malaria. Medical Reporter 2: 65-71.

Schmidt, G.D. & L.S. Roberts. 1985. Foundations of Parasitology. Times Mirror/Mosby College Publ. St. Louis, Toronto. Santa Clara.

Snowden, F.M. 2006. The conquest of malaria. Italy, 1900-1962. Yale University Press. New Haven & London.

Tan, S.Y. & A. Ahana. 2009. Charles Laveran (1845-1922): Nobel lauréate pioneer of malaria. Singapore Medical Journal 50: 657-658.

von Drigalski, W. 1954. Hombres contra microbios. La victoria de la Humanidad sobre las grandes epidemias. Ed. Labor. Barcelona. 368 pp.

Yoeli, M. 1973. Sir Ronald Ross and the evolution of malaria research. Bulletin of the New York Academy of Medicine 49: 722-735.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Historias de la malaria: Charles Louis Alphonse Laveran y el protozoo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Historias de la malaria: El parásito

- Historias de la malaria: El charlatán y caballero Sir Robert Talbor

- Historias de la malaria: El árbol de la quina

Superelasticidad nanométrica

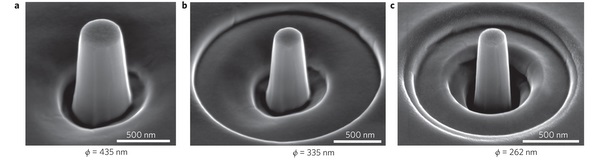

La superelasticidad es una propiedad física por la que se puede deformar un material en gran medida, hasta un 10 % —un porcentaje muchísimo mayor que en la elasticidad—, de forma que aplicando una tensión a una varilla recta, esta puede formar una U, y al eliminar la tensión aplicada, la varilla recupera completamente su forma inicial. Aunque está más que probada en materiales macroscópicos, “hasta ahora nadie había podido estudiar estas propiedades de superelasticidad en dimensiones micrométricas y nanométricas”, explica José María San Juan, investigador principal y catedrático de la UPV/EHU.

Investigadores del Departamento de Física de la Materia Condensada y de Física Aplicada II de la UPV/EHU han conseguido ver que “el efecto superelástico se mantiene en dispositivos realmente pequeños de una aleación de cobre-aluminio-niquel”. Se trata de una aleación con memoria de forma en la que el equipo de investigación lleva más de 20 años trabajando a nivel macroscópico: Cu-Al-Ni, una aleación que muestra superelasticidad a temperatura ambiente.

Utilizando un equipo denominado Focused Ion Beam, “un cañón de iones que actúa como una especie de cuchillo atómico que talla el material”, explica San Juan, han construido micropilares y nanopilares de esta aleación de diámetros comprendidos entre 2 µm y 260 nm —un micrómetro es una millonésima parte de un metro y un nanómetro es una mil millonésima parte de un metro— a los que han aplicado una tensión con un sofisticado equipo llamado nanoindentador, que “permite aplicar fuerzas extremadamente pequeñas” y han medido su comportamiento.

Los investigadores han constatado y cuantificado por primera vez que en diámetros menores de un micrómetro hay un cambio notable de las propiedades relacionadas con la tensión crítica para la superelasticidad: “El material se empieza a comportar de manera diferente y requiere una tensión mucho más elevada para que se produzca. La aleación sigue presentando superelasticidad pero para tensiones más elevadas”. San Juan remarca la novedad de ese incremento de la tensión crítica con el tamaño, y subraya, además, que han podido explicar la razón de dicho cambio de comportamiento: “Hemos propuesto un modelo atómico que permite entender por qué y cómo cambia la estructura atómica de estos pilares cuando se les aplica una tensión”.

El catedrático de la UPV/EHU destaca la importancia de este descubrimiento, “un comportamiento superelástico espectacular a pequeña escala”, que abre nuevas vías en el diseño de estrategias de aplicación de aleaciones con memoria de forma para el desarrollo de microsistemas y nanosistemas electromecánicos flexibles. “La electrónica flexible está muy presente en el mercado actual, se utiliza cada vez más en prendas de vestir, zapatillas de deporte, en diversos displays…”. Asimismo, afirma que todo ello es de suma importancia para el desarrollo de dispositivos inteligentes médico-sanitarios implantables en el cuerpo humano, del tipo Lab on a chip o laboratorio en un chip: “Se podrán construir pequeñas microbombas o microactuadores que se puedan implantar en un chip, que permitan liberar y regular una sustancia dentro del cuerpo humano para diversos tratamientos médicos”.

Se trata de un descubrimiento que “se espera que tenga una gran repercusión científica y tecnológica y que pueda revolucionar ciertos aspectos en campos afines”, concluye San Juan, y se congratula de que “hemos sido capaces de transferir todo el conocimiento necesario y de conseguir las herramientas de trabajo que tienen los centros más avanzados para abrir una nueva línea de investigación con la capacidad de desarrollarla íntegramente en la UPV/EHU”.

Referencia:

Jose F. Gómez-Cortés, Maria L. Nó, Iñaki López-Ferreño, Jesús Hernández-Saz, Sergio I. Molina, Andrey Chuvilin and Jose M. San Juan. Size effect and scaling power-law for superelasticity in shape-memory alloys at the nanoscale. Nature Nanotechnology. May 2017. DOI: 10.1038/nnano.2017.91.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Superelasticidad nanométrica se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una puerta cuántica robusta y ultrarrápida

- La máquina de vapor (1)

- La fusión nuclear como fuente de neutrones eficiente

II Concurso de Cristalización en la Escuela del País Vasco

La final de la segunda edición del Concurso de Cristalización en la Escuela tuvo lugar el pasado 5 de mayo en el Aula Magna de la UPV/EHU en Leioa. En la misma se dieron a conocer los ganadores del concurso quienes, además de un diploma acreditativo, también recibieron un detalle.

El concurso, dirigido a estudiantes de educación secundaria (ESO y bachillerato), tiene el objetivo de acercar el mundo científico al alumnado, aprovechando el atractivo de la cristalografía.

Además de subrayar la importancia que tienen los cristales en la sociedad, el concurso también busca ”fomentar el estudio, el trabajo sistemático, el pensamiento racional y la comunicación, utilizando como base la cristalografía”, tal como explica Begoña Bazán, organizadora del evento.

La edición de este año ha reunido maquetas de todo tipo, desde un parque de atracciones, una réplica del Guggenheim con Puppy incluído, volcanes, fondos marinos, hasta el hundimiento del Titanic pasando por el sistema solar.

Acercar la metodología científica

Para participar en el concurso el alumnado utiliza un kit didáctico que permite hacer crecer cristales de fosfato monoamónico (dihidrógeno fosfato de amonio). El kit permite modificar variables físicas (temperatura solubilidad, concentración, etc.), lo que posibilita variar los procesos de cristalización y obtener distintos resultados.

Los participantes deben presentar, además de una maqueta con los cristales creados, un póster con formato científico en el que se detallan los objetivos, materiales, métodos, resultados y las conclusiones. Por último, también deben presentar un cuaderno de laboratorio con los procesos seguidos y las respuestas obtenidas.

El formato del concurso acerca la metodología científica a los más jóvenes, ya que incluye todos sus elementos empezando por la investigación en el laboratorio hasta la presentación de resultados en un congreso científico creado a tal efecto. Mediante esta actividad amena y visual el alumnado se familiariza con el método científico. También permite introducir la cristalografía y la cristalización en el temario educativo, temas en los que no se suele profundizar o que, directamente, están ausentes.

Implicación docente

La participación no solo atañe a los estudiantes, también requiere el compromiso del profesorado. El concurso tiene una duración aproximada de un curso académico y está dividido en tres fases:

- Fase 1. Curso de formación para el profesorado de secundaria. En esta primera fase el profesorado responsable de cada centro educativo realiza un curso de formación donde personal de la UPV/EHU les dota de las herramientas científico-didácticas para la realización de los experimentos.

- Fase 2. Realización de los proyectos de cristalización y seguimiento del concurso. Durante esta fase el profesorado orienta a los participantes en los experimentos. Esta fase tiene una duración de cinco meses.

- Fase 3. Final del concurso de cristalización. En esta fase se exponen los resultados obtenidos en formato de congreso científico.

Tres grupos de jurados han evaluado los distintos trabajos, valorando cada grupo dos ítems: (i) póster y entusiasmo, (ii) rigor científico y cuaderno y (iii) cristal y montaje. En cuanto a los criterios de evaluación, los principales han sido: la creatividad, la aplicación del método científico, la calidad de los cristales, la originalidad de la maqueta, la claridad en el cuaderno de laboratorio, el conocimiento del procedimiento utilizado para el crecimiento cristalino, utilización del lenguaje cinetífico-técnico apropiado, orden y claridad en el póster…

La edición de Euskadi 2017 ha contado con la participación de 31 centros (24 de Bizkaia, 5 de Gipuzkoa y 2 de Araba). En todo el proceso del concurso más de 1.200 estudiantes han formado parte de la iniciativa.

Por segundo año consecutivo el concurso ha sido organizado por el grupo IMaCris/MaKrisil del departamento de Mineralogía y Petrología de la UPV/EHU, en colaboración con Geobizirik y la Cátedra de Cultura Científica.

—————————-

Agradecemos a Begoña Bazán, profesora de la UPV/EHU y coordinadora del concurso de cristalización, la información proporcionada.

Texto elaborado por Ziortza Guezuraga, periodista y colaboradora de la Cátedra de Cultura Científica de la UPV/EHU.

El artículo II Concurso de Cristalización en la Escuela del País Vasco se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ‘Cristalización en la escuela’, un concurso para fomentar el interés por la ciencia

- LocosxCiencia llega al País Vasco

- Estudio de eficacia escolar en el País Vasco

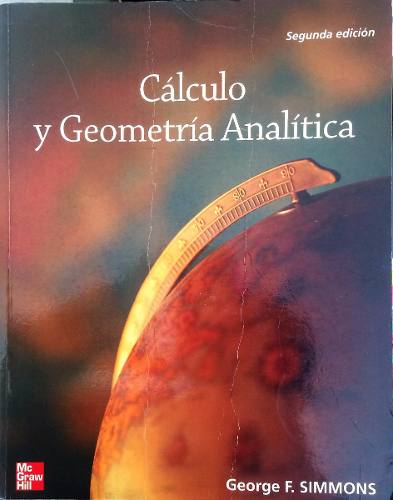

Cálculo y geometría analítica, de George F. Simmons

En Editoralia lectores, autores o editores presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

Pablo Rodríguez Sánchez, lector

Tenía 18 años, y, aunque yo no me daba cuenta, aún era un poco idiota. Pasando por alto las más elementales leyes de la prudencia, había decidido matricularme en la carrera de física; las enormes dificultades y padecimientos que había sufrido con las matemáticas en el instituto no lograron frenarme.

Necesitaba un libro para preparar la asignatura de cálculo infinitesimal (aquello de las derivadas y las integrales), de modo que acudí a una librería, no muy bien surtida en libros de ciencia, y agarré el primero que vi. Ya he mencionado que entonces era un poco idiota.

El libro que me llevé de la tienda resultó ser una auténtica joya, aunque yo aún tardé unas semanas en abrirlo y darme cuenta.

Me refiero a “Cálculo y geometría analítica”, de George Finlay Simmons. Se trata de una magnífica introducción al cálculo infinitesimal. A primera vista parece un libro normal y corriente, con sus capítulos, sus problemas, etcétera. Pero son varias las cosas las que lo convierten en un libro digno de mención.

Lo primero que llama la atención, debido al uso recuadros de diferente color, es la gran cantidad de notas históricas que se introducen en medio del texto. Estas notas tienen la peculiaridad de que, en lugar de centrarse únicamente aspectos biográficos de matemáticos célebres, conceden tanta o incluso más importancia a un problema matemático clásico (que el lector puede comprender con las herramientas del propio capítulo)1.

Otra curiosidad llamativa: a menudo, en los márgenes aparece dibujada la imagen de una señal de tráfico como esta:

Esta señal indica que el párrafo adyacente debe ser leído despacio y reproduciendo los cálculos uno mismo con lápiz y papel.

Con el tiempo he apreciado otros detalles más sutiles. La estructura es un constante malabarismo entre conceptos teóricos, aplicaciones prácticas y notas históricas casi novelescas. Los métodos analíticos se explican con muchísimo detalle y siempre desde el punto de vista del estudiante, casi se diría que con cariño. Los problemas combinan ejercicios rutinarios con otros muy creativos, y como es tradición, se incluye la solución de todos los ejercicios impares. El lenguaje es elegante y claro sin dejar de ser cercano. Los ejemplos prácticos brillan tanto por su cantidad como por su calidad.

Todos estos detalles responden a un objetivo: enseñar de la forma más clara y duradera posible.

Gracias a este libro empezaron, por fin, a dárseme bien las matemáticas. Sus señales de obra me enseñaron cómo se deben leer las matemáticas. Algunos de sus problemas eran tan entretenidos que aún los recuerdo. Sus notas históricas me enseñaron que la ciencia es una empresa humana y no solamente sus resultados, y además me mantuvieron horas pegado al libro como si de una novela se tratase. Sus lecciones fueron tan duraderas que, salvo por placer, no he tenido que volver a abrir un libro de cálculo jamás. Por todo ello, lo recomiendo a cualquiera que tenga interés.

Referencia: (concretamente leí esta traducción, pero el original está en inglés)

Cálculo y geometría analítica (2ª ed.)

George F. Simmons, 2002

Editorial: S.A. MCGRAW-HILL / INTERAMERICANA DE ESPAÑA

Lengua: CASTELLANO

ISBN: 9788448135911

1 En este sentido cabe mencionar también otro libro del mismo autor, Calculus Gems: brief lives and memorable mathematics, centrado únicamente en la historia de las matemáticas

El artículo Cálculo y geometría analítica, de George F. Simmons se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El primer instrumento logarítmico: la regla de cálculo

- Las matemáticas como herramienta (III): La Ilustración y el nuevo cálculo

- Las matemáticas como herramienta (II): La Revolución Científica y el cálculo

Arte & Ciencia: La importancia de la ciencia para la conservación del arte

El arte y la ciencia son dos formas de conocimiento aparentemente alejadas, en gran medida consecuencia de la especialización profesional y la educación compartimentada. Del estudio de esta impostada separación surgió el estereotipo de las dos culturas, las ciencias y las humanidades, para referirnos a esa brecha de conocimiento. La realidad es que la ciencia y el arte sí están conectadas y que ninguna forma de conocimiento es impermeable a otra. Por poner algunos ejemplos: ¿Cómo podría crearse una obra plástica sin las técnicas propiciadas por la ciencia? ¿Cómo podríamos interpretar la elección de materiales?

Estas y otras cuestiones relacionadas furon tratadas por destacados profesionales -artistas, ilustradores, filósofos y científicos- que han puesto el foco en ese difuso trazo que une la ciencia y el arte. El ciclo Ciencia & Arte se desarrolló, bajo la dirección de Deborah García Bello, a lo largo de cuatro jornadas que se celebraron los jueves días 6 y 27 de abril y 11 y 25 de mayo de 2017 en el auditorio del Museo Guggeheim Bilbao.

Esta actividad de la Cátedra de Cultura Científica de la UPV/EHU se enmarca en el programa TopARTE que conmemora el XX Aniversario del Museo Guggenheim Bilbao.

Primera jornada. 1ª conferencia:

Ainhoa Sanz López de Heredia, coordinadora de conservación del Museo Guggenheim Bilbao: La importancia de la ciencia para la conservación del arte

Las ciencias experimentales juegan un papel esencial en el análisis, tratamiento y conservación de las obras de arte. Estos procesos nos ofrecen, además, información valiosa sobre el contenido de la obra y las circunstancias en las que fue creada. Ciencia y arte tienen una relación mucho más íntima de lo que imaginamos, ya que el conocimiento científico es una herramienta imprescindible para artistas, restauradores y analistas. Les permite conocer las cualidades de los materiales para optar por unos u otros, prever cómo se degradarán los pigmentos o determinar la mejor manera para conservar una escultura.

La importancia de la ciencia para la conservación del arteEdición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Arte & Ciencia: La importancia de la ciencia para la conservación del arte se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Para qué sirve la ciencia?

- Ciencia, naturaleza y arte: la química y sus metáforas, por Fernando Cossío

- Arte para explicar la ciencia

Cartografiando el Cosmos

“El mundo esta cambiando… lo siento en la tierra… lo veo en el agua… lo huelo en el aire…”

De vez en cuando me viene a la memoria esta primera frase de la versión cinematográfica de “La comunidad del Anillo”. Pero las palabras de Galadriel resuenan ligeramente distintas dentro de mi cabeza:

“La Astronomía está cambiando… lo siento en los observatorios… lo veo en los congresos… lo huelo en las políticas científicas…”

Y esto es realmente así. La Astronomía o, mejor dicho, la forma de hacer Astronomía, está cambiando rápidamente.

Hace un par de décadas lo más normal era que cada astrónomo o pequeño grupo de astrónomos en una universidad o instituto de investigación solicitara tiempo de telescopio para observar ellos mismos durante unas pocas noches al año. Buscaban datos para su propio proyecto de investigación, y prácticamente todo tenían que hacerlo ellos. Los astrofísicos tenían que preparar la propuesta de observación (para convencer a un comité de que su proyecto era interesante y conseguir el deseado tiempo de telescopio), entender las características de telescopio e instrumentos a usar, realizar las observaciones astronómicas, reducir los datos conseguidos (esto es, preparar los datos para ser analizados, por ejemplo calibrar correctamente las imágenes para realizar fotometría o ajustar correctamente la longitud de onda de los datos al realizar espectroscopía), analizar dichos datos (a veces comparando con modelos teóricos, otras veces comparando con más observaciones previas), extraer resultados y finalmente publicar el artículo científico con las conclusiones del estudio.

En esencia, ésta sería la pauta que se seguiría más o menos hoy día en el proceso de investigación astrofísica, aunque yo añadiría como último punto (que, en mi sesgada opinión, es fundamental, y mucho más en los tiempos que corren) la transmisión de los resultados científicos tanto en congresos de astrofísicos profesionales como en actividades de divulgación científica.

El autor de este artículo preparando el Telescopio Carlos Sánchez, de 1.5m de diámetro, en el Observatorio del Teide (Tenerife), para comenzar las observaciones de galaxias del tipo Wolf-Rayet en infrarrojo cercano para su tesis doctoral, en marzo de 2003. Crédito: Ángel R. López-Sánchez.

Pero, como decía con la cita de “El Señor de los Anillos”, los tiempos están cambiado. Aunque es cierto que aún muchos astrofísicos siguen el procedimiento brevemente descrito arriba, en los últimos años se están imponiendo “los grandes cartografiados astronómicos” (“large astronomical surveys”) para estudiar el Cosmos. Incluso se construyen instrumentos científicos (es más, ¡a veces hasta observatorios completos!) directamente pensados para trabajar “en formato survey”, y las propias políticas científicas están cada vez más dirigidas a esos “grandes proyectos”.

¿Qué quiere decir esto? Directamente que a la hora de enfrentarse ahora al quehacer de un astrofísico profesional son esenciales un nuevo tipo de conocimientos, mientras que otros antes fundamentales ahora son apenas relevantes.

Por ejemplo, muchos jóvenes astrofísicos que empiezan su carrera directamente a trabajar en alguno de estos “grandes cartografiados” no necesitan saber nada de observación astronómica, o de preparar propuestas de observación, o de qué ventaja tiene un telescopio/instrumento respecto a otro. Sí, es cierto que los grandes cartografiados también necesitan observadores, pero cada vez es más común que estos sean astrónomos especializados y dedicados casi completamente a ello, cuando no los datos se obtienen de forma semi (o casi) automática. En muchos casos, los astrónomos tampoco “reducen” ya los datos: las rutinas especializadas de los telescopios los dejan prácticamente “listos” para ser analizados.

Sin embargo, ahora es fundamentar saber gestionar bases de datos enormes, muchas veces albergadas en distintos sitios del planeta. El “Big Data” hace tiempo que llegó a la Astrofísica, y ha llegado para quedarse. Por lo tanto, los jóvenes astrofísicos necesitan herramientas de programación, tanto de gestión de bases de datos como estadística a alto nivel (ya no vale una regresión lineal, hay que usar métodos bayesianos o saber hacer un análisis de componentes principales, cuando no procesos más complejos), además de una excelente base en programación y saber usar herramientas óptimas de visualización y representación de datos para poder desarrollar el trabajo de astrofísico. Dicho de otra manera: ¿quieres ser astrofísico, pero no te gusta programar? Lo tienes complicado…

El “Big Data” en Astrofísica ha venido para quedarse. En esta imagen se muestra una toma de alta definición del centro de la Vía Láctea observada en infrarrojo medio tal por el Telescopio Espacial Spitzer (NASA). La pantalla, que consta de 128 monitores LCD de alta definición (longitud total de 7 metros), posee 250 millones de píxeles y se encuentra en Ames Research Center de NASA en Moffett Field, California, EE.UU.. Crédito: NASA/Ames/JPL-Caltech.

¿Cuándo comenzó el auge de los cartografiados astronómicos? En realidad, siempre han existido: desde la Antigüedad los astrónomos escudriñaban los cielos para tener el censo completo de objetos celestes visibles. Estos estudios venían dados simplemente por mapas y tablas donde se codificaban ciertas propiedades (identificación del objeto, coordenadas celestes, brillo, color,…). Tras la invención del telescopio y la confirmación de que “había muchas cosas más ahí arriba de las que veían nuestros ojos” estos catálogos se fueron haciendo más extensos. A principios del siglo XVII el astrónomo alemán Johann Bayer publicaba su famoso atlas estelar “Uranometría”. A finales del siglo XVIII el noble francés Charles Messier confeccionó el primer catálogo de objetos nebulares para ayudar a la hora de identificar un nuevo cometa (la “moda” de entonces). A finales del siglo XIX el astrónomo danés irlandés John Dreyer completó el “Nuevo Catálogo General” (NGC, por sus siglas en inglés, “New General Catalogue”) de nebulosas y cúmulos estelares (basado en los catálogos del famoso astrónomo inglés William Herschel) mientras que las “computadoras del Observatorio de Harvard” escudriñaban placas fotográficas (1), midiendo posiciones, buscando estrellas variables y estudiando por primera vez los espectros estelares. Ya en el siglo XX entramos en los cartografiados de galaxias, destacando los trabajos de Allan Sandage (quien en 1961 publicó el “Atlas Hubble de galaxias” usando todas las observaciones que tanto su predecesor y mentor, Edwin Hubble, como el mismo Sandage, habían realizado en este campo) y también por original el “Atlas de galaxias peculiares” confeccionado por Halton Arp en 1966. Obviamente, en el último siglo se han preparado una infinidad de catálogos de objetos celestes de diversa extensión, de los que podríamos estar hablando durante cientos de páginas.

Pero los “grandes cartografiados astronómicos” propiamente dichos (y ya no catálogos de objetos) empezaron hace apenas 20 años. La diferencia fundamental entre un “catálogo” y un “cartografiado” (o “mapeo” o “sondeo”, que serían la traducción de la palabra inglesa “survey”) es que mientras los primeros sólo buscan “listar” objetos, los segundos pretenden obtener información astrofísica y avanzar en el conocimiento del Cosmos con las observaciones. De hecho, hacen falta “catálogos de objetos” para preparar un “cartografiado”. Además de la lista de los objetos y las propiedades que se derivan de cada uno, en muchos casos los cartografiados también liberan los datos obtenidos para así facilitar el avance del conocimiento científico y que los propios datos sirvan a nuevos proyectos.

En imágenes astronómicas, el primer “cartografiado completo del cielo” fue el “Digitized Sky Survey” (DSS). Se trataban de las placas fotográficas de todo el cielo, digitalizadas con mucho esmero, obtenidas con los telescopios Schmidt localizados en los observatorios de Monte Palomar (en EE.UU., para el hemisferio norte celeste) y Siding Spring (en Australia, para el hemisferio sur celeste). DSS fue publicado originariamente en 1994 usando 102 CD-ROMs, los datos están ahora actualizados y disponibles gratuitamente en internet.

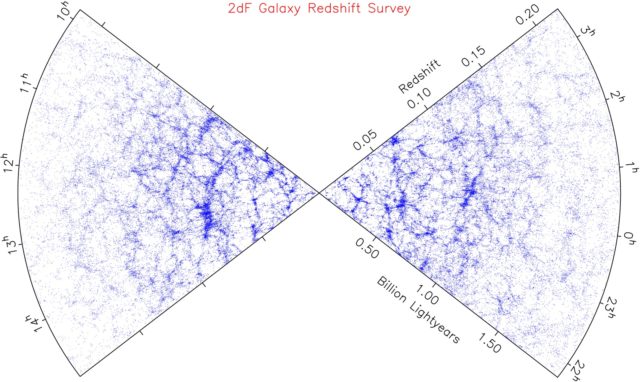

Resultados del The 2dF Galaxy Redshift Survey (“Cartografiado 2dF de desplazamiento al rojo de galaxias”), usando datos de 230 mil galaxias observadas con el instrumento 2dF en el Telescopio Anglo-Australiano. Cada punto azul representa una de estas galaxias. La Vía Láctea estaría en el centro de la figura, estando la galaxia cada vez más lejos de nosotros según se aleja a la derecha o la izquierda (nótese que la cuña derecha incluye en su parte inferior la escala en miles de millones de años luz, “billones” en inglés). La Estructura a Gran Escala, con sus filamentos y vacíos, destaca claramente en la imagen. Crédito: Matthew Colless / colaboración 2dFGRS.

En el campo de la espectroscopía astronómica tuvo un papel clave la fabricación del instrumento multi-fibra 2dF (de “Two Degrees Field”, “campo de dos grados”), instalado en 1997 en el Telescopio Anglo-Australiano (Observatorio de Siding Spring, Australia), y que permitía observar, a la vez, 400 objetos. Con este instrumento se desarrollaron dos cartografiados de galaxias que fueron fundamentales a la hora de empezar a entender la estructura a gran escala del Universo y la evolución de las galaxias. Por un lado, el The 2dF QSO Redshift Survey (o “Cartografiado 2dF de desplazamiento al rojo de cuásares”), que en apenas un lustro proporcionó la distancia a 35 mil cuásares a distancias cosmológicas. Por otro lado, el The 2dF Galaxy Redshift Survey (“Cartografiado 2dF de desplazamiento al rojo de galaxias”) completó un sondeo muy profundo de dos regiones concretas del cielo, proporcionado la distancia a más de 230 mil galaxias, y dando así una exquisita visión de la estructura a gran escala del Universo hasta 2500 millones de años luz.

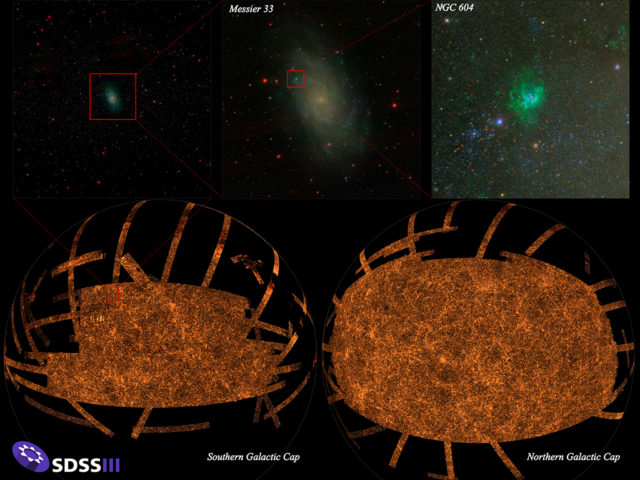

No obstante, la gran revolución llegó con el “Sloan Digital Sky Survey” (SDSS, “Cartografiado Digital del Cielo Sloan), que sigue en activo (aunque “subdividido” en varios proyectos grandes). Originariamente usando sólo el telescopio de 2.5m del Observatorio de Apache Point (APO, Nuevo México, EE.UU.), completamente dedicado a SDSS, este cartografiado obtenía a la vez fotometría (imágenes) en distintos filtros de todo el cielo visible desde ese telescopio y espectros de galaxias. Desde 1998, SDSS ha obtenido observaciones fotométricas de más de 500 millones de objetos y observaciones espectroscópicas de más de 3 millones de galaxias. Muchos datos están públicos en la web, otros aún son propiedad sólo del proyecto, aunque se van liberando poco a poco. A fecha de hoy, más de 5800 publicaciones científicas en revistas con árbitro han usado datos de SDSS (la gran mayoría de ellos escritos por astrofísicos no pertenecientes a SDSS), siendo los resultados citados en más de 245 mil artículos científicos. De esta forma, SDSS es uno de los cartografiados más citados en la Historia de la Astronomía.

La “Araña Naranja” del Sloan Digital Sky Survey” (SDSS, “Cartografiado Digital del Cielo Sloan) ilustra la enorme cantidad de información a gran y pequeña escala obtenida en este cartografiado. La imagen de arriba a la izquierda muestra la visión que da SDSS de una zona del cielo centrada alrededor de la galaxia M 33. A su derecha aparecen dos ampliaciones de dicha imagen, mostrando tanto la galaxia M 33 en su totalidad (centro arriba) como la gigantesca región de formación estelar NGC 604 (derecha arriba), que brilla en color verdoso por la combinación de filtros usados para obtener el color. Las dos figuras inferiores (las “Arañas Naranjas”) muestran un mapa de todo el cielo tal con los datos de SDSS. A la derecha aparece el hemisferio norte celeste, prácticamente observado en su totalidad, a la izquierda se representa el hemisferio sur celeste. En este mapa se aprecian concentraciones de galaxias (cúmulos), filamentos y zonas aparentemente más vacías, definiendo la estructura a gran escala del Universo. Crédito: M. Blanton and SDSS.

Fue tal la cantidad tan ingente de datos que el cartografiado SDSS produjo que no había, ni de lejos, suficientes astrónomos para analizarlos todos. Precisamente éste fue el origen de “Galaxy Zoo”, el primer proyecto de Ciencia Ciudadana usando grandes datos en internet que necesitaba la interacción de los participantes. Lanzado en julio de 2007, Galaxy Zoo invitaba a los usuarios a clasificar galaxias (¿espiral o elíptica? ¿con brazos o sin ellos? ¿con prominente bulbo central o no?) detectadas de forma automática con las observaciones robóticas conseguidas con el cartografiado SDSS. Se liberaron unas 900 mil galaxias, obteniendo como resultado más de 50 millones de clasificaciones dadas por más de 150 mil participantes durante el primer año. Fue un éxito rotundo y el germen de una miríada de otros muchos proyectos similares que se han extendido más allá de la Astrofísica (muchos de ellos, no todos, compilados en ZooUniverse). La explosión de proyectos de Ciencia Ciudadana usando grandes bases de datos científicos es un ejemplo más de lo “desbordante” que es actualmente para los científicos (en particular, astrofísicos) digerir tanto número.

Y, en efecto, en la última década los grandes cartografiados no han hecho nada más que aumentar en número y complejidad. A SDSS se unió recientemente el “Skymapper Southern Sky Survey”, también usando un telescopio robótico expresamente construido para el proyecto, que busca “completar fotométricamente el cielo del Hemisferio Sur” (entre otras muchas más cosas). En los análisis de galaxias destacan los cartografiados “6dF Galaxy Survey” (6dFGS, en el Telescopio Schmidt del Observatorio de Siding Spring), GAMA (“Galaxy and Mass Assembly”, en el Telescopio Anglo-Australiano) y VIPERS (“VIMOS Public Extragalactic Redshift Survey”, usando el instrumento VIMOS instalado en una de las unidades de 8.2 metros del Very Large Telescope (VLT), en el Observatorio de Paranal, Chile), pero hay multitud más.

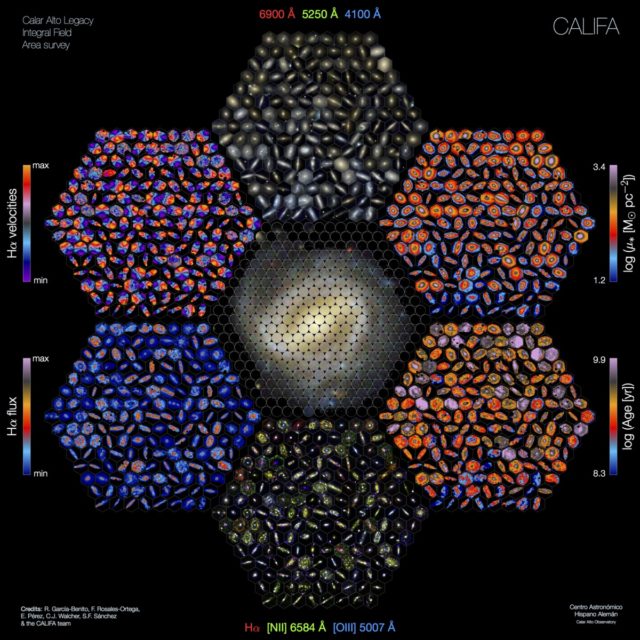

Los cartografiados de galaxias se han hecho cada vez más sofisticados al introducir un nuevo tipo de observación: la espectroscopía de campo integral (o espectroscopía 3D), con la que se obtienen a la vez imágenes y espectros. El sondeo CALIFA (“Calar Alto Legacy Integral Field spectroscopy Area survey”), que usa datos del telescopio de 3.5m del Observatorio de Calar Alto (Almería), ha sido pionero y es referencia mundial en la actualidad a la hora de “diseccionar” las galaxias usando la técnica de la espectroscopía de campo integral. En la actualidad los cartografiados de galaxias que usan este tipo de observaciones son el “SAMI Galaxy Survey” (que emplea un novedoso instrumento instalado en el Telescopio Anglo-Australiano) y MaNGA (“Mapping Nearby Galaxies at APO”, también parte de SDSS), con algunos más en camino.

El “Mandala de CALIFA” representa las propiedades física básicas de 169 galaxies extraídas aleatoriamente del cartografiado CALIFA (“Calar Alto Legacy Integral Field spectroscopy Area survey”), que usa datos de espectroscopía de campo integral obtenidos con el telescopio de 3.5m del Observatorio de Calar Alto (Almería). Comenzando por el panel superior y en el sentido de las agujas del reloj se muestran (1) imágenes a color, (2) mapa de la densidad de masa de cada galaxia, (3) edades, (4) imágenes en falso color mostrando el brillo del gas ionizado, (5) emisión de las nebulosas siguiendo la emisión en hidrógeno-alpha y (6) la cinemática del gas usando los datos en H-alpha. Crédito: Rubén García Benito, Fabián Rosales-Ortega, Enrique Pérez, C.J. Walcher, Sebastián Sánchez y la colaboración CALIFA.

A la hora de estudiar las estrellas de nuestra Galaxia, los sondeos más relevantes en la actualidad son GALAH (“Galactic Archaeology with Hermes”, para el que específicamente se construyó el espectrógrafo HERMES en el Telescopio Anglo-Australiano), APOGEE (que está dentro de los nuevos cartografiados de SDSS) y Gaia-ESO (que usa el instrumento FLAMES del VLT).

La búsqueda de exoplanetas alrededor de otras estrellas ha motivado cartografiados como AAPS (Anglo-Australian Planet Search), HARPS (High Accuracy Radial velocity Planet Searcher), WASP (Wide Angle Search for Planets) o CARMENES (“Calar Alto high-Resolution search for M dwarfs with Exoearths with Near-infrared and optical Échelle Spectrographs”, en el telescopio de 3.5m del Observatorio de Calar Alto), todos ellos usando instrumentos (y a veces telescopios) construidos expresamente para este fin. Por supuesto, sin olvidar incluso satélites artificiales como Kepler (NASA), que literalmente ha cambiado la concepción que teníamos de los exoplanetas.

En el campo de la cosmología destacan los cartografiados profundos de galaxias como “Dark Energy Survey” (DES, usando una avanzada cámara construida por el equipo para el Telescopio Blanco, de 4 metros de tamaño, en Chile) y OzDES (“Australia DES”, también en el Telescopio Anglo-Australiano y usando el instrumento 2dF), ambos buscando medir distancias cosmológicas para entender mejor la naturaleza de la energía oscura usando la detección de supernovas en ellas.

Finalmente, en esta larga lista incompleta (quizá bastante sesgada) no me puedo dejar atrás los cartografiados que se están haciendo o se van a hacer muy pronto usando radio interferómetros. Hay muchos, tal y como detallé en un artículo anterior, pero por cercanía y conocimiento destaco aquí los dos cartografiados principales a realizar en el nuevo interferómetro australiano ASKAP (“Australian SKA Pathfinder”): WALLABY (“Widefield ASKAP L-band Legacy All-Sky Blind Survey”), que proporcionará datos del hidrógeno atómico de centenares de miles de galaxias localizadas en un radio de unos 3000 millones de años luz, y EMU (“Evolutionary Map of the Universe”), que espera detectar la emisión de radio-continuo de cerca de 70 millones de galaxias.

El nuevo radio-interferómetro ASKAP (“Australian SKA Pathfinder”), en Australia Occidental, casi listo para comenzar las observaciones para sus grandes cartografiados. Crédito: Alex Cherney/terrastro.com.

En resumen, si en los últimos años hemos vivido una explosión de datos astronómicos dados por grandes cartografiados, en la próxima década todo esto se va a incrementar mucho más. Cada vez mayor proporción de astrofísicos estarán involucrados en estas grandes colaboraciones internacionales, construyendo ya no sólo instrumentos sino telescopios, satélites artificiales, y otras instalaciones más complejas como interferómetros para llevar a cabo grandes cartografiados. Conseguir tiempo de observación en telescopios grandes para proyectos pequeños va a estar cada vez más limitado (y va a ser más difícil) por el aumento considerable de tiempo dedicado expresamente a observaciones de grandes cartografiados. A su vez, estos grandes proyectos tendrán cada vez más preferencia a la hora de diseñar políticas científicas y de decidir qué proyectos científicos se financian y cuáles no.

Como corolario, en este artículo también quiero transmitir a los más jóvenes algo que llevo cierto tiempo repitiendo en mis conversaciones con ellos y en las redes sociales: los conocimientos astronómicos no bastan para ser astrofísico. Era patente cuando yo era estudiante (y tampoco hace tanto, terminé la tesis hace justo una década) que para tener éxito en astrofísica también era muy importante saber programar. Bueno, ahora no es importante, ahora es fundamental saber hacerlo, sobre todo entender y manejar grandes bases de datos, las herramientas estadísticas para extraer información de ellos, cómo lograr una correcta visualización de estos grandes datos, y cómo compartir en red toda esta información. Entre los astrofísicos jóvenes está claro: el lenguaje de programación que hay que saber dominar es Python. Así que mi recomendación para futuros jóvenes astrofísicos es esta: saber reconocer el cielo por la noche, identificar los objetos astronómicos por ti mismo (lo que hacen los astrónomos aficionados) no es importante en Astrofísica. Saber programar, particularmente en Python, es esencial, y va a ser cada vez más crítico. Invertid una buena parte de vuestra formación en aprender a programar bien.

Ya que estoy en ello, y desviándome completamente del tema principal de este artículo, me gustaría añadir un segundo consejo a los más jóvenes, también viviéndolo de mi experiencia personal: hay que saber comunicar lo que se hace, a la vez que entender lo que otros están haciendo. Y para ello lo primero y fundamental es tener un excelente nivel en inglés hablado y escrito. Aún llevando 10 años viviendo en un país cuyo idioma oficial es el del Shakespeare, el no ser nativo en este idioma sigue “lastrando” de vez en cuando mi investigación y desarrollo profesional (dejo aparte mi “acento peculiar” y que me llame Ángel, un nombre que las personas nativas inglesas no saben pronunciar en castellano, todo esto daría de sí otro artículo). Tal es así que, actualmente, equiparo los conocimientos en inglés y en programación (insisto: Python) a los propios conocimientos en Física y Astrofísica a la hora apostar por una carrera en investigación astrofísica.

Si te falla uno de estos tres pilares básicos (conocimientos de Astrofísica, programación e inglés) vas a tener muy complicado poder dedicarte de forma profesional a la investigación astrofísica. Los tiempos cambian, hay que saber adaptarse y, a riesgo de sonar egoísta, hay que planificar desde muy pronto una estrategia a años vista para conseguir trabajar, disfrutando, de la investigación del Cosmos. Y, si al final no funciona (y cada vez es más difícil llegar a dedicarte de por vida a la investigación científica) hay que tener claro que los conocimientos adquiridos (particularmente programación con grandes bases de datos e inglés) tienen unas salidas enormes y aplicación directa en muchos otros campos. Ya dije arriba que el “Big Data” viene a quedarse. En Astrofísica está dirigido por los grandes cartografiados. Pero fuera de ella, incluso fuera de la Ciencia, hay multitud de aplicaciones que lo usan, algunas tan sutiles que las usamos a diario ya sin darnos cuenta.

(1) Recomiendo encarecidamente la lectura del fascinante libro “El Universo de Cristal”, de Dava Sobel, donde se detalla la a veces desconocida pero fundamental labor que astrofísicas como Williamina Fleming, Antonia Maury, Annie Jump Cannon, Henrietta Swan Leavitt, Margaret Harwood o Cecilia Payne realizaron como “mapeadoras del Cosmos”.

Este post ha sido realizado por Ángel López Sánchez (@El_Lobo_Rayado) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU

El artículo Cartografiando el Cosmos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El hidrógeno en el Universo (V): Cartografiando las galaxias en hidrógeno atómico

- Los abismos oscuros del Cosmos

- Cartografiando automáticamente áreas quemadas a nivel global

De cómo la ludificación del aula prepara a los niños para vivir en un estado policial

Laura R. Pinkerton

![]()

Es bien sabido que la vigilancia afecta a cómo nos comportamos. Un estudio reciente sobre el tema mostró que el tráfico en los artículos de Wikipedia sobre temas polémicos cayó significativamente después de que Edward Snowden desvelase la amplitud de la vigilancia que sobre Internet realizan la NSA y GCHQ [véase nota del traductor 1].

Esto demuestra tanto el efecto a corto como a largo plazo que la intrusión en nuestra vida privada puede tener sobre actividades perfectamente legales. También refleja el “efecto panóptico” descrito por el teórico social francés Michel Foucault.

El panóptico [2] era una prisión del siglo XVIII diseñada de tal manera que los guardias de la prisión podían ver el interior de las celdas de la prisión desde su torre, pero los prisioneros no podían ver a los guardias. Su propósito era motivar a los presos a comportarse bien, no a través de la fuerza bruta, sino a través de su miedo a ser vistos.

Si bien la vigilancia masiva en Reino Unido no conlleva la misma amenaza de daño físico experimentada por aquellos que viven bajo dictaduras violentas, sí amenaza con moldear nuestra manera de hablar y actuar unos con otros, creando una sociedad menos libre.

Ludificando el aula

Este aumento en la vigilancia masiva también está ocurriendo en el aula: a través del uso de juegos en línea que guardan la puntuación e informan al maestro en tiempo real sobre el comportamiento y habilidades del alumno.

La “ludificación” en las escuelas enseña a los niños que deben esperar que todos sus movimientos van ser vigilados, evaluados y posiblemente compartidos públicamente. Hace que la falta de privacidad parezca normal y prepara a los jóvenes para aceptar la vigilancia masiva en su vida adulta.

El Presidio Modelo, un diseño panóptico, en la Isla de la Juventud (Cuba). Fuente: Friman/Wikipedia

Mientras que la ludificación ha jugado un papel en la educación a través de estrategias de enseñanza no-digitales tales como gráficos de pegatinas y escuelas, en los últimos años el interés ha aumentado. Ahora los maestros usan nuevas herramientas digitales tales como plataformas de gestión del aula y programas educativos parecidos a juegos para ver, capturar y juzgar una gama más amplia de comportamientos infantiles con un detalle cada vez mayor.

Algunos proveedores de sistemas educativos, como el supercomputador de lectura de emociones Watson de IBM y el editor de materiales educativos Pearson, incluso esperan registrar y entender cómo piensan y sienten los estudiantes.

Observaciones sobre el terreno

Mi estudio sobre cómo los nuevos estándares de computación en el currículo nacional de Inglaterra se están experimentando en las aulas de la escuela primaria ha documentado varios casos de ludificación que se han convertido en Big Brother [3]. En un colegio vi la introducción de un nuevo sistema de casas [4] donde los puntos los daban los estudiantes veteranos, que se ocultaban en las esquinas de los pasillos, tomando notas sobre niños desprevenidos.

Estas notas se subían todas las noches a ClassDojo (una plataforma en la nube para el seguimiento e información del comportamiento de los estudiantes) para que los padres las pudiesen ver. El agregado semanal de estas puntuaciones se mostraba a toda la clase cada viernes, para que los estudiantes pudieran ver sus resultados y compararse con sus compañeros.

El aula: ludificada. Fuente: Pexels

En otra colegio su profesor recordaba frecuentemente a los estudiantes fueron que ella podía ver todo lo que hicieron en sus iPads individuales mediante un programa de captura de pantalla. Más tarde, esta maestra compararía su estilo de enseñanza relativamente suave con el utilizado en algunos de los padres de los niños en el extranjero, donde los estudiantes tenían que arrodillarse sobre cáscaras de coco rotas hasta que recitaban con éxito sus tablas de multiplicar.

Supongo que es fácil ver cómo este tipo de seguimiento moderno se ve como relativamente inofensivo en comparación con la violencia experimentada por algunos escolares en otras partes del mundo.

Más mal que bien

Pero aunque la ludificación del aula a través del software educativo es claramente menos violenta físicamente que el castigo corporal, no debemos engañarnos creyendo que la ludificación es una experiencia universalmente divertida y atractiva para todos los niños. Y puede incluso causar daño o tener un impacto negativo en los estudiantes, si se usa sin comprender los riesgos que conlleva.

Incluso en los casos en que tenga un efecto positivo en el comportamiento del estudiante, debemos proceder con cautela. Porque, si no tenemos cuidado, corremos el riesgo de enseñar a los niños pequeños a aceptar un ojo que todo lo ve omnisciente en sus vidas. Y que esta mirada “panóptica” debe ser temida y valorada más que las motivaciones internas como la curiosidad, la pasión y el impulso.

La popularidad de la ludificación es comprensible. El aprendizaje debe ser divertido al menos parte del tiempo y los maestros necesitan saber lo que los estudiantes están haciendo en su aula. Pero con cada vez más medios de vigilancia de masas en el mundo adulto, deberíamos estar enseñando a los niños a pensar críticamente acerca de la privacidad y el miedo, en lugar de entrenarlos para que renuncien a la primera y vivan según el segundo.

Sobre la autora:

Laura R. Pinkerton es ayudante de investigación en el Oxford Internet Institute de la Universidad de Oxford (Reino Unido).

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 12 de mayo de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0)

Notas del traductor:

[1] NSA = National Security Agency, Agencia de Seguridad Nacional de los Estados Unidos; GCHQ = Government Communications Headquarters, Cuartel General de Comunicaciones del Gobierno del Reino Unido

[2] Panóptico

[3] Big Brother (literalmente, gran hermano o hermano mayor) es un personaje de la novela de George Orwell “1984” que representa el control omnipresente y opresivo del estado totalitario.

[4] El sistema de casas es una forma de organización de los colegios británicos. Si ha visto alguna película o leído algún libro de la saga Harry Potter el lector está familiarizado con él sin saberlo, ya que el colegio Hogwarts está dividido en cuatro casas, perteneciendo Potter a una de ellas, Gryffindor.

![]()

El artículo De cómo la ludificación del aula prepara a los niños para vivir en un estado policial se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- #Naukas16 Cómo escribir un libro de ciencia para niños

- ¿Quién quiere vivir para siempre?

- Es hora de prepararse para el Maquinoceno

Adiós a las microesferas de plástico en los cosméticos

Las microesferas de plástico son las minúsculas partículas de plástico que contienen algunos productos cosméticos, como pastas de dientes, geles de ducha o exfoliantes, que las incluyen por su capacidad abrasiva.

Los microplásticos son una parte teóricamente pequeña del problema de la contaminación por plásticos, pero su impacto es especialmente grave porque se utilizan en productos cuyos residuos se van por el desagüe y llegan con mucha facilidad a los sistemas de tratamiento de aguas, donde no siempre pueden ser eliminados de forma eficaz y acaban acumulándose en el mar.

¿Para qué usamos cosméticos con microplásticos?

La mayor parte de los cosméticos que contienen microplásticos están diseñados para exfoliar la piel.

La exfoliación es un proceso de renovación natural de la piel a través del que se eliminan las células muertas de la epidermis. Cuando las células muertas de la epidermis se acumulan (hiperqueratosis) provocan un indeseable engrosamiento de la piel.

La exfoliación también se puede inducir utilizando productos exfoliantes. Estos cosméticos se emplean para eliminar esas escamas o células muertas de piel mediante una acción química o física. Se usan para mejorar el aspecto de la piel dañada por el sol, disminuir arrugas, mejorar cicatrices de acné o varicela, y decolorar o eliminar manchas [1].

En la exfoliación química (también denominada peeling químico) se utilizan enzimas o sustancias ácidas, como el ácido salicílico y ácido tricloroacético. Debido a su elevada capacidad de penetración en la piel y a su poder abrasivo, deben ser aplicados con supervisión profesional.

En la exfoliación física (también denominada exfoliación mecánica) se emplean materiales que, por roce con la piel, ayudan a sustraer las células muertas y los contaminantes que se acumulan en la epidermis. Se emplean sales minerales, semillas molidas, polvos de piedra pómez y, sobre todo, microplásticos. Estos microplásticos son partículas de un milímetro de diámetro o menos que suelen ser de polietileno (PE). También los hay de tereftalato de polietileno (PET), polipropileno (PP) y polimetacrilato de metilo (PMMA).

El mar de plástico

Han bastado un par de generaciones en las que hemos utilizado plásticos de forma masiva, para generar un problema de contaminación marina que ahora la ciencia trata de abordar. Todavía hay muchas incógnitas, pero algunas estimaciones ayudan a vislumbrar la magnitud del posible desastre. Cada año llegan al mar unos ocho millones de toneladas de plástico. China, Indonesia y Filipinas encabezan la clasificación de los países que más cantidad arrojan, y los 20 primeros –todos en Asia y África, excepto Estados Unidos y Brasil– son responsables del 83% del plástico mal gestionado que puede acabar en el mar [2].

De todo el plástico que llega al mar, el 1,5% son microplásticos [3]. Parte de estos microplásticos antes eran botellas, tapones, redes, cualquier cosa, y se han ido fragmentando hasta hacerse tan pequeños que son muy difíciles de eliminar. Se denominan microplásticos secundarios.

A estos microplásticos secundarios que se van produciendo en el proceso de biodegradación natural, hay que sumarles los microplásticos de los productos cosméticos.

Probablemente, el estrato de plástico que deje nuestra civilización sea uno de nuestros legados geológicos [4]. Un legado geológico de cuyas consecuencias ecológicas se tienen cada vez más indicios: la vida marina no solo incorpora estos residuos a sus hábitos (para depositar huevos o desplazarse, por ejemplo), sino que existen evidencias de ingestión y ahogamientos en diversidad de organismos [5].

El plástico no afecta a la salud, afecta al medioambiente

Actualmente no hay evidencias científicas suficientes para preocuparse por los efectos toxicológicos de estos plásticos, y es por ello por lo que su uso está permitido en cosmética, porque no acarrean ningún riesgo para la salud. El problema no es sanitario, sino de carácter medioambiental.

Esa imagen que guardamos en la memoria de plásticos formando enormes islas compactas y flotantes, aunque sea un mito, ayudó a la concienciación sobre el problema medioambiental. Aunque existen proyectos para ‘limpiar’ el plástico de los océanos, esa tarea se ha convertido en algo inabarcable [6]. Es por ello por lo que se ha puesto el foco en tierra, no en mar: hay que evitar que los microplásticos lleguen al mar.

Aunque sólo el 1,5% del plástico que llega al mar son microplásticos y esto no parece demasiado, la parte que aporta el uso de estos cosméticos puede eliminarse con relativa sencillez.

¿Por qué los exfoliantes llevan microplásticos y no otras sustancias?

Los microplásticos empezaron a emplearse en los productos exfoliantes porque suponían ventajas frente al uso de otras sustancias abrasivas. La principal ventaja estriba en su carácter inerte y su ligereza. A la hora de formular cosméticos, es interesante que estas partículas no afecten a la estabilidad y conservación del producto. Los plásticos que se emplean se mantienen inalterables y resulta sencillo mantenerlos en suspensión. Esto se vuele más complejo si utilizamos partículas biodegradables, ya que son menos estables y pueden reducir la vida útil del producto.

Otra ventaja frente a algunos exfoliantes minerales, como los que contienen piedra pómez o roca volcánica pulverizada, es que los microplásticos son menos agresivos para la piel. Estos exfoliantes minerales no siempre pueden utilizarse sobre el rostro, sobre pieles secas o sensibles, ya que de por sí son sustancias deshidratantes. Los microplásticos se convirtieron en la opción idónea para formular productos cosméticos de alta calidad y específicos para pieles sensibles.

Los laboratorios cosméticos se alían contra los microplásticos

En Estados Unidos el uso de microplásticos en productos cosméticos estará prohibido, por motivos medioambientales, a partir de julio de 2017 [7]. Esta ley afecta también a otras industrias que los emplean, como el sector textil y otros sectores industriales (ingredientes de tintas de impresión, pinturas spray, molduras de inyección y abrasivos).

En cambio, el uso de microplásticos en cosmética sigue estando permitido en la Unión Europea, ya que no suponen ningún riesgo para la salud. Aun así, importantes laboratorios cosméticos han optado por dejar de utilizar microplásticos y emplear otras sustancias en su lugar. La motivación de estos laboratorios radica en su filosofía de marca. Para algunos, la cuestión medioambiental es suficientemente relevante como para modificar sus productos.

Dependiendo de la naturaleza del producto cosmético y sus indicaciones, los microplásticos se han cambiado por sales, semillas, minerales o cáscaras troceadas de diferentes frutas.

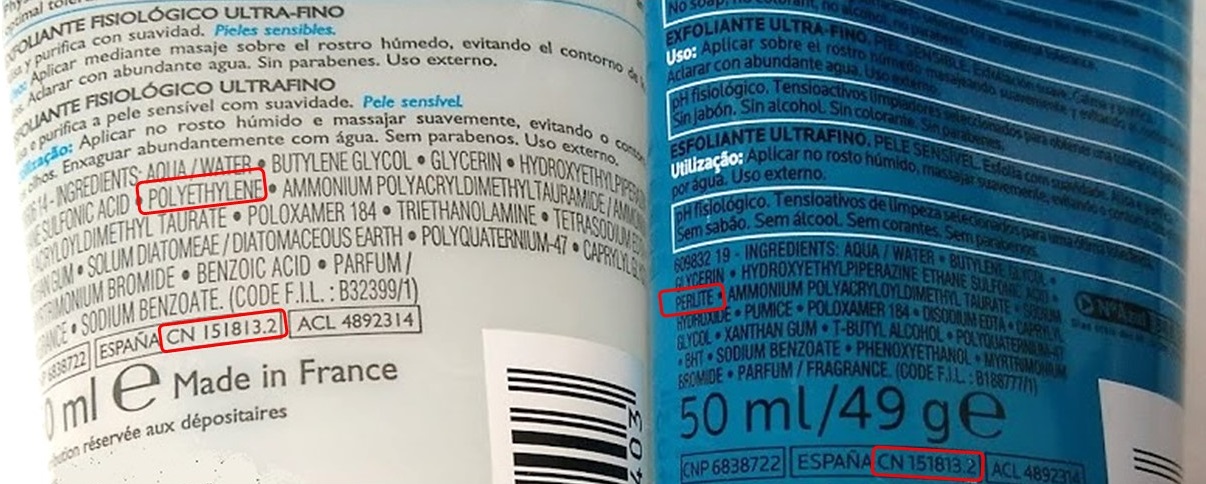

Este exfoliante específico para pieles sensibles contenía polietileno. Actualmente contiene mineral perlita.

Este proceso de cambio es más complejo de lo que puede parecer a simple vista: implica investigar nuevas opciones, adaptarlas a la indicación original del producto (no es lo mismo un producto para pieles secas o pieles grasas, por ejemplo), cambiar la formulación de un gran número de productos (no sólo de la sustancia abrasiva, sino del conjunto de componentes), volver a evaluarlos y pasar todos los controles de calidad como si se tratase de un producto nuevo.

Algunos laboratorios han iniciado las modificaciones de sus productos hace años. Algunos emprendieron estos cambios ya en 2013 [8]. Y durante este año, 2017, ya habrán modificado la formulación de todos sus productos para que ninguno contenga microplásticos.

Los laboratorios de mayor impacto en el mercado cosmético y en las tendencias de consumo ya han cambiado sus productos. Será cuestión de tiempo, de poco tiempo, que todos los demás, si quieren sobrevivir, tengan que sumarse a esta iniciativa sin microplásticos.

A veces la responsabilidad medioambiental de las empresas se adelanta a la ley. Que sirva de precedente.

Fuentes:

[1] Exfoliación química. Dermatología estética. Rubin, Mark G. Editorial Elsevier España, 2007.

[2] Océanos de plástico. Reportaje de Silvia Blanco y Elsa Fernández-Santos para El País Semanal, 2016.

[3] Las microesferas cosméticas que contaminan los mares. América Valenzuela. QUO, 2016.

[4] The Arctic Ocean as a dead end for floating plastics in the North Atlantic branch of the Thermohaline Circulation. Andrés Cózar, Elisa Martí, Carlos M. Duarte, Juan García-de-Lomas, Erik van Sebille, Thomas J. Ballatore. Science Advances, 2017.

[5] Use of Micro-Plastic Beads in Cosmetic Products in Europe and Their Estimated Emissions to the North Sea Environment. T. Gouin, J. Avalos, I. Brunning, K. Brzuska, J. de Graaf, J. Kaumanns, T. Koning, M. Meyberg, K. Rettinger, H. Schlatter, J. Thomas, R. van Welie, T. Wolf. SOFW Journal, 2015.

[6] El joven holandés que está obsesionado con sacar el plástico del mar. BBC Mundo, 2015.

[7] H.R. 1321, the “Microbead-Free Waters Act of 2015,” which prohibits the manufacture and introduction into interstate commerce of rinse-off cosmetics containing intentionally-added plastic microbeads. The White House, Office of the Press Secretary. December 28, 2015.

[8] Eliminación gradual de las microesferas de plástico. Nota de prensa de L’Oréal, 2016.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Adiós a las microesferas de plástico en los cosméticos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Estimada OCU: recuerda que NO se pueden utilizar las cremas solares del año pasado

- El mejor lacón con grelos tiene su ciencia

- Corales, ciencia y plástico.

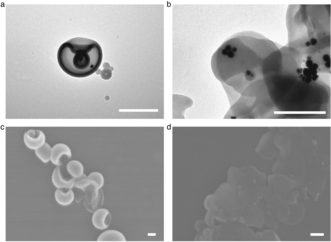

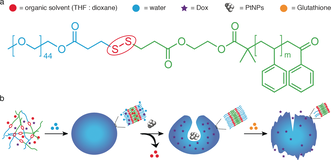

Un nanosubmarino, autoensamblado, autoorientable y autodestruible

La búsqueda autónoma de la diana terapéutica y la liberación de fármacos en su sitio de acción son características deseadas y buscadas en los nuevos sistemas nanomédicos. Un equipo de científicos holandeses ha diseñado un “nanosubmarino” que tiene estas funciones: Un fármaco antitumoral encapsulado en estomatocitos (una especie vesícula que recuerda a glóbulos rojos deformados) autopropulsados y autoensamblados se transporta a través de la membrana celular y se libera dentro de la célula mediante una señal redox química que desmonta la membrana de la vesícula. Suena complicado pero no lo es en absoluto. Vamos a verlo paso a paso, porque es fascinante.

Las nanovesículas automotrices son vehículos de transporte de medicamentos muy interesantes. Si se alimentan de peróxido de hidrógeno como “combustible”, estas vesículas pueden dirigirse como respuesta al gradiente de concentración de éste, como si siguieran un caminito de migas de pan en el que las migas son cada vez más grandes.

Combinando las ideas de nanomotores autopropulsados, de encapsulación de fármacos y de destrucción controlada del nanotransporte, los investigadores han diseñado una vesícula artificial auto-propulsada, sellada por una capa de copolímero en bloque, que se abre para liberar la carga de fármaco si se encuentra mayores concentraciones de glutatión, una molécula antioxidante ubicua en el interior de las células.

El glutatión es una molécula redox. En la célula, este pequeño péptido actúa como un eliminador de especies reactivas del oxígeno; además, sirve como una reserva del aminoácido cisteína. En las células tumorales se encuentran niveles elevados de glutatión, por lo tanto, al encontrar estos niveles anormalmente altos de glutatión de las células tumorales se desencadena el desmontaje de la membrana vesicular, y el contenido de la vesícula, el fármaco, se distribuye en la célula diana.

Veámoslo ahora todo junto.

El material de la membrana vesicular es un copolímero en bloque hecho de poli (etilenglicol) (PEG) y poliestireno. Durante el autoensamblaje, se encapsula un fármaco anticanceroso hidrofílico. Luego, al añadir el motor, que no es otra cosa que nanopartículas de platino, la vesícula artificial se transforma en un estomatocito en forma de cuenco, una vesícula con una abolladura o ranura especial. El platino es un catalizador que degrada el peróxido de hidrógeno producido por las células tumorales, propulsando los estomatocitos a través de la membrana celular, guiados por la cada vez mayor cantidad de peróxido de hidrógeno. Una vez dentro, las altas concentraciones de glutatión abren la cerradura química, rompen la vesícula, liberan el fármaco y detienen el movimiento por el envenenamiento del catalizador.

Esto es, se ha conseguido introducir un fármaco que no puede entrar por sí mismo en las células exactamente en aquellas que queremos eliminar, las tumorales, dejando intactas a las sanas.

Los investigadores comprobaron en células humanas in vitro que el nanosubmarino funciona perfectamente. Una idea muy interesante en la que seguir investigando.

Referencia:

Yingfeng Tu et al (2017) Redox-Sensitive Stomatocyte Nanomotors: Destruction and Drug Release in the Presence of Glutathione Angewandte Chemie International Edition doi: 10.1002/anie.201703276

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo Un nanosubmarino, autoensamblado, autoorientable y autodestruible se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Otra pieza en el puzle de la fotosíntesis

- Cómo sintetizar casi cualquier biomaterial usando ADN

- Usando ADN para sintetizar nanoestructuras de oro

Círculos japoneses

El pasado mes de enero de 2017, la revista de cultura, moda y tendencias The Balde, que se publicaba en euskera e inglés, sacó su último número, el 89, tras 15 años en activo. Aunque el trabajo de todos estos años no se ha perdido, puesto que los 89 números de la revista siguen estando accesibles en la red en la siguiente dirección: the Balde .

Portada del número 87 de la revista The Balde, que llevaba por título “Geometría Besatzen / Pitagora’s nightmare”. La imagen es obra de BYG

En la entrada del Cuaderno de Cultura Científica de hoy os traigo precisamente un interesante proyecto artístico que fue publicado en el número 50 de The Balde, en el año 2010.

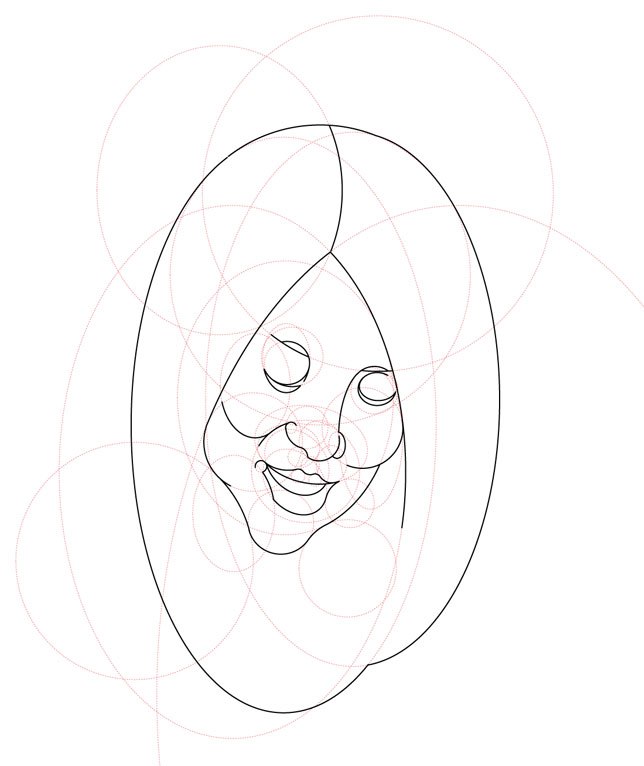

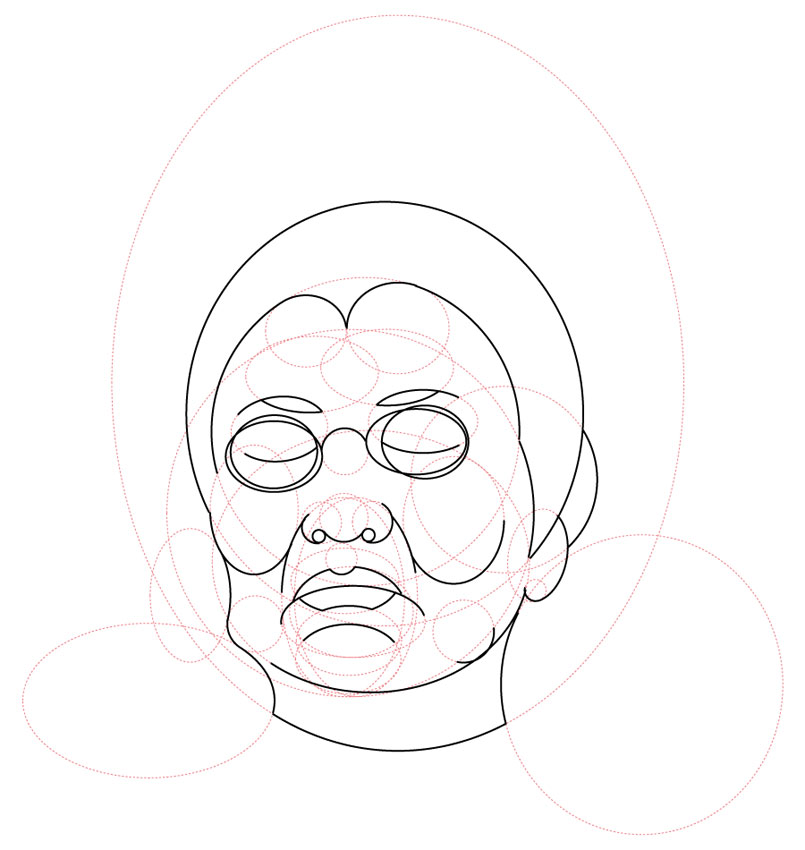

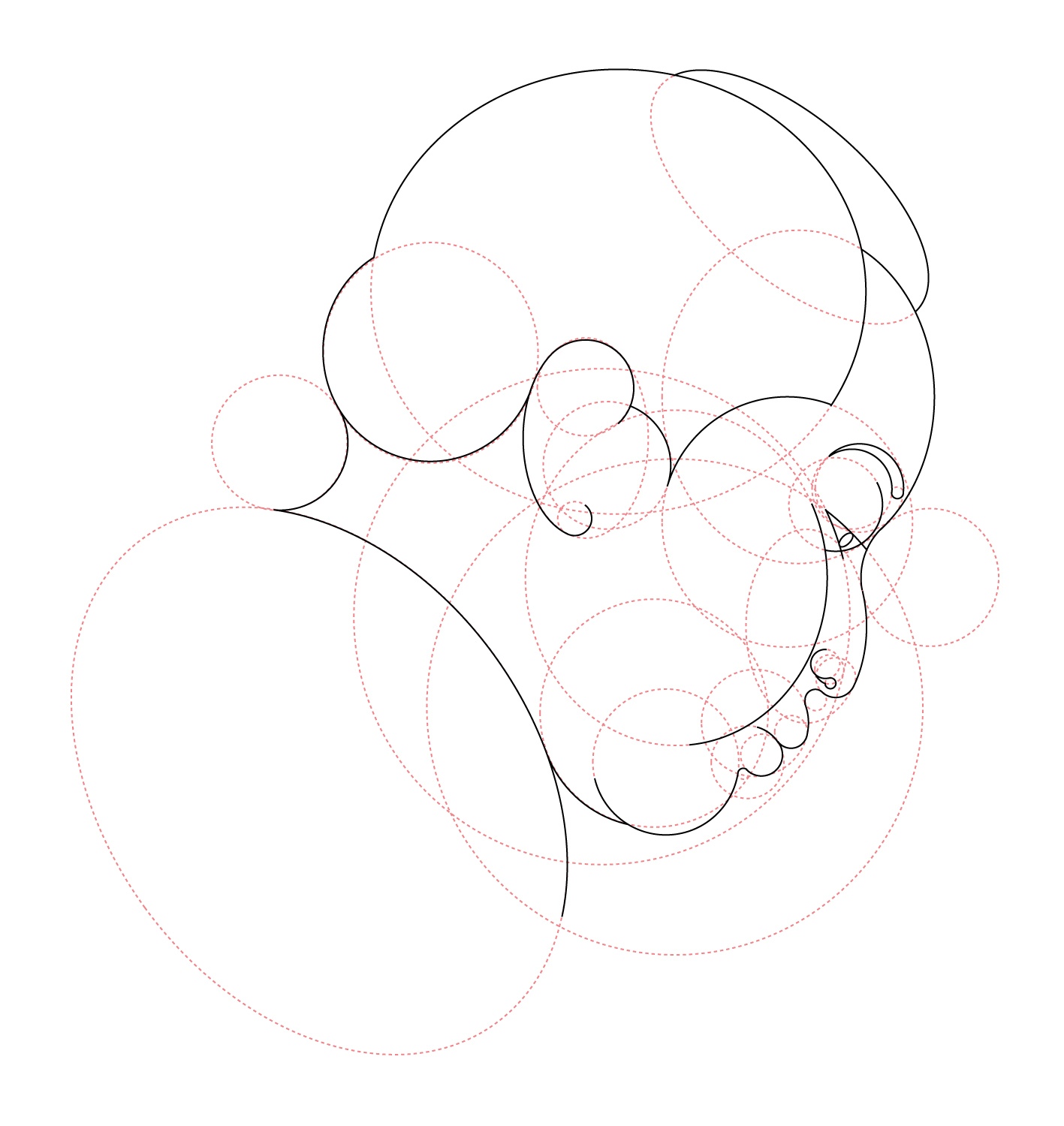

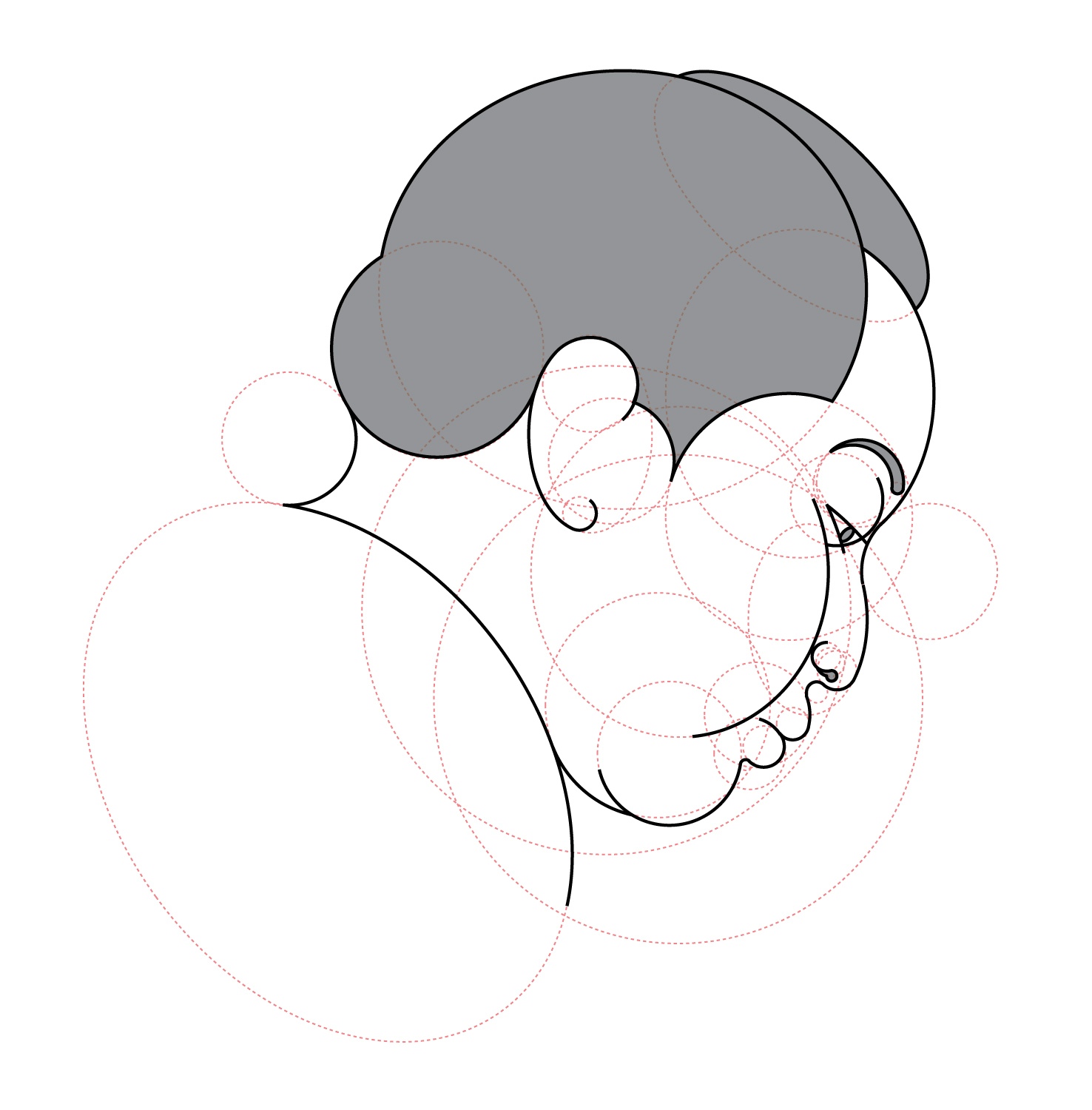

Círculos japoneses 1 / borobil japoniarrak 1/ japanese circles 1, de txo!?, 2010

Círculos japoneses 2 / borobil japoniarrak 2/ japanese circles 2, de txo!?, 2010