Dispositivos microfluídicos de separación de plasma por impresión 3D

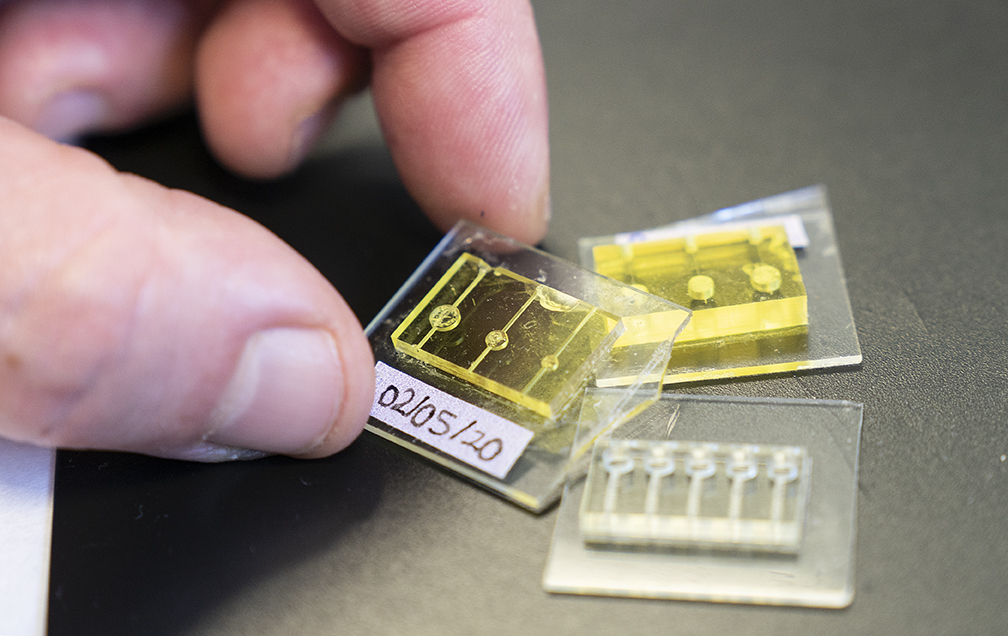

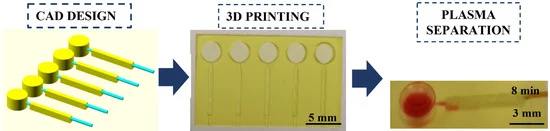

El Clúster de Microfluídica de la UPV/EHU ha utilizado una formulación de resina hecha a medida para impresión 3D de alta resolución para la fabricación de dispositivos modulares de separación de plasma que trabajan con tamaños de muestra muy reducidos. La metodología empleada demuestra la gran contribución que esta tecnología microfluídica puede aportar al mercado de los dispositivos biomédicos de separación de plasma.

En el marco de los dispositivos de tipo ‘Lab-on-a-Chip’, que integran una o varias funciones propias de un laboratorio en un único chip de dimensiones milimétricas, se están desarrollando con éxito pruebas de diagnóstico para la determinación de biomarcadores en sangre. Las mejoras que la microfluídica puede aportar al análisis y a los dispositivos de tipo médico son muy sustantivas, porque se trabaja con cantidades muy pequeñas y se obtienen los mismos resultados. La impresión 3D ha tenido un impacto significativo en este campo, aunque el desarrollo de plataformas microfluídicas impresas en 3D totalmente funcionales con componentes integrados sigue siendo un reto.

Las células sanguíneas interfieren en muchas determinaciones de biomarcadores, lo que conduce a valores de concentración inexactos. De ahí que la separación del plasma sea un paso crítico para mejorar el rendimiento analítico y desarrollar sistemas de detección fiables y precisos. La estudiante de doctorado del Clúster de Microfluídica de la UPV/EHU Sandra García Rey utilizó una formulación de resina hecha a medida para impresión 3D de alta resolución para lograr una rápida optimización de un prototipo operativo de un módulo de separación de plasma.

Nuevos dispositivos biomédicos de separación de plasma

“Imagínate un canal de unas cinco o diez micras —explica el doctor Fernando Benito López, uno de los investigadores principales del clúster—, cuya superficie está funcionalizada con receptores para capturar cierta molécula, o biomarcador, de la sangre y analizarla mediante fluorescencia. Los glóbulos rojos impedirían la visión de esa fluorescencia. Por tanto, hemos generado una especie de agujero donde se eliminan los glóbulos blancos y rojos por gravedad; así, por el canal solo pasa el plasma y se eliminan las interferencias que podrían provocar en el sistema integrado de detección por métodos ópticos. Es decir, este módulo se pondría delante del sistema de análisis”. En opinión de Benito López, este nuevo sistema permite que todo el proceso esté integrado dentro del dispositivo fluídico. Además, el dispositivo mejora la calidad del análisis, “porque es más rápido y se producen menos errores, porque la intervención humana es menor”.

El dispositivo microfluídico fabricado para separar el plasma de la sangre de forma fácil y fiable ha demostrado el potencial de la tecnología de impresión estereolitográfica (tecnología láser que emplea una resina líquida sensible a la luz UV) en 3D para la microfabricación. “Se puede conseguir una estructura fluídica óptima de una forma mucho más rápida que utilizando métodos convencionales, como la fotolitografía”, señala el doctor Benito López. Los investigadores afirman que esta investigación permitirá la fabricación de dispositivos de una sola pieza impresos en 3D con componentes de separación de plasma integrados para la detección de biomarcadores en la sangre. Además, han demostrado que “se puede trabajar con diferentes resinas”.

Referencia:

Sandra Garcia-Rey, Jacob B. Nielsen, Gregory P. Nordin, Adam T. Woolley, Lourdes Basabe-Desmonts, Fernando Benito-López (2022) High-Resolution 3D Printing Fabrication of a Microfluidic Platform for Blood Plasma Separation Polymers DOI: 10.3390/polym14132537

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Dispositivos microfluídicos de separación de plasma por impresión 3D se ha escrito en Cuaderno de Cultura Científica.

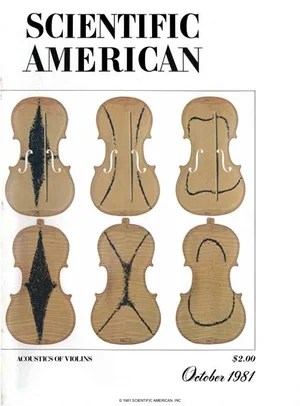

Chladni y el eufón

Cuando un cuerpo vibra (y hay alguien cerca para oírlo), decimos que produce sonido [*] . En ocasiones, esa vibración es periódica. Entonces nos produce una sensación de “tono” que viene determinada por la frecuencia natural de vibración del objeto. Si lo que vibra es una cuerda, por ejemplo, su tono tendrá una frecuencia fundamental que depende de su longitud, su grosor y su tensión. Pero además de esta frecuencia fundamental, el tono está compuesto por una serie de armónicos cuyas frecuencias son múltiplos de la fundamental.

Las cuerdas, como los tubos de los instrumentos de viento, son objetos alargados, tienen un patrón de vibración aproximadamente unidimensional. Por eso, los sonidos que generan son perfectamente armónicos, sus distintos modos de vibración responden a un único eje de simetría. En cambio, los cuerpos bidimensionales o tridimensionales suelen presentar modos de vibración más complejos, que responden a simetrías respecto a múltiples ejes. En la mayoría de los casos, esto significa que al vibrar producen una onda no periódica, ruidosa o semi ruidosa, que está compuesta por frecuencias no armónicas.

Los modos de vibración de los objetos bidimensionales fueron estudiados por Ernst Chladni. Este físico, considerado como el padre de la Acústica, es recordado por las figuras que llevan su nombre y que ya exploramos en otra entrada del Cuaderno de Cultura Científica. Al rociar un polvo fino sobre una superficie sonora, como una plancha de cristal o de metal, este tiende a acumularse sobre los nodos del movimiento, haciendo visible la vibración. Es un fenómeno muy sorprendente, resulta casi hipnótico. Pero además de estos experimentos, Chladni fue el primer físico que estudió de manera sistemática la vibración del diapasón, alrededor del año 1800. Lo modeló como una barra recta, libre por ambos extremos, que se dobla gradualmente hasta alcanzar una forma de U. Aunque hoy sabemos que este modelo no permite calcular correctamente los sobretonos del diapasón [1], el trabajo de Chladni allanó el camino que convertiría a este instrumento en una herramienta indispensable en toda orquesta y en todo laboratorio de física durante el siglo XIX.

El interés de Chladni por el diapasón tenía una motivación bastante práctica. Este abogado reconvertido en físico basó su modo de vida en demostraciones públicas de experimentos físicos que representaba por toda Europa. Era una suerte de físico ambulante. Durante sus giras, además de dejar al público anonadado con sus famosas figuras, Chladni solía interpretar música con diversos instrumentos de su propia invención. Uno de los más famosos era el eufón y estaba íntimamente relacionado con el diapasón.

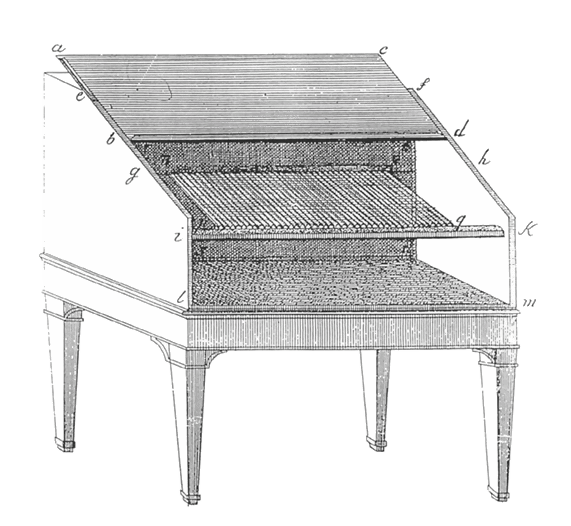

El primer eufón de Chladni. Fuente: Wikimedia Commons.

El primer eufón de Chladni. Fuente: Wikimedia Commons.El eufón era un instrumento de teclado que funcionaba con barras de vidrio resonantes, equivalentes a diapasones. Podríamos imaginarlo como en el tatarabuelo del piano Rhodes, solo que sin amplificación, ni martillos, ni grupos de rock melenudos. Estaba inspirado en otro instrumento de cristal que, para desgracia de Chladni, acabó siendo mucho más popular que su propio invento: la armónica de cristal de Benjamin Franklin. Esta armónica consta de una serie de platos o boles de cristal de diferentes tamaños que giran accionados por un pedal. El instrumentista debe mojarse los dedos ligeramente y al rozar con ellos los platos giratorios, produce un sonido brillante y puro. Y sí, el señor que sale en los billetes de cien dólares, además de arquitecto y presidente de los Estados Unidos, en sus ratos libres se dedicaba a inventar instrumentos musicales.

En el eufón, no hay platos giratorios sino unas barras que se frotan contra una rueda giratoria cubierta de fieltro. Hoy es común encontrar instrumentos llamados eufones con barras de metal en internet, aunque el descendiente más claro de este instrumento es el Cristal Baschet.

Aunque el eufón disfrutó de una amplia aclamación en tiempos de Chladni, nunca llegó a establecerse como un instrumento orquestal serio. En parte, porque su sonido resultaba tenue y difícil de modular. Otros instrumentos basados en el diapasón, como el dulcitono, el tipofono, el euphonium y otros inventos de la época corrieron una suerte parecida. Solo en el siglo XX y gracias a la electrónica, los diapasones pudieron proyectar su voz, y con ella, conquistaron de nuevo el mundo de la música.

Referencia:

[1] Daniel A. Russell (2020) The Tuning Fork- An Amazing Acoustics Apparatus Acoustics Today

[*] Nota del editor:

Esta frase, sobre todo la parte entre paréntesis, podría suscitar en un lector precipitado el deseo de iniciar algún tipo de discusión metafísica. Posibilidad que debería disolverse si se define sonido no como «vibración» sino como «la percepción de la vibración por un encéfalo humano», que es como debe interpretarse a la vista de lo que sigue. Sobre esta cuestión véase Sonido (1).

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Chladni y el eufón se ha escrito en Cuaderno de Cultura Científica.

El rompecabezas del abogado galés

Hace unos días estaba yo documentándome sobre ejemplos de arte textil relacionados con los cuadrados latinos cuando me encontré con el trabajo del biólogo, estadístico, coleccionista de arte textil y artista textil estadounidense Stephen Threlkeld. En la galería de arte Oxford Treehouse Gallery (Oxford Mississippi, Estados Unidos) me encontré con dos obras textiles que llamaron mi atención, Fibonacci Spiral (espiral de Fibonacci) y Latin Square I (cuadrado latino I).

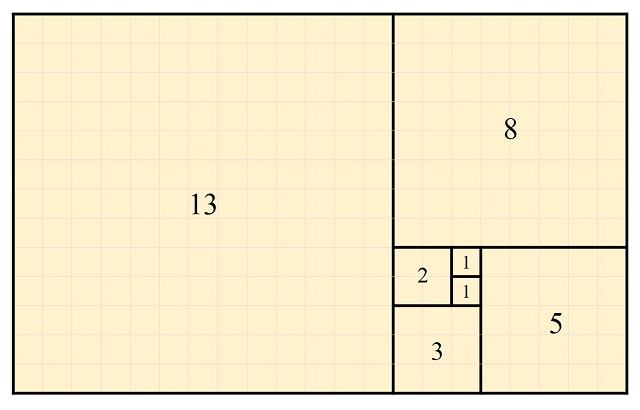

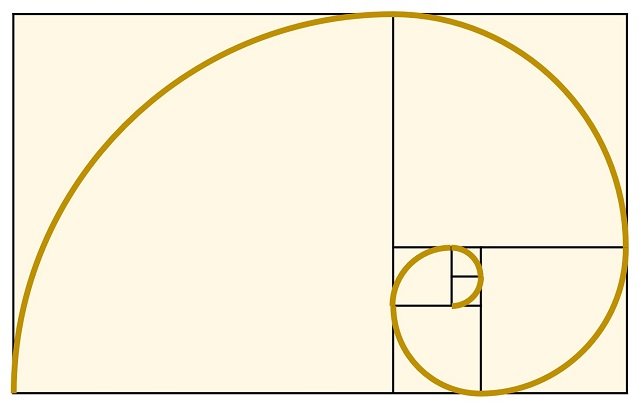

Fibonacci Spiral (espiral de Fibonacci), del artista estadounidense Stephen Threlkeld. Imagen de Oxford Treehouse Gallery

Fibonacci Spiral (espiral de Fibonacci), del artista estadounidense Stephen Threlkeld. Imagen de Oxford Treehouse Gallery

La primera pieza textil, Fibonacci Spiral (espiral de Fibonacci), está relacionada con la famosa sucesión de Fibonacci (véanse las entradas ¡Póngame media docena de fibonaccis!, El origen poético de los números de Fibonacci o Poemas Fibonacci). Esta sucesión numérica empieza con los siguientes números 1, 1, 2, 3, 5, 8, 13, 21, 34, 55, etcétera, y tiene la propiedad de que cada término de la sucesión es la suma de los dos términos anteriores. A partir de esta sucesión se puede construir una espiral de la siguiente forma. Primero se construye una sucesión de cuadrados, cuyos lados están determinados por los números de la sucesión, que se unen formando un rectángulo de la siguiente forma.

Después, en cada cuadrado se traza un arco de circunferencia, de radio igual al lado del correspondiente cuadrado, de forma que la unión de los arcos forma una espiral (véase la siguiente imagen) que recibe el nombre de espiral de Fibonacci.

Espiral de Fibonacci

Espiral de Fibonacci

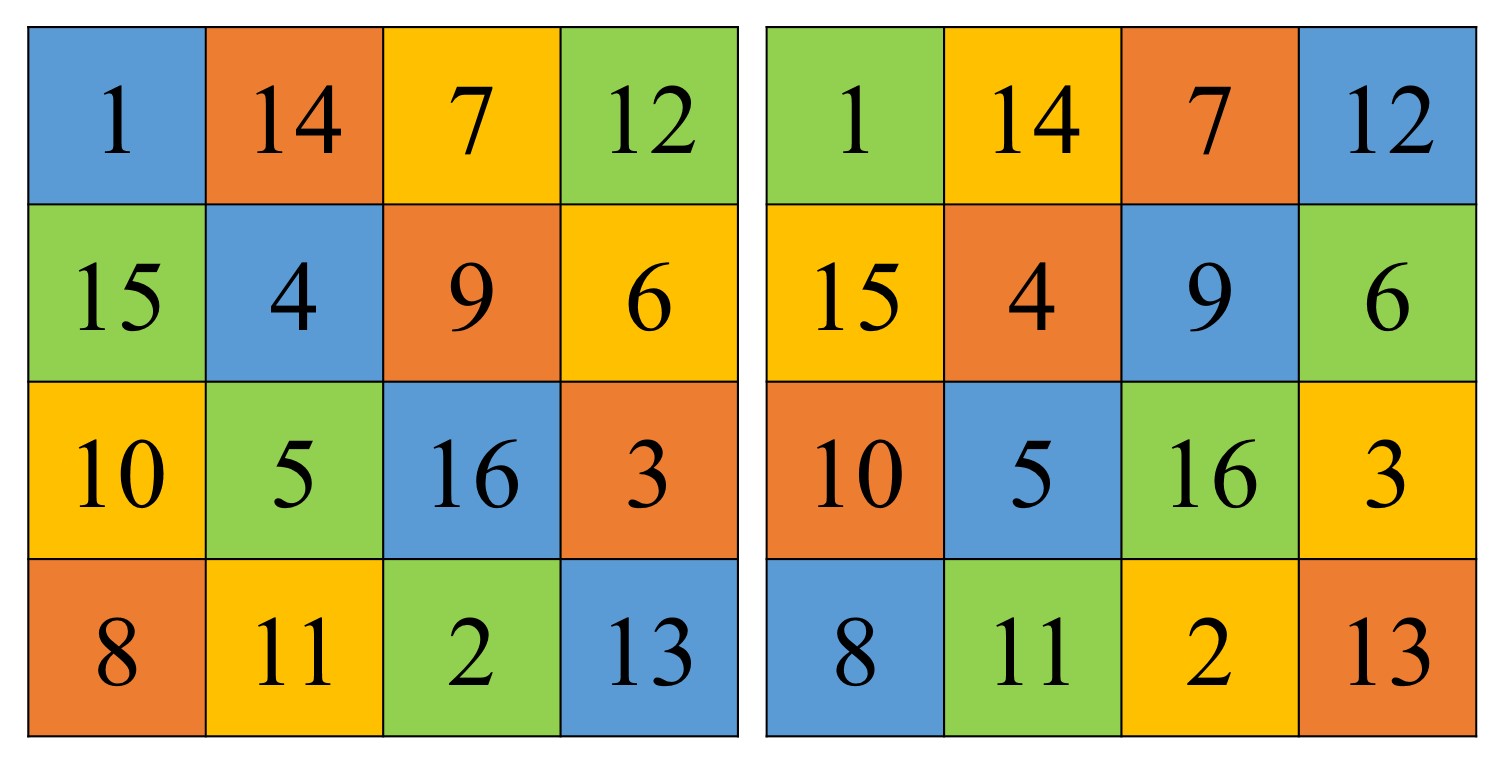

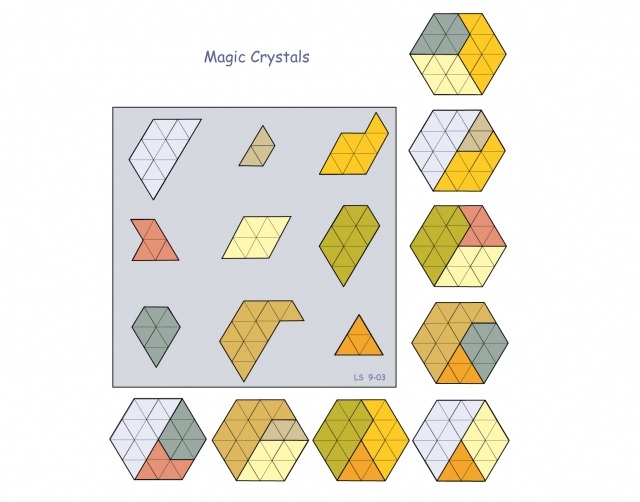

La segunda obra textil, Latin Square I (cuadrado latino I), es la que llamó mi atención desde la perspectiva de encontrar arte textil relacionado con los cuadrados latinos. Esta obra es, de hecho, un cuadrado latino de orden 5 formado por colores. Recordemos que un cuadrado latino de orden n es un retículo cuadrado de tamaño n x n en el que cada entrada es un número del 1 al n (aunque bien pueden considerarse n símbolos cualesquiera, por ejemplo, las letras del alfabeto latino que utilizó el matemático suizo Leonhard Euler o los colores utilizados por algunos artistas contemporáneos, como el artista concreto Richard P. Lohse o el artista textil Stephen Threlkeld, una de cuyas obras se muestra en la siguiente imagen), de tal forma que cada número de {1,…, n} aparece una vez, y sólo una vez, en cada fila y cada columna. Para más información sobre los cuadrados latinos véase la entrada Cuadrados latinos, matemáticas y arte abstracto.

Latin Square I (cuadrado latino I), del artista estadounidense Stephen Threlkeld. Imagen de Oxford Treehouse Gallery

Latin Square I (cuadrado latino I), del artista estadounidense Stephen Threlkeld. Imagen de Oxford Treehouse Gallery

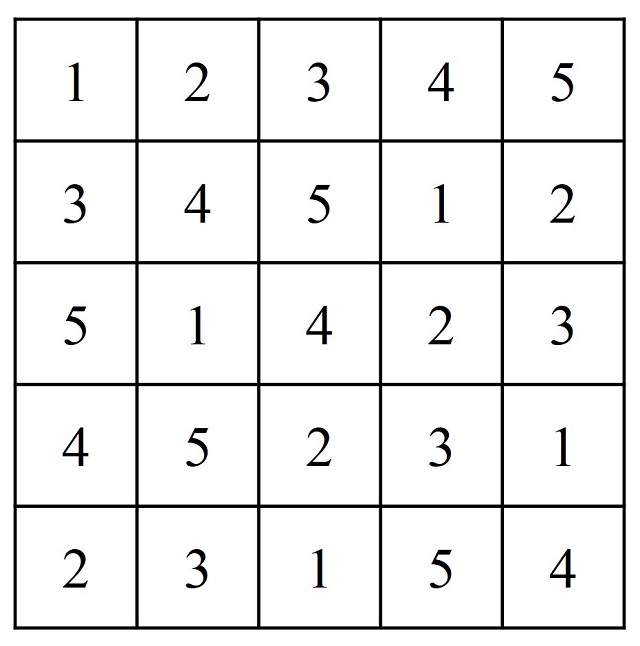

Si asignamos los números 1, 2, 3, 4, 5 a los colores de la primera fila, el cuadrado latino de orden 5 numérico, asociado al anterior cuadrado latino de colores, es el que aparece en la siguiente imagen.

Tanto este cuadrado latino, como el que aparece en otra de sus obras, Latin Square II (cuadrado latino II), son cuadrados latinos de orden 5 que no están ligados a un grupo algebraico, es decir, no son la tabla de Cayley de un grupo finito de 5 elementos (para más información sobre la relación entre cuadrados latinos y grupos algebraicos, véase la entrada Cuadrados latinos, matemáticas y arte abstracto o el libro Cayley, el origen del algebra moderna). Esta era una propiedad que a mí me interesaba especialmente, aunque el interés de Stephen Threlkeld en los cuadrados latinos, como entenderemos en un momento, no estaba relacionado con el álgebra moderna, sino con su utilización en el diseño de experimentos estadísticos (también en la entrada Cuadrados latinos, matemáticas y arte abstracto se muestra un sencillo ejemplo de este tipo de aplicación en estadística).

Para entender el interés de Stephen Threlkeld en los cuadrados latinos hay que saber más sobre este artista. En la página de la galería de arte Oxford Treehouse Gallery dan una pequeña reseña biográfica que nos permitirá conocerle un poco mejor y entender el motivo de su interés en estos objetos combinatorios.

Stephen Threlkeld se licenció en Oceanografía y se doctoró en Zoología, trabajó como ecólogo acuático y estadístico, fue autor y editor durante unos 40 años, así como profesor de biología. En paralelo, llevaba una segunda vida como coleccionista de arte.

Tras sus primeras incursiones en la pintura y el diseño gráfico, tomó clases para aprender a tejer en Nuevo México y Carolina del Norte, y ahora se expresa artísticamente a través de este medio. Sus tejidos se inspiran a menudo en rasgos y colores del paisaje americano, y a veces incluyen series matemáticas o temas biológicos.

Aunque en esta pequeña reseña biográfica ya nos dan una pista de cuál podía ser el interés de Threlkeld por los cuadrados latinos, cuando me puse en contacto con él, por correo electrónico, para interesarme por estas obras me confirmó que durante sus años de profesor de biología había enseñado en sus clases diseño de experimentos estadísticos.

Por otra parte, en nuestra comunicación por correo electrónico, Stephen Threlkeld llamó mi atención sobre una obra textil suya que yo no había descubierto en mi búsqueda, The Welsh Lawyer (el abogado galés), que estaba basada en el “rompecabezas/problema del abogado galés”, que el estadístico y biólogo británico Ronald A. Fisher (1890-1962), autor del libro The Designs of Experiments / El diseño de experimentos (1935), había propuesto en su libro.

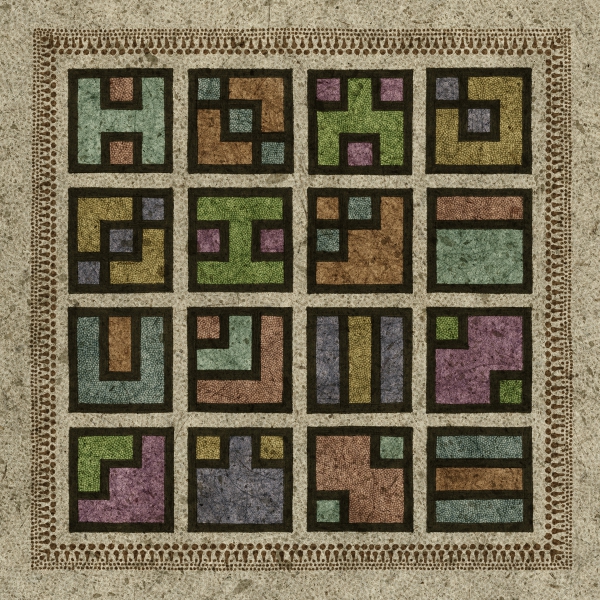

The Welsh Lawyer (el abogado galés), del artista estadounidense Stephen Threlkeld. Mi más sincero agradecimiento a Stephen Threlkeld por enviarme esta imagen de su obra

The Welsh Lawyer (el abogado galés), del artista estadounidense Stephen Threlkeld. Mi más sincero agradecimiento a Stephen Threlkeld por enviarme esta imagen de su obra

Efectivamente, el estadístico y biólogo Ronald Fisher incluye el siguiente rompecabezas en su libro El diseño de experimentos, por el siguiente motivo, “es útil para familiarizar la mente con las relaciones combinatorias que subyacen en el uso del cuadrado latino, y similares, para el diseño experimental”.

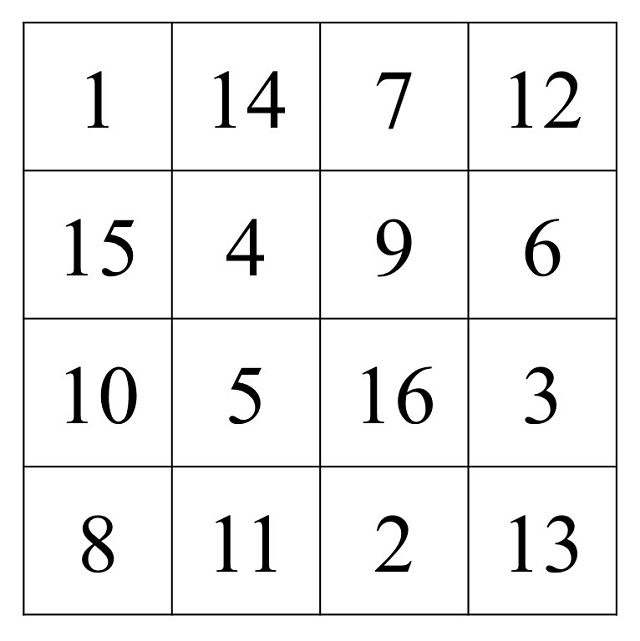

Rompecabezas del abogado galés: Dieciséis pasajeros de un transatlántico descubren que son un grupo excepcionalmente representativo. Cuatro son ingleses, cuatro escoceses, cuatro irlandeses y cuatro galeses. También hay cuatro de cuatro edades diferentes, 35, 45, 55 y 65 años, y no hay dos de la misma edad que sean de la misma nacionalidad. Por profesión, cuatro son abogados, cuatro soldados, cuatro médicos y cuatro clérigos, y no hay dos de la misma profesión con la misma edad o nacionalidad.

También resulta que cuatro son solteros, cuatro casados, cuatro viudos y cuatro divorciados, y que no hay dos del mismo estado civil que tengan la misma profesión, ni la misma edad, ni la misma nacionalidad. Por último, cuatro son conservadores, cuatro liberales, cuatro socialistas y cuatro fascistas, y no hay dos de las mismas simpatías políticas que tengan el mismo estado civil, ni la misma profesión, ni la misma edad, ni la misma nacionalidad.

Se sabe que tres de los fascistas son un abogado inglés soltero de 65 años, un militar escocés casado de 55 años y un médico irlandés viudo de 45 años. Es fácil entonces precisar el fascista restante.

Además, el socialista irlandés tiene 35 años, el conservador de 45 años es escocés y el inglés de 55 años es clérigo. ¿Qué sabes del abogado galés?

La solución de este rompecabezas está relacionada, como mencionaba R. A. Fisher, con los cuadrados latinos, más concretamente con los cuadrados latinos mutuamente ortogonales. A continuación, expliquemos brevemente qué son estos objetos combinatorios, de los que ya habíamos hablado en la entrada Los cuadrados greco-latinos de Leonhard Euler.

Para introducir los cuadrados latinos mutuamente ortogonales vamos a aprovechar un rompecabezas clásico, relacionado con este concepto. En 1725, el matemático francés Jacques Ozanam (1640-1718) incluye en su libro Récréations mathématiques et physiques el siguiente rompecabezas con cartas.

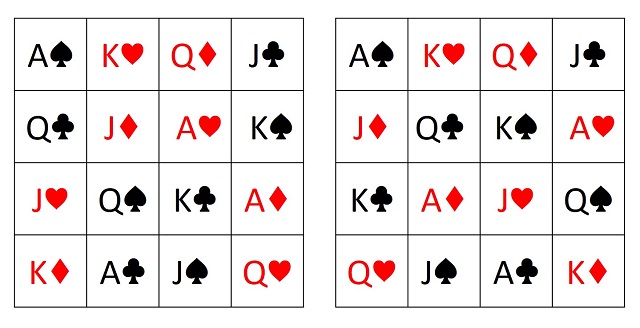

Rompecabezas con cartas de Jacques Ozanam: Colocar los reyes, reinas, jotas y ases de una baraja de cartas, formando un cuadrado 4 x 4, tal que cada fila y cada columna contenga una vez, y solo una vez, cada una de las figuras y cada uno de los palos.

Si nos fijamos un momento en el rompecabezas podemos descubrir que en las soluciones al mismo, ya que hay más de una solución, hay dos cuadrados latinos implicados. Si nos fijamos solo en las figuras (reyes, reinas, jotas y ases) estas forman un cuadrado latino, ya que en la solución “cada fila y cada columna contiene una vez, y solo una vez, cada una de las figuras”, lo mismo ocurre si solo nos fijamos en los palos (corazones, diamantes, tréboles y picas, en la baraja francesa, o copas, oros, bastos y espadas, en la baraja española). Por otra parte, estos dos cuadrados latinos están relacionados por el hecho de que cada carta tiene una figura y un palo, y esa carta es la única con esa figura y ese palo. Esta propiedad es la que nos va a indicar que los dos cuadrados latinos, de figuras y de palos, son mutuamente ortogonales. Pero antes de meternos en este concepto combinatorio, veamos alguna solución del rompecabezas de las cartas de Jacques Ozanam.

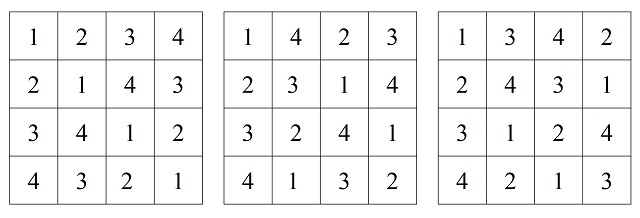

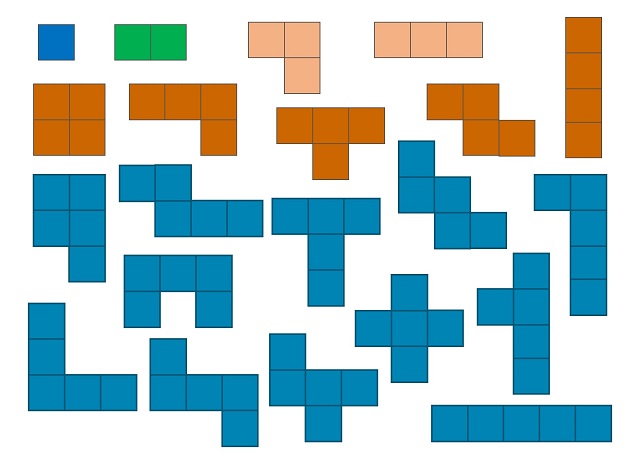

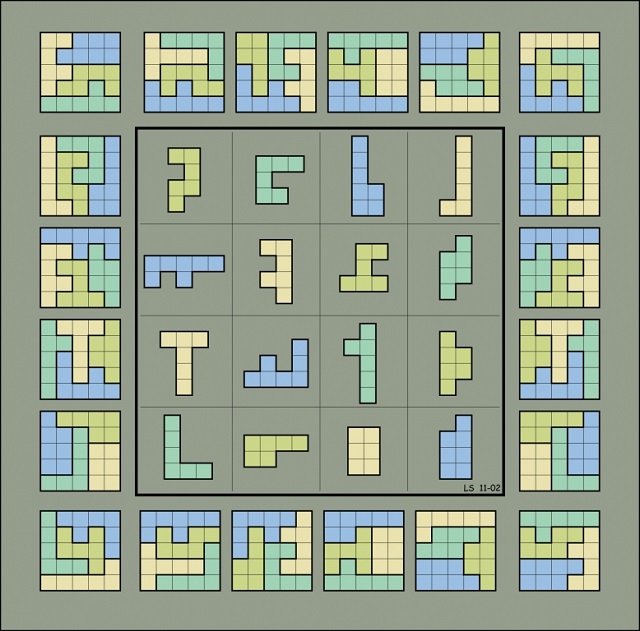

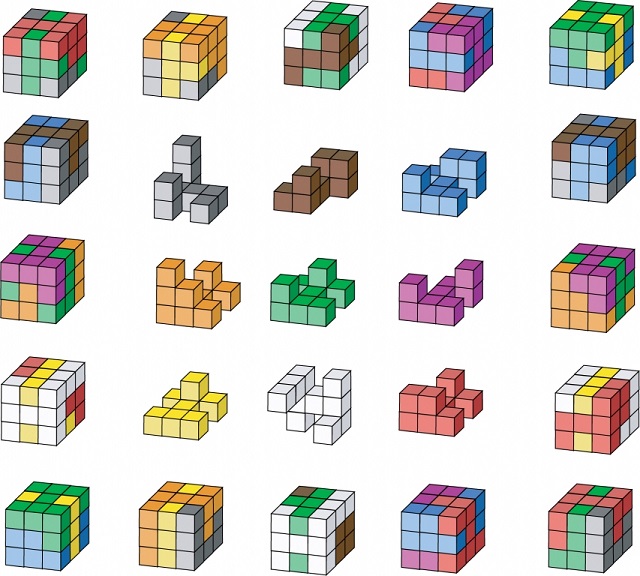

Dos soluciones del rompecabezas de las cartas de Jacques Ozanam

Dos soluciones del rompecabezas de las cartas de Jacques Ozanam

Como vemos en la imagen, tanto las figuras, como los palos, de estas dos soluciones, son cuadrados latinos. Pero vayamos al concepto matemático que recoge que los cuadrados latinos sean mutuamente ortogonales.

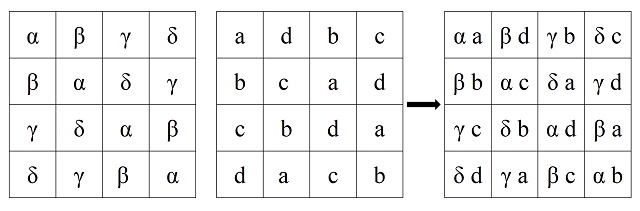

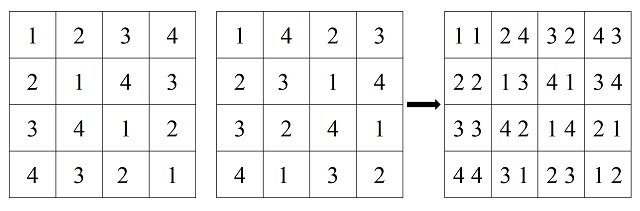

Dados dos cuadrados latinos L1 y L2 de orden n (es decir, que son retículas de tamaño n x n con una serie de n símbolos, por ejemplo, los números del 1 al n, distribuidos en la retícula según el concepto de cuadrado latino, luego cada símbolo aparece una vez, y sólo una vez, en cada fila y cada columna) se puede construir con ellos un nuevo retículo cuadrado n x n formado por pares ordenados de símbolos de esos dos cuadrados latinos, de forma que cada casilla del retículo está formada por el par ordenado que consiste en el símbolo de la misma casilla del cuadrado latino L1 y el símbolo de la misma casilla de L2 (los símbolos de cada cuadrado latino pueden ser distintos, por ejemplo, Leonhard Euler utilizaba letras latinas para uno de los cuadrados latinos y letras griegas para otro, por eso, al retículo que se forma con los dos se le suele llamar cuadrado greco-latino). Entonces, se dice que los cuadrados latinos son mutuamente ortogonales si cada uno de los n2 posibles pares ordenados, formados por los n símbolos, aparece exactamente una vez en toda la retícula n x n, como en el siguiente ejemplo.

Cuadrados latinos de orden 4 mutuamente ortogonales, con símbolos que son letras griegas en el primer caso y letras latinas en el segundo

Cuadrados latinos de orden 4 mutuamente ortogonales, con símbolos que son letras griegas en el primer caso y letras latinas en el segundo

Como se observa en la anterior imagen tenemos dos cuadrados latinos de orden 4, uno con letras griegas y otro con letras latinas, de forma que al formar el retículo 4 x 4 de los pares ordenados están las 16 combinaciones posibles de pares de letra griega y letras latina (y solo una vez). Aunque si preferís ver el ejemplo con números, sería el que aparece en la siguiente imagen.

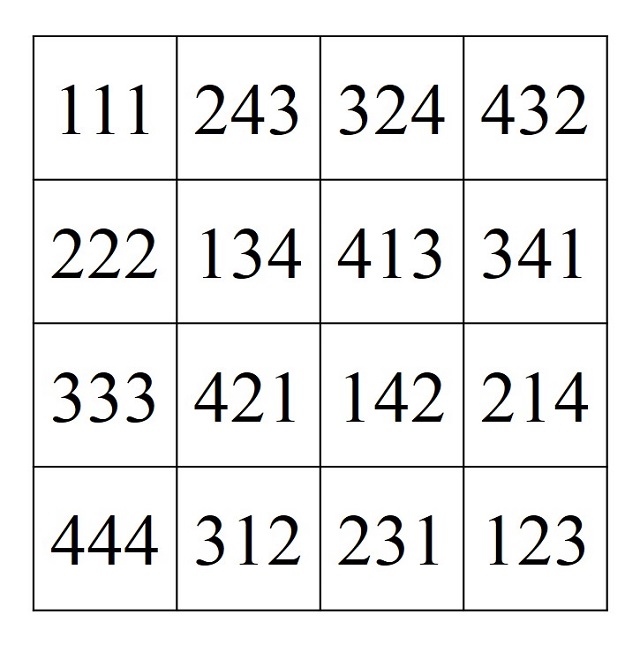

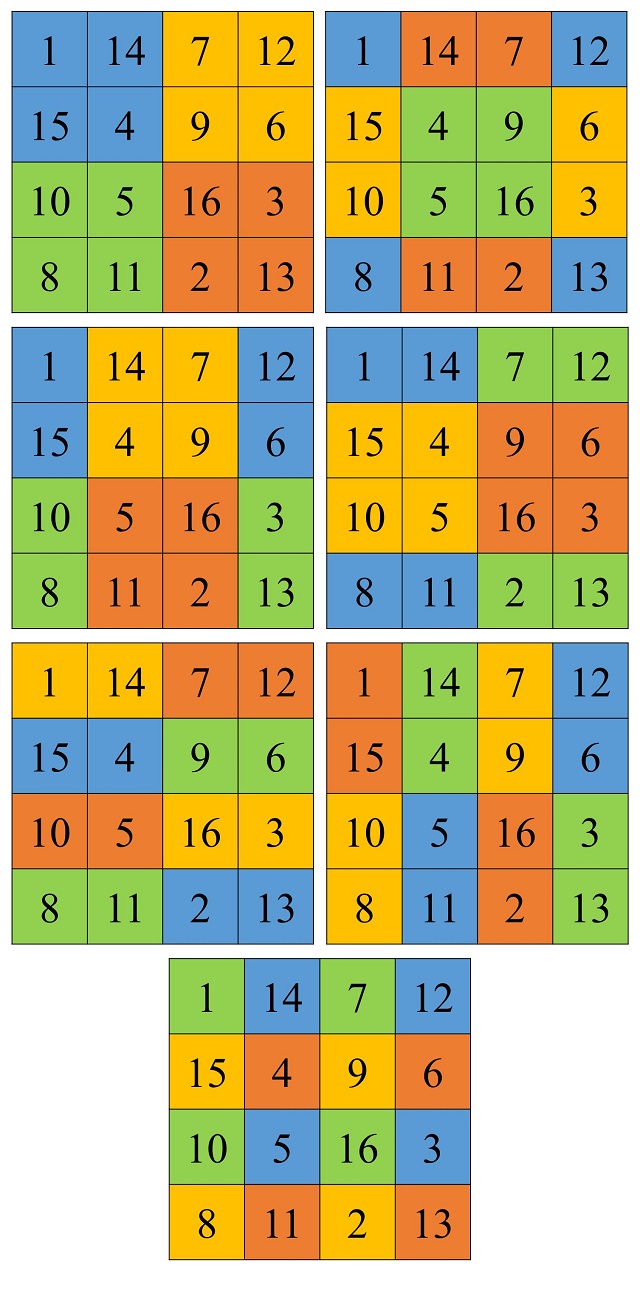

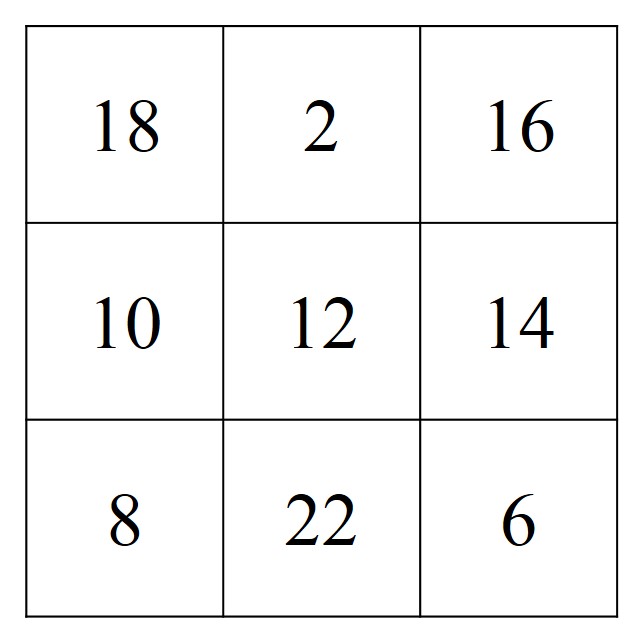

Los dos cuadrados latinos de orden 4 mutuamente ortogonales, de la anterior imagen, pero expresados con números

Los dos cuadrados latinos de orden 4 mutuamente ortogonales, de la anterior imagen, pero expresados con números

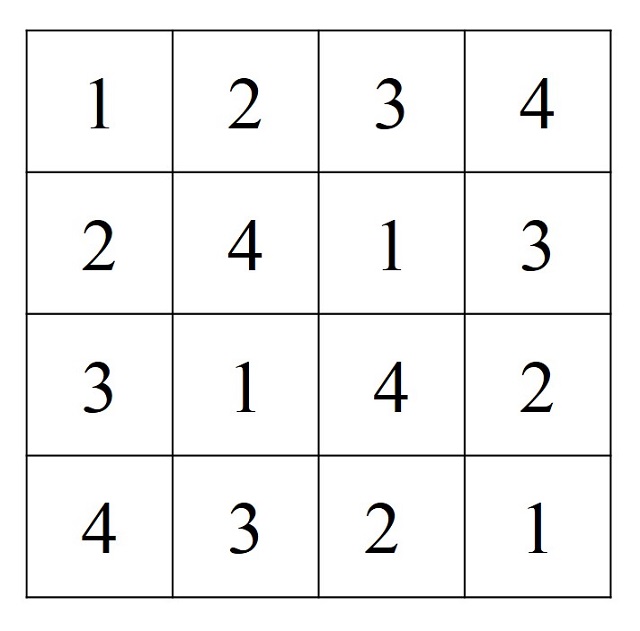

Hemos visto dos cuadrados latinos de orden 4 que son mutuamente ortogonales, pero también existen cuadrados latinos (como el siguiente, de orden 4) que no admiten ningún cuadrado latino tal que ambos sean mutuamente ortogonales.

Ejemplo de cuadrado latino de orden 4 que no admite ningún cuadrado latino tal que ambos sean mutuamente ortogonales

Ejemplo de cuadrado latino de orden 4 que no admite ningún cuadrado latino tal que ambos sean mutuamente ortogonales

No es difícil demostrar que no existe un cuadrado latino de orden 4 que junto al anterior sean mutuamente ortogonales. Dejo esta pequeña cuestión como problema para quien quiera disfrutar del placer de la demostración.

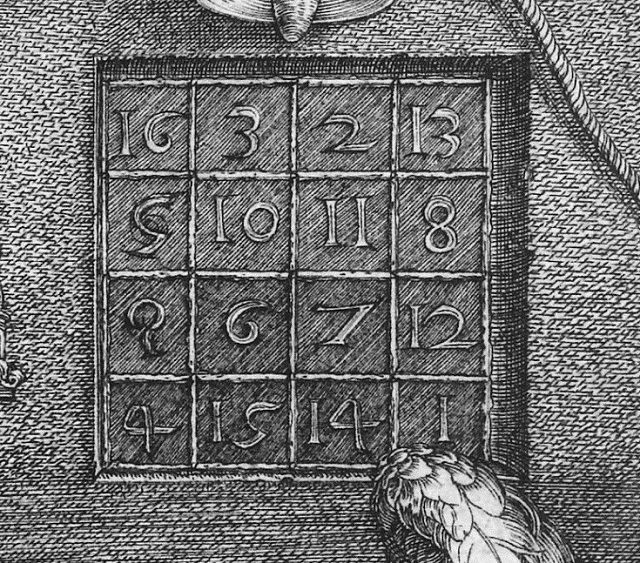

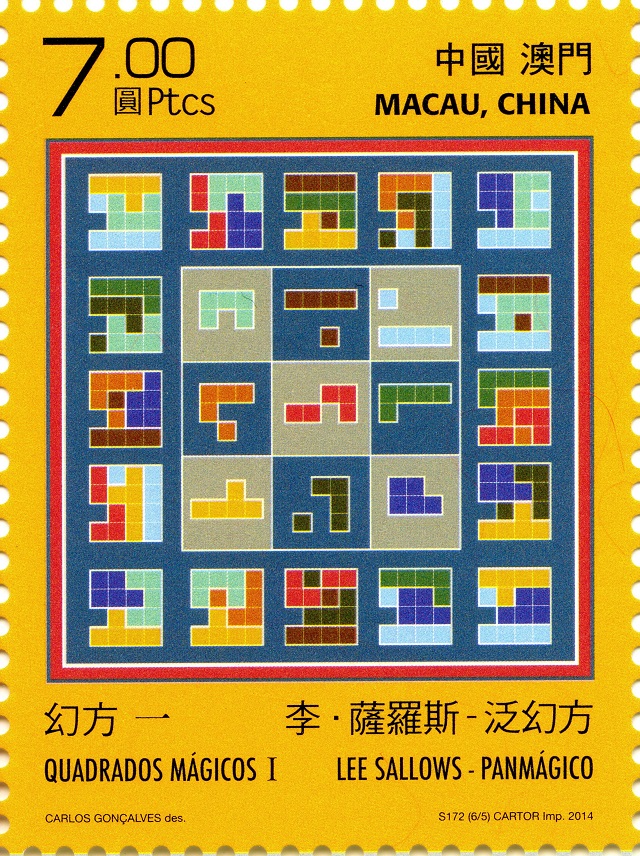

Como se explica en la entrada Los cuadrados greco-latinos de Leonhard Euler, el matemático suizo Leonhard Euler introdujo y estudió, en los artículos De Quadratis Magicis (1776) y Recherches sur une nouvelle espece de carrés magiques (1782), los cuadrados greco-latinos como un nuevo método para construir cuadrados mágicos, aunque también el matemático coreano Choi Seok-jeong (1646-1715), en su texto Gusuryak (1700), utilizó cuadrados latinos ortogonales para construir un cuadrado mágico (véase Las matemáticas como herramienta de creación artística).

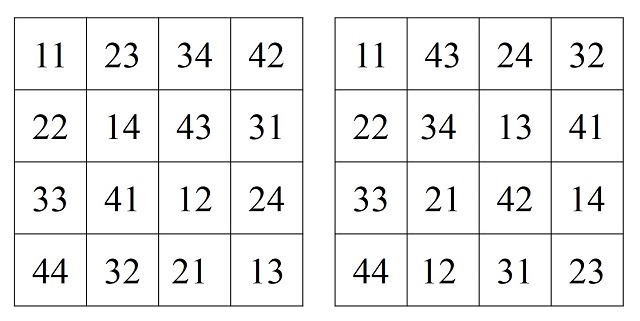

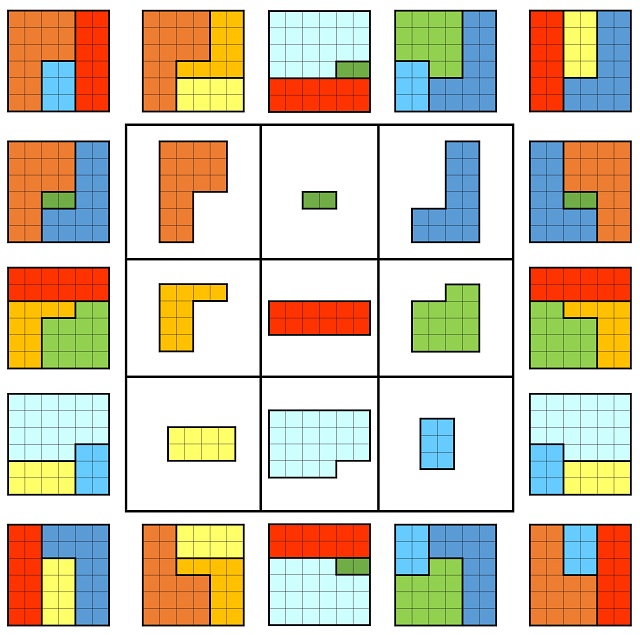

Por otra parte, el concepto de cuadrados latinos mutuamente ortogonales se puede extender a más de dos cuadrados latinos de la siguiente forma. Dados k cuadrados latinos de orden n, L1, L2, …, Lk, se dice que son mutuamente ortogonales si son mutuamente ortogonales dos a dos. Veamos un par de ejemplos. El primero está formado por los siguientes tres cuadrados latinos mutuamente ortogonales.

Tres cuadrados latinos de orden 4 mutuamente ortogonales

Tres cuadrados latinos de orden 4 mutuamente ortogonales

Los dos primeros claramente son mutuamente ortogonales ya que son el ejemplo que hemos mostrado más arriba. Además, el primero y el tercero son mutuamente ortogonales, así como el segundo y el tercero, como se puede observar a través de los retículos 4 x 4 formados a partir de esas parejas de cuadrados latinos (primero y tercero; segundo y tercero), los cuadrados greco-latinos asociados, que se muestran en la siguiente imagen.

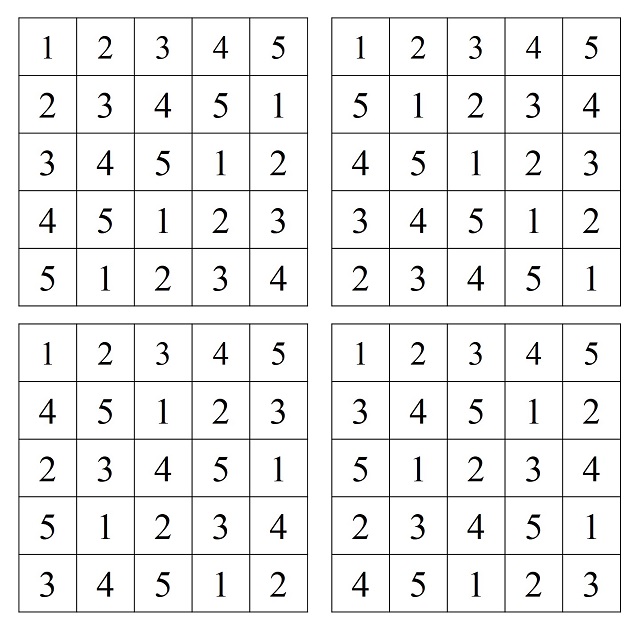

Otro ejemplo serían los siguientes cuatro cuadrados latinos de orden 5 que son también mutuamente ortogonales (como podéis comprobar vosotros mismos).

Al igual que a partir de dos cuadrados latinos de orden n mutuamente ortogonales se puede construir el nuevo retículo n x n, el cuadrado greco-latino, para k cuadrados latinos de orden n mutuamente ortogonales se puede también definir un nuevo retículo formado por las k-tuplas ordenadas de los elementos de los k cuadrados latinos, una especie de cuadrado greco-latino generalizado, que recoge la información de los k cuadrados latinos. Por ejemplo, en el caso de los tres cuadrados latinos de orden 4 mutuamente ortogonales anteriores, el cuadrado greco-latino generalizado asociado es el que aparece en la siguiente imagen.

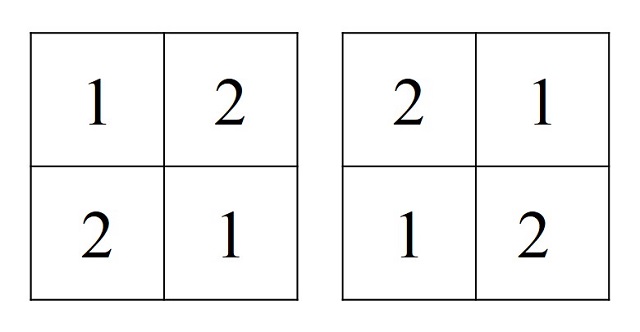

Existe mucha investigación sobre los cuadrados latinos mutuamente ortogonales, aunque en esta entrada solo vamos a comentar un resultado importante. Una pregunta lógica cuando se introduce el concepto de cuadrados latinos de orden n mutuamente ortogonales es cuántos cuadrados latinos pueden ser mutuamente ortogonales para cada orden. Por ejemplo, para orden 2 no hay cuadrados mutuamente ortogonales, ya que los dos únicos cuadrados latinos de orden 2 (véase la siguiente imagen) no son mutuamente ortogonales.

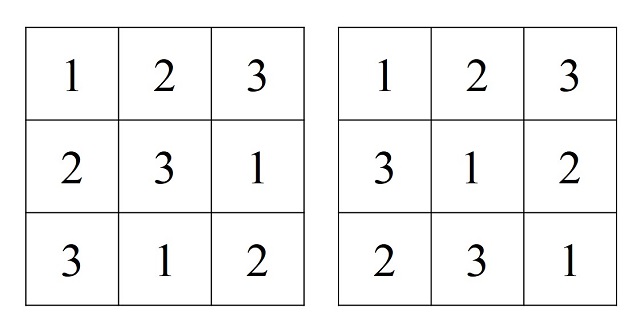

Para orden 3 solo puede haber dos cuadrados latinos que sean mutuamente ortogonales, como los de la siguiente imagen, pero no podemos conseguir tres cuadrados latinos de orden 3, entre los 12 que existen, que sean mutuamente ortogonales.

Para orden 4 solo pueden conseguirse hasta tres cuadrados latinos mutuamente ortogonales, como en el ejemplo anterior, pero ya no es posible encontrar cuatro cuadrados latinos de orden 4 que sean mutuamente ortogonales. De hecho, en general, para cuadrados latinos de orden n, la cantidad de cuadrados latinos que pueden llegar a ser mutuamente ortogonales –que se suele denotar N(n)– siempre es menor o igual que n – 1. Aunque no siempre se alcanza la cantidad n – 1. De hecho, para n = 6 no existen cuadrados latinos (de orden 6) mutuamente ortogonales, luego N(6) = 1, es la conocida conjetura de Euler, probada por el matemático amateur francés Gaston Tarry en 1901 (véase la entrada Los cuadrados greco-latinos de Leonhard Euler).

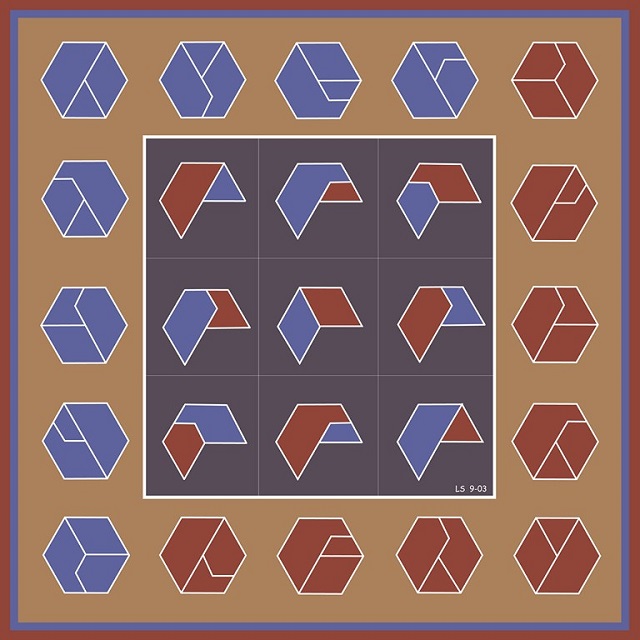

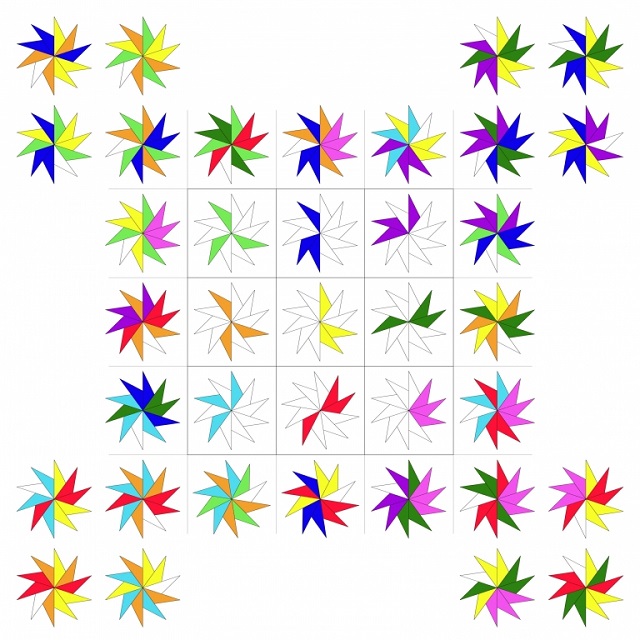

Abstruse Puzzle / Puzzle abstruso (2018), del artista Conan Chadbourne, que representa tres cuadrados latinos de orden 4 mutuamente ortogonales, a través del cuadrado greco-latino generalizado, que son los cuadrados latinos dados por pares de colores (rojo-cian, azul-naranja, verde-magenta y amarillo-violeta), simetría (uno o dos ejes de reflexión, alineados en paralelo a los lados del cuadrado o en diagonal) y proporción del símbolo que se rellena con un patrón determinado (2/9, 1/3, 2/3 o 7/9). Imagen de Mathematical Art Galleries

Abstruse Puzzle / Puzzle abstruso (2018), del artista Conan Chadbourne, que representa tres cuadrados latinos de orden 4 mutuamente ortogonales, a través del cuadrado greco-latino generalizado, que son los cuadrados latinos dados por pares de colores (rojo-cian, azul-naranja, verde-magenta y amarillo-violeta), simetría (uno o dos ejes de reflexión, alineados en paralelo a los lados del cuadrado o en diagonal) y proporción del símbolo que se rellena con un patrón determinado (2/9, 1/3, 2/3 o 7/9). Imagen de Mathematical Art Galleries

Pero volvamos al rompecabezas del abogado galés. Los datos de este problema eran los siguientes:

“Dieciséis pasajeros de un transatlántico descubren que son un grupo excepcionalmente representativo. Cuatro son ingleses, cuatro escoceses, cuatro irlandeses y cuatro galeses. También hay cuatro de cuatro edades diferentes, 35, 45, 55 y 65 años, y no hay dos de la misma edad que sean de la misma nacionalidad. Por profesión, cuatro son abogados, cuatro soldados, cuatro médicos y cuatro clérigos, y no hay dos de la misma profesión con la misma edad o nacionalidad.

También resulta que cuatro son solteros, cuatro casados, cuatro viudos y cuatro divorciados, y que no hay dos del mismo estado civil que tengan la misma profesión, ni la misma edad, ni la misma nacionalidad. Por último, cuatro son conservadores, cuatro liberales, cuatro socialistas y cuatro fascistas, y no hay dos de las mismas simpatías políticas que tengan el mismo estado civil, ni la misma profesión, ni la misma edad, ni la misma nacionalidad.”

Las hipótesis del rompecabezas nos recuerdan al concepto de cuadrados latinos mutuamente ortogonales. De hecho, se puede resolver con los tres cuadrados latinos de orden 4 anteriores (que en esencia es el único ejemplo para ese orden), como veremos a continuación.

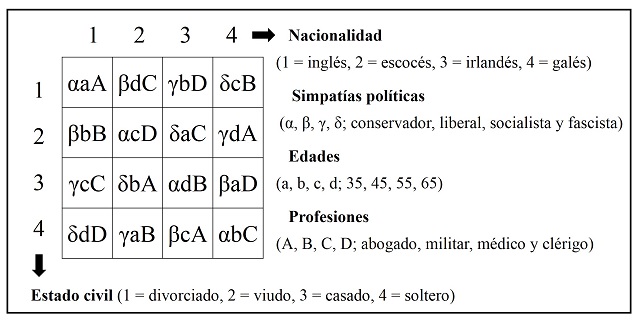

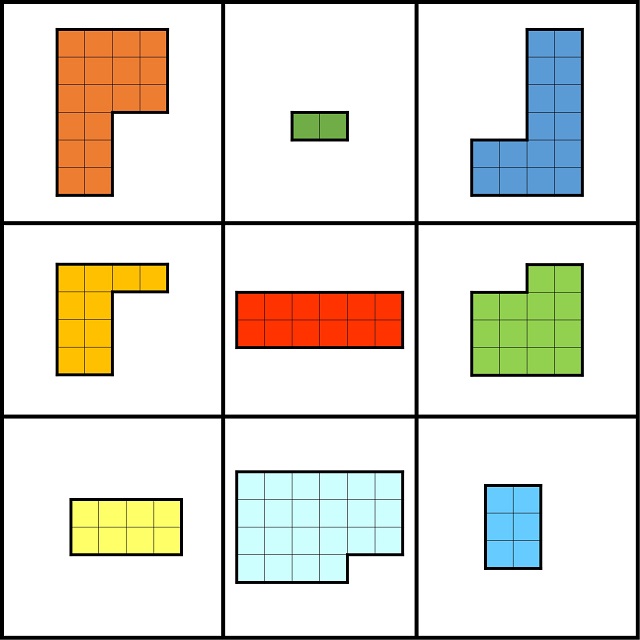

Vamos a considerar que las columnas del cuadrado greco-latino generalizado (de orden 4) que vamos a asociar al problema, que numeramos 1, 2, 3, 4, son las nacionalidades de los pasajeros (1 = inglés, 2 = escocés, 3 = irlandés, 4 = galés) y que las filas son los estados civiles de los pasajeros (1 = divorciado, 2 = viudo, 3 = casado, 4 = soltero). Además, vamos a designar con las cuatro primeras letras griegas (alpha, beta, gamma, delta) las simpatías políticas, que representaremos como el primer cuadrado latino del ejemplo anterior (ya que sabemos que ninguno de los pasajeros comparte nacionalidad, estado civil y simpatías políticas, aunque aún no sabemos la correspondencia con las cuatro opciones (conservador, liberal, socialista y fascista), que descubriremos más adelante con la información extra del rompecabezas. El segundo cuadrado latino de orden 4 del ejemplo (que junto al anterior cuadrado latino son mutuamente ortogonales) lo vamos a utilizar para las edades (35, 45, 55 y 65) y las denotaremos con letras latinas minúsculas (a, b, c d), que nos interesa que ambos cuadrados latinos sean mutuamente ortogonales ya que ninguno de los pasajeros comparte nacionalidad, estado civil, simpatías políticas y edades. Finalmente, el tercer cuadrado latino, que junto a los otros dos son mutuamente ortogonales, lo utilizaremos para las profesiones (abogado, soldado, médico y clérigo) y las denotaremos con las letras latinas mayúsculas (A, B, C, D). Todo esto lo podemos resumir en la siguiente imagen.

Pero el rompecabezas nos da algo más de información:

“Se sabe que tres de los fascistas son un abogado inglés soltero de 65 años, un militar escocés casado de 55 años y un médico irlandés viudo de 45 años. Es fácil entonces precisar el fascista restante.

Además, el socialista irlandés tiene 35 años, el conservador de 45 años es escocés y el inglés de 55 años es clérigo. ¿Qué sabes del abogado galés?”

Esta información nos va a permitir conocer qué letras representan a qué características. Así, como: i) uno de los fascistas es soltero, inglés, abogado y de 65 años, nos vamos al cuadrado greco-latino generalizado anterior y miramos a la casilla que corresponde con inglés (columna 1) y soltero (fila 4), luego “delta d D”, de donde deducimos que delta = fascista, d = 65 y D = abogado; ii) otro fascista es militar escocés (columna 2) casado (fila 3) de 55 años, de donde sacamos que b = 55 y A = militar; iii) otro es médico irlandés (columna 3) viudo (fila 2) de 45 años, por tanto, a = 45 y C = médico; respecto al cuatro fascista, por el que nos preguntan en el rompecabezas, como no hay dos pasajeros que compartan nacionalidad, estado civil, simpatías políticas, edades y profesiones, entonces tiene que ser divorciado (fila 1), galés (columna 4), clérigo y de 35 años, de donde c = 35 y B = clérigo.

Las asignaciones que faltan, para las letras griegas, la sacamos de la información restante. El socialista irlandés (columna 3) tiene 35 años (c), luego como en la columna 3 la casilla con una c es “beta c A”, entonces beta = socialista; además, el socialista irlandés que tiene 35 años es militar y está soltero. Como el conservador de 45 años (a) es escocés (columna 2), luego miramos la columna 2, la casilla con la letra a, que es “gamma a B”, de donde, gamma = conservador; y podemos completar su información conservador, escocés, 45 años, clérigo y soltero. Ya solo nos falta saber a qué corresponde alpha, que por descarte es alpha = liberal.

Recogiendo toda esta información en el retículo cuadrado tenemos:

La pregunta del rompecabezas es “¿Qué sabes del abogado galés?”. Si tenemos en cuenta que abogado es la letra D y galés es la columna 4, vamos a la casilla que tiene la letra D en la columna 4, que es “beta a D”, en la fila 3, de donde deducimos que:

¡el abogado galés es socialista, está casado y tiene 45 años!

Para terminar solo me queda animaros a que volváis a ver la obra textil The Welsh Lawyer (el abogado galés), de Stephen Threlkeld, que la disfrutéis y que comprobéis que efectivamente es el cuadrado greco-latino generalizado de tres cuadrados latinos de orden 4 mutuamente ortogonales.

Bibliografía:

1.- Raúl Ibáñez, Cayley, el origen del algebra moderna, RBA, 2017.

2.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, El mundo es matemático, RBA, 2015.

3.- Raúl Ibáñez, Las matemáticas como herramienta de creación artística, Catarata, 2023 (pendiente de publicación).

4.- Stephen Threlkeld, comunicación privada

5.- Página web del artista Stephen Threlkeld

6.- Ronald A. Fisher, The Designs of Experiments, Oliver and Boyd, 1935.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El rompecabezas del abogado galés se ha escrito en Cuaderno de Cultura Científica.

Neurociencia de la conducta social

Es conocido que el contacto social genera sensaciones positivas, afecto, vínculos y confianza, que pueden desembocar en el establecimiento de relaciones interpersonales a distinta escala: familias, redes sociales, comunidades y sociedades. El contacto social promueve la salud tanto mental como física y es clave para el bienestar a largo plazo. Sin embargo, el contexto en el que se establece el contacto social también puede generar sensaciones negativas relacionadas con el tipo y la cantidad de contacto que estén socialmente aceptados, algo en lo que intervienen variables como el género, la raza, la edad, el estatus o la cultura.

Foto: Nick Fewings / Unsplash

Foto: Nick Fewings / UnsplashLa conducta social viene de serie: está programada en el sistema nervioso de forma estereotípica y es específica de cada especie, si bien está modulada en cada individuo por sus experiencias previas. Solo ahora estamos empezando a comprender la interacción entre los circuitos neuronales subyacentes, desde la periferia (la piel) hasta el encéfalo, donde se generan respuestas conductuales ante el contacto social.

En 2019, el investigador Ikerbasque Mazahir T. Hasan, del centro Achucarro Basque Center for Neuroscience, desarrolló una tecnología genética llamada vGATE por sus siglas en inglés (virus-delivered Genetic Activity-induced Tagging of cell Ensembles) [1] que permite identificar y marcar permanentemente circuitos cerebrales activados vía experiencias previas. Lo verdaderamente revolucionario de la tecnología vGATE es que permite que las neuronas marcadas puedan ser manipuladas de diversas formas, lo que abre la puerta a investigar de manera precisa sus propiedades y poder así asociar el papel de los circuitos concretos con experiencias sensoriales y procesos de aprendizaje, memoria y conducta.

Los ratones se utilizan en neurociencia para estudiar varios tipos de conducta social. Cuando dos ratones se encuentran por primera vez sus interacciones a lo largo del tiempo se pueden dividir en varias fases: detección, acercamiento, investigación y acción. Los investigadores emplearon el sistema vGATE [2] centrándose en una región del cerebro: el núcleo intralaminar posterior del tálamo. Con este sistema, identificaron y marcaron ensamblajes celulares (o engramas) activados por el contacto social.

En las neuronas objetivo los investigadores introdujeron una proteína capaz de activarlas con un control temporal preciso. La activación quimiogenética de las neuronas marcadas provocó un aumento en las interacciones físicas directas entre roedores hembras familiares sin afectar otras maneras de conducta social. Los investigadores concluyeron que los engramas o ensamblajes identificados muy probablemente modulan la conducta social en mamíferos.

Neurociencia de la conducta socialEste resultado es solo un primer paso para elaborar una neurociencia de la conducta social. En estudios futuros el sistema vGATE podría ser utilizado para mapear y manipular circuitos encefálicos asociados a diferentes tipos de conducta social, incluyendo la cooperación.

Un posibilidad muy interesante surge del hecho de que el sistema vGATE también es capaz de identificar circuitos encefálicos alterados, anormales o patológicos. Así, proyectos futuros podrían descifrar la conexión entre el contacto de la piel y los circuitos encefálicos donde la experiencia del tacto puede transformarse en respuestas conductuales diferentes dependiendo del estado del propio encéfalo. Si bien el contacto social táctil puede provocar sensaciones positivas en una mayoría de individuos, en otros puede provocar lo contrario, como es común en un gran número de individuos neurodivergentes, por ejemplo con trastorno del espectro autista (TEA).

Comprender los mecanismos que utilizan los circuitos encargados del contacto social, así como la conducta que sigue a esta activación, podría abrir nuevos e innovadores caminos para el campo de la terapéutica de los circuitos cerebrales. Algo que haría algo más fácil la vida de las personas con TEA.

Referencias:

[1] Hasan et al. (2019) A fear memory engram and its plasticity in the hypothalamic oxytocin system Neuron doi: 10.1016/j.neuron.2019.04.029

[2] Keller et al. (2022) A thalamo-preoptic pathway promotes social grooming in rodents Current Biology doi: 10.1016/j.cub.2022.08.062

Para saber más:

Mala neurociencia

Todo cabe en el encéfalo

Carácter emocional e hipersocial del cerebro

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Neurociencia de la conducta social se ha escrito en Cuaderno de Cultura Científica.

¿Una pluma en el manto de Marte?

En la geología planetaria estamos acostumbrados a ir cambiando la visión de nuestro Sistema Solar de tanto en tanto. Casi podríamos decir que nuestra concepción de la vida interna de los planetas y satélites de nuestro vecindario planetario era bastante aburrida hasta entrada la década de los ochenta.

Las misiones espaciales cada vez más capaces y numerosas nos obligaron a cambiar la mentalidad: nuestro Sistema Solar vivía más allá de la Tierra. Veíamos volcanes activos en pequeñas lunas y superficies jóvenes que nos indicaban que la geología había transformado recientemente las caras de algunos planetas y otros tantos satélites. Esto ha supuesto una verdadera revolución y un cambio de paradigma, hasta cierto punto inesperado, que de nuevo demuestra que nuestro planeta no es único ni especial, sino que forma parte de una diversidad de cuerpos con distintos grados de actividad interna y externa. Esta diversidad no podía conocerse hasta el inicio de la carrera espacial, porque para hacer geología muchas veces lo primero que tiene que hacer el geólogo es mirar y poder ver.

En ese reconocimiento de ignorancia, pero también de humildad, son muchas las sorpresas que nos está desvelando Marte en los últimos años, quizás también porque es el cuerpo mejor explorado hasta el momento que no sea la Tierra o la Luna.

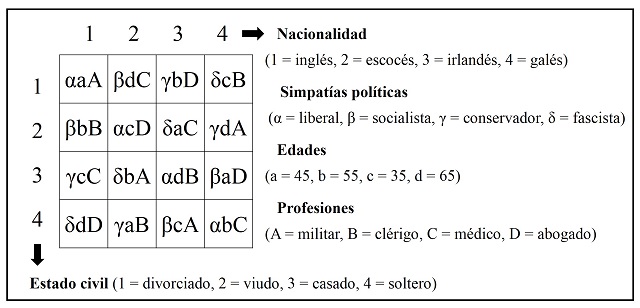

El cráter Mariner, “fotografiado” por la sonda Mariner IV. Un panorama desolador, muy diferente a la imagen que tenemos hoy del planeta Marte. Imagen cortesía de NASA/JPL.

El cráter Mariner, “fotografiado” por la sonda Mariner IV. Un panorama desolador, muy diferente a la imagen que tenemos hoy del planeta Marte. Imagen cortesía de NASA/JPL.Pienso ahora en las primeras imágenes que tomamos de la superficie de Marte con la misión Mariner IV en 1965 y el jarro de agua fría que pudo suponer a los científicos el ver de cerca un planeta en apariencia muerto. Sin ríos, sin océanos, sin actividad volcánica aparente y cubierto por cráteres. Muy diferente a los mapas con “canales” que incluso en la década de los 60 todavía aparecían sobre las cartografías -aunque cada vez menos científicos creían que existían-, pero que daban el aspecto de que algo se movía en el planeta.

Con cada pizca de conocimiento ganado nos hemos dado cuenta de que nuestro Sistema Solar no es un lugar de blancos y negros, sino que hay una escala de grises que hace que cada cuerpo sea diferente a todos los demás, aunque en el fondo seamos muy parecidos.

Algunas de las fracturas de Cerberus Fossae observadas desde la sonda europea Mars Express. Como podemos ver en la imagen, algunos de los cráteres son anteriores a esta forma geológica. Imagen cortesía de: ESA/DLR/FU Berlin.

Algunas de las fracturas de Cerberus Fossae observadas desde la sonda europea Mars Express. Como podemos ver en la imagen, algunos de los cráteres son anteriores a esta forma geológica. Imagen cortesía de: ESA/DLR/FU Berlin.En abril de este año nos hacíamos otra pregunta “¿Hay terremotos de origen volcánico en Marte?”, ya que la misión InSight, que aterrizó en 2019 en Marte, detectó unos terremotos cuya forma de onda recordaba mucho a algunos terremotos de origen volcánico en nuestro planeta.

Lo curioso del caso es que aterrizó en un sitio que, a priori, parecía aburrido, pero lo suficientemente plano como para posarse sin problemas y encontrar un hueco entre las rocas donde colocar el sismógrafo, pero a una distancia lo suficientemente cerca de un punto de gran interés donde parecía haber existido actividad en el pasado reciente, tanto a nivel volcánico como a nivel sísmico.

¿Qué fuerza estaba alimentando esos fenómenos? ¿Está Marte todavía activo en su interior? Hoy sabemos que Marte tuvo una gran actividad geológica en los primeros 1000 o 1500 millones de años después de su formación, pero que paulatinamente esta fue descendiendo hasta convertirse en el Marte aparentemente frío que observamos hoy.

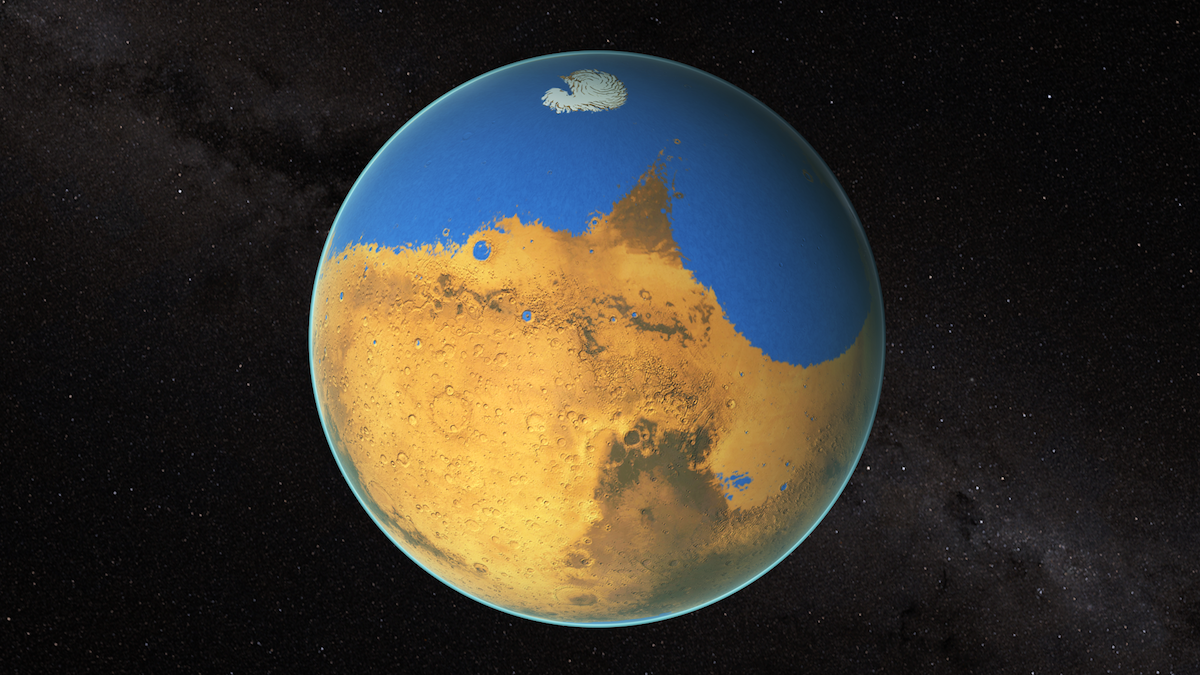

Pero las observaciones nos remiten a erupciones volcánicas que pudieron ocurrir hace tan solo unos 50.000 años, un tiempo verdaderamente reciente a escala geológica en una región conocida como Elysium Planitia, y donde el número de eventos sísmicos parece más alto que en el resto del planeta.

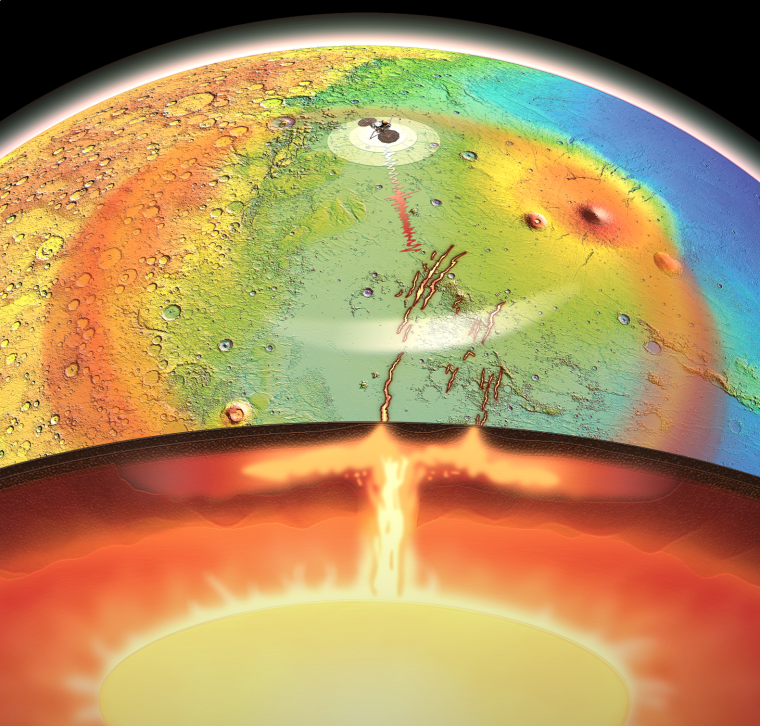

Un nuevo estudio publicado en Nature Astronomy da un verdadero golpe de efecto explicando la causa de esta actividad: una pluma en el manto de Marte. ¿Qué son las plumas del manto? Bueno, para que nos hagamos una idea son masas de roca a muy alta temperatura que comienzan a ascender a través del manto gracias a su menor densidad.

Recreación artística de la pluma del manto en Marte, con la posición de la sonda InSight marcada por su silueta. Imagen cortesía de Adrien Broquet & Audrey Lasbordes.

Recreación artística de la pluma del manto en Marte, con la posición de la sonda InSight marcada por su silueta. Imagen cortesía de Adrien Broquet & Audrey Lasbordes.Para quien no se imagine como son este tipo de fenómenos, una forma sencilla de visualizarlo es mediante una lámpara de lava, en la que un material -normalmente una cera- es más densa que el agua cuando está fría y cae hacia el fondo de la lámpara, pero cuando se calienta en contacto con la bombilla que hay debajo e ilumina la lámpara se expande y logra flotar hasta la parte de arriba.

En nuestro planeta las plumas del manto son responsables de la formación de archipiélagos como el de Hawái o también de grandes erupciones volcánicas como las que ocurren en lo que denominamos grandes provincias ígneas.

Precisamente, una de las explicaciones sobre la existencia de volcanes de gran tamaño como los que vemos en la región marciana de Tharsis es la existencia de una pluma que alimentó durante mucho tiempo el vulcanismo, permitiendo un importante crecimiento de los edificios volcánicos desde un punto fijo, a diferencia de nuestro planeta, donde la corteza se iría moviendo sobre la pluma del manto debido a la tectónica de placas.

Los científicos han encontrado distintas evidencias -además de la actividad volcánica- que apuntan en la dirección de que la actividad observada hoy día en la región de Elisyum Planitia tiene como origen una pluma todavía activa hoy en el manto de Marte, contradiciendo la visión que teníamos anteriormente en la que Marte era un planeta prácticamente inactivo por dentro.

Imagen de una de las zonas donde podría haber ocurrido vulcanismo en los últimos 50.000 años. Imagen cortesía de NASA/JPL/ASU/MSSS.

Imagen de una de las zonas donde podría haber ocurrido vulcanismo en los últimos 50.000 años. Imagen cortesía de NASA/JPL/ASU/MSSS.¿Cuáles son estas evidencias? La primera es que estos materiales han abombado la corteza de Marte en más de 1500 metros en algunos puntos, y los análisis gravimétricos muestran que esta deformación está sustentada por los materiales que hay abajo.

Y hay dos expresiones geológicas y topográficas que complementan esta observación: La primera es que los cráteres anteriores al ascenso de esta pluma del manto están inclinados, como si algo les hubiese empujado desde abajo, y además esta inclinación tiene consistencia con el abombamiento de la corteza.

El segundo es que este hinchamiento provoca una extensión de la corteza que se traduce en la presencia de fallas normales y fosas tectónicas como Cerberus Fossae, que a su vez es el punto donde se ha detectado la actividad sísmica y volcánica más reciente del planeta.

Todos estos datos apuntan a la posible existencia de una pluma de más de 4000 kilómetros de diámetro, lo que hace que tengamos que replantearnos que mecanismo puede hacer que todavía a día de hoy haya una pluma como esta activa en el interior de Marte.

Este descubrimiento no solo tiene implicaciones puramente geológicas, sino que también puede tener algunas de orden astrobiológico, ya que la presencia de unas temperaturas adecuadas cerca de la superficie podría generar ambientes habitables en el interior de Marte, convirtiendo este lugar en una diana perfecta para la búsqueda de vida pasada o presente en el planeta rojo.

Referencia:

Broquet, A., Andrews-Hanna, J.C. (2022) Geophysical evidence for an active mantle plume underneath Elysium Planitia on Mars. Nat Astron doi: 10.1038/s41550-022-01836-3

Para saber más:

¿Hay terremotos de origen volcánico en Marte?

Vulcanismo y habitabilidad planetaria

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo ¿Una pluma en el manto de Marte? se ha escrito en Cuaderno de Cultura Científica.

Las religiones condicionan los valores culturales

Foto: Nicole Geri on Unsplash

Foto: Nicole Geri on UnsplashHan estudiado la influencia de la nacionalidad y las creencias religiosas en la semejanza o diferencia entre los valores culturales de la gente. Lo han hecho a partir de las respuestas dadas en la Encuesta Mundial de Valores por 243,118 personas de 88 países, entre 2005 y 2019. El estudio ha arrojado resultados interesantes pero, antes de glosarlos, conviene advertir de que, aunque las distancias entre los miembros de diferentes religiones son mayores si se incluyen en el análisis valores religiosos o relacionados directamente con ellos, no desaparecen cuando solo se consideran los valores culturales no relacionados con la moral o creencias religiosas.

La distancia cultural entre los cristianos y los seguidores de las otras religiones del Libro o abrahámicas –musulmanes y judíos–, son menores que la que mantienen con hindúes, taoístas, creyentes de religiones ancestrales, y espiritualistas y paganos. Por otro lado, los valores culturales de los cristianos de diferentes tradiciones se asemejan bastante entre sí, sobre todo los de católicos y protestantes; los ortodoxos están algo más alejados. Los budistas, por su parte, tienden a parecerse más a los seguidores de tradiciones orientales –taoístas y religiones nativas– e hinduistas, aunque no difieren tanto de los cristianos como cabría suponer. Es reseñable también que, consideradas en conjunto, las llamadas Cinco Grandes Religiones –cristianismo, islam, judaísmo, hinduismo y budismo– se asemejen bastante en sus valores culturales y estén, en conjunto, más alejadas de las religiones ancestrales y de las paganas y espiritualistas. Al fin y al cabo, las Cinco Grandes tienen algo en común: han configurado sistemas de cooperación a gran escala mediante mecanismos tales como rituales, devociones, parentescos ficticios y sistemas de castigo y recompensa –a cargo de Dios, para las religiones del Libro, y del Karma en el hinduismo y budismo–.

En un mismo país, los fieles de una tradición religiosa se parecen más a los de su misma tradición que a los de otras. Y aunque la nacionalidad es el factor que en mayor medida condiciona los valores culturales, la distancia entre los de personas de diferentes países es menor para quienes comparten una misma fe. En otras palabras, la pertenencia a la misma religión contribuye a reducir la distancia cultural entre países. Por otro lado, incluso en países con conflictos de base religiosa, las diferencias culturales entre los fieles de diferentes credos son menores que las que tienen con correligionarios de otra nacionalidad. Este hallazgo sugiere que esos conflictos no tienen, en realidad, fundamento religioso, sino identitario. La adscripción religiosa operaría en este caso como elemento de identidad.

Cuando se comparan correligionarios de diferentes credos, se observa que la mayor semejanza entre los de distinta nacionalidad se produce en los católicos, una religión con una larga historia de gran influencia de una autoridad –el Papa– sobre los fieles. Esto también se observa en los ortodoxos, aunque en menor medida. Los correligionarios menos parecidos pertenecen a religiones mucho más fragmentadas desde el punto de vista doctrinal. Por último, las personas muy religiosas tienden a compartir valores culturales, incluso aunque pertenezcan a diferentes credos. Lo mismo ocurre con las poco religiosas. De hecho, dentro de un mismo país y credo, hay diferencias entre las personas más y menos religiosas. Así pues, el grado de compromiso con la religión es un condicionante en sí mismo de los valores culturales.

El sistema de creencias, las normas y el código moral propio de las religiones hacen de estas factores culturales muy poderosos. Gran parte de las diferencias culturales y sociales entre los grupos humanos tienen su origen, por ello, en las creencias religiosas.

Fuente: White, C. J. M., Muthukrishna, M., Norenzayan, A. (2021): Cultural similarity among coreligionists within and between countries. PNAS 118 (37) e2109650118

Para saber más:

Nacionalismo, ideología y religión

Ciencia, arte, religión

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Las religiones condicionan los valores culturales se ha escrito en Cuaderno de Cultura Científica.

Las bases genéticas de las enfermedades digestivas

Las enfermedades gastrointestinales son trastornos que suelen manifestarse a causa de problemas en el aparato digestivo. Algunas de las más conocidas como la enfermedad intestinal inflamatoria o el síndrome del colon irritable pueden derivar en problemas graves para la salud humana y requerir, en algunos casos, incluso de cirugía.

Algunos factores ambientales, la microbiota y la desregulación del sistema inmune pueden llegar a influir directamente en la aparición de ciertas enfermedades digestivas. En algunos casos, como el de la enfermedad de Crohn o la colitis ulcerosa, ambas consideradas como enfermedad intestinal inflamatoria, muestran un potente componente genético y hereditario. En este sentido, para poder conocer más acerca del posible origen de estas enfermedades es clave profundizar en el estudio de los genes, de la microbiota y de la función del intestino.

A este respecto, en el Instituto de Investigación Sanitaria ISS Biodonostia de Donostia-San Sebastián trabajan en una línea de investigación enfocada en la genética gastrointestinal y en cómo la herencia genética puede llegar a afectar a la microbiota de los humanos.

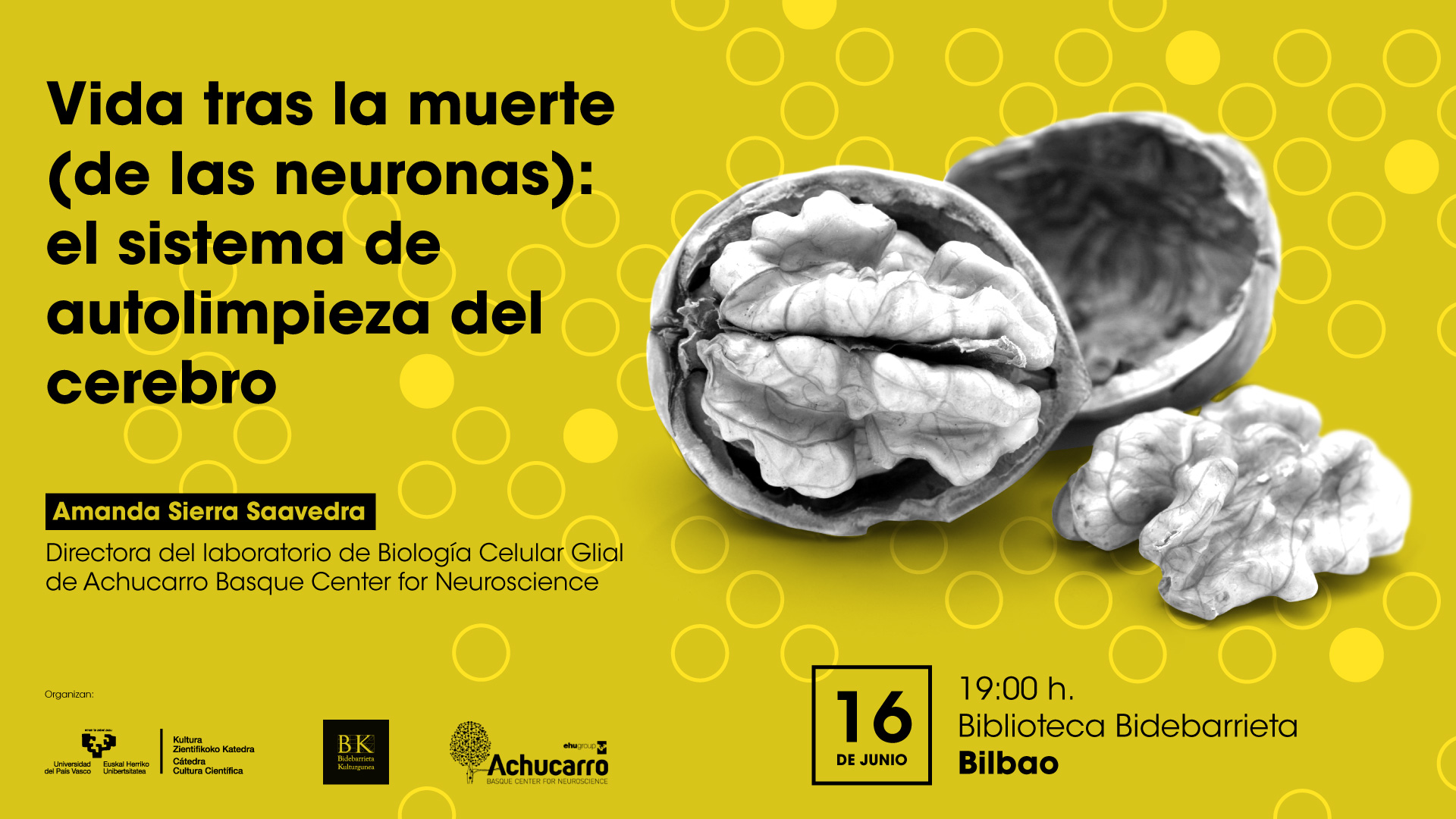

Con el objetivo de mostrar al público el papel que juega la genética en el desarrollo de enfermedades y síndromes del aparato digestivo, el líder del grupo de Genética Gastrointestinal del ISS Biodonostia, Koldo García, ofreció el 15 de diciembre de 2021 la charla “Desentrañando las bases genéticas de las enfermedades digestivas”, en la Biblioteca Bidebarrieta de Bilbao.

Durante la charla, además de mostrar los últimos avances en el estudio de los procesos digestivos, Koldo García, licenciado en Biología y doctor en Genética por la Universidad del País Vasco, explicó los progresos en materia genética que a día de hoy están permitiendo avanzar en el diagnóstico de este tipo de enfermedades. Asimismo, profundizó en otros factores ambientales que tienen relación con los procesos gastrointestinales.

(Si no se reproduce el vídeo en su navegador, pulse el enlace)

Para saber más:

ADN, microbiota y riesgo de celiaquía

Sobre la predisposición genética a padecer enfermedades

Edición realizada por César Tomé López

El artículo Las bases genéticas de las enfermedades digestivas se ha escrito en Cuaderno de Cultura Científica.

La profesora me tiene manía

Fuente

FuenteImaginemos la siguiente situación: Inés, profesora de inglés, entra al aula en su primer día de clase. Tras una mirada a su grupo de estudiantes, se fija en los dos chicos sentados en la última fila.

Al girarse para escribir en la pizarra se crea un cierto alboroto. Inés se vuelve, con el propósito de restablecer el orden, y a quienes primero dirige la mirada es a esos dos chicos de la última fila; sin embargo, eran de los que observaban con interés lo que escribía.

Cuando Inés reflexione acerca de lo ocurrido se podría plantear: ¿por qué al darme la vuelta he mirado en primer lugar a esos alumnos? Si lo hace, indicaría que es consciente en alguna medida de su comportamiento.

Análisis, contraste y reconocimientoUna vez aquí, el reto es dotar a Inés de las herramientas necesarias para comprender ese comportamiento y así poder hacerle frente. Estas herramientas partirán del análisis de la situación, pasarán por el contraste entre el comportamiento manifestado y otros modos de actuar, y finalizarán reconociendo qué creencias y valores subyacen a su comportamiento.

Si, por el contrario, nuestra profesora imaginaria no es capaz de reconocer que ante el alboroto ha fijado la atención en los chicos de la última mesa, la situación es más compleja. Puede ser porque no es consciente de su propio comportamiento. O porque, aun siéndolo, no quiere reconocerlo, bien por “no dar su brazo a torcer” o bien porque carece de herramientas para enfrentarse a ello.

¿Existen los comportamientos inconscientes?Aunque hay una serie de rasgos que definen nuestro carácter y que tienen que ver con nuestro repertorio de comportamientos, también hay respuestas automáticas o reactivas.

Cuando hacemos una valoración inicial de una persona o de una situación, utilizamos modelos y estereotipos más que argumentos. Además, esperamos una serie de respuestas o comportamientos que asociamos a esa valoración. Incluso, somos capaces de modular nuestro comportamiento para obtener una respuesta que confirme esa creencia.

Esa necesidad de confirmación se debe en realidad a una necesidad de seguridad, más imprescindible aún cuanto más automático sea nuestro proceder. A más automatismo, menos consciencia, y más dificultad de “dar nuestro brazo a torcer”.

Una suma de experienciasEsos comportamientos son automáticos porque se construyen a partir de la suma de las experiencias vividas, observadas y escuchadas tanto por Inés como por su alumnado y por sus padres y madres. Se construyen a través de la interrelación con las personas del entorno, y muy especialmente con aquellas que consideramos “de prestigio”.

Esa suma de experiencias aprendidas mediante modelado, sin la intermediación de la palabra, crea la estructura desde la que se construyen nuestros comportamientos más automáticos.

La personalidad o el carácterEsa estructura, configurada de un modo casi inconsciente, tiene, paradójicamente, la responsabilidad de constituir nuestro carácter. Influye directamente en el modo en que nos presentamos y nos reconocemos, en el modo en que presentamos y reconocemos a los demás.

Es la referencia desde la que evaluamos nuestras actuaciones y las de las personas que nos rodean, la referencia de nuestros valores. Es también la referencia desde la que surgen las creencias que nos sirven para considerar el por qué y para qué de esto o de aquello, de este comportamiento o de aquel.

Y también es la referencia de las expectativas, esas que nos informan acerca de qué se puede esperar de tal o cual comportamiento.

Para ser más conscientes de nuestros comportamientos y sus motivaciones y efectos es imprescindible la utilización del lenguaje.

El lenguaje permitirá a Inés comprender el porqué de su comportamiento y el de los alumnos, observar los estereotipos, contraponerlos con reflexiones e identificar las creencias y los valores sobre los que se ha construido su comportamiento.

Explicar y debatirComo conocedora y principal responsable del diseño y gestión de las relaciones en el aula, es la primera a la que le corresponde realizar ese trabajo. Pero lo necesitan también los estudiantes de su clase y, por supuesto, los padres y las madres.

Para empezar, Inés debe de expresar con argumentos adaptados a la edad de su alumnado aspectos referidos tanto a la dinámica de la clase como al aprendizaje en sí. Debe explicarles qué es para ella importante en esa relación, qué es el respeto, qué comportamientos lo reflejan y cuáles no, la importancia del debate, qué hay que tener en cuenta para debatir, etc.

En cuanto al aprendizaje, tendrá que señalar qué conceptos es imprescindible conocer o cuál es el camino a recorrer cuando algo no se entiende.

Escuchar y argumentarAnte estas propuestas justificadas por la docente, el alumnado podrá contraargumentar; padres y madres serán informados y escuchados, aunque la responsabilidad última de esas decisiones las tenga ella.

La importancia de hacer todas estas normas y expectativas explícitas radica en que, cada vez que se expresan razones, se da un espacio al otro y a sus opiniones: el otro se siente escuchado y considerado. Esto facilita el que, ante cualquier incumplimiento de los acuerdos en los que se basa esa relación, se utilicen razones y no juicios arbitrarios basados en estereotipos.

En el caso de Inés, la profesora de inglés del principio, ella podría admitir que ha mirado en primer lugar a los estudiantes de la fila de atrás; darse cuenta de que es uno de sus comportamientos automáticos, porque demasiado a menudo ha escuchado que los estudiantes que se ponen detrás el primer día de clase suelen ser los más disruptivos; pero contrastarlo con su experiencia como docente, que le ha demostrado en muchas ocasiones que eso no es así.

Por eso, sus estudiantes tendrían el derecho y el deber de criticar, respetuosamente, ese comportamiento automático y contraponerlo al que piensan que sería correcto.![]()

Sobre la autora: Ana Arribillaga, Profesora titular del departamento de psicología evolutiva y de la educación, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

Para saber más:

El artículo La profesora me tiene manía se ha escrito en Cuaderno de Cultura Científica.

Minerales que nos orientan

Lo reconozco, he usado un título muy “clickbait”. O muy “anzuelo” si nos olvidamos de los anglicismos. Porque, aunque parezca que me he pasado al lado oscuro de las pseudociencias que abogan por pregonar unos falsos “poderes mágicos” de esos sólidos cristalinos que son los minerales, nada más lejos de la realidad.

Ahora nos parece muy fácil orientarnos cuando iniciamos un viaje gracias al dispositivo GPS, que incluso tenemos incluido en el propio teléfono móvil. Pero, ¿qué pasa cuando perdemos cobertura y no hay señal con los satélites? Pues solo tenemos dos opciones: o nos perdemos (y reconozco que yo soy bastante de este grupo) o utilizamos un aparatito muy cómodo y que cualquier profesional de la Geología siempre lleva en su mochila, una brújula.

Agregado de cristales de magnetita o “piedra imán” recogida en San Pablo de los Montes, provincia de Toledo, expuesto en el Museo Geominero (IGME-CSIC) de Madrid. Fuente: IGME-CSIC

Agregado de cristales de magnetita o “piedra imán” recogida en San Pablo de los Montes, provincia de Toledo, expuesto en el Museo Geominero (IGME-CSIC) de Madrid. Fuente: IGME-CSICLa historia de la brújula también es muy geológica. Para ello tenemos que remontarnos más de 2000 años en el pasado a una región llamada Magnesia, que actualmente forma parte de Turquía pero que, en aquella época, estaba incluida en territorio griego. Allí, un joven pastor encontró una extraña roca que tenía la propiedad de atraer el hierro a la que llamaron “piedra de Magnesia” (no es que se volvieran muy locos a la hora de ponerle nombre, la verdad). Esta propiedad obsesionó al propio Tales de Mileto, que descubrió que este mineral no sólo atraía el hierro, sino que cualquier pieza de hierro que era frotada con la roca acababa adquiriendo esa misma propiedad. Hoy en día conocemos a ese mineral con el nombre de magnetita (cuya fórmula química es Fe3O4) y a la propiedad que tiene de atraer metales la denominamos magnetismo.

No volvemos a saber mucho de este mineral hasta un par de siglos después, cuando quedan registros por escrito de que los antiguos chinos utilizaron la magnetita para imantar pequeñas piezas de hierro que, al dejarlas que girasen libremente sobre una tabla de madera flotando en un cuenco con agua, descubrieron que siempre señalaban en la misma dirección: el N-S magnético. Aunque tampoco tenemos pruebas escritas de que le diesen alguna utilidad, más allá de cuestiones pseudomágicas, a este descubrimiento.

Hasta que llegamos al s. XII, donde escritos ingleses reflejan que algunos navegantes utilizaban estas pequeñas piezas de hierro imantadas con magnetita y dejadas girar sobre un corcho en un cuenco de agua para orientarse en alta mar cuando no disponían de otras referencias como el sol, la estrella Polar o la línea de costa. Así es como nacieron las primeras brújulas de la historia.

Pero la magnetita no es el único mineral que ha utilizado el ser humano en su historia para orientarse en sus viajes náuticos. En las sagas vikingas, se alude a la “piedra solar” como un instrumento empleado por estos famosos navegantes para conocer su localización en alta mar sin ninguna referencia terrestre y cuando el día estaba tan nublado que era imposible localizar la posición del sol.

Fotograma de la serie “Vikings”, de History Channel, donde se muestra a dos de los protagonistas empleando un cristal de espato de Islandia, o “piedra solar”, para orientarse en su viaje hacia el norte de Inglaterra. Fuente: www.history.com

Fotograma de la serie “Vikings”, de History Channel, donde se muestra a dos de los protagonistas empleando un cristal de espato de Islandia, o “piedra solar”, para orientarse en su viaje hacia el norte de Inglaterra. Fuente: www.history.comAunque todavía se especula sobre qué mineral podría ser esta “piedra solar” vikinga, parece que hay dos posibles candidatos con muchas opciones. El primero es la cordierita, un silicato de hierro, aluminio y magnesio (con la fórmula química (Mg,Fe)2Al4Si5O18) muy común en las rocas de las tierras nórdicas y que tiene una curiosa propiedad, la birrefringencia. Se trata de una propiedad óptica que tienen algunos minerales y que consiste en una doble refracción de la luz, es decir, en una división de un solo haz luminoso en dos rayos paralelos. De esta manera, si ponemos un cristal de cordierita lo más transparente posible sobre un texto escrito, veremos duplicadas las letras, lo cual llama mucho la atención en actividades de divulgación con peques (y no tan peques).

Cristal transparente de Calcita, variedad espato de Islandia, procedente de El Barrueco, provincia de Madrid, expuesto en el Museo Geominero (IGME-CSIC) de Madrid. Fuente: IGME-CSIC

Cristal transparente de Calcita, variedad espato de Islandia, procedente de El Barrueco, provincia de Madrid, expuesto en el Museo Geominero (IGME-CSIC) de Madrid. Fuente: IGME-CSICEl otro candidato a “piedra solar” de los vikingos es una variedad de calcita (cuya fórmula química es CaCO3) conocida como espato de Islandia. Se trata de cristales muy transparentes y que también poseen la propiedad de la birrefringencia, muy abundante en la isla de la que toma el nombre. Como los vikingos ya realizaban expediciones náuticas antes de conquistar Islandia, parece que utilizaron de manera habitual la cordierita hasta que descubrieron los abundantes yacimientos de esta variedad de calcita, pudiendo sustituir entonces su GPS mineral.

La importancia de la birrefringencia es que no es necesario que los cristales minerales reciban una luz directa muy potente, de tal manera que, en días nublados donde es muy difícil precisar la posición exacta del Sol, el fenómeno óptico se sigue produciendo de manera muy evidente. Aunque es cierto que no se sabe muy bien cómo empleaban estos minerales los vikingos para orientarse en alta mar, ya que apenas hay evidencias arqueológicas y sólo podemos remitirnos a textos escritos, se especula que podrían hacerlo de dos maneras: o bien levantando hacia el cielo un único cristal para calcular el ángulo de refracción de ambos haces de luz, o bien utilizando dos minerales a la vez y realizando una triangulación con una tercera pieza, posiblemente de madera, que permaneciese siempre en una posición fija. Lo que sí es seguro es que, empleando unos simples minerales, consiguieron navegar de manera precisa por el norte de Europa y América.

Resulta sorprendente cómo el ser humano ha sido capaz de lograr culminar esas epopeyas náuticas durante los siglos pasados empleando únicamente un par de minerales, sin saber exactamente la ciencia que había detrás de las propiedades que los caracteriza. Pero esto no tenía nada de magia, por lo que ya tenemos una herramienta más para poner en evidencia a esas pseudociencias de las que hablaba al principio. ¿O acaso no os han entrado ganas de poneros a hablar de griegos, chinos y vikingos cuando alguien intente explicaros las propiedades místicas de los minerales?

Para saber más:

Introducción histórica a la mineralogía

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Minerales que nos orientan se ha escrito en Cuaderno de Cultura Científica.

Magdalena Mouján Otaño, la matemática que escribía relatos de ciencia ficción

Es un problema que con la lógica común no podemos manejar. Demasiadas paradojas. Otra lógica necesitamos, que aún no ha sido construida.

Extracto de Gu ta Gutarrak de Magdalena Mouján Otaño

Magdalena Mouján Otaño. Fuente: Zientzia Kaiera.

Magdalena Mouján Otaño. Fuente: Zientzia Kaiera.

Magdalena Mouján Otaño nació en la localidad de Pehuajó (provincia de Buenos Aires, Argentina) el 26 de marzo de 1926. Era hija de Armando Mouján y María Teresa Otaño Alberdi.

El abuelo materno de Magdalena, Pedro Mari Otaño (1857-1910), fue un famoso poeta descendiente de una dinastía de bertsolaris y natural de Zizurkil (Gipuzkoa). Por avatares de la vida, emigró a Argentina en 1898 junto a su esposa, María Magdalena Alberdi Descarga, y tres hijos. María Teresa, la madre de Magdalena, nació en Argentina en 1899. Aunque Mouján Otaño nació 16 años después del fallecimiento de su abuelo materno, estuvo muy influenciada por su poesía y sus raíces vascas; su madre le enseñó el idioma de sus antepasados, el euskera.

Magdalena asistió a las escuelas primaria y secundaria en Pehuajó. Posteriormente ingresó en la Universidad Nacional de La Plata, donde tuvo como profesores a los matemáticos Manuel Sadosky (1914-2005) –considerado por algunas personas como el padre de la computación en Argentina– y a Luis Santaló (1911-2001) –quien había abandonado España por motivos políticos durante la Guerra Civil Española–.

Se graduó en matemáticas en la Universidad Nacional de La Plata y consiguió un doctorado en esta área en 1950.

Mouján Otaño comenzó a enseñar matemáticas, área en la que también investigó, y escribió algunos artículos de divulgación para la revista Mundo Atómico entre los años 1952 y 1955.

Investigación operativa: una nueva disciplinaEn 1957, el matemático Agustín Durañona y Vedia (1904-1980) propuso a la Junta de Investigaciones Científicas y Experimentaciones de las Fuerzas Armadas (JICEFA) la creación de un Grupo de Investigación Operativa –que lideraría él mismo– al que se incorporaron Magdalena Mouján Otaño, el ingeniero de estructuras Horacio C. Reggini (1933-2022) y el ingeniero de caminos Isidoro Marín (1921-2020). Tras dos años de estudio e investigación en esta nueva disciplina, los componentes de grupo publicaron más de veinte trabajos teórico-prácticos, asesoraron a organismos del estado, e impartieron cursos y conferencias. Con su trabajo, los miembros de este equipo ayudaron a introducir la investigación operativa en Argentina.

Durante su trayectoria docente, Magdalena Mouján Otaño enseñó matemáticas y estadística en varias universidades públicas y privadas de Argentina, como la Universidad Católica de la Plata, la Universidad Nacional de Córdoba, la Universidad Nacional del Comahue o la Universidad Nacional de Luján.

La computadora ClementinaEn 1966, Mouján Otaño entró a formar parte de la Comisión Nacional de Energía Atómica y fue una de las primeras personas en trabajar con la computadora Clementina, ubicada en el Instituto de Cálculo dependiente de la Universidad de Buenos Aires. Este ordenador, un Ferranti Mercury, fue la primera computadora en instalarse en Argentina con fines científicos. Su nombre se debía a que había sido programada para reproducir la canción Oh My Darling, Clementine.

Sadosky fue el responsable de llevar ese ordenador a Argentina; el equipo que lideraba el trabajo de la computadora Clementina contaba, además, con dos amigas y compañeras de estudios de Magdalena, la matemática Rebeca Guber (1916-2020) y la matemática y programadora Cecilia Berdichevsky (1925-2010).

Cecilia Berdichevsky trabajando con la computadora Clementina. Fuente: Wikimedia Commons

Cecilia Berdichevsky trabajando con la computadora Clementina. Fuente: Wikimedia Commons

Parte de los cálculos realizados con ayuda de ese ordenador se utilizaron en la construcción del reactor RA1.

Mouján Otaño, escritora de ciencia ficciónEn 1966, tras el golpe de estado del general Juan Carlos Onganía, Magdalena abandonó temporalmente la docencia universitaria, al no apoyar al golpista. Al cabo de unos años, Mouján Otaño regresó a su trabajo de profesora y comenzó a crear relatos de ciencia ficción bajo el seudónimo de Inge Matquim, consiguiendo un gran éxito como escritora.

Uno de sus relatos más conocidos es Gu ta Gutarrak –Nosotros y los nuestros, en euskera–. Trata de una familia vasca que realiza un viaje en el tiempo para encontrar sus orígenes. Este cuento se lo dedicó a su abuelo, quién escribió en 1899 el poema del mismo título en el que se preguntaba –lejos del lugar en el que había nacido– sobre el origen del euskera y del pueblo vasco.

En esta divertida historia, uno de los hijos del protagonista –Xaviertxo, que es superdotado– se convierte en físico para «estudiar la estructura del continuo espacio-tiempo». Sus conocimientos le permiten construir una máquina del tiempo –bautizada como Pimpilimpausa (mariposa, en euskera)– con la ayuda de su hermana pequeña –Malentxo– que inventa una nueva lógica, la necesaria para evitar las paradojas producidas por los saltos en el tiempo. Esta máquina supone «… la gran revolución en la física, algo mucho más importante que la relatividad, y que la teoría cuántica y la bomba atómica…». Gu ta Gutarrak puede leerse en este enlace.

Magdalena Mouján Otaño falleció el 16 de julio de 2005, a los 79 años. Pidió ser enterrada junto a su abuelo, el bertsolari, en el cementerio de Mar del Plata.

Referencias-

Carlos Domingo, Construcción, uso y reforma del Reactor Argentino 1 (RA1), 2005

-

Marta Macho Stadler, Magdalena Mouján Otaño: matemáticas y ciencia ficción, Mujeres con ciencia, Vidas científicas, 29 marzo 2018

-

Isidoro Marín, Investigación Operativa en Argentina, Investigación Operativa no. 38 (2015) 2-17

- John J. O’Connor and Edmund F. Robertson, Magdalena Mouján, MacTutor History of Mathematics archive, University of St Andrews

-

Uxune Martinez, Magdalena Mouján (1926-2005): Argentinako matematikari gutarra, Zientzia Kaiera, 26 diciembre 2014

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Magdalena Mouján Otaño, la matemática que escribía relatos de ciencia ficción se ha escrito en Cuaderno de Cultura Científica.

Einstein y Werner Heisenberg

El físico alemán Werner Heisenberg fue uno de los primeros investigadores de la mecánica cuántica, ayudando a establecer sus ecuaciones y contribuyendo a la interpretación más extendida de éstas, la que se conoce como interpretación de Copenhague. Einstein fue uno de los ídolos de Heisenberg, y los dos científicos se reunieron en múltiples ocasiones para discutir las implicaciones de la mecánica cuántica, pero discreparon a menudo y en multitud de temas, desde la ciencia a la política.

Asistentes a la Conferencia Solvay de 1927. Sentado, en el centro de la primera fila, Einstein. De pie, tercero por la derecha, Heisenberg.

Asistentes a la Conferencia Solvay de 1927. Sentado, en el centro de la primera fila, Einstein. De pie, tercero por la derecha, Heisenberg.Werner Heisenberg descubrió el trabajo de Einstein mientras estudiaba en la Universidad de Múnich, donde asistió a un curso sobre la relatividad que impartió Arnold Sommerfeld. A Heisenberg le encantó la insistencia de Einstein en que sólo debemos teorizar sobre lo que podemos percibir (posición que tenía su origen en la influencia de Ernst Mach): toda la relatividad surgía de la insistencia en que, si bien diferentes personas observan diferentes sucesos, todas esas observaciones son válidas. Este concepto se grabó en el cerebro de Heisenberg, y se convertiría en una de las creencias fundamentales que darían forma a su ciencia posterior.

Heisenberg quería escribir su tesis doctoral sobre la relatividad, pero fue disuadido de ello por su compañero de estudios Wolfgang Pauli. En esa época Pauli estaba escribiendo lo que llegaría a ser el primer gran ensayo sobre la teoría de la relatividad, que para él era un campo de la ciencia que ya había sido bastante bien establecido. El verdadero futuro está, le dijo Pauli a Heisenberg, en la física atómica.

Heisenberg, sin embargo, se sentía intrigado por la figura de Einstein. En 1922, el joven alemán se dirigió a Leipzig para asistir a una conferencia de su ídolo. Habría sido la primera vez que Heisenberg se encontrase con el hombre al que tanto respetaba, pero no sería así. La fecha de la conferencia coincidió con el comienzo de los ataques antisemitas contra Einstein: es el año de publicación de La crisis actual de la física alemana de Johannes Stark. Nada más llegar a la sala donde tendría lugar la conferencia, a Heisenberg le entregaron un folleto en el que, según Heisenberg escribiría en su libro La parte y el todo, se denunciaba a Einstein como “un extraño al espíritu alemán, y exagerado por la prensa judía”. Heisenberg, cristiano luterano y “ario”, había pertenecido al movimiento juvenil nacionalista de Alemania casi toda su vida, por lo que se vio sorprendido por este ataque nacionalista a un campo exclusivamente científico. Ese día, habida cuenta de las tensiones existentes y los previsibles incidentes, se buscó un sustituto: Max von Laue fue el conferenciante.

Einstein y Heisenberg se encontraron por primera vez en 1924, durante una visita que Einstein hizo a la Universidad de Gotinga. En esta universidad defendería Heisenberg ese mismo año su tesis doctoral, codirigida por Max Born y Arnold Sommerfeld, tras haber ampliado sus conocimientos de matemáticas con David Hilbert. En ese período, se estaba desarrollando la teoría de la mecánica cuántica, y a Einstein no le gustaba el rumbo que esas teorías estaban tomando: conforme los físicos intentaban aportar nuevas explicaciones a cómo los átomos emitían radiación, desarrollaban teorías que sólo ofrecían respuestas probabilísticas. Sus teorías podían predecir un rango de posibilidades para cómo se comportaría un átomo, pero una y otra vez, los científicos se veían forzados a creer que no había un resultado definido para un suceso dado. Cuando se trataba de partículas, decían estos físicos, simplemente no hay una perfecta correlación entre causa y efecto. Heisenberg fue arrastrado por el entusiasmo de crear un nuevo campo científico. Einstein, por otro lado, no podía creer la alocada dirección que estaba tomando la física. Por tanto el encuentro entre Einstein y Heisenberg fue interesante: el joven de 23 años conoció a su ídolo solo para descubrir que tenían ideas opuestas. Fue el comienzo de una separación creciente entre Einstein y la mayoría de sus contemporáneos, pero Heisenberg todavía tenía la esperanza de convencer a Einstein de la corrección de la nueva ciencia.

Fue en septiembre de 1925 cuando Heisenberg hizo su primera aportación asombrosa a la física. Publicó un artículo en el que se exponían las matemáticas necesarias para crear las predicciones probabilísticas que otros estaban estudiando. Básicamente esta fue la primera formulación de la mecánica cuántica. Esta formulación se llama álgebra de matrices [1], y conseguía lo mismo que la famosa ecuación de Schrödinger, que éste desarrollaría el año siguiente. Hubo una gran rivalidad entre los dos hombres sobre qué método debería ser usado. Hoy día se usan ambos, pero la mayoría de los científicos prefieren la mecánica ondulatoria de Schrödinger por ser más simple.

Años después, Heisenberg diría que desarrolló sus teorías basándose en lo que él veía como la filosofía de Einstein de solo analizar observables. Pero el artículo de las matrices de Heisenberg no consiguió que Einstein cambiara sus posiciones ni un ápice. Casi inmediatamente Einstein replicó con una carta a Heisenberg en la que planteaba numerosas objeciones, y que Heisenberg respondió en noviembre rebatiendo cada una de ellas. En esta carta parece que Heisenberg todavía creía que sus dos puntos de vista podrían reconciliarse algún día.