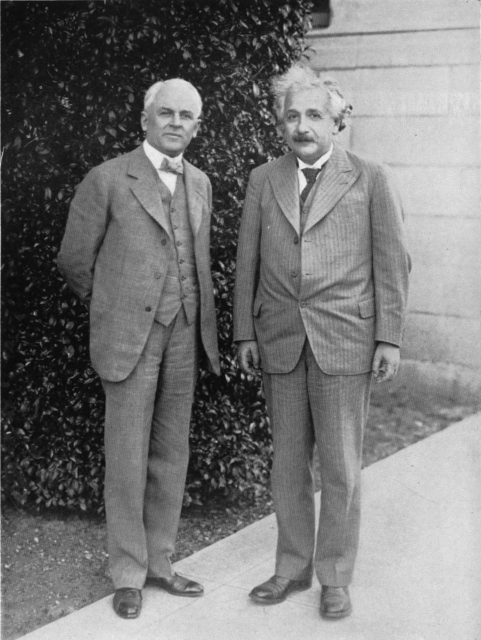

Einstein y Wolfgang Pauli

Wolfgang Pauli fue una de las figuras principales en el desarrollo de la mecánica cuántica y su trabajo le valió el premio Nobel de física en 1945. Veinte años más joven que Einstein, colaboró con él cuando ambos trabajaron en Princeton. Pauli tenía una lengua viperina y, si bien respetaba los primeros trabajos de Einstein sobre la relatividad, se mostró muy desdeñoso con sus últimas ideas.

Einstein y Pauli en Princeton. Fuente: Wikimedia Commons

Einstein y Pauli en Princeton. Fuente: Wikimedia CommonsNacido en Viena (Austria) el 25 de abril de 1900, Pauli estuvo en contacto con la ciencia desde su más tierna infancia. De ello se encargaron su padre químico, Joseph Pauli, y un íntimo amigo de su padre, el físico Ernst Mach, cuyas ideas tanto influyeron en las primeras teorías de Einstein. En el instituto Pauli estudió la teoría de la relatividad especial de Einstein por su cuenta, a menudo escondiendo artículos en su pupitre que leía cuando las clases se volvían inaguantables. Nada más terminar el instituto, Pauli publicaría su primer artículo científico, como no podía ser de otra manera, sobre la relatividad de Einstein.

Pauli estudió física en la Universidad de Munich (Alemania), donde rápidamente su genio fue detectado y alentado por Arnold Sommerfeld. Este, conociendo de lo que era capaz su alumno de doctorado, le pidió que fuese él quien escribiese el artículo sobre la relatividad para la Encyklopaedie der mathematischen Wissenschaften (Enciclopedia de ciencias matemáticas). Dos meses después de presentar su tesis doctoral sobre la teoría cuántica de la molécula de hidrógeno ionizada, presentó el trabajo sobre la relatividad. Nada más y nada menos que 237 páginas en las que describía el estado actual de la teoría y aportaba sus propias interpretaciones. Este artículo dio a conocer a Pauli en el mundo científico. De hecho, a Sommerfeld le gustó tanto que se lo envió al propio Einstein, que alabó el genio de este joven de 21 años. Ciertamente genial, ya que el artículo de Pauli es reconocido hoy día como el catalizador del consenso de la comunidad científica sobre la relatividad.

Una vez finalizado su doctorado, pasó un año en la Universidad de Gotinga con Max Born, y a continuación investigó junto a Niels Bohr en Copenhague durante otro año. De vuelta en Alemania y mientras era profesor de la Universidad de Hamburgo, en 1924, Pauli completó la que es probablemente su contribución más famosa a la teoría cuántica: el Principio de Exclusión de Pauli. Básicamente, lo que dice el principio es que dos electrones en la órbita de un mismo átomo no pueden tener exactamente el mismo estado energético. Esta afirmación trajo como consecuencia la asignación de una nueva propiedad a los electrones, a la que él denominó espín.

Pauli también es conocido por otra contribución a la física que realizó antes de cumplir los treinta años: predijo la existencia de una partícula fundamental completamente nueva, el neutrino. No fue hasta los años sesenta que la existencia del minúsculo neutrino fue probada de forma concluyente, algo que no vería Pauli, pero que él percibió como una realidad basándose solamente en su necesidad matemática.

Un efecto menos científico también lleva el nombre de Pauli. Parece ser que tenía la facultad de influir en los experimentos, y en los aparatos necesarios para llevarlos a cabo, de la manera más extraña y siempre para mal. Las máquinas se rompían por su mera presencia. Sus amigos se referían a esto como “el efecto Pauli” y Pauli parece ser que se divertía con su reputación.

Pauli tenía fama de ser un perfeccionista. Existen numerosas referencias a él como la “conciencia de la física”, dado el interés que mostraba en ser el Pepito Grillo del trabajo de sus colegas. Es sabido que Pauli era capaz de los comentarios más mordaces y feroces acerca de la forma de hacer ciencia y de las publicaciones de otros científicos. Una de sus citas más famosas sobre un artículo es “No solo no es correcto, es que ni siquiera es incorrecto”. A Paul Ehrenfest, por ejemplo, le llegó a decir “Creo que me gustas más tú que tus artículos”.

Einstein tampoco escapó del agudo ingenio de Pauli. Si bien ambos hombres mantenían una relación cordial, Pauli se burlaba a menudo de los intereses científicos de Einstein. Pauli era uno de los muchos científicos que estaba de acuerdo con Niels Bohr en lo que se refería a la mecánica cuántica, aceptando la aproximación dada por Bohr conocida como la interpretación de Copenhague. Einstein, sin embargo, se negaba a admitir que la mecánica cuántica estuviese completa. Estaba decidido a encontrar una nueva teoría que incluyese las matemáticas de la nueva física, que Einstein tenía que admitir que hacían un magnífico trabajo previendo los resultados de los experimentos, y que también las mejorase. Einstein se refería a esta deseada teoría como teoría del campo unificado y Pauli se mofaba de este intento de unir las dos bases fundacionales de la física moderna; le gustaba repetir “Lo que Dios ha separado, el hombre nunca lo unirá”.

En 1932, Pauli escribió una revisión bastante cruel del trabajo sobre la teoría unificada de Einstein, diciendo: “La inventiva inasequible al desaliento de Einstein, así como su tenaz energía en la búsqueda de la unificación, nos han garantizado en los años recientes, en promedio, una teoría por año… Es psicológicamente interesante que durante algún tiempo la teoría en vigor es usualmente considerada por su autor como la solución definitiva”.

Tras la anexión de Austria por parte de Alemania, Pauli se mudó a Estados Unidos. Trabajó en Princeton entre 1940 y 1946, donde Einstein también tenía su oficina. A pesar del desprecio de Pauli por la teoría de la unificación de Einstein, estaba claro que ambos hombres se respetaban como colegas. Colaboraron solamente en un artículo, en 1943, sobre la teoría de la relatividad.

En enero de 1945 Einstein mandó un telegrama al comité del premio Nobel en el que decía: “Nomino a Wolfgang Pauli para el premio de física stop Sus contribuciones a teoría cuántica moderna consistente en así llamado principio de exclusión o Pauli han llegado a ser parte fundamental física cuántica moderna siendo independiente otros axiomas básicos de esa teoría stop Albert Einstein”. Wolfgang Pauli recibió el premio Nobel en la ceremonia de ese año, con 45 años, por el trabajo que hizo cuando tenía 24.

Nota:

Wolfgang Pauli no debe ser confundido con Wolfgang Paul, también ganador del Nobel de física y a quien Pauli se refería como “su parte real” (quien sepa matemáticas que entienda).

Referencia:

Einstein, A., & Pauli, W. (1943). On the Non-Existence of Regular Stationary Solutions of Relativistic Field Equations The Annals of Mathematics, 44 (2) DOI: 10.2307/1968759

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 20 de septiembre de 2009.

El artículo Einstein y Wolfgang Pauli se ha escrito en Cuaderno de Cultura Científica.

¿Influye la luna sobre la salud de las personas? No, solo refleja cómo pueden engañarse a sí mismas

Desde tiempos remotos, numerosas culturas han creído que la luna tenía una influencia poderosa sobre los humanos, más allá de sus efectos más visibles, como las mareas. Aunque lejos quedaron las épocas en las que las sociedades adoraban a dioses relacionados con este satélite, parte del misticismo lunar sigue presente en nuestra época actual. Incluso conservamos vestigios de ellos en nuestra propia lengua. Un ejemplo de ello es la palabra «lunático», que según la Real Academia Española significa: «Que padece locura, no continua, sino por intervalos». El término proviene del latín «lunatĭcus», palabra en relación con dicho satélite que se utilizaba desde antiguo para referirse a las personas que tenían comportamientos extraños de forma errática, por culpa (supuestamente) de los ciclos lunares. De hecho, documentos de la época del famoso médico Hipócrates (400 a.e.c.) ya acusaban a la luna llena (plenilunio) de las súbitas y estrafalarias conductas de las personas.

Imagen: Josep Monter Martinez / Pixabay

Imagen: Josep Monter Martinez / Pixabay

Dejando a un lado el estigma de la luna sobre los trastornos mentales, lo cierto es que las creencias sobre el poder de este satélite abarcan otros muchos aspectos de la salud humana y los profesionales sanitarios no están precisamente libres de ellas: varias encuestas realizadas a este colectivo indican que un porcentaje significativo de ellos cree que la luna influye sobre aspectos tan dispares como los ingresos a urgencias, la aparición de ataques de epilepsia o de infartos cardíacos, las agresiones físicas, la alteración del sueño, o el ciclo menstrual. No son una minoría: en 1995, el 43 % de los profesionales de salud mental encuestados pensaba que la luna llena alteraba el comportamiento de las personas. Esta idea sigue muy presente en los sanitarios de multitud de países, incluida España.

¿Tienen algún respaldo científico las creencias acerca del poder de la luna sobre la salud humana o es un engaño colectivo que se resiste a morir a pesar del paso de miles de años? Múltiples estudios se han realizado en las últimas décadas para aclarar el papel de este satélite en diferentes facetas sanitarias. La tónica general, sobre todo entre los estudios más rigurosos, es la misma: la luna no influye en absoluto y, si lo hace, el efecto es tan pequeño que no podemos descartar que se deba al puro azar o a las limitaciones del propio estudio (muchos poseen fallos importantes en su diseño o análisis estadístico). Es común que al intentar reproducir los resultados de algún estudio que afirma haber detectado efectos modestos de la luna sobre el cuerpo humano estos no vuelvan a mostrarse.

Esta es una panorámica general de la ciencia sobre la supuesta influencia de la luna sobre la salud:

- ¿La luna llena provoca más errores en las cirugías? Los estudios más extensos al respecto no encuentran ningún efecto de este astro. Una investigación publicada en la revista Anesthesiology no detectó ninguna diferencia significativa en más de 18.000 pacientes a los que se les realizó un bypass coronario (para asegurar la vascularización del corazón) entre 1993 y 2006. Las fases de la luna no influían en modo alguno. Otro , con datos de más de 12.000 pacientes, en el que se evaluaba el dolor tras la cirugía y los efectos adversos relacionados con el tratamiento, tampoco detectó ningún efecto lunar. Los autores concluían su artículo con «Por tanto, no hay razón para que los pacientes pospongan las cirugías o para que tengan miedo a las cirugías en una fecha concreta». Otra investigación, enfocada en los resultados de cirugías de cáncer pulmón de 2.411 pacientes, tampoco fue capaz de detectar ninguna influencia del citado satélite.

- ¿Más ingresos en urgencias en plenilunio? Las investigaciones serias lo descartan. Un estudio publicado en la revista American Journal of Emergency Medicine en 1996 no encontró ninguna diferencia entre las noches de luna llena y el resto de noches tras analizar más de 150.000 registros de visitas a urgencias.

- Quizás, ¿más visitas a urgencias o a consultas por trastornos mentales con luna llena? , numerosos estudios que, en conjunto, incluyen a decenas de miles de pacientes muestran que el ciclo lunar no tiene ningún efecto sobre ellos.

- ¿Más aparición de ataques epilépticos durante luna llena? Las al respecto lo descartan también. No se ve ningún efecto.

- ¿Sincronización del ciclo menstrual con el ciclo lunar? Tampoco. Que ambos fenómenos duren de forma similar (aunque, en realidad, la duración del ciclo menstrual varía según la mujer) no indica que se sincronicen. Un estudio que analizó el ciclo menstrual de 74 mujeres durante un año no encontró ninguna relación con las fases de la luna. Otra investigación, a partir de los datos de 1 millón y medio de mujeres que no usaban anticonceptivos hormonales y 7,5 millones de ciclos menstruales tampoco encontró sincronización alguna con la luna.

- ¿Más problemas de sueño durante las noches de luna llena? Aunque algunos estudios han observado algún , en relación con los niveles de melatonina (hormona que interviene en el sueño), otras investigaciones, más amplias y con miles de personas, no han podido observar este fenómeno.

¿Por qué, a pesar de esta aplastante evidencia científica en contra de los efectos de la luna, las creencias persisten incluso entre los profesionales sanitarios? Este fenómeno se origina a partir de un sesgo cognitivo concreto denominado «sesgo de confirmación». En esencia, cuando una persona cree en algo, de forma consciente o inconsciente tiende a prestar más atención y considerar los datos que refuerzan sus creencias, mientras que ignora o descarta los hechos que van en contra. Al final, este fenómeno distorsiona la percepción de la realidad. En medio de la vorágine de fake news en la que nos encontramos, la viñeta de Daniel Paz explica de forma muy cómica y contundente este fenómeno:

«-No, papá. Esa es una noticia falsa…

-Pero, ¿cómo va a ser falsa si dice justo lo que yo pienso?»

En el caso de la supuesta influencia de la luna sobre la salud, las personas que creen en ello se fijan especialmente si cuando hay, por ejemplo, más urgencias o más casos de visitas de psiquiatría, coincide con la luna llena en el cielo. En caso afirmativo, refuerzan sus creencias y piensan: «Debe ser la luna llena”. Todo ello a pesar de que también se dan noches, con otros ciclos lunares, en las que hay igual o más casos. Además, otro mecanismo de autoengaño es sobredimensionar el número de casos en plenilunio y llegar a pensar que son más de lo normal.

En realidad, la creencia del poder de la luna sobre el cuerpo humano nos dice mucho sobre los mecanismos psicológicos involucrados en el autoengaño y su persistencia y nada sobre sus efectos físicos reales: no hay ningún fenómeno que pudiera explicar la influencia de dicho satélite sobre la salud, más allá de su brillo por las noches. De hecho, la supuesta influencia gravitatoria de la luna llena, que ya de por sí es mínima sobre las personas, debería estar también presente con luna nueva que es cuando aparecen las mareas vivas y se suma la fuerza gravitatoria de la Luna con la de la Tierra. Más allá de este hecho físico, hay otro aún más evidente: la influencia gravitatoria de una persona que durmiera al lado de otra es mucho mayor que la de la luna. En definitiva, la física más elemental y los estudios científicos sobre diferentes aspectos de la salud humana rebaten de forma rotunda la supuesta influencia de la luna llena.

Para saber más:

Sesgos cognitivos que aquejan a la ciencia

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo ¿Influye la luna sobre la salud de las personas? No, solo refleja cómo pueden engañarse a sí mismas se ha escrito en Cuaderno de Cultura Científica.

Diapasones para afinar la velocidad de la luz

Albert A. Michelson, premio Nobel en 1907, se reincorporó a la Armada de los Estados Unidos cuando el país decidió intervenir en la Primera Guerra Mundial. Aquí fotografiado en 1918 con uniforme de capitán de corbeta (lieutenant commander). Fuente: Wikimedia Commons

Albert A. Michelson, premio Nobel en 1907, se reincorporó a la Armada de los Estados Unidos cuando el país decidió intervenir en la Primera Guerra Mundial. Aquí fotografiado en 1918 con uniforme de capitán de corbeta (lieutenant commander). Fuente: Wikimedia CommonsEn 1879, Albert A. Michelson midió la velocidad de la luz con una precisión sin precedentes. Para entonces, había cumplido 26 años, trabajaba como instructor de la Marina de los Estados Unidos, tenía muy poca formación en física y ninguna experiencia en investigación, pero su trabajo resultó revolucionario. Aquel experimento mejoró la precisión de la constante c en un orden de magnitud y sentó unas nuevas bases para hacer mediciones de alta precisión. En los siguientes años, Michelson inventó el interferómetro que hoy lleva su nombre y realizó un primer experimento para confirmar (o desmentir, más bien) la existencia del éter. En 1907 fue el primer científico norteamericano en ganar el premio Nobel de Física.

Lo más sorprendente es que los orígenes de Michelson no habían sido precisamente “prometedores” para la carrera de un científico. Cuando tenía cuatro años, su familia huyó de Polonia a California. Su padre era vendedor ambulante y se instalaron en Murphy’s Camp, “una ciudad sin ley de la fiebre del oro —según palabras de Daniel Kleppner1— que resultaba óptima para que un niño aprendiera a pelear, pero no a leer y escribir”. Cuando Albert cumplió 14 años, lo enviaron a San Francisco para estudiar secundaria. Allí, su talento científico conmovió al director del centro, que le proporcionó alojamiento y comida, además de un trabajo como ayudante en las clases de física. Gracias a él, Michelson pudo terminar el instituto y alistarse en la Academia Naval de los EE. UU., la única manera de seguir estudiando ciencias a pesar de sus pocos recursos.

Tras graduarse como marine en 1873, Michelson fue destinado a Annapolis como profesor de física y química. Fue entonces cuando su comandante le pidió que investigara la medida de la velocidad de la luz de Léon Foucault, publicada en 1862, y ante semejante reto, Michelson se vino arriba. En apenas dos años consiguió incrementar la precisión de su predecesor por diez.

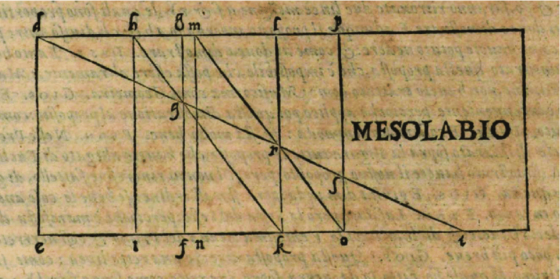

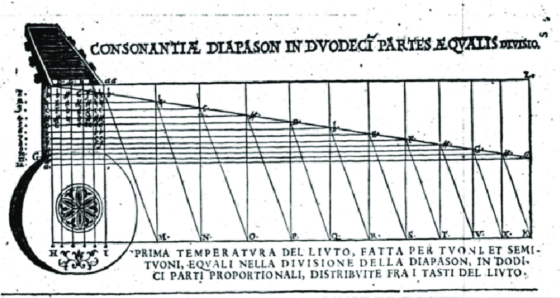

¿Pero en qué consistía el experimento de Foucault que Michelson tanto se esforzó en superar? ¿Cómo se mide algo que es, en esencia, instantáneo, lo más rápido que uno pueda imaginar? Pues bien, con un muy buen cronómetro. Pero no un cronómetro común, como los que usan los entrenadores en las pistas de atletismo, sino un cronómetro hecho de espejos.

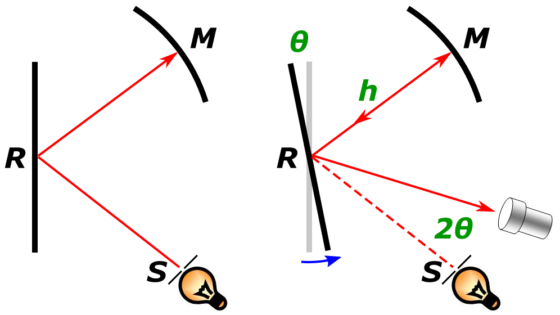

Es posible que hayas oído hablar del experimento de Foucault con anterioridad: en su montaje, la luz viaja desde una rendija hasta un primer espejo que está en movimiento (R en la figura). Allí rebota y llega a un segundo espejo esférico que está quieto (M). Regresa por donde ha venido y se vuelve a encontrar con el espejo rotatorio (R) para, finalmente, volver a su punto de origen (S). O más bien, volvería al punto de origen si el espejo rotatorio se encontrase en la misma posición que estaba cuando el rayo de luz se lo topó por primera vez. Pero la gracia de todo este montaje es que, en el camino de ida y vuelta de la luz, el espejo rotatorio ha cambiado ligeramente de posición y por eso, el rayo genera una imagen desplazada respecto a la de la rendija inicial. Midiendo este desplazamiento (2θ, en la figura), podemos calcular cuánto ha girado el espejo mientras la luz hacía su recorrido de ida y vuelta (θ). Y conociendo la velocidad angular del espejo rotatorio, sabremos cuánto tiempo ha pasado. Es el cronómetro perfecto.

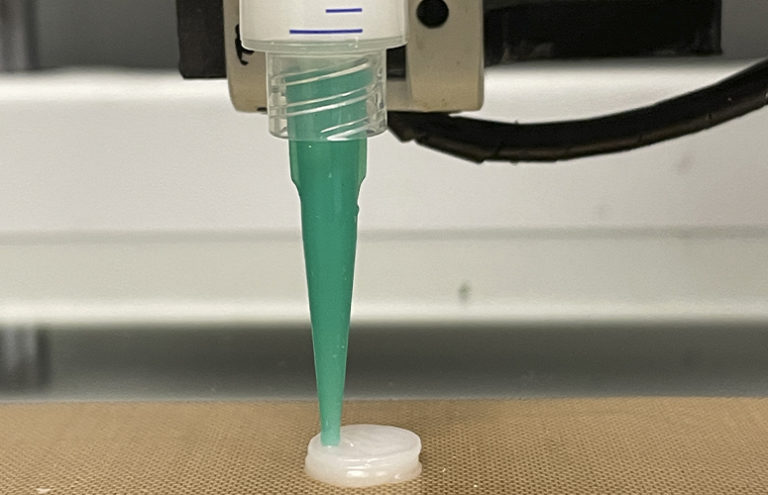

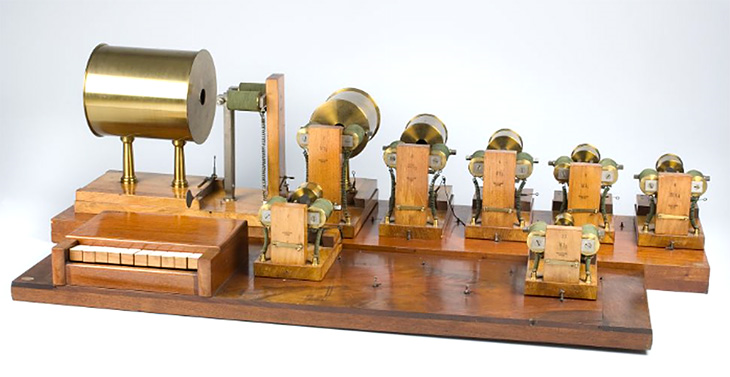

Todo este dispositivo experimental ya lo había ideado Foucault. Pero para perfeccionarlo y llevar su precisión hasta el extremo, Michelson lo repitió todo a lo grande. Para empezar, aumentó la distancia entre los espejos, hasta más de 600 metros. Pero además, necesitaba que la rotación del espejo fuese rapidísima (256 rotaciones por segundo) y, además, muy estable y muy precisa.

Una frecuencia rápida, estable y precisa, ¿os suena de algo? Dado el título de esta serie, supongo que a nadie le sorprenderá descubrir que Michelson utilizó diapasones para calibrar la velocidad de sus espejos. Parió de un sistema muy parecido, de hecho, al empleado por Lissajous para afinar el la universal. Michelson observaba los pulsos de luz de la rendija utilizando un pequeño espejo en la punta de un diapasón, que se mantenía en constante vibración gracias a una fuente electromagnética (igual que los diapasones parlantes de Helmholtz). Sincronizó la frecuencia del espejo con el diapasón ajustando la velocidad del primero hasta que la imagen se hacía estacionaria. Este diapasón se calibraba, a su vez, comparando su frecuencia con la de otro diapasón estándar, que se guardaba en una cámara aislada a una temperatura controlada. Y la frecuencia de este segundo diapasón estándar se había medido con ayuda de un cronoscopio, que permitía visualizar sus vibraciones sobre un tambor rotatorio. El cronoscopio comparaba dicha vibración con el tiempo marcado por un cronómetro, que se había calibrado tomando como referencia el tiempo de rotación de la Tierra, que se había medido desde Observatorio Naval de los EE. UU., en función de los tránsitos de las estrellas… Que ya que te pones a calibrar, pues calibras el laboratorio entero, y acabas recurriendo al movimiento de la mismísima Tierra.

Está claro que el virtuosismo experimental de Michelson y su obsesión por el detalle no conocían límites. Sus notas están llenas de detalles que lo dejan a uno alucinado (podéis leer más en el artículo de Kleppner1). Gracias a ello, obtuvo un resultado sorprendentemente ajustado, teniendo en cuenta los recursos con los que contaba: c = 299 940 ± 50 km/s, lo que constituye un error de menos del 0,05% (1 entre 2000) respecto al valor que hoy damos por bueno, c = 299 792,458 km/s.

Su logro lo convirtió en toda una celebridad en EE. UU. Y, sin embargo, no le sirvió para ganar muchos galones dentro de su oficio como militar. En 1880, consiguió permiso para ausentarse de su cargo y viajar a Europa, donde por fin podría estudiar física y matemáticas de manera rigurosa. Una vez en el viejo continente, Michelson inventó el interferómetro por el que hoy le recordamos, buscó el éter sin ningún éxito y ayudó a desmentir su existencia (el experimento Michelson-Morley, es hoy todo un hito de la física). Según cuenta Kleppner, su obsesión por medir la velocidad de la luz de manera cada vez más precisa nunca lo abandonó. El día de su muerte, el 9 de mayo de 1931, lo pilló redactando unas notas sobre cómo realizar una nueva medida. Tenía 78 años de edad.

Referencia:

1Kleppner, D. (2007). Master Michelson’s measurement. Physics Today, 60(8), 8-9. DOI: 10.1063/1.2774115

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Diapasones para afinar la velocidad de la luz se ha escrito en Cuaderno de Cultura Científica.

Naukas Pro 2022: El lenguaje, espejo de desigualdades y mecanismo de evolución social

El lenguaje es mucho más que un simple instrumento de descripción y comunicación. A pesar de que la sociedad lo percibe como una mera herramienta de interacción social que nos ayuda a describir el mundo, a transmitir ideas y sentimientos, y a conocer las de los demás, su potencial es mucho mayor: está estrechamente ligado a nuestro pensamiento, puede modificar nuestra visión del mundo e influir en nuestra toma de decisiones.

Por ejemplo, un lenguaje sexista oculto, utilizado de forma recurrente y generalizada, puede ser una fuente inagotable de desigualdades sociales y sesgos de género. La lingüística, que lleva a cabo un estudio científico del lenguaje, es una poderosa arma de concienciación y cambio social al ser capaz de desenmascarar esas asimetrías.

Gracias a la lingüística cognitiva y a la psicolingüística podemos comprobar que el lenguaje está íntimamente relacionado con el pensamiento y con el conocimiento, y que es un potente instrumento que nos ayuda a conceptualizar la realidad y a visualizarla desde diversas perspectivas. El lenguaje no es capaz de crear la realidad, pero sí de presentarnos visiones distorsionadas y variadas de la misma.

Lorena Pérez Hernández, profesora titular de la Universidad de La Rioja y lingüista cognitiva, participó el jueves 15 de septiembre en Naukas Pro en el Palacio Euskalduna de Bilbao para analizar el papel del lenguaje como espejo de desigualdades, pero también como mecanismo de evolución social. Pérez Hernández explicó a la audiencia del Euskalduna la forma en la que la lingüística cognitiva estudia los mecanismos que subyacen al lenguaje y que están estrechamente ligados con los procesos de construcción del conocimiento.

Esta disciplina es la que nos ayuda a analizar la huella lingüística que dejan esos procesos para realizar un diagnóstico de la sociedad y desvelar las desigualdades y asimetrías sociales que en ocasiones pasan desapercibidas. Una vez obtenido ese diagnóstico podemos explorar la relación que existe entre el lenguaje, por un lado, y el pensamiento y el conocimiento por otro, y diseñar intervenciones que tengan como objetivo favorecer cambios sociales positivos.

La lingüista mencionó varias iniciativas con las que se pretende realizar un diagnóstico sobre aspectos sociales como la educación, las desigualdades, el ámbito discursivo y la comunicación política y comercial, entre otros. El objetivo de estas líneas de investigación es utilizar dichos diagnósticos para diseñar líneas de actuación que contribuyan a favorecer una evolución social positiva en términos de efectividad, sostenibilidad e igualdad.

La educación, elemento de construcción del conocimientoLos proyectos llevados a cabo hasta el momento, en colaboración con las investigadoras Iraide Ibarretxe-Antuñano (U. de Zaragoza) y Paula Pérez Sobrino (U. de La Rioja), han logrado identificar usos diferenciales del lenguaje cotidiano que se utiliza con niños y niñas, y han permitido apuntar una posible explicación a un fenómeno social concreto: la falta de interés de las pequeñas por las carreras STEM.

Además, según Pérez Hernández, estos proyectos también han puesto de relieve que las metáforas conceptuales sobre educación han comenzado a cambiar y a reflejar un nuevo concepto: la educación ha pasado de entenderse como una simple transferencia de conocimiento a concebirse como construcción del conocimiento.

Después de reiterar que el lenguaje “es mucho más que un instrumento de descripción y comunicación”, Lorena Pérez Hernández destacó que “las diferentes metáforas sobre la enseñanza condicionan en gran medida el diseño del currículum y de las intervenciones educativas”. “En este caso, el proyecto tiene como objetivo determinar si la visión de la realidad que nos transmiten esas metáforas educativas se corresponde con los resultados de aprendizaje reales”.

La lingüista explicó que su investigación tiene un doble impacto social: por un lado, pretende “servir de espejo a las desigualdades sociales y a la visión que tiene una sociedad concreta del mundo”, y por otro, busca contribuir a desarrollar intervenciones sociales positivas orientadas a los Objetivos de Desarrollo Sostenible de Naciones Unidas, temática de fondo de todas las ponencias de Naukas Pro de esta edición.

El lenguaje no es inocenteAsí, Lorena Pérez Hernández parte de la base de que “el lenguaje no es inocente” sino que está estrechamente unido al pensamiento y refleja fielmente nuestra visión del mundo. “La elección de una palabra u otra, de una estructura sintáctica u otra, etc., revelan nuestra forma de pensar y de concebir la realidad”; por eso, si analizamos el lenguaje que utilizan los hablantes de una sociedad, “podemos descubrir con un alto índice de fiabilidad cómo es esa sociedad”. “No cómo se describe a sí misma sino cómo es realmente. El lenguaje nos revela y nos delata. El análisis del lenguaje es, por lo tanto, un instrumento muy preciso de diagnóstico social”, precisó.

A continuación, constató que existe una relación íntima entre lenguaje y pensamiento, en la que el primero puede influir en el segundo. “El lenguaje no solo nos ayuda a descubrir cómo pensamos y cómo vemos el mundo, sino que también nos permite actuar sobre ese pensamiento para modificarlo” e “influir en la toma de decisiones y en las acciones de las personas de una manera compatible con los Objetivos de Desarrollo Sostenible”.

Si no ve correctamente el vídeo use este enlace.

Para saber más:

El lenguaje antes del lenguaje y normas sociales

Crónica de Roberto de la Calle / GUK

El artículo Naukas Pro 2022: El lenguaje, espejo de desigualdades y mecanismo de evolución social se ha escrito en Cuaderno de Cultura Científica.

¿Por qué moja el agua? La física de fluidos inunda nuestras vidas

Ruth Lazkoz

Shutterstock / carlos castilla

Shutterstock / carlos castilla

“El agua moja” es una frase que se utiliza como sinónimo de obviedad. Pero ¿sabemos explicar por qué? Toca ponerse exquisitos para visitar ese y muchos otros fenómenos cotidianos usando la física de fluidos.

La física de fluidos surgió como disciplina formal en el siglo XVI para contradecir algunos planteamientos de Aristóteles. Según el filósofo, la naturaleza no aprobaba la existencia del vacío. Pero Pascal y otros abordaron la cuestión desde la perspectiva contraria. Para escudriñar la ausencia de materia había que estudiar la materia en sí.

El encargo de Pascal hecho a su cuñado de ascender a lo más alto de un volcán extinto con un par de barómetros de mercurio corroboró los experimentos sobre el peso de la atmósfera y la existencia del vacío realizados por su predecesor Torricelli. Y eso abrió una enorme compuerta del saber.

Fluidos son los gases y los líquidos, tanto el humo de una chimenea como el agua. Todos ellos son sustancias con fuerzas tan débiles entre sus partículas que no pueden recuperar su forma si la pierden.

De la pasta de dientes a la Fórmula 1Pero ¿dónde hallamos la física de fluidos en las rutinas diarias? Por ejemplo, en la manera en que se transmiten los cambios de presión entre dos puntos de un fluido. Con ello conseguimos sacar la pasta de dientes del tubo usando el mismo principio que hace funcionar la jeringa y los frenos hidráulicos.

Si nos atrevemos a generalizarlo para fluidos en movimiento encontramos, por la senda de Bernoulli, la explicación al efecto suelo de los bólidos de la Fórmula 1 –que hace que el vehículo se quede pegado al asfalto para mejorar su aerodinámica– o de cómo las marmotas enfrían sus madrigueras. De hecho, esas leyes se aplican a cualquier proceso de succión, como mamar de la teta.

Otro entorno secularmente ligado a los fluidos es la medicina. Cualquier anestesista ha de tener conocimientos sólidos de la física de líquidos y gases para manejar catéteres o sistemas de ventilación. Médicos eran también los hermanos Weber, expertos en la circulación de la sangre, cuya mágica viscosidad la hace fluir más despacio cerca de las paredes de los vasos, como mostró el también médico Pouiseille.

Es lo mismo que ocurre cuando movemos una galleta sobre la superficie de unas natillas en un cuenco. Cuanto menos líquido haya en el recipiente más fácil resultará el desplazamiento. Así es también como se comportan las placas tectónicas al desplazarse sobre el manto terrestre, una de tantas aplicaciones de la física de fluidos a la geología. Es interesante que ambas ciencias se den la mano con lo cotidiano mediante la física de fluidos. Otro nexo es la ley de Darcy para el paso de un líquido por un medio poroso, que puede ser un suelo de arena pero también el grano molido de una cafetera italiana.

Sin salirnos de la cocina, pero retornando a la viscosidad, aún nos quedan ejemplos atractivos por mencionar. Cuando el kétchup encerrado en la botella recibe un golpe certero fluye con más facilidad. El engrudo, junto con el yogur, la mayonesa y otros alimentos viscosos entra dentro de no newtonianos, así llamados por ser físicamente más complejos que aquellos con los que el gran genio se adentró en esta subdisciplina física cuando se propuso echarla a andar con su sabiduría.

Entre fogones nos resulta fácil experimentar sobre el efecto de las condiciones físicas en los fluidos en general. Queda bien patente cuando observamos que la miel fluye más fácilmente al calentarla. Esto vuelve a indicarnos cuántos flancos hay que cubrir al investigar la física de fluidos.

¿Por qué los fluidos se comportan como fluidos?No obstante, los ejemplos dados no son de excusas para esquivar el tema inicial. ¿Por qué el agua moja, el aceite mancha y la tinta tiñe? Se debe a las fuerzas de adhesión. Es decir, la afinidad entre sustancias líquidas y sólidas.

Esto se traduce en que, al poner un tejido en contacto con esos líquidos, treparían desafiando a la gravedad (fenómeno de capilaridad). Pero los líquidos son narcisistas. Sienten un tremendo apego a sí mismos: las fuerzas de cohesión. Eso genera la llamada tensión superficial, responsable de que se formen las gotas de agua y otros líquidos y mantengan su forma esférica. De ello se valen las hormigas obreras para transportar agua a su colonia.

¿Brindará conmigo para celebrar tanta ciencia? Pues entonces le invito a observar las lágrimas del vino, otra consecuencia de la tensión superficial.

Lamentablemente solo puedo cubrir la amplitud de la física de fluidos dando unas pinceladas. Al decirlo recuerdo que el hecho de que la pintura sea un fluido no newtoniano permitió inventar el gotelé. Pero no merece la pena enredarme en la nostalgia y aparcar temas de absoluta urgencia y actualidad.

La física de fluidos es fundamental para explicar un amplio abanico de fenómenos atmosféricos y oceanográficos. Y permite desmentir que el deshielo del Polo Norte eleve el nivel del mar. El argumento usa el principio de Arquímedes, el mismo que mantiene a flote los barcos de exploración de ese ámbito científico. En este contexto quiero señalar que el cambio climático hace los vuelos más susceptibles al fenómeno de la turbulencia.

Pero entonces me tentaría mucho hacerlo visual recurriendo a Humphrey Bogart. Tomaría así su imagen fumando un cigarro y liberando una columna de humo que se convierte en un festival de vueltas y revueltas.

Mejor dar un respiro a la audiencia. Y sirva la metáfora para recomendar prudencia mientras la covid-19 siga entre nosotros. Para alcanzar ese objetivo, la física de fluidos seguirá asistiendo de forma brillante a otras disciplinas y hablándonos de las gotículas y sus viajes.![]()

Sobre la autora: Ruth Lazkoz es profesora de Física Teórica en la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo ¿Por qué moja el agua? La física de fluidos inunda nuestras vidas se ha escrito en Cuaderno de Cultura Científica.

El azúcar añadido y el azúcar libre no son lo mismo pero sus efectos (perjudiciales) si lo son

Maitane González-Arceo, Saioa Gómez-Zorita y María P. Portillo

Siempre es mucho mejor la fruta de verdad y sin azúcares añadidos. Foto: Liliana Olivares / Unsplash

Siempre es mucho mejor la fruta de verdad y sin azúcares añadidos. Foto: Liliana Olivares / UnsplashNuestra dieta incluye diferentes fuentes de azúcares o hidratos de carbono simples, que están formados por una o dos moléculas, y pueden encontrarse unidos o no a la matriz, es decir, a otros componentes del alimento. De esta forma, se clasifican en libres o no libres. El azúcar libre puede encontrarse de las siguientes maneras:

-

De manera natural como ocurre en la miel.

-

Añadido voluntariamente, tanto a nivel doméstico como industrial, con el fin de endulzar los alimentos, de modo que el producto sea más apetecible.

-

Liberado de otros componentes de los alimentos a los que se encontraba previamente unido, como la fibra. Esto ocurre, por ejemplo, al exprimir las frutas para obtener zumo.

El hecho de que esté libre (da igual que sea añadido o no) favorece que el azúcar se absorba más rápidamente que cuando está unido, ya que el cuerpo no necesita romper esas uniones entre el azúcar y la matriz del alimento previamente a la digestión y la absorción. Además, se ha observado que la ingesta de azúcares libres contribuye a incrementar la densidad calórica de la dieta. Por ejemplo, cuando se ingiere zumo de fruta exprimido se emplea mayor cantidad de fruta que cuando se ingiere entera, ya que cuando ingerimos la fruta a bocados solemos consumir una sola pieza, mientras que cuando la exprimimos se suelen emplear varias piezas para rellenar un vaso.

A diferencia del azúcar que se encuentra en los alimentos unido a la matriz, por ejemplo en la fruta y la verdura sin procesar, el azúcar libre se vincula con numerosas enfermedades metabólicas crónicas de gran prevalencia en los países occidentales como la obesidad, la dislipemia (hipercolesterolemia, hipertrigliceridemia…), la resistencia a la insulina, la diabetes mellitus tipo 2, la enfermedad de hígado graso no alcohólico y las enfermedades cardiovasculares.

Por otro lado, la ingesta de alimentos que contienen azúcar libre desplaza y, por lo tanto, reduce la ingesta de alimentos saludables como la fruta, la verdura o las legumbres. La evidencia científica no ha podido determinar cuál es la ingesta máxima de estos azúcares libres que no perjudique la salud, por lo que se debe reducir su consumo al máximo. En concreto la Organización Mundial de la Salud (OMS) recomienda limitar la ingesta de azúcares libres a menos del 5% de la ingesta calórica total.

Entonces, ¿qué alimentos se deben evitar por su alto contenido en azúcar libre?El azúcar libre está en productos como pasteles, bollería industrial y otros dulces (caseros y no caseros), bebidas azucaradas como los refrescos y zumos comerciales, postres lácteos azucarados (yogures y otras bebidas) y otros ultraprocesados. Además, también se encuentra en otros productos como la miel o los siropes o en alimentos que los contienen, tanto comprados como hechos en casa.

En el caso de los productos comerciales, se puede saber si durante su elaboración se ha añadido azúcar o no leyendo la lista de ingredientes del envase. Además, hay que tener en cuenta que los ingredientes aparecen en el listado ordenados de mayor a menor peso o cantidad. De este modo, el ingrediente que aparece en primer lugar siempre será aquel que se ha usado en mayor cantidad y los ingredientes que están al final, serán aquellos que están en menor cantidad. Por lo tanto, es importante fijarse en qué posición se encuentra el azúcar dentro del listado, ya que cuanto más atrás esté, menos azúcar tendrá el producto.

En la siguiente lista se detallan los principales nombres bajo los que puede esconderse el azúcar (libre) en los alimentos: almidón modificado, caramelo, concentrado de jugo de frutas, dextrina, dextrosa, fructosa, galactosa, glucosa, isomaltosa, jarabe (de maíz, arroz, arce, glucosa…), maltodextrina, maltosa, miel, néctar, puré de frutas, sacarosa y sirope como el de agave.

En resumen, es conveniente limitar al máximo el consumo de alimentos que contengan alto contenido de azúcar libre, añadido o no, y aumentar la ingesta de alimentos más saludables que contengan el azúcar unido a otros componentes del alimento como es el caso de las frutas y verduras. El consumo de frutas y verduras, a diferencia del consumo de alimentos con azúcar libre, no se ha asociado con ninguna enfermedad metabólica.

Sobre las autoras: Maitane González-Arceo, Saioa Gómez-Zorita y María P. Portillo pertenecen al Grupo Nutrición y Obesidad en la Facultad Farmacia de la UPV/EHU, al Centro de investigación Biomédica en red (CiberObn) y al Instituto de Investigación Sanitaria Bioaraba.

Para saber más:

El azúcar oculto en los alimentos

Azúcar y otros edulcorantes

El artículo El azúcar añadido y el azúcar libre no son lo mismo pero sus efectos (perjudiciales) si lo son se ha escrito en Cuaderno de Cultura Científica.

El rompecabezas de Sol LeWitt

En algunas entradas del Cuaderno de Cultura Científica hemos hablado de cómo las matemáticas recreativas y, en particular, algunos rompecabezas matemáticos, habían inspirado al arte, siendo utilizados como herramientas de creación artística. Por ejemplo, el conocido rompecabezas geométrico Tangram (véase la entrada El arte contemporáneo que mira al Tangram), el rompecabezas cubo soma (véase la entrada El cubo soma: diseño, arte y matemáticas), la disección de Dudeney, una disección geométrica de un triángulo equilátero cuyas piezas se pueden reordenar formando un cuadrado o viceversa (véase la entrada La disección de Dudeney, de rompecabezas matemático a creación artística) o los cuadrados latinos (véase la entrada Cuadrados latinos, matemáticas y arte abstracto). Sin embargo, en esta entrada vamos a mostrar un ejemplo de cómo el arte también puede inspirar a la matemática recreativa, en concreto, enseñaremos cómo una obra del artista conceptual y minimalista estadounidense Sol LeWitt (1928-2007) ha motivado la creación de algunos rompecabezas matemáticos.

Bandas de color (portafolio Wadsworth) del artista estadounidense Sol LeWitt. Imagen de WikiArt

Bandas de color (portafolio Wadsworth) del artista estadounidense Sol LeWitt. Imagen de WikiArtEl artista minimalista y conceptual Sol Lewitt

Podemos relacionar al artista Sol LeWitt con dos movimientos artísticos, el minimalismo y el arte conceptual. Estos pueden ser descritos brevemente con dos lemas. La expresión que nos explica en tres palabras qué es el arte minimal es “menos es más”, atribuida al arquitecto germano-estadounidense Ludwig Mies van der Rohe (1886-1969), por ser quien la popularizó, aunque la primera vez que se publica en este sentido es de la mano del también artista estadounidense minimalista y conceptual Ad Reinhardt (1913-1967), en una entrevista en la que afirmó que “Mientras más cosas contenga, cuanto más ocupada sea la obra de arte, peor será. Más es menos. Menos es más”. Sin embargo, la frase “menos es más” se encuentra con anterioridad en la poesía, por ejemplo, en el poema Andrea del Sarto (1855) del poeta y dramaturgo británico Robert Browning (1812-1889) o en el poema Deseo de año nuevo (1774) del poeta alemán Christoph Martin Wieland (1733-1813).

Mientras que la cita que nos sirve para entender en pocas palabras qué es el arte conceptual se debe al propio Sol LeWitt, quien resumió este movimiento artístico con la frase “La idea se convierte en una máquina que hace arte”, después de afirmar que “en el arte conceptual, la idea o el concepto es el aspecto más importante de la obra. Cuando un artista utiliza una forma de arte conceptual, significa que toda la planificación y las decisiones se toman de antemano y la ejecución es un asunto superficial”.

Estructura geométrica abierta IV (1990), del artista minimalista y conceptual Sol Lewitt, que fue expuesta en la Galería Elvira González de Madrid en 2015

Estructura geométrica abierta IV (1990), del artista minimalista y conceptual Sol Lewitt, que fue expuesta en la Galería Elvira González de Madrid en 2015Líneas rectas en cuatro direcciones y todas sus posibles combinaciones

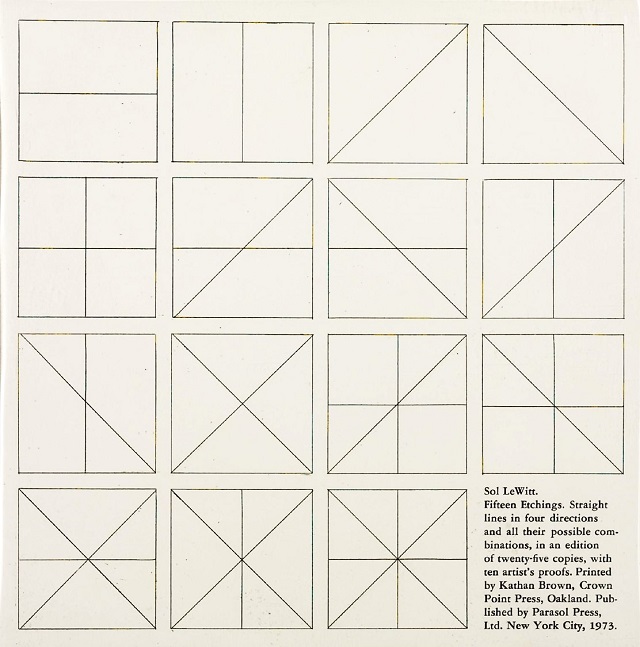

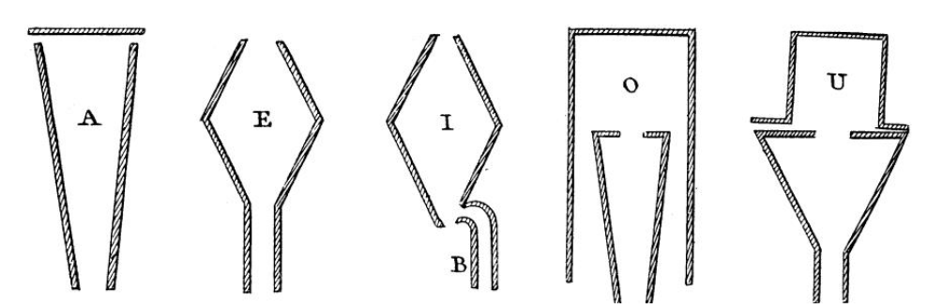

Si observamos el trabajo de este artista conceptual y minimalista descubriremos un arte muy geométrico, en el que la combinatoria juega también un papel fundamental. Un ejemplo es la obra que nos ocupa hoy, titulada Líneas rectas en cuatro direcciones y todas sus posibles combinaciones (1975) y formada por 15 grabados. Esta obra (que podemos observar en la siguiente imagen) describe gráficamente de qué formas podemos trazar en un cuadrado grupos de segmentos rectos dentro del conjunto de cuatro tipos de líneas rectas, en horizontal, en vertical o en diagonal (ascendente o descendente), que pasan por el centro del cuadrado. La respuesta es 15, como la cantidad de grabados que compone esta obra, si excluimos la forma número 16 que sería sin ninguna línea recta, es decir, el cuadrado vacío.

Líneas rectas en cuatro direcciones y todas sus posibles combinaciones (1975), del artista Sol Lewitt

Líneas rectas en cuatro direcciones y todas sus posibles combinaciones (1975), del artista Sol Lewitt

Aunque este no es el objetivo de esta entrada, la obra que nos ocupa está relacionada con lo que en combinatoria se llama “números combinatorios” –de cuántas formas se pueden elegir k objetos de un grupo total de n objetos– y con las partes –o subconjuntos- de un conjunto dado de n elementos.

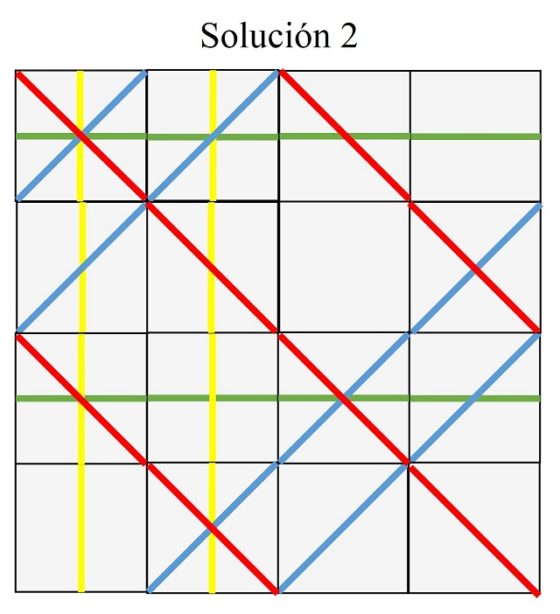

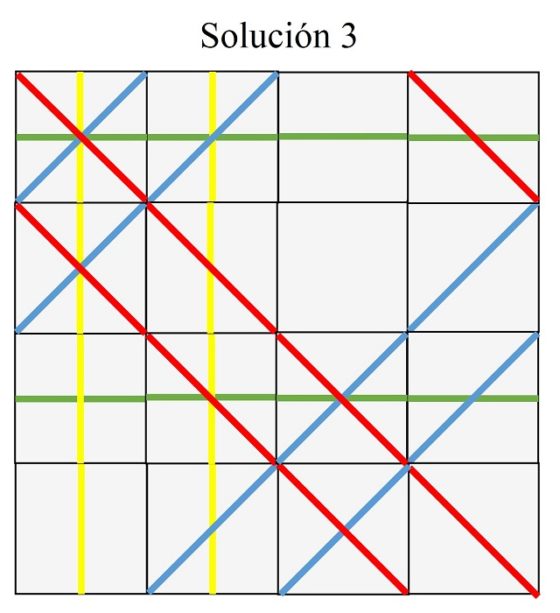

El rompecabezas inspirado en la obra de Sol LewittCuando el matemático y divulgador estadounidense Barry Cipra vio la obra del artista Sol Lewitt, Líneas rectas en cuatro direcciones y todas sus posibles combinaciones (1975), observó que había líneas que se continuaban desde un lado a otro del cuadrado 4 x 4 que formaba la obra con los 15 + 1 (el 1 extra es el cuadrado vacío de rectas, que estaría abajo a la derecha, donde el texto) grabados juntos (imagen anterior), como la línea diagonal que parte del segundo cuadrado de la cuarta y última fila, pasando por el tercer cuadrado de la tercera fila y llegando al cuarto de la segunda fila, mientras que otras líneas no cumplían esta propiedad, como las líneas verticales del segundo y tercer cuadrados de la primera columna, que no se continúan ni hacia arriba, ni hacia abajo, hasta llegar a los lados de la obra. Entonces se le ocurrió la idea de si sería posible recolocar los 16 (15 + 1) cuadrados, sin rotar ninguno, de forma que se pudieran continuar las líneas rectas desde un lado a otro de la parte exterior de la estructura cuadrada 4 x 4 que forman los 16 cuadrados. Esta idea dio lugar al llamado rompecabezas de Sol Lewitt, que Cipra propuso por primera vez en libro What’s Happening in the Mathematical Sciences 1998-1999 / Qué está pasando en las ciencias matemáticas 1998-1999.

A continuación, vamos a describir con más detalle los elementos y las reglas del rompecabezas de Sol Lewitt, con la idea de que podáis construir vuestra propia versión física y jugar con ella.

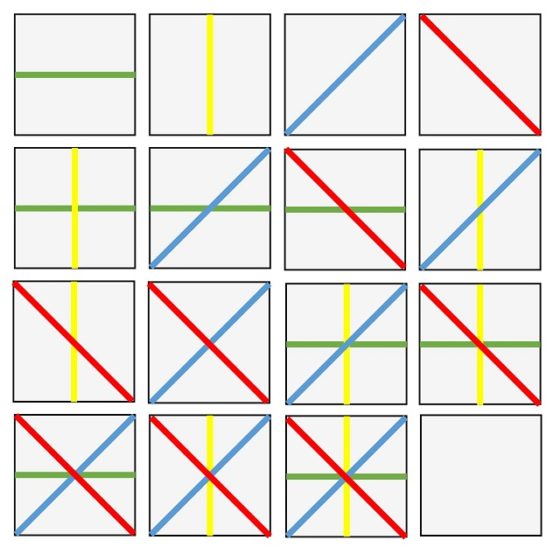

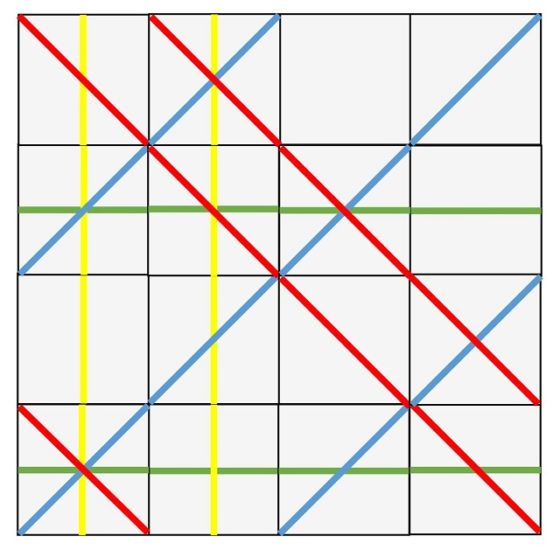

Para empezar, debemos construir las 16 fichas del rompecabezas (por ejemplo, en cartulina, o en madera si somos más atrevidos), que son los 16 cuadrados con las diferentes opciones de representar una, dos, tres o cuatro de las líneas rectas que pasan por el centro del cuadrado, en vertical, horizontal o diagonal (ascendente o descendente). Para facilitar el desarrollo del juego –en concreto, que no se pueden girar las piezas, de forma que una línea vertical pase a horizontal, o viceversa, o que una línea diagonal en un sentido pase a una línea diagonal en el otro sentido– vamos a colorear las líneas según a la dirección de las mismas. Por ejemplo, las líneas horizontales en verde, las verticales en amarillo, las diagonales en un sentido en azul y en el otro en rojo, como se muestra en la siguiente imagen.

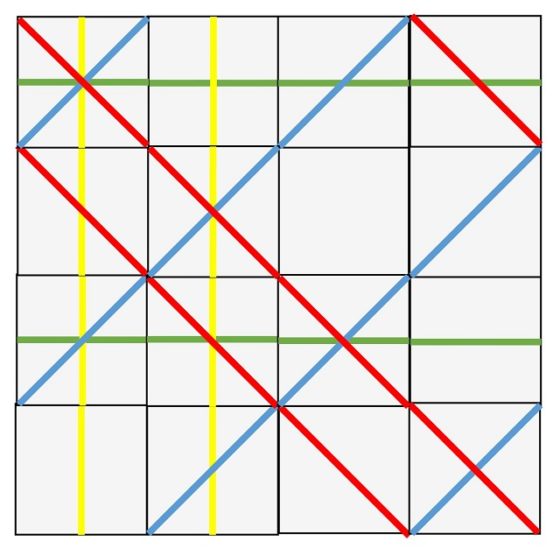

Las 16 piezas, con líneas coloreadas, del rompecabezas de Sol Lewitt

Las 16 piezas, con líneas coloreadas, del rompecabezas de Sol LewittEl rompecabezas de Sol Lewitt consiste en colocar las 16 piezas cuadrados que hemos construido formando una estructura cuadrada 4 x 4, sin rotar ninguna de las piezas, es decir, las líneas horizontales (verdes) siempre son horizontales, las verticales (amarillas) siempre verticales, las diagonales ascendentes (azules) siempre son diagonales ascendentes y las diagonales descendentes (rojas) no dejan de ser diagonales descendentes, de forma que formen líneas ininterrumpidas de un lado al otro de la estructura cuadrada 4 x 4. Así las líneas amarillas van desde la parte superior a la inferior, las verdes de la parte de la izquierda a la parte de la derecha, las azules desde el lado izquierdo al lado superior, o del lado inferior al lado derecho, y las rojas del lado superior al lado derecho, o del lado izquierdo al lado inferior.

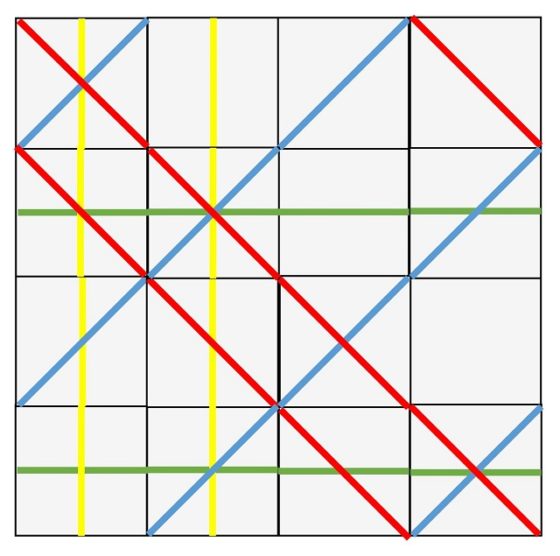

Por ejemplo, una solución del rompecabezas es la que se muestra a continuación (que llamaremos “solución 1”).

Una de las soluciones del rompecabezas de Sol Lewitt

Una de las soluciones del rompecabezas de Sol Lewitt

Como siempre que hablamos de algún rompecabezas matemático, os animamos a que primero os construyáis las dieciséis piezas geométricas y luego intentéis vosotros mismos encontrar alguna solución al rompecabezas de Sol Lewitt.

Las soluciones del rompecabezas de Sol LewittCuando el matemático Barry Cipra propuso el rompecabezas de Sol Lewitt, lo hizó sabiendo que existía alguna solución. Sin embargo, fue el matemático británico John H. Conway (1937-2020), de quien hemos hablado en la entrada Teoremas geométricos sin palabras: Conway, quien demostró que había tres soluciones “básicas” distintas (que mostramos al final de esta entrada).

Cuando decimos “básicas” queremos decir que las demás se obtienen a partir de estas a través de una serie de procesos geométricos o matemáticos, que vamos a describir a continuación. Utilizaremos la solución que hemos visto (anterior imagen) para entender mejor estos procesos.

1. Rotación de 90 grados.

Dada una solución del rompecabezas de Sol LeWitt, una rotación de 90 grados (en el sentido contrario de las agujas del reloj) nos da otra solución del rompecabezas. Tengamos en cuenta dos cuestiones. La primera es que, si realizamos una rotación de 90 grados, el conjunto de los 16 diseños combinatorios posibles con cuatro direcciones de líneas rectas –las 16 piezas del rompecabezas– se transforma de nuevo en los 16 diseños combinatorios. Es decir, seguimos teniendo todas las piezas del rompecabezas. Aunque si observamos nuestro añadido de color, las líneas horizontales ahora son amarillas, en lugar de verdes, las líneas verticales son verdes, en lugar de amarillas, las líneas diagonales ascendentes son rojas, en lugar de azules, mientras que las líneas diagonales descendentes son azules, en lugar de rojas. Pero recordemos que el color no es importante, es solo un añadido para ayudarnos a distinguir las líneas de cada dirección. Por otra parte, las líneas continuas al rotarlas siguen siendo líneas continuas, luego obtenemos una nueva solución del juego. En la siguiente imagen podemos observar la rotación de 90 grados (en el sentido contrario de las agujas del reloj) de la solución 1, que es una nueva solución.

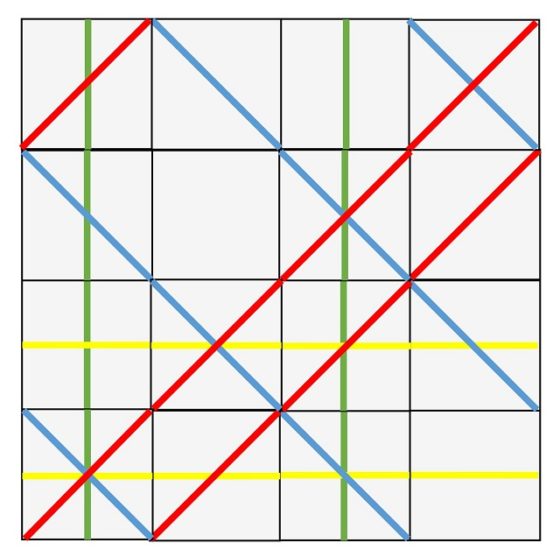

Solución del rompecabezas de Sol LeWitt que consiste en la rotación de 90 grados, en el sentido contrario de las agujas del reloj, de la solución 1

Solución del rompecabezas de Sol LeWitt que consiste en la rotación de 90 grados, en el sentido contrario de las agujas del reloj, de la solución 1

2. Reflexión.

Por otra parte, si realizamos una reflexión de una solución del rompecabezas de Sol LeWitt, es decir, si damos la vuelta a una solución, se obtiene una nueva solución. De hecho, los dos comentarios anteriores para la simetría rotacional siguen siendo válidos para las reflexiones.

Solución del rompecabezas de Sol LeWitt que consiste en una reflexión vertical, es decir, dar la vuelta a nuestra solución de derecha a izquierda, de la solución 1

Solución del rompecabezas de Sol LeWitt que consiste en una reflexión vertical, es decir, dar la vuelta a nuestra solución de derecha a izquierda, de la solución 1

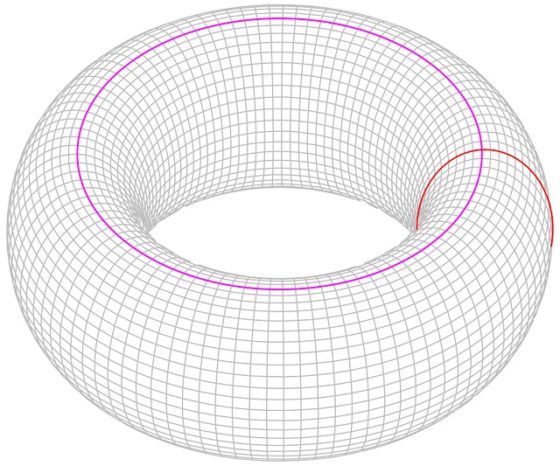

3. Simetría “toroidal”.

Partamos de nuevo de una solución del rompecabezas de Sol Lewitt, si tomamos la columna de piezas de la izquierda y la trasladamos a la parte derecha (como en la siguiente imagen se ha hecho para la solución 1) se obtiene una nueva solución.

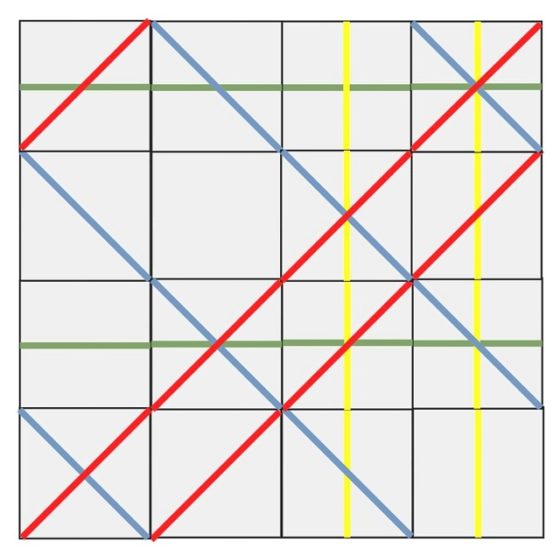

Solución del rompecabezas de Sol LeWitt que consiste en trasladar la columna de la izquierda de la solución 1 al extremo derecho

Solución del rompecabezas de Sol LeWitt que consiste en trasladar la columna de la izquierda de la solución 1 al extremo derecho

Lo mismo ocurre para las filas, si tomamos la fila de arriba de la solución y la trasladamos a la parte de abajo (como en la siguiente imagen se ha hecho para la solución 1) se obtiene también una nueva solución.

Solución del rompecabezas de Sol LeWitt que consiste en trasladar la fila de arriba de la solución 1 al extremo de abajo

Solución del rompecabezas de Sol LeWitt que consiste en trasladar la fila de arriba de la solución 1 al extremo de abajo

Pensando matemáticamente, es como si nuestra solución del rompecabezas estuviese dibujada sobre la superficie de un toro (matemático), es decir, la parte de la izquierda estuviese “pegada” a la derecha y la parte de arriba a la de abajo.

La superficie de un toro. Imagen de Wikimedia Commons, de Krishnavedala

La superficie de un toro. Imagen de Wikimedia Commons, de Krishnavedala

4. Simetría no geométrica.

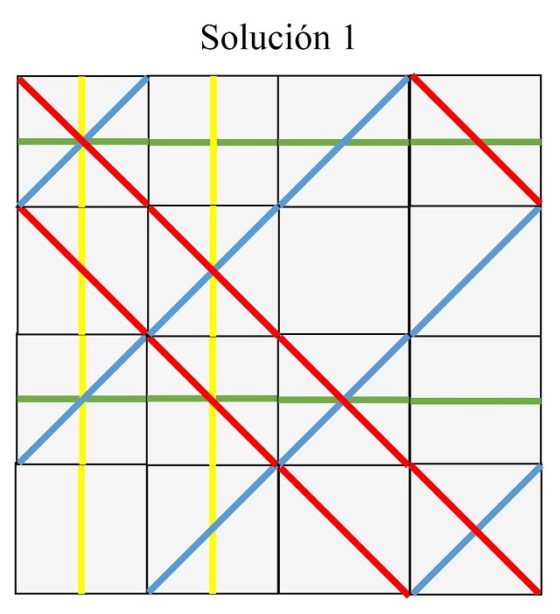

Existe otro tipo de transformación, aunque no es geométrica, que convierte una solución del rompecabezas en otra distinta. Fijémonos en una cierta dirección de las líneas rectas de las dieciséis piezas que componen el juego (y la obra del artista Sol Lewitt), por ejemplo, en las líneas horizontales. Cada pieza cuadrada o tiene una línea horizontal o no la tiene, y además, la mitad de las piezas la tienen, es decir, ocho piezas, mientras que las otras ocho no la tienen. Nuestra transformación consiste en “quitar” las líneas horizontales de las piezas que las tienen y “ponerlas” en las que no las tienen. De esta forma, nuestra solución del rompecabezas da lugar a una nueva solución. En la siguiente imagen hemos realizado esta operación para la solución 1, obteniendo una nueva solución del juego.

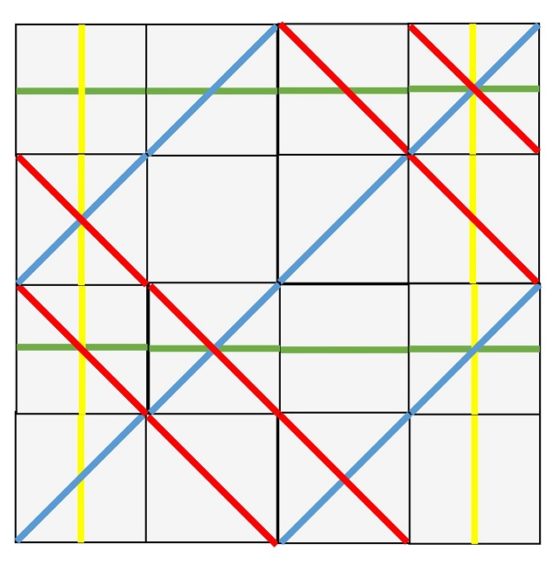

Solución del rompecabezas de Sol LeWitt que consiste en “trasladar” las líneas horizontales de las piezas que las tienen a las piezas que no las tienen en la solución 1

Solución del rompecabezas de Sol LeWitt que consiste en “trasladar” las líneas horizontales de las piezas que las tienen a las piezas que no las tienen en la solución 1

Estos son los cuatro tipos de transformaciones que llevan una solución del juego diseñado por Barry Cipra en otra distinta.

Por lo tanto, lo que demostró el matemático John H. Conway fue que existen únicamente tres soluciones, salvo transformaciones como de las vistas anteriormente, del rompecabezas de Sol Lewitt. La demostración de este resultado puede verse en el artículo de Barry Cipra titulado The Sol LeWitt Puzzle: A Problem in 16 Squares, en Puzzlers’ Tribute: A Feast for the Mind.

Las únicas tres soluciones “básicas” que existen son las siguientes.

Bibliografía:

1.- Barry Cipra, What’s Happening in the Mathematical Sciences 1998-1999, volume 4, AMS, 1999.

2.- Barry Cipra, The Sol LeWitt Puzzle: A Problem in 16 Squares, en Puzzlers’ Tribute: A Feast for the Mind (editores: D. Wolfe and T. Rodgers), A K Peters, 2002.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El rompecabezas de Sol LeWitt se ha escrito en Cuaderno de Cultura Científica.

Einstein y Niels Bohr

Niels Bohr fue uno de los fundadores de la física del siglo XX, aunque sea recordado mayormente por haber desarrollado la conocida como interpretación de Copenhague de la mecánica cuántica. Intelectualmente a la par, Einstein y Bohr mantuvieron una estrecha amistad, llena de conversaciones animadas y debates científicos. Los dos representan los dos pilares de la física moderna, la relatividad y la mecánica cuántica.

Einstein y Niels Bohr en Bruselas en 1930. Foto: Paul Ehrenfest / Wikimedia Commons

Einstein y Niels Bohr en Bruselas en 1930. Foto: Paul Ehrenfest / Wikimedia CommonsNiels Bohr comenzó a labrarse una reputación internacional cuando, en 1913, publicó la primera descripción del aspecto que tendría un átomo de hidrógeno cuántico viable: incluyendo un núcleo, el recientemente descubierto electrón y el concepto de estado estacionario. El modelo del átomo de Bohr se basaba en el modelo estrictamente clásico de Ernest Rutherford al que el físico danés añadió la nueva idea de que la energía no era continua, sino que venía en paquetes llamados cuantos. Este apaño de mezclar una vieja teoría con una nueva terminó no siendo la solución perfecta, pero fue el primer paso en el camino hacia la comprensión de la física atómica y representó el comienzo de un maridaje de Bohr con la física atómica que duraría toda su vida. Einstein se interesó inmediatamente por este trabajo. Solamente era seis años mayor que Bohr, y también estaba comenzando a hacerse un nombre; los dos estaban llamados a ser colegas, y cada uno siguió de cerca el trabajo del otro.

A lo largo de la siguiente década tanto Einstein como Bohr crecieron en fama y en estatura intelectual. Einstein se hizo mundialmente famoso cuando su teoría general de la relatividad fue comprobada experimentalmente en 1919, mientras que su trabajo le había proporcionado una cátedra a Bohr en la Universidad de Copenhague en 1916. En 1920 comenzaba a funcionar un centro creado para él por la Universidad, el Instituto de Física Teórica [*].

El primer encuentro entre Einstein y Bohr tuvo lugar en 1920 en Berlín. Como si se conociesen de toda la vida, hablaron de relatividad y física atómica, acerca de la creciente preocupación de Einstein de que la física cuántica estaba abandonando las leyes de la causalidad, acerca de si la luz era una onda o una partícula, acerca, en definitiva, de todo lo que estaba ocurriendo en el mundo de la física. Poco después de esta reunión ambos escribieron cartas en las que expresaban la experiencia tan formidable que había sido. Einstein a Bohr: “No a menudo en la vida un ser humano me ha causado tanta alegría por su mera presencia como tú lo has hecho”. Bohr a Einstein: “Conocerte y hablar contigo ha sido una de las mejores experiencias que nunca haya tenido”.

En 1924, Bohr propuso una teoría junto a Hendrik Anton Kramers y John Clarke Slater que capturó brevemente la imaginación de sus contemporáneos como una posible explicación a cómo interactúan la luz y la materia. La teoría BKS, como se la conoce, resultó ser incorrecta, pero es digna de mención por dos motivos. El primero es que rechazaba la existencia de partículas de luz, insistiendo en que la luz era una onda y solo una onda. En esa época, la mayor parte de la comunidad de físicos estaba de acuerdo en que la luz estaba constituida por cuantos de energía, tal y como Einstein había predicho en 1905 (efecto fotoeléctrico). Bohr sería uno de los últimos en apoyar la idea de que la luz era simultáneamente una onda y un corpúsculo (Einstein fue el primero) y es interesante hacer notar durante cuánto tiempo rechazó la teoría corpuscular de la luz.

Es llamativo que, de igual forma que Bohr fue uno de los últimos en aceptar las partículas de luz, los fotones, una vez que estuvo convencido lo hizo plenamente y sin reservas: apoyó, como converso que era, más fervientemente que nadie el concepto aparentemente absurdo de que la luz era tanto una onda como un corpúsculo, dependiendo de cómo la midieses. Este tipo de cambio de dogma intelectual es muy infrecuente, muchos científicos acabaron su carrera investigadora por no poder aceptar este tipo de cambios; Einstein sería uno de ellos. Einstein escribiría de Bohr treinta años después: “Expone sus opiniones como alguien que está siempre buscando a tientas y nunca como alguien que se cree en posesión de la verdad definitiva”. La grandeza del genio de Bohr estuvo en su increíble capacidad para mantener una mente abierta.

El segundo punto de interés de la teoría BKS es que fue la primera vez en la que Einstein y Bohr estuvieron claramente en campos opuestos. La teoría BKS abandonaba la causalidad y eso era algo que Einstein no estaba dispuesto a aceptar, lo que puso a muchos científicos frente a un dilema. Muchos de ellos respetaban tanto la inteligencia de Einstein y su liderazgo que les resultaba difícil apoyar una teoría que él rechazaba. En un mundo ideal, estos conflictos personalistas no deberían importar a la hora de determinar la corrección objetiva de una teoría, pero incluso los científicos son humanos. El hecho cierto es que tener a dos de los más grandes científicos del momento enfrentados dejó a muchos de sus colegas desubicados. Muchos se negaban a comentar qué científico pensaban que tenía razón, y los que lo hacían estaban muy incómodos con la situación. Cuando se vio forzado a tomar partido, Paul Ehrenfest, amigo íntimo de Einstein, lloró (literalmente) al declarar que pensaba que el punto de vista de Bohr era el correcto.

Los debates Bohr – EinsteinPero pronto todo el mundo tomó partido. La quinta conferencia Solvay, celebrada en octubre de 1927, ha pasado a la historia como uno de los diálogos intelectualmente más transcendentes de la historia contemporánea. Todo el mundo, incluido Einstein, veía la nueva mecánica cuántica como una herramienta matemática muy potente a la hora de predecir cómo funcionaban tanto átomos como partículas subatómicas. Pero había desacuerdos sobre las implicaciones de esa herramienta matemática. Algunos, liderados por Bohr y Werner Heisenberg, creían que la mecánica cuántica era la última palabra. Si las matemáticas decían que el futuro de átomo no era completamente preciso, entonces, simplemente, no lo era. En el otro lado estaban otros cuantos, liderados por Einstein y Erwin Schrödinger, que afirmaban que la mecánica cuántica era una maravillosa herramienta estadística, pero que en la realidad los átomos sí se comportaban con absoluta precisión y algún día, de alguna manera, los científicos desarrollarían teorías completamente nuevas que darían formalismo a esta idea.

Las discusiones ocuparon a los científicos día y noche. Uno de los participantes, Otto Stern, ofreció una narración vívida de la conferencia, describiendo como cada mañana Einstein llegaba al desayuno con una nueva contraargumentación y cada tarde aparecía Bohr con una nueva refutación. Estas discusiones han sido elevadas a la categoría de leyenda, y se las conoce como los debates Bohr-Einstein. De hecho, incluso los participantes parecían estar sobrecogidos ante lo que estaba ocurriendo en esta conferencia. En 1949 Bohr escribió un ensayo, “Discusión con Einstein sobre los problemas epistemológicos en la física atómica”, para el libro “Albert Einstein, filósofo-científico”, en el que atribuye al conjunto de los ingeniosos experimentos mentales propuestos por Einstein el haber sido el catalizador que le permitió llegar a comprender lo que ocurre en el mundo atómico.

Si bien estos debates entre Einstein y Bohr se suelen describir como batallas, Bohr mismo los recordaría como bastante agradables. En el ensayo que mencionábamos Bohr se refiere a los nuevos experimentos mentales de Einstein como “graciosos” y, Einstein en plan de burla preguntaba si “las autoridades providentes recurrían a las tiradas de dados”. En el transcurso de la conferencia las cosas se volvieron en contra de Einstein completamente. Los que antes de la conferencia habían tenido dudas, al final de la misma aceptaban la versión de Bohr de la mecánica cuántica. Esta versión llegó a ser conocida como la interpretación de Copenhague (tanto Bohr como Heisenberg eran profesores de esa universidad en el momento de celebrase la conferencia).

Einstein, sin embargo, nunca aceptó la interpretación de Copenhague, y los debates entre Einstein y Bohr continuaron durante décadas. En la sexta conferencia Solvay, celebrada en Bruselas en 1930 (y a la que corresponde la imagen, tomada por Ehrenfest), Einstein presentó un nuevo experimento mental: si una caja llena de radiación fuese dispuesta de tal manera que estuviese sobre una balanza, y que un reloj controlase que un fotón y sólo un fotón escapase de la caja en un momento concreto, se podría medir perfectamente el cambio de peso de la caja. Por tanto, y de forma simultánea, se podría medir el tiempo y la cantidad de energía de ese fotón, en abierta contradicción con el principio de incertidumbre de Heisenberg, que afirmaba que esas dos magnitudes no podían conocerse con precisión a la vez. Bohr estuvo perplejo durante unas doce horas, llegando a decir “sería el fin de la física si Einstein tuviese razón”. Pero a la mañana siguiente Bohr apareció con una refutación (además una que escoció a Einstein): teniendo en cuenta la teoría de la relatividad, al retroceder la caja debido a la emisión del fotón, el tiempo mismo del marco de referencia de la caja se vería afectado. El tiempo, después de todo, no podía medirse de forma precisa. Los dos hombres continuaron la discusión pero esa fue la última conferencia Solvay a la que asistiría Einstein, ya que en 1933 abandonaría Europa para nunca más volver.

Volverían a encontrarse en los Estados Unidos cuando Bohr visitó Princeton. Y seguían con la misma dinámica. Bohr también refutó uno de los más famosos experimentos mentales de Einstein, el argumento Einstein-Podolsky-Rosen. Bohr nunca convenció a Einstein, como no lo consiguió ningún otro físico, de que aceptara la interpretación de Copenhague.

A pesar de la Resistencia de Einstein a aceptar la interpretación de Copenhague, él consideraba que el desarrollo de la mecánica cuántica había sido una enorme logro, uno que debería incorporarse a la “teoría verdadera”, sea esta la que fuese, que tendría que desarrollarse dentro de no demasiado tiempo. Einstein también consideraba asombrosa la aportación de Bohr a la mecánica cuántica. En el ensayo que escribió en 1949 para “Albert Einstein, filósofo-científico”, Einstein afirmaría: “El que esta base tan insegura y contradictoria fuese suficiente para permitir a un hombre, con el instinto y tacto únicos de Bohr, descubrir las leyes principales de las líneas espectrales y de las capas de los electrones de los átomos, junto con su importancia para la química, me parece un milagro; y me sigue pareciendo un milagro incluso hoy”.

A pesar de una vida de disputas acerca de la mecánica cuántica, la amistad entre estos hombre se mantuvo sólida y sincera, ayudada por una tremenda admiración de la inteligencia genial del otro.

Nota:

[*] En la actualidad Instituto Niels Bohr. Se creó con fondos en su mayoría provenientes de la empresa de cervezas Carlsberg, la misma que llevaba financiando los viajes de estudios de Bohr en los últimos años. Desde 1931 hasta su muerte Bohr viviría como huésped en un palacete que fue propiedad del fundador de la empresa.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Una versión anterior de este artículo se publicó en Experientia Docet el 1 de agosto de 2010.

El artículo Einstein y Niels Bohr se ha escrito en Cuaderno de Cultura Científica.

El misterio de Fobos y Deimos

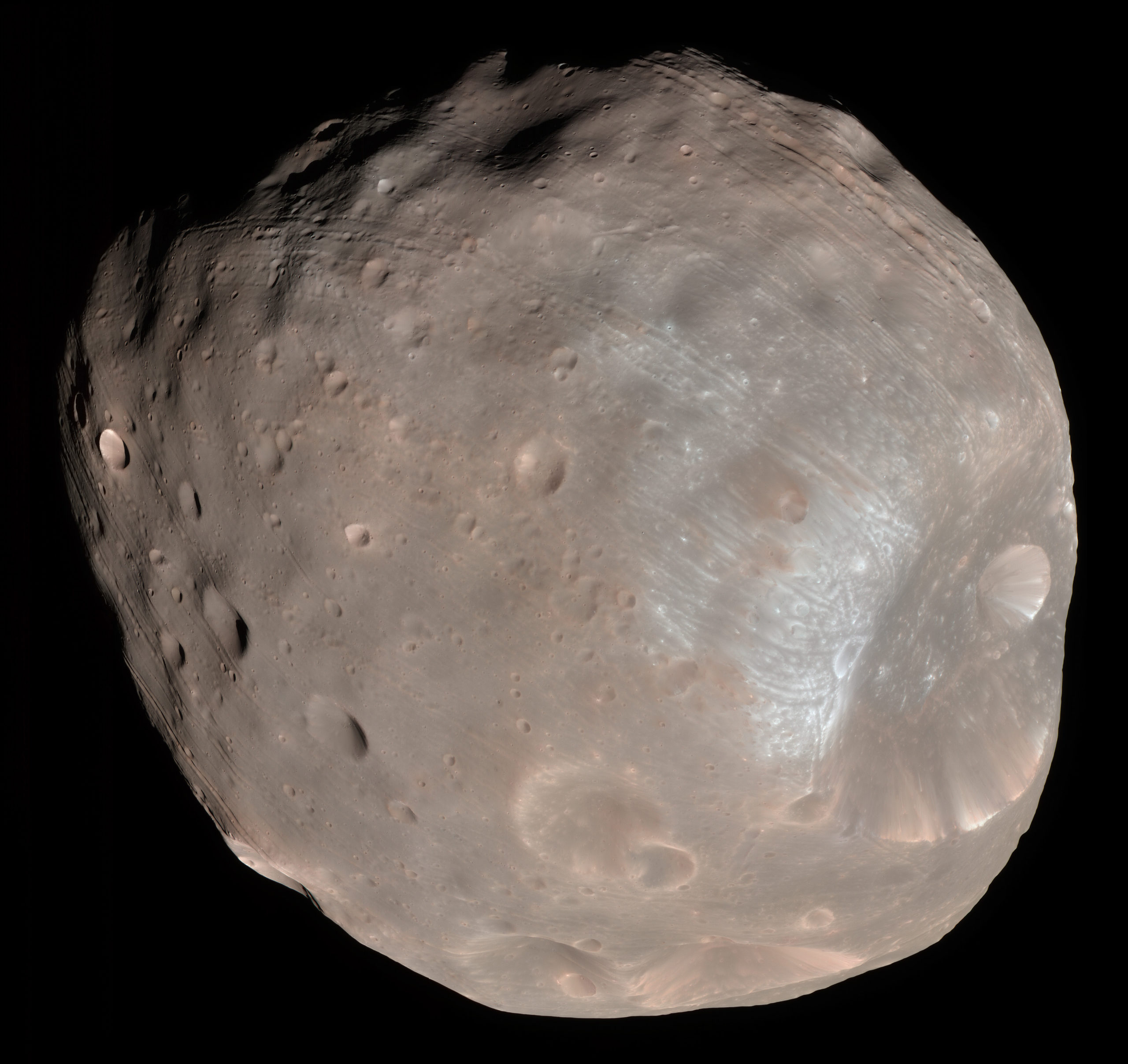

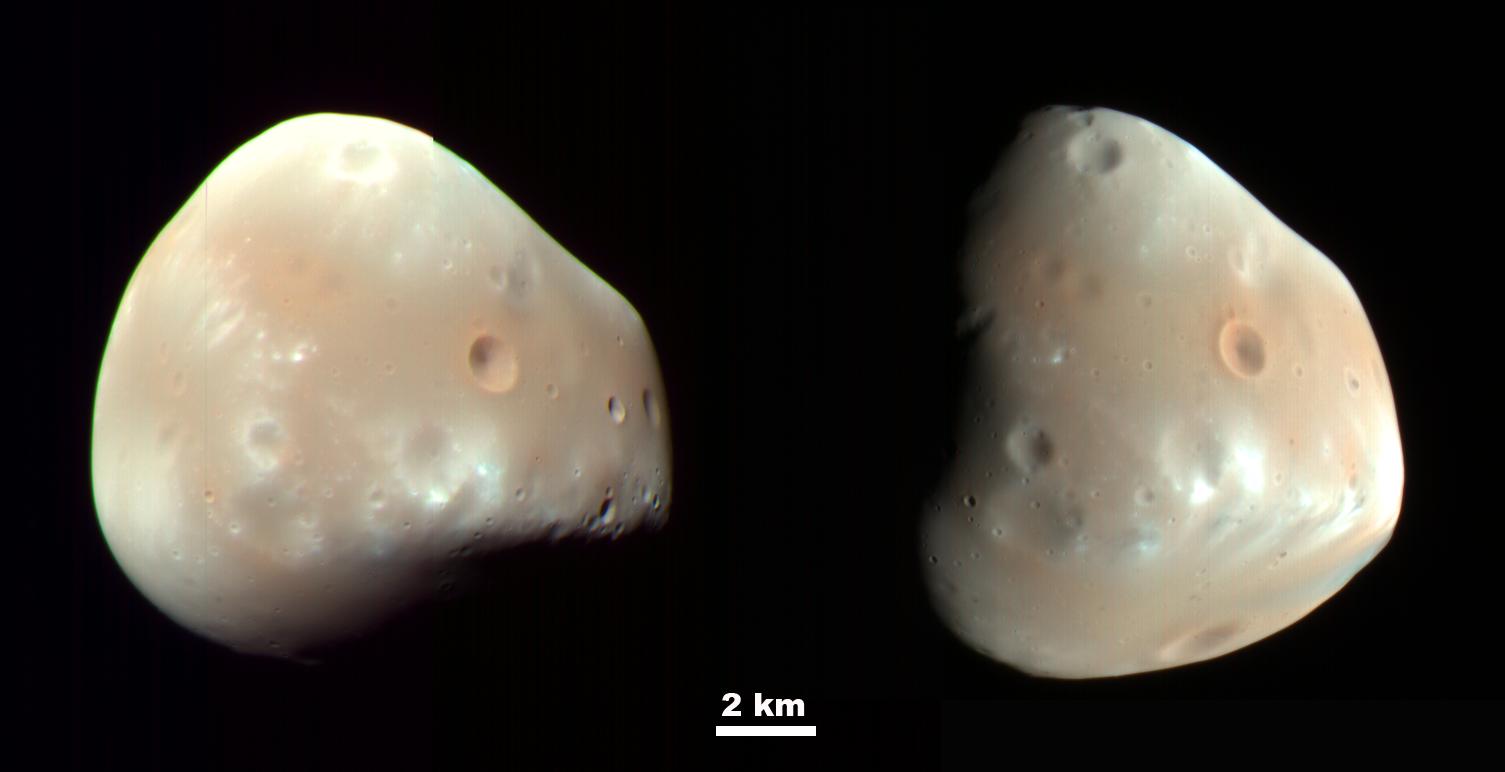

Los satélites de Marte, Fobos y Deimos, han sido -y siguen siendo- uno de los grandes misterios de la geología planetaria, en tanto que todavía no comprendemos muy bien su mecanismo de formación. Por su aspecto, muy parecido al de un asteroide común, y el espectro de la luz reflejada por la superficie, similar al de los asteroides de tipo D (asteroides muy primitivos, cuya composición estaría formada principalmente por silicatos, compuestos orgánicos e incluso por hielo de agua), se ha pensado durante décadas que podrían haber sido asteroides capturados al pasar cerca del planeta Marte.

Fobos visto desde la Mars Reconaissance Orbiter. NASA / JPL-Caltech / University of Arizona

Fobos visto desde la Mars Reconaissance Orbiter. NASA / JPL-Caltech / University of Arizona¿Cómo podía Marte capturar unos satélites de este tamaño con su campo gravitatorio? Pues algunos científicos pensaron que esto sería posible si Fobos y Deimos hubiesen pasado a través de la atmósfera de Marte, frenándose, y esta pérdida de velocidad facilitando su entrada en órbita alrededor de Marte en vez de continuar su camino. Esta teoría, francamente, era muy difícil de asumir, ya que la atmósfera de Marte es muy tenue, no siendo suficiente para frenar los cuerpos, y sabemos por su densidad que estructuralmente cualquiera de estos dos satélites hubiera tenido muy difícil sobrevivir a este mecanismo de captura, fragmentándose y cayendo sobre el planeta debido a las enormes tensiones que hubiese sufrido en su contacto con la atmósfera.

Otro autor, Landis (2002), sugiere que en realidad los satélites de Marte no es que fuesen asteroides capturados, sino que serían los satélites de sistemas binarios de asteroides que Marte robaría con su campo gravitatorio al pasar cerca de Marte, quedándose girando alrededor del planeta rojo.

Pero estos mecanismos no convencen del todo a la comunidad científica, ya que, entre otras cosas, las órbitas de estos satélites deberían, si fueron capturados, ser bastante elípticas en comparación con lo que observamos, aunque por supuesto, los autores de estas teorías proponen mecanismos adicionales que permitirían una circularización orbital con el paso del tiempo.

Deimos captado por la Mars Reconaissance Orbiter. NASA / JPL-Caltech / University of Arizona.

Deimos captado por la Mars Reconaissance Orbiter. NASA / JPL-Caltech / University of Arizona.La mayoría de la comunidad científica hoy día se inclina por un escenario muy similar al de la formación de nuestro satélite, la Luna: uno o varios grandes impactos contra Marte lanzarían al espacio un anillo de material rocoso que poco a poco iría coalesciendo hasta formar los satélites.

Esta teoría es muy atractiva porque sabemos que especialmente en la infancia de nuestro Sistema Solar la ocurrencia de grandes impactos era algo relativamente habitual, por lo que es un mecanismo muy posible, y los satélites formados a partir de un anillo pueden conservar una órbita más o menos circular, como la que se observa en ambos satélites de Marte.

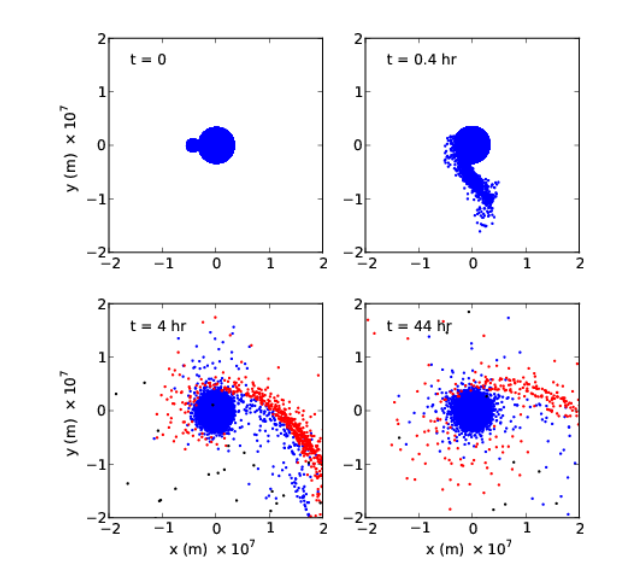

Simulación de la formación de los satélites de Marte mediante un impacto gigante, donde se aprecia la gran cantidad de materia que sale despedida como fruto de la colisión. Imagen cortesía de Citron et al. (2015).

Simulación de la formación de los satélites de Marte mediante un impacto gigante, donde se aprecia la gran cantidad de materia que sale despedida como fruto de la colisión. Imagen cortesía de Citron et al. (2015).Además, cuando observamos de cerca a Fobos y Deimos vemos su superficie completamente cubierta por cráteres de impacto, lo que nos hace pensar -pendientes de poder traer muestras que podamos datar en nuestro planeta- que son satélites formados hace mucho tiempo, por lo que su edad de formación y esa etapa violenta del Sistema Solar podrían coincidir.

Pero todavía hay al menos una teoría más y que desde hace algún tiempo rondaba la mente de algunos de los científicos: ¿Y si Fobos y Deimos en realidad fueron originalmente un solo satélite?

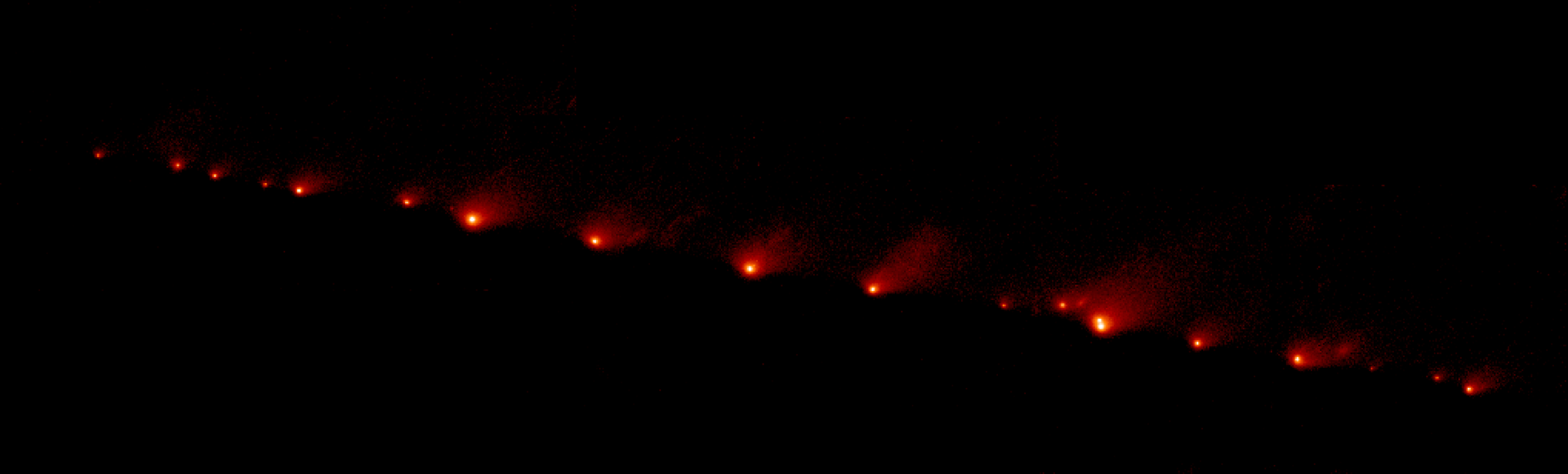

Esta teoría dice que Marte poseía un satélite que fue destrozado o bien por un violento impacto o bien por la gravedad de Marte al acercarse al límite de Roche, una distancia a la cual un cuerpo astronómico, al acercarse a otro, acaba desintegrándose porque la fuerza de gravedad que ejerce el cuerpo más grande es superior a la fuerza que mantiene unido y cohesionado al cuerpo más pequeño. Un ejemplo de este fenómeno lo tenemos en la fragmentación del cometa Shoemaker-Levy 9 en julio de 1992, y cuyos restos acabarían impactando contra Júpiter en 1994.

Fragmentos del cometa Shoemaker-Levy 9 antes de su colisión con Júpiter, observados en mayo de 1994 por el telescopio espacial Hubble. NASA, ESA, and H. Weaver and E. Smith (STScI)

Fragmentos del cometa Shoemaker-Levy 9 antes de su colisión con Júpiter, observados en mayo de 1994 por el telescopio espacial Hubble. NASA, ESA, and H. Weaver and E. Smith (STScI)Este fenómeno habría ocurrido aproximadamente en un rango de fechas que oscila entre los 1000 y los 2800 millones de años (Bagheri et al. (2021)). Al fragmentarse ese satélite primigenio, se habría formado un enorme anillo rocoso alrededor de Marte, posteriormente uniéndose parte de esos trozos y formando sus dos satélites actuales, mientras que otra parte del material habría caído, probablemente, de nuevo sobre la superficie del planeta.

Pero un nuevo estudio publicado en agosto de este mismo año por Landis et al. (2022) empieza a poner en serios apuros a esta teoría: Las simulaciones demuestran que si hubiese ocurrido esto, Marte todavía tendría un sistema de anillos, algo que no observamos en la actualidad.

Pero, además, han realizado numerosas simulaciones en las que han reconstruido la evolución de las órbitas de Fobos y Deimos tal y como si se hubiesen formado a partir de un satélite anterior, observando que tenían unas probabilidades muy altas de chocar a muy alta velocidad, destruyendo ambos satélites en el impacto, de nuevo generando un sistema de anillos que hoy también sería visible.

Así que, de momento, seguimos sin saber con cierto nivel de seguridad como pudieron formarse sus satélites, aunque de momento la teoría que más aceptada se encuentra en la comunidad científica hoy día es que fueron formados a partir de uno o grandes impactos que pusieron en órbita de Marte el material suficiente para dar lugar a estos satélites, aunque todavía queda mucho tiempo para poder confirmar qué pasó realmente.

Si todo va bien, en septiembre de 2024 despegará rumbo a Marte la misión Martian Moons eXploration (MMX), que no solo se encargará de estudiar los satélites marcianos desde la distancia con sus cámaras y espectrómetros, sino que intentará tomar muestras de Fobos para su retorno a la Tierra, que está programado para el mes de julio de 2029, y con las que probablemente podamos responder a cuál fue el verdadero origen de estos satélites marcianos.

Referencias:

Landis, G. (2002). Origin of Martian Moons from Binary Asteroid Dissociation. Accedido: 12 Septiembre de 2022, de 10.48550/arXiv.0903.3434

Citron, R., Genda, H., & Ida, S. (2015). Formation of Phobos and Deimos via a Giant Impact. ArXiv. 10.48550/ARXIV.1503.05623

Bagheri, A., Khan, A., Efroimsky, M. et al. Dynamical evidence for Phobos and Deimos as remnants of a disrupted common progenitor. Nat Astron 5, 539–543 (2021). doi: 10.1038/s41550-021-01306-2

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo El misterio de Fobos y Deimos se ha escrito en Cuaderno de Cultura Científica.

La vida del metabolismo

Foto: Paolo Bendandi / Unsplash

Foto: Paolo Bendandi / UnsplashAunque a veces percibimos el latido del corazón, por regla general no somos conscientes de lo que ocurre en nuestro interior. Lo normal es que no percibamos, por ejemplo, el trajín de las neuronas, ni el trasiego de sales y agua en los riñones. La física y química subyacentes a esos procesos son las que conforman el metabolismo basal, las que nos mantienen vivos. La energía que gastamos en ellas es el precio que, en todo momento, pagamos por estar vivos y viene a representar entre el 50% y el 70% de toda la que utilizamos.

Otros procesos físicos y químicos nos permiten desarrollar actividades tales como hablar, andar o trabajar. A la larga, también los necesitamos para vivir, aunque no en todo momento; la actividad metabólica correspondiente está vinculada a esas actividades físicas. Llamamos metabolismo de rutina, o habitual, a la suma de ambas fracciones.

En la fase fetal el metabolismo es intenso. Por un lado, los organismos de pequeño tamaño tienen, de suyo, una actividad metabólica muy alta; es un fenómeno biológico universal. Y por el otro, el feto es un organismo en crecimiento, en su interior se están formando órganos y tejidos nuevos con rapidez y esa actividad es metabólicamente cara. No obstante, si se descuenta el efecto del tamaño, la intensidad metabólica total de los más pequeños no es tan alta; estaría por debajo, incluso, de la de las personas adultas. Influye el hecho de que en el útero materno la actividad física está, muy comprensiblemente, limitada.

Después del nacimiento, ambos niveles metabólicos, el basal y el habitual, se elevan muy rápidamente hasta alcanzar valores máximos alrededor del primer año de vida. Las criaturas de esa edad tienen un metabolismo que es, descontado el antedicho efecto del tamaño, un 50% más intenso que el de los adultos. La gran producción de tejido nuevo que exige el crecimiento está en la base de ese metabolismo tan alto. Este es un aspecto importante, porque cuanto más intensa es la actividad metabólica, más alimento hay que suministrar al bebé en construcción.

A partir de los 15 meses de vida, el metabolismo desciende hasta los 20 años, para mantenerse después prácticamente constante hasta la quinta o sexta década. En torno a esta edad vuelve a iniciarse un descenso en el nivel metabólico que parece estar relacionado con el deterioro orgánico que se produce asociado al envejecimiento. Salvo durante la fase fetal, en la que el metabolismo ligado a la actividad es de menor entidad, durante el resto de la vida ambas fracciones, la correspondiente al mantenimiento vital y la asociada a la actividad física, llevan cursos bastante paralelos.

El descenso con la edad de la actividad metabólica basal ocurre, en gran medida, porque se reduce la actividad biológica de todos los órganos y, en especial, de los más activos metabólicamente, como el encéfalo y el hígado. Y el de la componente ligada a la actividad muscular, porque tras alcanzar valores máximos entre los 5 y los 10 años, desciende hasta los 18 con rapidez, se estabiliza a continuación, y vuelve a descender más lentamente a partir de los 45 años, aproximadamente.

En síntesis, el periodo vital de máxima intensidad metabólica basal es el primer año de vida, debido al fuerte crecimiento de órganos muy activos metabólicamente. El de máxima actividad física, son los años anteriores a la pubertad. La intensidad metabólica mínima se alcanza a edades avanzadas, pasados los 70, para ambas componentes del metabolismo, porque tanto la actividad de órganos y tejidos como la del sistema muscular se encuentran en declive ya desde años antes.

Fuente: Pontzer, H., Yamada, Y., Sagayama, H. et al, Daily energy expenditure through the human life course. Science 13 Aug 2021, 373 (6556): 808-812 DOI: 10.1126/science.abe5017

Para saber más:

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La vida del metabolismo se ha escrito en Cuaderno de Cultura Científica.

CienciaClip 2020 – El eleixir de la eterna juventud

Ciencia Clip es un concurso de vídeos divulgativos de ciencia diseñados, producidos y protagonizados por estudiantes de Educación Secundaria.

El objetivo del concurso es fomentar el interés por la ciencia y la tecnología. Y ofrecer a los concursantes una oportunidad para ejercitar su creatividad y habilidades comunicativas usando herramientas que proporciona internet.

Ciencia Clip es una iniciativa de la Cátedra de Cultura Científica de la UPV/EHU y en la que colaboran Euskampus Fundazioa, Naukas, Scenio y Big Van.

Los ganadores de la edición 2022 ya están en la página web del concurso. La entrega de premios y el anuncio del vídeo ganador del premio especial se realizarán durante el evento Naukas Bilbao. En la edición de 2020 resultó ganador en la categoría de 3º y 4º de de la ESO Luis Gutiérrez, de Cáceres, con este vídeo:

Edición realizada por César Tomé López

El artículo CienciaClip 2020 – El eleixir de la eterna juventud se ha escrito en Cuaderno de Cultura Científica.

El acoso escolar se ceba en los estudiantes con altas capacidades

Shutterstock / Ground Picture