Los vampiros

“Vampiro. 1. Espectro o cadáver que, según cree el vulgo en algunos países, va por las noches a chupar poco a poco la sangre de los vivos hasta matarlos.

2. Murciélago hematófago de América del Sur.”

Diccionario de la Lengua.

“Si hay una historia bien documentada en el mundo, es la de los vampiros. No falta nada: interrogatorios, certificaciones de notables, de cirujanos, de sacerdotes de la parroquia, de magistrados. La prueba judicial es una de las más completas. Y con todo eso, ¿quién cree en los vampiros? ¿Estaremos todos condenados por no haber creído?

Jean-Jacques Rousseau, Carta a Christopher de Beaumont, 1762.

“Los vampiros les causan a menudo grandes sufrimientos, mordiéndoles en la cruz, no tanto a causa de la pérdida de sangre que resulta de la mordedura, como a causa de la inflamación que luego produce el roce de la silla. Sé que en Inglaterra han puesto en duda últimamente la veracidad de este hecho; por tanto, es una buena suerte el haber estado yo presente un día en que se cogió a uno de esos vampiros (Desmodus d’Orbigny, Wat.), en el mismo dorso de un caballo. Vivaqueábamos muy tarde una noche cerca de Coquinho, en Chile, cuando mi criado, advirtiendo que un caballo de los nuestros estaba muy agitado, fue a ver qué ocurría; creyendo distinguir algo encima del lomo del caballo, acercó con rapidez una mano y cogió un vampiro. A la mañana siguiente, la hinchazón y los coágulos de sangre permitían ver dónde había sido mordido el caballo; tres días después hicimos uso de éste, sin que pareciera resentirse ya de la mordedura.”

Charles Darwin, Viaje de un naturalista alrededor del mundo, 1839.

Contaba Anthony Masters en su libro sobre vampiros, publicado en 1974, que hay dos tipos de vampiro, el mítico y el real, y ambos, según cuenta, pueden matar y son asesinos. El mítico, cuenta la leyenda, mata personas por miles, incluso solo por el terror que provoca. En su tiempo, y quizá ahora, era juzgado, condenado y ejecutado por asesino psicópata o, si no era así, simplemente era linchado. El vampiro real ataca para alimentarse y se le tiene por cruel y estremecedor.

Foto: Clément Falize / Unsplash

Foto: Clément Falize / UnsplashLa mitología del vampiro, de ese vampiro mítico, no el real, aparece en muchas culturas y religiones de todo el mundo, tal como detalla Anthony Masters. La definición de vampiro y de vampirismo varía según el origen de la leyenda. En la mitología, los vampiros son seres no muertos, inmortales por tanto, y misteriosos y nocturnos. Ocupan la frontera, que atraviesan si les apetece, entre el mundo de los vivos y el de los muertos. El grupo de K. Gubb, del Hospital Box-Hill de Melbourne, en Australia, escribe que los vampiros son criaturas poderosas que provocan miedo, intrigan y fascinan, y dominan a otras personas. Se hicieron famosos y conocidos con los escritos de John Polidori y Bram Stoker en el siglo XIX.

En la revisión sobre vampirismo, que publicaron en 2013, Lennon da Costa Santos y sus colegas, de la Universidad Federal de Minas Gerais, en Brasil, proponen que se cree en la existencia de los vampiros cuando, en alguna persona, se observan síntomas de algunas enfermedades que recuerdan la descripción del aspecto de los vampiros de las leyendas. Mencionan la porfiria, que provoca un semblante anémico con una palidez exagerada. Es una enfermedad causada por un defecto metabólico que impide la síntesis de la hemoglobina de la sangre y, como efectos, hay anemia y palidez. La síntesis de la hemoglobina se detiene un paso anterior, cuando se produce la porfirina, molécula que precede a la hemoglobina, que, por tanto, se acumula en los tejidos del paciente, sobre todo en la zona subcutánea, los huesos y los dientes.

Además, la porfirina reacciona a la luz y produce radicales de oxígeno que, al sol, pueden provocar heridas en la piel. De ello la leyenda sobre la aversión al sol de los vampiros que, incluso, los puede destruir, y su obligada vida nocturna. La porfirina, en casos graves, llega a deformar el rostro, retrae los labios y muestra la dentadura que, así, parece más grande de lo habitual. Son los afilados colmillos del vampiro. Los enfermos de porfiria desarrollan conductas antisociales, agresividad y aislamiento, incluso desórdenes mentales. Para la imaginación popular, son seres malditos o demonios encarnados.

Vampiro (1895) de Edvard Munch

Vampiro (1895) de Edvard MunchLos autores aluden al Doctor Juan Gómez Alonso que, en su tesis, defendida en 1992, y en publicaciones posteriores, relaciona el vampirismo popular con la rabia y menciona la coincidencia de una epidemia de esta enfermedad en Hungría, a principios del siglo XVIII, con la difusión de leyendas sobre vampiros en áreas montañosas y remotas de los Cárpatos. Gómez Alonso comenta que el vampirismo, según el mito, se transmite por mordedura, como muchas enfermedades transmitidas por animales y, entre ellas, la rabia. Además, el vampiro se puede transformar a voluntad en lobo, perro o murciélago, animales todos ellos que pueden contagiar de la rabia.

Es una enfermedad que altera la conducta, provoca más agresividad, y actúa en áreas cerebrales del sistema límbico, como el hipotálamo o la amígdala, encargadas de sentimientos y emociones. Lleva a conductas nocturnas, como la leyenda dice de los vampiros. Hay otros síntomas de la rabia que recuerdan a los relatos de vampiros: espasmos musculares, gruñidos, hidrofobia, fotofobia o, incluso, evitar la propia imagen en el espejo.

En conclusión, para Gómez Alonso, las epidemias de rabia del siglo XVIII pudieron ampliar y difundir los mitos sobre vampiros, ya existentes, en Europa centra y oriental.

Una tercera enfermedad a la que se atribuye la leyenda sobre los vampiros es la pelagra, provocada por la deficiencia en vitamina B3 o niacina que, en el siglo XVIII, en la época de la difusión de las leyendas sobre vampiros, se atribuye a la extensión del cultivo del maíz, que llegó a Europa desde América y, poco a poco, por su fácil cultivo y rendimiento, se convirtió en la base de la alimentación de las clases más pobres. La falta de vitamina B3 en el maíz provocó la deficiencia en esta vitamina en quienes lo tenían como el alimento más consumido.

Según la hipótesis de Jeffrey Hampl y William Hampl III, de las universidades de Massachusetts y de Rhode Island, la pelagra provoca dermatitis y demencia, con insomnio e irritabilidad, y, además, hipersensibilidad a la luz que les provoca alteraciones en la piel y quemaduras. Se inflaman los labios y los dientes parecen más grandes. Todos ellos son síntomas que también describen a los vampiros.

En psiquiatría, el vampirismo clínico se define como una creencia en fantasmas chupadores de sangre o que intentan conseguir sangre pues les produce un profundo placer sexual. Otros autores, según Gubb, consideran que el vampirismo clínico es el acto concreto de beber sangre de la víctima, una conducta poco común que se asocia con la esquizofrenia. Y hay expertos que asocian el vampirismo con actos agresivos o sexuales con cadáveres o con moribundos. Incluso se han descrito pacientes con autovampirismo cuando el sujeto bebe su propia sangre.

Uno de los vampiros más famosos del último siglo fue Peter Kürten, conocido como el Vampiro de Dusseldorf, nacido en 1893, asesinó, según la sentencia que le condenó, a nueve personas, con más intentos frustrados y más de ochenta agresiones sexuales. Murió guillotinado en 1931, a los 48 años, y la leyenda cuenta que preguntó, poco antes de la ejecución, si, una vez cortada la cabeza, oiría, aunque fueran unos segundos, la sangre saliendo de su cuerpo. En el juicio relató su pasión por beber la sangre de sus víctimas, en un síndrome llamado hematodipsia.

A pesar de la popularidad del vampirismo, las publicaciones científicas sobre este síndrome son escasas, sobre todo a partir de 1940, lo que indica la escasa investigación sobre ello. El grupo de Gubb llega a esta conclusión después de comentar trabajos publicados en Sudáfrica, Francia, Suiza y Estados Unidos hasta 2006.

Un vampiro común (Desmodus rotundus) alimentándose de un cerdo (animales disecados expuestos en el Museo de Historia Natural de Viena). Foto: Sandstein /Wikimedia Commons

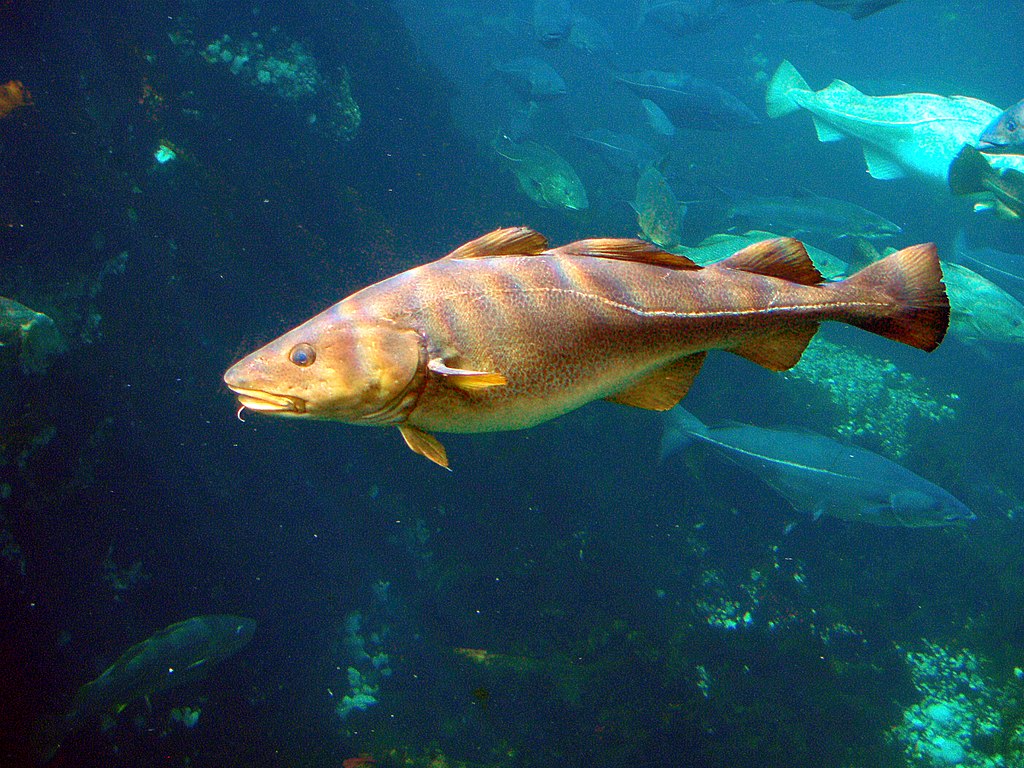

Un vampiro común (Desmodus rotundus) alimentándose de un cerdo (animales disecados expuestos en el Museo de Historia Natural de Viena). Foto: Sandstein /Wikimedia CommonsDespués de repasar el mito vamos a conocer la realidad del vampiro. Son murciélagos con una dieta exclusivamente de sangre. Son los únicos mamíferos con alimentación hematófaga o, si se quiere, sanguívora aunque sea una palabra que no está en el Diccionario. Solo hay tres especies de murciélagos con dieta de sangre: el vampiro común, Desmodus rotundus, que ya conocía Darwin; el vampiro de piernas peludas, o Dyphylla ecaudata, y el vampiro de alas blancas o Diaemus youngi, que solo gusta de la sangre de aves. Las tres especies se encuentran en Centro y Sudamérica, desde México hasta Chile y Argentina.

Las tres especies pertenecen a la misma familia aunque a distintos géneros, y se supone que han tenido un antepasado común. En esa familia hay murciélagos con dietas muy variadas como, por ejemplo, se alimentan con néctar, polen, insectos, frutas, pescado y carne. Y, como sabemos, solo tres especies tienen dieta de sangre, unos 10 mililitros al día. Al morder, segregan un anticoagulante que es una proteína muy apropiadamente llamada draculina. Horas después de la mordedura, la herida sigue sangrando con suavidad. Por cierto, rara vez muerden a una persona y, si lo hacen, es en las extremidades, los dedos o la nariz.

Es una dieta poco habitual y supone adaptaciones para que sea funcional y eficaz: mucho líquido y, por tanto, un potente sistema renal para eliminarlo, y una gran vejiga para almacenar la orina; riesgo, si no se controla y elimina el exceso de hierro, de provocar síntomas de toxicidad; además, es una dieta con exceso de proteínas y pocos carbohidratos y vitaminas; fuertes caninos para morder; sistema sensorial para detectar, por medio de infrarrojos, las zonas calientes de la piel de la víctima como las áreas con más cercanía del sistema circulatorio y de la sangre y allí, morder,…

El estudio del genoma del vampiro común, Desmodus rotundus, del grupo de Lisardia Zepeda, de la Universidad de Copenhague, ha localizado algunas de las adaptaciones a la dieta de sangre. Tienen vías de síntesis de vitamina B, que es muy escasa en la sangre y necesitan elaborarla. Hay proteínas en el intestino del vampiro que, con agua y dióxido de carbono, abundantes en la sangre, sintetizan hidratos de carbono. El exceso de hierro en la sangre se controla por genes que dirigen su eliminación. Las proteínas de la sangre se metabolizan y los productos resultantes se eliminan por el sistema renal en la orina.

Estos autores también han localizado los genes que dirigen la detección de radiación infrarroja, es decir, de calor, para encontrar en la piel las zonas con más circulación de sangre y, así, elegir el lugar para morder.

Estas adaptaciones, según el estudio publicado por el grupo de Fidel Botero Castro, de la Universidad de Montpellier, sobre el ADN de las mitocondrias, revelan que se habían seleccionado hace unos 4 millones de años, con una relativa rapidez para lo que duran estos procesos.

Referencias:

Botero Castro, F. et al. 2018. In cold blood: Compositional bias and positive selection drive the high evolutionary rate of vampire bats mitocondrial genomes. Genome Biology and Evolution 10: 2218-2239.

Gómez, J.A. 1998. Rabies: a posible explanation for vampire legend. Neurology 51: 856-859.

Gubb, K. et al. 2006. Clinical vampirism: a review and illustrative case report. South African Psychiatry 9: 163-168.

Hampl, J.S. & W.S. Hampl III. 1997. Pellagra and the origin of a myth: evidence from European literatura and folklore. Journal of the Royal Society of Medicine 90: 636-639.

Masters, A. 1974. Historia natural de los vampiros. Ed. Bruguera. Barcelona. 318 pp.

Santos, L.C.S. et al. Medical explanations for the myth of vampirism. Revista Medica de Minas Gerais 23: 510-514.

Velasco, E. 2018. Descubren cómo los vampiros pasaron a alimentarse solo de sangre. La Vanguardia 20 enero.

Wikipedia. 2018. Vampire bat. 29 October.

Wikipedia. 2020. Peter Kürten. September 4.

Zepeda Mendoza, M.L. et al. 2018. Hologenomic adaptations underlying the evolution of sanguivory in the common vampire bat. Nature Ecology & Evolution doi: 10.1038/s41559-018-0476-8

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Los vampiros se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:César Tomé López – Naukas P4K 2019: ¿Eureka?¿En serio?

Aunque un experimento te lo cuente cualquier libro de texto no quiere decir que como te lo cuentan sea correcto. Por eso es tan importante reproducir los experimentos. El caso de Arquímedes y la corona ilustra el argumento. Da la charla César Tomé López, editor de este Cuaderno de Cultura Científica, de Mapping Ignorance y responsable de proyección internacional de Euskampus Fundazioa.

La conferencia se impartió dentro del marco del festival Passion for Knowledge 2019 (P4K) organizado por el Donostia International Physics Center (DIPC).

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo César Tomé López – Naukas P4K 2019: ¿Eureka?¿En serio? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- José Miguel Viñas – Naukas P4K 2019: De nubes las pinacotecas están llenas

- Joaquín Sevilla – Naukas P4K 2019: Lo que esconden unos champiñones al ajillo

- Ambrosio Liceaga – Naukas P4K 2019: Nunca quisimos coches voladores

El cannabis rompe el equilibrio metabólico entre neuronas y astrocitos alterando el comportamiento social

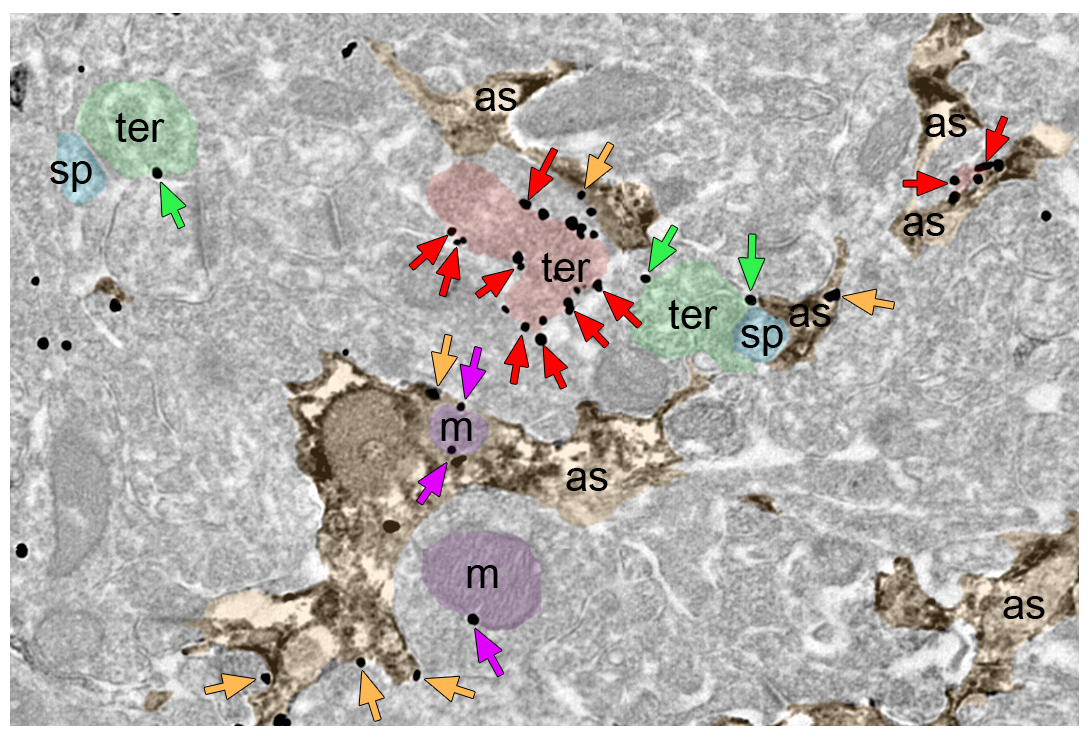

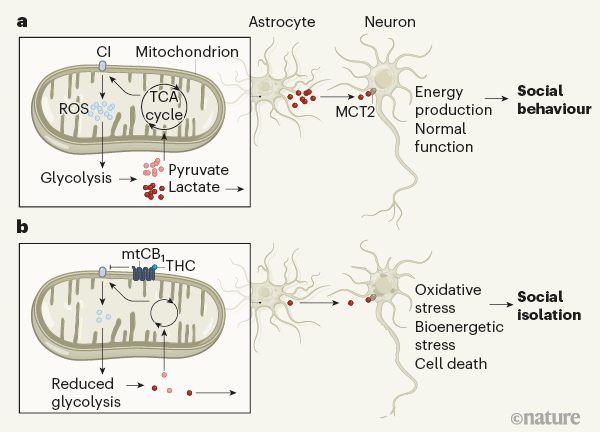

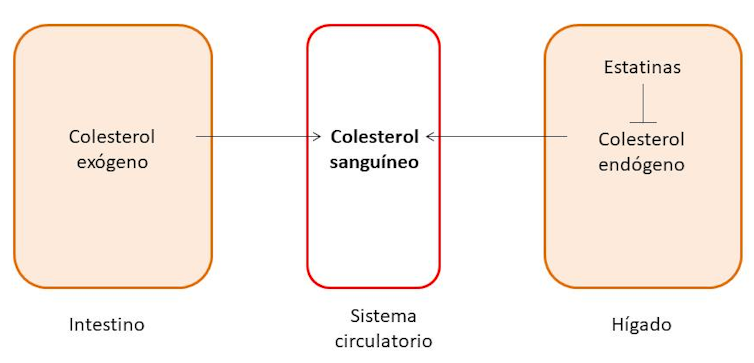

El sistema nervioso está formado por neuronas y células gliales. De estas últimas, las más abundantes son los astrocitos, que, entre otras muchas funciones, se encargan de captar la glucosa del torrente sanguíneo para proporcionar energía y permitir la actividad neuronal necesaria, y así asegurar que las funciones cognitivas se ejecuten de una manera correcta. Los receptores cannabinoides tipo 1 (CB1), que modulan la comunicación entre los astrocitos y las neuronas, constituyen la principal diana del componente psicoactivo del cannabis, llamado delta-9-tetrahidrocannabinol (THC).

¿Qué pasa cuando el THC actúa sobre los astrocitos? La investigación, en la que ha participado el grupo del doctor Pedro Grandes del Departamento de Neurociencias de la Facultad de Medicina y Enfermería de la UPV/EHU, concluye que la activación de los receptores de cannabinoides CB1 en las mitocondrias (orgánulos celulares encargados de la producción de energía) de los astrocitos de ratón impide el metabolismo de la glucosa y la producción de lactato en el cerebro, lo cual altera la función neuronal, causando un deterioro de las conductas de interacción social.

Según el Dr. Grandes, “la activación de estos receptores conduce a que los astrocitos generen una menor cantidad de especies reactivas de oxígeno, lo que afecta negativamente a la producción glucolítica de lactato causando un estrés neuronal y una falta de interacción social. La importancia de esta investigación radica no sólo en la identificación de este déficit que puede revertirse mediante la manipulación genética y farmacológica de estos cambios moleculares y bioquímicos causados por el tratamiento cannabinoide, sino también por lo que aporta al conocimiento de las alteraciones causadas por el cannabis en el cerebro”.

La colaboración del grupo de investigación del Dr. Pedro Grandes con el equipo del Dr. Giovanni Marsicano, de la Universidad de Burdeos, resultó fundamental hace unos años para demostrar por primera vez la presencia de receptores CB1 en las mitocondrias de las neuronas, cuya activación reduce la actividad mitocondrial causando pérdida de memoria. Los resultados de estos estudios se publicaron en el año 2012 en Nature Neuroscience y en 2016 en Nature. Sin embargo, “quedaba pendiente conocer cuál era la función de los receptores CB1 localizados en mitocondrias de astrocitos, de ahí la relevancia de este nuevo hallazgo, que además supone una continuidad en la línea de investigación y cooperación transfronteriza”, explica el doctor Grandes. Este descubrimiento se ha publicado en Nature.

Referencias:

Jimenez-Blasco D, Busquets-Garcia A, Hebert-Chatelain E, Serrat R, Vicente-Gutierrez C, Ioannidou C, Gómez-Sotres P, Lopez-Fabuel I, Resch-Beusher M, Resel E, Arnouil D, Saraswat D, Varilh M, Cannich A, Julio-Kalajzic F, Bonilla-Del Río I, Almeida A, Puente N, Achicallende S, Lopez-Rodriguez ML, Jollé C, Déglon N, Pellerin L, Josephine C, Bonvento G, Panatier A, Lutz B, Piazza PV, Guzmán M, Bellocchio L, Bouzier-Sore AK, Grandes P, Bolaños JP, Marsicano G. (2020) Glucose metabolism links astroglial mitochondria to cannabinoid effects Nature doi: 10.1038/s41586-020-2470-y

Magistretti, P.J. (2020) How lactate links cannabis to social behaviour Nature (News & Views) 583, 526-527 doi: 10.1038/d41586-020-01975-5

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo El cannabis rompe el equilibrio metabólico entre neuronas y astrocitos alterando el comportamiento social se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El límite entre la vida y la muerte en las neuronas

- Un nexo cannabinoide entre mitocondrias y memoria

- El citoesqueleto de las neuronas y el alzhéimer

Mayas y aztecas en la orquesta

Concha trompeta de Chipícuaro. Arte tolteca (años 300-900). Fuente: Smithsonian Institution

Concha trompeta de Chipícuaro. Arte tolteca (años 300-900). Fuente: Smithsonian Institution

Las caracolas han fascinado a los humanos desde siempre. Sus formas intrincadas, sus hermosos colores y patrones, el misterio de su cámara interior capturan la imaginación. Pero además de estas cualidades visuales, tienen un encanto adicional. Gracias a su potente sonido, las caracolas se han utilizado desde la antigüedad en culturas de todo el mundo para atravesar las distancias y el corazón de los dioses. En Nueva Guinea, aún existen llamadas estándar que dan la voz alarma, anuncian una caza exitosa u otros eventos importantes. Sus poderes sobrenaturales fueron conocidos asimismo en Europa. En Bohemia Occidental, se hacía sonar una caracola para ahuyentar a las tormentas. En la India, el shankha es una pieza esencial del budismo y el hinduismo. Constituye un recipiente ritual, así como un instrumento para ocasiones solemnes y ceremonias religiosas. En la mitología hindú, es un emblema sagrado del dios Vishnu. Los monjes tibetanos aún hoy la hacen sonar para convocar a los devotos. Como los niños náufragos de la novela de Golding, los fieles acuden a su llamada limpia y penetrante a través de la distancia.

Quetzalcoatl con la coraza del viento al cuello. Fuente: Wikimedia Commons.

Quetzalcoatl con la coraza del viento al cuello. Fuente: Wikimedia Commons.De entre todas estas culturas, la caracola jugó un papel ritual especialmente importante en las sociedades precolombinas de América central y América del sur. Su uso está particularmente bien documentado en la mayoría de las áreas culturales de mesoamérica y en la zona de México occidental, donde se vinculaba a eventos sociales y ceremonias religiosas. Muchos de sus restos se han encontrado en sitios funerarios, indiando su papel como ofrendas1 en diversos ritos de paso. Normalmente, estaban ricamente decoradas, con todo tipo de relieves y pinturas. Cumplían asimismo un papel importante en la guerra, como instrumento de llamada. En algunas sociedades, se asociaban a los rituales y la parafernalia de los chamanes, que ejercían como líderes tanto espirituales y guerreros. De manera más general, la caracola se asociaba como símbolo a Quetzalcoatl, la serpiente emplumada, el dios azteca del viento, el aire y el aprendizaje que siempre llevaba alrededor del cuello la «coraza de viento» o ehecailacocozcatl. Este talismán con forma espiral se fabricaba, precisamente, a paritr de la sección transversal de una caracola y fue usado como collar por gobernantes y sacerdotes.

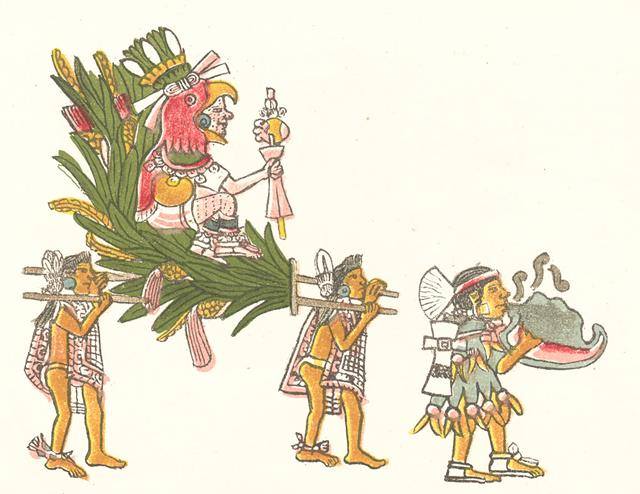

Una ilustración en el Códice Magliabecchiano muestra a un caracolista (en la cultura azteca eran conocidos como quiquizoani)con su mano introducida dentro de su instrumento (quiquiztli). Podría parecer una forma casual de sujetarlo pero no es el caso. Una de las limitaciones de la concha, es que, a priori, no puede producir más de una nota. Su tono viene dado por su longitud y a priori, este parámetro no es algo que se pueda cambiar. Sin embargo, los caracolistas como Steve Turre, son capaces de afinar varios sonidos introduciendo la mano en el extremo abierto de la caracola. Al hacerlo, el espacio disponible en su interior se vuelve más pequeño, las ondas sonoras se acortan y el resultado es un sonido sensiblemente más agudo que el original. El efecto es el mismo que cuando alguien vierte agua dentro una botella para cambiar su tono: la mano haría la función del líquido, en este caso. Hoy en día, los intérpretes de trompa utilizan esta misma técnica de afinación “manual” para afinar ciertas notas. Este instrumento de viento metal hermosamente acaracolado, tiene de hecho un origen muy similar al de la concha. Las versiones primitivas de la trompa consistían sencillamente en cuernos de animales encontrados (en inglés su nombre todavía es horn, de hecho), que fueron ganando complejidad hasta adquirir su actual forma metálica. Sin embargo, el recurso de afinar con la mano no fue explotado en Europa hasta el siglo XVIII. La ilustración del Códice Magliabecchiano sugiere que ya era utilizado por los intérpretes de conchas aztecas al menos desde dos siglos antes.

Códice Magliabecchiano, XIII, 11, 3. Xochipilli, “noble flor”, dios del sol naciente, las flores y la alegría, es llevado en una litera adornada con mazorcas. Códice Magliabechiano, f. 35r. Reprografía: Marco Antonio Pacheco / Raíces. Fuente: Wikimedia Commons

Códice Magliabecchiano, XIII, 11, 3. Xochipilli, “noble flor”, dios del sol naciente, las flores y la alegría, es llevado en una litera adornada con mazorcas. Códice Magliabechiano, f. 35r. Reprografía: Marco Antonio Pacheco / Raíces. Fuente: Wikimedia Commons

Curiosamente, la vinculación de las conchas con las culturas de centroamérica ha traído de vuelta este instrumento al mundo de las orquestas. Muchos compositores contemporáneos, especialmente en ese lindísimo país llamado México, han utilizado su característico sonido para evocar los ecos del pasado de su nación. Recuerdo la primera vez que yo escuché el penetrante tono de una caracola, brillante, tenso y doloroso, llenando la sala Nezahualcóyotl de la Ciudad de México. Sonaba el último movimiento La Noche de los Mayas (20’30’’) de Silvestre Revueltas y el público había hecho suyo aquel concierto. Fue un momento emocionante.

Referencia:

1Novella, Robert. (1991). Shell Trumpets from Western Mexico. Papers from the Institute of Archaeology. 2. 42. 10.5334/pia.16.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Mayas y aztecas en la orquesta se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Un juego con un premio colosal

Se propone un juego entre cuatro personas (Ana, Blas, Carmen y David) con un “colosal” ipremio para aquella que gane: las obras completas de Paul Erdős.

Las reglas del juego son las siguientes: cada participante recibe dos dados con las caras numeradas de una manera que no es la habitual. El primer dado tiene marcadas en sus caras los números 2, 7, 7, 12, 12 y 17, y el segundo las cifras 3, 8, 8, 13, 13, y 18. Los dados son equilibrados, es decir, cada cara tiene la misma probabilidad de salir, que es de 1/6.

En privado, sin nadie observando, cada participante tira 20 veces ambos dados. Anota el resultado de la suma de las cantidades alcanzadas en cada tirada y adiciona los veinte resultados obtenidos. Gana la persona cuya puntuación final sea mayor.

Sin embargo, quizás por los nervios o quizás por torpeza, puede suceder que las sumas no sean correctas. Incluso puede ocurrir que alguno de los participantes, pensando que así tendrá más posibilidades de vencer en el juego, mienta en su resultado. La posibilidad engañar existe, ya que nadie les está vigilando.

Por todo ello se dispone de un juez imparcial, Ernesto, preparado para descalificar a cualquier participante si, con un 90 % de certeza, cree que ese jugador o jugadora ha fallado al sumar o, abiertamente, ha mentido.

Después de explicar estas reglas, los participantes se encierran para proceder a lanzar sus dados… y sumar (¿quizás inventar?). Tras finalizar sus tiradas, declaran lo siguiente:

-

Ana confirma que ha sacado 385 puntos,

-

Blas dice que ha obtenido 840 puntos,

-

Carmen afirma que sus tiradas suman 700 puntos y

-

David anuncia que ha conseguido 423 puntos.

Pocos minutos después, Ernesto, el juez, declara: “Sin ninguna duda, Ana es la ganadora”.

¿Sabrías explicar la razón?

Antes de argumentar, vamos a reflexionar sobre las sumas que se pueden obtener.

-

Observar que los números del primer dado son todos congruentes con 2 módulo 5, es decir, las cifras 2, 7, 12 y 17, al dividirlas por 5, dan como resto 2. Del mismo modo, los números del segundo dado son todos congruentes con 3 módulo 5, es decir, las cifras 3, 8, 13 y 18, al dividirlas por 5 dan como resto 3. Así, al sumar las cantidades obtenidas en una tirada (las procedentes de los dos dados), la cantidad resultante es siempre un múltiplo de 5, por lo que la suma final también debe serlo.

-

La menor suma que puede obtenerse en una tirada es 5 (2+3) y la mayor 35 (17+18). Así, el resultado final de las sumas tras las 20 tiradas oscila entre 100 (5×20) y 700 (35×20).

Tras estas sencillas observaciones, Ernesto ha podido descalificar directamente a David (la suma que da este jugador no es un múltiplo de 5) y a Blas (es imposible obtener 840 puntos sumando los resultados de las 20 tiradas) que, o bien se han equivocado al sumar o bien han querido hacer trampa.

Carmen afirma que sus tiradas han sumado 700, lo que significa que, en cada una de las 20 tiradas, ha obtenido la máxima puntuación, que es de 35… y desde luego es posible que eso haya sucedido. Pero, ¿cuál es la probabilidad de que suceda? La probabilidad de que salga 35 en una tirada es de 1/62=1/36 (se debe obtener 17 en el primer dado y 18 en el segundo). Por lo tanto, la probabilidad de que salga 35 en las veinte tiradas es de 1/640 (cada tirada es un suceso independiente). Y este número es del orden de 1,34×10-31, una cantidad realmente pequeña. Claro que es posible que Carmen haya sacado un montante de 700 por azar, pero es muy poco probable. Así que Ernesto, con el 90 % de certeza, puede descalificar a Carmen.

¿Lo que dice Ana es creíble? Desde luego 385 es un múltiplo de 5. El resultado más probable es el de 400 (20×20=400). ¿Por qué? Porque puede obtenerse una suma de 20 en una tirada de diez maneras distintas: 2+18 (un modo), 7+13 (cuatro formas), 12+18 (cuatro maneras) y 17+3 (un modo). El resto de las sumas posibles son: 5 (2+3), 10 (2+8, 7+3; de cuatro modos), 15 (2+13, 7+8; 12+3, de ocho maneras), 25 (7+18, 12+13; 17+8; de ocho maneras), 30 (12+18, 17+13; de cuatro modos) y 35 (17+18; de una manera).

Por otro lado, la suma de 385 es posible de obtener (por ejemplo, con 17 tiradas sumando 20 y otras tres sumando 15. O con 10 tiradas de 25, 7 de 15 y 3 de 10, etc.). Así que lo que dice Ana es creíble y, habiendo sido excluidos Blas, Carmen y David, ¡ella es la ganadora!

Notas:

Este problema se ha extraído de ¿Puedes resolver el acertijo del rey tramposo? de Dan Katz en TED-ed.

iPaul Erdös (1913-1996) fue uno de los más prolíficos matemáticos en cuanto a publicaciones científicas: unos 1.500 artículos con más de 500 coautores. Por ello podemos calificar sus obras completas como un premio “colosal”.

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Un juego con un premio colosal se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El juego del Sim

- Un juego de mesa para entender la irreversibilidad

- Matemáticas en el juego de cartas SET (1)

La impureza, por definición, de las muestras radiactivas

Foto: ActionVance on Unsplash

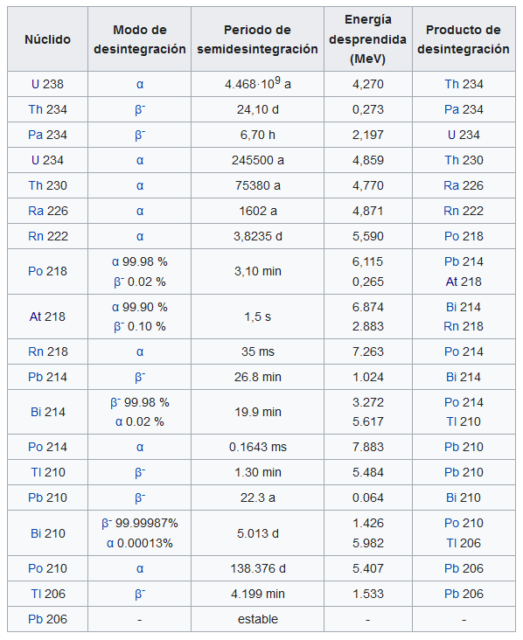

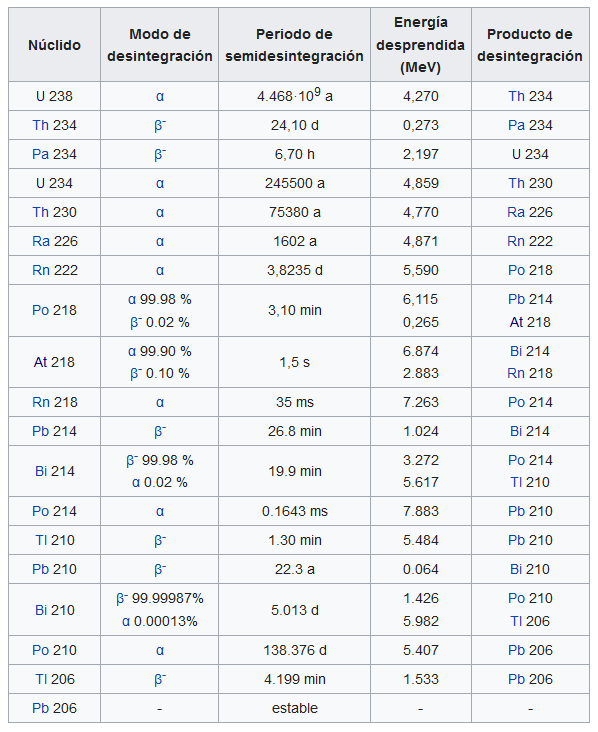

Foto: ActionVance on UnsplashConviene quizás en este punto de nuestra exploración del núcleo atómico pararnos un momento a considerar qué significa desde el punto de vista práctico que tengamos una muestra de un determinado material radiactivo puro. La muestra, sin actuar sobre ella y aislada, no será pura si pasa el tiempo suficiente. Esto es algo fundamental que hace que un material radiactivo sea algo completamente diferente de una sustancia o un elemento no radiactivos. Para ilustrar esta idea recomendamos leer Las series de desintegración radiactiva y tener presente la tabla que presentábamos en esa anotación:

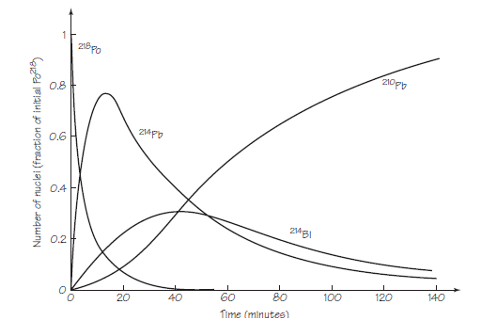

Fijémonos, por ejemplo, en la porción de la serie uranio-radio que empieza con el polonio-218. Se puede recoger polonio-218 exponiendo un trozo de material ordinario, como una lámina delgada de aluminio, a gas radón. Algunos de los átomos de radón se desintegran en átomos de polonio-218, que luego se adhieren a la superficie de la lámina. Ya tenemos nuestra muestra pura. Ahora la dejamos aislada y no hacemos nada. ¿Qué ocurre? Lo ilustra la siguiente gráfica:

El polonio-218 (218Po) se desintegra en plomo-214 (214Pb), que se desintegra en bismuto-214 (214Bi), que se desintegra en polonio-214 (214Po), luego plomo-210 (210Pb), luego bismuto-210 (210Bi), etc. Si la muestra original contenía 1,000,000 átomos de 218Po cuando la recogimos, después de 20 min contendrá alrededor de 10,000 átomos de 218Po, alrededor de 660,0000 átomos de 214Pb, alrededor de 240,000 átomos de 214Bi y alrededor de 90,000 átomos de 210Pb. El número de átomos de 214Po es insignificante porque la mayoría de los 214Po se habrá transformado en 210Pb en una pequeña fracción de segundo.

Análogamente, una muestra de radio puro recién obtenida (226Ra) también cambiaría en composición de una manera compleja, pero mucho más lentamente. Con tiempo suficiente, consistiría en una mezcla de algo de 226Ra restante, más radón-222, polonio-218, plomo-214 y el resto de los miembros de la cadena hasta el «radio G» estable (plomo-206). De manera similar, una muestra de uranio puro puede contener, después de un tiempo, otros 14 elementos de los cuales 13 (todos menos la última parte estable) contribuyen a la emisión radiactiva, cada uno a su manera.

En todos estos casos, el resultado es una mezcla compleja de elementos. Pero, fijémonos, que desde el punto de vista de las emisiones radiactivas también se ha producido un cambio fundamental: Tras comenzar como un emisor alfa puro, la muestra original termina emitiendo toda clase de partículas, alfa, beta y rayos gamma, aparentemente de forma continua y simultánea.

Vemos pues que la separación de los diferentes miembros de una cadena radiactiva entre sí es algo muy difícil, especialmente si algunos miembros de la cadena se desintegran rápidamente. Uno de los métodos empleados con éxito dependía de la hábil purificación química de una sustancia radiactiva en concreto, como habían hecho los Curie con el radio y el polonio. La enorme complejidad y el ingenio del trabajo experimental necesarios para aislar y determinar las propiedades de cada uno de los elementos de una serie radiactiva son dignos de admiración.

Supongamos ahora que hemos obtenido una muestra de la que se han eliminado todos los átomos radiactivos excepto los de radio-226. La muestra comienza a emitir gas radón inmediatamente. Este último puede extraerse y examinarse sus propiedades antes de que se contamine seriamente por la desintegración de muchos de sus átomos en polonio-218. Si conseguimos hacer esto, encontraremos que el radón se desintegra (a través de varias transformaciones) en plomo mucho más rápidamente que el radio se desintegra en radón. Pero, ¿cómo medimos la velocidad de desintegración y por qué existen velocidades diferentes?

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La impureza, por definición, de las muestras radiactivas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La transformación radiactiva

- La carga de las partículas radiactivas

- Las series de desintegración radiactiva

Las huellas dactilares, el FBI y la teoría de Fourier modernizada

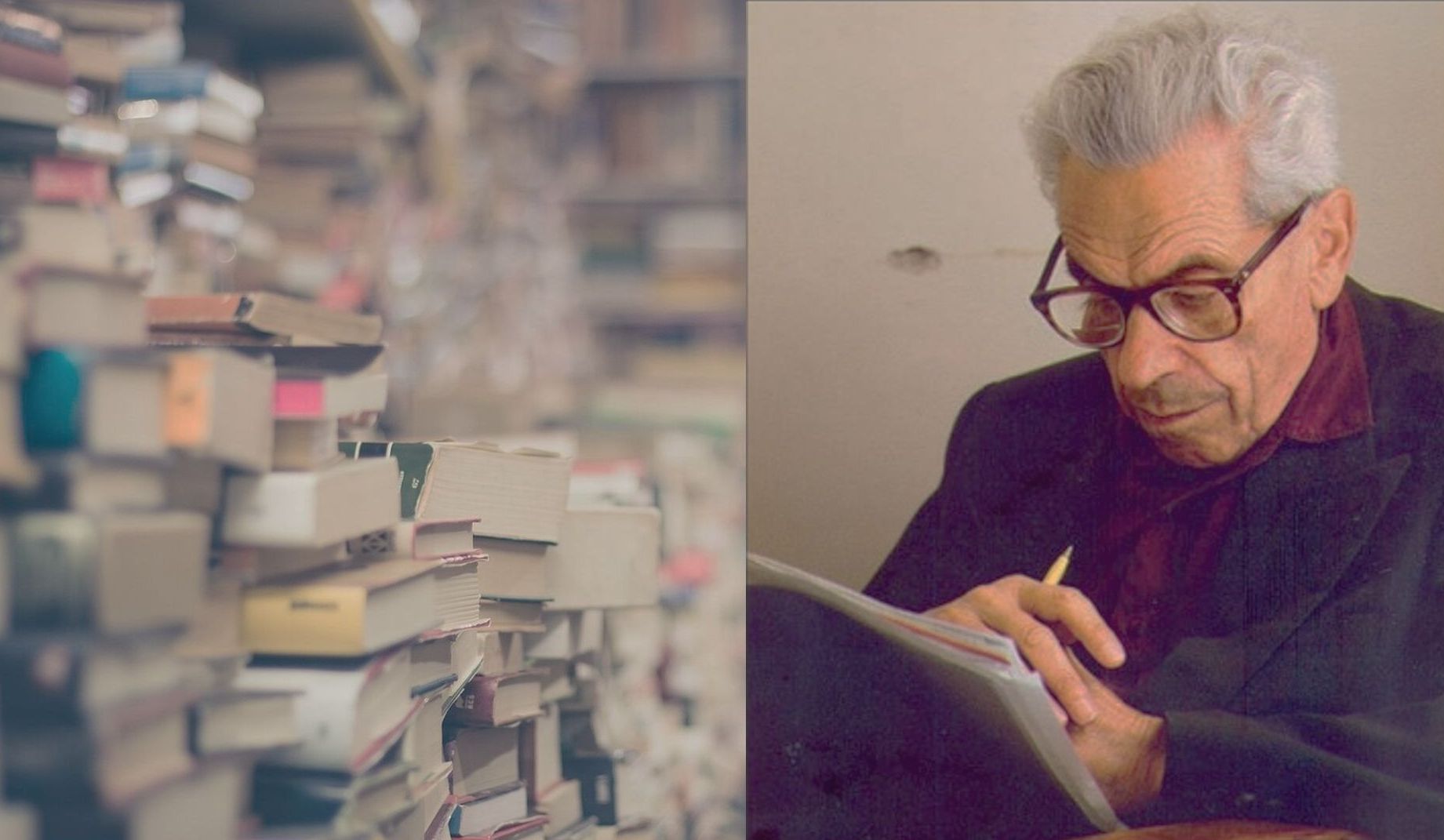

Javier Duoandikoetxea

Las huellas dactilares nos identifican, por eso los detectives las buscan en el lugar donde se ha producido un delito. No resulta sorprendente, por tanto, saber que hay colecciones gigantescas de huellas dactilares en los archivos policiales.

Imagen 1: Ventana de vidrio simulando huellas dactilares. (Fotografía: Eveline de Bruin – Licencia Pixabay. Fuente: pixabay.com)

Imagen 1: Ventana de vidrio simulando huellas dactilares. (Fotografía: Eveline de Bruin – Licencia Pixabay. Fuente: pixabay.com)El FBI comenzó a tomar huellas dactilares en 1924 mediante el uso de fichas de cartón, en las que los dedos mojados en tinta dejaban su marca. En 1993, ya tenía almacenadas más de 25 millones de fichas. Para entonces, el uso de los ordenadores ya había comenzado a extenderse y estaba claro que los archivos digitales reportarían grandes ventajas, tanto para guardar huellas dactilares como para realizar búsquedas, por lo que se procedió a la digitalización.

Es importante asegurar con la mayor precisión posible a quién pertenece una huella dactilar. Por eso, para digitalizar los archivos se eligió una imagen de 500 puntos por pulgada, a escala de colores grises de 8 bytes. Esto generaba un fichero de 10 MB de cada ficha, de modo que la digitalización de todo el archivo requería soportes con gran espacio. Además, hace 25 años la capacidad de almacenamiento de los dispositivos era muy inferior a la actual. Entonces, ¿qué hacer? La clave estaba en la compresión.

Recordemos que comprimir es reducir el tamaño del fichero y que, para que eso resulte útil, hay que hacerlo sin perder información importante. El sistema de compresión JPEG, habitual para las fotografías, se lanzó en 1992 y fue el elegido por los expertos del FBI para llevar a cabo el proceso de digitalización. A pesar de ello, no quedaron satisfechos con los resultados, ya que la imagen resultante no les parecía adecuada. ¿Por qué?

En la mayoría de los casos, al pasar de un píxel a otro el cambio de color que se produce es pequeño, que es lo que aprovecha el sistema JPEG. Por eso, en las zonas de los bordes el resultado no es tan bueno, ya que se pueden producir cambios de color importantes en los píxeles de alrededor. Se puede decir, en cierta medida, que en las imágenes de las huellas dactilares lo único que tiene importancia son los bordes (rayas).

Para resolver el problema, investigadores de varias universidades y agencias gubernamentales de Estados Unidos colaboraron en la búsqueda de un buen algoritmo adaptado a la compresión de imágenes de huellas dactilares.

Intervalo matemático

En 1984, el matemático francés Yves Meyer trabajaba como profesor en la Universidad de París-Orsay cuando un compañero físico le enseñó un artículo, pensando que sería de su interés. Los autores eran Jean Morlet y Alex Grossmann, ingeniero geofísico de la empresa Elf Aquitaine el primero y físico de la Universidad de Marsella el segundo.

Imagen 2: Alex Grossmann (1930-2019) y Jean Morlet (1931-2007), en 1991. (Fuente: Centre de Physique Théorique, Universidad de Marsella)

Imagen 2: Alex Grossmann (1930-2019) y Jean Morlet (1931-2007), en 1991. (Fuente: Centre de Physique Théorique, Universidad de Marsella)El artículo proponía una nueva vía de detección de gas y petróleo. Para detectar el petróleo y las bolsas de gas subterráneas, se emite una onda y, mediante el análisis de la señal que regresa tras atravesar varias capas, se obtiene información sobre la composición interna. Morlet presentó una nueva técnica para hacerlo y trabajó el campo matemático con Grossmann, pero no tuvo mucho éxito en la empresa y, según dicen, únicamente consiguió una jubilación anticipada. Sin embargo, la fama le llegó del mundo de la ciencia.

Yves Meyer se quedó sorprendido por lo que vio en el artículo: en él se encontró con fórmulas conocidas, de un campo que dominaba perfectamente, y consideró que podía ser un camino fructífero entablar relación con los autores. Según cuenta él mismo, tomó el tren para Marsella en busca de Grossmann. En pocos años, Meyer y sus colegas y discípulos convirtieron aquellos torpes pasos iniciales en una teoría matemática.

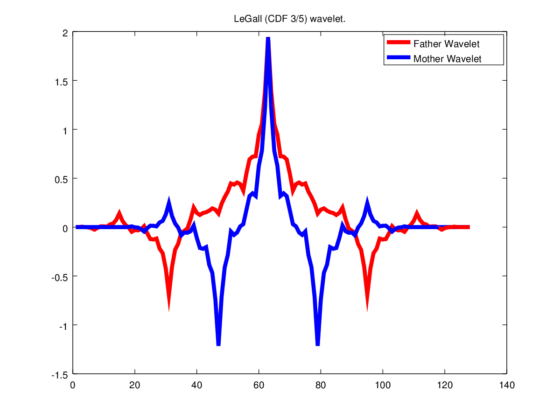

Los componentes básicos para desarrollar una función en la teoría clásica de Fourier son las funciones trigonométricas. En la nueva teoría, estos componentes básicos cambian y se utilizan dilataciones y traslaciones de una función madre. Eso sí, esa madre necesita propiedades adecuadas para ser de utilidad. De todas formas, hay muchas opciones y se puede decidir la más apropiada en función del uso, lo cual ya es, en sí mismo, una ventaja en las aplicaciones.

Morlet le puso un nombre francés al nuevo objeto: ondelette. Posteriormente, cuando el término llegó al inglés, se convirtió en wavelet, que es la denominación con la que ha recorrido el mundo científico. Aunque muchos usuarios utilizan el préstamo tal cual (wavelet), existen términos adaptados a cada idioma: ondícula (esp.), ondeta (cat.), onduleta (port.), por ejemplo.

Imagen 3: Stéphane Mallat, Yves Meyer, Ingrid Daubechies y Emmanuel Candès han tenido una gran importancia en el desarrollo de la teoría de las wavelets y sus aplicaciones. (Fotografía: S. Jaffard – La lettre d’infos du CMLA, junio de 2017)

Imagen 3: Stéphane Mallat, Yves Meyer, Ingrid Daubechies y Emmanuel Candès han tenido una gran importancia en el desarrollo de la teoría de las wavelets y sus aplicaciones. (Fotografía: S. Jaffard – La lettre d’infos du CMLA, junio de 2017)El análisis tradicional de Fourier no detecta bien los grandes cambios de una función que se producen en un intervalo reducido, porque las funciones trigonométricas que utiliza como componentes no están localizadas. Las ondículas, en cambio, se localizan y se adaptan mejor para estudiar cambios drásticos de funciones. Además, conviene elegir la ondícula madre adecuada según el uso que le vayamos a dar. Esto puede tener un coste matemático mayor y, si es para aplicarlo, quizás también un coste económico, pero hará mejor el trabajo que queremos o necesitamos.

Sistemas de compresión WSQ y JPEG2000

La teoría de las ondículas, a diferencia de la teoría de las series de Fourier que le precedió, ha abordado al mismo tiempo el campo puramente matemático y las aplicaciones. Se comenzó a utilizar inmediatamente para el procesamiento de las señales y las técnicas habituales se adaptaron al nuevo campo. El salto de aquellos primeros pasos al mundo real no se hizo esperar. Es más, las aplicaciones han alimentado la propia teoría matemática, lanzando nuevos problemas.

El sistema de compresión WSQ (Wavelet Scalar Quantization) para las necesidades del FBI se inventó con ayuda de ondículas. Además, lo pusieron a disposición de todo el mundo, libre. Este sistema usa matemáticamente una pareja de wavelets madre, una para la descomposición y la segunda para la reconstrucción de la imagen. Básicamente, siempre se hace lo mismo para la compresión: proporcionar la información que queremos guardar mediante una receta de componentes básicos (en este caso, wavelets) y hacer 0 los coeficientes de componentes de menor relevancia. Así, en la información que se va a almacenar se obtienen muchos ceros; se han ideado medios para guardar de forma breve esas listas de ceros.

Imagen 4: para la compresión WSQ se utiliza una ondícula descubierta por la matemática Ingrid Daubechies.

Imagen 4: para la compresión WSQ se utiliza una ondícula descubierta por la matemática Ingrid Daubechies.Sin embargo, el uso de las ondículas para la compresión no quedó ahí. El mismo grupo que inventó el JPEG para las fotografías, creó otro estándar a través de wavelets: JPEG2000. Este modelo también se utiliza en la compresión de huellas dactilares cuando se toman imágenes de 1000 puntos por pulgada, pero no solo para eso: JPEG2000 se utiliza tanto en el cine digital, como en las imágenes que toman los satélites o en el protocolo DICOM de imágenes médicas.

Fourier moderno vs. Fourier clásico

El análisis de Fourier se enmarcó en el campo de las matemáticas teóricas a lo largo del siglo XIX y principios del XX. Sin embargo, posteriormente, se descubrieron multitud de campos en los que podía aplicarse en el mundo real, y con el aumento de la capacidad de cálculo de los ordenadores, se ampliaron aún más las posibilidades: señales, sonidos, imágenes médicas, espectrometría, cristalografía, telecomunicaciones, astronomía, visión artificial, reconocimiento de voz, etc.

La teoría de las ondículas, el nuevo campo que hemos visto crear y desarrollar, ha dado un nuevo impulso a estas aplicaciones. En el caso mencionado, el de las huellas dactilares, ofrece mejores resultados que la vía clásica, pero cabe preguntarse ¿merecerá la pena utilizar siempre las wavelets en lugar de las funciones trigonométricas? No, decidiremos en función de lo que queramos hacer. Por ejemplo, en nuestras cámaras fotográficas utilizamos JPEG porque no merece la pena recurrir a otro sistema de compresión para hacer fotos normales. La nueva teoría complementa la anterior, no la sustituye.

En 2017 el matemático Yves Meyer fue galardonado con el mayor premio que existe actualmente en matemáticas, el Premio Abel, «por su trabajo fundamental en el desarrollo de la teoría matemática de las ondículas«. Y en 2020 Yves Meyer, Ingrid Daubechies, Terence Tao y Emmanuel Candès han sido premiados con el Premio Princesa de Asturias de Investigación Científica y Técnica 2020, «por sus contribuciones pioneras y trascendentales a las teorías y técnicas matemáticas para el procesamiento de datos, que han ampliado extraordinariamente la capacidad de observación de nuestros sentidos y son base y soporte de la moderna era digital».

Para saber más:

En la red se puede encontrar más información sobre el tema. Estas son algunas de las fuentes que se pueden consultar:

- C. M. Brislawn, C.M. (1995). Fingerprints go digital. Notices of the American Matematical Society, 42 (11), 1278-1283.

- Web Mathouriste: Après Fourier, c’est encore du Fourier! (Hay abundante información sobre el análisis de Fourier, histórica en particular, en varias páginas del sitio web.)

- Web The Abel Przie: The Abel Prize Laureate 2017 – Yves Meyer.

Sobre el autor: Javier Duoandikoetxea es catedrático jubilado de Análisis Matemático en la UPV/EHU.

Este artículo se publicó originalmente en euskara el 19 de junio de 2019 en el blog Zientzia Kaiera. Artículo original.

El artículo Las huellas dactilares, el FBI y la teoría de Fourier modernizada se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una teoría cinética para los sistemas financieros

- Elogio de la teoría

- Pál Turán: teoría de grafos y fábricas de ladrillos

Zorros (auto)domesticados

Foto: UW Urban Canid Project

Foto: UW Urban Canid ProjectDimitri Beliáyev fue un genetista que vivió y trabajó en una época y un país en los que la genética mendeliana era considerada una falsa ciencia. El lugar era Rusia y la época, el periodo durante el que Iósif Stalin regía los destinos de la Unión Soviética, las décadas centrales del siglo XX. Algunos genetistas pagaron su adhesión a la ciencia con duras penas de prisión, y alguno incluso con la muerte. Beliáyev, sin embargo, consiguió mantener su posición en el Departamento de Reproducción de Animales Peleteros gracias a que hacía pasar sus estudios como investigaciones de fisiología. En 1948, no obstante, fue cesado como director del Departamento. Tras la muerte de Stalin en 1953 las cosas mejoraron para los genetistas, y en 1958 empezó a trabajar en la División Siberiana de la Academia de Ciencias de la URSS, de cuyo Instituto de Citología y Genética fue nombrado director en 1963, cargo que ocupó hasta su muerte en 1985.

En el instituto desarrolló, junto con Lyudmila Trut, uno de los experimentos de más largo alcance en la historia de la biología, tanto por su duración (sigue en marcha), como por su contenido. Criaron zorros plateados (Vulpes vulpes) en cautividad, y de cada generación seleccionaban a los más mansos. En la décima generación un 18% de la progenie eran mansos, y en la vigésima ese porcentaje había llegado al 33%. Así, mediante un programa de reproducción selectiva de los más mansos consiguieron zorros plateados domesticados.

Lo más interesante del experimento de Beliáyev y Trut es que verificaron en los zorros domesticados la aparición de un conjunto de rasgos al que se denomina síndrome o fenotipo de domesticación. Es algo que se había observado en otras especies y que había sido descrito por el mismo Darwin. Los rasgos anatómicos propios del síndrome, aunque no aparezcan los mismos en todas las especies domesticadas, son los siguientes: orejas flácidas, pigmentación irregular (a veces en forma de motas), cara (u hocico) corto, molares más pequeños, cráneo más redondeado y pequeño, y cuerpo de menor tamaño. En la edad adulta retienen rasgos juveniles (fenómeno denominado neotenia) y son más fértiles. Además, tienen un umbral de reacción a los estímulos externos más alto y se asustan menos por la presencia de ejemplares de otras especies.

El síndrome de domesticación parece ser debido a déficits leves en el número de células de la cresta neural, una estructura característica del desarrollo embrionario de los vertebrados. Y, al parecer, ese déficit podría tener su origen en cambios de carácter epigenético en genes implicados en el desarrollo temprano de esa estructura embrionaria.

Durante prácticamente todo el último siglo, los zorros comunes han ido penetrando en grandes ciudades, no solo de Europa Continental, sino también de Gran Bretaña y Australia. En las últimas décadas su número se ha multiplicado y lo ha hecho gracias, principalmente, a los zorros urbanos. Se han adaptado a utilizar los residuos que, de una u otra forma, abandonan los seres humanos, y han perdido el miedo a acercárseles. Los raposos parecen haber iniciado una relación de comensalismo con las personas similar a la que, muy probablemente, condujo a la domesticación de los perros y, quizás, otras especies también. Seguramente por eso no tienen miedo a acercarse a los seres humanos. Y, tal y como hemos sabido este mismo año, han experimentado algunos cambios anatómicos compatibles con el síndrome de domesticación.

Si ese proceso está, efectivamente, en marcha, los zorros estarían experimentando su propia autodomesticación. No debería extrañarnos: al fin y al cabo, como los zorros, también los seres humanos nos hemos domesticado a nosotros mismos.

Fuentes:

Anastasiadi D., Piferrer F. (2019): Epimutations in developmental genes underlie the onset of domestication in farmed European sea bass. Molecular Biology and Evolution DOI: 10.1093/molbev/msz153

Dugatin L. A., Trut L. (2017): How to Tame a Fox (and Build a Dog) The University of Chicago Press.

Parsons K. J. et al (2020): Skull morphology diverges between urban and rural populations of red foxes mirroring patterns of domestication and macroevolution. Proceedings of the Royal Society B. 28720200763

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Zorros (auto)domesticados se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Joaquín Sevilla – Naukas P4K 2019: Lo que esconden unos champiñones al ajillo

Fuente: Cocinatis

Fuente: CocinatisLas leyes científicas se cumplen en todas partes y en todo momento, por eso son leyes. Esto incluye el cocinar unos champiñones al ajillo. Nos lo explica Joaquín Sevilla, doctor en físicas, profesor de tecnología electrónica y director de área de Cultura y Divulgación en la Universidad Pública de Navarra (UPNA).

La conferencia se impartió dentro del marco del festival Passion for Knowledge 2019 (P4K) organizado por el Donostia International Physics Center (DIPC).

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Joaquín Sevilla – Naukas P4K 2019: Lo que esconden unos champiñones al ajillo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ambrosio Liceaga – Naukas P4K 2019: Nunca quisimos coches voladores

- José Miguel Viñas – Naukas P4K 2019: De nubes las pinacotecas están llenas

- Naukas Bilbao 2017 – Joaquín Sevilla: Los instrumentos del capitán Fitzroy

Cómo garantizar la seguridad del suministro eléctrico en España sin nucleares ni carbón

Investigadores de la UPV/EHU y el BC3 han proyectado la evolución que tendrán la demanda y la generación eléctrica en España en las próximas décadas; se considera un futuro sin energía nuclear ni proveniente del carbón, y con mayor peso de fuentes renovables. Han simulado la seguridad de suministro en ese escenario y proponen que, entre otras medidas, las centrales hidroeléctricas podrían ayudar a mitigar el riesgo de falta de suministro que pudiera darse.

Embalses de La Serena y Orellana (parte superior derecha) en Badajoz (España)

Embalses de La Serena y Orellana (parte superior derecha) en Badajoz (España)Los investigadores del Instituto de Economía Pública de la UPV/EHU y el BC3, el Centro Vasco contra el Cambio Climático, llevan varios años colaborando en el estudio y proyección de lo que se conoce como seguridad del suministro eléctrico en España. El país es una “isla eléctrica”, debido a su escasa interconexión con los países vecinos, característica clave para hacer una proyección de la demanda y la capacidad de generación y suministro que tendrá España en las próximas décadas. Esto les ha permitido modelar el nivel de seguridad del suministro, y evaluar cómo cambiará esa seguridad en función de las fuentes de electricidad que se vayan impulsando o abandonando.

Partiendo de valores conocidos de consumo y generación eléctrica, el grupo de investigadores ha desarrollado un modelo mediante el que han podido proyectar la evolución de estas dos variables en los años 2020, 2030, 2040 y 2050. “Otros autores han realizado proyecciones del consumo eléctrico, y apuntan a que este consumo irá creciendo década a década, algo más de un 1 % cada año. En cuanto a las fuentes de electricidad, en los próximos 10 años las proyecciones indican que la electricidad proveniente del carbón y la nuclear sufrirán un recorte considerable, y ya en 2040 estas dos tecnologías dejarán de operar”, comenta José Manuel Chamorro Gómez, investigador del Instituto de Economía Pública de la UPV/EHU. La capacidad de generación que se perderá se compensará con un aumento de energías renovables. Es más, “la capacidad del total de centrales renovables que se pondrán en marcha será mayor que la ya instalada de generación no renovable, pero todo parece indicar que la seguridad de suministro se verá afectada”, añade el investigador.

La naturaleza propia de las fuentes renovables de electricidad introduce en el sistema incertidumbre, intermitencia e incapacidad de gestión, lo que eleva el riesgo de que una fracción de la demanda de electricidad se quede sin cubrir por las fuentes disponibles, haciendo el suministro menos seguro. “Ahora mismo el sistema existente no garantiza el 100 % del suministro en cualquier escenario, pero en nuestros modelos hemos visto que la fracción potencialmente no cubierta será mucho mayor en el futuro, y esa falta de suministro se dará con una frecuencia mayor”, detalla el investigador.

Los investigadores han estudiado en detalle las posibilidades que ofrece una fuente de energía renovable que se presta a una gestión más flexible: la hidráulica. “Las centrales hidroeléctricas pueden ser moduladas por las personas responsables de su gestión, y pueden regular el flujo de agua hacia la turbina en todo momento, algo que sin duda aliviaría en parte el riesgo de falta de suministro. Es más, aquellas centrales hidroeléctricas con turbinas reversibles desempeñan una doble función: además de aumentar la generación eléctrica en los momentos de mayor demanda, cuando esta es baja pueden utilizar la turbina para bombear agua hacia la parte superior de la presa (consumiendo energía), y así acumular agua que poder utilizar para generar electricidad nuevamente cuando vuelva a aumentar la demanda. Según hemos comprobado, esto aliviaría hasta cierto punto el riesgo de no poder responder a la demanda de electricidad en los momentos en los que esta crece”, argumenta.

No obstante, los autores también mencionan los aspectos medioambientales que deben ser tenidos en cuenta a la hora de plantear y planificar el uso y gestión de las centrales hidroeléctricas: “Desde el punto de vista de generación eléctrica, el agua constituye un recurso, pero, claro, este recurso está en un contexto. El impacto que las centrales y las presas tienen en las cuencas de los ríos es innegable. Por tanto, las administraciones o los agentes que están por encima de quien opera las centrales son quienes tienen que marcar las reglas de juego, y estas reglas tienen que ser claras, en cuanto a caudales ecológicos, frecuencias de descarga y demás parámetros”, opina Chamorro.

Además del recurso de las centrales hidroeléctricas, el investigador enumera otra serie de medidas que se podrían tomar para atender plenamente a la demanda, y así garantizar la seguridad de suministro: “Por un lado, hay mucha investigación en temas de almacenamiento de electricidad. Si consigues un sistema de almacenamiento, donde, digamos, acumulas la electricidad que ha generado el viento en un tramo horario con escasa demanda, tendrás forma de utilizarla cuando sí sea necesaria. O impulsar a los consumidores a hacer uso de sus electrodomésticos en las franjas horarias en las que el precio de la electricidad es más bajo. O incluso los coches eléctricos podrían abastecer en un momento dado de electricidad a la red, para complementar el suministro. Se está avanzando en diferentes aspectos para alcanzar un sistema donde los picos de demanda estén lo más cubiertos posible”, concluye.

Referencia:

Luis M. Abadie, José M. Chamorro, Sébastien Huclin, Dirk-Jan van de Ven (2020) On flexible hydropower and security of supply: Spain beyond 2020 Energy doi: 10.1016/j.energy.2020.117869

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Cómo garantizar la seguridad del suministro eléctrico en España sin nucleares ni carbón se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Generada en plataformas eólicas marinas, desembarcada como hidrógeno

- Desmantelando metódicamente instalaciones nucleares

- La gestión de la salud y seguridad en el trabajo de las mujeres

La mielitis transversa: el embotellamiento inflamatorio de la médula espinal

Diego Clemente

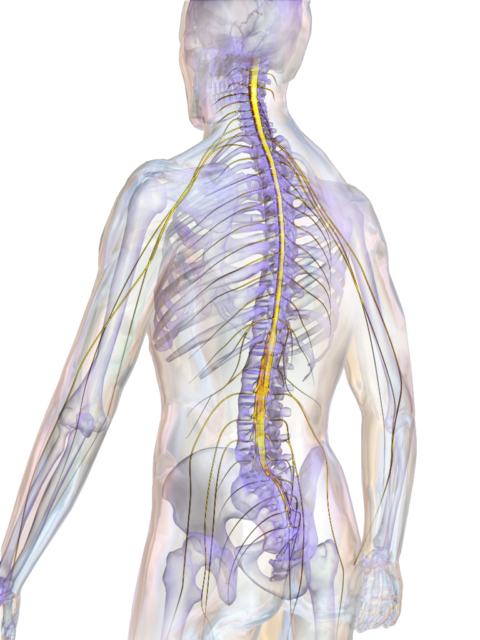

Funete: Wikimedia Commons

Funete: Wikimedia CommonsLa empresa farmacéutica AstraZeneca ha pausado el ensayo clínico de la vacuna contra la COVID-19 que desarrolla junto a la Universidad de Oxford debido a un evento adverso serio aparecido en uno de los participantes. Aunque no se ha confirmado la naturaleza clínica de tal evento, el New York Times ha revelado que podría tratarse de mielitis transversa. ¿Qué es esta enfermedad?

La palabra mielitis ya nos indica que es una enfermedad neurológica, en la que se inflama la médula espinal. Por otro lado, transversa indica que afecta de manera completa –es decir, bilateral, tanto al área derecha como a la izquierda– a un segmento concreto de la médula.

Al igual que en la esclerosis múltiple, esta inflamación suele conllevar desmilienización. En otras palabras, se elimina la capa lipídica que envuelve los axones de las neuronas lo que, en consecuencia, produce fallos en el impulso nervioso. En la esclerosis múltiple este proceso no suele ser completo ni afectar a un único segmento de la médula, y también se ve afectada la mielina del cerebro.

La mielina es una adquisición evolutiva del sistema nervioso central que sirve para que el impulso nervioso se transmita a una alta velocidad sin necesidad de tener un axón muy grueso. Esto permite tener muchos axones más finos en un pequeño espacio. Gracias a ella podemos sentir y enviar órdenes a los músculos u órganos en milésimas de segundo, algo muy útil ante un peligro inminente o cuando tenemos que hacer varias cosas a la vez. A veces, la velocidad es un factor importante para poder sobrevivir o para destacar sobre otros individuos.

En el caso de la mielitis transversa, la desmielinización del segmento concreto de la médula puede tener una causa sospechada o no. Aunque se han descrito casos de esta enfermedad tras procesos de vacunación, un buen número de los casos de mielitis transversa son posteriores a una infección viral, o a una invasión bacteriana.

En ese caso, podría ser el propio invasor quien ataque a la mielina y ser el disparador de la desmielinización. Pero también puede ser la consecuencia del ataque inmunitario al microorganismo invasor, con lo que sería la propia respuesta del sistema inmune la causante de la desmielinización. En este caso, hablaríamos de un fenómeno de autoinmunidad.

¿Qué quiere decir esto? Pues que nuestras propias defensas atacan a nuestro organismo, sin conocerse muchas veces la causa concreta que les impulsa a hacerlo. En la mielitis transversa, no está claro aún si es una o ambas razones la que la causan. También puede estar asociada a otras patologías autoinmunes o incluso a determinados tumores. Pero hay que destacar que, en la mayoría de los casos, la mielitis transversa no tiene una causa sospechada, denominándose en ese caso como idiopática. Finalmente, hay que apuntar que también se ha descrito algún caso de mielitis transversa asociada a la COVID-19.

Otro aspecto a tener en cuenta en esta mielitis viene dado por el apellido de la enfermedad: transversa. No en todas las mielitis transversas se afecta el mismo segmento de la médula. Este aspecto es crucial para saber el grado de afectación de la persona con esta enfermedad.

¿Qué pasa cuando se ve afectado por completo un segmento de la médula espinal?

La médula espinal tiene muchas neuronas en su interior, las motoneuronas, que mandan órdenes a los músculos. También reciben muchos axones de neuronas sensitivas alojadas en los ganglios espinales y cuya información sensorial de músculos u otros órganos hace una primera parada en la propia médula espinal sobre las denominadas interneuronas quienes, a su vez, se comunican con las motoneuronas. De hecho, ambas señales, la de envío de órdenes y la de recepción de sensaciones, se integran y ordenan en la médula espinal.

Dependiendo del nervio espinal del que vengan o hacia donde vayan, el ordenamiento y procesamiento de esta información se hace a un nivel u otro de la médula espinal. Por ello, de manera general podemos decir que los segmentos cervicales participan en integración de información de cuello y músculos de la respiración, los torácicos del torso y parte de los brazos, los lumbares, las caderas y piernas, y los sacros, la ingle, los dedos de los pies y parte de las piernas.

Pero no pensemos en la médula espinal como un conjunto de anillas colocadas una encima de otra que no se comunican entre sí, sino que hay comunicación entre unos segmentos y otros, también a través de axones, también con mielina.

Para más complicación, la médula espinal es una gran autovía de paso de información desde todas las partes del cuerpo al cerebro y desde este a la médula y después a los órganos y músculos de nuestro cuerpo. Los carriles de la autovía son los axones de las neuronas, los vehículos los impulsos nerviosos, y la mielina sirve para que señales del cerebro lleguen a la punta del pie y viceversa muy rápidamente.

Por ello, cuando todo un segmento de la médula espinal se ve afectado por la mielitis transversa, no solo se afectan los músculos u órganos a los que envía y de los que reciben información las neuronas de esa parte concreta, sino que se ve afectada la intercomunicación entre segmentos, sobre todo con los segmentos por debajo de este y, algo muy importante, se ve muy afectada la movilidad en la gran autovía de impulsos nerviosos hacia o procedentes del cerebro.

Por esta razón, si la afectación medular es en los niveles más cercanos al cuello, el embotellamiento nervioso será mucho mayor y afectará a todos los segmentos inferiores al mismo, mientras que si es en la zona sacra se verán afectados menos segmentos de la médula y los síntomas serán menores. Normalmente, en la mielitis transversa se suele ver afectada la zona torácica, la de la parte alta de la espalda.

Síntomas y pronóstico variable

De ahí que los síntomas de la mielitis transversa varíen entre personas, aunque de manera más habitual son dolor, modificaciones en la sensibilidad y percepción de sensaciones aberrantes como hormigueos, parálisis de las extremidades (brazos o piernas dependiendo del segmento afectado), que pueden llegar incluso a ser causantes de una paraplejia y, en muchas ocasiones, afectación de la vejiga y de los intestinos, lo que afecta de manera importante a la vida diaria de las personas.

Al contrario que en la esclerosis múltiple, en la mielitis transversa se suele dar un único episodio sintomático del que la persona se puede recuperar completa o parcialmente, o de la que, lamentablemente, no puede recuperarse. Aproximadamente se calcula en un tercio cada una de las tres posibilidades.

Hoy en día no existe tratamiento curativo para la mielitis transversa, aunque normalmente se aplican corticoides al paciente para reducir la inflamación de la misma.

En la actualidad se investiga en conocer la causa de esta patología y en buscar terapias que ayuden a regenerar lo dañado por la inflamación. De lo que no hay duda, y de eso sabemos y mucho en el Hospital Nacional de Parapléjicos, es de que los pacientes cuya médula espinal está afectada se ven muy beneficiados por una buena rehabilitación, adecuada y específica a las partes del cuerpo que sean coordinadas por el segmento desmielinizado, pero también por los posteriores, así como por la comunicación con el cerebro. De ahí que sea tan importante la existencia de centros como el nuestro, donde, además de los músculos, se rehabilita la mente, la sexualidad, y se ayuda a afrontar la nueva vida de cada persona.

Sobre el autor: Diego Clemente es Investigador Principal del Laboratorio de Neuroinmuno-Reparación del Hospital Nacional de Parapléjicos

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo La mielitis transversa: el embotellamiento inflamatorio de la médula espinal se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: la médula espinal

- Estar obeso se parece mucho (demasiado) a envejecer

- Los supermicrobios amenazan con ser más letales que el cáncer

Arte Moebius (I)

A lo largo de algunas entradas de la sección Matemoción del Cuaderno de Cultura Científica hemos mostrado ejemplos de cómo las matemáticas han sido, y son, tanto una fuente de inspiración para el arte –en especial para el arte contemporáneo–, como una herramienta en el proceso creativo del artista. Algunos ejemplos para el caso de las artes plásticas pueden encontrarse en las siguientes entradas:

– Cuadrados latinos, matemáticas y arte abstracto

– Hipercubo, visualizando la cuarta dimensión

– Bernar Venet, la estética de las matemáticas

– El teorema de Pitágoras en el arte

– El poema de los números primos

– La geometría poética del cubo

– El arte contemporáneo que mira al tangram

E incluimos más entradas en la misma línea en la bibliografía de esta. Aunque estos son solamente una pequeña cantidad de ejemplos de la profunda e interesante interacción entre las matemáticas y las artes plásticas.

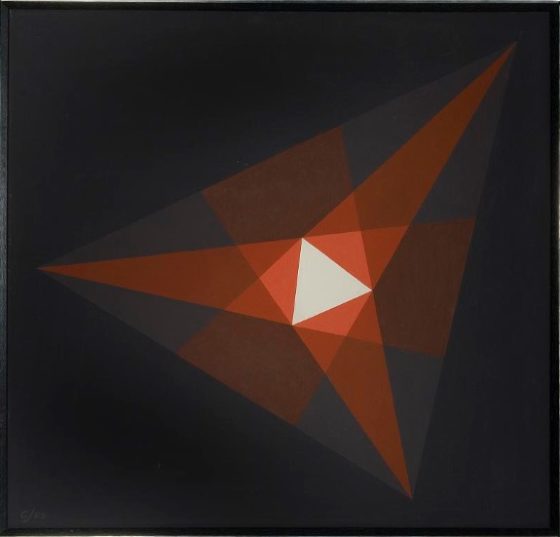

Triángulo de Morley (1969), de Crockett Johnson. Imagen de la página web de The National Museum of American History

Triángulo de Morley (1969), de Crockett Johnson. Imagen de la página web de The National Museum of American History

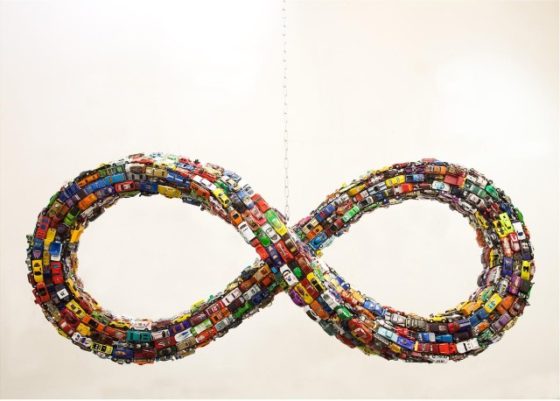

En la presente entrada vamos a centrar nuestra atención en uno de los objetos más interesantes e inspiradores de la geometría y la topología, la banda de Moebius. No es la primera vez que se habla de este objeto geométrico en relación al arte en el Cuaderno de Cultura Científica, ya que se han dedicado algunas entradas a su presencia en la novela gráfica (De menú para hoy dos novelas gráficas negras con salsa matemática y Guía matemática para el cómic Promethea), en la poesía (Poesía retorcida sobre banda de Mobius) o en la literatura (Cuatro leyes consumadas siguiendo una banda de Mobius). Y para conocer más ejemplos se puede consultar el artículo de Marta Macho, Listing, Möbius y su banda o el libro de Clifford Pickover, The Möbius strip (2006). Aunque en la serie de entradas que iniciamos aquí, vamos a mostrar una pequeña colección de ejemplos de su presencia en las artes plásticas, y en especial, en la escultura.

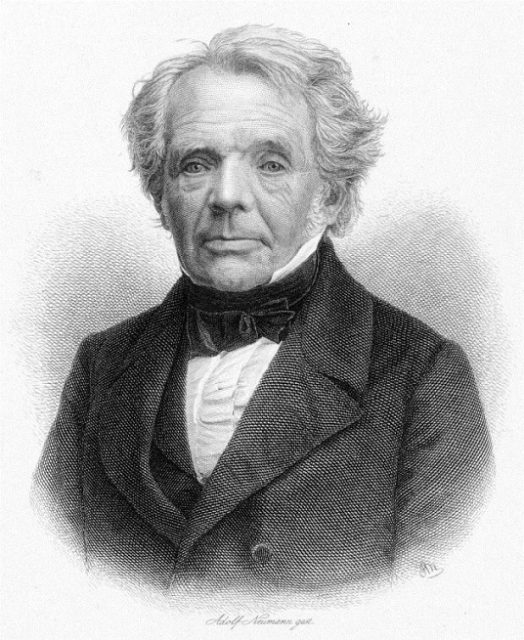

La banda de Moebius es una superficie “topológica” (véase la entrada La topología modifica la trayectoria de los peces) que fue descubierta, de forma independiente, por los matemáticos alemanes Johann Benedict Listing (1808-1882) y August Ferdinand Moebius (1790-1868). Es decir, es un objeto matemático, pero que también podemos observar y entender en nuestra vida cotidiana.

Grabado del matemático alemán August Ferdinand Moebius, realizado por Adolf Neumann alrededor de 1850. Imagen de Wikimedia Commons

Grabado del matemático alemán August Ferdinand Moebius, realizado por Adolf Neumann alrededor de 1850. Imagen de Wikimedia Commons

Las superficies que vemos a nuestro alrededor, como una hoja de papel, un canutillo de cartón o una pelota, tienen dos caras, sin embargo, aunque pueda parecer sorprendente existen superficies que solamente poseen una única cara, como la cinta de Moebius.

Para construir esta superficie, la banda de Moebius, de una forma sencilla y cotidiana solamente se necesita una tira de papel y cinta adhesiva. Por ejemplo, puede cogerse una hoja de papel DIN A4 y cortar a lo largo una tira de unos 2 o 3 centímetros de anchura. Si juntamos los extremos de la tira de papel y los pegamos con la cinta adhesiva, se obtiene una banda normal, con dos caras, la interior y la exterior, que podríamos pintarlas de dos colores distintos. Pero además tiene dos bordes, “el de arriba y el de abajo”.

Pero, si cogemos una nueva tira de papel y antes de juntar los extremos, como hemos hecho antes, giramos uno de ellos media vuelta y después los pegamos, la superficie que se obtiene es una banda retorcida, la superficie de Moebius.

Podemos intentar comprobar experimentalmente cuántas caras tiene esta nueva superficie, para lo cual se va a utilizar un rotulador. Se empieza pintando la tira de papel retorcida en un punto dado y se continúa pintando en una cierta dirección hasta llegar al punto por el que habíamos empezado. Y descubriremos que está pintada toda la banda, luego solo tiene una cara, ya que para pintarla entera solo se utiliza un color.

Pero hay más sorpresas, si ahora tomamos otro rotulador y vamos recorriendo el borde de la banda de Moebius, veremos que cuando regresemos al punto inicial habremos recorrido todo el borde, es decir, ¡la banda de Moebius tiene un único borde!

Esta superficie tiene insólitas propiedades. Veamos una de ellas en el siguiente experimento que podéis realizar en casa. La cuestión que nos planteamos en este experimento es la siguiente: ¿Qué ocurre si cortamos la cinta de una sola cara por la mitad (con un corte longitudinal)?

Si cortásemos longitudinalmente una banda normal y corriente por la mitad, lo que se obtienen son dos bandas normales de igual longitud, pero más estrechas que la original. Mientras que si se realiza un corte longitudinal a una banda de Moebius lo que ocurre es que se tiene una única banda retorcida de doble de longitud que la banda de Moebius original.

Aunque la cuestión ahora es qué tipo de superficie es la que se ha generado, si será como una cita de Moebius o como una banda normal. O, dicho de otra manera, nos preguntamos cuántas caras tiene. Si utilizásemos de nuevo el rotulador podríamos observar que tiene dos caras y dos bordes, luego no es una banda del tipo de la de Moebius, sino una “banda normal retorcida” (es decir, si partimos de una tira de papel, se ha dado una vuelta entera a la tira antes de pegar los extremos).

Todas estas primeras cuestiones pueden verse en el en el video de la sección Una de mates, del programa de humor y ciencia de televisión, dirigido por José A. Pérez Ledo, Orbita Laika (primera temporada) de La2, de Televisión Española: La banda de Moebius.

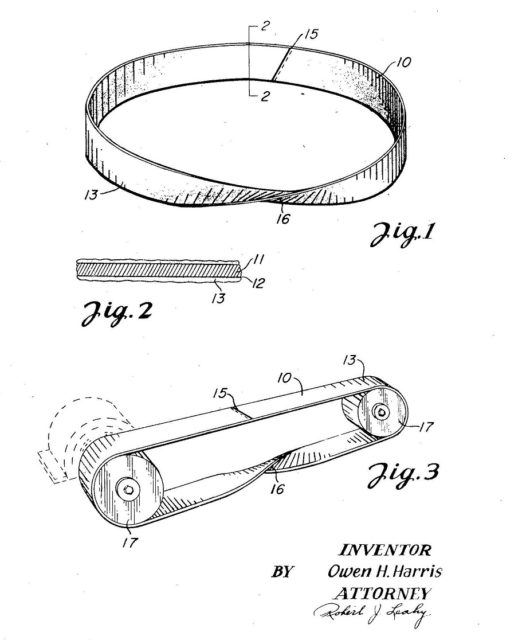

Imagen de la patente US2.479.929, del inventor Owen H. Harris, de una correa abrasiva que, en lugar de tener la forma de una banda normal, tiene la forma de una banda de Moebius, para duplicar la zona de abrasión

Imagen de la patente US2.479.929, del inventor Owen H. Harris, de una correa abrasiva que, en lugar de tener la forma de una banda normal, tiene la forma de una banda de Moebius, para duplicar la zona de abrasión

Las extraordinarias propiedades de la superficie de Moebius, que solo tenga una cara y un borde, han cautivado no solo a personas del mundo de la ciencia y las matemáticas, sino también del arte. Por ejemplo, el director de cine, actor y escritor norteamericano Woody Allen, en su cuento El sol no sale para todos del libro Pura Anarquía (2007), escribía:

Deseoso de captar su atención, me había propuesto levantar en dos tiempos una barra equivalente en peso a un par de Steinways cuando de pronto mi columna vertebral adoptó la forma de una banda de Möbius, y buena parte de mi cartílago se separó audiblemente.

En particular, esta superficie ha cautivado a muchas personas del ámbito de las artes plásticas, con una especial incidencia en el mundo de la escultura, como veremos en esta serie de entradas.

Sin ninguna duda, el artista que más se relaciona con la banda de Moebius es el artista suizo Max Bill (1908-1994), uno de los máximos representantes del denominado arte concreto y miembro del grupo Abstracción-Creación (véase El teorema de Pitágoras en el arte para ver otras obras de Max Bill relacionadas con las matemáticas).

Como cuenta mi compañera y amiga Marta Macho en el artículo Listing, Mobius y su banda, en 1935 Max Bill estaba trabajando “en distintas posibilidades estéticas para una escultura colgante, cuando creó un objeto de una sola cara al que llamó Unendliche Schleife (cinta sin fin), sin ser consciente de que tales superficies se conocían desde hacía un siglo. Se comenta que sintió tal frustración al saber que él no había sido el inventor de esta forma, que pasó una larga temporada sin trabajar sobre ella”.

En cualquier caso, Max Bill diseñó y realizó hermosas esculturas con esta superficie sin fin y gracias a él fue ampliamente conocida en el mundo del arte. Veamos dos de estas esculturas de Max Bill.

Cinta sin fin (1953, original de 1935), de Max Bill. Museo de Arte de Baltimore

Cinta sin fin (1953, original de 1935), de Max Bill. Museo de Arte de Baltimore

Giro sin fin (1953-1956), de Max Bill. Museo de Amberes

Giro sin fin (1953-1956), de Max Bill. Museo de Amberes

Tanto la obra artística de Max Bill, como su filosofía del arte, han tenido una gran influencia en el arte contemporáneo.

Uno de los artistas vascos contemporáneos por el que siento una gran admiración y en el que se puede apreciar una clara influenciada de la obra de Max Bill, de hecho, también se ha interesado por la banda de Moebius, es el artista navarro José Ramón Anda. Como comentamos en la entrada La geometría poética del cubo, dentro del arte de José Ramón Anda, una de las figuras fundamentales de la escultura vasca contemporánea, conviven dos grandes corrientes artísticas como son la abstracción geométrica, con una fuerte influencia del arte concreto, y la escultura orgánica, en la cual la naturaleza y sus formas, en particular, la madera, como material e inspiración, reivindican su importancia.

En sus primeros años, el escultor navarro realizó dos esculturas con cintas sin fin, realizadas en madera de roble, Dos cintas sin fin (1975, roble) y Cintas macladas triangulares (1975, roble).

Dos cintas sin fin (1975), de José Ramón Anda, realizada en madera de roble. Imagen de la página web de José Ramón Anda

Dos cintas sin fin (1975), de José Ramón Anda, realizada en madera de roble. Imagen de la página web de José Ramón Anda

En la magnífica exposición la exposición LANTEGI, José Ramón Anda, que tuvo lugar en la sala Kubo Kutxa de Donostia-San Sebastián, desde el 23 de mayo al 25 de agosto de 2019, pudimos observar una nueva escultura con una banda de Moebius.

Otro artista influenciado por el trabajo escultórico de Max Bill fue el artista británico John Robinson (1935-2007). En la década de los años 70, tras haber estado trabajando en escultura figurativa, empezó a realizar esculturas simbólicas abstractas con inspiración matemática. Entre los temas matemáticos con los que trabaja están los anillos de Borromeo (véase su definición en la Wikipedia), la teoría de nudos (puede leerse sobre nudos en las entradas La artista Anni Albers, The Walking Dead y la teoría de nudos y Del nudo gordiano al nudo de los enamorados por territorio matemático), los nudos tóricos (recordemos que en matemáticas un “toro” es la superficie que tiene la forma de un flotador), los fractales (véase Fractus, arte y matemáticas) o la banda de Moebius. Pueden verse muchas de sus obras simbólicas abstractas en la página del artista en la Fundación Bradshaw.

Una de sus obras simbólicas más emblemáticas es Inmortalidad (1982), que es una banda de Moebius con forma de nudo de trébol, realizada en bronce.

Inmortalidad (1990), de John Robinson, realizada en bronce y acero. Propiedad del departamento de matemáticas de la Universidad de Bangor (Gales). Imagen de ArtUK

Inmortalidad (1990), de John Robinson, realizada en bronce y acero. Propiedad del departamento de matemáticas de la Universidad de Bangor (Gales). Imagen de ArtUK

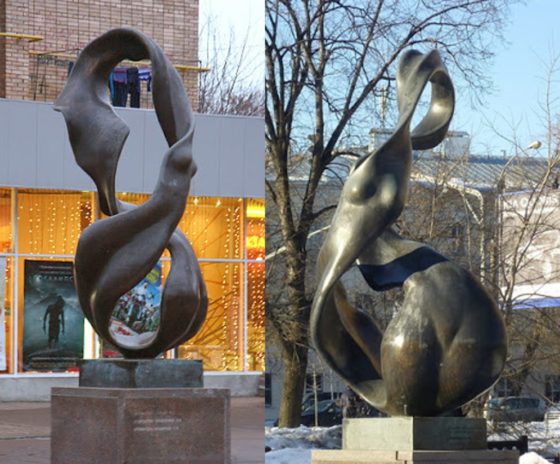

Otra serie de sugerentes y hermosas esculturas con la idea de la superficie de una sola cara es la formada por obras como Seres dependientes (1980, bronce pulido y patinado) o Eternidad (1980, bronce pulido). Si pensamos en la obra Seres dependientes, podemos entender su estructura de dos formas distintas. La primera sería pensar en una banda de Moebius, como la que hemos construido con una tira de papel, pero en lugar de tener un grosor de 0,1 milímetros –que es más o menos el grosor de una hoja de papel–, que tenga un grosor del mismo ancho del papel, de unos 2 o 3 centímetros. Ahora el borde se convierte en otra banda de Moebius, de forma que la escultura posee dos cintas sin fin “entrelazadas”. Como decía el propio escultor, en relación a Seres dependientes (escultura del Centre de Recerca Matemàtica, de Barcelona): “el hombre y la mujer entrelazados para formar un solo Ser”.

Seres dependientes (1980), de John Robinson, realizada en bronce pulido y patinado, perteneciente al Centre de Recerca Matemàtica, de Barcelona)

Seres dependientes (1980), de John Robinson, realizada en bronce pulido y patinado, perteneciente al Centre de Recerca Matemàtica, de Barcelona)

Pero esta escultura la podemos entender también de otra forma. Si nos fijamos, la sección de la escultura es más o menos un cuadrado, luego puede entenderse la figura geométrica de estas esculturas como considerar un prisma cuadrado largo y flexible, retorcerlo media vuelta y unir los extremos.

Por otra parte, la escultura Eternidad (1980), que realizó después de Seres dependientes (1980), está realizada con una sección triangular, en lugar de cuadrada. Es decir, sería como considerar un prisma triangular largo y flexible, retorcerlo un tercio de vuelta –120 grados– para que vaya lado con lado y unir los extremos. De esta forma se genera una única superficie de tipo Moebius, de una sola cara.

Eternidad (1980), de John Robinson, realizada en bronce pulido. La escultura está en la plaza Pietre de Camberra, Australia

Eternidad (1980), de John Robinson, realizada en bronce pulido. La escultura está en la plaza Pietre de Camberra, Australia

Detalle de la realización de la escultura Eternidad (1980), de John Robinson, utilizando 100 triángulos equiláteros

Detalle de la realización de la escultura Eternidad (1980), de John Robinson, utilizando 100 triángulos equiláteros

En la página del artista en la Fundación Bradshaw se pueden encontrar gifs de estas y otras esculturas de John Robinson.

La siguiente serie de esculturas de cintas si fin la descubrí por casualidad. Estaba viendo la película de intriga estadounidense Un pequeño favor (2018), dirigida por Paul Feig, el creador de la serie Freaks and Geeks (1999), e interpretada por Anna Kendrick y Blake Lively. En una de las escenas aparece una escultura en la entrada de una casa, como se ve en la siguiente imagen, y rápidamente me puse a averiguar de quien era esa escultura. Su autor es el artista británico Jeremy Guy, en cuya página web pueden verse muchas de sus esculturas.

Escena de la película Un pequeño favor (2018), dirigida por Paul Feig, en la que se ve la escultura Mobius H3, del escultor inglés Jeremy Guy. Imagen de la página web del escultor

Escena de la película Un pequeño favor (2018), dirigida por Paul Feig, en la que se ve la escultura Mobius H3, del escultor inglés Jeremy Guy. Imagen de la página web del escultor

Dentro de esa serie de obras está por ejemplo Mobius H12, realizada en granito negro, que el artista inglés realizó para el centro comercial Ion Orchard de Singapur.

Mobius H12, del escultor inglés Jeremy Guy. Imagen de la página web del escultor