El ARN está de moda… desde hace 3 800 millones de años

Carlos Briones

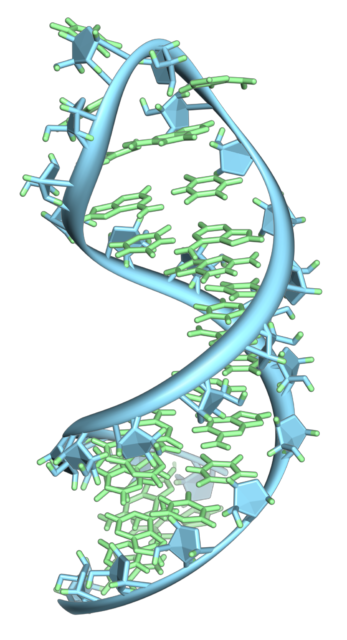

Una estructura de horquilla en una molécula de ARN. Se trata de una sola cadena que se pliega sobre sí misma, no de una doble hélice como en el ADN. Esta estructura en concreto pertenece al ARN mensajero. Fuente: Vossman / Wikimedia Commons

Una estructura de horquilla en una molécula de ARN. Se trata de una sola cadena que se pliega sobre sí misma, no de una doble hélice como en el ADN. Esta estructura en concreto pertenece al ARN mensajero. Fuente: Vossman / Wikimedia Commons

La pandemia de COVID-19 ha protagonizado este año 2020 y está teniendo terribles consecuencias sanitarias, sociales y económicas en todo el mundo. Afortunadamente, durante las últimas semanas hemos comenzado a ver la luz al final del túnel gracias a la publicación de los resultados, muy positivos en cuanto a seguridad y eficacia, de los primeros candidatos a vacunas que entraron en la fase 3 de sus ensayos clínicos. Dos de ellas, las producidas por las empresas Moderna y Pfizer/BioNTech, han mostrado ya eficacias en torno al 95 %. Aunque aún falta medio año para que termine dicha fase 3 pronto comenzarán a administrarse en Estados Unidos y Europa.

Ambas vacunas están basadas en una molécula bien conocida en diferentes campos de investigación, pero que hasta ahora nunca había saltado a la opinión pública: el ARN (abreviatura de ácido ribonucleico). En concreto, utilizan un tipo llamado ARN mensajero (ARNm), con las instrucciones para que determinadas células de nuestro sistema inmune produzcan la proteína S que forma la espícula del coronavirus SARS-CoV-2, lo que desencadena una respuesta protectora en la persona que recibe la vacuna.

El ARN es una molécula que puede degradarse con facilidad, principalmente por la acción de proteínas catalíticas (o enzimas) especializadas en cortarla. Por ello, el ARN vacunal se administra incluyendo una media de 10 moléculas de ese ARNm en vesículas esféricas protectoras, formadas por lípidos (similares a los que constituyen las membranas celulares) y de tamaño nanométrico (mucho menor que nuestras células).

Foto: Daniel Schludi / Unsplash

Foto: Daniel Schludi / UnsplashA diferencia de otros tipos de vacunas, las basadas en ARN han de mantenerse ultracongeladas hasta casi el momento de su administración. Sin embargo, el ARN no es una molécula que se haya puesto de moda ahora, sino que lo ha estado desde hace mucho tiempo. En concreto, durante los últimos 3 800 millones de años.

El ARN, molécula central en la biología

El análisis a nivel molecular de todos los seres vivos conocidos, y en concreto la comparación de sus genomas, ha mostrado grandes similitudes entre ellos. Esto mostró, hace más de cuarenta años, que las tres grandes ramas del árbol de la vida (bacterias, arqueas y eucariotas) provienen del mismo antepasado.

A esa especie (o, tal vez, a esa comunidad de ellas) la conocemos como “último ancestro común universal” (LUCA, acrónimo formado por sus iniciales en inglés) y se estima que pudo vivir hace unos 3 700 millones de años (Ma), solo 800 millones después de que se formaran la Tierra y la Luna.

LUCA ya tenía las principales características que aparecen en toda la biología actual, y basaba su funcionamiento en tres moléculas clave: el ADN (archivo de información genética), las proteínas (moléculas catalíticas o enzimas, responsables del metabolismo, y también estructurales), y el ARN (intermediario en el flujo de información genética, que se produce en el sentido ADN→ARN→Proteínas).

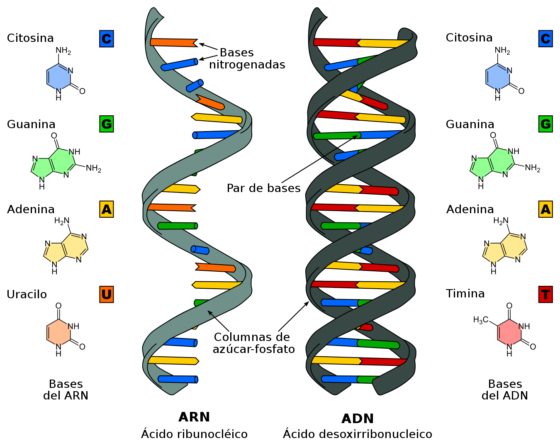

El ARN es un ácido nucleico, un polímero formado por unidades o monómeros llamados ribonucleótidos. Estos pueden ser de cuatro tipos: A, C, G y U. Su estructura más estable es la cadena sencilla, en vez de la doble hélice característica del ADN.

Fuente: Wikimedia Commons

Fuente: Wikimedia CommonsSin embargo, aunque sea una cadena sencilla, cualquier molécula de ARN se pliega sobre sí misma cuando está en disolución, debido a que sus monómeros tienden a reconocerse entre ellos siguiendo las reglas A-U, G-C y G-U. Así, el ARN acaba formando estructuras más o menos complejas, lo que le permite realizar diversas funciones en las células. De hecho, el paso ARN→Proteínas está protagonizado por diferentes tipos de ARN:

- La información genética, previamente copiada (transcrita) desde el ADN, se encuentra en forma de ARNm (como el usado en las vacunas comentadas).

- Su traducción a proteínas se realiza en los ribosomas (agregados de ARN ribosomal, ARNr, y proteínas)

- En este proceso de decodificación de la información también participan los llamados ARN de transferencia (ARNt).

Además, todo el flujo de información genética está regulado por otras moléculas de ARN.

El ARN también constituye el genoma de gran número de “entidades replicativas” que no pueden considerarse auténticos seres vivos, pero que resultan fundamentales en la evolución por su continua interacción con las células a las que parasitan: muchas familias de virus (entre ellos los coronavirus), y también unos patógenos de plantas más sencillos llamados viroides.

Las dos caras de la moneda de la vida

Por lo que acabamos de comentar, el ARN es mucho más que una molécula intermediaria en el flujo de información genética. De hecho, puede servir tanto de genotipo (secuencia con información genética) como de fenotipo (molécula estructural y funcional). Es decir, el ARN es tan versátil como para poder representar las dos caras de la moneda de la vida, algo que no está al alcance del ADN (solo actúa como genotipo) ni de las proteínas (únicamente contribuyen al fenotipo).

En este sentido, un descubrimiento fundamental realizado en 1982 es que en la biología actual existen moléculas de ARN cuya estructura tridimensional les permite actuar como catalizadores, acelerando ciertas reacciones bioquímicas. Hasta entonces se pensaba que las funciones catalíticas solo podían ser realizadas por las enzimas de naturaleza proteica y, por analogía, a estos catalizadores de ARN se les llamó ribozimas. Sus descubridores recibieron el Premio Nobel de Química en 1989.

Uno de los tipos de ribozima. Fuente: Wikimedia Commons

Uno de los tipos de ribozima. Fuente: Wikimedia CommonsActualmente conocemos ocho tipos de ribozimas naturales diferentes, y otros han sido obtenidos artificialmente mediante experimentos de evolución molecular in vitro. Además, en los laboratorios también utilizamos esta tecnología para seleccionar moléculas de ARN llamadas aptámeros, que se unen a los ligandos deseados con tanta afinidad y especificidad como los anticuerpos a sus antígenos.

¿Un “mundo de ARN” en el origen de la vida?

En el campo de investigación sobre el origen de la vida, tras las ideas seminales de Charles Darwin a mediados del siglo XIX y los modelos planteados por Alexander Oparin y John Haldane en la década de 1920, las primeras aproximaciones experimentales fueron realizadas por Stanley Miller en 1953 y Joan Oró en 1959. Con ello se inauguraba un campo denominado química prebiótica, que desde entonces ha permitido obtener, a partir de compuestos químicos sencillos, los monómeros o moléculas biológicas básicas como aminoácidos, nucleótidos, azúcares y lípidos simples.

De esta forma se ha demostrado que a partir de la química existente en la Tierra primitiva, sumada a los aportes realizados por meteoritos y cometas durante la infancia de nuestro planeta, pudo formarse una sopa prebiótica (acertada metáfora que debemos a Oparin) de la que surgió la biología. Pero desde esos monómeros hasta LUCA debió recorrerse un largo camino en el que las moléculas químicas y sus interacciones se fueron haciendo cada vez más complejas, hasta llegar a formarse sistemas que combinaban los tres componentes fundamentales de los seres vivos: un compartimento basado en membranas, metabolismo para procesar la materia y la energía del entorno, y la replicación de una molécula genética.

Precisamente en esa etapa intermedia volvemos a encontrarnos con el ARN, ya que debido a su capacidad para actuar como genotipo y fenotipo se considera que pudo ser anterior a las proteínas y al ADN. Así, el modelo conocido como “mundo del ARN” plantea que entre la química prebiótica y LUCA pudieron existir protocélulas basadas en ARN (denominadas ribocitos por algunos científicos) que contenían un genoma de ARN y ribozimas como catalizadores metabólicos, cuyas funciones podrían estar moduladas por otras biomoléculas (como péptidos o diversos compuestos orgánicos) e incluso por los metales y minerales presentes en el medio.

El mundo del ARN permite resolver una paradoja que es equivalente a la del huevo y la gallina, pero en versión molecular. En efecto, si volvemos al esquema del flujo de información biológica en todas las células (ADN→ARN→Proteínas) asumimos que sin ADN no puede haber proteínas. Pero a su vez las proteínas también son necesarias para que exista el ADN, ya que la replicación de este ácido nucleico es realizada por proteínas enzimáticas. Entonces, ¿quién apareció antes, el ADN o las proteínas? Como acabamos de ver, quizá ninguna de esos dos biopolímeros sino el ARN.

Esta sugerente hipótesis aún tiene varios aspectos pendientes de resolver, pero muchos científicos consideramos al ARN como el punto de partida de la evolución darwiniana en la Tierra… o tal vez fuera de ella.

En 2021, unos 3 800 millones de años después de que el ARN protagonizara el origen de la vida, una variante de esa misma molécula va a colaborar decisivamente a la supervivencia de una especie animal que siempre se creyó superior a las demás, pero que ha sido amenazada muy seriamente por un virus también basado en ARN.

Sobre el autor: Carlos Briones es científico titular del Centro de Astrobiología (INTA-CSIC)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo El ARN está de moda… desde hace 3 800 millones de años se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los meteoritos ya no son lo que eran desde hace 466 millones de años

- Los misterios que rodean al máximo térmico de hace 56 millones de años

- Relaciones a distancia desde hace 16.000 años

La forma de las proteínas mediante inteligencia artificial

Max Perutz recibió el premio Nobel en 1962 por su descubrimiento de la estructura de la hemoglobina, la proteína que da el color rojo a la sangre. En la imagen finalizando el primer modelo en alta resolución de la hemoglobina. Fuente: Max Perutz Labs.

Max Perutz recibió el premio Nobel en 1962 por su descubrimiento de la estructura de la hemoglobina, la proteína que da el color rojo a la sangre. En la imagen finalizando el primer modelo en alta resolución de la hemoglobina. Fuente: Max Perutz Labs.Lo más probable es que al leer la palabra proteína, esta se asocie, de forma casi automática, a la carne, si se piensa en alimentos, o a la musculatura corporal, si es el organismo humano lo que se tiene en mente. Efectivamente, los músculos tienen un alto contenido en proteínas, porque son filamentos de esas moléculas las estructuras cuyo deslizamiento genera la contracción muscular.

Sin embargo, además de ser las responsables de que se contraigan los músculos y, de esa forma, trabajen, las proteínas cumplen otros cometidos esenciales en los seres vivos. Catalizan prácticamente todas las reacciones químicas que tienen lugar en los organismos; llevan oxígeno de los órganos respiratorios a los tejidos; transportan o ayudan a transportar sustancias del exterior al interior de las células, configuran arquitecturas celulares internas que cumplen funciones variadas, reciben señales del exterior de la célula y transfieren la información al interior, entre otras tareas de importancia capital.

Las proteínas están constituidas por aminoácidos, pequeñas moléculas formadas por carbono, hidrógeno, oxígeno y nitrógeno, y uno de ellos, la serina, también azufre. La inmensa mayoría de seres vivos no tiene más de veinte de estos aminoácidos. Las proteínas son cadenas, de longitud muy variable, de esas moléculas. Su estructura tridimensional depende de su composición, o sea, de los aminoácidos que las constituyen y del orden preciso en que se disponen en la cadena. Esa estructura es muy importante, porque determina su función, y muy delicada, de manera que factores ambientales como la radiación, el calor o el pH la pueden alterar impidiendo que la proteína desempeñe su función.

En la actualidad, para conocer la estructura se utilizan varios métodos. El más tradicional es la cristalografía de rayos X, basada en el análisis del patrón de difracción que se forma cuando estos se dirigen a una sustancia en estado cristalino. En esta técnica, la interacción de los rayos X con la nube de electrones del cristal genera una imagen característica, el patrón de difracción, que permite deducir la posición de los átomos y, por lo tanto, la estructura de la molécula. El problema es que este método es laborioso y no es aplicable a muchas estructuras. Más reciente es la criomicroscopía electrónica, una modalidad de microscopía que trabaja con muestras congeladas a temperaturas bajísimas, de manera que se evita la aparición de artefactos.

Pues bien, hace unos días se ha dado a conocer un avance tecnológico de gran importancia en este campo a cargo de la empresa DeepMind. Mediante inteligencia artificial, un algoritmo (denominado AlphaFold) ha sido capaz de determinar, con altísimo grado de acierto, la estructura de proteínas a partir de su secuencia de aminoácidos.

El método de AlphaFold no se basa en el conocimiento de las propiedades fisicoquímicas de las moléculas y, a partir de ese conocimiento, la deducción de sus propiedades y su forma. Lo que hace es comparar estructuras y secuencias de aminoácidos de las ciento setenta mil proteínas para las que se cuenta con el conocimiento necesario (de los doscientos millones que existen en la naturaleza); a partir de esa comparación “aprende” y predice la forma de proteínas cuya estructura se desconoce, pero de las que se sabe su secuencia.

Los creadores de AlphaFold sostienen que este desarrollo es la puerta que abrirá el paso al diseño y producción de fármacos con la forma adecuada para actuar sobre dianas específicas. Pero quizás esas pretensiones sean prematuras. El avance, no obstante, es impresionante, y marcará un antes y un después en el conocimiento de las estructuras de los seres vivos y en sus posibles aplicaciones.

Fuentes:

Michael LePage (2020): DeepMind’s AI biologist can decipher secrets of the machinery of life. New Scientist.

Robert F. Service (2020): ‘The game has changed.’ AI triumphs at solving protein structures. Science.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo La forma de las proteínas mediante inteligencia artificial se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Proteínas plasmáticas

- La búsqueda de la inteligencia artificial

- Máquinas inteligentes (II): Inteligencia artificial y robótica

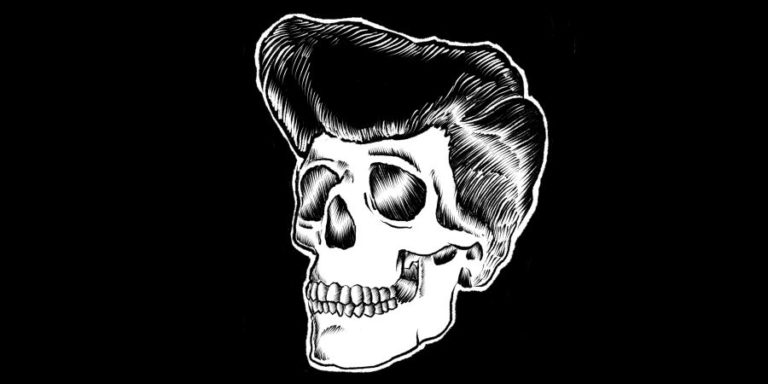

Catástrofe Ultravioleta #32 TANATOS 1

Catástrofe Ultravioleta #32 TANATOS 1

Catástrofe Ultravioleta #32 TANATOS 1El ser humano ha desarrollado cientos de expresiones culturales para afrontar o entender la muerte. Desde los tiempos mas ancestrales: mitologías, cuentos, leyendas, luces al final del tunes, poemas, obituarios… lo único seguro en la vida es la muerte. La historia de hoy es la suma de más de dos años de entrevistas e investigación.

https://www.ivoox.com/t03e08-tanatos_md_61156819_wp_1.mp3Puedes escucharnos en:

– Podium Podcast

– iVoox

– Spotify

– Apple Podcasts

Agradecimientos: Antonio Osuna Mascaró y Susana Monsó (ambos del Messerli Research Institute, Viena), y Javier Almunia (Loro Parque)

** Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #32 TANATOS 1 se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Catástrofe Ultravioleta #31 SIBERIA

- Catástrofe Ultravioleta #04 Morgan

- Catástrofe Ultravioleta #29 ALHAMBRA

El material volcánico que protege las pinturas de Pompeya las daña al salir a la luz

Un estudio llevado a cabo por el grupo IBeA de la UPV/EHU ha probado que los piroclastos pueden poner en riesgo la conservación de las pinturas de Pompeya. Los iones lixiviados de estos materiales y las aguas subterráneas ricas en iones procedentes de rocas volcánicas pueden provocar la cristalización de sales en las pinturas. El flúor podría utilizarse como marcador de monitorización in situ del alcance de los daños de los murales.

Maite Maguregui realizando mediciones con herramientas portátiles en las pinturas murales de Pompeya. Fuente: IBeA / UPV/EHU

Maite Maguregui realizando mediciones con herramientas portátiles en las pinturas murales de Pompeya. Fuente: IBeA / UPV/EHULa antigua ciudad de Pompeya (al sur de Italia) quedó sepultada por material volcánico y cenizas el año 79 a.e.c., como consecuencia de la erupción del monte Vesubio. Aquel fatídico suceso ha favorecido una conservación sin precedentes del yacimiento arqueológico del entorno, debido a que los materiales piroclásticos expulsados por el Vesubio han protegido a los vestigios de las agresiones externas. Son, de hecho, unos yacimientos muy preciados tanto cultural como científicamente, en los que se entremezclan turistas y gente de ciencia.

El grupo de investigación de la UPV/EHU IBeA, adscrito al departamento de Química Analítica, lleva más de 10 años trabajando en Pompeya, en el marco del proyecto Analytica Pompeiana Universitatis Vasconicae-APUV. En 2015, la UPV/EHU y el Parque Arqueológico de Pompeya firmaron el primero de los convenios, gracias a que las metodologías y los dispositivos portátiles que utiliza el grupo de investigación permiten analizar las pinturas mediante técnicas no destructivas.

Diversos estudios llevados a cabo en la Casa de Marcus Lucretius, en la Casa Ariadne y en la Casa degli amorini dorati (casa de los cupidos dorados) han concluido que “son las sales las que provocan los mayores y más visibles daños en los murales. Al final, las sales se pueden disolver, y como consecuencia se pueden perder materiales, como pigmentos, la capa pictórica, el mortero, etc.”, señala Maite Maguregui, la investigadora principal de este estudio.

En este sentido, los investigadores han concluido que los iones lixiviados de los materiales piroclásticos y las aguas subterráneas ricas en iones procedentes de rocas volcánicas favorecen la cristalización de algunas sales. “Mientras las pinturas están bajo tierra, los piroclastos las protegen; pero una vez que son sacadas a la superficie, por efecto del aire, la humedad, etc., empiezan a formarse las sales. Por tanto, para la conservación de las pinturas murales es importante saber, en cada caso, cuál es la carga salina de los piroclastos del entorno, para poder bloquear, disminuir o prevenir las potenciales patologías. De hecho, en Pompeya hay todavía una gran parte enterrada por estudiar”, añade Maguregui.

“Cuando el volcán entró en erupción expulsó grandes cantidades de materiales, y el material piroclástico no es homogéneo en todo el entorno; pueden encontrarse numeroso estratos diferentes”, explica la investigadora. En el estudio se han realizado análisis mineralógicos de muestras tomadas en diversos puntos, y se han determinado las composiciones de los lixiviados. Por otra parte, se han realizado modelizaciones termodinámicas para predecir qué sales pueden precipitarse como consecuencia de estas lixiviaciones, así como determinar sus orígenes. Así, han concluido que las sales que da la modelización coinciden con las detectadas en las pinturas.

Las sales analizadas en los murales contienen entre otros iones el fluoruro. “Los fluoruros son iones de origen volcánico; no es uno de los elementos principales en la atmósfera. La aparición de sales de flúor indica que los materiales volcánicos y las aguas subterráneas están influyendo en la cristalización de estas sales —detalla—. Por tanto, con el flúor encontrado en un mural se puede trazar el impacto que han tenido y están teniendo los piroclastos y las aguas subterráneas en las pinturas”. El siguiente objetivo del grupo sería “hacer grandes mapeos en los murales, para ver el alcance de las sales, así como para poder determinar las pautas para el personal conservador cuando procedan a desenterrar una pintura mural”, añade.

Referencia:

Silvia Pérez-Diez, Luis Javier Fernández-Menéndez, Héctor Morillas, Alberta Martellone, Bruno De Nigris, Massimo Osanna, Nerea Bordel, Francesco Caruso, Juan Manuel Madariaga and Maite Maguregui (2020) Elucidation of the Chemical Role of the Pyroclastic Materials on the State of Conservation of Mural Paintings from Pompeii Angewandte Chemie doi: 10.1002/anie.202010497

El artículo El material volcánico que protege las pinturas de Pompeya las daña al salir a la luz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Errores de interpretación en radiografías de pinturas

- Un material que cambia de color en función de la polarización de la luz incidente

- Óxido de vanadio (IV), un material para una revolución de ciencia ficción

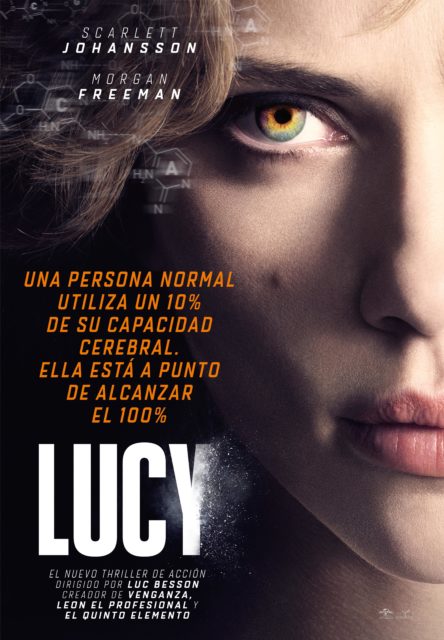

Desmitificando: El 10% del cerebro

Es un mito antiguo, algo más de un siglo, y muchas veces desmitificado. Pero ahí sigue, muy popular y extendido, y anima a seguir desmitificándolo. El mito consiste en afirmar que sólo utilizamos el 10% de nuestro cerebro. Un ejemplo actual de su popularidad es la película “Lucy”, dirigida por Luc Besson, estrenada en 2014 y protagonizada por Scarlett Johansson y Morgan Freeman. Todo estrellas y, por tanto, llegó al público, aunque parece que no gustó mucho. Su cartel anunciador proclama que “Una persona normal utiliza un 10% de su capacidad cerebral. Ella está a punto de alcanzar el 100%”. La protagonista sufre el “síndrome de Obélix” y recibe una sobredosis de una misteriosa droga que le cambia el cerebro. Con su cerebro al 100%, aprende chino en un instante, destroza a los malos y conduce coches con la mente. Algo extraordinario.

Otra muestra del alcance actual del mito del 10% nos llega desde Londres en el estudio de Marta Ferrero y su grupo. Detectan que, en 2016, el 44% de los maestros de primaria y secundaria españoles creen que usamos solo el 10% del cerebro. Y son menos de la mitad, pues hay otros países en que la creencia supera el 50% de los maestros, sobre todo en Norteamérica. En 2013, el 65% de la población de Estados Unidos creía en el mito. También en Países Bajos el 42% de los maestros aceptan el mito del 10% del cerebro, el 26% en los británicos o el 53% de los universitarios brasileños. Incluso el 6% de los neurocientíficos lo creen. También el 30% de los maestros portugueses creen en el uso del 10% del cerebro, según el estudio de Joana Rodrigues Rato y sus colegas, de la Universidad Católica de Portugal en Lisboa, con 538 voluntarios maestros desde preescolar a bachillerato.

En un estudio detallado, Sanne Dekker y su equipo, de la Universidad de Amsterdam y publicado en 2012, revelan que para el 48% y el 46% de los maestros encuestados en el Reino Unido y en los Países Bajos, es aceptable el mito del 10%. Además, el que tengan o no grandes conocimientos sobre el cerebro, pues a muchos les interesa la neurociencia, no evita la creencia en el mito. Según Dekker, tienen dificultades en distinguir ciencia y pseudociencia.

Para 2018, en una encuesta por internet en Gran Bretaña, Christian Jarrett añade que, con 220 voluntarios, de 19 a 66 años, el 40% cree que el mito del 10% es probable o definitivamente verdadero.

Un año antes, en 2017, Kelly Macdonald y sus colegas, de la Universidad de Houston, publicaron un estudio similar al de Dekker, pero con maestros de Estados Unidos. Eran 3877 voluntarios separados en tres grupos: el primero formado por el público en general, con 3045 voluntarios; el segundo con educadores, con 598 personas; y el tercero con 234 formados en neurociencia.

El 68% del primer grupo dio los neuromitos como ciertos; en el segundo grupo, el porcentaje que los aceptó fue del 56%; y en el tercer grupo, con los conocedores de neurociencias, el 47% admitió los neuromitos.

Los resultados de Macdonald son parecidos al estudio de Dekker en Gran Bretaña y los Países Bajos. La educación de los maestros en neurociencias puede reducir pero no eliminar la creencia en neuromitos, incluido el uso del 10% del cerebro. Encuentran la influencia de estas creencias en la práctica docente de los maestros.

La preparación y excelencia del maestro no influye en la aceptación de neuromitos y, se puede sospechar en su transmisión a los alumnos. Jared Horvath y su grupo, de la Universidad de Melbourne, encuestaron a 50 maestros, algunos de ellos premiados por su docencia, sobre su aceptación de neuromitos. En las respuestas, se observa que, de 15 neuromitos, solo hay dos en que se diferencian los maestros normales y los premiados por su excelencia. Y en esos dos mitos, las diferencias son pequeñas. En relación con el 10% del cerebro ambos grupos de maestros lo aceptan en parecido porcentaje.

Estos son algunos de los datos y estudios que me animan a seguir desmitificando el mito de la utilización del 10% del cerebro.

Foto: Pierre Acobas / Unsplash

Foto: Pierre Acobas / UnsplashEl nacimiento de este mito se atribuye a una breve frase del psicólogo William James (1842-1910), de la Universidad de Harvard, en su publicación de 1907 titulada “The energies of men”. Decía que “Estamos haciendo uso de solo una pequeña parte de nuestros recursos mentales y físicos posibles”. De aquí a precisar que trataba del uso del 10% del cerebro se sigue un camino tortuoso y todavía en debate. Incluso es un concepto que se ha asociado a Albert Einstein, sin confirmación y, quizá, para justificar su poderosa inteligencia.

La neurociencia demuestra que utilizamos el 100% del cerebro para realizar tareas. El escáner del cerebro lo muestra con detalle, incluso cuando la persona está en reposo. Solo cuando hay lesiones cerebrales y graves daños hay áreas inactivas. Los daños tienen consecuencias en las capacidades mentales, vegetativas y de conducta. El escáner del cerebro, la localización de funciones ce cerebrales, el análisis de estructuras y los estudios metabólicos muestran que se utiliza con normalidad mucho más del 10% del cerebro.

Francisco Mora, de la Universidad de Granada, menciona que, desde un enfoque evolutivo, si el uso del 10% fuera cierto, la selección natural, durante millones de años, seleccionó un cerebro que pasó de pesar 450 gramos a 1500 gramos y, a la vez, dejando el 90% de ese órgano sin función e inutilizado. Con el gasto de energía que supone el cerebro, hasta el 30% del total gastado en el organismo para la especie humana, la selección natural de un órgano caro e inútil no tiene sentido.

Sin embargo, el mito perdura. Primero, porque para muchos, el mito del 10% es, sobre todo, esperanza pues se ve en términos de mejora, de que existe un gran potencial personal de que se puede llegar lejos. Se acepta que, como en la película Lucy, el aumento del uso del cerebro, más allá del 10%, permitirá aprender idiomas, tocar instrumentos musicales, mejorar en el deporte, … y mucho más.

Además, en nuestra sociedad del Primer Mundo y consumista, el mito del 10% es un buen negocio con la venta de muchos y variados métodos para pasar del 10% al 100% del cerebro como, por ejemplo, la droga de la película Lucy. Y, en tercer lugar, la creencia en el mito del 10% no supone ni perjuicio ni riesgo o daño alguno para el creyente.

Referencias:

Boyd, R. 2008. Do people only use 10 percent of their brains? Scientific American February 2.

Dekker, S. et al. 2012. Neuromyths in education: Prevalence and predictors of misconceptions among teachers. Frontiers in Psychology 3: 429.

Ferrero, M. et al. 2016. Neuromyths in education: Prevalence among Spanish teachers and an exploration of cross-cultural variation. Frontiers in Human Neuroscience 10: 496.

Horvath, J.C. et al. 2018. On the irrelevance of neuromyths to teacher effectiveness: Comparing neuro-literacy levels amongst award-winning and non-award winning teachers. Frontiers in Psychology 9: 1666.

James, W. 1907. The energies of men. The Philosophical Review 16: 1-20.

Jarrett, C. 2014. All you need to know about the 10 percent brain myth, in 60 seconds. Wired Science July 24.

Jarrett, C. 2018. Belief in brain myths and child development myths continues even among those who’ve studied psychology. BPS Research Digest March 5.

Macdonald, K. et al. 2017. Dispelling the myth: training in education or neuroscience decreases but does not eliminate beliefs in neuromyths. Frontiers in Psychology 8: 1314.

Mora, F. 2018. Mitos y verdades del cerebro. Paidós. Barcelona. 215 pp.

Rato, J.R. et al. 2013. Neuromyths in education: what is fact and what is fiction for Portuguese teachers? Educational Research 55: 441-453.

Vreeman, R.C. & A.E. Carroll. 2007. Medical myths. Bristish Medical Journal 335: 1288-1289.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Desmitificando: El 10% del cerebro se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Nuevas tecnologías para el estudio del cerebro: Desde Cajal a nuestros días

- Desmitificando: Vacunas peligrosas

- Desmitificando: Adopción y embarazo

Buscando una matemática en el castillo

En enero de 2014 se publicó en el periódico New York Times, en su columna de juegos y crucigramas Wordplay, un problema de ingenio bajo el título El problema de la princesa, que nosotros hemos reescrito para esta entrada del Cuaderno de Cultura Científica como El problema de la matemática excéntrica.

El problema de la matemática excéntrica: Érase una vez una matemática que vivía en un enorme castillo. El ala este del edificio, en la que ella hacía su vida, disponía de un largo pasillo con diecisiete habitaciones, cada una de las cuales tenía una puerta que daba al pasillo, para entrar y salir de la misma, así como una puerta conectando con cada habitación contigua. La matemática era un poco excéntrica y no le gustaba dormir dos noches en la misma habitación. Por este motivo, cada noche cambiaba y dormía en una habitación adyacente a la que había dormido la noche anterior, elegida al azar.

La habitante del castillo era una prestigiosa matemática con la que muchas personas querían investigar. Por este motivo, cuando alguien le proponía colaborar con ella, invitaba a esa persona a pasar treinta días en su castillo, en el ala oeste para invitados, para que pasara dos pruebas. La primera era que durante esos treinta días demostrase tener los conocimientos necesarios para investigar con ella y la otra era un entretenido reto. La excéntrica matemática, tras explicar sus manías para dormir, proponía a su invitada que cada mañana llamara a una de las diecisiete puertas, si ella abría la puerta, porque había pasado la noche en esa habitación, el reto estaría superado, si no podría intentarlo al día siguiente. Si tú fueses la persona invitada al castillo, ¿podrías desarrollar una estrategia para encontrar a la matemática antes de que pasen los treinta días?

Este problema había aparecido, en 2010, en el hilo math puzzles for dinner (rompecabezas matemáticos para la cena) de Christian Blatter para MathOverflow, que en la propia página se describen como “una página web de preguntas y respuestas para matemáticos profesionales”.

Por otra parte, el matemático ruso Alexander Shapovalov en su página web [ashap.info/], en el apartado dedicado a “problemas para divertirse y para competiciones matemáticas” afirma que el problema fue presentado por el matemático ruso V. Shorin y él mismo en la competición internacional Tournaments of Towns, que es una especie de olimpiada internacional para educación primaria que se originó en Rusia, en la edición de 1999.

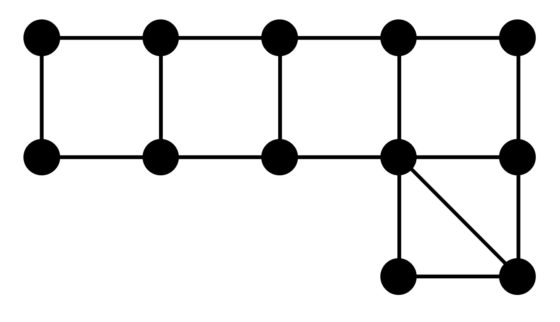

Dos años después de la publicación del problema de la búsqueda de la princesa en el hilo math puzzles for dinner (rompecabezas matemáticos para la cena) de MathOverflow, los matemáticos británicos John R. Britnell y Mark Wildon hicieron público su artículo Finding a princess in a palace: A pursuit-evasion problem (Buscando una princesa en un palacio: un problema de persecución-evasión) en el analizaban matemáticamente el problema de la princesa sobre un grafo, donde las habitaciones son los vértices del grafo y las aristas son las puertas que comunican dos habitaciones.

Recordemos que un grafo está formado simplemente por puntos –llamados vértices del grafo- y líneas que unen algunos de esos puntos –llamadas aristas del grafo- (véase, por ejemplo, El problema de los tres caballeros y los tres criados, El grafo de Marion (Gray) o El juego de Sim, entre otros), y que es una estructura matemática muy sencilla, pero a la vez muy versátil.

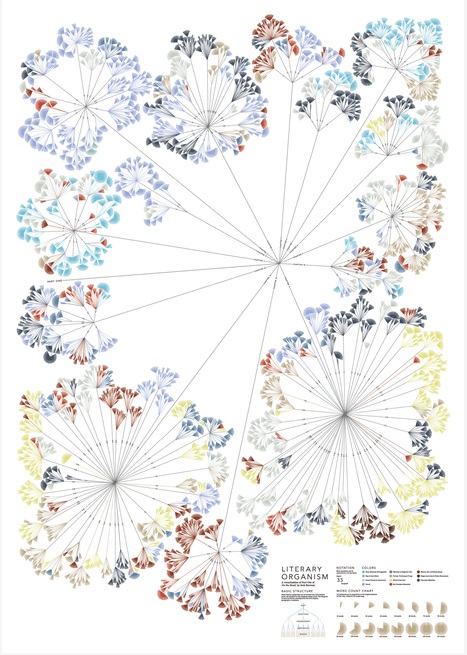

Ilustración de la diseñadora Stefanie Posavec. Texto del artículo ¿Cómo reducir una novela a sus signos de puntuación? de Elena Sevillano para la revista Yorokobu: “un proyecto de la artista británica Stefanie Posavec que contempla una novela como un «organismo literario» y lo ‘reinterpreta’ mediante diagramas de árbol —«una estructura de planta»— y códigos de colores. Capítulos que se dividen en párrafos; párrafos que se dividen en frases; frases que se dividen en palabras. Con este método, Posavec plasmó visualmente En el camino, de Jack Kerouac. El resultado, muy bello, inspiró a Rougeux para desarrollar su Between the Words. «Quise encontrar nuevas direcciones, porque ella había explorado ya opciones muy interesantes», explica”. Imagen de la página de Stefamie Posavec.

Ilustración de la diseñadora Stefanie Posavec. Texto del artículo ¿Cómo reducir una novela a sus signos de puntuación? de Elena Sevillano para la revista Yorokobu: “un proyecto de la artista británica Stefanie Posavec que contempla una novela como un «organismo literario» y lo ‘reinterpreta’ mediante diagramas de árbol —«una estructura de planta»— y códigos de colores. Capítulos que se dividen en párrafos; párrafos que se dividen en frases; frases que se dividen en palabras. Con este método, Posavec plasmó visualmente En el camino, de Jack Kerouac. El resultado, muy bello, inspiró a Rougeux para desarrollar su Between the Words. «Quise encontrar nuevas direcciones, porque ella había explorado ya opciones muy interesantes», explica”. Imagen de la página de Stefamie Posavec.

Como ya se indica en el título del artículo de Britnell y Wildon, este pasatiempo pertenece a la familia de problemas de tipo persecución-evasión (como el “juego de policías y ladrones”), que son aquellos en los cuales un grupo –en este caso quien intenta resolver el rompecabezas– intenta localizar a los miembros de otro grupo –en este caso la excéntrica matemática– en un entorno cerrado –las diecisiete habitaciones comunicadas de forma lineal–.

El estudio matemático de los problemas persecución-evasión sobre grafos se remonta a la década de 1970. Por ejemplo, en el artículo Pursuit-evasion in a graph se plantea ya la cuestión general: “Supongamos que una persona está perdida y vagando por una oscura cueva. Un grupo de rescate que conoce la cueva será enviado para buscarle. ¿Cuál es el mínimo número de personas en el grupo de rescate que se necesita para encontrarle independientemente de cómo se comporte?”.

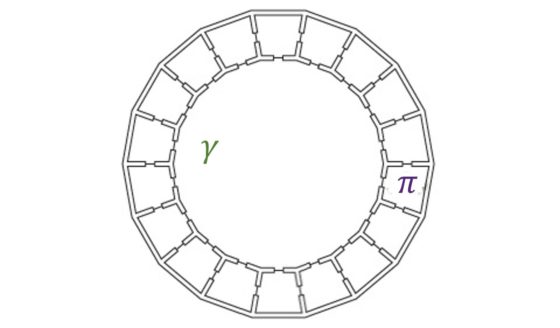

Y seguía explicando: “Existen muchas formulaciones matemáticas, no equivalentes, de este problema, dependiendo de la naturaleza de la cueva y los posibles comportamientos de la persona perdida y de las personas del grupo de rescate. […] Un ejemplo es una cueva circular, que requiere un mínimo de dos personas en el grupo de recate: la persona perdida podría moverse siempre en la parte opuesta a una única persona de rescate”.

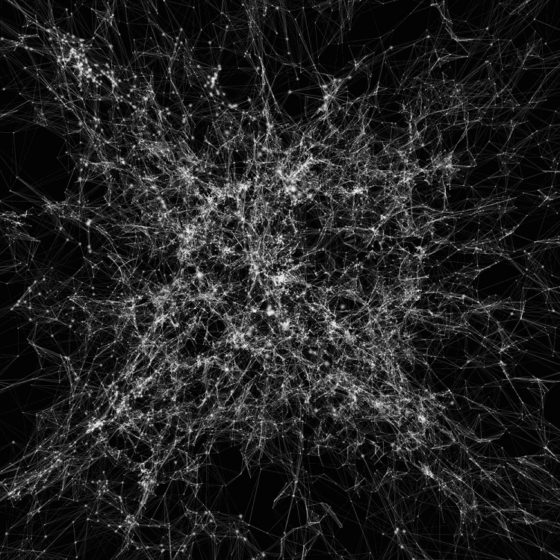

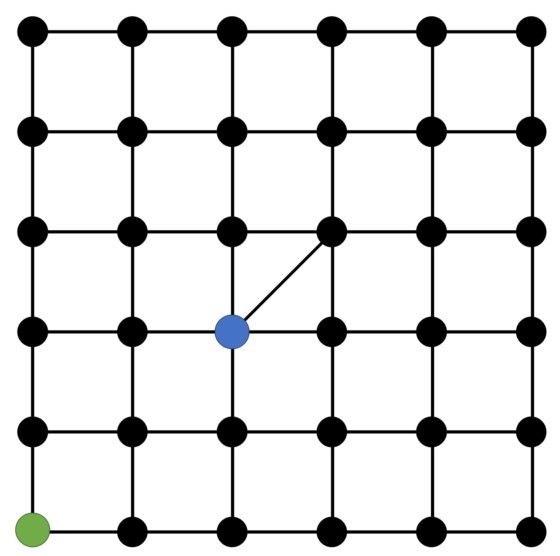

Imagen perteneciente al interesante proyecto Cosmic Web, cuya visualización corresponde a Kim Albrecht.

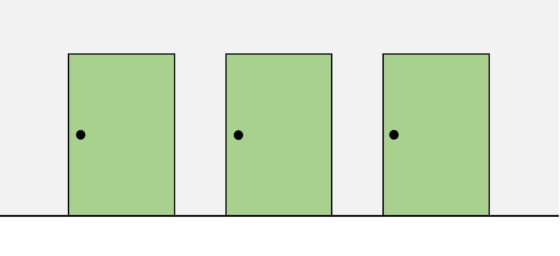

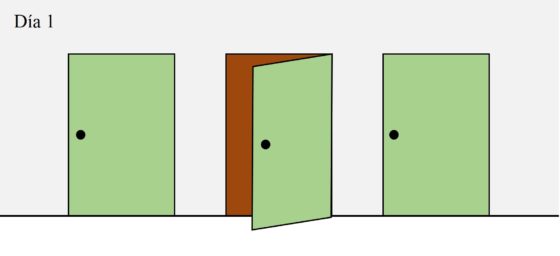

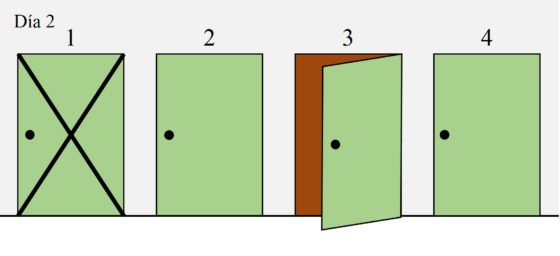

Imagen perteneciente al interesante proyecto Cosmic Web, cuya visualización corresponde a Kim Albrecht.Pero regresemos al problema de la matemática excéntrica y planteemos cómo resolverlo. Lo primero que hay que hacer siempre es leer bien el rompecabezas e intentar entender todos los elementos que aparecen en el mismo. Además, en problemas como este, en el cual aparecen diecisiete habitaciones conectadas en línea, lo mejor es simplificar el problema, para comprender bien en qué consiste y analizar la solución en una situación sencilla, para luego ir complicándola hasta tener la idea de la solución del problema original. Por este motivo, imaginemos que en el pasillo del castillo solo hubiese tres habitaciones en línea, como en la siguiente imagen.

Antes de abrir ninguna puerta, la matemática puede estar en cualquier habitación, por este motivo hemos pintado de verde las puertas. ¿Qué puerta deberíamos abrir el primer día? La mejor opción es la puerta que está en el medio.

Si la matemática está en esa habitación, la hemos encontrado y se terminó. Pero si no está, entonces estará en cualquiera de las dos habitaciones, las de los extremos. Teniendo en cuenta la costumbre de la matemática de dormir cada noche en una habitación distinta, pero adyacente, la siguiente noche necesariamente dormirá en la habitación de en medio. Por lo tanto, si el segundo día abrimos la puerta de esa habitación la habremos encontrado.

En conclusión, si seguimos esta estrategia como mucho tardaremos dos días en encontrarla, resolviendo en ese plazo el reto propuesto.

¿Qué habría pasado si el primer día hubiésemos abierto una de las puertas de los extremos? Si al abrir esa puerta la habitación estuviese vacía, al día siguiente la matemática podría estar de nuevo detrás de cualquiera de las tres puertas y sería otra vez una cuestión de suerte. Abrir alguna de las puertas de los extremos no aporta ninguna certeza sobre dónde puede estar, o no estar, la matemática.

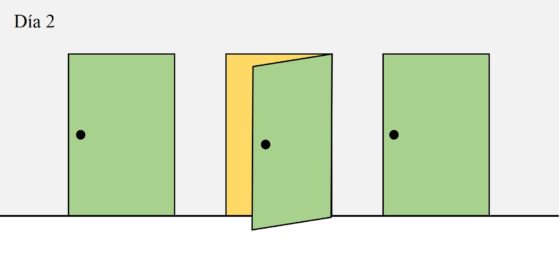

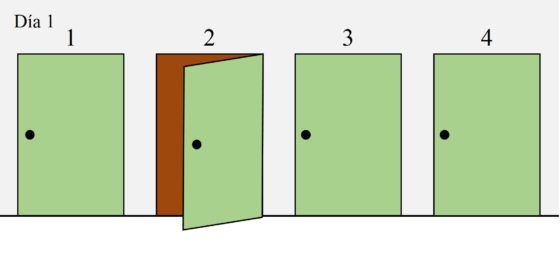

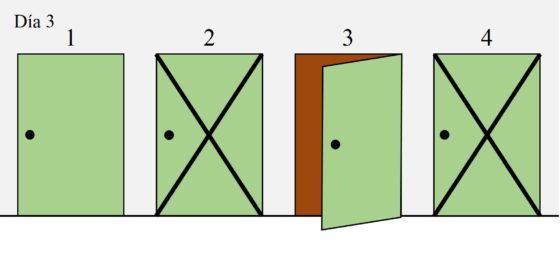

Compliquemos un poco más el problema y consideremos ahora que en el pasillo hay cuatro puertas. ¿Cuál debe ser la estrategia para encontrar a la matemática en la menor cantidad de días posibles? Ahora hemos añadido un número encima de cada puerta para identificar mejor cada una de las habitaciones.

¿Qué ocurriría si empezamos abriendo, el primer día, la puerta número 2, siguiendo la misma idea del anterior caso?

Si al abrir la puerta número 2 la matemática está ahí, entonces la hemos encontrado, aunque haya sido con un poco de suerte, ya que teníamos una probabilidad de 1 entre 4 de acertar. Pero si no hay nadie en esa habitación, al menos tenemos una pista para el siguiente día. No podrá estar en la habitación 1, puesto que para eso tendría que haber estado en la habitación 2 el día anterior, por su manía de trasladarse solo a habitaciones adyacentes.

La apertura de puertas debe estar pensada para obtener algunas certezas para el siguiente día e ir eliminando opciones. Por este motivo, el segundo día abriríamos la puerta 3.

La probabilidad de que la matemática esté tras la puerta número 3 el segundo día es de un tercio. Pero si no está en esa habitación preguntémonos qué conclusiones podemos extraer para el siguiente día. Como la habitación 2 tiene a las habitaciones 1 y 3 como adyacentes y no estaba en esas habitaciones el segundo día, entonces el tercer día no va a poder estar en la habitación 2. Lo mismo pasa con la habitación 4, que tiene a la habitación 3 como única adyacente. Por lo tanto, solo tenemos dos opciones posibles para el tercer día, habitaciones 1 y 3.

Por lo tanto, vamos a abrir la puerta 3. Si la científica no está detrás de esa puerta, al día siguiente solo podría estar en la habitación 2 y al cuarto día, como mucho, la habríamos encontrado.

Por otra parte, si el primer día empezamos abriendo las puertas 1 o 4 no obtendremos ninguna información para el día siguiente, por lo tanto, no son opciones buenas para empezar a buscar a la matemática excéntrica.

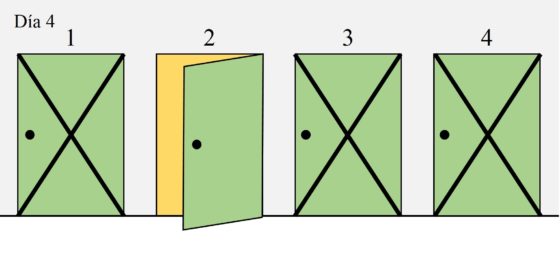

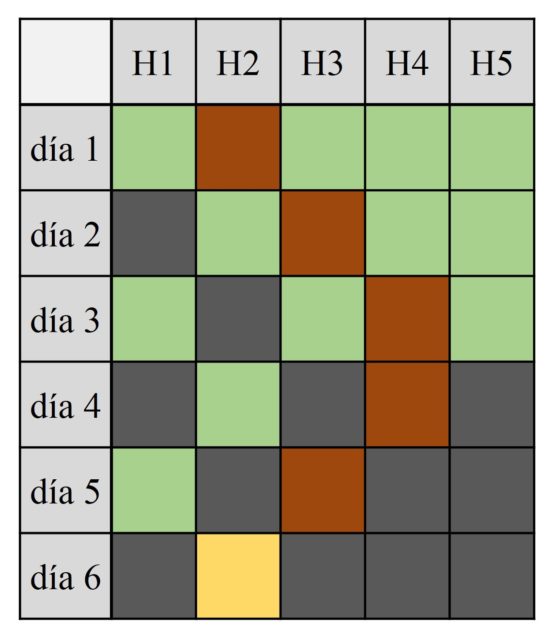

Podemos resumir nuestra estrategia para cuatro habitaciones, con las diferentes opciones, en la siguiente tabla. Cada columna es una habitación y cada fila un día. Además, las celdas verdes son las habitaciones en las que puede estar la matemática, las celdas marrones las que abrimos cada día, las celdas grises en las que no puede estar y la celda amarilla en la que va a estar finalmente, si no la hemos encontrado antes.

Por lo tanto, la secuencia de apertura de puertas [2, 3, 3, 2] es una estrategia ganadora para encontrar a la matemática. Así mismo, el razonamiento que hemos hecho nos dice que no podemos estar seguros de encontrarla en menos movimientos.

Si ahora analizamos el problema de la matemática excéntrica con cinco habitaciones, la estrategia ganadora es [2, 3, 4, 4, 3, 2] como queda explicada en la siguiente tabla. Es decir, se necesitan un mínimo de seis días para encontrar, con toda seguridad, a la persona buscada.

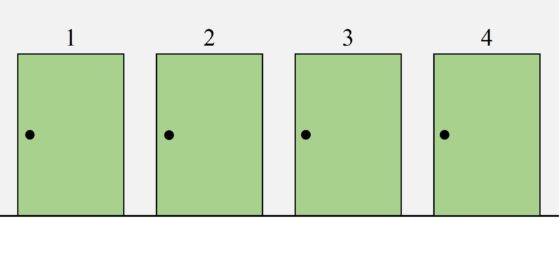

Si ahora volvemos al problema original, con diecisiete habitaciones, se podría dibujar una tabla similar a las anteriores y obtener que la estrategia ganadora es [2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 16, 15, 14, 13, 12, 11, 10, 9, 8, 7, 6, 5, 4, 3, 2]. Se necesitan, como mucho, treinta días para encontrar a la dueña del castillo.

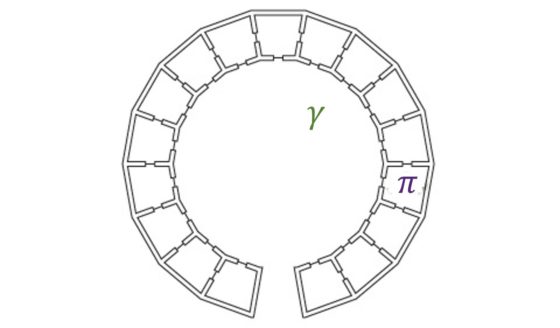

Si observamos la imagen que acompañaba al pasatiempo matemático en el New York Times nos podemos plantear claramente qué ocurriría si tuviésemos habitaciones, por ejemplo, dieciocho, distribuidas en un pasillo circular, como en la anterior imagen. Ahora no existe ninguna estrategia ganadora que nos asegure que podemos encontrar a la matemática. Podría pasar que siempre abriéramos una puerta en la que no está, incluso la que está en la posición diametralmente opuesta. En este caso todo se reduce al azar.

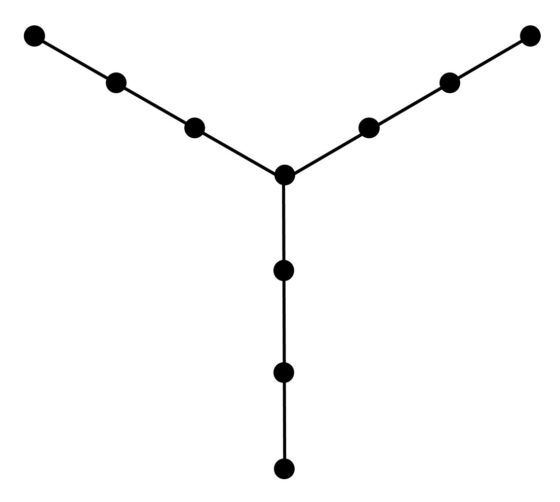

De hecho, nos podemos plantear si existen estrategias ganadoras dependiendo de la forma en la que están conectadas las habitaciones (matemáticamente, para diferentes grafos). Claramente, por lo comentado en el ejemplo circular, cualquier distribución/grafo que tenga ciclos, partes circulares, no va a tener estrategia ganadora. En el artículo Finding a princess in a palace: A pursuit-evasion problem (Buscando una princesa en un palacio: un problema de persecución-evasión) se mostraba el grafo más sencillo, sin partes circulares, en la cual la matemática podría no ser encontrada. Es la que mostramos en la siguiente imagen.

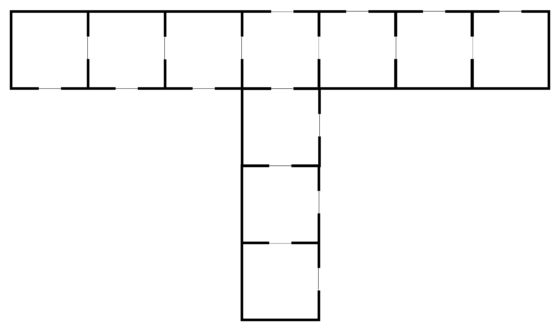

Como cada vértice se corresponde con una habitación y cada arista a una puerta entre habitaciones, la distribución de habitaciones relacionada con el anterior grafo es la que aparece en la siguiente imagen.

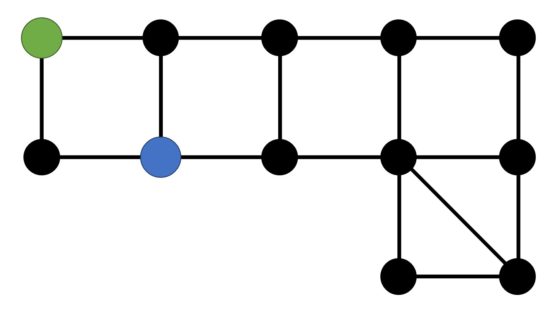

Un juego clásico de la familia de problemas de tipo persecución-evasión es el juego de policías y ladrones, del que ya hablaremos en alguna otra entrada del Cuaderno de Cultura Científica. Para abrir boca, vamos a terminar esta entrada con una versión sencilla de este juego.

Reglas del juego policías y ladrones:

El tablero del juego consta de doce posiciones posibles –puntos negros– conectadas con líneas, como aparece en la imagen.

Es un juego para dos jugadores, el policía y el ladrón, cada uno con su ficha. La posición inicial de las fichas del policía (azul) y del ladrón (verde) es la que aparece en la imagen.

El objetivo del juego es doble. El policía debe intentar atrapar al ladrón, es decir, colocar su ficha en la posición en la que esté la ficha del ladrón; y el ladrón debe intentar no dejarse atrapar. Las reglas son las siguientes:

i) cada jugador, policía y ladrón, mueve su ficha obligatoriamente de una posición a otra que esté conectada con una línea;

ii) cada jugador, de forma alternada, realiza un solo movimiento por turno;

iii) empieza moviendo el policía.

El juego termina cuando el policía atrapa al ladrón o cuando desiste de hacerlo.

En el libro Matemáticas para divertirse de Martin Gardner se presenta este juego, pero con otro tablero y con un zorro y un ganso en lugar de un policía y un ladrón. El tablero es el de la siguiente imagen, con las posiciones iniciales que se muestran.

Bibliografía

1.- John R. Britnell, Mark Wildon, Finding a princess in a palace: A pursuit-evasion problem, The Electronic Journal of Combinatorics 20 (1), 2013.

2.- Raúl Ibáñez, Del ajedrez a los grafos, la seriedad matemática de los juegos, El mundo es matemático, RBA, 2015.

3.- T. D. Parsons, Pursuit-evasion in a graph, en Theory and Applications in Graphs, Springer-Verlag, 1978, pp. 426-441.

4.- F.V. Fomin, D.M. Thilikos, An annotated bibliography on guaranteed graph searching, Theoret. Comput. Sci. 399, pp. 236-245, 2008.

5.- Tatjana V. Abramovskaya, Fedor V. Fomin, Petr A. Golovach, Michał Pilipczuk, How to hunt an invisible rabbit on a graph, European Journal of Combinatorics 52, pp. 12-26, 2016.

6.- Mohammed Ammar, Is it possible to catch the thief? , del canal de youtube Logically yours.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Buscando una matemática en el castillo se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La invención matemática

- Buscando lagunas de números no primos

- Buscando las soluciones del cubo de Anda

Historia de la primera red social

Las redes sociales son aplicaciones o herramientas que sirven para publicar, difundir y compartir contenido entre los miembros de una comunidad y propiciar la interacción y conexión entre quienes las usan. Las redes sociales son habituales en nuestro día a día, sin embargo, ¿cómo comenzaron?

En 1995 vio la luz la web SixDegrees. SixDegrees es considerada la primera red social. Esta red permitía poner en contacto a amigas y amigos, agrupándolos según el grado de relación que tuvieran, para que interactuaran a través del envío de mensajes. SixDegrees estaba basada en la teoría de los seis grados de separación del psicólogo Stanley Milgram. Esta teoría sustenta que vivamos donde vivamos estamos conectadas y conectados, entre nosotros, a través de seis pasos. SixDegrees señalaba en su presentación: “Only social network where you will meet amazing people based on your interests” (red social donde conocerás gente increíble según tus intereses). Esta descripción dejó al descubierto el nexo de unión entre quienes usamos las redes sociales, el compartir intereses comunes.

Los vídeos de Historias de la Ciencia presentan de forma breve y amena pasajes de la nuestra historia científica y tecnológica. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

El artículo Historia de la primera red social se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:La cámara de niebla

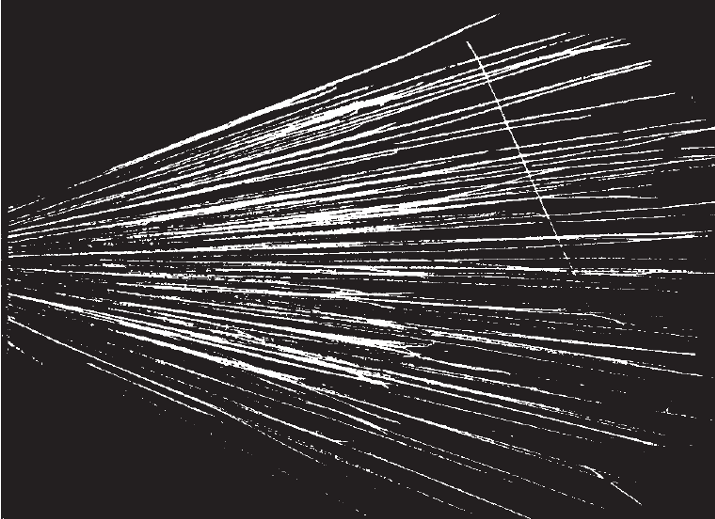

Cámara de niebla Wilson empleada en 1955 en el Brookhaven National Laboratory para el estudio de rayos cósmicos.

Cámara de niebla Wilson empleada en 1955 en el Brookhaven National Laboratory para el estudio de rayos cósmicos.Fue posible distinguir experimentalmente entre las dos hipótesis posibles para explicar la desintegración artificial mediante el uso de un dispositivo llamado «cámara de niebla», que permite visualizar la trayectoria de cada partícula cargada. La cámara de niebla fue inventada por C.T.R. Wilson y perfeccionada por él a lo largo de los años. A partir de 1911 se convertiría en un importante instrumento científico para estudiar el comportamiento de las partículas subatómicas.

En el caso de la desintegración artificial, recordemos, las dos hipótesis eran:

(a) El núcleo del átomo bombardeado pierde un protón, que se “desprende” como resultado de una colisión con una partícula alfa especialmente rápida.

(b) La partícula alfa es “capturada” por el núcleo del átomo al que ha golpeado, formando un nuevo núcleo que, inmediatamente después, emite un protón.

Si la hipótesis (a) es válida, el protón “desprendido” sería la cuarta trayectoria en la fotografía de una desintegración en una cámara de niebla: observaríamos la de una partícula alfa antes de la colisión, la de la misma partícula alfa después de la colisión, la del núcleo que que se desplaza tras la colisión y la del protón desprendido.

En el caso de que la (b) fuese la válida, en cambio, la partícula alfa incidente debería desaparecer en la colisión, y solo se verían tres trayectorias en la fotografía: la de la partícula alfa antes de la colisión y las del núcleo desplazado tras la colisión y el protón emitido.

La cuestión se resolvió en 1925 cuando P.M.S. Blackett estudió las trayectorias producidas cuando las partículas atravesaban gas nitrógeno en una cámara de niebla. Encontró que las únicas trayectorias en las que se podía ver la desintegración artificial eran las de la partícula alfa incidente, un protón y el núcleo desplazado. La ausencia de una trayectoria correspondiente a una partícula alfa tras la colisión demostró que la partícula desaparecía por completo y que el caso (b) es la interpretación correcta de la desintegración artificial: la partícula alfa es capturada por el núcleo del átomo que golpea, formando una nuevo núcleo que luego emite un protón.

Trayectorias de partículas alfa atravesando (de izquierda a derecha) gas nitrógeno. Una de ellas ha golpeado un átomo de nitrógeno, convirtiéndolo en oxígeno y emitiendo un protón. ¿Ves las tres trayectorias? Fuente: Cassidy Physics Library

Trayectorias de partículas alfa atravesando (de izquierda a derecha) gas nitrógeno. Una de ellas ha golpeado un átomo de nitrógeno, convirtiéndolo en oxígeno y emitiendo un protón. ¿Ves las tres trayectorias? Fuente: Cassidy Physics LibraryEl proceso en el que una partícula es absorbida por un núcleo de nitrógeno y se emite un protón puede representarse mediante una «ecuación». La ecuación expresa el hecho de que el número de masa total es el mismo antes y después de la colisión (es decir, hay conservación del número de masa) y el hecho de que la carga total es la misma antes y después de la colisión (hay conservación de carga).

![]()

Esta reacción muestra que ha tenido lugar la transmutación de un átomo de un elemento químico en un átomo de otro elemento químico. La transmutación no se ha producido de forma espontánea, como ocurre en el caso de la radiactividad natural; se produce exponiendo átomos (núcleos) objetivo a proyectiles emitidos por un nucleido radiactivo. Es, pues, una transmutación artificial. En el artículo en el que informó sobre esta primera reacción nuclear producida artificialmente, Rutherford dijo:

Los resultados en su conjunto sugieren que, si se dispusiera de partículas alfa, o proyectiles similares, de energía aún mayor para experimentar, podríamos esperar que se descompusiera la estructura nuclear de muchos de los átomos más ligeros.[1]

El estudio posterior de las reacciones que involucran núcleos ligeros condujo al descubrimiento de una nueva partícula y a un modelo muy mejorado de la constitución del núcleo. Se han observado muchos tipos de reacciones con núcleos de todas las masas, desde los más ligeros hasta los más pesados, y las posibilidades indicadas por Rutherford han ido mucho más allá de lo que jamás podría haber imaginado en 1919.

Nota:

[1] Este llamamiento a conseguir mayores energías de «proyectiles» fue respondido no mucho después con la construcción de aceleradores de partículas.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La cámara de niebla se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El descubrimiento de la desintegración artificial

- El problema de la estructura nuclear

- La hipótesis protón-electrón de la composición nuclear

La senescencia celular: el gran desafío para entender y tratar el cáncer

Manuel Collado Rodríguez

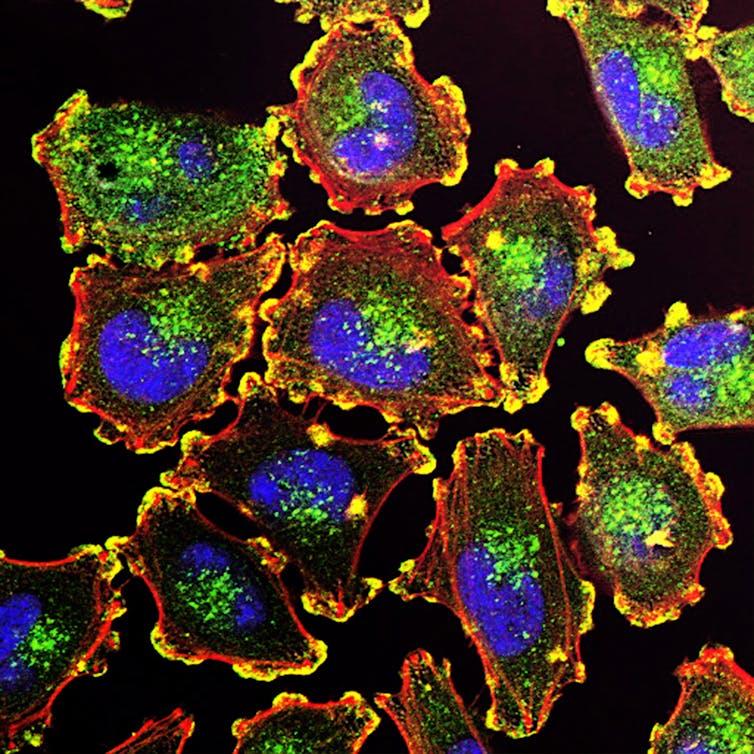

Células metastáticas. Fuente: Unsplash / National Cancer Institute

Células metastáticas. Fuente: Unsplash / National Cancer Institute

Hace 50 años el presidente estadounidense Richard Nixon declaró la “guerra al cáncer”. Seguía así la estela de otros exitosos programas que concentraron esfuerzos para alcanzar un objetivo que pusiera al país a la cabeza del progreso mundial. Años antes, los recursos se habían puesto para desarrollar la bomba atómica y llegar a la Luna. En el caso del cáncer, la iniciativa pretendía promover centros de investigación que reuniesen a los mejores investigadores para encontrar tratamientos contra una enfermedad que suponía una amenaza cada vez mayor para la sociedad.

Multitud de éxitos y fracasos después, asistimos ahora a un nuevo esfuerzo por impulsar la investigación biomédica contra el cáncer. Esta es la base de la iniciativa Grandes Desafíos del Cáncer, que arrancó en 2015. Su objetivo es mejorar nuestra capacidad de prevención, detección y tratamiento de la enfermedad. Para ello, busca identificar las cuestiones clave pendientes de resolver.

Un comité de sabios plantea cuáles son esas grandes preguntas que necesitan ser respondidas antes de continuar avanzando. Uno de estos grandes retos es entender y explotar en nuestro favor la senescencia celular.

¿Qué es la senescencia celular?

La división celular es el proceso que hace que una célula dé lugar a dos hijas idénticas. Esta es la base de la proliferación celular. La senescencia consiste en la incapacidad de llevar a cabo este ciclo.

Durante la senescencia, las células sufren unos cambios en su morfología y en su patrón de expresión de genes, y muestran unas secreciones extracelulares (que denominamos SASP). A este estado se llega como respuesta a daños en la integridad de la célula. Diversas agresiones celulares ponen en marcha este proceso.

La apoptosis (el proceso de suicidio celular) y la senescencia celular son los dos programas de defensa esenciales del organismo ante daños irreparables que ponen en peligro la transmisión íntegra de la información genética y la actividad correcta de las células. Si estos mecanismos fallan y permitimos que las células dañadas continúen proliferando, las células aberrantes crecerán desordenadamente hasta formar un tumor.

Por tanto, ambos son mecanismos de defensa antitumorales esenciales. Ahí tenemos una primera razón de peso para considerar que la investigación en senescencia celular es clave para entender el cáncer.

A lo largo de la vida se suceden todo tipo de agresiones a las células y, en muchas ocasiones, esto resulta en la inducción de senescencia. Esto contrasta con el hecho de que el cáncer es fundamentalmente una enfermedad del envejecimiento, mucho más frecuente en adultos y cuya incidencia aumenta claramente con la edad.

Si un organismo envejecido acumula células que han activado una respuesta de protección frente al cáncer con éxito, ¿cómo es que el cáncer se da más en personas de edad avanzada cuyos órganos y tejidos se están ya defendiendo? Una posibilidad es que la acumulación de daño con la edad termine por deshabilitar la respuesta protectora de la senescencia. Otra, inquietante, es que las células senescentes que no pueden dividirse alteren al resto hasta convertirlas en tumorales.

Así, lo que inicialmente nos protege podría volverse en nuestra contra y facilitar la enfermedad.

Las células dañadas que disparan la senescencia echan el freno para impedir su proliferación descontrolada. Además, secretan el SASP para enviar señales complejas a su entorno. Creemos que pueden estar destinadas a promover la reparación y regeneración del tejido dañado.

Así, una agresión celular es respondida mediante la parada en seco de la proliferación de la célula –ahora dañada– para impedir que pueda dividirse hasta formar un grupo de células aberrante. Además de dejar de proliferar, esas células secretan mensajes moleculares al exterior que por una parte avisan a su entorno, por otra llaman a la reparación y finalmente estimulan su propia eliminación.

Este sería el sistema cuando funciona a la perfección.

Demasiadas agresiones o un sistema ineficaz de eliminación de células dañadas puede conducir a una señalización de reparación constante y perjudicial que cause enfermedades. Este es el caso de patologías asociadas al envejecimiento como la osteoartritis, la fibrosis pulmonar y renal, el alzhéimer y el cáncer. Conocemos aspectos de esta compleja respuesta y tenemos indicios de la asociación entre acumulación de células senescentes y desarrollo de enfermedad, pero necesitamos concretar aún más cómo se desarrolla el proceso para entenderlo mejor y poder manipularlo en nuestro beneficio.

En ciencia, lo que no se ve no existe. O, al menos, se le asigna una menor importancia de la que pueda tener. En el caso de la senescencia celular, y tras décadas de estudio, carecemos de “marcadores” específicos del proceso, biomoléculas cuya aparición se asocie con la aparición de la senescencia y su evolución. Esto dificulta el trabajo en el laboratorio y su aplicación a la enfermedad humana. Debemos avanzar en este aspecto. Para ello, necesitamos emplear todos los recursos que puedan ofrecer diversas disciplinas y que, con enfoques novedosos, permitan el desarrollo de nuevas herramientas.

Fuente: Unsplash / National Cancer Institute

Fuente: Unsplash / National Cancer InstituteCómo eliminar células senescentes

En los últimos años hemos aprendido que es posible eliminar las células senescentes. Esto no parece perjudicar al organismo y ha demostrado, de momento en animales, una capacidad asombrosa para mejorar enfermedades asociadas al envejecimiento. Todas ellas tienen como base la acumulación de células senescentes que alteran los tejidos en los que residen y se han acumulado.

Una de las aproximaciones terapéuticas más avanzada, en experimentación clínica en humanos para conocer su potencial terapéutico, son los compuestos senolíticos. Esta es la denominación genérica que reciben los compuestos capaces de inducir la muerte específica de células senescentes, dejando intactas a las células normales. Pero quizá sea poco realista plantear una terapia contra el cáncer mediante la administración de senolíticos de manera preventiva para eliminar estas células dañadas, según vayan surgiendo, para evitar su acumulación. Se requerirá mucho conocimiento para asegurarse de que una estrategia así está exenta de peligros y puede usarse sin temor a causar un perjuicio mayor que el que se quiere evitar.

Una línea de investigación más directa para explotar nuestro conocimiento de la senescencia celular en la terapia frente al cáncer consiste en intentar controlar el crecimiento tumoral. ¿Cómo? Reactivando esta respuesta protectora del organismo en las células tumorales que proliferan sin control. Dar con fármacos que induzcan este estado de incapacidad proliferativa puede evitar la progresión de los tumores. De hecho, reevaluando algunos de los fármacos antitumorales usados en la actualidad en la quimioterapia, desarrollados con el objetivo de inducir la muerte de las células tumorales, nos encontramos con que en muchas ocasiones inducen senescencia en las células tumorales.

Hasta qué punto la senescencia es nuestro aliada contra el cáncer es algo que por el momento desconocemos. Una posibilidad que manejamos es que la inducción de senescencia durante el tratamiento antitumoral pueda limitar la eficacia de la terapia. La única célula tumoral buena es la célula tumoral muerta, y dejar células tumorales zombis en el organismo puede ser beneficioso a corto plazo, pero desembocar en efectos posteriores perjudiciales. Para muchos, las células tumorales senescentes producidas por la quimioterapia suponen la base de las recaídas tan frecuentes en pacientes tras terapia. En muchas ocasiones, estas recaídas se producen por tumores que muestran unas características aún más agresivas que las originales.

Fuente:Unsplash / National Cancer Institute

Fuente:Unsplash / National Cancer InstituteLa estrategia “uno-dos”

En este contexto surge la estrategia “uno-dos”. Esta pretende detener: primero, el crecimiento tumoral mediante la inducción de senescencia celular de la célula tumoral. Segundo, inducir de forma selectiva su muerte mediante la aplicación de un senolítico. Esta estrategia ha comenzado ya a ensayarse en modelos animales de cáncer y lo que hemos observado es que el efecto de la combinación de quimioterapia inductora de senescencia junto al senolítico es más eficaz que la quimioterapia sola.

Existe un aspecto positivo extra nada desdeñable en esta estrategia. Los agresivos tratamientos provocan desagradables efectos secundarios en los pacientes sometidos a quimioterapia. Al parecer, en muchos casos estos efectos secundarios derivan de la inducción de senescencia en células no tumorales que quedan dañadas. Estas pueden ser eliminadas eficazmente por los agentes senolíticos al mismo tiempo que las tumorales senescentes generadas por la quimioterapia, lo cual podría proporcionar un efecto terapéutico beneficioso con mínimos efectos secundarios.

Todos estos aspectos mencionados en el artículo son el objetivo de multitud de grupos de investigación en el mundo. Definir los objetivos prioritarios de esta investigación, plantear nuevas iniciativas para resolver las dudas y desarrollar nuevas y más eficaces intervenciones terapéuticas basadas en el uso de la senescencia celular constituyen el esfuerzo en el que se han embarcado numerosos grupos. Estos tratan de reunir fuerzas en consorcios internacionales multidisciplinares para buscar el apoyo financiero de la iniciativa Grandes Desafíos del Cáncer, que nos permita dar un gran salto hacia adelante en nuestro conocimiento y manejo del cáncer.![]()

Sobre el autor: Manuel Collado Rodríguez, Investigador, director del laboratorio de investigación en Células Madre en Cáncer y Envejecimiento, SERGAS Servizo Galego de Saúde

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo La senescencia celular: el gran desafío para entender y tratar el cáncer se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los supermicrobios amenazan con ser más letales que el cáncer

- Nanopartículas recubiertas para el tratamiento localizado del cáncer por hipertermia magnética

- Lo que la búsqueda de inteligencia extraterrestre nos enseña para entender la pandemia

Genética eres tú

Rosa García-Verdugo, autora

Hoy vengo a hablar de mi libro. Siempre quise decir esta frase. Y hoy, puedo por fin usarla. Y es que desde el 17 de noviembre está a la venta mi primer libro de la serie Para Curiosos de la Editorial Paidós (Grupo Planeta).

Hace ya casi dos años que mi editor, Sergi, me llamó preguntándome si me había planteado escribir un libro de ciencia, y me dio libertad total para elegir la temática. Como soy bioquímica, y desde niña tengo una fascinación total con el mundo de la genética, no lo dudé, mi libro tratará de genética. Y escribí el libro de genética que a mi me gustaría leer si no supiera nada del tema.

Un libro que empieza con un viaje por el pasado de la genética y los consabidos guisantes de Mendel y las observaciones de Darwin, pero que en vez de quedarse ahí como la mayoría de libros de texto del tema, pasa a explicar de una manera práctica –y cercana, creo– para qué sirve la genética hoy en día y que podemos esperar de ella en el futuro. Aunque este libro llevaba ya prácticamente un año escrito cuando estalló la crisis del COVID-19, no pude mantenerme al margen y por supuesto, el libro también incluye un breve capítulo dedicado a la reina de la actualidad, pero desde la perspectiva de la genética.

Son casi trescientas páginas de lectura amena, donde intento traer referencias cercanas para hacer más fácil la comprensión de conceptos, que de primeras pueden confundir hasta los expertos, además de pequeñas notas y curiosidades que poder llevar a la mesa el domingo para compartir con la familia o los amigos.

El libro se titula Genética eres tú, y es una referencia al comienzo del primer capítulo, que trata sobre el pasado de la genética. Ese capítulo comienza con una reflexión en cuanto a lo que la genética significa, no solo para los científicos, sino para todos los seres vivos, incluidos naturalmente nosotros. Y la forma en que se me ocurrió expresarlo fue adaptando un poema clásico. ¿Reconocéis la referencia?

¿Qué es genética?

Me preguntas mientras clavas en mi pupila tu pupila azul…

¿Qué es genética?

¿Y tú me lo preguntas?

Genética eres tú.

Como digo en el libro, espero que el autor, Gustavo Adolfo Bécquer, no se revuelva en su tumba al ver lo que hice con su poema, pero espero me perdone la licencia por la causa.

He pensado que para abrir boca, voy a copiar por aquí el contenido de uno de los llamados datos curiosos del libro, que por cierto ¡también tiene dibujos! y es que he podido contar con un ilustrador de lujo: Javier Pérez de Amézaga Tomás. Espero que este aperitivo os deje con las ganas de hincarle el diente al libro y que aprovechando que las fiestas se acercan y este año preveo que pasaremos mucho tiempo en casa, lo pongáis en la carta a los Reyes Magos.

Científicos colocados

Pues si os creíais que el inventor de la PCR ha sido el único científico o inventor con afición por las drogas, siento decepcionaros, porque no estaba solo. De hecho, forma parte de un grupo más que numeroso de mentes de reconocido prestigio a las que también les gusta irse «de viaje» de vez en cuando. Apuesto a que algunos de los nombres de esta lista van a sorprenderos…

Según sus preferencias por una droga en concreto:

LSD. Steve Jobs y Bill Gates tienen algo más en común que ser rivales en el mundo de la informática. Francis Crick, uno de los descubridores de la estructura tridimensional del ADN dijo que la vio en un viaje de LSD.

Cocaína. Al inventor de la bombilla incandescente Thomas Edison le iba la coca, lo mismo que al padre del psicoanálisis Sigmund Freud y a mi héroe de la infancia, que aunque sea solo un genio literario, también se merece un puesto en esta lista: el señor Sherlock Holmes.

Marihuana. Entre aquellos a los que les gustaba fumar a lo Bob Marley tenemos al biólogo evolucionista Stephen Jay Gould y al astrofísico Carl Sagan.

Combinación de diferentes sustancias. Por último, tenemos a los que les gusta mezclar drogas, como Richard Feynman (físico célebre), al que le iba la marihuana y el LSD, o el neurocientí co John C. Lilly, que consumía LSD y ketamina.Seguro que esta lista se queda corta y hay muchos otros que también se «colocan» porque, a excepción de la cocaína, las otras drogas tienen entre sus efectos el liberar la creatividad del yugo del control prefrontal y por ello es posible que hayan sido las preferidas —y una ayuda— en momentos de «eureka» para alguno de estos genios.

Ficha:

Autora: Rosa García-Verdugo

Editorial: Ediciones Paidós

Año: 2020

Colección: Para curiosos.

ISBN: 978-8449336584

Sobre la autora: Rosa García-Verdugo estudió bioquímica en Oviedo, terminando dichos estudios con un proyecto de investigación en la Universidad de Leiden (Países Bajos). Después comenzó su periplo por varios laboratorios en Madrid, Barcelona y finalmente Múnich donde en 2015 consiguió su doctorado en Neurobiología en el Instituto Max-Planck. Tras diez años dedicados a la ciencia, decide colgar la bata y ahondar en su otra pasión: la comunicación científica. Actualmente trabaja como escritora freelance y asesora de comunicación para empresas de biotecnología. Es colaboradora habitual de Mapping Ignorance.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo Genética eres tú se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las herramientas de edición genética CRISPR y los ratones avatar

- Sobre la predisposición genética a padecer enfermedades

- Sobre la predisposición genética a padecer enfermedades (II)

Elisa Sainz de Murieta – Naukas Pro 2019: Impactos del cambio climático

Foto: Tiko Giorgadze / Unsplash

Foto: Tiko Giorgadze / UnsplashUna introducción a qué es y qué factores afectan al cambio climático y como abordarlos, incluyendo los aspectos socioeconómicos. Esto es lo que ofrece Elisa sainz de Murieta al presentar el trabajo que se realiza en el Basque Centre for Climate Change (BC3) en esta charla de 2019.

Elisa Sainz de Murieta es geóloga e investigadora principal del BC3 en varios proyectos H2020 relacionados con la evaluación de los costes del cambio climático y la adaptación a los efectos costeros del cambio climático en la ciudad de Dakar.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Elisa Sainz de Murieta – Naukas Pro 2019: Impactos del cambio climático se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Bilbao 2017 – José Miguel Viñas: Me río yo del cambio climático

- Los ecosistemas acuáticos de África y el cambio climático

- Dani y Fiti sobre el cambio climático

Cómo pronosticar el éxito del tratamiento del cáncer con inmunoterapia

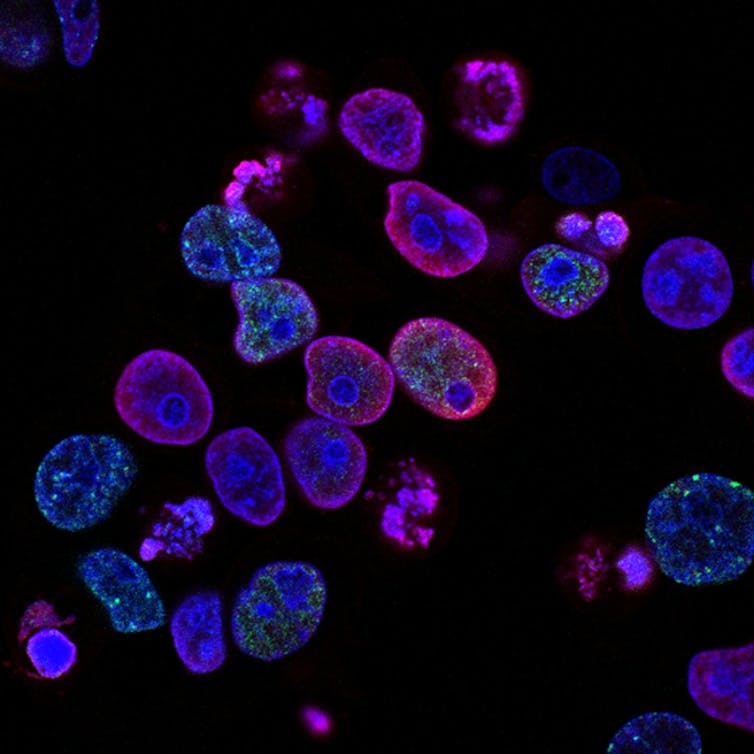

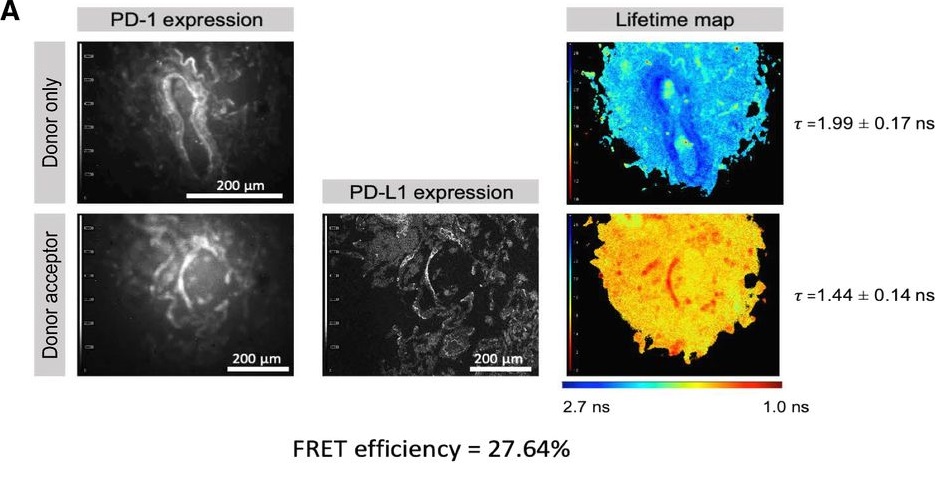

Un grupo internacional liderado por la doctora Banafshe Larijani, investigadora Ikerbasque adscrita al Instituto Biofisika (UPV/EHU, CSIC), ha desarrollado un nuevo método de diagnóstico que permite pronosticar con precisión qué pacientes de cáncer responderán positivamente a la inmunoterapia. Este método permitirá a los oncólogos adecuar el tratamiento a cada paciente y evitar las terapias que no vayan a tener éxito.

La inmunoterapia es un tipo de tratamiento del cáncer que ayuda al sistema inmunológico del paciente a combatirlo y tiene un impacto profundamente positivo en los tratamientos oncológicos, si bien no funciona en todos los casos: tiene mucho éxito en algunos pacientes, mientras que en otros tiene poco o ningún efecto. Dados los riesgos inherentes a estos procedimientos, se ha establecido una necesidad creciente de definir qué pacientes tienen más probabilidades de beneficiarse, evitando la exposición innecesaria a aquellos que no lo harán.

En el grupo liderado por la doctora Larijan, quien también es directora del Centro de Innovación Terapéutica (CTI) de la Universidad de Bath (Reino Unido), han colaborado colegas de otros centros en Euskadi (Biocruces, PIE, BCAM), europeos y la empresa FASTBASE Solutions Ltd. La nueva herramienta de pronóstico ha sido desarrollada utilizando una plataforma de microscopía avanzada que identifica las interacciones de las células inmunes con las células tumorales y también informa sobre el estado de activación de los puntos de control inmunitarios que amortiguan la respuesta antitumoral.

En una persona sana, los llamados puntos de control inmunológico regulan estrechamente la respuesta inmunitaria del cuerpo, actuando como un interruptor para prevenir enfermedades autoinmunes e inflamatorias. El equipo de la doctora Larijan ha analizado un punto de control inmunológico que consta de dos proteínas: PD-1 (presente en células inmunitarias llamadas linfocitos T) y PD-L1 (presente en otros tipos de células inmunitarias y en la superficie de muchos tipos diferentes de tumores).

Por lo general, cuando el PD-1 en la superficie de los linfocitos T se acopla con el PD-L1 en la superficie de otras células inmunes, apaga eficazmente la función inmunológica de la célula T. Y eso es lo que hacen las células tumorales: al expresar PD-L1 en su superficie, activan PD-1 en el linfocito T, con lo que desactivan su función antitumoral y permiten la supervivencia y el crecimiento del tumor. Los inhibidores empleados en la inmunoterapia funcionan interrumpiendo la interacción entre el PD-L1 en el tumor y el PD-1 en la célula T, y así restablecen la actividad antitumoral del paciente. Esta nueva herramienta determina el alcance de la interacción PD-1 / PD-L1 en una biopsia del tumor, prediciendo si es probable que la terapia con inhibidores del punto de control tenga un beneficio clínico significativo.

“Actualmente, las decisiones sobre si proceder con el tratamiento con inhibidores de puntos de control se basan simplemente en si PD-1 y PD-L1 están presentes en las biopsias, más que en su estado funcional. Sin embargo, nuestro trabajo ha demostrado que es mucho más importante saber que las dos proteínas realmente interactúan y, por lo tanto, es probable que tengan un impacto funcional en la supervivencia del tumor», indica la profesora Larijani.

Referencia:

Lissete Sánchez-Magraner, James Miles, Claire L. Baker, Christopher J. Applebee, Dae-Jin Lee, Somaia Elsheikh, Shaimaa Lashin, Katriona Withers, Andrew G. Watts, Richard Parry, Christine Edmead, Jose Ignacio Lopez, Raj Mehta, Antoine Italiano, Stephen G. Ward, Peter J. Parker and Banafshé Larijani (2020) High PD-1/PD-L1 checkpoint interaction infers tumour selection and therapeutic sensitivity to anti-PD-1/PD-L1 treatment Cancer Research doi: 10.1158/0008-5472.CAN-20-1117

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Cómo pronosticar el éxito del tratamiento del cáncer con inmunoterapia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Inmunoterapia contra el cáncer

- Magnetosomas para el tratamiento del cáncer

- Nanopartículas recubiertas para el tratamiento localizado del cáncer por hipertermia magnética

Un genio desconocido del Renacimiento

Ilustración basada en una foto de Wikimedia Commons

Ilustración basada en una foto de Wikimedia CommonsFue contemporáneo de Leonardo da Vinci, solo un poco mayor que Miguel Ángel y, quizás, el único creador renacentista comparable a ellos dos en cuanto a talla artística y relevancia histórica. Y, sin embargo, es probable que nunca hayas escuchado siquiera su nombre. Me refiero al compositor Josquin Desprez. Pocos músicos a lo largo de la historia han gozado de mayor prestigio entre sus contemporáneos o han ejercido una influencia más profunda y duradera sobre los que les siguieron. Desprez fue aclamado en vida como “el mejor compositores de nuestro tiempo”, el “padre de los músicos”, “el amo de todas las notas” —como se refirió a él Martín Lutero.

Josquin desarrolló su carrera en una etapa de grandes cambios musicales, que darían paso a un lenguaje musical internacional dentro de Europa. Él fue uno de los artistas que ayudó a guiar esta transición, incorporando los valores humanistas del Renacimiento en el mundo de la música. Frente a la música teórica, cerebral y erudita de la etapa anterior, sus composiciones muestran la influencia de formas populares del momento, como la frottola, un tipo de canción con una textura simple (generalmente homofónica, lo que significa que todas las voces se mueven a la vez y complementan a la principal, siguiendo el mismo ritmo), melodías fáciles de seguir, estribillos pegadizos y un texto laico generalmente alegre, desenfadado o hasta irónico. Dentro de este afán por simplificar la música y acercarla a su público, Josquin fue conocido por su don para la melodía y su capacidad de ligarla al texto para hacerlo más comprensible. Para él y otros compositores renacentistas, la música había dejado de ser una creación puramente intelectual, el resultado de complejas relaciones numéricas y mudas. La música era, ante todo, una extensión de las emociones humanas y como tal, debía imitar la entonación de los actores que con su voz eran capaces de conmover al público.

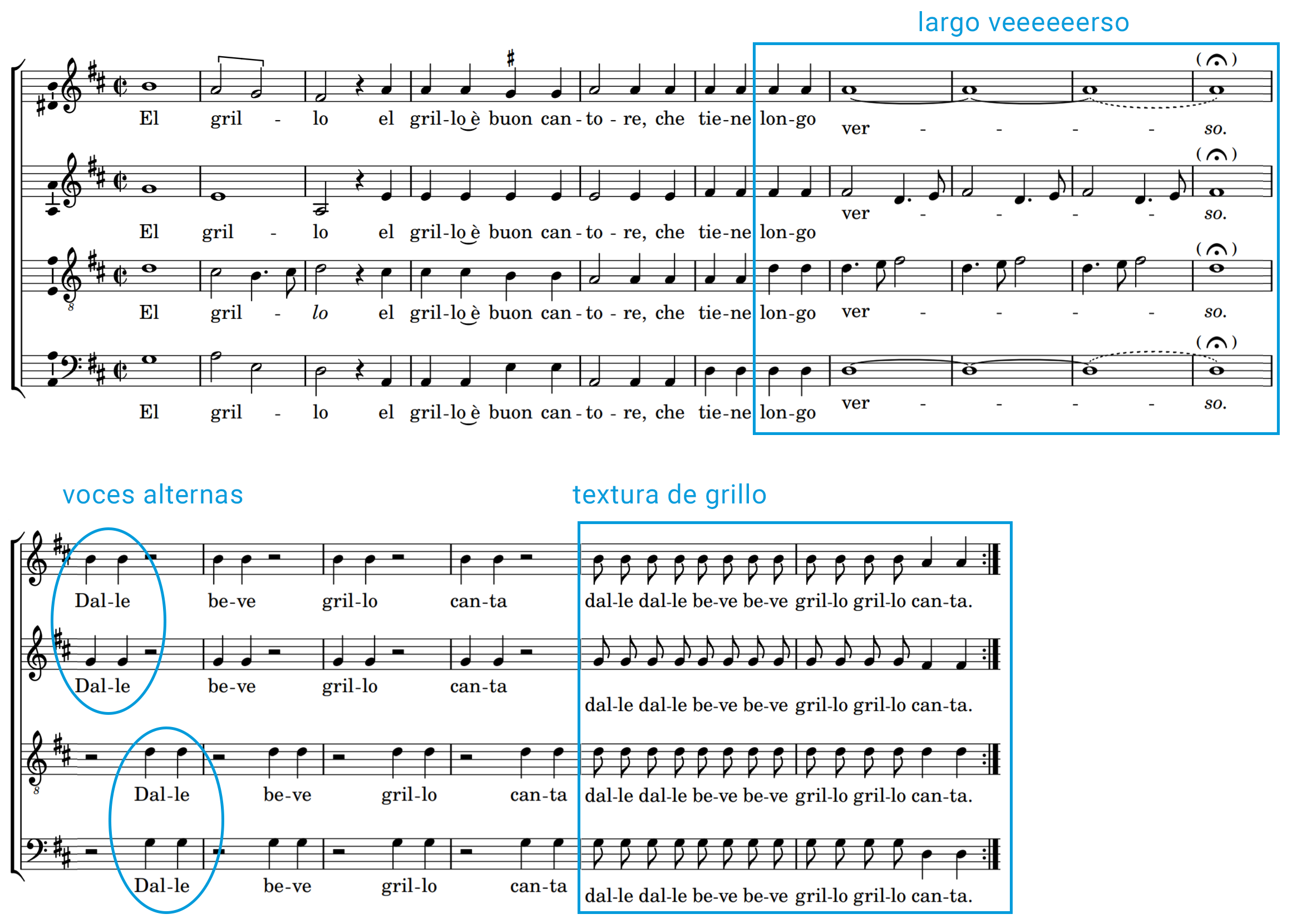

Y por qué os cuento todo esto, os preguntaréis. Pues porque tengo un problema. Tengo una canción pegadiza que me invade la cabeza cada dos por tres y que fue compuesta hace más de 500 años. La melodía es esta:

El grillo es, probablemente, la frottola más popular de Josquin Desprez. Irónica y tierna, habla de lo “buon cantore” que es el pequeño insecto y lo bien que aguanta las notas largas. Aunque también se ha especulado que Josquin podría estar refiriéndose a su amigo el cantante Carlo Grillo. Grillo formaba parte de la capilla musical del cardenal Ascanio Sforza que, al parecer, era bastante rácano a la hora de remunerar a sus músicos. Desprez podría estar al tanto de los aprietos económicos de su compañero y por ello compone esta frottola con un doble sentido, a modo de canción protesta. Léase: señor cardenal, pague usted al buen Grillo, que al contrario que muchos pájaros, él es un músico fiel y canta por amor.

El grillo è buon cantore,Che tienne longo verso,

Dalle beve grillo canta.Ma non fa come gli altri uccelli,

Come li han cantato un poco,

Van’ de fatto in altro loco

Sempre el grillo sta pur saldo,Quando la maggior è’l caldo

Al’ hor canta sol per amore. El grillo es un buen cantante

de verso y notas largas

¡Vamos, grillo, bebe, canta!No hace como los otros pájaros.

Que cantan un poco

Y luego se van a otro sitio,

El grillo se mantiene donde está …Si el mes de mayo es cálido

él canta solo por amor.

Lo más llamativo de la canción es que la música ilustra el texto en varios momentos ¡e imita incluso el canto del simpático bicho! Nada más empezar, por ejemplo, cuando la letra que el grillo es capaz de cantar notas o versos largos (longo verso), la melodía principal se detiene obstinadamente sobre una nota exageradamente larga, mientras las voces intermedias se alternan para dibujar una especie de vaivén: el cantar rugoso del propio grillo. Más adelante, los distintos cantantes se van turnando en una textura cada vez más rápida de notas repetidas que, de nuevo, recuerda al sonido vibrante del propio grillo.