Neandertales arcaicos en el yacimiento de la Sima I de la cueva de El Polvorín

Asier Gómez Olivencia et al.*

Los neandertales habitaron Europa y parte de Asia desde hace unos 200.000 años hasta se extinguieron, hace 40.000 años. A nivel esquelético, las diferencias que podemos encontrar entre neandertales y nuestra especie, Homo sapiens, son muchas, y ambos grupos se pueden distinguir incluso con el hueso más pequeño del esqueleto: el estribo del oído medio. Por ello, los neandertales podrían considerarse como una especie paleontológica. Sin embargo, somos parientes cercanos y compartimos con los neandertales un antepasado común con una antigüedad de entre hace un millón a 500.000 años del que descendemos las dos especies. De hecho, el estudio del genoma neandertal ha permitido demostrar que hubo hibridación entre este grupo humano y las poblaciones de nuestra propia especieque habían salido de África. Debido a ello, una parte de las poblaciones de Homo sapiens actuales preservan entre un 2 y un 4% de ADN neandertal.

El origen de los neandertales hay que buscarlo en las poblaciones humanas del Pleistoceno medio. Por ejemplo, la población de la Sima de los Huesos, que tiene una cronología entre 430.000 y 300.000 años, presenta rasgos anatómicos considerados claramente neandertales mezclados con otros más primitivos. Es decir, la población de la Sima de los Huesos muestra algunos, pero no todos los rasgos anatómicos típicos de los neandertales del Pleistoceno superior. La mayor parte del registro neandertal que se conoce tiene una cronología posterior a 135.000 años de antigüedad y suele consistir, mayoritariamente, en dientes u otros restos aislados. Hasta la fecha se han recuperado alrededor de 40-50 esqueletos parciales o completos, en algunos casos en conexión anatómica, es decir, con los huesos colocados en la posición en la que estarían en vida. Muchos de estos casos han sido interpretados como enterramientos intencionales. Además, algunos conjuntos de restos neandertales muestran marcas de corte y huesos fracturados intencionalmente, que son interpretados como evidencia de la práctica de canibalismo. Sin embargo, a excepción de la Sima de los Huesos, los restos del linaje neandertal de más de 135.000 años son muy escasos y, aunque conocemos la evolución de este grupo a grandes rasgos, todavía existen muchos interrogantes.

Desfiladero del río Karrantza (Bizkaia). Foto: Javier Trueba (Madrid Scientific Films).

Desfiladero del río Karrantza (Bizkaia). Foto: Javier Trueba (Madrid Scientific Films).En el País Vasco se conocen varios yacimientos arqueológicos con evidencias de ocupaciones neandertales entre hace unos 200.000 y 40.000 años, como, por ejemplo, Axlor (Dima), Aranbaltza (Barrika), Arlanpe (Lemoa), Lezetxiki (Arrasate), y Amalda (Zestoa). Sin embargo, el número de yacimientos con restos humanos es mucho más escaso: Axlor ha proporcionado un resto craneal, un premolar perteneciente a un adulto y cuatro dientes de leche; en Arrillor (Zigoitia, Araba) se ha recuperado un único diente de leche y Lezetxiki ha proporcionado restos de distintas cronologías. Por un lado, un húmero recuperado en los niveles inferiores del yacimiento, que presenta ciertos rasgos similares a los húmeros de la Sima de los Huesos, y que fue datado mediante la técnica de las series del uranio, arrojando una edad mínima de 164.000 ± 9.000 años Por otro lado, los niveles superiores de Lezetxiki han proporcionado dos restos dentales, recientemente re-estudiados. Los recientes descubrimientos de la Sima I de El Polvorín incrementan notablemente el registro fósil de este linaje en el País Vasco.

La cueva y el yacimiento Entrada de la cueva de El Polvorín. Foto: Javier Trueba (Madrid Scientific Films).

Entrada de la cueva de El Polvorín. Foto: Javier Trueba (Madrid Scientific Films).La cueva de El Polvorín (Karrantza, Bizkaia) se encuentra situada en la ladera SE de la Peña de Ranero, en las estribaciones montañosas de acceso al desfiladero del río Karrantza. La boca de la cueva presenta una forma redondeada (6 x 6 m) y se sitúa a 180 m sobre el nivel del mar. Su desarrollo interno es bastante complejo y se compone de tres pisos de galerías intercomunicadas. Esta cueva es conocida por albergar una importante secuencia arqueológica, especialmente en su entrada, que fue excavada por J.M. de Barandiarán y T. Aranzadi en 1931, y por R. Ruiz Idarraga y F. d’Errico entre los años 2005 y 2010.

Muela carnicera de hiena (Crocuta spelaea) de la Sima I de la cueva de El Polvorín. Créditos de la fotografía: Javier Trueba (Madrid Scientific Films).

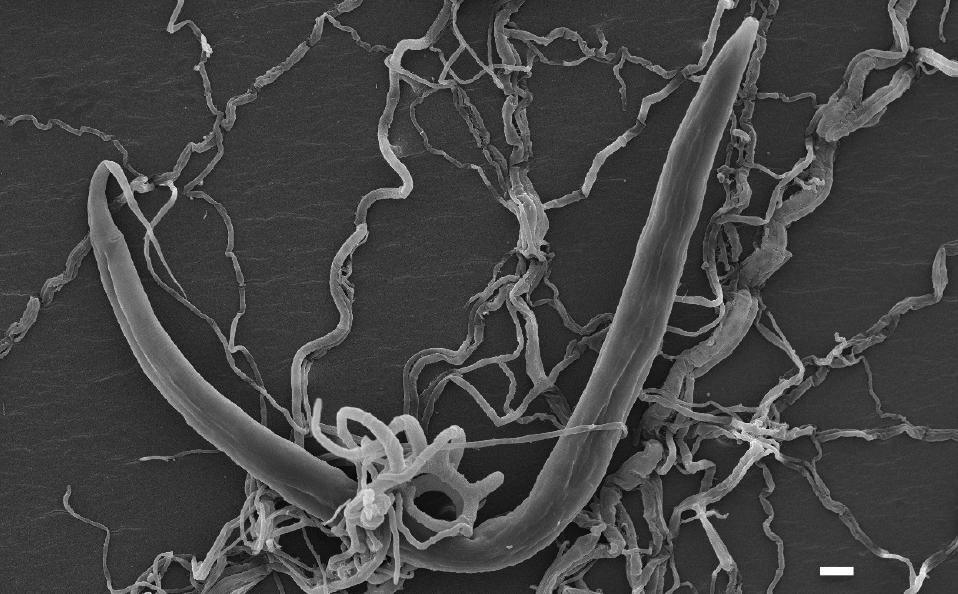

Muela carnicera de hiena (Crocuta spelaea) de la Sima I de la cueva de El Polvorín. Créditos de la fotografía: Javier Trueba (Madrid Scientific Films).El yacimiento paleontológico de la Sima I de la cueva de El Polvorín se descubrió con posterioridad a la secuencia arqueológica de la entrada, en las exploraciones realizadas entre noviembre y diciembre de 1982 por el Speleo Talde (grupo espeleológico) Illuntasunaren Lagunak. El yacimiento se sitúa en una galería inferior y el acceso al mismo se realiza a través de una galería lateral a 50 m de la entrada, para posteriormente descender una sima vertical de 7 m y después una rampa de otros 25 m. Este descenso implica utilizar un equipo y conocimientos de espeleología. En 1983 se realizó una primera extracción de fósiles, principalmente osos de las cavernas y hienas. En el año 2000 el mismo grupo realizó una segunda recogida superficial de fósiles, que también depositaron en el museo. A mediados de 2020, en una revisión de estos materiales en el Arkeologia Museoa, nuestro equipo identificó un resto humano entre los restos de fauna de la Sima I. En una posterior búsqueda sistemática, en noviembre del 2020, se identificaron nuevos restos humanos y se pudo observar que dichos restos presentaban rasgos morfológicos presentes en el linaje neandertal. En el año 2021 se inicia un proyecto de investigación, todavía en marcha, cuyo objetivo es estudiar los restos humanos y faunísticos de la Sima I de El Polvorín, así como su origen, acumulación y cronología. Además de estudiar los restos depositados en el Arkeologia Museoa, también se están realizando nuevas campañas de excavación en el propio yacimiento.

Proceso de excavación de la Sima I de la cueva de El Polvorín (diciembre de 2021). Foto: Equipo de Investigación de la Sima I de El Polvorín.Los restos humanos

Proceso de excavación de la Sima I de la cueva de El Polvorín (diciembre de 2021). Foto: Equipo de Investigación de la Sima I de El Polvorín.Los restos humanos

Izquierda: Fragmento de hueso frontal de la Sima I de la cueva de El Polvorín recuperado en 2022. Foto: Javier Trueba (Madrid Scientific Films). Derecha: Vista del fragmento de hueso frontal de la Sima I de la cueva de El Polvorín sobre el cráneo del neandertal de La Quina H5. Imagen: Antoine Balzeau (Muséum National d’Histoire Naturelle, Paris).

Izquierda: Fragmento de hueso frontal de la Sima I de la cueva de El Polvorín recuperado en 2022. Foto: Javier Trueba (Madrid Scientific Films). Derecha: Vista del fragmento de hueso frontal de la Sima I de la cueva de El Polvorín sobre el cráneo del neandertal de La Quina H5. Imagen: Antoine Balzeau (Muséum National d’Histoire Naturelle, Paris).Entre los fósiles del museo y las que se han excavado en las campañas de 2021 y 2022, actualmente se contabilizan 18 restos humanos pertenecientes a distintas regiones anatómicas del esqueleto, tanto del cráneo como del postcráneo. No hay elementos duplicados, y los fósiles presentan compatibilidad en cuanto al tamaño y el estado del desarrollo. Por tanto, podrían pertenecer a un mismo individuo. Las características gráciles del cráneo y del radio hacen pensar que se podría tratar de un individuo femenino, al que se ha denominado “Andere” (mujer en euskera).

Radio derecho de El Polvorín recuperado en 1983. Foto: Javier Trueba (Madrid Scientific Films).

Radio derecho de El Polvorín recuperado en 1983. Foto: Javier Trueba (Madrid Scientific Films).Curiosamente, su radio presenta una morfología más similar a la de la población de la Sima de los Huesos (de entre 430.000 y 300.000 años) que a la de los neandertales más recientes (de entre 135.000 y 40.000 años). Estas características sugieren que los restos de El Polvorín podrían ser los más antiguos de Bizkaia e, incluso, igual de antiguos (o más) que el húmero de Lezetxiki. Además, en el caso de la Sima I de El Polvorín, por primera vez se han descubierto restos de diferentes partes del esqueleto parcialmente conservado, lo cual aumenta la información que podemos obtener a partir de ellos. Varios restos humanos neandertales de este yacimiento se expondrán en una exposición sobre los neandertales en el País Vasco que tendrá lugar próximamente en el Arkeologia Museoa (Bilbao).

Contexto de los restos paleontológicosEl estudio de la cavidad ha puesto de manifiesto la complejidad de los procesos geológicos que han ocurrido en el interior de la misma, con varios eventos de sedimentación y de erosión. De momento no se han podido datar los restos humanos, ya que derivan de sedimentos en posición secundaria. Sin embargo, las investigaciones en la cueva han descubierto fósiles de fauna en su posición estratigráfica original (sin desplazamiento) de distintos momentos cronológicos. Uno de los objetivos de la excavación que se está llevando a cabo es encontrar contextos sin alterar en los que se recuperen nuevos restos humanos.

Cráneo parcial de oso de las cavernas (Ursus spelaeus) de la Sima I de la cueva de El Polvorín, recuperado en 1983. Foto: Javier Trueba (Madrid Scientific Films).

Cráneo parcial de oso de las cavernas (Ursus spelaeus) de la Sima I de la cueva de El Polvorín, recuperado en 1983. Foto: Javier Trueba (Madrid Scientific Films).Recientemente se ha publicado el primer estudio tafonómico de los restos de osos recuperados en los años 1983 y 2000 en la Sima I de El Polvorín. Los osos no fueron acumulados por la acción de las hienas o por la acción del ser humano. Su acumulación se debe a mortandad natural durante la hibernación, a la caída desde una galería superior, o a una combinación de ambas razones. Además, se han identificado osos pertenecen a dos cronologías distintas: la mayor parte corresponden a osos de las cavernas (Ursus spelaeus), mientras que una pequeña parte de la colección restos se ha atribuido a su antepasado, el oso de Deninger (Ursus deningeri). Cabe mencionar que, a poca distancia de Polvorín, en la cueva de Santa Isabel de Ranero, Trinidad de Torres excavó en los años 90 la mayor acumulación de restos de oso de Deninger de Bizkaia, con una cronología aproximada de 300.000 años.

Referencias:

Arsuaga, J.L., Carretero, J.-M., Lorenzo, C., Gómez-Olivencia, A., Pablos, A., Rodríguez, L., García-González, R., Bonmatí, A., Quam, R.M., Pantoja-Pérez, A., Martínez, I., Aranburu, A., Gracia-Téllez, A., Poza-Rey, E., Sala, N., García, N., Alcázar de Velasco, A., Cuenca-Bescós, G., Bermúdez de Castro, J.M., Carbonell, E., (2015) Postcranial morphology of the middle Pleistocene humans from Sima de los Huesos, Spain. Proceedings of the National Academy of Sciences of the United States of America 112, 11524–11529.

Arsuaga, J.L., Martínez, I., Arnold, L.J., Aranburu, A., Gracia-Téllez, A., Sharp, W.D., Quam, R.M., Falguères, C., Pantoja-Pérez, A., Bischoff, J., Poza-Rey, E., Parés, J.M., Carretero, J.M., Demuro, M., Lorenzo, C., Sala, N., Martinón-Torres, M., García, N., Alcázar de Velasco, A., Cuenca-Bescós, G., Gómez-Olivencia, A., Moreno, D., Pablos, A., Shen, C.-C., Rodríguez, L., Ortega, A.I., García, R., Bonmatí, A., Bermúdez de Castro, J.M., Carbonell, E. (2014) Neandertal roots: Cranial and chronological evidence from Sima de los Huesos. Science 344, 1358–1363.

Bailey, S.E., Davies, T.W., Imbrasas, M.D., Lazuen, T., Hublin, J.-J., González-Urquijo, J., (2024) New Neanderthal remains from Axlor cave (Dima, Biscay, northern Iberian Peninsula). Journal of Human Evolution 187, 103483. doi: 10.1016/j.jhevol.2023.103483

Basabe, J.M., (1966) El húmero premusteriense de Lezetxiki (Guipúzcoa). Munibe XVIII, 13-32.

Basabe, J.M. (1970) Dientes humanos del paleolítico de Lezetxiki (Mondragón). Munibe XXII, 113-124.

Bermúdez de Castro, J.M., Sáenz de Buruaga, A. (1999) Étude Préliminaire du site Pléistocène Supérieur à hominidé d’Arrillor (Pays Basque, Espagne). L’Anthropologie 103, 633-639.

de-la-Rúa, C., Altuna, J., Hervella, M., Kinsley, L., Grün, R. (2016) Direct U-series analysis of the Lezetxiki humerus reveals a Middle Pleistocene age for human remains in the Basque Country (northern Iberia). Journal of Human Evolution 93, 109-119. http://dx.doi.org/10.1016/j.jhevol.2016.02.001

Gómez-Olivencia, A., López-Onaindia, D., Sala, N., Balzeau, A., Pantoja-Pérez, A., Arganda-Carreras, I., Arlegi, M., Rios-Garaizar, J., Gómez-Robles, A. (2020) The human remains from Axlor (Dima, Biscay, northern Iberian Peninsula). American Journal of Physical Anthropology 172, 475-491. https://doi.org/10.1002/ajpa.23989

López-Onaindia, D., Lozano, M., Gómez-Robles, A., Arrizabalaga, A., Subirà, M.E. (2023) Neanderthal teeth from Lezetxiki (Arrasate, Iberian Peninsula): New insights and reassessment. American Journal of Biological Anthropology 180 745-760. doi: 10.1002/ajpa.24694

Pettitt, P.B. (2011) The Paleolithic origins of human burial. Routledge, London.

Rodríguez-Almagro, M., Gómez-Olivencia, A., Villalba de Alvarado, M., Arsuaga, J.L., Sala, N. (2024) Taphonomic study of the cave bears (Ursus cf. deningeri and U. spelaeus) from the Sima I of the El Polvorín cave (Northern Iberian Peninsula). Quaternary Science Advances 13, 100171 doi: 10.1016/j.qsa.2024.100171

Torres, T., Nestares, T., Cobo, R., Ortiz, J. E., Cantero, M. A., Ortiz, J., Vidal, R. & Prieto, J. O. (2001) Análisis morfológico y métrico de la dentición y metapodios del oso de Deninger (Ursus deningeri Von Reichenau) de la Cueva Sta. Isabel de Ranero. Aminocronología (Valle de Carranza – Bizkaia – País Vasco). Munibe (Ciencias Naturales – Natur Zientziak) 51, 107–141.

Torres, T., Ortiz, J. E., Fernández, E., Arroyo–Pardo, E., Grün, R. & Pérez–González, A. (2014) Aspartic acid racemization as a dating tool for dentine: A reality. Quaternary Geochronology 22, 43–56. https://doi.org/10.1016/j.quageo.2014.02.004

*Autoras: Asier Gómez Olivencia, Julia Aramendi, Mikel Arlegi, Martin Arriolabengoa, Antoine Balzeau, Isabelle Crevecoeur, Julia Galán, Aurore Issartel, Diego López Onaindia, Lucía López-Polín, Marina Lozano, Virginia Martínez Pillado, Javier Moreno, Adrián Pablos, Ana Pantoja Pérez, Manuel Rodríguez Almagro, Nohemi Sala, Mónica Villalba de Alvarado.

Agradecimientos: Las autoras desean expresar su agradecimiento al Arkeologia Museoa, y a todo su personal por facilitar este estudio. Este proyecto ha contado con la inestimable ayuda de los grupos espeleológicos ADES espeleología Elkartea, Grupo Espeleológico Esparta, Haitzulo Espeleo Taldea y de miembros de C.D. Eibar/Antxieta Arkeologi Elkartea. Gracias también a Ane, Josu y Nazan por su ayuda en diversas labores de campo y laboratorio.

El artículo Neandertales arcaicos en el yacimiento de la Sima I de la cueva de El Polvorín se ha escrito en Cuaderno de Cultura Científica.

Jugando la Eurocopa de fútbol en una mina

En estos días estamos viviendo uno de los numerosos eventos deportivos que nos deparará el verano, la Eurocopa de Naciones de Fútbol en categoría masculina de 2024, que se celebra en Alemania. Y uno de los estadios que está levantando mayor expectación entre los medios de comunicación y las personas aficionadas que disfrutan de los partidos, tanto de manera presencial en el campo como virtual a través de las retransmisiones televisadas, es el del equipo Schalke 04. Llamado antiguamente Arena auf Schalke, renombrado recientemente como Veltins-Arena, lo que hace tan especial a este estadio es que el túnel que atraviesan los jugadores de los dos equipos que van a disputar el partido para salir al campo imita el túnel de entrada a una mina. Y esto no es casualidad.

Aspecto del túnel de acceso al terreno de juego del estadio Veltins-Arena del equipo Schalke 04 de la localidad alemana de Gelsenkirchen.

Aspecto del túnel de acceso al terreno de juego del estadio Veltins-Arena del equipo Schalke 04 de la localidad alemana de Gelsenkirchen.El Schalke 04 es el equipo de la localidad de Gelsenkirchen, que se encuentra en el estado federal de Renania del Norte-Westfalia, situado en el sector noroccidental de Alemania. Geológicamente hablando, en esta zona afloran materiales de finales del Carbonífero, en concreto de hace entre unos 315 y 307 millones de años. En aquellos momentos, en este lugar se desarrollaron grandes pantanos completamente bordeados por gigantescos helechos arborescentes y coníferas que superaban los 20m de altura. Era tal la cantidad de vegetación que, cuando morían y caían al agua, los organismos descomponedores no fueron capaces de eliminar toda la materia orgánica generada, que se fue enterrando en diversas capas una sobre otra en los fondos arcillosos de las masas de agua pantanosas. Con el paso del tiempo, fruto de la presión y el aumento de la temperatura debido a la compactación y el enterramiento cada vez a mayor profundidad en el subsuelo, esta materia orgánica sufrió una transformación mineral, acabando por convertirse en carbón.

Es tal la cantidad de yacimientos de carbón que encontramos en este estado alemán, que se llegó a definir un Piso geológico de la subdivisión clásica europea del Periodo Carbonífero nombrado en su honor: el Westfaliense. Nomenclatura ya obsoleta en las cronologías mundiales estándares de la Tabla Cronoestratigráfica Internacional, pero ampliamente utilizada todavía en la actualidad en muchas zonas centroeuropeas e, incluso, en la Península Ibérica.

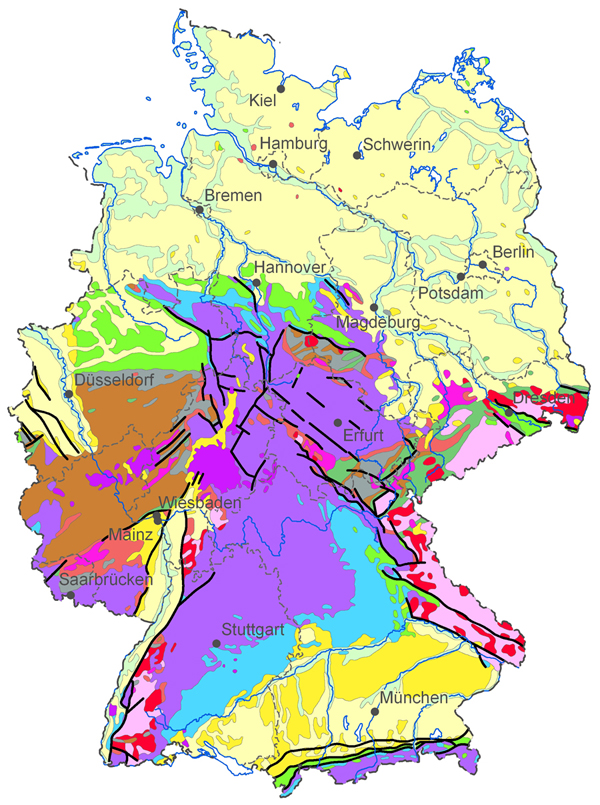

Mapa geológico de Alemania a escala 1:2.000.000, donde los materiales geológicos del Westfaliense aparecen representados de color marrón en el sector occidental del país. Fuente:l Bundesanstalt für Geowissenschaften und Rohstoffe (Instituto Federal de Geociencias y Recursos Naturales de Alemania)

Mapa geológico de Alemania a escala 1:2.000.000, donde los materiales geológicos del Westfaliense aparecen representados de color marrón en el sector occidental del país. Fuente:l Bundesanstalt für Geowissenschaften und Rohstoffe (Instituto Federal de Geociencias y Recursos Naturales de Alemania)Además, y como no podía ser de otra manera, el descubrimiento de estos abundantes yacimientos de carbón supuso un enorme motor económico para toda la zona occidental alemana durante la Revolución Industrial. Así, a mediados del siglo XIX, la localidad de Gelsenkirchen pasó de ser una pequeña ciudad post-medieval prusiana a convertirse en uno de los centros neurálgicos de la industrialización alemana. Actividad minera que prácticamente se mantuvo activa hasta los últimos estertores del siglo XX.

Esta importancia de la minería del carbón aún queda latente en la localidad. En su escudo heráldico podemos encontrar un cuadrante con una maza y un martillo cruzados, símbolo minero por excelencia, ambos de color blanco destacando sobre un fondo negro. Negro carbón, por supuesto. Y por toda la localidad se pueden encontrar antiguas explotaciones, fábricas, maquinaria y chimeneas de tratamiento del carbón que permanecen en pie como testigos mudos de todo este proceso industrial. Pero lo más llamativo lo encontramos en el aspecto deportivo, en concreto, en ese túnel de acceso de los jugadores al campo de fútbol.

Una vez más, os puedo mostrar un ejemplo de cómo la Geología condiciona todo el desarrollo social de un entorno, hasta el punto de caracterizar su ambiente deportivo. Lo mejor es cuando esta interacción supera las fronteras locales, pasando a obtener fama mundial gracias a un evento del que millones de personas, más allá de Europa, está pendiente. Sobre todo, porque el personal que comenta los partidos se centra en destacar, continuamente, esta particularidad tan geológica.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Jugando la Eurocopa de fútbol en una mina se ha escrito en Cuaderno de Cultura Científica.

La historia de Mobius, un ejercicio topológico

Mobius the Stripper es una de las historias contenidas en la antología del mismo título, Mobius the Stripper. Stories and short plays, del escritor británico Gabriel Josipovici (1940).

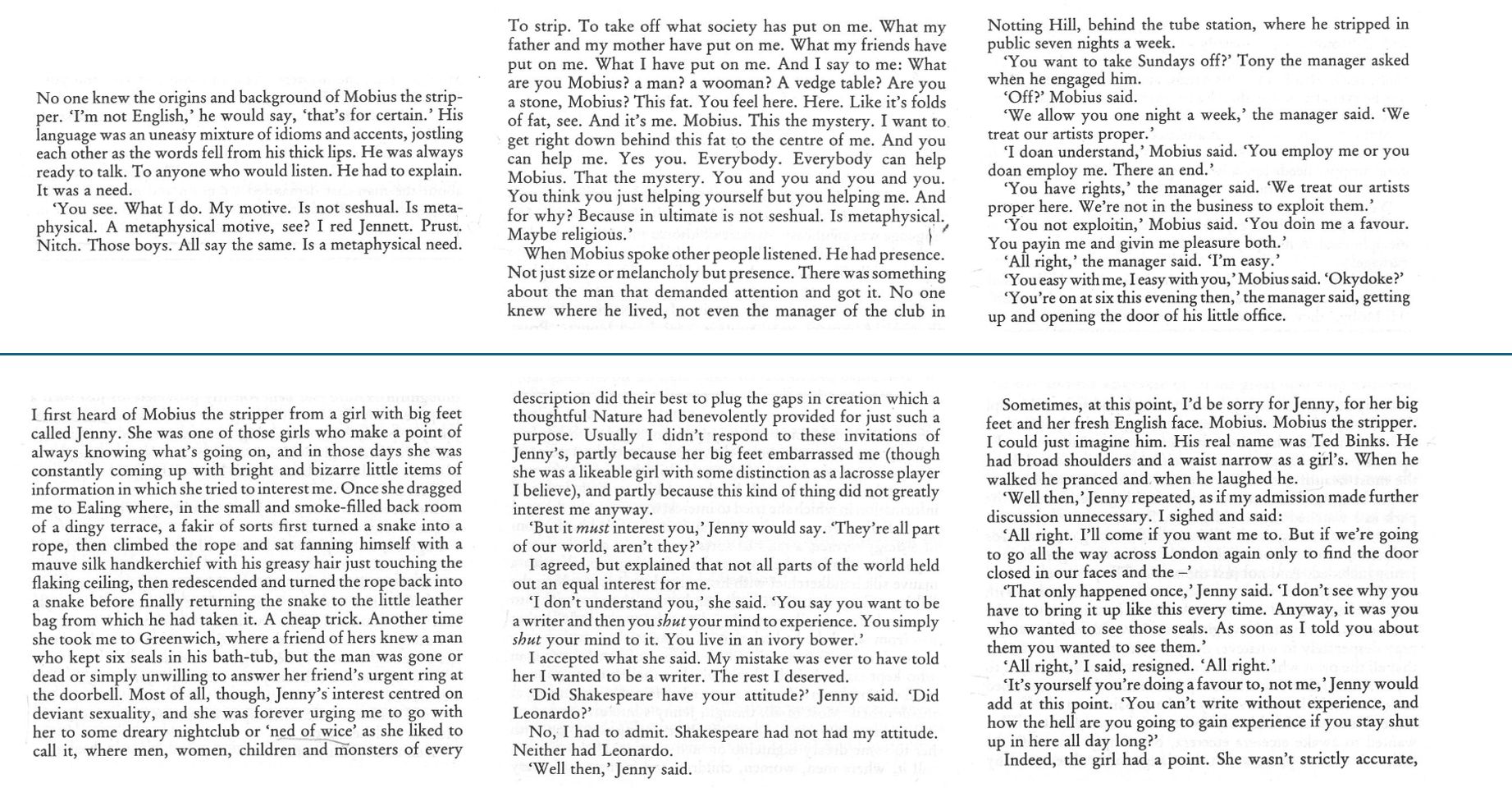

La breve historia Mobius the Stripper lleva como subtítulo A Topological Exercise (Un ejercicio topológico). Las veinte páginas que componen este texto comparten la misma estructura: una línea horizontal las separa en dos trozos en los que se narran dos relatos distintos, pero entrelazados.

Las tres primeras páginas de Mobius the Stripper colocadas consecutivamente formando una tira.

Las tres primeras páginas de Mobius the Stripper colocadas consecutivamente formando una tira.

Encima y debajo de la línea horizontal se narran dos historias distintas, pero relacionadas de alguna manera en cada una de las páginas. Puede pensarse que cada uno de esos dos relatos está escrito por un único lado de una larga tira de papel.

En la primera de esas tiras se cuenta la historia de Mobius (el nombre aparece escrito de este modo, no como Möbius o Moebius), un hombre que siente una “necesidad metafísica” (según sus propias palabras) de desnudarse, “de quitarme lo que la sociedad me ha puesto”, para poder descubrir su verdadero yo. Trabaja como stripper en un club nocturno de Londres, en el que, mientras actúa, habla. Lo que desnuda mientras se exhibe de este modo es su alma, no su cuerpo.

La segunda tira, formada yuxtaponiendo los textos situados en la segunda mitad de cada hoja (la situada bajo la línea horizontal), relata la historia de un joven escritor que se enfrenta a una crisis creativa. Ansía escribir algo diferente, pero, intimidado por los grandes escritores del pasado, está bloqueado. Su amiga Jenny le anima a ir a ver el espectáculo del stripper Mobius, sugiriéndole que sería un medio para distraerse, cambiar sus ideas y encontrar la inspiración.

El ejercicio topológico comienza al tomar estas dos historias, estas dos largas tiras de papel, y pegarlas: la segunda tira se gira 180 grados (esta operación se precisa para, tras terminar el “ejercicio topológico”, poder leer correctamente) y se encola en el reverso de la primera tira. Se consigue de este modo una nueva tira de papel, en la que la historia de Mobius está escrita en el anverso y la del joven escritor en el reverso. Si se pegan los dos extremos estrechos de esta tira para formar una banda de Möbius, se obtiene un relato escrito sobre una única cara. Tras leer la historia del stripper, comienza la del escritor, íntimamente ligada a la de Mobius. ¿Es Mobius una creación del escritor o su inspiración? ¿Cuál de las dos historias es realmente la primera? ¿La del stripper o la del escritor? ¿Quién ha creado a quién? ¿Mobius es quien inspira y libera al escritor, o es el autor quien imagina y da vida a este extraño stripper? ¿Cuál es el principio? ¿Cuál es el final?

La historia principal, la de Mobius, finaliza cuando el stripper se suicida, pegándose un tiro frente a un espejo, sonriendo. Crea de este modo una página en blanco ante la que el escritor reacciona. Y empieza entonces a escribir una historia (¿la historia?) sobre Mobius, el stripper a quien nunca ha visto: «Quizás era solo una historia, arbitraria, incompleta, pero de repente supe que crearía su propia necesidad y en el proceso me devolvería mi yo perdido».

Bonus: Diario de un mal añoDiary of a Bad Year (Text Publishing, 2007, traducido al castellano como Diario de un mal año en Mondadori) del Premio Nobel John Maxwell Coetzee (1940) también utiliza la línea horizontal como recurso para contar al mismo tiempo hasta tres historias entrelazadas.

Los primeros cinco capítulos del libro constan de páginas divididas en dos trozos por una línea horizontal. El texto principal, sobre la línea, contiene las anotaciones del diario de un hombre, el Señor C, un reconocido autor que escribe sobre temas políticos. En la parte de debajo se cuenta la historia del autor de este diario. A partir del capítulo 6 (hasta el último capítulo, el 24) se introduce una segunda línea horizontal, con lo que cada página se descompone en tres partes. Las dos primeras continúan del mismo modo que en los primeros capítulos y, en el tercer nivel del texto, se introduce a Anya, que vive en el mismo edificio del Señor C y que mecanografía los textos del escritor.

Como en el caso de Mobius the Stripper, las tres narraciones simultáneas (que conviven en la misma página) están relacionadas, y cada una revela diferentes aspectos del mismo relato: el diario (los pensamientos) del Señor C, la crónica del enamoramiento del escritor por Anya, y finalmente los esfuerzos de la mujer que debe mantener a raya a su novio Alan que siente celos del autor. Son diferentes textos que se complementan, se cruzan y crean finalmente un relato completo y único.

La geometría de las páginas de Diario de un mal año no obedece a un ejercicio topológico como en Mobius the Stripper, pero la herramienta narrativa sigue la misma estructura.

Referencias

- Gabriel Josipovici, Mobius the Stripper. Stories and short plays, Littlehampton Book Services Inc., 1974

- John Maxwell Coetzee, Diario de un mal año, Penguin Random House, 2014

- Éric Paul Meljac (2009). Seductive Lines: The Use of Horizontal Bars by Josipovici and Coetzee, and the Art of Seduction, Journal of Modern Literature 33 (1) 92-101

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y editora de Mujeres con Ciencia

El artículo La historia de Mobius, un ejercicio topológico se ha escrito en Cuaderno de Cultura Científica.

La cuestión de la equidad ilumina la cuestión de qué es difícil

Teóricos de la complejidad computacional han descubierto una nueva y sorprendente forma de comprender qué hace difíciles ciertos problemas.

Un artículo de Lakshmi Chandrasekaran. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

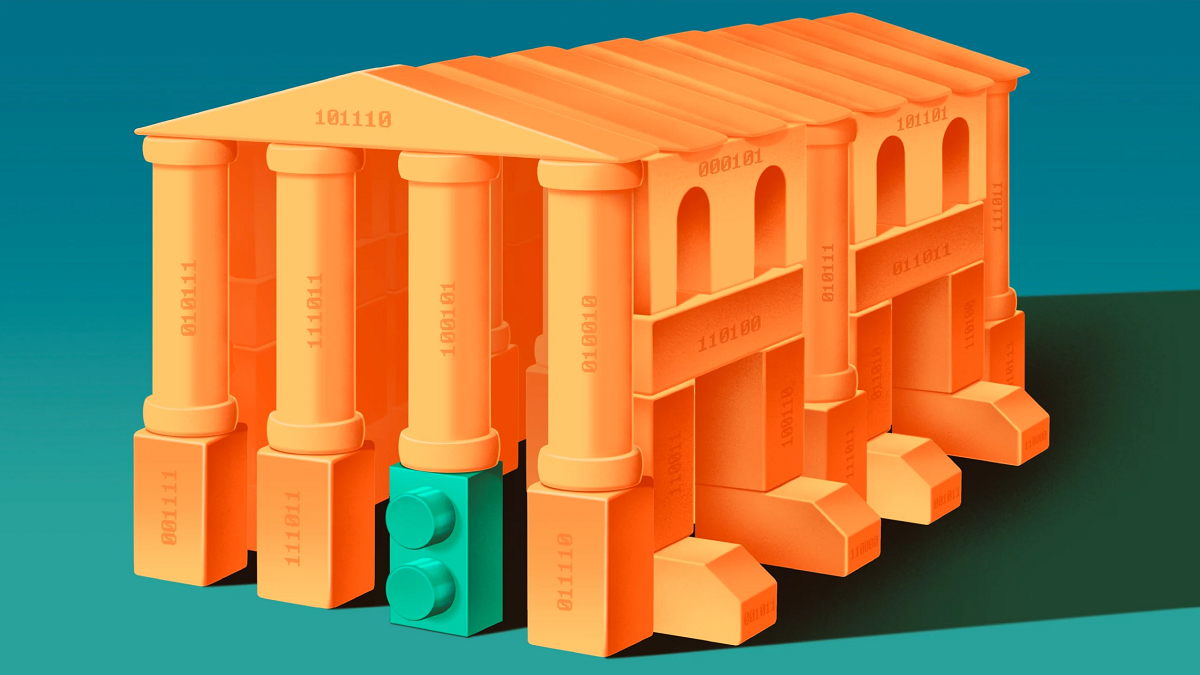

Ilustración: Nash Weerasekera para Quanta Magazine

Ilustración: Nash Weerasekera para Quanta MagazineLos informáticos teóricos se ocupan de ideas complicadas. Pero siempre que sea posible, preferirán trabajar con otras más simples. Una herramienta de 2009 conocida como lema de la regularidad les ofrece una excelente manera de hacerlo. De hecho, les permite dividir un problema o función computacional determinado en partes más simples.

Para los teóricos de la complejidad computacional, que estudian la dificultad relativa de diferentes problemas, esta capacidad de simplificar les ha ayudado durante mucho tiempo a comprender funciones matemáticas difíciles de manejar. Pero ciertos problemas con partes complejas todavía desafían el análisis.

Ahora, un nuevo trabajo proporciona una manera de analizar esos problemas difíciles de entender. El avance proviene de un área inesperada de la informática: la equidad algorítmica, donde algoritmos como los utilizados por bancos y compañías de seguros se examinan para asegurar que tratan a las personas de manera justa. Los nuevos resultados muestran que las herramientas de equidad pueden mapear efectivamente las diferentes partes de un problema difícil y aislar las regiones precisas del problema que dificultan su solución.

“Es realmente un trabajo fantástico. Creo que es muy emocionante”, afirma Michael Kim, científico informático de la Universidad de Cornell que ayudó a crear una de las herramientas de equidad que se ha reutilizado en el nuevo trabajo. «Como teórico que trabaja en estos espacios, es un resultado ideal que alguien tome tu trabajo de un área y lo aplique a otra».

Pronósticos de precisiónA medida que las instituciones se sienten más cómodas usando algoritmos para decidir quién obtiene un préstamo bancario, por ejemplo, o quién debe recibir libertad condicional, se ha vuelto más importante tener una manera formal de verificar que los prejuicios humanos no se están infiltrando en los cálculos. Pero hay más de una forma de medir lo que es justo.

Comencemos con el problema general de medir la precisión de una predicción. Digamos que se te ocurre un programa de ordenador que predice si va a llover en tu ciudad y quieres medir su precisión. Digamos también que tiende a llover alrededor del 40% de los días del año. Si utilizas una herramienta de equidad llamada multiprecisión, tu algoritmo podría considerarse preciso si realiza una predicción promedio cercana al 40%. Esto podría lograrse si el algoritmo predice un 40% de probabilidad de lluvia todos los días del año, o si predice un 100% de lluvia solo el 40% de los días (ya que el promedio sería el mismo). Sin embargo, si le pides que sea más específico: ¿lloverá el martes? – y el mismo algoritmo puede no ser preciso.

Consideremos ahora un algoritmo que predice si es probable que los solicitantes de préstamos realicen todos sus pagos. No es suficiente tener un algoritmo que prediga la tasa general correcta: el 40% de probabilidad de lluvia en nuestro ejemplo anterior. Necesita predecir la tasa de individuos específicos en diferentes grupos de población de una manera que sea tan precisa como justa.

Las predicciones precisas generalmente disminuyen a medida que se agregan capas de complejidad, como una fecha específica para el pronóstico del tiempo o una persona específica que solicita un préstamo. Las situaciones de la vida real rápidamente se vuelven demasiado complejas para que la precisión múltiple sea la mejor forma de medirlas.

En 2018, Kim y otros investigadores en equidad idearon un paradigma de equidad nuevo y más sólido llamado multicalibración, que tiene en cuenta estos niveles de complejidades. Este enfoque impone predicciones “calibradas”; básicamente, cada capa de complicación se tiene en cuenta en el sistema. La multicalibración significa que las predicciones de un algoritmo son precisas, ya sea que se miren todos los días o solo el martes. O si estás haciendo predicciones de préstamos para todas las personas o solo para ciertos tipos de personas. La multicalibración debería garantizar la equidad en todos los ámbitos.

Pero su utilidad no termina aquí.

Más allá de la equidadEl año pasado un equipo de informáticos teóricos vio la oportunidad de llevar estas herramientas a un campo diferente. Mostraron cómo la multiprecisión y la multicalibración eran equivalentes a los teoremas existentes en la teoría de grafos, una disciplina matemática que estudia las relaciones entre objetos. Esto hizo que Salil Vadhan, un científico informático de la Universidad de Harvard, se preguntara dónde más podría ser útil la herramienta.

«Vimos que estaban obteniendo resultados [usando] la multicalibración en teoría de grafos», cuenta Vadhan, uno de los autores del lema de la regularidad de 2009, así como del trabajo más reciente. «Ahora intentemos hacerlo también con la teoría de la complejidad». Formó equipo con su colega de Harvard Cynthia Dwork, quien también fue una de las autoras del artículo sobre teoría de grafos, y su estudiante de grado Sílvia Casacuberta (que ahora es estudiante de posgrado en la Universidad de Oxford).

Desde la izquierda: Cynthia Dwork, Salil Vadhan, y Sílvia Casacuberta adaptaron una herramienta del campo de la equidad algorítmica para mejorar nuestra comprensión de ciertos problemas difíciles. Fuentes: (desde la izquierda) Cynthia Dwork; Eliza Grinnell/Harvard SEAS; Allison Olivia Choat/Harvard University

Desde la izquierda: Cynthia Dwork, Salil Vadhan, y Sílvia Casacuberta adaptaron una herramienta del campo de la equidad algorítmica para mejorar nuestra comprensión de ciertos problemas difíciles. Fuentes: (desde la izquierda) Cynthia Dwork; Eliza Grinnell/Harvard SEAS; Allison Olivia Choat/Harvard UniversityEl trío terminó estableciendo una especie de diccionario que traducía entre herramientas de equidad e ideas en la teoría de la complejidad. Demostraron que cualquier población (ya sean días por pronosticar o solicitantes en espera de préstamos) podría traducirse en un panorama de posibles entradas para un problema computacional.

Una vez establecidas las conexiones, los investigadores demostraron que la multiprecisión, la herramienta de equidad más débil, es equivalente al lema de la regularidad: una función simple, como la predicción promedio de las precipitaciones, puede aproximarse a una compleja, como el promedio verdadero (calculado usando la ocurrencia real de lluvia). «La conexión con la multiprecisión y la regularidad es solo un cambio de terminología», afirma Vadean.

Después de demostrar esto, los investigadores naturalmente se preguntaron si la multicalibración, la herramienta de equidad más poderosa, podría aplicarse para demostrar algo más sólido. Se podía: descubrieron que la capacidad de un algoritmo de equidad para mantener predicciones precisas dentro de subpoblaciones podría aplicarse para fortalecer otro lema, conocido como el lema fundamental de Impagliazzo. El lema nos ayuda a comprender la estructura de un problema difícil, observando todas sus posibles entradas (inputs) y preguntándonos cuáles serían las más difíciles de resolver.

Para imaginar un problema que solo es difícil con ciertos inputs, volvamos a la lluvia. Consideremos una región con una estación lluviosa, en la que llueve casi todos los días, y una estación seca, en la que casi nunca llueve. Gracias a esto, podemos predecir correctamente si lloverá el 90% del tiempo. El 10% restante (presumiblemente días en el límite entre las dos estaciones, en los que la lluvia y los cielos despejados son igualmente probables) son inputs difíciles. Las predicciones para esos días no pueden ser mucho mejores que las conjeturas aleatorias.

«¿Qué inputs de un problema computacional [descrito por una función difícil] son más fáciles y cuáles son más difíciles?» se preguntó el fallecido Luca Trevisan, científico informático teórico de la Universidad Bocconi en Italia y uno de los autores del lema de la regularidad de 2009. Impagliazzo demostró que, para cualquier problema difícil, siempre hay un conjunto común de puntos difíciles que son difíciles para cualquier algoritmo eficiente.

Los autores del nuevo trabajo han demostrado que la aplicación de los estrictos requisitos de la multicalibración mejoran el lema, generalizándolo para aplicarlo a más problemas. Los intentos anteriores de identificar los inputs concretos de un problema, en lugar de simplemente demostrar que existen, implicaban dividir los inputs en fragmentos más pequeños y buscar una función de aproximación que siguiera funcionando. Finalmente, después de suficientes divisiones, era posible identificar los inputs que no podían aproximarse. El único problema era que la división daba como resultado un número exponencial de fragmentos a procesar, por lo que el enfoque no era factible. Pero al aplicar la multicalibración, los investigadores han podido reducir el número total de divisiones, simplificando así el enfoque para aproximar la función difícil.

«Me gusta mucho su resultado», comenta Huijia (Rachel) Lin, científica informática teórica de la Universidad de Washington y una de las autoras del artículo sobre teoría de grafos del año pasado. «Realmente se trata de volver al clásico [lema fundamental] y darle un nuevo giro».

«Es realmente genial ver que tenemos este enfoque de predicción inspirado en la complejidad que ha promovido nuevas ideas chulas en equidad, [y] es guay verlas volver a la complejidad y cerrar el círculo», comenta Kim. «Creo que tienes esperanza en [que] este tipo de cosas [ocurran]».

El artículo original, The Question of What’s Fair Illuminates the Question of What’s Hard, se publicó el 24 de junio de 2024 en Quanta Magazine.

Traducido por César Tomé López

El artículo La cuestión de la equidad ilumina la cuestión de qué es difícil se ha escrito en Cuaderno de Cultura Científica.

Una nueva (e inesperada) función de los sacos aéreos

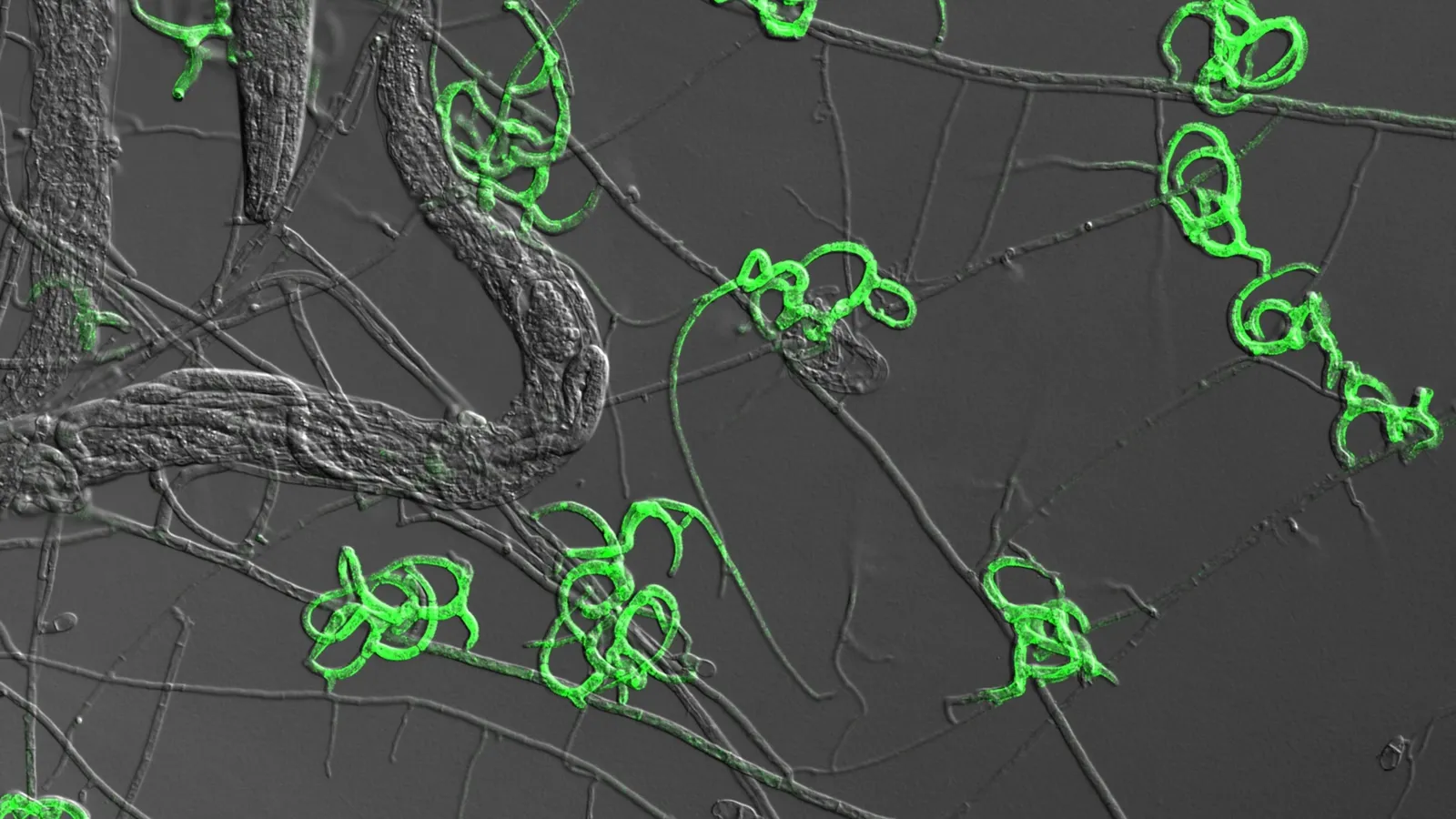

Desde el punto de vista energético el vuelo de las aves es prodigioso. Los músculos de las aves, y de forma especial los pectorales, requieren un ingente aporte de energía para cumplir su función. El esfuerzo muscular y el mantenimiento de una temperatura constante hacen que las aves consuman una gran cantidad de alimento, generalmente entre el 10 y el 20% de su masa corporal cada día. El caso extremo es el de los colibríes, los animales endotérmicos con mayor tasa metabólica, que pueden consumir diariamente hasta cinco veces su masa corporal.

El alimento no es el único condicionante del metabolismo aviar. Ese alimento debe ser oxidado para producir energía, por lo que el sistema respiratorio debe suministrar oxígeno en grandes cantidades. Esta es la razón por la que el sistema respiratorio de las aves es completamente diferente al de cualquier otro grupo de vertebrados, incluyendo a los mamíferos. Y un componente esencial de este particular sistema son los sacos aéreos.

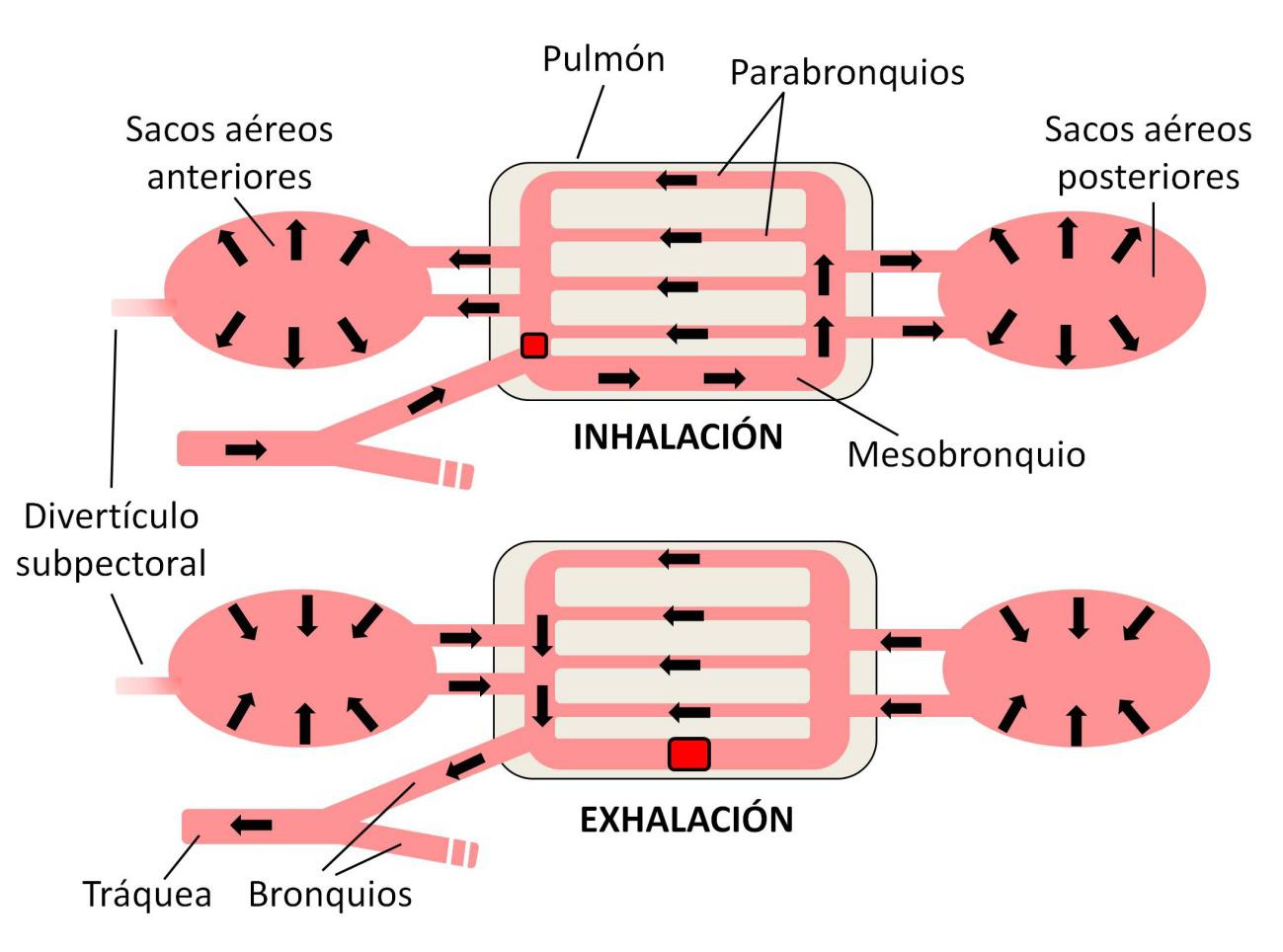

Los sacos aéreos son divertículos de los pulmones que se distribuyen por el cuerpo del animal. Un grupo se localiza en la parte anterior del tronco y otro en la región posterior del tórax y en el abdomen. Se les atribuyen funciones tales como regular la temperatura interna, reducir la fricción entre los músculos o disminuir la densidad corporal. Pero su función principal está relacionada con el sofisticado sistema de ventilación pulmonar de las aves.

Los pulmones de las aves no se hinchan y deshinchan como los nuestros. Esto no sería suficientemente eficaz, ya que en los pulmones de los mamíferos el contenido en oxígeno se va empobreciendo tras la inspiración, al ir pasando a la sangre. Al final del ciclo el aire enrarecido es exhalado y se renueva en la siguiente inspiración.

Figura 1. Ciclo de ventilación pulmonar en las aves. Durante la inhalación, el aire llena los sacos aéreos posteriores y circula por los parabronquios. El aire empobrecido en oxígeno se acumula en los sacos aéreos anteriores. En la exhalación, la contracción de los sacos aéreos posteriores mantiene una corriente de aire fresco a través de los parabronquios, mientras que se expulsa el aire de los sacos anteriores. Un sistema de válvulas (en rojo) regula los flujos. Se muestra la posición del divertículo subpectoral

Figura 1. Ciclo de ventilación pulmonar en las aves. Durante la inhalación, el aire llena los sacos aéreos posteriores y circula por los parabronquios. El aire empobrecido en oxígeno se acumula en los sacos aéreos anteriores. En la exhalación, la contracción de los sacos aéreos posteriores mantiene una corriente de aire fresco a través de los parabronquios, mientras que se expulsa el aire de los sacos anteriores. Un sistema de válvulas (en rojo) regula los flujos. Se muestra la posición del divertículo subpectoralLos pulmones de las aves (Figura 1) están formados por una compleja red de tubos finos y muy vascularizados llamados parabronquios. Por estos parabronquios circula una corriente continua de aire fresco, lo que mantiene siempre altos los niveles de oxígeno para su captación por la sangre. Los sacos aéreos posteriores, funcionando como el fuelle de la gaita gallega, almacenan el aire de entrada y lo dirigen hacia los parabronquios durante la espiración. El aire empobrecido en oxígeno se almacena en los sacos anteriores hasta su expulsión. Así, aunque el ave inspire y espire de forma cíclica, el flujo de aire en los parabronquios es continuo, unidireccional y rico en oxígeno.

El llenado y vaciado rítmico de los sacos aéreos se logra por acción de los músculos torácicos y abdominales. Es decir, la acción muscular contribuye a la ventilación pulmonar, de una forma análoga a lo que hace nuestro diafragma. Por eso ha resultado tan sorprendente el descubrimiento de que, a la inversa, los sacos aéreos tienen una función importante en la mecánica del vuelo, en concreto del vuelo planeado.

Figura 2. El alimoche (Neophron percnopterus) es un ave planeadora que utiliza el mecanismo de los divertículos subpectorales para reducir el esfuerzo de sus músculos pectorales. Fuente: lifegyptianvulture.it

Figura 2. El alimoche (Neophron percnopterus) es un ave planeadora que utiliza el mecanismo de los divertículos subpectorales para reducir el esfuerzo de sus músculos pectorales. Fuente: lifegyptianvulture.itLas aves planeadoras mantienen las alas desplegadas para generar su sustentación (Figura 2). Sus músculos pectorales tienen que trabajar menos que los encargados de batir las alas, pero así y todo deben realizar un esfuerzo sustancial para mantener el despliegue de las alas. Curiosamente, las aves planeadoras generalmente tienen unos pequeños divertículos de los sacos aéreos anteriores, localizados bajo los músculos pectorales y de función hasta ahora desconocida. Se denominan divertículos subpectorales, y no aparecen en aves con vuelo batido.

Un reciente artículo publicado en Nature ha mostrado que este divertículo apareció al menos siete veces de forma independiente en la evolución de las aves, siempre coincidiendo con el desarrollo del vuelo planeado. Tienen divertículos subpectorales las gaviotas, grullas, albatros, cormoranes, pelícanos, águilas y otras rapaces planeadoras. La propuesta de los autores de este estudio es que el inflado del divertículo subpectoral disminuye el esfuerzo necesario para mantener el despliegue de las alas durante el vuelo planeado.

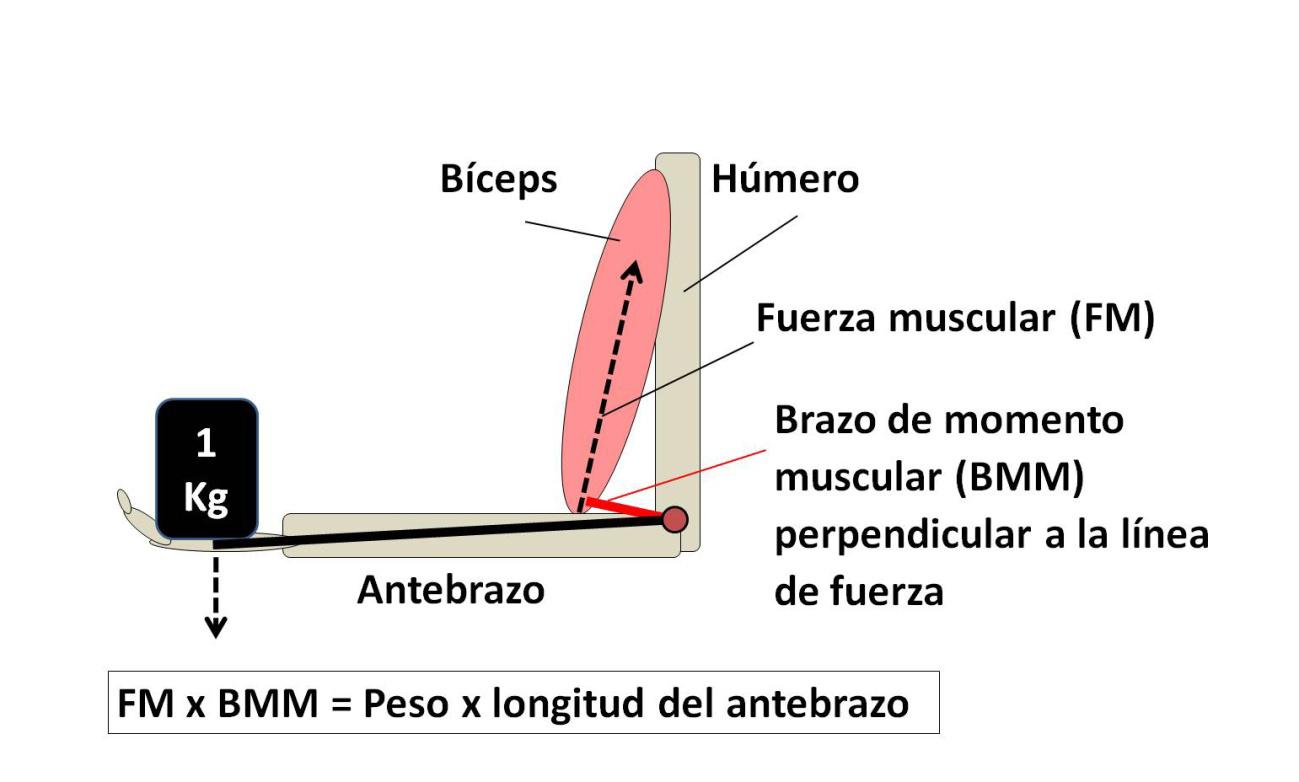

Figura 3. Cuando sostenemos un peso con el brazo en ángulo recto a una distancia determinada del codo, dicha distancia multiplicada por el peso debe ser igual a la fuerza ejercida por el bíceps multiplicada por el brazo de momento muscular

Figura 3. Cuando sostenemos un peso con el brazo en ángulo recto a una distancia determinada del codo, dicha distancia multiplicada por el peso debe ser igual a la fuerza ejercida por el bíceps multiplicada por el brazo de momento muscularPara comprender esto tenemos que explicar el concepto de brazo de momento, la distancia perpendicular entre la línea de acción de una fuerza y un eje de rotación. La figura 3 ilustra esta idea. Si ponemos el brazo en ángulo recto y sostenemos un peso, la fuerza que tenemos que hacer será tanto mayor cuando más cerca del codo esté el eje del bíceps y viceversa. Esta distancia perpendicular entre línea de fuerza muscular y articulación del codo es el brazo de momento muscular.

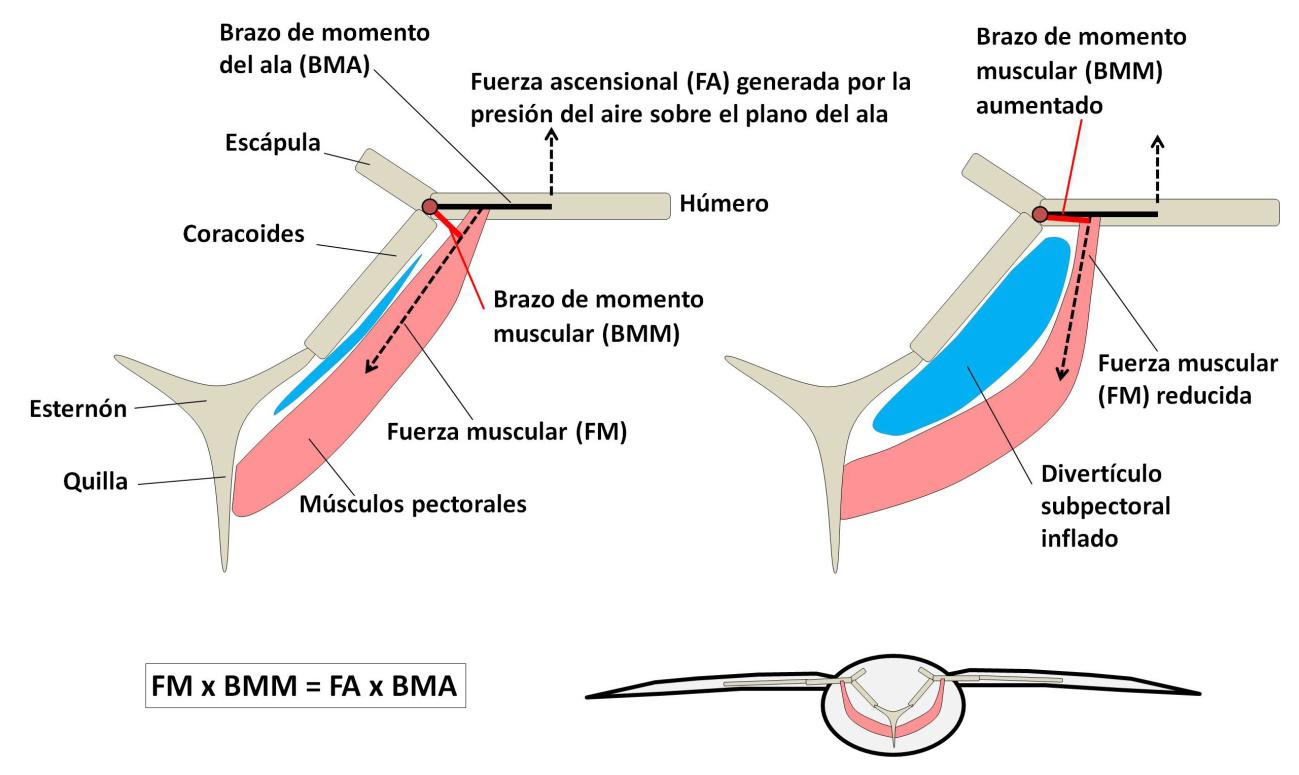

Figura 4. La disminución del esfuerzo necesario para mantener el ala desplegada en las aves planeadoras se produce por el inflado del divertículo subpectoral, que cambia el ángulo de inserción de los músculos pectorales sobre el húmero. De esta forma, aumenta el brazo de momento muscular

Figura 4. La disminución del esfuerzo necesario para mantener el ala desplegada en las aves planeadoras se produce por el inflado del divertículo subpectoral, que cambia el ángulo de inserción de los músculos pectorales sobre el húmero. De esta forma, aumenta el brazo de momento muscularLa figura 4 ayudará a entender la insospechada función de los divertículos subpectorales. Los músculos pectorales se insertan en el húmero y en el esternón, pasando por encima de otros huesos de la cintura pectoral (coracoides y clavícula). Para mantener el planeo, la fuerza desplegada por los músculos debe compensar la fuerza ascensional generada por la presión del aire sobre las alas. Para ser más preciso, el brazo de momento muscular de los pectorales (BMM) multiplicado por la fuerza muscular (FM) debe igualar al brazo de momento del ala (BMA) multiplicado por la fuerza ascensional (FA):

BMM x FM = BMA x FA

La clave está en que el inflado del divertículo subpectoral aumenta el brazo de momento muscular, y disminuye proporcionalmente el esfuerzo muscular necesario para equilibrar la fuerza ascensional. Se trata de una nueva e inesperada función de los sacos aéreos, una innovación adquirida al menos por siete linajes de aves de forma concomitante al desarrollo del vuelo planeado. Y otro fascinante ejemplo de bricolaje evolutivo.

Referencias:

Schachner, E.R., Moore, A.J., Martinez, A. et al. (2024) The respiratory system influences flight mechanics in soaring birds. Nature. doi:10.1038/s41586-024-07485-y

Tobalske BW. (2024) Air sacs reduce energy costs for soaring birds. Nature. doi: 10.1038/d41586-024-01508-4.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga

El artículo Una nueva (e inesperada) función de los sacos aéreos se ha escrito en Cuaderno de Cultura Científica.

Algo repentino acabó con el mamut lanudo

Un análisis genómico demuestra que la población de estos grandes mamíferos en la isla de Wrangel, en Rusia, fue relativamente estable hasta su repentina desaparición hace tan solo 4000 años. Este descubrimiento refuta la teoría de que se extinguieron por razones genéticas.

Colmillo de mamut lanudo (Mammuthus primigenius) en la isla rusa de Wrangel. Foto: Love Dalén

Colmillo de mamut lanudo (Mammuthus primigenius) en la isla rusa de Wrangel. Foto: Love DalénLa última población de mamut lanudo (Mammuthus primigenius) quedó aislada en la isla de Wrangel (Rusia), frente a la costa de Siberia, hace unos 10.000 años, cuando el nivel del mar subió y separó la montañosa isla del continente.

Un nuevo análisis genómico revela que los mamuts aislados, que vivieron en la isla durante los 6.000 años siguientes, se originaron a partir de un máximo de 8 individuos, pero crecieron hasta 200-300 ejemplares en 20 generaciones.

Según el estudio, publicado en la revista Cell, los genomas de los mamuts de la isla de Wrangel mostraban signos de endogamia y baja diversidad genética, pero no hasta el punto de poder explicar su definitiva y misteriosa extinción.

«Ahora podemos rechazar con confianza la idea de que la población era simplemente demasiado pequeña y que estaban condenados a extinguirse por razones genéticas», afirma la autora principal Love Dalén, genetista evolutiva del Centro de Paleogenética (iniciativa conjunta del Museo Sueco de Historia Natural y la Universidad de Estocolmo).

«Esto significa que probablemente fue algún suceso aleatorio el que acabó con ellos, y si ese suceso no hubiera ocurrido, entonces seguiríamos teniendo mamuts hoy en día», afirma.

Enseñanzas para la conservaciónAdemás de arrojar luz sobre la dinámica de población del mamut lanudo, este análisis de los mamuts de la isla rusa podría ayudar a fundamentar las estrategias de conservación de animales actuales en peligro de extinción.

«Los mamuts son un sistema excelente para comprender la actual crisis de biodiversidad y lo que ocurre desde el punto de vista genético cuando una especie sufre un cuello de botella poblacional, porque reflejan el destino de muchas poblaciones actuales», afirma la primera autora, Marianne Dehasque, del Centro de Paleogenética.

Para comprender las consecuencias genómicas del cuello de botella de la isla de Wrangel en la población de mamuts, el equipo analizó los genomas de 21 mamuts lanudos: 14 de la isla de Wrangel y 7 de la población continental anterior al cuello de botella. En total, las muestras abarcaban los últimos 50.000 años de existencia del mamut lanudo, lo que permitía comprender cómo había cambiado la diversidad genética de los mamuts a lo largo del tiempo.

La comparación de los genomas de los mamuts de la isla con los de sus antepasados del continente fue lo que reveló los signos de endogamia y baja diversidad genética en los primeros. Además, mostraban una diversidad reducida en el complejo mayor de histocompatibilidad, un grupo de genes conocidos por desempeñar un papel fundamental en la respuesta inmunitaria de los vertebrados.

Foto de la réplica de mamut en el Royal British Columbia Museum. Foto: Geoff Peters / Wikimedia CommonsUn tamaño de la población estable

Foto de la réplica de mamut en el Royal British Columbia Museum. Foto: Geoff Peters / Wikimedia CommonsUn tamaño de la población estable

Los investigadores demostraron que la diversidad genética de la población siguió disminuyendo durante los 6.000 años que los mamuts habitaron la isla de Wrangel, aunque a un ritmo muy lento, lo que indica que el tamaño de la población se mantuvo estable hasta el final.

Y aunque la población de mamuts de la isla fue acumulando mutaciones moderadamente dañinas a lo largo de sus 6.000 años de permanencia, los investigadores demostraron que la población iba purgando lentamente las mutaciones más dañinas.

«Si un individuo tiene una mutación extremadamente dañina, básicamente no es viable, así que esas mutaciones desaparecieron gradualmente de la población con el tiempo, pero por otro lado, vemos que los mamuts fueron acumulando mutaciones medianamente dañinas casi hasta que se extinguieron», dice Dehasque.

«Es importante que los programas de conservación actuales tengan en cuenta que no basta con que la población vuelva a tener un tamaño decente –subraya–, y también hay que vigilarla genéticamente y de forma activa, porque estos efectos genómicos pueden durar más de 6.000 años».

Los últimos años del mamutAunque los genomas de mamut analizados en este estudio abarcan un amplio periodo de tiempo, no incluyen los últimos 300 años de existencia de la especie. Sin embargo, los investigadores han desenterrado fósiles del periodo final del mamut y planean llevar a cabo la secuenciación genómica en el futuro.

«No sabemos por qué se extinguieron después de haber estado más o menos bien durante 6.000 años, pero creemos que fue algo repentino», afirma Dalén, que concluye: «Yo diría que aún hay esperanzas de averiguar por qué se extinguieron, pero no hay promesas».

Una versión anterior de este artículo se ha publicado originalmente en SINC

El artículo Algo repentino acabó con el mamut lanudo se ha escrito en Cuaderno de Cultura Científica.

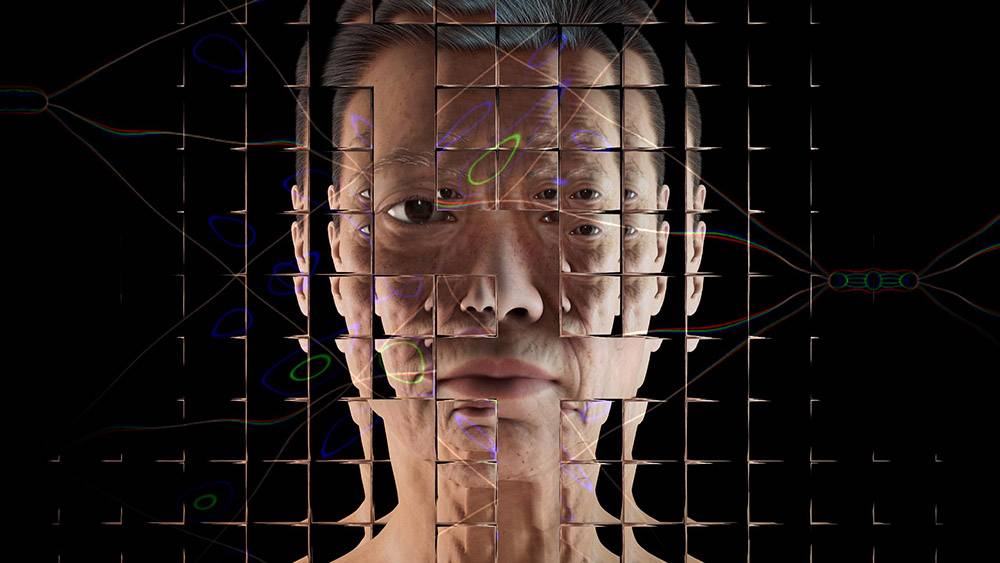

Cambios cerebrales durante el embarazo y la maternidad

Los cambios del cerebro durante el embarazo y la maternidad, cómo el estrés ha pasado de ser un mecanismo de supervivencia a un eventual elemento de riesgo para nuestra salud o cuál ha sido el papel que ha jugado el suicidio en la evolución del ser humano fueron algunos de los temas que se tratarán en la VI Jornada Nacional sobre Evolución y Neurociencias.

La jornada tuvo lugar el Bizkaia Aretoa de la UPV/EHU los pasados 25 y 26 de abril y estuvo dirigida por Eva Garnica y Pablo Malo, de la Red de Salud Mental de Bizkaia, institución que organizó la jornada junto a la Cátedra de Cultura Científica de la UPV/EHU.

El encuentro, cuya primera edición se celebró en 2017, se ha convertido en una cita imprescindible para las y los expertos en ámbitos como la psiquiatría, la psicología o la biología. Una jornada que sirve para analizar el comportamiento humano desde un punto de vista evolutivo y divulgar de un modo accesible para todos los públicos.

Los cambios fisiológicos y neuronales asociados al embarazo y crianza de los hijos transforman a la persona. Susana Carmona nos explica cómo afectan al cerebro de las madres en Cambios cerebrales durante el embarazo y la maternidad.

Susana Carmona Cañabate, psicóloga clínica y doctora en neurociencias, es investigadora principal del Grupo de Neuroimagen del Hospital General Universitario Gregorio Marañón (Madrid).

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Cambios cerebrales durante el embarazo y la maternidad se ha escrito en Cuaderno de Cultura Científica.

La IA podría convertir la ciencia en algo incomprensible

Hace unos días un artículo preaceptado en la revista Nature nos hablaba de las maravillas del modelo de inteligencia artificial (IA) AlphaFold 3, que superaban en mucho a su versión anterior. Se trata de un sistema capaz de predecir la estructura de proteínas, ácidos nucleicos y moléculas pequeñas cuyo potencial para la medicina de precisión y la creación de medicamentos es enorme. Además, el uso de modelos –tanto predictivos como generativos– de IA para diagnóstico está produciendo resultados asombrosos.

Casi al mismo tiempo, se nos informaba en los medios del proyecto de creación en la Unión Europea de un centro de investigación en IA dedicado especialmente al desarrollo de sistemas útiles para la investigación científica.

Todo esto no ha hecho más que comenzar. Las consecuencias que la extensión del uso de modelos predictivos tendría para la ciencia desde el punto de vista epistemológico y metodológico es un asunto sobre el que hay un creciente interés.

Esta imagen fue creada por Twistedpoly como parte del proyecto Visualizando la IA de Google DeepMind. Foto: Google DeepMind / Unsplash

Esta imagen fue creada por Twistedpoly como parte del proyecto Visualizando la IA de Google DeepMind. Foto: Google DeepMind / UnsplashEn otro artículo publicado este año en Nature se señalan tres ilusiones a las que puede conducir una aplicación acrítica de la IA en la investigación científica:

- La ilusión de profundidad explicativa. Consistiría en hacer creer a los científicos que entienden más sobre un conjunto de fenómenos porque han sido predichos con exactitud por un modelo de IA.

- La ilusión de amplitud exploratoria. Consistiría en creer que lo que puede ser modelizado por la IA agota la realidad que ha de ser explorada.

- La ilusión de objetividad. Consistiría en creer que las herramientas de la IA eliminan cualquier elemento de subjetividad y representa a todos los puntos de vista relevantes.

Son tres peligros que habrá que esquivar. La pérdida de importancia de la comprensión profunda de los fenómenos en la ciencia es un riesgo. La ciencia ha buscado la explicación y la predicción. Cabe la posibilidad de que el enorme éxito predictivo conseguido a través de sistemas de IA –que se comportan como cajas negras, puesto que son incapaces de justificar sus resultados–, relegue a un segundo plano la capacidad explicativa.

Como resultado, perdería peso la elaboración teórica en la ciencia y la búsqueda de las causas.

Estos modelos predictivos pueden ser muy útiles en la práctica, puesto que son capaces establecer correlaciones precisas que nos avisen con bastante seguridad de cuándo puede suceder algo –cuándo está aumentando la incidencia de una enfermedad–, pero el precio a pagar podría ser la imposibilidad de desentrañar lo que ocurre para encontrar una explicación causal.

Es cierto que no todos los sistemas de IA que se emplean en investigación funcionan como cajas negras. También es cierto que las correlaciones halladas por los modelos predictivos podrían ayudar a encontrar, mediante investigaciones ulteriores, relaciones causales imprevistas, conexiones nuevas e incluso fenómenos no conocidos o no conceptualizados hasta entonces.

Sin embargo, el empleo cada vez más extendido de sistemas de IA que presentan lo que se ha denominado opacidad epistémica puede conducir a la merma en la comprensión de la realidad que nos procura la capacidad explicativa de hipótesis, modelos y teorías.

“Calla y calcula”Se suele decir que la interpretación de Copenhague de la mecánica cuántica se resume en el mandato “calla y calcula”. Es una exageración, claro está, que buscaba que los físicos no se entretuvieran demasiado con las cuestiones de fundamento, ampliamente filosóficas, y se centraran en el éxito predictivo de la teoría. Cabría la posibilidad de que muchos científicos tomaran esa boutade como un mandato inevitable de la ciencia sometida a los designios de la IA.

Esta actitud podría tener consecuencias negativas en ciencias sociales y biomédicas, en las que se basan políticas públicas, y las decisiones que se tomen pueden afectar a la vida de las personas a causa, por ejemplo, de sesgos no detectados. Estas ciencias tratan sobre sistemas complejos en los que con frecuencia una pequeña variación en las condiciones iniciales puede llevar a resultados completamente diferentes.

¿Cómo decirle a un paciente que un modelo predictivo ha dado como resultado una alta probabilidad de padecer una enfermedad mortal de la que no muestra ningún síntoma, pero sin que haya posibilidad de darle ninguna explicación acerca de cómo el sistema ha llegado a tal conclusión? ¿Bastará con señalarle que el sistema es altamente fiable porque su éxito predictivo está bien constatado? ¿Debería un médico actuar de alguna manera o prescribir un tratamiento sin tener una garantía epistémica adicional que justifique su intervención?

Un resultado interesante a este respecto es que algunos estudios recientes han mostrado que las personas son favorables a priorizar la exactitud en las predicciones de los sistemas de IA frente a la explicabilidad de los resultados si tienen que elegir entre ambas cosas.

De esa elección entre explicación y predicción podrían decir mucho todas las ciencias basadas en modelos matemáticos, como la economía o la biología evolutiva. Pero, hasta ahora, incluso en esas ciencias los modelos cuantitativos buscaban establecer en la medida de lo posible relaciones causales, cosa que no es objetivo central de los modelos predictivos de IA, que solo buscan el acierto.

Sin embargo, la tentación de usar estos modelos predictivos es fuerte, puesto que los gestores de políticas públicas reclaman con frecuencia a los científicos sociales respuestas claras para los problemas acuciantes. Aquí se trata en el fondo de obtener respuestas fiables a problemas complejos, aún a costa de no entender bien por qué esa debe ser la respuesta correcta. Hay quienes abogan por una integración de ambos tipos de modelos, los centrados en la explicación causal y los centrados en la predicción. Está por ver cómo lograr tal cosa.

¿Hacia una ciencia ininteligible?El uso generalizado de estos modelos en la ciencia afectaría también a la idea de que el progreso científico se basa en la elaboración de hipótesis revisables que van siendo sustituidas por mejores hipótesis. En ese proceso, como ya señaló el filósofo de la ciencia Larry Laudan, una ganancia explicativa puede compensar una cierta pérdida predictiva.

No menos perturbadora sería la tendencia a creer que lo no tratable mediante modelos de IA deja de tener interés para la propia ciencia. En último extremo, podría conducir incluso a una ciencia en buena medida ininteligible para los humanos, en el sentido de que tendrán resultados conseguidos mediante modelos no interpretables. Este cambio nos obligaría a replantearnos no ya solo qué noción de verdad es la que aceptaremos sino, incluso, si no tendríamos que abandonar el concepto como tal, contentándonos con la mera utilidad de una creencia.

No parece que el ser humano esté, de momento, capacitado para este cambio.

Todo esto son buenas razones para no poner todo el peso de la investigación en los modelos predictivos, por beneficiosos que puedan ser. Estos modelos han de ser completados con el uso de modelos explicativos y con la búsqueda de hipótesis explicativas contrastables. Una contrastación para la que los modelos predictivos pueden cumplir una importante función.

Otra cosa sería que finalmente pudiera lograrse abrir de algún modo esas cajas negras, quizás mediante otros sistemas de IA que no fueran a su vez ellos mismos cajas negras, o bien que pudiera alcanzarse en el futuro una IA transparente, en la que los algoritmos fueran capaces de dar cuenta cabal de sus resultados de un modo inteligible para los seres humanos. Es un objetivo en el que se trabaja con creciente atención por parte de la inteligencia artificial explicable (XAI), pero el camino es aún incierto. Ojalá seamos capaces de hallarlo pronto.![]()

Sobre los autores: Antonio Diéguez Lucena, Catedrático de Lógica y Filosofía de la Ciencia, Universidad de Málaga e Iñigo De Miguel Beriain, Investigador distinguido, Facultad de Derecho, Ikerbasque Research Professor, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo La IA podría convertir la ciencia en algo incomprensible se ha escrito en Cuaderno de Cultura Científica.

El software humano del Proyecto Manhattan

A día de hoy, impresiona bastante darse cuenta de que algunos de los hitos científicos y tecnológicos más relevantes de la historia reciente se consiguieron con una capacidad computacional limitada por la cantidad de cerebros humanos que hubiera disponibles para trabajar en un problema. Pero el caso es que, en algunos centros de investigación, esos cerebros estaban casi mejor organizados que cualquier máquina de la que pudieran disponer. Ese fue el caso, alrededor de 1943, de las instalaciones de computación de Los Alamos durante el Proyecto Manhattan.

Lo importante de toda esta cuestión, y sin entrar ahora a detallar cómo se gestó o las circunstancias científicas, políticas y bélicas que llevaron hasta la determinación de financiar la creación de la primera bomba atómica, es que en los años cuarenta del siglo XX, los cálculos necesarios para diseñar un artefacto semejante no eran, ni mucho menos, triviales. Sobre todo en lo que concernía al diseño del mecanismo y el cálculo de la hidrodinámica de implosión de la bomba de plutonio ―el tipo que la que se probó en el test Trinity―, lo que suponía, entre otras cosas, determinar cuánta energía liberaría el artefacto. La imposibilidad, sobre todo al principio, de hacer pruebas implicaba que había que trabajar con modelos matemáticos que conllevaban la resolución de ecuaciones diferenciales en derivadas parciales no lineales, algo, para cualquiera que no esté familiarizado con ellas, bastante arduo sin un ordenador.

En aquel momento, sobre todo antes de la Segunda Guerra Mundial, se contaba, principalmente, con tres tipos de dispositivos de cálculo: calculadoras electromecánicas de escritorio; máquinas tabuladoras de tarjetas perforadas, y analizadores diferenciales ―un tipo de computador analógico como el que Vannevar Bush construyó en el MIT―. En el Proyecto Manhattan se utilizaron, sobre todo, los dos primeros. El analizador diferencial se destinó durante la guerra sobre todo a la elaboración de tablas de artillería.

A principios de 1943, Stanley P. Frankel y Edred Nelson llegarían a Los Alamos para encargarse de organizar todo el trabajo de matemáticas teórico. Ya habían adquirido experiencia de ese tipo en el Laboratorio Lawrence de Berkeley haciendo cálculos relacionados con la separación de isótopos de uranio y la estimación de la masa crítica necesaria para mantener una reacción en cadena. En Nuevo México se encargarían, en un principio, de los cálculos relacionados con la bomba de uranio, de tipo balístico, para más tarde, hacia 1944 y tras la insistencia de John von Neumann en un cambio de enfoque, pasar a encargarse de los relacionados con la bomba de uranio y su mecanismo de implosión.

Para ello, lo primero que hicieron fue encargar ciertas unidades de calculadoras de escritorio Marchant, Fridens y algunas Monroe, y las distribuyeron entre las «computadoras humanas» que se encargarían del proceso y que solían ser mujeres. Más adelante empezaron a valorar la posibilidad de utilizar máquinas tabuladoras y en marzo de 1944 llegó el refuerzo de las IBM 601, entre otras.

En Los Alamos, computadoras humanas, normalmente mujeres, realizaban a mano los cálculos necesarios para el desarrollo de la bomba atómica con calculadoras electromecánicas Marchant similares a la que aparece en la foto. Fuente: CC0 1.0/Daderot

En Los Alamos, computadoras humanas, normalmente mujeres, realizaban a mano los cálculos necesarios para el desarrollo de la bomba atómica con calculadoras electromecánicas Marchant similares a la que aparece en la foto. Fuente: CC0 1.0/Daderot

La IBM 601 era una máquina tabuladora capaz de multiplicar ―aunque no dividir― dos números que se introducían en ella utilizando tarjetas perforadas. Se llegaron a instalar cuatro de ellas en Los Alamos para finales de 1944, además de otros modelos similares de IBM con otras aplicaciones. El sistema se componía de ocho máquinas en total. Fuente: CC BY-SA 3.0/Sandstein

La IBM 601 era una máquina tabuladora capaz de multiplicar ―aunque no dividir― dos números que se introducían en ella utilizando tarjetas perforadas. Se llegaron a instalar cuatro de ellas en Los Alamos para finales de 1944, además de otros modelos similares de IBM con otras aplicaciones. El sistema se componía de ocho máquinas en total. Fuente: CC BY-SA 3.0/SandsteinAquí merece la pena hacer un inciso. Es de sobra conocido que, en los inicios de la historia de la computación, quienes se encargaban principalmente de las labores de programación de los primeros computadores eran ellas. En el caso del Proyecto Manhattan, quienes lo hacían eran, en un gran porcentaje, las esposas de los científicos que trabajaban allí. Así, podemos encontrar nombres como Mary Frankel, que llegó a supervisar uno de los grupos de cálculo, o Mici Teller, cuyos apellidos de casadas no deberían resultar desconocidos. También son reseñables los trabajos que Klara Dan von Neumman llevó a cabo allí tras la guerra con el ENIAC. Se estima que hubo más de trescientas mujeres allí ocupando puestos técnicos en el Proyecto Manhattan. En el caso de Los Alamos, el lugar era, además, una ciudad en miniatura donde se mudaron familias enteras, y se incentivó activamente el trabajo de estas mujeres, muchas de ellas amas de casa, otorgándoles ciertas ayudas, normalmente relacionadas con el cuidado del hogar y de los hijos.

Mary Frankel (X214) y Mici Teller (X169) fueron dos de las numerosas mujeres calculadoras que trabajaban en Los Alamos. Fuente: Los Alamos National Laboratory

Mary Frankel (X214) y Mici Teller (X169) fueron dos de las numerosas mujeres calculadoras que trabajaban en Los Alamos. Fuente: Los Alamos National Laboratory

No obstante, lo que más llama la atención del el equipo de computación de Frankel y Nelson no eran ni las mujeres calculadoras ni las máquinas que utilizaban en sí, sino la organización. Cuando empezaron a valorar el uso de máquinas tabuladoras para realizar los cálculos, idearon un sistema para agilizarlos creando una especie de «programa» o diagrama de flujo que dividía el proceso de resolución de una ecuación en pasos sencillos. Hasta que contaron con las IBM no pudieron probarlo directamente, así que hicieron una especie de simulacro utilizando el equipo de mujeres calculadoras. El proceso era bastante intuitivo. Con su Marchant encima de la mesa, cada una efectuaba uno de los pasos: unas hacían multiplicaciones, otras divisiones, otras raíces cuadradas… siempre lo mismo, y pasaban su resultado a la siguiente mesa en una tarjeta para que otra compañera continuara con su parte del cálculo. El sistema funcionó increíblemente bien, muchísimo mejor y más eficientemente que si una sola persona resolvía la ecuación completa paso a paso.

En medio de todo aquello se encontraba un jovencísimo físico de veintiséis años que en el futuro casi pasaría más a la historia por tocar los bongos que por ganar un premio Nobel: Richard Feynman. Era uno de los que se encargaba de reparar las calculadoras Marchant cuando se rompían ―no había tiempo de enviarlas al fabricante y esperar a que las devolviera―, y conocía muy bien el funcionamiento de todo aquello. Cuando llegaron las primeras IBM, en abril de 1944, también ayudó a Frankel y Nelson a montarlas ―el secretismo extremo alrededor de todo lo relacionado con el Proyecto Manhattan complicó, en un primer momento, que ningún empleado de IBM consiguiera autorización para ir a Los Alamos para hacerlo―. Y en cuanto todo estuvo listo, obviamente, Feynman tuvo una de sus peculiares ideas: poner a competir a las mujeres calculadoras y a las máquinas tabuladoras realizando el mismo trabajo: ¿quién tardaría menos en resolver un problema? A día de hoy, diríamos que cualquier ordenador, pero entonces ganaron las mujeres. La única desventaja que mostraron, utilizando el mismo proceso de cálculo, era que, obviamente y a diferencia de las IBM, la fatiga acababa haciendo mella en ellas.

Aquel «programa» humano, unido al uso de las máquinas tabuladoras ya operativas, supuso un aumento de rendimiento espectacular porque, además, vieron que de esta manera no tenían que limitarse a realizar un solo cálculo por vez, sino que podían llegar a efectuar hasta dos o tres en paralelo. Utilizando tarjetas de colores, en cada puesto se realizaba el mismo paso siempre, pero para diferentes asuntos, cada uno identificado con un color.

Es curioso, además, como aquellas máquinas tan básicas hicieron perder la cabeza a Stanley Frankel, que se puso a utilizarlas para cualquier cosa menos para lo que las habían comprado y a probar qué serían capaces de hacer ―como el geek que se compra un PC nuevo con las últimas especificaciones del mercado―. Feynman acabaría sustituyéndolo en su puesto, y demostró ser un gran organizador. El equipo que trabajaba con las máquinas tabuladoras, ahora formado principalmente por chavales jóvenes sacados del instituto con algún conocimiento técnico o de ingeniería, ni siquiera sabía para qué eran todos aquellos cálculos. Feynman consiguió permiso para contárselo y, de nuevo, la productividad se disparó: los chicos empezaron a buscar maneras de mejorar y agilizar los procesos trabajando día y noche. Se pasó de resolver tres problemas en nueve meses, antes de las tabuladoras y de aquel software humano, a nueve problemas en tres meses.

Es increíble, que con tan solo lápiz, papel y talento, los científicos sacaran todo ese partido a aquellas máquinas rudimentarias y se las apañaran para desentrañar uno de los secretos más intrincados del átomo.

La única imagen a color de la explosión de Trinity con buena exposición, tomada por Jack Aeby. Fuente: Wikimedia Commons

La única imagen a color de la explosión de Trinity con buena exposición, tomada por Jack Aeby. Fuente: Wikimedia Commons

Bibliografía

Archer, B. J. (2021). The Los Alamos computing facility during the Manhattan Project. Nuclear technology, 204, pp. S190-S203. doi: 10.1080/00295450.2021.1940060

Feynman, R. P. (2018 [1987]). ¿Está usted de broma, Sr. Feynman? Aventuras de un curioso personaje. Alianza Editorial.

Howes, R. y Herzenberg, C. L. (1999). Their day in the sun. Women of the Manhattan Project labor and social change. Temple University Press.

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo El software humano del Proyecto Manhattan se ha escrito en Cuaderno de Cultura Científica.

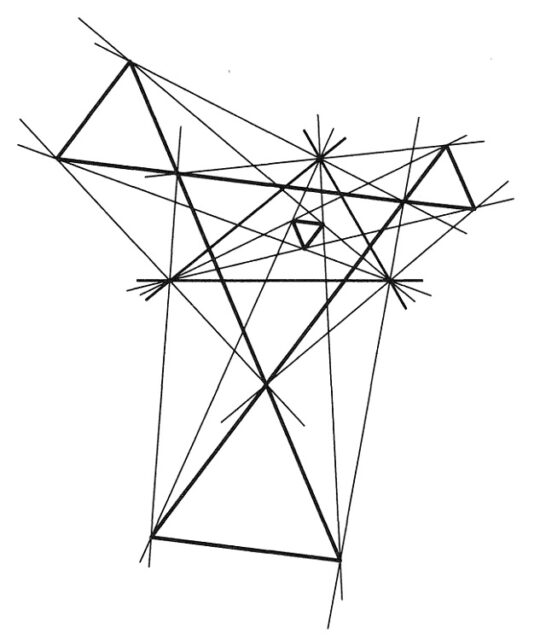

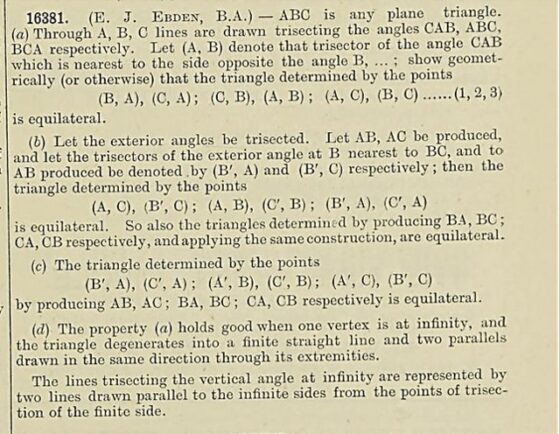

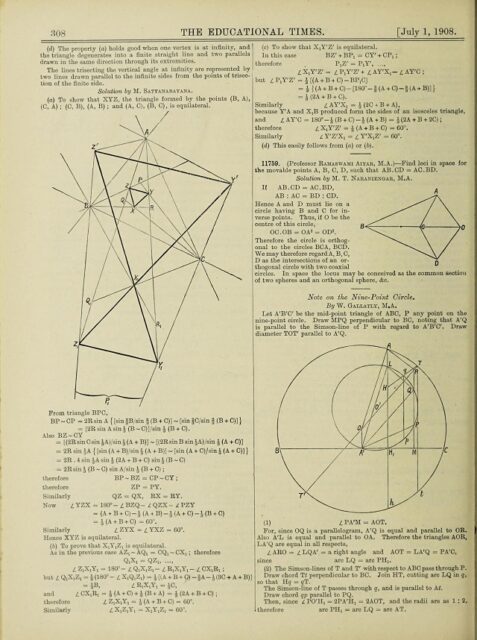

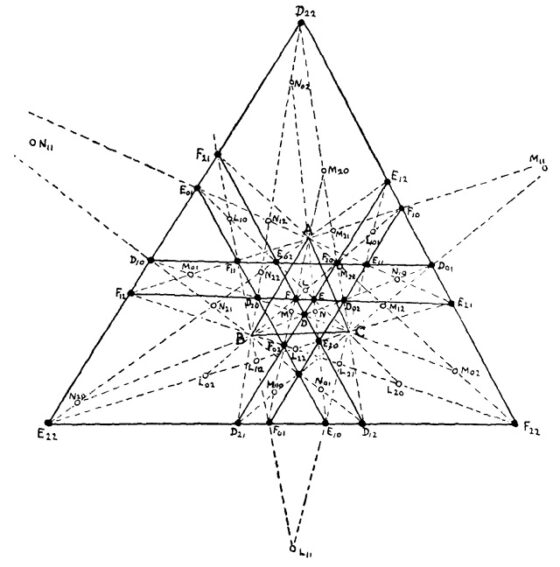

El teorema de Morley

La geometría euclidiana y, en particular, la geometría plana, está repleta de hermosos y sorprendentes teoremas, que suelen venir acompañados de diagramas con mucho encanto, como el teorema de Napoleón (véase la entrada Variaciones artísticas del teorema de Napoleón), el teorema de van Aubel (véase la entrada Una pequeña joya geométrica: el teorema de van Aubel), el teorema de Viviani (cuya demostración sin palabras podéis admirar en la entrada Teoremas geométricos sin palabras: Viviani), el teorema de la circunferencia de Conway (un moderno resultado geométrico del que podéis leer en la entrada Teoremas geométricos sin palabras: Conway), el teorema de Marion (véase la entrada El teorema de Marion (Walter)), el teorema de la bandera británica (véase la entrada El teorema de la ikurriña), o el mismísimo teorema de Pitágoras (véase la entrada Pitágoras sin palabras), entre muchos otros.

Línea polar de un punto y un círculo (Apolonio), del dibujante e ilustrador infantil estadounidense Crockett Johnson (1906-1975). Imagen de la página web de The National Museum of American History

Línea polar de un punto y un círculo (Apolonio), del dibujante e ilustrador infantil estadounidense Crockett Johnson (1906-1975). Imagen de la página web de The National Museum of American HistoryExisten muchos otros fascinantes teoremas geométricos del plano. En esta entrada del Cuaderno de Cultura Científica vamos a hablar de uno especialmente interesante y atractivo, que ha cautivado a muchas personas, en particular, del ámbito de las matemáticas, a lo largo del siglo XX (no es un teorema antiguo). Durante este tiempo se han desarrollado una cantidad importante de diferentes demostraciones, muchas de ellas de la mano de grandes matemáticos, como el matemático francés, que recibió la Medalla Fields en 1982, Alain Connes (1947), el matemático húngaro Béla Bollobás (1943), el matemático, físico y científico de la computación Edsger W. Dijkstra (1930-2002), el prolífico e imaginativo matemático británico John H. Conway (1937-2020), creador del autómata celular denominado el juego de la vida, o el matemático y físico matemático británico Roger Penrose (1931), que recibió el Premio Nobel de Física en 2020, entre muchos otros. Es el teorema de Morley, que debe su nombre al matemático británico, que vivió gran parte de su vida en Estados Unidos, Frank Morley (1860-1937), relacionado con las trisectrices de un triángulo cualquiera.

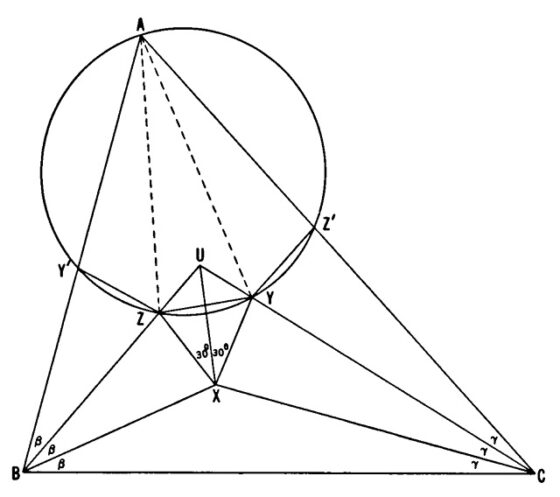

El teorema de las trisectrices de MorleyAntes de nada, enunciemos la versión simple del teorema de Morley, que es un resultado geométrico de una especial sencillez en su enunciado, pero de una gran profundidad en su significado.

Teorema de Morley (1899): Los puntos de intersección de las trisectrices adyacentes de los ángulos de un triángulo cualquiera, son los vértices de un triángulo equilátero.

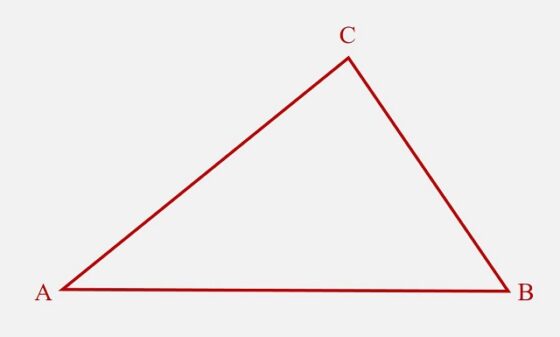

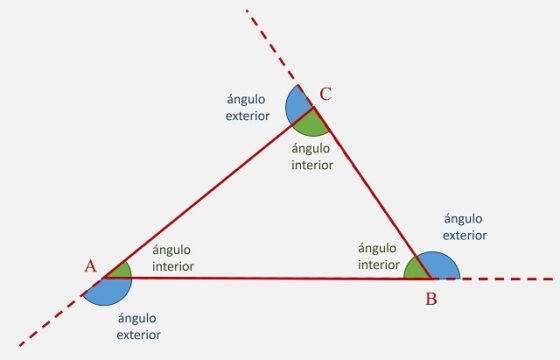

Expliquémoslo brevemente. Partimos de un triángulo ABC cualquiera, como el que vemos en la siguiente imagen.

Triángulo ABC

Triángulo ABC

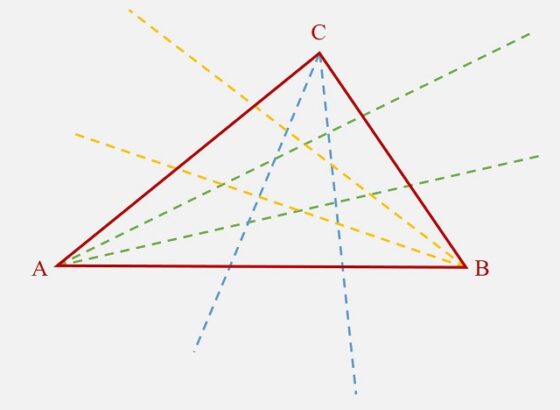

A continuación, en cada uno de los tres ángulos del triángulo ABC se trazan las trisectrices, es decir, las dos rectas que dividen al ángulo en tres ángulos iguales, como se muestra en la siguiente imagen.

Los tres pares de trisectrices, líneas rectas, de los ángulos del triángulo ABC

Los tres pares de trisectrices, líneas rectas, de los ángulos del triángulo ABC

Alguien, al leer que estamos tomando las trisectrices de un ángulo, podría pensar que esto no es posible. La confusión puede venir del hecho de que hay tres problemas clásicos de la matemática griega, la cuadratura del círculo, la trisección de un ángulo y la duplicación de un cubo, que no tienen solución, pero solo si esta solución se intenta construir “con regla y compás”, que son los instrumentos clásicos de la matemática griega (véase, por ejemplo, el artículo Los tres problemas clásicos, de Santiago Fernánez, o el libro Historia de las matemáticas, de Carl B. Boyer).

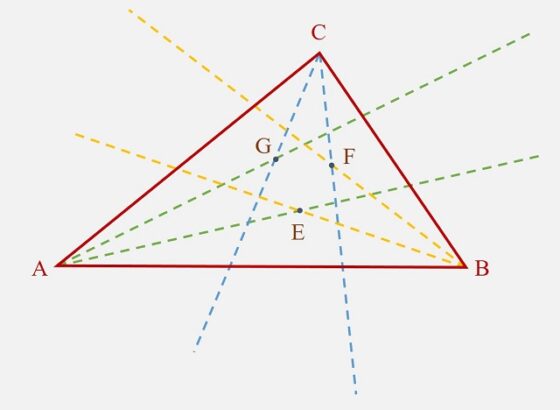

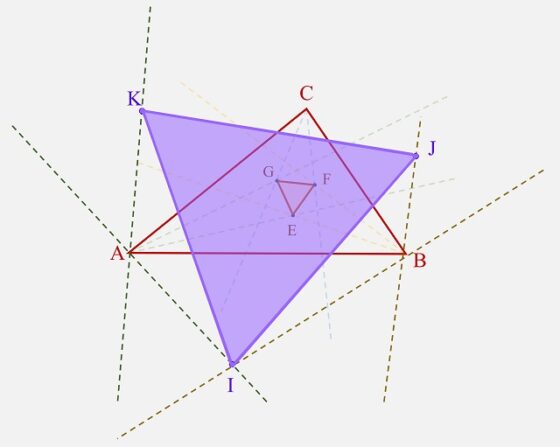

A continuación, se toman los tres puntos que son la intersección de las trisectrices adyacentes de los ángulos del triángulo ABC, que en la imagen hemos denominado E, F y G.

Los puntos E, F y G son las intersecciones de las trisectrices adyacentes de los ángulos del triángulo ABC

Los puntos E, F y G son las intersecciones de las trisectrices adyacentes de los ángulos del triángulo ABC

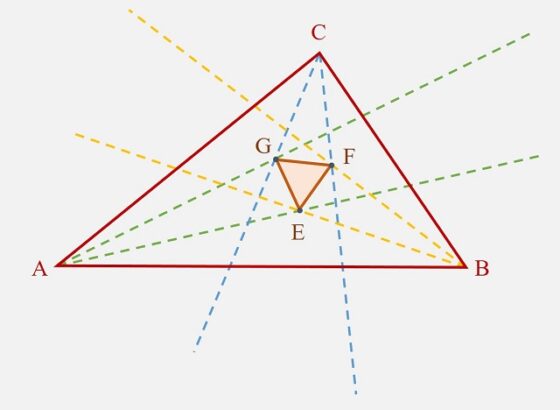

Entonces, el teorema de Morley establece que el triángulo EFG, cuyos vértices son los puntos de intersección de las trisectrices adyacentes de los ángulos del triángulo ABC, es un triangulo equilátero, es decir, con los tres lados iguales (así como sus ángulos, de 60 grados). A este triángulo equilátero se le llama “triángulo de Morley”.

El triángulo EFG es equilátero

El triángulo EFG es equilátero

Si en lugar de tomar las trisectrices de los ángulos interiores del triángulo, se toman las trisectrices de los ángulos exteriores, se forma otro triángulo equilátero. Antes de mostrar este resultado, recordemos cuales son los ángulos exteriores de un triángulo.

Ángulos interiores y exteriores de un triángulo ABC

Ángulos interiores y exteriores de un triángulo ABC

Por lo tanto, también sería cierto el teorema de Morley para ángulos exteriores, es decir, que los puntos de intersección de las trisectrices adyacentes de los ángulos exteriores de un triángulo cualquiera, son los vértices de un triángulo equilátero.

Teorema de Morley para las trisectrices de los ángulos exteriores, es decir, el triángulo IJK es equilátero

Teorema de Morley para las trisectrices de los ángulos exteriores, es decir, el triángulo IJK es equiláteroLa historia del teorema de Morley

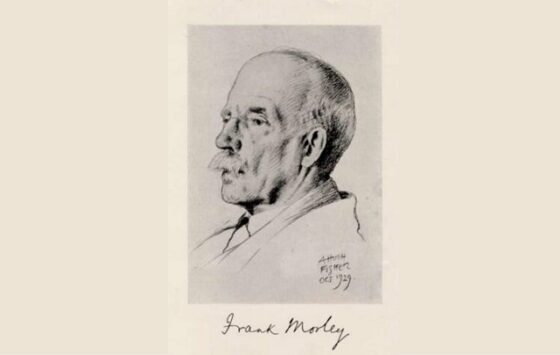

Como se comentaba al principio de esta entrada del Cuaderno de Cultura Científica, el teorema de Morley debe su normbre al matemático británico, afincado en Estados Unidos, Frank Morley (1860-1937).

Aunque de origen británico, Frank Morley, graduado en el King’s College de la Universidad de Cambridge en 1884, emigró a Estados Unidos en 1887, donde fue contratado en el Haverford College, en centro cuáquero de Pensilvania. Como se puede leer en el obituario de la American Mathematical Society, Frank Morley, In memoriam, en 1889 se casó con la británica Lilian Janet Bird y tuvieron tres hijos, el periodista y escritor Christopher Morley, autor de novelas como La librería ambulante, La librería encantada o Kathleen, que pueden leerse en las ediciones en castellano de la editorial Periférica, el periodista, ganador del Premio Pulitzer, Felix Morley, y el matemático Frank Vigor Morley, que publicaría con su padre el libro Inversive Geometry.

Tras su periodo en el Haverford College, en 1900 se trasladó a la Universidad Johns Hopkins, en Baltimore (Maryland), donde dirigió el departamento de matemáticas hasta que se jubiló en 1928, siendo además editor de su prestigiosa revista, American Journal of Mathematics, de 1900 a 1920. Fue miembro de la New York Mathematical Society (fundada en 1888) y su sucesora la American Mathematical Society, donde ocupó varios cargos, entre ellos su presidencia. Entre sus publicaciones destacan los libros A Treatise on the Theory of Functions (Macmillan, 1893) y Introduction to the Theory of Analytic Functions (Macmillan, 1898).

Retrato del matemático británico-estadounidense Frank Morley, realizado por el artista y fotógrafo Alfred Hugh Fisher (1867-1945)