El protagonismo de los cuidados en la evolución humana

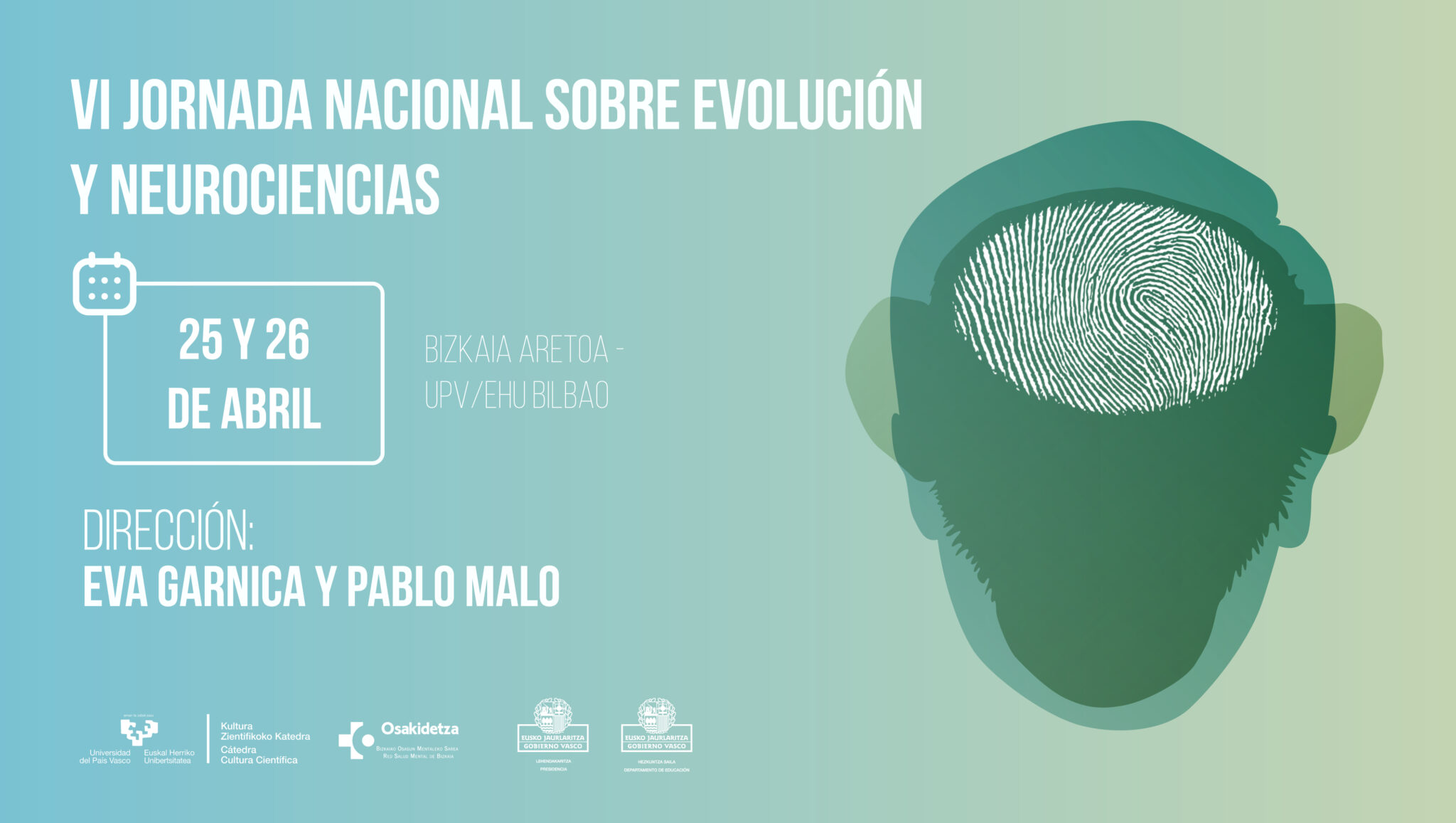

Los cambios del cerebro durante el embarazo y la maternidad, cómo el estrés ha pasado de ser un mecanismo de supervivencia a un eventual elemento de riesgo para nuestra salud o cuál ha sido el papel que ha jugado el suicidio en la evolución del ser humano fueron algunos de los temas que se tratarán en la VI Jornada Nacional sobre Evolución y Neurociencias.

La jornada tuvo lugar el Bizkaia Aretoa de la UPV/EHU los pasados 25 y 26 de abril y estuvo dirigida por Eva Garnica y Pablo Malo, de la Red de Salud Mental de Bizkaia, institución que organizó la jornada junto a la Cátedra de Cultura Científica de la UPV/EHU.

El encuentro, cuya primera edición se celebró en 2017, se ha convertido en una cita imprescindible para las y los expertos en ámbitos como la psiquiatría, la psicología o la biología. Una jornada que sirve para analizar el comportamiento humano desde un punto de vista evolutivo y divulgar de un modo accesible para todos los públicos.

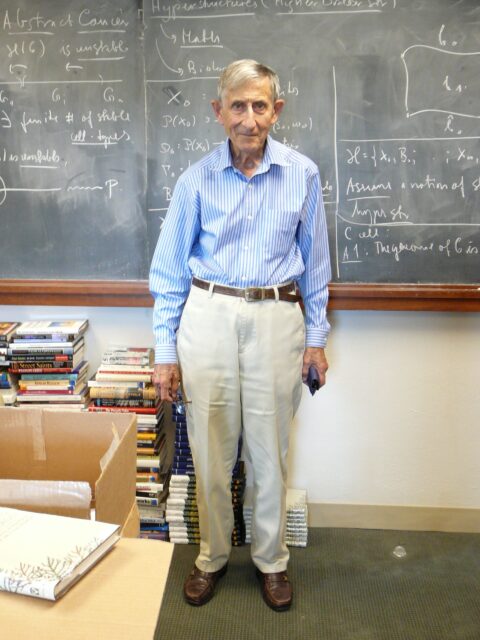

¿Cuándo comenzamos a cuidarnos entre los humanos? ¿Cómo se encuadra este comportamiento en nuestra evolución? Los orígenes de los cuidados están estrechamente vinculados al desarrollo de comportamientos que consideramos emblemáticamente humanos: en particular, nuestra disposición a cooperar por un bien mayor y nuestras habilidades de organización social. Explorar cuándo y por qué surgió este rasgo es un reto apasionante, y debe hacernos reflexionar sobre el impacto que su estudio debe producir, y produce, en la ciencia y en la sociedad actual. Estos son los temas que trata la conferencia El protagonismo de los cuidados en la evolución humana. La imparte Roberto Sáez, Doctor en Antropología, Máster en Ingeniería Industrial y divulgador científico, experto en Evolución Humana y en la Bioarqueología del Cuidado. Sáez es el autor del blog Nutcracker man.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo El protagonismo de los cuidados en la evolución humana se ha escrito en Cuaderno de Cultura Científica.

Uso y abuso de la pregabalina

Envase de Lyrica (pregabalina) comercializado en Finlandia. Fuente: Acdx / Wikimedia Commons

Envase de Lyrica (pregabalina) comercializado en Finlandia. Fuente: Acdx / Wikimedia CommonsEl pasado mes de marzo, una noticia llegada desde Reino Unido generó cierta alarma respecto a la seguridad de la pregabalina, medicamento utilizado frecuentemente para el tratamiento del dolor crónico y la ansiedad. Una investigación del periódico británico The Sunday Times relacionaba el consumo de este fármaco con la muerte de 3 400 personas en los últimos años y describía los problemas de abuso y adicción que puede generar.

Dada la gravedad de la crisis sociosanitaria que sufre EE. UU. por la adicción a los opioides, los problemas de seguridad que puede plantear el uso de medicamentos como la pregabalina constituye un tema de especial interés.

Usos no contemplados en la ficha técnicaLa pregabalina es un medicamento con una estructura química similar a la del neurotransmisor GABA (ácido gamma-amino-butírico), sustancia que regula de forma inhibitoria la actividad del cerebro. Junto con la gabapentina, forma un grupo de medicamentos denominado gabapentinoides.

En España, el primer medicamento con pregabalina lo lanzó al mercado el laboratorio farmacéutico Pfizer, con el nombre comercial Lyrica. Inicialmente, fue aprobado para tratar la epilepsia y el dolor neuropático, y después se autorizó para tratar el trastorno de ansiedad generalizada.

Con el tiempo, el uso de Lyrica se amplió para tratar otras patologías que no contaban con la autorización sanitaria, como el dolor crónico, el dolor lumbar, la prevención del dolor postoperatorio, la fibromialgia y la profilaxis de la migraña. Esta aplicación se conoce como off-label o fuera de ficha técnica. En ocasiones, dichos usos pueden estar médicamente justificados si no existen alternativas terapéuticas autorizadas, y en todo caso se encuentran regulados por ley.

Lo que está prohibido es publicitarlo, y esto condenó a Pfizer a pagos de multas millonarias. Es conveniente recordar que el uso off-label de los medicamentos puede constituir un problema de seguridad, incrementar los costes del tratamiento o, directamente, resultar ineficaz, ya que se ha demostrado que su beneficio terapéutico es insuficiente.

Sin embargo, distintos estudios concluyen que más de la mitad de las recetas de gabapentinoides se realizan para indicaciones no autorizadas; mayoritariamente para tratar distintos tipos de dolor, a pesar de que los estudios científicos no recomiendan su uso.

Un consumo disparadoHoy en día, disponemos de 168 medicamentos que contienen pregabalina, incluidos los llamados genéricos. Los datos de consumo se pueden consultar en la página web de la Agencia Española de Medicamentos y Productos Sanitarios (AEMPS), concretamente en el informe sobre la utilización de analgésicos no opioides.

Esta información se expresa en DHD, es decir, en la dosis diaria definida (DDD) por cada 1 000 habitantes y día. Así sabemos que en los últimos 10 años el consumo de pregabalina se ha incrementado un 66 %, puesto que entre 2012 y 2022 el DHD pasó de 3,56 a 5,92. Este último dato significa que cada día un promedio de 5,92 personas de cada 1 000 recibe una DDD de pregabalina. Actualmente, se encuentra en el tercer puesto de fármacos analgésicos no opioides con mayor consumo en España, por detrás del paracetamol y el metamizol.

¿Es seguro tomar pregabalina?La pregabalina, como todos los medicamentos, no está libre de producir efectos adversos, es decir, efectos que no deseamos pero que en muchos casos no se pueden evitar. Por suerte, los más frecuentes, que aparecen en al menos una de cada 10 personas, son leves. Entre ellos destacan los mareos, la somnolencia y el dolor de cabeza.

También pueden manifestarse otros con menor frecuencia. Todos ellos pueden ser consultados en la ficha técnica en la página web del centro de información de la AEMPS, de acceso abierto, o en el prospecto del medicamento. Es importante señalar que los efectos adversos son más frecuentes cuando la pregabalina se toma en dosis altas y de forma crónica. Y en cualquier caso, este tipo de uso no ha demostrado aliviar mejor del dolor.

Entre los efectos más graves encontramos el riesgo de reducir la respiración, debido a que actúan sobre la zona del cerebro que controla esa función. Es importante tener esto en cuenta si el paciente ya está tomando otros medicamentos que tienen el mismo efecto, ya que su combinación en dosis altas podría llegar a paralizar la respiración y causar la muerte.

Estos otros medicamentos depresores son los analgésicos opioides (como la morfina), que utilizamos para aliviar dolores fuertes, y las benzodiazepinas (como el orfidal), que tomamos para dormir o calmar los nervios. Diversos estudios indican que el 60 % de los pacientes que usa gabapentinoides toma también los otros depresores. Una combinación fatal podría estar detrás del incremento de muertes asociadas al uso de pregabalina que describía el The Sunday Times.

Ese mismo efecto depresor de la pregabalina, pero ejercido sobre el sistema límbico del cerebro, produce una sensación de euforia y bienestar que puede conducir a comportamientos de abuso y dependencia. El concepto de dependencia se refiere a la necesidad de seguir tomando una sustancia para experimentar sus efectos deseados o aliviar el malestar que causa no consumirla (síndrome de abstinencia).

Si no se ingiere el medicamento, aparecen síntomas que provocan malestar y empujan a seguir tomándolo, a pesar de los posibles efectos negativos; es lo que coloquialmente llamamos “estar enganchado”. Son especialmente vulnerables aquellas personas que han sufrido con anterioridad problemas de adicción.

Siempre bajo supervisión médicaLos riesgos asociados al abuso de pregabalina pueden minimizarse con un seguimiento adecuado de la pauta médica, valorando periódicamente la necesidad de mantener o retirar el tratamiento según criterios de eficacia, tolerabilidad, efectos adversos y adherencia. Si la valoración recomienda suspender el tratamiento, se realizará de forma gradual y con supervisión médica.

En todo caso, la pregabalina está autorizada para tratar el dolor neuropático –que se produce por el daño de un nervio–, la epilepsia y la ansiedad porque los estudios indican que los beneficios del tratamiento superan los riesgos. En este contexto, la evaluación de la relación riesgo-beneficio del tratamiento con pregabalina corresponde a los profesionales médicos y cuentan con el apoyo de la AEMPS.

Finalmente, no podemos olvidar el papel de la ciudadanía en la gestión activa de su salud: es fundamental seguir las indicaciones médicas y comunicar si sufrimos efectos adversos y si notamos que el tratamiento no está funcionando. Transmitir toda esta información en las visitas a la consulta es clave para que el médico o la médica evalúe correctamente la utilidad del tratamiento y su seguridad.![]()

Sobre las autoras: María Torrecilla Sesma y Cristina Bruzos Cidón son Profesoras de Farmacología en la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Uso y abuso de la pregabalina se ha escrito en Cuaderno de Cultura Científica.

Un coloso de la informática

El 18 de enero de 1944, llegó a Bletchley Park un camión con una carga muy especial: una máquina de cálculo que pesaba una tonelada, medía 2,13 x 5,18 x 3,35 metros, estaba construida con alrededor de 1600 válvulas termoiónicas y era capaz de operar a una velocidad de 5000 caracteres por segundo. La llamaron Colossus, se considera la primera computadora electrónica, programable y digital de la historia… y estuvo a punto de no existir.

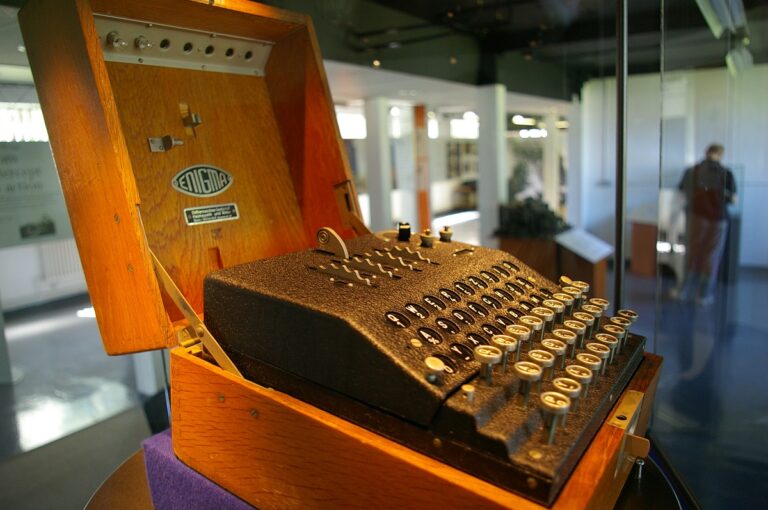

Durante la Segunda Guerra Mundial, Bletchley Park fue uno de los centros neurálgicos de los servicios de inteligencia británicos. Bajo el nombre en clave de Ultra, allí se descifraban todas las comunicaciones que Inglaterra interceptaba al Ejército y la diplomacia de la Alemania nazi y pasó a la historia, sobre todo, por el duelo que tuvo lugar allí entre el matemático inglés Alan Turing y la supuestamente impenetrable Enigma naval de la Kriegsmarine que utilizaban los U-Boote del Atlántico.

Máquina enigma de cuatro rotores expuesta en Bletchley Park. Funete: Tim Gage / CC BY-SA 2.0

Máquina enigma de cuatro rotores expuesta en Bletchley Park. Funete: Tim Gage / CC BY-SA 2.0

En 1941, casi a la par que la Enigma naval quedaba al descubierto tras un arduo trabajo por parte del barracón 8 que dirigía Turing, las estaciones de escucha británicas comenzaron a interceptar una nueva clase de mensajes indescifrables que no se estaban retransmitiendo en morse, como los de Enigma, sino en el código internacional del teletipo. Alemania había puesto en escena una nueva máquina de cifrado automática y mucho más sofisticada que Enigma para las comunicaciones diplomáticas: la Lorenz SZ, a la que apodaron Tunny.

En este caso, fue el coronel John Tiltman quien consiguió descifrar un mensaje de Tunny por primera vez a finales de aquel mismo año. Con el trabajo de este, el matemático Bill Tutte dedujo cómo debía de ser el funcionamiento de la máquina. Por último, Alan Turing ideó un método algorítmico, la «turingería» ―de «Turing» e «ingeniería»― que permitió acotar sustancialmente las posibles configuraciones de los doce rotores de los que constaba el disposivo y… entonces se marchó a Estados Unidos.

Máquina de cifrado Lorenz SZ40, sin la carcasa, en el US National Cryptologic Museum. En ella se pueden apreciar los doce rotores. Fuente: Mark Pellegrini / CC BY-SA 2.5

Máquina de cifrado Lorenz SZ40, sin la carcasa, en el US National Cryptologic Museum. En ella se pueden apreciar los doce rotores. Fuente: Mark Pellegrini / CC BY-SA 2.5

Fue Bill Tutte el que continuó trabajando en nuevos métodos de descifrado de Tunny, pero, a medida que Alemania aumentó la extensión aquella red de comunicaciones, que los aliados bautizaron como Fish, y mejoró la seguridad, los cálculos empezaron a volverse inabarcables: se iba a necesitar algún tipo de dispositivo electromecánico para realizarlos, al igual que se habían necesitado las Bombe para poder romper Enigma.

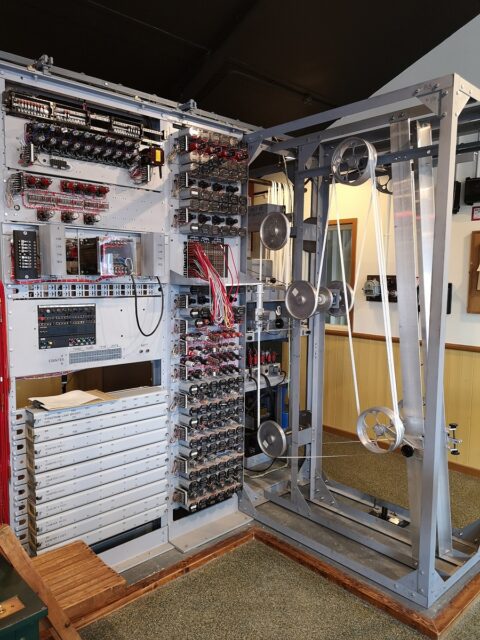

El primer intento de mecanizar el descifrado de Tunny vino de la mano de Max Newman y sus «Heath Robinson» unos cacharros llamados así en honor a William Heath Robinson, un ilustrador que solía hacer dibujos de inventos bizarros dada la lentitud, imprecisión y tendencia al sobrecalentamiento que tenían. Pero un ingeniero eléctrico de Bletchley Park, al que, en un principio, habían reclutado como ayudante de Alan Turing, tenía en mente desde hacía algún tipo una idea de máquina mucho más rápida, precisa y eficiente.

Réplica de una de las Heath Robinson de Max Newman en el National Museum of Computing, de Bletchley Park. Fuente: TedColes / CC BY-SA 4.0

Réplica de una de las Heath Robinson de Max Newman en el National Museum of Computing, de Bletchley Park. Fuente: TedColes / CC BY-SA 4.0

Tommy Flowers había nacido en una familia humilde en uno de los distritos más pobres de Londres, Poplar, muy cerca de Whitechapel, y ya desde muy pequeño le había llamado la atención la ingeniería. Estuvo durante un tiempo como aprendiz en el Arsenal Real de Londres hasta que encontró trabajo en el departamento de ingeniería de Correos mientras se sacaba el título en la escuela nocturna. Allí conoció y empezó a investigar las posibilidades que ofrecía un nuevo componente electrónico que podía realizar tareas de interruptor a una velocidad mucho más alta de la habitual: la válvula termoiónica o de vacío.

Tommy Flowers. Fuentes: Dominio público

Tommy Flowers. Fuentes: Dominio público

Aunque ya se estaban utilizando en algunos dispositivos ―y las Heath Robinson eran uno de ellos, aunque solo parcialmente―, el uso de las válvulas de vacío aún era bastante limitado. Tommy Flowers fue el primero al que se le ocurrió que podían utilizarse en un número mucho mayor para fabricar máquinas de computación completamente electrónicas. Pero, como sucede casi siempre que alguien presenta una idea demasiado disruptiva, en Bletchley Park aquello les pareció una locura.

Sin el apoyo que necesitaba, pero convencido de que un computador completamente electrónico era posible, pese a las dificultades de diseño que presentaba, Flowers reunió a cincuenta científicos, ingenieros y técnicos del laboratorio de la oficina de Correos de Dollis Hill donde trabajaba y se pusieron manos a la obra, trabajando doce horas al día, seis días y medio a la semana para crear, en un tiempo récord de diez meses, el primer computador electrónico: Colossus. Cuando se presentaron con él en Bletchley Park y, más aun, cuando lo pusieron en funcionamiento, el personal no daba crédito a lo que tenía delante.

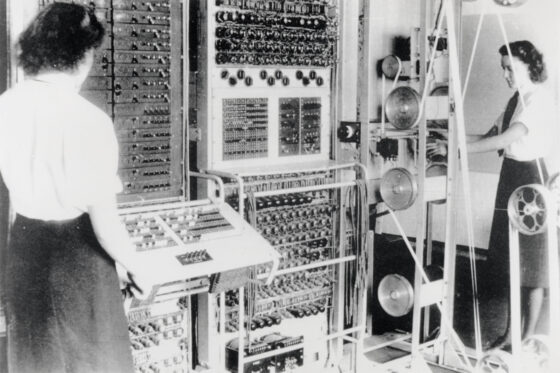

El primer prototipo de Colossus que llegó a Bletchley funcionaba muy bien, pero no lo todo lo rápido que se necesitaba, así que Tommy Flowers y su equipo se pusieron de nuevo a trabajar contrarreloj en una versión mejorada que el Gobierno quería tener lista, como muy tarde, para el 1 de junio: aquella iba a ser la fecha inicial en la que iba a tener lugar el Día-D y se necesitaba que la máquina estuviera ya operativa. Colossus Mark II, con 2400 válvulas y una velocidad de 25 000 caracteres por segundo, lo estuvo y, de hecho, el 5 de junio se descifró con ella un mensaje de Adolf Hitler dirigido al mariscal Erwin Rommel en el que los aliados pudieron confirmar que la maniobras de los servicios secretos para desviar la atención del Führer lejos de las playas de Normandía había funcionado. Al día siguiente, el Ejército aliado tomó la costa francesa y comenzó la ofensiva por la liberación de Europa occidental. Mientras tanto, una Colossus tras otra iba llegando a Bletchley Park a medida que las fuerzas aliadas penetraban en el continente. Veinticuatro horas al día, siete días la semana, un ejército de WRENs ―mujeres pertenecientes al Women’s Royal Naval Service― averiguaba sin descanso la configuración diaria de la las máquinas Tunny y dejaba al descubierto las comunicaciones enemigas.

Colossus Mark II en Bletchley Park, operada por las WRENs (Women’s Royal Naval Service) Dorothy Du Boisson y Elsie Booker en 1943.

Colossus Mark II en Bletchley Park, operada por las WRENs (Women’s Royal Naval Service) Dorothy Du Boisson y Elsie Booker en 1943.

A menudo se ha tratado de establecer el impacto que todo el trabajo de criptoanálisis de Bletchley Park tuvo sobre el desarrollo de la guerra. Hay quienes dicen que ayudó a acortar el conflicto en unos dos o tres años, por ello, resulta bastante inquietante pensar que Colossus fue posible gracias a una serie de serendipias que podrían, perfectamente, no haber tenido lugar.

A finales de agosto de 1939, y con las tensiones en Europa a punto de hacer estallar todo, algún superior no muy centrado envió a Tommy Flowers a Berlín en viaje de trabajo. Tan pronto como este puso el pie en la capital alemana, la Embajada británica lo llamó para advertirle de que abandonara el país lo antes posible. Flowers consiguió cruzar a Holanda apenas unas horas antes de que se cerraran las fronteras de Alemania, evitando así, seguramente, acabar como prisionero del régimen nazi. También fue providencial que luego la oficina de Correos lo enviara a él, y no a otro, a ayudar a Alan Turing con Enigma y las Bombe, porque cuando alguien iba a consultarle al matemático cualquier tema de ingeniería o problema con los equipos, Alan simplemente respondía: «Flowers»… Lo que llevó a este hasta Newman, luego hasta Tunny, luego hasta Colossus y, finalmente, a marcar ―casualidades que pasan― el primer gran hito de la historia de la computación.

Referencias:

Copeland, B. Jack, et. al. (2006). Colossus. The secrets of Bletchley Park’s codebreaking computers. Oxford University Press.

Copeland, B. Jack (2021 [2013]). Alan Turing. El pionero de la era de la información. Turner.

Para saber más:

Marian Rejewski, el matemático que «rompió» la Máquina Enigma

Sobre la autora: Gisela Baños es divulgadora de ciencia, tecnología y ciencia ficción.

El artículo Un coloso de la informática se ha escrito en Cuaderno de Cultura Científica.

El infinito en un segmento (3)

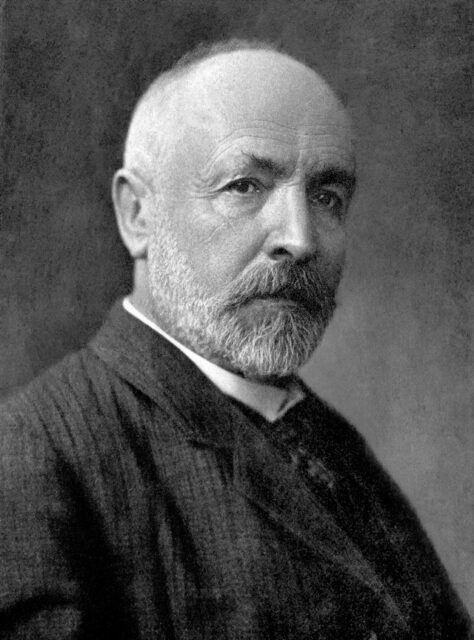

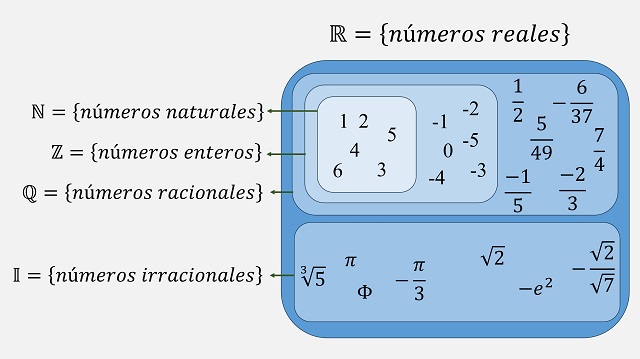

A finales del siglo XIX, el matemático ruso-alemán Georg Cantor (1845-1918) conmocionó al mundo de las matemáticas, rompiendo las creencias existentes sobre el concepto de infinito. Entre los revolucionarios resultados que demostró están que existe más de un infinito o que la cantidad de puntos de un segmento es la misma que la cantidad de puntos de un cuadrado. A esta revolución matemática hemos dedicado, en el Cuaderno de Cultura Científica, la miniserie titulada El infinito en un segmento.

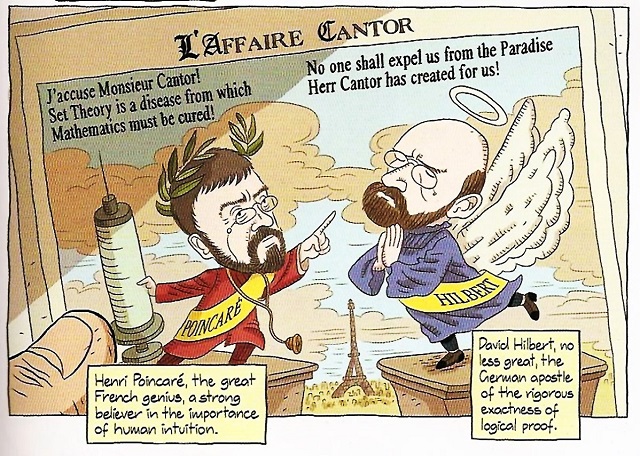

Página de la novela gráfica Logicomix, de Apostolos Doxiadis y Christos H. Papadimitiou, Bloomsbury, 2009. En la viñeta se muestra una noticia con motivo del Congreso Internacional de Matemáticos de 1900, con una caricatura de dos matemáticos enfrentados, el francés Henri Poincaré, con su frase “¡Le acuso Señor Cantor! ¡La teoría de conjuntos es una enfermedad de la que hay que curar a las matemáticas!”, y el alemán David Hilbert, con su frase “Nadie nos expulsará del paraíso que Herr Cantor ha creado para nosotros”

Página de la novela gráfica Logicomix, de Apostolos Doxiadis y Christos H. Papadimitiou, Bloomsbury, 2009. En la viñeta se muestra una noticia con motivo del Congreso Internacional de Matemáticos de 1900, con una caricatura de dos matemáticos enfrentados, el francés Henri Poincaré, con su frase “¡Le acuso Señor Cantor! ¡La teoría de conjuntos es una enfermedad de la que hay que curar a las matemáticas!”, y el alemán David Hilbert, con su frase “Nadie nos expulsará del paraíso que Herr Cantor ha creado para nosotros”

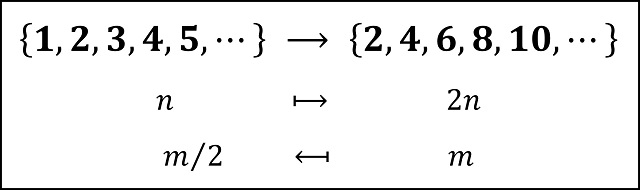

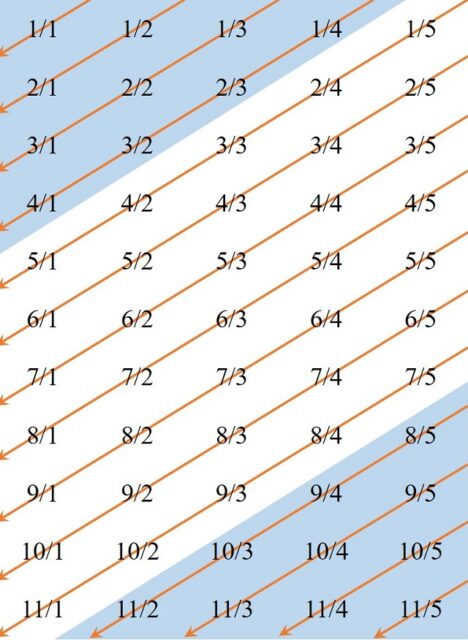

La primera entrega de esta miniserie, El infinito en un segmento (1), se centró en cómo resolvió el matemático ruso-alemán el problema de comparar dos conjuntos con infinitos elementos. La respuesta es sencilla y está en la base del origen del concepto de número. Dos conjuntos tienen la misma cantidad de elementos cuando se puede establecer una “correspondencia uno-a-uno” entre los elementos de los dos conjuntos. De esta forma, llegamos a la paradoja de que para un conjunto infinito existen subconjuntos propios del mismo que tienen la misma cantidad de elementos que el propio conjunto. Por ejemplo, el conjunto de los números pares tiene la misma cantidad de elementos que el conjunto de los números naturales (que está formado por los números pares y los números impares).

Existe una correspondencia uno-a-uno entre el conjunto de los números pares y el conjunto de los números naturales

Existe una correspondencia uno-a-uno entre el conjunto de los números pares y el conjunto de los números naturales

De hecho, Georg Cantor tomó esta paradoja del ininfito como definición de “conjunto infinito”, es decir, un conjunto es infinito si existe un subconjunto propio suyo que tiene la misma cantidad de elementos que el conjunto.

En esta primera entrega de la serie se demostró también que los conjuntos de los números enteros y de los números racionales son conjuntos numerables, es decir, tienen la misma cantidad de elementos que el conjunto de los números naturales.

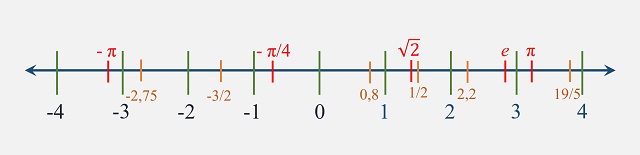

En la segunda entrega de esta miniserie, El infinito en un segmento (2), se mostró que el conjunto de los números reales (de forma explícita, en la demostración se consideró el intervalo (0,1), es decir, los números reales entre 0 y 1) no es numerable, no se puede poner en correspondencia uno-a-uno con los números naturales. Por lo tanto, existe más de un infinito, al menos, el infinito de los números naturales (cuyo cardinal se denomina aleph-zero) y el infinito de los números reales (cuyo cardinal se denomina cardinal del continuo, c).

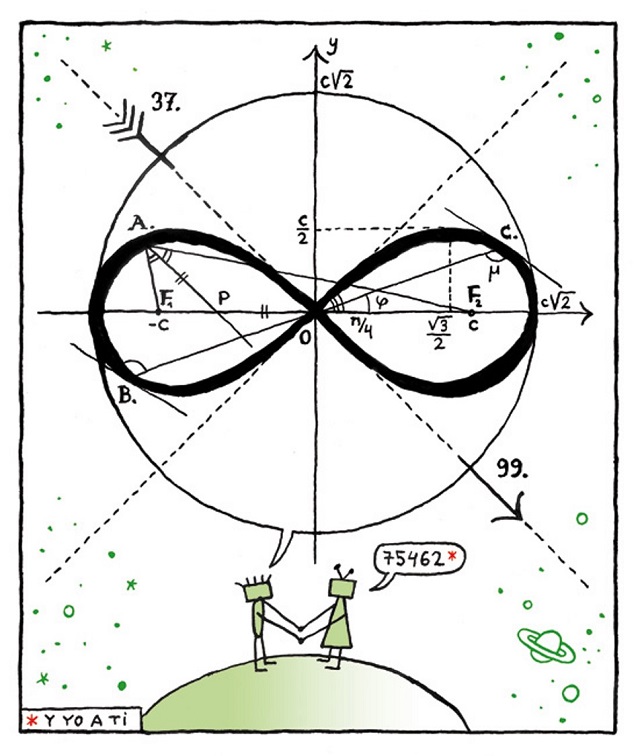

El bueno de Cuttlas (4MOR, 37 & 99), de Calpurnio, publicado en 20 MinutosEl infinito en un cuadrado

El bueno de Cuttlas (4MOR, 37 & 99), de Calpurnio, publicado en 20 MinutosEl infinito en un cuadrado

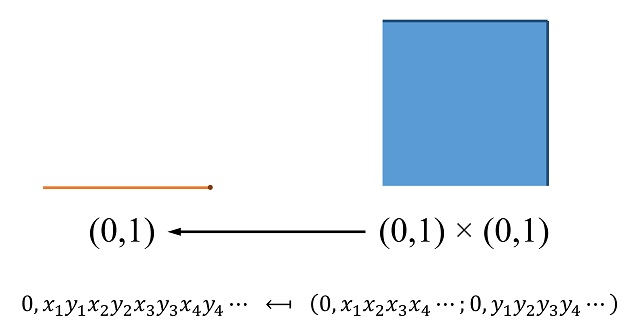

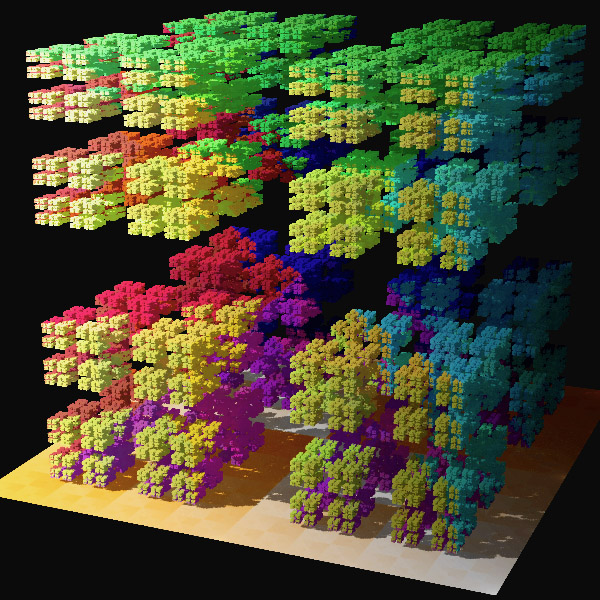

Como se comentó al final de la segunda entrada de esta miniserie, una vez demostrado que el cardinal del continuo c (el infinito de los números reales) es mayor que aleph-zero (el infinito de los números naturales), Georg Cantor se planteó si el plano (de dimensión 2) tiene una mayor cantidad de puntos que la recta (de dimensión 1), es decir, si el infinito del plano es mayor que el infinito del continuo. Simplificando la cuestión.

Problema: ¿Hay la misma cantidad de puntos en el segmento unidad [0,1] que en el cuadrado unidad [0,1] x [0,1]?

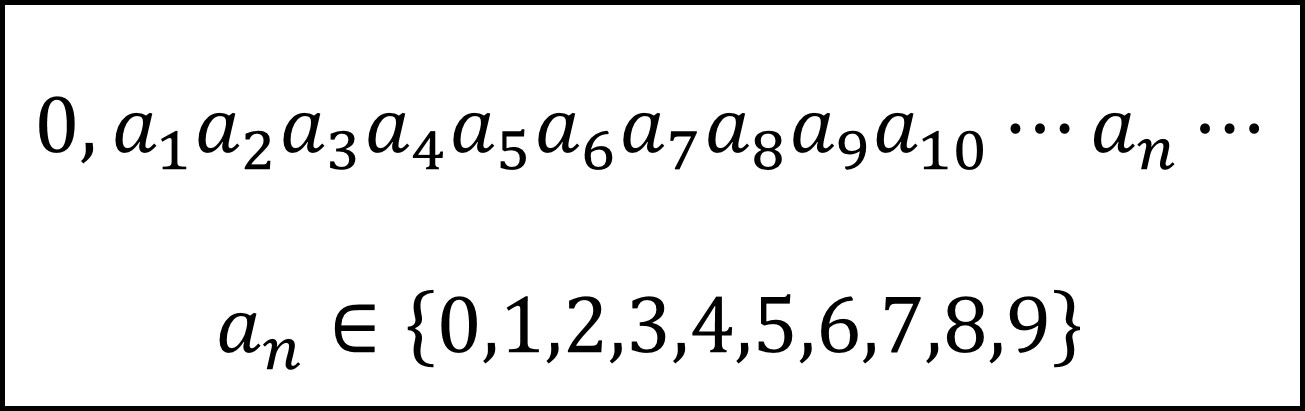

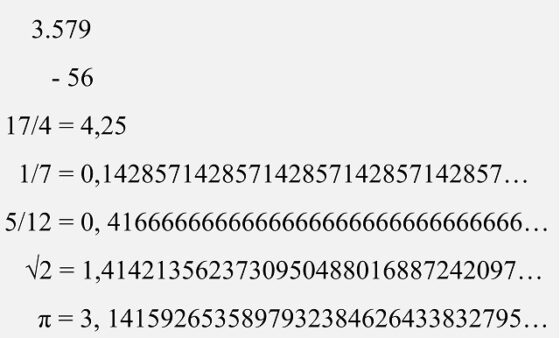

Para abordar el anterior problema, primero recordemos un par de cuestiones básicas. La primera es que los números reales del intervalo [0,1], es decir, mayores que 0 y menores que 1, se escriben en forma decimal como

donde, si todos los dígitos son 0 se obtendría el número cero (0), y si todos los decimales son 9 se obtendría el número uno (1), ya que, como se comentó en la anterior entrada, el número 1 se puede representar de dos formas distintas 1,00000000… (infinitos ceros) y 0,99999999… (infinitos nueves). Por ejemplo, el número pi menos 3, que es un número real del intervalo (0,1) se expresa como 0,1415926535…

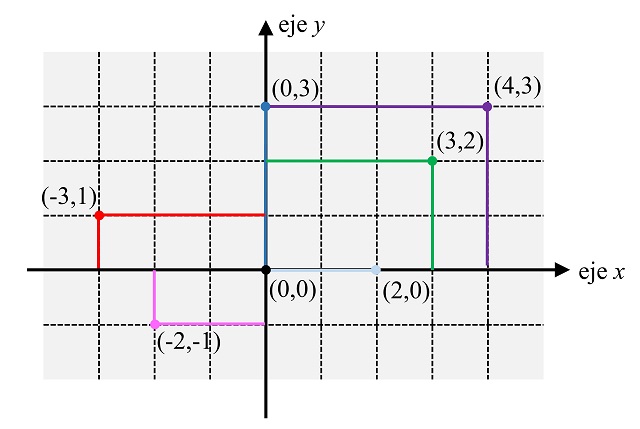

La segunda cuestión básica es que todo elemento del plano real se puede identificar con sus coordenadas cartesianas, es decir, con un par (x, y), donde x e y son números reales, como se muestra en la siguiente imagen (aunque en ella solamente se han utilizado puntos cuyas coordenadas x e y son números enteros).

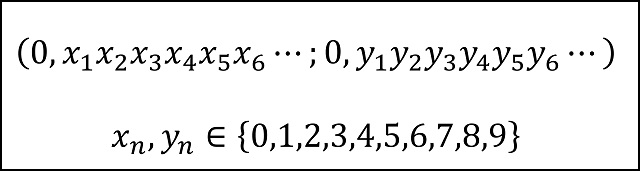

De manera, que los elementos del cuadrado [0,1] x [0,1], serán los puntos del plano (x, y), donde x e y son números reales del intervalo [0,1]. Es decir, son de la forma

(Nota: hemos utilizado el punto y coma “;” para separar las coordenadas, en lugar de la tradicional coma “,”, con la intención de que quede más clara la separación entre las dos coordenadas)

(Nota: hemos utilizado el punto y coma “;” para separar las coordenadas, en lugar de la tradicional coma “,”, con la intención de que quede más clara la separación entre las dos coordenadas)

Ahora, una cuestión técnica. Antes de entrar en la construcción de la buscada correspondencia uno-a-uno entre el segmento y el cuadrado, vamos a tener en cuenta lo siguiente, de cara a dicha construcción. Como se puede demostrar (aunque no quiero meterme ahora en esta cuestión para no complicar más esta entrada) que los segmentos [0,1], es decir, los números reales mayores o iguales que 0 y menores o iguales que 1; (0,1], es decir, los números reales mayores que 0 y menores o iguales que 1; y (0,1), es decir, los números reales mayores que 0 y menores que 1, tienen la misma cantidad de elementos (existen correspondencias uno-a-uno entre ellos), es equivalente demostrar que existe una correspondencia uno-a-uno entre el segmento [0,1] y el cuadrado [0,1] x [0,1], que entre el segmento (0,1] y el cuadrado (0,1] x (0,1] o que entre el segmento (0,1) y el cuadrado (0,1) x (0,1). Por motivos técnicos, nosotros vamos a centrarnos en construir una correspondencia uno-a-uno entre el segmento (0,1] y el cuadrado (0,1] x (0,1], es decir, los puntos (x, y) tales que sus coordenadas x e y pertenecen a (0, 1].

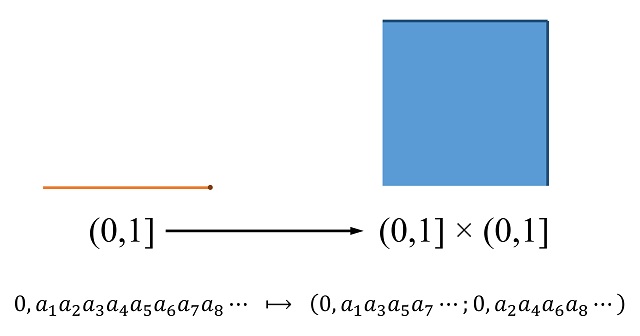

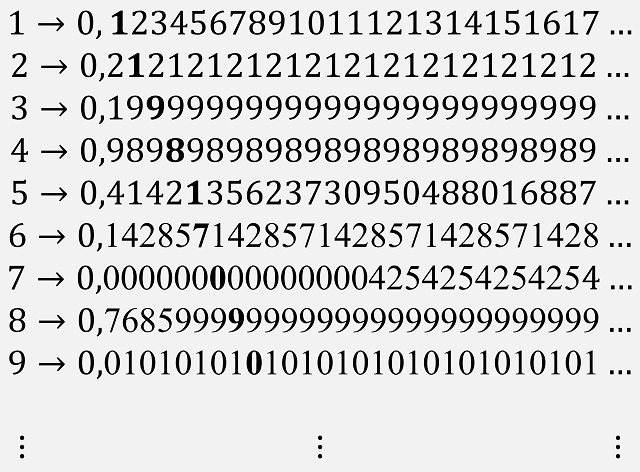

Por lo tanto, ya estamos en condiciones de mostrar la construcción de Georg Cantor de la correspondencia uno-a-uno entre los elementos del segmento (0,1] y los elementos del cuadrado (0,1] x (0,1], que prueba que ambos conjuntos tienen la misma cantidad de elementos. La idea básica es asignar a cada elemento A del intervalo (0,1], es decir, un número real con su expresión decimal (por ejemplo, 0,1234567891011…), un elemento (B, C) del cuadrado (0,1] x (0,1] tal que los decimales de la primera coordenada B son los decimales en las posiciones impares de A y los decimales de la segunda coordenada C son los decimales en posiciones pares de A, como se muestra en la imagen.

Y cuya aplicación inversa, es decir, que envía los elementos del cuadrado (0,1] x (0,1] en elementos del segmento (0,1], está definida mediante la construcción inversa, juntando los decimales de ambas coordenadas e intercalándolos en posiciones impares y pares.

Por ejemplo, la imagen de la conocida “constante de Champernowne”, que es el número real, entre 0 y 1, cuyos decimales son los números naturales ordenados de izquierda a derecha, es decir,

0,123456789101112131415161718192021…

es el punto del cuadrado (0,1] x (0,1] cuyas coordenadas son

(0,135790123456789012…; 0,24681111111111222…).

Por otra parte, si tomamos el punto del cuadrado (0,1] x (0,1] dado por las coordenadas (x, x), donde x es la raíz de 2 menos 1, es decir, el punto

(0, 41421356237309…; 0, 41421356237309…),

su imagen, mediante la aplicación inversa, es el elemento del segmento (0,1] dado por la siguiente expresión

0, 4411442211335566223377330099…

Resolviendo algunas cuestiones técnicasLa idea de Cantor es ingeniosa, sin embargo, el hecho de que haya números reales, en concreto, los números racionales con un número finito de decimales (incluido en caso en el que no hay decimales, es decir, los números enteros) que tienen dos representaciones genera algunos problemas en la anterior aplicación, que hay que resolver.

Problema 1. Como decíamos, hay números que tienen dos representaciones decimales, por ejemplo, el número racional 11/20 se puede representar como 0,55 (o si lo preferimos 0,55000000…) y 0,54999999… Esto es un problema, ya que ese número racional tendría dos posibles imágenes mediante la anterior construcción

(0,500000…; 0,500000…) y (0,599999…; 0,499999…).

Por lo tanto, lo que hizo Cantor fue quedarse con una única representación de las dos, la que tiene infinitos nueves, en este caso, 0,54999999… De esta forma, solo existe, a priori, una imagen en (0,1] x (0,1] de cada número real de (0,1], que, en el ejemplo anterior, es (0,599999…; 0,499999…).

Problema 2. Pero al elegir una única representación de las dos se genera un problema añadido, ya que puede haber números reales de (0,1] cuya imagen contenga una expresión de las primeras y ya no sea válida, como 118/275 = 0,429090909…, cuya imagen sería, por la construcción de Cantor, el punto del cuadrado (0,49999…; 0,20000…), que ya no es un punto válido puesto que para el número 0,2 se ha elegido la representación 0,199999… Notemos que si se admitiesen aquí las dos representaciones se tendría que dos números reales distintos 0,429090909… y 0,4199999999… tendrían la misma imagen (0,49999…; 0,20000…) = (0,49999…; 0,19999…), es decir, la correspondencia no sería uno-a-uno.

Este nuevo problema lo resuelve Cantor de una forma ingeniosa. En la aplicación del segmento (0,1] en el cuadrado (0,1] x (0,1], en lugar de separar dígitos en posiciones pares e impares (y en la aplicación inversa intercalar los dígitos de las dos coordenadas del punto), lo que propone es separar (respectivamente, intercalar) grupos de dígitos, de manera que los ceros consecutivos dentro de la representación decimal se “pegan” al siguiente dígito no nulo. Por ejemplo, los grupos de dígitos de 118/275 = 0,429090909… serían

4 / 2 / 9 / 09 / 09 / 09 …

Por lo tanto, su imagen mediante la aplicación de Cantor sería ahora

(0,49090909…; 0,2090909…).

De hecho, el punto (0,49090909…; 0,2090909…) sería el único punto de (0,1] x (0,1] cuya imagen es 118/275 = 0,429090909…

Veamos otro ejemplo. El número real 0,01002000300004000005… tendría los siguientes grupos de dígitos

01 / 002 / 0003 / 00004 / 000005 …

por lo que su imagen sería el punto del cuadrado de coordenadas (0,010003000005…; 0,002000040000006…). Y ese punto del cuadrado es el único cuya imagen inversa es el número real 0,01002000300004000005…

Por supuesto, los números que no tienen ceros entre sus decimales funcionan como antes. Así, 1/2 = 0,4999999… tiene como imagen (0,4999999…, 0,9999999) y este punto es el único cuya imagen inversa es 1/2 = 0,4999999…

En conclusión, Cantor demostró que existen tantos puntos en el intervalo (0,1], como en el cuadrado (0,1] x (0,1].

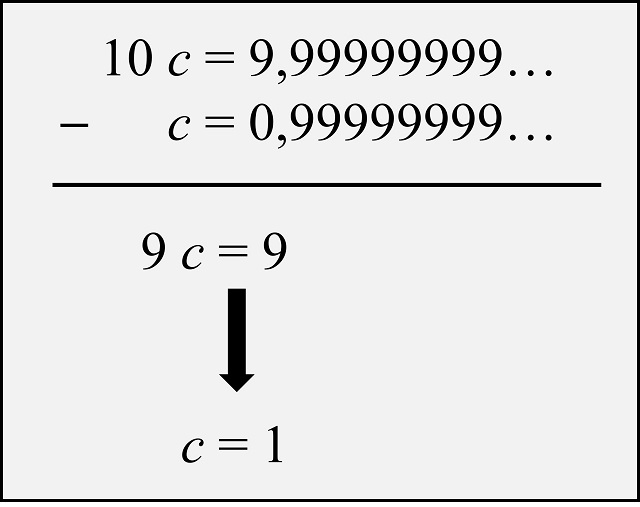

Retrato del matemático ruso-alemán Georg Cantor, de alrededor de 1910. Imagen obtenida de “Library of Congress, courtesy AIP Emilio Segrè Visual Archives”

Retrato del matemático ruso-alemán Georg Cantor, de alrededor de 1910. Imagen obtenida de “Library of Congress, courtesy AIP Emilio Segrè Visual Archives”Bibliografía

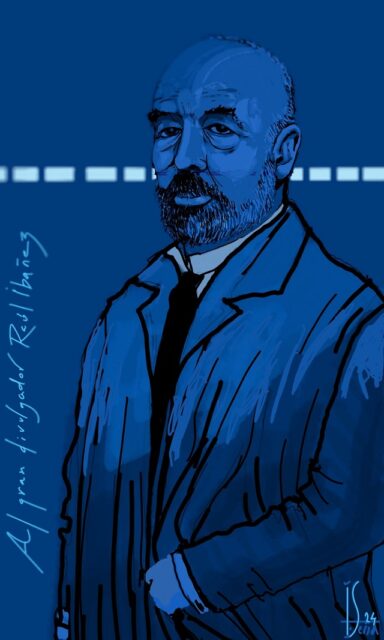

1.- R. Ibáñez, La gran familia de los números, Libros de la Catarata – FESPM, 2021.

2.- David Foster Wallace, Todo y más, Breve historia del infinito, RBA, 2013.

3.- J. Stillwell, The Real Numbers: An Introduction to Set Theory and Analysis, Undergraduate Texts in Mathematics, Springer, 2013.

4.- Eli Maor, To infinity and Beyond, A Cultural History of Infinity, Birkhauser, 1987.

5.- José A. Prado-Bassas, Historia del infinito (el apasionante relato de uno de los conceptos más profundos y enigmáticos de las matemáticas), Pinolia, 2023.

6.- Erich Kamke, Theory of Sets, Dover, 1950.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El infinito en un segmento (3) se ha escrito en Cuaderno de Cultura Científica.

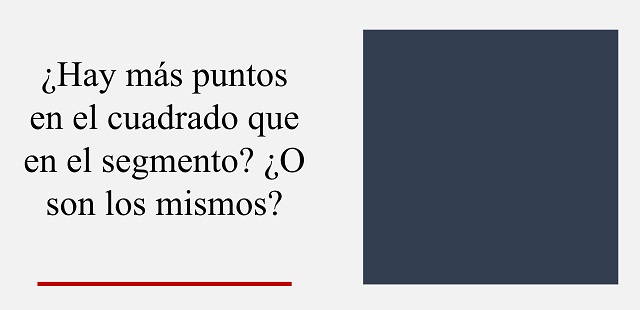

La carga efectiva del protón depende del isospín

Al calcular las propiedades de los núcleos pesados los teóricos suelen centrarse en un subconjunto de los nucleones (protones y neutrones) y suponen que estas partículas tienen “cargas efectivas” que de alguna manera compensan todos los nucleones que se ignoran. Sin embargo, elegir las cargas efectivas adecuadas puede resultar complicado. Ahora Andrea Jungclaus, del Instituto de Estructura de la Materia (IEM-CSIC), y sus colegas han proporcionado la primera evidencia experimental clara de que las cargas efectivas dependen del isospín (groseramente, la proporción neutrón-protón) y han medido esta dependencia de forma inequívoca. La nueva información debería mejorar la precisión de los cálculos para núcleos pesados y ricos en neutrones, para los cuales existen datos experimentales limitados.

El Radioactive Isotope Beam Factory de RIKEN, donde se realizaron los experimentos. Fuente: RIKEN

El Radioactive Isotope Beam Factory de RIKEN, donde se realizaron los experimentos. Fuente: RIKENLas partículas subatómicas que interaccionan a través de la interacción fuerte se conocen como hadrones. Esta categoría incluye a los protones, los neutrones y los piones. El espín isotópico o isospín es un número cuántico que se aplica a los hadrones para diferenciar los elementos de un conjunto de partículas que difieren en sus propiedades electromagnéticas pero que, por lo demás, son indiscernibles. Así, si se ignoran las interacciones electromagnéticas y débiles, el protón no puede distinguirse del neutrón por sus interacciones fuertes: el isospín se introdujo para distinguirlos.

El modelo nuclear de capas asigna a cada nucleón un estado de partícula única que es similar al orbital de un electrón en un átomo. La investigación había demostrado previamente que la carga efectiva es diferente para diferentes núcleos, pero no había quedado claro si la variación era atribuible a diferencias en la configuración orbital de los núcleos o a diferencias en el isospín (o ambas).

Jungclaus y sus colegas aislaron el efecto del isospín comparando las propiedades del estado excitado del cadmio-130 con las medidas previamente en cadmio-98. Estos dos núcleos tienen números muy diferentes de neutrones y, por tanto, una gran diferencia en isospín. Pero tienen configuraciones orbitales similares, ya que ambos tienen capas de neutrones completas y solo les faltan dos protones para tener capas de protones completas.

Los investigadores observaron núcleos de cadmio-130 que se produjeron cuando un haz de uranio colisionó con una diana de berilio en RIKEN (Japón). Combinaron los cálculos del modelo de capas y los nuevos datos junto con datos previos para determinar una carga efectiva de protones de +1,35 para este núcleo rico en neutrones, en comparación con +1,17 para el cadmio-98, lo que sugiere una inesperada dependencia del isospín importante de la carga efectiva.

Para saber más:

Una introducción fácil y paso a paso al núcleo atómico: El núcleo (serie)

Referencias:

A. Jungclaus et al. (2024) Excited-State Half-Lives in 130Cd and the Isospin Dependence of Effective Charges Phys. Rev. Lett. doi: 10.1103/PhysRevLett.132.222501

D. Ehrenstein (2024) Proton Effective Charge Depends on Neutron Population Physics 17, s65

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La carga efectiva del protón depende del isospín se ha escrito en Cuaderno de Cultura Científica.

¿Es esta la (otra) prueba definitiva de que Venus tiene volcanes activos?

Hace poco más de un año, escribíamos en esta sección el artículo “¿Es esta la prueba definitiva de que Venus tiene volcanes activos?” en el cual hablábamos de la que podría ser la primera observación directa de una erupción volcánica en Venus tras el estudio de las imágenes tomadas por el radar de la misión Magellan de la NASA a principios de la década de los 90.

Como también comentábamos en el anterior artículo, y a modo de introducción para quien no lo leyese entonces, no sería extraño que Venus tuviese un nivel de actividad geológica similar a nuestro planeta porque, al fin y al cabo, tienen un tamaño y composición muy parecidos y, por lo tanto, podríamos asumir que todavía mantiene una importante cantidad de calor interno que le permita tener actividad geológica. Si esto no fuese así, deberíamos replantearnos los modelos de evolución planetaria.

Obviamente que sean parecidos no es una razón suficiente para justificar la existencia de actividad geológica, sino que necesitamos pruebas fehacientes de procesos volcánicos y sísmicos que ocurran en Venus a día de hoy. Pero es un planeta terrible tanto para observarlo desde la superficie del planeta como desde la órbita: Una temperatura media superior a los 450ºC -de día y de noche- y una presión atmosférica 90 veces la terrestre hacen muy complicada la supervivencia de la electrónica a largo plazo.

Desde la órbita la dificultad es otra, y es la imposibilidad de estudiar Venus con longitudes de onda visibles, ya que su superficie está completamente cubierta por nubes. Eso sí, este problema tiene una solución más sencilla: El uso de radares de apertura sintética que permitan estudiar la superficie como ya hizo la Magellan en este planeta, la Cassini en Titán o continuamente en la Tierra.

Pero el problema que tenemos es que hasta la próxima década no tendremos nuevas misiones en Venus capaces de estudiar su superficie con radar, la EnVision de la ESA y la VERITAS de la NASA, que nos aportarán una visión mucho más detallada de su superficie de lo que jamás la habíamos visto. Mientras tanto, todavía podemos aprovechar los datos de misiones anteriores para revisitarlos con una mayor capacidad de computación que cuando se tomaron los datos.

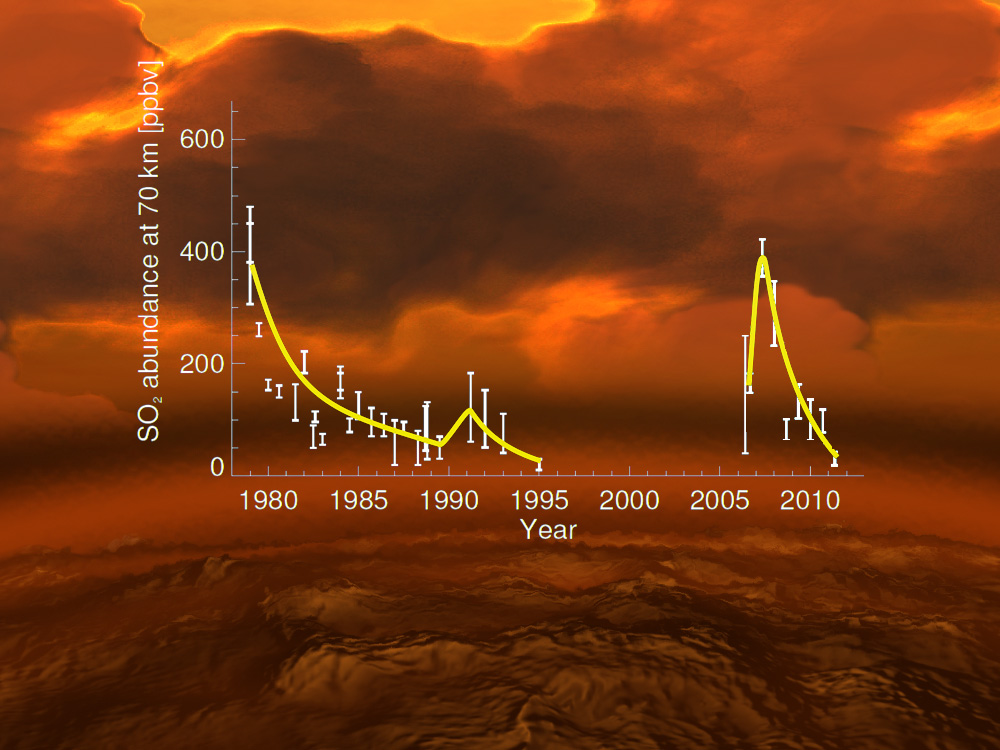

Cambios en la concentración de dióxido de azufre desde 1980 hasta 2011. Estas fuertes variaciones podrían apuntar a inyecciones de este gas a causa de las erupciones volcánicas. Imagen cortesía de E. Marcq et al. (Venus Express); L. Esposito et al. (datos antiguos); imagen de fondo: ESA/AOES Medialab

Cambios en la concentración de dióxido de azufre desde 1980 hasta 2011. Estas fuertes variaciones podrían apuntar a inyecciones de este gas a causa de las erupciones volcánicas. Imagen cortesía de E. Marcq et al. (Venus Express); L. Esposito et al. (datos antiguos); imagen de fondo: ESA/AOES MedialabA pesar de todos estos inconvenientes, ya tenemos una serie de pruebas importantes a favor del vulcanismo activo en Venus: cambios en la concentración de dióxido de azufre -un gas que en nuestro planeta proviene principalmente de la actividad volcánica- en la atmósfera; zonas con muy pocos cráteres de impacto -atestiguando un relieve muy reciente-; anomalías térmicas -en este caso, puntos calientes- sobre la superficie en lugares que parecen volcanes – y que podrían indicar coladas de lava recientes o actividad en los puntos de emisión volcánicos-; y por último, el descubrimiento del fosfano en la atmósfera, que también podría estar relacionado con las erupciones volcánicas y no tanto con la vida como se sugirió inicialmente.

El pasado año, Herrick et al. (2023) publicaban en Science la que podría haber sido la primera evidencia inequívoca de una erupción volcánica en Venus, eso sí, ocurrida treinta años antes y de la que tendríamos una imagen del antes y otra del después, pero que debido al ingente volumen de datos, los cambios entre las dos imágenes habían pasado desapercibidos para los científicos de la época y, solo ahora que podemos procesar y comparar las imágenes con mucha mayor capacidad, había podido detectarse.

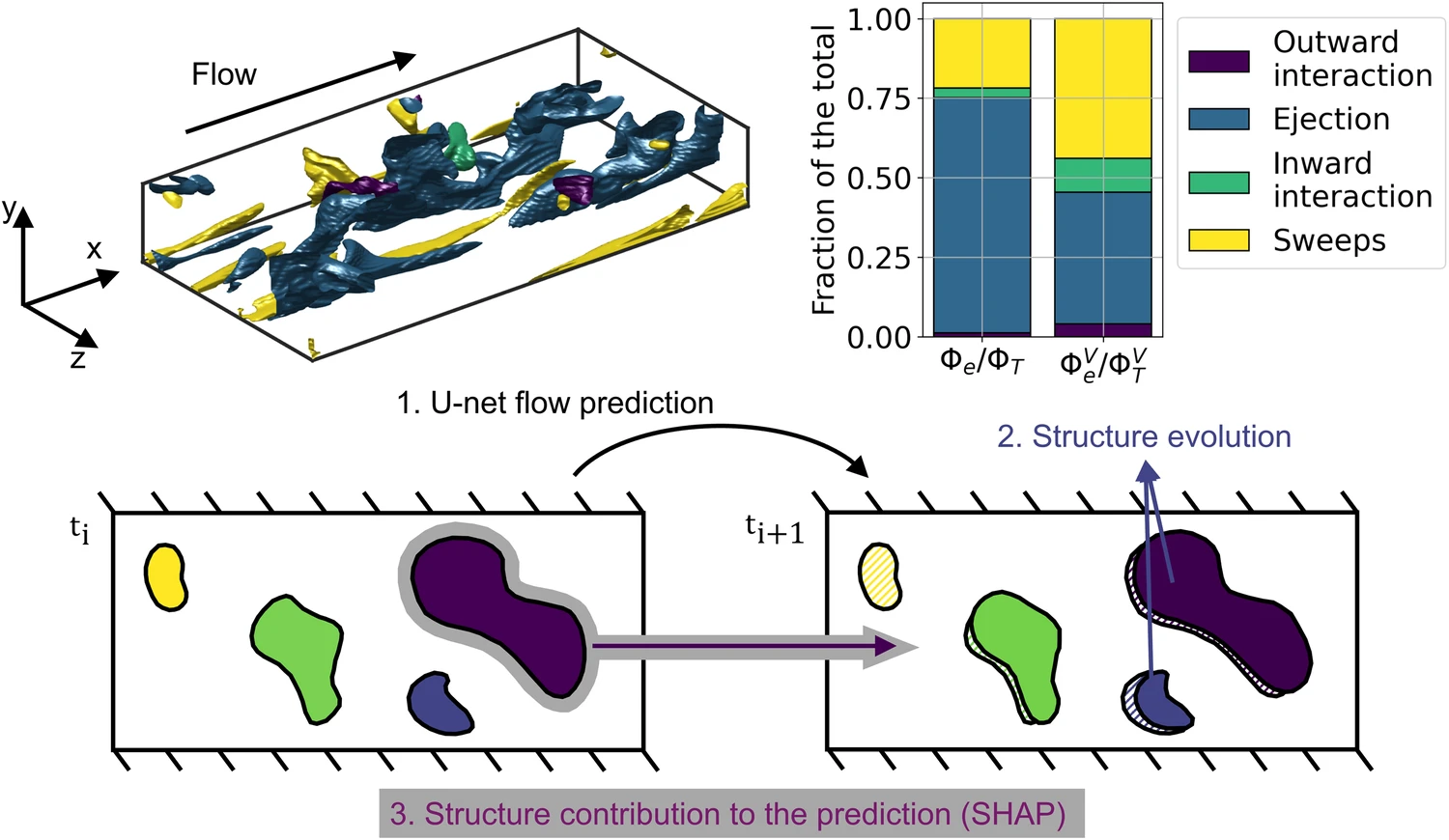

Pero, ¿había más erupciones volcánicas escondidas en las imágenes de la Magellan? Parece que sí. Un estudio publicado a finales de mayo por Sulcanese et al. (2024) sugiere que tanto en el flanco occidental de Sif Mons como en Niobe Planitia se aprecian alteraciones compatibles con la ocurrencia de erupciones volcánicas.

Este nuevo artículo se basa en el estudio del fenómeno de la retrodispersión de las ondas de radar que emitía la Magellan para tomar imágenes del planeta. La retrodispersión es la proporción de la señal del radar que se refleja en la dirección de la antena tras rebotar en el suelo. El estudio de esta señal nos aporta detalles sobre la rugosidad topográfica y la composición de la superficie.

Los datos de radar no suelen ser tan fácilmente interpretables como las imágenes en luz visible, lo que supone un reto a la hora de procesar los datos y evitar malentendidos. Para solucionar este problema, los autores del estudio han corregido los datos originales teniendo en cuenta el ángulo de incidencia de la señal del radar, ya que puede tener influencia en el reflejo, así como normalizar los datos para poder comparar mejor los pares de imágenes sin que una de las imágenes tuviese una mayor influencia que la otra y así evitar falsos positivos.

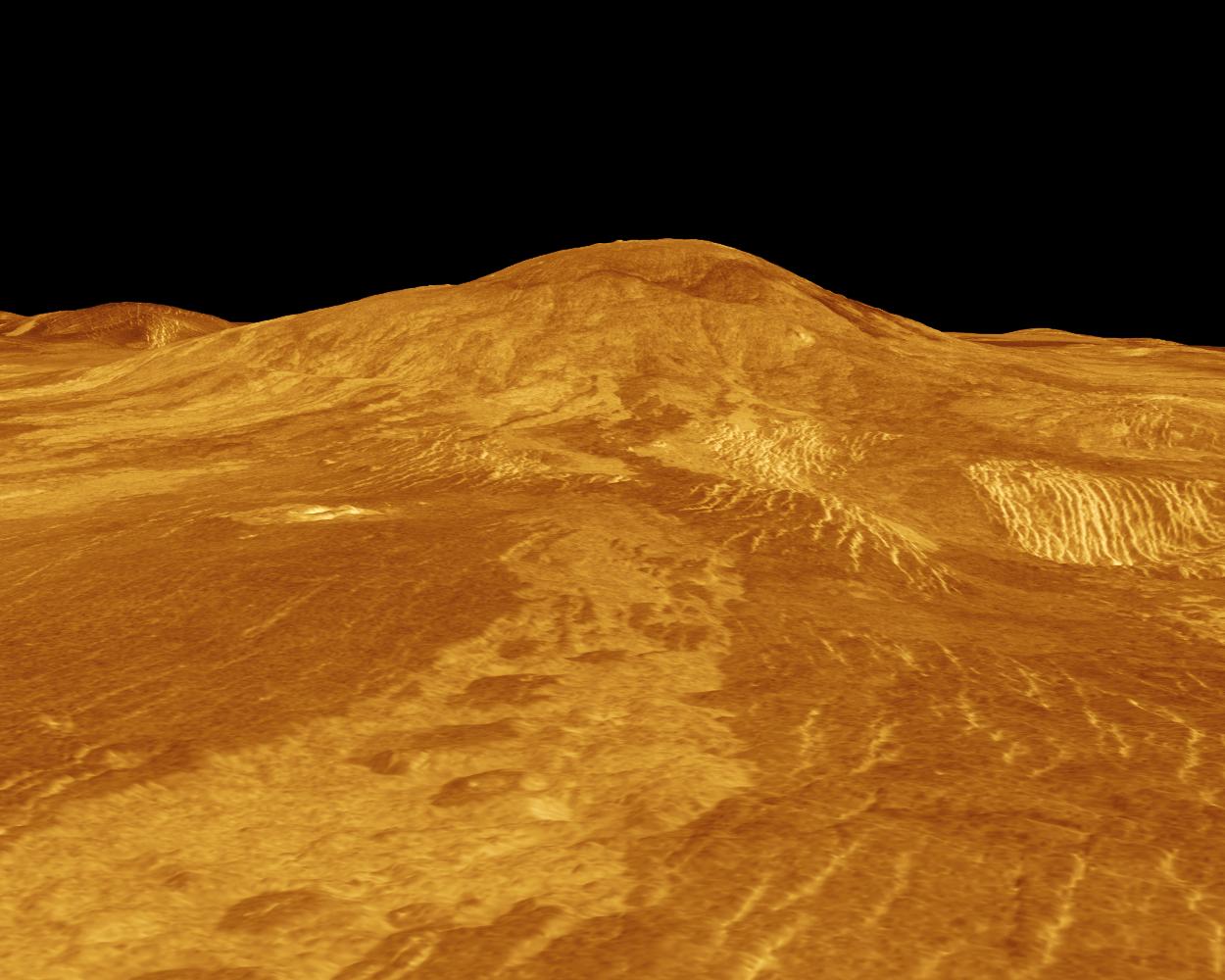

Reconstrucción tridimensional de Sif Mons realizada con datos de la Magellan. Cortesía de NASA/JPL.

Reconstrucción tridimensional de Sif Mons realizada con datos de la Magellan. Cortesía de NASA/JPL.Pero, ¿qué se ha detectado y en donde? En Sif Mons los autores han encontrado cambios en la retrodispersión de la señal del radar que son compatibles con la aparición de nuevas coladas de lava sobre la superficie. Sif Mons es un gran volcán en escudo, tanto que tiene un diámetro de unos 300 kilómetros y más de 2000 metros de altura. Este tipo de volcanes son como los que forman hoy día la isla de Hawaii en nuestro planeta o la Isla de Fernandina, en las Galápagos, por poner algunos ejemplos.

El otro lugar donde se han detectado cambios es Niobe Planitia, una gran llanura -forma aproximadamente un 13% de la superficie de Venus- donde se existen distintos tipos de volcanes así como evidencias de que muchos de los cráteres de impacto que pueblan su superficie han sufrido cambios posteriores a su formación, como el relleno por coladas de lava. Aquí los científicos también han observado una serie de formas lineales y en abanico que no existían antes y cuyo mecanismo de formación estaría también relacionado con la aparición de nuevas coladas de lava que cubren la superficie.

Por si no fuese suficiente, los investigadores además han realizado un análisis topográfico: Es decir, han estudiado las pendientes de Sif Mons y de Niobe Planitia y comprobado hacia donde tendrían que moverse las coladas de lava, comprobando que los cambios observados en la superficie siguen ese camino y no otro.

Imagen de la superficie de Venus donde se pueden ver distintas coladas de lava y una aparente ausencia de cráteres de impacto. Cortesía de NASA/JPL.

Imagen de la superficie de Venus donde se pueden ver distintas coladas de lava y una aparente ausencia de cráteres de impacto. Cortesía de NASA/JPL.Un último paso ha sido el comparar los datos de Venus con los de una erupción en la Tierra, en este caso la del volcán Pacaya, en Guatemala, y observar si los cambios relacionados con la erupción del año 2014 -observada con los radares en la órbita de nuestro planeta- sufría una amplificación en la señal retrodispersada, cosa que ocurría también en la Tierra, apoyando con ello las observaciones hechas por los investigadores.

Este nuevo estudio pone de manifiesto que Venus está más activo de lo que pensábamos y que probablemente hemos estado durante décadas ante un sesgo observacional a la hora de cuantificar su actividad de nuestro “gemelo” planetario, ya que los medios de los que disponíamos nos aportaban una visión muy limitada espacial y temporalmente, pero también por una menor capacidad de procesamiento que la que tenemos hoy.

Venus, por lo tanto, es un planeta que requiere repensar nuestra estrategia de exploración espacial puesto que, a la vista de los descubrimientos que se están haciendo en los últimos años, todavía podría guardar muchos secretos sobre la evolución de los planetas a lo largo del tiempo.

Nota:

Gracias a Davide Sulcanese por proveerme de una copia del artículo para poder comentarlo en Planeta B.

Referencias:

Marcq, Emmanuel, Jean Loup Bertaux, Franck Montmessin, and Denis Belyaev (2013) Variations of Sulphur Dioxide at the Cloud Top of Venus’s Dynamic Atmosphere Nature Geoscience doi: 10.1038/ngeo1650.

Zhang, Xi. (2014) On the Decadal Variation of Sulphur Dioxide at the Cloud Top of Venus EPSC Abstracts Vol. 9, EPSC2014-189.

Bains, William, Oliver Shorttle, Sukrit Ranjan, Paul B Rimmer, Janusz J Petkowski, Jane S Greaves, and Sara Seager (2022) Constraints on the Production of Phosphine by Venusian Volcanoes Universe doi: 10.3390/universe8010054

Herrick, Robert R, and Scott Hensley (2023) Surface Changes Observed on a Venusian Volcano during the Magellan Mission Science doi: 10.1126/science.abm7735

Shalygin, E. V., A. T. Basilevsky, W. J. Markiewicz, D. V. Titov, M. A. Kreslavsky, and Th Roatsch. “Search for Ongoing Volcanic Activity on Venus: Case Study of Maat Mons, Sapas Mons and Ozza Mons Volcanoes.” Planetary and Space Science 73, no. 1 (2012): 294–301. https://doi.org/10.1016/j.pss.2012.08.018.

Smrekar, Suzanne E., Ellen R. Stofan, Nils Mueller, Allan Treiman, Linda Elkins-Tanton, Joern Helbert, Giuseppe Piccioni, and Pierre Drossart. “Recent Hotspot Volcanism on Venus from VIRTIS Emissivity Data.” Science 328, no. 5978 (2010): 605–8. https://doi.org/10.1126/science.1186785.

Basilevsky, A. T., E. V. Shalygin, D. V. Titov, W. J. Markiewicz, F. Scholten, Th Roatsch, M. A. Kreslavsky, et al. “Geologic Interpretation of the Near-Infrared Images of the Surface Taken by the Venus Monitoring Camera, Venus Express.” Icarus 217, no. 2 (2012): 434–50. https://doi.org/10.1016/j.icarus.2011.11.003.

Bains, William, Oliver Shorttle, Sukrit Ranjan, Paul B. Rimmer, Janusz J. Petkowski, Jane S. Greaves, and Sara Seager. Only Extraordinary Volcanism Can Explain the Presence of Parts per Billion Phosphine on Venus. Proceedings of the National Academy of Sciences of the United States of America 119, no. 7 (2022): 2–3. https://doi.org/10.1073/pnas.2121702119.

Cordiner, M. A., G. L. Villanueva, H. Wiesemeyer, S. N. Milam, I. de Pater, A. Moullet, R. Aladro, et al. Phosphine in the Venusian Atmosphere: A Strict Upper Limit From SOFIA GREAT Observations. Geophysical Research Letters 49, no. 22 (2022). https://doi.org/10.1029/2022GL101055.

Sulcanese, Davide, Giuseppe Mitri, and Marco Mastrogiuseppe (2024) Evidence of Ongoing Volcanic Activity on Venus Revealed by Magellan Radar 2024. doi: 10.1038/s41550-024-02272-1

Herrick, Robert R., and Scott Hensley. Surface Changes Observed on a Venusian Volcano during the Magellan Mission. Science 379, no. 6638 (2023): 1205–8. https://doi.org/10.1126/science.abm7735.

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario, divulgador científico u autor de la sección Planeta B.

El artículo ¿Es esta la (otra) prueba definitiva de que Venus tiene volcanes activos? se ha escrito en Cuaderno de Cultura Científica.

¡Abre los ojos! La ciencia de la visión y de la mirada

El sistema visual de los mamíferos, y de los vertebrados, en general, es de una complejidad asombrosa. El ojo es una estructura tan complicada y su función, tan relevante, que el mismísimo Charles Darwin lo tenía por la principal amenaza para su teoría sobre el origen de las especies. Y no fue el único; también a Ramón y Cajal le asaltó la duda. El ojo humano, principalmente, pero también los sistemas visuales y las estructuras fotorreceptoras de otras especies son el tema del libro de Conchi Lillo ‘¡Abre los ojos!’.

Fuente: Next Door Publishers

Fuente: Next Door PublishersEl libro empieza por invocar la evolución y el mecanismo que (a mi juicio) le es más propio, la selección natural. Entiendo que ese es el mejor punto de partida posible para un libro como este, porque si bien el adagio de Theodosius Dobzhansky «En biología nada tiene sentido si no es a la luz de la evolución» –que diese título a su ensayo de 1973– es válido en cualquier caso, resulta especialmente luminoso cuando nos referimos a una modalidad de recepción sensorial con una plasticidad tan grande como la de la visión y con una relación, en general (aunque no en todos sus aspectos), tan evidente con las características del entorno.

A esa inicial contextualización evolutiva de la visión, sigue una descripción del ojo humano. La autora presenta su estructura, tanto del órgano receptor –la retina–, con sus elementos, como de las estructuras accesorias.

Los colores no existen aunque los veasMás adelante se adentra en el mundo de los colores –la visión en color–, para explicar que el fenómeno se basa en la posesión de pigmentos visuales que responden de forma diferente a las distintas longitudes de onda de las radiaciones electromagnéticas que constituyen la luz visible. Es visible, precisamente, porque los pigmentos, al absorber la radiación, reaccionan y desencadenan una secuencia de acontecimientos que desemboca en la generación de señales nerviosas. En definitiva, la energía que portan los fotones se acaba convirtiendo en la energía bioeléctrica propia de los impulsos nerviosos.

El título de este apartado –‘Los colores no existen’– me ha recordado una conversación que tuve hace años con mi madre, a quien se lo dije con esas mismas palabras: «¿Sabes que los colores no existen?» «¿Qué tontería es esa?» me respondió ella. «¿Cómo no van a existir si los estoy viendo?» Traté de explicárselo lo más claramente que pude, pero me resultó imposible. Incluso a mis estudiantes les resulta una noción extraña, y el argumento, un tanto alambicado. Pero Conchi Lillo lo explica muy bien; mi madre, a ella, se lo habría entendido.

El color de los ojos también es objeto de su atención; en el libro se explica la razón por la que unas personas tenemos los ojos oscuros y otras los tienen claros. O, incluso, a qué se debe que, como le ocurría a un compañero de estudios en el instituto de Portugalete, haya quien tiene uno de cada color. Conviví con ese compañero –de clase y de francachelas– en el aula, el patio y los bares, durante meses, sin percatarme de su rareza. Hasta que me lo dijo una compañera. Siempre me había parecido que tenía una mirada extraña, pero me tuvieron que decir que tenía un ojo castaño y otro azul para percatarme. Entendí entonces la razón de mi perplejidad.

Problemas de visiónA los problemas visuales se les dedica un extenso capítulo. Es extenso porque al tratarse de un sistema tan complejo, con tantos elementos, las posibilidades de que funcione de forma anómala se multiplican. Son muchos los fallos posibles del sistema, tanto en los fotorreceptores y sus características pigmentarias, como en el efecto que el paso del tiempo tiene sobre las estructuras retinianas o las averías de algunos componentes accesorios. Cataratas, fatiga visual, miopía, degeneración macular y otros males asoman a las páginas del libro. Y uno no puede dejar de pensar que vemos de milagro. Aunque, en realidad, la reflexión pertinente es otra: qué sistema tan maravilloso es el de la visión que a pesar de tantos elementos constituyentes y potencialmente falibles, lo normal es que durante gran parte de nuestra vida nos preste un servicio excelente.

Tampoco aquí debemos perder de vista la lógica evolutiva. La mayor parte de esos problemas, al menos los que pueden comprometer la supervivencia o capacidad para dejar descendencia, surgen precisamente cuando ya la hemos dejado o, en todo caso, hemos perdido la oportunidad de hacerlo. En otras palabras, la selección natural ha actuado descartando variantes que limitaban a nuestros ancestros; las pocas anomalías que aparecen a edades jóvenes son eso, pocas: excepciones, en realidad.

Los artistas plásticos –me refiero aquí a los pintores, principalmente– también sufren problemas de visión y las consecuencias de esos problemas, de una u otra forma, quedan reflejados en su obra. Es interesantísimo seguir la pista de las deficiencias visuales que delatan los cuadros: miopía, cataratas, estrabismo y otros, son afecciones cuya huella queda impresa en la obra del artista.

Percepción animalUno de los aspectos más interesantes de la visión como modalidad sensorial es el fenómeno perceptivo, la forma en que la información recogida por los sistemas receptores es procesada por los centros superiores del cerebro y el papel que juega en ese procesamiento la memoria, las emociones y, en general, cualquier tipo de información –incluida la que se recibe por otras vías sensoriales– que interactúa con la de origen visual para generar la percepción. De hecho, lo que vemos acaba siendo el resultado de la confluencia, con las señales procedentes de la retina, de expectativas, recuerdos, sentimientos y otros elementos de nuestra experiencia presente o pasada. Por esa razón, nunca dos personas ven lo mismo cuando contemplan una misma escena.

La autora deja para casi el final, un recorrido por los sistemas visuales de diferentes especies, como bivalvos, cefalópodos, crustáceos, insectos o arácnidos. Este es el apartado que mejor ilustra el apotegma antes citado del señor Teodosio. Y es, por eso mismo, el que mejor muestra la asombrosa diversidad de soluciones que ha generado la naturaleza para, sirviéndose de la información contenida en ciertos intervalos de longitudes de onda de las radiaciones electromagnéticas que “bañan” el universo, dotar a las criaturas animales de herramientas mediante las que desenvolverse con éxito en entornos de lo más dispares.

Cierra el libro una breve mirada a lo que nos puede deparar el futuro desde la tecnología electrónica y telemática, en combinación –casi simbiosis– con nuestro sistema visual. Pero el futuro no está escrito y aunque lo que cuenta Lillo es apasionante, estoy seguro de que nos deparará maravillas aún más asombrosas de lo que hoy somos capaces de vislumbrar.

En resumen, querido lector, querida lectora, si tiene curiosidad acerca del funcionamiento de la visión, la nuestra y la de otros seres vivos, ‘¡Abre los ojos!’ es, por claridad, rigor y amenidad, una lectura muy recomendable.

Autora: Conchi Lillo

Título: ¡Abre los ojos!

Ed por Next Door (2023)

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

Una versión de este texto de Juan Ignacio Pérez Iglesias apareció anteriormente en Lecturas y Conjeturas (Substack).

El artículo ¡Abre los ojos! La ciencia de la visión y de la mirada se ha escrito en Cuaderno de Cultura Científica.

Una (pre)historia de violencia

Los cambios del cerebro durante el embarazo y la maternidad, cómo el estrés ha pasado de ser un mecanismo de supervivencia a un eventual elemento de riesgo para nuestra salud o cuál ha sido el papel que ha jugado el suicidio en la evolución del ser humano fueron algunos de los temas que se tratarán en la VI Jornada Nacional sobre Evolución y Neurociencias.

La jornada tuvo lugar el Bizkaia Aretoa de la UPV/EHU los pasados 25 y 26 de abril y estuvo dirigida por Eva Garnica y Pablo Malo, de la Red de Salud Mental de Bizkaia, institución que organizó la jornada junto a la Cátedra de Cultura Científica de la UPV/EHU.

El encuentro, cuya primera edición se celebró en 2017, se ha convertido en una cita imprescindible para las y los expertos en ámbitos como la psiquiatría, la psicología o la biología. Una jornada que sirve para analizar el comportamiento humano desde un punto de vista evolutivo y divulgar de un modo accesible para todos los públicos.

¿Puede hablarse de violencia en los animales sin suponer que tienen «intención»? Es decir, sin antropomorfizarlos. ¿Qué nos dice esto sobre la violencia entre esos homininos llamados humanos? En Una (pre)historia de violencia, José Miguel Martínez Gázquez, psicólogo y primatólogo, parte de la definición de violencia como el uso intencionado de la fuerza contra otro, para llegar a conclusiones que pueden sorprender a más de uno.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Una (pre)historia de violencia se ha escrito en Cuaderno de Cultura Científica.

Fatiga mecánica en las turbinas eólicas flotantes

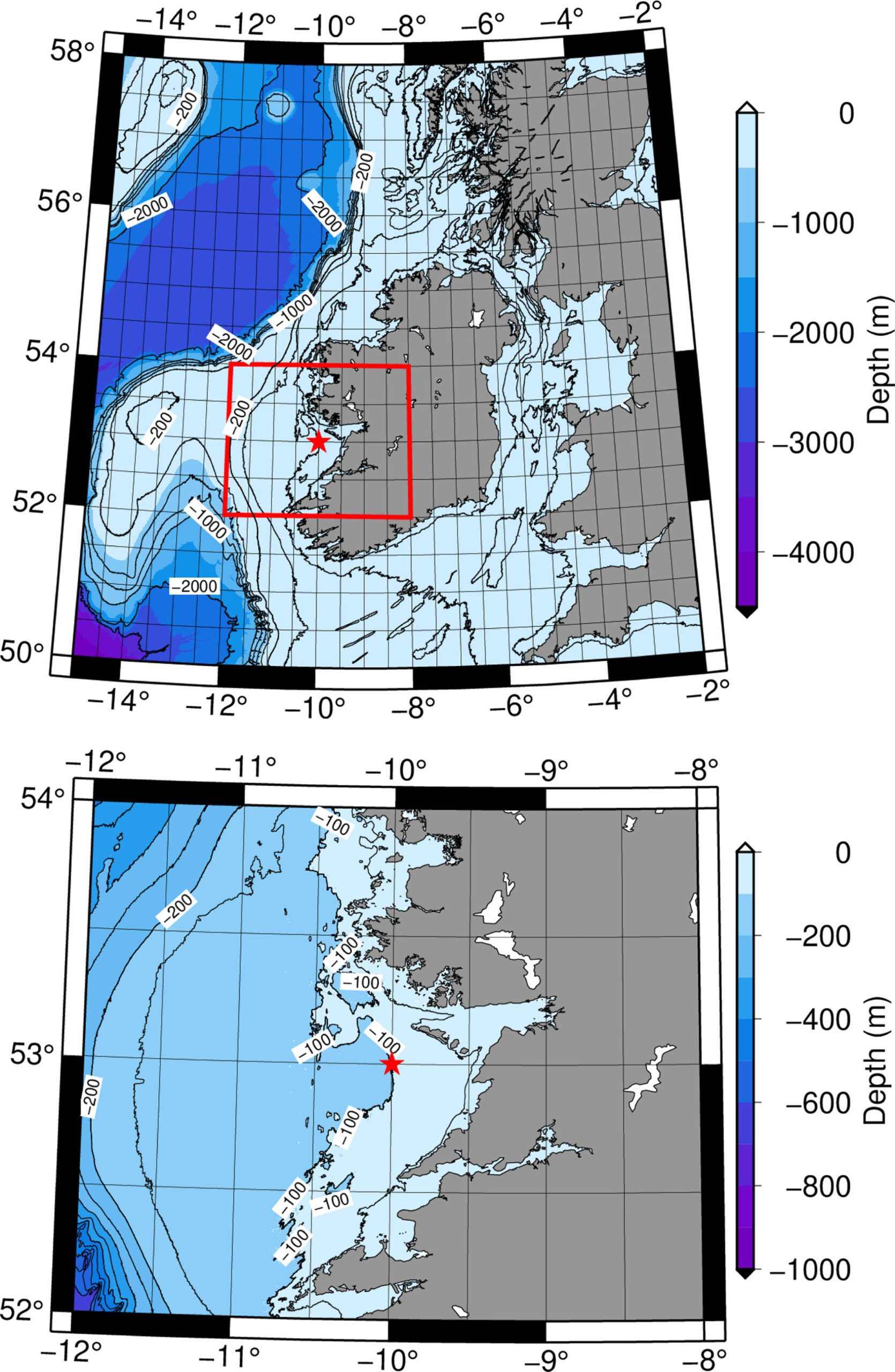

Los datos del viento y oleaje de un emplazamiento muy energético en la costa de Irlanda entre 1920 y 2010 han permitido analizar la evolución de las condiciones del mar y generar un modelo de cálculo de la fatiga mecánica que esas condiciones pueden provocar en las turbinas eólicas flotantes. Este método matemático-estadístico permite calcular el tiempo de vida de las turbinas en función de la meteorología de un emplazamiento concreto.

Fuente: 123rf

Fuente: 123rfEn un estudio realizado por el grupo de investigación EOLO de la Universidad del País Vasco/Euskal Herriko Unibertsitatea, se ha desarrollado un método matemático-estadístico que permite conocer “la conveniencia de instalar parques eólicos flotantes en un emplazamiento concreto. Por ejemplo, si existe una elevada probabilidad de que los aerogeneradores sufran fatiga mecánica o unas condiciones marinas extremas a pesar de ser un lugar muy energético”, explica Alain Ulazia, profesor de la Escuela de Ingeniería de Gipuzkoa (Eibar).

Según el investigador, la pregunta más frecuente en la generación de energía eólica marina es “qué cambios (subidas o bajadas) se sucederán en la producción de energía en función de las condiciones climáticas”; es decir, lo que se mira es cuánta energía se puede producir en función de la climatología. Sin embargo, la investigación dirigida por Ulazia ha ido un paso más allá y se ha centrado en la fatiga mecánica de las turbinas eólicas marinas, es decir, la rotura en última instancia como consecuencia de los choques y las tensiones repetitivas que no son capaces de romper el material individualmente: “Las condiciones del mar (viento y oleaje) pueden influir en la reducción del tiempo de vida de las turbinas flotantes. De hecho, es posible que afecten más a la duración de algunas piezas de las turbinas que a la producción industrial de energía, y que en vez de durar 20 años duren 15 años. Esto puede influir decisivamente en los costes y en la inversión de un proyecto”.

Condiciones marinas en un emplazamientoEl grupo de investigación EOLO lleva años trabajando en proyectos relacionados con la meteorología, el clima y el medio ambiente. “Hemos realizado numerosos estudios sobre la relación a largo plazo entre el cambio climático y la generación de energías renovables. Teniendo en cuenta los cambios producidos a lo largo de varias décadas, hacemos estudios históricos y proyecciones para el futuro”, explica Ulazia.

Mapa de la profundidad del mar frente a la costa de Galway (Irlanda)

Mapa de la profundidad del mar frente a la costa de Galway (Irlanda)En este estudio se ha seleccionado un lugar muy energético de Irlanda: a partir de los datos relativos al viento y al oleaje registrados entre 1920 y 2010 en la bahía de Galway, en la costa oeste de Irlanda, han determinado los cambios históricos ocurridos a lo largo de esas décadas mediante la utilización de modelos meteorológicos avanzados, en colaboración con los miembros del Centre for Ocean Energy Research de la Universidad de Maynooth (Irlanda). Estos datos históricos han servido para determinar la evolución de las condiciones marinas y crear un modelo que represente la fatiga a largo plazo que estas provocarán en los aerogeneradores. Este modelo podrá ser utilizado para realizar proyecciones futuras.

La danza de las turbinas eólicas flotantesUtilizando simulaciones, los investigadores han calculado la energía que producirían algunas turbinas flotantes de referencia en las ocho situaciones marinas más probables en la bahía de Galway y, por otro lado, han visto la fatiga mecánica que provocarían en algunos elementos de las turbinas. “Hemos utilizado un simulador que nos ofrece en unos segundos la danza que hace la turbina debido a las olas y el viento, y hemos desarrollado un método matemático-estadístico para implementar cambios en los estados marinos a largo plazo y, en consecuencia, poder determinar la evolución de la fatiga que soportaría la máquina, teniendo en cuenta estos cambios históricos”, explica el investigador del grupo EOLO.

A pesar de que el método ha sido aplicado en esa ubicación irlandesa, “este método es universal. Podemos hacer el análisis en cualquier parte del mundo”, ha señalado. La energía eólica marina es muy apropiada porque “no es turbulenta, como la de las montañas. Sin embargo, hay que invertir mucho más en el mar. Este es el principal problema para la implantación de la energía eólica marina”, explica Ulazia. El cambio climático está provocando acontecimientos extremos, cada vez más, y los inversores se muestran precavidos ante el riesgo de este tipo de proyectos: “Aunque el emplazamiento sea muy energético, ¿merece la pena poner el parque eólico allí si en algún momento puede verse afectado por un fenómeno climatológico o si los elementos de la turbina van a sufrir graves problemas de fatiga?”, afirma. El método desarrollado por el grupo de investigación EOLO de la Universidad del País Vasco ha dado luz a esta cuestión.

Referencia:

Alain Ulazia, Hodei Ezpeleta, Gabriel Ibarra-Berastegi, Jon Sáenz, Nahia Martinez-Iturricastillo, John V. Ringwood (2024) Historical trends of floating wind turbine fatigue loads (Ireland 1920–2010) Ocean Engineering doi: 10.1016/j.oceaneng.2024.117424

El artículo Fatiga mecánica en las turbinas eólicas flotantes se ha escrito en Cuaderno de Cultura Científica.

¿Con qué relleno el arenero de mi gato?

Cuando tenemos una mascota felina en casa, una de las principales cosas en la que tenemos que pensar es en prepararle un lugar en el que pueda hacer sus necesidades. Generalmente, optamos por un cajetín plástico y resistente dentro del cual verteremos un material absorbente en el que nuestra mascota pueda escarbar, hacerse un hueco y sentirse cómoda en esos momentos íntimos, pero que también elimine los olores y la humedad. Es en este momento cuando nos surgen todas las dudas sobre qué elementos utilizar para que cumplan esta función de la manera más eficiente posible. Y, como siempre, la mejor solución nos la aporta la Geología y no es la arena: emplearemos minerales de la arcilla.

Foto: Lina Angelov / Unsplash

Foto: Lina Angelov / UnsplashEn primer lugar, hay que aclarar lo que significa la palabra arcilla, porque, en Geología, este término tiene dos significados distintos, pero relacionados entre sí. Por un lado, arcilla se refiere a un tamaño de grano del sedimento, incluyendo todas aquellas partículas minerales que midan menos de dos micras de diámetro (es decir, inferiores a 0,002 mm). Y, por otro, tenemos los minerales de la arcilla, que es un término que engloba a minerales del grupo de los filosilicatos que, generalmente, son los principales componentes de los sedimentos de tamaño arcilla, de ahí su nombre.

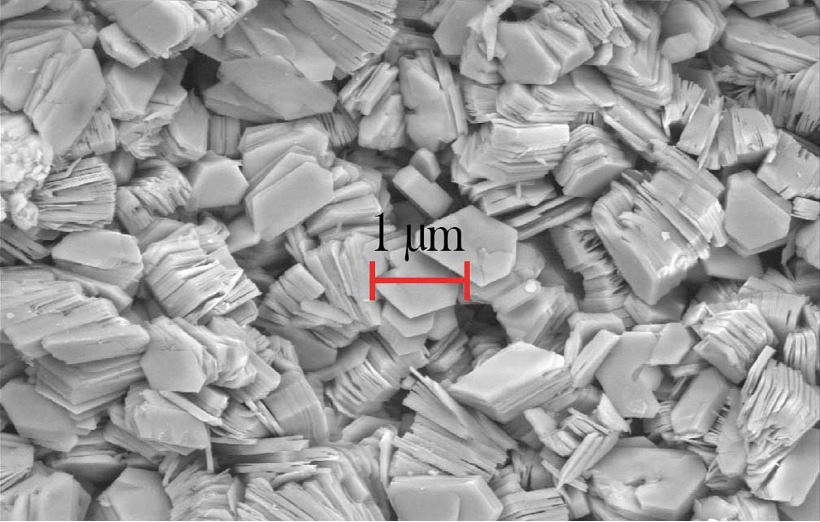

Imagen de Microscopio Electrónico de Barrido (SEM) de minerales de la arcilla, en donde se aprecia su disposición en láminas superpuestas. La escala representa 1 micra, que equivale a 0,001 mm. Fuente: Paedona / Wikimedia Commons

Imagen de Microscopio Electrónico de Barrido (SEM) de minerales de la arcilla, en donde se aprecia su disposición en láminas superpuestas. La escala representa 1 micra, que equivale a 0,001 mm. Fuente: Paedona / Wikimedia CommonsLos filosilicatos tienen una particularidad que ya nos está chivando su propio nombre, que deriva del griego phyllon (que podemos traducir como hoja). Químicamente, son moléculas conformadas por átomos de oxígeno y silicio con otros cationes, tales como aluminio o magnesio, que adquieren forma de tetraedros u octaedros. Estas moléculas se disponen en el espacio dando lugar a unas estructuras cristalinas con aspecto de láminas o escamas situadas unas sobre otras. Y, entre cada una de esas láminas, se generan una serie de cavidades o poros de tamaño atómico, es decir, microscópico. Es en esta propiedad química en donde radica uno de sus secretos, su capacidad absorbente.

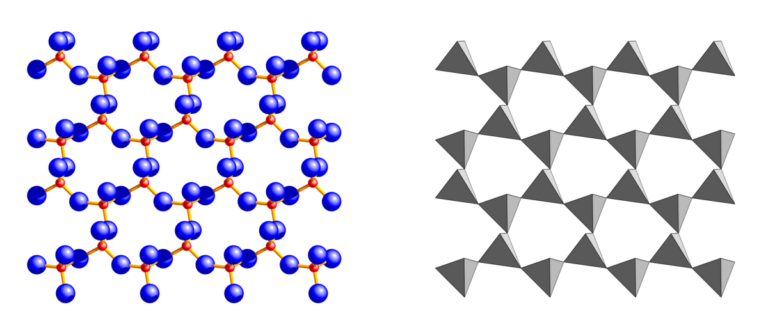

Representación de la estructura cristalina de la moscovita, un mineral del grupo de los filosilicatos, donde los tetraedros de oxígeno y silíceo se van uniendo entre sí formando láminas. Imagen: Finger, L.W., Kroeker, M., Toby, B.H. (2007). DRAWxtl, an open-source computer program to produce crystal-structure drawings. Journal of Applied Crystallography, 40, 188-192 / Wikimedia Commons

Representación de la estructura cristalina de la moscovita, un mineral del grupo de los filosilicatos, donde los tetraedros de oxígeno y silíceo se van uniendo entre sí formando láminas. Imagen: Finger, L.W., Kroeker, M., Toby, B.H. (2007). DRAWxtl, an open-source computer program to produce crystal-structure drawings. Journal of Applied Crystallography, 40, 188-192 / Wikimedia CommonsAsí, los minerales de la arcilla pueden captar nuevos componentes en su estructura cristalina, tanto en forma de partículas sólidas como en estado líquido, dándoles un montón de utilidades en nuestra sociedad. Por ejemplo, esta alta facilidad de absorción los convierte en unas herramientas excelentes para regenerar medios contaminados, como zonas donde se ha producido un derrame de petróleo o suelos afectados por vertidos químicos, ya que, si me permitís el símil, chuparían esas partículas como si fuesen esponjas. También se emplean para potabilizar agua en zonas remotas, al hacer pasar el líquido elemento por membranas recubiertas de estos minerales, que atraen y retienen las partículas sólidas y los contaminantes. Incluso, en la industria se utilizan como soportes de catalizadores o como recubrimiento de superficies para evitar la corrosión por el agua. Y, por supuesto, son el elemento básico en la alfarería y la cerámica, ya que al mezclar los minerales de la arcilla con agua se vuelven una pasta flexible y moldeable que permite deslizar con facilidad las láminas cristalinas una sobre la otra para darle la forma deseada, recuperando su resistencia inicial al desecarlos.

A este elevado nivel de absorción hay que sumarle otra ventaja, ya que también captan las partículas químicas, presentes tanto en estado gaseoso, líquido y sólido, que generan olores. De ahí que los minerales de la arcilla sean los productos favoritos, por encima de materiales vegetales como el serrín, para las camas de los animales domésticos, los suelos de las granjas o las bases de carpas o urinarios públicos temporales colocados en zonas festivas. Y, geológicamente hablando, los minerales de la arcilla no son un producto escaso y difícil de conseguir, en realidad son muy comunes en todo el planeta, encontrándose en diferentes contextos geológicos y no resultando demasiado complicada ni su extracción, ni su procesado para poder emplearlos en nuestro día a día. Por ejemplo, para los areneros de las mascotas simplemente se obtiene el material en canteras, se tritura, se tamiza para elegir el tamaño adecuado, se embolsa y se vende. Esta facilidad en su obtención y tratamiento es la guinda del pastel que convierte a los minerales de la arcilla en materiales tan utilizados, versátiles y con unas aplicaciones industriales y sociales futuras sorprendentes.

Aspecto de los minerales de la arcilla que se comercializan como arena para gatos.

Aspecto de los minerales de la arcilla que se comercializan como arena para gatos.Para terminar, dejadme daros un consejo para elegir el mejor material absorbente para el aseo de vuestras mascotas. Coged uno de los fragmentos minerales de las distintas bolsas que encontraréis en el mercado, humedeced vuestra lengua y acercad el fragmento a la punta de la misma. Aquel que se quede más pegado, será el elegido. Obviamente, haced esta prueba antes de rellenar el arenero del animal, no después de que Castaño (que así se llama mi gato) haya usado su cuarto de baño. Pero si preferís simplemente mirar la etiqueta del producto sin tener que “chupar piedras”, os recomiendo decantaros por aquellos que contengan fragmentos de sepiolita, ya que este mineral posee la capacidad absorbente más elevada de entre aquellos que podemos encontrar en el mercado.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo ¿Con qué relleno el arenero de mi gato? se ha escrito en Cuaderno de Cultura Científica.

Despedidas matemáticas

Foto: Scott Rodgerson / Unsplash

Foto: Scott Rodgerson / Unsplash

Poeta de Guardia (1917-1998)

Ya creo que lo he dicho todo

y que todo lo amé.

G. F.

Este epitafio es de la poeta Gloria Fuertes; su hermosa despedida la recuerda y describe impecablemente su carácter y manera de afrontar la vida.

Los que siguen son epitafios de cinco matemáticos y una astrónoma que, como en el caso de la poeta, describen su trabajo o su singular personalidad. Comencemos.

Diofanto de Alejandría (hacia 200-hacia 280)

Se sabe que el matemático Diofanto de Alejandría, el padre del álgebra, vivió 84 años. Y se conoce porque su epitafio tiene forma de enunciado matemático que permite deducir a que edad falleció (aunque se desconoce el año):

Transeúnte, esta es la tumba de Diofanto: los números pueden mostrar, ¡oh maravilla! la duración de su vida. Su niñez ocupó la sexta parte de su vida; después, durante la doceava parte, de vello se cubrieron sus mejillas. Pasó aún una séptima parte de su vida antes de tomar esposa y, cinco años después, tuvo un precioso niño que, una vez alcanzada la mitad de la edad de la vida de su padre, pereció de una muerte desgraciada. Su padre tuvo que sobrevivirle, llorándole, durante cuatro años. De todo esto se deduce su edad.

Efectivamente, si x denota la edad a la que falleció Diofanto, el epitafio afirma que:

x = x/6 + x/12 + x/7 + 5 + x/2 + 4,

y un simple cálculo, lleva a la igualdad x = 84, la edad a la que falleció Diofanto (y su hijo, por supuesto, murió a los 42).

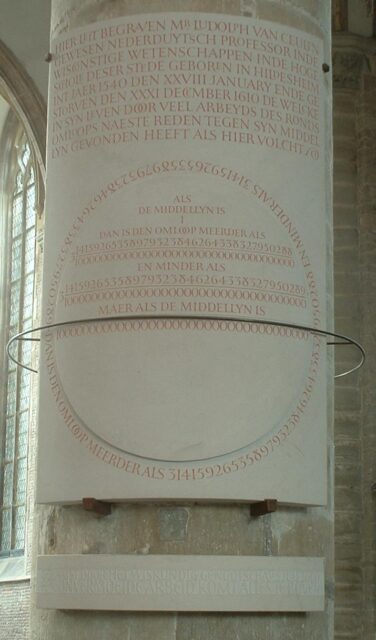

Ludoph van Ceulen (1540-1610)

El matemático Ludolph van Ceulen fue un calculador excepcional. Se le conoce fundamentalmente por haber aproximado el valor del número pi (la relación entre la longitud de una circunferencia y su diámetro) con 35 cifras decimales exactas. Para ello calculó el perímetro de un polígono regular de 262 lados. Estaba tan orgulloso de este logro, que hizo inscribir esta aproximación en su lápida; en ella se indicaba que el número pi estaba comprendido entre los valores 3,14159265358979323846264338327950288 y 3,14159265358979323846264338327950289.

Copia de la lápida de van Ceulen (perdida hacia 1800). Fuente: Wikimedia Commons.

Copia de la lápida de van Ceulen (perdida hacia 1800). Fuente: Wikimedia Commons.Fundamentalmente en textos alemanes, el número pi fue conocido durante mucho tiempo como número ludolphino.

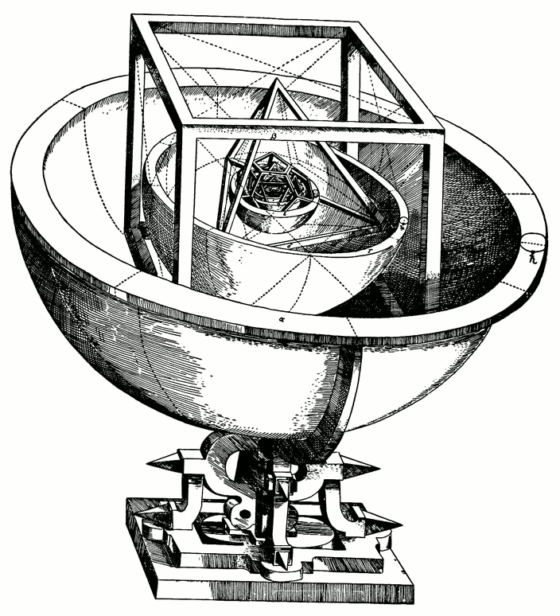

Johannes Kepler (1571-1630)

El matemático y astrónomo Johannes Kepler proponía en su Mysterium Cosmographicum (1596) que la relación entre las distancias de los seis planetas conocidos en su tiempo (Mercurio, Venus, Tierra, Marte, Júpiter y Saturno) podía entenderse en términos de los cinco sólidos platónicos, encerrados dentro de una esfera que representaba la órbita de Saturno.

Modelo de Kepler de las órbitas de los planetas del Sistema Solar. Fuente: Wikimedia Commons.

Modelo de Kepler de las órbitas de los planetas del Sistema Solar. Fuente: Wikimedia Commons.Realizó cálculos durante toda su vida para entender cómo se movían los planetas. Así quiso expresar su trabajo en su epitafio escrito en latín:

Mensus eram coelos, nunc terrae metior umbras; Mens coelestis erat, corporis umbra iacet. [Medí los cielos y ahora mido las sombras. Mi mente tenía por límite los cielos, mi cuerpo descansa encerrado en la Tierra.]

Caroline Lucretia Herschel (1750-1848)

La astrónoma Caroline Lucretia Herschel colaboró con su hermano William en el cálculo, diseño y construcción de telescopios, en la anotación de las observaciones nocturnas del astrónomo y en la catalogación, revisión e interpretación de sus análisis. Además, descubrió ocho cometas y tres nebulosas de manera independiente.

Su epitafio, escrito por ella misma, evoca todo el trabajo que realizó, siempre a la sombra de su hermano:

[…] Los ojos de aquella que pasó a la gloria, mientras abajo se volvían hacia los cielos estrellados; sus propios descubrimientos de los cometas y su participación en los trabajos inmortales de su hermano, William Herschel, dan testimonio de ello para épocas posteriores. […]

David Hilbert (1862-1943)

El matemático alemán David Hilbert fue un científico influyente en su época; trabajó y contribuyó en varias áreas de las matemáticas. Durante el Congreso Internacional de Matemáticos que tuvo lugar en París en 1900 propuso 23 problemas matemáticos, algunos de los cuales continúan sin resolverse.

Enterrado en Gotinga, su epitafio parece indicar su certeza de que esos problemas que propuso terminarían por resolverse:

Wir müssen wissen. Wir werden wissen. [ Debemos saber. Sabremos.]

Además, parece ser la respuesta al lema Ignoramus et ignorabimus (Ignoramos e ignoraremos) expresado en 1880 por el médico alemán Emil du Bois-Reymond durante una conferencia ante la Academia Ciencias de Berlín. A lo largo de su discurso definió siete enigmas del mundo que consideraba capitales. En su opinión, tres de estos problemas no podrían nunca ser explicados ni por la ciencia ni por la filosofía.

Paul Erdős (1913-1996)

Paul Erdős fue uno de los más prolíficos matemáticos en cuanto a publicaciones científicas; firmó unos 1500 artículos con más de 500 coautores. Trabajó en problemas de combinatoria, teoría de grafos, teoría de números, análisis clásico, teoría de aproximación, teoría de conjuntos y teoría de probabilidad.

Para su epitafio sugirió una ingeniosa frase (escrita en húngaro) a modo de despedida:

Végre nem butulok tovább. [Finalmente he dejado de hacerme cada vez más tonto.]

Una última despedida

Terminamos como empezamos, con una poeta. Emily Dickinson (1830-1886) escribió su propio epitafio, una despedida breve y contundente:

Called Back. [Me llaman.]

Para saber más:

Muerte entre las ecuaciones (Historias de muerte y matemáticas 1)

Los matemáticos también mueren (Historias de muerte y matemáticas 2)

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Despedidas matemáticas se ha escrito en Cuaderno de Cultura Científica.

Las matemáticas intentan escudriñar más allá del Big Bang

Al estudiar la geometría de los modelos de espacio-tiempo, los investigadores ofrecen visiones alternativas de los primeros momentos del universo.

Un artículo de Steve Nadis. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Ilustración: Nico Roper / Quanta Magazine

Ilustración: Nico Roper / Quanta MagazineHace unos 13.800 millones de años todo el cosmos estaba formado por una pequeña, densa y caliente bola de energía que de repente explotó.

Así empezó todo, según la historia científica estándar sobre el Big Bang, una teoría que tomó forma por primera vez en la década de 1920. La historia se ha perfeccionado a lo largo de las décadas, sobre todo en la década de 1980, cuando muchos cosmólogos llegaron al convencimiento de que en sus primeros momentos el universo pasó por un breve período de expansión extraordinariamente rápida llamado inflación antes de reducir la marcha.

Se cree que ese breve período fue causado por una forma peculiar de materia de alta energía que invierte la gravedad, “inflando” la estructura del universo exponencialmente y provocando que crezca en un factor de un cuatrillón en menos de una milmillonésima de una milmillonésima de una milmillonésima de segundo. La inflación explica por qué el universo parece tan liso y homogéneo cuando los astrónomos lo examinan a gran escala.

Pero si la inflación es responsable de todo lo que podemos ver hoy, eso plantea la pregunta: ¿qué vino antes, si es que hubo algo?

Aún no se ha ideado ningún experimento que pueda observar lo que sucedió antes de la inflación. Sin embargo, los matemáticos pueden plantear algunas posibilidades. La estrategia consiste en aplicar la teoría general de la relatividad de Einstein (una teoría que equipara la gravedad con la curvatura del espacio-tiempo) tan atrás en el tiempo como sea posible.

Esta es la esperanza de tres investigadores: Ghazal Geshnizjani del Perimeter Institute, Eric Ling de la Universidad de Copenhague y Jerome Quintin de la Universidad de Waterloo. El trío ha publicado recientemente un artículo en el Journal of High Energy Physics en el que, explica Ling, «demostramos matemáticamente que podría haber una manera de ver más allá de nuestro universo».

En colaboración con Jerome Quintin y Eric Ling, Ghazal Geshnizjani, del Perimeter Institute, ha examinado formas en las que el espacio-tiempo podría extenderse más allá del Big Bang. Foto: Evan Pappas /Perimeter Institute

En colaboración con Jerome Quintin y Eric Ling, Ghazal Geshnizjani, del Perimeter Institute, ha examinado formas en las que el espacio-tiempo podría extenderse más allá del Big Bang. Foto: Evan Pappas /Perimeter InstituteRobert Brandenberger, un físico de la Universidad McGill que no ha participado en el estudio, comenta que el nuevo artículo «establece un nuevo estándar de rigor para el análisis» de las matemáticas del comienzo del tiempo. En algunos casos, lo que de primeras parece ser una singularidad (un punto en el espacio-tiempo donde las descripciones matemáticas pierden su significado) puede ser en realidad una ilusión.

Una taxonomía de singularidadesLa cuestión central a la que se enfrentan Geshnizjani, Ling y Quintin es si hay un punto antes de la inflación en el que las leyes de la gravedad se descomponen en una singularidad. El ejemplo más simple de una singularidad matemática es lo que le sucede a la función 1/x cuando x tiende a cero. La función toma un número x como entrada y genera otro número. A medida que x se hace cada vez más pequeño, 1/x se hace cada vez más grande, acercándose al infinito. Si x es cero, la función ya no está bien definida: no se puede confiar en ella como una descripción de la realidad.

«Hemos demostrado matemáticamente que podría haber una manera de ver más allá de nuestro universo», afirma Eric Ling de la Universidad de Copenhague. Foto: Annachiara Piubello

«Hemos demostrado matemáticamente que podría haber una manera de ver más allá de nuestro universo», afirma Eric Ling de la Universidad de Copenhague. Foto: Annachiara PiubelloA veces, sin embargo, los matemáticos pueden sortear una singularidad. Por ejemplo, consideremos el primer meridiano, que pasa por Greenwich, Inglaterra, en la longitud cero. Si tuvieras una función de 1/longitud, se volvería loca en Greenwich. Pero en realidad no hay nada físicamente especial en los suburbios de Londres: podrías redefinir fácilmente la longitud cero para que pasara por algún otro lugar de la Tierra, y entonces tu función se comportaría con perfecta normalidad al acercarte al Observatorio Real de Greenwich.