Faringe, esófago y buche

Cavidad bucal, faringe, esófago y, si es el caso, buche conforman lo que podemos considerar como sistema digestivo anterior. Tras este conjunto de estructuras se encuentra el sistema digestivo medio. La boca ya se trató en la anotación anterior, por lo que en esta nos ocuparemos de la faringe, el esófago y el buche. Los sistemas digestivos mejor conocidos son el de insectos y, sobre todo, el de vertebrados, por lo que en adelante nos referiremos a esos sistemas, principal, pero no exclusivamente.

El sistema digestivo anterior de los insectos, llamado estomodeo, comienza en la boca y en él se diferencian la faringe (que es parte de la boca), el esófago (de forma tubular), el buche, que es un ensanchamiento de la parte final del esófago, y los proventrículos. La válvula estomodeal regula el paso del alimento y jugos digestivos del estomodeo al sistema digestivo medio, llamado mesenterón en los insectos. Una membrana gruesa, de cutícula, tapiza el interior del estomodeo; puede tener pliegues y proyecciones, o cerdas o espículas. Cada vez que muda el insecto se renueva.

En el sistema digestivo de los vertebrados la faringe es la parte de la garganta que sigue a las cavidades bucal y nasal, y precede al esófago y la laringe. Es una vía común al sistema digestivo y al respiratorio. Al acto de tragar el alimento se denomina deglución en terminología técnica.

La fase orofaríngea de la deglución en vertebrados empieza cuando la lengua (que es precisamente una adquisición de los cordados) empuja al bolo alimenticio hacia la parte trasera de la cavidad bucal y la faringe. Los barorreceptores de la faringe, al ser estimulados por la presión que ejerce el bolo, envían señales al centro de deglución que se encuentra en la médula (en el tronco encefálico), lo que desencadena una respuesta refleja por parte del citado centro y que es la que activa los músculos implicados. La musculatura actúa de manera que, a la vez que desplaza el alimento hacia la faringe y de ahí hacia el esófago, evita que retorne a la cavidad bucal, se eleve hacia la cavidad nasal y se dirija hacia la laringe y la tráquea. Para ello, hace lo siguiente:

- La posición de la lengua contra el paladar evita el retorno a la cavidad bucal.

- El velo del paladar (proyección colgante trasera) se eleva y cierra el acceso de la faringe a la cavidad nasal.

- La laringe se eleva y se produce el cierre hermético de las cuerdas vocales1 a lo largo de la glotis (apertura de la laringe). Además, el bolo alimenticio empuja a la epiglotis2 hacia abajo, de manera que cubre la glotis y refuerza su cierre.

- En humanos los movimientos respiratorios están inhibidos durante el breve periodo de tiempo que dura la deglución.

- La musculatura faríngea empuja el bolo hacia el esófago mientras se mantienen sellados laringe y tráquea.

La fase esofágica viene a continuación. El esófago es un tubo recto muscular que se extiende desde la faringe hasta el estómago. Hay especies en las que la musculatura del esófago es lisa (aves y humanos, por ejemplo), en otras es estriada (rumiantes y perros, por ejemplo); en gatos y caballos es esquelética (estriada) las dos terceras partes iniciales y lisa la tercera última parte.

Dos esfínteres cierran el esófago por sus dos extremos. El superior (faringoesofágico) se mantiene cerrado para evitar el paso de aire hacia el las zonas inferiores del sistema digestivo, pero se abre al llegar el bolo alimenticio. En ese momento, al contactar el bolo con la mucosa esofágica, el centro de deglución provoca una onda peristáltica primaria que se desplaza todo a lo largo del tubo empujando el bolo hacia el estómago3. En humanos la onda peristáltica se prolonga entre 5 y 9 s y su velocidad es controlada por el centro de deglución a través del nervio vago4.

Pero puede ocurrir que el bolo, por su tamaño y consistencia, se atasque y la onda peristáltica primaria sea incapaz de empujarlo. En ese caso, los receptores de presión del propio esófago activan una respuesta que consiste en la distensión de la pared y la generación de una onda peristáltica secundaria, más fuerte que la primaria. En este reflejo no interviene el centro de deglución, sin que se produce por mediación del plexo nervioso local que, además, da lugar a un aumento de la producción de saliva para lubrificar más el bolo y ayudar a su progresión.

El esfínter del extremo inferior (gastroesofágico) permanece normalmente contraído (cerrado) para evitar el reflujo de jugos gástricos hacia el esófago pero, como es lógico, se relaja de forma refleja al llegar el bolo para que pueda pasar al estómago.

En varios grupos (anélidos, gasterópodos, insectos y algunos dinosaurios, incluidas algunas aves) el esófago presentan un engrosamiento que da lugar a una especie de bolsa a la que llamamos buche. Cumple funciones de almacenamiento y es especialmente importante en los insectos que se alimentan de fluidos, como sangre o néctar. Suelen tener un buche bien desarrollado las aves granívoras y piscívoras, y no tanto las insectívoras y las rapaces.

En las especies con buche, el bolo alimenticio puede o bien quedar retenido temporalmente allí, o proseguir hasta el complejo proventrículo-molleja. La estancia del alimento en el buche se ajusta al tiempo de vaciado del complejo proventrículo-molleja, y todo ello es regulado a través del nervio vago.

En las palomas las células epiteliales del buche son sensibles a la hormona prolactina, la misma que promueve la síntesis de leche en mamíferos. Durante la incubación de los huevos, tanto machos como hembras experimentan una elevación de los niveles de prolactina circulantes en la sangre, lo que da lugar a una proliferación de las células epiteliales citadas. Esas células tienen un contenido lipídico muy alto. Al eclosionar los huevos se desprenden del epitelio y, junto con otros materiales almacenados en el buche, se utilizan para, regurgitándolos en su esófago, alimentar a los polluelos. A esa sustancia lipídica se la denomina “leche del buche”.

Notas:

1 En ese momento las cuerdas vocales cumplen, de hecho, un función que nada tiene que ver con la producción de sonidos.

2 Lámina cartilaginosa que en reposo se encuentra orientada hacia arriba.

3 El estómago, por cierto, puede estar por encima de la boca, como en los casos en los que el animal baja el cuello para comer.

4 Nervio perteneciente a la división parasimpática del sistema nervioso autónomo.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Faringe, esófago y buche se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El pulmón de los mamíferos

- Sistemas nerviosos: moluscos

- Sistemas nerviosos: el sistema periférico de vertebrados

¿Anti-oxidantes o pro-oxidantes?

Saioa Gómez Zorita, Andrea Mosqueda Solís & Jenifer Trepiana

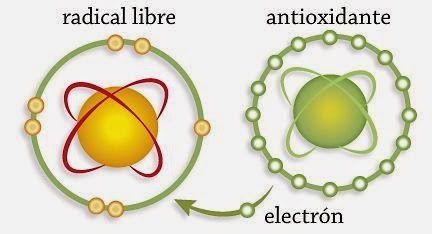

Para comprender qué son y cómo actúan los radicales libres hay que tener en cuenta que las moléculas están formadas por átomos, y que estos tienen alrededor protones (carga positiva) y electrones (carga negativa). Estos electrones pueden compartirse con otros átomos para que la molécula resultante sea más estable. Si alguno de estos electrones no se aparea (comparte) o son impares, se forma un radical libre. Por consiguiente, los radicales libres son moléculas muy inestables al contener un electrón desapareado, y por ello reaccionan con otras moléculas con el fin de encontrar otro electrón (agente oxidante) para de este modo poder convertirse en moléculas estables. También pueden sustraer un electrón a otra molécula, la cual quedará inestable convirtiéndose de este modo en un nuevo radical libre, ya que quedará con un electrón no apareado, que a su vez podrá hacer lo mismo con otra molécula. Así, se inicia una cascada o reacción en cadena que puede dañar nuestras células.

Los radicales libres provienen principalmente del oxígeno, el nitrógeno y el azufre, dando lugar así a especies reactivas de oxígeno (ERO o ROS en inglés), de nitrógeno o de azufre respectivamente. Entre los radicales de oxígeno se encuentran: el anión superóxido (O2•-), y los radicales hidroxilo (HO•), peroxilo (RO2•), y alcoxilo (RO•). Así mismo, encontramos moléculas no-radicales que también se comportan como agentes oxidantes entre los que se hayan: el peróxido de hidrógeno (H2O2), el ácido hipocloroso (HOCl), el ozono (O3) y el oxígeno simple (1O2). De entre todas las ERO, el radical hidroxilo es el más peligroso y el responsable de la mayor parte de los daños celulares relacionados con el estrés oxidativo. Para entenderlo mejor, podemos definir el estrés oxidativo como el incremento de los niveles de radicales libres, debido a una disminución en la eliminación de éstos por parte de las defensas antioxidantes. Las ERO se forman de manera natural en las células como consecuencia de la respiración celular en las mitocondrias, por la oxidación de los ácidos grasos para conseguir energía, en el proceso de fagocitosis, o por enzimas encargadas de eliminar productos tóxicos para el organismo. Además, otros factores externos como el alcohol, el tabaco, los rayos ultravioletas, la actividad física excesiva, o los pesticidas promueven una mayor producción de radicales libres.

Tenemos que tener en cuenta que los radicales libres de oxígeno, cumplen numerosas funciones en el organismo actuando como mensajeros en la señalización celular, el crecimiento, la diferenciación celular, la eliminación de células infectadas o malignas, y la destrucción de organismos patógenos. No obstante, las ERO se deben mantener en niveles adecuados, ya que su producción excesiva puede generar estrés oxidativo y daño celular que se asocia con un mayor riesgo de desarrollar enfermedades crónicas como el cáncer, enfermedades cardiovasculares o trastornos neurológicos y metabólicos.

¿Qué daño producen los radicales libres sobre las moléculas?

-

En el caso de los lípidos, dañan las estructuras ricas en ácidos grasos como las membranas celulares, alterándose la permeabilidad de las mismas y provocando edemas y la muerte celular. Además, oxidan las lipoproteínas de baja densidad (LDL) generando placas de ateroma. Es importante señalar, que el ácido graso, al oxidarse, se convierte en radical de ácido graso con capacidad de oxidar a otras moléculas, con lo que se propaga el proceso oxidativo o peroxidación lipídica. Se generan numerosos subproductos como el malondialdehído, que es uno de los métodos de evaluar o cuantificar el estrés oxidativo.

-

En lo que respecta a las proteínas, los radicales libres pueden oxidar los aminoácidos que forman estas moléculas, como la cisteína y tirosina entre otros, provocando cambios en su estructura y/o función que puede desencadenar la inactivación de las proteínas, y como consecuencia imposibilita el desarrollo de sus funciones: transporte, receptores y mensajeros celulares, enzimas que regulan el metabolismo, etc.

-

Otra molécula que puede ser dañada es el ADN, lo que tiene serias consecuencias en el desarrollo de mutaciones y carcinogénesis. Como resultado de los daños provocados en el material genético, el ciclo celular de las células se puede ver alterado, lo que puede acarrear la parada de la división celular o incluso la muerte de la célula.

-

No únicamente las moléculas anteriores pueden ser dañadas, así mismo los glúcidos también pueden ser alterados y degradados perdiendo su función y pudiendo inducir el proceso de inflamación.

Por consiguiente, es de gran importancia mantener un equilibrio entre la producción y la eliminación de radicales libres en el organismo. El cuerpo cuenta con dos mecanismos internos, denominados antioxidantes, para protegerse de los efectos nocivos de estas especies: un sistema enzimático y otro no enzimático. Entre los sistemas enzimáticos se encuentra la glutatión peroxidasa, que cataliza la reducción del peróxido de hidrógeno (H2O2) a agua, utilizando como agente reductor el glutatión reducido, en el citoplasma de las células; la catalasa, que transforma el peróxido de hidrógeno en oxígeno y agua, en los peroxisomas; y la superóxido dismutasa, que transforma el anión superóxido en peróxido de hidrógeno, manteniendo las concentraciones del anión superóxido lo suficientemente bajas para evitar la formación de peroxinitrito. Por otro lado, entre los sistemas no enzimáticos, se encuentran los antioxidantes como la vitamina A, la coenzima Q10 y el glutatión. A pesar de que poseamos estos dos métodos antioxidantes para neutralizar los radicales libres, en ocasiones resulta insuficiente por lo que los antioxidantes exógenos como los ingeridos en la dieta juegan un papel importante para mantener la homeostasis (equilibrio) ya que refuerzan los mecanismos internos.

Los antioxidantes están presentes de manera natural en algunos alimentos que tomamos en mayor o menor medida a través de la dieta, como la fruta y la verdura, que contienen polifenoles, ascorbato (vitamina C), α-tocoferol (vitamina E) o β-caroteno entre otros. No obstante, también están presentes en alimentos de origen animal como el pescado que puede ser rico en ácidos grasos poliinsaturados de cadena larga n-3.

¿Cómo actúan los antioxidantes?

-

Como quelantes de metales pro-oxidantes, como son el hierro y el cobre. Estos metales no pueden ser metabolizados por el organismo, donde persisten y pueden ejercer efectos tóxicos. Así, estos metales inducen daño oxidativo, por reacciones catalizadoras, que generan excesivos radicales libres. Los quelantes se unen a los metales dando lugar a una molécula más estable, lo que evitará la formación de radicales libres.

-

Como secuestradores de radicales, que cumplen la función de eliminarlos, evitando así que ataquen las moléculas diana.

-

Como inhibidores de oxidasas, como la lipoxigenasa, la ciclooxigenasa, la mieloperoxidasa, la NADPH oxidasa y la xantina oxidasa. De esta manera se evita la generación de ERO, así como de hidroperóxidos orgánicos.

-

Como inhibidores de enzimas involucradas indirectamente en los procesos oxidativos, como la fosfolipasa A2.

-

Como estimulantes de enzimas con propiedades antioxidantes, como son la catalasa, la glutatión peroxidasa y la superóxido dismutasa.

¿Qué ocurre para que siempre no sean tan beneficiosos los antioxidantes?

Los radicales libres se consideran pro-oxidantes, ya que como hemos mencionado anteriormente, son sustancias químicas que inducen estrés oxidativo, normalmente mediante la formación de especies reactivas o por inhibición de los sistemas antioxidantes. Al igual que los radicales libres, los antioxidantes también pueden tener un comportamiento pro-oxidante dependiendo de diversos factores como son: la dosis (cantidad ingerida), el tipo de antioxidante y la matriz (componentes de los alimentos) en la que se encuentre. Por tanto, como podemos imaginar, son numerosos los estudios que muestran los efectos beneficiosos del empleo de antioxidantes pero también algunos muestran el efecto contrario.

Uno de los ejemplos más conocidos es el del estudio del efecto del β-caroteno sobre el cáncer de pulmón. Numerosos estudios mostraban que alimentos ricos en β-caroteno prevenían el cáncer de pulmón, por lo que a los pacientes del estudio se les suministró β-caroteno aislado. Dicha intervención tuvo que suspenderse ya que entre los fumadores la suplementación estaba incrementando el cáncer de pulmón (Omenn GS, 1996).

También se han estudiado, algunos de los mecanismos a través de los cuales los flavonoides, compuestos fenólicos que podemos encontrar en frutas, verduras, así como en el vino, pueden ejercen acciones pro-oxidantes, incluyendo la reducción temporal de Cu (II) a Cu (I), (Brown, 1998) la generación de ERO, (Sahu, 1997), así como la afectación de las funciones de los componentes del sistema de defensa antioxidante nuclear: glutatión y glutatión-S transferasa (Sahu, 1996). En concreto, se ha visto que el flavonoide quercetina, puede actuar como pro-oxidante al producir daño en el ADN mediante el ciclo redox Cu(II)/Cu(I) capaz de generar ERO y lesionar el material genético mediante oxidación (Yoshino, 2002).

Entonces… ¿qué hacemos?

Es muy probable que cuando los antioxidantes forman parte de los alimentos y se ingieren dentro de una dieta equilibrada, predominen los efectos beneficiosos; en cambio, en forma de suplementos que generalmente emplean altas concentraciones de antioxidantes, éstos pueden actuar como pro-oxidantes.

Como norma general, con una dieta equilibrada rica en fruta y verduras, se cubren los requerimientos de antioxidantes lo que a su vez puede contribuir a la prevención de enfermedades y al incremento de la esperanza de vida. Además, en cuanto al tratamiento de las patologías, no se puede pensar que ayudan o curan cualquier enfermedad ni que aquellos más de “moda” son los más efectivos.

A pesar de lo dicho anteriormente, hay grupos de población, como los ancianos, los deportistas, los bebedores y los fumadores, en los que el empleo de determinados suplementos antioxidantes podría ser beneficioso. No obstante, en el caso de los deportistas los radicales libres juegan un papel importante en las adaptaciones a la actividad física, y por tanto según en qué fase de la “temporada” se encuentren, la suplementación con antioxidantes podría ser beneficioso o perjudicial al inhibir parcialmente las adaptaciones. Por consiguiente, tanto en deportistas como en cualquier otro colectivo, en caso de administrar suplementos antioxidantes de este modo, se debe tener en cuenta al menos la historia clínica (hábitos) y el análisis bioquímico (estrés oxidativo, niveles de antioxidantes, etc).

¿Consumir más vitaminas es MEJOR o PEOR?

Por sus propiedades y funciones, la vitamina C, el β-caroteno (principal fuente de vitamina A) y la vitamina E son considerados antioxidantes, ya que son los únicos nutrientes esenciales que atrapan directamente radicales libres, y debido a esto, pueden proteger a las células al reducir el daño oxidativo provocado por las ERO. La vitamina C es soluble en agua (hidrosoluble), ubicándose en el citoplasma celular; mientras que la vitamina E y el β-caroteno son solubles en lípidos (liposolubles) actuando como antioxidante a nivel de las membranas celulares.

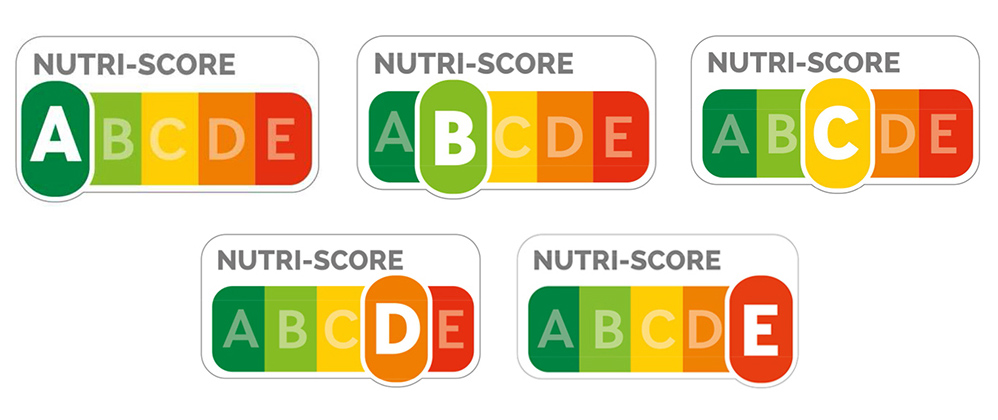

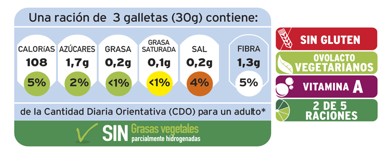

Los antioxidantes son añadidos con frecuencia a alimentos comerciales y suplementos deportivos con el fin de extender su vida útil. Sin embargo, la principal fuente natural son los alimentos, como verduras, frutas cítricas, nueces, granos, semillas y aceites. La dosis diaria recomendada de vitamina A, C y E, son distintas para cada etapa de la vida. A continuación, en las tablas podrás observar las cantidades recomendadas y los alimentos con alto contenido de estas vitaminas. Así, podrás observar cómo la suplementación de ciertas vitaminas no es necesaria si se tiene una alimentación adecuada.

Dosis diaria recomendada de vitamina A (National Institutes of Health, 2017):

Etapa de la vida

Límite máximo recomendado

Bebés hasta los 12 meses de edad

2.000 UI

Niños de 1 a 3 años

2.000 UI

Niños de 4 a 8 años

3.000 UI

Niños de 9 a 13 años

5.667 UI

Adolescentes de 14 a 18 años

9.333 UI

Adultos

10.000 UI

UI: Unidades internacionales. El contenido en vitamina A de los alimentos se mide como equivalentes de actividad de retinol (EAR). Un EAR es igual a la actividad de 1 mg de retinol (1 mg de retinol es igual a 3,33 unidades internacionales [UI]).

Alimentos con alto contenido de vitamina A:

Vitamina A (EAR)

Alimento

15.534

200 g pavo

5.553

150 g zanahoria cruda

6.882

150 g espinacas cocinadas

2.337

100 g verduras mixtas congeladas

725

150 g brócoli cocinado

450

150 g tomates

430

150 g coles

Adultos, cantidad diaria recomendada = 700-900 EAR/día, dependiendo del sexo.

Dosis diaria recomendada de vitamina C (National Institutes of Health, 2017):

Etapa de la vida

Cantidad recomendada

Bebés hasta los 6 meses de edad

40 mg

Bebés de 7 a 12 meses de edad

50 mg

Niños de 1 a 3 años de edad

15 mg

Niños de 4 a 8 años de edad

25 mg

Niños de 9 a 13 años de edad

45 mg

Adolescentes (varones) de 14 a 18 años de edad

75 mg

Adolescentes (niñas) de 14 a 18 años de edad

65 mg

Adultos (hombres)

90 mg

Adultos (mujeres)

75 mg

Adolescentes embarazadas

80 mg

Mujeres embarazadas

85 mg

Adolescentes en período de lactancia

115 mg

Mujeres en período de lactancia

120 mg

Alimentos con alto contenido de vitamina C:

Vitamina C

Alimento

190 mg

1 taza de pimiento verde

137 mg

2 Kiwis

132 mg

1 cabeza pequeña de brócoli

128 mg

1 cabeza pequeña de coliflor

122 mg

1 mango

120 mg

1 taza de pimiento verde

108 mg

1 taza de chile

88 mg

1 taza de papaya

85 mg

1 taza de fresas

80 mg

1 taza de col rizada

79 mg

1 taza de piña

75 mg

Coles de Bruselas

67 mg

½ naranja

Dosis recomendada de vitamina E (National Institutes of Health, 2017):

Etapa de la vida

Cantidad recomendada

Bebés hasta los 6 meses de edad

4 mg (6 UI)

Bebés de 7 a 12 meses de edad

5 mg (7.5 UI)

Niños de 1 a 3 años de edad

6 mg (9 UI)

Niños de 4 a 8 años de edad

7 mg (10.4 UI)

Niños de 9 a 13 años de edad

11 mg (16.4 UI)

Adolescentes de 14 a 18 años de edad

15 mg (22.4 UI)

Adultos

15 mg (22.4 UI)

Mujeres y adolescentes embarazadas

15 mg (22.4 UI)

Mujeres y adolescentes en período de lactancia

19 mg (28.4 UI)

Alimentos con alto contenido de vitamina E:

Vitamina E

Alimento

35 mg

100 g de pipas de calabaza

26 mg

100g de almendras

15 mg

100g de avellanas

5,6 mg

1 cucharada de aceite de girasol

3,8 mg

100 g de aceitunas

2,1 mg

½ aguacate

2,0 mg

100 g de espinaca

1,5 mg

100 g de brócoli

100 g de puré de calabaza

Se pueden encontrar diversos estudios científicos sobre la toxicidad provocada por una ingesta elevada de las vitaminas anteriormente descritas. Dosis excesivas de vitamina A (de más de 100 veces la cantidad necesaria) de forma persistente superan la capacidad del hígado de almacenar dicha vitamina y pueden producir intoxicación. Además, esto puede conllevar cambios en el color de la piel y producir exfoliación. Por otra parte, la vitamina C es uno de los suplementos utilizados con más frecuencia en EE.UU. Los efectos adversos de dosis elevadas de esta vitamina son trastornos digestivos y diarreas. Además, puede aumentar el riesgo de formar cálculos renales de oxalato. Referente a la vitamina E, aunque ingestas elevadas de vitamina E parecen ser bien toleradas por el organismo, dosis elevadas puede reducir la capacidad del cuerpo de utilizar otras vitaminas liposolubles. Asimismo, en los últimos años, se han publicado datos contradictorios acerca del aporte complementario de vitamina E en dosis altas y sus efectos adversos, con los que debería estudiarse en profundidad (Gerss J, 2009).

En lo referente a la complementación en la actividad deportiva, no existe evidencia científica consistente de mejoría en el desempeño físico tras una suplementación con antioxidantes.

Nieman et al., realizó un estudio en corredores donde midió la influencia de la suplementación con vitamina C y un placebo en cambios oxidativos e inmunitarios antes y después de una maratón y concluyó que dicha suplementación no puede utilizarse como variable para observar cambios oxidativos y del sistema inmunitario en atletas.

Otro estudio realizado para determinar el efecto de la suplementación de vitamina C sobre la frecuencia, duración y gravedad de las infecciones de las vías respiratorias en nadadores adolescentes, observó que no había efectos considerables para disminuir los resfriados que aparecen con frecuencia en la población estudiada. Por otro lado, los efectos de una suplementación de 400mg de acetato de α-tocoferol (vitamina E) diariamente durante seis semanas comparado con un grupo placebo, observó que las adaptaciones al entrenamiento mejoraron la función fisiológica y el rendimiento físico, pero no fue así en el grupo suplementado con la vitamina.

Como hemos visto, el consumo excesivo de antioxidantes puede provocar efectos pro-oxidantes. Una suplementación excesiva de vitamina E (800 UI/día) durante dos meses en combinación con un entrenamiento prolongado y de intensidad alta incrementa el estrés oxidativo y la reacción inflamatoria durante el ejercicio.

Sujetos no entrenados recibieron suplementación de 1000 mg al día de vitamina C durante un programa de entrenamiento de 8 semanas y se demostró una mejoría muy baja en su capacidad aeróbica.

Investigadores como Yftanti, sugieren que la administración de vitamina C y vitamina E en personas que no tengan una deficiencia vitamínica previa no presentan ningún efecto en las adaptaciones físicas al entrenamiento de resistencia.

Recuerda que todo es cuestión de balance, nunca excederte ya que todo tiene un efecto secundario en nuestro organismo.

Referencias:

Brown JE, Khodr H, Hider RC, Rice-Evans CA. Structural dependence of flavonoids interactions with Cu2+ ions: implications for their antioxidant properties. Biochem J 1998;330:1173-8.

Omenn, G. S., Goodman, G., Thornquist, M., Barnhart, S., Balmes, J., Cherniack, M., … & Meyskens Jr, F. (1996). Chemoprevention of lung cancer: the beta-Carotene and Retinol Efficacy Trial (CARET) in high-risk smokers and asbestos-exposed workers. IARC scientific publications, (136), 67.

Sahu SC, Gray GC. Pro-oxidant activity of flavonoids: effects on glutathione and glutathione-S transferase in isolated rat liver nuclei. Cancer Lett 1996;104:193-6

Sahu SC, Gray GC. Lipid peroxidation and DNA damage induced by morin and naringenin in isolated rat liver nuclei. Food Chem Toxicol 1997;35:4436-47.

Yoshinoa M, Haneda M, Naruseb M, Htay H.H, Iwata S, Tsubouchi R, Murakami K. Prooxidant action of gallic acid compounds: copper-dependent strand breaks and the formation of 8-hydroxy-2′-deoxyguanosine in DNA. Toxicology in Vitro 2002; 16: 705-709.

Gerss J, Kopcke W: The questionable association of vitamin E supplementation and mortality—inconsistent results of different meta-analytic approaches, Cell Mol Biol 55:1111S, 2009.

L.K. Mahan, S Escott-Stump, JL Raymond. Krause dietoterapia. 13ª edición. Ed. Elsevier España; 2012.

Gomez-Cabrera MC, et al. Oral administration of vitamin c decreases muscle mitochondriak biogénesis and hampers training-induced adaptations in endurance performance. Am J Clin Nutr. 2008 Jan; 87 (1):142-9.

Burke L. Practial Sport Nutrition 1st edition. Human kinetics; 2007.

Yfanti C, et al. Antioxidant supplementation does not alter endurance-training adaptation. Med Sci Sports Exerc. 2010;42(7):1388-95

Mastalouidis A, et al. Antioxidant supplementation prevents exercise-induced lipid peroxidation, but not inflammation in ultra marathon runners. Free Radic Biol Med. 2004 May 15;36 (10) 1329-41

Sobre las autoras:

Saioa Gómez Zorita (@saioasgz) es doctora en farmacia, Andrea Mosqueda Solís (@andreamoss87) es doctora en nutrigenómica y nutrición personalizada y Jenifer Trepiana es doctora en biología molecular y biomedicina. Trabajan en el grupo de fisiopatología de la obesidad y nutrición (CIBERobn) del Instituto de Salud Carlos III y en el Departamento de Farmacia y Ciencias de los Alimentos de la Facultad de Farmacia de la UPV/EHU.

El artículo ¿Anti-oxidantes o pro-oxidantes? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Color de las lechugas y antioxidantes

- Una planta amazónica podría acabar con las células tumorales hepáticas

- 10 aditivos alimentarios que proceden de la naturaleza y quizá no lo sabías

Carlos Briones – Naukas Bilbao 2018: Os voy a contar una historia (en imágenes)

El pasado 15 de septiembre, durante Naukas Bilbao 2018, Carlos Briones ofreció una de las charlas de divulgación más impactantes, por diferente, desde el inicio de estos eventos divulgativos. Además de investigador del Centro de Astrobiología del CSIC, Briones es músico y un gran aficionado al arte, y combina su erudición renacentista para contarte la historia del universo como nunca te la habían contado. Y en 10 minutos.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Carlos Briones – Naukas Bilbao 2018: Os voy a contar una historia (en imágenes) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Naukas Pro 2017: Carlos Briones y el origen de la vida

- El universo en un día: El origen de la vida, por Carlos Briones

- Naukas Bilbao 2017 – Laura Morrón: La gran divulgadora

Un hidrogel de almidón/grafeno, conductor y antibacteriano, para implantes neurológicos

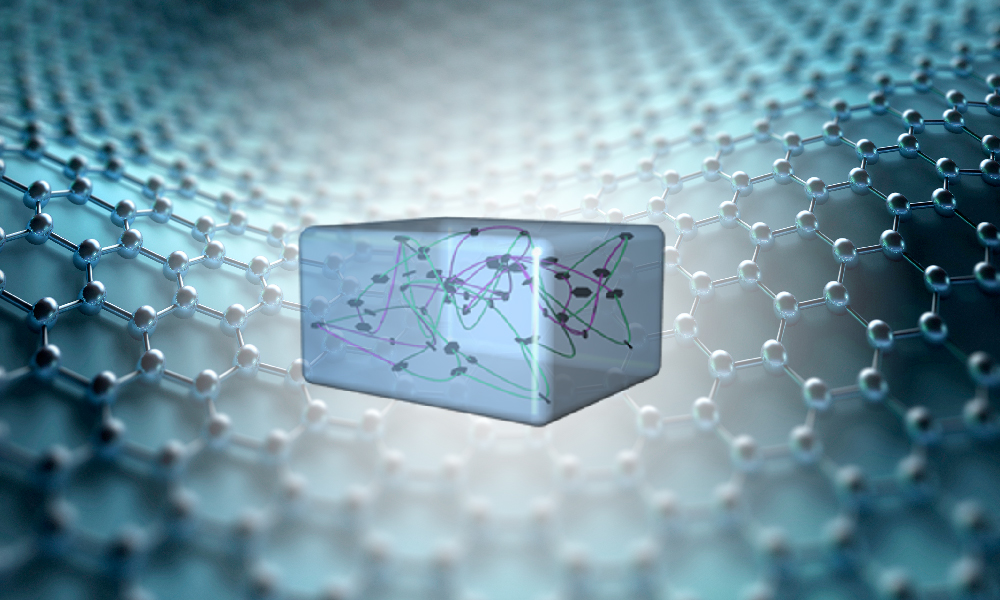

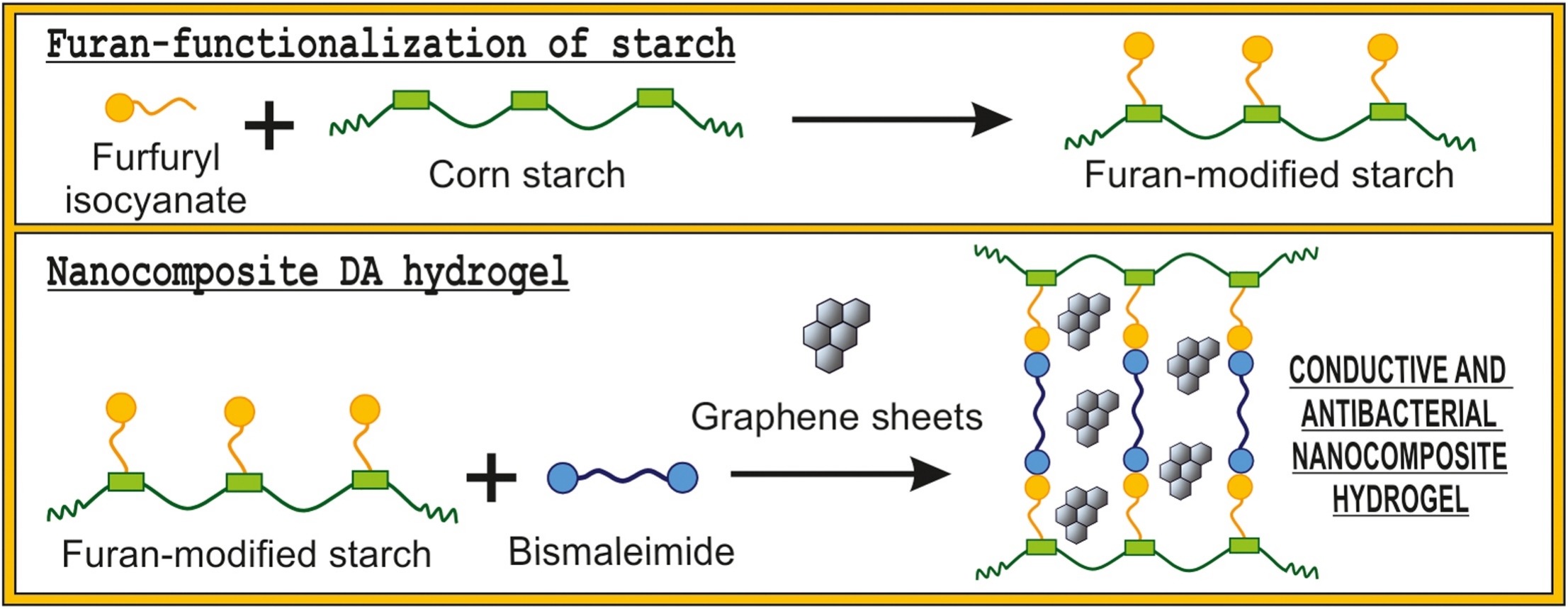

Los hidrogeles son redes poliméricas capaces de retener grandes cantidades de líquido en entornos acuosos sin perder su estabilidad dimensional. Se utilizan en numerosas aplicaciones, y al incorporarles diferentes componentes, adquieren propiedades específicas, como la conductividad eléctrica. Esta ha sido la vía seguida por el grupo de investigación Materiales+Tecnología del Departamento de Ingeniería Química y del Medio Ambiente de la Escuela de Ingeniería de Gipuzkoa de la UPV/EHU para un hidrogel para el que han elegido un biopolímero que no se había utilizado hasta la fecha para ese tipo de aplicaciones: el almidón.

En la creación del nuevo hidrogel los miembros del grupo tenían en mente su utilización en interfases neuronales, es decir, las partes encargadas de la conexión eléctrica en los implantes que interactúan con el sistema nervioso. “Los electrodos tradicionales de las interfases neuronales, de platino u oro, por ejemplo, al ser rígidos, requieren de revestimientos poliméricos conductores para acercar su flexibilidad a la de los tejidos neuronales. Actualmente, sin embargo, se demandan dispositivos más pequeños, así como que cuenten con mejores propiedades mecánicas, eléctricas y biológicas”, explica la investigadora Kizkitza Gonzalez Munduate. Los hidrogeles desarrollados “responden muy bien a esas demandas”.

Para dotar al hidrogel de conductividad eléctrica, los investigadores recurrieron al grafeno, “un material de gran interés. Proporciona unas propiedades eléctricas muy adecuadas al hidrogel, pero también presenta un inconveniente: no se estabiliza muy fácilmente en agua. Para superar ese obstáculo, y hacer al grafeno estable en un medio acuoso, utilizamos extractos de salvia. Estos extractos, además, hacen al hidrogel aún más adecuado, si cabe, para ser utilizado en medicina, ya que también tienen propiedades antimicrobianas y antiinflamatorias”, añade Gonzalez Munduate.

Una de las características distintivas de esta investigación ha sido la utilización de la denominada química click para la elaboración del hidrogel. “Es una estrategia que en los últimos años está acaparando la atención de la comunidad científica, porque a diferencia de otras vías de síntesis, la química click generalmente no utiliza catalizadores en las reacciones; además no se generan subproductos, y son reacciones de gran rendimiento”, explica la investigadora.

Aunque ha sido diseñado para una aplicación muy específica, Gonzalez Munduate reconoce que este producto de bioingeniería debe recorrer un largo camino todavía hasta que pueda llegar a ser utilizado con pacientes: “Ha sido una investigación de nivel inicial, centrada en la parte de la ingeniería, relacionada con el material. A partir de ahora, se deberían ir superando niveles paulatinamente y diseñando los correspondientes ensayos”.

Referencia:

Kizkitza González, Clara García-Astrain, Arantzazu Santamaria-Echart, Lorena Ugarte, Luc Avérous, Arantxa Eceiza, Nagore Gabilondo (2018) Starch/graphene hydrogels via click chemistry with relevant electrical and antibacterial properties Carbohydrate Polymers doi: 10.1016/j.carbpol.2018.09.007

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Un hidrogel de almidón/grafeno, conductor y antibacteriano, para implantes neurológicos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Polímeros biocompatibles para integrar dispositivos electrónicos en nuestro cuerpo

- Naukas Pro 2017: Amaia Zurutuza y el grafeno

- Un atlas para materiales 2D

Los parabenos usados en cosmética son seguros

Recientemente el CIR (Cosmetic Ingredient Review), que es el panel de expertos en EEUU en materia de cosmética, ha publicado la última revisión sobre los parabenos y su uso en cosmética. El CIR es el organismo análogo al SCCS europeo. Ambos organismos se han encargado de recopilar todos los estudios científicos independientes relativos al uso de parabenos en cosmética y así poder hacer una evaluación exhaustiva de sus implicaciones en la salud. Los dos organismos están libres de conflictos de interés y actúan de forma completamente independiente.

Los parabenos se utilizan en cosmética como conservantes. Tienen actividad antimicrobiana y antifúngica, por lo que protegen al producto de la degradación y por tanto, protegen al consumidor. Su uso se ha puesto en entredicho desde 2004, cuando se publicó un estudio realizado en una universidad de Reino Unido en el que se habían detectado parabenos en tejido tumoral mamario. Aunque las conclusiones de este estudio no fueron que los parabenos estuviesen implicados en el cáncer de mama, muchos medios de comunicación lo contaron así. Después de ese estudio se hicieron cientos de estudios más para tratar de encontrar alguna relación entre el cáncer y el uso de parabenos en cosmética. Todos los estudios científicos realizados hasta la fecha han desestimado esta relación. La evidencia científica nos dice que los parabenos usados en cosmética son seguros.

El panel de expertos del CIR está compuesto por dermatólogos, toxicólogos, químicos, defensores de la protección del consumidor y expertos en salud pública que han sido nominados públicamente por grupos de consumidores, científicos y médicos, agencias gubernamentales e industrias. La Administración de Alimentos y Medicamentos de EEUU (FDA), la Federación de Consumidores de América (CFA) y la industria participan como miembros sin derecho a voto en las deliberaciones del panel de expertos del CIR.

En esta última revisión sobre los parabenos se ha evaluado su posible efecto como disruptores endocrinos, el efecto de la bioacumulación y uso prolongado, y las diferentes fuentes de exposición, no solo cosmética, sino a través de fármacos y alimentos. La conclusión a la que han llegado es clara: los parabenos usados en cosmética son seguros.

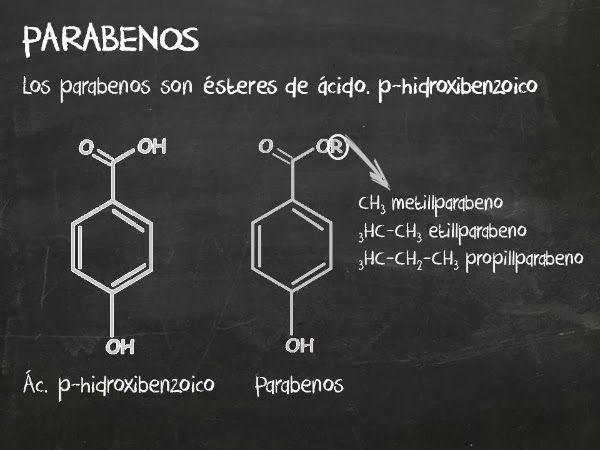

Imagen de www.cosmeticosaldesnudo.com

Imagen de www.cosmeticosaldesnudo.comCuando hablamos de parabenos, nos referimos a una familia de compuestos muy amplia. Los parabenos son derivados del ácido para-hidroxibenzoico (PHBA) que se produce de forma natural en muchas frutas y verduras, como pepinos, zanahorias, cerezas, arándanos y cebollas, así como en la descomposición de algunos aminoácidos en nuestro organismo. Sin embargo, los parabenos que utilizamos en los cosméticos son de síntesis, por lo que no se malgastan plantas ni alimentos en su fabricación. Producimos PHBA a través de la reacción modificada de Kolbe-Schmitt entre el dióxido de carbono y el benzoato de potasio, que a su vez se obtiene del ácido benzoico que podemos extraer del petróleo. Es un proceso relativamente sencillo y que produce menor impacto medioambiental que su extracción de plantas.

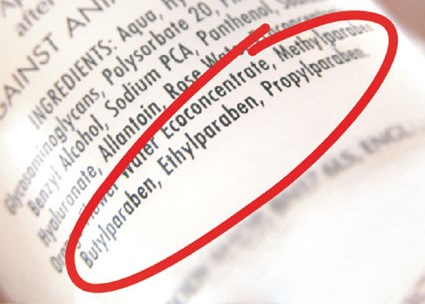

En cosmética solo se utilizan el metil, etil, propil y butilparaben y sus sales. Es decir, no todos los compuestos denominados parabenos pueden emplearse en cosmética. De hecho, en el Reglamento de la UE es donde se especifica los compuestos que podemos usar en cosmética y en qué cantidades. En ese reglamento aparecen estos parabenos. En el anexo V encontramos los parabenos permitidos en cosmética y la concentración a la que se pueden emplear. 0,8% en el caso de mezclas de parabenos y 0,4% en el caso de usar un único parabeno. Los parabenos permitidos en cosmética los denominamos “parabenos de cadena corta” para diferenciarlos de los parabenos que sí han demostrado cierto efecto estrogénico, los “parabenos de cadena larga”. Por cierto, los parabenos de cadena larga no se emplean en cosmética.

Para que un compuesto llegue a formar parte de la lista de ingredientes permitidos en un cosmético debe demostrar que su uso está justificado, es decir, que cumple una función coherente dentro del producto, y debe demostrar que su uso es seguro. Para ello se hacen estudios toxicológicos. En los estudios toxicológicos se mide qué cantidades se pueden emplear sin que supongan un riesgo para la salud. Se tienen en cuenta los efectos acumulativos, es decir, cómo influiría un uso prolongado, y el llamado “efecto cóctel”, es decir, cómo interfiere con otros ingredientes. Para la evaluación toxicológica se emplean varios parámetros, como el MoS, que es la relación existente entre el valor del NOAEL (No Observed Adverse Effects Level: cantidad máxima de producto administrado con la que no se observan efectos adversos, 10.000 veces por debajo del DL50), y la SED (Dosis de Exposición Sistémica). Es decir, se mide. A partir de estos y otros parámetros se calculan las concentraciones permitidas, que están muy por debajo de las dosis con efectos tóxicos detectables. Así que cuando se determina el 0,8% de concentración máxima de parabenos en un cosmético, estamos siendo extremadamente prudentes.

Llevamos utilizando parabenos en cosmética casi 80 años. La razón es que son muy versátiles y estables en prácticamente cualquier tipo de formulación cosmética. Combaten la proliferación de un amplio espectro de hongos y bacterias, por lo que son muy seguros. Funcionan a baja concentración, por lo que se emplean dosis muy bajas y siguen siendo efectivos. Esto lo vemos en los ingredientes de los cosméticos, ya que aparecen como los últimos de la lista, es decir, como los componentes minoritarios, ya que las listas de ingredientes van de mayor a menor cantidad en el producto. Y además no son considerados alérgenos, por lo que los encontramos en productos denominados hipoalergénicos y en formulaciones específicas para pieles sensibles y reactivas. Son los mejores conservantes que conocemos.

Desgraciadamente la desinformación y la incultura científica nos ha llevado a la situación actual. Los consumidores no quieren parabenos. No saben lo que son, pero saben que no los quieren. Esa es la razón por la que muchos laboratorios tomaron la decisión de dejar de utilizarlos y poner otros conservantes en su lugar. Si el consumidor tiene un miedo, sea o no infundado, la industria le pone remedio. Por eso en la UE resulta casi imposible encontrar un cosmético que no se publicite como “sin parabenos”.

En lugar de parabenos se emplean otros conservantes como el phenoxyethanol, el sodium benzoate con potassium sorbate, el dehydracetic acid, o el gluconodactone con sodium benzoate. Es decir, otros compuestos que en conjunto dan un resultado similar al de los parabenos. Normalmente se utiliza una combinación de varios para cubrir todo el espectro que antes cubrían los parabenos, y en más concentración, para que la actividad sea equivalente a la de los parabenos. Todos ellos también son seguros.

Afortunadamente la industria llegó a alternativas que respondieron a la presión social contra los parabenos. Para ello no solo tuvieron que cambiar unos conservantes por otros, sino que estos cambios afectaron a la formulación de productos enteros. Por eso la composición de algunos cosméticos en EEUU (donde muchos siguen conteniendo parabenos y a nadie le importa) no es la misma que en Europa. En Europa, el miedo hacia los parabenos fue un monstruo mucho más grande que en EEUU.

Conclusiones

-

Los parabenos son conservantes. Su uso está permitido.

-

La seguridad de los parabenos fue puesta en entredicho por la incorrecta interpretación de un estudio científico publicado en 2004. Ese fue el origen del miedo hacia estos compuestos.

-

Los laboratorios que decidieron dejar de utilizar parabenos no lo hicieron por una razón sanitaria sino por presión social. Tuvieron que reformular sus productos para poder utilizar conservantes diferentes a los parabenos.

-

El CIR ha publicado un trabajo en el que se ha revisado toda la literatura científica acerca de los parabenos. Se ha evaluado su efecto como disruptores endocrinos y su relación con el cáncer, y su efecto bioacumulativo teniendo en cuenta todas las fuentes de exposición, no solo la fuente cosmética. La conclusión es rotunda: los parabenos son seguros.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Los parabenos usados en cosmética son seguros se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ciencia en la cosmética o el triunfo del absurdo

- La ciencia que deberías saber antes de comprar tu protector solar (2)

- Los champús sin sulfatos y la libertad de decidir

Y tú, ¿cómo cuentas con los dedos? (1)

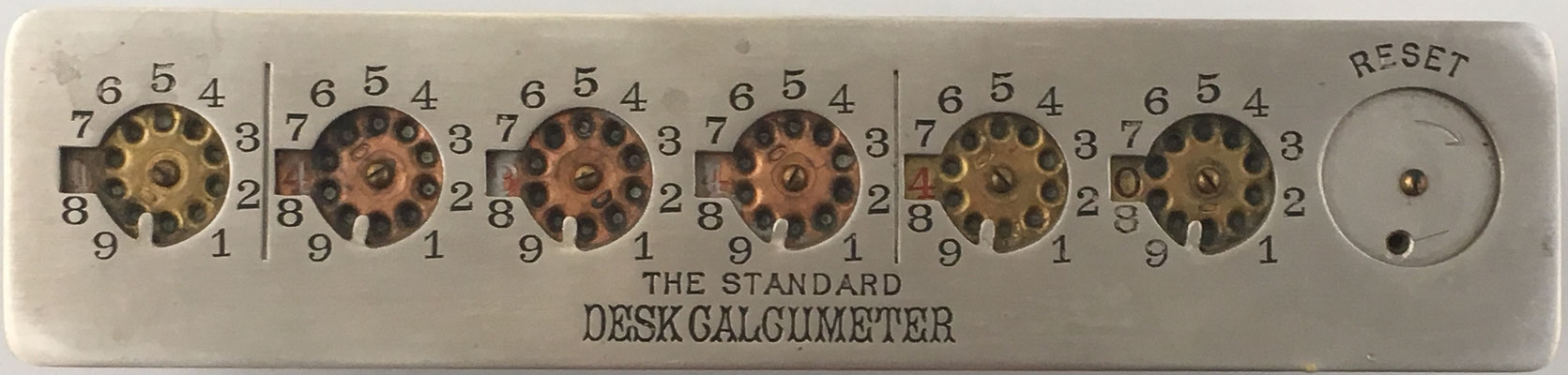

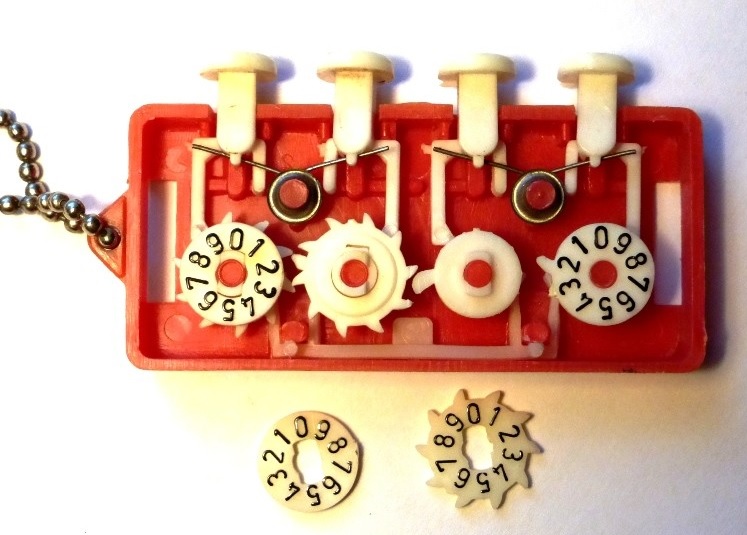

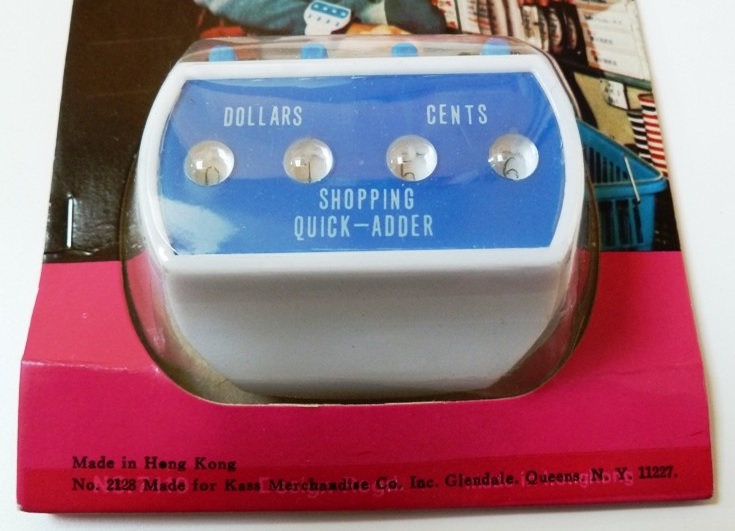

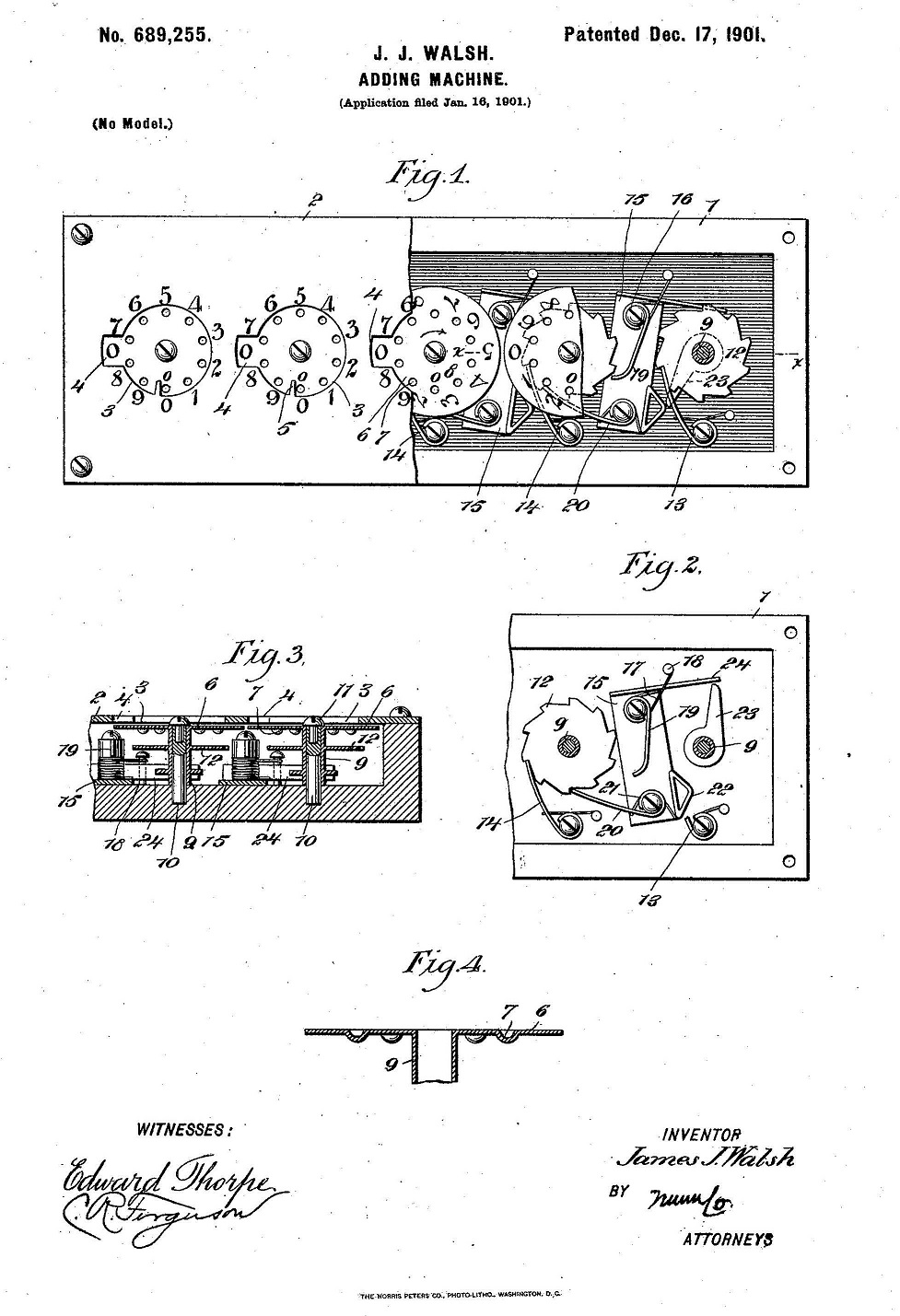

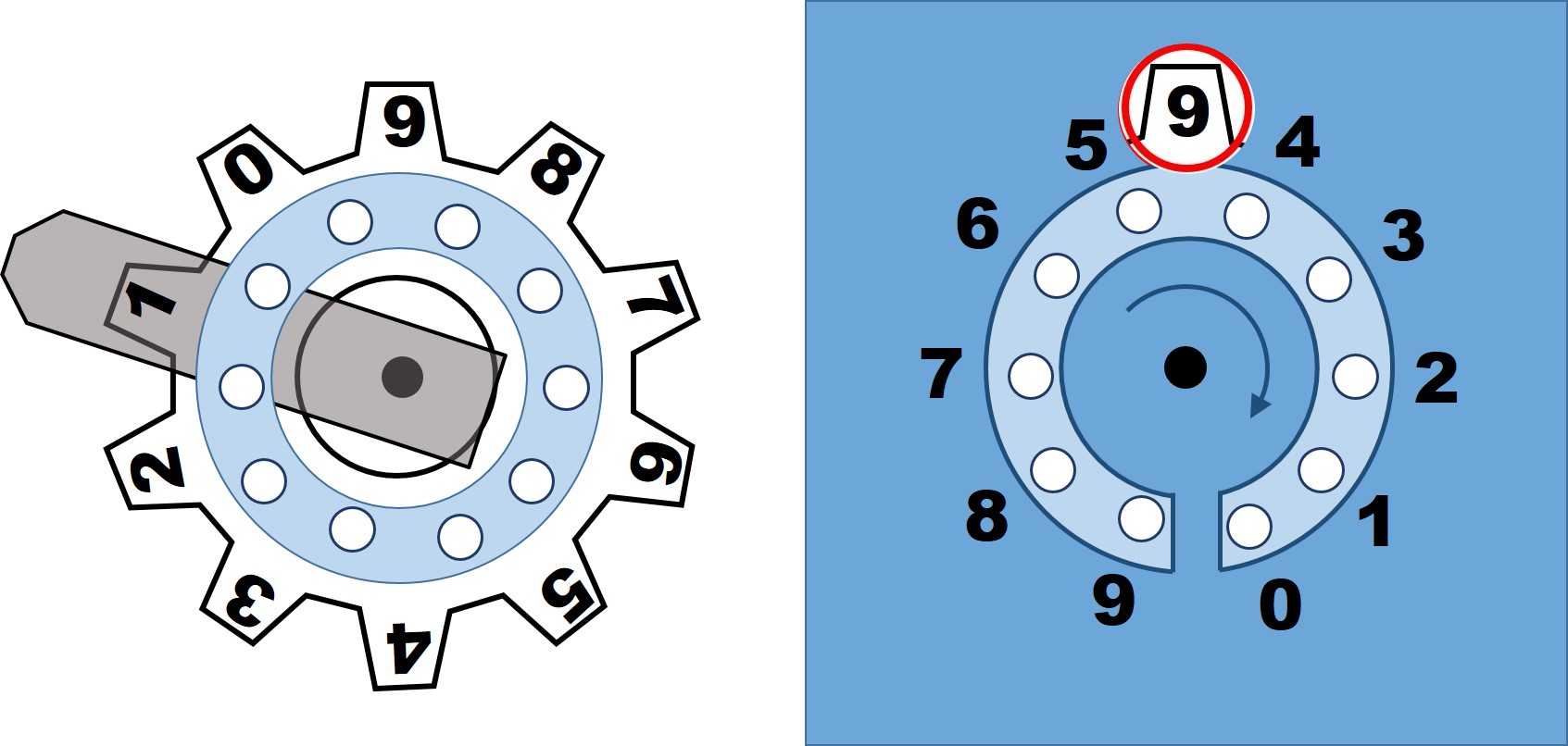

En mi última entrada de la sección Matemoción del Cuaderno de Cultura Científica, titulada Construye tu propia calculadora de sumas y restas, hablábamos de construir una sencilla calculadora mecánica para sumar y restar. Aunque, sin lugar a dudas, la primera calculadora de la que dispusieron los seres humanos fueron sus manos. Estas se han utilizado, desde hace muchos, muchos milenios, cuando la humanidad empezó a introducir el concepto de número, para contar, así como para realizar las operaciones aritméticas básicas, lo cual ha quedado reflejado en el hecho de que la mayoría de los sistemas de numeración son decimales.

Por este motivo, me ha parecido que podía ser interesante abordar en esta entrada cómo contamos las personas con los dedos de nuestras manos y cómo han contado, utilizando sus manos, los diferentes pueblos a lo largo de la historia de la humanidad.

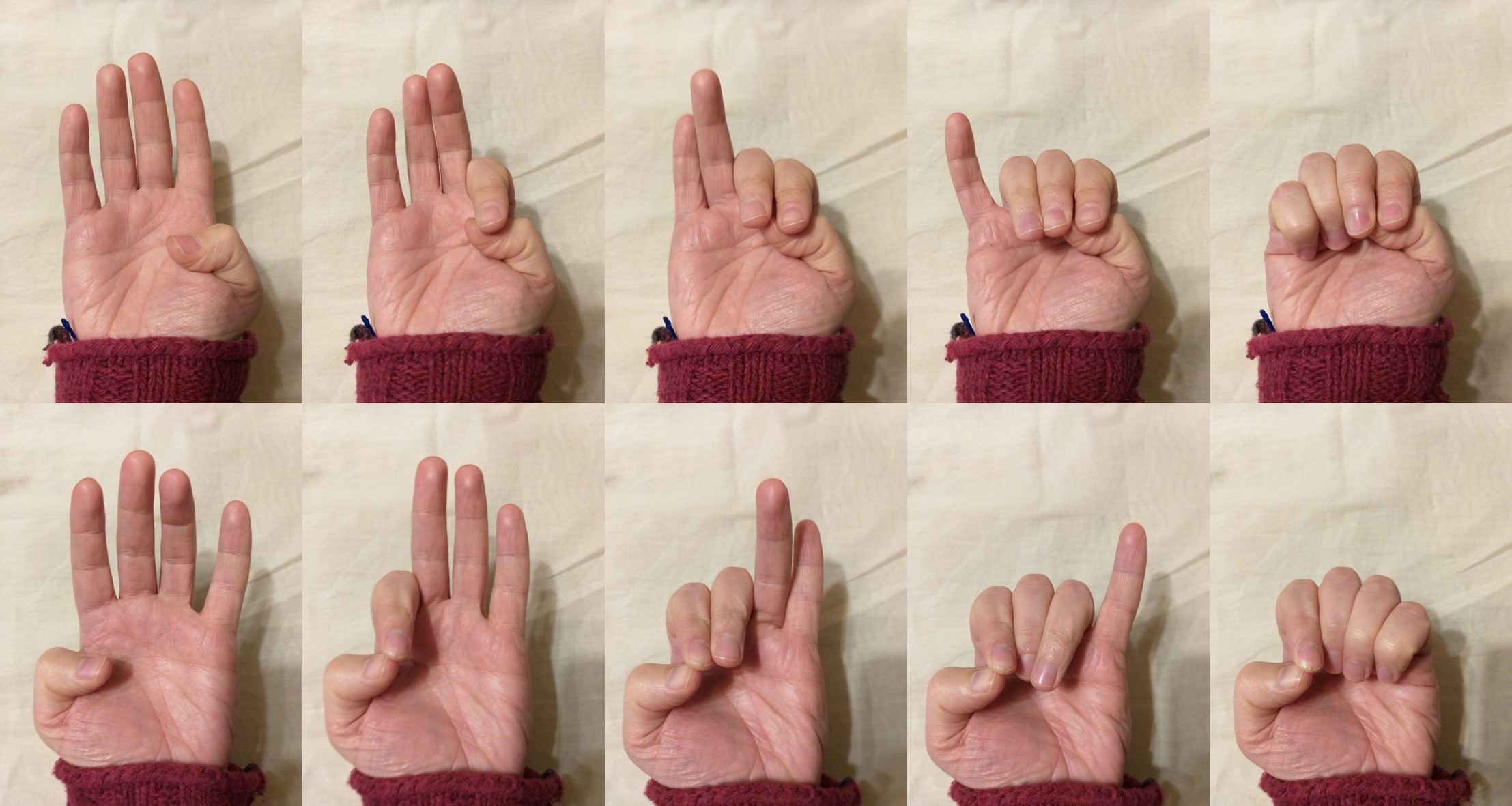

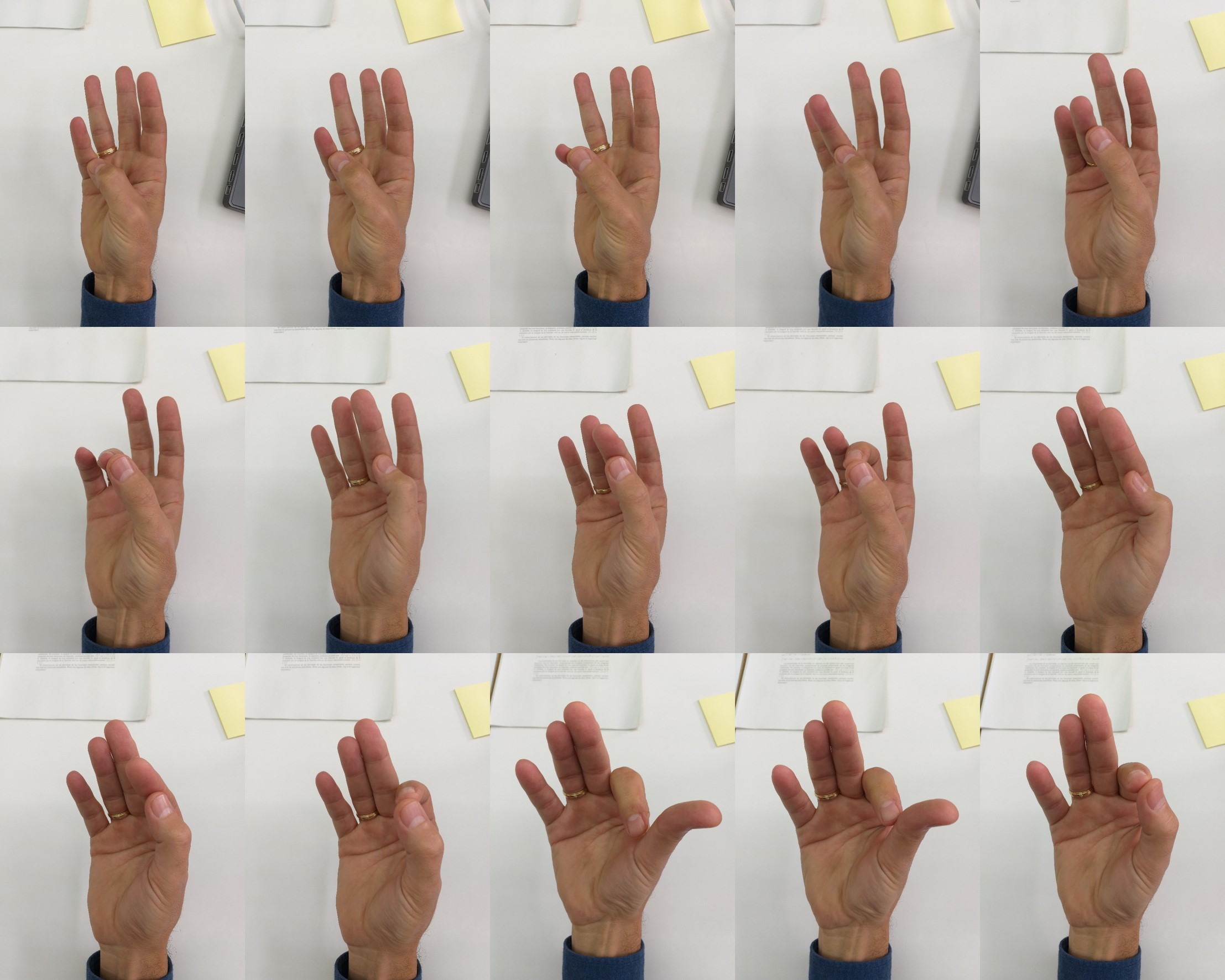

Lo primero que me planteé fue cómo cuento yo mismo, si para ello utilizo los dedos de las manos, y cómo lo hacen las personas de mi entorno. Yo cuento de la siguiente manera. Empiezo con la mano izquierda cerrada y con la zona de los dedos hacia arriba, y voy levantando los dedos, mientras cuento, en el siguiente orden, primero el pulgar para el uno, el índice para el dos, el corazón para el tres, el anular para el cuatro y el meñique para el cinco, manteniéndolos levantados. Después, mientras mantengo la mano izquierda extendida, paso a la mano derecha, con la misma postura, el mismo método y en el mismo orden, contando desde el pulgar, que extiendo para contar el seis, índice, siete, corazón, ocho, anular, nueve, hasta el meñique, para el diez.

Forma en la que yo cuento, del 1 al 10, con los dedos de las manos. Empiezo por la izquierda, extendiendo los dedos desde el pulgar al meñique, para contar del uno al cinco, y luego paso a la derecha, mientras mantengo la izquierda abierta para mantener el valor del cinco, extendiendo de nuevo los dedos del pulgar al meñique, para los números del seis al diez

Forma en la que yo cuento, del 1 al 10, con los dedos de las manos. Empiezo por la izquierda, extendiendo los dedos desde el pulgar al meñique, para contar del uno al cinco, y luego paso a la derecha, mientras mantengo la izquierda abierta para mantener el valor del cinco, extendiendo de nuevo los dedos del pulgar al meñique, para los números del seis al diezPero, ¿será este el método habitual para contar con las manos para las personas que están en mi entorno? Más aún, empecé a plantearme otras cuestiones más o menos sencillas, pero lógicas. ¿Existirá una forma estándar de contar con los dedos? ¿Por qué mano empezamos a contar? ¿Y, de hecho, qué dedo utilizamos primero en dicha mano? ¿Empleamos el mismo método, de forma simétrica, con las dos manos, como hacía yo mismo o cambiamos en la segunda mano? Y otras preguntas similares.

Me pareció que el problema planteado requería de un pequeño trabajo de campo. Por este motivo, pregunté a varias personas de mi entorno laboral y personal “cómo contaban (del uno al diez) con los dedos de las manos”. En total fueron 48 personas encuestadas, incluido yo mismo. Obviamente, esta no es una encuesta realizada de forma científica, de la que podamos extraer información concluyente, pero me sirve para tener una ligera idea de las cuestiones que me había planteado.

Una de las primeras cosas que llamó mi atención fue que no parecía existir una relación directa entre ser diestro o zurdo y la mano con la que se empezaba a contar. Al parecer, la gente empieza indistintamente con la mano derecha o la izquierda, aunque normalmente quien lo hace por una de ellas, por ejemplo, yo con la mano izquierda, casi siempre inicia el conteo con esa mano. De las 48 personas entrevistadas, 23 empezaron con la mano derecha y 25 con la mano izquierda. La mayoría de las personas entrevistadas eran diestras, pero no se veía un patrón en ninguno de los dos grupos.

Respecto al dedo de inicio para contar los números desde el uno en adelante, la mayoría de las personas empezaban por el dedo pulgar o el meñique, aunque algunas empezaron por el dedo índice. Las cifras fueron las siguientes: con el pulgar, 19 personas, con el meñique, 24 de las entrevistadas, y con el índice, tan solo 5.

Escultura de manos gigantes durante la Bienal de Venecia de 2017, del artista italiano Lorenzo Quinn. Imagen de la Galería Halcyon, en Venecia, extraída de la página de Lorenzo Quinn

Escultura de manos gigantes durante la Bienal de Venecia de 2017, del artista italiano Lorenzo Quinn. Imagen de la Galería Halcyon, en Venecia, extraída de la página de Lorenzo QuinnTambién me fijé en que la mayoría de las personas entrevistadas, en concreto, 32 de las 48, utilizaban el mismo método en ambas manos y en el mismo orden, como lo hacía yo mismo. Sin embargo, había 12 personas que utilizaban el mismo método, pero en el sentido opuesto. Por ejemplo, si una persona empezaba por la mano izquierda con el mismo método que yo, desplegando los dedos desde el pulgar (1) al meñique (5), en la mano derecha desplegaba los dedos desde el meñique (6) hasta el pulgar (10). Y había algunos casos, 4, en los que se cambiaba de método de una mano a otra.

Respecto al método utilizado para contar, el más común, que me mostraron 34 de las 48 personas participantes en la encuesta, ha sido “desplegar los dedos de cada mano”, con algunas variaciones.

Analicemos las variantes dentro del grupo de desplegar los dedos de cada mano. Esencialmente hay dos grupos, los que empiezan a contar con el pulgar, como yo, o los que empiezan a contar con el meñique (como muestra la siguiente imagen), en ambos casos pueden empezar por la mano izquierda o la derecha, aunque como comentábamos, quien lo hace con una mano, casi siempre lo hace con esa misma mano. Una curiosidad de este método es que era el elegido por la mayoría de las personas que empezaban a contar con el pulgar, 17 de las 19 comentadas más arriba. Mientras que solo 12 de las 24 que empezaban con el meñique, lo hacían con la técnica de desplegar los dedos.

La otra variación es que utilicen el mismo orden de despliegue en las dos manos o que cambien de orden, como en la siguiente imagen, que en la mano izquierda se cuenta desplegando de meñique (1) a pulgar (5), mientras que en la derecha se despliegan los dedos de pulgar (6) a meñique (10).

Esta es la manera en la que cuenta mi compañera María Merino, del Departamento de Matemática Aplicada, Estadística e Investigación Operativa, de la Facultad de Ciencia y Tecnología (UPV/EHU). Empieza por la mano izquierda, extendiendo los dedos desde el meñique al pulgar, para contar del uno al cinco, y luego pasa a la derecha, mientras mantiene la izquierda abierta, para mantener el valor del cinco, extendiendo de nuevo los dedos, pero ahora en sentido opuesto, del pulgar al meñique, para los números del seis al diez

Esta es la manera en la que cuenta mi compañera María Merino, del Departamento de Matemática Aplicada, Estadística e Investigación Operativa, de la Facultad de Ciencia y Tecnología (UPV/EHU). Empieza por la mano izquierda, extendiendo los dedos desde el meñique al pulgar, para contar del uno al cinco, y luego pasa a la derecha, mientras mantiene la izquierda abierta, para mantener el valor del cinco, extendiendo de nuevo los dedos, pero ahora en sentido opuesto, del pulgar al meñique, para los números del seis al diezPor otra parte, las cinco personas que empezaron a contar por el dedo índice utilizaron el método de desplegar los dedos. Dos de ellas, iniciaron el conteo por la mano derecha, aunque podría haber sido con la izquierda, y desplegaron los dedos en este orden, índice (1), corazón (2), anular (3), meñique (4) y pulgar (5), y después siguieron con la otra mano, en el mismo sentido, índice (6), corazón (7), anular (8), meñique (9) y pulgar (10). Mientras que otras dos personas contaron igual que antes en la primera mano, pero en la segunda empezaron por el pulgar, así pulgar (6), índice (7), corazón (8), anular (9) y meñique (10).

La quinta persona planteó una variante curiosa. Empezó con la mano derecha cerrada. Primero levantó el índice para 1, que le acompañó el corazón para el 2, mientras que para el 3 cambió de dedos y levantó corazón, anular y meñique (debido a la dificultad para mantener índice, corazón y anular levantados a la vez), a los que añadió el índice para el 4 y el pulgar para el 5, como se muestra en la siguiente imagen. Para contar los números del 6 al 10, mantuvo la mano derecha extendida, y utilizó la misma técnica con la mano izquierda.

Forma de contar del 1 al 5, representada por mí, de una de las personas entrevistadas. Despliega los dedos, empezando por el índice, aunque en un orden particular. Para los números del 6 al 10 se mantiene la mano derecha extendida y se continúa contando con la izquierda de la misma forma que en la imagen

Forma de contar del 1 al 5, representada por mí, de una de las personas entrevistadas. Despliega los dedos, empezando por el índice, aunque en un orden particular. Para los números del 6 al 10 se mantiene la mano derecha extendida y se continúa contando con la izquierda de la misma forma que en la imagen  Escultura La mano (1995) del artista colombiano Fernando Botero, que está ubicada en el Paseo de la Castellana, en Madrid. Fotografía de Manuel González Olaechea

Escultura La mano (1995) del artista colombiano Fernando Botero, que está ubicada en el Paseo de la Castellana, en Madrid. Fotografía de Manuel González OlaecheaLa otra técnica utilizada mayoritariamente, después de desplegar los dedos, para contar con los dedos de las manos ha consistido en tocar, o incluso agarrar, los dedos de una mano con otro dedo de la otra mano, o de la misma. En total, 12 personas de las 48 entrevistadas contaron utilizando alguna variante de “tocar los dedos con otro dedo”, de las que podríamos decir que 7 indicaban con el dedo índice de la otra mano y 5 con el pulgar de la misma mano. Como curiosidad mencionemos que la mayoría de las personas entrevistadas que utilizaron esta técnica, empezaron por el meñique, lo cual no deja de ser significativo.

Veamos primero un ejemplo de este método, en la variante de indicar con el dedo índice de una mano, los dedos, mientras se cuentan, de la otra.

Esta es la manera en la que cuenta mi compañera Marta Macho, del departamento de matemáticas de la Facultad de Ciencia y Tecnología (UPV/EHU). Con el índice de la mano derecha va indicando, mientras cuenta, los dedos de la mano izquierda, desde el meñique al pulgar, para contar del uno al cinco, y luego pasa a la derecha, contando con el índice de la mano izquierda, del meñique al pulgar, para los números del seis al diez

Esta es la manera en la que cuenta mi compañera Marta Macho, del departamento de matemáticas de la Facultad de Ciencia y Tecnología (UPV/EHU). Con el índice de la mano derecha va indicando, mientras cuenta, los dedos de la mano izquierda, desde el meñique al pulgar, para contar del uno al cinco, y luego pasa a la derecha, contando con el índice de la mano izquierda, del meñique al pulgar, para los números del seis al diezEn este grupo sí encontramos cierta relación con la lateralidad. De las siete personas que, más o menos, están en este grupo, las seis que son diestras empiezan utilizando el dedo índice de la mano derecha para contar sobre la izquierda (pueden empezar por el dedo meñique o el pulgar, incluso hay una persona que no solo los toca con el dedo índice, sino que los agarra con el índice y el pulgar) y después cambian, el dedo índice de la izquierda cuenta tocando los dedos de la mano derecha. Y la única persona zurda de este grupo, lo hace justo al revés, empieza utilizando el índice de la mano izquierda para contar sobre la mano derecha.

Una de las personas entrevistadas y que hemos incluido en este grupo, utiliza una variación curiosa para la segunda mano, que consiste en establecer una relación uno a uno entre los dedos de las dos manos. Cuenta así. Para empezar, con el índice de la mano derecha toca, mientras cuenta, los dedos de la mano izquierda, meñique (1), anular (2), corazón (3), índice (4) y pulgar (5). Y para la mano derecha, el meñique de la mano izquierda toca por detrás al meñique de la mano derecha, para indicar el 6, el anular de la mano izquierda toca por detrás el anular de la mano derecha, para indicar el 7, y así sigue con el corazón (8), índice (9) y pulgar (10).

Forma de contar mixta que consiste en contar con el índice de la mano derecha tocando los dedos de la izquierda, del meñique (1) al pulgar (5), y los dedos de la segunda mano, la derecha, se cuentan tocando desde abajo con el correspondiente dedo de la mano izquierda, en una correspondencia uno a uno, así el meñique de la mano izquierda toca por detrás al meñique de la mano derecha (6), el anular de la mano izquierda toca el anular de la derecha (7), hasta el pulgar izquierdo tocando al pulgar derecho (10)

Forma de contar mixta que consiste en contar con el índice de la mano derecha tocando los dedos de la izquierda, del meñique (1) al pulgar (5), y los dedos de la segunda mano, la derecha, se cuentan tocando desde abajo con el correspondiente dedo de la mano izquierda, en una correspondencia uno a uno, así el meñique de la mano izquierda toca por detrás al meñique de la mano derecha (6), el anular de la mano izquierda toca el anular de la derecha (7), hasta el pulgar izquierdo tocando al pulgar derecho (10)Por otra parte, mi amigo Luis Javier Rodríguez, físico del Departamento de Electricidad y Electrónica, de la Facultad de Ciencia y Tecnología de la UPV/EHU, utiliza una mezcla de los dos métodos principales. El método de tocar con el índice de la mano derecha los dedos de la izquierda (también es diestro), para contar del 1 al 5, mientras que en la mano derecha despliega los dedos, para contar del 6 al 10, como vemos en el siguiente video que me ha enviado.

https://culturacientifica.com/app/uploads/2018/11/contar-con-los-dedos.mp4

Dentro de este grupo de “tocar los dedos con otro dedo”, tenemos aquellas personas, 5 de las 12 de este grupo, que tocan los dedos que van contando con el pulgar de la misma mano. De nuevo, en este grupo no encontramos ninguna relación con la lateralidad, seguramente porque se está contando con el pulgar de la misma mano, y empiezan a contar indistintamente por la derecha o la izquierda.

En este caso, con el pulgar de la mano por la que se empieza a contar se toca al meñique (1), anular (2), corazón (3) e índice (4), y aquí llegan las pequeñas variaciones, hay quienes en este punto abren la mano entera para contar 5, quienes encogen el pulgar como señalándose a sí mismo o quienes señalan la base del meñique o del índice. En la otra mano se realiza la misma operación para contar del 6 al 10.

Esta es la manera en la que cuenta mi compañera Naiara Arrizabalaga, del departamento de matemáticas de la Facultad de Ciencia y Tecnología (UPV/EHU). Con el pulgar de la mano izquierda va tocando, mientras cuenta, los dedos de esa misma mano, meñique (1), anular (2), corazón (3), índice (4) y finalmente la base del meñique para contar 5. Con la mano derecha realiza una operación simétrica, para los números del 6 al 10

Esta es la manera en la que cuenta mi compañera Naiara Arrizabalaga, del departamento de matemáticas de la Facultad de Ciencia y Tecnología (UPV/EHU). Con el pulgar de la mano izquierda va tocando, mientras cuenta, los dedos de esa misma mano, meñique (1), anular (2), corazón (3), índice (4) y finalmente la base del meñique para contar 5. Con la mano derecha realiza una operación simétrica, para los números del 6 al 10Para terminar, entre las 48 personas entrevistadas, solo una de ellas ha utilizado un método del que pensé que habría más ejemplos. Mi amigo Ángel Ordóñez, que es periodista, empieza con las manos extendidas y va replegando los dedos. En su caso empieza por la mano izquierda, replegando desde el meñique, para el 1, hasta el pulgar, para el 5, y luego pasa a la mano derecha, donde repliega de igual forma para los números del 6, el meñique, al 10, el pulgar.

Cueva de las manos, Cañadón del Río Pinturas, Santa Cruz, Argentina. Fotografía de PabloGimenez.com

Cueva de las manos, Cañadón del Río Pinturas, Santa Cruz, Argentina. Fotografía de PabloGimenez.comDespués de analizar los resultados de esta pequeña encuesta, podemos extraer algunas conclusiones informales, aunque nada rigurosas, puesto que la encuesta ha sido más un mero juego, que una encuesta diseñada y ejecutada de forma rigurosa.

Mirando a mi entorno más cercano, existen esencialmente dos formas de contar, desplegando los dedos de las manos y tocando los dedos de las manos con otro dedo, ya sea de la otra mano (que suele ser el índice) o de la misma mano (el pulgar). No existe una uniformidad respecto a la mano con la que se empieza a contar, derecha o izquierda, salvo en el caso de contar con el dedo índice indicando los dedos de la otra mano, en cuyo caso los diestros empiezan a contar con el índice de la mano derecha sobre los dedos de la izquierda y los diestros al revés. Se suele empezar a contar mayoritariamente por el dedo pulgar o el meñique. Las personas que despliegan los dedos se inclinan un poco más por empezar por el pulgar, mientras que entre los que tocan los dedos de la mano con otro dedo suelen empezar con el meñique.

Fotografía de la iniciativa Arroces del Mundo que tiene lugar en el barrio bilbaíno de Bilbao La Vieja. Fotografía de Naiz

Fotografía de la iniciativa Arroces del Mundo que tiene lugar en el barrio bilbaíno de Bilbao La Vieja. Fotografía de NaizAyer, cuando terminé de escribir lo que acabáis de leer, me pregunté cómo contarían en la actualidad las personas de otras partes del mundo. Teniendo en cuenta que yo vivo en el barrio Bilbao La Vieja, el barrio más antiguo de Bilbao, y este es realmente una pequeña copia del mundo, me animé a bajar a la calle y preguntar a unas pocas personas de diferentes procedencias cómo contaban ellas con los dedos de las manos. Estas fueron las respuestas que obtuve.

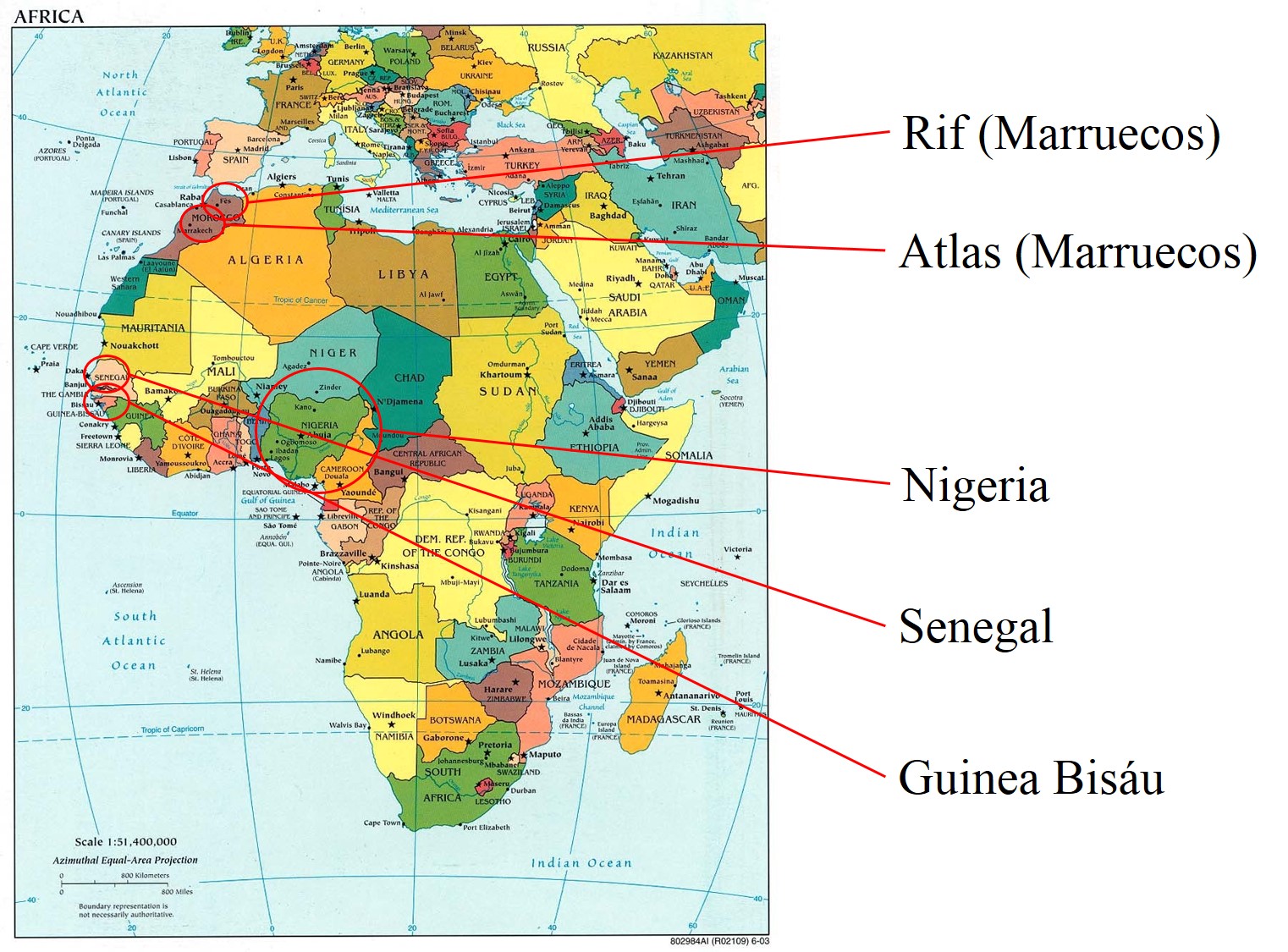

En primer lugar, les pregunté a dos hombres de Nigeria, que como ellos mismos me dijeron en nuestra conversación, este país africano es el país del mundo con más negros. Ellos contaban contrayendo los dedos de las manos. Empezaron con la mano derecha extendida, contrayendo el pulgar (1), el índice (2), el corazón (3), el anular (4) y finalmente, el meñique (5), para acabar con la mano cerrada. Entonces, mientras mantenían la mano derecha cerrada, continuaron contando con la mano izquierda, y de la misma forma, contaron del 6, contrayendo el dedo pulgar, hasta el 10, contrayendo el dedo meñique.

Representación de la forma en la que contaban dos personas de Nigeria con las que hablé, mientras contaban contraían los dedos de las manos, primero de la derecha y luego de la izquierda, empezando por el dedo pulgar

Representación de la forma en la que contaban dos personas de Nigeria con las que hablé, mientras contaban contraían los dedos de las manos, primero de la derecha y luego de la izquierda, empezando por el dedo pulgarUn joven de Senegal a quien también pregunté resultó que utilizaba el mismo método para contar con los dedos que los dos hombres de Nigeria, pero él empezaba por la mano izquierda y en el sentido contrario, primero el meñique y terminando en el pulgar, en cada mano.

Otro joven africano, pero este de Guinea Bisáu, contaba con el mismo método descrito antes que consiste en tocar con el dedo índice de una mano los dedos de la otra mano. De hecho, lo hacía de la forma usual vista más arriba. Con el índice de la mano derecha tocaba desde el meñique de la izquierda, para contar uno, siguiendo el orden natural hasta el pulgar, para el cinco, y continuaba con la otra mano, utilizando el índice de la mano izquierda para señalar desde el meñique al pulgar de la derecha, para contar del 6 al 10.

Mapa político de África en el que están destacados los lugares de procedencia de las personas del continente africano que he entrevistado

Mapa político de África en el que están destacados los lugares de procedencia de las personas del continente africano que he entrevistadoEn el Berebar de la calle San Francisco de Bilbao pregunté a un joven bereber, originario de la zona de las montañas del Rif en Marruecos, en concreto de la ciudad de Alhucemas. Utilizaba una singular manera de contar. Empezó con la mano derecha cerrada, con los dedos mirando hacia arriba, y fue extendiendo los dedos desde el meñique hasta el pulgar, para contar del 1 al 5, al llegar al cinco la mano quedaba extendida, y continuó contando con esa misma mano, pero ahora recogiendo los dedos, desde el pulgar (6) hasta el meñique (10). Después, continuaba contando con la mano izquierda, mediante la misma técnica, para contar desde el 11 hasta el 20. Es decir, este joven bereber contaba hasta el número 20 con sus dos manos. Era el primer ejemplo que me encontraba, posiblemente relacionado con la base 20, entre las personas a las que había preguntado.

Fotografía del exterior del Restaurante Berebar, en la calle San Francisco de Bilbao, en la que podemos ver al escritor bilbaíno Jon Arretxe, autor de la saga de libros del detective Touré, un detective muy particular del barrio bilbaíno de Bilbao La Vieja, burkinés, emigrante africano, sin papeles, que hace de todo para poder vivir y que en muchas ocasiones se pasa por el Berebar

Fotografía del exterior del Restaurante Berebar, en la calle San Francisco de Bilbao, en la que podemos ver al escritor bilbaíno Jon Arretxe, autor de la saga de libros del detective Touré, un detective muy particular del barrio bilbaíno de Bilbao La Vieja, burkinés, emigrante africano, sin papeles, que hace de todo para poder vivir y que en muchas ocasiones se pasa por el BerebarUn compañero de mi departamento, Abdelmalik Moujahid, que también es bereber y cuya familia es de la zona montañosa del Atlas en Marruecos, me contó la forma en la que su padre y su madre, y muchas de las personas del lugar del que es originaria su familia, contaban.

Esta forma de contar, que de hecho se ha utilizado en muchos países cuya religión es el islam, tiene su origen en una práctica religiosa. Es la forma que tienen los musulmanes de enumerar los 99 nombres, o atributos divinos, de Alá (se le atribuye a Mahoma la frase “Dios tiene noventa y nueve nombres, cien menos uno. Quien los cuente entrará en el Paraíso. Él es el singular, y le gusta el non (número impar)”) o también a modo de rosario, cuando no se tiene este, para rezar.

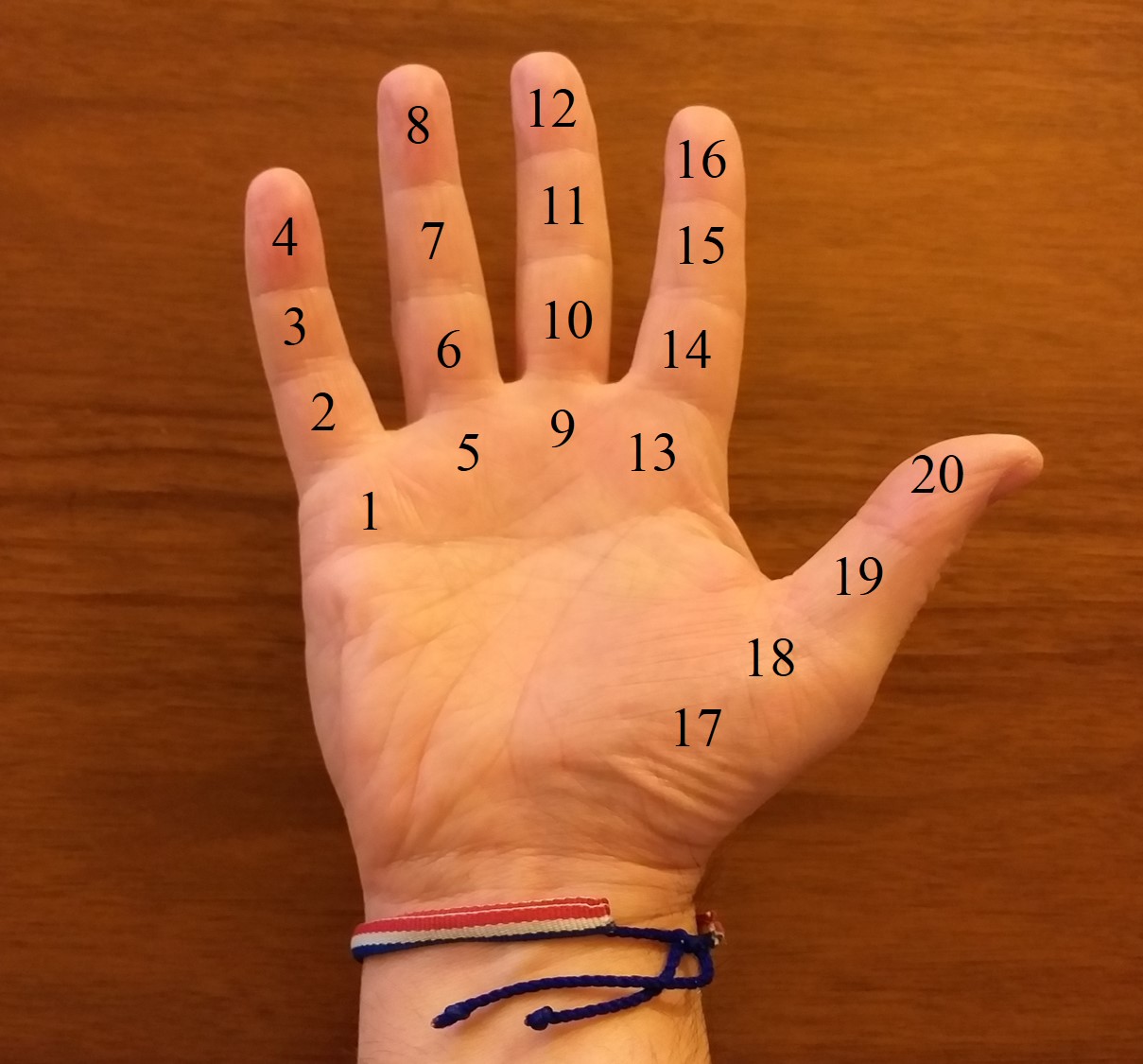

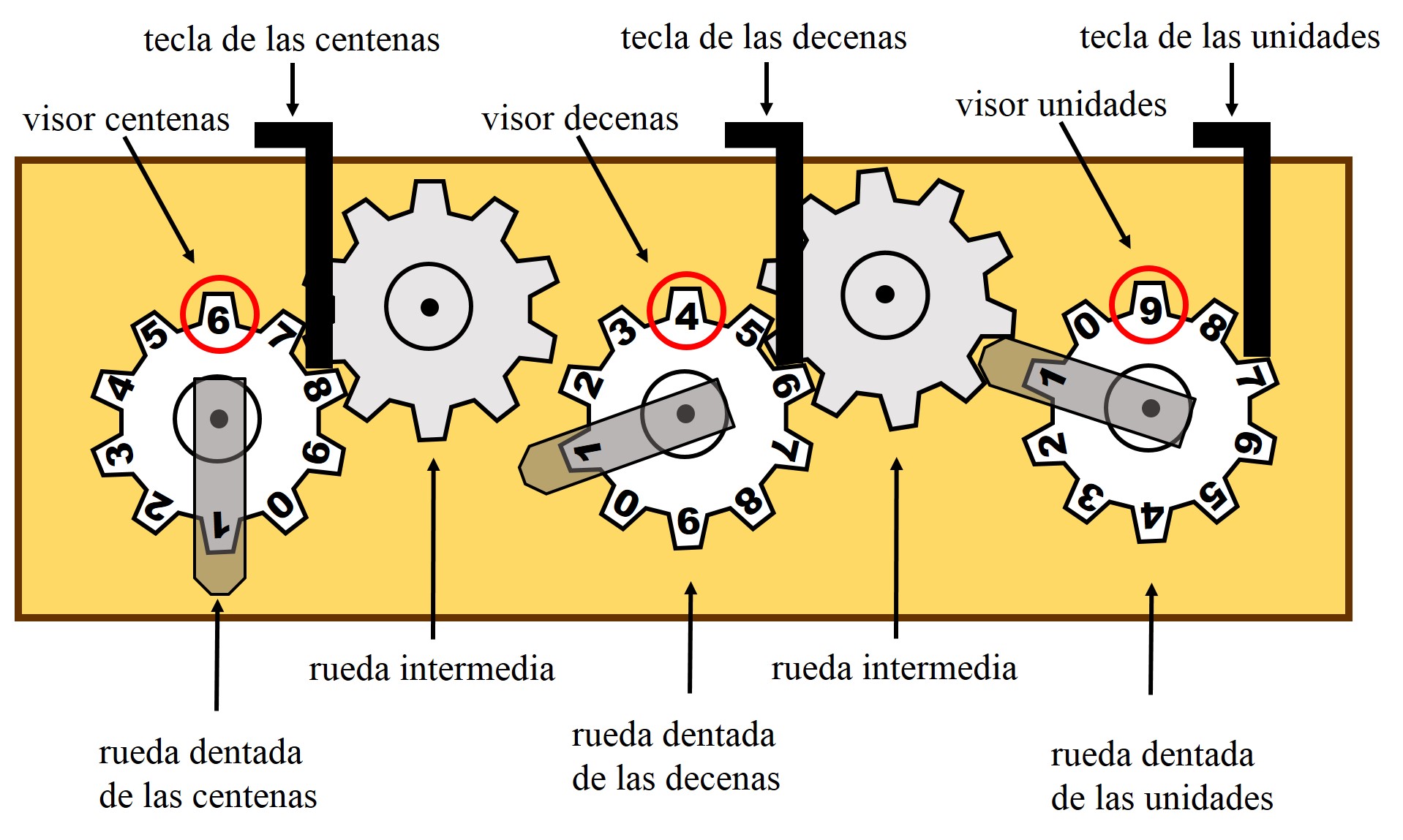

Pero expliquemos como se cuenta. Como vemos en la imagen de abajo, se cuenta señalando cada una de las tres falanges de los dedos de la mano (aunque el pulgar solo tiene dos falanges, se considera como si tuviese tres). Se utiliza primero la mano derecha (aunque podría empezarse por la izquierda), contando en cada dedo las falanges (o también, las articulaciones) de abajo a arriba, empezando por el meñique. Por lo tanto, de esta forma puede contarse 15 con cada mano, luego 30 con las dos manos. Según me ha dicho Abdelmalik, para contar los 99 nombres se cuenta tres veces las dos manos, es decir, tres veces treinta, y luego se cuenta 9 más.

Esta es la forma en la que se contaba en la zona del Atlas en Marruecos, de donde es originaria la familia de mi compañero Abdelmalik Moujahid, del departamento de matemáticas de la Facultad de Ciencia y Tecnología (UPV/EHU). Se cuentan las 15 falanges de cada mano (considerando que el pulgar también tuviese tres falanges), empezando por el meñique y de abajo a arriba, luego 30 con las dos manos

Esta es la forma en la que se contaba en la zona del Atlas en Marruecos, de donde es originaria la familia de mi compañero Abdelmalik Moujahid, del departamento de matemáticas de la Facultad de Ciencia y Tecnología (UPV/EHU). Se cuentan las 15 falanges de cada mano (considerando que el pulgar también tuviese tres falanges), empezando por el meñique y de abajo a arriba, luego 30 con las dos manosEn algunos otros lugares de religión musulmana, lo que se cuentan son los nudillos de los dedos de las manos, es decir, por la parte dorsal. De nuevo, cada dedo tiene tres nudillos, salvo el pulgar, aunque también se le considera como si tuviese tres.

Otra variante a la hora de recitar los 99 nombres de Alá, o de rezar, es que se cuenta primero 33, contando después del 30, las puntas de los tres dedos (meñique, anular y corazón) de la segunda mano, y esto se repite tres veces, es decir, 3 33 = 99.

Seguí preguntando a mis vecinos de barrio. La siguiente persona a la que pregunté era de Pakistán. Este hombre empezó a contar con la mano izquierda abierta y la palma hacia arriba, levantando ligeramente cada dedo para contar del 1 al 5, meñique (1), anular (2), corazón (3), índice (4) y pulgar (5). Y la misma operación con la mano derecha para contar del 6 al 10.

Y la última persona a la que pregunté, aunque me habría gustado que fuesen muchas más, era una de las personas que trabaja en una pequeña frutería que hay cerca de mi casa. Él es originario de Bangladesh, el país situado al este de la India. El método que utiliza para contar también es muy interesante.

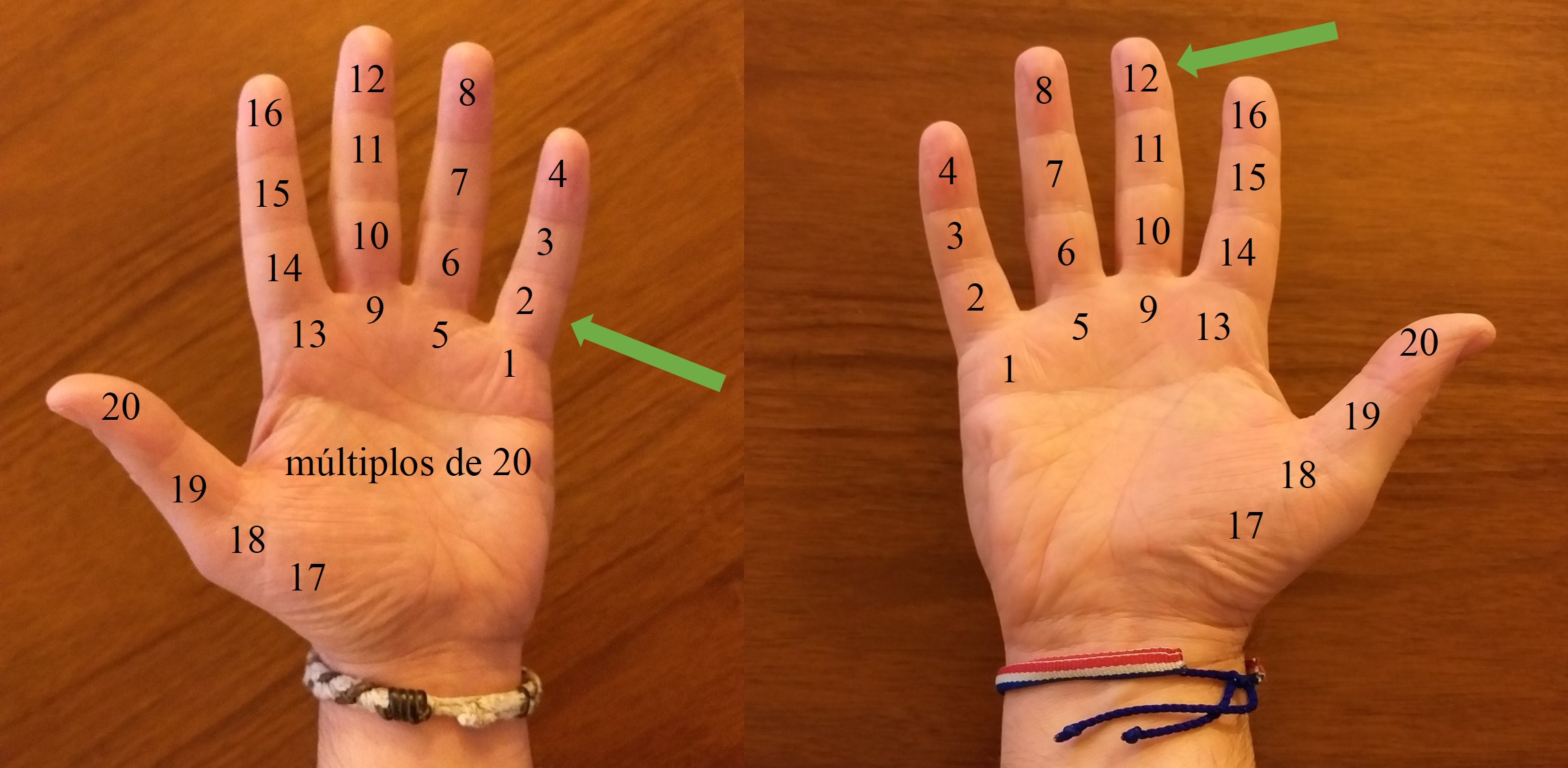

Utiliza la mano derecha para contar de 1 a 20, indicando con el dedo índice de la otra mano, cada una de las posiciones. Cada dedo, desde el meñique al pulgar, está dividido en cuatro zonas, separadas por las articulaciones de la mano. Aunque el pulgar solo tiene tres, él considera que también tiene cuatro zonas. Por lo tanto, 5 4 = 20 zonas. Cuando le pedí que contase los números desde el uno, empezó a contar por el meñique, desde la zona de abajo hacia arriba, del 1 al 4, luego el anular, del 5 al 8, el corazón del 9 al 12, el índice del 13 al 16 y finalmente, el pulgar, del 17 al 20, como se muestra en la imagen.

El frutero de Bangladesh de mi barrio utiliza la mano derecha para contar del 1 al 20, señalando con el índice de la mano izquierda las zonas que hay en cada dedo separadas por las articulaciones (considerando que en el pulgar también hay cuatro zonas, y no tres), que se muestran en la imagen

El frutero de Bangladesh de mi barrio utiliza la mano derecha para contar del 1 al 20, señalando con el índice de la mano izquierda las zonas que hay en cada dedo separadas por las articulaciones (considerando que en el pulgar también hay cuatro zonas, y no tres), que se muestran en la imagenPero la cantidad de números que puede contar no termina ahí, como me comentó, puesto que utiliza la otra mano, la izquierda, para indicar los múltiplos de 20. Si se toca a la zona del 1 es 20, si se toca el 2 es 40, el 3 sería 60, etcétera. De esta forma para contar el número 52 se tocaría con el índice de la mano derecha la segunda posición, desde abajo, del meñique de la izquierda (2 20 = 40) y después con el índice de la izquierda se tocaría en la zona de arriba del dedo corazón de la mano derecha (12), como indica la imagen.

El frutero de Bangladesh de mi barrio utiliza la mano derecha para contar del 1 al 20, y la mano izquierda para los múltiplos de 20, así las flechas de la imagen están indicando el número 52, que es 2 veces 20 y 12

El frutero de Bangladesh de mi barrio utiliza la mano derecha para contar del 1 al 20, y la mano izquierda para los múltiplos de 20, así las flechas de la imagen están indicando el número 52, que es 2 veces 20 y 12Este sistema para contar, de mi frutero de Bangladesh, es claramente un sistema de numeración de base 20.

Estas son algunas de las formas en las que hoy en día seguimos contando con los dedos de las manos, pero… y tú, ¿cómo cuentas con los dedos?

El caballero de la mano en el pecho (aprox. 1580), del artista toledano, nacido en la isla griega de Creta, Doménikos Theotokópoulos, conocido como El Greco. Cuadro perteneciente a la colección del Museo del Prado. Fotografía del Museo, a través de Wikimedia Commons.

El caballero de la mano en el pecho (aprox. 1580), del artista toledano, nacido en la isla griega de Creta, Doménikos Theotokópoulos, conocido como El Greco. Cuadro perteneciente a la colección del Museo del Prado. Fotografía del Museo, a través de Wikimedia Commons.En mi próxima entrada de la sección Matemoción del Cuaderno de Cultura Científica, haremos un repaso a diferentes formas de contar con los dedos de las manos, a lo largo de la historia.

Bibliografía

1.- Levi Leonard Conant, Counting, The world of mathematics, volumen 1, James Newman (editor), Dover, 1956.

2.- Georges Ifrah, Historia universal de las cifras, Ensayo y pensamiento, Espasa, 2002 (quinta edición).

3.- Página web del artista Lorenzo Quinn

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Y tú, ¿cómo cuentas con los dedos? (1) se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La morra, jugando a contar con los dedos

- La insoportable levedad del TRES, o sobre la existencia de sistemas numéricos en base 3

- El gran cuatro, o los números siguen estando locos

Cuando las ondas se encuentran

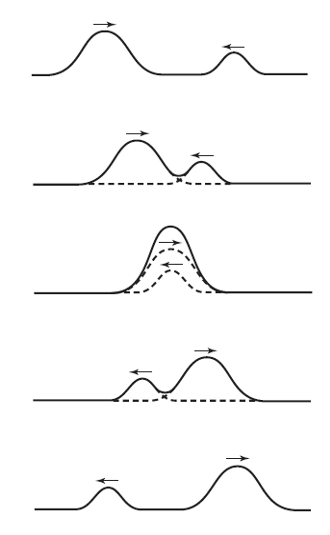

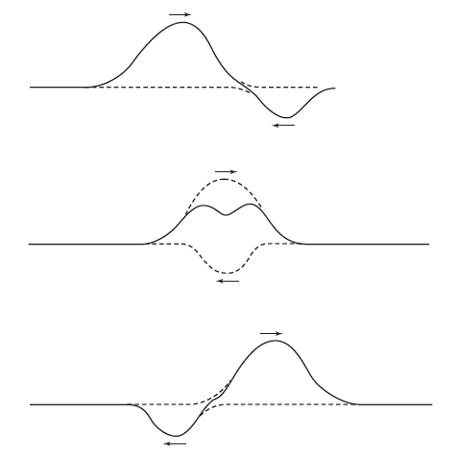

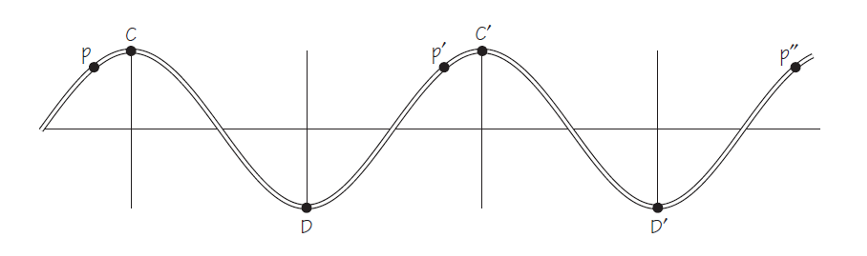

Con los conceptos que hemos visto ya estamos en disposición de explorar un territorio fascinante. Hasta ahora hemos considerado ondas individuales. ¿Qué ocurre cuando se encuentran dos ondas en el mismo medio? Supongamos que dos ondas se aproximan la una a la otra en una cuerda, una se desplaza hacia la derecha y la otra hacia la izquierda. La serie de imágenes de la Figura 1 muestra lo que sucedería si hiciéramos este experimento. Las ondas se atraviesan la una a la otra sin sufrir modificación alguna. ¿Te sorprende? No debería.

Figura 1.

Figura 1.Después del encuentro, cada onda tiene el mismo aspecto que antes del mismo y sigue avanzando como antes. (¡Algo completamente diferente al encuentro de dos partículas!). Este fenómeno de ondas que se atraviesan sin ser alteradas se puede observar con todos los tipos de ondas. Se puede ver experimentalmente muy fácilmente en las ondulaciones superficiales en el agua. También ocurre con las ondas de sonido, la prueba la tenemos en que alrededor de una mesa pueden mantenerse varias conversaciones al mismo tiempo sin que se distorsionen entre sí, no digamos ya en una discoteca.

¿Qué sucede durante el tiempo en que en el que las dos ondas estás superpuestas? Los desplazamientos que provocan se suman en cada punto del medio. Dicho de otra manera, el desplazamiento de cualquier punto en la región de superposición es solo la suma de los desplazamientos que serían causados en ese momento por cada una de las dos ondas por separado, como se muestra en la Figura 1. En esta figura vemos dos ondas que se desplazan en sentidos opuestos en una cuerda. Una tiene un desplazamiento máximo de 0,4 cm hacia arriba y la otra un desplazamiento máximo de 0,8 cm hacia arriba. El desplazamiento total máximo hacia arriba de la cuerda en un punto en el que estas dos ondas se cruzan será de 1,2 cm.

Figura 2.

Figura 2.Este comportamiento de las ondas es muy simple y facilita mucho las cosas. Veámoslo. Cada onda avanza a lo largo de la cuerda haciendo su propia contribución al desplazamiento de la cuerda sin importar lo que haga cualquier otra onda. Esta propiedad de las ondas se llama superposición. Usándolo podemos determinar fácilmente de antemano qué aspecto tendrá la cuerda en cualquier momento dado. Todo lo que hay que hacer es sumar los desplazamientos que causará cada onda en cada punto a lo largo de la cuerda en ese instante. La figura 2 muestra una superposición de ondas más general, en la que una de ellas provoca desplazamientos negativos; los desplazamientos se siguen sumando, cada uno con su signo. Esto significa que si los desplazamientos son en sentidos opuestos tienden a cancelarse entre sí.

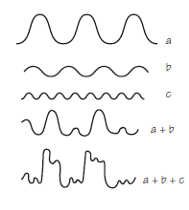

El principio de superposición se aplica sin importar cuántas ondas o perturbaciones individuales estén presentes en el medio. En los ejemplos que acabamos de ver solo había dos ondas. Pero, experimentalmente se comprueba (en la discoteca mismo) que el principio de superposición funciona igual de bien para tres, diez o cualquier cantidad de ondas. Cada una hace su propia contribución, y el resultado neto es simplemente la suma de todas las contribuciones individuales (Figura 3).

Figura 3.

Figura 3.Si las ondas se agregan como acabamos de describir, de ahí se sigue que podemos considerar cualquier onda compleja como la suma de un conjunto de ondas (sinusoidales) simples. En 1807, el matemático francés Augustin Jean Fourier presentó un teorema muy útil. Fourier afirmó que cualquier oscilación periódica continua, por compleja que sea, puede analizarse como la suma de movimientos de onda más simples.

Esto también se demuestra experimentalmente. Los sonidos de los instrumentos musicales también se pueden analizar de esta manera y este análisis de Fourier (o análisis armónico) permite “imitar” los instrumentos electrónicamente combinando y emitiendo las proporciones correctas de vibraciones simples, que corresponden a tonos puros.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Cuando las ondas se encuentran se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Hablar de lo que pasa y de lo que pasó

Hubo una época en la que el ser humano no dudaba de su inteligencia privilegiada como especie sobre las demás. Pero luego fuimos aprendiendo sobre las distintas habilidades de otros animales y esto de la inteligencia única y especial hubo que ponerlo en cuarentena.

Resulta que muchos otros animales pueden comunicarse entre sí a través de distintos sistemas. A las hienas se les da muy bien contar y comparar el tamaño de un grupo invasor con el del suyo. Primates como gorilas y chimpancés saben fabricar y utilizar herramientas para conseguir lo que buscan, casi siempre comida. Los cetáceos se comunican con distintos idiomas según el grupo en el que han crecido, es decir, tienen algo similar a lo que nosotros llamamos cultura. Todo apunta a que los elefantes lloran a sus muertos. Animales tan diversos como urracas y macacos han demostrado tener conciencia de sí mismos y reconocerse ante un espejo.

Los orangutanes también hablan del pasado

Recientemente, otra habilidad que creíamos exclusiva del ser humano ha demostrado no serlo: la capacidad de hablar del pasado. Los orangutanes también saben hacerlo.

Cuando los orangutanes divisan a un depredador, hacen un sonido, como el chasquido de un beso muy fuerte. Ese sonido hace saber al depredador que ha sido detectado, y avisa a otros orangutanes de que el peligro está cerca. Ahora, un grupo de científicos asegura que ha oído a los orangutanes hacer ese mismo sonido un buen rato después de que el depredador se hubiese marchado, y lo consideran la primera evidencia de que estos primates, además de los humanos, son capaces de hablar de lo que ya ha pasado.

“Una de las características que define a un idioma son las referencias desplazadas, es decir, la capacidad de transmitir información sobre algo que no está presente o sobre un evento ocurrido en el pasado o que ocurrirá en el futuro. Es algo muy raro en la naturaleza [pero que se da en todos los idiomas humanos] y que hasta ahora no habíamos visto en ningún primate no humano, lo cual ha hecho más confuso el estudio de los precursores y la evolución del lenguaje”, explican los autores en el estudio.

Hay que aclarar que muchos otros mamíferos y aves tienen señales de alarma, algunas muy completas que incluyen información sobre el tipo y tamaño del depredador, su posición y distancia y el nivel de peligro que suponen. Pero hasta ahora, nunca se había oído a un animal anunciando el peligro después de que ocurriese. Sí se sabe que los cercopitecos verdes, un tipo de mono que vive en el África subsahariana, emite señales de alarma en ausencia de depredadores, pero estas llamadas se consideran estrategias de engaño y no referencias desplazadas.

Un caso aparte son las abejas, capaces de indicar a sus compañeras la dirección y distancia de un lugar con alimento abundante, algo que también se puede considerar una referencia desplazada. En este caso se considera más el resultado de un proceso de inteligencia colectiva y convergencia de distintos procesos que una representación de la comunicación entre individuos como tal.

Silencio ante el peligro… y señal de alarma después

Para llegar a estas conclusiones, los propios investigadores hicieron de depredadores. En la jungla de Ketambe en Sumatra, donde se ha estudiado a los orangutanes durante décadas, el estudiante postdoctoral Adriano Reis e Lameira desarrolló un sencillo experimento para analizar las señales de alarma de estos primates: un miembro del equipo vestido con un traje de rayas como si fuera un tigre debía caminar a cuatro patas por la jungla, justo bajo las ramas de los árboles donde hembras solitarias de orangután se encontraban sentadas, a una altura de entre 5 y 20 metros.

Una vez que sabían que ellas les habían visto, el falso tigre rondaba el lugar un par de minutos antes de desaparecer de la vista. Lameira esperaba oír su señal de alarma en ese momento, pero no fue así. La primera orangután con la que probaron no hizo ni un ruido. “Dejó lo que estaba haciendo, cogió a su cría, defecó (una señal de estrés y miedo) y comenzó a trepar árbol arriba en silencio”.