Sigue Naukas Bilbao 2025

Un año más -y ya van quince- el mayor espectáculo de divulgación científica a nivel estatal, Naukas Bilbao, regresa con su fórmula única para acercar el conocimiento científico de manera sencilla y desenfadada. Organizado por la plataforma de divulgación científica Naukas en colaboración con la Cátedra de Cultura Científica de la EHU, el evento reunirá del 19 al 20 de septiembre a más de medio centenar de divulgadores del panorama científico local y estatal.

Durante dos días, el público podrá disfrutar de monólogos de 10 minutos, espectáculos y experimentos científicos. Esta edición especial aniversario promete grandes novedades. Entre ellas, destaca la incorporación al programa general de Naukas Pro, propuesta en la que científicos y miembros de centros de investigación comparten sus investigaciones y experiencias. Entre otras, la psiquiatra Eva Garnica (RSMB) explicará ante el público la relación entre la microbiota y la salud mental, y la matemática Judith Rivas (EHU) mostrará la fascinante conexión entre las danzas vascas y las matemáticas.

Junto a las nuevas incorporaciones, también participarán en el decimoquinto aniversario del evento rostros conocidos para el público de Naukas Bilbao como el biólogo Luisma García Escudero (Universidad de Sevilla), que pondrá el foco en las dobleces de los ojos de los insectos, o el físico Daniel Marín, que hablará sobre la conquista del espacio por parte de tecnoligarcas como Elon Musk y Jeff Bezos.

Además, el periodista Antonio Martínez Ron conversará con Eloísa del Pino, presidenta del Consejo Superior de Investigaciones Científicas (CSIC), desde el auditorio del Euskalduna Bilbao.

Lo ideal es que vivas la experiencia en persona, pero, si no puedes acudir, recurre al streaming a través de EiTB y en su canal de Youtube. Programa

VIERNES 19 DE SEPTIEMBRE – SESIÓN DE MAÑANA

10:00 a 10:10 – Daniel Torregrosa – Mr. Tompkins en el país de las magufadas cuánticas

10:10 a 10:20 – Eva Garnica – ¿Se puede trasplantar la enfermedad mental?

10:20 a 10:30 – Sara Barja – H2Ohhh: Las fascinantes propiedades del agua

10:30 a 10:40 – Miguel García – Perspectivas cartográficas: imposiciones narrativas

10:40 a 10:50 – Estibaliz Díaz – Las anguilas nacen donde les da la gana

10:50 a 11:00 – Luis María Escudero – Doblez

11:00 a 11:20 – Antonio Martínez Ron entrevista a Eloísa del Pino, presidenta del CSIC (20 minutos)

11:20 a 11:30 – Isabel Moreno – No eres yo, soy tú… o ¿cómo era?

11:30 a 11:40 – Judith Rivas – Pasos de baile a ritmo de matemáticas

11:40 a 12:00 – Descanso de 20 minutos

12:00 a 12:10 – Juan Antonio Cuesta – Matemáticas avanzadas para hacer buenas hamburguesas

12:10 a 12:20 – Álvaro Bayón – Bahía Botánica

12:20 a 12:30 – Laura Morán – Perfectamente imperfectas

12:30 a 12:40 – Marc Ruiz de Minteguía – Tengo miedo a dar una charla en Naukas

12:40 a 12:50 – Iván Rivera – La bomba lenta que arrasó América

12:50 a 13:00 – Carlos Lobato – Rock Stars

VIERNES 19 SEPTIEMBRE – SESIÓN DE TARDE

17:00 a 17:20 – Almudena M. Castro, Iñaki Úcar y Daahoud Abdul Salim Álvarez – Balas y baladas (20 minutos)

17:20 a 17:30 – Oskar González – La mano de Sofonisba

17:30 a 17:40 – Carmen Agustín Pavón – Neuronas viejóvenes

17:40 a 17:50 – Laura Gómez Zamanillo – Cuando las máquinas aprenden a ver bichos

17:50 a 18:00 – Conchi Lillo – Lo nunca visto

18:00 a 18:10 – Daniel Marín – Cómo los tecnoligarcas tomaron el cosmos

18:10 a 18:20 – Francis Villatoro – La teoría del invariante

18:20 a 18:30 – Lorena Pérez Hernández – El lenguaje es la mejor medicina. Sin efectos secundarios

18:30 a 18:40 – Joaquín Sevilla – Revisando la ciencia del botijo

18:40 a 19:00 – Descanso (20 minutos)

19:00 a 19:10 – Eparquio Delgado – Guía inútil para enfadarse como un argentino y llorar como un coreano

19:10 a 19:20 – Raquel Sastre – Ver… Comprobar para creer

19:20 a 19:30 – Javier Armentia – Eclipses, ocultaciones y apagones

19:30 a 19:40 – Ricardo Moure – Hasta el ñoco de El Rey León

19:40 a 19:50 – Pedro A. León – Las cacas de la Luna

19:50 a 20:00 – Javier Pedreira (Wicho) – El culebrón de decidir cuál fue el primer ordenador

SÁBADO 20 DE SEPTIEMBRE – SESIÓN DE MAÑANA

10:00 a 10:10 – Javier Panadero – Con estas manitas y algo más

10:10 a 10:20 – Virginia Arechavala Gomeza – No es una cura. Es un experimento

10:20 a 10:30 – Nahúm Méndez Chazarra – ¿Puede la geología dar respuesta a la paradoja de Fermi?

10:30 a 10:40 – Gemma Marfany – El misterio de la momia maldita

10:40 a 10:50 – Ujué Agudo – Los efectos «colaterales» de la toma de decisiones con IA

10:50 a 11:00 – Clara Peñalver – T-Di. Mi muy querido y temido cerebro

11:00 a 11:10 – Imanol Ituiño (Festival JA!) – ¡Rayos! Houdini y Nueva York, mano a mano

11:10 a 11:20 – Teresa Valdés Solís – Las 4 Rs

11:20 a 11:30 – Fernando Frías – La sábana doblada

11:30 a 11:40 – Elixabete Rezabal – ¿Hueles vibraciones?

11:40 a 12:00 – Descanso de 20 minutos

12:00 a 12:10 – Natalia Ruiz Zelmanovitch y Manuel González – El cielo no cayó sobre nuestras cabezas, una no-tragedia en cuatro actos. Acto 1

12:10 a 12:20 – Alberto García Salido – El día que fuimos Brad Pitt

12:20 a 12:30 – Iñigo Careaga – Cocinando baterías: recetas de ayer y de hoy (y de mañana)

12:30 a 12:40 – Antonio Martínez Ron – Curso rápido de perspectiva

12:40 a 12:50 – Carlos Briones – Sumando y restando

12:50 a 13:00 – Natalia Ruiz Zelmanovitch y Manuel González – El cielo no cayó sobre nuestras cabezas, una no-tragedia en cuatro actos. Acto 2

SÁBADO 20 SEPTIEMBRE – SESIÓN DE TARDE

17:00 a 17:10 – Natalia Ruiz Zelmanovitch y Manuel González – El cielo no cayó sobre nuestras cabezas, una no-tragedia en cuatro actos. Acto 3

17:10 a 17:20 – Gemma del Caño – Misterio en Riverside, cuando la química rozó la ciencia ficción

17:20 a 17:30 – Ana Tamayo – Al manicomio por lavarse las manos

17:30 a 17:40 – Elena Casado – Del castigo bíblico al pinchazo moderno

17:40 a 17:50 – Anabel Forte – To Bayes or not to Bayes

17:50 a 18:00 – Lluis Montoliu – ¿Para qué quieren desextinguir el mamut?

18:00 a 18:10 – Manuel Vicente – El telescopio de los nobeles

18:10 a 18:20 – Sergio Pérez Acebrón – Emergencia celular

18:20 a 18:40 – Miguel Santander y Pablo Rodríguez – Perversión por pares

18:40 a 19:00 Descanso (20 minutos)

19:00 a 19:10 – Natalia Ruiz Zelmanovitch y Manuel González – El cielo no cayó sobre nuestras cabezas, una no-tragedia en cuatro actos. Acto 4

19:10 a 19:20 – Helena Matute – Experimentos con humanos e IAs: 2ª temporada

19:20 a 19:30 – Eva Caballero – Kit de primeros auxilios para conversaciones incómodas

19:30 a 19:40 – Javier S. Burgos – Caballeros, esto no es una farsa

19:40 a 19:50 – Miguel Ángel Cajigal (El Barroquista) – Cuando Bernini casi destruye el Vaticano

19:50 a 20:00 – ENTREGA PREMIO TESLA 2025 + Despedida y cierre

Esta actividad forma parte de Bilbo Zientzia Plaza 2025, una iniciativa de divulgación científica organizada por la Cátedra de Cultura Científica de la EHU, con el patrocinio del Ayuntamiento de Bilbao y Euskampus Fundazioa, y la colaboración del Departamento de Ciencia, Universidades e Innovación del Gobierno Vasco, Donostia International Physics Center (DIPC), Metro Bilbao y EiTB.

El artículo Sigue Naukas Bilbao 2025 se ha escrito en Cuaderno de Cultura Científica.

Viendo a los electrones moldear las reacciones químicas

Imagina capturar en una fotografía un momento efímero: el movimiento de un electrón durante una reacción química. Desde los albores de la química moderna, la idea de «ver» cómo se desplazan estas partículas subatómicas parecía un sueño imposible, o en todo caso, el capricho de un novelista de ciencia ficción poco riguroso. Sin embargo, un equipo dirigido por Ian Gabalski, de la Universidad de Stanford, ha logrado un avance decisivo para convertirlo en realidad. Su estudio demuestra por primera vez que es posible observar directamente la dinámica de los electrones de valencia —aquellos que participan activamente en las reacciones químicas— en tiempo real.

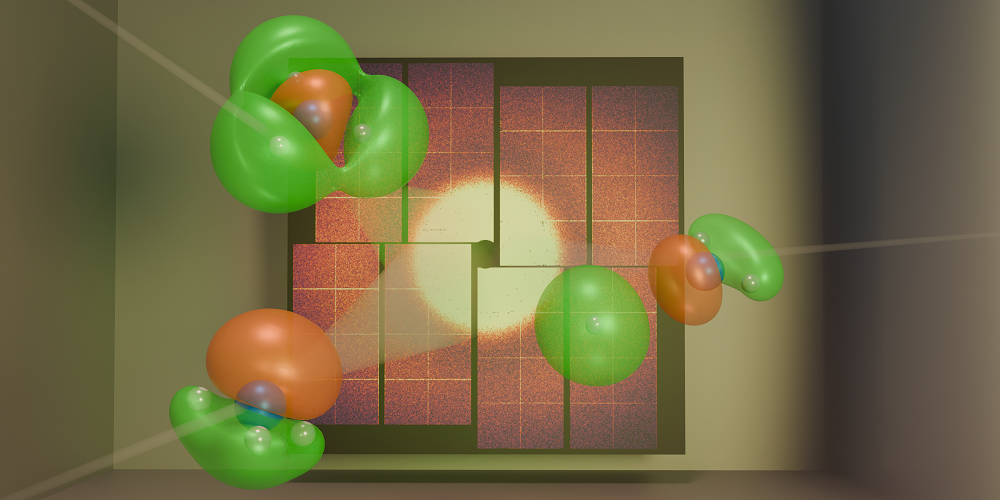

Fuente: I. Gabalski / Stanford University / SLAC National Accelerator Laboratory¿Por qué es tan complicado observar los electrones de valencia?

Fuente: I. Gabalski / Stanford University / SLAC National Accelerator Laboratory¿Por qué es tan complicado observar los electrones de valencia?

Las reacciones químicas se inician cuando los electrones más externos de los átomos, conocidos como electrones de valencia, se reorganizan: rompen enlaces existentes y forman nuevos. Estos electrones determinan cómo comienza una reacción y qué productos finales se obtienen. El desafío radica en que, en experimentos con rayos X, los electrones internos —los más cercanos al núcleo atómico y no involucrados en las reacciones— dominan la señal detectada, eclipsando las sutiles variaciones producidas por los electrones de valencia.

¿Cómo lo han logrado?El secreto reside en el uso de pulsos de rayos X ultracortos, cada uno de aproximadamente 30 femtosegundos (30 × 10⁻¹⁵ segundos), generados por el Linac Coherent Light Source (LCLS) en el Laboratorio Nacional de Aceleradores SLAC, en California.

El experimento comienza con un pulso de luz ultravioleta que excita una molécula de amoníaco (NH₃)*, alterando su geometría: de una estructura piramidal pasa a una planar. Esta transformación facilita que uno de los tres átomos de hidrógeno se desprenda, llevándose consigo un electrón de valencia que formaba parte del enlace. Dado que el hidrógeno no posee electrones internos (su único electrón es de valencia), este proceso deja expuesta la dinámica de los electrones de valencia sin la interferencia de señales de electrones centrales.

Inmediatamente después, el pulso de rayos X incide sobre la molécula. Los fotones de rayos X se dispersan en ángulos que dependen de la distribución espacial de los electrones (la densidad electrónica). Al capturar estos fotones dispersados en un detector bidimensional, los investigadores reconstruyen una «instantánea» de la densidad electrónica en ese momento preciso.

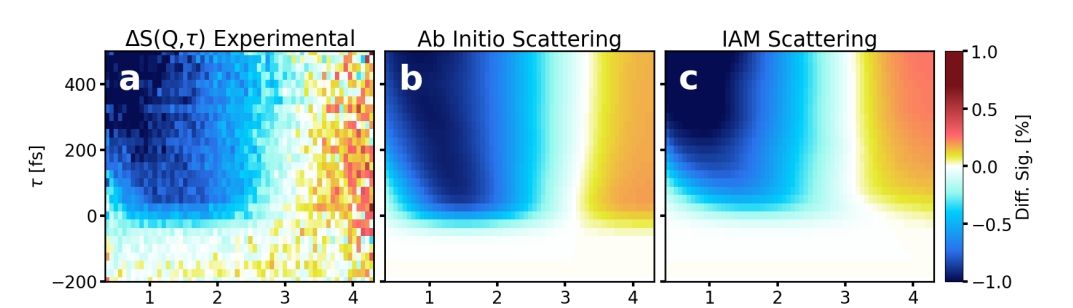

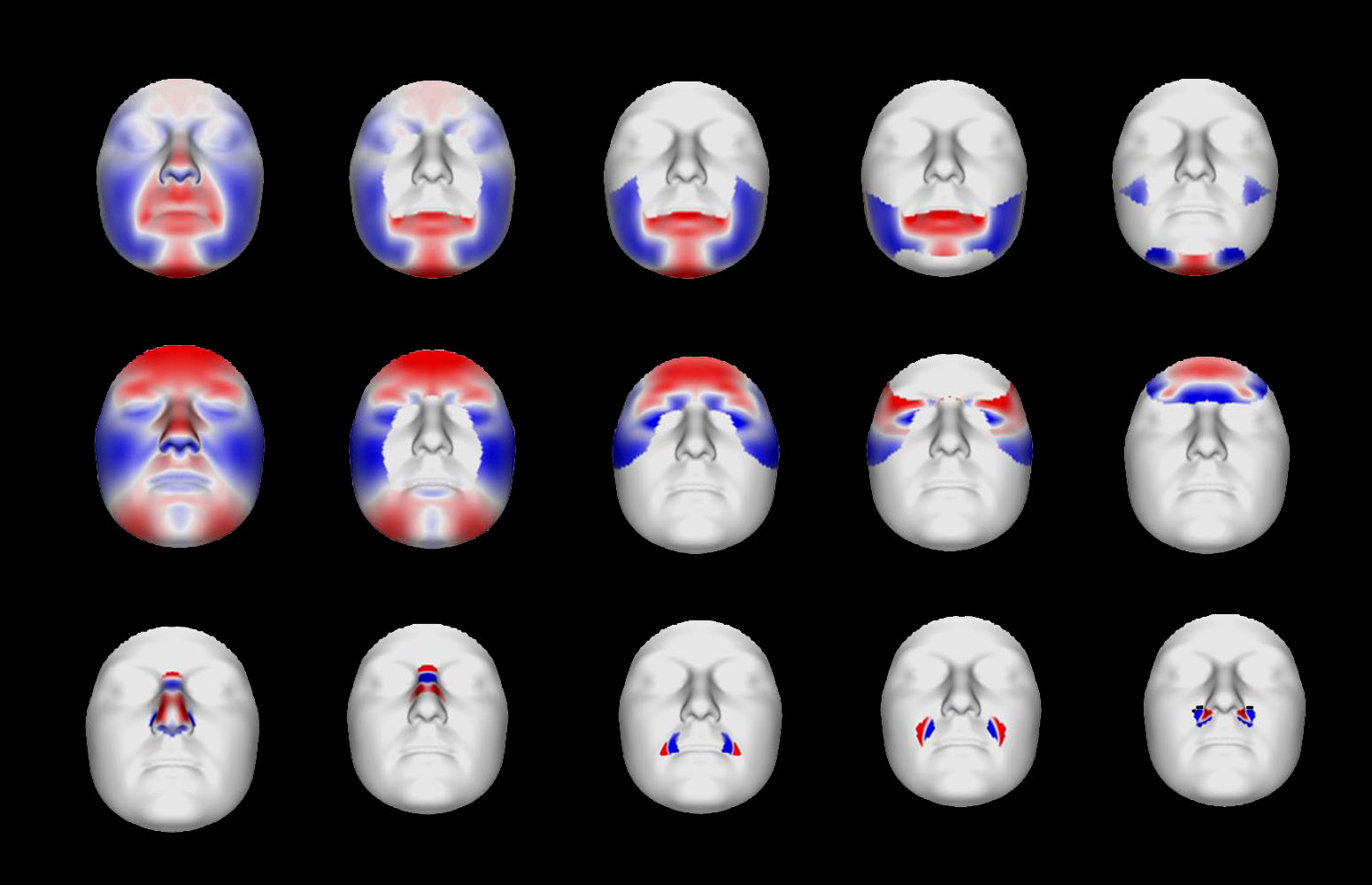

Dos caminos distintosGracias a esta técnica, el equipo identificó dos vías diferentes por las que el átomo de hidrógeno puede separarse de la molécula. En cada vía, la densidad de los electrones de valencia —es decir, la «forma» probabilística de su distribución en el espacio— era única. Estas diferencias se mantuvieron durante más de 200 femtosegundos. Al comparar los resultados experimentales con simulaciones cuánticas detalladas, los científicos confirmaron que estaban capturando con precisión la evolución de los electrones de valencia a lo largo de la reacción.

Resultado experimental (a) y los de las dos simulaciones realizadas (b,c). Fuente: Ian Gabalski et al (2025) Phys. Rev. Lett. doi: 10.1103/53h3-vyklComparación con otras técnicas

Resultado experimental (a) y los de las dos simulaciones realizadas (b,c). Fuente: Ian Gabalski et al (2025) Phys. Rev. Lett. doi: 10.1103/53h3-vyklComparación con otras técnicas

Una alternativa para generar «películas moleculares» es la difracción electrónica ultrarrápida, que emplea electrones de alta energía en lugar de rayos X como sonda. Este método permite visualizar estructuras atómicas en movimiento, pero su resolución temporal es inferior: típicamente superior a 50 femtosegundos. En contraste, la dispersión de rayos X ultrarrápida ofrece una vista más nítida y veloz de la dinámica electrónica, acercándose incluso a resoluciones por debajo de 10 femtosegundos.

¿Qué implicaciones tiene este avance?Este logro permite visualizar directamente cómo la dinámica de los electrones de valencia influye en el desarrollo de una reacción química. Hasta ahora, solo podíamos inferir estos movimientos mediante modelos teóricos —como una película imaginaria en nuestra mente—, pero ahora estamos empezando a obtener imágenes reales que la materializan.

Mediante esta combinación innovadora de pulsos láser ópticos y rayos X ultrarrápidos, estamos penetrando en el mundo microscópico para observar cómo los electrones actúan en tiempo real durante una reacción. Es como fotografiar el delicado ritmo de un enlace químico en transformación: lo que antes era invisible, ahora emerge y se deja capturar. Estos conocimientos podrían revolucionar el diseño de procesos industriales más eficientes y sostenibles, medicamentos más precisos o materiales con propiedades inéditas.

Los retos futurosEl próximo objetivo es alcanzar resoluciones temporales en la escala de attosegundos (10⁻¹⁸ segundos) para estudiar fenómenos aún más fugaces, como la migración de cargas o el movimiento correlacionado de electrones. Esto parece factible gracias al desarrollo de fuentes de rayos X de attosegundos en instalaciones como el LCLS-II en Estados Unidos o el European X-Ray Free-Electron Laser en Alemania. Otro desafío es extender estas técnicas a moléculas más complejas, donde los electrones internos podrían seguir ocultando señales, posiblemente mediante detectores que discriminen energías para aislar las contribuciones de los electrones de valencia.

(*) Nota: Siendo estrictos, amoniaco deuterado, esto es, amoniaco en el que los tres hidrógenos son deuterios.

Referencia:

Ian Gabalski et al (2025) Imaging Valence Electron Rearrangement in a Chemical Reaction Using Hard X-Ray Scattering Phys. Rev. Lett. doi: 10.1103/53h3-vykl

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Viendo a los electrones moldear las reacciones químicas se ha escrito en Cuaderno de Cultura Científica.

El metamorfismo como fuente de habitabilidad

La llegada de la sonda Dawn a Ceres en el año 2015 demostró que el cinturón de asteroides era un lugar mucho más diverso e interesante de lo que podríamos haber soñado. Ya en ese momento, Ceres había dejado de ser un asteroide cualquiera: en 2006 pasó a ser un “planeta enano” según la nueva nomenclatura de la IAU ya que no cumplía uno de los tres requisitos para ser planeta, el de haber limpiado su vecindario orbital.

Pero bajo -y bueno, sobre- su superficie escondía muchos más secretos. Cuando buscamos vida más allá de la Tierra, una parte de esta búsqueda se centra en lo que llamamos mundos “océano” u “oceánicos”, cuerpos que albergan o albergaron océanos de agua líquida bajo su superficie en algún momento de su existencia.

En nuestro sistema solar existen satélites como Europa o Encélado que son magníficos ejemplos de este tipo de cuerpos en los que, si bien es cierto que no hemos podido acceder a sus aguas -ya no es solo una cuestión de distancia a ello, sino de dificultad tecnológica- sabemos que albergan océanos por las distintas pruebas que estos dejan, entre otros lugares, en su superficie, pero también por pruebas indirectas como los datos gravimétricos o magnéticos.

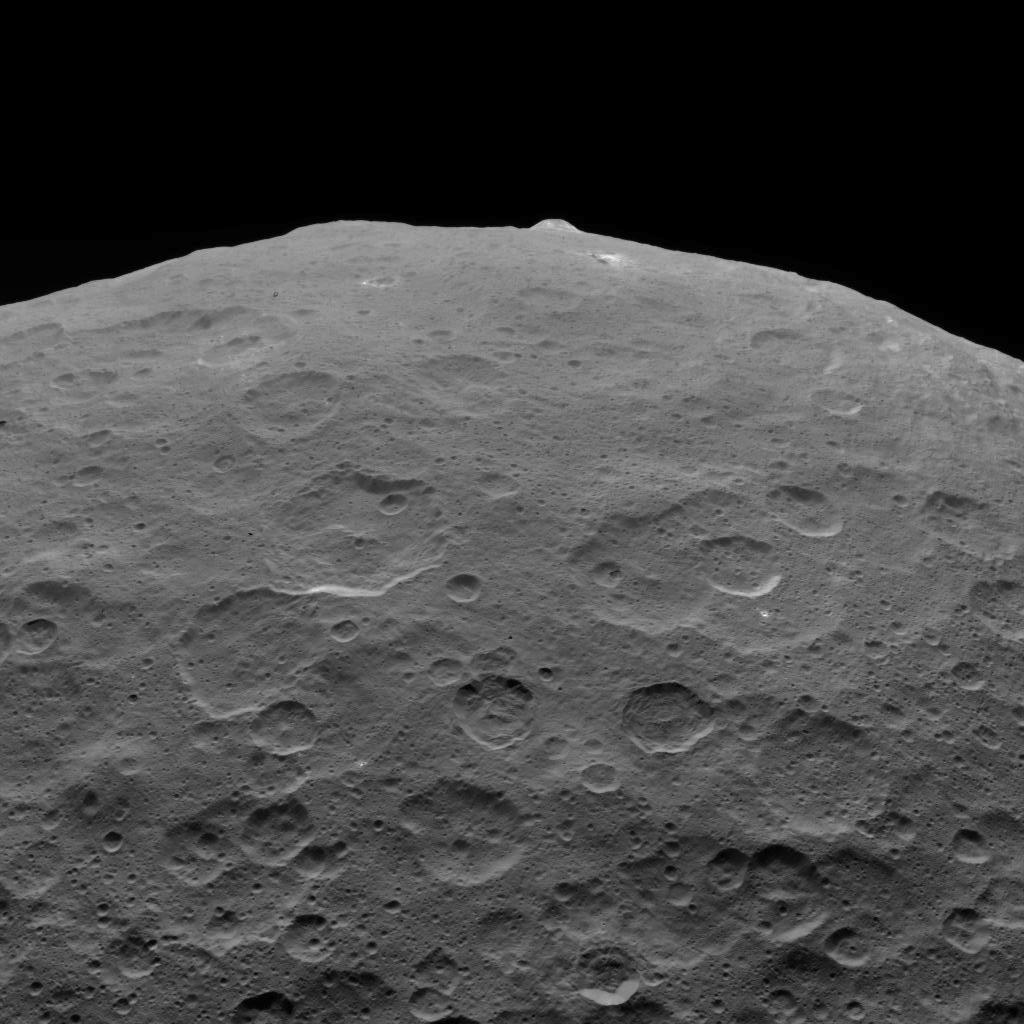

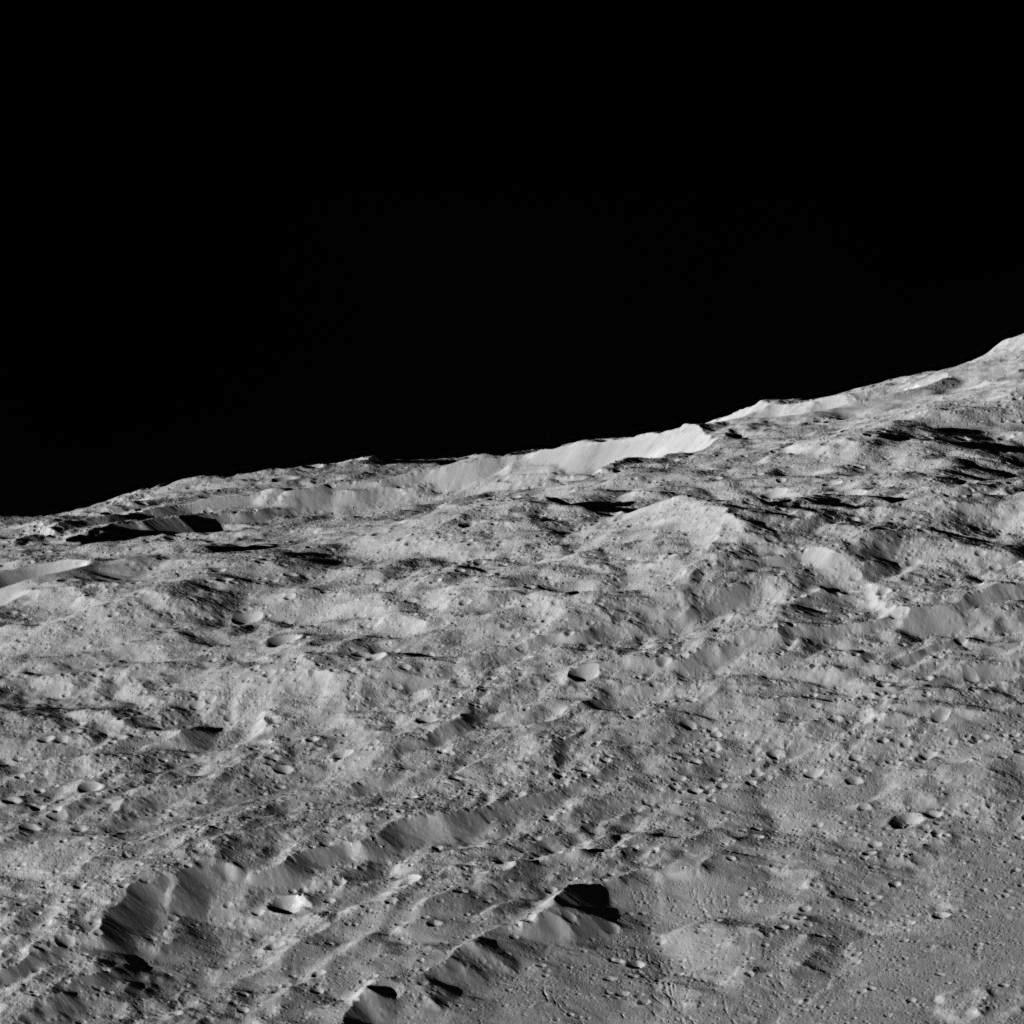

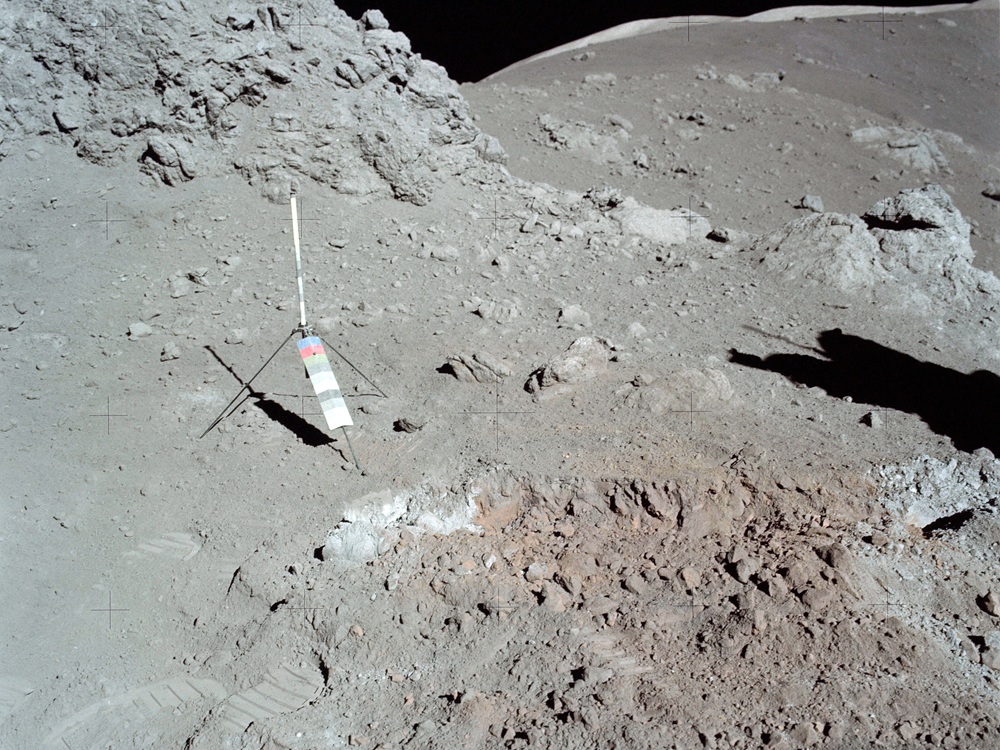

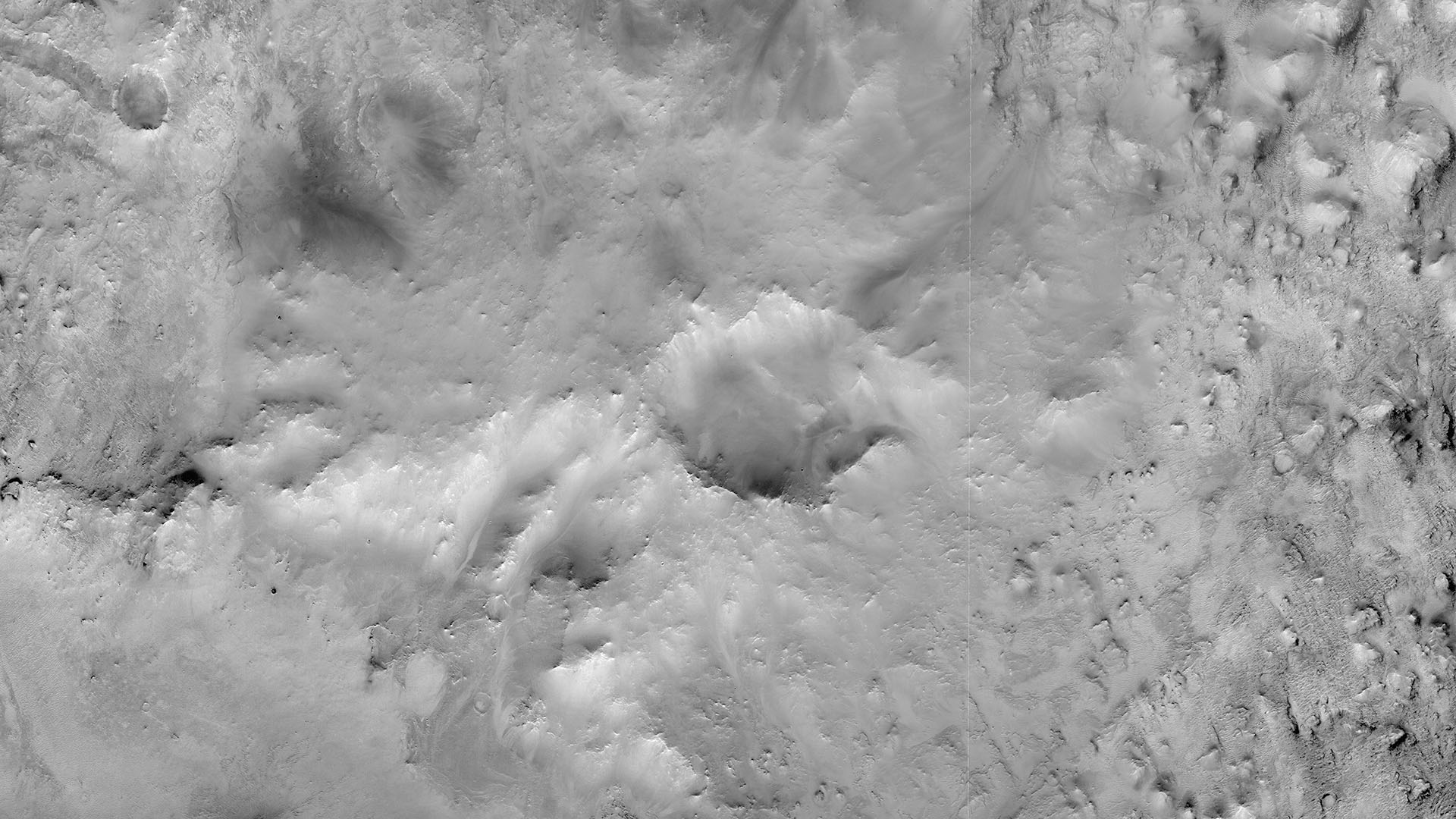

Ceres tal y como lo veríamos con nuestros ojos. En esta imagen tomada por la sonda Dawn, desde fuera, parece un cuerpo aburrido, cubierto de cráteres. Pero son solo las apariencias, y esconde una historia fascinante. Fuente: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.

Ceres tal y como lo veríamos con nuestros ojos. En esta imagen tomada por la sonda Dawn, desde fuera, parece un cuerpo aburrido, cubierto de cráteres. Pero son solo las apariencias, y esconde una historia fascinante. Fuente: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.Es cierto que es muy difícil que, a día de hoy, Ceres todavía tenga un importante océano de agua líquida bajo su superficie. Pero sí podría ser un buen ejemplo de una clase de objetos existentes en nuestro Sistema Solar que sean el reflejo de mundos que pudieron ser habitables, ya no por la propia energía del Sol o por la que generan las mareas, sino por el calor que podría haber ido liberando poco a poco su núcleo rocoso, pero no de la manera que esperaríamos en lugares como nuestro planeta. Más tarde entraremos en eso.

Ya sabemos que Ceres fue probablemente un mundo océano en parte gracias a distintos detalles que se han ido descubriendo en las últimas décadas: una baja densidad que hace ver que no es un cuerpo puramente rocoso, una mineralogía de su superficie rica en carbonatos y arcillas, evidencias de criovulcanismo…

Y es que, si realmente fue un mundo océano, también es de lógica pensar que contenía una gran parte de los ingredientes necesarios para la formación de la vida. Pero, sin embargo, quedaba por solucionar un problema: ¿de dónde saldría la energía para que esa vida pudiese florecer?

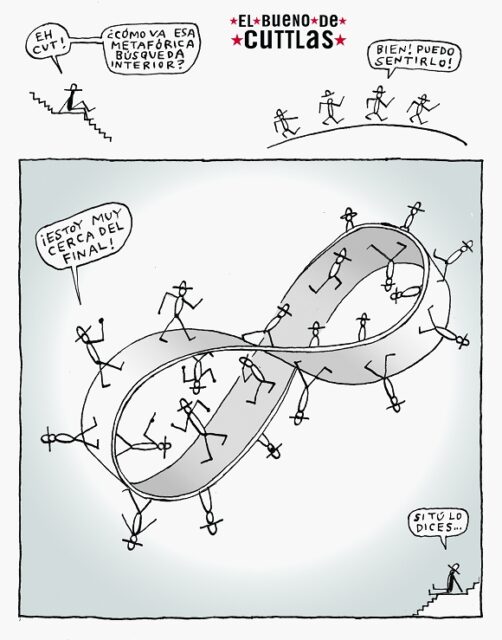

Me explico: para que la vida pueda surgir y mantenerse en un océano oscuro al que no llega la luz del Sol -imaginemos que sobre este océano habría una capa de hielo de varios kilómetros que actuaría como una capa totalmente opaca- se necesita una fuente de energía química que sea duradera en el tiempo. Y es aquí donde un nuevo estudio publicado por Courville et al. (2025) parece haber encontrado una respuesta que permitiría a Ceres mantener un ambiente habitable durante más de mil millones de años… el metamorfismo.

Para quienes no sean familiares con el término, el metamorfismo es un proceso geológico -o más bien una serie de procesos- por el cual las rocas sufren una transformación a nivel mineral, de textura y de la propia estructura de la roca cuando sufren un aumento en las condiciones de presión, temperatura y por la presencia de fluidos capaces de reaccionar con la propia roca. Esta alteración ocurre con la roca en estado sólido, al menos en su mayor parte, sin fundirse. En esta nueva situación los minerales se ven obligados a adquirir estructuras más estables bajo las nuevas condiciones, dando como resultado una nueva roca.

Volviendo al estudio, los autores detallan un nuevo modelo de evolución térmica y química de Ceres desde su nacimiento hasta hoy, presentándolo como un cuerpo formado por un 90% de roca y un 10% de hielo de agua, una composición similar a las condritas de tipo CI, unos meteoritos primitivos -y raros, en el sentido de poco abundantes- pero que han sufrido la alteración por el agua cuando formaban parte de un cuerpo más grande.

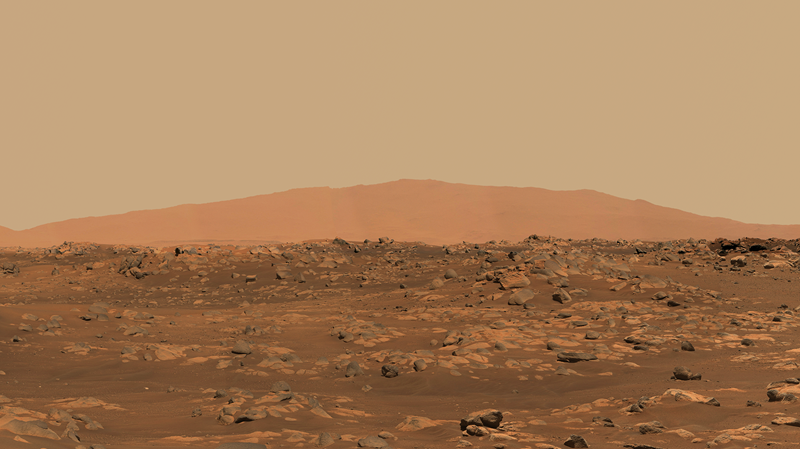

En esta imagen en la que podemos apreciar el horizonte de Ceres. Si se fijan bien, verán una especie de “verruga” cerca de la zona central del horizonte… es Ahuna Mons, uno de los relieves que hay en el planeta enano y que podrían estar relacionados directamente con fenómenos criovolcánicos. Fuente: ASA/JPL-Caltech/UCLA/MPS/DLR/IDA.

En esta imagen en la que podemos apreciar el horizonte de Ceres. Si se fijan bien, verán una especie de “verruga” cerca de la zona central del horizonte… es Ahuna Mons, uno de los relieves que hay en el planeta enano y que podrían estar relacionados directamente con fenómenos criovolcánicos. Fuente: ASA/JPL-Caltech/UCLA/MPS/DLR/IDA.Durante los primeros momentos de su existencia, el principal motor del cambio en el planeta enano fueron los isótopos radioactivos de vida corta, especialmente el aluminio-26. Este potente, pero efímero, isótopo servía como una fuente de calor extraordinaria para fundir el hielo acumulado en los primeros millones de años de su historia, provocando uno de los eventos geológicos más importantes de su infancia: la diferenciación. En este proceso, los materiales más densos y rocosos se hundieron por efecto de su propia densidad hacia el núcleo de Ceres, mientras que el agua líquida subió para formar un gran océano oculto bajo una capa de hielo que comenzaría a crecer.

Este océano “primordial” probablemente era más cálido y alcalino que el que podría existir hoy día. Y, a pesar de que podría satisfacer las necesidades básicas para la aparición de la vida, en este estudio se sugiere que el periodo más prometedor para que fuese habitable vendría mucho después. Cuando los isótopos de corta vida acabasen su trabajo, el núcleo continuaría calentándose por la desintegración de otros isótopos como los del potasio, uranio y torio. A lo largo de cientos de millones de años, este lento proceso de calentamiento aumentaría la temperatura del núcleo hasta un umbral crítico, llegando a aproximadamente unos 280ºC, cuando comenzaría una nueva y profunda transformación.

En ese momento comenzarían a producirse procesos metamórficos en el núcleo. Los silicatos hidratados que componían el núcleo y que se habían formado por la interacción entre el agua y la roca, se volvieron inestables por el aumento de la temperatura y la presión. Entonces, comenzaron a deshidratarse, liberando las moléculas de agua que estaban atrapadas en el interior de su estructura cristalina.

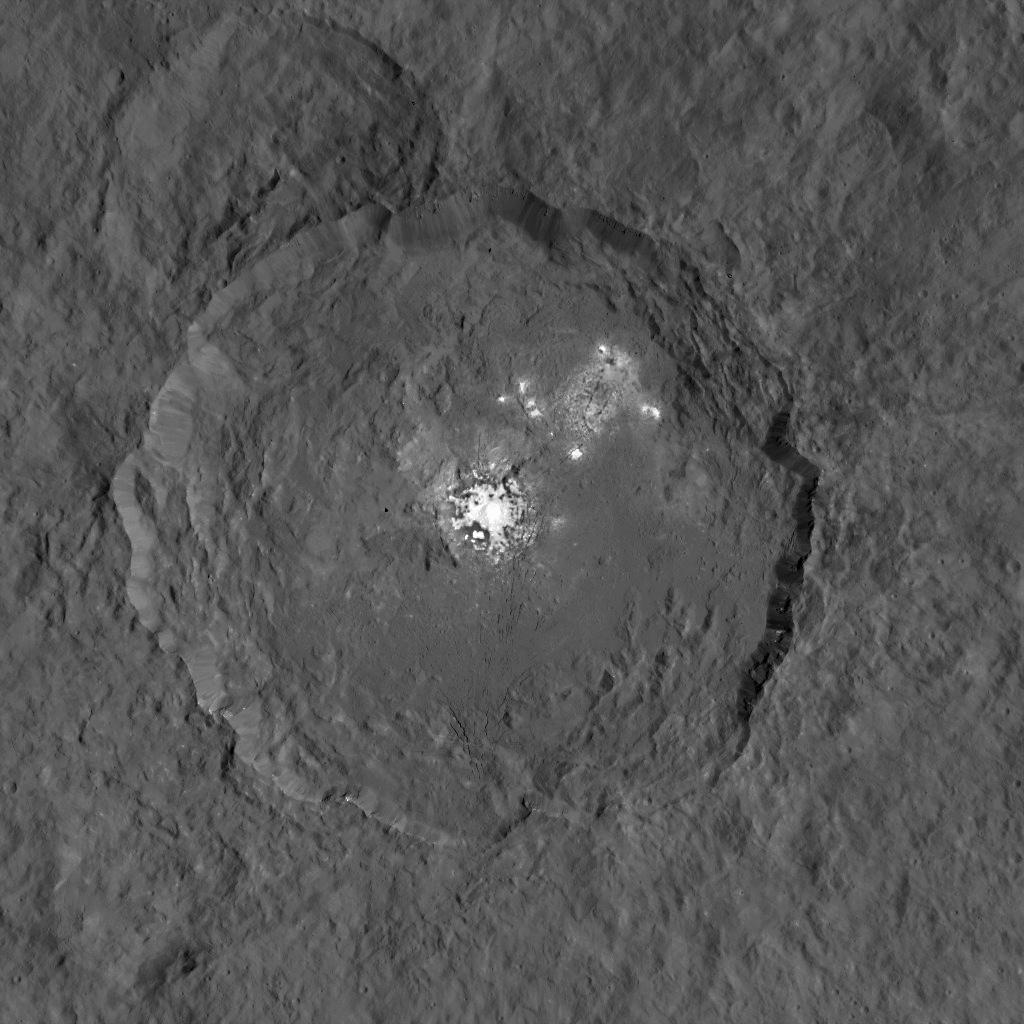

Imagen del cráter Occator de Ceres donde se aprecian unas manchas de un color blanco muy llamativo. En estas se ha encontrado carbonato de sodio, arcillas y sulfato de magnesio y, probablemente, se formaron a causa de la actividad hidrotermal que llegaba hasta la superficie a través de sistemas de fracturas. Fuente: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.

Imagen del cráter Occator de Ceres donde se aprecian unas manchas de un color blanco muy llamativo. En estas se ha encontrado carbonato de sodio, arcillas y sulfato de magnesio y, probablemente, se formaron a causa de la actividad hidrotermal que llegaba hasta la superficie a través de sistemas de fracturas. Fuente: NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.No se trataba simplemente de “echar” el agua de los minerales, sino de la generación de fluidos hidrotermales. Estos fluidos eran diferentes a nivel químico si los comparamos con el agua del océano que había por encima: estaba sobrecargado de compuestos disueltos, favoreciendo un desequilibrio químico que la vida podría aprovechar.

Precisamente, el modelo que presentan en este artículo se centra en una de las rutas metabólicas más antiguas y básicas que se conocen en nuestro planeta: la metanogénesis. Los fluidos que se liberaban fruto del metamorfismo eran probablemente ricos en hidrógeno disuelto y dióxido de carbono. A medida que estos migraban hacia arriba a través de poros y fisuras hacia el fondo del océano -mucho más frío- el desequilibrio químico también se iba desplazando. Para visualizar este ambiente, tenemos que imaginar algo similar a las chimeneas hidrotermales que existen en el fondo de nuestros océanos.

La reacción que permite formar el metano se volvió energéticamente favorable, ofreciendo una fuente de alimento “gratuita” para cualquier organismo quimiótrofo que pudiese existir y pudiese catalizar estas moléculas. El factor limitante de esta ruta metabólica era la abundancia de hidrógeno, lo que transformaba al suministro de estos fluidos metamórficos en un control fundamental de la habitabilidad dentro del océano.

La ventana de habitabilidad no fue algo fugaz ni efímero. El modelo también indica que el periodo en el que ocurría el metamorfismo en el núcleo y, por lo tanto, la liberación de los fluidos hacia el océano habría durado entre 500 y 2000 millones de años tras la formación de Ceres.

Los autores calculan que la tasa de liberación de fluidos por deshidratación sería de más de 300 kilogramos por segundo y, suponiendo unos requisitos energéticos similares a los de los microbios anaerobios de nuestro planeta, podría haber sostenido una biomasa total de unas 10^17 células. Es decir, que si se distribuyera por todo el océano, habría unas 1000 células por kilo de agua.

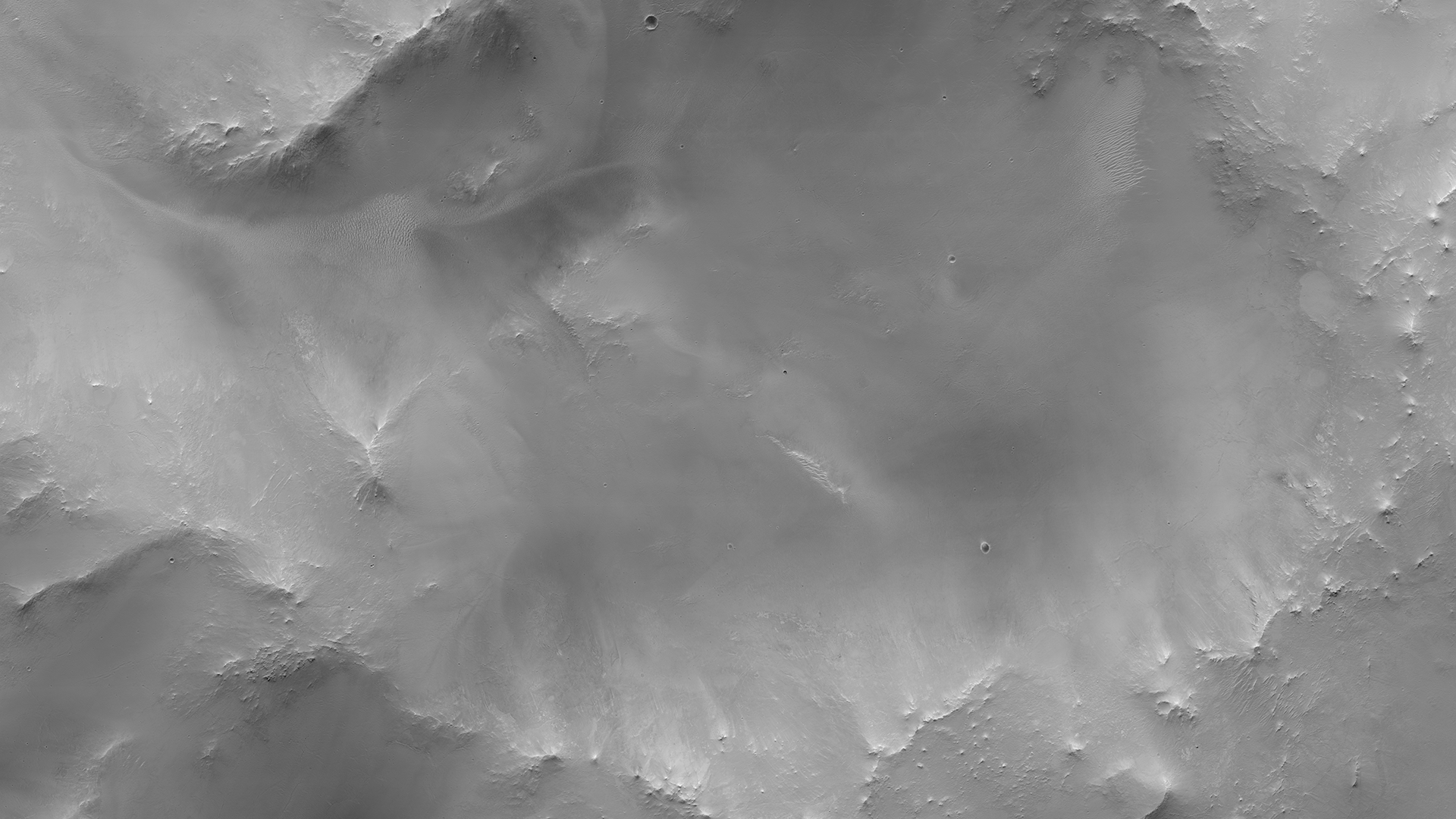

Las apariencias engañan. Bajo un aspecto casi lunar y quizás anodino, Ceres esconde una historia realmente fascinante. Fuente: de NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.

Las apariencias engañan. Bajo un aspecto casi lunar y quizás anodino, Ceres esconde una historia realmente fascinante. Fuente: de NASA/JPL-Caltech/UCLA/MPS/DLR/IDA.Aunque nos pueda parecer una densidad muy poca si la comparamos con las comunidades microbianas de la Tierra -que pueden alcanzar cifras de mil millones de células por kilo- no es para nada insignificante y nos sugiere que podría haber sido posible, con estas condiciones, una biosfera a escala planetaria.

Sin embargo, este escenario está basado en un equilibrio muy complicado: la migración de fluidos ascendente es fundamental para suministrar energía, pero una fuerte circulación hidrotermal también habría sido perjudicial, ya que un sistema muy activo habría transportado el calor fuera del núcleo muy rápido, enfriándolo de una manera prematura y apagando este motor metamórfico.

Pero, eventualmente, este motor interno tuvo que detenerse. A medida que los radioisótopos iban desintegrándose y disminuyendo la producción de calor, el núcleo de Ceres comenzó a enfriarse. El metamorfismo se detuvo y se interrumpió el suministro de energía química necesaria para la vida. Desde la superficie el océano siguió congelándose, sus aguas se enfriaron progresivamente y se concentraron más en sales con poder anticongelante como el amoniaco, y transformándose en una salmuera que quizás sea inhóspita para la vida.

A mi juicio, si me lo permiten, las implicaciones de este estudio van mucho más allá de Ceres. El modelo presentado podría servir para otros cuerpos helados de tamaño medio en el Sistema Solar, como algunos satélites de los planetas exteriores y quizás otros planetas enanos -para aquellos descubiertos y otros no-. Los objetos de un diámetro entre 500 y 1000 km podrían haber sufrido procesos similares y el metamorfismo del núcleo podría ser una etapa común en el desarrollo de estos cuerpos y quizás también de las condiciones habitables.

Y, de nuevo, observamos como las condiciones de habitabilidad no son una constante, sino algo que puede ir cambiando a lo largo de la historia de los sistemas planetarios y que, incluso temporalmente, las ventanas de habitabilidad no tienen por que coincidir… ¿qué nuevas sorpresas nos traerán esos cuerpos de nuestro Sistema Solar que todavía solo son un punto de luz en nuestros telescopios?

Referencias:

Courville, S. W., Castillo-Rogez, J. C., Daswani, M. M., Robare, J., & O’Rourke, J. G. (2025). Core metamorphism controls the dynamic habitability of mid-sized ocean worlds—The case of Ceres Science Advances doi: 10.1126/sciadv.adt3283

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo El metamorfismo como fuente de habitabilidad se ha escrito en Cuaderno de Cultura Científica.

Desinformación sobre salud mental en TikTok: qué sabemos y qué funciona para corregirla

TikTok concentra una parte relevante de la conversación sobre salud mental. La evidencia muestra dos cosas: (a) abundan contenidos inexactos; (b) intervenciones simples orientadas a influencers pueden aumentar el contenido basado en evidencia.

Imagen: David Farfan / Pixabay

Imagen: David Farfan / PixabaySe estima que TikTok tiene 1.590 Millones de usuarios activos [1]. El 65.5% de los usuarios buscan en TikTok consejos de salud [2]. Cuando se trata de buscar tratamiento para una enfermedad, uno de cada cinco prefiere abrir la app, antes que acudir al médico [3]. El resultado: un torrente de información que se siente cercana, humana, incluso urgente… pero que en más de la mitad de los casos es imprecisa. [4]

Lo que dice la evidenciaThe Guardian buscó los 100 vídeos más populares publicados bajo el hashtag #mentalhealthtips en TikTok y los compartió con psicólogos, psiquiatras y expertos académicos, quienes evaluaron si los contenidos contenían desinformación.

Los expertos determinaron que 52 de los 100 vídeos que ofrecían consejos para afrontar el trauma, la neurodivergencia, la ansiedad, la depresión y las enfermedades mentales graves contenían algún tipo de desinformación, y que muchos otros eran vagos o poco útiles.

En ciertos temas, la precisión es una rareza. En los vídeos sobre autismo, por ejemplo, solo el 27% se ajusta al consenso científico. [5]

Por qué ocurre estoEl problema es que, en TikTok, la verdad compite en desventaja. El algoritmo no discrimina entre la evidencia y el mito; solo mide el tiempo que pasas mirando.

Existe un desajuste de incentivos: los algoritmos de recomendación optimizan señales de rendimiento inmediato porque son medibles y predicen retención.

En la economía de la atención, los mensajes breves, simples y de alta activación emocional suelen obtener mejores métricas que las explicaciones matizadas. El resultado no implica mala fe: el sistema amplifica lo que retiene, no necesariamente lo que es cierto.

Consecuencias de consumir información errónea sobre salud mentalResumiendo la desinformación te hace menos capaz de regularte, más vulnerable al error y más dependiente de atajos que no funcionan, veamos por qué.

Imagina una joven llamada Laura.

Laura empezó a sentir una presión constante en el pecho. No era insoportable, así que se dijo a sí misma que “no era para tanto”. Semanas después, navegando por TikTok, encontró un vídeo que hablaba de “ataques de ansiedad” y decidió que eso era lo que tenía. Se tranquilizó: ya sabía el nombre. Lo que no sabía era que esa certeza retrasaría meses el diagnóstico correcto: angina de pecho.

Ahora imagina a un joven llamado Pablo

Pablo vio un anuncio que aseguraba que su falta de motivación se debía a que tenía TDAH. Lo que comenzó como una hipótesis se convierte en identidad: “tengo TDAH”. Esa frase le ayudó a sentirse mejor porque ya “sabía lo que tenía” pero le dejó sin poder hacer nada para mejorar.

Estas historias son ficticias, pero en terapia veo todas las semanas jóvenes que traen consigo un guion aprendido en las redes: la promesa de una cura rápida. Cuando la realidad no sigue el ritmo de las historias virales, la frustración crece y la salida fácil es abandonar el tratamiento porque “no funciona”.

En este ciclo, los consejos de “cortar por lo sano” o evitar el malestar se convierten en atajos que parecen proteger, pero en realidad desgastan nuestra capacidad para regularnos.

Herramientas prácticas para identificar y evitar la desinformaciónLa buena noticia: hay maneras concretas de romperlo. No requieren un máster en psicología ni conocimientos técnicos; solo práctica deliberada.

Sospecha de lo que te atrape demasiado rápido: Si un vídeo te provoca una reacción intensa (miedo, esperanza, indignación), pausa antes de creerlo. Los títulos sensacionalistas y las promesas de soluciones milagrosas son red flags clásicas

Pregúntate quién está hablando y por qué: ¿El creador es un profesional acreditado? ¿O alguien que relata su experiencia personal como si fuera una verdad universal? Verifica su historial y su formación

Contrasta con fuentes externas: Antes de compartir o aplicar un consejo, búscalo en webs de organizaciones reconocidas en salud mental. Si no aparece, o la versión que encuentras es distinta, probablemente no sea fiable

Evita autoevaluaciones rápidas: Que un vídeo describa algo que te ha pasado no significa que tengas un trastorno.

ConclusiónCuando yo tenía 16 años no existía TikTok, pero las historias impactantes se extendían con la misma viralidad de ahora, aunque no fuesen verdad. Todos oímos el rumor de que las gominolas están hechas de petróleo o la anécdota de Ricky Martin, Sorpresa Sorpresa, el armario y la mermelada.

El problema es que ahora es nuestra salud la que está en juego.

Pero no todo es malo, el mismo megáfono que se utiliza para enviar información engañosa puede utilizarse para propagar información basada en evidencia.

En marzo de 2023, un grupo de investigadores de Harvard envió a 105 creadores de TikTok un archivo PDF [6]. No era un contrato, ni un guion para un anuncio. Eran consejos prácticos para hablar de salud mental… pero con respaldo científico. No había promesas de dinero ni contratos publicitarios. Solo instrucciones claras y, sobre todo, verificadas.

Lo curioso es que funcionó. Los creadores que recibieron ese material empezaron a producir más vídeos con contenido basado en evidencia, y sus publicaciones atrajeron millones de visualizaciones adicionales.

La lección es doble. Como usuarios tenemos que asumir nuestra responsabilidad en el consumo de desinformación, al mismo tiempo debemos recordar a los influencers que tienen que pagar un precio por su alcance masivo, ese precio la responsabilidad de divulgar con sentido.

Esto, en el terreno de la salud mental, puede significar la diferencia entre un mito viral… y un consejo que salve vidas.

Referencias

[1] Singh, S. (2025, 31 de julio). How Many People Use TikTok (Users Statistics 2025). DemandSage. Recuperado el 25 de agosto de 2025, de https://www.demandsage.com/tiktok-user-statistics/

[2] Kirkpatrick, C. E., & Lawrie, L. L. (2024). TikTok as a Source of Health Information and Misinformation for Young Women in the United States: Survey Study. JMIR infodemiology, 4, e54663. doi: 10.2196/54663

[3] CharityRx News. (2022, 21 de septiembre). The shifting role of influence and authority in the Rx drug & health supplement market. Recuperado el 25 de agosto de 2025, de https://www.charityrx.com/blog/the-shifting-role-of-influence-and-authority-in-the-rx-drug-health-supplement-market/

[4] Hall, R., & Keenan, R. (2025, 31 de mayo). More than half of top 100 mental health TikToks contain misinformation, study finds. The Guardian. Recuperado el 25 de agosto de 2025, de https://www.theguardian.com/society/2025/may/31/more-than-half-of-top-100-mental-health-tiktoks-contain-misinformation-study-finds

[5] Aragon-Guevara, D., Castle, G., Sheridan, E., & Vivanti, G. (2025). The Reach and Accuracy of Information on Autism on TikTok. Journal of autism and developmental disorders, 55(6), 1953–1958. doi:10.1007/s10803-023-06084-6

[6] Motta, M., Liu, Y., & Yarnell, A. (2024). «Influencing the influencers:» a field experimental approach to promoting effective mental health communication on TikTok. Scientific reports, 14(1), 5864. doi: 10.1038/s41598-024-56578-1

Sobre el autor: David Carcedo es divulgador, psicólogo sanitario en Donostia y coordinador de sección de laboratorio en el BCBL.

El artículo Desinformación sobre salud mental en TikTok: qué sabemos y qué funciona para corregirla se ha escrito en Cuaderno de Cultura Científica.

Especies humanas en nuestro genoma y altruismo primate en el Día de Darwin 2025

El 12 de febrero la la Cátedra de Cultura Científica de la Universidad del País Vasco y el Círculo Escéptico celebraron una nueva edición del Día de Darwin en la Biblioteca Bidebarrieta de Bilbao. La sesión contó con dos conferencias centradas en la convivencia de especies humanas diferentes, por un lado, y el origen del altruismo social, por otro; con el objetivo de ampliar la mirada en torno a la singularidad de nuestra especie a través de la evolución.

El Día de Darwin conmemora cada 12 de febrero el nacimiento del biólogo y geólogo inglés Charles Darwin. Nacido en 1809, su figura ha quedado ligada a la historia tras la publicación en 1859 del libro ’El Origen de las Especies’ y su teoría sobre la evolución. Gracias a ella sabemos que todos los seres vivos procedemos de un antepasado común, que las especies varían a lo largo del tiempo, variación a la que se denomina evolución y que se produce por efecto de un mecanismo al que denominamos selección natural.

ProgramaEl Día de Darwin 2025 contó con las conferencias de Conchi de la Rúa, catedrática de Antropología Biológica en la Universidad del País Vasco-Euskal Herriko Unibertsitatea; de Ignacio Martínez, catedrático de Antropología Física en la Universidad de Alcalá; y de Mercedes Conde, doctora en Antropología Física de la Universidad de Alcalá.

Conchi de la Rúa impartió la conferencia “La huella de especies humanas del pasado en nuestro genoma” e Ignacio Martínez y Mercedes Conde la charla titulada “Primate altruista”. Ambas exposiciones muestran los resultados de las investigaciones que se están llevando a cabo en la actualidad en el ámbito de la evolución humana, gracias a las cuales tenemos la posibilidad de entender la historia de nuestra especie y la génesis de algunas de las características propias de los seres humanos.

ContenidoEn la conferencia “La huella de especies humanas del pasado en nuestro genoma” la investigadora de la UPV/EHU Conchi de la Rúa explica que el estudio del ADN fósil ha permitido conocer que en el pasado existieron encuentros entre especies humanas diferentes. Gracias a la paleogenómica, se sabe que neandertales y denisovanos convivieron con los primeros sapiens que llegaron a Eurasia hace unos 40 000 mil años, procedentes de sucesivas oleadas desde África, y que hubo intercambios genéticos entre ellos. Estos hallazgos han posibilitado una mirada más amplia sobre la unicidad de nuestra especie.

Por su lado, en la charla “Primate altruista” Ignacio Martínez y Mercedes Conde, investigadores de la Universidad de Alcalá, abordan una de las cuestiones más debatidas en biología evolutiva: el origen del altruismo. El altruismo es una de las características más extraordinarias de los seres humanos y conocer su historia evolutiva es importante para entender a la humanidad. El origen del altruismo está directamente relacionado con el de los cuidados a personas vulnerables. Este aspecto puede rastrearse en el registro fósil y los restos humanos que arrojan más luz sobre esta cuestión han aparecido en dos yacimientos españoles: Atapuerca (Burgos) y Cova Negra (Valencia).

ConferenciantesConcepción de la Rúa Vaca es licenciada en Medicina y en Biología y catedrática de Antropología Biológica en la Universidad del País Vasco. Es profesora e investigadora de la Facultad de Ciencia y Tecnología de la UPV/EHU, en la cual promovió la creación de un laboratorio de ADN antiguo en los inicios de esta disciplina. Es directora del grupo de investigación consolidado del sistema universitario vasco Biología Evolutiva Humana de la UPV/EHU. En su carrera profesional ha desarrollado y liderado proyectos de investigación interdisciplinares, destacando, entre otros, estudios paleogenómicos de humanos antiguos. En la actualidad, trabaja en un proyecto sobre la domesticación del lobo.

Ignacio Martínez Mendizábal es catedrático de Antropología Física de la Universidad de Alcalá. Pertenece desde 1984 al Equipo Investigador de los Yacimientos Pleistocenos de la Sierra de Atapuerca, que fue galardonado con el Premio Princesa de Asturias de Investigación Científica y Técnica del año 1997. Es especialista en el campo de la evolución humana, área en la que tiene una dilatada trayectoria profesional, siendo autor de artículos científicos de impacto y conferenciante de proyección internacional. Entre otros, es autor del libro ‘El primate que quería volar’ y co-autor, junto a Juan Luis Arsuaga, de los libros ‘La Especie Elegida’, ‘Amalur’, y ‘Atapuerca’ y la ‘Evolución Humana’.

Mercedes Conde Valverde es doctora en Antropología Física y profesora del Área de Antropología Física del Departamento de Ciencias de la Vida de la Universidad de Alcalá. Dirige la Cátedra de Investigación (HM Hospitales – Universidad de Alcalá) de Otoacústica Evolutiva y Paleoantropología. Es además Research Affiliate del Departamento de Antropología de Binghamton University (SUNY-USA), y profesora invitada de la Universidad de Buenos Aires. Miembro del equipo de investigación de Atapuerca desde 2012. Su actividad investigadora ha estado centrada en el estudio de la evolución del oído y el origen del lenguaje. Entre otros, ha participado en artículos científicos publicados en revistas de gran prestigio y es autora del libro ‘El lenguaje. En busca de las primeras palabras’.

Edición realizada por César Tomé López

El artículo Especies humanas en nuestro genoma y altruismo primate en el Día de Darwin 2025 se ha escrito en Cuaderno de Cultura Científica.

El arca de la microbiota

Las muestras son conservadas en condiciones de frío extremo en el Institute of Medical Microbiology de la Universidad de Zúrich. Fuente: Microbiota Vault Initiative

Las muestras son conservadas en condiciones de frío extremo en el Institute of Medical Microbiology de la Universidad de Zúrich. Fuente: Microbiota Vault Initiative

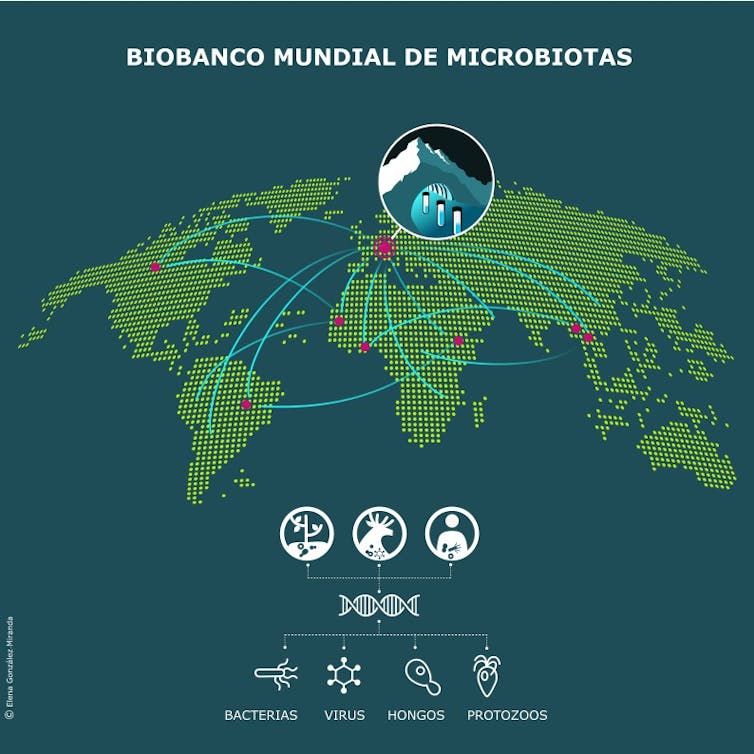

Puesta en marcha hace cuatro años, la iniciativa Microbiota Vault –también conocida como Arca de la Microbiota o Cámara de Seguridad de la Microbiota– tiene un objetivo tan ambicioso como necesario: conservar la diversidad microbiana de nuestro planeta para las generaciones futuras.

Los expertos ya han creado en su primera fase un biobanco con más de 1 200 muestras fecales humanas y 190 de alimentos fermentados. El proyecto se inspira en el Banco Mundial de Semillas de Svalbard, en Noruega, que protege la diversidad genética de los cultivos.

Las muestras, que proceden de colecciones de Benín, Brasil, Etiopía, Ghana, Laos, Tailandia y Suiza, se conservan congeladas a −80 °C en el Instituto de Microbiología Médica de la Universidad de Zúrich (Suiza). Su ubicación no es definitiva, ya que otros países con climas fríos, como Canadá, lo podrían albergar en el futuro.

Su meta es alcanzar las 20 000 microbiotas de personas, animales, plantas y ecosistemas en riesgo. Además, el proyecto facilitará la secuenciación de los genomas microbianos y su publicación en bases de datos de acceso abierto.

Biobanco mundial de Microbiotas Ilustración: Elena González MirandaUna extinción silenciosa

Biobanco mundial de Microbiotas Ilustración: Elena González MirandaUna extinción silenciosa

Los microbios –arqueas, bacterias, hongos, protozoos y virus– han evolucionado durante millones de años en estrecha relación con los demás seres vivos, configurando una diversidad esencial para el equilibrio de los ecosistemas. A pesar de su importancia, muchas de estas especies nunca han sido cultivadas en el laboratorio. El conocimiento sobre sus genomas sigue siendo limitado.

Aunque los microorganismos son vitales para la salud de personas y animales, la fertilidad del suelo o la regulación del clima, este mundo invisible está en grave peligro de desaparecer debido a la actividad humana.

Sin ir mas lejos, nuestra microbiota nos protege frente a patógenos, refuerza el sistema inmunitario, estimula el sistema nervioso y participa en la biosíntesis de vitaminas y otros metabolitos necesarios.

El uso excesivo de antibióticos, el aumento de las cesáreas, la disminución de la lactancia materna, el consumo de alimentos ultraprocesados o el estrés de la vida urbana alteran nuestros ecosistemas microbianos interiores.

Las consecuencias de esta disbiosis son importantes. Así, la desaparición de las bacterias Bifidobacterium longum variedad infantis, Treponema succinifaciens o Helicobacter pylori se ha relacionado con el aumento de enfermedades crónicas como alergias, diabetes o asma.

Adicionalmente, la pérdida de microbios del suelo compromete la resiliencia de los ecosistemas terrestres y marinos. Por ejemplo, Methanoflorens stordaliensis y otros microorganismos adaptados al permafrost (capa de suelo congelado permanentemente) ayudan a regular las emisiones de metano, y las acinetobacterias son cruciales en el ciclo del carbono. La desaparición de estos microorganismos acelera la liberación de gases de efecto invernadero y el cambio climático.

Tampoco hay que olvidar que los microbios pueden ser aliados terapéuticos. Algunos tratamientos con microbiomas, como el trasplante de heces, se están empleando en medicina con resultados prometedores. También hay propuestas esperanzadoras para su uso en agricultura y conservación ambiental.

Equidad y colaboración internacionalMicrobiota Vault se define como un proyecto internacional, privado y sin ánimo de lucro, respetuoso con el protocolo de Nagoya. Es decir, cada grupo participante decide libremente si desea compartir información genética, intercambiar muestras o colaborar en estudios conjuntos.

Como han manifestado la microbióloga María G. Dominguez-Bello y sus colaboradores en un reciente artículo, se trata de un esfuerzo global basado en la equidad, el respeto a los derechos de las comunidades indígenas y la colaboración internacional para fortalecer las redes de investigación sobre microbiota y apoyar la formación de científicos de países con menos recursos.

Los resultados y propuestas de la colaboración de personas expertas en campos tan diversos como microbiología, antropología, ética, salud pública o bioinformática se comparten en los congresos de la Red Mundial del Microbioma (Global Microbiome Network, GloMiNe).

La financiación podría ser un reto importante: como sucede con otros biobancos, estos proyectos no son prioritarios para los gobiernos. Además, las donaciones privadas son inestables y dependen de modas pasajeras o de los incentivos fiscales disponibles en cada momento.

One Health y microbiomaEsta iniciativa se alinea con el concepto de Salud Global (One Health) de la Organización Mundial de la Salud, basado en la interdependencia entre la salud de las personas, los animales y el medio ambiente.

Todavía no está demostrado que las microbiotas almacenadas puedan ser beneficiosas o reintroducirse con fines terapéuticos, ni contamos con la tecnología para hacerlo de forma segura. Sin embargo, su conservación permitirá futuras terapias cuando tengamos una sólida base científica.

Microbiota Vault se suma a otras propuestas de protección de la biodiversidad. Entre ellas se encuentran colecciones de cultivos microbianos como la Colección Española de Cultivos Tipo, el Banco Mundial de Semillas o la Conservación Global del Microbioma. Estas iniciativas podrían frenar la biopiratería y evitar que empresas y gobiernos poco escrupulosos se apropien de nuestra herencia microbiana sin permiso. También son clave para proteger el legado de las comunidades indígenas.

La esperanza dentro de la caja de PandoraNuestro mundo se enfrenta a múltiples crisis sanitarias, económicas y ecológicas. Por esto, la protección de la invisible vida microbiana es esencial. La conservación de esta biodiversidad microbiana mantendrá la esperanza de que en un futuro cercano podamos comprender mejor la vida en todas sus formas, curar enfermedades que hoy no tienen tratamiento y restaurar ecosistemas esenciales que se hayan perdido.![]()

Sobre el autor: Guillermo Quindós-Andrés, Catedrático de Microbiología Médica, Departamento de Inmunología, Microbiología y Parasitología, Facultad de Medicina y Enfermería, Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo El arca de la microbiota se ha escrito en Cuaderno de Cultura Científica.

El oro de las montañas rojizas que derrumbaron los romanos

Entre las zonas que, desgraciadamente, están siendo afectadas por los aterradores incendios que invaden la geografía ibérica, se encuentra la comarca leonesa de El Bierzo, en donde se localiza una joya natural que aúna, de manera ejemplar, el desarrollo social humano, la Arqueología y la Geología: Las Médulas.

Panorámica de Las Médulas. Foto: Rafael Ibáñez Fernández / Rayet, CC BY-SA 3.0, / Wikimedia Commons

Panorámica de Las Médulas. Foto: Rafael Ibáñez Fernández / Rayet, CC BY-SA 3.0, / Wikimedia CommonsDeclaradas “Patrimonio de la Humanidad” por la UNESCO en 1997, Las Médulas son una extraordinaria muestra de cómo las actividades humanas pueden modelar por completo el paisaje natural. Y para conocer esta increíble historia, debemos viajar en el tiempo hasta hace unos 2000 años. Cuando los romanos llegaron al noroeste de Hispania en el siglo I de nuestra era, observaron que los pueblos autóctonos obtenían oro bateando la arena del cauce del río Sil. Entonces, decidieron remontar sus aguas, buscando el origen de ese preciado metal amarillo, encontrándolo en unas colinas de colores rojizos y parduzcos, donde el oro se encontraba incrustado entre las rocas de tipo areniscas, gravas y conglomerados que se extendían por toda esta zona.

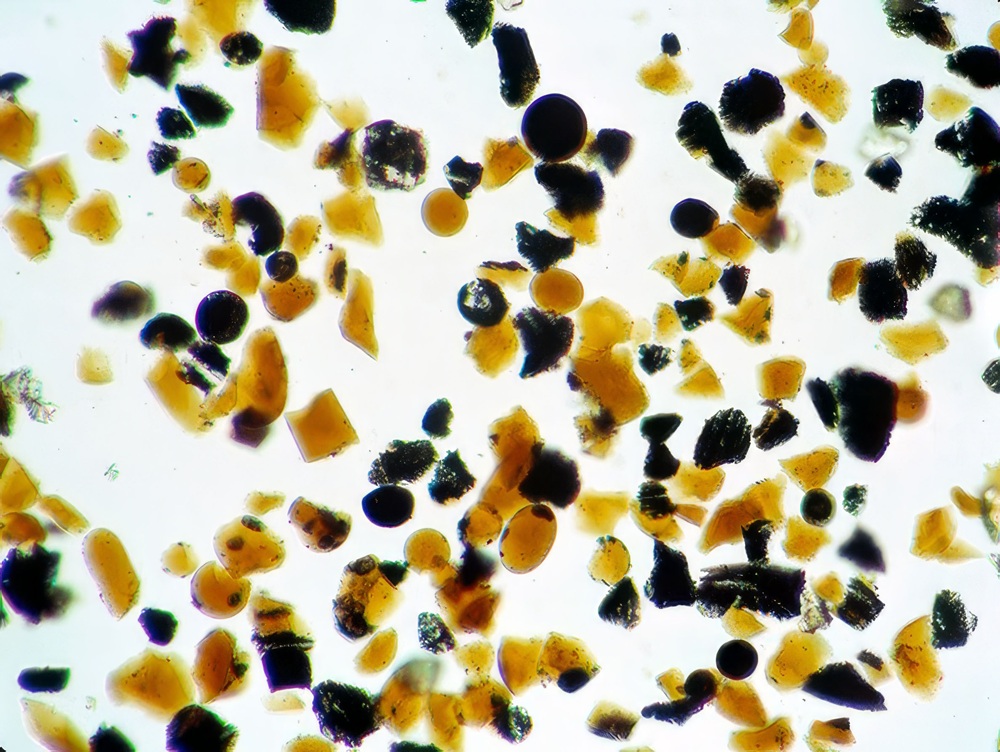

Detalle de los tipos de rocas presentes en Las Médulas, con conglomerados rojizos en la parte superior y areniscas anaranjadas en la inferior. Foto: A. Sánchez del Corral / Inventario Español de Lugares de Interés Geológico / Instituto Geológico y Minero de España (IGME-CSIC)

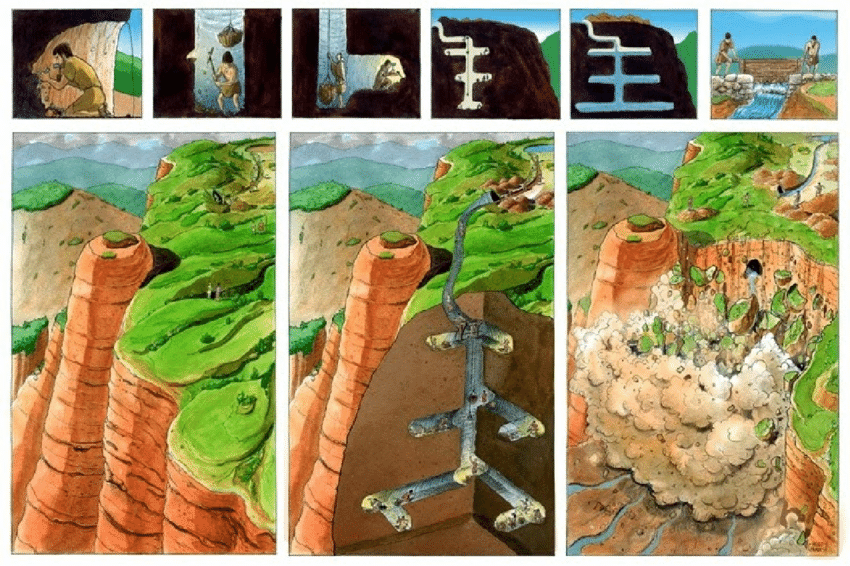

Detalle de los tipos de rocas presentes en Las Médulas, con conglomerados rojizos en la parte superior y areniscas anaranjadas en la inferior. Foto: A. Sánchez del Corral / Inventario Español de Lugares de Interés Geológico / Instituto Geológico y Minero de España (IGME-CSIC)Los ingenieros romanos no se vieron amedrentados ante la dificultad de sacar el oro de esas rocas tan duras y compactas. Al contrario, pusieron en marcha todo su ingenio hasta dar con la técnica minera más impresionante, a la vez que destructiva, del mundo antiguo: la “ruina montium”, cuya traducción, “derrumbe de montes”, ya nos está dando una clave de en qué consiste. Entrando en detalle, este sistema minero consistía en excavar una serie de canales y represas que traían el agua de las elevaciones cercanas hasta acumularlas por encima de las montañas que contenían el oro. Entonces seguían con las excavaciones, en este caso en forma de galerías verticales en el interior de las rocas que formaban esas colinas. Al terminar, estos conductos abrían los muros de las presas, dejando caer por ellos el agua a presión, lo que provocaba la rotura mecánica de las rocas y su arrastre hasta unas balsas de decantación excavadas al pie de las laderas. Allí, bateaban los sedimentos resultantes para separar, de manera manual, el oro del resto de materiales.

Esquema de las fases de la técnica minera roma “ruina montium”. Ilustración: Hugo Prades / Fundación Las Médulas

Esquema de las fases de la técnica minera roma “ruina montium”. Ilustración: Hugo Prades / Fundación Las MédulasLa explotación aurífera de Las Médulas por parte de los romanos estuvo activa de manera ininterrumpida durante casi 200 años, desde comienzos del siglo I hasta comienzos del siglo III, afectando a una superficie de unas 540 ha en la que se removieron más de 93.000.000 m3 de materiales que permitieron extraer unos 5.000 kg de oro. Pero también cambió para siempre el paisaje, generando un sistema complejo de cárcavas, barrancos, pináculos o columnas de roca cuyo origen se encuentra, exclusivamente, en la mano del ser humano.

Pero, ¿cómo se formó ese oro? Hace meses os expliqué el origen de algunos de los depósitos de oro que actualmente se explotan en Alaska, pues aquí tenemos algo muy parecido. Para conocer este proceso debemos volver a hacer un viaje en el tiempo, pero esta vez del tipo geológico, llegando a hace más de 300 millones de años. En estos momentos, se estaban produciendo diversas colisiones tectónicas que dieron como resultado la formación del último gran supercontinente de la historia de la Tierra, Pangea. En este contexto compresivo, en la zona donde nos encontramos con Las Médulas actuales se produjo el ascenso de un magma en el interior del terreno, pero este material fundido no llegó a salir a la superficie, se quedó enterrado a varios kilómetros de profundidad. Cuando los fluidos subterráneos circulaban cerca de este magma, se calentaban, aumentando su capacidad de “robar” elementos químicos de las rocas que atravesaban, entre ellos el oro, llevándolos en disolución. Hasta que encontraban alguna fractura del terreno que les permitía fluir hacia la superficie, lo que provocaba que se fuesen enfriando poco a poco, perdiendo esa capacidad de disolución, teniendo entonces que “soltar” los elementos químicos que transportaban. Sí, incluido el oro. Así se formaron unas mineralizaciones ricas en oro que atravesaban el terreno a las que denominamos diques.

Aspecto general de Las Médulas, donde se observa el paisaje de origen humano formado por cárcavas, pináculos, columnas y escarpes. Foto: A. Sánchez del Corral / Inventario Español de Lugares de Interés Geológico / Instituto Geológico y Minero de España (IGME-CSIC)

Aspecto general de Las Médulas, donde se observa el paisaje de origen humano formado por cárcavas, pináculos, columnas y escarpes. Foto: A. Sánchez del Corral / Inventario Español de Lugares de Interés Geológico / Instituto Geológico y Minero de España (IGME-CSIC)Pues hace unos 20 millones de años, con la tectónica ya más tranquilita, los agentes meteorológicos tomaron el protagonismo. Así, el agua de lluvia se encargó de erosionar los diques con mineralizaciones de oro que se encontraban en las montañas situadas al sur de Las Médulas, transportándolo ladera abajo, hasta depositarlo en capas acumuladas entre la arena, el barro y los fragmentos de rocas que arrastraban. El paso de los millones de años hizo entonces su trabajo, transformando estos sedimentos en rocas duras (las areniscas, gravas y conglomerados que os mencionaba al principio) ricas en depósitos de oro.

Hace dos milenios, esas rocas rojizas también sufrieron la erosión del agua que se llevaba el oro hasta acumularlo en el cauce del Sil, donde lo recogían las poblaciones autóctonas antes de la invasión romana. Pero los romanos no tuvieron paciencia, así que decidieron acelerar el proceso erosivo del agua con su técnica minera nunca antes vista en este lugar.

En los últimos siglos, tras el abandono de la explotación minera, la naturaleza recuperó parte de su terreno original, creciendo una tupida masa boscosa entre los restos de la destrucción provocada por el ser humano. Ahora, ese hermoso manto verde, es el que estamos viendo arder. Posiblemente pasen décadas antes de que la vegetación vuelva a cubrir esta hermosa zona, pero lo que no se ha perdido es su riqueza geológica y arqueológica. Y esta increíble historia que nos cuentan las rocas y el paisaje sigue siendo uno de los mayores reclamos turísticos de la zona. No dejemos de visitar Las Médulas, apoyando a los comercios locales de la comarca berciana, porque ese pequeño grano de arena puede significar mucho para la población.

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la EHU

El artículo El oro de las montañas rojizas que derrumbaron los romanos se ha escrito en Cuaderno de Cultura Científica.

El ARN es el sistema de alerta de emergencia de la célula

¿Cómo sabe una célula que ha sido dañada? Una alarma molecular, activada por ARN mutado y colisiones ribosómicas, señala el peligro.

Un artículo de Dan Samorodnitsky. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Ilustración: Wei-An Jin / Quanta Magazine

Ilustración: Wei-An Jin / Quanta Magazine¿Qué ocurre cuando el sol brilla sobre tu piel? ¿Y qué ha fallado cuando se produce una quemadura?

Detrás de ese dolor se esconde la respuesta de emergencia celular al daño en el ADN. Cuando un agente nocivo, como la luz ultravioleta, la radiación ionizante o ciertos productos químicos, daña el ADN, la célula debe reaccionar a toda velocidad. Idealmente, repara el daño en su repositorio de información genética o se sacrifica mediante un proceso de muerte celular controlada. Si no actúa con rapidez, corre el riesgo de una consecuencia más peligrosa: la necrosis, una muerte celular explosiva y descontrolada que daña a las células vecinas, o la transmisión de ADN mutado a sus descendientes, lo que podría derivar en cáncer.

Por tanto, es urgente que la célula identifique el daño en el ADN lo antes posible. Pero el genoma es enorme; cuando el ADN muta, la mutación puede no detectarse a tiempo —o incluso no detectarse en absoluto—. Para mantener el control de su destino, la célula necesita algún tipo de sistema de alarma frente al daño en el ADN.

Investigadores han identificado ahora ese sistema de alarma celular, que sorprendentemente no implica directamente al ADN. En su lugar, cuando se acumulan moléculas mutadas de ARN —el primo cercano del ADN— e interfieren con los procesos moleculares, se activa una vía de señalización que alerta de que algo va terriblemente mal en el código genético y que debe resolverse con urgencia. Estos hallazgos se publicaron en la revista Cell en 2024.

Recientemente, un equipo dirigido por Anna Constance Vind, bióloga molecular de la Universidad de Copenhague, ha confirmado que el ARN está en el centro de esta rápida e intrincada respuesta al daño en células de mamíferos —específicamente en células de ratones con quemaduras solares—, lo que sugiere que ocurre también en células humanas. Este trabajo se publicó en Molecular Cell.

La investigación de Anna Vind sobre el sistema de alarma de emergencia de las células revela otro papel fundamental del ARN en la biología celular. «Ahora se está viendo que el ARN sí importa», afirma. Foto: Anton Willemann / Københavns Universitet

La investigación de Anna Vind sobre el sistema de alarma de emergencia de las células revela otro papel fundamental del ARN en la biología celular. «Ahora se está viendo que el ARN sí importa», afirma. Foto: Anton Willemann / Københavns Universitet«Lo que intenta hacer la célula es decidir si vive o muere en función de cuán dañado esté el ADN. Si el ADN está demasiado deteriorado, habrá mutaciones que se heredarán», dice Rachel Green, bióloga especializada en ARN en la Universidad Johns Hopkins y coautora del estudio en Cell. «Pero lo asombroso es que es el ARN quien da la señal. Eso es lo realmente sorprendente».

Curso de colisiónLos científicos también son susceptibles a los mitos. La idea extendida era que el daño en el ADN lo detectaban proteínas que interactúan directamente con él. A medida que estas proteínas se desplazaban por la hebra de ADN, podían atascarse en lesiones, enlaces cruzados o mutaciones, como cuando uno pasa un hilo entre los dedos hasta encontrar un nudo. Entonces la célula intentaba reparar el ADN dañado, pero si la lesión era demasiado grave, iniciaba la apoptosis: una forma de suicidio celular ordenado, en la que la célula empaqueta su contenido y se elimina de manera segura sin perjudicar a las vecinas.

Pero esa historia nunca termina de encajar. Debido al enorme tamaño del genoma y al hecho de que el ADN solo se copia y explora en una fase específica del ciclo celular, cualquier sistema de alarma basado en el ADN sería lento y torpe. Los mecanismos internos de reparación del ADN pueden tardar entre 16 y 24 horas. Pero una vez que el ADN se daña, la célula toma una decisión trascendental mucho más rápido que eso.

«La decisión de vivir o morir se toma en 15 a 30 minutos», afirma Niladri Sinha, investigador posdoctoral en el laboratorio de Green y autor principal del estudio en Cell. «No quieres que el problema se extienda; tomas la decisión de detenerlo cuanto antes».

Además, nunca se ha establecido con firmeza una relación causal directa entre el daño en el ADN y la respuesta inflamatoria del sistema inmunitario en un organismo vivo.

Para resolver estas discrepancias, Vind necesita dañar intencionadamente el ADN en el laboratorio y observar cómo responde la célula. Así que su equipo provoca quemaduras solares en ratones: afeitan a dos grupos de ratones y los exponen a luz ultravioleta (UV). El primer grupo está formado por ratones normales, o «salvajes». El segundo grupo consiste en ratones modificados genéticamente para carecer de una proteína llamada ZAK.

ZAK está asociada a los ribosomas, las fábricas celulares encargadas de traducir ciertos tipos de ARN para producir proteínas. Es parte de un conjunto de proteínas que ayudan al ribosoma, por ejemplo, cargándolo con ARN, asistiendo en la síntesis proteica y supervisando su progreso. Además, ocupa una posición central en una cascada de señalización que transmite información del ribosoma al resto de la célula. Tras años de investigación, se ha establecido que ZAK desempeña un papel clave en una red de respuesta celular frente a los daños provocados por la radiación UV. Esos hallazgos se basan en estudios con células y gusanos en cultivo; Vind quiere comprobar cómo se desarrolla esta vía en un organismo complejo y más parecido al humano.

Cuando la luz UV penetra en las células, puede mutar el ADN; y lo que es crucial, provoca mutaciones similares en el ARN. En las células cutáneas de los ratones quemados por el sol, el grupo de Vind observa que los ribosomas tropiezan con ARN dañado. Los ribosomas no pueden interpretar ciertas mutaciones y avanzan con cautela por los obstáculos físicos provocados por daños más severos. Disminuyen su velocidad, dejan de funcionar y comienzan a colisionar entre sí.

Una investigación dirigida por la bióloga Rachel Green sitúa el ARN mutado y el colapso de los ribosomas en el centro de una rápida respuesta al daño celular. Cortesía de Rachel Green

Una investigación dirigida por la bióloga Rachel Green sitúa el ARN mutado y el colapso de los ribosomas en el centro de una rápida respuesta al daño celular. Cortesía de Rachel GreenEs entonces cuando los investigadores ven a ZAK entrar en acción. Esta proteína permanece inactiva hasta que dos ribosomas entran en contacto físico —es decir, colisionan—. En las células cutáneas de los ratones salvajes, a las seis horas de la exposición a la UV, ZAK pone en marcha una serie de reacciones celulares en respuesta a la desaceleración y colisiones ribosómicas. Cualquiera que haya sufrido una quemadura solar conoce estas reacciones: inflamación debida a la llegada masiva de células inmunitarias al área afectada, lo que causa hinchazón y enrojecimiento.

«ZAK inicia una vía de señalización como una alarma», explica Sinha. «El grado de activación marca el compromiso con la muerte». Cuantos más ribosomas colisionan, más señales emite ZAK. Cuando alcanza un umbral crítico, la célula opta por la apoptosis en lugar de arriesgarse a una necrosis o al cáncer. La célula intenta así proteger a sus vecinas, al propio organismo y a su ADN: la información que se transmitirá a la siguiente generación.

Sin embargo, los ratones sin ZAK reaccionan de forma completamente distinta. Seis horas después del tratamiento con UV, no muestran inflamación alguna. La respuesta rápida al daño solar brilla por su ausencia. Pasan uno o dos días hasta que estos ratones se enrojecen e inflaman como los salvajes.

Estos resultados demuestran que ZAK es necesario para que las células detecten rápidamente el daño en el ADN. Y lo hace detectando no el daño en el ADN directamente, sino en el ARN.

Todo o nadaLos síntomas de una quemadura solar se deben a que el sistema de alarma ribosómico de la célula activa un sistema de protección aguda conocido como respuesta al estrés ribotóxico (RSR, por sus siglas en inglés). Cuando una célula percibe que sus ribosomas se comportan de forma anómala —por ejemplo, colisionando entre sí, algo que normalmente no hacen—, ralentiza su metabolismo para decidir entre intentar una reparación o iniciar una muerte celular controlada.

Lo que hace del RSR un buen sistema de alarma rápido es la frecuencia con la que la célula utiliza el ARN: constantemente. Las células están casi siempre generando, manipulando o interactuando con ARN en alguna de sus formas. Puede tratarse de ARN mensajero (ARNm) que se traduce en proteínas, ARN no codificante que regula la expresión génica, o ARN ribosómico utilizado para construir las máquinas moleculares —una necesidad constante de las células y una de sus actividades que más energía consume.

«Lógicamente, que el ribosoma se atasque es un sistema mucho más sensible para detectar daños, porque los ribosomas están densamente distribuidos en el ARN», dice Craig Kaplan, biólogo del ARN en la Universidad de Pittsburgh, quien no ha participado en los estudios. «Que el ribosoma se atasque es la forma más rápida de detectar daños, y lo que estos estudios están revelando es que es el mecanismo dominante».

No es solo la familiaridad de la célula con el ARN lo que lo convierte en una molécula ideal para emitir alarmas, sino también su ubicuidad, abundancia, plasticidad y bajo coste de producción.

«Puedes pensar en [la respuesta al estrés ribotóxico] como una amplificación de la alarma», señala Lydia Contreras, bióloga molecular de la Universidad de Texas en Austin, que tampoco ha participado en los estudios. «Puedes hacer muchas copias de un ARN, así que es como un altavoz… Es una de las formas más baratas, molecularmente hablando», de generar una señal, añade. «Te comunicas rápidamente porque los estás produciendo muy rápido».

Además, tiene todo el sentido que un ribosoma detenido sea una señal de alarma para una célula. Un ribosoma bloqueado no ha terminado de fabricar su proteína, y las proteínas inacabadas pueden interferir con las sanas, lo que puede ser tóxico e incluso letal. Estos son desórdenes que la célula prefiere resolver antes de que se acumulen y generen problemas graves.

Más allá de las quemaduras solares, el RSR es la vía que lanza la señal de “todo o nada” ante casi cualquier desafío celular. Se activa cuando una célula sufre inanición. Se activa cuando una célula es envenenada con ricina. Se activa cuando un virus la invade. Detectar las colisiones ribosómicas y mantener un sistema de traducción proteica saludable es, por tanto, esencial para todas las células, en cualquier etapa de la vida y en casi cualquier circunstancia.

Para Kaplan, el RSR es un ejemplo maravilloso del lenguaje interno de la célula y de las formas indirectas en que puede evolucionar para acceder a la información necesaria para sobrevivir. «Las células no tienen un pequeño operario que dirija el tráfico y les explique en palabras lo que está ocurriendo. No usan ese tipo de lenguaje. Una de las cosas fascinantes de la biología es que la evolución ha vinculado un evento concreto» —como la colisión entre ribosomas— «con una consecuencia determinada» —una posible emergencia física y celular.

«A veces detectas cosas de forma indirecta», afirma. «Eso es lo que hace la evolución».

El artículo original, RNA Is the Cell’s Emergency Alert System, se publicó el 14 de julio de 2025 en Quanta Magazine. Cuaderno de Cultura Científica tiene un acuerdo de distribución en castellano con Quanta Magazine.

Traducido por César Tomé López

El artículo El ARN es el sistema de alerta de emergencia de la célula se ha escrito en Cuaderno de Cultura Científica.

La implantación del embrión en el útero, ex vivo y en directo

Las primeras etapas del desarrollo embrionario de los mamíferos son excepcionales en el mundo animal. La razón de esto se encuentra en otra característica única. El óvulo de los mamíferos placentados, humanos incluidos, carece de vitelo, es decir, de las sustancias nutritivas que necesita el embrión para su desarrollo. Por ello, necesita imperiosamente recibir cuanto antes nutrientes de la madre.

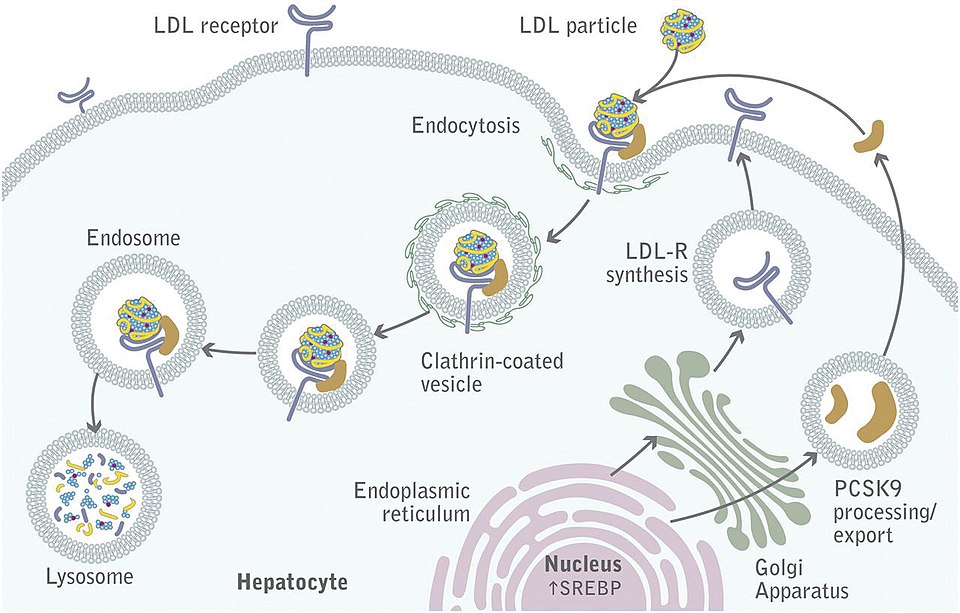

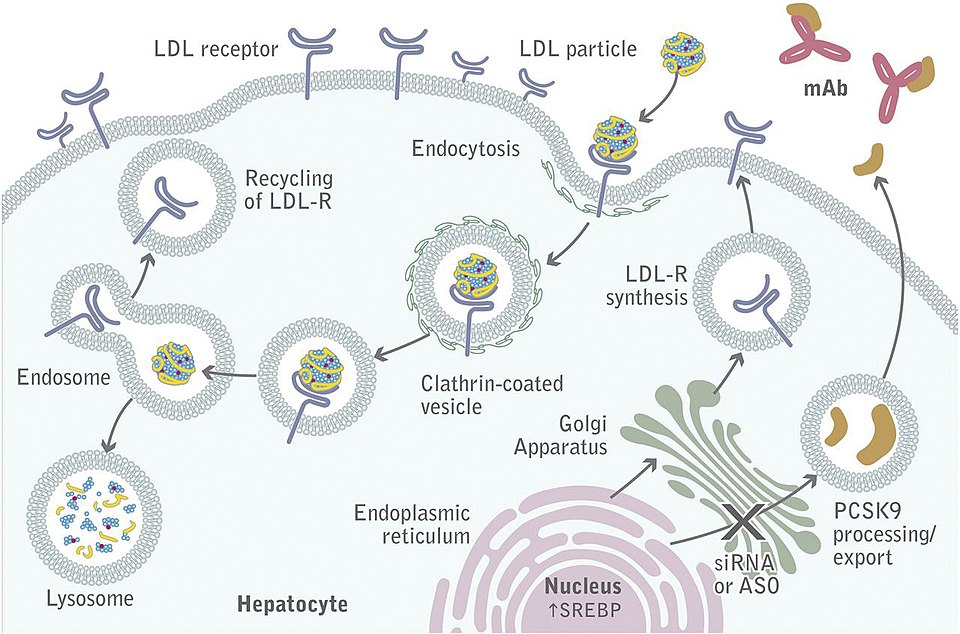

Cuando el óvulo es fecundado se divide varias veces y forma el blastocisto, compuesto por las células del futuro embrión y el trofoectodermo (figura 1). Para que el desarrollo pueda continuar, el blastocisto debe quedar implantado en el endometrio, la capa interna del útero. El trofoectodermo es el responsable de la implantación, se adhiere al epitelio uterino y comienza la invasión de los tejidos maternos. A consecuencia de la invasión se forman lagunas con sangre materna y se acondiciona el endometrio para organizar la futura placenta.

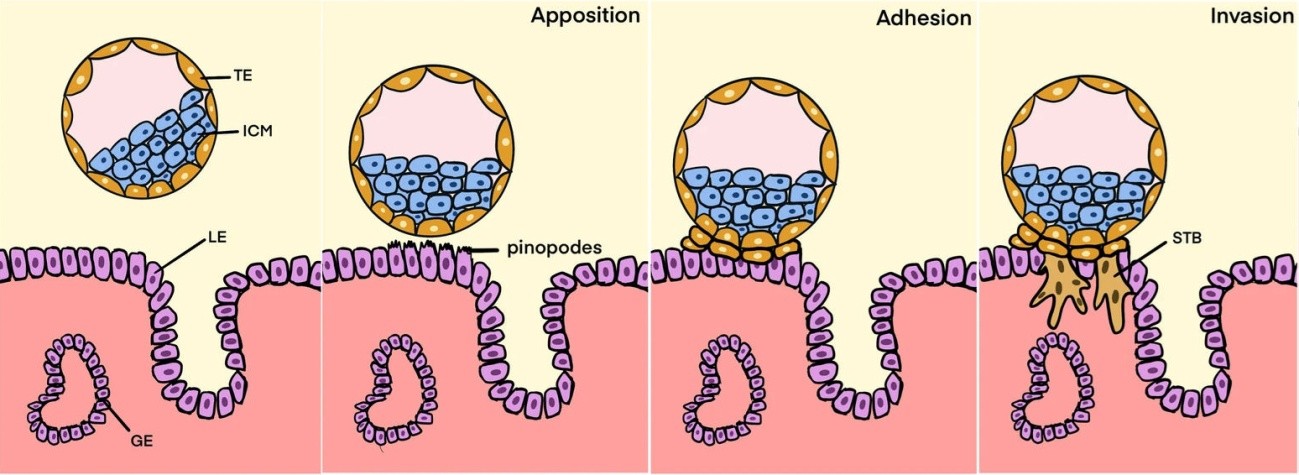

Figura 1. Etapas de la implantación. El blastocisto está formado por el trofoectodermo (TE) y la masa celular interna (ICM) de la que deriva el embrión. El trofoectodermo rompe el epitelio luminal del endometrio (LE) e invade la pared uterina formando el sincitiotrofoblasto (STB). GE=epitelio glandular uterino. Fuente: Li et al. (2022) Reproductive Biology and Endocrinology doi: 10.1186/s12958-022-00973-8 CC BY 4.0.

Figura 1. Etapas de la implantación. El blastocisto está formado por el trofoectodermo (TE) y la masa celular interna (ICM) de la que deriva el embrión. El trofoectodermo rompe el epitelio luminal del endometrio (LE) e invade la pared uterina formando el sincitiotrofoblasto (STB). GE=epitelio glandular uterino. Fuente: Li et al. (2022) Reproductive Biology and Endocrinology doi: 10.1186/s12958-022-00973-8 CC BY 4.0.La implantación es un momento crítico para que la gestación progrese. En la reproducción asistida humana, un 50-60% de los blastocistos fracasan a la hora de implantarse en el útero. Sin embargo, si la implantación tiene lugar, la tasa de abortos desciende al 15%.

Lo que conocíamos de la implantación procede de los estudios hechos sobre tejido fijado y modelos transgénicos de ratón. De esta forma se ha podido identificar un número de genes implicados en el proceso. Sin embargo, no ha sido posible, hasta ahora, observar directamente el proceso de implantación. Estamos hablando de un blastocisto que tiene unas 200 células, mide menos de 0,2 mm y puede implantarse en cualquier punto del útero. No es algo que pueda verse fácilmente.

Esto ha cambiado gracias a la técnica desarrollada por un equipo de investigación de la universidad de Osaka (Japón), que ha conseguido implantar blastocistos de ratón ex vivo, es decir, en una placa de cultivo.

La técnica, desarrollada tras múltiples ensayos, consiste en obtener pequeños fragmentos de útero de ratonas preñadas y, por otro lado, blastocistos de otras ratonas. En los dos casos el tiempo de obtención se ajustó a 3,75 días tras el apareamiento con machos. Los blastocistos se colocaron sobre el endometrio de los fragmentos uterinos y se cubrieron con un polímero de silicona (polidimetilsiloxano) biocompatible y muy permeable a los gases. Después de ensayar diversos medios de cultivo se seleccionó uno que contenía dosis muy precisas de estradiol y progesterona, hormonas necesarias para la gestación.

Más del 90% de los blastocistos así tratados se habían adherido al endometrio pasadas 24 h. A las 36 h, el trofoectodermo ya había roto el epitelio materno y comenzado la invasión de la pared uterina. Esta invasión era completa a las 48 h del comienzo del experimento. Al mismo tiempo, el embrión progresaba normalmente expresando los genes correspondientes a su estado de desarrollo (figura 2).

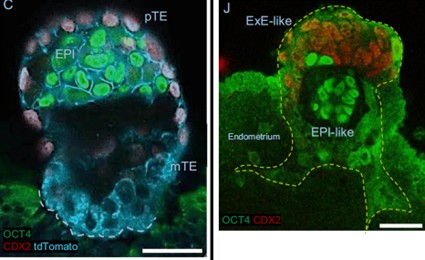

Figura 2. Implantación del blastocisto en el modelo ex vivo descrito en el texto. Izquierda y derecha: 24 y 48 horas tras la colocación sobre el fragmento de útero. El futuro embrión está marcado en verde, el trofoectodermo polar en rojo y el trofoectodermo mural en azul. El trofoectodermo mural es el que genera el sincitiotrofoblasto invasivo. La línea amarilla discontinua muestra el contorno de la invasión. Fuente: Hiraoka et al. (2025), (2025) Nat Commun. doi: 10.1038/s41467-025-60610-x CC BY-NC-ND 4.0.

Figura 2. Implantación del blastocisto en el modelo ex vivo descrito en el texto. Izquierda y derecha: 24 y 48 horas tras la colocación sobre el fragmento de útero. El futuro embrión está marcado en verde, el trofoectodermo polar en rojo y el trofoectodermo mural en azul. El trofoectodermo mural es el que genera el sincitiotrofoblasto invasivo. La línea amarilla discontinua muestra el contorno de la invasión. Fuente: Hiraoka et al. (2025), (2025) Nat Commun. doi: 10.1038/s41467-025-60610-x CC BY-NC-ND 4.0.Desafortunadamente, este sistema no permitió alcanzar mucho más allá de un desarrollo correspondiente a los 5,5 días post coitum. Sin embargo, sí permitió hacer algunos experimentos para conocer mejor el proceso de implantación. El más llamativo fue la investigación del papel desempeñado por la ciclooxigenasa-2 (COX-2) en dicho proceso. Esta enzima cataliza la producción de prostaglandinas, moléculas implicadas en la inflamación y el dolor. Precisamente la aspirina, como otros antiinflamatorios no esteroideos (AINEs), ejerce su función analgésica y antiinflamatoria mediante la inhibición de la COX-2.

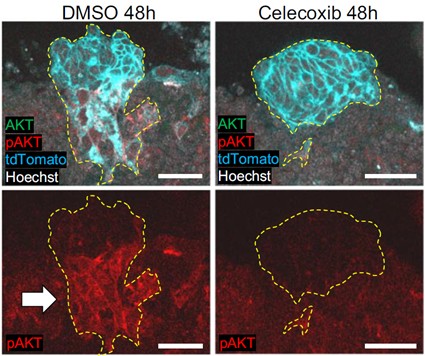

Desde hace tiempo se sabe que la COX-2 es necesaria para la implantación del blastocisto, y que es producida por células del endometrio, aunque se ignoraba su mecanismo de actuación. El grupo japonés confirmó en su modelo ex vivo que la inhibición de la COX-2 con celecoxib (un AINE) impedía la correcta implantación del blastocisto. El modelo permitió comparar la expresión génica de blastocistos en presencia de celecoxib y blastocistos control, que se implantaban normalmente. El resultado fue que un importante regulador de múltiples vías de señalización celular llamado AKT (o proteína kinasa B) no se activaba en el blastocisto si COX-2 no era operativa en el endometrio (figura 3).

Figura 3. Este experimento realizado sobre el modelo ex vivo de implantación muestra el mecanismo de actuación de la ciclooxigenasa-2 (COX-2) en el proceso. A la derecha, el tratamiento con celecoxib (inhibidor de la COX-2) frena la invasión del endometrio. Abajo podemos ver cómo la forma activada de la enzima AKT (pAKT) se reduce fuertemente en el blastocisto tras el tratamiento con celecoxib, revelando la importancia de esta vía de señalización en la implantación. Fuente: Hiraoka et al. (2025), (2025) Nat Commun. doi: 10.1038/s41467-025-60610-x CC BY-NC-ND 4.0.

Figura 3. Este experimento realizado sobre el modelo ex vivo de implantación muestra el mecanismo de actuación de la ciclooxigenasa-2 (COX-2) en el proceso. A la derecha, el tratamiento con celecoxib (inhibidor de la COX-2) frena la invasión del endometrio. Abajo podemos ver cómo la forma activada de la enzima AKT (pAKT) se reduce fuertemente en el blastocisto tras el tratamiento con celecoxib, revelando la importancia de esta vía de señalización en la implantación. Fuente: Hiraoka et al. (2025), (2025) Nat Commun. doi: 10.1038/s41467-025-60610-x CC BY-NC-ND 4.0.Esto se confirmó mediante inhibidores farmacológicos de AKT, que bloquearon también la implantación en el modelo ex vivo. Por otro lado, si se inducía la activación permanente de AKT, se soslayaba la necesidad de una COX-2 funcional en el endometrio. Por tanto, se demostró que las señales reguladas por la activación de AKT en el blastocisto son esenciales para su normal implantación.

El modelo ex vivo de implantación desarrollado por el grupo japonés ha demostrado ser una técnica del mayor interés para conocer los detalles de este momento crítico de la gestación. Los resultados que se deriven de su utilización pueden ser de mucha utilidad en el tratamiento de la infertilidad femenina.

Referencias

Hiraoka, T., Aikawa, S., Mashiko, D. et al. (2025). An ex vivo uterine system captures implantation, embryogenesis, and trophoblast invasion via maternal-embryonic signaling. Nat Commun. doi: 10.1038/s41467-025-60610-x.

Sobre el autor: Ramón Muñoz-Chápuli Oriol es Catedrático de Biología Animal (jubilado) de la Universidad de Málaga.

El artículo La implantación del embrión en el útero, ex vivo y en directo se ha escrito en Cuaderno de Cultura Científica.

La doble (y desconocida) historia del cuerpo humano

Ramón Muñoz-Chápuli, autor

¿Hasta qué punto conocemos nuestro cuerpo? No me refiero a poder indicar la localización de nuestros órganos internos, ni a recitar de carrerilla el nombre de los huesos o músculos principales. Estoy hablando de la historia de nuestro cuerpo, de cada uno de sus elementos. Detrás de todos ellos se esconde una historia fascinante o, mejor dicho, dos historias. Por un lado, cada componente de nuestro cuerpo es el resultado de innovaciones evolutivas que se han sucedido en el linaje de nuestros antepasados a lo largo de millones de años. Pero nuestro cuerpo también es el producto final de una historia que transcurre dentro del vientre de nuestra madre: un desarrollo embrionario a lo largo de nueve meses.

Ambas historias son muy poco conocidas. A lo largo de cuatro décadas enseñando evolución animal y anatomía comparada, he podido constatar la sorpresa de mis estudiantes cuando les desvelaba el origen de alguno de los componentes del cuerpo humano.

Fuente: Shackleton Books

Fuente: Shackleton BooksVeamos algunos ejemplos. Un momento crucial de la evolución de los vertebrados fue el desarrollo de las mandíbulas. Parece una cuestión secundaria, pero a esta innovación debemos numerosas características de nuestro cuerpo actual. Los primeros peces, habitantes de los mares del Cámbrico hace unos 500 millones de años, no tenían mandíbulas y se alimentaban por filtración a través de una gran faringe branquial. Esto limitaba su tamaño, que raramente superaba los 30 cm. Los depredadores de la época suponían una amenaza, y por ello el cuerpo de estos peces primitivos estaba cubierto por hueso dérmico.

El desarrollo de mandíbulas a partir del esqueleto branquial supuso un cambio radical en la forma de vida de los vertebrados. Los peces ya podían ser depredadores, y esto supuso un gran aumento de tamaño. Al mismo tiempo, los huesos dérmicos que protegían el cuerpo ya no eran tan necesarios y se redujeron a zonas corporales en los que cumplían alguna función. Nuestra bóveda craneana, protectora del encéfalo, nuestras mandíbulas, los dientes y las clavículas son derivados de aquel caparazón protector, y se siguen desarrollando en nuestra dermis de la misma forma que ocurría en nuestros antepasados.

El abandono del sistema primitivo de filtración a través de la faringe tuvo otra consecuencia curiosa. El órgano productor de mucus con el que se atrapaban las partículas alimenticias dio lugar a una glándula controladora del metabolismo. Me refiero a la tiroides, que recapitula su origen evolutivo al formarse a partir de un surco de la faringe embrionaria.

Otro momento estelar de la evolución de los vertebrados fue la transición del agua al medio aéreo. Conservamos numerosos rastros en nuestro cuerpo de los cambios que fueron necesarios para culminar esta transición. Por ejemplo, el esternón que refuerza la caja torácica, el ilion que conecta las patas posteriores a las vértebras sacras, o el estribo del oído medio, que deriva de un arco branquial modificado. Sin olvidar la profunda remodelación del corazón, que se vio enfrentado a la necesidad de atender a dos circuitos sanguíneos diferentes (el general del cuerpo y el pulmonar).

Podríamos seguir enumerando ejemplos acerca de los miembros, la musculatura facial, los riñones o los conductos reproductivos. Cada parte de nuestro cuerpo encierra esa doble historia que antes mencionaba, su origen evolutivo y su desarrollo embrionario. Parecen historias independientes, pero no es así.

Desde hace algunas décadas sabemos que el desarrollo embrionario está regulado por un conjunto relativamente pequeño de genes. Estos genes constituyen una especie de “caja de herramientas” compartida por todos los animales. Su funcionamiento es responsable de la construcción de cada organismo durante el desarrollo. Modificaciones en la forma en que estos genes se aplican a su tarea constructiva pueden generar novedades que terminen siendo integradas en el proceso evolutivo. Este nuevo concepto ha supuesto una importante ampliación de la Teoría de la Evolución.