LP 791-18d, el planeta cubierto de volcanes

LP 791-18d

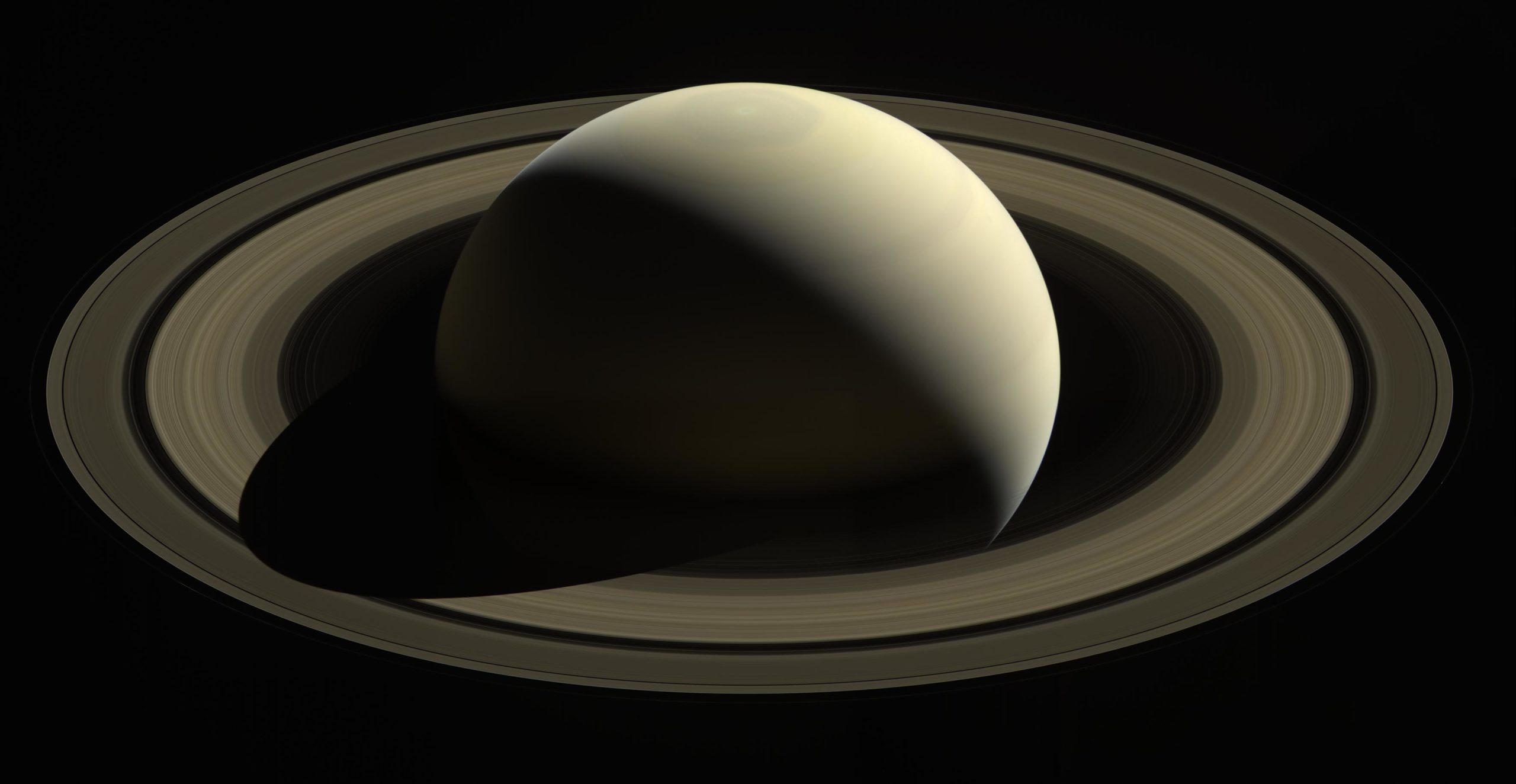

Una de las carreras más importantes que se están desarrollando en el campo de la astronomía hoy en día es la búsqueda de un planeta similar en tamaño y características a la Tierra, algo que desde el punto de vista de la geología nos podría ayudar mucho a saber que “ingredientes” son necesarios para la formación de planetas como el nuestro. De momento no hemos encontrado un planeta b, y es posible que tardemos en encontrarlo por dos cuestiones principales: por las dificultades propias de la observación de planetas tan relativamente “pequeños” y porque no sabemos todavía cómo de raros son los planetas como el nuestro -si es que hay más.

Pero el ir completando el catálogo de planetas extrasolares -aquellos que giran en torno a una estrella diferente a nuestro Sol- está aportándonos una visión sobre la enorme diversidad de planetas existentes, muchos de los cuales no tienen una representación directa en nuestro Sistema Solar.

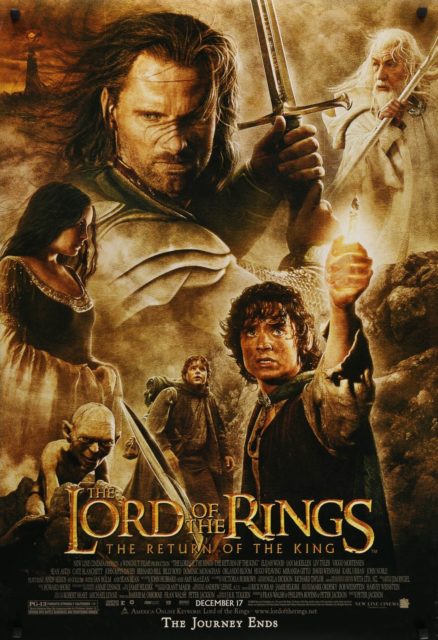

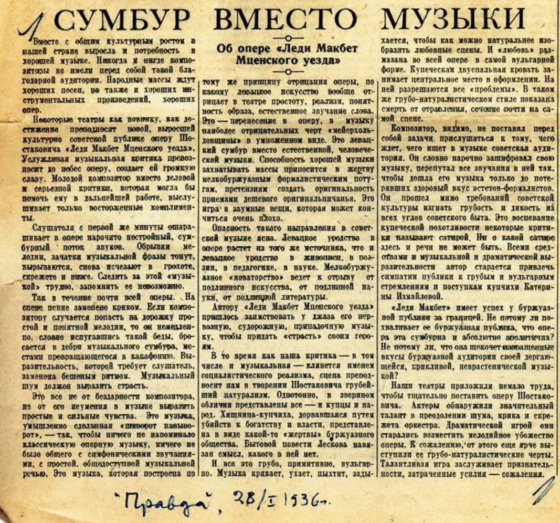

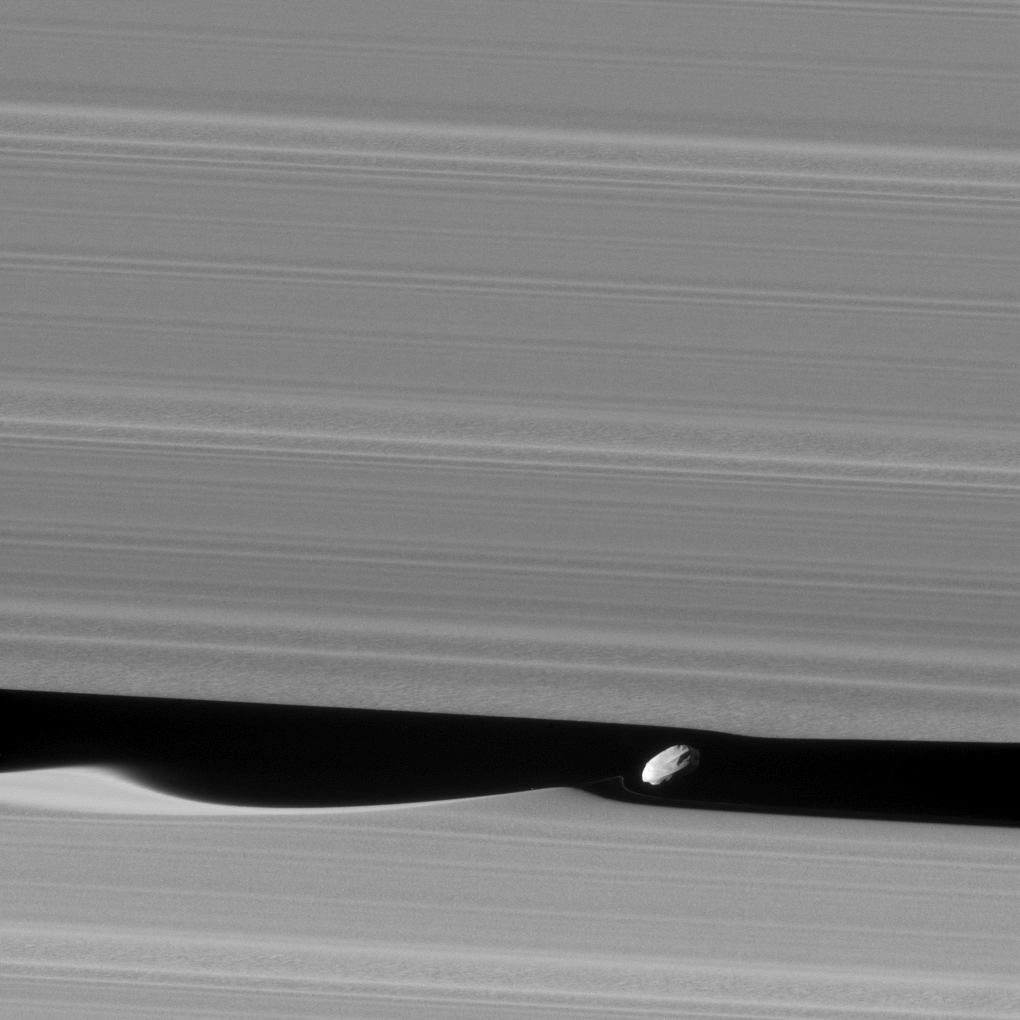

Figura 1. Reconstrucción artística de LP 791-18d. El punto azul en la lejanía correspondería con el LP 791-18c. Imagen cortesía de NASA’s Goddard Space Flight Center/Chris Smith/KRBwyle.

Figura 1. Reconstrucción artística de LP 791-18d. El punto azul en la lejanía correspondería con el LP 791-18c. Imagen cortesía de NASA’s Goddard Space Flight Center/Chris Smith/KRBwyle.Recientemente, se ha publicado un nuevo estudio en la revista Nature hablándonos de cómo podría ser un planeta de un tamaño similar al de la Tierra (1.03 radios terrestres) llamado LP 791-18d, situado a unos 90 años-luz de nuestro planeta y que gira en torno a una enana roja junto a otros dos planetas, estos dos últimos ya descubiertos en 2019.

Pero, ¿qué tiene de especial este planeta? Los científicos piensan que podría tener una gran actividad volcánica distribuida por toda su superficie, algo similar a lo que ocurre en Ío, un satélite de Júpiter. La actividad volcánica es muy importante en planetas rocosos, ya que puede ayudar a generar una atmósfera -los gases más importantes que emiten los volcanes son el vapor de agua, el dióxido de carbono y el de azufre, entre otros- y a ir rellenándola en el caso de que esta pueda sufrir pérdidas por cualquier motivo, como la carencia de un campo magnético o el propio viento estelar.

Además, las atmósferas de los planetas, si se dan las condiciones adecuadas, pueden permitir la existencia de agua líquida en la superficie, algo que, como sabemos, es de gran importancia para la astrobiología y la búsqueda de la vida más allá de nuestras fronteras.

Al mismo, tiempo, los volcanes son capaces de llevar a la superficie elementos que de otro modo estarían atrapados en su interior, pudiendo crear un ciclo de transferencia y reciclaje entre la corteza y el interior del planeta. También podrían incluso aportar calor a zonas más frías, como el fondo de posibles océanos, permitiendo ambientes menos hostiles.

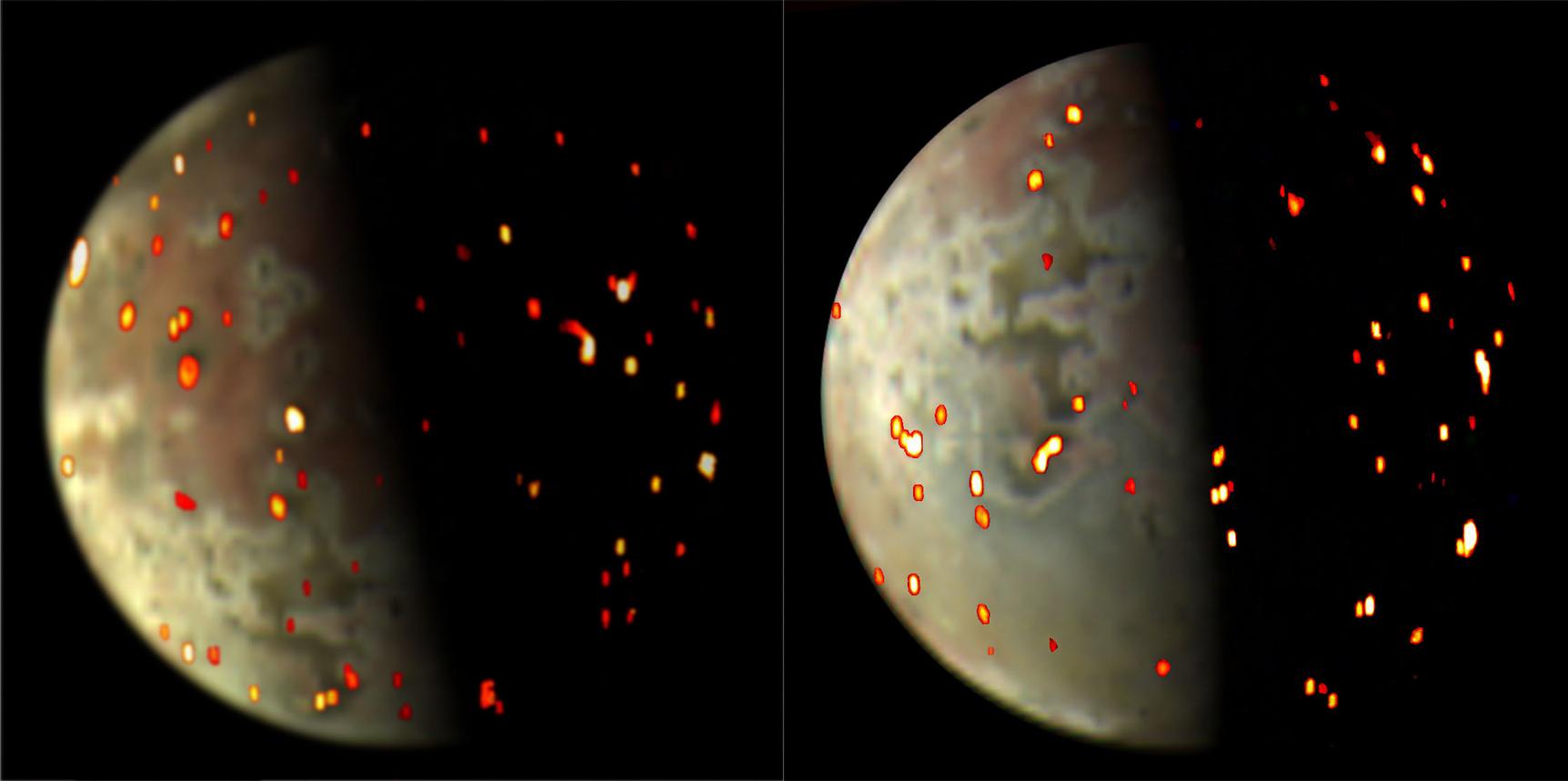

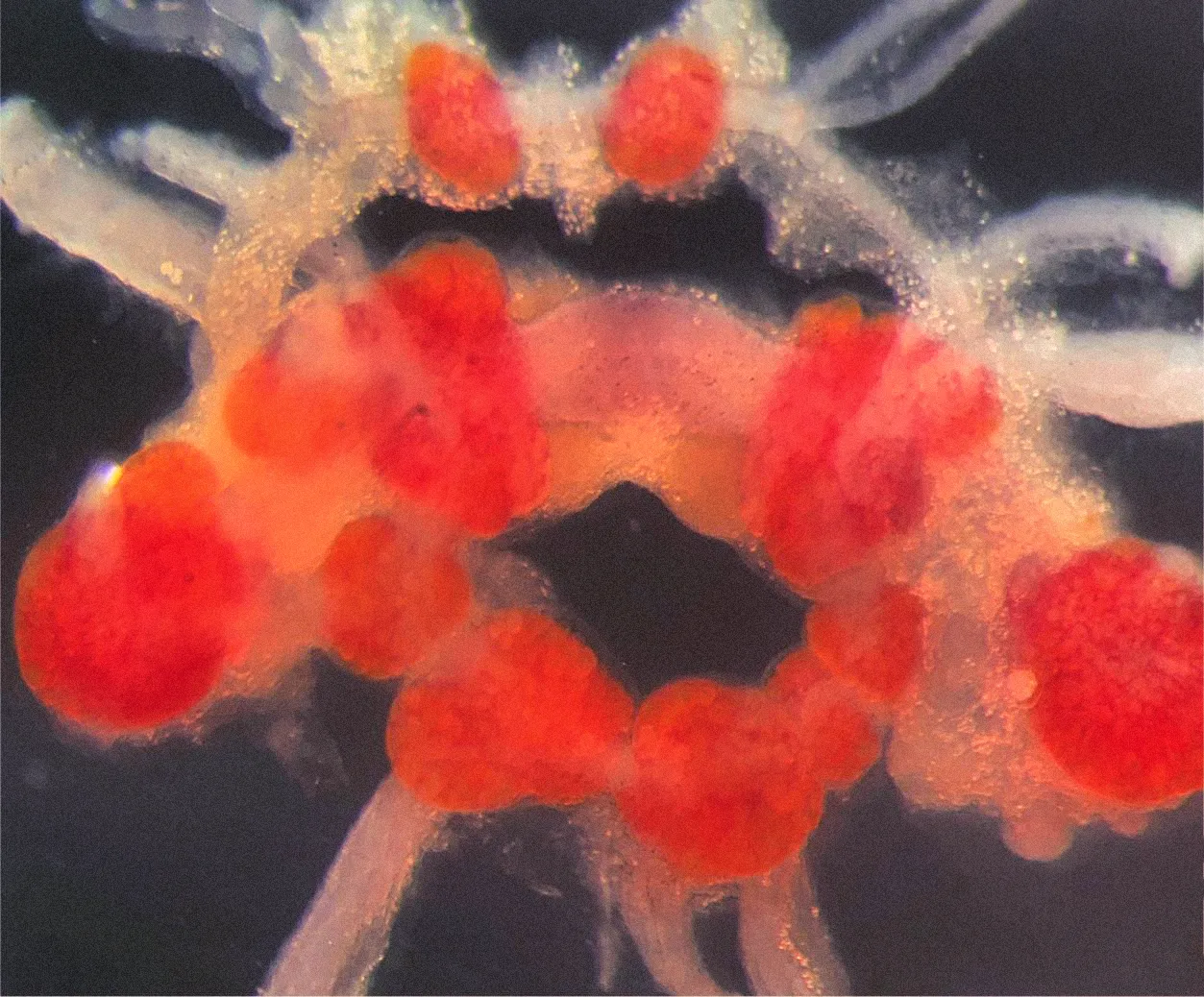

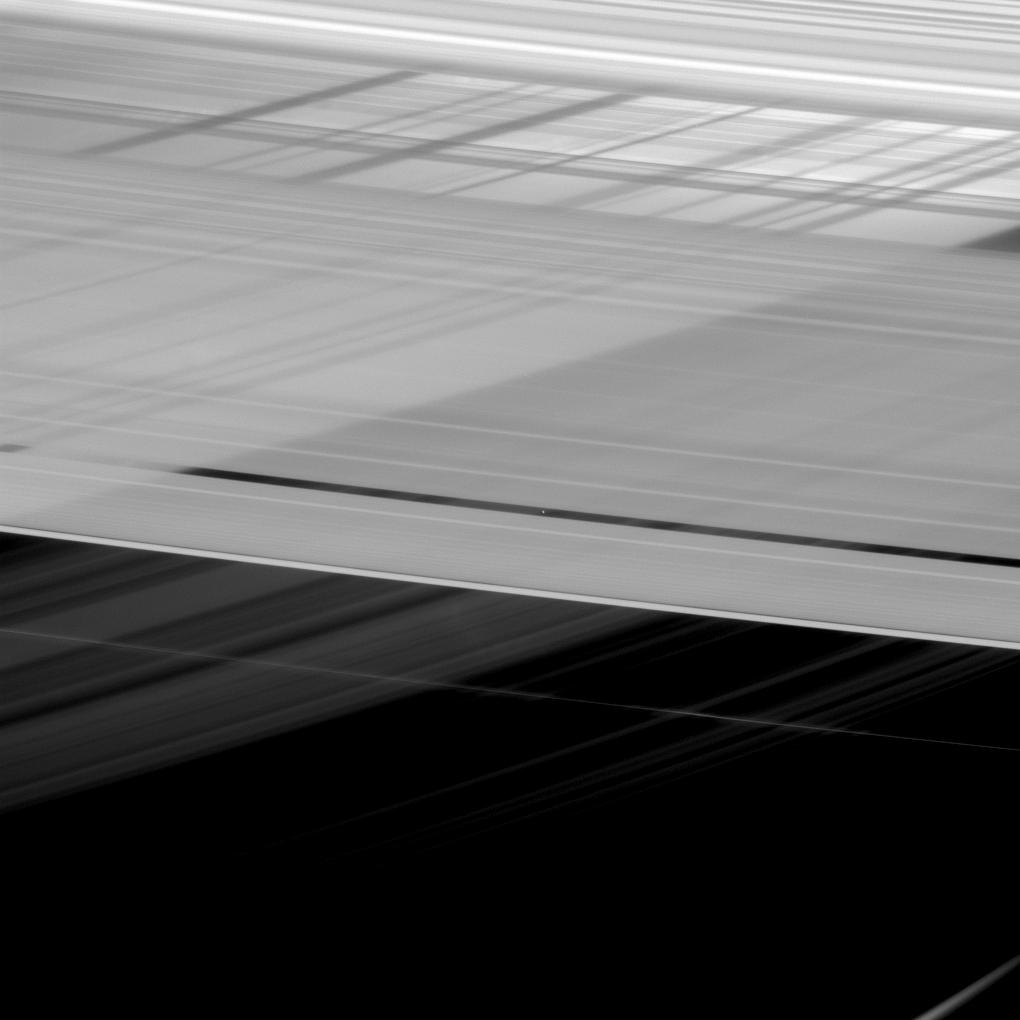

Figura 2. Dos imágenes de Ío tomadas el 14 de diciembre de 2022 y el 1 de marzo de 2023 desde la sonda Juno. En color podemos ver la superficie de Ío, y los puntos rojos, amarillos y blancos corresponden con puntos que tienen una elevada temperatura y que probablemente correspondan con puntos de emisión volcánica recientes o actuales. Cortesía de NASA/JPL-Caltech/SwRI/ASI/INAF/JIRAM.

Figura 2. Dos imágenes de Ío tomadas el 14 de diciembre de 2022 y el 1 de marzo de 2023 desde la sonda Juno. En color podemos ver la superficie de Ío, y los puntos rojos, amarillos y blancos corresponden con puntos que tienen una elevada temperatura y que probablemente correspondan con puntos de emisión volcánica recientes o actuales. Cortesía de NASA/JPL-Caltech/SwRI/ASI/INAF/JIRAM.¿De dónde sacaría este planeta la energía interna suficiente como para poder estar cubierto de volcanes? La respuesta está en la existencia de uno de los otros planetas, el c, que tiene una masa de aproximadamente nueve veces la de la Tierra. Conforme van haciendo órbitas alrededor de su estrella, los planetas c y d pasan cerca el uno del otro, de tal forma que el c es capaz de modificar ligeramente la órbita del d, haciéndola más elíptica.

Esta deformación en la órbita es suficiente como para que el planeta sufra un fenómeno que conocemos como calentamiento de marea, de tal forma que a lo largo de su órbita el planeta sufre una deformación en su superficie y su interior diferente en cada punto de la órbita debido a la atracción gravitatoria de su estrella y de los otros planetas del sistema.

Para que podamos entendernos, imagina que tienes una pelota antiestrés en las manos y que empiezas a comprimirla y a dejar que vuelva a su forma. Después de un rato, verás que esta ha aumentado ligeramente su temperatura y esto se debe en parte a la energía que transfiere el movimiento de tu mano sobre la propia pelota.

De una manera parecida, cuando un cuerpo masivo ejerce una fuerza de atracción gravitatoria sobre otro más pequeño, acaba provocando que el más pequeño sufra un proceso de deformación en el cual se comprime y se estira, parecido a lo que has hecho con la pelota. Esto ocurre normalmente porque la fuerza de atracción de la gravedad en un lado, el que mira al objeto más masivo, es más fuerte, y más débil su efecto sobre el lado opuesto.

Figura 3. En los planetas con acoplamiento de mareas no hay ciclo día-noche. Solo un lado donde hay oscuridad y otro donde es un día perpetuo. Imagen cortesía de la NASA y el JSC.

Figura 3. En los planetas con acoplamiento de mareas no hay ciclo día-noche. Solo un lado donde hay oscuridad y otro donde es un día perpetuo. Imagen cortesía de la NASA y el JSC.Este proceso, si ocurre en repetidas ocasiones, genera una serie de fricciones que a su vez se traducen en calor, a veces suficiente para generar magmas que pueden dar lugar a erupciones volcánicas, y como decíamos anteriormente, es el mismo proceso que ocurre sobre la luna de Júpiter Ío, y que lo convierte en uno de los objetos con mayor actividad del Sistema Solar.

Otro de los detalles aportados en el estudio sobre este planeta indica que sufre un acoplamiento de mareas con su estrella y que, por lo tanto, siempre tiene la misma cara apuntando a su estrella -algo parecido a lo que ocurre en nuestro planeta con la Luna, en la que el periodo de rotación es igual al orbital- y esto a su vez se traduce en que su cara diurna probablemente tenga una temperatura muy alta, aunque dependiendo de su atmósfera, el agua podría ser estable en su cara nocturna, donde las temperaturas serían menores.

Eso si no ha sufrido un proceso evolutivo como el de Venus, donde los volcanes han sido capaces de generar una atmósfera muy importante, capaz de equilibrar la temperatura en su lado nocturno y diurno, y volviendo totalmente inhabitable cualquier parte del planeta.

Pero precisamente este hecho abre otra cuestión muy importante de cara a entender la habitabilidad de la Tierra. Podríamos suponer que Venus y la Tierra tienen una actividad volcánica similar a grandes rasgos… entonces, ¿por qué Venus ha seguido sumando gases de efecto invernadero? Una de las posibles respuestas a esta pregunta es la existencia de una tectónica de placas capaz de almacenar parte de estos gases -obviamente, no en estado gaseoso sino transformado en otras sustancias químicas- dentro de su corteza o su manto, donde seguirá un ciclo en el que se vaya incorporando al interior del planeta y posteriormente siendo expulsado por los volcanes.

En nuestro planeta este ciclo viene regulado por la tectónica de placas, pero al menos aparentemente no hay una en Venus, y quizás tampoco lo exista en este exoplaneta, por lo que la tectónica de placas podría ser un condicionante para conseguir unas condiciones más habitables en los planetas. O quien sabe si hay algún detalle o mecanismo que todavía desconozcamos por completo a la hora de regular estos ciclos en otros planetas.

Sea como fuere, el estudio de los exoplanetas va a seguir aportándonos una importante visión no solo sobre la diversidad de mundos que pueblan nuestra galaxia, sino también ayudarnos a contestar aquellas preguntas que todavía tenemos sobre nuestro propio Sistema Solar.

Bibliografía:

Crossfield, I.J. et al. (2019) ‘A super-earth and sub-neptune transiting the late-type M dwarf LP 791-18’, The Astrophysical Journal Letters, 883(1). doi: 10.3847/2041-8213/ab3d30.

Peterson, M.S. et al. (2023) ‘A temperate Earth-sized planet with tidal heating transiting an M6 star’, Nature, 617(7962), pp. 701–705. doi: 10.1038/s41586-023-05934-8.

Para saber más:

25 años de planetas extrasolares

El valle de la evaporación de planetas

Sobre el autor: Nahúm Méndez Chazarra es geólogo planetario y divulgador científico.

El artículo LP 791-18d, el planeta cubierto de volcanes se ha escrito en Cuaderno de Cultura Científica.

Ingredientes para la receta: la vid

20. Noé se dedicó a la labranza y plantó una viña.

21. Bebió del vino, se embriagó, y quedó desnudo en medio de su tienda.

22. Vio Cam, padre de Canaán, la desnudez de su padre, y avisó a sus dos hermanos.

23. Entonces Sem y Jafet tomaron el manto, se lo echaron al hombro los dos, y andando hacia atrás, vueltas las caras, cubrieron la desnudez de su padre sin verla.

Biblia de Jerusalén, Génesis, 9: 20-23.

… El dios hijo de Zeus

da sin distinción al rico y al miserable

el goce apaciguador del vino.

Eurípides, Las bacantes, 405 a.C.

Porque con ser la vid un árbol tan pequeño, no es pequeño el fruto que da. Porque da uvas casi para todo el año, da vino que mantiene, esfuerza y alegra el corazón del hombre, da vinagre, da arrope, da pasas, que es mantenimiento sabroso y saludable para sanos y enfermos.

Fray Luis de Granada (1504-1588).

Foto: José Alfonso Sierra / Unsplash

Foto: José Alfonso Sierra / UnsplashTanto las uvas silvestres como las cultivadas se mencionan en la Biblia hasta en 72 capítulos o, también, en 12 del Corán. Por supuesto, solo hay que recordar a Noé, que también aparece su producto derivado más conocido, el alcohol, resultado de la fermentación de los azúcares de la uva, y el vino como objetivo final. Por todo ello, la vid es la planta más citada en los textos sagrados. Y también la cita Stephen Harris, de la Universidad de Oxford, entre las 50 plantas legendarias que cambiaron el mundo.

Las uvas silvestres, Vitis sylvestris, son autóctonas del Asia Menor y el Cáucaso donde se inició la viticultura y se difundió por el Mediterráneo, según Jules Janick, de la Universidad Purdue, en Estados Unidos. Se han encontrado semillas de uva en yacimientos prehistóricos de Europa y, en concreto, en Grecia, los Balcanes, Italia, Suiza, Alemania y Francia. La distribución de la vid silvestre va de Portugal al oeste hasta Turkmenistán al este, y desde Alemania al norte hasta Túnez en el sur.

Por tanto, se encuentra en la Península Ibérica, excepto en el norte y en Pirineos, como lo muestran los hallazgos de sus pepitas desde el Neolítico. Los datos confirman, según Ramón Buxó, de la Universidad Pompeu Fabra, que la vid es una planta indígena en todo el Mediterráneo y las pepitas de vid cultivada se han recuperado a partir de la Edad del Bronce.

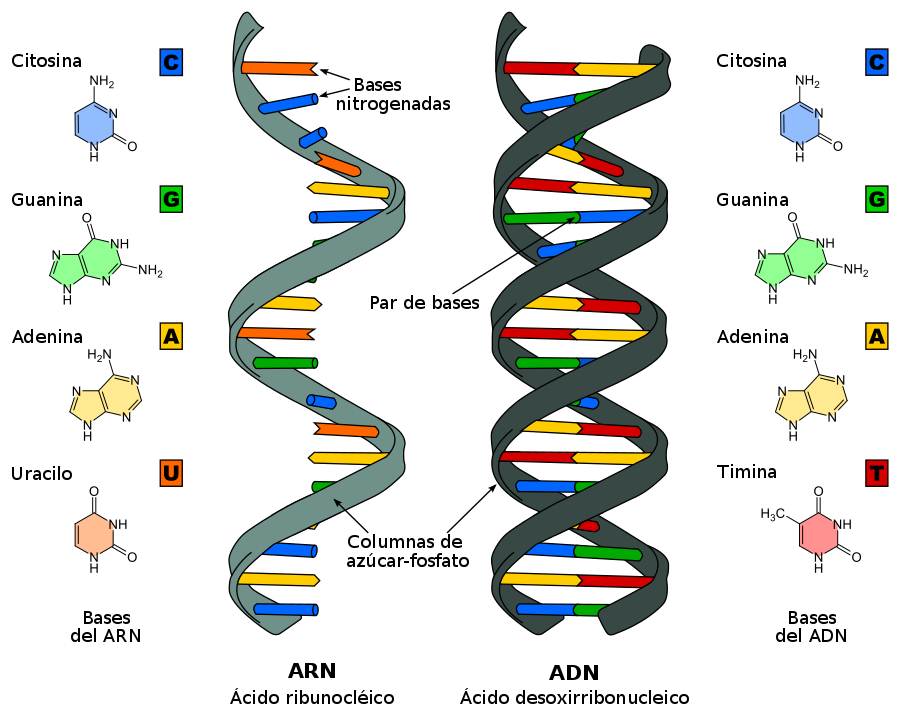

Todavía está abierto el debate que propone que, dada la extensión de la vid silvestre por la cuenca mediterránea, es posible que la vid doméstica se originara en más de un lugar de la región y no solo de Oriente Medio y el Cáucaso. Rosa Arroyo-García y sus colegas del Instituto Nacional de Investigación y Tecnología Agraria y Alimentaria de Madrid, han estudiado el ADN de los cloroplastos de 1201 muestras de vid silvestre y doméstica de toda el área de su distribución. Los resultados, según los autores, muestran que el 70% de las muestras de la Península Ibérica llevan cloroplastos que son únicamente compatibles con material derivado de poblaciones occidentales de la vid silvestre.

Otra investigación, centrada en los cloroplastos de las variedades silvestre y doméstica de la meseta de Castilla La Vieja, del grupo de José Carlos Santana, de la Universidad de Valladolid, diferencia hasta 121 genotipos diferentes. Es interesante que muchos de ellos muestran cruces entre la vid silvestre autóctona y vides domésticas de Francia que los autores sitúan en variedades que llegaron por el comercio a través del Camino de Santiago.

8000 años de vid domésticaAntes del 5000 a. C., la uva doméstica, Vitis vinifera , llegó de Anatolia a Oriente Próximo, desde el sur del Cáucaso, entre los mares Negro y Caspio y el Creciente Fértil, el valle del Jordán y Egipto, según el análisis genético de 1000 muestras de vides silvestres y domesticadas publicado por Sean Myles y su grupo, de la Universidad Cornell en Ithaca.

La fecha de la domesticación se sitúa hace entre 6000 y 8000 años atrás. Hay semillas de uva de la Edad del Bronce en Mesopotamia, Israel, Siria, Egipto, el Egeo y en lagos de Suiza, y también se han encontrado en América. Solo hay que recordar que cuando el vikingo Leif Erikson llegó a las costas de Labrador llamó Vinland, País del Vino, a aquel país por la abundancia de vides silvestres de la especie Vitis riparia, habitual en América del Norte.

De hace 4000 años, en la Edad del Bronce, se han encontrado vasijas para almacenar vino y pasas. En el yacimiento de Tel Kabri, en Israel, en un local se recuperaron hasta 40 vasijas con restos de compuestos típicos del vino como ácido tartárico, resinas, miel, aceite de cedro o de ciprés. Es, según Andrew Koh y sus colegas, de la Universidad Brandeis de Estados Unidos, una habitación donde se almacenaban vasijas con vino, es decir, una bodega, una de las más antiguas conocidas hasta ahora.

El estudio, reciente y publicado hace unas semanas, y dirigido por Yang Dong, de la Universidad Agrícola de Yunnan, en China, con 84 autores, se analizan datos genéticos de 3525 variedades de uva silvestre y uva cultivada de todo el planeta. Los resultados revelan los efectos del clima, en concreto de las glaciaciones, en los tamaños de población históricos, sugieren domesticaciones simultáneas de vino y uvas de mesa e identifican variantes asociadas con rasgos de domesticación como el color de la baya y la palatabilidad.

En el Pleistoceno, las condiciones climáticas empujaron a la selección de ecotipos de uva silvestre a lo que ayudó la fragmentación del hábitat. La domesticación ocurrió simultáneamente hace unos 11.000 años en Asia occidental y el Cáucaso para producir vides de frutas de mesa y vino. Las domesticadas de Asia occidental se dispersaron en Europa con los primeros agricultores, y se cruzaron con antiguos ecotipos occidentales salvajes y, posteriormente, se diversificaron ayudados por las migraciones humanas a finales del Neolítico.

Y de por entonces son los Mejillones con uvas que nos presentan Eudald Carbonell y Cinta Bellmunt con las fotografías de María Ángeles Torres desde la Universidad Rovira i Virgili y el grupo de Atapuerca. Es receta sencilla y rápida y un buen entrante para una comida en el campo.

Recolectamos los mejillones en las rocas de la costa más cercana y los tostamos a la hoguera encima de una piedra. Cuando se abran ponemos una uva en cada concha y los comemos a la vez, mejillón y uva.

La vid en AméricaUn ejemplo revelador de la difusión del cultivo de la vid nos llega desde América después de la llegada de Cristóbal Colón. Según lo resume Julio Luelmo, cuando llegaron los europeos encontraron muchas variedades de vid que crecían espontáneamente, sobre todo Vitis riparia, aunque no hay evidencias de que se utilizaran para obtener vino o cualquier otro líquido fermentado a pesar del nombre que los vikingos dieron al Labrador. La viticultura se introdujo en América con la importación de las cepas europeas. Los cultivos de vid resultaron en México, California y, sobre todo, en Sudamérica. En cambio, fracasaron al este de las Montañas Rocosas y en las Antillas donde lo había intentado Colón en 1493.

Hasta el siglo XIX no se conoció que fracasaron por la acción de un insecto de la especie Daktulosphaira vitifoliae, parásito de las especies americanas que ya estaban inmunizadas. Sin embargo, atacaba a las variedades europeas y, cuando llegó al Atlántico europeo, casi acaba con la viticultura en el continente durante el siglo XIX. Su recuperación llegó con injertos de la vid europea en troncos de la vid americana resistente.

Con la domesticación se seleccionan el aumento del tamaño de las uvas y su contenido en azúcar, los varios colores de la piel y la ausencia de semillas, importante para las uvas de mesa y las pasas. Según Stephen Harris, en la actualidad se conocen hasta 10000 cultivares distintos de uva y pocas de ellas llegan hasta el gran comercio. Muchas quedan en exclusiva para pequeños productores. Todo ello influye en la fermentación del mosto de la uva y la obtención del vino. La levadura convierte los azúcares del zumo de uva, glucosa y fructosa, en etanol y dióxido de carbono. Entre la levadura y otras bacterias se sintetizan compuestos aromáticos variados que darán la personalidad típica a cada vino.

Una de las pruebas arqueológicas más antiguas que conocemos de la producción de vino se ha encontrado en una aldea datada en el Neolítico de las montañas Zagros, en el norte de Irán. El grupo de Patrick McGovern, de la Universidad de Pennsylvania, encontró una vasija, fechada hace 7000 años, con residuos de ácido tartárico y de una resina del árbol Pistacia que se utiliza para mezclar con el vino y detener la formación de vinagre.

Las antocianinas son las responsables principales del color rojo en el vino. Se encuentran en la capa exterior de la piel de la uva y se extrae durante la maceración. La mayoría de los mostos, incluso los de uvas negras, son incoloros, y por ello la maceración es un proceso importante para la coloración de los vinos. El color rojo o rosado depende, por tanto, de la extracción de las antocianinas de la piel de la uva durante el proceso de fermentación. También se ha encontrado antocianina en vasijas fechadas hace 8000 años recuperadas de la excavación de Areni, en Armenia, y por tanto, otro de los más antiguos restos que indican la presencia de vino según Hans Barnard y sus colegas, de la Universidad de California en Los Angeles. Confirman la obtención de vino en el Cáucaso ya como ya se conocía de las montañas Zagros de Irán.

Foto: Jaime Casap / Unsplash

Foto: Jaime Casap / UnsplashEs interesante que nuestro gastrónomo romano de hace más de 15 siglos, Marco Gavio Apicio, destaque qué hacer para cambiar el color del vino y, en concreto, de vino tinto a vino blanco. Su consejo es “Pones en la botella harina de habas o bien tres claras de huevo y lo mezclas durante un buen rato. Al día siguiente, el vino será blanco. Las cenizas blancas de viña también pueden producir esta transformación”. Espero que le sea útil a quien le interese.

Es una receta de Juan Altamiras en su texto Nuevo arte de la cocina española. Así recomienda cocinar la Ternera estofada en vino blanco, que publicó en 1758. Era fraile franciscano y había nacido en 1709 en La Almunia de Doña Godina, Zaragoza. La fecha original de publicación de su libro era 1745 y es importante pues presenta la cocina española de la época anterior a la influencia de la cocina francesa a finales del siglo XVIII y en el siglo XIX. La receta aparece en la reciente edición sobre Altamiras publicada por Vicky Hayward.

De lo magro de la ternera cortarás pedazos como nuezes: freirás tocino, y con su pringue has de freír los trozos de ternera: echarás la carne en la olla, con el pringue que te quedó freirás cebolla menuda, y echarás con la carne, pondrás un poco de vino blanco, dos granos de ajos majados, sal, todas especias; peregil y unas hojas de laurel: después de este recado, la pondrás a fuego manso, con un papel en la boca del puchero, para que no levante el hervor, y con un pucherito, que la tape, con agua. Harás un poco masseta, y la pondrás en la circunferencia de la olla principal, de modo que no se exhale, dexala cocer dos horas: así sacarás poco, pero buen caldo, y muy gustoso.

El cultivo de la vid implica un extenso laboreo y la poda anual de los sarmientos. Es el arte de la poda lo que distingue al buen viñador. Y es la base de un plato típico de La Rioja: Chuletillas de cordero al sarmiento.

Una receta para celebrar en cualquier celebración que tenga lugar en tierras riojanas o en cualquier sitio al aire libre. Se trata básicamente de chuletas de cordero asadas, a las que habremos echado sal gorda. Aunque se pueden hacer, por supuesto, en una chimenea, estas chuletas se suelen asar al aire libre, usando para ello una parrilla puesta al fuego, prendido con sarmientos, es decir, ramas secas de vid. Las chuletas se colocan cuando el fuego ya se ha extinguido y sólo quedan las brasas. Es la temperatura ideal para asar las chuletillas. Hay quien les echa un chorro de vino de Rioja poco antes de sacarlas de la parrilla.

Las uvas se conservan secándolas al sol para producir pasas, o transformando el mosto de la uva en vino. Es la bebida alcohólica de difusión universal y, según Jean-François Revel, lo es por su capacidad de viajar y, también, por su gran variedad y, siendo siempre el zumo fermentado de la uva, mantiene características propias del lugar de origen por su sabor, aroma y color. Es una bebida que depende de la habilidad y perspicacia del viticultor y, en último término, de la capacidad y la memoria del catador. Para Revel, la degustación del vino es una partida de ajedrez de infinitas soluciones jamás agotadas.

Una vez probado el vino, el catador queda hechizado. El vino se asocia al amor y a la falta de amor, a la alegría y a la tristeza, al éxito y al fracaso, a la amistad, a los negocios, a la guerra y a la paz, al reposo y a la violencia, y a tantos otros sentimientos y conductas. Incluso el vino se asocia, inevitablemente, a la templanza, aunque Revel menciona civilizaciones donde dejar de beber vino es casi como renunciar a toda otra actividad, a todo intercambio, incluso supone dejar de pensar. Es lo que el ensayista, escritor y crítico literario Jean-François Revel opina sobre el vino en su historia literaria de la sensibilidad gastronómica.

Foto: Juan Ugarte / Pixabay

Foto: Juan Ugarte / PixabaySin embargo, después de los elogios al vino llega el debate actual sobre los beneficios y daños que provoca el alcohol en la salud humana. Como ejemplo sirve una publicación reciente de Aitor Hernández y sus colegas de la Universidad de Navarra sobre la relación en la ingesta de alcohol y la hipertensión. Son datos de la encuesta “Seguimiento Universidad de Navarra” que, desde octubre de 2015, hace un seguimiento de 14651 participantes con encuestas bianuales durante 14 años. Según los resultados, si el consumo de alcohol sigue las pautas de la dieta mediterránea se asocia con un menor riesgo cardiovascular, aunque todas las relaciones no son significativas según la estadística. En conclusión, se necesitan más datos.

Hace unos años, Jonathan Silvertown, de la Universidad de Edimburgo, escribía que la afinidad entre los humanos y el alcohol, y la levadura, de la especie Saccharomyces cerevisiae, que lo produce, es muy profunda. El alcohol posee el poder transformador de una droga que altera el estado mental. Eleva o deprime el ánimo, inspira o nubla el razonamiento, enciende la pasión, disminuye la pericia, induce la agresión y la violencia o, también, provoca el sueño.

El alcohol ata a los humanos con nudos difíciles, para muchos imposibles, de deshacer. En resumen, el alcohol es una toxina para la que tenemos una cierta tolerancia. Además, es una toxina sin otro equivalente funcional en el metabolismo humano, como pueden ser las que provocan los opioides que son el producto final de nuestro sistema de recompensa cerebral. Pero nuestra especie ha estado expuesta al alcohol resultado de la fermentación de azúcares, sobre todo en frutas maduras, incluso antes de la aparición de Homo. Nuestros ancestros comunes desde hace cinco millones de años ya comían abundante fruta que, al madurar y por la levadura, ya transformaban los azúcares en alcohol. Donde hay fruta madura hay levadura, y donde hay levadura habrá alcohol.

En Bilbao, a los mejillones se les llama mojojones o, con más precisión, se les llamaba así. Ahora mojojón es, me parece, una palabra moribunda. Ni siquiera aparece en el Diccionario de la Lengua y, en Bilbao, a los antiguos mojojones con tomate antes y ahora se les llama tigres. Sin embargo, aquí va una receta con mojojones. La incluye Íñigo Azpiazu en su libro sobre la cocina tradicional vasca y la titula como Mojojones bilbotarras, o sea, mejillones bilbaínos. Dice así, más o menos:

Necesitamos mojojones, puerros, chacolí, harina, limón, perejil, sal y pimienta. Hay quien le añade mostaza. Lavamos los mojojones y los ponemos al fuego en una cazuela grande para que se abran. Entonces los pasamos a otra cazuela grande, quitamos media concha y los regamos con el caldo de la primera hervida. Rehogamos en aceite los puerros picados muy finos, añadimos una cucharada de harina, y juntamos los mojojones y un vaso de chacolí. Hervimos unos diez minutos y añadimos el zumo de medio limón y un poco de pimienta. Dejar que se enfríen y ponemos una buena cantidad de perejil por encima, y a servir.

ReferenciasApicio, M.G. 2007. De re coquinaria. El arte de la cocina. Recetas de la Roma Imperial. Comunicaciones y Publicaciones. Barcelona. 119 pp.

Arroyo-García, R. et al. 2006. Multiple origins of cultivated grapevine (Vitis vinifera L. ssp. sativa) based on chloroplast DNA polymorphisms. Molecular Ecology 15: 3707-3714.

Azpiazu, I. 1989. La cocina tradicional vasca. Ed. Iru. Barcelona. 64 pp.

Barnard, H. et al. 2010. Chemical evidence for wine production around 4000 BCE in the Late Chalcolithic Near Eastern highlands. Journal of Archaeological Science doi: 10.1016/j.jas.2010.11.012.

Biblia de Jerusalén. 1967. Desclée de Brouwer Eds. Bilbao. 1693 pp.

Brothwell, D. & P. Brothwell. 1998. Food in Antiquity. A survey of the diet of early peoples. Johns Hopkins University Press. Baltimore and London. 283 pp.

Buxó, R. 1997. Arqueología de las plantas. La explotación económica de las semillas y los frutos en el marco mediterráneo de la Península Ibérica. Crítica. Barcelona. 367 pp.

Carbonell, E. et al. 2016. Recetas paleo. La dieta de nuestros orígenes para una vida saludable. Ed. Planeta. Barcelona. 143 pp.

Dong, Y. et al. 2023. Dual domestications and origin of traits in grapevine evolution. Science 379: 892-901.

Granada, Fray Luis de. 1947. Maravillas de las plantas y de los animales. Apostolado de la Prensa. Madrid. 184 pp.

Harris, S. 2021. Plantas legendarias: 50 plantas que cambiaron el mundo. Rey Naranjo Eds. Barcelona. 358 pp.

Hayward, V. 2017. Nuevo arte de la cocina española de Juan Altamiras. Círculo de Lectores. Barcelona. 493 pp.

Hernández-Hernández, A. et al 2023. Mediterranean alcohol-drinking pattern and arterial hypertension in the “Seguimiento Universidad de Navarra” (SUN) prospective cohort study. Nutrients doi: 10.3390/nu15020307.

Janick, J. 2007. Fruits of the Bibles. HortScience 42: 1072-1076.

Koh, A. J. et al. 2014. Characterizing a Middle Bronze palatial wine cellar from Tel Kabri, Isr ael. PLOS One 9: e106406.

Luelmo, J. 1975. Historia de la agricultura en Europa y América. Ed. Istmo. Madrid. 469 pp.

McGovern, P.E. et al. 1996. Neolithic resonated wine. Nature 381: 480-481.

Myles, S. et al. 2011. Genetic structure and domestication history of the grape. Proceedings of the National Academy of Sciences USA 108: 3530-3535.

Payo, A. 2023. Los ciclos glaciares determinaron la domesticación de la uva y la aparición del vino. Boletín SiNC 2 marzo.

Piqueras Haba, J. 2005. La filoxera en España y su difusión espacial: 1878-1926. Cuadernos de Geografía 77: 101-136.

Revel, J.-F. 1996. Un festín de palabras. Historia literaria de la sensibilidad gastronómica desde la Antigüedad hasta nuestros días. Tusquets Eds. Barcelona. 289 pp.

Santana, J.C. et al. 2010. Genetic structure, origins, and relationships of grapevine cultivars from the Castilian Plateau of Spain. American Journal of Enology and Viticulture 61: 214-224.

Silvertown, J. 2019. Cenando con Darwin. Tras las huellas de la evolución en nuestros alimentos. Crítica. Barcelona.285 pp.

Wikipedia. 2023. Vino. 14 marzo.

Zohary, D. & P. Spiegel-Roy. 1975. Beginnings of fruit growing in the Old World. Science 187: 319-327.

Para saber más:El consumo del alcohol no mata a las neuronas, pero sí las trastorna

La podredumbre noble: Cuando una infección mejora un vino

«Una copita de vino es buena para el corazón». Claro que sí, guapi.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Ingredientes para la receta: la vid se ha escrito en Cuaderno de Cultura Científica.

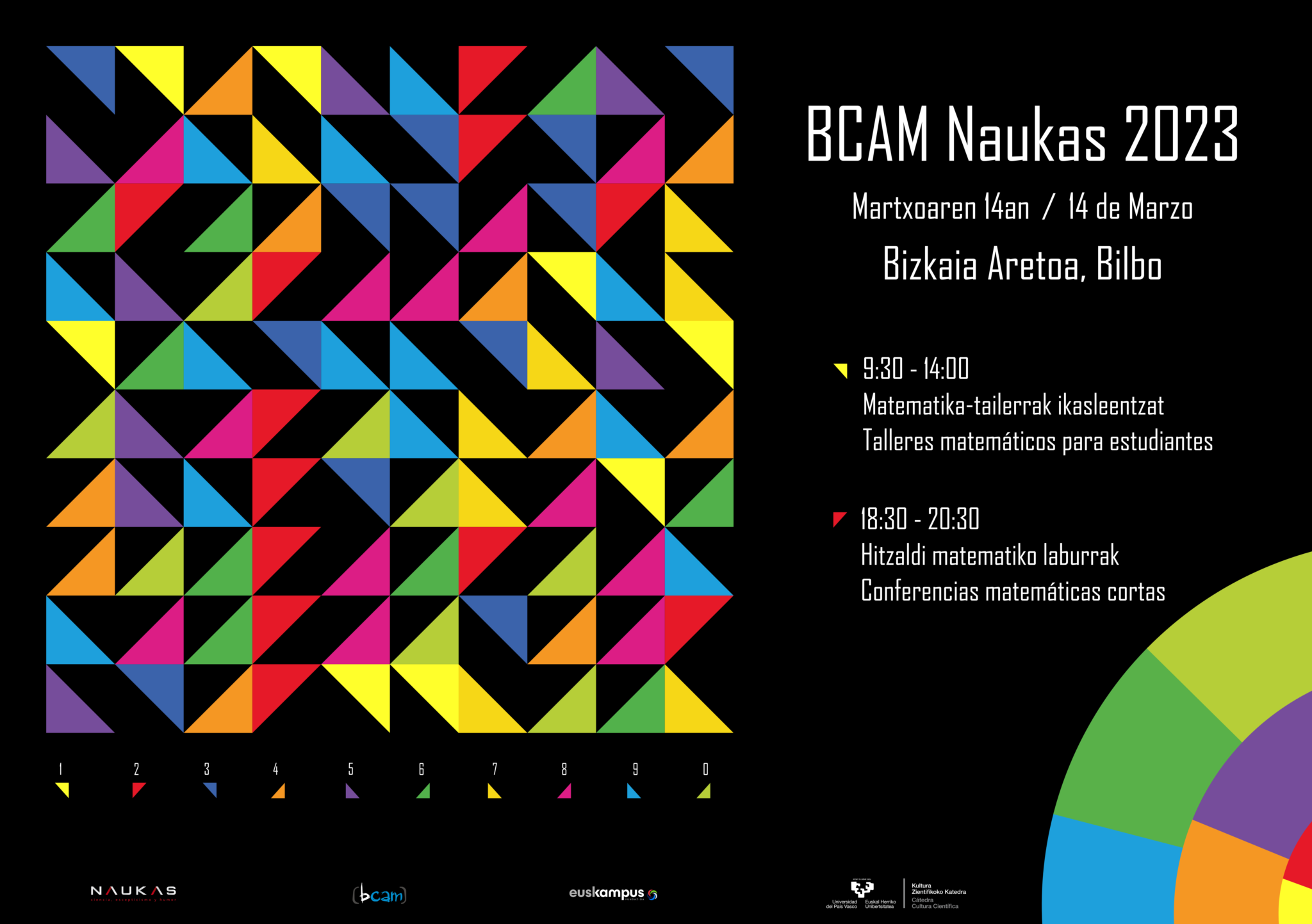

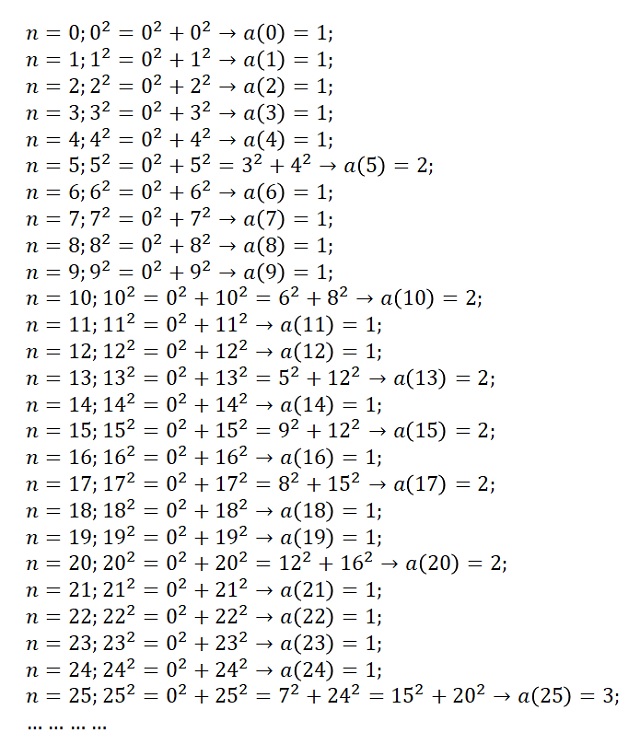

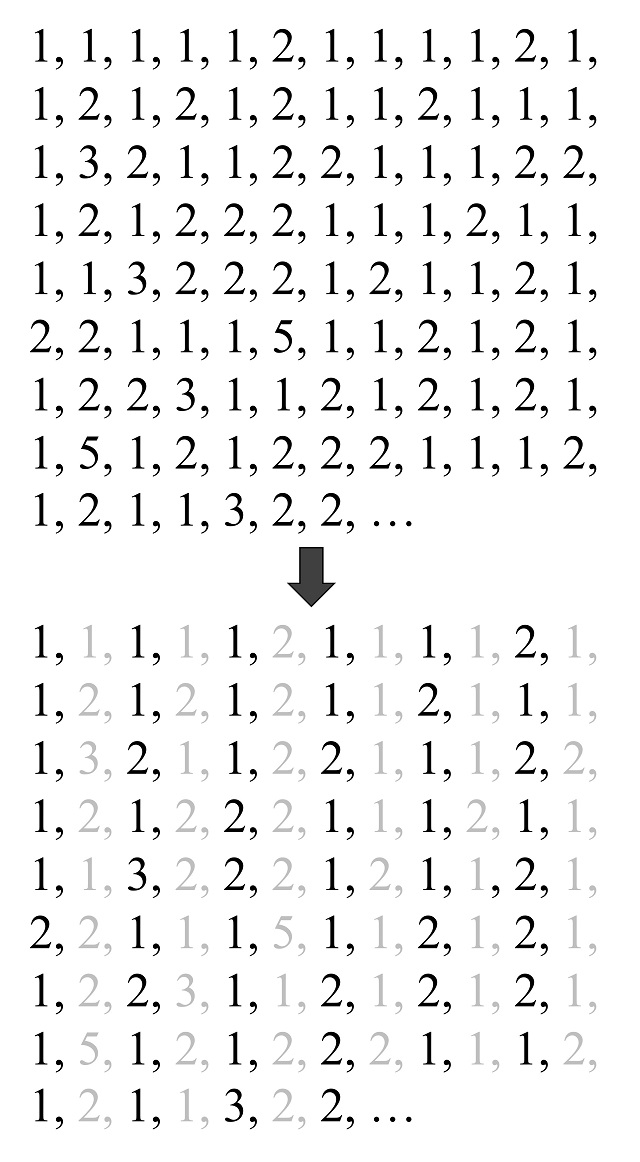

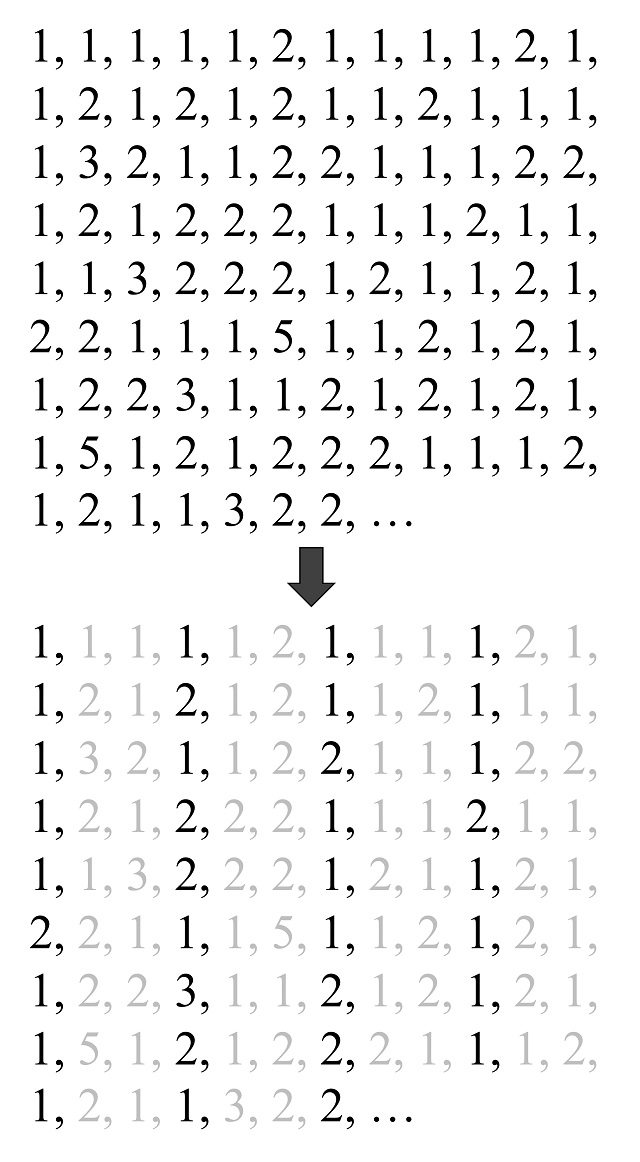

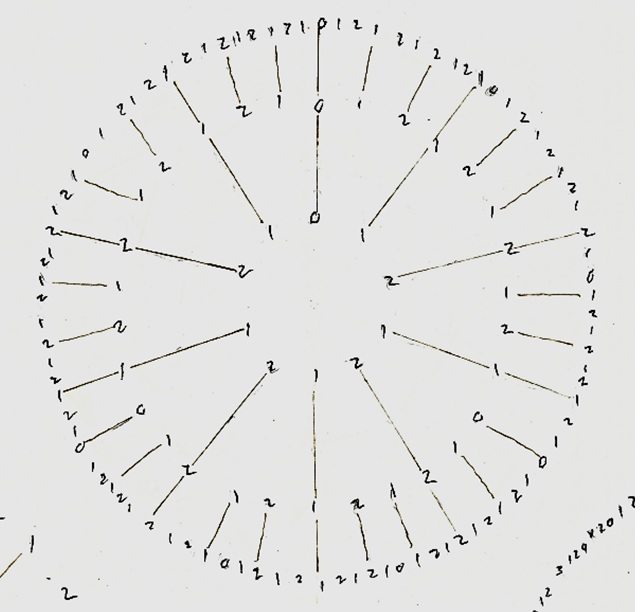

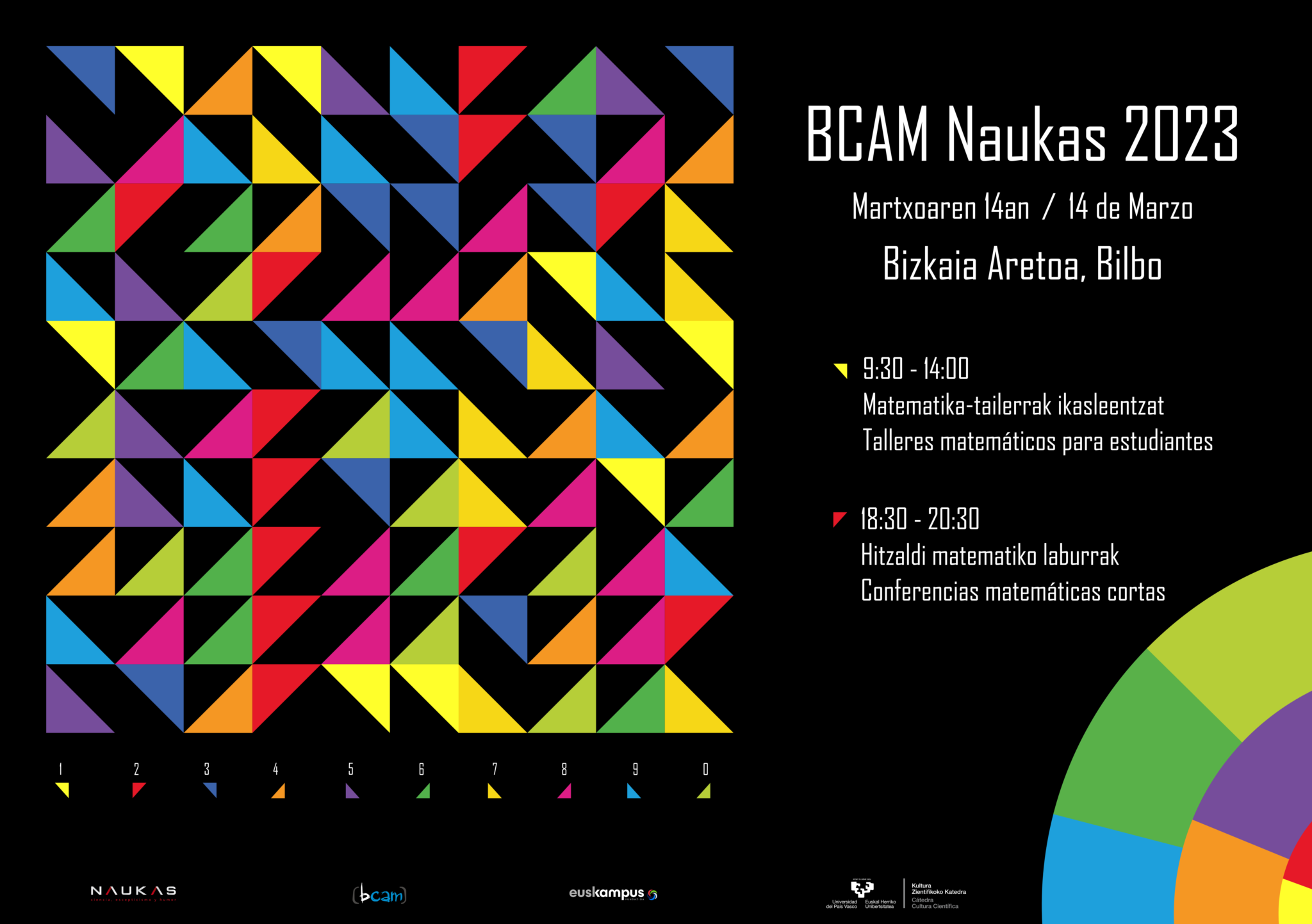

BCAM-Naukas 2023: Las sencillas matemáticas de nuestro universo

Quizás sea el número más famoso de la historia. Lo cierto es que el número Pi, representado por la letra griega π, es una de las constantes matemáticas más importantes que existen en el mundo, estudiada por el ser humano desde hace más de 4.000 años. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

La fascinación que ha suscitado durante siglos es tal que el popular número cuenta con su propio día en el calendario, así el mes de marzo se celebra el Día de Pi en todo el planeta.

Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien en 1988 lanzó la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática: 3-14 martxoaren 14 en euskara / 3-14 March, 14th en inglés. En los últimos años, la conmemoración del Día de Pi se ha ido extendiendo, hasta tal punto que el 26 de noviembre de 2019 la UNESCO proclamó el 14 de marzo Día Internacional de las Matemáticas.

Un año más, el Basque Center for applied Mathematics-BCAM y la Cátedra de Cultura Científica de la UPV/EHU se han sumado a la celebración, organizando la cuarta edición del evento BCAM NAUKAS, que tuvo lugar el 14 de marzo en el Bizkaia Aretoa de la UPV/EHU.

Las distribuciones normales, las famosas campanas de Gauss, aparecen tanto al hacer mediciones como en aquellos lugares del universo donde podamos hablar de poblaciones en sentido amplio. Laura Toribio nos explica qué son las funciones normales y nos da ejemplos de donde encontrarlas.

Laura Toribio San Cipriano es investigadora postdoctoral en el CIEMAT en cosmología. Licenciada en matemáticas por la Universidad de Salamanca, obtuvo su doctorado en astrofísica por la Universidad de la Laguna. Es una activa divulgadora científica.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo BCAM-Naukas 2023: Las sencillas matemáticas de nuestro universo se ha escrito en Cuaderno de Cultura Científica.

Células solares de perovskitas más estables

Los integrantes de la familia de compuestos, incluyendo sintéticos, que tienen el mismo tipo de fórmula química básica (ABX3, donde A y B son dos cationes y X es un anión, muchas veces un óxido) y estructura cristalina que el mineral perovskita CaTiO3, se conocen como perovskitas. En esta estructura se pueden integrar muchos cationes diferentes, lo que permite el desarrollo de diversos materiales de ingeniería.

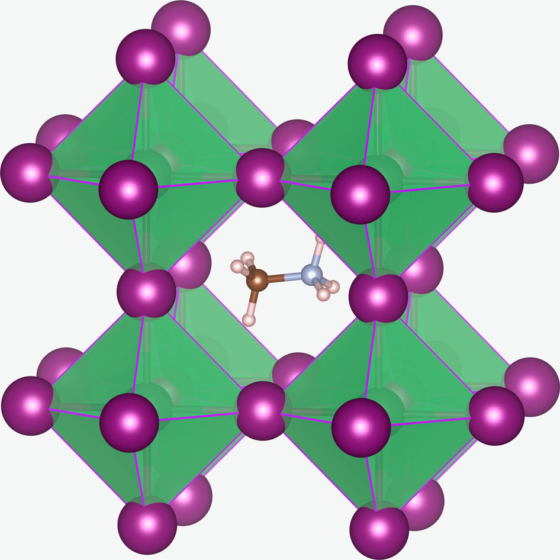

Estructura cristalina de una perovskita de CH3NH3PbX3 (X= I, Br, Cl). El catión metilamonio CH3NH3+ está rodeado por octaedros de PbX6

Estructura cristalina de una perovskita de CH3NH3PbX3 (X= I, Br, Cl). El catión metilamonio CH3NH3+ está rodeado por octaedros de PbX6Las células solares de perovskitas podrían ser la alternativa a las de silicio cristalino comercializadas actualmente, ya que presentan ventajas importantes frente a los paneles convencionales, como una mayor eficiencia (superior al 25%) y un menor coste. Las células de perovskita se fabrican mediante un proceso de deposición y cristalización a partir de una disolución (en esencia, de la misma forma que se obtiene la sal en una salina), lo que resulta económicamente mucho más barato y menos contaminante que la purificación del silicio.

Pero existe un motivo por el que las perovskitas aun no han reemplazado al silicio comercialmente: su estabilidad. Es en esta área donde actualmente se concentra la investigación científica.

Un equipo de investigadores de la Universidad de Oxford liderados por Henry Snaith (Universidad de Oxford, Reino Unido) y Juan Luis Delgado (Ikerbasque, POLYMAT y la Universidad del País Vasco, España) han unido fuerzas para investigar la utilización de aditivos de última generación para obtener células solares de alta eficiencia y estabilidad.

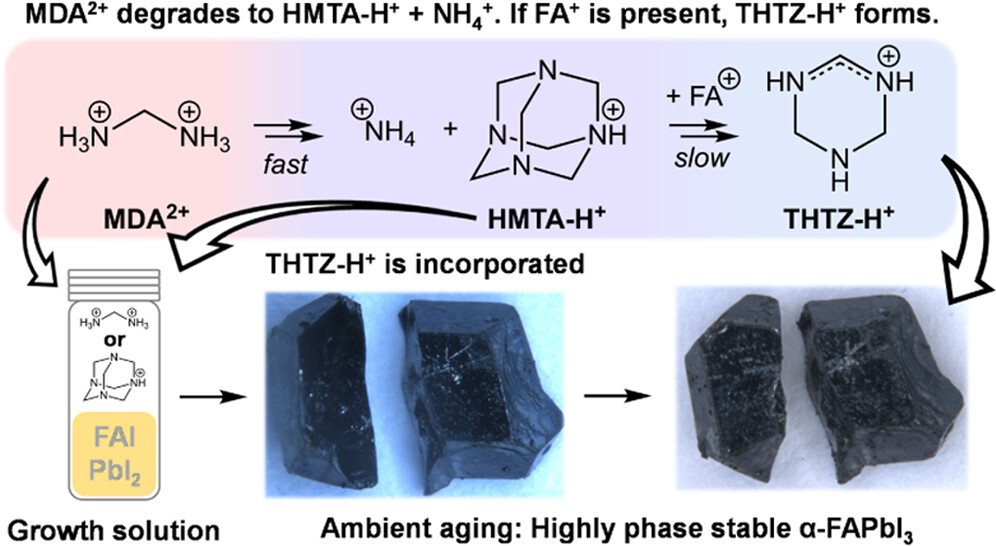

En los últimos tres años varios grupos de investigación han descrito células solares de perovskitas altamente eficientes mediante la incorporación de una pequeña cantidad de aditivo (dicloruro de metilendiamonio) hasta lograr la mayor eficiencia certificada hasta ahora para células solares de perovskitas (25,7% PCE). El equipo de investigación ha explorado los mecanismos tras este logro y cómo afecta el aditivo a la estabilidad. Para ello se ha centrado en el papel del aditivo durante el crecimiento de los cristales de la perovskita. Ha encontrado que este aditivo se descompone en el tiempo a formas químicas más estables que confieren una estabilidad mejorada a la perovskita (>1 año expuesta al aire).

Estos resultados tendrán consecuencias directas para el futuro desarrollo de dispositivos fotovoltaicos de perovskitas estables y de alta eficiencia.

Para saber más:

Paneles solares orgánicos…y de colores

Materiales tipo perovskita como contacto en pilas de combustible de óxido sólido

Referencia:

Elisabeth A. Duijnstee, Benjamin M. Gallant, Philippe Holzhey, Dominik J. Kubicki, Silvia Collavini, Bernd K. Sturdza, Harry C. Sansom, Joel Smith, Matthias J. Gutmann, Santanu Saha, Murali Gedda, Mohamad I. Nugraha, Manuel Kober-Czerny, Chelsea Xia, Adam D. Wright, Yen-Hung Lin, Alexandra J. Ramadan, Andrew Matzen, Esther Y.-H. Hung, Seongrok Seo, Suer Zhou, Jongchul Lim, Thomas D. Anthopoulos, Marina R. Filip, Michael B. Johnston, Robin J. Nicholas, Juan Luis Delgado, and Henry J. Snaith (2023) Understanding the Degradation of Methylenediammonium and Its Role in Phase-Stabilizing Formamidinium Lead Triiodide J. Am. Chem. Soc.https://doi.org/10.1021/jacs.3c01531

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Células solares de perovskitas más estables se ha escrito en Cuaderno de Cultura Científica.

Leyendas volcánicas

Los volcanes siempre han supuesto una fascinación para el ser humano. Temblores de tierra, fracturas del terreno de la que surgen grandes nubes de gases que oscurecen el día y enormes fragmentos de rocas negras y fuego brillante escupidos al cielo, lava que luego fluye por las laderas de las montañas como ríos candentes. ¿Quién no se asombraría viendo todo esto? Si encima le sumamos que, cuando ocurre una erupción en zonas habitadas las pérdidas sociales, económicas y, desgraciadamente, en muchas ocasiones también de vidas humanas son cuantiosas, ¿quién no se preguntaría si puede tratarse de algún tipo de castigo contra la población?

Esa atracción por el evento natural, unido al miedo a perder la vida, ha provocado que las sociedades humanas, a lo largo de la historia, hayan buscado una explicación para las erupciones volcánicas. Y si por algo se caracteriza nuestra especie es por inventar historias lo más épicas y llamativas posibles cuando el conocimiento científico no está lo suficientemente desarrollado como para dar un razonamiento basado en la evidencia. Así es como nacen los mitos y leyendas que se van transmitiendo de generación en generación.

La Fragua de Vulcano, obra pintada por Diego Rodríguez de Silva y Velázquez en el año 1630 que está expuesta en el Museo del Prado (Madrid). Imagen: Museo Nacional del Prado

La Fragua de Vulcano, obra pintada por Diego Rodríguez de Silva y Velázquez en el año 1630 que está expuesta en el Museo del Prado (Madrid). Imagen: Museo Nacional del PradoEs probable que os suene el nombre de Hefesto, el dios griego del fuego, la forja y la metalurgia. Según algunas leyendas, Hefesto estableció sus fraguas en el interior de varias montañas del Sur de las actuales Grecia e Italia, aunque parece que tenía preferencia por quedarse bajo el monte Etna. Allí, el dios se dedicaba a crear armas, ingenios mecánicos y regalos metálicos para otras divinidades y algunos semidioses como Aquiles o Heracles. Y las manifestaciones en superficie de sus martillazos y templados del material forjado eran los temblores de tierra, los ruidos ensordecedores, la expulsión de gases y la salida de lava ardiente que ocurrían, de vez en cuando, en estas montañas. Puede que os suene un poco más todo esto si os digo que los romanos, tras algunos pequeños retoques en la historia, llamaron a este dios Vulcano, del que procede la palabra volcán.

Pero la mitología griega clásica tiene un montón de versiones de la misma historia. Hay una reinterpretación de esta leyenda en la que se cuenta que, bajo estos volcanes mediterráneos, están encerrados algunos de los gigantes que se rebelaron contra los dioses en los primeros tiempos de dominio de los olímpicos. Y esas manifestaciones propias de una erupción volcánica son los lamentos, el aliento de fuego y los golpes contra los muros de la prisión propinados por estos gigantes en sus intentos de liberarse de su cautiverio.

Póster promocional de la película “El Señor de los Anillos: El Retorno del Rey”, estrenada en 2003, dirigida por Peter Jackson y distribuida por New Line Cinema, donde se representa el paisaje volcánico de Mordor. Imagen propiedad de New Line Cinema, tomada de tolkiengateway.net

Póster promocional de la película “El Señor de los Anillos: El Retorno del Rey”, estrenada en 2003, dirigida por Peter Jackson y distribuida por New Line Cinema, donde se representa el paisaje volcánico de Mordor. Imagen propiedad de New Line Cinema, tomada de tolkiengateway.netAunque tampoco hay que retroceder milenios en nuestra historia para encontrar leyendas similares. En el mundo fantástico creado por el escritor J. R. R. Tolkien en pleno siglo XX podemos encontrarnos una tierra baldía y negra, en la que mora el mal más tenebroso, llamada Mordor, en cuya parte central se alza una imponente montaña conocida como el Monte del Destino, en cuyo interior Sauron forjó el Anillo Único. Como os podéis imaginar, el Monte del Destino es un enorme volcán y las llanuras de Mordor están formadas por materiales volcánicos, principalmente coladas de lava enfriadas y piroclastos (es decir, fragmentos solidificados de lava que salen expulsados del cráter volcánico en las erupciones explosivas) de diferentes tamaños acumulados erupción tras erupción. Pero es que el propio escritor reconoció que se basó en el Estrómboli y el aspecto de las cuencas volcánicas del margen mediterráneo europeo para dar forma a estas tierras fantásticas. Creo que no hace falta decir en quién estaba pensando cuando puso a Sauron a forjar el anillo.

Volcanes Popocatépetl (que significa “Montaña Humeante”), al fondo de la imagen, e Iztaccíhuatl (traducido como “Mujer Dormida”), en primer término. Imagen cortesía de Diario Cambio (México)

Volcanes Popocatépetl (que significa “Montaña Humeante”), al fondo de la imagen, e Iztaccíhuatl (traducido como “Mujer Dormida”), en primer término. Imagen cortesía de Diario Cambio (México)Supongo que no os he sorprendido mucho hasta el momento con estas leyendas bastante conocidas. Por eso ahora quiero contaros otra que, espero, no os suene tanto. Aprovechando que el volcán Popocatépetl está despertando, manteniendo en vilo a miles de personas en México, os voy a contar la bonita, a la par que triste, historia azteca sobre su formación.

Cuenta la leyenda que una joven princesa azteca estaba prometida a un joven cacique que la amaba con pasión. Pero el muchacho tuvo que ir a la guerra con otros pueblos cercanos, momento que aprovechó un rival en el amor de la chica para engañarla contándole que su prometido había muerto en batalla. Tras romperle el corazón con la noticia, el traidor la prometió en matrimonio con la excusa de consolar su dolor. Pero, como no podía ser de otra manera, nuestro héroe volvió victorioso de la batalla y, al enterarse del engaño del rival, le retó a un combate para recuperar su honor y el de su amada. Por supuesto, el protagonista de la historia venció en la lucha, haciendo que el traidor huyese, quedando como un embustero y, a la vez, un cobarde. Aunque ahora viene el giro dramático. Cuando el héroe corrió para encontrarse con su amada, la encontró tendida en el suelo de un frondoso valle. La muchacha se había quitado la vida al sentirse deshonrada por el vil mentiroso. Entonces el héroe se arrodilló a su lado y lloró amargamente. Este dolor hizo estremecerse a los propios dioses, que expresaron su rabia haciendo que la tierra temblase, se abriese en dos y surgieran fuego y rocas que llegaron a oscurecer el día. Cuando la ira de los dioses se calmó, los habitantes de la zona descubrieron que, en lo que antes era un valle tranquilo, habían surgido dos enormes montañas: una con la figura de una mujer dormida (Iztaccíhuatl) y otra con la de un guerrero arrodillado a su lado (Popocatépetl).

Si queréis oír una versión más bonita y poética de esta historia, en la que una erupción volcánica dio origen a dos montañas formadas por la acumulación de lava solidificada y piroclastos, os recomiendo la canción “La Mujer Dormida (La Leyenda de Popocatépetl y Iztaccíhuatl)” del grupo español de folk metal Saurom (en este caso, terminado en la letra eme, aunque me permite relacionar todas las historias entre sí, aunque sea un poco “por los pelos”).

Hoy en día, gracias a los avances en la investigación y el conocimiento geológicos podemos darle una explicación científica al vulcanismo que, además, nos permite anticiparnos a las erupciones más peligrosas para prevenir los riesgos en la población. Pero a mí me sigue gustando recordar estas historias mitológicas cuando veo imágenes de erupciones en directo, porque me permiten ponerme en la piel de las civilizaciones pasadas, que alucinaban igual que yo con el tremendo poder de la naturaleza que representa un volcán activo, buscando una explicación de lo que estaban presenciando. Y, encima, son historias curiosas, emotivas y muy bonitas.

Para saber más:

Montañas y mitos

La Geología según Heracles

Los volcanes submarinos de Bizkaia y Gipuzkoa

Sobre la autora: Blanca María Martínez es doctora en geología, investigadora de la Sociedad de Ciencias Aranzadi y colaboradora externa del departamento de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Leyendas volcánicas se ha escrito en Cuaderno de Cultura Científica.

Grande, pero no infinito

De un tiempo a esta parte

el infinito

se ha encogido

peligrosamente.

Quién iba a suponer

que segundo a segundo

cada migaja

de su pan sin límites

iba así a despeñarse

como canto rodado

en el abismo.

Nina Rassen, Laws of the Creation: Law 3. Fuente: Wikimedia Commons.

Nina Rassen, Laws of the Creation: Law 3. Fuente: Wikimedia Commons.En matemáticas, la idea de infinito es difícil de aprehender; no hay un único infinito. Por ejemplo, los conjuntos de los números enteros y de los números reales son infinitos, pero el primero es numerable y el segundo no lo es. Ambos son conjuntos infinitos, pero “de distinto tamaño”.

Cuando hablamos de manera informal, mencionamos al infinito para referirnos a algo “muy grande”, a algo inalcanzable o lejano, a algo que no termina nunca. El infinito puede producir desasosiego; incluso existen personas que padecen de apeirofobia, de fobia al infinito.

Las dos propuestas siguientes involucran números muy grandes, pero no infinitos.

La biblioteca de BabelEl universo (que otros llaman la Biblioteca) se compone de un número indefinido, y tal vez infinito, de galerías hexagonales, con vastos pozos de ventilación en el medio, cercados por barandas bajísimas. Desde cualquier hexágono se ven los pisos inferiores y superiores: interminablemente.

Así comienza el cuento La Biblioteca de Babel de Jorge Luis Borges, que describe más adelante la composición de cada uno de los libros que la forman:

[…] cada libro es de cuatrocientas diez páginas; cada página, de cuarenta renglones; cada renglón, de unas ochenta letras de color negro.

[…] El número de símbolos ortográficos es veinticinco.

La biblioteca es enorme, aunque no infinita: si todos los libros se limitan a 410 páginas, tenemos 410 x 40 x 80 = 1 312 000 caracteres por libro. Cada carácter puede tomar 25 valores, con lo que hay más de 251312000 libros diferentes. Escribir esta cantidad de libros requiere unas 1 834 100 cifras (este es el valor aproximado de 1 312 000 log(25), donde log(b)=a si b=10a). Y, efectivamente, se trata de un número muy grande; para imaginarlo, pensemos que 10p se escribe con p+1 cifras…

Este desasosegante relato finaliza de esta manera:

[…] sospecho que la especie humana –la única– está por extinguirse y que la Biblioteca perdurará: iluminada, solitaria, infinita, perfectamente inmóvil, armada de volúmenes preciosos, inútil, incorruptible, secreta.

En esa biblioteca, por supuesto, no se aloja El libro de arena. No cumple las reglas respecto al número de páginas, de renglones y de letras; este libro sí es infinito:

El número de páginas de este libro es exactamente infinito. Ninguna es la primera; ninguna la última. No sé por qué están numeradas de ese modo arbitrario. Acaso para dar a entender que los términos de una serie infinita admiten cualquier número.

Que(ved)(n)eauQue(ved)(n)eau es el título de un poemario de la escritora Sofía Rhei en el que rinde homenaje a los escritores Francisco de Quevedo y Raymond Queneau (para comprender el título, “eau” se pronuncia como la vocal “o” en castellano).

De Quevedo, Sofía Rhei toma el soneto Amor constante, más allá de la muerte:

Cerrar podrá mis ojos la postrera

sombra que me llevare el blanco día,

y podrá desatar esta alma mía

hora a su afán ansioso lisonjera;

mas no, de esotra parte, en la ribera,

dejará la memoria, en donde ardía:

nadar sabe mi llama la agua fría,

y perder el respeto a ley severa.

Alma a quien todo un dios prisión ha sido,

venas que humor a tanto fuego han dado,

medulas que han gloriosamente ardido,

su cuerpo dejará, no su cuidado;

serán ceniza, mas tendrá sentido;

polvo serán, mas polvo enamorado.

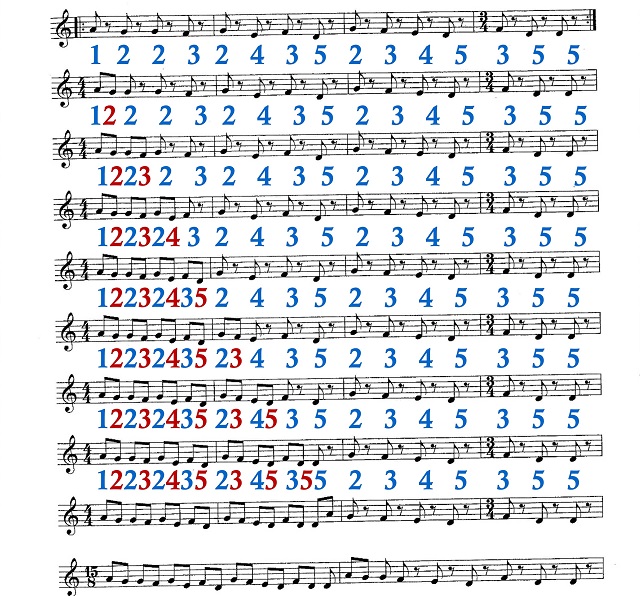

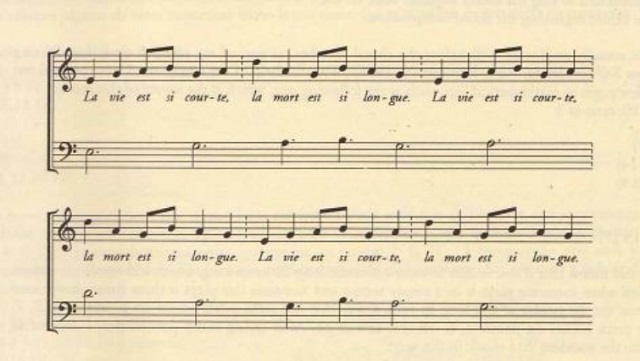

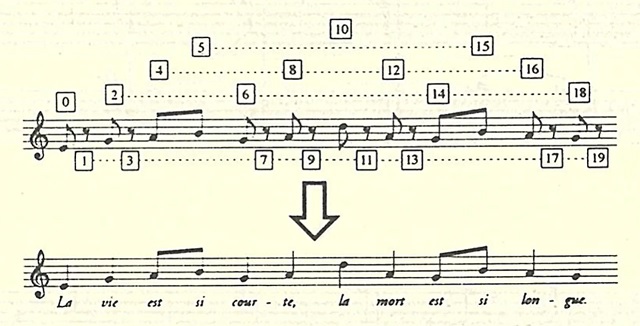

Y de este poema imita las rimas. Además, se inspira en Cent mille milliards de poèmes de Queneau para estructurar su poemario.

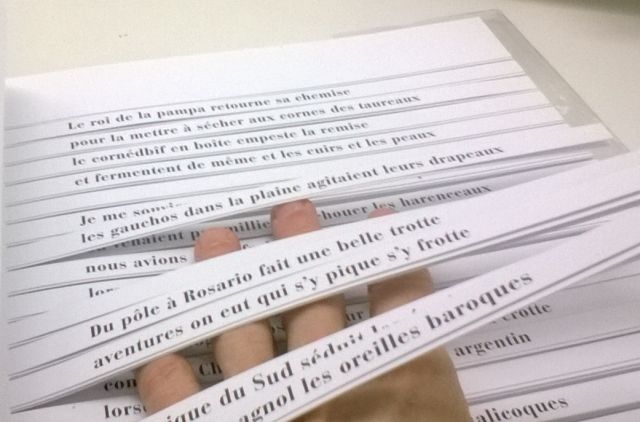

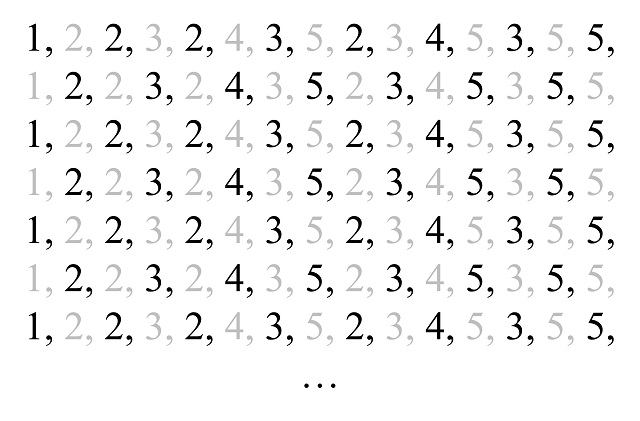

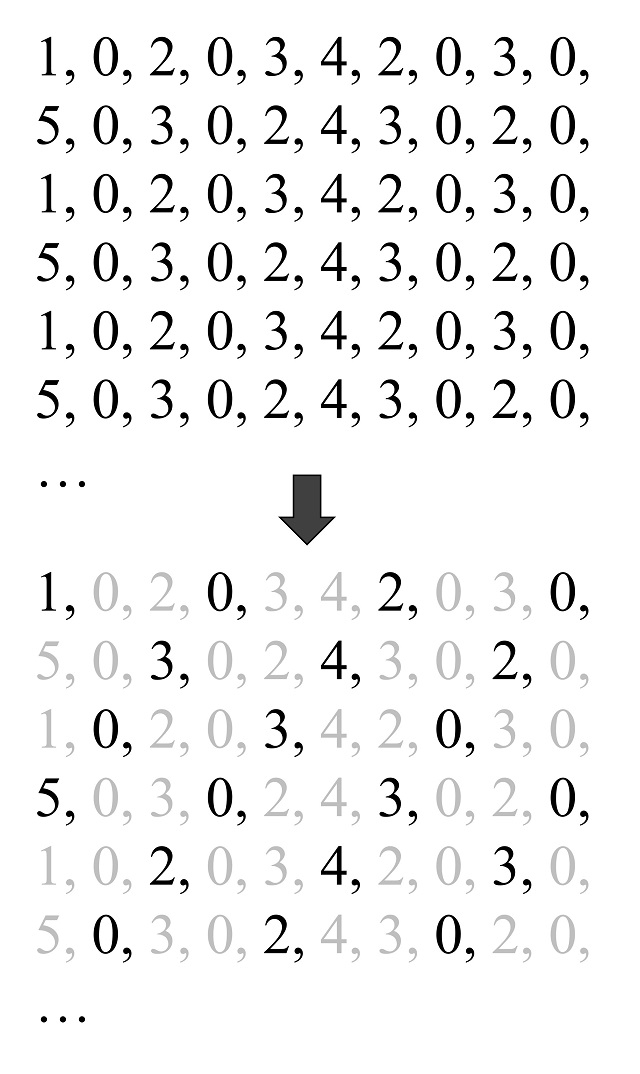

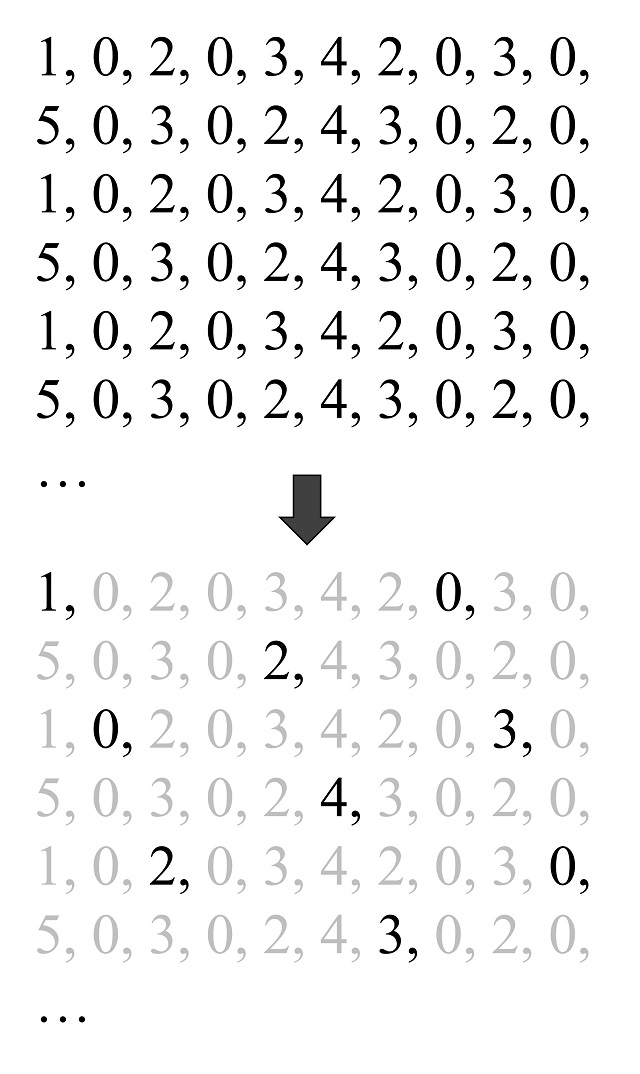

Cómo leer Cent mille milliards de poèmes. Fuente: Marta Macho Stadler.

Cómo leer Cent mille milliards de poèmes. Fuente: Marta Macho Stadler.Que(ved)(n)eau consta de diecinueve sonetos (dos cuartetos y dos tercetos) que se imprimen sobre diecinueve páginas –uno por página–. Después se recortan en tiras los catorce versos de cada uno de los diecinueve poemas.

De esta manera, se pueden crear nuevos sonetos decidiendo, por ejemplo, leer el primer verso del séptimo poema, seguido del segundo verso del décimo, del tercero del segundo, etc. ¿Cuántos sonetos podrían generarse de esta manera?

Hay diecinueve posibles maneras de elegir primer verso, diecinueve modos de seleccionar el segundo de manera independiente, y así hasta el catorce. Son, por lo tanto, 1914 = 799 006 685 782 884 096 posibles sonetos, aproximadamente 799 × 1015, es decir, 799 000 billones de poemas.

En Cent mille milliards de poèmes de Queneau, que incluye 1014 sonetos, el autor realiza un cálculo aproximado del tiempo que se precisaría para leer todos los poemas posibles contenidos. Tiene en cuenta las siguientes suposiciones: se necesitan 45 segundos para leer un poema, 15 segundos para cambiar las tiras, 8 horas de lectura al día y 200 días de lectura al año. Según la estimación de Queneau, la lectura de cada poema –incluido el cambio de tiras– precisaría un minuto; ocho horas de lectura durante doscientos días significan 96 000 minutos invertidos cada año. Y 1014 / 96 000 son aproximadamente 1 042 000 000 años. Es decir, se necesitarían 10 420 000 siglos para completar la lectura del libro.

Que(ved)(n)eau precisaría aún más tiempo. Según las reglas de Queneau serían necesarios 1914 / 96 000 años de lectura, más de 8,3 × 1012 años, es decir, más de 8,3 × 1010 siglos. Sin duda mucho tiempo para nuestras cortas vidas, aunque no sea infinito… Por cierto, Quevedo ya se había encontrado con el infinito en su soneto satírico A una nariz, donde describe la nariz de Luis de Góngora. El terceto final no deja lugar a dudas sobre el tamaño:

[…] Érase un naricísimo infinito,

muchísimo nariz, nariz tan fiera

que en la cara de Anás fuera delito.

Referencias

VV. AA. Textos potentes. Atlas de literatura potencial 2. Pepitas de Calabaza, 2019

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad

El artículo Grande, pero no infinito se ha escrito en Cuaderno de Cultura Científica.

Los recuerdos ayudan a los encéfalos a reconocer los nuevos eventos que merecen recordarse

Los recuerdos pueden afectar lo bien que aprenderá el encéfalo sobre eventos futuros al cambiar nuestras percepciones del mundo.

Un artículo de Yasemin Saplakoglu. Historia original reimpresa con permiso de Quanta Magazine, una publicación editorialmente independiente respaldada por la Fundación Simons.

Los recuerdos de eventos pasados significativos sintonizan nuestras percepciones con eventos relacionados en el futuro y nos preparan para recordar más sobre ellos. Ilustración: Kristina Armitage / Quanta Magazine

Los recuerdos de eventos pasados significativos sintonizan nuestras percepciones con eventos relacionados en el futuro y nos preparan para recordar más sobre ellos. Ilustración: Kristina Armitage / Quanta MagazineLos recuerdos son sombras del pasado pero también linternas para el futuro.

Nuestros recuerdos nos guían por el mundo, afinan nuestra atención y dan forma a lo que aprendemos más adelante en la vida. Los estudios en humanos y animales han demostrado que los recuerdos pueden alterar nuestras percepciones de eventos futuros y la atención que les damos. “Sabemos que la experiencia pasada cambia las cosas”, afirma Loren Frank, neurocientífico de la Universidad de California en San Francisco. «Cómo sucede exactamente esto no siempre está claro».

Un nuevo estudio publicado en la revista Science Advances ofrece ahora parte de la respuesta. Trabajando con caracoles, los investigadores han examinado cómo los recuerdos consolidados hacen que los animales tengan más probabilidades de formar nuevos recuerdos a largo plazo de eventos futuros relacionados que, de otro modo, podrían haber ignorado. El mecanismo simple que han descubierto hace esto alterando la percepción que el caracol tiene de estos eventos.

Los investigadores redujeron el fenómeno de cómo el aprendizaje pasado influye en el aprendizaje futuro «hasta una sola célula», explica David Glanzman, biólogo celular de la Universidad de California en Los Ángeles, que no participó en el estudio. Lo describe como un ejemplo atractivo «de usar un organismo simple para tratar de comprender los fenómenos de comportamiento que son bastante complejos».

Aunque los caracoles son criaturas bastante simples, la nueva información lleva a los científicos un paso más cerca de comprender la base neuronal de la memoria a largo plazo en animales de orden superior como los humanos.

Aunque a menudo no somos conscientes del reto, la formación de la memoria a largo plazo es «un proceso increíblemente energético», afirma Michael Crossley, investigador principal de la Universidad de Sussex y autor principal del nuevo estudio. Dichos recuerdos dependen de que forjemos conexiones sinápticas más duraderas entre las neuronas, y las células encefálicas necesitan reclutar muchas moléculas para hacer eso. Por lo tanto, para conservar recursos, un encéfalo debe ser capaz de distinguir cuándo vale la pena el coste de formar un recuerdo y cuándo no. Esto es cierto ya sea el encéfalo de un ser humano o el de un «pequeño caracol con un presupuesto energético ajustado», explica.

En una videollamada reciente, Crossley mostró uno de esos caracoles, un molusco Lymnaea del tamaño de un pulgar con un encéfalo que llamó «hermoso». Mientras que el encéfalo humano tiene 86 mil millones de neuronas, el del caracol tiene solo 20 000, pero cada una de sus neuronas es 10 veces más grande que las nuestras y son mucho más accesibles para el estudio. Estas neuronas gigantes y su circuitería encefálica bien mapeada han hecho de los caracoles un tema favorito de la investigación neurobiológica.

Investigadores de la Universidad de Sussex rastrearon un comportamiento aprendido en los caracoles Lymnaea hasta un circuito de solo cuatro neuronas en su encéfalo. Fuente: Michael Crossley and Kevin Staras

Investigadores de la Universidad de Sussex rastrearon un comportamiento aprendido en los caracoles Lymnaea hasta un circuito de solo cuatro neuronas en su encéfalo. Fuente: Michael Crossley and Kevin StarasLos pequeños recolectores también son «aprendices notables» que pueden recordar algo después de una sola exposición, continúa Crossley. En el nuevo estudio, los investigadores han observado profundamente los encéfalos de los caracoles para descubrir qué sucede a nivel neurológico cuando están creando recuerdos.

Recuerdos persuasivosEn sus experimentos, los investigadores dieron a los caracoles dos formas de entrenamiento: fuerte y débil. En un entrenamiento fuerte, primero rociaban a los caracoles con agua con sabor a plátano, que los caracoles tratan como neutral en su atractivo: tragan un poco pero después escupen un poco. Luego, el equipo les daba azúcar a los caracoles, que devoran con avidez.

Cuando comprobaron los caracoles hasta un día después, los caracoles demostraron que habían aprendido a asociar el sabor del plátano con el azúcar a partir de esa única experiencia. Los caracoles parecían percibir el sabor como más deseable: estaban mucho más dispuestos a tragar el agua.

Por el contrario, los caracoles no aprendieron esta asociación positiva en una sesión de entrenamiento débil, en la que a un baño con sabor a coco le sigue un postre de azúcar mucho más diluido. Los caracoles continuaron tragando y escupiendo el agua.

Hasta este punto, el experimento era esencialmente una versión para caracoles de los famosos experimentos de condicionamiento de Pavlov, en los que los perros aprendían a babear cuando escuchaban el sonido de una campana. Pero entonces los científicos observaron lo que sucedía cuando daban a los caracoles un entrenamiento fuerte con sabor a plátano seguido horas después por un entrenamiento débil con sabor a coco. De repente, los caracoles también aprendían del entrenamiento débil.

Cuando los investigadores cambiaron el orden e hicieron primero el entrenamiento débil, nuevamente falló en crear un recuerdo. Los caracoles aún formaban un recuerdo del entrenamiento fuerte, pero eso no tuvo un efecto de fortalecimiento retroactivo en la experiencia anterior. Intercambiar los sabores utilizados en los entrenamientos fuertes y débiles tampoco tuvo efecto.

Los científicos concluyen que el entrenamiento fuerte lleva a los caracoles a un período «rico en aprendizaje» en el que el umbral para la formación de recuerdos es más bajo, lo que les permite aprender cosas que de otro modo no aprenderían (como la asociación del entrenamiento débil entre un sabor y azúcar diluida). Un mecanismo así podría ayudar al encéfalo a dirigir los recursos hacia el aprendizaje en los momentos oportunos. La comida podría hacer que los caracoles estén más alerta ante posibles fuentes de alimento cercanas; los roces con el peligro podrían agudizar su sensibilidad a las amenazas.

Un caracol Lymnaea que asocia agua aromatizada con azúcar abre y cierra rápidamente la boca para tragarla (derecha). Un caracol que no ha aprendido esa asociación mantiene la boca cerrada (izquierda). Fuemte: Michael Crossley y Kevin StarasSin embargo, el efecto sobre los caracoles es fugaz. El período rico en aprendizaje persistía solo de 30 minutos a cuatro horas después del entrenamiento fuerte. Después de eso, los caracoles dejaban de formar recuerdos a largo plazo durante la sesión de entrenamiento débil, y no era porque hubieran olvidado su entrenamiento fuerte, el recuerdo persistió durante meses.

Tener una ventana crítica para el aprendizaje mejorado tiene sentido porque si el proceso no cesa, «eso podría ser perjudicial para el animal», explica Crossley. No solo podría el animal invertir demasiados recursos en el aprendizaje, sino que podría aprender asociaciones dañinas para su supervivencia.

Percepciones alteradasUsando electrodos, los investigadores descubrieron qué sucede dentro del encéfalo de un caracol cuando forma recuerdos a largo plazo durante los entrenamientos. Se producen dos ajustes paralelos en la actividad encefálica. El primero codifica el recuerdo en sí. El segundo está “estrictamente dedicado a alterar la percepción del animal de otros eventos”, afirma Crossley. “Cambia la forma en que ve el mundo en función de sus experiencias pasadas”.

También descubrieron que podían inducir el mismo cambio en la percepción de los caracoles al bloquear los efectos de la dopamina, la sustancia química encefálica producida por la neurona que activa el comportamiento de escupir. En efecto, esto apaga la neurona para escupir y deja encendida constantemente la neurona para tragar. La experiencia tuvo el mismo efecto de arrastre que el entrenamiento fuerte tuvo en los experimentos anteriores: horas más tarde, los caracoles formaron un recuerdo a largo plazo a partir del entrenamiento débil.

Los investigadores trazan completa y elegantemente un mapa del proceso desde «el comportamiento hasta los fundamentos electrofisiológicos de esta interacción entre los recuerdos pasados y nuevos», comenta Pedro Jacob, becario postdoctoral en la Universidad de Oxford que no participó en el estudio. «Tener el conocimiento de cómo sucede esto mecánicamente es interesante porque probablemente se conserve entre las especies».

Frank, sin embargo, no está completamente convencido de que el hecho de que los caracoles no hayan ingerido agua aromatizada después del entrenamiento débil signifique que no recordaban nada. Puedes tener un recuerdo pero no actuar basándote en él, afirma, por lo que hacer esta distinción puede requerir experimentos de seguimiento.

Los mecanismos trás el aprendizaje y la memoria son sorprendentemente similares en moluscos y mamíferos como los humanos, afirma Glanzman. Hasta donde saben los autores, este mecanismo exacto no se ha demostrado en humanos, explica Crossley. “Podría ser una característica ampliamente conservada y, por lo tanto, una que merece más atención”, concluye.

Sería interesante estudiar si un cambio en la percepción podría hacerse más permanente, comenta Glanzman. Sospecha que esto podría ser posible si a los caracoles se les da un estímulo aversivo, algo que los ponga enfermos en lugar de algo que les guste.

Por ahora, Crossley y su equipo sienten curiosidad por saber qué sucede en el encéfalo de estos caracoles cuando realizan múltiples comportamientos, no solo abrir o cerrar la boca. “Estas son criaturas fascinantes”, dice Crossley. «Realmente no te esperas que estos animales puedan realizar este tipo de procesos complejos».

El artículo original, Memories Help Brains Recognize New Events Worth Remembering, se publicó el 17 de mayo de 2023 en Quanta Magazine.

Traducido por César Tomé López

Nota del editor de Quanta: Loren Frank es investigador de la Iniciativa de Investigación del Autismo de la Fundación Simons (SFARI). La Fundación Simons también financia Quanta como revista editorialmente independiente. Las decisiones de financiación no tienen influencia en nuestra cobertura.

El artículo Los recuerdos ayudan a los encéfalos a reconocer los nuevos eventos que merecen recordarse se ha escrito en Cuaderno de Cultura Científica.

No, un metabolismo basal más lento no es el culpable de que ganes kilos con los años

metabolismo basal

El sobrepeso y la obesidad son dos graves problemas de salud pública que causan de, forma directa o indirecta, en torno a 130.000 muertes al año en España. Estas enfermedades se han convertido en unos de los principales riesgos para la salud, al aumentar de forma significativa el riesgo de sufrir diabetes tipo 2, enfermedades cardiovasculares, dolencias articulares, apnea del sueño, trastornos del ánimo y otros muchos problemas para la salud.

Foto: Towfiqu barbhuiya / Unsplash

Foto: Towfiqu barbhuiya / UnsplashDesde hace décadas, las cifras de sobrepeso y obesidad han ido incrementándose de forma progresiva hasta el punto de que en la actualidad más del 25 % de la población española sufre sobrepeso u obesidad. Todo apunta a que los casos de exceso de peso corporal irán a más en un futuro próximo. De seguir el ritmo actual, un estudio publicado en la Revista Española de Cardiología anticipa que el 55 % de las mujeres y el 80 % de los hombres serán obesos en nuestro país en 2030.

Las razones detrás de este fenómeno son múltiples y están interrelacionadas. Un factor de peso que contribuye a ello es el creciente sedentarismo entre los ciudadanos de nuestro país. Según el Eurobarómetro de 2022, el 58 % de los españoles nunca o raramente hace ejercicio físico o deporte. Por otro lado, en España se come cada vez peor: la dieta de gran parte de la población ha empeorado con el tiempo, con una presencia cada vez mayor de alimentos ultraprocesados (hipercalóricos, ricos en azúcares, grasas saturadas y sal), en detrimento de frutas, verduras y legumbres.

Sin embargo, tras el sedentarismo y una mala alimentación hay, en realidad, numerosos factores (determinantes sociales de la salud) que predisponen a caer en estos comportamientos: la falta de recursos económicos, el tiempo limitado para hacer la compra y cocinar, la publicidad de alimentos insanos, el predominio del ocio frente a las pantallas entre los jóvenes…

En la gran mayoría de los casos, el sobrepeso y la obesidad no aparece de la noche a la mañana, sino que se desencadenan de forma lenta, con la acumulación progresiva de kilos a lo largo de los años. En ese sentido, existe un mito muy extendido entre las sociedades occidentales: los adultos engordan, en parte, por un metabolismo más lento conforme se van cumpliendo años. De esta forma, aunque mantengamos el mismo nivel de actividad física y la misma dieta, ganar kilos es inevitable. ¿Qué hay de cierto en ello?

En primer lugar, lo que se conoce como metabolismo basal o tasa metabólica basal (TMB) es la energía que consume el organismo para realizar las funciones vitales básicas como el mantenimiento de la temperatura corporal, la respiración, la contracción cardíaca, el peristaltismo intestinal, la actividad cerebral, la producción de orina por parte de los riñones, la reparación o regeneración de los tejidos… En otras palabras, es el gasto calórico mínimo necesario para simplemente mantenernos con vida, sin considerar la actividad física.

Entonces, ¿cómo varía la TMB a lo largo de la vida? ¿»Quema» lo mismo un bebé, que un universitario o un anciano? Gracias a un extenso estudio, publicado en la revista Science en 2021, ahora conocemos muy bien cómo cambia nuestro metabolismo basal conforme vamos cumpliendo años. En esta investigación se analizó el gasto energético diario de más de 6.400 personas de 29 países diferentes y con edades que iban desde los 8 días tras el nacimiento hasta los 95 años. El gasto energético se evaluó gracias al agua doblemente marcada a partir de isótopos estables, no radiactivos, un método bastante preciso para este fin.

Los científicos descubrieron que, efectivamente, el metabolismo basal ajustado por el peso puede variar bastante a lo largo de la vida. No obstante, esto solo ocurre en cuatro etapas muy específicas. Los recién nacidos tienen un consumo metabólico equivalente a los adultos, pero a lo largo del primer año de vida experimentan un drástico incremento en su metabolismo, hasta el punto de que es un 50 % superior al de los adultos. Ya a partir del primer año y hasta los 20 años se produce un enlentecimiento progresivo del metabolismo (en torno a un 3 % al año). Entre los 20 y 60 años el consumo metabólico se mantiene estable y, a partir de los 60, este desciende un 0,7 % al año hasta llegar a un descenso del 20 % del gasto a los 95 años. Además, no hay diferencias evidentes entre el metabolismo de hombres y mujeres tras considerar la masa muscular y el tamaño corporal. En todo caso, sí que hay individuos que pueden tener un gasto energético considerablemente menor o mayor a lo esperado para su edad (25 % superior o inferior).

En otras palabras, un metabolismo basal más lento no es el culpable de que los adultos vayan ganando peso con la edad entre los 20 y 60 años, porque este metabolismo apenas varía en dicha etapa. ¿Por qué, entonces, tanta gente engorda a lo largo de la vida adulta? Generalmente, porque conforme se van cumpliendo años muchas personas tienden a tener una vida más sedentaria, comiendo lo mismo, lo que lleva irremediablemente a acumular grasa con el paso del tiempo por el menor gasto calórico total. Por esta y otras razones, fomentar la práctica de ejercicio físico y de deporte en nuestro país, a partir de múltiples y ambiciosas iniciativas por parte de las autoridades políticas y sanitarias, resulta esencial para limitar la «epidemia» de sobrepeso y obesidad a la que nos enfrentamos.

Sobre la autora: Esther Samper (Shora) es médica, doctora en Ingeniería Tisular Cardiovascular y divulgadora científica

El artículo No, un metabolismo basal más lento no es el culpable de que ganes kilos con los años se ha escrito en Cuaderno de Cultura Científica.

Disponibilidad de alimento y fecundidad humana

Jean-François Millet (1857) Des ganeuses / Las espigadoras. Óleo sobre lienzo. Fuente: Wikimedia Commons

Jean-François Millet (1857) Des ganeuses / Las espigadoras. Óleo sobre lienzo. Fuente: Wikimedia CommonsEn la especie humana, como en el resto de animales, la cantidad de alimento de que disponen los individuos –en el caso de nuestra especie, sobre todo las mujeres– influye de forma decisiva en la fecundidad. Esto, que parece obvio, no ha sido tan fácil de documentar, sobre todo porque en las sociedades desarrolladas contemporáneas la reproducción está sujeta a un control bastante efectivo por parte de las parejas y las decisiones reproductivas obedecen a razones de muy diversa índole.

Afortunadamente, se ha podido utilizar información histórica relativa a sociedades preindustriales para indagar acerca de estos asuntos. Un equipo de investigación ha recurrido a registros parroquiales para evaluar si existe alguna relación entre la fecundidad, por un lado, y el estatus socioeconómico, la disponibilidad de alimento y otros factores, por el otro. Para ello, han trabajado con registros parroquiales de zonas agrícolas de Finlandia que van de 1649 a 1900, y también han contado con datos relativos a las cosechas de centeno, el principal cereal y fuente de alimento del área en que se encontraban las parroquias estudiadas. Los investigadores estaban interesados en saber si el tiempo transcurrido desde el matrimonio hasta el primer alumbramiento puede considerarse un indicador adecuado de las condiciones nutricionales bajo las que vivían las parejas.

En promedio, el tiempo que transcurría entre el matrimonio y el nacimiento del primer hijo era de 25,9 meses, pero había diferencias significativas entre las tres clases socioeconómicas definidas por los investigadores, alta, media y baja. La mujeres pobres daban a luz a su primer hijo 2,6 meses después que las más acomodadas y 3,0 meses después que las de nivel intermedio. Las diferencias entre las mujeres de estos dos niveles, medio y alto, no eran significativas.

Las condiciones nutricionales –tal y como quedan reflejadas en la cosecha de grano de cada año– incidían en el tiempo transcurrido entre el casamiento y el primer nacimiento, pero solo en el caso de las mujeres de nivel económico bajo. Por lo tanto, las mujeres pobres eran las que sufrían las consecuencias de una menor disponibilidad de alimento sobre su capacidad para concebir. Las mujeres de nivel medio o alto, sin embargo, habrían gozado de recursos adicionales que les habrían permitido evadir o neutralizar los efectos de las malas cosechas.

Este estudio permitió al equipo de investigación llegar algo más lejos de donde se habían propuesto, ya que vieron que la duración del intervalo entre el casamiento y el primer alumbramiento estaba relacionada con otras variables reproductivas. Así, cuanto más corto era ese intervalo, la vida reproductiva era más prolongada, los intervalos entre nacimientos, más breves y, por lo tanto, el éxito reproductor global era mayor. Así pues, las mujeres con menos recursos no solo daban a luz más tarde, sino que tenían hijos durante un periodo de años más corto y los intervalos de tiempo transcurridos entre cada nacimiento eran más largos.

La función reproductiva es muy dependiente de la cantidad de alimento de que se dispone o se puede obtener. Incluso cuando las condiciones nutricionales no son tan severas como para influir en el ciclo menstrual, los niveles de las hormonas esteroideas se ven afectados por esas condiciones. Debido a ello, la probabilidad de concebir disminuye cuando las condiciones alimenticias empeoran. En poblaciones africanas de agricultores que no disponen de medios de control de natalidad, los niveles de esteroides de la mujeres en edad fértil antes de la cosecha son inferiores a los niveles que se registran tras la misma. Y esas variaciones explican el patrón estacional de nacimientos en esas poblaciones. Este fenómeno tiene un claro valor adaptativo, pues favorece la concepción en las épocas del año –tras la cosecha– en que el balance energético es positivo y hay recursos suficientes para satisfacer las elevadas demandas energéticas de un feto en desarrollo.

Normalmente no suele estudiarse el efecto que ejercen sobre la fecundidad las variaciones de la cantidad de alimento no demasiado pronunciadas. Se conocen mucho mejor los efectos de grandes hambrunas, que se saldan con caídas importantes de la tasa de nacimientos en el conjunto de la población. Son particularmente bien conocidos los efectos de las hambrunas de Finlandia del periodo 1866-1868, y las de la holandesa de 1944-1945, que consistieron en fuertes descensos de la fecundidad en mujeres de todos los niveles sociales, aunque de mayor magnitud en los más bajos.

Estudios como este ilustran esas relaciones entre variables demográficas y factores nutricionales. Y lo hacen, además, mostrando que la relación entre unas variables y otras no solo se manifiesta cuando se dan condiciones extremas –las hambrunas antes citadas–, sino también cuando son de menor magnitud. Conviene recordar que la selección natural opera mediante las variaciones y diferencias en el éxito reproductivo, por lo que este tipo de estudios sirve para arrojar luz sobre los mecanismos que han actuado y actúan en la evolución de nuestra especie. Sí, también de la nuestra.

Fuente:

Nenko I, Hayward A D, Lummaa V (2014): The effect of socio-economic status and food availability on first birth interval in a pre-industrial human population. Proc. R. Soc. B 281.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Disponibilidad de alimento y fecundidad humana se ha escrito en Cuaderno de Cultura Científica.

BCAM-Naukas 2023: Cómo calcular el número π a hostias

Quizás sea el número más famoso de la historia. Lo cierto es que el número Pi, representado por la letra griega π, es una de las constantes matemáticas más importantes que existen en el mundo, estudiada por el ser humano desde hace más de 4.000 años. Este número irracional, que determina la relación entre la longitud de una circunferencia y su diámetro, concierne a múltiples disciplinas científicas como la física, la ingeniería y la geología, y tiene aplicaciones prácticas sorprendentes en nuestro día a día.

La fascinación que ha suscitado durante siglos es tal que el popular número cuenta con su propio día en el calendario, así el mes de marzo se celebra el Día de Pi en todo el planeta.

Este evento internacional vino de la mano del físico estadounidense Larry Shaw, quien en 1988 lanzó la propuesta de celebrar esta efeméride. La forma en la que se escribe el 14 de marzo en inglés y euskera coincide con los tres primeros dígitos de la famosa constante matemática: 3-14 martxoaren 14 en euskara / 3-14 March, 14th en inglés. En los últimos años, la conmemoración del Día de Pi se ha ido extendiendo, hasta tal punto que el 26 de noviembre de 2019 la UNESCO proclamó el 14 de marzo Día Internacional de las Matemáticas.

Un año más, el Basque Center for applied Mathematics-BCAM y la Cátedra de Cultura Científica de la UPV/EHU se han sumado a la celebración, organizando la cuarta edición del evento BCAM NAUKAS, que tuvo lugar el 14 de marzo en el Bizkaia Aretoa de la UPV/EHU.

El número pi no solo aparece en geometría, el lugar que podemos entender como natural, sino en las ramas más insospechadas de las matemáticas. Tanto es así que existen formas muy variadas de calcularlo, unas más eficientes que otras y algunas extremadamente originales. De una de estas últimas nos habla Miguel Camarasa: como calcular pi a base de hacer que choquen cosas.

Miguel Camarasa es alumno de doctorado en BCAM. Además de poseer un grado y un máster en matemáticas por la Universidad de Valencia, es graduado en ingeniería aeronáutica y aeroespacial por la Universidad Politénica de Valencia. También es un conocido divulgador de las matemáticas en YouTube con su canal Mates Mike.

Si no ve correctamente el vídeo, use este enlace.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo BCAM-Naukas 2023: Cómo calcular el número π a hostias se ha escrito en Cuaderno de Cultura Científica.

¿Tenemos todos personalidad múltiple?

personalidad múltiple

Entre 1998 y 1999, Koldo Larrañaga acabó con la vida de la abogada Begoña Rubio y del empresario Agustín Ruiz, aunque la policía siempre sospechó que cometió dos asesinatos más. Una despiadada carrera criminal ha colocado a este asesino en serie en un capítulo muy destacado de la crónica negra de Álava. Su valoración más técnica la realizó durante el juicio por estos hechos el psiquiatra Miguel Gutiérrez, cuyo informe forense concluía que Larrañaga era un psicópata.

Sin embargo, una de las declaraciones que más sorprendió al Dr. Gutiérrez fue cuando el acusado, sin mostrar el más mínimo remordimiento por los asesinatos cometidos, manifestó que lo “único que le preocupaba era qué iba a pensar su hijo”.

Un individuo que fue capaz de asestar 17 puñaladas a la abogada Begoña Rubio, a la que no conocía de nada, parecía en ese momento un padre preocupado. ¿Cómo es esto posible?

Fuente: CampusaUn psicópata, ¿es todo el rato un psicópata?

Fuente: CampusaUn psicópata, ¿es todo el rato un psicópata?

La intuición nos sugiere que, si una persona es extraordinariamente perversa, lo es en todas las esferas de su vida. Y, por lo tanto, afecta a todas sus relaciones sociales y familiares. Pero, como acabamos de observar, la personalidad de Koldo Larrañaga no respondía a esta lógica.

Y no es el único. En la práctica profesional forense podemos conocer individuos despiadados y crueles que, no obstante, pueden adorar a sus madres, desvivirse por el bienestar de un hermano, entristecerse con los achaques de su mascota, etc.

Basta tomar como ejemplo al sanguinario Amon Goeth, el asesino más infame de la Alemania nazi. Este comandante de Hitler mostró compasión por la prisionera judía Natalia Karp después de su interpretación de un nocturno de Chopin al piano. Tanto es así que le perdonó la vida el mismo día de su llegada al campo de concentración de Płaszów, donde había sido trasladada para ser fusilada.

Todos tenemos “personalidad múltiple”…Estas paradojas incomprensibles solo parecen cobrar sentido bajo el prisma de la teoría de la personalidad modular. Esta teoría sugiere que todos poseemos lo que popularmente se conoce como personalidad múltiple. Es decir, una personalidad dividida en varios “yoes” diferentes que prestan atención a distintos tipos de información y recuerdan experiencias pasadas diferentes. También pueden albergar sentimientos dispares sobre el mismo asunto y, quizás, aspiran a objetivos vitales muy diversos.

Lo fascinante es que existe una base neurológica para explicar esta “compartimentación” de la personalidad. Un estudio de 1991 de los neurocientíficos J. Grigsby y J. L. Schneiders, confirmado por trabajos posteriores, sostiene que el comportamiento humano puede comprenderse mejor a la luz de los datos actuales sobre la organización estructural del sistema nervioso central. El cerebro, desde este enfoque, estaría organizado como un sistema modular en constante interacción con el entorno.

Una buena noticia que podemos añadir a este hallazgo es que nuestras variopintas contradicciones cotidianas tendrían una explicación científica. Como también las de los criminales.

… pero no todos tenemos un trastorno de identidadDe hecho, trasladando esta idea de la personalidad modular hasta un extremo patológico, nos encontraríamos ante un desorden psíquico conocido como trastorno de identidad disociativo.