Una conjetura sobre ciertos números en el ‘sistema Shadok’

Los Shadok son los personajes de una serie de animación francesa creada por Jacques Rouxel (1931-2004).

Imagen 1: Una de las imágenes del Doodle dedicado al 48 aniversario (29 de abril de 2016) de la primera emisión en televisión de Les Shadoks (29 de abril de 1968). En la etiqueta: ¡¿Por qué hacerlo simple cuando puede hacerse complicado?!

Los Shadok son seres antropomorfos, con la apariencia de pájaros ‘redondos’, con largas piernas y alas diminutas. Son bastante crueles y tontos; por ejemplo, se dedican a construir máquinas absurdas, que nunca funcionan.

La lengua shadok solo posee cuatro fonemas de base: GA, BU, ZO, MEU. En efecto, su cerebro está constituido por cuatro casillas, y no puede contener más sílabas… de hecho, los Shadok solo son capaces de hacer cuatro cosas; para aprender una nueva, deben olvidar otra…

Estos personajes pueden construir palabras usando las sílabas GA, BU, ZO y MEU… pero la lengua shadok es incomprensible, ya que las palabras son polisémicas. Así, todo Shadok puede emitir cualquier palabra y su interlocutor comprenderá lo que mejor le convenga… aunque intercambian ideas entre ellos. Por ejemplo, ZoGa significa ‘bombear’, ZoBuGa denota ‘bombear con una bomba pequeña’ y ZoBuBuGa representa ‘bombear con una bomba grande’. GaMeu es la noche, BuBu el mar y BuGa la tierra.

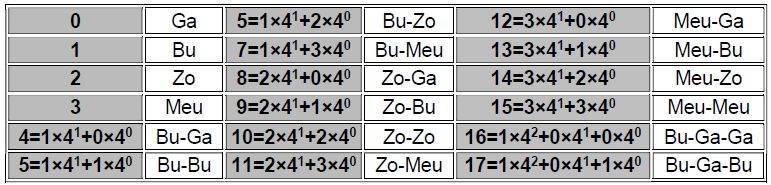

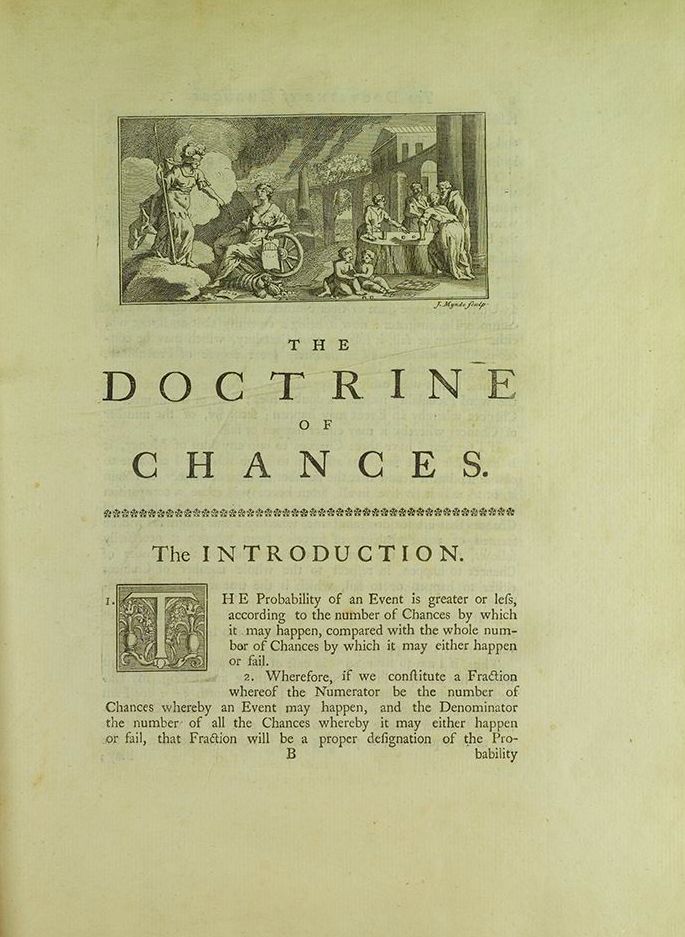

Estos cuatro fonemas sirven también para contar: GA (0), BU (1), ZO (2) y MEU (3), y cualquier número se construye a partir de estos cuatro por un sistema de numeración por posición, que es sencillamente la base 4:

Imagen 2: Base decimal versus base shadok.

Existen incluso páginas web destinadas a convertir números del sistema de numeración decimal al sistema shadok y viceversa. Por ejemplo, el número 100 se escribe en el sistema shadok:

BU-ZO-BU-GA.

El pasado domingo, en Blogdemaths (ver [1]) su autor escribía un artículo describiendo algunas propiedades interesantes de los números

Ga-Bu-Zo-Meu-Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu,

donde Ga-Bu-Zo-Meu se repetía n veces.

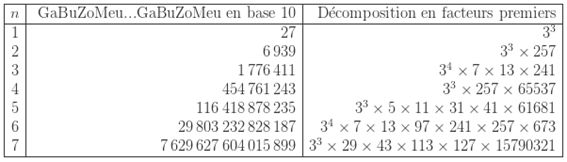

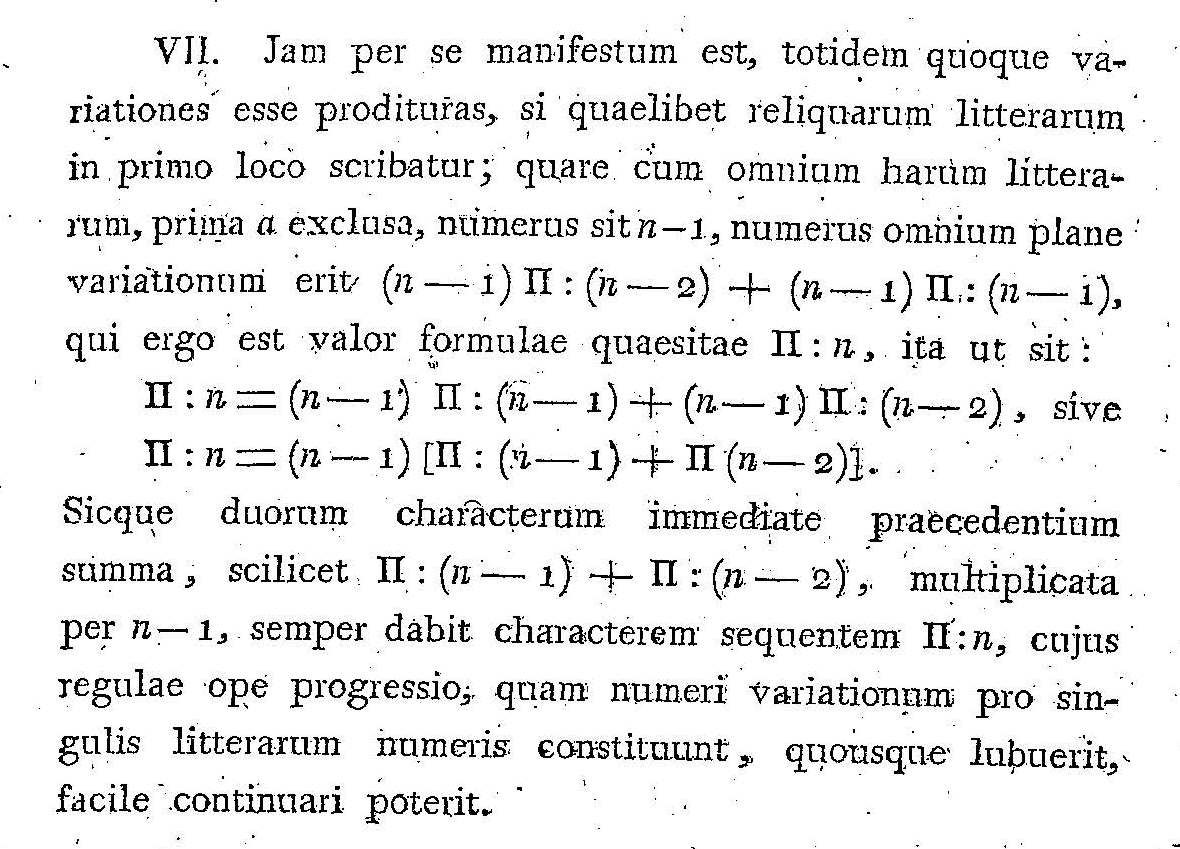

Los primeros valores de estos números son:

Imagen 3: Los primeros números de la forma Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu, en base 10 y su descomposición en factores primos. Extraído de [1].

A la vista de esta serie de valores, el autor del blog establece la siguiente conjetura:Conjetura: La descomposición en factores primos de los números

Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu

es el producto de una potencia de 3 por un entero libre de cuadrados.

Intentando probar esta conjetura (o encontrar un contraejemplo para ella), el autor obtiene una expresión general para estos números:

![]()

Así, para encontrar los divisores de Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu, basta con encontrar los divisores de 28n-1, que es un número de Mersenne.

Usando el teorema de Euler, el autor demuestra que

Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu (42 veces)

es divisible por 49… así que su conjetura es falsa. A partir de allí encuentra más contraejemplos a su conjetura, para

Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu (n veces)

con n = 54, 110, 120, 156,… todos ellos números pares.

La conjetura es falsa, pero el autor se pregunta a continuación, ¿quizás no existe un contraejemplo a su conjetura para

Ga-Bu-Zo-Meu-[…]-Ga-Bu-Zo-Meu (n veces)

con n impar? La respuesta es negativa; esta vez, usando números de Mersenne y números primos de Wieferich, es capaz de encontrar un contraejemplo con n impar a su conjetura, y lo descubre para n=91.

Aún es posible hacerse más preguntas, y el autor, efectivamente, las plantea: ¿es n=91 el menor contraejemplo impar a su conjetura?

Referencias

[1] GaBuZoMeu…GaBuZoMeu, Blogdemaths, 24 de septiembre de 2017

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Una conjetura sobre ciertos números en el ‘sistema Shadok’ se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Incendios, los grafos de visibilidad y la conjetura de Collatz

- La conjetura de Goldbach

- La conjetura de Poincaré-Perelman-Miander

Sistemas respiratorios: los límites a la difusión de los gases

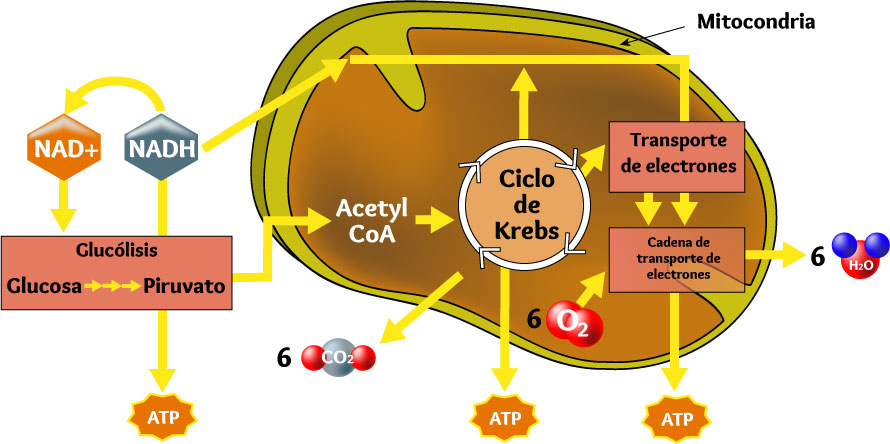

La mayor parte de los animales necesitan oxígeno para vivir. Es el aceptor final de electrones en la cadena respiratoria, por lo que sin su concurso no sería posible la síntesis de ATP que tiene lugar en el interior de las mitocondrias. Es, pues, la molécula clave para poder degradar las sustancias carbonadas que proporcionan la energía necesaria para el funcionamiento de los sistemas orgánicos. El catabolismo de esas moléculas, además de energía en forma de ATP, rinde CO2, sustancia que ha de ser expulsada al exterior, pues su acumulación en los medios interno o intracelular, daría lugar a peligrosas elevaciones del pH[1]. Llamamos respiración interna o respiración celular a los procesos metabólicos que tienen lugar en las mitocondrias y que, utilizando O2, dan lugar a la obtención de ATP y la producción de CO2 a partir de moléculas carbonadas.

Esquema de la respiración interna

El oxígeno se encuentra en el medio externo y ha de ser transferido al interior de las mitocondrias. Y, como se ha dicho, el CO2 ha de ser expulsado al exterior. Denominamos respiración externa al conjunto de procesos implicados en esas transferencias. Debemos, para empezar, considerar las limitaciones que afectan a la difusión de los gases respiratorios para, a continuación, analizar los dispositivos específicos que han permitido la superación de tales limitaciones.

Intercambio de gases en un alveolo pulmonar

La difusión es el proceso clave y universal mediante el que se produce el intercambio de gases entre el medio respiratorio y el organismo. Se produce de acuerdo con la denominada ley de Fick que, aplicada a los gases, establece que la tasa o velocidad a que se produce es directamente proporcional al denominado coeficiente de difusión (que depende de la permeabilidad para con cada gas de la barrera que hay que traspasar), a la superficie disponible para el intercambio, y al gradiente de presiones parciales del gas existente entre los dos compartimentos; y es inversamente proporcional a la distancia que ha de superar.

Llegados a este punto, conviene introducir la noción de presión parcial pues desde el punto de vista de la actividad biológica de los gases, es a ese parámetro al que hemos de atenernos y no a la concentración. A nivel del mar la presión atmosférica total es de 1 atm (atmósfera) o 760 mmHg (milímetros de mercurio). A dicha presión contribuyen todos los gases que hay en la mezcla y principalmente el N2 y el O2. El oxígeno representa un 21% del volumen del gas, por lo que su presión parcial (pO2) es de 159 mmHg. La del CO2 es de tan solo 0,03 mmHg. Si en vez de tratarse de un gas en la atmósfera, nos referimos a uno disuelto en agua o en alguna disolución fisiológica (medio interno, sangre, etc.), su presión parcial se define como la presión de ese mismo gas en una atmósfera con la que la disolución se encontrase en equilibrio.

Las configuraciones respiratorias más simples son aquellas en las que los gases pasan de un enclave a otro a través de procesos de difusión únicamente. A partir de cálculos teóricos basados en niveles metabólicos y requerimientos de O2 considerados “moderados” y dada una pO2 ambiental de 159 mmHg, la distancia de difusión –o distancia crítica– no debería superar el valor de 1 mm. Esta es una consecuencia de las características del proceso de difusión y supone, de hecho, una importante limitación fisiológica de partida. Hay animales en los que tal limitación no llega a operar. Son los más simples: organismos de muy pequeño tamaño –unicelulares incluso, como los paramecios u otros protozoos- o aquellos cuya anatomía permite que las células se encuentren en contacto con el medio externo o muy próximas a este, como esponjas, cnidarios o gusanos planos.

Sin embargo, la limitación anterior sí actúa sobre la mayor parte de los animales porque, como vimos aquí, en el curso de la evolución su tamaño ha tendido a crecer, además de haber aumentado también su complejidad. También han surgido grupos con muy altas demandas metabólicas (peces escómbridos, insectos voladores, aves y mamíferos). Y por otra parte, prácticamente todos o casi todos los enclaves acuáticos o terrestres de nuestro planeta -incluyendo zonas de muy diversa disponibilidad de oxígeno– han sido colonizados por algún grupo animal. Por todas esas razones, en el curso de la evolución todos esos animales se han dotado de dispositivos específicos que, actuando sobre los términos de la ley de Fick antes citados, facilitan el intercambio de gases respiratorios. Esos dispositivos son el aparato respiratorio, cuya función es realizar los intercambios directos con el exterior, y el sistema cardiovascular, que se ocupa de la transferencia interna (aquí vimos algunas características del sistema circulatorio humano, y aquí una panorámica de las bombas de impulsión). Veamos esto con cierto detalle.

El coeficiente de difusión es propio del gas y de la naturaleza de la barrera que separa el medio respiratorio del medio interno; obviamente, la selección natural no puede actuar sobre las características del gas, pero sí puede hacerlo sobre el epitelio que separa ambos medios. Por ello, los epitelios respiratorios y las paredes de los capilares sanguíneos presentan una alta permeabilidad para con los gases objeto de intercambio.

El área superficial también está sometida a la acción de la selección natural, y lo está en dos niveles. El primero corresponde a los órganos respiratorios, que consisten generalmente en múltiples pliegues del epitelio que se encuentra en contacto con el medio externo, llenos en ocasiones de infinidad de recovecos. A título de ejemplo valga el dato de que la superficie interna del total de alveolos pulmonares de un ser humano es de 100 m2. Cuando los pliegues se proyectan hacia el exterior del organismo en forma de evaginaciones, los órganos respiratorios reciben el nombre de branquias; son característicos de animales acuáticos. Y cuando consisten en invaginaciones reciben el nombre de pulmones; son característicos de animales terrestres. Los insectos, con sus tráqueas, constituyen un grupo aparte, aunque en rigor también su sistema traqueal es un sistema de invaginaciones. El segundo nivel corresponde a los enclaves en los que el sistema cardiovascular se halla en contacto con los tejidos. En este, la irrigación de los tejidos a cargo de variables (y en caso de ser necesarios, grandes) números de capilares sanguíneos ofrece enormes posibilidades para modificar la superficie de transferencia en la vía final de difusión a las células, incluyendo la posibilidad de aumentarla de manera considerable.

La selección natural también actúa sobre los dispositivos implicados en el intercambio de gases, de un modo tal que tienden a mantenerse gradientes de presiones parciales de la suficiente magnitud. También en este caso, son dos los enclaves implicados, órgano respiratorio y sistema circulatorio. Los gradientes amplios se consiguen en el aparato respiratorio impulsando el medio (aire o agua) a su través, de manera que su renovación permite mantener elevada la presión parcial de O2 y, por lo tanto, el gradiente. Lo opuesto vale para el CO2. Llamamos ventilación a la actividad que consiste en hacer circular el medio respiratorio sobre la superficie de los epitelios.

El mismo mecanismo sirve para la transferencia interna a través del sistema circulatorio, ya que la renovación de la sangre o medio interno que irriga o baña los tejidos permite mantener la pO2 relativamente alta y la pCO2 relativamente baja, lo que favorece el intercambio de esos gases con las células. De la misma forma se facilita la captación de O2 desde el medio respiratorio por la sangre, así como la cesión de CO2. En este caso es la bomba de impulsión del sistema circulatorio la que genera el movimiento, cuya velocidad puede también modificarse en función de las necesidades. Y además de lo anterior, muchos animales cuentan con unas sustancias de naturaleza proteica, a las que denominamos pigmentos respiratorios, que se combinan con el O2 y CO2, de manera que se reduce la presencia de dichos gases en la sangre en forma disuelta y por lo tanto, su presión parcial. El efecto de dichos pigmentos es muy importante; al reducir la pO2 en la sangre que irriga el órgano respiratorio, ayuda a mantener un gradiente entre los medios externo (respiratorio) e interno (sangre o hemolinfa) que facilita la transferencia de O2. Y lo mismo ocurre con el CO2 en los tejidos, aunque en este caso, los procesos implicados en su transporte interno son más complejos.

Por último, también la distancia de difusión está sometida a la actuación de la selección natural. Por un lado, los epitelios (respiratorio y capilar) a través de los cuales se produce difusión de gases son muy finos, por lo que la distancia de difusión se minimiza. Por el otro, la misma existencia de sistemas circulatorios equivale, en realidad, a una reducción funcional de la vía de difusión. Y por último, en los animales con sistemas circulatorios abiertos, no existen barreras a la difusión en la vía final, dado que el medio interno baña directamente las células.

Hasta aquí la descripción de los elementos funcionales que participan en los intercambios de gases respiratorios, así como del modo en que actúa la selección natural sobre los procesos representados por los términos de la ecuación de Fick. En posteriores anotaciones nos ocuparemos de otros aspectos de la respiración y de una descripción de la diversidad de órganos respiratorios.

Nota:

[1] Además de disolverse, el CO2 se combina con el agua para dar ácido carbónico, lo que potencialmente genera una elevación del pH.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Sistemas respiratorios: los límites a la difusión de los gases se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Sistemas nerviosos: el sistema central de vertebrados

- Sistemas nerviosos: el tálamo y el hipotálamo

- Sistemas nerviosos: el tronco encefálico y el cerebelo

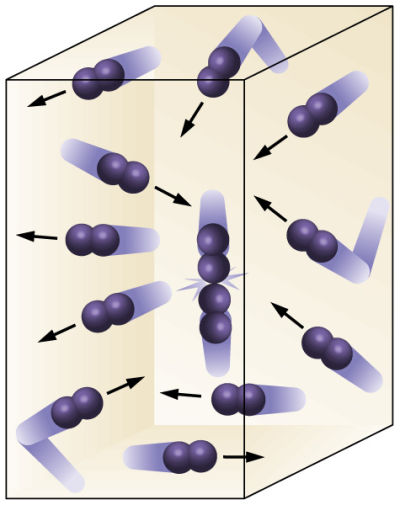

La ley del gas ideal a partir del modelo cinético

Tras exponer nuestro modelo simple del gas ideal, incorporar la distribución de las velocidades de las moléculas de Maxwell y tener en cuenta el efecto del tamaño de las moléculas, ya lo tenemos todo para ver cómo se deriva a partir del modelo cinético una ley a la que se ha llegado por estudios macroscópicos y fenomenológicos, la ley del gas ideal.

Según estableció Bernoulli, en la teoría cinética la presión de un gas es el resultado de los impactos contínuos de las partículas del gas contra las paredes del contenedor. Esto explica por qué la presión es inversamente proporcional al volumen (ley de Boyle) y directamete proporcional a la densidad: cuanto más pequeño sea el volumen o mayor la densidad, mayor será el número de partículas que colisionan con la pared en un momento dado. Pero la presión tambien depende de la energía cinética de las partículas (Ec)y, por tanto, de su velocidad, v, ya que Ec = 1/2 m·v2. Esta velocidad determina no solo la fuerza que se ejerce sobre la pared durante cada impacto, sino también la frecuencia de estos impactos.

Si las colisiones con la pared son perfectamente elásticas, la ley de conservación del momento lineal describe perfectamente el resultado del impacto. Un átomo que rebota e una pared sufre un cambio de momento lineal. Como el momento lineal es el producto de la masa por la velocidad, este cambio de momento se traduce en un cambio de velocidad, ya que asumimos que la masa es constante para la partícula (aquí habría que recordar que la velocidad es un vector). Pero si hay un cambio de momento lineal es porque se ha ejercido una fuerza sobre la partícula durante el impacto, como sabemos por las leyes de Newton. Por estas mismas leyes, para esa fuerza que ha hecho rebotar a la molécula de gas debe existir una fuerza de reacción que se aplica sobre la pared: esta fuerza es la contribución del impacto de la partícula a la presión.

Aplicando las mecánica de Newton a nuestro odelo simple de gas llegamos a la conclusión, para las tres dimensiones del movimiento, de que la presión P está relacionada con el promedio de la velocidad de los átomos al cuadrado, (v2)pr, y con el volumen, V, y la masa de la molécula de gas, m, según la expresión P = m· (v2)pr / 3V.

La derivación de esta expresión es muy sencilla y un magnífico ejemplo de la aplicación de las leyes de Newton en un dominio en el que el propio Newton no se aventuró.

Tenemos ahora dos expresiones para la presión de un gas. Una derivada de datos experimentales macroscópicos, P· V = k ·T y otra derivada de las leyes de Newton aplicadas a nuesto modelo simple, P = m· (v2)pr / 3V. Si ambas describen la misma realidad, entonces debe ocurrir que k · T = m · (v2)pr / 3. De aquí se deduce que la temperatura, T = 2/(3k) · m ·(v2)pr /2, es decir, la temperatura de un gas es proporcional a la energía cinética promedio de sus moléculas.

Ya teníamos alguna indicación de que aumentar la temperatura de un material afectaba de alguna manera al movimiento de sus “pequeños componentes”. También éramos conscientes de que cuanto mayor es la temperatura de un gas, más rápido se movían sus moléculas. La novedad es que ahora tenemos una relación cuantitativa precisa derivada del modelo cinético y de las leyes experimentales. Por fin podemos afirmar no solo que el calor no es algún tipo de fluido u otra sustancia, sino también que es solo la energía cinética de las partículas (átomos, moléculas) que constituyen el material*.

Nota:

* Para ser precisos, eso que estamos llamado calor, y que ya dejamos claro que es energía térmica, no solo es movimiento de las partículas, también es energía radiante. Pero baste esta forma de expresarse para los fines de esta serie.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo La ley del gas ideal a partir del modelo cinético se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ley del gas ideal y la tercera ley de la termodinámica

- Un modelo simple de gas

- Los antecedentes de la teoría cinética

Ignacio López-Goñi: “El sistema de defensa de las bacterias es el mejor editor de genomas que existe”

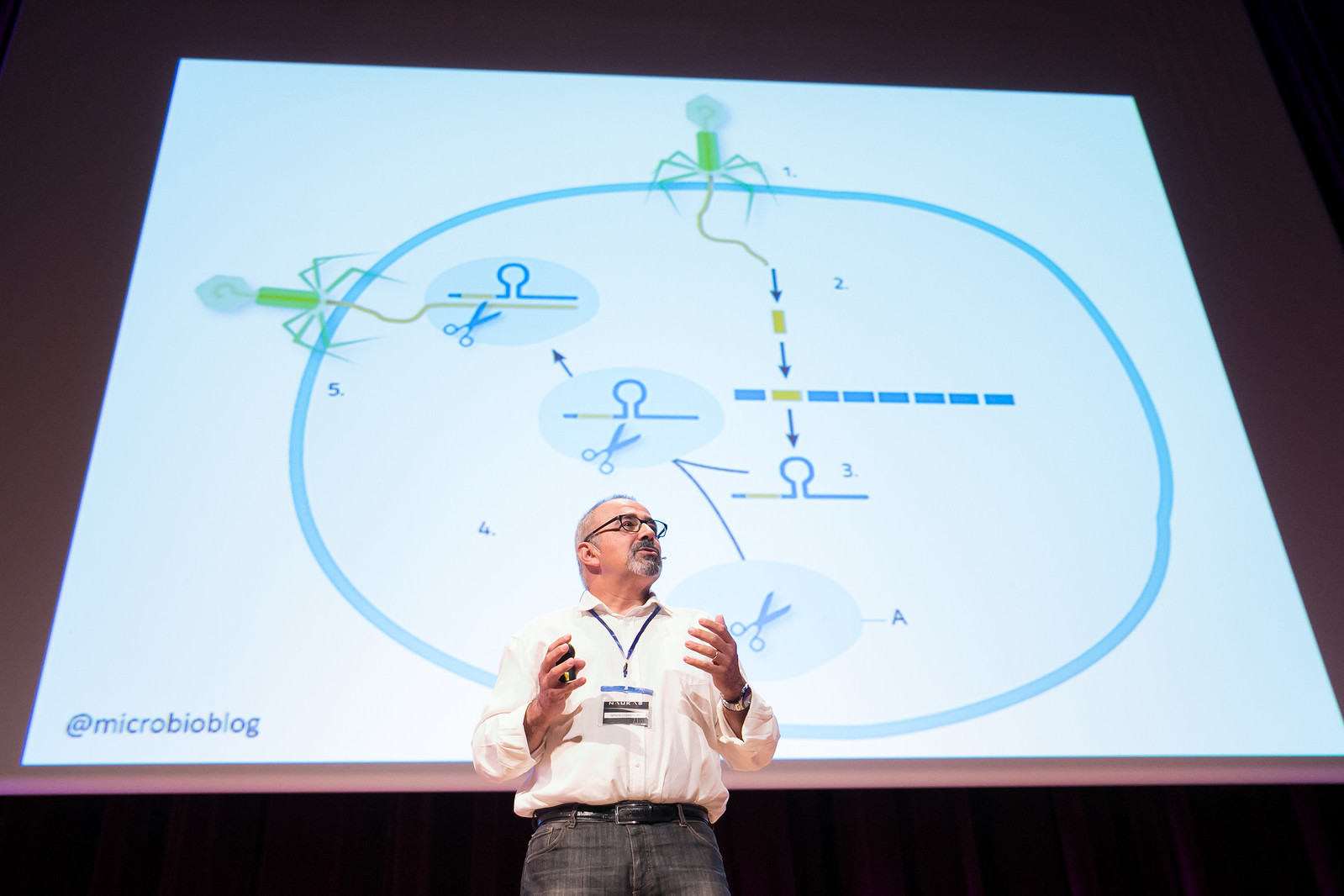

Las bacterias también se vacunan. Bajo esta premisa comenzó la ponencia que el microbiólogo navarro Ignacio López-Goñi, catedrático en la Universidad de Navarra, ofreció en la primera jornada del evento de divulgación científica Naukas, que este año cumple su séptima edición en el Palacio Euskalduna de Bilbao.

“Las bacterias no piensan, pero son muy listas”, anunció López-Goñi ante una audiencia apasionada de la ciencia que abarrotó el Auditorio del Palacio Euskalduna. Y es que, según avanzó el divulgador, cuando un virus infecta a una bacteria, la bacteria es capaz de coger parte de ese DNA e incluirlo en su genoma. “Así, en la siguiente infección, la bacteria es capaz de reconocer el virus y aniquilarlo. Así se vacunan las bacterias contra los virus”, explicó el científico en su ponencia.

El microbiólogo Ignacio López-Goñi el pasado 15 de septiembre en su intervención en Naukas Bilbao 2017. (Autor imagen: Iñigo Sierra)

Se trata de un avanzado sistema de defensa heredable mediante el cual las bacterias y sus descendientes guardan en su memoria una primera infección para hacer frente a las posteriores. Un sistema de defensa que “ha permanecido oculto durante millones de años”, según explicó López-Goñi, hasta que entró en juego la labor del microbiólogo español Francis Mojica, de la Universidad de Alicante.

Todo comenzó cuando el alicantino comenzó a estudiar el genoma de la arquea Haloferax mediterranei, un microorganismo que habita en las salinas de Santa Pola (Alicante) y que requiere de altas concentraciones de sal para vivir.

Fue entonces cuando descubrió unas secuencias de ADN que se repetían en el genoma del microorganismo; unas secuencias a las que denominó con las siglas CRISPR, o lo que es lo mismo, repeticiones palindrómicas cortas agrupadas y regularmente interespaciadas (Clustered Regularly Interspaced Short Palindromic Repeats, por sus siglas en inglés).

Estas secuencias repetidas hicieron al investigador recapacitar sobre la función que estas pudieran tener en la célula. Años más tarde, Mojica encontró la respuesta, y descubrió el maravilloso sistema de defensa que esta secuencias representaban para la bacteria.

En concreto, las procariotas son capaces de incorporar a su genoma un fragmento del ADN invasor que le sirve de guía para evitar futuras invasiones. Es decir, la secuencia del virus queda almacenada como información en el genoma de la bacteria y sus descendientes. Las bacterias quedan “vacunadas”.

Ignacio López-Goñi explicó en Naukas Bilbao 2017 que las bacterias también se vacunan. (Autor imagen: Iñigo Sierra)

A partir de 2012, y gracias a las investigaciones del español, la bioquímica francesa Emmanuelle Charpentier y la química estadounidense Jennifer Doudna demostraron que el mecanismo CRISPR descubierto por el alicantino se puede emplear como una herramienta para editar cualquier genoma; un auténtico “editor” genético que permite cortar y pegar trozos de ADN.

Se trata de una técnica de edición que, como si de un procesador de texto se tratara, y de una manera “sencilla, barata y precisa”, permite quitar y poner genes, además de estudiar y corregir mutaciones de los mismos. “El sistema de defensa de las bacterias ha resultado ser el mejor editor de genomas que existe”, aseguró en su ponencia el navarro López-Goñi.

Se trata de una técnica muy utilizada en los laboratorios de todo el mundo. Mediante este sistema, los microbiológicos y científicos son capaces de obtener plantas resistentes a plagas, animales con más masa muscular o mosquitos que no transmiten la malaria o el dengue. “Incluso puede servir para terapia génica y para la investigación de enfermedades raras e infecciosas”, explicó el científico.

Sin ir más lejos, este verano la técnica CRISPR se ha utilizado en Estados Unidos para modificar embriones con una enfermedad genética, eliminando de forma selectiva las secuencias de ADN no deseadas.

Ahora, más de 20 años después de que el microbiólogo alicantino descubriera las secuencias repetidas y el sistema de defensa de aquellas bacterias de Santa Pola, Francis Mojica es nuestro próximo candidato al Nobel de Medicina y Química.

Sobre la autora: Iraide Olalde, es periodista en la agencia de comunicación GUK y colaboradora de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Ignacio López-Goñi: “El sistema de defensa de las bacterias es el mejor editor de genomas que existe” se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Bacterias emisoras de rayos X

- Viscosidad negativa con bacterias

- ¿Dónde van las bacterias marinas en invierno?

Estroncio en la leche

El estroncio (Sr) es un elemento que en caso de accidente nuclear se vierte de forma mayoritaria a la atmosfera. El comportamiento químico del estroncio es similar al del calcio y se puede acumular en el suelo, en vegetales y en animales (especialmente en los huesos). Se trata de un elemento con dos principales radioisótopos (90Sr y 89Sr) que tienen una vida efectiva biológica relativamente alta para el ser humano, y debido a su fijación en los huesos, acaba impartiendo una dosis de radiación a lo largo de muchos años.

El Organismo Internacional de Energía Atómica (OIEA) ha propuesto, entre otros muchos, un método de detección rápida de Sr radiactivo en leche para casos de emergencia o accidente nuclear. Sin embargo, este tipo de métodos no es válido para su aplicación en medidas de rutina medioambientales, en los que los límites de detección son mucho menores que en los casos de emergencia nuclear. Es por ello que en un estudio llevado a cabo por el grupo de investigación Seguridad nuclear y radiológica del Departamento de Ingeniería Nuclear y Mecánica de Fluidos de la UPV/EHU ha obtenido las condiciones y los parámetros con los que convertir el método rápido propuesto por la OIEA en un método utilizable en los planes de vigilancia radiológica integrados en estudios medioambientales rutinarios.

El laboratorio del grupo de investigación Seguridad nuclear y radiológica es un laboratorio de medidas de baja actividad, que además de dedicarse a la investigación también realiza medidas de vigilancia radiológica para diferentes entidades como el Consejo de Seguridad Nuclear. En opinión de la doctora Raquel Idoeta, investigadora del grupo, “se trata de un método rápido, con rendimientos buenos y relativamente fácil y económico de adaptar”.

En el estudio han llevado a cabo tanto medidas experimentales como simulaciones numéricas para determinar los parámetros y condiciones de adaptación; asimismo, según explica Idoeta, han hecho una valoración económica “para ver qué facilidades pueden tener otro laboratorios para adaptarlo”. Y añade que “cualquier laboratorio medioambiental que tenga equipos de detección de partículas beta o que realice determinaciones de estroncio no requiere apenas de nada para integrar este método. Un laboratorio que aplicase este método de forma rutinaria, aunque adaptando en este caso los volúmenes y tiempos de medida, según lo determinado en nuestro estudio para alcanzar las exigencias en materia medioambiental, no tendría mayores problemas en aplicarlo debidamente en caso de una emergencia para dar una respuesta rápida a la determinación de estroncio radiactivo en leche”.

Referencia:

M. Herranz, R. Idoeta, S. Rozas, F. Legarda (2017) “Analysis of the use of the IAEA rapid method of 89Sr and 90Sr in milk for environmental monitoring”. Journal of Environmental Radioactivity. DOI: 10.1016/j.jenvrad.2017.06.003.

Edición realizada por César Tomé López a partir de materiales suministrados por UPV/EHU Komunikazioa

El artículo Estroncio en la leche se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un espectrómetro Raman portátil mide el punto óptimo de maduración del tomate

- La teoría de bandas de los sólidos se hace topológica

- Todo lo que se puede medir en un río

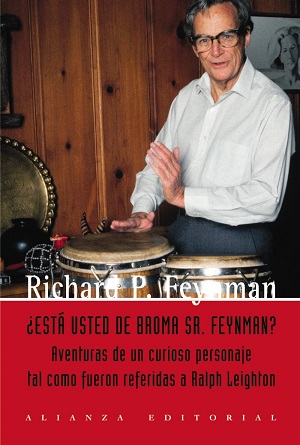

La cara más emocionante, humana y filosófica de la ciencia

Fernando del Álamo, lector

“¿Está Ud. de broma, Sr. Feynman?”, Richard P. Feynman, 1985, Alianza Editorial

Debía correr el año 1989, siendo yo estudiante, y charlando con el catedrático de física (del que decían que “libro que caía en sus manos, libro que leía”) me comentó:

– ¿No conoce Ud. a Richard Feynman?

– No.

– Sí hombre, fue Premio Nobel de Física y declarado deficiente mental por el ejército.

– ¡Ostrás!

– Hay un libro maravilloso titulado “¿Está Ud. de broma, Sr. Feynman?” donde habla de estas y otras cosas. Léalo, hombre, que le gustará.

Localicé el libro, lo compré y, literalmente, me enganché. No pude dejarlo hasta el final. En él narra las peripecias de su vida, había trabajado en el Proyecto Manhattan (donde, entre otras cosas, se dedicaba a reventar cajas fuertes). Lo interesante es que cuando empecé el libro pensé “este tío está un poco loco” y cuando lo finalicé pensé “¡claro! ¡tiene razón!”. No es un libro técnico, en absoluto, sino la visión de la ciencia y la vida que tiene una mente privilegiada como la suya.

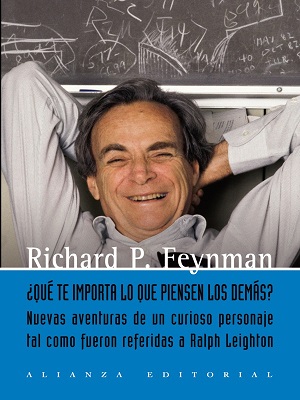

“¿Qué te importa lo que piensen los demás?”, Richard P. Feynman, 1988, Alianza Editorial

Posteriormente, me enteré de la existencia de su segundo libro: “¿Qué te importa lo que piensen los demás?”, en el que explica las investigaciones posteriores a la explosión del Challenger y cómo lo pasó con la enfermedad de su esposa. Da gusto ver cómo mientras otros iban de reunión en reunión, él se iba a hablar con los ingenieros.

“El arco iris de Feynman”, Leonard Mlodinow, 2003, Editorial Booket, Colección Drakontos bolsillo

Leídos estos dos libros, aquel mismo catedrático me enseño un tercer libro titulado “El arco iris de Feynman”, de Leonard Mlodinow. Me volvió a decir: “¿Ha leído Ud. esto? Es maravilloso”.

Con un apellido como ese me quedé un tanto escéptico. Pero si aquel catedrático me lo recomendaba, por algo iba a ser. Y no se equivocaba. El autor explica que era un joven físico, estudioso de Teoría de Cuerdas al que le dieron un despacho en un pasillo en el que había otros dos despachos con otros dos físicos: Murray Gell-Mann y el citado Richard Feynman. Ambos Premios Nobel, ambos mayores, ambos famosos; y Feynman con un cáncer que le estaba consumiendo.

¿Cómo puedo abordar a ese par de gigantes? Pensaba el autor. Y acercándose a ambos y dada una serie de circunstancias empieza a conocer la forma de ser y ver la vida de cada uno de ellos. Es maravilloso leer en esas páginas el cambio de mentalidad ante la vida y a qué dedicarse, llegando a abandonar la Teoría de Cuerdas para dedicarse, entre otras cosas, a escribir libros. ¡Y qué libros! Y, curiosamente, la mayoría sobre lo que es el ser humano más que libros especializados en física.

“El andar del borracho”, Leonard Mlodinow, 2008, Editorial Crítica, Colección Drakontos

“El andar del borracho”, en el que nos explica cómo, sin darnos cuenta, el azar tiene mucho que ver en nuestras vidas (me recordó mucho, aunque con un estilo totalmente diferente a “El hombre anumérico” del matemático John Allen Paulos). La importancia de los estudios como en el que se dieron cuenta de que en Londres moría más gente ajusticiada que no de hambre, cuando había muchísimos mendigos por las calles. O la forma en que estadísticamente Poincaré desenmascaró el fraude de poner menos masa de pan como media en las barras.

“Subliminal”, Leonard Mlodinow, 2012, Editorial Crítica, Colección Drakontos

“Subliminal”, por ejemplo, donde nos explica cómo nuestro subconsciente tiene más importancia de la que pensamos. Llega a citar situaciones reales como juicios a personas en las que el subconsciente jugó un papel clave para que lo condenaran viéndose posteriormente que era inocente.

“Las lagartijas no se hacen preguntas”, Leonard Mlodinow, 2016, Editorial Crítica, Colección Drakontos

“Las lagartijas no se hacen preguntas”, libro dedicado al recuerdo de su padre, desde un suceso en el campo de concentración de Auschwitz en la que había en juego un mendrugo de pan por una curiosidad. El autor prometió a su padre que escribiría un libro sobre por qué tenemos esas ansias de conocer, de saber. Y este es el libro, pero para ello tiene que explicar la historia de la humanidad desde los inicios viendo cómo poco a poco se va llegando a lo que somos hoy día.

Todos sus libros reflejan cultura, ciencia, conocimiento y, sobre todo, emoción. Son libros que tienen grandes momentos que marcan y hacen reflexionar. No son libros técnicos y lo que escribe está al alcance de cualquier persona.

Y en este artículo, quería mostraros precisamente esto: la cara más emocionante, humana y filosófica de la ciencia de la mano de estos dos hombres, de Richard Feynman y de Leonard Mlodinow. Recomiendo leer los libros en el orden en que los he ido citando. Espero que los disfrutéis.

En Editoralia personas lectoras, autoras o editoras presentan libros que por su atractivo, novedad o impacto (personal o general) pueden ser de interés o utilidad para los lectores del Cuaderno de Cultura Científica.

El artículo La cara más emocionante, humana y filosófica de la ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Ciencia a presión: ¿Periodismo científico o periodismo de “papers”?

La expresión publish or perish (publica o perece) es de sobra conocida en el ámbito científico. Quiere expresar la importancia que tienen las publicaciones en los currículos del personal investigador. En ciencia no basta con hacer observaciones, obtener unos resultados y derivar conclusiones. Hay, además, que hacerlo público y, a poder ser, en medios de la máxima difusión internacional. La ciencia que no se da a conocer, que no se publica, no existe. El problema es que de eso, precisamente, depende el éxito profesional de los investigadores, sus posibilidades de estabilización y de promoción. De ahí la conocida expresión del principio.

El mundo de la comunicación tiene también sus normas. En comunicación se trata de que lo que se publica sea consumido. De la misma forma que la ciencia que no se publica no existe, en comunicación tampoco existen los contenidos que no se consumen: o sea, no existen los artículos que no se leen, los programas de radio que no se oyen, los de televisión que no se ven o los sitios web que no se visitan. En comunicación valdría decir “sé visto, oído o leído, o perece”.

Ambas esferas tienen ahí un interesante punto en común. Y por supuesto, en comunicación o difusión científica el ámbito de confluencia se aprecia en mayor medida aún. Confluyen aquí ambas necesidades, la de hacer públicos los resultados de investigación y, además, conseguir que lleguen a cuantas más personas mejor.

El problema es que la presión por publicar y por tener impacto comunicativo puede conducir tanto a unos como a otros profesionales, a adoptar comportamientos deshonestos, contrarios a la ética profesional e, incluso, a desvirtuar completamente el fin de la ciencia y de su traslación al conjunto del cuerpo social. Y también puede conducir, y de hecho ha conducido, a que se haya configurado un sistema de publicaciones científicas con patologías.

De todo esto se trató el pasado 31 de marzo en “Producir o perecer: ciencia a presión”, el seminario que organizarono conjuntamente la Asociación Española de Comunicación Científica y la Cátedra de Cultura Científica de la UPV/EHU.

5ª Conferencia.

Ángela Bernardo, redactora de ciencia en Hipertextual: ¿Periodismo científico o periodismo de “papers”?

¿Periodismo científico o periodismo de “papers”?Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Ciencia a presión: ¿Periodismo científico o periodismo de “papers”? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ciencia a presión: Ciencia abierta vs. ciencia cerrada

- Ciencia a presión: Ciencia patológica y patología editorial

- Ciencia a presión: Científicos que avalan patrañas

Catástrofe Ultravioleta #19 ASTEROIDE

Catástrofe Ultravioleta #19 ASTEROIDE

¿Estamos realmente preparados para enfrentarnos a las amenazas del espacio? En Catástrofe Ultravioleta nos preguntamos si, utilizando solamente la tecnología que disponemos en la actualidad, podríamos detener un asteroide en rumbo de colisión con la Tierra. Repasamos la ciencia tras los asteroides en todas sus facetas, desde su detección y prevención, hasta su futura explotación en busca de recursos.

Agradecimientos: Josep M. Trigo (Institute of Space Sciences CSIC-IEEC), Víctor Manchado (Radio Skylab), Daniel Marín (Eureka), Álvaro Peralta (Centro español de láseres pulsados CLPU), Rafael Harillo (Consultoría Stardust), Pablo F. Burgueño (Abanlex), Faustino, Leonor y Fernando del Observatorio de la Hita, Jose María Madiedo (Universidad de Huelva).

* Catástrofe Ultravioleta es un proyecto realizado por Javier Peláez (@Irreductible) y Antonio Martínez Ron (@aberron) con el patrocinio parcial de la Cátedra de Cultura Científica de la Universidad del País Vasco y la Fundación Euskampus. La edición, música y ambientación obra de Javi Álvarez y han sido compuestas expresamente para cada capítulo.

El artículo Catástrofe Ultravioleta #19 ASTEROIDE se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Preparados para una Catástrofe Ultravioleta

- Catástrofe Ultravioleta #01 Expedición

- Catástrofe Ultravioleta #13 LEVIATÁN

Los rangos de la percepción

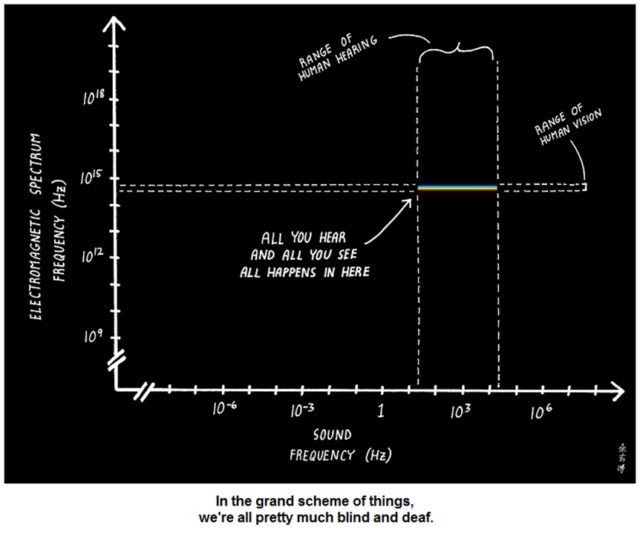

Los seres humanos somos sensibles a diversas magnitudes, tanto externas como internas. De entre ellas recibimos información de dos tipos de ondas: las de presión en el aire que nos rodea (sonido), y ondas electromagnéticas que llegan a nuestros ojos (luz). Para poder hacerlo disponemos de unos detectores considerablemente sofisticados. Tantos los oídos como los ojos poseen unas prestaciones verdaderamente notables, pero limitadas a unos determinados rangos de frecuencias. Si consideramos la amplitud de los espectros electromagnético y sonoro, podemos llegar a pensar que somos prácticamente sordociegos, como dice una figura que ha dado muchas vueltas por internet (figura 1). ¿Es esto realmente así?

“En la gran perspectiva de las cosas somos prácticamente sordociegos”. Esta figura ha dado muchas vueltas por las redes sociales (originalmente publicada en Abtruse Goose)

Hay tres características de la propagación del sonido que hay que tener en cuenta para comprender el interés evolutivo de percibir un rango particular de ondas sonoras. Por una parte, la atenuación del sonido es mayor cuanto más alta es la frecuencia o, visto al revés, los sonidos de bajas frecuencias son capaces de viajar distancias mayores. En segundo lugar tenemos que la reflexión del sonido es eficaz cuando choca con objetos del tamaño de la longitud de onda del mismo (o mayores). Por último, la capacidad de las ondas de rodear obstáculos (la difracción) también ocurre cuando las longitudes de onda y los obstáculos son de tamaños parecidos.

Así pues, los animales como murciélagos o delfines que utilizan el eco para localizar objetos (ecolocalización) tendrán que utilizar ondas de altas frecuencias (pequeñas longitudes de onda, por tanto) de forma que puedan resolver objetos pequeños y no verse afectados por la difracción. En cambio, los animales que utilicen el sonido para advertir la presencia de depredadores podrán beneficiarse de la difracción, de forma que les llegue información del peligro aunque haya obstáculos en el camino (piedras, matorrales, etc). Finalmente, hay animales que han desarrollado sistemas de comunicación a muy larga distancia, y para ello necesariamente han de emplear ondas de frecuencias muy bajas.

A lo anterior hay que añadir que los tamaños de los dispositivos para producir y recibir sonidos también están en proporción con la longitud de onda de los mismos. Así, solo animales grandes podrán acceder a los sistemas de transmisión a largas distancias, ya que las ondas de bajas frecuencias tienen longitudes de onda grandes. Es el caso de los elefantes y algunos cetáceos. Por el contrario, animales pequeños que usan la ecolocalización, como los murciélagos, perciben sonidos en un rango de 20 a 200 kHz. Sus sonidos más graves a nosotros nos resultan imperceptibles por ser demasiado agudos.

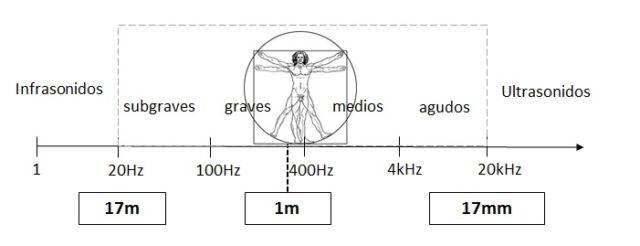

Se suele considerar que el intervalo audible para los humanos se extiende entre los 20 y los 20.000 Hz, aunque en condiciones de laboratorio algunos individuos perciben un rango algo más extenso; y en condiciones normales no pasamos de los 15.000, especialmente los adultos. Si nos fijamos en las longitudes de onda que corresponden a dicho intervalo (figura 2), vemos que está centrado en los tamaños de las personas, extendiéndose desde los 17 mm a los 17 m. Este intervalo es muy adecuado para controlar el entorno en un radio de unos 20 m. Resulta especialmente valiosa la difracción que permite que podemos oír personas en otra habitación aunque no podamos verlas.

Espectro sonoro.

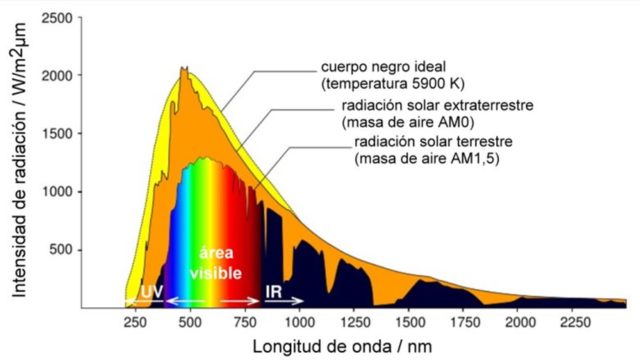

En el caso del intervalo visible, las restricciones son más severas, y de hecho las variaciones entre distintos animales son mucho más pequeñas que en el caso del sonido. El intervalo visible del espectro electromagnético está determinado por tres condicionantes. En primer lugar, es el principal componente de la radiación que nos envía el Sol. Nuestra estrella emite un espectro de radiación correspondiente al de la emisión de un cuerpo negro a 5900K que tiene pequeñas partes de ultravioleta e infrarrojo, flanqueando el grueso de su emisión, que es visible (figura 3).

Espectro solar.

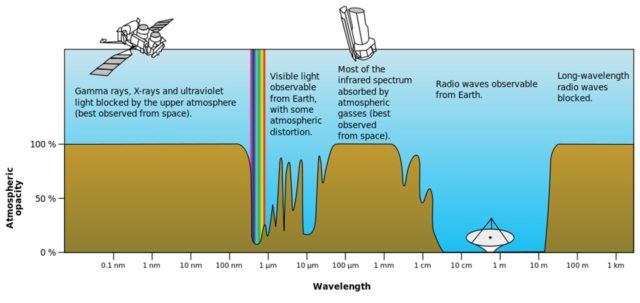

En segundo lugar, la atmósfera que recubre nuestro planeta es opaca a la mayoría del espectro electromagnético (figura 4). Si tomamos el rango de longitudes de onda que va desde un nanómetro hasta un kilómetro, catorce órdenes de magnitud, solo hay dos ventanas de transparencia. Una es para las ondas de radio (entre un centímetro y veinte metros, aproximadamente); y otra es en el visible y el infrarrojo, aunque con muchos altibajos debidos a la absorción de los distintos gases de la atmósfera. Es decir, de los catorce órdenes de magnitud considerados, solo dos y medio atraviesan la atmósfera. De hecho, cuando hemos querido observar el cosmos en otras zonas del espectro, ha sido necesario colocar los correspondientes telescopios en satélites. La observación terrestre se limita al visible y la radio (y las ondas de radio son demasiado grandes para que puedan resultar aprovechables por los animales).

Opacidad de la atmósfera

Por último, la energía de los fotones del rango visible es compatible con las moléculas orgánicas que componen los seres vivos. Energías mayores (ultravioleta y más allá) rompen enlaces e impiden la estabilidad molecular; mientras que energías menores interaccionan poco, y es difícil imaginar detectores basados en estas moléculas, como sí ocurre con el visible.

Tras estas consideraciones, podemos poner en perspectiva la figura del comienzo. Es verdad que en el universo hay ondas a las que no somos sensibles, pero o bien no las hay en la superficie del planeta, o bien son muy poco relevantes para animales como los humanos. Al menos así ha sido durante miles de años, hasta que en las últimas décadas la ciencia y la tecnología nos han permitido medirlas. A día de hoy disponemos de instrumentación capaz de extender el rango original de nuestros sentidos y hacerlo prácticamente ilimitado.

Este post ha sido realizado por Joaquín Sevilla (@Joaquin_Sevilla) y es una colaboración de Naukas con la Cátedra de Cultura Científica de la UPV/EHU.

El artículo Los rangos de la percepción se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Televisión y radar

- Cuántica y relatividad por todas partes

- Presentación del estudio “Percepción social de la ciencia y la tecnología en el País Vasco”

La educación no es la materia prima de la mano de obra

Steven Fesmire

![]()

Cuando se trata de debates actuales en política y políticas, incluso una defensa estridente de las humanidades, como la de George Anders “You Can Do Anything: The Surprising Power of a ‘Useless’ Liberal Arts Education” [Puedes hacer cualquier cosa: el sorprendente poder de una educación “inútil” en humanidades] o la de Randall Stross “A Practical Education: Why Liberal Arts Majors Make Great Employees” [Una educación práctica: ¿Por qué los grados en humanidades hacen grandes empleados?], tiende a aceptar que el empleo remunerado es el principal objetivo de la educación.

Como especialista en el filósofo y educador del siglo XX John Dewey, he estado observando estos debates con interés. El filósofo académico más citado del siglo XX, Dewey hizo, posiblemente, las contribuciones más significativas del siglo pasado al desarrollo del pensamiento educativo. Entre otras cosas, criticó influyentemente la educación concebida como “mera preparación para la vida posterior“.

Recordar a Dewey plantea preguntas pertinentes sobre la misión fundamental de la educación hoy en día. ¿Es el objetivo principal de la educación proporcionar un yugo acolchado para la población activa preexistente en el estado? ¿O es, en conjunto, mejorar nuestras vidas?

El propósito de la educación

En el siglo XIX, la defensora de los derechos de las mujeres Margaret Fuller criticó la práctica de educar a las niñas solo para ser esposas y madres. “Un ser de alcance infinito”, escribió, “no debe tratarse con una visión exclusiva para relación alguna. Dé al alma el curso libre … y el ser será apto para cualquiera y cada una de las relaciones para las que pueda ser llamado “.

En mi opinión, la política educativa en los Estados Unidos hoy en día es de una manera tangible tan restrictiva como la que criticó Fuller hace más de 150 años. Para muchos, la misión de primaria, secundaria y de la educación superior es, en palabras tristemente famosas del gobernador de Wisconsin Scott Walker, “desarrollar los recursos humanos que satisfagan las necesidades de población activa del estado“.

Sea lo que sea que uno pueda pensar en la política de Walker, su perspectiva general no es extraña. Tipifica la opinión de que la educación es principalmente una manera de alimentar a la industria con mano de obra cualificada, y está en tensión con el objetivo de preparar a los estudiantes “para cualquiera y cada una de las relaciones para las que pueda[n] ser llamado[s]”.

En lugar de educar a personas completas para el crecimiento a lo largo de toda la vida, este “modelo industrial” trata la educación tan solo como otro sector de la economía. Desde este punto de vista, el trabajo de la educación es fabricar mano de obra cualificada, y se espera que lo haga de una manera que sea lo más eficiente posible. El conocimiento es visto como una mercancía, los maestros y profesores son vehículos de entrega de contenido y los estudiantes son ya consumidores ya productos manufacturados.

Las instituciones educativas que siguen el modelo industrial son vistas como mercados en los que adquirir y entregar contenido. Y cuando hay matrícula de por medio, ésta es simplemente el precio justo para acceder a ese contenido.

¿Qué pierde la sociedad?

Cuando se describe de esta manera, parece un enfoque frío e inhumano de la educación. Sin embargo, los dos principales partidos políticos estadounidenses parecen haber adoptado el modelo industrial. Los partidos pueden estar en desacuerdo sustancial sobre los detalles de cómo proporcionar la educación, pero (en lo principal) los valores no económicos no merecen su atención demasiado a menudo.

Afirmo que algo se pierde cuando tratamos la educación como nada más que un sector de la economía industrial.

En primer lugar, el modelo industrial profundiza nuestros problemas sociales.

Es cierto que muchos objetivos específicos de la educación están, y deben estar, definidos por nuestra infraestructura económica, como la demanda de un énfasis curricular en STEM [véase nota 1]. Pero eso no significa que nuestro objetivo educativo primordial debe centrarse en esto. Capacitar a los estudiantes exclusivamente para ajustarse a las especificaciones existentes no sólo ahoga la imaginación y la innovación, sino que también dirige a los estudiantes por los mismos canales que están implicados en nuestros problemas sociales, económicos, ambientales y geopolíticos. Creo que esto sacrifica nuestra mejor esperanza de hacer las cosas mejor.

Y así llegamos a John Dewey. De niño, realizaba tareas habitualmente en la granja de su abuelo en las afueras de Burlington, Vermont. Posteriormente, lamentría que esos productivos suplementos ocupacionales a la educación formal estuvieran eclipsados casi completamente por la urbanización y la mecanización. Buscó maneras de llevar la vida diaria al aula para que la educación pudiera hablar a la vida.

Pero hay que hacer una distinción importante. En un enfoque, puedes infundir educación con contenido que hable de salidas potenciales – la llamada “vida real”. Por otro lado, podrías permitir que la infraestructura económica existente sea la única fuerza impulsora tras la práctica educativa. Esto último, en palabras de Dewey, convierte a estudiantes y profesores en “instrumento [s] en la realización del dogma feudal de la predestinación social”.

El primero es lo que la mayoría de los educadores esperan: estudiantes que se convierten en participantes en la redirección inteligente de la sociedad.

Culturas de imaginación, crecimiento y realización

No sólo el modelo industrial de educación debilita la acción social inteligente, sino que también sacrifica el enriquecimiento personal.

Una institución educativa es capaz de capacitar a más estudiantes con menos maestros o peor pagados, igual que un sector industrial puede producir más ropa, automóviles o proteína animal para satisfacer las demandas del mercado con menores costos generales. Estos productos se pueden comprar a un precio relativamente bajo y se utilizan para, o se ponen a trabajar para producir, más cosas.

¿Pero qué otra cosa producimos involuntariamente cuando la educación (o la industria, para el caso) se hace “eficiente” de esta manera? Por ejemplo, ¿hacemos que las vidas sean más pobres? ¿En palabras de Dewey, hacemos la vida más “congestionada, apresurada, confusa y extravagante“?

Tal y como se ve a través de una estrecha lente utilitario-industrial, simplemente no está claro cómo la educación podría abordar el crecimiento personal, la comunidad y la calidad de vida. Si no se aborda, creo que corremos el riesgo de marginar estos aspectos del enriquecimiento individual.

Democracia y educación

La democracia, insistía Dewey, no es una herencia estática de la que simplemente podamos vivir, sino un ideal que cada generación debe lograr a través del esfuerzo activo. Las escuelas son nuestros principales medios culturales para educar a ciudadanos libres que puedan participar de manera inteligente y creativa en este esfuerzo. La educación es cómo invertimos en el futuro de nuestra democracia.

Bajo las condiciones económicas y sociales de hoy, ¿qué significa si la “educación para la mano de obra del estado” es la principal misión de las escuelas? ¿Sacrifica la calidad de la vida presente de un estudiante en aras de un bien prometido? ¿Apoya un sistema de privilegios estático, un consumo frenético e insostenible y una eficiencia que amortece?

Dewey argumentó, en oposición, que todos deberían tener la oportunidad de una educación reflexiva críticamente y rica en ocupaciones que enfatice el crecimiento, el desarrollo emocional, el compromiso imaginativo, la vitalidad estética, la responsabilidad social y el cuidado. Desde primaria y secundaria a la universidad, esta educación puede ayudar a establecer las condiciones para el enriquecimiento personal, la investigación crítica y la participación democrática.

Nota del traductor:

[1] STEM es un acrónimo para ciencia, tecnología, ingeniería y matemáticas, por sus siglas en inglés.

Sobre el autor:

Steven Fesmire es profesor visitante de filosofía en el Middlebury College (Vermont, EE.UU.)

Texto traducido y adaptado por César Tomé López a partir del original publicado por The Conversation el 31 de agosto de 2017 bajo una licencia Creative Commons (CC BY-ND 4.0)

![]()

El artículo La educación no es la materia prima de la mano de obra se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las ideas erróneas sobre educación entre el profesorado: prevalencia, causas y soluciones

- Crónica de la jornada “Las pruebas de la educación”

- Cine y ciencia de la mano

Así es la mejor crema antiedad según la ciencia

¿Qué contiene la mejor crema antiedad? ¿Hialurónico, glicólico, retinol, coenzima Q10, vitamina C? La publicidad de los cosméticos antiedad suele centrar la atención en uno o dos de sus componentes, pero la mejor crema antiedad contiene varios principios activos que cuentan con el aval de la ciencia.

Las cremas antiedad combaten varios signos del envejecimiento, no sólo las arrugas. Las manchas en la piel, la falta de luminosidad, la pérdida de elasticidad o los poros abiertos son tanto o más importantes que las dichosas arrugas. Echemos un vistazo a los componentes que encontramos en la mejor crema antiedad y cómo funcionan sobre nuestra piel.

-

Hidroxiácidos

Los más comunes son el ácido glicólico, el salicílico, el mandélico o el láctico. Lo que hacen estos principios activos es debilitar los enlaces entre las células muertas de la piel con el resto de la epidermis, es decir, actúan como exfoliantes. Esto acelera el proceso normal de regeneración de la piel y aportan luminosidad.

En los últimos años se ha descubierto que, por ejemplo, el ácido glicólico incrementa la síntesis de colágeno, con lo que mejora la elasticidad y tersura de la piel. El ácido salicílico ha demostrado ser un principio activo que, además de desobstruir los poros, mitiga las manchas e ilumina la piel.

El inconveniente de estos hidroxiácidos es que su capacidad exfoliante puede producir irritación y además provoca que la piel sea más sensible al sol. Por este motivo los encontramos en cremas antiedad de noche o en cremas de día con un elevado índice de protección solar.

-

Ácido hialurónico

Esta sustancia se encuentra de forma natural en el cuerpo, en las articulaciones, el cartílago y la piel. Cumple una función estructural y, en el caso de la piel, su escasez se percibe como pérdida de firmeza. Con el paso de los años su proporción va disminuyendo. Por eso es importante ayudar a nuestro cuerpo a mantenerlo y a regenerarlo. En contra de la intuición, el ácido hialurónico que aplicamos sobre nuestra piel no penetra y suple las deficiencias, sino que se ha descubierto que funciona de otra manera.

Existen dos tipos de ácido hialurónico, el de alto peso molecular (APM) y el de bajo peso molecular (BPM). El APM está formado por agregados de moléculas de gran tamaño, por lo que no se absorbe, formando una película superficial que retiene el agua. Esta es su propiedad más codiciada, que es capaz de absorber 1.000 veces su peso en agua, lo que se traduce en un increíble poder hidratante. Para prevenir los signos de la edad es fundamental mantener la piel hidratada.

El BPM, también denominado ácido hialurónico fragmentado o hidrolizado, forma agregados moleculares de pequeño tamaño, capaces de penetrar hasta la dermis, captar agua y producir un efecto de relleno que atenúa las arrugas y mantiene la hidratación durante más tiempo. A medio plazo se ha comprobado que estimula la formación de más hialurónico. El BMP es el hialurónico más novedoso y también el más costoso de producir, por eso lo encontramos en productos de gama media-alta, especialmente en formato serum, mientras que el APM suele formar parte de cremas y geles más económicos.

-

Vitaminas

Una de las causas del envejecimiento de la piel es la formación de radicales libres por estrés oxidativo de las células, cosa que se acelera en presencia de radiación solar. Esto hace perder elasticidad porque se destruye la elastina y el colágeno. Para paliar la oxidación, las cremas antiedad contienen antioxidantes como algunas vitaminas. Normalmente estos antioxidantes son derivados de la vitamina C y la vitamina E con capacidad de penetración en la piel, como ascorbatos y acetatos respectivamente.

La vitamina C dinamiza la producción de colágeno y aclara las manchas. La encontramos en fórmulas ligeras, para pieles grasas o con acné. Como este activo se oxida con facilidad, el envase cobra importancia: ha de ser airless en tubo o con dosificador, cosa que encarece el producto final.

Otro antioxidante común es el derivado de la vitamina E, el tocoferol. Lo encontramos en fórmulas más untuosas y es más fácil de conservar. Se suele asociar a la vitamina C para conseguir mayor efecto. Posee acción hidratante, previene la formación de eritemas y quemaduras durante la exposición solar, tiene acción calmante, por lo que se utiliza con frecuencia en productos aftersun.

Otro antioxidante, más asequible que las vitaminas C y E, es el derivado de la coenzima Q10, el ubiquinol. Previene el estrés oxidativo y frena la destrucción del colágeno provocada por la radiación solar.

Otra vitamina común en estas cremas es la niacinamida o vitamina B3, que reduce la formación de manchas porque inhibe la acción de la tirosinasa, la enzima necesaria para la síntesis de la melanina. Si no se metaboliza, no se produce la mancha.

-

Retinoides

Los retinoides son derivados del ácido retinoico o vitamina A. En las cremas los encontramos como retinol y como retinaldehído. Previene el envejecimiento de la piel desde varios frentes. Es, posiblemente, el principio activo más prometedor de las cremas antiedad. A nivel de la epidermis reduce la cohesión de las células muertas, disminuye la actividad de los melanocitos, por lo que reducen las hiperpigmentaciones y estimula la cicatrización al promover el crecimiento de los tejidos y la síntesis de colágeno. A nivel de la dermis estimula la actividad de los fibroblastos, aumentando así la síntesis de colágeno y elastina. El conjunto de estas acciones se traduce en que difumina las líneas de expresión, reduce los poros, incrementa la elasticidad, previene y reduce las manchas y mejora el tono de la piel.

-

Ácidos grasos

Los ácidos grasos como el ácido linoleico tienen actividad antioxidante y contribuyen notablemente a la regeneración celular. Regulan de la permeabilidad de la piel, con lo que favorecen que otros principios activos penetren en ella. Desarrollan un papel importante en la hidratación y el mantenimiento de la integridad de la barrera cutánea.

-

Filtros solares

Los filtros solares son los ingredientes estrella de cualquier producto cosmético antiedad. No pueden faltar. La radiación solar, especialmente la radiación ultravioleta, es el mayor enemigo de nuestra piel. No solo produce quemaduras y aumenta el riesgo de cáncer, sino que además es el principal factor que provoca la aparición de manchas, la destrucción del colágeno y la elastina, la aparición y acentuación de arrugas. Es decir, además del paso del tiempo, la radiación ultravioleta es responsable de todos los signos de la edad. Por este motivo, la mejor crema antiedad es aquella que tenga protección solar, cuanto mayor factor SPF, mejor.

En ellas encontramos tanto filtros físicos como filtros químicos. Los primeros reflejan la radiación ultravioleta, como un espejo, y los segundos transforman la radiación ultravioleta en radiación inocua. Los físicos son menos cosméticos que los químicos, ya que dejan rastro blanco, así que lo habitual es encontrarse filtros químicos en las cremas de gama media-alta o una combinación de ambos.

-

Conclusiones

La mejor crema antiedad es aquella que mantiene la piel hidratada, libre de células muertas y de radicales libres y, sobre todo, protegida de la radiación solar. Eso lo hemos conseguido gracias a la investigación científica. Para lograrlo es necesaria una combinación de diferentes principios activos como hidroxiácidos, vitaminas, hialurónico, retinoides, ácidos grasos y filtros solares.

En la mayoría de los casos los encontramos en diferentes productos cosméticos, y no en uno solo, ya que algunos de estos activos compiten entre sí y no se pueden formular en un único producto. A esto hay que sumarle que las expectativas son diferentes en cada caso. No es lo mismo una piel de 35 años que una de 60. La piel de un hombre que la de una mujer. Una piel que ha sido maltratada por el sol, que otra que no lo ha sido. Una piel con arrugas y manchas ya marcadas o una que sólo las tiene incipientes. Igual que una piel seca que una piel grasa.

Hay que tener en cuenta que los resultados difieren entre unas personas y otras por estos y otros muchos factores, así que hay que mantener unas expectativas realistas. Estos principios activos funcionan difuminando los signos de la edad y, sobre todo y más importante, los previenen. Contra los signos de la edad, mejor prevenir que curar.

Las concentraciones de cada principio activo varían y se combinan en una fórmula que se adapta a diferentes tipos de piel y a diferentes bolsillos. Unos principios activos son más costosos que otros, por sí mismos y por las implicaciones que tienen sobre la fabricación y conservación del producto final. Unos requieren de bases ricas y otros de bases ligeras para ser realmente eficaces.

Hay muchas razones por las que no existe una única mejor crema antiedad, sino que en el mercado existe una gran variedad de mejores cremas antiedad. Eso sí, las mejores se fundamentan en principios activos de probada eficacia.

Es imposible ponerse de acuerdo sobre cuál es la mejor crema antiedad porque no existe la mejor crema antiedad universal, que satisfaga por igual todos los casos posibles. La que para mí es la mejor crema antiedad, por mi tipo de piel y mi estilo de vida, quizá para ti no lo sea, por muchos ingredientes que coincidan con los citados. Para averiguar cuál es tu mejor crema antiedad, acude a tu dermatólogo, a tu farmacéutico o a tu dermoconsejero. Cuanto mejor conozcas tu piel y tus necesidades, mejores opciones van a ofrecerte. Seguro que entre sus ingredientes encuentras algunos de estos seis principios activos que, según la ciencia, funcionan.

Fuentes principales:

Improvement of Naturally Aged Skin With Vitamin A (Retinol). Reza Kafi, MD; Heh Shin R. Kwak, MD; Wendy E. Schumacher, BS; et al Soyun Cho, MD, PhD; Valerie N. Hanft, MD; Ted A. Hamilton, MS; Anya L. King, MS; Jacqueline D. Neal, BSE; James Varani, PhD; Gary J. Fisher, PhD; John J. Voorhees, MD, FRCP; Sewon Kang, MD. Arch Dermatol. 2007;143(5):606-612.

Human skin penetration of hyaluronic acid of different molecular weights as probed by Raman spectroscopy. Essendoubi M , Gobinet C, Reynaud R, Angiboust JF, Manfait M, Piot O. Skin Res Technol. 2016 Feb;22(1):55-62

A Multicenter, Single-Blind Randomized, Controlled Study of a Volumizing Hyaluronic Acid Filler for Midface Volume Deficit: Patient-Reported Outcomes at 2 Years. Pocos J, Cox SE, Paradkar-Mitragotri D, Murphy DK. Aesthet Surg J. 2015 Jul;35(5):589-99

Glycolic acid treatment increases type I collagen mRNA and hyaluronic acid content of human skin. Bernstein EF1, Lee J, Brown DB, Yu R, Van Scott E. Dermatol Surg. 2001 May;27(5):429-33.

Topical ascorbic acid on photoaged skin. Clinical, topographical and ultrastructural evaluation: double-blind study vs. placebo. Philippe G. Humbert, Marek Haftek, Pierre Creidi, Charles Lapière, Betty Nusgens, Alain Richard, Daniel Schmitt, André Rougier, Hassan Zahouani. Experimental Dermatology. Volume 12, Issue 3. June 2003. Pages 237–244

Efecto de los alfahidroxiácidos en la permeabilidad de la epidermis humana in vitro. Octavio Díez Sales, Alfonso Copoví y Marina Herráez. Dep. de Farmacia y Tecnología Farmacéutica. Universidad de Valencia.

Coenzyme Q 10, a cutaneous antioxidant and Energizer. Hoppe, U.; Bergemann, J. Diembeck, W. Ennen, J. Gohla, S. Harris, I. Jacob, J. Kielholz, J. Mei, W. Pollet, D. Schachtschabel, D. Sauermann, G. Schreiner, V. Stäb, F. Steckel, F. Journal Biofactors, vol. 9, no. 2‐4, pp. 371-378, 1999

¿Cómo funciona tu crema solar? Dimetilsulfuro.es, 2015

Use of salicylic derivatives for the treatment of skin aging. Jean L. Leveque, Didier Saint Leger. Patent US 5262407 A, 1993.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo Así es la mejor crema antiedad según la ciencia se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El mejor lacón con grelos tiene su ciencia

- Azúcar moreno, ¿mejor que el azúcar blanco?

- Estimada OCU: recuerda que NO se pueden utilizar las cremas solares del año pasado

La materia oscura auto-interactuante y las curvas de rotación de las galaxias

La galaxia NGC 7479. Foto: Daniel López/IAC

La naturaleza de la materia oscura sigue siendo uno de los grandes misterios de la ciencia. Tanto es así que hay científicos que consiguen gran eco mediático simplemente proponiendo teorías en las que la materia oscura no aparece. Pero ninguna de estas teorías termina de explicar las cosas tan bien como lo hace la materia oscura. O las materias oscuras, porque sabemos tan poco de ella que no sabemos con seguridad si es caliente, fría, tibia o si interactúa consigo misma.

La materia oscura auto-interactuante -una forma hipotética de materia oscura hecha de partículas que interactúan entre sí- es un recurso que soluciona problemas en cosmología. A escalas galácticas o menores, puede corregir discrepancias entre las observaciones y las predicciones del modelo cosmológico estándar, que en su lugar considera una materia oscura “fría” que no interactúa consigo misma. Y esto lo hace dejando intacto el éxito del modelo estándar a escalas más grandes.

Ahora, Ayuki Kamada, de la Universidad de California en Irvine, y sus colegas demuestran que la materia oscura auto-interactuante también puede explicar la diversidad de curvas de rotación de las galaxias, para entendernos, las gráficas que resultan de representar las velocidades de las estrellas en una galaxia frente a su distancia al centro de la misma.

Las estrellas y el gas en las galaxias suelen girar a una velocidad constante más allá de una cierta distancia del centro de la galaxia: las curvas de rotación son esencialmente planas, sin importar lo masivos que sean los “halos” de materia oscura en los que están sumergidos. Pero las galaxias con halos de materia oscura de masa similar pueden tener curvas muy diferentes por debajo de esa distancia: algunas curvas suben abruptamente hacia la meseta y otras gradualmente. Esta diversidad es difícil de explicar en el marco del modelo de materia oscura fría estándar.

Los investigadores analizaron las curvas de rotación de 30 galaxias que representan esta diversidad y compararon las curvas con las que se derivan de un modelo galáctico que habían desarrollado. Este modelo incluye un halo de materia oscura que interactúa consigo mismo en la región interior, y tiene en cuenta la distribución de la materia visible en el halo, así como la historia de la formación del halo. Los investigadores encontraron que el modelo proporciona un ajuste excelente a los datos, dando apoyo a la hipótesis de que la materia oscura es auto-interactuante.

Con todo, este es solo un dato más entre los muchos que habrá que generar para algún día poder resolver uno de los grandes misterios de la ciencia de hoy, a saber, qué es la materia oscura.

Referencia:

Ayuki Kamada, Manoj Kaplinghat, Andrew B. Pace, and Hai-Bo Yu (2017) Self-Interacting Dark Matter Can Explain Diverse Galactic Rotation Curves Phys Rev. Lett. doi: 10.1103/PhysRevLett.119.111102

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

Este texto es una colaboración del Cuaderno de Cultura Científica con Next

El artículo La materia oscura auto-interactuante y las curvas de rotación de las galaxias se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Un 5 % de materia oscura menos

- ¿Y si lo que detectó LIGO fue materia oscura?

- El análisis del supercúmulo “El Gordo” limita qué puede ser la materia oscura

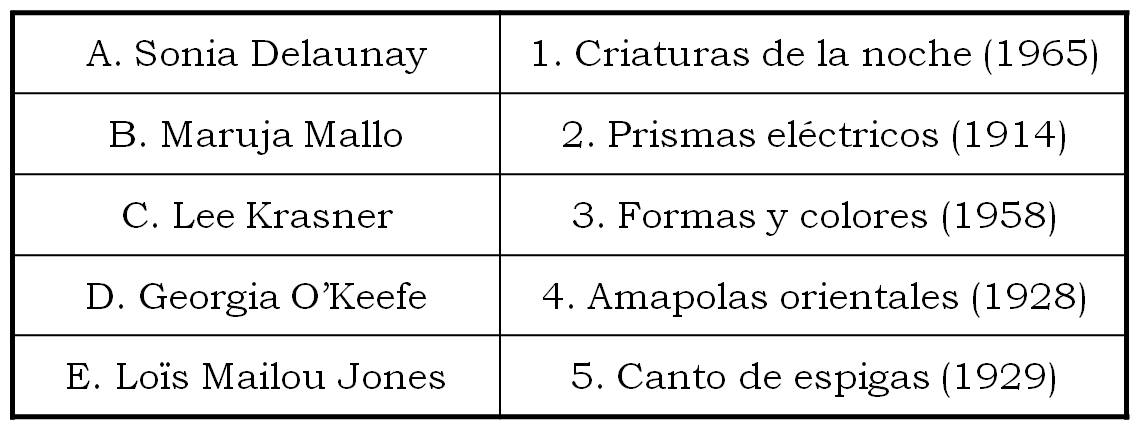

El problema matemático de las cartas extraviadas

Para empezar esta entrada del Cuaderno de Cultura Científica os voy a proponer un juego. A continuación, vamos a mostrar dos listas. La primera lista, la situada a la izquierda, está formada por los nombres de cinco grandes artistas del siglo XX (Sonia Delaunay, Maruja Mallo, Lee Krasner, Georgia O’Keefe y Loïs Mailou Jones) y la lista de la derecha contiene los títulos de cinco obras de arte, una de cada una de las artistas de la primera lista. El juego consiste en unir cada una de las artistas de la fila de la izquierda con su correspondiente cuadro en la lista de la derecha.

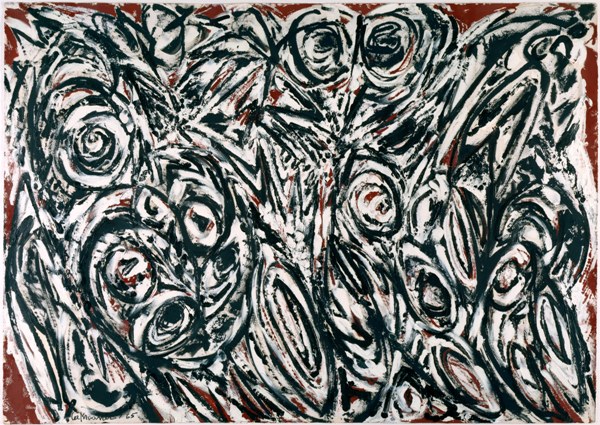

A continuación, podéis ver las obras mencionadas. Y mientras vais viendo cada una de las pinturas podéis intentar asociarla con la artista que la pintó, cuyo nombre es uno de los de la lista de arriba.

1. Criaturas de la noche (1965)

2. Prismas eléctricos (1914)

3. Formas y colores (1958)

4. Amapolas orientales (1928)

5. Canto de espigas (1929)

Si ya habéis dado una respuesta al juego, podéis seguir adelante con la lectura de esta entrada, aunque si aún no habéis asociado cada artista con una obra podéis volver a mirarlas y haced vuestra elección.

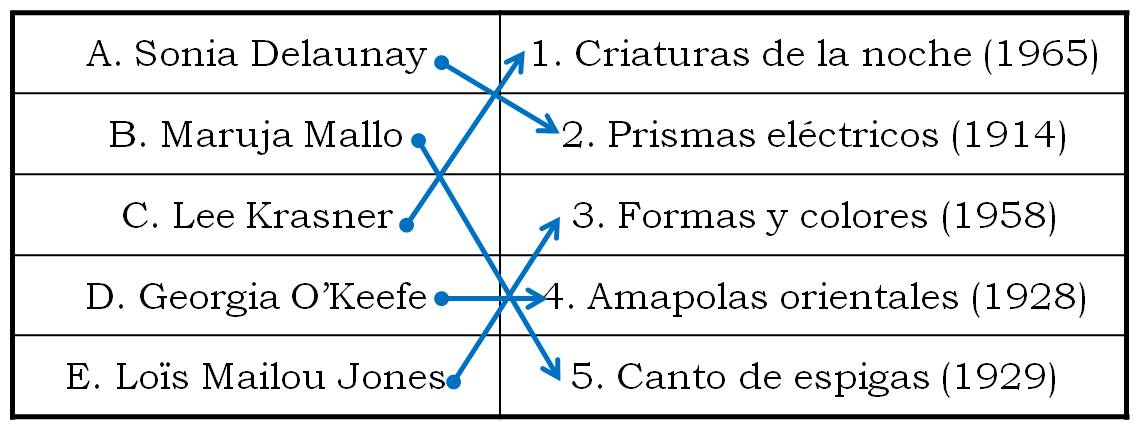

La respuesta correcta a este juego relacionado con el arte es: (A, 2), (B, 5), (C, 1), (D, 4) y (E, 3).

Pero pensemos un poco en el juego y en las diferentes elecciones que se podrían haber hecho. Para empezar, ¿cuántas formas existen de unir los cinco nombres de artistas con los cinco títulos de cuadros, es decir, cuántas posibles respuestas, aunque sean erróneas, tiene el juego?

La solución a esta cuestión seguro que ya la conocéis. Es el número de aplicaciones biyectivas del primer conjunto {A, B, C, D, E} en el segundo {1, 2, 3, 4, 5} o, equivalentemente, de permutaciones de cinco elementos. Si pensamos en que tenemos que asociar a cada una de las letras A, B, C, D y E (que son las artistas), uno de los números 1, 2, 3, 4 y 5 (que son los cuadros), cada posible respuesta al juego es una permutación de los números {1, 2, 3, 4, 5}. Así, la respuesta correcta era la permutación {2, 5, 1, 4, 3}. El número de permutaciones de 5 elementos, o lo que es lo mismo, respuestas al juego de los cuadros, correctas o no, es el factorial de 5, 5! = 5 × 4 × 3 × 2 × 1 = 120. Esto se debe a que, si empezamos por orden, a la artista A la podemos asociar con cada uno de los 5 números {1, 2, 3, 4, 5}, pero una vez realizada una elección para A, y para cada una de ellas, hay 4 posibles elecciones para B. En resumen, para A y B hay en total 5 × 4 = 20 posibles asociaciones de números. Seguimos. Fijadas A y B, y para cada una de las 20 elecciones posibles de ellas, quedarán 3 números libres para poder asociar a C, dos para D, elegida también la opción para C, y finalmente, fijadas las anteriores, solo habrá 1 posibilidad para E. Es decir, las posibles respuestas son 5 × 4 × 3 × 2 × 1 = 120.

Más aún, de esas 5! = 120 posibles respuestas al juego, solo una de ellas es la correcta, como sabemos (A, 2), (B, 5), (C, 1), (D, 4) y (E, 3), pero ¿para cuántas respuestas no habríamos acertado ninguno de los cuadros de las cinco artistas? ¿O un cierto número dado de cuadros, por ejemplo, solo uno? De estas cuestiones vamos a hablar en esta entrada del Cuaderno de Cultura Científica.

Este problema se conoce con el nombre de problema de las cartas extraviadas, o mal dirigidas, aunque también se conoce con otros muchos nombres, entre ellos, el problema de la encargada del guardarropa, el problema de los sombreros, el problema de las coincidencias, el problema de los desarreglos o el problema de Bernoulli-Euler.

El problema dice así:

Determinar el número de permutaciones de n elementos (por ejemplo, los n primeros números {1, 2, …, n}) en las que ningún elemento ocupa su posición natural.

Aunque normalmente el problema se expresa de una forma más divulgativa, cercana al juego que hemos planteado al principio de esta entrada, y que es el motivo por el que recibe el nombre de problema de las cartas extraviadas:

Una persona ha escrito n cartas a n personas distintas (por ejemplo, n amigas suyas) y escribe las direcciones de estas en n sobres. ¿De cuántas formas puede colocar las n cartas en los n sobres de forma que todas las cartas estén en sobres “incorrectos”, es decir, que no lleven la dirección que le corresponde a la carta que contienen?

Casillas antiguas de apartados de correos

El problema fue propuesto originalmente por el matemático francés Pierre Rémond de Montmort (1678-1719) en su libro sobre probabilidad y juegos de azar Essay d’analyse sur les jeux de hazard (Análisis de los juegos de azar), de 1708. De Montmort había introducido en su libro un juego de cartas llamado Treize (trece), que es como el juego la ratonera de Arthur Cayley, pero con 4 tacos de 13 cartas (precisamente una baraja francesa de póquer, tiene 52 cartas, con cuatro palos –corazones, diamantes, tréboles y picas– y cada palo con 13 cartas, que podemos considerar numeradas del 1 al 13).

Página del libro “Essay d’analyse sur les jeux de hazard”-Análisis de los juegos de azar- (1708), de Pierre Rémond de Montmort

De Montmort se propuso el análisis del juego del Treize, así como algunos problemas más sencillos relacionados con el mismo, entre los que estaba el que denominó el “problema del reencuentro”, que no es otro que el enunciado arriba (problema de las cartas extraviadas).

De Montmort discutió ampliamente este problema con su amigo el matemático Nicolas Bernoulli (1687-1759) en la extensa correspondencia que mantuvieron entre ambos, así como con Johann Bernoulli (1667-1748).

En la segunda edición de su libro Essay d’analyse sur les jeux de hazard, de 1813, de Montmort publica la solución del problema del reencuentro (problema de las cartas extraviadas), así mismo la solución de Nicolas Bernoulli aparece en la correspondencia con de Montmort, la cual es incluida por el francés en esa segunda edición. Otros grandes matemáticos analizaron el problema, como Leonhard Euler (1707-1783) en Calcul de la probabilité dans le jeu de rencontre (1743), Abraham de Moivre (1667-1754) en The Doctrine of Chances (1756), Johann H. Lambert (1728-1777) en Examen d’une espèce de superstition ramenée au calcul des probabilités (1773) o Pierre-Simon Laplace (1749-1827) en Théorie Analytique des Probabilités (1812).

Primer página del libro “The Doctrine of Chances” (1756) de Abraham de Moivre

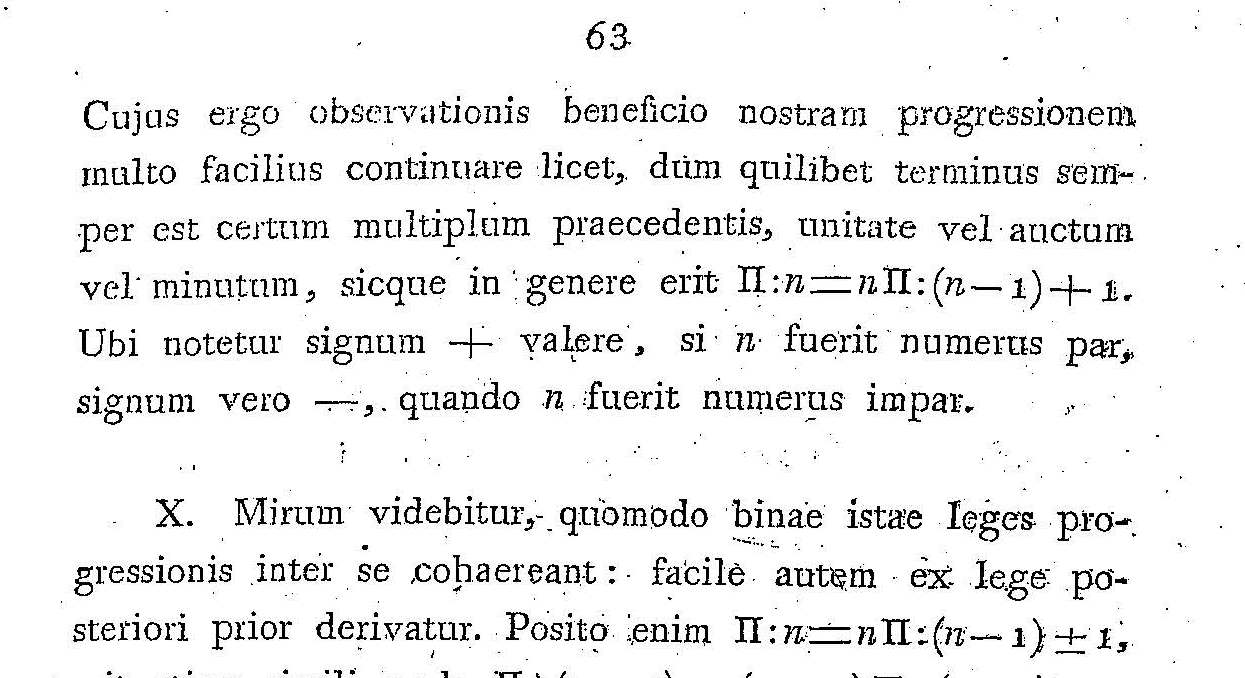

Pero vayamos con la demostración del problema de las cartas extraviadas. La demostración que vamos a mostrar aquí es la realizada por Leonhard Euler, y aparece recogida en el libro 100 Great Problems of Elementary Mathematics: Their History and Solutions.

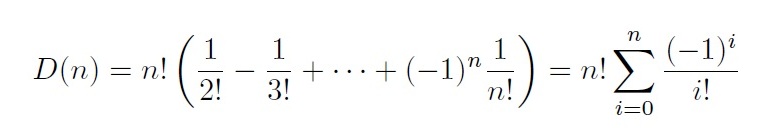

Vamos a denotar por c1, c2, …, cn los objetos (por ejemplo, las cartas), por S1, S2, …, Sn las posibles posiciones (en la versión de las cartas serían los sobres) y por D(n) el número de permutaciones de n objetos en las cuales ninguno queda en su posición original, es decir, ninguna carta está en el sobre que le corresponde.

Se consideran dos casos:

Caso 1. Las permutaciones de los objetos, esto es, las formas de meter las cartas en los sobres, de manera que la carta c1 está en el sobre S2 (en general, sería cuando el objeto c1 está en la posición S2) y la carta c2 está en el sobre S1.

En este caso, las demás cartas c3, c4, …, cn van a estar en los sobres S3, S4, …, Sn, pero cada una de esas n – 2 cartas ci no está en el sobre correcto Si (i = 3, 4, …, n). Por lo tanto, el número de estas permutaciones es D(n – 2), es decir, el número de permutaciones de n – 2 objetos de forma que ninguno esté en su posición original.

Caso 2. Las permutaciones para las cuales la carta c1 está en el sobre S2, pero la carta c2 no está en el sobre S1.

En estas permutaciones la carta c1 está en el sobre S2, y hay que distribuir las cartas c2, c3, …, cn en los sobres S1, S3, …, Sn, de forma que c2 no esté en S1, c3 no esté en S3, c4 no esté en S4, así hasta la carta cn que no puede estar en Sn. Es decir, si pensamos que al no poder estar la carta c2 en el sobre S1, podemos “asociar” c2 y S1, entonces el número de formas de realizar dicho reparto (la carta c1 está en el sobre S2, pero la carta c2 no está en el sobre S1) es D(n – 1).

En resumen, estos dos casos me muestran que el número de permutaciones de n objetos en las que ningún objeto está en su posición original, pero además c1 está en S2, es igual a

D(n – 2) + D(n – 1).

Y como un argumento similar se puede aplicar a los casos en los que c1 está en S3, S4, …, Sn, se ha demostrado que el número de permutaciones de n objetos en las que ningún objeto está en su posición original es

D(n) = (n – 1) · [D(n – 2) + D(n – 1)]. (fórmula 1)

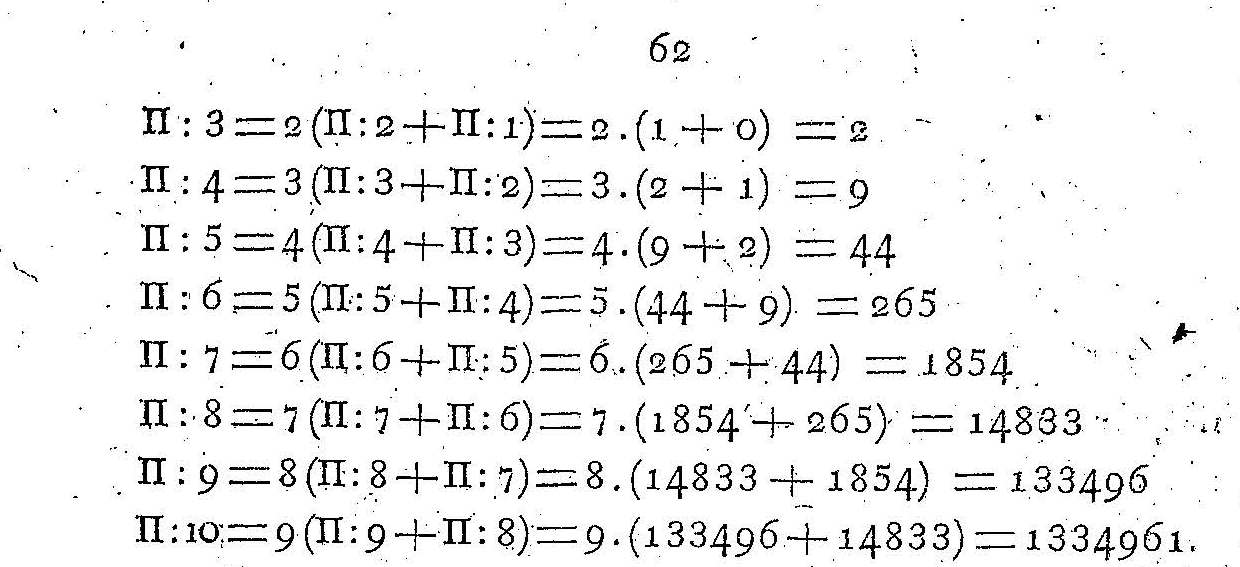

Fragmento del artículo “Solutio quaestionis curiosae ex doctrina combinationum” (1811), de Leonhard Euler en la que aparece la fórmula recursiva anterior. La notación de Euler para D(n) es Π:n

La fórmula (recursiva) 1 anterior puede reescribirse de la siguiente forma

D(n) – n · D(n – 1) = – [D(n – 1) – (n – 1) · D(n – 2)].

De donde se deduce por recursión y teniendo en cuenta que D(1) = 0 (no hay forma de meter 1 carta en 1 sobre sin acertar), D(2) = 1 (solo hay una forma de meter 2 cartas en 2 sobres de forma incorrecta, cada carta en el sobre que no es) y (–1)n-2 = (–1)n,

D(n) – n · D(n – 1) = (–1)n, (fórmula 2)

puesto que

D(n) – n · D(n – 1) = – [D(n – 1) – (n – 1) · D(n – 2)]

= (–1)2 [D(n – 2) – (n – 2) · D(n – 3)]

= (–1)3 [D(n – 3) – (n – 3) · D(n – 4)]

= … = (–1)n-2 [D(2) – 2 · D(1)].

Fragmento del artículo “Solutio quaestionis curiosae ex doctrina combinationum” (1811), de Leonhard Euler en la que aparece la fórmula recursiva 2. La notación de Euler para D(n) es Π:n

Si consideramos la fórmula (recursiva) 2 anterior y la dividimos por n!, se obtiene

D(n) / n! –D(n – 1) / (n – 1)! = (–1)n / n!.

De nuevo un argumento recursivo nos lleva a la fórmula

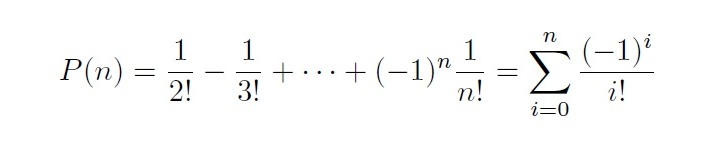

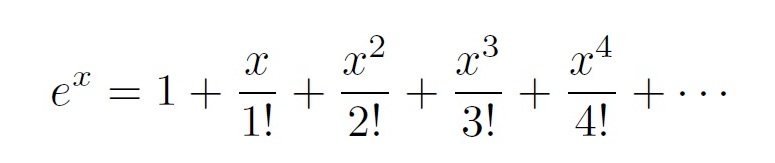

D(n) / n! = (–1)2 / 2! + (–1)3 / 3! + … + (–1)n / n!.

O equivalentemente,

Así, para un número n pequeño de objetos (respectivamente, de cartas) podemos calcular el número D(n) de las permutaciones de esos n objetos en las cuales ninguno queda en su posición original. En concreto, D(3) = 2, D(4) = 9, D(5) = 44, D(6) = 265 y D(7) = 1854. A estos números se les suele conocer con el nombre de números de Montmort o números de desarreglos, y en la Enciclodepia on-line de sucesiones de enteros (OEIS) es la sucesión de números A000166.

Fragmento del artículo “Solutio quaestionis curiosae ex doctrina combinationum” (1811), de Leonhard Euler en el que Euler calcula, utilizando la fórmula recursiva 1, el valor de D(n), que él denota Π:n, para valores de n entre 1 y 10

Si tenemos en cuenta que en el juego del inicio de esta entrada teníamos cinco artistas, es decir, n es 5, sabemos que el número de soluciones del juego para las cuales no se acierta ni uno solo de los cuadros es D(5) = 44, del total de 120 posibles.

La fórmula obtenida para D(n) se puede demostrar también utilizando el principio de inclusión-exclusión, que es como lo realizó Abraham de Moivre, y quien esté interesado en la misma la puede encontrar por ejemplo en el libro How to count, an introduction to combinatorics.

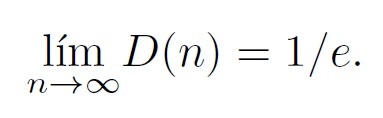

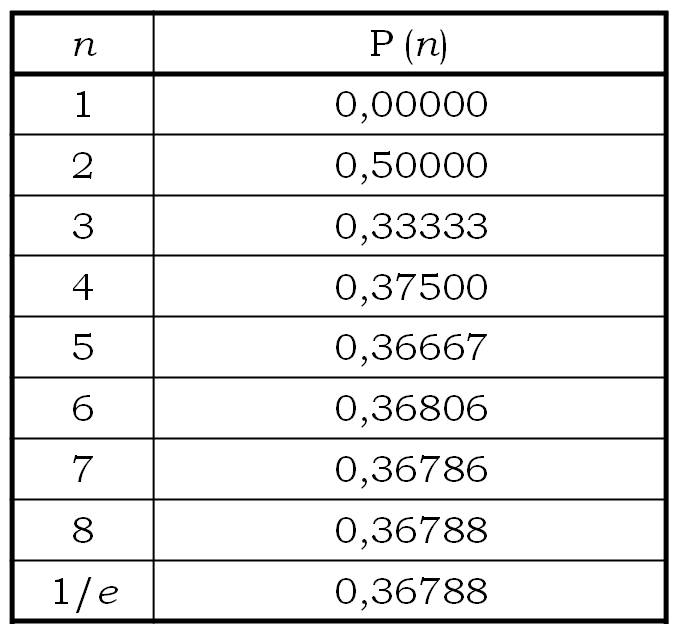

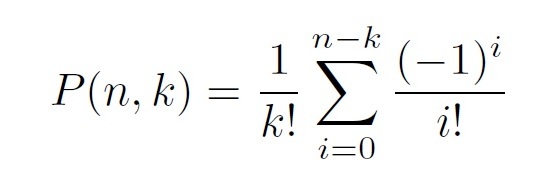

Pero el problema de las cartas extraviadas, o de los desarreglos, que aquí hemos presentado en su versión combinatoria, suele presentarse también en su versión probabilística.

Problema: Una persona ha escrito n cartas a n personas distintas, escribe las direcciones de estas en n sobres y mete “sin mirar” (al azar) las n cartas en los n sobres. ¿Cuál es la probabilidad de que ninguna de las cartas acabe en el sobre correcto, es decir, con la dirección que le corresponde?