Refracción de ondas

Imagen: Pixabay

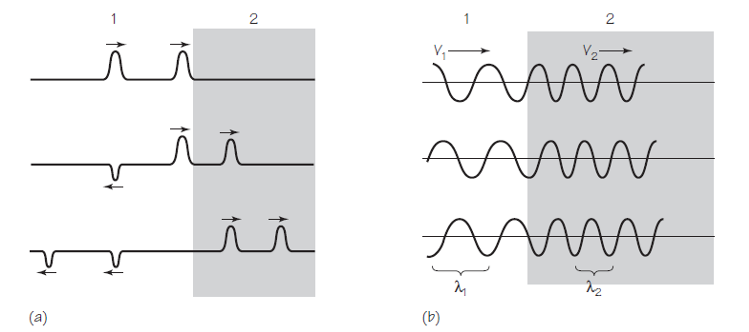

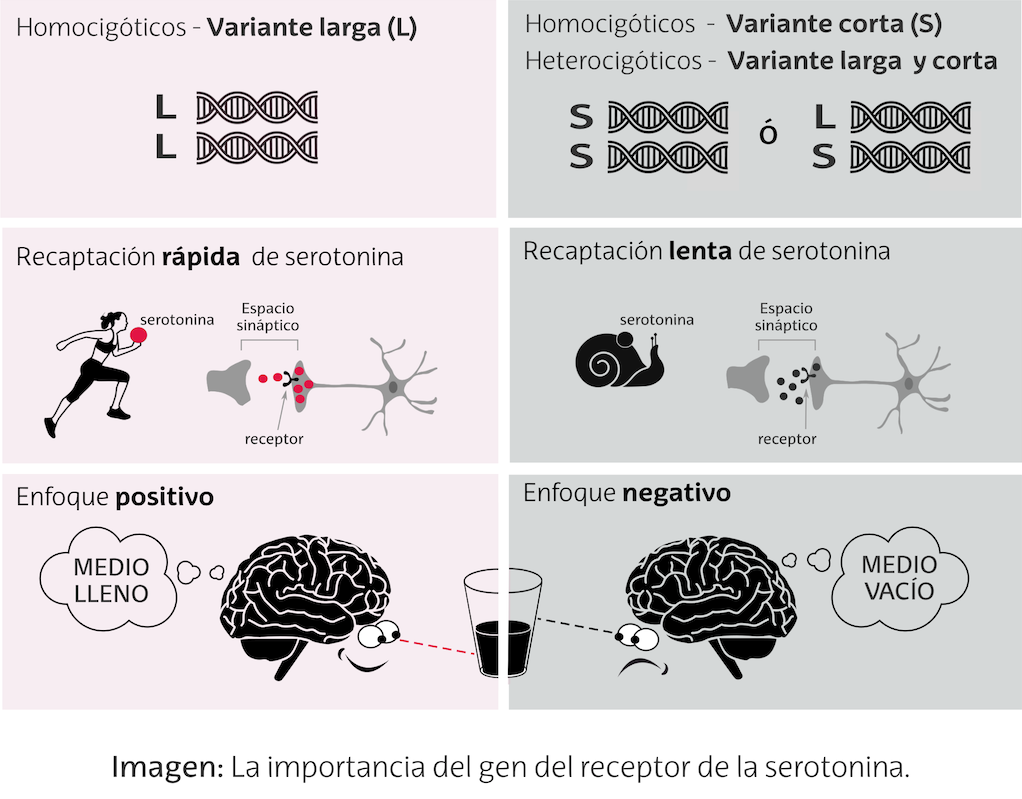

Imagen: Pixabay¿Qué sucede cuando una onda se propaga de un medio a otro en el que su velocidad de propagación es diferente? Fijémonos en la Figura 1(a). Dos pulsos unidimensionales se aproximan a un límite que separa dos medios. La velocidad de la propagación en el medio 1 es mayor que en el medio 2. Esta situación correspondería en el mundo real a pulsos en una cuerda ligera (medio 1) atada a una cuerda relativamente muy pesada (medio 2). Ya sabemos que podemos esperar que una parte de cada pulso se refleja en el límite. Esta componente reflejada se pone del revés en relación con el pulso original. ¿Pero qué pasa con esa parte de la onda que continúa en el segundo medio?

Figura 1. Fuente: Cassidy Physics Library

Figura 1. Fuente: Cassidy Physics LibraryComo vemos en la figura, los pulsos transmitidos están más juntos en el medio 2 que en el medio 1. La razón es que la velocidad de los pulsos es menor en la cuerda más pesada. Así que el segundo pulso, mientras todavía está en la cuerda ligera, está alcanzando al que ya está en la cuerda pesada. Por la misma razón, cada pulso se comprime en una forma más estrecha; es decir, cuando la parte frontal de un pulso ha entrado en la región de menor velocidad, la parte posterior sigue avanzando con mayor velocidad.

Con las ondas periódicas ocurre algo parecido. Lo tenemos en la Figura 1(b). Para simplificar suponemos que toda la onda se transmite y nada se refleja. Al igual que los dos pulsos se acercaron y cada pulso se apretó y se estrechó, el patrón de onda periódico también se comprime. Por lo tanto, la longitud de onda λ2 de la onda transmitida es más corta que la longitud de onda λ1 de la onda entrante o incidente.

Aunque la longitud de onda cambia cuando la onda pasa a través del límite, la frecuencia de la onda no puede cambiar. Si la cuerda no está rota, las trocitos de cuerda inmediatamente a ambos lados del límite deben subir y bajar juntos. Las frecuencias de las ondas incidentes y transmitidas deben, entonces, ser iguales. Podemos simplemente etiquetar ambas como f.

La relación entre longitud de onda, frecuencia y velocidad para las ondas incidentes y transmitidas se puede escribir por separado como λ1 f = v1 y λ2f = v2. Dividiendo una ecuación por la otra, eliminado f, obtenemos que

λ1 / λ2 = v1 / v2.

Esta ecuación nos dice que la razón entre las longitudes de onda en dos medios es igual a la razón entre las velocidades de propagación de las ondas en esos medios.

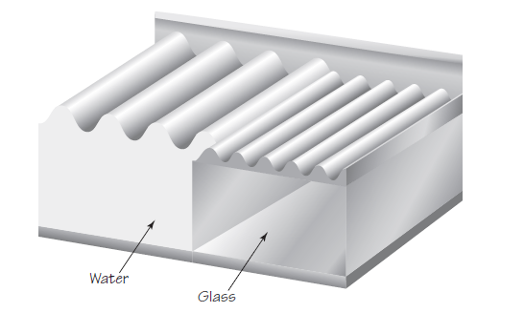

Figura 2. Fuente: Cassidy Physics Library

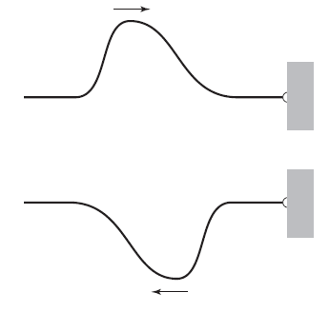

Figura 2. Fuente: Cassidy Physics LibraryLo mismo sucede cuando las ondulaciones del agua atraviesan un límite. Los experimentos muestran que las ondas se mueven más lentamente en aguas menos profundas. Si colocamos una pieza de vidrio en la parte inferior de un tanque de ondulación para hacer que el agua sea menos profunda estamos, de hecho, creando un límite entre la parte más profunda y la menos profunda (medio 1 y medio 2). La Figura 2 muestra el caso en que este límite es paralelo a las líneas de cresta de la onda incidente. Al igual que con las ondas en la cuerda, la longitud de onda de las ondas en el agua en un medio es proporcional a la velocidad en ese medio.

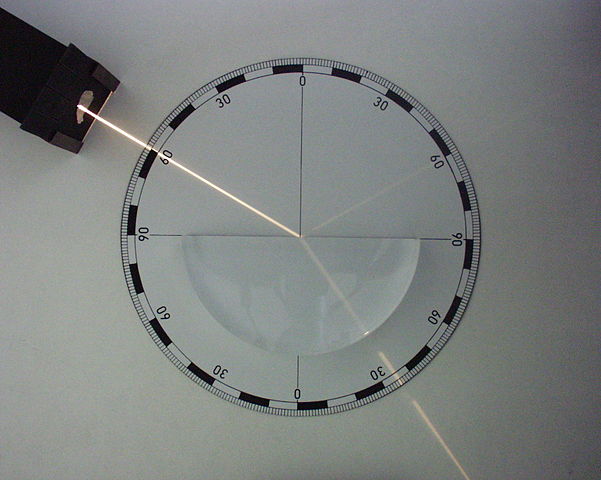

Figura 3. Fuente: Wikimedia Commons

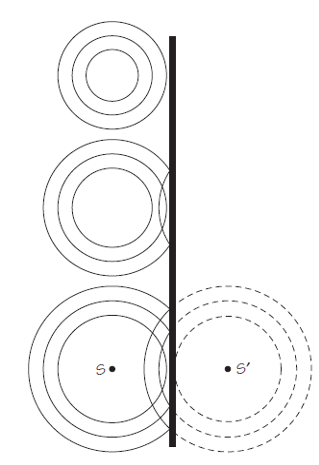

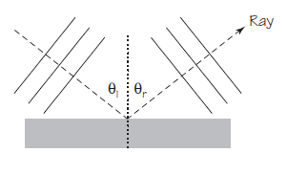

Figura 3. Fuente: Wikimedia CommonsLas ondas en el agua ofrecen una posibilidad no presente en las ondas en la cuerda. El frente de onda puede acercarse al límite en cualquier ángulo, no solo de frente. La Figura 3 ilustra este caso. La longitud de onda y la velocidad, por supuesto, cambian a medida que la onda pasa a través del límite. La dirección de la propagación de la onda también cambia al pasar de un medio a otro con diferente velocidad de transmisión. A medida que cada parte de un frente de onda en el medio 1 entra en el medio 2, su velocidad disminuye y comienza a quedarse atrás. Con el tiempo, las direcciones de todo el conjunto de frentes de onda en el medio 2 tienen direcciones diferentes a las del medio 1. Este fenómeno se llama refracción. Los frentes de onda “giran” para hacerse más paralelos al límite entre los medios.

Figura 4. Un frente de onda muy estrecho llegando con un ángulo de 60º al límite; una parte es reflejada (también con un ángulo de 60º) y otra pasa al medio 2 con un cambio de dirección. Fuente: Wikimedia Commons

Figura 4. Un frente de onda muy estrecho llegando con un ángulo de 60º al límite; una parte es reflejada (también con un ángulo de 60º) y otra pasa al medio 2 con un cambio de dirección. Fuente: Wikimedia CommonsCombinando todo lo que hemos visto encontramos una explicación a un fenómeno que habrás observado en las playas de arena, esas en las que la profundidad del agua aumenta lentamente conforme te alejas de la orilla. Da igual la dirección de las olas mar adentro: cerca de la orilla son prácticamente paralelas a la orilla.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Refracción de ondas se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cuando las ondas se encuentran

- Física de las ondas estacionarias: frecuencia fundamental y sobretonos

- Reflexión de ondas: rayos

Digestión estomacal (y II): regulación

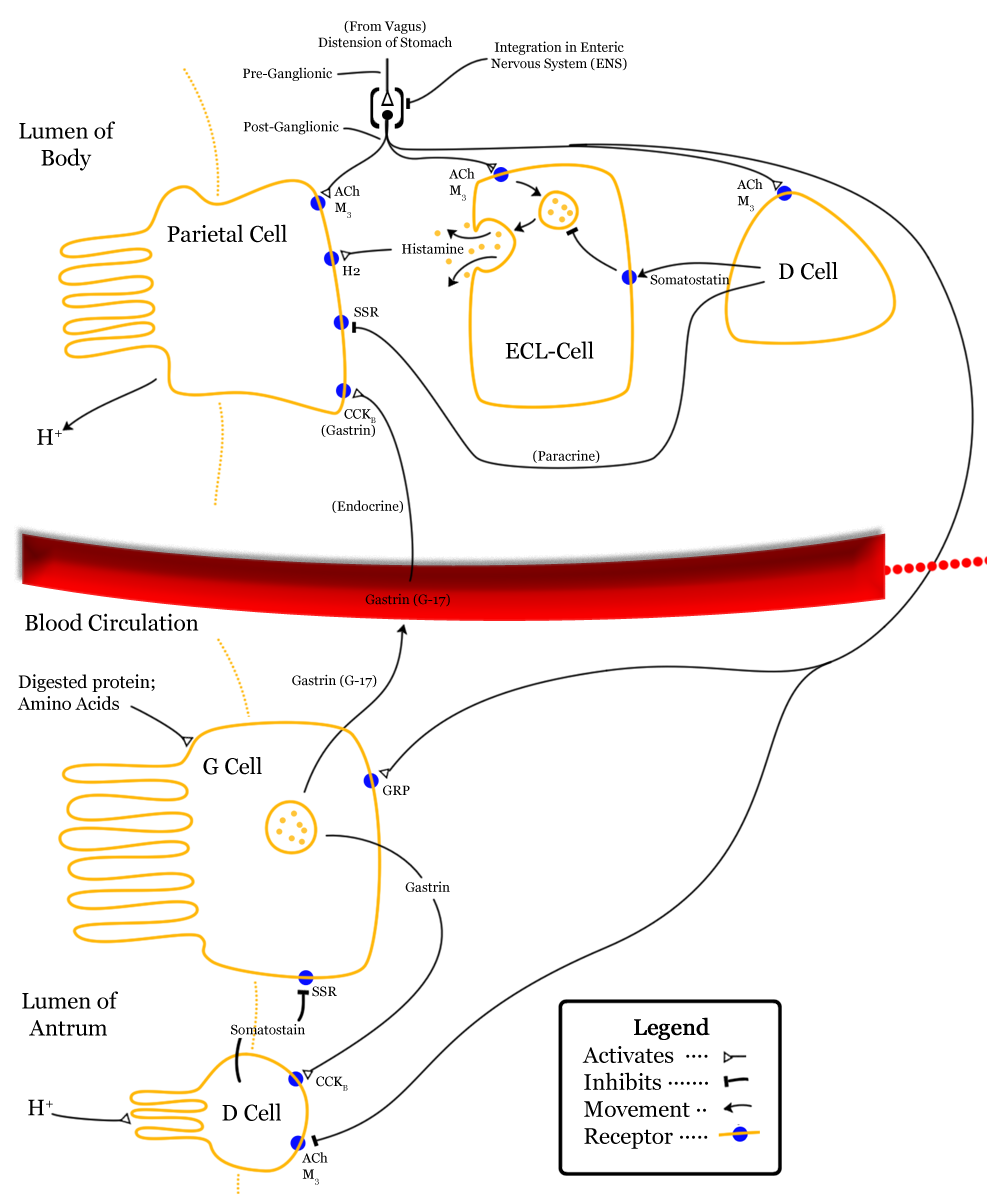

Además de las células propias de las glándulas de la mucosa oxíntica que se presentaron en la anotación anterior, en la mucosa gástrica hay otras que no liberan productos exocrinos, sino factores endocrinos (hormonas) o paracrinos con función reguladora. Son las siguientes:

(1) Las células enterocromafines se encuentran entre las células parietales y las células principales en las glándulas gástricas de la mucosa oxíntica. Secretan histamina.

(2) Las células G se encuentran en las glándulas del área de glándulas pilóricas. Son células endocrinas, que liberan la hormona gastrointestinal gastrina a la sangre.

(3) Las células D (o delta) se encuentran en número escaso en las glándulas de la zona pilórica pero son muy abundantes en el duodeno. Secretan somatostatina.

Imagen: Wikimedia Commons

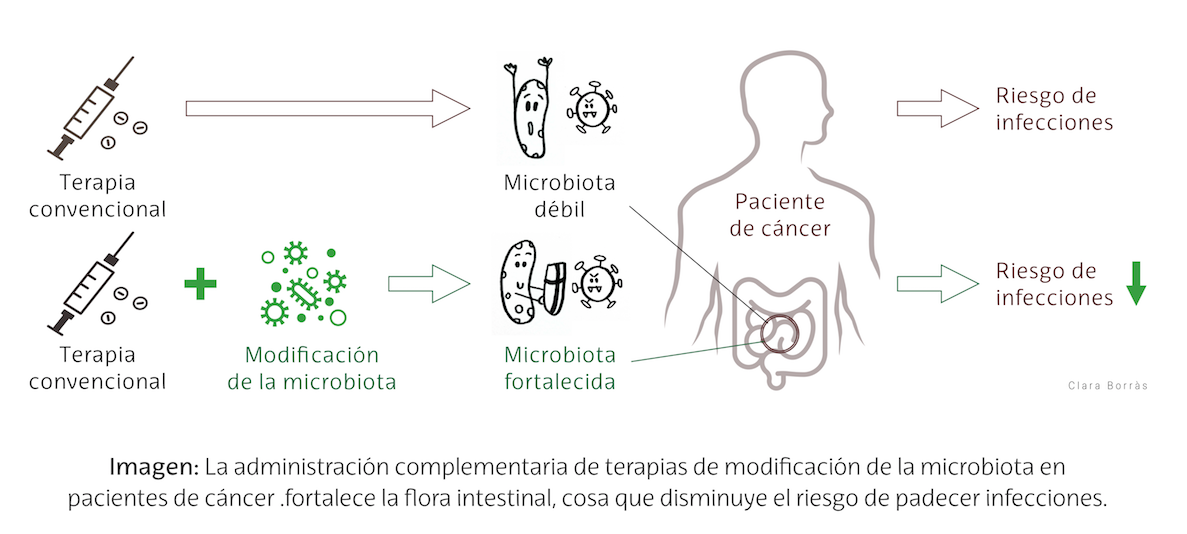

Imagen: Wikimedia CommonsLa secreción de los jugos gástricos que vimos en la anotación anterior se produce mediante la intermediación de cuatro mensajeros químicos, para los que las células parietales cuentan con sus correspondientes receptores. Acetilcolina, gastrina e histamina ejercen efectos estimulantes al promover la inserción de las unidades de ATPasa de H+/K+ -que se encuentran almacenadas en vesículas intracelulares- en la membrana de las células parietales, elevando así la secreción de HCl a la luz gástrica. La somatostatina, sin embargo, tiene efectos inhibitorios. La gastrina y la acetilcolina estimulan también la secreción de pepsinógeno por las células principales. Veamos estos mensajeros con algún detalle.

La acetilcolina es un conocido neurotransmisor. Se libera en el plexo nervioso intrínseco en respuesta a la estimulación por el nervio vago, y estimula las células parietales, principales, células G y las enterocromafines.

Las células G secretan gastrina al torrente sanguíneo, en respuesta a la presencia de proteínas en el interior del estómago y por efecto de la acetilcolina. Cuando vuelve al cuerpo y al fundus del estómago, las células parietales y principales elevan la secreción de jugos gástricos. Además, promueve la liberación de histamina por parte de las células enterocromafines.

La histamina es un agente paracrino liberado por las células enterocromafines en respuesta a la gastrina y la acetilcolina. Ejerce efectos locales (por eso es paracrina) en las células parietales de su entorno, potenciando la acción, precisamente, de las sustancias que han estimulado su liberación.

La somatostatina es liberada por las células delta (o células D) en respuesta a la acidez y su efecto es inhibitorio dando lugar a una retroalimentación negativa. Actúa como agente paracrino también, sobre las células de su entorno, inhibiendo la secreción de células parietales, células G y células enterocromafines.

La regulación de la digestión estomacal se produce mediante un conjunto de actuaciones complementarias. Son varios los estímulos capaces de provocar un aumento de la secreción de jugos gástricos. Unos son anteriores a la llegada del alimento a estómago, otros actúan cuando el alimento ya se encuentra en su interior, y otros proceden del duodeno una vez el quimo ha abandonado el estómago. Por esa razón la secreción gástrica sigue una secuencia en tres fases:

Fase cefálica. Antes de que el estómago reciba el alimento, determinados estímulos sensoriales (visuales, olfativos o el acto de masticar) anticipan su llegada. En ese caso la secreción gástrica se eleva por la acción del nervio vago en respuesta a los citados estímulos, acción que surte dos efectos: (1) promueve el aumento en la secreción de acetilcolina por los plexos nerviosos intrínsecos, lo que, a su vez, eleva la secreción de HCl y de pepsinógeno; (2) estimula la secreción de gastrina por las células G, lo que a su vez promueve la secreción de HCl y pepsinógeno; además, la secreción de clorhídrico también se eleva debido a que la gastrina induce la liberación de histamina.

Fase gástrica. Esta comienza al llegar el alimento al estómago. Los estímulos que actúan a este nivel (proteínas y péptidos, por un lado, y distensión estomacal por el otro) elevan la secreción gástrica debido a la acción superpuesta de diferentes vías. La acción más potente se debe a la presencia de proteínas en el estómago, que estimulan los quimiorreceptores que activan los plexos nerviosos intrínsecos, con la consiguiente estimulación por estos (mediante la acetilcolina) de la células secretoras. La presencia de proteínas en el estómago también actúa a través de la vía vagal, reforzando la fase cefálica. La consecuencia de estas acciones es la elevación de la secreción de ácido clorhídrico y de pepsinógeno, acentuándose así la digestión ya iniciada.

Fase intestinal. Hay factores intestinales que inciden en la secreción de jugos gástricos, aunque en este caso pueden ser estimuladores o inhibidores. La presencia en el duodeno de los productos de la digestión parcial de las proteínas estimula la liberación de gastrina intestinal, que es transportada al estómago por la sangre, actuando de la misma forma que la gastrina estomacal. Ahora bien, cuando el quimo llega las zonas iniciales del intestino delgado la secreción gástrica se reduce debido a tres factores:

(1) Por un lado, al vaciarse el estómago, disminuye la presencia de proteínas en su interior, desapareciendo de esa forma el principal factor que había provocado la elevación de la secreción de jugos.

(2) Conforme se vacía el estómago, su pH se reduce mucho, pues el HCl ya no es neutralizado por las sustancias del quimo; esa reducción estimula la liberación de somatostatina que, como hemos visto, ejerce efecto inhibidor sobre la secreción gástrica.

(3) Los mismos estímulos que inhiben la motilidad estomacal, inhiben también la secreción gástrica. El reflejo enterogástrico y las enterogastronas suprimen la actividad de las células secretoras gástricas, a la vez que reducen la excitabilidad de las células musculares lisas.

Llegados a este punto, la digestión estomacal ha terminado y sus productos han ido pasando del antro estomacal al duodeno e intestino delgado, donde se completará la digestión de los péptidos, lípidos y carbohidratos que no han sido hidrolizados en las fases anteriores.

Sobre el autor: Juan Ignacio Pérez (@Uhandrea) es catedrático de Fisiología y coordinador de la Cátedra de Cultura Científica de la UPV/EHU

El artículo Digestión estomacal (y II): regulación se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Digestión estomacal (I): el papel de las glándulas gástricas

- La motilidad estomacal

- Actividades digestivas y su regulación

Desmitificando: La barriga cervecera

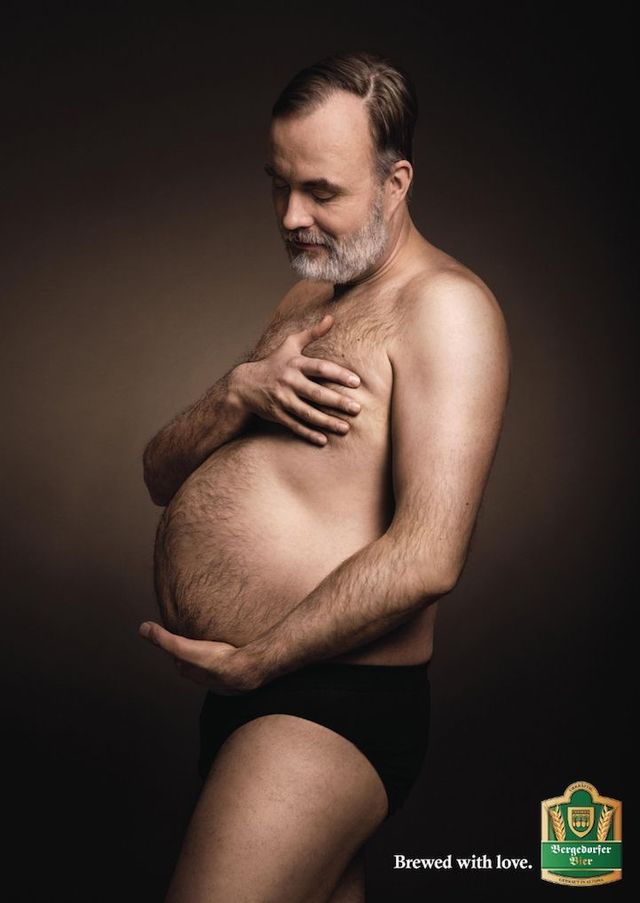

Una de las imágenes que la agencia Jung von Matt creó para Bergedorfer Bier en 2016

Una de las imágenes que la agencia Jung von Matt creó para Bergedorfer Bier en 2016Para empezar aquí van algunos ejemplos, de aquí y de allá, del consumo de cerveza. En Alemania y en 2006, era, por persona, de 112 litros al año y, también en Alemania y en 2011, más del 70% de los adolescentes y del 50% de las adolescentes había consumido cerveza en los 30 días anteriores a la encuesta. Cerca de Alemania, también en Europa central, en Chequia, el 79% de los hombres y el 55% de las mujeres consumen cerveza habitualmente. En España y en 2017, según el informe de Cerveceros de España, el consumo de esta bebida fue de 48.3 litros al año. Ese año, el consumo en Alemania fue de 104 litros al año.

Este consumo ha llevado a la extendida creencia popular de que el consumo de cerveza es la causa de la llamada barriga cervecera o, en términos más técnicos, la obesidad abdominal, tal como cuentan Schütze y sus colegas, del Instituto Alemán de Nutrición Humana de Nuthetal. Pero ya veremos como hay estudios que apoyan esta relación y otros que la niegan e, incluso, hay algunos que concluyen, y es sorprendente, que la relación es negativa, es decir, que la cerveza adelgaza.

En el trabajo de Schütze, con el método epidemiológico, participan 7876 hombres y 12749 mujeres, de 35 a 65 años, y con un seguimiento del peso, circunferencia en las caderas y consumo de cerveza en mililitros por día al inicio del estudio y a los seis años y a los ocho años y medio.

Los resultados muestran que en el 57% de los hombres y el 67% de las mujeres aumenta el peso durante los años que dura el estudio. En cuanto al consumo de cerveza, en el 57% de los hombres y el 69% de las mujeres se mantiene estable, y en el 30% de los hombres y el 22% de las mujeres, disminuye. Por tanto, en el 13% de los hombres y el 9% de las mujeres, el consumo de cerveza crece.

En los hombres con consumo alto, el peso y la circunferencia de las caderas crecen. El resultado es una curva en U: con el consumo moderado, de menos de medio litro al día, no cambian peso y circunferencia; y en los que más aumentan ambos parámetros es en los abstemios y en los que consumen más de un litro al día. En las mujeres, hay aumento de peso y circunferencia en consumidoras de poca cerveza y, en cambio, disminuyen con un consumo moderado, de unos 250 mililitros al día.

Los autores concluyen que hay relación entre el consumo de cerveza, si es elevado, y el peso, aunque dudan si el cambio detectado se debe más a los cambios en la distribución de grasas en el cuerpo habituales con la edad. Por tanto, la creencia popular de la relación entre la cerveza y la barriga cervecera no queda probada con este estudio.

En el estudio epidemiológico de Chequia, con 891 hombres y 1098 mujeres y edades de 25 a 64 años, la media semanal de toma de cerveza es de 3.1 litros en los hombres y de 0.31 litros en mujeres. Es en este estudio donde los autores detectan, en mujeres, una pequeña relación negativa entre el consumo de cerveza y el Índice de Masa Corporal, es decir, que la cerveza adelgaza, poco pero lo hace. En conclusión, en Chequia no existe relación entre la obesidad abdominal y la ingestión de cerveza.

Por el contrario, en Brasil, el estudio de Paula Aballo Nunes Machado y Rosery Sichieri, de la Universidad del Estado de Rio de Janeiro, encuentra relación entre la obesidad abdominal y la toma de cuatro o más copas al día, o sea, de casi litro y medio de cerveza. El estudio, epidemiológico, se hizo con 2441 voluntarios, el 57% mujeres, y edades de 20 a 60 años.

En un trabajo experimental, no epidemiológico, Javier Romeo y su grupo, del Instituto del Frío del CSIC, en Madrid, planificaron un experimento con 58 voluntarios, de ellos 27 mujeres, con una edad media de 36 años. Después de un mes de abstinencia alcohólica, los voluntarios consumieron, en el mes siguiente, 330 mililitros de cerveza al día las mujeres (lo que se llama un tercio o el contenido de una lata de cerveza) y 660 mililitros (dos latas) al día los hombres. Tras estudiar los datos, el grupo concluye que no hay relación entre el consumo de cerveza y cambios, ni positivos ni negativos, en el peso corporal, la circunferencia de las caderas o el Índice de Masa Corporal. Después de todo, una lata de cerveza supone unas 145 kilocalorías, algo más que un yogur con azúcar (o tres veces menos que una piña colada). No hay relación, en este estudio, entre cerveza y barriga cervecera.

En un meta-análisis sobre cerveza y obesidad publicado en 2013, Bendsen y sus colegas, de la Universidad de Copenhague, revisaron 35 estudios epidemiológicos con datos de peso y consumo de cerveza tomados de la población en general, con grupos de entre 317 y 44080 voluntarios y seguimientos de 3.7 a 10 años. También utilizaron doce estudios experimentales, con toma de cerveza y variaciones de peso. Consideraron que la ración estándar de cerveza es el tercio, o 330 mililitros, al día, y con 4.6 grados de alcohol.

Llegaron a varias conclusiones y, en primer lugar, los estudios epidemiológicos indican que consumir más de medio litro de cerveza al día está positivamente relacionado con la obesidad abdominal o, si se quiere decir así, con la barriga cervecera. En cambio, los estudios experimentales dan resultados diferentes. Seis de ellos indican que el consumo de cerveza por 21-126 días aumenta el peso una media de 0.73 kilogramos pero, sin embargo, otros cuatro estudios no demuestran aumentos de peso.

Según los autores y en general, aunque los datos publicados son de baja calidad, la conclusión final es que no hay evidencias de que el consumo moderado de cerveza, hasta medio litro al día, esté asociado a la obesidad abdominal. Pero el consumo por encima de estas cantidades parece que provoca la aparición de la barriga cervecera.

Por tanto, hay dudas sobre la existencia de la barriga cervecera, sobre todo para consumos moderados de cerveza, aunque, también es indiscutible, que la cerveza se bebe, a veces demasiada, y que la barriga, para muchos, existe, aunque, repito la relación entre ambas está en debate.

Referencias:

Bendsen, N.T. et al. 2013. Is beer consumption related to measures of abdominal and general obesity? A systematic review and meta-analysis. Nutrition Reviews 71: 67-87.

Bobak, M. et al. 2003. Beer and obesity: a cross-sectional study. European Journal of Clinical Nutrition 57: 1250-1253.

Cerveceros de España. 2018. Informe socioeconómico del sector de la cerveza en España. Ministerio de Agricultura, Pesca y Alimentación. Madrid. 56 pp.

Gaetano, C. de, et al. 2016. Effects of moderate beer consumption on health and disease: A consensus document. Nutrition, Metabolism & Cardiovascular Diseases doi: 10.1016/j.numecd.2016.03.007

Machado, P.A.N. & R. Sichieri. 2002. Relaçao cintura-quadril e fatores de dieta em adultos. Revista de Saùde Pública 36: 198-204.

Romeo, J. et al. 2007. ¿Influye la cerveza en el aumento de peso? Efectos de un consumo moderado de cerveza sobre la composición corporal. Nutrición Hospitalaria 22: 223-228.

Schütze, H. et al. 2009. Beer consumption and the “beer belly”: scientific basis or common belief? European Journal of Clinical Nutrition 63: 1143-1149.

Sobre el autor: Eduardo Angulo es doctor en biología, profesor de biología celular de la UPV/EHU retirado y divulgador científico. Ha publicado varios libros y es autor de La biología estupenda.

El artículo Desmitificando: La barriga cervecera se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Desmitificando: Las rubias son “tontas”

- Desmitificando: Alguien me está mirando…

- Desmitificando: La vitamina C y el resfriado

Los riesgos dormidos: lo que usted debería saber

Si cerrásemos los ojos para visualizar la imagen de un geólogo, probablemente imaginaríamos a una persona descubriendo fósiles y recopilando y coleccionando minerales. No obstante, esta disciplina académica cuenta con muchísimas más aplicaciones desconocidas para gran parte de la sociedad.

Con el objetivo de dar visibilidad a esos otros aspectos que también forman parte de este campo científico nacieron las jornadas divulgativas “Abre los ojos y mira lo que pisas: Geología para miopes, poetas y despistados”, que se celebraron los días 22 y 23 de noviembre de 2018 en el Bizkaia Aretoa de la UPV/EHU en Bilbao.

La iniciativa estuvo organizada por miembros de la Sección de Geología de la Facultad de Ciencia y Tecnología de la UPV/EHU, en colaboración con el Vicerrectorado del Campus de Bizkaia, el Ente Vasco de la Energía (EVE-EEE), el Departamento de Medio Ambiente, Planificación Territorial y Vivienda del Gobierno Vasco, el Geoparque mundial UNESCO de la Costa Vasca y la Cátedra de Cultura Científica de la UPV/EHU.

Los invitados, expertos en campos como la arquitectura, el turismo o el cambio climático, se encargaron de mostrar el lado más práctico y aplicado de la geología, así como de visibilizar la importancia de esta ciencia en otros ámbitos de especialización.

Virginia Ormaetxea de Harrilur Geotecnia y portavoz del Colegio de Geólogos de Euskadi (EGEO) expone dos de los riesgos geológicos que actualmente pueden afectarnos a cualquiera, cualquier día, debidos a la presión urbanística: los desprendimientos/deslizamientos de tierra y los riesgos asociados a las rocas ácido-sulfatadas.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Los riesgos dormidos: lo que usted debería saber se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Geología: la clave para saber de dónde venimos y hacia dónde vamos

- El (Paleo)Clima y ¿el frío que vendrá?

- #Naukas16 ¿Cómo saber si tu funeraria te estafa?

Espectrometría de masas: de un isótopo de neón a elefantes que vuelan

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebrará dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Durante las próximas semanas en el Cuaderno de Cultura Científica y en Zientzia Kaiera se publicarán regularmente artículos que narren algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas. Comenzamos con la serie “Espectrometría de masas”, técnica analítica que supone el ejemplo perfecto del incesante avance de la Ciencia y la Tecnología.

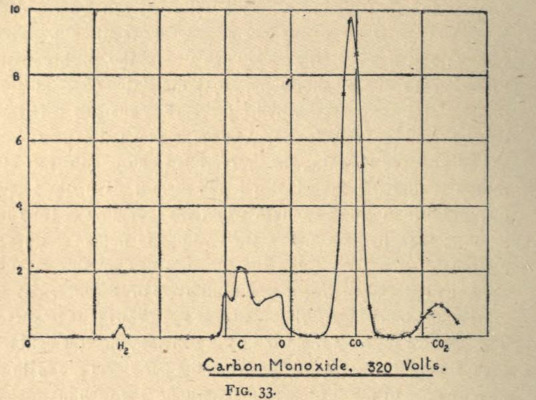

A principios del siglo XX J. J. Thomson estudiaba el cambio de trayectoria de los iones de ciertos gases sometidos a campos eléctricos y magnéticos. Estos experimentos derivaban del estudio de rayos catódicos que le habían valido el premio Nobel en 1906 y que habían esclarecido la naturaleza del electrón, entonces una partícula subatómica desconocida. Sir Thomson observó que los gases con carga positiva se podían separar en función de su relación masa/carga y que, conociendo el valor del campo eléctrico y magnético aplicado, podría determinar esta relación. En otras palabras, podía saber cuánto pesaban átomos o moléculas. Había nacido la espectrometría de masas.

Imagen 1. Espectro del monóxido de carbono (CO), uno de los primeros espectros de masas de la historia. Extraído de Rays of positive electricty and their applications to chemical Analysis de J.J. Thomson (1921). Fuente: Archive.org

Imagen 1. Espectro del monóxido de carbono (CO), uno de los primeros espectros de masas de la historia. Extraído de Rays of positive electricty and their applications to chemical Analysis de J.J. Thomson (1921). Fuente: Archive.orgLa espectrometría de masas es hoy en día la técnica analítica más versátil y potente que disponemos. En campos como el análisis forense, el análisis de alimentos o el estudio de contaminantes nos permite determinar la concentración de compuestos a niveles extremadamente bajos. Además, también sirve para identificar nuevas moléculas, algo que resulta de gran ayuda en el desarrollo de fármacos. Por si esto fuera poco, en el ámbito de la Medicina y la Fisiología está propiciando grandes avances médicos, porque permite estudiar cómo se distribuyen ciertas moléculas en órganos vitales. A lo largo de los artículos que componen esta serie nos adentraremos en este fascinante abanico de aplicaciones. Pero antes, veamos cómo hemos podido llegar a este punto en apenas cien años.

Los primeros pasos

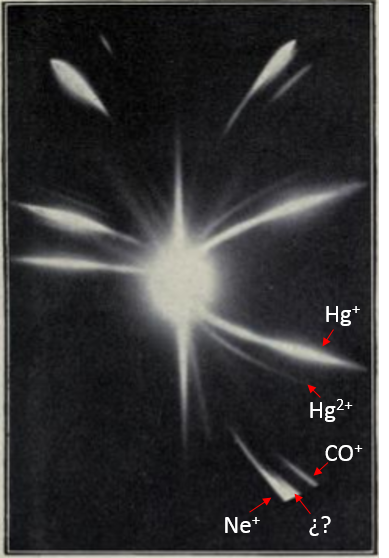

Viajemos hasta la Universidad de Cambridge, donde hemos dejado a Thomson trabajando con su protegido Francis William Aston. A él le debemos el siguiente gran hito en el campo que nos ocupa. En la Imagen 2 podéis observar el tipo de resultados que obtenían con aquellos primitivos espectrómetros de masas, entonces llamados espectrógrafos de parábola. En la placa fotográfica se pueden ver diferentes marcas ordenadas según las diferentes relaciones masa/carga. Aclararemos este concepto diciendo que no es otra cosa que la masa del átomo (o molécula) dividido entre el número de cargas. Por ejemplo, para el ion CO+ es 28 (la suma de la masa atómica* del carbono-12 y la del oxígeno-16 dividida entre uno), para el Hg+ es 200 y para el Hg2+ es 100 (dado que la masa atómica se divide entre dos por la doble carga). Como curiosidad añadiremos que a este parámetro se le asignó la unidad Th (Thomson) en honor al gran científico inglés, pero no ha sido reconocida internacionalmente y los resultados se presentan con el menos poético m/z.

Imagen 2. Parábolas de diferentes iones capturados en una placa fotográfica. Modificado de Rays of positive electricty and their applications to chemical Analysis de J.J. Thomson (1921). Fuente: Archive.org

Imagen 2. Parábolas de diferentes iones capturados en una placa fotográfica. Modificado de Rays of positive electricty and their applications to chemical Analysis de J.J. Thomson (1921). Fuente: Archive.orgAston observó que junto a la señal que correspondía al ion de neón (20 m/z) aparecía otra pequeña señal (22 m/z) cuyo origen era desconocido. ¿Qué demonios hacía eso ahí? Como bueno científicos, realizaron varios experimentos y fueron descartando hipótesis: no se trataba de moléculas de CO2 con doble carga (44/2) ni de hidruro de neón (NeH2). La misteriosa señal aparecía siempre que se analizaba este gas noble y era nueve veces más pequeña. No había otra explicación: también era neón. En 1913 propusieron que el neón era una mezcla de dos tipos de átomos con diferente masa (20 y 22) en proporción 9 a 1. De ahí la diferencia de intensidad en las señales obtenidas. Y de ahí que el peso atómico logrado para este elemento mediante la medida de la densidad fuese 20,2 (el promedio de las masas teniendo en cuenta su abundancia). Aston había descubierto un nuevo isótopo, término que había acuñado hacía poco Frederick Soddy por sugerencia de Margarett Todd para describir los átomos con propiedades idénticas, pero de diferente masa. Hoy en día nos puede parecer un asunto trivial y cualquiera que tenga unas nociones mínimas de química sabrá que esto se debe al diferente número de neutrones. ¡Pero tened en cuenta que todavía no se había descubierto esa partícula subatómica!

Tras la Gran Guerra, Aston mejoró su instrumento y desarrolló los primeros “espectrógrafos de masas” (Imagen 3) que le permitieron descubrir 212 isótopos naturales. Como premio ganó el Nobel de Química en 1922 (Soddy lo había ganado el año anterior). En esta tierna infancia de la espectrometría de masas no nos podemos olvidar de Arthur Dempster que en la Universidad de Chicago diseñó los primeros espectrómetros de sector magnético en los que se basan muchos de los instrumentos actuales y con los que descubrió el uranio-235.

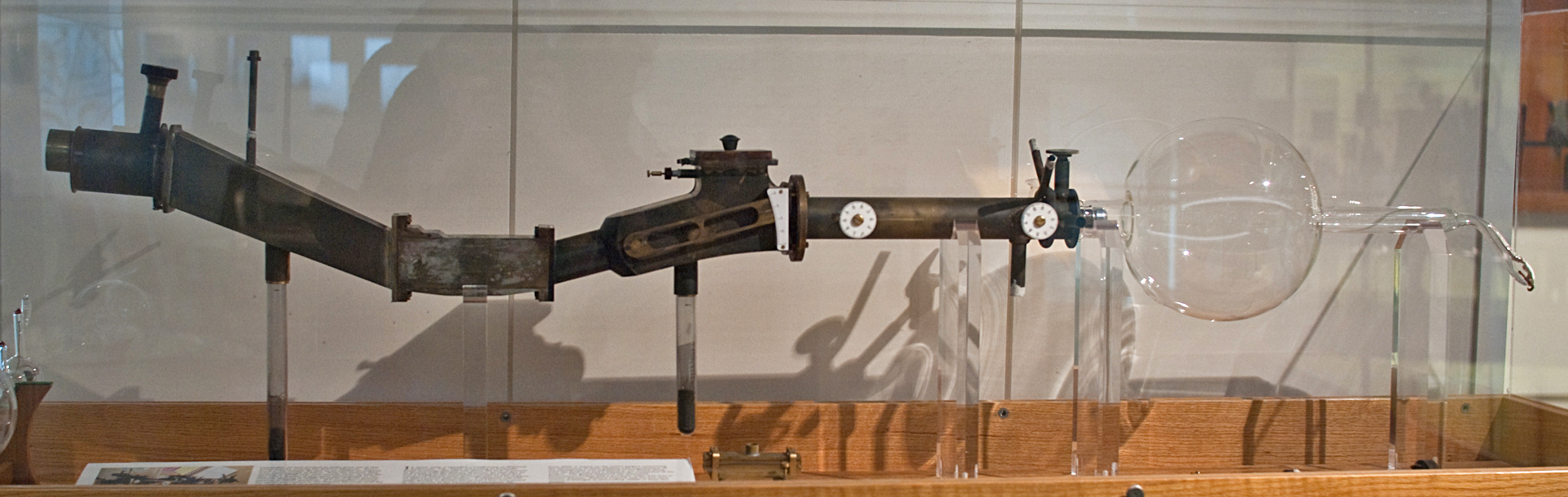

Imagen 3. Réplica del tercer espectrómetro de masas desarrollado por Aston: Fuente: Jeff Dahl /Wikimedia Commons.

Imagen 3. Réplica del tercer espectrómetro de masas desarrollado por Aston: Fuente: Jeff Dahl /Wikimedia Commons.

Guerras, avances y difusión

Es, precisamente, el uranio-235 el protagonista de una de las primeras aplicaciones prácticas de la espectrometría de masas. Desgraciadamente. Durante el Proyecto Manhattan, el físico Alfred Nier revolucionó la espectrometría de masas con nuevos instrumentos de sector que permitieron aislar y conocer mejor el isótopo empleado en Little Boy. Pero sería injusto juzgar a Nier por la aplicación que se hizo de sus avances. Este científico fue un visionario que comprendió la importancia de la espectrometría de masas y extendió, en muchas ocasiones de forma altruista, sus usos a campos como la Biología (enriquecimiento de carbono-13) o la Geología (datación isotópica de la corteza terrestre).

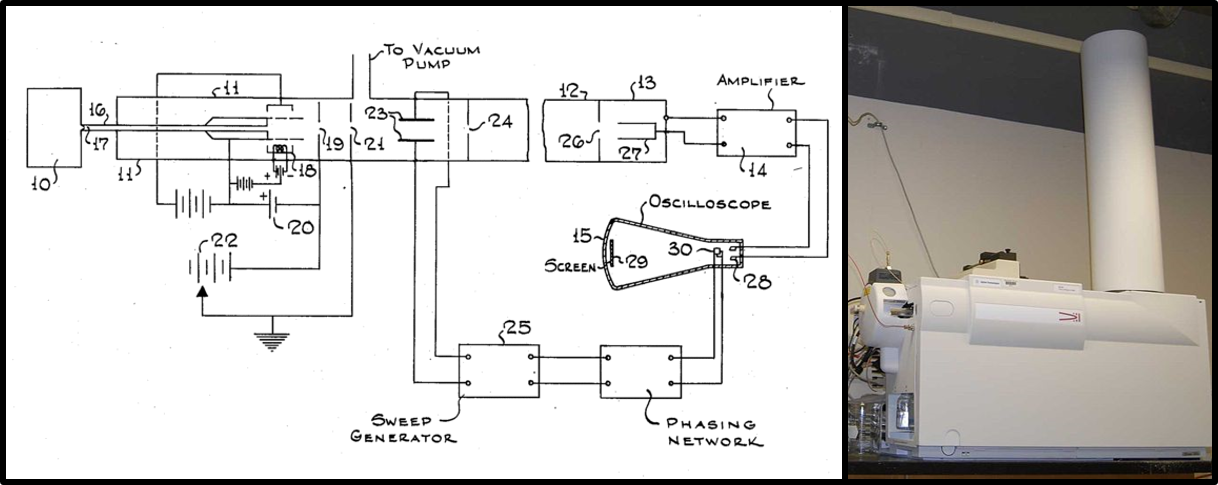

Durante los años 40 y los años 50 se realizaron importantes mejoras y aparecieron instrumentos basados en nuevos principios para separar iones. Por su relevancia destacaremos los instrumentos de tiempo de vuelo (Time of Flight) propuestos por W.E. Stephens, en los que la separación se logra por la diferente velocidad a la que se mueven las moléculas al someterlas a un impulso (Imagen 4). Este es el sistema de separación más fácil de visualizar: cuanto más pesada sea la molécula más tiempo tardará en llegar al detector. El otro gran avance fue la creación de los instrumentos tipo cuadrupolo en los que los iones se pueden separar gracias al uso de cilindros que permiten realizar variaciones de corriente continua y radiofrecuencias. Prueba de su importancia es que Wolfgang Paul y Hans Georg Dehmelt obtuvieron el premio Nobel de Física en 1989 por el desarrollo de la trampa iónica, en la que extendieron estos principios en tres dimensiones.

Imagen 4. Patente del espectrómetro tipo tiempo de vuelo de Stephens (1952) y un instrumento actual en el que se observa el “tubo de vuelo”. Fuente: Adaptado de Kkmurray/Wikimedia Commons.

Imagen 4. Patente del espectrómetro tipo tiempo de vuelo de Stephens (1952) y un instrumento actual en el que se observa el “tubo de vuelo”. Fuente: Adaptado de Kkmurray/Wikimedia Commons.Pero no avancemos tan rápido. Los primeros espectrómetros comerciales no recibieron una calurosa acogida. En gran medida por el desconocimiento de la técnica, la mayoría de las aplicaciones eran meramente cuantitativas, como por ejemplo el análisis de hidrocarburos en refinerías de petróleo. Es decir, se usaban para determinar la concentración de algún compuesto conocido en diferentes muestras (tengamos en cuenta que la señal del compuesto es proporcional a su concentración). De ese modo no se explotaba una de las grandes ventajas que ofrece la espectrometría de masas: la identificación de moléculas desconocidas. Conocer la masa molecular de un compuesto es un gran paso para esclarecer su identidad. Y se puede ir más allá. La molécula se puede fragmentar en el instrumento, por lo que también podemos conocer la masa de los fragmentos y elucidar la estructura original como si de un puzle se tratase. Hubo tres científicos que supieron ver esta gran ventaja: Fred McLafferty (conocido por su reordenamiento), Klaus Biemann y Carl Djerassi (aunque lo más fascinante es que Thomson ya había predicho su aplicabilidad para 1913). Gracias a ellos se extendió el uso de la espectrometría de masas en el campo de la química orgánica, aplicándose inicialmente al descubrimiento de alcaloides y esteroides (Djerassi fue uno de los padres de la píldora anticonceptiva). Así posibilitaron, en gran medida, que la espectrometría de masas se convirtiese, junto a la resonancia magnética nuclear, en la herramienta indispensable para conocer la estructura de nuevas moléculas.

El despegue definitivo

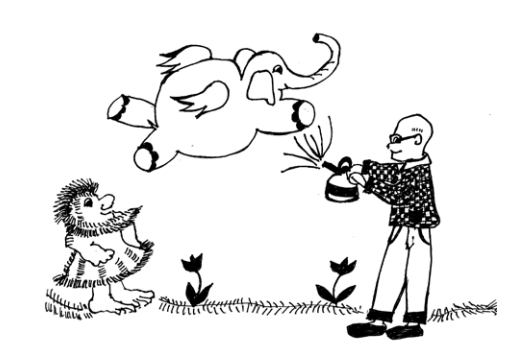

La espectrometría de masas empezaba a despuntar, pero todavía existía un enorme problema: ¿Cómo se convierten las moléculas en iones gaseosos? Hasta ahora nos hemos centrado en cómo medir la masa, dejando de lado este importante aspecto. Recordemos que esta técnica mide la relación masa/carga, así que si las moléculas no están ionizadas de poco nos puede servir. Los métodos empleados hasta finales de los 60 no eran aptos para moléculas no volátiles o provocaban la fragmentación total de la molécula causando la pérdida de información sobre la masa molecular. En esas condiciones la mayoría de biomoléculas no podían ser analizadas, especialmente las proteínas de gran tamaño. Hacía falta ir un paso más allá. Y entonces surgieron la Ionización por Electrospray (ESI) y la Ionización/Desorción Laser Asistida por Matriz (MALDI). Así se les puso alas a las “moléculas elefante” como dijo John B. Fenn en su conferencia por el premio Nobel de Química de 2002.

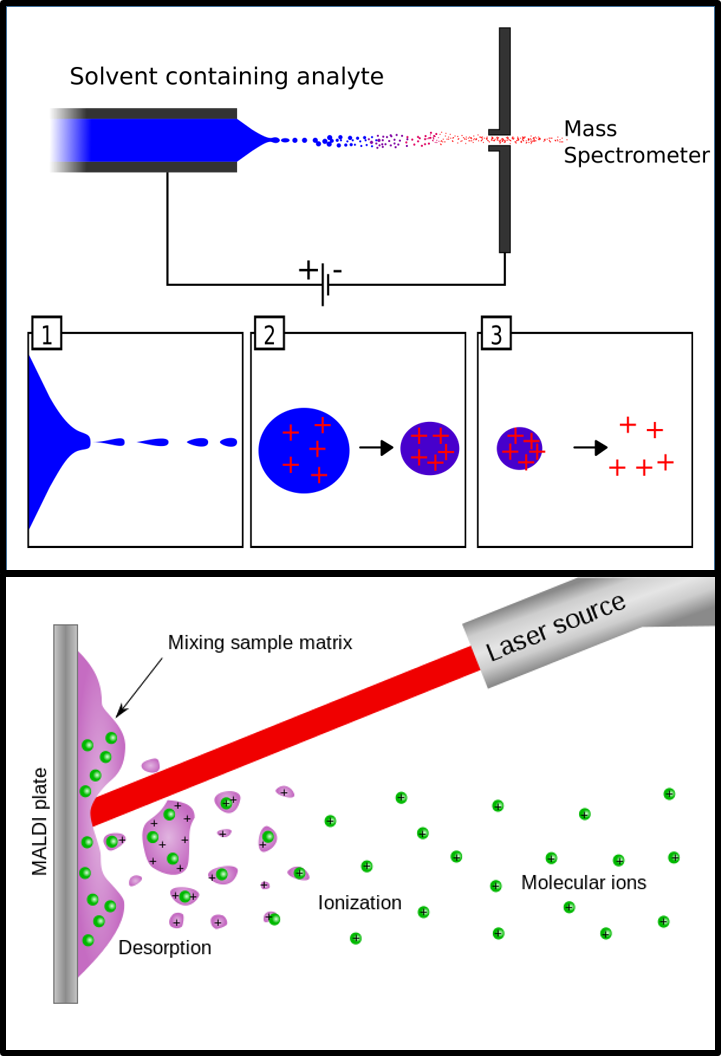

Imagen 5. Dibujo inspirado por el título de la conferencia por el premio Nobel de John Fenn. Fuente: Realizado por Marianne Steinberg para la National Science Academy [PDF].Fenn compartió una parte del premio Nobel de 2002 con el japonés Koichi Tanaka por el “Desarrollo de métodos de ionización blandos para el análisis mediante espectrometría de masas de macromoléculas biológicas”. El primero fue galardonado por desarrollar la técnica ESI, aunque la invención se la debemos a Malcom Dole en 1968. El principio sobre el que se sustenta este modo de ionización es relativamente sencillo. El disolvente que contiene la muestra atraviesa un capilar al que se le aplica un voltaje para ionizar las moléculas (es decir, ponerles carga positiva o negativa). Al salir, el líquido formará un aerosol (de ahí lo de spray) con la ayuda de un gas de nebulización y, según se vaya evaporando el disolvente, las gotitas serán cada vez más pequeñas. Llega un punto en que las gotas reducen tanto su tamaño que la fuerza de repulsión entre las moléculas cargadas es superior a la tensión superficial y “explotan” (Imagen 6). De este modo se logran iones en forma gaseosa que pueden pasar al analizador de masas. Este tipo de ionización permite analizar multitud de moléculas, incluso con masas moleculares que superan los 100 000 Da. Además, tiene la gran ventaja de emplear disolventes líquidos, lo que hace que sea compatible con una de las técnicas de separación más comunes: la cromatografía líquida.

Imagen 5. Dibujo inspirado por el título de la conferencia por el premio Nobel de John Fenn. Fuente: Realizado por Marianne Steinberg para la National Science Academy [PDF].Fenn compartió una parte del premio Nobel de 2002 con el japonés Koichi Tanaka por el “Desarrollo de métodos de ionización blandos para el análisis mediante espectrometría de masas de macromoléculas biológicas”. El primero fue galardonado por desarrollar la técnica ESI, aunque la invención se la debemos a Malcom Dole en 1968. El principio sobre el que se sustenta este modo de ionización es relativamente sencillo. El disolvente que contiene la muestra atraviesa un capilar al que se le aplica un voltaje para ionizar las moléculas (es decir, ponerles carga positiva o negativa). Al salir, el líquido formará un aerosol (de ahí lo de spray) con la ayuda de un gas de nebulización y, según se vaya evaporando el disolvente, las gotitas serán cada vez más pequeñas. Llega un punto en que las gotas reducen tanto su tamaño que la fuerza de repulsión entre las moléculas cargadas es superior a la tensión superficial y “explotan” (Imagen 6). De este modo se logran iones en forma gaseosa que pueden pasar al analizador de masas. Este tipo de ionización permite analizar multitud de moléculas, incluso con masas moleculares que superan los 100 000 Da. Además, tiene la gran ventaja de emplear disolventes líquidos, lo que hace que sea compatible con una de las técnicas de separación más comunes: la cromatografía líquida.

Por su parte, Tanaka logró ionizar proteínas con un método radicalmente diferente: empleando un láser. Pese a que su mérito como pionero en el uso de la ionización laser es incuestionable, hubo cierta polémica cuando le otorgaron el Premio Nobel. Hay quien piensa que el galardón debería haber recaído en Hillenkamp y Karas, ya que la técnica que actualmente conocemos como MALDI (del inglés Matrix Assisted Laser Desportion/Ionization) fue desarrollada por ellos y difiere en ciertos aspectos de la propuesta por Tanaka. Dejando estos conflictos de lado, sólo queda decir que la técnica MALDI se basa en un sistema de ionización indirecta. A la muestra se le añade una matriz que se ioniza fácilmente con un láser y es esta matriz la que transfiere su carga a las moléculas. Este método de ionización es de un gran interés, especialmente porque permite hacer imágenes de superficies como puede ser un tejido animal.

Imagen 6. Esquemas de ionización ESI (arriba) y MALDI (abajo). Fuente: Eva Mason y Mikayé

Imagen 6. Esquemas de ionización ESI (arriba) y MALDI (abajo). Fuente: Eva Mason y MikayéDurante el siglo XXI han continuado los avances en espectrometría de masas y los equipos de alta resolución (capaces de discernir entra moléculas con una relación masa/carga muy parecida) van ganado espacio. En este aspecto, puede que el mayor avance de los últimos años haya sido la aparición del Orbitrap, un espectrómetro de masas tipo trampa iónica con transformada de Fourier.

Pero del presente de la espectrometría de masas nos ocuparemos durante las próximas entregas de esta serie en la que iremos descubriendo diferentes casos en los que esta técnica ha sido de gran utilidad.

*N. del A. La forma de definir la masa atómica y el peso atómico ha variado a lo largo de los años. Diremos que la masa atómica es la masa de un isótopo específico y el peso atómico es el promedio de todos los isótopos de un elemento teniendo en cuenta su abundancia.

Para saber más:

Simon Maher et al. (2015) “Colloquium: 100 years of mass spectrometry: Perspectives and future trends” Reviews of Modern Physics, 87, 113-135.

Jennifer Griffiths et al. (2008) “A Brief History of Mass Spectrometry” Analytical Chemistry, 80, 5678-5683.

Stu Borman et al. (2003) “A Mass Spec Timeline” Today’s Chemist at Work, September, 47-49.

Sobre el autor: Oskar González es profesor en la Facultad de Ciencia y Tecnología y en la Facultad de Bellas Artes de la UPV/EHU.

El artículo Espectrometría de masas: de un isótopo de neón a elefantes que vuelan se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Así en la Tierra como en Marte: espectrógrafos y espectrómetros de masas

- Constantes durante al menos 12 mil millones de años

- En este núcleo sobra masa

La dieta saludable es cuestión de química

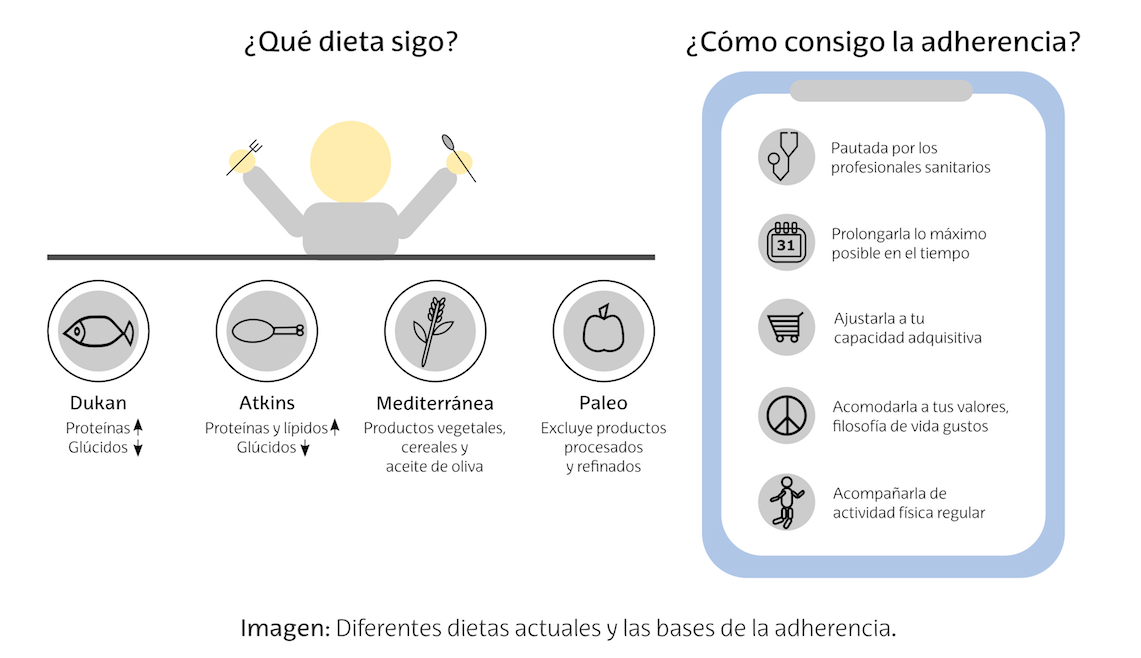

Mejor el pan y la pasta si son integrales. Mejor prescindir del azúcar. Mejor comer una fruta que beberse un zumo. Los cereales, las galletas y los cacaos de desayuno contienen mucho azúcar y harinas refinadas, por eso es mejor evitarlos. Más legumbres y menos pastas. Esto lo sabemos todos los que nos preocupamos por llevar una dieta saludable. La razón de todas estas decisiones tiene su origen en dos conceptos: el índice glucémico y la carga glucémica. Y todo esto puede explicarse de forma sencilla gracias a una rama de la química llamada bioquímica.

Tanto el índice glucémico como la carga glucémica tienen que ver con el contenido y tipo de hidratos de carbono que contienen los alimentos.

-

¿Qué son los hidratos de carbono y qué alimentos son ricos en ellos?

Hay una serie de alimentos que son ricos en hidratos de carbono, como por ejemplo el pan, la pasta, el arroz, en general todo aquello que se convierte en harinas o que se haga con harinas. También es un hidrato de carbono el azúcar y, en general, cualquier alimento dulce, desde pasteles a frutas son ricos en hidratos de carbono. De hecho, en bioquímica solemos denominar “azúcares” a todos los hidratos de carbono.

-

¿Cómo se metabolizan los hidratos de carbono?

Los hidratos de carbono de estos alimentos se acaban convirtiendo en moléculas más simples como la glucosa. La glucosa pasa a la sangre y las células la captan gracias a la insulina. La insulina es una hormona que se sintetiza en el páncreas y que actúa como llave de paso, permitiendo la entrada de la glucosa en las células.

Cuando comemos hidratos de carbono, lo primero que hace el organismo es almacenar la glucosa en forma de glucógeno, tanto en el músculo como en el hígado. Es una forma de almacenar energía. Pero una vez que estas reservas están llenas, el exceso de glucosa se transforma en grasa en los adipocitos.

-

¿Qué es el índice glucémico?

La índice glucémico (IG) nos dice con qué velocidad los hidratos de carbono se convierten en glucosa y pasan a la sangre. Los hay que lo hacen más rápido (alto IG) y más despacio (bajo IG).

Hay alimentos que van liberando poco a poco esa glucosa en la sangre, de modo que las células van gestionando sin problema esa glucosa que les llega progresivamente. Los alimentos que liberan su glucosa así, poco a poco, se denominan alimentos de bajo índice glucémico. En general son alimentos que contienen fibra, como los integrales, las frutas y las legumbres. Tampoco producen aumentos repentinos de insulina, sino que la insulina se libera también de forma progresiva. Estos alimentos tienen un IG por debajo de 55.

Alimentos de bajo IG

Alimentos de bajo IGHay alimentos que, por el contrario, liberan la glucosa en sangre rápidamente, de modo que las células son incapaces de gestionar tanta glucosa en tan poco tiempo y se disparan los niveles de insulina. Los alimentos que liberan glucosa así, de golpe, son los alimentos de alto índice glucémico. Son alimentos hechos con harinas refinadas, que no contienen suficiente fibra y, sobre todo, alimentos con azúcar añadido y azúcar libre. Estos alimentos tienen un IG entre 70 y 100.

-

Otros factores que afectan al índice glucémico

Al procesar y cocinar los alimentos podemos cambiar la estructura y la disponibilidad de sus hidratos de carbono. Por ejemplo, las harinas refinadas no contienen la fibra original del cereal, por lo que sus hidratos de carbono están más disponibles. Por eso las harinas, panes y pastas refinadas tienen un IG más alto que sus respectivos integrales.

Al cocinar los alimentos también alteramos su IG. Por ejemplo, al cocer la pasta alteramos la estructura interna del almidón, con lo que se liberan más hidratos de carbono simples. Así, cuanto más cocida esté una pasta, mayor será su IG.

El IG también se ve afectado por el resto de los alimentos que ingerimos a la vez. Por ejemplo, las proteínas y las grasas hacen que los alimentos estén durante más tiempo en el estómago y lleguen más lentamente al intestino, de modo que pueden reducir su IG.

No todos los azúcares se absorben igual. Por ejemplo, la fructosa, que es el azúcar de la fruta, se absorbe más lentamente y se metaboliza en el hígado, así que el índice glucémico de casi todas las frutas suele ser bajo. Como excepción tenemos el melón, la sandía, los dátiles y las frutas deshidratadas como higos o pasas. Pero no hay que preocuparse por ellos porque, aunque su IG sea alto, habría que consumir una cantidad muy elevada de ellos, ya que no contienen tantos hidratos de carbono.

-

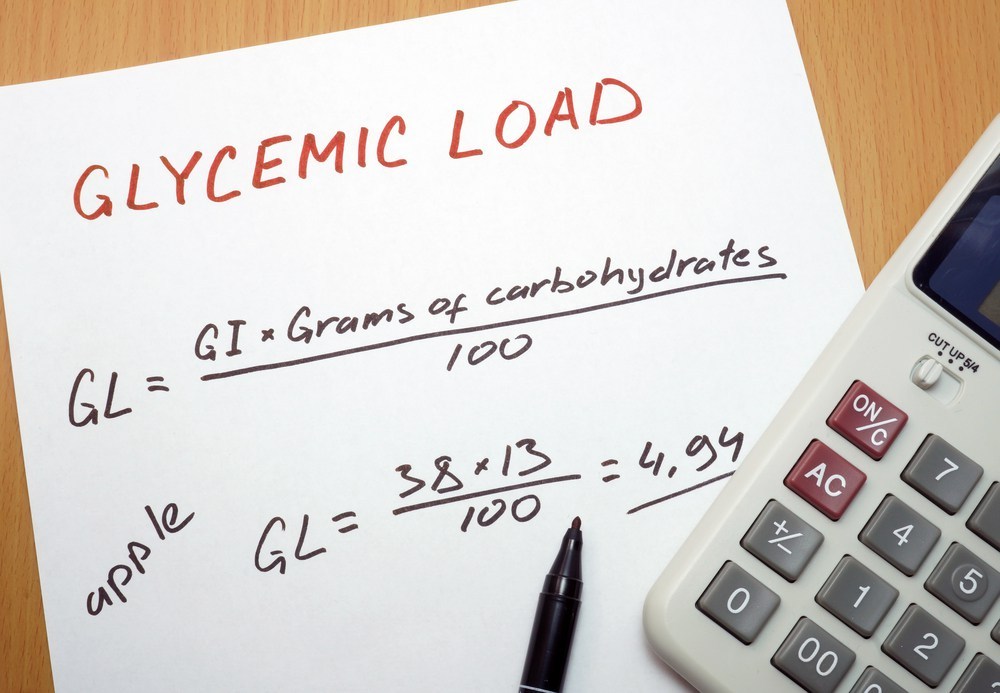

¿Qué es la carga glucémica?

El IG tiene sus limitaciones. Hay que tener en cuenta que los valores de IG se calculan para una cantidad de alimento tal que proporcione 50 gramos de hidratos de carbono disponibles biológicamente. En algunos alimentos esto se corresponde con una ración normal, pero en otros habría que consumir una ración extremadamente alta. Por ejemplo, la sandía es un alimento con alto IG, pero para que la sandía proporcione 50 g de hidratos de carbono tendríamos que comernos una sandía entera. De media, en 100 g de sandía hay solo 8 g de hidratos de carbono.

En cambio, en 100 g de pasta hay unos 80 de hidratos de carbono. Así, una ración de pasta, que tiene un IG medio, nos proporciona más hidratos de carbono que una porción del mismo peso de sandía. Para salvar esta limitación en el IG se emplea el término carga glucémica (CG), que tiene en cuenta tanto el IG del alimento como su contenido en hidratos de carbono.

La carga glucémica se calcula directamente a partir del IG, dividiéndolo por 100 y multiplicándolo por la cantidad de carbohidratos que aporta la ración de alimento. Así, la carga glucémica de la sandía es 4, y la de la pasta ronda el 70.

-

Consecuencias de consumir alimentos de alto índice glucémico y/o alta carga glucémica

El consumo de estos alimentos está relacionado con el sobrepeso, la obesidad, la diabetes tipo II y la percepción atrofiada del apetito.

El sobrepeso, la obesidad y sus enfermedades asociadas, como las cardiopatías [1], guardan cierta relación con el índice glucémico y la carga glucémica [2]. La razón principal estriba en el metabolismo de los hidratos de carbono. Parte de los hidratos de carbono de estos alimentos se transforman en grasas en lugar de almacenarse como glucógeno en el hígado y en el músculo, especialmente en personas que no hacen actividad física. Nuestras células no son capaces de gestionar tan rápido tanta cantidad de glucosa, con lo que los adipocitos terminan almacenando el exceso en forma de grasa. Así que, si sumamos la vida sedentaria a una dieta de alto índice y carga glucémica, estaremos aumentando el riesgo de padecer obesidad.

Los aumentos y descensos de insulina tan pronunciados que produce el consumo de estos alimentos está relacionado con una mayor incidencia de diabetes tipo II [3]. La diabetes tipo II es la resistencia a la insulina, es decir, que las células dejan de reconocer a la insulina y por tanto no permiten la entrada a la glucosa, con lo que ésta se queda en la sangre. De ahí expresiones del tipo “no tomo dulces porque me suben el azúcar”, ese azúcar es la glucosa en sangre incapaz de entrar en las células. La glucosa campando a sus anchas por nuestra sangre puede llegar a armar destrozos en nuestro organismo, dañando la retina, los riñones, las arterias o el corazón.

Las dietas con alimentos de bajo índice y carga glucémica, así como los alimentos ricos en fibra, son útiles para prevenir la diabetes tipo II [4].

Los alimentos de bajo índice y carga glucémica nos producen mayor saciedad. Cuando consumimos esta clase de alimentos, los niveles de glucosa en sangre se mantienen en el tiempo, y esto está relacionado con la percepción del apetito. Sin embargo, los alimentos de alto índice y carga glucémica producen aumentos repentinos de glucosa en sangre y su respectivo aumento en la secreción de insulina. Estos vaivenes en periodos cortos de tiempo rompen el equilibrio de saciedad/apetito provocando una falsa sensación de hambre al poco tiempo de haber comido.

Estas subidas y bajadas repentinas de glucosa e insulina repercuten en las hormonas que regulan el apetito, como la ghrelina y la leptina. En los casos en lo que ya hay sobrepeso y obesidad, el sistema hormonal que regula el apetito también pierde funcionalidad [5], con lo que seguir una dieta con alimentos de alto índice y carga glucémica, empeoran la situación y atrofian más si cabe la percepción de apetito.

-

Conclusión

Cuando decidimos consumir alimentos integrales, o dejamos de consumir azúcar, o alimentos con azúcar añadido, u optamos por comer fruta en lugar de beber zumo, lo hacemos por salud. Son decisiones que nos ayudan a prevenir la diabetes tipo II, la obesidad, el sobrepeso y nos ayudan a gestionar mejor el apetito. Todo esto puede entenderse desde un punto de vista metabólico, es decir, la química está detrás de las dietas saludables. Y dos de los conceptos clave para entender por qué esto es así son el índice glucémico y la carga glucémica de los alimentos.

Referencias:

[1] https://www.ncbi.nlm.nih.gov/pubmed/26480969

[2] https://www.ncbi.nlm.nih.gov/pubmed/23786819

[3] https://www.ncbi.nlm.nih.gov/pubmed/25547339

[4] https://www.ncbi.nlm.nih.gov/pubmed/12081851

[5] https://www.ncbi.nlm.nih.gov/pubmed/27376422

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo La dieta saludable es cuestión de química se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Ni dieta equilibrada ni nutrientes. Es cosa de adherencia

- Vida saludable contra la diabetes

- Los vegetales de la dieta neandertal

Un dulce problema de Paul Erdös

En mi anterior entrada del Cuaderno de Cultura Científica, Las dos culturas de las matemáticas: construir teorías o resolver problemas, estuvimos hablando precisamente de eso, de lo que se conoce como las dos culturas de las matemáticas, construir teorías o resolver problemas.

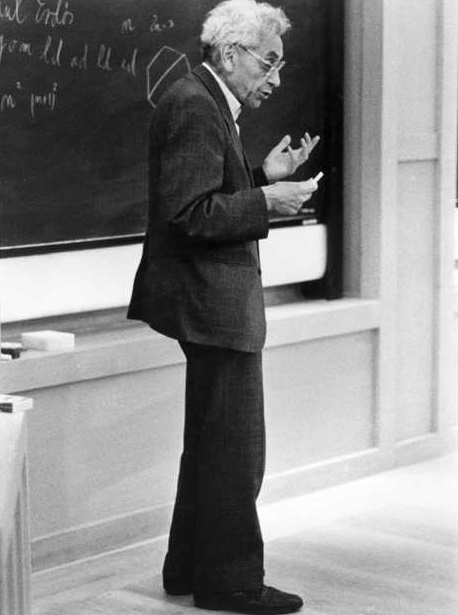

Dentro del grupo de personas que hacen matemáticas “cuyo objetivo central es resolver problemas” se citaba al matemático húngaro Paul Erdös (1913-1996), considerado “el príncipe de los que resuelven problemas y el monarca absoluto de quienes saben proponer problemas”.

Fotografía de Paul Erdös durante una conferencia en Trinity College (Universidad de Cambridge), en 1991, perteneciente al documental N is a number. A portrait of Paul Erdös (1993), del cineasta George P. Csicsery

Fotografía de Paul Erdös durante una conferencia en Trinity College (Universidad de Cambridge), en 1991, perteneciente al documental N is a number. A portrait of Paul Erdös (1993), del cineasta George P. CsicseryEste brillante y extravagante matemático, en la introducción del artículo Some of My Favourite Problems and Results (Algunos de mis problemas y resultados favoritos), escribe lo siguiente.

Los problemas han sido siempre una parte fundamental de mi vida matemática. Un problema bien elegido puede aislar una dificultad esencial en un área particular de las matemáticas, de forma que el mismo sirva de marca que hay que superar para que se produzca el progreso de esa área. Un problema de apariencia inocente a menudo no da ninguna pista de su verdadera naturaleza. Puede ser como un “malvavisco”, que sirve de delicioso bocado de cardenal proporcionando unos instantes de efímero placer. O puede ser como una “bellota”, que necesite agudos y profundos nuevos conocimientos a partir de los cuales pueda crecer un poderoso roble.

Leyendo estos días sobre algunos de los problemas que planteó y resolvió Paul Erdös, descubrí en el libro Mathematical Diamonds, del matemático canadiense Ross Honsberger (1929-2016), un curioso problema, con una sorprendente y hermosa demostración, que me ha parecido interesante comentaros en esta entrada del Cuaderno de Cultura Científica. Espero que disfrutéis de este problema “malvavisco”, tanto como yo disfruté cuando lo leí.

En la década de 1940, el matemático Paul Erdös estaba estudiando y planteando problemas relacionados con diferentes propiedades y estructuras de conjuntos de puntos del plano. Así, por ejemplo, en 1943 planteó en la revista American Mathematical Monthly el problema “Demostrar que, si un conjunto finito de puntos del plano no están todos sobre la misma recta, entonces existe una recta con exactamente dos de esos puntos”. Sin ser consciente de ello, Erdös reformuló el problema de la línea de Sylvester, que en su momento comentamos en la entrada El problema de la plantación de árboles en filas.

Pero vayamos al problema que nos interesa hoy. En el año 1945, Erdös planteó lo siguiente.

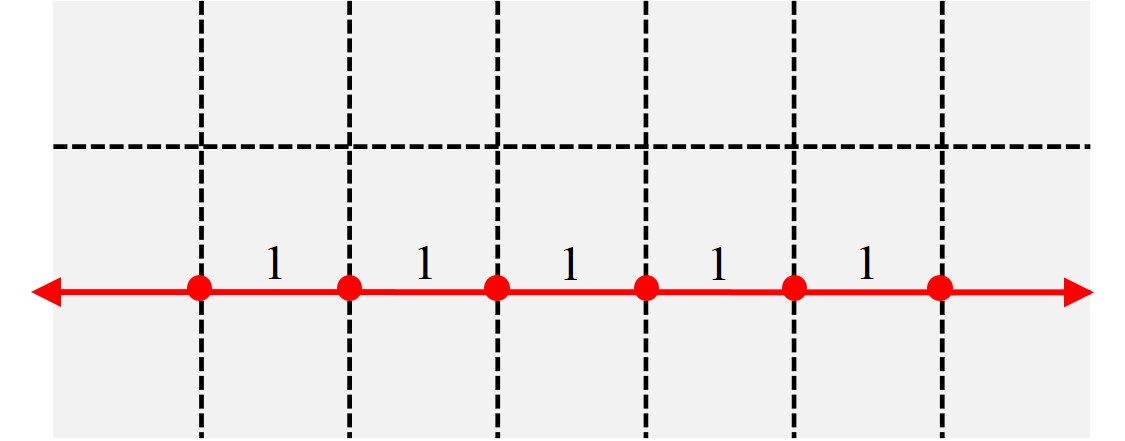

Problema (Paul Erdös): Si dado un conjunto infinito de puntos del plano, las distancias entre ellos son todas números enteros (podemos entender naturales), entonces todos los puntos están en una misma línea recta.

Claramente, si tomamos una recta cualquiera del plano podemos considerar una colección infinita de puntos tal que la distancia entre cualquier par de puntos sea un número natural, sin más que partir de un punto inicial e ir tomando hacia izquierda y derecha los puntos que están a una distancia unidad del inmediatamente anterior (como los puntos rojos que están sobre la recta roja del plano en la siguiente imagen). Lo sorprendente de la afirmación de Erdös en el enunciado del problema es que esa es la única forma de obtener una colección infinita de puntos tal que las distancias entre cualesquiera dos de ellos es siempre un número natural.

La demostración del problema es sencilla, sorprendente e ingeniosa, yo diría más, es una bella demostración. El argumento de la misma se centra en una curva de la familia de curvas cónicas, la hipérbola.

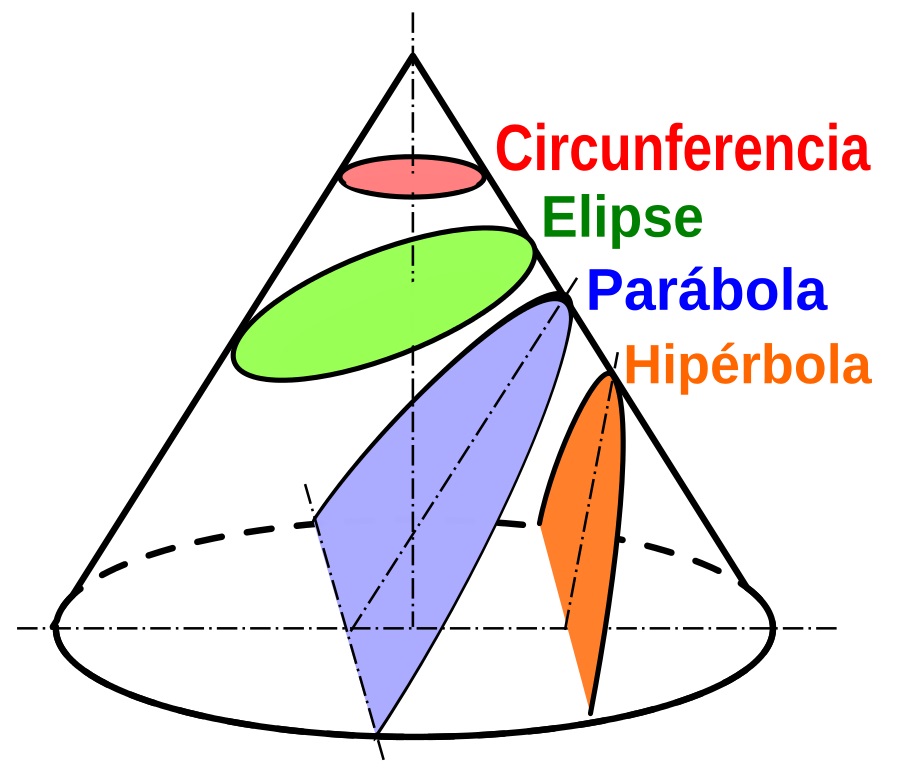

Las secciones cónicas son las curvas planas, que no son rectas, que se obtienen al intersecar un cono con un plano. Las curvas cónicas son la circunferencia, la elipse, la parábola y la hipérbola. Imagen: Wikimedia Commons

Las secciones cónicas son las curvas planas, que no son rectas, que se obtienen al intersecar un cono con un plano. Las curvas cónicas son la circunferencia, la elipse, la parábola y la hipérbola. Imagen: Wikimedia Commons El argumento de la demostración de Erdös es por “reducción al absurdo”. Supongamos que el resultado no fuese cierto, es decir, que existe un conjunto infinito de puntos del plano S, tal que la distancia entre cualesquiera dos de ellos es un número natural y que existen tres puntos A, B y C, del conjunto S, que no son colineales, no están en la misma recta. En ese caso, esos tres puntos determinan un triángulo del plano. Denotemos por a, b y c las longitudes de los lados del mismo, opuestas a los vértices A, B y C, respectivamente, que sabemos, por hipótesis, que son números naturales.

Ahora, consideremos otro punto cualquiera D del conjunto S (recordemos que este conjunto tiene infinitos puntos). Teniendo en cuenta que las distancias de D a los tres puntos A, B y C son también enteras, por estar todos en S, el matemático húngaro demostró que solamente puede haber un número finito de puntos del plano candidatos a ser D. En conclusión, S no puede ser infinito. Veámoslo.

El punto D no es uno de los vértices del triángulo, que son los puntos A, B y C, por lo que como mucho puede estar en una de las rectas que contienen a los lados del triángulo, AB, AC y BC. Es decir, podemos afirmar que existen (al menos) dos rectas, de las tres que contienen los vértices del triángulo, en los cuales no está el punto D. Supongamos que esas rectas, en las que no está el punto D, son las que contienen a los lados AC y BC.

Las distancias del punto D a los puntos B y C son números naturales, ya que los tres están en S, por lo tanto, la diferencia entre ellas |BD – CD| es también un número natural o cero. Como el punto D no está en la recta de BC, la desigualdad triangular (“la suma de las longitudes de dos lados cualesquiera de un triángulo es siempre mayor que la longitud del otro lado”) nos dice que |BD – CD| < BC = a.

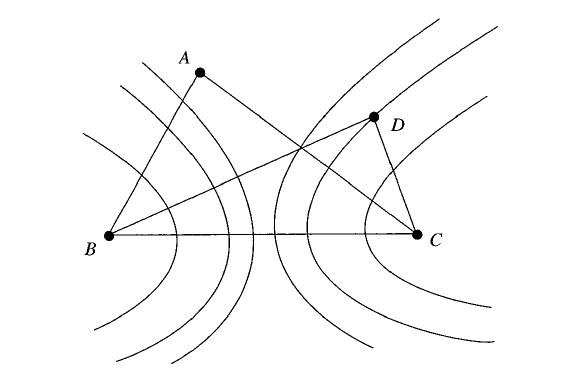

Juntando todo lo anterior, tenemos que |BD – CD| = k, donde k es uno de los números enteros 0, 1, 2, …, a – 1. Por lo tanto, D es un punto que pertenece a la hipérbola con focos B y C, y tal que la diferencia de la distancia de sus puntos a los focos es k. Es decir, D está en una de las a hipérbolas que forman la familia de hipérbolas de focos B y C, y diferencias constantes k = 0, 1, 2, …, a – 1.

Representación intuitiva de algunas de las hipérbolas de la familia de hipérbolas con focos B y C y diferencia k un número entero entre 0 y a – 1. Imagen del libro Mathematical Diamonds, de Ross Honsberger

Representación intuitiva de algunas de las hipérbolas de la familia de hipérbolas con focos B y C y diferencia k un número entero entre 0 y a – 1. Imagen del libro Mathematical Diamonds, de Ross HonsbergerAntes de continuar, recordemos brevemente la propiedad métrica, que estamos mencionando, de las hipérbolas. En general, todas las curvas cónicas se pueden caracterizar mediante una propiedad métrica. Por ejemplo, la circunferencia está formada por los puntos del plano que equidistan, es decir, que están a la misma distancia, de un punto fijo, el centro de la misma.

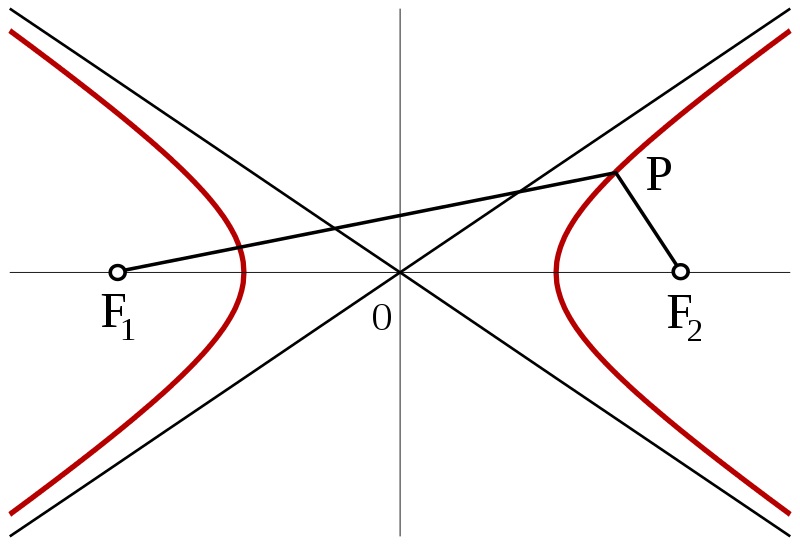

En el caso de la hipérbola, existen dos puntos destacados, los focos (F1 y F2 en la siguiente imagen), y cada hipérbola está caracterizada por estar formada por los puntos P del plano tales que la diferencia de las distancias a los focos |PF1 – PF2| es una constante k, para cada hipérbola. Luego, dados dos focos F1 y F2, para cada constante k se obtiene una hipérbola como la de la siguiente imagen (con dos ramas). Para k = 0 se obtendría una hipérbola degenerada, que es la recta mediatriz del segmento F1F2, es decir, los puntos que están a la misma distancia de cada uno de los focos.

Dibujo de una hipérbola (en rojo) con focos F1 y F2. Imagen: Wikimedia Commons

Dibujo de una hipérbola (en rojo) con focos F1 y F2. Imagen: Wikimedia Commons Regresemos a la demostración. Hemos probado que como el punto D no está en la recta de BC, D está en alguna de las a (que es un número natural) hipérbolas que forman la familia de hipérbolas de focos B y C, y diferencias constantes k = 0, 1, 2, …, a – 1. De la misma forma, tendrá que ser cierto que, como el punto D no está en la recta que contiene a AC, D está en alguna de las b (que también es un número natural) hipérbolas que forman la familia de hipérbolas de focos A y C, y diferencias constantes m = 0, 1, 2, …, b – 1.

Como dos hipérbolas cualesquiera se intersecarán, como mucho, en 4 puntos distintos, entonces las a hipérbolas de la primera familia y las b hipérbolas de la segunda, se intersecarán a lo sumo en 4ab puntos del plano. Es decir, solo existe un número finito de posibles puntos del plano, (como mucho) 4ab, candidatos a ser D. Esto nos lleva a una contradicción con el hecho de que S es un conjunto infinito, y D es un punto del conjunto, también infinito, S – {A, B, C}, ya que hemos probado que solo hay un número finito de posibles puntos D. Por lo tanto, cualesquiera tres puntos A, B y C, de S, deberán estar alineados, luego los puntos de S están sobre la misma recta.

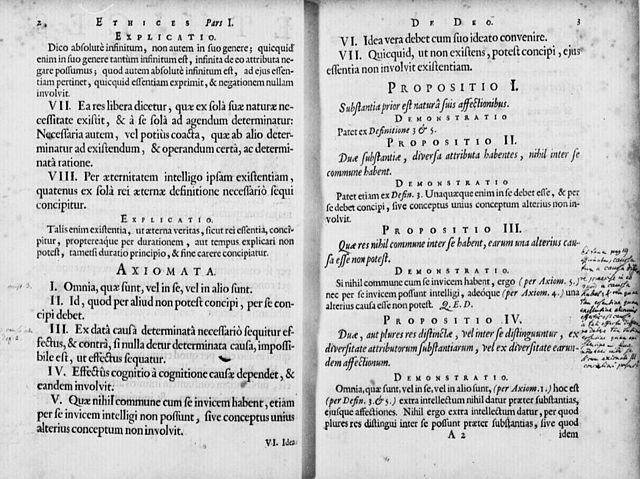

Q.E.D. (Quod erat demonstrandum)

Página del texto original de la obra Ethica more geometrico demonstrata (Ética demostrada a la manera geomérica) del filósofo Spinoza (1632-1677), en la que vemos la abreviatura Q.E.D. al final de la demostración de la tercera proposición. Q.E.D. es una abreviatura de la expresión latina quod erat demonstrandum, que significa “lo que se quería demostrar” y se coloca al final de una demostración matemática para indicar el final de la misma

Página del texto original de la obra Ethica more geometrico demonstrata (Ética demostrada a la manera geomérica) del filósofo Spinoza (1632-1677), en la que vemos la abreviatura Q.E.D. al final de la demostración de la tercera proposición. Q.E.D. es una abreviatura de la expresión latina quod erat demonstrandum, que significa “lo que se quería demostrar” y se coloca al final de una demostración matemática para indicar el final de la mismaPero, como suele ocurrir en matemáticas, no nos paramos aquí. Una vez demostrado el problema de Erdös (Si dado un conjunto infinito de puntos del plano, las distancias entre ellos son todas números enteros, entonces todos los puntos están en una misma línea recta), podemos preguntarnos qué ocurre con un número finito de puntos. ¿Será posible disponer de un número finito n de puntos, para cualquier n, de forma que las distancias entre cualesquiera dos puntos sean números enteros y no estén todos en una recta?

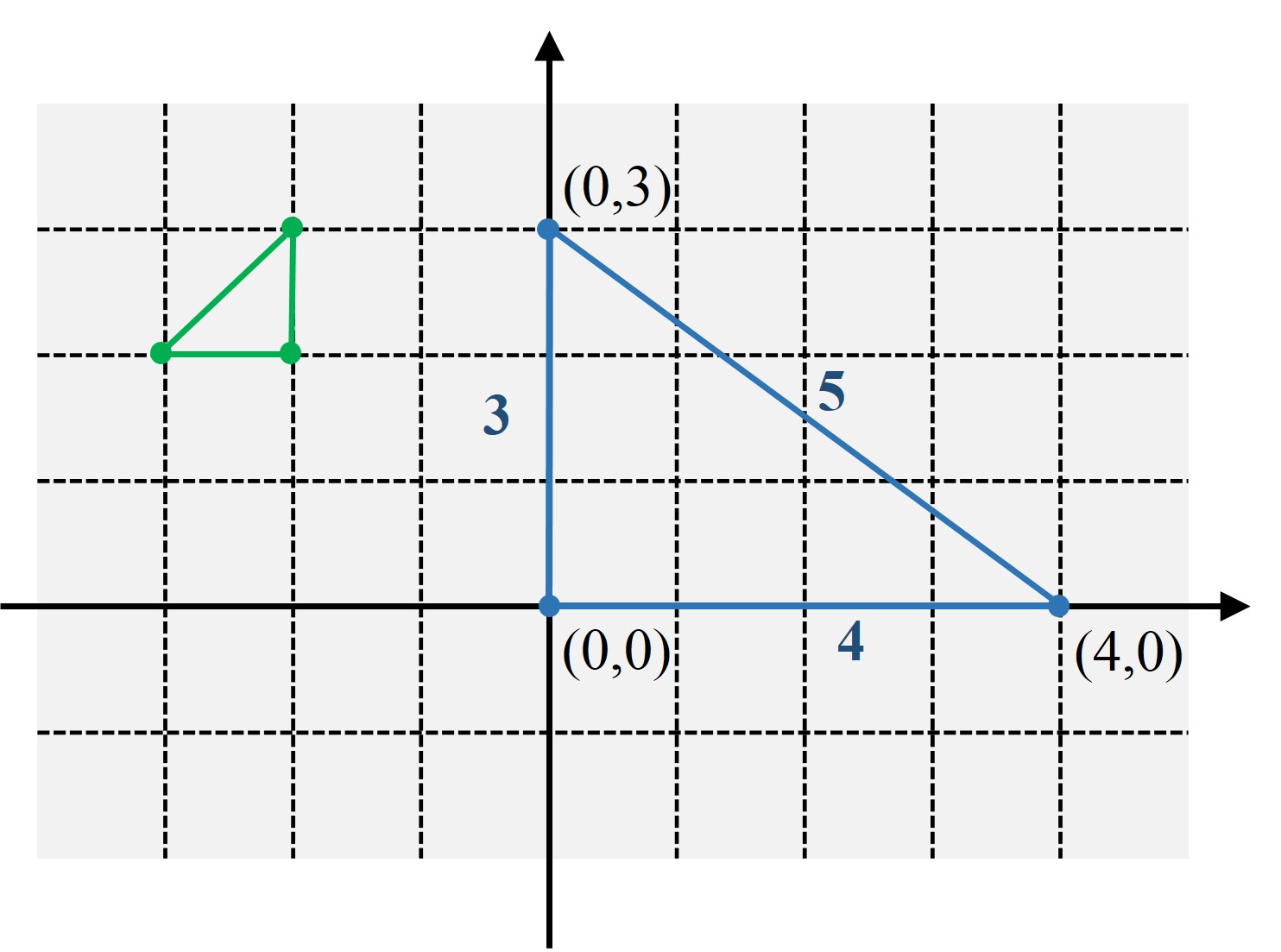

Empecemos planteando el problema para tres puntos. Si consideramos tres vértices de un cuadrado de lado 1, estos no nos valdrán ya que mientras que los lados sí son distancias enteras, en concreto, 1, no lo es la diagonal, cuyo valor es la raíz de 2, sencillamente por el teorema de Pitágoras. Pero este resultado de la geometría clásica nos da una idea para construir un triángulo cuyos tres lados sí sean números enteros. Tomemos una terna pitagórica cualquiera (a, b, c), es decir, a2 + b2 = c2, y construyamos el triángulo rectángulo que tiene por lados esa terna. Por ejemplo, en el plano coordenado los puntos (0, a), (0, 0) y (b, 0). En la imagen siguiente hemos dibujado (en azul) el correspondiente a la terna (3, 4, 5).

Precisamente, el matemático David Silverman, en 1963, utilizó las ternas pitagóricas irreducibles para demostrar que podía construirse un conjunto cualquiera de puntos del plano con distancias enteras entre ellos y que no fuesen colineales. Para empezar, recordemos que una terna pitagórica (a, b, c), es decir, a2 + b2 = c2, se dice que es irreducible si los tres números a, b y c no tienen, dos a dos, divisores comunes. Por ejemplo, la terna (3, 4, 5) es irreducible, pero no (6, 8, 10).

Sean m ternas pitagóricas irreducibles distintas, (ai, bi, ci), para i = 1, 2, …, m. Tomamos el producto P = a1 x a2 x … x am, David Silverman consideró los m + 1 puntos del plano coordenado siguientes:

(0, P) y ((bi / ai) P, 0), para i = 1, 2, …, m.

Como ai divide a P, cada uno de los puntos anteriores tienen coordenadas enteras, el primero está en el eje de ordenadas (eje y) y los demás en el eje de abscisas (eje x). Y, además, los puntos que están en el eje x distan entre ellos un número entero. Para concluir faltaría ver que la distancia entre el punto (0, P) y cualquiera de los otros ((bi / ai) P, 0) es entera. Esa distancia es

que claramente es entera, ya que ai divide a P.

Además, por ser los triples pitagóricos irreducibles cada punto ((bi / ai) P, 0) es distinto a los demás. Supongamos que existen i y j tales que ((bi / ai) P, 0) = ((bj / aj) P, 0), entonces bi / ai = bj / aj. Luego ai x bj = aj x bi. Como ai y bi no tienen divisores comunes, entonces ai divide a aj y como aj y bj no tienen divisores comunes, entonces aj divide a ai. En conclusión, ai = aj, y de forma equivalente se prueba que bi = bj, lo que implicaría que son el mismo triple pitagórico, lo cual no es cierto.

Por lo tanto, (0,0), (0, P) y ((bi / ai) P, 0), para i = 1, 2, …, m, son m + 2 puntos del plano, no colineales, y que distan entre ellos un número entero.

Efectivamente, el anterior es un ejemplo de un número finito de puntos no colineales que distan entre sí distancias enteras. Sin embargo, podríamos decir que dejan de ser colineales por la mínima ya que todos están en la misma recta, el eje x, salvo el punto (0, P).

En el libro Combinatorial Geometry in the plane, de Hugo Hadwiger y Hans Debrunner se obtiene un resultado más general. Se demuestra que, para cada n, existe un conjunto finito de n puntos del plano, de forma que las distancias entre cualesquiera dos puntos son números enteros y no solo no están todos en una misma recta, sino que, además, no hay tres puntos que sean colineales. Pero esa demostración la dejamos solo para las personas que estén interesadas en ir un poco más allá. Se puede leer en cualquiera de los libros mencionados, Mathematical Diamonds y Combinatorial Geometry in the plane.

El gol de Pitágoras (década 1990), 22 x 45 x 7,5 cm, obra del artista colombiano Bernardo Salcedo (1939-2007). Imagen de la galería El Museo

El gol de Pitágoras (década 1990), 22 x 45 x 7,5 cm, obra del artista colombiano Bernardo Salcedo (1939-2007). Imagen de la galería El Museo Bibliografía

1.- William Timothy Gowers, Las dos culturas de las matemáticas, La GACETA de la RSME, vol. 7.2, pag. 371–386, 2004 (publicado originalmente como The Two Cultures of Mathematics, en Mathematics: Frontiers and Perspectives, V.I. Arnold, M. Atiyah, P. Lax y B. Mazur (eds.), AMS, 1999).

2.- Raúl Ibáñez, La cultura científica o la misteriosa identidad del señor Gauss, CIC-Network, n. 8, pag. 14-17, 2010. (versión online en el Cuaderno de Cultura Científica)

3.- Paul Erdös, Some of My Favourite Problems and Results, perteneciente al libro The Mathematics of Paul Erdös I, editado por Ronald L. Graham y Jaroslav Nesetril, Springer-Verlag, 1997.

4.- Ross Honsberger, Mathematical Diamonds, MAA, 2003.

5.- Hugo Hadwiger, Hans Debrunner, Combinatorial Geometry in the Plane, Dover, 1964.

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo Un dulce problema de Paul Erdös se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El problema de la plantación de árboles en filas (2)

- El problema de la plantación de árboles en filas

- El problema de Malfatti

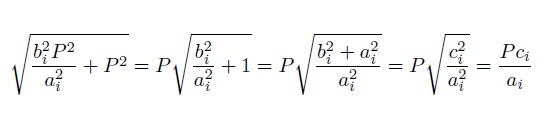

Aplicaciones de la reflexión de ondas: el sonar

Imagen sonar del fondo marino en la que destaca con increíble detalle el pecio del dragaminas de la marina soviética T-297, hundido en aguas de la actual República de Estonia. Imagen: Wikimedia Commons

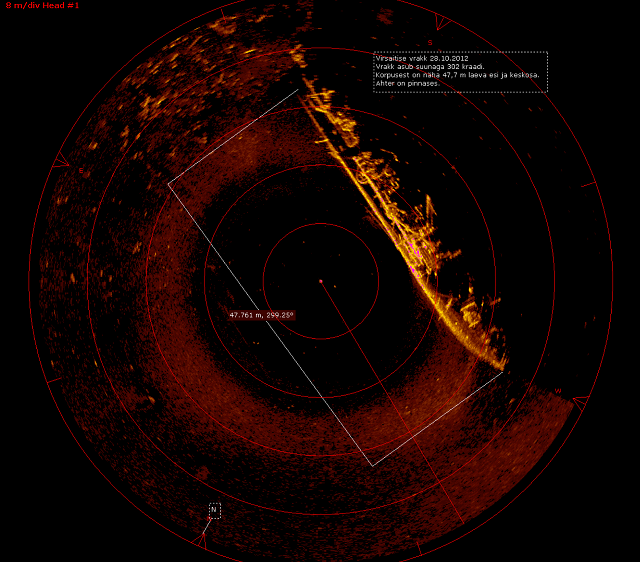

Imagen sonar del fondo marino en la que destaca con increíble detalle el pecio del dragaminas de la marina soviética T-297, hundido en aguas de la actual República de Estonia. Imagen: Wikimedia CommonsHemos visto que los principios básicos de la reflexión de ondas son muy sencillos. No solo eso, con el concepto de rayo son incluso fáciles de ilustrar. Vamos a usar este conocimiento para intentar entender la base de las tecnologías que empleamos diariamente, aunque no seamos conscientes de ello, y consolidarlo. Estas tecnologías se basan en el uso de reflectores de ondas. Podemos encontrar reflectores en los radares de tráfico o en los calefactores infrarrojos, por ejemplo.

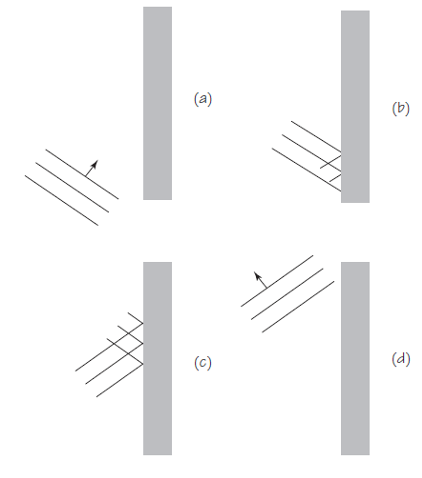

Un poco de geometría elemental nos será muy útil. La Figura 1 (a) y (b) muestra cómo los rayos se reflejan en dos reflectores circulares. Recordemos que en estos esquemas solo se muestran algunos rayos incidentes y reflejados. (Las líneas de puntos son perpendiculares a la superficie de la barrera, para recordarlos que el ángulo incidente es igual al ángulo del rayo reflejado, Θi = Θr .) Los rayos reflejados desde el semicírculo (a) se alejan en todas direcciones. Sin embargo, los rayos reflejados desde un pequeño segmento del círculo (b) se acercan hasta casi juntarse en un solo punto. Los reflectores en forma de semicírculo no son muy útiles.

Figura 1. Fuente: Cassidy Physics Library

Figura 1. Fuente: Cassidy Physics LibraryUna barrera con la forma de una parábola (c) enfoca los rayos con bastante precisión en un punto, el foco de la parábola. En otras palabras, una superficie parabólica refleja ondas planas y las concentra en un punto. Un ejemplo impresionante es un radiotelescopio. Su enorme superficie parabólica refleja ondas de radio muy débiles del espacio exterior para enfocarlas en un detector. El mismo principio lo emplean las antenas parabólicas para la recepción de señales de satélites, para ver la televisión, por ejemplo.

Radiotelescopio de Parkes (NSW, Australia), de 64 metros de tamaño, durante la puesta de Sol. La antena tiene forma parabólica y el detector está en su foco. Crédito: Ángel R. López-Sánchez (AAO/MQU).

Radiotelescopio de Parkes (NSW, Australia), de 64 metros de tamaño, durante la puesta de Sol. La antena tiene forma parabólica y el detector está en su foco. Crédito: Ángel R. López-Sánchez (AAO/MQU).Nada impide que las trayectorias de de los rayos indicadas en los diagramas se inviertan. Por ejemplo, si producimos ondas esféricas producidas en el foco las convertimos en ondas planas cuando se reflejan desde una superficie parabólica. La linterna y o el faro delantero de un coche son aplicaciones familiares de este principio. En estos casos una fuente de luz, ya sea una filamento incandescente, una bombilla halógena o un LED, colocados en el foco de un reflector parabólico producen rayos de luz casi paralelos.

En este punto es posible que sea necesario recordar que todas las afirmaciones que hemos hecho a lo largo de la serie se refieren a ondas mecánicas, auqnue estemos empleando la parte común con las ondas electromagnéticas en estos ejemplos.

Una aplicación con ondas sonoras es el sonar (del acrónimo inglés que se traduce como navegación y localización por sonido), empleado en la navegación y localización de objetos en el mar: desde barcos de pesca buscando bancos de peces, pasando por buques oceanográficos cartografiando el fondo marino o cazatesoros buscando barcos hundidos, a submarinos buscando su ruta o enemigos. Su desarrollo fue una cuestión de supervivencia durante la Primera Guerra Mundial, y para 1918 ya existían instrumento SONAR tanto activos (emiten sonido) como pasivos (solo “escuchan”). La Segunda Guerra Mundial llevó al desarrollo de su equivalente electromagnético, también como una cuestión de supervivencia para la bombardeada Inglaterra, el radar. Ambos sistemas se basan en dos principios básicos de la reflexión de ondas: el efecto eco y el desplazamiento Doppler.

El eco es un fenómeno muy familiar: grita tu nombre en una gran sala vacía y las paredes parecen gritarte a ti. Este tipo de eco es el resultado de la reflexión de las ondas de sonido en una superficie. Un pulso de ondas de sonido enviadas desde una antena se reflejará desde cualquier objeto que golpee, y parte de la onda volverá a donde se originó. El tiempo que transcurre entre la emisión del pulso y la recepción de la parte reflejada del pulso se puede usar para determinar la distancia entre el punto y la superficie reflectante. Esta es la descripción de un sonar activo.

![]()

El desplazamiento Doppler, también muy común en la vida diaria, ocurre cuando las ondas de cualquier tipo son emitidas o reflejadas por un cuerpo en movimiento. (Todo el mundo lo ha experimentado como el cambio en la frecuencia del ruido de un coche o el silbato de un tren mientras está en movimiento). Si las ondas enviadas desde un punto se reflejan en un cuerpo en movimiento, las ondas que regresan parecerán tener una mayor frecuencia si el objeto se mueve hacia el punto de emisión y una frecuencia más baja a medida que el objeto se aleja de él. Por lo tanto, la medición del desplazamiento Doppler de las ondas reflejadas se puede utilizar para determinar rápidamente la velocidad y la dirección de la superficie reflectante.

El sonar funciona muy bien en el agua y lo utilizan con gran éxito los submarinos para “ver” sin ver, tanto el entorno como a las amenazas. Pero el sonar no es práctico para su uso en el aire, porque en éste las ondas de sonido ordinarias no viajan lo suficientemente lejos, y su eco es demasiado débil para ser útil en detecciones precisas.

En este fragmento de “La caza del Octubre Rojo” vemos (y oímos) el uso del SONAR en todo su esplendor:

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Aplicaciones de la reflexión de ondas: el sonar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Reflexión de ondas: rayos

- Las ondas están por todas partes

- Patrón de interferencia en ondas periódicas

Estamos perdiendo el norte pero que no cunda el pánico porque lo vamos a recuperar

Hay pocas cosas inmutables en esta vida, e incluso aquellas que creemos que lo son a veces nos sorprenden mutando. El Polo Norte es una de ellas. Me refiero al polo norte magnético en esta ocasión, no al continente que llamamos Ártico o Polo Norte (de la deriva continental ya hablaremos otro día).

El caso es que el polo norte magnético, el punto hacia el que apuntan siempre nuestras brújulas y que utilizan los más sofisticados sistemas de posicionamiento como nuestros GPS y otros sistemas de satélites, ya no está donde estaba antes porque su posición está variando de forma constante y, sabemos ahora, más rápida de lo que los geólogos se esperaban.

Variación de la posición del polo norte magnético en periodos de 5 años, la última en 2015, y proyección de su posición en 2020. Fuente: World Data Center for Geomagnetism/Universidad de Kyoto

Variación de la posición del polo norte magnético en periodos de 5 años, la última en 2015, y proyección de su posición en 2020. Fuente: World Data Center for Geomagnetism/Universidad de KyotoQue el polo norte magnético de la Tierra se está desplazando no es una novedad, lo ha hecho desde siempre y siempre lo hemos sabido. Si en torno a 1900 se encontraba en algún punto bajo Canadá, desde entonces ha ido alejándose de Norteamérica y acercándose a Siberia.

Un modelo que se desactualiza por momentos

Conscientes de esta situación y de la necesidad que la tecnología tiene hoy en día de tener el campo magnético terrestre perfectamente ubicado, geólogos de distintas instituciones científicas crearon y mantienen el llamado Modelo Magnético Mundial, una representación detallada de los campos magnéticos de la Tierra que sirve como estándar para el trabajo y las observaciones, entre otros, de la OTAN, la OMS o el Departamento de Defensa Estadounidense. Es de donde sacan la referencia también los sistemas de GPS que utilizan servicios como Google Maps.

Este modelo iba ser actualizado este mes de enero (aunque con el cerrojazo al gobierno estadounidense no está claro si finalmente podrá ser así) y eso no estaba previsto. Los equipos encargados de esta tarea están un poco desconcertados. Porque la última actualización se produjo en 2015 y debía ser suficiente hasta 2020, pero acaba de empezar 2019 y el desplazamiento del polo norte se ha acelerado tanto en los últimos meses que la diferencia entre el modelo y la realidad no para de aumentar. A principios de 2018 esa diferencia estaba a punto de superar los márgenes de error aceptables para los sistemas de navegación, así que el nuevo cambio no puede esperar más.

¿Por qué este acelerón inesperado en un proceso, el de la deriva del polo norte magnético, que si bien todavía no comprendemos perfectamente sí hemos sabido predecir hasta ahora? Hay varios motivos que lo explican.

El inesperado meneo de 2016

El primero es que en 2016, justo después de la última actualización del Modelo Magnético Mundial, cuando lo teníamos todo perfectamente colocadito para los próximos cinco años, al campo magnético de la Tierra le dio por hacer cosas raras de repente: se aceleró temporalmente bajo la zona norte de Sudamérica y la zona este del Pacífico. Este fenómeno, que no se había previsto, ya descolocó de partida el modelo recién actualizado, provocando que el cambio sí previsto ocurriese a mayor velocidad.

Por otro lado, el propio movimiento del polo magnético que, como decimos, fascina a los geólogos desde que se documentó por primera vez en 1831 pero todavía no lo comprendemos del todo. Sí sabemos que ha ido cogiendo velocidad en las últimas décadas: si hasta los 90 se movía unos 15 kilómetros al año, en ese momento aceleró y comenzó a moverse unos 55 kilómetros anuales. En el año 2001 entró oficialmente en el Océano Ártico, y lo está cruzando desde entonces, desde Canadá hacia Siberia.

Las consecuencias de este movimiento y del error existente respecto al modelo establecido son relativas. No es lo mismo el uso de una brújula para orientarse si salimos de excursión a la montaña en España, por ejemplo, que si somos una expedición en el Ártico. Allí no solo hay muchas menos referencias orientativas, sino que además por la geografía del lugar y su cercanía al Polo, el error se magnifica y puede convertirse en un riesgo para barcos y equipos que se desorienten en el lugar.

Por eso se decidió adelantar la siguiente actualización del modelo. Equipos del NOAA (National Oceanic and Atmosferic Administration) y del British Geological Survey, en Edimburgo, han actualizado el sistema con datos exhaustivos de los últimos tres años, incluido el impulso magnético inesperado de 2016 para corregir los errores actuales y mantener el modelo hasta su siguiente actualización que debería hacerse, si todo sigue según lo previsto, en 2020.

¿Por qué está pasando esto?

También intentan entender por qué el desplazamiento magnético se ha acelerado tanto en las últimas décadas y a qué se deben los acelerones ocasionales para poder preverlos y adelantarse a ellos.

Lo ocurrido en 2016 no tiene aun una explicación clara, pero hay varias hipótesis. Una de ellas es que estuviese provocado el movimiento en forma de olas de los metales y otros materiales en estado líquido que se encuentran en el núcleo terrestre y que pueden alterar el campo magnético de la superficie.

En cuanto al desplazamiento habitual pero cada vez más rápido del polo norte desde Canadá hacia Siberia, se cree que el motivo podría ser también el movimiento de materiales líquidos en el núcleo de la Tierra. En concreto, se ha detectado y medido una corriente de hierro líquido que circula a gran velocidad precisamente debajo de Canadá, y ese parece ser el motivo. La corriente, que mide 420 kilómetros de ancho, ha ido creciendo a un ritmo de 40 kilómetros al año entre los años 2000 y 2016, explicando así la aceleración que los científicos han observado.

Referencias:

Earth’s magnetic field is acting up and geologists don’t know why – Nature.com

World Magnetic Model – British Geological Survey

Geomagnetic acceleration and rapid hydromagnetic wave dynamics in advanced numerical simulations of the geodynamo – Geophysical Journal International

An accelerating high-latitude jet in Earth’s core – Nature Geoscience

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Estamos perdiendo el norte pero que no cunda el pánico porque lo vamos a recuperar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Las tres conquistas del Polo Norte

- Geología: la clave para saber de dónde venimos y hacia dónde vamos

- El Antropoceno: ¿estamos en un nuevo tiempo geológico?

El ocre rojo de la antigüedad y los porqués de sus propiedades

Diferentes muestras de miltos. La muestra ‘e’ es una pieza otomana del siglo XVI, la ‘b’ es una muestra control de óxido amarillo. Fuente: E. Photos-Jones et al (2018)

Diferentes muestras de miltos. La muestra ‘e’ es una pieza otomana del siglo XVI, la ‘b’ es una muestra control de óxido amarillo. Fuente: E. Photos-Jones et al (2018)A la variedad de ocre rojo a la que los griegos llamaban miltos se le atribuían en la antigüedad clásica propiedades notables, razón por la que era muy valorado. Se utilizaba como pigmento para el mantenimiento de embarcaciones, en agricultura, como cosmético, y en medicina. El miltos es una mezcla de goethita (forma mineral del oxihidróxido de hierro), hematita (forma mineral del óxido férrico) y calcita (forma mineral del carbonato cálcico), y está formado por partículas muy finas. El que se usaba en la época clásica procedía de enclaves muy concretos, como la isla de Kea, en las Cíclades; la isla de Lemnos, en el mar Egeo; y Sinope, Capadocia, aunque muy probablemente, su composición variaba dependiendo de su procedencia.

Además de su composición química y estructura, las propiedades de los minerales pueden depender de los microorganismos adheridos a su superficie. Cuanto más pequeño es un objeto, mayor es la superficie con relación al volumen. Dado el pequeñísimo tamaño de las partículas que lo conforman -entre 30 y 700 nm de diámetro-, un mineral como el miltos tiene, por unidad de masa, una gran superficie y sobre ella puede crecer una rica película microbiana. Por otro lado, la composición de la comunidad microbiana depende de las propiedades químicas del mineral y muy en especial de su contenido en ciertos metales que pueden resultar tóxicos. Por ello, también sus posibles efectos sobre otros seres vivos variarán en función de esos rasgos.