Blanca Martínez García – Naukas Bilbao 2019: Godzilla, king of the geologists

Shin Godzilla. Fuente: Noger Chen / Wikimedia Commons

Shin Godzilla. Fuente: Noger Chen / Wikimedia CommonsEs muy humano eso de inventarse criaturas fantásticas para explicar cosas reales pero extraordinarias como terremotos o tsunamis. Blanca Martínez nos trae en esta charla una buena colección de cosas que no son dinosaurios radioactivos pero que sí salen en películas y que generan fenómenos naturales perfectamente explicables por la geología.

Blanca Martínez García es licenciada y doctora en Geología por la Universidad del País Vasco, siendo especialista en reconstrucciones paleoambientales, paleoecología y paleoceanografía (varios resultados de sus investigaciones han sido recogidos en el Cuaderno de Cultura Científica: 1, 2) . Actualmente es miembro activo de la Sociedad de Ciencias Aranzadi, vocal de la Sociedad Geológica de España y una de las coordinadoras de la Comisión Mujeres y Geología de la Sociedad Geológica de España.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Blanca Martínez García – Naukas Bilbao 2019: Godzilla, king of the geologists se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Zientziateka: Blanca Mª Martínez García – La geología fantástica de Verne, Poe y H.P. Lovecraft

- Blanca Martínez: “Los geólogos le tenemos mucho cariño a Godzilla”

- Alfredo García – Naukas Bilbao 2019: Derribando mitos sobre la energía nuclear

Gerrymandering: cuando los políticos eligen a sus votantes

Annick Laruelle

Campaña contra el gerrymandering en el estado Michigan (EE.UU.) en 2018. Fuente: Shutterstock / Susan Montgomery

Campaña contra el gerrymandering en el estado Michigan (EE.UU.) en 2018. Fuente: Shutterstock / Susan Montgomery

Para muchos estados, la representación en el congreso tiene que ser geográfica e igualitaria. El objetivo geográfico se obtiene dividiendo el país en circunscripciones electorales. Tradicionalmente hay dos formas de conseguir el objetivo igualitario. En los sistemas proporcionales cada circunscripción tiene un número de representantes que depende de su población. En los sistemas mayoritarios las circunscripciones tienen poblaciones parecidas y cada una de ellas tiene un único representante.

Cada diez años, se realiza el censo de la población en EEUU. El último fue en 2020. Éste va a determinar el número de escaños que tendrá cada estado en la Cámara de los Representantes hasta 2030. Según las primeras estimaciones unos 17 estados podrían ver su número de escaños afectado, lo que modificará el reparto de poder entre los estados.

Los datos del censo sirven también para garantizar que todas las circunscripciones electorales de un estado tengan poblaciones parecidas. En 2021 las fronteras de las circunscripciones se modificarán para satisfacer este objetivo. El diseño no es neutral, puede determinar el resultado electoral. Sin embargo, el dibujo de las fronteras está generalmente en manos del poder legislativo.

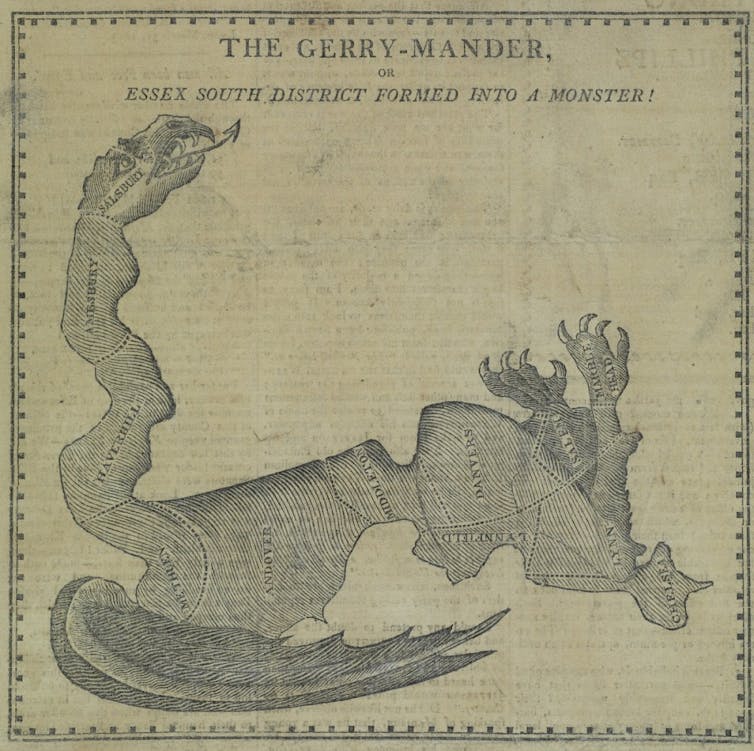

El gerrymandering dibuja las fronteras para favorecer a un grupo de la población o a un partido. El origen del nombre se remonta a 1812 cuando una circunscripción que diseñó el gobernador E. Gerry se caricaturizó como una salamandra (“salamander”).

Fuente: National Museum of American History / Smithsonian

Fuente: National Museum of American History / SmithsonianLos dos lemas del gerrymandering son “dispersión y concentración” (“CRACK and PACK”). Una técnica consiste en dispersar los votos de la oposición para dejarla en minoría en el mayor número de circunscripciones posible. Otra técnica consiste en concentrar los votos de la oposición en un pequeño número de circunscripciones donde la oposición gana con una amplia mayoría. Si las técnicas son muy antiguas, los métodos informáticos son cada vez más sofisticados y la información sobre los electores más extensa.

En 2010 un comité republicano creó el proyecto REDMAP para ayudar a redibujar las circunscripciones después del censo de 2010. Thomas Hofeller, uno los estrategas del proyecto, afirmó en una conferencia que este proceso era una elección a la inversa, en el sentido que permitía a los políticos elegir a sus votantes.

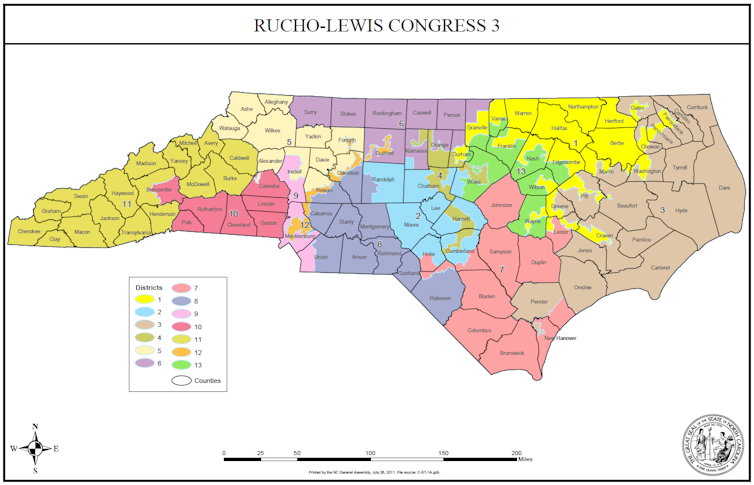

La efectividad del proyecto se puede ilustrar en el estado de Carolina del Norte.

Las 13 circunscripciones dibujadas después del censo de 2010 son muy poco compactas, en particular las con números 1, 4 y 12. En estas tres circunscripciones los demócratas ganaron las elecciones de 2012 y 2014 con porcentajes de votos superior al 70%. Los republicanos ganaron las elecciones en todos las otras circunscripciones (salvo una en 2012) pero con pequeños márgenes.

Mapa electoral de Carolina del Norte (elecciones 2012 y 2014). Fuente: North Carolina General Assembly

Mapa electoral de Carolina del Norte (elecciones 2012 y 2014). Fuente: North Carolina General AssemblyAl nivel global del estado, el partido demócrata consiguió menos de 31% de los escaños (4 de 13) en 2012, aunque recibió casi 51% de los votos. En 2014, obtuvo 44% de los votos, que se tradujeron en 23% de los escaños (3 de 13). En 2016, el tribunal supremo federal declaró el mapa anticonstitucional por gerrymandering de tipo racial. El poder legislativo tuvo que modificarlo.

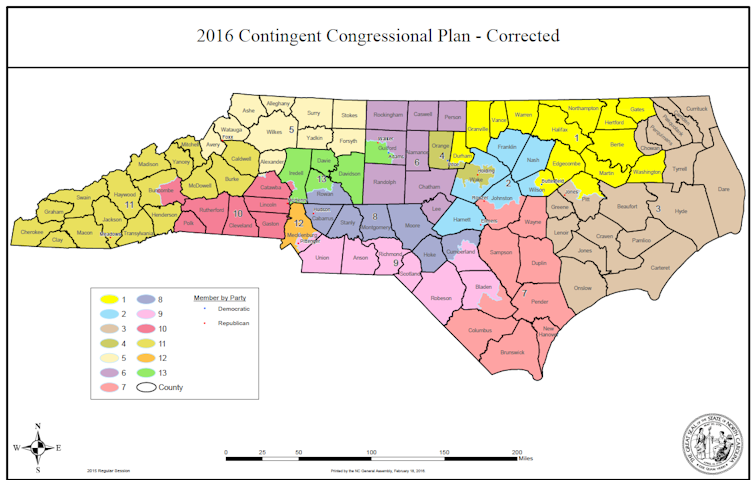

Mapa electoral de Carolina del Norte (elecciones 2016 y 2018). Fuente: North Carolina General Assembly

Mapa electoral de Carolina del Norte (elecciones 2016 y 2018). Fuente: North Carolina General AssemblyEn 2016 y 2018 el partido demócrata obtuvo de nuevo 23% de los escaños a pesar de haber obtenido en ambas elecciones más de 46% de los votos. En 2019 un tribunal estatal reconoció el carácter partidista del mapa electoral modificado. Una vez más el poder legislativo tuvo que redibujar las 13 circunscripciones.

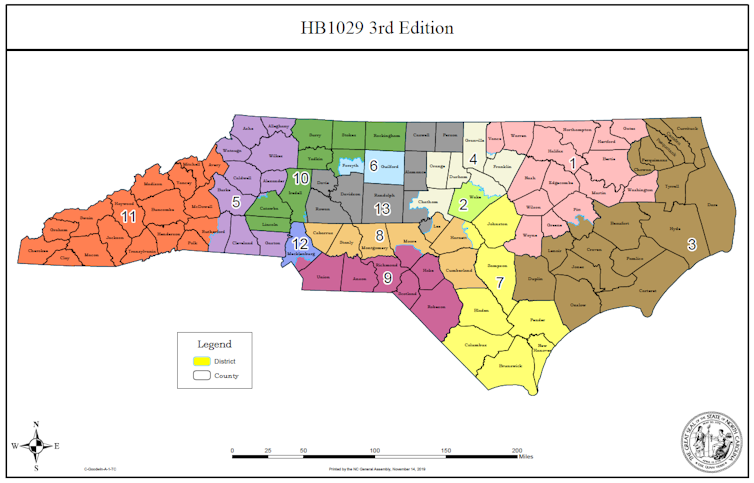

Mapa electoral de Carolina del Norte (eleccion de 2020). Fuente: North Carolina General Assembly

Mapa electoral de Carolina del Norte (eleccion de 2020). Fuente: North Carolina General AssemblyEn 2020 la diferencia entre porcentajes de votos y porcentaje de escaños se redujo: los demócratas obtuvieron casi 50% de los votos y 38% de los escaños (5 de 13). El censo realizado en 2020 modificará de nuevo el mapa, en principio con una circunscripción adicional.

Los republicanos no son los únicos que practican el gerrymandering. En 2019 se intentó conseguir la inconstitucionalidad del mapa electoral de Maryland (dibujado por los demócratas). Hasta la fecha los tribunales federales se han negado a condenar el gerrymandering de tipo partidista.

Demostrar la existencia de gerrymandering no es siempre una tarea fácil. No es suficiente constatar que el porcentaje de votos no coincide con el porcentaje de escaños. A veces es la geografía la que genera diferencias entre votos y escaños.

En un artículo reciente investigadores de la universidad de Duke analizaron los mapas electorales de Carolina del Norte. Dibujaron de manera aleatoria más de 66 000 mapas alternativos. Calcularon las distribuciones de escaños que se habrían obtenido con esos mapas. Las distribuciones de escaños obtenidas en las elecciones de 2012 y 2014 ocurren con una frecuencia inferior a 1% con los mapas alternativos, es decir son muy poco probables.

Además mostraron que pequeños cambios en las fronteras de las circunscripciones demócratas habrían modificado de manera sustancial los resultados. Concluyeron la existencia de gerrymandering. Sin embargo, admitieron que la geografía del estado es más favorable a los republicanos que a los demócratas.

Los objetivos de representación geográfica y representación igualitaria son difícilmente compatibles. Quizás es el momento de replantearse la importancia de la representación geográfica en comparación con el objetivo de tratamiento igual para todos los votantes.![]()

Sobre la autora: Annick Laruelle es profesora IKERBASQUE en el Departamento de Análisis Económico de la Universidad del País Vasco / Euskal Herriko Unibertsitatea

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Gerrymandering: cuando los políticos eligen a sus votantes se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Lo que la búsqueda de inteligencia extraterrestre nos enseña para entender la pandemia

- Políticos y científicos

- Cuando sí es lupus

Los antiguos radicales libres ahora se llaman ROS y no son tan malos

Alfonso Blázquez Castro

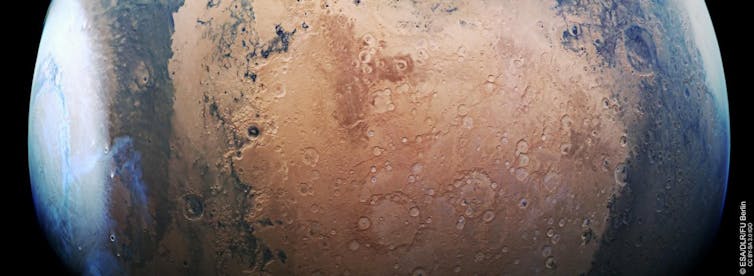

Distintos niveles de ROS (color rojo) en células humanas en cultivo. Fuente: Alfonso Blázquez Castro

Distintos niveles de ROS (color rojo) en células humanas en cultivo. Fuente: Alfonso Blázquez Castro

La virtud fue definida como “el punto medio entre dos vicios” hace más de dos mil años, por Aristóteles. Siglos después, Paracelso establecía que no existían venenos, sino concentraciones dañinas de todas las sustancias.

Estas dos reflexiones son perfectamente aplicables al papel del oxígeno en la biología celular, que ha pasado por distintas etapas en relación a su “bondad” o “maldad”. En un primer momento se observó que el oxígeno es imprescindible para sostener la vida tal y como la conocemos. Sin embargo, en la primera mitad del siglo XX se confirmó que el oxígeno daba lugar a una serie de alteraciones dañinas en las células a largo plazo.

Nacía así el concepto de radicales libres o “teoría de los radicales”, que achacaba a estos compuestos derivados del uso oxígeno el origen de muchos procesos negativos para la vida, como el envejecimiento, el cáncer y otras muchas enfermedades.

En los inicios del siglo XXI se ha empezado a entender mejor el papel de estos “radicales”. Los científicos que nos dedicamos a su estudio estamos encontrando “la virtud entre dos vicios” en relación con ellos. Aunque ahora los llamamos, más correctamente, especies reactivas de oxígeno (ROS, por sus siglas en inglés).

¿Qué son las Especies Reactivas de Oxígeno?

Son un conjunto de compuestos químicos que contienen oxígeno en su fórmula y una mayor o menor reactividad química y capacidad de oxidar. Las más conocidas son el superóxido (O2–), el peróxido de hidrógeno (H2O2, a menudo llamada “agua oxigenada”) y el radical hidroxilo (· OH).

Desde hace muchas décadas se sabe que estas ROS son el resultado inevitable de la respiración en las células. Podría decirse que son como el “humo” del tubo de escape del “motor celular”. A lo largo de los años esta contaminación provoca un daño en nuestras células. Las células pueden anular el daño de las ROS usando compuestos que llamamos reductores, que permiten mantener un equilibrio entre el daño y la salud celular.

Pero lo realmente interesante es que ahora sabemos que las células también producen ROS de manera intencionada. En este caso funcionan como “mensajeros” que llevan mensajes de una parte a otra de la célula, o entre distintas células del cuerpo. Por ejemplo, dependiendo del momento del ciclo celular, más cerca o lejos de dividirse, las células muestran niveles internos de ROS distintos.

Históricamente, la fuente principal de ROS han sido las mitocondrias. Estas estructuras producen la mayor parte de la energía de la célula. Actualmente siguen siendo una fuente muy importante de ROS, pero el giro interesante es que sabemos que muchas de esas ROS se producen a propósito en las mitocondrias y no como resultado de la “mala combustión” que mencionábamos antes.

En paralelo, se ha probado que existen mecanismos alternativos, también bajo un fuerte control celular, para producir ROS cuando son necesarias en otras partes de la célula, como la membrana, el retículo endoplasmático o el medio exterior. Estos mecanismos se basan en proteínas cuya función es la producción de ROS.

Al mismo tiempo, las células producen en todo momento esos compuestos reductores que controlan la acción de las ROS. De esta manera, son capaces de regular de manera muy precisa el dónde y el cuánto de los mensajes que usan ROS como señales.

El mecanismo de señalización de las ROS

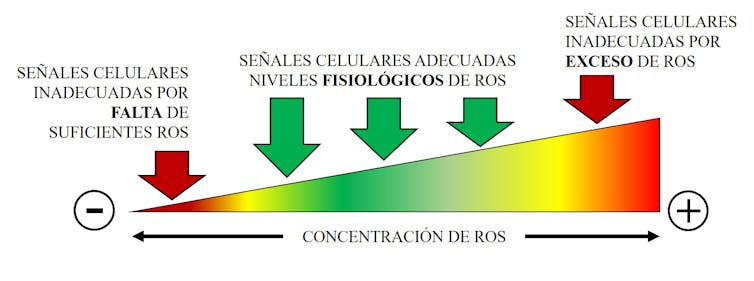

Al final, lo que parece indiscutible es que los niveles de ROS no deben ser ni muy altos, ya que provocan daños y “oxidan” la célula, ni muy bajos, ya que no podrían actuar como mensajeros.

En el siguiente esquema se plasma de manera sencilla esta idea. Existe un rango de niveles de ROS que son óptimos para su función celular. Demasiado altos o demasiado bajos, y se echa a perder su utilidad. Existe un punto intermedio adecuado entre dos extremos indeseables.

Los niveles de ROS no deben ser ni muy altos, ya que provocan daños a la célula, ni muy bajos, ya que no podrían actuar como mensajeros. Fuente: Alfonso Blázquez Castro

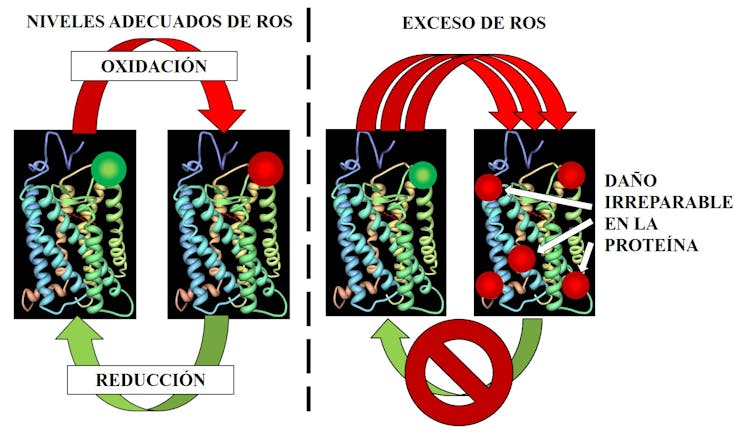

Los niveles de ROS no deben ser ni muy altos, ya que provocan daños a la célula, ni muy bajos, ya que no podrían actuar como mensajeros. Fuente: Alfonso Blázquez CastroPero, ¿cómo pueden las ROS actuar de mensajeros dada su reactividad? La respuesta se encuentra en las proteínas, las máquinas microscópicas que llevan a cabo el metabolismo celular. Algunas proteínas tienen partes que son especialmente sensibles a la oxidación de las ROS. En las concentraciones adecuadas, estas zonas se oxidan y cambian la estructura de la proteína.

Igual que ocurre con un interruptor, la proteína se puede “encender” o “apagar”, dependiendo de su función. Tras un cierto tiempo, la zona oxidada de la proteína se vuelve a reducir y la proteína vuelve a su estado inicial.

Esta es la base del control en las funciones celulares por parte de las ROS: niveles adecuados de ROS y de compuestos reductores permiten que las proteínas se “enciendan” o “apaguen” de manera correcta. Ahora bien, si hay un exceso de ROS, las proteínas se oxidan en demasiados sitios y estos cambios son permanentes: ya no se puede volver al estado inicial y la proteína queda dañada e inservible. Esta es la razón por la cual demasiadas ROS alteran de manera tóxica el metabolismo celular y terminan provocando multitud de trastornos y enfermedades.

A la izquierda, representación de cómo niveles adecuados de ROS y reductores permiten que las proteínas se enciendan o apaguen de manera correcta. A la derecha, lo que sucede cuando hay exceso de ROS: cambios permanentes que dañan las proteínas de manera irreversible. Fuente: Alfonso Blázquez Castro

A la izquierda, representación de cómo niveles adecuados de ROS y reductores permiten que las proteínas se enciendan o apaguen de manera correcta. A la derecha, lo que sucede cuando hay exceso de ROS: cambios permanentes que dañan las proteínas de manera irreversible. Fuente: Alfonso Blázquez CastroCon este mejor conocimiento de la acción de las ROS se están consiguiendo importantes progresos en el tratamiento de diversas enfermedades. Sabemos, por ejemplo, que se producen demasiadas ROS en el corazón durante los infartos de miocardio, o en el cerebro tras un ictus.

Una forma muy prometedora de abordar estos problemas es disminuir de manera eficaz la producción de ROS en el paciente con nuevos fármacos. Esta es una línea de investigación muy importante en la actualidad.

Y, así, buscando el punto medio entre dos extremos, encontramos no sólo la virtud sino también la salud.![]()

Sobre el autor: Alfonso Blázquez Castro es profesor ayudante doctor en genética en la Universidad Autónoma de Madrid

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Los antiguos radicales libres ahora se llaman ROS y no son tan malos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La ciencia de la cosmética antioxidante contra los radicales libres

- Radicales libres, el libro

- Cuando las algas rojas no pueden gestionar los radicales libres

6.174, un número seductor

Mientras escribía mi último libro Números primos, amigos y demás familia (Catarata, 2021), que estará en las librerías en abril, he descubierto números con propiedades muy curiosas e interesantes, entre ellos, la constante de Kaprekar.

Número 6.174 realizado con las Tarjetas de Cumpleaños Art Nouveau de la diseñadora estadounidense Laura Beckman. Imágenes de la página de Laura Beckman

Número 6.174 realizado con las Tarjetas de Cumpleaños Art Nouveau de la diseñadora estadounidense Laura Beckman. Imágenes de la página de Laura Beckman

El número 6.174 es aparentemente un número de lo más normal, un número de esos que no llamaría nuestra atención, sin embargo, posee una propiedad matemática que parece pura magia. En 1949 el matemático recreativo indio Dattatreya Ramchandra Kaprekar (1905–1986) publicó el artículo Another Solitaire Game, en la revista Scripta Mathematica, en el que describía las curiosas propiedades que había descubierto sobre el 6.174, aunque fue la publicación en la columna Mathematical Games de Martin Gardner en la revista Scientific American, lo que le daría un mayor reconocimiento.

Consideremos un número de cuatro dígitos cualquiera, tal que estos no sean todos iguales (por ejemplo, 6.282), con sus dígitos escribimos los números mayor y menor que se pueden representar, es decir, 8.622 y 2.268, y los restamos

8.622 – 2.268 = 6.354.

Ahora repetimos este proceso,

6.543 – 3.456 = 3.087.

Seguimos con el mismo proceso,

8.730 – 0378 = 8.352.

Este parece un proceso artificial en el que se irán generando números sin parar. Sin embargo, en el siguiente paso se alcanza el número 6.174, ya que

8.532 – 2.358 = 6.174.

Y nuestro número 6.174 es un número particular respecto a este proceso ya que este se estaciona y siempre queda 6.174.

7.641 – 1.467 = 6.174.

Al proceso descrito se le llama algoritmo de Kaprekar y lo sorprendente es que siempre –salvo para números con los cuatro dígitos iguales– se llega a la denominada constante de Kaprekar, el número 6.174. Veamos otro ejemplo. Si empezamos con el número de cuatro dígitos –recordemos que no todos iguales– 3.631, la sucesión de números que nos da el algoritmo de Kaprekar es

6.331 – 1.336 = 4.995;

9.954 – 4.599 = 5.355;

5.553 – 3.555 = 1.998;

9.981 – 1.899 = 8.082;

8.820 – 0288 = 8.532;

8.532 – 2.358 = 6.174;

donde se estaciona el proceso, ya que hemos llegado a la constante de Kaprekar. Mientras que en el primer ejemplo habíamos necesitado de cuatro pasos, en este han sido necesarios seis pasos.

Si todos los dígitos del número son iguales, como 7.777, entonces el algoritmo de Kaprekar se estaciona en el primer paso, llegando a cero, ya que el mayor y el menor número que se puede formar con esos dígitos es el mismo 7.777, y entonces 7.777 – 7.777 = 0.

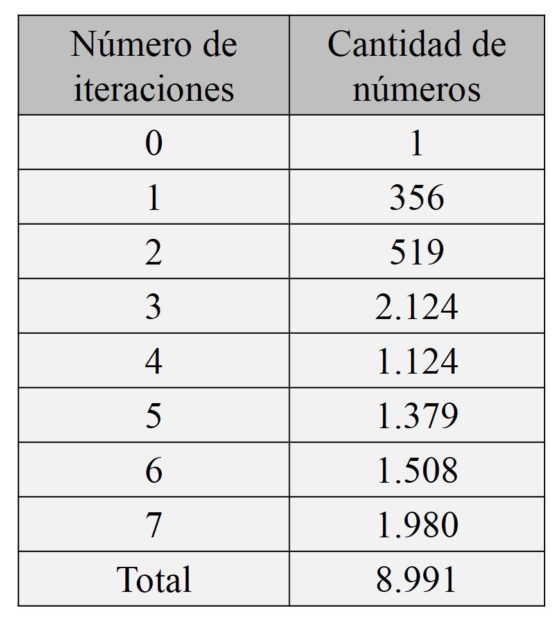

Número 6.174 realizado con la tipografía numérica diseñada por Muokkaa Studio (que es el diseñador madrileño Alejandro López Becerro). Imágenes de la página de Moukkaa en Behance

Número 6.174 realizado con la tipografía numérica diseñada por Muokkaa Studio (que es el diseñador madrileño Alejandro López Becerro). Imágenes de la página de Moukkaa en Behance

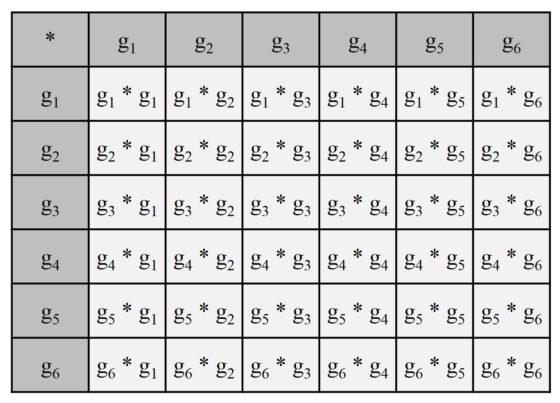

Por lo anteriormente visto, sabemos que el número 6.174 es un punto fijo del algoritmo de Kaprekar, es decir, al aplicarlo a él mismo, nos vuelve a dar ese número: 7.641 – 1.467 = 6.174. Una de las cuestiones que nos podríamos haber planteado inicialmente es el cálculo de todos los puntos fijos que existen para ese algoritmo. Veamos, a continuación, una idea de la prueba de que realmente la constante de Kaprekar es el único punto fijo posible.

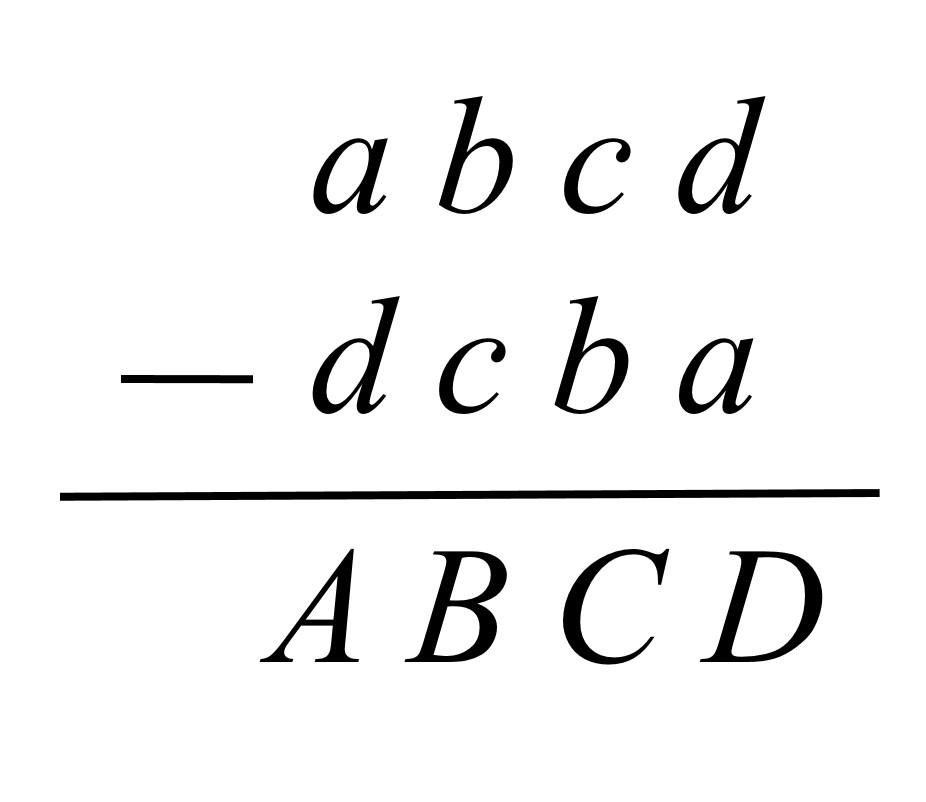

Sea un número de cuatro dígitos, no todos ellos iguales, entonces podemos expresar al mayor número que se puede representar con sus cuatro dígitos como abcd, donde 0 ≤ a ≤ b ≤ c ≤ d ≤ 9, y al menor como dcba, luego la resta de ambos será un número ABCD tal que

de donde se obtienen las siguientes relaciones:

D = 10 + d − a (a > d)

C = 10 + c − 1 − b = 9 + c − b (b > c − 1)

B = b − 1 − c (b > c)

A = a − d.

Como buscamos un punto fijo, sabemos que {A, B, C, D} = {a, b, c, d}, salvo el orden. Como existen 4! = 24 permutaciones (ordenes) posibles de {a, b, c, d}, si probamos todas ellas veremos que el anterior sistema con cuatro ecuaciones y cuatro incógnitas (a, b, c, d) tiene solución única solo cuando A = b, B = d, C = a, D = c. Además, en ese caso la solución única es precisamente a = 7, b = 6, c = 4 y d = 1.

Número 6.174 realizado con las dos tipografías de la UPV/EHU, sin y con serif

Número 6.174 realizado con las dos tipografías de la UPV/EHU, sin y con serif

La siguiente cuestión matemática sería demostrar esta propiedad mágica, es decir, que para cualquier número de cuatro dígitos, tal que estos no sean todos iguales, el algoritmo de Kaprekar llega siempre a la contante de Kaprekar, 6.174. Más aún, se puede probar que el número de pasos para llegar a la constante es como mucho siete. Para quien esté interesado en la demostración de esta propiedad puede consultarla en la literatura que existe sobre esta cuestión, por ejemplo, en el artículo The weirdness of number 6174, de Yutaka Nishiyama.

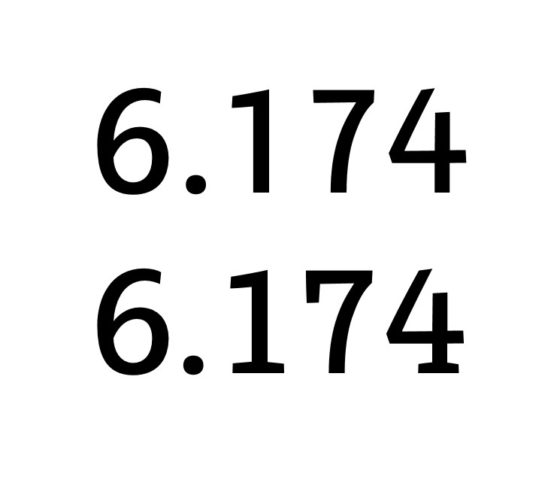

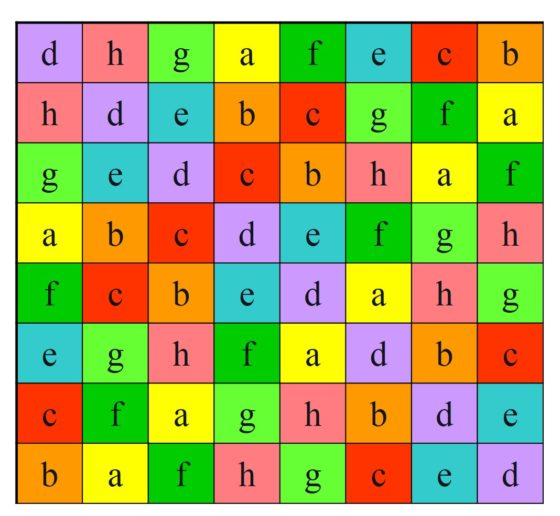

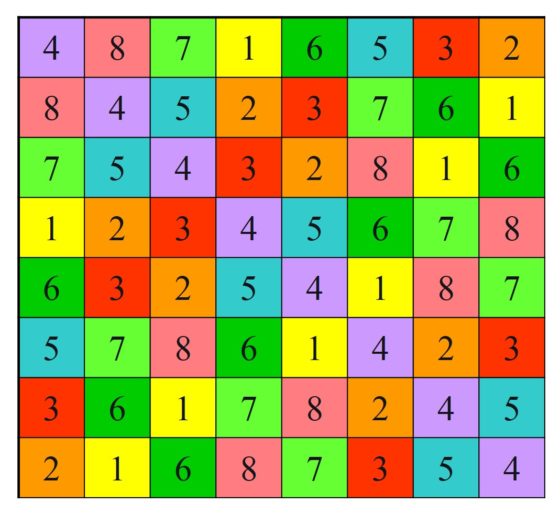

En los ejemplos que se han mostrado en esta entrada del Cuaderno de Cultura Científica, hemos visto que para el número 6.282 se necesitan 4 iteraciones del algoritmo de Kaprekar para llegar a la constante 6.174 y para el número 3.631 se necesitan 6 iteraciones. En el siguiente diagrama vemos la cantidad de números de cuatro dígitos, no todos ellos iguales, que necesitan una cantidad dada de iteraciones para alcanzar el 6.174.

Esta interesante propiedad descubierta por el matemático recreativo indio Dattatreya Ramchandra Kaprekar para números de cuatro dígitos la podríamos pensar para números con otras cantidades de dígitos.

Para números con dos dígitos veamos, para empezar, un ejemplo. Si tomamos el número 53 y realizamos el algoritmo de Kaprekar, la sucesión de números que aparecen es 18, 63, 27, 45, 09, 81 y se repetiría el ciclo 63, 27, 45, 09, 81 todo el tiempo. De hecho, esta situación es la general, para cualquier número de dos dígitos, tal que estos no sean todos iguales, el algoritmo de Kaprekar llega siempre al ciclo 63, 27, 45, 09, 81. Por lo tanto, no existe una contante de Kaprekar de dos dígitos.

Si tomamos un número de tres dígitos, como 184, entonces el algoritmo de Kaprekar da lugar a la sucesión 693, 594 y 495, siendo este último un punto fijo en el que se estaciona la sucesión. De hecho, para números de tres dígitos el número 495 es una constante de Kaprekar, la única para esta cantidad de dígitos.

No existe una constante de Kaprepkar para números de cinco dígitos. Para estos lo que ocurre es que el algoritmo de Kaprekar terminará en alguno de los ciclos siguientes:

Ciclo 1: 53.955, 59.994, 53.955;

Ciclo 2: 61.974, 82.962, 75.933, 63.954, 61.974;

Ciclo 3: 62.964, 71.973, 83.952, 74.943, 62.964.

Mientras que para seis dígitos tenemos una mezcla de las situaciones anteriores. Existen dos constantes de Kaprekar (549.945 y 631.764), es decir, puntos fijos del algoritmo de Kaprekar, a las que convergerán muchas de las sucesiones de números construidas mediante este algoritmo, y un ciclo (420.876, 851.742, 750.843, 840.852, 860.832, 862.632, 642.654, 420.876).

En la Enciclopedia on-line de sucesiones de números enteros (oeis.org [https://oeis.org/]), de N. J. A. Sloane, podéis encontrar la sucesión de constantes de Kaprekar. Es la sucesión etiquetada como A099009, cuyos primeros elementos son:

495, 6.174, 549.945, 631.764, 63.317.664, 97.508.421, 554.999.445, 864.197.532, 6.333.176.664, 9.753.086.421, 9.975.084.201, 86.431.976.532, 555.499.994.445, 633.331.766.664, 975.330.866.421, 997.530.864.201, 999.750.842.001, 8.643.319.766.532, 63.333.317.666.664, etc.

Crunching Numbers, del artista Dennis Kalow. Imagen de la página del artista en Society of Minnesota Sculptors

Crunching Numbers, del artista Dennis Kalow. Imagen de la página del artista en Society of Minnesota Sculptors

Bibliografía

1.- Raúl Ibáñez, Números primos, amigos y demás familia, Catarata, 2021.

2.- Martin Gardner, Los números mágicos del doctor Matrix, Gedisa, 2019.

3.- David Wells, The Penguin Dictionary of Curious and Interesting Numbers, Penguin Books, 1986.

4.- Yutaka Nishiyama, The weirdness of number 6174, International Journal of Pure and Applied Mathematics, vol. 80, no. 3, pp. 363 – 373, 2012.

5.- Wikipedia: Kaprekar routine

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo 6.174, un número seductor se ha escrito en Cuaderno de Cultura Científica.

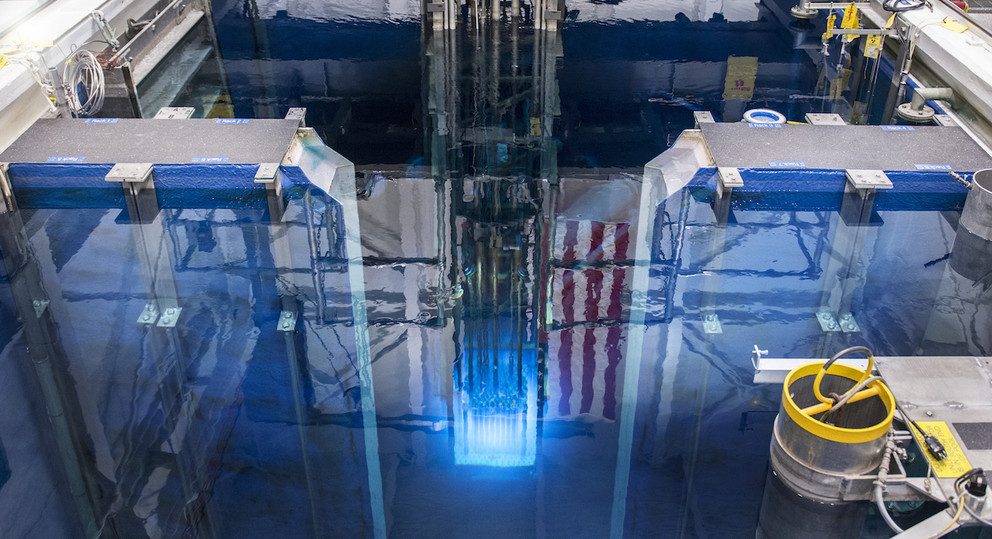

Entradas relacionadas:Control de la reacción nuclear en cadena (2): moderadores

Planta de producción de agua pesada en Arak (Irán). Fuente: Wikimedia Commons

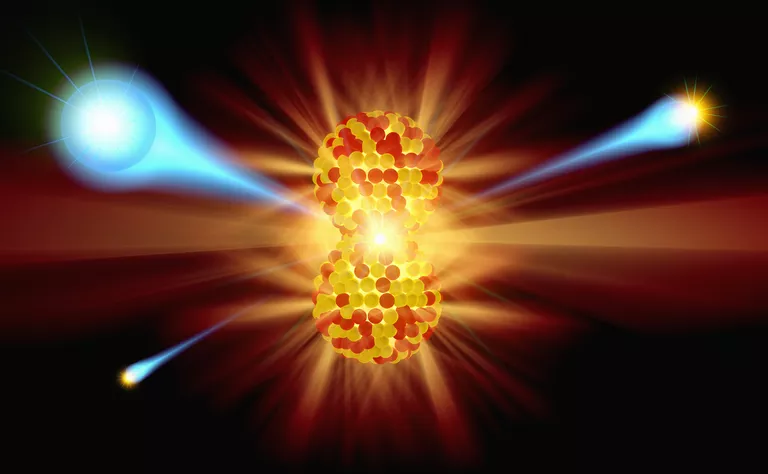

Planta de producción de agua pesada en Arak (Irán). Fuente: Wikimedia CommonsLos átomos de hidrógeno del agua son muy efectivos para ralentizar los neutrones por dos motivos: primero porque la masa de un núcleo de hidrógeno (un solo protón) es casi la misma que la de un neutrón y, segundo, porque la cantidad de átomos de hidrógeno por unidad de volumen es alta. Un neutrón, por tanto, puede perder una gran fracción de su energía en una colisión con un núcleo de hidrógeno. Solo se necesitan unas 20 colisiones, en promedio, para ralentizar el neutrón rápido a energías por debajo de 1 eV. Sin embargo, los neutrones también pueden ser capturados por el núcleo de hidrógeno en la colisión, según la reacción

![]()

La probabilidad de que ocurra esta reacción en lugar de una colisión elástica es lo suficientemente alta como para que no se pueda conseguir una reacción en cadena con uranio natural y agua ordinaria. Pero la absorción de un neutrón por un núcleo de deuterio, el isótopo del hidrógeno con un protón y un neutrón (hidrógeno-2), que se encuentra en la llamada agua pesada, tiene una probabilidad extremadamente pequeña.

Los neutrones no pierden tanta energía por colisión con los núcleos hidrógeno-2, pero esta desventaja se ve compensada por la tasa de absorción mucho más baja. Se puede lograr fácilmente una reacción en cadena con uranio natural y agua pesada. Se han construido reactores, con uranio natural como combustible y agua pesada como moderador, en Estados Unidos, Canadá, Francia, Suecia, Noruega y otros países, y científicos alemanes intentaron construirlos durante la Segunda Guerra Mundial [1].

El contraste entre las propiedades nucleares del hidrógeno hidrógeno-1 y el deuterio tiene importantes implicaciones para el desarrollo de los reactores nucleares. El agua pesada es cara de producir, pero cuando se utiliza con uranio natural (en su mayoría uranio-238), se puede lograr, como hemos mencionado, una reacción en cadena de manera eficiente. Aunque el uranio-238 normalmente absorbe neutrones en lugar de fisionarse, el agua pesada consigue ralentizar los neutrones por debajo de la energía a la que serían capturados por los núcleos de uranio-238. Un neutrón lento simplemente rebotará en los núcleos uranio-238 que encuentre hasta que finalmente sea absorbido por un mucho menos abundante núcleo de uranio-235, lo que provocará la fisión de este.

El agua corriente se puede utilizar como moderador en un reactor de uranio si se utiliza uranio enriquecido en el isótopo uranio-235 en lugar de uranio natural. En los Estados Unidos se han construido muchos reactores “alimentados” con uranio enriquecido y moderados con agua corriente. Estos reactores se denominan reactores de agua ligera. De hecho, este tipo de reactor general es el diseño preferido para la producción comercial de energía (electricidad), ya que es menos costoso de construir y menos probable que genere como subproductos materiales fisionables que podrían usarse para armas nucleares.

El carbono en forma de grafito ultrapuro se ha utilizado como moderador en muchos reactores, incluidos los primeros. Al ser más masivos sus átomos, no es tan bueno para ralentizar los neutrones rápidos como el agua ligera y el agua pesada; se necesitan aproximadamente 120 colisiones con átomos de carbono para ralentizar un neutrón rápido con una energía inicial de 2 MeV a la energía deseada de aproximadamente 0.025 eV; en agua pesada sólo se necesitan unas 25 colisiones. Pero aunque el carbono en forma de grafito puro no es el mejor moderador y absorbe algunos neutrones, sí permite que ocurra una reacción en cadena cuando se colocan trozos de uranio natural (barras cilíndricas que contienen gránulos de uranio, por ejemplo) en una gran masa de grafito. Determinar cómo se podría hacer esto realmente fue uno de los principales problemas ingenieriles que tuvo que resolverse antes de que la primera reacción en cadena del mundo se lograra en diciembre de 1942 por un equipo que lideraba Enrico Fermi en la Universidad de Chicago [2]. Muchos reactores moderados por grafito funcionan actualmente en todo el mundo.

El control de un reactor nuclear es relativamente sencillo. Para que no se produzca una fisión con demasiada frecuencia, se insertan algunas barras de control en el reactor. Las barras consisten en un material (como cadmio o boro) capaz de absorber los neutrones lentos, reduciendo así el número de neutrones en el reactor. La eliminación de las barras de control permitirá que aumente la tasa de fisión en el reactor.

Notas:

[1] No podemos dejar de mencionar en este punto la película “Los héroes de Telemark” (Anthony Mann, 1965) que recrea (con muchas licencias artísticas, porque en realidad no se disparó ni un solo tiro) una de las operaciones en la batalla por el agua pesada de la Segunda Guerra Mundial.

[2] Este experimento demostró que una reacción en cadena no era solo una especulación teórica, sino que era algo realizable y controlable en la práctica.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Control de la reacción nuclear en cadena (2): moderadores se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Control de la reacción nuclear en cadena (1): tamaño crítico

- Fisión nuclear (3): más neutrones

- Fisión nuclear (1): los elementos transuránidos

Ramón Picarte, una aproximación a la utopía

Alberto Mercado Saucedo

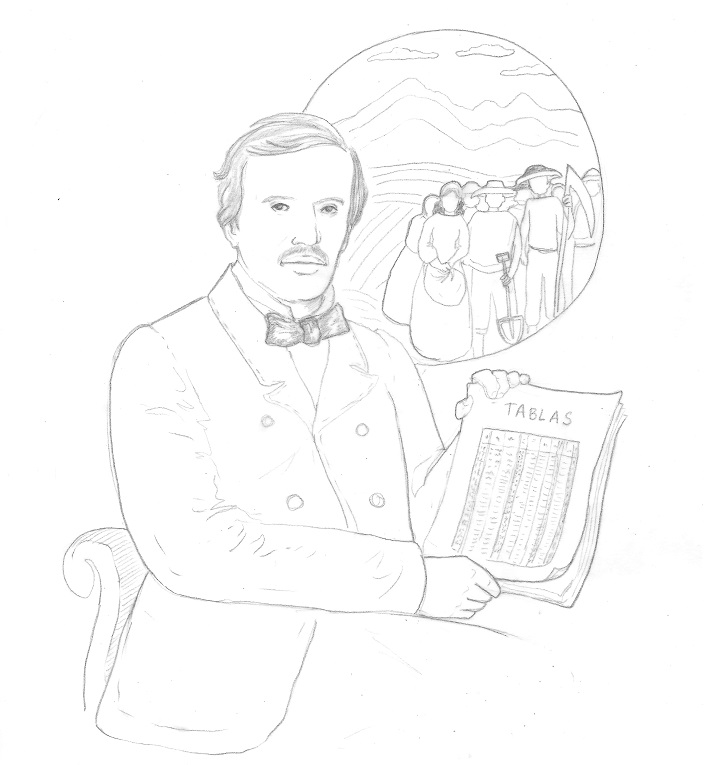

A mediados del siglo XIX, Ramón Picarte Mujica elaboró tablas de cálculo más precisas que las que se usaban en cualquier parte del mundo. Para publicarlas, viajó a Francia para someter su trabajo a la Academia de Ciencias de París. Regresó a Chile para dedicarse a otra obsesión: aplicar las matemáticas a la búsqueda del bienestar de los trabajadores. Ramón Picarte Mujica, nacido el 9 de junio de 1830, puede considerarse el primer matemático chileno. Esta es su historia.

Ilustración de Constanza Rojas-Molina. Todos los derechos reservados; cesión en exclusiva para su publicación en el Cuaderno de Cultura Científica.

Ilustración de Constanza Rojas-Molina. Todos los derechos reservados; cesión en exclusiva para su publicación en el Cuaderno de Cultura Científica.Enero de 1857 en Valparaíso. Frente a la principal puerta de entrada y salida de Chile, el mar parece infinito, tanto como los sueños, ambiciones o incertidumbre de las personas que comienzan aquí su personal aventura. Además de grandes embarcaciones que cargan y descargan mercancías de todo tipo, hay diplomáticos, traficantes, estudiantes que parten a estudiar a Europa o inmigrantes que llegan al país. El joven Ramón Picarte, de 26 años, está listo a embarcarse; lleva consigo muy poco equipaje y sus escasos ahorros de cien pesos, además de varios cuadernos y carpetas con hojas manuscritas en las que lleva un gran tesoro, su trabajo de los últimos años. Intenta que sea revisado y publicado, para lo cual necesita apoyo que no ha conseguido por ninguna parte. Apenas unas semanas atrás se entrevistaba con el ministro Antonio Varas, de quien recibió una rotunda respuesta negativa. Convencido de sus logros, no le queda opción que emprender una aventura solitaria, tomar un barco a otras latitudes y mostrar su trabajo a quien sí esté dispuesto a apreciarlo.

Cuando su padre falleció, él apenas tenía cinco años. Ramón Picarte y Castro había sido militar independentista, llegó a ser intendente de Valdivia y sus convicciones liberales le significaron enemistarse con superiores y ser dado de baja del ejército en 1830; murió olvidado y en la pobreza. Carmen Mujica quedó a cargo de sus cinco hijos pequeños y no conseguiría un montepío -pensión estatal- sino muchos años después. Ramón ingresó en 1840 al Instituto Nacional, la primera institución educativa del país independiente, fundada en 1813 a partir de casas de estudio de la época colonial con la misión expresa de formar los ciudadanos que dirigieran a la patria. Se convertiría en el más importante centro de educación media del país y llegaría al siglo XXI con el distintivo de liceo emblemático, siendo todavía un colegio sólo para estudiantes varones, con más de cuatro mil inscritos y manteniendo sin duda una particular mitología propia; del Instituto Nacional han egresado cantidad de jóvenes que se convertirían en deportistas, científicos y artistas -entre ellos premios nacionales de ciencias y artes- además de varios presidentes del país.

Ramón había comenzado sus estudios en humanidades, pero al poco andar cambió el derecho por las ciencias, a pesar de que ello significaba un posible futuro menos oneroso. Se graduó como agrimensor, título al que podía optar tras estudios científicos. Tuvo una valiosa influencia de Andrés Antonio Gorbea, ingeniero vasco que había sido contratado por el gobierno chileno para impartir clases en las instituciones recién creadas: fue profesor en el Instituto Nacional, donde se convirtió en mentor de Picarte, y posteriormente sería el primer decano de la Facultad de Ciencias Físicas y Matemáticas de la Universidad de Chile, fundada en 1843 y que, por cierto, sólo algunas décadas después incorporó en su Estatuto Orgánico a la investigación científica como una labor propia, lo que denota lo incipiente de esta actividad en la época. Gorbea conocía bien los textos matemáticos más modernos, tradujo cursos actualizados que se usaban en Francia y los hizo editar para ser usados en Chile. Sin duda que fue una gran influencia para Ramón Picarte.

Después de abordar una nave en Valparaíso, los pocos ahorros que Picarte había podido reunir no le permiten llegar muy lejos y debe quedarse en el puerto de Callao, en Lima, donde trabaja de cualquier cosa para subsistir durante un par de meses. Intenta conseguir algún editor para publicar sus tablas, sin éxito, y sufre un robo que le obliga a rehacer parte de sus tablas. ¿En qué consiste su trabajo? Simplemente, había mejorado las tablas de cálculo más precisas conocidas hasta entonces en todo el mundo. Diversas actividades requerían operaciones precisas de números con muchas cifras, y las computadoras de la época no eran sino tablas de cálculo: libros con tablas y tablas llenas de números, hojas de cálculo similares a las de Excel o de cualquier otro programa informático, pero no en una pantalla sino impresas en enormes volúmenes. Usadas de manera cuidadosa, el usuario podía realizar operaciones complejas apoyándose en varias operaciones sencillas.

Entre las tablas más usadas en la época estaban las de logaritmos del astrónomo francés Jérôme de Lalande, célebre por haber calculado la distancia de la Tierra a la Luna y la trayectoria de Venus, y sobre todo por haber corregido al astrónomo inglés Edmond Halley sobre el nuevo avistamiento del cometa que llevaría su nombre.Lalande predijo que sería visible en 1759, un año después de la fecha anunciada por Halley, tras calcular la perturbación ocasionada por la fuerza de gravedad de los grandes planetas del sistema solar. Lalande acertó y su logro ayudó al asentamiento de la física newtoniana en la ciencia francesa. Para realizar sus cálculos, Lalande se apoyaba en sus tablas de logaritmos, que se convirtieron en un clásico en todos aquellos campos de la técnica que requerían hacer operaciones con números de gran cantidad de cifras. En Chile estas tablas eran el estándar en el siglo XIX y todo mundo las utilizaba. Por supuesto, no eran perfectas, y ellas mismas eran el resultado de mejorar tablas más antiguas, pero ya llevaban un buen tiempo usándose y aún nadie había logrado mejorarlas. Hasta que llegó Ramón Picarte.

Picarte trabajó como profesor de matemáticas en la Escuela Militar hasta 1856. Como agrimensor, no se conformó con aprender a usar las tablas del astrónomo francés Lalande: después de dominar las propiedades matemáticas que las sustentaban, se propuso nada menos que mejorarlas, lo que consiguió después de mucho trabajo. ¿En qué consistía mejorar una tabla? No se trataba de simplemente añadir más resultados de operaciones matemáticas, hasta eventualmente incluir todas las operaciones posibles. Cada tabla tiene sus reglas de uso: una división u otra operación entre números grandes se obtiene como resultado de varias operaciones parciales más sencillas que dependen de los dígitos de los números en cuestión. El usuario debe conocer estas reglas para utilizar la tabla. Mejorar una tabla consistía en programarla de manera más eficiente. Picarte encontró una mejor manera de separar las operaciones en operaciones auxiliares para que el resultado final fuera más preciso, incluso usando una tabla más pequeña. Separó de ingeniosa manera las operaciones necesarias para hacer una división de una cifra, de manera que bastaba operar con cada dígito y luego sumar los resultados. Además, usó propiedades matemáticas para aumentar el número de dígitos conseguidos en la respuesta. Es decir, Picarte mejoró el algoritmo con el que funcionaban las tablas, fue un programador que dominó las matemáticas que sustentaban las tablas y así fue capaz de crear una tabla más poderosa.

Varado en Lima, sin dinero y sin poder publicar su trabajo, Picarte debe reunir lo suficiente para continuar su viaje. Consigue un préstamo de un compatriota, de apellido Prado, por mil pesos, un gran alivio después de tantas negativas recibidas antes de embarcarse en Valparaíso. Puede ser que en la búsqueda infructuosa de ayuda haya influido el hecho que Andrés Gorbea, su mentor, había fallecido poco antes, en 1852. Es de notar también que Antonio Varas, ministro del Interior y de Relaciones Exteriores, en quien Picarte había cifrado sus últimas esperanzas de obtener ayuda, había sido rector del Instituto Nacional durante los años en que Ramón fue estudiante. De hecho, la historia familiar de Antonio Varas es de cierta forma un reflejo de la trayectoria de la familia Picarte Mujica, desde el lado político opuesto: el padre de Varas había sido partidario de la corona española y después de la independencia, los bienes de la familia fueron incautados, y ésta cayó en la pobreza. Antonio Varas (trece años mayor que Picarte) también había estudiado ciencias en el Instituto Nacional, era agrimensor y abogado; es lógico pensar que comprendía bien el alcance del logro de Ramón Picarte, pero es un hecho que le negó su patrocinio. Quizá no le pareció redituable gastar dinero en ello o quizá simplemente estaba más ocupado en el proceso de colonización del sur del país que llevaba a cabo como ministro: su encargado Vicente Pérez Rosales gestionaba la llegada de ciudadanos europeos, en especial alemanes, para poblar tierras que les eran entregadas bajo condición de trabajarlas. Este proceso, por cierto, con el tiempo llevaría a ocupaciones irregulares de tierras que históricamente pertenecían a las comunidades mapuche y huilliche, originando así conflictos que desgraciadamente perduran hasta nuestros días. Como haya sido, el punto es que Ramón Picarte no había encontrado ningún apoyo del gobierno, y tampoco mucho entusiasmo de la comunidad académica del país.

En Lima, un poco de suerte sonríe a Picarte. Con la ayuda recibida logra proseguir su odisea. Viaja a Panamá y luego hace el largo trayecto hasta Southampton, en el Reino Unido, donde vende su reloj, la única herencia de su padre, para poder sortear el último tramo de su viaje. Picarte casi logra su cometido, está cerca de llegar a Paris y entrevistarse con los matemáticos franceses para mostrarles su trabajo. Irónicamente, sus detractores en Chile solían elogiar a los científicos de estas latitudes, pero lo hacían desde una perspectiva categórica, absolutamente conservadora, más bien una caricatura: “Los grandes descubrimientos de las ciencias están reservadas para los grandes sabios europeos”, había sido la triste declaración al consejo de la facultad de nada menos que el director de la Escuela de Artes y Oficios y que consta en actas de la universidad. Bajo esta óptica, Picarte había perdido su tiempo tratando de equipararse con los matemáticos franceses y debía ubicarse en el papel que esta visión colonial le reservaba. Afortunadamente, no se dejó menospreciar, él creía genuinamente que había conseguido algo importante. Quizá su trabajo tampoco había generado entusiasmo en el medio científico de la época. La astronomía, por ejemplo, desde esos años ya tenía actividad en Chile. En efecto, funcionaba el observatorio del Cerro Santa Lucía, presumiblemente el primero en Latinoamérica (además del pequeño observatorio, considerado más bien como de carácter aficionado, ubicado en el Cerro Cordillera de Valparaíso producto de la iniciativa de Juan Muat, relojero escocés asentado en el puerto chileno, apasionado de la astronomía y cuya historia merecería varias páginas). Hubiese sido natural que la actividad astronómica en Chile propiciara condiciones suficientes para que el trabajo de Picarte fuera reconocido y, por supuesto, utilizado. Después de todo, las tablas usadas hasta entonces eran las del astrónomo Lalande. Pero no fue así, nadie le dio importancia a la mejora de las tablas y todo mundo se conformaba con seguir usando las mismas herramientas conocidas. Los profesionales que observaban astros tan lejanos en el universo poseían una visión mas bien corta, y no fueron capaces de tomar otra decisión que quizá, imposible saberlo, habría propiciado un avance cualitativo en la ciencia chilena.

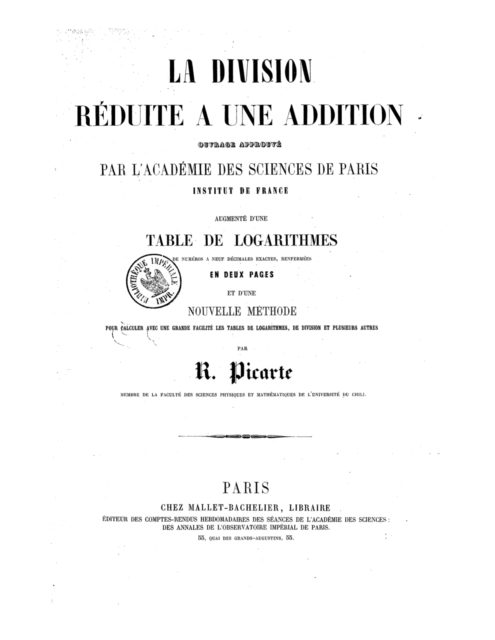

La miopía de las autoridades y la visión colonial de la comunidad científica era un hecho, y podríamos decir que desgraciadamente sigue siéndolo en alguna medida. Afortunadamente, Ramón Picarte no cejó y decidió emprender esta loca aventura. Después de vender su reloj llega a la capital francesa, su destino final. En Paris, ayudado por conocidos, logra entrevistarse con matemáticos de la Academia de Ciencias, con quienes acuerda los siguientes pasos a realizar: debe redactar un completo informe y pasar en limpio sus tablas, lo que lleva a cabo durante unos cinco meses de constante trabajo. Finalmente, en 1858 presenta sus tablas antes la Academia de Ciencias de Paris y éstas son sometidas a un minucioso examen. Le solicitan una segunda exposición junto con informes con más detalles. Claro, los matemáticos franceses no iban a aprobar tan a la ligera las tablas que pretendían mejorar el trabajo de Lalande. Pero Picarte consigue sortear todos los exámenes: en sesión de febrero de 1859, la Academia evalúa positivamente el trabajo y aprueba la publicación de las tablas con título La división reducida a una suma. Picarte tiene razón y su obstinación rinde frutos.

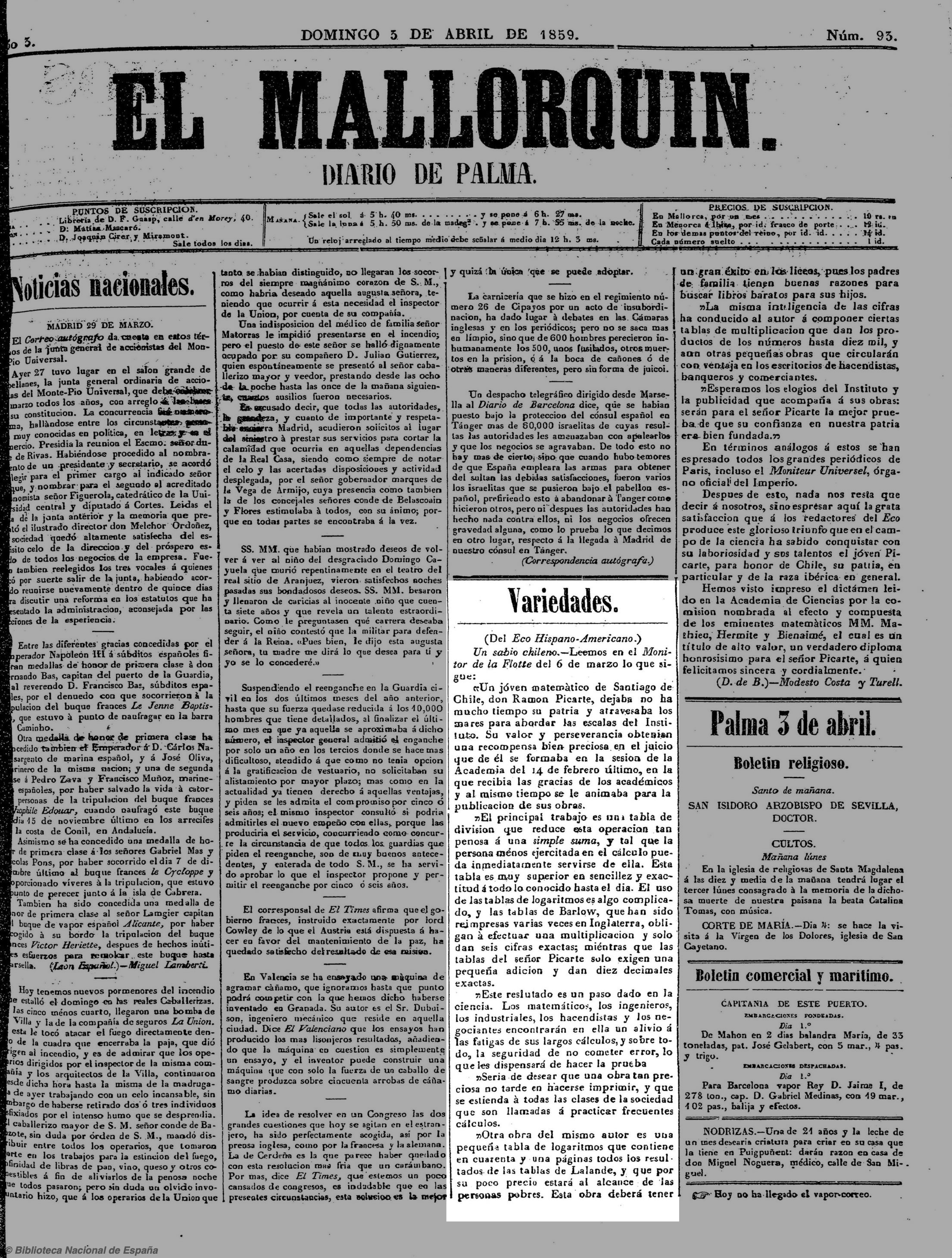

El logro de Ramón Picarte es una gran noticia, diarios de Francia, España y Chile consignan su proeza. Ahora sí, todos en su país natal reconocen que es un gran matemático, todo mundo lo reconoce y nadie parece recordar los sinsabores y el desprecio que Picarte sufrió por falta de apoyo. En mayo de 1859 el gobierno del país lo nombra adjunto a la Legación de Chile en Francia y en junio el Consejo de la Universidad de Chile lo nombra miembro corresponsal de la Facultad de Ciencias Físicas y Matemáticas. Se encarga a la Academia de Ciencias de París la impresión de trescientos ejemplares de las tablas. Llegan los tiempos de calma y satisfacción para Ramón Picarte, que extiende su estadía en Paris para estudiar directamente de los matemáticos franceses. Al parecer, en esa época se produce un punto de inflexión en sus intereses y motivaciones, pues además de matemáticas y agrimensura, se aboca a otra obsesión: el uso de la ciencia para lograr el bienestar de la sociedad.

En Chile se crea gran expectación, al menos en el medio académico, por tenerlo de regreso, lo cual sucede en 1862. Su primera actividad consiste en dar un discurso ante el Consejo de la universidad, en la sesión en que asume su nombramiento académico. Los académicos esperan ansiosos el mensaje que Picarte les dirigirá, después de haber llegado a la Academia de Ciencias de Paris, donde su trabajo había sido reconocido y publicado. Quizá suponen que les contará noticias sobre los temas científicos de vanguardia que se estudian en Francia en ese momento o sobre proyectos que tiene en mente para los siguientes años. Puede ser que algún antiguo detractor de Picarte tema alguna represalia por parte del ahora académico de la universidad. Pues bien, probablemente el discurso que escuchan extraña a varios de ellos, que no se esperan que la principal preocupación que Ramón Picarte transmite en su discurso sea la del bienestar de los trabajadores.

Como podemos leer en los Anales de la universidad de Chile, disponibles en línea, en su discurso de inauguración Picarte expuso con todo detalle sobre algunas propuestas para asegurar el bienestar de un trabajador, con cálculos precisos incluidos. En particular le preocupaba la ocurrencia de accidentes o enfermedades invalidantes, pues quienes sufrían algo así eran dejados a su suerte. Haciendo uso de las probabilidades, Picarte calculó lo que podía significar que cada trabajador ahorre pequeñas cantidades para usufructo común. Sostiene Picarte que era posible prever y ahorrar recursos para el futuro, organizarse y establecer un sistema de pensiones que permitieran vivir dignamente a quienes debieran dejar de trabajar. Probablemente en Francia se vio atraído por el socialismo utópico de Charles Fourier y otras corrientes de pensamiento similares; también conoció el funcionamiento de compañías de seguro que operaban en Europa. Menciona en su discurso que, para un buen desempeño del sistema de ahorro que propone, se debían evitar las altas cuotas que las compañías de seguros europeas cobraban a sus suscriptores y menciona el ejemplo de compañías británicas, que se estaban haciendo ricas con los altos comisiones cobradas por su servicio. Es inevitable preguntarse qué pensaría Ramón Picarte de los sistemas de capitalización individual para el retiro que rigen en tantos países en nuestros días, como como las AFP chilenas, que actualmente son objeto de importantes discusiones, aunque no es difícil imaginarlo.

Durante los años posteriores a su regreso a Chile, Picarte destinó su tiempo y energía a proyectos sociales, siembre con el objetivo de garantizar el bienestar de los trabajadores por medio del uso racional y equitativo de los recursos generados por el trabajo. Para ello solicitaba ayuda en muchas partes con variados resultados, incluso llegó a instalarse en un puesto permanente en una plaza pública para sumar adeptos a sus proyectos. En 1863 fundó en Santiago una sociedad de zapateros y otra de sastres y en 1864 formó la organización cooperativa “Sociedad trabajo para todos”, proyectos que al parecer tuvieron un modesto alcance y una corta vida. En 1866 se instaló en San Carlos, al sur de Chile, donde intentó crear un falansterio -o comuna-, agrupación de familias cuyo trabajo conjunto la hace autosustentable. Este ambicioso e inédito proyecto en estas latitudes tuvo un buen comienzo según fue comentado en la prensa de la época, pero no se tienen mayores registros sobre su desarrollo. Se casó en 1869 con Clorinda Pardo y se instalaron a vivir en el vecino poblado de Chillán.

Los proyectos sociales absorbieron entonces la energía de Picarte desde su retorno a Chile. De hecho, me parece que es más común encontrar su nombre en fuentes bibliográficas relacionadas con el origen del cooperativismo o del socialismo en Chile que en textos sobre los primeros científicos del país, por lo que su nombre resulta aún muy poco conocido. Una muy valiosa excepción la constituyen los trabajos de Claudio Gutierrez y Flavio Gutierrez, que han rescatado el papel de Ramón Picarte como pionero en la ciencia en Chile.

Sorprendentemente, no conocemos el final de esta historia, ni el de la vida de Ramón Picarte. Se sabe que publicó varias patentes de artefactos tecnológicos diversos y que eventualmente volvió a dedicar tiempo a confeccionar nuevas tablas de cálculo. Consiguió financiamiento para desarrollar y publicar unas “tablas de logaritmos de doce decimales” y emprendió un viaje a Francia en 1884, quizá para quedarse definitivamente allí, pues no se sabe con certeza qué pasó después de tal fecha y tampoco si las tablas fueron publicadas. Un diccionario biográfico en su reedición de 1897 se refiere escuetamente a Picarte con el texto “permanece en París consagrado a estudios científicos” sin proporcionar mayor detalle, y no hay referencias posteriores. Durante el 2019, pude dedicar algunos días de una estadía en Francia a buscar en archivos de Paris alguna pista de las actividades de Picarte. Desgraciadamente, al desconocer la dirección aproximada donde pudo haber fallecido, es difícil encontrar un registro de defunción. Encontré solamente dos pistas certeras: un par de registros de patentes de los años 1884 y 1888. Los artefactos descritos coinciden con actividades anteriores de Picarte, lo que significa una comprobación de su actividad en Paris posterior a su última salida de Chile. Desgraciadamente, la dirección en Paris registrada en la patente no me ayudó a encontrar información adicional.

¿Qué fue de Ramón Picarte? ¿Falleció en Francia? ¿Publicó sus tablas de doce decimales? ¿Se interesó por otros problemas? No lo sabemos aún y sólo podemos imaginar que durante los últimos años del siglo XIX, o quizá incluso durante los primeros del siglo XX, Ramón Picarte estuvo entusiasmado por otros proyectos, siempre con pasión y encarnando la frase del autor italiano Terencio: soy un hombre, nada humano me es ajeno.

Principales referencias

- Gutiérrez Claudio y Gutierrez, Flavio, «Ramón Picarte: la proeza de hacer matemáticas en Chile», Quipu, Revista Latinoamericana de Historia de las Ciencias y la Tecnología, Vol. 13, Num. 3, 2000.

- Gutiérrez Claudio y Gutierrez, Flavio, «Forjadores de la ciencia en Chile», RIL editores, 2008.

- Jaime Massardo, «La formación del imaginario político de Luis Emilio Recabarren», Santiago de Chile, Lom ediciones, 2008.

- Anales de la Universidad de Chile: https://anales.uchile.cl/

- Les procès-verbaux du Bureau des longitudes. http://bdl.ahp-numerique.fr/

- Gallica, Biblothèque Nationale de France https://gallica.bnf.fr/

Sobre el autor: Alberto Mercado Saucedo es profesor de matemáticas en la Universidad Técnica Federico Santa María (Valparaíso, Chile)

Sobre la ilustradora: Constanza Rojas Molina es profesora del departamento de matemáticas de la CY Cergy Paris Université (Cergy-Pontoise, Francia)

El artículo Ramón Picarte, una aproximación a la utopía se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Fraude científico (I). Una primera aproximación

- José Ramón Alonso – Naukas Bilbao 2019: Son nuestros amos y nosotros sus esclavos

- Roberto Frucht, matemático en tránsito

Así es el nuevo mercado matrimonial en España: si quieres pareja, ocúpate de cuidar

Teresa Martín García y Teresa Castro Martín

Foto: Taylor Deas-Melesh / Unsplash

Foto: Taylor Deas-Melesh / UnsplashEspaña se sitúa desde hace tiempo entre los países con una fecundidad más baja, tanto en el contexto europeo como en el mundial: la media de hijos por mujer fue de 1,23 en 2019. Una de las condiciones demográficas que más afectan a la (in)fecundidad es la situación del denominado “mercado matrimonial”.

Según datos de la Encuesta Continua de Hogares, el 39 % de las mujeres en edades centrales para la maternidad en nuestro país (30-34 años) no está casada ni convive con pareja (51 % de los hombres). Para los economistas, todo se reduce a un problema de escasez en el sentido más estricto del número. De hecho, un artículo de divulgación publicado con el título La curiosa razón por la que medio millón de españoles no podrá encontrar pareja señala el “desequilibrio” numérico entre hombres y mujeres más jóvenes como causa de la dificultad de formación de pareja en nuestro país.

La demografía condiciona, pero no determina. Este desequilibrio numérico puede ser efectivamente un problema allí donde el descenso de la natalidad no ha sido voluntario sino más bien consecuencia de la imposición del hijo único durante décadas, como en China, un país donde las mujeres valían menos que los hombres (lo que conducía al aborto selectivo en función del sexo). En el caso de España y Europa, más que de un supuesto desequilibrio numérico de cohortes consecutivas achacado al descenso de la natalidad, tenemos que hablar de otros factores que repercuten en la composición del mercado matrimonial.

Sin duda, uno de los más importantes es el hecho de que las diferencias de género en el logro educativo se han invertido en las últimas décadas a favor de las mujeres. En 2019, el porcentaje de mujeres de 30 a 34 años con estudios universitarios fue del 39,1 %, superando a los hombres en más de 14 puntos porcentuales.

¿Dónde están aquellas jóvenes casaderas? Estudiando

Tradicionalmente, los hombres solían emparejarse (y casarse) con mujeres con un nivel educativo y estatus socioeconómico menor que ellos (hipergamia educativa). Este patrón de emparejamiento respondía normalmente al hecho de que las mujeres no trabajaban fuera del ámbito doméstico y, si lo hacían, sus ingresos eran menores. Además, dicho patrón se basaba en preferencias y normas socialmente compartidas acordes con la hipergamia educativa (por ejemplo, que las mujeres fueran ligeramente más jóvenes).

Pues bien, la rápida expansión educativa y el sorpasso educativo de las mujeres han dificultado la continuidad de este patrón tradicional de emparejamiento. En concreto, ahora los hombres “no encuentran” mujeres más jóvenes con igual o menor nivel educativo, simplemente porque las generaciones recientes de mujeres, de media, tienen un mayor nivel educativo que los hombres.

La evidencia empírica sobre este tema nos muestra, sin embargo, que hombres y mujeres se han adaptado sorprendentemente rápido a las realidades cambiantes del mercado matrimonial. De hecho, en la mayoría de los países occidentales han aumentado considerablemente las parejas en las que las mujeres tienen un nivel educativo superior al de los hombres.

Constatamos también que ha disminuido la proporción de hombres que rechazan emparejarse con mujeres con ingresos superiores a los suyos, y viceversa en el caso de las mujeres. Ahora bien, todavía encontramos una cierta aversión de los hombres a emparejarse con mujeres altamente cualificadas y con éxito profesional.

En realidad, no es tanto el desequilibrio numérico causado por el descenso de la natalidad —una tendencia universal y difícil de revertir— sino el desajuste entre las expectativas individuales y la persistente desigualdad de género lo que impide que la adaptación a la nueva composición del mercado matrimonial sea completa. En este sentido, hay que decir que el cambio en los roles y relaciones de género ha sido asimétrico, ya que la vida de la mujer se ha transformado mucho más que la del hombre a lo largo de las últimas décadas. Además, los cambios han sido mucho más rápidos en algunas esferas, como la educación y el empleo, que en otras, como las relaciones intrafamiliares.

Emparejarse es hoy una opción, no un modo de subsistir

Históricamente, el matrimonio era concebido como una estrategia de supervivencia para la mayoría de las mujeres por la escasez de recursos propios, la dificultad de mantener un trabajo remunerado y el fuerte estigma social de no casarse. Hoy en día, en unas condiciones más flexibles, el matrimonio o el emparejamiento es una opción, no una obligación. Cuando el coste se percibe elevado, no solo en términos de tiempo y recursos, sino también de penalizaciones en la carrera laboral —sobre todo por parte de las mujeres con un nivel educativo más alto— las decisiones familiares tienden a aplazarse de forma temporal o definitiva.

En la década de los 80, se consolidó en España la disociación entre sexualidad y reproducción, gracias al uso generalizado de anticonceptivos modernos.

En la década de los 90, la expansión de la cohabitación fue el gran catalizador del cambio familiar, implicando la disociación entre matrimonio y reproducción.

Más recientemente, estamos asistiendo a una nueva disociación, esta vez entre conyugalidad y reproducción, a través de la maternidad sin pareja y la maternidad sin sexo, con el recurso de las técnicas de reproducción asistida. De hecho, en la actualidad casi la mitad de las mujeres que son madres en solitario lo son después de los 30 años, son laboralmente activas y tienen un nivel educativo medio o alto, por lo que muchas de ellas encajarían en el perfil de “madres solas por elección”. Es decir, ni el sexo ni los hijos son ya razones para que las mujeres formen pareja a cualquier coste.

Solo hay una posible “solución”, siguiendo la lógica del mercado matrimonial: que los hombres compensen su menor nivel educativo (aunque todavía conserven un mayor estatus socioeconómico) con actitudes igualitarias e implicándose más en los cuidados y el trabajo doméstico.

Parejas más estables con hombres que cuidan

La principal conclusión que se extrae de los análisis empíricos recientes es que el nivel de estudios o la participación laboral de la mujer no tienen por qué llevar necesariamente al abandono de su proyecto familiar.

En los países donde más se ha promovido la igualdad de género en el ámbito público y en el ámbito familiar, mediante una fuerte protección laboral de las madres trabajadoras, así como a través de medidas que incentivan la corresponsabilidad de padres y madres en los cuidados —por ejemplo, en los países nórdicos—, observamos que el gradiente de educación parece haberse invertido en las cohortes más jóvenes y es positivo: los hombres se ponen el delantal y cuidan de los hijos, lo que propicia parejas más estables y, por lo tanto, las mujeres con niveles educativos altos no rechazan convivir y tener descendencia.

En resumen, no hay un problema de escasez de mujeres más jóvenes, sino una falta de correspondencia entre las expectativas de hombres y mujeres en un mercado matrimonial cambiante, que no es único —no hay un solo mercado matrimonial sino muchos “mercados” dependiendo del nivel educativo, lugar de residencia, estilo de vida, etc.— y que ya no es solo matrimonial porque la cohabitación está progresivamente desplazando al matrimonio como vía de formación familiar.

Es necesaria una visión interdisciplinar que incorpore también a la sociología, la demografía, la psicología social y los estudios de género para explicar una realidad mucho más compleja de la contemplada en los modelos económicos basados estrictamente en la premisa de la escasez y los conceptos de demanda y oferta en el mercado matrimonial.

Además, este supuesto déficit de mujeres de cohortes más jóvenes no es necesariamente una mala noticia, ya que podría aumentar el poder de negociación de las mujeres a la hora de forjar relaciones de pareja más igualitarias.

En este asunto, bien vale atenerse a lo de “menos es más”. Cuanto menos igualitarios sean los hombres y menos se adentren en la esfera doméstica, más dificultades seguirán teniendo para encontrar pareja (heterosexual) en un contexto social como el español, en el que la brecha educativa se ha revertido claramente y funciona ya como una línea roja de no retorno respecto a la igualdad de género.

Sobre las autoras: Teresa Martín García es científica titular y Teresa Castro Martín profesora de investigación en el grupo de investigación sobre dinámicas demográficas del Departamento de Población del CSIC.

Este artículo fue publicado originalmente en SINC. Artículo original.

El artículo Así es el nuevo mercado matrimonial en España: si quieres pareja, ocúpate de cuidar se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- La violencia psicológica en las relaciones de pareja no entiende de fronteras

- Ciencia y democracia, una pareja bien avenida

- Por qué España es un modelo para el estudio de la economía

Adela Torres – Naukas Bilbao 2019: ¿Dónde está la mosca?

Foto: Sandhiya R / Unsplash

Foto: Sandhiya R / UnsplashLa genética del desarrollo es uno de los campos científicos en los que aun queda mucho por explorar, como ilustra estupendamente la divulgadora Adela Torres en esta charla.

Edición realizada por César Tomé López a partir de materiales suministrados por eitb.eus

El artículo Adela Torres – Naukas Bilbao 2019: ¿Dónde está la mosca? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Francisco Villatoro – Naukas Bilbao 2019: El abrazo de la plata

- José Ramón Alonso – Naukas Bilbao 2019: Son nuestros amos y nosotros sus esclavos

- Naukas Bilbao 2017 – María José Calderón y Belén Valenzuela: Esta física es la leche

¿Es imprescindible comer la fruta con piel para ingerir suficiente cantidad de fibra?

Saioa Gómez Zorita, Helen Carr-Ugarte, Jesús Salmerón y Maria Puy Portillo

Foto: Enrico Sottocorna / Unsplash

Foto: Enrico Sottocorna / Unsplash

La respuesta es no. Debemos comer más fruta, con o sin piel, como más nos guste, pero comer más. Tal vez la pregunta correcta debería ser: ¿debemos comer más fruta para ingerir suficiente cantidad de fibra? En este caso la respuesta sería claramente afirmativa.

Empecemos por ver qué es la fibra. Esta es la fracción comestible de alimentos de origen vegetal que no puede ser digerida por los enzimas digestivos y que, por tanto, no puede absorberse en el intestino. Sin embargo, algunos tipos de fibra sí pueden ser fermentados por la microbiota, lo que da lugar a compuestos beneficiosos para la salud como los ácidos grasos de cadena corta.

A pesar de que la fibra no se absorbe, sí debemos ingerirla en cantidad suficiente, porque tiene múltiples efectos beneficiosos. Por ejemplo, la prevención del estreñimiento y la disminución de las concentraciones de colesterol en sangre. De hecho, numerosos estudios epidemiológicos han puesto de manifiesto que aquellas personas con un bajo consumo de fibra tienen una mayor predisposición a padecer ciertas patologías como diabetes y enfermedades cardiovasculares.

En lo que respecta a las fuentes de fibra, algunos alimentos como los cereales integrales (trigo, avena…), las legumbres, las frutas, las verduras y los frutos secos son ricos en ella. Por el contrario, los de origen animal, como la carne, el pescado y los huevos, carecen de la misma.

¿Cuánta fibra debo ingerir?

Las recomendaciones de ingesta de fibra en adultos difieren según el organismo que las establezca. Según la Autoridad Europea de Seguridad Alimentaria (EFSA), la recomendación actual en adultos es de al menos 25 g/día. Sin embargo, el consumo actual de fibra en Europa se sitúa en torno a 14-23 g/día, por debajo de las recomendaciones. En concreto, el estudio ANIBES, indicó que en España el consumo medio de fibra era de 13 g/día en hombres y de 14 g/día en mujeres con edades comprendidas entre 18 y 64 años.

Para llegar a este consumo mínimo de fibra se deberían consumir al menos 5 raciones de fruta y verdura al día (unos 400 g) y 2 o 3 raciones de legumbre a la semana. Así mismo, se deberían consumir cereales integrales como el arroz integral.

No obstante muchos, en vez de preocuparnos por la baja ingesta de estos alimentos, lo hacemos por consumir la fruta con piel para aumentar la ingesta de fibra. Es cierto que la piel de la fruta tiene mayor cantidad que el resto de la fracción comestible, pero debido al bajo peso que supone en comparación con el peso total, la diferencia entre comerla con o sin piel es pequeña.

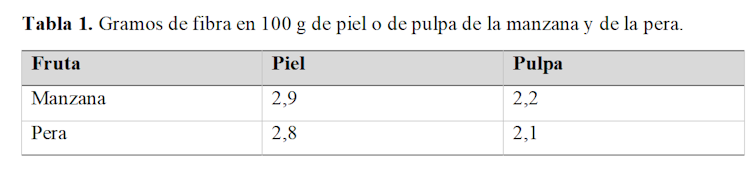

En la siguiente tabla se muestran los gramos de fibra en la pulpa y en la piel de la manzana y de la pera. Imaginemos que ingerimos 150 gramos de pera sin piel: en este caso, el contenido total de fibra ingerida sería 3,2 g. En cambio, si también ingerimos la parte correspondiente de piel, unos 5 g, estaríamos añadiendo únicamente 0,1 gramos extra de fibra.

A todo esto cabe añadir que, en numerosas ocasiones, hay más diferencia en el contenido en fibra entre distintas frutas e incluso entre clases o variedades de una misma fruta. Si este caso no supone ningún problema desde el punto de vista del consumo de fibra, ¿por qué se le da tanta importancia a cómo comer la fruta o la verdura?

En definitiva, a pesar de que el consumo de fruta y verdura con piel pueda suponer un ligero incremento en la ingesta de fibra, este es muy pequeño. Si para alguien puede suponer una reducción de la ingesta de fruta o verdura es preferible que le quite la piel. En este caso, lo principal es incrementar el consumo de frutas y verduras, no importa cómo las ingiramos.![]()

Sobre los autores: Saioa Gómez Zorita es profesora en la UPV/EHU e investigadora del Centro de Investigación Biomédica en Red de la Fisiopatología de la Obesidad y Nutrición (CiberObn) y del Instituto de Investigación Sanitaria Bioaraba; Helen Carr-Ugarte y Jesús Salmerón investigan en la UPV/EHU , donde Maria Puy Portillo es catedrática de nutrición.

Este artículo fue publicado originalmente en The Conversation. Artículo Original.

El artículo ¿Es imprescindible comer la fruta con piel para ingerir suficiente cantidad de fibra? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Puedes presumir de tener la mejor piel del mundo.

- Hidrógeno a partir de composites de fibra de carbono

- Una fibra óptica de plástico actúa como concentrador solar luminiscence

Música, guerra y paz

¿Qué es la música?

Preguntas mientras clavas en mi pupila tu pupila azul.

Foto: Ahmad Odeh / Unsplash

Foto: Ahmad Odeh / UnsplashComo las preguntas más interesantes, esta resulta fácil de contestar de manera cotidiana (todos reconocemos la música en nuestro entorno cotidiano) y, sin embargo, es muy difícil concretarla con palabras. Pero si amordazamos a los teóricos musicales y a los compositores de vanguardia, e intentamos encontrar una respuesta mediante una suerte de inferencia estadística, descubriremos que uno de los ingredientes más comunes de la música (aquello que la distingue de otras señales sonoras, como el habla o el ruido) es el ritmo.

El ritmo es una forma de repetición, al fin y al cabo; un patrón de duraciones sonoras que dividen el tiempo de manera recurrente. Esa recurrencia es lo que da sentido al pulso, la cuadrícula periódica de fondo que nos permite anticiparnos a lo que viene. El pulso es el instante en el que todos juntos, de manera instintiva, damos la misma palmada. Y puede que esa sea la clave de todo, el motivo por el que los humanos, al contrario que las máquinas y que otros tipos de monos, compartimos esa extraña capacidad de sincronizarnos con una señal sonora periódica. Puede que la razón de ser de la música, no sea su sonido, ni siquiera su ritmo, sino nuestra capacidad de movernos juntos cuando suena.

Música y movimiento van de la mano en todas las culturas que conocemos. Eso que hacemos en Occidente de sentarnos una butaca sin mover ni un pelo, para no molestar al de al lado durante los conciertos de música clásica, es una anomalía cultural (y, desde mi punto de vista, uno de los motivos por los que estos eventos no son demasiado populares). Fuera de los auditorios refinados, allí donde suena la música, hay gente que se mueve. Es más, en algunas culturas, ni siquiera existen palabras diferentes para distinguir la música y la danza: resulta que la música es lo que suena mientras la gente baila y baile es eso que hace la gente cuando suena la música.

Para que esa combinación sea posible, el ritmo es un ingrediente imprescindible. Los periodos regulares de tiempo de la música son uno de sus pocos rasgos universales. Los instrumentos de percusión son también los más comunes a lo largo y ancho del planeta (por encima de los instrumentos de viento o de cuerda). Lo que hace la música es el ritmo. Y el ritmo es eso que nos permite movernos todos juntos a la vez.

Incluso a nivel neurológico, música y movimiento se encuentran unidos. Cuando escuchamos música, incluso si estamos perfectamente quietos, se activan regiones motoras en nuestro encéfalo. Da igual que estés en la oficina, en una camilla o en un entierro: si escuchas música que te gusta, te costará dejar los pies quietos, ¡es lo que te pide el cuerpo! Como dice Oliver Sacks1: “El ritmo convierte a los oyentes en participantes, hace que la escucha sea activa y motora, y sincroniza el cerebro y la mente (y, ya que la emoción es siempre parte de la música, los «corazones») de todos los que la escuchan. Es muy difícil permanecer indiferente, resistirse a dejarse llevar por el ritmo del canto o el baile”.

La música nos mueve en todos los posibles sentidos de la palabra. Así, el ritmo podría dar también respuesta a una de las preguntas que intrigó al mismísimo Darwin: ¿qué sentido tiene la música desde un punto de vista evolutivo?, ¿a qué viene esta devoción que demostramos los humanos por ciertas ondas de presión ordenadas en el aire?

De acuerdo con varios estudios psicológicos, la sincronía, el hecho de movernos junto a otros, facilita nuestra cooperación con ellos y refuerza nuestros vínculos con el grupo2. También en palabras de Sacks: “la música es una experiencia comunitaria, y parece haber, en cierto sentido, una unión o «unión» real de los sistemas nerviosos, una «neurogamia» (para usar una palabra que favorecían los primeros mesmeristas). La unión se logra mediante el ritmo, no solo escuchado sino internalizado, de manera idéntica, en todos los presentes”. Encontramos música en todos los eventos sociales, en todos los ritos de paso, en todos los contextos destinados a unirnos con los demás (y, siendo monos sociales, como somos, eso son muchos contextos). Incluso en la guerra: allí donde hay armas, siempre hay también un señor con un tamborilete. Su ritmo facilita la unión de las tropas, las convierte en un todo cohesionado.

Sin embargo, hubo una vez durante la guerra en que la música sirvió para hacer la paz. Fue en 1914 durante la Primera Guerra Mundial. Un día de Navidad, hubo un montón de soldados que, en lugar de matarse entre sí, empezaron a colaborar y a intercambiar regalos. Nadie sabe cómo sucedió exactamente, pero la hipótesis más probable es que unos soldados alemanes empezaron a cantar villancicos, y los ingleses al otro lado de la trinchera, les respondieron uniéndose a ellos.

Me pregunto qué cantarían al día siguiente para volver a iniciar la guerra.

Referencias:

1Sacks, Oliver. Musicofilia. Editorial Anagrama, 2009.

2Mithen, Steven. The Singing Neanderthals: The Origins of Music, Language, Mind, and Body. Harvard University Press, 2009.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo Música, guerra y paz se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Almudena M. Castro – Naukas P4K 2019: Música, guerra y paz

- ¿Es la música un lenguaje universal?

- La emoción de las escalas musicales

El jugador: una lección de teoría de la probabilidad

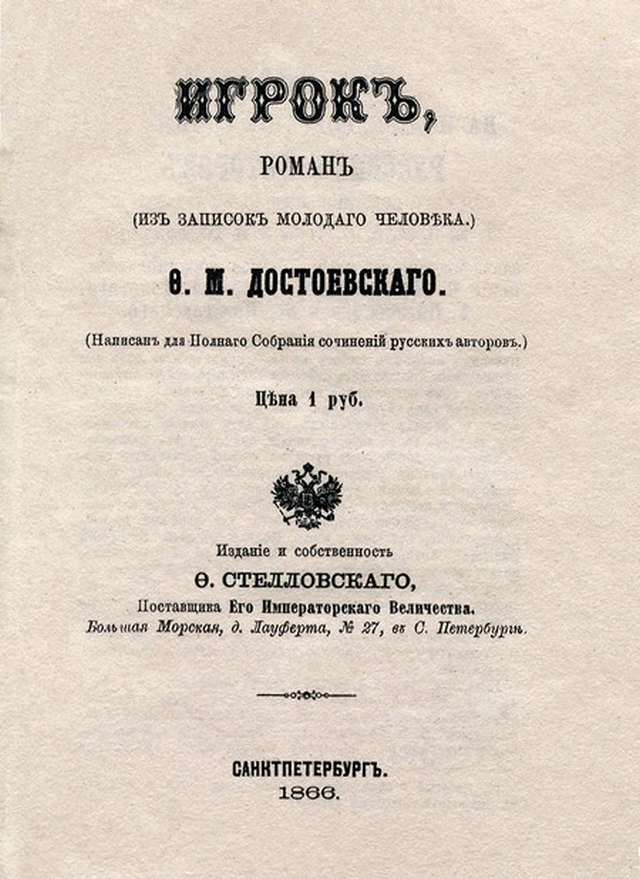

El jugador de Fiódor Dostoievski es la historia de una adicción al juego de la ruleta.

Portada de la primera edición de la novela. Imagen: Wikimedia Commons.

Portada de la primera edición de la novela. Imagen: Wikimedia Commons.

La teoría de la probabilidad está muy presente en la novela, en particular en el siguiente extracto del capítulo 10 en el que el azar convierte a una anciana en la admiración del casino…

Ella escuchaba atentamente, hacía nuevas preguntas y se instruía sobre el azar. De cada sistema de posturas se podía poner en seguida ejemplos, así es que muchas cosas las pudo aprender pronto y fácilmente. La abuela estaba encantada.

– ¿Y qué es eso del «cero»? Mira ese croupier de pelo rizado, el principal, que acaba de gritar «cero». ¿Por qué se ha llevado todo lo que había encima de la mesa? ¡Una cantidad tan enorme! ¿Qué significa eso?

– El «cero», abuela, queda a beneficio de la banca. Si la bola cae en el «cero» todo lo que está sobre la mesa, todo, sin distinción, pertenece a la banca. Cierto que se concede otra postura por pura fórmula, pero en caso de perder la banca no paga nada.

– ¡Toma! ¿Entonces si pongo al «cero» y gano no cobro nada?

– No, abuela. Si usted hubiese puesto previamente al «cero» y hubiese salido, cobraría treinta y cinco veces la puesta.

– ¡Cómo! ¡Treinta y cinco veces! ¿Y sale a menudo? ¿Por qué entonces esos imbéciles no juegan al «cero»?

– Hay treinta y cinco probabilidades en contra, abuela.

– ¡Qué negocio! ¡Potapytch, Potapytch! Espera, llevo dinero encima… ¡Aquí está! -sacó del bolsillo un portamonedas repleto y tomó un federico-. Toma, ponlo en el «cero».

– Pero, abuela, el «cero» acaba de salir -objeté-. No saldrá, por lo tanto, en mucho tiempo. Usted se arriesga demasiado, espere al menos un poco -insistí.

– ¡Ponlo y calla!

– Sea, pero quizá no saldrá ya más en todo el día.

– ¡No importa! Quien teme al lobo no va al bosque. Bien, ¿hemos perdido? ¡Pues vuelve a jugar!

Perdimos el segundo federico. Siguió un tercero. La abuela apenas si podía estarse quieta. Clavaba los ojos ardientes en la bola que zigzagueaba a través de las casillas del platillo móvil. Perdimos el tercer federico. La abuela estaba fuera de sí, se estremecía. Dio un golpe con el puño sobre la mesa cuando el croupier anunció el 36, en lugar del esperado «cero».

– ¡Ah! ¡El maldito! ¿Saldrá pronto? -decía irritada la abuela-.¡Dejaré mi piel, pero permaneceré aquí hasta que salga! ¡Tiene la culpa ese maldito croupier de pelo ondulado! Alexei Ivanovitch, pon dos federicos a la vez. Pones tan poco que no valdrá la pena cuando el «cero» salga.

– ¡Abuela!

– ¡Ponlos! ¡Ponlos! ¡El dinero es mío!

Puse los dos federicos. La bolita rodó largo tiempo sobre el platillo y comenzó a zigzaguearse a través de las casillas. La abuela, conteniendo la respiración, me agarró por el brazo. Y, de pronto, ¡crac!

– ¡»Cero«! -gritó el croupier.

– ¿Lo ves? ¿Lo ves? -exclamó la abuela, volviéndose hacia mí con aire de triunfo-. ¡Ya te lo decía yo! ¡Es el mismo Dios que me ha sugerido que pusiese dos monedas de oro! ¿Cuánto voy a cobrar? ¿Por qué no pagan? Potapytch, Marta, ¿dónde están? ¿Dónde se han ido los nuestros? ¡Potapytch, Potapytch!…

– En seguida, abuela -murmuré-. Potapytch se ha quedado a la puerta, no le dejarán entrar aquí. ¡Mire, ahora pagan!

Entregaron a la abuela un pesado cartucho de papel blanco que contenía cincuenta federicos. Le contaron además otros veinticinco federicos. Recogí todo aquello con la raqueta.

– ¡Hagan juego, señores! ¡Hagan juego! ¡No va más! -decía el croupier, dispuesto a hacer girar la ruleta.

– ¡Dios mío! ¡Es demasiado tarde! ¡Ya van a tirar!… ¡Juega, juega, pues! -decía, inquieta, la abuela-. ¡No te entretengas, atolondrado!

Estaba nerviosa y me daba con el codo con todas sus fuerzas.

– ¿A qué número juego, abuelita?

-Al «cero». ¡Otra vez al «cero»! ¡Pon lo más posible! ¿Cuántos tenemos? ¿Setecientos federicos? Pon veinte de una sola vez.

– ¡Reflexione, abuela! A veces está doscientas veces sin salir. Corre usted el riesgo de perder todo su dinero.

-No digas tonterías. ¡Juega! Oye cómo golpean con la raqueta. Sé lo que hago -dijo, presa de una agitación febril.

– El reglamento no permite poner en el «cero» más de doce federicos a la vez, abuela, y ya os he puesto.

– ¿Cómo no se permite? ¿Es esto cierto…? «¡Moussieé, moussieé!»

Tiró de la manga al croupier sentado a su lado, que se disponía a hacer girar la ruleta.

– «Combien zéro? Douze? Douze?»

Me apresuré a explicar al croupier la pregunta en francés.

– «Oui, madame» -confirmó, cortésmente, el croupier-; tampoco ninguna postura individual puede pasar de cuatro mil florines. Es el reglamento.

– Entonces, tanto peor. Pon doce.

– Hecho el juego -anunció el croupier.

El disco giró y salió el 30. ¡Habíamos perdido!

– ¡Sigue poniendo! -dijo la abuela.

Me encogí de hombros y sin replicar puse doce federicos. El platillo giró largo tiempo. La abuela observaba temblando. «¿Se imagina que el «cero» y va a ganar de nuevo?», pensé, contemplándola con sorpresa. La certeza absoluta de ganar se reflejaba en su rostro, la espera infatigable de que se iba a gritar: ¡»Cero»! La bola paró dentro de una casilla.

– ¡»Cero«! -cantó el croupier.

– ¡Lo ves! -gritó triunfalmente la abuela.

Comprendí en aquel momento que yo también era un jugador. Mis manos y mis piernas temblaban. Era realmente extraordinario que en un intervalo de diez jugadas el «cero» hubiese salido tres veces, pero sin embargo había sucedido así. Yo mismo había visto, la víspera, que el «cero» había salido tres veces seguidas y un jugador, que anotaba cuidadosamente en un cuadernito todas las jugadas, me hizo notar que la víspera, el mismo «cero» no se había dado más que una vez en veinticuatro horas.

Después de aquella jugada afortunada la abuela fue objeto de general admiración.

Cobró exactamente unos cuatrocientos veinte federicos, o sea, cuatro mil florines y veinte federicos, que le fueron pagados parte en oro y parte en billetes de banco.

Pero aquella vez la abuela no llamó a Potapytch. Tenía otra idea en la cabeza. No manifestó siquiera emoción.

Pensativa, me interpeló:

– ¡Alexei Ivanovitch! ¿Has dicho que se podían poner solamente cuatro florines a la vez?… ¡Toma, pon esos cuatro billetes al «rojo»! ¿Para qué intentar disuadirla? El platillo comenzó a girar.

– ¡»Rojo«! -cantó el croupier.

Nueva ganancia de cuatro mil florines, o sea, ocho mil en total.

– «Dame la mitad y pon la otra, de nuevo, al «rojo» – ordenó la abuela.

Puse los cuatro mil florines.

– ¡»Rojo«! -anunció el croupier.

– ¡Total, doce mil! Dámelo todo. Pon el oro en el bolso y guarda los billetes.

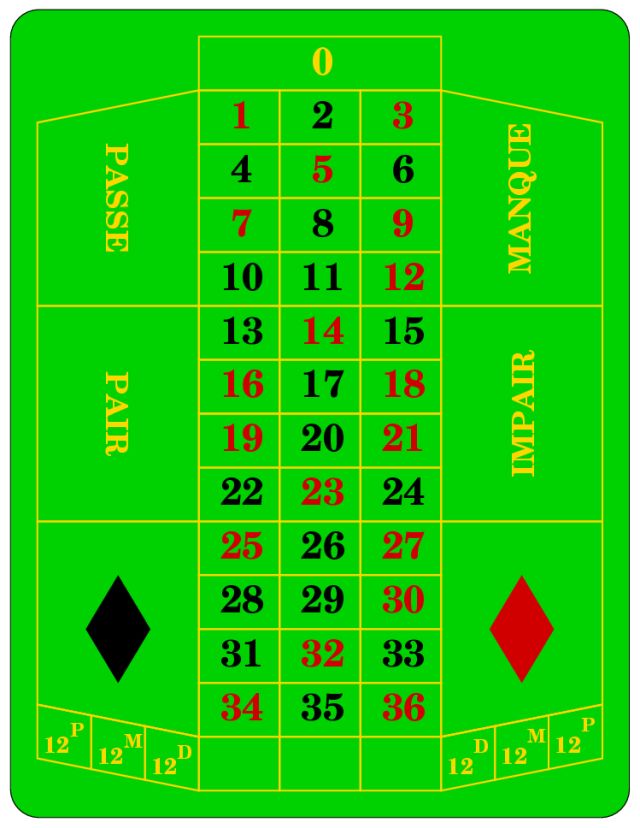

Ruleta francesa. Imagen: Wikimedia Commons.

Ruleta francesa. Imagen: Wikimedia Commons.

En la ruleta se puede apostar a los números del 0 al 36, con la misma probabilidad de salir cada uno de ellos: 1/37 (aproximadamente, 0,027). Además, con respecto a los comentarios de los protagonistas de esta escena:

-

La probabilidad de que el cero no salga en una jugada es de 36/37 (aproximadamente, 0,97).

-