La química del azul de Patinir

Patinir es considerado el primer paisajista flamenco. El azul de sus paisajes se concentra al fondo y va impregnando el cuadro hacia adelante, como una ola que avanza dejándolo todo perdido de color azul. Este efecto de avance lo consigue a través de planos paralelos escalonados. Al fondo el cielo, con la línea del horizonte bien alta, comparte azul con las montañas. Al fondo todo es azul.

Joachim Patinir. El paso de la laguna Estigia.1520 – 1524. Óleo sobre tabla, 64 x 103 cm.

Joachim Patinir. El paso de la laguna Estigia.1520 – 1524. Óleo sobre tabla, 64 x 103 cm.

Yves Klein decía que «el azul es lo invisible haciéndose visible». El azul se ha utilizado en arte como concepto, especialmente para hacer notar lo inmaterial. Para pintar el paraíso y la oscuridad. El artista contemporáneo Anish Kapoor pintó un limbo azul oscurísimo que atrapa la luz en su Descenso al limbo. Los impresionistas renegaron del negro y pintaron las sombras de azul. El azul del Renacimiento es el azul de Patinir.

Se podría contar gran parte de la historia del arte a través del azul. Desde el azul egipcio, el ultramarino, el azul de cobalto, el cerúleo, el azul de manganeso, el de Berlín, el de París, el de Prusia, el de Milori, el de Bremen, hasta el azul de montaña, la azurita. Cada uno de ellos tiene un azul particular que puede describirse en gran medida gracias a la química de coordinación, como los azules que son azules por la presencia de metales de transición (cobalto, cobre, hierro, manganeso…). Algunos azules tienen matices de color que hay quien colocaría dentro de los violetas o los verdes. Algunos incluso mutan como consecuencia de la química y el tiempo. Hay artistas que han utilizado estas mutaciones o aparentes defectos de color en su beneficio. Entre ellos está el azul de Patinir, con frecuencia a caballo entre el color azul ultramarino y el turquesa.

El azul de Patinir es el azul de montaña, comúnmente llamado azurita. Hasta mediados del siglo XVIII fue el pigmento más utilizado en la pintura europea, y vino a sustituir el valioso azul ultramar auténtico, el que se extraía del lapislázuli y que provenía de Afganistán. La azurita, en cambio, se extraía de las montañas germanas, de ahí su nombre azul de montaña.

Hay constancia de que se conocía desde la antigüedad: los armenium y caeruleum que menciona Plinio eran seguramente tipos de azurita. Para diferenciarlos del ultramar se denominaban azzurrum ciramarinum o azzurro dell’Allemagna.

-

La química de la azurita en pintura

Químicamente la azurita es un carbonato básico de cobre, con un contenido en agua de cristalización variable (Cu3(CO3)2(OH)2). En los yacimientos se encuentra junto a la malaquita, con la que guarda una importante similitud química.

Se puede utilizar con medios acuosos como el temple o con gomas vegetales. Desprende un color azul luminoso. En comparación con el ultramarino tiende a verdoso con una leve tonalidad violácea.

En pinturas con medio aceitoso, como el óleo, capa a capa el resultado puede parecer casi negro. Añadiendo blanco es como se obtienen los azules más puros y cubrientes. Además, como la azurita es estable frente a los álcalis, se puede utilizar en medios oleosos mezclado con cal. El problema del óleo es que puede presentar rechazos de coloración y verdear, principalmente por formación de oleato de cobre.

-

Verdeado de la azurita

El tono aturquesado del azul de Patinir tiene que ver con la química de la azurita y su parcial transmutación en malaquita. Si el pigmento absorbe agua, parte de él acaba transformándose en malaquita (Cu2CO3(OH)2) que es de color verde. Esta es la razón por la que habitualmente las piedras que contienen azurita también presentan coloración verdosa de malaquita y viceversa.

Tanto la azurita como la malaquita pueden oxidarse y dar lugar a óxido de cobre o a sulfuro de cobre, en ambos casos de color negruzco. De ahí las zonas más oscuras de la piedra de la imagen anterior.

En cuanto el pigmento se mezcla con el aglutinante oleaginoso para formar la pintura al óleo, esta transmutación azurita-malaquita se queda congelada en el tiempo. Esa es la razón por la que las pinturas al óleo de azurita tienen tonos de color sutilmente diferentes, más verdes o azules.

El verdeado también puede deberse al propio amarilleamiento del aglutinante y, en mayor medida, al uso de barnices. A la hora de restaurar un cuadro hay que evaluar si el verdeado es propio del pigmento o es consecuencia de una alteración del medio. De hecho, es habitual que algunos pintores apliquen veladuras amarillas sobre la azurita para potenciar el verdeado. O que directamente mezclen pinturas como el amarillo de plomo con la azurita para conseguir pintura verde.

-

La azurita en la actualidad

La azurita tiene una composición química tan sencilla que ha sido fácil de obtener de forma sintética. A los carbonatos básicos de cobre producidos artificialmente se les conoce bajo el nombre de verditer. El grano que se comercializa es fino y regular, y resulta indistinguible de la azurita natural más débil de color. A pesar de que en el siglo XVIII ya existía el verditer, la batalla del azul la ganó el azul Berlín, un ferrocioanuro férrico mucho más estable y económico. Unos decenios más tarde se sumaron como sustitutos el azul ultramar artificial y el azul cobalto.

- El paso de la laguna Estigia

En 2013 hubo una exposición en el Museo del Prado llamada Historias naturales, un proyecto de Miguel Ángel Blanco. La exposición consistió en la instalación de alrededor de 150 piezas de historia natural, procedentes en su mayoría del Museo Nacional de Ciencias Naturales del CSIC –animales, plantas y minerales- junto a 25 obras de la colección del Museo, que entrañaban una estrecha relación con las mismas.

Una de las instalaciones que mejor definió el papel de Blanco dentro de las salas del Museo es su intervención en el emblemático cuadro de Joachim Patinir, El paso de la laguna Estigia. Delante de él colocó una gigantesca roca de azurita. Una roca a modo de prolongación de la laguna, o como resultado de su desecación, añadiendo un plano más a la obra original. La elección de la roca es coherente porque precisamente la azurita es el pigmento del azul que Patinir empleó en este cuadro.

El paso de la laguna Estigia está dividido verticalmente en tres zonas. En él se mezclan imágenes bíblicas junto a otras propias del mundo grecorromano. A la derecha está el Paraíso, con una zona de entrada angosta. En él prima el verde fresco y los azules. A la izquierda está el Infierno, con una entrada amplia y fácil, con verdes apagados, y al fondo negros y rojos que quedan fuera de la vista del navegante. En el centro Caronte lleva en su barca a un alma. Surcan la laguna turquesa en dirección al infierno.

-

De Patinir a Mejuto

El artista contemporáneo Vítor Mejuto ha traducido algunos de los cuadros más icónicos de la historia a un lenguaje geométrico. Uno de ellos es El paso de la laguna Estigia de Patinir. Mediante un proceso de síntesis, economía de formas y economía de color, Mejuto ha pintado el paso de la laguna Estigia empleando exclusivamente ocho planos de color sin transición entre ellos. De la misma forma que Mondrian eliminaba el velo que no le permitía ver la realidad en sus obras neoplásticas, Mejuto rescata lo grueso del cuadro de Patinir, como un ejercicio de optimización de la memoria.

Vítor Mejuto. El paso de la laguna Estigia.2018. Acrílico sobre loneta resinada, 55 x 65 cm.

Vítor Mejuto. El paso de la laguna Estigia.2018. Acrílico sobre loneta resinada, 55 x 65 cm.

El azul de la laguna de Mejuto es el acrílico turquesa de Windsor & Newton. Este color se fabrica a partir del azul cobalto sintético o azul de Thénard, y químicamente es una espinela de óxido de cobalto (II) y óxido de aluminio (CoO·Al2O3), o aluminato de cobalto (II) (CoAl2O4). Es un pigmento de un azul intenso y puro que, combinado con óxido de cromo en la espinela, adquiere el color aturquesado final.

El uso del azul cobalto turquesa es la evolución lógica, desde un punto de vista técnico, de la renacentista azurita. Al igual que Patinir, Mejuto también empleó blanco en la mezcla para obtener el tono que encajaba. Patinir empleó blanco de plomo, actualmente en desuso por su toxicidad. Mejuto, blanco de zinc. También los blancos evolucionan en el arte cuanta más química sabemos sobre ellos.

Aunque el tema de El paso de la laguna Estigia es atemporal, tanto Patinir como Mejuto emplearon para pintarlo los azules de su tiempo.

Sobre la autora: Déborah García Bello es química y divulgadora científica

El artículo La química del azul de Patinir se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El Rubius hace un vídeo de química y la lía parda

- Los bimbaches de Punta Azul (El Hierro)

- Ensayo sobre el azul

El secreto de los números que no querían ser simétricos

Los números capicúas, o palíndromos, que son aquellos números tales que sus cifras leídas de izquierda a derecha y de derecha a izquierda son las mismas, son un tipo de números que, por la simetría que encierran, llaman la atención de la mayoría de las personas. De hecho, buscarlos, e incluso coleccionarlos, en las matrículas de los coches, los décimos de lotería, los billetes de medios de transporte, como autobús, tren o metro, los billetes de la moneda de cualquier país o cualquier otro lugar en el que aparezcan números de cuatro, o más dígitos, es algo bastante habitual. Más aún, muchas personas relacionan el hecho de encontrarse con un número capicúa, con la buena suerte.

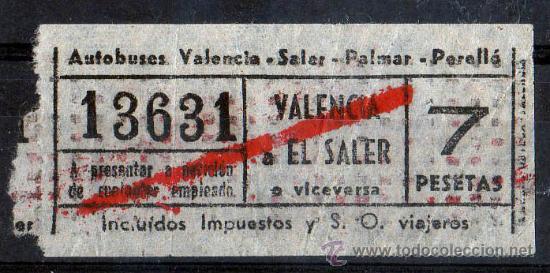

Billete de autobús Valencia-El Saler, con numeración capicúa, 13631. Imagen de la página web todocoleccion

Billete de autobús Valencia-El Saler, con numeración capicúa, 13631. Imagen de la página web todocoleccion

El concepto de número capicúa es muy sencillo y es muy fácil construir ejemplos de estos números. La forma más trivial es considerar un número con todos sus dígitos iguales, como 333.333.333, o se puede considerar una sucesión de cifras que luego se repiten en el sentido contrario, 12.433.421, aunque puede no repetirse el número central, 1.243.421. Así podemos crear todos los números palindrómicos que queramos: 232, 1.221, 55.555, 813.318, 1.756.571, etcétera. Claramente, existe una cantidad infinita de números capicúas, dado uno de estos números, siempre podemos generar uno más grande con solo añadir una misma cifra a la derecha y la izquierda del número, así dado el 121, podemos añadir el 7, obteniendo 71.217, si ahora añadimos el 3, se tiene 3.712.173, y este proceso es infinito.

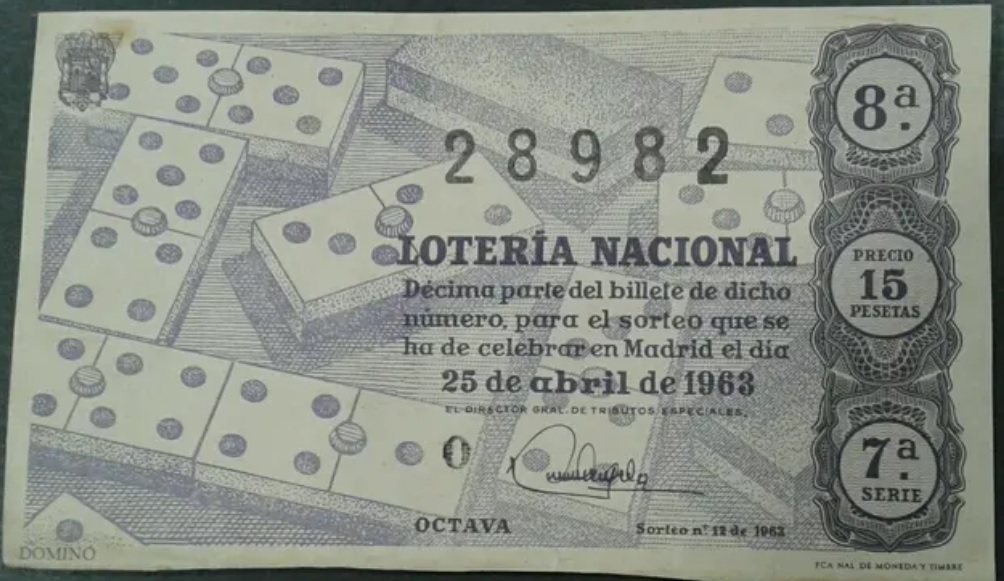

Antiguo billete de la Lotería Nacional, de abril de 1963, con un número capicúa, 28982. Imagen de la página Wallapop

Antiguo billete de la Lotería Nacional, de abril de 1963, con un número capicúa, 28982. Imagen de la página Wallapop

El concepto de palíndromo está fuertemente ligado a la representación posicional de los números, y además, depende de la base en la que se representan, en nuestro caso, es un sistema decimal, base 10. Por ejemplo, el número 2.002 es capicúa (en la base 10 en la que lo representamos de forma habitual), pero si se representa este mismo número en la base binaria, es decir, la base 2, con 0s y 1s, es decir, 11111010010, este ya no es capicúa. O si se representa el 2.002 en base octal, es decir, la base 8 (en la que utilizamos como cifras básicas 0, 1, 2, 3, 4, 5, 6 y 7), que se escribe como 3722, tampoco es capicúa.

Como sabemos, nuestro sistema de numeración posicional decimal viene la antigua India. Y precisamente, en la obra Ganatasarasamgraha – Compendio de la esencia de las matemáticas, del año 850, del matemático indio Mahaviracharya, se habla de un cierto número que “comienza por uno (y va aumentando de forma progresiva) hasta seis, para, a continuación, disminuir ordenadamente”, es decir, se refiere al número 123.45.654.321.

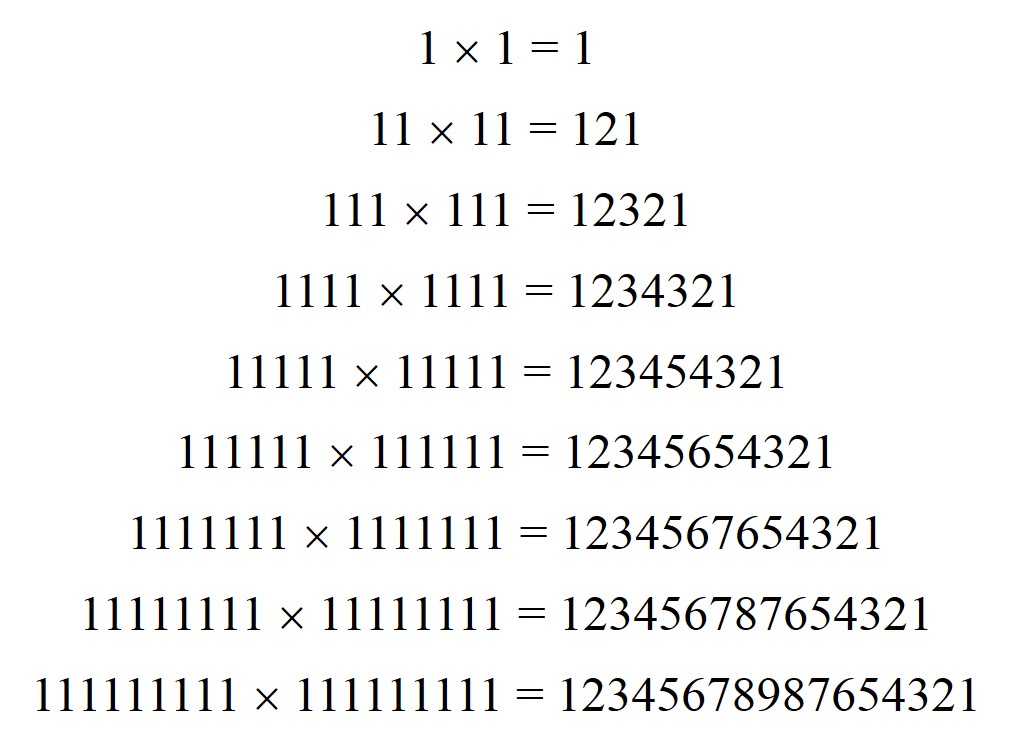

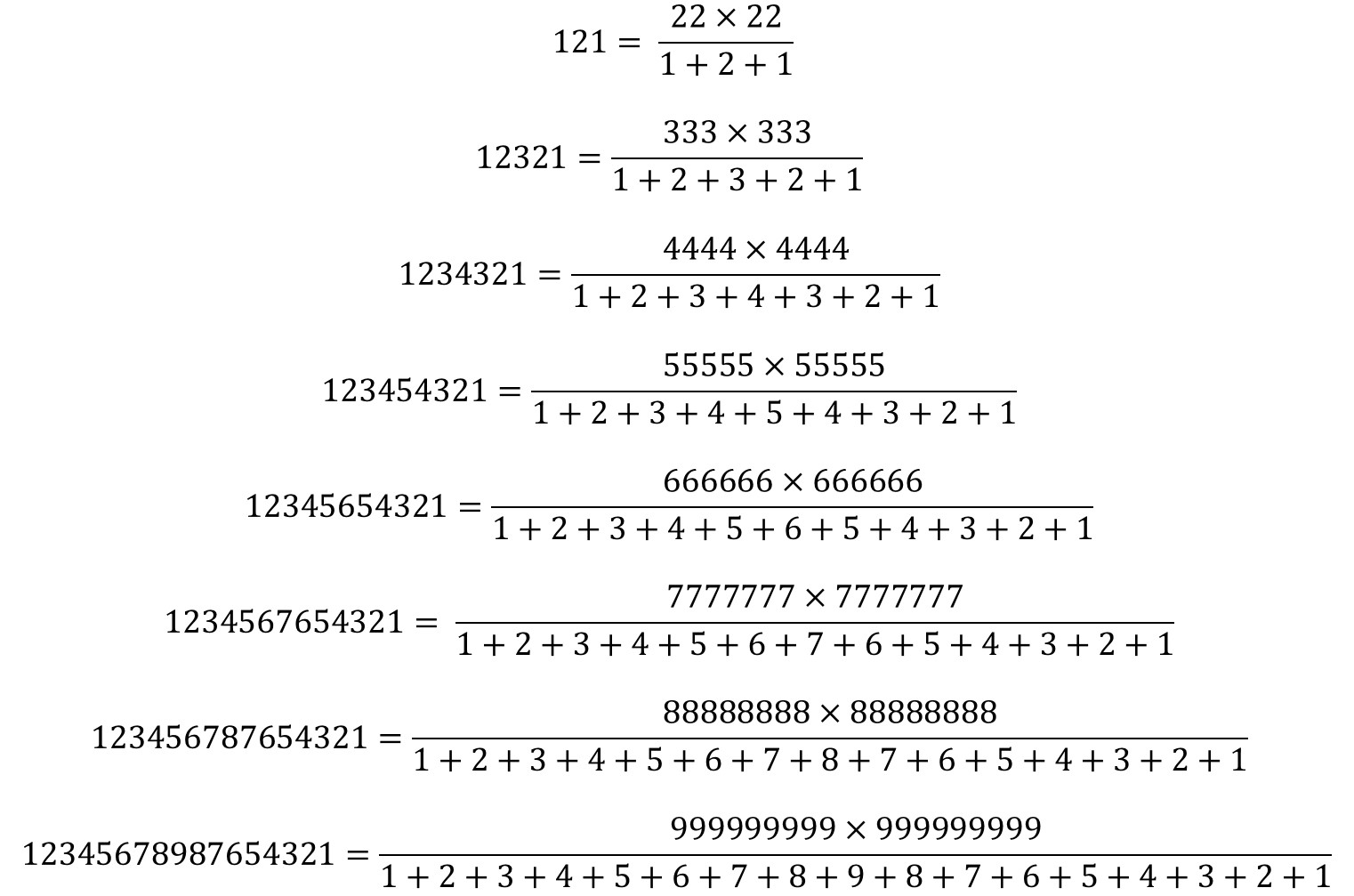

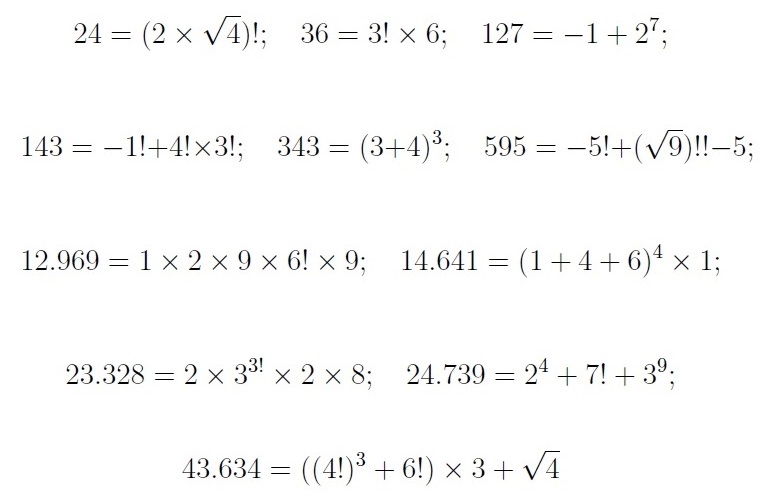

Esta familia de números capicúas, en la cual las cifras van subiendo, en una unidad, y luego bajando, tiene una propiedad curiosa, ya que puede obtenerse como el cuadrado de los números cuyos dígitos son solo unos:

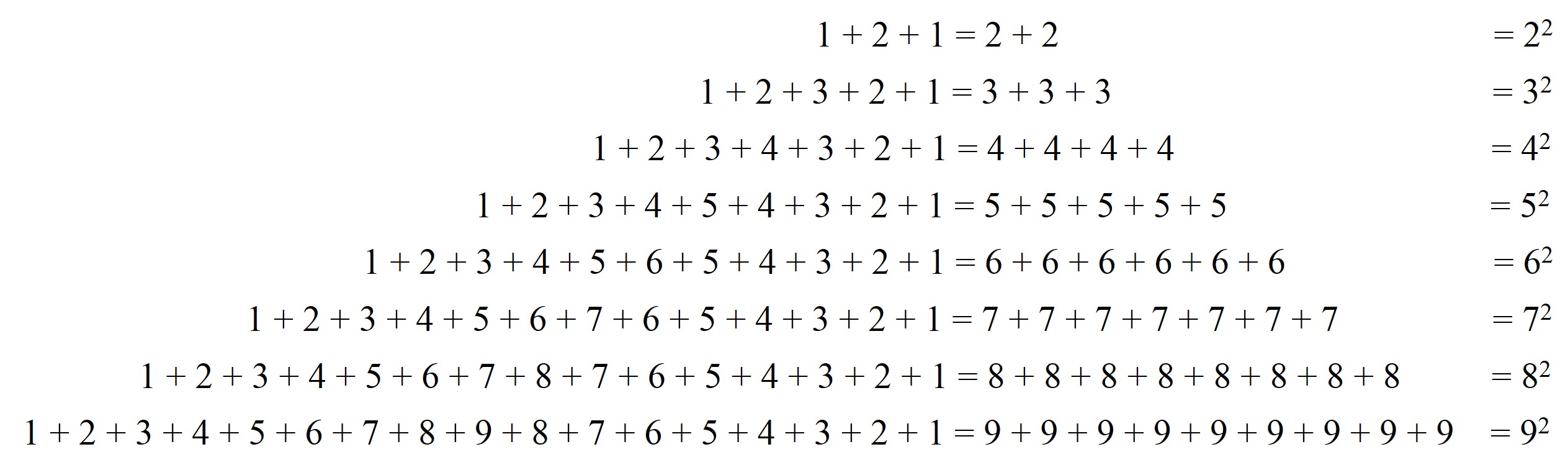

Además, si cogemos cada uno de esos palíndromos, se verifica que la suma de las cifras del número es un número cuadrado.

Más aún, estos particulares números capicúas, de la forma 12345654321, se pueden obtener también mediante una expresión simétrica bastante llamativa, aunque realmente solo es la combinación de las dos anteriores.

Pero vayamos con el objetivo central de esta entrada, una curiosa forma de obtener números capicúas. Tomemos un número cualquiera, por ejemplo, el 17 y sumémosle su simétrico, el 71, entonces se obtiene 17 + 71 = 55, que es palíndromo.

Probemos con otros números. Por ejemplo, el 75, entonces 75 + 57 = 132, que no es palíndromo, pero volvamos a realizar el mismo proceso con este resultado, 132 + 231 = 363, que ahora sí es capicúa, y lo hemos conseguido en dos pasos.

Veamos qué ocurre con algunos otros números. El 86, le sumamos su simétrico, 86 + 68 = 154, y como no es capicúa, seguimos el proceso, 154 + 451 = 605, una iteración más, 605 + 506 = 1111, de nuevo capicúa, en esta ocasión en tres pasos. Si empezamos en el número 87, después de cuatro pasos se obtiene el número 4.884, que es un número palindrómico. El número 88 ya es capicúa, es igual a su simétrico, luego no damos ningún paso con él. Si empezamos con el 89, necesitaremos 24 pasos hasta llegar a un número capicúa, el 8.813.200.023.188, como podéis comprobar.

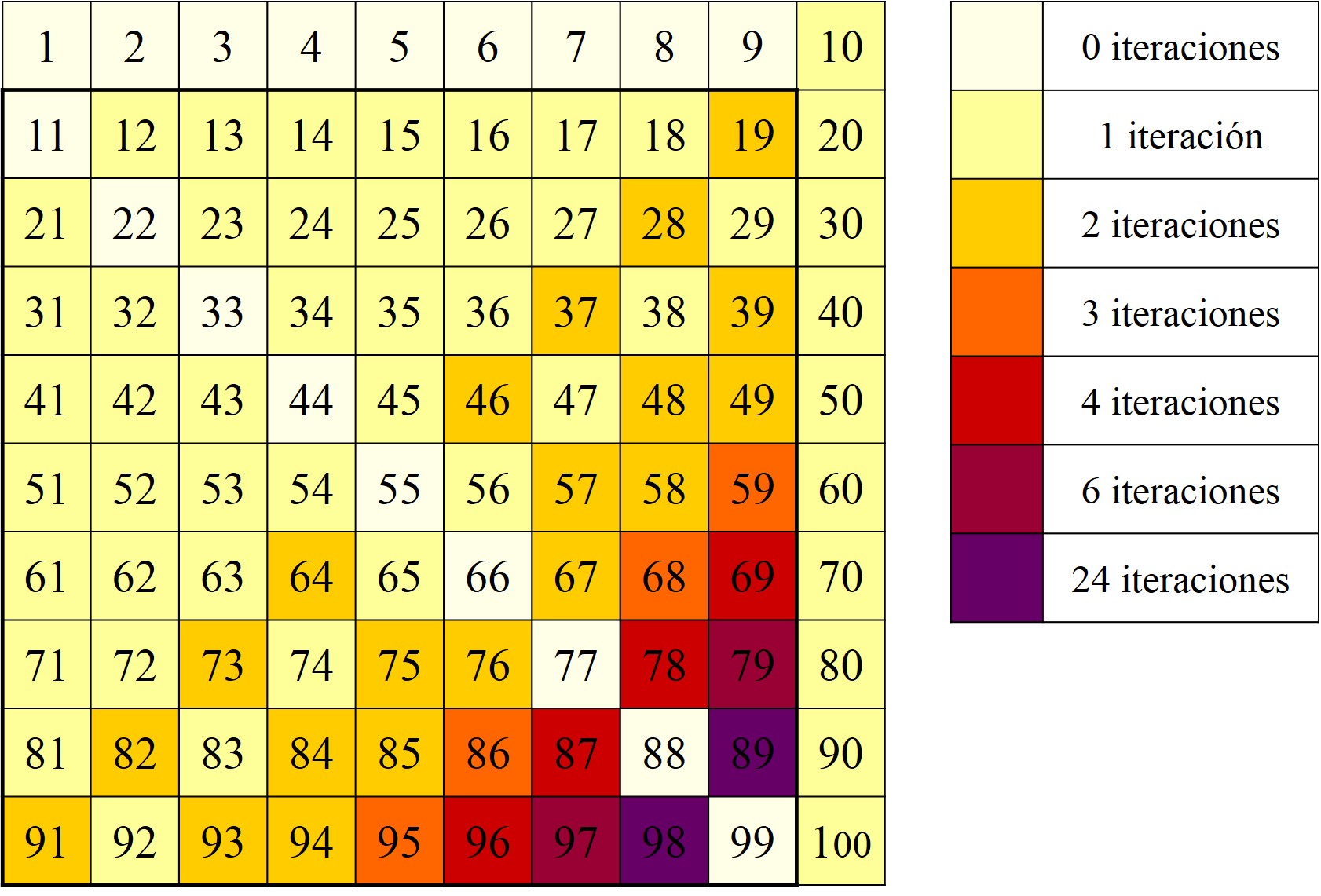

Antes de continuar, podemos hacer una representación, con colores, de los 100 primeros números, distribuidos en una matriz cuadrada 10 x 10, de manera que el color esté relacionado con la cantidad de iteraciones que se necesitan para llegar a un palíndromo.

Como puede observarse, existe una cierta simetría alrededor del eje de los números de dos cifras formados por dos dígitos iguales, como 44 o 77, ya que los números a un lado y otro de este eje son los simétricos, como 67 y 76, que tienen igual comportamiento frente a este proceso.

La pregunta que se nos ocurre después de estos ejemplos, e incluso podemos intentarlo con algunos números más a ver qué ocurre, es:

Problema: ¿Se obtendrá siempre un número capicúa mediante este método iterativo, de sumar a un número su simétrico?

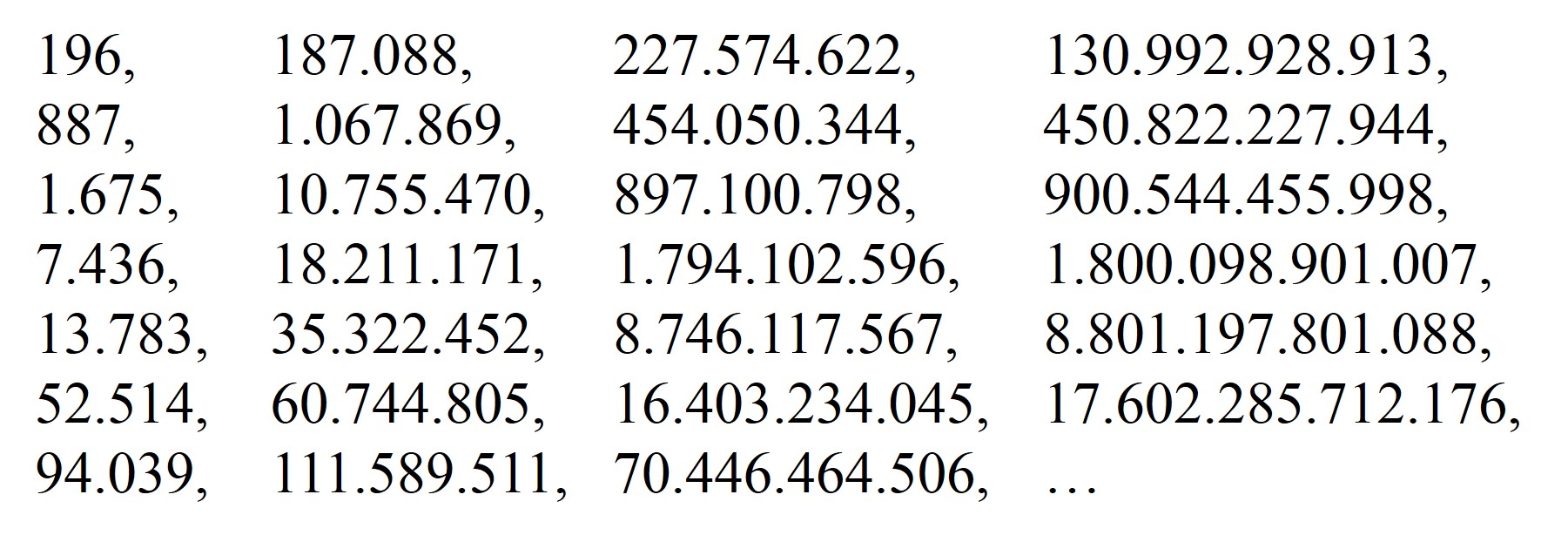

Este es un problema que aún está abierto, no se sabe si la respuesta es afirmativa o negativa. De hecho, el número 196, que no es un número muy grande, se desconoce si produce un número capicúa mediante este proceso iterativo. Veamos las primeras 26 iteraciones:

Desde la década de 1980, y haciendo uso de los ordenadores, se ha estado trabajando en realizar el mayor número de iteraciones posibles para ver si se alcanzaba un palíndromo, sin embargo, a día de hoy aún no se ha conseguido alcanzar un número con esta propiedad. En la actualidad, tenemos que Romain Dolbeau, con su programa “p196_mpi”, consiguió realizar en 2011 un billón de iteraciones, con las cuales alcanzó un número de más de 400 millones de dígitos, sin conseguir un número capicúa. Y en 2015 alcanzó un número con un billón de dígitos, sin conseguir el objetivo de llegar a un palíndromo. Por lo tanto, este es un problema abierto, aún se desconoce si empezando en el número 196, mediante el proceso iterativo “sumar el simétrico”, será posible obtener un número capicúa en algún momento, o si será este un proceso infinito, que nunca dará lugar a un palíndromo.

De hecho, se ha bautizado con el nombre de “números de Lychrel” (este nombre es un anagrama de Cheryl, el nombre de la novia, ahora mujer, de un matemático, Wade VanLandingham, que trabajaba en este tema), a aquellos números de los que se desconoce si generan un número palindrómico. Los primeros términos de la sucesión de estos números, etiquetada como A023108 en la Enciclopedia on-line de sucesiones de enteros de N. J. A. Sloane, son:

196, 295, 394, 493, 592, 689, 691, 788, 790, 879, 887, 978, 986, 1.495, 1.497, 1.585, 1.587, 1.675, 1.677, 1.765, 1.767, 1.855, 1.857, 1.945, 1.947, 1.997, …

Por otra parte, ya sabíamos que los números 887 y 1.675 también eran números de Lychrel, puesto que estaban en la sucesión de iteraciones del número 196. De hecho, se ha dividido a la familia de números de Lychrel en dos tipos de números, las “semillas”, que son los números más pequeños que generan un “hilo” de iteraciones, como el número 196, o los “familiares”, que son aquellos números que forman parte de un hilo generado por una “semilla”, como 887, 1.675 o 7.436, que están en el hilo del 196, o aquellos números que generan un mismo hilo que una semilla, como los números 295 (ya que, 295 + 592 = 887, que está en el hilo del 196, luego se genera este hilo a partir de 887), 394 (ya que, 394 + 493 = 887) o 689 (ya que, 689 + 986 = 1.675, que está en el hilo de 196). Dicho de otra forma, solamente hace falta estudiar las semillas, ya que los familiares tienen el mismo comportamiento que estas.

Solamente hay cuatro semillas menores que 10.000, que son 196, 879, 1.997 y 7.059, sin embargo, a partir de 10.000, ya hay muchas más semillas. Las siguientes son:

10.553, 10.563, 10.577, 10.583, 10.585, 10.638, 10.663, 10.668, 10.697, 10.715, 10.728, 10.735, 10.746, 10.748, 10.783, 10.785, 10.787, 10.788, 10.877, 10.883, 10.963, 10.965, 10.969, 10.977, 10.983, 10.985, 12.797, 12.898, etcétera.

Billete de España de 500 pesetas, del año 1979, con la imagen de Rosalía de Castro, y con un número de serie capicúa, 2152512. Imagen de la página de Numismática Bilbao

Billete de España de 500 pesetas, del año 1979, con la imagen de Rosalía de Castro, y con un número de serie capicúa, 2152512. Imagen de la página de Numismática Bilbao

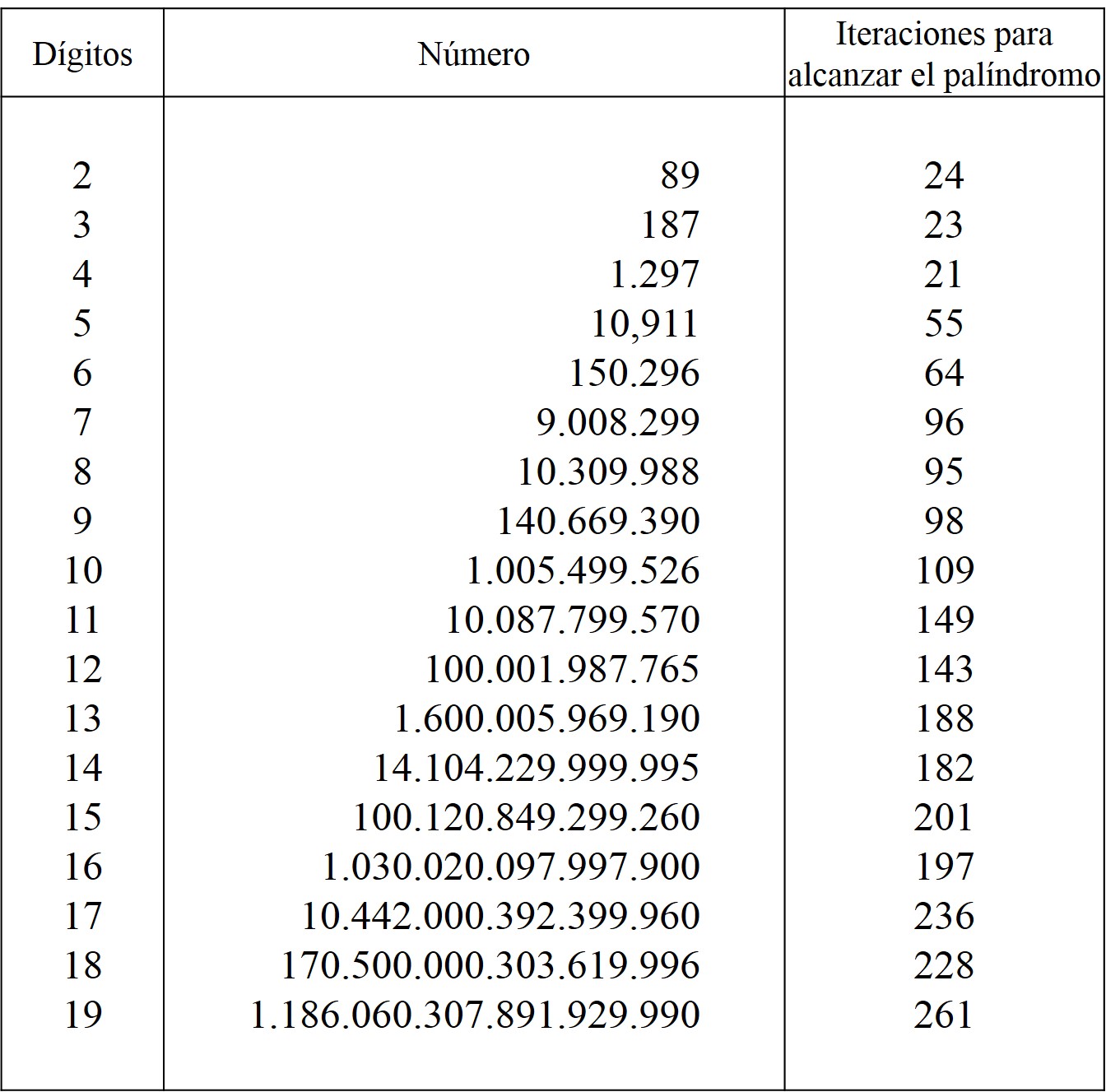

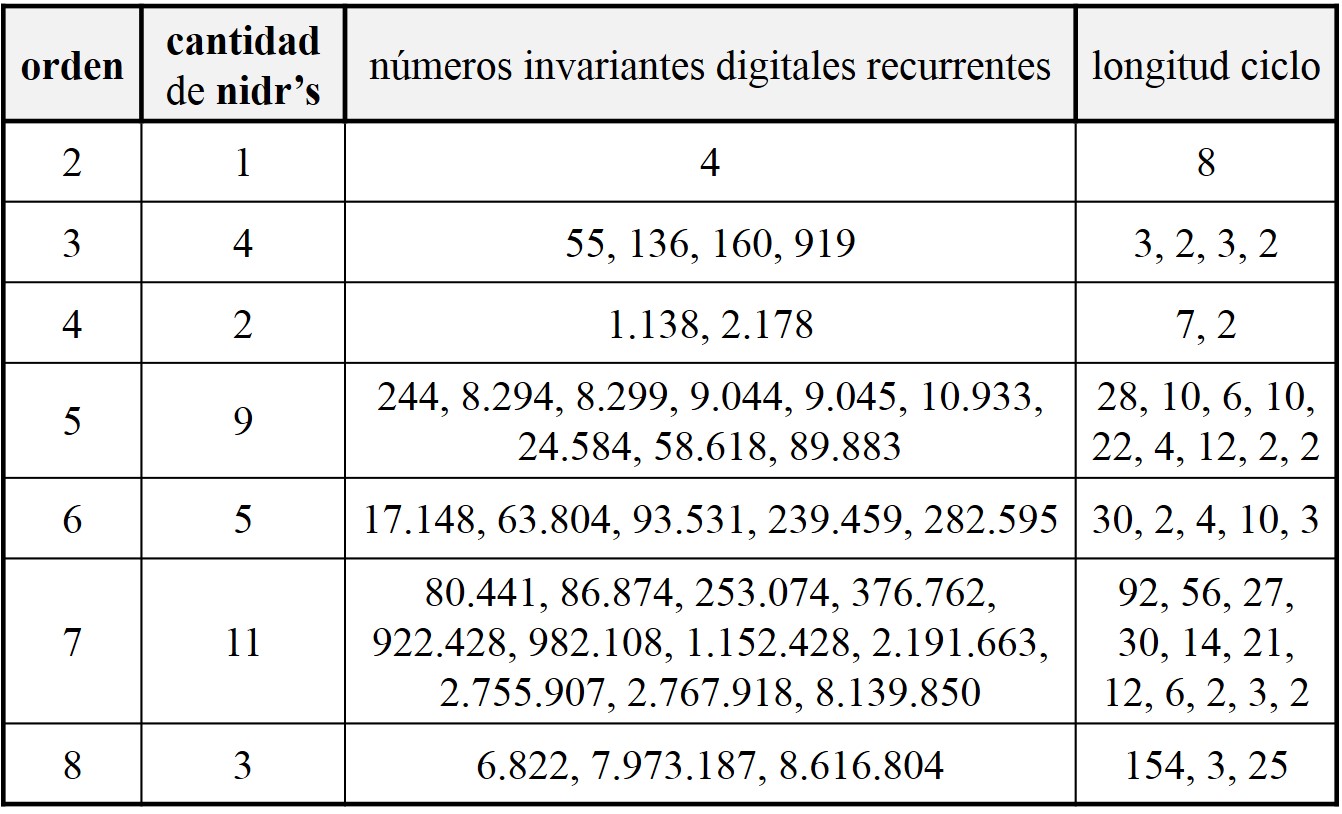

Volviendo a los números que sí generan un número capicúa mediante el proceso “sumar el simétrico”, hemos visto que el número 89 necesitaba de 24 iteraciones para alcanzar el palíndromo. Otra cuestión que nos podemos plantear es si, salvo en el caso de los números de Lychrel, se necesitan muchas iteraciones para llegar al capicúa. El mayor número de iteraciones para un número de 3 dígitos es 187, que necesita 23 pasos para alcanzar el palíndromo. Con 4 cifras es el 1.297, que necesita 21 iteraciones.

Aunque, a día de hoy, el mayor número de iteraciones necesarias para obtener un número palindrómico, mediante este proceso, es de 261, que convierten el número 1.186.060.307.891.929.990, con 19 dígitos, en un número capicúa de 119 dígitos. En el siguiente cuadro se recogen los records de iteraciones necesarias para números de entre 2 y 19 dígitos.

Para terminar, me gustaría hacer un breve comentario sobre algunas familias de números capicúa. En el mundo de las matemáticas nos encanta “jugar” y estudiar las diferentes propiedades matemáticas con las que nos encontremos, solo por el placer del conocimiento. Así, en el caso de los números palindrómicos, se estudian las familias de estos números que además satisfacen otras propiedades matemáticas, como ser números cuadrados, cúbicos o cualquier otra potencia, números triangulares y otros números poligonales, o números primos, así mismo se estudian diferentes objetos matemáticos formados con números capicúas, como las ternas pitagóricas o los cuadrados mágicos.

Veamos algunos ejemplos. Recordemos que los números triangulares son aquellos que se pueden representar con piedras como un triángulo equilátero y que coinciden con aquellos que son la suma de los primeros números naturales, como 1 + 2 + 3 = 6 ó 1 + 2+ 3 + 4 = 10 (véanse las entradas El asesinato de Pitágoras, historia y matemáticas (y II) o La magia de los números (el teorema de Moessner)). Y la fórmula general de los números triangulares es Tn = n x (n – 1) / 2.

¿Existirán números triangulares capicúas? Sí, por ejemplo, los primeros números triangulares capicúas son:

T1 = 1, T2 = 3, T3 = 6, T10 = 55, T11 = 66, T18 = 171, T34 = 595, T36 = 666, T77 = 3003, T109 = 5995, T132 = 8778, T173 = 15051, …

Por cierto, que el número de la bestia (véanse las entradas 666, el número de la Bestia (I) y 666, el número de la Bestia (II)) es un número triangular capicúa. Se conocen 147 números triangulares capicúas.

Un campo en el que se está trabajando mucho es en el estudio de los números capicúas primos, como los números 131 o 757. A continuación, os dejo el listado de los primeros palíndromos primos:

2, 3, 5, 7, 11, 101, 131, 151, 181, 191, 313, 353, 373, 383, 727, 757, 787, 797, 919, 929, 10.301, 10.501, …

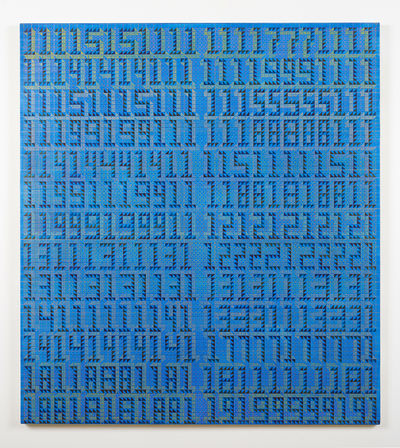

Obra Family vacation (2016), de la artista estadounidense Xylor Jane, en la que se observan dos columnas de 13 números, de 11 dígitos cada uno de ellos, que resultan ser números capicúas primos con 11 dígitos, que solo contienen 2 de las 10 cifras básicas, como 1.111.515.111 o 13.131.113.131. Imagen de la página web ART SY

Obra Family vacation (2016), de la artista estadounidense Xylor Jane, en la que se observan dos columnas de 13 números, de 11 dígitos cada uno de ellos, que resultan ser números capicúas primos con 11 dígitos, que solo contienen 2 de las 10 cifras básicas, como 1.111.515.111 o 13.131.113.131. Imagen de la página web ART SY

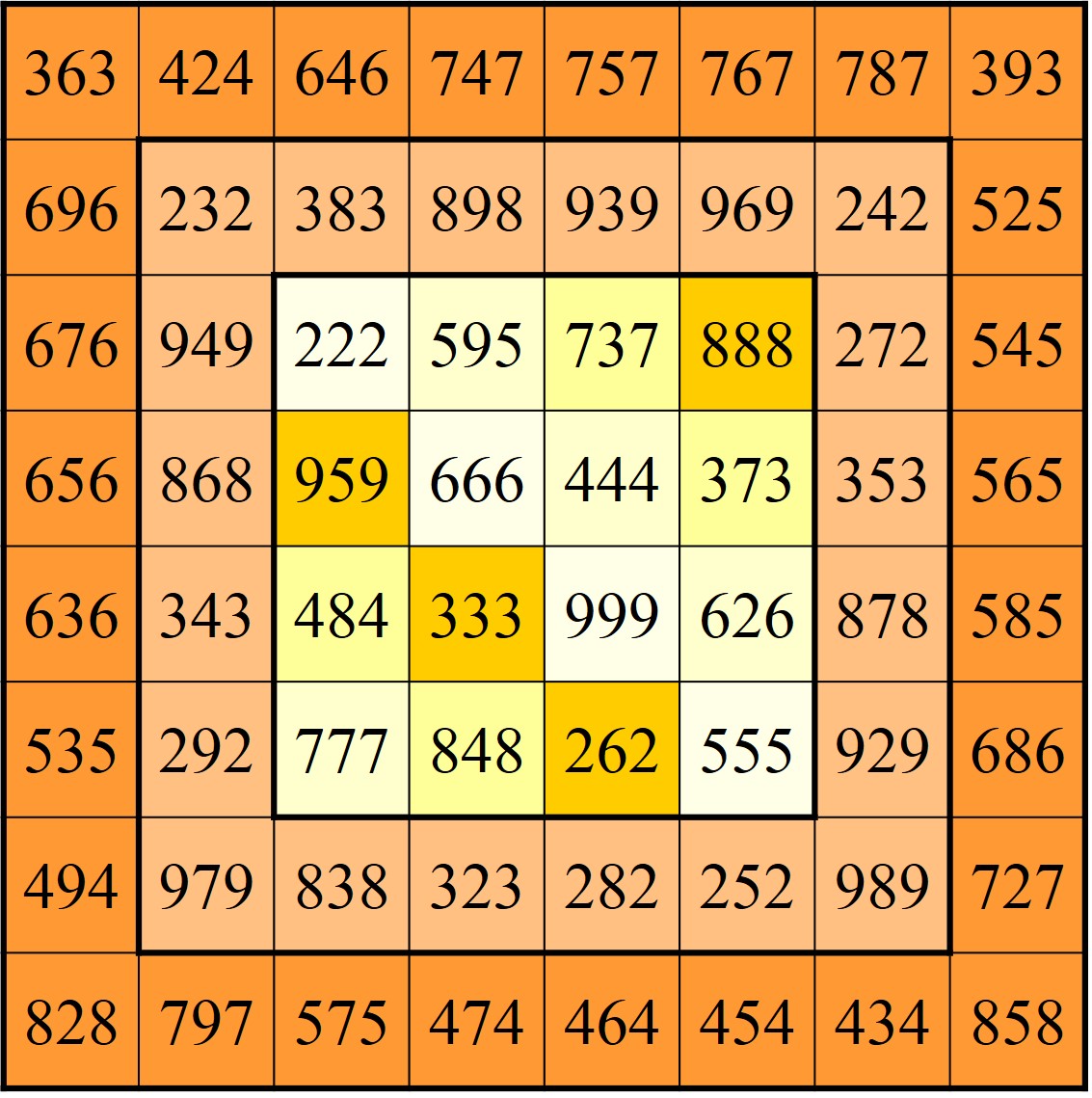

Vamos a terminar la entrada con tres cuadrados mágicos diabólicos (es decir, la suma de los elementos de las filas, de las columnas, de las diagonales principales, pero también de las diagonales no principales, que están partidas en dos partes), encajados, cada uno dentro del siguiente, formados con números capicúas, cuyas sumas mágicas son de nuevos números capicúas, 2.442 (en el central, de orden 4), 3.663 (en el de orden 6) y 4.884 (en el exterior de orden 8).

En el centro, un cuadrado mágico diabólico de orden 4 y suma mágica 2.442, formado por números capicúas. Se completa con un borde de números capicúas, dando lugar a un cuadrado mágico diabólico de orden 6 y suma mágica 3.663. Y se vuelve a completar con un borde de números capicúas, para dar lugar a un cuadrado mágico diabólico de orden 8 y suma mágica 4.884

En el centro, un cuadrado mágico diabólico de orden 4 y suma mágica 2.442, formado por números capicúas. Se completa con un borde de números capicúas, dando lugar a un cuadrado mágico diabólico de orden 6 y suma mágica 3.663. Y se vuelve a completar con un borde de números capicúas, para dar lugar a un cuadrado mágico diabólico de orden 8 y suma mágica 4.884

Bibliografía

1.- Clifford A. Pickover, El prodigio de los números. Desafíos, paradojas y curiosidades matemáticas, Ma Non Troppo (ediciones Robinbook), 2002.

2.- Clifford A. Pickover, La maravilla de los números. Un viaje por los secretos de las matemáticas, sus desafíos y caprichos, Ma Non Troppo (ediciones Robinbook), 2002.

3.- Harvey Heinz, Palindromes

4.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A006960 (sucesión de números formados por la iteración “suma del simétrico” a partir del número 196)

5.- Romain Dolbeau, The p196_mpi page

6.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A023108 (números de Lychrel)

7.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A063048 (números de Lychrel semillas)

8.- Jason Doucette, World Records

9.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A003098 (números triangulares capicúas)

10.- N. J. A. Sloane, The On-Line Encyclopedia of Integer Sequences, OEIS: sucesión A002385 (Números capicúas primos)

Sobre el autor: Raúl Ibáñez es profesor del Departamento de Matemáticas de la UPV/EHU y colaborador de la Cátedra de Cultura Científica

El artículo El secreto de los números que no querían ser simétricos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Una conjetura sobre ciertos números en el ‘sistema Shadok’

- El origen poético de los números de Fibonacci

- Los números enamorados

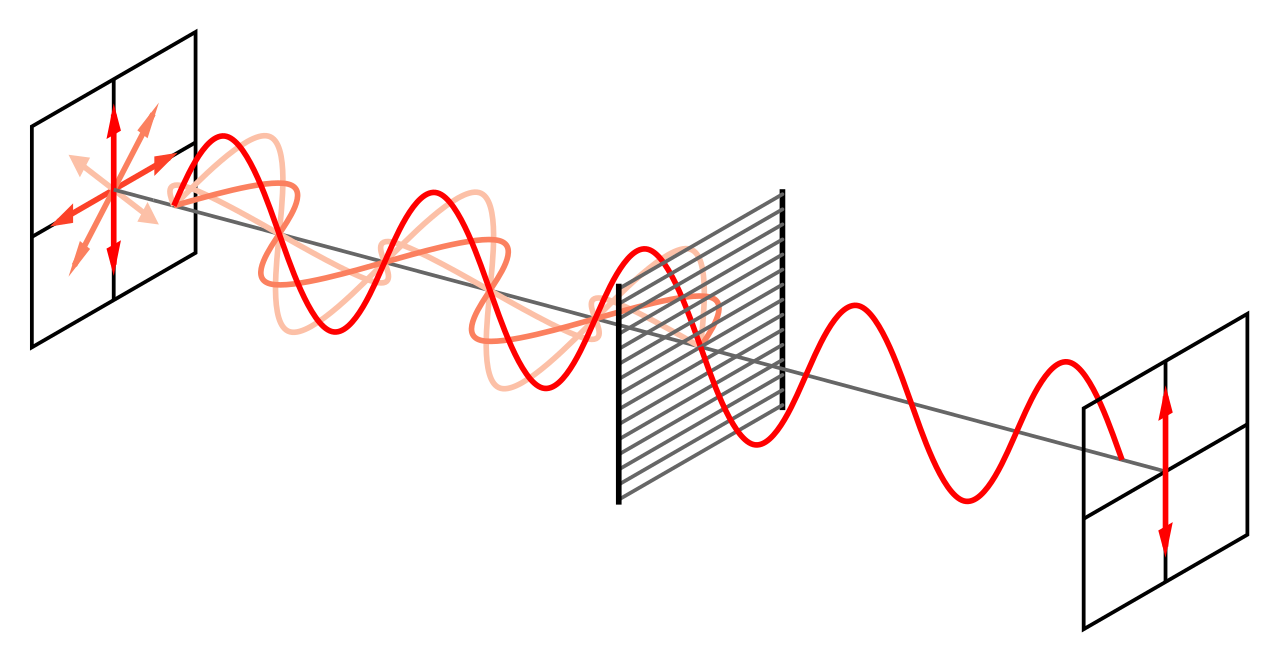

Polarizadores y el triunfo de la hipótesis ondulatoria

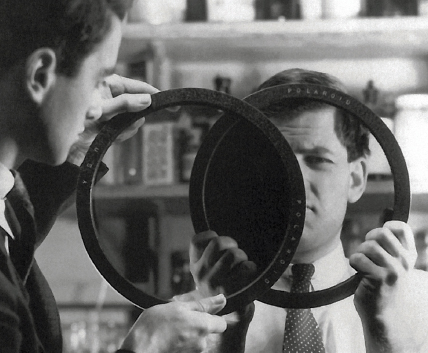

Fuente: Polaroid / Safilo

Fuente: Polaroid / Safilo

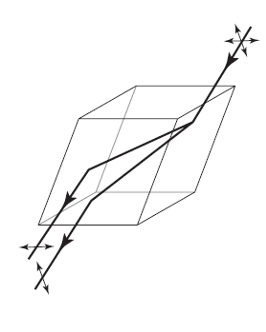

Los estudios científicos sobre la polarización de la luz continuaron a lo largo del siglo XIX. Por ejemplo, la forma en que el espato de Islandia separa un haz de luz no polarizada en dos haces polarizados se muestra en la de abajo y es una representación que conceptualmente data originalmente de esa época. Sin embargo, las aplicaciones prácticas se vieron frustradas, principalmente porque las sustancias polarizadoras como el propio espato de Islandia eran escasas y muy frágiles.

Fuente: Cassidy Physics Library

Fuente: Cassidy Physics Library

Uno de los mejores polarizadores era el cristal sintético herapatita, sulfato de yodo-quinina. Decimos sintético porque se descubrieron de forma accidental en 1852 cuando un estudiante añadió yodo a la orina de un perro al que habían suministrado quinina y observó que aparecían unos cristales verdosos. El responsable del laboratorio, William Bird Herapath, estudió los cristales al microscopio. Encontró que los cristales de herapatita en forma de aguja absorbían la luz que está polarizada en la dirección del eje largo del cristal y absorben muy poca de la luz polarizada en una dirección perpendicular al eje largo.

Los cristales de herapatita eran tan frágiles que parecía que no había forma de usarlos. Pero en 1928, Edwin H. Land, cuando aún era un estudiante de primer curso en la universidad, inventó una lámina de plástico que llamó “Polaroid”. Este primer polarizador era una película transparente de nitrocelulosa en la que había incrustado muchos pequeños cristales de herapatita de tal manera que, cuando se estiraba el plástico, los cristales en forma de aguja se alineaban en una dirección. Por lo tanto, todos interactuaban con la luz incidente de la misma manera.

Algunas de las propiedades de un material polarizador se pueden comprobar fácilmente. Por ejemplo, se pueden obtener dos superficies de polarización de las lentes de un par de gafas de sol polarizadas, o de las gafas “tridimensionales” usadas en los cines. Si sostenemos una de las lentes frente a una fuente de luz y miramos esta primera lente a través de la segunda, comprobamos que al girar la primera lente la intensidad de luz sube y baja alternativamente. Encontraremos que una rotación de 90º nos lleva de la intensidad másxima a la mínima.

Fuente: Wikimedia Commons

Fuente: Wikimedia Commons

¿Cómo se puede explicar este efecto? La luz que incide en la primera lente, o superficie de polarización, originalmente no está polarizada, es decir, es una mezcla de ondas polarizadas en diferentes direcciones, como ya vimos. La primera lente transmite solo las ondas que están polarizadas en una dirección y absorbe el resto. La onda transmitida que va hacia la segunda hoja ahora está polarizada en una dirección. Siempre que esta dirección coincida con la dirección de polarización de la segunda superficie, la onda no será absorbida por la segunda lente. Sin embargo, si la dirección es perpendicular a la dirección de polarización, la luz polarizada no pasará a través de la segunda lente, sino que será absorbida.

Como conclusión general de lo que hemos visto sobre las ondas de luz, vemos que los efectos de interferencia y difracción requerían un modelo de onda para la luz. Para explicar los fenómenos de polarización, el modelo de onda se tuvo que hacer más específico; la polarización podría explicarse solo si las ondas de luz son ondas transversales. En conjunto, este modelo para la luz explicaba muy satisfactoriamente todas las características de la luz consideradas hasta principios del siglo XX.

Pero, hay una nota disonante, ¿verdad? ¿En qué medio se transmiten las ondas de luz que vienen del Sol o de la Luna o de las estrellas?

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Polarizadores y el triunfo de la hipótesis ondulatoria se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:Química atmosférica a la caza de la primera feromona humana

Imagen: Unsplash

Imagen: Unsplash

¿Ha comprado usted alguna vez un perfume con feromonas con la esperanza de que le ayudase a ligar? O, mejor aun, ¿ha acudido a una de esas fiestas en las que los asistentes deben entregar al llegar una camiseta con la que hayan dormido varios días empaquetada en una bolsa hermética para que sea olisqueada a fondo por los participantes del sexo opuesto y así, en teoría, emparejarse con éxito? No me lo estoy inventando, estas cosas por lo visto existen.

Pues quizá haya usted salido de casa oliendo muy bien (o haya hecho un aporte apestoso a esa fiesta, qué sé yo) pero en cualquier casa, espero que no pagase demasiado por el componente feromónico porque, lo que es evidencia científica, nada de nada.

No sabemos cómo son las feromonas humanas

A día de hoy no se conoce todavía ningún compuesto químico que actúe en los seres humanos como feromonas, esas señales químicas principalmente olfativas que nuestros cuerpos generarían, supuestamente, para llevar a otros seremos humanos en principio, aunque no exclusavamente, del sexo opuesto a actuar de determinada forma para favorecer el éxito sexual y en definitiva reproductivo. Las hemos visto identificado en animales, pero en seres humanos, de momento, ni rastro.

Fue en 1959 cuando el bioquímico alemán Adolf Butenandt acuñó por primera vez el término feromona. Butenandt, que ya había ganado un Nobel de Química por su trabajo identificando y aislando las hormonas sexuales, publicó en ese año sus trabajos basados en la polilla de la seda Bombyx more y la estructura química de la sustancia que le sirve para atraer a sus congéneres.

Tras las polillas llegaron las hormigas, las abejas, los ratones… También se observó que las feromonas no tienen solo una finalidad sexual. Las abejas por ejemplo son capaces de generar señales químicas que sirven para dar la alarma a sus compañeras cuando hay algún peligro cerca. Salen de las llamadas glándulas de Nasorov, que se encuentran bajo el abdomen de estos insectos. Otras feromonas, utilizadas entre otras por las hormigas, sirven para indicar a los demás miembros de un grupo el camino hasta un lugar donde hay alimento, de forma que puedan ir a por él y transportarlo entre todas hasta el hormiguero.

Pero en humanos, de momento, no se conoce una feromona concreta que cumpla alguno de estos fines o ningún otro. Algunos estudios han sugerido que si bien no sabemos aun cuáles son esas sustancias o cómo actúan, deben existir y actuar de alguna forma y damos por cierta su existencia, pero algunos análisis críticos consideran poco sólidos esos estudios y por tanto sus conclusiones.

Imagen: Unsplash

Imagen: Unsplash

Estudiar la química del cuerpo como la química del aire

En estas semanas, un nuevo enfoque de estudio está tratando de averiguar si es posible encontrar estas esquivas sustancias en los seres humanos. Se trata de aplicar una técnica que emplean los químicos atmosféricos, llamada reacción de transferencia de protones – estectrometría de masas o PTR-MS por sus siglas en inglés, a la química de nuestro cuerpo para hallar las ansiadas feromonas humanas.

Cuenta este artículo en la revista Science que el químico climatólogo Jonathan Williams, del Instituto de Química del Max Plank, es uno de los participantes en las reuniones sobre comunicación química entre seres humanos que se han celebrado en la Royan Society para explicar cómo esta técnica que se utiliza para hallar trazas de determinadas sustancias químicas en la atmósfera podría llegar al rescate de este área de investigación que necesita un nuevo punto de vista para seguir adelante.

Un área que está en crisis en parte por la escasa financiación que recibe en general: el olfato es uno de los sentidos que menos atención e interés recibe por parte de las investigaciones en fisiología, los estudios al respecto suelen ser pequeños y por tanto estadísticamente endebles, y por otro lado el cuerpo humano emite cientos de sustancias volátiles susceptibles de ser olfateadas por otra persona, la comunicación química se mezcla con todas las demás formas de comunicación entre seres humanos y las posibles respuestas en formas de comportamiento, también. Los estudios realizados hasta ahora se han limitado a pedir a esos pocos participantes que duerman varios días con la misma camiseta o a colocarles compresas absorbentes bajo las axilas.

La PTR-MS puede aportar mucha más información. Esta técnica consiste en transferir un protón a esos compuestos volátiles y luego analizar su masa por la forma en que se desplazan en un campo eléctrico. Esto permite medirlos en tiempo real e identificar aquellos que, ante un determinado estímulo o comportamiento, aumentan en cantidad o sufren algún cambio.

Olemos diferente si nos reímos, nos tensamos o nos asustamos

Williams cuenta que se dio cuenta del potencial de esta técnica hace años tras analizar la composición química del aire alrededor de una hinchada de aficionados al fútbol durante un partido. “Podíamos averiguar el comportamiento de la gente haciendo un seguimiento de las trazas de sustancias químicas a su alrededor”, asegura. Por ejemplo, era posible saber cuándo el partido había llegado al descanso porque los niveles de acetonitrilo, un componente del humo del tabaco, alcanzaban el máximo rápidamente. En el descanso es cuando la mayoría de la gente aprovecha para fumarse un cigarro.

Imagen: Unsplash

Imagen: Unsplash

¿Sería posible ‘oler’ en el aire la euforia tras un gol del equipo local? Aquel partido en concreto no permitió a Williams responder a esa pregunta ya que terminó con un empate a cero. El científico decidió irse a olisquear una sala de cine, y allí descubrió que los espectadores de una comedia emiten sustancias químicas distintas que los que ven una película de suspense, y que esas emisiones cambian cuando el guión da un giro inesperado. “Viendo Los Juegos del Hambre era posible determinar el momento en el que empieza la gran pelea final”, asegura. En un estudio publicado al respecto contaba que los niveles de dióxido de carbono subían, seguramente debido a la aceleración de la respiración del público, así como los de isopreno, que podían provenir de una mayor tensión muscular.

Otro científico atmosférico, Ben Langford, del Centro de Ecología e Hidrología en Edimburgo, quedó tan intrigado por estos resultados que unió fuerzas con el psicólogo Craig Roberts, de la Universidad de Stirling, en el Reino Unido para profundizar en estos hallazgos. Entre los dos han realizado estudios, aun pendientes de publicar, en el que ponen a los voluntarios escenas de películas mientras analizan el aire bajo sus axilas. Ya han identificado algunos compuestos que varían durante las escenas de terror y quieren seguir investigando en esa línea. Aun no está claro si esos cambios suponen realmente una señal química de algún tipo.

Pero es interesante que se centren en las sustancias químicas en relación con el miedo o la agresión, ya que durante décadas las investigaciones sobre feromonas humanas se han centrado en señales relacionadas con el comportamiento sexual, que quizá sean precisamente más difíciles de encontrar.

No son los únicos que han decidido cambiar el amor por la agresividad en este campo. En otro estudio mencionado durante estas reuniones, los científicos han recogido sudor de soldados israelíes antes de su primer salto en paracaídas con sudor recogido en otro momento de sosiego. Quizá buscar cambios alrededor de esos momentos en los que por la mente se pasan pensamientos de vida o muerte sea la mejor oportunidad de encontrar estas esquivas señales químicas.

Imagen: Pixabay

Imagen: Pixabay

Eso sí, puede que esa señal no sea la producción de una feromona específica como las que conocemos en insectos o en algunos mamíferos. Quizá sea una serie de complicados cambios en la abundancia y concentración de varias o muchas sustancias distintas. Precisamente lo que los científicos atmosféricos están acostumbrados a estudiar. Quizá esto haga por fin avanzar este campo de investigación.

Claro que, de momento… dejen la colonia de feromonas en casa.

Referencias:

Can atmospheric chemists rescue the stalled quest for a human pheromone? – Science

Adolf Butenandt—Nobel Prize for Chemistry – Mayo Clinics Proceedings

Feromona – Wikipedia

Suspense in the movie theatre air: Cinemagoers’ exhaled breath reveals the scene that is playing – Phys.org

Sobre la autora: Rocío Pérez Benavente (@galatea128) es periodista

El artículo Química atmosférica a la caza de la primera feromona humana se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- De la materia a la vida: ¿Química? ¡Química!, por Jean-Marie Lehn

- Pensando la química matemáticamente

- Los cimientos de la química neumática al estilo van Helmont (y 3)

Ciudades sin coches

Calle Benito Corbal (Pontevedra). Imagen: Wikimedia Commons

Calle Benito Corbal (Pontevedra). Imagen: Wikimedia Commons

La introducción en 2003 de tarifas de congestión –pago por entrar, circular o salir del centro de la ciudad- en Londres tuvo una gran repercusión, pero no ha sido un caso aislado; cada vez más ciudades toman medidas para reducir el tráfico rodado de vehículos de combustión interna. En algunas ciudades se ha llegado, incluso, a suprimirlo en las áreas urbanas céntricas salvo para determinadas excepciones.

El ferroviario -metro o tren- es el medio de transporte que más personas desplaza por unidad de tiempo y por unidad de superficie urbana utilizada; en esos términos transporta diez veces más pasajeros que el automóvil particular. Y otras formas de movilidad registran eficiencias intermedias entre esos dos extremos. La contaminación es otro factor a considerar; a la provocada por el tráfico rodado -que incluye carbonilla, óxidos de nitrógeno y monóxido de carbono- se atribuyen, al menos, 184.000 muertes prematuras cada año en el mundo, la mayoría producidas por enfermedades cardíacas o pulmonares. Y a los accidentes provocados por automóvil se debe un millón de muertos anuales, además de causar cerca de ochenta millones de heridos.

El uso del coche reduce de forma considerable la actividad física, uno de los grandes problemas de salud de nuestro tiempo. Y hay estudios que sugieren que la exposición al ruido del tráfico eleva la probabilidad de sufrir depresión en adultos y genera problemas de atención en niños.

Las medidas que se han tomado para limitar el uso de automóviles en grandes ciudades han arrojado resultados positivos. El 14 de septiembre del año pasado se celebró en París el cuarto día sin coches y la contaminación por dióxido de nitrógeno en el entorno de las vías de mayor tráfico se redujo hasta en un 40%. En Bruselas, el hollín atmosférico se redujo en un 80% ese mismo día. Y tras implantar en Estocolmo la tasa de congestión en 2006, se registró un descenso en la incidencia de asma infantil.

El grado de actividad física que desarrollan los habitantes de las zonas en que se ha limitado el tráfico rodado también ha aumentado. A partir de 1960 Copenhague empezó a limitar el uso de automóviles en el centro urbano: en 2015 prohibió el aparcamiento en el centro de la ciudad, convirtió muchas vías rodadas en carriles-bici o peatonales, y aumentó la red de vías férreas; desde entonces no ha dejado de aumentar el número de personas que se desplazan en bicicleta por la ciudad y en la actualidad llegan al 60%. De Pontevedra -una ciudad de 84.000 habitantes (65.000 en el casco urbano)- se dice que ha logrado domesticar el tráfico; a partir de 1999 ha aumentado las zonas peatonales, ha ampliado las aceras, ha reducido a 30 km/h la velocidad máxima en todo el ámbito urbano y ha creado una red de nueve aparcamientos disuasorios con 16.000 plazas libres. Hoy más del 80% de escolares caminan hasta su centro de enseñanza y las muertes por accidente de tráfico han desaparecido.

Como es lógico, las limitaciones al tráfico rodado urbano han provocado la oposición de diversos sectores. Muchos ciudadanos se oponen porque entienden que se trata de limitaciones inaceptables a la libertad individual. Pero a esos argumentos se oponen los que se fundamentan en el valor de preservar la salud. Para mitigar la oposición se ha optado en muchos casos por aplicar las limitaciones e forma gradual. De hecho, aunque el debate público se mueve en esas coordenadas, las alternativas que barajan los especialistas en movilidad urbana se refieren a modalidades de limitación del tráfico, medidas complementarias y plazos de implantación. Su conveniencia apenas se discute.

El artículo Ciudades sin coches se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- El tamaño importa en organismos, empresas, ciudades y economías

- Los edificios y el mar

- Cerdos ferales

¿Cuál es la postura más aerodinámica en ciclismo?

Si has visto a ciclistas bajar un puerto de montaña, habrás notado que adoptan posiciones que parecen muy aerodinámicas. Lo hacen para rascar milésimas al crono. ¿Sirven para algo? Y de hacerlo, ¿cuál sería la mejor postura para conseguir más velocidad?

Los vídeos de ¿Preguntas frecuentes? presentan de forma breve y amena cuestiones que, probablemente, nos hayamos planteado en alguna ocasión. Los vídeos, realizados para la Cátedra de Cultura Científica de la UPV/EHU, se estrenan en el programa de ciencia Órbita Laika (@orbitalaika_tve), los lunes a las 22:00 en la 2 de RTVE.

Edición realizada por César Tomé López

El artículo ¿Cuál es la postura más aerodinámica en ciclismo? se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- ¿Qué pasa en tu cuerpo cuando te enamoras?

- ¿Hemos intentando contactar con extraterrestres?

- ¿Qué pasa en tu cerebro cuando duermes?

Energía oscura

La Facultad de Ciencias de Bilbao comenzó su andadura en el curso 1968/69. 50 años después la Facultad de Ciencia y Tecnología de la UPV/EHU celebra dicho acontecimiento dando a conocer el impacto que la Facultad ha tenido en nuestra sociedad. Publicamos en el Cuaderno de Cultura Científica y en Zientzia Kaiera una serie de artículos que narran algunas de las contribuciones más significativas realizadas a lo largo de estas cinco décadas.

Permítanme iniciar este escrito con un experimento imaginario. Supongamos que contamos con una manzana y la tiramos hacia arriba con cierta velocidad desde la superficie de la Tierra. Todos sabemos que ocurrirá después. La manzana ascenderá durante un tiempo, a medida que asciende la velocidad de la manzana disminuirá hasta llegar al punto álgido de su trayectoria en el que se parará. Todos hemos hecho este experimento en algún momento y entendemos perfectamente lo que ocurre. La atracción gravitatoria de la Tierra sobre la manzana ejerce una fuerza hacia abajo que se opone a la velocidad inicial de ésta. Esta fuerza produce una deceleración de la manzana hasta que se para en el punto más alto.

¿Pero qué pasaría si al repetir este experimento observásemos que la manzana llega hasta un punto y después se acelera y aumenta su velocidad ascendente hasta desaparecer en el cielo? Creo que estaremos todos de acuerdo en que si eso ocurriese nos sorprenderíamos un poco… Esto se debe, como digo, a que creemos que entendemos lo que ocurre en este experimento y no conocemos ninguna fuerza que empuje a la manzana hacia arriba. Pero permítanme que insista… ¿qué pasaría si lo observásemos? En ese caso, tendríamos que afrontar la realidad. Alguna de las suposiciones que habíamos hecho y que creíamos ciertas ha de ser incorrecta. ¿Pero cuál?

Antes de dejarnos llevar por el desasosiego causado por esta observación y de cuestionar nuestros conocimientos de física general y/o la validez de las ecuaciones de Newton, recordemos con cierto alivio que este era un experimento imaginario. Sin embargo, ilustra muy bien el estado de ánimo de la mayoría de la comunidad de científicos dedicados a la cosmología a finales del siglo pasado, en concreto en 1998. El origen de su preocupación no era una hipotética manzana voladora sino los resultados de ciertas observaciones cosmológicas realizadas por aquel entonces. Estas observaciones mostraban que nuestro universo no sólo se expande sino que se encuentra actualmente en un proceso de expansión acelerada. Esto es, la expansión del universo es cada vez más rápida hoy en día. Muchos cosmólogos se mostraron escépticos al principio con estos resultados esperando quizás, como en otros casos ha ocurrido, que la repetición de la observación diese lugar a otro resultado más acorde con nuestra intuición. Pero esto nunca ocurrió, de hecho, observaciones posteriores han corroborado este hallazgo hasta el punto que hoy en día prácticamente nadie las pone en duda. Pero, ¿porqué esperaba la comunidad científica otro tipo de resultado? La razón es simple; la situación es muy semejante al caso imaginario de la manzana.

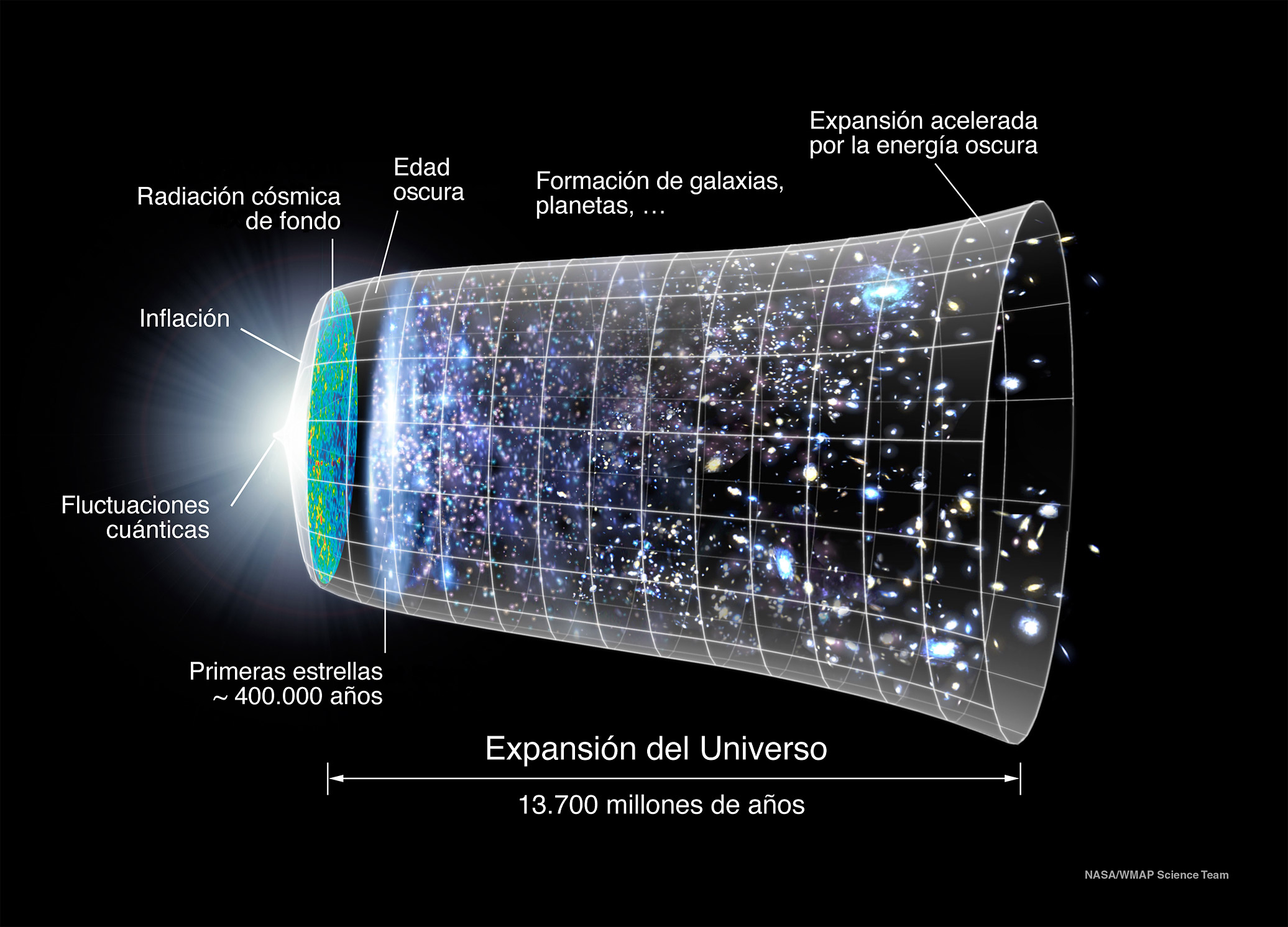

La evolución del universo desde sus orígenes y su reciente entrada en un periodo de expansión acelerada. Fuente: Wikimedia Commons

La evolución del universo desde sus orígenes y su reciente entrada en un periodo de expansión acelerada. Fuente: Wikimedia Commons

Como todo el mundo sabe, el universo se inició con una gran explosión (el Big Bang) que dio lugar a la condición inicial de expansión cosmológica (la situación análoga a la velocidad inicial de la manzana). Por otro lado la acción gravitatoria de la materia en el universo es atractiva y por lo tanto parece lógico concluir que la expansión del universo se verá ralentizada por la acción de la gravedad de la misma forma que la velocidad de la manzana disminuye con el paso del tiempo. Es por esto por lo que uno esperaría que el universo se expandiese cada vez más despacio o incluso que pudiese llegar un momento donde esta expansión se detuviese iniciando así un proceso de colapso. Sin embargo, los datos indicaban lo contrario, el universo se encontraba inmerso en un período de expansión acelerada. Es decir, el universo parecía comportarse como la manzana en nuestro inquietante experimento imaginario, se expande de forma acelerada en contra de lo que esperaríamos. Este ha sido, sin lugar a dudas, uno de los descubrimientos más sorprendentes de la física y la cosmología en los últimos 50 años.

Una vez pasado el shock inicial no queda otro remedio que asumir el resultado, no tiene sentido negar la evidencia observacional. La comunidad científica se preguntó entonces cuál de los supuestos anteriores debe relajarse para poder acomodar los resultados dentro de un marco teórico coherente con estas observaciones. A continuación describiremos algunas de estas posibilidades.

En primer lugar una posibilidad clara es que las ecuaciones de gravedad, las ecuaciones de Einstein de la Relatividad General, no funcionen a estas escalas y por lo tanto deban ser modificadas de tal manera que esta aceleración aparezca de forma natural como producto de esta alteración.

Otra posibilidad es que las ecuaciones de Einstein estén perfectamente como están y que simplemente exista otro tipo de materia que de lugar a que el universo se expanda cada vez más rápido cuando ésta domina sobre las otras formas de materia más comunes. ¿Pero qué tipo de materia puede dar lugar a una gravedad repulsiva?

Esto puede parecer una locura, ya que nuestra intuición nos dice que esto no ocurre en la Naturaleza. Sin embargo una de las características que se puede ver estudiando las ecuaciones de la Relatividad General aplicada a la cosmología, es que la evolución del universo no sólo está marcada por la densidad de energía (la masa) de la materia, sino también por su presión. Si uno considera un material con una gran dosis de presión negativa (la presión negativa es similar a la tensión presente en las gomas elásticas, por ejemplo.), su efecto puede contrarrestar la usual atracción de la materia y dar lugar a este efecto de gravedad repulsiva.

Lo realmente interesante de esta historia es que la primera persona que propuso la existencia de este tipo de materia fue el mismo Einstein mucho antes de que se realizasen estas observaciones. Einstein postuló la presencia de un nuevo término en sus ecuaciones que designó con el nombre de constante cosmológica. Este término era necesario para encontrar un punto de equilibrio en el que el universo pudiese ser estático, algo que en 1917 parecía la única opción válida. En este punto de equilibrio las fuerzas de atracción de la materia común tendrían su contrapunto perfecto con el efecto repulsivo originado por este nuevo término en las ecuaciones. Esta idea fue, según cuentan, descrita por el mismo Einstein como – “Uno de los mayores errores en mi vida…” y con razón, ya que pocos años más tarde Edwin Hubble descubrió las primeras evidencias de la expansión del universo. Sin embargo, este término, repudiado por Einstein después de las observaciones de Hubble y por mucha gente ignorado durante largo tiempo, volvió a la primera línea de investigación cuando se descubrió la reciente (en escalas cosmológicas) aceleración del universo.

Sin embargo, la idea de incluir una constante cosmológica para satisfacer las observaciones de la expansión acelerada del universo no está exenta de problemas. Es importante darse cuenta que el valor de la constante cosmológica recibe contribuciones de cualquier componente de la energía de vacío. Sí, el vacío en física no es exactamente lo que comúnmente conocemos por vacío (ausencia de todo, tanto de masa, como de energía) sino que tiene propiedades análogas a los materiales, en particular tiene una energía y una presión asociadas a él. Esto es debido a que la mecánica cuántica nos enseña que ni siquiera el vacío está libre de las pequeñas fluctuaciones de los campos que viven en él y que dan lugar a las partículas que conocemos. Son precisamente estas fluctuaciones cuánticas las que dan al vacío unas características idénticas a la constante cosmológica. Por otro lado, todos los intentos por estimar esta contribución a la energía de vacío basados en nuestro conocimiento presente de la mecánica cuántica y la gravedad dan unos resultados que se alejan en muchos órdenes de magnitud de la cantidad observada. Un universo con una constante cosmológica mucho mayor sería totalmente incompatible con la formación de estructuras como las galaxias y nuestra existencia. Este resultado realmente embarazoso nos indica que posiblemente debamos recurrir a nuevas ideas a la hora intentar dar algún paso adelante en nuestro entendimiento de este fenómeno.

Las fluctuaciones cuanticas dotan al vacio de propiedades como densidad de energia o presion que determinan su efectos cosmologicos. Fuente: Wikimedia Commons

Las fluctuaciones cuanticas dotan al vacio de propiedades como densidad de energia o presion que determinan su efectos cosmologicos. Fuente: Wikimedia Commons

Una de las ideas nuevas que ha surgido en estos últimos años es la posibilidad de que no exista un solo valor de la constante cosmológica, sino un gran número de vacíos distintos con valores muy dispares de su energía de vacío, muchos de los cuales estarían dentro del rango de los valores observados. Esto sólo sería posible si la teoría fundamental diese lugar a muchos de esos vacíos. Lo interesante de esta idea es que la Teoría de Cuerdas (nuestro mejor candidato a una teoría fundamental de la gravedad cuántica) tiene precisamente esta propiedad y por lo tanto parece ser un buen candidato para acomodar este escenario.

Por otro lado existen otras maneras de obtener de forma efectiva la aceleración del universo mediante el diseño de una constante cosmológica variable. El interés de este tipo de modelos es su dinámica distinta a la constante cosmológica y a sus posibles implicaciones sobre el futuro del universo a largo plazo.

Todos estos modelos son conocidos con el nombre genérico de Energía Oscura. Este es el nombre que se ha elegido para describir el tipo de materia (o energía) que da lugar a esta aceleración del universo, sea esta debida a una constante cosmológica o a una variación temporal de la energía del vacío. Existen varios experimentos que actualmente buscan mediante distintas observaciones ampliar nuestro conocimiento sobre las propiedades de esta energía oscura. Estas observaciones serán cruciales para ayudarnos a discernir entre los múltiples escenarios que hemos comentado.

El origen de la Energía Oscura es un problema muy complejo que toca áreas tan diversas como la Cosmología, la Gravitación, la Física de Partículas de Altas Energías y Teoría de Cuerda; temas todos ellos bien representados en los grupos de investigación del Departamento de Física Teórica de la Facultad de Ciencia y Tecnología de la UPV/EHU. Estos grupos estudian diversos aspectos de la energía oscura tanto desde el punto de vista puramente teórico como en su vertiente más fenomenológica.

Es justo reconocer que no tenemos en este momento una idea clara de cuál puede ser el origen de esta misteriosa energía. No obstante, la historia de la Física está plagada de grandes misterios que nos han permitido, mediante su resolución, avanzar en nuestro conocimiento. Esperemos que este caso no sea una excepción.

Sobre el autor: Jose Juan Blanco-Pillado es Ikerbasque Research Professor en el Departamento de Física Teórica del Facultad de Ciencia y Tecnología de la UPV/EHU

El artículo Energía oscura se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Se intuye la conservación de la energía (1)

- Una fórmula para dominarlos a todos: La conservación de la energía y la ley de la palanca

- Un modelo que unifica energía y materia oscuras

Peces carnívoros, vegetarianos y la acuicultura insostenible

![]()

Imagen: Kosin Sukhum / Shutterstock

Imagen: Kosin Sukhum / ShutterstockLa sostenibilidad es la forma de asegurar las necesidades actuales sin comprometer las futuras, las de nuestras próximas generaciones. La acuicultura actual, que lleva a nuestra mesa gran parte del pescado que comemos, dista de ser sostenible.

Vamos al mar a capturar pequeños peces que no nos gusta comer para transformarlos en pienso con el que alimentar a las especies que sí nos gusta comer. Somos así de exquisitos. También, siguiendo prácticas paloelíticas, recolectamos (que no producimos) pequeños crustáceos para alimentar a las crías de los peces que cultivamos.

Pero cada vez que realizamos una transformación tenemos pérdidas. Entonces, ¿por qué no nos comemos el pienso directamente? Quitaríamos escalones del proceso y lo haríamos más efectivo, más sostenible.

No sé si llegará ese día, pero mientras tanto, seguiremos comiendo pescados que nos acerquen al esnobismo. Porque ¿quién comía antes salmón, dorada o lubina? Casi nadie, especialmente fuera de los eventos gastronómicos navideños. Que hoy podamos incluir estas especies en nuestra dieta es uno de los grandes logros de la acuicultura occidental, más preocupada por las cuotas de mercado que por la sostenibilidad de los procesos de producción.

A fin de cuentas, es el mercado quien ha seleccionado las especies que cultivamos y ha marcado la sostenibilidad del proceso. Aquellos precios prohibitivos del pasado prometían grandes rentabilidades. Sin embargo, gran parte de estos peces, antaño caros, son carnívoros y ocupan los niveles más altos de la cadena trófica. Por eso necesitan grandes cantidades de proteínas y aceites de pescado para crecer. Un alimento que se obtiene, a su vez, de otros peces que capturamos y transformamos en pienso. Es “como el pez que se muerde la cola”, nunca mejor dicho.

Conseguir peces vegetarianos como solución

Las especies comerciales, de momento, son las que son. Pero llevar estos peces al mercado de forma rentable supone un elevado esfuerzo científico y tecnológico.

Una de las soluciones que se ha implementado es la sustitución de las harinas y aceites de pescado utilizados en los piensos por sus homólogos vegetales. En esta búsqueda, se han realizado investigaciones con muchos tipos vegetales buscando siempre plantas con un elevado contenido proteico y aceites con una composición óptima.

Estamos intentando convertir a nuestras especies en vegetarianas. Pero ¿acaso les gusta este cambio? No. Si nos pasamos con el porcentaje de proteína vegetal, no les gusta el pienso, no crecen tan bien, sufren a nivel intestinal y pueden tener, incluso, trastornos reproductivos inducidos por la presencia de fitoestrógenos. De hecho, todavía no se ha podido llegar a la sustitución total. Y será difícil que se consiga en el futuro.

Tanques experimentales para la cría de peces. Imagen: Instituto de Acuicultura de Torre de la Sal

Tanques experimentales para la cría de peces. Imagen: Instituto de Acuicultura de Torre de la SalAdemás, ante esta estrategia, podríamos preguntarnos: ¿esquilmar las pesquerías de anchoveta peruana (una especie parecida a nuestro preciado boquerón, de donde provienen la mayor parte de las harinas de pescado de los piensos) es más sostenible que quemar la selva amazónica para plantar los vegetales que destinamos a los piensos? ¿Es ético utilizar las pesquerías y los excedentes de vegetales para alimentar a nuestros peces carnívoros en lugar de para paliar hambrunas?

Los intentos de sustitución y la inversión colateral en investigación no han venido de la mano de mejoras en sostenibilidad. Por el contrario, provocan un incremento en los precios de las harinas de pescado que encarece la producción piscícola a niveles insostenibles.

La variabilidad de las pesquerías, debida a factores ambientales como la corriente de El Niño de las costas del Pacífico Sur, producen cambios impredecibles en los precios de los harinas. Y este es el motivo real que nos ha llevado a echar mano de los vegetales en la fabricación de piensos, no la sostenibilidad, aunque muchos quieran vender la historia al revés. Sorprendentemente, el efecto colateral de optimizar el negocio podría ser un acercamiento a la sostenibilidad.

Cambios de cara al futuro

Los consumidores no tenemos mucho margen de acción para aumentar la sostenibilidad del proceso. Debemos decidir entre gastronomía y alimentación sostenible, es decir, entre comer un pescado que nos gusta más o aparcar nuestra exquisitez y elegir un pescado más sostenible en su producción, sin olvidar la calidad nutricional.

Optar por la segunda vía nos obligará a explorar el cultivo de nuevas especies, a ser posible herbívoras. Hoy por hoy, especies como la carpa o la tilapia podrían mostrar un mayor grado de sostenibilidad en su cultivo, dado que su dieta se basa en vegetales.

Si queremos seguir comiendo especies carnívoras, debemos seguir explorando fuentes alternativas de materias primas más sostenibles e intentar llegar al 100% de sustitución. Actualmente hay cuatro líneas incipientes que plantean la utilización de harinas de insecto, fitoplancton, subproductos de pesca y alimenticios y proteínas sintéticas de bacterias como ingredientes alternativos. La producción de microalgas o fitoplancton solo requiere agua, luz y abono.

Cilindros para el cultivo de microalgas o fitoplacton. Imagen: Instituto de Acuicultura de Torre de la Sal

Cilindros para el cultivo de microalgas o fitoplacton. Imagen: Instituto de Acuicultura de Torre de la SalAdemás, tendremos que mejorar la eficiencia alimenticia de nuestros peces, es decir, conseguir que con la misma cantidad de alimento sean capaces de crecer más y más rápido. Aquí, la selección genética y las técnicas biotecnológicas serán de gran ayuda.

Lo que sí está en nuestra mano es consumir pescado producido en zonas cercanas a nuestra localidad aprovechándonos de la trazabilidad del producto (conocemos el camino que sigue desde su nacimiento hasta su comercialización) que nos proporciona la acuicultura. Esto reduce la contaminación asociada al proceso productivo, un parámetro que también debería entrar en la ecuación de sostenibilidad.

La acuicultura está aquí para quedarse, que nadie lo dude. Ayuda a paliar la sobrepesca en los caladeros y nos aporta alimento saludable y de gran calidad. Pero está en manos de la ciencia profundizar en la investigación para aportar mayor sostenibilidad a los procesos productivos.![]()

Sobre el autor: José Miguel Cerdá-Reverter es investigador y director del IATS – CSIC, Instituto de Acuicultura Torre de la Sal (IATS – CSIC)

Este artículo fue publicado originalmente en The Conversation. Artículo original.

El artículo Peces carnívoros, vegetarianos y la acuicultura insostenible se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Los peces en el río

- Peces capaces de respirar en aire y anfibios

- La regulación osmótica de los peces diádromos

El mapa del cólera de John Snow

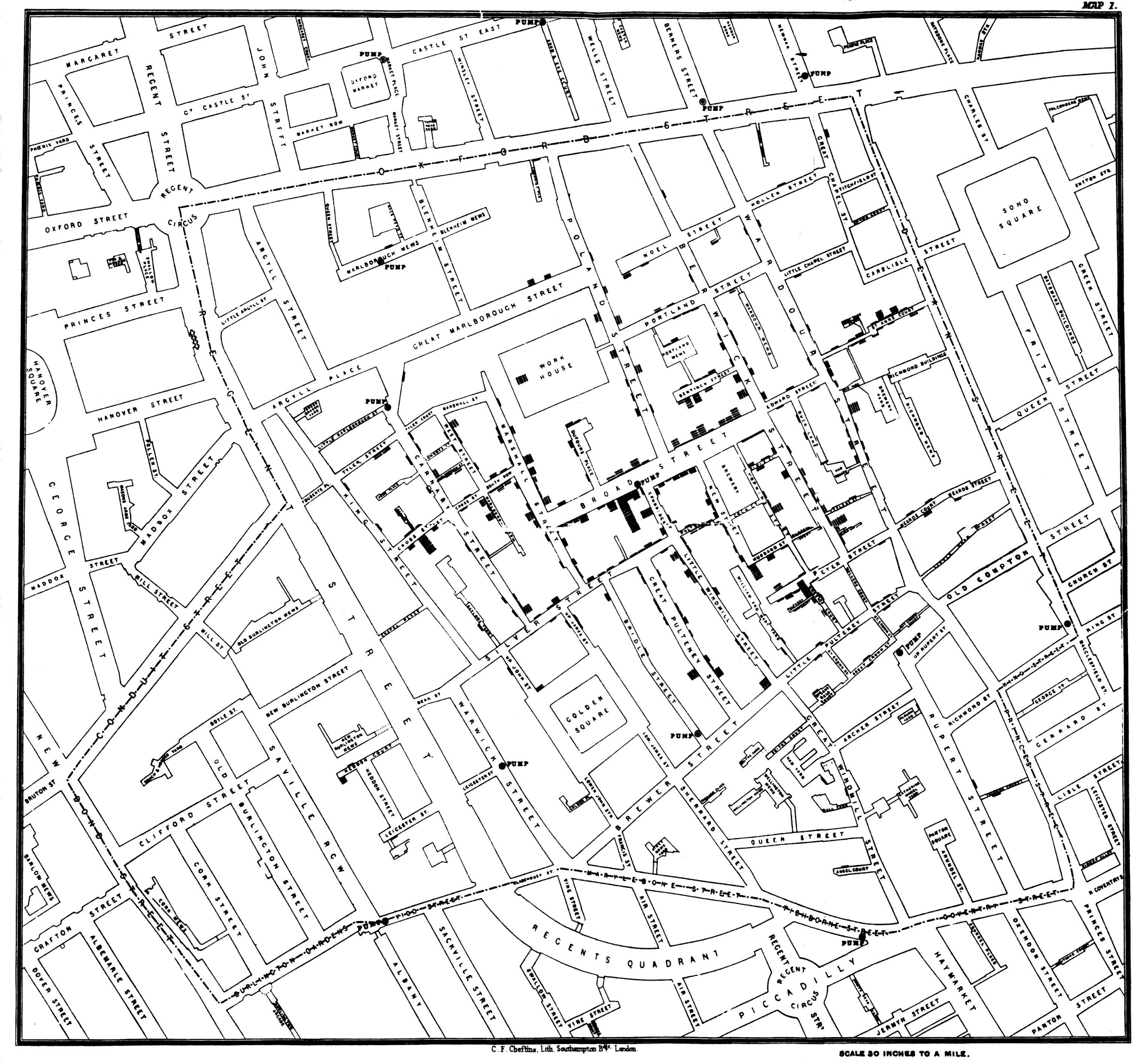

A mediados del siglo XIX, la creencia general presuponía que el cólera se propagaba a través del miasma en el aire. La teoría de los microbios y su relación con las enfermedades aún no estaba establecida (Pasteur tardaría aún 10 años en realizar los experimentos que le darían validez) y los brotes de cólera que asolaban Londres hacia 1850 eran, para todos, un misterio. Pero un gráfico iba a cambiar aquella situación: un simple mapa, hoy considerado el origen de la epidemiología, realizado por John Snow.

Snow (antes de convertirse en personaje de Juego de Tronos) fue un médico nacido en 1813, célebre por su contribución al desarrollo de la anestesia. Pero además, era un tipo inquieto con una teoría: él pensaba que el cólera se propagaba, no a través del aire, sino por el agua contaminada. En aquella época, el sistema de alcantarillado y suministro de agua de Londres dejaba mucho que desear. El agua se repartía en pozos públicos desde los que los ciudadanos bombeaban su propio suministro para llevarlo a sus hogares. Por otra parte, a menudo los desagües se vaciaban en pozos negros bajo las viviendas, más que en tuberías de alcantarillado. El resultado… era hediondo. El olor de heces humanas y animales se combinaba con el de la basura podrida. No es de extrañar que algunos atribuyesen a ese “miasma” la capacidad de enfermar a cualquiera.

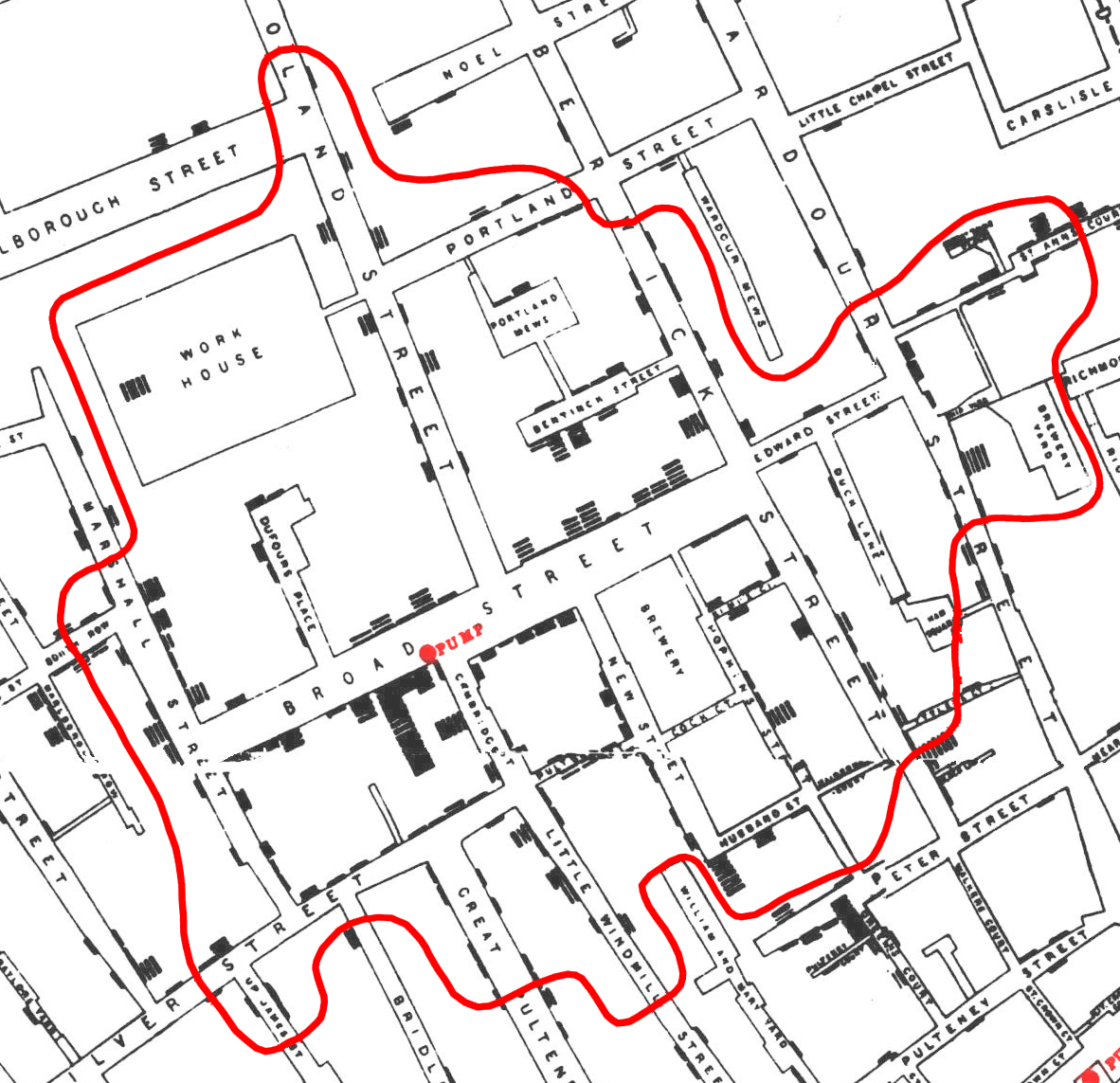

Pero Snow pensaba que el problema era el agua y, para demostrarlo, en 1854 empezó a registrar los casos de cólera del barrio de Soho, sobre un mapa centrado en torno a 13 fuentes: cada muerte era anotada como una línea sobre el lugar de residencia. En total, 578 muertes y el resultado dejaba lugar a pocas dudas: casi todas se concentraban alrededor de una fuente en Broad Street. En cuanto aparecía una nueva fuente, la enfermedad aparentemente se “frenaba”.

Para verificar que el área afectada por el cólera coincidía, efectivamente, con el área abastecida por la fuente, Snow comenzó por trazar un diagrama de Voronoi sobre el mapa. En este tipo de diagramas, el espacio se divide en regiones de cercanía a una serie de puntos y, en este caso, la región más cercana a la fuente de Broad Street parecía ser la más afectada por el cólera. Sin embargo, la coincidencia no era del todo exacta, por lo que Snow decidió repetir su diagrama teniendo en cuenta, esta vez, otro tipo de distancia: la distancia en tiempo, o distancia “caminada” a cada fuente (similar a la que registran los mapas isócronos). Para ello, tomó cuerda (para medir distancias sobre una trayectoria sinuosa) y un lápiz, y redibujó sus polígonos definidos, esta vez, como las zonas más cercana a una fuente a través de los caminos disponibles. La coincidencia se volvía aún mayor.

El mapa deja ver, también, algunas anomalías curiosas… Como la del bloque al este de la fuente contaminada, donde se encuentra una “brewery” o fábrica de cerveza. Parece que los trabajadores de la fábrica podían beber cerveza para calmar su sed. Por suerte, la fermentación acababa con las bacterias del cólera (sólo en este caso podría decirse que la cerveza es sana, en ningún otro).

También había casos aislados, fuera del área de influencia de la fuente, excepciones que Snow documentó de manera exhaustiva. Hoy casi sorprende el detalle de sus notas, como en el caso de una mujer de 59 años que “no había estado cerca de Broad Street en meses. Un carruaje iba de Broad Street a West End todos los días y le llevaba una botella de agua de la fuente de Broad Street, dado que ella la prefería. El agua fue tomada el jueves 31 de agosto, ella la bebió esa misma tarde y también el viernes. Tuvo un ataque de cólera por la tarde de este último día y falleció el sábado”. Otros casos alejados de la fuente correspondían de manera similar a gente que iba a trabajar o comprar a Broad Street y bebían de la fuente. Para colmo, esta tenía fama de tener buen sabor (mejor, al menos, que el de algunas de sus fuentes vecinas).

Por último, además de sus análisis geográficos, Snow tomó muestras de las distintas fuentes y las analizó bajo el microscopio. Confirmó la presencia de un organismo desconocido en la fuente de Broad Street. La fuente había sido contaminada por un pañal arrojado a un pozo negro cercano. Conformes, aunque no convencidos (la teoría de los microbios patógenos tardaría aún una década en ser aceptada), las autoridades decidieron cerrar el pozo de Broad Street y el brote de cólera pronto se sofocó. John Snow murió apenas cuatro años más tarde, en 1858, sin poder ver confirmada su teoría, sin terminar de decir “yo tenía la razón”.

Hoy, su mapa es considerado pionero en el uso del método geográfico para estudiar una epidemia. Pero además, cambió para siempre cómo percibimos las visualizaciones de datos: no sólo como un apoyo clarificador a un modelo ya conocido, sino como sustento y prueba del mismo. La teoría de Snow no hubiese podido ser mostrada únicamente mediante números y coordenadas; hubiese perdido, en el proceso de lectura, toda su elocuencia.

Referencias:

Un análisis contemporáneo del mapa de John Snow: Narushige Shiode, Shino Shiode, Elodie Rod-Thatcher, Sanjay Rana & Peter Vinten-Johansen (2015) The mortality rates and the space-time patterns of John Snow’s cholera epidemic map International Journal of Health Geographics doi: 10.1186/s12942-015-0011-y

Steven Johnson (2008) “El mapa fantasma”. Ilustrae.

Sobre la autora: Almudena M. Castro es pianista, licenciada en bellas artes, graduada en física y divulgadora científica

El artículo El mapa del cólera de John Snow se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Cómo conseguir que la vacuna del cólera no necesite cadena de frío

- Un mapa del discernimiento

- El mapa Big Brain

Pál Turán: teoría de grafos y fábricas de ladrillos

Pál Turán (1910-1976) fue un matemático húngaro que trabajó fundamentalmente en teoría de números. Durante cuarenta y seis años colaboró con su compatriota Paul Erdős, llegando a publicar veintiocho trabajos conjuntos. Por supuesto, el número de Erdős de Pál Turán es 1.

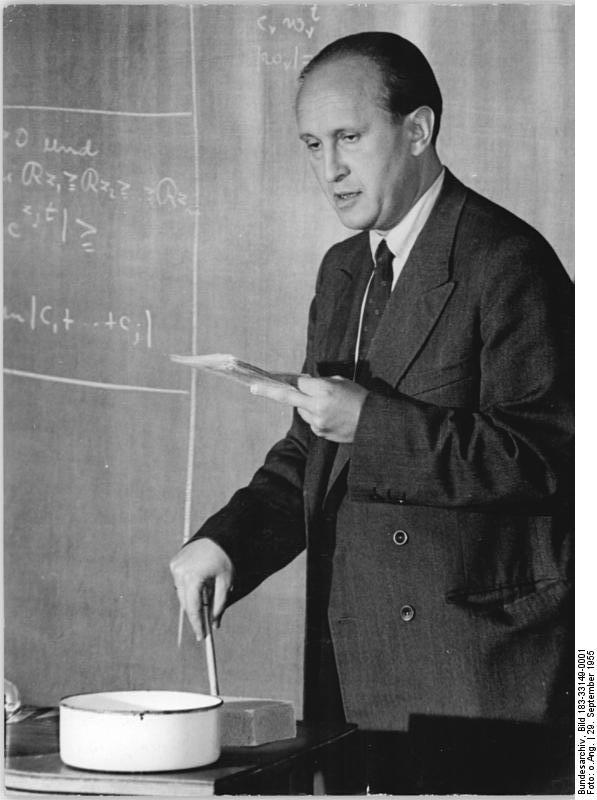

Pál Turán. Imagen: Wikimedia Commons.

Pál Turán. Imagen: Wikimedia Commons.

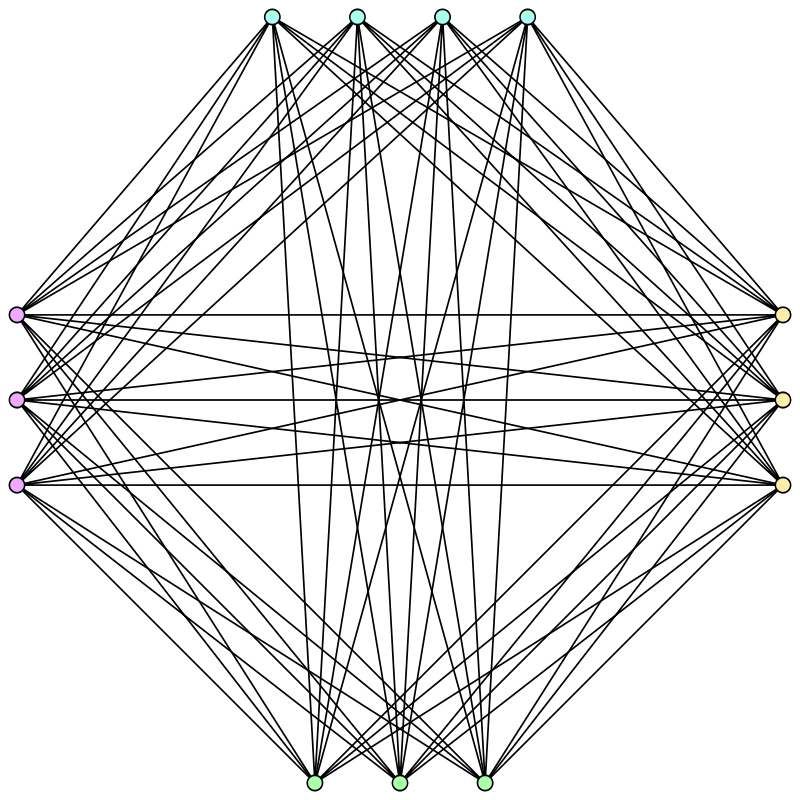

Alumno de Lipót Fejér –como los célebres matemáticos Paul Erdős, George Pólya, Tibor Radó, Marcel Riesz o John von Neumann, entre otros– Torán se casó en segundas nupcias con la también alumna de Féjer –y asimismo colaboradora de Paul Erdős y Alfréd Rényi– Vera T. Sós (1930). El teorema de Kővári–Sós–Turán es un trabajo conjunto del matrimonio con Tamás Kővári: en él proporcionan una cota superior para la solución del problema de Zarankiewicz, una cuestión no resuelta en matemáticas que intentar averiguar cuál es el mayor número posible de aristas en un grafo bipartito que tiene un número dado de vértices y no posee subgrafos bipartitos completos de un tamaño dado.

Varios conceptos y desigualdades llevan el nombre de este matemático. Por ejemplo, el teorema de Turán establece que el llamado grafo de Turán es el que tiene el mayor número de aristas entre todos los grafos que no contienen subgrafos completos.

El grafo de Turán T(13,4). Imagen: Wikimedia Commons.

El grafo de Turán T(13,4). Imagen: Wikimedia Commons.

En 1934, Turán utilizó la denominada criba de Turán –una técnica para estimar el tamaño de ciertos conjuntos de números enteros positivos– para dar una nueva y sencilla demostración de un teorema de 1917 de G. H. Hardy y Srinivāsa Ramanujan sobre el orden normal del número de divisores primos de un número entero positivo. La desigualdad de Turán–Kubilius generaliza el anterior resultado.

Llevan el nombre de desigualdades de Turán unas desigualdades sobre polinomios de Legendre que Turán encontró en 1950. También son conocidas la desigualdad de Erdős-Turán en teoría de la medida y las conjeturas de Erdős-Turán sobre progresiones aritméticas (demostrada en 1975 por Endre Szemerédi) y sobre bases aditivas (problema aún no resuelto).

Gran parte del trabajo de Turán en teoría de números abordó la hipótesis de Riemann. De hecho, Erdős comentaba en [1] que “Turán era un ‘no creyente’, de hecho, un “pagano”: no creía en la verdad de la hipótesis de Riemann”.

Durante la Segunda Guerra Mundial, Turán se vio obligado a trabajar en una fábrica de ladrillos. Su trabajo consistía en empujar un carro con briquetas a lo largo de una vía desde un horno hasta un almacén. La fábrica contenía varios hornos y varios lugares de almacenamiento, con vías que se entrecruzaban para realizar estos transportes. A Turán le resultaba difícil empujar el vagón a través de un cruce de vías, y comenzó a considerar cómo podría rediseñarse la fábrica para minimizar estos cruces.

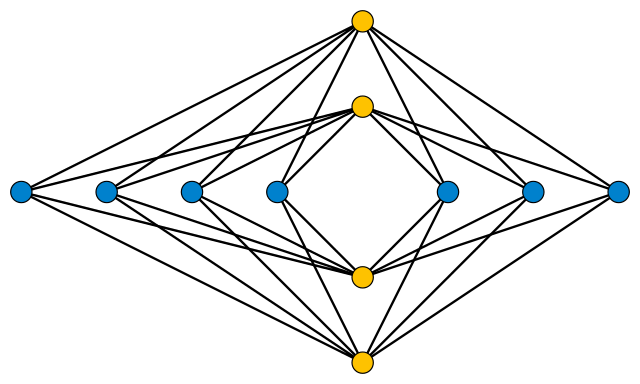

Tras finalizar la guerra, mencionó el problema a algunos de sus colegas. Los matemáticos Kazimierz Zarankiewicz y Kazimierz Urbanik abordaron esta cuestión. Demostraron que siempre es posible completar el diseño como se muestra en la figura 3: los hornos pueden colocarse a lo largo de un eje y los almacenes a lo largo del otro, organizando cada grupo de la manera más uniforme factible alrededor del origen y con las vías en forma de rectas entre cada posible par.

Imagen: Wikimedia Commons.

Imagen: Wikimedia Commons.

Si m es el número de hornos y n el de almacenes Zarankiewicz y Urbanik dieron una cota superior para el número de cruces (ver [3]). En el caso de la figura 3 (m=4 y n=7) esa cota se alcanza: hay 18 cruces.

¿Se trata de la manera óptima de hacerlo? Se desconoce la respuesta. Zarankiewicz y Urbanik pensaban que su fórmula proporcionaba el menor número posible de cruces, pero algunos años después descubrieron un error en su prueba. ¿Será posible diseñar una fábrica de ladrillos con menos cruces entre las vías uniendo hornos y almacenes? El problema continúa abierto…

Referencias:

[1] Paul Erdős, Some personal reminiscences of the mathematical work of Paul Turán, Acta Arithmetica XXXVII (1980) 3-8

[2] J J O’Connor and E F Robertson, Paul Turán, MacTutor History of Mathematics archive, University of St Andrews.

[3] Turán’s Brick Factory Problem, Futility Closet, 4 abril 2019

[4] Turán’s brick factory problem, Wikipedia (consultado 6 abril 2019)

[5] Pál Turán, Wikipedia (consultado 6 abril 2019)

Sobre la autora: Marta Macho Stadler es profesora de Topología en el Departamento de Matemáticas de la UPV/EHU, y colaboradora asidua en ZTFNews, el blog de la Facultad de Ciencia y Tecnología de esta universidad.

El artículo Pál Turán: teoría de grafos y fábricas de ladrillos se ha escrito en Cuaderno de Cultura Científica.

Entradas relacionadas:- Arthur Cayley, la teoría de grafos y los isómeros químicos

- La teoría de grafos y “Così Fan Tutte”

- Incendios, los grafos de visibilidad y la conjetura de Collatz

Polarización de la luz

Imagen: Wikimedia Commons

Imagen: Wikimedia Commons

Hooke y Huygens propusieron que la luz es en muchos aspectos como el sonido, es decir, que la luz es una onda que se propaga a través de un medio. Newton no pudo aceptar esta propuesta y argumentó que la luz también debe tener algunas propiedades similares a las partículas, además de su naturaleza ondulatoria*. Encontró que dos propiedades de la luz no podían explicarse, tal y como él lo entendía, a menos que la luz estuviera formada por partículas.

Primero, un haz de luz se propaga en el espacio en líneas rectas, mientras que las ondas, como el sonido, se extienden en todas las direcciones y son capaces de doblar las esquinas. Esta objeción no pudo responderse hasta principios del siglo XIX, cuando Thomas Young midió la longitud de onda de la luz y descubrió lo extremadamente pequeña que es. Incluso la longitud de onda de la luz roja, la longitud de onda más larga del espectro visible, es inferior a una milésima de milímetro. Mientras un rayo de luz brille sea el que ilumine los objetos o la luz entre a través de orificios de tamaño ordinario (unos pocos milímetros o más de ancho), la luz parecerá viajar en línea recta. Como vimos, los efectos de difracción y dispersión no se hacen evidentes hasta que una onda pasa sobre un objeto o por un agujero cuyo tamaño es aproximadamente igual o menor que la longitud de onda.

Newton basó su segunda objeción en el fenómeno de la “polarización” de la luz. En 1669, el científico danés Rasmus Bartholin descubrió que los cristales de espato Islandia (calcita) podían dividir un rayo de luz en dos rayos. Un texto escrito o cualquier objeto pequeño visto a través del cristal se veía doble.

Newton pensó que este comportamiento podría explicarse suponiendo que la luz está formada por partículas que tienen diferentes “lados”, por ejemplo, secciones transversales rectangulares. Razonó que las imágenes dobles representarían una clasificación de las partículas de luz que habían entrado en el medio con diferentes orientaciones.

Alrededor de 1820, Young y Fresnel dieron una explicación mucho más satisfactoria de la polarización, utilizando un modelo ondulatorio de la luz con una modificación crítica respecto al imperante. Hasta entonces los científicos generalmente habían asumido que las ondas de luz, como las ondas de sonido, debían ser longitudinales. Young y Fresnel demostraron que si las ondas de luz se consideraban transversales se podía explicar el fenómeno de la polarización muy fácilmente.

Imagen: Wikimedia Commons

Imagen: Wikimedia Commons

En una onda transversal de tipo mecánico, el movimiento del propio medio, como una cuerda, es siempre perpendicular a la dirección de propagación de la onda. Esto no significa que el movimiento del medio esté siempre en la misma dirección. De hecho, podría estar en cualquier dirección en un plano perpendicular a la dirección de propagación.

Sin embargo, si el movimiento del medio es principalmente en una dirección (por ejemplo, vertical), la onda está polarizada. Por lo tanto, una onda polarizada es en realidad el tipo más simple de onda transversal. Una onda transversal no polarizada es más complicada, ya que es una mezcla de varios movimientos transversales. Todo aplica también a las ondas de luz, a pesar de que no necesitan de un medio para propagarse.

Nota:

* No, Newton no se adelantó a de Broglie, aunque lo parezca. Simplemente estaba formulando hipótesis para intentar comprender un fenómeno, no afirmando la dualidad onda-corpúsculo.

Sobre el autor: César Tomé López es divulgador científico y editor de Mapping Ignorance

El artículo Polarización de la luz se ha escrito en Cuaderno de Cultura Científica.

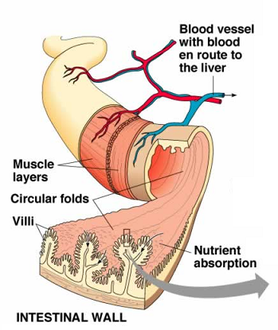

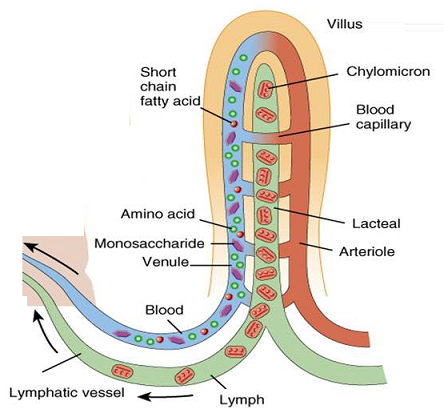

Entradas relacionadas:Absorción del alimento

Fuente: Biology Notes for IGCSE

Fuente: Biology Notes for IGCSE

La mucosa del intestino delgado de los mamíferos contiene glándulas exocrinas cuyo producto de secreción es una solución de moco y sal denominada succus entericus o jugo intestinal. La función de esa secreción es aportar un agente protector y lubricante de la pared intestinal (el moco) y agua, ya que la digestión requiere que los nutrientes se encuentren en disolución.

Las enzimas que realizan la digestión en la luz del intestino provienen del páncreas. Son la lipasa, tripsina, quimotripsina, carboxipeptidasa y amilasa. Los productos de esa digestión o bien son absorbidos directamente o son digeridos por enzimas del borde en cepillo de las células epiteliales. Las enzimas en cuestión son la enteroquinasa (que activa el tripsinógeno procedente del páncreas), las disacaridasas que finalizan la digestión de los carbohidratos (en mamíferos estas enzimas son maltasa, sacarasa, lactasa y trehalasa) y las aminopeptidasas, que hacen lo propio con la digestión de las proteínas. En las aves hay alguna diferencia con respecto a los mamíferos: carecen de lactasa, como es lógico, y muchos pájaros (no así los colibríes) no tienen sacarasa.

En principio, el intestino tiende a absorber todos los nutrientes (tras su digestión), electrolitos1, vitaminas y agua que han sido ingeridos. Aunque, como veremos en otra ocasión, es un órgano muy flexible, por lo que la capacidad para digerir y absorber unos nutrientes u otros se puede modificar en función de su presencia y proporción en la dieta habitual.

El agua se absorbe de forma pasiva impulsada por la absorción de Na+. Este, por su parte, puede pasar a favor de gradiente electroquímico –y, por lo tanto, de forma pasiva- desde la luz del tubo al fluido intersticial que hay entre los villi. Ese movimiento se produce a través de los espacios intercelulares; del líquido intersticial pasa a los capilares sanguíneos.

Pero también hay movimiento de sodio a través de las células epiteliales, y ese movimiento sí requiere gasto de energía. Puede entrar pasivamente en la célula a través de canales o en compañía de otro ión gracias al concurso de un transportador (simporter Na+/Cl–, antiporter Na+/H+ o simporter Na+-glucosa (o aminoácido)). Y sale de la célula epitelial, a través de su membrana basolateral hasta el líquido intersticial de los espacios intercelulares gracias a la acción de la bomba Na+/K+. La absorción de Cl–, H2O, glucosa y aminoácidos está vinculada a la absorción activa de sodio. El Cl– pasa a favor del gradiente eléctrico creado por el Na+, y el agua, por el flujo osmótico provocado por la alta concentración de NaCl en los espacios intersticiales.

La mayor parte de los carbohidratos en condiciones de ser absorbidos por las células epiteliales se encuentran, como ya se ha dicho, en forma de disacáridos. Las disacaridasas presentes en el borde en cepillo reducen esos azúcares a sus monómeros constituyentes: glucosa, galactosa y fructosa, dependiendo del disacárido original.